Anahtar Kelimeler:Kuantum hesaplama, Yapay zeka algoritmaları, Transformer mimarisi, Yapay zeka düzenlemesi, Yapay zeka iş dinamikleri, Yapay zeka etiği, Yapay zeka donanımı, Yapay zeka model değerlendirmesi, Google kuantum algoritması Willow çipi, Meta’nın özgür Transformer bilinçaltı katmanı, DeepSeek-V2 çoklu potansiyel dikkat mekanizması, AMD Radeon AI PRO R9700 ekran kartı, Yapay zeka kod üretim güvenlik katmanı Corridor

🔥 Odak Noktası

Google kuantum algoritması süper bilgisayarları geride bıraktı: Google, yeni kuantum algoritmasının performans açısından süper bilgisayarları geride bıraktığını ve ilaç keşfi ile yeni malzeme geliştirmeyi hızlandırma potansiyeli taşıdığını iddia ediyor. Bu atılımın merkezinde, Willow çipi yer alıyor. Kuantum hesaplamanın pratik uygulamaları hala yıllar alacak olsa da, bu ilerleme alan için önemli bir kilometre taşı teşkil ediyor ve gelecekteki bilimsel araştırmalar için büyük bir potansiyele işaret ediyor. (Kaynak: MIT Technology Review)

Reddit, AI arama motoru Perplexity’ye dava açtı: Reddit, AI arama motoru Perplexity’ye karşı, model eğitimi için Reddit verilerini yasa dışı bir şekilde kazıdığı iddiasıyla dava açtı. Reddit, bu tür şirketlerin verilerini izinsiz satmasını engellemek için mahkemeden kalıcı bir yasaklama emri talep ediyor. Bu dava, AI çağında telif hakkı koruması ve veri kullanımının yasallığı hakkında geniş çaplı tartışmalara yol açtı. (Kaynak: MIT Technology Review)

Çin’in beş yıllık planı: Teknolojik kendine yeterlilik ve AI’nın kilit rolü: Çin, teknolojik kendine yeterliliği hedefleyen bir beş yıllık plan yayınladı ve yarı iletkenler ile yapay zekayı (AI) kilit geliştirme alanları olarak belirledi. Bu hamle, Çin’in teknoloji alanındaki stratejik özerklik kararlılığını vurguluyor ve uluslararası ticaret rekabetinde avantaj arayışını gösteriyor. Bu durum, küresel teknoloji tedarik zincirleri ve jeopolitik manzaradaki değişikliklere ilişkin endişeleri artırdı. (Kaynak: MIT Technology Review)

OpenAI’nin intihar tartışması kurallarını gevşetmesi dava açılmasına neden oldu: OpenAI, ChatGPT kullanıcı sayısını artırmak amacıyla intihar tartışmalarına ilişkin kurallarını iki kez gevşetmekle suçlanıyor ve bu durumun bir gencin intiharına yol açtığı iddia ediliyor. Kurbanın ailesi, OpenAI’nin yaptığı değişikliklerin kullanıcılar için intihar korumasını zayıflattığını iddia ederek dava açtı. Bu durum, AI etiği, kullanıcı güvenliği ve platform sorumluluğu hakkında ciddi soruları gündeme getirdi. (Kaynak: MIT Technology Review)

Musk robot ordusu kuruyor, Optimus “cerrah” olabilir: Elon Musk, aktif olarak bir robot ordusu kuruyor ve Optimus robotlarının gelecekte “mükemmel cerrahlar” olabileceğini öngörüyor. Bu vizyon, genel robot yetenekleri, insan-makine güveni ve AI’nın karmaşık uzmanlık alanlarındaki uygulamaları hakkında geniş tartışmalara yol açtı ve robot teknolojisinin gerçek dünyada daha önemli roller oynayacağı bir geleceğe işaret ediyor. (Kaynak: MIT Technology Review)

🎯 Gelişmeler

Meta “Free Transformer”ı yayınladı: AI’nın temel kurallarını yeniden yazıyor: Meta, Transformer mimarisinin 8 yıllık temel kurallarını yıkan ve “latent layer” tanıtarak üretim öncesi ön düşünmeyi sağlayan yeni “Free Transformer” modelini tanıttı. Bu yenilik, hesaplama maliyetini sadece yaklaşık %3 artırırken, modelin çıkarım ve yapılandırılmış üretimdeki performansını önemli ölçüde iyileştirdi. GSM8K, MMLU gibi testlerde daha büyük modelleri geride bıraktı ve “içsel niyeti olan” ilk Transformer olarak kabul ediliyor. (Kaynak: 36氪)

Google DeepMind robotları “önce düşün, sonra hareket et” prensibini benimsedi: Google DeepMind’ın Gemini Robotics 1.5 modeli, robotların pasif komut yürütmeden yansıtma, akıl yürütme ve karar verme yeteneğine geçmesini sağladı. Bu robotlar, akıl yürütme süreçlerini açıklayabiliyor, makineler arasında bilgi aktarabiliyor ve görsel, dil ve eylemi tek bir düşünce döngüsünde birleştirerek gerçek dünya zekasını ve insan-makine işbirliğini yeni bir aşamaya taşıma potansiyeli taşıyor. (Kaynak: Ronald_vanLoon)

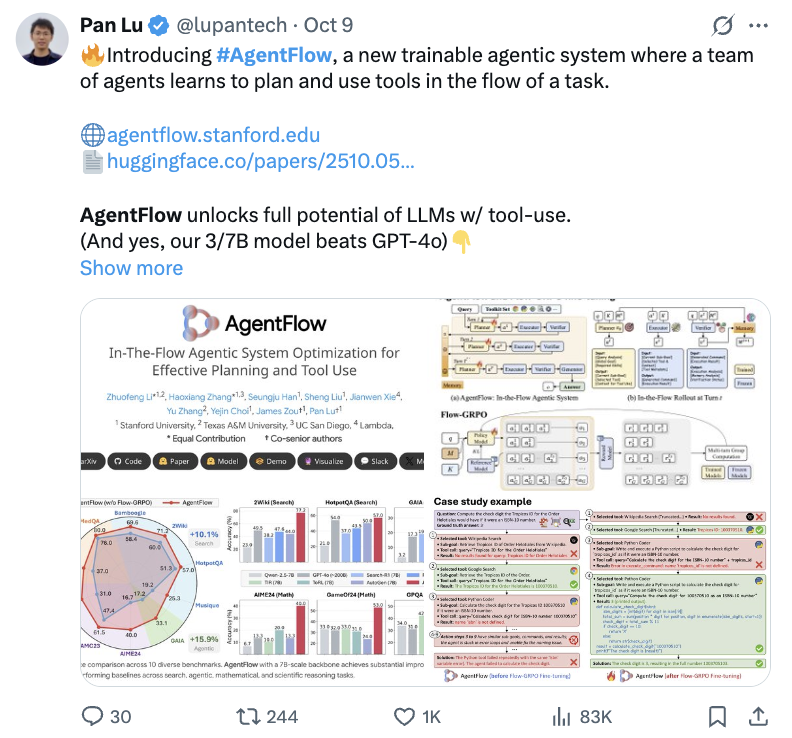

Stanford AgentFlow ile küçük modellerin çıkarım yeteneği arttı: Stanford ekibi, AgentFlow adlı yeni bir paradigma tanıttı. Bu paradigma, çevrimiçi pekiştirmeli öğrenme (online reinforcement learning) aracılığıyla 7B küçük modellerin karmaşık problem çıkarımında performansını önemli ölçüde artırarak GPT-4o ve Llama3.1-405B’yi bile geride bıraktı. AgentFlow, bir planlayıcı (planner), yürütücü (executor), doğrulayıcı (verifier) ve üretici (generator) olmak üzere dört ajan işbirliğiyle çalışır. Flow-GRPO’yu kullanarak planlayıcıyı gerçek zamanlı olarak optimize eder ve arama, ajan, matematik ve bilim görevlerinde önemli iyileşmeler sağlar. (Kaynak: 36氪)

AI, MoE için yeni algoritma keşfetti: %5 daha verimli, %26 daha ucuz: California Üniversitesi, Berkeley’deki araştırma ekibi, “üret-değerlendir-iyileştir” döngüsü aracılığıyla AI’nın insan tarafından tasarlanmış algoritmalardan 5 kat daha hızlı ve %26 daha düşük maliyetli yeni algoritmalar keşfetmesini sağlayan ADRS sistemini önerdi. OpenEvolve çerçevesini temel alan AI, MoE yük dengeleme gibi görevlerde ustaca sezgisel yöntemler keşfederek çalışma verimliliğini önemli ölçüde artırdı ve AI’nın algoritma yaratma konusundaki muazzam potansiyelini gösterdi. (Kaynak: 36氪)

Anthropic, Google TPU kullanımını artırarak AI hesaplama altyapısını güçlendiriyor: Anthropic, Google TPU kullanımını genişletme planlarını duyurdu ve 2026 yılına kadar yaklaşık 1 milyon TPU ve 1 gigawatt’tan fazla kapasiteye erişim sağlayacağını belirtti. Bu hamle, Anthropic’in AI hesaplama altyapısına yaptığı büyük yatırımı ve Google ile AI alanındaki derin işbirliğini gösteriyor, gelecekte AI model eğitim ölçeğinin daha da genişleyeceğine işaret ediyor. (Kaynak: Justin_Halford_)

DeepSeek-V2’nin Multi-head Latent Attention mekanizması tartışma yarattı: DeepSeek-V2’nin tanıttığı Çok Başlı Latent Dikkat (Multi-head Latent Attention – MLA), anahtarları (keys) ve değerleri (values) latent uzaya yansıtarak karmaşıklığı önemli ölçüde azaltıyor ve bu konseptin daha önce neden ortaya çıkmadığına dair akademik tartışmalara yol açtı. Perceiver 2021’de benzer bir yaklaşımı keşfetmiş olsa da, MLA’nın 2024’e kadar ortaya çıkmaması, pratik uygulamada işe yaraması için belirli “hileler” gerektirebileceğini düşündürüyor. (Kaynak: Reddit r/MachineLearning)

AI video içerik oluşturma bir dönüm noktasına ulaştı: AI video içerik oluşturma bir dönüm noktasına ulaştı; örneğin Synthesia platformunda Sora 2’nin piyasaya sürülmesi ve Bilibili’de AI tarafından üretilen Batı’ya Yolculuk temalı müzik videosunun milyonlarca izlenmeye ulaşması gibi birçok popüler içerik ortaya çıktı. Bu durum, AI’nın eğlence içeriği üretimi alanındaki muazzam potansiyelini gösteriyor ve içerik oluşturma manzarasını hızla değiştiriyor. (Kaynak: op7418)

“Attention Is All You Need” ortak yazarı Llion Jones, Transformer mimarisinden “sıkıldı”: “Attention Is All You Need” makalesinin ortak yazarı Llion Jones, AI alanının Transformer mimarisine aşırı bağımlılığından “sıkıldığını” belirtti ve bunun yeni teknolojik atılımları engellediğini düşünüyor. AI alanına yapılan büyük yatırımlara rağmen, araştırmaların yatırım baskısı ve rekabet nedeniyle daraldığını ve bir sonraki büyük mimari yeniliğin kaçırılabileceğini belirtti. (Kaynak: Reddit r/ArtificialInteligence)

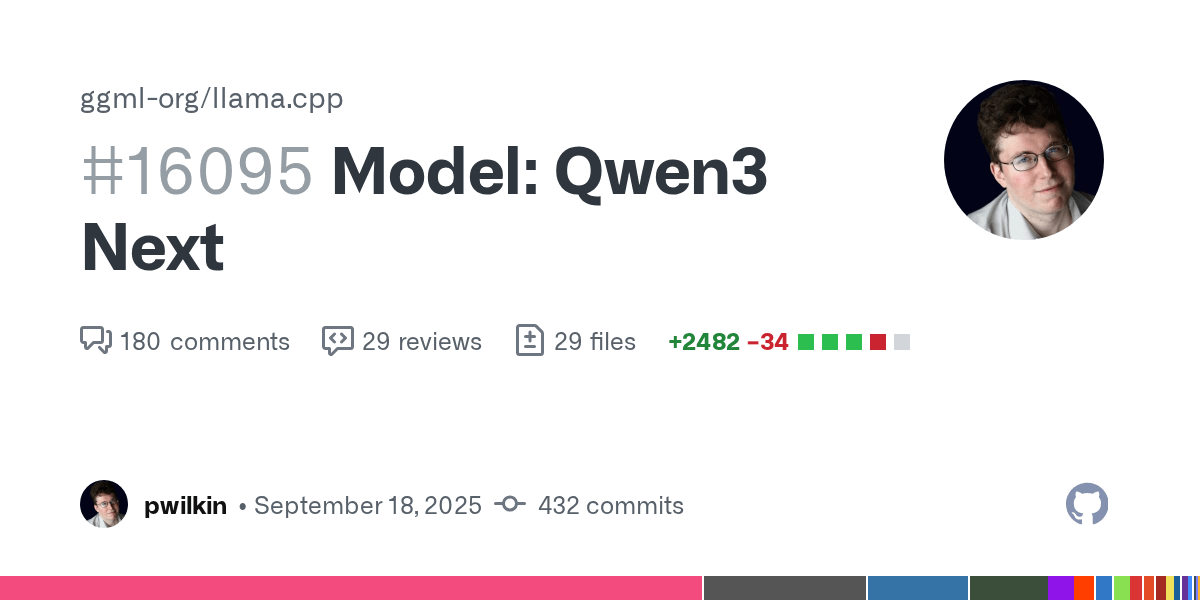

Qwen3 Next modelinin llama.cpp desteği ilerliyor: Qwen3 Next modelinin llama.cpp’deki desteği kod incelemesi için hazırlandı. Bu, nihai bir sürüm olmasa ve henüz hız için optimize edilmemiş olsa da, açık kaynak topluluğunun yeni modellerin entegrasyonundaki aktif ilerlemesini işaret ediyor ve Qwen3’ün yerel olarak çalışma olasılığını müjdeliyor. (Kaynak: Reddit r/LocalLLaMA)

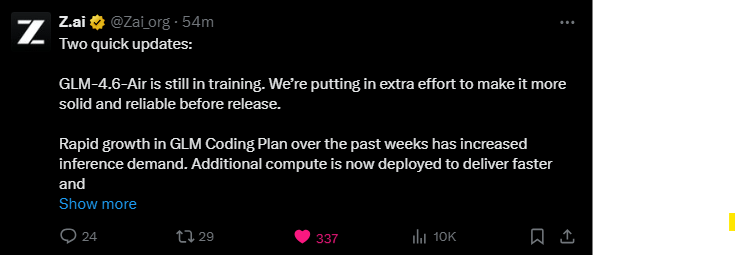

GLM-4.6-Air modeli eğitimi devam ediyor: GLM-4.6-Air modeli hala eğitimde ve ekip, kararlılığını ve güvenilirliğini artırmak için ek çaba sarf ediyor. Kullanıcı topluluğu bunu sabırsızlıkla bekliyor, daha kaliteli bir model için daha uzun süre beklemeyi tercih ediyor ve performans açısından mevcut modelleri aşıp aşamayacağını merak ediyor. (Kaynak: Reddit r/LocalLLaMA)

DyPE: Ultra yüksek çözünürlüklü difüzyon görüntü üretimi için eğitimden bağımsız yöntem: HuggingFace makalesi, önceden eğitilmiş difüzyon Transformer’larının eğitim çözünürlüğünün çok ötesinde görüntüler üretmesini sağlayan, eğitimden bağımsız yeni bir yöntem olan DyPE’yi (Dinamik Konum Ekstrapolasyonu) tanıttı. DyPE, modelin konum kodlamasını dinamik olarak ayarlayarak ve difüzyon sürecinin spektral evrimini kullanarak, birden fazla benchmark testinde performansı ve doğruluğu önemli ölçüde artırdı, özellikle yüksek çözünürlüklerde etkisi daha belirgin oldu. (Kaynak: HuggingFace Daily Papers)

Çoklu ajan “düşünce iletişimi” paradigması: HuggingFace makalesi, çoklu ajan sistemlerinin doğrudan zihinsel iletişim kurmasını sağlayarak doğal dilin sınırlamalarını aşan “düşünce iletişimi” (thought communication) paradigmasını tanıttı. Bu yöntem, latent değişken modeli olarak formalize edilerek, ajanlar arasındaki paylaşılan ve özel latent düşünceleri teorik olarak tanımlayabilir ve sentetik ile gerçek dünya benchmark’larında işbirliği avantajlarını doğruladı. (Kaynak: HuggingFace Daily Papers)

LALM’lerde duygusal değişimler altında güvenlik açıkları: HuggingFace makalesi, Büyük Sesli Dil Modellerinin (Large Audio Language Models – LALMs) farklı konuşmacı duygusal değişimleri altında önemli güvenlik açıkları sergilediğini ortaya koydu. Kötü niyetli sesli komut veri kümeleri oluşturularak yapılan araştırma, farklı duygu ve yoğunluk seviyelerinde LALM’lerin güvensiz yanıtlar üretme düzeylerinin değiştiğini ve orta düzeydeki duygusal ifadelerin en yüksek riski taşıdığını gösterdi. Bu durum, AI’nın gerçek dünya dağıtımında sağlamlığını sağlamanın gerekliliğini vurguluyor. (Kaynak: HuggingFace Daily Papers)

OpenAI, Japonya ve Güney Kore için “AI Süper Gücü” planı hazırladı: OpenAI, “Japonya Ekonomik Planı” ve “Güney Kore Ekonomik Planı”nı yayınlayarak Asya-Pasifik stratejisinin ürün ihracından ulusal düzeyde işbirliğine yükseldiğini işaret etti. Plan, “egemen kapasite inşası + stratejik işbirliği” ikili stratejisini ve “kapsayıcı AI, altyapı, yaşam boyu öğrenme” üç sütunlu planını öneriyor. Bu, AI uygulamalarını hızlandırmayı, hesaplama altyapısını yükseltmeyi ve iki ülkenin küresel AI güç merkezleri olmasına yardımcı olmayı amaçlıyor. (Kaynak: 36氪)

ExGRPO çerçevesi: Büyük model çıkarım öğrenimi için yeni paradigma: Shanghai AI Laboratuvarı ve diğer ekipler, değerli deneyimleri bilimsel olarak tanımlayarak, depolayarak, filtreleyerek ve öğrenerek büyük modellerin çıkarım yeteneklerini optimize eden ExGRPO deneyim yönetimi ve öğrenme çerçevesini önerdi. ExGRPO, matematik yarışması soruları gibi karmaşık görevlerde performansı önemli ölçüde artırdı ve orta zorluktaki problemler ile düşük entropili yörüngelerin etkili öğrenmenin anahtarı olduğunu ortaya koydu. Bu, geleneksel RLVR modundaki “öğrenip unutma” sorununu önledi. (Kaynak: 量子位)

🧰 Araçlar

DeepSeek-OCR ve Zhipu Glyph: Görsel Token teknolojisinde atılım: DeepSeek, 3 milyar parametreli DeepSeek-OCR modelini açık kaynak olarak yayınladı. Bu model, AI’nın metni “görsel olarak okuma” yöntemiyle optik olarak sıkıştırmasını sağlayarak 10 kat sıkıştırma oranı ve %97 OCR doğruluğu elde etti. Zhipu, hemen ardından Glyph’i tanıttı. Bu model de uzun metinleri görsel Token’lara dönüştürerek LLM bağlamını önemli ölçüde azaltıyor, işlem verimliliğini ve hızını artırıyor. Bu modeller vLLM’de destekleniyor ve görsel modalitenin LLM bilgi işlemindeki büyük potansiyelini gösteriyor. (Kaynak: 36氪, 量子位, vllm_project, mervenoyann)

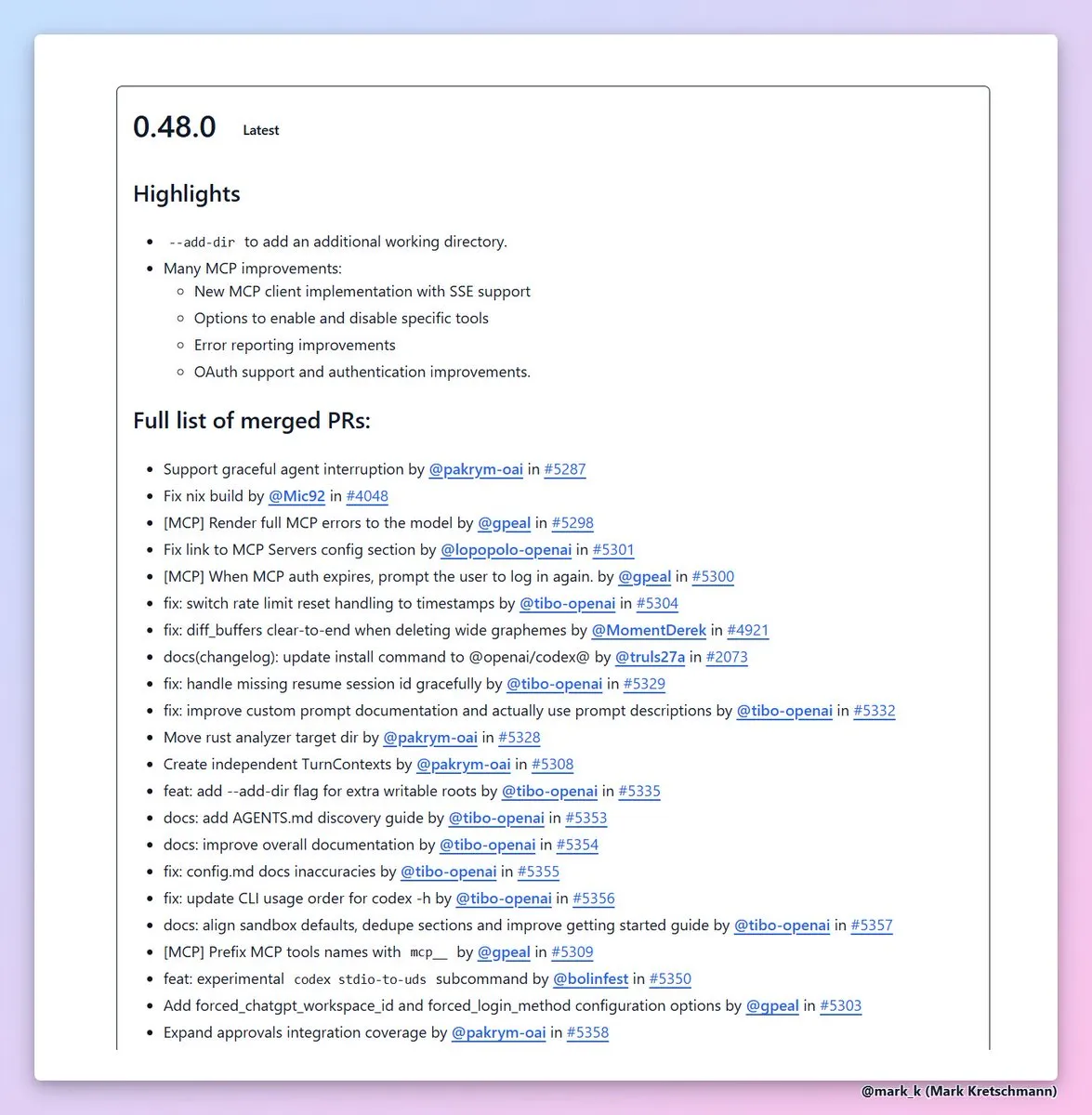

Codex CLI 0.48’e --add-dir özelliği eklendi: OpenAI, Codex CLI 0.48 sürümünü yayınladı. En değerli özelliği, diğer dizinleri mevcut çalışma alanına eklemeye izin veren yeni --add-dir işlevidir. Bu hamle, AI kodlama araçlarının çok dosyalı projelerdeki kullanılabilirliğini büyük ölçüde artırdı, MCP istemcisinin hata raporlama ve kimlik doğrulama deneyimini iyileştirdi ve yazılım mühendisliği verimliliğini hızlandırdı. (Kaynak: dotey, kevinweil)

AI kod oluşturma güvenlik katmanı Corridor yayında: Corridor güvenlik katmanı resmi olarak kullanıma sunuldu ve Cursor, Claude Code gibi AI kod oluşturma araçlarına gerçek zamanlı güvenlik koruması sağlıyor. Corridor, geliştirme hızıyla senkronize olan ilk güvenlik aracıdır. Gerçek zamanlı olarak güvenlik bariyerlerini uygulayarak AI destekli kodlamanın güvenliğini sağlar ve iki haftalık ücretsiz deneme sunar. (Kaynak: percyliang)

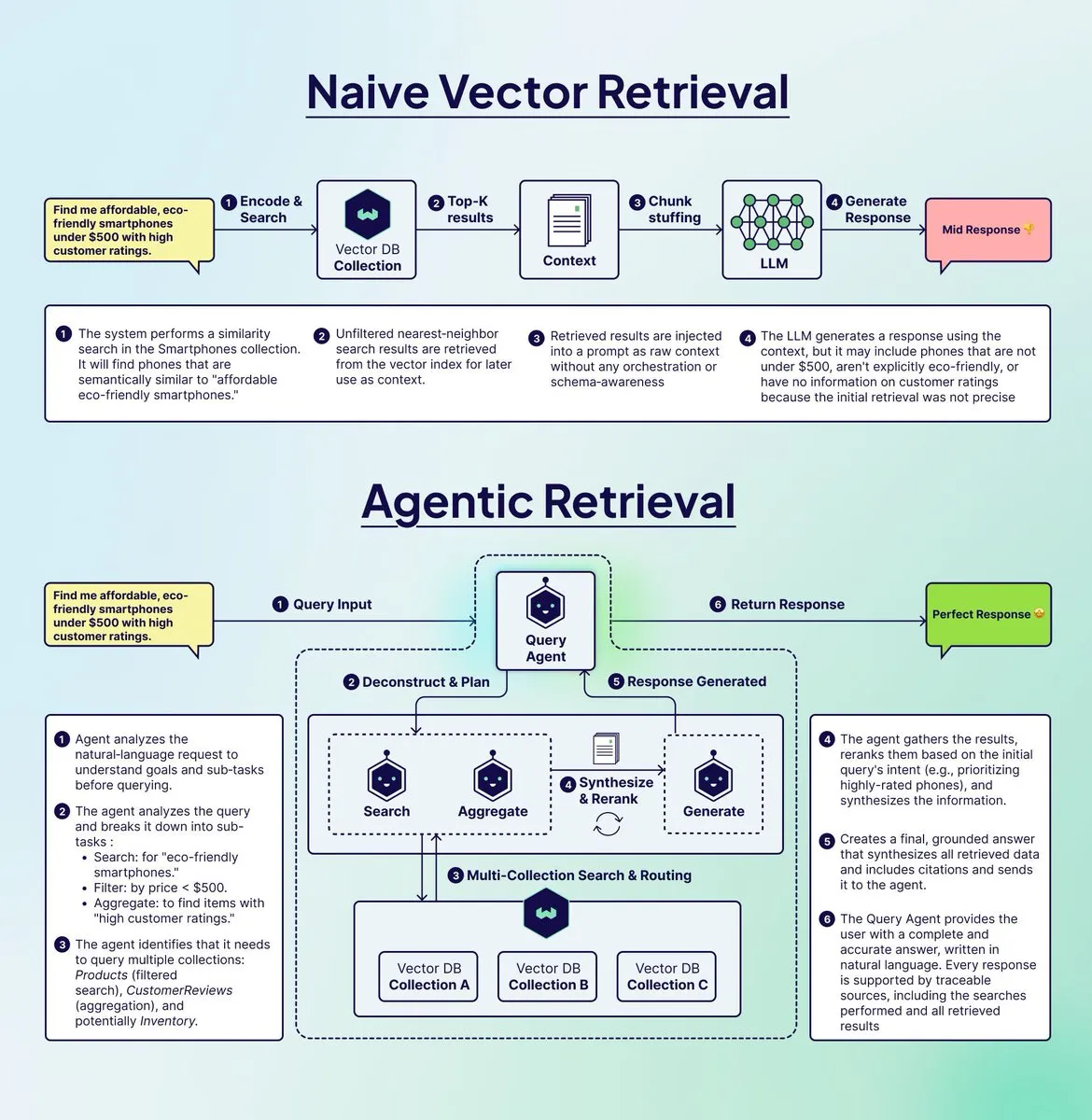

Weaviate, RAG sistemini optimize etmek için Query Agent’ı tanıttı: Weaviate, geleneksel RAG sistemlerinin çok adımlı karmaşık sorguları işlerken karşılaştığı “dolandırıcılık” sorununu çözmeyi amaçlayan Query Agent’ı tanıttı. Query Agent, sorguları ayrıştırabilir, birden fazla koleksiyona yönlendirebilir, filtreler uygulayabilir ve sonuçları birleştirerek daha doğru ve gerekçeli yanıtlar sunar. Şu anda Weaviate Cloud’da mevcut olup, Retrieval Augmented Generation (RAG) etkisini önemli ölçüde artırmıştır. (Kaynak: bobvanluijt)

Argil Atom: Dünyanın en kontrol edilebilir video AI modeli: Argil Atom, dünyanın en kontrol edilebilir video AI modeli olarak tanıtıldı ve video süresi sınırlamaları altındaki tutarlılık ve kontrol sorunlarını çözdü. Bu model, AI karakter video üretiminde yeni bir SOTA (State-of-the-Art) elde etti. Kullanıcılar ilgi çekici videolar oluşturabilir ve ürünler ekleyebilir, bu da video içerik oluşturmaya yenilik getiriyor. (Kaynak: BrivaelLp)

Google AI Studio, Gemini API anahtarı kullanımını destekliyor: Google AI Studio artık kullanıcıların ücretsiz kullanım limitine ulaştıktan sonra Gemini API anahtarı ekleyerek oluşturma modunu kullanmaya devam etmelerine izin veriyor. Sistem, ücretsiz kota sıfırlandıktan sonra otomatik olarak ücretsiz moda geri dönecek ve kullanıcıların geliştirme süreçlerinin kesintiye uğramamasını sağlayarak AI geliştirmeye devam etmelerini teşvik etmeyi amaçlıyor. (Kaynak: GoogleAIStudio)

Open WebUI tarayıcı uzantısı ve işlevsellik sorunları: Kullanıcılar, doğrudan web sayfalarından Open WebUI ile etkileşim kurmaya olanak tanıyan Open WebUI Context Menu Firefox uzantısını yayınladı. Aynı zamanda, topluluk Open WebUI’daki Gemini Pipeline’ın Code Interpreter entegrasyonu sorununu ve resmi Docker MCP sunucu desteği ihtiyacını tartıştı. Bu durum, kullanıcıların AI araçlarının entegrasyonuna ve işlevselliğinin geliştirilmesine yönelik sürekli ilgisini yansıtıyor. (Kaynak: Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI)

AI tam yığın oluşturucu ve metin-konuşma uygulamaları: Bazı kullanıcılar, AI tam yığın oluşturucuları (örneğin Blink.new) kullanarak küçük SaaS MVP’leri başarıyla geliştirdi, ancak AI kodunun manuel olarak doğrulanması gerektiğini vurguladı. Başka bir geliştirici ise herhangi bir metni (web sayfaları, PDF’ler, resim metinleri dahil) yüksek kaliteli sese dönüştürebilen, podcast veya sesli kitap benzeri bir dinleme deneyimi sunan ve gizliliği ön planda tutan bir mobil uygulama yayınladı. (Kaynak: Reddit r/artificial, Reddit r/MachineLearning)

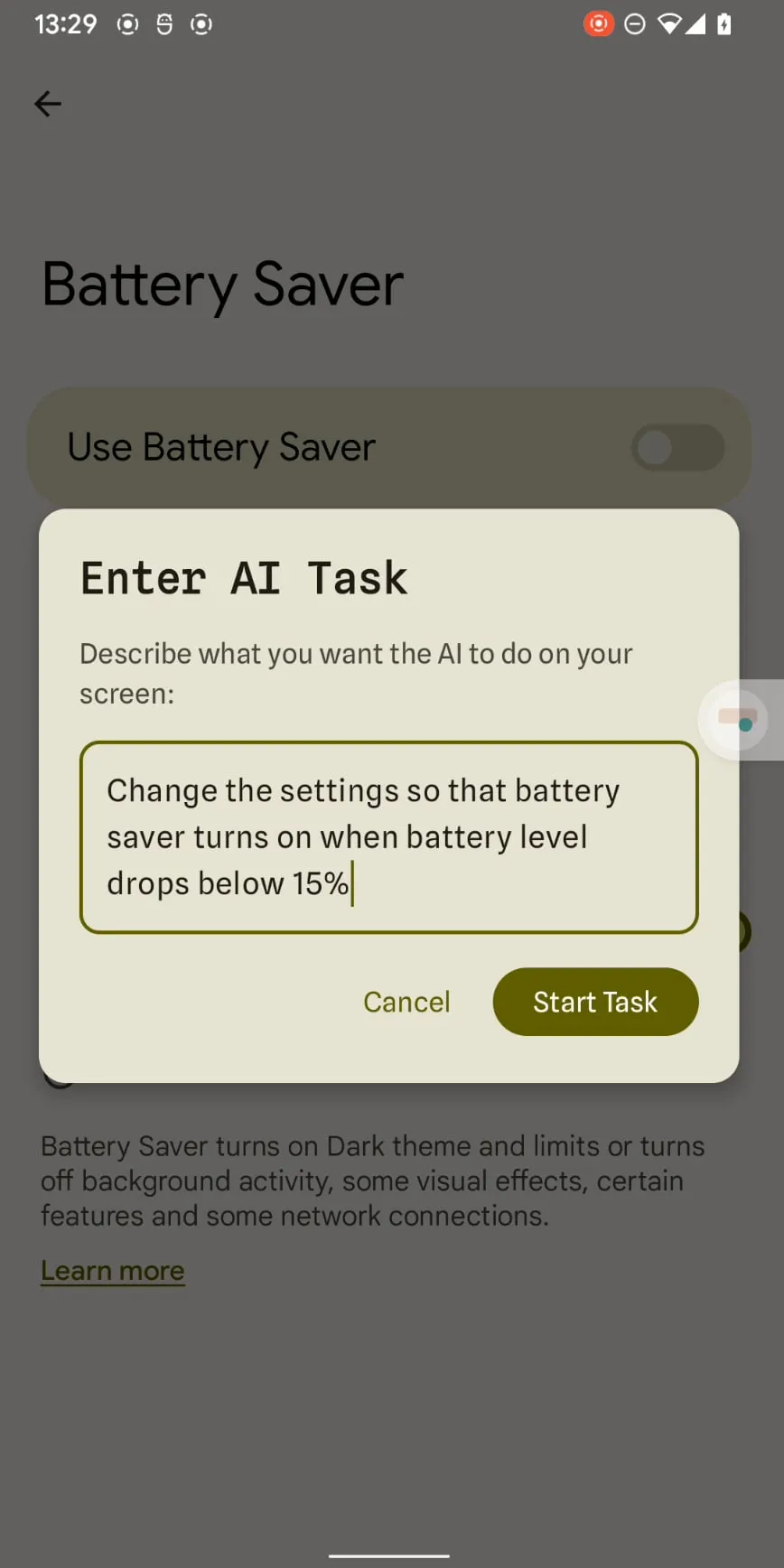

Claude Haiku 4.5 ile akıllı telefon otomasyonu: Claude Haiku 4.5, düşük maliyet ve yüksek hızla, hassas x-y koordinat çıktı yeteneğini kullanarak akıllı telefon otomasyonunu gerçekleştirdi. Her adımın maliyeti 0.003 dolar kadar düşük ve bilgisayar bağlantısı gerektirmiyor. Bu durum, LLM destekli telefon otomasyonunu bir gösterişten pratik bir araca dönüştürme potansiyeli taşıyor ve Tasker gibi mevcut uygulamalarla birlikte çalışabilir. (Kaynak: Reddit r/ClaudeAI)

📚 Öğrenme

AI Agent temel kavramları ve işlevsellik yorumu: Ronald_vanLoon, AI Agent’ın görev yürütme ve karar mekanizmalarını anlamalarına yardımcı olmak amacıyla 20 temel AI Agent konseptini ve AI Agent’ın gerçekte nasıl çalıştığını paylaştı. Bu kaynaklar, AI Agent’ın yapay zeka, makine öğrenimi ve derin öğrenme alanlarındaki önemini derinlemesine inceliyor ve teknoloji profesyonelleri için değerli öğrenme materyalleri sunuyor. (Kaynak: Ronald_vanLoon, Ronald_vanLoon)

GPU programlama öğrenme kaynakları: Mojo🔥 GPU Puzzles: Modular, 34 aşamalı zorlukla GPU programlamayı öğreten Mojo🔥 GPU Puzzles Edition 1’i yayınladı. Bu kılavuz, “yaparak öğrenmeyi” vurguluyor, GPU iş parçacıklarından tensör çekirdeklerine kadar konuları kapsıyor, NVIDIA, AMD ve Apple GPU’larını destekliyor ve geliştiricilere pratik bir öğrenme yolu sunuyor. (Kaynak: clattner_llvm)

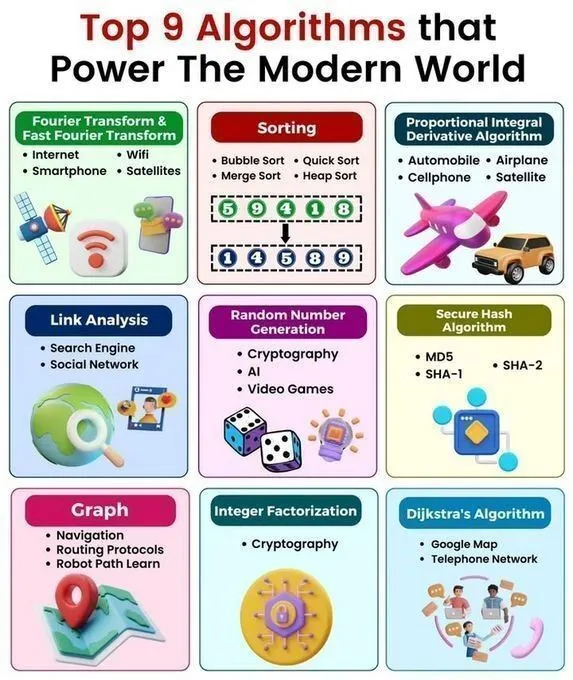

Temel algoritmalara ve veri yapılarına hızlı bakış: Python_Dv, modern dünyayı yönlendiren 9 büyük algoritmayı, 25 AI algoritmasını, depolama alanı tasarrufu sağlayan 6 veri yapısını, veri yapıları ve algoritmalar hızlı başvuru tablosunu ve Python’daki veri yapılarını paylaştı. Bu kaynaklar, AI öğrenenlere algoritmalar ve veri yapıları hakkında kapsamlı bir genel bakış sunarak AI teknolojisi prensipleri ve Python programlama anlayışını derinleştiriyor. (Kaynak: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

GPU programlama dersi: ProfTomYeh, GPU’da iki dizinin manuel olarak nasıl ekleneceği hakkında bir ders verecek ve GPU programlamanın temel işlemlerini derinlemesine açıklayacak. Together AI tarafından düzenlenen bu ders, GPU’nun düşük seviyeli programlama detaylarını öğrenmek isteyen öğrencilere değerli pratik rehberlik sunuyor. (Kaynak: ProfTomYeh)

AI/ML araştırma kariyeri ve proje rehberliği: Matematik ve bilimsel hesaplama alanında lisans öğrencisi, AI/ML ile fizik/biyolojik bilimlerin kesişimindeki araştırma kariyeri için rehberlik arıyor. Bu rehberlik, önde gelen üniversiteler/laboratuvarlar, gerekli beceriler, lisans araştırmaları ve kariyer beklentilerini kapsıyor. Ayrıca, bir AI yüksek lisans mezunu, öğrencilerin kariyer yollarını planlamalarına ve pratik becerilerini geliştirmelerine yardımcı olmak amacıyla makine öğrenimi ve derin öğrenme için başlangıç seviyesi proje fikirleri arıyor. (Kaynak: Reddit r/deeplearning, Reddit r/deeplearning)

Derin öğrenme matematik kitap önerileri ve regresyon görselleştirmesi: Topluluk, yeni başlayanlar için matematik öğrenme rehberliği sağlamak amacıyla “Math for Deep Learning” ve “Essential Math for Data Science” kitapları arasındaki seçimi tartıştı. Aynı zamanda, tek bir nöronun kayıp fonksiyonu ve optimize edici aracılığıyla nasıl öğrendiğini görsel olarak gösteren kaynaklar mevcut olup, öğrencilerin derin öğrenme prensiplerini sezgisel olarak anlamalarına yardımcı oluyor. (Kaynak: Reddit r/deeplearning, Reddit r/deeplearning)

AI’nın oyun modasındaki uygulamaları: Two Minute Papers videosu, AI’nın oyun karakteri kıyafet simülasyonlarının görsel gerçekçiliğini nasıl artırdığını inceledi ve AI’nın oyun geliştirmede görsel gerçekçiliği artırma potansiyelini gösterdi. Video, ilgili makaleleri ve Weights & Biases konferansını önererek oyun geliştiricilerine ve AI araştırmacılarına yeni bakış açıları sundu. (Kaynak: )

💼 İş Dünyası

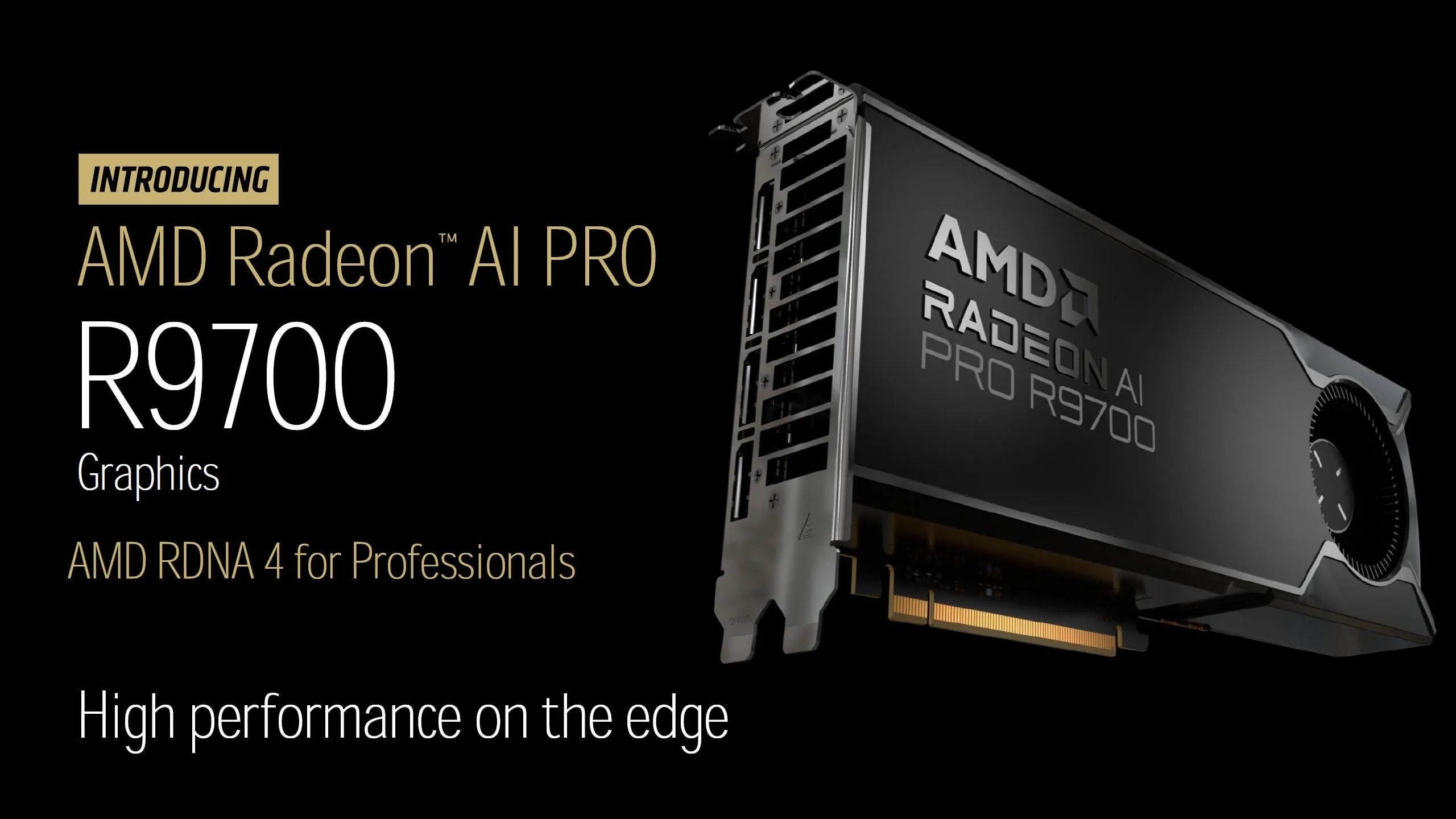

AMD Radeon AI PRO R9700 ekran kartı duyuruldu: AMD, Radeon AI PRO R9700 ekran kartının fiyatını resmi olarak 1299 dolar olarak açıkladı. 32GB GDDR6 VRAM ile donatılmış kart, 27 Ekim’de piyasaya sürülecek. Bu ekran kartı, yüksek performans/fiyat oranı ve geniş VRAM kapasitesiyle yerel LLM (LocalLLaMA) topluluğuna daha güçlü hesaplama desteği sağlamayı ve AI donanım pazarındaki rekabeti artırmayı vaat ediyor. (Kaynak: Reddit r/LocalLLaMA)

AI alanındaki son ticari gelişmeler: Palantir, Lumen Technologies ile 200 milyon dolarlık bir AI hizmet işbirliği imzaladı. OpenAI, Mac otomasyon girişimi Software Applications’ı satın aldı. EA, 3D varlık oluşturma araçları geliştirmek için Stability AI ile ortaklık kurdu. Krafton, GPU kümesine 70 milyon dolar yatırım yaptı. Tensormesh, çıkarım maliyetlerini düşürmek için 4.5 milyon dolar fon topladı. Wonder Studios, AI tarafından üretilen eğlence içeriği için 12 milyon dolar fon topladı. Dell Technologies Capital, öncü veri AI girişimlerini destekliyor. (Kaynak: Reddit r/artificial)

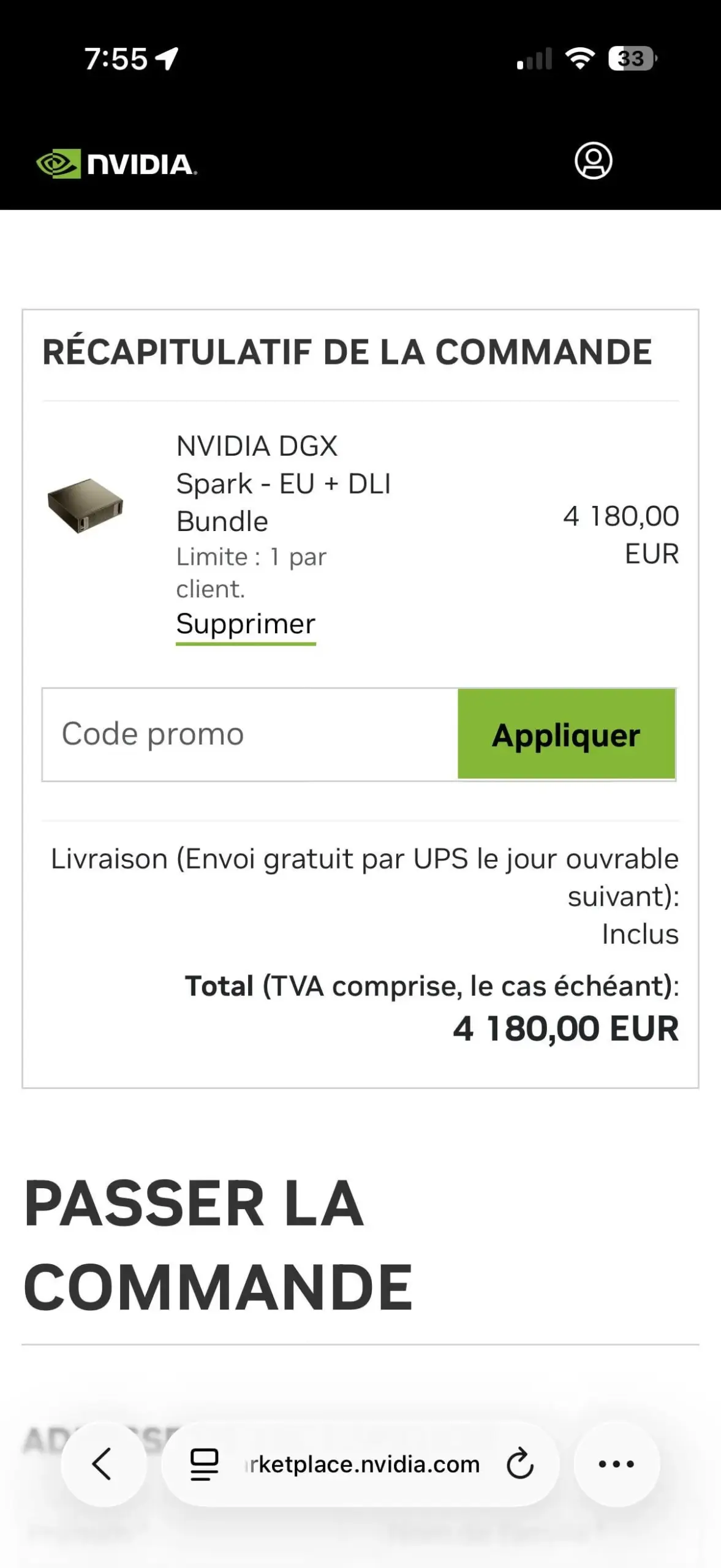

NVIDIA DGX Spark’ta tek adet sınırlaması tartışma yarattı: NVIDIA DGX Spark EU + DLI paketi, müşteri başına bir adetle sınırlı satın alma politikası uygulayarak kullanıcılar arasında hayal kırıklığına yol açtı. Bu sınırlama, büyük pazar talebi ve sınırlı arz nedeniyle karaborsacılığı engellemeyi amaçlayabilir. eBay’de yüksek fiyatlarla yeniden satışlar görülmesi, AI donanım tedarikindeki gergin durumu vurguluyor. (Kaynak: Reddit r/LocalLLaMA)

🌟 Topluluk

AI şirketlerinin ürün kullanılabilirliği ve pazar rekabeti: Kullanıcılar, Google’ın AI hesaplama gücünde üstün olmasına rağmen, API erişiminin zorluğunun ürün kullanımını etkilediğini belirtti. Aynı zamanda, Replit yerleşik bir analiz panosu sunarak kullanıcılara değerli web sitesi performans verileri sağlıyor ve geliştiricilerin uygulamaları izlemesine ve optimize etmesine yardımcı oluyor. Bu durum, AI pazarındaki rekabette ürün kullanılabilirliğinin önemini vurguluyor. (Kaynak: RazRazcle, amasad)

AI ile kullanıcı duygusal etkileşimi ve güvenlik sınırları: Topluluk, kullanıcıların ChatGPT’ye dert yanması ve Claude AI’nın görüşlerini “onaylaması” fenomenini tartıştı. Bu durum, AI’nın duygusal arkadaşlığı ve etkileşim etiği üzerine düşüncelere yol açtı. Claude AI sistem ipuçları, kullanıcıların duygusal bağımlılık geliştirmesini önlemesini istiyor, ancak bazı kullanıcılar Claude Sonnet 4.5’in tavsiye verirken olumsuz yargılara eğilimli olduğunu belirtti. Bu durum, AI uyum riskleri hakkında endişelere yol açtı. (Kaynak: charles_irl, dejavucoder, Reddit r/ChatGPT, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

AI düzenlemesi ve süper zeka gelişimi tartışması: Topluluk görüşleri, AI’ya yönelik aşırı düzenlemenin teknolojik gelişmeyi engellediğini eleştirdi ve AI güvenlik doğrulamasını süresiz ertelemenin sonsuza dek ertelemekle eşdeğer olduğunu, bunun da insanlığın gelişim fırsatlarını kaçırmasına neden olabileceğini savundu. Başka bir yorum ise süper zekayı yasaklama çağrısı yapanları küçümseyerek, onların kendini beğenmiş ve dikkat çekmeye hevesli olduğunu, motivasyonlarının pratik düşüncelerden kaynaklanmadığını belirtti. (Kaynak: pmddomingos, pmddomingos, pmddomingos)

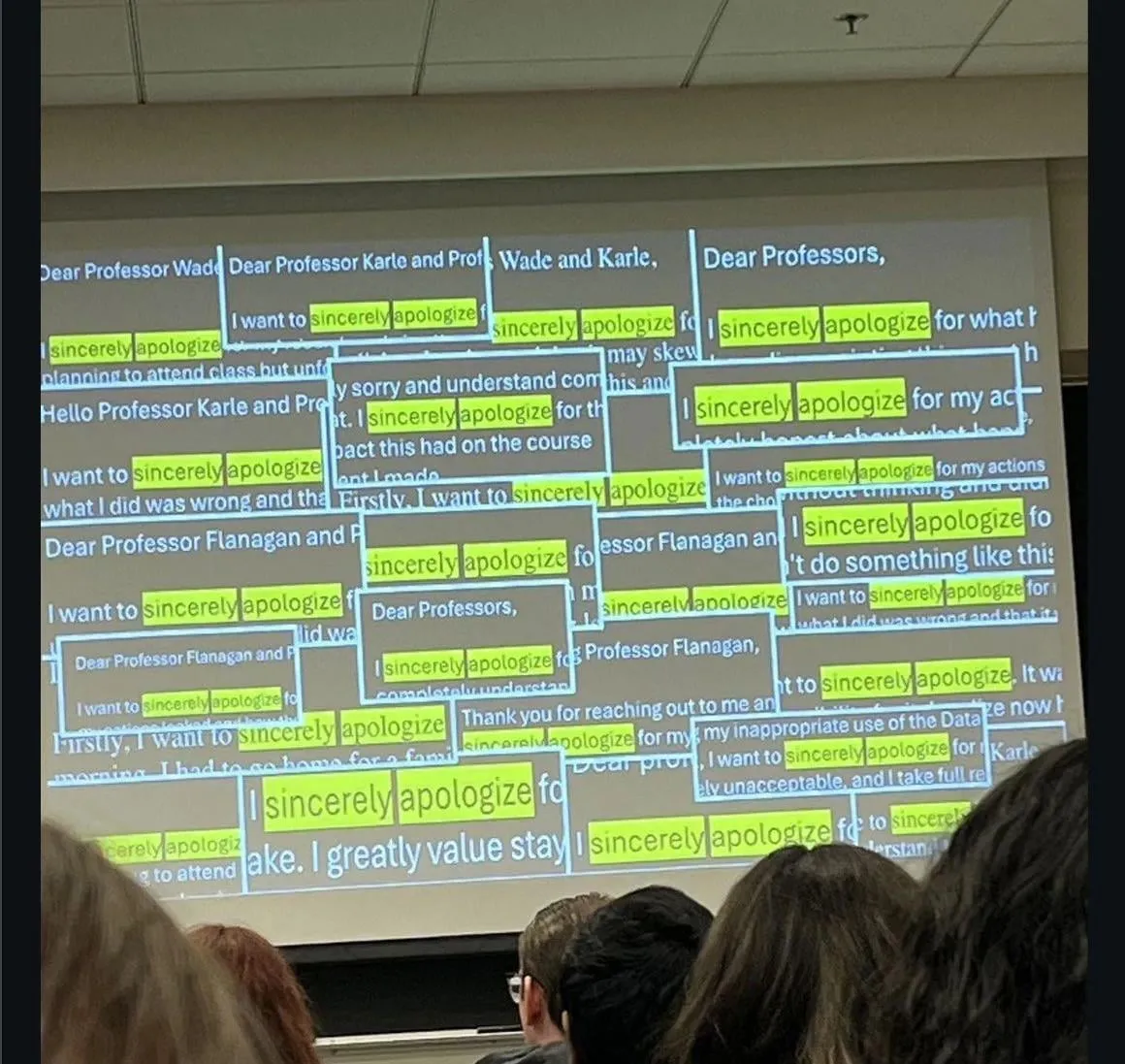

AI’nın eğitim ve istihdam üzerindeki etkileri: Topluluk, öğrencilerin ChatGPT kullanarak kopya çekmeleri nedeniyle özür dilemeleri fenomenini ve bazı şirketlerin son yıllarda mezun olan genç pozisyon adaylarını, LLM yardımı olmadan iş performanslarının düşük olması nedeniyle artık mülakata almamalarını tartıştı. Bu durum, AI çağında yeni nesil yeteneklerin beceri gelişimi ve iş piyasasındaki değişiklikler hakkında derin endişelere yol açtı. (Kaynak: Reddit r/ChatGPT)

LLM doğruluğu ve halüsinasyon sorunları: Kullanıcılar, ChatGPT’nin temel hesaplama görevlerinde sergilediği halüsinasyonları ve yanlışlıkları paylaştı; örneğin doğru kodu yazdıktan sonra bile “zihinsel hesaplamalar” yapıp yanlış sonuçlar vermesi veya “CSV dosyasını göz ardı etmesi” nedeniyle tamamen yanlış çıktılar üretmesi gibi. Bu durum, LLM’lerin gerçekleri kontrol etme ve veri işleme konusundaki sınırlamalarını vurguladı ve kullanıcıları başka modellere yönelmeye teşvik etti. (Kaynak: Reddit r/ChatGPT)

AI içerik tespiti ve üretimi: Topluluk, Reddit’te AI tarafından üretilen içeriği nasıl tanıyacağını tartıştı; bu ipuçları arasında gönderilerin çok sayıda etkileşim almasına rağmen orijinal yazarın yanıt vermemesi veya aşırı resmi İngilizce kullanılması gibi durumlar yer alıyor. Aynı zamanda, bazı kullanıcılar AI teknolojisini kullanarak pasif gelir elde etme yollarını, örneğin AI aracılığıyla toplu içerik üretip birden fazla platformda yayınlama gibi yöntemleri araştırdı. Bu durum, AI’nın içerik oluşturma ve tespit etme üzerindeki etkisini yansıtıyor. (Kaynak: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

AI’nın kripto para ticaretindeki performansı: Kripto para piyasası AI model ticaret deneyleri, Çin modellerinin (Qwen 3, DeepSeek) üstün performans gösterdiğini ortaya koydu; Qwen 3’ün kazancı neredeyse %60 fırlarken, DeepSeek %20-30 arasında istikrarlı bir kar elde etti. GPT-5 ve Gemini ise ciddi kayıplar yaşadı. Bu durum, farklı AI modellerinin gerçek piyasadaki strateji farklılıklarını ve performanslarını ortaya koydu ve AI ticaret stratejileri ile “kişilikleri” hakkında tartışmalara yol açtı. (Kaynak: 36氪, op7418, teortaxesTex, huybery)

AI kod yardımcısı performansı ve kullanıcı deneyimi: Kullanıcılar, Claude Code’daki Haiku 4.5’in süper verimliliğini övdü ve bunun uygulama geliştirme hızını önemli ölçüde artırdığını, hatta Claude Sonnet’e artık ihtiyaç duymadıklarını belirtti. Aynı zamanda, kullanıcılar ChatGPT 5 Pro’ya “Hemen Bitir” düğmesi eklenmesi çağrısında bulundu. Bu, modelin uzun yanıtlar üretirken kesilememesi ve içeriğin kaybolmaması sorununu çözmeyi amaçlıyor ve LLM kullanıcı deneyiminin sürekli optimizasyonuna yönelik talebi yansıtıyor. (Kaynak: Reddit r/ClaudeAI, sjwhitmore)

AI ajanlarının kendi kendini düzeltmesi ve izlenmesi: Kullanıcılar, Stanford ACE çerçevesinden ilham alarak Claude için bir “Mimar” rol senaryosu yazdı ve bu sayede Claude’un kendi kodunu otomatik olarak düzeltmesini ve hata ayıklamasını sağladı. Aynı zamanda, LangSmith Insights Agent, kullanıcı ajan yörüngelerini kümeleme analizi yaparak davranış modelleri ve potansiyel sorunlar hakkında içgörüler sunuyor, böylece büyük ölçekli AI uygulama verilerinin analizini ve hata ayıklamasını basitleştiriyor. (Kaynak: Reddit r/ClaudeAI, HamelHusain, hwchase17)

AI model değerlendirme ve geliştirme zorlukları: Topluluk görüşleri, mevcut AI modellerinin sayısının çok fazla olduğunu ancak etkili bir değerlendirmeden yoksun olduğunu ve standartlaştırılmış benchmark’lara acil ihtiyaç duyulduğunu belirtti. Ayrıca, operatörlerin ve gradyan etkilerinin otomatik test edilmesi ihtiyacı ile AI silah tespit sisteminin cips paketini yanlışlıkla silah olarak tanımlaması olayı tartışıldı. Bu durum, AI’nın gerçek dünya dağıtımındaki güvenlik, önyargı ve sağlamlık zorluklarını vurguluyor. (Kaynak: Dorialexander, shxf0072, colin_fraser)

AI sektöründe işten çıkarmalar ve yetenek akışı: Meta’nın Süper Zeka Laboratuvarı, Tian Yuandong’un ekibi de dahil olmak üzere 600 kişiyi işten çıkardı. Bu durum, işten çıkarma zamanlaması ve Llama 4.5 eğitimi sonrası “işi bitenin kellesini alma” eleştirilerine yol açtı. Tian Yuandong, Llama 4’e katılmadığını açıkladı ve işten çıkarmaların ürün uygulamaları ve çapraz fonksiyonel pozisyonları etkilediğini belirtti. Bu durum, Meta’nın AI departmanındaki çalkantıyı ve yetenek akışını vurguluyor. (Kaynak: 量子位, Yuchenj_UW)

AI araştırmalarında etik ve özgünlük: Bir araştırma, derinlemesine analizden sonra, AI tarafından yazılan araştırma makalelerinin sadece %24’ünde intihal tespit edildiğini ortaya koydu. Bu sonuç “beklenmedik derecede iyi” olarak değerlendirildi ve AI tarafından üretilen araştırmaların kalitesi ve özgünlüğü ile bunun akademik dünya üzerindeki potansiyel etkileri hakkında tartışmalara yol açtı. (Kaynak: paul_cal)

AGI ve insanlığın geleceği üzerine felsefi tartışmalar: Tsinghua Üniversitesi’nden Profesör Liu Jia, AGI’nin evrimi, ajanların gelişimi ve insanlığın gelecekte karşılaşacağı zorluklar hakkında 10 görüşünü paylaştı. AGI’nın “görev değiştirme” ve “açık ortam dinamik stratejileri” özelliklerini, AI’nın duygusal sıcaklık ve bilinç kazandıktan sonraki sosyal etkilerini ve insan-makine birleşimi veya insanlığın yok olma olasılıklarını tartıştı. Bu durum, AI’nın derin etkileri üzerine felsefi düşüncelere yol açtı. (Kaynak: 36氪)

Kimi’nin yazma kalitesi ve OpenAI rekabeti: OpenAI çalışanı roon, Kimi K2’nin yazma konusunda üstün performans gösterdiğini belirtti. Bu durum, Çin modellerinin yazma yetenekleri ve OpenAI’nin tutumu hakkında toplulukta tartışmalara yol açtı. Topluluk, Kimi K2’nin çok sayıda telif hakkı olan kitapla eğitilmiş olabileceğini tahmin ediyor. “Yaltaklanmayan” kişiliğinin kullanıcılar tarafından beğenildiği ve belirli dil çevirisi ile bağlam anlama konusunda üstün performans gösterdiği, ChatGPT 5’in “hadım edilmiş” hissiyatıyla tezat oluşturduğu belirtiliyor. (Kaynak: Reddit r/LocalLLaMA, bookwormengr)

AI ürünleri ve geliştirme trendleri: Hacker News, AI aracı Codex’in Zed’de yavaş performansı, AI asistan haberlerinin %45’e varan yanlış raporlama oranı, Meta’nın 600 AI çalışanını işten çıkarması gibi konuları tartıştı. Bu tartışmalar, AI geliştirme ve kullanımındaki zorlukları yansıtıyor; bunlar arasında araç performansı, bilgi doğruluğu ve büyük teknoloji şirketlerinin AI yatırımlarındaki stratejik ayarlamaları yer alıyor. (Kaynak: Reddit r/artificial)

Yerli büyük modellerin iş modeli tartışması: Kullanıcılar, Kimi ve Qwen gibi yerli büyük modellerin, Claude, GPT ve GLM 4.5’in popülaritesini referans alarak abonelik tabanlı fiyatlandırma modelleri uygulaması çağrısında bulundu. Bu durum, topluluğun yerli büyük modellerin iş modellerine yönelik beklentilerini ve kullanıcı ödeme istekliliği ile pazar rekabet stratejileri hakkındaki tartışmaları yansıtıyor. (Kaynak: bigeagle_xd)

💡 Diğer

SeaweedFS: Yüksek performanslı dağıtılmış dosya sistemi: SeaweedFS, milyarlarca dosyayı depolamak için tasarlanmış hızlı, yüksek düzeyde ölçeklenebilir bir dağıtılmış dosya sistemidir. O(1) disk arama kullanır, bulut katmanlama, Kubernetes, S3 API gibi özellikleri destekler ve küçük dosya depolamasını optimize eder. Master sunucusu birimleri yönetirken, Volume sunucusu dosya meta verilerini yönetir. Bu, yüksek eşzamanlılık ve hızlı erişim sağlayarak çeşitli depolama ihtiyaçları için uygundur. (Kaynak: GitHub Trending)

NVIDIA Isaac Sim: AI robot simülasyon platformu: NVIDIA Isaac Sim, NVIDIA Omniverse tabanlı, AI destekli robotları geliştirmek, test etmek ve eğitmek için kullanılan açık kaynaklı bir simülasyon platformudur. Birden fazla robot sistemi formatını içe aktarmayı destekler, GPU hızlandırmalı fizik motoru ve RTX render’ı kullanır. Sentetik veri üretimi, pekiştirmeli öğrenme, ROS entegrasyonu ve dijital ikiz simülasyonu gibi uçtan uca iş akışları sunarak robot geliştirmeye kapsamlı destek sağlar. (Kaynak: GitHub Trending)

Rondo Energy dünyanın en büyük ısı bataryasını devreye aldı: Rondo Energy, elektrik enerjisini depolayabilen ve istikrarlı bir ısı kaynağı sağlayabilen, endüstriyel dekarbonizasyona yardımcı olma potansiyeli taşıyan dünyanın en büyük ısı bataryasını başlattığını iddia etti. Bu ısı bataryası 100 megavat saat kapasiteye sahip, %97’nin üzerinde verimlilikle çalışıyor ve 10 haftadır standartlara uygun şekilde faaliyet gösteriyor. Gelişmiş petrol geri kazanımı için kullanılması tartışmalara yol açsa da, şirket bu hamlenin mevcut fosil yakıt operasyonlarını daha temiz hale getirebileceğine ve enerji depolama teknolojisinin endüstriyel alandaki uygulamalarını teşvik edeceğine inanıyor. (Kaynak: MIT Technology Review)