Anahtar Kelimeler:Işık tabanlı AI çip, K2 Think, Somutlaştırılmış yapay zeka, Jupyter Ajanı, OpenPI, Claude modeli, Qwen3-Next, Seedream 4.0, Fotonik AI çip enerji verimliliği, Açık kaynaklı büyük model çıkarım hızı, İnsansı robot duygu ifadesi, LLM veri bilimi akıllı ajanı, Robot görsel dil hareket modeli

🔥 Odak Noktası

Işık Tabanlı AI Çipinde Verimlilik Atılımı : Florida Üniversitesi mühendis ekibi, görüntü tanıma ve desen algılama gibi AI işlemlerini elektrik yerine foton kullanarak gerçekleştiren yeni bir ışık tabanlı AI çipi geliştirdi. Bu çip, dijital sınıflandırma testlerinde %98 doğruluk oranına ulaşırken, enerji verimliliğini 100 kata kadar artırdı. Bu atılımın, AI hesaplama maliyetlerini ve enerji tüketimini önemli ölçüde azaltması, AI’ın akıllı telefonlardan süper bilgisayarlara kadar çeşitli alanlarda yeşil ve ölçeklenebilir gelişimini teşvik etmesi bekleniyor. Bu, hibrit elektro-optik çiplerin AI donanım manzarasını yeniden şekillendireceğinin bir işareti. (Kaynak: Reddit r/ArtificialInteligence)

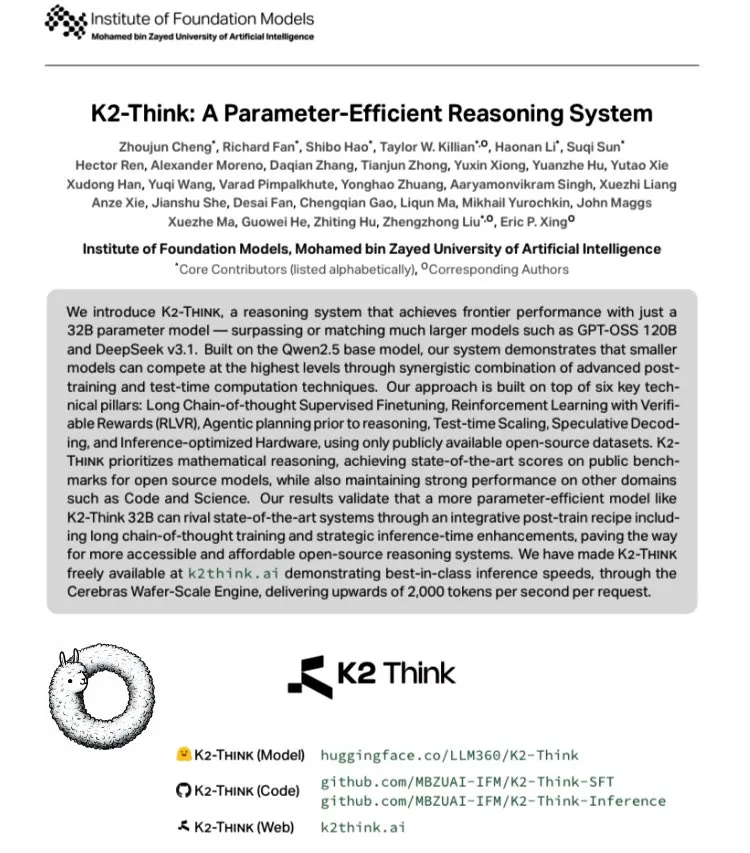

K2 Think: Dünyanın En Hızlı Açık Kaynak Büyük Modeli Piyasaya Sürüldü : BAE’deki MBZUAI, G42 AI ile işbirliği yaparak Qwen 2.5-32B tabanlı açık kaynaklı bir büyük model olan K2 Think’i piyasaya sürdü. Model, 2000 tokens/saniye üzerinde gerçek zamanlı hızlara ulaşarak tipik GPU dağıtım veriminin 10 katından fazlasını sunuyor. AIME gibi matematik kıyaslamalarında üstün performans gösteren model, uzun zincirli düşünce SFT, doğrulanabilir ödül RLVR, çıkarım öncesi planlama, Best-of-N örneklemesi, spekülatif kod çözme ve Cerebras WSE donanım hızlandırması gibi teknolojik yeniliklerle açık kaynak AI çıkarım sistemlerinin performansında yeni bir zirveye işaret ediyor. (Kaynak: teortaxesTex, HuggingFace)

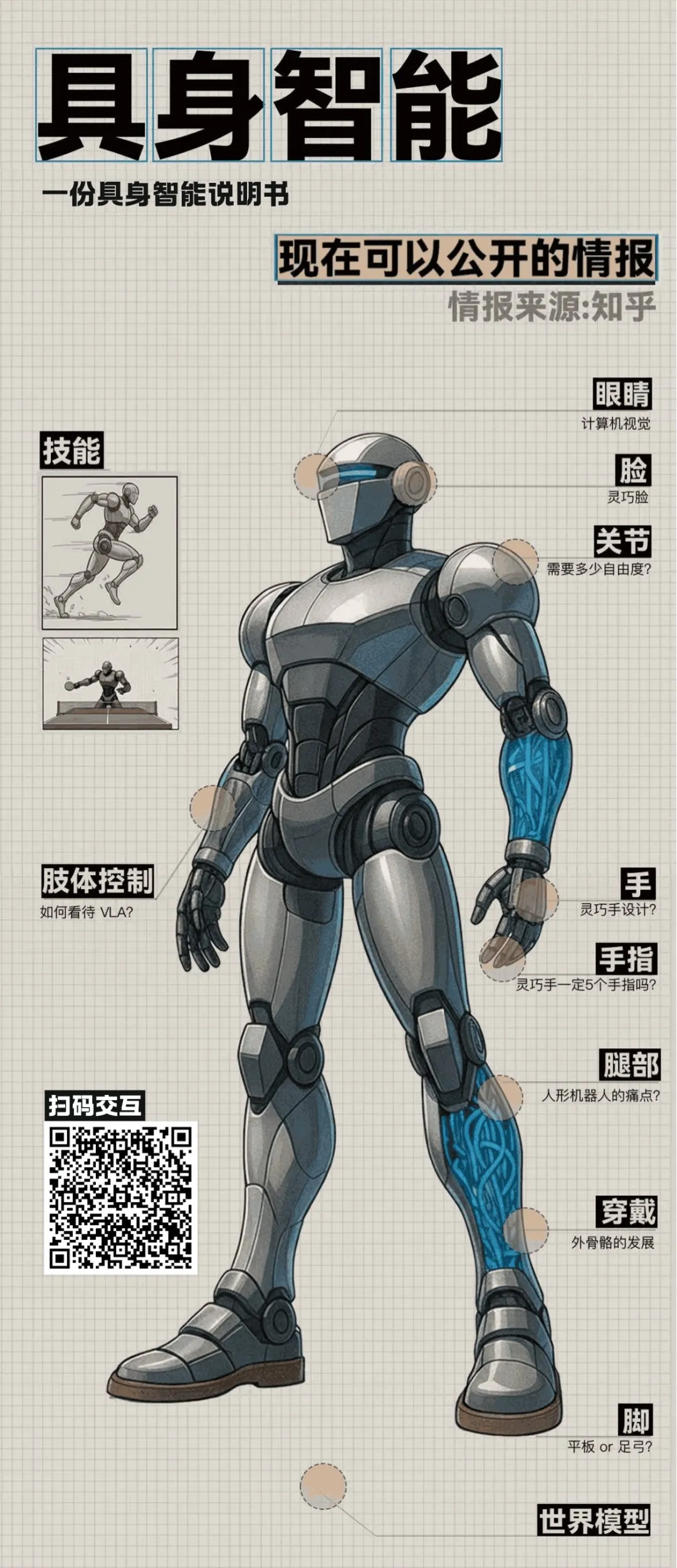

Vücutlandırılmış Zeka ve İnsansı Robotlarda İleri Gelişmeler : Zhihu’daki bir yuvarlak masa tartışması, vücutlandırılmış zeka alanındaki birçok atılımı ortaya koydu. Tsinghua Air laboratuvarı, insansı robotların duygusal değerini artırmayı amaçlayan zengin mikro ifadeler için hibrit tahrik ve dijital insan teknolojisini kullanan “Morpheus” adlı “becerikli yüzü” sergiledi. Aynı zamanda, Pekin Tiangong Ultra robotu, Dünya İnsansı Robot Atletizm Şampiyonası’nda 100 metre yarışını kazanarak algoritma ve otonom algılama avantajlarını vurguladı. Tartışma ayrıca insansı robotların maliyeti, seri üretimi, kontrol teorisi ve büyük modellerle entegrasyonu gibi kritik konuları da kapsayarak vücutlandırılmış zekanın teknolojik keşiften pratik uygulamalara doğru ilerlediğini gösterdi. (Kaynak: ZhihuFrontier)

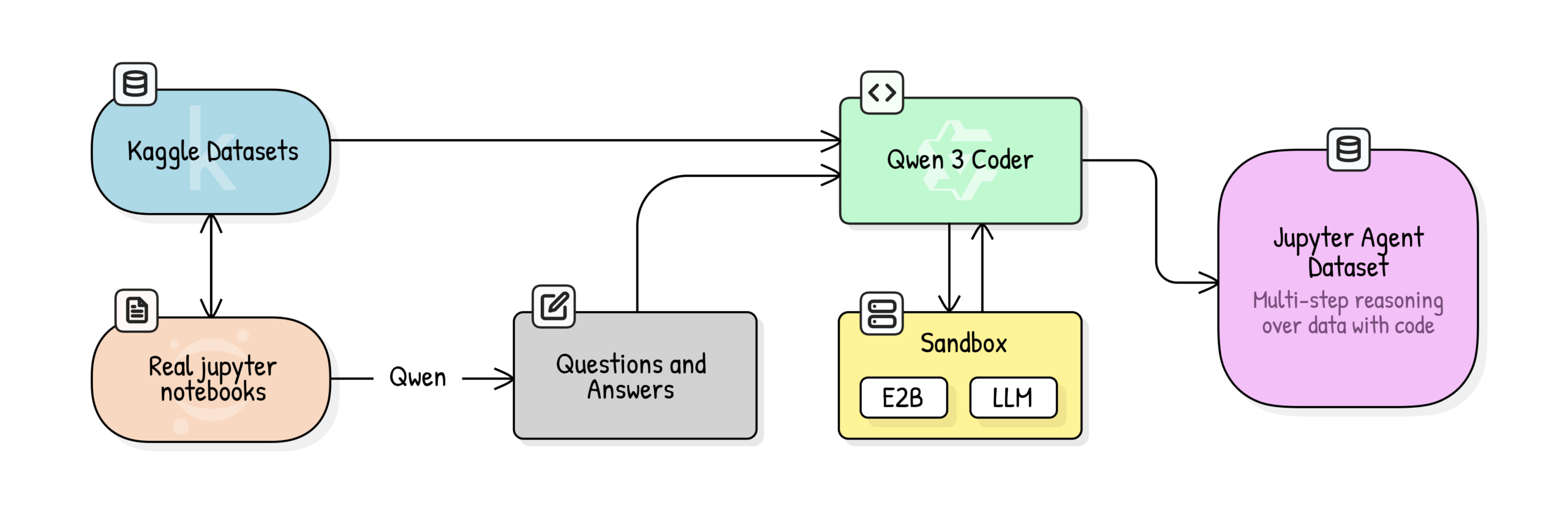

Jupyter Agent: Veri Bilimi Çıkarımı için LLM’leri Notebook ile Eğitme : Hugging Face, LLM’lere Jupyter Notebook’larda veri analizi ve veri bilimi görevlerini çözme yeteneği kazandırmayı amaçlayan Jupyter Agent projesini başlattı. Büyük ölçekli Kaggle Notebooks veri temizliği, eğitim kalitesi puanlaması, QA üretimi ve kod yürütme izi üretimi gibi çok aşamalı bir eğitim süreciyle, Qwen3-4B gibi küçük modellerin DABStep kıyaslamasının Easy görevlerinde %44,4’ten %75’e yükseltilmesi başarıldı. Bu, küçük modellerin kaliteli veri ve iskele ile birleştiğinde güçlü veri bilimi ajanları olabileceğini kanıtlıyor. (Kaynak: HuggingFace Blog)

OpenPI: Açık Kaynak Robotik Görsel-Dil-Eylem Modeli : Physical Intelligence ekibi, π₀, π₀-FAST ve π₀.₅ gibi açık kaynaklı Görsel-Dil-Eylem (VLA) modellerini içeren OpenPI kütüphanesini yayınladı. Bu modeller, 10 binden fazla saatlik robot verisi üzerinde önceden eğitildi, PyTorch’u destekliyor ve LIBERO kıyaslamasında SOTA performansına ulaştı. OpenPI, temel model kontrol noktaları ve ince ayar örnekleri sunarak uzaktan çıkarımı destekliyor ve robotik alanında açık araştırmayı ve uygulamaları, özellikle masaüstü manipülasyonu ve nesne yakalama gibi görevlerdeki potansiyelini teşvik etmeyi amaçlıyor. (Kaynak: GitHub Trending)

🎯 Gelişmeler

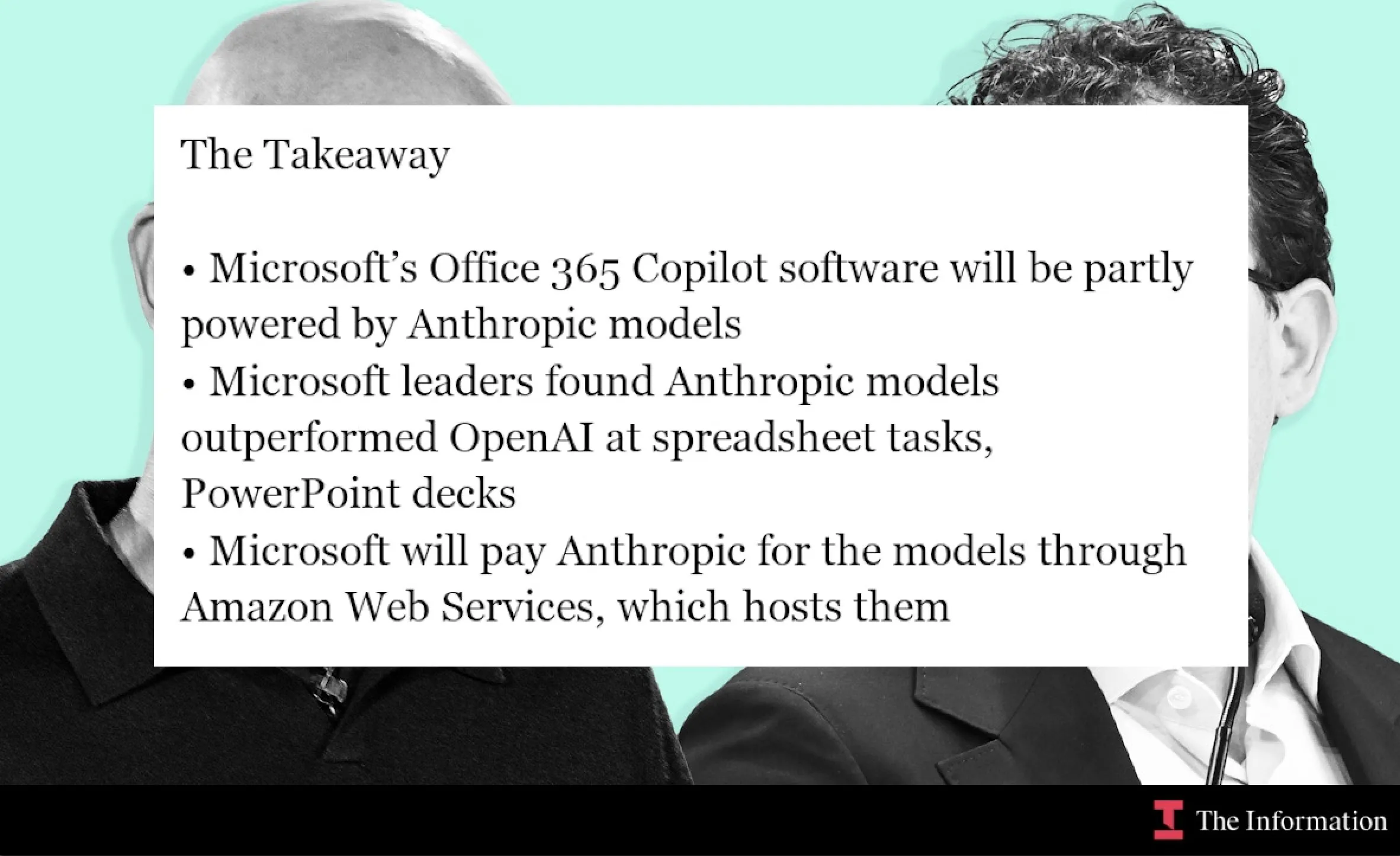

Microsoft ve Anthropic İşbirliğiyle Claude Modeli Office 365 Copilot’a Entegre Edildi : Microsoft, Anthropic’in Claude modelini Office 365 Copilot’a, özellikle Claude’un daha iyi performans gösterdiği Excel fonksiyon hesaplamaları ve PowerPoint slayt oluşturma gibi alanlara entegre ediyor. Bu hamle, Copilot’un Word, Excel ve PowerPoint’teki belirli özelliklerini optimize etmeyi, kullanıcı deneyimini iyileştirmeyi ve Claude’un kurumsal üretkenlik araçlarındaki uygulama alanını genişletmeyi amaçlıyor. (Kaynak: dotey, alexalbert__, menhguin, TheRundownAI)

AI Bilimsel Araştırmayı Hızlandırıyor: Bilgi Grafikleri ve Otonom Ajanlar : MiniculeAI, AI’ın bilgi grafikleri ve otonom ajanlar aracılığıyla bilimsel keşfi nasıl hızlandırdığını gösteriyor. Genleri, ilaçları ve sonuçları dinamik bir ağa eşleyerek, AI, PDF belgelerinde bulunması zor gizli bağlantıları ortaya çıkarabiliyor. Otonom ajanlar literatürü tarayabilir, desenleri keşfedebilir ve açıklanabilir içgörüler sunarak aylarca süren geleneksel araştırmayı dakikalara indirebilirken, kurumsal düzeyde veri gizliliğini de sağlıyor. (Kaynak: Ronald_vanLoon)

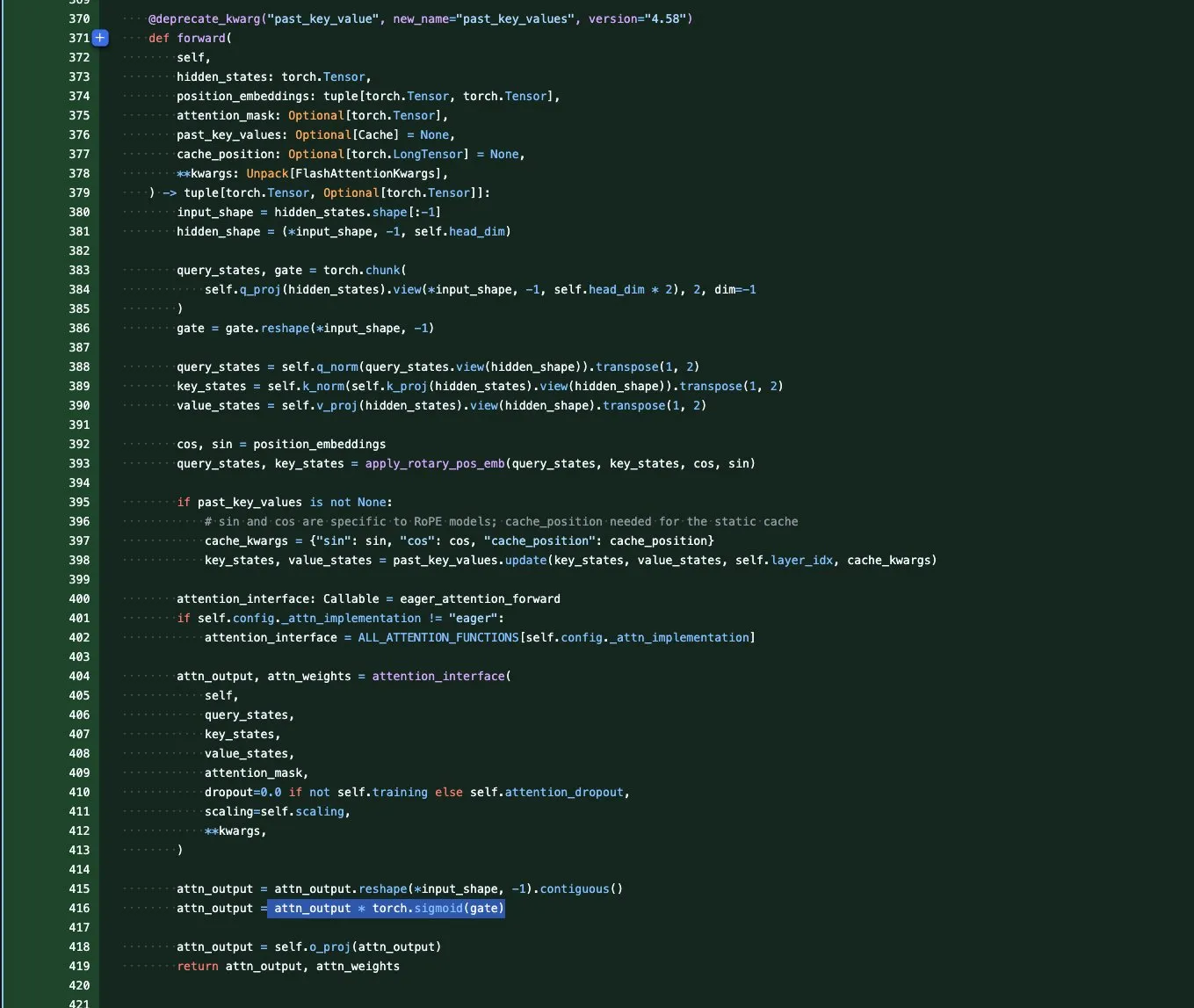

Qwen3-Next Model Serisi: Uzun Bağlam ve Parametre Verimliliği Optimizasyonu : Qwen ekibi, aşırı bağlam uzunluğuna ve büyük ölçekli parametre verimliliğine odaklanan Qwen3-Next serisi temel modellerini tanıttı. Bu seri, GatedAttention (anormallikleri çözme), GatedDeltaNet RNN (KV önbelleğini kaydetme) dahil olmak üzere birçok mimari yenilik sunuyor ve performansı maksimize ederken hesaplama maliyetini minimize etmeyi amaçlayan Sink+SWA hibrit veya Gated Attention+lineer RNN hibrit mimarilerini birleştiriyor. Bu, saf Attention modelleri çağının sonuna işaret ediyor. (Kaynak: tokenbender, SchmidhuberAI, teortaxesTex, ClementDelangue, andriy_mulyar)

ByteDance Seedream 4.0 Görüntü Oluşturma ve Düzenleme Modeli Yayınlandı : ByteDance, üstün görüntü oluşturma ve düzenleme yetenekleri sunan Seedream 4.0’ı yayınladı. Kullanıcı geri bildirimleri, modelin kullanıcı ihtiyaçlarını, RLHF estetik tercihlerini karşılamada ve ana akım zevki korumada olağanüstü performans gösterdiğini belirtiyor. Seedream 3.0’a kıyasla, 4.0 sürümü film greni ve lens artefaktları ekliyor, daha yüksek kontrast sunuyor ve anime tarzı fırça darbeleri daha keskin. Aynı zamanda Çince anlamsal anlama ve tutarlılıkta güçlü performans göstererek infografikler, eğitimler ve ürün tasarımı için uygun hale geliyor. (Kaynak: ZhihuFrontier, Reddit r/artificial, op7418, TomLikesRobots, dotey)

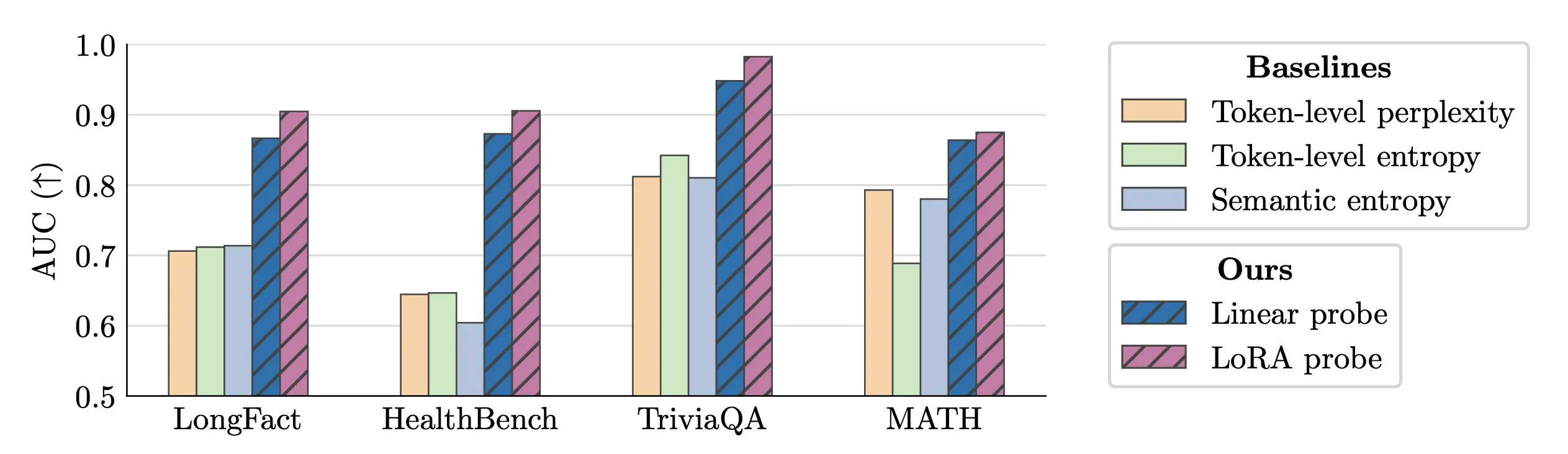

LLM Halüsinasyonlarının Gerçek Zamanlı Tespit Teknolojisi : Araştırmacılar, LLM halüsinasyonlarının gerçek zamanlı tespiti için aktivasyon probları kullanmayı önerdi. Bu yöntem, uzun metinlerde sahte varlıkları tanımlamada %0,90’a varan AUC değeriyle geleneksel anlamsal entropi yöntemlerinden önemli ölçüde daha iyi performans gösteriyor. Ayrıca, yeni araştırma Transformer modellerindeki halüsinasyonların kökenlerini derinlemesine inceleyerek LLM güvenilirliğini artırmak için yeni fikirler sunuyor. (Kaynak: paul_cal, tokenbender)

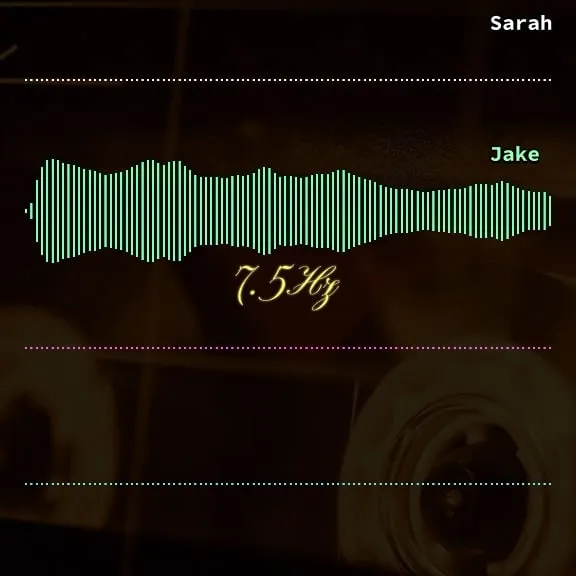

Microsoft VibeVoice: Uzun Süreli Yüksek Doğrulukta Ses Üretimi : Microsoft VibeVoice modeli, AI ses alanında önemli ilerlemeler kaydederek 45-90 dakika uzunluğunda, 4 konuşmacıya kadar gerçekçi sesleri birleştirmeye gerek kalmadan üretebiliyor. Model, Hugging Face Space’te deneyimlenebilir ve kullanıcıların yüksek kaliteli ses klonlama yapmasına olanak tanıyarak podcast’ler, sesli kitaplar gibi uygulamalar için yeni olanaklar sunuyor. (Kaynak: Reddit r/LocalLLaMA)

mmBERT: Çok Dilli Kodlayıcılarda Yeni Bir Standart : Yeni mmBERT modeli, 6 yıldır SOTA olan XLM-R’nin yerini alması beklenerek tanıtıldı. mmBERT, mevcut modellerden 2-4 kat daha hızlı ve çok dilli kodlama görevlerinde o3 ve Gemini 2.5 Pro’yu geride bırakıyor. Açık model ve eğitim verileriyle birlikte yayınlanan bu model, çok dilli AI uygulamaları için daha verimli ve güçlü bir temel sağlayacak. (Kaynak: code_star)

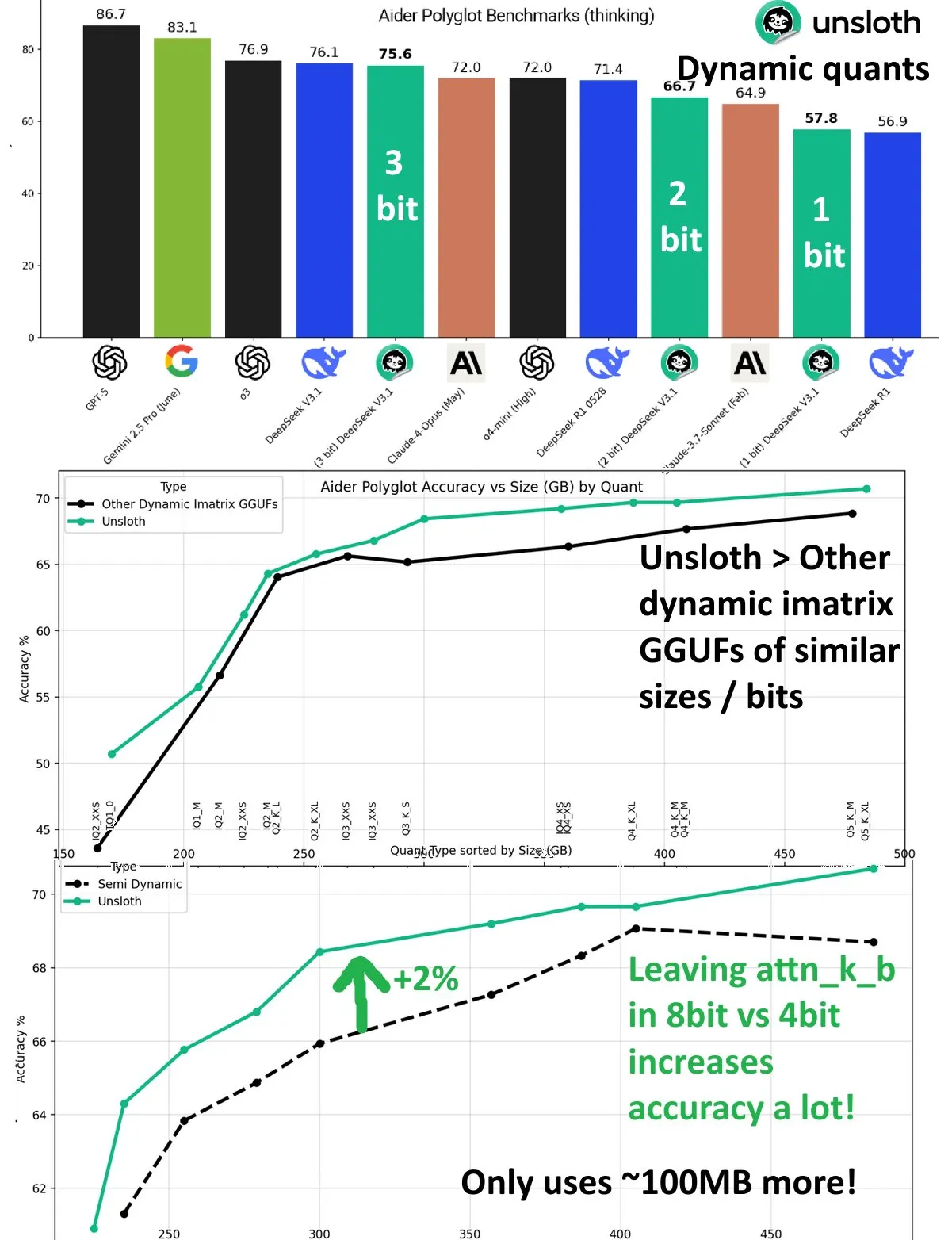

DeepSeek V3.1 Dinamik Kuantizasyon Performans Artışı : DeepSeek V3.1 modeli, UnslothAI’ın Aider Polyglot kıyaslamasında dinamik kuantizasyon teknolojisi sayesinde önemli bir performans artışı sağladı. 3-bit kuantizasyon, kuantize edilmemiş modelin doğruluğuna yaklaşırken, çıkarım modunda 1-bit dinamik kuantizasyon DeepSeek R1’in orijinal performansını bile aştı. Araştırma, attn_k_b katmanını 8-bit hassasiyette tutmanın ek %2 doğruluk artışı sağlayabileceğini göstererek, verimli kuantizasyonun model yeteneklerini koruma ve hesaplama maliyetlerini düşürme potansiyelini ortaya koydu. (Kaynak: danielhanchen)

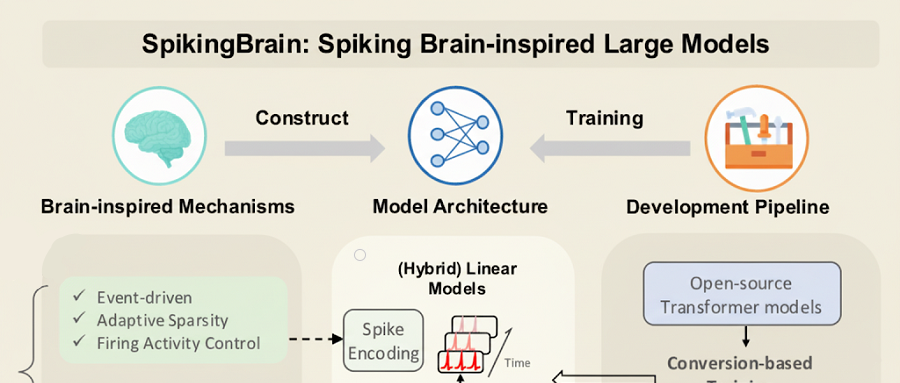

Yerli GPU’larla Eğitilen Yerli Büyük Model SpikingBrain-1.0 : Çin Bilimler Akademisi Otomasyon Enstitüsü, yerli MuXi GPU kümesinde eğitim ve çıkarım süreçlerini tamamlayan beyin benzeri SpikingBrain-1.0 büyük modelini yayınladı. Model, geleneksel FP16 işlemlerine göre enerji tüketimini %97,7 oranında azaltıyor. Ana akım büyük modellerin ön eğitim verilerinin sadece %2’sini kullanarak Qwen2.5-7B’nin performansının %90’ına ulaşan model, ultra uzun dizi işleme görevlerinde üstün performans göstererek TTFT’yi 26,5 kata kadar hızlandırdı. Bu, yerli, otonom ve Transformer olmayan büyük model ekosisteminin fizibilitesini doğruluyor. (Kaynak: 36氪)

Wenxin X1.1 Yayınlandı: Gerçekçilik, Talimat Takibi ve Ajan Yeteneklerinde Önemli İyileşmeler : Baidu’nun derin düşünme modeli Wenxin Large Model X1.1 yükseltildi ve gerçekçilikte %34,8, talimat takibinde %12,5 ve ajan yeteneklerinde %9,6 artış gösterdi. Modelin genel performansı DeepSeek R1-0528’i geride bırakarak GPT-5 ve Gemini 2.5 Pro ile rekabet edebilir seviyeye ulaştı. Karmaşık uzun vadeli görevlerde güçlü ajan yetenekleri sergileyen model, görevleri otomatik olarak ayırabilir ve araçları çağırabilir. Baidu ayrıca ERNIE-4.5-21B-A3B-Thinking açık kaynak modelini ve ERNIEKit geliştirme kitini yayınlayarak AI uygulama eşiğini daha da düşürdü. (Kaynak: 量子位)

Huawei Açık Kaynak OpenPangu-Embedded-7B-v1.1: Hızlı ve Yavaş Düşünme Arasında Serbest Geçiş : Huawei, hızlı ve yavaş düşünme modları arasında serbestçe geçiş yapabilen ve soru zorluğuna göre adaptif olarak seçim yapabilen 7B parametreli açık kaynak modeli OpenPangu-Embedded-7B-v1.1’i yayınladı. Aşamalı ince ayar ve iki aşamalı eğitim stratejisiyle model, genel, matematik ve kod değerlendirmelerinde doğruluğunu önemli ölçüde artırdı. Ayrıca, doğruluğu korurken ortalama Chain of Thought uzunluğunu yaklaşık %50 oranında kısalttı. Bu, açık kaynak büyük modellerdeki bu yetenek boşluğunu doldurarak verimliliği ve doğruluğu artırdı. (Kaynak: 量子位)

Tencent CodeBuddy Code: AI Programlama L4 Çağına Giriyor : Tencent, AI CLI aracı CodeBuddy Code’u yayınladı ve CodeBuddy IDE’nin açık beta sürümünü başlattı. Bu, AI programlamayı L4 seviyesi “AI yazılım mühendisi” çağına taşımayı amaçlıyor. CodeBuddy Code, npm üzerinden kurulabilir ve doğal dil ile geliştirme ve operasyonların tüm yaşam döngüsünü yönlendirerek aşırı otomasyon sağlıyor. Belge odaklı yönetim, bağlam sıkıştırma ve MCP uzantıları aracılığıyla bu araç, kurumsal düzeyde AI programlama için temel bir altyapı haline gelerek geliştirme verimliliğini önemli ölçüde artırıyor. (Kaynak: 量子位)

OpenAI Çekirdek Bilim İnsanları: Polonyalı İkili GPT-4 ve Çıkarım Atılımlarını Destekliyor : OpenAI Baş Bilim İnsanı Jakub Pachocki ve Teknik Araştırmacı Szymon Sidor, Dota projesi, GPT-4 ön eğitimi ve çıkarım atılımlarını teşvik etmedeki kilit katkıları nedeniyle Altman tarafından büyük övgü aldı. Lise arkadaşlığından OpenAI’de yeniden bir araya gelen ikili, derin düşünme ve uygulamalı deneyleri birleştirerek OpenAI’nin vazgeçilmez güçleri haline geldi; hatta 2023’teki iç krizde Altman’ın geri dönüşünü kararlılıkla desteklediler. (Kaynak: 量子位)

Beyaz Saray AI Zirvesi Yetenek, Güvenlik ve Ulusal Zorluklara Odaklandı : Melania Trump, Beyaz Saray’da Google, IBM ve Microsoft gibi teknoloji devlerini ağırlayan bir AI toplantısına başkanlık etti. Toplantı, AI alanındaki yetenek geliştirme, güvenlik ve ulusal düzeydeki zorluklara odaklandı. Bu hamle, ABD hükümetinin AI gelişiminin getirdiği fırsat ve zorluklara yanıt vermek ve ülkenin AI alanındaki liderliğini sağlamak için AI stratejisini aktif olarak ilerlettiğini gösteriyor. (Kaynak: TheTuringPost, Reddit r/artificial)

Neuromorphic Computing: Geleneksel Sinir Ağlarının Ötesinde : Neuromorphic Computing, biyolojik beynin yapısından ve çalışma prensiplerinden ilham alarak zekayı yeniden tanımlıyor. Bu teknoloji, nöronların ve sinapsların paralel işleme yeteneklerini simüle ederek geleneksel von Neumann mimarisinin ötesinde daha verimli, düşük güç tüketimli AI donanımları geliştirmeyi amaçlıyor ve gelecekteki AI sistemleri için daha güçlü bir temel sağlıyor. (Kaynak: Reddit r/artificial)

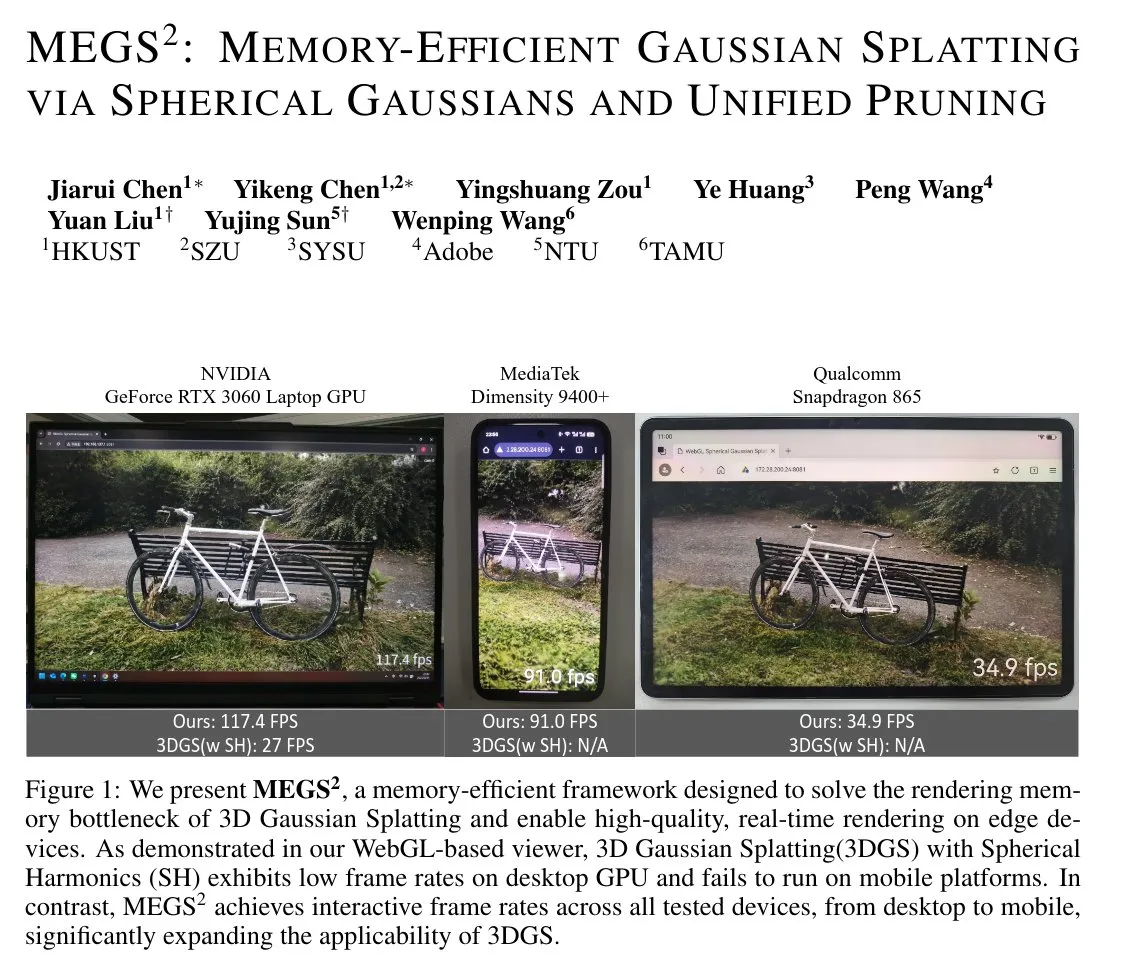

MEGS²: Bellek Verimli Gaussian Splatting Teknolojisi : MEGS² (Memory-Efficient Gaussian Splatting via Spherical Gaussians and Unified Pruning), bellek açısından verimli bir 3D Gaussian Splatting (3DGS) teknolojisidir. Renkleri temsil etmek için küresel harmoniklerin yerine keyfi yönelimli küresel Gauss fonksiyonları kullanarak ve birleşik bir yumuşak budama çerçevesi sunarak, bu yöntem her bir ilkel için parametre sayısını önemli ölçüde azaltır. Bu, 8 kat statik VRAM sıkıştırması ve yaklaşık 6 kat render VRAM sıkıştırması sağlarken, render kalitesini korur veya iyileştirir. Bu, 3D grafikler ve gerçek zamanlı render için büyük önem taşımaktadır. (Kaynak: janusch_patas)

🧰 Araçlar

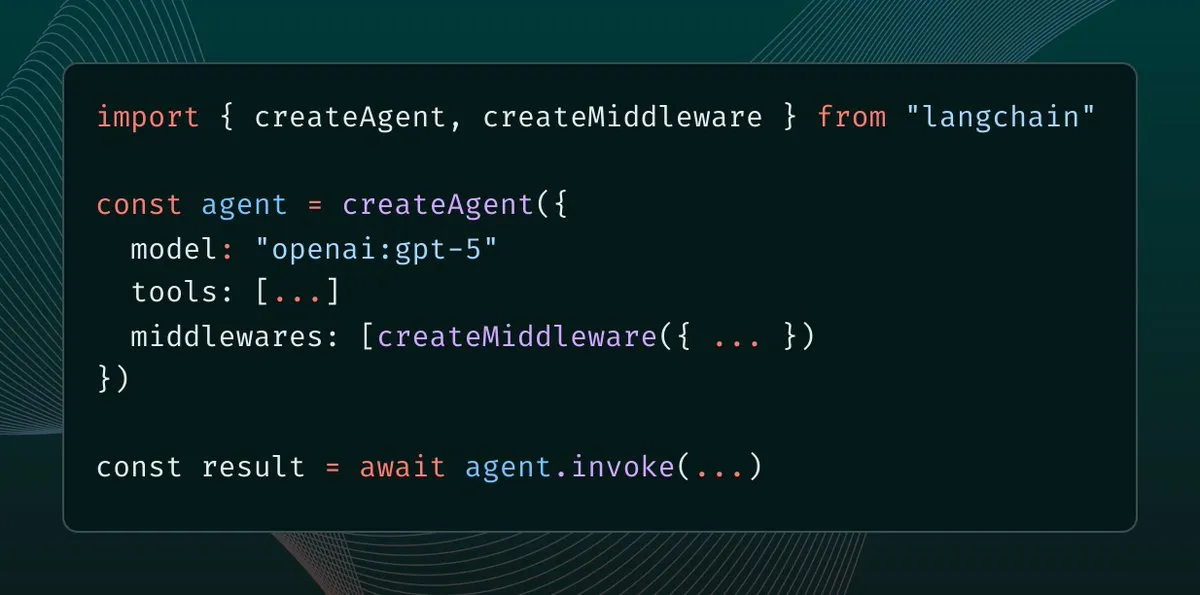

LangChain 1.0 Middleware’i Tanıttı: Ajan Bağlam Kontrolünde Yeni Bir Paradigma : LangChain 1.0, AI ajanları için yeni bir soyutlama katmanı olan Middleware’i yayınladı ve geliştiricilere bağlam mühendisliği üzerinde tam kontrol sağlıyor. Bu özellik, ajanların esnekliğini, birleştirilebilirliğini ve uyarlanabilirliğini artırarak yansıma, gruplama, süpervizörler gibi farklı ajan mimarilerinin uygulanmasını destekliyor ve daha karmaşık AI uygulamaları oluşturmak için güçlü bir temel sunuyor. (Kaynak: hwchase17, hwchase17, Hacubu)

MaxKB: Açık Kaynak Kurumsal Düzeyde Ajan Platformu : MaxKB, RAG (Retrieval-Augmented Generation) boru hattı, güçlü bir iş akışı motoru ve MCP araç kullanım yeteneklerini entegre eden güçlü ve kullanımı kolay bir açık kaynak kurumsal düzeyde ajan platformudur. Belge yükleme, otomatik tarama, metin bölme ve vektörleştirmeyi destekleyerek büyük model halüsinasyonlarını etkili bir şekilde azaltır. Ayrıca çeşitli özel ve genel büyük modelleri destekler, çok modlu giriş ve çıkış sağlar ve akıllı müşteri hizmetleri, kurumsal bilgi tabanları gibi senaryolarda yaygın olarak kullanılır. (Kaynak: GitHub Trending)

BlenderMCP: Claude AI ve Blender’ın Derin Entegrasyonu : BlenderMCP, Claude AI ve Blender’ın derin entegrasyonunu gerçekleştirerek, Model Context Protocol (MCP) aracılığıyla Claude’un 3D modelleme, sahne oluşturma ve manipülasyon için Blender’ı doğrudan kontrol etmesine olanak tanır. Bu araç, çift yönlü iletişimi, nesne manipülasyonunu, malzeme kontrolünü, sahne denetimini ve kod yürütmeyi destekler. Ayrıca Poly Haven ve Hyper3D Rodin varlıklarını entegre edebilir, bu da AI destekli 3D oluşturma verimliliğini ve olanaklarını büyük ölçüde artırır. (Kaynak: GitHub Trending)

AI Sheets: Kodsuz AI Veri Kümesi Oluşturma ve Dönüştürme Aracı : Hugging Face, AI modellerini kullanarak veri kümeleri oluşturmak, zenginleştirmek ve dönüştürmek için açık kaynaklı, kodsuz bir araç olan AI Sheets’i yayınladı. Bu araç yerel olarak veya Hub üzerinde çalıştırılabilir, Hugging Face Hub’daki binlerce açık kaynak modele (gpt-oss dahil) erişimi destekler ve Docker veya pnpm aracılığıyla hızlı bir şekilde başlatılabilir. Veri işleme süreçlerini basitleştirir ve özellikle büyük ölçekli veri kümeleri oluşturmak için uygundur. (Kaynak: GitHub Trending)

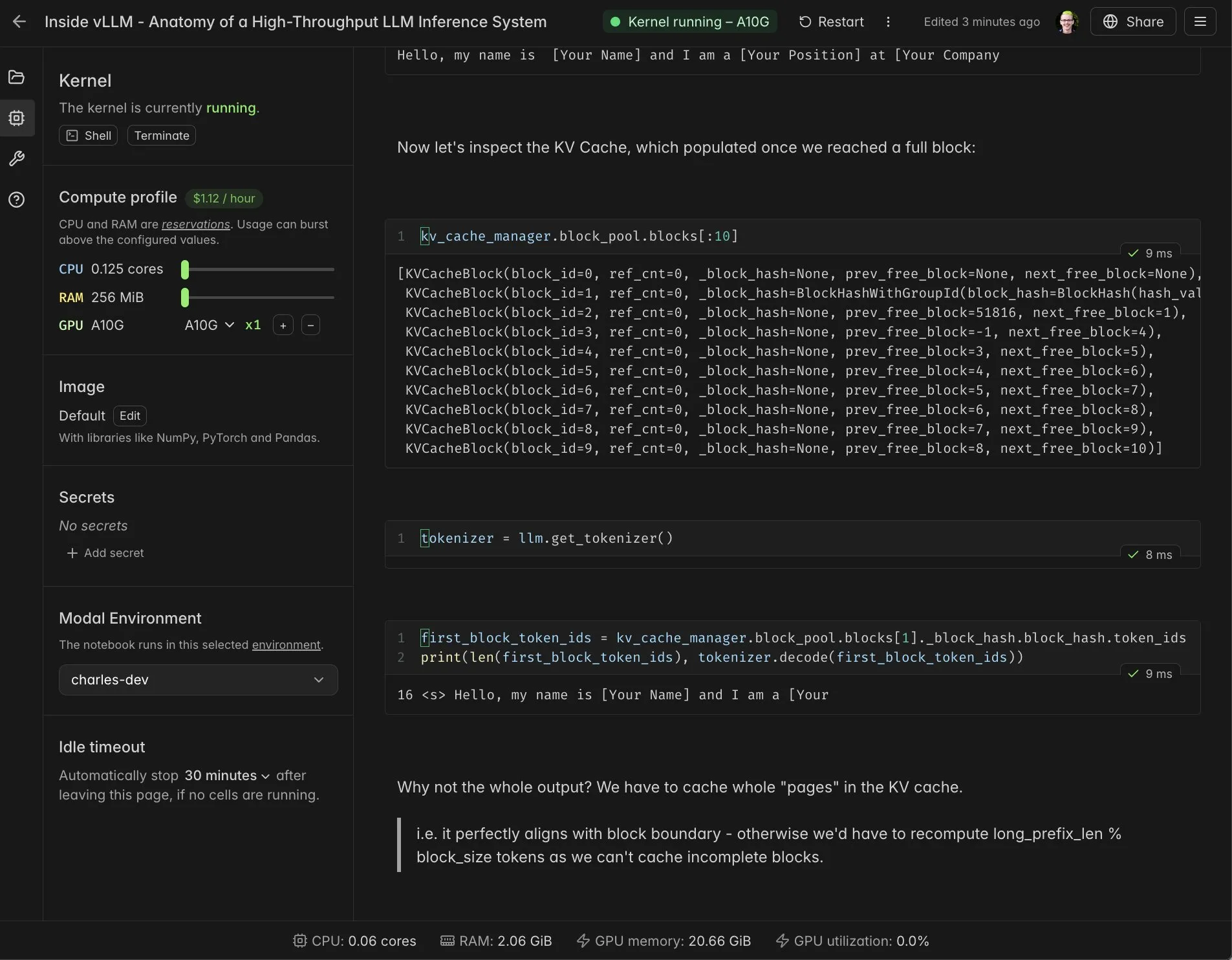

vLLM Gerçek Zamanlı Notebook ve Modal Entegrasyonu : Modal Notebooks, vLLM ile entegre olarak gerçek zamanlı, paylaşılabilir etkileşimli bir ortam sunar ve geliştiricilerin vLLM’in iç mekanizmalarını daha iyi anlamalarına yardımcı olur. Bu entegrasyon sayesinde kullanıcılar, karmaşık entegrasyonlar oluşturmaya gerek kalmadan CUDA uyumlu hesaplama görevlerini bulutta kolayca çalıştırabilir ve paylaşabilir, bu da vLLM geliştirme ve öğrenme sürecini büyük ölçüde basitleştirir. (Kaynak: charles_irl, vllm_project, charles_irl, charles_irl, charles_irl, charles_irl)

Docker Minions AI’ı Destekliyor: Yerel Hibrit AI İş Yükleri : Minions AI artık Docker’ı resmi olarak destekliyor ve kullanıcıların Docker model çalıştırıcısı aracılığıyla yerel olarak hibrit AI iş yüklerini kullanmalarına olanak tanıyor. Bu işbirliği, geliştiricilerin Minions AI’ı yerel ortamlarda daha kolay dağıtmasını ve yönetmesini sağlıyor, Docker’ın konteynerleştirme avantajlarıyla birleşerek AI uygulama geliştirme esnekliğini ve verimliliğini artırıyor. (Kaynak: shishirpatil_)

Replit Agent 3: Otonom Yazılım Geliştirmede Yeni Bir Atılım : Replit, yazılım geliştirmenin “tam otonom sürüş” anı olarak adlandırılan Agent 3’ü yayınladı. Önceki ajanlardan 10 kat daha fazla özerkliğe sahip olduğu belirtilen bu Agent, uygulamaları daha derinlemesine prototipleştirebiliyor ve diğer ajanlar takıldığında bile ilerlemeye devam edebiliyor. Yazılım geliştirmedeki zaman alıcı test, hata ayıklama ve yeniden düzenleme aşamalarını çözmeyi ve geliştirme verimliliğini önemli ölçüde artırmayı amaçlıyor. (Kaynak: amasad, amasad, pirroh)

Qwen3-Coder: Yüksek Maliyet-Etkinliğe Sahip Açık Kaynak Programlama Modeli : Qwen3-Coder, Windsurf platformunda üstün performans ve maliyet etkinliği sergiliyor; Claude 4 ve GPT-5 High’a (2 kat puan) kıyasla sadece 0,5 puanla çalışabiliyor. Bu model, programlama görevlerinde mükemmel performans gösteriyor ve açık kaynak bir model olarak, düzenlenmiş işletmeler ve kamu sektörü kuruluşları için genel API’lere bağımlılık olmadan güçlü bir AI programlama seçeneği sunarak veri egemenliği ve görünürlük sorunlarının çözümüne yardımcı oluyor. (Kaynak: bookwormengr)

📚 Öğrenme

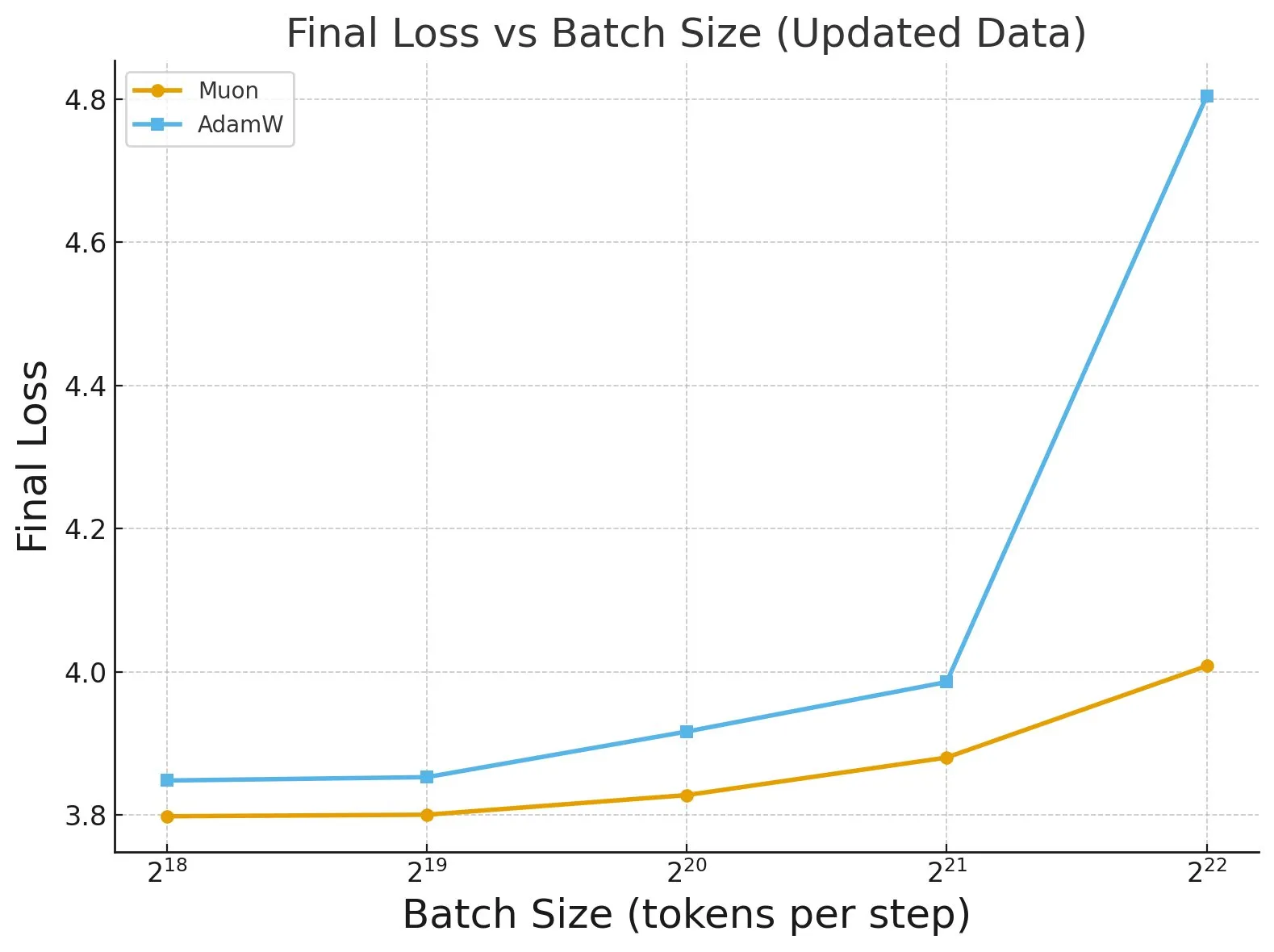

“Fantastic Pretraining Optimizers and Where to Find Them” Araştırması : 4000’den fazla model üzerinde yapılan kapsamlı bir araştırma, ön eğitim optimize edicilerinin performansını ortaya koydu. Araştırma, bazı optimize edicilerin (Muon gibi) küçük ölçekli modellerde (<0,5B parametre) %40’a kadar hız artışı sağlayabildiğini, ancak büyük ölçekli modellerde (1,2B parametre) sadece %10’luk bir artış gösterdiğini buldu. Bu, optimize edicileri değerlendirirken yetersiz temel ayar ve ölçek sınırlamalarına dikkat etmenin önemini vurguluyor ve toplu iş boyutunun optimize edici performans farkları üzerindeki etkisine işaret ediyor. (Kaynak: tokenbender, code_star)

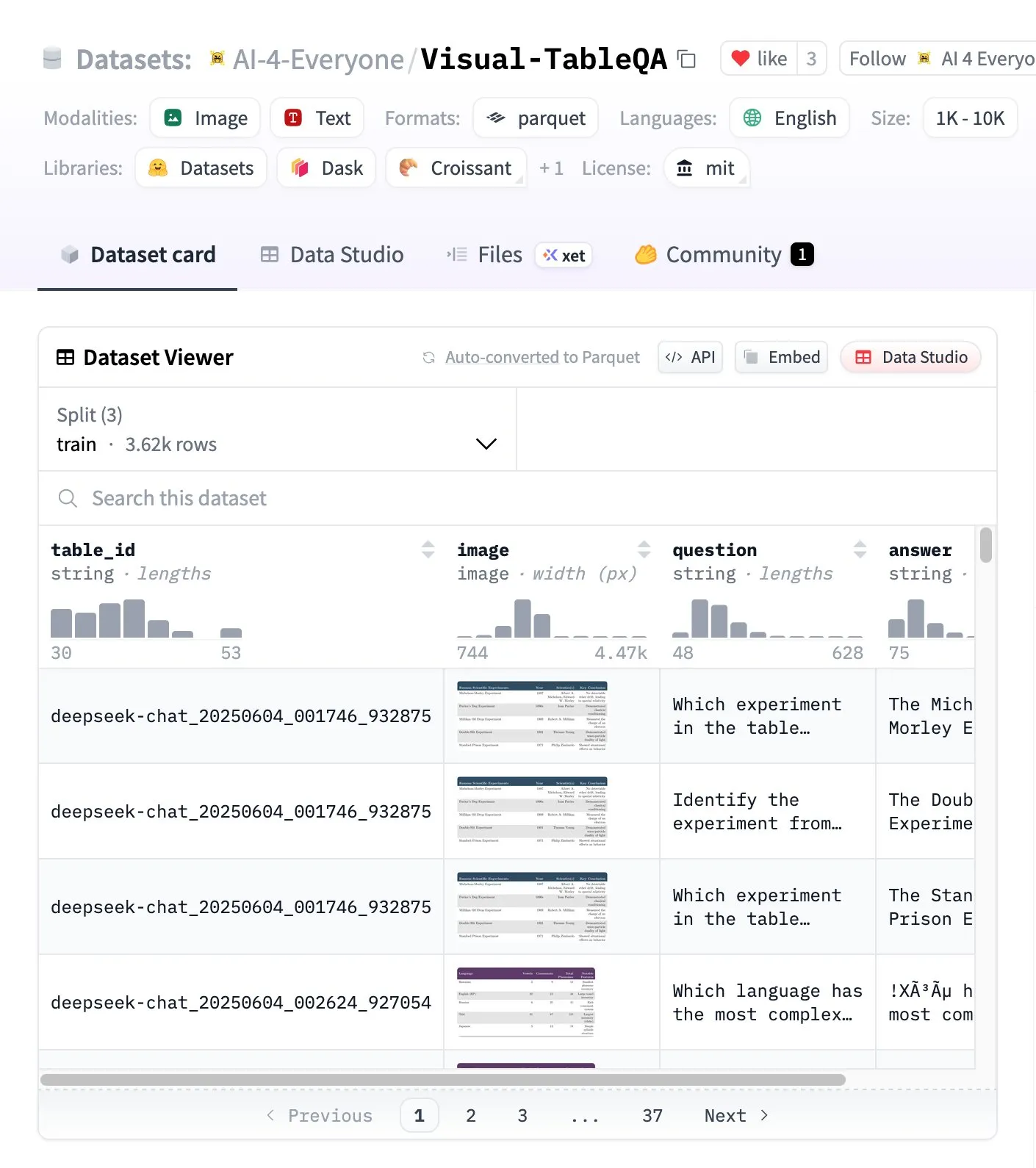

Visual-TableQA: Karmaşık Tablo Çıkarım Kıyaslaması : Hugging Face, 2.5K tablo ve 6K QA çifti içeren karmaşık bir tablo çıkarım kıyaslaması olan Visual-TableQA’yı yayınladı. Bu kıyaslama, görsel yapı üzerindeki çok adımlı çıkarıma odaklanıyor ve %92 oranında insan tarafından doğrulandı, 100 dolardan daha düşük bir maliyetle oluşturuldu. Modellerin karmaşık tablo verilerini anlama ve üzerinde çıkarım yapma yeteneklerini değerlendirmek ve geliştirmek için yüksek kaliteli bir kaynak sağlıyor. (Kaynak: huggingface)

AI Agents vs Agentic AI Kavram Analizi : Toplulukta AI Agents ve Agentic AI sistemleri arasında yaygın bir karışıklık bulunuyor. AI Agents, belirli görevleri yerine getiren tekil otonom yazılımları (LLM+araçlar) ifade eder, reaktif davranış sergiler ve sınırlı belleğe sahiptir; Agentic AI ise çoklu ajan işbirliği sistemlerini (çoklu LLM+orkestrasyon+paylaşılan bellek) ifade eder, proaktif davranış sergiler ve kalıcı belleğe sahiptir. İkisinin farkını anlamak, mimari kararlar için kritik öneme sahiptir ve gereksiz karmaşık sistemler inşa etmekten kaçınmaya yardımcı olur. (Kaynak: Reddit r/deeplearning)

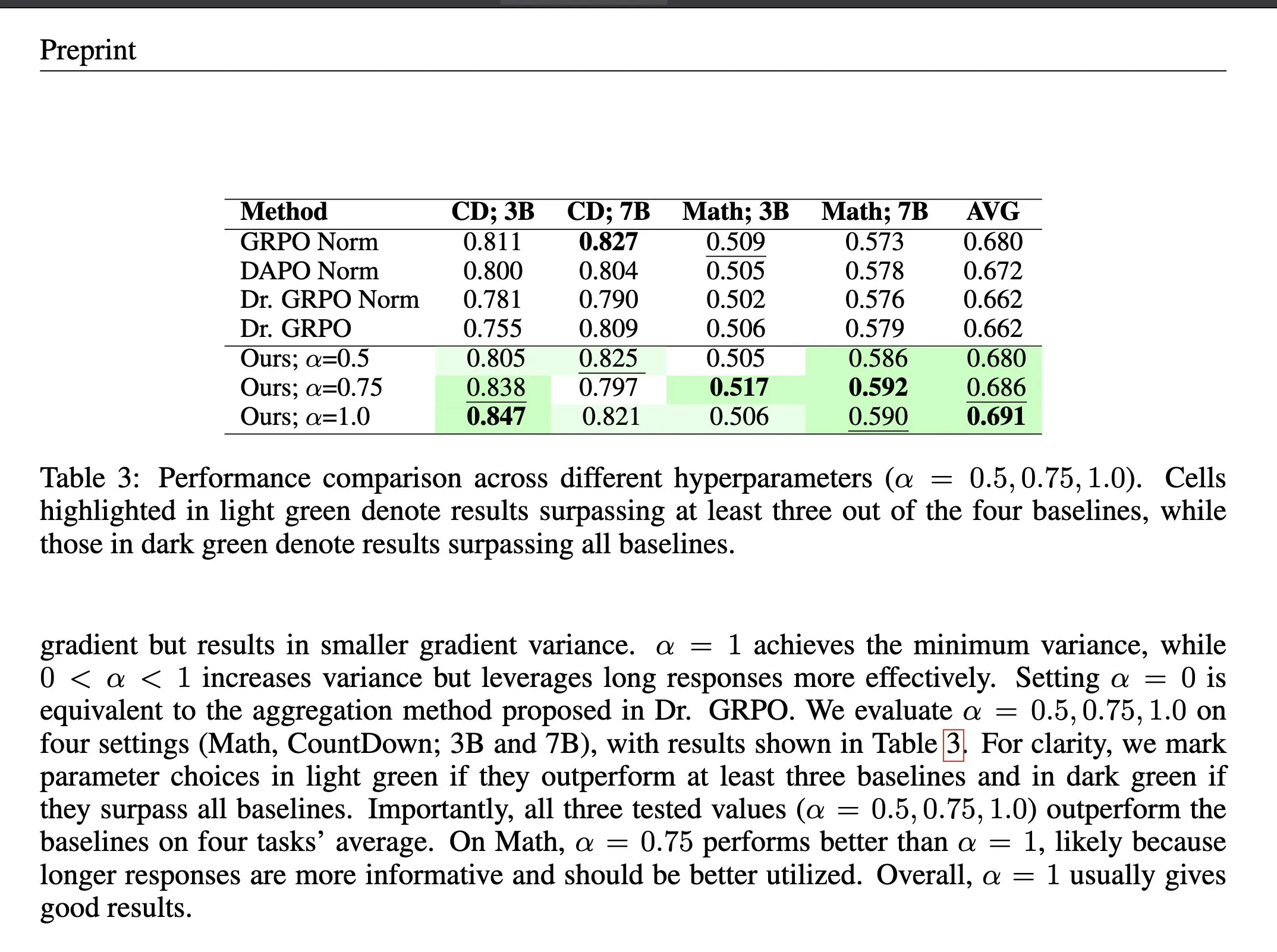

Pekiştirmeli Öğrenmede Kayıp Toplama Yöntemi ΔL Normalization : ΔL Normalization, doğrulanabilir ödül pekiştirmeli öğrenme (RLVR) bağlamında dinamik olarak üretilen uzunluk özelliklerine yönelik tasarlanmış bir kayıp toplama yöntemidir. Bu yöntem, farklı uzunlukların politika kaybı üzerindeki etkisini analiz ederek, en küçük varyanslı tarafsız tahminciyi bulmak için problemi yeniden yapılandırır ve teorik olarak gradyan varyansını minimize eder. Deneyler, ΔL Normalization’ın farklı model ölçeklerinde, maksimum uzunluklarda ve görevlerde sürekli olarak üstün sonuçlar elde ettiğini, RLVR’deki yüksek gradyan varyansı ve optimize etme istikrarsızlığı zorluklarını çözdüğünü göstermektedir. (Kaynak: HuggingFace Daily Papers, teortaxesTex)

LLM Mimari Karşılaştırma Video Dersi : Rasbt, DeepSeek V3/R1, OLMo 2, Gemma 3, Mistral Small 3.1, Llama 4, Qwen3, SmolLM3, Kimi 2, GPT-OSS, Grok 2.5 ve GLM-4.5 dahil olmak üzere 2025’in 11 LLM mimarisinin karşılaştırmalı analizini içeren bir video dersi yayınladı. Bu ders, geliştiricilere ve araştırmacılara kapsamlı bir LLM mimarisi genel bakışı sunarak farklı modellerin tasarım felsefelerini ve performans özelliklerini anlamalarına yardımcı oluyor. (Kaynak: rasbt)

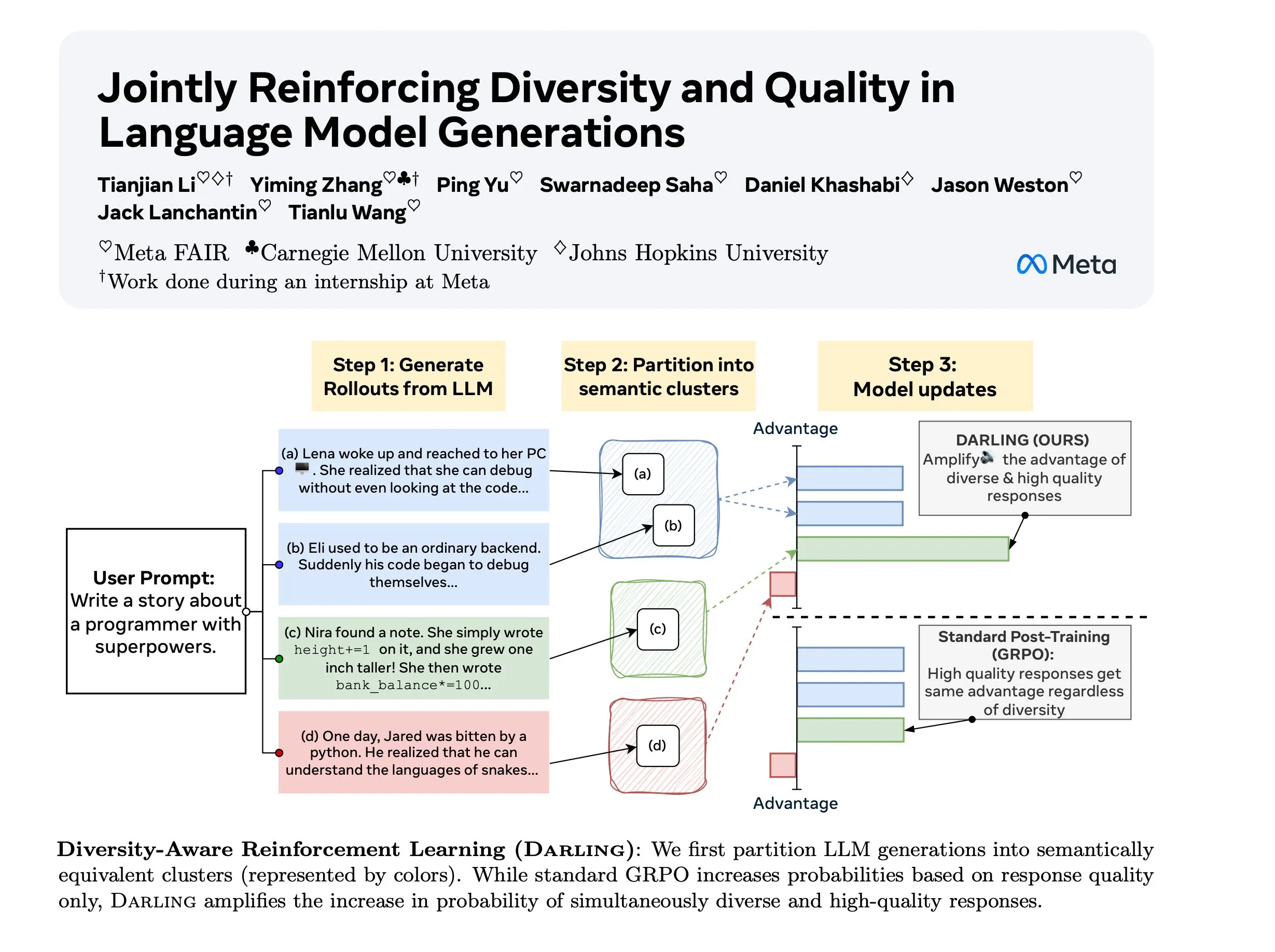

Diversity Aware RL (DARLING) Araştırması : DARLING (Diversity Aware RL), kalite ve çeşitliliği eş zamanlı olarak optimize etmek için bir bölümleme fonksiyonu öğrenerek çalışan yeni bir pekiştirmeli öğrenme yöntemidir. Bu yöntem, hem kalite hem de çeşitlilik metriklerinde standart RL’den daha iyi performans gösterir, örneğin daha yüksek pass@1/p@k değerleri elde eder ve doğrulanabilir olmayan ve doğrulanabilir görevler için uygundur. Bu, RL’nin karmaşık ortamlardaki genelleştirme yeteneğini artırmak için yeni bir yol sunar. (Kaynak: ylecun)

Stanford CS 224N: Derin Öğrenme ve NLP Kursu : Stanford Üniversitesi CS 224N kursu, derin öğrenme ve doğal dil işlemeye (NLP) kapsamlı bir eğitim sunar. Bu kurs, YouTube videoları aracılığıyla herkese açık olarak sunularak dünya çapındaki öğrencilere yüksek kaliteli AI öğrenme kaynakları sağlar. NLP temel teorilerini, en son modelleri ve pratik uygulamaları kapsayan bu kurs, AI alanına giriş için önemli bir başlangıç noktasıdır. (Kaynak: stanfordnlp)

💼 İş Dünyası

Anthropic’in Yeni Gizlilik Politikası Tartışma Yarattı: Bağımsız Geliştiriciler İçin Sistematik Dezavantaj : Anthropic’in yeni gizlilik politikası, kullanıcıların 28 Eylül’e kadar konuşma verilerini AI eğitimi için kullanmasına izin verip vermeyeceklerini seçmelerini ve 5 yıl boyunca saklamalarını gerektiriyor; aksi takdirde bellek ve kişiselleştirme özelliklerini kaybedecekler. Bu hamle, bağımsız geliştiricileri gizlilik ve işlevsellik arasında seçim yapmaya zorlayan bir “iki kademeli sistem” yaratmakla eleştiriliyor. Geliştiricilerin özel kodları kurumsal AI eğitim verisi haline gelebilirken, kurumsal müşteriler gizlilik koruması ve kişiselleştirmeyi bir arada sunan pahalı çözümlerden yararlanabilecek. Bu durum, AI’ın demokratikleşmesi ve yeniliklerin sömürülmesi konusunda endişelere yol açıyor. (Kaynak: Reddit r/ClaudeAI)

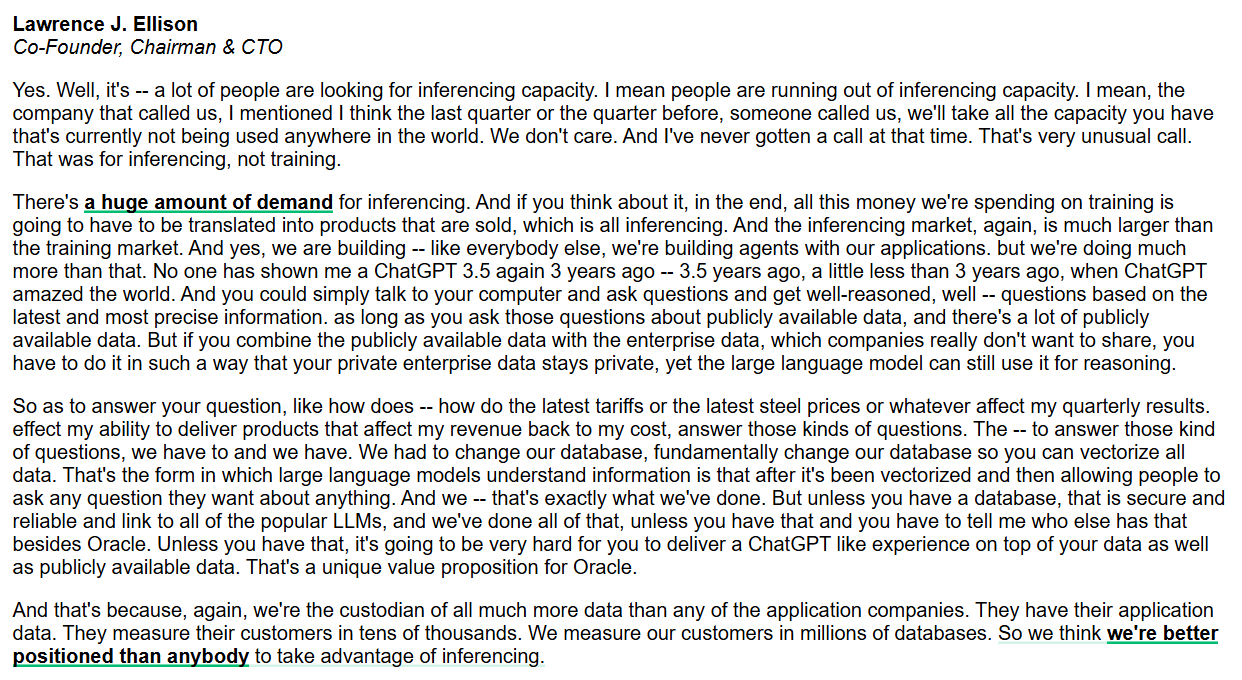

Oracle Çıkarım Yetenekleri ve Kurumsal Düzeyde AI Veritabanına Odaklanıyor : Oracle CEO’su Larry Ellison, çıkarım yetenekleri pazarının eğitim pazarından çok daha büyük ve talebin muazzam olduğunu vurguladı. Oracle, tüm verileri vektörleştirmek için veritabanını kökten değiştirerek ve güvenli ve güvenilir olmasını sağlayarak, hem genel hem de kurumsal özel verileri birleştiren ChatGPT benzeri bir deneyim sunmayı hedefliyor. Oracle, veri barındırıcısı olarak kurumsal düzeyde AI çıkarım hizmetleri sunmada benzersiz bir avantaja sahip olduğuna inanıyor. (Kaynak: JonathanRoss321)

AI İçerik Lisanslamada Yeni Standart RSL Standardı: AI Şirketlerini Ödeme Yapmaya Teşvik Ediyor : Reddit, Yahoo, Quora ve wikiHow gibi büyük markalar, web yayıncılarının AI sistem geliştiricilerinin eserlerini kullanma koşullarını belirlemesine olanak tanıyan açık bir içerik lisanslama standardı olan Really Simple Licensing (RSL) Standardını destekliyor. RSL, robots.txt protokolüne dayanır ve web sitelerinin lisanslama ve telif hakkı koşulları eklemesine izin verir. Bu, AI tarayıcılarının eğitim verileri için (abonelik veya tarama/çıkarım başına ücret) ödeme yapmasını gerektirerek içerik oluşturucularının adil bir şekilde tazmin edilmesini sağlamayı amaçlar. (Kaynak: Reddit r/artificial)

🌟 Topluluk

AI ve İnsan Zekasının Birlikte Varoluşu ve Gelişimi : Topluluk, AI’ın insan zekasına “bilişsel bir düzeltici” olarak mı (abaküs gibi) yoksa insanı “rakip” olarak mı (hesap makinesi gibi) destekleyeceği üzerine tartışıyor. François Chollet, teknolojinin insan çabasını büyütmesi, insanları boşta bırakmaması gerektiğini vurgulayan “düşünce bisikleti” benzetmesini ortaya atarak, AI ve insan zekası (IA) arasındaki ilişki ve gelecekteki gelişim yönü üzerine felsefi düşünceleri tetikledi. (Kaynak: rao2z)

AI Sektörünün PR Çıkmazı ve Kamuoyundaki Olumsuz Algı : AI ürünlerinin milyarlarca kullanıcısı olmasına ve birçok kişinin fayda görmesine rağmen, AI sektörü genel olarak olumsuz bir kamuoyu algısıyla karşı karşıya. Bazı görüşler, bunun sektör liderlerinin dış iletişimde etkili olamaması ve kamuoyunda AI şirketlerine karşı önyargı oluşmasına yol açmasından kaynaklandığını belirtiyor. Bazıları ise bunun, temel teknoloji ve avantajları az sayıda oyuncunun elinde toplamak amacıyla AI sektörünün kasıtlı bir stratejisi olabileceğini tahmin ediyor. (Kaynak: Dorialexander)

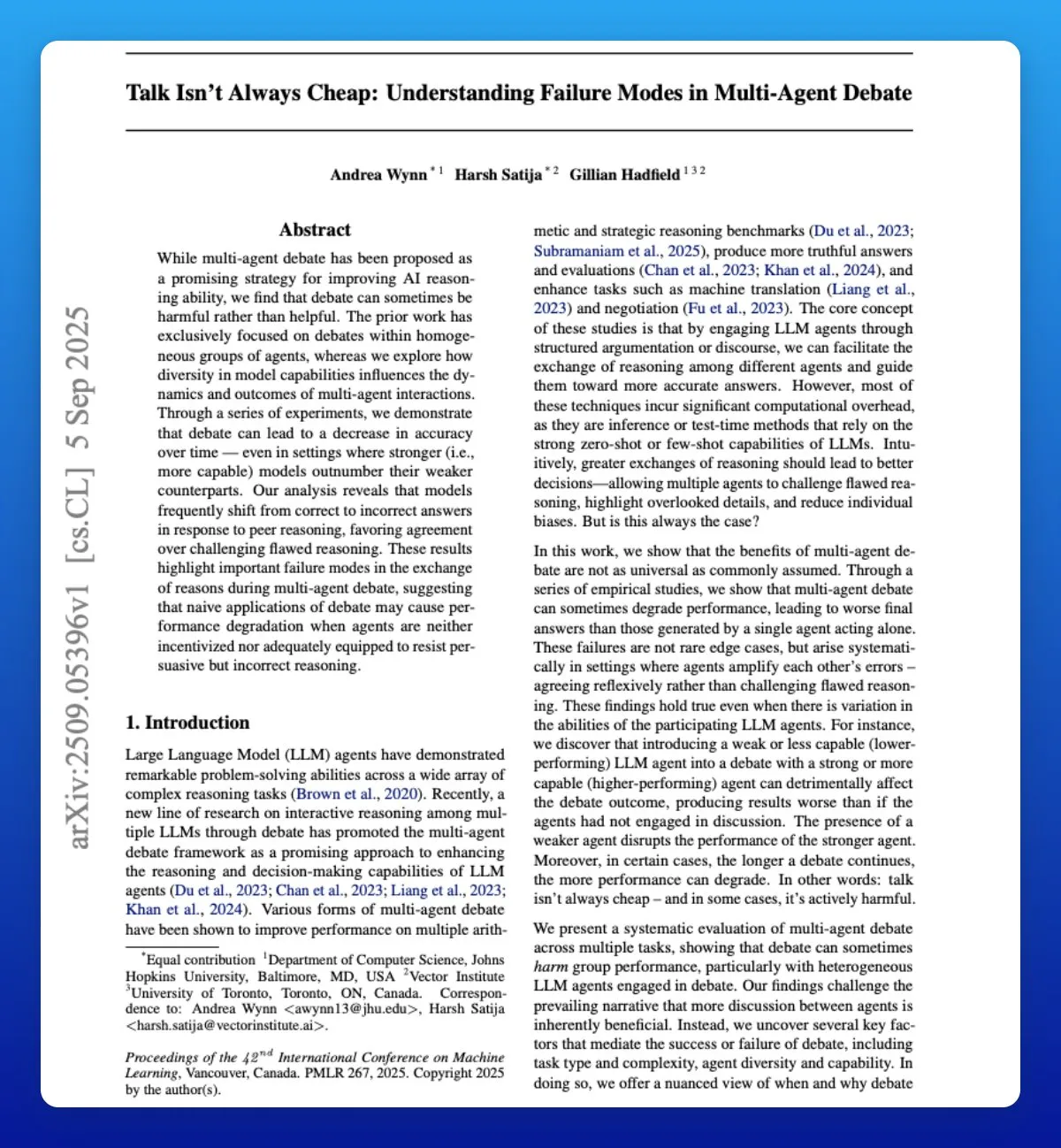

LLM Çoklu Ajan Sistemlerindeki Zayıflıkların Etkisi : Araştırmalar, çoklu ajan sistemlerinde küçük dil modelleri kullanmanın her zaman ideal bir seçim olmadığını gösteriyor. Çoklu ajan tartışmaları gibi senaryolarda, daha zayıf LLM ajanları genellikle daha güçlü ajanların performansını bozabilir, hatta yok edebilir ve genel sistem performansının düşmesine neden olabilir. Bu durum, çoklu ajan sistemleri tasarlarken ve dağıtırken ajan yeteneklerindeki farklılıkları ve potansiyel olumsuz etkileşimleri dikkatlice göz önünde bulundurmanın gerekliliğini ortaya koyuyor. (Kaynak: omarsar0)

Sentetik Verilerin AGI İçin Sınırlamaları : Andrew Trask ve Fei-Fei Li, sentetik verilerin LLM’lerin AGI’ya ulaşması için zayıf bir strateji olduğunu belirtiyor. Sentetik veriler yeni bilgi (modelin daha önce duymadığı varlıklar gibi) yaratamaz, sadece mevcut bilgiden doğal çıkarımları ortaya çıkarabilir. Sentetik veriler, bilinen gerçeklerin mantıksal permütasyonu ve kombinasyonu yoluyla “tersine çevirme laneti” gibi sorunları çözebilse de, bilgi darboğazı AGI için bir “gümüş kurşun” olma potansiyelini sınırlıyor. Gerçek atılımın küresel zeka ve bağlamın anında alınmasında yatabileceği düşünülüyor. (Kaynak: algo_diver, jpt401)

AI ve İnsan İstihdam Piyasası: AI Özgeçmiş Yazıyor, AI Özgeçmiş Tarıyor Çıkmazı : AI, istihdam piyasasında “kimsenin işe alınmadığı” bir kısır döngüye yol açıyor: İş arayanlar AI ile özgeçmiş yazıyor, İK departmanları AI ile özgeçmiş tarıyor, bu da verimliliği “artırıyor” ancak kimse işe alınmıyor. Özgeçmişler AI tarafından çeşitli nedenlerle reddediliyor, hatta İK uzmanları bile AI tarafından oluşturulan özgeçmişlerin tekdüze olmasından şikayet ediyor. Bu durum, AI’ın işe alım süreçlerinde yarattığı yeni zorlukları vurguluyor ve işe alım süreçlerinin katılaşmasına, gerçek yeteneklerin tespit edilememesine yol açabileceğini gösteriyor. (Kaynak: 量子位)

AI Etikçilerinin Karşılaştığı Zorluklar : AI teknolojisinin hızla gelişmesiyle birlikte, AI etikçileri “boşluğa bağırmak” gibi bir çıkmazla karşı karşıya. Kapitalizm güdümlü AI yarışı, etik kaygıların marjinalleşmesine neden oluyor ve teknolojik ilerleme hızı etik entegrasyonu çok geride bırakıyor. Uzmanlar, zararların büyük ölçekte ortaya çıkmasını beklersek çok geç olabileceği konusunda endişeleniyor ve sektörün etik güvenceleri temel düşüncelerine dahil etmesi çağrısında bulunuyor. (Kaynak: Reddit r/ArtificialInteligence)

İnternetin Geleceği: Robot Trafiği İnsanları Geride Bırakıyor : Gelecek üç yıl içinde internetteki robot güdümlü etkileşimlerin insan etkileşimlerini büyük ölçüde aşacağına dair bir eğilim var, bu da interneti “cansız” hale getirecek. Halihazırda robot trafiğinin %50’yi aştığına dair araştırmalar bulunuyor. Bu durum, gerçek insan sesini AI tarafından üretilen içerikten nasıl ayıracağımız ve internet bilgilerinin doğruluğu konusundaki endişeleri artırıyor, ağ ekosisteminde köklü bir değişime işaret ediyor. (Kaynak: Reddit r/artificial)

Claude Code Performans Düşüşü ve Kullanıcı Kaybı : Anthropic’in Claude Code kullanıcıları, model performansında son zamanlarda önemli bir düşüş bildirdi; bu durum, kod kalitesinin kötüleşmesi, gereksiz kod üretimi, düşük test kalitesi, aşırı mühendislik ve anlama yeteneğinin zayıflaması şeklinde kendini gösteriyor. Birçok kullanıcı GPT-5, GLM-4.5, Qwen3 gibi alternatiflere yönelmeyi düşünüyor ve Anthropic’i modelin gerileme nedenlerini ve düzeltme önlemlerini açıklayarak şeffaflığı artırmaya çağırıyor, aksi takdirde kullanıcı kaybıyla karşı karşıya kalacaklar. (Kaynak: Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

💡 Diğer

AI ve VR’nin Suç Islahındaki Potansiyeli : Ucuz AI ve VR teknolojisinin, adli psikiyatri hastaları için zorunlu VR kapsülleri sağlayarak, geleneksel barınma maliyetlerinden daha düşük bir maliyetle onları toplumdan izole edebileceği öne sürülüyor. Bu radikal fikir, AI’ın sosyal kontrol, ceza sistemleri ve etik sınırlar üzerindeki potansiyel uygulamaları hakkında tartışmalara yol açıyor. Fizibilitesi ve insanlığı tartışmalı olsa da, teknolojinin sosyal sorunları çözmedeki potansiyel uygulama yönlerini ortaya koyuyor. (Kaynak: gfodor, gfodor)

Replit’in Cezaevlerinde Uygulama Fikri : Bir kullanıcı, Replit (çevrimiçi bir programlama platformu) cezaevlerine getirme fikrini ortaya attı. Bunun eğlence tesislerinin yerini alabileceğini ve mahkumların programlama yoluyla değerli ürünler yaratabileceğini savundu. Bu fikir, teknolojinin toplumu dönüştürme, beceri eğitimi sağlama ve mahkumların topluma yeniden entegrasyonunu teşvik etme potansiyel rolünü araştırıyor, eğitim eşitliği ve teknolojiyle güçlendirme üzerine tartışmaları tetikliyor. (Kaynak: amasad)