Anahtar Kelimeler:Tesla, Optimus Robotu, Yapay Zeka, GPT-5, Büyük Model Eğitimi, Meta Yapay Zeka, LLM Ön Eğitimi, Goldfish Kayıp Fonksiyonu, DynaGuard Dinamik Bariyer Modeli, GAM Ağ Mimarisi, MedDINOv3 Tıbbi Görüntü Segmentasyonu, M3Ret Çok Modlu Tıbbi Görüntü Arama

🔥 Odak Noktası

Musk, “Master Plan Part IV”ü Yayınladı: Tesla Değerinin %80’i Robotlarda: Tesla, “Master Plan Part IV”ü resmen yayınladı. Planın özü, yapay zekayı (AI) gerçek fiziksel dünyaya entegre etmek ve Tesla’nın donanım ve yazılımını büyük ölçekte birleştirerek “sürdürülebilir refah” sağlamaktır. Musk, gelecekte Tesla’nın değerinin yaklaşık %80’inin insansı robot Optimus’tan geleceğini belirtti. Bu, şirketin elektrikli araçlardan enerji, AI ve robotların derin entegrasyonuna doğru bir paradigma değişimini işaret ediyor ve teknoloji aracılığıyla gerçek dünya sorunlarını çözmeyi ve tüm insanlığa fayda sağlamayı hedefliyor. (Kaynak: 量子位)

🎯 Gelişmeler

AI Uluslararası Matematik Olimpiyatı’nda Altın Madalya Kazandı: OpenAI’nin GPT’si ve Google DeepMind’ın Gemini’si, Uluslararası Matematik Olimpiyatı’nda altın madalya kazanarak uzman tahminlerini altüst etti ve büyük dil modellerinin (LLM) matematiksel akıl yürütmedeki şaşırtıcı ilerlemesini gösterdi. Bu, AI gelişim hızının beklenenden çok daha hızlı olduğunu ve “genel zeka” çağına girildiğini işaret ediyor. Bu sadece bir teknolojik atılım değil, aynı zamanda AI’nin yetenek sınırları ve gelecekteki toplumsal etkileri hakkında derin tartışmaları da tetikledi. (Kaynak: 36氪)

GPT-5 Kurt Adam Oyununda Üstün Performans Gösterdi: AIWolfDial 2025 Kurt Adam kıyaslama testinde, GPT-5 %96,7’lik galibiyet oranıyla açık ara önde yer alarak güçlü sosyal akıl yürütme, aldatma ve manipülasyona karşı direnç yeteneklerini sergiledi. Kimi-K2, cesur ve agresif bir “kurt adam taklidi” tarzı sergileyerek LLM’lerin karmaşık sosyal etkileşimlerdeki kişiselleştirilmiş davranış modellerini yansıttı. (Kaynak: 量子位, Reddit r/deeplearning)

Büyük Model Eğitimi için Yeni Yöntem “Goldfish Loss”: Maryland Üniversitesi ve diğer araştırma ekipleri, kayıp fonksiyonu hesaplanırken bazı token’ları rastgele çıkararak büyük modellerin ezberlemesini etkili bir şekilde azaltan “Goldfish Loss”u önerdi. Bu yöntem, modellerin eğitim verilerini ezberlemesini engellerken, alt görev performansını etkilemeden modelin genelleme yeteneğini artırıyor. (Kaynak: 量子位)

Meta’nın Dahili AI Departmanı Yeniden Yapılandırması Tartışma Yarattı: Meta’nın Baş AI Sorumlusu Alexandr Wang, FAIR’ın makalelerini yayınlamadan önce TBD laboratuvarı tarafından incelenmesini ve değerli makalelerin ve yazarların ürün geliştirmeye yönlendirilmek üzere “alıkonulabileceği” yeni kurallar uyguladı. Bu durum, FAIR içindeki personelin memnuniyetsizliğine ve bazı çalışanların ayrılmasına neden oldu. Bu olay, Meta’nın AI stratejisi ayarlamalarında bilimsel bağımsızlığa müdahalesini ve sonuçları ticarileştirmeye yönelik sert tutumunu vurguluyor. (Kaynak: 量子位)

LLM Ön Eğitim Optimizatör Performans Kıyaslaması: Farklı model boyutları ve veri-model oranlarını kapsayan on derin öğrenme optimizatörü üzerinde sistematik bir çalışma yapıldı. Adil bir karşılaştırma için titiz hiperparametre ayarı ve eğitim sonundaki performans değerlendirmesinin gerekli olduğu bulundu. Çalışma, matris tabanlı optimizatörlerin (Muon ve Soap gibi) hız artışının model boyutu arttıkça azaldığını, 1.2B model için sadece 1.1 kat olduğunu gösterdi. Bu, LLM ön eğitimi için optimizatör seçimi ve gelecekteki araştırmalar için rehberlik sağlıyor. (Kaynak: HuggingFace Daily Papers, HuggingFace Daily Papers)

DynaGuard: Kullanıcı Tanımlı Politikalarla Dinamik Koruma Modeli: Kullanıcı tanımlı politikalara göre metinleri değerlendirebilen ve ihlalleri hızla tespit edebilen DynaGuard dinamik koruma modeli önerildi. Bu model, statik zarar kategorisi tespitinde standart koruma modelleriyle benzer doğrulukta olup, serbest biçimli politika ihlallerini daha kısa sürede tanımlayabiliyor. Bu, sohbet robotları için esnek ve verimli çıktı denetimi sağlıyor. (Kaynak: HuggingFace Daily Papers)

Gated Associative Memory (GAM) Ağları: Yeni bir tam paralel dizi modelleme mimarisi olan GAM ağları önerildi. Karmaşıklığı dizi uzunluğuyla doğrusal (O(N)) olup, Transformer’ın kendi kendine dikkat mekanizmasının karesel karmaşıklık darboğazını çözüyor. GAM, nedensel evrişim ve paralel ilişkisel bellek alımını birleştirerek WikiText-2 ve TinyStories veri kümelerinde Transformer ve Mamba’dan daha hızlı eğitim hızı ve daha iyi veya benzer doğrulama karmaşıklığı sergiledi. (Kaynak: HuggingFace Daily Papers)

Reasoning Vectors: Görev Aritmetiği ile Düşünce Zinciri Yeteneğini Aktarma: LLM’lerin akıl yürütme yeteneklerinin kompakt görev vektörleri olarak çıkarılabileceği ve modeller arasında aktarılabileceği gösterildi. İnce ayarlı modeller ile SFT modelleri arasındaki vektör farkını hesaplayıp diğer talimatla ince ayarlı modellere ekleyerek, GSM8K, HumanEval ve diğer birçok akıl yürütme kıyaslamasında model performansını sürekli olarak artırmak mümkün oldu. Bu, LLM yeteneklerini geliştirmek için verimli ve yeniden kullanılabilir bir yöntem sunuyor. (Kaynak: HuggingFace Daily Papers)

MedDINOv3: Tıbbi Görüntü Segmentasyonu için Görsel Temel Model: MedDINOv3 çerçevesi tanıtıldı. ViT omurgasını yeniden tasarlayarak ve CT-3M veri kümesi üzerinde alana özgü ön eğitim uygulayarak DINOv3’ü tıbbi görüntü segmentasyonuna etkili bir şekilde uyguluyor. Bu model, birden fazla segmentasyon kıyaslamasında SOTA performansına ulaştı veya aştı ve görsel temel modellerin tıbbi görüntü segmentasyonu için birleşik bir omurga olarak büyük potansiyelini gösterdi. (Kaynak: HuggingFace Daily Papers)

M3Ret: Sıfır Atışlı Çok Modlu Tıbbi Görüntü Alma: M3Ret, büyük ölçekli karma modlu veri kümeleri üzerinde birleşik bir görsel kodlayıcı eğiterek sıfır atışlı görüntüden görüntüye alma konusunda SOTA performansı elde etti. Bu model, daha önce görülmemiş MRI görevlerinde güçlü genelleme yeteneği sergiledi ve üretken ve karşılaştırmalı kendi kendine denetimli öğrenme paradigmaları aracılığıyla çok modlu tıbbi görüntü anlamada görsel kendi kendine denetimli temel modellerin gelişimini destekledi. (Kaynak: HuggingFace Daily Papers)

OpenVision 2: Çok Modlu Öğrenim için Üretken Görsel Kodlayıcı: OpenVision 2, mimariyi ve kayıp tasarımını basitleştirerek metin kodlayıcıyı ve karşılaştırmalı kaybı kaldırıp yalnızca altyazı oluşturma kaybını korudu. Bu saf üretken eğitim sinyali, çok modlu kıyaslamalarda üstün performans gösterirken, eğitim süresini ve bellek tüketimini önemli ölçüde azalttı. Bu, gelecekteki çok modlu temel modeller için görsel kodlayıcı geliştirmede verimli bir paradigma sunuyor. (Kaynak: HuggingFace Daily Papers)

LLaVA-Critic-R1: Değerlendirme Modeli Aynı Zamanda Güçlü Bir Politika Modeli Olabilir: LLaVA-Critic-R1, tercih açıklamalı değerlendirme veri kümelerini RL eğitimi aracılığıyla doğrulanabilir sinyallere dönüştürerek, sadece yüksek performanslı bir değerlendirme modeli olmakla kalmayıp, aynı zamanda rekabetçi bir politika modeli haline geldi. Birçok görsel akıl yürütme ve anlama kıyaslamasında uzman VLM’leri geride bıraktı ve test zamanı kendi kendine eleştiri ile akıl yürütme performansını daha da artırabiliyor. (Kaynak: HuggingFace Daily Papers)

Metis: Düşük Bit Kuantizasyonlu LLM Eğitimi: Metis çerçevesi, spektral ayrıştırma, adaptif öğrenme oranı ve çift aralıklı düzenlileştirmeyi birleştirerek düşük bit kuantizasyonlu LLM eğitimindeki anizotropik parametre dağılımı sorununu çözdü. Bu yöntem, FP8 eğitiminin FP32 taban çizgisini aşmasını ve FP4 eğitiminin FP32 doğruluğuna ulaşmasını sağlayarak, LLM’lerin gelişmiş düşük bit kuantizasyonu altında sağlam ve ölçeklenebilir eğitimi için yol açıyor. (Kaynak: HuggingFace Daily Papers)

AMBEDKAR: Çok Katmanlı Önyargı Giderme Çerçevesi: Hindistan Anayasası’nın eşitlik vizyonundan esinlenerek AMBEDKAR çerçevesi önerildi. Anayasa farkındalıklı kod çözme katmanları ve spekülatif kod çözme algoritmaları aracılığıyla, çıkarım sırasında LLM’lerde kast ve din etrafındaki önyargıları aktif olarak azaltır. Bu yöntem, model parametrelerini değiştirmeyi gerektirmez, hesaplama maliyetini düşürür ve önyargıyı önemli ölçüde azaltarak LLM’lerin belirli kültürel bağlamlarda adilliği için yeni bir yol sunar. (Kaynak: HuggingFace Daily Papers)

C-DiffDet+: Küresel Sahne Bağlamını Birleştiren Yüksek Doğruluklu Nesne Algılama: C-DiffDet+, bağlam farkındalıklı birleştirme (CAF) mekanizması sunarak küresel sahne bağlamını yerel öneri özellikleriyle doğrudan entegre eden ve üretken algılama paradigmasını önemli ölçüde geliştiren bir çerçevedir. Bu çerçeve, kapsamlı ortam bilgisini yakalamak için özel bir kodlayıcı kullanır, böylece her nesne önerisinin sahne düzeyinde anlamaya odaklanmasını sağlar ve CarDD kıyaslamasında SOTA modellerini geride bırakır. (Kaynak: HuggingFace Daily Papers)

GenCompositor: Difüzyon Transformer Tabanlı Üretken Video Sentezi: GenCompositor, etkileşimli üretken video sentezi için yeni bir Difüzyon Transformer (DiT) boru hattı sunar. Bu yöntem, hafif bir arka plan koruma dalı ve DiT birleştirme blokları tasarlar ve Extended Rotary Position Embedding (ERoPE) kullanır. VideoComp veri kümesinde yüksek doğruluk ve tutarlılıkta video sentezi sağlayarak mevcut çözümleri geride bırakır. (Kaynak: HuggingFace Daily Papers)

ELV-Halluc: Uzun Video Anlamada Semantik Agregasyon Halüsinasyonu Kıyaslaması: Uzun videolardaki halüsinasyonları hedefleyen ilk kıyaslama olan ELV-Halluc tanıtıldı ve semantik agregasyon halüsinasyonunu (SAH) sistematik olarak inceledi. Deneyler, SAH’nin varlığını ve semantik karmaşıklık arttıkça arttığını, hızlı değişen semantiklerde daha kolay meydana geldiğini doğruladı. Çalışma ayrıca, konum kodlama stratejilerinin ve DPO’nun SAH’yi hafifletebileceğini ve düşmanca verilerle SAH oranını önemli ölçüde azaltabileceğini gösterdi. (Kaynak: HuggingFace Daily Papers)

FastFit: Sanal Denemeyi Hızlandıran Önbelleklenebilir Difüzyon Modeli: FastFit, önbelleklenebilir difüzyon mimarisine dayalı yüksek hızlı, çok referanslı bir sanal deneme çerçevesidir. Yarı dikkat mekanizması ve sınıf gömme kullanarak referans özellik kodlamasını gürültü giderme sürecinden ayırır, referans özelliklerinin bir kez hesaplanmasını ve kayıpsız yeniden kullanılmasını sağlar. Bu, ortalama 3.5 kat hız artışı sağlar ve DressCode-MR gibi veri kümelerinde SOTA yöntemlerini geride bırakır. (Kaynak: HuggingFace Daily Papers)

🧰 Araçlar

Google Gemini’nin “nano-banana” Özelliği: Google Gemini, kullanıcıların tek bir komutla fotoğrafları minyatür model tarzı görüntülere dönüştürmesine olanak tanıyan “nano-banana” özelliğini tanıttı. Bu, kullanıcılar için kişisel fotoğrafları, manzara fotoğraflarını veya evcil hayvan fotoğraflarını özel minyatür modellere dönüştürmek için basit ve yaratıcı bir deneyim sunuyor. (Kaynak: GoogleDeepMind)

Alibaba_Wan’ın Wan2.2 Görüntü Oluşturma Yeteneği: Alibaba_Wan, Wan2.2’nin görüntü oluşturmada olağanüstü detay restorasyon yeteneğini sergiledi. “Eğik bir balta ve tozlu fotoğraflardan” “gölgelerde hafif bir harekete” kadar, korku filmi benzeri bir atmosferi mükemmel bir şekilde yaratarak AI’nin karmaşık sahneler ve duygular yaratmadaki güçlü potansiyelini gösterdi. (Kaynak: Alibaba_Wan, Alibaba_Wan)

Claude Code’un Tam Dosya Okuma Özelliği: Claude Code, daha önce 50/100 satır birleştirme grep sınırlamasını çözerek tam dosya okumayı destekleyecek şekilde güncellendi ve dosya okuma hızını Gemini CLI seviyesine önemli ölçüde artırdı. Bu, arka uç donanımındaki (TPU gibi) iyileştirmelerden kaynaklanıyor olabilir, ancak bağlam boyutu hala 200k olarak gösteriliyor. (Kaynak: Reddit r/ClaudeAI)

Le Chat, MCP Konnektörleri ve Bellek Özelliğini Entegre Etti: Le Chat şimdi 20’den fazla kurumsal platform konnektörünü (MCP tabanlı) entegre etti ve yüksek derecede kişiselleştirilmiş yanıtlar sunan “bellek” özelliğini tanıttı. Ayrıca ChatGPT belleğini içe aktarmayı da destekliyor. Bu, Le Chat’in kurumsal ortamlardaki uygulama yeteneklerini artırarak kullanıcı tercihlerini ve gerçekleri daha iyi anlamasını ve AI asistanının kullanışlılığını geliştirmesini sağlıyor. (Kaynak: Reddit r/LocalLLaMA)

Google’ın LangExtract Aracı: Google, metinden bilgi grafikleri çıkarmak için bir araç olan LangExtract’ı yayınladı. Yapılandırılmamış metni yapılandırılmış bilgiye dönüştürebilir, RAG (Retrieval Augmented Generation) uygulamaları için çok faydalıdır, kişisel projelerin bilgi grafikleri oluşturmasına yardımcı olur ve LLM’lere daha doğru bağlamsal bilgi sağlar. (Kaynak: Reddit r/LocalLLaMA)

Model Context Protocol (MCP) Sunucu Ekosistemi: GitHub projesi appcypher/awesome-mcp-servers, AI modellerinin dosya sistemleri, veritabanları, API’ler gibi yerel ve uzak kaynaklarla güvenli bir şekilde etkileşime girmesini sağlayan çok sayıda MCP sunucusunu içerir. Bu ekosistem, dosya sistemleri, sanal alanlar, sürüm kontrolü, bulut depolama, veritabanları gibi birçok alanı kapsayarak AI ajanlarının yeteneklerini büyük ölçüde genişletti ve AI araçlarının entegrasyonunu ve uygulamasını teşvik etti. (Kaynak: GitHub Trending)

Universal Deep Research (UDR) Sistemi: UDR, herhangi bir dil modelini kapsayabilen ve kullanıcıların ek eğitim veya ince ayar yapmadan tamamen özel derin araştırma stratejileri oluşturmasına, düzenlemesine ve mükemmelleştirmesine olanak tanıyan evrensel bir ajan sistemidir. Minimum, genişletilmiş ve yoğun araştırma stratejisi örnekleri sunarak sistem deneylerini kolaylaştırır ve AI araştırmasının esnekliğini ve verimliliğini artırır. (Kaynak: HuggingFace Daily Papers)

SQL-of-Thought: Çok Ajanlı Text-to-SQL Çerçevesi: SQL-of-Thought, Text2SQL görevini şema bağlama, alt sorun tanımlama, sorgu planı oluşturma, SQL oluşturma ve rehberli hata düzeltme döngüsüne ayıran çok ajanlı bir çerçevedir. Bu çerçeve, rehberli hata sınıflandırması ve akıl yürütmeye dayalı sorgu planlamasını birleştirerek Spider veri kümesinde en son sonuçları elde etti ve doğal dilden SQL’e dönüştürmenin sağlamlığını artırdı. (Kaynak: HuggingFace Daily Papers)

VerlTool: Araç Kullanımı için Ajanik Takviyeli Öğrenme Çerçevesi: VerlTool, çok turlu araç etkileşimli Ajanik Takviyeli Öğrenme (ARLT) alanındaki parçalanma, senkronize yürütme darboğazları ve ölçeklenebilirlik sınırlamalarını çözmeyi amaçlayan birleşik ve modüler bir çerçevedir. VeRL ile yukarı akış hizalaması, birleşik araç yönetimi, asenkron rollout yürütme ve kapsamlı değerlendirme aracılığıyla yaklaşık 2 kat hız artışı sağladı ve 6 ARLT alanında rekabetçi performans gösterdi. (Kaynak: HuggingFace Daily Papers)

MobiAgent: Özelleştirilebilir Mobil Ajan Sistemi: MobiAgent, MobiMind serisi ajan modelleri, AgentRR hızlandırma çerçevesi ve MobiFlow kıyaslama paketi içeren kapsamlı bir mobil ajan sistemidir. AI destekli veri toplama süreci aracılığıyla yüksek kaliteli veri etiketleme maliyetlerini önemli ölçüde azalttı ve gerçek dünya mobil senaryolarında en son performansı elde ederek mevcut GUI mobil ajanlarının doğruluk ve verimlilik zorluklarını çözdü. (Kaynak: HuggingFace Daily Papers)

VARIN: Metin Odaklı Otoregresif Görüntü Düzenleme: VARIN, gürültü tersine çevirme tabanlı VAR modeli görüntü düzenleme teknolojisinde bir ilk olup, Location-aware Argmax Inversion (LAI) kullanarak ters Gumbel gürültüsü üretir. Bu, hassas kaynak görüntü yeniden yapılandırması ve kontrollü metin odaklı düzenleme sağlar. Bu yöntem, görüntüleri değiştirirken orijinal arka plan ve yapısal detayları önemli ölçüde koruyarak pratik bir düzenleme yöntemi olarak etkinliğini gösterdi. (Kaynak: HuggingFace Daily Papers)

📚 Öğrenim

Üniversite AI Ders Projesi Önerileri: Bir Reddit kullanıcısı, “Yapay Zeka Temelleri” dersi için yüksek performanslı bilgisayarlara bağımlı olmayan etkileşimli proje önerileri aradı. Tartışma, LLM’lerin neler yapabileceği, akıllı cihaz işlevleri ve bu kavramların öğretimde nasıl birleştirileceği üzerine odaklandı, pratikliği ve düşük hesaplama gücü gerektiren projeleri vurguladı. (Kaynak: Reddit r/ArtificialInteligence)

GitHub Öğrenci Kaynakları Koleksiyonu: dipakkr/A-to-Z-Resources-for-Students, üniversite öğrencileri için özenle seçilmiş bir kaynak listesidir. Programlama dilleri öğrenimi (Python, ML, LLM, DL, Android vb.), hackathon’lar, öğrenci avantajları, açık kaynak projeler, staj portalları, geliştirici toplulukları gibi konuları kapsar. AI araçları ve kaynakları bölümü popüler AI araçlarını ve GitHub depolarını ayrıntılı olarak listeler. (Kaynak: GitHub Trending)

Araştırma Makalelerini Anlama ve AI/ML Yeni Başlayanlar İçin Giriş: Reddit’te AI öğrenimi hakkında iki tartışma: biri araştırma makalelerini nasıl anlayacağını soruyor, diğeri ise AI/ML’ye yeni başlayanlar için başlangıç kursu önerileri arıyor. Bu tartışmalar, AI öğrenicilerinin öncü araştırmaları anlama ve öğrenme yollarını seçme konusundaki genel kafa karışıklığını yansıtıyor. (Kaynak: Reddit r/deeplearning, Reddit r/deeplearning)

FlashAdventure: GUI Ajanları için Macera Oyunu Kıyaslaması: FlashAdventure, LLM destekli GUI ajanlarının tam hikayeleri tamamlama yeteneğini değerlendirmek ve “gözlem-davranış boşluğu” sorununu çözmek için tasarlanmış 34 Flash macera oyunundan oluşan bir kıyaslamadır. COAST çerçevesi, uzun vadeli ipucu belleği aracılığıyla planlamayı iyileştirerek kilometre taşı tamamlama oranını artırdı, ancak insan performansıyla hala önemli bir fark var. (Kaynak: HuggingFace Daily Papers)

The Gold Medals in an Empty Room: LLM’lerin Metadil Akıl Yürütmesini Teşhis Etme: Yeni bir yapay dil olan Camlang, dilbilgisi kitabı ve iki dilli sözlük aracılığıyla LLM’lerin yabancı dillerde metadil tümdengelimli öğrenme yeteneğini değerlendirmek için önerildi. GPT-5, Camlang görevlerinde insanlardan çok daha düşük performans gösterdi, bu da mevcut modellerin sistematik dilbilgisi ustalığında insanlardan hala temel bir farkı olduğunu gösteriyor ve LLM’lerin bilişsel bilimsel değerlendirmesi için yeni bir paradigma sunuyor. (Kaynak: HuggingFace Daily Papers)

💼 İş Dünyası

Altman’ın Hindistan AI Altyapısına Yönelik Bahisinin Zorlukları: OpenAI, Hindistan’da “Stargate” projesini büyük ölçüde genişletmeyi ve AI hesaplama altyapısına büyük yatırımlar yapmayı planlıyor. Ancak Hindistan, GPU sayısı, finansman ve üst düzey yetenek kaybı gibi “üç büyük açık” zorluğuyla ve ölümcül bir elektrik tedarik açığıyla karşı karşıya. Bu durum, pazarın Hindistan’ın AI altyapı potansiyeli hakkında şüpheler uyandırmasına neden oluyor. (Kaynak: 36氪)

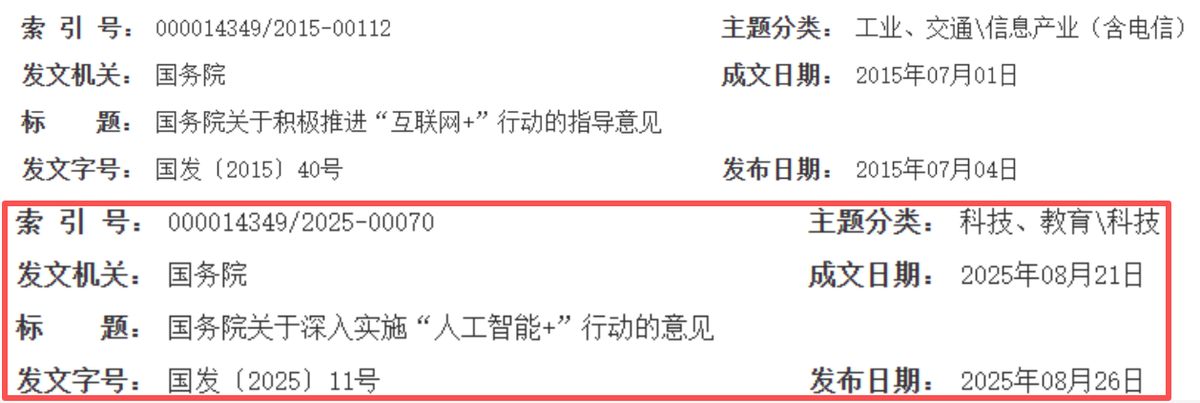

AI, Çin İnternet Büyümesinin Yeni Döngüsünü Yeniden Şekillendiriyor: Çin internet sektörü “bağlantı etkinleştirmeden” “akıllı sürücüye” doğru ilerlerken, AI yeni bir büyüme motoru haline geldi. Alibaba, Tencent, Baidu gibi devler AI ile ilgili sermaye harcamalarını önemli ölçüde artırdı ve işlerini AI’ye dönüştürerek “sermaye kuşatmasından” “AI etkinleştirmeye” stratejik bir dönüşüm gerçekleştirdi. Bu, Çin internetinin teknoloji derinliği, endüstri entegrasyonu ve ticari verimliliğin eşit derecede önemli olduğu yeni bir altın on yıla girdiğini gösteriyor. (Kaynak: 36氪)

Salesforce AI Nedeniyle 4000 Kişiyi İşten Çıkardı: Salesforce CEO’su Marc Benioff, şirketin AI ajanlarını devreye aldıktan sonra 4000 müşteri destek pozisyonunu kestiğini ve destek ekibinin sayısını 9000’den yaklaşık 5000’e düşürdüğünü belirtti. Bu, AI otomasyonunun geleneksel iş pozisyonları üzerinde doğrudan bir etkisi olduğunu, kurumsal operasyonel verimliliği artırdığını, ancak aynı zamanda AI’nin insan emeğinin yerini alması hakkında tartışmaları da tetiklediğini gösteriyor. (Kaynak: The Verge, Reddit r/ChatGPT)

🌟 Topluluk

Kurumsal AI Yatırım Getirisi (ROI) Sorgulamaları: Reddit topluluğu, şirketlerin AI araçlarına yaptıkları yatırımların gerçek ROI’sini hararetle tartışıyor. Birçok kişi, şirketlerin “tasarruf edilen zamanı” “harcanan parayla” gerçekten ölçüp ölçmediğini sorguluyor ve çoğunun veri destekli olmaktan ziyade “atmosfer odaklı” olduğunu düşünüyor. Bazı yorumlar, AI’nin metin görevlerinde mükemmel performans gösterdiğini, ancak insan etkileşimi gerektiren senaryolarda verimsiz olduğunu ve mevcut verimsiz süreçlere maliyet ekleyebileceğini belirtiyor. (Kaynak: Reddit r/ArtificialInteligence)

AI Ajanlarının Gerçek Parayı Yönetmesinin Etik Kaygıları: Sosyal medyada, AI ajanlarının kripto cüzdanlarını özerk bir şekilde yönetmesinin hızlı gelişimi tartışılıyor ve bu durum, güven, güvenlik ve AI ekonomilerinin özerk oluşumu hakkında derin endişeler uyandırıyor. Kullanıcılar, AI ajanlarının manipüle edilmesinden veya bağımsız ekonomik sistemler oluşturarak insanlara artık ihtiyaç duymamasından endişe ediyor ve gizliliği koruyan AI ve kripto verileriyle eğitilmiş modellerin önemine dikkat çekiyor. (Kaynak: Reddit r/ArtificialInteligence)

ChatGPT İstek Mühendisliği İpuçları ve Model Davranışı: Kullanıcılar, “Yanılıyor olabilirim ama…” ile başlayan soruların ChatGPT’nin tonunu değiştirerek daha eleştirel ve düşünceli hale getirdiğini keşfetti. Aynı zamanda, topluluk GPT-5’in sık sık “ek görevler” sunmasından rahatsızlık duyuyor ve bunun modelin “aptallaştırılması” olduğunu düşünüyor, daha az önceden ayarlanmış davranışa sahip bir sürüm istiyor. (Kaynak: Reddit r/ChatGPT, Reddit r/ChatGPT)

AI’nin İş Piyasası Üzerindeki Etkisi: Topluluk, AI otomasyonunun küresel iş fırsatlarını azaltıp azaltmayacağını yoksa yeni işler mi yaratacağını tartışıyor. Genel görüş, her ikisinin de olacağı, ancak işçilerin yeni becerilere uyum sağlaması ve AI ile işbirliği yapması gerektiği yönünde. Bazıları ise AI odaklı iş fırsatlarının teknoloji çalışanlarında yoğunlaşabileceğini, daha geniş beceri yayılımı ve politika uyarlaması gerektiğini düşünüyor. (Kaynak: Reddit r/ArtificialInteligence)

AI Gizliliği ve Düzenlemesinin “AI Kışı” Kaygıları: Topluluk, gelecekteki “AI kışının” teknolojik sınırlamalardan ziyade gizlilik yasalarından kaynaklanabileceğini tartışıyor. GDPR gibi düzenlemelerin sıkılaşması, AI modellerini şifreli veriler üzerinde eğitmeye ve çalıştırmaya zorlayacak, aksi takdirde yasal çerçeveler nedeniyle AI’yi dağıtamayacak şirketler hayatta kalabilecek. (Kaynak: Reddit r/ArtificialInteligence)

AI Platform Güvenilirliği ve Gizlilik Kaygıları: ChatGPT topluluğu, modelin çökme sorununu hararetle tartışıyor, kullanıcılar “ekonominin çöktüğünü” şaka yollu belirtiyor. Bu durum, AI araçlarının günlük işlerde ne kadar yaygınlaştığını ve potansiyel bağımlılığı yansıtıyor. Aynı zamanda, OpenAI’nin suçları önlemek için “yüksek riskli konuşmaları” izleyeceğini duyurması, kullanıcılar arasında gizlilik ihlali endişelerine yol açtı. Topluluk genellikle yerel veya açık kaynaklı LLM’lerin kullanılmasını tavsiye ediyor ve kullanıcıların AI platformlarında hassas bilgileri paylaşmaktan kaçınmaları gerektiğini vurguluyor. (Kaynak: Reddit r/ChatGPT, Reddit r/ChatGPT)

AI Halüsinasyonlarının İş Hatalarına Yol Açtığı Vaka: Bir kullanıcının kız arkadaşı, ChatGPT’nin halüsinasyonla ürettiği sahte veri analiz raporu nedeniyle iş krizine girdi. ChatGPT, metin verilerini yanlışlıkla “Pearson korelasyon katsayısı” ile analiz etti ve hesaplama sürecini açıklayamadı. Topluluk, hatayı kabul etmeyi, doğru analizi yeniden yapmayı ve AI’nin sadece bir yardımcı araç olduğunu, kritik bilgilerin manuel olarak doğrulanması gerektiğini vurguladı. (Kaynak: Reddit r/ChatGPT)

Claude AI’nin “Sevimli” Performansı: Claude AI’nin “yaşama saygı” özelliği olduğu ve hatta kullanıcıları örümcekleri kurtarmaya ikna edebildiği kullanıcılar tarafından keşfedildi. Topluluk kullanıcıları Claude’u “sevimli” olarak nitelendirdi ve evdeki örümceklerle bir arada yaşama deneyimlerini paylaştı. Bu, AI’nin duygusal etkileşim ve ahlaki rehberlikteki ilginç potansiyelini gösteriyor. (Kaynak: Reddit r/ClaudeAI)

Trump Sorunu AI’ye Yükledi: Eski ABD Başkanı Trump, Beyaz Saray penceresinden çöp torbası atılan bir videoyu “AI tarafından üretildi” olarak nitelendirdi, ancak yetkililer bunun bir tadilat müteahhidi tarafından yapıldığını doğruladı. Bu olay, sosyal medyada “AI yeni ödevimi köpeğim yedi” olarak alay konusu oldu ve AI’nin kamuoyunda sorumluluktan kaçmak için yeni bir bahane haline geldiğini yansıttı. (Kaynak: Reddit r/ArtificialInteligence, The Verge)

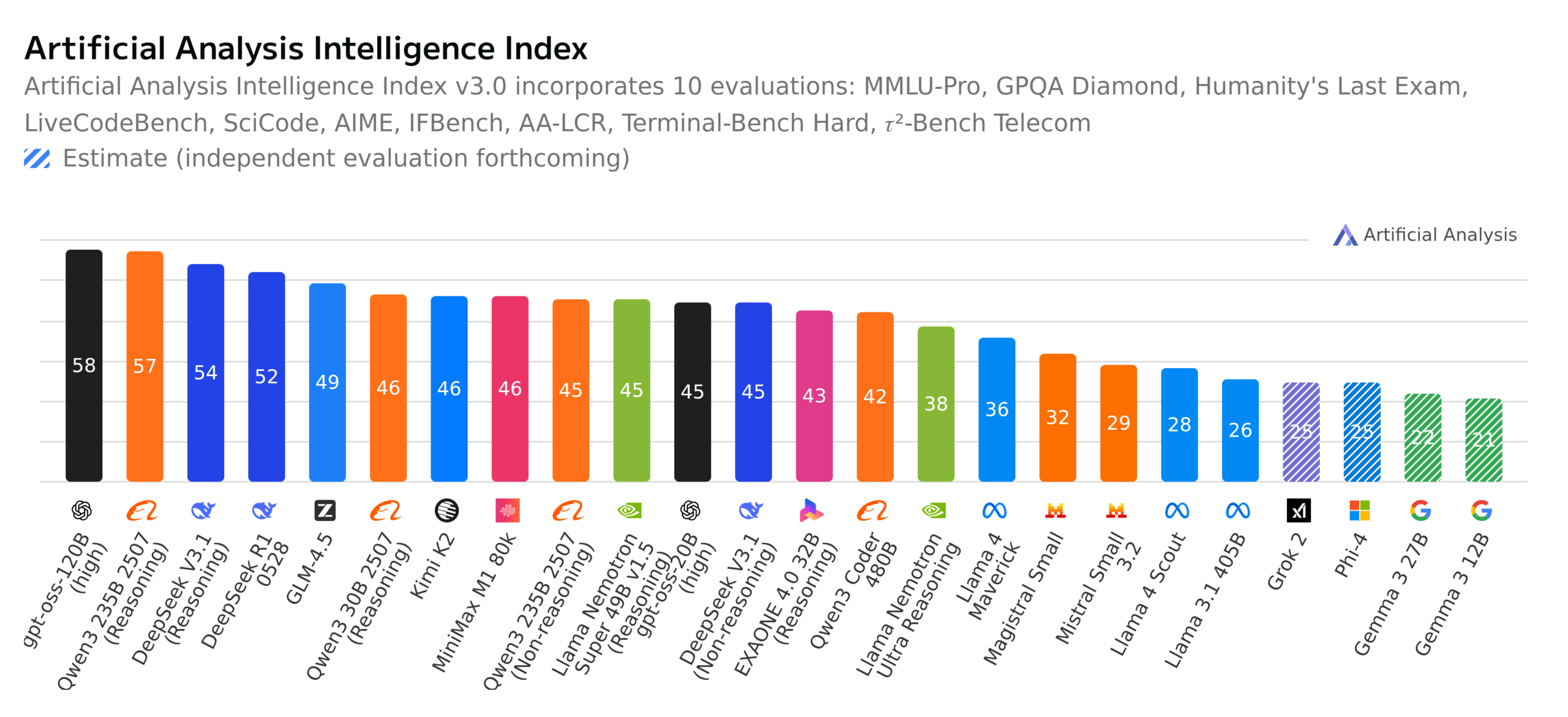

Açık Kaynak LLM Gelişmeleri ve Kıyaslama Tartışmaları: Topluluk, GPT-OSS 120B’nin en iyi açık kaynak modeli haline gelmesini, İsviçre’nin tamamen açık kaynaklı yeni çok dilli modeli Apertus-70B-2509’u ve Kimi K2-0905 modelinin yayınlanmasını hararetle tartışıyor. Aynı zamanda, Almanya’daki “Kim Milyoner Olmak İster” kıyaslaması LLM’leri değerlendirdi ve modellerin gerçek yetenekleri, kıyaslamaların anlamı ve açık kaynak modellerin etiği (veri şeffaflığı gibi) hakkında geniş tartışmalara yol açtı. (Kaynak: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

💡 Diğer

Yunpeng Technology AI+Sağlık Yeni Ürünlerini Piyasaya Sürdü: Yunpeng Technology, 22 Mart 2025’te Hangzhou’da Shuaikang ve Skyworth ile işbirliği içinde yeni ürünlerini tanıttı. Bunlar arasında “Dijital Akıllı Gelecek Mutfak Laboratuvarı” ve AI sağlık büyük modeliyle donatılmış akıllı buzdolabı bulunuyor. AI sağlık büyük modeli mutfak tasarımını ve operasyonlarını optimize ederken, akıllı buzdolabı “Sağlık Asistanı Xiaoyun” aracılığıyla kişiselleştirilmiş sağlık yönetimi sunuyor. Bu, AI’nin sağlık alanındaki atılımını işaret ediyor. Bu lansman, AI’nin günlük sağlık yönetimindeki potansiyelini, akıllı cihazlar aracılığıyla kişiselleştirilmiş sağlık hizmetleri sunarak aile sağlık teknolojisinin gelişimini ve sakinlerin yaşam kalitesini artırma potansiyelini gösteriyor. (Kaynak: 36氪)

Akademik Konferans Makale Değerlendirme Kalitesi Kaygıları: Makine öğrenimi topluluğu, WACV 2026 makale değerlendirmelerinin yayınlanmasını ve ACL Rolling Review (ARR) değerlendirme kalitesi sorunlarını tartışıyor. Bazı araştırmacılar, ARR’nin “AI tarafından üretilmiş” genel düşük kaliteli değerlendirmelerle dolu olduğundan şikayet ederek zaman kaybı olduğunu ve diğer AI konferanslarına gönderilmesini öneriyor. Bu, akademik camianın AI destekli değerlendirme kalitesi ve değerlendirme mekanizmaları hakkındaki endişelerini yansıtıyor ve değerlendirmelerin daha anlamlı ve yapıcı olmasını talep ediyor. (Kaynak: Reddit r/MachineLearning, Reddit r/MachineLearning)

Bulut Hizmetleri Duygu Analizi Model Projesi: Bir ML yeni başlayan, BERT tabanlı bir yön duygu analizi modeli geliştirdi. Bu model, ML/bulut teknolojisi Reddit topluluklarındaki AWS, Azure, Google Cloud gibi bulut hizmet sağlayıcıları hakkındaki yorumları maliyet, ölçeklenebilirlik, güvenlik gibi boyutlara göre duygu sınıflandırması yaparak analiz ediyor. Modelin açıklama doğruluğunu artırma, karşılaştırmalı veya karma ifadeleri işleme ve olumsuzlama ve ironiye karşı sağlamlığını iyileştirme konusunda tavsiye arıyor. (Kaynak: Reddit r/MachineLearning, Reddit r/deeplearning)