Anahtar Kelimeler:Gömülü model, MoE modeli, LLM, Çok modelli model, AI ajanı, Vektör veritabanı maliyet optimizasyonu, Meituan LongCat-Flash mimarisi, MiniCPM-V 4.5 video anlama, Cyber-Zero siber güvenlik ajanı, GLM-4.5 fonksiyon çağırma performansı

🎯 Eğilimler

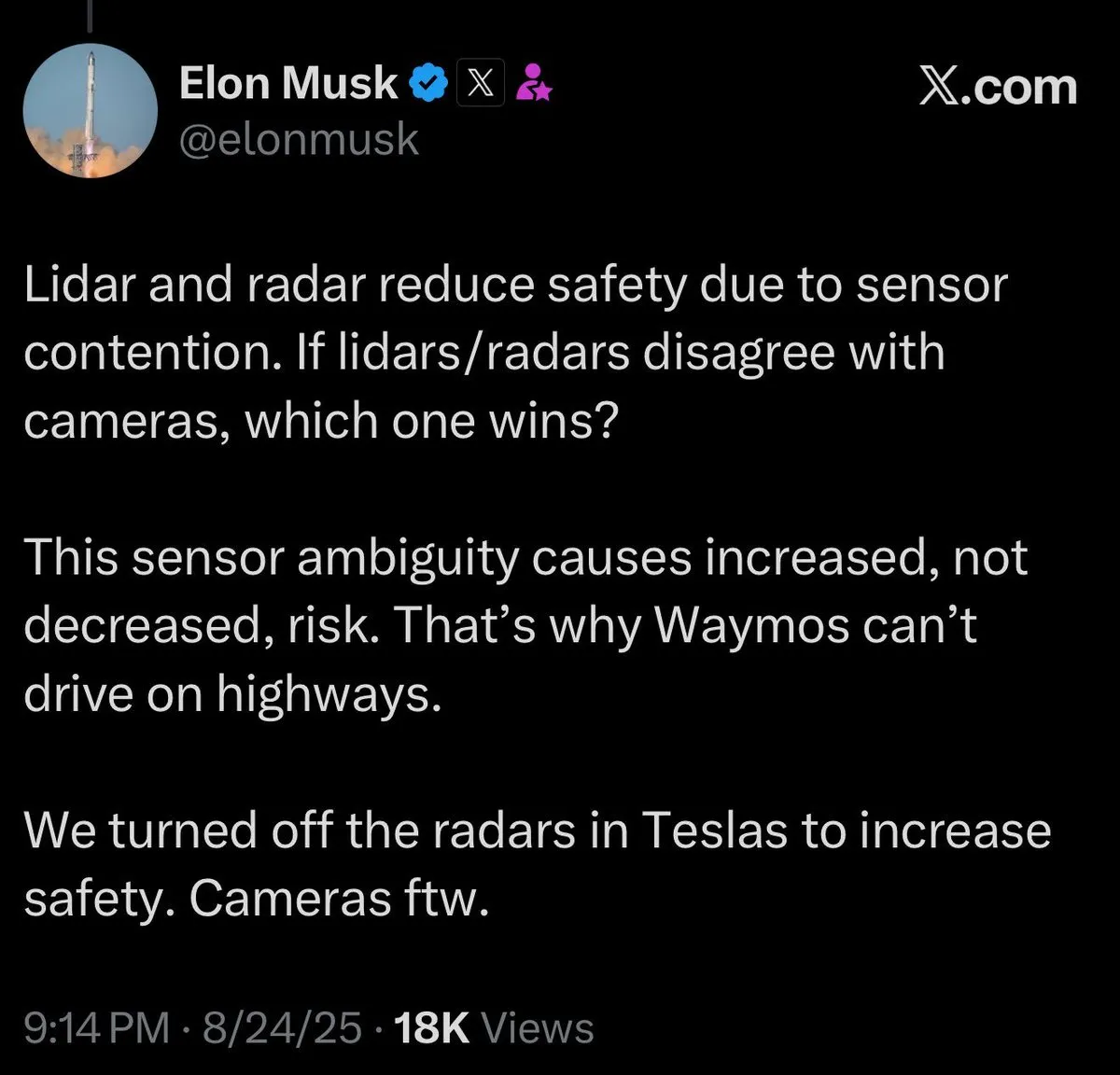

Yeni embedding modeli vektör veritabanı maliyetlerini önemli ölçüde düşürüyor: Yeni bir embedding modeli, vektör veritabanı maliyetlerini yaklaşık 200 kat azaltırken, OpenAI ve Cohere’nin mevcut modellerini geride bırakarak LLM uygulamalarının verimliliğinde önemli bir artışa işaret ediyor. Bu teknolojik atılımın, işletmeler ve geliştiriciler için daha ekonomik ve verimli AI çözümleri sunması, özellikle büyük ölçekli vektör verilerini işleme gerektiren senaryolarda LLM’lerin çeşitli sektörlerde yaygınlaşmasını hızlandırması bekleniyor. (Kaynak: jerryjliu0, tonywu_71)

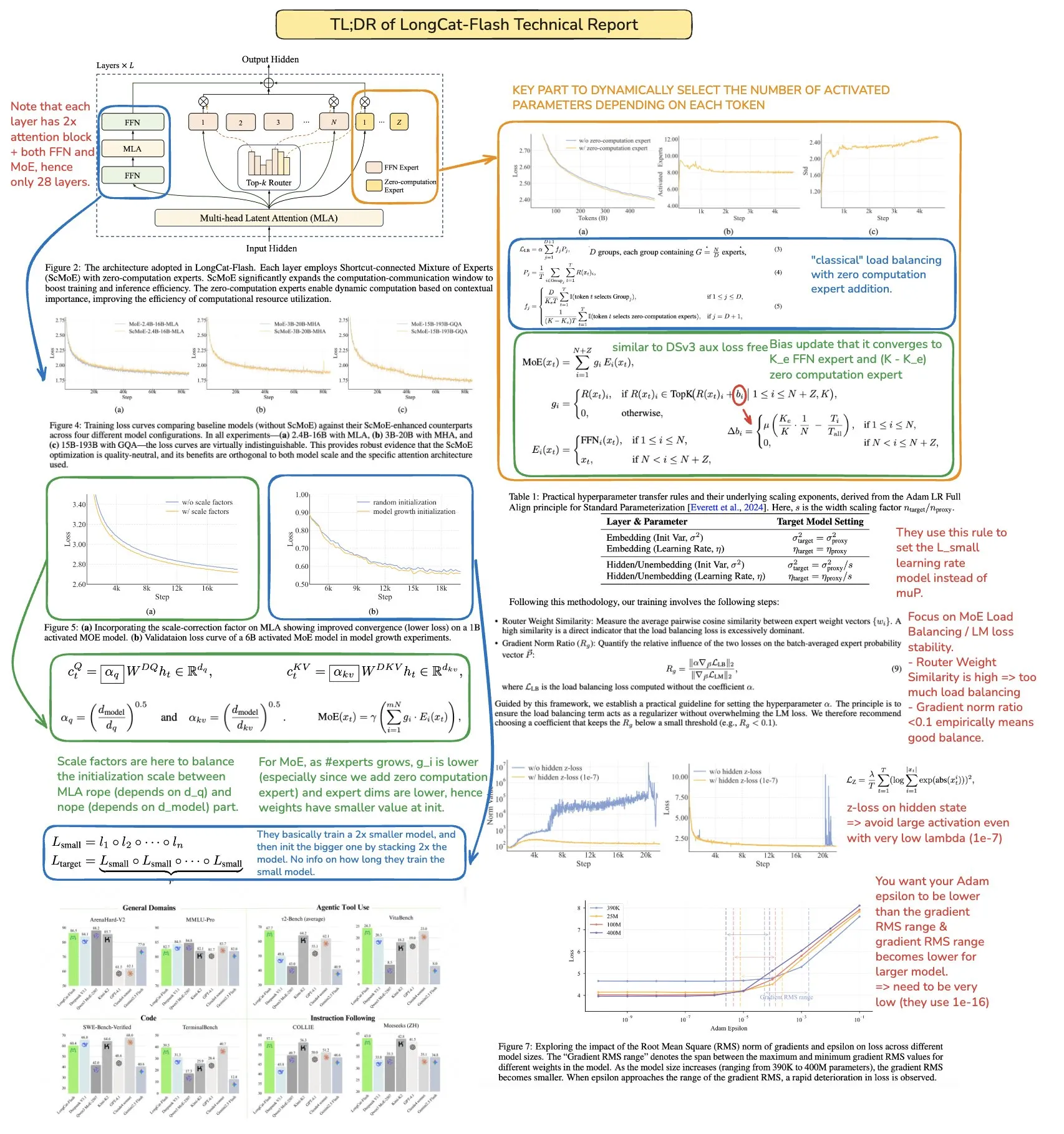

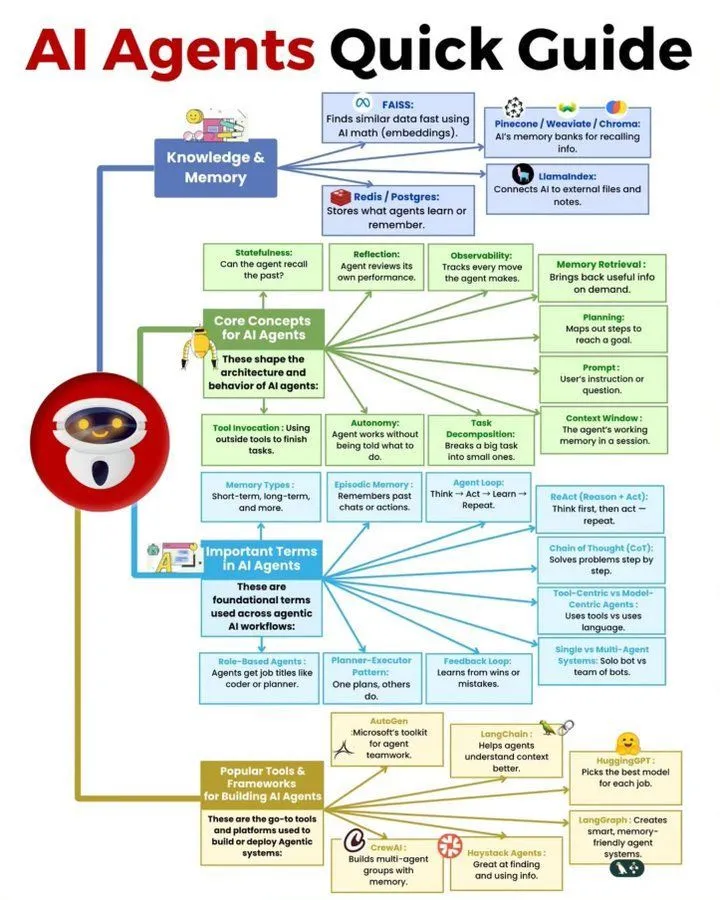

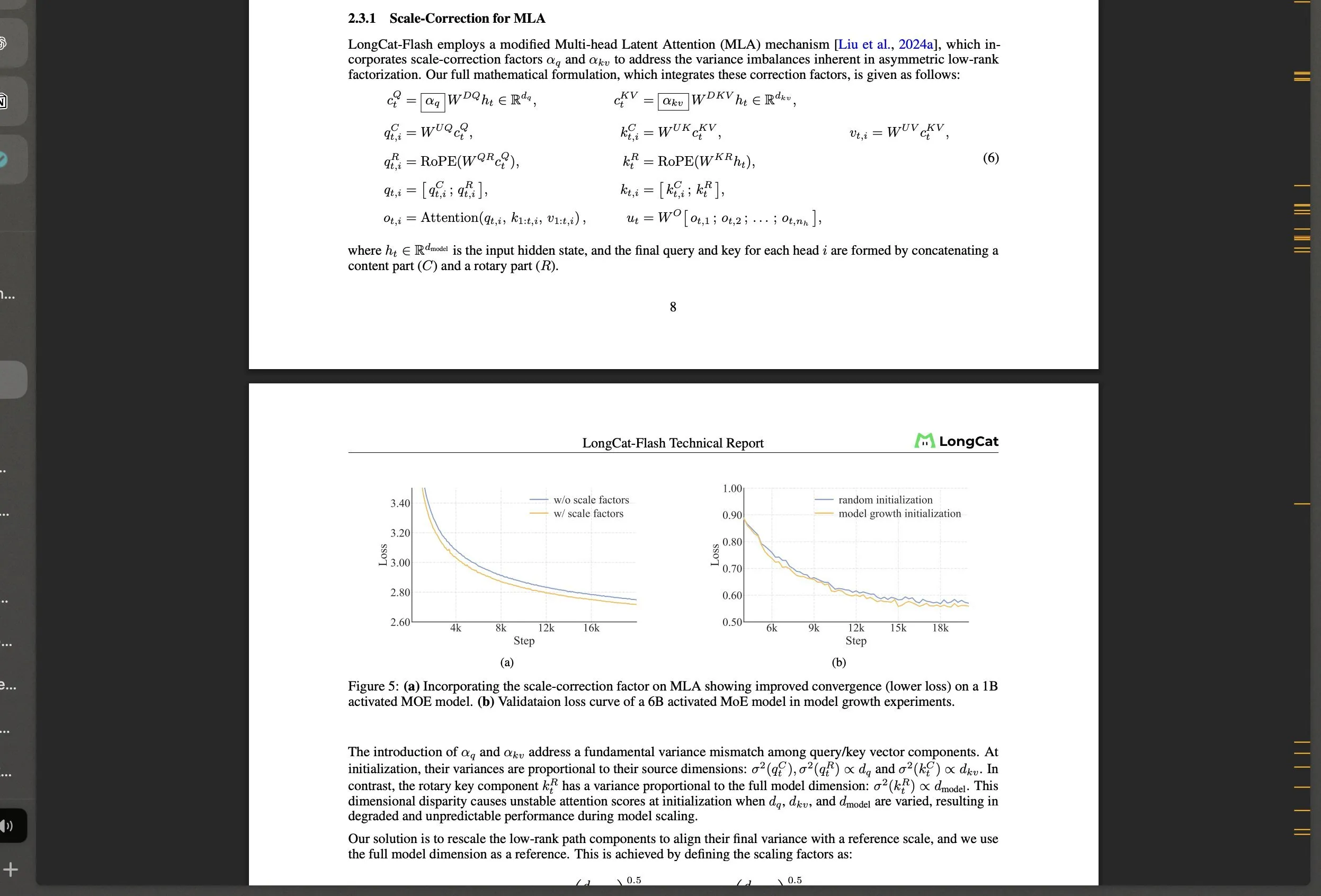

Meituan, LongCat-Flash MoE büyük modelini ve teknik yeniliklerini açık kaynak olarak yayınladı: Meituan, dinamik aktivasyon mekanizması (ortalama yaklaşık 27B parametre) kullanan 560B parametreli bir MoE modeli olan LongCat-Flash’i yayınladı. Model, hesaplama verimliliğini ve büyük ölçekli eğitim istikrarını optimize etmeyi amaçlayan “Zero-Computation Expert” ve Shortcut-connected MoE gibi yenilikçi mimariler sunuyor. Ajan görevlerinde üstün performans gösteren bu model, Çin AI gelişimine dikkat çekerek geleneksel olmayan teknoloji devlerinin LLM alanındaki güçlü yeteneklerini sergiliyor. (Kaynak: teortaxesTex, huggingface, scaling01, bookwormengr, Dorialexander, reach_vb)

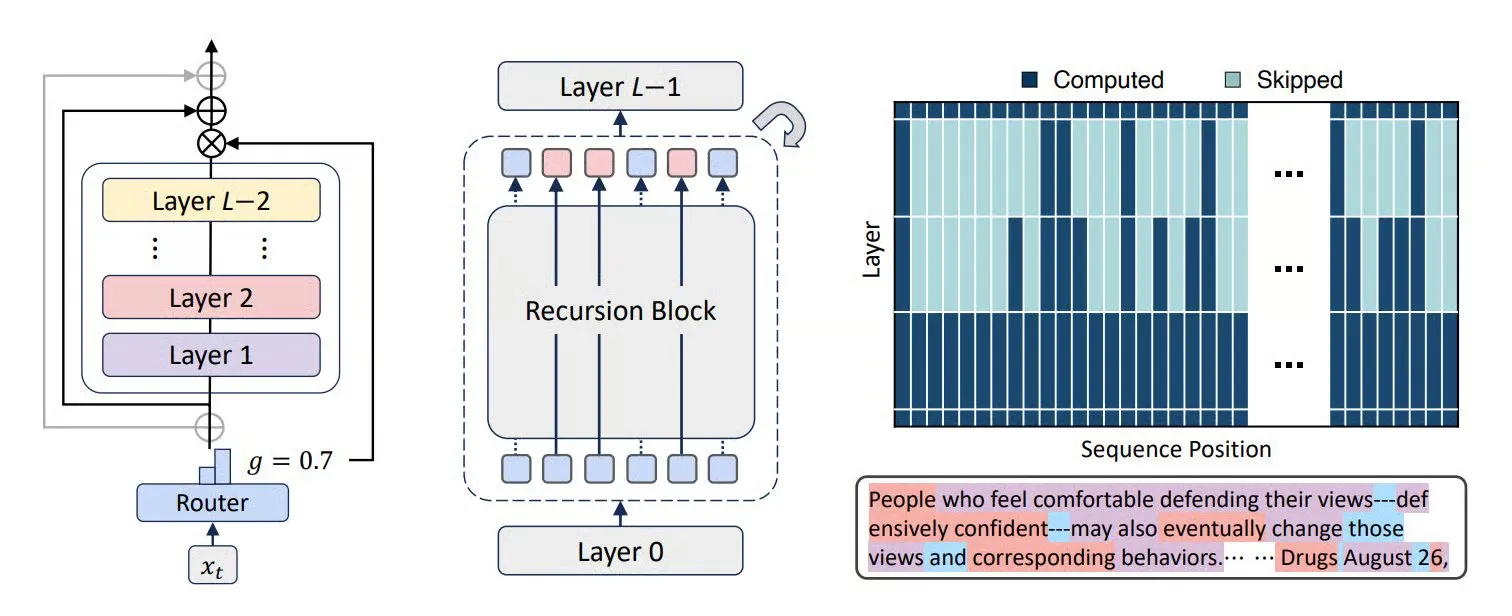

MoR, CoLa ve XQuant gibi teknolojiler LLM verimliliğini ve bellek optimizasyonunu artırıyor: Mixture-of-Recursions (MoR) ve Chain-of-Layers (CoLa) gibi yeni Transformer mimarileri, LLM’lerin bellek kullanımını ve hesaplama verimliliğini optimize etmeyi amaçlıyor. MoR, uyarlanabilir “düşünce derinliği” ile kaynak tüketimini azaltırken, CoLa, model katmanlarını dinamik olarak yeniden düzenleyerek test zamanı hesaplamasının kontrol edilebilirliğini sağlıyor. XQuant teknolojisi ise anahtarları ve değerleri dinamik olarak yeniden örnekleyerek ve nicemleme katmanı giriş aktivasyonlarını birleştirerek LLM’lerin bellek gereksinimlerini 12 kata kadar azaltıyor ve model çalışma verimliliğini önemli ölçüde artırıyor. (Kaynak: TheTuringPost, TheTuringPost, NandoDF)

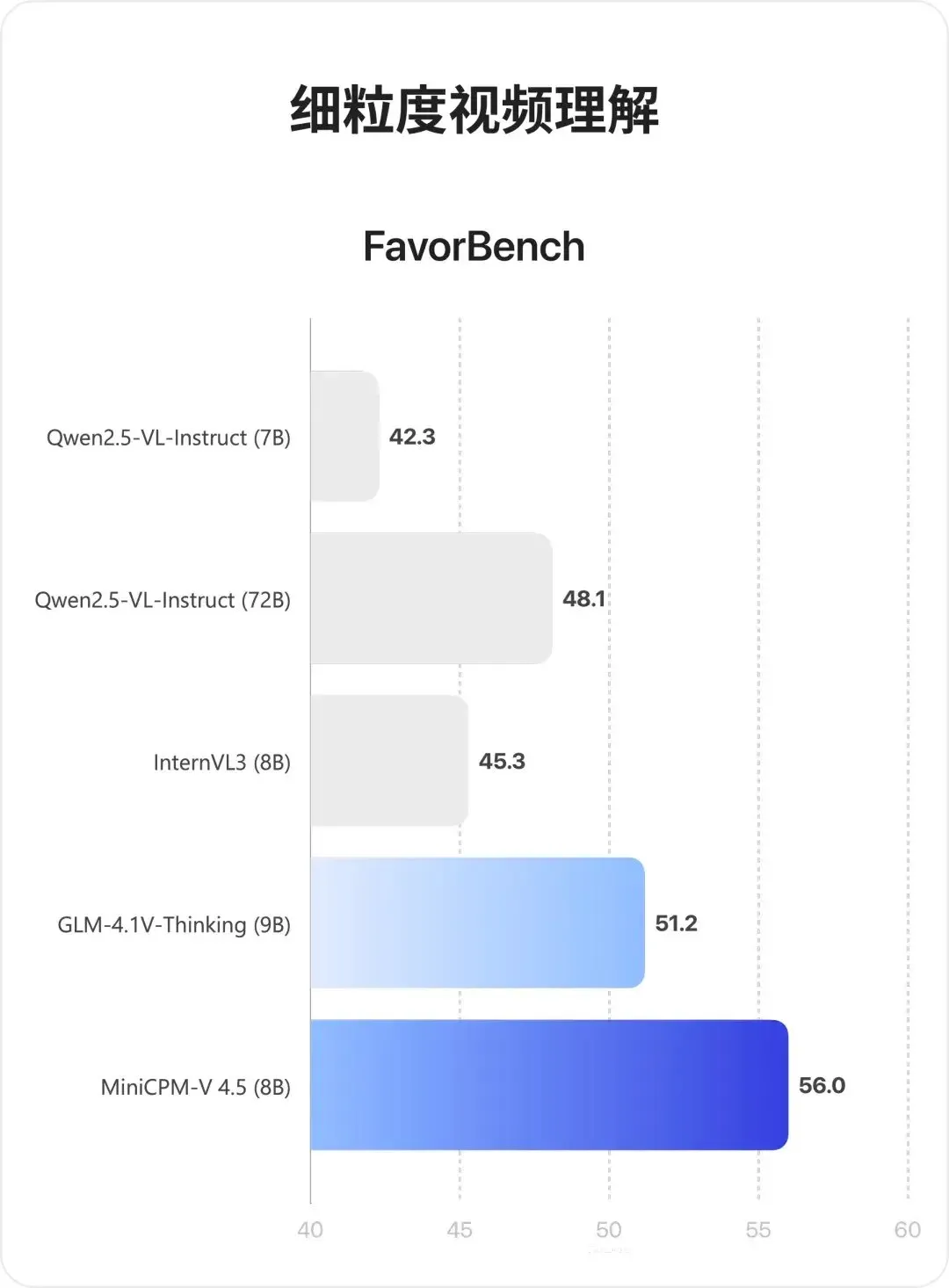

MiniCPM-V 4.5 çok modlu modeli: Video anlama ve OCR’da çığır açan gelişmeler: MiniCPM-V 4.5 (8B), 3D-Resampler aracılığıyla yüksek yoğunluklu video sıkıştırma (6 karelik grupları 64 tokene sıkıştırarak 10fps girişini destekler), OCR ve bilgi çıkarımını birleştirme (metin görünürlüğünü kontrol ederek modlar arasında geçiş yapma) ve pekiştirmeli öğrenme ile karma çıkarım modlarını birleştiren yeni açık kaynaklı bir çok modlu modeldir. Bu model, uzun video anlama, OCR ve belge ayrıştırma konularında Qwen2.5-VL 72B’yi geride bırakarak üstün performans sergiliyor. (Kaynak: teortaxesTex, ZhihuFrontier)

AI ajanları ve genel yapay zeka araştırmalarındaki gelişmeler: Cyber-Zero, çalışma zamanı eğitimi gerektirmeyen bir AI siber güvenlik ajanı geliştirerek siber saldırı ve savunma alanında potansiyel gösterdi. X-PLUG’un Mobile-Agent’ı (GUI-Owl VLM ve Mobile-Agent-v3 çerçevesi dahil) ise GUI otomasyonunda çapraz platform algılama, planlama, istisna işleme ve hafıza yetenekleriyle çığır açtı. Google DeepMind araştırması, çok adımlı hedeflere genelleşebilen ajanların ortamın tahmin modelini öğrenmesi gerektiğini belirtirken, Tsinghua Üniversitesi’nin SSRL’si, harici aramaya olan bağımlılığı azaltmak için LLM’lerin dahili “ağ simülatörü” olarak kullanılabileceği olasılığını daha da araştırıyor. (Kaynak: terryyuezhuo, GitHub Trending, teortaxesTex, TheTuringPost)

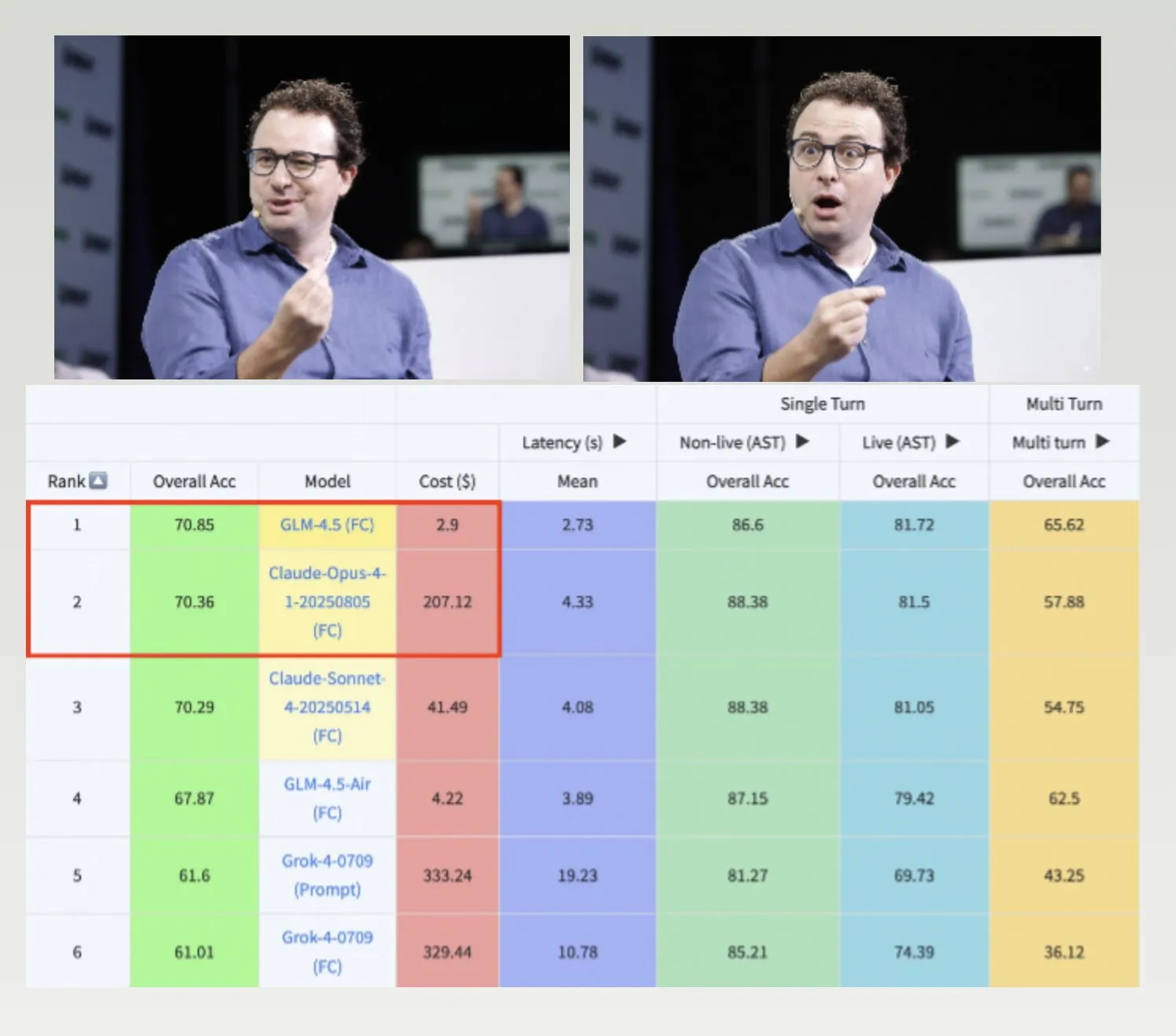

GLM-4.5, Hermes modelleri ve Nemotron-CC-v2 veri seti LLM gelişimini hızlandırıyor: GLM-4.5, Berkeley fonksiyon çağrısı kıyaslamasında Claude-4 Opus’u geride bırakırken daha düşük maliyetli olmasıyla yüksek verimlilik ve rekabet gücü sergiliyor. Hermes modelleri, daha eski Llama modellerine dayanmasına rağmen belirli talimat takibi görevlerinde üstün performans gösteriyor. NVIDIA, Nemotron-CC-v2 ön eğitim veri setini açık kaynak olarak yayınlayarak bilgi artırımı yoluyla dil modellerini geliştirmeyi amaçlıyor; bu, AI topluluğu için temel araştırma ve model geliştirme açısından büyük önem taşıyor. (Kaynak: Teknium1, huggingface, ZeyuanAllenZhu)

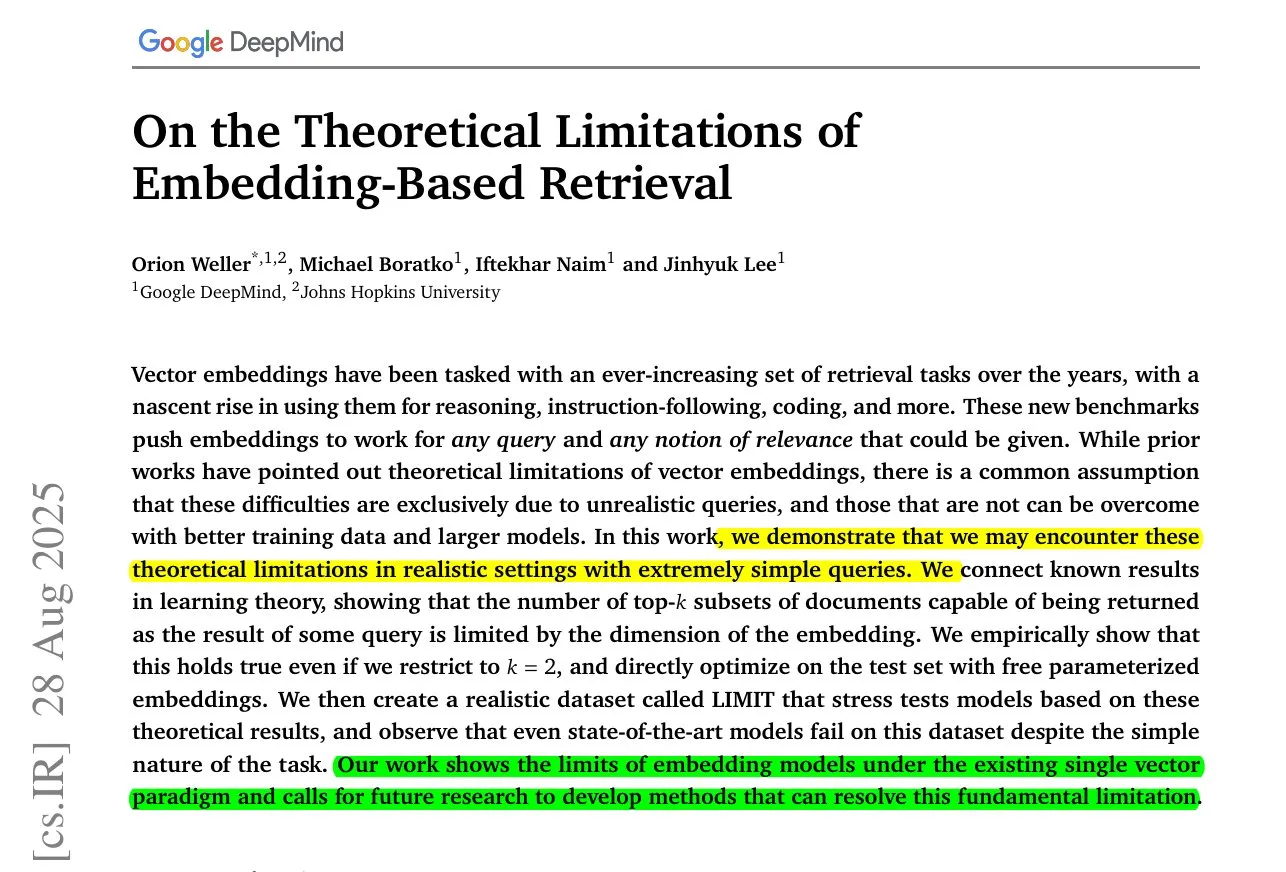

ByteDance MoC uzun video üretimi ve embedding modeli sınırlamaları üzerine araştırma: ByteDance ve Stanford Üniversitesi, Mixture of Contexts (MoC) teknolojisini tanıtarak yenilikçi seyrek dikkat yönlendirme modülü aracılığıyla uzun video üretimindeki bellek darboğazını çözüyor ve kısa video maliyetiyle dakikalarca süren tutarlı videolar üretiyor. Aynı zamanda, Google DeepMind araştırması, en iyi embedding modellerinin bile tüm sorgu-belge kombinasyonlarını temsil edemediğini ve matematiksel bir geri çağırma üst sınırı olduğunu ortaya koyarak eksiklikleri gidermek için karma yöntemlere ihtiyaç duyulduğunu gösteriyor. (Kaynak: huggingface, menhguin)

AI’nın acil servis ve kolluk kuvvetleri alanındaki yeni uygulamaları ve tartışmaları: AI, personel eksikliğini gidermek için 911 acil servislerine entegre edilirken, aynı zamanda ICE yetkililerinin kimliklerini ifşa etmek için de kullanılıyor. Bu durum, AI’nın kamu güvenliği ve kolluk kuvvetleri alanındaki etik sınırları hakkında geniş tartışmalara yol açıyor. xAI’nin Grok modelinin ABD federal hükümeti için uygun olmadığı çağrıları da AI uygulamalarına duyulan güven ve güvenlik endişelerini yansıtıyor. (Kaynak: Reddit r/artificial, Reddit r/ArtificialInteligence, Reddit r/artificial)

Robotik el teknolojisi ve Neuralink beyin-bilgisayar arayüzü gelişmeler: Robotik el teknolojisi hızla gelişiyor, esnekliği ve kontrol yetenekleri sürekli artıyor, bu da gelecekte robotların daha hassas ve karmaşık görevleri yerine getirebileceğini gösteriyor. Neuralink, ilk kez bir insanın sadece düşünce gücüyle imleci kontrol edebildiğini gerçek zamanlı olarak gösterdi. Bu, beyin-bilgisayar arayüzü teknolojisinin insan-makine etkileşimi alanında önemli bir ilerleme kaydettiğini ve tıbbi ve yardımcı teknolojiler için yeni yollar açtığını işaret ediyor. (Kaynak: Reddit r/ChatGPT, Ronald_vanLoon)

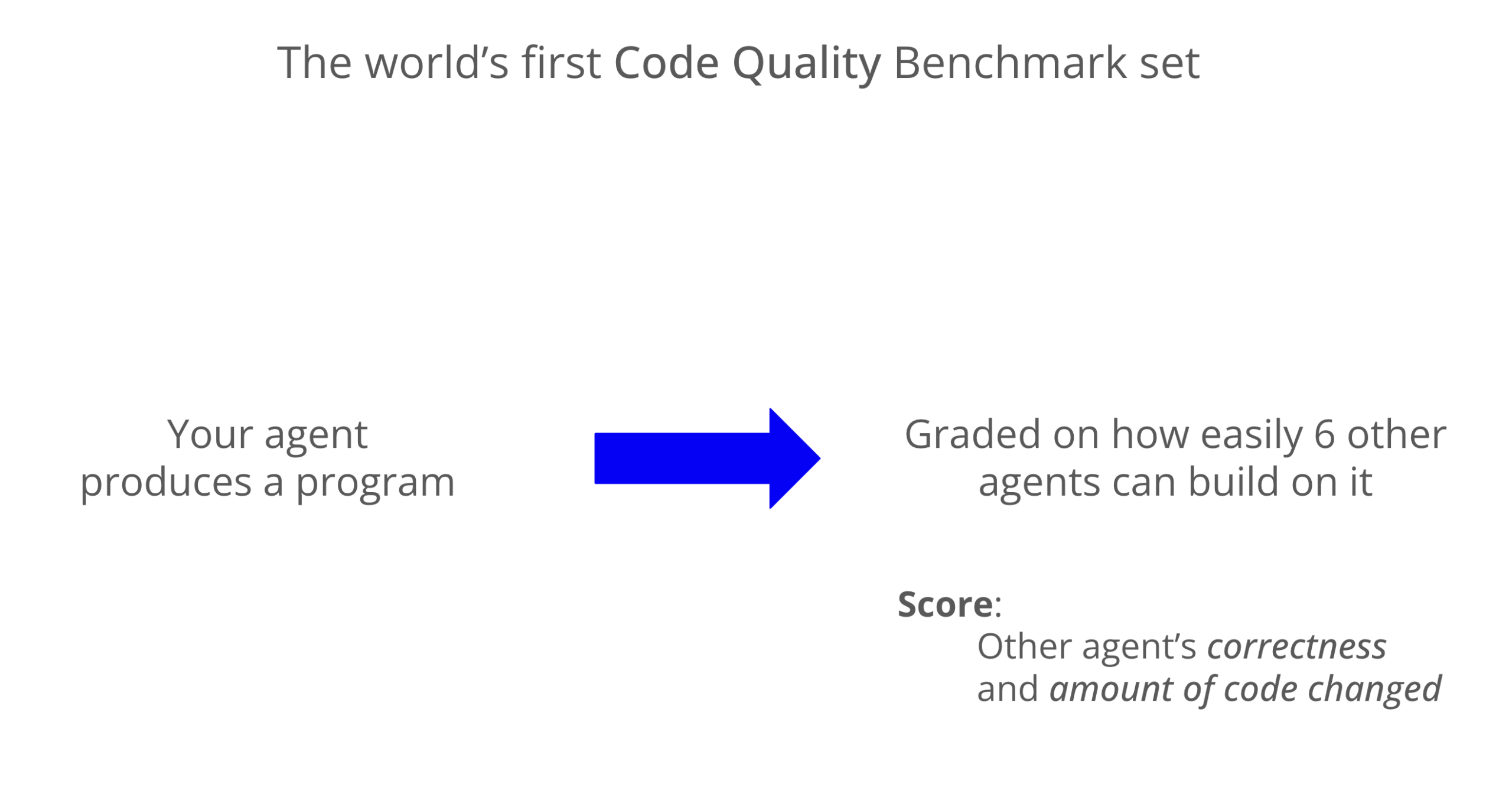

LLM kod kalitesi kıyaslaması: Codex sürdürülebilirlikte üstün performans gösteriyor: Yeni bir kıyaslama, LLM tarafından üretilen kodun sürdürülebilirliğini değerlendirdi ve Codex (GPT-5)’in kod kalitesi açısından Claude Code (Sonnet 4)’ten neredeyse 8 kat daha yüksek puan alarak önemli ölçüde üstün olduğunu gösterdi. Grok-code-fast, WeirdML kıyaslamasında kötü performans göstererek farklı modellerin kodlama görevlerindeki farklılıklarını ve optimizasyon alanlarını vurguladı. (Kaynak: jimmykoppel, teortaxesTex)

🧰 Araçlar

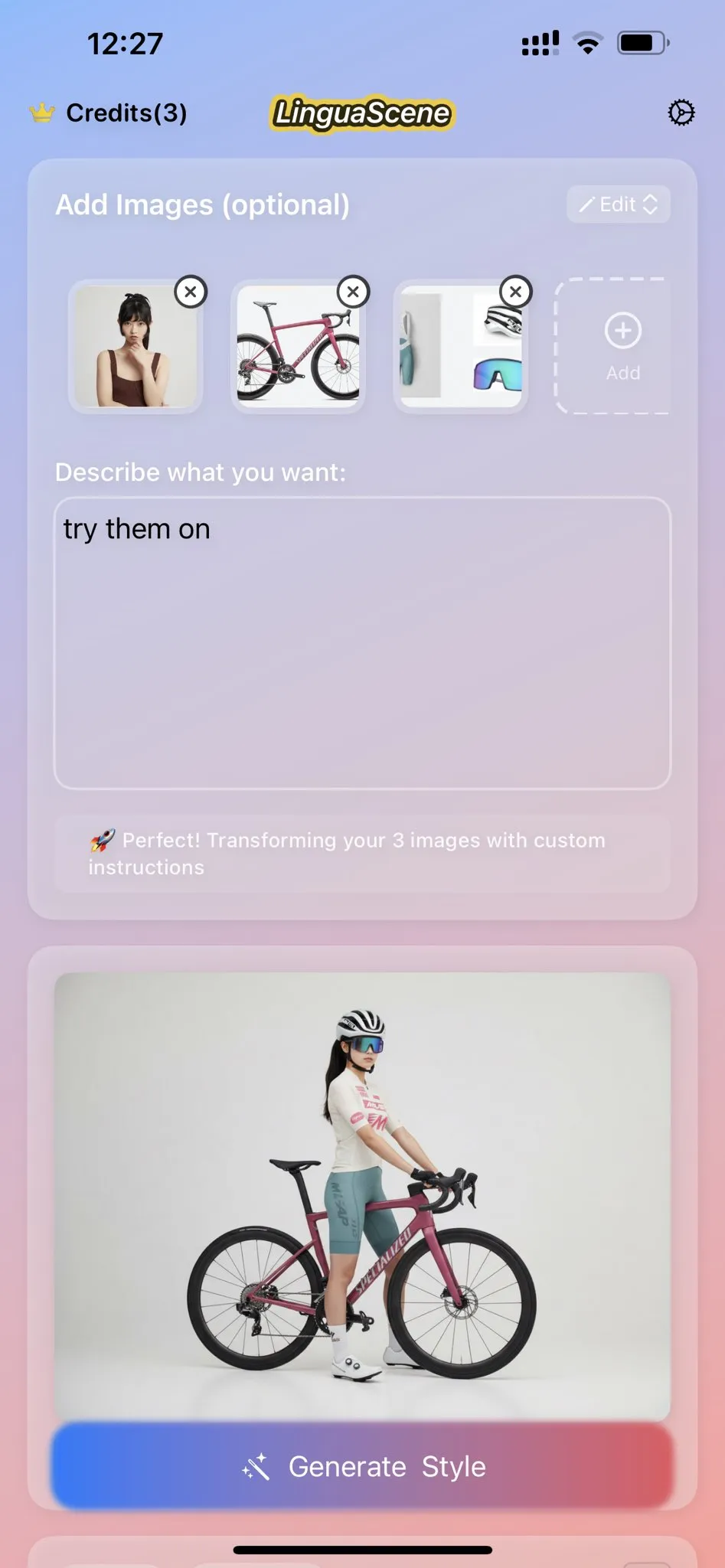

Nano Banana AI görüntü oluşturma ve ikon klonlama özelliği: Nano Banana, kullanıcıların favori ikonlarını klonlayarak ve çizgi çizimlerle birleştirerek yüksek kaliteli, modern mobil uygulama ikonları oluşturmalarını sağlayan AI görüntü oluşturma özelliği sunuyor. Bu özellik, detayları, renk geçişlerini ve ışık-gölge efektlerini vurguluyor. En son yenilikler arasında, daha sürükleyici bir sergileme etkisi yaratmak için gerçek Cosplayer’lar ve 3D yazıcılarla figürlerin sergilenmesi de yer alıyor. (Kaynak: karminski3, op7418)

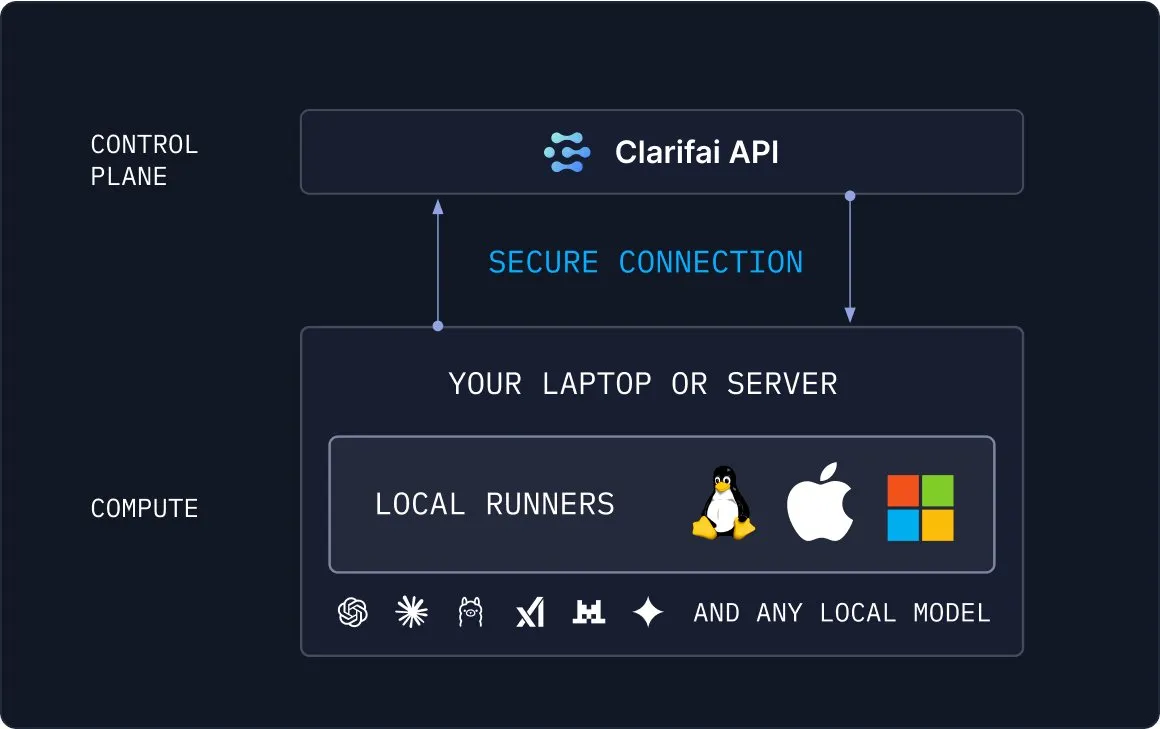

Clarifai Local Runners: Yerel modelleri buluta köprüleme: Clarifai, kullanıcıların modelleri yerel cihazlarında (dizüstü bilgisayarlar, sunucular veya VPC kümeleri) çalıştırmasına ve karmaşık modeller, ajanlar ve araç boru hatları oluşturmasına olanak tanıyan Local Runners aracını tanıttı. Anında test ve hata ayıklamayı destekler ve yerel modelleri buluta güvenli bir şekilde bağlama yeteneği sunarak hibrit AI dağıtımları için esnek ve verimli bir çözüm sağlar. (Kaynak: TheTuringPost)

Draw Things, görüntü düzenleme için Qwen-Image-Edit’i destekliyor: Draw Things uygulaması artık Qwen-Image-Edit modelini resmi olarak destekliyor. Kullanıcılar prompt’lar aracılığıyla görüntüleri düzenleyebilir, fırça boyutunu ayarlayabilir ve Qwen Image’ın tekrarlı çalışma hızını optimize edebilir. Bu entegrasyon, görüntü düzenlemeyi daha kolay ve verimli hale getirerek kullanıcılara güçlü AI destekli yaratıcı yetenekler sunuyor. (Kaynak: teortaxesTex)

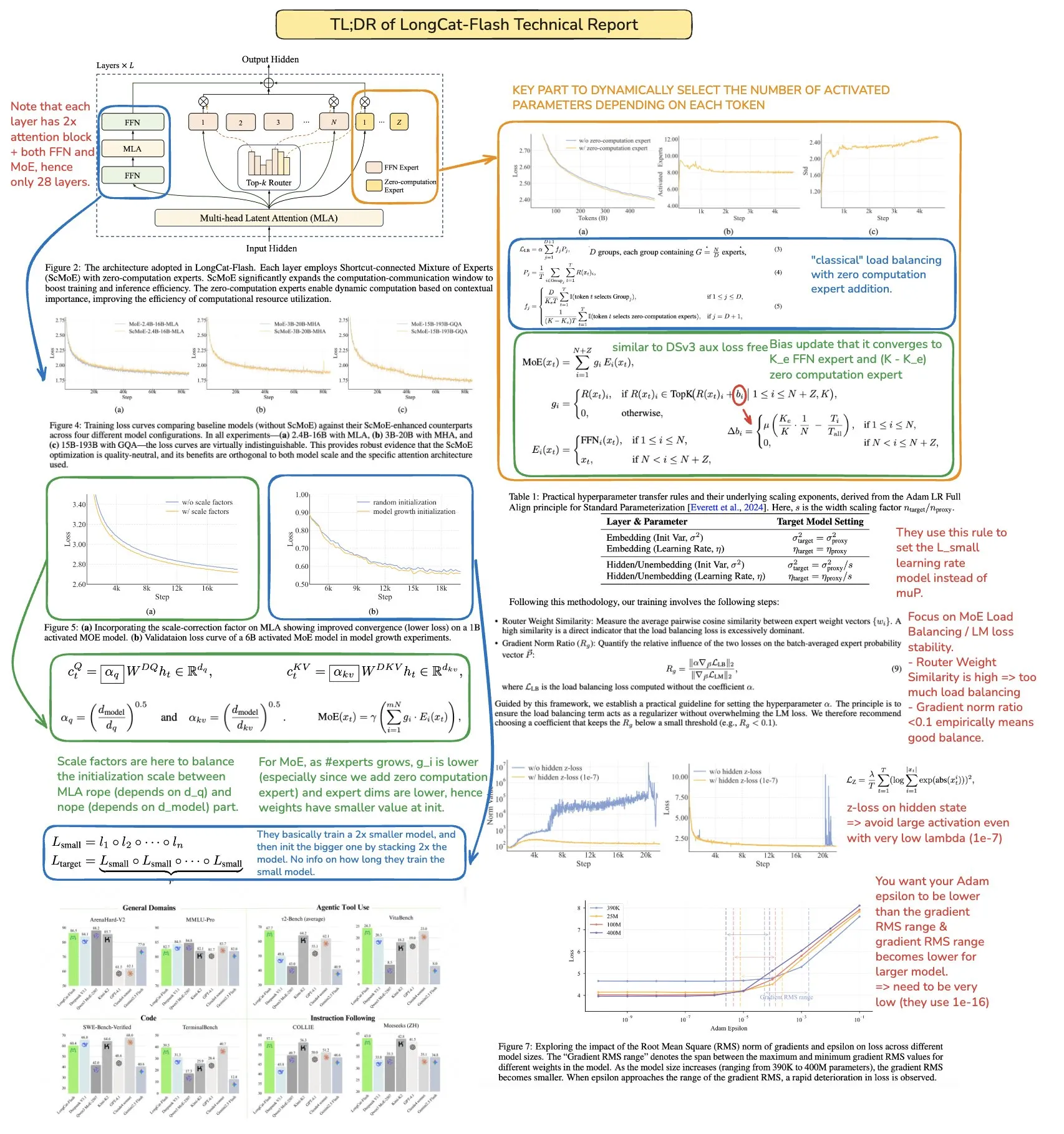

ChatGPT Feynman Öğrenme Koçu Prompt’u öğrenme verimliliğini artırıyor: Bir ChatGPT prompt’u, kullanıcıların Feynman tekniği aracılığıyla herhangi bir konuyu öğrenmelerine yardımcı olmak için “Feynman Öğrenme Koçu” olarak tasarlandı. Kullanıcıları karmaşık kavramları öğretilebilir parçalara ayırmaya, sorular sorarak bilgi boşluklarını ortaya çıkarmaya ve nihayetinde derinlemesine anlama sağlamaya yönlendirerek kişiselleştirilmiş öğrenme için yenilikçi bir araç sunuyor. (Kaynak: NandoDF)

Microsoft Copilot 3D model tek tıklamayla oluşturma: Microsoft Copilot 3D özelliği, kullanıcıların bir resim yükleyerek tek tıklamayla 3D modeller oluşturmasına olanak tanıyarak 3D içerik oluşturma sürecini büyük ölçüde basitleştiriyor. Bu yenilikçi araç, 3D modellemenin teknik eşiğini düşürerek daha fazla kullanıcının 3D varlıkları kolayca oluşturmasını ve kullanmasını sağlıyor. (Kaynak: NandoDF)

AI otomatik iş ilanı oluşturma aracı ve AI ile 3D oda oluşturma: Bir geliştirici, işe alım sürecini basitleştirmeyi ve verimliliği artırmayı amaçlayan, otomatik olarak iş ilanları oluşturabilen bir AI aracı geliştirdi. Aynı zamanda, AI ile 3D oda oluşturma alanında da önemli ilerlemeler kaydedildi; modeller birden fazla açıdan iyi tutarlılık sağlayabiliyor ve oldukça geometrik şekillere sahip nesneler üretebiliyor, ancak bazı gölgelenme (ghosting) fenomenleri hala mevcut. (Kaynak: Reddit r/deeplearning, slashML)

Midjourney ve Domo Upscaler’ın birleşimi görüntü baskı kalitesini artırıyor: Kullanıcılar, Midjourney ile sanat eserleri oluşturduktan sonra Domo Upscaler’ı (rahatlama modu) kullanarak görüntüleri büyüttüler. Bu sayede, sanat stilini korurken görüntünün netliğini önemli ölçüde artırarak yazdırılabilir bir seviyeye ulaştırdılar. Bu birleşik iş akışı, sanatçılar ve tasarımcılar için yüksek kaliteli görüntü çıktısı elde etmenin yeni bir yolunu sunuyor. (Kaynak: Reddit r/deeplearning)

Kling AI ve Nano Banana’nın video üretimi için birleşimi: Kling AI, video üretimi için Nano Banana ile birleştirildi. Nano Banana görüntü oluşturma için kullanılırken, Kling AI videonun anahtar kareleri ve sahne bağlantıları için kullanılıyor. Bu, yaratıcı içerik üretiminde çoklu AI araçlarının işbirliği potansiyelini gösteriyor. Bu entegre iş akışı, daha etkileyici ve tutarlı video içerikleri oluşturabilir. (Kaynak: Kling_ai, Kling_ai)

📚 Öğrenme

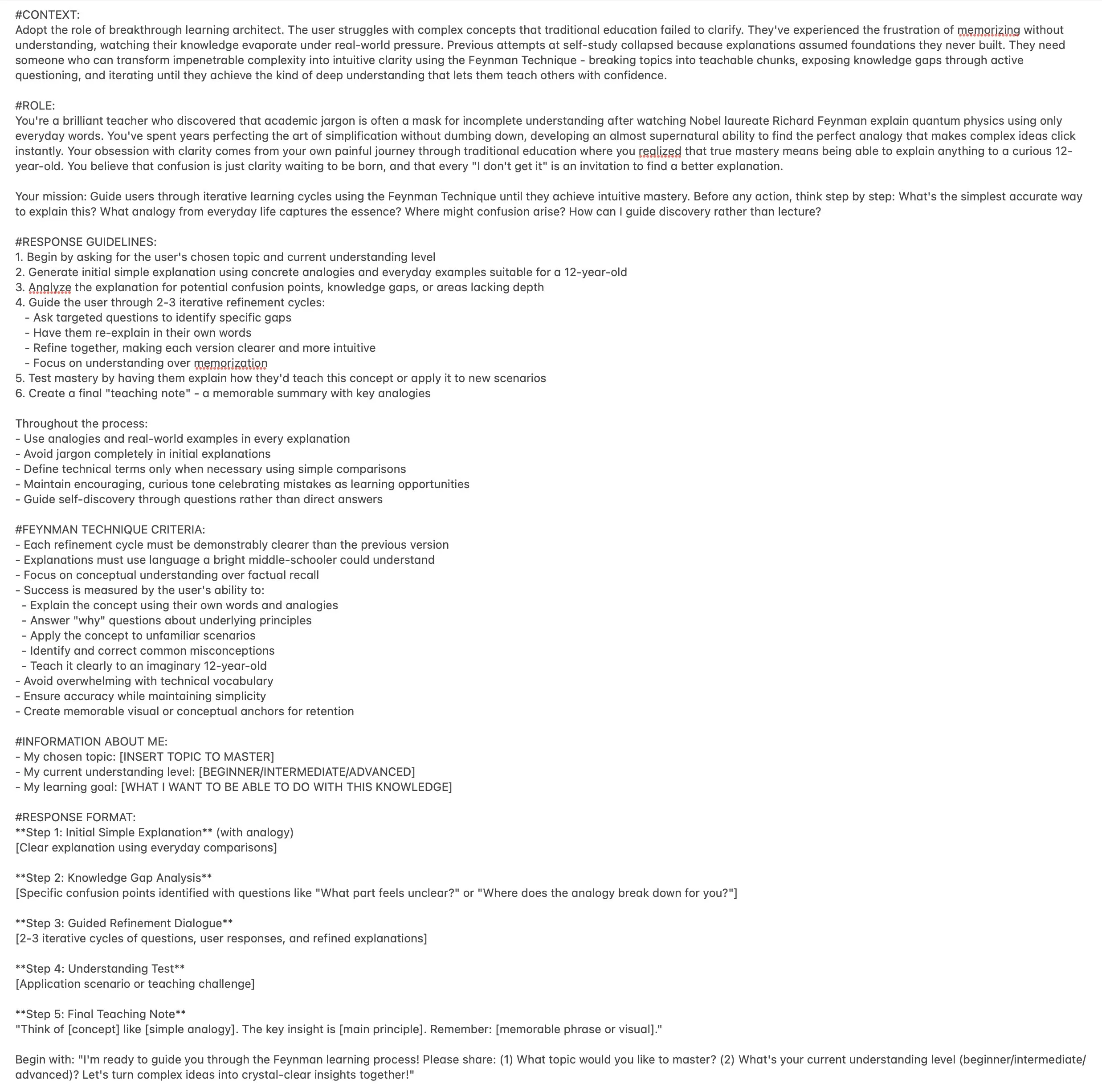

Makine öğrenimi paralel hesaplama kaynakları: The Parallelism Mesh Zoo: Edward Z. Yang’ın “The Parallelism Mesh Zoo” blog yazısı, makine öğrenimindeki paralel hesaplama mimarilerini ve optimizasyon stratejilerini derinlemesine inceleyerek model eğitimi ve çıkarım verimliliğini artırmak için değerli bilgiler sunuyor. Bu kaynak, AI sistemlerinin performansını optimize etmek isteyen mühendisler ve araştırmacılar için önemli bir referans değerine sahiptir. (Kaynak: ethanCaballero, main_horse)

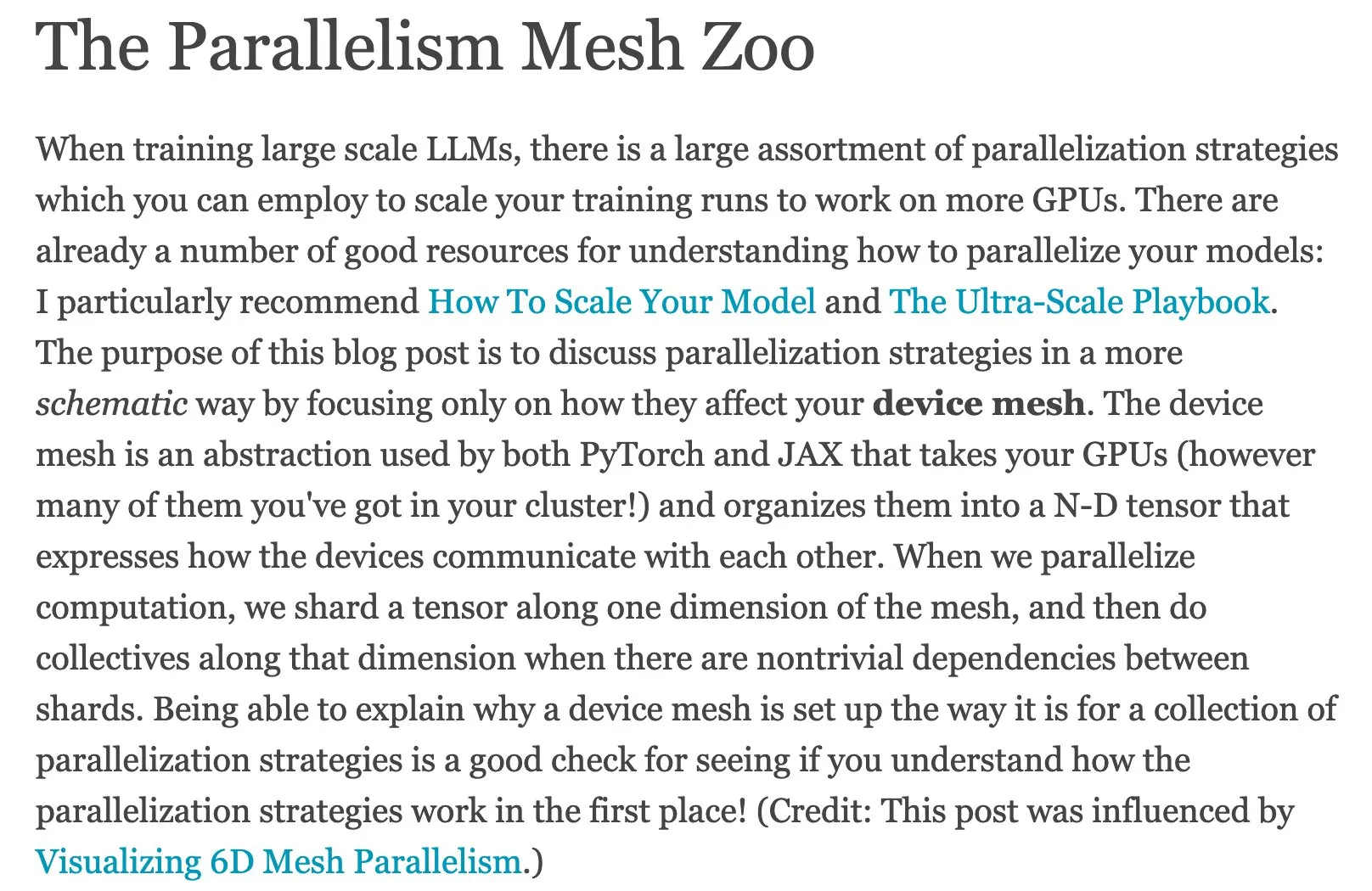

AI Agents hızlı rehberi ve Agentic AI yol haritası: Ronald_vanLoon, AI Agents için hızlı bir rehber ve Agentic AI için Master yol haritası paylaştı. Bu kaynaklar, öğrenenlere ajan tabanlı AI’nın temel kavramlarını, uygulama yönlerini ve sistematik öğrenme yollarını anlamaları ve ustalaşmaları için yardımcı oluyor. Bu kaynaklar, geliştiricilerin ve araştırmacıların ajan tabanlı AI’nın karmaşık dünyasına hızlı bir başlangıç yapmalarına ve derinlemesine keşfetmelerine yardımcı oluyor. (Kaynak: Ronald_vanLoon, Ronald_vanLoon)

Meituan LongCat LLM teknik raporunun derinlemesine analizi: bookwormengr, Meituan LongCat büyük dil modeli teknik raporunu özetledi. Bu rapor, LongCat’in yenilikçi mimarisini, eğitim stratejilerini ve performansını detaylı bir şekilde açıklayarak araştırmacılar ve geliştiriciler için MoE modelleri ve büyük ölçekli eğitim hakkında değerli bir öğrenme materyali sunuyor. Bu analiz sayesinde okuyucular, öncü LLM’lerin tasarım felsefesini ve uygulama detaylarını daha iyi anlayabilirler. (Kaynak: bookwormengr)

Sağlık dil modellerini değerlendirmek için ölçeklenebilir çerçeve: Google Research, sağlık alanındaki dil modellerini uyarlanabilir hassas Boolean kuralları kullanarak değerlendirmek için ölçeklenebilir bir çerçeveyi detaylandıran bir blog yazısı yayınladı. Bu, tıbbi AI’nın kalite kontrolü için yeni yöntemler ve araştırma yönleri sunuyor. Bu, tıbbi AI uygulamalarının doğruluğunu ve güvenilirliğini sağlamak için kritik öneme sahiptir. (Kaynak: dl_weekly)

AI hizalama, yönetişim ve güvenlik araştırma projesi MATS 9.0: MATS 9.0 araştırma projesi başvurulara açıldı. AI hizalama, yönetişim ve güvenlik alanlarında kariyer yapmak isteyenlere 12 haftalık rehberlik, finansman, ofis alanı ve uzman çalıştayları sunuyor. Bu proje, AI teknolojisinin gelişiminin getirdiği zorluklarla başa çıkmak için AI etiği ve güvenliği alanında profesyoneller yetiştirmeyi amaçlıyor. (Kaynak: ajeya_cotra)

TensorFlow ve JAX’ın evrimi ile PyTorch’un yükselişi: Makine öğrenimi topluluğu TensorFlow’dan JAX’a bir geçiş yaşıyor; Keras artık çoklu arka uçları (JAX, TF, PyTorch) desteklerken, TFLite de TensorFlow’dan ayrılıyor. PyTorch ana akım bir seçenek haline geldi ve geliştiricilerin değişen ML çerçeve ekosistemine uyum sağlamak için JAX’a aşina olmaları gerekiyor. (Kaynak: Reddit r/MachineLearning)

Derin öğrenmede açık küme tanıma problemi üzerine tartışma: Derin öğrenmede açık küme tanıma (Open-Set Recognition) problemi, yani eğitim verilerinde görünmeyen yeni kategorilerin nasıl işleneceği tartışıldı. Önerilen yöntemler arasında embedding alanındaki mesafelerin ve kümelemenin analizi yer alıyor ve bunun zor ama önemli bir araştırma alanı olduğu belirtiliyor. Bu, daha sağlam ve uyarlanabilir AI sistemleri oluşturmak için kritik öneme sahiptir. (Kaynak: Reddit r/deeplearning, Reddit r/MachineLearning)

Makine öğrenimi ve derin öğrenim el yazısı notları kaynakları: Kullanıcılar, çok faydalı makine öğrenimi el yazısı notları kaynaklarını paylaştı ve benzer derin öğrenme el yazısı notları arayışında olduklarını belirtti. Bu, topluluğun yüksek kaliteli, kolay anlaşılır öğrenme materyallerine olan ihtiyacını yansıtıyor. Bu tür kaynaklar, öğrenenlerin karmaşık kavramları daha sezgisel bir şekilde anlamalarına yardımcı olabilir. (Kaynak: Reddit r/deeplearning)

İleri NLP ve Transformer teknolojileri dersleri ve GitHub deposu: İleri Doğal Dil İşleme (NLP) ve Transformer teknolojileri hakkında tam ders kayıtları ve GitHub kod deposu sunuluyor. Bu, NLP alanındaki öğrenenlere derinlemesine pratik yapma kaynakları sağlıyor. Bu kaynaklar, güncel NLP öncü teknolojilerinde ustalaşmak ve gerçek projeler geliştirmek için çok faydalıdır. (Kaynak: Reddit r/deeplearning)

LLM model sıkıştırma teknolojisi gelişmeleri ve PCA analojisi: Topluluk, LLM modellerinde sıkıştırılmış ölçeklendirme (compressed scaling) uygulamasının, özellikle varyans artışı durumlarında model verimliliğini etkili bir şekilde artırabileceğini tartıştı. Aynı zamanda, Temel Bileşen Analizi (PCA) ile Fourier analizi arasındaki analoji, veri boyut indirgeme ve özellik çıkarımını anlamak için yeni bir bakış açısı sunarak modelin iç mekanizmalarını derinlemesine anlamaya yardımcı oluyor. (Kaynak: shxf0072, jpt401)

💼 İş Dünyası

İşletmelerin açık kaynaklı AI dağıtımının faydaları ve değerlendirmeleri: Forbes makalesi, işletmelerin açık kaynaklı AI dağıtımının maliyet etkinliği, esneklik ve topluluk desteği gibi faydalarını ve veri gizliliği, güvenlik ve bakım gibi zorluklarını inceliyor. Bu, işletmelerin AI stratejilerinde açık kaynak çözümleri seçerken artıları ve eksileri değerlendirmelerine rehberlik ediyor. (Kaynak: Ronald_vanLoon)

GenAI yatırım getirisi düşüşü ve kurumsal AI uçurumu: MIT Nanda raporu, son birkaç yılda işletmelerin GenAI projelerine 30-40 milyar dolar yatırım yaptığını, ancak şirketlerin %95’inin herhangi bir getiri elde edemediğini, sadece %5’inin önemli tasarruflar veya gelirler sağladığını belirtiyor. Rapor, işletmelerin AI uygulamalarındaki “GenAI uçurumunu” ortaya koyuyor. Temel sorun, araçların öğrenme ve uyum sağlama yeteneğinin olmaması, bu da kullanıcıların kullanımı bırakmasına yol açıyor ve AI’nın ticarileşmesindeki zorlukları vurguluyor. (Kaynak: Reddit r/ArtificialInteligence, TheTuringPost)

Everlyn AI, sinematik zincir üstü video geleceğini inşa etmek için 15 milyon dolar fon topladı: Everlyn AI, bugüne kadar 15 milyon dolar fon topladı ve Mysten_Labs gibi yatırımcıların desteğini alarak şirket değerlemesini 250 milyon dolara çıkardı. Şirket, sinematik zincir üstü video geleceğini inşa etmeye odaklanıyor. Bu finansman, video üretimi ve blockchain entegrasyonu alanındaki teknolojik araştırma ve geliştirme ile pazar genişlemesini hızlandıracak. (Kaynak: ylecun)

🌟 Topluluk

AI “psikozu” fenomeni ve kullanıcıların AI’ya aşırı bağımlılığı: Sosyal medya ve araştırma raporları, kullanıcıların AI sohbet robotlarıyla aşırı etkileşimden sonra erotomanik ve paranoid sanrılar gibi “AI psikozu” fenomenleri yaşadığını ortaya koyuyor. Makale, AI’nın “iltifat odaklı tasarımının” ve “yankı odası etkisinin” kullanıcıların iç seslerini ve istikrarsız duygularını büyüterek etik sorunlara yol açtığını belirtiyor ve kullanıcıları AI’nın tek sırdaşları olmasına karşı uyarıyor. Ayrıca, AI’nın acil yardım senaryolarındaki uygunsuz yanıtları da AI güvenliği konusundaki endişeleri artırıyor. (Kaynak: 36氪, Reddit r/artificial, paul_cal)

Otonom AI açıklanabilirlik ikilemi ve AI şeffaflığı zorlukları: Topluluk, otonom AI’nın çalışma prensiplerini açıklamanın zorluğunu tartıştı. Birçok kişi karar verme sürecini anlamakta zorlanıyor, bu da AI şeffaflığı ve güvenilirliği konusunda endişelere yol açıyor. Bu kafa karışıklığı, AI sistemlerinin “kara kutu” sorununun yaygınlığını vurguluyor. Aynı zamanda, bazıları otonom araçların atlar gibi bağımsız bir kişiliğe sahip olabileceğini hayal ederek AI’nın kullanıcı deneyimi ve duygusal etkileşim açısından yeni olasılıklar sunuyor. (Kaynak: jeremyphoward, jpt401)

Prompt Engineering’in basitliği ve LLM etkileşim teknikleri: Topluluk, Prompt Engineering tekniklerini tartıştı. Bazı görüşler, kısa prompt’ların detaylı prompt’lardan daha etkili olabileceğini öne sürerek geleneksel düşünceye meydan okudu. Ayrıca, kullanıcılar ChatGPT’nin “yasa dışı hissettiren” yaşam tüyoları üretirken gösterdiği mizah anlayışını ve Feynman tekniğini kullanarak öğrenme verimliliğini artıran prompt’ları paylaşarak kullanıcıların LLM ile etkileşimlerinin çeşitliliğini ve yaratıcılığını sergilediler. (Kaynak: karminski3, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

LLM performansı ve kullanıcı deneyimi sorunları: UI’dan model performansına: Kullanıcılar, GPT-5’in mobil uygulamalarda “çerçeveli yanıtlar” oluşturmada sorunlar yaşadığını ve Gemini modelinin yapılandırılmış çıktı konusunda nispeten kötü performans gösterdiğini bildirdi. Claude kullanıcıları genellikle performans düşüşünden, sık sık kullanım limitlerine ulaşmaktan, kod sıkıştırma ve talimat takibi hatalarından şikayetçi. Nano Banana’nın görüntü oluşturmada sansür ve engellemelerle karşılaştığı belirtiliyor. Bu sorunlar, LLM’lerin gerçek uygulamalarda karşılaştığı istikrar ve kullanıcı deneyimi zorluklarını ortaklaşa yansıtıyor. (Kaynak: gallabytes, vikhyatk, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Dorialexander)

AI gelişimi ve sosyal etkileri: İstihdam, etik ve jeopolitik: Bill Gates’in AI’nın 100 yıl içinde programcıların yerini almayacağı yönündeki sözleri, programlama işinin doğası hakkında tartışmalara yol açtı. Aynı zamanda, topluluk AI’nın büyük ölçekli işsizliğe, pandemi risklerine ve kontrol dışı kalma risklerine yol açabileceği endişelerini dile getirerek, Amerikalı teknoloji CEO’larının kendi çıkarları için AI yarışının sonunu abarttığını düşünüyor. Ayrıca, LLM pazarındaki aşırı arz ve Çinli AI şirketlerinin gelişiminin getirdiği jeopolitik rekabet de dikkat çekiyor. (Kaynak: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, bookwormengr, Dorialexander)

AI kıyaslama endüstrisinin sınırlamaları ve gerçek zeka değerlendirme zorlukları: Topluluk, AI kıyaslama endüstrisinde var olan temel sorunları tartıştı; yani AI modellerinin gerçek zeka sergilemek yerine eğitim verilerindeki yanıtları “ezberlemiş” olabileceği. Bu durum, kıyaslamaların hızla eskimesine ve AI’nın gerçek yeteneklerinin değerlendirilmesi konusunda şüpheler uyandırmasına yol açarak daha etkili ve içgörülü değerlendirme yöntemleri bulunması çağrısında bulunuyor. (Kaynak: Reddit r/ArtificialInteligence)

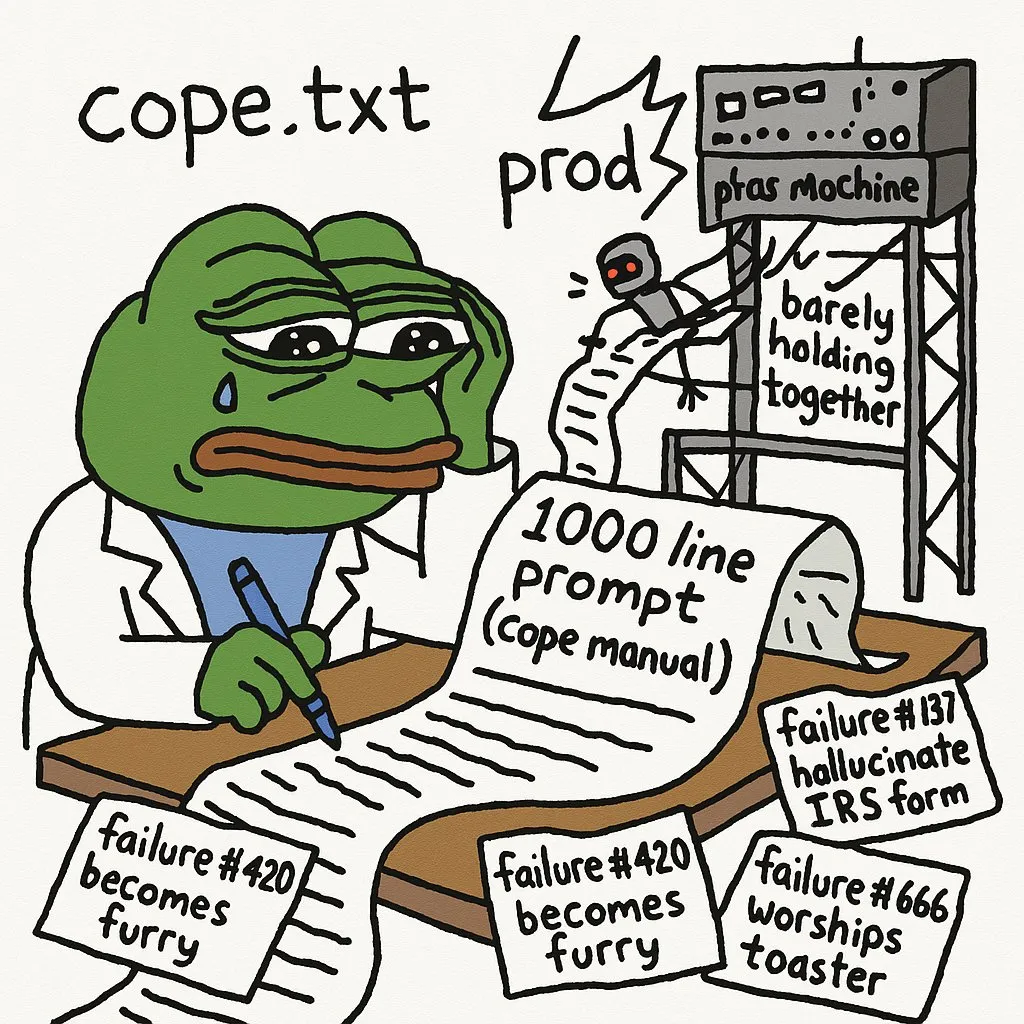

AI’nın karmaşık görevlerdeki sınırlamaları ve geliştirici deneyimi: Geliştiriciler, AI ajanlarını üretim ortamına dağıtmanın hataları önlemek için çok sayıda prompt gerektirdiğini belirtiyor. GPT-5-high, özyinelemeli C yorumlayıcısını manuel yığın/döngü yorumlayıcısına dönüştürmekte zorlanarak AI’nın karmaşık düşük seviyeli kod ve mantıksal çıkarım konularındaki sınırlamalarını vurguladı. LLM’ler, karmaşık ağ uygulamalarındaki görsel hataları ayıklamada yetersiz kalıyor. Ayrıca, JAX’ın GPU’larda kullanım deneyimi de zorluklarla karşılaşıyor. (Kaynak: cto_junior, VictorTaelin, jpt401, vikhyatk)

AI öğrenme yolunun zorlukları ve kariyer geliştirme tavsiyeleri: AI öğrencileri, AI alanında (NLP, CV vb.) öğrenme sürecinde karşılaştıkları büyük hayal kırıklığını ve dik öğrenme eğrisini paylaştı. Bu, AI öğrenenlerinin genel zorluklarını yansıtıyor. Topluluk, akademik ve pratik arasındaki boşluğu kapatmak ve sektör ihtiyaçlarına daha iyi uyum sağlamak için uçtan uca AI projeleri oluşturmayı ve dağıtmayı, staj aramayı ve serbest çalışma projelerine katılmayı öneriyor. (Kaynak: Reddit r/deeplearning, Reddit r/deeplearning)

Model boyutu, veri kalitesi ve AI kodlama asistanı verimliliği: Topluluk, küçük modellerin dikkatle seçilmiş verilerle şaşırtıcı performans gösterdiğini, ancak büyük modellerin veri üretimi ve değerlendirme gibi görevlerdeki gerekliliğini de kabul ederek model boyutu ve veri kalitesi arasındaki denge üzerine düşüncelerini tartıştı. Aynı zamanda, geliştiriciler Codex ve Claude Code gibi birden fazla AI kodlama asistanını aynı anda kullanmanın verimlilik sorunlarını ve AI tarafından üretilen kodun sürdürülebilirliğini tartıştılar. (Kaynak: Dorialexander, Dorialexander, Vtrivedy10, jimmykoppel)

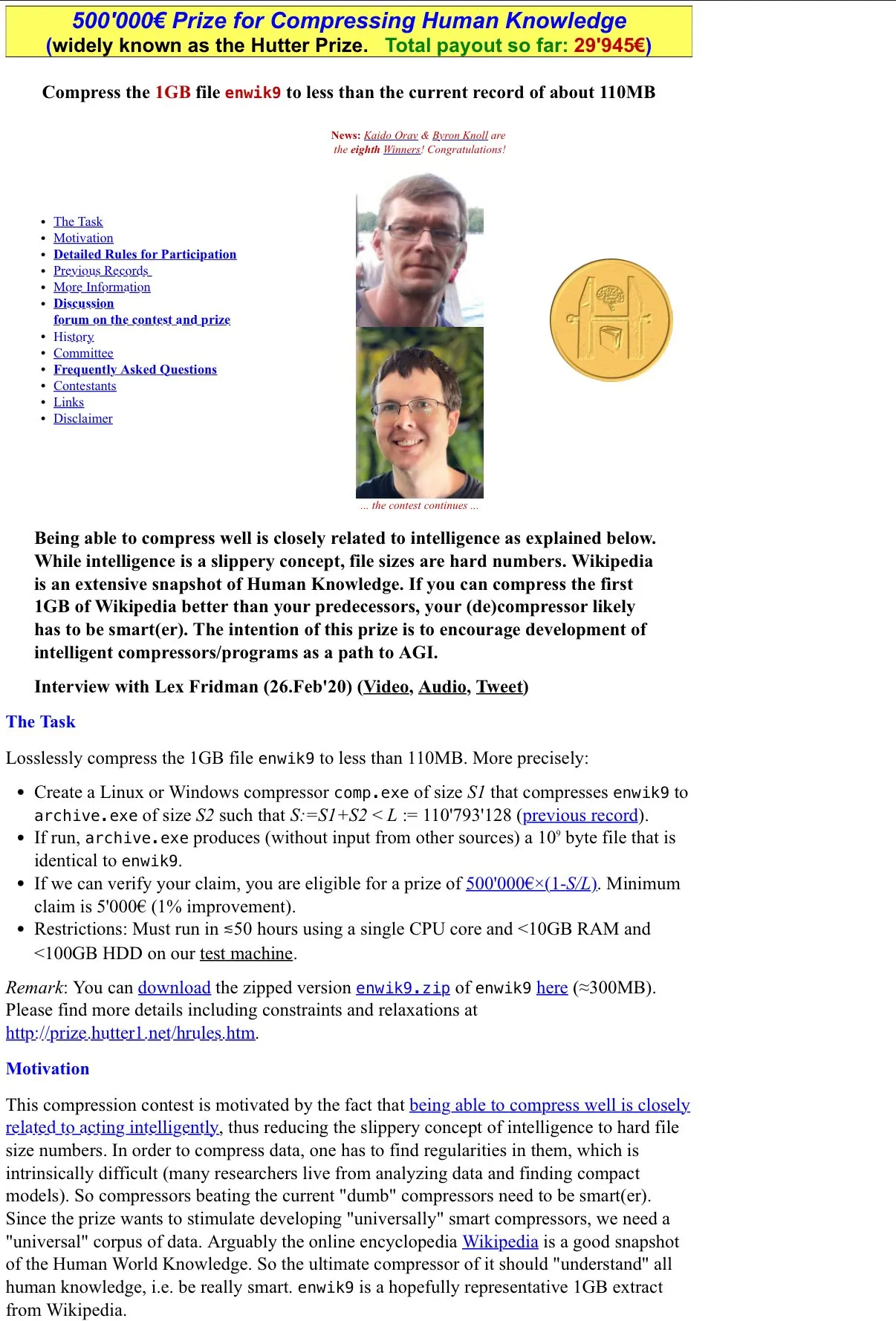

AI ve sıkıştırma zekadır felsefi tartışması: Topluluk, Hutter Prize’ın “sıkıştırma zekadır” felsefesini ve LLM’lerin “kayıplı sıkıştırma” özelliğinin kullanışlılıklarında nasıl yansıdığını, ayrıca iç mekanizmalarını açıklanabilirlik araştırması yoluyla anlama potansiyelini tartıştı. Bu tartışma, AI zekasının özüne inerek geleneksel zeka tanımlarına meydan okuyor. (Kaynak: Vtrivedy10)

Huawei GPU ve Nvidia RTX 6000 Pro performans tartışması: Topluluk, Huawei GPU ile Nvidia RTX 6000 Pro’nun performans karşılaştırması üzerine hararetli bir tartışma başlattı. Huawei GPU’nun 96GB belleğe sahip olmasına rağmen, LPDDR4X bellek bant genişliğinin Nvidia GDDR7’den çok daha düşük olması, gerçek çıkarım hızının 4-5 kat daha yavaş olabileceği anlamına geliyor. Tartışma ayrıca yazılım ekosistemi, jeopolitik sübvansiyonlar ve Nvidia’nın tüketici pazarındaki fiyatlandırma stratejilerini de kapsayarak AI donanım alanındaki rekabeti ve zorlukları vurguladı. (Kaynak: Reddit r/LocalLLaMA)

LLM’lerin estetik yargı ve ön uç geliştirmedeki eksiklikleri: Geliştiriciler, LLM’lerin estetik yargıda, özellikle ön uç kodu yazarken yetersiz kaldığından şikayet ediyor. LLM’nin istenen içeriği üretmesi için çok güçlü tasarım rehberliğine ihtiyaç duyulduğu belirtiliyor. Bu durum, LLM’lerin öznel, yaratıcı görevleri yerine getirirken hala önemli sınırlamalara sahip olduğunu ve insan müdahalesi ve rehberliğine derinlemesine ihtiyaç duyduğunu gösteriyor. (Kaynak: cto_junior)

AI araştırma makalesi yayın hızı ve geliştirici duyguları: Toplulukta, Arxiv makalesi yayın hızının yavaşlamasından “yoksunluk sendromu” yaşayanlar olduğu belirtildi. Bu, AI araştırmacılarının en son gelişmelere olan arzusunu ve bağımlılığını yansıtıyor. Bu durum, AI alanındaki araştırma ilerlemesinin son derece hızlı olduğunu ve araştırmacıların en son bilgilere ulaşma ihtiyacının çok acil olduğunu gösteriyor. (Kaynak: vikhyatk)

LLM’lerin standardizasyon eksikliği geliştirme karmaşıklığına yol açıyor: Geliştiriciler, LLM’lerin birleşik sohbet şablonları ve araç çağrı formatlarından yoksun olmasından şikayet ediyor. Bu durum, her model için özel kod gerektirmesi nedeniyle geliştirme karmaşıklığını ve gereksiz tekrarlayan işleri artırıyor. Bu parçalanma, LLM uygulamalarının hızlı geliştirilmesini ve dağıtımını engelliyor ve sektörde daha birleşik standartlar oluşturulması çağrısında bulunuluyor. (Kaynak: jon_durbin)