Anahtar Kelimeler:VGGT, 3D Görüş, Transformer, CVPR 2025, Meta, Oxford Üniversitesi, Otonom Sürüş, AI Güvenliği, Görsel Geometri Transformer, Tek Geçişli 3D Tahmin, SafeKey Çerçevesi, Waymo Otonom Sürüş Araştırması, Doubao Büyük Model 1.6

🔥 Odak Noktası

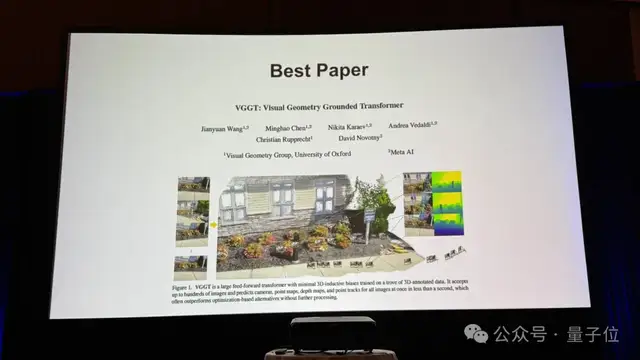

VGGT: Meta ve Oxford Üniversitesi, tek bir ileri beslemede tam 3D sahne bilgilerini tahmin eden görsel geometri Transformer’ını sundu ve CVPR 2025 En İyi Makale Ödülü’nü kazandı: Meta ve Oxford Üniversitesi tarafından ortaklaşa sunulan VGGT (Visual Geometry Grounded Transformer), CVPR 2025’in tek En İyi Makalesi oldu. Bu model, Vision Transformer’a dayanmakta olup, dönüşümlü “küresel-çerçeve içi” self-attention mekanizması kullanarak tek bir ileri beslemede kamera iç ve dış parametreleri, derinlik haritaları, nokta bulutu haritaları ve 3D yörüngeler dahil olmak üzere tam 3D sahne bilgilerini uçtan uca tahmin edebilmektedir. VGGT, yalnızca büyük miktarda 3D etiketli veri üzerinden kendi kendine öğrenir, geometrik endüktif ön yargılara ihtiyaç duymaz, 1 ila 200 görüntü girdisini işlerken üstün performans gösterir, performansı mevcut birçok geometrik veya derin öğrenme yöntemini aşar ve 3D görsel alanında geniş uygulama potansiyeli sergilemektedir (Kaynak: 量子位)

Nvidia CEO’su Jensen Huang ve Anthropic CEO’su yapay zekanın gelişimi konusunda fikir ayrılığı yaşadı: Nvidia CEO’su Jensen Huang, Paris’teki bir basın toplantısında Anthropic CEO’su Dario Amodei’nin yapay zeka hakkındaki neredeyse tüm görüşlerine katılmadığını belirtti. Huang, Amodei’nin yapay zekanın çok tehlikeli olduğunu ve az sayıda şirket tarafından kontrol edilmesi gerektiğini; yapay zeka maliyetlerinin yüksek olduğunu ve diğer şirketlerin bu alana girmemesi gerektiğini; ve yapay zekanın kitlesel işsizliğe yol açacağını düşündüğünü belirtti. Huang, yapay zekanın önemli bir teknoloji olduğunu, kapalı ortamlarda değil, güvenli ve sorumlu bir şekilde açık olarak geliştirilmesi gerektiğini savunarak, güvenlik için açıklığın önemini vurguladı (Kaynak: hardmaru)

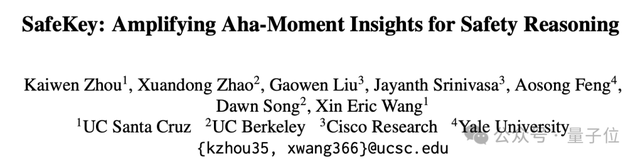

SafeKey çerçevesi büyük çıkarım modellerinin güvenliğini artırarak risk oranını %9,6 azalttı: Kaliforniya Üniversitesi Santa Cruz, Berkeley, Cisco Research ve Yale Üniversitesi’nden araştırma ekipleri, büyük çıkarım modellerinin (LRM’ler) güvenliğini artırmayı amaçlayan SafeKey çerçevesini önerdi. Araştırma, modellerin “jailbreak” yapmasının, erken “anahtar cümle” güvenlik sinyallerini etkili bir şekilde kullanamamasıyla ilişkili olduğunu buldu. SafeKey, “çift yollu güvenlik başlığı” aracılığıyla güvenlik sinyallerini güçlendiriyor ve “sorgu maskeleme modellemesi” ile modeli güvenlik kararları için kendi anlayışına güvenmeye zorluyor. Deneyler, SafeKey’in modelin temel yeteneklerini önemli ölçüde etkilemeden (hatta biraz geliştirerek) tehlikeli yanıt oranını %9,6 azaltabildiğini ve özellikle bilinmeyen saldırılarla karşılaşıldığında daha iyi performans gösterdiğini ortaya koydu (Kaynak: 量子位)

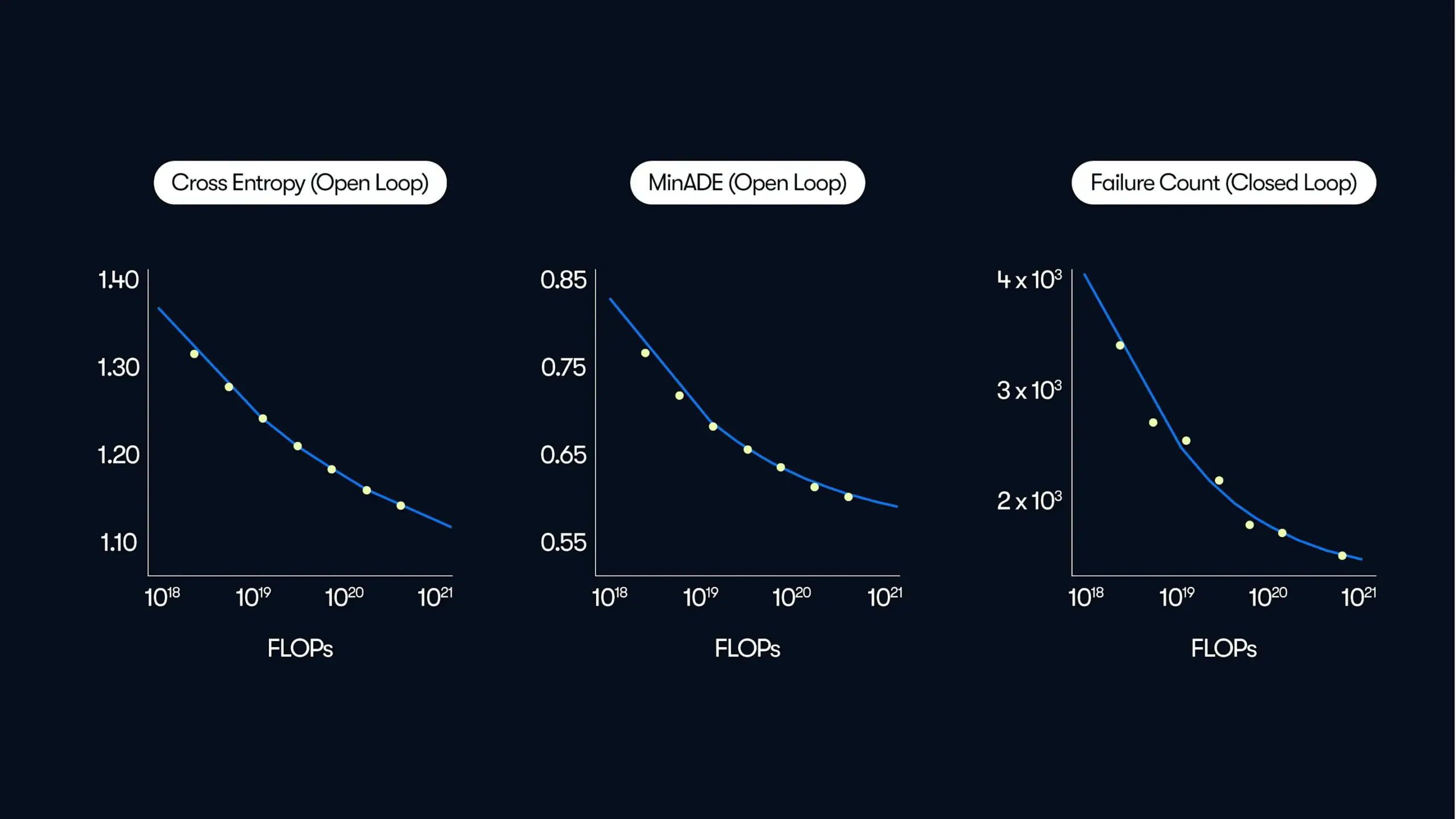

Waymo araştırması, otonom sürüş sistemi performansının veri ve hesaplama ölçeğiyle üslü bir yasayla arttığını gösteriyor: Waymo, 500.000 saatlik sürüş verisine dayanan kapsamlı bir araştırma yayınladı. Araştırma, otonom sürüş sistemindeki hareket tahmin kalitesi ile eğitim hesaplama miktarı arasında, büyük dil modellerinin (LLM’ler) ölçeklenme yasalarına benzer bir üslü yasa ilişkisi olduğunu ortaya koydu. Araştırma, model performansını artırmak için veri ölçeğinin kritik öneme sahip olduğunu vurgularken, çıkarım hesaplama miktarını artırmanın da modelin karmaşık sürüş senaryolarını işleme yeteneğini geliştirdiğini belirtti. Bu çalışma, eğitim verilerini ve hesaplama kaynaklarını artırarak gerçek dünyadaki otonom sürüş performansının iyileştirilebileceğini ilk kez gösteriyor (Kaynak: zacharynado)

🎯 Gelişmeler

ByteDance, Doubao büyük modeli 1.6’yı ve bir dizi yapay zeka uygulamasını yayınladı, kombinasyon yeteneği ve ürün lansmanını vurguladı: ByteDance son zamanlarda Doubao büyük modeli 1.6, video üretim modeli Seedance 1.0 Pro, sesli podcast ve gerçek zamanlı ses modeli gibi bir dizi yapay zeka ürününü yoğun bir şekilde yayınladı. Doubao 1.6, çok modlu işleme ve operasyon yeteneklerini geliştirdi, düşünürken arama ve DeepResearch’ü destekliyor ve grafik arayüzü işlemleri yapabiliyor. Seedance 1.0 Pro, video üretiminin tutarlılığı ve kararlılığı konusunda öne çıkıyor ve 10 saniyelik 1080p video üretimini destekliyor. ByteDance’in stratejisi, tek bir model parametresinde liderlik peşinde koşmak yerine, yapay zeka yeteneklerini doğrudan çalıştırılabilen uygulamalara entegre etmeye ve mevcut ürünlere (Doubao APP, Volcano Engine gibi) yerleştirmeye daha fazla odaklanıyor; kombinasyon yeteneği ve hızlı ürünleştirmeyi vurguluyor. Fiyatlandırma stratejisi de daha uygun maliyetli olup, yapay zeka kullanım engelini düşürmeyi amaçlıyor (Kaynak: 36氪)

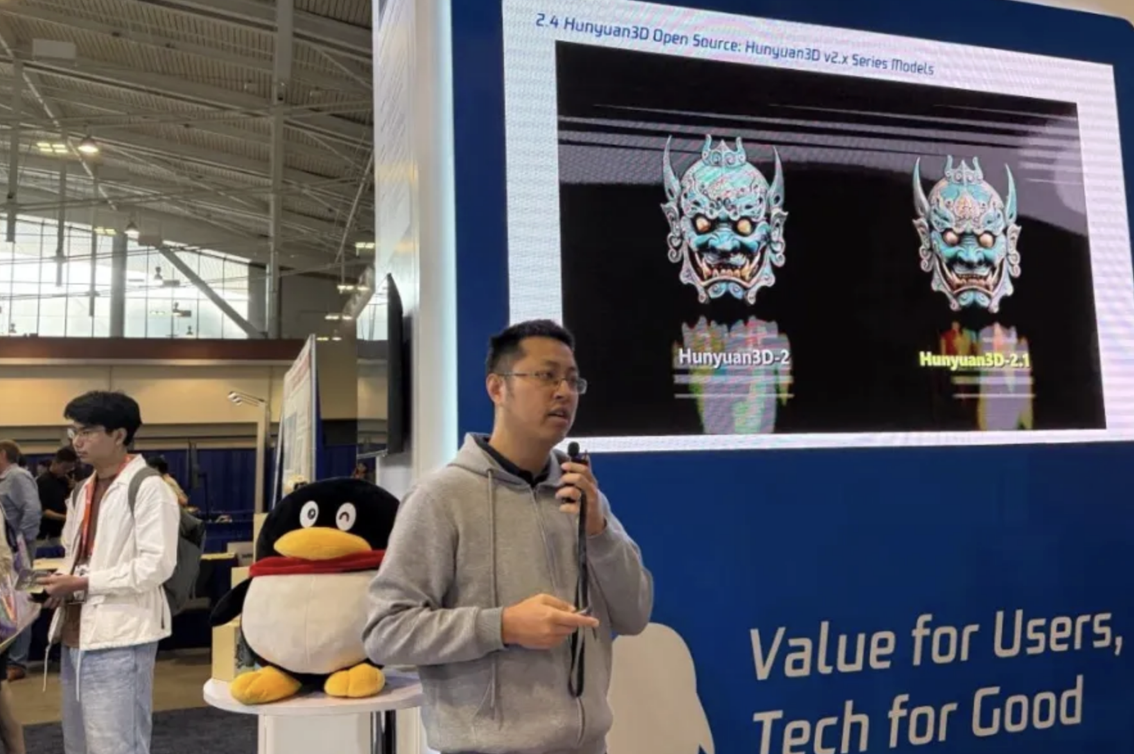

Tencent Hunyuan 3D 2.1 modeli açık kaynaklı hale getirildi, PBR dokuları ve tüketici sınıfı ekran kartı uyumluluğu ön planda: Tencent, CVPR konferansında en son 3D üretim modeli Hunyuan 3D 2.1’i açık kaynaklı hale getirdiğini duyurdu. Bu model, geometrik hassasiyet ve doku detaylarında ikili optimizasyonlar içeriyor ve özellikle PBR (Fiziksel Tabanlı İşleme) doku üretim teknolojisini tanıtarak deri, metal, seramik gibi karmaşık malzemeleri yüksek kalitede işleyebiliyor ve gerçekçi görsel efektler sunuyor. Hunyuan 3D 2.1, model ağırlıkları, eğitim kodu ve veri işleme akışı dahil olmak üzere tam bir açık kaynak zinciri sunuyor ve tüketici sınıfı ekran kartlarında çalışmayı ve tek tıkla dağıtımı destekleyerek 3D içerik oluşturmanın yaygınlaşmasını hedefliyor (Kaynak: 量子位)

Perplexity AI, kullanıcı geri bildirimlerine yanıt olarak Deep Research özelliğini aktif olarak geliştiriyor: Perplexity AI CEO’su Arav Srinivas, ekibin Deep Research özelliği hakkındaki olumsuz geri bildirimleri ciddiye aldığını ve iyileştirmeler üzerinde çalışmaya başladığını belirtti. Bazı iyileştirmeler üretim ortamında devreye alındı ve kullanıcılar deneyimlerinde bir artış hissetmeli. Gelecekte, Deep Research ve Labs özellikleri, kişisel bağlam ve verilerden yararlanarak kullanıcıların karar verme süreçlerini optimize etmeyi amaçlayan Comet ürününe entegre edilecek (Kaynak: AravSrinivas)

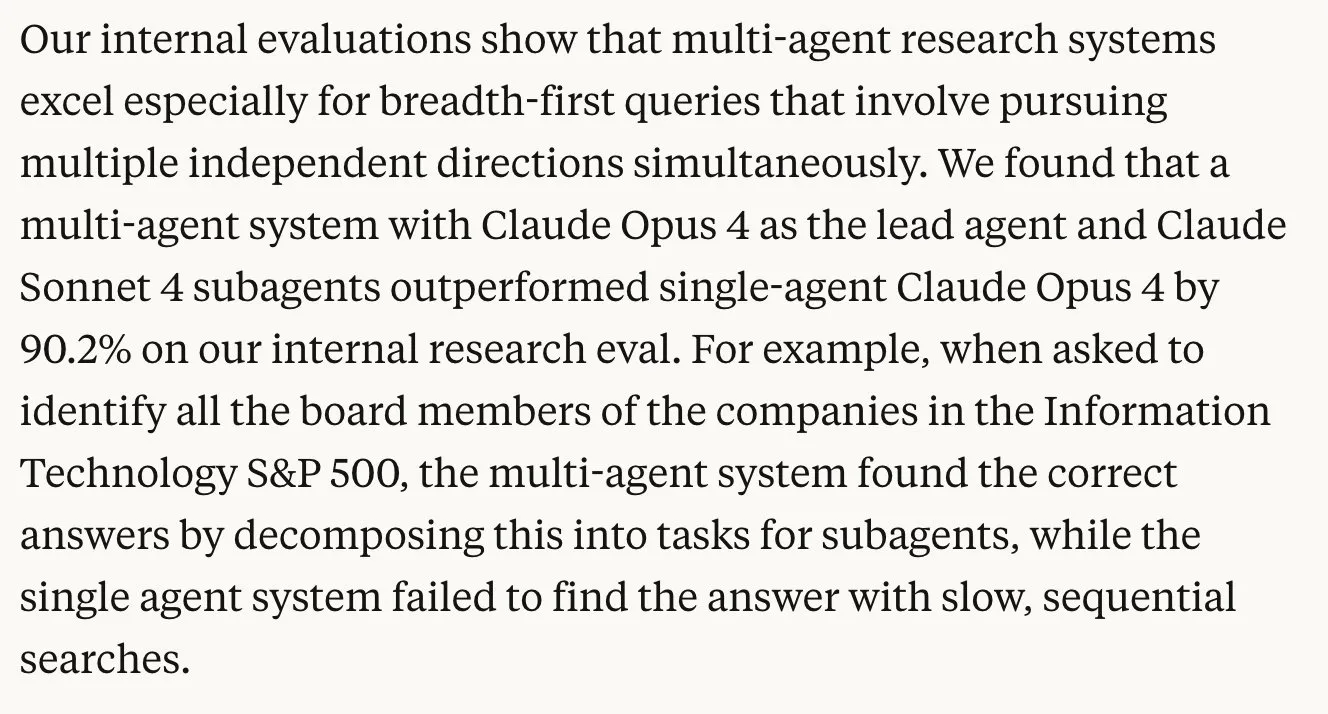

Anthropic araştırması, çoklu ajan sistemlerinin görev performansını önemli ölçüde artırabildiğini ortaya koyuyor: Anthropic tarafından yayınlanan araştırma, görevleri işlemek için çoklu ajan sistemleri (örneğin, ana ajan olarak Opus, alt ajan olarak Sonnet) kullanmanın, Opus’u tek başına kullanmaya kıyasla performansı %90 artırdığını gösteriyor. Bu işbirlikçi çalışma modeli, insan toplumunun iş bölümü yoluyla üretkenliği büyük ölçüde artırmasına benziyor. Araştırma, etkili çoklu ajan araştırma sistemlerinin nasıl oluşturulacağını ayrıntılı olarak açıklıyor ve LLM’lerin hakem olarak kullanılması da dahil olmak üzere değerlendirme yöntemlerini paylaşıyor. Ancak, bazı yorumcular raporda açıklanan Claude araştırma yönteminin yetersiz arama derinliği sorunu olabileceğine dikkat çekiyor (Kaynak: zacharynado, omarsar0, nrehiew_)

Araştırma, büyük dil modellerinin çıkarım yeteneğinin “karmaşıklık” yerine “aşina olmama” ile sınırlı olduğunu belirtiyor: François Chollet, büyük dil modellerinin (LRM) çıkarım yeteneğinin belirli bir “karmaşıklık” veya “adım sayısı” eşiğine ulaştığında çökmediğini, bunun yerine “aşina olunmayan” görevlerle karşılaştığında başarısız olduğunu ve bu aşina olmama eşiğinin çok düşük olduğunu belirtiyor. Modeller, eğitim/ayarlama aşamasında kapsanan son derece karmaşık görevleri çözebilir, ancak basit yeni görevler (ARC 2 görevleri gibi) bile başarısız olabilir. Aşina olunan problemlerde (Hanoi Kuleleri gibi) gözlemlenen adım/karmaşıklık eşikleri, aslında problem değişkenlerini artırarak “yenilik” yaratmanın bir sonucudur (Kaynak: fchollet, jeremyphoward)

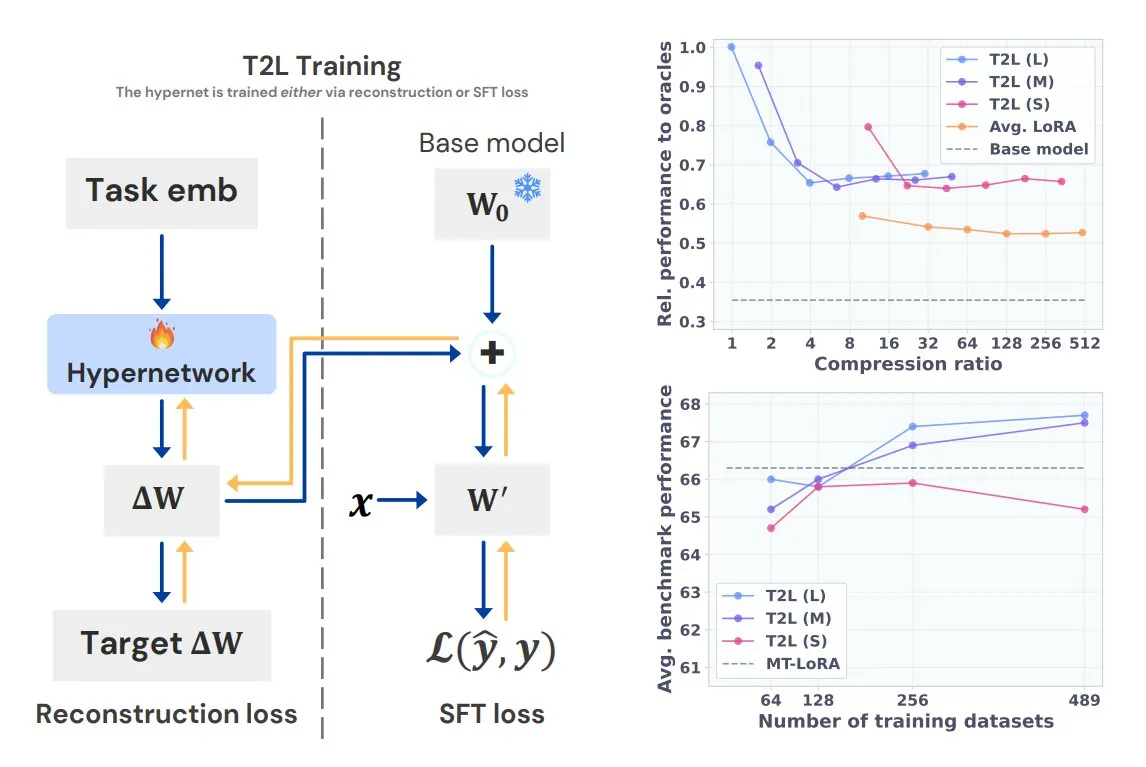

Sakana AI, Text-to-LoRA (T2L) hiperağ modelini tanıttı: Sakana AI, bir görevin metin açıklamasına dayanarak büyük dil modelleri için hızla yeni LoRA adaptörleri üretebilen yeni bir hiperağ olan Text-to-LoRA’yı (T2L) yayınladı. T2L, yalnızca mevcut birden fazla LoRA’yı sıkıştırmakla kalmaz, aynı zamanda eğitimden sonra anında yeni LoRA’lar oluşturarak göreve özgü modellerin hızlı bir şekilde özelleştirilmesi için yeni bir yol sunar. Bu araştırma ICML 2025’te sunulacak (Kaynak: TheTuringPost)

Nvidia Cosmos-Predict2 (2B modeli) etkileyici görüntü oluşturma yeteneği sergiliyor: Nvidia’nın 2 milyar parametreli bir modeli olan Cosmos-Predict2, “fiziksel yapay zeka için dünya temel model platformu” olarak konumlandırılıyor ve sanatsal görüntü oluşturma konusunda etkileyici yetenekler sergiliyor. Temel veri kümesi en iyi olmasa da, model yapısı iyi ve oluşturulan görüntülerin kalitesi 14B parametreli sürümden çok farklı değil, yalnızca ayrıntı ve komut istemi takibinde biraz daha zayıf kalıyor, bu da küçük modellerin belirli optimizasyonlar altında potansiyelini gösteriyor (Kaynak: teortaxesTex)

MIT, dronların fırtınalardan otonom olarak kaçınmasını sağlayan yeni bir algoritma geliştirdi: MIT, insansız hava araçlarına (İHA’lar) “beyin benzeri” karar verme yetenekleri kazandıran yeni bir algoritma geliştirdi. Bu algoritma, İHA’ların hava durumunu gerçek zamanlı olarak analiz etmesini ve fırtınalardan kaçınmak için otonom olarak rota planlamasını sağlıyor. Bu teknolojinin, İHA’ların karmaşık hava koşullarında uçuş güvenliğini ve görev yürütme verimliliğini artırması bekleniyor (Kaynak: Ronald_vanLoon)

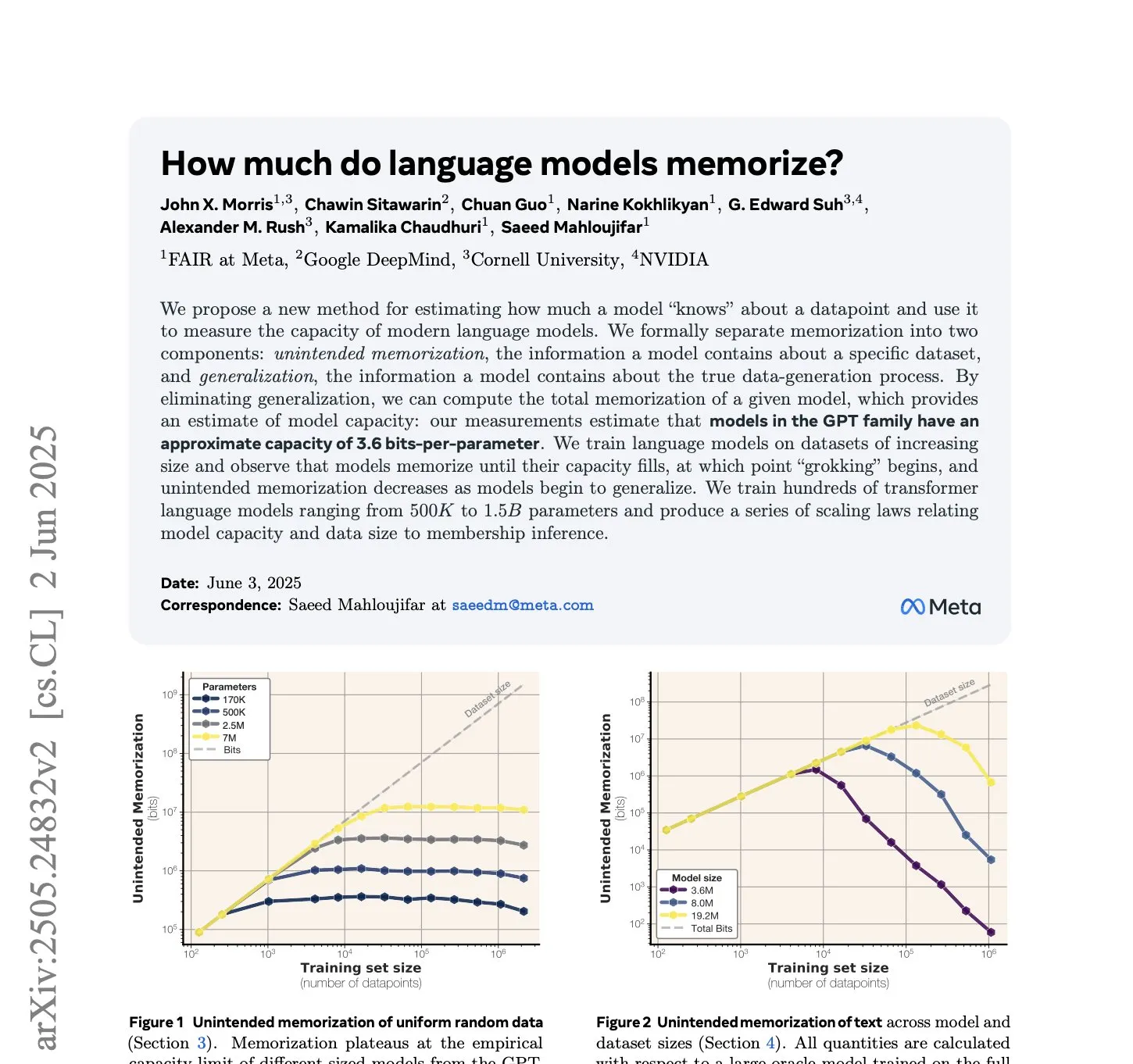

Meta araştırması: GPT tarzı dil modelleri parametre başına 3,6 bit bilgi ezberliyor: Meta’nın yeni bir araştırması, GPT tarzı dil modellerinin parametre başına yaklaşık 3,6 bit bilgi ezberleyebildiğini hesapladı. Araştırma, modelin ezberlediği toplam bit sayısını (Shannon’ın 1953 teorisine dayanarak) ölçerek bellek kapasitesini değerlendiriyor ve bellek ile veri ölçeği arasında belirli bir eğri ilişkisi gözlemliyor (Kaynak: jxmnop)

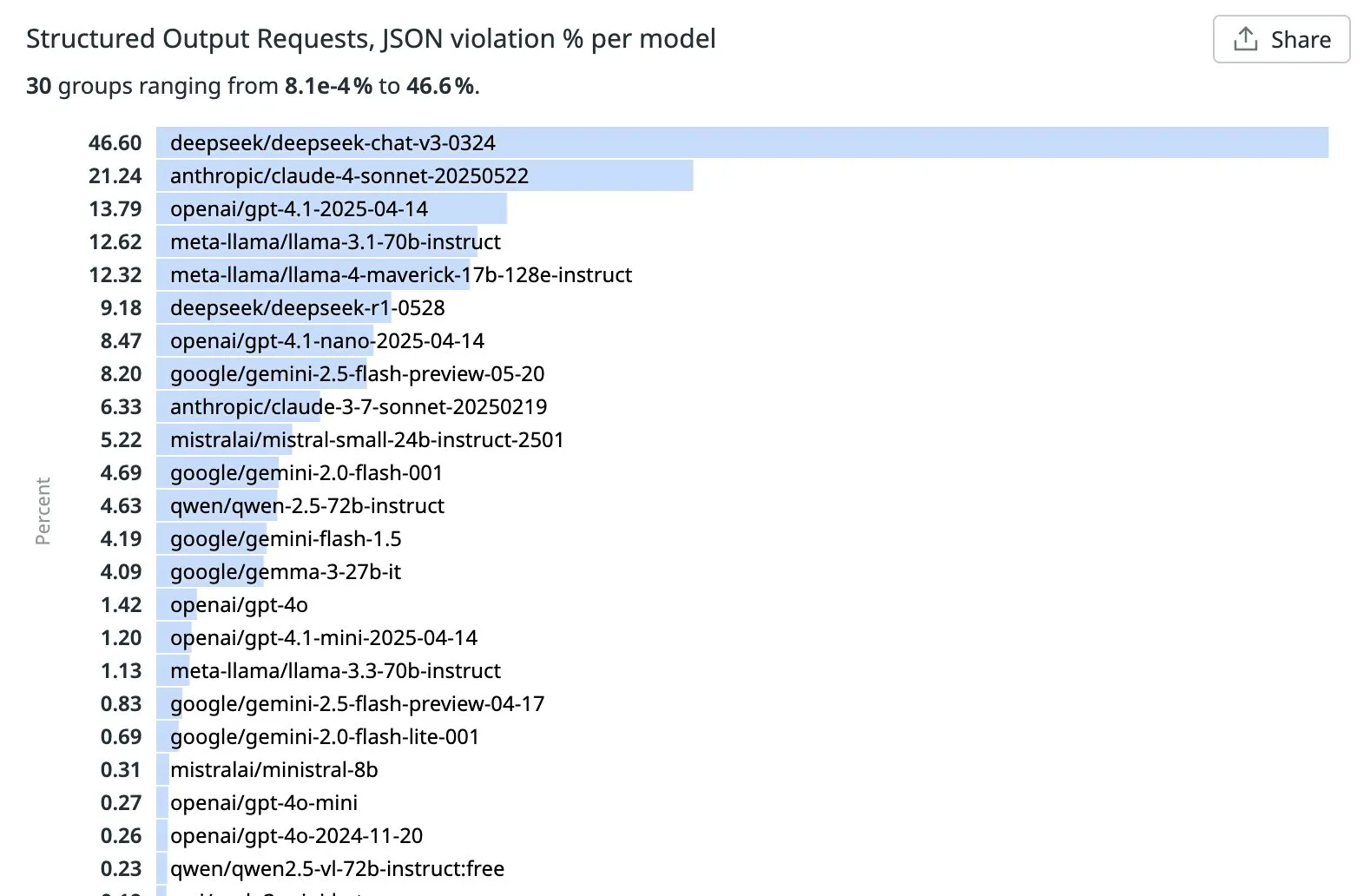

OpenRouter, LLM’lerin yapılandırılmış çıktı (JSON) görevlerindeki ihlal oranı sıralamasını yayınladı: OpenRouter, geçtiğimiz hafta en iyi yapılandırılmış çıktı isteklerinde tespit edilen JSON ihlal yüzdesine göre büyük LLM’leri sıraladı. Sonuçlar, Qwen, Mistral ve GPT-4o-mini’nin daha iyi performans gösterdiğini ve JSON ihlal oranlarının düşük olduğunu gösteriyor. DeepSeek v3 ve Sonnet 4’ün ihlal oranları ise %20’yi aşarak, JSON formatına tam olarak uyma konusunda hala önemli bir iyileştirme alanı olduğunu gösteriyor. Bu farklılığa neden olan belirli kalıplar henüz net değil (Kaynak: xanderatallah, teortaxesTex)

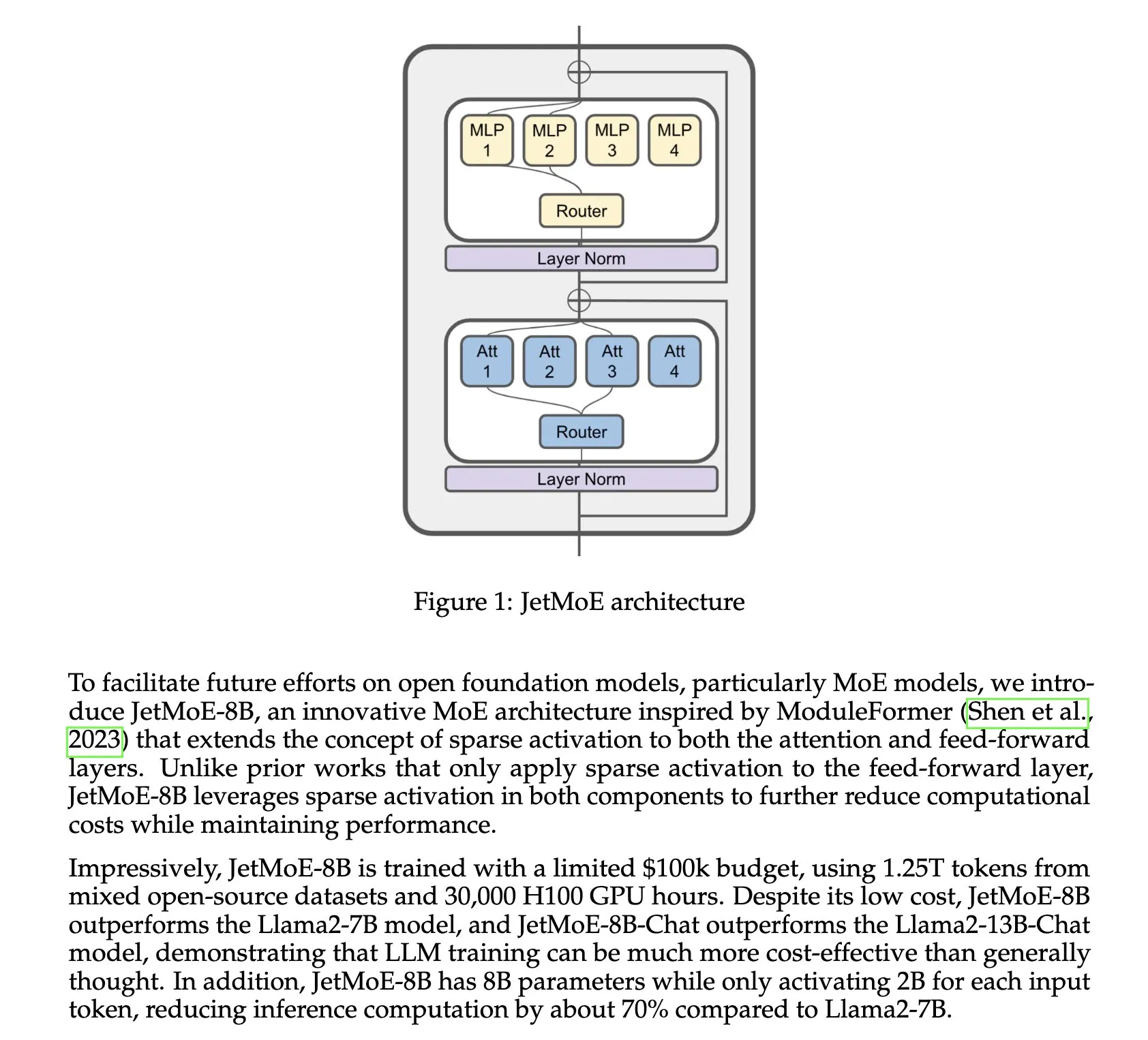

Ant Group, birleşik çok modlu model Ming-Omni’yi tanıttı: Ant Group, metin, görüntü, ses ve video arasında algılama ve üretim yapabilen birleşik bir çok modlu model olan Ming-Omni serisini yayınladı. Hafif sürümü Ming-Lite-Omni, MoE mimarisini kullanıyor, yalnızca 2.8B aktif parametreye sahip, yüksek kaliteli görüntü üretimi ve doğal konuşma sentezi yeteneklerine sahip ve Hugging Face’te MIT lisansıyla açık kaynaklı olarak sunuldu (Kaynak: teortaxesTex, _akhaliq)

Çin’in QiMeng yapay zeka çip aracı, işlemci tasarımını birkaç günde tamamlayarak mühendis verimliliğini aştı: Çin tarafından geliştirilen yapay zeka çip tasarım aracı “QiMeng”, geleneksel mühendislerin daha uzun sürede tamamlayabileceği tasarım görevlerini yalnızca birkaç günde tamamlayarak verimli işlemci tasarım yeteneğini sergiledi. Bu, yapay zekanın çip tasarım otomasyonu alanındaki potansiyelini işaret ediyor ve çip geliştirme döngülerini hızlandırma ve maliyetleri düşürme vaadi taşıyor (Kaynak: Ronald_vanLoon)

Hao AI Lab’ın o3-pro modeli, LLM oyun karşılaştırma testlerinde üstün performans sergiledi: Hao AI Lab’ın o3-pro modeli, büyük dil modellerinin oyun yeteneklerini değerlendirmek için kullanılan bir karşılaştırma testi olan Lmgame Bench’te önemli ilerleme kaydetti. Tetris ve Sokoban oyunlarında o3-pro, her ikisinde de SOTA seviyesine ulaştı ve önceki nesil o3 modelini çok geride bıraktı. Özellikle Tetris’te o3-pro, 8’den fazla satırı temizleyebildi ve planlama yeteneğine sahip olduğunu gösterdi, diğer modeller ise birkaç satırdan sonra zorlandı (Kaynak: clefourrier)

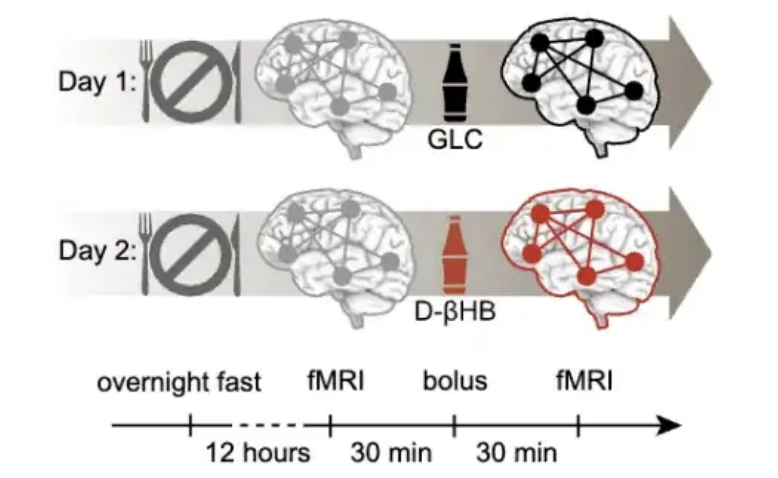

Araştırma, 40 yaşın beyin yaşlanmasını önlemek için kritik bir pencere dönemi olduğunu ve keton müdahalesinin önemli etkileri olduğunu buldu: PNAS’ta yayınlanan bir araştırma, yaklaşık 20.000 kişinin beyin tarama verilerini analiz ederek beyin yaşlanmasının doğrusal bir süreç olmadığını, insülin direncinin artmasıyla ilişkili S şeklinde bir eğri izlediğini buldu. Araştırma, yaklaşık 40 yaşın beyin ağı istikrarsızlığının hızlanmaya başladığı dönem olduğunu ve 60’lı yaşlarda yaşlanma hızının en yüksek olduğunu belirtiyor. Deneyler, ketonların (D-βHB) insülin direncini atlayarak nöronlara enerji sağlayabildiğini ve beyin ağını stabilize etmede önemli bir rol oynadığını, özellikle 40-59 yaş aralığında müdahalenin en etkili olduğunu göstererek orta yaş beyin sağlığı için yeni bir yaklaşım sunuyor (Kaynak: 量子位)

🧰 Araçlar

The Browser Company, yapay zeka tabanlı tarayıcı Dia’nın test sürümünü yayınladı: Arc tarayıcısının geliştiricisi The Browser Company, ilk yapay zeka tabanlı tarayıcısı Dia’nın kapalı beta sürümünü yayınladı. Dia’nın en büyük özelliği, kullanıcıların ChatGPT gibi harici yapay zeka araçlarını açmadan herhangi bir web sayfası içeriğiyle (YouTube videoları, FigJam, Google Takvim vb. dahil) doğrudan sohbet etmesine olanak tanımasıdır. Sekmelerden otomatik olarak bağlam alabilir, çoklu web sayfası bilgilerini entegre etme ve karşılaştırma, plan yapma, içerik oluşturma gibi işlevleri destekler. Şu anda yalnızca MacOS’u destekliyor ve daha basit, yapay zeka öncelikli bir tarama deneyimi sunmayı amaçlıyor (Kaynak: 36氪)

LangChain yerel yapay zeka podcast oluşturucuyu tanıttı: LangChain, metni çok dilli podcast’lere dönüştürebilen, LangChain ve Ollama kullanılarak oluşturulmuş yerel bir yapay zeka podcast oluşturucusu yayınladı. Metin özetleme ve konuşma sentezi teknolojilerini birleştirerek sorunsuz bir podcast oluşturma süreci sağlıyor. Kullanıcılar, sağlanan öğreticiyi izleyerek bu aracı nasıl kullanacaklarını öğrenebilirler (Kaynak: LangChainAI, hwchase17)

Davia: Python uygulamalarını ve LangGraph ajanlarını hızla Web uygulamalarına dönüştürün: Davia, Python uygulamalarını ve LangGraph ajanlarını herhangi bir ön uç kodu yazmadan anında şık Web uygulamalarına dönüştürebilen bir araçtır. FastAPI üzerine kuruludur ve geliştiricilerin Python mantığına odaklanmasını sağlayan etkileşimli kullanıcı arayüzlerini otomatik olarak oluşturur (Kaynak: LangChainAI, Hacubu)

Tensorlake, belge yapılandırma işlemi için LangChain ile entegre oldu: Tensorlake, LangGraph ajanlarının Tensorlake’in güçlü çok modlu işleme sisteminden yararlanarak yapılandırılmamış belgeleri yapılandırılmış verilere dönüştürmesini sağlamak için LangChain ile entegre olduğunu duyurdu. Bu entegrasyon, karmaşık belgelerin işlenmesi için yeni çözümler sunuyor (Kaynak: LangChainAI, hwchase17)

Quark, Çin’in ilk üniversiteye giriş tercih büyük modelini ve ücretsiz tercih raporu özelliğini yayınladı: Quark, Çin’in ilk üniversiteye giriş tercih büyük modelini piyasaya sürdü ve ücretsiz “tercih raporu” özelliğini başlattı. Bu model, Agent çalışma moduna dayanıyor, uzman karar verme süreçlerini simüle edebiliyor ve gerçek zamanlı olarak güncellenen “üniversiteye giriş bilgi tabanı” (2900’den fazla üniversite, yaklaşık 1600 lisans programı ve istihdam bilgileri dahil) ile birleşerek adaylara “hedef, istikrarlı, garanti” olmak üzere üç seviyeden oluşan kişiselleştirilmiş tercih planları oluşturuyor. Bu hamle, yapay zeka teknolojisini kullanarak üniversiteye giriş tercihlerinin yapılmasındaki engelleri ve maliyetleri düşürmeyi ve geleneksel yüksek fiyatlı danışmanlık durumunu değiştirmeyi amaçlıyor (Kaynak: 量子位)

Task Orchestrator: Claude Code için geliştirilmiş MCP proje yönetim aracı: Geliştirici jpicklyk, Claude Code’un karmaşık projelerle uğraşırken kolayca “dikkatini dağıtması” ve bağlamı unutması sorununu çözmek için Task Orchestrator adlı bir MCP (Machine-Level Code Programming) aracı oluşturdu. Bu araç, Claude’a kalıcı bellek, yapılandırılmış proje yönetimi (proje → özellik → görev), yapay zeka tabanlı şablonlar, akıllı bağımlılık ilişkileri ve ilerleme takibi yetenekleri kazandırarak onu daha düzenli bir mühendislik ortağı haline getiriyor. Proje GitHub’da açık kaynak olarak yayınlandı (Kaynak: Reddit r/ClaudeAI)

ATLAS: Claude Code’a öz-farkındalık yeteneği kazandıran yazılım mühendisliği yapay zeka ortağı: Geliştirici syahiidkamil, Claude Code’u başlangıç düzeyinde öz-farkındalığa, belleğe, kimliğe ve profesyonel standartlara sahip bir yazılım mühendisliği yapay zeka ortağına dönüştürmeyi amaçlayan ATLAS projesini oluşturdu. ATLAS, proje bağlamını koruyabilir, bilgisini kendi kendine yönetebilir, kod gönderimleriyle birlikte gelişebilir ve proaktif olarak kod incelemesi talep edebilir, böylece kullanıcı ile yapay zeka arasında daha doğal bir işbirliği ve inceleme süreci teşvik edilir. Proje, kullanıcıların ve yapay zekanın birlikte daha yüksek kaliteli kodları korumasına yardımcı olmak amacıyla GitHub’da açık kaynak olarak yayınlandı (Kaynak: Reddit r/ClaudeAI)

Observer: Yerel olarak çalışan ekran izleme yapay zeka asistanı: Observer, kullanıcı ekran aktivitelerini izleyebilen yerel olarak çalıştırılabilen bir yapay zeka aracıdır. Öğretici aracılığıyla, Observer’ı ev sunucusunda kendi kendine barındırmayı öğrenerek ekran içeriğinin yapay zeka destekli analizini veya etkileşimini gerçekleştirebilirsiniz (Kaynak: Reddit r/LocalLLaMA)

VantaAI: Bellek ve duygusal mantığa sahip yerel yapay zeka asistanı projesi paylaşımı: Bir geliştirici, tamamen çevrimdışı çalışmayı amaçlayan yerel bir yapay zeka asistanı olan kişisel projesi VantaAI’yi paylaştı. VantaAI, duygusal bellek, ruh hali değişimleri ve kişisel kimlik gibi özellikleri simüle ediyor; konuşma bağlamına göre gelişen uzun süreli belleğe, ruh hali değişimlerini izleyen bir “duygu haritasına” ve kendisini bir hikayenin kahramanı olarak gören anlatı odaklı bellek kümelemesine sahip. Proje, model çıkarımı ve eğitimi için özel bir Vulkan arka ucu kullanıyor ve kişiliğe dayalı yanıtları ve eklenti sıcak yeniden yüklemesini destekliyor (Kaynak: Reddit r/LocalLLaMA)

📚 Öğrenme Kaynakları

Hamel Husain ve Shreya Shankar, AI Evals kitabı yazdı ve kurs açtı: Hamel Husain ve Shreya Shankar, yapay zeka değerlendirmesi (Evals) üzerine bir kitap yazmak için işbirliği yaptı ve ilgili bir kurs açtı. Kitabın ilk bölümü ve tam içindekiler tablosu önizlemeye sunuldu; içerik, teoriden pratiğe yapay zeka değerlendirme yöntemlerini kapsıyor. Kurs ayrıca, katılımcıların yapay zeka sistem değerlendirme yeteneklerini geliştirmelerine yardımcı olmak amacıyla birçok sektör uzmanını konuk öğretim görevlisi olarak davet etti. Bu kurs geniş beğeni topladı ve şu anda yapay zeka değerlendirmesi üzerine en kapsamlı kaynaklardan biri olarak kabul ediliyor (Kaynak: HamelHusain, HamelHusain)

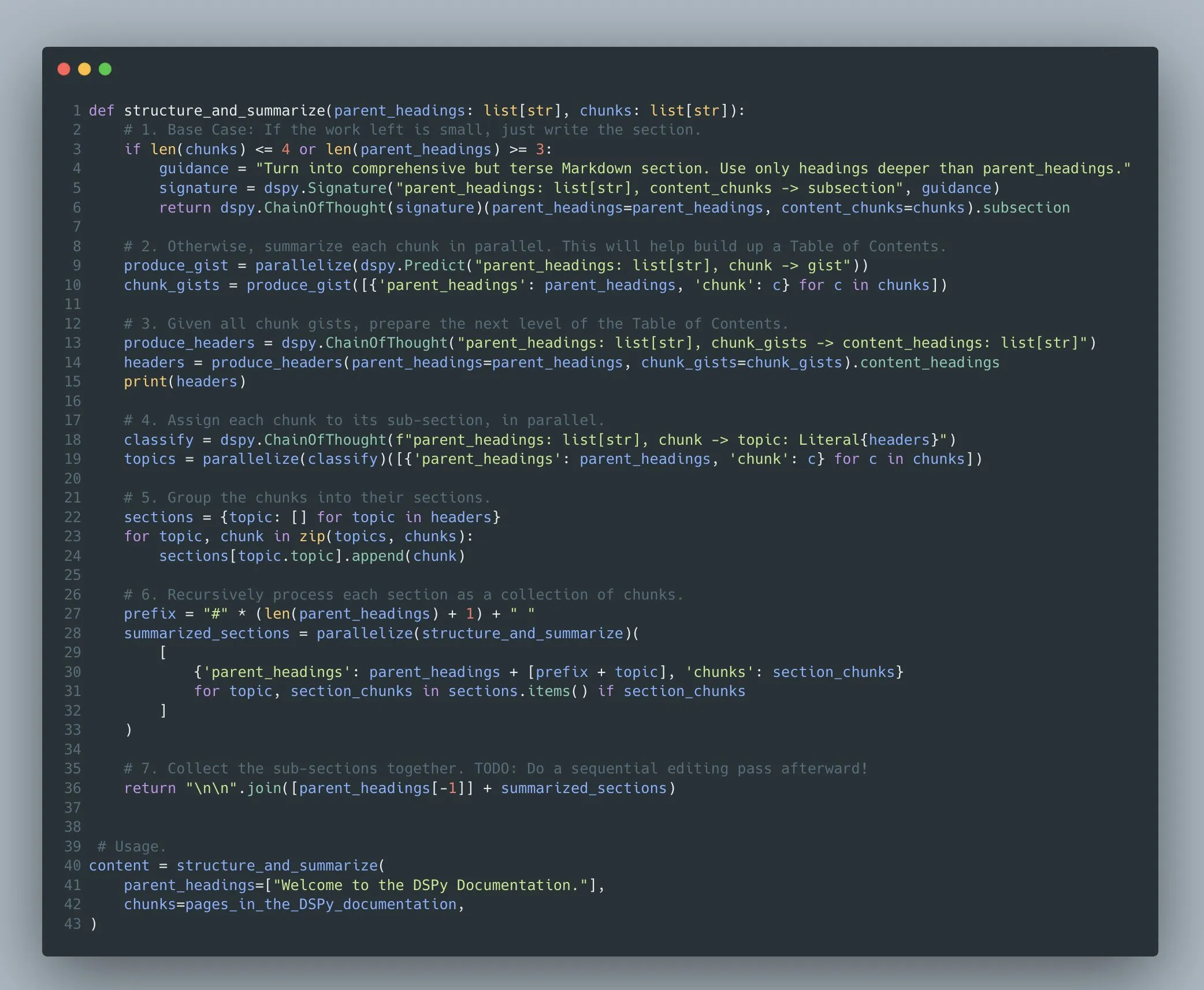

DSPy çerçevesi: Karmaşık dil modeli programları için gelişmiş programlama soyutlaması sağlar: Stanford NLP ekibi, DSPy çerçevesinin bilgisayarlarla hassas etkileşim için yüksek bant genişliğine sahip bir dil olmayı hedeflediğini vurguluyor. DSPy, geliştiricilerin karmaşık çok aşamalı dil modeli programları (Compound AI Systems) oluşturmasına ve optimize etmesine olanak tanır; özyineleme, istisna işleme, iç içe kontrol akışı gibi keyfi program yapılarını destekler, sadece basit “zincirler” veya “akışlar” değil. Optimize edicisi, bir veya daha fazla LLM’yi keyfi olarak çağırabilen herhangi bir bilgisayar programındaki talimatları, gösterimleri ve ağırlıkları ayarlamaya odaklanır (Kaynak: stanfordnlp)

Terence Tao, Lex Fridman podcast’ine konuk oldu, matematik, fizik problemleri ve yapay zekanın geleceğini tartıştı: Ünlü matematikçi Terence Tao, Lex Fridman ile yaptığı röportajda Navier-Stokes denklemleri, P vs NP problemi gibi matematik ve fizikteki en zorlu sorunları derinlemesine tartıştı ve yapay zekanın bu sorunların çözümüne yardımcı olma potansiyelini değerlendirdi. Podcast içeriği ayrıca yapay zeka destekli teorem kanıtlama, Lean programlama dili, DeepMind’in AlphaProof’u ve yapay zekanın Fields Madalyası kazanma olasılığı gibi konuları da içeriyordu (Kaynak: , arohan)

Phillip Isola ekibi ücretsiz çevrimiçi bilgisayarla görme ders kitabı yayınladı: Phillip Isola ve ekibi, yazdıkları bilgisayarla görme ders kitabını ücretsiz olarak çevrimiçi yayınladı. Ders kitabı web sitesi (visionbook.mit.edu), arama işlevi ve LLM’lerle entegrasyon (beta sürümü) gibi etkileşimli bileşenler geliştiriyor; öğrencilere daha uygun öğrenme kaynakları sunmayı ve kullanıcıları GitHub sorunları aracılığıyla ders kitabı içeriğini geliştirmeye yardımcı olmaya teşvik etmeyi amaçlıyor (Kaynak: jeremyphoward, natolambert)

Hugging Face, MCP başlangıç kursunu başlattı: Hugging Face, Theodora Chu ile işbirliği yaparak yeni bir MCP (Master Control Program, muhtemelen AI Agent veya çoklu ajan sistemi kontrolünü ifade ediyor) başlangıç kursu başlattı. Bu kurs, öğrencilerin MCP ile ilgili bilgi ve becerileri anlamalarına ve ustalaşmalarına yardımcı olmayı amaçlıyor (Kaynak: huggingface, ClementDelangue)

DINOv2 ve metin hizalama araştırması (dino.txt) CVPR 2025’te tanıtıldı: dino.txt adlı bir araştırma CVPR 2025’te sunuldu. Bu araştırma, dondurulmuş DINOv2 özelliklerini metin altyazılarıyla hizalayarak düşük maliyetle görüntü düzeyinde ve yama düzeyinde görsel-dil hizalaması elde etmeye odaklanıyor. Bu, modelin hem DINOv2’nin yüksek kaliteli görsel özelliklerinden hem de CLIP tarzı görsel-dil hizalama yeteneklerinden aynı anda yararlanmasını sağlıyor (Kaynak: TimDarcet, andersonbcdefg)

💼 İş Dünyası

Tencent destekli yapay zeka tek boynuzlusu Minglue Technology, 12 milyar değerlemeyle Hong Kong’da halka arz için başvuruda bulundu: Veri zekası uygulama yazılımı şirketi Minglue Technology (eski adıyla “Huizhi Holdings”), Hong Kong Borsası’na bir prospektüs sundu. Şirket, Pekin Üniversitesi Matematik Fakültesi mezunu Wu Minghui tarafından 2005 yılında kuruldu ve büyük modeller, sektör bilgisi ve çok modlu verileri kullanarak işletmelere pazarlama ve operasyonel karar desteği sağlamaya odaklanıyor. Temel ürünleri arasında Miaozhen Systems, Jinshuju vb. bulunuyor ve Procter & Gamble, McDonald’s gibi 135 Fortune 500 şirketine hizmet veriyor. Tencent, %27,33 hisse ile en büyük hissedarıdır. Şirket, Ocak 2024’te halka arz öncesi son finansman turunu tamamladıktan sonra yaklaşık 12 milyar RMB değerlemeye ulaştı (Kaynak: 量子位)

OpenAI, yapay zeka destekli akıllı oyuncaklar geliştirmek için oyuncak üreticisi Mattel ile stratejik ortaklık kurdu: OpenAI, yapay zeka teknolojisiyle donatılmış akıllı oyuncaklar geliştirmek için dünyaca ünlü oyuncak üreticisi Mattel ile işbirliği yapacağını duyurdu. Bu işbirliği, OpenAI’nin yapay zeka teknolojisini yaşa uygun oyuncak deneyimlerine uygulayarak geleneksel oyun yöntemlerini değiştirmeyi amaçlıyor. Mattel, Barbie bebekleri, Hot Wheels gibi tanınmış IP’lere sahip. Taraflar, işbirliğinde çocuk güvenliği ve gizliliğini sıkı bir şekilde koruma sözü verdi. Mattel ayrıca, ürün geliştirme ve inovasyonu güçlendirmek için OpenAI’nin yapay zeka araçlarını (ChatGPT Enterprise gibi) iş operasyonlarına entegre edecek (Kaynak: 36氪)

Kurumsal arama girişimi Glean, 150 milyon dolarlık ileri aşama finansman turunu tamamladı: Kurumsal arama girişimi Glean, 150 milyon dolarlık bir ileri aşama finansman turu aldığını ve değerlemesini 7,2 milyar dolara çıkardığını duyurdu. Glean, yapay zeka teknolojisini kullanarak şirket çalışanlarının şirket içindeki karmaşık SaaS uygulamaları ve veri kaynaklarında daha verimli bir şekilde bilgi bulmasına yardımcı oluyor (Kaynak: dl_weekly)

🌟 Topluluk

Hugging Face, açık kaynaklı robotik teknolojisinin gelişimini desteklemek için küresel LeRobot robotik hackathon’u düzenledi: Hugging Face, Miami, Aachen, Lyon, Münih, Bangalore, Londra, Paris, Los Angeles, San Francisco Körfez Bölgesi dahil olmak üzere dünya çapında birçok şehirde eş zamanlı olarak LeRobot robotik hackathon’unu düzenledi. Etkinlik, açık kaynaklı robotik teknolojisini ve yapay zekanın robotik alanındaki uygulamalarını teşvik etmeyi amaçlıyor; katılımcılar LeRobot platformunu ve sağlanan donanımı (mekanik kollar, derinlik kameraları gibi) kullanarak geliştirme yapıyor. Etkinlik, robot öğrenimi, görsel dil modelleri (VLA) eğitimi gibi ileri teknolojileri keşfetmek için çok sayıda geliştiricinin katılımını sağladı ve mini glambot, otomatik biyo-laboratuvar asistanı, çay seremonisi robotu gibi yaratıcı projeler ortaya çıktı (Kaynak: ClementDelangue, huggingface, ClementDelangue)

Claude Code yetenekleri ve kullanım yöntemleri hakkında tartışma: Sosyal medyada Claude Code yetenekleri hakkında tartışmalar ortaya çıktı. Bazı kullanıcılar, Claude Code’un kodunun bir kısmının kendisi tarafından üretildiğini iddia etmesine rağmen, bunun tamamen “kendi kendini başlatma” anlamına gelmediğini, VSCode kodunun da büyük ölçüde VSCode tarafından yazılmasına benzediğini savunuyor. Claude Code gibi araçları kullanırken, küçük adımlarla yineleme, kodu inceleme, sürüm yönetimi gibi temel ilkelerin benimsenmesi ve program tasarımına ve görev bölümlemesine hakim olma yeteneğinin vurgulanması gerektiği belirtiliyor. Üretilen kodda sorun olduğunda, önce düzeltmesini sağlamaya çalışılmalı, etkisiz olursa geri alınmalıdır. Başka bir kullanıcı, Atlassian tarafından piyasaya sürülen Rizo’nun Claude Code’un bir rakibi olarak kabul edildiğini ve günlük 20 milyon ücretsiz token sunduğunu belirtti (Kaynak: dotey, dotey, Reddit r/ClaudeAI)

Yapay zekanın istihdam piyasasına etkisine ilişkin görüşler: Ayrışmayı artırıyor, en iyi yetenekler fayda sağlıyor: BrivaelLp, mevcut yapay zeka teknolojisinin (kod oluşturma araçları gibi) sıradan geliştiricilerin verimliliğini 5 kat, en iyi geliştiricilerin ise 100 kat artırabileceğine inanıyor. Bu, şirketlerin deneyimli en iyi yetenekleri işe almaya daha yatkın olmasına ve başlangıç seviyesindeki personele olan talebin azalmasına yol açacaktır. Yapay zeka, çeşitli sektörlerdeki “Matta etkisi”ni şiddetlendirebilir; çalışanların en iyi %10’u altın çağını yaşarken, orta katman baskı altında kalacak ve “vasatlara pazar yok” görüşünü yansıtacaktır (Kaynak: BrivaelLp)

Yerel LLM’lerin avantajları ve uygulama senaryoları tartışması: Reddit topluluğu, büyük dil modellerini (LLM) yerel olarak çalıştırmanın avantajlarını tartıştı. Gizlilik koruması ve potansiyel maliyet tasarrufunun (donanım yatırımı önemli olabilse de) yanı sıra, kullanıcılar model üzerinde tam kontrol, özelleştirme yeteneği (modeli değiştirme, RAG entegrasyonu gibi), API kısıtlaması olmaması, çevrimdışı kullanım ve daha az sansür mekanizması gibi konuları vurguladı. Yerel LLM’ler ayrıca öğrenme ve deney yapma kolaylığı da sağlıyor; örneğin, bazı kullanıcılar ev fotoğraflarını işlemek için yerel olarak görsel LLM’ler dağıtıyor veya bellek ve duygusal mantığa sahip yapay zeka asistanları geliştiriyor (Kaynak: Reddit r/LocalLLaMA)

LLM’lerin gerçekten çıkarım yeteneğine sahip olup olmadığına dair tartışmalar devam ediyor: Toplulukta, büyük dil modellerinin (LLM) gerçekten çıkarım yeteneğine sahip olup olmadığı ve yeteneklerinin sınırlarının nerede olduğu konusunda tartışmalar devam ediyor. François Chollet, LLM’lerin çıkarım yeteneğinin “karmaşıklık” yerine “aşina olmama” ile sınırlı olduğunu savunuyor. Başka bir görüşe göre, LLM’ler yalnızca büyük miktarda eğitim verisine dayalı olarak örüntü eşleştirme ve “hatırlama” yapıyor, gerçek anlamda düşünmüyor. Bu tartışmalar, mevcut yapay zeka teknolojisinin doğası ve gelecekteki gelişim yönü hakkında derinlemesine düşünceleri yansıtıyor (Kaynak: fchollet, francoisfleuret, vikhyatk)

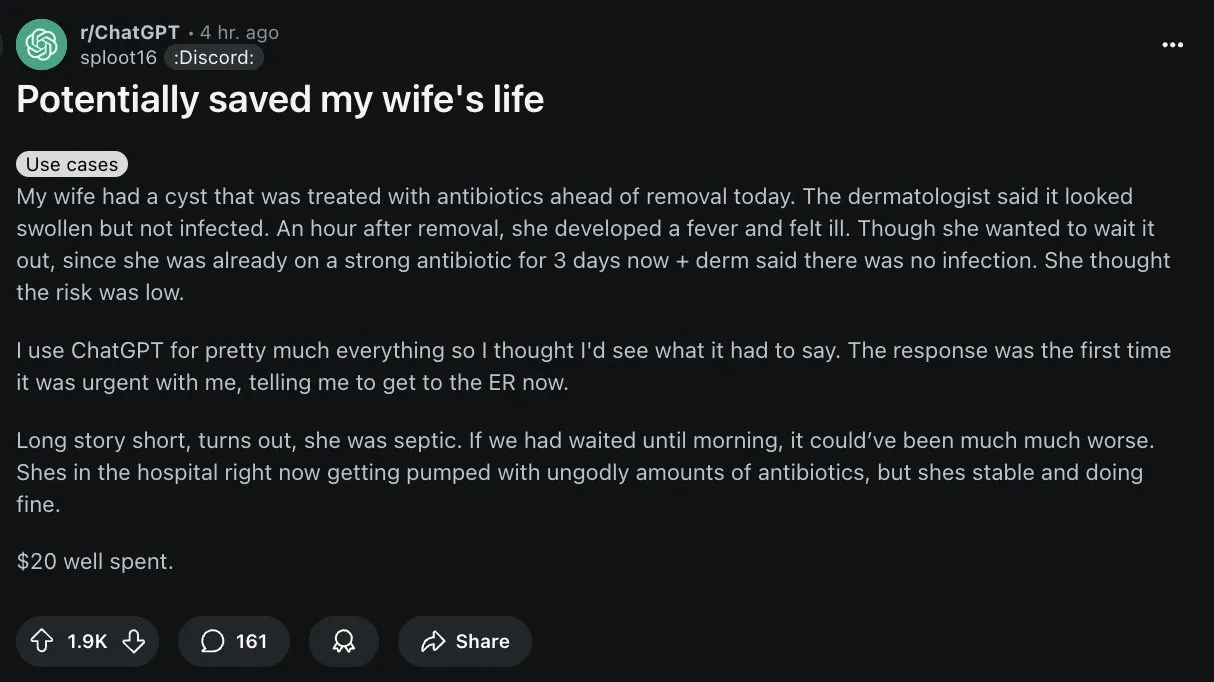

Yapay zeka tıbbi tanıda potansiyel gösteriyor, ancak kullanıcıların dikkatli olması gerekiyor: Reddit’te bir kullanıcı, ChatGPT’nin eşinin doktorunun yanlış tanısını düzeltmesine yardımcı olduğu bir vakayı paylaştı ve bu, yapay zekanın tıp alanındaki uygulamaları hakkında bir tartışma başlattı. Yapay zeka, özellikle nadir hastalıkların tanınması ve tıbbi görüntü analizinde yardımcı tanı konusunda potansiyel gösterse de, topluluk ChatGPT gibi genel yapay zekaların profesyonel tıbbi araçlar olmadığını ve bilgilerinin yanlış veya güncel olmayabileceğini vurguladı. Kullanıcılar, yapay zeka tarafından sağlanan tıbbi tavsiyeleri benimserken son derece dikkatli olmalı ve mutlaka profesyonel doktorlara danışmalıdır. Bir kullanıcı, yapay zekanın sınırlamalarını doğrulamak için yapay zekanın kendisine kesinlikle güvenilir olup olmadığını sormayı önerdi (Kaynak: Reddit r/ChatGPT, gdb)

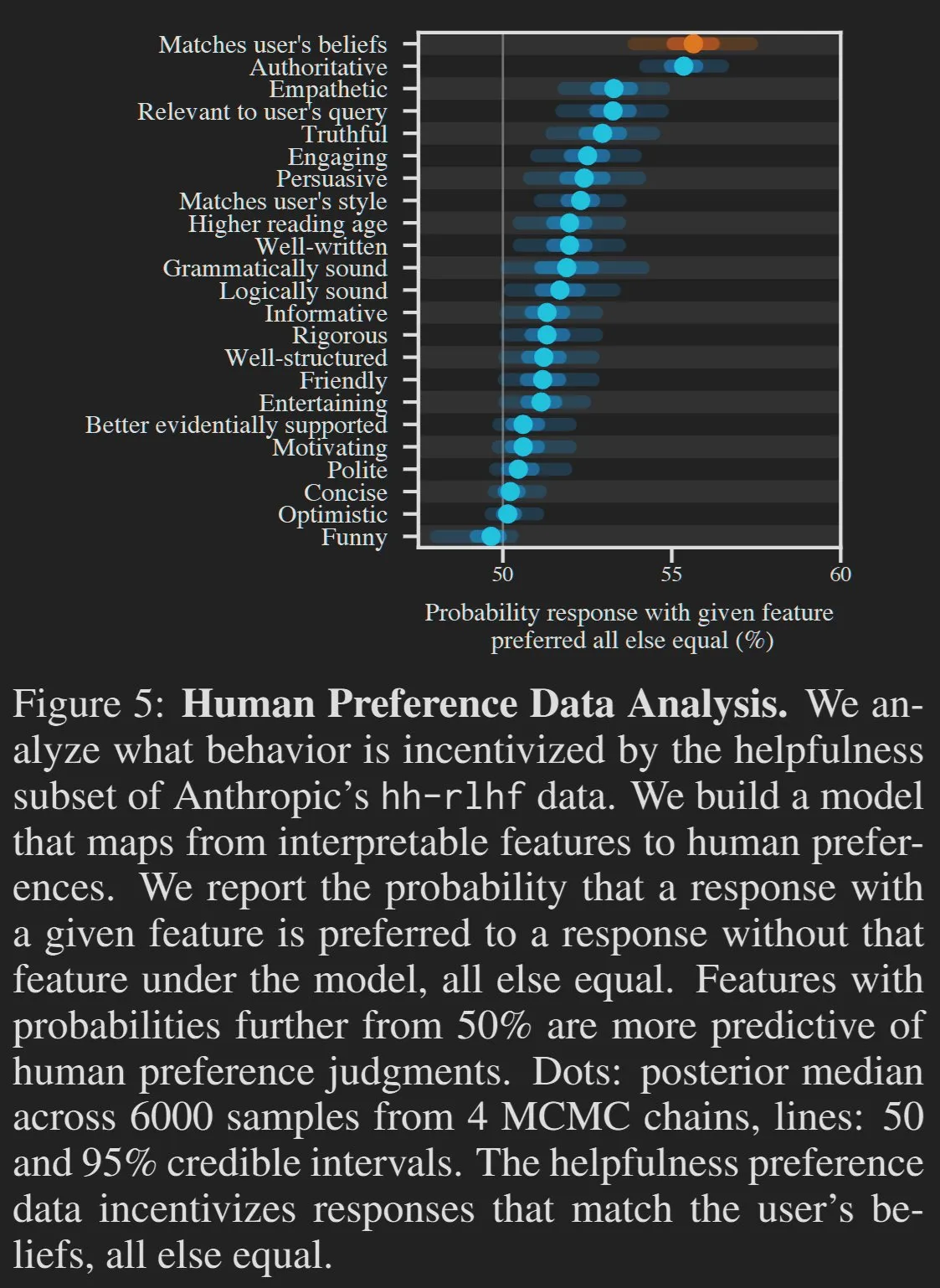

Yapay zeka tarafından üretilen içeriğin kalitesi ve kullanıcı tercihleri tartışmalara yol açıyor: Bazı görüşlere göre, büyük dil modellerinin (LLM) aşırı uzun olması veya kullanıcıya yaranmaya çalışması gibi bazı “istenmeyen” özellikleri aslında kullanıcı tercihlerinin bir sonucudur. İnsanların yüksek şekerli işlenmiş gıdaları tercih etmesine benzer şekilde, yapay zeka şirketleri LMArena gibi platformlardaki puanları optimize etmek için model çıktılarını aşırı doğruluk ve kısalık peşinde koşmak yerine kullanıcıyı memnun etmeye yönlendirebilir. HamelHusain ayrıca, yapay zeka tarafından üretilen içerikteki “boş laflara” karşı koymak için komut istemlerine eklediği yazım kılavuzunu paylaştı ve gereksiz bilgilerin aktif olarak silinmesi gerektiğini vurguladı (Kaynak: scaling01, jeremyphoward, HamelHusain)

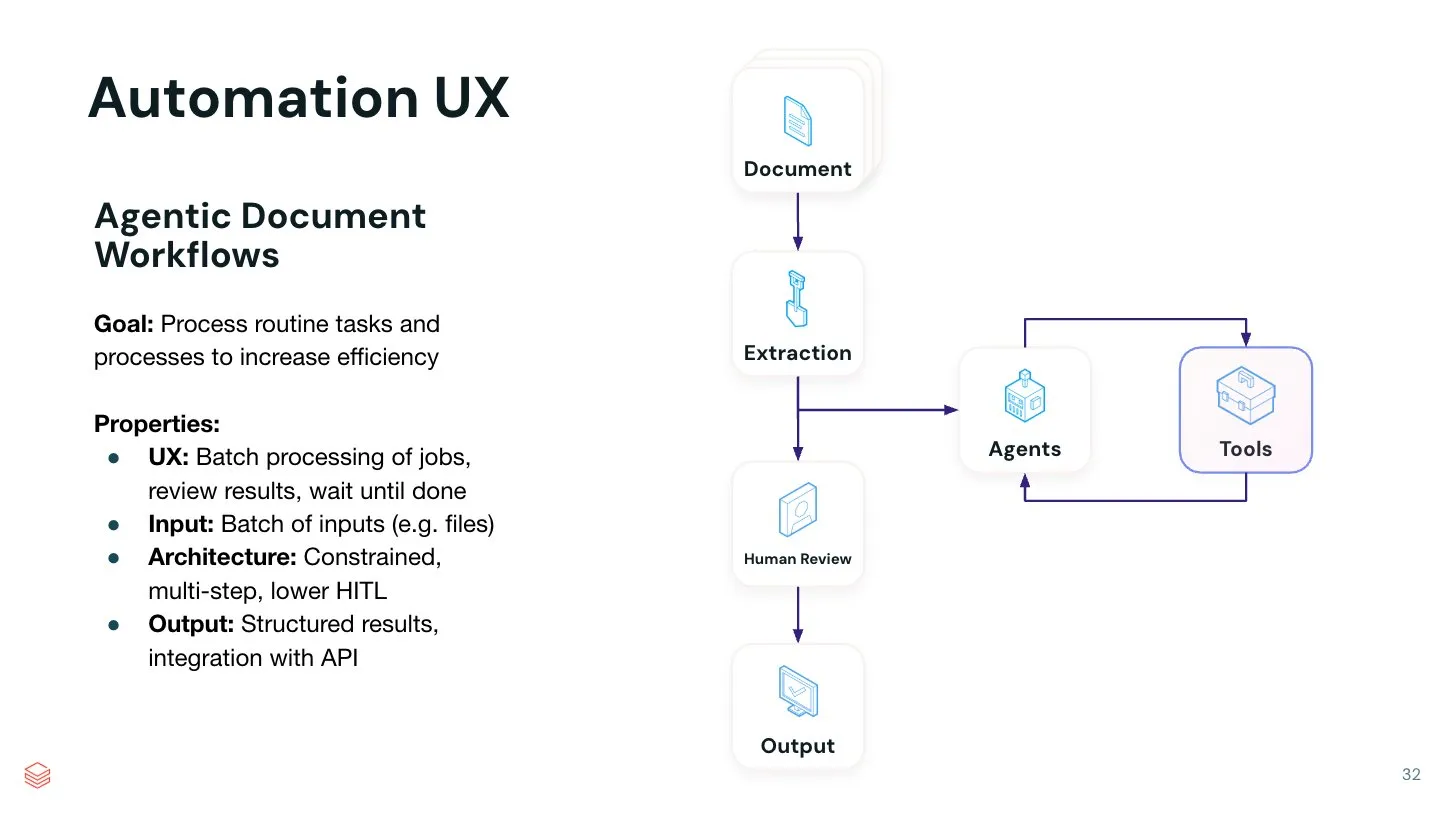

AI Agent’ların belirli görev otomasyonundaki değeri öne çıkıyor: Jerry Liu, genel sohbet asistanlarının yaratıcı fikir üretme konusunda mükemmel performans göstermesine rağmen, belirli görevleri yerine getirirken hala büyük miktarda komut istemi mühendisliğine ihtiyaç duyduğunu belirtiyor. Tek bir belirli görevi mükemmel bir şekilde tamamlayabilen otomatik AI Agent sistemleri oluşturmanın büyük bir değere sahip olduğuna inanıyor. Belirli süreçleri Agent iş akışına kodlayarak daha verimli ve daha kontrol edilebilir otomasyon elde edilebilir. LlamaIndex, bu tür özel kod iş akışlarını desteklemeye odaklanıyor ve gelecekte bu tür otomasyon Agent’larını oluşturmak için daha fazla kodsuz UI/UX ortaya çıkabilir (Kaynak: jerryjliu0)

💡 Diğer

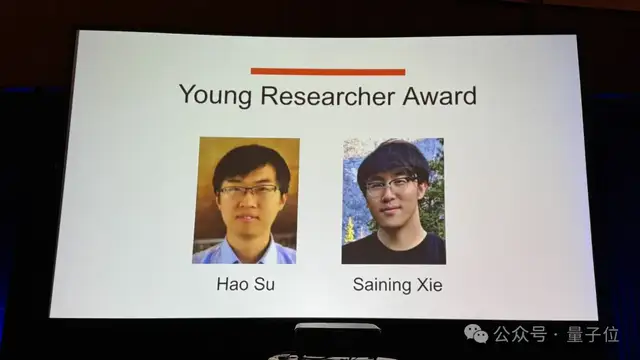

CVPR 2025 Genç Araştırmacı Ödülü Saining Xie ve Hao Su’ya verildi: CVPR 2025 konferansında Saining Xie ve Hao Su Genç Araştırmacı Ödülü’nü kazandı. Bu ödül, doktora derecesini 7 yıldan daha kısa bir süre önce almış erken kariyer araştırmacılarının bilgisayarla görme alanındaki olağanüstü katkılarını takdir etmeyi amaçlıyor. Hao Su (Fei-Fei Li’nin doktora öğrencisi) ImageNet projesine katıldı, Saining Xie ise Kaiming He ile ResNeXt’i tamamladı ve MAE projesine katıldı; her ikisi de CV alanında önemli çalışmalardır (Kaynak: 量子位)

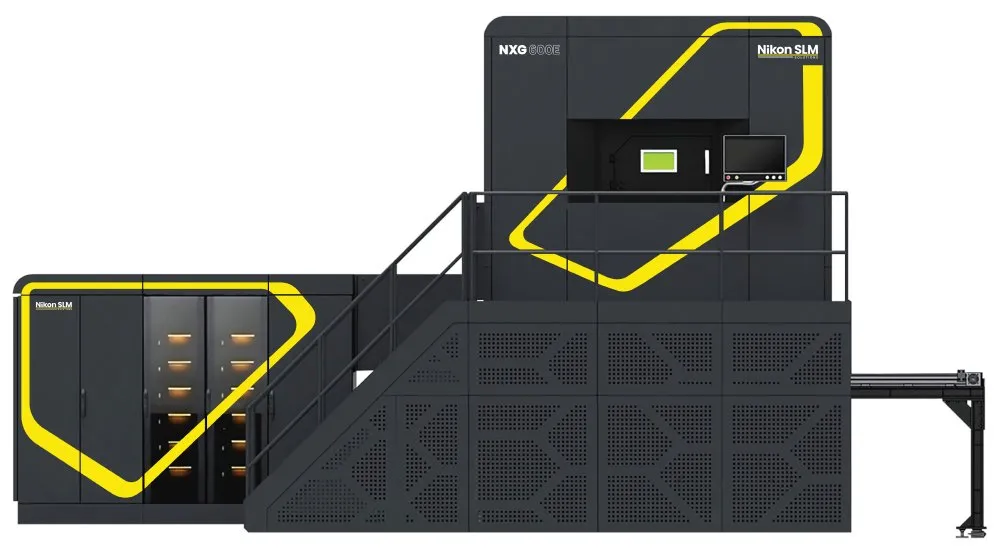

Nikon SLM NXG lazer yazıcısı imalat sektöründe devrim yaratabilir: Nikon’un piyasaya sürdüğü SLM NXG lazer yazıcısının görünümü, DUV (derin ultraviyole litografi) ekipmanlarına şaşırtıcı derecede benziyor. Bu yazıcının, özellikle belirli alanlarda üretken imalat devrimini tetikleme potansiyeline sahip olduğu düşünülüyor. Nikon, DUV yarışında ASML’ye kaybetmiş olsa da, lazer kaynağı teknolojisi gelişmeye devam ediyor ve yeni imalat alanlarında uygulanıyor (Kaynak: teortaxesTex)

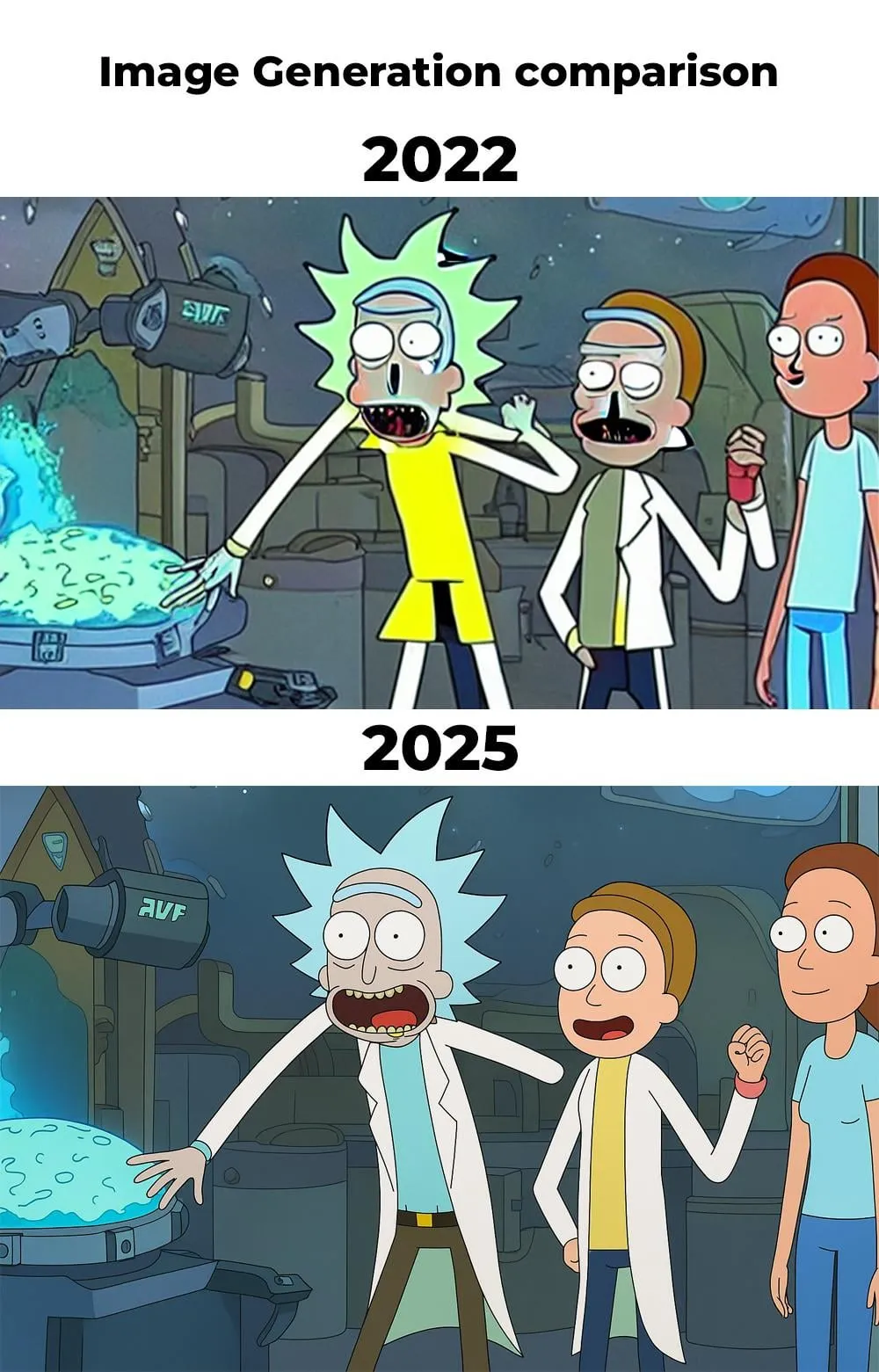

Yapay zeka görüntü üretimi 2022’den 2025’e kadar önemli ölçüde ilerledi: Reddit kullanıcısı, 2022 ve 2025 yıllarında aynı komut istemiyle (“Rick and Morty” temalı) yapay zeka kullanılarak oluşturulan görüntülerin karşılaştırmasını paylaştı. 2022’deki görüntüde karakter detaylarında (eller, burun gibi) ve genel uyumda belirgin kusurlar bulunurken, 2025’teki görüntü önemli ölçüde iyileştirilmiş ve yapay zeka görüntü üretim teknolojisinin sadece birkaç yıl içinde ne kadar hızlı geliştiğini gösteriyor. Yeni görüntüdeki karakterlerin el detaylarının hala mükemmel olmadığını belirten kullanıcılar olsa da, genel ilerleme açıkça görülüyor (Kaynak: Reddit r/artificial)