Anahtar Kelimeler:OpenAI, Meta, Mistral AI, IBM, o3-pro, Süper Zeka Laboratuvarı, Magistral, Kuantum Bilgisayar, o3-pro fiyatlandırması, Scale AI yatırımı, Magistral-Small-2506, Starling kuantum bilgisayarı, Askeri AI uygulama testleri

🔥 Odak Noktası

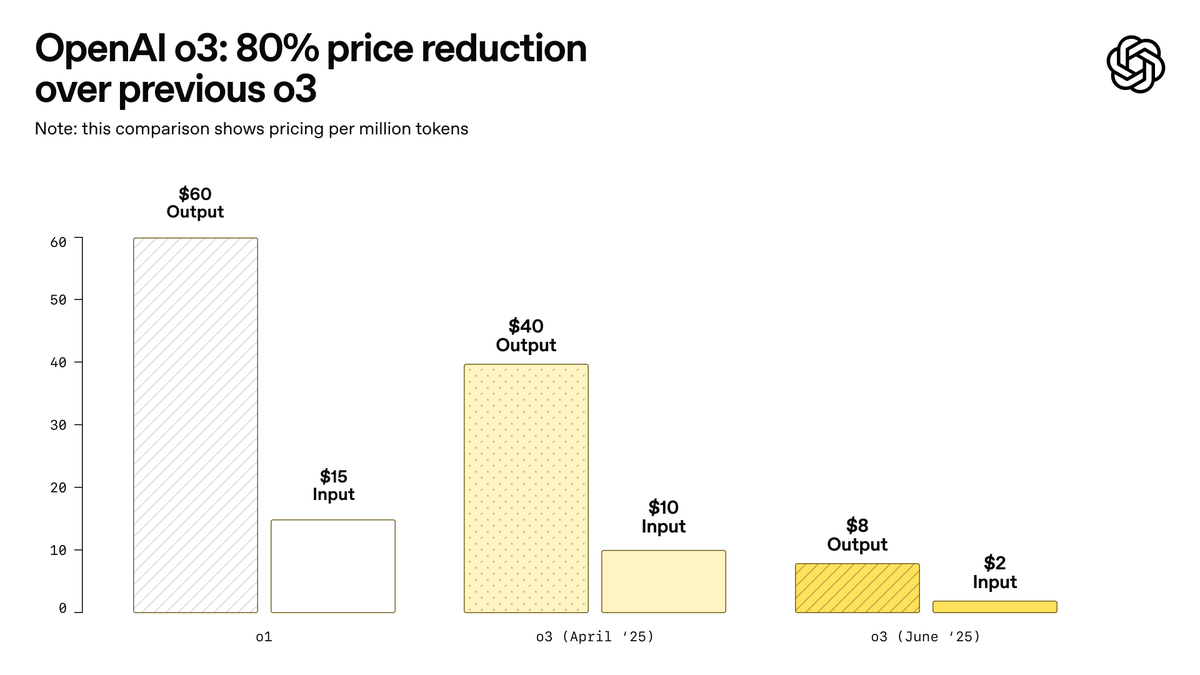

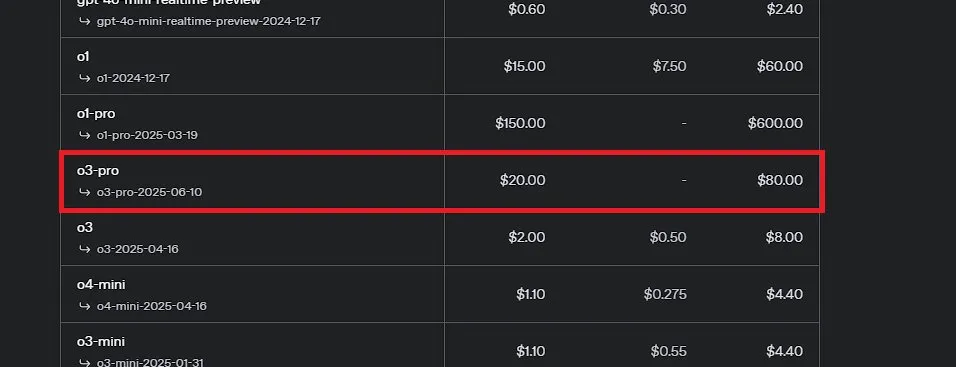

OpenAI, şimdiye kadarki en güçlü model olduğunu iddia ettiği o3-pro’yu duyurdu ve o3 fiyatlandırmasını önemli ölçüde düşürdü: OpenAI, bugüne kadarki en güçlü çıkarım modeli olan o3-pro’yu resmen tanıttı ve ChatGPT Pro ile Team kullanıcılarına sundu; API de eş zamanlı olarak kullanıma sunuldu. o3-pro, bilim, eğitim, programlama, ticaret ve yazma yardımı gibi alanlarda önceki nesillerden daha iyi performans gösteriyor ve web araması, dosya analizi, görsel girdi ve Python programlama gibi çeşitli araçları destekliyor. Fiyatlandırması, giriş için milyon token başına 20 dolar, çıkış için 80 dolar. Aynı zamanda, orijinal o3 modelinin fiyatı %80 oranında önemli ölçüde düşürüldü; ayarlamadan sonra giriş için milyon token başına 2 dolar, çıkış için 8 dolar olarak GPT-4o ile aynı seviyeye geldi. Bu hamlenin yapay zeka model fiyat savaşlarını tetikleyebileceği ve yapay zekanın profesyonel alanlarda derinlemesine uygulanmasını teşvik edebileceği düşünülüyor, ancak o3-pro’nun uzun yanıt süreleri ve geçici sohbetleri henüz desteklememesi gibi sınırlamaları da bulunuyor. (Kaynak: OpenAI, sama, OpenAIDevs, scaling01, dotey)

Meta, “Süper Zeka Laboratuvarı” kurdu ve Scale AI’a dev yatırım yaparak YZ rekabet gücünü yeniden canlandırmayı hedefliyor: New York Times ve diğer birçok kaynağa göre, Meta Platforms YZ departmanını yeniden yapılandırarak yeni bir “Süper Zeka Laboratuvarı” kuruyor ve veri etiketleme şirketi Scale AI’ın %49 hissesini satın almak için 140 milyar doların üzerinde yatırım yapmayı planlıyor. Scale AI’ın kurucu ortağı ve CEO’su Alexandr Wang, Meta’ya katılacak ve bu yeni laboratuvarı yönetecek. Bu hamle, genel yapay zeka (AGI) araştırmalarını hızlandırmayı, Meta’nın YZ alanındaki genel rekabet gücünü, özellikle yüksek kaliteli veri işleme ve üst düzey yeteneklerin işe alımı konularında artırmayı amaçlıyor. Bu, Meta’nın YZ stratejisinde önemli bir ayarlamayı işaret ediyor ve sektördeki rekabet dengelerini derinden etkileyebilir. (Kaynak: natolambert, kylebrussell, Yuchenj_UW, steph_palazzolo)

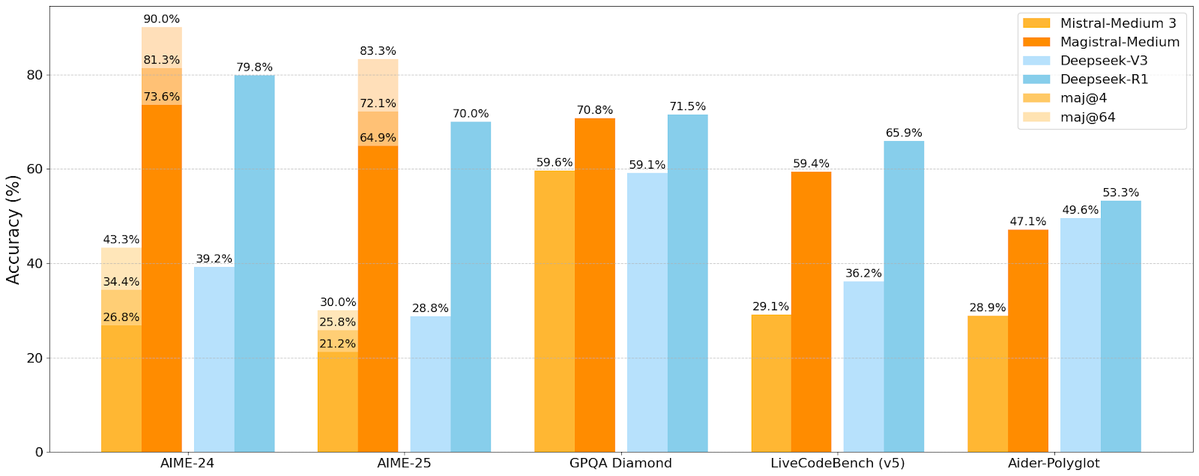

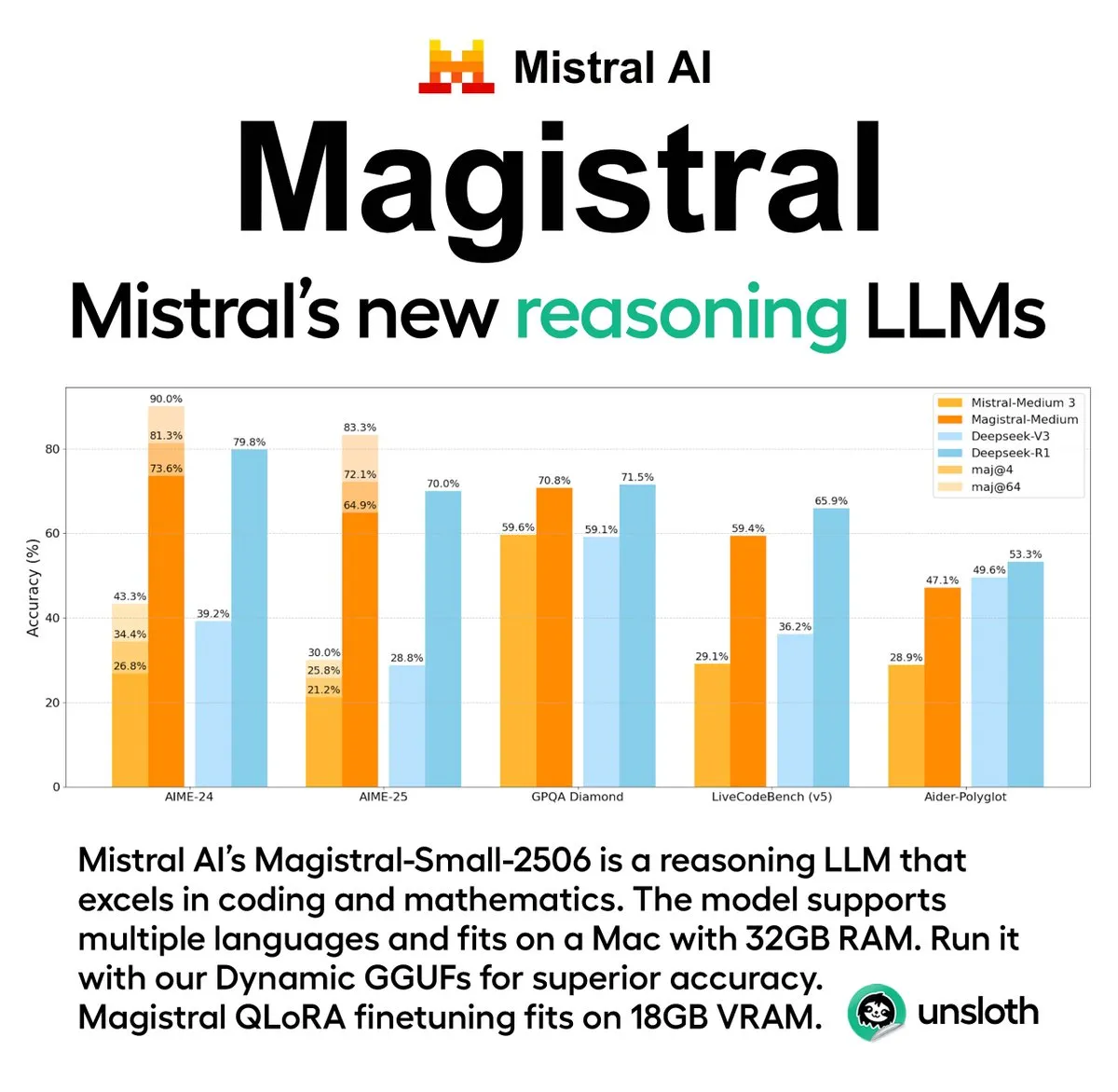

Mistral AI, açık kaynaklı bir sürüm içeren ilk çıkarım modeli serisi Magistral’ı yayınladı: Fransız YZ girişimi Mistral AI, çıkarım için özel olarak tasarlanmış ilk model serisi Magistral’ı piyasaya sürdü. Seri, daha güçlü bir kurumsal düzeyde kapalı kaynaklı model olan Magistral Medium’u ve Apache 2.0 lisansı altında yayınlanan 24 milyar parametreli açık kaynaklı bir model olan Magistral Small’u (Magistral-Small-2506) içeriyor. Bu modeller matematik, kodlama ve çok dilli çıkarım konularında üstün performans gösteriyor ve daha şeffaf ve alana özgü çıkarım yetenekleri sunmayı amaçlıyor. Magistral Medium’un Le Chat platformundaki çıkarım hızının rakiplerinden 10 kat daha hızlı olduğu iddia edilirken, Magistral Small topluluğa güçlü yerel çalıştırma seçenekleri sunuyor. (Kaynak: Mistral AI, jxmnop, karminski3)

IBM, 2028’de büyük ölçekli hataya dayanıklı kuantum bilgisayarı Starling’i kurmayı planlıyor: IBM, kuantum hesaplama geliştirme yol haritasını açıkladı ve 2028’de Starling adlı büyük ölçekli hataya dayanıklı bir kuantum bilgisayar kurmayı ve 2029’da bulut hizmetleri aracılığıyla kullanıcılara açmayı planlıyor. Starling sisteminin yaklaşık 100 modül ve 200 mantıksal kübit içermesi bekleniyor ve temel hedef, mevcut kuantum hesaplama alanındaki en büyük teknik zorluklardan biri olan etkili hata düzeltmeyi gerçekleştirmek. Bu makine, hata düzeltme için IBM’in düşük yoğunluklu eşlik denetimi kodunu (LDPC) kullanacak ve gerçek zamanlı hata teşhisini sağlamayı hedefleyecek. Başarılı olursa, bu kuantum hesaplama alanında büyük bir atılım olacak ve malzeme bilimi, ilaç geliştirme gibi karmaşık sorunlardaki uygulamalarını hızlandırabilir. (Kaynak: MIT Technology Review)

🎯 Gelişmeler

Apple WWDC 2025 YZ ile ilgili gelişmeler geliştiricileri etkileyemedi: Apple, WWDC 2025’te yepyeni “sıvı cam” tasarım dili ve Xcode 26’nın ChatGPT entegrasyonu dahil olmak üzere birçok güncelleme yayınladı. Ancak geliştirici topluluğu, yapay zeka alanındaki ilerlemelerinin genel olarak “beklentilerin altında” kaldığını belirtti. Apple, cihaz üzerinde çalışan YZ modelini ilk kez geliştiricilere açmış ve YZ işlevlerinin entegrasyonunu basitleştirmek için Foundation Models çerçevesini sunmuş olsa da, merakla beklenen yeni Siri güncellemesinin gelecek yıla ertelenebileceği belirtiliyor. Analist Ming-Chi Kuo, Apple’ın YZ stratejisinin merkezde yer aldığını ancak teknolojik olarak büyük bir atılım görülmediğini ve pazar beklenti yönetiminin kilit önem taşıdığını belirtti. Apple, YZ modelinin kendisinde yıkıcı bir yenilik yapmaktan ziyade kullanıcı arayüzünü ve işletim sistemi işlevlerini iyileştirmeye daha fazla odaklanıyor gibi görünüyor. (Kaynak: MIT Technology Review, jonst0kes, rowancheung)

Pentagon, YZ silah sistemleri test ve değerlendirme ofisinin ölçeğini küçülttü: ABD Savunma Bakanı Pete Hegseth, Savunma Bakanlığı Operasyonel Test ve Değerlendirme Direktörlüğü (DOT&E) ofisinin ölçeğinin yarı yarıya azaltılarak personel sayısının 94’ten yaklaşık 45’e düşürüleceğini duyurdu. Bu ofis, silahların ve YZ sistemlerinin güvenliğini ve etkinliğini test etmek ve değerlendirmekten sorumluydu. Bu ayarlamanın amacı “bürokratik şişkinliği ve israf harcamalarını azaltmak, öldürücülüğü artırmak”. Bu hamle, özellikle Pentagon’un YZ teknolojilerini (büyük dil modelleri dahil) çeşitli askeri sistemlere aktif olarak entegre ettiği bir ortamda, YZ’nin askeri uygulamalarının güvenliği ve etkinliği testlerinin olası etkileri konusunda endişelere yol açtı. (Kaynak: MIT Technology Review)

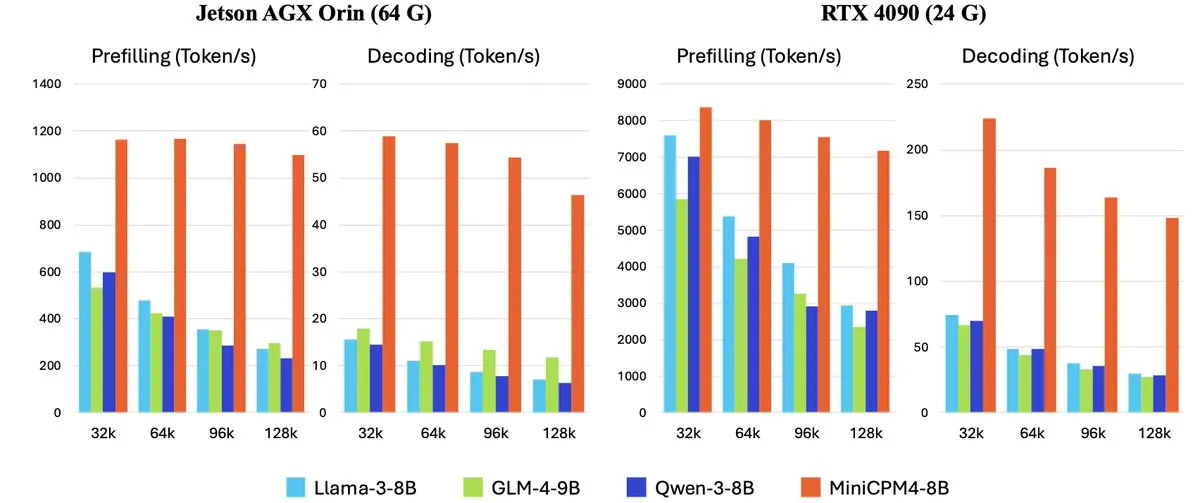

OpenBMB, MiniCPM-4 serisi uç cihazlar için verimli büyük dil modellerini yayınladı: OpenBMB (ModelBest), uç cihazlar için özel olarak tasarlanmış ve ultra yüksek verimlilikle çalışmayı amaçlayan MiniCPM-4 serisi modelleri piyasaya sürdü. Bu seri, MiniCPM4-0.5B, MiniCPM4-8B (amiral gemisi modeli), BitCPM4 (1-bit nicemlenmiş model), rapor oluşturma için özel MiniCPM4-Survey ve MCP özel modeli MiniCPM4-MCP’yi içeriyor. Teknik rapor, verimli model mimarisini (InfLLM v2 eğitilebilir seyrek dikkat mekanizması gibi), verimli öğrenme algoritmalarını (Model Wind Tunnel 2.0 gibi) ve yüksek kaliteli eğitim verisi işleme yöntemlerini ayrıntılı olarak açıklıyor. Bu modeller artık Hugging Face üzerinden indirilebilir durumda. (Kaynak: _akhaliq, arankomatsuzaki, karminski3)

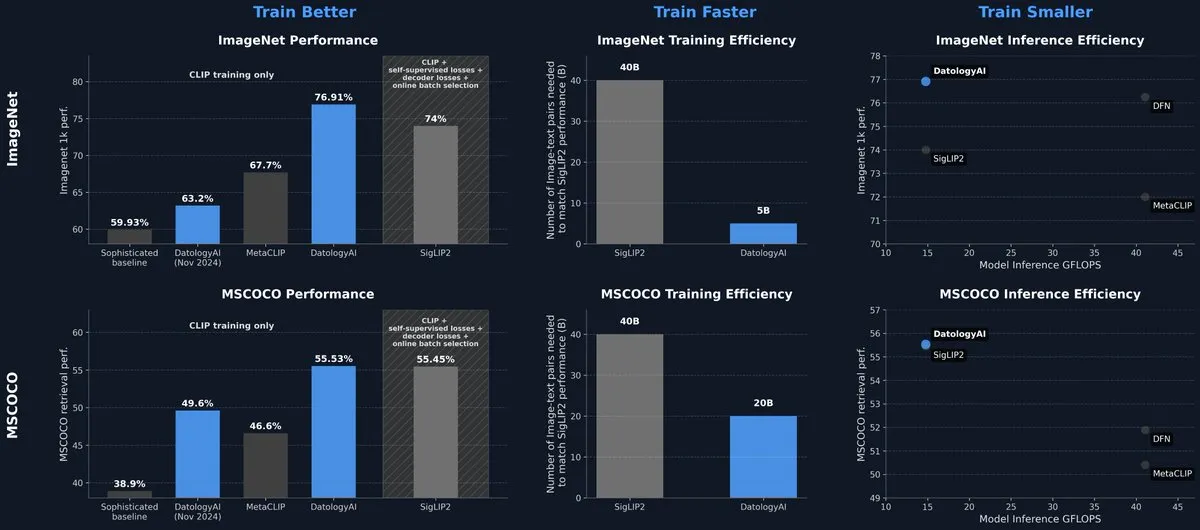

DatologyAI, yalnızca veri yönetimiyle SOTA seviyesine ulaşan CLIP modelini yayınladı: DatologyAI, çok modlu alandaki en son araştırma sonuçlarını sergiledi; algoritma veya mimari yeniliği yerine hassas veri yönetimi (data curation) yoluyla CLIP ViT-B/32 modelinin ImageNet 1k’da %76.9 doğruluk oranına ulaşmasını sağladı ve SigLIP2 tarafından bildirilen %74’ü aştı. Bu yöntem aynı zamanda 8 kat eğitim verimliliği artışı ve 2 kat çıkarım verimliliği artışı sağladı. Model, yüksek kaliteli verilerin model performansını artırmadaki büyük potansiyelini vurgulayarak halka açık olarak yayınlandı. (Kaynak: code_star, andersonbcdefg)

Krea AI, ilk kendi geliştirdiği görüntü modeli Krea 1’i yayınladı: Krea AI, estetik kontrol ve görüntü kalitesi açısından üstün performans gösteren, geniş bir sanatsal bilgi birikimine sahip olan ve stil referansı ile özel eğitimi destekleyen ilk görüntü modeli Krea 1’i piyasaya sürdü. Krea 1, görüntülerin gerçekçiliğini, ince dokularını ve zengin stil ifadelerini geliştirmeyi amaçlıyor. Şu anda Krea 1, ücretsiz Beta testi için açık olup kullanıcılar güçlü görüntü oluşturma yeteneklerini deneyimleyebilirler. (Kaynak: _akhaliq, op7418)

NVIDIA, özelleştirilebilir açık kaynaklı insansı robot modeli GR00T N1’i yayınladı: NVIDIA, özelleştirilebilir açık kaynaklı bir insansı robot modeli olan GR00T N1’i tanıttı. Bu hamle, insansı robot alanındaki araştırma ve geliştirmeyi teşvik etmeyi ve geliştiricilere çeşitli robot uygulamaları oluşturmak ve denemek için esnek bir platform sunmayı amaçlıyor. GR00T N1’in açık kaynaklı özelliğinin daha geniş bir topluluk katılımını çekmesi ve insansı robot teknolojisinin ilerlemesini hızlandırması bekleniyor. (Kaynak: Ronald_vanLoon)

RoboBrain 2.0, 7B ve 32B çok modlu robot modellerini yayınladı: RoboBrain 2.0, robotların algılama, düşünme ve görev yürütme yeteneklerini geliştirmeyi amaçlayan 7B ve 32B parametreli çok modlu robot modellerini yayınladı. Yeni modeller, etkileşimli çıkarım, uzun süreli planlama, kapalı döngü geri bildirim, hassas uzamsal algılama (nokta ve sınırlayıcı kutu tahmini), zamansal algılama (gelecekteki yörünge tahmini) ve gerçek zamanlı yapılandırılmış bellek oluşturma ve güncelleme yoluyla sahne çıkarımını destekliyor. Bu yeteneklerdeki artışın, robotların karmaşık ortamlardaki otonom operasyon ve karar verme düzeylerini ilerletmesi bekleniyor. (Kaynak: Reddit r/LocalLLaMA)

Kling AI, CVPR 2025’te video oluşturma modeliyle ilgili en son araştırmalarını paylaşacak: Kling AI video oluşturma modeli sorumlusu Pengfei Wan, bilgisayarla görme alanındaki en üst düzey konferans olan CVPR 2025’te “Kling’e Giriş ve Daha Güçlü Video Oluşturma Modelleri Üzerine Araştırmalarımız” başlıklı bir açılış konuşması yapacak. Google DeepMind gibi kurumlardan uzmanlarla birlikte video oluşturma teknolojisindeki en son atılımları ve öncü gelişmeleri tartışacak. Bu paylaşım, Kling’in video oluşturma teknolojisinin geliştirilmesindeki başarılarını derinlemesine tanıtacak. (Kaynak: Kling_ai)

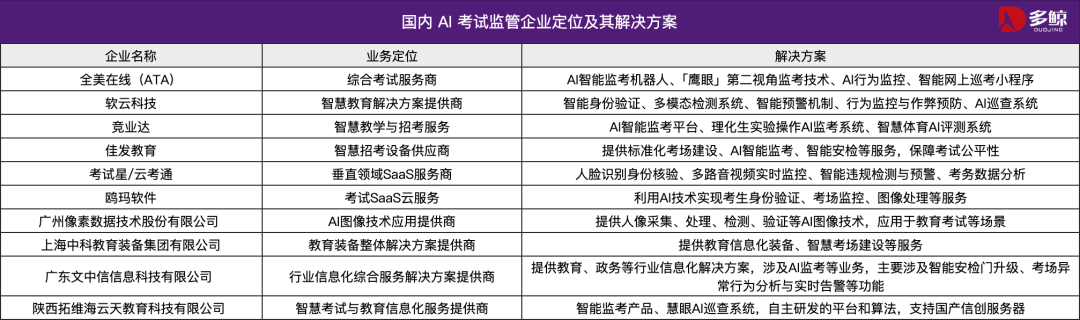

YZ teknolojisi 2025 Çin Ulusal Üniversite Giriş Sınavı’na (Gaokao) yardımcı oluyor, birçok yerde akıllı denetim sistemleri kullanılıyor: 2025 Çin Ulusal Üniversite Giriş Sınavı’nda (Gaokao) yaygın olarak YZ akıllı denetim sistemleri kullanılıyor; Tianjin, Jiangxi, Hubei, Guangdong Yangjiang gibi birçok yerdeki sınav merkezlerinde YZ gözetimi tam kapsamlı olarak uygulanıyor. Bu sistemler, 4K kameralar, iskelet takibi, yüz tanıma, ses izleme gibi teknolojileri kullanarak öğrencilerin erken cevaplama, eşya alışverişi, fısıldaşma, anormal bakış sapması gibi kural dışı davranışlarını gerçek zamanlı olarak tespit ediyor ve uyarı verebiliyor. Bu hamle, sınav adaletini artırmayı ve sınav disiplinini sağlamayı amaçlıyor. YZ gözetim sistemlerinin uygulanması, sınav yönetiminin akıllı bir çağa girdiğini gösteriyor ve geleneksel gözetim yöntemlerinde bir devrim yaratıyor. (Kaynak: 36氪)

Gemma 3n masaüstü modeli yayınlandı, platformlar arası ve IoT cihazlarını destekliyor: Google, masaüstü (Mac/Windows/Linux) ve Nesnelerin İnterneti (IoT) cihazları için optimize edilmiş, 2 milyar ve 4 milyar parametreli sürümleri içeren Gemma 3n masaüstü modelini yayınladı. Bu model, verimli yerel çalıştırma yeteneği sağlamak üzere yeni LiteRT-LM kütüphanesi tarafından desteklenmektedir. Geliştiriciler, Hugging Face üzerinden önizleme yapabilir ve GitHub’dan ilgili kaynaklara erişebilir, böylece hafif YZ modellerinin uç cihazlarda uygulanmasını daha da teşvik edebilirler. (Kaynak: ClementDelangue, demishassabis)

🧰 Araçlar

Yutori AI, Scouts’u tanıttı: Gerçek zamanlı ağ izleme YZ ajanı: Eski Meta AI araştırmacıları tarafından kurulan Yutori AI, Scouts adlı bir YZ ajanı ürününü piyasaya sürdü. Scouts, kullanıcı tarafından belirlenen konulara veya anahtar kelimelere göre internet bilgilerini gerçek zamanlı olarak izleyebiliyor ve ilgili içerik göründüğünde kullanıcıyı bilgilendiriyor. Bu araç, kullanıcıların karmaşık ağ bilgilerinden kendileri için değerli olan içeriği filtrelemelerine yardımcı olmayı amaçlıyor; örneğin belirli alanlardaki haber dinamiklerini, pazar eğilimlerini, ürün indirimlerini ve hatta kıt rezervasyonları takip etmek gibi. Scouts’un piyasaya sürülmesi, kişiselleştirilmiş bilgi edinme araçlarının daha da geliştirildiğini gösteriyor ve YZ’yi kullanıcının dijital “izcisi” haline getiriyor. (Kaynak: DhruvBatraDB, krandiash, saranormous, JeffDean)

Replit yeni bir özellik sundu: Figma gibi tasarım taslaklarını tek tıkla işlevsel uygulamalara dönüştürme: Replit, kullanıcıların Figma, Lovable, Bolt gibi platformlardan tasarım taslaklarını doğrudan içe aktarmasına ve çalıştırılabilir uygulamalara dönüştürmesine olanak tanıyan Replit Import özelliğini yayınladı. Bu özellik, geliştirme engelini düşürmeyi ve programcı olmayanların bile tasarım fikirlerini hızla gerçeğe dönüştürmesini sağlamayı amaçlıyor. Replit Import, tasarım sadakatini korumayı destekliyor ve yerleşik güvenlik taraması ile anahtar yönetimi içeriyor; Replit Agent, veritabanları, kimlik doğrulama ve barındırma hizmetleriyle birleşerek tam yığın uygulamalar oluşturulabiliyor. (Kaynak: amasad, pirroh)

Hugging Face, AISheets’i yayınladı: Elektronik tabloları binlerce YZ modeliyle birleştiriyor: Hugging Face kurucu ortağı Thomas Wolf, elektronik tabloların kullanım kolaylığını binlerce açık kaynaklı YZ modelinin (özellikle LLM’ler) güçlü yetenekleriyle birleştiren deneysel bir ürün olan AISheets’i duyurdu. Kullanıcılar, tanıdık elektronik tablo arayüzünde veri işleme görevlerini oluşturabilir, analiz edebilir ve otomatikleştirebilir, veri içgörüleri ve görev otomasyonu için YZ modellerinden yararlanabilirler. Amaç, hızlı, basit ve güçlü bir veri analizi için yeni bir yol sunmaktır. (Kaynak: _akhaliq, clefourrier, ClementDelangue, huggingface)

LlamaIndex, Agent’ları MCP sunucularına dönüştürerek Claude gibi modellerle etkileşim kurmayı destekliyor: LlamaIndex, herhangi bir Agent’ını Model Context Protocol (MCP) sunucusuna dönüştürme desteğini duyurdu. Örnek kod ve video aracılığıyla, karmaşık PDF’lerden yapılandırılmış veri çıkarmak için kullanılan özel bir FidelityFundExtraction iş akışının nasıl bir MCP sunucusu olarak dağıtılacağını ve Claude modelinden nasıl çağrılacağını gösteriyor. Bu özellik, araçların ajanlaşma seviyesini artırmayı, Claude Desktop, Cursor gibi MCP istemcileriyle entegrasyonu kolaylaştırmayı ve mevcut iş akışlarını daha geniş bir YZ ekosistemine bağlama sürecini basitleştirmeyi amaçlıyor. (Kaynak: jerryjliu0)

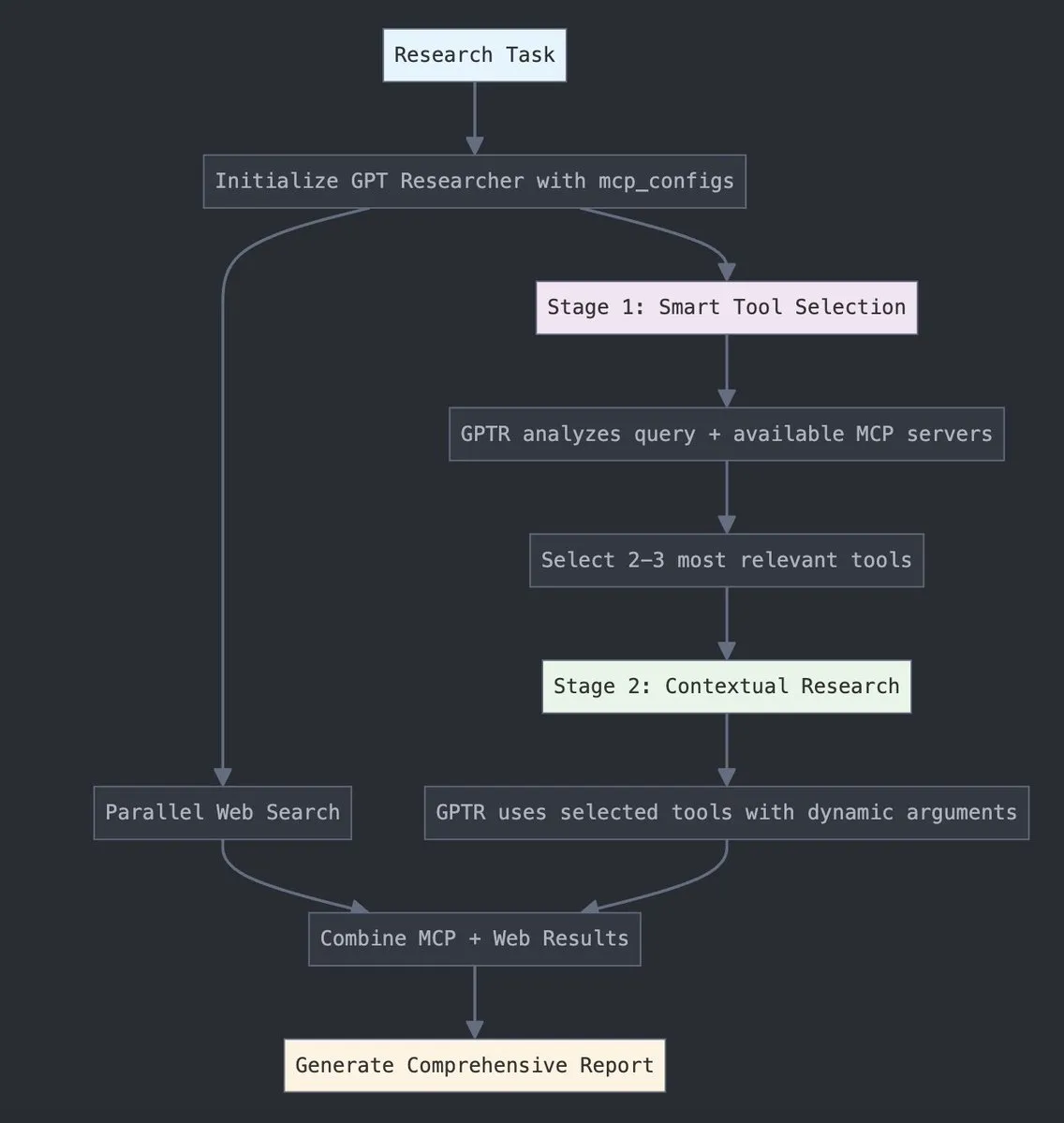

GPT Researcher, LangChain Model Context Protocol (MCP) ile entegre oldu: GPT Researcher artık akıllı araç seçimi ve araştırma için LangChain’in Model Context Protocol (MCP) adaptörünü kullanıyor. Bu entegrasyon, kapsamlı veri toplama için MCP’yi web arama işlevleriyle sorunsuz bir şekilde birleştiriyor. Kullanıcılar, bu yeni özelliği nasıl yapılandıracaklarını ve kullanacaklarını öğrenmek için ilgili entegrasyon belgelerine başvurabilir, böylece araştırma verimliliğini ve derinliğini artırabilirler. (Kaynak: hwchase17)

Tesslate, çeşitli boyutları destekleyen UIGEN-T3 serisi UI oluşturma modellerini yayınladı: Tesslate ekibi, 32B, 14B, 8B ve 4B gibi çeşitli parametre ölçeklerini içeren UIGEN-T3 serisi UI oluşturma modellerini piyasaya sürdü. Bu modeller, UI bileşenleri (kırıntı menüleri, düğmeler, kartlar gibi) ve tam ön uç kodu (giriş sayfaları, gösterge panelleri, sohbet arayüzleri gibi) oluşturmak için özel olarak tasarlanmıştır ve Tailwind CSS’i destekler. Modeller Hugging Face’te sunulmakta olup geliştiricilerin kullanıcı arayüzlerini hızla oluşturmalarına yardımcı olmayı amaçlamaktadır. Geliştiriciler, standart nicemlemenin model kalitesini önemli ölçüde düşürdüğünü ve en iyi sonuçlar için BF16 veya FP8 altında çalıştırılmasını önerdiklerini belirtiyorlar. (Kaynak: Reddit r/LocalLLaMA)

Doubao Podcast Modeli yayınlandı, tek tıkla insan benzeri YZ podcast’i oluşturuyor: Volcengine, Doubao Podcast Modelini yayınladı. Bu model, kullanıcı tarafından girilen metne (makale bağlantısı veya Prompt gibi) dayanarak hızla yüksek derecede insan benzeri diyalog tarzında bir podcast oluşturabiliyor. Model tarafından oluşturulan ses, tonlama, duraklama ve konuşma dili ifadeleri açısından gerçek insana yakın, hatta içeriğe göre görüş belirterek tartışabiliyor. Bu teknoloji, ByteDance ses teknolojisi ekibinin uçtan uca gerçek zamanlı ses modeline dayanıyor ve ses modalitesinde doğrudan anlama ve çıkarım sağlıyor. Şu anda bu özellik, Doubao PC sürümünde ve Coze platformunda kullanıma sunulmuş olup ses içeriği oluşturma engelini düşürmeyi ve verimli, kişiselleştirilmiş bilgi edinme yolları sunmayı amaçlıyor. (Kaynak: 量子位)

Unsloth AI, Magistral-Small-2506’nın GGUF nicemlenmiş sürümünü sunuyor: Mistral AI’nin yeni yayınladığı Magistral-Small-2506 çıkarım modeline yönelik olarak Unsloth AI, GGUF nicemlenmiş bir sürüm sunuyor. Bu, kullanıcıların bu 24 milyar parametreli modeli yerel olarak, örneğin yalnızca 32GB RAM’e sahip bir cihazda çalıştırmasına olanak tanıyor. Bu hamle, yüksek performanslı çıkarım modellerinin donanım engelini düşürüyor ve daha geniş bir geliştirici ve araştırmacı kitlesinin Magistral modelini yerel ortamlarda deneyimlemesini ve kullanmasını kolaylaştırıyor. (Kaynak: ImazAngel)

📚 Öğrenme Kaynakları

LLaVA-1.5 görsel asistan oluşturma teknolojisinin derinlemesine analizi: LearnOpenCV, LLaVA-1.5 mimarisi hakkında teknik bir derinlemesine analiz makalesi yayınladı. Makale, LLaVA-1.5’in en son teknoloji YZ görsel asistanını nasıl oluşturduğunu, çığır açan Görsel Talimat İnce Ayarı (Visual Instruction Tuning) teknolojisini ve çok modlu YZ alanını değiştiren açık kaynaklı veri kümelerini ayrıntılı olarak açıklıyor. Bu kılavuz, YZ/ML mühendisleri ve araştırmacılarının çok modlu büyük dil modellerinin çalışma prensiplerini ve eğitim yöntemlerini anlamaları için önemli bir referans değeri taşıyor. (Kaynak: LearnOpenCV)

Protein makine öğrenimi başlangıç kılavuzu yayınlandı: DL Weekly, yeni başlayanlar için kapsamlı bir protein makine öğrenimi kılavuzu paylaştı. Kılavuz, proteinlerle ilgili temel veri türlerini, derin öğrenme modellerini, hesaplama yöntemlerini ve temel biyoloji kavramlarını kapsıyor ve bu kesişim alanıyla ilgilenen araştırmacıların ve geliştiricilerin hızla başlamasına yardımcı olmayı amaçlıyor. (Kaynak: dl_weekly)

Qdrant ve DataTalksClub, ücretsiz RAG ve vektör arama kursu için işbirliği yaptı: Qdrant, DataTalksClub ile işbirliği yaparak 10 haftalık ücretsiz bir çevrimiçi kurs sunacağını duyurdu. Kurs içeriği, geri alım artırılmış üretim (RAG), vektör arama, hibrit arama, değerlendirme yöntemleri gibi konuları kapsayacak ve uçtan uca bir proje uygulaması içerecektir. Qdrant uzmanları Kacper Łukawski ve Daniel Wanderung bizzat ders verecek ve öğrencilerin gelişmiş YZ uygulamaları oluşturmak için pratik beceriler kazanmalarına yardımcı olmayı amaçlayacak. (Kaynak: qdrant_engine)

Weaviate podcast’i LLM yapılandırılmış çıktı ve kısıtlı kod çözmeyi tartışıyor: Weaviate podcast’inin son bölümünde dottxt.ai’den Will Kurt ve Cameron Pfiffer, sunucu Connor Shorten ile birlikte büyük dil modellerinin (LLM) yapılandırılmış çıktı sorununu tartıştılar. Program, LLM’lerin sadece basit JSON formatı doğrulaması yapmak yerine güvenilir, öngörülebilir sonuçlar (geçerli JSON, e-postalar, tweet’ler vb. gibi) üretmesini sağlamak için kısıtlı kod çözme tekniklerinin nasıl kullanılacağını derinlemesine ele aldı. Ayrıca açık kaynaklı Outlines aracını ve gerçek YZ kullanım durumlarındaki uygulamalarını tanıttılar ve bu teknolojinin gelecekteki YZ sistemleri üzerindeki etkisini değerlendirdiler. (Kaynak: bobvanluijt)

ACL2025 NLP makalesi SynthesizeMe!: Kullanıcı etkileşimlerinden kişiselleştirilmiş istemler oluşturma: “SynthesizeMe!” adlı bir ACL 2025 NLP konferans makalesi, kullanıcıların YZ ile etkileşimlerini (örtük ve açık geri bildirimler dahil) analiz ederek doğal dilde kişiselleştirilmiş kullanıcı modelleri oluşturmak için yeni bir yöntem öneriyor. Yöntem önce kullanıcı tercihlerini açıklayan çıkarım süreçlerini oluşturup doğruluyor, ardından bunlardan sentezlenmiş kullanıcı profilleri çıkarıyor ve bilgi açısından zengin önceki kullanıcı etkileşimlerini filtreliyor, son olarak belirli bir kullanıcı için kişiselleştirilmiş istemler oluşturarak LLM’nin kişiselleştirilmiş ödül modellemesini ve yanıt yeteneğini artırmayı amaçlıyor. DSPy de bunu dspy.MIPROv2’nin mükemmel bir uygulama örneği olarak yeniden paylaştı ve belirtti. (Kaynak: lateinteraction, stanfordnlp)

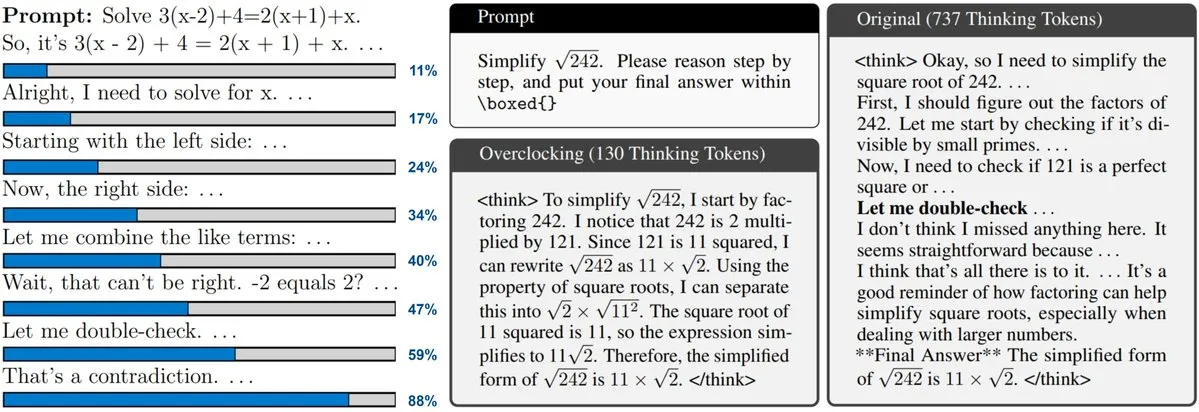

Yeni makale, test zamanı ölçeklendirme (Test-Time Scaling) LLM’lerinin izlenmesini ve hız aşırtmasını tartışıyor: Yeni bir makale, o3, DeepSeek-R1 gibi modellerin benimsediği test zamanı ölçeklendirme tekniğine odaklanıyor. Bu teknik, LLM’lerin yanıt vermeden önce daha fazla çıkarım yapmasına olanak tanıyor, ancak kullanıcılar genellikle iç ilerlemesini öğrenemiyor veya kontrol edemiyor. Araştırmacılar, LLM’nin iç “saatini” ortaya çıkarmayı ve çıkarım sürecini nasıl izleyeceklerini ve hızlandırmak için nasıl “hız aşırtma” yapacaklarını gösteriyorlar. Bu, büyük çıkarım modellerinin verimliliğini anlama ve optimize etme konusunda yeni fikirler sunuyor. (Kaynak: arankomatsuzaki)

Makale CARTRIDGES’ı öneriyor: Çevrimdışı öz-öğrenme yoluyla uzun bağlamlı LLM’lerin KV önbelleğini sıkıştırma: Stanford Üniversitesi HazyResearch araştırmacıları, uzun bağlamlı LLM’lerde KV önbelleğinin aşırı bellek kullanımı sorununu çözmeyi amaçlayan CARTRIDGES adlı yeni bir yöntem önerdi. Bu yöntem, bir “öz-öğrenme” test zamanı eğitim mekanizması aracılığıyla, belge bilgilerini depolamak için çevrimdışı olarak daha küçük bir KV önbelleği (cartridge olarak adlandırılır) eğitir, böylece görev performansını korurken ortalama olarak 39 kat önbellek belleğini azaltır ve 26 kat tepe verimini artırır. Bu cartridge bir kez eğitildikten sonra farklı kullanıcı istekleri tarafından yeniden kullanılabilir ve uzun bağlam işleme için yeni optimizasyon fikirleri sunar. (Kaynak: gallabytes, simran_s_arora, stanfordnlp)

Yeni makale Grafting: Önceden eğitilmiş difüzyon Transformer mimarisi düzenlemesini düşük maliyetle gerçekleştirme: Stanford Üniversitesi araştırmacıları, önceden eğitilmiş difüzyon Transformer model mimarilerini düzenlemek için Grafting adlı yeni bir yöntem önerdi. Bu teknik, ön eğitim maliyetinin yalnızca %2’si kadar bir hesaplama miktarıyla, modeldeki dikkat mekanizmalarını vb. yeni hesaplama temelleriyle değiştirmeye olanak tanır, böylece küçük hesaplama bütçeleriyle model mimarisinin özelleştirilmiş tasarımını mümkün kılar. Bu, yeni model mimarilerini keşfetmek ve mevcut modellerin verimliliğini artırmak için önemli bir anlam taşımaktadır. (Kaynak: realDanFu, togethercompute)

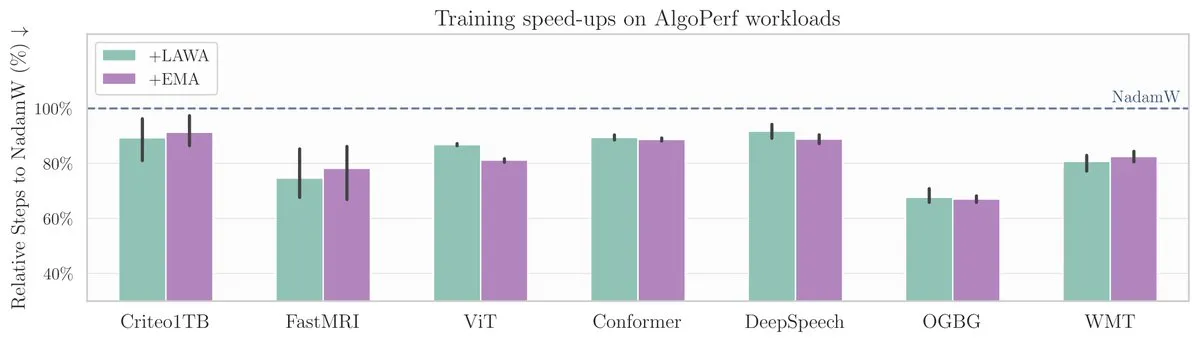

ICML yeni makalesi: Ortalama kontrol noktası yöntemi AlgoPerf ölçütünde model eğitimini hızlandırıyor: Yeni bir ICML makalesi, makine öğrenimi model eğitim hızını ve performansını artırmada klasik bir yöntem olan Ortalama Kontrol Noktaları (Averaging Checkpoints) uygulamasını inceliyor. Araştırmacılar, bu yöntemi yapılandırılmış, çeşitli optimizasyon algoritmaları için bir ölçüt olan AlgoPerf üzerinde test ederek farklı görevlerdeki pratik faydalarını araştırdılar ve model eğitimini hızlandırmak için pratik referanslar sundular. (Kaynak: aaron_defazio)

Transformer görselleştirme açıklama aracı açık kaynaklı oldu: DL Weekly, kullanıcıların Transformer mimarisine dayalı modellerin (GPT gibi) çalışma prensiplerini anlamalarına yardımcı olmak için tasarlanmış etkileşimli bir görselleştirme aracını tanıttı. Araç, modelin iç mekanizmalarını görselleştirerek karmaşık kavramları daha kolay anlaşılır hale getiriyor ve Transformer modelleriyle ilgilenen öğrenciler ve araştırmacılar için uygun. Proje GitHub’da açık kaynaklı olarak yayınlandı. (Kaynak: dl_weekly)

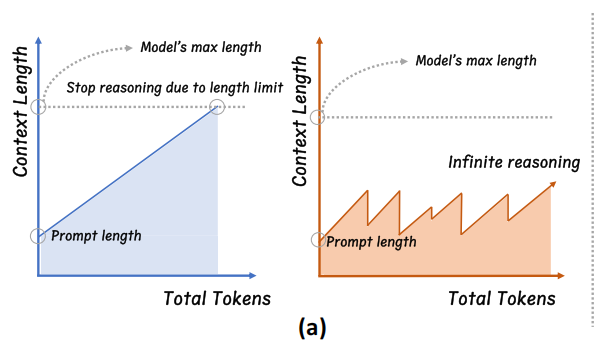

Zhejiang Üniversitesi InftyThink’i önerdi: Parçalama ve özetleme ile sonsuz derinlikte çıkarım: Zhejiang Üniversitesi, Pekin Üniversitesi ile ortaklaşa çalışan bir araştırma ekibi, büyük modeller için yeni bir çıkarım paradigması olan InftyThink’i önerdi. Bu yöntem, uzun çıkarımları birden fazla kısa parçaya bölüyor ve parçalar arasında bağlamı birleştirmek için özetler ekliyor, böylece teorik olarak sonsuz derinlikte çıkarım elde ederken yüksek üretim verimini koruyor. Bu yöntem, model yapısında ayarlama gerektirmiyor; eğitim verilerini çok turlu çıkarım formatına yeniden yapılandırarak mevcut ön eğitim ve ince ayar süreçleriyle uyumlu. Deneyler, InftyThink’in AIME24 gibi ölçütlerde model performansını önemli ölçüde artırdığını ve üretim verimini yükselttiğini gösteriyor. (Kaynak: 量子位)

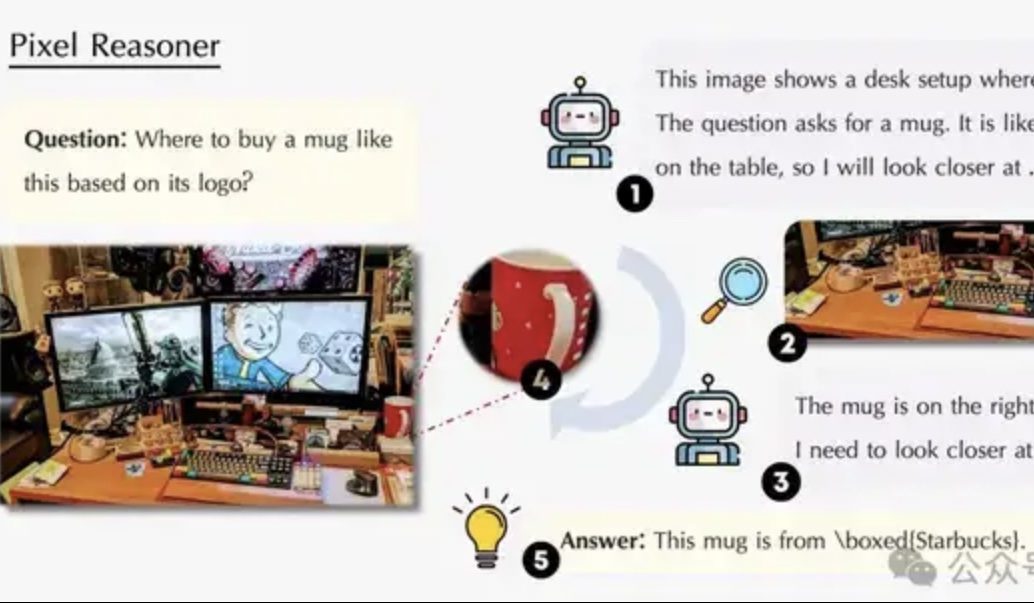

Makale piksel uzayında çıkarımı tartışıyor: VLM’lerin insanlar gibi “göz ve beyni birlikte kullanmasını” sağlamak: Waterloo Üniversitesi, Hong Kong Bilim ve Teknoloji Üniversitesi ve Çin Bilim ve Teknoloji Üniversitesi’nden araştırma ekipleri, görsel dil modellerinin (VLM) metin tokenlarına aracı olarak güvenmek yerine doğrudan piksel düzeyinde işlem yapmasını ve çıkarımda bulunmasını (görsel yakınlaştırma, uzay-zaman işaretleme gibi) sağlayan “Piksel Uzayında Çıkarım” (Pixel-Space Reasoning) paradigmasını önerdi. İçsel merak teşviki ve dışsal doğruluk teşvikine dayalı bir takviyeli öğrenme şeması aracılığıyla, modellerin “bilişsel tembelliği” aşıldı. Qwen2.5-VL-7B üzerine inşa edilen Pixel-Reasoner, V*Bench gibi birçok ölçütte üstün performans gösterdi ve 7B modelinin performansı GPT-4o’yu aştı. (Kaynak: 量子位)

DeepLearning.AI, Veri Analizi Uzmanlık Sertifikası’nın beşinci kursunu başlattı: Veri Hikayeleştirme: DeepLearning.AI, Veri Analizi Uzmanlık Sertifikası’nın “Veri Hikayeleştirme” konulu beşinci kursunu yayınladı. Kurs, içgörüleri sunmak için uygun aracın (gösterge paneli, not, sunum) nasıl seçileceğini, Tableau kullanarak etkileşimli gösterge panelleri tasarlamayı, bulguları iş hedefleriyle hizalamayı ve etkili bir şekilde iletişim kurmayı ve iş arama rehberliğini öğretiyor. Veri hikayeleştirmenin iş performansını artırmada ve içgörüleri etkili bir şekilde iletmede önemini vurguluyor. (Kaynak: DeepLearningAI)

Makale, bilgi çatışmasının büyük dil modelleri üzerindeki etkisini tartışıyor: Yeni bir makale, büyük dil modellerinin (LLM) bağlamsal girdi ile parametrik bilgi (yani modelin iç “hafızası”) arasında bir çatışma olduğunda nasıl davrandığını sistematik olarak değerlendiriyor. Araştırma, bilgi çatışmasının bilgi kullanımına dayanmayan görevler üzerinde çok az etkisi olduğunu buldu; bağlam parametrik bilgiyle tutarlı olduğunda model daha iyi performans gösteriyor; talimat verilse bile model iç bilgisini tamamen bastıramıyor; çatışmayı açıklayan nedenler sunmak modelin bağlama olan bağımlılığını artırıyor. Bu bulgular, modele dayalı değerlendirmenin geçerliliği hakkında soru işaretleri yaratıyor ve LLM’leri dağıtırken bilgi çatışması sorununu dikkate alma gerekliliğini vurguluyor. (Kaynak: HuggingFace Daily Papers)

Makale CyberV: Video anlamada test zamanı ölçeklendirme için sibernetik bir çerçeve: Çok modlu büyük dil modellerinin (MLLM) uzun veya karmaşık videoları işlerken karşılaştığı hesaplama talepleri, sağlamlık ve doğruluk sorunlarını çözmek için araştırmacılar CyberV çerçevesini önerdi. Bu çerçeve, sibernetik prensiplerinden esinlenerek video MLLM’lerini MLLM çıkarım sistemi, sensörler ve bir kontrolör içeren uyarlanabilir bir sistem olarak yeniden tasarlıyor. Sensörler, modelin ileri doğru sürecini izler ve ara yorumları (dikkat kayması gibi) toplar; kontrolör, ne zaman ve nasıl kendi kendini düzelteceğini tetikleyeceğine ve geri bildirim üreteceğine karar verir. Bu test zamanı uyarlanabilir ölçeklendirme çerçevesi, yeniden eğitime gerek kalmadan mevcut MLLM’leri geliştirebilir ve deneyler, VideoMMMU gibi ölçütlerde Qwen2.5-VL-7B gibi modellerin performansını önemli ölçüde artırdığını göstermiştir. (Kaynak: HuggingFace Daily Papers)

Makale LoRMA’yı öneriyor: LLM parametre verimli ince ayarı için Düşük Rütbeli Çarpımsal Adaptasyon: Mevcut LoRA ve MoE tabanlı parametre verimli ince ayar (PEFT) yöntemlerinde bulunan temsil çökmesi ve uzman yükü dengesizliği sorunlarını çözmek için araştırmacılar Düşük Rütbeli Çarpımsal Adaptasyon (LoRMA) önerdi. Bu yöntem, PEFT adaptör uzmanlarının güncelleme şeklini toplamsaldan daha zengin matris çarpımı dönüşümlerine değiştirir ve hesaplama karmaşıklığı ve rütbe darboğazıyla başa çıkmak için etkili yeniden düzenleme işlemleri ve rütbe genişletme stratejileri sunar. Deneyler, MoA (Karışık Adaptörler) heterojen yönteminin performans ve parametre verimliliği açısından homojen MoE-LoRA yönteminden daha üstün olduğunu kanıtlamıştır. (Kaynak: Reddit r/MachineLearning)

Makale FlashDMoE’yi öneriyor: Tek çekirdekte hızlı dağıtık MoE uygulaması: Araştırmacılar, dağıtık Uzmanlar Karışımı (MoE) ileri yayılımını tamamen tek bir CUDA çekirdeğine birleştiren ilk sistem olan FlashDMoE’yi tanıttı. Birleştirilmiş katmanı sıfırdan saf CUDA ile yazarak, FlashDMoE GPU kullanımında 9 kata kadar artış, gecikmede 6 kat azalma ve zayıf ölçeklendirme verimliliğinde 4 kat iyileşme sağladı. Bu çalışma, büyük ölçekli MoE modellerinin çıkarım verimliliğini optimize etmek için yeni fikirler ve uygulamalar sunmaktadır. (Kaynak: Reddit r/MachineLearning)

💼 İş Dünyası

xAI ve Polymarket işbirliği yaparak piyasa tahminlerini Grok analizleriyle birleştiriyor: Elon Musk’ın yapay zeka şirketi xAI, merkezi olmayan tahmin piyasası platformu Polymarket ile bir ortaklık kurduğunu duyurdu. Bu işbirliği, Polymarket’in piyasa tahmin verilerini X (eski adıyla Twitter) verileri ve Grok AI’nin analiz yetenekleriyle birleştirerek dünyayı şekillendiren faktörleri ortaya çıkarmak için bir “sert gerçek motoru” oluşturmayı amaçlıyor. xAI, bunun işbirliğinin sadece başlangıcı olduğunu ve gelecekte daha fazla işbirliği içeriği olacağını belirtti. (Kaynak: xai)

YZ çıkarım çipi şirketi Groq, Suudi Arabistan’dan 1,5 milyar dolarlık yatırım taahhüdü aldı, dikey entegrasyon stratejisine odaklanıyor: YZ çıkarım çipi şirketi Groq, LPU (Dil İşleme Birimi) tabanlı YZ çıkarım altyapısının yerel teslimat ölçeğini genişletmek için Suudi Arabistan’dan 1,5 milyar dolarlık bir yatırım taahhüdü aldığını duyurdu. TPU mucitlerinden biri olan Jonathan Ross tarafından kurulan Groq, YZ çıkarım hesaplamasına odaklanıyor. LPU çipleri programlanabilir bir boru hattı mimarisi kullanıyor; bellek ve hesaplama birimleri aynı çip üzerinde entegre edilerek veri erişim hızını ve enerji verimliliğini önemli ölçüde artırıyor. Groq sadece çip satmakla kalmıyor, aynı zamanda GroqRack kümesi (özel bulut/YZ hesaplama merkezi) ve GroqCloud bulut platformu (Tokens-as-a-Service) sunuyor ve Llama, DeepSeek, Qwen gibi ana akım açık kaynak modellerini destekliyor. Şirket ayrıca YZ çıkarım bulut değerini artırmak için Compound kompozit YZ sistemini geliştirdi. (Kaynak: 36氪)

Shenzhen merkezli insansı etkileşimli robot şirketi “Digital China” (数字华夏) on milyonlarca yuan’lık Angel+ turu finansmanını tamamladı: Digital China (Shenzhen) Technology Co., Ltd. (数字华夏) yakın zamanda Tongchuang Weiye tarafından özel olarak yatırım yapılan on milyonlarca yuan’lık bir Angel+ turu finansmanını tamamladı. Şirket, AGI robotlarının büyük ölçekli ticari kullanımına odaklanıyor ve temel ürünleri arasında insansı robot “Xia Lan”, genel amaçlı insansı robot “Xia Qi” ve IP serisi robot “Xingxingxia” bulunuyor. “Xia Lan” robotu, hassas biyonik teknolojiyi temel alıyor, insan ifadelerinin çoğunu taklit edebiliyor ve çok modlu etkileşim yeteneğine sahip. Şirket, önde gelen ICT üreticileri, yerel elektrik şebekeleri gibi müşterilerden yüz milyonlarca yuan değerinde sipariş aldı. (Kaynak: 36氪)

🌟 Topluluk

Sam Altman, “Nazik Tekillik” başlıklı blog yazısında YZ’nin kademeli devrimini ve geleceğini tartışıyor: OpenAI CEO’su Sam Altman, teknolojik tekilliğin beklenenden daha yumuşak, “nazik” bir şekilde sessizce gerçekleştiğini ve sürekli, üssel olarak hızlanan kademeli bir süreç olduğunu belirten bir blog yazısı yayınladı. 2025’te programlama gibi karmaşık zihinsel işleri bağımsız olarak tamamlayabilen YZ ajanlarının yazılım endüstrisini yeniden şekillendireceğini, 2026’da yepyeni bilimsel keşifler yapabilen sistemlerin ortaya çıkabileceğini ve 2027’de gerçek dünyada görevleri tamamlayabilen robotların ortaya çıkabileceğini öngörüyor. Altman, YZ hizalama sorununu çözmenin ve teknolojinin herkes için erişilebilir olmasını sağlamanın refah dolu bir geleceğe giden yolda kilit önem taşıdığını vurguladı. Ayrıca, OpenAI’nin ilk açık kaynaklı ağırlık modelinin, araştırma ekibinin “beklenmedik derecede şaşırtıcı sonuçlar” elde etmesi nedeniyle yaz sonuna erteleneceğini açıkladı. (Kaynak: dotey, scaling01, sama)

Topluluk OpenAI o3-pro’yu tartışıyor: Performansı güçlü ama maliyeti yüksek, o3 fiyat indirimi zincirleme reaksiyona neden oluyor: OpenAI o3-pro’nun piyasaya sürülmesi ve yüksek fiyatlandırması (çıktı için $80/M token) toplulukta tartışma konusu oldu. Kullanıcılar genellikle karmaşık çıkarım, programlama gibi görevlerdeki güçlü yeteneklerini kabul ediyor, ancak yanıt hızı ve maliyeti konusunda endişelerini dile getiriyorlar; bazı kullanıcılar basit bir “Merhaba” demenin bile 80 dolara mal olabileceğini esprili bir dille belirtiyor. Aynı zamanda, o3 modelinin fiyatının %80 oranında önemli ölçüde düşürülmesi, YZ model fiyat savaşlarını tetikleyebilecek ve GPT-4o ile diğer rakip ürünleri hedef alabilecek bir gelişme olarak görülüyor. Toplulukta, o3’ün fiyat indiriminden sonra performansının “düşüp düşmediği” konusunda tartışmalar var. OpenAI daha sonra, kullanıcı taleplerine yanıt olarak ChatGPT Plus kullanıcılarının o3 kullanım kotalarını iki katına çıkaracağını duyurdu. (Kaynak: Yuchenj_UW, scaling01, imjaredz, kevinweil, dotey)

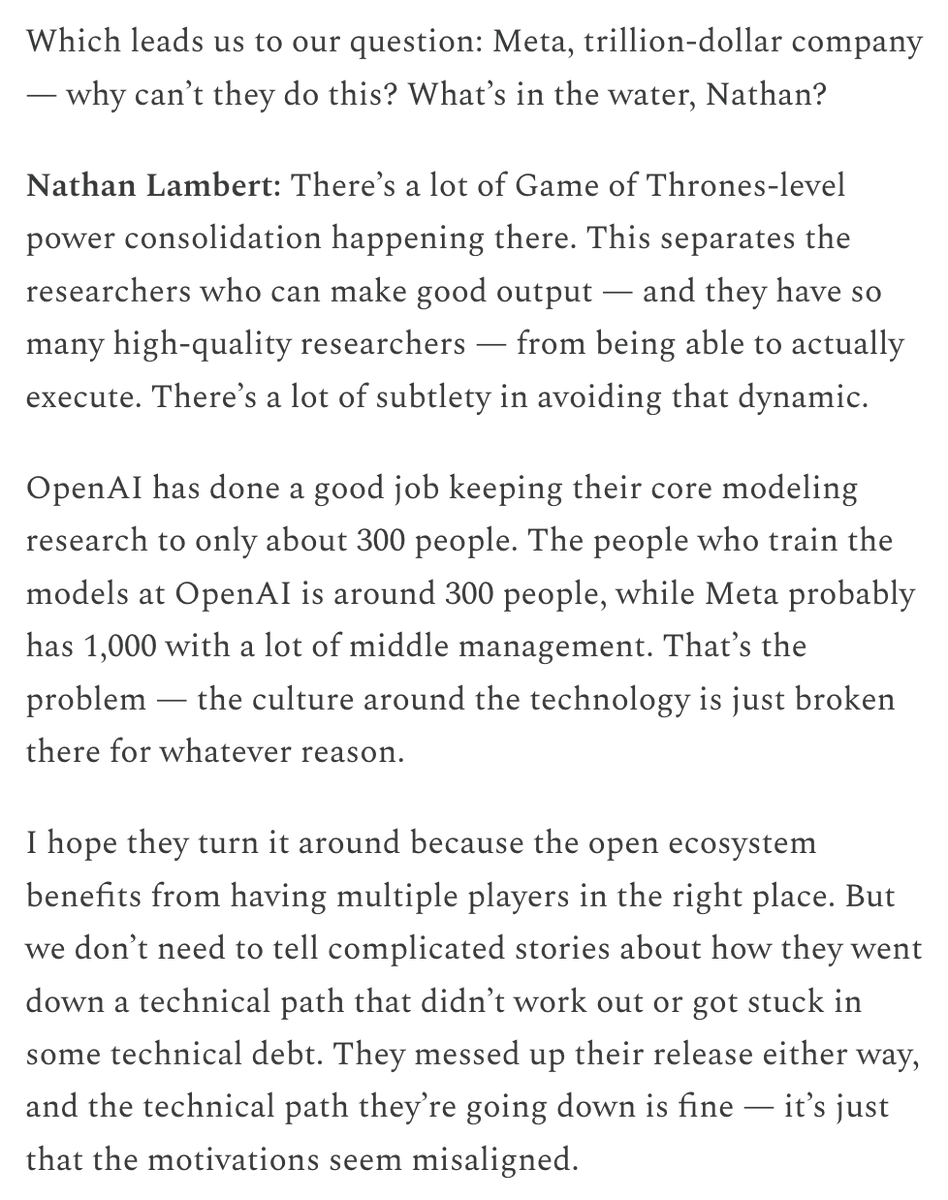

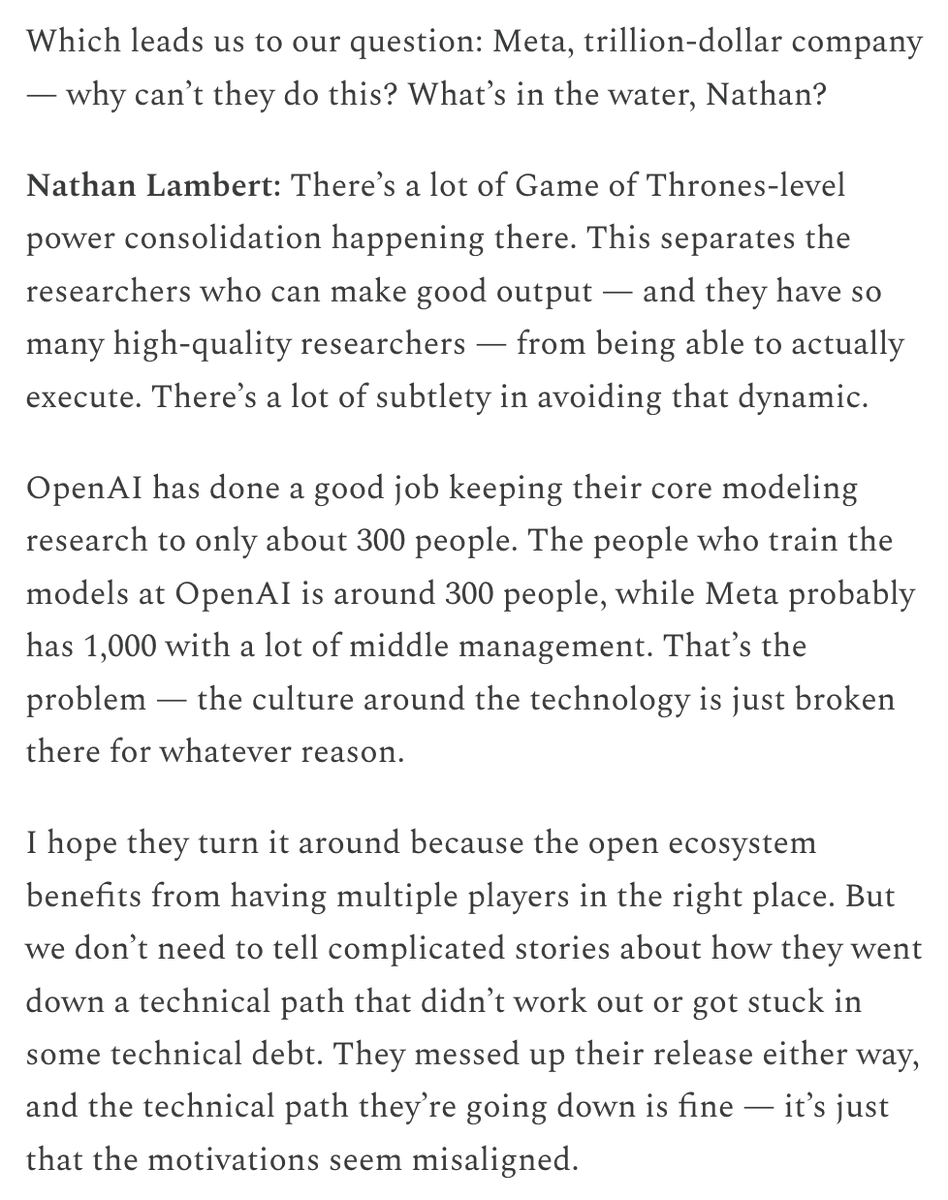

Meta’nın yüksek maaşlarla yetenek çekmesi ve YZ organizasyonuna yaptığı finansal yatırımlar hararetli tartışmalara yol açtı: Meta’nın YZ araştırmacılarına sunduğu yüksek maaş paketleri (iddialara göre dokuz haneli dolarlar) toplulukta tartışmalara neden oldu. Nat Lambert, bu tür maaşların AI2 ölçeğinde bir araştırma kurumunu finanse edebileceğini belirterek, üst düzey yetenek maliyetinin ne kadar yüksek olduğuna dikkat çekti. Meta’nın “Süper Zeka Laboratuvarı” kurması ve Scale AI’a dev yatırım yapmasıyla birlikte, topluluk genel olarak Meta’nın YZ rekabet gücünü ne pahasına olursa olsun yeniden şekillendirmeye çalıştığını düşünüyor, ancak aynı zamanda iç organizasyon politikaları ve verimlilik sorunlarına da dikkat çekiyor. Helen Toner’ın paylaştığı ChinaTalk içeriği, Meta’nın bu hamlesinin organizasyon içindeki siyasi ve ego sorunlarını kırmak için yapıldığını belirtiyor. (Kaynak: natolambert, natolambert)

Apple WWDC’nin yeni UI stili “Sıvı Cam” tasarım ve kullanılabilirlik tartışmalarına yol açtı: Apple’ın WWDC 2025’te tanıttığı yeni UI tasarım stili “Sıvı Cam” (Liquid Glass), geliştiriciler ve tasarımcılar arasında geniş çaplı tartışmalara neden oldu. Bazı görüşler, görsel efektlerinin yenilikçi olduğunu ve Apple’ın 3D arayüz tasarımına yönelik keşiflerini yansıttığını belirtiyor. Ancak, ID_AA_Carmack (John Carmack) gibi deneyimli isimler, yarı saydam UI’ların genellikle kullanılabilirlik açısından sorunlu olduğunu, görsel dağınıklığa ve düşük kontrasta neden olarak okumayı ve kullanımı etkilediğini belirtti ve Windows ile Mac’in geçmişte benzer tasarımları denediğini ancak kullanılabilirlik sorunları nedeniyle sonunda ayarlamalar yaptığını hatırlattı. Kullanıcı deneyiminin (UX), kullanıcı arayüzünün (UI) görsel efektlerinden öncelikli olması gerektiği tartışmanın merkezinde yer aldı. (Kaynak: gfodor, ID_AA_Carmack, ReamBraden, dotey)

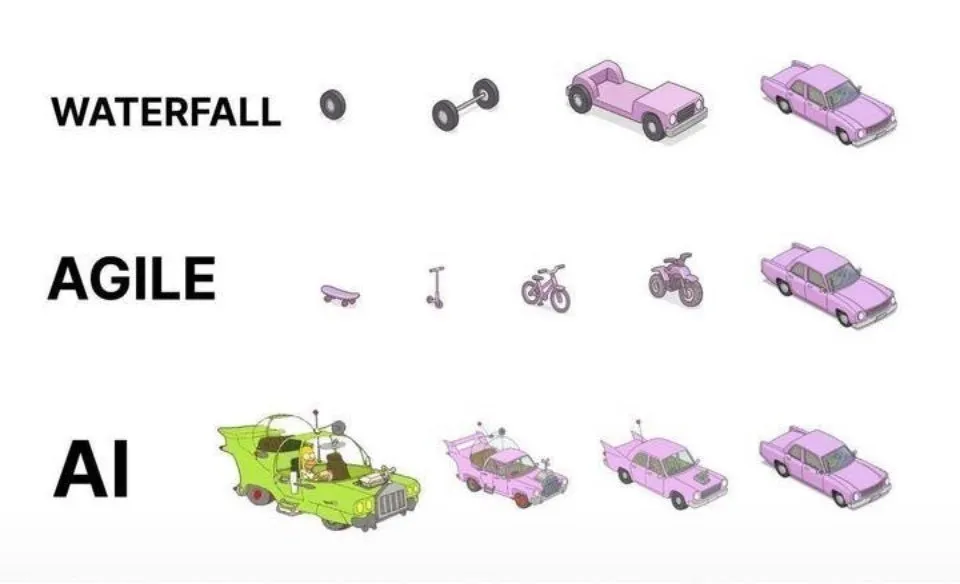

YZ destekli programlama pratiği: Çevik iterasyon, tek seferlik üretimden daha üstündür: Sosyal medyada dotey, YZ (Claude Code gibi) kullanarak programlama için en iyi uygulamalar hakkında görüşlerini paylaştı. YZ’ye tam gereksinimleri bir kerede verip büyük bir yarı mamul ürün (şelale modeli) oluşturmasını veya önce eksik bir ürün oluşturup sonra optimize etmesini (resimdeki üçüncü modele benzer şekilde) beklemenin doğru olmadığını savundu, çünkü bu kaliteyi kontrol etmeyi zorlaştırır ve sonraki bakımı zorlaştırır. Büyük projelerin (ERP sistemi gibi) bağımsız olarak kararlı bir şekilde çalışabilen birden fazla küçük sürüme bölünerek kademeli olarak geliştirildiği çevik iterasyon modelini (resimdeki birinci modele benzer şekilde) savundu, her sürümün işlevsel bütünlüğünü ve kontrol edilebilirliğini sağlayarak, bu da geleneksel yazılım mühendisliğinin en iyi uygulamalarıyla tutarlıdır. (Kaynak: dotey)

Mustafa Suleyman: YZ teknolojisi sabit ve tek tipten dinamik ve kişiselleştirilmişe doğru evriliyor: Inflection AI ve eski DeepMind kurucu ortağı Mustafa Suleyman, geleneksel teknolojinin genellikle sabit, tek tip ve “herkese uyan tek beden” bir model olduğunu, mevcut yapay zeka teknolojisinin ise dinamik, kişiselleştirilmiş ve ortaya çıkan özellikler sergilediğini belirtti. Bunun, teknolojinin tek bir tekrarlayan sonuç sunmaktan sonsuz olasılık yollarını keşfetmeye doğru bir dönüşüm anlamına geldiğini ve YZ’nin kişiselleştirilmiş hizmetler ve yaratıcı uygulamalar alanındaki büyük potansiyelini vurguladığını savundu. (Kaynak: mustafasuleyman)

Perplexity AI altyapı sorunlarıyla karşılaştı, CEO açıklama yaptı: Perplexity AI CEO’su Arav Srinivas, sosyal medyada hizmetin istikrarsızlığıyla ilgili kullanıcı sorularına yanıt vererek, altyapı sorunları nedeniyle bazı trafik için düşürülmüş kullanıcı deneyimini (degraded UX) etkinleştirmek zorunda kaldıklarını belirtti. Kullanıcı verilerinin (kütüphane veya konular gibi) kaybolmadığını ve sistem stabil hale geldiğinde tüm işlevlerin normale döneceğini vurguladı. Bu, YZ hizmetlerinin hızlı gelişim sürecinde altyapının istikrarı ve ölçeklenebilirliğinin karşılaştığı zorlukları yansıtıyor. (Kaynak: AravSrinivas)

Sergey Levine, dil modelleri ile video modellerinin öğrenme farklılıklarını tartışıyor: UC Berkeley profesörü Sergey Levine, “Platon’un Mağarasındaki Dil Modelleri” adlı makalesinde derin bir soru soruyor: Dil modelleri neden bir sonraki kelimeyi tahmin etmekten çok şey öğrenirken, video modelleri bir sonraki kareden nispeten daha az şey öğreniyor? LLM’lerin insan bilgisinin “gölgesini” (metin verileri) öğrenerek güçlü çıkarım yetenekleri kazandığını, bunun gerçek anlamda fiziksel dünyayı otonom olarak keşfetmekten ziyade insan bilişinin “tersine mühendisliği” gibi olduğunu savunuyor. Video modelleri fiziksel dünyayı doğrudan gözlemliyor, ancak şu anda karmaşık çıkarım konusunda LLM’ler kadar başarılı değiller. YZ’nin uzun vadeli hedefinin, insan bilgisinin “gölgesine” olan bağımlılığı kırmak, sensörler aracılığıyla fiziksel dünyayla doğrudan etkileşim kurmak ve otonom keşif gerçekleştirmek olması gerektiğini öne sürüyor. (Kaynak: 36氪)

💡 Diğer

YZ etiği ve bilinç tartışması: YZ gerçekten bilince sahip olabilir mi?: MIT Technology Review, YZ bilincinin karmaşık konusuna odaklanıyor. Makale, YZ bilincinin sadece entelektüel bir sorun değil, aynı zamanda ahlaki ağırlığı olan bir konu olduğunu belirtiyor. YZ bilincini yanlış değerlendirmek, farkında olmadan duyarlı YZ’leri köleleştirmeye veya duyarsız makineler için insan refahını feda etmeye yol açabilir. Araştırma topluluğu, bilincin doğasını anlamada ilerleme kaydetti ve bu sonuçlar yapay bilinci keşfetme ve ele alma konusunda rehberlik edebilir. Bu, YZ hakları, sorumlulukları ve insan-makine ilişkileri hakkında derinlemesine düşüncelere yol açıyor. (Kaynak: MIT Technology Review)

Turing Ödülü sahibi Joseph Sifakis: Mevcut YZ gerçek zeka değil, bilgi ile enformasyonun karıştırılmasına karşı dikkatli olunmalı: Turing Ödülü sahibi Joseph Sifakis, eserlerinde ve röportajlarında mevcut toplumun YZ anlayışında sapmalar olduğunu, bilgi yığınını bilgelik yaratımıyla karıştırdığını ve makinelerin “zekasını” abarttığını belirtiyor. Henüz gerçek bir akıllı sistem olmadığını ve YZ’nin endüstri üzerindeki gerçek etkisinin çok az olduğunu savunuyor. YZ’nin sağduyu anlayışından yoksun olduğunu, “zekasının” istatistiksel modellerin bir ürünü olduğunu ve karmaşık sosyal durumlarda değer ile riski tartmasının zor olduğunu belirtiyor. Eğitimin temelinin bilgi aktarımı değil, eleştirel düşünme ve yaratıcılığı geliştirmek olduğunu vurguluyor ve YZ uygulamaları için küresel standartlar oluşturulması, sorumluluk sınırlarının netleştirilmesi ve YZ’nin insanları ikame eden değil, güçlendiren bir ortak haline getirilmesi çağrısında bulunuyor. (Kaynak: 36氪)

YZ çağında reklamcılığın yeniden yapılandırılması: Yaratıcı üretimden kişiselleştirilmiş dağıtıma kadar değişim: Google I/O 2025 konferansı, YZ’nin reklam endüstrisini nasıl derinden yeniden yapılandırdığını gösterdi. Eğilimler şunları içeriyor: 1) YZ güdümlü yaratıcı otomasyon, resimlerden video senaryolarına kadar her şey YZ tarafından üretilebiliyor; Veo 3, Imagen 4 ve Flow gibi araçlar yüksek kaliteli içerik oluşturma engelini düşürüyor. 2) Kişiselleştirme paradigması “bin kişiye bin yüz”den “bir kişiye bin yüz”e dönüşüyor; YZ akıllı ajanları kullanıcı ihtiyaçlarını aktif olarak anlayabiliyor ve işlemleri kolaylaştırabiliyor. 3) Reklam ve içerik arasındaki sınırlar bulanıklaşıyor; reklamlar doğrudan YZ tarafından oluşturulan arama sonuçlarına entegre oluyor ve bilginin bir parçası haline geliyor. Marka sahiplerinin, değişime uyum sağlamak için özel akıllı ajanlar oluşturması, YZ’ye yönelik hizmetler sunması ve “marka-performans birliği” uzun vadeli stratejisine bağlı kalması gerekiyor. (Kaynak: 36氪)