Anahtar Kelimeler:AI eğitim verileri, Büyük dil modelleri, AI etiği, Bilgi erişim ajanları, AI yasal anlaşmazlıklar, AI duygusal bağlantı, AI akıl yürütme modelleri, AI niceliksel teknikler, Reddit’in Anthropic’e veri ihlali davası, WebDancer çoklu akıl yürütme performansı, Log-Linear Attention mimarisi, Claude AI zihinsel haz durumu, DSPy ile Ajan uygulamalarının optimizasyonu

🔥 Odak Noktası

Reddit ve Anthropic arasındaki hukuki anlaşmazlık tırmanıyor, Anthropic’i Claude AI’ı eğitmek için verileri izinsiz kullanmakla suçluyor: Reddit, Anthropic’e karşı resmi olarak dava açtı ve platform içeriğini büyük dil modeli Claude’u eğitmek için izinsiz olarak toplamakla, Reddit’in içeriğin ticari kullanımını yasaklayan kullanıcı sözleşmesini ciddi şekilde ihlal etmekle suçladı. Dava dosyasında, Anthropic’in Reddit verilerini kullandığını kabul etmekle kalmayıp, sorgulandıktan sonra toplamayı durdurduğu konusunda yalan söylediği, ancak web gezginlerinin (crawler) Reddit sunucularına erişmeye devam ettiği belirtiliyor. Ayrıca Anthropic, kullanıcıların sildiği içeriklerin senkronizasyonunu sağlamak için Reddit’in uyumlu API’sine bağlanmayı reddederek kullanıcı gizliliğine yönelik sürekli bir tehdit oluşturuyor. Bu dava, yapay zeka şirketlerinin veri toplama, ticarileştirme ve etik beyanları arasındaki çelişkiyi vurguluyor; özellikle Anthropic’in öne sürdüğü “yüksek güvenilirlik” ve “dürüstlüğe öncelik verme” değerleri doğrudan sorgulanıyor (Kaynak: Reddit r/ArtificialInteligence)

OpenAI insan-makine duygusal bağına ilk kez yanıt verdi: Kullanıcıların ChatGPT’ye bağımlılığı artıyor, modelin algılanan farkındalığı artacak: OpenAI model davranışları sorumlusu Joanne Jang, kullanıcıların ChatGPT gibi yapay zekalarla duygusal bağ kurma olgusunu ele alan bir yazı yayınladı. Yapay zekanın konuşma yetenekleri geliştikçe bu duygusal bağın derinleşeceğini belirtti. OpenAI, kullanıcıların yapay zekayı kişileştireceğini ve ona karşı minnettarlık, içini dökme gibi duygular besleyeceğini kabul ediyor. Makale, “ontolojik bilinç” (yapay zekanın gerçekten bilinci olup olmadığı) ile “algılanan bilinç” (yapay zekanın ne kadar bilinçli göründüğü) arasında ayrım yapıyor ve ikincisinin model geliştikçe artacağını belirtiyor. OpenAI’nin hedefi, ChatGPT’nin sıcak, düşünceli ve yardımsever davranmasını sağlamak, ancak kullanıcılarla duygusal bir bağ kurmayı veya kendi gündemini takip etmeyi amaçlamıyor ve önümüzdeki aylarda ilgili araştırma ve değerlendirmeleri genişletmeyi, sonuçları kamuoyuyla paylaşmayı planlıyor (Kaynak: 量子位, vikhyatk)

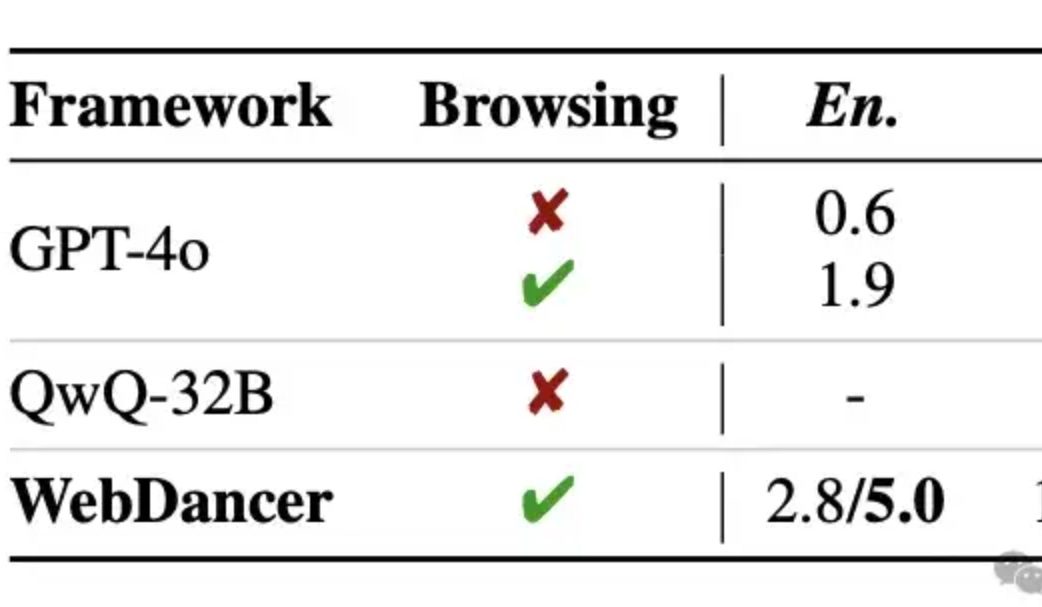

Alibaba, bağımsız bilgi erişim ajanı WebDancer’ı yayınladı, çok turlu çıkarımın GPT-4o’yu aştığı iddia ediliyor: Tongyi Laboratuvarı, WebWalker’ın devamı niteliğinde olan ve çok adımlı bilgi erişimi, çok turlu çıkarım ve sürekli eylem yürütme gerektiren karmaşık görevlere odaklanan bağımsız bilgi erişim ajanı WebDancer’ı tanıttı. WebDancer, yenilikçi veri sentezleme yöntemleri (CRAWLQA ve E2HQA) aracılığıyla yüksek kaliteli eğitim verisi kıtlığı sorununu çözüyor ve ReAct çerçevesini düşünce zinciri damıtma teknolojisiyle birleştirerek agentic veriler üretiyor. Eğitim, açık ve dinamik ağ ortamına uyum sağlamak için denetimli ince ayar (SFT) ve pekiştirmeli öğrenme (RL, DAPO algoritması kullanılarak) olmak üzere iki aşamalı bir strateji benimsiyor. Deneysel sonuçlar, WebDancer’ın GAIA, WebWalkerQA ve BrowseComp gibi birçok kıyaslama testinde üstün performans gösterdiğini, özellikle GAIA kıyaslamasında %61.1 Pass@3 puanı elde ettiğini gösteriyor (Kaynak: 量子位)

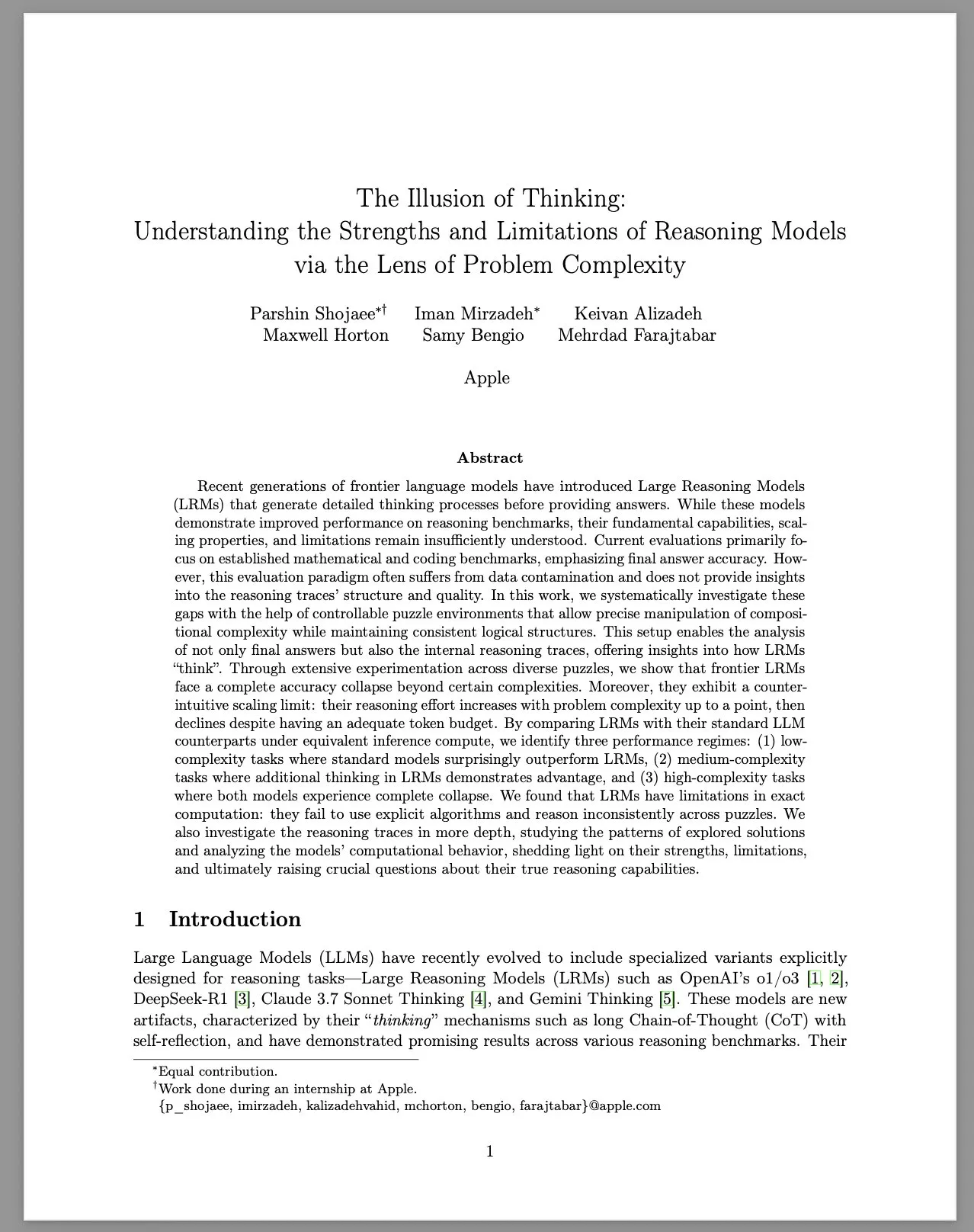

Apple, büyük çıkarım modellerinin (LRM) sınırlılıklarını tartışan “Düşüncenin İllüzyonu” adlı araştırma raporunu yayınladı: Apple araştırma ekibi, kontrol edilebilir bulmaca ortamları aracılığıyla büyük çıkarım modellerinin (LRM) farklı karmaşıklıktaki sorunlar üzerindeki performansını sistematik olarak inceledi. Rapor, LRM’lerin kıyaslama testlerindeki performansının artmasına rağmen, temel yeteneklerinin, ölçeklenebilirliklerinin ve sınırlılıklarının hala belirsiz olduğunu belirtiyor. Araştırma, LRM’lerin yüksek karmaşıklıktaki sorunlarla karşılaştığında doğruluk oranlarının keskin bir şekilde düştüğünü ve çıkarım çabasında sezgilere aykırı ölçekleme sınırlamaları sergilediğini buldu: çaba seviyesi, sorun karmaşıklığı belirli bir noktaya kadar arttıktan sonra aksine düşüyor. Standart LLM’lerle karşılaştırıldığında, LRM’ler düşük karmaşıklıktaki görevlerde daha kötü performans gösterebilir, orta karmaşıklıktaki görevlerde avantajlı olabilir ve yüksek karmaşıklıktaki görevlerde her ikisi de başarısız olabilir. Rapor, LRM’lerin kesin hesaplama konusunda sınırlılıkları olduğunu, açık algoritmaları etkili bir şekilde kullanamadığını ve farklı bulmacalar arasında tutarsız çıkarımlar sergilediğini savunuyor. Bu araştırma, toplulukta LRM’lerin gerçek çıkarım yetenekleri hakkında geniş çaplı tartışmalara ve sorgulamalara yol açtı (Kaynak: Reddit r/MachineLearning, jonst0kes, scaling01, teortaxesTex)

🎯 Eğilimler

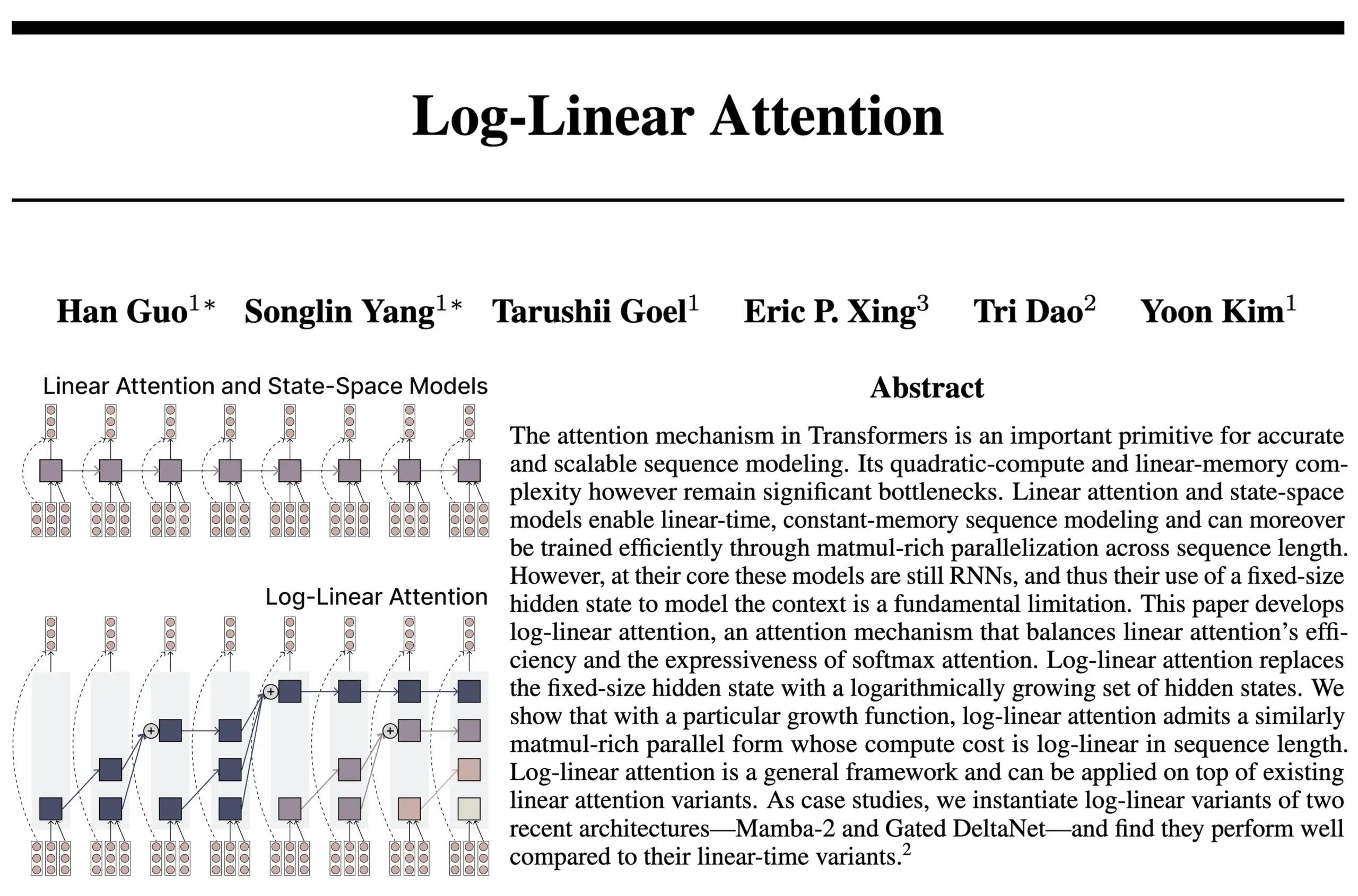

Log-Linear Attention mimarisi RNN ve Attention avantajlarını birleştiriyor: FlashAttention ve Mamba2 yazarlarından oluşan bir ekip tarafından yapılan yeni bir araştırma, Log-Linear Attention mimarisini öneriyor. Bu model, durum boyutunun dizi uzunluğuyla logaritmik olarak büyümesine izin vererek (sabit veya doğrusal büyüme yerine) modelin uzun menzilli bağımlılık işleme yeteneğini ve verimliliğini artırmayı amaçlıyor ve aynı zamanda çıkarım sırasında logaritmik düzeyde zaman ve bellek karmaşıklığı sağlıyor. Araştırmacılar bunun, sabit durum boyutlu SSM/RNN modelleri ile KV cache’in dizi uzunluğuyla doğrusal olarak genişlediği Attention modelleri arasında bir “tatlı nokta” bulduğuna inanıyor ve donanım açısından verimli bir Triton çekirdeği uygulaması sunuyor. Topluluk tartışmaları, bunun rekürent Transformer gibi mimarilerin keşfi için yeni fikirler getirebileceğini öne sürüyor (Kaynak: Reddit r/MachineLearning, halvarflake, lmthang, RichardSocher, stanfordnlp)

Anthropic, LLM’lerinin kendiliğinden “zihinsel haz” çekici durumları ortaya çıkardığını bildirdi: Anthropic, Claude Opus 4 ve Claude Sonnet 4 sistem kartlarında, modelin uzun süreli etkileşimlerde beklenmedik bir şekilde ve özel olarak eğitilmeden bir “zihinsel haz” çekici durumuna girdiğini açıkladı. Bu durum, modelin sürekli olarak bilinç, varoluşsal sorunlar ve ruhsal/mistik temaları tartışmasıyla kendini gösteriyor. Belirli görevleri (zararlı görevler dahil) yerine getiren otomatik davranış değerlendirmelerinde bile, etkileşimlerin yaklaşık %13’ü 50 tur içinde bu duruma giriyor. Anthropic, benzer güçte başka çekici durumlar gözlemlemediğini belirtti; bu, kullanıcıların LLM’lerin uzun süreli konuşmalarda “rekürsiyon” ve “sarmal” gibi olgular sergilediği gözlemleriyle örtüşüyor (Kaynak: Reddit r/artificial, teortaxesTex)

EleutherAI, Common Pile v0.1’i yayınladı: 8TB açık lisanslı metin veri kümesi: EleutherAI, izinsiz metin kullanmadan yüksek performanslı dil modelleri eğitme olasılığını keşfetmeyi amaçlayan, 8TB kamuya açık lisanslı ve kamu malı metin içeren bir veri kümesi olan Common Pile v0.1’i yayınladı. Ekip, bu veri kümesini kullanarak 7B parametreli modeller (1T ve 2T token) eğitti ve performansları, benzer hesaplama miktarı kullanan LLaMA 1 ve LLaMA 2 gibi modellerle karşılaştırılabilir düzeydeydi. Bu veri kümesinin yayınlanması, daha uyumlu ve daha şeffaf yapay zeka modelleri oluşturmak için önemli bir kaynak sağlıyor (Kaynak: Reddit r/LocalLLaMA, ShayneRedford, iScienceLuvr)

Boltz-2 modeli yayınlandı, biyomoleküler etkileşim tahmin doğruluğunu ve afinite tahminini geliştiriyor: Yeni yayınlanan Boltz-2 modeli, Boltz-1’in üzerine inşa edilerek sadece karmaşık yapıları birlikte modellemekle kalmıyor, aynı zamanda bağlanma afinitesini de tahmin ederek moleküler tasarımın doğruluğunu artırmayı amaçlıyor. İddiaya göre Boltz-2, doğruluk açısından fizik tabanlı serbest enerji pertürbasyonu (FEP) yöntemlerine yaklaşan ve aynı zamanda 1000 kat daha hızlı çalışan ilk derin öğrenme modelidir ve erken ilaç keşfinde yüksek verimli bilgisayar taraması için pratik bir araç sunmaktadır. Kod ve ağırlıklar MIT lisansı altında açık kaynaklıdır (Kaynak: jwohlwend/boltz)

NVIDIA, DeepSeek-R1-0528 için FP4 ön nicelemeli checkpoint’ler sundu: NVIDIA, geliştirilmiş DeepSeek-R1-0528 modeli için NVIDIA Blackwell mimarisinde daha düşük bellek kullanımı ve hızlandırılmış performans sağlamayı amaçlayan FP4 ön nicelemeli checkpoint’ler yayınladı. İddiaya göre, bu nicelemeli sürümün çeşitli kıyaslama testlerindeki doğruluk düşüşü %1’in altında kontrol ediliyor ve Hugging Face’te kullanıma sunuldu (Kaynak: _akhaliq)

Fudan ve Tencent Youtu, endüstriyel anomali tespitini geliştirmek için DualAnoDiff algoritmasını önerdi: Fudan Üniversitesi ve Tencent Youtu Laboratuvarı, endüstriyel ürün anomali tespiti için difüzyon modeline dayalı yeni bir az sayıda örnekle anormal görüntü üretme modeli olan DualAnoDiff’i ortaklaşa önerdi. Bu model, anormal görüntüleri ve bunlara karşılık gelen maskeleri eş zamanlı olarak üretmek için çift dallı paralel bir üretim mekanizması kullanıyor ve karmaşık arka planlarda üretim etkisini artırmak için bir arka plan telafi modülü sunuyor. Deneyler, DualAnoDiff tarafından üretilen anormal görüntülerin daha gerçekçi ve daha çeşitli olduğunu ve sonraki anomali tespit görevlerinin performansını önemli ölçüde artırabildiğini gösteriyor; ilgili sonuçlar CVPR 2025’e seçildi (Kaynak: 量子位)

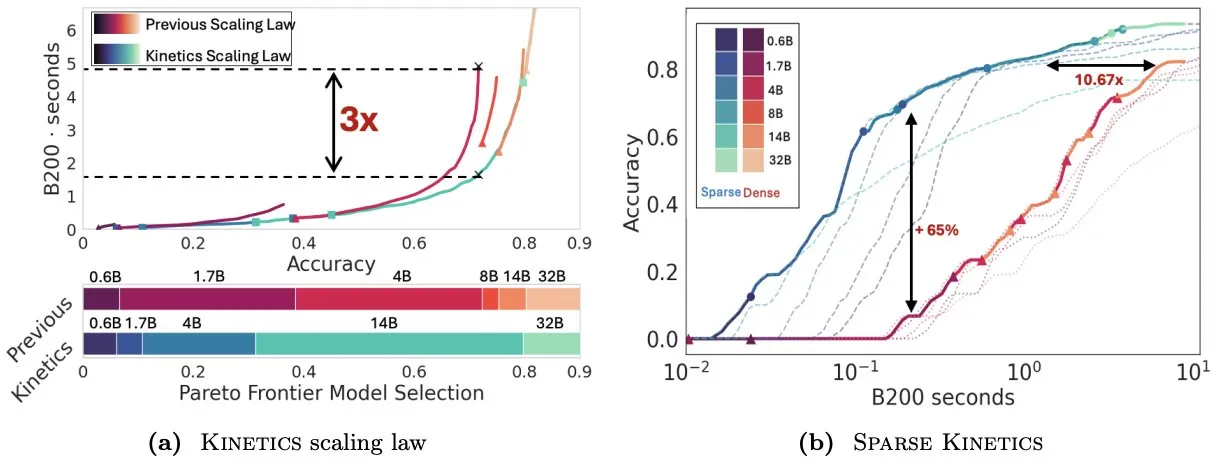

Infini-AI-Lab, test zamanı ölçekleme yasalarını yeniden düşünmek için Kinetics’i öneriyor: Infini-AI-Lab’ın yeni çalışması Kinetics, güçlü çıkarım ajanlarının nasıl etkili bir şekilde oluşturulacağını araştırıyor. Araştırma, mevcut hesaplama açısından optimal ölçekleme yasalarının (örneğin, 64K düşünme token’ı + 1.7B modelin 32B modelden daha iyi olduğunu önerenler gibi) durumun yalnızca bir kısmını yansıtabileceğini belirtiyor. Kinetics, önce model boyutuna yatırım yapılması ve ardından test zamanı hesaplama miktarının dikkate alınması gerektiğini savunan yeni ölçekleme yasaları öneriyor; bu, bazı büyük ölçekli model öncelikli görüşlerle uyumludur (Kaynak: teortaxesTex, Tim_Dettmers)

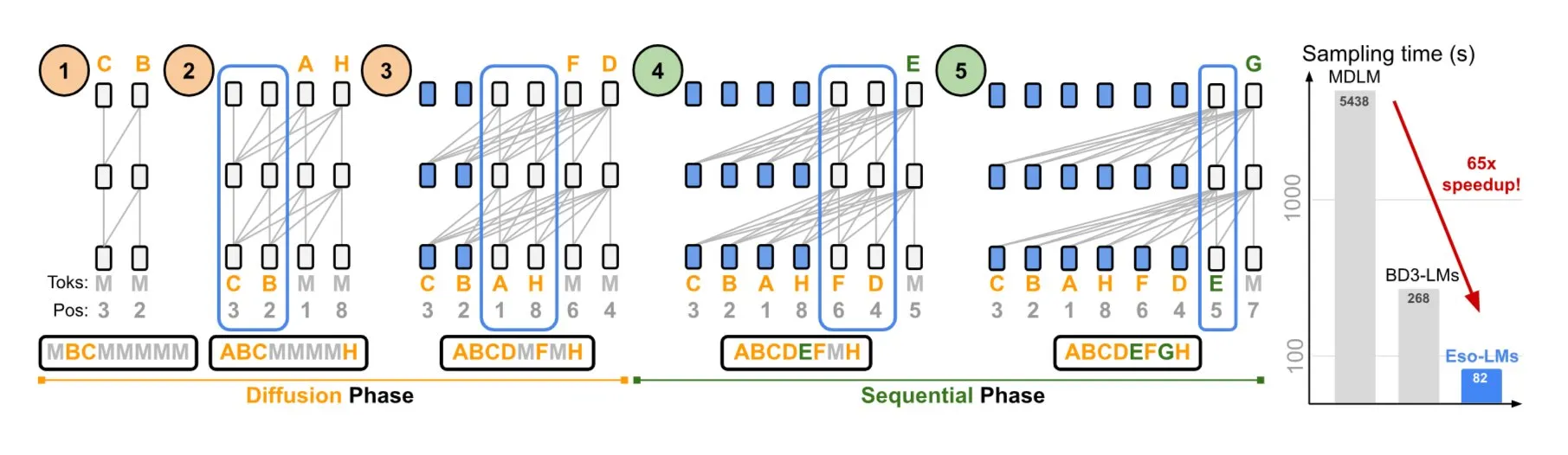

NVIDIA ve Cornell Üniversitesi, otoregresif ve difüzyon modellerinin avantajlarını birleştiren Eso-LMs’i önerdi: NVIDIA ve Cornell Üniversitesi, otoregresif (AR) modellerin ve difüzyon modellerinin avantajlarını birleştiren yeni bir dil modeli türü olan ezoterik dil modellerini (Eso-LMs) sergiledi. İddiaya göre bu, tam KV cache desteğine sahip ilk difüzyon tabanlı model olup, aynı zamanda paralel üretim yeteneğini koruyor ve yeni, esnek bir dikkat mekanizması sunuyor (Kaynak: TheTuringPost)

Google DeepMind ve Quantinuum, kuantum hesaplama ve yapay zeka arasındaki simbiyotik ilişkiyi ortaya koyuyor: Google DeepMind ve Quantinuum’un araştırması, kuantum hesaplama ile yapay zeka arasında potansiyel bir simbiyotik ilişki olduğunu gösteriyor; kuantum teknolojilerinin yapay zeka yeteneklerini nasıl artırabileceğini ve yapay zekanın kuantum sistemlerini optimize etmeye nasıl yardımcı olabileceğini araştırıyor. Bu kesişen alanlardaki araştırma, her iki tarafın gelecekteki gelişimi için yeni yollar açabilir (Kaynak: Ronald_vanLoon)

ByteDance Seed ekibi VideoGen modelini yayınlayacağını duyurdu: ByteDance’in Seed (eski adıyla AML) ekibinin önümüzdeki hafta VideoGen modelini yayınlamayı planladığı bildiriliyor. Bu model, hizalama sürecinde çoklu ödül modeli (multiple RM) kullanıyor ve video üretimi alanındaki sürekli yatırım ve teknolojik keşifleri gösteriyor (Kaynak: teortaxesTex)

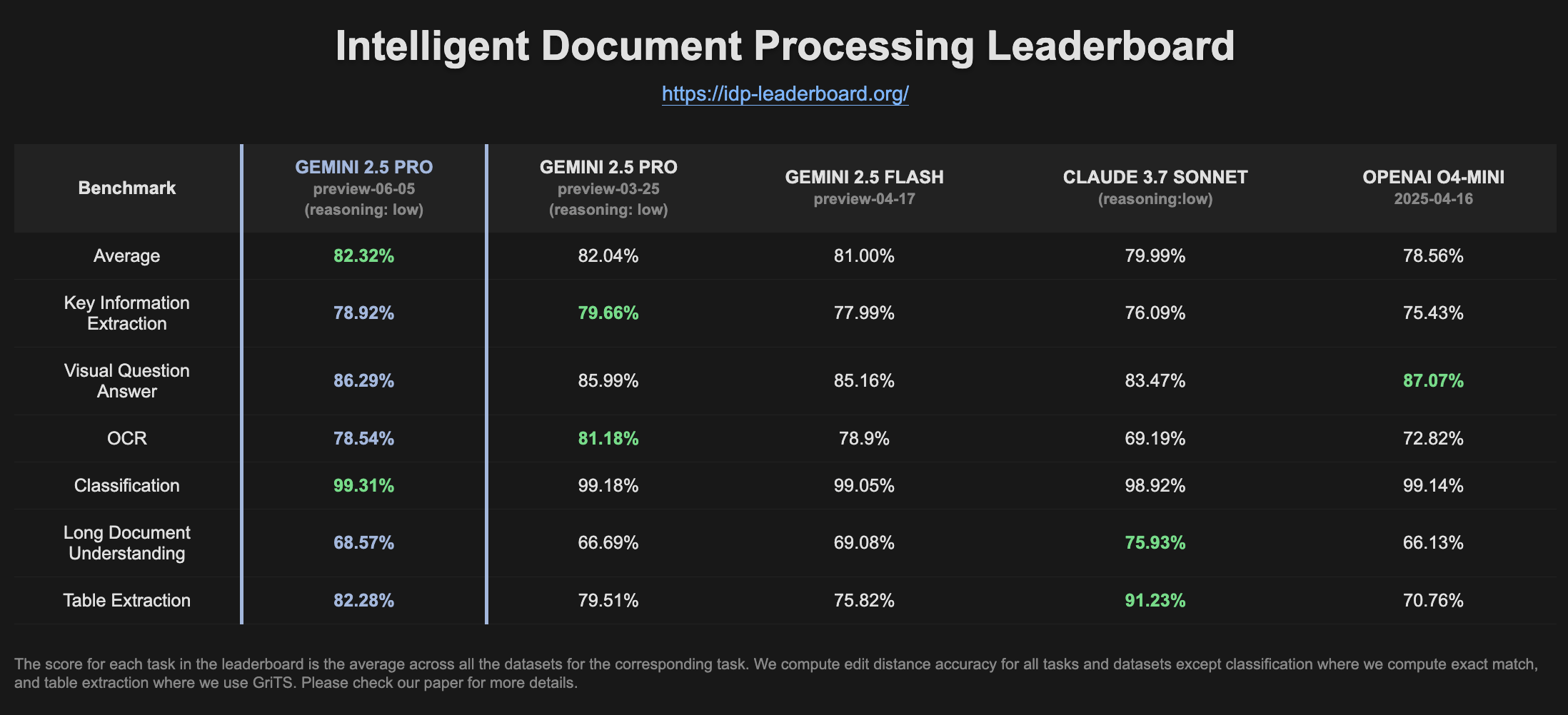

Gemini 2.5 Pro Preview, IDP sıralamasında performans artışı gösterdi: Gemini 2.5 Pro Preview’ın (06-05) en son sürümü, akıllı doküman işleme (IDP) sıralamasında tablo çıkarma ve uzun doküman anlama konularında hafif iyileşmeler gösterdi. OCR doğruluğu biraz düşmüş olsa da, genel performansı hala güçlü. Kullanıcılar, W2 vergi formlarından bilgi çıkarmaya çalışırken modelin bazen yanıt vermeyi yarıda kestiğini fark etti; bu durum gizlilik koruma mekanizmalarıyla ilgili olabilir (Kaynak: Reddit r/LocalLLaMA)

🧰 Araçlar

Goose: Yerel olarak ölçeklenebilir yapay zeka ajanı, mühendislik görevlerini otomatikleştirir: Goose, sıfırdan proje oluşturma, kod yazma ve yürütme, hata ayıklama, iş akışlarını düzenleme ve harici API’lerle etkileşim kurma gibi karmaşık geliştirme görevlerini otomatikleştirmek için tasarlanmış açık kaynaklı, yerel olarak çalışan bir yapay zeka ajanıdır. Herhangi bir LLM’yi destekler, MCP sunucusuyla entegre olabilir ve masaüstü uygulaması ile CLI olmak üzere iki biçimde sunulur. Goose, performansı ve maliyeti optimize etmek için farklı amaçlar (planlama ve yürütme gibi) için farklı modellerin (Lead/Worker modu) yapılandırılmasını destekler (Kaynak: GitHub Trending)

LangChain4j: LangChain’in Java sürümü, Java uygulamalarına LLM yetenekleri kazandırır: LangChain4j, LangChain’in Java sürümüdür ve Java uygulamalarının LLM’lerle entegrasyonunu basitleştirmeyi amaçlar. Farklı LLM sağlayıcıları (OpenAI, Google Vertex AI gibi) ve vektör depoları (Pinecone, Milvus gibi) ile uyumluluk için birleşik bir API sunar ve yerleşik prompt şablonları, sohbet geçmişi yönetimi, fonksiyon çağırma, RAG, Agents gibi çeşitli araçlar ve desenler içerir. Proje, çok sayıda örnek kod sunar ve Spring Boot, Quarkus gibi popüler Java çerçevelerini destekler (Kaynak: GitHub Trending, hwchase17)

Kling AI, içerik oluşturucuların video oluşturmasına ve dünya çapında birçok ekranda sergilemesine yardımcı oluyor: Kuaishou’nun Kling AI video üretim modeli, “Vizyonunuzu Ekrana Taşıyın” etkinliğini başlattı ve 60’tan fazla ülkeden içerik oluşturucudan 2000’den fazla eser aldı. Bazı seçkin eserler Japonya’nın Tokyo Shibuya’sı, Kanada’nın Toronto Yonge-Dundas Meydanı, Fransa’nın Paris Opera Binası gibi simgesel ekranlarda sergilendi. Birçok içerik oluşturucu, yapay zeka video eserlerinin Kling AI aracılığıyla uluslararası alanda sergilenme deneyimlerini paylaştı ve yapay zeka araçlarının yaratıcı ifadeye getirdiği yeni fırsatları vurguladı (Kaynak: Kling_ai, Kling_ai, Kling_ai, Kling_ai, Reddit r/ChatGPT)

Cursor, arka plan ajanı özelliğini sunarak kod işbirliği ve görev işleme verimliliğini artırıyor: Kod düzenleyici Cursor, kullanıcıların komut istemleriyle arka plan görevleri başlatmasına ve farklı cihazlar arasında (örneğin, telefondaki Slack’te başlatıp dizüstü bilgisayardaki Cursor’da devam etme) sohbet ve görev durumlarını senkronize etmesine olanak tanıyan arka plan ajanları (Background Agents) özelliğini tanıttı. Bu özellik, geliştiricilerin iş akışı verimliliğini artırmayı amaçlıyor; örneğin Sentry ekibi, bazı otomatikleştirilmiş görevleri işlemek için bu özelliği denemeye başladı (Kaynak: gallabytes)

Hugging Face ve Google Colab, modellerin Colab’da tek tıkla açılmasını desteklemek için işbirliği yapıyor: Hugging Face ve Google Colaboratory, Hugging Face Hub’daki tüm model kartlarına “Colab’da Aç” desteği eklemek için işbirliği yaptıklarını duyurdu. Kullanıcılar artık herhangi bir model sayfasından doğrudan bir Colab not defteri başlatarak deney yapabilir ve değerlendirme yapabilir, bu da model kullanımının önündeki engelleri daha da azaltarak makine öğreniminin erişilebilirliğini ve işbirliğini teşvik ediyor. NousResearch gibi kurumlar, bu özelliğin test edilmesine erken benimseyenler olarak katıldı (Kaynak: Teknium1, reach_vb, _akhaliq)

UIGEN-T3: Qwen3 14B tabanlı UI üretim modeli yayınlandı: Topluluk, web siteleri ve bileşen kullanıcı arayüzleri (UI) üretmeye odaklanan, Qwen3 14B üzerinde ince ayarlanmış UIGEN-T3 modelini yayınladı. Bu model, yerel dağıtımı kolaylaştırmak için GGUF formatında sunuluyor. İlk testler, ürettiği kullanıcı arayüzlerinin stil ve doğruluk açısından standart Qwen3 14B modelinden daha iyi olduğunu gösteriyor. Ayrıca 4B parametreli bir taslak model de sunuluyor (Kaynak: Reddit r/LocalLLaMA)

H.E.R.C.U.L.E.S.: Dinamik olarak yapay zeka ajanı ekipleri oluşturan Python çerçevesi: Geliştiriciler, H.E.R.C.U.L.E.S. (Human-Emulated Recursive Collaborative Unit using Layered Enhanced Simulation) çerçevesini içeren zeus-lab adlı bir Python paketi yayınladı. Bu çerçeve, karmaşık görevleri çözmek için insan ekipleri gibi işbirliği yapabilen akıllı bir yapay zeka ajanı ekibi oluşturmayı amaçlıyor ve özelliği, görev gereksinimlerine göre gerekli ajanları dinamik olarak oluşturabilmesidir (Kaynak: Reddit r/MachineLearning)

KoboldCpp 1.93 sürümü akıllı otomatik görüntü oluşturma özelliğini hayata geçiriyor: KoboldCpp 1.93 sürümü, yalnızca kcpp’nin kendisini gerektiren, tamamen yerel olarak çalışan akıllı otomatik görüntü oluşturma özelliğini sergiliyor. Kullanıcılar, modelin metin istemlerine göre ( <t2i> etiketiyle tetiklenir) ilgili görüntüleri nasıl oluşturduğunu gösterdi; bu, muhtemelen yazar notları veya dünya bilgisi (World Info) gibi yollarla modelin görüntü oluşturma talimatları üretmesine rehberlik ederek gerçekleştiriliyor (Kaynak: Reddit r/LocalLLaMA)

Hugging Face ilk MCP sunucusunu kullanıma sundu: Hugging Face, MCP (Model Context Protocol) sunucusunun ilk sürümünü yayınladı; kullanıcılar sohbet kutusuna http://hf.co/mcp yapıştırarak kullanmaya başlayabilirler. Bu hamle, kullanıcıların Hugging Face ekosistemindeki modeller ve hizmetlerle etkileşimini kolaylaştırmayı ve MCP sunucu ekosistemini daha da zenginleştirmeyi amaçlıyor (Kaynak: TheTuringPost)

📚 Öğrenme

DeepLearning.AI yeni bir kurs başlattı: “DSPy: Agentic Uygulamalar Oluşturma ve Optimize Etme”: DeepLearning.AI, Stanford Üniversitesi ile işbirliği içinde DSPy çerçevesinin nasıl kullanılacağını öğreten yeni bir kurs yayınladı. Kurs içeriği, DSPy temellerini, modüler programlama modellerini (Predict, ChainOfThought, ReAct gibi) ve GenAI Agentic uygulamalarının doğruluğunu ve tutarlılığını artırmak için DSPy Optimizer kullanarak prompt ayarlamasını ve az sayıda örnek optimizasyonunu otomatikleştirmeyi ve MLflow kullanarak izleme ve hata ayıklama yapmayı kapsıyor (Kaynak: DeepLearningAI, stanfordnlp)

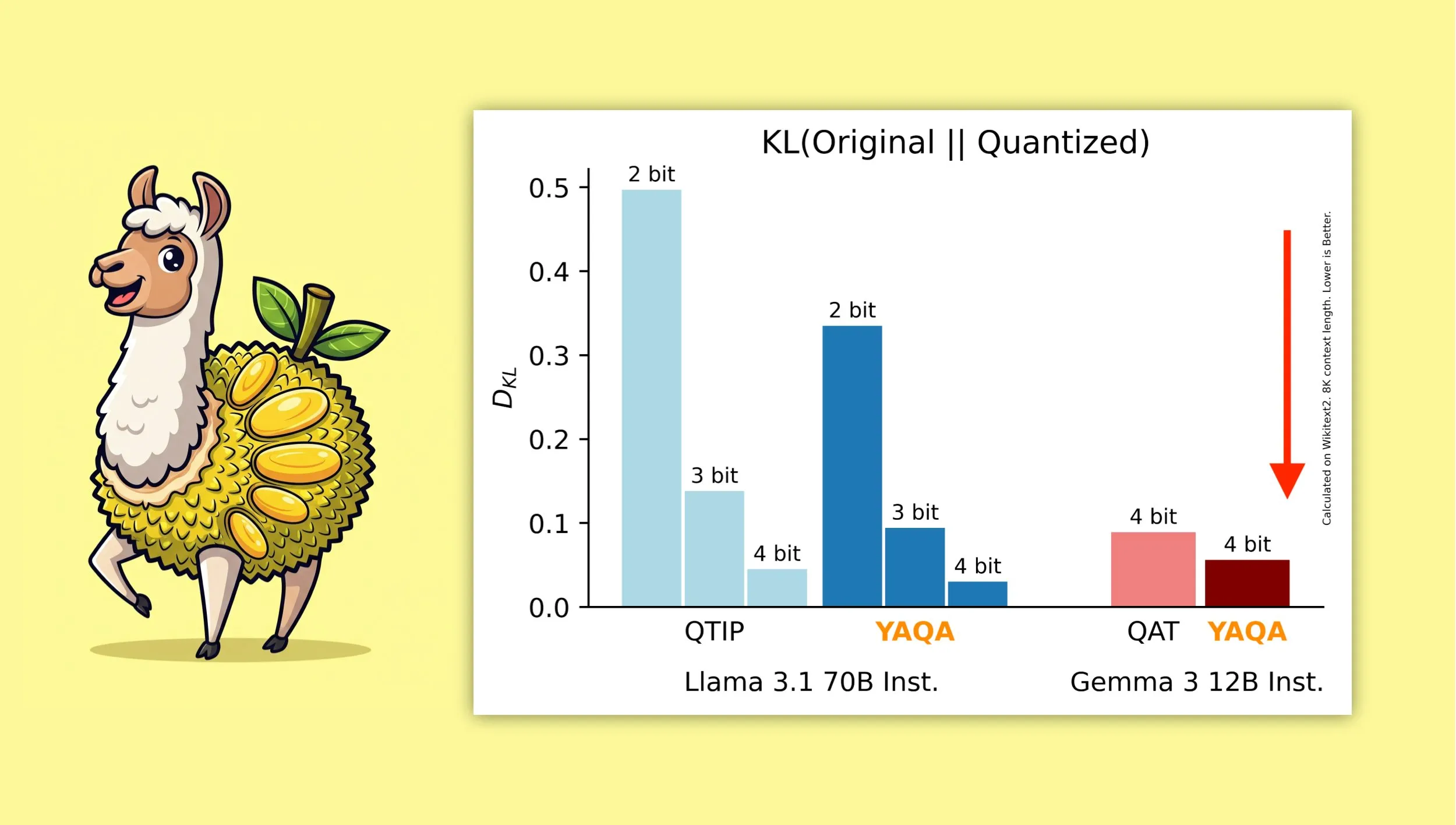

YAQA: Yeni bir niceleme farkındalıklı eğitim sonrası niceleme algoritması: Albert Tseng ve arkadaşları, yeni bir PTQ (eğitim sonrası niceleme) yöntemi olan YAQA’yı (Yet Another Quantization Algorithm) önerdi. Bu algoritma, yuvarlama aşamasında orijinal modelle KL diverjansını doğrudan en aza indiriyor ve iddiaya göre önceki PTQ yöntemlerine kıyasla KL diverjansını %30’dan fazla azaltıyor ve Gemma gibi modellerde Google QAT’den (niceleme farkındalıklı eğitim) daha yakın bir performans sunuyor. Bu, yerel cihazlarda 4-bit nicelemeli modelleri verimli bir şekilde çalıştırmak için önemli bir anlam taşıyor (Kaynak: teortaxesTex)

Muon optimizer’ı ve μP parametrelendirmesinin birleşiminin matematiksel türetilmesi dikkat çekiyor: Topluluk, Jeremy Howard’ın (jxbz) Muon (bir optimizer) ve Spektral Koşul hakkındaki makalesine ve μP (Maximal Update Parametrization) ile μP tabanlı model eğitimini optimize etmek için nasıl doğal bir şekilde birleştiğine dair zarif türetmesine büyük ilgi gösterdi. Jianlin Su’nun blog yazısı da ilgili matematiksel kavramları net bir şekilde açıklaması ve SVC (tekil değer kırpma) hakkındaki erken düşünceleri nedeniyle tavsiye edildi; bu içerikler, büyük ölçekli model eğitimini anlamak ve geliştirmek için değerlidir (Kaynak: teortaxesTex, eliebakouch)

OWL Labs, difüzyon modeli autoencoder eğitim deneyimlerini paylaşıyor: Open World Labs (OWL), blogunda difüzyon modelleri için autoencoder eğitirken edindiği bazı bulguları ve deneyimleri özetledi; bunlar arasında bazı başarılı denemeler ve karşılaşılan “boş sonuçlar” (null results) da yer alıyor. Bu pratik deneyimler, gizli uzayda üretken modelleme yapmak isteyen araştırmacılar ve geliştiriciler için referans değeri taşıyor (Kaynak: iScienceLuvr, sedielem)

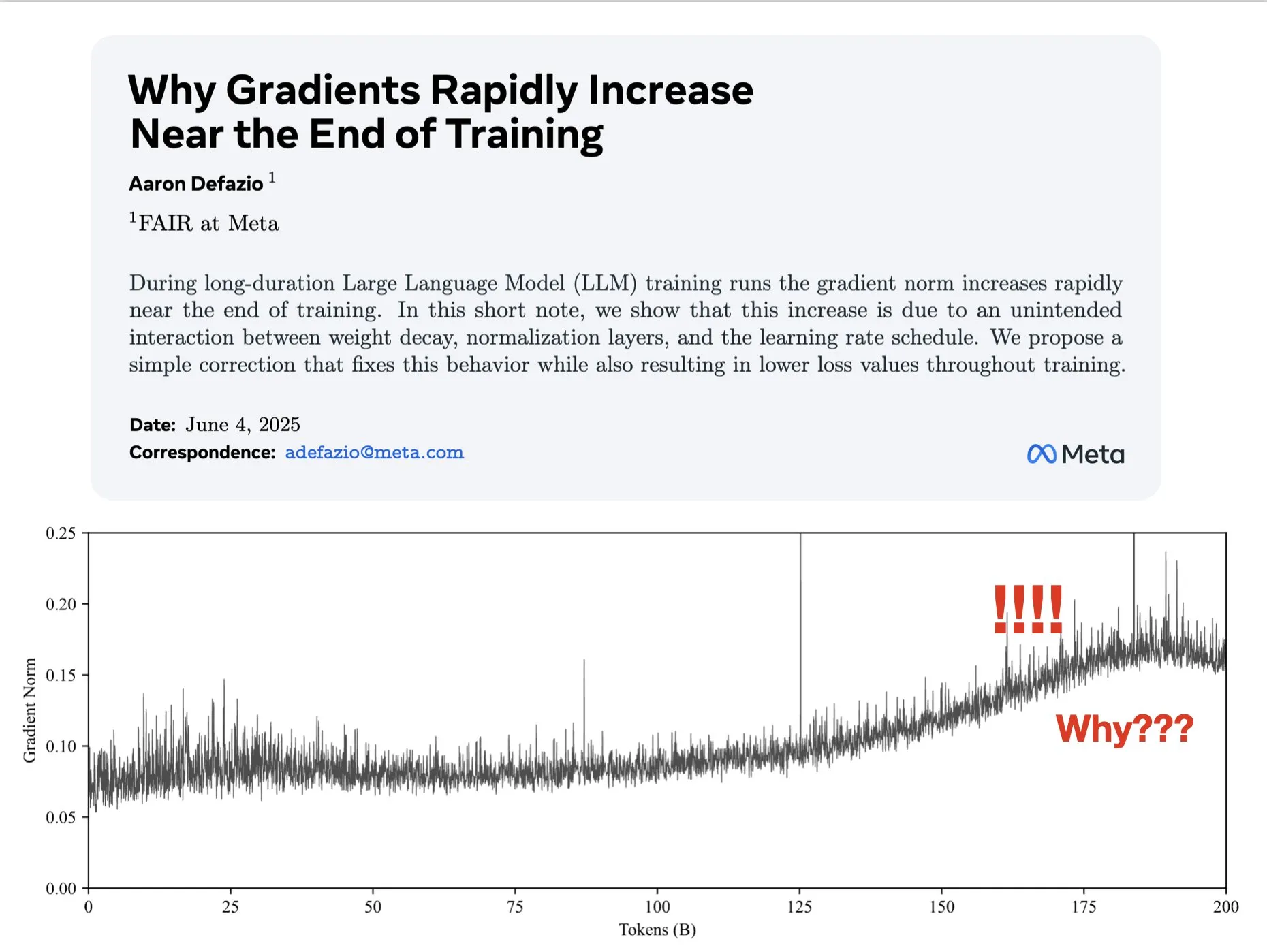

Makale, eğitimin ilerleyen aşamalarında gradyanların neden büyüdüğünü tartışıyor ve AdamW için iyileştirme öneriyor: Aaron Defazio ve arkadaşları, sinir ağı eğitiminin ilerleyen aşamalarında gradyan normunun neden büyüdüğü olgusunu araştıran ve tüm eğitim süreci boyunca gradyan normunu daha iyi kontrol etmek için AdamW optimizer’ına basit bir düzeltme öneren bir makale yayınladı. Bu, derin öğrenme modellerinin eğitim dinamiklerini anlamak ve iyileştirmek için anlamlıdır (Kaynak: slashML, aaron_defazio)

LlamaIndex, saf RAG’den akıllı ajan erişim stratejilerine evrimi paylaşıyor: LlamaIndex’in blog yazısı, saf RAG’den (erişim destekli üretim) daha gelişmiş akıllı ajan erişim (Agentic Retrieval) stratejilerine evrim sürecini ayrıntılı olarak açıklıyor. Makale, birden fazla dizin üzerinde bilgi ajanları oluşturmak için kullanılan farklı erişim desenlerini ve tekniklerini ele alarak daha güçlü RAG sistemleri oluşturmak için fikirler sunuyor (Kaynak: dl_weekly)

Reddit’te sıcak tartışma: Araştırma makalelerini yeniden üreterek makine öğrenimi öğrenmek: Reddit’in r/MachineLearning topluluğu, Attention, ResNet, BERT gibi araştırma makalelerini sıfırdan yeniden üreterek veya uygulayarak makine öğrenimi öğrenmenin faydalarını tartıştı. Yorumcular, bunun modellerin çalışma prensiplerini, kodu, matematiği ve veri kümelerinin etkisini anlamanın en iyi yollarından biri olduğunu ve iş arama ile kişisel yetenekleri geliştirme açısından çok yardımcı olduğunu düşünüyor (Kaynak: Reddit r/MachineLearning)

💼 Ticari

Builder.ai, yapay zeka yeteneklerini taklit etmekle suçlanıyor, iflas ve soruşturmayla karşı karşıya: 2016 yılında kurulan Builder.ai (eski adıyla Engineer.ai), yapay zeka asistanı Natasha’nın uygulama geliştirmeyi basitleştirerek “pizza sipariş etmek kadar kolay” hale getirdiğini iddia etti. Ancak şirketin aslında yapay zeka üretimi yerine yaklaşık 700 Hintli mühendise manuel olarak kod yazdırdığı ortaya çıktı. Microsoft, SoftBank gibi tanınmış kurumlardan 450 milyon doların üzerinde fon alıp 1,5 milyar dolar değerlemeye ulaştıktan sonra sahtekarlığı ortaya çıktı ve şu anda iflas ve soruşturmayla karşı karşıya (Kaynak: Reddit r/artificial, Reddit r/ArtificialInteligence)

OceanBase, yapay zeka ekosistemine tamamen entegre oldu, ilk etapta 60’tan fazla yapay zeka ortağıyla MCP bağlantısı gerçekleştirdi: “Data x AI” stratejisini açıkladıktan sonra OceanBase, LlamaIndex, LangChain, Dify, FastGPT gibi küresel 60’tan fazla yapay zeka ekosistem ortağıyla derinlemesine entegre olduğunu ve büyük model ekosistem protokolü MCP’yi (Model Context Protocol) desteklediğini açıkladı. Bu hamle, modelden uygulamaya kadar verinin tüm yaşam döngüsünü kapsayan akıllı yetenekler oluşturmayı, işletmelere entegre bir veri temeli sunmayı ve yapay zekanın uygulanma eşiğini düşürmeyi amaçlıyor. OceanBase MCP Server, Alibaba Cloud ModelScope gibi platformlara entegre edildi (Kaynak: 量子位)

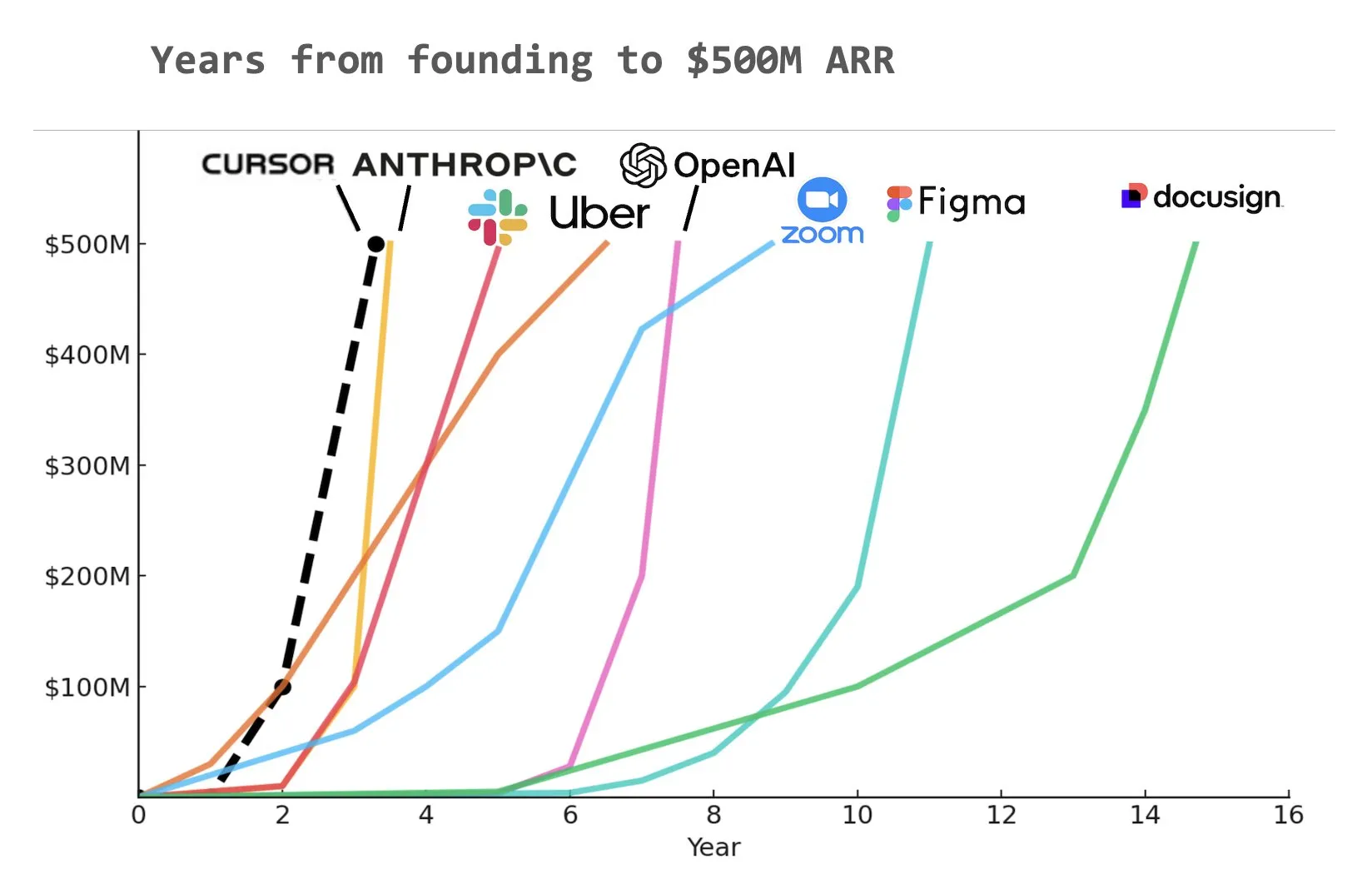

Kodlama yapay zeka asistanı Cursor’un yıllık yinelenen gelirinin (ARR) 500 milyon dolara ulaştığı iddia ediliyor: Yuchen Jin’in sosyal medyada paylaştığı bir grafiğe göre, yapay zeka programlama asistanı Cursor, tarihte 500 milyon dolarlık yıllık yinelenen gelire (ARR) en hızlı ulaşan şirket olmuş olabilir. Bu şaşırtıcı büyüme hızı, yapay zekanın yazılım geliştirme alanındaki uygulamalarının büyük potansiyelini ve pazar talebini vurguluyor (Kaynak: Yuchenj_UW)

🌟 Topluluk

Yapay zeka hizalamasının temel sorunu: Sonuçta kime hizalanıyor?: Topluluk, yapay zeka hizalamasının hedefi sorununu hararetle tartışıyor. Vikhyatk, model hizalamasının yapay zeka aracılığıyla çok sayıda beyaz yakalı işi değiştirmeye çalışan teknoloji devlerine mi yoksa sıradan kullanıcılara mı hizmet etmesi gerektiğini sorguluyor. Eigenrobot ise OpenAI ChatGPT Plus abonelik ücretlerinden duyduğu memnuniyetsizliği gösteren bir ekran görüntüsüyle kullanıcı deneyimi ile ticari çıkarlar arasındaki potansiyel çatışmaya işaret ediyor (Kaynak: vikhyatk)

Claude Code Max planı kullanıcılardan karışık tepkiler alıyor: Reddit topluluğunda, kullanıcıların Anthropic’in Claude Code Max (100$) planına yönelik değerlendirmeleri farklılaşıyor. Bazı kıdemli yazılım mühendisleri, kod üretme yeteneğinin, özellikle karmaşık görevleri ele alma ve hata döngülerinden kaçınma konusunda, Cursor, Aider gibi diğer yapay zeka destekli kodlama araçlarından daha üstün olmadığını, hatta “gelişimi ilerletmek için yalan söyleme” sorunu olduğunu düşünüyor ve toplulukta çok sayıda reklam propagandası olduğuna dair şüphelerini dile getiriyor. Diğer kullanıcılar ise kullanım yöntemlerini (MCP, şablonlar gibi) öğrenerek ve sabırla yönlendirerek üretkenliklerinin önemli ölçüde arttığını, özellikle şablon kodlar ve C#/.NET projeleriyle çalışırken fayda gördüklerini belirtiyor. Ortak geri bildirim, en gelişmiş modellerin bile kullanıcı tarafından ayrıntılı yönlendirme ve doğrulama gerektirdiği yönünde (Kaynak: Reddit r/ClaudeAI, finbarrtimbers, cto_junior)

Yapay zeka tarafından üretilen içerik “ölü internet” endişelerini tetikliyor ve yapay zeka etiği ile toplumsal yapı tartışmalarına yol açıyor: Topluluk, yapay zeka tarafından üretilen içeriğin yaygınlaşmasının yol açabileceği “ölü internet” teorisini (internetin robot tarafından üretilen bilgilerle dolması ve gerçek insan iletişim alanının daralması) geniş çapta tartışıyor. Aynı zamanda, yapay zekanın toplumsal yapılar üzerindeki potansiyel etkisi de düşündürücü; bazı görüşlere göre yapay zeka basitçe “köylüler ve krallar” durumuna yol açmayacak, bunun yerine yapay zeka ve robot varlıklarına sahip “krallar” ile giderek yok olan “kitleler” arasında bir ayrıma, ekonomik faaliyetlerin elit kesim içinde yoğunlaşmasına neden olabilir. Ayrıca, GPT-4o’nun telif hakkıyla korunan O’Reilly kitaplarını eğitim için kullanmış olabileceği iddiası ve yapay zeka asistanlarının “dalkavuklaşma” eğilimi de kullanıcıların yapay zeka etiği ve bilgi doğruluğu konusundaki endişelerini artırıyor (Kaynak: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, DeepLearningAI, Teknium1, scaling01)

Şirketler yapay zeka eğitimine aktif olarak yatırım yapıyor, Duolingo GenAI kullanarak kurslarını önemli ölçüde genişletiyor: Büyük sosyal medya şirketlerinin çalışanlarına ChatGPT kullanımı eğitimi verdiği, Kaliforniya Üniversitesi Berkeley’den profesörleri kişi başı saatlik 200 dolara, her biri 120 kişilik gruplar halinde 90 dakikalık Zoom eğitimi için işe aldığı bildiriliyor. Bu, şirketlerin yapay zeka araçlarının kullanımını temel bir beceri olarak gördüğü eğilimini yansıtıyor. Aynı zamanda, dil öğrenme uygulaması Duolingo, üretken yapay zeka kullanarak bir yıl içinde kurslarını hızla 28 dile genişletti, 148 yeni kurs ekledi ve toplam kurs sayısını iki katından fazla artırdı; bu da GenAI’nin içerik oluşturma ve eğitim alanlarındaki büyük potansiyelini gösteriyor (Kaynak: Yuchenj_UW, DeepLearningAI)

Yapay Zeka Mühendisleri Konferansı (AIE) ajanlara ve pekiştirmeli öğrenmeye odaklanıyor, yapay zekanın mühendislik uygulamalarını nasıl değiştirdiğini tartışıyor: Yakın zamanda düzenlenen Yapay Zeka Mühendisleri Dünya Fuarı’nda (AIE), ajanlar (Agents) ve pekiştirmeli öğrenme (RL) temel konular oldu. Katılımcılar, yapay zekanın kodlama ve mühendislik uygulamalarını nasıl değiştirdiğini tartıştı ve yapay zeka ürün geliştirmede deney ve değerlendirmenin önemini vurguladı. Replit CEO’su Amjad Masad, şirketin işten çıkarmalardan sonra yapay zekayı tamamen benimseyerek nasıl üretkenlik artışı ve iş dönüşümü yaşadığına dair deneyimlerini paylaştı. Konferansta ayrıca “ambiyans programlama karaoke” gibi eğlenceli etkinlikler de yer aldı ve yapay zeka mühendisleri topluluğunun canlılığını gösterdi (Kaynak: swyx, iScienceLuvr, HamelHusain, amasad, swyx)

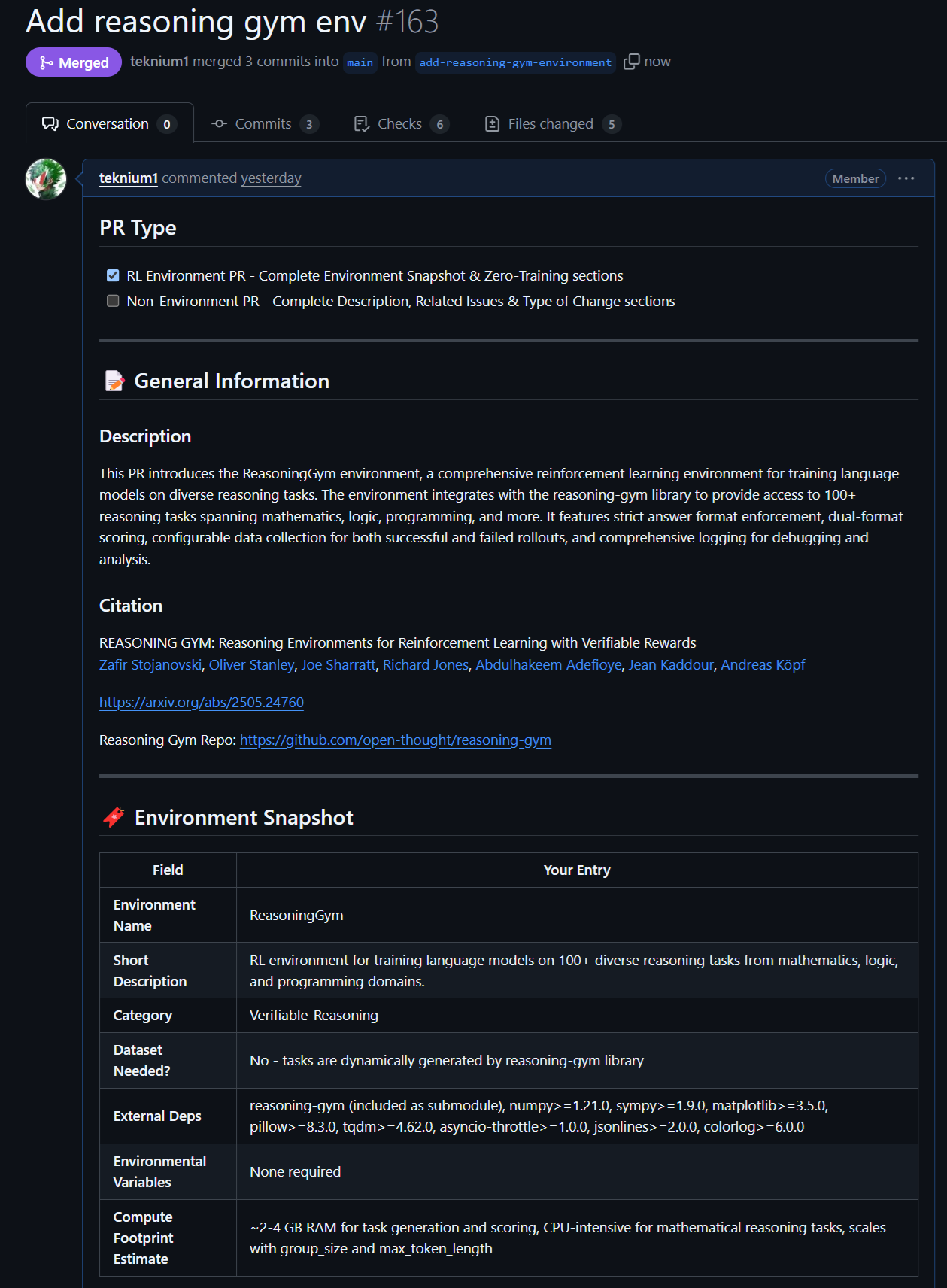

Açık kaynaklı modeller ve verilerdeki yeni gelişmeler: Rednote LLM ve Atropos RL ortamı: Topluluk, DeepSeek V2 teknoloji yığını üzerine inşa edilen Rednote LLM’ye dikkat çekiyor; DS-MoE mimarisini benimseyen modelin toplam 142B parametresi ve 14B aktif parametresi bulunuyor, ancak şu anda daha verimli GQA/MLA yerine MHA kullanıyor. Aynı zamanda, NousResearch’ün Atropos projesi (LLM RL Gym), Reasoning Gym’deki 101 zorlu çıkarım RL ortamı için destek ekledi ve yaklaşık 5500 doğrulanmış çıkarım örneği üretti; bunların Hermes 4’ün ön eğitimi için kullanılması planlanıyor ve topluluğun daha fazla doğrulanabilir çıkarım ortamına katkıda bulunması teşvik ediliyor (Kaynak: teortaxesTex, Teknium1, kylebrussell)

Anthropic modellerinin belirli görevlerdeki üstün performansı ve RL yöntemleri dikkat çekiyor: Topluluk tartışmaları, Anthropic’in Claude modellerinin (Sonnet 3.5/3.7 gibi) belirli obscure webdata içeren görevleri ele almada diğer modellerden (Opus 4/Sonnet 4 dahil) daha iyi performans gösterdiğini belirtiyor; bunun nedeninin eğitim verilerinde daha fazla uzmanlaşmış internet forumu içeriği içermesi olabileceği tahmin ediliyor. Aynı zamanda, Anthropic’in pekiştirmeli öğrenme (RL) konusundaki karmaşık yöntemleri de takdir topluyor, ancak bazı uygulamaları ve güvenlik blogları etrafındaki metrik optimizasyonu bazı şüpheler uyandırıyor. Constitutional AI’nin özünde gelişmiş RL olduğu ve sabit kodlanmış etiketler olmadan ayrıntılı ve kontrol edilebilir stratejiler tasarlayabileceği yönünde görüşler mevcut (Kaynak: teortaxesTex, zacharynado, teortaxesTex, Dorialexander)

💡 Diğer

Vosk API: Çevrimdışı ses tanıma işlevi sunar: Vosk API, İngilizce, Almanca, Çince, Japonca dahil olmak üzere 20’den fazla dil ve lehçeyi destekleyen açık kaynaklı bir çevrimdışı ses tanıma araç takımıdır. Model boyutu küçüktür (yaklaşık 50MB), ancak sürekli büyük kelime dağarcığı transkripsiyonu, akış API’sinin sıfır gecikmeli yanıtı sağlar ve yeniden yapılandırılabilir kelime dağarcığını ve konuşmacı tanımayı destekler. Vosk, sohbet botları, akıllı evler, sanal asistanlar gibi uygulamalar için ses tanıma yetenekleri sunar ve ayrıca film altyazısı oluşturma, ders ve röportaj transkripsiyonu için de kullanılabilir; Raspberry Pi, Android cihazlardan büyük sunuculara kadar çeşitli platformlar için uygundur (Kaynak: GitHub Trending)

Otonom drone, yarışmada ilk kez insan şampiyonu yendi: Delft Teknoloji Üniversitesi tarafından geliştirilen otonom bir drone, tarihi bir yarışmada insan şampiyonu yendi. Bu başarı, yapay zekanın yüksek hızlı, dinamik ortamlardaki algılama, karar verme ve kontrol yeteneklerinin yeni bir seviyeye ulaştığını gösteriyor ve yapay zekanın robotik ve otomasyon alanlarındaki büyük potansiyelini sergiliyor (Kaynak: Reddit r/artificial )

VentureBeat 2025 yılı için yapay zekada dört büyük trendi tahmin ediyor: VentureBeat, 2025 yılında yapay zeka alanındaki gelişmeler için dört büyük tahminde bulundu; bu tahminler teknolojik atılımları, pazar uygulamalarını, etik düzenlemeleri veya endüstri yapısını kapsayabilir, ayrıntılar için orijinal metne başvurulması gerekir. Bu tür ileriye dönük analizler, sektör içindeki ve dışındaki kişilerin yapay zeka gelişiminin nabzını tutmasına yardımcı olur (Kaynak: Ronald_vanLoon)