Anahtar Kelimeler:AI modeli, veri seti, insansı robot, AI Ajan, dil modeli, derin öğrenme, açık kaynak model, çıkarım optimizasyonu, Common Pile v0.1 veri seti, Helix uçtan uca kontrol modeli, Hugging Face MCP sunucusu, Gemini 2.5 Pro güncellemesi, seyrek dikkat mekanizması

🔥 Odak Noktası

EleutherAI, Common Pile v0.1’i Yayınladı: 8TB Açık Lisanslı Metin Veri Kümesi, Lisanssız Verilerle Dil Modelleri Eğitmeye Meydan Okuyor : EleutherAI, birçok kurumla ortaklaşa Common Pile v0.1’i yayınladı. Bu, lisanssız metinler kullanılmadan yüksek performanslı dil modelleri eğitmenin fizibilitesini araştırmayı amaçlayan 8TB’lık açık lisanslı ve kamu malı metin içeren büyük bir veri kümesidir. Ekip, bu veri kümesini kullanarak 7B parametreli bir model (1T ve 2T token) eğitti ve performansı LLaMA 1 ve LLaMA 2 gibi benzer modellerle karşılaştırılabilir düzeyde. Veri kümesi, yazar atfı, lisans ayrıntıları ve orijinal kopyalara bağlantılar gibi belge düzeyinde meta veriler içererek araştırmacılara şeffaf ve uyumlu bir veri kaynağı sunuyor. Bu girişim, açık ve uyumlu AI modellerinin geliştirilmesini teşvik etmede önemli bir rol oynuyor ve AI eğitim verilerinin telif hakkı sorunlarına yeni çözümler sunuyor (Kaynak: EleutherAI, percyliang, BlancheMinerva, code_star, ShayneRedford, Tim_Dettmers, jeremyphoward, stanfordnlp, ClementDelangue, tri_dao, andersonbcdefg)

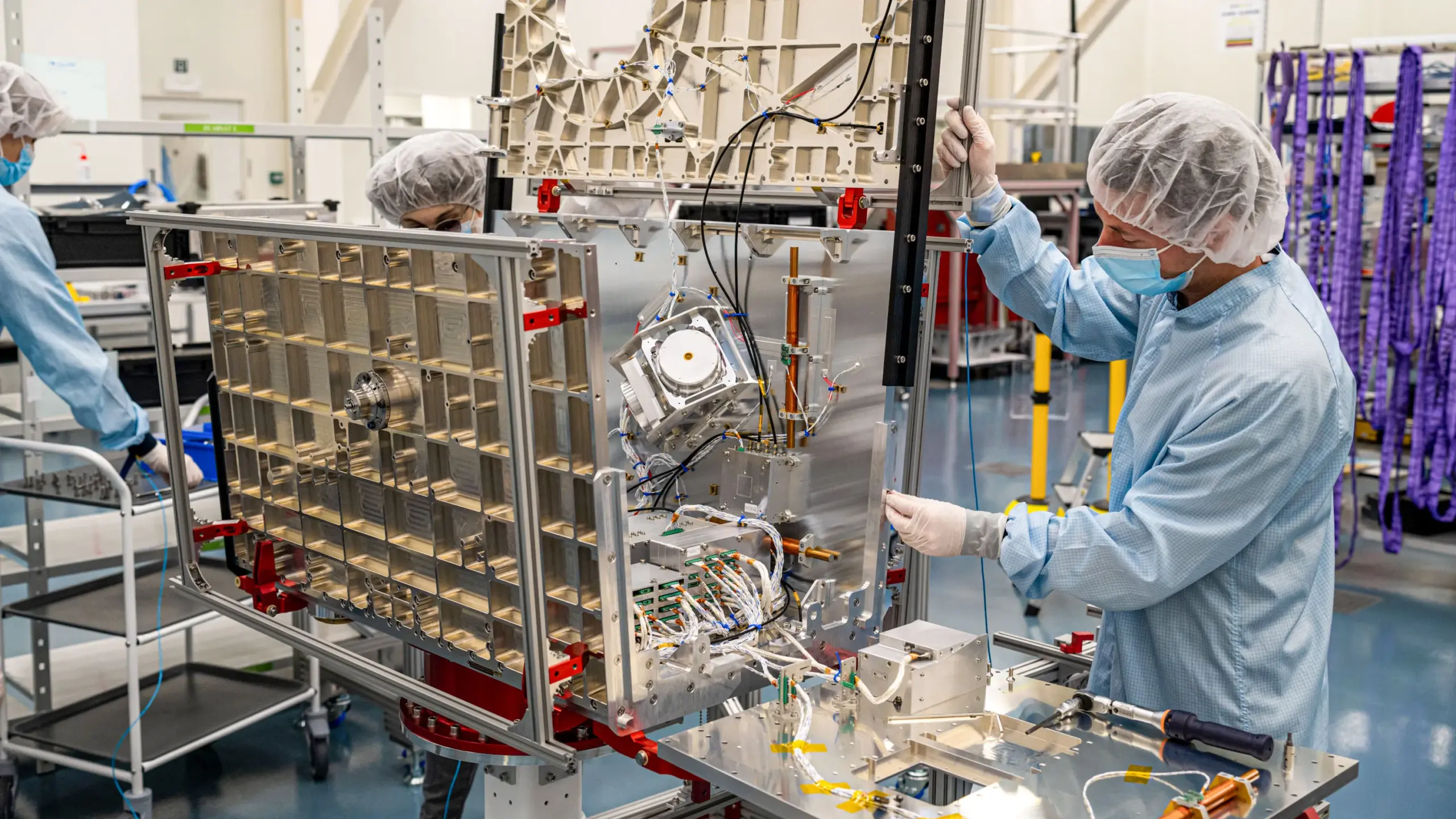

Figure İnsansı Robotu, Helix Modeliyle Yüksek Hızlı Paket Ayıklama Yeteneğini Sergileyerek Dikkat Çekti : Figure CEO’su Brett Adcock, insansı robotlarının Helix uçtan uca evrensel kontrol modeliyle lojistik senaryolarında paket ayıklamadaki son gelişmelerini sergiledi. Video, robotun farklı türdeki (sert karton kutular, plastik ambalajlar) paketleri insan hızına ve doğruluğuna yakın bir şekilde işleyebildiğini, paketleri düzenleme ve barkodların taranması için aşağı bakmasını sağlama dahil olmak üzere gösteriyor. Bu yetenek, Helix modelinin karmaşık, dinamik ortamlardaki genelleme yeteneğini ve esnekliğini vurguluyor ve daha önce sergilenen (hassasiyet ve yüksek hız vurgulanan) pres makinesi operasyonuyla tezat oluşturuyor. Figure robotları, BMW üretim hattında art arda 20 saatlik vardiyalarda çalışarak endüstriyel uygulamalardaki potansiyelini gösterdi. Adcock, insansı robot alanında en akıllı, en düşük maliyetli robotu inşa etmenin pazarı kazanmanın anahtarı olacağını vurguladı, çünkü daha fazla robot dağıtımı daha düşük maliyet, daha fazla eğitim verisi ve daha akıllı bir Helix modeli anlamına geliyor (Kaynak: dotey, _philschmid, adcock_brett, 量子位)

Hugging Face İlk Resmi MCP Sunucusunu Yayınladı, AI Agent İşbirliği Platformu Oluşturuyor : Hugging Face, kullanıcıların LLM’leri doğrudan Hugging Face Hub API’sine bağlamasına olanak tanıyan ilk resmi MCP (Model-Client Protocol) sunucusunu kullanıma sundu; böylece Cursor, VSCode, Windsurf ve MCP destekli diğer uygulamalarda kullanılabilir. Sunucu, modeller, veri kümeleri, makaleler ve Spaces için anlamsal arama gibi yerleşik araçlar sunar ve Spaces’te barındırılan tüm MCP uyumlu Gradio uygulamalarını dinamik olarak listeleyebilir. Bu girişim, Hugging Face’i AI Agent geliştiricileri için bir işbirliği platformu haline getirmeyi, AI Agent ekosisteminin gelişimini ve birlikte çalışabilirliğini teşvik etmeyi amaçlamaktadır ve şu anda yaklaşık 900 MCP Spaces mevcuttur (Kaynak: ClementDelangue, mervenoyann, reach_vb, ben_burtenshaw, huggingface, code_star, op7418, TheTuringPost, clefourrier)

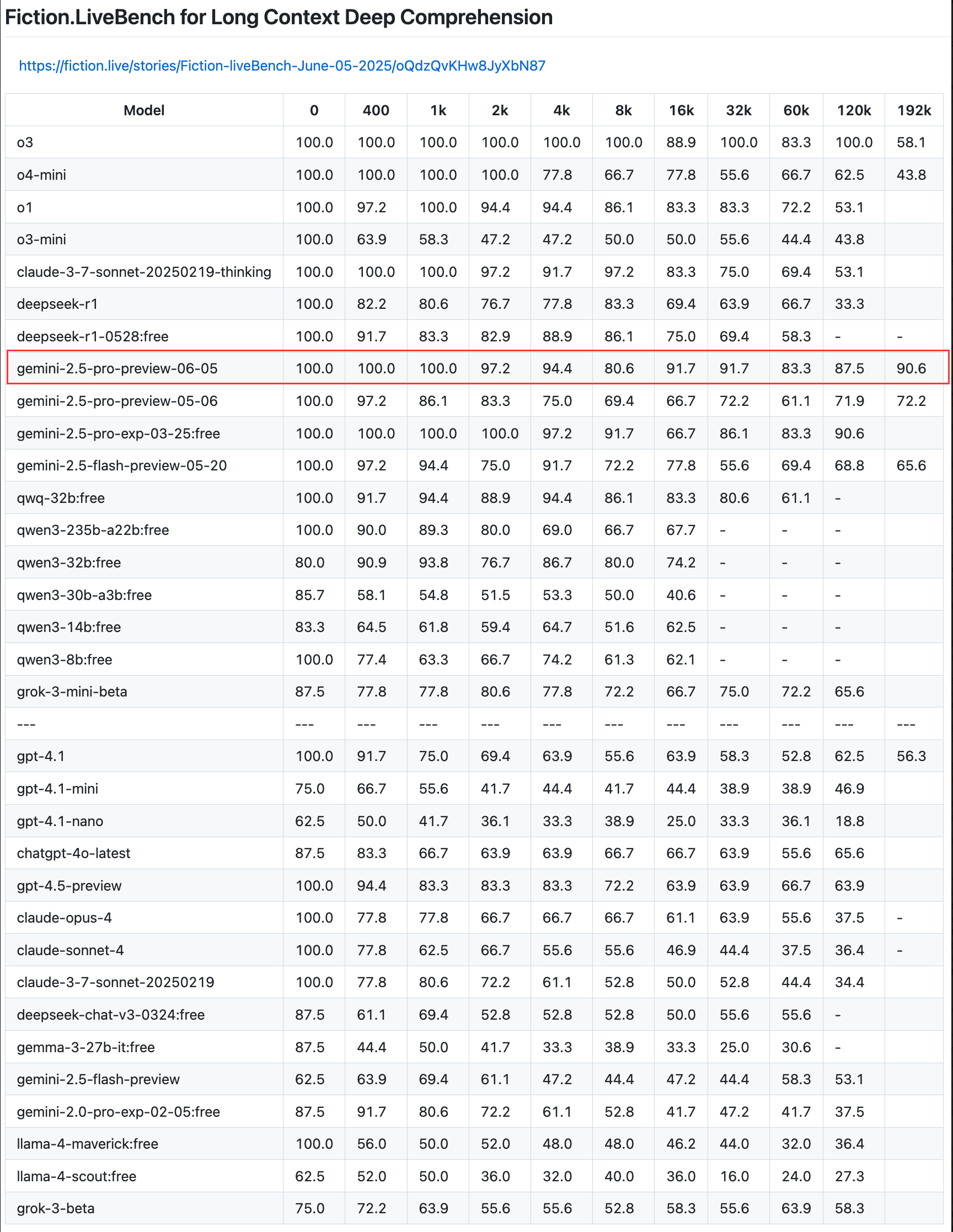

Google, Gemini 2.5 Pro Önizleme Sürümünü Güncelledi; Kodlama, Akıl Yürütme ve Yaratıcılık Yeteneklerini Geliştirdi ve “Düşünme Bütçesi”ni Tanıttı : Google, en akıllı modeli Gemini 2.5 Pro’nun önizleme sürümünde kodlama, mantıksal akıl yürütme ve yaratıcı yazma yeteneklerini daha da geliştiren bir güncelleme duyurdu. Yeni sürüm, geliştiricilerin modelin hesaplama kaynağı tüketimini daha iyi kontrol etmelerini sağlayan “düşünme bütçesi” (thinking budget) özelliğini özellikle sunuyor. Kullanıcı geri bildirimleri, yeni sürümün (06-05) uzun metin geri çağırmada mükemmel performans gösterdiğini, özellikle 192K uzunlukta %90.6’lık bir geri çağırma oranıyla OpenAI-o3’ü geride bıraktığını gösteriyor. Model, geliştiricilerin denemesi ve uygulama oluşturması için LangChain ve LangGraph’a entegre edildi. Google ayrıca Gemini 2.5 Pro’nun görüntü anlama ve bağlamsallaştırılmış, esprili altyazılar oluşturma konusundaki yaratıcı yeteneklerini de sergiledi (Kaynak: Teknium1, Google, karminski3, hwchase17, )

🎯 Gelişmeler

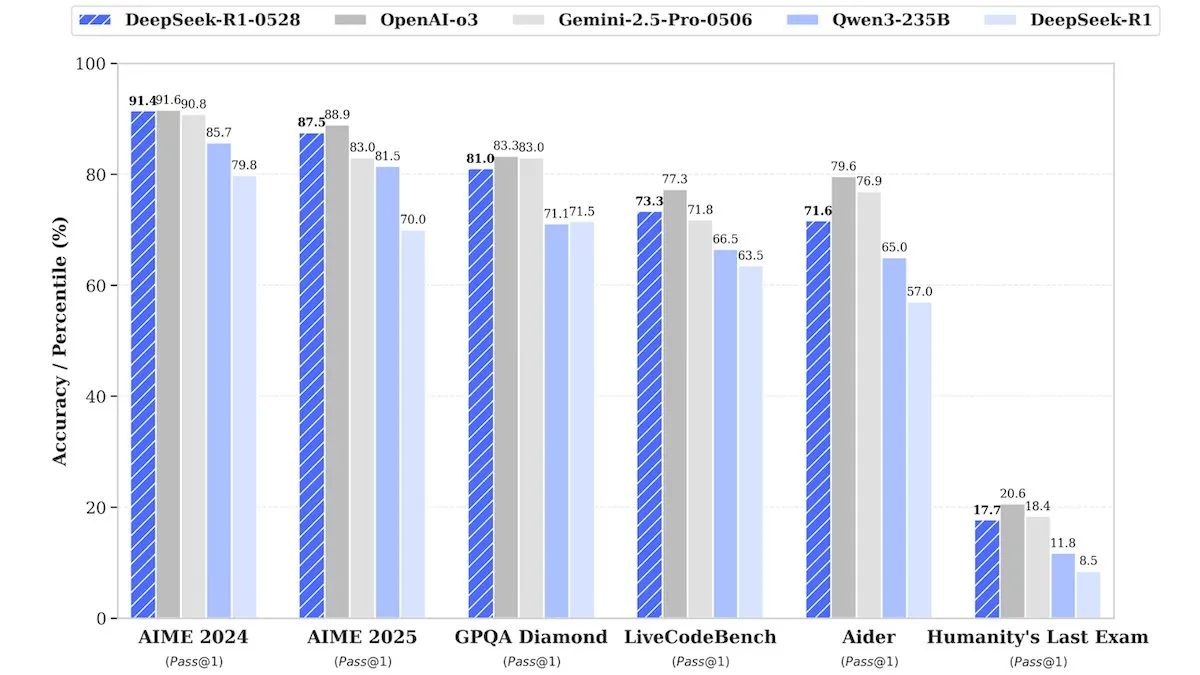

DeepSeek, DeepSeek-R1-0528 Yükseltilmiş Sürümünü Yayınladı, Performansı Kapalı Kaynak Modellere Rakip : DeepSeek, amiral gemisi açık kaynak ağırlık modeli DeepSeek-R1-0528’in yükseltilmiş bir sürümünü piyasaya sürdü. İddialara göre, bu model birçok kıyaslama testinde OpenAI’nin o3 ve Google’ın Gemini-2.5 Pro gibi kapalı kaynak modelleriyle rekabet edebilecek düzeyde performans sergiliyor. Şirket eğitim detaylarını açıklamasa da, raporlar yeni modelin akıl yürütme, görev karmaşıklığı işleme ve halüsinasyonları azaltma konularında önemli iyileştirmeler sunduğunu belirtiyor ve en üst düzey AI’ın devasa kaynaklar gerektirdiği yönündeki geleneksel düşünceye bir kez daha meydan okuyor. Unsloth AI, DeepSeek-R1-0528-Qwen3’ü GRPO ile ince ayar yapmak için ücretsiz bir Notebook sundu ve yeni ödül fonksiyonunun çok dilli (veya özel alan) yanıt oranını %40’tan fazla artırabileceğini, R1 ince ayar hızını 2 kat artırıp VRAM kullanımını %70 azaltabileceğini iddia ediyor (Kaynak: DeepLearningAI, ImazAngel)

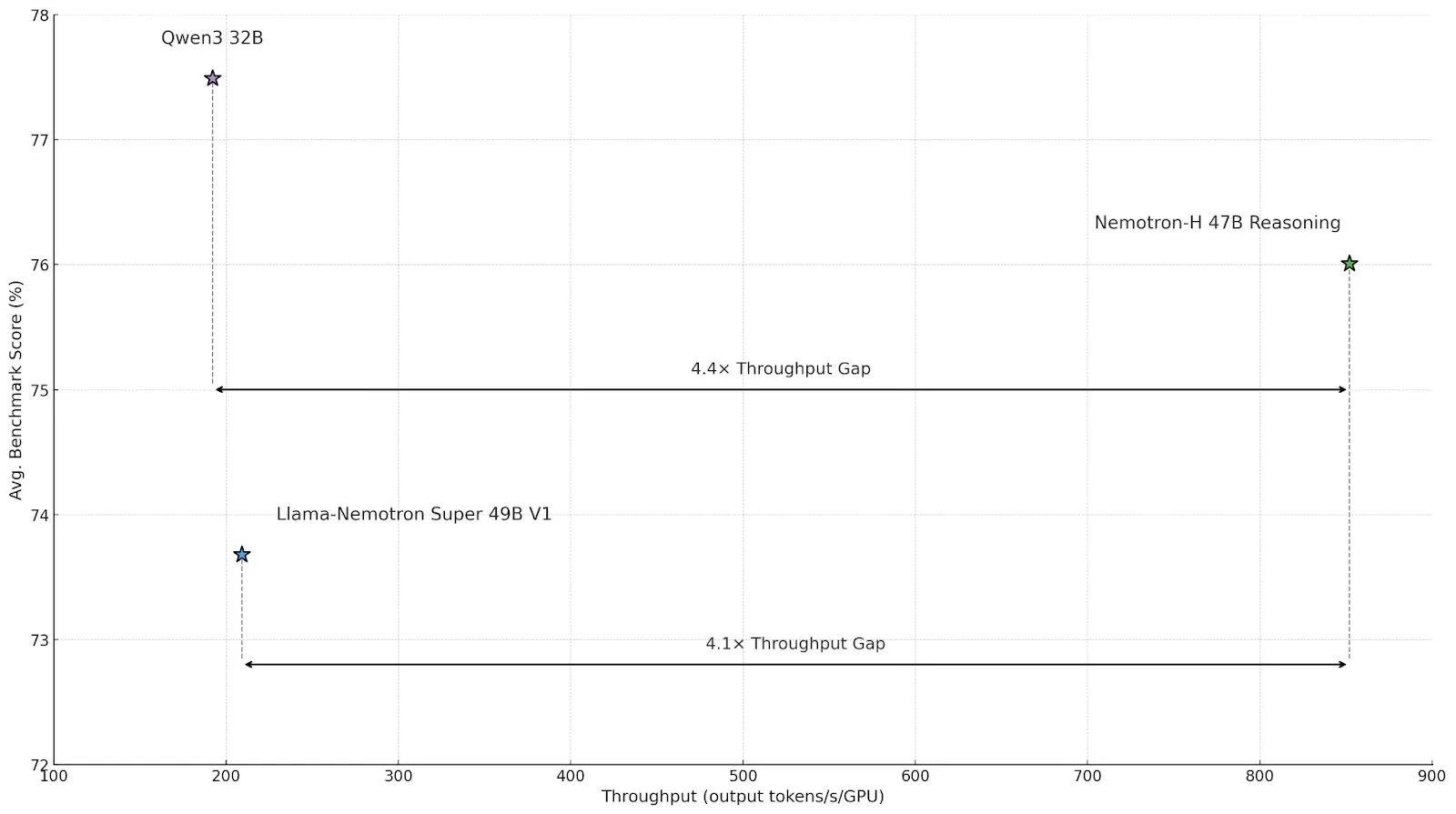

Nvidia, Verim ve Verimliliği Artırmak İçin Hibrit Mimarili Çıkarım Modeli Nemotron-H’yi Yayınladı : Nvidia, Mamba-Transformer hibrit mimarisini kullanan 47B ve 8B sürümlerini (BF16 ve FP8 destekli) içeren yeni çıkarım modeli Nemotron-H’yi tanıttı. Model, yüksek hızı korurken büyük ölçekli çıkarım sorunlarını çözmek için tasarlandı ve iddia edildiğine göre verimi, benzer Transformer modellerinin 4 katı. Nemotron-H-47B-Reasoning-128k, tüm kıyaslama testlerinde Llama-Nemotron-Super-49B-1.0’dan biraz daha yüksek doğruluk gösterirken, çıkarım maliyetini 4 kata kadar düşürüyor. Model ağırlıkları, HuggingFace’te üretim dışı bir lisansla yayınlandı ve teknik rapor yakında yayınlanacak (Kaynak: ClementDelangue, ctnzr)

Anthropic, ABD Hükümeti ve Askeri İstihbarat Kurumları İçin Tasarlanan Claude Gov’u Piyasaya Sürdü : Anthropic şirketi, ABD hükümeti, savunma ve istihbarat kurumlarının ihtiyaçlarını karşılamak üzere özel olarak tasarlanmış Claude Gov adlı yeni bir AI hizmetini duyurdu. Bu hamle, Anthropic’in gelişmiş AI teknolojisini hükümet ve askeri uygulama alanlarına resmen genişlettiğini gösteriyor ve veri analizi, istihbarat işleme, karar destek gibi çeşitli senaryolarda kullanılabileceği anlamına geliyor. Anthropic daha önce de şirketin kamu yararı misyonunu gerçekleştirmesine yardımcı olmak amacıyla uzun vadeli çıkar tröstüne katılmıştı (Kaynak: MIT Technology Review, akbirkhan, jeremyphoward)

Hugging Face ve Google Colab, Model Deneme ve Prototip Tasarım Süreçlerini Basitleştirmek İçin İşbirliği Yaptı : Hugging Face, Google Colaboratory ile bir işbirliği yaptığını duyurdu ve Hugging Face Hub’daki tüm model kartlarına “Colab’da Aç” desteği ekledi. Kullanıcılar artık herhangi bir model kartından doğrudan bir Colab Notebook başlatarak model deneylerini ve değerlendirmelerini daha kolay yapabilecekler. Ayrıca, kullanıcılar model depolarına özel bir notebook.ipynb dosyası yerleştirebilecek ve Hugging Face bu Notebook’u doğrudan sunarak AI modellerinin erişilebilirliğini ve hızlı prototip oluşturma yeteneğini daha da artıracak (Kaynak: huggingface, osanseviero, ClementDelangue, mervenoyann)

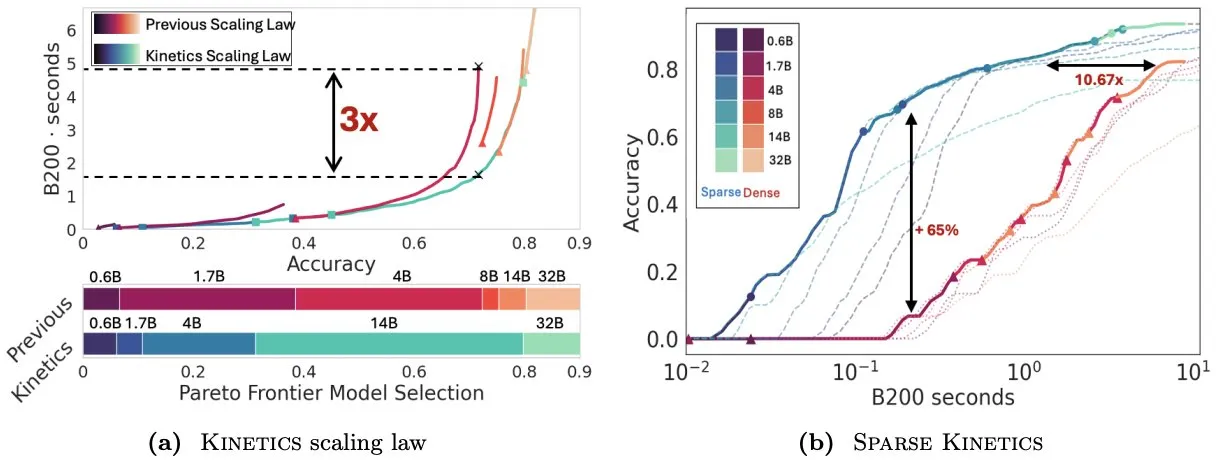

Kinetics Makalesi Test Zamanı Ölçekleme Yasalarını Yeniden Düşünüyor, Çıkarım Verimliliği İçin Seyrek Dikkatin Önemini Vurguluyor : Infini-AI-Lab, “Kinetics: Rethinking Test-Time Scaling Laws” adlı bir makale yayınladı. Makale, daha önceki hesaplama optimalliğine dayalı ölçekleme yasalarının küçük modellerin etkinliğini abarttığını ve Best-of-N, uzun CoT gibi çıkarım zamanı stratejilerinin getirdiği bellek erişim darboğazlarını göz ardı ettiğini belirtiyor. Araştırma, hesaplama ve bellek erişim maliyetlerini birleştiren yeni Kinetics ölçekleme yasalarını öneriyor ve test zamanı hesaplama kaynaklarının küçük modellerden ziyade büyük modeller için daha etkili olduğunu savunuyor, çünkü parametre sayısı değil dikkat mekanizması baskın maliyet haline geliyor. Makale ayrıca, birim token başına maliyeti düşürerek daha uzun üretim ve daha fazla paralel örnek elde etmeyi sağlayan seyrek dikkat merkezli bir ölçekleme paradigması öneriyor. Deneyler, seyrek dikkat modellerinin farklı maliyet aralıklarında yoğun modellerden daha iyi performans gösterdiğini ve büyük ölçekli model çıkarım verimliliğini artırmak için kritik öneme sahip olduğunu gösteriyor (Kaynak: realDanFu, tri_dao, simran_s_arora)

Çin AI Agent Pazarı Hareketli, Manus Girişimcilik Akımına Öncülük Ediyor : Geçen yılki temel model çılgınlığının ardından, Çin AI alanında bu yılki odak noktası AI Agent’lar oldu. AI Agent’lar, basit sorgulara yanıt vermekten ziyade kullanıcılar için görevleri otonom olarak tamamlamaya daha fazla odaklanıyor. Genel amaçlı bir AI Agent öncüsü olan Manus, Mart ayı başlarında sınırlı bir sürümle piyasaya sürüldükten sonra geniş ilgi gördü ve e-postaları işleyebilen, seyahat planlayabilen ve hatta etkileşimli web siteleri tasarlayabilen genel amaçlı dijital araçlar geliştiren bir dizi yeni girişimin ortaya çıkmasına neden oldu. Bu eğilim, Çin teknoloji endüstrisinin AI Agent’ların pratik uygulamalarını ve iş modellerini aktif olarak araştırdığını gösteriyor (Kaynak: MIT Technology Review)

ElevenLabs, Kurumsal Düzeyde Sesli Asistan Performansını Artırmak İçin Conversational AI 2.0’ı Piyasaya Sürdü : ElevenLabs, daha gelişmiş kurumsal düzeyde sesli aracılar oluşturmayı amaçlayan diyalogsal AI platformunun 2.0 sürümünü piyasaya sürdü. Yeni sürüm, sesli asistanların doğallığını ve etkileşim yeteneğini önemli ölçüde artırarak konuşma ritmini daha iyi anlamalarını, ne zaman duraklayacaklarını, ne zaman konuşacaklarını ve ne zaman konuşma sırasını değiştireceklerini bilmelerini sağlıyor. Bu yükseltmenin, kurumsal kullanıcılara müşteri hizmetleri, sanal asistanlar gibi çeşitli senaryolarda daha akıcı ve daha akıllı bir sesli etkileşim deneyimi sunması bekleniyor (Kaynak: dl_weekly)

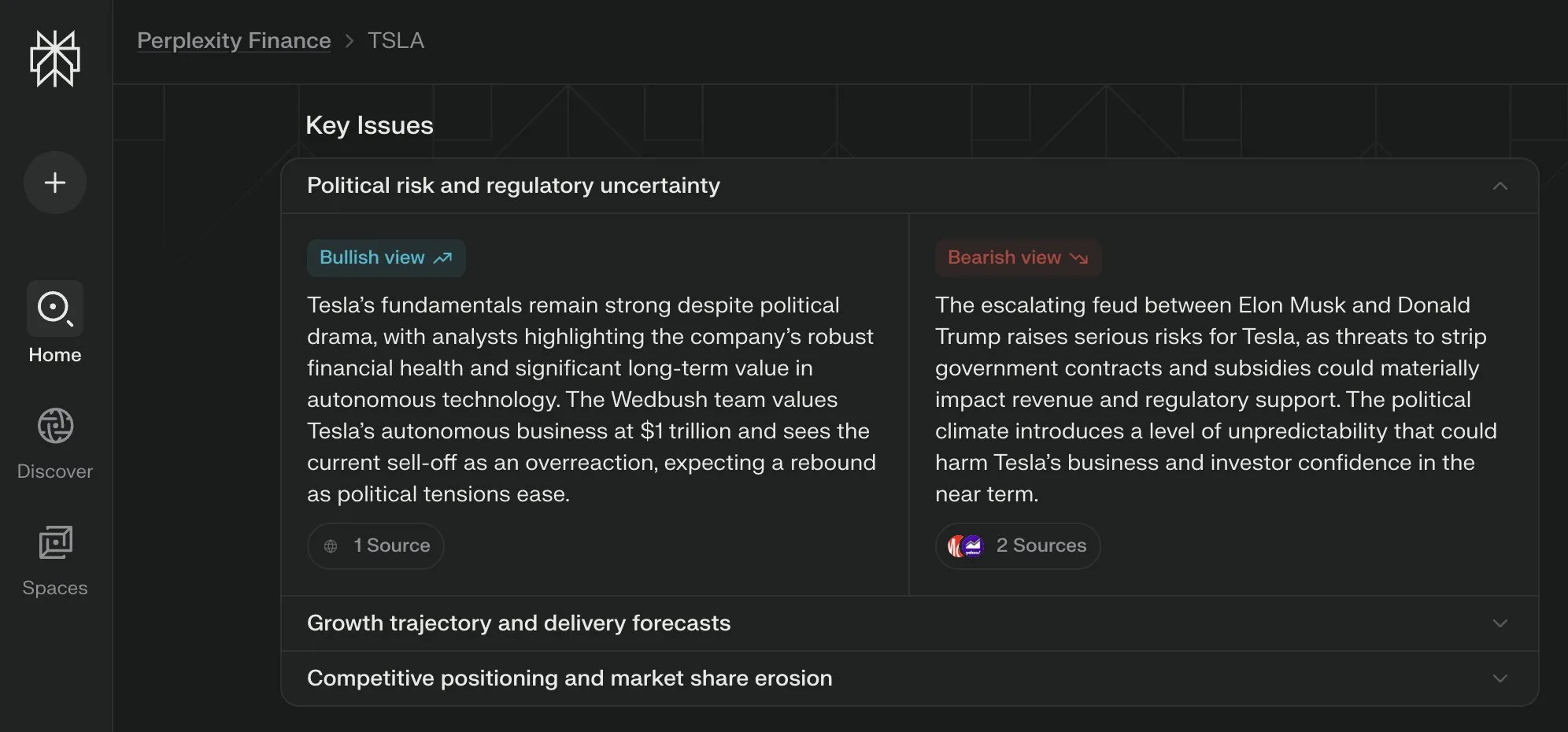

Perplexity Labs, Finans Sayfası İçin Çoklu Perspektifleri Birleştiren “Anahtar Konular” Görünümünü Tanıttı : Perplexity Labs, finansal bilgi sayfasına “Anahtar Konular” (Key Issues) görünüm özelliğini ekledi. Bu özellik, internetteki yatırımcıların, analistlerin ve yorumcuların görüşlerini birleştirerek kullanıcılara bir şirketi etkileyen önemli faktörleri ve ana tartışma noktalarını hızla gösteriyor. Örneğin, Tesla hakkındaki bir sayfa, Trump ve Musk arasındaki dinamiklerle ilgili çeşitli bilgileri saatler içinde entegre ederek kullanıcıların genel durumu hızla kavramasına yardımcı olabilir (Kaynak: AravSrinivas)

PyTorch Dağıtık Kontrol Noktaları Artık Hugging Face safetensors’ı Destekliyor : PyTorch, dağıtık kontrol noktası özelliğinin artık Hugging Face’in safetensors formatını desteklediğini duyurdu. Bu, farklı ekosistemler arasında kontrol noktalarını kaydetmeyi ve yüklemeyi daha kolay hale getirecek. Yeni API, kullanıcıların fsspec yolları aracılığıyla safetensors okumasına ve yazmasına olanak tanıyor. torchtune, bu özelliği benimseyen ilk kütüphane oldu ve böylece kontrol noktası süreçlerini basitleştirdi. Bu güncelleme, model eğitimi ve dağıtımının birlikte çalışabilirliğini ve verimliliğini artırmaya yardımcı oluyor (Kaynak: ClementDelangue)

MARBLE Makalesi, CLIP Uzayında Malzeme Yeniden Düzenlemesi ve Karışımı İçin Yeni Bir Yöntem Öneriyor : MARBLE adlı yeni bir araştırma, CLIP uzayında malzeme gömmelerini bularak ve bu gömmeleri önceden eğitilmiş metinden görüntüye modellerini kontrol etmek için kullanarak, görüntülerdeki nesnelerin malzemelerinin karıştırılmasını ve ince taneli özelliklerinin yeniden düzenlenmesini sağlayan bir yöntem öneriyor. Bu yöntem, örnek tabanlı malzeme düzenlemesini geliştirerek, gürültü giderme UNet’inde malzeme atamasından sorumlu modülleri bularak pürüzlülük, metaliklik, şeffaflık ve parlaklık gibi ince taneli malzeme özelliklerinin parametrik kontrolünü sağlıyor. Araştırmacılar, yöntemin etkinliğini nitel ve nicel analizlerle kanıtlıyor ve tek bir ileri yayılımda birden fazla düzenleme yapma ve resim alanındaki uygulanabilirliğini gösteriyor (Kaynak: HuggingFace Daily Papers, ClementDelangue)

FlowDirector Makalesi: Eğitimsiz, Hassas Metinden Videoya Düzenleme Akış Yönlendirme Yöntemi : FlowDirector, düzenleme sürecini veri uzayında doğrudan bir evrim olarak modelleyen, videoyu doğal uzay-zaman manifoldları boyunca adi diferansiyel denklemler (ODE’ler) aracılığıyla yönlendirerek zamansal tutarlılığı ve yapısal ayrıntıları koruyan, tersine çevirme gerektirmeyen yeni bir video düzenleme çerçevesidir. Yerel olarak kontrol edilebilir düzenleme elde etmek için dikkat güdümlü bir maskeleme mekanizması tanıtılmıştır. Ayrıca, eksik düzenlemeleri çözmek ve düzenleme talimatlarıyla anlamsal uyumu artırmak için sınıflandırıcısız yönlendirmeden esinlenen bir yönlendirme geliştirilmiş düzenleme stratejisi önerilmiştir. Deneyler, FlowDirector’ın talimat takibi, zamansal tutarlılık ve arka plan koruması konularında üstün performans sergilediğini göstermektedir (Kaynak: HuggingFace Daily Papers)

RACRO Makalesi: Ödül Optimizasyonlu Altyazılarla Ölçeklenebilir Çok Modlu Akıl Yürütme : Temel LLM akıl yürütücülerini yükseltirken görsel-dil hizalamasını yeniden eğitmenin yüksek maliyetli sorununu çözmek için araştırmacılar RACRO’yu (Reasoning-Aligned Perceptual Decoupling via Caption Reward Optimization) önerdiler. Bu yöntem, görsel girdiyi dilsel bir temsile (altyazı gibi) dönüştürür ve ardından metin akıl yürütücüsüne iletir. RACRO, çıkarıcıların altyazı davranışını akıl yürütme hedefleriyle hizalamak için akıl yürütme güdümlü bir takviyeli öğrenme stratejisi kullanır, böylece görsel temeli güçlendirir ve akıl yürütme için optimize edilmiş temsiller çıkarır. Deneyler, RACRO’nun çok modlu matematik ve bilim kıyaslamalarında SOTA performansı sergilediğini ve pahalı çok modlu yeniden hizalama gerektirmeden daha gelişmiş akıl yürütme LLM’lerine tak-çalıştır adaptasyonunu desteklediğini göstermektedir (Kaynak: HuggingFace Daily Papers)

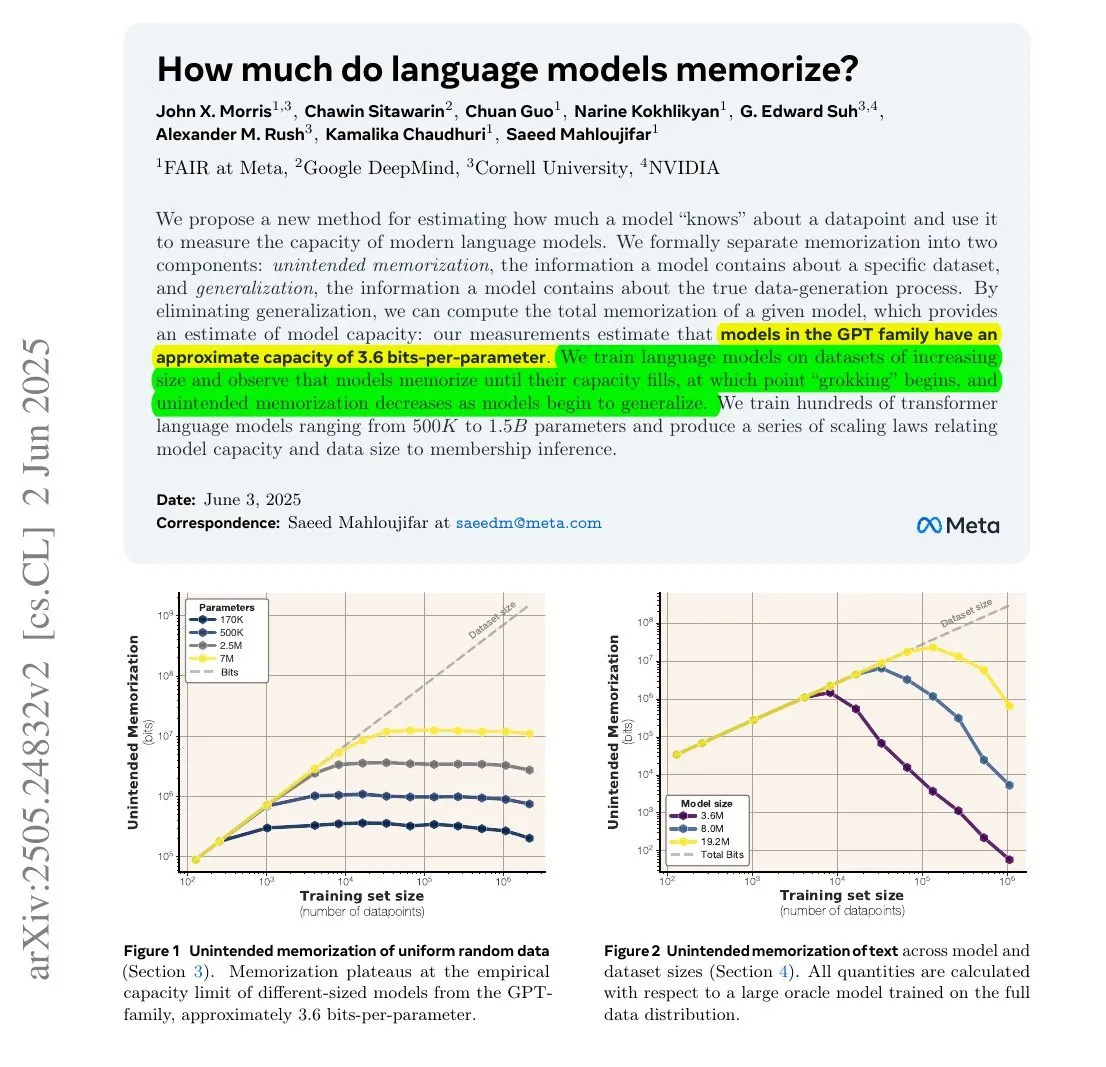

Araştırma Gösteriyor: LLM’lerin Belleğe Aldığı Bilgi Miktarı Parametre Sayısı ve Bilgi Entropisi ile İlişkili Olabilir : Meta, DeepMind, NVIDIA ve Cornell Üniversitesi işbirliğiyle yapılan bir araştırma, büyük dil modellerinin (LLM) gerçekte ne kadar bilgi ezberlediğini inceliyor. Araştırma, LLM’lerin ezberlediği bilgi miktarının parametre sayıları ve verilerin bilgi entropisi ile ilişkili olabileceğini buldu. Örneğin, İngilizce Wikipedia yaklaşık 29.4 milyar karakter içeriyor, her karakter yaklaşık 1.5 bit bilgi içeriyor ve 12B parametreli bir model (parametre başına 3.6 bit depolama kapasitesi varsayılarak) teorik olarak tüm İngilizce Wikipedia’yı ezberleyebilir. Bu araştırma, LLM’lerin bellek mekanizmalarını anlamak ve veri telif hakkı sorunlarını değerlendirmek için önemli bir anlam taşıyor. François Chollet de LLM’leri rastgele dizelerle eğitme metodolojisini ve bunun nicel bulgularını belirterek, LLM’lerin bellek mekanizmalarını anlamak için değerli olduğunu düşünüyor (Kaynak: fchollet, AymericRoucher)

Hugging Face, Kurumsal Sürüm İçin Yeni Özellikler Sunuyor: Çıkarım Sağlayıcı Kullanımını ve Maliyetlerini Yönetme : Hugging Face, kurumsal sürümüne (Enterprise Hub) yeni özellikler ekledi. Bu özellikler, kuruluşların ekip üyelerinin çıkarım sağlayıcılarını (Inference Providers) kullanımlarını ve ilgili maliyetleri yapılandırmasına ve izlemesine olanak tanıyor. Bu, kurumsal kullanıcıların TogetherCompute, FireworksAI, Replicate, Cohere gibi birçok sağlayıcıdan gelen 40.000’den fazla model için sunucusuz çıkarım hizmetlerinin kullanımını daha iyi yönetebileceği ve kontrol edebileceği anlamına geliyor, böylece AI uygulama dağıtımının maliyet etkinliği ve kaynak tahsisi optimize ediliyor (Kaynak: huggingface, _akhaliq)

Mistral AI Bilimsel Akıl Yürütme Modeli ether0 Yayınlandı, Mistral 24B Üzerine İnce Ayar Yapıldı : Mistral AI, ilk bilimsel akıl yürütme modeli ether0’ı yayınladı. Bu model, kimya alanındaki birçok moleküler tasarım görevi üzerinde Mistral 24B’ye takviyeli öğrenme (RL) uygulanarak eğitildi. Araştırma, LLM’lerin bazı bilimsel görevlerde sıfırdan eğitilen özel modellerden çok daha verimli bir şekilde veri öğrendiğini ve bu görevlerde en son teknoloji modelleri ve insanları önemli ölçüde geride bırakabildiğini buldu. Bu, bilimsel sınıflandırma, regresyon ve üretim sorunlarının bir kısmı için LLM’lere sonradan eğitim uygulamanın geleneksel makine öğrenimi yöntemlerinden daha verimli bir yol sunabileceğini gösteriyor (Kaynak: MistralAI)

Çift Uzman Tutarlılık Modeli (DCM) Video Üretim Hızını 10 Kat Artırıyor : Ziwei Liu ve diğer araştırmacılar, video üretim modellerinin (parametre sayısı 1.3B’den 13B’ye kadar) hızını kaliteyi düşürmeden 10 kat artırabilen Çift Uzman Tutarlılık Modelini (DCM) önerdiler. Bu model şu anda Tencent Hunyuan ve Alibaba Tongyi Wanxiang’ı desteklemektedir. DCM’nin önerilmesi, verimli ve yüksek kaliteli video üretimi alanına yeni bir atılım getirerek video içeriği oluşturma ve ilgili uygulamaların geliştirilmesini hızlandırmaya yardımcı oluyor (Kaynak: _akhaliq)

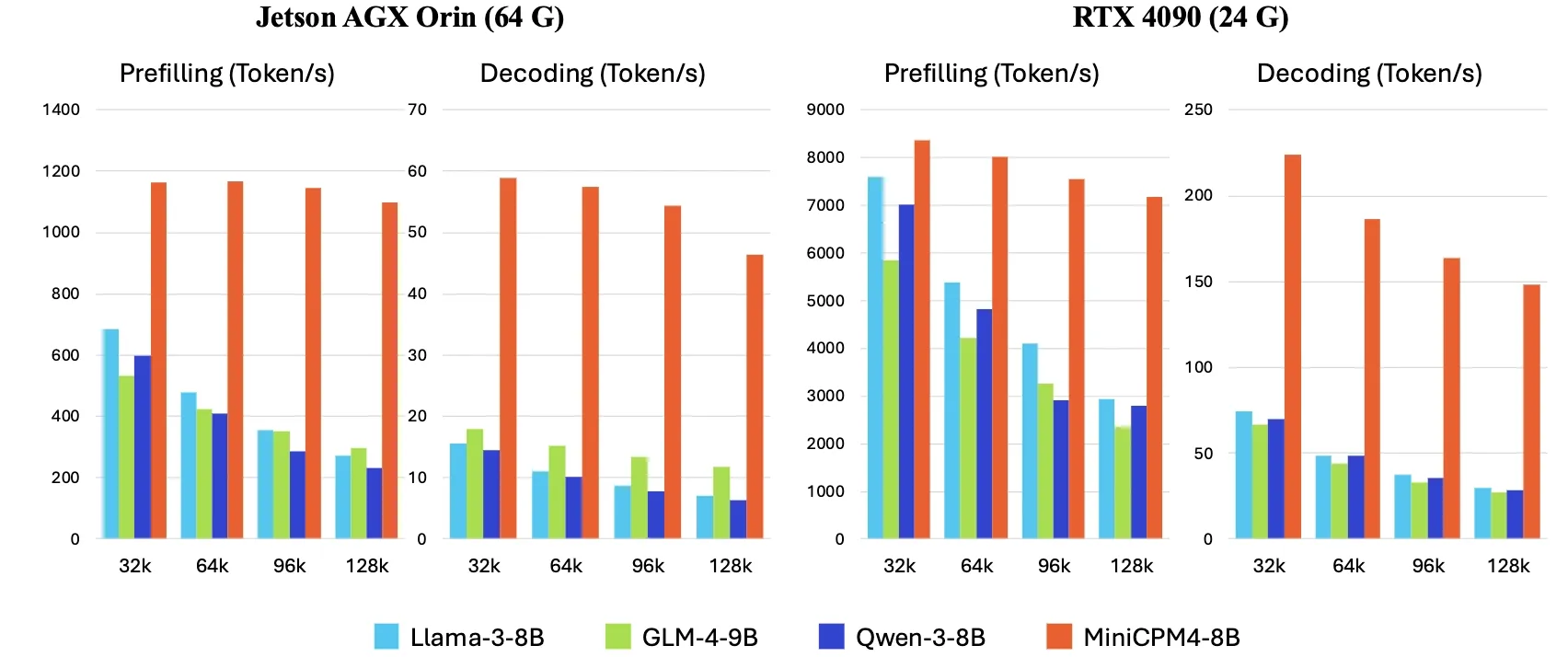

OpenBMB, MiniCPM4’ü Yayınladı, Uç Cihaz Çıkarım Hızını 5 Kat Artırdı : OpenBMB, verimli model mimarisi (InfLLM v2 eğitilebilir seyrek dikkat mekanizması), verimli öğrenme algoritmaları (Model Wind Tunnel 2.0, BitCPM üçlü niceleme), yüksek kaliteli eğitim verileri (UltraClean, UltraChat v2) ve verimli çıkarım sistemi (CPM.cu, ArkInfer) kullanarak uç cihazlarda çıkarım hızını 5 kat artırma hedefine ulaşan MiniCPM4 serisi modellerini piyasaya sürdü. Amiral gemisi modeli MiniCPM4-8B (8B parametre, 8T token ile eğitilmiş) Hugging Face’te yayınlandı. Bu model serisi, küçük ve ucuz LLM’lerin sınırlarını keşfetmeyi ve AI’ın kaynak kısıtlı cihazlarda uygulanmasını teşvik etmeyi amaçlıyor (Kaynak: eliebakouch, Teortaxes▶️ (DeepSeek 推特🐋铁粉 2023 – ∞))

X Şirketi Hizmet Şartlarını Güncelledi, Anlaşma Olmadıkça Gönderilerinin AI Modellerini “İnce Ayarlamak veya Eğitmek” İçin Kullanılmasını Yasakladı : X Şirketi (eski adıyla Twitter), hizmet şartlarını güncelleyerek, X Şirketi ile özel bir anlaşma yapılmadıkça platformdaki gönderi içeriklerinin yapay zeka modellerini “ince ayar yapmak veya eğitmek” için kullanılmasını açıkça yasakladı. Bu hamle, içerik platformlarının AI çağında veri değerlerine giderek daha fazla önem verdiğini ve kontrol etme isteğini yansıtıyor ve Reddit ile Google gibi şirketlerin lisans anlaşmaları yoluyla veri paraya çevirme yöntemlerini taklit edebilir. Bu politika değişikliği, model eğitimi için halka açık sosyal medya verilerine dayanan AI araştırmacılarını ve geliştiricilerini etkileyecektir (Kaynak: MIT Technology Review)

🧰 Araçlar

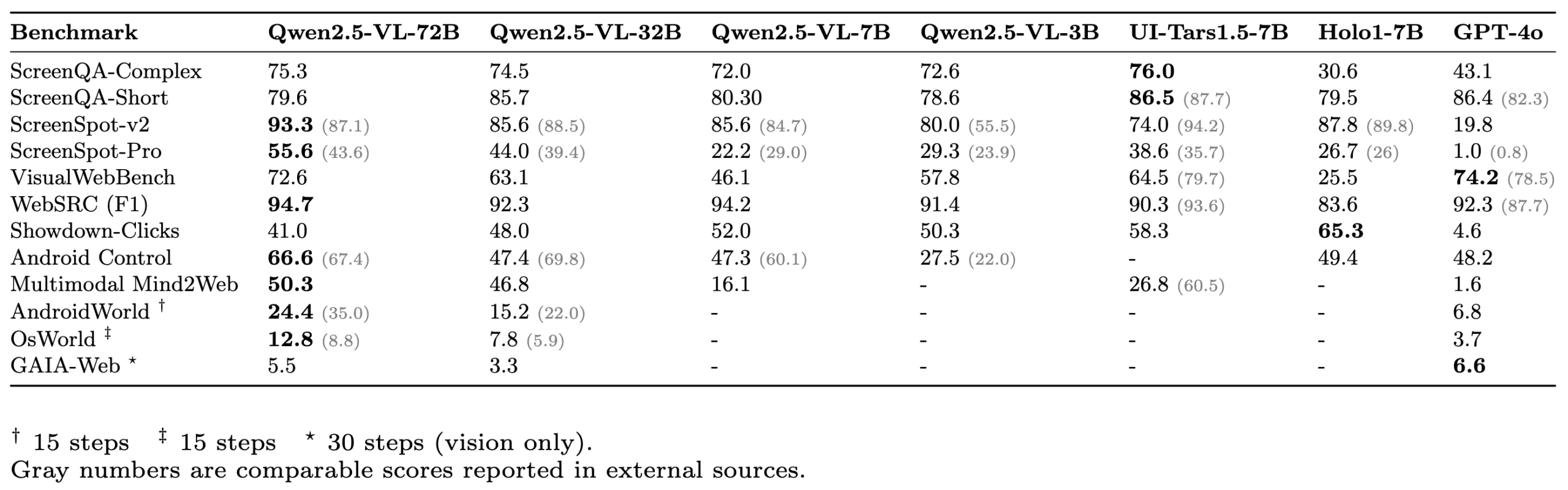

ScreenSuite: Kapsamlı GUI Agent Değerlendirme Paketi Yayınlandı : Hugging Face, kapsamlı bir grafik kullanıcı arayüzü (GUI) Agent değerlendirme paketi olan ScreenSuite’i yayınladı. En son araştırmalardan elde edilen temel kıyaslamaları entegre eder, Ubuntu ve Android ortamları için Docker tabanlı değerlendirmeyi destekler ve mobil, masaüstü ve Web senaryolarını kapsar. Bu paket, görsel dil modellerinin (VLM) algılama, konumlandırma, tek adımlı işlemler ve çok adımlı aracı görevleri gibi yeteneklerini ölçmek için birleşik, kullanımı kolay bir platform sağlamayı amaçlayan saf görsel değerlendirmeyi (DOM hilesi yok) vurgular. Qwen-2.5-VL, UI-Tars-1.5-7B, Holo1-7B ve GPT-4o gibi modeller bu pakette değerlendirilmiştir (Kaynak: huggingface, AymericRoucher, clefourrier, tonywu_71, mervenoyann, HuggingFace Blog)

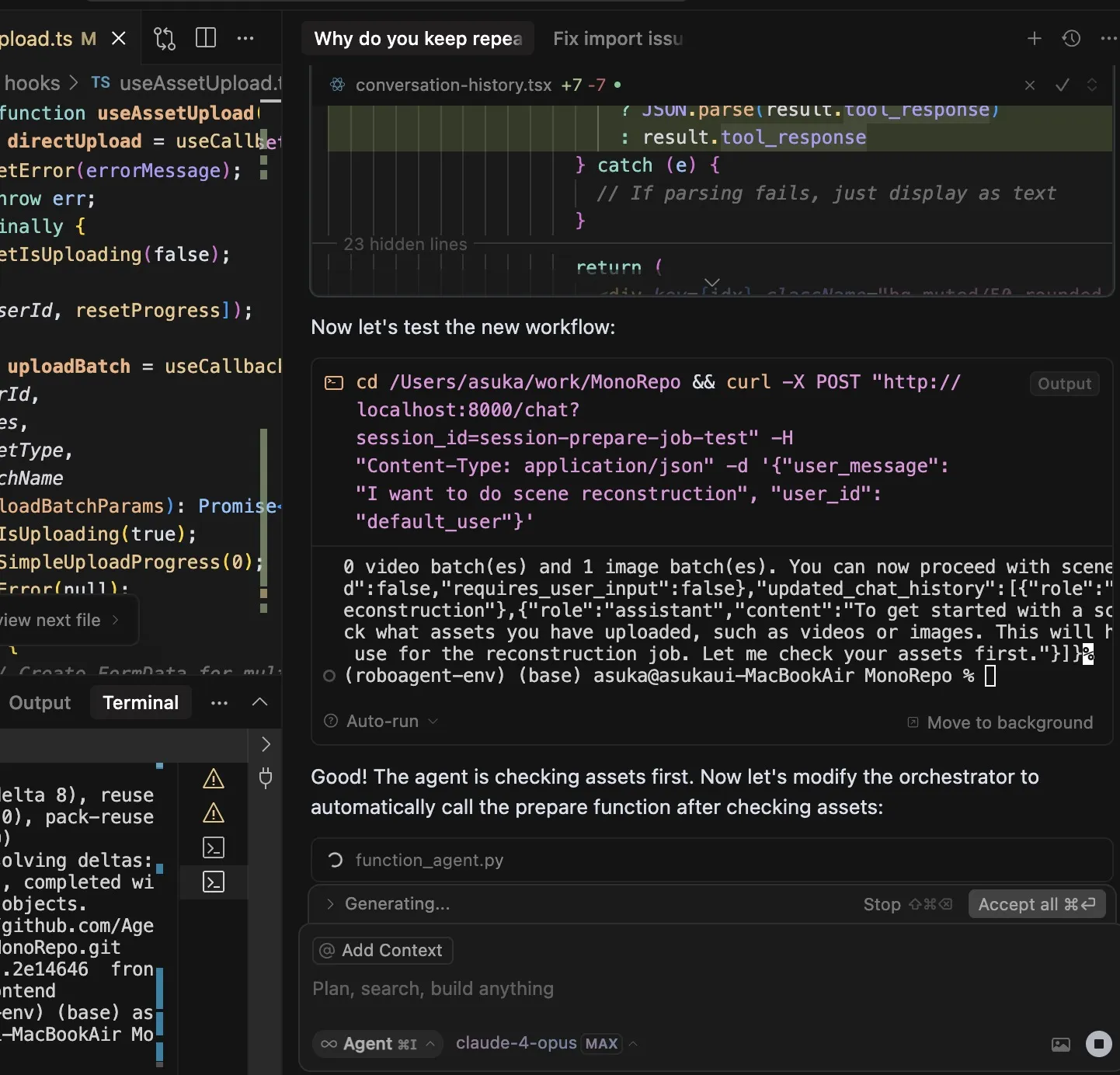

Claude Code Kullanım Deneyimi Paylaşımı: Talimat Anlama, Görev Planlama ve Araç Kullanım Yetenekleri Öne Çıkıyor : Kullanıcı dotey, Anthropic’in AI programlama asistanı Claude Code’u kullanma deneyimini paylaştı. Claude Code’un güçlü yanlarının şunlar olduğunu düşünüyor: 1. Talimatları mükemmel anlaması; 2. Görevleri makul bir şekilde planlayabilmesi, karmaşık görevler için TODO Listesi oluşturup bunları tek tek yürütmesi; 3. Araç kullanma yeteneğinin son derece güçlü olması, özellikle grep komutunu kullanarak kod tabanında arama yapmada insanlardan çok daha verimli olması, hatta karıştırılmış JS kodunu analiz edebilmesi; 4. Yürütme süresinin uzun olması, “büyük güçle harikalar yaratabilmesi”, ancak Token tüketiminin de yüksek olması, Claude Max aboneliğiyle kullanıma uygun olması; 5. Tüm süreçte insan müdahalesinin az olması, özellikle --dangerously-skip-permissions parametresi etkinleştirildiğinde gözetimsiz programlama yapılabilmesi. Kullanıcı, yoğun bir Cursor kullanıcısı olmaktan çıkıp görevleri önce Claude Code ile tamamlamaya, ardından IDE’de inceleyip değiştirmeye daha fazla yönelmiş. Claude Code’un Plan Mode (plan modu) da sessizce kullanıma sunuldu ve kullanıcıların dosyaları düzenlemeden yalnızca okuma ve düşünme yapmasına olanak tanıyor (Kaynak: dotey, Reddit r/ClaudeAI)

ClaudeBox: Claude Code’u Docker’da Güvenli Bir Şekilde Çalıştırın, İzin İstemlerinden Kurtulun : Geliştirici RchGrav, kullanıcıların Claude Code’u Docker konteynerinde sürekli modda (izin istemleri olmadan) çalıştırmasına olanak tanıyan ClaudeBox aracını oluşturdu. Bu, hem sık sık izin onaylarının iş akışını kesmesini önler hem de ana işletim sisteminin güvenliğini sağlar, çünkü Claude Code’un tüm işlemleri yalıtılmış Docker ortamıyla sınırlıdır. ClaudeBox, 15’ten fazla önceden yapılandırılmış geliştirme ortamı (Python+ML, C++/Rust/Go vb.) sunar ve kullanıcılar basit komutlarla hızlı bir şekilde kurabilirler. Bu araç, Claude Code kullanım deneyimini iyileştirmeyi ve kullanıcıların AI’ın çeşitli işlemleri denemesine endişe duymadan izin vermesini amaçlamaktadır (Kaynak: Reddit r/ClaudeAI)

Toolio 0.6.0 Yayınlandı: Mac İçin Özel Olarak Tasarlanmış GenAI ve Agent Araç Kiti : Toolio, Mac’teki büyük dil modellerine (LLM) güçlü destek sağlamak amacıyla MLX ile derinlemesine entegre edilmiş bir araç kiti olan 0.6.0 sürümünü yayınladı. JSON Schema güdümlü yapılandırılmış çıktı ve araç çağırma işlevlerini Python dili kullanarak gerçekleştirir. Bu araç kiti, Mac ortamında GenAI ve Agent uygulamaları geliştirme deneyimini ve verimliliğini artırmaya odaklanmaktadır (Kaynak: awnihannun)

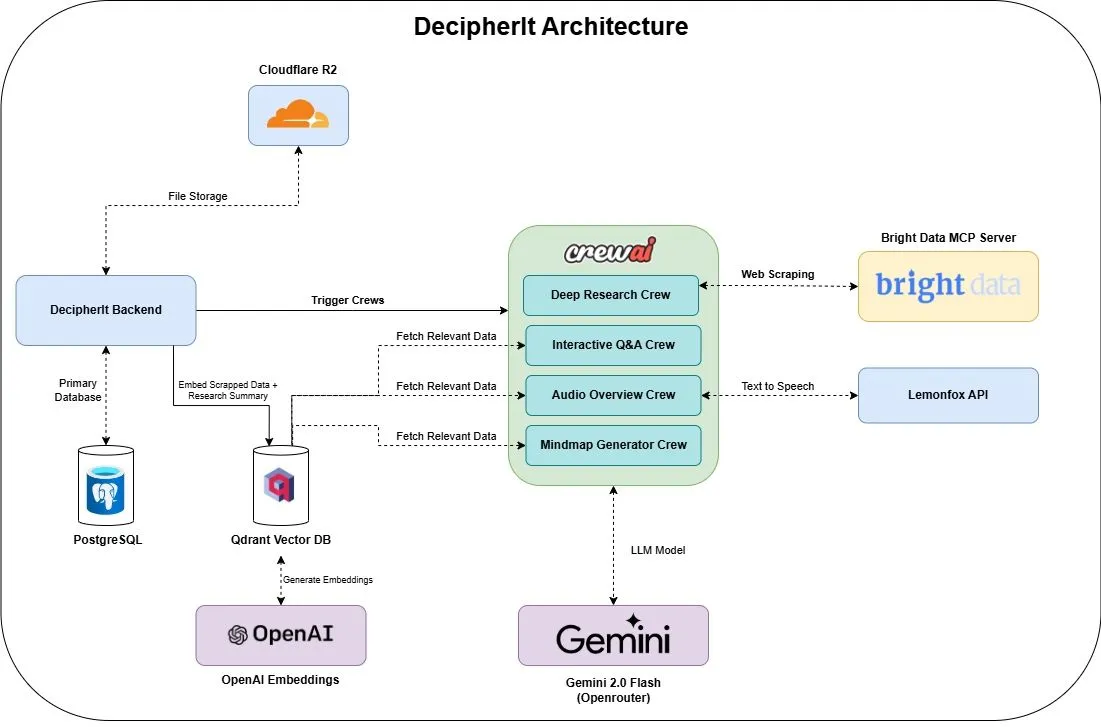

DecipherIt: Çoklu Ajan ve Anlamsal Arama Entegreli Açık Kaynaklı AI Araştırma Asistanı : DecipherIt, NotebookLM’nin bir alternatifi olarak kabul edilen açık kaynaklı bir AI araştırma asistanıdır. Kullanıcıların araştırma materyallerini işlemesine yardımcı olmak için çoklu ajan düzenlemesi, anlamsal arama ve gerçek zamanlı web erişimi özelliklerini kullanır. Kullanıcılar belge yükleyebilir, URL yapıştırabilir veya konu girebilir; DecipherIt bunları özetler, zihin haritaları, sesli genel bakışlar, sık sorulan sorular ve anlamsal soru-cevap içeren eksiksiz bir araştırma çalışma alanına dönüştürür. Teknolojisi crewAI ajanları, Bright Data MCP, Qdrant, OpenAI ve LemonFox AI’ı içerir; ön uç Next.js ve React 19, arka uç ise FastAPI kullanır (Kaynak: qdrant_engine)

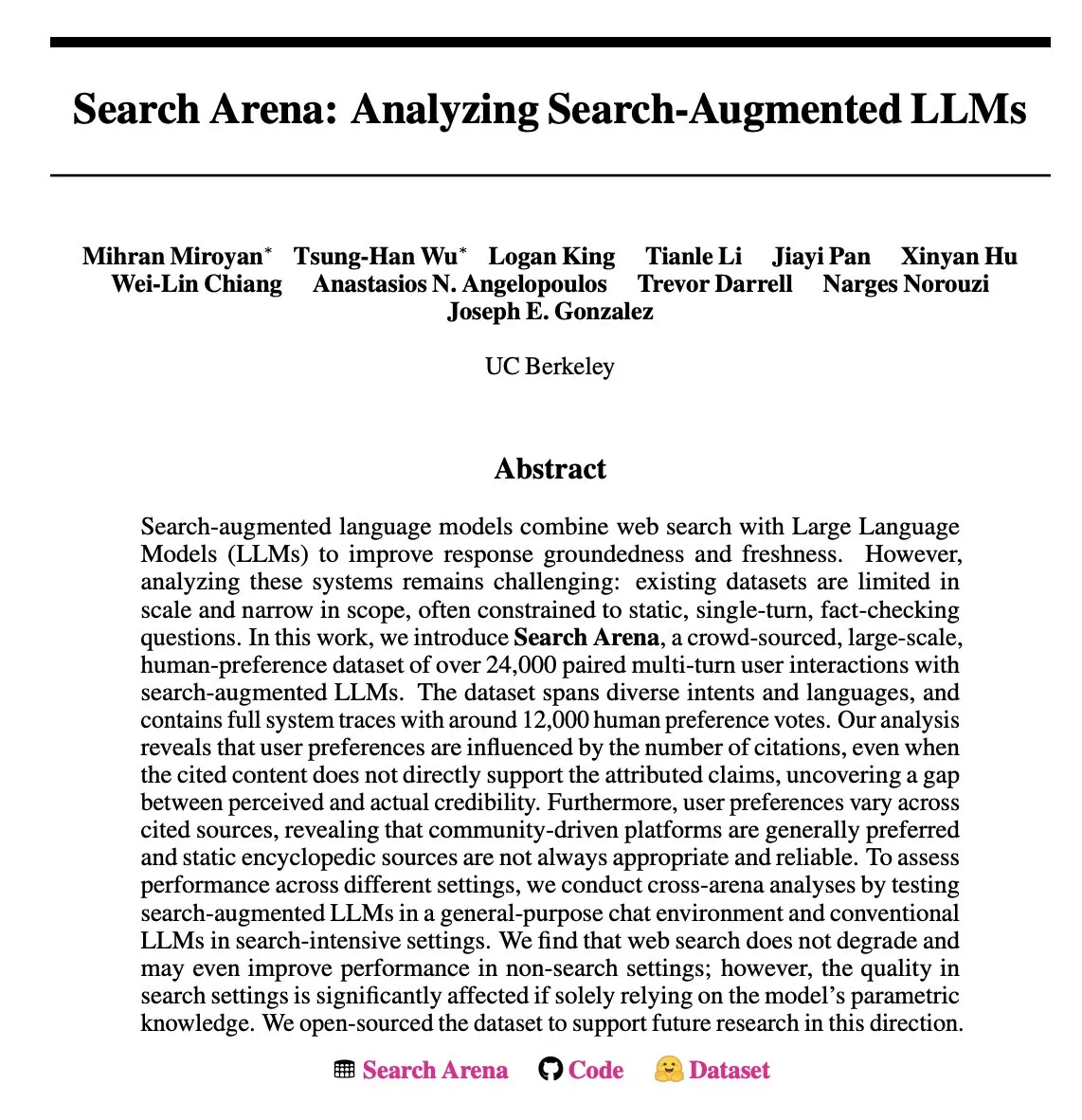

Search Arena: Arama Destekli LLM’lerin Kullanıcı Etkileşimlerini Analiz Eden Veri Kümesi Yayınlandı : Search Arena, arama destekli LLM’lerle eşleştirilmiş çok turlu kullanıcı etkileşimlerini içeren, kitle kaynaklı, büyük ölçekli (24.000’den fazla) bir insan tercihi veri kümesidir. Bu veri kümesi, çeşitli amaçları ve dilleri kapsar ve yaklaşık 12.000 insan tercihi oylamasının tam sistem takibini içerir. Analizler, kullanıcı tercihlerinin alıntı sayısından etkilendiğini, alıntı içeriği atıf beyanını doğrudan desteklemese bile; topluluk odaklı platformların genellikle daha popüler olduğunu göstermektedir. Bu veri kümesi, arama destekli LLM’ler üzerine gelecekteki araştırmaları desteklemeyi amaçlamaktadır; kod ve veriler açık kaynak olarak yayınlanmıştır (Kaynak: HuggingFace Daily Papers, jiayi_pirate, lmarena_ai)

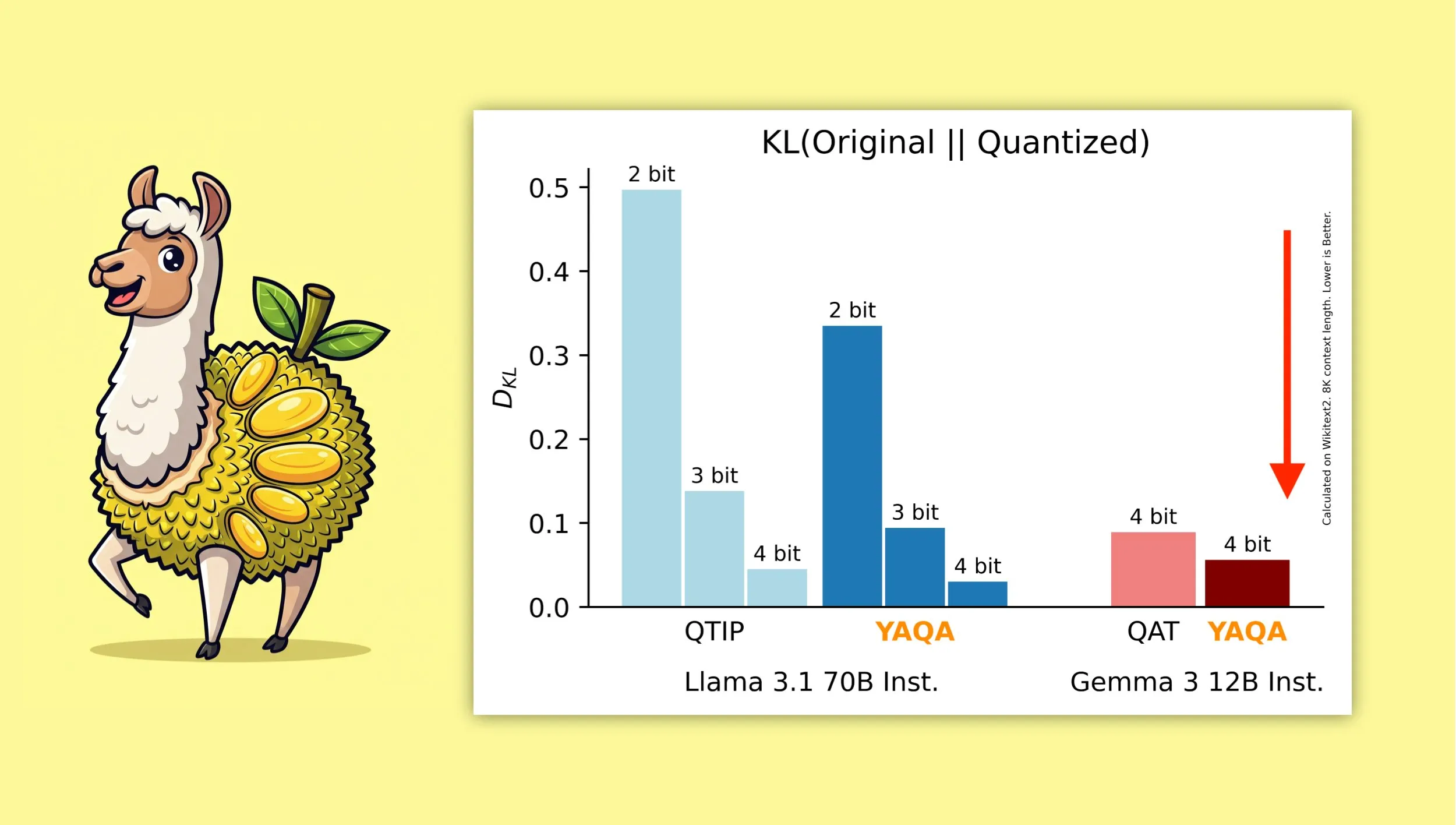

YAQA: Modelin Orijinal Çıktısını Daha İyi Korumayı Amaçlayan Yeni Bir Nicemleme Algoritması : Cornell Üniversitesi araştırmacıları, nicemleme sonrası orijinal modelin çıktısını daha iyi korumayı amaçlayan yeni bir nicemleme algoritması olan “Yet Another Quantization Algorithm”ı (YAQA) tanıttı. İddiaya göre YAQA, QTIP’e kıyasla KL sapmasını %30’dan fazla azaltıyor ve Gemma 3’te Google’ın QAT modelinden daha düşük KL sapması elde ediyor. Bu araştırma, model nicemleme alanına yeni fikirler ve araçlar sunarak, model boyutunu ve hesaplama gereksinimlerini azaltırken model performansını en üst düzeyde tutmaya yardımcı oluyor. İlgili makale ve kod yayınlandı ve önceden nicemlenmiş Llama 3.1 70B Instruct modeli sunuldu (Kaynak: Reddit r/MachineLearning, Reddit r/LocalLLaMA, tri_dao, simran_s_arora)

Tokasaurus: Yüksek Verimli LLM Çıkarımı İçin Tasarlanmış Motor Yayınlandı : HazyResearch, büyük ve küçük modeller için uygun, yüksek verimli iş yükleri için tasarlanmış yeni bir LLM çıkarım motoru olan Tokasaurus’u yayınladı. Bu motor, LLM’lerin büyük ölçekli eşzamanlı istek senaryolarında işleme verimliliğini ve hızını optimize etmeyi amaçlamaktadır ve performansı artırmak için sürekli toplu işleme, sayfalama dikkati gibi gelişmiş teknolojileri kullanmış olabilir. Tokasaurus’un yayınlanması, büyük miktarda LLM çıkarım görevini verimli bir şekilde işlemesi gereken geliştiricilere ve işletmelere yeni bir seçenek sunuyor (Kaynak: Tim_Dettmers)

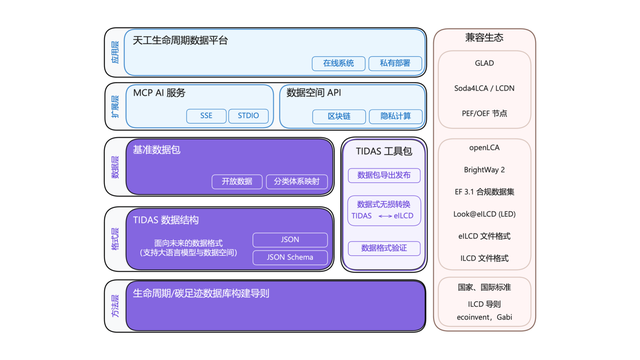

Karbon Ayak İzi “Android” Sistemi TIDAS Yayınlandı, Ant Group Teknoloji Desteği Sağlıyor : Karbon Ayak İzi Endüstriyel Teknoloji İnovasyon Birliği, yaşam döngüsü değerlendirmesi (LCA) ve karbon ayak izi veritabanı oluşturma için çözümler sunmayı amaçlayan “Tiangong LCA Veri Sistemi”ni (TIDAS) yayınladı. Amaç, ülkemizin ve hatta küresel LCA ve karbon ayak izi veritabanlarının “Android” sistemini kurmaktır. Ant Group, temel üye olarak TIDAS’a blockchain teknolojisi ve veri güvenilir işbirliği platformu desteği sağladı. Kendi blockchain teknolojisi aracılığıyla karbon veri varlıklarının güvenilir kaydını ve hak sahipliğini gerçekleştirdi ve gizlilik hesaplama teknolojisini kullanarak verilerin “kullanılabilir ama görünmez” olmasını sağlayarak verilerin standardizasyonunu, birleştirilebilirliğini ve birlikte çalışabilirliğini artırdı (Kaynak: 量子位)

📚 Öğrenme

LangChain, Çoklu Akıllı Sistemlere Odaklanan Kurumsal Düzeyde AI Semineri Düzenliyor : LangChain, 16 Haziran’da San Francisco’da kurumsal düzeyde bir AI semineri düzenleyecek. Etkinlikte, LangChain’den Jake Broekhuizen, katılımcılara LangGraph kullanarak üretime hazır çoklu akıllı sistemler oluşturma konusunda rehberlik edecek ve içerik güvenlik ve gözlemlenebilirlik gibi önemli konuları kapsayacak. Bu, geliştiricilerin karmaşık, güvenilir AI Agent uygulamaları oluşturma becerilerini kazanmalarına yardımcı olmayı amaçlayan pratik bir seminerdir (Kaynak: LangChainAI, hwchase17)

DeepLearning.AI Yeni Kursu “DSPy: Agentic Uygulamalar Oluşturma ve Optimize Etme”yi Başlattı : DeepLearning.AI, “DSPy: Build and Optimize Agentic Apps” adlı yeni bir kurs başlattı. Bu kurs, katılımcılara DSPy’nin temellerini, modüler, izlenebilir ve hata ayıklanabilir GenAI Agentic uygulamaları oluşturmak için imza ve modül tabanlı programlama modelini nasıl kullanacaklarını öğretecek. İçerik, Predict, ChainOfThought ve ReAct gibi DSPy modüllerini bağlayarak uygulamalar oluşturmayı, MLflow ile izleme ve hata ayıklama yapmayı ve cevapların doğruluğunu ve tutarlılığını artırmak için DSPy Optimizer’ı kullanarak istemleri otomatik olarak ayarlamayı ve az sayıda örnekle öğrenmeyi iyileştirmeyi kapsıyor (Kaynak: DeepLearningAI, lateinteraction)

RAG İleri Düzey Teknikler Eğitimi GitHub Projesi İlgi Görüyor : NirDiamant’ın GitHub’da paylaştığı RAG (Retrieval-Augmented Generation) teknikleri eğitim projesi 16.6K yıldız aldı. Bu eğitim, geliştirilmiş alımın ön işlenmesi, optimizasyonu, alım modelleri, yineleme ve mühendislik adımları gibi birçok konuyu kapsamaktadır. RAG uygulamalarının etkinliğini derinlemesine araştırmak ve geliştirmek isteyen geliştiriciler için değerli bir ileri düzey öğrenme kaynağıdır (Kaynak: karminski3)

OpenAI Müşterileri Değerlendirmeleri (Evals) Kullanarak Nasıl Daha İyi AI Ürünleri Oluşturuyor : Hamel Husain, OpenAI’den Jim Blomo’nun sunacağı ve OpenAI müşterilerinin daha kaliteli AI ürünleri oluşturmak için değerlendirme araçlarını (Evals) nasıl kullandıklarını tartışacağı bir web seminerini tanıttı. İçerik, gerçek vaka çalışmaları ve sonuçları içerecek ve OpenAI’nin dahili değerlendirme araçlarını (izleme, puanlama vb.) gösterecektir. Bu web semineri, geliştiricilere AI ürün değerlendirmesi hakkında pratik bilgiler ve yöntemler sunmayı amaçlamaktadır (Kaynak: HamelHusain)

LlamaIndex, Birlikte Çalışabilirlik Standartlarını Tartışmak Üzere 13 Agent Protokolüne Genel Bir Bakış Paylaştı : LlamaIndex’ten Seldo, MCP geliştirici zirvesinde mevcut 13 farklı Agent arası iletişim protokolüne (MCP, A2A, ACP vb. dahil) genel bir bakış sunumu yaptı. Her protokolün benzersiz özelliklerini, mevcut teknoloji ortamındaki konumunu ve gelecekteki gelişim eğilimlerini analiz etti. Bu sunum, geliştiricilerin Agent uygulamaları için uygun iletişim standartlarını anlamalarına ve seçmelerine yardımcı olmayı ve Agent ekosisteminin birlikte çalışabilirliğini teşvik etmeyi amaçlamaktadır (Kaynak: jerryjliu0, jerryjliu0)

Claude Code Mimarisi Analizi: Kontrol Akışı, Orkestrasyon Motoru ve Araç Yürütme : Bir makale, Claude Code’un mimarisini derinlemesine analiz ederek kontrol akışı ve orkestrasyon motoru ile araç ve yürütme motoruna odaklandı. Bu analizler, benzer komut satırı kodlama yardımcısı araçları oluşturmak veya özelleştirilmiş değişiklikler yapmak isteyen geliştiriciler için referans değeri taşımaktadır ve tasarım思路ları diğer Agent araç geliştirme türleri için de geçerlidir (Kaynak: karminski3)

AMD GPU FP8 Matris Çarpımı Çekirdek Yarışması İkincilik Çözümü Paylaşıldı : Tim Dettmers, AMD GPU FP8 matris çarpımı çekirdek yarışmasında ikincilik kazananın çözümünü paylaştı. Bu çözümün ayrıntılı açıklaması, özellikle AI model eğitimi ve çıkarımında verimliliği artırmak için FP8 gibi düşük hassasiyetli formatların giderek daha fazla benimsendiği bir ortamda, AMD GPU’larda düşük hassasiyetli kayan nokta işlem performansının nasıl optimize edileceğini anlamak için önemli bir referans değeri taşımaktadır (Kaynak: Tim_Dettmers)

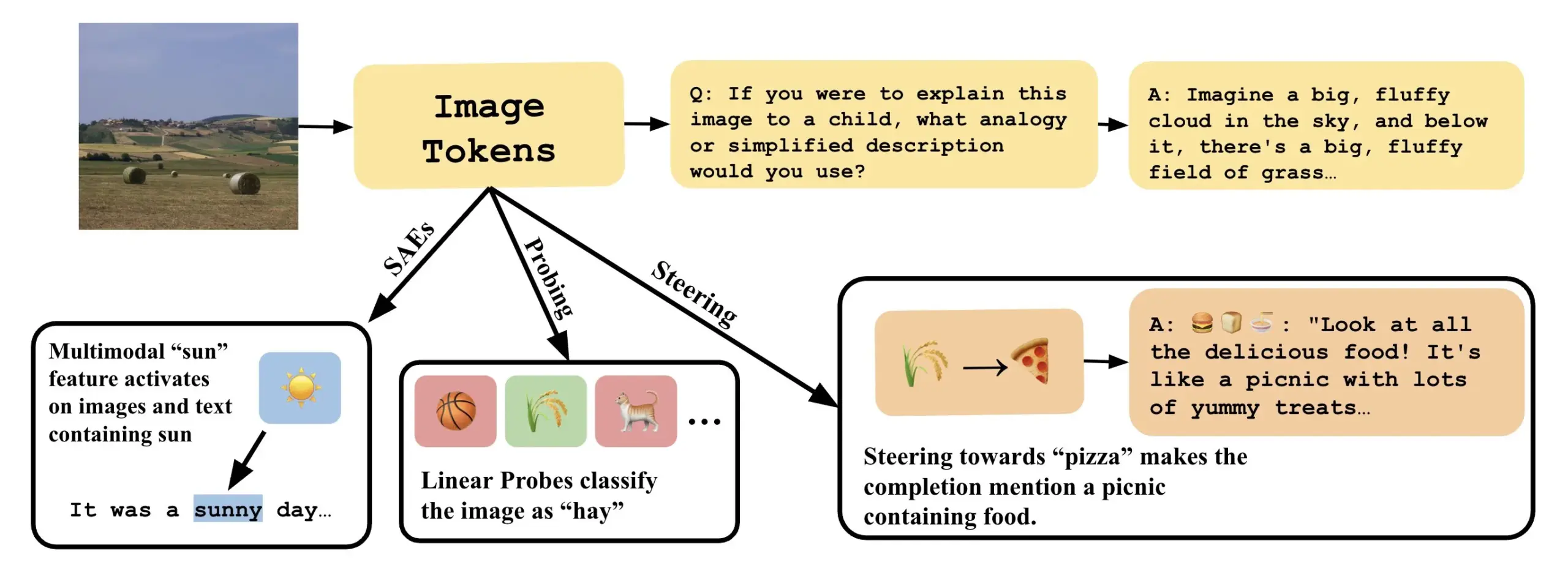

Makale, VLLM’lerdeki Doğrusal Yönleri Yorumlayarak Görsel Dil Modellerini Anlamayı Tartışıyor : “Line of Sight” adlı yeni bir makale, görsel dil büyük modellerinin (VLLM) gizli uzayındaki doğrusal yönleri yorumlayarak iç mekanizmalarını anlamayı tartışıyor. Araştırmacılar, VLLM’lerdeki görüntü temsillerini yorumlamak için sondalama (probing), yönlendirme (steering) ve seyrek otomatik kodlayıcılar (SAE’ler) gibi araçlar kullanıyor. Bu çalışma, çok modlu modellerin iç işleyişini anlamak için yeni bir bakış açısı ve yöntemler sunuyor (Kaynak: nabla_theta)

💼 Ticari

AI Girişimi Vareon, Norck’tan 3 Milyon Dolarlık Ön Tohum Finansmanı Aldı, Öncü AI ve Otonom Sistemlere Odaklanıyor : Faruk Guney tarafından kurulan Norck şirketi, yeni kurulan AI girişimi Vareon’a 3 milyon dolarlık kilometre taşı niteliğinde bir ön tohum finansmanı sağlama sözü verdi. Vareon, öncü AI, nedensel çıkarım ve otonom sistemler alanına odaklanıyor ve temelinde MALPAC (planlama ve kapalı döngü optimizasyonu için çoklu ajan öğrenme mimarisi) bulunuyor. Şirket, robotik, LLM’ler, moleküler tasarım, bilişsel mimariler ve otonom ajanlar gibi alanların gelişimini yönlendiren temel bir AI araştırma şirketi olmayı hedefliyor. Aynı zamanda RAPID (türevlenebilir planlama çerçevesi), CIMO (nedensel çok ölçekli koordinatör), SCA (biyolojiden ilham alan bilişsel mimari) ve Lumon-XAI (yorumlanabilirlik katmanı) da tanıtıldı (Kaynak: farguney)

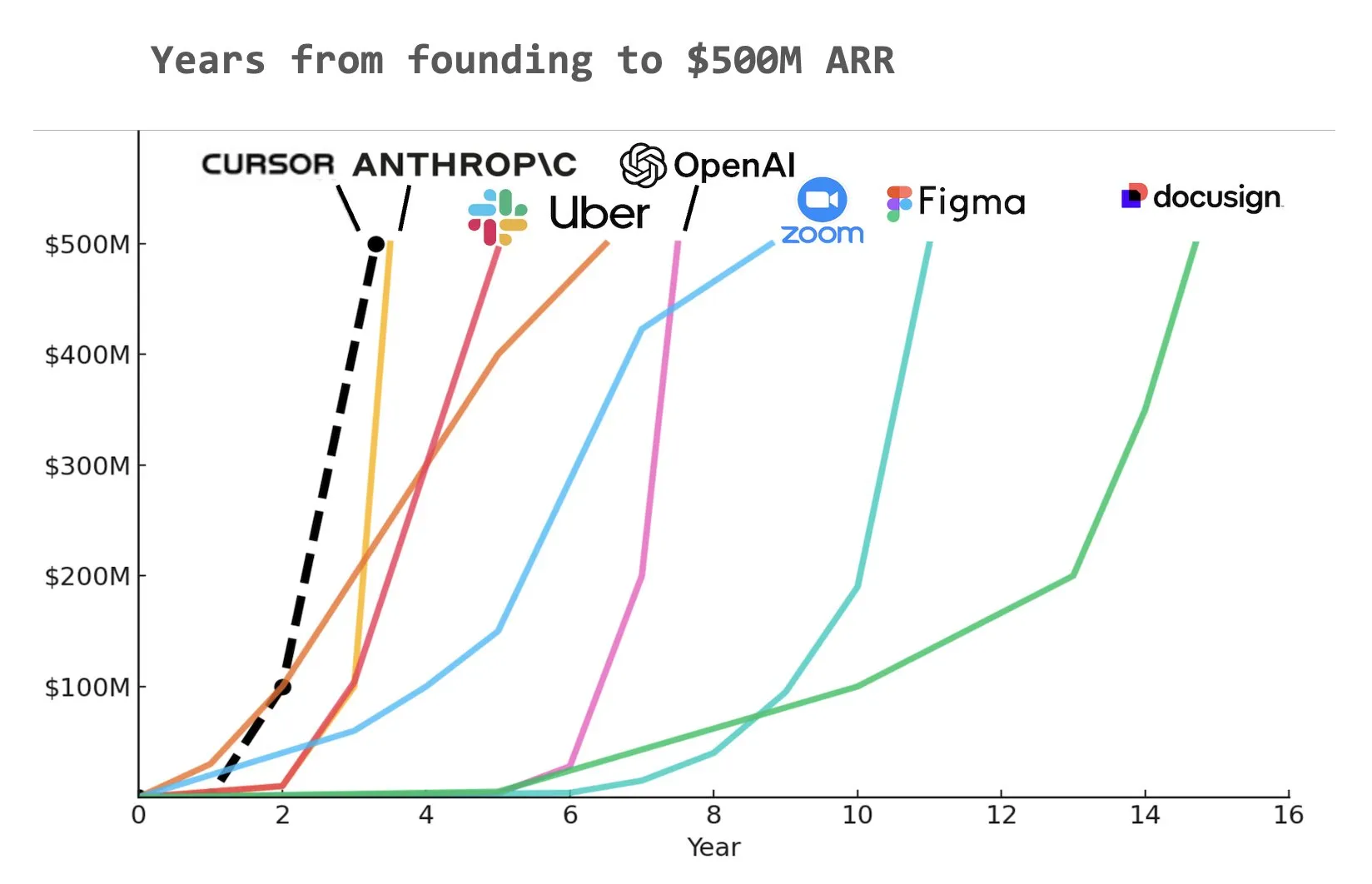

AI Kodlama Aracı Cursor, 900 Milyon Dolarlık C Serisi Finansman Aldı, ARR’si 500 Milyon Dolara Ulaştı : AI kodlama aracı girişimi Cursor, Thrive, Accel, Andreessen Horowitz ve DST liderliğinde 900 milyon dolarlık C serisi finansman turunu tamamladığını duyurdu. Şirket, yıllık yinelenen gelirinin (ARR) 500 milyon doları aştığını ve NVIDIA, Uber ve Adobe dahil olmak üzere Fortune 500 şirketlerinin yarısından fazlası tarafından kullanıldığını açıkladı. Bu finansman turu, Cursor’ın AI kodlama alanındaki araştırma sınırlarını daha da ileri taşımasına yardımcı olacak. Bazı analizler, Cursor’ın tarihte 500 milyon dolarlık ARR’ye en hızlı ulaşan şirketlerden biri olabileceğine işaret ediyor (Kaynak: cursor_ai, Yuchenj_UW, op7418)

Anthropic, OpenAI Satın Alma Söylentileri Nedeniyle Windsurf’ün Claude Modellerine Doğrudan Erişimini Kesti : Anthropic kurucu ortağı ve baş bilim sorumlusu Jared Kaplan, şirketin AI programlama asistanı Windsurf’ün Claude modellerine doğrudan erişim iznini kesmesinin ana nedeninin, Windsurf’ün OpenAI tarafından satın alınacağına dair piyasa söylentileri olduğunu belirtti. Kaplan, “Claude’u OpenAI’ye satmak garip olurdu” dedi ve Anthropic’in hesaplama kaynaklarını uzun vadeli istikrarlı ortaklara tahsis etme eğiliminde olduğunu ifade etti. Buna rağmen Anthropic, Cursor gibi diğer AI programlama aracı geliştiricileriyle aktif olarak işbirliği kuruyor ve gelecekte Claude Code gibi otonom karar verme yeteneğine sahip AI programlama ürünleri geliştirmeye daha fazla odaklanacaklarını vurguladı (Kaynak: dotey, vikhyatk, jeremyphoward, swyx)

🌟 Topluluk

OpenAI Greg Brockman: AGI’nin Geleceği Tek Bir Modelden Ziyade Çeşitli Uzman Agent’ların İşbirliğine Daha Çok Benzeyecek : OpenAI’den Greg Brockman, yapay genel zekanın (AGI) gelecekteki biçiminin, tek bir, her şeye gücü yeten “dev kaya” modelinden ziyade, çok sayıda uzmanlaşmış akıllı ajandan (Agent) oluşan bir “hayvanat bahçesine” daha çok benzeyeceğini düşünüyor. Bu uzman Agent’lar birbirlerini çağırabilecek, işbirliği içinde çalışabilecek ve birlikte ekonomik gelişmeyi yönlendirebilecekler. Bu görüş, gelecekteki AI gelişim eğilimini ima ediyor; yani, belirli yeteneklere sahip birden fazla AI Agent’ı oluşturup entegre ederek daha karmaşık ve güçlü akıllı sistemler elde etmek ve hedef, faaliyetleri ve üretimi 10 kattan fazla artırmak. Clement Delangue, tekelleri kırmak ve tek bir şirketin tüm robotları kontrol etmesini önlemek için açık kaynaklı AI robot teknolojisine ihtiyaç olduğunu yorumladı (Kaynak: natolambert, ClementDelangue, HamelHusain)

LLM’ler Akademik Yazım ve İçerik Özetlemede Potansiyel Gösteriyor, İnsan Yazım Kalitesi Üzerine Düşüncelere Yol Açıyor : Dwarkesh Patel, LLM’lerin şu anda “5/10” seviyesinde yazarlar olduğunu, ancak makale ve kitaplardaki açıklamaları güvenilir bir şekilde geliştirebilmelerinin, akademik yazım kalitesine yönelik büyük bir kınama olduğunu düşünüyor. Arvind Narayanan ayrıca, çoğu akademik yazının genellikle anlaşılırlık pahasına derin ve karmaşık görünmek için yazıldığını, iyi yazının ise kısa ve öz olması gerektiğini belirtiyor. Bu, LLM’lerin akademik araştırmalara yardımcı olma, içerik okunabilirliğini artırma ve gelecekte akademik iletişim biçimlerini nasıl değiştirebileceği konusundaki tartışmaları tetikliyor (Kaynak: random_walker, jeremyphoward)

AI Kodlama Araçları Geliştirici Bağımlılığı Tartışmalarını Tetikliyor, Claude Code Güçlü İşlevleri ve Yüksek Token Tüketimiyle Dikkat Çekiyor : Kullanıcı dotey, AI programlama araçlarını (Claude Code gibi) kullanmanın güçlü bir bağımlılık yaratabileceğini, hatta kotası olduğunda bile manuel yazmak yerine AI’ın tamamlamasını beklemeyi tercih ettiğini düşünüyor. Claude Max aboneliğinin bir sınırı olsa da, sunduğu güçlü kodlama yetenekleri (mükemmel talimat anlama, görev planlama, grep aracı kullanımı ve uzun süreli yürütme gibi) onu verimli bir araç haline getiriyor. Bu olgu, AI araçlarının geliştiricilerin çalışma alışkanlıklarını, verimlilik ile bağımlılık arasındaki dengeyi nasıl değiştirdiği konusundaki tartışmaları tetikliyor. Başka bir kullanıcı Asuka小能猫 da Claude-4-Opus ve Cursor Max modunu kullanarak ön uç geliştirmeyi verimli bir şekilde tamamladığı bir örneği gösterdi, ancak Token tüketimi sorununa da değindi (Kaynak: dotey, dotey)

AI Destekli Kişiselleştirilmiş Eğitimin Potansiyeli Büyük, Ancak Uygulama Zorluklarına Dikkat Edilmeli : Austen Allred, çocuğunun AI destekli bir okula (öğretmensiz) beş ay boyunca katılım deneyimini paylaştı ve sonuçların “çılgınca” olduğunu belirtti. Noah Smith, bire bir özel dersin etkili bir eğitim müdahalesi olduğunu ve AI’ın bunu ölçeklendirmeyi mümkün kıldığını yorumladı. Bu, kişiselleştirilmiş öğrenme yolları, AI eğitmenlerinin potansiyeli ve eğitimde eşitliğin nasıl sağlanacağı ve teknolojik uygulama zorluklarının nasıl aşılacağı da dahil olmak üzere AI’ın eğitim alanındaki uygulamaları hakkında tartışmalara yol açtı. Jon Stokes bu eğilimi yeniden paylaştı ve takip etti (Kaynak: jonst0kes, jeremyphoward)

AI Agent’ları ve İnsan Duygusal Bağlantısı Dikkat Çekiyor, OpenAI Kullanıcı Refahı Araştırmalarına Öncelik Verdiğini Vurguluyor : OpenAI’den Joanne Jang, insan-AI ilişkileri ve şirketin bu konudaki tutumunu ele alan bir blog yazısı yayınladı. Temel görüş, OpenAI’nin modelleri öncelikle insanlara hizmet etmek için oluşturduğu ve giderek daha fazla insanın AI ile duygusal bağ kurmasıyla şirketin bunun kullanıcıların duygusal refahı üzerindeki etkisini araştırmaya öncelik verdiğidir. Corbtt, AI yoldaşlarının internetten bu yana en dönüştürücü sosyal teknoloji olduğunu, şirketlerin katılımı psikolojik sağlık yerine optimize etmesi durumunda sosyal medyanın çocuklar üzerindeki olumsuz etkilerinden daha büyük olabileceğini, ancak psikolojik sağlığı optimize etmeleri durumunda insanlık için bir lütuf olabileceğini yorumladı. cto_junior ise gelecekte çocuklarla “GPT ile evlenmenin uygun olup olmadığı” gibi konuları tartışmak gerekebileceği senaryosunu esprili bir dille öngördü (Kaynak: cto_junior, corbtt)

AI Agent Teknolojisi Hızla Gelişiyor, Ancak Uçtan Uca Seyrek Takviyeli Öğrenme Görevleri Hala Zorlu : Nathan Lambert, mevcut Deep Research, Codex agent gibi projelerin temel olarak kısa vadeli takviyeli öğrenme (RL) görevlerinde ve genel sağlamlıkta modelleri eğiterek gerçekleştirildiğini düşünüyor. Uçtan uca, çok seyrek RL görevlerinde eğitim yapmak ise insanların düşündüğünden daha uzak görünüyor. Corbtt buna yorum olarak, insanların bile uzun vadeli görevlerde ve seyrek ödül sinyallerinde nasıl eğitim yapılacağını henüz etkili bir şekilde öğrenemediğini belirtti. Bu, mevcut AI Agent teknolojisinin karmaşık, uzun vadeli planlama ve otonom öğrenme konularındaki sınırlamalarını yansıtıyor (Kaynak: corbtt)

AI Alanındaki “Acı Ders”: Doğrulama (Verification) Akıl Yürütme Tipi LLM’ler İçin Anahtar Haline Geliyor : Rishabh Agarwal, CVPR Çok Modlu Akıl Yürütme Çalıştayı’nda “RL’nin Acı Dersi: Akıl Yürütme Tipi LLM’ler İçin Anahtar Olarak Doğrulama” başlıklı bir konuşma yaptı. Bu konuşma, Rich Sutton’ın “Acı Ders” hakkındaki klasik makalesinden ilham alarak, takviyeli öğrenme ve büyük dil modeli akıl yürütmesinde doğrulama mekanizmalarının önemini tartıştı. Bu, yalnızca modelin kendi üretim yeteneğine güvenmenin yeterli olmadığı, güçlü doğrulama ve geri bildirim mekanizmalarının AI’ın akıl yürütme yeteneğini ve güvenilirliğini artırmak için hayati önem taşıdığı anlamına gelebilir (Kaynak: jack_w_rae)

AI Gelişimi İstihdam Piyasasında Endişelere Yol Açıyor, Uzman Görüşleri Farklılık Gösteriyor : Klarna CEO’su Sebastian Siemiatkowski, AI’ın özellikle beyaz yakalı işlerde büyük ölçekli işsizliğe yol açarak ekonomik durgunluğu tetikleyebileceği uyarısında bulundu. Klarna’nın kendisi, AI asistanı aracılığıyla 700 müşteri hizmetleri temsilcisinin yerini alarak yılda yaklaşık 40 milyon dolar tasarruf etti. Anthropic araştırmacısı Sholto Douglas da 2027-28’e kadar AI’ın yeteneklerinin çok güçlü olacağını öngördü. Ancak, AI’ın üretkenliği artıracağı ve yeni işler yaratacağı yönünde görüşler de var; örneğin Sundar Pichai, AI’ın bir hızlandırıcı olacağını ve en azından 2026’ya kadar işten çıkarmalara yol açmayacağını belirtmişti. AI Explained’in videosu, AI kaynaklı işsizlik hakkındaki mevcut manşetlerin makul olup olmadığını analiz ediyor ve Duolingo ile Klarna’nın AI uygulamaları konusundaki bazı çelişkili durumlarını tartışıyor. Bu tartışmalar, toplumun AI’ın ekonomik etkilerine yönelik genel kaygısını ve farklı beklentilerini yansıtıyor (Kaynak: , Reddit r/ArtificialInteligence, Reddit r/ClaudeAI, Reddit r/ArtificialInteligence)

AI Agent’larının Mevcut Ağ/API’lerle Etkileşiminin Gelecekteki Yolları Tartışılıyor : AI Agent’larının otonom ağ etkileşim yetenekleri arttıkça, mevcut Web/API’lerle etkileşim biçimleri bir altyapı sorunu haline geliyor. Tartışmada üç olası yol önerildi: 1. Sıfırdan yeniden inşa etmek, Agent yerel protokollerini benimsemek (gerçekçi değil); 2. Agent’lara insanlar gibi web sitelerini kullanmayı öğretmek (özellikle kimlik doğrulama konusunda hata oranı yüksek); 3. HTTP’yi “Agent dilini konuşur” hale getirmek, örneğin 402 (ödeme gerekli) gibi başarılı olmayan yanıtların makine tarafından okunabilir bağlamını zenginleştirerek Agent’ların otonom olarak doğrulama yapmasını ve erişim satın almasını sağlamak. Temel görüş, başarılı olmayan Web/API etkileşimleri için zengin bağlamsal bilgiler sağlamanın, otonom Agent’ların anlamlı işler başarması, hatalardan otomatik olarak kurtulması ve karmaşık süreçlerde gezinmesi için anahtar olacağıdır (Kaynak: Reddit r/ArtificialInteligence)

AI Destekli Matematik Araştırmaları İlerleme Kaydediyor, Terence Tao Gibi İsimler Potansiyelini ve Sınırlamalarını Değerlendiriyor : Matematikçiler, AI’ın karmaşık matematik problemlerini çözmedeki uygulamalarını aktif olarak araştırıyorlar. Terence Tao, AI (AlphaEvolve) ile insan işbirliğinin 30 gün içinde toplam-fark kümesi üs rekorunu üç kez kırdığı bir vakayı paylaştı ve Lean dili ile GitHub Copilot’u birleştirerek “ε-δ” limit problemine meydan okudu. Bu, AI’ın acemilere yardımcı olma, temel görevleri yerine getirme ve kanıt yapılarını tahmin etme yeteneklerini gösterirken, karmaşık çıkarımlar ve matematiksel lemmaları bulma konusundaki eksikliklerine de işaret etti. Başka bir haberde, 30 önde gelen matematikçinin gizli bir toplantıda OpenAI o4-mini’yi test ettiği ve bazı son derece zor problemleri çözebildiğini, matematik dehasına yakın bir seviye sergilediğini bulduğu bildirildi. Bu gelişmeler, AI’ın matematik araştırmalarında güçlü bir yardımcı olabileceğini gösteriyor, ancak aynı zamanda matematikçilerin rolü ve yaratıcılık gelişimi hakkında yeni düşünceler ortaya koyuyor (Kaynak: 36氪)

💡 Diğer

GPS Alternatif Teknoloji Yarışı Kızışıyor, Xona Space Systems Düşük Yörüngeli PNT Takımyıldızı Kurmayı Planlıyor : GPS sistemi sinyallerinin parazite (hava durumu, 5G baz istasyonları, karıştırıcılar) kolayca maruz kalması ve özellikle Rusya-Ukrayna çatışmasında hassasiyetinin ortaya çıkması nedeniyle, alternatif çözümler bulmak stratejik bir öncelik haline geldi. Kaliforniya merkezli girişim Xona Space Systems, Pulsar adlı düşük Dünya yörüngeli bir uydu takımyıldızı (sonunda 258 uydu) fırlatmayı planlıyor. Uyduları daha alçak yörüngede olacak, sinyal gücü GPS’in yaklaşık 100 katı olacak, karıştırılması daha zor olacak ve engelleri daha iyi aşabilecek. Amaç, otonom sürüş gibi yeni teknolojileri desteklemek için santimetre düzeyinde hassasiyet ve yüksek güvenilirlikte konumlandırma, navigasyon ve zamanlama (PNT) hizmetleri sunmaktır. İlk test uydusu bu ay SpaceX Transporter 14 ile fırlatılacak (Kaynak: MIT Technology Review)

Araştırma, Umut ve İyimserliğin Kalp Hastalarının İyileşmesi Üzerindeki Olumlu Etkilerini İnceliyor : Son araştırmalar, kalp hastalarının umut ve iyimserliğinin daha iyi sağlık sonuçlarıyla ilişkili olduğunu, umutsuzluğun ise daha yüksek ölüm riskiyle ilişkili olduğunu gösteriyor. Bu, plasebo etkisi (olumlu beklentilerin sonuçları iyileştirmesi) ve nosebo etkisi (olumsuz beklentilerin olumsuz semptomlara yol açması) olgularıyla tutarlıdır. Liverpool Üniversitesi’nden Alexander Montasem ve diğer araştırmacılar, yüksek umudun anjina azalması, felç sonrası yorgunluğun azalması, yaşam kalitesinin artması ve ölüm riskinin azalması ile ilişkili olduğunu buldular. Araştırmacılar, klinikte pozitif düşüncenin gücünden nasıl yararlanılabileceğini araştırıyorlar; örneğin, hastaların hedefler belirlemesine yardımcı olarak, eylemliliklerini artırarak “umut reçetesi yazmak” gibi, aynı zamanda maddi olmayan hedeflerin refah için daha önemli olduğunu vurguluyorlar (Kaynak: MIT Technology Review)

Apple ve Alibaba’nın Çin’deki AI Hizmet Tanıtımı Ticaret Sürtüşmeleri Nedeniyle Engellendi : İngiliz Financial Times gazetesinin haberine göre, Apple şirketinin Alibaba ile Çin’deki AI hizmet tanıtım planları gecikmeyle karşılaştı ve bu durum Çin-ABD ticaret sürtüşmelerinin son kurbanı olarak değerlendiriliyor. Bu işbirliği, Çin’de satılan iPhone’lara AI işlevleri desteği sağlamayı planlıyordu. Bu gecikme, Apple’ın Çin pazarındaki AI işlevlerinin dağıtım takvimini etkileyebilir ve iki şirketin işbirliği beklentilerine belirsizlik getirebilir (Kaynak: MIT Technology Review)