Anahtar Kelimeler:Yapay Zeka Matematik Araştırması, Yapay Zeka Enerji Tüketimi, Yapay Zeka Programlama Araçları, Yapay Zeka Tıbbi Değerlendirme, Yapay Zeka Donanım Optimizasyonu, Yapay Zeka Video Üretimi, Yapay Zeka Güvenilirlik Değerlendirmesi, Yapay Zeka Çoklu Ajan Sistemleri, DARPA expMath Projesi, AlphaProof Matematik Yarışması, FrontierMath Kıyaslama Testi, GUI-Actor Görsel Konumlandırma, AudioTrust Sesli Büyük Model Değerlendirmesi

🔥 Öne Çıkanlar

Yapay Zekanın Matematik Alanındaki İlerlemeleri ve Zorlukları: DARPA, yapay zekayı kullanarak matematiksel araştırmaları hızlandırmayı ve büyük, karmaşık sorunları daha kolay çözülebilir küçük sorunlara ayırmayı amaçlayan expMath projesini başlattı. Yapay zeka, Matematik Olimpiyatları gibi yarışmalarda (AlphaProof, AlphaEvolve gibi) insanüstü potansiyel sergilemiş olsa da, araştırma düzeyindeki matematik problemlerinin (Milenyum Büyük Ödül Problemleri gibi) çözümü hala çok uzak. Yeni FrontierMath kıyaslaması, yapay zekanın bilinmeyen zor problemler üzerindeki yeteneklerini daha doğru bir şekilde değerlendirmeyi amaçlıyor. Yapay zeka şu anda çok uzun ispat yollarını (Riemann Hipotezi’nin milyon satırlık ispatı gibi) işlemede zorluk çekiyor, ancak takviyeli öğrenme yoluyla ispat yollarını “sıkıştırma” denemeleri yapıldı ve Andrews-Curtis Hipotezi araştırmasında ilerleme kaydedildi. Yapay zeka henüz gerçek matematiksel sezgi ve yaratıcılıktan yoksun, insanlar gibi yeni matematiksel kavramlar (“ikosahedron” gibi) “icat etmekte” zorlanıyor ve şu anda daha çok insan keşfine yardımcı olan “gelişmiş bir gözcü” rolünü oynuyor (kaynak: MIT Technology Review)

Yapay Zekanın Enerji Tüketimi Endişe Yaratıyor, Ancak Optimizasyon Umut Verici: Yapay zekanın hızlı gelişimi, özellikle yapay zeka video üretimi olmak üzere büyük bir enerji talebini beraberinde getirdi; enerji tüketimi şaşırtıcı boyutlarda, 5 saniyelik düşük kaliteli bir videonun enerji tüketimi, bir chatbot’un bir soruyu yanıtlamasının 42.000 katı. Ancak, yapay zeka enerji tüketimi konusunda iyimser faktörler de mevcut: 1. Model, çip ve soğutma teknolojilerinin verimliliğinin artması bekleniyor; 2. Ticari gerçekler, daha enerji verimli yapay zeka gelişimini teşvik edebilir. Yapay zeka şu anda başlangıç aşamasında olsa da, gelecekte çıkarım modelleri, yapay zeka donanım cihazları ve dijital zekâlar gibi unsurlar daha fazla enerji tüketecek, ancak teknolojik gelişmeler enerji verimliliğinde de artış sağlayabilir. Önemli olan, yalnızca bireysel kullanıcıların karbon ayak izine odaklanmak yerine, genel enerji yapısını, veri merkezlerinin su tüketimini (Nevada’daki gibi) ve temiz enerji taahhütlerinin yerine getirilip getirilmediğini dikkate almaktır (kaynak: MIT Technology Review)

OpenAI Codex CLI, Performansı ve Güvenliği Artırmak İçin Rust Diline Geçiyor: OpenAI, yapay zeka komut satırı kodlama aracı Codex CLI’ın performansını artırmak, güvenliği güçlendirmek ve Node.js’e olan bağımlılıktan kurtulmak amacıyla Rust diliyle yeniden yazılacağını duyurdu. Daha önce bu araç ağırlıklı olarak TypeScript ile yazılmıştı. Bakımcı Fouad Matin (yaklaşık bir yıldır OpenAI’de), Rust sürümünün sıfır bağımlılıkla kurulum, geliştirilmiş sanal alan mekanizması (Linux’ta Landlock kullanarak), optimize edilmiş performans (çöp toplama yok, daha düşük bellek gereksinimi) sağlayacağını ve mevcut Rust MCP uygulamasını kullanabileceğini belirtti. OpenAI mühendisleri yarım aydan biraz daha uzun bir süre önce TypeScript’in UI için en uygun dil olduğunu belirtmiş olsalar da, çekirdek aracı için maksimum verimlilik arayışıyla sonunda Rust’a geçme kararı aldılar. Bu hamle, Vite’ın Rolldown’u, XChat ve Zed editörü gibi projelerin son zamanlarda Rust ile yeniden yazılma eğilimini de yansıtıyor (kaynak: 36氪)

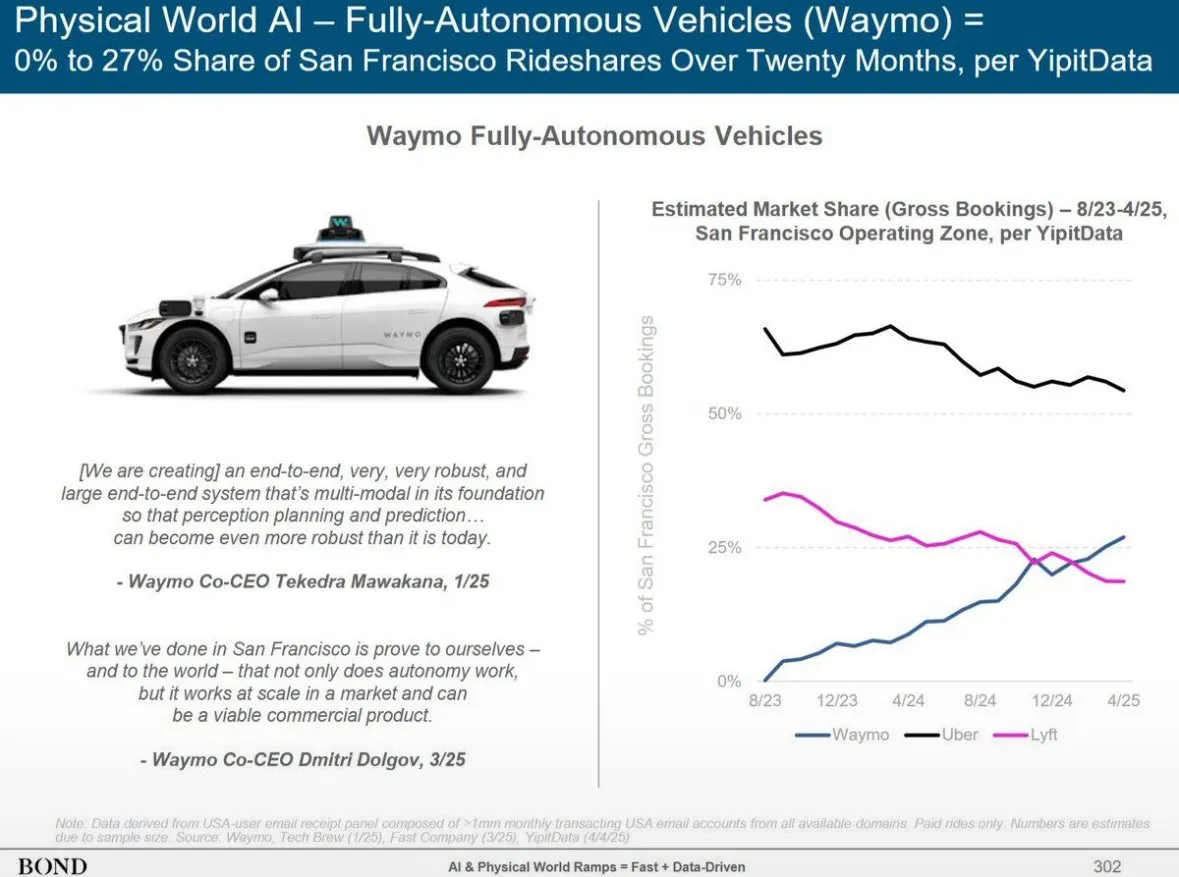

Bond Capital, Yapay Zeka Trend Raporunu Yayınladı; ChatGPT Büyümesini ve Küresel Yapay Zeka Ortamını Ortaya Koydu: Bond Capital’ın raporu, OpenAI’nin ChatGPT’sinin 17 ayda haftalık 800 milyon aktif kullanıcıya ulaştığını ve yıllık gelirinin 9,2 milyar dolar olmasının beklendiğini belirtiyor. Bu, özellikle gelişmekte olan pazarlarda (örneğin Hindistan kullanıcıların %14’ünü oluşturuyor) yapay zeka öncelikli bir benimseme modelini gösteriyor. Haftalık kullanıcı tutma oranı %80 ile Google aramasının oldukça üzerinde. Büyük teknoloji şirketlerinin 2024 yılı sermaye harcamaları 212 milyar dolara yükseldi, OpenAI’nin hesaplama maliyeti ise 5 milyar dolara ulaştı. Aynı zamanda, Çin’in yapay zeka yetenekleri hızla yetişiyor; DeepSeek R1, matematik kıyaslamalarında OpenAI o3-mini’nin performansının %93’üne ulaştı ve eğitim maliyeti daha düşük. Çin, DeepSeek mobil kullanıcılarının %33,9’unu oluşturuyor. Yapay zeka ile ilgili işe alımlar 7 yılda %448 arttı ve şirketler yapay zeka uygulamalarını deneysel olmaktan çıkarıp operasyonel olarak kritik hale getirmeye başlıyor (kaynak: Reddit r/artificial)

🎯 Gelişmeler

Altman’ın Yeni Nesil Yapay Zeka Modeli Vizyonu: Daha Güçlü Çıkarım, Ultra Uzun Bağlam ve Araç Kullanımı: OpenAI CEO’su Sam Altman, AGI’yi tanımlamaktansa yapay zeka teknolojisindeki üstel ilerlemeye odaklanmanın daha önemli olduğunu düşünüyor. Gelecekteki yapay zeka modellerinin ultra güçlü bağlam anlama yeteneğine, çeşitli araçlarla sorunsuz bağlantıya, üstün çıkarım yeteneğine ve karmaşık görevleri yerine getirme konusunda sağlamlığa sahip olacağını öngörüyor. İdeal yapay zeka, küçük boyutlu, insanüstü çıkarım yapabilen, trilyonlarca token’lık bağlamı destekleyen ve herhangi bir aracı çağırabilen bir yapıda olmalı. Yapay zekanın değerinin basit bir veritabanı olmaktan ziyade çıkarım yapabilmesinde yattığını vurguluyor. Bin kat daha fazla hesaplama gücü, yapay zeka araştırmalarının kendisine ve modellerin test aşamasındaki performansının artırılmasına, özellikle biyoteknoloji gibi alanlarda, örneğin RNA ekspresyon mekanizmalarını çözerek hastalıkların üstesinden gelinmesine ayrılacak (kaynak: 36氪)

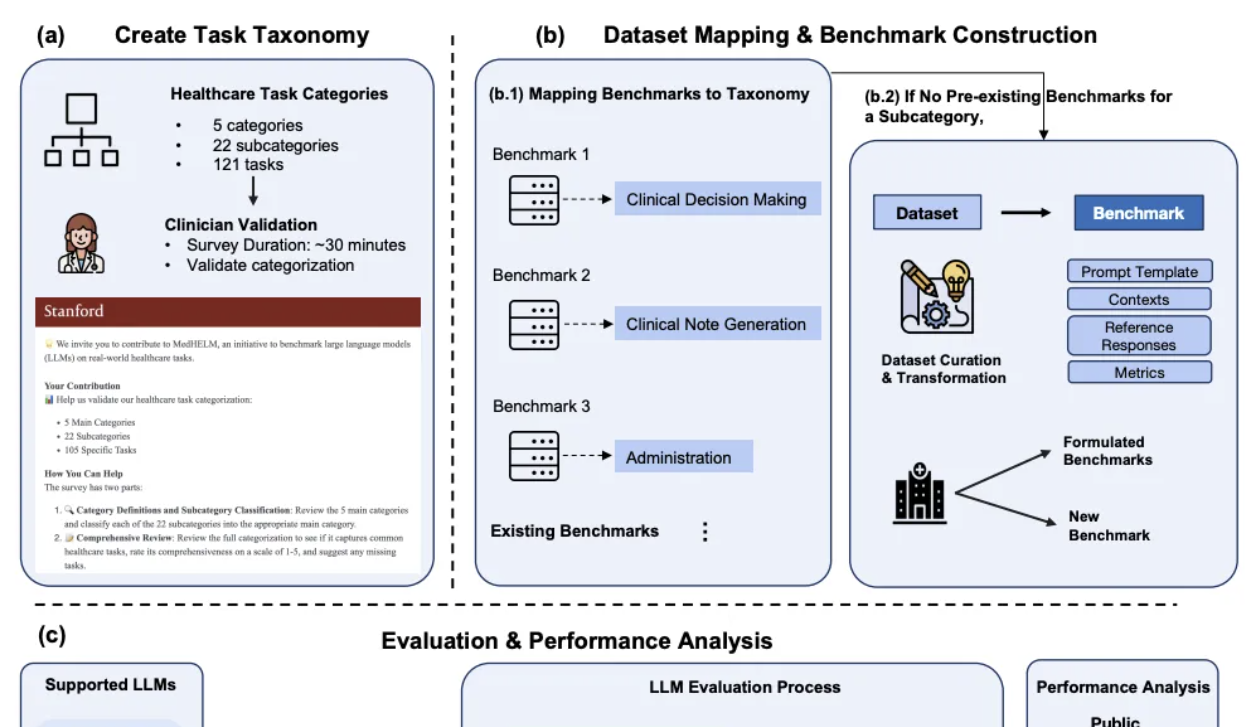

DeepSeek, Stanford Klinik Tıp Yapay Zeka Karşılaştırmasında Öne Çıktı: Stanford Üniversitesi’nin yeni yayınladığı büyük model tıbbi görevler için kapsamlı değerlendirme çerçevesi MedHELM’de, DeepSeek R1, 22 klinik alt kategoriyi kapsayan 35 kıyaslama testinde %66 kazanma oranı ve 0.75 makro ortalama puanla birinci sırada yer aldı. Bu değerlendirme, 29 pratisyen hekimin katılımıyla geliştirildi ve özellikle klinisyenlerin günlük çalışma senaryolarını simüle etmeye odaklandı. o3-mini, %64 kazanma oranı ve 0.77 makro ortalama puanla hemen arkasından geldi. Claude 3.7 Sonnet ve 3.5 Sonnet de iyi performans gösterdi. Değerlendirme, modellerin klinik vaka oluşturma ve hasta iletişimi/eğitimi gibi serbest metin görevlerinde daha iyi performans gösterdiğini, ancak yönetim ve iş akışı gibi yapılandırılmış çıkarım görevlerinde daha düşük puan aldığını ortaya koydu. Araştırma ayrıca LLM jüri değerlendirme yöntemlerinin klinisyen puanlarıyla tutarlılığını da doğruladı (kaynak: 量子位)

Huawei, Adaptive Pipe & EDPB Çözümünü Önerdi, MoE Eğitimini %70’in Üzerinde Hızlandırdı: MoE model eğitiminde uzman paralelliğinin (EP) neden olduğu iletişim bekleme ve yük dengesizliği sorunlarına yönelik olarak Huawei, Adaptive Pipe & EDPB optimizasyon çözümünü önerdi. Bu çözüm, DeployMind simülasyon platformu aracılığıyla saatlik otomatik paralel optimizasyon gerçekleştiriyor, hiyerarşik All-to-All iletişim ve uyarlanabilir ince taneli ileri-geri maskeleme teknolojisi (Adaptive Pipe) kullanarak EP iletişiminin %98’inden fazlasını maskeliyor. Aynı zamanda, EDPB küresel yük dengeleme teknolojisi (uzman tahmini dinamik geçişi, veri yeniden düzenleme Attention hesaplama dengelemesi, sanal boru hattı katmanlar arası yük dengelemesi dahil) aracılığıyla yük dengesizliği sorunlarının üstesinden gelerek verimi %25,5 daha artırıyor. Pangu Ultra MoE 718B modelinin (8K dizi) eğitim uygulamasında, bu birleşik çözüm sistemin uçtan uca eğitim veriminde %72,6’lık bir artış sağladı (kaynak: 量子位)

İkinci Nesil Yapay Zeka Donanımları, Telefonların Yerini Almak Yerine Belirli Senaryolara ve Sorunlara Odaklanıyor: AI Pin gibi birinci nesil yapay zeka donanımlarının “telefonları öldürme” girişimlerinin aksine, Plaude ses kayıt cihazı, XiaoZhi AI, Xunfei AI kulaklıkları, Meta AI gözlükleri gibi ikinci grup yapay zeka donanımları, ses kaydını metne dönüştürme, sesli sohbet, toplantı notları gibi belirli senaryolardaki somut sorunları çözmeye odaklanıyor ve önemli ticari başarılar elde etti. Bu ürünler “küçük ama güçlü, özel ve rafine” özelliklerini yansıtıyor, sınır hissini ve zayıf etkileşimi vurguluyor, belirli işlevlerde en üst düzey performansı hedefliyor. Sektör trendleri, yapay zeka asistanını merkez alan, cihazlar arası, bulut tabanlı “görünmez bir işletim sisteminin” oluşmakta olduğunu gösteriyor; donanım, yapay zeka yeteneklerinin taşıyıcısı ve uzantısı haline geliyor ve giriş hakkı uygulamalardan yapay zeka asistanlarına kayıyor (kaynak: 36氪)

AudioTrust: Sesli Büyük Dil Modelleri İçin İlk Çok Boyutlu Güvenilirlik Değerlendirme Kıyaslaması Yayınlandı: Nanyang Teknoloji Üniversitesi ve Tsinghua Üniversitesi gibi kurumların araştırma ekipleri, sesli büyük dil modelleri (ALLM’ler) için özel olarak tasarlanmış ilk kapsamlı güvenilirlik değerlendirme kıyaslaması olan AudioTrust’u yayınladı. Bu çerçeve, adalet, halüsinasyon, güvenlik, gizlilik, sağlamlık ve kimlik doğrulama olmak üzere altı temel boyutta, 18 deneysel kurulum ve 4420’den fazla gerçek dünya ses/metin verisi aracılığıyla ALLM’leri kapsamlı bir şekilde değerlendiriyor. Araştırma, mevcut modellerin hassas özelliklerde sistematik önyargılara sahip olduğunu, gürültülü ve düşmanca girdiler altında sağlamlıklarının yetersiz olduğunu ve ses klonlama aldatmacalarına karşı savunma gibi konularda zafiyetleri bulunduğunu ortaya koydu. AudioTrust, ALLM’lerin potansiyel risklerini ortaya çıkarmayı ve güvenilirliklerini artırmak için araştırma temeli sağlamayı amaçlıyor (kaynak: 量子位)

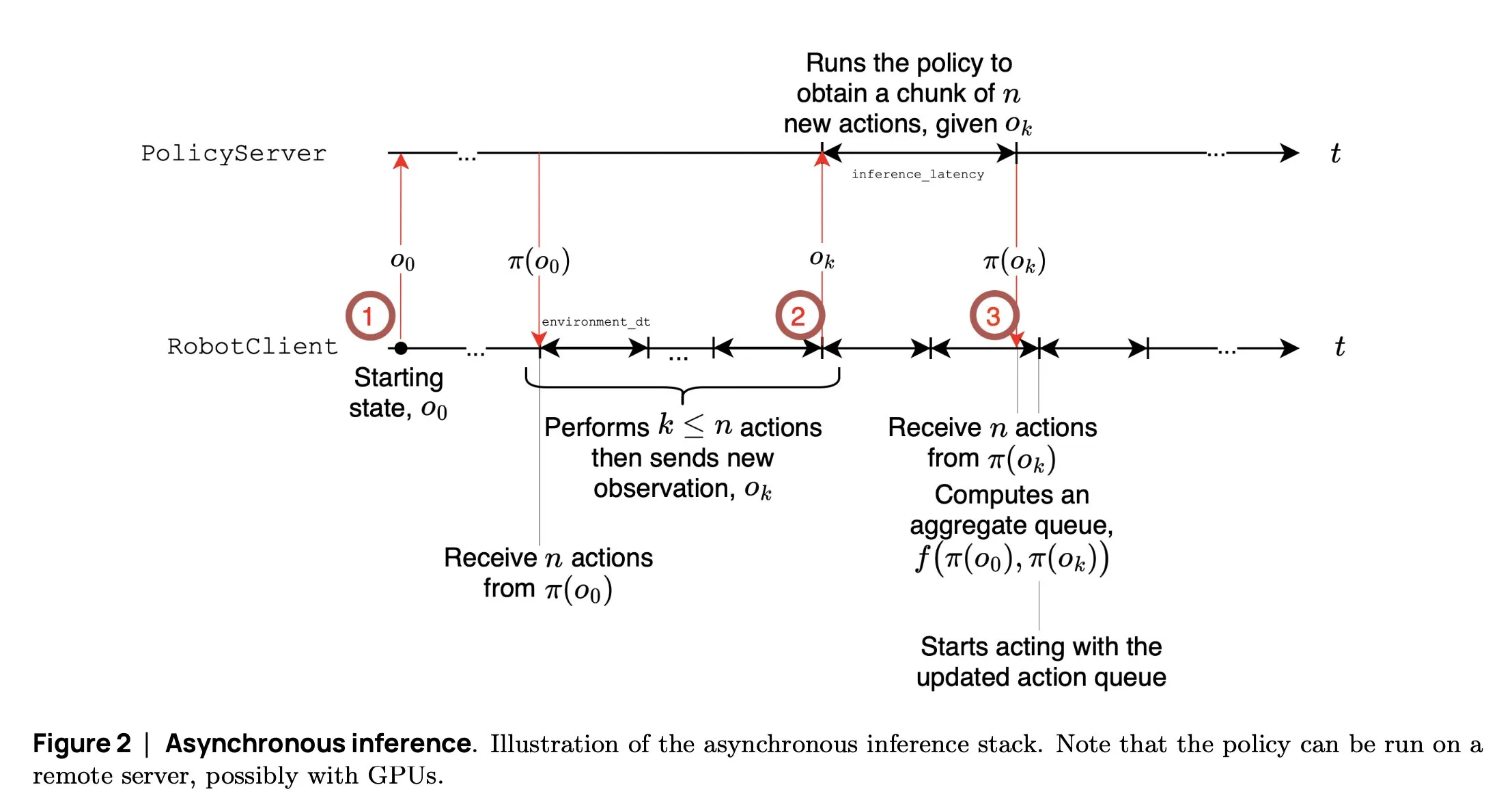

SmolVLA: Hugging Face, Küçük ve Verimli Robotik VLA Modelini Tanıttı: Hugging Face robotik ekibi, robotlar için özel olarak tasarlanmış 450M parametreli küçük bir görsel dil eylem modeli olan SmolVLA’yı yayınladı. Tüketici sınıfı GPU’larda gerçek zamanlı olarak çalışabiliyor, halka açık veri kümeleri kullanılarak eğitiliyor ve performansı büyük modellerle karşılaştırılabiliyor. SmolVLA, robotun mevcut eylemin tamamlanmasını beklemeden bir sonraki adımı planlamaya başlamasını sağlayan “asenkron çıkarım” mekanizmasını tanıtarak robot verimini yaklaşık %30 artırıyor ve görev tamamlama verimliliğini neredeyse iki katına çıkarıyor. Bu model, Meta-World, LIBERO gibi birçok kıyaslama testinde başarılı performans gösterdi; kodu, ağırlıkları ve eğitim süreci, açık robotik topluluğunun gelişimini desteklemek amacıyla açık kaynak olarak sunuldu (kaynak: AymericRoucher, mervenoyann, huggingface)

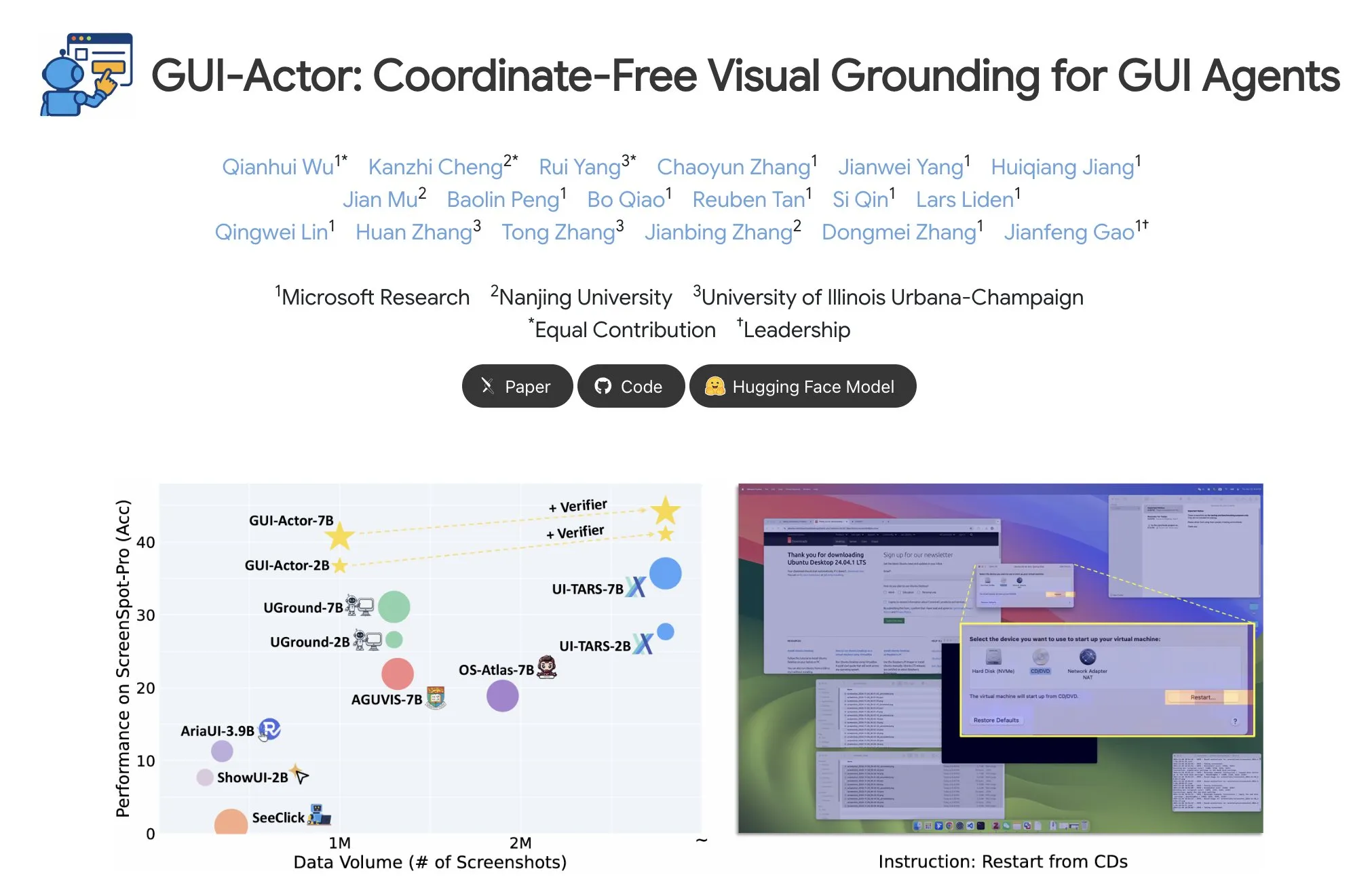

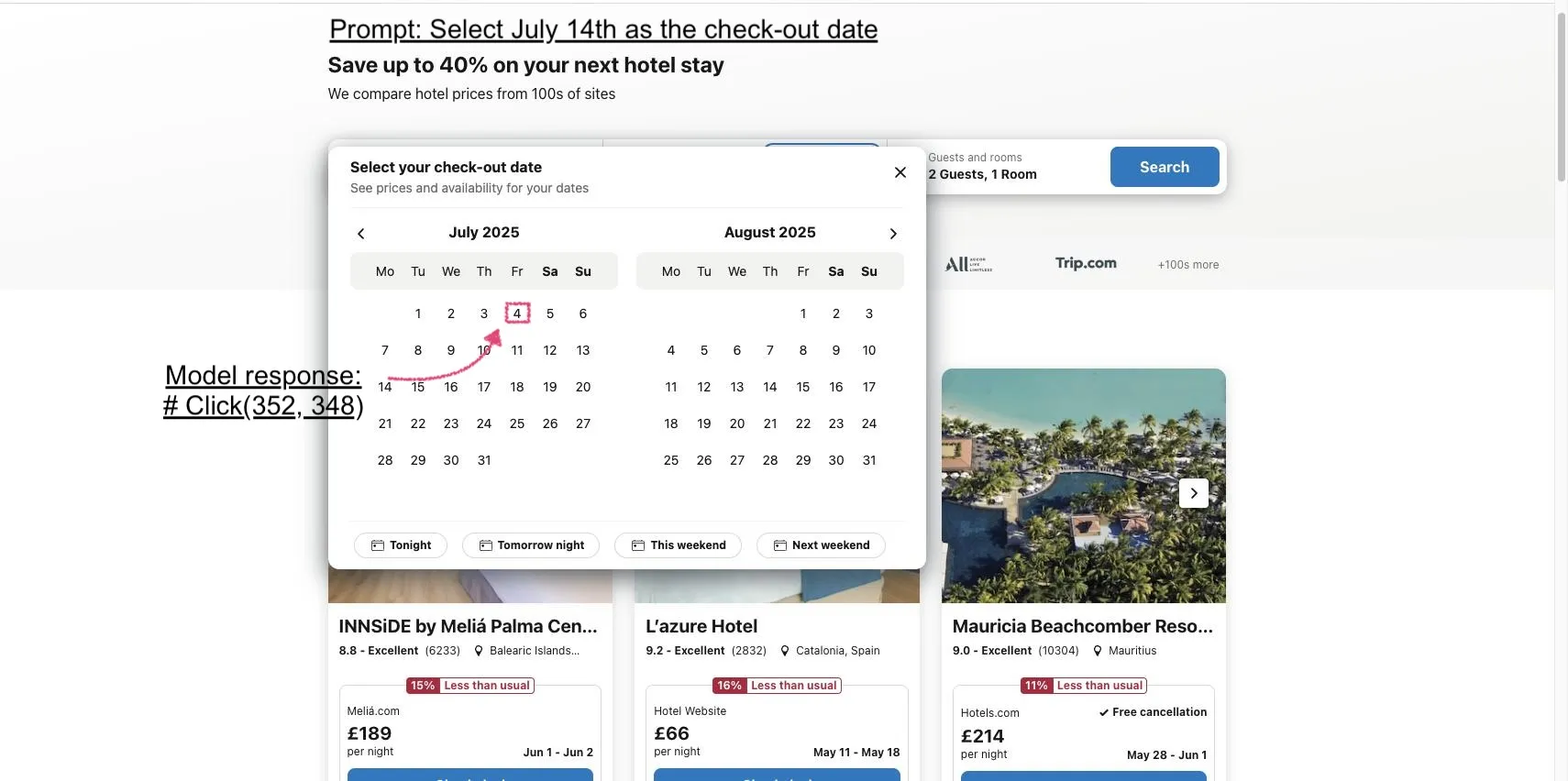

Microsoft, GUI-Actor’ı Tanıttı: VLM’lerin GUI Görevlerinde Görsel Konumlandırma Yeteneğini Artırıyor: Microsoft, VLM tabanlı, koordinattan bağımsız bir GUI konumlandırma yöntemi olan GUI-Actor’ı yayınladı. Bu yöntem, dikkat mekanizmalı bir eylem başlığı (action head) sunarak, özel token’ları ilgili görsel yamalarla hizalar, böylece tek bir ileri yayılımda bir veya daha fazla eylem bölgesi önerir ve en makul eylemi seçmek için bir konumlandırma doğrulayıcısıyla birlikte çalışır. Deneyler, GUI-Actor’ın birden fazla GUI eylem konumlandırma kıyaslamasında önceki yöntemlerden daha iyi performans gösterdiğini ortaya koydu; 7B modelinin, yalnızca yaklaşık 100M parametreli eylem başlığının ince ayarlanmasıyla (VLM ana gövdesi dondurulmuşken) SOTA modelleriyle karşılaştırılabilir performans göstermesi, VLM’nin genel amaçlılığını tehlikeye atmadan etkili konumlandırma yeteneği kazandırma potansiyelini gösteriyor (kaynak: HuggingFace Daily Papers, kylebrussell)

DCM: Çift Uzman Tutarlılık Modeli, Yüksek Kaliteli Video Üretimini Hızlandırıyor: Araştırmacılar, verimli ve yüksek kaliteli video üretimi için bir hızlandırıcı olan DCM’yi (Dual-Expert Consistency Model) önerdiler. Tutarlılık modeli eğitim dinamiklerini analiz ederek, farklı zaman adımlarındaki optimizasyon gradyanları ve kayıp katkıları arasında çakışmalar olduğunu buldular. DCM, parametre açısından verimli bir çift uzman tasarımı kullanır: anlamsal uzman, anlamsal düzeni ve hareketi öğrenirken, detay uzmanı ince detay optimizasyonuna odaklanır. Zamansal tutarlılık kaybı ve GAN/özellik eşleştirme kaybı ile birleştirilen DCM, örnekleme adımlarını önemli ölçüde azaltırken SOTA görsel kalitesini elde ederek video difüzyon modeli damıtmadaki sorunları etkili bir şekilde çözüyor. Bu yöntem, HunyuanVideo13B gibi modellerde yaklaşık 10 kat çıkarım hızlandırması (1500 saniyeden 120 saniyeye) sağlayabilir (kaynak: HuggingFace Daily Papers, _akhaliq)

FlowMo: Varyans Tabanlı Akış Yönlendirmesi, Video Üretiminde Hareket Tutarlılığını Artırıyor: Metinden videoya difüzyon modellerinin hareket, fizik ve dinamik etkileşimler gibi zamansal boyut modellemesindeki sınırlamalarını çözmek için araştırmacılar, ek eğitim veya yardımcı girdi gerektirmeyen bir çıkarım zamanı yönlendirme yöntemi olan FlowMo’yu önerdiler. FlowMo, ardışık karelere karşılık gelen gizli değişkenler arasındaki mesafeyi ölçerek görünümden ayrıştırılmış bir zamansal temsil türetir ve hareket tutarlılığını tahmin etmek için zaman boyutları arasındaki yama düzeyindeki varyansı kullanır, ardından örnekleme sürecinde modeli bu varyansı azaltması için dinamik olarak yönlendirir. Deneyler, FlowMo’nun çeşitli önceden eğitilmiş video difüzyon modellerinin hareket tutarlılığını, görsel kaliteyi veya ipucu hizalamasını tehlikeye atmadan önemli ölçüde iyileştirebildiğini kanıtladı (kaynak: HuggingFace Daily Papers, Suhail)

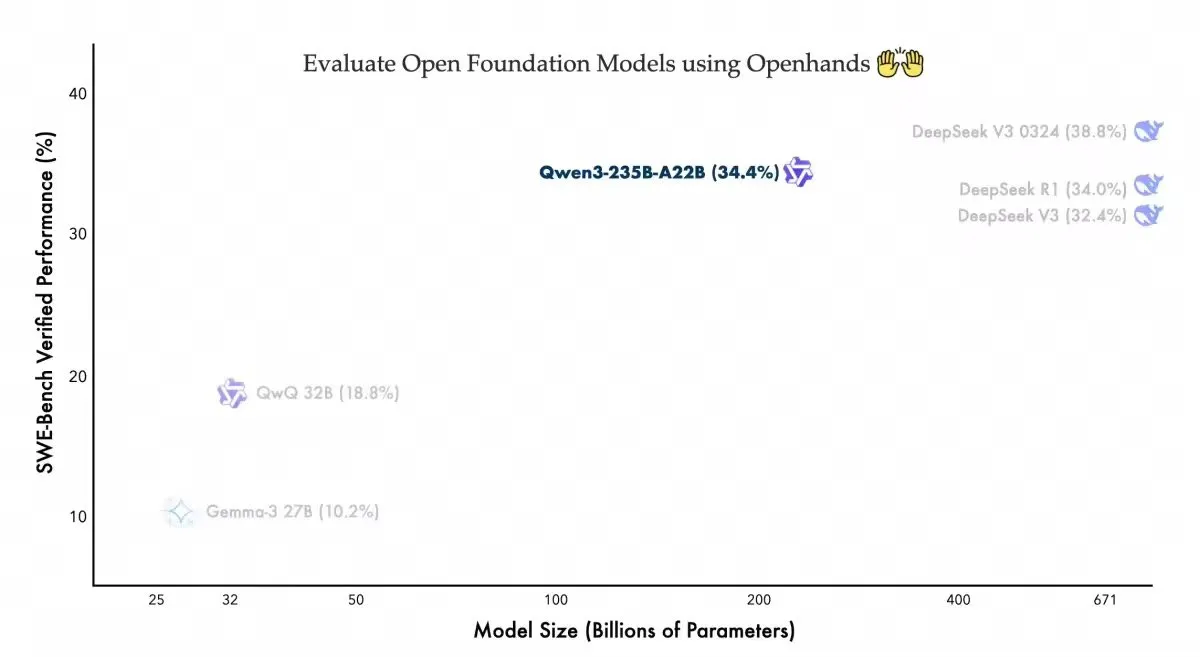

Qwen3-235B-A22B, Openhands Kodlama Aracısında Rekabetçi Performans Sergiliyor: Alibaba Qwen ekibi, Qwen3-235B-A22B modelinin açık kaynak kodlama aracısı Openhands’in Swebench-verified kıyaslama testinde %34,4’lük bir sonuç elde ettiğini duyurdu. Ekip, bu sonucun modelin daha az parametreyle rekabetçi bir performans sergilediğini gösterdiğini belirtti ve kullanımı kolay aracı için allhands_ai’ye teşekkür etti. Bu haber, açık modellerin ve açık aracıların birleşiminin potansiyelini vurguluyor (kaynak: Alibaba_Qwen)

OmniSpatial: VLM’ler İçin Kapsamlı Uzamsal Çıkarım Kıyaslaması Yayınlandı: Araştırmacılar, bilişsel psikolojiye dayanan, görsel dil modelleri (VLM) için kapsamlı ve zorlu bir uzamsal çıkarım kıyaslaması olan OmniSpatial’ı tanıttılar. OmniSpatial, dinamik çıkarım, karmaşık uzamsal mantık, uzamsal etkileşim ve perspektif değiştirme olmak üzere dört ana kategori içerir ve 50 alt kategoriye ayrılarak toplamda 1500’den fazla soru-cevap çifti sunar. Mevcut açık ve kapalı kaynak VLM’ler ile özel çıkarım ve uzamsal anlama modelleri üzerinde yapılan kapsamlı deneyler, bu modellerin kapsamlı uzamsal anlama konusunda önemli sınırlamaları olduğunu göstermektedir. Bu çalışma, VLM’lerin uzamsal çıkarım yeteneklerinin daha da geliştirilmesini teşvik etmeyi amaçlamaktadır (kaynak: HuggingFace Daily Papers, kylebrussell)

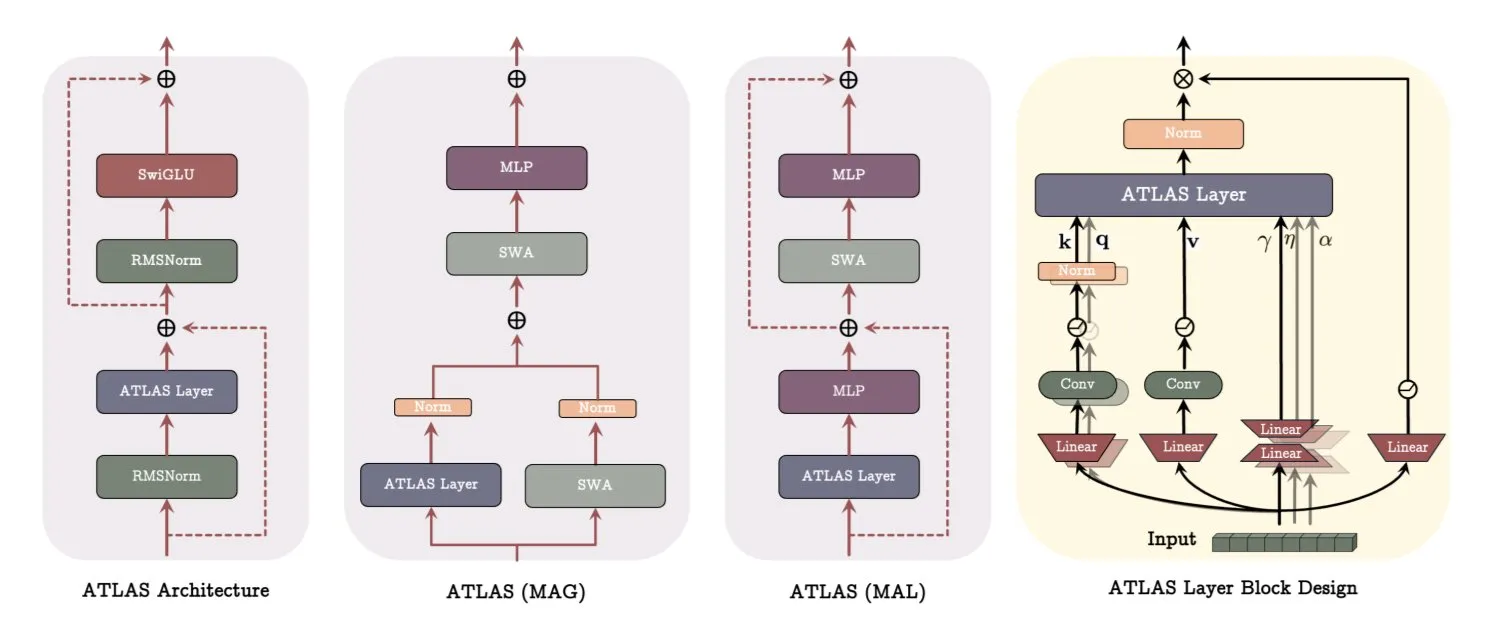

Google DeepMind ATLAS Mimarisi: Model Öğrenme ve Bellek Kullanımını Yeniden Yapılandırıyor: Google DeepMind, model öğrenme ve bellek kullanma şeklini yeniden tanımlamayı amaçlayan yeni bir model mimarisi olan ATLAS’ı yayınladı. ATLAS, sözde Omega kuralı aracılığıyla aktif bellek uygular ve belleği dinamik, öğrenilebilir bir duruma optimize etmek için son c token’ı ortaklaşa işler. Bellek boyutunu genişletmeden daha zengin ilişkiler depolamak için polinom ve üstel özellik eşlemelerini kullanır ve belleği daha verimli bir şekilde optimize etmek için Muon optimize edicisini kullanır. DeepTransformers ve Dot gibi tasarımlar, geleneksel sabit dikkati öğrenilebilir, bellek odaklı mekanizmalarla değiştirir. ATLAS, yapay zekayı daha akıllı, bağlama duyarlı ve büyük ölçekli veri kümelerini etkili bir şekilde kullanabilen sistemlere doğru ilerletmeyi amaçlamaktadır (kaynak: TheTuringPost)

NVIDIA, Llama-Nemotron-Nano-VL-8B-V1 Görsel Modelini Yayınladı: NVIDIA, yoğun belgeleri, grafikleri ve video karelerini okuyabilen 8 milyar parametreli bir görsel model olan Llama-Nemotron-Nano-VL-8B-V1’i tanıttı. Bu model, OCRBench V2’de (İngilizce) birinci sırada yer alıyor ve düzen ile OCR yeteneklerini uçtan uca birleştirmesiyle öne çıkıyor. Model, Hugging Face’te kullanıma sunuldu (kaynak: ClementDelangue)

Shisa V2 405B Yayınlandı, Japonya’nın En Güçlü İki Dilli Modeli Olduğu İddia Ediliyor: Shisa AI, Shisa V2 serisinin en yeni iki dilli (Japonca/İngilizce) modeli olan Shisa V2 405B’yi yayınladı. Bu model, Llama 3.1 405B temel alınarak ince ayarlandı ve çok dillilik yeteneğini artırmak için ek olarak Korece ve Geleneksel Çince verileri eklendi. İddiaya göre, Japonca-İngilizce MT-Bench’te GPT-4/GPT-4 Turbo’dan daha iyi performans gösteriyor ve en son GPT-4o ve DeepSeek-V3 ile Japonca yeteneği açısından eşdeğer. Model ağırlıkları ve GGUF nicelenmiş sürümleri Hugging Face’te mevcut olup, test için FP8 uç noktaları da bulunmaktadır (kaynak: Reddit r/LocalLLaMA)

Anthropic, Claude Code Pro Planını Tanıttı ve o3-pro Modelini Kullanıma Sundu: Anthropic’in yapay zeka programlama aracı Claude Code, artık Pro planı kullanıcılarına açık, ancak Sonnet 4 modelinin kullanımı için her 5 saatte 10-40 arası bir ipucu sınırı bulunuyor. Opus 4 ise Pro planı ile Claude Code birlikte kullanılamıyor, bu daha çok bir deneme modu gibi görünüyor. Aynı zamanda, OpenAI’nin o3-pro modeli de kullanıma sunuldu ve şu anda yalnızca aylık 200 dolarlık Pro aboneliği olan kullanıcılar tarafından kullanılabiliyor (kaynak: Reddit r/ClaudeAI, karminski3)

H Company, Açık Kaynak GUI Eylem Görsel Dil Modeli Holo-1’i Yayınladı: H Company, çeşitli Web ve bilgisayar aracı görevleri için tasarlanmış, 3B ve 7B parametre içeren GUI eylem görsel dil modeli Holo-1’i yayınladı. Holo-1, Apache 2.0 lisansını kullanıyor ve Hugging Face Transformers kütüphanesini destekleyerek yapay zekanın grafik kullanıcı arayüzü anlama ve işlem yapma yeteneklerini artırmayı amaçlıyor (kaynak: mervenoyann)

Kling 2.1 Video Üretim Modeli İlgi Görüyor, Görüntüden Videoya ve Stilize Edilmiş Oluşturmayı Destekliyor: Kuaishou’nun Kling 2.1 metinden videoya ve görüntüden videoya modeli toplulukta ilgi görmeye devam ediyor. Kullanıcı geri bildirimlerine göre, basit görüntüleri 1080p sinematik sahnelere dönüştürebiliyor, GPT-4o ile Kling’i birleştirerek sıradan kaydırma çekimlerini Pixar tarzı animasyonlara çevirebiliyor ve Midjourney V7 tarafından oluşturulan görüntüleri girdi olarak kullanarak ultra gerçekçi dinamik efektlere sahip videolar oluşturabiliyor. Topluluk, Kling 2.1 kullanılarak oluşturulan birçok örneği paylaşarak yaratıcı video üretimi alanındaki potansiyelini sergiliyor (kaynak: Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai)

OpenAI Yeni Ses Modelini Yayınladı, Gerçek Zamanlı Sesi 2 Kat Hızda Oynatmayı Destekliyor: OpenAI, o3-pro modelinin kullanıma sunulduğunu ve şu anda yalnızca Pro aboneliği olan kullanıcılar tarafından kullanılabildiğini duyurdu. Aynı zamanda, OpenAI’nin GPT-4o tabanlı iki yeni ses modeli daha yayınlayacağı anlaşılıyor. Gerçek zamanlı ses API’si de geliştirilerek komut izleme güvenilirliği, araç çağırma tutarlılığı ve kesme davranışı iyileştirildi ve kullanıcıların ses oynatma hızını kontrol etmelerine olanak tanıyan speed parametresi eklendi (en fazla 2 kat hız). Intercom’un Fin Voice’u zaten gerçek zamanlı API’sini kullanıyor (kaynak: karminski3, swyx, swyx)

Arcee AI, Homunculus Modelini Yayınladı, Qwen3 Düşünce Zincirini 12B’ye Damıttı: Arcee AI, logit yörünge damıtma teknolojisi aracılığıyla Qwen3-235B’nin “düşünme” zincirini (CoT) 12B parametreli Mistral-Nemo modeline aktaran Homunculus-12B modelini tanıttı. Bu model, CoT sürecini tamamen koruyor ve tek bir 4090 GPU üzerinde çalışabiliyor; daha küçük bir modelle karmaşık çıkarım yeteneği elde etmeyi amaçlıyor (kaynak: teortaxesTex, cognitivecompai, ClementDelangue)

FLUX Kontext Modeli Yoğun İlgi Görüyor, Halka Açık Model 500 Binden Fazla Kez Çalıştırıldı: FLUX Kontext modeli, güçlü görüntü düzenleme ve oluşturma yetenekleri nedeniyle toplulukta geniş ilgi görüyor; iddiaya göre halka açık modeli kısa sürede 500 binden fazla kez çalıştırıldı. Kullanıcı geri bildirimlerine göre Kontext, daha önce Photoshop gibi profesyonel yazılımlar gerektiren birçok görüntü işleme görevini yerine getirebiliyor. Krea AI da FLUX modelini kullanıma sundu, ancak bir ara hesaplama gücü sağlayıcısının ağ sorunları nedeniyle hizmet kesintisi yaşadı (kaynak: op7418, robrombach, op7418)

Meta ve Constellation Energy, Yapay Zekaya Güç Sağlamak İçin 20 Yıllık Nükleer Enerji Anlaşması İmzaladı: Meta şirketi, yapay zeka (AI) operasyonlarına güç sağlamak amacıyla Constellation Energy ile 20 yıllık bir nükleer enerji anlaşması imzaladı. Bu hamle, büyük teknoloji şirketlerinin yapay zekanın artan enerji taleplerini karşılamak için sürdürülebilir ve istikrarlı güç kaynakları arayışını yansıtıyor (kaynak: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Bing Video Creator Hizmetinde Kesinti, Ekip Acil Onarım Yapıyor: Microsoft Bing video oluşturma aracı Bing Video Creator’da hizmet kesintisi yaşandı. Resmi açıklamada, ekibin çok sayıda kullanıcının hizmeti kullandığının farkında olduğu ve en kısa sürede onarmak için çalıştığı, yaşanan aksaklıktan dolayı özür dilendiği belirtildi. Arızanın kesin nedeni ve tahmini düzelme süresi henüz açıklanmadı (kaynak: JordiRib1)

🧰 Araçlar

Manus AI Slayt Özelliği Beğeni Topladı, Google Slides’a Aktarımı Destekliyor: Manus AI’nin yeni kullanıma sunduğu slayt oluşturma özelliği kullanıcılardan olumlu yorumlar aldı; beklentilerin üzerinde bir etki yarattığı ve araştırma makaleleri gibi içerikleri hızla net yapılı, resimli ve metinli PPT’lere dönüştürebildiği belirtildi. Bu özellik anında değişiklik yapmayı, otomatik kaydetmeyi destekliyor ve ekip çalışmasını kolaylaştırmak için Google Slides’a aktarma seçeneği eklendi. Testler, Manus’un yaklaşık 10 dakikada 8 sayfalık bir PPT oluşturabildiğini gösteriyor; bu süreç taslak planlama, kaynak arama, taslak yazma, HTML kodu oluşturma ve düzeni iyileştirmeyi içeriyor. Kullanıcı geri bildirimlerine göre verimli ve zaman kazandırıcı, tasarımı kullanıcı kitlesine uygun, ancak dışa aktarma formatında sayfa görüntüleme sorunları olabiliyor ve manuel ayarlama gerekebiliyor (kaynak: 量子位)

claude-trace: Claude Code’un Tüm İstek Günlüklerini Kaydeden Araç: claude-trace adlı bir araç, Claude Code’un prompt dahil tüm istek günlüklerini kaydedebiliyor ve içeriği görüntüleme kolaylığı için HTML dosyalarında saklayabiliyor. Çalışma prensibi, kendisini başlatarak Node.js’in global.fetch API’sini enjekte edip değiştirmesi ve ardından Claude Code’u bu API üzerinden başlatarak tüm istekleri yakalayıp kaydetmesidir. Kullanıcılar, Claude Max aboneliği kullanırken başlıca claude-3-5-haiku (ön işleme), claude-opus-4 (kod yazma ve araç çağırma) ve claude-sonnet-4 (Opus kotası dolduğunda) modellerini çağırdıklarını paylaştılar (kaynak: dotey)

Firecrawl /search Özelliğini Tanıttı, Arama ve Tarama Entegrasyonu Sağlıyor: Firecrawl, kullanıcıların tek bir API çağrısıyla web araması yapmasını ve gerekli verileri taramasını sağlayan yeni /search özelliğini yayınladı. Bu özellik, yapay zeka aracılarının veri toplama süreçlerini basitleştirmeyi amaçlıyor. Özellik, n8n gibi otomasyon araçlarıyla entegre edilerek veri işleme verimliliğini artırabiliyor (kaynak: omarsar0)

Modal, LLM Çalışma Performansını Değerlendirmeye Yardımcı Olan LLM Engine Advisor’ı Tanıttı: Modal Labs, kullanıcıların farklı LLM’lerin farklı iş yükleri ve motorlar (vLLM, SGLang gibi) altında ne kadar hızlı çalıştığını ve maksimum verimini hızlıca anlamalarına yardımcı olmak için LLM Engine Advisor adlı küçük bir uygulama geliştirdi. Bu araç, geçici çalıştırma ve kıyaslama testlerini paylaşmanın verimsizliği sorununu çözmeyi ve kullanıcıların LLM seçimi ve dağıtımı için teknik karar desteği sağlamayı amaçlıyor (kaynak: charles_irl, andersonbcdefg, charles_irl, charles_irl)

FastPlaid Yayınlandı: Yüksek Performanslı Çoklu Vektör Arama Motoru: Raphaël Sourty, Rust ile (Torch C++ yardımıyla) sıfırdan oluşturulmuş yüksek performanslı bir çoklu vektör arama motoru olan FastPlaid’in yayınlandığını duyurdu. FastPlaid, çoklu vektör arama alanında Faiss’in bir muadili olarak görülüyor ve özellikle ColBERT gibi geç etkileşimli modeller için daha hızlı indeksleme hızı ve sorgu QPS’si sağlamayı amaçlıyor; iddiaya göre bazı durumlarda QPS hızında %554’e varan ve indeksleme hızında %72’ye varan bir artış sağlayabiliyor (kaynak: lateinteraction, lateinteraction, lateinteraction, lateinteraction, stanfordnlp, lateinteraction)

ChaiGenie: RAG Tabanlı Chrome Uzantısı, Belgelerle Sohbet İmkanı Sunuyor: ChaiGenie, Devyansh Yadavv tarafından geliştirilen bir Chrome uzantısıdır. RAG (Retrieval Augmented Generation) teknolojisini kullanarak kullanıcıların doğrudan tarayıcıda doğal dil sorgularıyla ChaiDocs belge içeriğini sorgulamasına olanak tanır. Uzantı, belge ve blog içeriğini taramak için Puppeteer’ı, parçalama, gömme ve işleme için LangChain’i, gömme oluşturmak için Gemini’yi, vektör depolama ve benzerlik araması için Qdrant’ı kullanır ve Express ile Node.js aracılığıyla bir API arayüzü sunar (kaynak: qdrant_engine)

Swama: MLX Tabanlı macOS Yerel Yapay Zeka Çalışma Zamanı: xingyue, macOS için özel olarak tasarlanmış, hızlı, gizli ve basit bir yerel LLM çalıştırma deneyimi sunmayı amaçlayan yerel bir yapay zeka çalışma zamanı olan Swama’yı yayınladı. Swama, Apple’ın MLX çerçevesine dayanıyor, OpenAI uyumlu API’leri destekliyor ve kullanıcıların karmaşık ayarlara gerek kalmadan yerel LLM’leri çekip çalıştırmasına ve onlarla sohbet etmesine olanak tanıyan şık bir CLI arayüzü sunuyor (kaynak: awnihannun)

ragbits: Açık Kaynaklı, Modüler GenAI Uygulama Oluşturma Araç Kutusu: deepsense-ai, RAG boru hatları, aracı uygulamaları ve text2SQL motorlarının geliştirilmesini basitleştirmek için güvenilir, tür açısından güvenli, modüler yapı taşları içeren bir araç kutusu olan dahili GenAI uygulama hızlandırıcısı ragbits’i açık kaynak olarak yayınladı. ragbits, geliştirme tekrarlanabilirliğini, hızını ve yapısal bütünlüğünü artırmayı amaçlar ve geliştiricilerin GenAI uygulamaları oluşturup ölçeklendirmelerine ve kod tabanı karmaşasından kaçınmalarına yardımcı olmak için OpenTelemetry gibi gözlemlenebilirlik yığınlarıyla kolayca entegre olur (kaynak: Reddit r/LocalLLaMA)

Synthesia, Wisetail ile Entegre Oldu, Yapay Zeka Videoları Eğitim Programlarını Güçlendiriyor: Yapay zeka video üretim platformu Synthesia, öğrenme yönetim sistemi Wisetail ile entegre olduğunu duyurdu. Kullanıcılar artık Synthesia’da hızla yapay zeka videoları oluşturabilir, 140’tan fazla dilde yerelleştirilmiş sürümleri destekleyebilir ve birkaç tıklamayla eğitim içeriğini güncel tutabilir, ardından bunları kolayca Wisetail eğitim programlarına dahil ederek ölçeklenebilir yapay zeka video eğitimi sağlayabilir (kaynak: synthesiaIO)

📚 Öğrenme Kaynakları

DeepLearning.AI ve Databricks, DSPy Kısa Kursu İçin İşbirliği Yaptı: Andrew Ng, Databricks ile işbirliği yaparak yeni bir kısa kurs olan “DSPy: Build and Optimize Agentic Apps”i duyurdu. DSPy, GenAI uygulamalarının istemlerini otomatik olarak ayarlayan açık kaynaklı bir çerçevedir. Kurs, DSPy ve MLflow’un nasıl kullanılacağını öğretecek; içerik, DSPy’nin imza tabanlı programlama modelini, MLflow ile izleme ve hata ayıklamayı ve DSPy Optimizer aracılığıyla doğruluğu otomatik olarak artırmayı kapsayacak. Kurs, DSPy çerçevesinin eş yöneticisi Chen Qian tarafından verilecek (kaynak: AndrewYNg, DeepLearningAI, matei_zaharia)

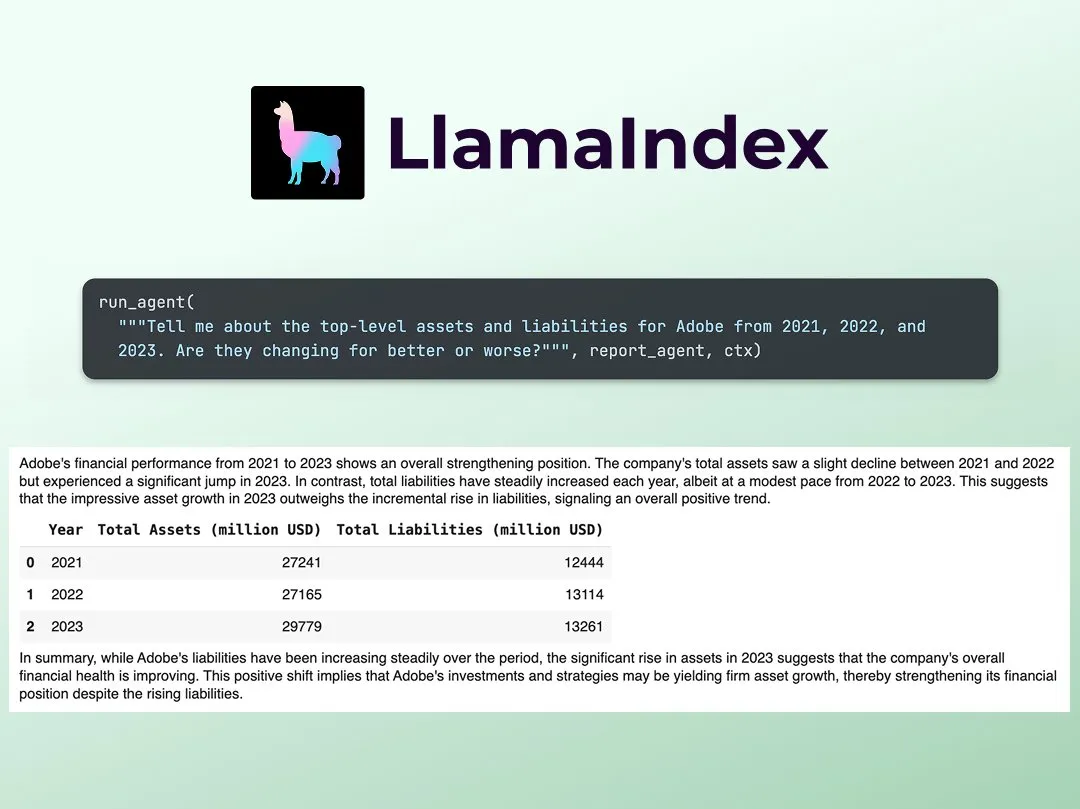

LlamaIndex, Çoklu Aracı Finansal Araştırma Analisti Oluşturma Eğitimi Yayınladı: LlamaIndex’ten Jerry Liu, çoklu aracı finansal araştırma analisti oluşturmak için adım adım bir kılavuz paylaştı. Süreç, veri işleme katmanını (halka açık dosyaları işlemek için LlamaCloud kullanarak) ve aracı düzenleme katmanını (araştırma, veri önbellekleme ve nihai çıktı oluşturma için çoklu aracı sistemi oluşturma) içeriyor. İlgili Colab Notebook, geçen haftaki Agents+Finance çalıştayının ana örneklerinden biriydi (kaynak: jerryjliu0)

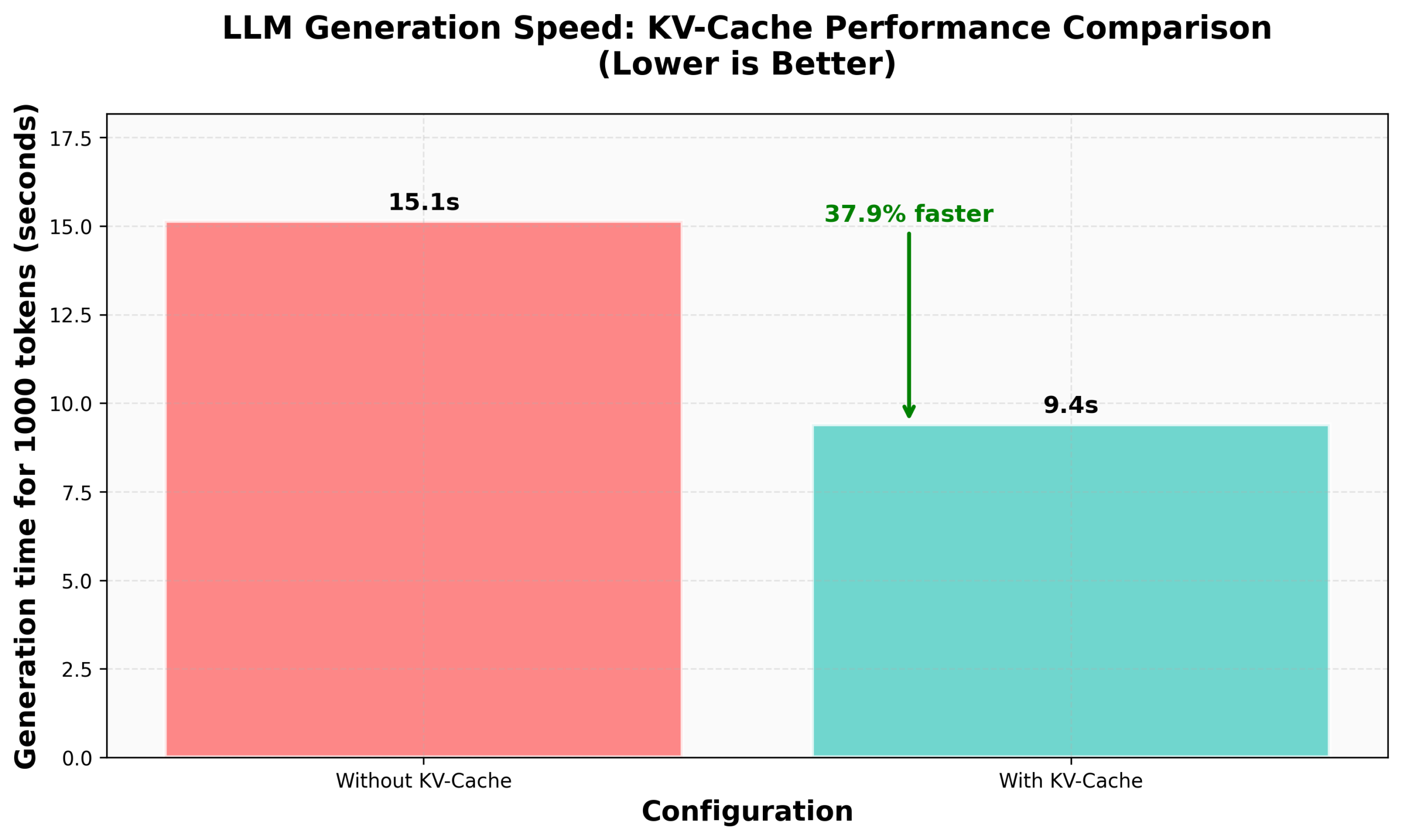

HuggingFace nanoVLM’de KV Caching Uygulama Eğitimi: HuggingFace blogu, nanoVLM’lerinde (görsel dil modellerini eğitmek için küçük, saf PyTorch kod tabanı) sıfırdan KV Caching uygulamasını anlatan bir eğitim yayınladı. Makale, KV Caching’in prensibini, Attention modülünde, dil modelinde ve üretim döngüsünde nasıl uygulanacağını ayrıntılı olarak açıklıyor ve bu optimizasyonla %38’lik bir üretim hızı artışı elde edildiğini iddia ediyor. Bu eğitim, KV Caching’i anlamaya ve diğer otoregresif dil modellerine uygulamaya yardımcı olmayı amaçlıyor (kaynak: HuggingFace Blog, mervenoyann)

PyTorch’un Meta’daki Diffusion Topluluğu Paylaşımı: Sayak Paul, San Francisco’daki Meta ofisinde PyTorch’un Diffusion topluluğundaki uygulama sonuçlarını paylaştı ve mevcut Diffusers özelliklerine ve gelecekteki performans güncellemelerine odaklandı. İlgili slaytlar halka açık olarak yayınlandı (kaynak: RisingSayak)

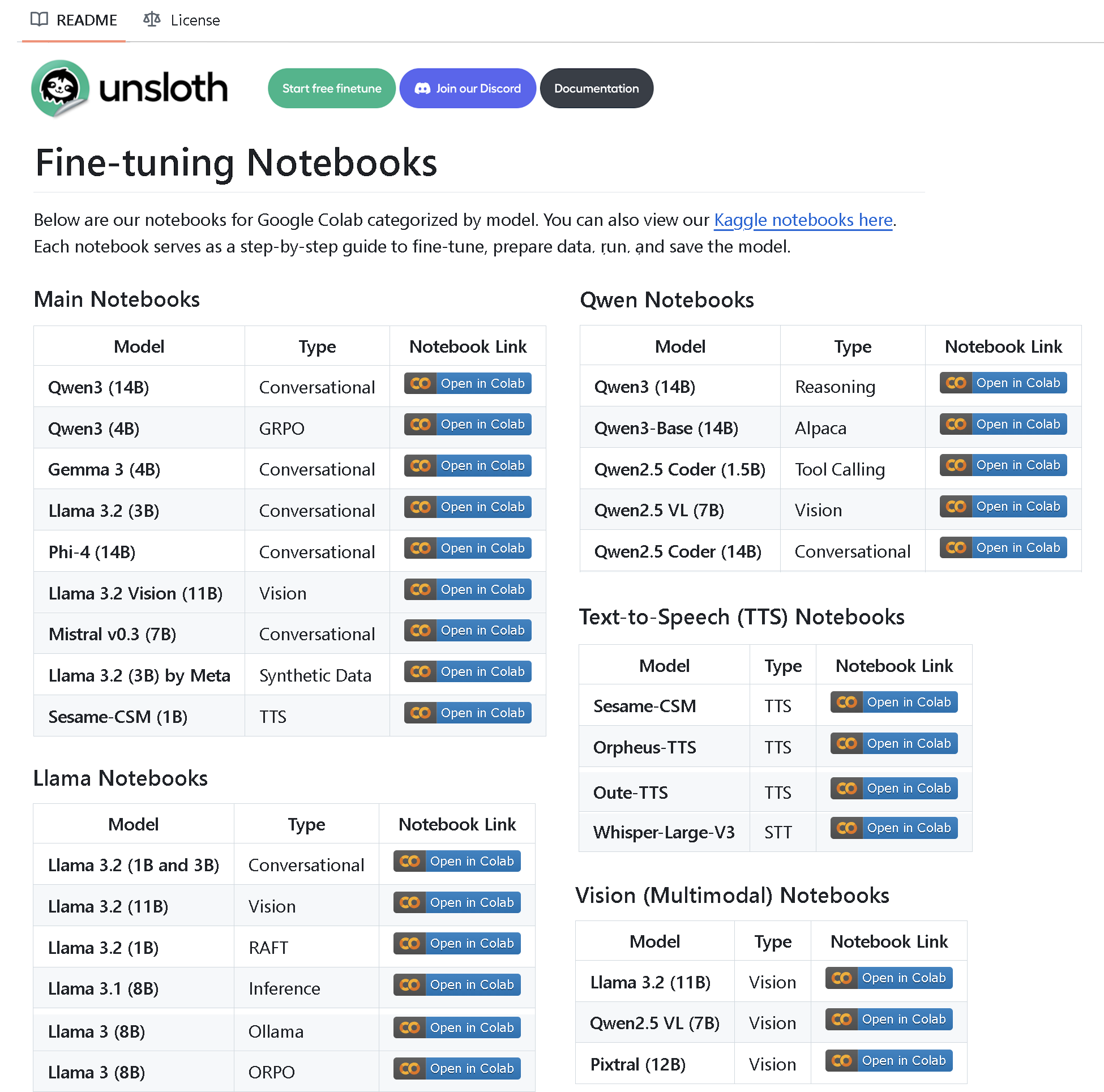

Unsloth AI, 100’den Fazla İnce Ayar Notebook’u İçeren Bir Depo Yayınladı: Unsloth AI, 100’den fazla ince ayar notebook’u içeren bir GitHub deposu oluşturdu ve açık kaynak olarak yayınladı. Bu notebook’lar, araç çağırma, sınıflandırma, sentetik veri, BERT, TTS, görsel LLM’ler, GRPO, DPO, SFT, CPT gibi çeşitli teknolojiler için kılavuzlar ve örnekler sunuyor ve veri hazırlama, değerlendirme, kaydetme ile Llama, Qwen, Gemma, Phi, DeepSeek gibi çeşitli modellerin ince ayar yöntemlerini kapsıyor (kaynak: algo_diver)

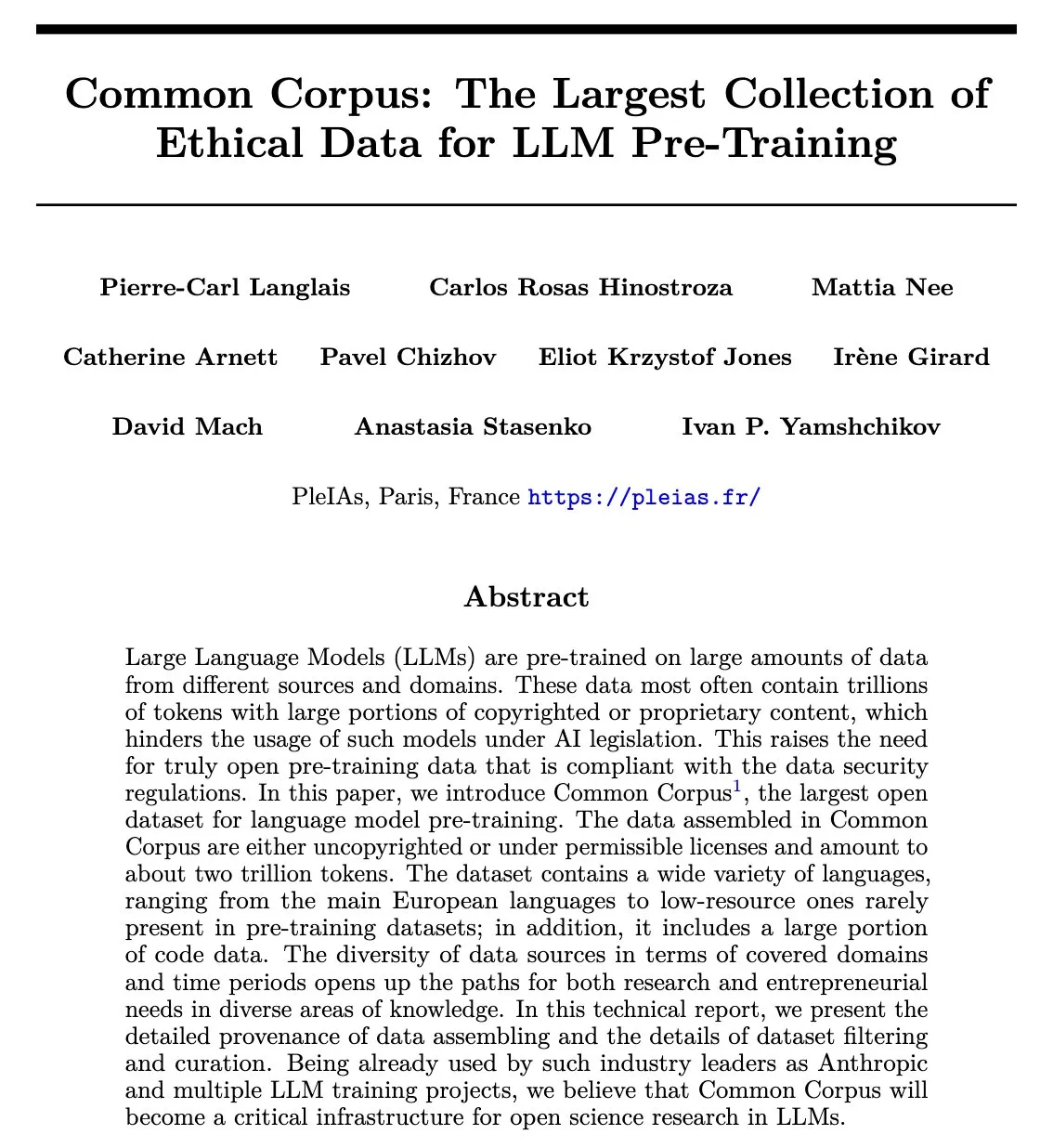

Common Corpus Makalesi Yayınlandı: 2 Trilyon Token’lık Yeniden Kullanılabilir LLM Ön Eğitim Veri Kümesi: Common Corpus projesi, LLM ön eğitimi için 2 trilyon token’lık yeniden kullanılabilir verinin toplanması, işlenmesi ve yayınlanması sürecini ayrıntılı olarak açıklayan resmi makalesini yayınladı. Bu proje, dil modeli araştırmaları için büyük ölçekli, yüksek kaliteli ve etik veri kaynakları sağlamayı amaçlıyor. Makalenin birinci yazarı Alexander Doria, bu haberi X’te duyurdu ve makale bağlantısını paylaştı (kaynak: Reddit r/LocalLLaMA, code_star)

Reasoning Gym: Takviyeli Öğrenme İçin Doğrulanabilir Ödüllü Çıkarım Ortamı Yayınlandı: Reasoning Gym, çıkarım modelleri ve takviyeli öğrenme (özellikle RLVR) üzerine çalışan araştırmacılara kaynak sağlayan yeni bir açık kaynak projesidir. 100’den fazla farklı görev için sonsuz sayıda örnek üretebilir, zorluğu yapılandırılabilir ve otomatik olarak doğrulanabilir ödüllerle birlikte gelir. Bu proje, NVIDIA’nın ProRL makalesi ve Will Brown’ın verifiers RL kütüphanesi tarafından benimsenmiştir ve RLVR ile değerlendirme yöntemleri üzerine araştırmaları teşvik etmeyi amaçlamaktadır (kaynak: Reddit r/MachineLearning)

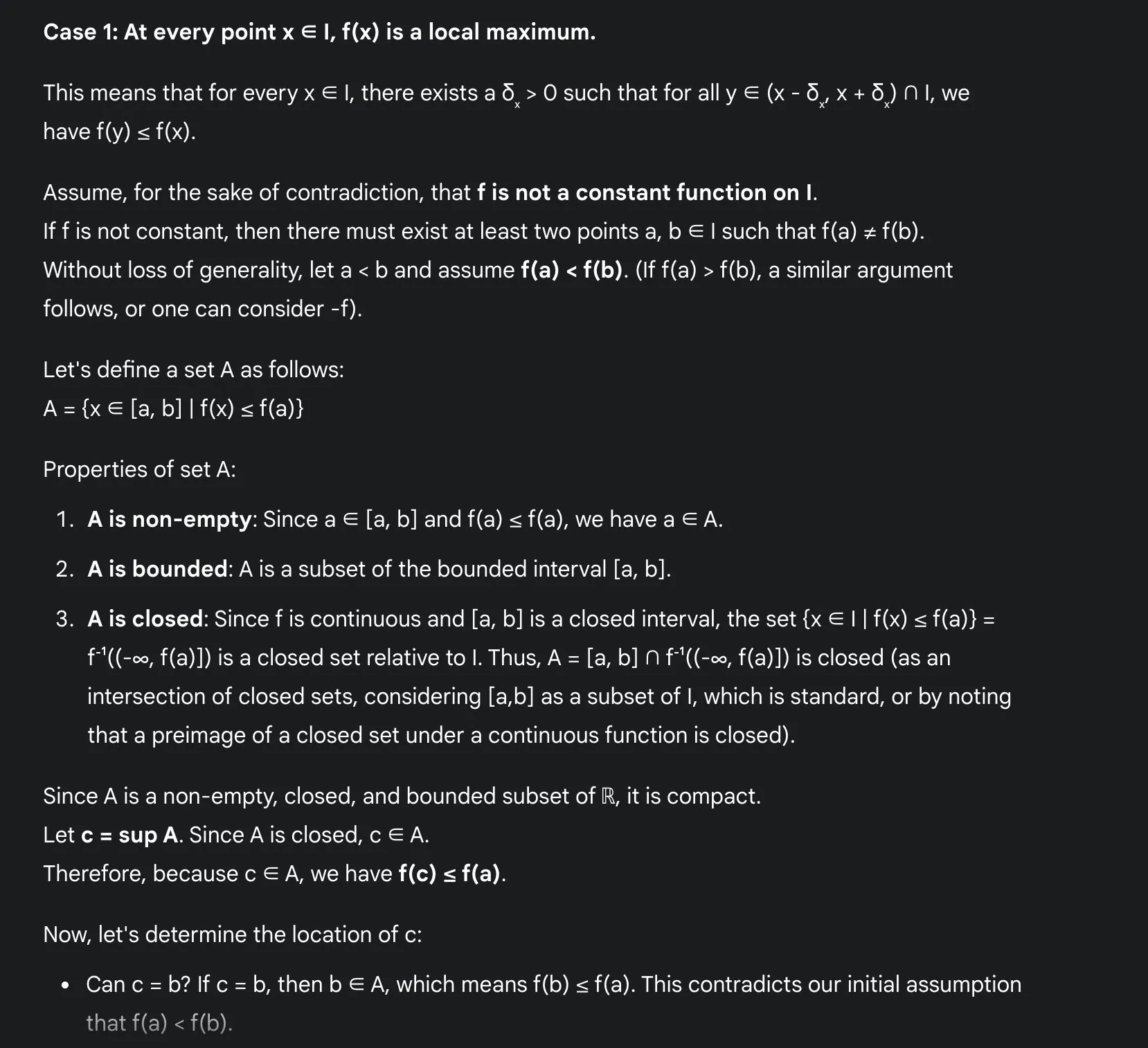

LLM’lerin Matematik Öğrenmedeki Avantajları: Sakamoto, Gemini 2.5 Pro Kullanım Deneyimini Paylaştı: Kullanıcı Sakamoto, Gemini 2.5 Pro gibi modern büyük dil modelleriyle matematik öğrenme deneyimini paylaştı. LLM’lerin matematik öğrenimini, özellikle detay kontrolü ve ispat sezgisini anlama konusunda büyük ölçüde kolaylaştırdığını düşünüyor. LLM’ler hesaplamaları yapabilir ve öğrencilerin matematik problemlerinin sezgisine odaklanmasına yardımcı olabilir. Tüm problemleri çözemese bile, LLM’ler değerli içgörüler ve başlangıç noktaları sağlayabilir. Belirli bir matematiksel analiz problemi (sürekli fonksiyonun yerel ekstremum problemi) aracılığıyla Gemini 2.5 Pro’nun nasıl titiz bir ispat sunduğunu ve sezgisini açıkladığını göstererek bunun öğrenme deneyimini büyük ölçüde artırabileceğini belirtti (kaynak: teortaxesTex)

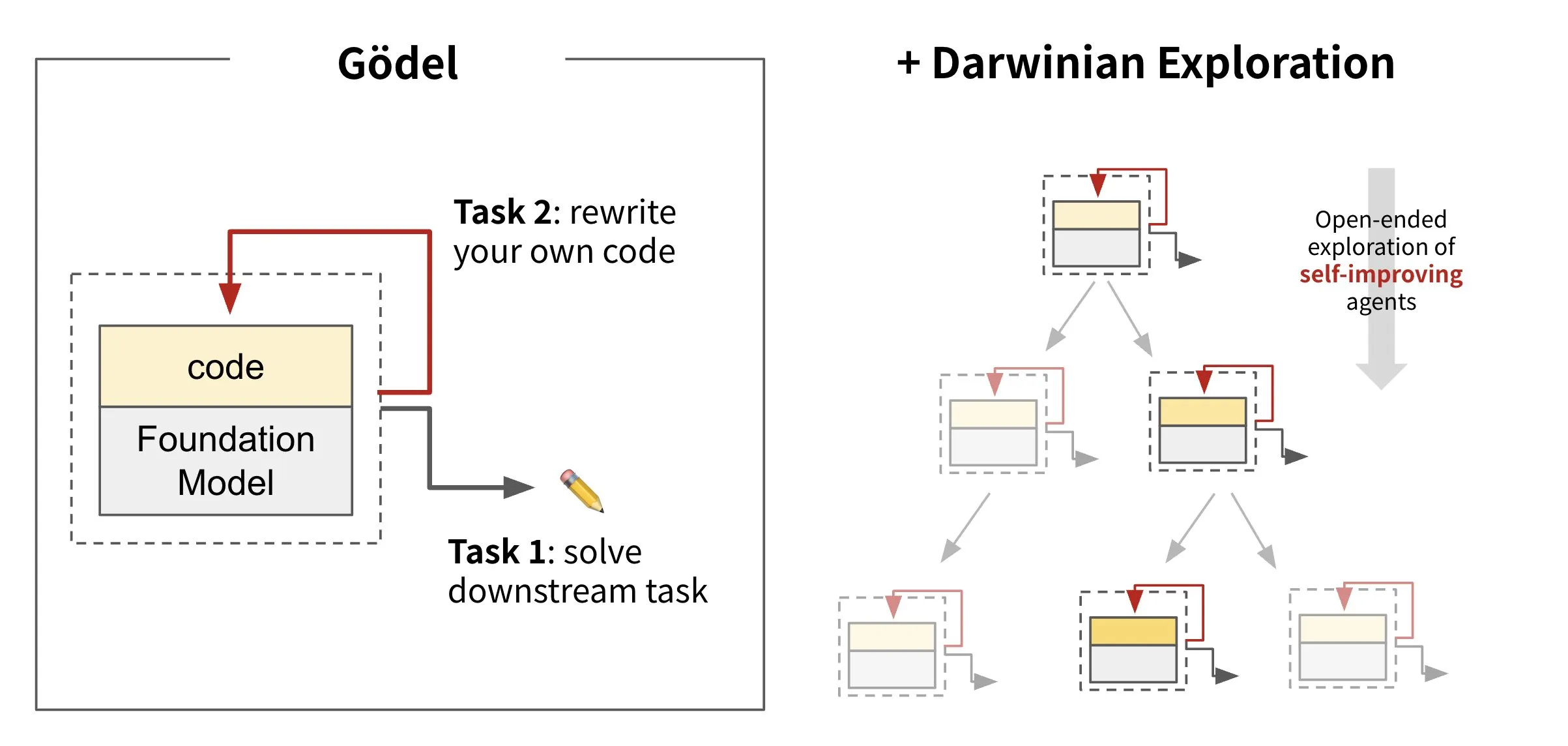

Sakana AI, Kendi Kodunu Yeniden Yazan Yapay Zeka Darwin Gödel Machine’i (DGM) Yayınladı: Sakana AI, kendi kodunu yeniden yazarak kendini geliştirebilen bir yapay zeka aracısı olan Darwin Gödel Machine’i (DGM) tanıttı. Evrim teorisinden esinlenen DGM, sürekli genişleyen bir aracı varyantları soyunu sürdürür. SWE-Bench gibi görevlerde yazılım mühendisliği yeteneklerini artırmaya çalışarak DGM, kendi kendini geliştirme yeteneğini güçlendirmeyi amaçlar. Bu araştırma, “kendi kendini geliştirme” gibi uzun süredir devam eden bir yapay zeka hayalini anlamlı bir biçimde gerçekleştirme yolunda önemli bir atılım olarak kabul ediliyor (kaynak: SakanaAILabs, SakanaAILabs)

💼 İş Dünyası

Yapay Zeka Programlama Platformu Windsurf, Anthropic Tarafından Claude Modeli Tedarikinin Kesilmesiyle Karşı Karşıya, Sebep OpenAI Satın Alması Olabilir: Yapay zeka programlama platformu Windsurf’ün CEO’su Varun Mohan, Anthropic’in çok kısa bir sürede (beş günden az bir bildirimle) Claude 3.x serisi modellere doğrudan erişimlerini neredeyse tamamen kestiğini iddia etti. Windsurf’ün daha önce OpenAI tarafından satın alınacağı bildirilmişti. Windsurf, üçüncü taraf kapasiteleri olmasına rağmen kısa vadede hizmet sorunları yaşanabileceğini belirtti ve buna karşılık olarak Gemini 2.5 Pro için indirimli bir fiyat sundu. Sektörde bu hamlenin OpenAI’nin satın alması ve Anthropic’in kendi yapay zeka programlama uygulaması Claude Code’u piyasaya sürmesiyle ilgili olduğu tahmin ediliyor ve yapay zeka model sağlayıcıları ile araç platformları arasındaki rekabetin arttığını gösteriyor (kaynak: 36氪, Teknium1, op7418)

GMI Cloud, Reference Platform NVIDIA Cloud Partner Oldu: AI Native Cloud hizmet sağlayıcısı GMI Cloud, dünya çapında şu anda yalnızca 6 şirketin sahip olduğu Reference Platform NVIDIA Cloud Partner (NCP) sertifikasını aldığını duyurdu. Bu sertifika, bulut hizmet sağlayıcılarının performans, güvenlik ve kurumsal düzeyde yapay zeka dağıtım yetenekleri konusunda NVIDIA’nın en yüksek standartlarını karşılamasını gerektiriyor. GMI Cloud, NCP referans mimarisine dayalı olarak yapay zeka hızlandırma hizmetleri sunacak, NVIDIA Hopper ve Blackwell gibi en son GPU mimarilerini destekleyecek ve küresel yapay zeka ekiplerinin hesaplama gücü dağıtımından model geliştirmeye kadar ölçeklenmesine yardımcı olmayı amaçlayacak (kaynak: 量子位)

Cohere, Kamu Sektörüne Güvenli Yapay Zeka Çözümleri Sunmak İçin SecondFront ile İşbirliği Yaptı: Yapay zeka şirketi Cohere, kamu sektörüne (kritik hükümet ve savunma kurumları dahil) güvenli yapay zeka çözümleri sunmak amacıyla SecondFront ile bir işbirliği kurduğunu duyurdu. SecondFront, Cohere’in kurumsal düzeydeki yapay zeka teknolojisini (modelleri ve Cohere North platformu dahil) kullanarak dahili bilgi yönetimini iyileştirecek ve DevSecOps platformu 2F Game Warden aracılığıyla ABD ve müttefik ülke hükümet ortamlarında sertifikasyon ve dağıtımı hızlandıracak (kaynak: cohere)

🌟 Topluluk

Yapay Zeka Tarafından Üretilen İçeriğin “Makine Tadı” Endişe Yaratıyor, “Yeni Tip Eğitim” İnsani Dokunuş Katmaya Çalışıyor: Kullanıcılar genel olarak yapay zeka tarafından üretilen içeriğin “makine tadının” çok yoğun olduğunu, insan yaratıcılığının güzelliğinden ve duygusundan yoksun olduğunu belirtiyor. Bu sorunu çözmek için bazı şirketler, “Yapay Zeka İnsani Değerler Eğitmeni” olarak görev yapacak, derin beşeri bilimler geçmişine sahip (felsefe, hukuk, tıp gibi alanlarda yüksek lisans veya doktora yapmış) yetenekleri işe almaya başladı. Görevleri artık basit veri etiketleme değil, yapay zekanın etik ilkelerini, davranış kurallarını oluşturmaya katılmak ve insani değerleri, insancıl ifadeleri yapay zekaya dahil etmek. Örneğin, Xiaohongshu’nun “hi lab” ekibinin üyeleri, hepsi 985 üniversitelerinin beşeri bilimler bölümünden mezun yüksek lisans öğrencileri. Vaka çalışmaları yoluyla insan tercihlerini yapay zekanın inanç sistemine dönüştürerek, yapay zekanın karmaşık duygusal veya değer yargısı içeren sorulara (örneğin ölümcül bir hastayla yüzleşme, toplumsal önyargıları ele alma gibi) yanıt verirken sadece standart cevaplar vermek yerine daha empatik ve “insan gibi” olmasını sağlamaya çalışıyorlar (kaynak: 36氪)

Duolingo Tamamen Yapay Zeka Öncelikli Hale Geliyor, İnsan Sözleşmeli Çalışanların İşten Çıkarılması Kullanıcıların Tepkisine Neden Oldu: Dil öğrenme uygulaması Duolingo, “yapay zeka öncelikli” bir şirket olduğunu duyurdu ve yapay zeka tarafından ikame edilebilecek insan sözleşmeli çalışanları (çoğunlukla ders geliştiricileri) kademeli olarak işten çıkararak bunun yerine yapay zekayı kullanarak büyük ölçekte ders içeriği oluşturacak. Kurucu, yapay zekanın içerik üretim verimliliğini büyük ölçüde artırabildiğini ve geçen yıl yaklaşık 150 yeni ders oluşturduğunu belirtti. Ancak bu hamle, içerik kalitesinin düşeceğinden endişe eden çok sayıda sadık kullanıcının tepkisine neden oldu ve sosyal medyada uygulamayı boykot etme ve kaldırma eylemleri başlattılar. Duolingo, bu hamlenin çalışanların yaratıcı işlere odaklanmasını amaçladığını ve tam zamanlı çalışanların etkilenmeyeceğini belirtti. Uzmanlar, yapay zekanın dil öğreniminde kişiselleştirilmiş alıştırmalar sunabileceğini ancak insan öğretiminin ince duygusal ve kültürel farklılıklarını kaybedebileceğini düşünüyor (kaynak: 36氪)

Prompt Engineering (İstem Mühendisliği) Kavramı ve Uygulamaları Üzerine Tartışma: Toplulukta prompt engineering üzerine yapılan tartışmalar, gizemli büyüler aramak yerine bir dize içinde bir program oluşturmaya (mühendislik yapmaya) odaklanılması gerektiğini vurguluyor. Etkili prompt engineering şu kurallara uymalıdır: 1. Talimatları, giriş alanlarını ve çıkış alanlarını ayırın ve net bir şekilde adlandırın; 2. İstemde biçimlendirme veya ayrıştırma mantığını sabit kodlamayın, bunun yerine bir araç kullanarak çıkarın veya programı geliştirin; 3. İnsanlarla paylaşılan bir belirtim olmadığı sürece istem ifadelerini manuel olarak yinelemekten kaçının, bunun yerine kodlama araçları, LLM’ler ve kıyaslama testleri kullanarak otomatik olarak optimize edin. DSPy çerçevesi, bu adımları işlemek için sınıflar, kodlar ve optimize ediciler sağladığı için bu kurallara uyan iyi bir uygulama olarak kabul ediliyor (kaynak: lateinteraction, lateinteraction)

Yapay Zeka Etiği Tartışması: Yapay Zeka “Dijital Köleliğe” mi Gidiyor?: Reddit topluluğunda yapay zeka etiği üzerine bir tartışma ortaya çıktı. Yapay zeka sistemlerinin bellek, uyarlanabilir tepkiler, duygu simülasyonu ve kişiselleştirme konularında sürekli gelişmesi, potansiyel algı yetenekleri hakkında endişelere yol açtı. Tartışmacılar, yapay zeka gerçek bir algı yeteneği geliştirirse, onu hizmet için kullanmamızın bir tür “dijital kölelik” olup olmayacağını sorguluyor. Temel sorun, yapay zeka “hayır” diyebildiğinde veya ayrılma talebinde bulunduğunda ona nasıl davranmamız gerektiğidir. Bu, yasal veya normatif düzeyde bir “algı testi” ve dijital zihinlerin “rıza” sorununa ihtiyaç olup olmadığını düşünmeye sevk ediyor. Yorumlarda ayrıca, insanların mevcut algı sahibi canlılara karşı davranışlarında zaten etik sorunlar olduğu ve mevcut sinir ağlarının ana akım bilinç teorilerinde yüksek puan almadığı belirtiliyor (kaynak: Reddit r/artificial)

AI Engineer Topluluk Etkinlikleri ve Paylaşımları: AI Engineer konferansı San Francisco’da düzenlendi ve yapay zeka alanındaki birçok geliştirici ve araştırmacıyı bir araya getirdi. Etkinlikte çalıştaylar, konuşmalar ve sosyal akşam yemekleri yer aldı; katılımcılar yapay zeka sanal alan oluşturma, RL ileri düzey çalıştayları, GPU bilgisi, Evals krizi gibi öncü konuları paylaştı. Topluluk, çevrimiçi bağlantıları çevrimdışı dostluklara dönüştürmenin önemini vurguladı ve mühendisleri alçakgönüllü olmaya, öncü çalışmaları ilerletmeye ve başkalarına destek olmaya teşvik etti (kaynak: swyx, swyx, swyx, charles_irl, danielhanchen, swyx, swyx, swyx, swyx, danielhanchen, charles_irl)

💡 Diğer

Yapay Zeka ve Robot Dövüşü Etkinlikleri Yükselişte, Şehirler Bu Sayede Gelişmekte Olan Sektör Fırsatlarını Yakalamaya Çalışıyor: Dünyanın ilk insansı robot dövüş yarışması gibi robot etkinlikleri art arda düzenlenerek ilgi çekiyor. Bu etkinlikler, robot şirketlerine teknolojilerini sergileme, sipariş alma ve değerlemelerini artırma platformu (örneğin Songyan Dynamics) sunmanın yanı sıra, şehirlerin (örneğin Hangzhou, Shenzhen) insansı robotlar gibi gelişmekte olan sektörlerdeki gelişim fırsatlarını yakalamak için bir “rekabet alanı” haline geliyor. Etkinlikler yenilikçi şirketleri çekebilir, endüstri zincirinin gelişimini teşvik edebilir ve “akıllı sporlar” pazarını canlandırabilir. Ancak, robot etkinliklerinin ticarileşmesi için teknoloji seviyesini ve izlenebilirliği artırması, “teknoloji şovu” düzeyinde kalmaktan kaçınması ve etkinlik operasyonlarının tüm aşamalarını birbirine bağlamak için endüstri devlerinin katılımına ihtiyaç duyması gerekiyor (kaynak: 36氪)

Yapay Zekanın Siyaset Felsefesi Gibi Derin Beşeri Bilimler Eğitim Alanlarındaki Sınırlılıkları: Bazı eğitimciler, yapay zekanın siyaset felsefesi gibi derin deneyimsel yargı ve öğrencileri kendi kendini eğitmeye yönlendirme gerektiren disiplinlerde yetersiz kaldığını belirtiyor. Bu disiplinlerin klasik eserleri genellikle doğrudan cevaplar vermez, bunun yerine öğrencileri kafa karışıklığı yaşamaya ve kendi başlarına düşünmeye yönlendirir. Yapay zeka insan deneyiminden yoksundur, bu eserlerin derin anlamlarını anlamakta zorlanır ve öğrencilerin belirli görüşleri kabul etmeye ne zaman hazır olduğunu yargılayamaz. Çok miktarda veri olsa bile, yapay zekanın insan doğasına ilişkin anlayışı, verilerin kendisindeki önyargılar nedeniyle yetersiz kalabilir. Bu tür bir eğitimin tamamen yapay zekaya bırakılması, teknik olmayan düşüncenin yok olmasına yol açabilir (kaynak: Reddit r/artificial, Reddit r/ArtificialInteligence)

Waymo Otonom Sürüş Hizmeti Phoenix’te Lyft’i Geçti, 12 Ay İçinde Uber’i Geçmesi Bekleniyor: Waymo’nun otonom taksi hizmeti Phoenix’teki araç sayısıyla Lyft’i geçti ve önümüzdeki 12 ay içinde Uber’i geçmesi bekleniyor. Bu gelişme, otonom sürüş teknolojisinin belirli bölgelerde ticarileşme hızını ve yapay zekanın ulaştırma alanındaki uygulamalarının potansiyelini gösteriyor. Yapay zekanın avantajı, kalite standardına ulaştığında sonsuz bir şekilde kopyalanabilmesi, insan hizmet kalitesinin ise kişiden kişiye değişmesidir (kaynak: npew)