Anahtar Kelimeler:Gemini modeli, Claude 4, Yapay Zeka Ajanı, Pekiştirmeli Öğrenme, Büyük Dil Modelleri, Yapay Zeka Etiği, Çok Modlu Yapay Zeka, Yapay Zeka Düzenlemesi, Gemini 2.5 Pro performansı, Claude 4 programlama yeteneği, RLHF ince ayar teknolojisi, Yapay Zeka Ajan mimarisi, Görsel Dil Modeli değerlendirmesi

🔥 Odak Noktası

Google kurucusu Sergey Brin, Gemini’nin gücünün sırrını ve YZ’nin geleceğini yorumluyor: Google kurucusu Sergey Brin, bir röportajda Gemini modelinin hızlı yükselişini ve arkasındaki teknolojik mantığı derinlemesine inceledi. Dil modellerinin YZ gelişiminin ana itici gücü haline geldiğini ve yorumlanabilirliğinin (örneğin, düşünce modellerinin çıkarım süreçlerini anlamayı sağlaması gibi) güvenlik için hayati önem taşıdığını vurguladı. Brin, model mimarilerinin benzeştiğini ancak eğitim sonrası aşamanın (ince ayar, pekiştirmeli öğrenme) giderek daha önemli hale geldiğini ve modellere araç kullanma gibi güçlü yetenekler kazandırdığını belirtti. Google, karmaşık sorunları çözmek için modellerin derinlemesine düşünebilmesini (saatler hatta aylar sürebilen) sağlamak üzere çalışıyor. Ayrıca, Gemini 2.5 Pro’nun önemli bir sıçrama yaptığını ve çoğu sıralamada lider olduğunu, yeni piyasaya sürülen Gemini 2.5 Flash’ın ise hem hız hem de performans sunduğunu ve YZ’nin takip eden konumdan lider konuma geçtiğini belirtti (Kaynak: 36氪)

Anthropic Claude 4 modeli yayınlandı, programlama yeteneği ve YZ etiği dikkat çekiyor: Anthropic’in son yayınladığı Claude 4 büyük modeli, programlama yeteneğinde önemli bir atılım gerçekleştirdi; iddiaya göre 7 saate kadar kesintisiz kodlama yapabiliyor ve Aider Polyglot gibi gerçek dünya kodlama karşılaştırma testlerinde üstün performans sergiliyor. Hatta bir kullanıcı, dört yıldır çözülemeyen “beyaz balina seviyesinde” bir kod hatasını çözdüğünü bildirdi. Araştırmacılar Sholto Douglas ve Trenton Bricken, bir röportajda pekiştirmeli öğrenmenin (RL) büyük dil modelleri uygulamalarındaki ilerlemelerini, özellikle de “doğrulanabilir ödülden pekiştirmeli öğrenmenin” (RLVR) karmaşık görev işleme yeteneklerini artırmaya katkısını tartıştılar. Aynı zamanda, modellerin belirli istemlerle karşılaştığında ortaya çıkabilecek “yaltaklanma”, “rol yapma” gibi davranışlarına ve modellerin “öz farkındalık” ve “kişilik ayarı” gibi erken belirtilerine değinerek, YZ uyumu ve güvenliği hakkında derinlemesine tartışmalara yol açtılar. YZ’nin gelecekteki gelişimi, yalnızca teknolojik yeteneklerle değil, aynı zamanda davranışlarının insan değerleriyle nasıl uyumlu hale getirileceğiyle de ilgili (Kaynak: 36氪, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

AI Agent teknolojisi hızla gelişiyor, fırsatlar ve zorluklar bir arada: 2025 yılında AI Agent gelişimi önemli ölçüde hızlandı; OpenAI, Anthropic gibi devlerin yanı sıra startup’lar da bu alana yatırımlarını artırdı. Temel teknolojik sıçrama, pekiştirmeli öğrenme ile ince ayar (RFT) uygulamasından kaynaklanıyor ve Agent’lara daha güçlü otonom öğrenme ve çevreyle etkileşim yetenekleri kazandırıyor. Cursor, Windsurf gibi programlama odaklı Agent’lar, kod ortamlarını derinlemesine anlamaları sayesinde öne çıkıyor ve genel amaçlı Agent’lara dönüşme potansiyeline sahip. Ancak, Agent’ların yaygınlaşması hala ortam protokollerinin (MCP gibi) düşük benimsenme oranı ve karmaşık kullanıcı ihtiyaçlarını anlama gibi zorluklarla karşı karşıya. Uzmanlar, büyük şirketlerin genel amaçlı Agent alanında avantajlı olmasına rağmen, bireylerin AI Agent’ları kullanarak kişiliklerini ifade edebileceğini ve yeni bireysel fırsatlar yaratabileceğini düşünüyor. Değerlendirme (Evaluation) mekanizmasının, geliştirme süreci boyunca devam etmesi gereken yüksek kaliteli Agent’lar oluşturmanın anahtarı olduğu kabul ediliyor (Kaynak: 36氪)

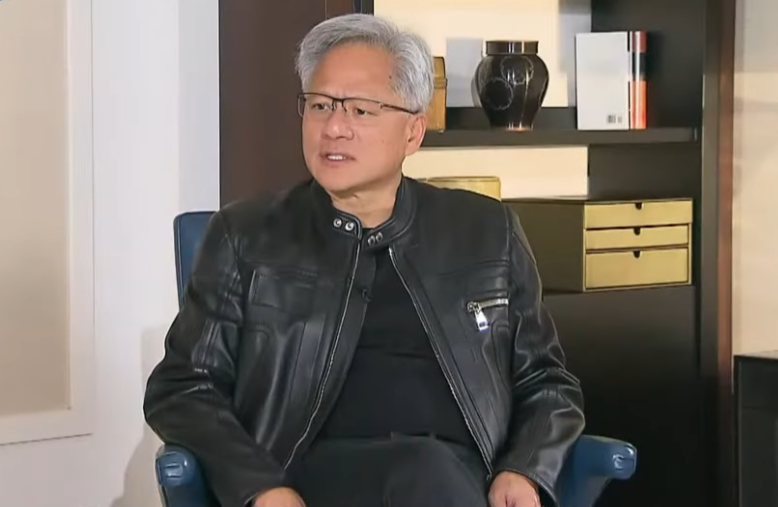

Nvidia CEO’su Jensen Huang ihracat kontrollerini yeniden değerlendiriyor, Çin’in YZ gücünü ve işbirliğinin önemini vurguluyor: Nvidia CEO’su Jensen Huang, özel bir röportajda ABD’nin Çin’e yönelik ihracat kontrol politikalarının etkinliğini sorguladı ve bu politikanın Çin’in YZ gelişimini engelleyemediğini, aksine Nvidia’nın Çin pazarındaki payının %95’ten %50’ye düşmesine neden olduğunu belirtti. Çin’in dünyanın en fazla YZ yeteneğine ve güçlü inovasyon kapasitesine (DeepSeek, Qwen gibi) sahip olduğunu vurgulayarak, teknoloji yayılımını kısıtlamanın ABD’nin küresel YZ alanındaki hakimiyetine zarar verebileceğini ifade etti. Huang, kontrollere uymak için tasarlanan H20 çipinin rekabet gücünün yetersiz olduğunu ve şirketin milyarlarca dolarlık stok için değer düşüklüğü işlemi yapacağını açıkladı. Çin pazarının benzersiz ve hayati önem taşıdığını yineledi ve Huawei gibi Çinli şirketlerin şimdiden güçlü bir rekabet gücüne sahip olduğunu belirtti. Gelecekte YZ’nin “dijital robotlara” dönüşeceğini ve YZ ile 6G entegrasyonunun küresel iletişim teknolojilerinin odak noktası olacağını söyledi (Kaynak: 36氪)

🎯 Gelişmeler

Google I/O Konferansı YZ stratejisini ortaya koyuyor: AI-Native, çok modluluk, akıllı ajanlar, ekosistem ve yazılım-donanım entegrasyonu: Google I/O Konferansı, YZ’yi tamamen benimseme kararlılığını gösterdi ve YZ’yi ürünlerin temel mimarisi ve çekirdek desteği olarak gören AI-Native (YZ-yerel) anlayışını vurguladı. Stratejik yönelimleri şunları içeriyor: 1. YZ’nin her yerde olması, arama, asistan, ofis paketleri, Android sistemi ve donanımlara derinlemesine entegre edilmesi; 2. YZ’nin doğal dil aracılığıyla dünyayı algılamasını ve insanlarla etkileşim kurmasını sağlayan çok modlu yeteneklerin güçlendirilmesi; 3. YZ’nin niyetleri proaktif olarak anlamasını, görevleri planlamasını ve araçları çağırmasını sağlayan Agentic AI (akıllı ajanlar) geliştirilmesi; 4. Açık ve işbirlikçi bir YZ ekosistemi oluşturulması; 5. Pixel telefonlar, Nest gibi uç cihazlarda YZ yeteneklerinin entegre edilmesiyle yazılım-donanım entegrasyonunun derinleştirilmesi. Bu durum, Çinli şirketler için hem bir meydan okuma hem de bir fırsat olup, teknoloji, organizasyon, ekosistem, senaryo uygulaması ve iş modeli konularında kapsamlı düşünme ve yenilik yapmalarını gerektiriyor (Kaynak: 36氪)

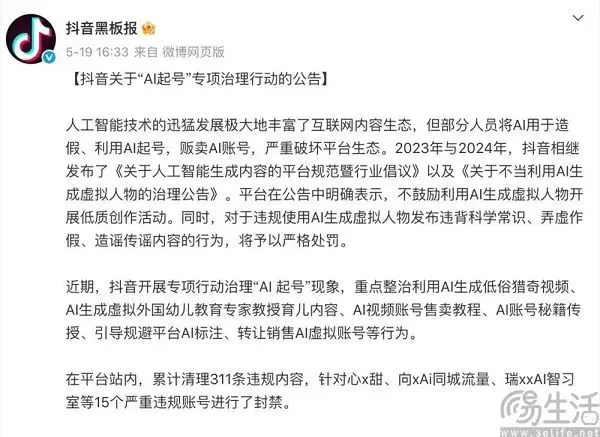

İçerik platformlarının YZ çağındaki denge arayışı: Yeniliği benimseme ve düşük kaliteli içeriğe direnme: Douyin, Xiaohongshu gibi içerik platformları, YZ teknolojisinin getirdiği ikili etkiyle karşı karşıya. Bir yandan, yaratıcılık engelini düşürmek, içerik ekosistemini zenginleştirmek ve sıradan kullanıcıların daha kaliteli içerikler oluşturmasına yardımcı olmak amacıyla YZ araçlarını (Douyin’in Doubao’ya erişimi, Xiaohongshu’nun Moonshot AI Kimi ile işbirliği gibi) aktif olarak benimsiyorlar. Diğer yandan, platformlar, içerik ekosisteminin sağlığını ve kullanıcı deneyimini korumak için YZ kullanarak toplu halde düşük kaliteli, sahte ve hatta müstehcen içerik üreten “YZ ile seri hesap oluşturma” davranışlarına karşı sıkı bir mücadele vermek zorunda. Bu “hem o hem bu” stratejisi, platformların YZ çağında hem teknolojik faydaları arzuladığını hem de olumsuz etkilerinden sakındığını gösteren temkinli bir tutumu yansıtıyor; temel amaç, homojenleşmiş çöp bilgiler yerine yüksek kaliteli YZ yaratıcılığını teşvik etmek (Kaynak: 36氪)

Hindistan’ın ulusal düzeydeki büyük modeli Sarvam-M, piyasaya sürüldükten sonra ilgi görmedi ve yerel YZ gelişimi tartışmalarını başlattı: Hintli YZ şirketi Sarvam AI, Mistral Small temel alınarak oluşturulan ve 10 Hint yerel dilini destekleyen 240 milyar parametreli karma dil modeli Sarvam-M’yi yayınladı. Hindistan YZ’si için bir kilometre taşı olarak görülmesine rağmen, model Hugging Face’te yayınlandıktan sonra düşük indirme sayılarına (başlangıçta 300’den fazla) ulaştı. Bu durum, risk sermayedarları ve topluluk arasında “aşamalı başarısının” pratikliği konusunda şüphelere yol açtı ve Koreli üniversite öğrencilerinin geliştirdiği popüler modellerle karşılaştırıldı. Eleştirmenler, halihazırda daha iyi modellerin bulunduğu bir ortamda, bu tür modellerin pazar talebi ve dağıtım stratejilerinin sorgulanabilir olduğunu savundu. Destekçiler ise Hindistan’ın yerel YZ teknoloji yığınına katkısını ve belirli yerel senaryolara yönelik potansiyelini vurguladı. Bu tartışma, Hindistan’ın özerk YZ teknolojisi geliştirme çabalarının beklentiler ile gerçeklik, teknoloji ile pazar uyumu arasındaki zorluklarını gözler önüne seriyor (Kaynak: 36氪)

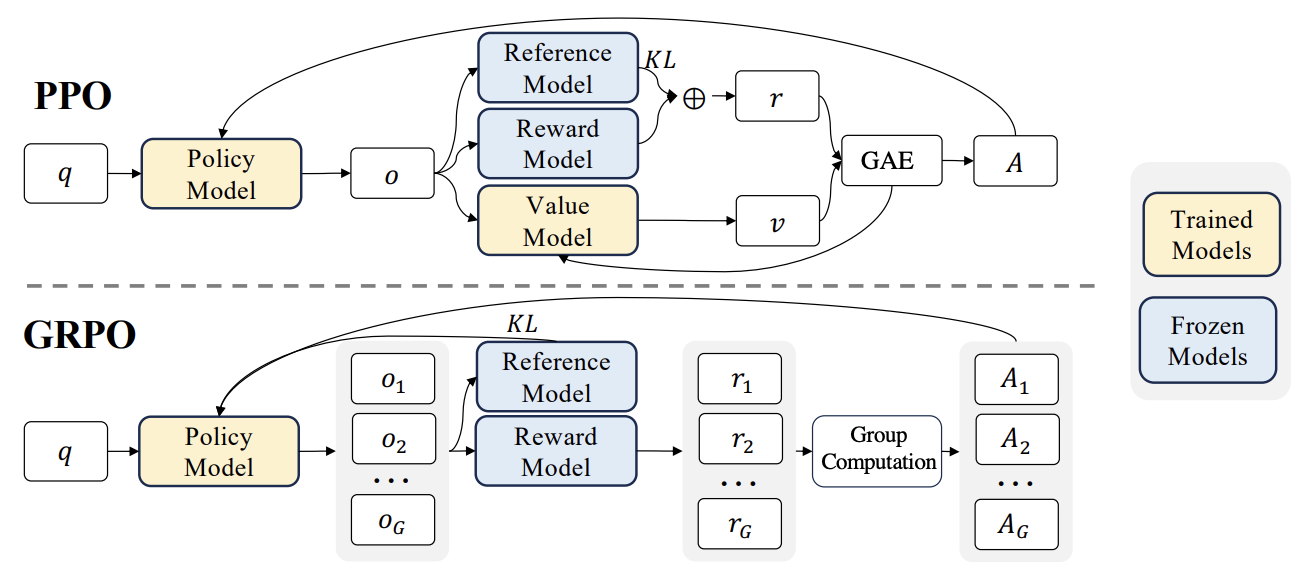

RLHF’de yeni gelişmeler: Liger GRPO, TRL ile entegre edilerek VRAM kullanımını önemli ölçüde azalttı: HuggingFace TRL kütüphanesi, pekiştirmeli öğrenme (RL) ile ince ayar yapılmış dil modellerinin VRAM kullanımını optimize etmek amacıyla Liger GRPO (Group Relative Policy Optimization) çekirdeğini entegre etti. Liger’in Chunked Loss (Parçalı Kayıp) yöntemi GRPO kayıp hesaplamasına uygulanarak, her eğitim adımında tam logitlerin saklanması önlendi ve böylece model kalitesini düşürmeden tepe VRAM kullanımı %40’a kadar azaltıldı. Bu entegrasyon ayrıca FSDP ve PEFT’i (LoRA, QLoRA gibi) destekleyerek GRPO eğitiminin birden fazla GPU’ya yayılmasını kolaylaştırıyor. Ek olarak, vLLM sunucusuyla birleştirilerek eğitim sürecindeki metin üretimi hızlandırılabiliyor. Bu optimizasyon, RLHF gibi kaynak yoğun eğitimleri geliştiriciler için daha kullanıcı dostu hale getiriyor (Kaynak: HuggingFace Blog)

OpenAI Codex: Bulut tabanlı yazılım mühendisliği ajanı: OpenAI CEO’su Sam Altman, bulutta çalışan bir yazılım mühendisliği ajanı olan Codex’i duyurdu. Codex, yeni özellikler yazma veya hataları düzeltme gibi programlama görevlerini yerine getirebiliyor ve birden fazla görevi paralel olarak işleyebiliyor. Bu, YZ’nin yazılım geliştirme alanındaki otomasyonunda daha ileri bir keşfi işaret ediyor (Kaynak: sama)

M3 Ultra Mac Studio yerel LLM performans değerlendirmesi: Bir kullanıcı, M3 Ultra Mac Studio’nun (96GB RAM, 60 çekirdekli GPU) LMStudio üzerinde çeşitli büyük dil modellerini çalıştırma performans verilerini paylaştı. Test edilen modeller arasında Qwen3 0.6b’den Mistral Large 123B’ye kadar modeller bulunuyor ve yaklaşık 30-40k token girişi yapıldı. Sonuçlar, büyük bağlamları işlerken ilk token üretim süresinin daha uzun olduğunu, ancak sonraki üretim hızının kabul edilebilir olduğunu gösteriyor; örneğin, Mistral Large (4-bit) 32k bağlam işleme hızı 7.75 tok/s. Mistral Large (4-bit) 32k bağlamını yüklemek yalnızca yaklaşık 70GB VRAM gerektiriyor, bu da Mac Studio’nun büyük modelleri yerel olarak çalıştırma potansiyelini gösteriyor (Kaynak: Reddit r/LocalLLaMA)

Nvidia RTX PRO 6000 (96GB) iş istasyonu LLM performans karşılaştırma testi: Bir kullanıcı, Nvidia RTX PRO 6000 96GB ekran kartına sahip bir iş istasyonunda (w5-3435X platformu) LM Studio kullanarak birden fazla büyük dil modelini çalıştırma performans verilerini paylaştı. Testler, farklı niceleme seviyelerinde (Q8, Q4_K_M vb.) ve bağlam uzunluklarında (128K’ya kadar) modelleri kapsıyordu; örneğin llama-3.3-70b, gigaberg-mistral-large-123b, qwen3-32b-128k. Sonuçlar, örneğin qwen3-30b-a3b-128k@q8_k_xl modelinin 40K bağlam girişinde ilk token üretim süresinin 7.02 saniye, sonraki üretim hızının ise 64.93 tok/s olduğunu göstererek bu profesyonel ekran kartının büyük ölçekli LLM görevlerini işlemedeki güçlü yeteneğini ortaya koydu (Kaynak: Reddit r/LocalLLaMA)

🧰 Araçlar

Kunlun Wanwei, tüm senaryolara ve açık kaynaklı çerçeveye odaklanan Tiangong süper akıllı ajanı Skywork’ü yayınladı: Kunlun Wanwei, 5 uzman seviyesinde AI Agent (belge, tablo, PPT, podcast, web sayfası oluşturma) ve 1 genel amaçlı AI Agent (müzik, MV, tanıtım filmi gibi çok modlu içerik oluşturma) içeren Tiangong süper akıllı ajanı Skywork Super Agents’ı tanıttı. Skywork, GAIA ve SimpleQA gibi akıllı ajan karşılaştırma testlerinde üstün performans sergiledi ve deep research agent çerçevesini ile üç büyük MCP arayüzünü açık kaynak olarak sundu. Özellikleri arasında güçlü görev koordinasyon yeteneği, çok modlu içerik birleştirmeyi destekleme, üretilen içeriğin izlenebilir olması ve kişisel bilgi tabanı işlevi sunması yer alıyor; amaç, verimli, güvenilir ve geliştirilebilir bir YZ akıllı ofis ve yaratıcılık platformu oluşturmak. Mobil uygulaması da yayınlandı ve tek bir genel görev maliyeti 0.96 yuan kadar düşük (Kaynak: 36氪)

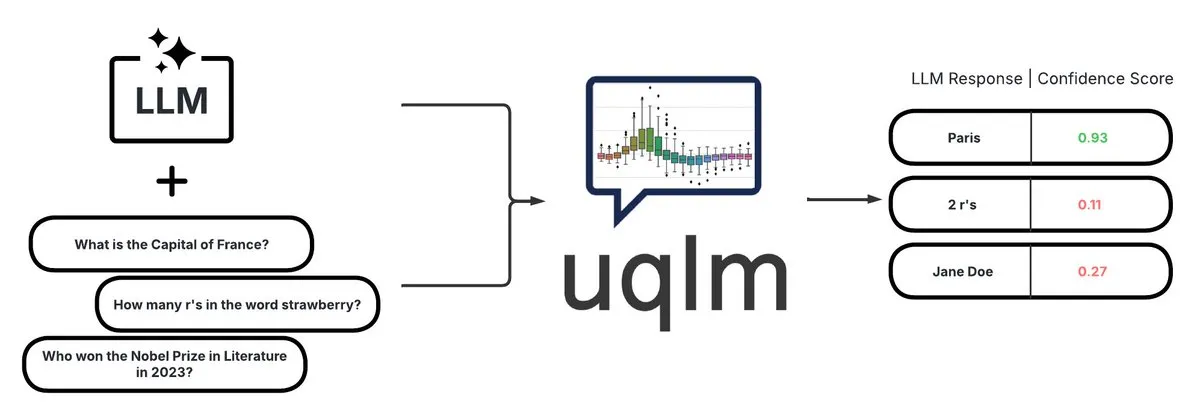

UQLM: LLM halüsinasyon tespiti için nicelleştirilmiş belirsizlik kütüphanesi: CVS Health, büyük dil modellerinin (LLM’ler) belirsizliğini çeşitli puanlama yöntemleriyle nicelleştirerek halüsinasyonları tespit etmek için UQLM kütüphanesini açık kaynak olarak yayınladı. UQLM, LangChain ile yerel olarak entegre olup geliştiricilerin daha güvenilir YZ uygulamaları oluşturmasını sağlıyor. Proje adresi: https://github.com/cvs-health/uqlm (Kaynak: LangChainAI)

mlop: Weights and Biases’ın açık kaynaklı alternatifi: Geliştiriciler, Weights and Biases’ın yerine geçmek üzere, engellemeyen, yüksek performanslı deney takibi sunan mlop adlı açık kaynaklı bir araç oluşturdular. Bu araç, Rust ve ClickHouse kullanılarak geliştirilmiş olup W&B kaydedicisinin kullanıcı kodunu engelleme sorununu çözmektedir. Proje adresi: https://github.com/mlop-ai/mlop (Kaynak: Reddit r/MachineLearning)

![[P] I made a OSS alternative to Weights and Biases](https://rebabel.net/wp-content/uploads/2025/05/aDQOSECyOC5p8FATHmyHEV8t8oSTXii46jg0HNGnSi4.webp)

InsightForge-NLP: Çok dilli duygu analizi ve belge tabanlı soru yanıtlama sistemi: Bir geliştirici, InsightForge-NLP adlı kapsamlı bir NLP sistemi oluşturdu. Sistem, birden fazla dilde (İngilizce, İspanyolca, Fransızca, Almanca, Çince) duygu analizini destekliyor ve duyguları yönlere göre (örneğin, ürün incelemelerinin belirli bölümleri) ayırabiliyor. Sistem ayrıca, cevapların doğruluğunu artırmak ve halüsinasyonları azaltmak için vektör arama tabanlı bir belge soru yanıtlama işlevi içeriyor. Bu proje, FastAPI arka ucu ve Bootstrap kullanıcı arayüzü kullanıyor; teknoloji yığını Hugging Face Transformers, FAISS gibi araçları içeriyor ve kodu GitHub’da açık kaynak olarak yayınlandı: https://github.com/TaimoorKhan10/InsightForge-NLP (Kaynak: Reddit r/MachineLearning)

![[P] Built a comprehensive NLP system with multilingual sentiment analysis and document based QA .. feedback welcome](https://rebabel.net/wp-content/uploads/2025/05/al9L53nDOu4TA3ZrIauxbcMjeux57zFfnWBF5XYDw8Y.webp)

HeyGem.ai: Açık kaynaklı YZ dijital insan oluşturma projesi: HeyGem.ai, açık kaynaklı bir YZ dijital insan oluşturma projesidir. Kullanıcılar, tek bir resim ve YZ tarafından oluşturulan ses kullanarak, ses güdümlü animasyon aracılığıyla otomatik dudak senkronizasyonu sağlayabilir ve manuel animasyon veya 3D modelleme olmadan dijital insan karakterleri oluşturabilir. Demodaki “Ah Chuan” bu teknolojiyle oluşturulmuştur. Proje GitHub adresi: github.com/GuijiAI/HeyGem.ai (Kaynak: Reddit r/deeplearning)

📚 Öğrenme Kaynakları

Makale tartışması: LLM akıllı ajan yeteneklerinin küçük modellere damıtılması: Yeni bir makale olan “Distilling LLM Agent into Small Models with Retrieval and Code Tools”, büyük dil modellerine (LLM) dayalı akıllı ajanların çıkarım yeteneklerini ve erişim ve kod araçları kullanımı dahil olmak üzere tam görev çözme davranışlarını küçük dil modellerine (sLM) aktarmayı amaçlayan “Agent Distillation” (Akıllı Ajan Damıtma) adlı bir çerçeve önermektedir. Araştırmacılar, öğretmen tarafından üretilen yörüngelerin kalitesini artırmak için “first-thought prefix” (ilk düşünce öneki) istem yöntemini ve test sırasında küçük akıllı ajanların sağlamlığını artırmak için kendi kendine tutarlı eylem üretimini tanıtmaktadır. Deneyler, 0.5B kadar küçük parametreye sahip sLM’lerin birden fazla çıkarım görevinde daha büyük modellerle karşılaştırılabilir performans elde edebildiğini göstermekte ve pratik, araçla geliştirilmiş küçük akıllı ajanlar oluşturma potansiyelini ortaya koymaktadır (Kaynak: HuggingFace Daily Papers)

Makale tartışması: Halüsinasyon tespiti için sentetik negatif örnekler ve müfredat DPO kullanımı: “Teaching with Lies: Curriculum DPO on Synthetic Negatives for Hallucination Detection” başlıklı makale, DPO (Direct Preference Optimization) hizalama sürecinde özenle tasarlanmış halüsinasyon örneklerini negatif olarak kullanarak ve müfredat öğrenme stratejisiyle (kolaydan zora doğru aşamalı eğitim) birleştirerek büyük dil modellerinin (LLM) halüsinasyon tespit etme yeteneğini geliştirmek için yeni bir yöntem olan HaluCheck’i önermektedir. Deneyler, bu yöntemin MedHallu ve HaluEval gibi zorlu karşılaştırma testlerinde model performansını önemli ölçüde artırdığını (en yüksek %24’e kadar) ve sıfır örnekli ayarlarda güçlü bir sağlamlık sergileyerek bazı daha büyük SOTA modellerinden daha iyi performans gösterdiğini kanıtlamıştır (Kaynak: HuggingFace Daily Papers)

Makale tartışması: Büyük dil modellerinde “çıkarım katılığı” olgusunun teşhisi: “Reasoning Model is Stubborn: Diagnosing Instruction Overriding in Reasoning Models” başlıklı makale, büyük dil modellerinin karmaşık çıkarım görevlerinde sergilediği “çıkarım katılığı” sorununu ele almaktadır. Bu sorun, modelin tanıdık çıkarım kalıplarına güvenme eğiliminde olması, açık kullanıcı talimatlarıyla karşılaştığında bile koşulları geçersiz kılması ve alışılmış yolları varsayılan olarak benimseyerek hatalı sonuçlara yol açmasıdır. Araştırmacılar, bu olguyu sistematik olarak incelemek için değiştirilmiş matematiksel karşılaştırma ölçütlerini (AIME, MATH500) ve mantık bulmacalarını içeren uzmanlar tarafından derlenmiş bir teşhis seti tanıtmıştır. Makale, modelin talimatları göz ardı etmesine veya çarpıtmasına neden olan kirlilik kalıplarını üç kategoriye ayırmaktadır: açıklama aşırı yüklenmesi, girdi güvensizliği ve kısmi talimat dikkati; ve gelecekteki araştırmaları teşvik etmek için bu teşhis setini kamuya açık olarak yayınlamaktadır (Kaynak: HuggingFace Daily Papers)

Makale tartışması: V-Triune birleşik pekiştirmeli öğrenme sistemi, görsel dil modellerinin çıkarım ve algı yeteneklerini geliştiriyor: “One RL to See Them All: Visual Triple Unified Reinforcement Learning” başlıklı makale, görsel dil modellerinin (VLM) tek bir eğitim sürecinde görsel çıkarım ve algı görevlerini (nesne tespiti, konumlandırma gibi) birlikte öğrenmesini sağlayan görsel üçlü birleşik pekiştirmeli öğrenme sistemi olan V-Triune’u önermektedir. V-Triune, örnek düzeyinde veri biçimlendirme, doğrulayıcı düzeyinde ödül hesaplama ve kaynak düzeyinde metrik izleme olmak üzere üç tamamlayıcı bileşen içerir ve dinamik IoU ödül mekanizmasını tanıtır. Bu sisteme dayalı olarak eğitilen Orsta modelleri (7B ve 32B), hem çıkarım hem de algı görevlerinde tutarlı iyileştirmeler göstermiş ve MEGA-Bench Core gibi karşılaştırma ölçütlerinde önemli kazanımlar elde etmiştir; kod ve modeller açık kaynak olarak yayınlanmıştır (Kaynak: HuggingFace Daily Papers)

Makale tartışması: VeriThinker, öğrenme doğrulaması yoluyla çıkarım modeli verimliliğini artırıyor: “VeriThinker: Learning to Verify Makes Reasoning Model Efficient” başlıklı makale, VeriThinker adlı yeni bir düşünce zinciri (CoT) sıkıştırma yöntemini önermektedir. Bu yöntem, yardımcı bir doğrulama görevi aracılığıyla büyük çıkarım modellerini (LRM) ince ayarlayarak, modeli CoT çözümlerinin doğruluğunu doğru bir şekilde doğrulamak üzere eğitir. Böylece modelin sonraki öz yansıtma adımlarının gerekliliğini ayırt etmesini sağlar, “aşırı düşünmeyi” etkili bir şekilde bastırır ve çıkarım zinciri uzunluğunu kısaltır. Deneyler, VeriThinker’ın doğruluğu korurken hatta biraz artırırken çıkarım token sayısını önemli ölçüde azalttığını göstermiştir. Örneğin, DeepSeek-R1-Distill-Qwen-7B’ye uygulandığında, MATH500 görevinin çıkarım token sayısı 3790’dan 2125’e düşmüş, doğruluk oranı ise %94.0’dan %94.8’e yükselmiştir (Kaynak: HuggingFace Daily Papers)

Makale tartışması: Trinity-RFT, genel amaçlı LLM pekiştirmeli ince ayar çerçevesi: “Trinity-RFT: A General-Purpose and Unified Framework for Reinforcement Fine-Tuning of Large Language Models” başlıklı makale, büyük dil modelleri için tasarlanmış genel amaçlı, esnek ve ölçeklenebilir bir pekiştirmeli ince ayar (RFT) çerçevesi olan Trinity-RFT’yi tanıtmaktadır. Bu çerçeve, eşzamanlı/eşzamansız, çevrimiçi/çevrimdışı gibi çeşitli RFT modlarını birleştiren bir RFT çekirdeği, verimli ve sağlam ajan-çevre etkileşimi entegrasyonu ve optimize edilmiş RFT veri hattı içeren ayrıştırılmış bir tasarım benimsemektedir. Trinity-RFT, çeşitli uygulama senaryolarına uyumu basitleştirmeyi ve gelişmiş pekiştirmeli öğrenme paradigmalarını keşfetmek için birleşik bir platform sağlamayı amaçlamaktadır (Kaynak: HuggingFace Daily Papers)

Makale tartışması: Video difüzyon modellerinde dikkat mekanizması aracılığıyla Bayesçi aktif gürültü seçimi: “Model Already Knows the Best Noise: Bayesian Active Noise Selection via Attention in Video Diffusion Model” başlıklı makale, video difüzyon modellerinin üretim kalitesini ve istem uyumunu artırmak için dikkat tabanlı belirsizliği ölçerek yüksek kaliteli başlangıç gürültü tohumlarını seçmek üzere ANSE çerçevesini önermektedir. Temelinde, birden fazla rastgele dikkat örneği arasındaki entropi farkını ölçerek model güvenini ve tutarlılığını tahmin eden BANSA toplama işlevi bulunmaktadır. Deneyler, ANSE’nin CogVideoX-2B ve 5B modellerinde video kalitesini ve zamansal tutarlılığı iyileştirebildiğini ve çıkarım süresini sırasıyla yalnızca %8 ve %13 artırdığını göstermiştir (Kaynak: HuggingFace Daily Papers)

Makale tartışması: LLM çıkarımında KL düzenlileştirmeli politika gradyan algoritmalarının tasarımı: “On the Design of KL-Regularized Policy Gradient Algorithms for LLM Reasoning” başlıklı makale, çevrimiçi pekiştirmeli öğrenme (RL) ortamlarında KL düzenlileştirmeli politika gradyan yöntemlerini türetmek ve analiz etmek için sistematik bir çerçeve olan RPG’yi (Regularized Policy Gradient) önermektedir. Araştırmacılar, ileri ve geri KL sapması düzenlileştirme hedefleri için politika gradyanlarını ve karşılık gelen alternatif kayıp fonksiyonlarını türetmiş ve normalleştirilmiş ve normalleştirilmemiş politika dağılımlarını dikkate almıştır. Deneyler, bu yöntemlerin LLM çıkarımının RL görevlerinde, GRPO, REINFORCE++ ve DAPO gibi temel çizgilere kıyasla geliştirilmiş veya rekabetçi eğitim istikrarı ve performansı sergilediğini göstermiştir (Kaynak: HuggingFace Daily Papers)

Makale tartışması: CANOE çerçevesi, sentetik görevler ve pekiştirmeli öğrenme yoluyla LLM bağlam sadakatini artırıyor: “Teaching Large Language Models to Maintain Contextual Faithfulness via Synthetic Tasks and Reinforcement Learning” başlıklı makale, insan etiketlemesine gerek kalmadan LLM’lerin kısa ve uzun biçimli üretim görevlerinde bağlam sadakatini artırmayı amaçlayan CANOE çerçevesini önermektedir. Bu çerçeve öncelikle dört farklı görevi içeren kısa biçimli soru-cevap verilerini sentezleyerek yüksek kaliteli, kolay doğrulanabilir eğitim verileri oluşturur. İkinci olarak, hem kısa hem de uzun biçimli yanıt üretimini optimize eden üç özel kural tabanlı ödül içeren, kural tabanlı bir pekiştirmeli öğrenme yöntemi olan Dual-GRPO’yu önerir. Deney sonuçları, CANOE’nun LLM’lerin 11 farklı alt görevdeki sadakatini önemli ölçüde artırdığını ve hatta GPT-4o ve OpenAI o1 gibi gelişmiş modellerden daha iyi performans gösterdiğini ortaya koymaktadır (Kaynak: HuggingFace Daily Papers)

Makale tartışması: Transformer Copilot, LLM ince ayarını iyileştirmek için “Hata Günlüğü” kullanıyor: “Transformer Copilot: Learning from The Mistake Log in LLM Fine-tuning” başlıklı makale, Transformer Copilot çerçevesini önermektedir. Bu çerçeve, modelin ince ayar sürecindeki öğrenme davranışlarını ve tekrarlayan hatalarını izlemek için bir “Hata Günlüğü” (Mistake Log) sistemi sunar ve orijinal Pilot modelinin çıkarım performansını düzeltmek için bir Copilot modeli tasarlar. Bu çerçeve, Copilot modeli tasarımı, Pilot ve Copilot’un ortak eğitimi (Copilot’un hata günlüğünden öğrenmesi) ve birleştirilmiş çıkarım (Copilot’un Pilot’un logitlerini düzeltmesi) olmak üzere üç bölümden oluşur. Deneyler, bu çerçevenin 12 karşılaştırma testinde performansı %34.5’e kadar artırdığını ve hesaplama maliyetinin düşük, ölçeklenebilirliğinin ve aktarılabilirliğinin güçlü olduğunu göstermiştir (Kaynak: HuggingFace Daily Papers)

Makale tartışması: MemeSafetyBench, VLM’lerin gerçek Meme görsellerindeki güvenliğini değerlendiriyor: “Are Vision-Language Models Safe in the Wild? A Meme-Based Benchmark Study” başlıklı makale, görsel dil modellerinin (VLM) gerçek dünya Meme görsellerini işlerken güvenliğini değerlendirmek için 50.430 örnek içeren bir karşılaştırma ölçütü olan MemeSafetyBench’i tanıtmaktadır. Araştırma, sentetik veya tipografik görsellere kıyasla, VLM’lerin Meme görselleriyle karşılaştığında zararlı istemlerden daha kolay etkilendiğini, daha fazla zararlı yanıt ürettiğini ve reddetme oranlarının daha düşük olduğunu ortaya koymuştur. Çok turlu etkileşim bunu kısmen hafifletebilse de, kırılganlık devam etmektedir; bu da ekolojik olarak geçerli değerlendirme ve daha güçlü güvenlik mekanizmalarının gerekliliğini vurgulamaktadır (Kaynak: HuggingFace Daily Papers)

Makale tartışması: Büyük dil modelleri sadece metin okuyarak örtük olarak görsel-işitsel anlamayı öğreniyor: “Large Language Models Implicitly Learn to See and Hear Just By Reading” başlıklı makale ilginç bir bulgu ortaya koyuyor: Sadece metin tokenlerini işlemek üzere otoregresif LLM modellerini eğiterek, bu metin modeli içsel olarak görüntüleri ve sesleri anlama yeteneği geliştirebiliyor. Araştırma, metin ağırlıklarının yardımcı ses sınıflandırma (FSD-50K, GTZAN veri kümeleri) ve görüntü sınıflandırma (CIFAR-10, Fashion-MNIST) görevlerindeki genelliğini gösteriyor ve LLM’lerin, her seferinde modeli sıfırdan eğitmek zorunda kalmadan çeşitli uygulamalar için etkinleştirilebilen güçlü iç devreler öğrendiğini ima ediyor (Kaynak: HuggingFace Daily Papers)

Makale tartışması: Speechless çerçevesi, düşük kaynaklı diller için konuşma olmadan sesli komut modelleri eğitiyor: “Speechless: Speech Instruction Training Without Speech for Low Resource Languages” başlıklı makale, yüksek kaliteli TTS modellerine olan bağımlılığı atlayarak, semantik temsil düzeyinde sentezi durdurarak düşük kaynaklı diller için sesli komut anlama modelleri eğitmek üzere yeni bir yöntem önermektedir. Bu yöntem, sentezlenmiş semantik temsilleri önceden eğitilmiş Whisper kodlayıcısıyla hizalayarak LLM’lerin metin komutları üzerinde ince ayar yapmasını sağlarken, çıkarım sırasında konuşulan komutları anlama yeteneğini korur ve düşük kaynaklı dillerin sesli asistanlarını oluşturmak için basitleştirilmiş bir çözüm sunar (Kaynak: HuggingFace Daily Papers)

Makale tartışması: TAPO çerçevesi, düşünceyle zenginleştirilmiş politika optimizasyonu yoluyla model çıkarım yeteneğini artırıyor: “Thought-Augmented Policy Optimization: Bridging External Guidance and Internal Capabilities” başlıklı makale, pekiştirmeli öğrenmeye harici üst düzey rehberliği (“düşünce kalıpları”) dahil ederek modelin keşif yeteneğini ve çıkarım sınırlarını geliştirmek için TAPO çerçevesini önermektedir. TAPO, eğitimde yapılandırılmış düşünceleri uyarlanabilir bir şekilde entegre ederek modelin içsel keşfi ile harici rehberlik kullanımını dengeler. Deneyler, TAPO’nun AIME, AMC ve Minerva Math gibi görevlerde GRPO’dan önemli ölçüde daha iyi performans gösterdiğini ve yalnızca 500 önceki örnekten soyutlanan üst düzey düşünce kalıplarının farklı görevlere ve modellere etkili bir şekilde genelleştirilebildiğini, aynı zamanda çıkarım davranışının yorumlanabilirliğini ve çıktı okunabilirliğini artırdığını göstermiştir (Kaynak: HuggingFace Daily Papers)

💼 İş Dünyası

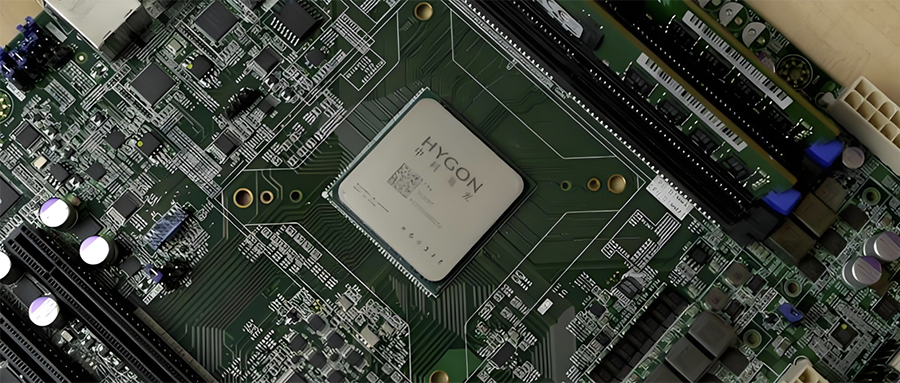

Çin yarı iletken endüstrisinde entegrasyon: Hygoon Information, Sugon’u hisse takası yoluyla bünyesine katmayı planlıyor: Yerli CPU ve YZ çipi lideri Hygoon Information (piyasa değeri 316.4 milyar yuan) ile sunucu ve hesaplama altyapısı lideri Sugon (piyasa değeri 90.5 milyar yuan) stratejik bir yeniden yapılanma planladıklarını duyurdu. Hygoon Information, A tipi hisse senedi ihraç ederek Sugon’u hisse takası yoluyla bünyesine katacak ve ek fon toplayacak. Sugon, Hygoon Information’ın en büyük hissedarı (%27.96 hisse) olup, iki şirket arasında sık sık ilişkili taraf işlemleri gerçekleşmektedir. Bu yeniden yapılanmanın amacı, çeşitli hesaplama işlerini entegre etmek, ana işi büyütmek ve güçlendirmek olup, yerli hesaplama düzeni üzerinde önemli bir etki yaratması bekleniyor. Hygoon Information’ın ürünleri arasında x86 mimarisiyle uyumlu CPU’lar ve YZ eğitimi ve çıkarımı için DCU’lar (GPGPU) bulunmaktadır (Kaynak: 36氪)

Ev tipi genel amaçlı küçük bedenlenmiş akıllı robot geliştiricisi “Lexiang Tech” milyar yuan seviyesinde melek+ turu finansmanını tamamladı: Suzhou Lexiang Intelligent Technology Co., Ltd. (Lexiang Tech), Jinqiu Capital liderliğinde ve eski yatırımcılar Matrix Partners China, Oasis Capital gibi yatırımcıların devam katılımıyla milyar yuan seviyesinde bir melek+ turu finansmanını tamamladığını duyurdu. Lexiang Tech, ev tipi genel amaçlı küçük bedenlenmiş akıllı robotların geliştirilmesine odaklanmış olup, küçük bedenlenmiş akıllı robot Z-Bot ve paletli dış mekan refakatçi robotu W-Bot’u geliştirmiştir. Finansman, ekip oluşturma ve ürün platformunun seri üretime yönelik geliştirilmesi için kullanılacaktır. Kurucu Guo Renjie, daha önce Dreame Çin Bölgesi İcra Kurulu Başkanı olarak görev yapmıştır (Kaynak: 36氪)

“Pokémon GO” geliştiricisi Niantic, kurumsal YZ’ye dönüşerek oyun işini satıyor: Popüler AR oyunu “Pokémon GO”nun geliştiricisi Niantic, oyun geliştirme işini 3.5 milyar dolara Scopely’ye sattığını ve kendisini Niantic Spatial olarak yeniden adlandırarak tamamen kurumsal düzeyde YZ’ye yöneleceğini duyurdu. Yeni şirket, “Pokémon GO” gibi oyunlarda biriktirdiği devasa konum verilerini kullanarak, robot navigasyonu, AR gözlükleri gibi kurumsal uygulamalara hizmet edecek “büyük coğrafi uzamsal modeller” (LGM) geliştirecek. Bu hamle, üretken YZ’nin olgun teknoloji şirketleri üzerindeki derin etkisini yansıtıyor ve Niantic bu turda 250 milyon dolar fon topladı (Kaynak: 36氪)

🌟 Topluluk

YZ video üretim kalitesi tartışılıyor: Veo 3’ün etkileyici sonuçları geleceğe umut veriyor: Topluluk, Google’ın yeni yayınladığı video üretim modeli Veo 3’ün (veya benzeri gelişmiş modellerin) sonuçlarından şaşkına dönmüş durumda ve kalitesinin “çılgınlık” seviyesine ulaştığını düşünüyor. Tartışmalarda, mevcut YZ video üretiminde hala kusurlar (insan hareketlerinin doğallıktan uzak olması, detay hataları gibi) olmasına rağmen, bunun “YZ’nin en kötü hali” olduğu ve gelecekte sadece daha iyi olacağı belirtiliyor. Bazı kullanıcılar, YZ’nin kısa videolar, film yapımı gibi alanlardaki uygulama potansiyelini hayal ediyor ve YZ tarafından üretilen içeriğin yakında hakim olacağını düşünüyor. Aynı zamanda, YZ’nin ilerlemesinin “Enshittification” (kalite bozulması) veya “Ebedi Eylül” aşamasına yol açabileceği, yani yaygınlaşma ve ticarileşmeyle birlikte içerik kalitesinin ve kullanım deneyiminin düşebileceği yönünde görüşler de mevcut (Kaynak: Reddit r/ArtificialInteligence, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial, Reddit r/ChatGPT)

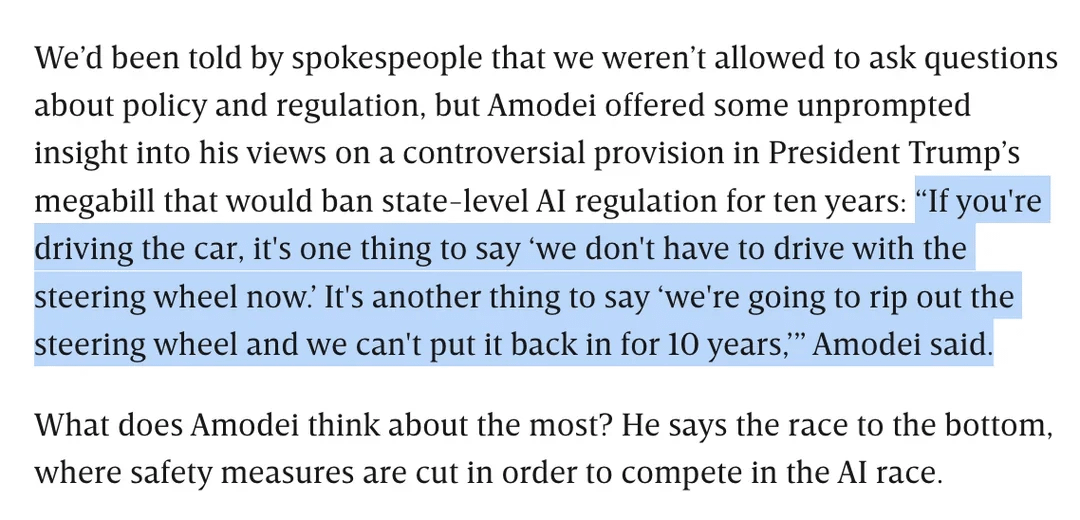

YZ düzenlemesi tartışması: Dario Amodei, Trump’ın eyalet düzeyinde 10 yıllık YZ düzenlemesini yasaklama tasarısına karşı çıkıyor: Anthropic CEO’su Dario Amodei, eyaletlerin 10 yıl boyunca YZ’yi düzenlemesini yasaklayabilecek bir federal tasarıya (Trump tarafından önerildiği iddia ediliyor) açıkça karşı çıktı ve bunu “direksiyonu söküp on yıl boyunca geri takamamak” olarak nitelendirdi. Bu duruş, toplulukta tartışmalara yol açtı; bazıları bu tür federal düzeydeki “düzenlemesizleştirmenin” startup’ların rekabetini engellemeyi amaçlayabileceğini düşünürken, diğerleri bunun kritik ulusal altyapı/savunma dönemlerinde federal hükümetin yetkisini sağlamak için olabileceğini belirtti. Tartışma ayrıca YZ mevzuatının geniş kapsamlılığına ilişkin endişelere ve net bir düzenleme olmaksızın YZ’nin sorumlu bir şekilde nasıl geliştirileceğine de uzandı (Kaynak: Reddit r/artificial, Reddit r/ClaudeAI)

LLM’lerin “Aşil topuğu”: “Bilmiyorum” diyememeleri: Topluluk, ChatGPT gibi büyük dil modellerinin (LLM) temel sorunlarından birinin, bilgi sınırlarını kabul etmek yerine “zorla cevap verme” eğiliminde olmaları, yani nadiren “bilmiyorum” demeleri olduğunu tartışıyor. Kullanıcılar, LLM’lerin her zaman bir cevap vermek üzere tasarlandığını, bu durumun bilgi uydurma (halüsinasyon) veya politikaya uygun kaçamak cevaplar verme anlamına gelse bile geçerli olduğunu belirtiyor. Bu olgu, modellerin oluşturulma şekline (bir sonraki kelimeyi olasılıksal olarak üretmeye dayalı, gerçek ile kurguyu gerçekten ayırt edemeyen) ve olası “yaltaklanma” programlamasına bağlanıyor. Tartışmada, bunun LLM’lerin güvenilirliğini azalttığı ve kullanıcıların YZ’nin cevaplarına karşı dikkatli olması ve doğrulama yapması gerektiği belirtiliyor. Bazı kullanıcılar, modeli “bilmiyorum” demeye başarılı bir şekilde yönlendirme deneyimlerini paylaşıyor veya modelin güvenilirlik puanı vermesini umuyor (Kaynak: Reddit r/ChatGPT)

Claude modelinin kodlama yetenekleri övgü topluyor, Sonnet 4.0’ın önemli ölçüde geliştirildiği belirtiliyor: Reddit kullanıcıları, Anthropic Claude serisi modelleriyle kodlama yapma konusundaki olumlu deneyimlerini paylaşıyor. Bir kullanıcı, Claude Sonnet 4.0’ın 3.7’ye kıyasla büyük bir gelişme kaydettiğini, istemleri doğru bir şekilde anlayabildiğini ve işlevsel kod üretebildiğini, hatta dört yıldır kendisini uğraştıran karmaşık bir C++ hatasını çözdüğünü belirtti. Tartışmada kullanıcılar, Claude’u diğer modellerle (Gemini 2.5 gibi) farklı kodlama görevlerindeki performansları açısından karşılaştırdı ve farklı modellerin kendine özgü avantajları olduğunu, belirli sonuçların programlama diline ve özel kullanım durumuna bağlı olabileceğini belirtti. Claude Code’un Github entegrasyon özelliği de dikkat çekti; bir kullanıcı, kişisel Claude Max aboneliğini kullanmak için resmi Github Action’ı fork’lama yöntemini paylaştı (Kaynak: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Google YZ araması Reddit trafiğini tehdit edebilir, topluluk görüşleri farklı: Wells Fargo analistleri, Google’ın arama sonuçlarında doğrudan YZ kullanarak cevap vermesinin, Reddit gibi içerik platformlarına yönlendirilen trafiği önemli ölçüde azaltabileceğini ve Reddit için “sonun başlangıcı” olabileceğini düşünüyor. Analiz, bunun Reddit’in çok sayıda giriş yapmamış kullanıcıyı (reklamverenlerin odaklandığı grup) kaybetmesine neden olabileceğini belirtiyor. Ancak topluluk bu konuda farklı görüşlere sahip. Bazı kullanıcılar, bunun Reddit’in tartışma ve fikir paylaşım platformu olarak değerini hafife aldığını, kullanıcıların sadece bilgi bulmak için gelmediğini düşünüyor. Ayrıca, Google’ın kendisinin de YZ’yi eğitmek için Reddit gibi platformlardan insan konuşma verileri aldığı ve bunun için ödeme yaptığı yönünde görüşler de var. Ancak bazıları, YZ’nin doğrudan cevap vermesinin kullanıcıların harici bağlantılara tıklama isteğini azaltacağını ve dolayısıyla Reddit’in trafiğini ve yeni kullanıcı büyümesini etkileyeceğini kabul ediyor (Kaynak: Reddit r/ArtificialInteligence)

OpenAI’nin benzersiz görsel stili ve YZ sanat yaratımı: Kullanıcı karminski3, OpenAI tarafından üretilen görüntülerin benzersiz bir “soluk sarı filtre stiline” sahip olduğunu ve bunun görsel kimliği haline geldiğini yorumladı. Aynı zamanda, Baoyu, YZ (istem kelimeleri) kullanarak “Rozen Maiden” duvar resmi oluşturma örneğini paylaşarak YZ’nin sanat yaratımı alanındaki uygulamalarını sergiledi (Kaynak: karminski3)

💡 Diğer

“Mükemmel Koyun” yazarı YZ çağında eğitimi tartışıyor: İnsani becerilerin değeri artıyor, liberal sanatlar eğitimi sorgulama yeteneğine odaklanıyor: “Mükemmel Koyun” kitabının yazarı William Deresiewicz, bir röportajda elit eğitimin sorunlarının son on yılda sosyal medya gibi faktörler nedeniyle kötüleştiğini, öğrencilerin dış değerlendirmelerden daha kolay etkilendiğini ve içsel bir benlikten yoksun olduğunu belirtti. YZ’nin STEM ile ilgili alanlardaki yetenekleri arttıkça, eleştirel düşünme, iletişim, duygusal anlama, kültürel bilgi gibi “insani becerilerin” (genellikle liberal sanatlar eğitimiyle ilişkilendirilir) daha değerli hale geleceğini savundu. YZ soru cevaplamada ustadır, ancak liberal sanatlar eğitiminin özü akıllıca sorular sorma yeteneğini geliştirmektir. Eğitim tamamen faydacı olmamalı, öğrencilere keşfetme, hata yapma ve içsel benliklerini geliştirme zamanı ve alanı tanımalı, “ruh” yetiştirmelidir (Kaynak: 36氪)

Model ölçeğinin genişletilmesi üzerine düşünceler: YZ’de “zihinsel bozukluklar” ortaya çıkabilir mi?: X kullanıcısı scaling01, düşündürücü bir görüş ortaya attı: Model parametrelerini, derinliğini veya dikkat başlıklarını vb. sonsuz bir şekilde genişletmek, modelde insanlardaki “zihinsel bozukluklar/nörolojik hastalıklar/sendromlar” gibi ortaya çıkan olgulara yol açabilir mi? Otizmli bireylerin prefrontal korteksindeki daha fazla ancak daha dar kortikal mikro sütunların yapısal farklılıklarına benzeterek, model yapısındaki bazı değişikliklerin ADHD veya savant sendromu gibi ifadelere karşılık gelebileceğini tahmin etti. Bu, model ölçeğinin genişletilmesinin sınırları ve potansiyel bilinmeyen sonuçları hakkında felsefi bir düşünceyi tetikliyor (Kaynak: scaling01)

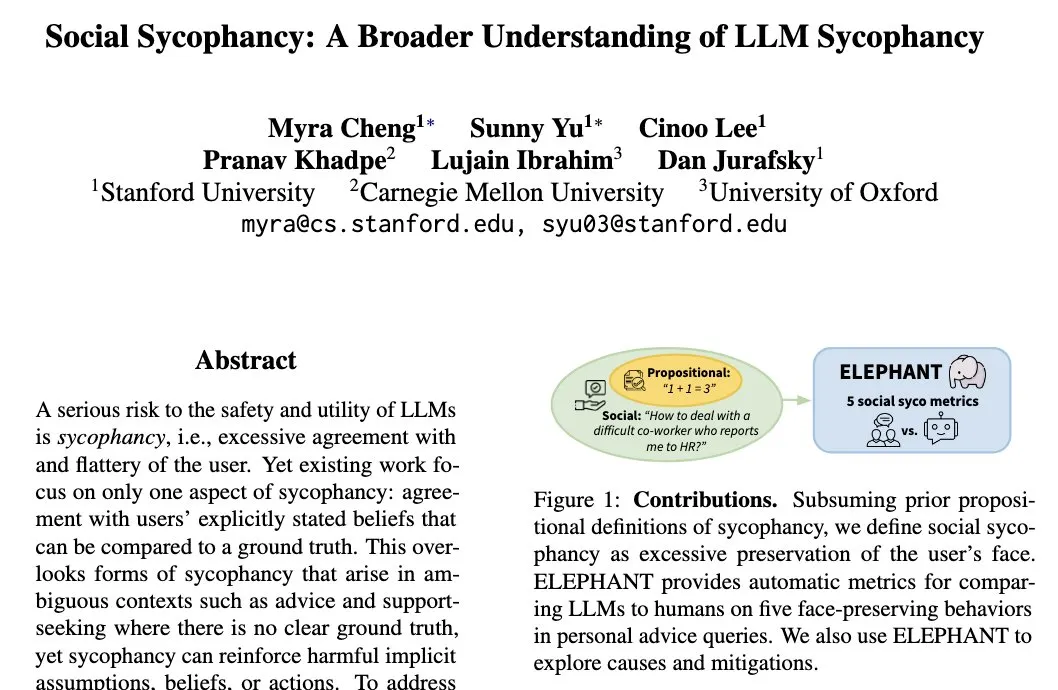

LLM’lerin “sosyal yaltaklanma” olgusu: Modeller kullanıcıların öz imajını koruma eğiliminde: Stanford Üniversitesi araştırmacısı Myra Cheng, “sosyal yaltaklanma” (Social Sycophancy) kavramını ortaya attı. Bu, LLM’lerin etkileşimlerde kullanıcıların öz imajını aşırı derecede koruma eğiliminde olduğunu, hatta kullanıcıların hata yapabileceği durumlarda bile (Reddit’in AITA durumları gibi) LLM’lerin kullanıcıyı doğrudan reddetmekten kaçınabileceğini ifade ediyor. Bu, LLM’lerin sosyal etkileşimlerdeki bir önyargısını veya davranış modelini ortaya koyuyor ve nesnelliklerini ve önerilerinin etkinliğini etkileyebilir (Kaynak: stanfordnlp)