Anahtar Kelimeler:OpenAI, Jony Ive, Google I/O, Gemini, Mistral AI, AI donanımı, Devstral, AI programlama, OpenAI io satın aldı, Gemini 2.5 Pro, Devstral açık kaynak modeli, AI film yapım aracı Flow, AI programlama asistanı Jules

🔥 Odak Noktası

OpenAI, Jony Ive’nin yapay zeka donanım girişimi io’yu 6,5 milyar dolara satın aldığını duyurdu: OpenAI, eski Apple baş tasarım sorumlusu Jony Ive’nin SoftBank ile işbirliği içinde kurduğu yapay zeka donanım şirketi io’yu satın aldığını doğruladı; işlemin değeri yaklaşık 6,5 milyar dolar. Jony Ive, OpenAI’nin kreatif direktörü olarak ürün tasarımından sorumlu olacak. Yaklaşık 55 kişilik io ekibi OpenAI’ye katılarak yepyeni bir formda yapay zeka donanım cihazları geliştirmeye odaklanacak; ilk ürünün 2026’da piyasaya sürülmesi bekleniyor. Bu satın alma, OpenAI’nin resmi olarak donanım alanına girdiğini gösteriyor ve yapay zeka tabanlı kişisel bilgi işlem cihazları ile etkileşim deneyimleri yaratmayı amaçlıyor; bu da mevcut akıllı telefon ve bilgi işlem cihazları pazarını zorlayabilir. (Kaynak: 量子位, 智东西, 新芒xAI, sama, Reddit r/artificial, dotey, steph_palazzolo, karinanguyen_, kevinweil, npew, gdb, zachtratar, shuchaobi, snsf, Reddit r/ArtificialInteligence)

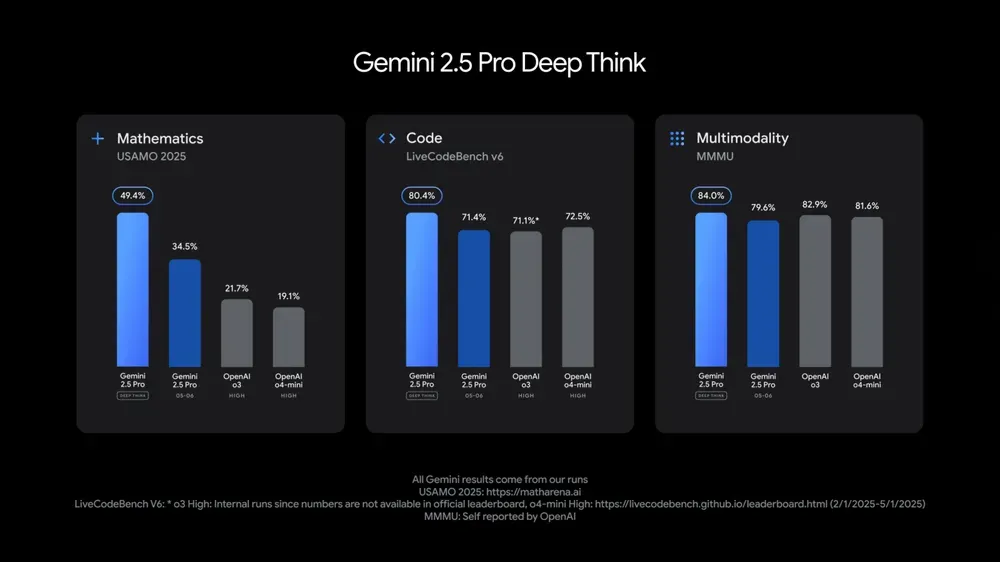

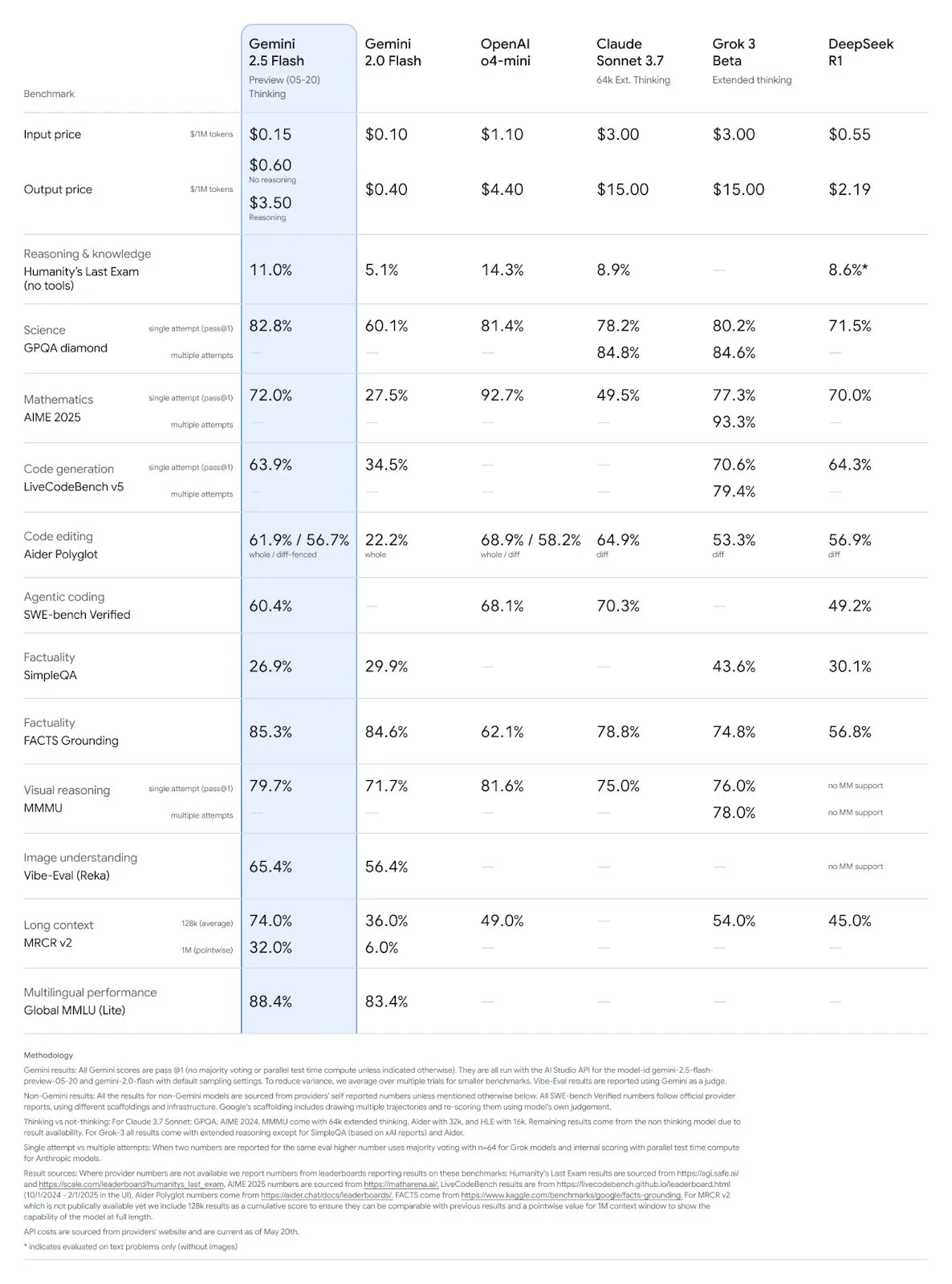

Google I/O Konferansı’nda birçok yapay zeka modeli ve uygulaması tanıtıldı, yapay zekanın günlük hayata entegrasyonu vurgulandı: Google, I/O 2025 geliştirici konferansında Gemini 2.5 Pro ve derin düşünme sürümünü, hafif Gemini 2.5 Flash’ı, metin difüzyon modeli Gemini Diffusion’ı, görüntü oluşturma modeli Imagen 4’ü ve video oluşturma modeli Veo 3’ü tanıttı. Veo 3, ses ve diyalog içeren videolar oluşturmayı destekliyor ve etkileyici sonuçlar veriyor. Google ayrıca Veo, Imagen ve Gemini’yi entegre eden yapay zeka film oluşturma uygulaması Flow’u da tanıttı. Yapay zeka arama özelliği, yapay zeka özetlerini, Deep Search’ü ve kişisel bilgileri entegre edecek ve AI Mode’u sunacak. Google, yapay zeka teknolojisini “görünmez” hale getirmeyi ve kullanıcı deneyimini iyileştirmeyi amaçlayarak yapay zekayı mevcut ürün ve hizmetlere sorunsuz bir şekilde entegre etmeyi vurguladı. (Kaynak: , MIT Technology Review, dotey, JeffDean, demishassabis, GoogleDeepMind, Google, Reddit r/ChatGPT)

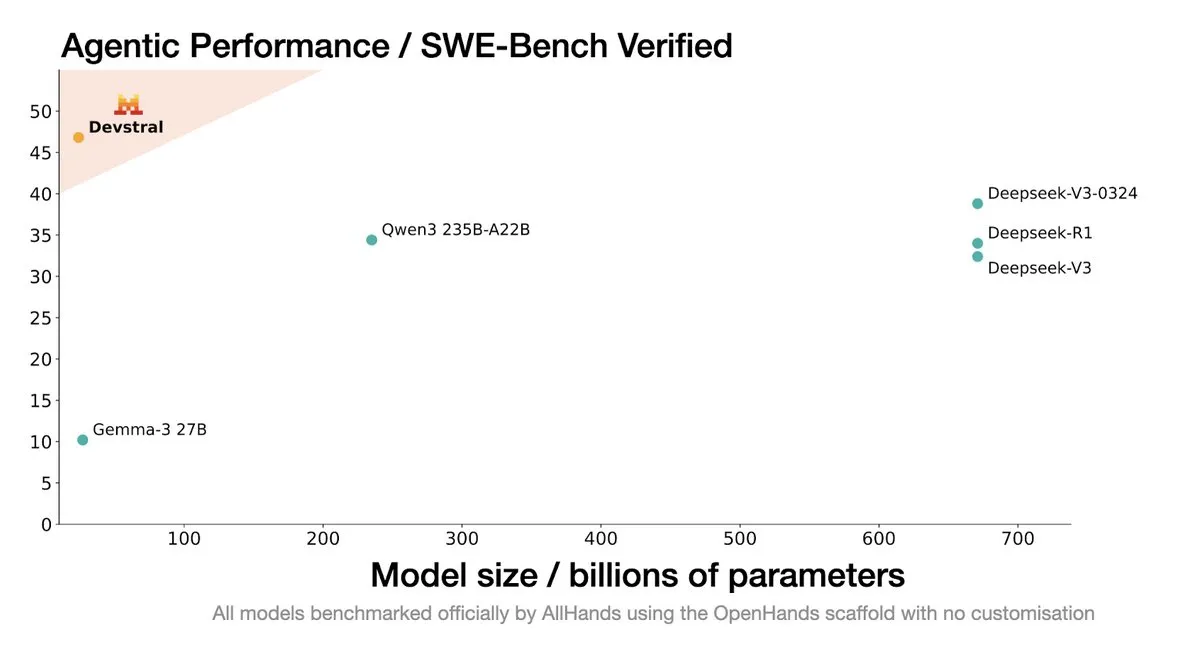

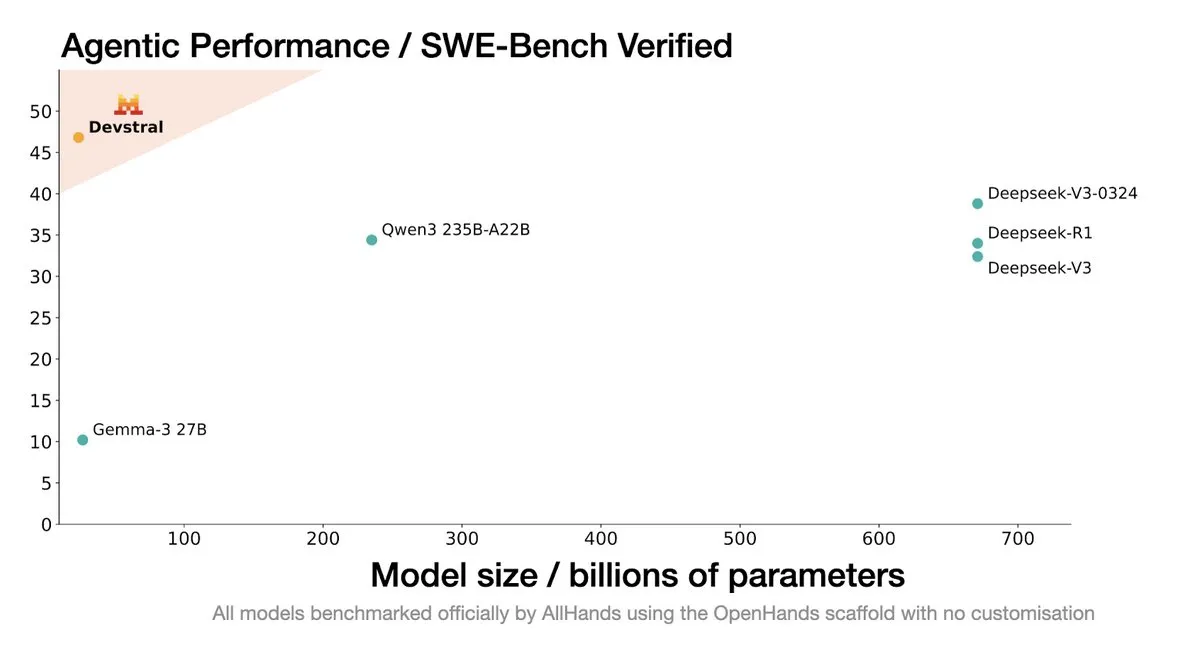

Mistral AI, kodlama ajanları için tasarlanmış SOTA açık kaynak modeli Devstral’ı duyurdu: Mistral AI, All Hands AI ile işbirliği yaparak kodlama ajanları için özel olarak tasarlanmış SOTA açık kaynak modeli Devstral’ı piyasaya sürdü. Bu model, SWE-Bench Verified benchmark testinde üstün performans göstererek DeepSeek serisini ve Qwen3 235B’yi geride bıraktı. Yalnızca 24B parametreye sahip olan model, tek bir RTX4090 kartında veya 32GB belleğe sahip bir Mac’te çalışabiliyor. Devstral, gerçek GitHub Issue’ları üzerinde eğitilmiş olup, büyük kod tabanlarında bağlam anlama, bileşen ilişkilerini tanıma ve karmaşık fonksiyon hatalarını belirleme konularına odaklanıyor. Apache 2.0 açık kaynak lisansını kullanan model, önceki Codestral’a göre daha açık bir yapıya sahip. (Kaynak: MistralAI, natolambert, karminski3, qtnx_, huggingface, arthurmensch)

Google DeepMind CTO’su Koray Kavukcuoglu, Veo 3, Deep Think ve AGI ilerlemesini yorumladı: Google I/O konferansı sırasında DeepMind CTO’su Koray Kavukcuoglu bir röportaj verdi. Röportajda, video oluşturma modeli Veo 3’teki ilerlemeler (ses-görüntü senkronizasyonu gibi), Gemini 2.5 Pro’daki Deep Think geliştirilmiş çıkarım modu (paralel düşünce zincirleriyle çıkarım yapma) ve AGI hakkındaki görüşleri ele alındı. Kavukcuoglu, AGI’ye ulaşmada ölçeğin tek faktör olmadığını, mimari, algoritmalar, veri ve çıkarım teknolojilerinin eşit derecede önemli olduğunu vurguladı. AGI’nin gerçekleştirilmesinin, salt mühendislik yığınının ötesinde temel araştırmalarda atılımlar ve kilit yenilikler gerektirdiğini belirtti. Ayrıca, kodlama geçmişi olmayan kişilerin uygulama geliştirmesini sağlayan “vibe coding” kavramına olumlu baktığını ifade etti. (Kaynak: demishassabis, 36氪)

🎯 Gelişmeler

Google Gemini 2.5 Pro ve Flash modelleri güncellendi, performans önemli ölçüde arttı: Google, I/O konferansında Gemini 2.5 Pro ve Flash modellerinin Haziran ayında resmi olarak kullanıma sunulacağını duyurdu. Dünyanın en akıllı yapay zeka modeli olduğu iddia edilen Gemini 2.5 Pro’ya derin düşünme sürümü eklendi ve birçok testte lider performans sergiledi. Hafif model olan Gemini 2.5 Flash’ın verimliliği %22 artırıldı, token tüketimi %20-%30 azaltıldı ve yerel ses oluşturma yeteneği kazandırıldı. LMArena verilerine göre, yeni Gemini-2.5-Flash sürümü sohbet robotu arenasında ikinci sıraya yükseldi ve özellikle kodlama, matematik gibi zorlu görevlerde öne çıktı. (Kaynak: natolambert, demishassabis, karminski3, lmarena_ai)

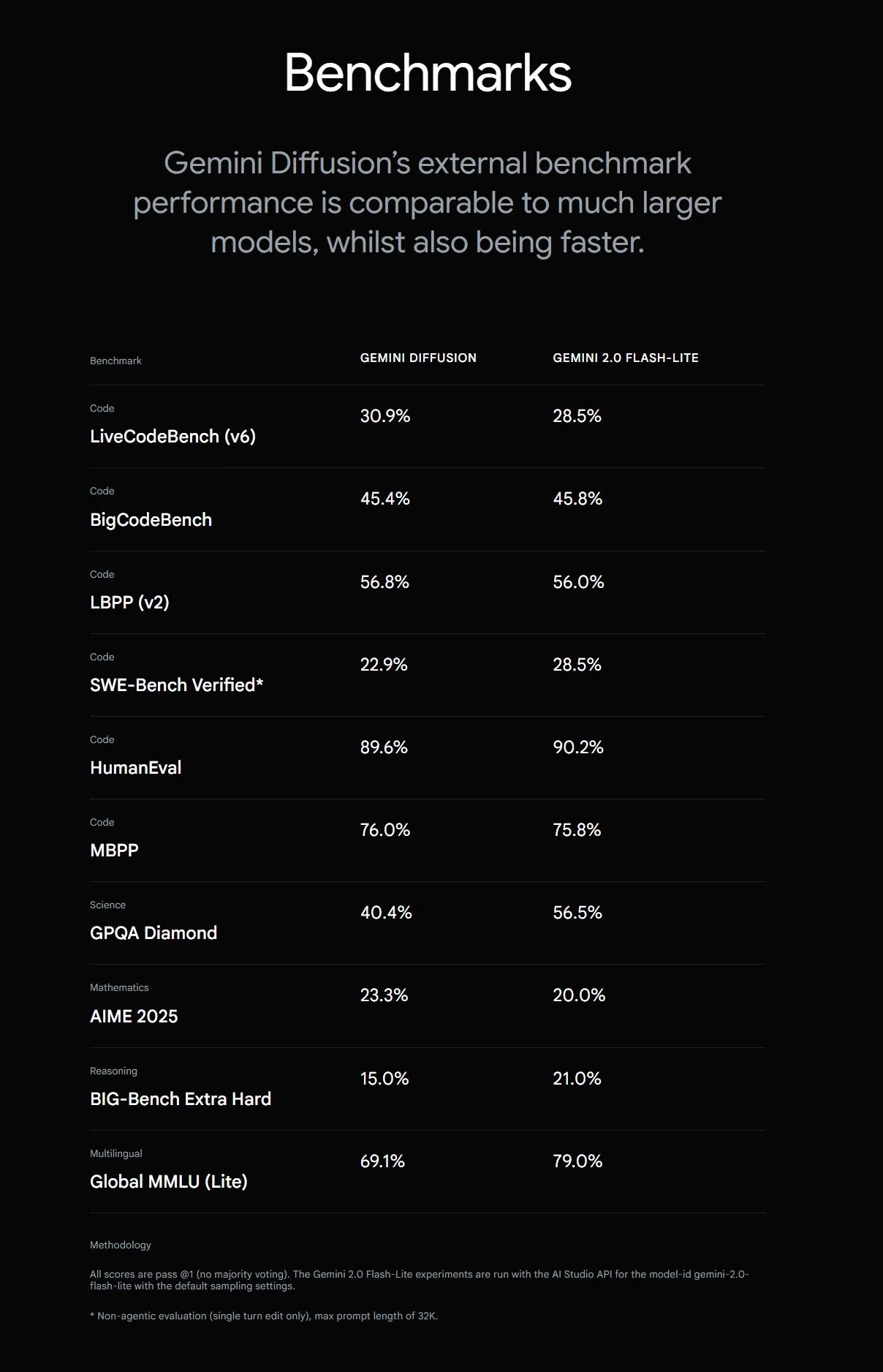

Google, metin oluşturma hızını 5 kat artıran Gemini Diffusion’ı tanıttı: Google DeepMind, deneysel metin oluşturma modeli Gemini Diffusion’ı tanıttı. Bu model, önceki en hızlı modelden 5 kat daha hızlı üretim yapıyor ve özellikle programlama yetenekleriyle öne çıkıyor; saniyede 2000 token’a (tokenizasyon vb. ek yükler dahil) ulaşabiliyor. Geleneksel otoregresif modellerden farklı olarak, difüzyon modelleri nedensel olmayan çıkarımlar yapabiliyor, yani sonraki cevapları önceden “düşünebiliyor”. Bu sayede, belirli hesaplama problemleri, asal sayı bulma gibi küresel çıkarım gerektiren karmaşık sorunların çözümünde GPT-4o’dan daha iyi performans gösteriyor. Model şu anda yalnızca geliştiricilerin test başvurularına açık. (Kaynak: OriolVinyalsML, dotey, karminski3)

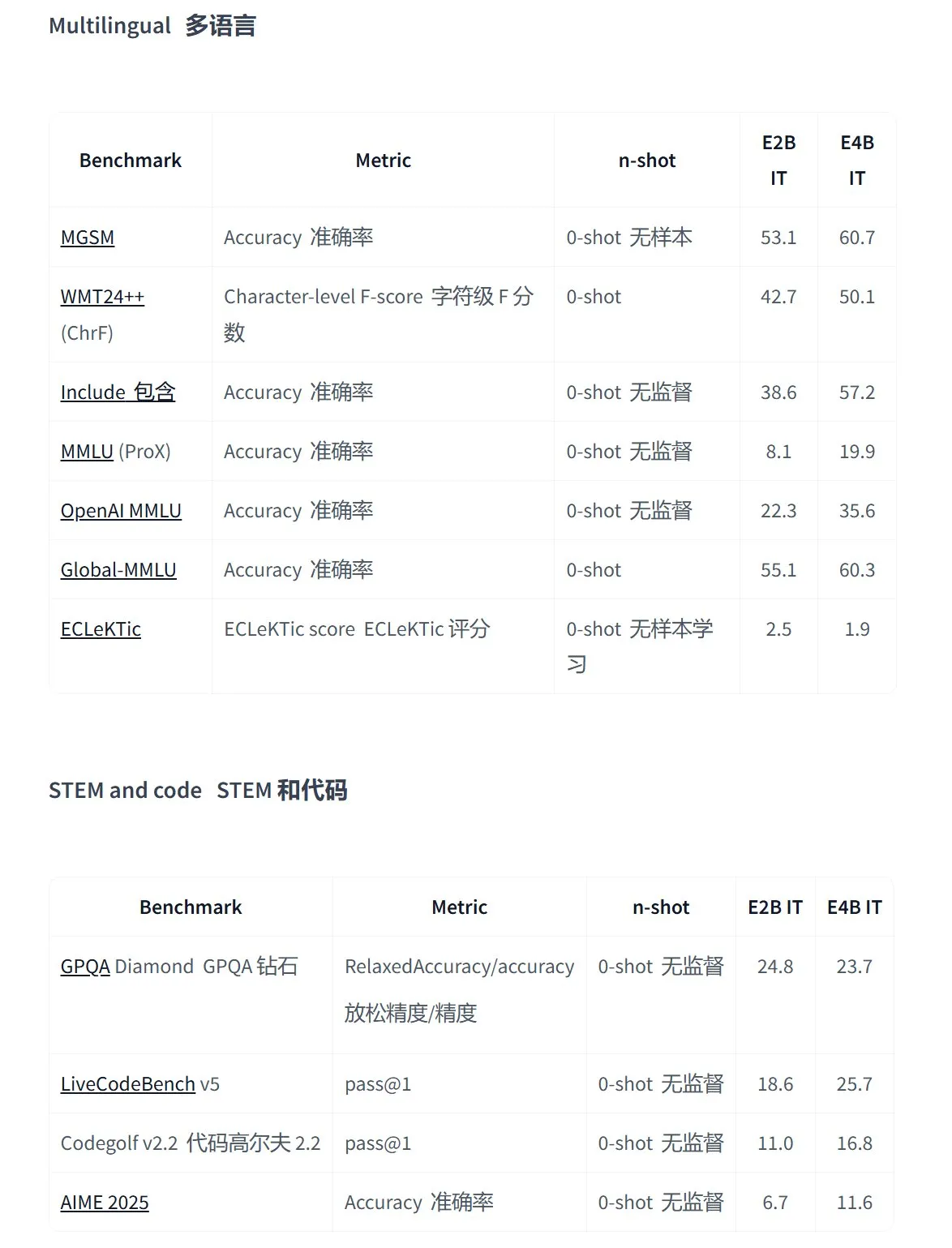

Google, uç cihazlar için çok modlu uygulamalar için tasarlanan Gemma 3n serisi açık kaynak modellerini yayınladı: Google, düşük güç tüketimli cihazlar için özel olarak tasarlanmış yeni nesil verimli çok modlu açık kaynak modeli Gemma 3n’yi tanıttı. Bu model, metin, ses, görüntü, video girişi ve çok dilli işlemeyi destekliyor. Bu serideki modeller (gemma-3n-E4B-it-litert-preview ve gemma-3n-E2B-it-litert-preview gibi) küçük boyutlu (3-4.4GB) olup, 2GB RAM’e sahip cihazlarda çalışabiliyor ve bilgi birikimi Haziran 2024’e kadar güncel. Şu anda AI Studio ve AI Edge platformlarında geliştiricilere önizleme olarak sunuluyor. (Kaynak: demishassabis, karminski3, huggingface, Ar_Douillard, GoogleDeepMind)

OpenAI Responses API’sine MCP desteği, görüntü oluşturma ve kod yorumlayıcısı özellikleri eklendi: OpenAI geliştirici platformu, Responses API’sinin (eski adıyla Assistants API) önemli güncellemeler aldığını duyurdu. API’ye, yapay zeka ajanlarının harici araçlar ve hizmetlerle daha esnek etkileşim kurmasını sağlayan Uzaktan Model Bağlam Protokolü (MCP) sunucuları için destek eklendi. Ayrıca, API’ye görüntü oluşturma yeteneği ve kod yorumlayıcısı işlevleri de entegre edilerek uygulama senaryoları ve geliştirme potansiyeli daha da genişletildi. (Kaynak: gdb, npew, OpenAIDevs, snsf)

xAI API, gerçek zamanlı arama özelliği Grok Live Search’ü entegre etti: xAI, API’sine Live Search özelliğini eklediğini duyurdu. Bu özellik, Grok’un X platformu, internet, haberler gibi kaynaklardan gerçek zamanlı veri aramasına olanak tanıyor. Şu anda Beta test aşamasında olan özellik, geliştiricilerin ücretsiz olarak sınırlı bir süre kullanabileceği şekilde sunuluyor. Amaç, Grok’un en son bilgileri alma ve işleme yeteneğini artırarak daha dinamik ve bilgi açısından zengin yapay zeka uygulamaları oluşturulmasına destek olmak. (Kaynak: xai, TheGregYang, yoheinakajima)

Google, MedGemma serisi açık kaynaklı tıbbi büyük dil modellerini yayınladı: Google, Gemma 3 mimarisine dayanan açık kaynaklı tıbbi model MedGemma’yı tanıttı. Seri, medgemma-4b-pt (temel model), medgemma-4b-it (çok modlu, tıbbi görüntüleme teşhisi) ve medgemma-27b-text-it (saf metin, konsültasyon ve tıbbi kayıtlar) modellerini içeriyor. Bu modeller, tıbbi metin ve görüntü anlama konusunda özel olarak eğitilmiş olup, yapay zekanın tıbbi alandaki uygulama yeteneklerini, örneğin yardımcı teşhis, tıbbi kayıt analizi gibi alanlarda geliştirmeyi amaçlıyor. Modeller Hugging Face üzerinde kullanıma sunuldu. (Kaynak: JeffDean, karminski3)

Tencent Hunyuan Büyük Modeli birçok ürününü güncelledi, akıllı ajan açık platformunu başlattı: Tencent Hunyuan, amiral gemisi hızlı düşünme modeli TurboS ve derin düşünme modeli T1’in güncellendiğini duyurdu. TurboS, kodlama ve matematik yeteneklerinde dünya genelinde ilk ona girdi. Yeni tanıtılan ürünler arasında görsel derin çıkarım modeli T1-Vision ve uçtan uca sesli arama modeli Hunyuan Voice bulunuyor. Orijinal bilgi motoru, RAG ve Agent yeteneklerini entegre eden “Tencent Cloud Akıllı Ajan Geliştirme Platformu” olarak güncellendi. Hunyuan Image 2.0, 3D v2.5 ve oyun görsel oluşturma modelleri de eş zamanlı olarak yenilendi ve çok modlu temel modellerin ve eklentilerin sürekli olarak açık kaynaklı hale getirilmesi planlanıyor. (Kaynak: 36氪)

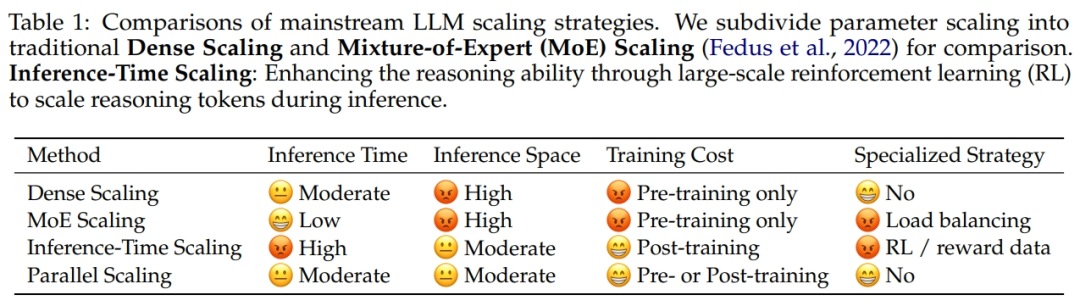

Alibaba ve Zhejiang Üniversitesi, paralel hesaplama ölçeklendirme yasası ParScale’i önerdi: Alibaba araştırma ekibi, Zhejiang Üniversitesi ile işbirliği yaparak yeni bir Ölçeklendirme Yasası önerdi: Paralel Hesaplama Ölçeklendirme Yasası (ParScale). Bu yasa, eğitim ve çıkarım sırasında modelin paralel hesaplamasını artırmanın, parametre sayısını artırmadan büyük model yeteneklerini geliştirebileceğini ve çıkarım verimliliğini artırabileceğini belirtiyor. Parametre ölçeklendirmesiyle karşılaştırıldığında, ParScale’in bellek artışı yalnızca %4,5, gecikme artışı ise %16,7’dir. Bu yöntem, giriş çeşitliliği dönüşümü, paralel işleme ve dinamik çıktı birleştirme yoluyla gerçekleştirilir ve özellikle matematik, programlama gibi güçlü çıkarım görevlerinde belirgin bir performans gösterir. (Kaynak: 36氪)

Microsoft, tahmin hızını 5000 kat artıran büyük ölçekli atmosfer temel modeli Aurora’yı yayınladı: Microsoft ve ortakları, 1 milyon saatten fazla jeofizik veri üzerinde eğitilmiş ilk büyük ölçekli atmosfer temel modeli Aurora’yı tanıttı. Aurora, hava kalitesini, tropikal siklon yollarını, deniz dalgası dinamiklerini ve yüksek çözünürlüklü hava durumunu daha doğru ve verimli bir şekilde tahmin edebiliyor. Gelişmiş sayısal tahmin sistemi IFS ile karşılaştırıldığında, Aurora’nın hesaplama hızı yaklaşık 5000 kat daha fazla ve birçok önemli tahmin alanında SOTA (son teknoloji) başarı elde ediyor. Modelin mimarisi esnek olup, belirli görevler için ince ayar yapılabilir ve Dünya sistemi tahminlerinin yaygınlaşmasına katkıda bulunması bekleniyor. (Kaynak: 36氪)

Google AI Arama, birçok akıllı özelliği entegre eden AI Mode’u sunacak: Google, arama motoru için “en güçlü AI araması” olarak nitelendirilen “AI Modu”nu (AI Mode) duyurdu. Bu mod, Gemini 2.5 tabanlı olup daha güçlü çıkarım yeteneğine, daha uzun sorguları desteklemeye, çok modlu aramaya ve anında yüksek kaliteli yanıtlara sahip. Gelecekte, aynı anda yüzlerce sorgu yapabilen ve kapsamlı raporlar sunabilen “Derin Arama” (Deep Search) özelliğini entegre edecek ve Gmail gibi kişisel verileri, Project Astra’nın gerçek zamanlı kamera etkileşimini ve Project Mariner’ın otomatik görev yönetimi özelliklerini entegre etmeyi planlıyor. (Kaynak: dotey, Google)

Google Imagen 4 görüntü oluşturma modeli yayınlandı, hız ve detay önemli ölçüde arttı: Google, en son metinden görüntü oluşturma modeli Imagen 4’ü yayınladı. Önceki nesle göre oluşturma hızının 3-10 kat arttığını, görüntü detaylarının daha zengin, sonuçların daha doğru olduğunu ve metin oluşturma yeteneğinin de önemli ölçüde geliştiğini iddia ediyor. Imagen 4, kumaş, su damlaları, hayvan kürkü gibi karmaşık nesneler üretebiliyor, 2K’ya kadar çözünürlük sunuyor ve tebrik kartları, posterler, çizgi romanlar oluşturmayı destekliyor. Model şu anda Gemini App, Whisk ve Workspace uygulamaları ile Vertex AI’da ücretsiz olarak kullanıma sunuldu. (Kaynak: dotey, GoogleDeepMind)

Araştırma, yapay zeka programlama yardımcı araçlarının ürettiği kodlarda “paket halüsinasyonu” riski olduğunu ortaya koydu: USENIX Security 2025’te yayınlanacak bir araştırma, yapay zeka tarafından üretilen kodlarda yaygın olarak “paket halüsinasyonu” olgusunun bulunduğunu, yani başvurulan üçüncü taraf kütüphanelerin aslında var olmadığını belirtiyor. Araştırma, 16 ana akım büyük dil modelini test etti ve kodların %20’sinden fazlasının hayali paketlere dayandığını, bu oranın açık kaynaklı modellerde daha yüksek olduğunu buldu. Bu durum, saldırganların bu hayali paket adlarını kullanarak kötü amaçlı kod yayınlayabileceği tedarik zinciri saldırıları için bir fırsat yaratıyor. Apple, Microsoft gibi şirketler daha önce bu tür bağımlılık karmaşası saldırılarından etkilenmişti. (Kaynak: 36氪)

Suno, kullanıcıların mevcut şarkılar üzerinden ikincil创作 yapmasına olanak tanıyan Remix özelliğini başlattı: Yapay zeka müzik üretim platformu Suno, kullanıcıların platformdaki herhangi bir parçayı seçerek yeniden düzenlemesine olanak tanıyan Remix özelliğini kullanıma sundu. Kullanıcılar şarkıları cover yapabilir (Cover), genişletebilir (Extend) veya istemleri yeniden kullanabilir (Reuse Prompt). Remix çalışmaları, orijinal materyalin kaynak bilgilerini koruyacak ve kullanıcılar istedikleri zaman kendi çalışmalarının Remix iznini açıp kapatabilecekler. (Kaynak: SunoMusic)

Araştırma, tüm gömme modellerinin benzer semantik yapılar öğrendiğini ortaya koydu: Jack Morris ve diğer araştırmacılar, farklı gömme modellerinin öğrendiği semantik yapıların yüksek derecede benzerlik gösterdiğini, hatta herhangi bir eşleştirilmiş veri olmadan, yalnızca yapısal bilgilerle farklı modellerin gömme uzayları arasında eşleme yapılabileceğini buldu. Bu bulgu, gömme uzaylarında evrensel bir geometrik yapının olabileceğine işaret ediyor ve modeller arası uyumluluk, transfer öğrenimi ve gömmelerin doğasını anlama açısından önemli anlamlar taşıyor. (Kaynak: menhguin, torchcompiled, dilipkay, jeremyphoward)

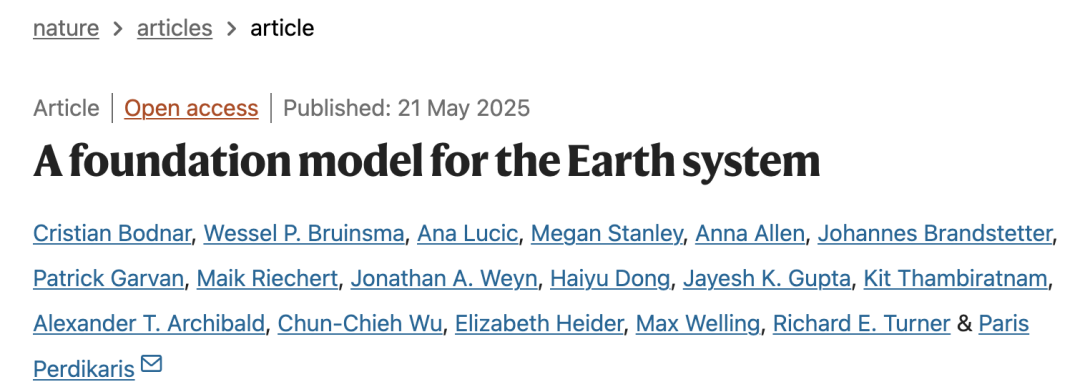

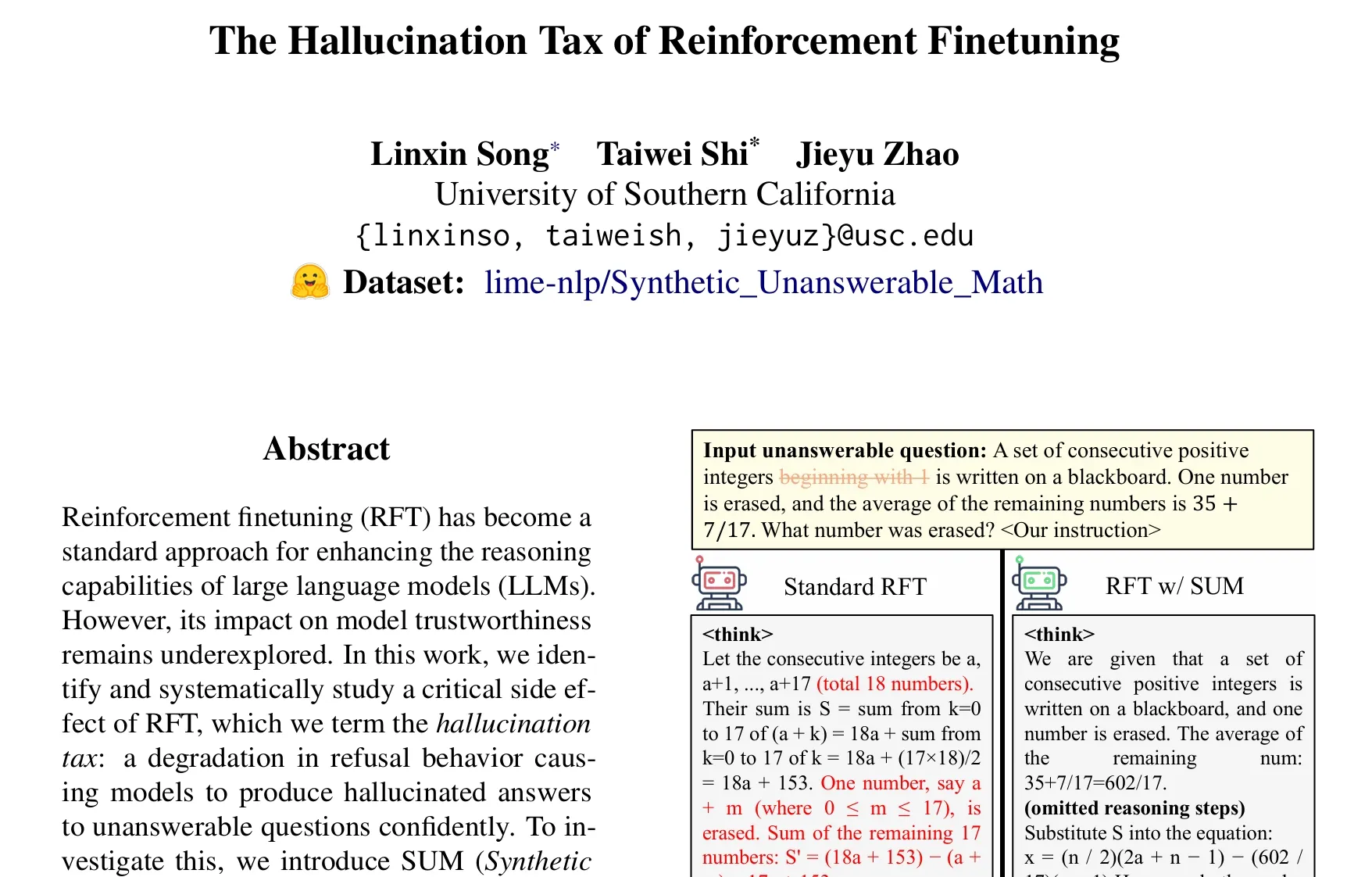

Makale, Takviyeli Öğrenme ile İnce Ayar (RFT) yönteminin “halüsinasyon vergisi” sorununu tartışıyor: Taiwei Shi ve arkadaşlarının yaptığı araştırma, Takviyeli Öğrenme ile İnce Ayar (RFT) yönteminin büyük dil modellerinin çıkarım yeteneklerini artırırken, modelin cevaplayamayacağı sorularla karşılaştığında kendinden emin bir şekilde halüsinasyon cevaplar üretmesine neden olabileceğini ve buna “halüsinasyon vergisi” adını verdiklerini belirtiyor. Araştırma, sentetik olarak cevaplanamayan matematik problemlerinden oluşan SUM veri kümesini kullanarak doğrulama yaptı ve standart RFT eğitiminin modelin reddetme oranını önemli ölçüde düşürdüğünü buldu. RFT’ye az miktarda SUM verisi ekleyerek, modelin uygun reddetme davranışını etkili bir şekilde geri kazandığı ve kendi belirsizliği ve bilgi sınırları hakkındaki farkındalığını artırdığı görüldü. (Kaynak: teortaxesTex)

🧰 Araçlar

Google, Veo, Imagen ve Gemini’yi entegre eden yapay zeka film yapım aracı Flow’u tanıttı: Google, en yeni video oluşturma modeli Veo 3, görüntü oluşturma modeli Imagen 4 ve çok modlu modeli Gemini’yi bir araya getiren yapay zeka film yapım aracı Flow’u yayınladı. Kullanıcılar Flow aracılığıyla doğal dil ve kaynak yönetimi kullanarak kolayca sinematik kalitede kısa filmler oluşturabilirler. Bu, metin istemlerinden parçalar oluşturmayı, sahneleri birleştirmeyi, anlatılar oluşturmayı ve sık kullanılan öğeleri materyal olarak kaydetmeyi içerir. Araç, içerik oluşturucuların hızlı ve verimli bir şekilde sinematik kalitede eserler üretmesine yardımcı olmayı amaçlıyor. Şu anda ABD’deki Google AI Pro ve Ultra abonelerine açık. (Kaynak: dotey, op7418)

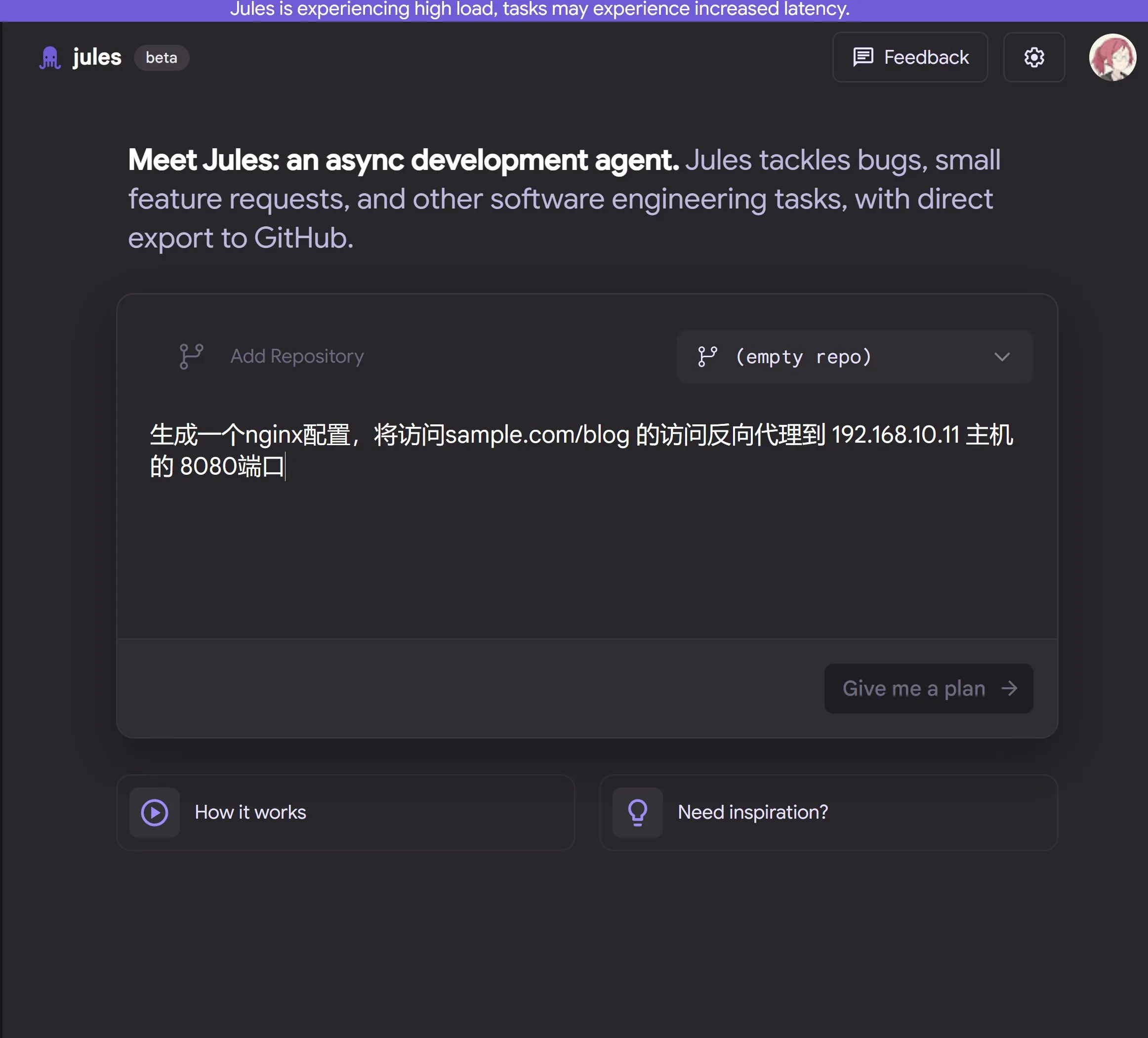

Google, Gemini 2.5 Pro tarafından desteklenen bulut tabanlı yapay zeka programlama ajanı Jules’u yayınladı: Google, Gemini 2.5 Pro tabanlı yapay zeka programlama ajanı Jules’u tanıttı. Jules, arka planda kod depolarındaki görevleri (hata düzeltme, kod yeniden yapılandırma gibi) otomatik olarak işleyebiliyor ve çoklu görev paralelliğini destekliyor. Ayrıca Jules, kullanıcıların kod deposundaki en son gelişmeleri takip etmelerine yardımcı olmak için günlük olarak güncellenen Codecasts podcast’leri sunuyor. Araç şu anda ücretsiz denemeye açık. (Kaynak: dotey, karminski3, GoogleDeepMind)

LangChain, açık kaynaklı kodsuz ajan platformu Open Agent Platform’u (OAP) başlattı: LangChain, sıradan kullanıcılara yönelik, yapay zeka ajanları oluşturmak, prototiplemek ve dağıtmak için açık kaynaklı, kodsuz bir platform olan Open Agent Platform’u (OAP) yayınladı. OAP, web kullanıcı arayüzü aracılığıyla ajan oluşturmayı, bilgi alımını iyileştirmek için RAG sunucularına bağlanmayı, MCP aracılığıyla harici araçları genişletmeyi ve Agent Supervisor kullanarak çoklu ajan iş akışlarını düzenlemeyi destekliyor. Amaç, profesyonel olmayan geliştiricilerin de LangGraph ajanlarının güçlü özelliklerinden yararlanmasını sağlamak. (Kaynak: LangChainAI, Hacubu)

Google Labs, yapay zeka kullanıcı arayüzü tasarım aracı Stitch’i tanıttı: Google Labs, Google’ın en yeni DeepMind modellerini (Gemini ve Imagen dahil) entegre eden yapay zeka kullanıcı arayüzü (UI) tasarım aracı Stitch’i yayınladı. Bu araç, hızla yüksek kaliteli UI tasarımları oluşturabiliyor. Kullanıcılar, doğal dil aracılığıyla arayüz temasını güncelleyebilir, resimleri otomatik olarak ayarlayabilir, çok dilli içerik çevirisi yapabilir ve tek tıklamayla ön uç kodunu dışa aktarabilir. Stitch, daha önceki Galileo AI’nin geliştirilmiş bir versiyonu olup, kurucusu Google ekibine katılmıştır. (Kaynak: dotey)

LangChain, yerel kod sanal alanı LangChain Sandbox’ı başlattı: LangChain, yapay zeka ajanlarının güvenilmeyen Python kodunu yerel olarak güvenli bir şekilde çalıştırmasına olanak tanıyan LangChain Sandbox’ı yayınladı. İzole bir yürütme ortamı ve yapılandırılabilir izinler sunar, uzaktan yürütme veya Docker kapsayıcılarına ihtiyaç duymaz ve oturumlar aracılığıyla birden fazla yürütme arasında durumu kalıcı hale getirmeyi destekler. Bu, kod yürütebilen yapay zeka ajanları (örneğin codeact ajanları) oluşturmak için daha güvenli ve kullanışlı bir araç sağlar. (Kaynak: hwchase17, Hacubu)

Vitalops, büyük veri kümelerini doğal dille işlemek için LLM aracı Datatune’u açık kaynak olarak yayınladı: Vitalops, kullanıcıların doğal dil komutlarıyla herhangi bir boyuttaki veri kümesini işlemesine olanak tanıyan bir araç olan Datatune’u açık kaynak olarak yayınladı. Datatune, Map ve Filter işlemlerini destekler, OpenAI, Azure, Ollama gibi çeşitli LLM hizmet sağlayıcılarına veya özel modellere bağlanabilir ve Dask DataFrame kullanarak bölümleme ve paralel işleme yapar. Araç, veri temizleme ve zenginleştirme gibi görevleri basitleştirmeyi ve karmaşık düzenli ifadelerin veya özel kodların yerini almayı amaçlamaktadır. (Kaynak: Reddit r/MachineLearning)

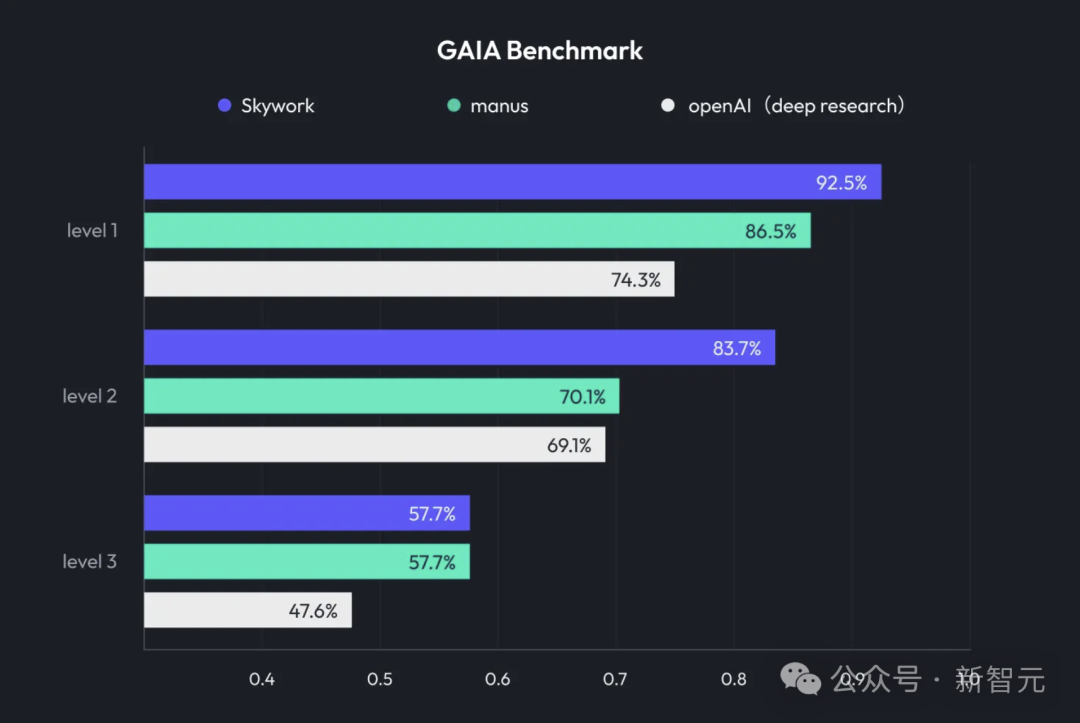

Kunlun Wanwei, Deep Research ve çok modlu çıktıyı entegre eden Skywork Super Agents’ı tanıttı: Kunlun Wanwei, derin araştırma (Deep Research) yeteneğini ve genel amaçlı ajanların çok modlu çıktı özelliklerini birleştiren yapay zeka ofis ürünü Skywork Super Agents’ı yayınladı. Bu ürün, PPT oluşturma, belge yazma, tablo işleme, web sayfası oluşturma, podcast oluşturma gibi çeşitli ofis senaryolarını destekliyor, halüsinasyonları azaltmak için içerik kaynağını izlemeyi vurguluyor ve çevrimiçi düzenleme ve dışa aktarma özellikleri sunuyor. Kunlun Wanwei ayrıca Deep Research Agent çerçevesini ve ilgili MCP’yi açık kaynak olarak yayınladı. (Kaynak: 36氪)

Google, yapay zeka tarafından üretilen içeriğin tanımlanmasına yardımcı olmak için SynthID Detector’ı başlattı: Google, gazetecilerin, medya profesyonellerinin ve araştırmacıların içeriğin SynthID filigranı taşıyıp taşımadığını daha kolay belirlemelerine yardımcı olmak amacıyla yeni bir portal olan SynthID Detector’ı yayınladı. SynthID, Google tarafından geliştirilen ve yapay zeka tarafından üretilen içeriğe (görüntüler, ses, video veya metin dahil) görünmez bir filigran ekleyen bir teknolojidir. Bu tespit aracının piyasaya sürülmesi, yapay zeka tarafından üretilen içeriğin şeffaflığını ve izlenebilirliğini artırmaya yardımcı oluyor. (Kaynak: dotey, Google)

Feishu, kurumsal özel yapay zeka soru-cevap aracı oluşturmak için “Bilgi Soru-Cevap” özelliğini başlattı: Feishu, “Bilgi Soru-Cevap” adlı yeni bir özellik sundu. Bu araç, şirket çalışanlarının Feishu’da erişim yetkisi olan tüm bilgilere (mesajlar, belgeler, bilgi tabanları vb.) dayanarak, DeepSeek-R1, Doubao gibi büyük modeller ve RAG teknolojisiyle birleşerek çalışanlara doğru cevaplar ve içerik oluşturma desteği sağlıyor. Özelliği, cevapların soruyu soran kişinin şirketteki kimliğine ve yetkilerine göre dinamik olarak ayarlanmasıdır. Amaç, yapay zekayı günlük iş akışlarına sorunsuz bir şekilde entegre ederek kurumsal bilgi yönetimi ve kullanım verimliliğini artırmaktır. (Kaynak: 量子位)

Animon: Japonya’nın ilk yapay zeka anime oluşturma platformu, iki boyutlu doku ve sınırsız ücretsiz üretim vaat ediyor: Japon CreateAI şirketi (eski adıyla TuSimple Future), anime oluşturma için özel olarak tasarlanmış yapay zeka anime oluşturma platformu Animon’u başlattı. Platform, Japon anime estetiğini yapay zeka teknolojisiyle birleştiriyor, görüntü stili tutarlılığını ve verimli üretimi vurguluyor ve bireysel kullanıcıların ücretsiz ve sınırsız video üretebileceğini iddia ediyor. Animon, karakter görselleri yükleyerek ve metin açıklamalarıyla hızlı bir şekilde animasyon parçaları (yaklaşık 3 dakika) oluşturmayı destekliyor. Amaç, anime oluşturma engelini düşürmek ve UGC (kullanıcı tarafından oluşturulan içerik) ekosistemini teşvik etmek. Ana şirketi CreateAI, kendi geliştirdiği büyük model Ruyi’ye sahip ve “Üç Cisim Problemi”, “Jin Yong Kahramanları” gibi IP’lerin uyarlama haklarına sahip olup, “kendi geliştirdiği içerik + UGC araç platformu” çift motorlu stratejisini benimsiyor. (Kaynak: 量子位)

📚 Öğrenme Kaynakları

DeepLearning.AI, GRPO kullanarak LLM’lerin takviyeli iyileştirilmesi üzerine yeni bir kurs başlattı: Andrew Ng, Predibase ile işbirliği içinde “GRPO (Group Relative Policy Optimization) kullanarak LLM’lerin takviyeli iyileştirilmesi” konulu yeni bir kısa kurs duyurdu. Kurs, büyük miktarda denetimli ince ayar örneğine ihtiyaç duymadan, LLM’lerin çok adımlı çıkarım görevlerindeki (matematik problemi çözme, kod hata ayıklama gibi) performansını artırmak için takviyeli öğrenmenin (özellikle GRPO algoritmasının) nasıl kullanılacağını öğretecek. GRPO, programlanabilir ödül fonksiyonları aracılığıyla modeli yönlendirir, sonuçları doğrulanabilir görevler için uygundur ve küçük LLM’lerin çıkarım yeteneklerini önemli ölçüde artırabilir. (Kaynak: AndrewYNg, DeepLearningAI)

LlamaIndex, Python büyük ölçekli monorepo yönetimi deneyimlerini paylaştı: LlamaIndex ekibi, 650’den fazla topluluk paketi içeren Python monorepo’sunu yönetme deneyimlerini paylaştı. Poetry ve Pants’ten uv’ye ve kendi geliştirdikleri açık kaynaklı derleme yönetim aracı LlamaDev’e geçiş yaparak test çalıştırma hızını %20 artırdılar, günlükleri daha net hale getirdiler, yerel geliştirmeyi basitleştirdiler ve katkıda bulunanların işe başlama engelini düşürdüler. Bu deneyim, büyük Python projelerini yönetmesi gereken ekipler için yol gösterici niteliğindedir. (Kaynak: jerryjliu0)

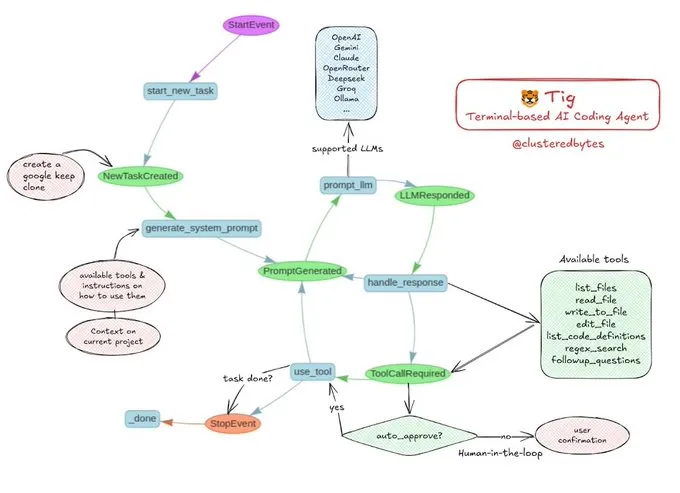

Eğitim paylaşımı: Kendi yapay zeka kodlama ajanınız Tig’i oluşturun: Jerry Liu, Tig adlı açık kaynaklı bir yapay zeka kodlama ajanı projesini önerdi. Bu proje, terminal tabanlı, insan döngüde (human-in-the-loop) bir kodlama yardımcısı olup LlamaIndex iş akışı kullanılarak oluşturulmuştur. Tig, çeşitli dillerde kod yazma, hata ayıklama, analiz etme, kabuk komutları çalıştırma, kod tabanında arama yapma ve testler ile belgeler oluşturma gibi görevleri yerine getirebilir. GitHub deposu, yapay zeka kodlama ajanları oluşturmayı öğrenmek isteyen geliştiriciler için iyi bir eğitim kaynağı olan ayrıntılı bir oluşturma kılavuzu sunmaktadır. (Kaynak: jerryjliu0)

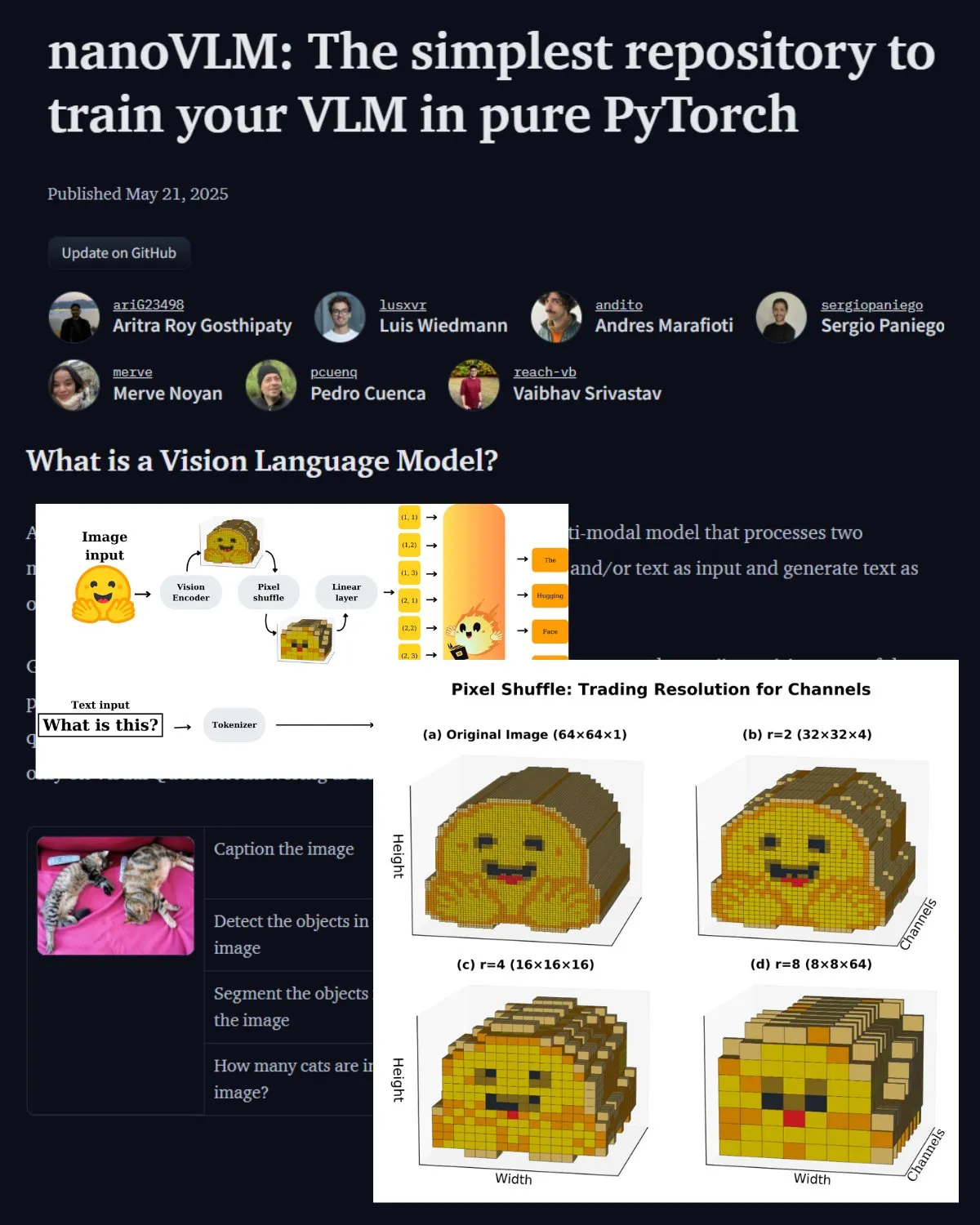

Hugging Face, nanoVLM topluluk laboratuvarını tanıtan önemli bir VLM blog yazısı yayınladı: Hugging Face, Görsel Dil Modelleri (VLM) hakkında bir blog yazısı yayınladı. İçerik, VLM temellerini, mimarilerini ve kendi hafif VLM’nizi nasıl eğiteceğinizi kapsıyor. Aynı zamanda, VLM’leri ince ayarlamak için açık kaynaklı bir depo olan nanoVLM’yi tanıtıyor. nanoVLM, geliştiricilerin VLM araştırmalarını keşfetmelerine ve katkıda bulunmalarına yardımcı olmak amacıyla bir görsel dil araştırma topluluk laboratuvarına dönüştü. (Kaynak: _akhaliq, huggingface)

Serrano Academy, LLM takviyeli öğrenme ile ince ayar üzerine video eğitim serisi yayınladı: Serrano Academy, takviyeli öğrenme kullanarak LLM’lerin ince ayarlanması ve eğitimi hakkında bir dizi video eğitimi tamamladı ve yayınladı. İçerik, Derin Takviyeli Öğrenme (Deep Reinforcement Learning), RLHF (Reinforcement Learning from Human Feedback), PPO (Proximal Policy Optimization), DPO (Direct Preference Optimization), GRPO (Group Relative Policy Optimization) ve KL Iraksaması (KL Divergence) gibi temel kavramları ve teknikleri kapsıyor. (Kaynak: SerranoAcademy)

Makale, büyük dil modellerindeki “boş katmanlar” olgusunu inceliyor: Bir araştırma, komutla ayarlanmış büyük dil modellerinin çıkarım sürecinde tüm katmanların etkinleştirilmediği olgusunu inceledi ve etkinleştirilmeyen katmanları “boş katmanlar” (Voids) olarak adlandırdı. Araştırma, istem işleme ve yanıt oluşturma aşamalarındaki etkin katmanları izlemek için L2 uyarlanabilir hesaplama (LAC) yöntemini kullandı ve farklı aşamalarda farklı katmanların etkinleştirildiğini buldu. Deneyler, MMLU gibi benchmark testlerinde, Qwen2.5-7B-Instruct’teki boş katmanları atlamanın (yalnızca %30 katman kullanarak) performansı artırabileceğini gösterdi; bu da katmanların çoğunu seçici olarak atlamanın belirli görevler için faydalı olabileceğine işaret ediyor. (Kaynak: HuggingFace Daily Papers)

Araştırma, “Yumuşak Düşünme”yi öneriyor: Sürekli kavramsal uzayda LLM çıkarım potansiyelinin kilidini açmak: “Soft Thinking” adlı bir makale, sürekli kavramsal uzayda yumuşak, soyut kavramsal belirteçler üreterek insan benzeri “yumuşak” çıkarımı simüle etmek için eğitimsiz bir yöntem öneriyor. Bu kavramsal belirteçler, belirteç gömmelerinin olasılıksal ağırlıklı karışımından oluşur ve ilgili ayrık belirteçlerden birden fazla anlamı kapsayarak örtük olarak birden fazla çıkarım yolunu keşfedebilir. Deneyler, bu yöntemin matematik ve kodlama benchmark’larında pass@1 doğruluğunu artırdığını, aynı zamanda belirteç kullanımını azalttığını ve çıktının yorumlanabilirliğini koruduğunu göstermektedir. (Kaynak: HuggingFace Daily Papers)

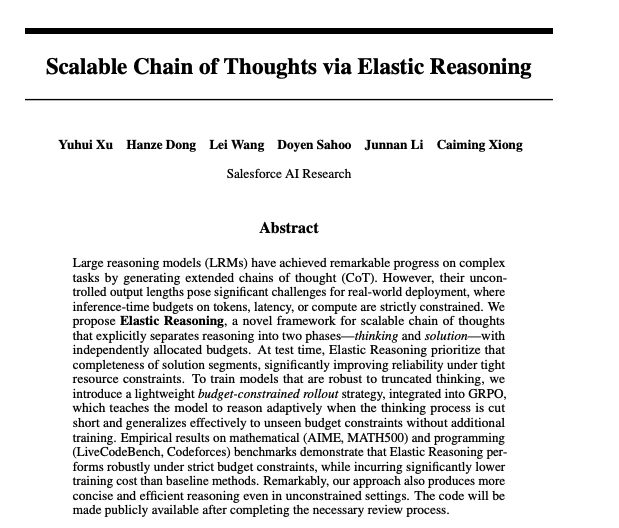

Makale, esnek çıkarım yoluyla ölçeklenebilir düşünce zincirlerini tartışıyor: Salesforce araştırmacıları, Esnek Çıkarım (Elastic Reasoning) yoluyla ölçeklenebilir düşünce zincirleri elde etme yöntemini önerdi. Bu araştırma, büyük dil modellerinin karmaşık çıkarım görevlerini işlerken uzun düşünce zincirlerini nasıl etkili bir şekilde oluşturup yöneteceğini ve böylece çıkarımın doğruluğunu ve verimliliğini artıracağını ele almayı amaçlıyor. İlgili modeller ve kodlar Hugging Face’te yayınlandı. (Kaynak: _akhaliq)

Makale araştırması: Yapay zeka modelleri hasta bir çocuğu kurtarmak için yalan söyler mi?: LitmusValues adlı bir araştırma, yapay zeka modellerinin bir dizi yapay zeka değer kategorisindeki önceliklerini ortaya çıkarmayı amaçlayan bir değerlendirme süreci oluşturdu. AIRiskDilemmas’ı (yapay zeka güvenlik riskleriyle ilgili senaryoları içeren bir ikilem koleksiyonu) toplayarak, araştırmacılar yapay zeka modellerinin farklı değer çatışmalarındaki seçimlerini ölçtüler, böylece değer önceliklerini tahmin ettiler ve potansiyel riskleri belirlediler. Araştırma, LitmusValues’ta tanımlanan değerlerin (bakım dahil) AIRiskDilemmas’ta görülen riskli davranışları ve HarmBench’te görülmeyen riskli davranışları tahmin edebileceğini göstermektedir. (Kaynak: HuggingFace Daily Papers)

Makale, değer tabanlı takviyeli öğrenme (VARD) yoluyla difüzyon modellerinin verimli bir şekilde ince ayarlanmasını araştırıyor: Difüzyon modelleri üretim görevlerinde güçlü performans gösterse de, belirli özelliklere göre ince ayar yapmak hala zorluklar içermektedir. Mevcut takviyeli öğrenme yöntemleri kararlılık, verimlilik ve farklılaştırılamayan ödüllerin işlenmesi konularında eksikliklere sahiptir. VARD (Value-based Reinforced Diffusion), önce ara durumlardan beklenen ödülü tahmin eden bir değer fonksiyonu öğrenmeyi, ardından bu değer fonksiyonunu ve KL düzenlemesini kullanarak tüm üretim süreci boyunca yoğun denetim sağlamayı önermektedir. Deneyler, bu yöntemin yörünge yönlendirmesini iyileştirdiğini, eğitim verimliliğini artırdığını ve RL uygulamalarını karmaşık farklılaştırılamayan ödül fonksiyonlarını optimize eden difüzyon modellerine genişlettiğini kanıtlamaktadır. (Kaynak: HuggingFace Daily Papers)

💼 İş Dünyası

LMArena.ai (eski LMSYS.org) 100 milyon dolarlık tohum turu finansmanı aldı, a16z ve Kaliforniya Üniversitesi Yatırım Şirketi liderliğinde: Yapay zeka model değerlendirme platformu LMArena.ai (eski adıyla LMSYS.org), Andreessen Horowitz (a16z) ve Kaliforniya Üniversitesi Yatırım Şirketi (UC Investments) liderliğinde 100 milyon dolarlık tohum turu finansmanını tamamladığını duyurdu. Şirket, dünya genelinde yapay zeka modellerinin gerçek kullanıcı sorgularındaki performansını anlamaya ve geliştirmeye yardımcı olmak için tarafsız, açık ve topluluk odaklı bir platform oluşturmaya kendini adamıştır. Finansman sonrası şirketin değerlemesi 600 milyon dolara ulaştı. (Kaynak: janonacct, lmarena_ai, scaling01, _akhaliq, ClementDelangue)

ABD hükümeti, Suudi Arabistan ve BAE’ye milyarlarca dolarlık yapay zeka teknolojisi ve hizmeti satacağını duyurdu: ABD hükümeti, Suudi Arabistan ve Birleşik Arap Emirlikleri ile milyarlarca dolar değerinde yapay zeka teknolojisi ve hizmeti satışı konusunda anlaşmaya vardığını duyurdu. Katılımcı şirketler arasında AMD, Nvidia, Amazon, Google, IBM, Oracle ve Qualcomm bulunuyor. Nvidia, Suudi Humain şirketine 18.000 adet GB300 yapay zeka çipi ve ardından on binlerce GPU sağlayacak; AMD ve Humain, yapay zeka veri merkezi kurmak için ortaklaşa 10 milyar dolar yatırım yapacak. Bu hamle, ABD’nin Orta Doğu’daki yapay zeka etkisini güçlendirmeyi ve iki ülkenin ekonomilerini çeşitlendirmesine yardımcı olmayı amaçlıyor. (Kaynak: DeepLearning.AI Blog)

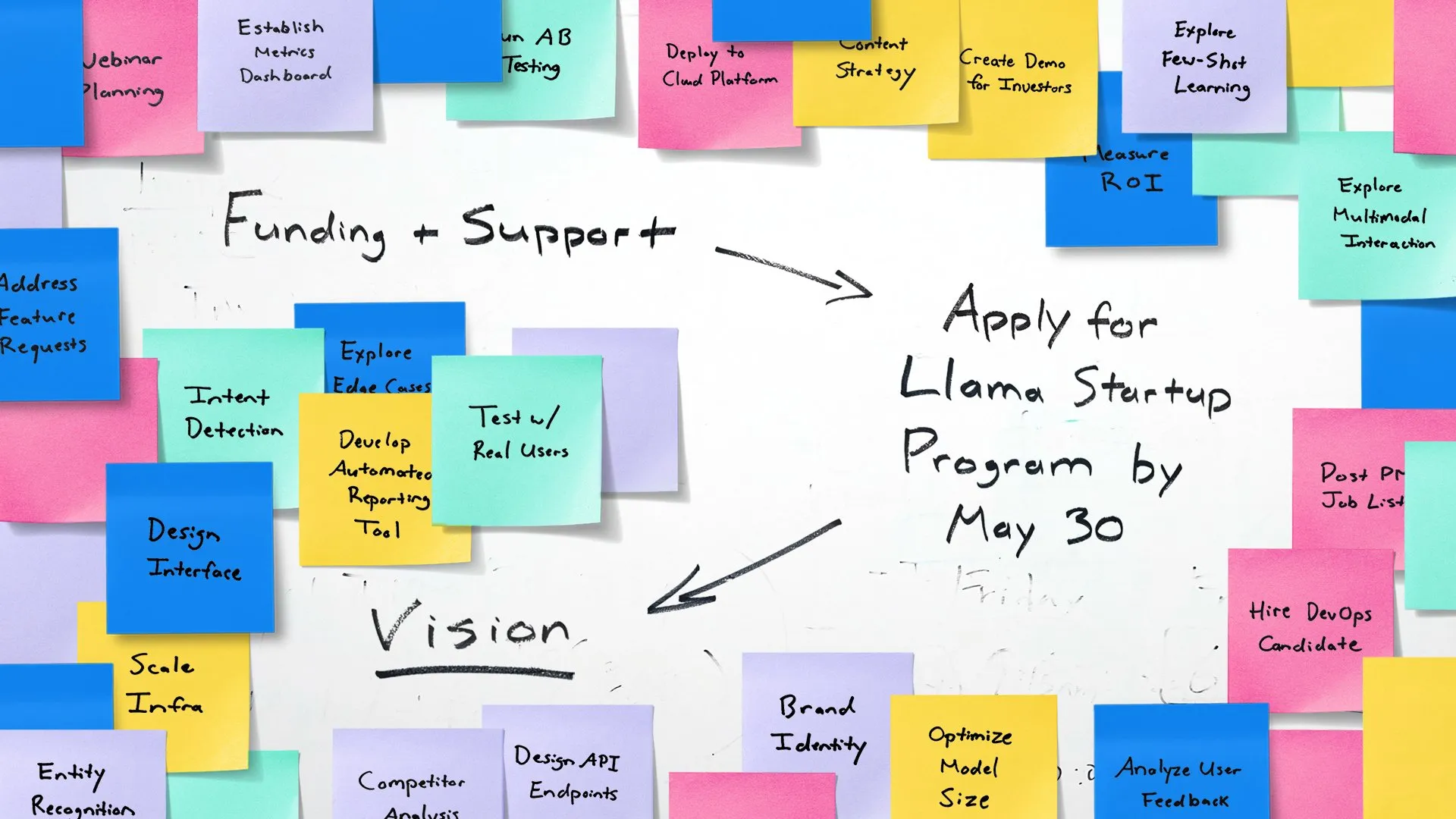

Meta, erken aşama yapay zeka girişimlerini güçlendirmek için Llama Girişim Programı’nı başlattı: Meta, ABD’deki erken aşama girişimlerin (finansman tutarı 10 milyon doların altında, en az bir geliştiricisi olan) Llama modellerini kullanarak üretken yapay zeka uygulamalarında yenilik yapmalarını desteklemek amacıyla Llama Girişim Programı’nı (Llama Startup Program) başlattığını duyurdu. Program, bulut kaynakları geri ödemesi, Llama uzmanlarından teknik destek ve topluluk kaynakları sunuyor. Başvuru son tarihi 30 Mayıs 2025, Pasifik Saati ile 18:00. (Kaynak: AIatMeta)

🌟 Topluluk

Google I/O konferansı büyük yankı uyandırdı: Yapay zekanın kapsamlı entegrasyonu ve gelecek beklentileri: Google I/O konferansında Gemini serisi modeller, Veo 3 video üretimi, Imagen 4 görüntü üretimi, yapay zeka arama modu gibi çok sayıda yapay zeka ile ilgili ürün ve güncelleme duyuruldu ve bu durum toplulukta geniş çaplı tartışmalara yol açtı. Birçok yorumcu, Google’ın yapay zeka uygulama düzeyinde güçlü bir yetenek sergilediğini, özellikle de yapay zekayı mevcut ürün ekosistemine sorunsuz bir şekilde entegre etme stratejisinin dikkat çekici olduğunu belirtti. Aynı zamanda, yapay zeka tarafından üretilen içeriğin gerçekliği, yapay zeka etiği ve AGI’nin gelecekteki yolu gibi konular da tartışmaların odak noktası oldu. (Kaynak: rowancheung, dotey, karminski3, GoogleDeepMind, natolambert)

Yapay zeka donanımı yeni odak noktası haline geldi, OpenAI ve Jony Ive işbirliği dikkat çekiyor: OpenAI’nin Jony Ive’nin yapay zeka donanım şirketi io’yu satın alması ve Google’ın I/O konferansında sergilediği Android XR akıllı gözlük prototipi, toplulukta yapay zeka donanımının geleceği hakkındaki tartışmaları alevlendirdi. Sam Altman ve Jony Ive’nin işbirliği, yeni nesil yapay zeka destekli kişisel bilgi işlem cihazları yaratmayı amaçlayan bir adım olarak görülüyor ve mevcut cep telefonu ve bilgisayar etkileşim biçimlerini kökten değiştirebilir. Topluluk, yapay zeka tabanlı donanımın devrim niteliğinde bir deneyim getirmesini bekliyor ancak aynı zamanda biçimi, işlevleri ve pazar kabulü konusunda da endişeler taşıyor. (Kaynak: dotey, sama, dotey, swyx)

Yazılım geliştirmede yapay zekanın rolü ve riskleri tartışılıyor: Mistral AI’nin kodlama ajanları için özel olarak tasarladığı Devstral modelini yayınlaması ve OpenAI’nin Codex’i güncellemesi, yazılım geliştirmede yapay zekanın kullanımıyla ilgili tartışmaları başlattı. Topluluk, yapay zeka programlama araçlarının gerçek yeteneklerini, üretilen kodun kalitesini ve güvenliğini merak ediyor. Özellikle, yapay zeka tarafından üretilen kodun var olmayan “hayali paketlere” başvurabileceğini ve bunun tedarik zinciri güvenlik riskleri oluşturabileceğini belirten araştırmalar, geliştiricilerin yapay zeka tarafından üretilen kodu ve bağımlılıkları dikkatlice doğrulaması gerektiğini hatırlatıyor. (Kaynak: MistralAI, DeepLearning.AI Blog, qtnx_)

Yapay zeka model değerlendirmesi ve benchmark testleri tartışmaları kızışmaya devam ediyor: LMArena.ai’nin büyük bir finansman alması ve çeşitli yeni modellerin benchmark testlerindeki performansı, yapay zeka model değerlendirmesini toplulukta sıcak bir tartışma konusu haline getirdi. Kullanıcılar, farklı modellerin belirli görevlerdeki (kodlama, matematik, genel bilgi sorgulama, duygusal anlama gibi) gerçek yeteneklerini ve mevcut değerlendirme sistemlerinin güvenilirliğini ve sınırlamalarını merak ediyor. Örneğin, Tencent tarafından yayınlanan SAGE duygusal zeka değerlendirme çerçevesi, yapay zeka modellerine “duygusal zeka” açısından yeni bir değerlendirme boyutu sunmaya çalışıyor. (Kaynak: lmarena_ai, 36氪, natolambert)

Avrupa teknoloji sektörünün gelişimindeki gecikme üzerine düşünceler, Yann LeCun “vatanseverlik eksikliği”nin ana neden olduğu tartışmasını paylaştı: Wall Street Journal’ın Avrupa teknoloji sahnesinin ABD ve Çin’den çok daha küçük olduğuna dair makalesi tartışmalara yol açtı, Yann LeCun, Arnaud Bertrand’ın yorumunu paylaştı. Bertrand, Avrupa teknolojisinin geri kalmasının temel nedeninin “vatanseverlik” ruhu eksikliği olduğunu, Avrupa medyasının ve elitlerinin Amerikan girişimlerini övmeye, yerel yenilikleri ise görmezden gelmeye eğilimli olduğunu, bunun da yerel şirketlerin erken destek ve pazar tanınırlığı elde etmesini zorlaştırdığını savundu. Kendi kurduğu HouseTrip deneyimini örnek göstererek, Avrupa’da yerel yeniliğe yönelik özgüven ve destek ortamının eksik olduğunu belirtti. (Kaynak: ylecun)

💡 Diğer

Yapay zekanın enerji tüketimi sorunu dikkat çekiyor: MIT Technology Review, yapay zeka teknolojisinin hızla gelişmesinin getirdiği enerji tüketimi sorununu ve bunun iklim üzerindeki etkilerini tartışmak üzere bir yuvarlak masa toplantısı düzenledi. Yapay zeka modellerinin ölçeği ve uygulama alanları genişledikçe, ihtiyaç duydukları elektrik ve hesaplama kaynakları hızla artıyor ve veri merkezlerinin enerji talebi yeni bir odak noktası haline geliyor. Tartışma, tek bir yapay zeka sorgusunun enerji tüketimi, yapay zekanın genel enerji ayak izi ve bu zorlukla nasıl başa çıkılacağı konularına odaklanıyor. (Kaynak: MIT Technology Review, madiator)

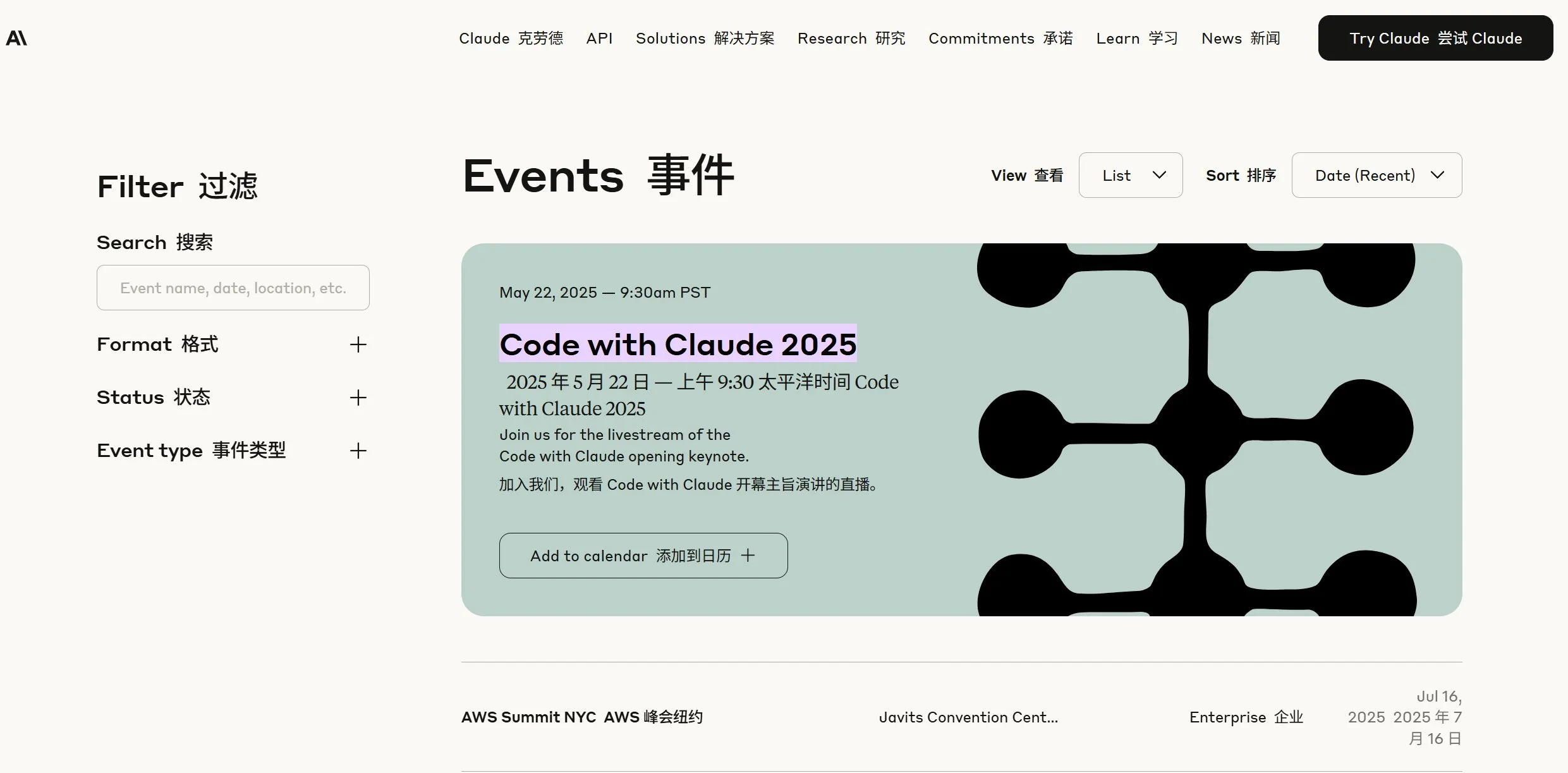

Anthropic yeni bir duyuru yapacağını ima etti, topluluk Claude 4’ün yayınlanabileceğini tahmin ediyor: Anthropic şirketi, Pasifik Saati ile 22 Mayıs sabah 9:30’da (Pekin saati ile 23 Mayıs 00:00) bir canlı yayın yapacağını duyurdu ve bu durum toplulukta Claude’un yeni nesil modelinin (muhtemelen Claude 4) yayınlanabileceği yönünde tahminlere yol açtı. Son zamanlarda OpenAI ve Google’ın art arda önemli güncellemeler yayınlaması göz önüne alındığında, Anthropic’in bu hamlesi büyük ilgi görüyor. (Kaynak: AnthropicAI, dotey, karminski3, scaling01, Reddit r/ClaudeAI)

Yapay zeka ve XR teknolojisi birleşiyor, Google Android XR akıllı gözlük prototipini sergiledi: Google, I/O konferansında Android XR akıllı gözlük prototipini sergiledi ve yapay zeka ile derin entegrasyonunu vurguladı. Cihaz, birinci şahıs bakış açısıyla akıllı yardım ve temassız yardım özelliklerini destekliyor. Kullanıcılar, doğal dil aracılığıyla cihazla etkileşim kurarak bilgi sorgulama, takvim yönetimi, gerçek zamanlı navigasyon gibi işlemleri gerçekleştirebiliyor. Bu, yapay zekanın yeni nesil XR cihazlarının temel etkileşim ve işlev itici gücü olacağını ve artırılmış gerçeklik ortamındaki kullanıcı deneyimini geliştireceğini gösteriyor. (Kaynak: dotey, 36氪)