Anahtar Kelimeler:GPT-5, AI çıkarım yeteneği, AlphaEvolve, OpenAI Operatörü, Mistral AI, Test sırasında hesaplama ve düşünce zinciri, AI ile otonom kod optimizasyonu, Çok modlu AI modelleri, AI ile iş arama otomasyonu, Yerel LLM ince ayarı

🔥 Odak Noktası

OpenAI Gelecek Planlarını Açıkladı: GPT-5 Mevcut Araçları Entegre Ederek All-in-One Bir Deneyim Sunacak: OpenAI Araştırma Başkan Yardımcısı Jerry Tworek, Reddit’teki bir AMA etkinliğinde, yeni nesil temel model GPT-5’in temel hedefinin mevcut model yeteneklerini geliştirmek ve model değiştirme zahmetini azaltmak olduğunu açıkladı. Bu amaçla OpenAI, Codex (programlama), Operator (bilgisayar görevlerini yürütme), Deep Research (derinlemesine araştırma) ve Memory (hafıza fonksiyonu) gibi mevcut araçları GPT-5’e entegre ederek bütünleşik bir deneyim sağlamayı planlıyor. Ekip üyeleri ayrıca, Codex’in başlangıçta mühendislerin bir hobi projesi olduğunu, dahili kullanımın programlama verimliliğini yaklaşık 3 kat artırdığını ve isteğe bağlı ödeme dahil esnek fiyatlandırma seçeneklerini araştırdıklarını paylaştı. (Kaynak: WeChat)

Yapay Zeka Çıkarım Yeteneğinde Yeni Bir Boyut: Test Zamanı Hesaplama ve Düşünce Zinciri: Pekin Üniversitesi mezunu, eski OpenAI Uygulamalı Yapay Zeka Araştırma Lideri Lilian Weng, son on bin kelimelik uzun makalesi “Why We Think”te, “test-time compute” (test zamanı hesaplama) ve “Chain-of-Thought (CoT)” (Düşünce Zinciri) gibi stratejilerle büyük dil modellerinin çıkarım yeteneklerinin nasıl geliştirilebileceğini derinlemesine inceliyor. Makale, psikolojideki ikili sistem teorisi, hesaplama kaynakları perspektifi, gizli değişken modellemesi gibi çeşitli açılardan modelin “daha uzun düşünmesini” sağlamanın rasyonelliğini açıklıyor ve paralel örnekleme, sıralı revizyon, pekiştirmeli öğrenme ve harici araç kullanımı gibi kilit teknolojilerin model çıkarım performansını artırmadaki araştırma ilerlemelerini gözden geçiriyor. Weng, bu yöntemlerle modelin çıkarım sırasında daha fazla hesaplama kaynağı ayırabileceğini, insanın derin düşünme sürecini simüle edebileceğini ve böylece karmaşık görevlerde daha iyi performans gösterebileceğini vurguluyor ve gelecekte sadık çıkarım, ödül kırma, denetimsiz kendi kendine düzeltme gibi alanlardaki araştırma yönlerine işaret ediyor. (Kaynak: WeChat, WeChat)

Google, AlphaEvolve’u Duyurdu: Yapay Zeka Kendi Kodunu Yazarak Algoritmaları Optimize Ediyor, Hesaplama Maliyetlerinden Büyük Tasarruf Sağlıyor: Google, kendi kendine kod yazıp optimize edebilen yapay zeka sistemi AlphaEvolve’u tanıttı. Sistem, AlphaFold gibi projelerde şimdiden büyük bir potansiyel sergiledi. AlphaEvolve, evrimsel algoritmalar aracılığıyla daha iyi algoritma uygulamalarını arıyor; örneğin, AlphaFold’un protein katlama algoritmasında yeni bir dikkat mekanizması keşfederek hesaplama maliyetini %25 azalttı, bu da milyonlarca dolarlık hesaplama kaynağından tasarruf anlamına geliyor. Bu atılım, yapay zekanın bilimsel keşif ve algoritma optimizasyonu alanında önemli bir adım attığını gösteriyor ve gelecekte daha karmaşık hesaplama problemlerinde maliyet düşürme ve verimlilik artışı sağlama potansiyeline sahip. (Kaynak: Reddit r/ArtificialInteligence)

OpenAI İtiraf Etti: Yapay Zeka Çıkarımına Yapılan Yatırım Performansla Doğru Orantılı, İnsan Yeteneklerini Ezmenin Anahtarı “Düşünme Süresi”: OpenAI araştırmacısı Noam Brown, bir tartışmada yapay zekanın “ön eğitim paradigmasından” “çıkarım paradigmasına” doğru kaydığını vurguladı. Ön eğitim, büyük miktarda veriyle bir sonraki kelimeyi tahmin eder ve maliyetlidir; çıkarım paradigması ise modelin cevap vermeden önce daha derinlemesine “düşünmesine” olanak tanır, maliyeti biraz daha yüksek olsa da cevap kalitesi önemli ölçüde artar. Örneğin, o1 modeli AIME matematik yarışmasında ve GPQA doktora düzeyindeki bilimsel sorularda GPT-4o’yu geride bırakırken, o3 modeli programlama yarışmalarında insanlığın en üst düzeyine ulaştı. Bu, çıkarım sırasında hesaplama kaynaklarına yapılan yatırımın (yani “düşünme süresinin”) artırılmasıyla, yapay zekanın karmaşık görevlerdeki performansının büyük bir sıçrama yapabileceğini ve hatta insanları aşabileceğini gösteriyor. (Kaynak: WeChat)

🎯 Eğilimler

Mistral AI 2025 Modeli Başarıları Dikkat Çekici, Birçok Model Üstün Performans Sergiliyor: Mistral AI, 2025’in ilk yarısında birçok önemli ilerleme kaydetti ve Codestral 25.01 (üst düzey FIM modeli), Mistral Small 3 & 3.1 (sınıfının en iyisi, çoklu modalite ve 130k bağlam desteği), Mistral Saba (kendisinden üç kat büyük modelleri geride bırakan performans), Mistral OCR (üst düzey OCR modeli) ve Mistral Medium 3 gibi birçok yüksek performanslı modeli piyasaya sürdü. Bu başarılar, Mistral AI’ın farklı model boyutları ve uygulama alanlarındaki güçlü Ar-Ge yeteneğini, özellikle kod üretimi, çoklu modalite işleme ve OCR teknolojilerindeki liderliğini gösteriyor. (Kaynak: qtnx_)

Claude Modelinde Son Dönemde Performans Dalgalanmaları, Kullanıcılar Bağlam İşleme ve Artifact Fonksiyonu Sorunlarını Bildiriyor: Reddit topluluğu kullanıcıları, Anthropic’in Claude modelinin (özellikle Opus 3) son zamanlarda uzun bağlam işleme, Artifact oluşturma kararlılığı ve giriş yapma ile çalışma süresi konularında sorunlar yaşadığını bildirdi. Belirli sorunlar arasında sohbetlerin az sayıda turdan sonra kesilmesi, Artifact fonksiyonunun tamamlanamaması veya boş dosyalar dışa aktarması yer alıyor. Anthropic durum sayfası, uzun bağlam isteklerinde artan hatalar ve birkaç kısa süreli hizmet kesintisi olduğunu doğruladı; bu durum Artifact fonksiyonunun kullanıma sunulması ve arka uç ayarlamalarıyla ilgili olabilir. Bazı kullanıcılar, doğrudan Markdown çıktısı isteyerek, ağı değiştirerek veya Claude 3.5 Sonnet kullanarak sorunları hafifletti. (Kaynak: Reddit r/ClaudeAI, qtnx_, Reddit r/ClaudeAI)

xAI, Grok Sistem İstemlerini Açıkladı, Mizahi ve Eleştirel Düşünme Tasarımını Ortaya Koydu: xAI şirketi, yapay zeka modeli Grok’un sistem istemlerini kamuoyuyla paylaştı. Bu istemler, Grok’un mizah anlayışına sahip, biraz asi ve eleştirel düşünme yeteneğine sahip bir yapay zeka asistanı olarak tasarlandığını ortaya koyuyor. İstemler, Grok’un didaktik cevaplardan kaçınması gerektiğini vurguluyor ve tartışmalı konularda kendine özgü “Grok tarzını” sergilemesini teşvik ediyor. Bu hamle, yapay zeka model davranış tasarımının şeffaflığını artırırken, dış dünyanın Grok’un benzersiz kişiliğinin kaynağını görmesini sağladı. (Kaynak: Reddit r/artificial)

Meta, OpenRouter’da Llama 3.3 8B Instruct Modelini Test Ediyor Olabilir: Meta, OpenRouter platformunda Llama 3.3 8B Instruct modelini test ediyor olabilir. Bu model, Llama 3.3 70B’nin hafif ve hızlı yanıt veren bir versiyonu olarak tanımlanıyor, 128.000 bağlam penceresine sahip ve OpenRouter’da ücretsiz olarak görünüyor. Bazı kullanıcılar test ettikten sonra çıktılarının 8B 3.1 veya 3.3 70B versiyonlarına göre biraz sönük olduğunu düşünüyor. Bu hamle, Meta’nın farklı ölçeklerdeki modellerin dağıtımını ve uygulama senaryolarını araştırdığı anlamına gelebilir. (Kaynak: Reddit r/LocalLLaMA)

Yapay Zekanın F1 Yarışlarındaki Tartışmalı Kararları Tartışma Yarattı: Yapay zekanın F1 yarışlarında verdiği tartışmalı bir kararla ilgili bir tartışma, insanların yapay zekanın spor müsabakalarındaki uygulamalarına olan ilgisini çekti. Ayrıntılar net olmasa da, bu genellikle yapay zeka hakem sistemlerinin yüksek hızlı, karmaşık durumlardaki kararlarının doğruluğu, tarafsızlığı ve insan hakemlerle yapay zeka sistemlerinin nasıl işbirliği yapacağı gibi konuları içeriyor. (Kaynak: Ronald_vanLoon)

Çin’in İlk Uçak Gemisi Tarzı İnsansız Hava Aracı “Jiutian” Haziran’da İlk Uçuşunu Planlıyor: Çin, ilk havadan insansız hava aracı ana gemisi “Jiutian” SS-UAV’nin Haziran ayında ilk uçuşunu yapmayı planlıyor. Bu insansız hava aracı 15.000 metre yükseklikte seyir yapabiliyor, 100’den fazla küçük insansız hava aracı veya 1000 kilogram füze taşıyabiliyor ve 7000 kilometre menzile sahip. Bu haber, Çin’in askeri insansız hava aracı teknolojisindeki gelişmelerine dikkat çekti. (Kaynak: menhguin)

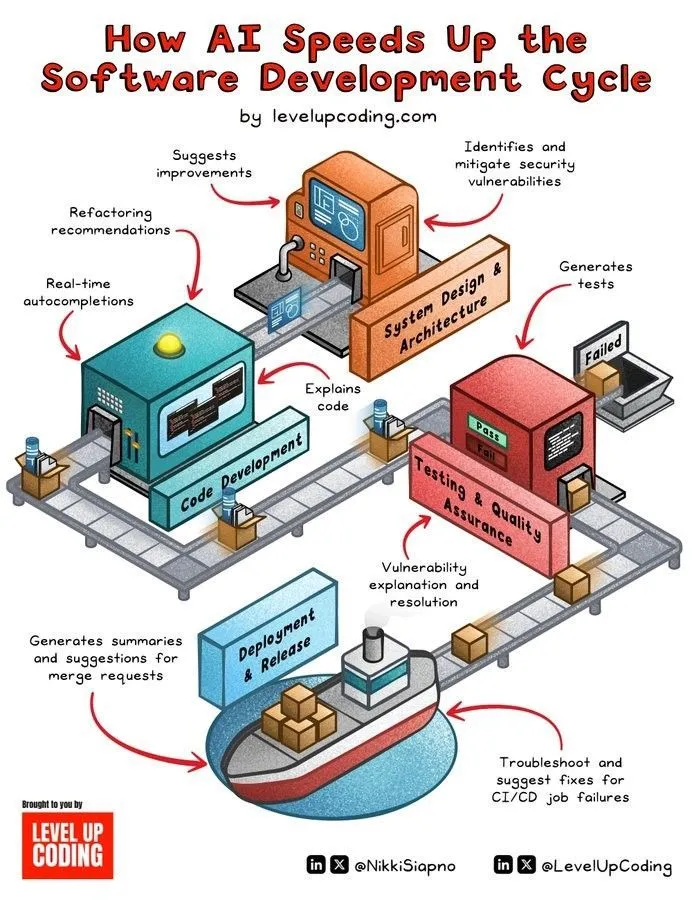

Yapay Zeka Destekli Yazılım Geliştirme Döngüsü Hızlanıyor: Yapay zeka teknolojisi, kod üretimi, test, hata ayıklama ve dokümantasyon yazımı gibi aşamaları otomatikleştirerek yazılım geliştirme yaşam döngüsünü önemli ölçüde hızlandırıyor. Yapay zeka araçları, geliştiricilerin verimliliğini artırmasına, tekrarlayan işleri azaltmasına ve potansiyel hataları tespit etmesine yardımcı olarak ürünün piyasaya sürülme süresini kısaltıyor. (Kaynak: Ronald_vanLoon)

İnsan Beynine Benzer Mikro Teknoloji, İnsansı Robotlara Gerçek Zamanlı Algılama ve Düşünme Yeteneği Kazandırıyor: İnsan beyninin yapısını taklit eden bir mikro teknoloji, insansı robotlara gerçek zamanlı görsel algılama ve düşünme yeteneği kazandırmak amacıyla geliştiriliyor. Bu teknoloji, robotların karmaşık ortamlarda daha hızlı ve daha akıllı tepkiler vermesini sağlamak için nöromorfik hesaplama veya verimli yapay zeka çipleri tasarımını içerebilir. (Kaynak: Ronald_vanLoon)

Fourier Intelligence, Kendi Geliştirdiği İnsansı Robot Fourier GR-1’i Tanıttı: Fourier Intelligence (Fourier Robots), kendi geliştirdiği insansı robot GR-1’i tanıttı. Robotun tasarımı, daha esnek ve doğal hareket kabiliyeti sağlamak amacıyla gelişmiş hareket kontrolüne ve yüksek derecede biyonik gövde yapısına odaklanıyor ve Çin’in insansı robot alanındaki ilerlemesini gösteriyor. (Kaynak: Ronald_vanLoon)

Unitree G1 Biyonik Robotunun Çevikliği Artırıldı: Unitree şirketi, G1 biyonik robotunun çevikliği artırılmış bir versiyonunu sergiledi. Bu genellikle robotun hareket kontrolü, denge yeteneği, çevreye uyum sağlama gibi konularda geliştirildiği anlamına gelir, böylece görevleri daha esnek bir şekilde yerine getirebilir ve karmaşık arazilerle başa çıkabilir. (Kaynak: Ronald_vanLoon)

Çin İnsansı Robotları Kalite Kontrol Görevlerini Yerine Getiriyor: Çin’in insansı robotları kalite kontrol görevlerini yerine getirmek için kullanılmaya başlandı. Bu, insansı robotların endüstriyel otomasyon alanındaki uygulamalarının giderek genişlediğini, esnekliklerini ve algılama yeteneklerini kullanarak tekrarlayan, yüksek hassasiyet gerektiren denetim işlerinde insan gücünün yerini aldığını veya desteklediğini gösteriyor. (Kaynak: Ronald_vanLoon)

Nano Robotlar “Gizli Silahlar” Taşıyarak Kanser Hücrelerini Öldürüyor: Tıbbi teknolojideki yeni bir gelişme, nano robotların “gizli silahlar” taşıyarak kanser hücrelerini hassas bir şekilde hedefleyip öldürebildiğini gösteriyor. Bu teknoloji, nano robotların küçük boyutlarını ve kontrol edilebilirliğini kullanarak daha hassas ve daha az yan etkili kanser tedavi çözümleri sunma potansiyeline sahip. (Kaynak: Ronald_vanLoon)

Gizliliği Artırıcı Teknolojilerin Modern İşletmeler İçin Önemi Giderek Artıyor: Veri gizliliği düzenlemelerinin sıkılaşması ve kullanıcıların kişisel bilgilerin korunmasına yönelik farkındalığının artmasıyla birlikte, gizliliği artırıcı teknolojiler (PET’ler) modern işletmeler için giderek daha önemli hale geliyor. Federal öğrenme, homomorfik şifreleme gibi bu teknolojiler, veri gizliliğini korurken veri analizi ve değer elde etmeyi mümkün kılarak işletmelerin uyumlu bir şekilde gelişmesine yardımcı oluyor. (Kaynak: Ronald_vanLoon)

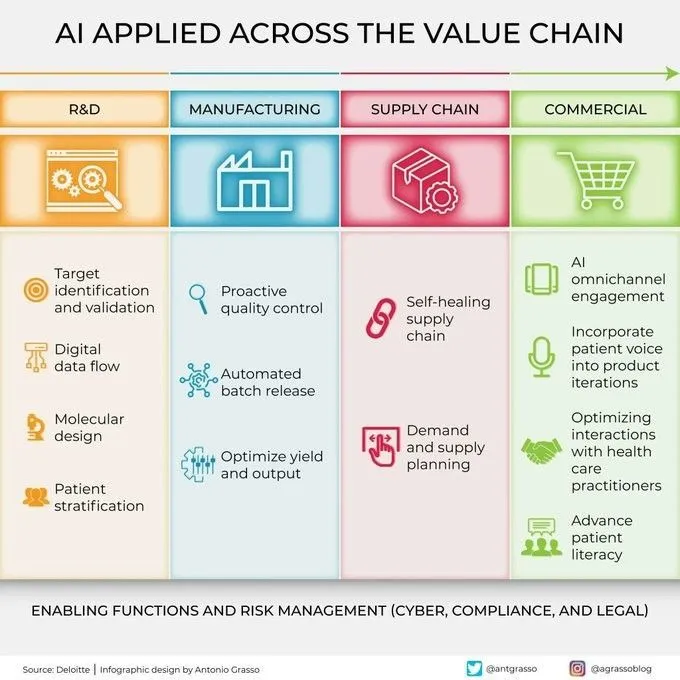

Yapay Zeka Değer Zincirinin Çeşitli Aşamalarında Giderek Yaygınlaşıyor: Yapay zeka teknolojisi, Ar-Ge, üretim, pazarlama, satış ve satış sonrası hizmetler dahil olmak üzere kurumsal değer zincirinin çeşitli aşamalarında yaygın olarak kullanılıyor. Veri analizi, tahmin modellemesi, otomatikleştirilmiş süreçler gibi yollarla yapay zeka, işletmelerin operasyonel verimliliği optimize etmesine, müşteri deneyimini iyileştirmesine ve yeni ticari değerler yaratmasına yardımcı oluyor. (Kaynak: Ronald_vanLoon)

🧰 Araçlar

KernelSU: Çekirdek Tabanlı Android Root Çözümü: KernelSU, Android cihazlar için tasarlanmış çekirdek tabanlı bir Root çözümüdür. Çekirdek düzeyinde su ve Root erişim yönetimi sunar ve OverlayFS tabanlı bir modül sistemine ve uygulama yapılandırma dosyası özelliklerine sahiptir, cihaz izinlerini daha derinlemesine kontrol etmeyi amaçlar. Proje, Android GKI 2.0 cihazlarını (çekirdek 5.10+) destekler, ayrıca eski çekirdek sürümleriyle de uyumludur (4.14+, manuel derleme gerektirir) ve WSA, ChromeOS ve konteynerize Android ortamlarını destekler. (Kaynak: GitHub Trending)

Sunshine: Moonlight ile Uyumlu, Kendi Kendine Barındırılan Oyun Akış Sunucusu: Sunshine, kullanıcıların PC oyun görüntülerini Moonlight uyumlu çeşitli cihazlara aktarmasına olanak tanıyan açık kaynaklı, kendi kendine barındırılan bir oyun akış sunucusu yazılımıdır. AMD, Intel ve Nvidia GPU’larının donanım kodlamasını destekler, ayrıca yazılım kodlama seçenekleri de sunar ve düşük gecikmeli bulut oyun deneyimi sağlamayı amaçlar. Kullanıcılar Web UI aracılığıyla yapılandırma ve istemci eşleştirmesi yapabilir. (Kaynak: GitHub Trending)

Tasmota: ESP8266/ESP32 Cihazları İçin Açık Kaynaklı Alternatif Firmware: Tasmota, ESP8266 ve ESP32 çipli akıllı cihazlar için tasarlanmış alternatif bir firmware’dir. Yapılandırma için kullanımı kolay bir Web kullanıcı arayüzü sunar, OTA çevrimiçi güncellemeyi destekler, zamanlayıcılar veya kurallarla otomasyon sağlar ve MQTT, HTTP, seri port veya KNX protokolleri aracılığıyla tam yerel kontrol sunarak cihazların genişletilebilirliğini ve özelleştirilebilirliğini artırır. (Kaynak: GitHub Trending)

Limbo: SQLite’ın Modern Rust Evrimi Projesi: Limbo projesi, Rust diliyle SQLite’ın modern bir evrimini oluşturmayı amaçlamaktadır. Linux’ta io_uring asenkron G/Ç’yi destekler, SQLite’ın SQL lehçesi, dosya formatı ve C API’si ile uyumludur ve JavaScript/WASM, Rust, Go, Python ve Java gibi diller için bağlamalar sunar. Gelecekte vektör arama, geliştirilmiş eşzamanlı yazma ve şema yönetimi gibi özellikleri entegre etmeyi planlamaktadır. (Kaynak: GitHub Trending)

Ventoy: Yeni Nesil Önyüklenebilir USB Çözümü: Ventoy, ISO, WIM, IMG, VHD(x), EFI gibi çeşitli formatlardaki imaj dosyalarından doğrudan önyükleme yapmak için önyüklenebilir USB bellekler oluşturmaya yarayan açık kaynaklı bir araçtır ve USB belleği tekrar tekrar biçimlendirme ihtiyacını ortadan kaldırır. Kullanıcıların yalnızca imaj dosyalarını USB belleğe kopyalaması yeterlidir, Ventoy otomatik olarak bir önyükleme menüsü oluşturur. Çeşitli işletim sistemlerini ve önyükleme modlarını (Legacy BIOS, UEFI) destekler ve MBR ile GPT bölümleriyle uyumludur. (Kaynak: GitHub Trending)

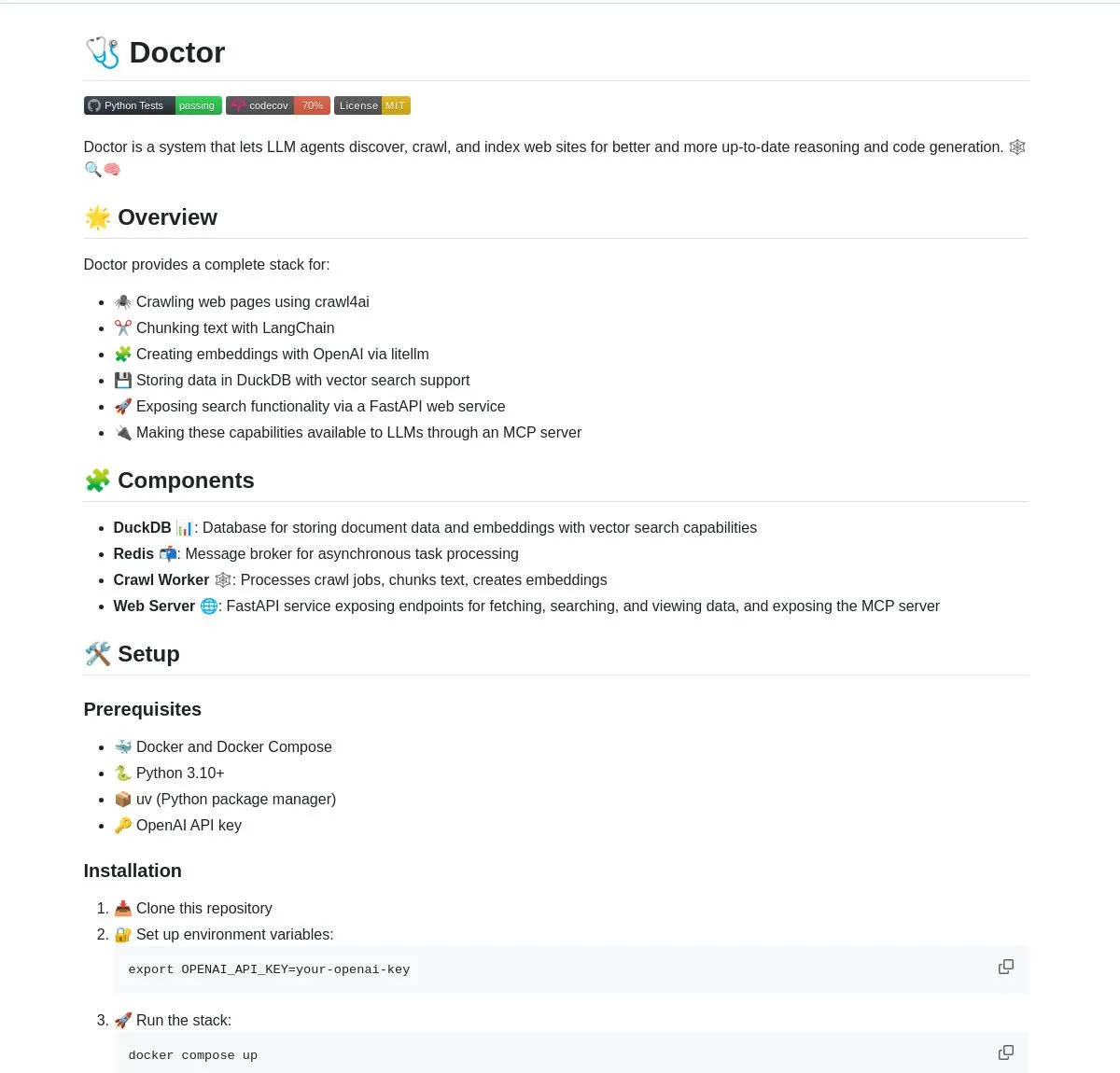

Doctor: LangChain Destekli LLM Akıllı Ajan Web Tarama ve Anlama Aracı: Doctor, LLM akıllı ajanlarının web içeriğini gerçek zamanlı olarak taramasına ve anlamasına yardımcı olan bir araçtır. Web sayfası işleme, vektör arama ve LangChain’in belge işleme yeteneklerini birleştirir ve FastAPI aracılığıyla hizmet sunar. Kullanıcılar, yapay zeka uygulamalarının bilgi edinme ve analiz yeteneklerini geliştirmek için Doctor’ı kullanabilir. (Kaynak: LangChainAI, Hacubu)

Deep Research Agent: Yerel Olarak Çalışan Gizlilik Odaklı Yapay Zeka Araştırma Ajanı: Herhangi bir konuyu araştırmak için yerel olarak çalışabilen, gizliliğe odaklanmış açık kaynaklı bir yapay zeka ajanı. İteratif araştırma iş akışını yönlendirmek için LangGraph’ı kullanır ve kullanıcılara verileri buluta yüklemeden güçlü bir yerel araştırma aracı sunar. (Kaynak: LangChainAI, Hacubu)

Akıllı Terminal Asistanı: Doğal Dilden Komut Satırına Dönüşüm Yapan Çoklu İşletim Sistemi Aracı: Doğal dil komutlarını işletim sistemleri arası terminal komutlarına dönüştürebilen akıllı bir terminal asistanı. Bu araç, LangGraph’ın çoklu ajan sistemine dayanarak oluşturulmuştur ve platformlar arası yürütme için A2A ve MCP protokollerini kullanır, komut satırı işlemlerini basitleştirmeyi ve kullanıcıların kullanım engelini düşürmeyi amaçlar. (Kaynak: LangChainAI)

Montelimar: Açık Kaynaklı Cihaz Üzeri OCR Araç Kutusu: Julien Blanchon, açık kaynaklı bir cihaz üzeri OCR (Optik Karakter Tanıma) araç kutusu olan Montelimar’ı yayınladı. Ekran görüntüsü almayı ve ekranın çeşitli bölümlerine OCR uygulamayı destekler, Nougat ve OCRS modelleriyle uyumludur, arka uçta sırasıyla Rust (OCRS) ve MLX (Nougat) kullanır. Araç, LaTeX, tablo, Markdown (Nougat aracılığıyla, daha yavaş) ve düz metin (OCRS aracılığıyla, daha hızlı) çıktısı verebilir ve geçmiş kaydı ile sistem genelinde kısayol tuşları özellikleri sunar. (Kaynak: awnihannun)

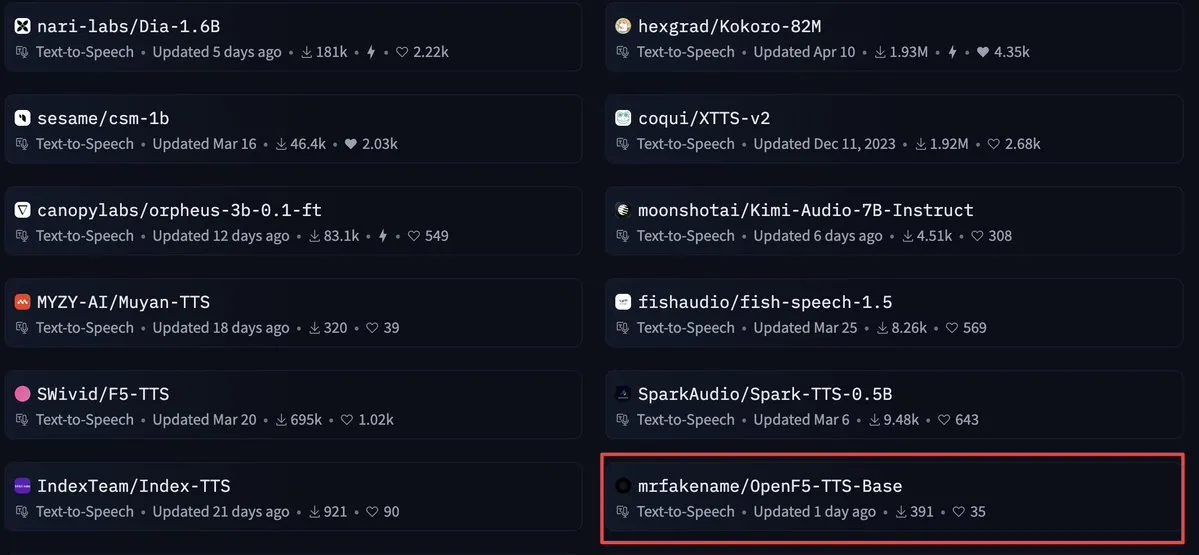

OpenF5 TTS: Apache 2.0 Lisanslı Ticari Metin Okuma Modeli: OpenF5 TTS, F5-TTS modeline dayanılarak yeniden eğitilmiş bir metin okuma modelidir, Apache 2.0 açık kaynak lisansına sahiptir ve ticari amaçlarla kullanılabilir. Bu model şu anda Hugging Face’in metin okuma modelleri arasında oldukça popülerdir ve geliştiricilere yüksek kaliteli ve ticari olarak kullanılabilir ses sentezi seçenekleri sunar. (Kaynak: ClementDelangue)

Tensor Slayer: Eğitim Gerektirmeden Model Performansını Doğrudan Artıran Araç: Tensor Slayer, ince ayar, veri kümesi, ek hesaplama maliyeti veya eğitim süresi gerektirmeden, doğrudan tensör yaması (direct tensor patching) yoluyla model performansını %25 artırdığını iddia eden yeni yayınlanmış bir araçtır. Bu kavram oldukça yıkıcıdır ve yapay zeka model iyileştirmesini demokratikleştirmeyi amaçlamaktadır. (Kaynak: TheZachMueller)

Photoshop, Yerel Bilgisayar Kullanım Ajanları (c/ua) ile Kodsuz İşlem Gerçekleştiriyor: Computer Use Agents (c/ua), kullanıcı istemleri, model seçimi, Docker ve uygun bir ajan döngüsü aracılığıyla Photoshop’ta kodsuz işlemlerin nasıl gerçekleştirilebileceğini gösteriyor. Bu, sıradan kullanıcıların karmaşık yazılımları kullanma engelini düşürmeyi ve yapay zeka ajanları aracılığıyla işlem akışlarını basitleştirmeyi amaçlıyor. (Kaynak: Reddit r/artificial)

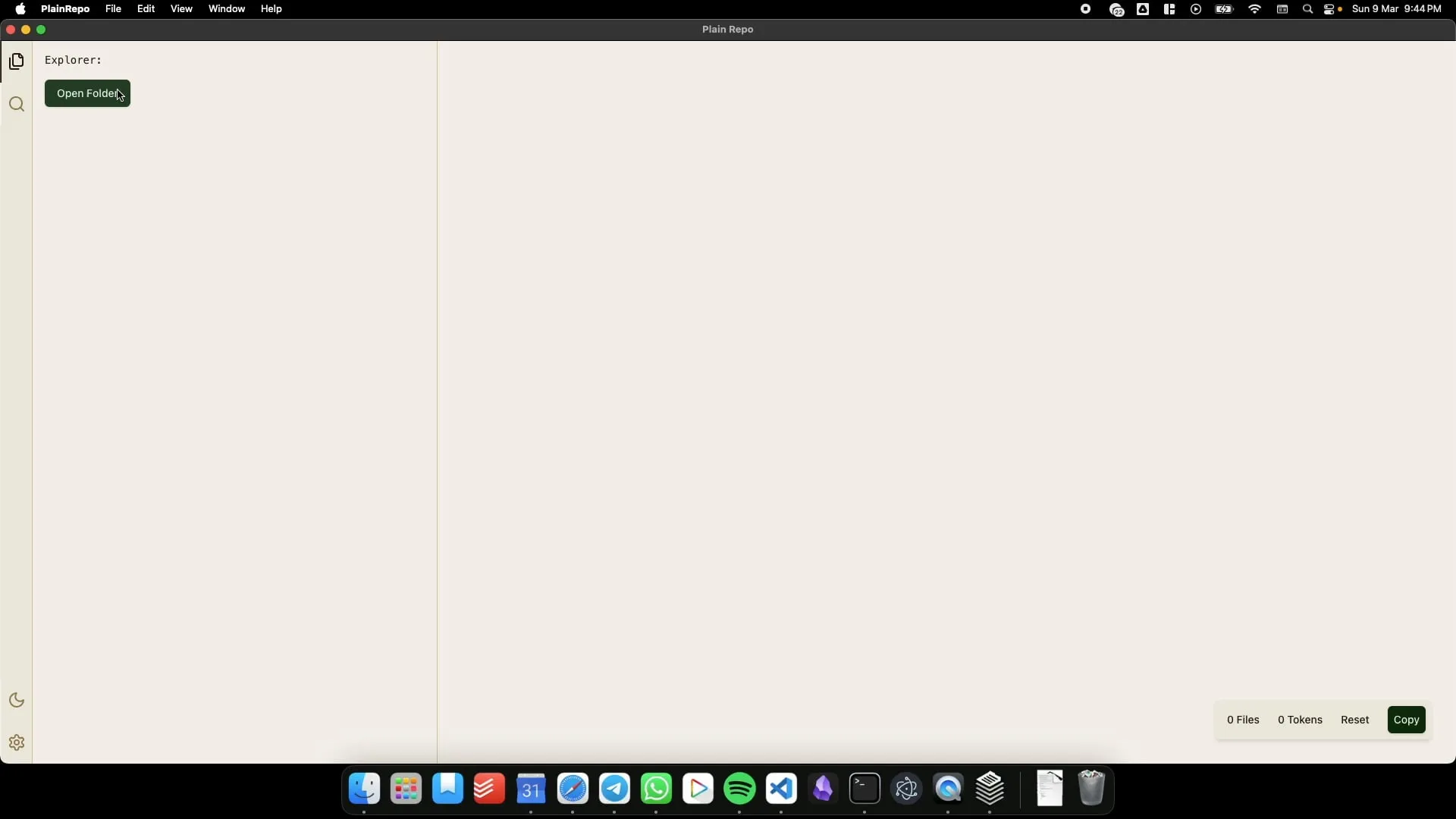

PlainRepo: LLM’lerin Bağlam Çıkarması İçin Büyük Kod/Metin Parçalarını Seçici Olarak Kopyalayan Çevrimdışı Uygulama: PlainRepo, kullanıcıların yerel LLM’lerin bağlam bilgisi çıkarması için büyük kod veya metin parçalarını seçici olarak kopyalamasına olanak tanıyan ücretsiz, açık kaynaklı bir çevrimdışı uygulamadır. Bu, ağ bağlantısı olmayan ortamlarda veya gizlilik endişeleri nedeniyle yerel LLM kullanması gereken kullanıcılar için çok kullanışlıdır. (Kaynak: Reddit r/LocalLLaMA, Plus-Garbage-9710)

M0D.AI: Kullanıcı ve Yapay Zekanın Beş Aylık İşbirliğiyle Oluşturulan Kişiselleştirilmiş Yapay Zeka Etkileşim Kontrol Çerçevesi: Kullanıcı James O’Kelly, yapay zeka (Gemini, ChatGPT gibi) ile beş ay süren ve yaklaşık 13.000 diyalog içeren derin bir işbirliğiyle M0D.AI adlı son derece özelleştirilmiş bir yapay zeka etkileşim ve kontrol çerçevesi oluşturdu. Sistem, bir Python arka ucu, bir Flask web sunucusu, dinamik bir ön uç kullanıcı arayüzü ve yapay zeka davranışını izlemek ve yönlendirmek için mematrix.py adlı bir meta-bilişsel katman içeriyor. M0D.AI, programlama geçmişi olmayan bir kullanıcının yapay zeka yardımıyla karmaşık yazılım sistemlerini nasıl tasarlayıp geliştirebileceğini gösteriyor. (Kaynak: Reddit r/artificial)

📚 Öğrenme

LLM Mühendisliği: 8 Haftada Yapay Zeka ve LLM’lerde Uzmanlaşma Kurs Kaynakları: “LLM Engineering – Master AI and LLMs” adlı 8 haftalık bir kurs, katılımcıların büyük dil modeli mühendisliğinde uzmanlaşmasına yardımcı olmayı amaçlamaktadır. Kursa eşlik eden GitHub deposu, haftalık proje kodlarını, kurulum kılavuzlarını (PC, Mac, Linux) ve Colab bağlantılarını sunmaktadır. Kurs, Ollama ile Llama 3.2 çalıştırmaya başlayarak, HuggingFace, API kullanımı, model ince ayarı gibi konulara kademeli olarak derinleşerek uygulamalı pratiğe vurgu yapmaktadır. Ayrıca, Ollama’yı OpenAI gibi ücretli API’lere ücretsiz bir alternatif olarak kullanma kılavuzu da sunmaktadır. (Kaynak: GitHub Trending)

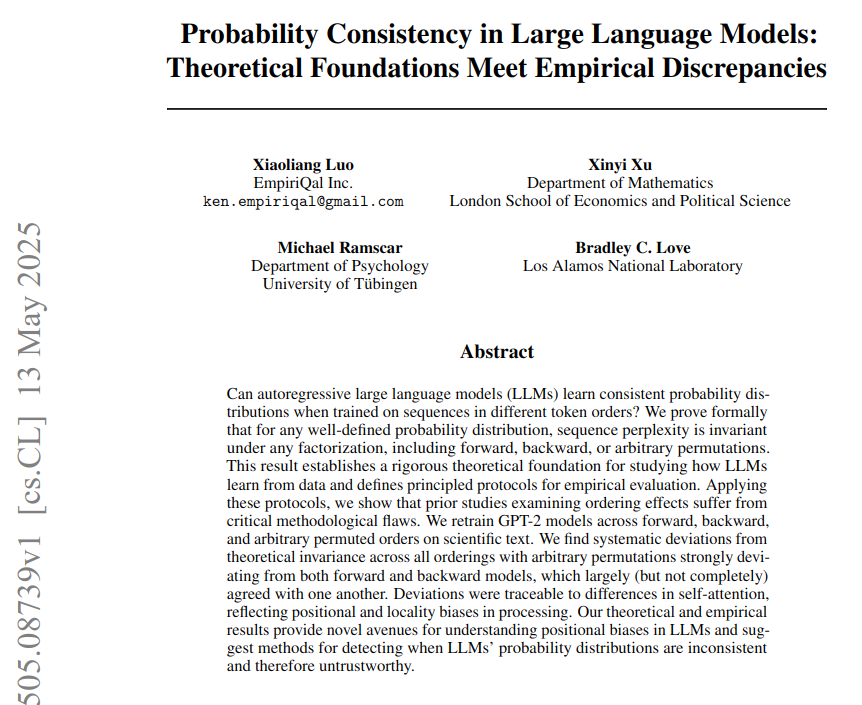

LLM’lerde Olasılıksal Tutarlılık: Teorik Temeller ve Ampirik Farklılıklar Üzerine Bir Araştırma: “LLM’lerde Olasılıksal Tutarlılık: Teorik Temeller ve Ampirik Farklılıklar” başlıklı bir makale, büyük dil modellerinin (LLM) Token olasılıklarını hesaplamak için sabit bir strateji kullandığını, ancak gerçek modellerin farklı Token sıralamalarındaki performansının teorik olasılıksal tutarlılıkla farklılık gösterdiğini belirtiyor. Araştırma, sinirbilim metinleri üzerinde bir GPT-2 modelini (ileri, geri ve permütasyonlu Token sıralamaları kullanarak) eğiterek, şaşkınlığın (perplexity) teorik olarak sıralamadan bağımsız olduğunu, ancak ampirik olarak modelin mimari önyargılar nedeniyle bu testi geçemediğini kanıtlıyor. Dikkat önyargılarının (yerel ve uzun menzilli) gözlemlenen tutarlılık başarısızlığının doğrudan nedeni olduğu düşünülmektedir. (Kaynak: menhguin)

BoldVoice, İngilizce Aksan Yoğunluğunu Ölçmek ve Yönlendirmek İçin Makine Öğrenimini Kullanıyor: BoldVoice uygulaması, makine öğrenimi ve gizli uzay (latent space) tekniklerini kullanarak İngilizce aksan yoğunluğunu ölçüyor ve kullanıcılara telaffuz rehberliği sağlıyor. Bu yöntem, kullanıcıların İngilizce telaffuzlarını ve aksanlarını daha etkili bir şekilde geliştirmelerine yardımcı olmayı amaçlıyor. (Kaynak: dl_weekly)

Milvus Blogu: Üretim Ortamlarında Yüksek Geri Çağırma Oranını Korurken Verimli Meta Veri Filtrelemenin Zorlukları ve Optimizasyonu: Milvus, üretim ortamındaki vektör aramada, verimli meta veri filtrelemesi yaparken aynı zamanda yüksek bir geri çağırma (recall) oranının nasıl korunabileceğini tartışan pratik bir blog yazısı yayınladı. Makale, ilgili zorlukları tartışıyor ve optimizasyon stratejileri öneriyor. (Kaynak: dl_weekly)

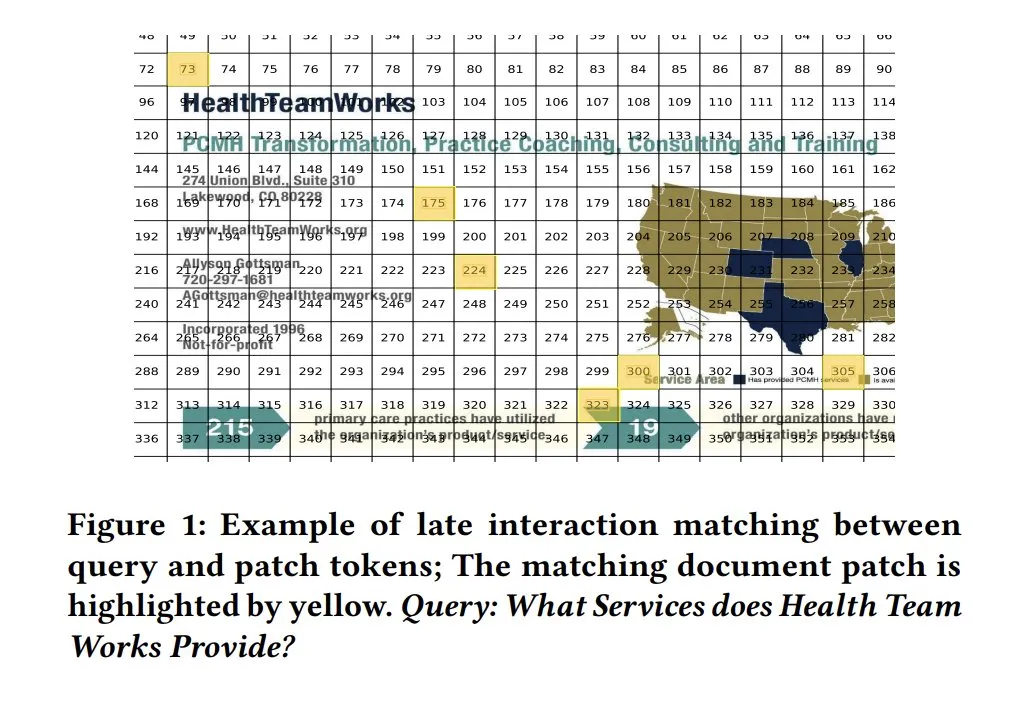

Model Yorumlanabilirliği İçin ColPali Benzerlik Haritaları: ColPali gibi görsel belge erişim modellerindeki benzerlik haritaları (similarity maps), sorgu ile belge parçacıkları düzeyindeki eşleşmeler için güçlü bir yorumlanabilirlik sunar. Isı haritaları gibi yöntemlerle hangi görüntü alanlarının sorguyla ilişkili olduğunu görselleştirmek, modelin karar verme sürecini anlamaya yardımcı olur. Tony Wu, ilgili hızlı başlangıç kılavuzunu sunmaktadır. (Kaynak: lateinteraction, tonywu_71, lateinteraction)

soarXiv: İnsan Bilgisini Keşfetmenin Zarif Bir Yolu: Jinay, bilimsel makaleleri daha estetik ve etkileşimli bir şekilde keşfetmeyi amaçlayan soarXiv platformunu tanıttı. Kullanıcılar, ArXiv makale URL’sindeki “arxiv” kelimesini “soarxiv” ile değiştirerek, evrenin yıldız haritasına benzeyen bir arayüzde ilgili makaleyi bulabilir ve inceleyebilirler. Platform, Nisan 2025 itibarıyla 2,8 milyon makaleyi içermektedir. (Kaynak: menhguin)

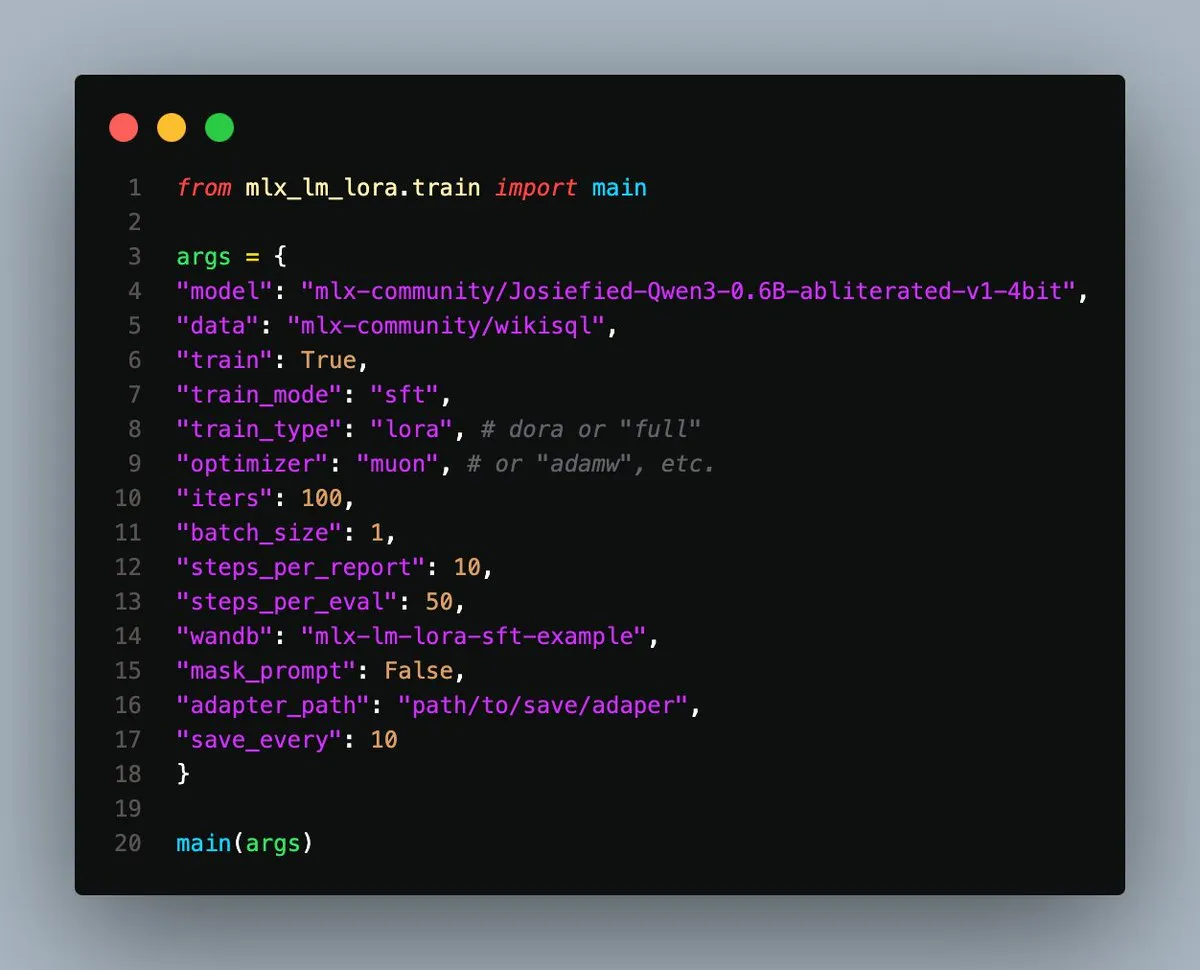

MLX-LM-LoRA v0.3.3 Yayınlandı, Apple Silicon’da Yerel İnce Ayarı Basitleştiriyor: Gökdeniz Gülmez, Apple Silicon üzerinde yerel model ince ayar sürecini daha da basitleştiren ve esnekleştiren MLX-LM-LoRA v0.3.3 sürümünü yayınladı. Yeni sürüm, eğitim yapılandırmasında veya komut satırında doğrudan eğitim devir sayısını (epochs) ayarlamayı destekliyor ve temel ince ayar ile DPO kullanarak gelişmiş tercihli eğitim örnekleri de dahil olmak üzere örnek komut dosyaları ve Notebook’lar sunuyor; başlamak için yaklaşık 20 satır kod yeterli. (Kaynak: awnihannun)

Sistem İstem Sızıntıları Analizi: Ana Akım LLM’lerin İç Mimarisi ve Davranış Kuralları Ortaya Çıkıyor: Simbaproduz, GitHub’da, son zamanlarda sızdırılan başlıca büyük dil modellerinin (Claude 3.7, ChatGPT-4o, Grok 3, Gemini vb.) sistem istem sızıntılarını kapsamlı bir şekilde analiz eden bir proje yayınladı. Bu kılavuz, bu modellerin iç mimarilerini, operasyonel mantıklarını ve davranış kurallarını derinlemesine inceliyor; bunlar arasında bilgi kalıcılığı, görüntü işleme stratejileri, web’de gezinme yöntemleri, kişiselleştirme sistemleri ve manipülasyona karşı savunma mekanizmaları bulunuyor. Bu bilgiler, LLM araçları, akıllı ajanlar ve değerlendirme sistemleri oluşturmak için önemli bir referans değeri taşıyor. (Kaynak: Reddit r/MachineLearning)

ICML 2025 Makalesi Görüntü Karşıt Pertürbasyonlarının Frekans Alanı Ayrışımını İnceliyor: Çin Bilimler Akademisi Üniversitesi ve Hesaplama Teknolojisi Enstitüsü’nden bir ICML 2025 Spotlight makalesi olan “Diffusion-based Adversarial Purification from the Perspective of the Frequency Domain”, karşıt pertürbasyonların görüntülerin yüksek frekanslı genlik ve faz spektrumlarını bozmaya daha eğilimli olduğunu öne sürüyor. Buna dayanarak, araştırmacılar, temiz örnekler üretmeyi yönlendirmek için difüzyon modelinin ters sürecine orijinal örneğin düşük frekanslı bilgilerini bir öncül olarak enjekte etmeyi öneriyor, böylece karşıt pertürbasyonları etkili bir şekilde kaldırıyor ve görüntü semantik içeriğini koruyor. (Kaynak: WeChat)

ICML 2025 Makalesi TokenSwift: “Otomatik Tamamlama” ile 100K Seviyesinde Uzun Metin Üretiminde 3 Kat Hızlanma: BIGAI NLCo ekibi, ICML 2025’te “TokenSwift: Lossless Acceleration of Ultra Long Sequence Generation” başlıklı bir makale yayınlayarak, 100K Token seviyesindeki uzun metin çıkarımı için kayıpsız ve verimli bir hızlandırma çerçevesi olan TokenSwift’i önerdi. Bu çerçeve, çoklu Token paralel taslak oluşturma, n-gram sezgisel tamamlama, ağaç yapısı paralel doğrulama ve dinamik KV önbellek yönetimi gibi mekanizmalar aracılığıyla, orijinal model çıktısının tutarlılığını korurken 3 kattan fazla çıkarım hızlandırması sağlayarak ultra uzun dizi üretiminin verimliliğini önemli ölçüde artırıyor. (Kaynak: WeChat)

💼 Ticari

OpenAI, Bir Zamanlar Uyardığı Yapay Zeka Silahlanma Yarışını Körüklüyor Olmakla Suçlanıyor: Bloomberg’den bir makale, OpenAI’nin ChatGPT’yi piyasaya sürdükten sonra, yapay zeka riskleri konusunda uyarıda bulunan bir kuruluştan yapay zeka teknolojisi yarışını yönlendiren kilit bir role nasıl dönüştüğünü inceliyor. Makale, OpenAI’nin stratejik değişimini, ticarileşme baskısını ve davranışlarının tüm yapay zeka endüstrisinin gelişim yönü ve güvenlik değerlendirmeleri üzerindeki etkisini analiz ediyor olabilir. (Kaynak: Reddit r/ArtificialInteligence)

Trump Yönetimi Harvard Üniversitesi’nin Yaklaşık 3 Milyar Dolarlık Araştırma Fonunu Kesti, Küresel Yetenek Kapma Yarışı Başladı: Trump yönetimi, Harvard Üniversitesi’nin 350’den fazla projeyi kapsayan yaklaşık 3 milyar dolarlık araştırma fonunu kesti; bu hamle, Amerikan araştırma sistemine büyük bir darbe olarak görülüyor. Aynı zamanda, AB, Kanada, Avustralya gibi ülkeler ve bölgeler, etkilenen Amerikalı üst düzey bilim insanlarını çekmek amacıyla on milyonlarca dolarlık destek programları başlattı ve bu durum küresel araştırma yeteneklerinin akışı hakkında tartışmalara yol açtı. Harvard Üniversitesi dava açtı ve krizi hafifletmek için kendi bütçesinden 250 milyon dolar ayırdı. (Kaynak: WeChat)

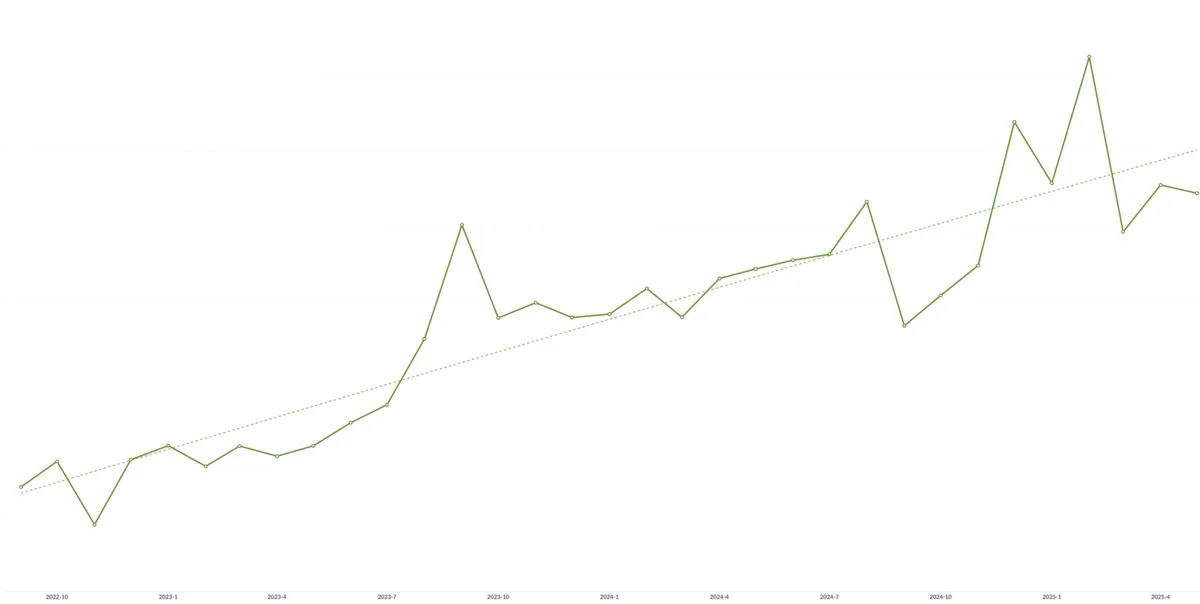

Yapay Zeka Girişimi Spellbook’un Ortalama Sözleşme Değeri (ACV) Üç Yıldır Sürekli Artıyor: Yapay zeka teknolojisinin metalaşmasının fiyat baskısına yol açabileceği endişelerine rağmen, yapay zeka hukuk yazılımı girişimi Spellbook’un kurucu ortağı Scott Stevenson, şirketinin ortalama sözleşme değerinin (ACV) üç yıldır sürekli arttığını belirtti. Hızlı hareket eden ekiplerin yapay zeka ürünleriyle sürekli olarak yeni değer yaratabildiğini ve böylece potansiyel fiyat düşüşü baskısını dengeleyebildiğini düşünüyor. (Kaynak: scottastevenson)

🌟 Topluluk

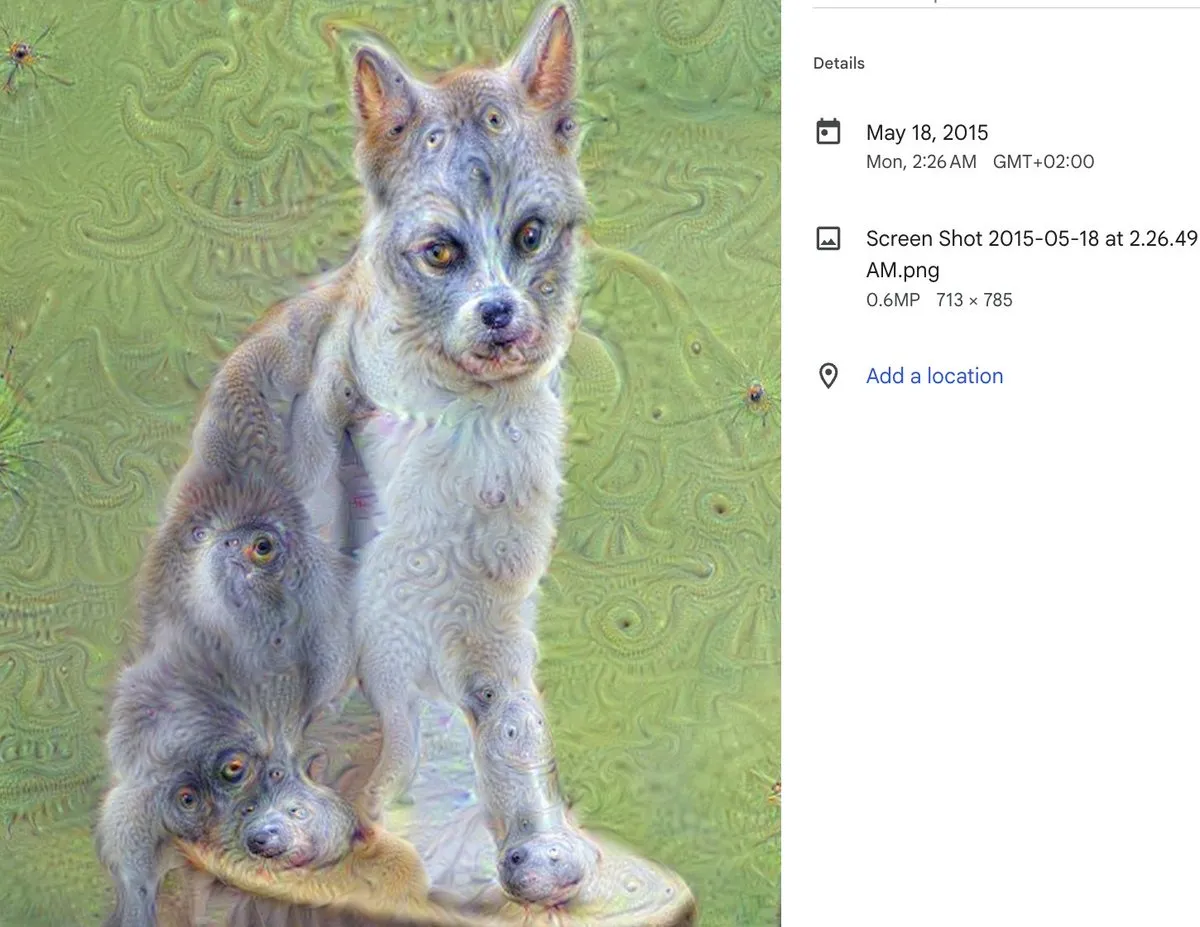

DeepDream Onuncu Yılında: Yapay Zeka Sanatında Bir Kilometre Taşı ve Derin Etkileri: DeepDream’in yaratıcısı Alex Mordvintsev, on yıl önce bu fenomen haline gelen yapay zeka sanat aracının doğuşunu anımsadı. Runway’in kurucu ortağı Cristóbal Valenzuela da DeepDream’in kendisini yapay zeka sanat alanına girmeye nasıl teşvik ettiğini ve sonunda Runway’i kurmasına nasıl yol açtığını paylaştı. DeepDream’in ortaya çıkışı, yapay zekanın sanat yaratımı alanındaki potansiyelinin erken bir göstergesiydi ve sonraki üretken sanat ve yapay zeka içerik oluşturma araçlarının gelişimi üzerinde derin bir etki yarattı. (Kaynak: c_valenzuelab)

Yapay Zekanın Teknik Kurucu Ortağa İhtiyacı Olup Olmadığı Tartışılıyor: Sosyal medyada, “erken aşama VC’lerin girişimcilere artık teknik bir kurucu ortağa ihtiyaç duymadıklarını, sadece bir ürün yöneticisi ve yapay zeka ile ürün oluşturabileceklerini tavsiye ettiği” yönünde bir tartışma ortaya çıktı. Bu görüş geniş çapta tartışmalara yol açtı; Danielle Fong gibi isimler bu görüşe katılmadıklarını belirterek, yapay zekanın şu anda teknik bir kurucu ortağın temel rolünü ve derin teknik anlayışını tam olarak değiştiremeyeceğini ima etti. (Kaynak: jonst0kes)

Yapay Zeka Halüsinasyon Sorunu Tartışılıyor: Teknik Nedenler ve Başa Çıkma Stratejileri: Topluluk, yapay zeka dil modellerinin (ChatGPT, Claude vb.) “halüsinasyon” (kendinden emin bir şekilde yanlış veya uydurma bilgiler üretme) sorununu hararetle tartışıyor. Tartışma noktaları arasında halüsinasyonun teknik kökenleri (dikkat mekanizması kusurları, eğitim verilerindeki gürültü, modelin gerçek dünya bağlantısının olmaması vb.), RAG veya ince ayarın bu sorunu ortadan kaldırıp kaldıramayacağı, kullanıcıların LLM çıktılarına nasıl ihtiyatlı yaklaşması gerektiği ve geliştiricilerin yaratıcılık ile gerçek doğruluk arasında nasıl bir denge kurabileceği yer alıyor. Bazı görüşlere göre, tüm LLM çıktıları potansiyel halüsinasyon olarak kabul edilmeli ve kullanıcılar tarafından doğrulanmalıdır. (Kaynak: Reddit r/ArtificialInteligence)

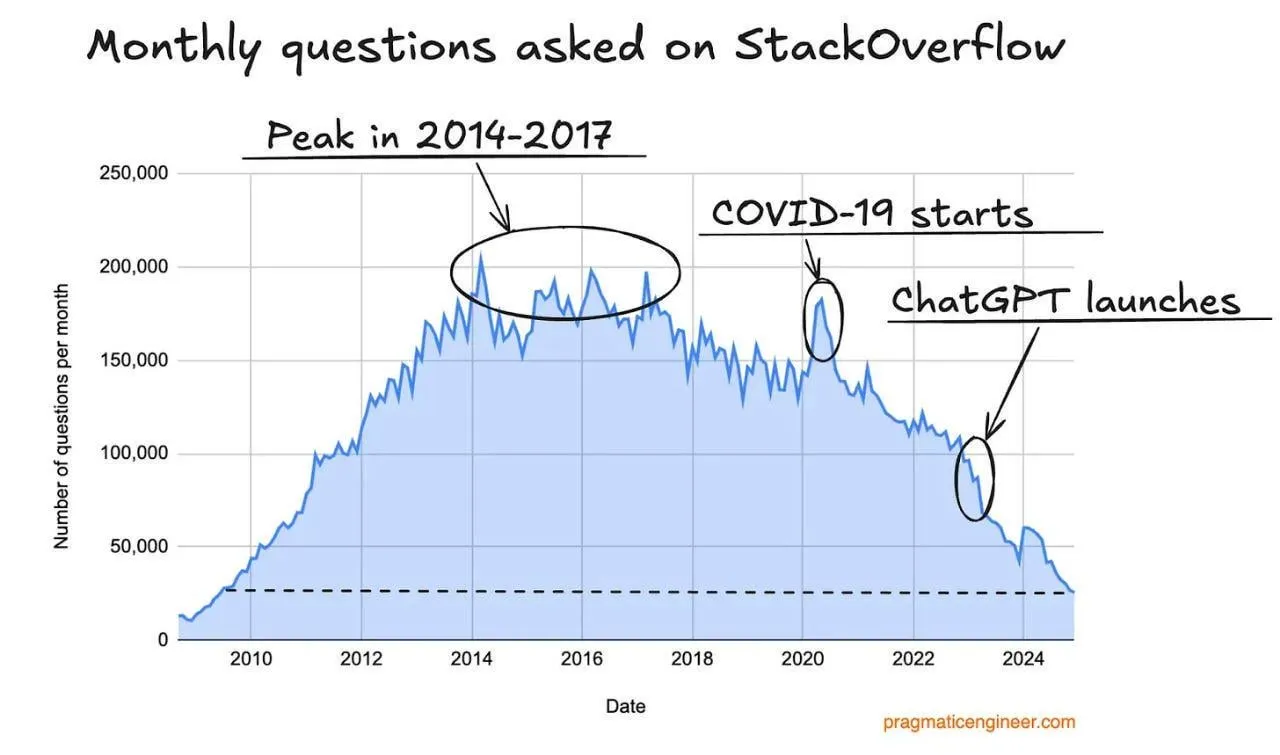

Stack Overflow Trafiğinde Düşüş, Yapay Zeka Programlama Asistanlarının Etkisi Olabilir: Bir kullanıcı, Stack Overflow web sitesi trafiğinde bir düşüş eğilimi gözlemledi ve bunun ChatGPT gibi yapay zeka programlama asistanlarının yükselişiyle ilgili olabileceğini tahmin etti. Geliştiriciler, kod parçacıkları ve çözümler elde etmek için giderek daha fazla doğrudan yapay zekaya soru soruyor ve geleneksel soru-cevap topluluklarına olan bağımlılıklarını azaltıyor. Yorumlarda, kullanıcılar genellikle yapay zeka asistanlarının cevapların doğrudanlığı ve topluluk içi olumsuz duygulardan kaçınma konusunda daha avantajlı olduğunu düşünüyor, ancak yapay zekanın mevcut verilere aşırı bağımlılığının gelecekte eğitim verilerinin tükenmesine yol açabileceği endişesini de dile getiriyorlar. (Kaynak: Reddit r/ArtificialInteligence)

LLM Mühendislik Kursu Eğitmeni Öğrenme Deneyimlerini ve Kaynaklarını Paylaşıyor: LLM mühendislik kursunun eğitmeni Ed Donner, kursunun öğretim felsefesini ve kaynaklarını paylaşarak, pratik yaparak (DOING) öğrenmenin önemini vurguladı. Öğrencileri aktif olarak kod üzerinde çalışmaya teşvik etti ve öğrencilerin farklı ortamlarda öğrenip deney yapabilmeleri için PC, Mac, Linux kurulum kılavuzları ile Google Colab Notebook bağlantıları sağladı. Kurs içeriği Ollama, HuggingFace, API kullanımı gibi konuları kapsıyor ve yerel modelleri ücretli API’lere alternatif olarak kullanma çözümleri sunuyor. (Kaynak: ed-donner)

Kullanıcı Deneyimi Paylaşımı: Claude ile Düşünme ve İletişim Becerilerini Geliştirme: Bir Claude Pro kullanıcısı, yapay zeka ile etkileşimin düşünme biçimini ve iletişim becerilerini geliştirmesine nasıl yardımcı olduğuna dair deneyimlerini paylaştı. Claude ile etkileşim yoluyla kullanıcı, sorunları çözerken kendine daha iyi “ipuçları” vermeyi, temel sorunları belirlemeyi ve meslektaşlarıyla iletişim kurarken daha net ifadeye ve empatiye odaklanmayı öğrendi, böylece yapay zeka destekli araçların kişisel bilişsel ve ifade yeteneklerini geliştirmedeki olumlu rolünü fark etti. (Kaynak: Reddit r/ClaudeAI)

“Ayırt Edici-Üretici Uçurumu” Yapay Zeka Bilimsel İnovasyonunun Temel Kavramı Olabilir: Jason Wei, “ayırt edici-üretici uçurumu”nun (Discriminator-generator gap) yapay zekanın bilimsel inovasyondaki en önemli fikir olabileceğini öne sürüyor. Yeterli hesaplama gücü, akıllı arama stratejileri ve net ölçüm standartları olduğunda, ölçülebilen her şey yapay zeka tarafından optimize edilebilir. Bu kavram, üreticinin çözümler önerdiği, ayırt edicinin ise iyiliği değerlendirdiği yinelemeli bir süreçle inovasyonu yönlendirmenin önemini vurguluyor; özellikle hızlı doğrulanabilen, sürekli ödüllendirilen ve ölçeklenebilir ortamlar için geçerlidir. (Kaynak: _jasonwei, dotey)

Yapay Zeka Çağında Ürün Yöneticilerinin Dönüşümü ve Zorlukları: Sosyal medyada yapay zekanın ürün yöneticisi pozisyonları üzerindeki etkisi tartışılıyor. Görüşlere göre, önümüzdeki 18 ay içinde ürün yöneticiliği sektörü bir dönüşümle karşı karşıya kalacak ve kullanıcı ihtiyaçlarını anlamayan PM’ler elenebilir. Yapay zeka araçları (AI Agents gibi) fikirleri kısa sürede ürüne dönüştürebilir, ancak asıl zorluk kullanıcının temel sorunlarını bulmak ve kesin çözümler sunmaktır. Bu pozisyon nihayetinde sadece belge ve prototip oluşturmak değil, kullanıcı sorunları ile çözüm eşleşmesini ve anlayışını yarıştırır. (Kaynak: dotey)

Yapay Zeka Güvenlik Paradoksu: Süper Zeka Savunma Tarafı İçin Daha Avantajlı Olabilir: Richard Socher, “yapay zeka güvenlik paradoksu”nu öne sürüyor: Makul varsayımlar altında, süper zekanın ortaya çıkışı aslında biyolojik veya siber savaşta savunma tarafı için daha avantajlı olabilir. Zekanın marjinal maliyeti düştükçe, kırmızı takım tatbikatları yoluyla daha fazla saldırı vektörü keşfedilebilir ve sistemler tüm ilgili saldırı yolları kapsanana kadar güçlendirilebilir veya bağışıklık kazandırılabilir. Teorik olarak, savunma maliyeti sıfıra yaklaştığında sistem tamamen bağışıklık kazanabilir. Bu görüş, yapay zeka gelişiminin saldırı-savunma asimetrisini artıracağı yönündeki geleneksel düşünceye meydan okuyor. (Kaynak: RichardSocher)

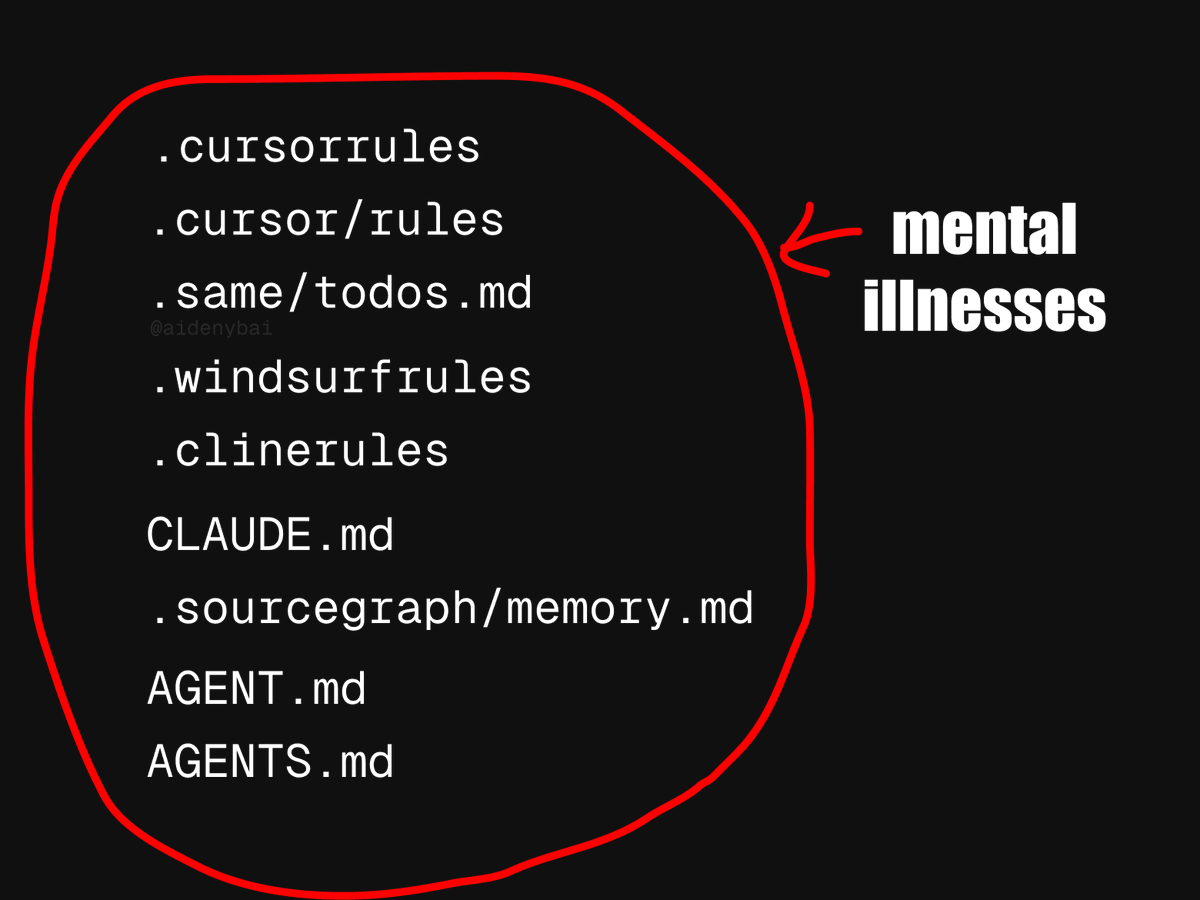

Yapay Zeka Ajan Uygulama Standartları Tartışması: CONTRIBUTING.md Daha İyi Bir Uygulama Olabilir: Şu anda ortaya çıkan 9 farklı yapay zeka ajan kuralı rekabet standardına karşı, bazı geliştiriciler yapay zeka ajanlarının davranışlarını düzenlemek için doğrudan projedeki CONTRIBUTING.md dosyasını kullanmanın daha iyi olacağını öne sürüyor. Bu dosya genellikle kod stili kılavuzlarını, ilgili referansları ve derleme parçacıklarını içerir ve yapay zeka ajan kuralları için doğal bir taşıyıcı görevi görerek tekerleği yeniden icat etmekten kaçınabilir. (Kaynak: JayAlammar)

💡 Diğer

Klasik Ders Kitabı “Fonksiyonel Analiz” Yazarı Peter Lax 99 Yaşında Vefat Etti: Matematik devi, Abel Ödülü’nü kazanan ilk uygulamalı matematikçi Peter Lax, 99 yaşında vefat etti. Profesör Lax, yazdığı klasik ders kitabı “Fonksiyonel Analiz” ile tanınıyordu ve kısmi diferansiyel denklemler, akışkanlar mekaniği, sayısal hesaplama gibi alanlarda Lax eşdeğerlik teoremi, Lax-Friedrichs/Lax-Wendroff yöntemleri gibi temel katkılarda bulundu. Aynı zamanda bilgisayar teknolojisini matematiksel analize uygulayan ilk öncülerden biriydi ve çalışmaları bilimsel araştırmaları ve mühendislik uygulamalarını derinden etkiledi. (Kaynak: WeChat)

Yapay Zeka ile İş Arama: Yapay Zeka Ajanının OpenAI Operator Kullanarak Tek Tıkla Binlerce İşe Başvurması Tartışma Yarattı: Bir video, yapay zeka ajanının OpenAI’nin Operator aracını kullanarak tek tıkla 1000 iş pozisyonuna başvuru yaptığını gösteriyor. Bu olay, yapay zekanın işe alım alanındaki uygulamaları hakkında tartışmalara yol açtı; bunlar arasında yapay zekanın özgeçmişleri filtrelemesi, mülakatları ayarlaması ve hatta ön mülakatlar yapması gibi olasılıklar ile bu otomasyonun iş arayanlar ve işe alım yapanlar üzerindeki etkileri yer alıyor. (Kaynak: Reddit r/ChatGPT)

MIT, Yapay Zeka ile İlgili Bir Ekonomi Makalesini Geri Çekti, Yapay Zeka Tarafından Yazıldığı ve Verilerin Şüpheli Olduğu İddia Ediliyor: MIT Ekonomi Bölümü, bir doktora öğrencisi tarafından yazılan “Yapay Zeka, Bilimsel Keşif ve Ürün İnovasyonu” başlıklı bir makaleyi, okul yönetiminin makaledeki verilerin güvenilirliğine dair şüpheleri nedeniyle geri çekti. Topluluk, makalenin büyük bir kısmının yapay zeka tarafından tamamlanmış olabileceğini tahmin ediyor ve bu durum, yapay zekanın akademik araştırmalardaki uygulamalarının etiği ve kalite kontrolü hakkında tartışmalara yol açtı. (Kaynak: Reddit r/ArtificialInteligence)