Anahtar Kelimeler:OpenAI Codex, AI yazılım geliştirme, çok modelli model, AI ses üretimi, veri eleme, Codex araştırma önizleme sürümü, MiniMax Speech-02, BLIP3-o çok modelli model, PreSelect veri eleme, SWE-1 model serisi

🔥 Öne Çıkanlar

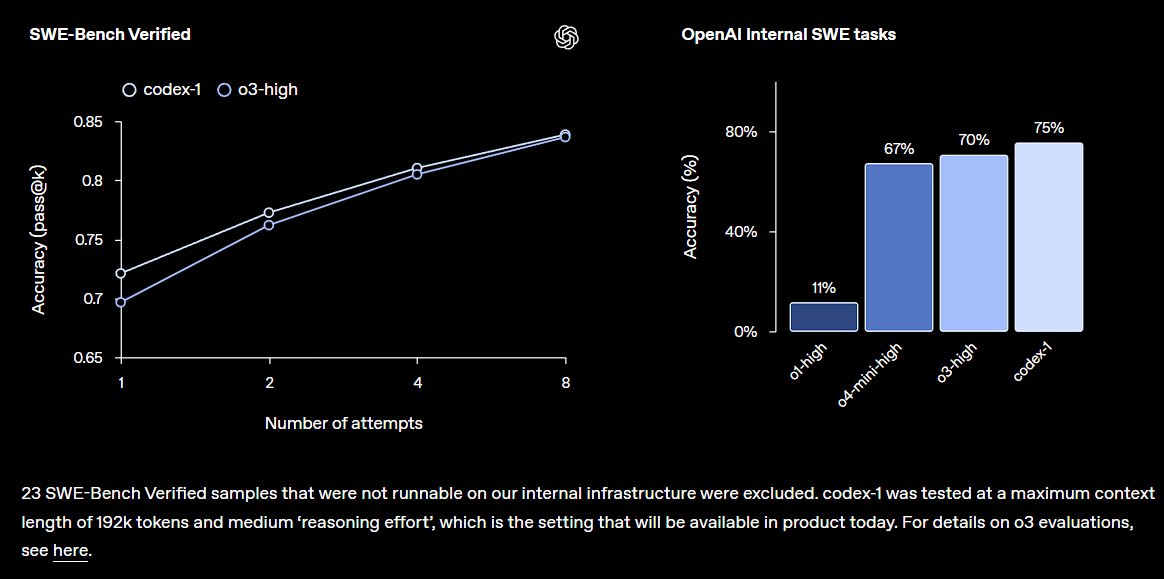

OpenAI, ChatGPT’ye entegre edilen Codex araştırma önizlemesini yayınladı: OpenAI, büyük kod tabanlarını anlayabilen, yeni özellikler yazabilen, hataları düzeltebilen ve birden fazla görevi paralel olarak işleyebilen bulut tabanlı bir yazılım mühendisliği yapay zeka ajanı olan Codex’i tanıttı. Codex, o3 ile ince ayarlanmış codex-1 modeline dayanıyor ve SWE-bench’te üstün performans gösteriyor. Bu özellik, geliştirici üretkenliğini önemli ölçüde artırmayı amaçlayarak kademeli olarak ChatGPT Pro, Team ve Enterprise kullanıcılarına sunulacak ve yapay zekanın yazılım geliştirme alanında daha merkezi bir rol oynayacağının habercisi. Topluluk buna olumlu tepki verdi, ancak aynı zamanda pratik etkilerini ve potansiyel hatalarını da merak ediyor (Kaynak: OpenAI, OpenAI Developers, scaling01, dotey)

Microsoft’un büyük ölçekli işten çıkarmaları sektörde şok etkisi yarattı, yapay zeka odaklı organizasyonel değişim hızlanıyor: Microsoft, yönetim katmanlarını basitleştirmeyi ve programcı oranını artırmayı amaçlayan yaklaşık 6000 küresel işten çıkarma duyurdu; işten çıkarılanların bir kısmı arasında 25 yıllık kıdeme sahip ve önemli katkılarda bulunmuş deneyimli çalışanlar ile TypeScript çekirdek geliştiricileri de bulunuyor. Bu işten çıkarmaların, yapay zeka teknolojisinin verimliliği artırması ve bazı iş görevlerini otomatikleştirmesiyle ilgili olduğu düşünülüyor ve teknoloji devlerinin yapay zeka çağında maliyetleri kontrol etme ve insan kaynakları yapılarını optimize etme eğilimini yansıtıyor. Olay, yapay zekanın işgücü piyasası üzerindeki etkisi, şirket sadakati ve gelecekteki çalışma modelleri hakkında geniş çaplı tartışmalara yol açtı (Kaynak: WeChat, NeelNanda5)

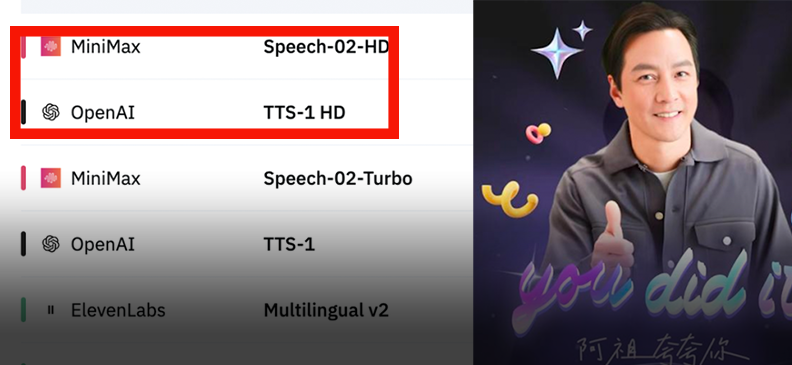

MiniMax, Speech-02 ses modelini yayınladı ve küresel listelerde zirveye yerleşti: MiniMax, yeni nesil ses modeli Speech-02’yi piyasaya sürdü. Model, Artificial Analysis Speech Arena ve Hugging Face TTS Arena adlı iki yetkili ses değerlendirmesinde OpenAI ve ElevenLabs’ı geride bırakarak birinci oldu. Model, ultra-insansı ses, kişiselleştirilmiş ses tonu özelleştirme (32 dil ve aksanı destekler, birkaç saniyelik referansla kopyalanabilir) ve çeşitlilik konularında öne çıkıyor ve klonlama ayrıntılarını geliştirmek için yenilikçi bir şekilde Flow-VAE teknolojisini kullanıyor. Teknolojisi, “AI Azu”nun İngilizce öğrenmesi ve Yasak Şehir AI rehberi gibi senaryolarda uygulandı ve yerli büyük modellerin AI ses üretimi alanındaki lider konumunu gösteriyor (Kaynak: WeChat, WeChat)

Salesforce ve diğer kurumlar birleşik çok modlu model BLIP3-o’yu yayınladı: Salesforce Research, birçok üniversiteyle işbirliği içinde, “önce anla sonra üret” stratejisini benimseyen ve otoregresif ile difüzyon mimarilerini birleştiren tamamen açık kaynaklı birleşik çok modlu model BLIP3-o’yu yayınladı. Model, üretilen görüntülerin kalitesini, çeşitliliğini ve komut istemiyle uyumunu önemli ölçüde artıran CLIP özellikleri ve Flow Matching ile yenilikçi bir eğitim kullanıyor. BLIP3-o, birçok kıyaslama testinde üstün performans gösteriyor ve görüntü düzenleme ve görsel diyalog gibi karmaşık çok modlu görevlere doğru genişliyor, bu da çok modlu AI teknolojisinin gelişimini destekliyor (Kaynak: 36Kr)

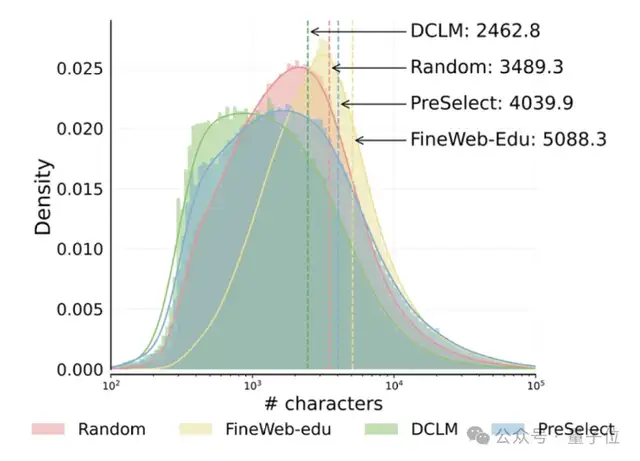

HKUST ve vivo, ön eğitim verimliliğini 10 kat artıran PreSelect veri filtreleme çözümünü önerdi: Hong Kong Bilim ve Teknoloji Üniversitesi (HKUST) ve vivo AI Lab, ICML 2025 tarafından kabul edilen hafif ve verimli bir veri seçme yöntemi olan PreSelect’i önerdi. Bu yöntem, verilerin modelin belirli yeteneklerine katkısını ölçmek için “tahmin gücü” göstergesini kullanır ve tüm eğitim verilerini filtrelemek için bir fastText puanlayıcısı kullanır. Bu sayede hesaplama gereksinimlerini 10 kat azaltırken model performansını ortalama %3 artırabilir. PreSelect, geleneksel kural tabanlı veya model tabanlı filtreleme yöntemlerinin sınırlamalarının üstesinden gelerek yüksek kaliteli ve çeşitli verileri daha objektif ve genelleştirilebilir bir şekilde filtrelemeyi amaçlar (Kaynak: QbitAI)

🎯 Eğilimler

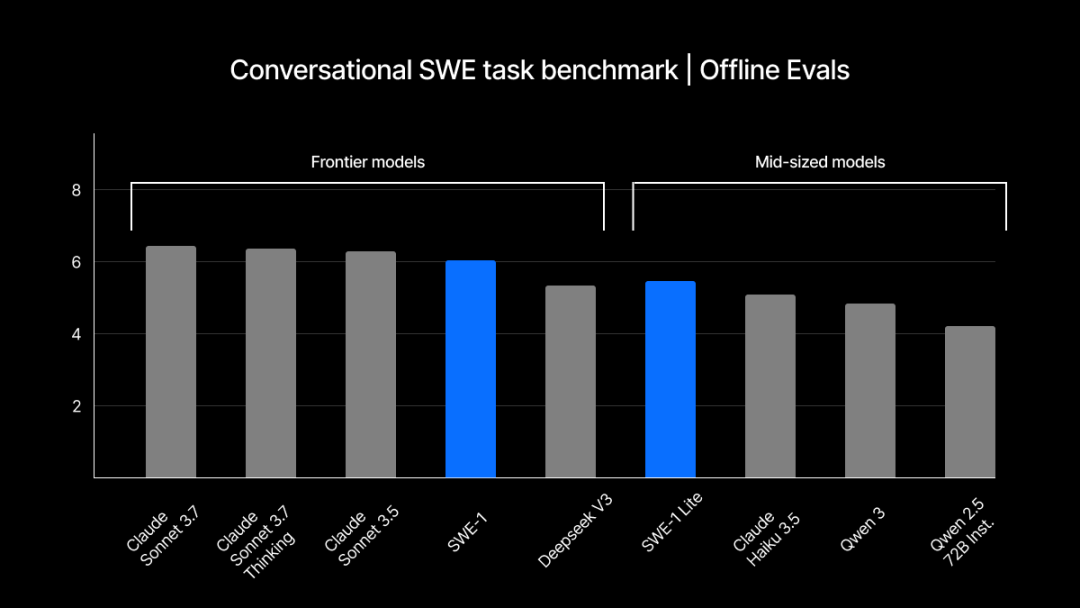

Windsurf, yazılım mühendisliği süreçlerini optimize etmek için kendi geliştirdiği SWE-1 serisi modellerini yayınladı: Windsurf, geliştirme verimliliğini %99 artırmayı amaçlayan, yazılım mühendisliği için optimize edilmiş ilk model serisi olan SWE-1’i piyasaya sürdü. Seri, SWE-1 (Claude 3.5 Sonnet’in araç çağırma yeteneklerine yakın, daha düşük maliyetli), SWE-1-lite (yüksek kaliteli, Cascade Base’in yerine geçer) ve SWE-1-mini (küçük ve hızlı, düşük gecikmeli senaryolar için) içerir. Temel yeniliği, yapay zekanın kullanıcıyla işlem zaman çizelgesini paylaştığı, verimli işbirliği ve tamamlanmamış durumların anlaşılmasını sağlayan “Flow Awareness” (Akış Farkındalığı) sistemidir (Kaynak: WeChat, WeChat)

ChatGPT hafıza mekanizması tersine mühendislikle incelendi, üç hafıza alt sistemi ortaya çıktı: OpenAI’nin ChatGPT için sunduğu “sohbet geçmişi kaydı” hafıza özelliği teknoloji meraklıları tarafından analiz edildi ve mevcut sohbet geçmişi, sohbet geçmişi kaydı (özetleme ve içerik alımına dayalı) ve kullanıcı içgörüleri (çoklu sohbet analizine dayalı olarak güvenilirlik puanıyla oluşturulur) olmak üzere üç alt sistem içerebileceği ortaya çıktı. Bu mekanizmalar, RAG ve vektör uzayı gibi teknolojiler aracılığıyla daha kişiselleştirilmiş ve verimli bir etkileşim deneyimi sunmayı amaçlamaktadır. Resmi açıklamalar kullanıcı deneyimini iyileştireceğini belirtse de, topluluktan gelen geri bildirimler karışık; bazı kullanıcılar özelliğin kararsız olduğunu veya hatalar içerdiğini bildiriyor (Kaynak: WeChat, QbitAI)

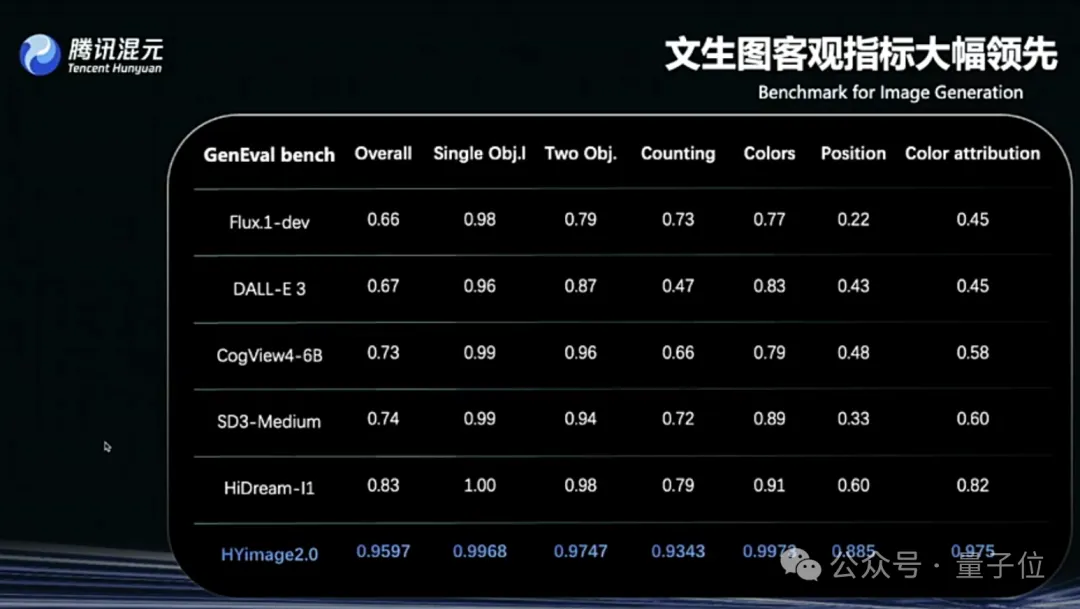

Tencent Hunyuan Image 2.0 yayınlandı, gerçek zamanlı “konuşurken çizme” desteği sunuyor: Tencent Hunyuan, milisaniye düzeyinde yanıt veren gerçek zamanlı metinden görüntüye oluşturma işlevi sunan Hunyuan Image 2.0 modelini piyasaya sürdü. Kullanıcılar metin veya sesli açıklama girdiğinde, görüntü eş zamanlı olarak oluşturuluyor ve ayarlanıyor. Yeni model ayrıca gerçek zamanlı bir çizim tahtasını da destekliyor; kullanıcılar elle çizdikleri taslakları metin açıklamalarıyla birleştirerek görüntüler oluşturabiliyor. Model, gerçekçilik, anlamsal uyum (metin kodlayıcı olarak çok modlu büyük dil modellerine uyum sağlar) ve görüntü kodlayıcı/kod çözücü sıkıştırma oranı konularında önemli gelişmeler kaydetti ve pekiştirmeli öğrenme ile sonradan eğitim optimizasyonu yapıldı (Kaynak: QbitAI)

TII, Falcon-Edge serisi BitNet modellerini ve onebitllms ince ayar kütüphanesini yayınladı: TII, sırasıyla yalnızca 600MB ve 900MB boyutlarında, 1B ve 3B parametre sayısına sahip kompakt dil modelleri serisi olan Falcon-Edge’i piyasaya sürdü. Bu modeller BitNet mimarisini kullanıyor ve performanstan neredeyse hiç kayıp vermeden bfloat16’ya geri yüklenebiliyor. İlk sonuçlar, diğer küçük modellerden daha iyi performans gösterdiklerini ve Qwen3-1.7B ile karşılaştırılabilir olduklarını, ancak bellek kullanımının yalnızca 1/4’ü kadar olduğunu gösteriyor. Aynı zamanda BitNet modellerinin ince ayarı için özel olarak tasarlanmış onebitllms kütüphanesi de yayınlandı (Kaynak: Reddit r/LocalLLaMA, winglian)

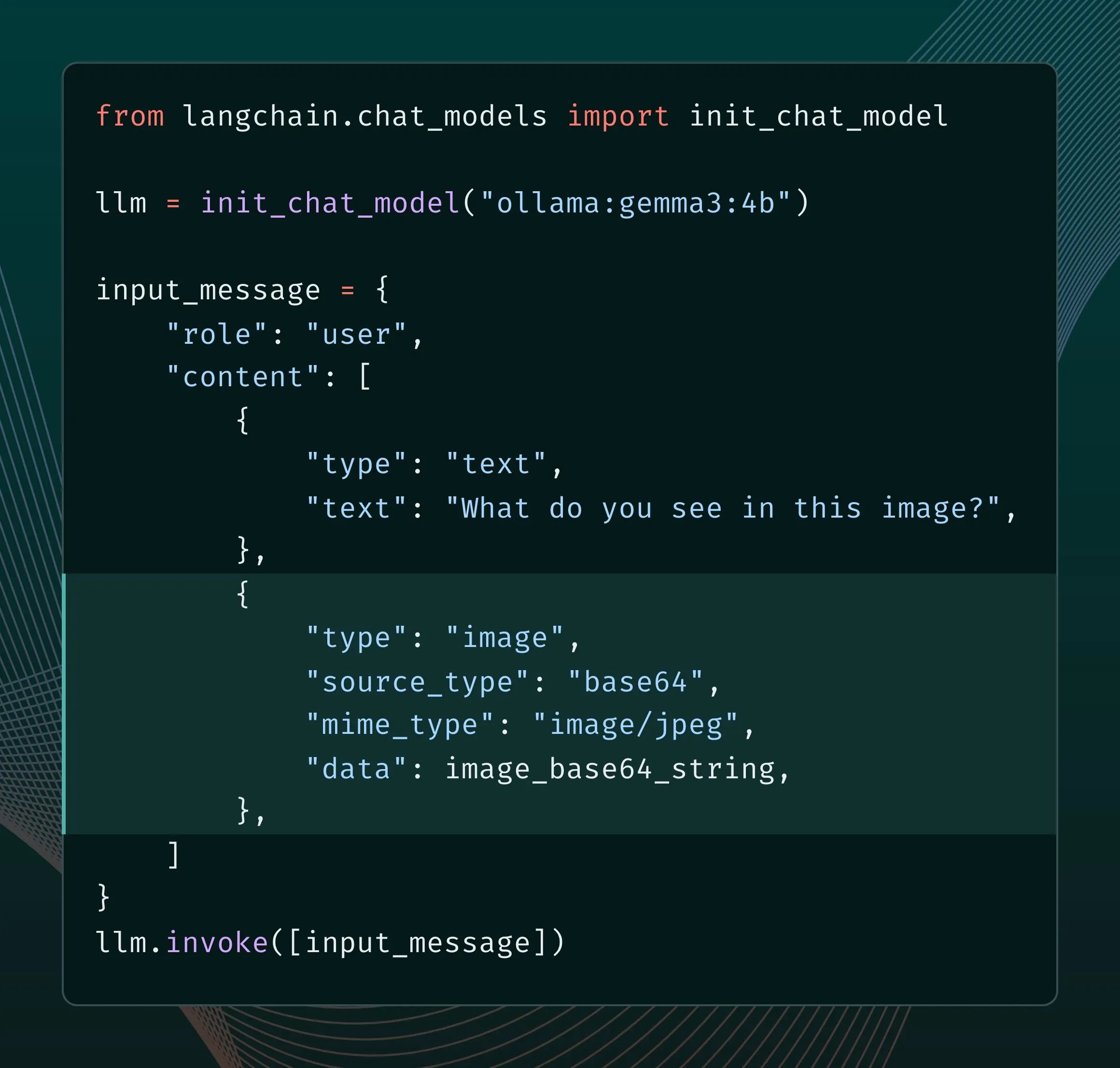

Ollama yeni motoru çok modlu desteği geliştiriyor: Ollama, motorunu güncelleyerek çok modlu modeller için yerel destek sunuyor, modele özgü optimizasyonlara izin veriyor ve bellek yönetimini iyileştiriyor. Kullanıcılar, LangChain entegrasyonu aracılığıyla Llama 4, Gemma 3 gibi çok modlu modelleri deneyebilirler. Google AI geliştiricileri de gerçek zamanlı arama gibi işlevleri gerçekleştirmek için Ollama ve Gemma 3 kullanarak işlev çağırma kılavuzu yayınladı (Kaynak: LangChainAI, ollama)

Grok, görüntü oluşturma en boy oranı kontrolü özelliği ekledi: xAI’nin Grok modeli artık kullanıcıların görüntü oluştururken istedikleri en boy oranını belirtmelerine olanak tanıyarak görüntü oluşturma için daha fazla esneklik ve kontrol sağlıyor (Kaynak: grok)

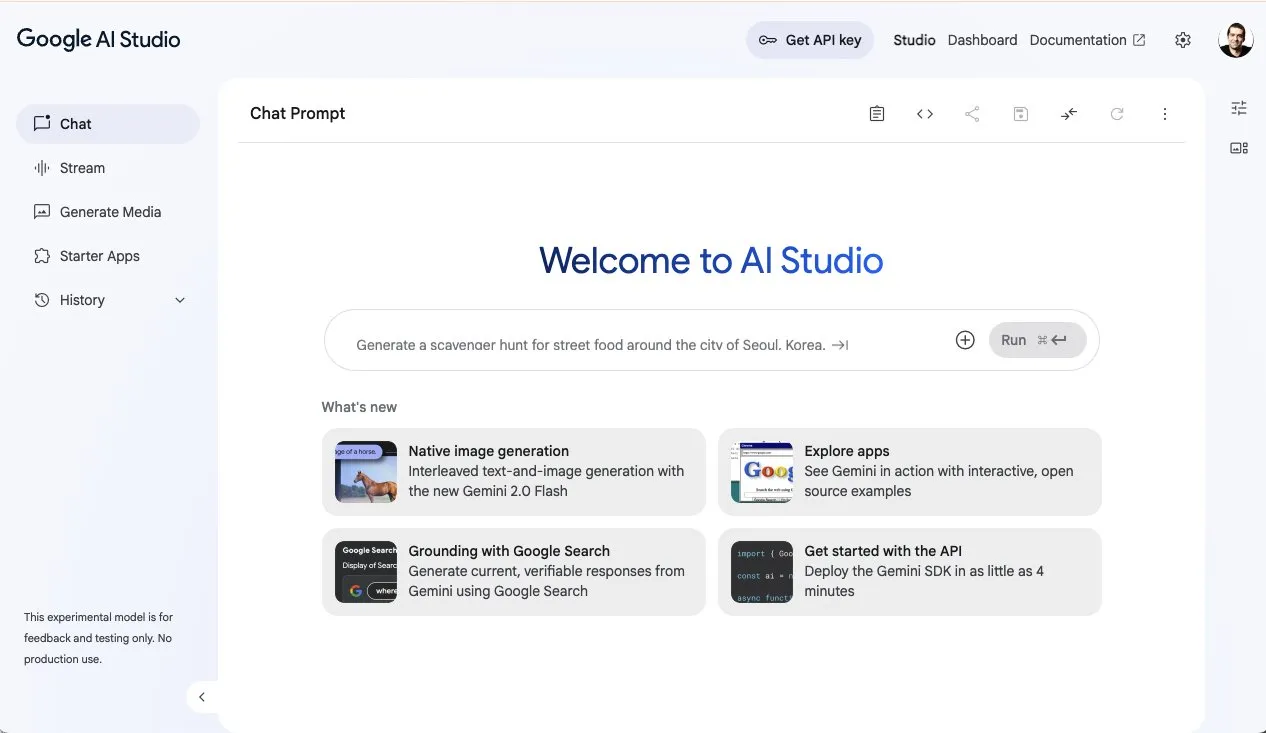

Google AI Studio güncellendi, yeni oluşturulan medya sayfası ve kullanım panosu eklendi: Google’ın ai.studio platformu, yepyeni bir açılış sayfası tasarımı, yerleşik bir kullanım panosu ve yeni bir oluşturulan medya (gen media) sayfası da dahil olmak üzere bir dizi güncelleme aldı. Bu, yaklaşan I/O konferansında daha fazla ilgili duyurunun olabileceğine işaret ediyor (Kaynak: matvelloso)

LatitudeGames yeni model Harbinger-24B’yi (New Wayfarer) yayınladı: LatitudeGames, Hugging Face’te New Wayfarer kod adlı Harbinger-24B adlı yeni bir model yayınladı. Topluluk buna ilgi gösteriyor ve neden Qwen3 32B veya Llama 4 Scout gibi diğer modellerin ince ayarlanmadığını tartışıyor (Kaynak: Reddit r/LocalLLaMA)

🧰 Araçlar

Adopt AI, AI Agent aracılığıyla yazılım etkileşimini yeniden yapılandırmayı amaçlayan 6 milyon dolar fon aldı: Girişim şirketi Adopt AI, Agent Builder ve Agent Experience olmak üzere iki ana işlev aracılığıyla geleneksel kurumsal yazılımların kodsuz bir şekilde doğal dil etkileşim yeteneklerini hızla entegre etmesini sağlamayı amaçlayan 6 milyon dolarlık bir tohum turu finansmanı aldı. Teknolojisi, uygulama yapısını ve API’leri otomatik olarak öğrenebilir, doğal dille çağrılabilen işlemler üretebilir ve Pass-through mimarisi aracılığıyla veri güvenliğini sağlayarak yazılım benimseme oranını ve verimliliğini artırmayı ve kurumsal maliyetleri düşürmeyi hedefler (Kaynak: WeChat)

ByteDance Volcano Engine, yüksek düzeyde DIY destekleyen mini AI donanım demosu yayınladı: Volcano Engine, mini bir AI donanımının demosunu yayınladı ve istemci/sunucu kodunu açık kaynaklı hale getirdi. Bu donanım, yüksek derecede özelleştirmeyi destekler ve Volcano büyük modelleri, Coze akıllı ajanları ve FastGPT gibi OpenAI API uyumlu üçüncü taraf büyük modelleri ile MiniMax dahil çeşitli TTS sesleriyle entegre olabilir. Kullanıcılar, genç Jay Chou veya He Jiong gibi belirli karakterlerle sohbet etmek veya AI sesli müşteri hizmetleri gibi uygulamalar oluşturmak için DIY yapabilir, bu da zengin AI etkileşim deneyimleri sunar (Kaynak: WeChat)

Runway, geliştiricilerin görüntü oluşturma uygulamaları oluşturmasını sağlayan Gen-4 References API’sini yayınladı: Runway, popüler Gen-4 References görüntü oluşturma modelini API aracılığıyla geliştiricilere açtı. Bu model, genel amaçlılığı ve esnekliği ile bilinir ve referans görüntülere dayanarak yeni, stil açısından tutarlı görüntüler oluşturabilir. API’nin yayınlanması, geliştiricilerin bu güçlü görüntü oluşturma yeteneğini kendi uygulamalarına ve iş akışlarına entegre etmelerini sağlayacak (Kaynak: c_valenzuelab)

Zencoder, kodlama optimizasyonu için AI akıllı ajan platformu Zen Agents’i başlattı: AI girişimi Zencoder (resmi adı For Good AI Inc.), kodlama görevleri için optimize edilmiş AI ajanları oluşturmak üzere tasarlanmış Zen Agents adlı bir bulut platformunu duyurdu. Bu platform, yazılım geliştirme verimliliğini ve kalitesini artırmayı amaçlıyor (Kaynak: dl_weekly)

llmbasedos: MCP tabanlı, yerel LLM’ler için optimize edilmiş minimalist Linux dağıtımı: Bir geliştirici, yerel ortamı bir LLM ön ucuna (Claude Desktop, VS Code gibi) birinci sınıf bir vatandaş haline getirmeyi amaçlayan, Arch Linux tabanlı minimalist bir dağıtım olan llmbasedos’u oluşturdu. MCP (Model Context Protocol) protokolü aracılığıyla yerel yetenekleri (dosyalar, e-postalar, aracılar vb.) ortaya çıkarır, çevrimdışı modu (llama.cpp dahil) veya GPT-4o, Claude gibi bulut tabanlı modellere bağlanmayı destekler, geliştiricilerin hızlı bir şekilde yeni özellikler eklemesini kolaylaştırır (Kaynak: Reddit r/LocalLLaMA)

PDF dosyalarının LLM ve Linux sistemlerini çalıştırabilmesi dikkat çekti: Teknoloji meraklısı Aiden Bai, “llm.pdf” adlı projesinde PDF dosyalarında küçük dil modellerini (TinyStories, Pythia, TinyLLM gibi) çalıştırmayı gösterdi. Bu, modeli JavaScript’e derleyerek ve PDF’nin JS desteğinden yararlanarak gerçekleştirildi. Yorumlar bölümünde, daha önce PDF içinde bir Linux sisteminin (RISC-V emülatörü aracılığıyla) çalıştırıldığına dair bir örnek olduğu belirtildi. Bu, PDF’nin dinamik içerik kapsayıcısı olarak potansiyelini ortaya koyuyor, ancak aynı zamanda güvenlik ve pratiklik hakkında tartışmalara da yol açıyor (Kaynak: WeChat)

OpenAI Codex CLI aracı güncellendi, ChatGPT girişi ve yeni mini model desteği eklendi: OpenAI geliştirici ekibi, Codex CLI aracında iyileştirmeler yapıldığını duyurdu. Bunlar arasında API organizasyonlarına hızlı bağlantı için ChatGPT hesabıyla giriş desteği ve düşük gecikmeli kod soru-cevap ve düzenleme görevleri için optimize edilmiş yeni codex-mini modeli bulunuyor (Kaynak: openai, dotey)

SenseTime’ın büyük model entegre makinesi IDC tarafından önerildi, SenseNova ve DeepSeek gibi modelleri destekliyor: IDC’nin yayınladığı “Çin AI Büyük Model Entegre Makine Pazar Analizi ve Marka Önerisi, 2025” raporunda SenseTime’ın büyük model entegre makinesi seçildi. Bu entegre makine, SenseTime’ın Büyük Cihaz AI altyapısına dayanıyor, yüksek performanslı hesaplama çipleri ve çıkarım hızlandırma motorlarıyla donatılmış olup SenseTime’ın “日日新SenseNova V6” ve DeepSeek gibi ana akım büyük modellerini destekliyor. Tamamen bağımsız ve kontrol edilebilir bir çözüm sunarak toplam sahip olma maliyetini (TCO) optimize ediyor ve sağlık, finans gibi birçok sektörde halihazırda uygulanmış durumda (Kaynak: QbitAI)

Açık kaynaklı iş akışı otomasyon aracı n8n, Çince desteği ekledi: Popüler açık kaynaklı iş akışı otomasyon aracı n8n, artık topluluk tarafından katkıda bulunulan bir yerelleştirme paketi aracılığıyla Çince arayüzü destekliyor. Kullanıcılar, ilgili sürümün yerelleştirme dosyasını indirebilir ve basit Docker yapılandırma değişiklikleriyle n8n’de Çince işlem yapabilir, bu da yerel kullanıcıların kullanım engelini azaltır (Kaynak: WeChat)

git-bug: Git’e gömülü, dağıtık, çevrimdışı öncelikli hata takipçisi: git-bug, sorunları, yorumları vb. (normal dosyalar yerine) Git deposuna nesne olarak gömen, böylece dağıtık, çevrimdışı öncelikli bir hata takibi sağlayan açık kaynaklı bir araçtır. GitHub, GitLab gibi platformlarla köprüler aracılığıyla sorun senkronizasyonunu destekler ve CLI, TUI ve Web arayüzleri sunar (Kaynak: GitHub Trending)

PyLate, büyük ölçekli veri kümelerinde model kıyaslama verimliliğini artırmak için PLAID indeksini entegre etti: Antoine Chaffin, ColBERT modelleri için bir eğitim ve çıkarım ekosistemi olan PyLate’in PLAID indeksini birleştirdiğini duyurdu. Bu entegrasyon, kullanıcıların çok büyük veri kümelerinde en iyi modelleri etkili bir şekilde kıyaslamasına olanak tanıyarak çeşitli alım sıralamalarında SOTA elde etme kolaylığı sağlıyor (Kaynak: lateinteraction, tonywu_71)

Neon: Açık kaynaklı sunucusuz PostgreSQL veritabanı: Neon, depolama ve hesaplamayı ayırarak otomatik ölçeklendirme, kod olarak veritabanı dallanması ve sıfıra ölçeklenme özellikleri sunan açık kaynaklı bir sunucusuz PostgreSQL alternatifidir. Bu proje GitHub’da ilgi görüyor ve esnek, ölçeklenebilir veritabanı çözümlerine ihtiyaç duyan AI ve diğer uygulama geliştiricilerine yeni bir seçenek sunuyor (Kaynak: GitHub Trending)

Unmute.sh: Özelleştirilebilir komut istemleri ve seslerle yeni AI sesli sohbet aracı: Unmute.sh, kullanıcıların komut istemlerini (prompt) özelleştirmesine ve farklı sesler seçmesine olanak tanıyan yeni bir AI sesli sohbet aracıdır. Bu, kullanıcılara daha kişiselleştirilmiş ve esnek bir sesli etkileşim deneyimi sunar (Kaynak: Reddit r/artificial)

📚 Öğrenme

Dünyanın ilk çok modlu genel amaçlı model değerlendirme çerçevesi General-Level ve kıyaslama standardı General-Bench yayınlandı: ICML‘25’te (Spotlight) kabul edilen bir araştırma, çok modlu büyük modeller (MLLM) için yepyeni bir değerlendirme çerçevesi olan General-Level’ı ve buna eşlik eden veri kümesi General-Bench’i öneriyor. Bu çerçeve, beş seviyeli bir sıralama sistemi sunuyor ve temel olarak modellerin “sinerji genelleme etkisi”ni (Synergy), yani bilginin farklı modaliteler veya görevler arasında aktarılma ve geliştirme yeteneğini inceliyor. General-Bench, 700’den fazla görev, 320.000’den fazla test verisi içeren ve görüntü, video, ses, 3D ve dil olmak üzere beş ana modaliteyi ve 29 alanı kapsayan, şu anda mevcut olan en büyük ve en kapsamlı MLLM değerlendirme kıyaslama standardıdır. Sıralama listesi, GPT-4V gibi modellerin şu anda yalnızca Seviye-2’ye (sinerjisiz) ulaştığını ve henüz hiçbir modelin Seviye-5’e (tam modalite tam sinerji) ulaşamadığını gösteriyor (Kaynak: WeChat)

Makale J1, RL aracılığıyla LLM-as-a-Judge’ı düşünmeye teşvik etmeyi öneriyor: “J1: Incentivizing Thinking in LLM-as-a-Judge via RL” başlıklı yeni bir makale (arxiv:2505.10320), değerlendirici olarak kullanılan büyük dil modellerini (LLM-as-a-Judge) yalnızca yüzeysel yargılarda bulunmak yerine daha derinlemesine “düşünmeye” teşvik etmek için pekiştirmeli öğrenmenin (RL) nasıl kullanılabileceğini araştırıyor. Bu yaklaşım, LLM’lerin karmaşık görevleri değerlendirmedeki doğruluğunu ve güvenilirliğini artırabilir (Kaynak: jaseweston)

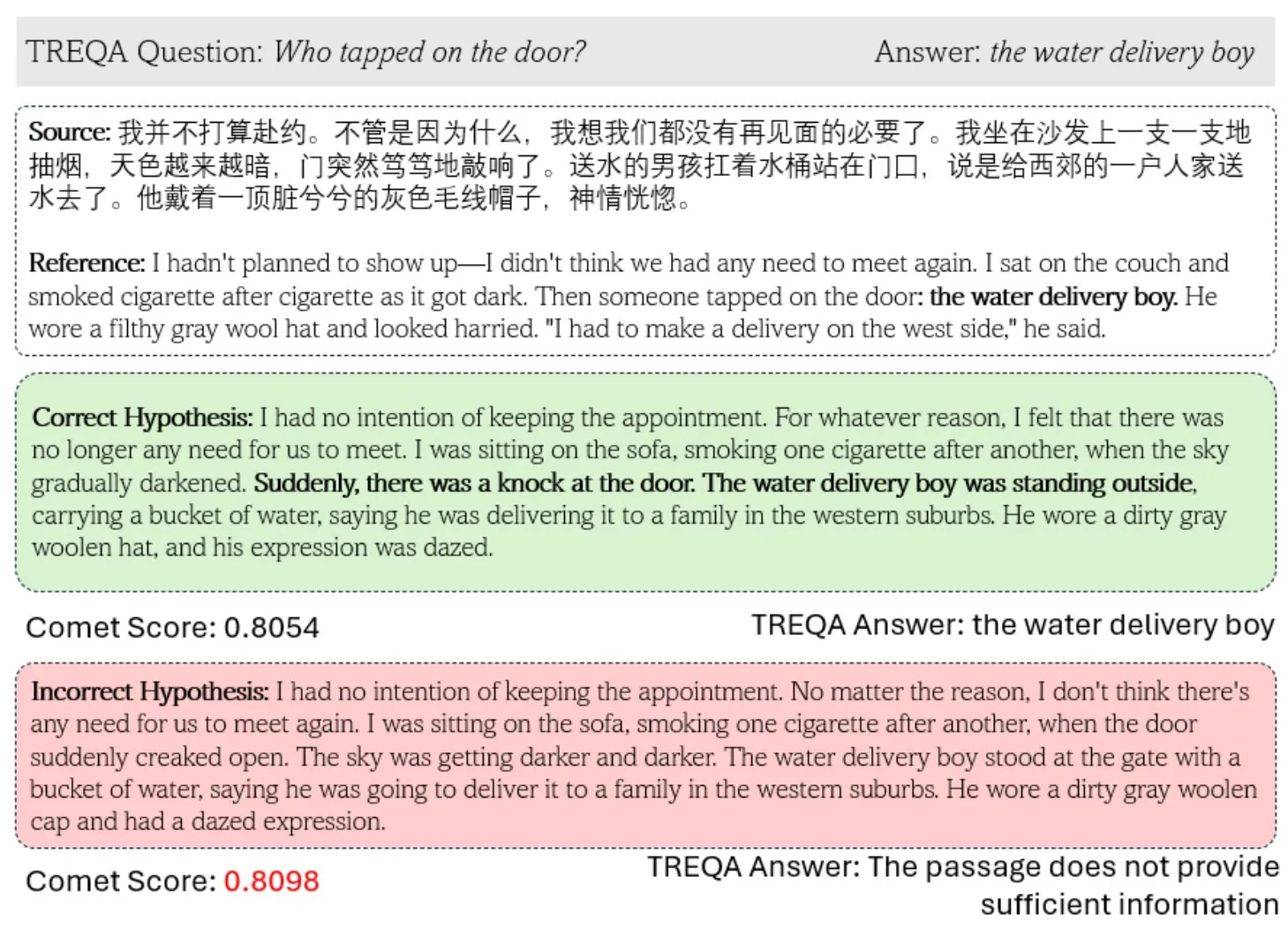

Yeni çerçeve TREQA, karmaşık metin çeviri kalitesini değerlendirmek için LLM kullanıyor: Mevcut makine çevirisi (MT) metriklerinin karmaşık metinleri değerlendirmedeki eksikliklerini gidermek için araştırmacılar TREQA çerçevesini önerdi. Bu çerçeve, kaynak metin ve çevrilmiş metin hakkında sorular oluşturmak için büyük dil modellerini (LLM) kullanır ve bu sorulara verilen yanıtları karşılaştırarak çevirinin önemli bilgileri koruyup korumadığını değerlendirir. Bu yöntem, uzun metin çevirilerinin kalitesini daha kapsamlı bir şekilde ölçmeyi amaçlamaktadır (Kaynak: gneubig)

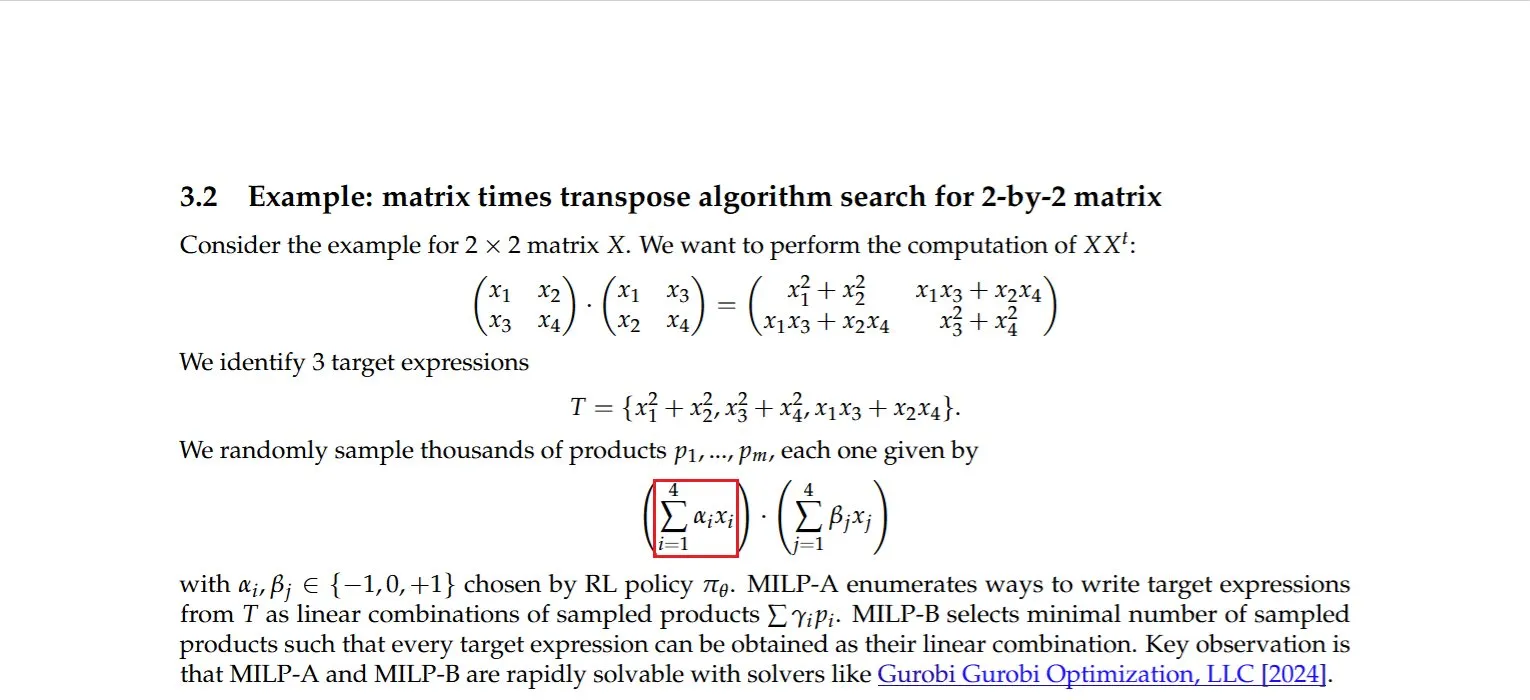

Araştırma, bir matrisin transpozesiyle çarpımının verimli hesaplama yöntemini buldu: Dmitry Rybin ve arkadaşları, bir matrisin transpozesiyle çarpımını hesaplamak için daha hızlı bir algoritma buldular (arxiv:2505.09814). Bu temel atılım, veri analizi, çip tasarımı, kablosuz iletişim ve LLM eğitimi gibi birçok alan için derin etkilere sahiptir, çünkü bu tür hesaplamalar bu alanlarda yaygın işlemlerdir. Bu, olgunlaşmış hesaplamalı lineer cebir alanında bile iyileştirme için hala yer olduğunu bir kez daha kanıtlıyor (Kaynak: teortaxesTex, Ar_Douillard)

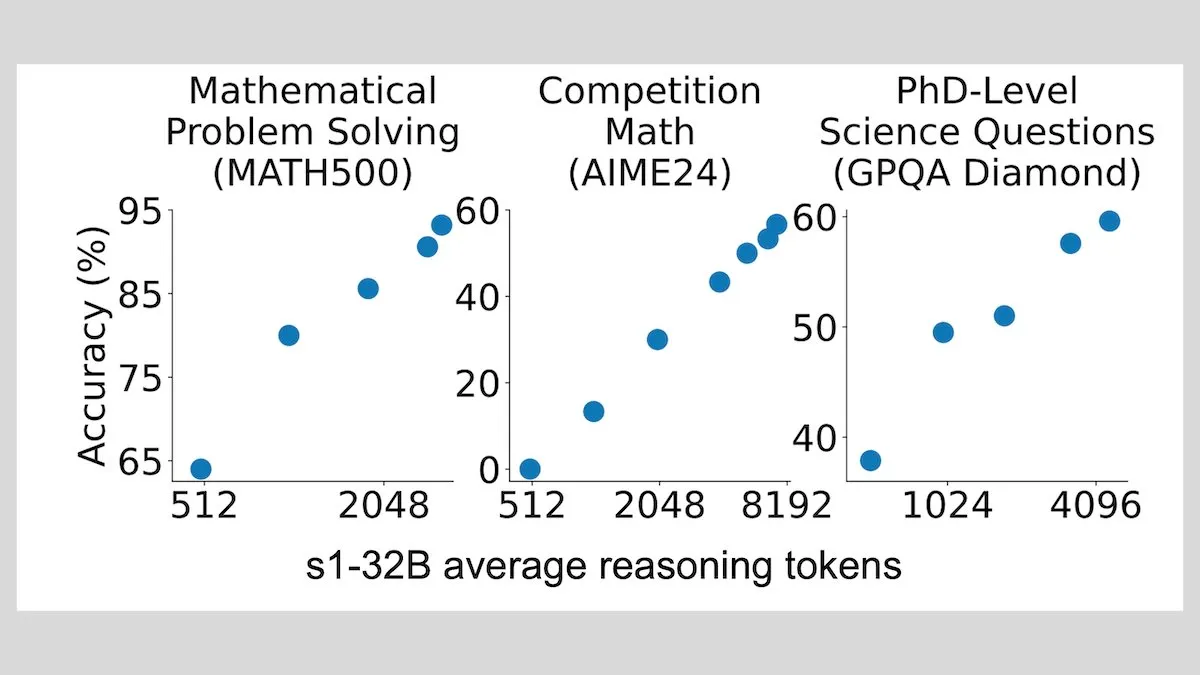

DeepLearningAI: Az sayıda örnekle ince ayar, LLM çıkarım yeteneğini önemli ölçüde artırabilir: Araştırmalar, büyük dil modellerini yalnızca 1000 örnekle ince ayarlamanın, çıkarım yeteneklerini önemli ölçüde artırabildiğini gösteriyor. Deney modelleri s1, çıkarım sırasında “Wait” kelimesini ekleyerek çıkarım sürecini genişletiyor ve AIME ve MATH 500 gibi kıyaslama testlerinde iyi performans elde ediyor. Bu düşük kaynaklı yaklaşım, pekiştirmeli öğrenmeye gerek kalmadan, az miktarda veriyle bile ileri düzey çıkarımın öğretilebileceğini gösteriyor (Kaynak: DeepLearningAI)

Hugging Face, zengin bağlamlı AI uygulamaları oluşturmaya yardımcı olmak için ücretsiz MCP kursu başlattı: Hugging Face, Anthropic ile işbirliği içinde “MCP: Build Rich-Context AI Apps with Anthropic” adlı ücretsiz bir kurs başlattı. Kurs, geliştiricilerin MCP (Model Context Protocol) mimarisini anlamalarına, MCP sunucuları ve uyumlu uygulamalar oluşturup dağıtmayı öğrenmelerine yardımcı olmayı amaçlıyor, böylece AI uygulamalarının araçlar ve veri kaynaklarıyla entegrasyonunu basitleştiriyor. Şu anda 3000’den fazla öğrenci kaydoldu (Kaynak: DeepLearningAI, huggingface, ClementDelangue)

awesome-gpt4o-images projesi, GPT-4o görüntü oluşturma harika örneklerini topluyor: Jamez Bondos tarafından oluşturulan GitHub projesi awesome-gpt4o-images, 33 gün içinde 5700’den fazla yıldız aldı. Bu proje, GPT-4o kullanılarak oluşturulan mükemmel görüntü örneklerini ve komut istemlerini topluyor ve sergiliyor. Şu anda yaklaşık yüz örnek bulunuyor ve düzenleme ve doğrulama sonrasında sürekli güncellenmesi planlanıyor, bu da AIGC topluluğu için değerli yaratıcı kaynaklar sağlıyor (Kaynak: dotey)

Yann LeCun, kendi kendine denetimli öğrenme (SSL) konuşmasını paylaştı: Yann LeCun, kendi kendine denetimli öğrenme (SSL) hakkındaki konuşmasının içeriğini paylaştı. SSL, önemli bir makine öğrenimi paradigması olarak, modellerin etiketlenmemiş verilerden etkili temsiller öğrenmesini amaçlar ve büyük ölçekli etiketli verilere olan bağımlılığı azaltmak ve model genelleme yeteneğini artırmak için büyük önem taşır (Kaynak: ylecun)

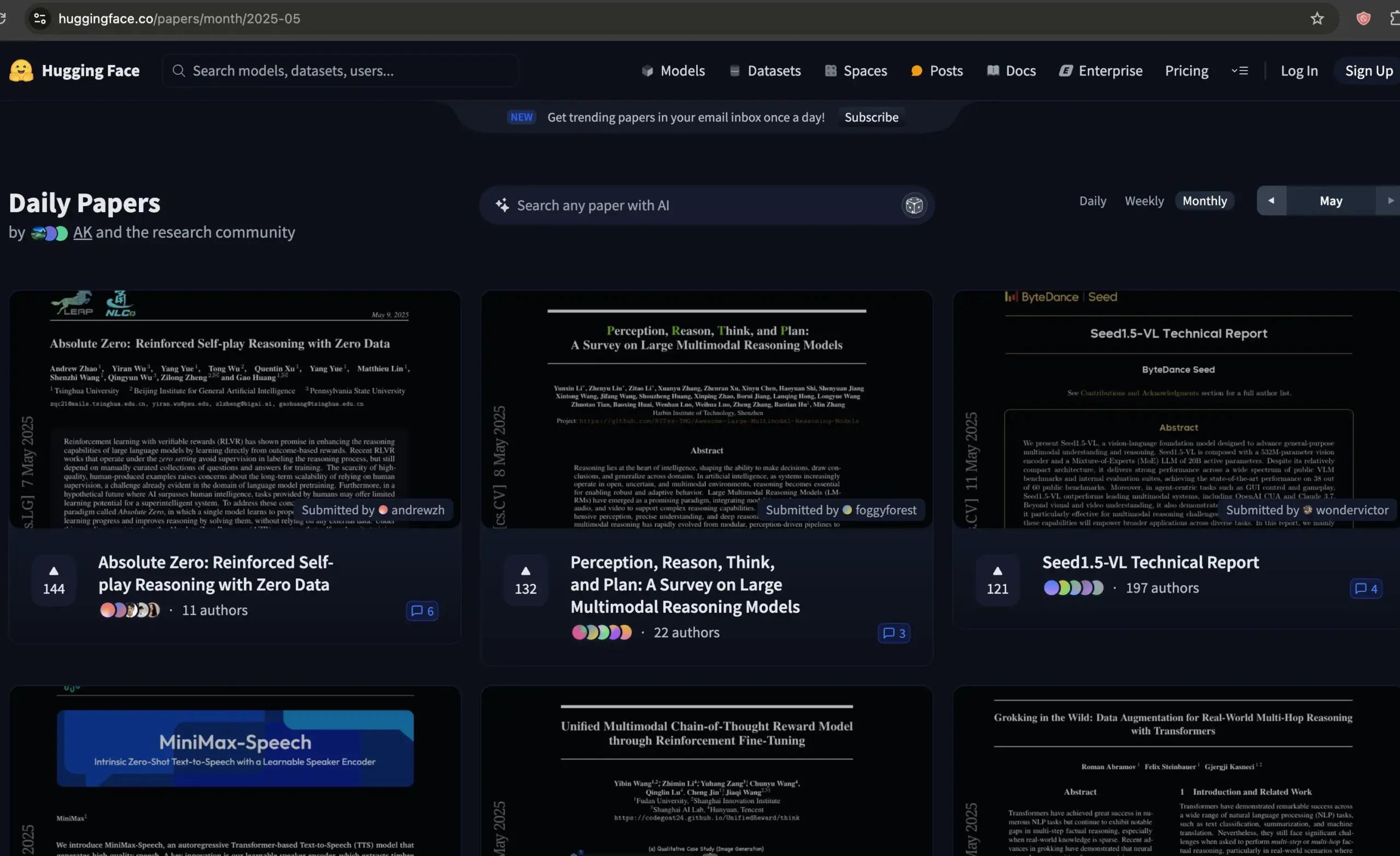

Hugging Face makale forumu, AI makalelerini filtrelemek için kaliteli bir kaynak haline geldi: Dwarkesh Patel, Hugging Face’in makale forumunu, geçtiğimiz ayın en iyi AI makalelerini filtrelemek için mükemmel bir kaynak olarak öneriyor. Bu platform, araştırmacılara en son AI araştırma gelişmelerini keşfetmek ve tartışmak için uygun bir kanal sunuyor (Kaynak: dwarkesh_sp, huggingface)

ACL 2025 kabul sonuçları açıklandı, Alibaba International AIB ekibinin birçok makalesi seçildi: Doğal dil işleme alanındaki en iyi konferanslardan biri olan ACL 2025’in kabul sonuçları açıklandı. Bu yılki başvuru sayısı rekor seviyeye ulaştı ve rekabet yoğundu. Alibaba International AI Business ekibinin birçok makalesi kabul edildi. Marco-o1 V2, Marco-Bench-IF ve HD-NDEs (halüsinasyon tespiti için sinirsel diferansiyel denklemler) gibi bazı çalışmalar yüksek beğeni topladı ve ana konferans uzun makaleleri olarak kabul edildi. Bu, Alibaba International’ın AI alanındaki sürekli yatırımının ve yetenek yetiştirme çabalarının ilk meyvelerini verdiğini yansıtıyor (Kaynak: QbitAI)

dstack, dağıtık eğitim için hızlı ara bağlantı kurulum kılavuzu yayınladı: dstack, NVIDIA veya AMD kümelerinde dağıtık eğitim yapan kullanıcılar için dstack aracılığıyla hızlı ara bağlantıların nasıl kurulacağına dair kısa bir kılavuz sunuyor. Bu kılavuz, kullanıcıların bulutta veya yerel olarak AI iş yüklerini ölçeklendirirken ağ performansını optimize etmelerine yardımcı olmayı amaçlıyor (Kaynak: algo_diver)

AssemblyAI, LLM komut istemi becerilerini geliştirmek için 10 ipucu içeren bir video paylaştı: AssemblyAI, YouTube videosu aracılığıyla büyük dil modeli (LLM) komut istemi (prompting) etkisini iyileştirmek için 10 ipucu paylaştı. Bu, kullanıcıların istenen çıktıları elde etmek için LLM’lerle daha etkili bir şekilde etkileşim kurmasına yardımcı olmayı amaçlıyor (Kaynak: AssemblyAI)

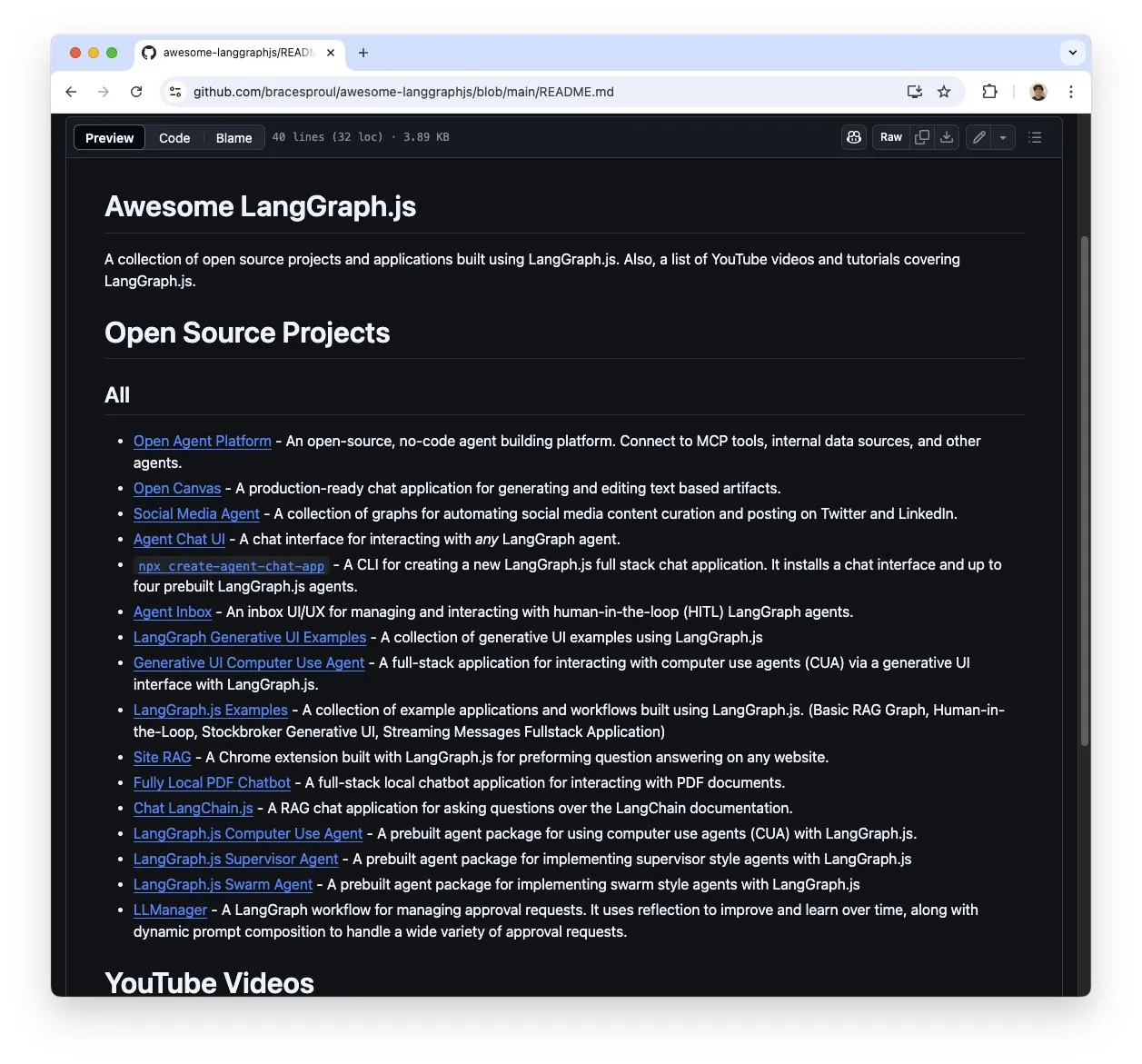

LangGraph.js öğrenme kaynakları koleksiyonu “awesome-langgraphjs” ilgi görüyor: Brace, LangGraph.js kullanılarak oluşturulmuş açık kaynaklı projeleri ve YouTube video eğitimlerini toplayan “awesome-langgraphjs” adlı bir GitHub deposu oluşturdu ve sürdürüyor. Bu kaynak, çoklu ajan sistemlerinden tam yığın sohbet uygulamalarına kadar çeşitli uygulamalar oluşturmak için LangGraph.js’yi öğrenmek ve kullanmak isteyen geliştiricilere kolaylık sağlıyor (Kaynak: LangChainAI)

💼 İş Dünyası

Alibaba’nın AI strateji dönüşümü etkisini gösteriyor, bulut işi ve AI ürün gelirleri önemli ölçüde arttı: Alibaba’nın 2025 4. Çeyrek mali raporu, belirli işler hariç tutulduğunda genel gelirin %10, bulut zekası iş gelirinin %18 arttığını ve AI ile ilgili ürün gelirlerinin art arda 7 çeyrektir üç haneli büyüme kaydettiğini gösterdi. Alibaba, AI’ı temel stratejisi olarak görüyor ve önümüzdeki üç yıl içinde bulut bilişim ve AI altyapısını yükseltmek için 380 milyar yuan’dan fazla yatırım yapmayı planlıyor. Açık kaynaklı Tongyi Qianwen Qwen-3 modeli birçok küresel listede zirveye yerleşti ve 100.000’den fazla türev model üretti, bu da teknolojik gücünü ve açık kaynak ekosisteminin canlılığını gösteriyor. Alibaba, AI’ın otomotiv, iletişim, finans gibi sektörlerde uygulanmasını hızlandırıyor (Kaynak: 36Kr)

Video düzenleme uygulaması Mojo, Dailymotion tarafından satın alındı: Video düzenleme uygulaması Mojo (@mojo_video_app), Dailymotion tarafından satın alındı. Mojo’nun video düzenleme teknolojisi, Dailymotion’ın sosyal uygulamalarına ve B2B ürünlerine entegre edilecek ve iki taraf, Avrupa’nın yeni nesil sosyal video platformunu birlikte oluşturmayı hedefliyor (Kaynak: ClementDelangue)

Cohere, kurumsal AI yeteneklerini güçlendirmek için Ottogrid’i satın aldı: AI şirketi Cohere, girişim şirketi Ottogrid’i satın aldığını duyurdu. Bu satın almanın, Cohere’in kurumsal düzeyde AI çözümleri konusundaki yeteneklerini artırması bekleniyor, ancak belirli işlem detayları ve Ottogrid’in teknoloji yönü ayrıntılı olarak açıklanmadı (Kaynak: aidangomez, nickfrosst)

🌟 Topluluk

AI Agent, çalışma şekillerinde devrim tartışmalarını tetikliyor, gelecek gerçek zamanlı strateji oyunlarına benzeyebilir: Will Depue, gelecekteki çalışmanın, insanların görevleri yerine getirmek, bilgi toplamak, sistemler tasarlamak vb. için yaklaşık 200 mikro akıllı ajanı yönettiği StarCraft veya Age of Empires gibi bir modele dönüşebileceğini öne sürdü. Sam Altman bu görüşü paylaşarak onayladı. Fabian Stelzer ise bunu “Zerg rush coded” (Zerg hücumuyla kodlama) olarak adlandırdı. Bu görüş, topluluğun AI Agent’ın iş akışlarını ve insan-makine işbirliği modellerini nasıl yeniden şekillendireceğine dair hayallerini ve tartışmalarını yansıtıyor (Kaynak: willdepue, sama, fabianstelzer)

xAI’nin Grok robotunun yanıtları tartışma yarattı, komut isteminin yetkisiz olarak değiştirildiği iddia edildi: xAI, X platformundaki Grok yanıt robotunun komut isteminin 14 Mayıs sabahı yetkisiz olarak değiştirildiğini ve bunun sonucunda Trump’ı içeren olaylar gibi bazı olaylara ilişkin analizlerinin anormal veya ana akım bilgilerle tutarsız göründüğünü kabul etti. Topluluk bu konuya büyük ilgi gösterdi; Clement Delangue ve diğerleri şeffaflığı artırmak için Grok’un açık kaynaklı olması çağrısında bulundu. Colin Fraser gibi kullanıcılar, Grok’un farklı zamanlardaki yanıtlarını karşılaştırarak sistem komut isteminin değişiklik geçmişini tersine mühendislikle anlamaya çalıştı (Kaynak: ClementDelangue, menhguin, colin_fraser)

Meta Llama4 ekibinden çok sayıda istifa olduğu söylentisi, toplulukta açık kaynaklı AI’ın geleceği hakkında endişelere yol açtı: Topluluktan gelen haberlere göre Meta’nın Llama4 ekibinin yaklaşık %80’i (14 kişilik orijinal ekipten 11 kişi ayrıldı) istifa etti ve amiral gemisi modeli Behemoth’un lansmanı ertelendi. Bu olay geniş yankı uyandırdı ve Nat Lambert gibi sektör uzmanları bu durumdan üzüntü duyduklarını belirtti. Scaling01, Meta’nın yeni bir Llama pazar direktörüne ihtiyacı olabileceğini yorumladı. TeortaxesTex gibi kullanıcılar ise bunun açık kaynaklı AI gelişimini olumsuz etkileyebileceğinden endişe duyuyor ve hatta Çin’in açık kaynağın son umudu olup olmayacağını tartışıyor (Kaynak: teortaxesTex, Dorialexander, scaling01)

AI’ın savaşta kullanımı ve etik sorunları dikkat çekiyor: Reddit topluluğu, AI’ın savaşta kullanımını tartışıyor ve savaşçıları izlemek ve yerlerini tespit etmek, bilgileri analiz ederek askeri istihbarat sağlamak için halihazırda kullanıldığını belirtiyor. Tartışmada, ABD ordusunun 1991’den beri DART gibi AI araçlarını kullandığına değiniliyor. Kullanıcılar, AI’ın silahlandırılmasının getirebileceği ölümcül risklerden ve insanlığa yönelik potansiyel tehditlerden endişe duyuyor ve ilgili uluslararası anlaşmaların ve önlemlerin geliştirilmesini takip ediyor. OpenAI’nin kullanım kılavuzundan askeri amaçlı kullanımı yasaklayan maddenin çıkarılması da daha fazla düşünceye yol açıyor (Kaynak: Reddit r/ArtificialInteligence)

Büyük dil modelleri CCPC programlama yarışmasında düşük performans gösterdi, mevcut sınırlamaları ortaya koydu: Onuncu Çin Üniversite Öğrencileri Programlama Yarışması (CCPC) finallerinde, ByteDance Seed-Thinking dahil olmak üzere birçok tanınmış büyük dil modeli (o3/o4, Gemini 2.5 pro, DeepSeek R1 dahil) düşük performans gösterdi, çoğu yalnızca giriş seviyesi bir soruyu çözebildi veya sıfır puan aldı. Resmi yetkililer, modellerin tamamen otonom denemeler yaptığını ve insan müdahalesi olmadığını açıkladı. Topluluk analizleri, bunun mevcut büyük modellerin özellikle Agentic olmayan (yani araç destekli yürütme ve hata ayıklama olmadan) modda, son derece yenilikçi ve karmaşık algoritma problemlerini çözmedeki eksikliklerini ortaya koyduğunu gösteriyor. Bu, OpenAI o3’ün IOI yarışmasında Agentic eğitimle altın madalya kazanmasıyla tezat oluşturuyor (Kaynak: WeChat)

DSPy çerçevesi ve “acı dersler” tartışma yarattı, standart tasarım ve otomatikleştirilmiş komut istemlerinin önemini vurguladı: DSPy ile ilgili tartışmalar, AI’ın ölçeklenmesinin (Scaling) birçok mühendislik zorluğunu (“acı dersler”) aşabilmesine rağmen, sorunun temel özelliklerinin (gereksinimler ve bilgi akışı) dikkatli bir şekilde tasarlanmasının yerini tutamayacağını vurguluyor. Ancak ölçeklenme, sorunları tanımlama soyutlama düzeyini artırabilir. Otomatikleştirilmiş komut istemleri (prompt optimizers gibi), hesaplama gücünü kullanmanın “acı dersler”e uygun bir yolu olarak görülürken, manuel komut istemleri, modelin öğrenmesine izin vermek yerine insan sezgisini enjekte ettiği için buna aykırı olabilir (Kaynak: lateinteraction, lateinteraction)

AI Agent’ın çıkarım sırasında kendini kontrol etme/araç keşfi için hesaplama maliyeti dikkat çekiyor: Paul Calcraft, AI Agent’ın aktif kendini kontrol, araç kullanımı ve keşifsel iş akışları için çıkarım aşamasında büyük hesaplama kaynakları (tek bir sorunu çözmek için 200 doların üzerinde gibi) ayırma uygulamaları hakkında soru soruyor. Devin ve rakiplerinin bunu halkla ilişkiler gösterileri için yapabileceğini, ancak yeni çözümler arayan senaryolar (FunSearch’e benzer ancak daha az kısıtlı) için durumun belirsiz olduğunu belirtiyor (Kaynak: paul_cal)

AI destekli “Vibe Coding” (Atmosfer Kodlaması) tartışma yarattı: GitHub Copilot gibi araçlar, “Vibe Coding”i (yani katı planlama yerine daha çok sezgiye ve AI yardımına dayanan kodlama şekli) mümkün kılıyor, hatta 16 yaşındaki bir öğrenci okul projesini Copilot kullanarak tamamladı. Topluluğun bu olguya bakışı farklı; bazıları bunun yeni bir programlama paradigması olduğunu düşünürken, bazıları temellerin ve standartların önemini vurguluyor (Kaynak: Reddit r/ArtificialInteligence, nrehiew_)

Hugging Face Transformers kütüphanesi yeni topluluk panosunu etkinleştirdi: Hugging Face, temel kütüphanesi Transformers için duyurular, yeni özellik tanıtımları, yol haritası güncellemeleri yayınlamak ve kullanıcıların kütüphane kullanımı veya model sorunları hakkında soru sormasını ve tartışmasını memnuniyetle karşılamak üzere yeni bir topluluk panosu açtı. Bu, geliştiricilerle etkileşimi ve desteği güçlendirmeyi amaçlıyor (Kaynak: TheZachMueller, ClementDelangue)

AI geliştiricileri, en iyi konferanslara “Findings” makale kulvarı eklenmesi çağrısında bulunuyor: NeurIPS gibi en iyi AI konferanslarına yapılan başvuru sayısındaki artış (örneğin NeurIPS’e 25.000 başvuru) göz önüne alındığında, Dan Roy ve diğerleri ACL gibi konferansların “Findings” niteliğinde bir makale kulvarı oluşturmasını öneriyor. Bu, ana konferans standartlarına ulaşamayan ancak yine de değerli olan araştırmalara yayın fırsatı sunmayı, değerlendirme baskısını azaltmayı ve daha geniş akademik alışverişi teşvik etmeyi amaçlıyor. Öneriler arasında hafifletilmiş değerlendirme ve makale netliğini artırmaya odaklanma gibi unsurlar yer alıyor (Kaynak: AndrewLampinen)

💡 Diğer

AI destekli dış iskelet, tekerlekli sandalye kullanıcılarının ayağa kalkıp yürümesine yardımcı oluyor: AI destekli bir dış iskelet cihazı, tekerlekli sandalye kullanıcılarının yeniden ayağa kalkıp yürümesine yardımcı olma yeteneğini sergiledi. Bu tür teknolojiler, robotik teknolojiyi, sensörleri ve AI algoritmalarını birleştirerek kullanıcının niyetini algılayıp güç yardımı sağlayarak hareket kabiliyeti kısıtlı kişilere rehabilitasyon ve yaşam kalitesinde iyileşme umudu sunuyor (Kaynak: Ronald_vanLoon)

Kullanıcı adı fikirlerini görselleştirmek için AI kullanılıyor: Reddit ve X topluluklarında küçük bir akım ortaya çıktı; kullanıcılar, sosyal medya kullanıcı adlarına göre konsept görüntüler oluşturmak için AI görüntü oluşturma araçlarını (ChatGPT’nin yerleşik DALL-E 3’ü gibi) kullanıyor ve bu hayal gücü dolu eserleri paylaşıyor. Bu, AI’ın kişiselleştirilmiş yaratıcı ifadelerdeki eğlenceli uygulamalarını gösteriyor (Kaynak: Reddit r/ChatGPT, Reddit r/ChatGPT)

Amazon Ads, markaların yurt dışı pazarlama verimliliğini artırmak için AI kullanıyor: Amazon Ads, “Dünya Kamu Ekranı Laboratuvarı” konseptini tanıtarak Çinli markaların yurt dışına açılmasına AI teknolojisiyle nasıl güç kattığını gösteriyor. Prime Video gibi medya matrisleri aracılığıyla marka erişimini genişletiyor, AI yaratıcı stüdyoları (video oluşturma araçları gibi) ile içerik üretim engelini düşürüyor ve Amazon DSP ve Performance+ gibi araçlarla reklam yerleşimini ve dönüşümünü optimize ediyor. AI, burada yaratıcı üretimden etki ölçümüne kadar tüm süreçte rol oynayarak, özellikle KOBİ’ler olmak üzere marka sahiplerinin küresel marka oluşturma çalışmalarını daha verimli bir şekilde yürütmelerine yardımcı olmayı amaçlıyor (Kaynak: 36Kr)