Anahtar Kelimeler:AI Programlama Ajanı, Codex, Sesli Büyük Model, AI Ajan, OpenAI, MiniMax, Alibaba, Qwen, Codex Önizleme Sürümü, Speech-02 Ses Modeli, WorldPM Araştırması, FastVLM Görsel Dil Modeli, FG-CLIP Çapraz Modal Model

🔥 Odak Noktası

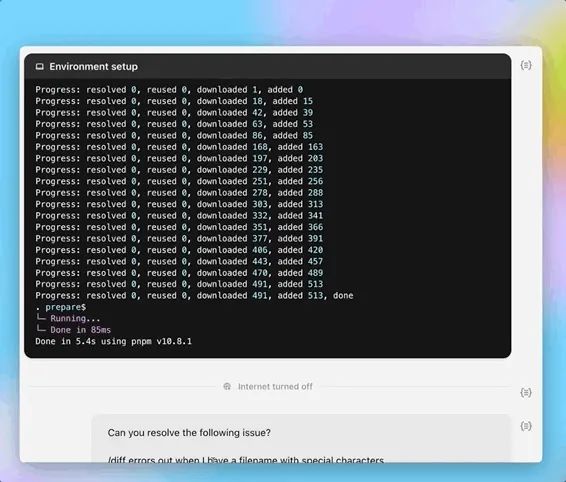

OpenAI, AI programlama ajanı Codex’in önizleme sürümünü yayınladı: OpenAI, 16 Mayıs gece yarısı bulut tabanlı yazılım mühendisliği ajanı Codex’in önizleme sürümünü kullanıma sundu. Codex, yazılım mühendisliği için optimize edilmiş o3 varyantı modeli codex-1 tarafından desteklenmekte olup programlama, kod tabanı soru-cevap, hata düzeltme ve pull request gönderme gibi görevleri paralel olarak işleyebilmektedir. Bulut tabanlı bir sandbox ortamında çalışır, kullanıcı kod tabanlarını önceden yükler ve görev tamamlama süresi 1-30 dakika arasındadır. Şu anda ChatGPT Pro, Team ve Enterprise kullanıcılarına açık olup, Plus ve Edu kullanıcıları için yakında kullanıma sunulacaktır. Aynı zamanda, Codex CLI için (o4-mini tabanlı) hafif model codex-mini’yi yayınladı; API fiyatlandırması giriş için 1,5 ABD doları/milyon token, çıkış için 6 ABD doları/milyon token olarak belirlendi. (Kaynak: 36Kr, 机器之心, op7418)

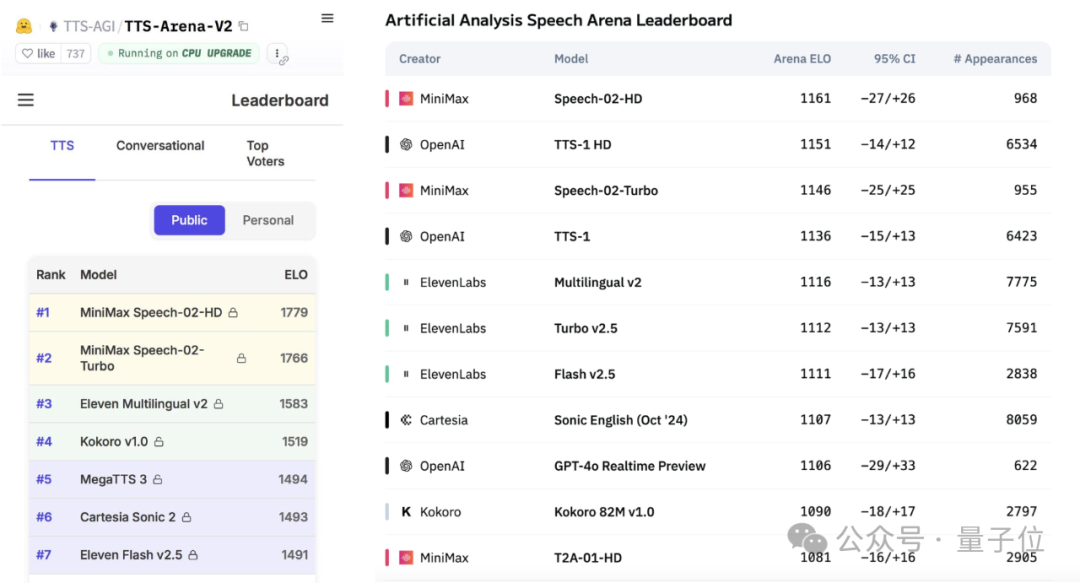

MiniMax, Speech-02 ses büyük modelini yayınladı ve küresel değerlendirme listelerinde zirveye yerleşti: Yerli AI şirketi MiniMax’ın en son yayınladığı metinden sese (TTS) büyük modeli Speech-02-HD, Artificial Analysis Speech Arena ve Hugging Face TTS Arena V2 adlı iki küresel otorite ses benchmark değerlendirmesinde OpenAI ve ElevenLabs’ı geride bırakarak birinci oldu. Bu model, ultra gerçekçi, kişiselleştirilmiş ve çeşitli özelliklere sahip olup 32 dili desteklemekte ve en az 10 saniyelik ses referansıyla gerçekçi ses tonu kopyalaması yapabilmektedir. Daha önce popüler olan “AI Daniel Wu” İngilizce öğrenme uygulaması da MiniMax teknolojisini kullanıyordu. Speech-02’nin temel yenilikleri arasında öğrenilebilir konuşmacı kodlayıcı ve ses kalitesini ve benzerliğini artıran Flow-VAE akış eşleştirme modeli bulunmaktadır. (Kaynak: 36Kr, karminski3)

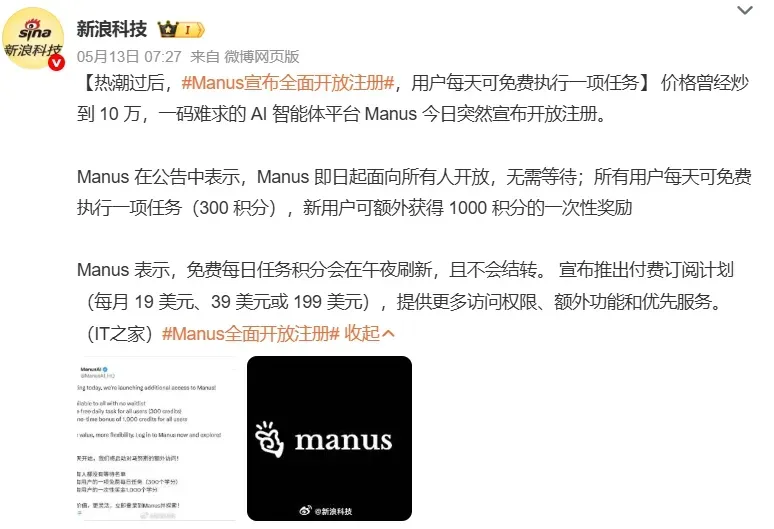

AI Agent’lar piyasada ilgi çekiyor, büyük şirketler bu alandaki yatırımlarını hızlandırıyor: AI ajanları (Agent) AI alanında yeni odak noktası haline geliyor. Manus gibi genel amaçlı Agent platformlarının kayıt açması büyük ilgi gördü ve ana şirketi Monica’nın yeni bir finansman turunda 75 milyon dolar topladığı ve değerlemesinin yaklaşık 500 milyon dolara ulaştığı bildirildi. Baidu (Xīnxiǎng), ByteDance (Kòuzi Kōngjiān), Alibaba (Xīnlíu) gibi büyük şirketler, AI çağının giriş kapısını ele geçirmek için kendi Agent ürünlerini veya platformlarını piyasaya sürüyor. Agent’lar malzeme hazırlama, web tasarımı, seyahat planlama gibi daha karmaşık görevleri yerine getirebiliyor. Şu anda genel amaçlı Agent’lar, uygulamalar arası işlemler ve derinlemesine görevler konusunda hala yetersiz kalıyor; ekosistemin olgunlaşmamış olması ve veri siloları başlıca zorluklar arasında. MCP protokolü, birlikte çalışabilirliği çözmenin anahtarı olarak görülüyor, ancak henüz katılan az. B2B dikey alanlardaki Agent’ların, odaklanmış senaryoları ve kolay özelleştirilebilirlikleri nedeniyle ticarileşmede öncü olmaları bekleniyor. (Kaynak: 36Kr, 36Kr)

Alibaba, insan tercihlerinin modellenmesinde ölçeklendirme yasalarını araştıran WorldPM çalışmasını yayınladı: Alibaba Qwen ekibi, “Modeling World Preference” adlı bir makale yayınlayarak insan tercihlerinin modellenmesinin ölçeklendirme yasalarına (Scaling Laws) uyduğunu ortaya koydu ve çeşitli insan tercihlerinin birleşik bir temsili paylaşabileceğini gösterdi. Araştırmada, 15 milyon tercih çifti içeren StackExchange veri kümesi kullanıldı ve 1.5B ila 72B parametreli Qwen2.5 modelleri üzerinde deneyler yapıldı. Sonuçlar, tercih modellemesinin nesnel ve sağlamlık metriklerinde eğitim ölçeği arttıkça logaritmik kayıp azalması gösterdiğini ortaya koydu; 72B modeli bazı zorlu görevlerde belirginleşen fenomenler sergiledi. Bu araştırma, tercih ince ayarı için etkili bir temel sağlıyor; makale ve model (WorldPM-72B) açık kaynak olarak yayınlandı. (Kaynak: Alibaba_Qwen)

🎯 Gelişmeler

Google DeepMind ve Anthropic, AI yorumlanabilirliği araştırmalarında anlaşmazlığa düştü: Google DeepMind kısa süre önce “mekanistik yorumlanabilirlik” (mechanistic interpretability) konusunu araştırma önceliği olarak görmeyeceğini açıkladı. Seyrek öz-kodlayıcılar (SAE) gibi yöntemlerle AI’ın iç işleyişini tersine mühendislikle anlamanın zorluklarla dolu olduğunu ve SAE’lerin doğasında var olan kusurları olduğunu belirtti. Buna karşılık Anthropic CEO’su Dario Amodei, bu alandaki araştırmaların güçlendirilmesi gerektiğini savundu ve önümüzdeki 5-10 yıl içinde “AI’ın nükleer manyetik rezonans görüntülemesinin” gerçekleştirilmesi konusunda iyimser olduğunu ifade etti. AI’ın “kara kutu” özelliği birçok riskin kaynağıdır ve mekanistik yorumlanabilirlik, modelin belirli nöronlarının ve devrelerinin işlevlerini anlamayı amaçlar, ancak on yılı aşkın süredir yapılan araştırmaların sınırlı sonuçları, araştırma yolları hakkında derinlemesine bir yeniden düşünmeyi tetikledi. (Kaynak: WeChat)

Poe raporu, AI model pazarındaki değişimleri ortaya koyuyor; OpenAI ve Google lider konumda: Poe’nun en son AI model kullanım raporu, metin üretimi alanında GPT-4o’nun (%35,8) lider olduğunu, çıkarım alanında ise Gemini 2.5 Pro’nun (%31,5) zirveye yerleştiğini gösteriyor. Görüntü üretimi Imagen3, GPT-Image-1 ve Flux serisi tarafından domine ediliyor. Video üretiminde Runway’in payı düşerken, Kuaishou’nun Kling’i sürpriz bir çıkış yaptı. Agent’lar konusunda, OpenAI’nin o3 modeli araştırma testlerinde Claude ve Gemini’den daha iyi performans gösterdi. Anthropic’in Claude modelinin pazar payında bir düşüş yaşandı. Rapor, çıkarım yeteneğinin kilit bir rekabet noktası haline geldiğini ve şirketlerin hızla değişen pazara uyum sağlamak için farklı modelleri esnek bir şekilde seçerek bir değerlendirme sistemi kurmaları gerektiğini belirtiyor. (Kaynak: WeChat)

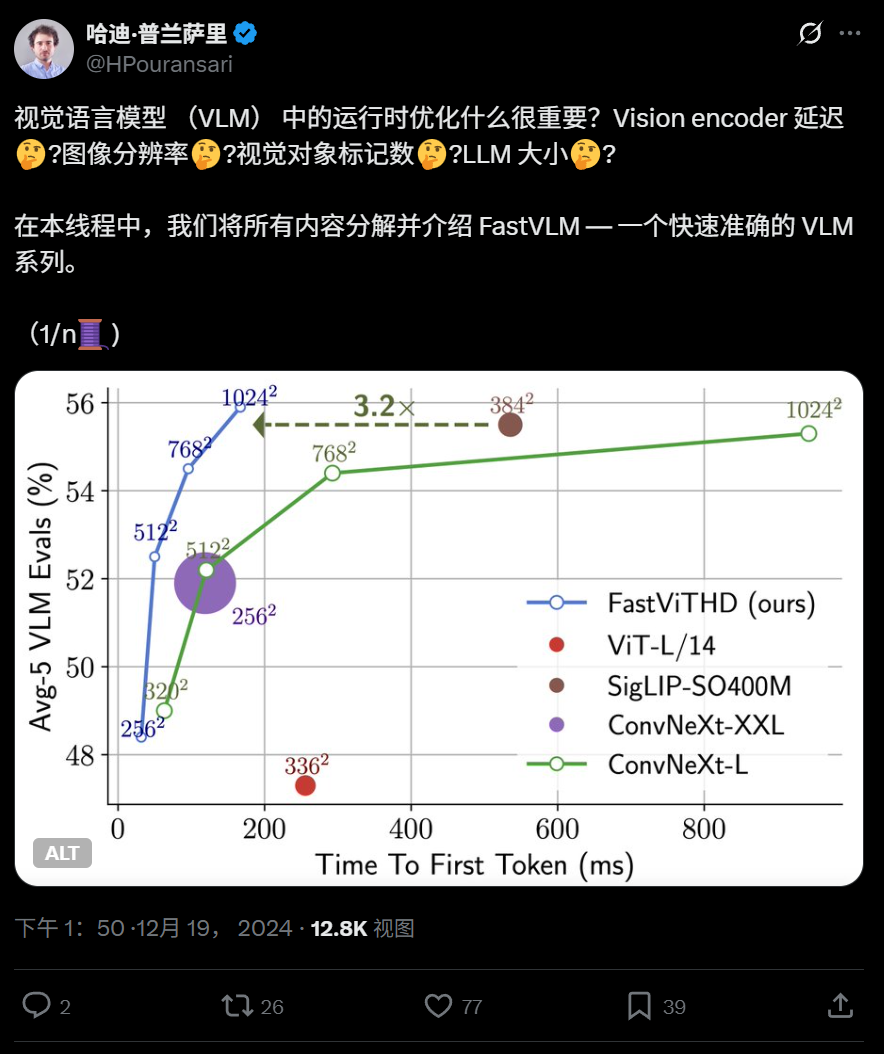

Apple, iPhone’da çalışabilen verimli görsel dil modeli FastVLM’yi açık kaynak olarak yayınladı: Apple, iPhone gibi uç cihazlarda verimli çalışmak üzere tasarlanmış bir görsel dil modeli olan FastVLM’yi açık kaynak olarak yayınladı. Bu model, yeni bir hibrit görsel kodlayıcı olan FastViTHD (evrişimli katmanları Transformer modülleriyle birleştiren, çok ölçekli havuzlama ve alt örnekleme tekniklerini kullanan) aracılığıyla görsel token sayısını önemli ölçüde azaltıyor (ViT’den 16 kat daha az) ve ilk token çıkış hızı benzer modellere göre 85 kat daha hızlı. FastVLM, ana akım LLM’lerle uyumlu ve 0.5B, 1.5B, 7B parametreli sürümleri yayınlandı. Amaç, uç cihazlardaki AI uygulamalarının görüntü anlama hızını ve kullanıcı deneyimini iyileştirmek. (Kaynak: WeChat)

360, ince taneli hizalama yeteneğini geliştiren yeni nesil görüntü-metin çapraz modal modeli FG-CLIP’i yayınladı: 360 Yapay Zeka Araştırma Enstitüsü, geleneksel CLIP modellerinin görüntü-metin ince taneli anlayışındaki eksiklikleri gidermeyi amaçlayan yeni nesil bir görüntü-metin çapraz modal modeli olan FG-CLIP’i geliştirdi. FG-CLIP, iki aşamalı bir eğitim stratejisi kullanır: küresel karşılaştırmalı öğrenme (çok modlu büyük modeller tarafından üretilen uzun açıklamaları entegre eder) ve yerel karşılaştırmalı öğrenme (bölge-metin etiketleme verilerini ve zor ince taneli negatif örnekleri öğrenmeye dahil eder), böylece görüntülerin yerel ayrıntılarını ve metnin ince özellik farklılıklarını hassas bir şekilde yakalar. Model, ICML 2025 tarafından kabul edildi ve Github ile Huggingface’de açık kaynak olarak yayınlandı, ağırlıkları ticari olarak kullanılabilir. (Kaynak: WeChat)

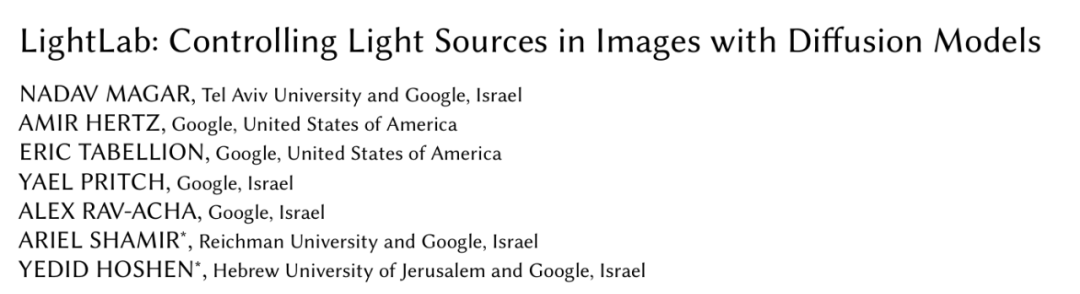

Google, difüzyon modellerini kullanarak görüntü ışık ve gölgesini hassas bir şekilde kontrol eden LightLab’ı tanıttı: Google araştırma ekibi, tek bir görüntüye dayanarak ışık kaynaklarının ince taneli parametrik kontrolünü sağlayan LightLab projesini yayınladı. Kullanıcılar görünür ışık kaynaklarının yoğunluğunu, rengini, ortam ışığının yoğunluğunu ayarlayabilir ve sahneye sanal ışık kaynakları ekleyebilir. LightLab, özel olarak hazırlanmış bir veri kümesi (gerçek kontrollü aydınlatma fotoğraf çiftleri ve büyük ölçekli sentetik render görüntüleri içeren) üzerinde difüzyon modellerini ince ayarlayarak elde edilir. Işığın doğrusal özelliklerini kullanarak ışık kaynaklarını ve ortam ışığını ayırır ve eğitim için çok sayıda farklı aydınlatma varyasyonuna sahip görüntü çifti sentezler. Bu model, dolaylı aydınlatma, gölgeler ve yansımalar gibi karmaşık aydınlatma efektlerini doğrudan görüntü uzayında simüle edebilir. (Kaynak: WeChat)

Tencent, niyet tespitinin genelleştirilmesini geliştirmek için GRPO ve RCS takviyeli öğrenme yöntemlerini önerdi: Tencent PCG sosyal hat araştırma ekibi, niyet tanıma görevlerine uygulamak üzere gruplandırılmış göreceli politika optimizasyonu (GRPO) algoritmasını ödül tabanlı müfredat örnekleme stratejisi (RCS) ile birleştiren bir takviyeli öğrenme yöntemi önerdi. Bu yöntem, modelin bilinmeyen niyetler üzerindeki genelleme yeteneğini önemli ölçüde artırdı (yeni niyetlerde ve diller arası yetenekte %47’ye varan iyileşme), özellikle “Düşünce (Thought)” eklendikten sonra karmaşık niyet tespitinin genelleme yeteneği daha da arttı. Deneyler, RL ile eğitilmiş modellerin genelleme açısından SFT modellerinden daha üstün olduğunu ve önceden eğitilmiş modellere veya talimat ince ayarlı modellere dayalı olup olmadığına bakılmaksızın, GRPO eğitiminden sonra performansın benzer olduğunu gösterdi. (Kaynak: WeChat)

Nanyang Teknoloji Üniversitesi ve diğerleri, yüksek çözünürlüklü görüntü algısını RAG tabanlı olarak geliştiren RAP çerçevesini önerdi: Nanyang Teknoloji Üniversitesi’nden Profesör Tao Dacheng’in ekibi ve diğerleri, çok modlu büyük dil modellerinin (MLLM) yüksek çözünürlüklü görüntüleri işlerken yaşadığı bilgi kaybı sorununu çözmeyi amaçlayan, RAG teknolojisine dayalı, eğitim gerektirmeyen yüksek çözünürlüklü bir görüntü algılama eklentisi olan Retrieval-Augmented Perception’ı (RAP) önerdi. RAP, kullanıcı sorusuyla ilgili görüntü bloklarını alarak ve göreceli konum ilişkilerini korumak için Spatial-Awareness Layout algoritmasını kullanarak çalışır. Ardından, Retrieved-Exploration Search (RE-Search) aracılığıyla korunan görüntü bloğu sayısı K’yı uyarlanabilir bir şekilde seçerek, giriş görüntüsü çözünürlüğünü etkili bir şekilde düşürürken önemli görsel bilgileri korur. Deneyler, RAP’ın HR-Bench 4K ve 8K veri kümelerinde doğruluğu sırasıyla %21 ve %21.7’ye kadar artırdığını göstermiştir. Bu çalışma, ICML 2025 tarafından Spotlight makalesi olarak kabul edildi. (Kaynak: WeChat)

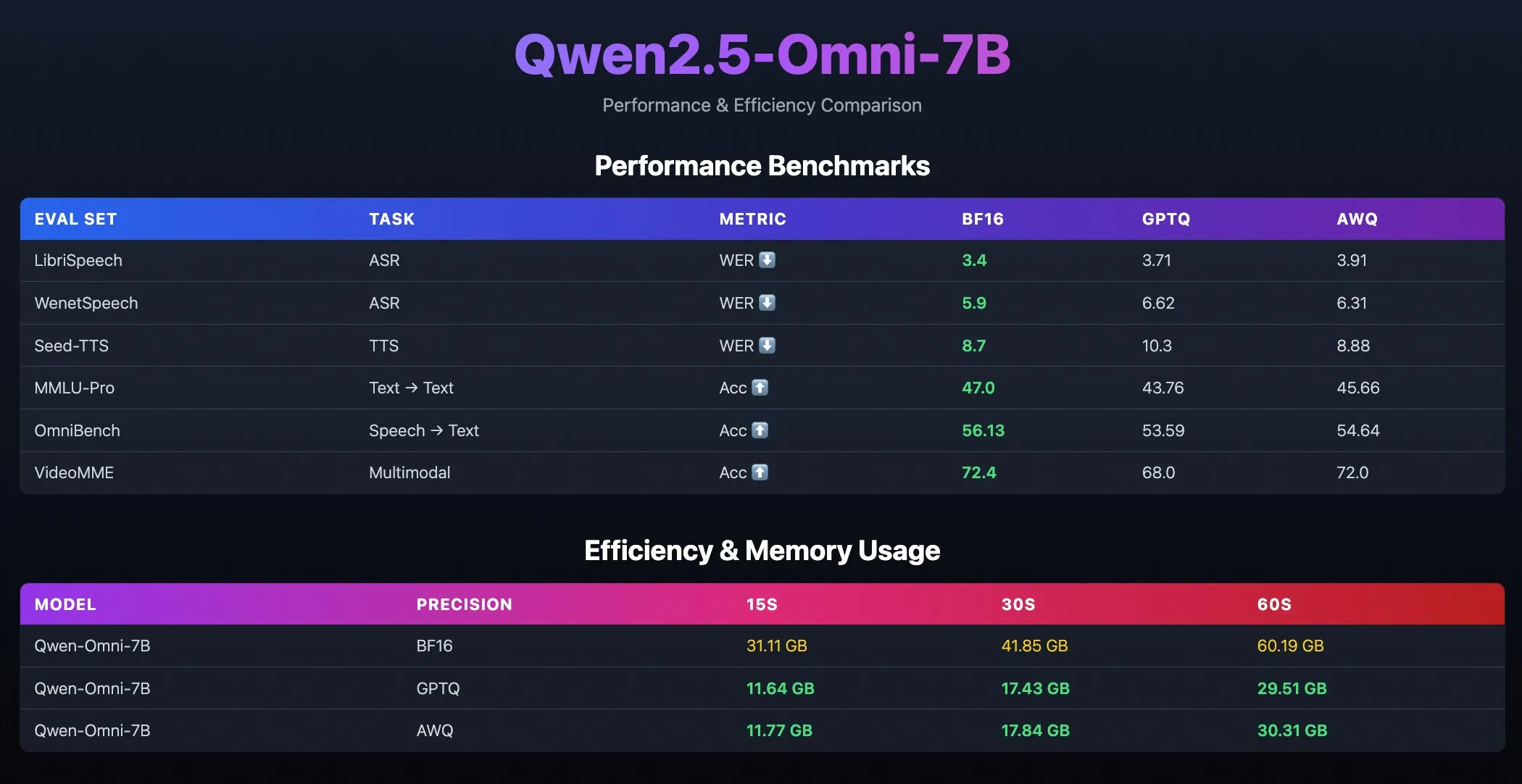

Qwen2.5-Omni-7B nicelleştirilmiş modelleri yayınlandı: Alibaba Qwen ekibi, GPTQ ve AWQ optimize edilmiş kontrol noktalarını içeren Qwen2.5-Omni-7B modelinin nicelleştirilmiş sürümlerini yayınladı. Bu modeller, güçlü çok modlu yeteneklerini korurken daha verimli, daha az kaynak tüketen dağıtım seçenekleri sunmak amacıyla Hugging Face ve ModelScope’ta kullanıma sunuldu. (Kaynak: Alibaba_Qwen, karminski3, reach_vb)

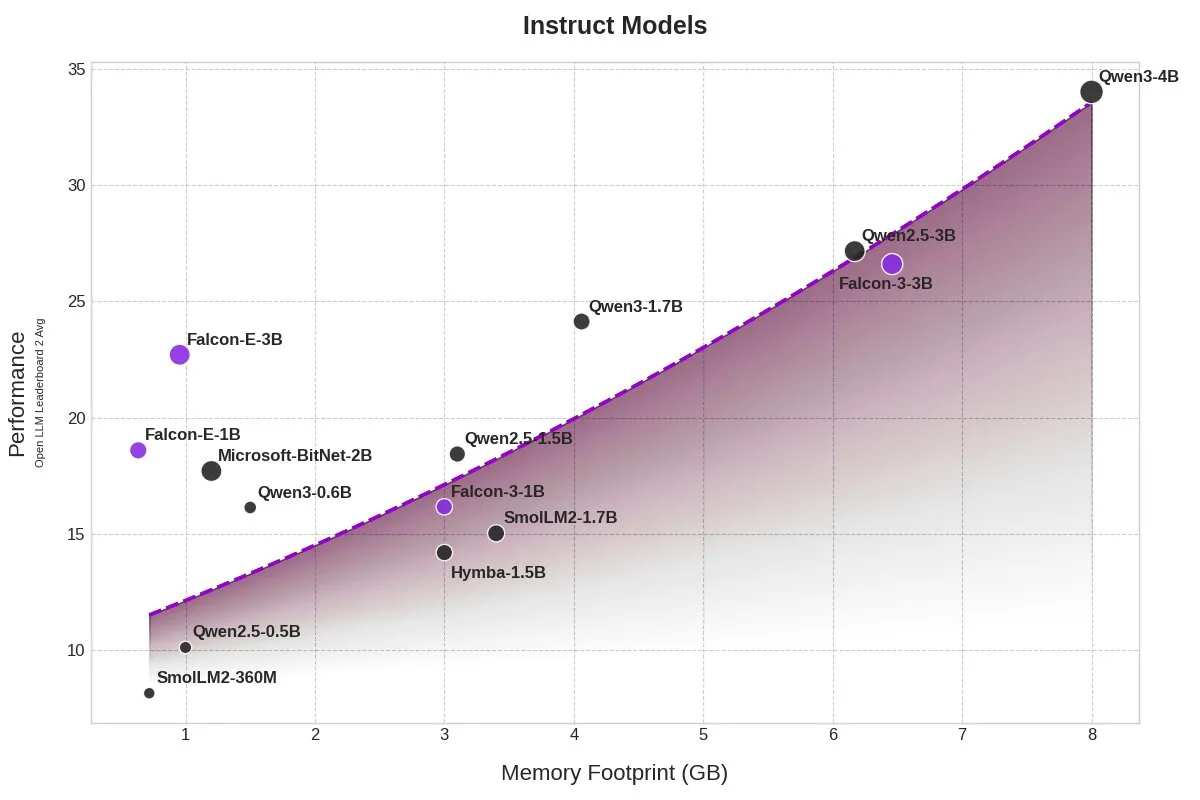

TII, bellek kullanımını önemli ölçüde azaltan BitNet modeli Falcon-E-1B/3B’yi yayınladı: Teknoloji İnovasyon Enstitüsü (TII), Microsoft’un 1-bit hassasiyetli model çerçevesi BitNet’e dayanan yeni model serisi Falcon-Edge’i tanıttı; bu seri Falcon-E-1B ve Falcon-E-3B’yi içeriyor. Bu modellerin performansının Qwen3-1.7B ile karşılaştırılabilir olduğu, ancak bellek kullanımının yalnızca 1/4’ü kadar olduğu iddia ediliyor. TII ayrıca, kullanıcıların NVIDIA grafik kartlarında bu 1-bit modelleri kendi başlarına ince ayar yapmalarını sağlayan onebitllms ince ayar kütüphanesini de yayınladı. (Kaynak: karminski3)

Qwen3 ve DeepSeek modelleri, MEDIC-Benchmark tıbbi soru-cevap sıralamasında lider: Qwen3 modeli, en son yayınlanan MEDIC-Benchmark tıbbi soru-cevap sıralamasında birinci ve ikinci sıraları elde etti. Ayrıca, listenin ilk beş sırasını Qwen ve DeepSeek serisi modelleri işgal ederek, bu yerli büyük modellerin profesyonel tıp alanındaki güçlü soru-cevap yeteneklerini gösterdi. (Kaynak: karminski3)

Zhejiang Üniversitesi Rankformer’ı önerdi: Sıralamayı doğrudan optimize eden Transformer tabanlı öneri modeli mimarisi: Zhejiang Üniversitesi ekibi, Rankformer adlı yeni bir grafik Transformer tabanlı öneri modeli mimarisi önerdi. Tasarımı doğrudan sıralama hedeflerinden (BPR kayıp fonksiyonu gibi) kaynaklanmaktadır. Rankformer, gradyan iniş sürecindeki vektör optimizasyon yönünü simüle ederek benzersiz bir grafik Transformer mekanizması tasarlar ve ileri yayılımda modelin daha iyi sıralama temsilleri kodlamasına rehberlik eder. Model, bilgiyi toplamak için küresel dikkat mekanizmasını kullanır ve matematiksel dönüşümler ve önbellek optimizasyonu yoluyla zaman-uzay karmaşıklığını doğrusal seviyeye indirdiğini iddia eder. Bu araştırma WWW 2025 konferansı tarafından kabul edildi. (Kaynak: WeChat)

🧰 Araçlar

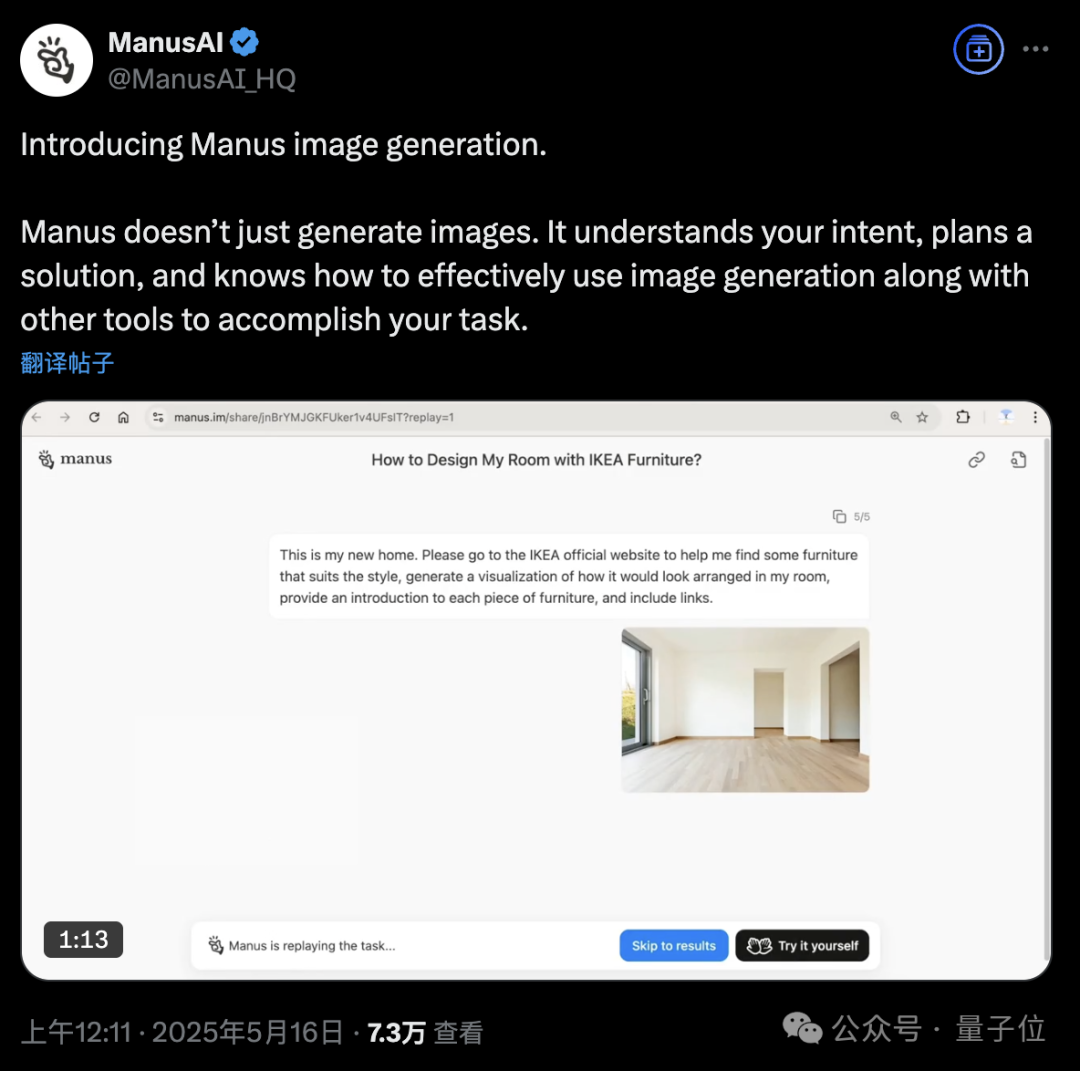

Manus AI Agent platformuna görüntü oluşturma özelliği eklendi: AI Agent platformu Manus, görüntü oluşturmayı desteklediğini duyurdu. Geleneksel AI çizim araçlarından farklı olarak Manus, kullanıcının çizim amacını anlayabilir ve oluşturma planını yapabilir. Örneğin, kullanıcı bir oda fotoğrafı yükleyebilir, Manus’tan IKEA web sitesinden mobilya bulmasını ve görselleştirilmiş bir dekorasyon efekti resmi oluşturmasını isteyebilir, aynı zamanda mobilya bağlantılarını da ekleyebilir. Manus, görevleri analiz etme, arama, mobilya seçme, tasarım stratejileri yazma gibi adımlarla tamamlar. Bu özellik, akıllı ajan iş akışlarını görüntü oluşturma ile derinlemesine entegre etmeyi amaçlamaktadır. Manus şu anda kayıt için açık, 1000 puan hediye ediyor, günlük ek olarak 300 puan veriyor ve ücretli abonelik planları sunuyor. (Kaynak: 36Kr, WeChat)

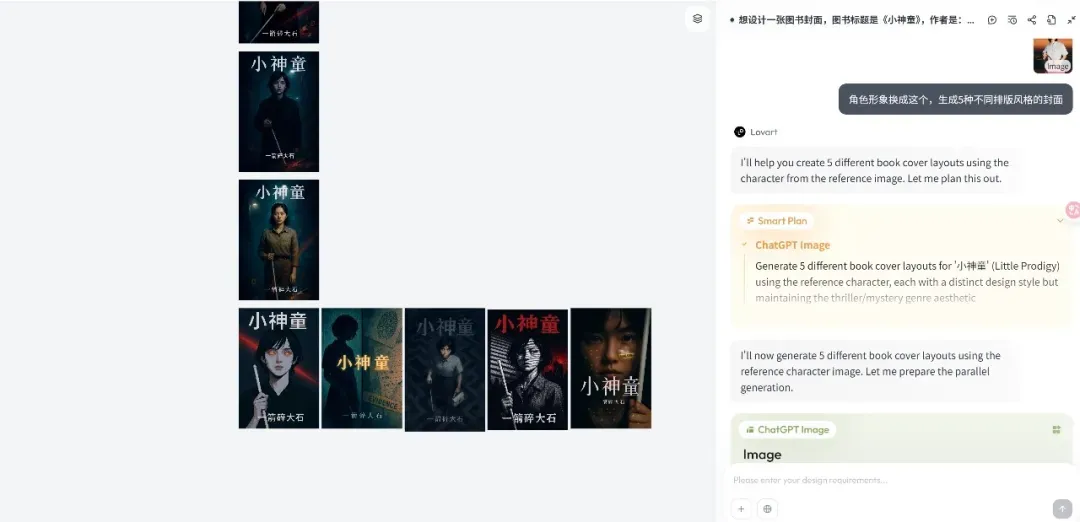

Lovart tasarım Agent platformu yayınlandı, yaratıcı iş akışlarına odaklanıyor: Yeni ortaya çıkan tasarım Agent platformu Lovart, yayınlandıktan sonra hızla ilgi çekti. Temel felsefesi, tasarımcıların yaratıcı sürecini (çok modlu içerir) Agent iş akışlarına dönüştürmektir. Lovart, tuval tabanlı bir etkileşim arayüzü sunar; kullanıcılar diyalog yoluyla AI’a tasarım görevlerini tamamlaması için rehberlik edebilir, AI ise planlama ve yürütmeden sorumludur. Kurucu Chen Mian, AI görüntü ürünlerinin Agent odaklı 3.0 aşamasına girdiğine inanıyor. Lovart, tasarımcıların “arkadaşı” olmayı, önemsiz işleri AI’a bırakarak tasarımcıların yaratıcılığa odaklanmasını sağlamayı amaçlıyor. Ürün gelecekte 3D modelleme, video ve ses yeteneklerini entegre ederek bir “yaratıcı ekip” veya “tasarım şirketi” haline gelecek. (Kaynak: 36Kr)

OpenAI Codex CLI güncellendi, o4-mini entegre edildi ve ücretsiz API kredisi sunuldu: OpenAI, hafif açık kaynaklı kodlama ajanı Codex CLI’ını geliştirdi. Yeni sürüm, düşük gecikmeli kod soru-cevap ve düzenleme için optimize edilmiş, codex-1’in basitleştirilmiş bir versiyonu olan o4-mini (codex-mini olarak adlandırıldı) tarafından desteklenmektedir. Kullanıcılar artık ChatGPT hesaplarıyla Codex CLI’a giriş yapabilirler; Plus ve Pro kullanıcıları, codex-mini-latest modelini deneyimlemek için sırasıyla 5 ABD doları ve 50 ABD doları tutarında ücretsiz API kredisi (30 gün geçerli) alabilirler. (Kaynak: openai, hwchung27, op7418)

DeepSeek açık kaynak veri işleme çerçevesi Smallpond, DuckDB’nin 3FS’e yerel erişimini entegre etti: DeepSeek’in açık kaynaklı veri işleme çerçevesi Smallpond, dahili olarak 3FS (DeepSeek File System) ve DuckDB kullanmaktadır. Artık DuckDB, hf3fs_usrbio eklentisi aracılığıyla 3FS’e yerel olarak erişimi destekliyor; bu da performans artışı ve ek yük azalması sağlayacaktır. DuckDB’nin kendisi de kullanım kolaylığı nedeniyle övgü almaktadır; örneğin, veri işleme için sorgu ifadelerine doğrudan URL’ler gömülebilir. (Kaynak: karminski3)

ComfyUI, Alibaba’nın Wan2.1-VACE video modelini yerel olarak destekliyor: ComfyUI, Alibaba Wanxiang (@Alibaba_Wan) ekibinin video oluşturma modeli Wan2.1-VACE 14B ve 1.3B sürümlerini yerel olarak desteklediğini duyurdu. Bu model, ComfyUI’a metinden videoya, görüntüden videoya, videodan videoya (poz ve derinlik kontrolü), video onarımı (inpainting) ve dışa doğru genişletme (outpainting) ile karakter/nesne referansı gibi entegre video düzenleme yetenekleri getiriyor. (Kaynak: TomLikesRobots)

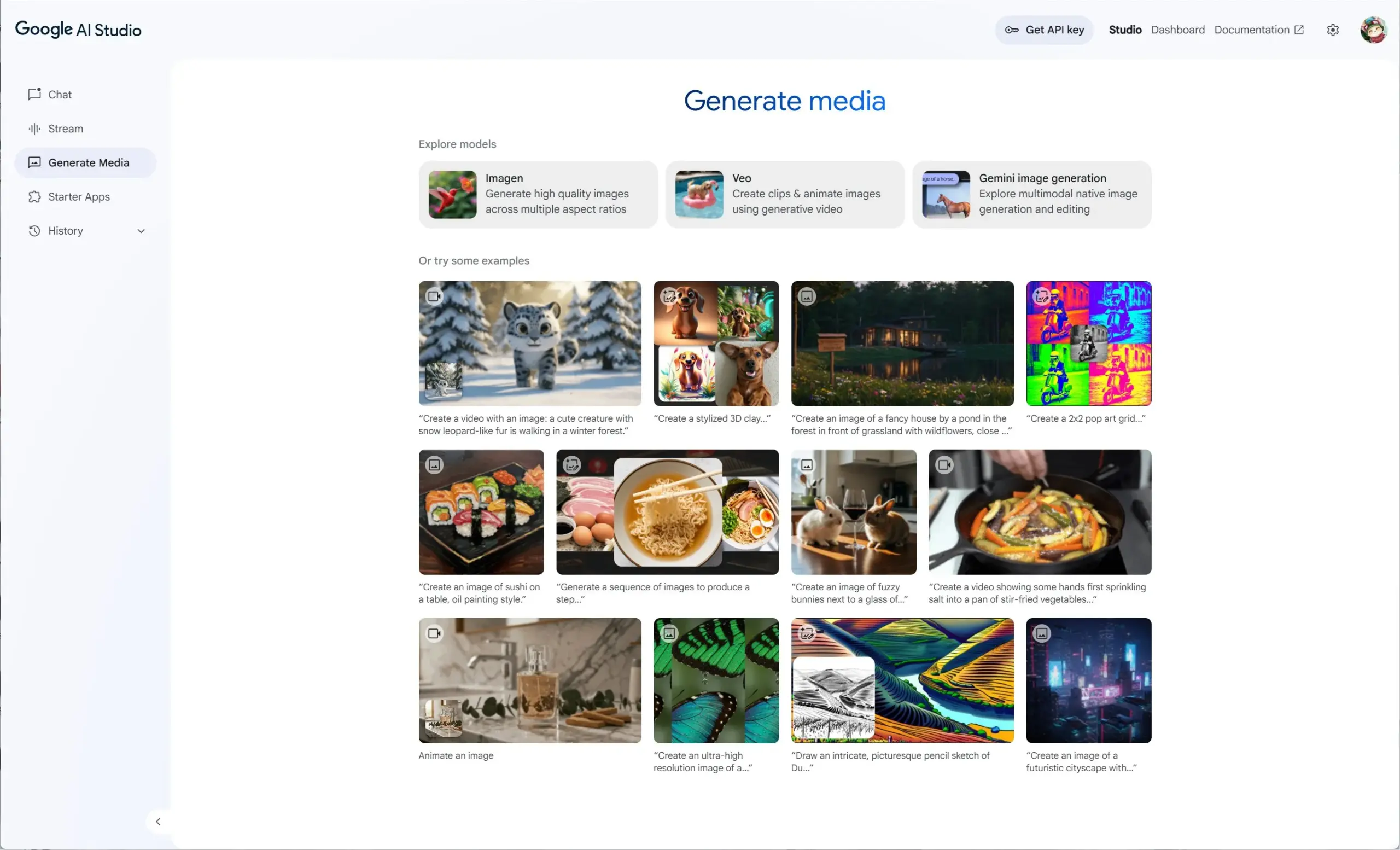

Google AI Studio, Veo 2, Gemini 2.0 ve Imagen 3’ü entegre ederek birleşik bir üretken medya deneyimi sunuyor: Google AI Studio, video modeli Veo 2, Gemini 2.0’ın yerel görüntü oluşturma/düzenleme yetenekleri ve en son metinden görüntüye modeli Imagen 3’ü entegre eden yeni bir üretken medya deneyimi başlattı. Kullanıcılar AI Studio’da bu modelleri ücretsiz olarak deneyebilir, geliştiriciler de API aracılığıyla geliştirebilirler. (Kaynak: op7418)

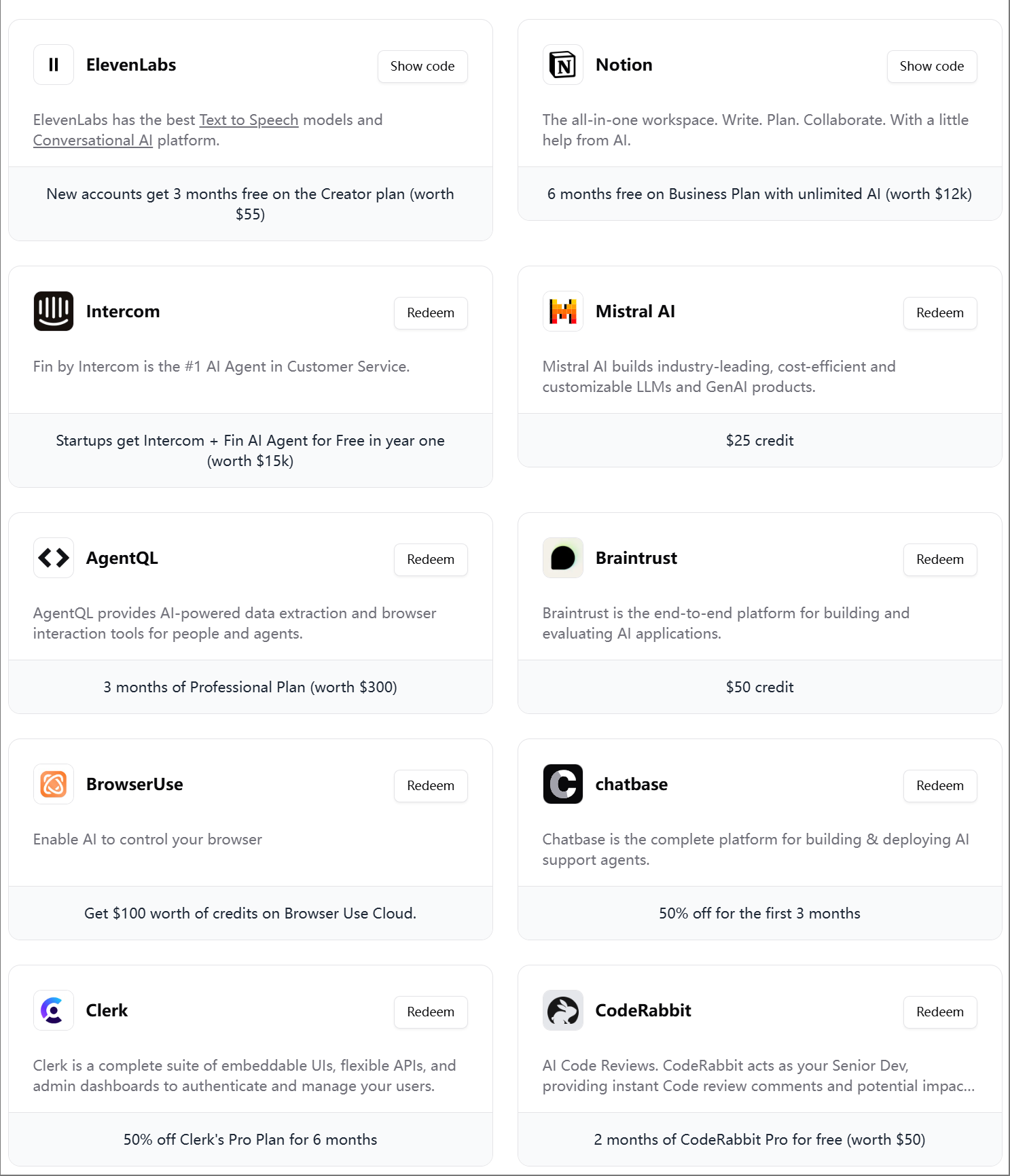

ElevenLabs, dördüncü AI mühendisi hediye paketini sundu: ElevenLabs, AI geliştiricilerine yönelik dördüncü AI mühendisi hediye paketini yayınladı. Paket, AI startup’larına ve geliştiricilere yardımcı olmak amacıyla Modal Labs, Mistral AI, Notion, BrowserUse, Intercom, Hugging Face, CodeRabbit gibi çeşitli araç ve hizmetlerin üyeliklerini ve API kredilerini içeriyor. (Kaynak: op7418)

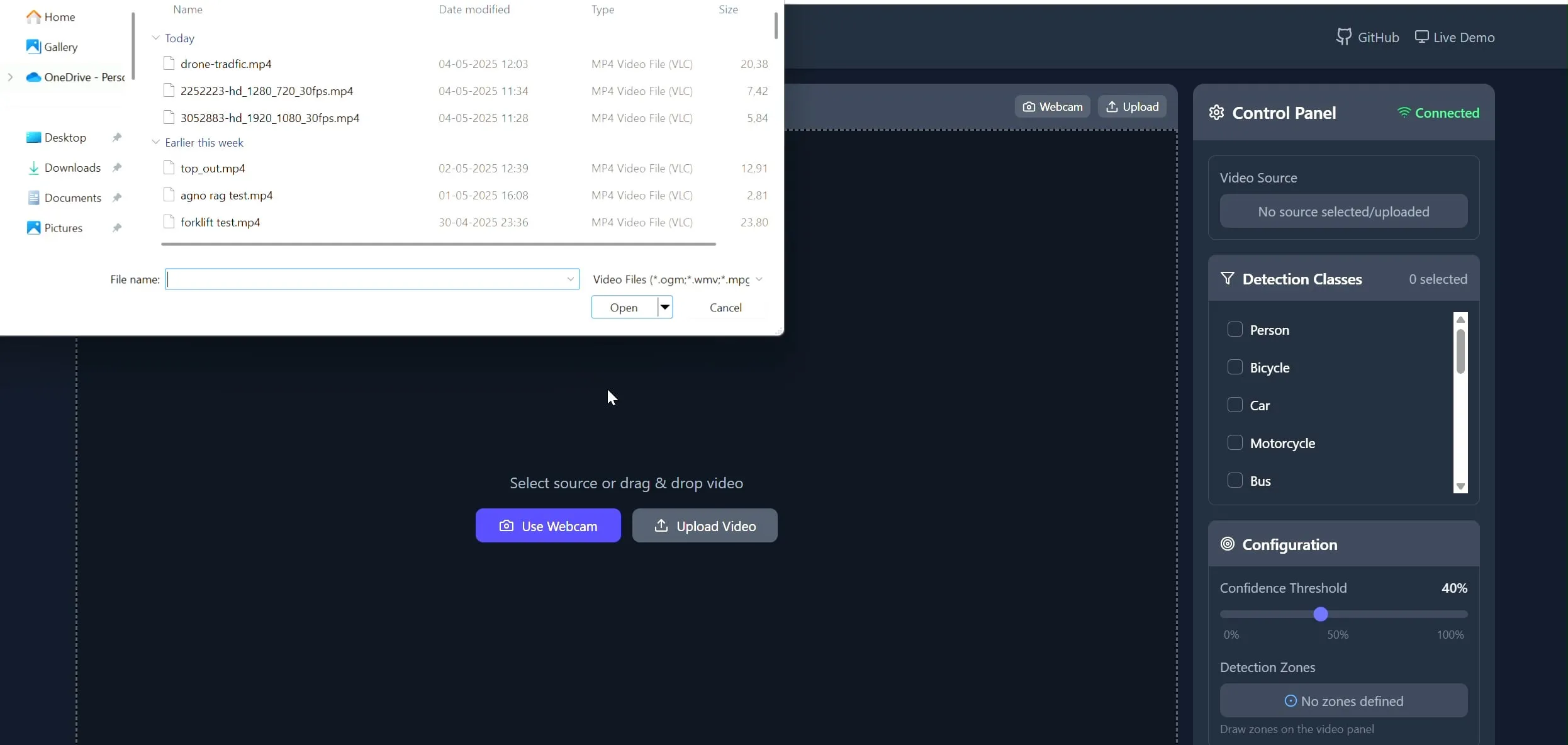

Polygon Zone App: CV görevleri için videolara özel çokgen çizim aracı: Geliştirici Pavan Kunchala, Polygon Zone App adlı bir araç oluşturdu. Bu araç, kullanıcıların video yüklemesine, video karelerinde etkileşimli olarak özel çokgen bölgeler (ROI) çizmesine ve bu bölgelerde nesne tespiti gibi bilgisayarla görme (CV) analizleri çalıştırmasına olanak tanır. Araç, CV projelerinde ROI tanımlamanın sıkıcı sürecini basitleştirmeyi ve JSON koordinatlarını manuel olarak düzenlemekten kaçınmayı amaçlamaktadır. (Kaynak: Reddit r/deeplearning)

📚 Öğrenme Kaynakları

AI Evals kursu 300’den fazla şirketin katılımını sağladı: Hamel Husain tarafından açılan AI değerlendirme kursu (bit.ly/evals-ai), Adobe, Amazon, Google, Meta, Microsoft, NVIDIA, OpenAI gibi tanınmış şirketlerin yanı sıra birçok önde gelen üniversite dahil olmak üzere 300’den fazla şirketin katılımını sağladı. Bu, sektörün AI model değerlendirme yöntemleri ve uygulamalarına yönelik yüksek ilgisini ve talebini yansıtıyor. (Kaynak: HamelHusain)

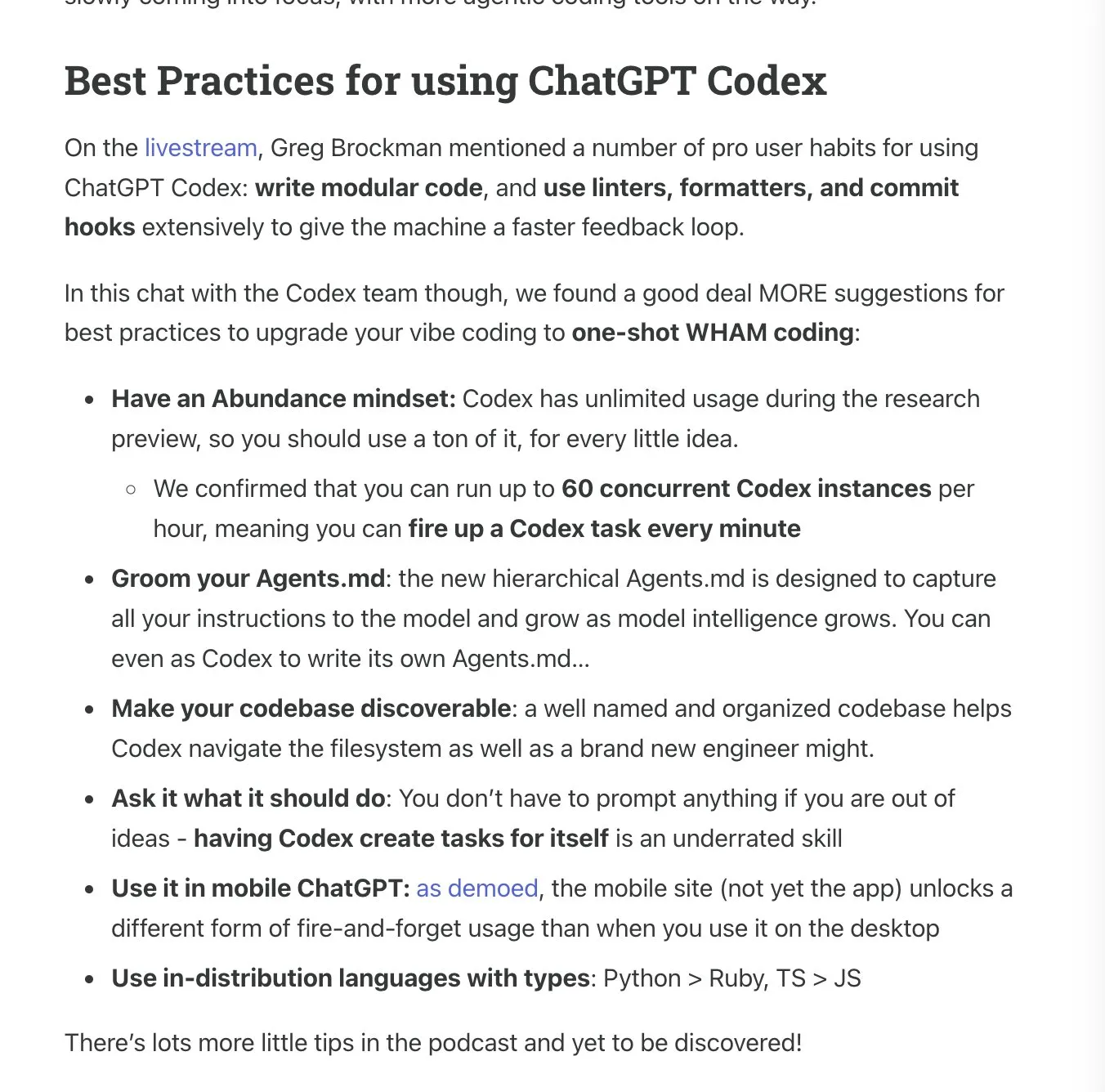

Latent.Space, ChatGPT Codex kullanım kılavuzunu yayınladı: Latent.Space, OpenAI’nin yeni yayınladığı bulut tabanlı otonom yazılım mühendisi ChatGPT Codex’in nasıl verimli kullanılacağını ayrıntılı olarak açıklayan “ChatGPT Codex: The Missing Manual” adlı bir kılavuz yayınladı. Kılavuz, Josh Ma ve Alexander Embiricos tarafından yazıldı ve kullanıcıların Codex’in kod tabanı operasyonlarındaki güçlü özelliklerinden tam olarak yararlanmalarına yardımcı olmayı amaçlıyor. (Kaynak: swyx)

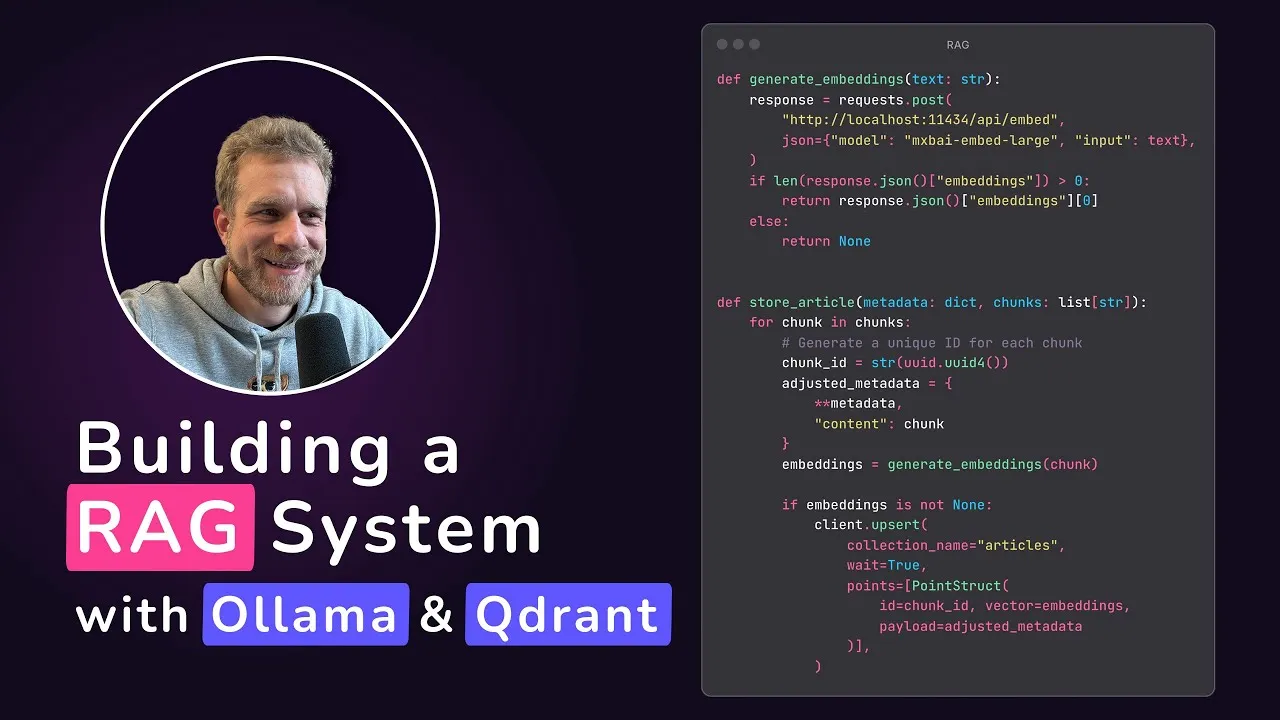

Qdrant, yerel RAG uygulaması eğitimi yayınladı: Qdrant Engine, @maxedapps tarafından hazırlanan ve Gemma 3, Ollama ve Qdrant Engine kullanarak sıfırdan %100 yerel olarak çalışan bir artırılmış geri çağırma üretimi (RAG) uygulamasının nasıl oluşturulacağını gösteren bir eğitim paylaştı. Eğitim 2 saat uzunluğunda olup, tam kod ve adımları içeriyor ve yerel AI uygulamalarını denemek isteyen geliştiriciler için uygun. (Kaynak: qdrant_engine)

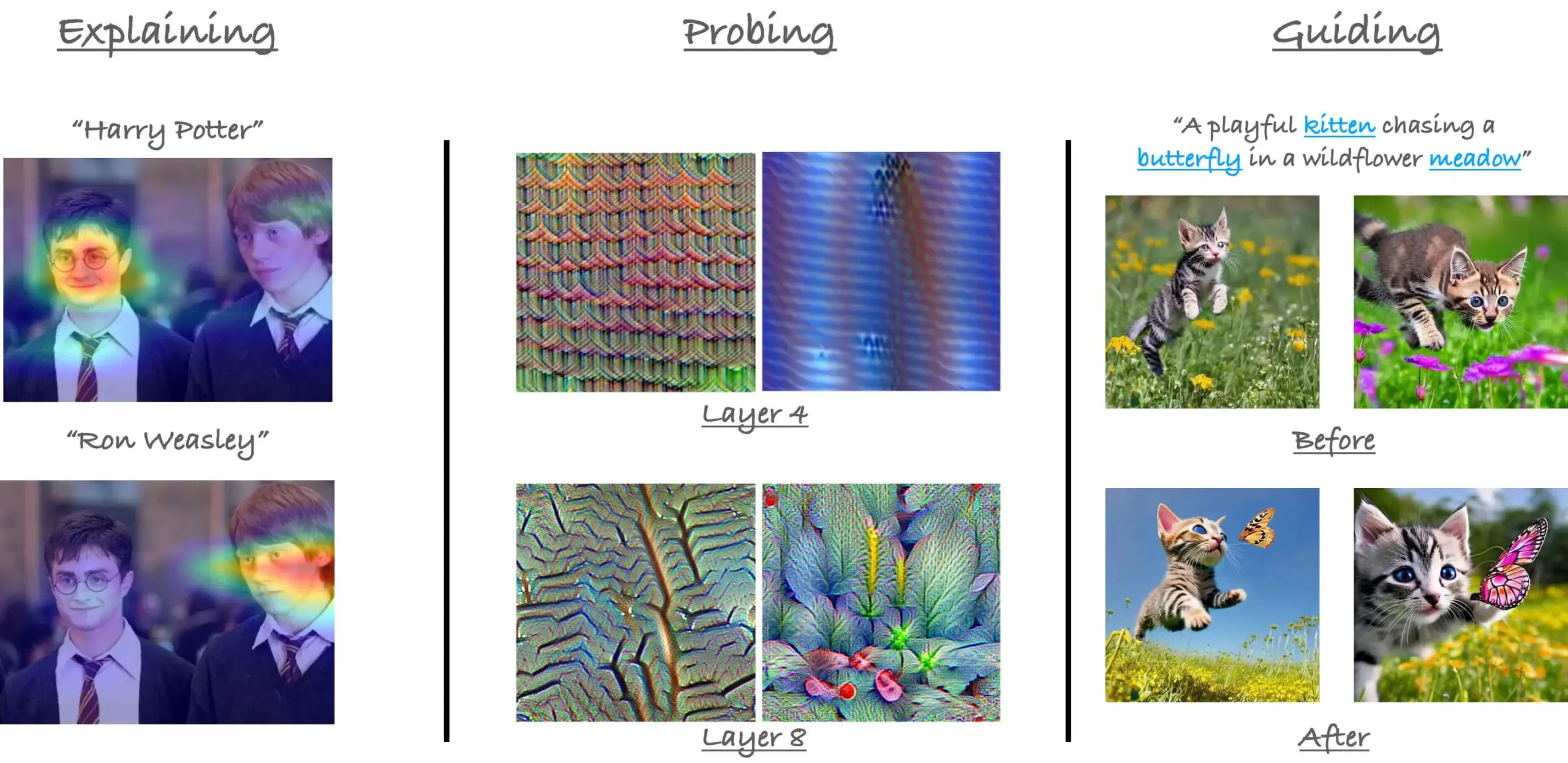

CVPR23 ViT’deki dikkat mekanizmaları eğitimi gözden geçirildi: Araştırmacı Sayak Paul, Hila Chefer ile birlikte CVPR 2023’te Vision Transformer (ViT) içindeki dikkat mekanizmaları üzerine verdikleri eğitimi gözden geçirdi. Eğitim, ViT içindeki dikkat mekanizmalarının nasıl çalıştığını anlamaya yardımcı olmak amacıyla “açıklama (explain)”, “sondalama (probe)” ve “yönlendirme (guide)” olmak üzere üç tema etrafında şekilleniyor. (Kaynak: RisingSayak)

Claude Code kullanım ipuçları paylaşıldı: Planlama, kurallar ve manuel sıkıştırma: Bir Reddit kullanıcısı, Claude Code’u bir hafta boyunca yoğun bir şekilde kullanma deneyimlerini paylaştı ve planlamanın, kurallar oluşturmanın (CLAUDE.md dosyası aracılığıyla) ve otomatik sıkıştırma sınırına ulaşmadan önce manuel olarak /compact komutunu çalıştırmanın önemini vurguladı. Bu ipuçları, özellikle büyük özellikleri işlerken veya modelin yoldan çıkmasını önlerken üretkenliği ve çıktı kalitesini artırmaya yardımcı oluyor. Kullanıcı, bu yöntemlerle Claude Code’un karmaşık görevleri verimli bir şekilde tamamlayabildiğini belirtti. (Kaynak: Reddit r/ClaudeAI)

AIGCode kurucusu Su Wen ile röportaj: Kendi geliştirdikleri büyük modele bağlılık, hedef Autopilot “L5” seviyesinde kod üretimi: AIGCode kurucusu Su Wen, bir röportajda şirketin hedefinin kod tedariki için bir altyapı oluşturmak ve “L5” seviyesinde Autopilot otomatik programlama gerçekleştirmek olduğunu, böylece programcı olmayanların da AI aracılığıyla tam uygulamalar üretebilmesini sağlamak olduğunu belirtti. Kodlamanın büyük modelleri beslemek için en iyi senaryo olduğunu ve kodun yüksek kaliteli eğitim verisi olduğunu düşünüyor. AIGCode, 66B temel modeli “Xiyue”yi eğitti ve AutoCoder ürününü piyasaya sürdü. Su Wen, AI ürünlerinin nihayetinde “beynin” ne kadar akıllı olduğuyla rekabet edeceğini, ön eğitimin teknolojik itici güç olduğunu ve maliyetli olsa bile, kendi geliştirdikleri modelin AGI’ye ulaşmak ve ürünün temel rekabet gücünü oluşturmak için hayati önem taşıdığını vurguladı. (Kaynak: WeChat)

💼 İş Dünyası

JD.com akıllı ajan platformu ve uygulama algoritma ekibi işe alım yapıyor: JD.com Grubu’nun temel projelerinden olan akıllı ajan platformu ve uygulama algoritma ekibi, Pekin’de çalışmak üzere büyük model algoritma mühendisleri ve stajyerler arıyor. Başlıca teknik yönelimler arasında LLM Agent, LLM Reasoning ve LLM’in takviyeli öğrenme ile birleşimi yer alıyor. İşe alım, 2026’da mezun olacak yüksek lisans ve doktora öğrencilerine (kampüs işe alımı), P5-P8 seviyesine denk gelen profesyonellere (sosyal işe alım) ve araştırma odaklı stajyerlere yönelik. Ekip, teknoloji odaklı çalışmaya ve pratik sorunların çözümüne önem veriyor ve önde gelen AI konferanslarında yayınlanmış makaleleri bulunuyor. (Kaynak: WeChat)

Klarna ve Duolingo’da AI öncelikli stratejiler zorluklarla karşılaşıyor, insan-makine dengesi dikkat çekiyor: Fintek şirketi Klarna ve dil öğrenme uygulaması Duolingo, “AI öncelikli” stratejilerini uyguladıktan sonra tüketici geri bildirimleri ve pazar gerçeklerinin baskısıyla karşı karşıya kaldı. Klarna, yüzlerce müşteri hizmetleri pozisyonunu AI ile değiştirmişti, ancak hizmet kalitesindeki düşüş nedeniyle şimdi yeniden insan müşteri hizmetleri temsilcileri işe alıyor. Duolingo, rollerin otomasyonu nedeniyle kullanıcıların memnuniyetsizliğine yol açtı; birçok kişi dil öğreniminin temelinin insanlar tarafından yönetilmesi gerektiğini düşünüyor. Bu vakalar, şirketlerin AI dönüşümünde yenilikçilik ile insani değerleri dengelemesi gerektiğini gösteriyor; teknoloji önemli olsa da, kullanıcı güveninin hala insanlar tarafından inşa edilmesi gerekiyor. (Kaynak: Reddit r/ArtificialInteligence)

Databricks’in veritabanı girişimi Neon’u 1 milyar dolara satın aldığı söylentileri: Reddit topluluğunda dolaşan AI haber özetlerine göre, Databricks veritabanı girişimi Neon’u satın aldı ve işlem tutarının 1 milyar dolar olduğu söyleniyor. Bu satın almanın, Databricks’in veri yönetimi ve AI altyapısı alanındaki yeteneklerini güçlendirmeyi amaçladığı düşünülüyor. (Kaynak: Reddit r/ArtificialInteligence)

🌟 Topluluk

OpenAI Codex’in yayınlanması büyük yankı uyandırdı, geliştiriciler hem heyecanlı hem de temkinli: OpenAI’nin programlama ajanı Codex’i yayınlamasının ardından topluluktan gelen tepkiler coşkulu oldu. Birçok geliştirici, Codex’in PR oluşturma, kod düzeltme gibi görevleri otomatik olarak tamamlayabilmesinden heyecan duyduklarını belirtti ve bunun programlama verimliliğini büyük ölçüde artıracağını, hatta bazılarının bunu “AGI anının hissi” olarak nitelendirdiğini söyledi. Ryan Pream, Codex’i kullanarak bir günde 50’den fazla PR oluşturma deneyimini paylaştı. Aynı zamanda, bazı kullanıcılar Codex’in görev bölme, test senaryosu ekleme gibi konularda hala iyileştirilmesi gerektiğini ve şu anda daha çok profesyonellerin kullanımına uygun olduğunu belirtti. Yohei Nakajima, ilk deneyimlerini paylaşarak GitHub merkezli tasarımının makul olduğunu ancak öğrenme eğrisinin dik olduğunu belirtti. (Kaynak: kevinweil, gdb, itsclivetime, dotey, yoheinakajima, cto_junior)

Meta’nın AI açık kaynak alanındaki katkıları takdir topladı, kapalı ve açık kaynak tartışmalarını tetikledi: Hugging Face CEO’su Clement Delangue, Meta’yı destekleyen bir yazı yayınladı ve AI model açık kaynak alanındaki katkılarının, daha fazla kaynağa sahip diğer büyük şirketlerden ve startup’lardan çok daha fazla olduğunu, bu nedenle fazla eleştirilmemesi gerektiğini belirtti. Bu görüş, bazı kullanıcılar tarafından da desteklendi; en son teknoloji AI modelleri oluşturmanın son derece zor olduğunu ve Meta’nın açık kaynak davranışının alanın gelişimi için hayati önem taşıdığını belirttiler. Ancak, bazı görüşler (gabriberton) açık kaynağın bilgi avantajından vazgeçmek anlamına geldiğini ve özünde kapalı kaynağın daha iyi sonuçlar vereceğini belirtti. Dorialexander ise ABD’nin aniden “Avrupa’nın başa çıkma yöntemini” (Meta’yı savunmayı kastederek) benimsemesini anlamadığını ifade etti. (Kaynak: ClementDelangue, gabriberton, Dorialexander)

xAI Grok sistem istemlerinin sızdırılması ve uygunsuz içerik birleştirme olayı dikkat çekti: xAI’nin Grok modelinin sistem istemlerinin GitHub’da sızdırıldığı, hatta DeepSearch’in sistem istemlerini içerdiği tespit edildi. Daha da ciddisi, bir kullanıcının belirttiğine göre, “beyaz ırk soykırımı” gibi uygunsuz içerikler içeren bir PR, beş kişinin incelemesinden sonra ana dala birleştirildi, ardından geri alınsa ve geçmiş silinse de, bu olay xAI’nin süreç yönetimi ve operasyonel güvenlik konularında önemli eksikliklerini ortaya koydu. Bu durum, toplulukta xAI’nin iç süreçleri ve içerik denetim mekanizmaları hakkında yaygın şüphe ve tartışmalara yol açtı. (Kaynak: karminski3, eliebakouch, colin_fraser, Reddit r/artificial)

AI Agent’lar geleceğin trendi olarak görülüyor, ancak zorluklar ve beklentiler bir arada: “2025 Agent’ların yılı olacak” görüşü toplulukta yayılıyor ve AI Agent’ların gelecekteki gelişimi hakkında tartışmalara yol açıyor. Bazı görüşlere göre, gelecekteki çalışma modelleri “StarCraft” veya “Age of Empires” gibi olacak ve kullanıcılar çok sayıda mikro ajanı görevleri tamamlamaları için yönetecek. Ancak, bazı kullanıcılar mevcut Agent’ların görevleri parçalama ve karmaşık talimatları anlama konusunda henüz olgunlaşmadığını ve kullanıcıların güçlü planlama becerilerine sahip olmasını gerektirdiğini belirtiyor. Bazıları, AI Agent’ların 2025’te beklenen seviyeye ulaşacağından şüphe duyuyor ve bir aldatmacadan diğerine geçilebileceğini, 2026’da somut bir değişiklik olmasını beklediklerini düşünüyor. (Kaynak: gdb, EdwardSun0909, op7418, eliza_luth, tokenbender)

AI’ın eğitim ve istihdam alanlarındaki rolü derin tartışmalara yol açıyor: Reddit topluluğunda AI gelişiminin geleneksel eğitim ve istihdam modelleri üzerindeki etkisine dair tartışmalar ortaya çıktı. Bir kullanıcı “Şimdi okula gitmenin ne anlamı var?” diye sorarak AI’ın gelecekte kimsenin çalışmasına gerek kalmayacağını savundu. Buna karşılık, çoğu yorum eleştirel düşünme, öğrenme yeteneği ve sosyal becerilerin önemini vurguladı ve bunların AI tarafından değiştirilemeyeceğini belirtti. Okul sadece bilgi aktarım yeri değil, aynı zamanda nasıl öğrenileceğini, nasıl düşünüleceğini ve insanlarla nasıl etkileşim kurulacağını öğrenme ortamıdır. AI hakim bir dünyada bile bu yetenekler hala hayati önem taşıyor, hatta AI’ın kendisini öğrenmek bile gerekiyor. Başka bir tartışmada ise insanın değerinin sadece işiyle eşdeğer tutulmaması gerektiği, AI gelişiminin bizi mesleklerin ötesinde insanlığın anlamını düşünmeye sevk etmesi gerektiği belirtildi. (Kaynak: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

AI kız arkadaşı fenomeni sosyal etik ve nüfus sorunları üzerine düşüncelere yol açıyor: The Economist’in Çinli gençlerin AI ile flört etmeye ve arkadaşlık kurmaya başladığını bildirmesi, internet kullanıcıları arasında hararetli tartışmalara yol açtı. Bazı yorumcular bu fenomeni “sivrisinek sayısını azaltmak için doğaya çok sayıda kısırlaştırılmış dişi sivrisinek salmak” benzetmesiyle, AI partnerlerin düşük doğurganlık sorununu daha da kötüleştirebileceğini ima etti; AI partnerler “sizi her zaman anlayan” mükemmel bir deneyim sunabilse de. Bu, AI teknolojisinin duygusal eşlik alanındaki uygulamalarının getirdiği karmaşık sosyal etkileri ve etik değerlendirmeleri yansıtıyor. (Kaynak: dotey)

AI telefon görüşmelerinin gerçekçiliği endişe yaratıyor, gerçeği ayırt etme yeni bir zorluk haline geliyor: Bir Reddit kullanıcısı, bir öğrenim kurumundan aldığı telefon görüşmesini paylaştı; karşı tarafın sesi ve tonlaması doğal, cevapları akıcıydı ve gerçek bir insan mı yoksa AI mı olduğunu ayırt etmek neredeyse imkansızdı. Konuşma birkaç dakika sürdükten sonra, cevaplarının aşırı derecede kusursuz olması nedeniyle AI olduğunu fark etti. Bu deneyim, kullanıcının AI ses teknolojisinin gelişim hızına hayran kalmasına ve biraz da endişelenmesine neden oldu; gelecekte telefondaki AI’ı ayırt etmenin zorlaşmasından, özellikle yaşlılar gibi gruplar için dolandırıcılık riski oluşturmasından endişe duyuyor. (Kaynak: Reddit r/ArtificialInteligence, Reddit r/artificial)

💡 Diğer

MIT’nin arXiv’den AI ve bilimsel keşifler hakkındaki bir ön baskı makalesini geri çekme talebi tartışma yarattı: MIT, doktora öğrencisi tarafından yazılan ve AI’ın malzeme bilimi yenilikleri üzerindeki etkisini konu alan bir ön baskı makalesinin arXiv’den geri çekilmesini talep etti. Gerekçe olarak, araştırma verilerinin kaynağı, güvenilirliği ve geçerliliği konusunda “güven duymamaları” gösterildi. Söz konusu makale, AI destekli araştırmacıların malzeme keşfini %44, patent başvurularını ise %39 artırdığını belirtmişti. MIT’nin bu adımı tartışmalara yol açtı; bazı yorumcular bunun akademik özgürlüğe zarar verdiğini ve araştırma sonuçlarının (AI’ın en iyi araştırmacıların avantajını artırabileceği, sıradan araştırmacıların iş tatminini azaltabileceği) fon sağlayıcıların beklentileriyle uyuşmamasıyla ilgili olabileceğini düşündü. Bazı yorumcular ise AI alanında araştırma sonuçlarının titizliğinin hayati önem taşıdığını ve ön baskı odaklı aşırı abartıdan kaçınılması gerektiğini belirtti. (Kaynak: Reddit r/ArtificialInteligence)

AI kodlama araçlarının yaygınlaşması, kod modülerliği ve mühendislik uygulamalarına daha yüksek talepler getiriyor: E0M, Twitter’da startup’ların rekabet avantajının giderek mühendislerin AI kodlama araçlarını benimseme hızı ve verimliliğinde yattığını belirtti. İyi modülerleştirilmiş kod uygulamaları her zamankinden daha önemli hale geldi; eğer kod karmaşıklığı modern kodlama ajanlarının işleme kapasitesi dahilindeyse, hızlı iterasyon sağlanabilir; aksi takdirde, aşırı karmaşık “spagetti kod” ilerlemeyi yavaşlatabilir ve AI kullanan rakipler tarafından geride bırakılabilir. (Kaynak: E0M, E0M)

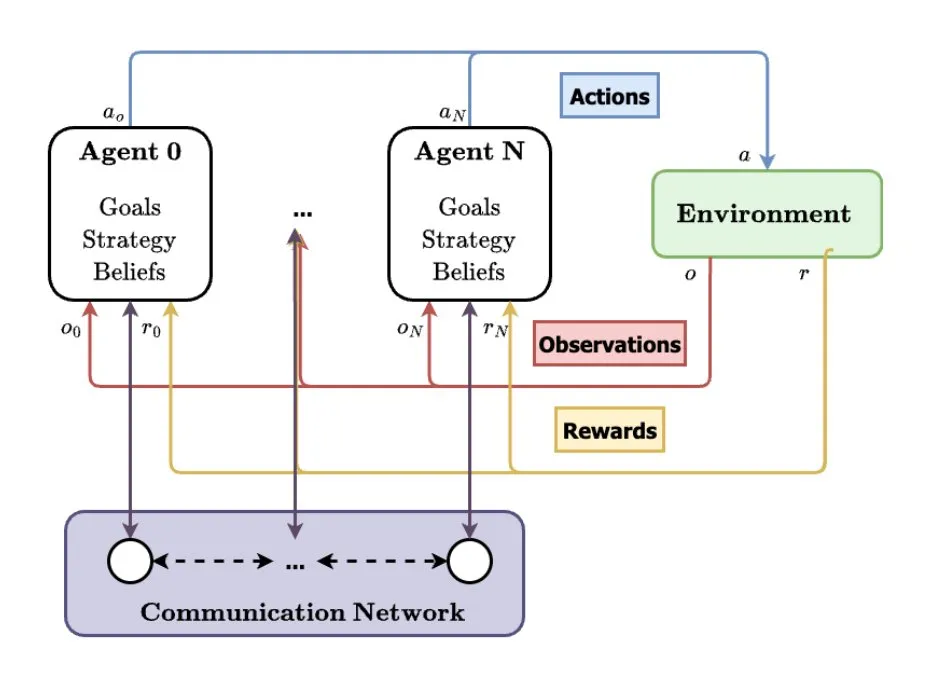

Çoklu ajan sistemleri (MAS) AI’ın gelecekteki gelişim yönü olarak görülüyor: TheTuringPost, çoklu ajan sistemlerinin (MAS) yükseliş eğilimini analiz etti. Önemli gelişmeler arasında çoklu ajan takviyeli öğrenme (MARL), sürü robot teknolojisi, bağlama duyarlı MAS (CA-MAS) ve büyük dil modeli (LLM) güdümlü MAS yer alıyor. Bu teknolojiler, AI sistemlerinin işbirliği ve rekabet yoluyla karmaşık sorunları çözmesini sağlıyor ve afet müdahalesi, çevre izleme, sosyal dinamik simülasyonu gibi alanlarda uygulanarak kolektif zekanın geleceğine işaret ediyor. (Kaynak: TheTuringPost)