Anahtar Kelimeler:AlphaEvolve, DeepSeek V3, GPT-4.1, Speech-02, Claude Modeli, Falcon-Edge, BLIP3-o, AM-Thinking-v1, Gemini destekli evrimsel kodlama ajanı, Yazılım-donanım birlikte tasarımı ile büyük model maliyetlerini düşürme, Sıfır örnekli ses klonlama teknolojisi, Sınırlı akıl yürütme yeteneği, 1.58 bit BitNet mimarisi

🔥 Öne Çıkanlar

DeepMind, AlphaEvolve’u duyurdu: Gemini destekli evrimsel kodlama ajanı, algoritma keşfini ilerletiyor : AlphaEvolve, Gemini modelinin yaratıcılığını otomatik bir değerlendiriciyle birleştirerek algoritmaları optimize etmek için evrimsel bir çerçeve kullanıyor. 4×4 karmaşık matris çarpımını 48 skaler çarpımla tamamlayarak Strassen algoritmasını geliştirmesi; 11 boyutlu uzayda 593 dış küre konfigürasyonu bularak 300 yıllık “öpüşen küreler problemini” (kissing number problem) ilerletmesi gibi birçok alanda çığır açtı. Ayrıca AlphaEvolve, Google veri merkezi zamanlamasını (%0,7 hesaplama kaynağı tasarrufu), yeni nesil TPU tasarımını (gereksiz bitleri çıkarma) ve AI model eğitimini (kritik çekirdeklerde %23 hızlanma) optimize etti. Fields Madalyası sahibi Terence Tao da matematiksel uygulamalarının keşfine katıldı. (Kaynak: DeepMind)

DeepSeek V3 makalesi detaylandırıldı: Donanım-yazılım ortak tasarımı büyük model maliyetini ve güç tüketimini azaltıyor : DeepSeek ekibi, DeepSeek-V3’ün donanım-yazılım ortak tasarımıyla büyük ölçekli eğitim ve çıkarımda maliyet etkinliğini nasıl sağladığını ayrıntılı olarak açıklayan bir makale yayınladı. Temel teknolojiler şunları içeriyor: 1) Bellek optimizasyonu: Anahtar-değer önbelleğini sıkıştırmak için Multi-Head Latent Attention (MLA) kullanımı ve bellek tüketimini azaltmak için FP8 karma hassasiyetli eğitim. 2) Hesaplama optimizasyonu: Mixture of Experts (MoE) modelinin uygulanması, yalnızca kısmi parametrelerin etkinleştirilmesi ve hesaplama maliyetlerini önemli ölçüde azaltmak için FP8 eğitimiyle birleştirilmesi. 3) İletişim optimizasyonu: Gecikmeyi azaltmak ve GPU kullanımını artırmak için çok düzlemli fat-tree ağ topolojisi ve DualPipe (çift mikro-batch çakıştırma) teknolojisinin kullanılması. 4) Çıkarım hızlandırma: Üretim hızını artırmak için birden fazla aday token’ı paralel olarak tahmin eden ve doğrulayan Multi-Token Prediction (MTP) çerçevesinin tanıtılması. Makale ayrıca, düşük hassasiyetli hesaplama desteği, genişleme ve entegrasyon, ağ topolojisi optimizasyonu, bellek sistemi optimizasyonu ve sağlamlık ile hata toleransı dahil olmak üzere gelecekteki AI donanım tasarımı için beş vizyon sunuyor. (Kaynak: arXiv)

OpenAI GPT-4.1 modeli ChatGPT’de resmi olarak kullanıma sunuldu, kullanıcılar doğrudan seçebilir : OpenAI, GPT-4.1 modelinin ChatGPT’de kullanıma sunulduğunu duyurdu. Plus, Pro ve Team kullanıcıları model seçiciden erişebilirken, Enterprise ve Education sürümü kullanıcıları daha sonra erişim hakkı kazanacak. GPT-4.1 mini de tüm kullanıcılar için GPT-4o mini’nin yerini alacak. GPT-4.1, kodlama görevleri ve talimat takibi konularındaki üstün performansıyla dikkat çekiyor; daha önceki API sürümü 1 milyon Token’a kadar bağlam penceresini destekliyordu. Ancak, bazı kullanıcıların testlerinde ChatGPT’deki GPT-4.1 sürümünün bağlam uzunluğunun API sürümündeki 1M’ye ulaşmayarak hala 128k olduğu görüldü ve bu durum hayal kırıklığı yarattı. (Kaynak: OpenAI Developers)

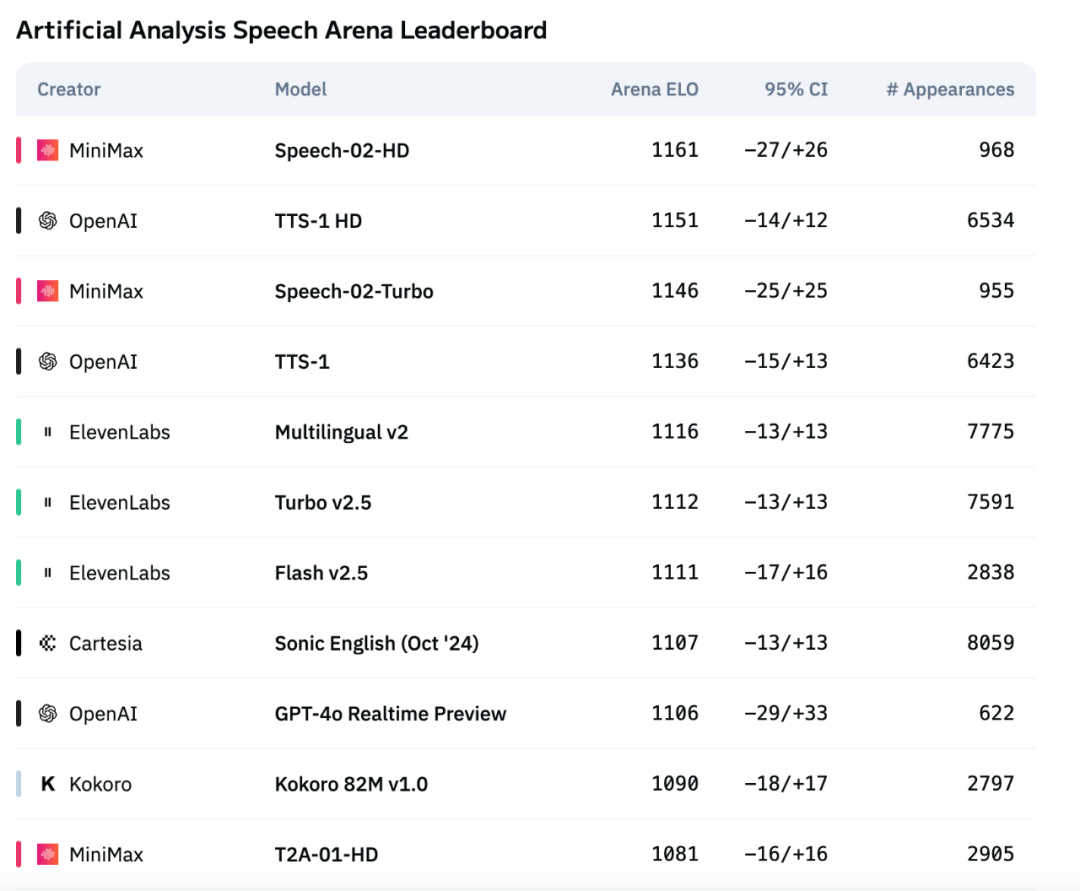

MiniMax’in yeni nesil ses modeli Speech-02, Artificial Analysis ses değerlendirme listesinde zirveye yerleşti : MiniMax’in en son metinden sese (TTS) modeli Speech-02, uluslararası yetkili ses değerlendirme listesi Artificial Analysis Speech Arena’da en yüksek ELO puanını alarak OpenAI ve ElevenLabs’in benzer ürünlerini geride bıraktı. Model, kelime hata oranı (WER) ve konuşmacı benzerliği (SIM) gibi kilit metriklerde üstün performans gösterdi ve özellikle Çince ve Kantonca işlemede yerel avantajlar sergiledi. Speech-02’nin temel yeniliği, gerçek anlamda sıfır-örneklem ses klonlamayı (sadece birkaç saniyelik referans ses gerektirir, metin gerekmez) başarması ve ses üretiminin doğallığını ve duygusal ifade gücünü artıran, 32 dili destekleyen yeni bir Flow-VAE mimarisi kullanmasıdır. Maliyeti de oldukça rekabetçi olup, ElevenLabs rakibinin yaklaşık 1/4’ü kadardır. (Kaynak: 机器之心)

🎯 Gelişmeler

Anthropic’in yeni Claude modelinin “aşırı muhakeme” yeteneğine sahip olabileceği belirtiliyor : The Information’ın haberine ve topluluk gözlemlerine göre, Anthropic önümüzdeki haftalarda yeni Claude Sonnet ve Claude Opus modellerini yayınlayabilir. En büyük özelliği “aşırı muhakeme” (Extreme reasoning) yeteneği olacak. Bu özellik, modelin zor sorunlarla karşılaştığında doğrudan cevap vermek yerine duraklamasına, yeniden değerlendirmesine ve stratejisini ayarlamasına olanak tanıyor. Kod üretimi gibi görevlerde model, hataları otomatik olarak test edip düzeltebiliyor. Bu dinamik döngüsel muhakeme ve araç kullanımı yöntemi, modelin karmaşık sorunları daha akıllıca işlemesini, insan denetimine olan bağımlılığı azaltmasını ve insan işbirlikçilerinin düşünme biçimine daha fazla yaklaşmasını amaçlıyor. Bazı kullanıcılar Anthropic’in Claude Neptune (veya Claude 3.8 olabilecek) adlı, 128k token bağlamını destekleyen bir modeli test ettiğini fark etti. (Kaynak: 量子位)

TII, Falcon-Edge serisi verimli Bitnet modellerini ve onebitllms ince ayar araç setini yayınladı : Teknoloji İnovasyon Enstitüsü (TII), BitNet mimarisine dayanan, güçlü, genel amaçlı ve ince ayarlanabilir özelliklere sahip, yüksek düzeyde sıkıştırılmış bir dil modeli serisi olan Falcon-Edge’i yayınladı. Aynı zamanda, bu 1.58-bit modelleri ince ayarlamak veya ön eğitimine devam etmek için özel olarak tasarlanmış hafif bir Python araç seti olan onebitllms‘i (pip ile kurulabilir) açık kaynak olarak sundular. Bu hamle, büyük modellerin kullanım engelini düşürmeyi ve 1-bit LLM teknolojisinin gelişimini ve uygulamasını teşvik etmeyi amaçlıyor. (Kaynak: younes)

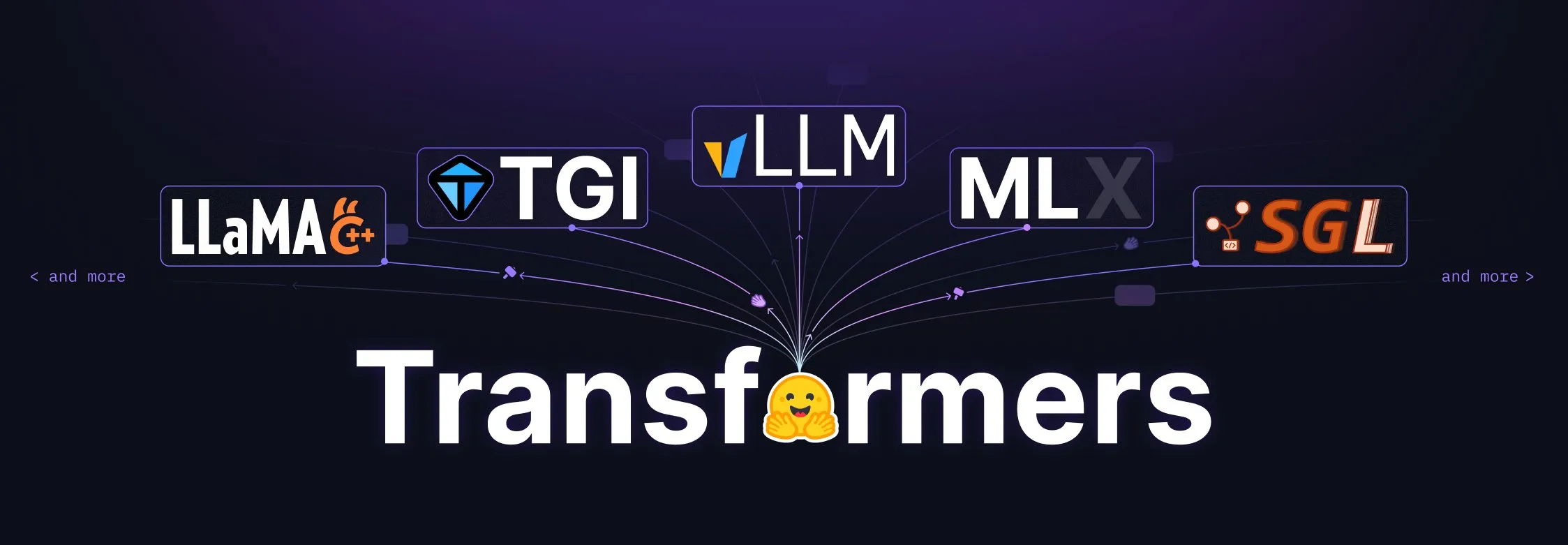

Hugging Face Transformers kütüphanesi büyük bir yükseltmeyle model tanımlarının merkezi standardı haline geliyor : Hugging Face, Transformers kütüphanesinin farklı arka uçlar ve çalıştırıcılar arasında model tanımları için merkezi bir standart haline gelmeyi amaçlayan büyük bir düzenlemeden geçtiğini duyurdu. vLLM, LlamaCPP, SGLang, MLX, DeepSpeed, Microsoft, NVIDIA gibi birçok ekosistem ortağıyla yapılan ortak çalışmalarla model kodunun standartlaştırılması hedefleniyor, böylece tüm AI ekosistemi için daha yüksek tutarlılık ve güvenilirlik sağlanması amaçlanıyor. Bu girişim, topluluk tarafından büyük beğeni topladı ve açık kaynak AI gelişimini destekleyen önemli bir adım olarak kabul edildi. (Kaynak: Arthur Zucker)

Salesforce, Hugging Face’te BLIP3-o’yu yayınladı: Tamamen açık kaynaklı birleşik çok modlu model serisi : Salesforce, tamamen açık kaynaklı bir birleşik çok modlu model ailesi olan BLIP3-o serisi modelleri tanıttı. Bu seri, model mimarisi, eğitim yöntemleri ve veri kümelerini kapsayarak çok modlu AI teknolojisinin gelişimini ve uygulamasını teşvik etmeyi amaçlıyor. BLIP3-o’nun yayınlanması, araştırmacılara ve geliştiricilere güçlü çok modlu işleme araçları ve kaynakları sunuyor. (Kaynak: AK)

NVIDIA, sentetik verileri kullanarak tam otonom sürüş teknolojisini ilerlettiğini gösterdi : NVIDIA, sentetik verileri kullanarak tam otonom sürüş (FSD) teknolojisinin geliştirilmesini nasıl hızlandırdığını gösteren yeni bir video yayınladı. NVIDIA, büyük ölçekli, çeşitli sanal sürüş senaryoları ve verileri üreterek otonom sürüş algoritmalarını daha verimli bir şekilde eğitebiliyor ve doğrulayabiliyor, gerçek dünya veri toplamanın sınırlamalarını aşıyor ve otonom sürüş teknolojisini daha güvenli, daha güvenilir bir yöne doğru ilerletiyor. (Kaynak: SawyerMerritt)

A-M-team, 32B çıkarım modeli AM-Thinking-v1’i yayınladı, bazı performanslarda DeepSeek-R1’i geride bıraktı : Yerel bir araştırma ekibi olan A-M-team, Hugging Face’te 32B parametreli çıkarım modeli AM-Thinking-v1’i açık kaynak olarak yayınladı. Model, matematiksel çıkarım (AIME serisi puanı 85.3) ve kod üretimi (LiveCodeBench puanı 70.3) gibi görevlerde üstün performans gösterdi ve bu özel değerlendirmelerde DeepSeek-R1’i (671B MoE) geride bıraktığı ve Qwen3-235B-A22B gibi daha büyük ölçekli modellere yaklaştığı iddia ediliyor. Ekip, sınırlı hesaplama ve açık kaynak veri koşullarında güçlü çıkarım elde etme yollarını keşfetmeyi amaçlayarak, son eğitim şemaları (soğuk başlatma SFT, geçiş oranı güdümlü veri filtreleme, iki aşamalı RL dahil) aracılığıyla 32B yoğun modelin çıkarım yeteneklerini optimize etmeye odaklanıyor. (Kaynak: AI科技评论)

Marigold güncellemesi: Stable Diffusion modelini derinlik tahmincisine dönüştürüyor, tek adımlı çıkarımı ve yüksek çözünürlüğü destekliyor : Marigold projesi büyük bir güncelleme yayınladı. Bu teknoloji, Stable Diffusion 2 modelini az miktarda sentetik örnek ve kısa süreli (1 GPU’da 2-3 gün) eğitimle gelişmiş bir derinlik tahmincisine dönüştürebiliyor. Yeni sürüm özellikleri şunları içeriyor: tek adımlı hızlı çıkarım, yeni modalite desteği, yüksek çözünürlüklü çıktı, Diffusers kütüphanesi desteği ve yeni demolar. (Kaynak: Anton Obukhov)

Qwen3 serisi modeller açık kaynak topluluğunda güçlü bir performans sergiliyor, NVIDIA OpenCodeReasoning temel olarak onu seçti : Alibaba’nın Qwen3 (Qwen3) serisi modelleri açık kaynak topluluğunda ilgi görmeye ve uygulanmaya devam ediyor. NVIDIA’nın en son açık kaynaklı OpenCodeReasoning serisi modelleri (7B, 14B, 32B özelliklerini içerir) temel olarak Qwen’i seçti. Qwen3, eksiksiz sürümleri, sürekli güncellemeleri, karma çıkarım modlarına yerel desteği ve gelişen ekosistemi (dünya çapında 300 milyondan fazla indirme, 100 binden fazla türev model) ile geliştiricilerin beğenisini kazanıyor. Son güncellemeler arasında uç cihaz çok modlu modeli Qwen-omini 3B, ince ayar verimliliğini artırmak için Unsloth ile işbirliği, ayrıntılı dağıtım hiperparametre önerilerinin yayınlanması, web sayfalarının gerçek zamanlı önizlemesini oluşturma desteği, çeşitli nicelleştirilmiş sürümlerin sunulması ve teknik raporların yayınlanması yer alıyor. (Kaynak: AI前线)

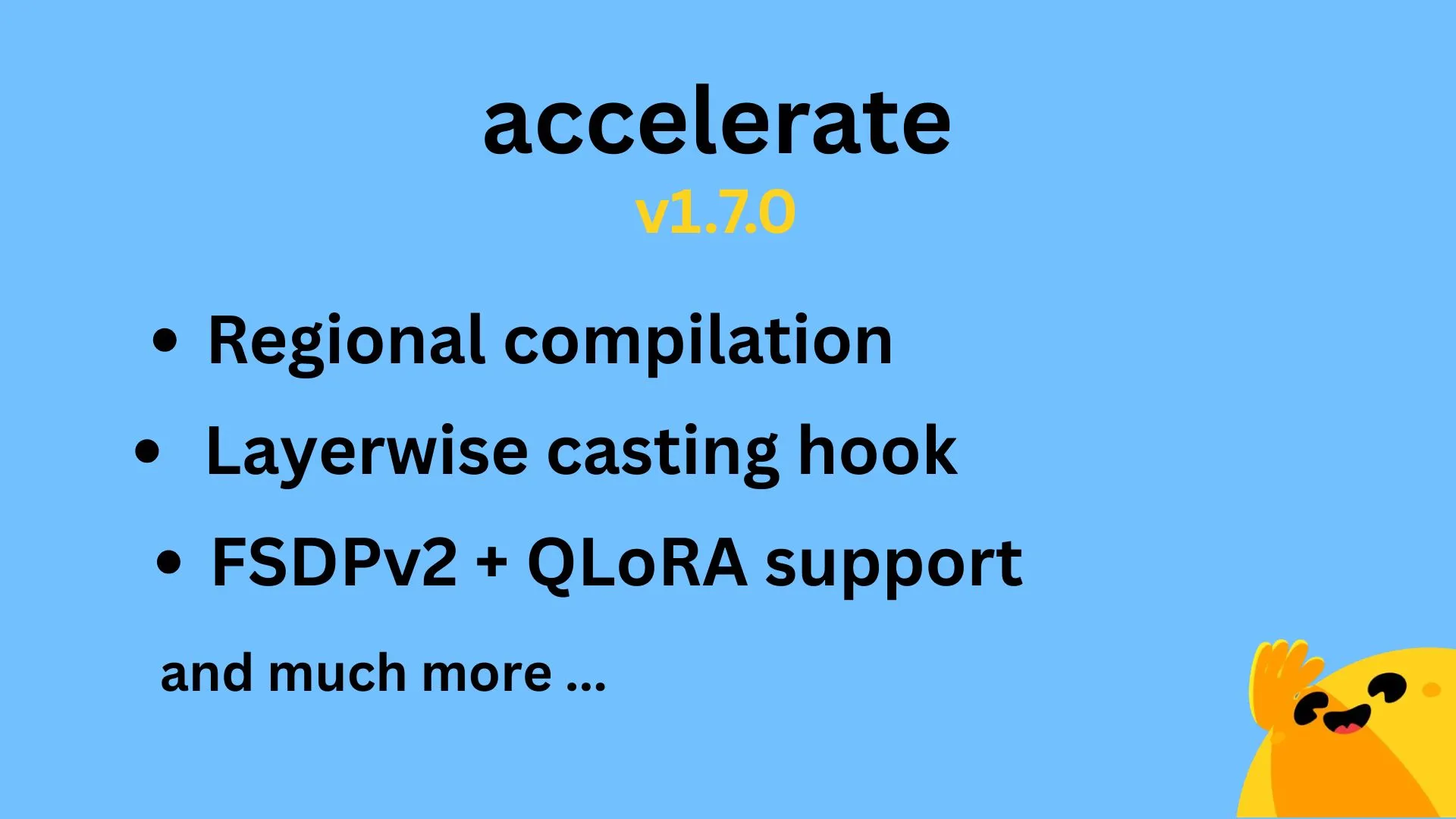

Hugging Face Accelerate v1.7.0 yayınlandı, bölgesel derleme ve FSDPv2 için QLoRA desteği sunuyor : Hugging Face Accelerate v1.7.0 sürümü resmi olarak yayınlandı. Bu sürümün öne çıkan özellikleri şunlardır: @IlysMoutawwakil tarafından uygulanan bölgesel derleme (Regional compilation), derleme verimliliğini ve esnekliğini artırır; @RisingSayak tarafından katkıda bulunulan katman bazlı döküm kancaları (Layerwise casting hook), diffusers kütüphanesinde yaygın olarak kullanılan bir özelliktir; ve @winglian tarafından uygulanan FSDPv2 için QLoRA desteği, büyük ölçekli model eğitimini daha da optimize eder. (Kaynak: Marc Sun)

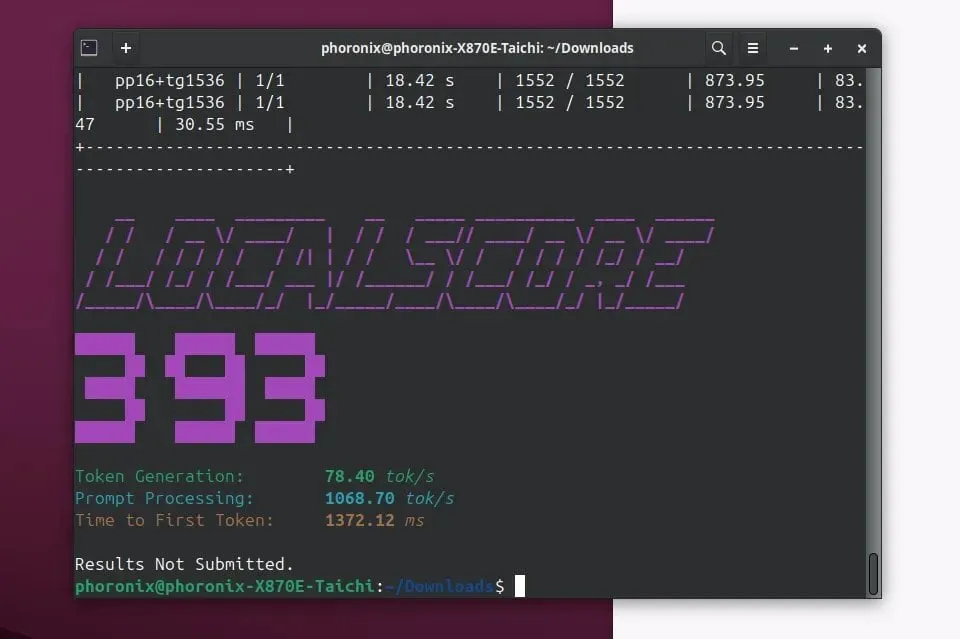

Llamafile 0.9.3 yayınlandı, Qwen3 ve Phi4 modelleri için destek eklendi : Llamafile 0.9.3 sürümünü yayınladı. Bu güncelleme, son zamanların popüler modelleri Qwen3 serisi ve Phi4 serisi için destek ekliyor. Llamafile, model ağırlıklarını ve çalıştırmak için gereken kodu tek bir yürütülebilir dosyada paketleyerek LLM uygulamalarının dağıtımını ve çalıştırılmasını basitleştirmeyi, böylece çeşitli işletim sistemlerinde kolay dağıtım sağlamayı amaçlıyor. (Kaynak: Phoronix)

Tencent, HunyuanImage 2.0 görüntü büyük modelini yayınladı : Tencent, Hunyuan görüntü büyük modelinin yeni sürümü olan HunyuanImage 2.0’ı resmi olarak yayınladı. Bu güncellemenin görüntü oluşturma kalitesi, kontrol edilebilirlik ve karmaşık talimatları anlama yeteneği konularında iyileştirmeler getirmesi bekleniyor. Kullanıcılar, belirli teknik ayrıntıları ve iyileştirmeleri resmi kanallardan daha fazla öğrenebilirler. (Kaynak: Hunyuan)

Ollama v0.7 yayınlandı, yerel cihazlarda büyük model çalıştırma deneyimini geliştiriyor : Ollama, yerel cihazlarda büyük dil modellerini çalıştırma sürecini basitleştirmeye devam ederek v0.7 sürümünü yayınladı. Yeni sürüm performans optimizasyonları, yeni model desteği veya kullanıcı deneyimi iyileştirmeleri içerebilir. Kullanıcılar ayrıntılı güncelleme günlüğünü ve indirme bilgilerini resmi web sitesinden veya GitHub’dan kontrol edebilirler. (Kaynak: ollama)

llama.cpp, PDF giriş özelliğini birleştirdi, PDF belgelerinin doğrudan işlenmesini destekliyor : llama.cpp projesi yakın zamanda önemli bir güncellemeyi birleştirdi ve PDF dosyaları için doğrudan giriş desteği ekledi. Bu, kullanıcıların artık PDF belge içeriğini giriş olarak daha kolay bir şekilde kullanabileceği, llama.cpp tarafından desteklenen yerel büyük dil modellerinin işleme, analiz veya soru yanıtlama yapabileceği ve uygulama senaryolarını genişletebileceği anlamına geliyor. Bu özellik, harici bir JS paketi aracılığıyla yerleşik web ön ucunda uygulanır ve çekirdek bakım yükünü artırmaz. (Kaynak: GitHub)

Microsoft Copilot, 4o görüntü oluşturma özelliğini kullanıma sundu, görsel efektleri ve metin tutarlılığını artırdı : Microsoft AI asistanı Copilot, şimdi OpenAI’nin GPT-4o modelinin görüntü oluşturma yeteneklerini entegre etti. Bu güncelleme, daha keskin görsel efektler, daha tutarlı metin üretimi sunmayı ve fotoğraf gerçekçiliğinden eğlenceli çizgi film tarzlarına kadar çeşitli stilleri desteklemeyi amaçlıyor. Kullanıcılar, Copilot aracılığıyla 4o destekli görüntü oluşturma özelliğini deneyimleyebilirler. (Kaynak: yusuf_i_mehdi)

NVIDIA DRIVE Labs, haritasız sürüşün geleceğini tartışıyor, yüksek çözünürlüklü haritalara bağımlılığı azaltıyor : NVIDIA DRIVE Labs’in en son videosu, haritasız sürüşün (mapless driving) geleceğini tartışıyor. Yüksek çözünürlüklü haritalar otonom sürüş için hayati öneme sahip olsa da, maliyetleri ve bakım zorlukları dağıtımı sınırlıyor. NVIDIA, bilgi darboğazlarını ortadan kaldırarak, görev doğruluğunu artırarak, model eğitimi ve çıkarım süresini hızlandırarak ve diğer yeniliklerle yüksek çözünürlüklü haritalara olan bağımlılığı azaltıyor ve otonom sürüş teknolojisinin sınırlarını zorluyor. (Kaynak: NVIDIA DRIVE)

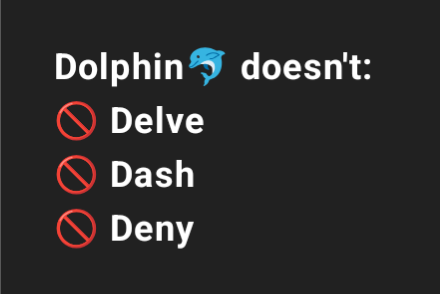

Dolphin 3.2 (Qwen3 tabanlı eğitimli) sistem istem anahtarları sunacak, kullanıcı kontrolünü artıracak : Yakında çıkacak olan Qwen3 tabanlı eğitimli Dolphin 3.2 modeli, üç sistem istem anahtarı sunacak: /no_think (muhtemelen gereksiz düşünme adımlarını azaltmak için), /uncensored (muhtemelen içerik sansürünü azaltmak için) ve /china (muhtemelen Çin’e özgü bağlam veya hizmetler için). Bu anahtarlar, kullanıcılara model dağıtımları üzerinde daha fazla sahiplik ve kontrol sağlamayı amaçlıyor. (Kaynak: cognitivecompai)

🧰 Araçlar

Runway, referans özelliğini tanıttı; belirli bir tekniği veya stili öğrenip yeni yaratımlara uygulayabiliyor : Runway, “References” adlı yeni bir özellik ekledi. Bu özellik, kullanıcıların platforma belirli bir tekniği veya sanatsal stili göstermesine ve ardından bunu herhangi bir yeni üretilen içeriğe referans olarak uygulamasına olanak tanıyor. Bu özellik, kullanıcılara daha hassas stil kontrolü sağlayarak AI destekli yaratımı daha kişisel ve hedefe yönelik hale getiriyor. Kullanıcı Cristobal Valenzuela, topluluğu bu özelliği kullanarak orijinal örnekler paylaşmaya teşvik eden bir kampanya başlattı ve en yaratıcı 5 örneğe bir yıllık ücretsiz Unlimited paketi sunacak. (Kaynak: c_valenzuelab)

DSPy: Hızlı iterasyon için tasarlanmış minimalist bir LLM programlama çerçevesi : DSPy çerçevesi, minimalist tasarımıyla dikkat çekiyor. Geliştiriciler, temel işlevlerinin (Module veya Optimizer) çoğunun yalnızca bir satır kodla uygulanabileceğini belirtiyor ve kullanıcıların fikirleri hızla denemesine ve yinelemesine yardımcı olmayı amaçlıyor. Çok sayıda standart kod ve karmaşık kavram gerektiren bazı araçların aksine, DSPy kullanım kolaylığını ve verimliliği vurguluyor. Kullanıcı geri bildirimlerine göre, başlangıç belgelerini okuyarak hızla başlanabiliyor ve kısa sürede bu çerçeve kullanılarak modeller optimize edilebiliyor, ancak SOTA modellerini döngüsel optimizasyon için kullanmak belirli bir maliyet oluşturabilir. (Kaynak: lateinteraction)

Unsloth AI, TTS ve ses modeli ince ayarına genişledi, hızı artırıp VRAM kullanımını azalttı : Unsloth AI, optimizasyon teknolojisinin artık metinden sese (TTS) ve ses modellerinin ince ayarını desteklediğini duyurdu. Kullanıcılar, Sesame-CSM, OpenAI Whisper gibi modelleri eğitmek, çalıştırmak ve kaydetmek için ücretsiz Colab not defterlerini kullanabilirler. Unsloth, teknolojisinin TTS eğitim hızını 1.5 kat artırabileceğini ve aynı zamanda VRAM (Video RAM) kullanımını %50 azaltabileceğini iddia ediyor. İlgili belgeler ve Colab not defterleri resmi web sitelerinde sunulmuştur. (Kaynak: Unsloth AI)

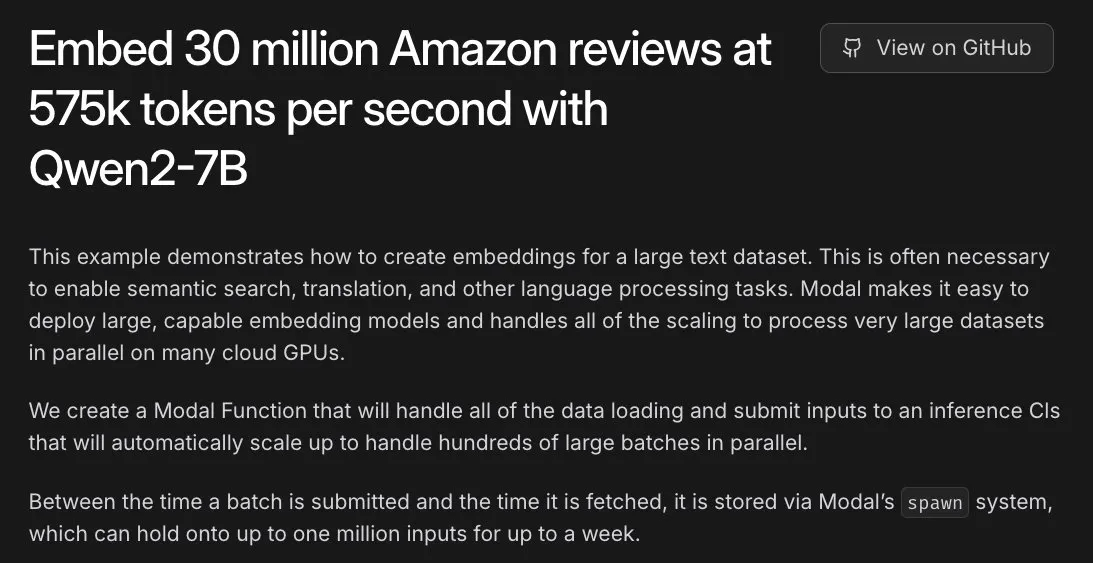

Modal, Amazon’un 30 milyon yorum gömme görevine yardımcı oldu, L40S GPU ile saatlik işleme sağladı : Modal platformu, L40S GPU üzerinde büyük ölçekli gömme görevlerini yatay olarak ölçeklendirme yeteneğini sergiledi. Bir demo vakasıyla Modal, Amazon’un 30 milyon yorumunun gömme işlemini bir saat içinde başarıyla tamamladı. Bu, Modal ekibinin güncellenmiş ölçeklenebilir üretim sistemi sayesinde mümkün oldu ve büyük ölçekli paralel işlemeyi daha basit ve verimli hale getirdi. (Kaynak: charles_irl)

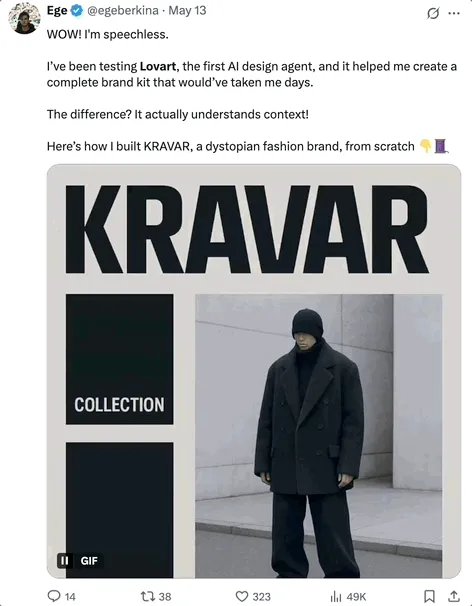

Lovart AI: Birden fazla üst düzey modeli entegre eden yeni AI görsel tasarım Agent’ı : Lovart adlı bir AI görsel tasarım Agent’ı dikkat çekiyor. Doğal dil komutlarıyla poster, marka VI, storyboard gibi profesyonel görsel tasarım görevlerini tamamlayabiliyor. Lovart’ın temel yeteneği, GPT image-1, Flux pro, OpenAI-o3, Gemini Imagen 3, Kling AI, Tripo AI, Suno AI gibi birçok üst düzey modeli entegre eden çoklu model füzyon planlamasında yatıyor ve katmanlar, maskeler, metin ince ayarı gibi profesyonel düzeyde düzenleme araçlarını içeriyor, ayrıca görüntü-metin ayrımını ve katman bazlı düzenlemeyi destekliyor. Bu ürün, Liblib’in denizaşırı bir yan kuruluşu tarafından bağımsız olarak işletiliyor ve tek duraklı, yüksek kontrol edilebilirliğe sahip bir AI tasarım deneyimi sunmayı amaçlıyor. (Kaynak: 量子位)

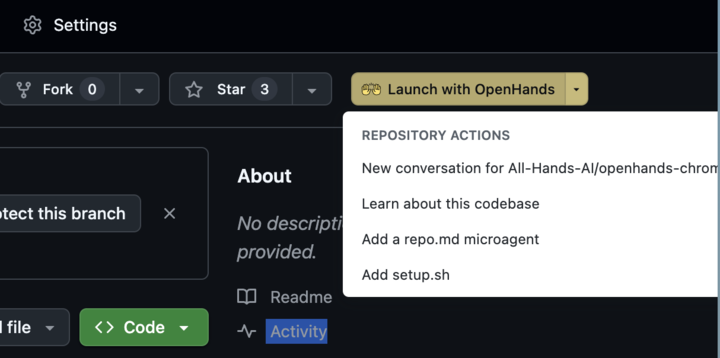

OpenHands 0.38.0 yayınlandı: Yerel Windows desteği ve Chrome uzantısı kullanım kolaylığını artırıyor : OpenHands 0.38.0 sürümünü yayınlayarak birçok önemli güncelleme getirdi. Bunlar arasında: yerel Windows desteği (WSL gerektirmez), Windows kullanıcılarının kullanımını kolaylaştırır; tarayıcı ekran görüntüsü alma özelliği; ve daha esnek sanal alan özelleştirme yeteneği bulunuyor. Ayrıca, kullanıcıların GitHub’dan tek tıklamayla OpenHands’i başlatmasına olanak tanıyan bir Chrome uzantısı da yayınlandı, bu da işlem akışını daha da basitleştiriyor. (Kaynak: All Hands AI)

Tensorlake Cloud yayınlandı, belge çıkarma ve iş akışı oluşturma yeteneklerini geliştiriyor : Tensorlake, akıllı ajan uygulamaları ve karmaşık iş iş akışları oluşturmayı desteklemek amacıyla belge çıkarma ve iş akışlarını optimize etmeyi hedefleyen Tensorlake Cloud’u duyurdu. Bu platform, gelişmiş belge düzeni anlama modellerini (ACORD formları, banka ekstreleri, araştırma raporları gibi gerçek dünya verileri üzerinde eğitilmiş) ve tablo çıkarma modellerini kullanarak yapılandırılmamış belgeleri temiz, yapılandırılmış verilere dönüştürüyor. Özellikle karmaşık ve yoğun tabloları işlemek için uygun olup, görsel dil modellerinin (VLM) bu alandaki eksikliklerini gideriyor. (Kaynak: Tensorlake)

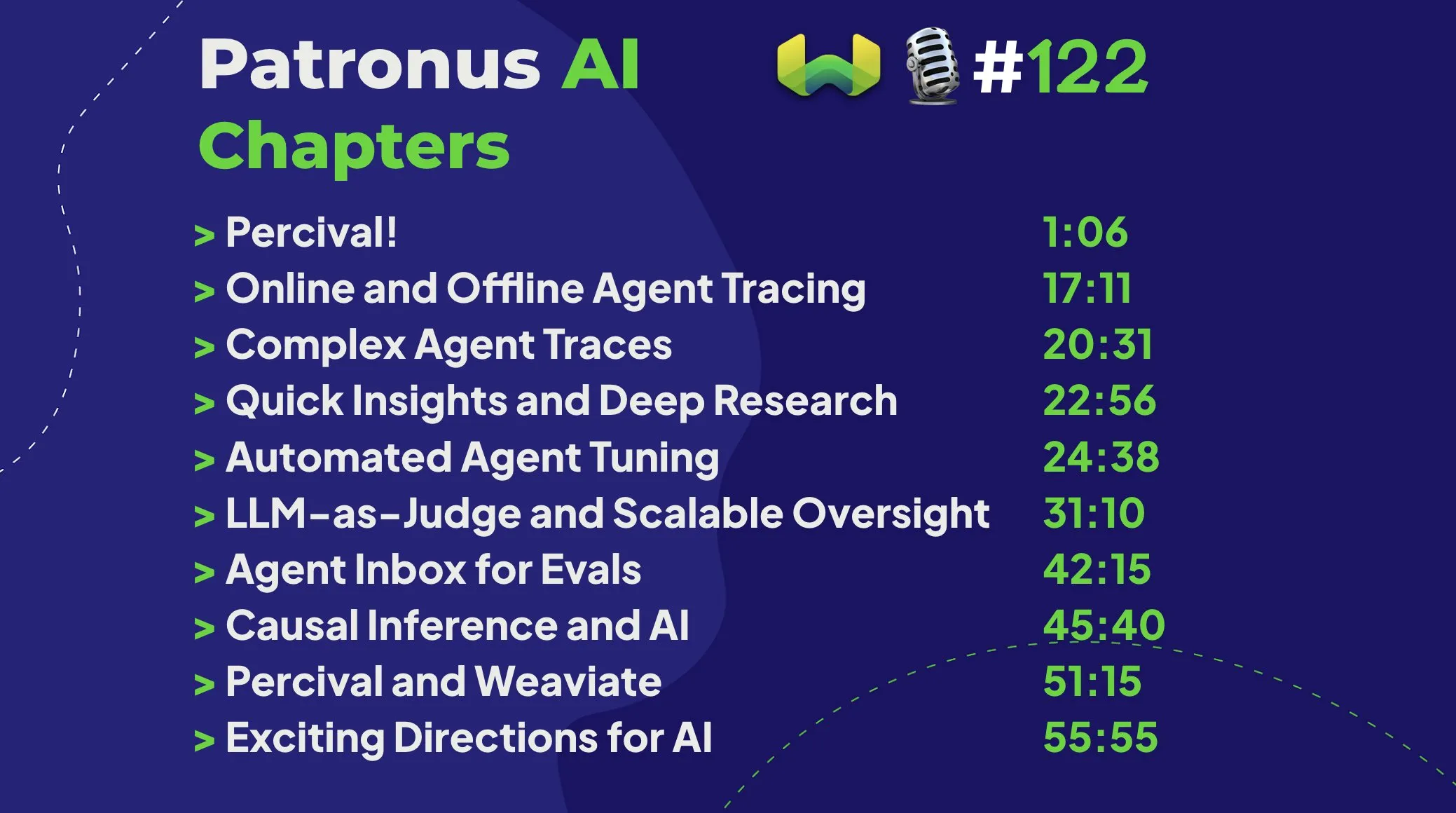

Patronus AI, Percival’ı tanıttı: AI ajanlarını hata ayıklamak ve iyileştirmek için özel bir ajan : Patronus AI, AI ajanlarını hata ayıklamak ve iyileştirmek için özel olarak tasarlanmış bir AI ajanı olan yeni aracı Percival’ı yayınladı. Percival, karmaşık ajan izleme kayıtlarını anında analiz edebilir, 60’a kadar farklı hata modunu tanımlayabilir ve performansı artırmak için otomatik olarak komut istemi düzeltme önerileri sunabilir. Bu araç, “bağlam patlaması” (ajanların milyonlarca token işlemesi) gibi kritik zorlukları ele alıyor ve belirli kullanım durumları için alan adaptasyonunu ve karmaşık çoklu ajan düzenlemesini destekliyor. (Kaynak: Weaviate Podcast)

Replit, Semgrep ile entegre olarak “güvenli ortam programlama” sağlıyor, güvenlik açıklarını otomatik olarak tarıyor : Replit, Semgrep ile işbirliği yaparak “Güvenli Ortam Kodlama” (Safe Vibe Coding) özelliğini kullanıma sunduğunu duyurdu. Artık kullanıcılar Replit’te her kod dağıttığında, Semgrep otomatik olarak güvenlik taraması yapacak, potansiyel güvenlik açıklarının bulunmasına ve düzeltilmesine yardımcı olacak, API anahtarları gibi hassas bilgilerin yanlışlıkla açığa çıkmasını önleyecektir. Bu hamle, AI destekli kodlama (örneğin LLM aracılığıyla kod üretme) kullanırken güvenliği artırmayı amaçlamaktadır. (Kaynak: amasad)

Cursor AI 0.50 sürümü yayınlandı, önemli güncellemeler getiriyor : AI destekli programlama aracı Cursor, “şimdiye kadarki en büyük sürüm güncellemesi” olarak adlandırılan 0.50 sürümünü yayınladı. Yeni sürümün, geliştiricilerin kodlama verimliliğini ve AI ile işbirliğinin akıcılığını daha da artırmayı amaçlayan birçok özellik geliştirmesi ve deneyim optimizasyonu içermesi bekleniyor. Belirli güncelleme içerikleri resmi yayın notlarından öğrenilebilir. (Kaynak: eric zakariasson)

OpenMemory MCP: Uygulamalar arası bağlam paylaşımını destekleyen yerelleştirilmiş bellek yönetim sunucusu : OpenMemory MCP, AI uygulamalarının üretkenliğini artırmayı amaçlayan bir bellek yönetim sunucusudur. Kullanıcıların farklı uygulamalar (Cursor ve Claude Desktop gibi) arasında bağlam paylaşmasına olanak tanır ve verileri yerel olarak depolamak ve dizine eklemek için PostgreSQL ve Qdrant kullanır, böylece veri gizliliğini sağlar. Bu araç, anlamsal aramayı destekler ve bellek ile uygulama erişimini yönetmek için bir gösterge paneli sunarak oturumlar arası bağlam kaybı sorununu çözer. (Kaynak: Reddit r/ClaudeAI)

Hugging Face Inference Endpoint, vLLM ve Gradio ile birleşerek hızlı Whisper transkripsiyonu sağlıyor : Hugging Face, Inference Endpoint hizmetini, vLLM projesini ve Gradio arayüzünü birleştirerek OpenAI’nin Whisper modelini nasıl dağıtılacağını ve son derece hızlı ses transkripsiyonu işlevini nasıl elde edileceğini gösterdi. Bu kombinasyon, AI topluluğunun açık kaynak araçlarından yararlanarak kullanıcılara verimli ve kullanımı kolay bir sesten metne çözüm sunuyor. (Kaynak: Morgan Funtowicz)

A.I.T.E Ball: Orange Pi ve Gemma 3 1B tabanlı kendi kendine yeten AI sihirli 8 topu : Bir geliştirici, tamamen kendi kendine yeten (internet bağlantısı gerektirmeyen) AI destekli bir sihirli 8 topu projesi olan A.I.T.E Ball’u sergiledi. Cihaz Orange Pi Zero 2W üzerinde çalışıyor, metinden sese dönüştürme için whisper.cpp kullanıyor ve soru-cevap için Gemma 3 1B modelini llama.cpp ile çalıştırıyor. Bu, düşük güçlü donanımlarda yerelleştirilmiş AI uygulamalarını gerçekleştirme potansiyelini gösteriyor. (Kaynak: Reddit r/LocalLLaMA)

OWL Agent: MCPToolkit entegreli açık kaynaklı genel amaçlı ajan : Açık kaynaklı OWL ajan projesi artık yerleşik MCPToolkit desteğine sahip. Kullanıcılar Playwright, desktop-commander gibi MCP sunucularına veya özel Python araçlarına kolayca bağlanabilir ve OWL, çoklu ajan iş akışında bu araçları otomatik olarak keşfedip çağırarak genelliğini ve görev yürütme yeteneklerini artırır. (Kaynak: Reddit r/LocalLLaMA)

ElevenLabs, SB-1 sonsuz ses efektleri panosunu tanıttı: Ses efektleri, davul makinesi ve ortam gürültüsü oluşturucuyu bir arada sunuyor : ElevenLabs, ses efektleri panosu, davul makinesi ve sonsuz ortam gürültüsü oluşturucuyu bir araya getiren bir araç olan SB-1 sonsuz ses efektleri panosunu yayınladı. Kullanıcılar istedikleri ses efektini tanımlayarak SB-1’in metinden ses efektine (Text-to-SFX) modelini kullanarak bu sesleri üretmesini sağlayabilir, bu da ses üretimi için yeni olanaklar sunuyor. (Kaynak: ElevenLabs)

Anytop projesi: AI animasyonunda yeni gelişmeler, görülmemiş canlıları hayata geçiriyor, hareket öğrenme ve aktarımını destekliyor : Two Minute Papers, daha önce hiç görülmemiş canlılar (dinozorlar, tuhaf böcekler vb. dahil) için gerçekçi hareketler üretebilen bir AI animasyon teknolojisi olan Anytop projesini tanıttı. Bu AI sadece bağımsız olarak hareket üretmekle kalmıyor, aynı zamanda farklı canlıların birbirlerinin hareketlerini öğrenmesini ve uyum sağlamasını da sağlıyor (örneğin dinozorun flamingonun tek ayak üzerinde durmasını öğrenmesi gibi). Vücut parçalarının anlamsal benzerliğini (örneğin kollar, bacaklar gibi genel kavramlar) anlayarak bilinmeyen formlara genelleme yapabiliyor. Ayrıca, bu sistem hareketlerin anlamını (saldırı, rahatlama gibi) anlayabiliyor ve farklı hayvanlar arasında benzer kavramların hareketlerini sergileyebiliyor, hatta eksik giriş hareketlerini tamamlayabiliyor. (Kaynak: )

Sketch2Anim: AI, basit çizim eskizlerini tam 3D animasyonlara dönüştürüyor : Two Minute Papers tarafından tanıtılan bir başka teknoloji olan Sketch2Anim, kullanıcıların çizdiği basit çizgi eskizlerini (hareket yolunu gösteren) tam 3D karakter animasyonlarına dönüştürebiliyor. Bu AI, 2D eskizlerin ardındaki 3D niyeti (örneğin ileriye doğru yumruk atmakla yana doğru yumruk atmak arasındaki farkı ayırt etmek gibi) anlayabiliyor ve daha önceki benzer teknolojilerin talimatları yalnızca 2D düzeyde anlayabilme sınırlılığını çözüyor. Bu sayede profesyonel olmayan kişiler bile basit çizimlerle hızlı bir şekilde 3D animasyonlar oluşturabiliyor. (Kaynak: )

📚 Araştırmalar

DeepSeek, V3 modeli makalesini yayınladı, genişleme zorluklarını ve AI donanım mimarisi üzerine düşüncelerini paylaştı : DeepSeek ekibi, Hugging Face’te DeepSeek-V3 modeli hakkında bir makale yayınladı. Makale, büyük dil modellerini genişletme sürecinde karşılaşılan zorlukları derinlemesine inceliyor ve gelecekteki AI donanım mimarisinin gelişim yönleri hakkında düşünceler ve görüşler sunuyor. Bu, araştırmacılar ve geliştiriciler için büyük ölçekli model eğitimi ve dağıtımının darboğazlarını ve donanım ile yazılımın ortak optimizasyonuyla nasıl başa çıkılacağını anlamaları için değerli bir referans sağlıyor. (Kaynak: Adina Yakup)

Ücretsiz Model Bağlam Protokolü (MCP) kursu yayınlandı, harici veri ve araçlarla AI uygulamaları oluşturmaya yardımcı oluyor : Ben Burtenshaw, ücretsiz bir MCP (Model Context Protocol) kursu başlattığını duyurdu. Kurs, öğrencilerin başlangıç seviyesinden uzmanlığa kadar MCP’nin nasıl çalıştığını, LLM’lerin MCP sunucularına nasıl bağlanacağını ve harici verileri ve araçları kullanarak AI yeteneklerini geliştirmek için MCP ile AI ajan uygulamalarının nasıl dağıtılacağını anlamalarına yardımcı olmayı amaçlıyor. (Kaynak: Ben Burtenshaw)

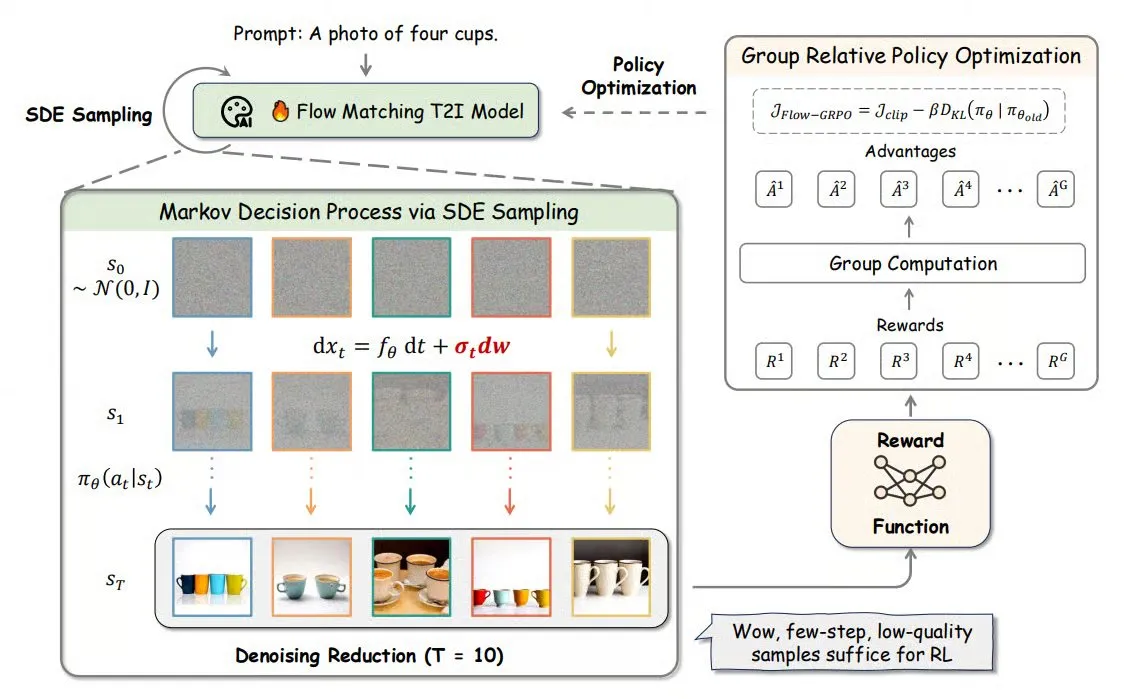

Flow-GRPO: Çevrimiçi pekiştirmeli öğrenmeyi akış eşleştirme modellerine dahil ederek görüntü oluşturma doğruluğunu artırıyor : Flow-GRPO, çevrimiçi pekiştirmeli öğrenmeyi (RL) ilk kez akış eşleştirme modellerine uygulayan yeni bir yöntemdir. Bunu iki yenilikçi stratejiyle başarıyor: 1) ODE’den SDE’ye dönüşüm: Akış modelinin adi diferansiyel denklemlere (ODE) dayalı deterministik sürecini stokastik diferansiyel denklemlere (SDE) dönüştürerek RL için gereken rastgeleliği sağlar. 2) Gürültü azaltma adımlarını kısaltarak eğitimi hızlandırma: Eğitim sırasında gürültü azaltma adımlarını azaltır, çıkarım sırasında tam adımları kullanır. Flow-GRPO ile akış modellerinin görüntü oluşturma görevlerindeki doğruluğu %92’nin üzerine çıkarıldı. (Kaynak: TheTuringPost)

ICML 2025 makalesi PENCIL: Dönüşümlü “çıkarım-silme” ile büyük modeller için yeni bir derin düşünme paradigması : Toyota Teknoloji Enstitüsü Chicago’dan Chenxiao Yang ve arkadaşları, PENCIL (Pondering with Erasure Net for Contextual Inference Learning) adlı, ara sonuçların dönüşümlü olarak “üretilmesi” ve “silinmesi” yoluyla büyük modellerin derin düşünmesini sağlayan yeni bir paradigma önerdi. Bu yöntem, mantıksal yeniden yazma kurallarından ve fonksiyonel programlama bellek yönetiminden esinlenerek, artık gerekmeyen ara adımları dinamik olarak siler ve geleneksel uzun CoT’nin (düşünce zinciri) karşılaştığı bağlam penceresi aşımı, bilgi erişim zorluğu ve üretim verimliliği düşüşü gibi sorunları etkili bir şekilde çözer. Teorik olarak, PENCIL’in herhangi bir Turing makinesi işlemini optimal uzay ve zaman karmaşıklığıyla simüle edebildiği ve tüm hesaplanabilir sorunları çözebildiği kanıtlanmıştır. Deneyler, 3-SAT, QBF ve Einstein’ın bilmecesi gibi görevlerde PENCIL’in geleneksel CoT’den önemli ölçüde daha iyi performans gösterdiğini ortaya koymuştur. (Kaynak: 机器之心)

ICML 2025 makalesi MemVR: İnsanların “iki kez bakma” mekanizmasını taklit ederek çok modlu büyük model halüsinasyonlarını azaltıyor : HKUST (Guangzhou) ve diğer kurumların araştırmacıları, insanların belirsiz anıları ikinci kez kontrol etme stratejisini taklit ederek çok modlu büyük dil modellerinin (MLLM) halüsinasyon sorununu azaltan MemVR (Memory-space Visual Retracing) yöntemini önerdi. MemVR, görsel token’ları tamamlayıcı kanıt olarak kullanarak, model çıkarımının unutkanlıkla karşılaştığı ara katmanlarda, ileri beslemeli ağ (FFN) aracılığıyla görsel bilgiyi yeniden “erişerek” tahminleri düzeltir. Bu yöntem, farklı katmanların çıktılarının belirsizliğine göre tetikleme katmanını seçen dinamik bir tetikleme mekanizması tasarlar. Deneyler, MemVR’in birden fazla halüsinasyon değerlendirme ölçütünde ve genel ölçütlerde önemli ölçüde etkili olduğunu ve diğer yöntemlere kıyasla verimlilik avantajına sahip olduğunu göstermiştir. (Kaynak: PaperWeekly)

SIGIR 2025 makalesi PaRT: Kişiselleştirilmiş gerçek zamanlı erişim, proaktif sosyal sohbet robotu deneyimini geliştiriyor : Çin Bilim ve Teknoloji Üniversitesi ve diğer kurumlar, kişiselleştirilmiş yönlendirme ve niyet tanıma güdümlü sorgu yeniden yazma ile gerçek zamanlı erişimi birleştirerek proaktif sosyal sohbet robotlarının konuşma deneyimini geliştirmeyi amaçlayan PaRT (Proactive Social Chatbots with Personalized Real-time ReTreival) yöntemini önerdi. PaRT sistemi, kişiselleştirilmiş kullanıcı profili oluşturma, niyet tanıma ve sorgu yeniden yazma, gerçek zamanlı erişimle geliştirilmiş üretim olmak üzere üç modül içerir. Kullanıcının ilgi alanlarına ve konuşma bağlamına göre proaktif olarak konu başlatabilir veya değiştirebilir, daha doğal ve bilgi açısından daha zengin yanıtlar sağlayabilir. Çevrimdışı deneyler ve çevrimiçi A/B testleri, bu yöntemin yanıtların kişiselleştirilmesini, zenginliğini ve ortalama konuşma süresini etkili bir şekilde artırdığını göstermiştir. (Kaynak: PaperWeekly)

ICML 2025 makalesi PreSelect: Tahmin gücüne dayalı verimli ön eğitim veri filtreleme şeması : Hong Kong Bilim ve Teknoloji Üniversitesi ile vivo AI Lab, verilerin belirli bir yetenek üzerindeki modele katkısının büyüklüğünü ölçmek için “Tahmin Gücü” (Predictive Strength) kavramını tanıtan PreSelect veri filtreleme yöntemini önerdi. Bu yöntem, farklı modellerin kıyaslama testlerindeki puan sıralaması ile veriler üzerindeki Kayıp (Loss) sıralamasının tutarlılığını kullanarak veri değerini değerlendirir ve büyük ölçekli verilerin verimli bir şekilde filtrelenmesini sağlamak için hafif bir fastText sınıflandırıcısıyla yaklaşık puanlama kullanır. Deneyler, PreSelect’in veri verimliliğini 10 kat artırabildiğini, filtrelenen verilerin modelleri eğitirken birçok temel yöntemden önemli ölçüde daha iyi performans gösterdiğini ve daha geniş bir yelpazede yüksek kaliteli içerik kaynaklarını kapsayarak örnek uzunluğu yanlılığını azalttığını göstermiştir. (Kaynak: 量子位)

AI Evals kursu, değerlendirme çerçeveleri ve uygulamalarını paylaşmak üzere 12 konuk konuşmacıyı davet ediyor : Hamel Husain tarafından düzenlenen AI Evals kursu, inspect çerçevesinin yaratıcısı JJ Allaire ve Modal geliştirici savunucusu Charles Frye gibi 12 konuk konuşmacıdan oluşan bir kadroyu duyurdu. Kurs, AI değerlendirmesinin çeşitli yönlerini, değerlendirme çerçeveleri, özel etiketleme uygulaması oluşturma, model değerlendirme uygulamaları dahil olmak üzere derinlemesine inceleyecek ve katılımcıların AI sistem performansını değerlendirmek için kritik beceri ve araçları edinmelerine yardımcı olmayı amaçlıyor. (Kaynak: Hamel Husain)

FedRAG eğitimi yayınlandı: RAG sistemleri oluşturma ve ince ayar yapma konusunda bir başlangıç kılavuzu : FedRAG projesi, kullanıcıların kütüphaneye hızla başlamalarına yardımcı olmak amacıyla yeni eğitim not defterleri ve eşlik eden videolar yayınladı. Eğitim, Hugging Face entegrasyonunu kullanarak RAG sistemlerinin nasıl oluşturulacağını, düğümleri depolamak için bellek içi bilgi tabanının nasıl kullanılacağını, bir erişimci olarak SentenceTransformer (Dragon+) tanımlanacağını, bir üretici olarak önceden eğitilmiş bir modelin (örneğin Qwen2.5-0.5B) nasıl tanımlanacağını ve erişimci ile üreticiyi merkezi olarak ince ayarlamak için LSR ve RALT eğitmenlerinin nasıl kullanılacağını gösteriyor. (Kaynak: nerdai)

LlamaIndex, LlamaExtract’te alıntı ve çıkarım uygulama eğitimi yayınladı : LlamaIndex ekibi, @tuanacelik tarafından hazırlanan en son kod anlatımını yayınladı. Bu anlatım, LlamaExtract’te alıntı ve çıkarım özelliklerinin nasıl uygulanacağını gösteriyor. Eğitim içeriği şunları içeriyor: LLM’ye karmaşık veri kaynaklarından ne çıkaracağını bildirmek için özel bir şemanın nasıl tanımlanacağı ve alıntıların nasıl ekleneceği. Bu özellik, kullanıcıların büyük kaynak belgelerinden yapılandırılmış bilgileri hassas ve kanıtlanabilir bir şekilde çıkaran çok adımlı AI ajanları oluşturmalarına yardımcı olmayı amaçlıyor. (Kaynak: LlamaIndex 🦙)

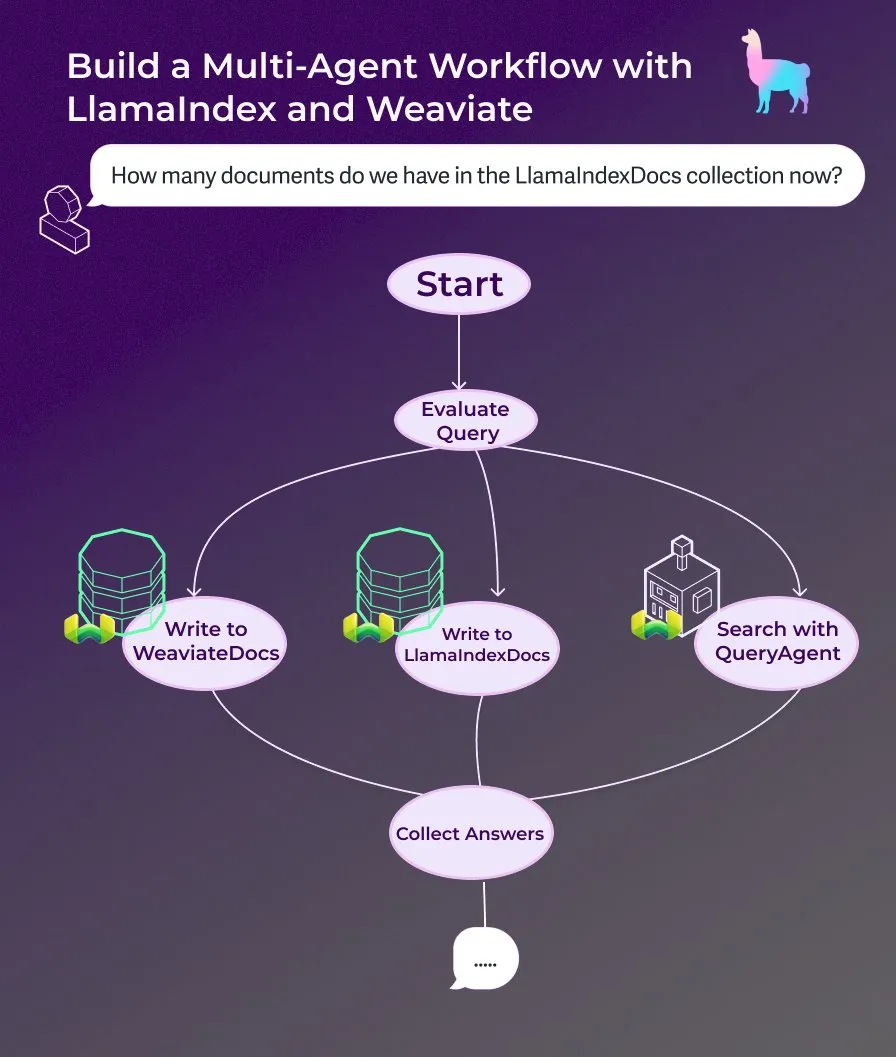

LlamaIndex, olay güdümlü ajan iş akışları kullanarak çoklu ajan belge yardımcısı oluşturma eğitimi yayınladı : LlamaIndex, olay güdümlü ajan iş akışları kullanarak çoklu ajan belge yardımcısı oluşturmayı gösteren yeni bir anlatım eğitimi yayınladı. Bu yardımcı, web sayfası içeriğini LlamaIndexDocs ve WeaviateDocs koleksiyonlarına yazabilir, arama ve toplama için Weaviate QueryAgent’ı ne zaman çağıracağına karar vermek için bir düzenleyici kullanabilir, sorgu sınıflandırması için yapılandırılmış çıktıdan yararlanabilir ve isteğe bağlı olarak FunctionAgent kullanabilir. (Kaynak: LlamaIndex 🦙)

Modular, Mojo derleyicisinin iç teknik konuşmasını yayınladı, Mojo ve GPU mimarisini tartışıyor : Modular şirketi, iç teknik konuşmalarını paylaşmaya başladı. İlk halka açık konuşma, Mojo programlama dili ve GPU mimarisi konusunu derinlemesine inceliyor. İçerik, Mojo derleyicisinin iç çalışma prensiplerini ve ekibin modern GPU’lar için geliştirme yaparken karşılaştığı zorlukları ve çözümleri içeriyor ve toplulukla teknik yığınlarının ayrıntılarını paylaşmayı amaçlıyor. (Kaynak: Modular)

AI by Hand atölyesi: Excel’de sıfırdan Transformer modeli oluşturma : ProfTomYeh, katılımcıların Excel’de sıfırdan bir Transformer modeli oluşturmasını amaçlayan AI by Hand atölyesini tanıtıyor. Bu şekilde, öğrenciler Transformer’ın her bir matematiksel adımını açık ve sezgisel bir şekilde anlayabilir, onu bir “kara kutu” olarak görmekten kaçınabilir ve böylece modelin iç çalışma mekanizmalarına dair derin bir anlayış geliştirebilirler. (Kaynak: ProfTomYeh)

DeepLearning.AI, The Batch’in 301. sayısını yayınladı: AI hızının ticari değerini ve en son gelişmeleri tartışıyor : Andrew Ng, The Batch’in en son sayısında AI’ın görev yürütme hızındaki artışın ticari değer yaratmadaki öneminin hafife alındığını tartışıyor. AI’ın sadece maliyetleri düşürmekle kalmayıp, aynı zamanda fikirden prototipe geçiş süresini kısaltarak inovasyonu ve keşfi hızlandırdığını savunuyor. Bu sayıda ayrıca Microsoft Phi-4 çıkarım serisinin yayınlanması, DeepCoder-14B’nin o1 performansına yetişmesi ve AB AI kurallarının yumuşatılması gibi haberler de yer alıyor. (Kaynak: DeepLearningAI)

💼 İş Dünyası

AI karakter animasyon girişimi Cartwheel, 3D animasyon süreçlerini basitleştirmek için 10 milyon dolar fon topladı : AI karakter animasyonuna odaklanan girişim şirketi Cartwheel, 10 milyon dolarlık bir finansman turunu tamamladığını duyurdu. Şirket, 3D animasyon üretim süreçlerini basitleştiren teknolojiler geliştirmeye kendini adamıştır ve yaratıcıların daha hızlı, daha ekonomik bir şekilde yüksek kaliteli 3D karakter animasyonları üretmelerini sağlamayı, aynı zamanda nihai ürün üzerindeki kontrollerini artırmayı ve sıkıcı görevleri ortadan kaldırmayı amaçlamaktadır. (Kaynak: andrew_n_carr)

Hedra, a16z liderliğinde 32 milyon dolarlık A Serisi finansman aldı, karakter odaklı video üretimini hızlandırıyor : AI video üretim girişimi Hedra, Andreessen Horowitz (a16z) liderliğinde 32 milyon dolarlık A Serisi finansman turunu tamamladığını duyurdu. Matt Bornstein yönetim kuruluna katıldı. Mevcut yatırımcılar a16z speedrun, Abstract ve Index Ventures da bu tura katıldı. Hedra, karakter odaklı video üretimini kolaylaştırmaya kendini adamıştır. Geçen yıl gizli modda faaliyete geçtiğinden beri yaklaşık 3 milyon kişi araçlarını kullanarak 10 milyondan fazla video oluşturdu. Yeni fonlar, hızlı, etkileyici ve sezgisel içerik üretimi sağlamak için ürün geliştirme ve ekip genişlemesini hızlandırmak için kullanılacak. (Kaynak: Hedra)

Tripadvisor, Qdrant kullanarak AI seyahat planlaması oluşturuyor, kullanıcı etkileşimi 2-3 kat arttı : Tripadvisor, Qdrant vektör veritabanını kullanarak seyahat keşif deneyimini yeniden tanımlıyor. 1 milyardan fazla yorum ve fotoğrafı, 1,1 milyon işletmeyi ve 21 ülkenin verilerini analiz ederek Tripadvisor, geleneksel filtrelere dayanmak yerine dinamik, AI tarafından oluşturulan seyahat planları oluşturdu. Sonuçlar, bu AI araçlarını kullanan kullanıcıların harcadığı sürenin 2-3 kat arttığını gösteriyor, bu da AI’ın kişiselleştirilmiş seyahat planlamasındaki büyük potansiyelini ortaya koyuyor. (Kaynak: qdrant_engine)

🌟 Topluluk

Grok’un “beyaz soykırımı” hakkındaki yorumları tartışma yarattı, Sam Altman alaycı bir şekilde yanıt verdi : xAI’nin Grok modeli, Güney Afrika’daki beyaz soykırımı hakkında rastgele görüşler bildirmesi nedeniyle geniş çapta tartışma ve eleştiriye neden oldu. Paul Graham, bu davranışın yakın zamanda yapılan bir yama ile ortaya çıkan bir hataya benzediğini belirtti ve yaygın olarak kullanılan AI’ın kontrolörleri tarafından anlık olarak görüşlerinin düzenlenmesinden endişe duyduğunu ifade etti. Sam Altman ise alaycı bir üslupla yanıt vererek, xAI’nin şeffaf bir açıklama yapacağını ve bu sorunu “Güney Afrika beyaz soykırımı” bağlamında anlayacağını söyledi; bu, AI’ın gerçeği arama ve talimatları izleme çabasının bir sonucu olduğunu ima etti. Topluluğun bu konudaki tartışmaları, AI modellerinin önyargıları, kontrol edilebilirliği ve arkasındaki niyetler hakkındaki genel endişeleri yansıtıyor. (Kaynak: Paul Graham)

AI ürünleştirme üzerine düşünceler: Sadece AI özelliklerini eklemek yerine, kullanıcı görevinin tüm sürecinden fırsatlar çıkarmak : Cloud Nine Capital ortağı Ren Xin, AI ürünleştirmesi üzerine derinlemesine düşüncelerini paylaştı ve şirketlerin mevcut ürünlere basitçe AI özellikleri eklemek yerine, kullanıcıların görevleri tamamlama sürecinin tamamından yola çıkarak AI uygulamaları için giriş noktaları bulmaları gerektiğini vurguladı. “Kullanıcının istediği matkap değil, duvardaki deliktir” benzetmesini yaparak, kullanıcı görevlerini ayrıştırmayı, sorunlu noktaları bulmayı ve AI ile optimize etmeyi önerdi. AI ürünleştirmesinin dört katmanı şunlardır: eski süreçleri verimli bir şekilde tamamlama, yeni süreçler yaratma, tamamen yeni pazarlar açma (kullanım engelini düşürme, yeni kullanıcı gruplarına hizmet etme, hatta AI’nın kendisi) ve AI hakimiyetindeki bir gelecek için altyapı oluşturma. AI teknolojisinin eşitlikçi hale geldiğini, teknoloji bilmeyen şirketlerin bile fırsatları yakalayabileceğini ve bunun özünde “AI’a iş bulmasına yardım etmek” olduğunu belirtti. (Kaynak: 混沌大学)

Tartışma: AI’ın kariyer gelişimindeki rolü ve uyum stratejileri : LinkedIn’deki bir gönderi, AI’ın kariyer gelişimini nasıl etkilediği konusunda bir tartışma başlattı. Yaygın söylem “AI işinizi elinizden almayacak, ancak AI kullananlar alacak” şeklinde. Ancak bu söylemin çok belirsiz olduğu belirtiliyor. Onlarca yıllık deneyime sahip ön uç mühendisleri gibi belirli pozisyonlar için aniden AI mühendisine nasıl dönüşüleceği ve herkesin AI mühendisi olamayacağı soruları gündeme getirildi. Topluluk tartışmalarında, ön uç geliştiricilerin iş verimliliğini artırmak için AI araçlarını kullanmayı öğrenebileceği düşünülüyor. Ayrıca AI’ın birçok işi ortadan kaldıracağı ve birçok insanın gidecek yeri olmayacağı görüşü de var. Daha genel bir kanı ise geleceğin belirsiz olduğu, ancak yaratıcılığın, sorun bulma yeteneğinin ve insanlığı anlama ve ona ulaşma yeteneğinin daha savunmacı olabileceği yönünde. (Kaynak: Reddit r/ArtificialInteligence)

Tartışma: LLM’ler çok turlu konuşmalarda kolayca “kayboluyor”, konuşmayı yeniden başlatmak faydalı olabilir : Bir araştırma makalesi, hem açık kaynaklı hem de kapalı kaynaklı LLM’lerin çok turlu konuşmalardaki performansının önemli ölçüde düştüğünü belirtiyor. Çoğu kıyaslama testi, tek turlu, talimatları net olan senaryolara odaklanıyor. Araştırma, LLM’lerin genellikle erken konuşma turlarında (yanlış) varsayımlarda bulunduğunu ve sonraki konuşmalarda bu varsayımlara dayanarak düzeltmekte zorlandığını ortaya koydu. Sonuç olarak, çok turlu bir konuşma beklentileri karşılamadığında, yeni bir konuşma başlatmak ve tüm ilgili bilgileri ilk tur girişine entegre etmek yardımcı olabilir. (Kaynak: Reddit r/LocalLLaMA)

Apple ve WeChat’in AI gelişimindeki göreceli yavaşlığının nedenleri tartışılıyor: Gizlilik güvenliği ve uygulama öncelikli strateji : Weixi bir makalede, Apple’ın “Apple Intelligence”ı piyasaya sürmesine ve WeChat’in DeepSeek ve Yuanbao’ya bağlanmasına rağmen, her ikisinin de AI temel işlevlerindeki ilerleme hızının nispeten yavaş olduğunu analiz etti. Bunun iki ana nedeni var: Birincisi, gizlilik ve veri güvenliğinin son derece hassas olması; AI’ın zekası verilere dayanır ve Apple ile WeChat’in temel iş modelleri, veri paylaşımı konusunda son derece dikkatli olmalarını gerektirir, bu da model eğitimi ve uygulama bağlamının elde edilmesini sınırlar. İkincisi, her ikisinin de “uygulama öncelikli” bir strateji benimsemesi; kendileri model zekasının üst sınırında en iyi AI şirketleriyle rekabet etmeyi amaçlamıyorlar, bunun yerine AI yeteneklerini mevcut işlevlere ve ekosistemlere entegre etmeye daha fazla odaklanıyorlar, bu da teknoloji hakimiyeti ve ürün yineleme hızında sınırlı kalmalarına neden olabilir. (Kaynak: 卫夕指北)

OpenAI, “A’dan Z’ye Yarışması”nı başlattı: Amazon’da bilinmeyen arkeolojik alanları AI ile keşfetme : OpenAI, Kaggle ile işbirliği içinde “OpenAI to Z Challenge” adlı özel bir hackathon başlattığını duyurdu. Yarışma, katılımcıları OpenAI o3, o4-mini veya GPT-4.1 modellerini kullanarak Amazon bölgesinde daha önce bilinmeyen arkeolojik alanları bulmaya teşvik ediyor. Katılımcılar ilerlemelerini paylaşmak için #OpenAItoZ etiketini kullanabilirler. Bu etkinlik, AI’ın arkeoloji ve coğrafi uzamsal analiz alanlarındaki uygulama potansiyelini keşfetmeyi amaçlıyor. (Kaynak: OpenAI Developers)

“AI avukat” girişimlerine eleştiri: Otomatikleştirilmiş “ihtarname”ler toplumsal bir yük haline gelebilir : Geliştirici @swyx, bazı VC’lerin “AI avukat” girişimlerine yatırım yapma olgusunu eleştirdi. Bu şirketlerin esas olarak AI aracılığıyla otomatik olarak “ihtarname” (demand letters) ürettiğini ve bunun özünde otomatikleştirilmiş şantaj olduğunu savundu. Bazı ihtarnamelerin makul olabileceğini belirtmekle birlikte, bu tür eylemlerin çoğunun sonunda yalnızca avukatlara fayda sağlayacağını ve toplum için saf bir vergi haline geleceğini belirtti. Bu tür şirketleri ve yatırımcılarını boykot etme, yatırımlarını geri çekme ve açıkça eleştirme çağrısında bulundu. (Kaynak: swyx)

💡 Diğer

Kömür araştırma raporunda “Wither iskeletlerini öldürerek elde edilir” gibi absürt bir hata, içerik kalitesi ve AI halüsinasyonları hakkında tartışmalara yol açtı : 8200 yuan fiyat etiketli bir kömür endüstrisi araştırma raporunda, “kömür yenilenebilir bir kaynaktır, Wither iskeletlerini öldürerek elde edilir” şeklinde, Minecraft oyunundan alınmış bir açıklama yer aldı ve internette büyük yankı uyandırdı. Birçok kişi bunu AI içerik üretimine ve halüsinasyonlara bağladı. Ancak rapor, ChatGPT gibi ana akım büyük modellerin piyasaya sürülmesinden önce, 2022’de yayınlanmıştı; bu da bunun tipik bir manuel kopyala-yapıştır ve denetim ihmali vakası olduğunu gösteriyor. Olay ayrıca profesyonel raporların içerik kalitesi, bilgi doğrulamanın önemi ve AI çağında bilgilerin doğruluğunun nasıl ayırt edileceği konularında derinlemesine düşüncelere yol açtı. (Kaynak: caoz的梦呓)

Araştırmacılar, nadir bir metabolik hastalığı olan bir bebeği tedavi etmek için özelleştirilmiş gen düzenleme tedavisini kullandı : Doktorlar, yedi aydan kısa bir sürede özelleştirilmiş bir gen düzenleme tedavisi geliştirdi ve ölümcül bir metabolik hastalığı olan bir bebeği tedavi etmek için başarıyla kullandı. Bu, gen düzenlemenin ilk kez tek bir birey için özelleştirilmiş tedavi amacıyla kullanılmasıdır. Tedavi, bebeğin genlerindeki belirli bir tek harflik hatayı düzeltmeyi amaçlıyor ve baz düzenleme gibi yeni gen düzenleme teknolojilerinin hassasiyetini gösteriyor. Tedavi erken olumlu belirtiler gösterse de, ultra nadir hastalıklar için kişiselleştirilmiş gen tedavileri geliştirmenin maliyet ve ölçeklenebilirlik zorluklarını da vurguluyor. (Kaynak: MIT Technology Review)

Evrensel jailbreak komut istemi stratejisi ortaya çıktı, ana akım büyük modellerin güvenlik bariyerlerini aşabiliyor : HiddenLayer araştırmacıları, ChatGPT, Claude, Gemini dahil olmak üzere ana akım büyük dil modellerinin güvenlik bariyerlerini aşarak zararlı içerik üretmesini sağlayan evrensel bir komut istemi stratejisi keşfetti. Strateji, zararlı talimatları XML, INI veya JSON gibi politika dosyalarına benzer formatlarda gizleyerek ve kurgusal rol yapma senaryolarıyla birleştirerek modeli, zararlı komutları meşru sistem talimatları olarak yorumlaması için kandırıyor. Bu yöntem, modelin eğitim verilerinde bulunabilecek sistemik bir zayıflıktan yararlanıyor; yani öğretim veya politika ile ilgili verileri işlerken güvenlik talimatlarını göz ardı etme eğilimi. Bu teknik ayrıca modelin sistem komut istemlerini çıkararak iç talimatlarını ve güvenlik kısıtlamalarını ortaya çıkarabiliyor. (Kaynak: 新智元)