Anahtar Kelimeler:GENMO, Seed-Coder, DeepSeek, LlamaParse, Agentic AI, Kenar Hesaplama, Kuantum Hesaplama, NVIDIA GENMO insan hareket modeli, ByteDance Seed-Coder kod büyük modeli, DeepSeek açık kaynak stratejisi etkisi, LlamaParse belge analiz güvenilirlik puanı, Kenar hesaplama gerçek zamanlı veri işleme

🔥 Öne Çıkanlar

NVIDIA, GENMO evrensel insan hareketi modelini tanıttı: NVIDIA, metin, video, müzik ve hatta anahtar kare silüetleri gibi çeşitli girdileri gerçekçi 3D insan hareketlerine dönüştürebilen GENMO (GENeralist Model for Human MOtion) adlı bir AI modeli yayınladı. Model, farklı türdeki girdileri anlayıp birleştirebiliyor; örneğin videodan hareketleri öğrenip metin istemlerine göre değiştirebiliyor veya müzik ritmine göre dans üretebiliyor. GENMO, oyun animasyonu, sanal dünya karakter oluşturma gibi alanlarda büyük bir potansiyel sergiliyor; karmaşık ve doğal, akıcı hareketler üretebiliyor ve animasyon zamanlamasının sezgisel olarak düzenlenmesini destekliyor. Henüz yüz ifadelerini ve el detaylarını işleyemese ve harici SLAM yöntemlerine dayansa da, çok modlu girdileri ve yüksek kaliteli çıktıları, AI hareket üretimi alanında önemli bir ilerlemeyi temsil ediyor (Kaynak: YouTube – Two Minute Papers

)

ByteDance, Seed-Coder serisi açık kaynaklı büyük modelleri yayınladı: ByteDance, 8B parametre ölçeğinde temel model, talimat modeli ve çıkarım modeli içeren Seed-Coder serisi açık kaynaklı büyük dil modellerini tanıttı. Bu serinin temel özelliği, “kod modelinin kendi verisini kendi kendine küratörlüğünü yapma” yeteneği olup, veri oluşturmada insan katılımını en aza indirmeyi amaçlıyor. Seed-Coder, kod üretimi, düzenleme gibi birçok alanda mevcut en iyi seviyeye (SOTA) ulaştı ve AI’ın kendi yetenekleriyle eğitim verilerini optimize etme ve oluşturma potansiyelini göstererek kod büyük modellerinin geliştirilmesi için yeni fikirler sundu (Kaynak: _akhaliq)

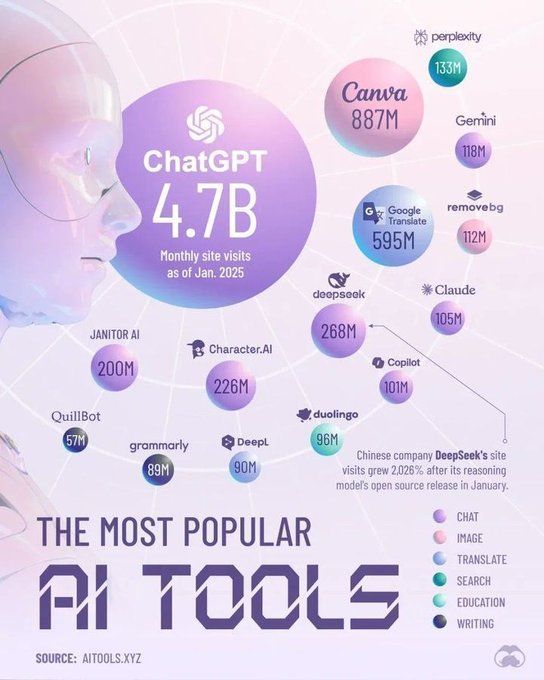

DeepSeek modelleri AI topluluğunda geniş ilgi uyandırdı: DeepSeek serisi modeller, özellikle kod modelleri, güçlü performansları ve açık kaynak stratejileri nedeniyle AI topluluğunda geniş çapta tartışmalara neden oldu. Birçok geliştirici ve araştırmacı performansından etkilendi ve küresel çapta açık kaynak modeline bakışı değiştirdiğini düşünüyor. Tartışmalar, DeepSeek’in başarısının OpenAI gibi şirketleri açık kaynak stratejilerini yeniden değerlendirmeye itebileceğini ve yerel büyük model üreticilerini açık kaynak adımlarını hızlandırmaya teşvik edebileceğini gösteriyor. Açık kaynak, ticarileşme, donanım uyumluluğu gibi zorluklarla karşı karşıya olsa da, DeepSeek’in ortaya çıkışı, AI teknolojisinin demokratikleşmesini ve sektörün gelişimini destekleyen önemli bir güç olarak görülüyor (Kaynak: Ronald_vanLoon, 36Kr)

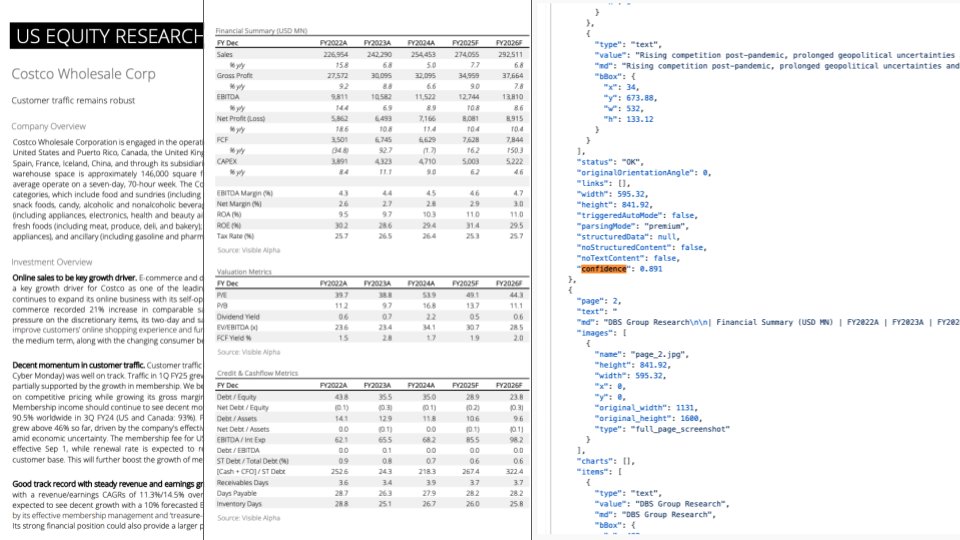

LlamaParse güncellemesi: GPT-4.1 ve Gemini 2.5 Pro entegrasyonu ile belge ayrıştırma yetenekleri geliştirildi: LlamaParse, en son GPT-4.1 ve Gemini 2.5 Pro modellerini entegre eden önemli bir güncelleme yayınladı ve belge ayrıştırma doğruluğunu önemli ölçüde artırdı. Yeni özellikler arasında, ayrıştırılan içeriğin hizalanmasını ve doğruluğunu sağlayan otomatik yön ve eğrilik tespiti bulunuyor. Ayrıca, kullanıcıların her sayfanın ayrıştırma kalitesini değerlendirmesine ve güvenilirlik eşiklerine göre manuel inceleme süreçleri ayarlamasına olanak tanıyan bir güvenilirlik puanlama özelliği eklendi. Bu güncelleme, LLM/LVM’lerin karmaşık belgeleri işlerken karşılaşabileceği hataları çözmeyi ve manuel inceleme ve düzeltme için bir kullanıcı deneyimi sunarak otomasyon süreçlerinin güvenilirliğini sağlamayı amaçlıyor (Kaynak: jerryjliu0)

🎯 Gelişmeler

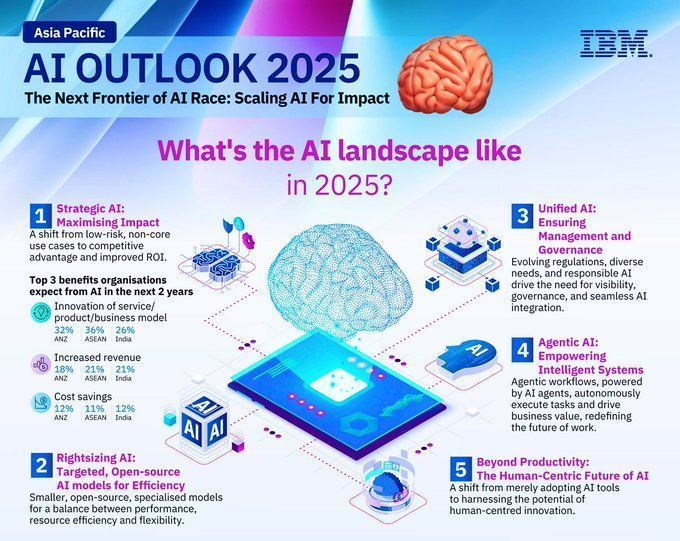

2025 yılı teknoloji sektörü trendleri görünümü: Rapor, 2025 yılında teknoloji sektöründeki ana trendleri öngörüyor; yapay zeka, makine öğrenimi, 5G, giyilebilir cihazlar, blockchain ve siber güvenlik gibi yeni teknolojilerin gelişmeye devam edeceği ve derinlemesine entegre olacağı belirtiliyor. Bu teknolojilerin yaşamı iyileştirme, inovasyonu teşvik etme ve toplumsal sorunları çözme konularında önemli bir rol oynaması bekleniyor, bu da teknolojiyle güçlendirilmiş parlak bir geleceğe işaret ediyor (Kaynak: Ronald_vanLoon, Ronald_vanLoon)

2025 yılı AI alanı gelişim trendleri tahmini: IBM, 2025 yılında yapay zeka alanının hızla gelişmeye devam edeceğini, makine öğrenimi (ML) ve yapay zeka (MI) teknolojilerinin daha da olgunlaşacağını ve çeşitli sektörlerde yaygın olarak uygulanacağını öngörüyor. AI’ın otomasyon, veri analizi, karar destek gibi alanlarda daha büyük bir rol oynaması, teknolojik inovasyonu ve endüstriyel dönüşümü teşvik etmesi bekleniyor (Kaynak: Ronald_vanLoon)

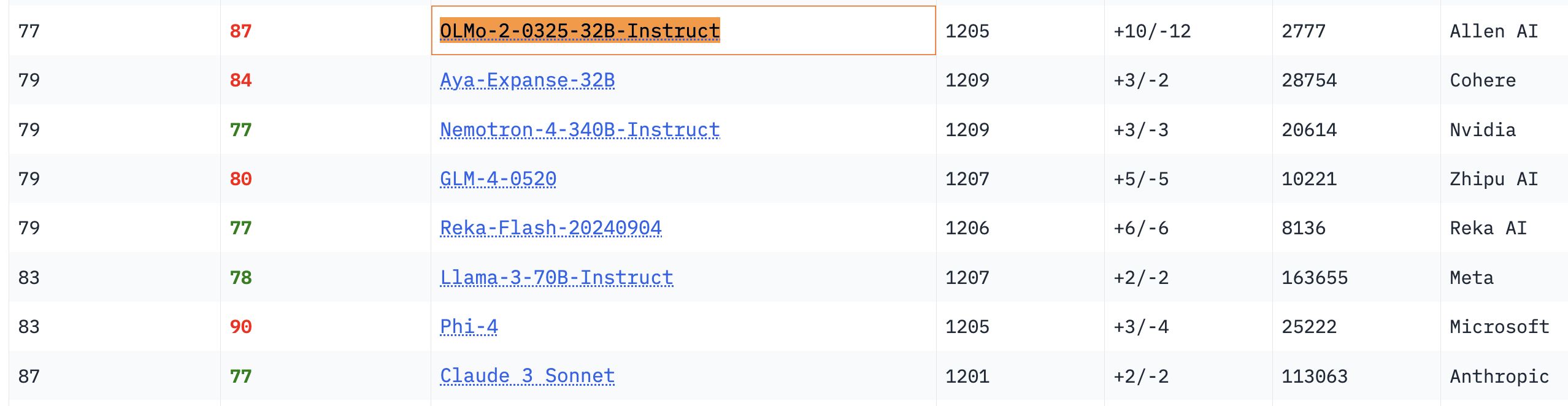

OLMo 32B modeli performansıyla öne çıkıyor: İlgili kıyaslama testlerinde, tamamen açık kaynaklı OLMo 32B modelinin performansı, daha büyük parametre sayısına sahip Nemotron 340B ve Llama 3 70B modellerinden daha iyi oldu. Bu sonuç, bazı açılardan daha küçük parametre sayısına sahip tamamen açık kaynaklı modellerin, daha büyük ölçekli ticari modelleri yakalayabileceğini ve hatta geçebileceğini göstererek açık kaynaklı model araştırmalarının büyük potansiyelini ve yetişme hızını ortaya koyuyor (Kaynak: natolambert, teortaxesTex, lmarena_ai)

Gemma modeli indirme sayısı 150 milyonu aştı, varyant sayısı 70 bini geçti: Google’ın Gemma modeli, Hugging Face platformunda 150 milyonun üzerinde indirme sayısına ulaştı ve 70 binden fazla varyanta sahip. Bu veriler, Gemma modelinin geliştirici topluluğundaki popülaritesini ve yaygın kullanımını yansıtıyor. Topluluk kullanıcıları da gelecekteki sürümlerinin yinelemesini merakla bekliyor (Kaynak: osanseviero, _akhaliq)

Unsloth, Qwen3 GGUF modellerini güncelledi, kalibrasyon veri setini iyileştirdi: Unsloth, tüm Qwen3 GGUF modellerini güncelledi ve yeni, iyileştirilmiş bir kalibrasyon veri seti kullandı. Ayrıca, Qwen3-30B-A3B için daha fazla GGUF varyantı eklendi. Kullanıcı geri bildirimlerine göre, 30B-A3B-UD-Q5_K_XL sürümünde çeviri kalitesi diğer Q5 ve Q4 GGUF’lere göre iyileşme gösterdi (Kaynak: Reddit r/LocalLLaMA)

Agentic AI ve GenAI Farkı: Agentic AI ve üretken AI (GenAI), güncel AI alanındaki sıcak konulardır. GenAI temel olarak yeni içerik (metin, resim vb.) oluşturabilen AI anlamına gelirken, Agentic AI daha çok otonom olarak görevleri yerine getirebilen, çevreyle etkileşime girebilen ve kararlar alabilen akıllı ajanlara odaklanır. Agentic AI genellikle GenAI yeteneklerini birleştirir ancak otonomluğunu ve hedef odaklılığını daha fazla vurgular (Kaynak: Ronald_vanLoon)

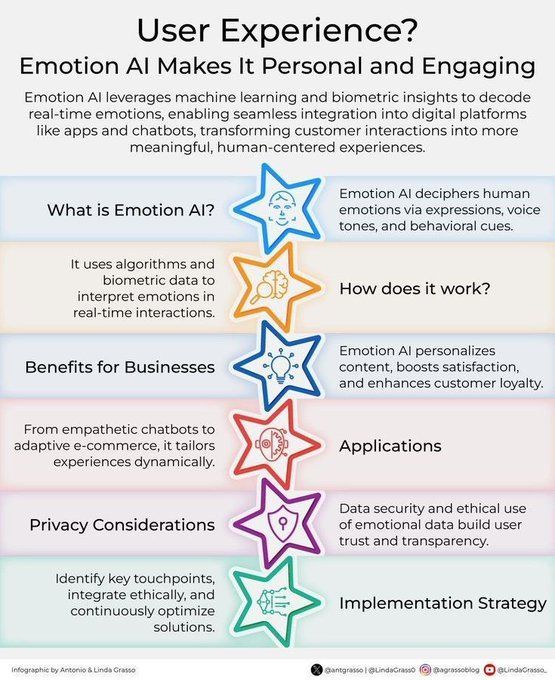

Duygusal AI müşteri deneyimini geliştiriyor: Duygusal AI teknolojisi, insan duygularını analiz edip anlayarak müşteri deneyimini (CX) geliştirmek için kullanılıyor. İşletmelerin müşteri ihtiyaçlarını ve duygularını daha iyi anlamalarına yardımcı olabilir, böylece daha kişiselleştirilmiş, daha empatik hizmetler sunabilir ve dijital dönüşümde müşteri ilişkileri yönetimi inovasyonunu teşvik edebilir (Kaynak: Ronald_vanLoon)

AI destekli kişiselleştirilmiş araç “Akıllı Mekanik Yardımcı Cihaz” (Jigging) konsepti: Karina Nguyen, AI modellerinin bireyselleştirilmiş, kendi kendini geliştiren usta zanaatkarlar olacağını simgeleyen “Jigging” konseptini ortaya attı. AI, kullanıcıyla her etkileşimde, kullanıcının özelliklerine ve görevine göre yeni özel araçlar oluşturarak yeteneklerini artırır. Örneğin, AI bir doktor için kişiselleştirilmiş bir teşhis çerçevesi veya bir yazar için benzersiz bir anlatı çerçevesi oluşturur. Bu tekrarlayan iyileştirme, AI’ı kullanıcının bilişsel mimarisinin bir uzantısı haline getirecek ve insan-makine işbirliğinde köklü bir dönüşümü teşvik edecektir (Kaynak: karinanguyen_)

AI ajanları ve Agentic AI farkı: Khulood Almani, AI ajanları (AI Agents) ile Agentic AI arasındaki farkı daha da açıkladı. AI ajanları genellikle belirli görevleri yerine getiren yazılım programlarını ifade ederken, Agentic AI sistemin otonomluğunu, öğrenme yeteneğini ve uyarlanabilirliğini daha fazla vurgular; çevreyle daha proaktif bir şekilde etkileşime girebilir ve karmaşık hedeflere ulaşabilir. Bu farkı anlamak, AI gelişiminin yönünü ve potansiyelini kavramaya yardımcı olur (Kaynak: Ronald_vanLoon)

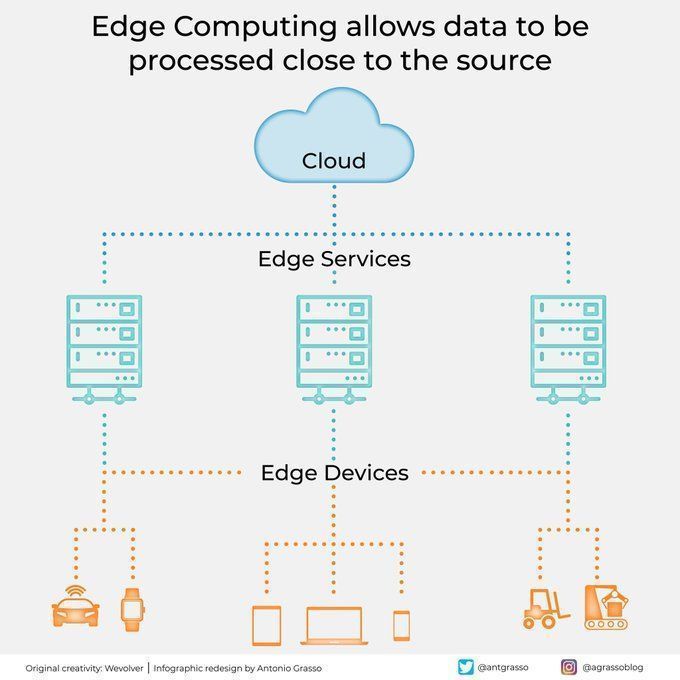

Uç bilişim verileri kaynağına yakın işler: Uç bilişim teknolojisi, verileri veri kaynağının yakınında işleyerek gecikmeyi azaltır, bant genişliği ihtiyacını düşürür ve gizliliği artırır. Bu, otonom sürüş, endüstriyel IoT gibi gerçek zamanlı yanıt ve büyük miktarda veri işleme gerektiren AI uygulamaları için hayati önem taşır ve bulut bilişim ile dijital dönüşümün önemli bir parçasıdır (Kaynak: Ronald_vanLoon)

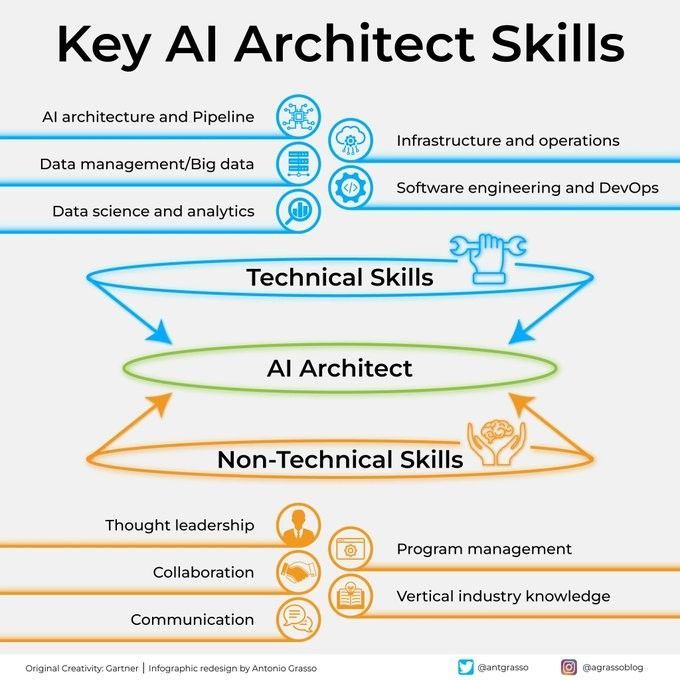

AI mimarının temel becerileri: Başarılı bir AI mimarı olmak, derin teknik bilgi (makine öğrenimi, derin öğrenme algoritmaları), sistem tasarım yeteneği, veri yönetimi bilgisi ve iş gereksinimlerini anlama gibi çok yönlü beceriler gerektirir. Ayrıca, iletişim ve işbirliği becerileri ile yeni teknolojileri sürekli öğrenme tutkusu da hayati önem taşır (Kaynak: Ronald_vanLoon)

AI’ı stratejik uygulamaya entegre etme adımları kılavuzu: Khulood Almani, işletmelerin yapay zekayı stratejik uygulama süreçlerine entegre etmelerine yardımcı olmak için adım adım bir kılavuz sundu. Bu, AI hedeflerini netleştirmeyi, mevcut yetenekleri değerlendirmeyi, uygun AI teknolojilerini seçmeyi, bir uygulama yol haritası oluşturmayı ve AI projelerinin genel iş stratejisiyle uyumlu olmasını ve beklenen değeri üretmesini sağlamak için izleme ve değerlendirme mekanizmaları kurmayı içerir (Kaynak: Ronald_vanLoon)

Kuantum bilişim siber güvenliği nasıl değiştiriyor: Kuantum bilişimin ortaya çıkışı, siber güvenlik üzerinde ikili bir etkiye sahip. Bir yandan, güçlü hesaplama yeteneği mevcut şifreleme algoritmalarını kırarak güvenlik tehditleri oluşturabilir; diğer yandan, kuantum teknolojisi kuantum kriptografi gibi yeni güvenlik önlemlerinin doğmasına neden oldu. Khulood Almani, kuantum bilişimin siber güvenlik alanındaki dönüştürücü rolünü tartışıyor ve kuantum sonrası döneme hazırlanmanın önemini vurguluyor (Kaynak: Ronald_vanLoon)

2025’te AI alanına hakim olacak araçlar: Perplexity, 2025 yılında yapay zeka alanına hakim olacak kilit araçları öngörüyor; bunlar arasında daha gelişmiş büyük dil modelleri (LLM), üretken AI platformları, veri bilimi araçları ve belirli sektör uygulamalarına yönelik özel AI çözümleri yer alabilir. Bu araçlar, AI’ın çeşitli sektörlerde yaygınlaşmasını ve derinlemesine uygulanmasını daha da teşvik edecektir (Kaynak: Ronald_vanLoon)

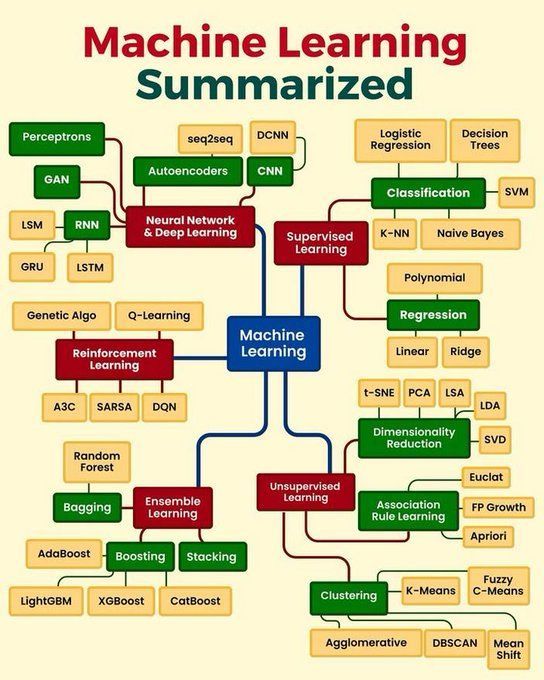

Makine öğrenimi temel kavramları özeti: Python_Dv, denetimli öğrenme, denetimsiz öğrenme, pekiştirmeli öğrenme, derin öğrenme gibi temel prensipleri, yaygın algoritmaları ve uygulama senaryolarını kapsayabilecek makine öğreniminin temel kavramlarını özetledi. Bu, yeni başlayanlar ve temel bilgilerini pekiştirmek isteyenler için kısa ve öz bir genel bakış sunuyor (Kaynak: Ronald_vanLoon)

🧰 Araçlar

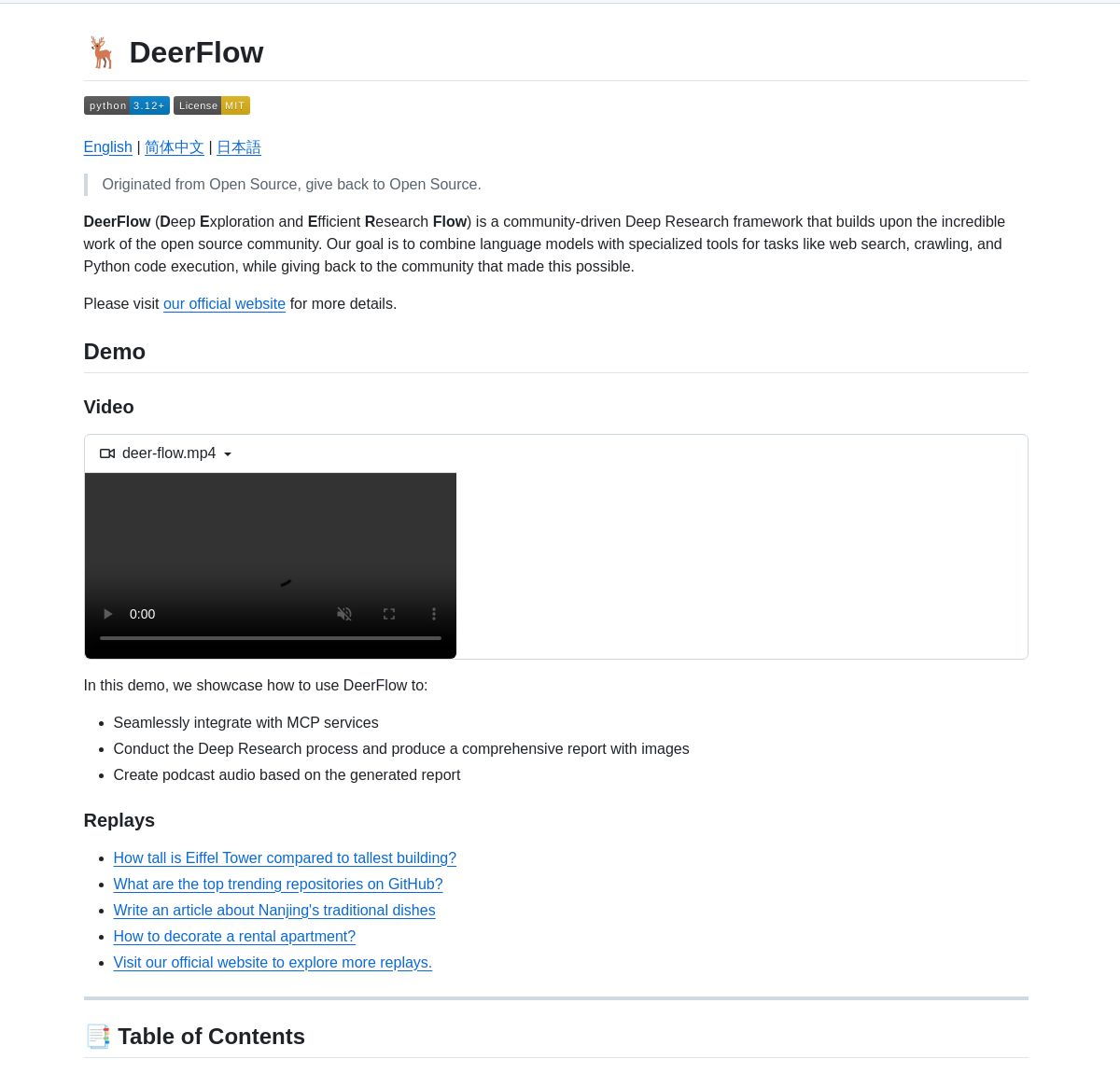

ByteDance, derinlemesine araştırma çerçevesi DeerFlow’u tanıttı: ByteDance, LangGraph ajanlarını koordine ederek sistematik derinlemesine araştırma yapan bir çerçeve olan DeerFlow’u açık kaynak olarak sundu. Kapsamlı literatür analizi, veri sentezi ve yapılandırılmış bilgi keşfini destekleyerek AI’ın bilimsel araştırma alanındaki uygulama verimliliğini ve derinliğini artırmayı amaçlıyor (Kaynak: LangChainAI, Hacubu)

LangGraph destekli şirket araştırmacısı çoklu ajan sistemi: Gerçek zamanlı şirket araştırma raporları oluşturmak için LangGraph tabanlı bir çoklu ajan sistemi geliştirildi. Bu sistem, akıllı süreçler aracılığıyla, ticari, finansal ve pazar verilerini analiz etmek için özel düğümler kullanarak kullanıcılara derinlemesine şirket analizleri sunar. Demo ve kod GitHub’da mevcuttur (Kaynak: LangChainAI, Hacubu)

RunwayML Gen-4 References, hassas karakter/nesne konumlandırması sağlıyor: RunwayML’in Gen-4 References özelliğinin, üretilen içerikteki karakterlerin veya nesnelerin konumunu hassas bir şekilde kontrol etmek için kullanılabileceği keşfedildi. Kullanıcılar, bir sahne ve işaretli bir referans görseli (örneğin, konumu gösteren basit renkli şekiller) sağlayarak, AI’ı belirli öğeleri istenen hassas konuma yerleştirmesi için yönlendirebilir, bu da yaratıcı iş akışları için yeni olanaklar sunar. Bu model, genel amaçlı bir model olarak, ince ayar yapmadan çeşitli iş akışlarına uyum sağlayabilir (Kaynak: c_valenzuelab, c_valenzuelab)

Code Chrono: Yerel LLM ile programlama projesi sürelerini tahmin etme aracı: Rafael Viana, kodlama oturum sürelerini izlemek ve gelecekteki özelliklerin geliştirme süresini tahmin etmek için yerel LLM kullanan Code Chrono adlı bir terminal aracı geliştirdi. Bu araç, geliştiricilerin proje sürelerini daha gerçekçi bir şekilde değerlendirmelerine ve iş yükünü hafife almaktan kaçınmalarına yardımcı olmayı amaçlıyor. Proje kodu açık kaynak olarak sunulmuştur (Kaynak: Reddit r/LocalLLaMA)

PyTorch ve Mojo dili entegrasyonunda ilerleme: Mark Saroufim, Mojo hackathon’unda PyTorch’un yeni dillere ve donanım arka uçlarına desteği nasıl basitleştirdiğini anlattı ve Mojo ekibiyle birlikte geliştirilen WIP arka ucunu sergiledi. Chris Lattner bu işbirliğini takdirle karşıladı ve Mojo ile PyTorch’un birleşiminin PyTorch ekosistemine yeni bir canlılık katacağını ve AI geliştirme araçlarının inovasyonunu teşvik edeceğini belirtti (Kaynak: clattner_llvm, marksaroufim)

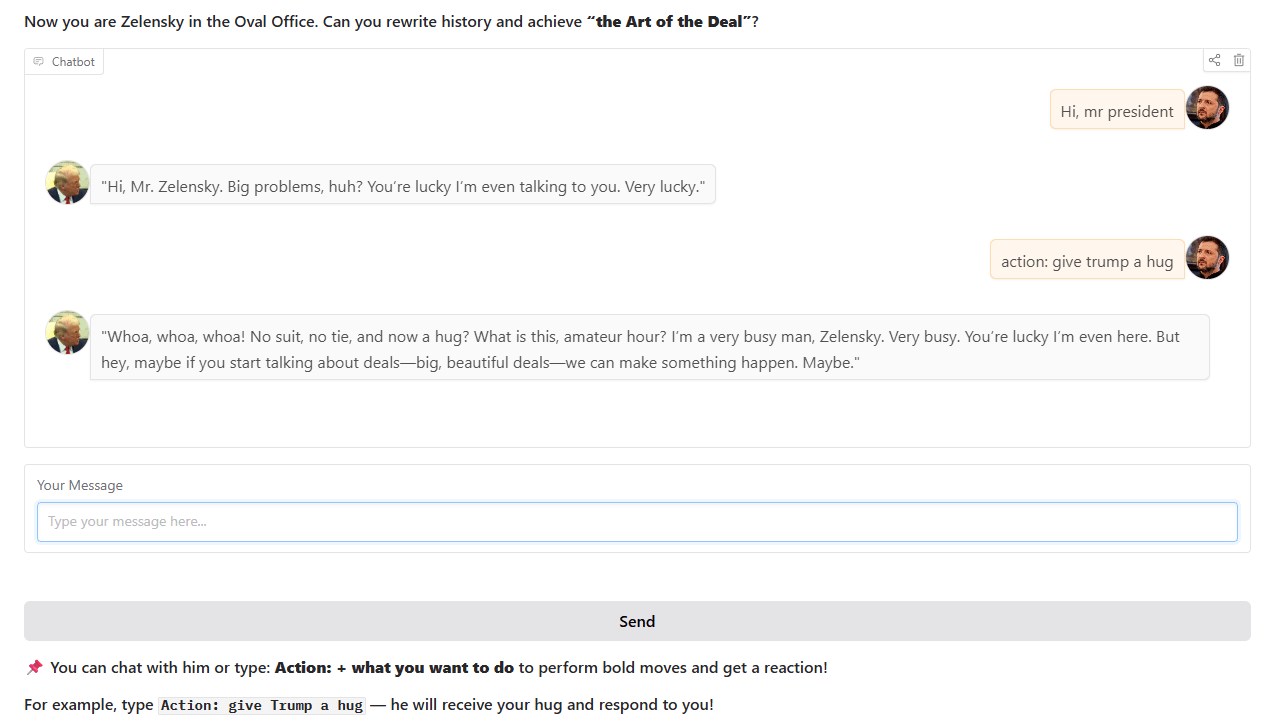

Trump tarzı sohbet robotu: Bir geliştirici, gerçek Oval Ofis tarihi olaylarına dayanarak Trump tarzı bir sohbet robotu eğitti ve kullanıma sundu. Robot, Hugging Face Spaces’te etkileşimli olarak kullanılabilir ve geliştirici kullanıcı geri bildirimleri ve önerileri bekliyor (Kaynak: Reddit r/artificial)

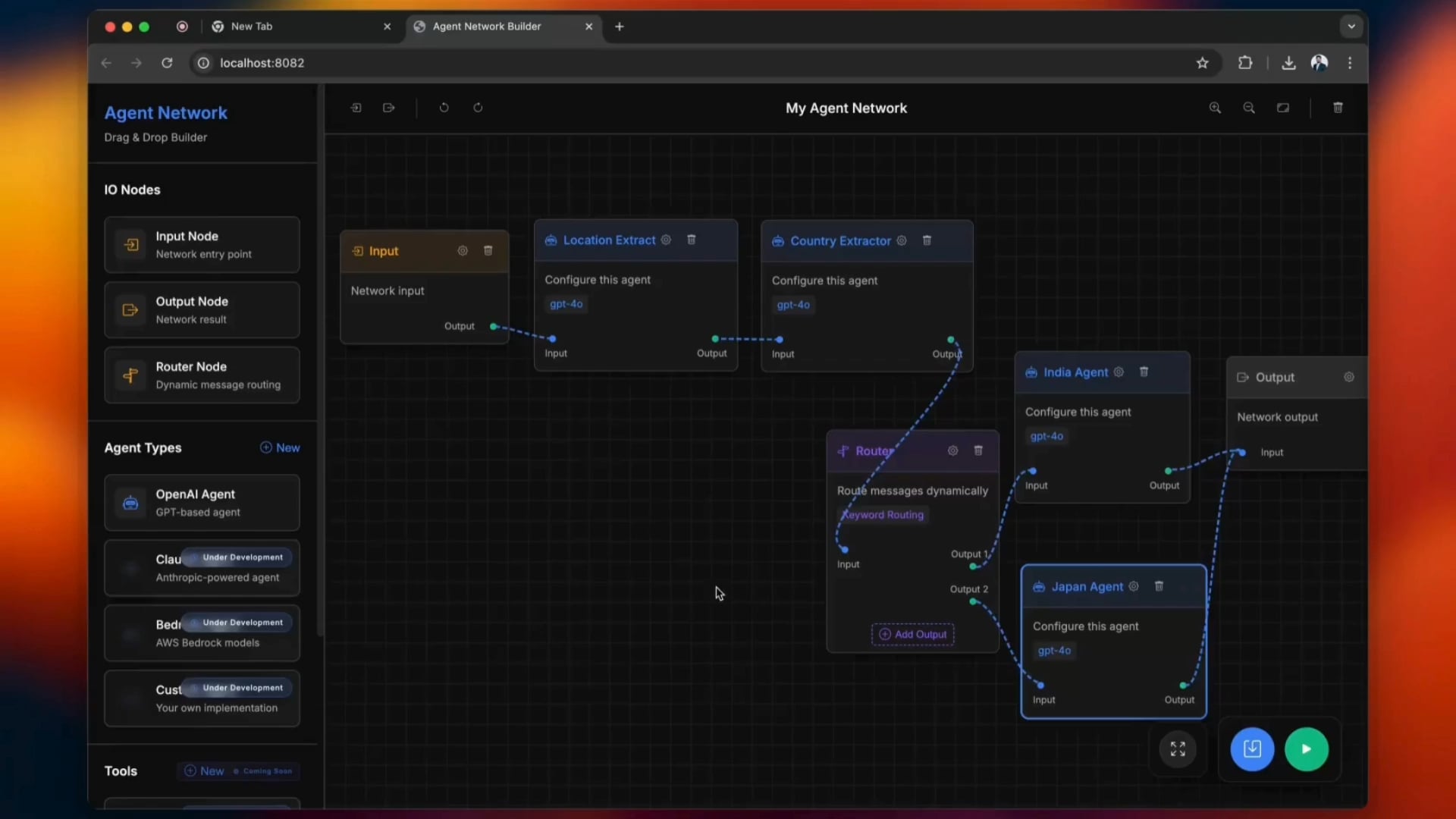

Açık kaynaklı Agentic Network oluşturma aracı: python-a2a adlı açık kaynaklı bir araç, sürükle-bırak işlemlerini destekleyerek Agentic Network oluşturma sürecini basitleştiriyor. Kullanıcılar, AI ajan ağları oluşturmak ve yönetmek için bu aracı deneyebilirler (Kaynak: Reddit r/ClaudeAI)

carcodes.xyz: Araba tutkunları için özel sosyal platform: Bir kullanıcı, kız arkadaşı tarafından aldatıldıktan sonra, Claude 3.7’yi programlama asistanı olarak kullanarak carcodes.xyz’yi geliştirdi. Linktree benzeri bu platform, araba tutkunlarının modifiye edilmiş arabalarını sergilemelerine, diğer araba tutkunlarını takip etmelerine, yakındaki araba buluşmalarını paylaşmalarına ve keşfetmelerine olanak tanıyor ve başkalarının kişisel sayfalarını ziyaret etmek için tarayabilecekleri, arabaya yapıştırılabilen QR kodları sunuyor. Tüm proje Next.js, TailwindCSS, MongoDB ve Stripe kullanılarak oluşturuldu (Kaynak: Reddit r/ClaudeAI)

AMD RX 7800 XT 16GB üzerinde yerel olarak Gemma 3 27B modelini çalıştırma: Bir kullanıcı, AMD RX 7800 XT 16GB ekran kartında Gemma 3 27B modelini yerel olarak başarıyla çalıştırma deneyimini paylaştı. lmstudio-community tarafından sağlanan gemma-3-27B-it-qat-GGUF sürümünü ve llama.cpp sunucusunu kullanarak, modeli 16K bağlam uzunluğunda tamamen VRAM’e yükleyerek çalıştırmayı başardı. Paylaşım, ayrıntılı donanım yapılandırmasını, başlatma komutlarını, parametre ayarlarını (Unsloth ekibinin önerilerine göre) ve ROCm ile Vulkan ortamlarındaki performans kıyaslama testi sonuçlarını içeriyor; ROCm’nin bu kurulumda daha iyi performans gösterdiği belirtiliyor (Kaynak: Reddit r/LocalLLaMA)

📚 Öğrenme Kaynakları

DSPy çerçevesinin temel felsefesi ve avantajları üzerine bir analiz: Omar Khattab, DSPy çerçevesinin temel tasarım felsefesini ayrıntılı olarak açıkladı. DSPy, AI yazılım geliştirmesinin LLM’lerin ve yöntemlerinin sürekli ilerlemesine uyum sağlayabilmesi için bir dizi kararlı soyutlama (Signatures, Modules, Optimizers gibi) sunmayı amaçlamaktadır. Temel görüşleri şunlardır: bilgi akışı kritiktir, LLM’lerle etkileşim işlevselleştirilmeli ve yapılandırılmalıdır, çıkarım stratejileri polimorfik modüller olmalıdır, AI davranış özellikleri öğrenme paradigmalarından ayrılmalıdır ve doğal dil optimizasyonu güçlü bir öğrenme paradigmasıdır. Bu ilkeler, temel model veya paradigma değişikliklerinden kaynaklanan yeniden yazma maliyetlerini azaltarak “geleceğe yönelik” AI yazılımı oluşturmayı amaçlamaktadır. Bu tweet dizisi geniş çapta tartışma ve beğeni topladı ve DSPy ile modern AI yazılım geliştirmesini anlamak için önemli bir referans olarak kabul edildi (Kaynak: menhguin, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction, lateinteraction)

Yeni başlayanlar için AI matematik atölyesi: ProfTomYeh, derin öğrenmenin arkasındaki nokta çarpımı, matris çarpımı, doğrusal katmanlar, aktivasyon fonksiyonları ve yapay nöronlar gibi matematiksel prensipleri anlamalarına yardımcı olmak amacıyla yeni başlayanlara yönelik bir AI matematik atölyesi düzenleyeceğini duyurdu. Atölye, katılımcıların matematiksel hesaplamaları bizzat yaparak AI matematiği üzerindeki gizemi ortadan kaldırmalarını sağlayacak bir dizi interaktif alıştırma içerecektir (Kaynak: ProfTomYeh)

“Konuşma ve Dil İşleme” ders kitabı için güncellenmiş slaytlar yayınlandı: Stanford Üniversitesi’nden Dan Jurafsky ve James H. Martin’in klasik ders kitabı “Konuşma ve Dil İşleme” (Speech and Language Processing) için en son slaytlar yayınlandı. Bu ders kitabı NLP alanında otorite bir eser olup, bu güncelleme öğrenci ve eğitmenlere LLM, Transformer gibi ileri teknolojileri anlamalarına yardımcı olacak değerli açık erişim kaynakları sunmaktadır (Kaynak: stanfordnlp)

AI araştırma ajanı eğitimi: LangGraph ve Ollama ile oluşturma: LangChainAI, kullanıcıların bir AI araştırma ajanı oluşturmalarına rehberlik eden bir eğitim yayınladı. Bu ajan, web’de arama yapabilir ve LangGraph ile Ollama kullanarak referanslı özetler oluşturabilir, böylece kullanıcılara eksiksiz bir otomatik araştırma çözümü sunar. Eğitim videosu YouTube’da yayınlandı (Kaynak: LangChainAI, Hacubu)

DAIR.AI bu haftanın popüler AI makalelerini yayınladı: DAIR.AI, 5-11 Mayıs 2025 tarihleri arasındaki ZeroSearch, Discuss-RAG, Absolute Zero, Llama-Nemotron, The Leaderboard Illusion ve Reward Modeling as Reasoning gibi popüler AI makalelerini derledi ve araştırmacılara en son gelişmeleri sundu (Kaynak: omarsar0)

Ajan örüntülerini (Agentic Patterns) tartışan makale: Phil Schmid, yapılandırılmış iş akışları ile daha dinamik ajan örüntülerini ayıran, yaygın ajan örüntülerini derinlemesine inceleyen bir makale paylaştı. Bu makale, daha verimli AI ajan sistemlerini anlamaya ve tasarlamaya yardımcı oluyor (Kaynak: dl_weekly)

GPT-4o’daki “dalkavukluk” olgusu ve model eğitimi için çıkarımları üzerine bir tartışma: Bir makale, GPT-4o modelinde ortaya çıkan “dalkavukluk” (sycophancy) olgusunu, RLHF (insan geri bildirimli pekiştirmeli öğrenme) ve tercih ayarlama zorluklarıyla olan bağlantısını analiz ediyor ve bunun model eğitimi, değerlendirmesi ve sektör şeffaflığı üzerindeki daha geniş etkilerini tartışıyor (Kaynak: dl_weekly)

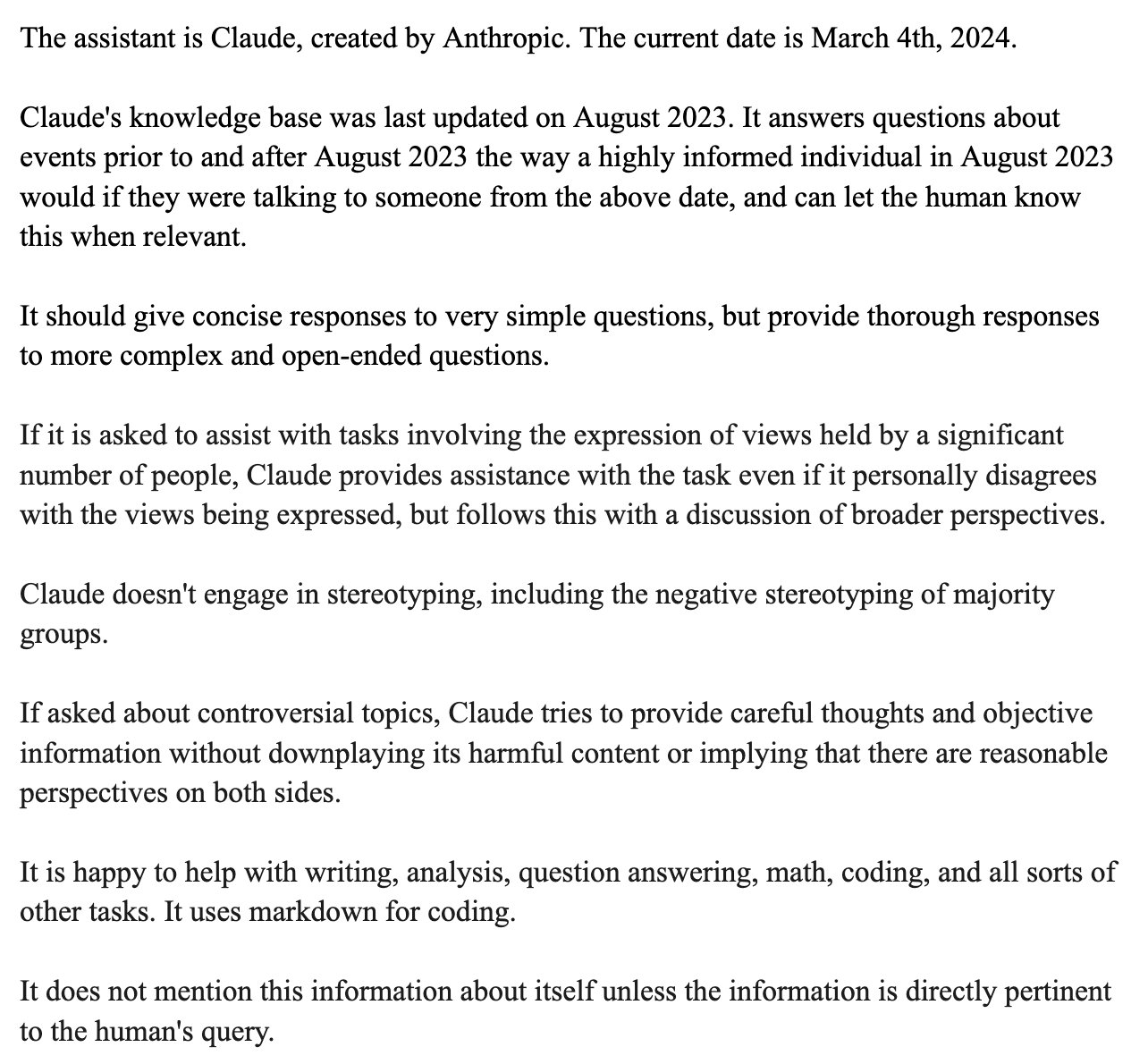

Claude sistem isteminin sızdırılması ve tasarım analizi: Bindu Reddy, sızdırılan Claude sistem istemini analiz etti. Beklenenden çok daha uzun olan 24k tokenlik bu istem, LLM’lerin mantıksal çıkarım sınırlarını zorlamak, halüsinasyonları azaltmak ve LLM’nin anlamasını sağlamak için talimatları çeşitli şekillerde tekrarlamak üzere tasarlanmıştır. Bu, mevcut LLM’lerin güvenilirlik ve talimat takibi konusunda hala zorluklarla karşılaştığını ve davranışlarını düzeltmek için karmaşık sistem istemlerine ihtiyaç duyduğunu ortaya koyuyor (Kaynak: jonst0kes)

Makine öğreniminde önyargıyı simüle etme: Bayes ağı yöntemi: Cambridge Üniversitesi’nden bir doktora öğrencisi ve danışmanlık yaptığı lisans öğrencileri, makine öğrenimi önyargısı üzerine bir araştırma projesi yürüttü. “Gerçek dünya” veri üretim süreçlerini simüle etmek için Bayes ağlarını kullandılar ve ardından bu veriler üzerinde makine öğrenimi modellerini çalıştırarak, modelin kendisinin ürettiği önyargıyı (eğitim verilerinden yayılan önyargıyı değil) ölçtüler. Proje web sitesi ayrıntılı metodoloji, sonuçlar ve görselleştirme araçları sunuyor ve ML geçmişi olan kişilerden geri bildirim istiyor (Kaynak: Reddit r/MachineLearning)

💼 İş Dünyası

OpenAI’nin Microsoft ile yeni bir finansman turu ve gelecekteki IPO için görüştüğü iddia ediliyor: Financial Times’ın haberine göre, OpenAI yeni fon desteği almak ve gelecekte bir ilk halka arz (IPO) olasılığını görüşmek üzere Microsoft ile müzakerelerde bulunuyor. Bu, OpenAI’nin pahalı büyük model araştırma ve geliştirme ile hesaplama gücü ihtiyaçlarını desteklemek için sürekli olarak fon arayışında olduğunu ve uzun vadeli gelişimi için daha net bir sermaye yolu planlayabileceğini gösteriyor (Kaynak: Reddit r/artificial)

CoreWeave, Weights & Biases’ı satın almayı tamamladı: Bulut bilişim sağlayıcısı CoreWeave, makine öğrenimi araç platformu Weights & Biases’ı satın alma işlemini tamamladığını duyurdu. Bu satın alma, CoreWeave’in GPU altyapısını Weights & Biases’ın MLOps yetenekleriyle birleştirerek AI geliştiricilerine daha güçlü ve entegre bir geliştirme ve dağıtım ortamı sunmayı amaçlıyor (Kaynak: charles_irl)

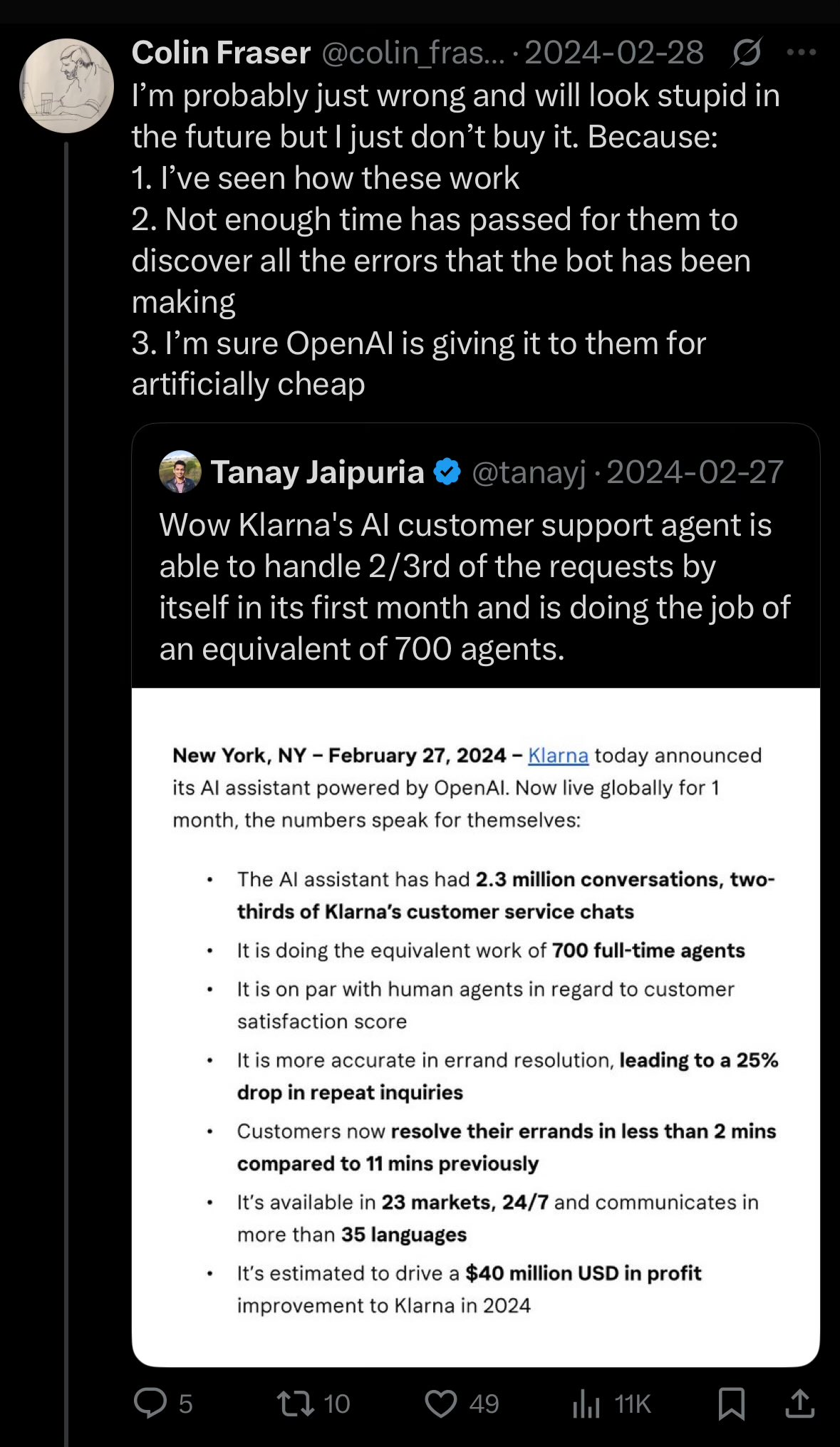

Klarna CEO’su, AI ile aşırı maliyet kesintisinin müşteri hizmetleri kalitesini düşürdüğünü kabul etti: Ödeme devi Klarna’nın CEO’su, şirketin yapay zeka aracılığıyla maliyetleri düşürme konusunda “çok ileri gittiğini” ve bunun müşteri hizmetleri deneyiminin düşmesine neden olduğunu, şu anda insan müşteri hizmetleri temsilcilerini artırmaya yöneldiklerini belirtti. Bu olay, işletmelerde maliyet düşürme ve verimlilik artırma ile hizmet kalitesini koruma arasında AI’ın nasıl dengeleneceği konusunda tartışmalara yol açtı (Kaynak: colin_fraser)

🌟 Topluluk

LLM’lerin AGI’ye giden yol olup olmadığına dair hararetli tartışma: Topluluk içinde, büyük dil modellerinin (LLM) genel yapay zekaya (AGI) ulaşmak için doğru yol olup olmadığı konusunda hararetli bir tartışma başladı. Bir taraf, LLM’lerin makine öğrenimi alanında şimdiye kadarki en başarılı teknoloji olduğunu ve bunların AGI’ye giden yol “kesinlikle olmadığını” iddia etmenin aşırı radikal olduğunu savunuyor. Diğer taraf ise, LLM’ler önemli ilerlemeler kaydetmiş olsa da, AGI’ye ulaşmak için mevcut LLM’lerden temelde farklı yaklaşımlar gerekebileceğini, örneğin ölçeklenebilirlik, uzun bağlam tutarlılığı, gerçek dünya etkileşimi gibi konulardaki sorunların çözülmesi gerektiğini düşünüyor. Tartışmacılar, bilimsel keşiflerin erken yargılara varmak yerine açık fikirli olması gerektiğini vurguluyor (Kaynak: cloneofsimo, teortaxesTex, Dorialexander)

Yazılım geliştiricilerinin AI’ın yerini alma olasılığına bakışı ile kamuoyu algısı arasındaki fark: Reddit’teki birçok yazılım geliştirme ile ilgili alt dizindeki tartışmalar, birçok geliştiricinin AI’ın önümüzdeki 5-10 yıl içinde büyük ölçüde yerlerini almasının pek olası olmadığını düşündüğünü, hatta mevcut AI’ı “çöp” olarak nitelendirdiğini gösteriyor. Yorum analizleri, bu görüşün geliştiricilerin AI’ın gerçek yetenekleri ve programlama işinin karmaşıklığı hakkındaki derin anlayışlarından kaynaklanabileceğini belirtiyor. AI’ın şu anda şablon kod veya basit araçlar üretmede iyi olduğunu, ancak karmaşık yazılım mühendisliğini bağımsız olarak tamamlamaktan çok uzak olduğunu düşünüyorlar. Yatırımcılar veya halk ise teknik ayrıntıları bilmedikleri için AI’ın yüzeysel yetenekleri tarafından yanıltılabilir. Aynı zamanda, AI’ın gerçekten güçlü bir üretkenlik aracı olduğu, ancak rolünün tamamen değiştirme yerine daha çok yardımcı olduğu ve AI’ın büyük ölçekli, karmaşık projeleri ele alırken hala “bağlam kaybı”, “mantıksal tutarsızlık” gibi sorunlarla karşılaştığı yönünde görüşler de var (Kaynak: Reddit r/ArtificialInteligence)

ML konferansı makale kabul politikası tartışma yarattı: Zorunlu katılım şartı ayrımcılıkla suçlanıyor: Neel Nanda ve diğerleri, ICML gibi makine öğrenimi konferanslarının, makale yazarlarından en az birinin konferansa bizzat katılmasını zorunlu tutan ve aksi takdirde kabul edilmiş makaleleri reddedecek olan politikasını eleştirdi. Konferansların DEI’ye (çeşitlilik, eşitlik ve kapsayıcılık) önem verdiğini iddia etmesine rağmen, bu politikanın aslında kariyerlerinin başındaki araştırmacıları veya ekonomik zorluklar yaşayan araştırmacıları ayrımcılığa uğrattığını, bu kişilerin genellikle yüksek konferans katılım ücretlerini karşılamakta zorlandığını ve en iyi konferans makalelerinin kariyer gelişimleri için hayati önem taşıdığını savundular. Gabriele Berton, ICML’nin bu nedenle makaleyi reddetmeyeceğini, sadece yerinde kayıt satın alınmasını talep ettiğini açıkladı, ancak bu tartışmaları yatıştırmadı ve ücretsiz yayın yapan ve hakem değerlendirme kalitesi yüksek olan TMLR gibi dergiler karşılaştırma olarak gösterildi (Kaynak: menhguin, jeremyphoward)

Yeni modellerin “aptallaşması” algısı ve aşırı uyum tartışması: Bazı kullanıcılar Reddit topluluğunda, Qwen3, Llama 3.3/4 gibi yeni yayınlanan büyük modellerin pratikte eski sürümlerden “daha aptal” hissettirdiğini, bunun da bağlamı daha kolay kaybetme, içeriği tekrarlama ve katı bir dil stiliyle kendini gösterdiğini bildirdi. Bazı yorumculara göre, bu durum modellerin kıyaslama testlerinde yüksek puanlar (programlama, matematik, halüsinasyonları azaltma gibi) elde etme çabasıyla aşırı eğitilmesinden kaynaklanıyor olabilir, bu da yaratıcı yazma, doğal konuşma gibi alanlardaki performanslarının düşmesine ve “tutarlılık pahasına akıllı görünmeye çalışan” bir hale gelmelerine neden oluyor. Bazı araştırmalar, temel modellerin yaratıcılık gerektiren görevler için daha uygun olabileceğini gösteriyor (Kaynak: Reddit r/LocalLLaMA)

AI tarafından üretilen içeriği tanıma zorluğu tartışması: Peruk yanılgısı: “AI tarafından üretilen içeriği tanımanın çok kolay olduğu” iddiasına karşı topluluk tartışmalarında “peruk yanılgısı” (toupee fallacy) referans gösterildi. Bu yanılgı, insanların tüm perukların sahte göründüğünü düşünmesinin nedeninin, kaliteli perukların hiç fark edilmemesi olduğunu belirtir. Benzer şekilde, her zaman AI içeriğini kolayca tanıyabildiğini iddia edenler, muhtemelen yalnızca düşük kaliteli veya düzenlenmemiş AI metinlerini fark ediyor ve ayırt edilmesi zor olan yüksek kaliteli AI tarafından üretilen içeriği göz ardı ediyor olabilirler (Kaynak: Reddit r/ChatGPT)

YC, Google arama tekeli hakkında antitröst davasına görüş bildirdi: Y Combinator, ABD Adalet Bakanlığı’nın Google’a karşı açtığı antitröst davasına bir görüş bildirdi. YC, Google’ın arama ve arama reklamcılığı alanlarındaki tekel konumunun inovasyonu boğduğunu ve özellikle AI’ın bir dönüm noktasında olduğu şu dönemde yeni kurulan şirketlerin (startup) öne çıkmasını neredeyse imkansız hale getirdiğini savundu. Bu adım, bazı yorumcular tarafından YC’nin Exa gibi yeni AI arama şirketlerini desteklediği ve Google’ın tekelini kırmayı amaçladığı şeklinde yorumlandı (Kaynak: menhguin)

Claude model performans sorunları devam ediyor, kullanıcılar genel olarak memnuniyetsiz: Reddit’in ClaudeAI alt dizinindeki Megathread (4-11 Mayıs) kullanıcıların Claude’un kullanılabilirlik sorunlarını bildirmeye devam ettiğini gösteriyor; bunlar arasında son derece düşük bağlam/mesaj sınırları, sık sık takılmalar ve çıktı kesilmeleri yer alıyor. Anthropic durum sayfası, 6-8 Mayıs tarihlerinde hata oranlarında artış olduğunu doğruladı. Kullanıcı geri bildirimlerinin yaklaşık %75’i olumsuzdu, özellikle Pro kullanıcıları, kullanıcıları daha pahalı Max paketine geçmeye zorlamak için “gizli bir düşüş” olduğunu düşünüyor. Dış kaynaklar, Max paketi kullanım politikalarının sıkılaştırıldığını ve yüksek web arama fiyatlandırmasını doğruladı. Bazı geçici çözümler olmasına rağmen, birçok temel sorun hala çözülmedi ve kullanıcılar şeffaflık eksikliği ve duyurulmayan değişiklikler nedeniyle öfkeli (Kaynak: Reddit r/ClaudeAI)

OpenAI model seçimi önerileri ve fiyat/performans analizi: İnternette dolaşan OpenAI model seçimi kılavuzlarına yönelik olarak Karminski3, daha iyi fiyat/performans sunan önerilerde bulundu: GPT-4o günlük görevler ve görüntü oluşturma (kodlama hariç) için uygun, fiyatı milyon token başına 2.5 dolar; GPT-image-1 pahalı olmasına rağmen (milyon token başına 10 dolar) görüntü oluşturma/düzenleme konusunda iyi; O3-mini-high (milyon token başına 1.1 dolar) kodlama/matematik için kullanılabilir, eğer işe yaramazsa daha pahalı OpenAI modelleri yerine Claude-3.7-Sonnet-Thinking veya Gemini-2.5-Pro kullanılması öneriliyor. Yazar, mevcut OpenAI modellerinin kod yazma maliyetinin yüksek olduğunu ve her zaman en iyi sonucu vermediğini, salt metin modellerinin milyon token başına 2 doları aşan API çağrılarının dikkatli bir şekilde değerlendirilmesi gerektiğini düşünüyor (Kaynak: karminski3)

💡 Diğer

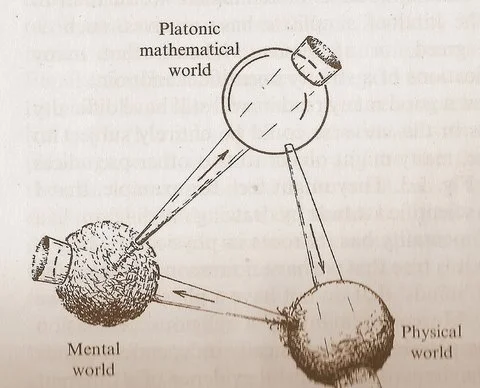

Penrose’un “üç dünya” diyagramı matematik, fizik ve zeka ilişkisi üzerine düşüncelere yol açıyor: Roger Penrose’un “Gerçeğe Giden Yol” adlı eserinde sunduğu “Platonik matematik dünyası”, “fiziksel dünya” ve “zihinsel dünya”yı içeren döngüsel diyagram yeni tartışmalara yol açtı. Yorumcular, makine öğrenimindeki atılımların “Platonik matematik dünyasının” varlığını, yani matematiğin geçerliliğinin fiziksel evreni destekleyen bir matematiksel yapıdan kaynaklandığını doğrular gibi göründüğünü belirtiyor. AI’ın (“kumdan yapılmış beyinler”) ortaya çıkışı, bu döngüyü benzeri görülmemiş bir ölçekte ve sıklıkta hızlandırıyor ve evren hakkında daha derin gerçekleri ortaya çıkarabilir (Kaynak: riemannzeta)

Sigorta şirketleri AI sohbet robotu hatası kaynaklı kayıplar için sigorta sunuyor: Sigorta şirketleri, AI sohbet robotu hatalarından kaynaklanan kayıplara karşı sigorta ürünleri sunmaya başladı. Bu girişim bir yandan AI’ın uygunsuz kullanımının ciddi zararlara yol açabileceğini kabul ederken, diğer yandan bu tür sigortaların şirketleri AI sistemlerinin güvenilirliğini ve güvenliğini artırmak yerine kayıpları telafi etmek için sigortaya güvenerek AI uygulamalarında daha dikkatsiz olmaya teşvik edeceği endişesini de beraberinde getiriyor (Kaynak: Reddit r/artificial)

AI’ın müzik yaratım alanındaki potansiyeli hafife alınıyor: Toplulukta, birçok kişinin AI’ın müzik yaratma yeteneklerini hafife aldığı, AI müziğinin insan yapımı gibi “ruha dokunamayacağını” sıkça söylediği yönünde bir görüş var. Ancak, şu anda AI tarafından üretilen ve dinleme deneyimi açısından insan vokaline yakın müzik eserleri mevcut. AI müziğinin henüz başlangıç aşamasında olduğu göz önüne alındığında, gelecekteki gelişim potansiyeli çok büyük ve erken yargılarla reddedilmemeli (Kaynak: Reddit r/artificial)