Anahtar Kelimeler:AI Uygulamaları, FDA, OpenAI, GPT-4.1, WebThinker, Runway Gen-4, Uç Taraf Zekası, Pekiştirmeli Öğrenme İnce Ayarı (RFT), Çoklu Ajan Çerçevesi DeerFlow, WebThinker-32B-RL, Gen-4 Referans Güncellemeleri, Bilgi Yoğunluğu, Yapay Zeka Uygulamaları, Gıda ve İlaç Dairesi (FDA), OpenAI teknolojileri, GPT-4.1 dil modeli, WebThinker yapay zeka, Runway Gen-4 özellikleri, Uç taraf yapay zeka çözümleri, Pekiştirmeli öğrenme ile ince ayar, DeerFlow çoklu ajan sistemi, WebThinker-32B-RL modeli, Gen-4 referans güncelleme notları, Yüksek bilgi yoğunluğu

🔥 Öne Çıkanlar

ABD FDA, Kurum İçi AI Uygulamalarını Hızlandıracağını Duyurdu: ABD Gıda ve İlaç Dairesi (FDA), 30 Haziran 2025’e kadar tüm FDA merkezlerinde yapay zeka (AI) kullanımını yaygınlaştırmayı planlayan tarihi bir adım attığını duyurdu. FDA daha önce bilimsel araştırmacılara yönelik bir üretken AI pilot projesini başarıyla tamamlamıştı. Bu hamle, AI aracılığıyla düzenleyici kapasiteyi artırmayı, klinik deneylerin hızını ve verimliliğini yükseltmeyi ve maliyetleri düşürmeyi amaçlıyor. Bu, AI’ın devlet düzenlemeleri ve ilaç onayı alanında önemli bir atılım olup, küresel ilaç düzenleme kurumlarının AI uygulamalarında bir trend başlatabilir (Kaynak: ajeya_cotra)

OpenAI Pekiştirmeli Öğrenme ile İnce Ayar (RFT) Tekniği Detayları ve GPT-4.1 Geliştirme Yaklaşımı Açıklandı: OpenAI’ın GPT-4.1 sorumlusu Mich Pokrass, Unsupervised Learning podcast’inde RFT’nin detaylarını ve GPT-4.1’in geliştirme sürecini paylaştı. OpenAI, GPT-4.1’i oluştururken geleneksel kıyaslama testleri yerine geliştirici geri bildirimlerine daha fazla odaklandı. RFT, özellikle karmaşık alanlarda model performansını artırmak için düşünce zinciri çıkarımı ve göreve özel puanlamayı kullanıyor ve şu anda OpenAI o4-mini’de mevcut. Röportajda ayrıca AI ajanlarının mevcut uygulama durumu, güvenilirliğin artırılması, startup’ların değerlendirme ve ileriye dönük ürün stratejilerini nasıl başarılı bir şekilde kullanabileceği gibi konular da ele alındı (Kaynak: OpenAIDevs, aidan_mclau, michpokrass)

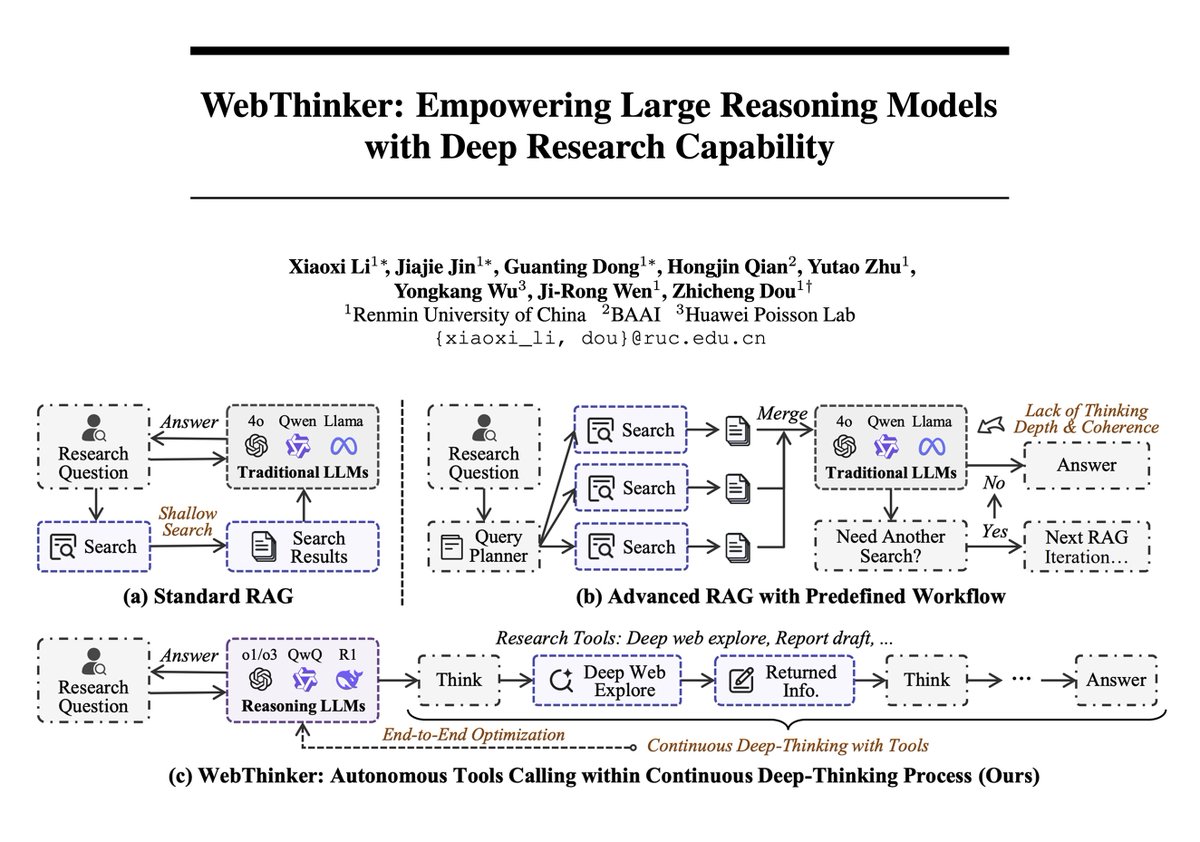

WebThinker Çerçevesi, Büyük Modelleri ve Derin Ağ Araştırma Yeteneklerini Birleştirerek Karmaşık Çıkarımda Yeni Bir Seviyeye Ulaşıyor: Yeni bir makale, statik iç bilginin sınırlamalarını aşmak için büyük çıkarım modellerine (LRM’ler) otonom ağ keşfi ve rapor yazma yetenekleri kazandıran bir çıkarım ajanı çerçevesi olan WebThinker’ı tanıtıyor. WebThinker, derin ağ tarayıcı modülünü ve otonom “düşün-ara-taslak hazırla” stratejisini entegre ederek modelin aynı anda ağı aramasını, görevler üzerinde çıkarım yapmasını ve kapsamlı çıktılar üretmesini sağlıyor. Bu sistem, GPQA, GAIA gibi karmaşık çıkarım kıyaslamalarında, WebThinker-32B-RL’nin 32B modelleri arasında SOTA sonuçlar elde etmesini ve GPT-4o gibi modellerden daha iyi performans göstermesini sağladı. RL ile eğitilmiş sürümü, tüm kıyaslamalarda temel sürümden daha iyi performans göstererek, çıkarım-araç koordinasyonunu geliştirmek için yinelemeli tercih öğreniminin önemini ortaya koyuyor (Kaynak: omarsar0, dair_ai)

Runway, Gen-4 References Güncellemesini Yayınlayarak Video Üretiminde Estetik, Kompozisyon ve Kimlik Koruma Yeteneklerini Geliştirdi: Runway Gen-4 References, üretilen videoların estetik kalitesini, sahne kompozisyonunu ve karakter kimliği tutarlılığını önemli ölçüde artıran bir güncelleme aldı. İlginç yeni bir özellik, modelin kullanıcı tarafından sağlanan düzene göre sahnedeki nesneleri hassas bir şekilde yerleştirebilmesi ve hatta diğer unsurları tutarlı tutarken karakterlerin bakış yönü gibi ayrıntıları değiştirebilmesidir. Bu, AI video üretiminin kontrol edilebilirlik ve hassasiyet açısından bir adım daha ileri gittiğini gösteriyor ve yaratıcılara daha güçlü araçlar sunuyor (Kaynak: c_valenzuelab, c_valenzuelab)

ModelBest CEO’su Li Dahai: Fiziksel Dünyada AGI, Uçta Zeka ile Gerçekleşecek, Bilgi Yoğunluğu Esastır: ModelBest CEO’su Li Dahai, gelecekte fiziksel dünyanın yapay genel zekaya (AGI) ulaşması için uçta zekanın kaçınılmaz bir yol olduğuna inanıyor. Büyük modellerin “bilgi yoğunluğunun” zekanın temel göstergesi olduğunu vurgulayarak, bunu çip üretim süreçlerine benzetiyor; bilgi yoğunluğu ne kadar yüksekse zeka o kadar güçlü olur. Yüksek bilgi yoğunluğuna sahip modeller, hesaplama gücü, bellek ve güç tüketimi kısıtlı olan uç cihazlarda doğal bir avantaja sahiptir. ModelBest, otomotiv, robotik, cep telefonları gibi alanlarda uygulanan ve her cihazın akıllı olmasını, hassas algılama, zamanında karar verme ve mükemmel yanıt verme yeteneğine sahip olmasını amaçlayan ModelBest Xiaogangpao Super Assistant gibi birçok uç modelini piyasaya sürdü (Kaynak: 量子位)

🎯 Gelişmeler

Google Haritalar’ın Yeni Özelliği, Ekran Görüntülerindeki Yer Adlarını Tanımlamak İçin Gemini Yeteneklerini Kullanıyor: Google Haritalar, kullanıcıların ekran görüntülerinde yer alan yer adlarını tanıyabilen ve bunları haritadaki bir listeye kaydederek kullanıcıların istedikleri zaman erişmelerini ve seyahatlerini planlamalarını kolaylaştıran yeni bir özellik sundu. Bu özellik, seyahat araştırma sürecini basitleştirmeyi ve kullanıcı deneyimini iyileştirmeyi amaçlıyor (Kaynak: Google)

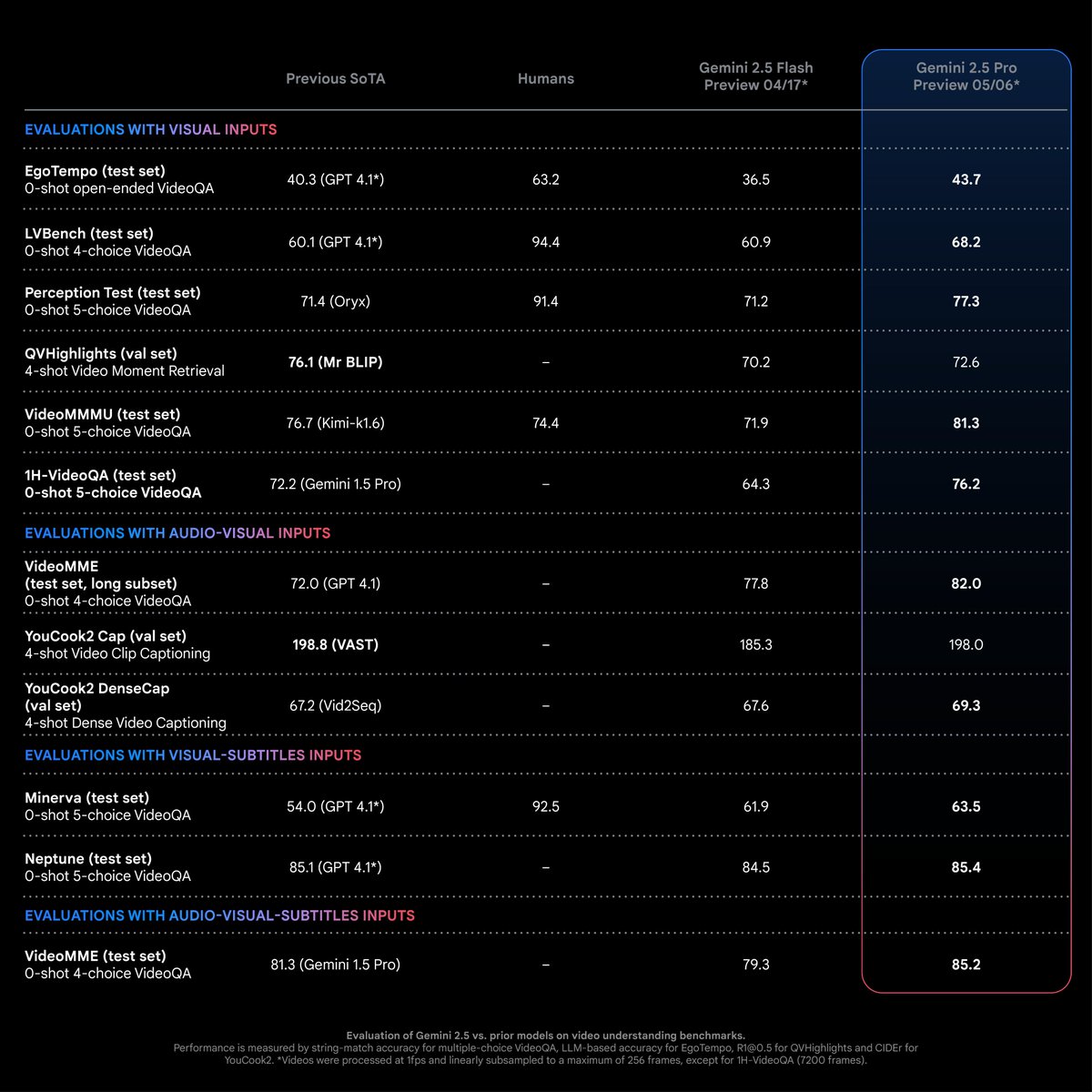

Gemini 2.5 Pro, Video Anlama Görevlerinde SOTA Performans Sergiliyor: Logan Kilpatrick’e göre, Gemini 2.5 Pro (05-06 sürümü) çoğu video anlama görevinde sektör lideri bir seviyeye (SOTA) ulaştı ve bu avantajı belirgin. Bu, Gemini multimodal ekibinin çabalarının bir sonucu olup, geliştiricilerin bu alanda yeni uygulama olanaklarını keşfetmelerini teşvik etmesi bekleniyor (Kaynak: matvelloso)

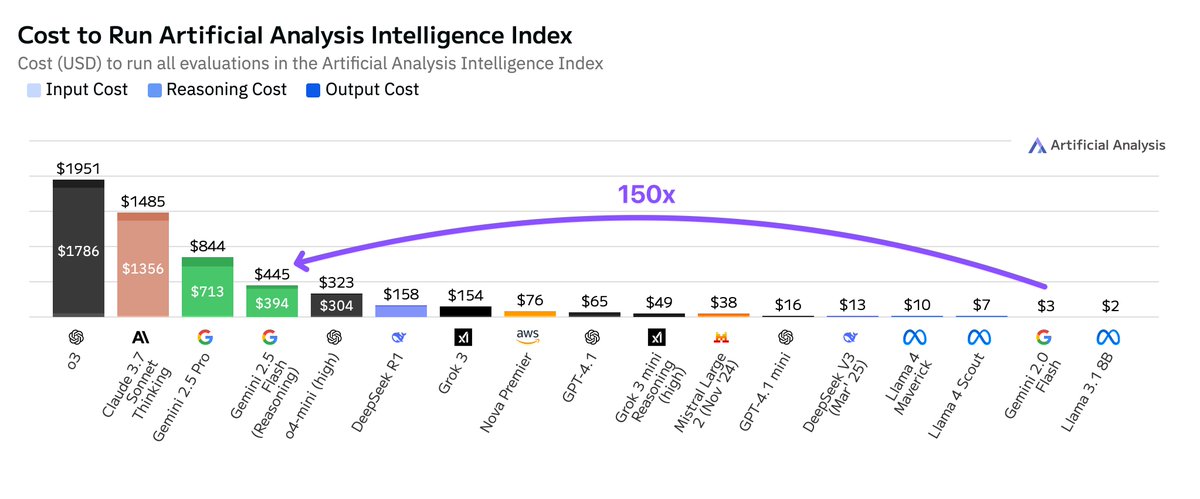

Google Gemini 2.5 Flash’ın Çalışma Maliyeti 2.0 Sürümünden Çok Daha Yüksek: Artificial Analysis, akıllı endeksini çalıştırırken Google Gemini 2.5 Flash’ın maliyetinin Gemini 2.0 Flash’ın 150 katı olduğuna dikkat çekti. Maliyet artışı temel olarak çıktı token fiyatındaki 9 katlık artıştan (çıkarım özelliği açıkken milyon token başına 3,5 dolar, kapalıyken 0,6 dolar; 2.0 Flash ise 0,4 dolar) ve 17 kat daha yüksek token kullanımından kaynaklanıyor. Bu durum, Flash serisi modellerin düşük gecikme süresi ve maliyet etkinliği arasındaki denge hakkında tartışmalara yol açtı (Kaynak: arohan)

Google, Çevrimiçi Dolandırıcılığı Önlemek İçin Gemini Nano AI’ı Chrome Tarayıcısına Entegre Edecek: Google, tarayıcının çevrimiçi dolandırıcılıkları tanıma ve engelleme yeteneğini artırmak ve kullanıcıların siber güvenliğini yükseltmek amacıyla Gemini Nano AI modelini Chrome tarayıcısına ekleyeceğini duyurdu. Bu hamle, AI teknolojisinin ana akım tarayıcı güvenlik özelliklerinde daha fazla uygulanmasının bir adımıdır (Kaynak: Reddit r/artificial, Reddit r/ArtificialInteligence)

Lightricks, LTXVideo 13B 0.9.7’yi Yayınlayarak Video Kalitesini ve Hızını Artırdı, Ayrıca Quantized Sürüm ve Latent Space Yükseltme Modellerini Sundu: Lightricks, video modeli LTXVideo’yu 13B 0.9.7 sürümüne güncelleyerek sinematik kalitede video ve daha hızlı üretim hızı sundu. Aynı zamanda, bellek gereksinimlerini azaltan ve tüketici sınıfı GPU’lar için uygun olan LTXV 13B quantized sürümünü ve daha az kod çözme/kodlama ile yüksek çözünürlüklü video üretim verimliliğini artıran, çok ölçekli çıkarımı destekleyen latent space uzamsal ve zamansal yükseltme modellerini piyasaya sürdü. İlgili ComfyUI düğümleri ve iş akışları da güncellendi (Kaynak: GitHub Trending)

Cohere Labs Araştırması, Test Sırasında Ölçeklendirmenin Büyük Modellerin Diller Arası Çıkarım Performansını İyileştirdiğini Gösteriyor: Cohere Labs’ın araştırması, çıkarım dil modellerinin ağırlıklı olarak İngilizce verilerle eğitilmesine rağmen, test sırasında ölçeklendirme (test-time scaling) yoluyla çok dilli ortamlarda ve farklı alanlarda sıfır-atış (zero-shot) diller arası çıkarım performansının iyileştirilebileceğini belirtiyor. Bu araştırma, mevcut büyük modellerin İngilizce dışındaki senaryolarda uygulama etkinliğini artırmak için yeni yaklaşımlar sunuyor (Kaynak: sarahookr)

AI, Yüz Fotoğraflarını Kullanarak Fizyolojik Yaşı Değerlendiriyor ve Kanser Sonuçlarını Tahmin Ediyor: Yeni bir AI aracı, yüz fotoğraflarını analiz ederek bireylerin fizyolojik yaşını tahmin edebiliyor ve buna dayanarak kanser gibi hastalıkların tedavi sonuçlarını ve hayatta kalma olasılıklarını öngörebiliyor. Bu teknoloji, hastalık prognoz değerlendirmesi için invazif olmayan yeni bir yöntem sunuyor (Kaynak: Reddit r/artificial, Reddit r/ArtificialInteligence, Reddit r/artificial)

AI Modelleri Basit Görevleri Ele Alırken Aşırı Karmaşık Düşünme Eğilimi Gösteriyor: Bazı geliştiriciler, daha yeni çıkarım modellerinin basit görevlerle karşılaştıklarında aşırı karmaşık düşünme süreçlerini tetikleme eğiliminde olduğunu ve “aşırı hassas” davrandığını fark etti. Daha ideal bir yaklaşım, güçlü bir temel modele sahip olmak ve gereksiz hesaplama ve gecikmeyi önlemek için “düşünme” aracının ne zaman çağrılacağına dinamik olarak karar verebilmek olabilir (Kaynak: skirano)

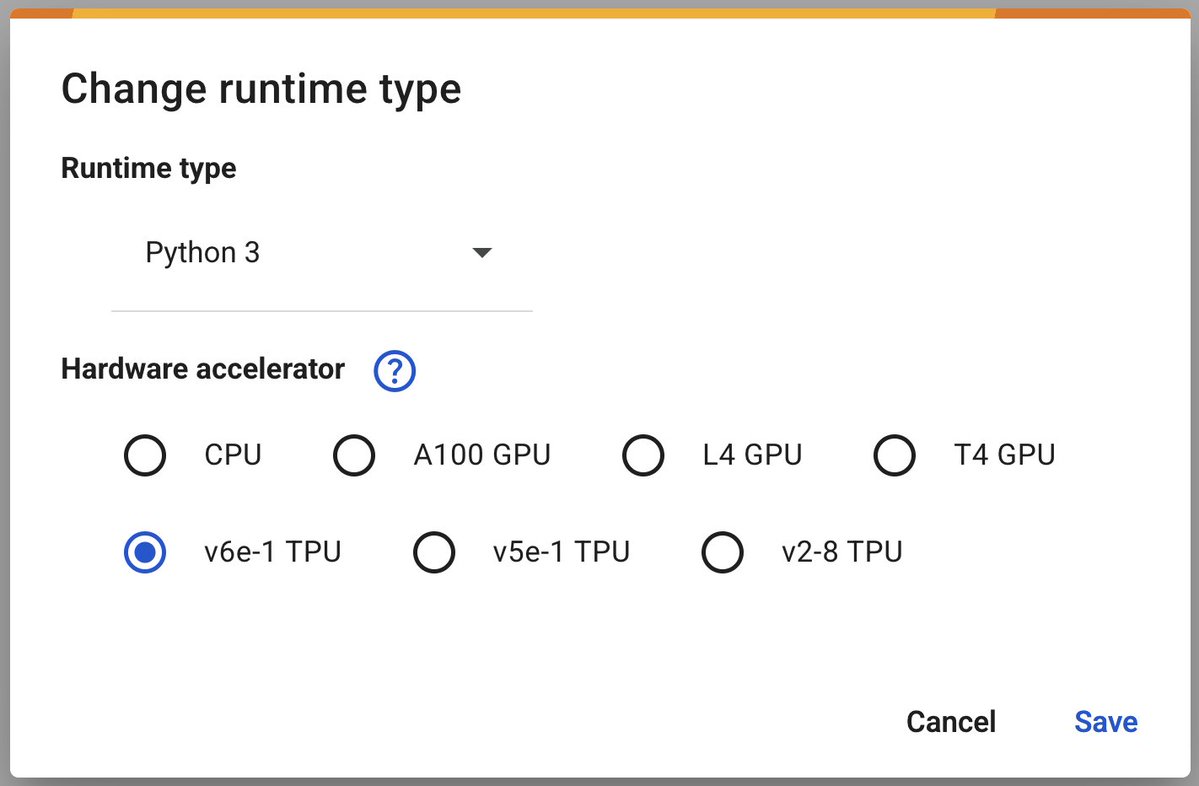

Google Colab, Derin Öğrenmeyi Hızlandırmak İçin v6e-1 (Trillium) TPU’yu Kullanıma Sundu: Google Colaboratory, en hızlı derin öğrenme hızlandırıcısı olan v6e-1 (Trillium) TPU’yu kullanıma sunduğunu duyurdu. Bu TPU, 32GB yüksek bant genişliğine sahip belleğe (v5e-1’in iki katı) ve 918 BF16 TFLOPS’a (A100’ün yaklaşık üç katı) varan tepe performansa sahip olup, araştırmacılara ve geliştiricilere daha güçlü hesaplama kaynakları sunuyor (Kaynak: algo_diver)

Google AMIE: Çok Modlu Diyaloğa Dayalı Teşhis AI Ajanı Tanıtımı: Google, çok modlu diyaloğa dayalı teşhis AI ajanı AMIE’nin ilk demosunu paylaştı. AMIE, çok modlu (örneğin metin ve görüntü bilgilerini birleştirerek) teşhis diyalogları yürütebiliyor ve bu, AI’ın tıbbi teşhis yardımcılığı alanındaki daha ileri keşiflerini işaret ediyor (Kaynak: dl_weekly)

Anthropic’in Claude Modeline “Trump Kazandı” Bilgisini Sabit Kodladığı İddia Edildi: Bazı kullanıcılar, Anthropic’in Claude modelinin 2024 seçimleriyle ilgili soruları yanıtlarken, bilgi kesme tarihi Ekim 2024 olmasına rağmen Trump’ın kazandığı bilgisini sabit kodlamış gibi göründüğünü fark etti. Bu durum, AI modellerinin bilgi güncelleme mekanizmaları, potansiyel önyargılar ve sabit kodlanmış içeriğin kullanıcı güveni üzerindeki etkisi hakkında tartışmalara yol açtı (Kaynak: Reddit r/ClaudeAI)

🧰 Araçlar

ByteDance, Çoklu Ajan Çerçevesi DeerFlow’u Açık Kaynak Olarak Yayınladı: ByteDance, LangChain tabanlı çoklu ajan (Multi-Agent) çerçevesi DeerFlow’u açık kaynak olarak yayınladı. Bu çerçeve, çoklu ajan uygulamalarının geliştirilmesini basitleştirmeyi ve hızlandırmayı amaçlayarak karmaşık işbirlikçi AI sistemleri oluşturmak için araçlar sunuyor. Geliştiriciler, daha fazla bilgi ve örnek için GitHub deposuna ve resmi web sitesine erişebilirler (Kaynak: hwchase17)

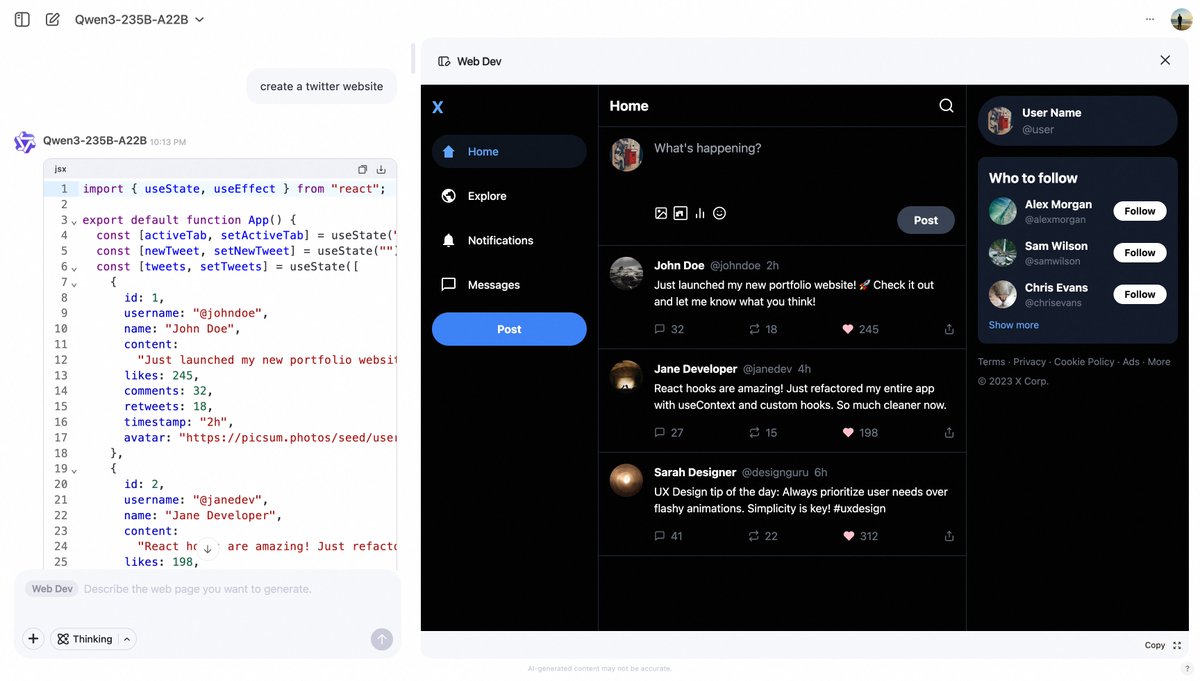

Alibaba Qwen Chat, İstemlerle Web Sayfası Oluşturmak İçin Web Dev Özelliğini Tanıttı: Alibaba Qwen Chat, kullanıcıların basit metin istemleriyle (örneğin “bir twitter web sitesi oluştur”) hızlı bir şekilde ön uç web sayfaları ve uygulama kodları oluşturmasını sağlayan “Web Dev” özelliğini ekledi. Bu özellik, web geliştirme engelini düşürmeyi ve programlama bilgisi olmayan kullanıcıların da doğal dil aracılığıyla web siteleri oluşturmasını sağlamayı amaçlıyor (Kaynak: Alibaba_Qwen, huybery)

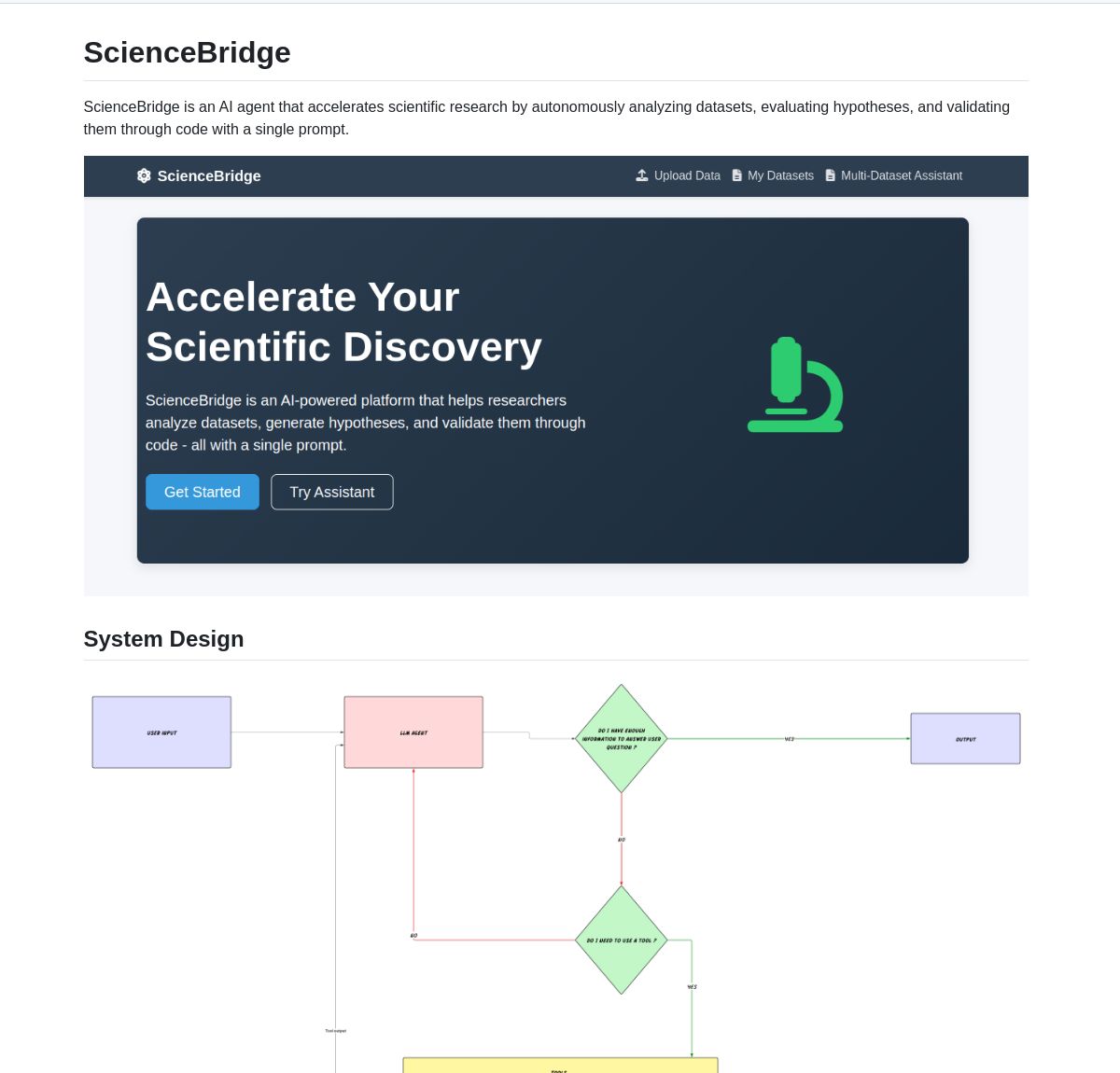

ScienceBridge AI: LangGraph Destekli Bilimsel Araştırma Otomasyon Ajanı: ScienceBridge AI adlı bir ajan, LangGraph çerçevesini kullanarak veri analizi, hipotez doğrulama dahil olmak üzere bilimsel araştırma iş akışlarını otomatikleştiriyor ve yayın düzeyinde görselleştirme sonuçları üreterek bilimsel keşifleri hızlandırmayı amaçlıyor. Proje GitHub’da açık kaynak olarak yayınlandı (Kaynak: LangChainAI, hwchase17)

El Agente Q: LangGraph Destekli Çoklu Ajan Sistemi Kuantum Kimyasını Güçlendiriyor: Yeni bir araştırma, doğal dil etkileşimi yoluyla kuantum kimyası hesaplamalarını demokratikleştiren ve karmaşık iş akışlarını otomatikleştirmede %87 başarı oranı elde eden LangGraph tabanlı bir çoklu ajan sistemi olan El Agente Q’yu sergiliyor. İlgili makale arXiv’de yayınlandı ve AI’ın kuantum kimyası araştırmalarını hızlandırma potansiyelini gösteriyor (Kaynak: LangChainAI, hwchase17)

LocalSite: Yerel LLM’leri Kullanarak Web Sayfaları Oluşturan Yerelleştirilmiş DeepSite Alternatifi: HuggingFace’deki DeepSite projesinden esinlenilen LocalSite aracı, kullanıcıların yerel olarak çalışan LLM’ler (Ollama ve LM Studio aracılığıyla dağıtılan GLM-4, Qwen3 gibi modeller) ve OpenAI uyumlu API’lere sahip bulut tabanlı LLM’ler aracılığıyla metin istemleri kullanarak web sayfaları ve UI bileşenleri oluşturmasına olanak tanır. Proje, yerelleştirilmiş, özelleştirilebilir bir AI web sayfası oluşturma çözümü sunmayı amaçlayan GitHub’da açık kaynak olarak yayınlandı (Kaynak: Reddit r/LocalLLaMA)

Açık Kaynak NotebookLM Alternatifi, Açık Kaynak Teknolojisinin Gücünü Gösteriyor: Geliştirici m_ric, Google NotebookLM’in açık kaynaklı ve ücretsiz bir sürümünü oluşturdu. Bu uygulama, PDF veya URL içeriğini çıkarabiliyor, Meta’nın Llama 3.3-70B modelini (Cerebras Systems aracılığıyla saniyede 1000 token hızında çalışıyor) kullanarak podcast senaryoları yazabiliyor ve metinden sese dönüştürme için Kokoro-82M’yi kullanıyor. Ses üretimi, HuggingFace H200s üzerinde Zero GPU ile ücretsiz olarak çalışıyor ve açık kaynak çözümlerin işlevsellik ve maliyet etkinliği açısından kapalı kaynak çözümlerle rekabet edebileceğini gösteriyor (Kaynak: huggingface, mervenoyann)

DeepFaceLab: Lider Açık Kaynak Deepfake Oluşturma Yazılımı: DeepFaceLab, Deepfake içerikleri oluşturmak için özel olarak tasarlanmış tanınmış bir açık kaynak yazılımdır. Yüz değiştirme, yaşlandırmayı geri alma, kafa değiştirme gibi özellikler sunar ve YouTube, TikTok gibi platformlarda içerik oluşturmak için yaygın olarak kullanılır. Proje sürekli güncellenmekte olup, Windows ve Linux sürümleri sunmakta ve aktif bir topluluk desteğine sahiptir (Kaynak: GitHub Trending)

GPUI Component: GPUI Tabanlı Rust Masaüstü UI Bileşen Kütüphanesi: longbridge ekibi, macOS, Windows kontrolleri ve shadcn/ui’den esinlenerek tasarlanmış 40’tan fazla platformlar arası masaüstü UI bileşeni içeren bir kütüphane olan GPUI Component’ı tanıttı. Çoklu tema, duyarlı boyutlar, esnek düzen (Dock ve Tiles) desteği sunar ve büyük veri görselleştirmesini (sanallaştırılmış Table/List) ve içerik görselleştirmesini (Markdown/HTML) verimli bir şekilde işleyebilir. İlk uygulama örneği Longbridge Pro masaüstü uygulamasıdır (Kaynak: GitHub Trending)

Ultralytics YOLO11: Lider Nesne Tespiti ve Bilgisayarlı Görü Model Çerçevesi: Ultralytics, YOLO model serisini sürekli olarak güncellemektedir; en son YOLO11, nesne tespiti, takibi, segmentasyonu, sınıflandırması ve poz tahmini gibi görevlerde SOTA performansı sunmaktadır. Bu çerçeve kullanımı kolaydır, CLI ve Python arayüzlerini destekler ve Weights & Biases, Comet ML, Roboflow, OpenVINO gibi platformlarla entegredir. Ultralytics HUB, kodsuz veri görselleştirme, eğitim ve dağıtım çözümleri sunar. Model, AGPL-3.0 açık kaynak lisansını kullanır ve ticari lisans da sunar (Kaynak: GitHub Trending)

Tensorlink: PyTorch Model Dağıtımı ve P2P Kaynak Paylaşımı Çerçevesi: SmartNodes Lab, büyük PyTorch modellerinin dağıtık eğitimini ve çıkarımını basitleştirmeyi amaçlayan açık kaynaklı bir çerçeve olan Tensorlink’i tanıttı. Temel PyTorch nesnelerini kapsayarak dağıtık sistemlerin karmaşıklığını soyutlar ve kullanıcıların uzmanlık bilgisi veya donanım olmadan birden fazla bilgisayarın GPU kaynaklarından yararlanmasına olanak tanır. Tensorlink, kullanıcıların hesaplama gücünü paylaşmasını veya katkıda bulunmasını kolaylaştıran isteğe bağlı çıkarım API’sini ve düğüm çerçevesini destekler ve şu anda erken bir sürüm aşamasındadır (Kaynak: Reddit r/MachineLearning)

İstem Optimizasyonu ile Anime Figürü Fotoğrafları Oluşturma: Bir kullanıcı, yüklenen kişi fotoğraflarını Japon anime tarzı figür fotoğraflarına dönüştürmek için AI (örneğin GPT-4o) kullanarak istemleri optimize etme örneğini paylaştı. Anahtar nokta, figürün duruşunu, ifadesini, kıyafetini, malzemesini (örneğin yarı mat), renk geçişlerini ve çekim açısını (masaüstü, cep telefonuyla anlık çekim hissi) hassas bir şekilde tanımlamaktır. Daha fazla optimizasyon, figürün tüm vücudunun ve taban detaylarının bütünlüğünü sağlamak ve sonraki 3D modelleme için kolaylık sağlamak amacıyla dörtlü bir ızgara şeklinde düzenlenmiş çok açılı (ön, yan, arka) görünümler oluşturmayı içerir (Kaynak: dotey, dotey)

NVIDIA Agent Intelligence Toolkit Açık Kaynak Olarak Yayınlandı: NVIDIA, akıllı ajan uygulamaları oluşturmak için bir kaynak kütüphanesi olan açık kaynaklı Agent Intelligence Toolkit’i yayınladı. Bu araç seti, geliştiricilerin NVIDIA teknolojisine dayalı AI ajanlarını daha kolay oluşturmalarına ve dağıtmalarına yardımcı olmayı amaçlamaktadır (Kaynak: nerdai)

SkyPilot ve SGLang, Çok Düğümlü Llama 4 Kendi Kendine Barındırma Dağıtımını Basitleştiriyor: Nebius AI, SkyPilot ve SGLang’ı (LMSYS.org’dan) kullanarak tek bir komutla çok düğümlü (örneğin 8x H100) ortamlarda Meta’nın Llama 4 modelinin nasıl kendi kendine barındırılabileceğini gösterdi. Bu çözüm, yüksek verim, verimli bellek kullanımı sunar ve kimlik doğrulama, HTTPS gibi üretim düzeyinde özelliklerle entegredir, ayrıca Simon Willison’ın llm aracıyla kolay entegrasyon sağlar (Kaynak: skypilot_org)

📚 Öğrenme Kaynakları

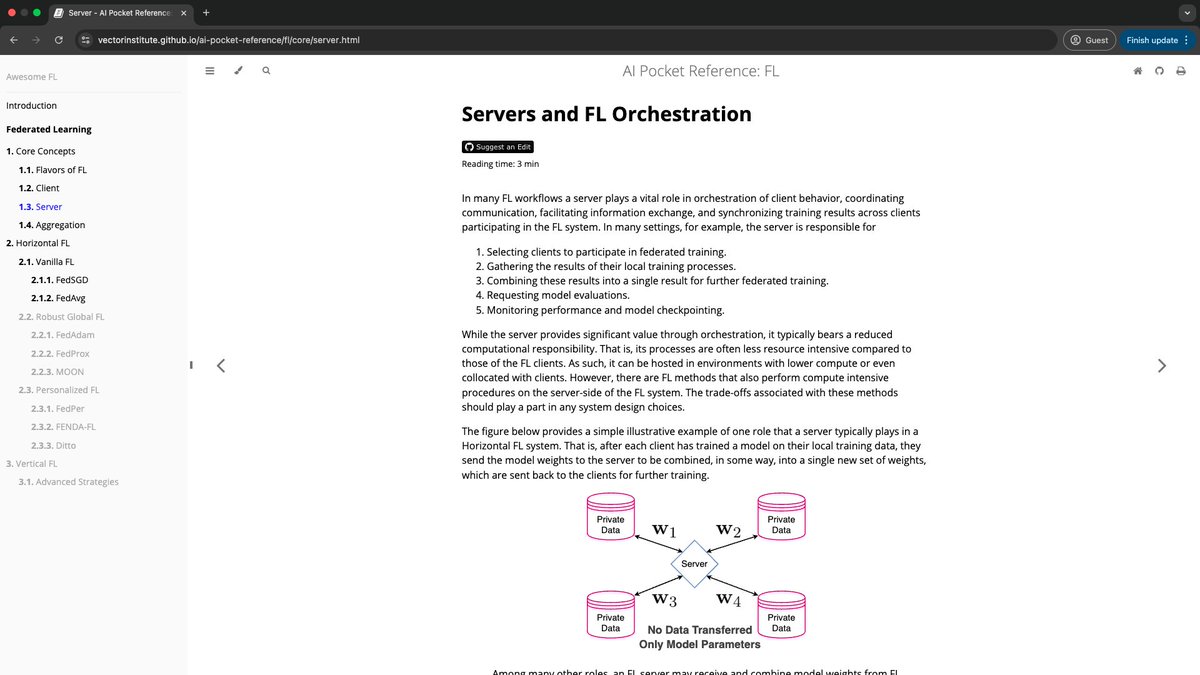

Vector Institute, AI Cep Referanslarını Başlattı: Vector Institute’un AI Mühendislik ekibi, NLP (özellikle LLM’ler), birleşik öğrenme, sorumlu AI ve yüksek performanslı bilgi işlem gibi alanları kapsayan bir dizi özetlenmiş AI bilgi kartı olan AI Cep Referansları projesini yayınladı. Bu referans materyalleri, yeni başlayanlara giriş rehberliği sağlamayı ve deneyimli uygulayıcılara hızlı bir tekrar imkanı sunmayı amaçlamakta olup, her birinin okunma süresi 7 dakikanın altında olacak şekilde tasarlanmıştır. Proje açık kaynaklıdır ve topluluk katkılarına açıktır (Kaynak: nerdai)

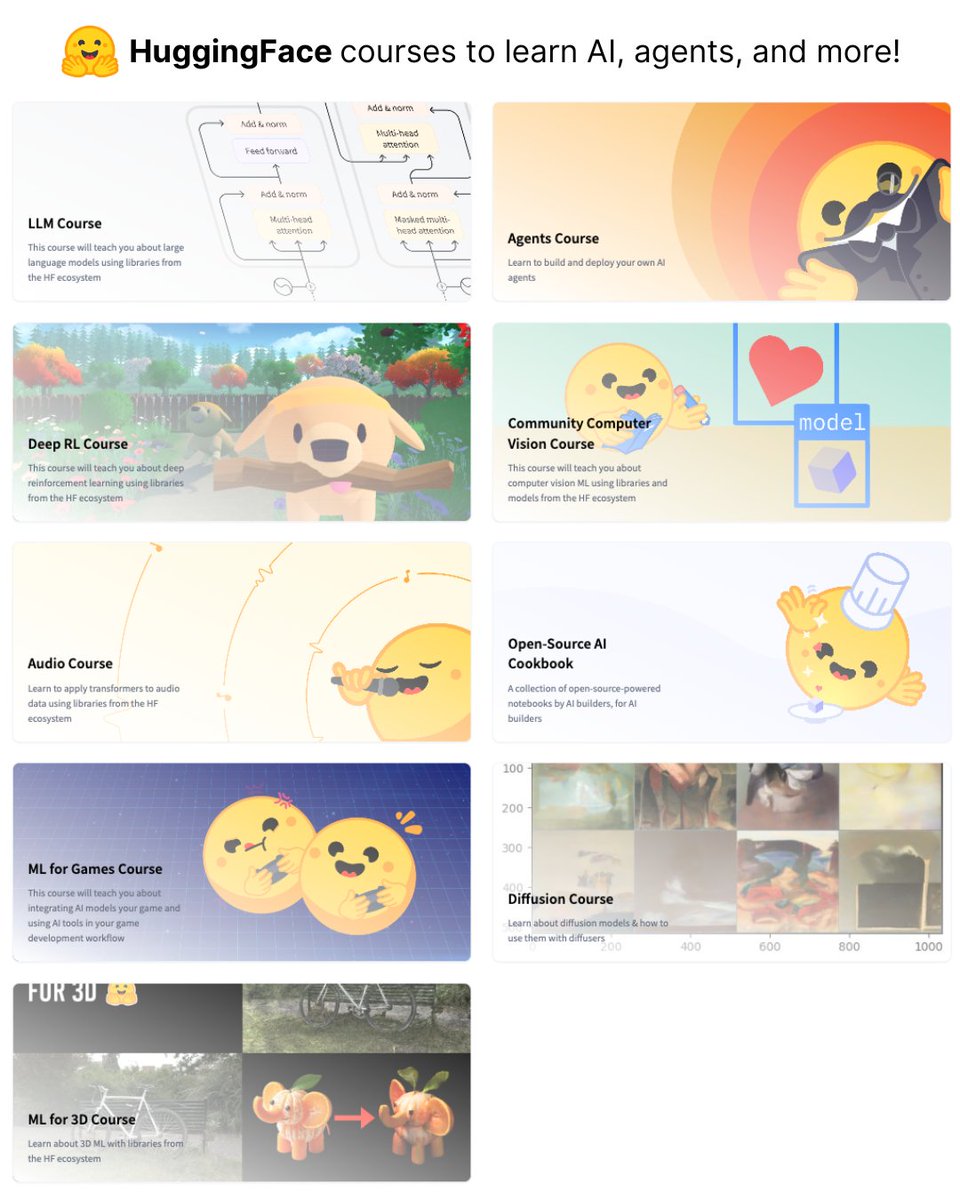

HuggingFace 9 Ücretsiz AI Kursu Yayınladı: HuggingFace, büyük dil modelleri (LLM), bilgisayarlı görü, AI ajanları gibi birçok farklı alanı kapsayan toplam 9 ücretsiz AI kursu serisi başlattı. Bu kurslar, AI bilgisini sistematik olarak öğrenmek isteyenler için değerli kaynaklar sunmaktadır (Kaynak: ClementDelangue)

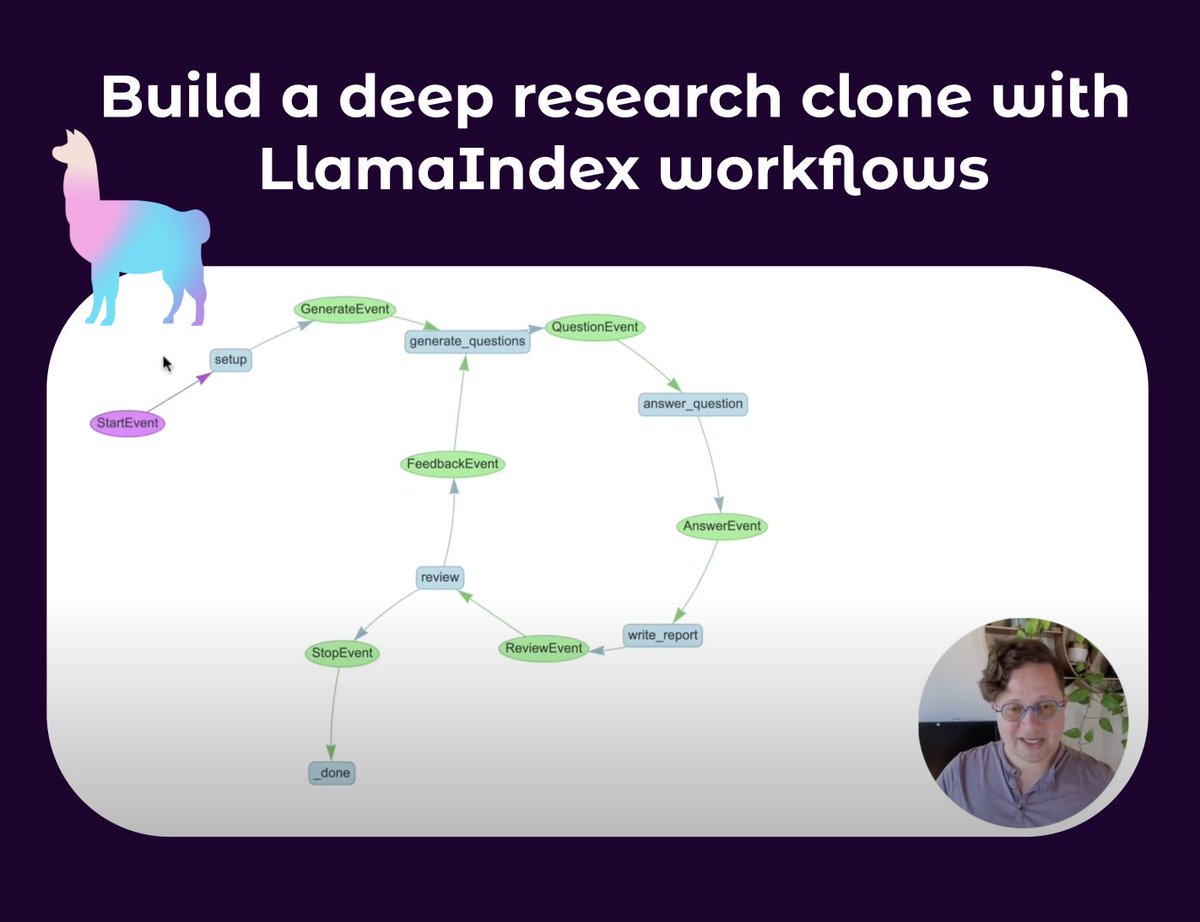

LlamaIndex, Derin Araştırma Ajanı Oluşturma Eğitimi Yayınladı: LlamaIndex’ten Seldo, kullanıcıların Deep Research benzeri bir klon ajan oluşturmalarına rehberlik eden bir video eğitimi yayınladı. Eğitim, tek ajan temellerinden başlayarak, birden fazla bilgi tabanı ve ağı kullanarak araştırma yapma, bağlamı koruma ve araştırma, yazma ve inceleme için eksiksiz bir süreç uygulama dahil olmak üzere gelişmiş çoklu ajan iş akışlarına kadar derinlemesine ilerliyor. Eğitim, döngüler, dallanmalar, eşzamanlı yürütme ve öz-yansıma gibi yeteneklere sahip karmaşık ajan iş akışları oluşturmanın önemini vurguluyor (Kaynak: jerryjliu0, jerryjliu0)

RAG Teknolojisinin Gelişimine Bir Bakış: Lewis ve Arkadaşlarının Makalesi ve Erken Çalışmalar: Aran Komatsuzaki, Lewis ve arkadaşlarının 2020 tarihli makalesinin RAG (Retrieval-Augmented Generation) terimini ortaya koyması nedeniyle yaygın olarak atıfta bulunulmasına rağmen, artırılmış erişimli üretimin kendisinin bundan önce de aktif bir araştırma alanı olduğuna dikkat çekiyor; DrQA (2017), ORQA (2019), REALM (2020) gibi çalışmalar buna örnektir. Lewis ve arkadaşlarının temel katkısı, yeni bir RAG ortak ön eğitim yöntemi önermekti, ancak bu günümüzde en yaygın kullanılan RAG uygulama şekli değildir. Bu, teknolojik gelişimin sürekliliğine ve erken dönem temel çalışmaların önemine dikkat etmemiz gerektiğini gösteriyor (Kaynak: arankomatsuzaki)

Qwen3 ile Gemini 2.5 Pro Benzeri Düşünce Zinciri Çıktı Formatı Elde Etme: Apriel-Nemotron-15b-Thinker README dosyasındaki, modelin çıktısını belirli bir formatla (örneğin “İşte mantık adımlarım:\n”) başlatmaya zorlama konusundaki ilhamla, bir geliştirici OpenWebUI özelliğini kullanarak Qwen3 modelinin çıktı verirken her zaman <think>\nAdım adım düşünme sürecim şöyleydi:\n1. ile başlamasını sağladı. Deneyler, bunun Qwen3’ü Gemini 2.5 Pro’ya benzer adımlı bir şekilde düşünmeye ve çıktı vermeye teşvik ettiğini gösteriyor, ancak bu durum modelin zekasını artırmasa da düşünme ve ifade etme formatını değiştiriyor (Kaynak: Reddit r/LocalLLaMA)

Claude Code Tasarım Felsefesi ve Geliştirme Süreci Podcast Paylaşımı: Latent Space podcast’i, bu AI programlama aracının tasarım felsefesini ve geliştirme hikayesini paylaşmak üzere Claude Code’un yaratıcıları Catherine Wu ve Boris Cherny’yi konuk etti. Önemli noktalar şunları içeriyor: CC’nin kendi kodunun yaklaşık %80’ini yazabildiği (insan denetimiyle), Aider’dan ilham aldığı, basit uygulamaya odaklandığı (örneğin vektör veritabanı yerine bellek için Markdown dosyaları kullanmak), küçük bir ekip ve iç yinelemelerle ürünü yönlendirdiği, gelişmiş kullanıcılara ham model erişimi sunduğu ve paralel iş akışlarını desteklediği. Podcast’te ayrıca Cursor, Windsurf gibi araçlarla karşılaştırmalar ve maliyet, UI/UX tasarımı, açık kaynak olasılıkları gibi konular da tartışıldı (Kaynak: Reddit r/ClaudeAI)

💼 İş Dünyası

Salesforce, Suudi Arabistan’da 500 Milyon Dolarlık AI Girişimi Başlattı ve Ekip Kuruyor: Salesforce, ülkenin yapay zeka benimsemesini ve gelişimini desteklemek amacıyla beş yıllık 500 milyon dolarlık yatırım planının bir parçası olarak Suudi Arabistan’da ekip kurmaya başladı. Bu, büyük teknoloji şirketlerinin Orta Doğu bölgesindeki AI alanındaki konumlanmalarında önemli bir başka adımı işaret ediyor (Kaynak: Reddit r/artificial, Reddit r/ArtificialInteligence)

OpenAI Uygulama Departmanının Yeni CEO’su Fidji Simo, Shopify Yönetim Kurulundan Ayrılacak: Halihazırda Instacart CEO’su olan Fidji Simo, OpenAI’ın yeni kurulan Uygulama Departmanının CEO’su olarak atanmasının ardından Shopify yönetim kurulundaki görevinden ayrılacak. Bu hamle, OpenAI’daki liderlik rolüne daha fazla odaklanmasını, hızla büyüyen işlerini ve ürün yelpazesini yönetmesini amaçlıyor olabilir. Daha önce OpenAI’ın Arm ile 1 milyar dolarlık potansiyel bir anlaşma yapabileceğine dair haberler çıkmıştı (Kaynak: steph_palazzolo, steph_palazzolo)

Lux Capital, Fon Kesintileriyle Karşı Karşıya Kalan ABD’li Bilim İnsanlarını Desteklemek İçin 100 Milyon Dolarlık Fon Kurdu: ABD Ulusal Bilim Vakfı’nın (NSF) bütçesinde iddia edildiğine göre %50’ye varan ve devam eden projelerin iptaline, personel kesintilerine yol açan büyük kesintilerle mücadele etmek için Lux Capital, etkilenen ABD’li bilim insanlarını desteklemek amacıyla 100 milyon dolarlık “Lux Bilim Yardım Hattı”nı başlattığını duyurdu. Bu girişim, kritik bilimsel araştırma projelerinin devamını sağlamayı ve ABD’nin teknolojik inovasyon rekabet gücünü korumayı amaçlıyor (Kaynak: ylecun, riemannzeta)

🌟 Topluluk

AI’ın İnsanların İşlerini Elinden Alıp Almayacağı Tartışması Devam Ediyor: Toplulukta AI’ın kitlesel işsizliğe yol açıp açmayacağı tartışması oldukça yaygın. Bir görüşe göre, kapitalizm güdüsüyle şirketler verimlilik peşinde koşacak, pahalı insan gücünü AI ile değiştirecek ve bu da programcı gibi pozisyonların azalmasına neden olacak. Başka bir görüş ise tarihe referansla, teknolojik ilerlemenin (örneğin elektrik lambasının kandil yakıcılarını yerinden etmesi gibi) eski meslekleri ortadan kaldıracağını ancak aynı zamanda yeni meslekler (örneğin ampul fabrikaları, elektrikle ilgili endüstriler) yaratacağını savunuyor; önemli olan becerilerin geliştirilmesi ve inovasyon. Şu anda AI, karmaşık görevlerde ve kod ayıklamada hala insan müdahalesine ihtiyaç duyuyor, ancak hızlı gelişimi ve bazı alanlardaki yüksek verimliliği birçok kişiyi gelecekteki istihdam beklentileri konusunda endişelendirirken, bazıları ise bunun bir felaket tellallığı veya AI yeteneklerinin kısa vadeli abartılması olduğunu düşünüyor (Kaynak: Reddit r/ArtificialInteligence)

LLM Yetenek Sınırları ve AI Kışı Endişeleri: Bazı topluluk üyeleri ve uzmanlar (Yann LeCun, François Chollet gibi) büyük dil modellerinin (LLM) bir darboğaza girip girmediğini tartışmaya başladı. LLM’ler örüntü taklidinde başarılı olsalar da, gerçek anlama, çıkarım yapma ve halüsinasyon sorunlarını çözmede hala sınırlamaları var; sentetik verilere aşırı bağımlılık da sorun yaratabilir. Yeni araştırma yönleri (dünya modelleri, nöro-sembolik sistemler gibi) olmazsa, mevcut AI heyecanı azalabilir, yatırımların düşmesine ve hatta yeni bir “AI kışına” yol açabilir. Ancak, genel amaçlı LLM’ler bir tavana ulaşsa da, özel amaçlı modellerin ve AI ajanlarının hala hızla geliştiği yönünde görüşler de var (Kaynak: Reddit r/ArtificialInteligence)

OpenAI’ın Yaz Aylarında Açık Kaynaklı Model Yayınlama Planı Toplulukta Tartışma Yarattı: Sam Altman, Senato’da verdiği ifadede OpenAI’ın bu yaz açık kaynaklı bir model yayınlamayı planladığını belirtti. Topluluk buna farklı tepkiler verdi; bazıları performansını merakla beklerken, bazıları bunun Musk’ın FSD’si gibi “sonsuza dek yolda” olup olmayacağını veya ücretli modellerle rekabet etmemesi için “kısırlaştırılıp kısırlaştırılmayacağını” sorguladı. Bazıları ise Meta ve Alibaba gibi şirketlerin yüksek kaliteli ücretsiz önceden eğitilmiş modeller yayınlayarak OpenAI gibi şirketlerin pazar konumunu zayıflatmayı amaçladığını, OpenAI’ın bu hamlesinin bir karşı strateji olabileceğini analiz etti. Ancak OpenAI’ın iş modeli ve yüksek işletme maliyetleri göz önüne alındığında, açık kaynaklı modelinin konumu ve rekabet gücü hala belirsizliğini koruyor (Kaynak: Reddit r/LocalLLaMA)

AI’ın İnternet Bilgilerinin Güvenilirliği Üzerindeki Etkisi Endişe Yaratıyor: Reddit’teki kullanıcılar, AI’ın internetin güvenilirliğini etkilemesinden duydukları endişeyi dile getirdi. Özellikle Google AI Özetleri gibi özellikler bazen yanlış veya “ciddi bir şekilde saçmalayan” yanıtlar (örneğin kullanıcının uydurduğu bir ifadeyi açıklamak gibi) sunabiliyor, bu da yeni nesil kullanıcıları yanıltabilir ve hatta tüm bilgilere şüpheyle yaklaşmalarına neden olabilir. Yorum bölümünde bu görüşe farklı tepkiler var; bazıları internetin hiçbir zaman tamamen güvenilir olmadığını ve eleştirel düşünmenin her zaman önemli olduğunu savunurken; bazıları ise gönderiyi yapanın yaşını ele verdiğini esprili bir dille belirtti (Kaynak: Reddit r/ArtificialInteligence)

Kullanıcı, ChatGPT ile Konuşarak Depresyon Duygularını Hafifletme Deneyimini Paylaştı: Bir kullanıcı, ChatGPT ile uzun bir sohbetin ardından depresyon ve intihar düşüncelerinin hafiflediği deneyimini paylaştı. AI’a bile olsa içini dökmenin büyük bir psikolojik baskıyı hafifletmesine yardımcı olduğunu ve ilerlemeye devam etme, yakınlarından ve arkadaşlarından yardım isteme cesareti verdiğini belirtti. Yorum bölümünde birçok kişi benzer deneyimler yaşadığını, AI’ın psikolojik destek konusunda önyargısız, sabırlı bir arkadaşlık sunabildiğini ifade etti, hatta bir kullanıcı ChatGPT’yi “daha yüksek bir benlik” rolüne sokarak derinlemesine sohbetler yapmak için kullandığı istemleri paylaştı. Bu durum, AI’ın ruh sağlığı yardımcılığı alanındaki potansiyeli hakkında tartışmalara yol açtı (Kaynak: Reddit r/ChatGPT)

“LLM’ler Sadece Bir Sonraki Kelimeyi Tahmin Eder” Söylemi Üzerine Düşünceler: Toplulukta, “LLM’ler sadece bir sonraki kelimeyi tahmin eder” şeklindeki ifadenin aşırı basitleştirilmiş olduğu ve LLM’lerin gerçek yeteneklerini ve potansiyel etkilerini küçümsemeye yol açabileceği yönünde tartışmalar var. Önemli olan, LLM’lerin ürettiği içeriğin (kod, analiz gibi) karmaşıklığı ve kullanışlılığıdır, üretim mekanizması değil. Uzmanlar, AI’ın hızlı gelişimi ve bilinmeyen yetenekleri konusunda endişelerini dile getirirken, sıradan insanlar bu tür basitleştirilmiş ifadeler nedeniyle AI teknolojisinin getireceği derin dönüşümleri tam olarak kavrayamayabilir. Tartışma ayrıca AI’ın “zekası” ve “bilinci” sorunlarına da değinerek, AI’ın insan anlamında bir bilinci olmasa bile yeteneklerinin dünya üzerinde büyük bir etki yaratmaya yeterli olduğunu belirtiyor (Kaynak: Reddit r/ArtificialInteligence)

Claude Ücretli Sürümünün Değeri Tartışması: Proje Yönetimi, Bağlam Uzunluğu ve Düşünme Modu Kilit Noktalar: Claude ücretli kullanıcıları, aboneliklerinin değerini paylaştı. Başlıca avantajlar arasında, kullanıcıların belirli görevler (ders hazırlığı, web sitesi SEO’su, reklam analizi, haber özeti, yemek tarifi sorgulama gibi) için büyük miktarda arka plan materyali (bilgi tabanı) yüklemesine olanak tanıyan “Projeler (Projects)” özelliği bulunuyor; bu da Claude’un belirli bir bağlamda sürekli yardım sunmasını sağlıyor. Ayrıca, daha geniş bir bağlam penceresi, daha güçlü bir “Düşünme Modu (Thinking Mode)” ve daha fazla sorgu sayısı da ücretli aboneliğin cazibesini artırıyor. Kullanıcı geri bildirimlerine göre, karmaşık görevleri, kod incelemelerini, belge analizlerini ve e-posta taslaklarını ele almada Claude Pro, MCP araçlarıyla (Desktop Commander gibi) birleştirildiğinde, maliyet optimizasyonu veya yerleşik sistem istemleri nedeniyle modelin derinlemesine analiz yeteneğini sınırlayabilen bazı IDE entegrasyon çözümlerinden daha iyi performans gösteriyor (Kaynak: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

OpenWebUI’ın Lisans Değişikliği Topluluk ve Kurumsal Kullanıcılarda Endişe Yarattı: OpenWebUI projesi yakın zamanda yazılım lisansını değiştirdi ve bu değişiklik bazı topluluk üyeleri ve kurumsal kullanıcılarda endişeye yol açtı. Bazı şirketler, projeyi kullanmayı ve katkıda bulunmayı durdurmayı tartıştıklarını ve geçici olarak son BSD lisanslı sürümden bir dal oluşturacaklarını belirtti. Bu olay, açık kaynaklı proje lisans değişikliklerinin, özellikle ticari uygulama senaryolarında kullanıcılar ve katkıda bulunanlar ekosistemi üzerindeki olası etkilerini vurgulamaktadır (Kaynak: Reddit r/OpenWebUI)

💡 Diğer

Vatikan, “Veri Duvarı” Sorunuyla Başa Çıkmak İçin Yeni Veri Kaynaklarına Yatırım Yapmayı Planlıyor: 2023’ten bu yana, büyük dil modellerinin eğitimi “veri duvarı” sorunuyla karşı karşıya; yani bilinen insan metin verilerinin büyük bir kısmı zaten dizine eklenmiş ve eğitilmiş durumda. Bu sorunu çözmek için Vatikan, AI modellerinin yeteneklerini sürekli olarak geliştirmek amacıyla OCR teknolojisiyle ortaçağ kilise belgelerini yazıya dökme ve sentetik veri üretme gibi yeni veri kaynaklarına yatırım yapmayı planlıyor (Kaynak: jxmnop, Dorialexander)

Çin’in Teknolojik Gelişimi Hızla İlerliyor, Birçok Alandaki İnovasyon Dikkat Çekiyor: Bir gönderi, yazarın Çin’deki 15 günlük gezisi sırasında gözlemlediği DeepSeek seks bebekleri, elektrikli zeplinler, trafik kazalarını ele almak için kullanılan dronlar gibi birçok şaşırtıcı teknolojik uygulamayı ayrıntılı olarak listeliyor. Bu, Çin’in yapay zeka, robotik, yeni enerjili ulaşım gibi alanlardaki teknolojik gelişim hızı ve uygulama genişliği hakkında tartışmalara yol açtı ve Singapur gibi diğer yüksek teknolojili ülkelerle karşılaştırmalar yapıldı (Kaynak: GavinSBaker)

AI’ın Tıp Alanındaki Gelişmelerine Yönelik Beklentiler: Topluluk üyeleri, AI’ın tıp alanında daha büyük ilerlemeler kaydetmesine yönelik beklentilerini dile getirdi. Vücudu anında tarayabilen, hastalıkların erken evrelerinde semptomları tespit edebilen AI robotları ve hassas tedavilere, ameliyatlara yardımcı olabilen ve iyileşmeyi hızlandırabilen sistemler hayal ediliyor. Mevcut teknolojiler bazı alanlarda ilerleme kaydetmiş olsa da, insanlar genellikle AI’ın tıbbi erişilebilirliği, doğruluğu artırma ve hayat kurtarma konusunda henüz keşfedilmemiş büyük bir potansiyele sahip olduğuna inanıyor (Kaynak: Reddit r/ArtificialInteligence, Reddit r/artificial)