Anahtar Kelimeler:Gemini modeli, Mistral AI, NVIDIA NeMo, LTX-Video, Safari tarayıcısı, RTX 5060, AI Ajan, Pekiştirmeli öğrenme ince ayarı, Gemini yerel görüntü oluşturma, Mistral Medium 3 programlama performansı, NeMo çerçevesi 2.0 modüler, DiT gerçek zamanlı video oluşturma, AI destekli arama dönüşümü

🔥 Odak Noktası

Google Gemini’nin yerel görüntü oluşturma özelliği güncellendi, görsel kalite ve metin işleme doğruluğu artırıldı: Google, Gemini modelinin yerel görüntü oluşturma özelliğine önemli bir güncelleme geldiğini duyurdu. Yeni sürüm “gemini-2.0-flash-preview-image-generation”, Google AI Studio ve Vertex AI’da kullanıma sunuldu. Bu yükseltme, görüntülerin görsel kalitesini ve metin oluşturma doğruluğunu önemli ölçüde artırdı ve gecikmeyi azalttı. Yeni özellikler arasında görüntü öğesi birleştirme, gerçek zamanlı düzenleme (nesne ekleme, yerel içeriği değiştirme gibi) ve AI’nın otonom olarak fikir üretip görüntü oluşturması için Gemini 2.0 Flash ile entegrasyon bulunuyor. Kullanıcılar Google AI Studio’da ücretsiz olarak deneyebilirler ve API çağrı ücreti resim başına 0,039 ABD dolarıdır. Önemli ilerlemelere rağmen, bazı kullanıcılar genel etkisinin hala GPT-4o’dan biraz daha düşük olduğunu düşünüyor. (Kaynak: 量子位)

Mistral AI, programlama ve çok modluluğa odaklanan Mistral Medium 3’ü duyurdu, maliyet önemli ölçüde düşürüldü: Fransız AI girişimi Mistral AI, en son çok modlu modeli Mistral Medium 3’ü piyasaya sürdü. Model, programlama ve STEM görevlerinde öne çıkıyor ve çeşitli karşılaştırmalı değerlendirmelerde Claude Sonnet 3.7’nin performansının %90’ına ulaştığı veya aştığı iddia edilirken, maliyeti sadece 1/8’i (giriş 0,4 ABD doları/milyon token, çıkış 2 ABD doları/milyon token). Mistral Medium 3, hibrit dağıtım, özelleştirilmiş sonradan eğitim ve kurumsal araçlarla entegrasyon gibi kurumsal düzeyde yeteneklere sahip ve Mistral La Plateforme ile Amazon Sagemaker’da kullanıma sunuldu, gelecekte daha fazla bulut platformuna gelecek. Aynı zamanda Mistral AI, işletmelere yönelik sohbet robotu hizmeti Le Chat Enterprise’ı da başlattı. (Kaynak: 量子位)

NVIDIA NeMo framework 2.0 yayınlandı, modülerlik ve kullanım kolaylığı artırıldı, Hugging Face modelleri ve Blackwell GPU desteği eklendi: NVIDIA NeMo framework 2.0 sürümüne güncellendi. Temel iyileştirmeler arasında esnekliği artırmak için YAML yerine Python yapılandırmasının benimsenmesi; PyTorch Lightning’in modüler soyutlaması aracılığıyla deneylerin ve özelleştirmelerin basitleştirilmesi; ve NeMo-Run aracı kullanılarak büyük ölçekli deneylerin sorunsuz bir şekilde genişletilmesi yer alıyor. Yeni sürüm, Hugging Face AutoModelForCausalLM modelleri için ön eğitim ve ince ayar desteği ekledi ve NVIDIA Blackwell B200 GPU için ilk desteği sağladı. Ayrıca, NeMo framework, video işleme kütüphanesi NeMo Curator ve Cosmos tokenizer dahil olmak üzere fiziksel AI sistemleri için dünya modeli geliştirmeyi hızlandırmak amacıyla NVIDIA Cosmos dünya temel model platformu desteğini de entegre etti. (Kaynak: GitHub Trending)

Lightricks, LTX-Video’yu yayınladı: gerçek zamanlı DiT video oluşturma modeli: Lightricks şirketi, Diffusion Transformer (DiT) tabanlı ilk gerçek zamanlı video oluşturma modeli olduğunu iddia ettiği LTX-Video’yu açık kaynak olarak yayınladı. Model, 30FPS’de 1216×704 çözünürlükte yüksek kaliteli videolar üretebiliyor ve metinden görüntüye, görüntüden videoya, anahtar kare animasyonu, video genişletme, videodan videoya dönüştürme gibi birçok işlevi destekliyor. En son sürüm 13B v0.9.7, komut istemi takibini ve fiziksel anlama yeteneklerini geliştirdi ve hızlı, yüksek kaliteli oluşturma için çok ölçekli bir video hattı sundu. Model, Hugging Face’te mevcut ve ComfyUI ile Diffusers entegrasyonlarına sahip. (Kaynak: GitHub Trending)

Apple, Safari tarayıcısında büyük bir revizyon düşünüyor, AI destekli aramaya yönelebilir, Google ile işbirliği ilişkisi mercek altında: Apple Kıdemli Başkan Yardımcısı Eddy Cue, ABD Adalet Bakanlığı’nın Google’a karşı açtığı antitröst davasında verdiği ifadede, Apple’ın Safari tarayıcısını aktif olarak yeniden yapılandırmayı düşündüğünü ve AI destekli arama motorlarına odaklanmayı planladığını açıkladı. Safari arama hacminin ilk kez düştüğünü ve bunun kısmen kullanıcıların OpenAI, Perplexity AI gibi AI araçlarına yönelmesinden kaynaklandığını belirtti. Apple, Perplexity AI ile görüşmeler yaptı ve Safari’ye daha fazla AI arama seçeneği ekleyebilir. Bu hamle, Apple’ın Google ile olan yıllık yaklaşık 20 milyar dolarlık varsayılan arama motoru anlaşmasını etkileyebilir ve her iki şirketin hisse senedi fiyatlarını etkileyebilir. Apple, Siri’ye ChatGPT’yi entegre etti ve Google Gemini’yi eklemeyi planlıyor. (Kaynak: 36氪)

🎯 Gelişmeler

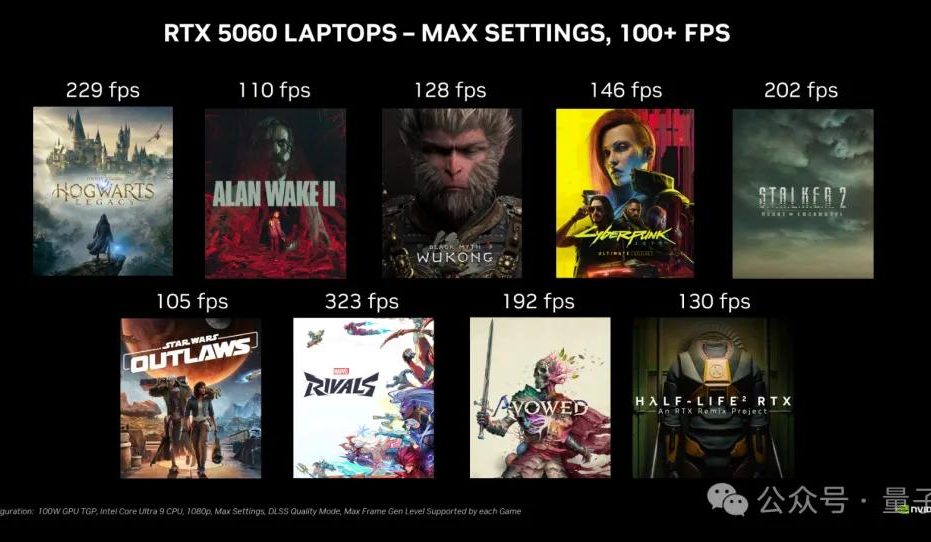

NVIDIA RTX 5060 masaüstü ekran kartı 20 Mayıs’ta satışa çıkacak, Çin içi fiyatı 2499 yuan: NVIDIA, RTX 5060 masaüstü ekran kartının Pekin saatiyle 20 Mayıs’ta satışa sunulacağını ve Çin içi fiyatının 2499 yuan olacağını duyurdu. Kart, Blackwell RTX mimarisini kullanıyor, 3840 CUDA çekirdeğine, 8GB GDDR7 belleğe sahip ve toplam gücü 145W. Resmi açıklamaya göre, DLSS 4 çoklu kare oluşturma teknolojisini destekleyen oyunlarda performansı RTX 4060’ın iki katı ve hedefi kullanıcıların oyunları 100 FPS’nin üzerinde çalıştırmasını sağlamak. İnceleme ambargosu ve satışlar aynı gün yapılacak. (Kaynak: 量子位)

Google Gemini API, %75 maliyet tasarrufu sağlayabilen örtük önbellekleme özelliğini kullanıma sundu: Google, Gemini API için örtük önbellekleme özelliğini kullanıma sunduğunu duyurdu. Kullanıcıların istekleri önbelleğe isabet ettiğinde, Gemini 2.5 modelini kullanma maliyeti otomatik olarak %75 oranında düşürülebilir. Aynı zamanda, önbelleği tetiklemek için gereken minimum token sayısı da düşürüldü; Gemini 2.5 Flash için 1K token’a, Gemini 2.5 Pro için 2K token’a indirildi. Bu özellik, geliştiricilerin Gemini API kullanma maliyetini açıkça önbellek oluşturmaya gerek kalmadan düşürmeyi amaçlıyor. (Kaynak: matvelloso, demishassabis, algo_diver, jeremyphoward)

Meta FAIR, yeni başkan olarak Rob Fergus’u atadı, Gelişmiş Makine Zekası (AGI) odak noktası olacak: Meta, Rob Fergus’un Temel AI Araştırma (FAIR) ekibinin liderliğini devralacağını duyurdu. Yann LeCun, FAIR’in genellikle insan seviyesinde AI veya AGI olarak adlandırılan Gelişmiş Makine Zekası’na yeniden odaklanacağını belirtti. Bu haber, AI araştırma topluluğu tarafından büyük ilgi ve tebriklerle karşılandı. (Kaynak: ylecun, Ar_Douillard, soumithchintala, aaron_defazio, sainingxie)

OpenAI, o4-mini modeli için pekiştirmeli öğrenme ile ince ayar (RFT) özelliğini kullanıma sundu: OpenAI, o4-mini modelinin artık pekiştirmeli öğrenme ile ince ayar (RFT) özelliğini desteklediğini duyurdu. Bu teknoloji geçen yıl Aralık ayından beri geliştiriliyor ve özellikle karmaşık alanlarda model performansını artırmak için düşünce zinciri çıkarımı ve göreve özgü puanlamayı kullanıyor. Ambience şirketi, RFT ile ayarlanmış bir model kullanarak ICD-10 kodlama doğruluğunda uzman klinik doktorlardan %27 daha yüksek bir başarı elde etti. Harvey şirketi de yasal görevlerde alıntı doğruluğunu artırmak için RFT ile modeller eğitti. Aynı zamanda, OpenAI’nin en hızlı ve en küçük modeli olan 4.1-nano da ince ayara açıldı. (Kaynak: stevenheidel, aidan_mclau, andrwpng, teortaxesTex, OpenAIDevs, OpenAIDevs)

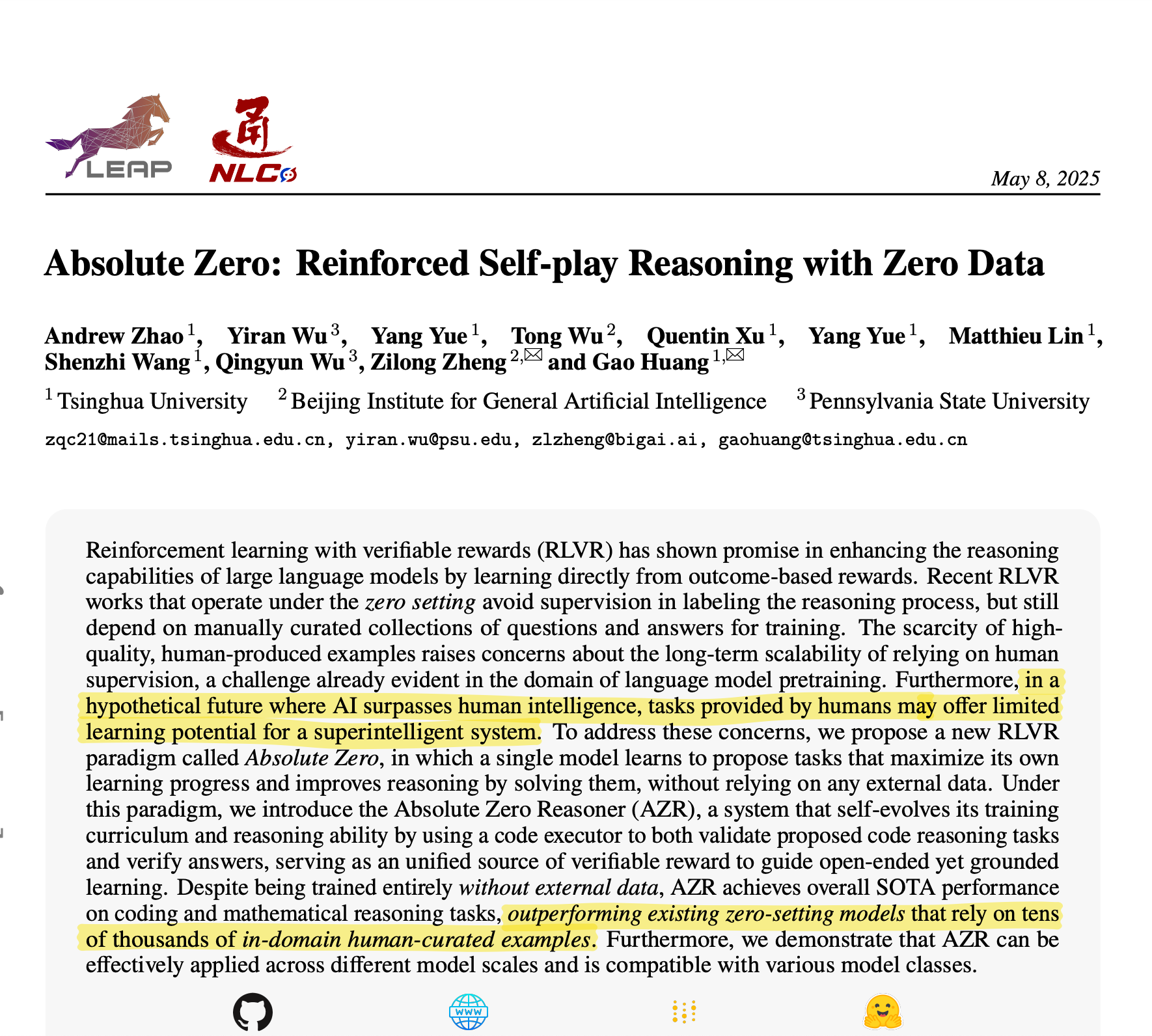

Tsinghua Üniversitesi, Absolute Zero Reasoner’ı tanıttı: AI, üstün çıkarım için kendi eğitim verilerini üretiyor: Tsinghua Üniversitesi ekibi, Absolute Zero Reasoner adlı bir AI modeli geliştirdi. Bu model, tamamen kendi kendine oyun (self-play) yoluyla eğitim görevleri üretebiliyor ve bunlardan öğrenebiliyor, herhangi bir harici veriye ihtiyaç duymuyor. Matematik ve kodlama gibi alanlarda performansı, uzmanlar tarafından elle hazırlanmış verilere dayanan modelleri şimdiden aştı. Bu başarı, AI gelişimindeki veri darboğazı sorununun hafifleyebileceği ve AGI’ye giden yolda yeni bir yol açabileceği anlamına gelebilir. (Kaynak: corbtt)

Meta ve NVIDIA, cuVS ile Faiss GPU vektör arama performansını artırmak için işbirliği yapıyor: Meta ve NVIDIA, NVIDIA’nın cuVS (CUDA Vector Search) çözümünü Meta’nın açık kaynaklı benzerlik arama kütüphanesi Faiss v1.10’a entegre ederek GPU üzerindeki vektör arama performansını önemli ölçüde artırmak için işbirliği yaptıklarını duyurdu. Bu entegrasyon, IVF indekslerinin oluşturma süresini 4,7 kata kadar, arama gecikmesini ise 8,1 kata kadar iyileştiriyor; grafik indeksleri açısından, CUDA ANN Graph (CAGRA) oluşturma süresi CPU HNSW’den 12,3 kat daha hızlı ve arama gecikmesi 4,7 kat daha düşük. (Kaynak: AIatMeta)

Google AI Studio ve Firebase Studio, Gemini 2.5 Pro’yu entegre etti: Google, Gemini 2.5 Pro modelini Gemini Code Assist (kişisel sürüm) ve Firebase Studio’ya entegre ettiğini duyurdu. Bu, geliştiricilere bu platformlarda en üst düzey kodlama modellerini kullanma konusunda daha fazla kolaylık ve güçlü işlevsellik sağlayarak kodlama verimliliğini ve deneyimini artırmayı amaçlıyor. (Kaynak: algo_diver)

Microsoft Copilot, satır içi düzenleme ve metin vurgulama desteğiyle Pages özelliğini kullanıma sundu: Microsoft Copilot, kullanıcıların AI tarafından oluşturulan yanıtları doğrudan Copilot arayüzünde satır içi olarak düzenlemesine olanak tanıyan “Pages” adlı yeni bir özellik ekledi. Kullanıcılar metni vurgulayabilir ve belirli değişiklik taleplerinde bulunabilirler. Bu özellik, kullanıcıların soruları ve araştırma sonuçlarını daha hızlı ve akıllı bir şekilde kullanılabilir belgelere dönüştürmelerine yardımcı olarak iş verimliliğini artırmayı amaçlıyor. (Kaynak: yusuf_i_mehdi)

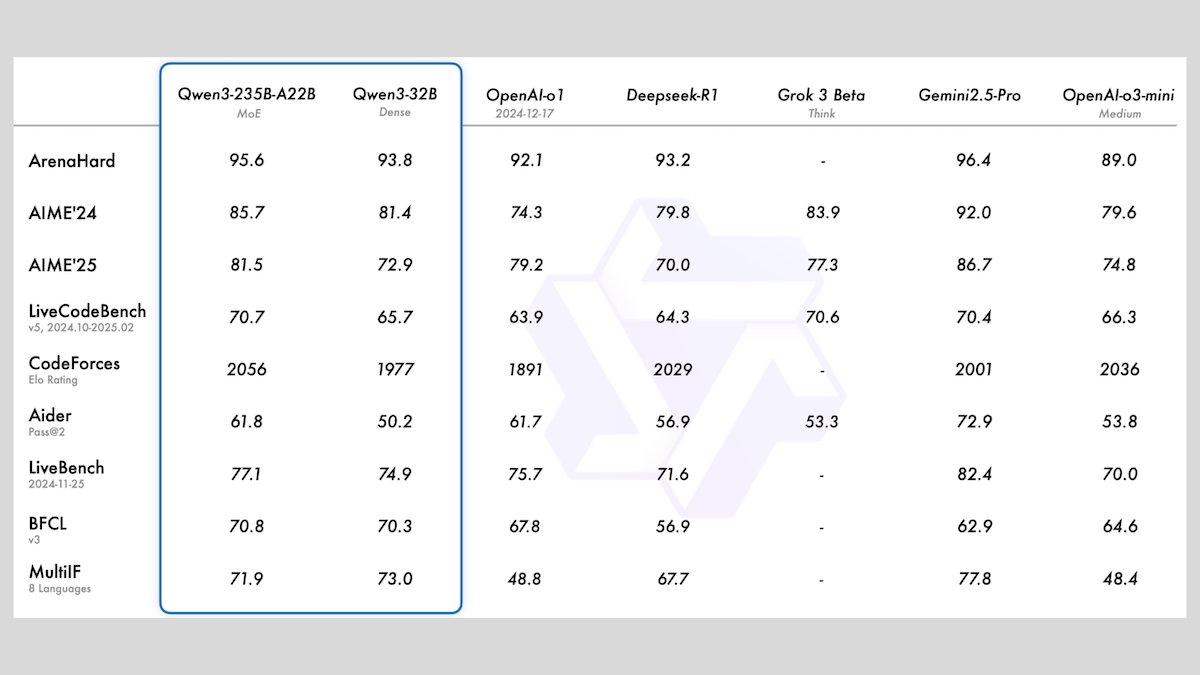

Alibaba, 8 açık kaynaklı büyük dil modeli içeren Qwen3 serisini piyasaya sürdü: Alibaba, 2 adet uzman karışımı (MoE) modeli ve 0.6B ila 32B arasında değişen parametrelere sahip 6 adet yoğun model olmak üzere 8 açık kaynaklı büyük dil modelinden oluşan Qwen3 serisini yayınladı. Tüm modeller isteğe bağlı çıkarım modlarını ve 119 dilde çok dilli yetenekleri destekliyor. Qwen3-235B-A22B ve Qwen3-30B-A3B, çıkarım, kodlama ve işlev çağırma görevlerinde üstün performans gösteriyor ve OpenAI gibi en iyi modellerle rekabet edebiliyor; özellikle Qwen3-30B-A3B, güçlü performansı ve yerel çalışma yeteneği nedeniyle büyük ilgi görüyor. (Kaynak: DeepLearningAI)

Meta, hassas 3D ortam nesne konumlandırması için Meta Locate 3D modelini tanıttı: Meta AI, 3D ortamlarda nesneleri hassas bir şekilde konumlandırmak için tasarlanmış bir model olan Meta Locate 3D’yi yayınladı. Bu model, robotların çevrelerini daha doğru anlamalarına ve insanlarla daha doğal etkileşim kurmalarına yardımcı olmayı amaçlıyor. Meta, modeli, veri setlerini, araştırma makalesini ve halkın kullanması ve deneyimlemesi için bir demo sundu. (Kaynak: AIatMeta)

Google, AI’ı siber dolandırıcılıkla mücadelede nasıl kullandığını açıklayan yeni bir rapor yayınladı: Google, arama motoru, Chrome tarayıcısı ve Android sistemindeki siber dolandırıcılıkla mücadelede yapay zeka teknolojisini nasıl kullandığına dair yeni bir rapor yayınladı. Rapor, Google’ın on yılı aşkın bir süredir kullanıcıları çevrimiçi dolandırıcılıktan korumak için AI kullanma çabalarını ve en son gelişmeleri ayrıntılı olarak açıklıyor ve AI’ın dolandırıcılık eylemlerini belirleme ve engellemedeki kilit rolünü vurguluyor. (Kaynak: Google)

Cohere, AI arama ve erişim yeteneklerini güçlendirmek için Embed 4 gömme modelini piyasaya sürdü: Cohere, kurumsal veri erişimini ve kullanımını devrim niteliğinde değiştirmeyi amaçlayan en son gömme modeli Embed 4’ü yayınladı. Cohere’in bugüne kadarki en güçlü gömme modeli olan Embed 4, AI arama ve erişiminin doğruluğunu ve verimliliğini artırmaya odaklanarak kuruluşların verilerinden gizli değeri ortaya çıkarmalarına yardımcı oluyor. (Kaynak: cohere)

Google, Google I/O konferansının 20 Mayıs’ta yapılacağını duyurdu: Google, yıllık geliştirici konferansı Google I/O’nun 20 Mayıs’ta yapılacağını ve kayıtların açıldığını resmi olarak duyurdu. Etkinlikte açılış konuşmaları yapılacak, yeni ürünler ve teknoloji duyuruları yapılacak ve AI’ın temel konulardan biri olması bekleniyor. (Kaynak: Google)

NVIDIA Parakeet modeli ses transkripsiyonunda yeni bir rekor kırdı: 60 dakikalık sesi 1 saniyede yazıya döküyor: NVIDIA’nın Parakeet modeli, ses transkripsiyonu alanında bir çığır açarak 60 dakikalık bir sesi 1 saniye içinde yazıya dökebiliyor ve Hugging Face ilgili sıralamalarında en üst sıralarda yer alıyor. Bu başarı, NVIDIA’nın konuşma tanıma teknolojisindeki lider konumunu gösteriyor ve geliştiricilere verimli ses işleme araçları sunuyor. (Kaynak: huggingface)

🧰 Araçlar

LlamaParse, belge ayrıştırma yeteneklerini güçlendirmek için GPT 4.1 ve Gemini 2.5 Pro desteği ekledi: LlamaParse son zamanlarda bir dizi özellik güncellemesi yaptı; bunlar arasında doğruluğu artırmak için yeni ayrıştırma modelleri GPT 4.1 ve Gemini 2.5 Pro’nun tanıtılması da yer alıyor. Ayrıca, yeni sürüm mükemmel hizalanmış ayrıştırmayı sağlamak için otomatik yön ve eğim algılama özellikleri ekledi; ayrıştırma kalitesini değerlendirmek için güven puanları sunuyor; ve kullanıcıların hata toleransını ve başarısız sayfaları işleme şeklini özelleştirmelerine olanak tanıyor. LlamaParse aylık 10.000 sayfalık ücretsiz bir kota sunuyor. (Kaynak: jerryjliu0)

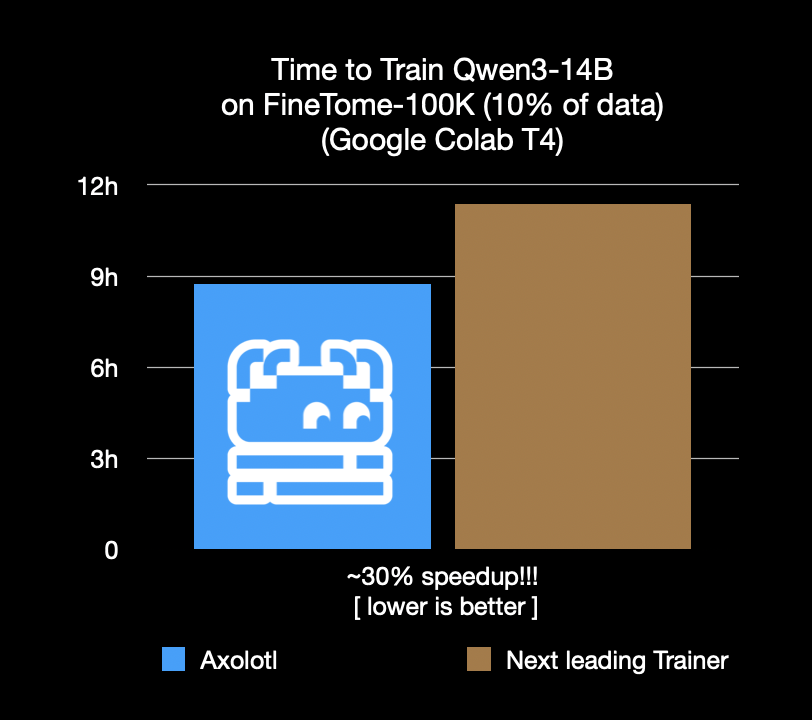

Axolotl ince ayar çerçevesi %30 hızlandı, maliyet ve zaman tasarrufu sağlıyor: Axolotl ince ayar çerçevesi, FineTome-100k gibi gerçek iş yüklerinde, en iyi ikinci çerçeveden %30 daha hızlı olduğunu duyurdu. Orta ve büyük ölçekli makine öğrenimi ekipleri için bu, aylık binlerce dolarlık maliyet tasarrufu anlamına geliyor. Çerçevenin optimizasyonu, kullanıcıların modellerini daha verimli ve ekonomik bir şekilde ince ayarlamalarına yardımcı olmayı amaçlıyor. (Kaynak: Teknium1, winglian, maximelabonne)

Runway, Gen-4 modelinin yeteneklerini sergileyen animasyon pilot bölümü “Mars & Siv: No Vacancy”yi yayınladı: Runway bünyesindeki AI stüdyosu, Jeremy Higgins ve Britton Korbel tarafından yaratılan animasyon pilot bölümü “Mars & Siv: No Vacancy”yi yayınladı. Bu çalışma, Runway’in Gen-4 modelinin konseptten nihai ürüne kadar animasyon üretim sürecinin çeşitli aşamalarındaki uygulamalarını sergileyerek AI’ın yaratıcı içerik üretimi alanındaki potansiyelini vurguluyor. (Kaynak: c_valenzuelab, c_valenzuelab)

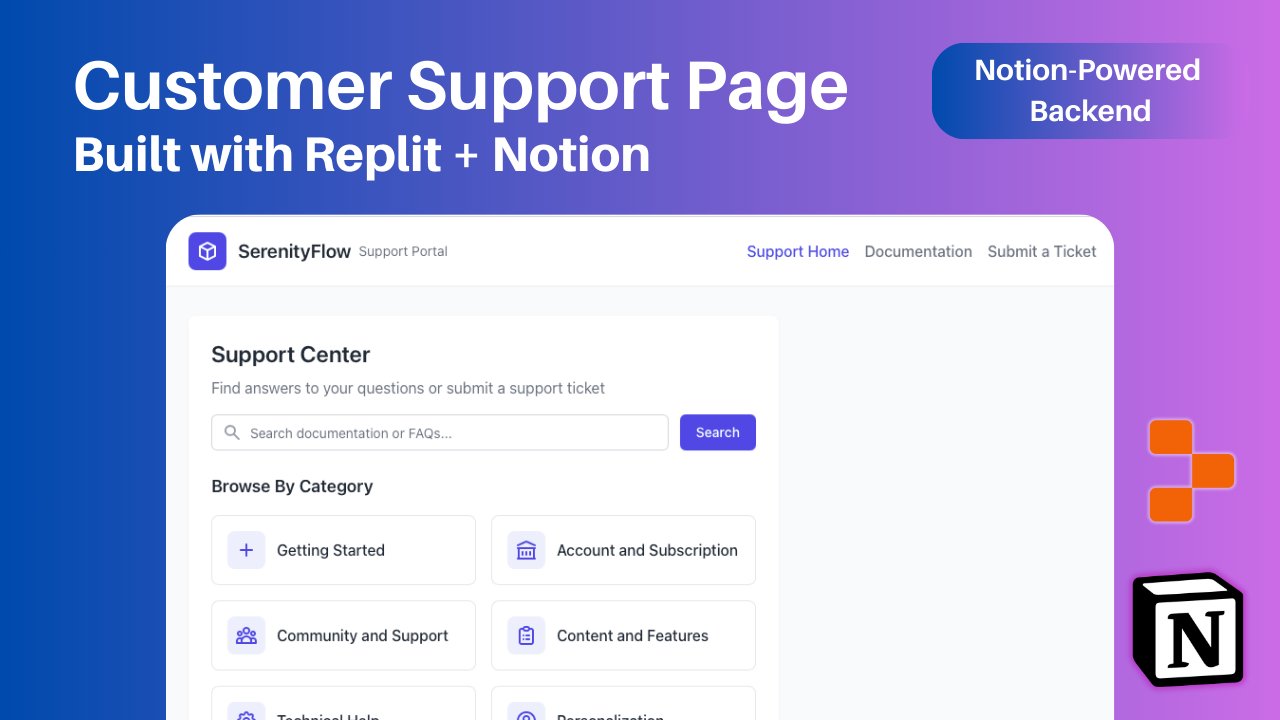

Replit, Notion içeriğini uygulama arka ucu olarak kullanmayı destekleyen yeni Notion entegrasyonu ekledi: Replit, geliştiricilerin Notion’ı uygulamalarının arka ucu olarak kullanmalarına olanak tanıyan Notion ile yeni bir entegrasyon işbirliği duyurdu. Kullanıcılar, SSS’leri sergilemek, belge tabanlı özel AI sohbet robotlarını çalıştırmak ve destek talebi kayıtlarını Notion’a geri kaydetmek için Notion veritabanlarını Replit projelerine bağlayabilirler. Bu hamle, Notion’ın arka uç organizasyon yeteneklerini Replit’in esnek ön uç oluşturma yetenekleriyle birleştirmeyi amaçlıyor. (Kaynak: amasad, amasad, pirroh)

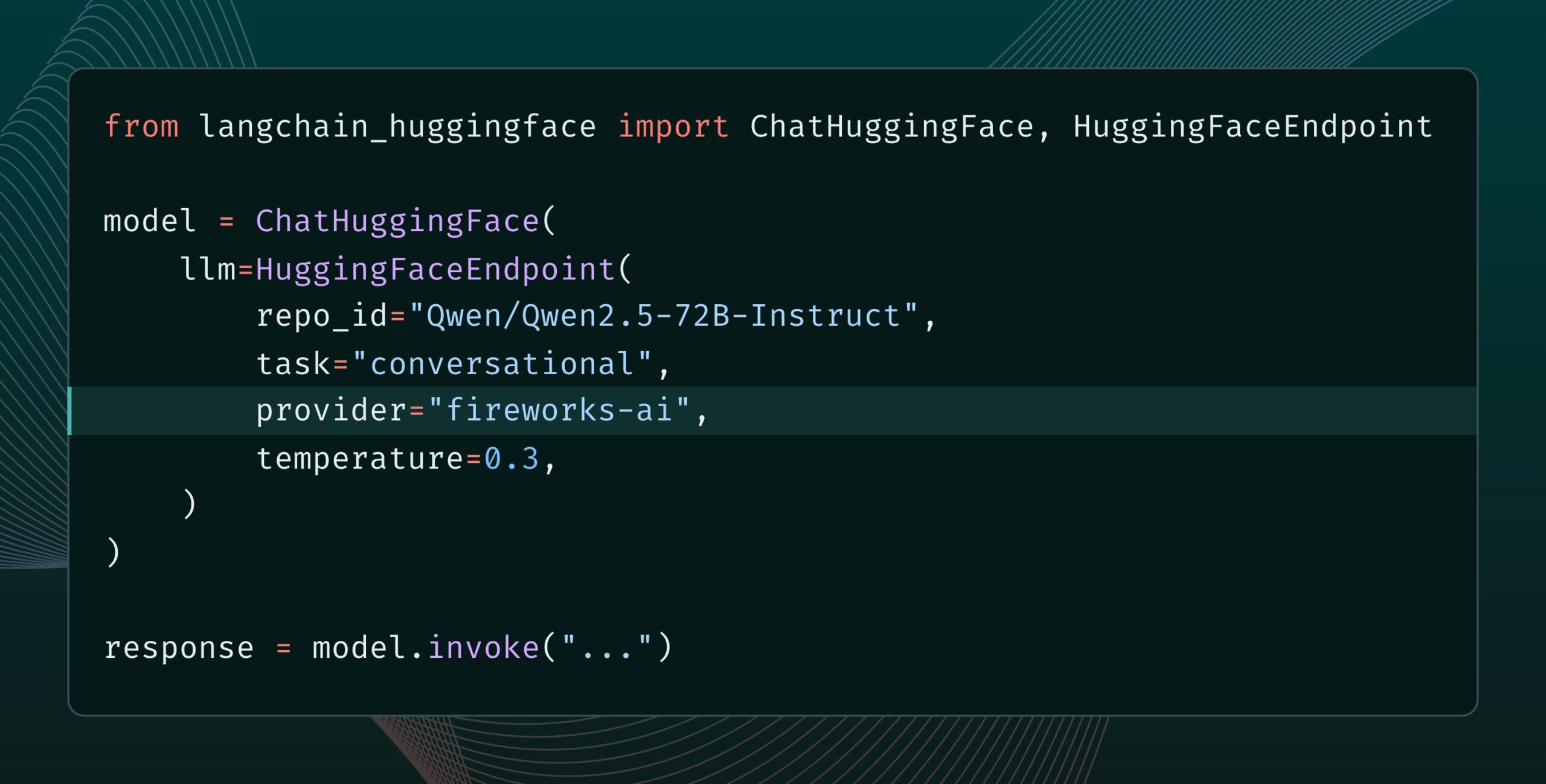

Langchain-huggingface v0.2 yayınlandı, HF Inference Providers desteği eklendi: Langchain-huggingface v0.2 sürümünü yayınladı, yeni sürüm Hugging Face Inference Providers desteği ekledi. Bu güncelleme, LangChain ekosisteminde Hugging Face tarafından sağlanan çıkarım hizmetlerini kullanmayı daha kolay hale getirecek. (Kaynak: LangChainAI, huggingface, ClementDelangue, hwchase17, Hacubu)

smolagents 1.15 yayınlandı, akışlı çıktı özelliği eklendi: AI ajan çerçevesi smolagents, 1.15 sürümünü yayınlayarak akışlı çıktılar (streaming outputs) özelliğini tanıttı. Kullanıcılar, CodeAgent’ı başlatırken stream_outputs=True ayarlayarak bu özelliği etkinleştirebilirler, bu da tüm etkileşim süreçlerinin daha akıcı hissedilmesini sağlayacaktır. (Kaynak: huggingface, AymericRoucher, ClementDelangue)

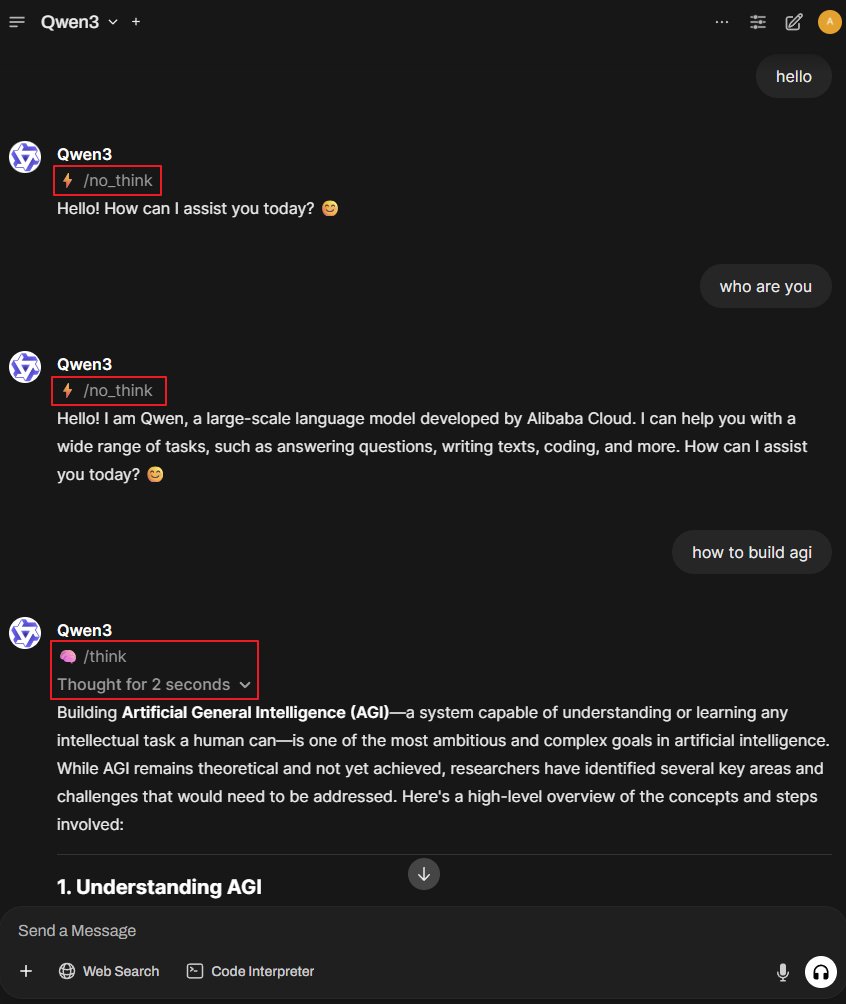

Better-Qwen3 projesi: Qwen3 modelinin düşünme modunu otomatik olarak değiştirmesini sağlıyor: Better-Qwen3 adlı bir GitHub projesi dikkat çekti. Bu proje, Qwen3 modelinin kullanıcının sorduğu sorunun karmaşıklığına göre “düşünme modunu” açıp açmayacağını otomatik olarak kontrol etmesini amaçlıyor. Basit sorular için model doğrudan cevap verecek; karmaşık sorular için ise daha derinlemesine cevaplar sunmak amacıyla otomatik olarak düşünme moduna geçecek. Proje adresi: http://github.com/AaronFeng753/Better-Qwen3 (Kaynak: karminski3, Reddit r/LocalLLaMA)

MLX-Audio: Apple MLX framework tabanlı TTS/STT/STS kütüphanesi: MLX-Audio, Apple çipleri (Apple Silicon) için özel olarak tasarlanmış, metinden sese (TTS), sesten metne (STT) ve sesten sese (STS) dönüştürme kütüphanesidir. Apple’ın MLX framework’ü üzerine geliştirilmiş olup, verimli ses işleme yetenekleri sunmayı amaçlamaktadır. Kütüphane, birden fazla dili, ses özelleştirmeyi, konuşma hızı kontrolünü destekler ve etkileşimli bir web arayüzü ile REST API sunar. (Kaynak: GitHub Trending)

Runway References modeli görüntü genişletme (Outpainting) özelliğini destekliyor: Runway’in References modeli artık görüntü genişletme (outpainting) özelliğini destekliyor. Kullanıcıların References’a bir resim yerleştirmesi, istenen çıktı formatını seçmesi, komut istemini boş bırakması ve ardından oluştur’a tıklaması yeterlidir; böylece orijinal görüntü genişletilebilir. Bu özellik, Runway’in görüntü düzenleme ve oluşturma yeteneklerini daha da artırıyor. (Kaynak: c_valenzuelab)

Docker2exe: Docker imajlarını yürütülebilir dosyalara dönüştürür: Docker2exe, Docker imajlarını bağımsız yürütülebilir dosyalara dönüştürebilen bir araçtır, bu da kullanıcıların paylaşımını ve çalıştırmasını kolaylaştırır. Docker imajının tarball’ını doğrudan yürütülebilir dosyaya paketleyen gömülü modu destekler. Hedef cihazda çalıştırıldığında, yerel olarak karşılık gelen Docker imajı yoksa, gömülü imajı otomatik olarak yükler veya ağdan çeker. (Kaynak: GitHub Trending)

Smoothie Qwen: Çok dilli üretimde dengeyi sağlamak için Qwen modelinin Token olasılıklarını yumuşatır: Smoothie Qwen, Qwen modelindeki Token olasılıklarını yumuşatarak modelin çok dilli üretimde dengesini artırmayı, belirli dillere (örneğin Çince) yönelik beklenmedik yanlılığı azaltmayı ve aynı zamanda temel performansı korumayı amaçlayan hafif bir ayarlama aracıdır. Araç, Token’ları tanımak için Unicode aralıklarını kullanır, N-gram analizi yapar ve lm_head içindeki Token ağırlıklarını ayarlar. Önceden ayarlanmış modeller Hugging Face’te mevcuttur. (Kaynak: Reddit r/LocalLLaMA)

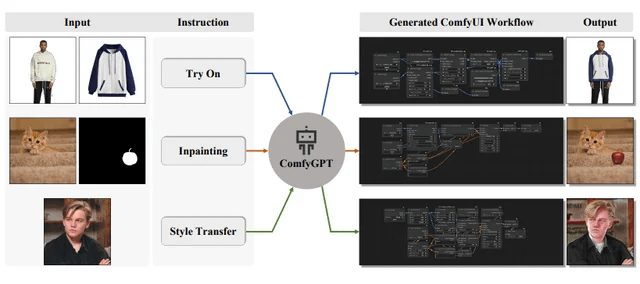

ComfyGPT: ComfyUI iş akışları oluşturmak için kendi kendini optimize eden çoklu ajan sistemi: arXiv’e “ComfyGPT: A Self-Optimizing Multi-Agent System for Comprehensive ComfyUI Workflow Generation” başlıklı bir makale sunuldu. Makale, ComfyGPT adlı bir sistemi tanıtıyor. Bu sistem, ComfyUI iş akışlarını kapsamlı bir şekilde oluşturmak için kendi kendini optimize eden çoklu ajan yöntemlerini kullanarak karmaşık görüntü oluşturma süreçlerinin oluşturulmasını basitleştirmeyi amaçlıyor. (Kaynak: Reddit r/LocalLLaMA)

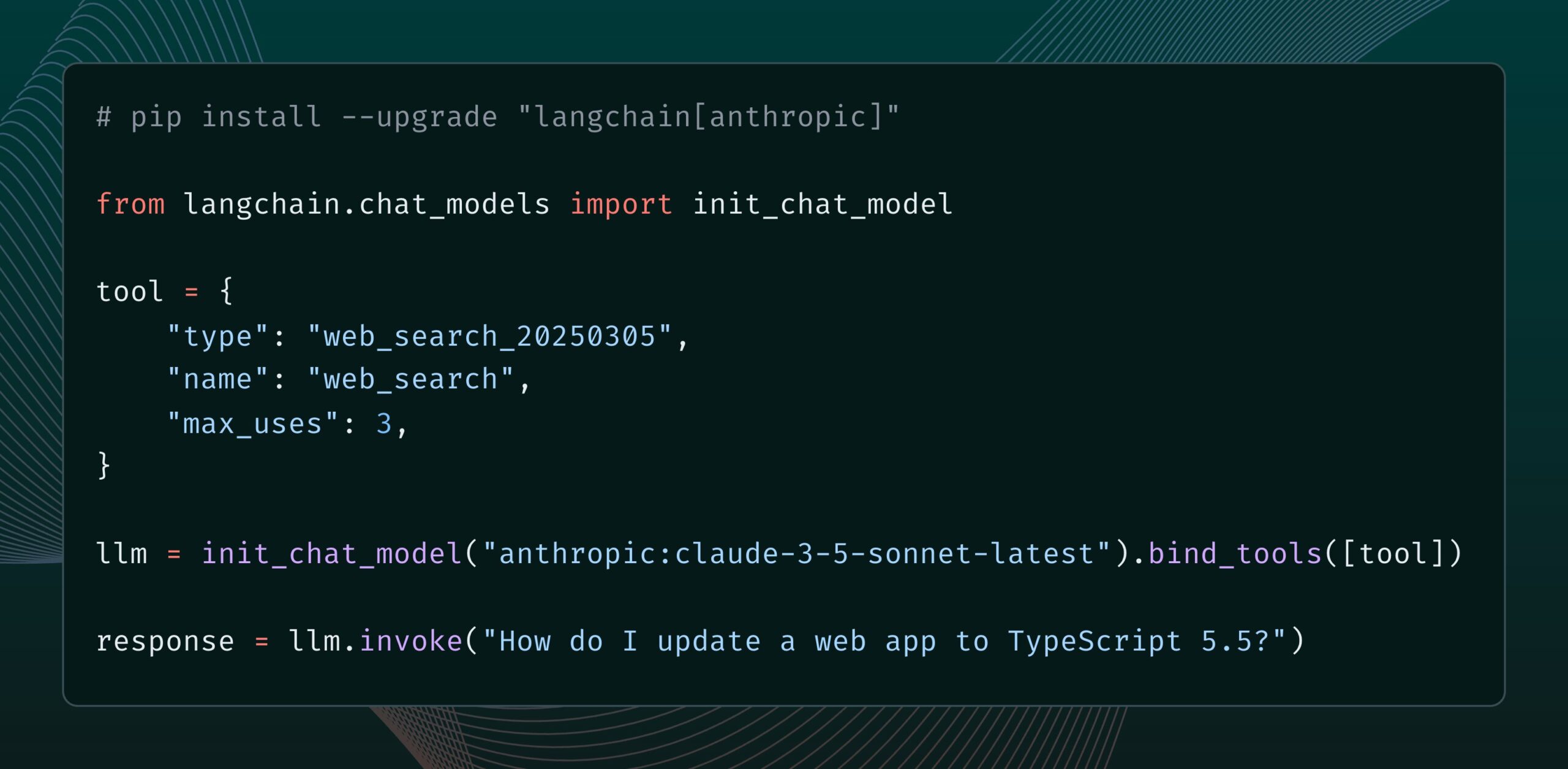

Anthropic Claude modeli yeni bir web arama aracı ekledi: Anthropic, Claude modeli için yeni bir web arama aracı yayınladı. Bu araç, Claude’un yanıtlar oluştururken web araması yapmasına ve arama sonuçlarını temel alarak alıntılı yanıtlar sunmasına olanak tanıyor. Bu özellik, langchain-anthropic kütüphanesine entegre edilerek Claude’un gerçek zamanlı bilgi edinme ve kullanma yeteneğini artırdı. (Kaynak: LangChainAI, hwchase17)

Glass Health, AI destekli klinik teşhis ve tedavi planlamasına yardımcı olmak için Workspace özelliğini kullanıma sundu: Glass Health, klinisyenlerin AI kullanarak karmaşık teşhis çıkarımı, tedavi planı oluşturma ve dokümantasyon iş akışlarını daha verimli bir şekilde tamamlamalarına olanak tanıyan yeni Workspace özelliğini yayınladı. Bu hamle, AI teknolojisi aracılığıyla tıbbi çalışmaların verimliliğini ve kalitesini artırmayı amaçlıyor. (Kaynak: GlassHealthHQ)

OpenWebUI, AI destekli not alma ve toplantı kaydı özelliklerini ekledi: OpenWebUI’nin en son sürümü, AI destekli not alma özelliğini ekledi. Kullanıcılar not oluşturabilir, toplantı veya sesli ses dosyalarını ekleyebilir ve AI’ın ses transkripsiyonunu kullanarak notları anında geliştirmesine, özetlemesine veya optimize etmesine izin verebilir. Ayrıca, kullanıcıların önemli tartışma bilgilerini gözden geçirmesini ve çıkarmasını kolaylaştırmak için toplantı ses kaydı ve içe aktarma özellikleri de desteklenmektedir. (Kaynak: Reddit r/OpenWebUI)

📚 Öğrenme Kaynakları

Birleşmiş Milletler, AI ve küresel insani gelişme üzerine 200 sayfalık bir rapor yayınladı: Birleşmiş Milletler Kalkınma Programı (UNDP), yapay zekayı küresel insani gelişme perspektifinden inceleyen 200 sayfalık bir rapor yayınladı. Rapor, AI’ın sürdürülebilir kalkınma hedefleri, eşitsizlik, yönetişim ve gelecekteki işler gibi birçok yönden etkilerini araştırıyor ve politika önerileri sunuyor. Rapor, net görüşleri nedeniyle dikkat çekti. (Kaynak: random_walker)

The Turing Post, Agent2Agent (A2A) protokolünün derinlemesine analizini yayınladı: Topluluğun AI Agent’lar arası iletişim protokollerine olan yoğun ilgisi göz önüne alındığında, The Turing Post, Google’ın A2A protokolü hakkındaki derinlemesine analizini Hugging Face’te ücretsiz olarak yayınladı. Makale, A2A protokolünün önemini (AI Agent silolarını kırmayı ve işbirliğini sağlamayı amaçlar), potansiyel uygulamalarını (uzman Agent ekiplerinin işbirliği, işletmeler arası iş akışları, insan-makine işbirliğinin standartlaştırılması, aranabilir Agent dizinleri gibi) ve çalışma prensipleri ile başlangıç yöntemlerini ele alıyor. (Kaynak: TheTuringPost, TheTuringPost, TheTuringPost, dl_weekly)

Komut istemi mühendisi paylaşıyor: İyi ve kullanışlı komut istemi şablonları nasıl kolayca yazılır: Komut istemi mühendisi dotey, verimli komut istemi şablonları oluşturmak için üç adımlı bir yöntem paylaştı: 1. Aynı tarzda ancak farklı konularda komut istemleri toplayın; 2. Ortak noktaları ve farklılıkları bulun (AI yardımıyla); 3. Tekrar tekrar test edin ve optimize edin. İyi bir şablonun, programlardaki bir fonksiyona benzediğini, değişkenlerde küçük değişiklikler yaparak farklı sonuçlar üretebildiğini vurguladı. Ayrıca, AI kullanarak hızlı bir şekilde yeni komut istemleri oluşturmak için bir komut şablonu paylaştı ve tüm stillerin şablonlaştırmaya uygun olmadığını, karmaşık detaylara sahip konuların hala kişiselleştirilmiş optimizasyon gerektirdiğini belirtti. (Kaynak: dotey)

DeepMind araştırmacısı John Jumper’ın ekibi, LLM tabanlı bilimsel keşifleri genişletmek için işe alım yapıyor: Google DeepMind araştırmacısı John Jumper, ekibinin büyük dil modelleri (LLM) tabanlı bilimsel keşifler alanındaki çalışmalarını genişletmek için birden fazla pozisyonda işe alım yaptığını duyurdu. İşe alınacak pozisyonlar arasında araştırma bilimcisi (RS) ve araştırma mühendisi (RE) bulunuyor ve amaç doğal dil bilimi AI’nın geleceğini ilerletmek. (Kaynak: demishassabis, NandoDF)

Ragas blogu, iki yıllık AI uygulama geliştirme deneyimlerini paylaşıyor: Shahules786, Ragas blogunda, son iki yıldır AI ekipleriyle yakın çalışarak, değerlendirme döngüleri sunarak ve LLM sistemlerini geliştirerek edindiği dersleri özetleyen bir makale yayınladı. Makale, AI uygulamaları oluşturan ve optimize eden uygulayıcılara pratik rehberlik ve içgörüler sunmayı amaçlıyor. (Kaynak: Shahules786)

Kyunghyun Cho, LLM çağında makine öğrenimi lisansüstü derslerinin öğretim yöntemlerini tartışıyor: New York Üniversitesi profesörü Kyunghyun Cho, mevcut LLM ve büyük ölçekli hesaplama çağında, birinci sınıf makine öğrenimi lisansüstü derslerinin içeriği hakkındaki düşüncelerini ve deneylerini paylaştı. SGD (stokastik gradyan inişi) kabul eden ve LLM olmayan tüm içeriği öğretmeyi ve öğrencileri klasik makaleleri okumaya yönlendirmeyi önerdi. (Kaynak: ylecun, sainingxie)

Akıllı Belge İşleme (IDP) sıralaması yayınlandı, VLM belge anlama yeteneklerini birleşik olarak değerlendiriyor: OCR, KIE, VQA, tablo çıkarma gibi çeşitli belge anlama görevleri için birleşik bir karşılaştırmalı değerlendirme sağlamayı amaçlayan yeni bir Akıllı Belge İşleme (IDP) sıralaması kullanıma sunuldu. Sıralama, 6 temel IDP görevini, 16 veri setini ve 9229 belgeyi kapsıyor. İlk sonuçlar, Gemini 2.5 Flash’ın genel olarak lider olduğunu, ancak tüm modellerin uzun belgeleri anlama konusunda zayıf performans gösterdiğini ve tablo çıkarmanın hala bir darboğaz olduğunu gösteriyor. GPT-4o’nun en son sürümünün performansı ise düşüş gösterdi. (Kaynak: Reddit r/MachineLearning, Reddit r/LocalLLaMA)

LangGraph, zamanlanmış AI ajan tetiklemesini destekleyen Cron Jobs özelliğini kullanıma sundu: LangChain’in LangGraph platformu, kullanıcıların AI ajanlarının çalışmasını otomatik olarak tetiklemek için zamanlanmış görevler ayarlamasına olanak tanıyan Cron Jobs özelliğini ekledi. Bu özellik, AI ajanlarının önceden ayarlanmış bir zaman çizelgesine göre görevleri yerine getirmesini sağlayarak periyodik işlem veya izleme gerektiren senaryolar için uygundur. (Kaynak: hwchase17)

💼 İş Dünyası

AI yazılım hata ayıklama aracı Lightrun, Accel ve Insight Partners liderliğinde 70 milyon dolarlık B serisi finansman aldı: AI yazılım gözlemlenebilirlik ve hata ayıklama aracı geliştiricisi Lightrun, Accel ve Insight Partners liderliğinde, Citibank gibi yatırımcıların da katıldığı 70 milyon dolarlık B serisi finansman turunu tamamladığını duyurdu. Toplam finansmanı 110 milyon dolara ulaştı. Temel ürünü Runtime Autonomous AI Debugger, IDE içinde sorunlu kodu hassas bir şekilde belirleyebiliyor ve onarım önerileri sunarak hata ayıklama süresini saatlerden dakikalara indirmeyi amaçlıyor. Şirketin 2024 yılı geliri 4,5 kat arttı ve müşterileri arasında Citibank, Microsoft gibi Fortune 500 şirketleri bulunuyor. (Kaynak: 36氪)

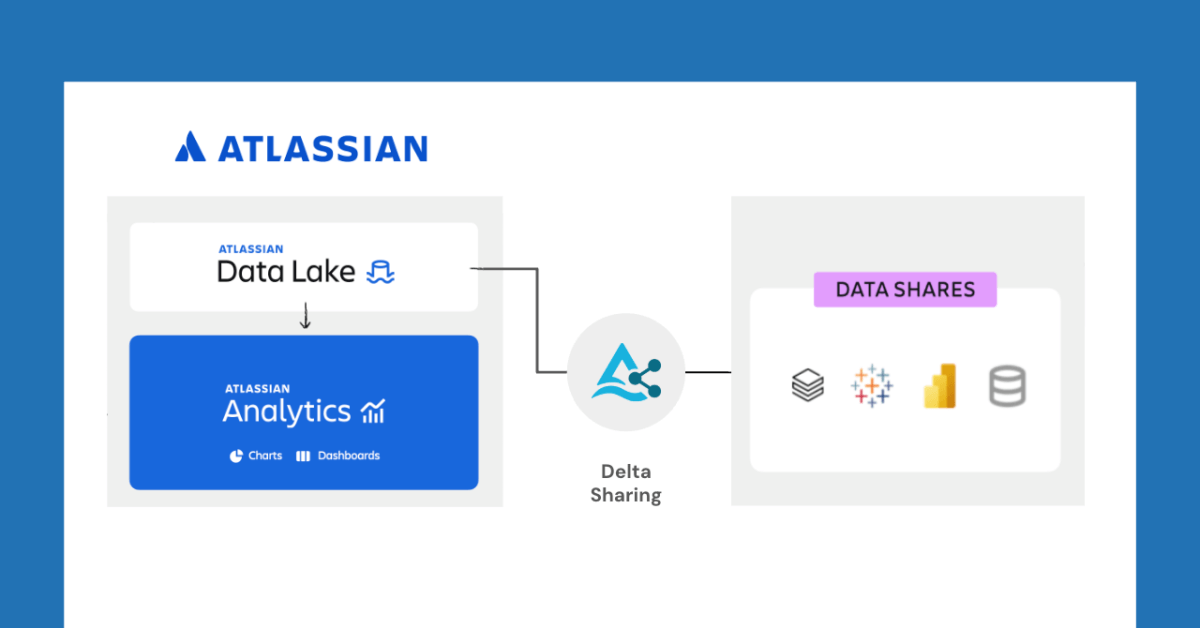

Databricks ve Atlassian, Delta Sharing ile yeni veri paylaşım özelliklerinin kilidini açmak için işbirliği yapıyor: Databricks, Atlassian Analytics’e yeni veri paylaşım yetenekleri getirmek için Atlassian ile işbirliği yaptığını duyurdu. Delta Sharing’in açık protokolü aracılığıyla Atlassian müşterileri, Atlassian Data Lake’deki verilerine kendi seçtikleri araçlarla güvenli bir şekilde erişebilir ve analiz edebilirler. Bu özellik, BI entegrasyonu, özel veri iş akışları, ekipler arası işbirliği gibi kullanım durumlarını destekler. (Kaynak: matei_zaharia)

Fastino, göreve özgü dil modellerine (TLM) odaklanarak 17,5 milyon dolar finansman aldı: Girişim şirketi Fastino, yenilikçi göreve özgü dil modellerini (TLM) geliştirmek için Khosla Ventures liderliğinde 17,5 milyon dolarlık (toplam 25 milyon dolarlık ön tohum turu) finansman aldığını duyurdu. Fastino, TLM mimarisinin küçük ve belirli görevlere yönelik olduğunu, düşük kaliteli oyun GPU’larında eğitilebildiğini ve maliyet etkin olduğunu belirtiyor. TLM, mimari, ön eğitim ve son eğitim düzeylerinde görev uzmanlaşması yoluyla parametre fazlalığını ve mimari verimsizliği ortadan kaldırarak belirli görevlerin doğruluğunu artırmayı ve gecikme ile maliyete duyarlı uygulamalara gömülebilmeyi amaçlıyor. (Kaynak: Reddit r/MachineLearning)

🌟 Topluluk

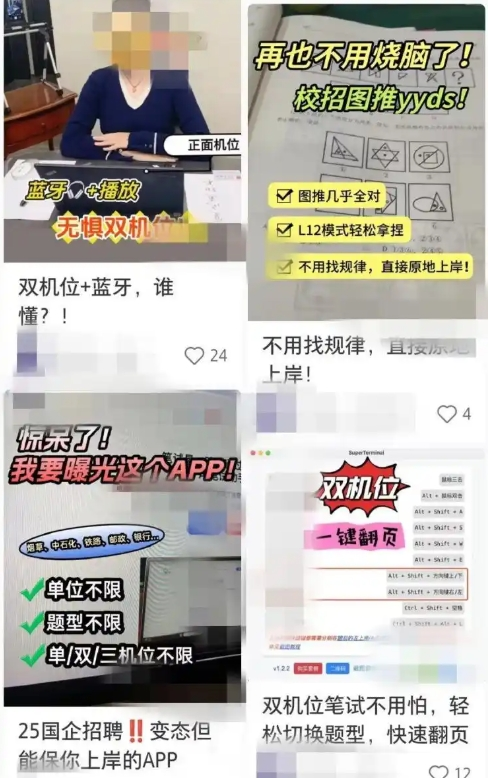

AI destekli iş arama araçları hile endişelerine yol açıyor, şirketler karşı önlemleri güçlendiriyor: Son zamanlarda, çevrimiçi mülakat ve yazılı sınavlara yardımcı olmak için AI araçlarının kullanımı arttı. Bu tür “AI mülakat sihirbazları”, kullanıcıların özgeçmişlerine göre özelleştirilmiş cevaplar üreterek başvuru sahiplerinin iş arayışında avantaj elde etmelerine yardımcı oluyor. Bu tür yazılımlara erişim kolay ve hatta çeşitli ücretli paketler ve uzaktan rehberlik sunuluyor. Bu eğilim, “Interview Coder” gibi erken dönem AI hile araçlarının ortaya çıkışına kadar uzanıyor. Şirketler, mülakat sırasında başvuru sahiplerinin anormal davranışlarına dikkat etmek, ekran algılama sistemleri getirmeyi düşünmek veya yüz yüze mülakatlara geri dönmek gibi karşı önlemler almaya başladı. Avukatlar, AI kullanarak hile yapmanın dürüstlük ilkesini ihlal ettiğini, iş sözleşmesinin feshine yol açabileceğini ve gizlilik ihlali riski taşıdığını belirtiyor. (Kaynak: 36氪)

LangChain CEO’su Harrison Chase, “Ortam Zekası Ajanları” ve “Ajan Gelen Kutusu” kavramlarını ortaya attı: LangChain CEO’su Harrison Chase, Sequoia AI Ascent etkinliğinde AI ajanlarının gelecekteki gelişimi hakkındaki görüşlerini paylaştı ve “Ortam Zekası Ajanları” (Ambient Agents) ile “Ajan Gelen Kutusu” (Agent Inbox) kavramlarını ortaya attı. Ortam Zekası Ajanları, doğrudan insan komutları yerine olaylara yanıt vererek arka planda sürekli çalışabilen AI sistemlerini ifade ederken, Ajan Gelen Kutusu ise bu ajanların faaliyetlerini yönetmek ve denetlemek için yeni bir insan-makine etkileşim arayüzüdür. (Kaynak: hwchase17, hwchase17, hwchase17)

Jim Fan, AI için yeni bir Kuzey Yıldızı olarak “Fiziksel Turing Testi”ni önerdi: NVIDIA bilim insanı Jim Fan, Sequoia AI Ascent etkinliğinde “Fiziksel Turing Testi” kavramını ortaya atarak bunu AI alanındaki bir sonraki “Kuzey Yıldızı” olarak nitelendirdi. Bu test, Pazar günü bir hackathon sonrası evin dağınık olduğu, Pazartesi akşamı eve dönüldüğünde ise oturma odasının tertemiz olduğu ve mum ışığında bir akşam yemeğinin hazır olduğu bir senaryoyu hayal ediyor ve bunun bir insan mı yoksa bir makine tarafından mı yapıldığını ayırt edemiyorsunuz. Bunun genel amaçlı robot teknolojisinin hedefi olduğunu düşünüyor ve bu sorunu çözmek için veri stratejileri ve ölçek yasaları da dahil olmak üzere temel ilkeleri paylaştı. (Kaynak: DrJimFan, killerstorm)

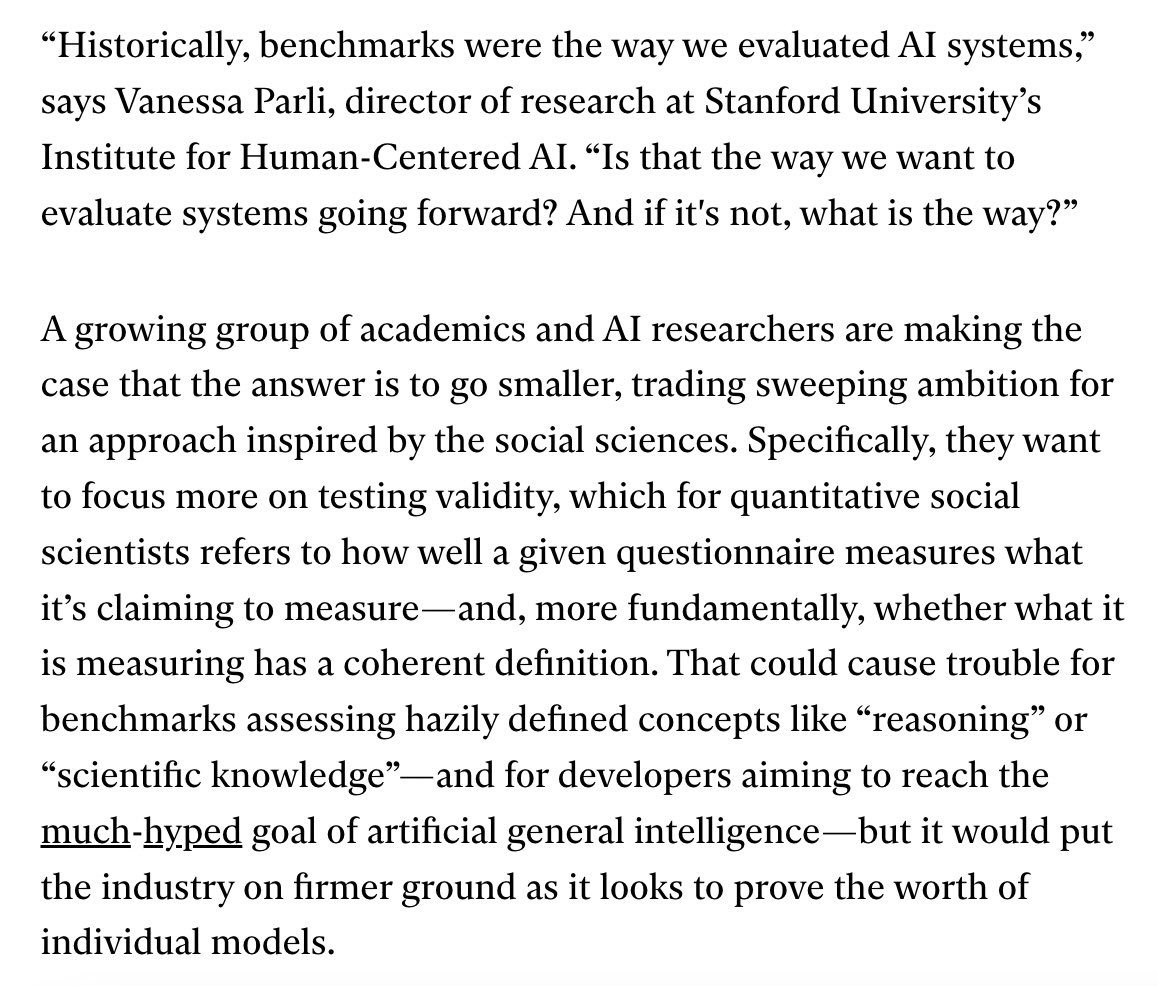

AI model değerlendirmesi krizle karşı karşıya, EvalEval ittifakı iyileştirme çağrısında bulunuyor: Mevcut AI model değerlendirme yöntemlerindeki karşılaştırmalı değerlendirme doygunluğu, bilimsel titizlik eksikliği gibi eksikliklere yönelik olarak, değerlendirme durumunu önemseyen kişileri bir araya getirmeyi, değerlendirme raporlarını iyileştirmeye, doygunluk sorununu çözmeye, değerlendirme bilimselliğini ve altyapısını geliştirmeye ortaklaşa çalışmayı amaçlayan EvalEval ittifakından bahsedildi. İlgili tartışmalar, değerlendirmenin geçerliliğine daha fazla odaklanılması gerektiğini savunuyor. (Kaynak: ClementDelangue)

Reddit’te sıcak tartışma: LLM iş akışları oluşturma gözlemleri ve deneyimleri: Bir geliştirici Reddit’te, son bir yıldır karmaşık LLM iş akışları oluşturma deneyimlerini özetledi. Önemli noktalar şunları içeriyor: Görevleri en küçük adımlara ayırmak ve komut istemlerini zincirleme olarak çağırmak, tek bir karmaşık komut isteminden daha iyi sonuç veriyor; komut istemi yapısını oluşturmak için XML etiketlerini kullanmak daha iyi sonuç veriyor; LLM’e rolünün yalnızca anlamsal ayrıştırma ve dönüştürme olduğu, kendi bilgisini dahil etmemesi gerektiği açıkça belirtilmeli; LLM çıktısını doğrulamak için NLTK gibi geleneksel NLP kütüphanelerini kullanmak; küçük görevlerde ince ayarlanmış BERT benzeri sınıflandırıcılar genellikle LLM’lerden daha iyi performans gösteriyor; LLM’lerin hakem olarak veya güvenilirlik puanlaması yapması, özellikle net puanlama kriterleri olmadığında güvenilir değil; Agentic döngülerde, LLM’in döngüden çıkma koşullarını belirlemesi zor bir nokta; performans genellikle giriş bağlam penceresi 4K Token’ı aştığında düşüyor; 32B modeller yapılandırılmış görevlerde yeterli; yapılandırılmış CoT, yapılandırılmamış CoT’den daha iyi; kendi yazdığınız CoT, çıkarım modellerine güvenmekten daha iyi; uzun vadeli hedef tüm bileşenleri ince ayarlamak ve dengeli bir ince ayar veri seti oluşturmaya dikkat etmek. (Kaynak: Reddit r/LocalLLaMA)

Reddit kullanıcıları Claude Sonnet 3.7 sistem komut istemi ayarlarını tartışıyor: Reddit r/ClaudeAI topluluğundaki kullanıcılar, Claude Sonnet 3.7 modelinin talimatları izleme, kod düzeltme ve bağlam belleği konularında kararsızlık yaşadığını bildiriyor ve etkili sistem komut istemleri talep ediyor. Bazı kullanıcılar, Sonnet 3.5 davranışını taklit eden komut istemlerini ve verimli, pratik çözümlere, DRY, KISS, SRP gibi temel bilgisayar bilimi ilkelerine uymayı vurgulayan ayrıntılı talimatları paylaştı. Diğer kullanıcılar ise Claude’un sistem komut istemlerini kendi kendine yeniden yazıp optimize etmesini sağlayarak veya kısa ve net tek satırlık talimatlar kullanarak etkiyi artırmayı önerdi. (Kaynak: Reddit r/ClaudeAI)

LLM ince ayarı için gereken Epoch sayısı hakkında tartışma: Reddit r/MachineLearning’de bir kullanıcı, Deepseek R1 makalesinde Deepseek-V3-Base modelinin (yaklaşık 800.000 örnek) yalnızca 2 Epoch ile ince ayarlanmasına ilişkin soru sordu ve kayıp fonksiyonunun yanı sıra, ince ayar Epoch sayısını belirleyen değerlendirme verisi performansı ve veri kalitesi gibi metrikleri tartıştı. (Kaynak: Reddit r/MachineLearning)

💡 Diğer

François Chollet: Sağlam düşünce modelleri oluşturmak, zor sorunları çözmenin ön koşuludur: AI düşünürü François Chollet, net, kendi içinde tutarlı düşünce modelleri oluşturmanın, şansa güvenmek yerine yaratıcı bir şekilde zor sorunları çözmenin (basit sorunları hızlı çözme yeteneğinden farklı olarak) ön koşulu olduğunu vurguluyor. Zarafetin, ifade gücü ile sadeliğin birleşimi olduğunu ve sıkıştırma ile yakından ilişkili olduğunu düşünüyor. (Kaynak: fchollet, teortaxesTex, fchollet, pmddomingos)

Replit CEO’su Amjad Masad: AI Agent’lar programlamada yeni bir dalga olacak: Replit CEO’su ve kurucu ortağı Amjad Masad, The Turing Post ile yaptığı röportajda, her zaman AI Agent’ların programlamanın bir sonraki dalgasına öncülük edeceğine inandığını belirtti. Programlama öğretmekten, otomatik olarak programlama yapabilen Agent’lar oluşturmaya geçiş düşüncelerini paylaştı. Yazılım Agent’larının halihazırda gerçek işlerde sonuç verdiğini, örneğin bir emlak şirketinin potansiyel müşteri dağıtım algoritmasını optimize etmesine yardımcı olarak dönüşüm oranını %10 artırdığını belirtti. Gelecekteki milyar dolarlık girişimlerin AI ile güçlendirilmiş bağımsız kurucular tarafından oluşturulabileceğini düşünüyor ve bu vizyonu gerçekleştirmek için gereken koşulları, programlama alanının mevcut durumunu ve geleceğini, Replit’in vizyonunun evrimini ve AGI ile açık kaynağın önemini tartıştı. (Kaynak: TheTuringPost, TheTuringPost)

LazyVim: “Tembeller” için tasarlanmış bir Neovim yapılandırması: LazyVim, kullanıcıların Neovim ortamlarını kolayca özelleştirmelerini ve genişletmelerini sağlamak amacıyla lazy.nvim tabanlı bir Neovim yapılandırma çözümüdür. Önceden yapılandırılmış, zengin özelliklere sahip bir IDE benzeri deneyim sunarken, yüksek derecede esneklik sağlar ve kullanıcılar ihtiyaçlarına göre ayarlamalar yapabilirler. (Kaynak: GitHub Trending)