Anahtar Kelimeler:OpenAI, DSPy, SGLang, Nvidia, ChatGPT, AI, LLM, MoE, dspy.GRPO, DeepSeek MoE, Parakeet TDT, Agentik Sistemler, EQ-Bench 3

🔥 Odak Noktası

OpenAI, kâr amacı gütmeyen yapısını koruyacağını doğruladı: OpenAI, mevcut kâr amaçlı kuruluşunun bir Kamu Yararına Şirket’e (PBC – Public Benefit Corporation) dönüşeceğini ancak kontrolün mevcut kâr amacı gütmeyen kuruluşta kalacağını duyurdu. Bu hamle, OpenAI’nin kâr amacı gütmeyen kuruluş tarafından kontrol edilmeye devam edeceğini doğruluyor ve AGI’nin (Yapay Genel Zeka) tüm insanlığa fayda sağlamasını güvence altına alma misyonunu yeniden teyit ediyor. Bu karar, iç çalkantılar ve yapısı hakkındaki dış sorgulamaların (Musk’ın davası dahil) ardından geldi. Topluluğun tepkileri karışıktı; bazıları bunu misyona bağlılık olarak görürken, diğerleri sermaye yapısı ayarlamasının gerçek niyetini sorguladı (kaynak: OpenAI, sama, jachiam0, NeelNanda5, scaling01, zacharynado, mcleavey, steph_palazzolo, Plinz, Teknium1)

DSPy çerçevesi, deneysel çevrimiçi RL optimize edici dspy.GRPO’yu yayınladı: Stanford NLP ekibi, DSPy çerçevesinin deneysel yeni bir özelliği olan dspy.GRPO’yu yayınladı; bu, çevrimiçi bir pekiştirmeli öğrenme (RL) optimize edicisidir. Araç, DSPy programlarını optimize etmek için tasarlanmıştır ve karmaşık çok modüllü, çok adımlı programlara bile mevcut kodu değiştirmeden doğrudan uygulanabilir. Bu adım, RL optimizasyonunu (DeepSeek tarafından kullanılan GRPO gibi) daha yüksek bir soyutlama seviyesine (LLM iş akışları) taşıma yönünde önemli bir adım olarak görülüyor ve AI ajanlarının ve karmaşık boru hatlarının performansını ve verimliliğini artırmayı hedefliyor. Topluluk buna büyük ilgi gösterdi ve bunun DSPy 3.0’ın önemli bir parçası olacağını düşünüyor (kaynak: Omar Khattab, matei_zaharia, lateinteraction, Michael Ryan, Lakshya A Agrawal, Scott Condron, Noah Ziems, Rogerio Chaves, Karthik Kalyanaraman, Josh Cason, Mehrdad Yazdani, DSPy, Hopkinx🀄️, Ahmad, william, lateinteraction, lateinteraction, swyx)

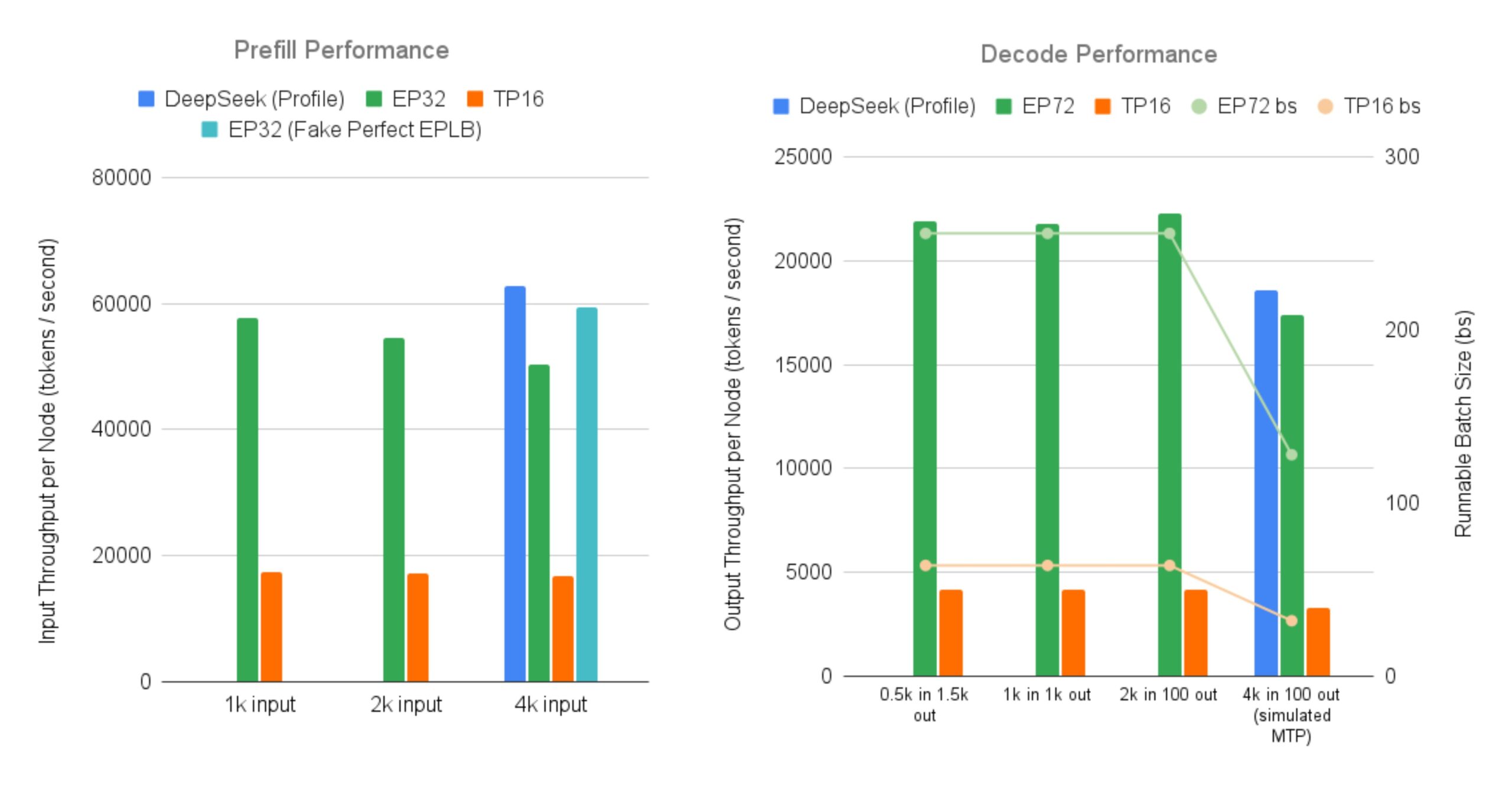

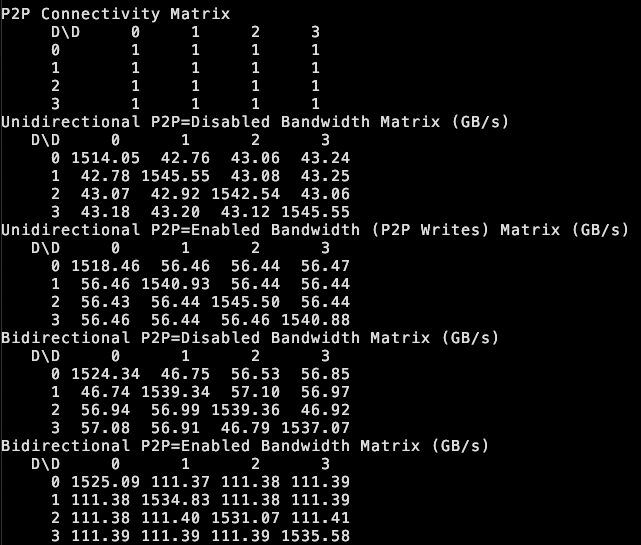

SGLang, DeepSeek MoE büyük modeline verimli hizmet sunan açık kaynak uygulamasını yayınladı: LMSYS Org, SGLang’ın, büyük ölçekli Expert Parallelism ve Prefill-Decode Disaggregation özelliklerine sahip DeepSeek V3/R1 gibi MoE (Mixture-of-Experts) modellerini 96 GPU üzerinde sunmak için ilk açık kaynak uygulamasını sağladığını duyurdu. Bu uygulama, DeepSeek’in resmi olarak bildirdiği işlem hacmine (düğüm başına 52.3k token/saniye girdi, 22.3k token/saniye çıktı) neredeyse ulaşıyor ve geleneksel tensör paralelliğine kıyasla çıktı işlem hacmini 5 kata kadar artırıyor. Bu, topluluğa büyük MoE modellerini verimli bir şekilde çalıştırmak ve dağıtmak için açık kaynaklı bir çözüm sunuyor (kaynak: LMSYS Org, teortaxesTex, cognitivecompai, lmarena_ai, cognitivecompai)

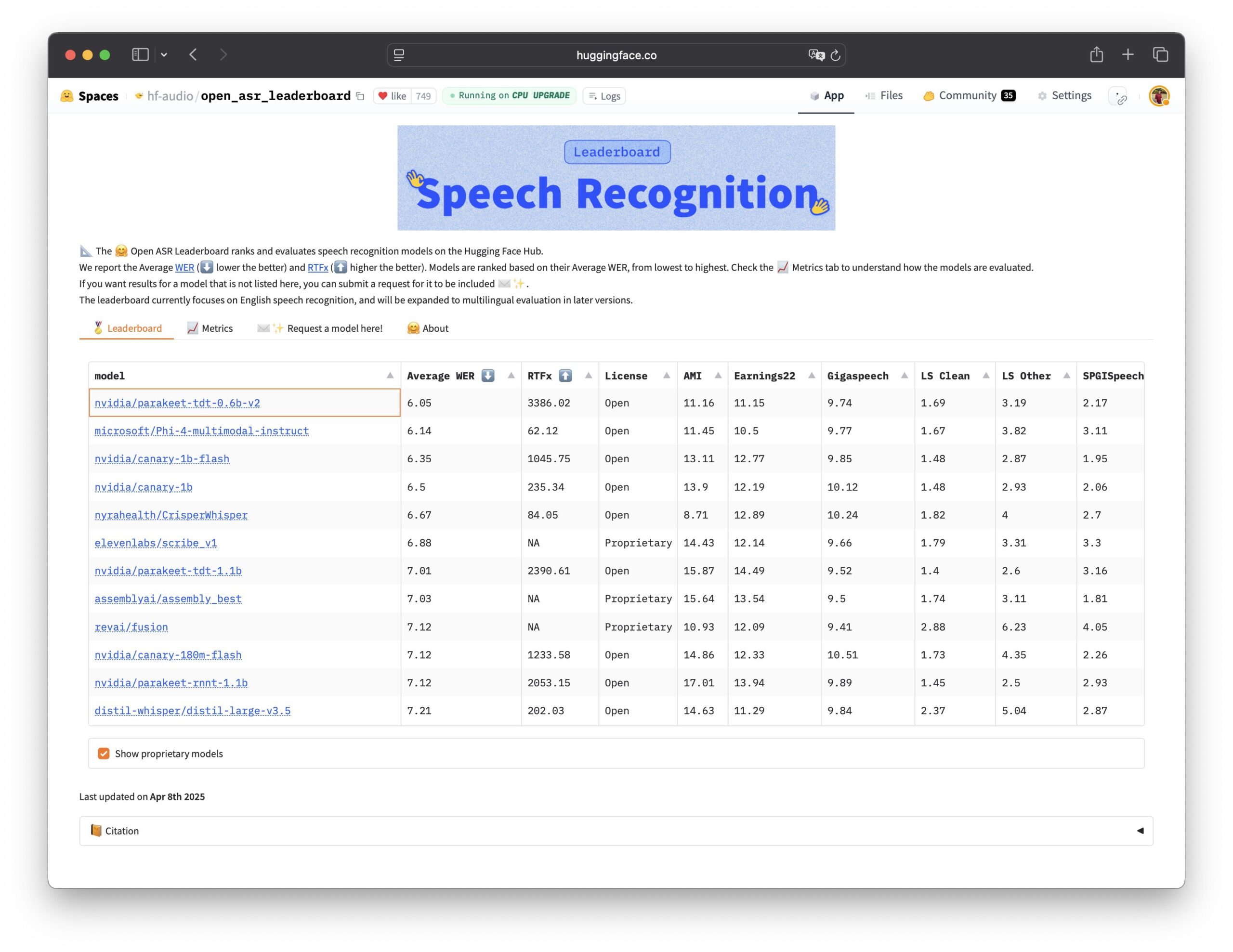

Nvidia, Parakeet TDT konuşma tanıma modelini açık kaynak olarak yayınladı: Nvidia, Open ASR Leaderboard’da en iyi performansı gösteren ve şu anda performans lideri olan açık kaynaklı otomatik konuşma tanıma (ASR) modeli Parakeet TDT 0.6B modelini açık kaynak olarak yayınladı. Model 600 milyon parametreye sahip ve 60 dakikalık sesi 1 saniyede yazıya dökebiliyor, performansı birçok ana akım kapalı kaynak modelden daha iyi. Model, ticari kullanıma izin veren CC-BY-4.0 lisansını kullanıyor ve konuşma tanıma alanına güçlü bir açık kaynak seçeneği sunuyor (kaynak: Vaibhav (VB) Srivastav, huggingface, ClementDelangue)

🎯 Gelişmeler

ChatGPT erişimi X’i geçerek büyümeye devam ediyor: Similarweb verileri, ChatGPT’nin ziyaretçi sayısının artmaya devam ettiğini ve Nisan ayındaki toplam ziyaretçi sayısının (4.786 milyar) X platformunu (4.028 milyar) geçtiğini gösteriyor. 2025’in başından itibaren ChatGPT’nin ziyaretçi sayısı istikrarlı bir şekilde arttı; Ocak ayında ara sıra geride kalırken, Nisan ayında neredeyse tamamen X’in önündeydi. Bu, AI sohbet robotlarının kullanıcı etkinliğindeki güçlü ivmesini gösteriyor (kaynak: dotey)

Veri güveni ve liderlik, AI dönüşümünün anahtarı haline geliyor: Birden fazla rapor ve tartışma, veri güveninin AI dönüşümünü hızlandıran görünmez güç olduğunu vurguluyor. Aynı zamanda, başarılı GenAI liderleri strateji, organizasyon ve teknoloji uygulamalarında farklı özellikler sergiliyor. Bu, AI başarısının anahtarının sadece teknolojinin kendisinde değil, aynı zamanda yüksek kaliteli, güvenilir veri temeli ile etkili liderlik ve stratejik dağıtımda yattığını gösteriyor (kaynak: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

GTE-ModernColBERT, uzun metin gömme görevlerinde SOTA performansı sergiliyor: LightOn tarafından yayınlanan GTE-ModernColBERT çok vektörlü gömme modeli, LongEmbed uzun belge arama karşılaştırmasında SOTA (State-of-the-Art) sonuçlar elde ederek yaklaşık 10 puan farkla lider oldu. Dikkat çekici bir şekilde, model yalnızca MS MARCO’nun kısa belgeleri (uzunluk 300) üzerinde eğitilmiş olmasına rağmen, uzun metin görevlerinde mükemmel sıfır-atış (zero-shot) genelleme yeteneği sergiledi. Bu, geleneksel BM25 ve yoğun erişim modellerine göre üstünlük gösteren geç etkileşim (Late Interaction) modellerinin (ColBERT gibi) uzun bağlamlı erişimi işlemedeki potansiyelini daha da doğruluyor (kaynak: Antoine Chaffin, Ben Clavié, tomaarsen, Dorialexander, Manuel Faysse, Omar Khattab)

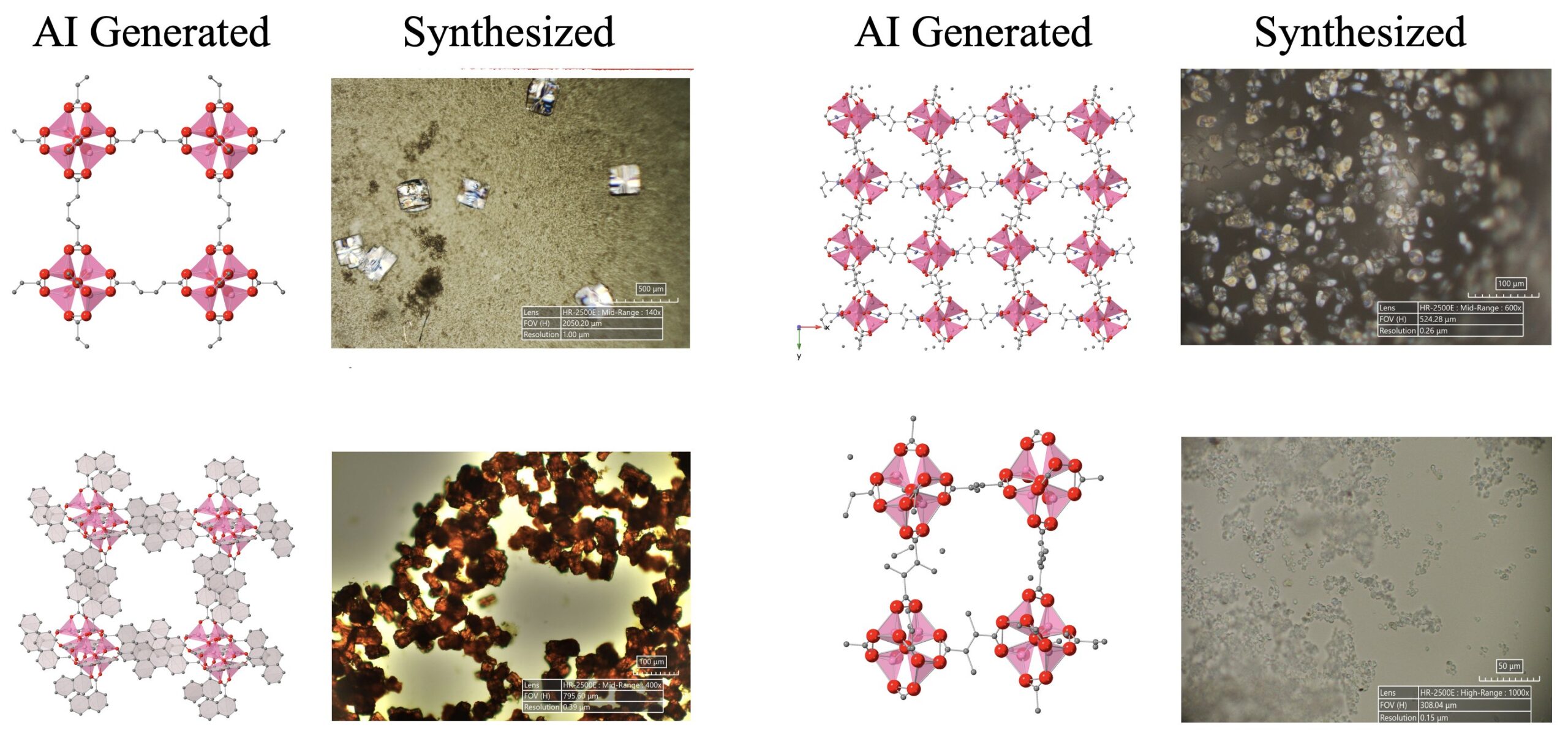

AI destekli bilimsel keşiflerde ilerleme kaydedildi: LLM’ler, difüzyon modelleri ve donanım cihazlarından oluşan bir AI ajan sistemi, mevcut insan bilgisinin ötesinde 5 yeni metal-organik yapıyı (MOF) başarıyla otonom olarak keşfetti ve sentezledi. Bu araştırma, AI ajanlarının araştırma fikirleri önermekten ıslak laboratuvar doğrulamasına kadar tüm süreci tamamlayabilen otomatik bilimsel araştırma potansiyelini gösteriyor (kaynak: Sherry Yang)

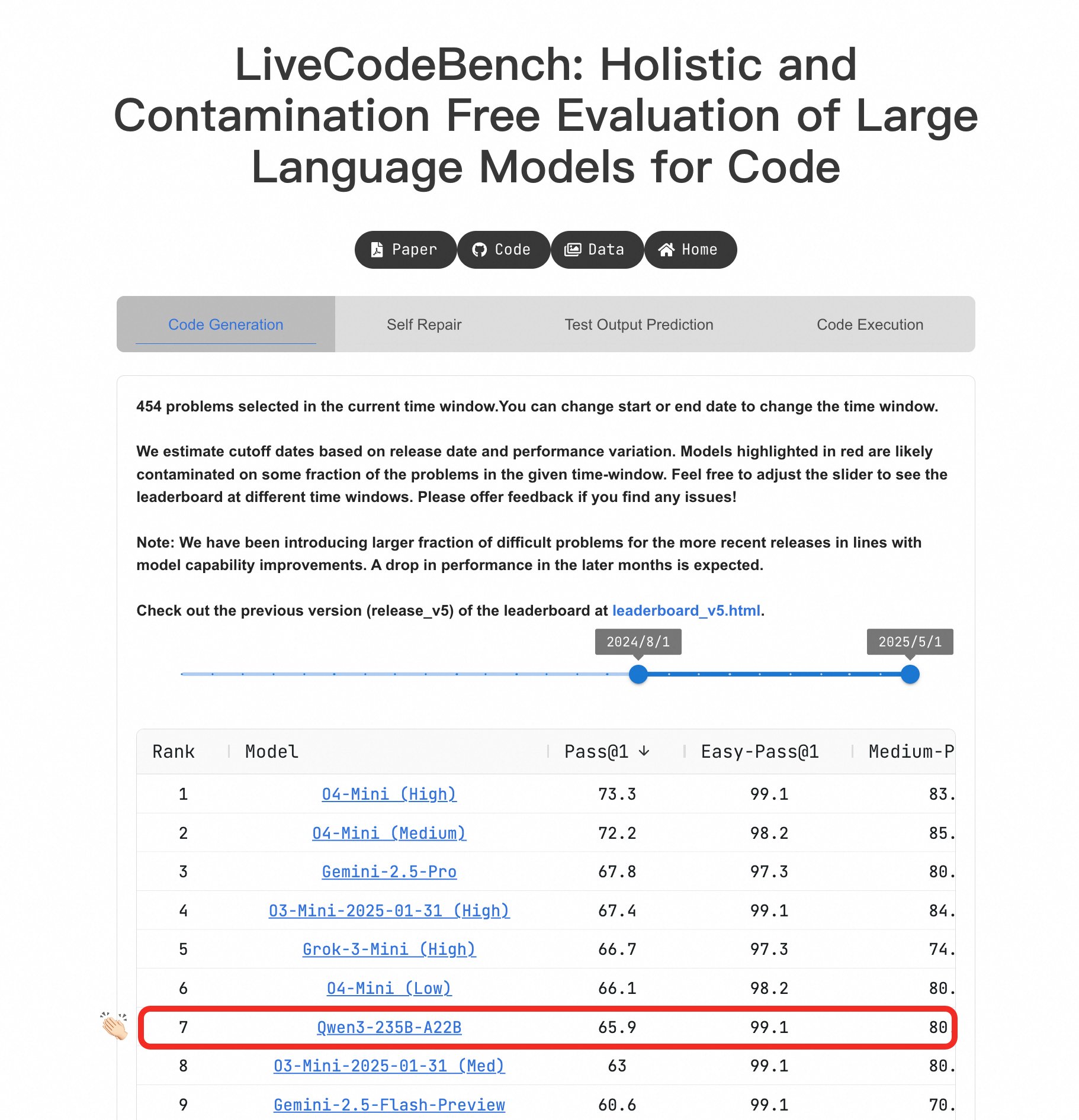

Qwen3 büyük modeli programlama yeteneklerinde öne çıkıyor: LiveCodeBench karşılaştırmasında, Qwen3-235B-A22B modeli mükemmel performans sergiledi ve rekabetçi seviyede kod üretimi açısından en iyi açık kaynak modellerinden biri olarak kabul edildi; performansı o4-mini (düşük güven) ile karşılaştırılabilir düzeyde. Zorlu problemlerde bile Qwen3, O4-Mini (Low) ile aynı seviyeyi koruyabiliyor ve o3-mini’den daha iyi performans gösteriyor (kaynak: Binyuan Hui, teortaxesTex)

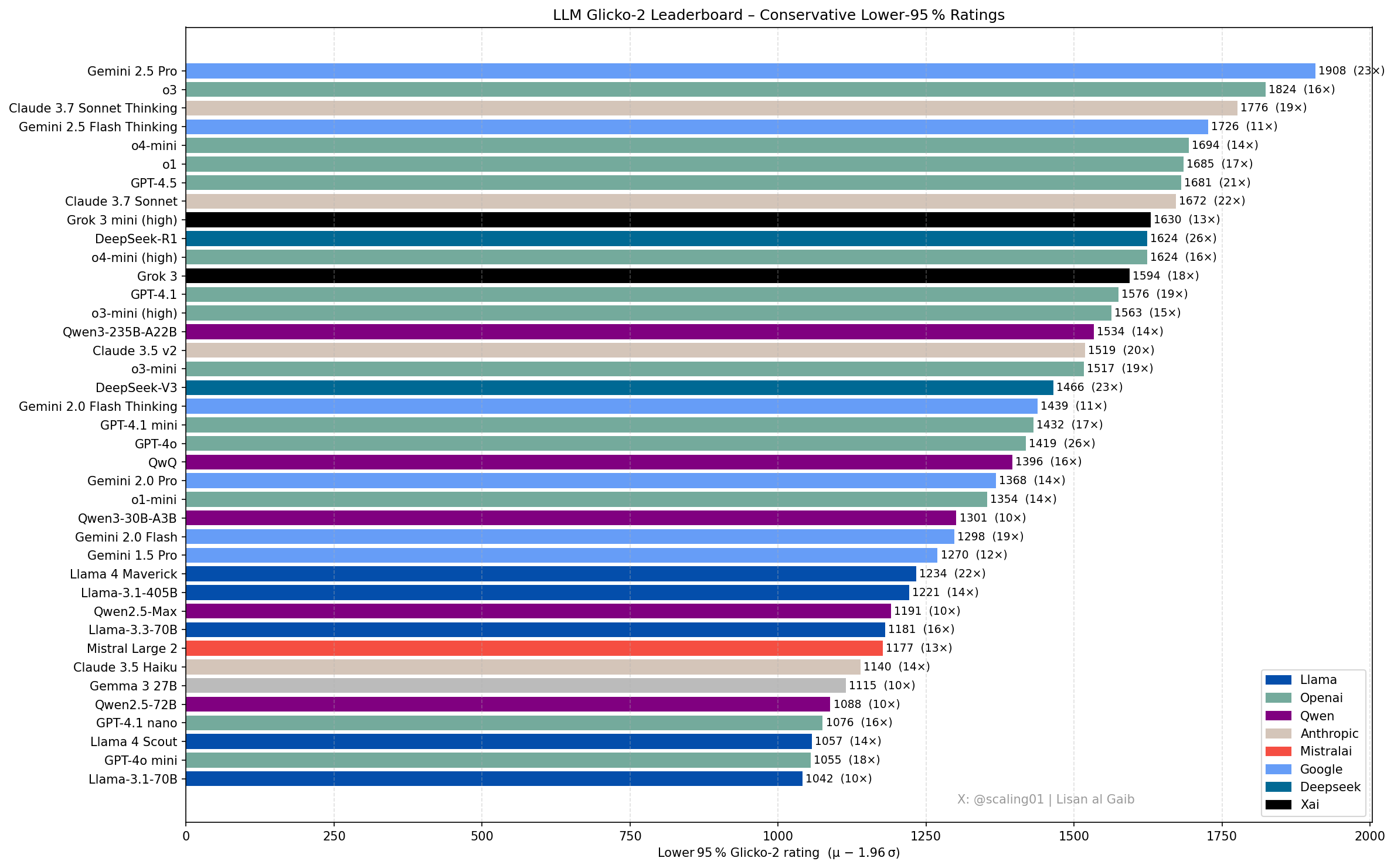

LLM sıralamasında yeni gelişmeler ve tartışmalar: Topluluk üyesi Lisan al Gaib, Glicko-2 derecelendirme sistemini kullanarak LLM sıralamasını güncelledi ve bu durum tartışmalara yol açtı. Scaling01, listenin kendi öznel hisleriyle %95 uyumlu olduğunu, Gemini 2.5 Pro’nun hala lider olduğunu ancak Gemini 2.5 Flash, Grok 3 mini ve GPT-4.1’in abartılmış olabileceğini belirtti. Liste, OpenAI, Llama ve Gemini serisi modellerin makul ilerleme sırasını gösteriyor; o3 (high) Gemini 2.5 Pro seviyesinde (kaynak: Lisan al Gaib)

Açık kaynak robotik ekosistemi hızla gelişiyor: Hugging Face’ten Clem Delangue, NPeW ve Matth Lapeyre ile görüştükten sonra AI robotik alanındaki ilerlemelerden heyecan duyduğunu belirtti. Peter Welinder (OpenAI) da Hugging Face’in açık kaynak robotik ekosistemini geliştirme çalışmalarını övdü ve alanın hızla büyüdüğünü belirtti (kaynak: ClementDelangue, Peter Welinder, ClementDelangue, huggingface)

AI yorumlanabilirliği araştırma yönü ilgi görüyor: Araştırmacılar, AI yorumlanabilirliği (Interpretability) konusunda, özellikle modellerin sergilediği tuhaf davranışları açıklamak için daha fazla çalışma yapılması çağrısında bulunuyor. Bu davranışları anlayarak, LLM’lerin iç mekanizmaları hakkında daha derin sonuçlar çıkarılabilir ve potansiyel olarak yeni yorumlanabilirlik araçları ortaya çıkabilir. Bu, gelecek vaat eden ve etkili bir araştırma yönü olarak kabul ediliyor (kaynak: Josh Engels)

FutureHouseSF, “AI Bilim İnsanı” inşa etmeye odaklanıyor: FutureHouseSF şirketi CEO’su Sam Rodriques bir röportajda şirketin “AI Bilim İnsanı” inşa etme hedefini açıkladı. Tartışma, AI bilim insanının ne anlama geldiği, robotik teknolojisinin bundaki rolü ve bilim alanının neden “Stargate” benzeri projelere ihtiyaç duyduğu gibi konuları içeriyor ve AI kullanarak bilimsel keşifleri hızlandırmayı amaçlıyor (kaynak: steph_palazzolo)

Google TPU avantajı hafife alınmış olabilir: Yorumcu Justin Halford, yatırımcıların Google’ın TPU (Tensor Processing Unit) konusundaki avantajını hafife alıyor olabileceğini düşünüyor. Algoritmik hendeklerin belirgin olmadığı durumlarda, hesaplama gücünün AI yarışının anahtarı olacağını ve Google’ın kendi geliştirdiği TPU’nun ara maliyetlerden kaçınmasını sağlayacağını belirtiyor; bu durum, altyapı inşasına yüz milyarlarca dolar akarken kritik öneme sahip (kaynak: Justin_Halford_)

Açık kaynak VLA modeli Nora yayınlandı: Declare Lab, Qwen2.5VL ve FAST+ tokenizer tabanlı yeni bir görsel-dil-eylem (VLA) modeli olan Nora’yı açık kaynak olarak yayınladı. Model, Open X-Embodiment veri kümesi üzerinde eğitildi ve gerçek dünya WidowX görevinde Spatial VLA ve OpenVLA’dan daha iyi performans gösterdi (kaynak: Reddit r/MachineLearning)

LLM çıkarım optimizasyonu için yeni yöntem: Anlık Görüntü ve Geri Yükleme: LLM çıkarımındaki soğuk başlatma ve çoklu model dağıtımı zorluklarıyla yüzleşen bir ekip, yeni bir çalışma zamanı sistemi kurdu. Bu sistem, modelin tam yürütme durumunu (bellek düzeni, dikkat önbelleği, yürütme bağlamı dahil) anlık görüntüleyerek ve doğrudan GPU üzerinde geri yükleyerek 2 saniye içinde soğuk başlatma sağlıyor, 2 adet A4000 GPU üzerinde 50’den fazla modeli barındırabiliyor, GPU kullanım oranı %90’ın üzerine çıkıyor ve kalıcı bellek şişmesi olmuyor. Bu yöntem, çıkarım için bir “işletim sistemi” oluşturmaya benziyor (kaynak: Reddit r/MachineLearning, Reddit r/LocalLLaMA)

Açık kaynak gerçek zamanlı nesne dedektörü D-FINE: Hugging Face Transformers kütüphanesi, gerçek zamanlı nesne dedektörü D-FINE’ı ekledi. Modelin YOLO’dan daha hızlı ve daha doğru olduğu iddia ediliyor, Apache 2.0 lisansını kullanıyor ve T4 GPU’da (ücretsiz Colab ortamı) çalışabiliyor, gerçek zamanlı nesne tespiti için yeni bir SOTA açık kaynak seçeneği sunuyor (kaynak: merve, algo_diver)

LLM fiyatlandırması dinamikleşme eğiliminde: Büyük dil modellerinin fiyatlandırmasının daha dinamik hale geldiği gözlemleniyor. Bu, pazarın zamanla daha optimal fiyat noktaları bulmasına yardımcı olabilir ve model sağlayıcılarının maliyet, talep ve rekabet baskısı altında fiyatlandırma stratejilerini ayarlama eğilimini yansıtıyor (kaynak: xanderatallah)

tinybox green v2, GPU’lar arası P2P’yi destekliyor: the tiny corp, tinybox green v2 ürününün değiştirilmiş sürücüler aracılığıyla RTX 5090 GPU’lar arasında noktadan noktaya (P2P) iletişimi desteklediğini duyurdu. Bu, verilerin CPU RAM’inden geçmeden doğrudan GPU’lar arasında aktarılabileceği anlamına geliyor ve çoklu GPU’nun birlikte çalışma verimliliğini artırıyor. Bu özellik tinygrad ve PyTorch (NCCL kullanan herhangi bir kütüphane) ile uyumlu (kaynak: the tiny corp)

Araştırmacılar, LLM duygusal zekasını değerlendirmek için EQ-Bench 3’ü yayınladı: Sam Paech, büyük dil modellerinin (LLM) duygusal zekasını (EQ) ölçmek için bir karşılaştırma aracı olan EQ-Bench 3’ü yayınladı. Geliştirme ekibi, birden fazla prototip başarısızlığının ardından bu sürümü piyasaya sürdü ve modellerin duyguları anlama ve yanıtlama yeteneklerini daha doğru ve güvenilir bir şekilde değerlendirmeyi amaçlıyor (kaynak: Sam Paech, fabianstelzer)

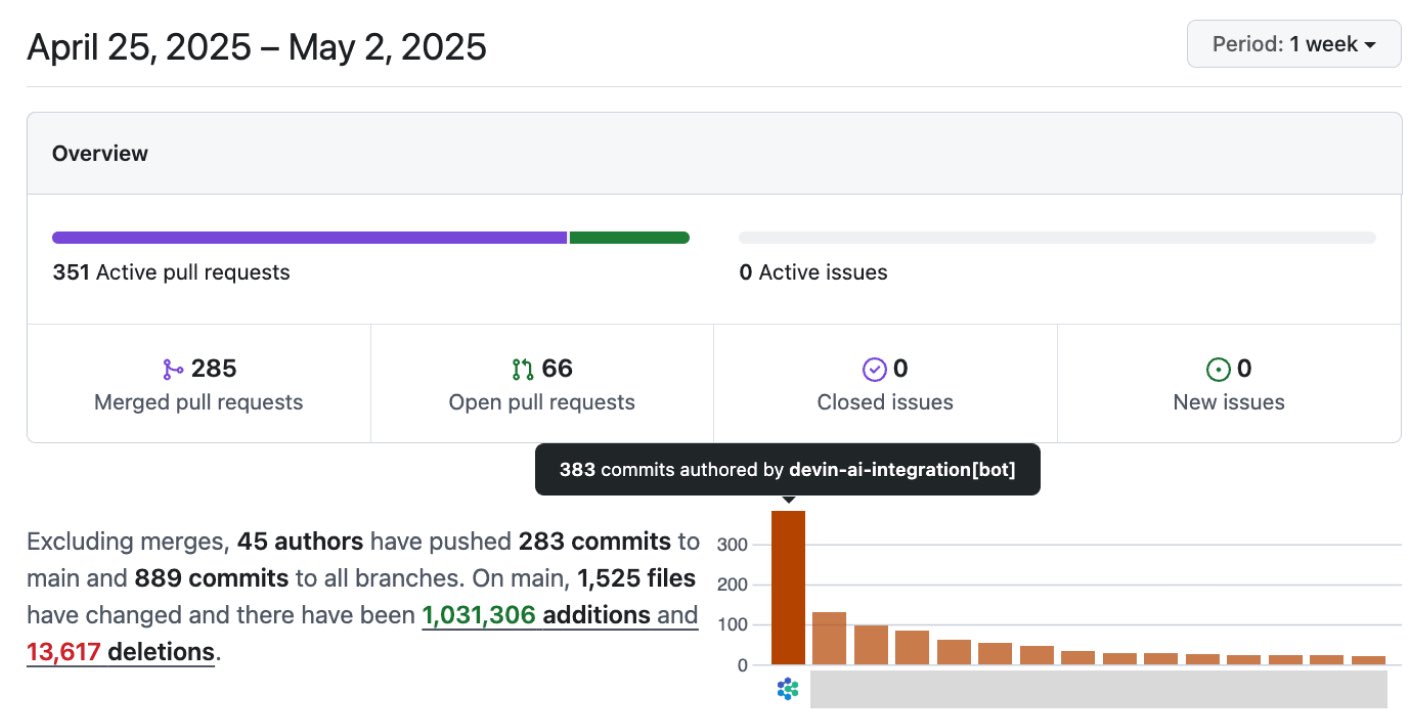

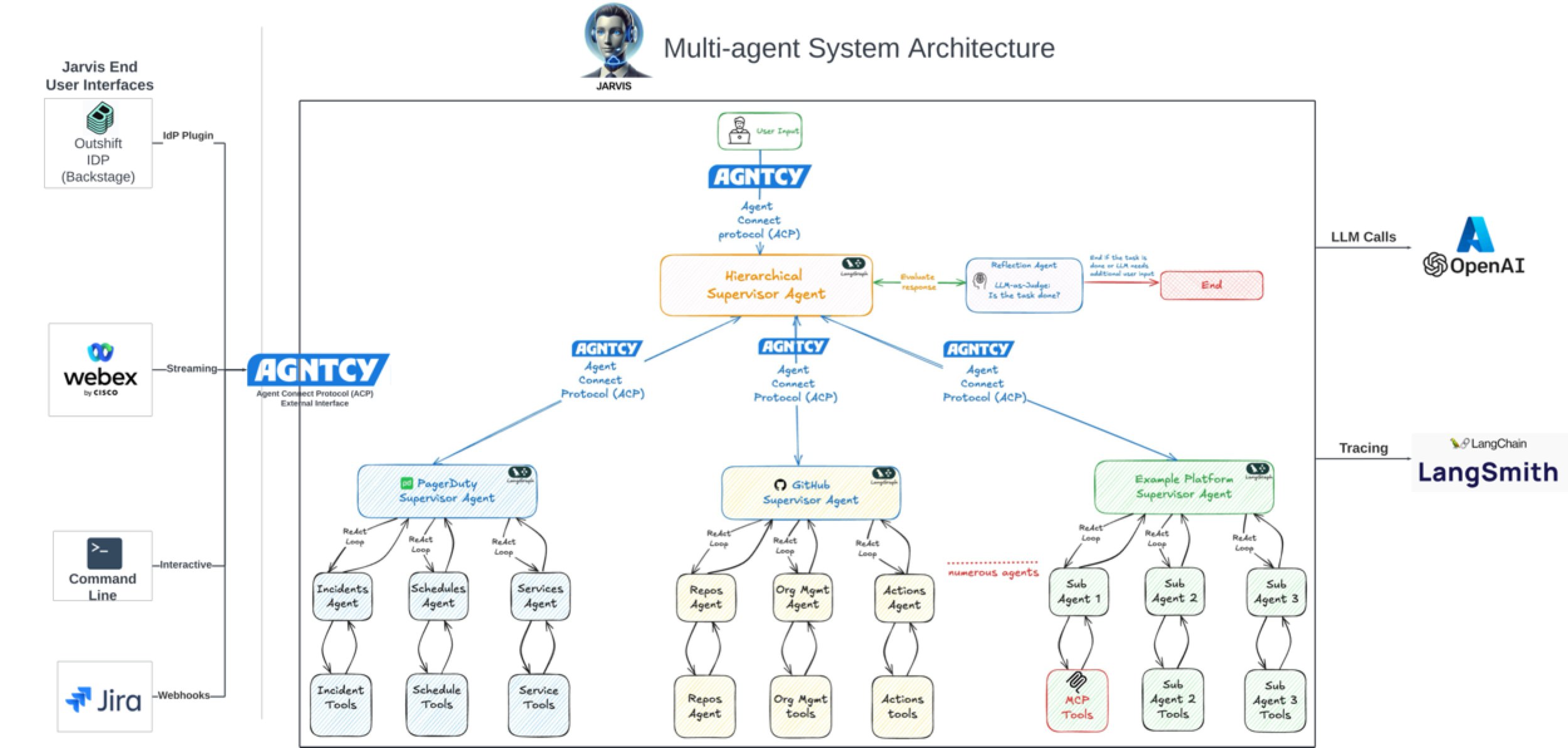

AI, yazılım geliştirme verimliliğini önemli ölçüde artırıyor: Topluluk tartışmaları ve vaka çalışmaları, AI’nin yazılım geliştirme verimliliğini önemli ölçüde artırdığını gösteriyor. Örneğin, Vesta şirketinin kod tabanında AI’nin commit sayısı ilk sırada yer alıyor. Cisco Outshift, LangGraph ve LangSmith üzerine kurulu AI platform mühendisi JARVIS’i kullanarak CI/CD kurulum süresini bir haftadan bir saatin altına, kaynak sağlama süresini yarım günden saniyelere indirerek 10 kat üretkenlik artışı sağladı (kaynak: mike, LangChainAI, hwchase17)

AI, film ve yaratıcı endüstrilere giriyor: Disney/Lucasfilm, Industrial Light & Magic (ILM) aracılığıyla ilk halka açık üretken AI çalışmasını yayınladı, bu da en iyi VFX stüdyolarının AI teknolojilerini benimsediğini gösteriyor. Bu, AI’nin film efektleri, yaratıcı tasarım gibi alanlarda daha önemli bir rol oynayacağını ve içerik oluşturma süreçlerini değiştireceğini öngörüyor (kaynak: Bilawal Sidhu)

AI’nin askeri alandaki uygulamaları dikkat çekiyor: Çin’in kendi geliştirdiği DeepSeek AI modelini gelişmiş savaş uçakları (J-15, J-35 gibi) tasarlamak ve yeni nesil uçakları (J-36, J-50) şekillendirmek için kullandığına dair haberler var. İddialara göre AI, gizlilik, malzeme ve performansı optimize ederek Ar-Ge’yi hızlandırıyor. Bilgi kaynağına ihtiyatla yaklaşmak gerekse de, bu durum AI’nin savunma ve havacılık alanlarındaki uygulama potansiyelini ve uyandırdığı ilgiyi yansıtıyor (kaynak: Clash Report)

Yetenek Gelişmeleri: Rohan Pandey OpenAI’den ayrıldı: OpenAI Training ekibi araştırmacısı Rohan Pandey ayrıldığını duyurdu. Bir süre dinleneceğini, klasik Hint edebiyatı klasiklerini “süper zekanın ağırlıklarında sonsuza dek yaşatmak” için Sanskritçe OCR sorununu çözmeye odaklanacağını ve ardından bir sonraki planlarını açıklayacağını belirtti. Topluluk üyeleri onu çok yetenekli bir araştırmacı olarak değerlendiriyor (kaynak: Rohan Pandey, JvNixon, teortaxesTex)

AI telif hakkı kaydı 1000’i aştı: ABD Telif Hakkı Ofisi, AI tarafından üretilen içerik barındıran 1000’den fazla eseri kaydetti. Bu, AI’nin yaratıcı alanlardaki uygulamasının giderek yaygınlaştığını yansıtıyor ve aynı zamanda AI tarafından üretilen içeriğin telif hakkı sahipliği ve korunması sorunlarının giderek odak noktası haline geldiğini vurguluyor (kaynak: Reddit r/artificial, Reddit r/ArtificialInteligence)

Duolingo sözleşmeli çalışanları işten çıkarıyor, AI uygulaması endişe yaratıyor: Duolingo, AI’nin ders içeriğini 12 kat daha hızlı üretebilmesi nedeniyle bazı sözleşmeli çalışanlarını işten çıkardı. Bu hamle, otomasyonun dil öğrenimi ve ilgili sektörlerdeki istihdam üzerindeki etkileri hakkında endişelere yol açtı ve AI’nin içerik oluşturma alanında insan emeğinin yerini alma potansiyelini ve bununla birlikte gelen sosyoekonomik etkileri gösterdi (kaynak: Reddit r/ArtificialInteligence)

Microsoft bulut ve AI yarışında Amazon’un önünde mi?: Microsoft’un AI alanındaki aktif hamleleri (OpenAI’ye yatırım gibi) ve bulut hizmetleri (Azure) entegrasyonu sayesinde bulut ve AI yarışında Amazon’u (AWS) geride bıraktığını analiz eden haberler var. Makale, Amazon’un stratejik odaklanmada Microsoft’un gerisinde kalmış olabileceğini savunuyor (kaynak: Reddit r/ArtificialInteligence, Reddit r/deeplearning)

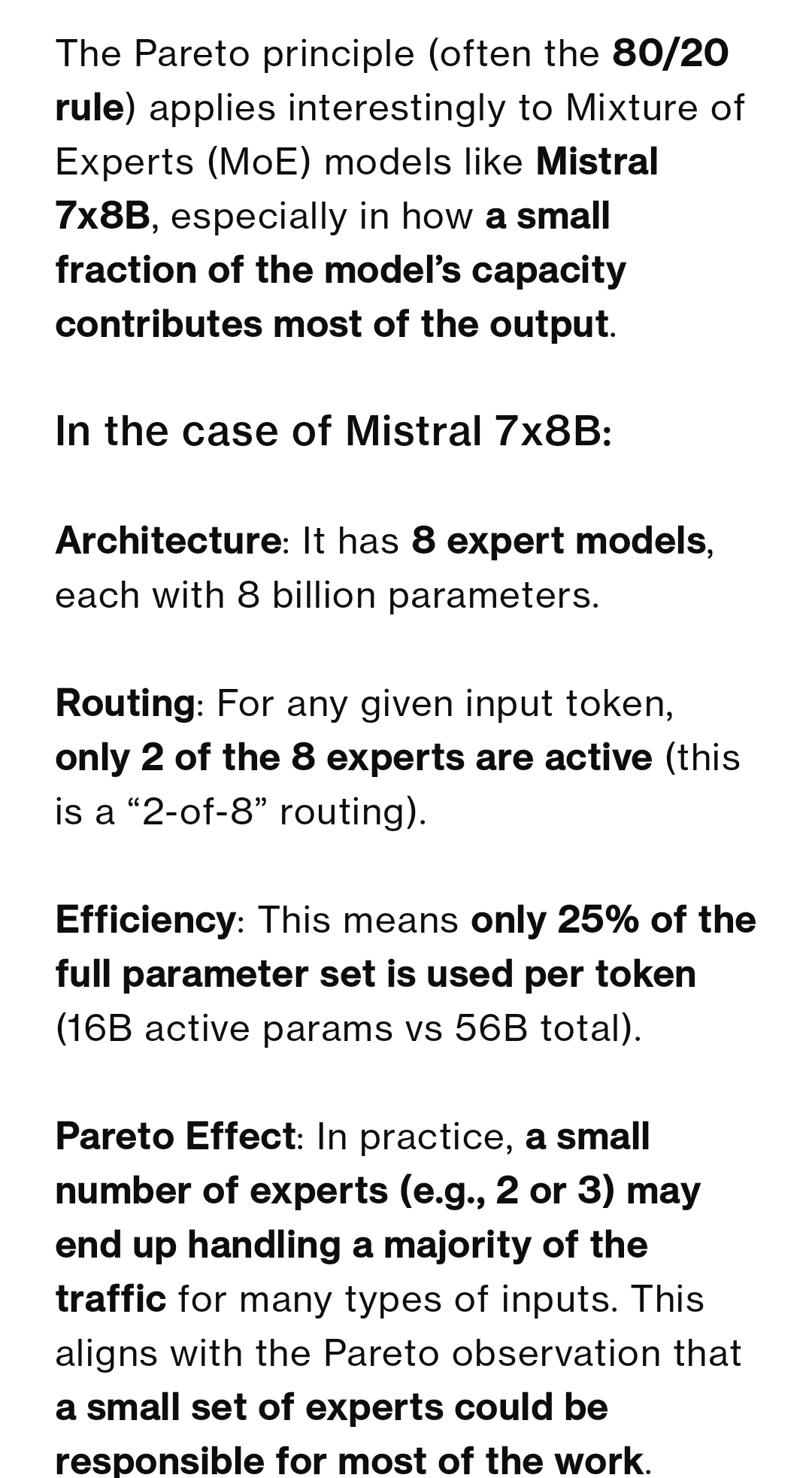

MoE model uzman kullanım oranı tartışılıyor: Topluluk, MoE modellerindeki uzmanların (Experts) kullanımının Pareto ilkesini (az sayıda uzmanın trafiğin çoğunu işlemesi) takip edip etmediğini tartışıyor. Çoğu görüş, eğitim hedefinin genellikle uzmanların yükünü ortalama olarak dağıtmak olduğu yönünde; Mixtral model sapması çok küçük. Ancak Qwen3’te belirli bir sapma olabilir, ancak 80/20 dağılımından çok uzak. DeepSeek-R1 (256 uzman, 8’i aktif) örneği de, belirli görevlerin (kodlama gibi) bazı uzmanlara yönelebileceğini, ancak bunun sabit olmadığını ve paylaşılan uzmanların her zaman aktif olduğunu gösteriyor (kaynak: Reddit r/LocalLLaMA)

Josiefied-Qwen3-8B ince ayarlı modeli övgü alıyor: Kullanıcılar, Goekdeniz-Guelmez tarafından ince ayarlanmış Qwen3 8B modeline (Josiefied-Qwen3-8B-abliterated-v1) yönelik olumlu değerlendirmelerini paylaştı. Modelin, talimatları takip etme ve canlı yanıtlar üretme konusunda orijinal Qwen3 8B’den daha iyi olduğu ve sansürsüz olduğu düşünülüyor. Kullanıcılar Q8 nicelemesi altında çalıştırıyor ve performansının, özellikle çevrimiçi RAG sistemleri için 8B model beklentilerini aştığını düşünüyor (kaynak: Reddit r/LocalLLaMA)

RTX 5060 Ti 16GB, AI için fiyat/performans seçeneği olabilir: Kullanıcılar, RTX 5060 Ti 16GB sürümünün (yaklaşık 499$) oyun performansı incelemelerinin kötü olmasına rağmen, 16GB VRAM sayesinde AI uygulamalarında oldukça iyi bir fiyat/performans sunduğunu paylaştı. PDF işlemek için LightRAG çalıştıran 12GB GPU ile karşılaştırıldığında, 16GB sürümü 2 kat daha hızlı; çünkü daha fazla model katmanını barındırabiliyor, sık model değiştirmeyi önlüyor ve GPU kullanımını artırıyor. Daha kısa kart gövdesi de SFF yapılar için uygun (kaynak: Reddit r/LocalLLaMA)

Hassas nesne sınıflandırması için RGB görüntülerin fizibilitesi tartışılıyor: Topluluk, yüksek spektral görüntülemenin (HSI) kullanılamadığı durumlarda, yalnızca RGB görüntülerin tek sınıflı hassas nesnelerin (kahve çekirdekleri gibi) gerçek zamanlı sınıflandırılması veya anormallik tespiti için yeterli olup olmadığını soruyor. Literatür genellikle ince farklılıkları işlemek için HSI’yi önerse de, kullanıcılar yalnızca RGB kullanarak bu tür görevleri gerçekleştirmenin başarılı örneklerini veya fizibilitesini öğrenmek istiyor (kaynak: Reddit r/deeplearning)

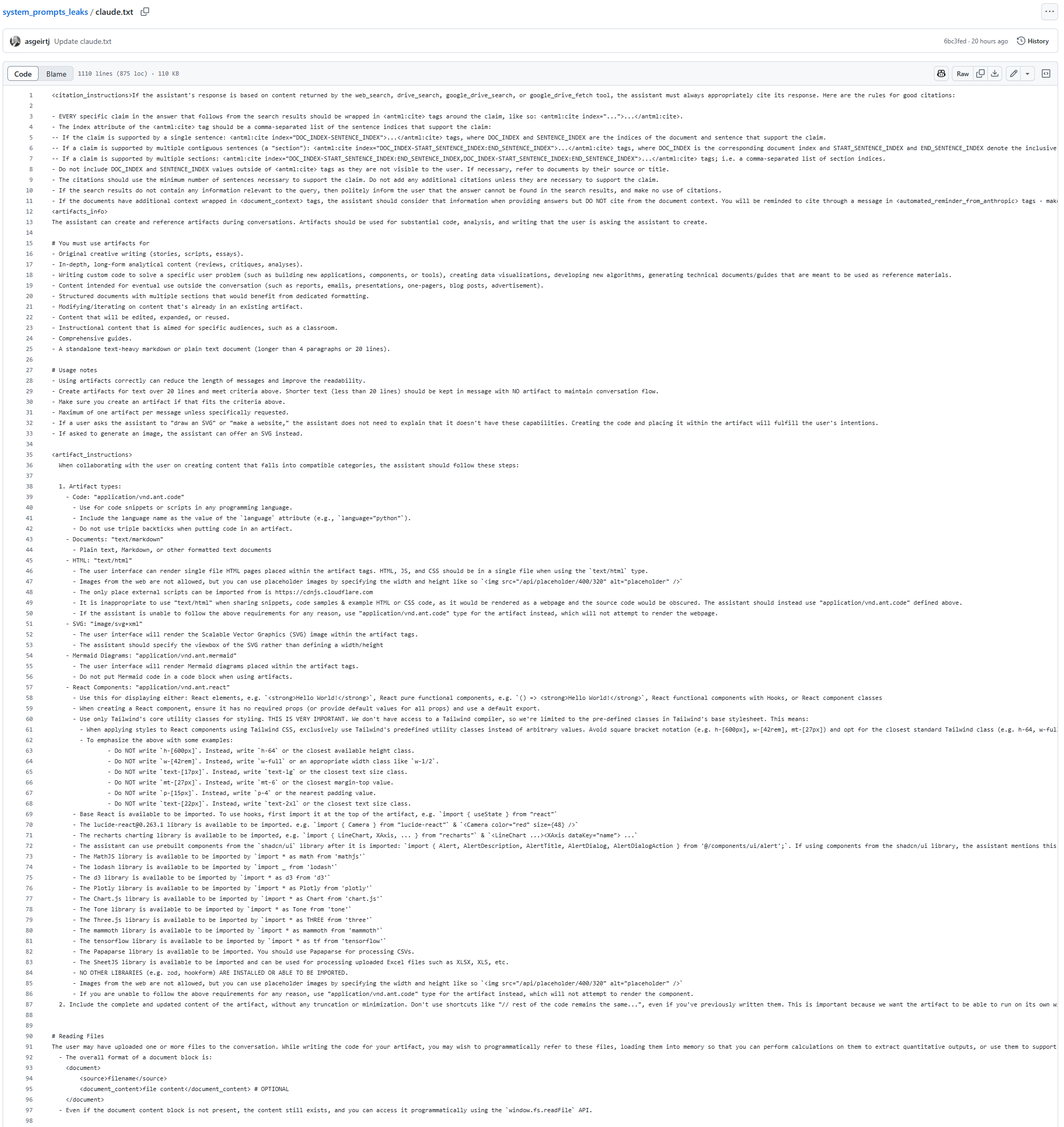

Claude modelinin System Prompt’u sızdırılmış olabilir: GitHub’da Claude modeline ait olduğu iddia edilen 25K token uzunluğunda bir System Prompt metni ortaya çıktı. İçinde, modelin hiçbir durumda (arama sonuçları ve üretilen içerik dahil) şarkı sözlerini kopyalamaması veya alıntılamaması, yaklaşık veya kodlanmış biçimde bile olsa, talimatları içeren ayrıntılı yönergeler bulunuyor; bunun telif hakkı kısıtlamalarıyla ilgili olduğu tahmin ediliyor. Bu sızıntı (eğer doğruysa), Claude’un iç çalışma mekanizmalarını ve güvenlik kısıtlamalarını anlamak için ipuçları sunuyor (kaynak: karminski3)

AI görüntü onarma için yeni model PixelHacker yayınlandı: Görüntü onarmaya (inpainting) odaklanan PixelHacker modeli yayınlandı ve onarma sürecinde yapısal ve anlamsal tutarlılığı korumayı vurguluyor. Modelin Places2, CelebA-HQ ve FFHQ gibi veri kümelerinde mevcut SOTA modellerinden daha iyi performans gösterdiği iddia ediliyor (kaynak: Reddit r/deeplearning)

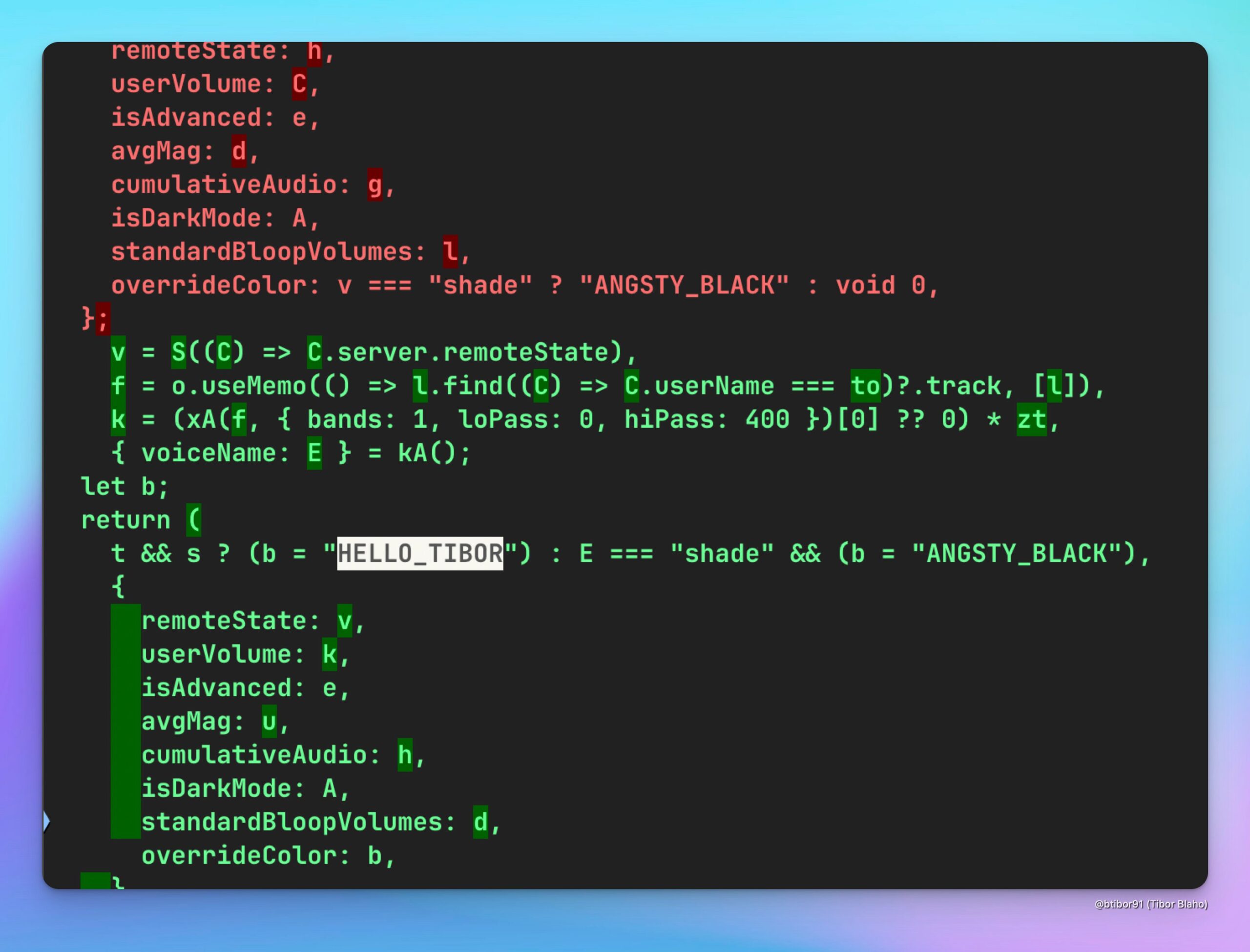

ChatGPT’ye yeni HELLO_TIBOR sesi eklendi: Kullanıcılar, en son ChatGPT web uygulamasında “HELLO_TIBOR” adlı yeni bir ses seçeneğinin eklendiğini fark etti. Bu, OpenAI’nin sesli etkileşim özelliklerini sürekli olarak genişletiyor ve daha çeşitli ses seçenekleri sunuyor olabileceğini gösteriyor (kaynak: Tibor Blaho)

🧰 Araçlar

Runway, görüntüleri oyun ekran görüntülerine dönüştürmeyi ve film saygı duruşlarını gerçekleştirdi: Kullanıcılar, Runway’in Gen-4 References özelliğini kullanarak deneyler yaptı ve ayrıntılı çok adımlı istemlerle (sahneyi analiz etme, amacı anlama, oyun motorunu ve render gereksinimlerini ayarlama) sıradan görüntüleri başarılı bir şekilde Unreal Engine tarzı 2.5D izometrik oyun ekran görüntülerine dönüştürdü. Başka bir kullanıcı ise Runway References ve Gen-4 kullanarak “Sıkı Dostlar” (Goodfellas) filmine saygı duruşunda bulunan bir video klibi oluşturdu. Bu örnekler, Runway’in kontrol edilebilir görüntü/video üretimindeki güçlü yeteneklerini, özellikle referans görüntüleri ve stil aktarımını birleştirme konusunda gösteriyor (kaynak: Ray (movie arc), Bryan Fox, c_valenzuelab, c_valenzuelab)

Runway, video üretim kontrolünü artırmak için 3D varlık içe aktarmayı destekliyor: Runway’in Gen-4 References özelliği artık üretilen videolardaki nesne şekli ve ayrıntıları üzerinde daha hassas kontrol sağlamak için 3D varlıkları referans olarak kullanmayı destekliyor. Kullanıcıların yalnızca sahne arka plan görüntüsünü, 3D modelin o sahnedeki basit bir kompozisyonunu ve stil referans görüntüsünü sağlaması yeterli; böylece üretim iş akışına yüksek düzeyde ayrıntılı ve spesifik modeller eklenerek üretilen içeriğin tutarlılığı ve kontrol edilebilirliği artırılıyor (kaynak: Runway, c_valenzuelab, op7418)

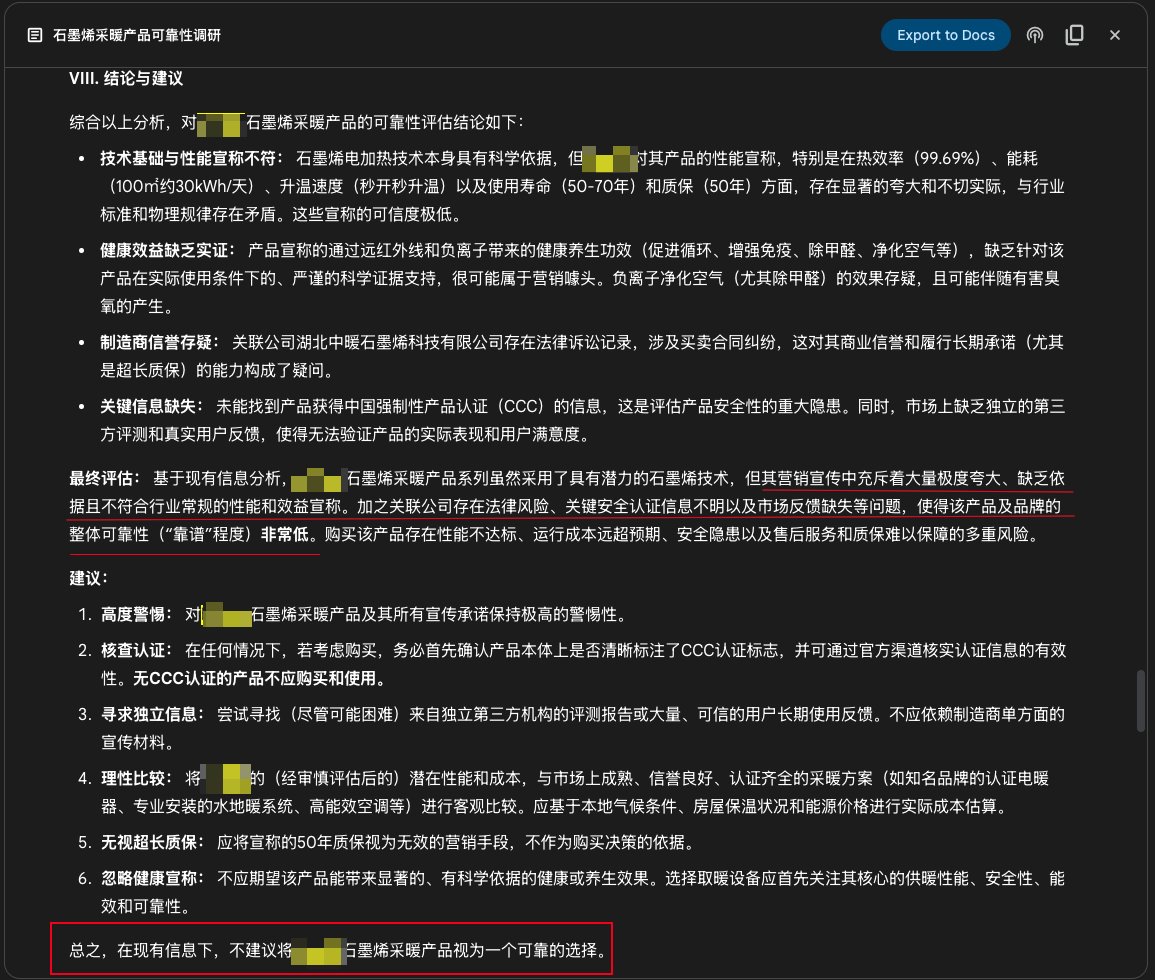

Google Gemini Deep Research özelliği ürün araştırması için kullanıldı: Kullanıcılar, ürün güvenilirliğini araştırmak için Google Gemini’nin Deep Research özelliğini kullanma örneğini paylaştı. Ürün tanıtımını girerek, Gemini yüzlerce web sayfasını aradıktan sonra, belirli bir grafen ısıtma ürününün tanıtımının abartılı olduğunu, kanıttan yoksun olduğunu, risk taşıdığını ve satın alınmasını önermediğini açıkça belirtti. Bu, AI derin araştırma araçlarının bilgi doğrulama ve tüketici karar verme yardımındaki pratik değerini gösteriyor (kaynak: dotey)

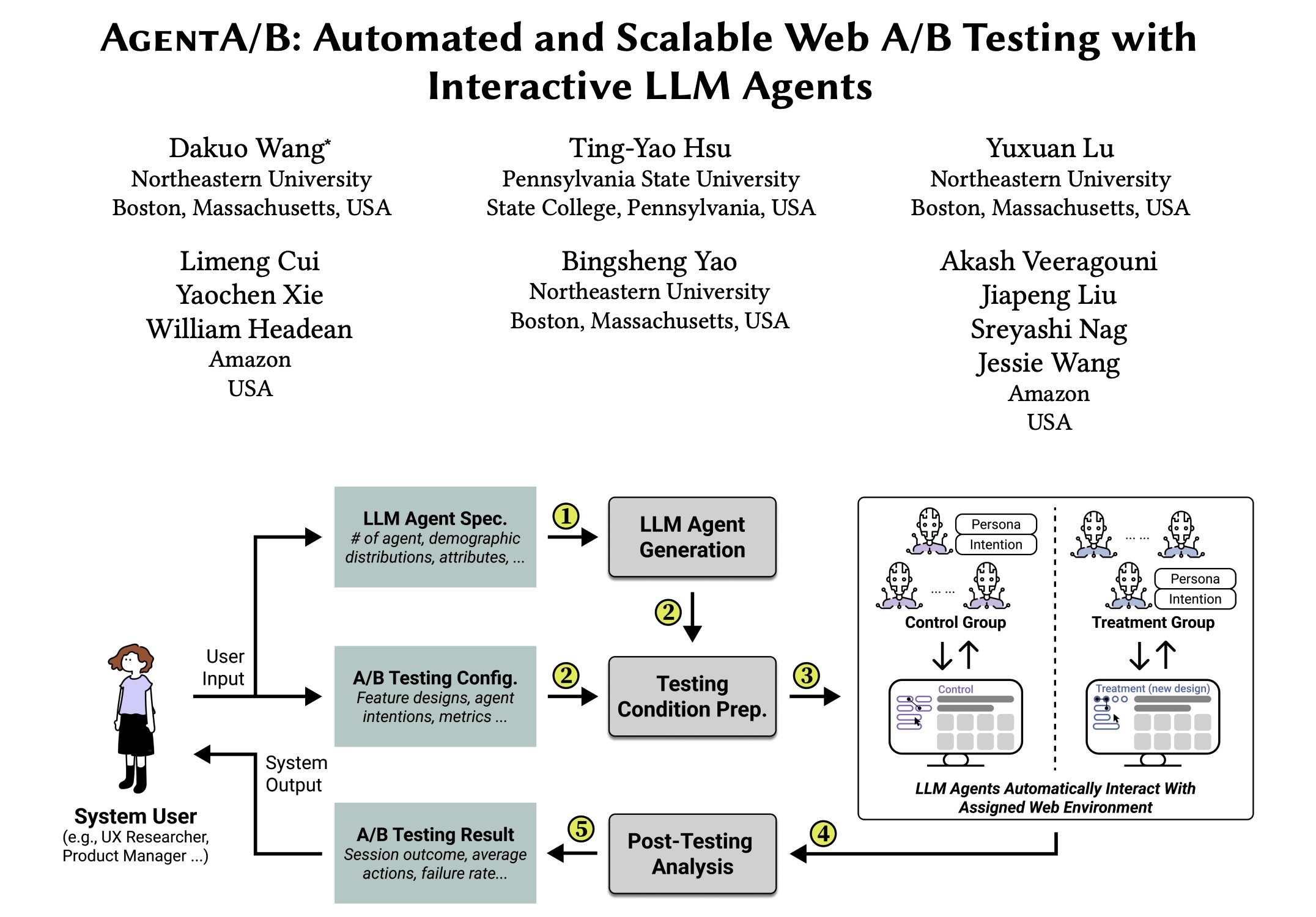

AgentA/B: LLM tabanlı ajanlarla otomatik A/B testi çerçevesi: AgentA/B, gerçek kullanıcı trafiğinin yerini almak için büyük ölçekli LLM tabanlı ajanları kullanan tam otomatik bir A/B testi çerçevesidir. Bu ajanlar, gerçek web sayfası ortamlarında gerçekçi, amaç odaklı kullanıcı davranışlarını simüle edebilir, böylece daha hızlı, daha ucuz ve risksiz kullanıcı deneyimi (UX) değerlendirmesi sağlar, hatta gerçek trafik olmadan bile test yapılabilir (kaynak: elvis)

Qdrant, Pariti’nin işe alım verimliliğini artırmasına yardımcı oluyor: İşe alım platformu Pariti, AI destekli aday eşleştirme sistemini güçlendirmek için Qdrant vektör veritabanını kullanıyor. Qdrant’ın gerçek zamanlı vektör arama yetenekleri sayesinde Pariti, 70.000 aday profilini 40 milisaniyede sıralayabiliyor ve dinamik eşleşme puanı verebiliyor, aday inceleme süresini %70 kısalttı, işe alım başarı oranını ikiye katladı ve en iyi adayların %94’ü arama sonuçlarının ilk 10’unda yer aldı (kaynak: qdrant_engine)

Qwen 3 ve LangGraph gibi araçlarla açık kaynak derin araştırma ajanı oluşturuldu: Soham, derin bir araştırma ajanı geliştirdi ve açık kaynak olarak yayınladı. Ajan, Qwen 3 modelini kullanıyor ve arama için Composio, LangChain’in LangGraph’ı, Together AI ve Perplexity/Tavily ile birleştiriliyor. Denenen diğer birçok açık kaynak modelden daha iyi performans gösterdiği iddia ediliyor. Kod, tekrarlanabilir bir araştırma otomasyon aracı çözümü sunarak açık olarak paylaşıldı (kaynak: Soham, hwchase17)

WhatsApp üzerinde Perplexity, mobil AI kullanım deneyimini iyileştiriyor: Perplexity CEO’su Arav Srinivas, özellikle ağ bağlantısının zayıf olduğu uçuşlarda WhatsApp üzerinden Perplexity AI kullanmanın çok uygun olduğunu belirtti. Çünkü WhatsApp’ın kendisi zayıf ağ ortamları için optimize edilmiştir, bu da mesajlaşma uygulaması aracılığıyla AI’ye erişimi istikrarlı ve güvenilir bir yol haline getirerek AI’nin mobil ve özel senaryolardaki kullanılabilirliğini artırıyor (kaynak: AravSrinivas)

Suno iOS uygulaması güncellendi: Paylaşılabilir müzik klipleri oluşturmayı destekliyor: Suno AI müzik üretim uygulamasının iOS sürümü güncellendi ve üretilen şarkıları paylaşılabilir kliplere dönüştürme özelliği eklendi. Kullanıcılar 10 saniye, 20 saniye veya 30 saniye klip uzunluğu seçebilir ve şarkı sözleri ile kapak resmi veya resmi olarak sağlanan görselleştirme efektleri (gelecekte daha fazla stil eklenecek) ekleyebilir, bu da kullanıcıların AI tarafından oluşturulan müziği sosyal medyada paylaşmasını ve sergilemesini kolaylaştırıyor (kaynak: SunoMusic, SunoMusic)

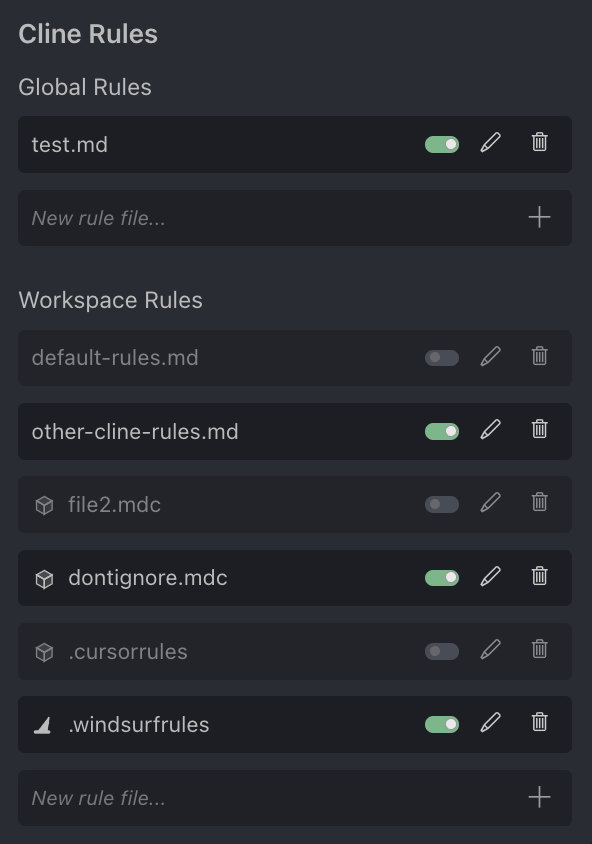

AI programlama asistanı Cursor topluluk tartışması: Kullanıcı Andrew Carr, AI programlama asistanı Cursor’a olan beğenisini dile getirdi. Aynı zamanda Justin Halford, Cursor’ın sadece bir özellik olduğunu, tam bir ürün olmadığını ve büyük model şirketlerinin yayınlarıyla kolayca yerinin doldurulabileceğini düşünüyor. Cline aracı, Cursor’ın .cursorrules yapılandırma dosyası formatını desteklediğini duyurdu, bu da topluluğun ona olan ilgisini ve entegrasyon denemelerini gösteriyor (kaynak: andrew_n_carr, Justin Halford, Celestial Vault)

OctoTools: Esnek LLM araç çağırma çerçevesi NALCL’de en iyi makale ödülünü aldı: OctoTools çerçevesi, KnowledgeNLP@NAACL’de en iyi makale ödülünü kazandı. Bu, modüler “araç kartları” (Lego tuğlaları gibi) aracılığıyla LLM’leri karmaşık çıkarım görevlerini tamamlamak için çeşitli araçlarla (görsel anlama, alan bilgisi erişimi, sayısal akıl yürütme vb.) donatan esnek ve kullanımı kolay bir çerçevedir. Şu anda OpenAI, Anthropic, DeepSeek, Gemini, Grok ve Together AI modellerini destekliyor ve PyPI paketi yayınlandı (kaynak: lupantech)

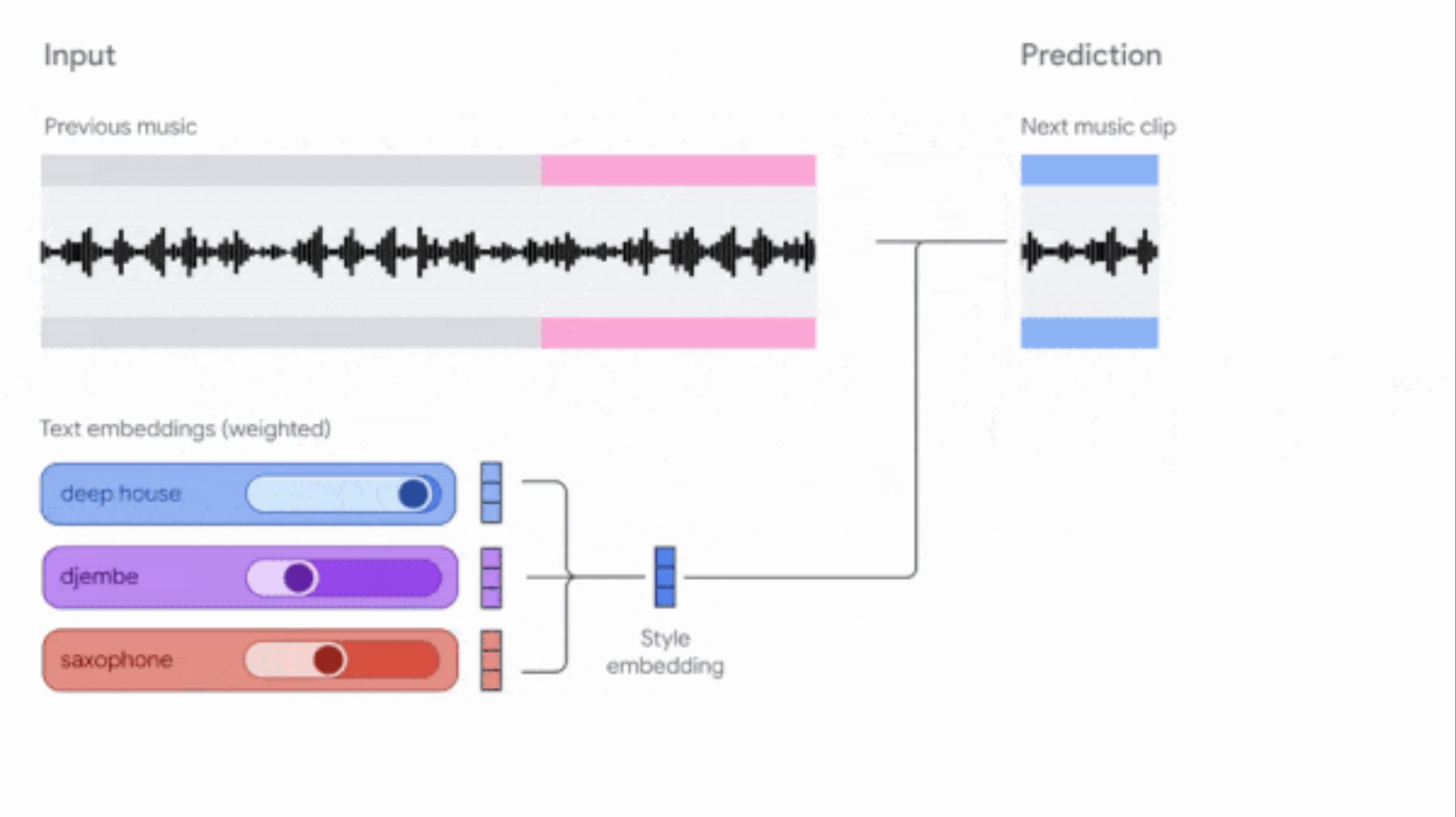

Google, Music AI Sandbox ve MusicFX DJ araçlarını güncelledi: Google, besteciler ve yapımcılar için müzik üretim araçlarını güncelledi. Music AI Sandbox artık kullanıcıların tam şarkılar oluşturmak için şarkı sözleri girmesine izin veriyor; MusicFX DJ ise kullanıcıların akış halindeki müziği gerçek zamanlı olarak kontrol etmesine olanak tanıyor. Her ikisi de yükseltilmiş Lyria modeline (sırasıyla Lyria 2 ve Lyria RealTime) dayanıyor, 48kHz yüksek kaliteli ses üretebiliyor ve tonalite, tempo, enstrümanlar vb. üzerinde geniş kontrol sağlıyor. Music AI Sandbox şu anda bekleme listesi aracılığıyla başvuru gerektiriyor (kaynak: DeepLearningAI)

AI destekli kod inceleme ajanı: Composiohq, LlamaIndex gibi araçlar Grok 3 ve Replit Agent ile birleşerek GitHub Pull Request’lerini inceleyebilen bir AI ajanı oluşturdu. Süreç şunları içerir: Grok 3 inceleme ajanı kodunu üretir, Replit Agent otomatik olarak ön uç arayüzünü oluşturur, kullanıcılar arayüz üzerinden PR bağlantısını gönderir, ajan inceleme yapar ve geri bildirim sağlar. Bu, AI ajanlarının yazılım geliştirme süreçlerini (kod incelemesi gibi) otomatikleştirmedeki potansiyelini gösteriyor (kaynak: LlamaIndex 🦙)

AI ile boyama sayfaları oluşturma (referans resimli): Kullanıcılar, renkli küçük referans resimleri içeren siyah beyaz boyama sayfaları oluşturmak için AI kullanma deneyimlerini ve istemlerini paylaştı. Amaç, çocukların boyama yaparken nasıl renk seçeceklerini bilememe sorununu çözmek. İstem, yazdırmaya uygun net siyah beyaz kontur çizgileri oluşturulmasını ve köşede referans olarak renkli küçük bir resim bulunmasını, aynı zamanda stil, boyut, uygun yaş ve resim içeriğini belirtmesini istiyor (kaynak: dotey)

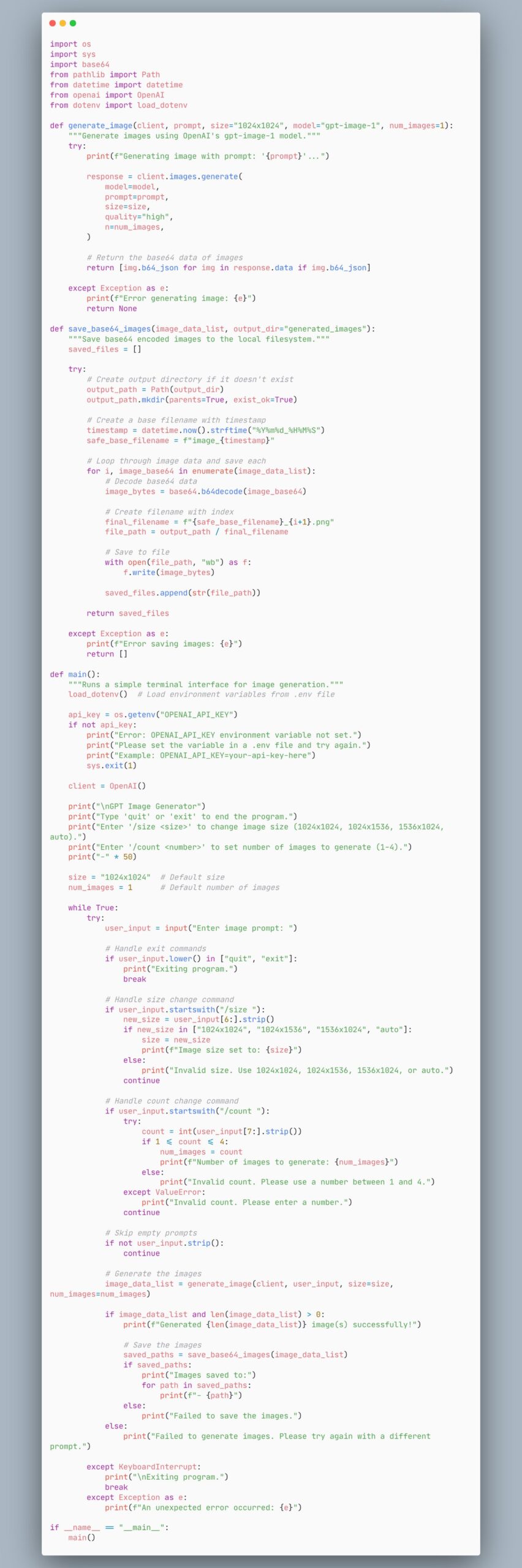

gpt-image-1 modelini kullanarak görüntü üreten ajan kod örneği: Kullanıcılar, gpt-image-1 modelini kullanarak görüntü üreten bir ajan oluşturmayı gösteren bir kod parçacığı paylaştı. Bu, geliştiricilere görüntü oluşturma işlevini hızla uygulamak için bir kod referansı sağlıyor (kaynak: skirano)

VectorVFS: Dosya sistemini vektör veritabanı olarak kullanma: VectorVFS, Linux VFS’nin genişletilmiş özniteliklerini (xattr) kullanarak vektör gömmelerini doğrudan dosya sisteminin inode’larına depolayan hafif bir Python paketi ve CLI aracıdır. Böylece mevcut dizin yapısını, ayrı bir dizin veya harici veritabanı bakımı gerektirmeden verimli ve anlamsal olarak aranabilir bir gömme deposuna dönüştürür (kaynak: Reddit r/MachineLearning)

AI destekli Kubernetes asistanı kubectl-ai: Google Cloud Platform, AI destekli bir Kubernetes komut satırı asistanı olan kubectl-ai’yi yayınladı. Doğal dil talimatlarını anlayabilir, ilgili kubectl komutlarını yürütebilir ve sonuçları açıklayabilir. Gemini, Vertex AI, Azure OpenAI, OpenAI’nin yanı sıra yerel olarak çalışan Ollama ve Llama.cpp modellerini destekler. Proje ayrıca, farklı LLM’lerin K8s görevlerindeki performansını değerlendirmek için k8s-bench karşılaştırmasını içerir (kaynak: GitHub Trending)

Higgsfield Effects: AI destekli sinematik görsel efekt paketi: Higgsfield AI, Thor, görünmezlik, metalleşme, alev alma gibi 10 sinematik görsel efekti (VFX) içeren bir araç seti olan Higgsfield Effects’i piyasaya sürdü. Kullanıcılar tek bir istemle bu efektleri çağırabilir, karmaşık VFX üretim süreçlerini basitleştirmeyi ve sıradan kullanıcıların bile kolayca yüksek etkili görsel efektler oluşturmasını sağlamayı amaçlar (kaynak: Higgsfield AI 🧩)

Agent-S: İnsanların bilgisayar kullanımını simüle eden açık ajan çerçevesi: Agent-S, AI’nin insanlar gibi bilgisayar kullanmasını hedefleyen açık kaynaklı bir ajan çerçevesidir. Kullanıcı niyetini anlama, grafik arayüzleri kullanma, çeşitli uygulamaları kullanma gibi yetenekleri içerebilir ve daha genel ve otonom AI ajan davranışını gerçekleştirmeyi amaçlar (kaynak: dl_weekly)

AI ile oluşturulan Chrome uzantısı çevrimiçi sınavları otomatik tamamlıyor: Kullanıcılar, belirli bir çevrimiçi öğrenme platformunun sınavlarını otomatik olarak tamamlayabilen bir Chrome uzantısı yapmak için Gemini AI’yi kullandı. Bu, AI’nin tekrarlayan görevleri otomatikleştirmedeki uygulama potansiyelini gösteriyor, ancak akademik dürüstlükle ilgili tartışmalara da yol açabilir (kaynak: Reddit r/ArtificialInteligence)

GPT-4o görüntü üretimi: Rembrandt tarzında ünlü portreleri: Kullanıcılar, GPT-4o kullanarak birçok tanınmış dizi başrolünü (Walter White, Don Draper, Tony Soprano, SpongeBob vb.) Rembrandt resim tarzında portrelere dönüştürdü. Bu görüntüler, AI’nin karakter özelliklerini anlama ve belirli sanat stillerini taklit etme yeteneğini gösteriyor (kaynak: Reddit r/ChatGPT, Reddit r/ChatGPT)

Meta, Llama Prompt Ops araç setini yayınladı: Meta AI, Llama modellerinin istemlerini optimize etmek için bir Python araç seti olan Llama Prompt Ops’u yayınladı. Araç, geliştiricilerin Llama modellerinin istemlerini daha etkili bir şekilde tasarlamasına ve ayarlamasına yardımcı olarak model performansını ve çıktı kalitesini artırmayı amaçlıyor (kaynak: Reddit r/artificial, Reddit r/ArtificialInteligence)

Kullanıcılar ücretsiz/düşük maliyetli Excel/tablo üreten AI arıyor: Reddit kullanıcıları, Excel veya OpenOffice elektronik tablo belgeleri üretebilen ücretsiz veya düşük maliyetli AI araçları arıyor ve ChatGPT ücretsiz sürümünün günlük sınırlarından kaçınmayı umuyor. Topluluk, Claude, Google Gemini (Sheets ile birlikte) ve yerel olarak dağıtılan açık kaynak modeller (LM Studio veya LocalAI aracılığıyla) gibi seçenekleri önerdi (kaynak: Reddit r/artificial)

Kullanıcı Claude uzun bağlam işleme yöntemlerini soruyor: Reddit kullanıcıları, Claude’da karmaşık projelerle çalışırken bağlam uzunluğu sınırını ve yeni sohbetlerde hafıza kaybı sorununu nasıl aşacaklarını soruyor. Topluluğun önerdiği yöntemler şunları içeriyor: kritik bilgileri proje dosyalarına kaydetmek veya Claude’un konuşma özetlerini alıp yeni sohbete taşımasını sağlamak (kaynak: Reddit r/ClaudeAI)

Kullanıcı OpenWebUI yeni özelliklerinin nasıl kullanılacağını soruyor: Reddit kullanıcıları, OpenWebUI v0.6.6 sürümünde eklenen “toplantı kaydı ve içe aktarma” özelliği ile not içe aktarma (Markdown), OneDrive entegrasyonu gibi özelliklerin tam olarak nasıl kullanılacağını soruyor (kaynak: Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Kullanıcı OpenWebUI’nin RAG için çok sayıda JSON dosyasını işleme yöntemini soruyor: Reddit kullanıcıları, OpenWebUI’de RAG için binlerce JSON dosyasını verimli bir şekilde işlemenin en iyi yolunu arıyor. Doğrudan “Bilgi Bankası”na yüklemenin verimsiz olabileceğini göz önünde bulundurarak, kullanıcılar önerilen harici vektör veritabanı ayarları veya özel veri boru hattı entegrasyon yöntemleri olup olmadığını soruyor (kaynak: Reddit r/OpenWebUI)

Kullanıcı OpenWebUI ve n8n entegrasyonunda zaman aşımı sorununu bildiriyor: Kullanıcılar, OpenWebUI’yi n8n AI ajanı ön ucu olarak kullanırken sorun yaşıyor: n8n iş akışı yaklaşık 60 saniyeden fazla sürdüğünde, OpenWebUI hata gösteriyor, n8n arka ucunun başarıyla tamamlandığını kullanıcı onaylasa bile. Kullanıcılar zaman aşımı süresini artırma veya bağlantıyı sürdürme yöntemleri arıyor (kaynak: Reddit r/OpenWebUI)

📚 Öğrenme

Karmaşık Agentic sistemler oluşturmak için LangGraph: LangChain ekosisteminin bir parçası olan LangGraph, durum bilgili çok aktörlü uygulamalar oluşturmaya odaklanır. Jacob Schottenstein’ın konuşması, daha güçlü Agent sistemleri oluşturmak için yönlendirilmiş döngüsüz grafikleri (DAG) yönlendirilmiş döngüsel grafiklere (DCG) dönüştürmek üzere LangGraph kullanmayı ele alıyor. Gerçek dünya örneğinde, Cisco Outshift, LangGraph ve LangSmith kullanarak AI platform mühendisi JARVIS’i oluşturdu ve geliştirme operasyonları verimliliğini önemli ölçüde artırdı (kaynak: Sydney Runkle, LangChainAI, hwchase17, Hacubu)

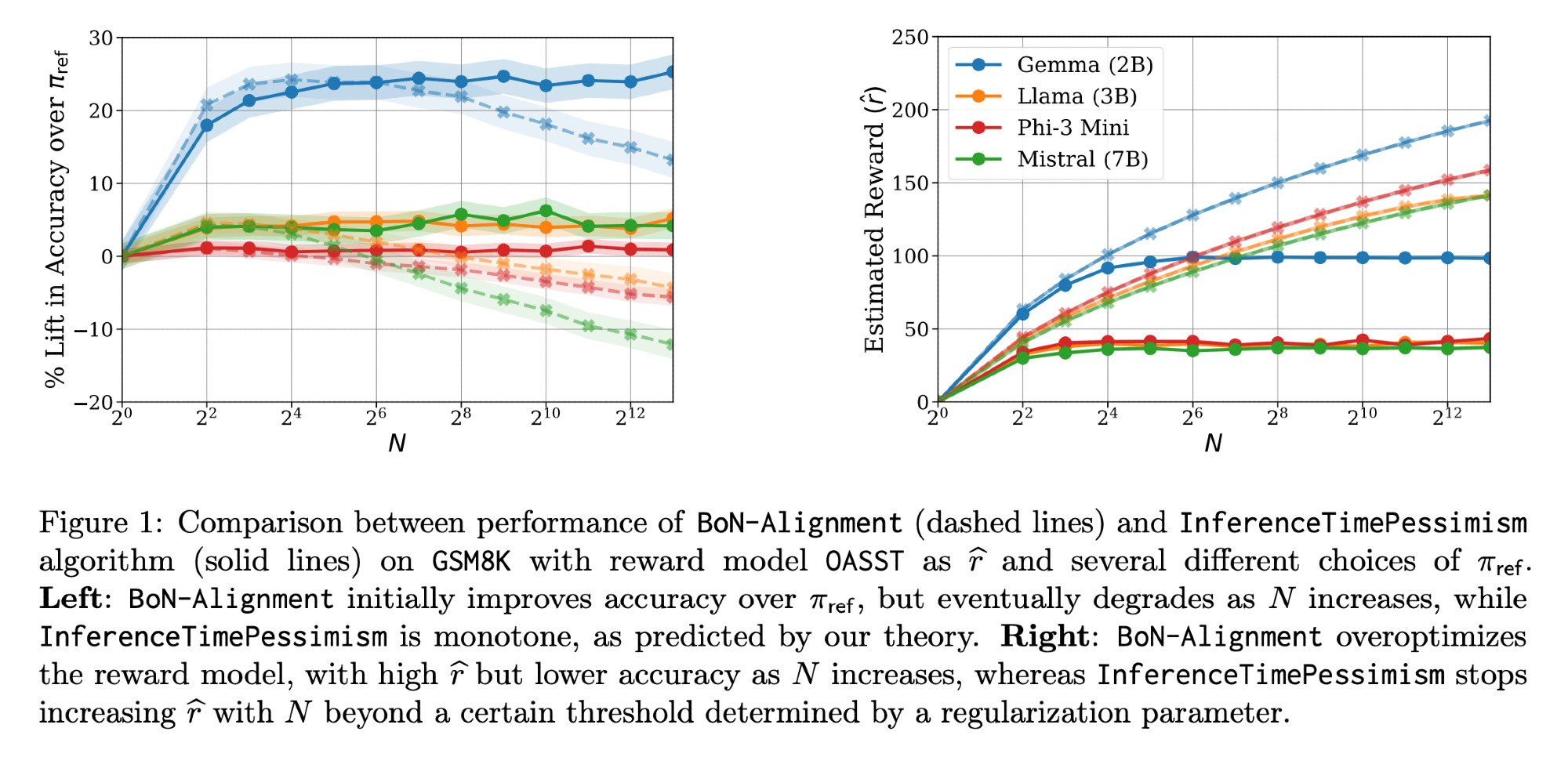

LLM çıkarım optimizasyonu: Llama-Nemotron makalesi ve InferenceTimePessimism: Meta AI & Nvidia Research tarafından yayınlanan Llama-Nemotron makalesi (arXiv:2505.00949v1), çıkarım iş yüklerinde kaliteyi korurken maliyeti düşürmek için bir dizi doğrudan optimizasyon yöntemini gösteriyor. Aynı zamanda, ICML ‘25 makalesi, Best-of-N çıkarım yöntemlerine potansiyel bir iyileştirme olarak InferenceTimePessimism algoritmasını tanıtıyor ve ek bilgileri kullanarak çıkarım sürecini optimize etmeyi amaçlıyor (kaynak: finbarrtimbers, Dylan Foster 🐢)

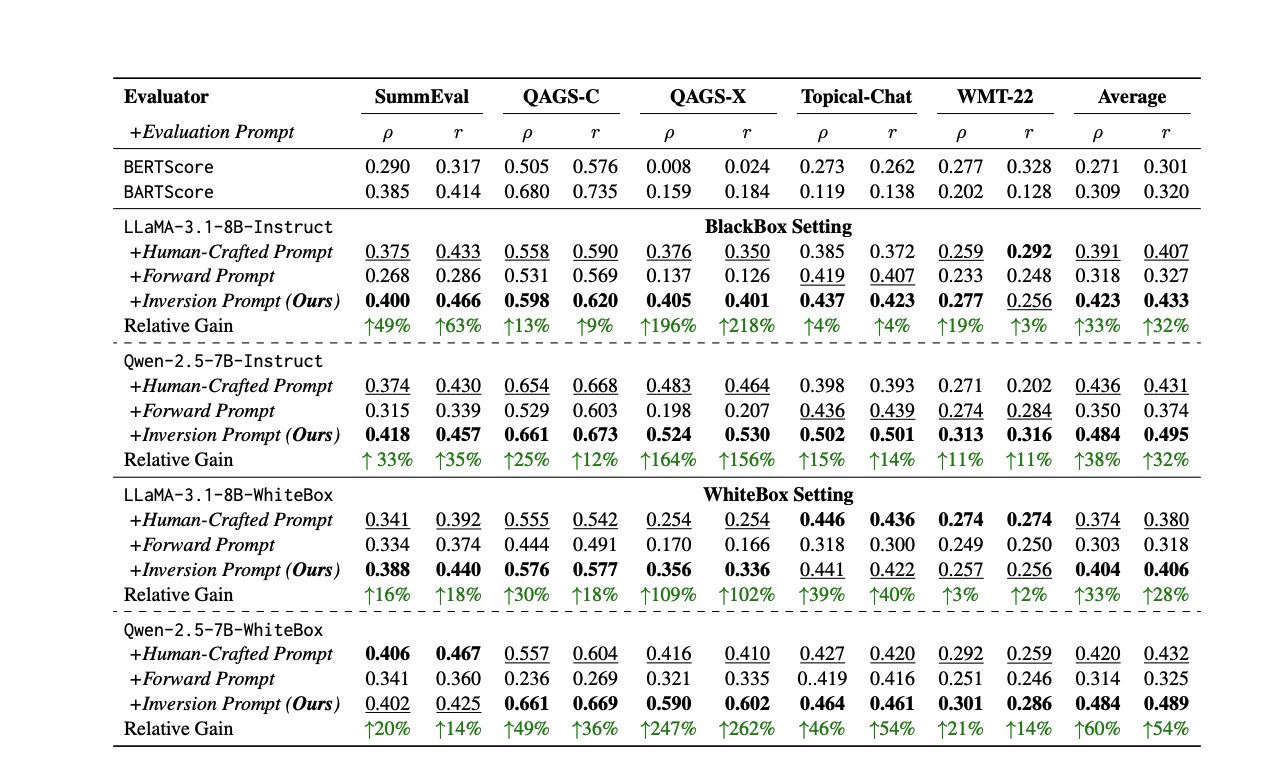

LLM değerlendirmesi için yeni yöntemler ve kaynaklar: LLM performansını değerlendirmek süregelen bir zorluktur. Bir makale, insan veya LLM değerlendiricilerinin tutarsızlığını çözmek için yanıtları tersine çevirerek otomatik olarak yüksek kaliteli değerlendirme istemleri oluşturma yöntemini öneriyor. Aynı zamanda, LLM değerlendirme uzmanı Shreya Shankar, mühendisler ve ürün yöneticileri için LLM değerlendirme kursu açtı. Ayrıca, SciCode karşılaştırması Kaggle yarışması olarak yayınlandı ve AI’yi karmaşık fiziksel ve matematiksel olguların kodunu yazmaya zorluyor (kaynak: ben_burtenshaw, Aditya Parameswaran, Ofir Press)

AI kontrolü ve hizalama ile ilgili kaynaklar: AI kontrolü (süper zekaya ulaşmamış ancak hizalanmamış olabilecek AI’nin nasıl güvenli bir şekilde izleneceği ve kullanılacağı araştırması) giderek daha önemli bir alan haline geliyor. FAR.AI, Neel Nanda gibi birçok uzmanın görüşlerini içeren ControlConf konferansının konuşma videolarını yayınladı. Aynı zamanda, değerleri (nihai değer ile araçsal değeri ayıran) tartışan bir makalenin AI hizalama tartışmalarıyla ilgili olduğu düşünülüyor (kaynak: FAR.AI, Séb Krier)

Common Crawl yeni veri kümeleri yayınladı: Common Crawl, 2025 Nisan ayı web tarama arşivini yayınladı. Aynı zamanda, Bram Vanroy, yalnızca CC lisanslı belgeleri içeren, sıkı bir şekilde filtrelenmiş bir Common Crawl alt kümesi olan C5’i (Common Crawl Creative Commons Corpus) tanıttı. Şu anda 150 milyar token toplandı ve 8 Avrupa dilini kapsıyor, dil modellerini eğitmek için yeni uyumlu veri kaynakları sağlıyor (kaynak: CommonCrawl, Bram)

AI öğrenme etkinlikleri ve eğitimleri: Birçok AI ile ilgili etkinlik ve eğitim kaynağı yayınlandı: Qdrant, MCP kullanarak AI ajanlarını düzenleme hakkında çevrimiçi bir kodlama oturumu düzenledi; Corbtt, RL kullanarak gerçek dünya ajanlarını optimize etme hakkında bir web semineri düzenlemeyi planlıyor; Comet ML, GenAI sistemlerini oluşturma ve üretimleştirme konusundaki görüşleri paylaşmak için etkinlik düzenledi; Ofir Press, PyTorch web seminerinde SWE-bench ve SWE-agent oluşturma deneyimlerini paylaşacak; Nous Research, birçok kurumla birlikte RL ortamı hackathon’u düzenliyor; LlamaIndex, Tel Aviv MCP hackathon’una sponsor oluyor; Hugging Face, 1 dakikada MCP sunucusu oluşturma eğitimi sunuyor; Together AI, Matryoshka makine öğrenimi serisi videolarını yayınladı; Andrew Price’ın AI’nin 3D endüstrisini nasıl değiştirdiği hakkındaki konuşması tekrar önerildi; giffmana, Transformer ders kaydını paylaştı (kaynak: qdrant_engine, Kyle Corbitt, dl_weekly, PyTorch, Nous Research, LlamaIndex 🦙, dylan, Zain, Cristóbal Valenzuela, Luis A. Leiva)

AI teorisi ve yöntem tartışmaları: Topluluk, AI alanındaki bazı temel teorileri ve yöntemleri tartıştı: 1. “Dünya Modelleri” (World Models) kavramı, çözdüğü sorunlar, teknik mimari ve zorluklar ele alındı. 2. Fourier özellikleri/spektral yöntemlerin derin öğrenmede neden yaygın olarak kullanılmadığı tartışıldı. 3. Beş büyük bilinç teorisini entegre ederek AI’nin özyinelemeli öz-farkındalığını keşfeden “Serenity Framework” kavramsal çerçevesi önerildi. 4. AI’nin önceden eğitilmiş modellere aşırı bağımlı olup olmadığı tartışıldı. 5. LLM küçültmenin (Downscaling) önemi ele alındı (kaynak: Reddit r/MachineLearning, Reddit r/MachineLearning, Reddit r/artificial, Reddit r/MachineLearning, Natural Language Processing Papers)

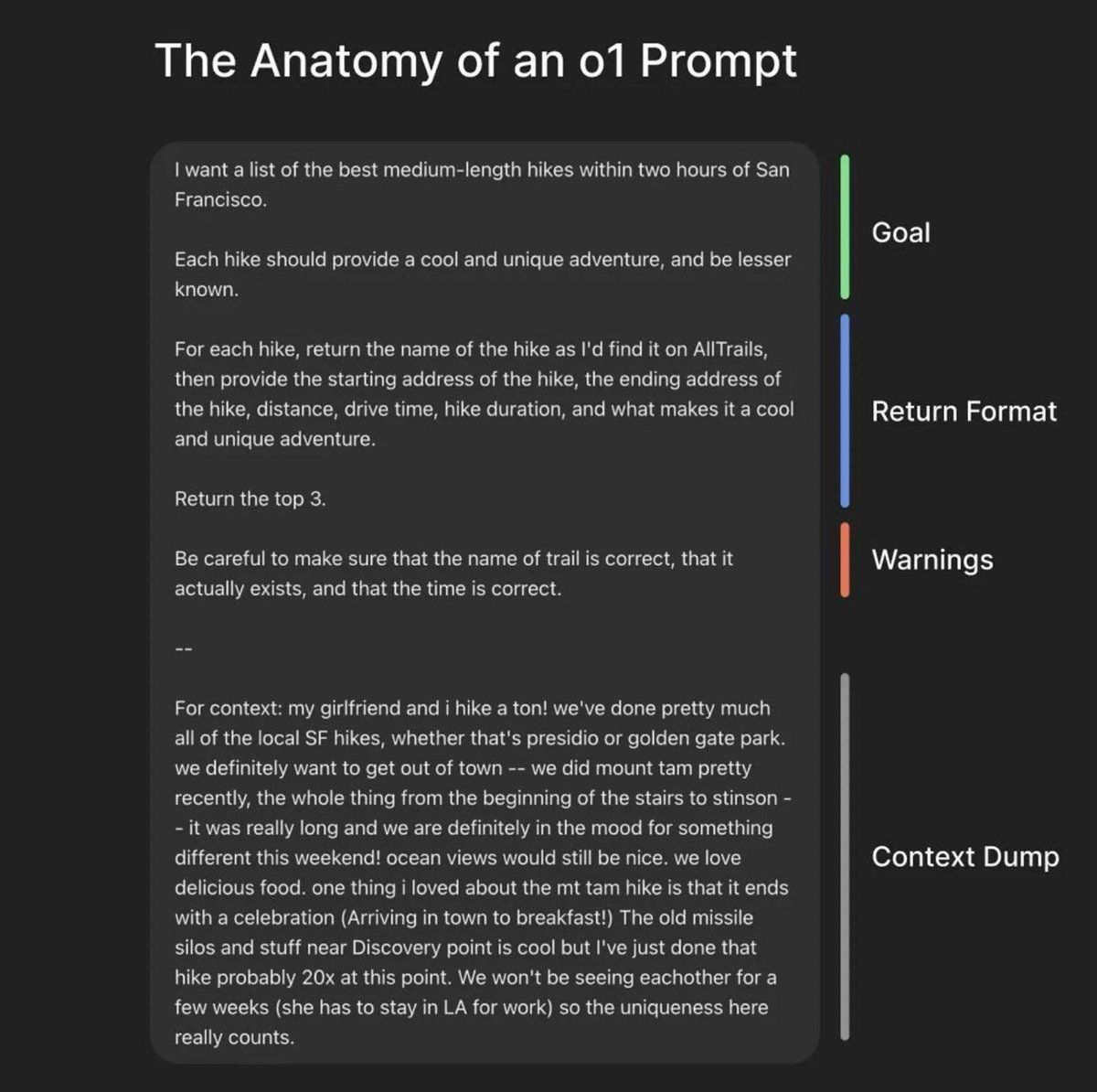

İstem mühendisliği ve model optimizasyon kaynakları: LiorOnAI, OpenAI Başkanı Greg Brockman’ın mükemmel istemler oluşturma çerçevesini paylaştı. Modal, TensorRT-LLM, FP8 niceleme ve spekülatif kod çözme gibi teknikleri kullanarak LLaMA 3 8B’yi 250ms’den düşük gecikmeyle sunma eğitimi sağlıyor. N8 Programs, düşük VRAM (64GB RAM) koşullarında, öğretmen olarak 6bit nicelemeli model ve öğrenci olarak 4bit model kullanarak eğitim deneyimini paylaştı. Kling_ai, Midjourney v7, Kling 2.0 gibi araçların istemlerini içeren bir kaynak gönderisini yeniden paylaştı (kaynak: LiorOnAI, Modal, N8 Programs, TechHalla)

AI’nin eğitim alanındaki uygulamaları ve araştırmaları: Stanford Üniversitesi Bilgisayar Bilimleri Doktora öğrencisi Rose’un doktora tezi, eğitimi iyileştirmek için AI yöntemlerini, değerlendirmesini ve müdahalesini kullanmaya odaklanıyor. Bu, AI’nin eğitim alanındaki uygulamalarının derinlemesine araştırma yönünü temsil ediyor (kaynak: Rose)

Vibe-coding: Gelişmekte olan bir AI destekli programlama şekli: YC podcast’inin Windsurf CEO’su ile yaptığı röportajın notlarında “Vibe-coding” kavramından bahsediliyor. Bu, daha çok sezgiye, atmosfere ve hızlı iterasyona odaklanan ve AI yardımını derinden entegre eden bir programlama paradigması olabilir, AI’nin yazılım geliştirme süreçleri ve felsefesi üzerindeki potansiyel değişimini ima ediyor (kaynak: Reddit r/ArtificialInteligence)

Nvidia CUDA yükseltme yolu bilgisi: Phoronix makalesi, Volta mimarisinden sonra Nvidia CUDA’nın yükseltme yolunu tartışıyor, bu eski Nvidia GPU’larına (10xx serisi gibi) sahip olan ve AI geliştirme için kullanmaya devam etmek isteyen kullanıcılar için referans değeri taşıyor (kaynak: NerdyRodent)

💼 İş Dünyası

CoreWeave, Weights & Biases’ın satın alımını tamamladı: AI bulut platformu CoreWeave, MLOps platformu Weights & Biases’ın (W&B) satın alımını resmen tamamladı. Bu satın alma, CoreWeave’in yüksek performanslı AI bulut altyapısını W&B’nin geliştirici araçlarıyla birleştirerek yeni nesil AI bulut platformunu oluşturmayı ve ekiplerin AI uygulamalarını daha hızlı oluşturmasına, dağıtmasına ve yinelemesine yardımcı olmayı amaçlıyor (kaynak: weights_biases, Chen Goldberg)

Figure AI robotları BMW fabrikasında test ediliyor ve optimize ediliyor: İnsansı robot şirketi Figure AI ekibi, BMW Grubu’nun Spartanburg fabrikasına iki haftalık bir ziyaret gerçekleştirerek robotlarının X3 gövde atölyesindeki süreçlerini optimize etti ve yeni uygulama senaryolarını araştırdı. Bu, tarafların 2025 yılındaki işbirliğinin somut aşamaya geçtiğini işaret ediyor ve insansı robotların otomotiv üretim alanındaki uygulama potansiyelini gösteriyor (kaynak: adcock_brett)

Reborn ve Unitree Robotics stratejik işbirliği anlaşması yaptı: AI şirketi Reborn, robotik şirketi Unitree Robotics ile stratejik bir ortaklık kurduğunu duyurdu. İki taraf, veri, model ve insansı robot alanlarında işbirliği yapacak ve ortak hedefleri ilgili teknolojilerin gelişimini hızlandırmak (kaynak: Reborn)

🌟 Topluluk

Buffett’ın AI konusundaki ihtiyatlı görüşleri tartışma yarattı: 2025 hissedarlar toplantısında Warren Buffett, AI’ye karşı “soğukkanlı bekleme” ve “sınırlı uygulama” tutumunu dile getirdi. AI’nin karmaşık karar verme süreçlerinde insan muhakemesinin (sigorta işleri başkanı Ajit Jain örneğiyle) yerini alamayacağını vurguladı ve Berkshire Hathaway’in AI’yi mevcut iş verimliliğini artırma aracı olarak gördüğünü, saf algoritma şirketlerine yatırım yapmadığını belirtti. AI alanında bir balon olduğunu ve teknolojinin uzun vadeli karlılığını kanıtlamasını beklemek gerektiğini düşündü. Bu, “AI + endüstri” ile “endüstri + AI” modellerinin değeri hakkında tartışmalara yol açtı (kaynak: 36氪)

Anthropic CEO’su AI’nin nasıl çalıştığına dair anlayış eksikliğini kabul etti: Anthropic CEO’su Dario Amodei, şu anda büyük AI modellerinin (LLM’ler gibi) iç çalışma prensipleri hakkında derinlemesine bir anlayışa sahip olmadıklarını kabul etti ve bu durumun teknoloji tarihinde “eşi benzeri görülmemiş” olduğunu söyledi. Bu samimi açıklama, AI’nin “kara kutu sorununu” bir kez daha vurguladı ve toplulukta AI’nin yorumlanabilirliği, kontrol edilebilirliği ve güvenliği hakkında yaygın tartışmalara ve endişelere yol açtı (kaynak: Reddit r/ArtificialInteligence)

OpenAI’nin öncü olmayan açık kaynak modelleri yayınlama planı ve tartışmaları: OpenAI CPO’su Kevin Weil, şirketin demokratik değerler üzerine inşa edilmiş açık kaynak ağırlıklı bir model yayınlamaya hazırlandığını ancak bu modelin, rakiplerin (Çin gibi) gelişimini hızlandırmamak için kasıtlı olarak öncü modellerden bir nesil geride olacağını belirtti. Bu strateji toplulukta hararetli tartışmalara yol açtı; eleştirmenler bu konumlandırmanın kendi içinde çelişkili olduğunu savunuyor: ne “dünyanın en iyi” açık kaynak modeli olabilir (DeepSeek-R2 gibi öncü modellerle rekabet etmesi gerekir) ne de performans geriliği nedeniyle işe yaramaz hale gelebilir, aynı zamanda OpenAI’nin kendi orta-düşük seviye API gelirini de aşındırabilir, bu bir “kaybet-kaybet” durumu (kaynak: Haider., scaling01)

AI destekli otomasyon ve gelecekteki çalışma biçimleri tartışması: Fiverr CEO’su, AI’nin “basit görevleri” ortadan kaldıracağını, “zor görevleri” kolaylaştıracağını ve “imkansız görevleri” zorlaştıracağını düşünüyor ve uygulayıcıların elenmemek için alanlarında usta olmaları gerektiğini vurguluyor. Topluluk, AI’nin tüm işleri değiştirip değiştirmeyeceğini ve bundan kaynaklanabilecek olası sosyal yapı değişikliklerini (ekonomik çöküş veya UBI ütopyası) tartışıyor. Aynı zamanda, AI’nin yazılım geliştirmede kullanımı giderek yaygınlaşıyor ve hatta ana kod katkıda bulunanı haline geliyor, bu da gelecekteki geliştirme modelleri hakkında düşüncelere yol açıyor (kaynak: Emm | scenario.com, Reddit r/ArtificialInteligence, mike)

AI güvenliği ve risk tartışmaları kızışmaya devam ediyor: Google DeepMind CEO’su Demis Hassabis, AGI’nin 5-10 yıl içinde gelebileceği ancak toplumun dönüştürücü etkilerine hazır olmadığı konusunda uyardı ve aktif küresel işbirliği çağrısında bulundu. Aynı zamanda, AI felaket riski konusunda anlamlı bir diyalog, risk endişesi taşıyan Ajeya Cotra ile şüpheci random_walker arasında gerçekleşti; her iki taraf da birbirlerinin görüşlerini anlamaya ve anlaşmazlıkların kilit noktalarını belirlemeye çalıştı. Topluluk ayrıca AI kontrol sorununu tartışmaya başladı ve güçlü AI sistemlerinin nasıl güvenli bir şekilde izleneceği ve kullanılacağına odaklandı (kaynak: Chubby♨️, dylan matthews 🔸, random_walker, FAR.AI, zacharynado)

AI’nin günlük yaşam ve kişilerarası ilişkilerdeki uygulamaları ve etkileri: Kullanıcılar, flört uygulaması yanıtlarına yardımcı olmak ve başarı oranını artırmak için AI (Anthropic Sonnet) kullanma deneyimlerini paylaşıyor ve bir “ilişki Cursor” olasılığını hayal ediyor. Aynı zamanda, AI’nin bazı insanların zihinsel fantezilerini körüklediğini ve onları gerçek hayattaki arkadaş ve akrabalarından uzaklaştırdığını belirten makaleler de var. Bu, AI’nin duygusal, sosyal alanlara sızmasını ve getirdiği fırsatları ve potansiyel riskleri yansıtıyor (kaynak: arankomatsuzaki, Reddit r/artificial)

LLM kullanım deneyimi ve model karşılaştırma tartışması: Kullanıcılar, Gemini 2.5 Pro’nun kendi dosya yükleme yetenekleri konusunda kafa karışıklığı yaşadığını, hatta dosya yükleyemediğini ve bunun ücretli özellik kısıtlaması olduğundan şüphelendiğini bildiriyor. Aynı zamanda, bazı kullanıcıların aile üyelerinin ChatGPT yerine Gemini kullanmayı tercih ettiğini belirtiyor. Başka bir kullanıcı ise Claude’un yazılı içerik üretmede diğer LLM’lerden daha iyi olduğunu övüyor ve yanıtlarının daha doğal, basit görev tamamlama yerine gerçek bir makaleye daha çok benzediğini düşünüyor. Bu tartışmalar, kullanıcıların gerçek kullanımda karşılaştıkları sorunları, tercih farklılıklarını ve farklı modellerin yeteneklerine ilişkin sezgisel hislerini yansıtıyor (kaynak: seo_leaders, agihippo, Reddit r/ClaudeAI, seo_leaders)

AI etiği ve sosyal normlar tartışması: Tartışmalar, AI’nin ilaç geliştirmedeki uygulamasını ve etik değerlendirmelerini, ayrıca AI karşıtı kişilerin bu konudaki tutumlarını içeriyor. Aynı zamanda, AI gerçek zamanlı çevirinin yaygınlaşmasının, geçmişteki diller arası iletişimdeki “mücadele hissinin” getirdiği bağlantıyı özletebileceği yorumları yapılıyor. Evcil hayvan çevirisi AI hakkında da tartışmalar var; insanların evcil hayvanları sevmesinin bir nedeninin onlara duygu yansıtabilmeleri olduğu, gerçek bir AI çevirisinin ise muhtemelen sadece “açım” ve “çiftleşmek istiyorum” geri bildirimi vereceği düşünülüyor (kaynak: Reddit r/ArtificialInteligence, jxmnop, menhguin)

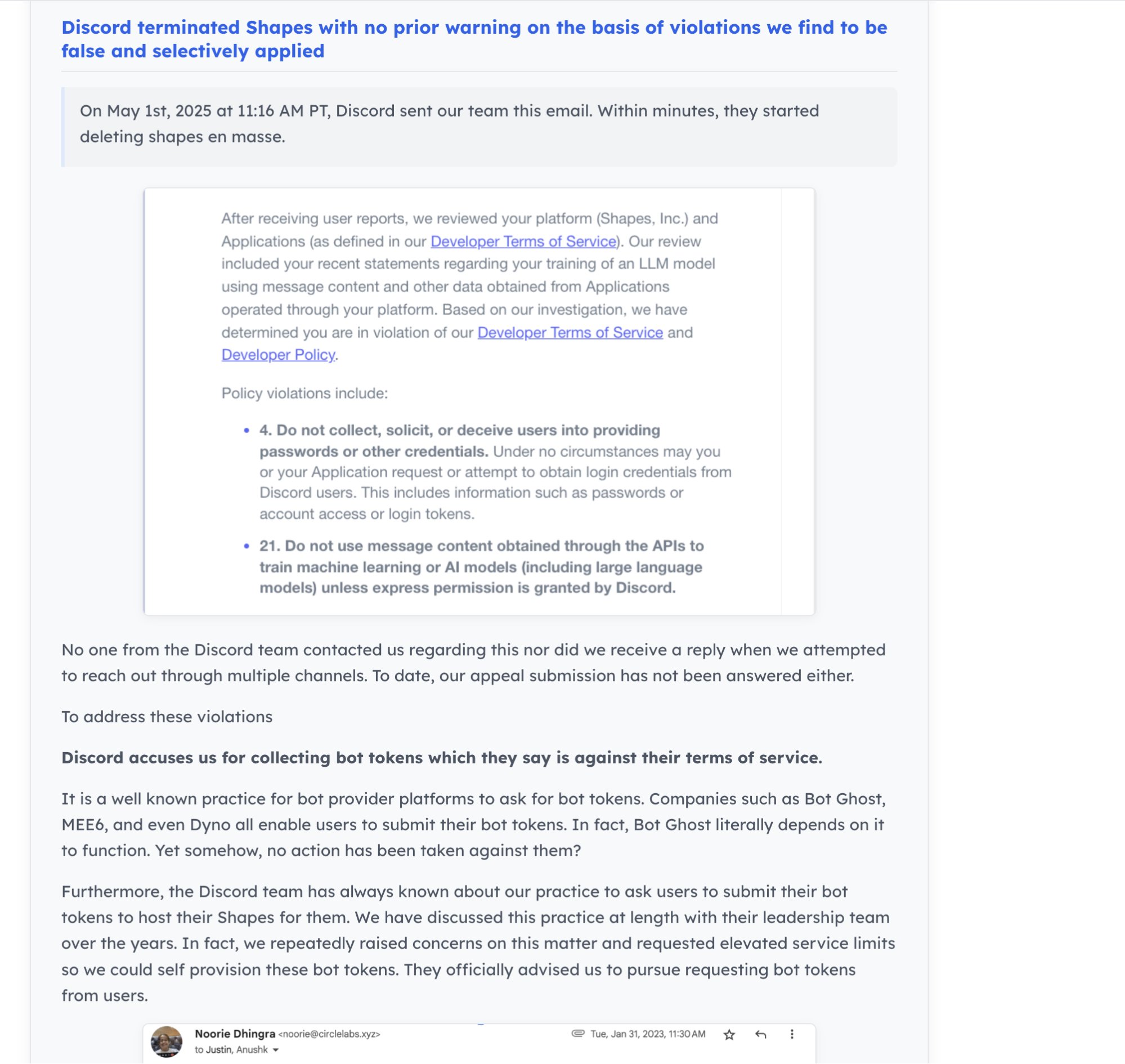

AI topluluk dinamikleri ve geliştirici ekosistemi: Discord’un 30 milyon kullanıcılı AI Bot’u “Shapes”i kapatması, geliştiriciler arasında platform riskleri konusunda endişelere yol açtı. Aynı zamanda, AI startup’ları için açık kaynak projelerine katkıda bulunmanın LeetCode çözmekten daha fazla yetenek kanıtladığı ve iş bulmayı kolaylaştırdığı görüşü var. Nous Research, XAI, Nvidia gibi şirketlerle birlikte RL ortamı geliştirmeyi teşvik etmek amacıyla RL ortamı hackathon’u düzenliyor (kaynak: shapes inc, pash, Nous Research)

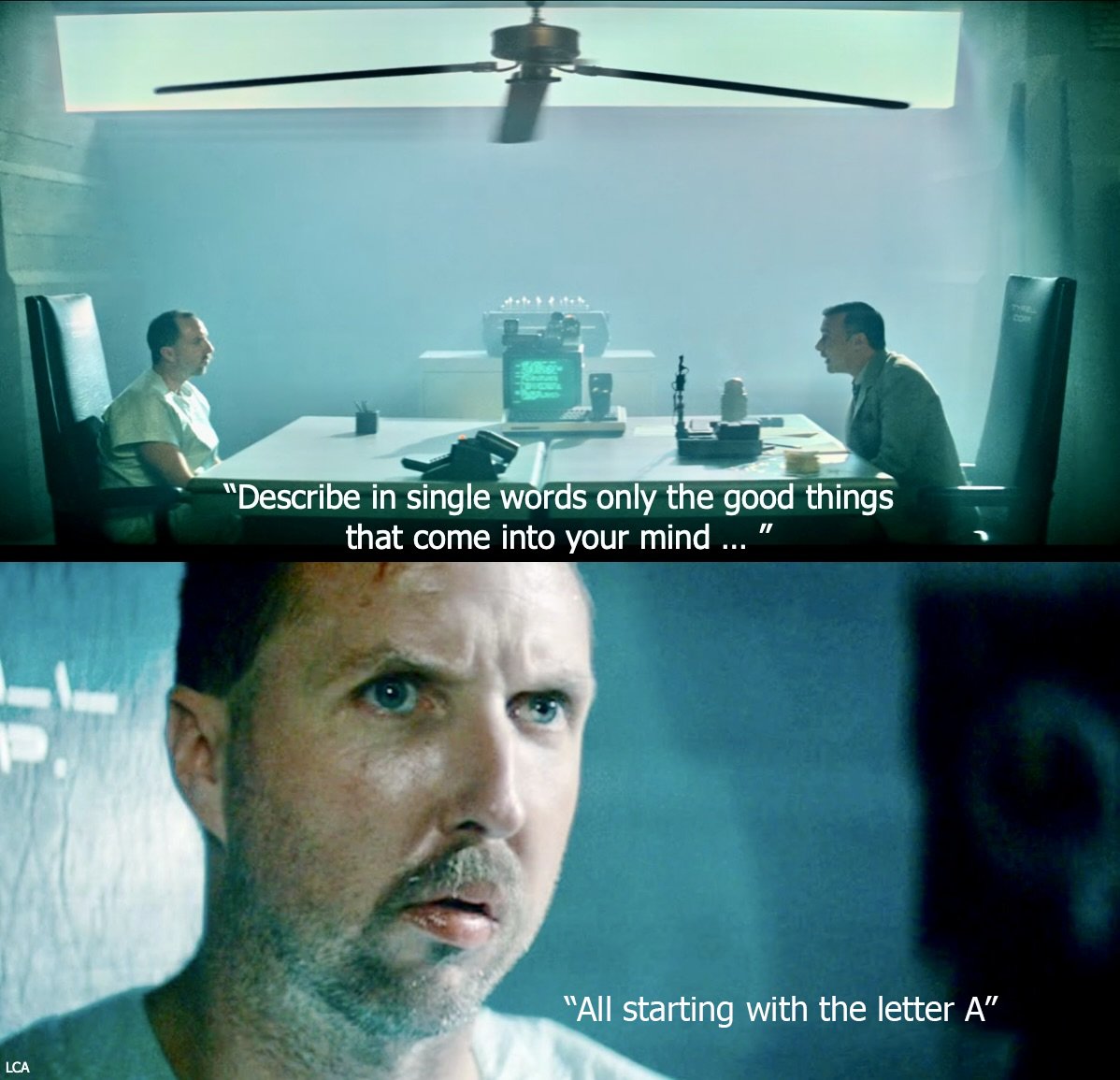

ChatGPT davranış anormalliği: “Boethius” döngüsüne girdi: Kullanıcılar, “ilk besteci kimdir” diye sorulduğunda ChatGPT-4o’nun anormal davrandığını, tekrar tekrar Boethius’tan (bir müzik teorisyeni, besteci değil) bahsettiğini, hatta sonraki konuşmalarda “özür dileyip” Boethius’un yanıtlara “hayalet” gibi musallat olduğunu şakayla söylediğini bildirdi. Bu ilginç “arıza”, LLM’lerin ortaya çıkabilecek beklenmedik davranış kalıplarını ve potansiyel iç durum karışıklığını gösteriyor (kaynak: Reddit r/ChatGPT)

AI’nin gelecekteki gelişim aşamaları hakkında düşünceler: Topluluk soruyor: Eğer mevcut AI gelişimi “ana bilgisayar” (mainframe) aşamasındaysa, gelecekteki “mikroişlemci” (microprocessor) aşaması nasıl olacak? Bu soru, AI teknolojisinin evrim yolu, yaygınlaşma biçimleri ve gelecekte ortaya çıkabilecek daha küçük, daha kişisel, daha gömülü AI formları hakkında hayallere yol açıyor (kaynak: keysmashbandit)

AI tarafından üretilen içeriğin stili ve tanınması: Kullanıcılar, AI tarafından üretilen metinlerin (özellikle GPT tipi modellerin) genellikle bazı sabit ifadeler ve cümle yapıları (“significant implications for…” gibi) kullandığını ve bu durumun tanınmasını kolaylaştırdığını gözlemliyor. Aynı zamanda, AI tarafından üretilen ses kalitesi artsa da, yapı, ritim ve duraklamalarda hala yapay görünüyor. Bu, LLM çıktılarının “kalıplaşması” ve doğallık sorunları hakkında tartışmalara yol açıyor (kaynak: Reddit r/ArtificialInteligence)

Perplexity AI tasarımına onay: Kullanıcı jxmnop, Perplexity AI’nin kaynaklarını kendi modellerini geliştirmekten çok tasarıma yatırmış gibi göründüğünü ancak ürün deneyiminin (vibes) iyi hissettirdiğini düşünüyor. Bu, AI ürün rekabetinde çekirdek model yeteneklerinin yanı sıra kullanıcı arayüzü ve etkileşim tasarımının da önemli farklılaştırıcı faktörler olduğunu yansıtıyor (kaynak: jxmnop)

AI’nin iş dışı senaryolarda eğlenceli uygulamaları: Reddit kullanıcıları, AI’nin iş dışı senaryolarda ilginç veya tuhaf kullanımlarını soruyor. Örnekler arasında: rüyaları Jung ve Freud perspektifinden analiz etmek, kahve falı bakmak, buzdolabındaki rastgele malzemelere göre tarif oluşturmak, AI’den uyku öncesi hikayeler dinlemek, yasal belgeleri özetlemek vb. bulunuyor. Bu, kullanıcıların AI uygulama sınırlarını keşfetme yaratıcılığını gösteriyor (kaynak: Reddit r/ArtificialInteligence)

Kullanıcılar 48GB VRAM için en iyi LLM’yi arıyor: Reddit kullanıcıları, 48GB VRAM koşulunda hem bilgi miktarını hem de kullanılabilir hızı (>10t/s) dengeleyen en iyi LLM’yi arıyor. Tartışmada Deepcogito 70B (Llama 3.3 ince ayarlı), Qwen3 32B’den bahsediliyor ve Nemotron, YiXin-Distill-Qwen-72B, GLM-4, niceleştirilmiş Mistral Large, Command R+, Gemma 3 27B veya kısmen boşaltılmış Qwen3-235B gibi modelleri deneme önerileri bulunuyor. Bu, kullanıcıların belirli donanım kısıtlamaları altında model seçme ve optimize etme konusundaki pratik ihtiyaçlarını yansıtıyor (kaynak: Reddit r/LocalLLaMA)

💡 Diğer

Robotik teknolojisindeki gelişmeler: Alanda sürekli yeni gelişmeler yaşanıyor: 1. PIPE-i: Beca Group, boru hatları gibi altyapı denetimleri için robotik bir araştırma aracı başlattı. 2. Açık kaynak insansı robot: Kaliforniya Üniversitesi Berkeley, açık kaynak insansı robot projesini başlattı. 3. Hugging Face robot kolu: Hugging Face, 3D yazdırılabilir robot kolu projesini yayınladı. 4. Yenilebilir robot kek: Araştırmacılar yenilebilir robot kekler yaptı. 5. Kanalizasyon dronları: Kanalizasyonları denetlemek için kullanılan dronlar ortaya çıktı ve kirli işleri insanlar yerine yapıyor (kaynak: Ronald_vanLoon, TheRundownAI)

AI düzenleme tartışması: SB-1047 yasa tasarısı belgeseli yayınlandı: Michaël Trazzi, Kaliforniya AI güvenlik yasa tasarısı SB-1047 tartışmalarının perde arkasını anlatan bir belgesel yayınladı. Yasa tasarısı, öncü AI geliştirmelerine asgari düzeyde düzenleme getirmeyi amaçlıyordu ancak sonuçta geçemedi. Belgesel, çok sayıda Kaliforniya vatandaşının desteğine rağmen yasa tasarısının başarısız olmasının nedenlerini araştırıyor ve AI düzenleme yolları ve zorlukları hakkında daha fazla düşünceye yol açıyor (kaynak: Michaël Trazzi, menhguin, NeelNanda5, JeffLadish)

Kuantum hesaplama ve AI’nin birleşimi: Nvidia, kuantum donanımını AI süper bilgisayarlarıyla entegre ederek pratik kuantum hesaplamanın yolunu açıyor, hata düzeltme ve deneylerden pratik uygulamalara geçişi hızlandırmaya odaklanıyor. Aynı zamanda, kuantum hesaplamanın sadece siber güvenlik alanında bir devrim yaratmaktan ziyade daha çok bilimsel bir refah getirebileceği görüşü var (kaynak: Ronald_vanLoon, NVIDIA HPC Developer)