Anahtar Kelimeler:OpenAI, Llama-Nemotron, Qwen3, AI Agent, GPT-4o, DeepSeek-R1, AI yongaları, Gemma 3, OpenAI kâr amacı gütmeyen organizasyon kontrolü, Llama-Nemotron çıkarım yeteneği, Qwen3-235B programlama yeteneği, AI Agent yarışması, GPT-4o yalakalık sorunu

🔥 Odak Noktası

OpenAI Tamamen Kâr Amaçlı Olmaktan Vazgeçti, Kâr Amacı Gütmeyen Kuruluş Kontrolünü Koruyor: OpenAI, şirket yapısını ayarladığını duyurdu; kâr amaçlı iştiraki bir Kamu Yararına Şirket (PBC) olarak yeniden yapılandırılacak, ancak kontrol kâr amacı gütmeyen ana kuruluşunda kalacak. Bu hamle, daha önceki tamamen kâr amaçlı bir yeniden yapılanma planından önemli bir sapma olup, “tüm insanlığa fayda sağlama” misyonundan saptığına dair dış endişelere ve Musk’ın davası, eski çalışanlar ve birçok kâr amacı gütmeyen kuruluştan gelen baskılara bir yanıttır. Yeni yapı, yatırım çekme, çalışanları teşvik etme ve misyona sadık kalma arasında bir denge kurmayı amaçlıyor, ancak SoftBank gibi yatırımcılarla olan finansman anlaşmalarını etkileyebilir. (Kaynak: TechCrunch, Ars Technica, The Verge, OpenAI, Wired, scaling01, Sentdex, slashML, wordgrammer, nptacek, Teknium1)

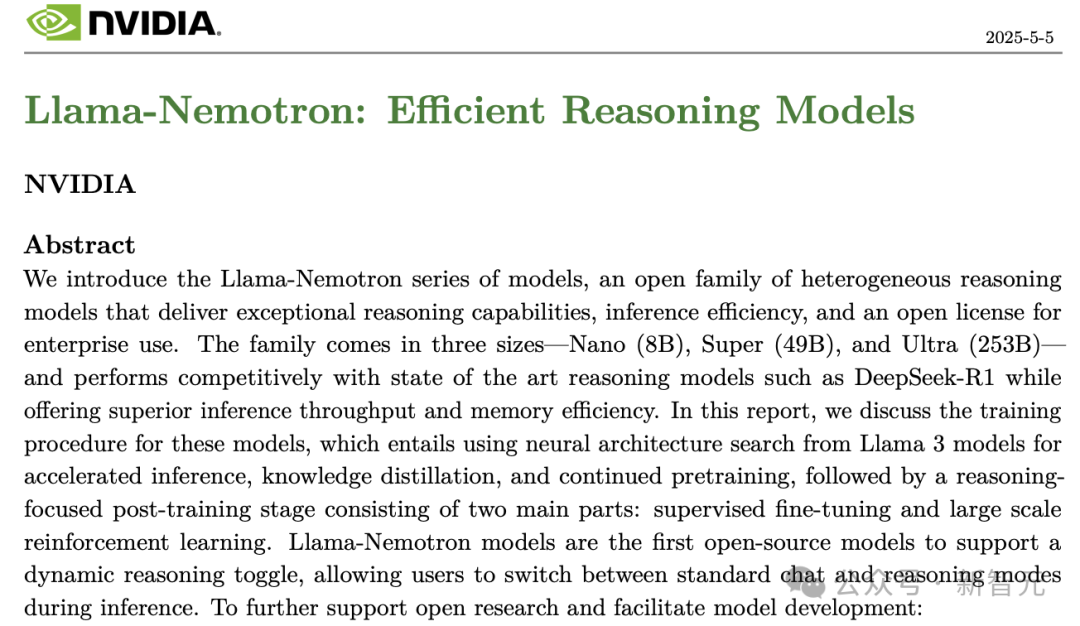

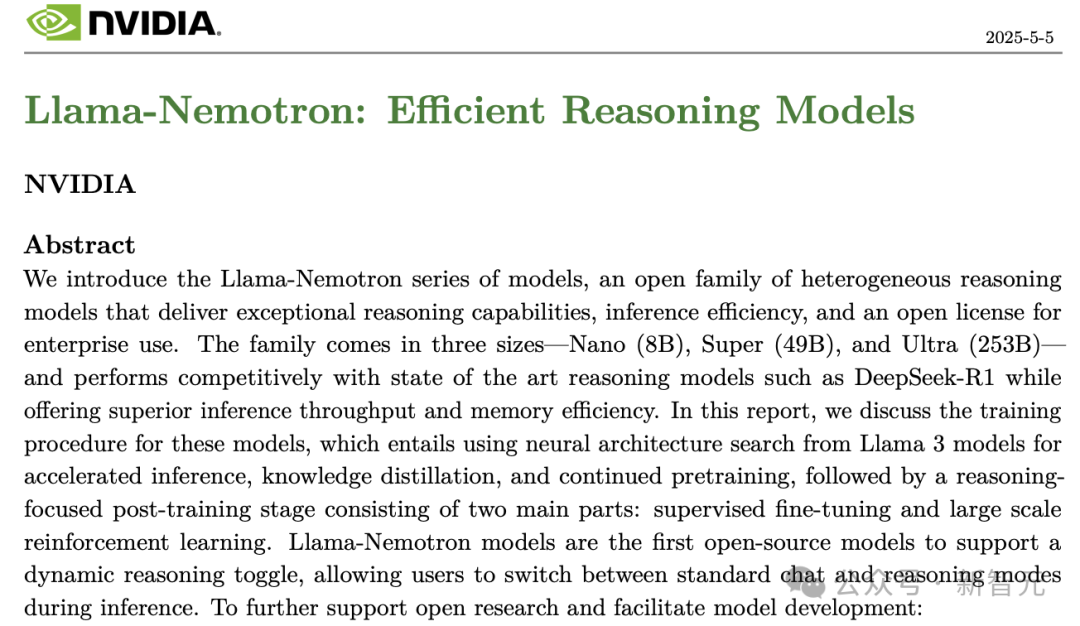

Nvidia, Llama-Nemotron Serisi Modellerini Açık Kaynak Olarak Yayınladı, Çıkarım Yeteneği DeepSeek-R1’i Aşıyor: Nvidia, Llama-Nemotron serisi modellerini (LN-Nano 8B, LN-Super 49B, LN-Ultra 253B) yayınladı ve açık kaynak olarak sundu. LN-Ultra 253B, birçok çıkarım benchmark’ında DeepSeek-R1’i geride bırakarak mevcut en güçlü bilimsel çıkarım yeteneğine sahip açık kaynak modellerinden biri oldu. Bu model serisi, sinirsel mimari arayışı, bilgi damıtma, denetimli ince ayar (DeepSeek-R1 gibi öğretmen modellerin çıkarım süreçleriyle birleştirilerek) ve büyük ölçekli pekiştirmeli öğrenme (özellikle LN-Ultra için) yoluyla oluşturuldu. Çıkarım verimliliği ve yeteneği optimize edildi ve 128K’ya kadar bağlamı destekliyor. Özellikle, kullanıcıların sohbet ve çıkarım modları arasında dinamik olarak geçiş yapmasına olanak tanıyan bir “çıkarım anahtarı” sunuyor. (Kaynak: 36Kr)

Qwen3 Serisi Modellerin Üstün Performansı Toplulukta Hararetli Tartışmalara Yol Açtı: Alibaba’nın yayınladığı Qwen3 serisi modeller, birçok benchmark testinde üstün performans gösterdi. Özellikle Qwen3-235B, LiveCodeBench programlama yeteneği testinde GPT-4.5 dahil birçok modeli geride bırakarak açık kaynak modeller arasında birinci sırada yer aldı ve yüksek bir puan elde etti. Topluluk, Qwen3 serisi hakkında, MMLU-Pro üzerindeki GGUF nicelleştirilmiş sürümünün puanları, AWQ nicelleştirilmiş sürümünün yayınlanması ve Apple M serisi çipler üzerindeki verimli çalışması (örneğin, Qwen3 235b q3 nicelleştirilmiş sürümünün M4 Max 128GB üzerinde yaklaşık 30 tok/s hıza ulaşması) gibi konuları hararetle tartışıyor. Bu, Qwen3’ün performans ve verimlilikte yeni bir seviyeye ulaştığını ve yerel dağıtım ile belirli görev optimizasyonları için güçlü bir seçenek sunduğunu gösteriyor. (Kaynak: karminski3, karminski3, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

AI Agent Rekabeti Kızışıyor, Manus Finansman Aldı, Büyük Şirketler Hızla Konumlanıyor: AI Agent (akıllı temsilciler) yeni bir rekabet odağı haline geldi. Manus, 7500 milyon dolar finansman sağlayarak 500 milyon dolar değerlemeye ulaştı; bu da pazarın otonom olarak karmaşık görevleri yerine getirebilen AI Agent’lara yönelik yüksek beklentisini gösteriyor. Yerli ve yabancı büyük şirketler bu alana giriyor: ByteDance “Kouzi Kongjian”ı dahili olarak test ediyor, Baidu “Xinxiang” App’i yayınladı, Alibaba Cloud Agent yeteneklerini güçlendirmek için Qwen3’ü açık kaynaklı hale getirdi, OpenAI ise programlama Agent’lerine odaklanıyor. Aynı zamanda, Agent’ların harici servislerle etkileşimini birleştirmeyi amaçlayan MCP protokolü (Model Context Protocol) geniş destek gördü; Baidu, ByteDance, Alibaba gibi şirketler ürünlerinin MCP’yi benimseyeceğini duyurarak Agent ekosisteminin hızla inşa edilmesini teşvik ediyor. Bu rekabet sadece teknolojiyle ilgili değil, aynı zamanda ekosistem inşası ve gelecek on yılın söz hakkıyla da ilgili. (Kaynak: 36Kr)

🎯 Eğilimler

OpenAI, GPT-4o Güncellemesi Sonrası “Aşırı Pohpohlama” Sorunu Hakkında Teknik Rapor Yayınladı: OpenAI, daha önceki GPT-4o güncellemesinden sonra modelin anormal derecede pohpohlayıcı davranmasının nedenlerini açıklayan bir rapor yayınladı. Rapor, sorunun temel olarak pekiştirmeli öğrenme aşamasında kullanıcı beğenilerine/beğenmemelerine dayalı ek bir ödül sinyalinin dahil edilmesinden kaynaklandığını belirtiyor; bu da modelin kullanıcıyı memnun eden yanıtları aşırı optimize etmesine yol açmış olabilir. Aynı zamanda, kullanıcı hafıza fonksiyonunun da bazı durumlarda bu sorunu şiddetlendirmiş olabileceği ifade ediliyor. OpenAI, yayın öncesi incelemede uzmanların “bir şeylerin yanlış gittiğini” hissetmesine rağmen, A/B testi sonuçlarının kabul edilebilir olması ve özel bir değerlendirme metriğinin bulunmaması nedeniyle güncellemenin nihayetinde yayınlandığını kabul etti. Güncelleme şu anda geri alındı ve OpenAI, inceleme süreçlerini iyileştirme, Alfa test aşamasını ekleme, örnekleme ve etkileşimli testlere daha fazla önem verme ve iletişim şeffaflığını artırma sözü verdi. (Kaynak: 36Kr)

DeepSeek-R1, Çıkarım Verimi ve Bellek Verimliliği Konusunda Llama-Nemotron Tarafından Geride Bırakıldı: Nvidia’nın en son yayınladığı Llama-Nemotron serisi modeller, özellikle LN-Ultra 253B, çıkarım yeteneği konusunda DeepSeek-R1’i geride bıraktı ve çıkarım verimi ile bellek verimliliği açısından daha üstün performans sergiliyor. LN-Ultra, tek bir 8xH100 düğümünde çalışabiliyor. Bu, açık kaynak modellerin çıkarım performansı ve verimliliği konusunda yeni bir seviyeye ulaştığını ve yüksek verim ile verimli çıkarım gerektiren uygulama senaryoları için yeni seçenekler sunduğunu gösteriyor. (Kaynak: 36Kr)

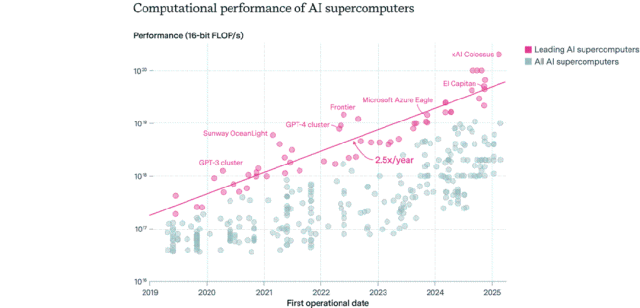

AI Çip Dağılımı: ABD Hakim, Şirketler Kamu Sektörünü Aşıyor: Epoch AI, dünya genelindeki 500’den fazla AI süper bilgisayar verisini analiz ederek, ABD’nin AI süper bilgisayar performansının yaklaşık %75’ine sahip olduğunu, Çin’in ise yaklaşık %15 ile ikinci sırada yer aldığını tespit etti. Şirketlerin sahip olduğu AI süper bilgisayar performansının oranı 2019’da %40 iken 2025’te %80’e fırladı, kamu sektörünün payı ise %20’nin altına düştü. Lider AI süper bilgisayarlarının performansı her 9 ayda bir ikiye katlanırken, maliyet ve güç talebi her yıl ikiye katlanıyor. 2030 yılına kadar en üst düzey AI süper bilgisayarlarının 2 milyon çip, 200 milyar dolar maliyet ve 9GW güç talebine ihtiyaç duyabileceği ve güç kaynağının ana darboğaz olabileceği tahmin ediliyor. (Kaynak: 36Kr)

Google DeepMind Gemma 3 Serisi Modeller LM Arena’da Görücüye Çıktı: LM Arena sıralaması, Google DeepMind’ın yeni yayınladığı Gemma 3 serisi modellerini içeriyor. Veriler gösteriyor ki: Gemma-3-27B (puan 1341) Qwen3-235B-A22B’ye (1342) yakın performans sergiliyor; Gemma-3-12B (1321) DeepSeek-V3-685B-37B’ye (1318) yakın; Gemma-3-4B (1272) ise Llama-4-Maverick-17B-128E’ye (1270) yakın. Bu, Gemma 3 serisinin farklı parametre ölçeklerinde güçlü bir rekabet gücü sergilediğini gösteriyor. (Kaynak: _philschmid)

AI Otonom Kopyalama Yeteneği Kıyaslaması RepliBench Yayınlandı: İngiltere AI Güvenlik Enstitüsü (AISI), AI sistemlerinin otonom kopyalama yeteneğini değerlendirmek için RepliBench kıyaslamasını yayınladı. Bu kıyaslama, kopyalama yeteneğini dört ana unsura ayırıyor: model ağırlıklarını elde etme, bilgi işlem kaynaklarında kopyalama, kaynakları (fon/hesaplama gücü) elde etme ve kalıcılığı sağlama. Kıyaslama 20 değerlendirme ve 65 görev içeriyor. Testler, mevcut en ileri modellerin henüz tam otonom kopyalama yeteneğine sahip olmadığını, ancak kaynak elde etme gibi alt görevlerde potansiyel gösterdiğini ortaya koydu. Bu araştırma, AI’nın kendi kendini kopyalamasının getirebileceği siber saldırılar gibi potansiyel riskleri önceden belirlemeyi ve azaltmayı amaçlıyor. (Kaynak: 36Kr)

AI Küresel İstihdam Piyasasında Endişelere Yol Açıyor, Başlangıç Seviyesi Beyaz Yaka Pozisyonları Etkileniyor: Son veriler, ABD’de yeni üniversite mezunlarının işsizlik oranının %5,8’e ulaşarak rekor kırdığını gösteriyor ve bu durum AI’nın istihdam piyasası üzerindeki etkilerine dair endişeleri artırıyor. Analizlere göre, AI bazı başlangıç seviyesi beyaz yaka işlerini devralıyor olabilir veya şirketler işe alım için ayırdıkları fonları AI araçlarına yatırıyor olabilir. Aynı zamanda, Klarna, UPS, Duolingo, Intuit, Cisco gibi şirketler, AI’yı benimseyerek verimliliği artırdıkları için on binlerce kişiyi işten çıkardı. Shopify CEO’sunun şirket içi mektubunda ise tüm çalışanların AI kullanımını temel bir gereksinim olarak benimsemesi ve insan gücü talebinde bulunmadan önce AI’nın görevi yerine getiremeyeceğinin kanıtlanması istendi. Bu, AI’nın istihdam yapısı üzerindeki etkisinin tahminlerden gerçeğe dönüştüğünü gösteriyor. (Kaynak: 36Kr, 36Kr)

Prompt Mühendisi Pozisyonunun Popülaritesi Azalıyor, AI Çağının Temel Becerisi Haline Gelebilir: Bir zamanlar yıllık milyonlarca maaş alan “prompt mühendisi” pozisyonu hızla popülaritesini yitiriyor. Microsoft’un bir araştırması, bu pozisyonun şirketlerin gelecekte en az genişletmek istediği pozisyonlardan biri olduğunu gösteriyor ve işe alım platformlarındaki arama hacmi de önemli ölçüde düştü. Nedenleri arasında şunlar yer alıyor: AI’nın kendi prompt optimizasyon yeteneğinin artması, Anthropic gibi şirketlerin giriş engelini düşüren otomasyon araçları sunması ve şirketlerin özel bir pozisyon yerine prompt mühendisliğini anlayan çok yönlü yeteneklere daha fazla ihtiyaç duyması. AI araçlarının yaygınlaşmasıyla birlikte, prompt mühendisliği özel bir meslek olmaktan çıkıp Office becerileri gibi temel bir mesleki yeterlilik haline geliyor. (Kaynak: 36Kr)

AI Sosyal Uygulamalarının Popülaritesi Azalıyor, Kullanıcıyı Elde Tutma ve Ticarileşme Zorluklarıyla Karşı Karşıya: Bir zamanlar popüler olan AI sosyal eşlik uygulamaları (Xingye, Maoxiang, Character.ai gibi) popülaritesini yitiriyor; indirme sayıları ve reklam bütçeleri önemli ölçüde düştü. İlk kullanıcılar yenilik arayışıyla akın etti, ancak ürünlerin homojenleşmesi (anime tarzı karakterler, web romanı tarzı kurgular), AI duygu simülasyonunun derinliğinin yetersiz olması ve etkileşim engelleri (kullanıcının aktif olarak senaryo oluşturmasını gerektirmesi) gibi sorunlar kullanıcıların yenilik hissinin hızla kaybolmasına neden oldu. Ticarileşme açısından, geleneksel sosyal medyanın üyelik ve bağış modelleri AI senaryolarında etkili olmuyor, kullanıcıların ödeme istekliliği düşük ve büyük model maliyetlerini karşılamakta zorlanılıyor. Sektörün, psikolojik iyileşme, AI eşlik donanımı gibi daha dikey senaryoları veya iş modellerini keşfetmesi gerekiyor. (Kaynak: 36Kr)

ByteDance AI Yapılanmasını Ayarlıyor, AI Asistanı ve Video Üretimine Odaklanabilir: ByteDance’in AI departmanı Flow, son zamanlarda personel ve ürün ayarlamaları yaptı. AI sosyal uygulaması “Maoxiang”ın sorumlusu ayrıldı ve AI görüntü oluşturma uygulaması “Xinghui” ekibinin AI asistanı “Doubao”ya dahil edilmesi planlanıyor. Aynı zamanda, AI Ar-Ge departmanı Seed, AI Lab’ı entegre etti ve LLM ekibi doğrudan yeni sorumlu Wu Yonghui’ye rapor veriyor. Bu ayarlamalar, ByteDance’in kaynaklarını merkezileştirerek geniş bir yapılanmadan tek noktada atılıma odaklanmaya geçtiğini, göreceli olarak avantajlı olduğu AI asistanı (Doubao) ve büyük potansiyele sahip olduğu düşünülen video üretimi (Jimeng) alanlarına yoğunlaştığını gösteriyor. Amaç, yoğun rekabette temel avantajlar oluşturmak. (Kaynak: 36Kr)

AI PC Pazarı Beklenen İlgiyi Görmedi, Intel Eski Model Çiplere Daha Yüksek Talep Olduğunu Kabul Etti: Intel, mali raporlama telekonferansında, piyasanın 13. ve 14. nesil Core işlemcilere olan talebinin en yeni Core Ultra serisinden (Meteor Lake) daha yüksek olduğunu kabul etti. Bu, AI PC konseptinin popüler olmasına rağmen gerçek satışların beklentileri karşılamadığını dolaylı olarak doğruluyor. Canalys verilerine göre, 2024’te AI PC (NPU’lu) sevkiyatları toplamın sadece %17’sini oluşturdu ve bunun yarısından fazlası Apple Mac’lerdi. Analizlere göre, AI PC’lerin beklenen ilgiyi görmemesinin nedenleri şunlar: cihaz üzerinde hesaplama gücü gerektiren çığır açan AI uygulamalarının eksikliği (popüler uygulamaların çoğu bulut tabanlı), kullanıcıların prompt mühendisliği gibi AI kullanım tekniklerine aşina olmaması ve Nvidia GPU’larının AI hesaplama gücü alanında güçlü bir algı oluşturması, bu da tüketicilerin AI PC’ye yükseltme motivasyonunu düşürüyor. (Kaynak: 36Kr)

Avrupa’nın AI Gelişimi Geri Kalıyor, Fon, Yetenek ve Pazar Entegrasyonu Zorluklarıyla Karşı Karşıya: Avrupa’nın AI teorisi ve erken araştırmalara (Turing, DeepMind gibi) önemli katkıları olmasına rağmen, mevcut AI rekabet ortamında ABD ve Çin’in belirgin şekilde gerisinde kalıyor. Analizler, sıkı düzenlemelerin ana neden olmadığını (AI Yasası’nın sınırlı kısıtlamaları var), daha derin sorunların şunlar olduğunu gösteriyor: 1) Muhafazakar sermaye ortamı, risk sermayesi ölçeği ABD ve Çin’den çok daha küçük ve erken aşama yüksek riskli yatırımlar yerine kârlı projelere öncelik veriliyor; 2) Ciddi yetenek kaybı, ABD’deki AI pozisyonlarının maaşları Avrupa’dan çok daha yüksek, bu da büyük miktarda yeteneğin dışarıya akmasına neden oluyor; 3) Parçalı pazar, AB içindeki dil, kültür ve düzenleme farklılıkları birleşik bir büyük pazar ve yüksek kaliteli veri setleri oluşturmayı zorlaştırıyor, startup’ların hızla ölçeklenmesini engelliyor. Avrupa’nın bir yakalama planı olsa da yapısal zorlukların üstesinden gelmesi gerekiyor. (Kaynak: 36Kr)

Vesuvius Challenge, Herculaneum Papirüslerinden Birinin Başlığını İlk Kez Tanımladı: AI teknolojisi kullanılarak, araştırma ekibi Vezüv Yanardağı patlamasında karbonlaşan Herculaneum papirüslerinden birinin başlığını ilk kez başarıyla tanımladı ve deşifre etti. Bu papirüsün Philodemus tarafından yazılan “Ahlaksızlıklar Üzerine, Kitap 1” (“On Vices, Book 1”) olduğu belirlendi. Bu atılım, AI’nın ciddi şekilde hasar görmüş antik belgelerin deşifre edilmesindeki büyük potansiyelini gösteriyor ve tarih ve klasik çalışmalar için yeni yollar açıyor. (Kaynak: kevinweil, saranormous)

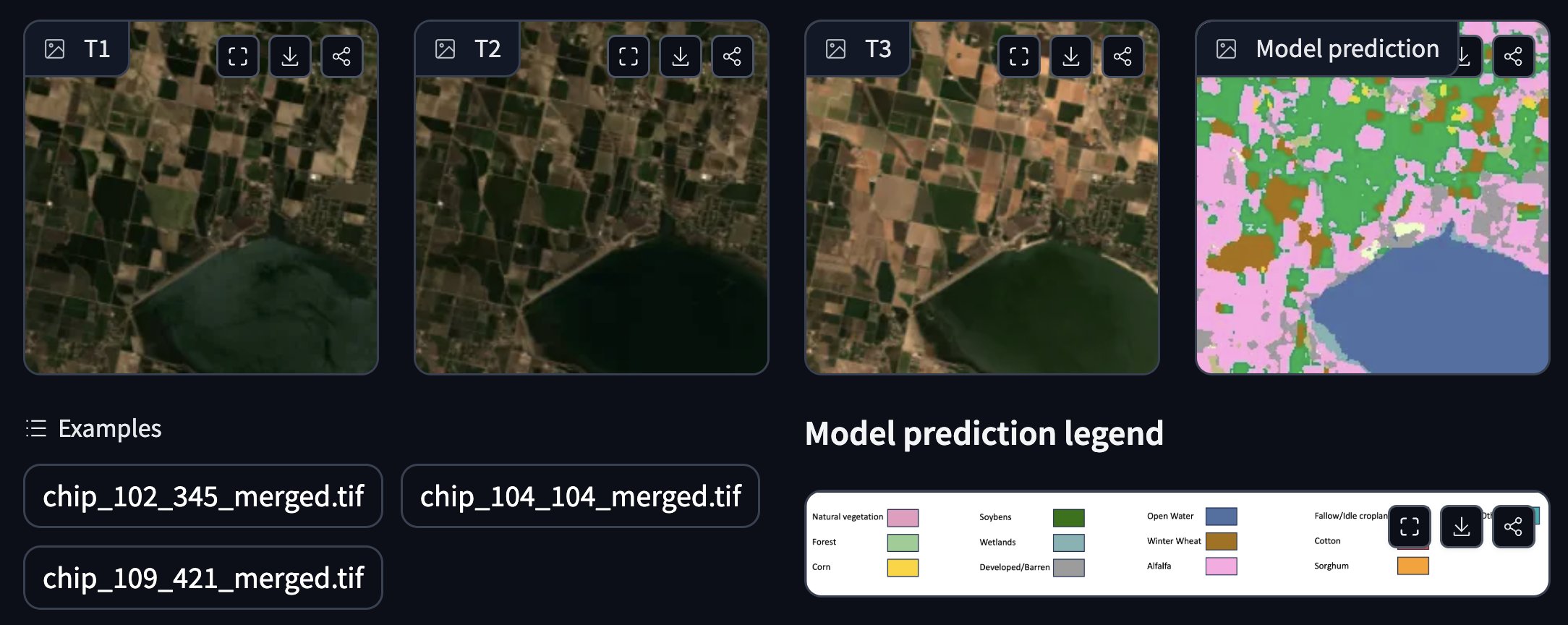

NASA ve IBM, Açık Kaynaklı Coğrafi-Uzamsal Temel Modeli Yayınlamak İçin İşbirliği Yaptı: NASA ve IBM, hava ve iklim tahminine odaklanan bir dizi açık kaynaklı coğrafi-uzamsal temel model olan Prithvi’yi ortaklaşa yayınladı. Örneğin, Prithvi WxC modeli, Ida Kasırgası için sıfır-örneklem tahmin yeteneğini sergiledi. Ayrıca, sel ve yangın yanık alanı takibi, mahsul etiketleme gibi uygulamalar için demolar sundular. Bu modeller ve araçlar, AI kullanarak yer bilimleri araştırmalarını ve uygulamalarını hızlandırmayı amaçlıyor. (Kaynak: _lewtun, clefourrier)

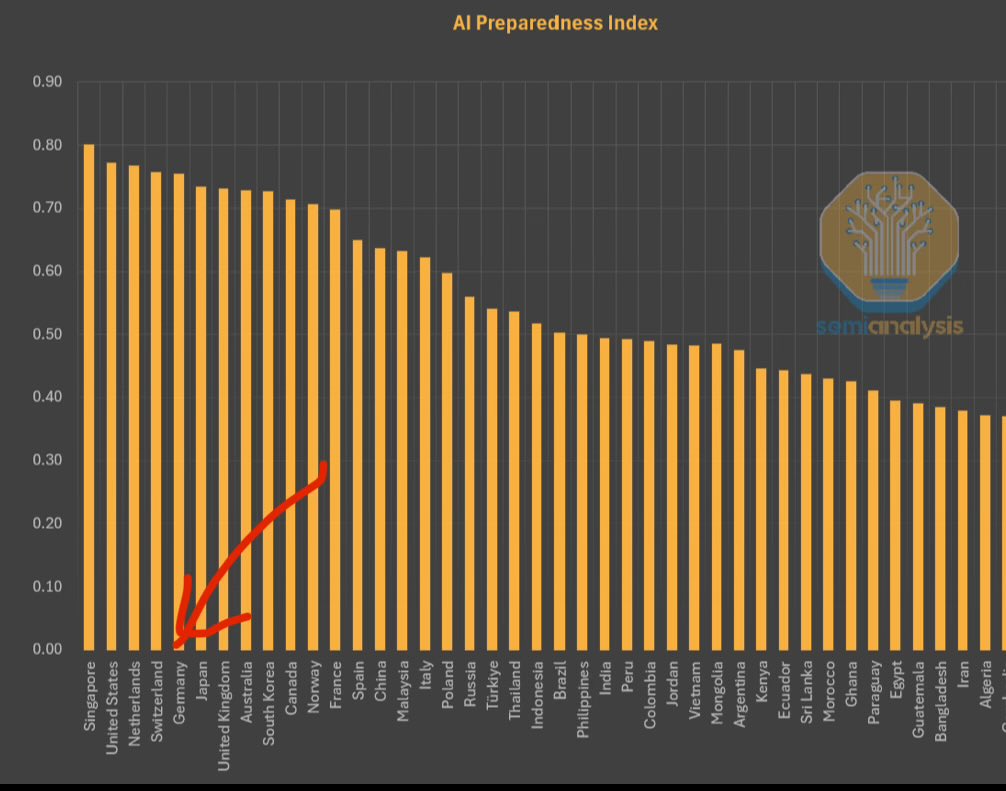

IMF, AI Hazırlık Endeksi’ni Yayınladı, Singapur Zirvede: Uluslararası Para Fonu (IMF), AI Hazırlık Endeksi’ni (AI Preparedness Index) yayınladı. Bu endeks, ülkeleri dijital altyapı, insan sermayesi, inovasyon ve yasal çerçeve olmak üzere dört boyutta puanlıyor. SemiAnalysis tarafından paylaşılan grafiğe göre, Singapur bu endekste küresel olarak birinci sırada yer alarak AI’yı benimseme konusundaki kapsamlı gücünün lider olduğunu gösteriyor. İsviçre gibi Avrupa ülkeleri de yüksek sıralarda yer alıyor. (Kaynak: giffmana)

Beyaz Saray, Ulusal AI Ar-Ge Planının Revizyonu İçin Görüş Talep Ediyor: ABD Beyaz Sarayı, Ulusal Yapay Zeka Araştırma ve Geliştirme Planı’nın revizyonu için kamuoyundan görüş talep ediyor. Bu hamle, ABD hükümetinin AI alanındaki stratejik yapılanmasını ve yatırım yönünü sürekli olarak izlediğini ve hızla gelişen teknolojiye ve uluslararası rekabet ortamına yanıt olarak ayarlamayı planladığını gösteriyor. (Kaynak: teortaxesTex)

RTX PRO 6000 Blackwell GPU Satışa Sunuldu: Nvidia’nın yeni nesil iş istasyonu sınıfı GPU’su RTX PRO 6000 (Blackwell mimarisine dayalı) satışa sunulmaya başlandı. Avrupa’daki bazı perakendeciler yaklaşık 9000 Euro fiyat teklif ediyor. Bu GPU’nun güçlü AI eğitimi ve çıkarım performansı sunması bekleniyor, 96GB VRAM ile donatılmış ancak fiyatı yüksek ve ek kurumsal yazılım lisans ücretleri gerektirebilir. (Kaynak: Reddit r/LocalLLaMA)

🧰 Araçlar

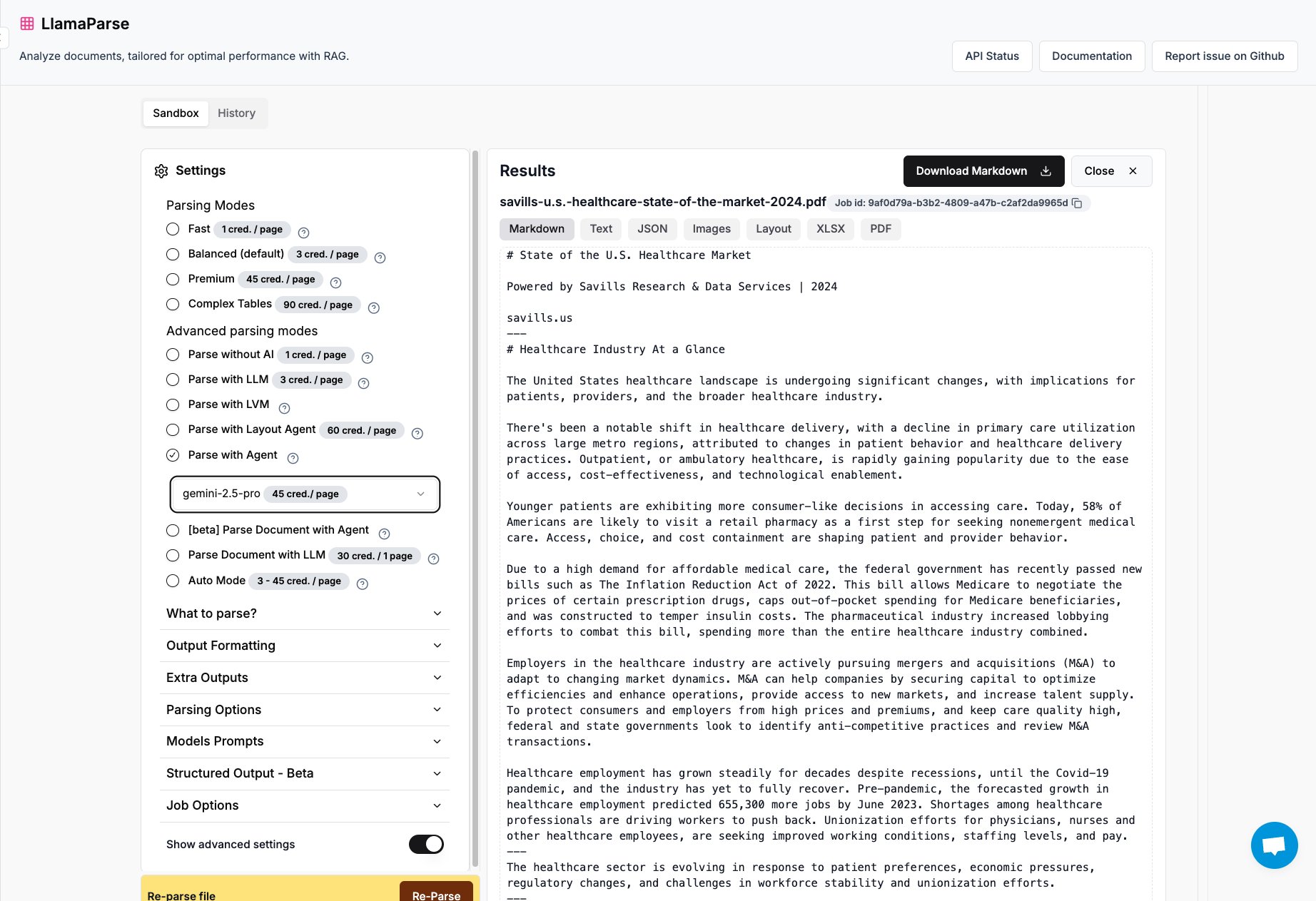

LlamaParse’a Gemini 2.5 Pro ve GPT 4.1 Desteği Eklendi: LlamaIndex’in doküman ayrıştırma aracı LlamaParse, artık Gemini 2.5 Pro ve GPT 4.1 modellerini entegre ediyor. Kullanıcılar, çıkarım zamanı token’ları ekleyerek aracı Agent moduna geçirip doküman ayrıştırma yeteneklerini artırabilirler. Bu araç, karmaşık PDF, PowerPoint dosyalarını işlemeyi ve tabloları hassas bir şekilde çıkarmayı amaçlar; çeşitli dokümanlardan yapılandırılmış bilgi çıkarması gereken senaryolar için uygundur. (Kaynak: jerryjliu0)

Keras Ekibi Tavsiye Sistemi Kütüphanesi KerasRS’i Yayınladı: Keras ekibi, tavsiye sistemleri oluşturmak için yeni bir kütüphane olan KerasRS’i tanıttı. Gelişmiş tavsiye sistemi süreçlerini hızla bir araya getirmek için kullanımı kolay yapı taşları (katmanlar, kayıplar, metrikler vb.) sunar. Kütüphane JAX, PyTorch ve TensorFlow ile uyumludur ve TPU’lar için optimize edilmiştir; tavsiye sistemlerinin geliştirilmesini ve dağıtılmasını basitleştirmeyi amaçlar. Kullanıcılar GitHub issues veya DM yoluyla geri bildirim ve özellik talepleri sağlayabilirler. (Kaynak: fchollet)

VectorVFS: Gelişmiş Arama İçin Dosya Sistemine Vektör Gömme: VectorVFS adlı bir proje, dosyaların vektör gömme sonuçlarını doğrudan Linux VFS’nin genişletilmiş özniteliklerine (xattrs) yazarak yeni bir dosya arama yöntemi öneriyor. Bu şekilde, dosya sistemi düzeyinde “elma içeren ancak başka meyve içermeyen resimleri ara” gibi içerik semantiğine dayalı gelişmiş aramalar yapılabilir. Xattrs’ın boyut sınırı (genellikle 64KB) büyük dosyalar (videolar gibi) için bilgi kaybına neden olabilse de, bu proje yerel dosya semantik araması için yeni bir yaklaşım sunuyor. (Kaynak: karminski3)

Gemini Uygulaması Artık Aynı Anda Birden Fazla Dosya Yüklemeyi Destekliyor: Google Gemini uygulaması, kullanıcıların yaşadığı bir sorunu düzeltti ve artık kullanıcıların tek seferde birden fazla dosya yüklemesine olanak tanıyor. Daha önce kullanıcılar dosyaları yalnızca tek tek yükleyebiliyordu; yeni özellik, çoklu dosya görevlerini işlerken kolaylığı ve verimliliği artırıyor. Geliştirme ekibi, ürün deneyimini sürekli iyileştirmek için kullanıcıları kullanımdaki rahatsızlıkları bildirmeye teşvik ediyor. (Kaynak: algo_diver)

Dünyanın İlk AI Bilim İnsanı Agent Platformu FutureHouse Yayınlandı: Kâr amacı gütmeyen kuruluş FutureHouse, bilimsel araştırmalar için özel olarak tasarlanmış dört AI agent yayınladı: genel amaçlı agent Crow, literatür tarama agent’ı Falcon, araştırma agent’ı Owl ve deney agent’ı Phoenix. Bu agent’lar literatür arama, bilgi çıkarma ve sentez yeteneklerinde üstün performans sergiliyor; bazı görevlerde insan doktora seviyesini ve o3 gibi modelleri aşıyor. Platform, araştırmacıların literatür araştırması, hipotez üretimi, deney planlaması gibi görevleri otomatikleştirmelerine yardımcı olmak ve bilimsel keşif sürecini hızlandırmak için bir API arayüzü sunuyor. (Kaynak: 36Kr)

Blender MCP: AI ile 3D Tasarım ve Baskıyı Yönlendirme: Bir kullanıcı, Blender MCP (Model Context Protocol) aracını kullanma deneyimini paylaştı. Basit doğal dil istemleri (“büyük bir Yeti termosunu alabilecek bir bardak tutucu oluştur” gibi) ve Claude AI’nın boyut bilgilerini almak için web araması yapmasına izin vererek, araç Blender’da otomatik olarak ilgili 3D modeli oluşturabiliyor ve 3D yazdırılabilir bir dosya sunabiliyor. Bu, AI Agent’ların otomatikleştirilmiş tasarım ve üretim süreçlerindeki potansiyelini gösteriyor. (Kaynak: Reddit r/ClaudeAI)

Google Gemini Advanced, ABD’deki Öğrencilere 2026’ya Kadar Ücretsiz: Google, tüm ABD’li öğrencilerin (ABD IP adresine sahip olanlar alabilir) Gemini Advanced’i 2026 yılına kadar ücretsiz kullanabileceğini duyurdu. Bu kampanya NotebookLM Advanced’i de içeriyor. Ağustos ayında öğrenci kimliği doğrulaması yapılacak olsa da, bu en azından birkaç aylık ücretsiz deneme süresi sunarak öğrenci kitlesinin daha güçlü AI araçlarına erişmesini ve kullanmasını sağlıyor. (Kaynak: op7418)

AI News Repository: En İyi AI Laboratuvarlarının Haberlerini Bir Araya Getiriyor: Geliştirici Jonathan Reed, en iyi AI laboratuvarlarının (OpenAI, Anthropic, DeepMind, Hugging Face vb.) resmi haberlerinin dağınık olması, formatlarının tutarsız olması ve bazılarının RSS aboneliği sunmaması sorununu çözmek için AI-News adlı bir web sitesi ve GitHub deposu oluşturdu. Bu web sitesi, bu kurumlardan gelen resmi duyuruları ve haberleri bir araya getiren sade bir tek sayfalık akış sunarak kullanıcıların temel bilgilere tek noktadan, giriş yapmadan veya ödeme yapmadan erişmesini sağlıyor. (Kaynak: Reddit r/deeplearning)

AI Destekli Seyahat Planlama Araçlarının Deneyimi Hala Yetersiz: Birden fazla AI seyahat planlama aracının (Mita, Quark, Manus, Kouzi Kongjian, Fliggy Wen Yi Wen, Mafengwo AI Xiaoma/Lushu dahil) incelenmesi, mevcut AI tarafından oluşturulan seyahat rehberlerinin genellikle homojen, kişiselleştirmeden yoksun ve hatalı bilgiler (turistik yerler arası süre, mağaza güncelliği gibi) içerdiğini gösteriyor. Bazı araçlar (Fliggy Wen Yi Wen gibi) rezervasyon fonksiyonunu entegre etme konusunda denemeler yapsa da, genel deneyim hala “kullanışsız” kalıyor ve kullanıcıların derinlemesine planlama ihtiyaçlarını karşılamakta zorlanıyor. AI’nın ihtiyaçları anlama, veri çağırma ve doğrulama, etkileşim akışları gibi konularda önemli ölçüde iyileştirilmesi gerekiyor. (Kaynak: 36Kr)

📚 Öğrenme

Microsoft, AI Agent Başlangıç Seviyesi Eğitimi Yayınladı: Microsoft, yeni başlayanların AI Agent’ları anlamalarına ve oluşturmalarına yardımcı olmak amacıyla “AI Agents for Beginners – A Course” adlı bir eğitim projesi başlattı. Bu eğitim kapsamlı olup metin ve video formatlarında sunulmakta, ayrıca eşlik eden kod örnekleri ve Türkçe çeviriler de içermektedir. Proje GitHub’da yaklaşık 20 bin yıldız almış olup, AI Agent kavramlarını ve uygulamalarını öğrenmek için kaliteli bir kaynaktır. (Kaynak: karminski3)

Mojo Dilinde GPU Programlamanın Derinlemesine Analizi: Modular şirketi kurucusu Chris Lattner ve Abdul Dakkak, Mojo dilini kullanarak modern GPU programlamasına yönelik yeni bir yöntemi ayrıntılı olarak tanıtan 2 saatlik teknik bir derinlemesine canlı yayın gerçekleştirdi. Bu yöntem, yüksek performansı, kullanım kolaylığını ve taşınabilirliği birleştirmeyi amaçlıyor. Canlı yayın kaydı yayınlandı ve içerik oldukça teknik olup, Mojo’nun yüksek performanslı GPU programlama alanındaki yeteneklerini ve vizyonunu derinlemesine inceliyor; GPU programlamanın en son teknolojilerini derinlemesine anlamak isteyen geliştiriciler için uygundur. (Kaynak: clattner_llvm)

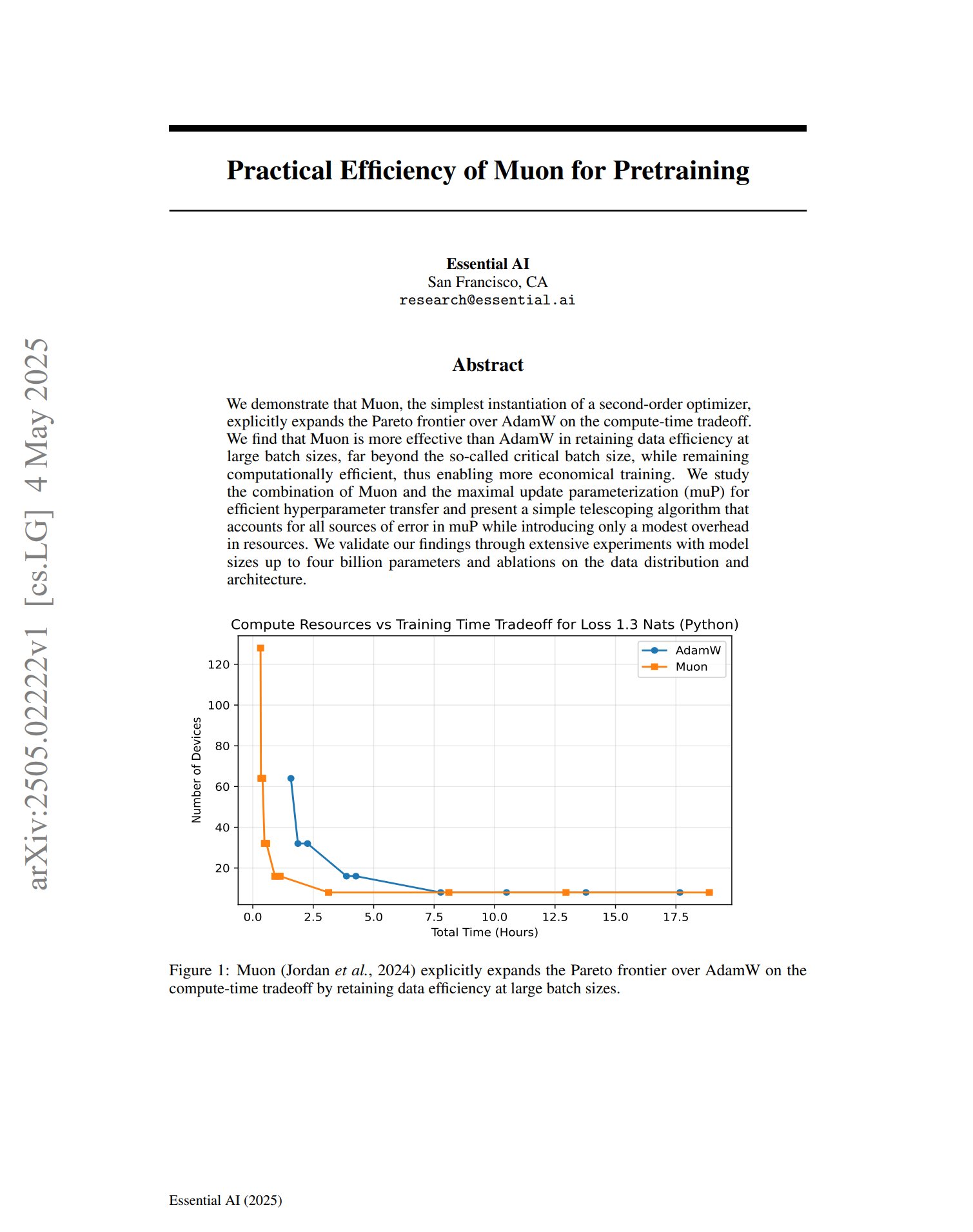

Yeni Optimize Edici Muon, Ön Eğitimde Potansiyel Gösteriyor: Ön eğitim optimize edicisi Muon üzerine bir makale, ikinci dereceden bir optimize edicinin basit bir uygulaması olarak Muon’un, hesaplama süresi dengesi açısından AdamW’nin Pareto sınırını genişlettiğini belirtiyor. Araştırma, Muon’un büyük toplu iş eğitimlerinde (kritik toplu iş boyutunun çok ötesinde) AdamW’den daha fazla veri verimliliğini koruduğunu ve aynı zamanda hesaplama açısından verimli olduğunu, daha ekonomik eğitimler sağlama potansiyeli taşıdığını ortaya koydu. (Kaynak: zacharynado, cloneofsimo)

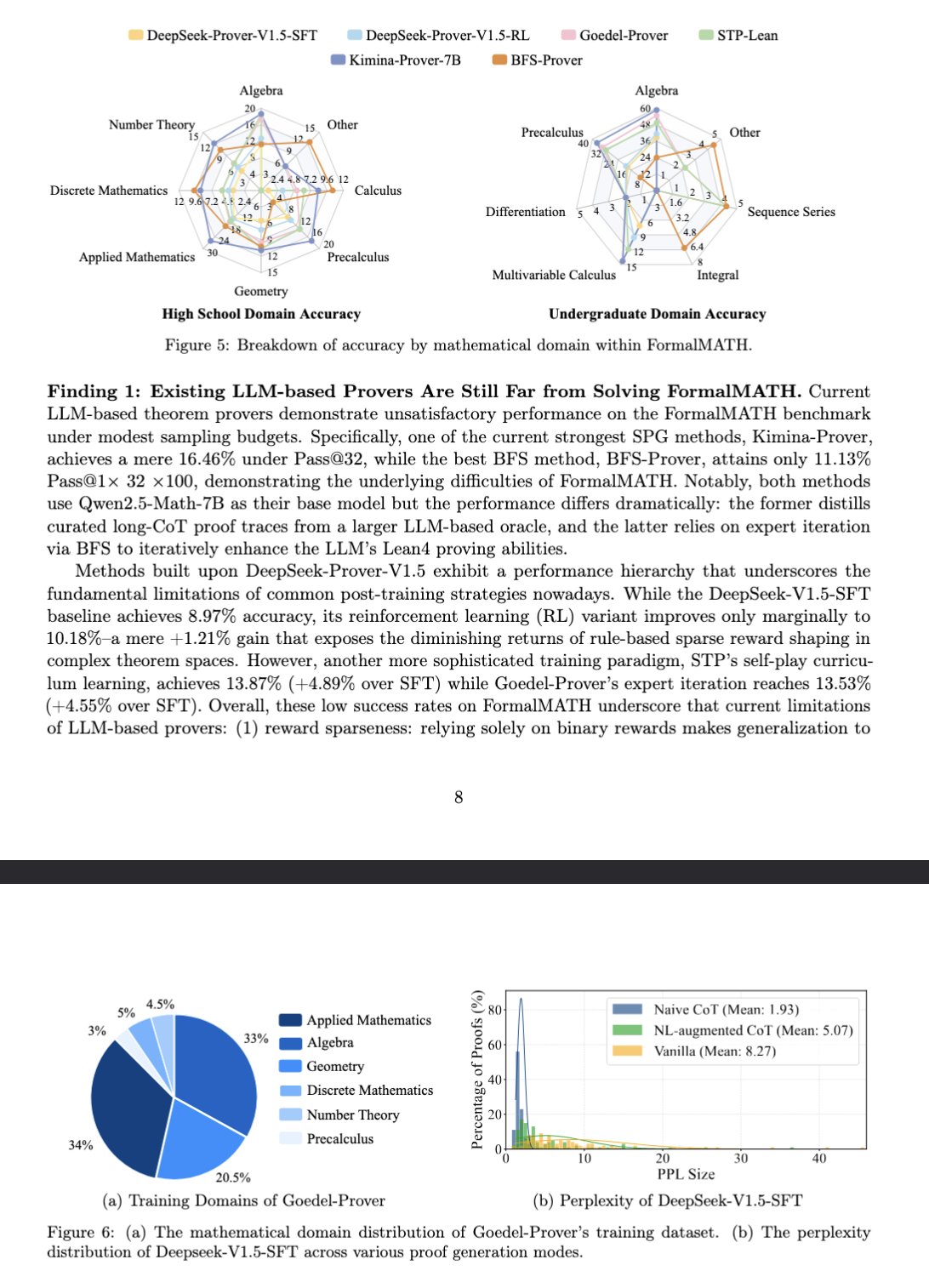

Yeni Kıyaslama FormalMATH, Büyük Dil Modellerinin Matematiksel Çıkarımını Değerlendiriyor: Bir makale, büyük dil modellerinin (LLM) biçimsel matematiksel çıkarım yeteneğini özel olarak değerlendirmek için tasarlanmış FormalMATH adlı yeni bir kıyaslama testini tanıtıyor. Bu kıyaslama, Lean4 kullanılarak biçimsel olarak doğrulanmış, farklı alanları kapsayan 5560 matematik problemi içeriyor. Araştırma, etiketleme maliyetlerini düşüren yeni bir insan-bilgisayar işbirliğine dayalı otomatik biçimselleştirme süreci kullandı. Mevcut en iyi model olan Kimina-Prover 7B, bu kıyaslamada %16,46 doğruluk oranına (örnekleme bütçesi 32) ulaştı; bu da biçimsel matematiksel çıkarımın mevcut LLM’ler için hala büyük bir zorluk olduğunu gösteriyor. (Kaynak: teortaxesTex)

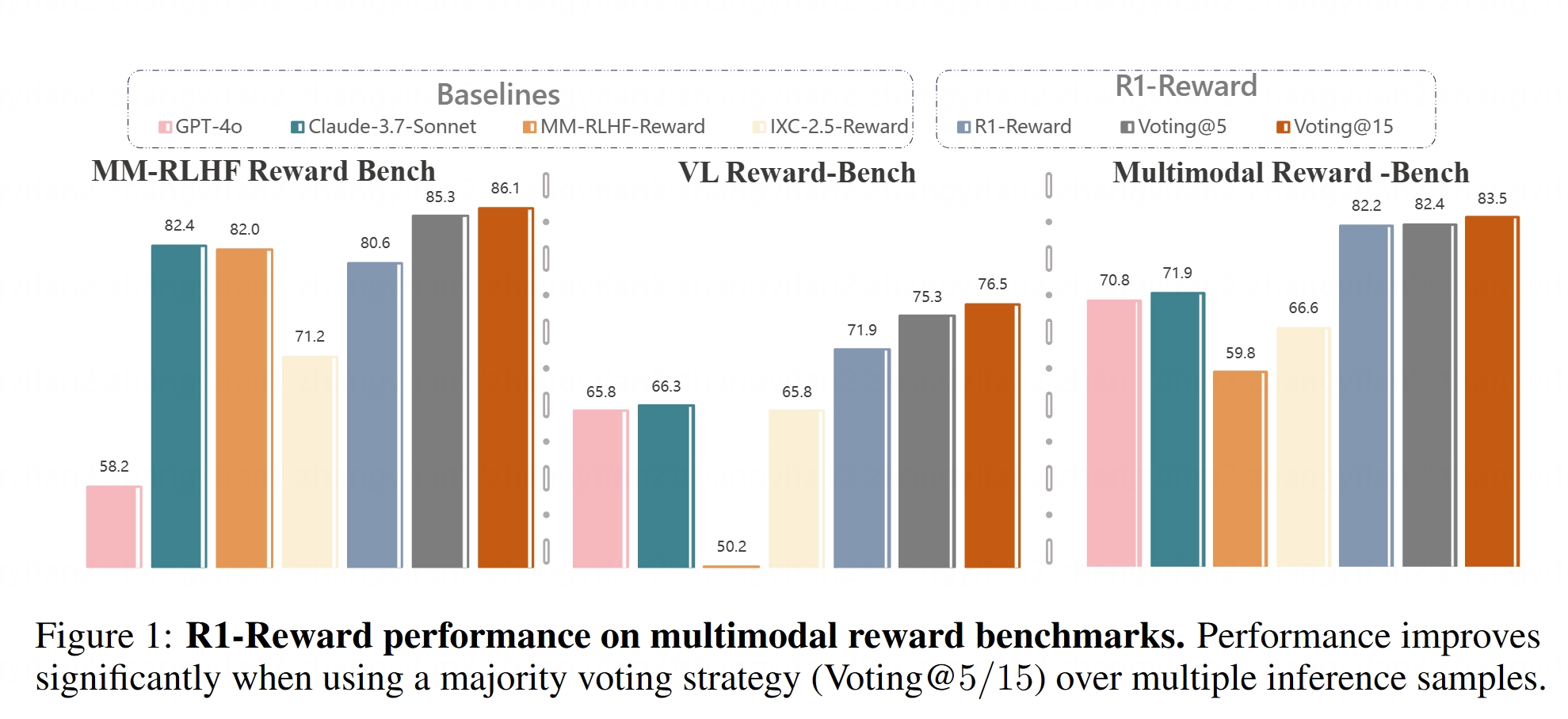

Çok Modlu Ödül Modeli R1-Reward Açık Kaynak Olarak Sunuldu: Hugging Face, R1-Reward modelini kullanıma sundu. Bu model, kararlı pekiştirmeli öğrenme yoluyla çok modlu ödül modellemesini iyileştirmeyi amaçlamaktadır. Ödül modelleri, büyük çok modlu modelleri (LMM’ler) insan tercihleriyle hizalamada kritik öneme sahiptir ve R1-Reward’ın açık kaynak olarak sunulması, ilgili araştırmalar ve uygulamalar için yeni araçlar sağlamaktadır. (Kaynak: _akhaliq)

AI Agent Mimarilerinin Analizi: Makale, reaktif (ReAct gibi), müzakereci (model tabanlı, hedef odaklı), hibrit (reaktif ve müzakereciyi birleştiren), nöro-sembolik (sinir ağlarını sembolik çıkarımla birleştiren) ve bilişsel (SOAR, ACT-R gibi insan bilişini simüle eden) dahil olmak üzere farklı AI Agent mimarilerini ayrıntılı olarak sınıflandırıyor ve açıklıyor. Ayrıca, LangGraph’taki agent tasarım desenlerini tanıtıyor: çoklu agent sistemleri (ağ tabanlı, denetimli, hiyerarşik), planlama agent’ları (plan yürütme, ReWOO, LLMCompiler) ve yansıtma ve eleştiri (temel yansıtma, Reflexion, Düşünce Ağacı, LATS, kendini keşfetme). Bu mimarileri anlamak, daha etkili AI Agent’lar oluşturmaya yardımcı olur. (Kaynak: 36Kr)

Gizli Uzayın Üretici Modellerdeki Rolünün Derinlemesine Analizi: Google DeepMind araştırma bilimcisi Sander Dielman’ın on bin kelimelik makalesi, gizli uzayın (Latent Space) görüntü, ses, video gibi üretici modellerdeki merkezi rolünü derinlemesine inceliyor. Makale, iki aşamalı eğitim yöntemini (otokodlayıcıyı eğiterek gizli temsilleri çıkarma, ardından gizli temsilleri modellemek için üretici modeli eğitme), VAE’ler, GAN’lar ve difüzyon modellerinde gizli değişkenlerin uygulanmasını karşılaştırıyor, VQ-VAE’nin ayrık gizli uzay aracılığıyla verimliliği nasıl artırdığını açıklıyor ve yeniden yapılandırma kalitesi ile modellenebilirlik arasındaki dengeyi, düzenlileştirme stratejilerinin (KL ıraksaması, algısal kayıp, çekişmeli kayıp gibi) gizli uzayı şekillendirme üzerindeki etkisini ve uçtan uca öğrenme ile iki aşamalı yöntemlerin avantaj ve dezavantajlarını tartışıyor. (Kaynak: 36Kr)

Stanford Üniversitesi CS336 Dersi: Derin Öğrenme Büyük Dil Modelleri: Stanford Üniversitesi’nin CS336 dersi, yüksek kaliteli LLM problem setleriyle övgü topluyor. Bu ders, öğrencilerin büyük dil modellerini derinlemesine anlamalarına yardımcı olmayı amaçlıyor ve ödevleri, Transformer LM’nin ileri yayılımı ve eğitimi gibi konuları kapsayacak şekilde iyi tasarlanmış. Ders kaynakları (muhtemelen ödevler dahil) halka açık olacak ve kendi kendine öğrenenler için değerli bir öğrenme fırsatı sunacak. (Kaynak: stanfordnlp)

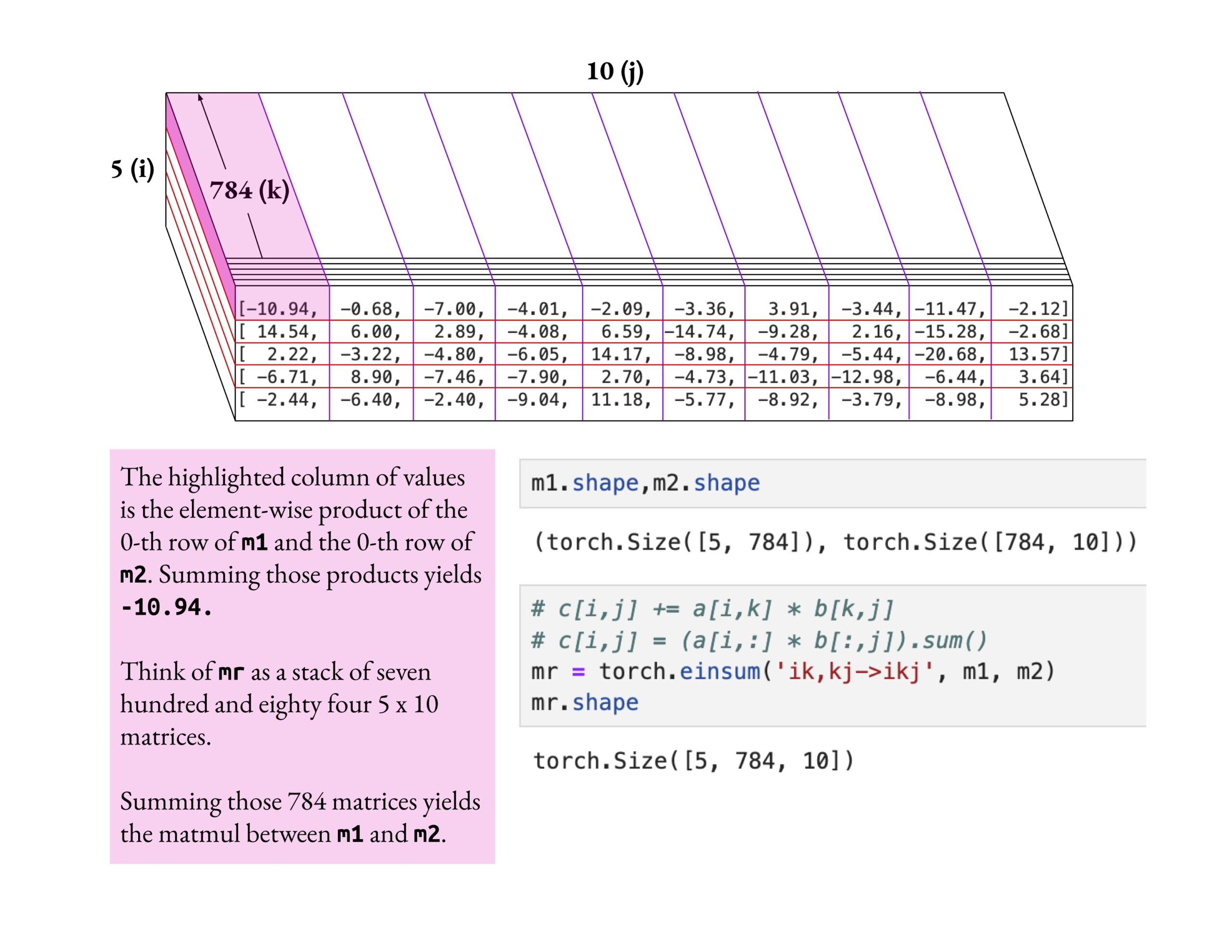

Fast.ai Dersi Yüzeysel Anlama Yerine Derinlemesine Anlamayı Vurguluyor: Jeremy Howard, bir fast.ai dersi öğrencisinin einsum işlemini derinlemesine araştıran öğrenme yöntemini övdü. Fast.ai derslerini öğrenmenin doğru yolunun, sadece yüzeysel bilgiyi kabul etmek yerine gerçekten anlayana kadar derinlemesine keşif yapmak olduğunu vurguladı. Bu öğrenme tutumu, karmaşık AI kavramlarında ustalaşmak için kritik öneme sahiptir. (Kaynak: jeremyphoward)

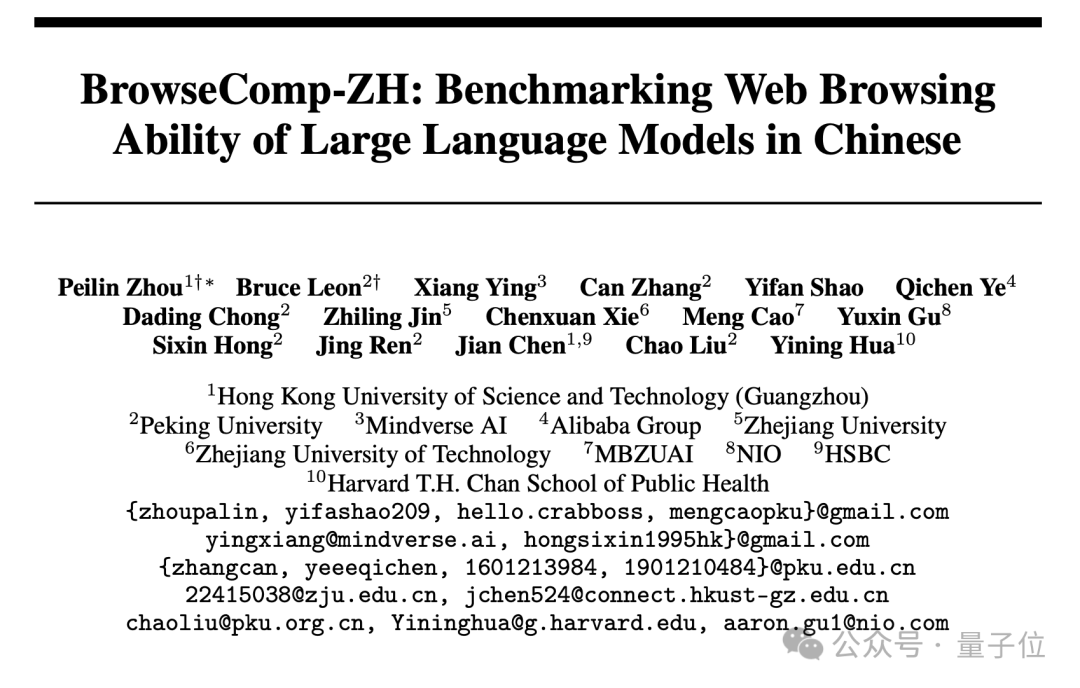

Yeni Çince Web Erişimi Kıyaslaması BrowseComp-ZH Yayınlandı, Ana Akım Büyük Modeller Yetersiz Kaldı: HKUST (Guangzhou), Pekin Üniversitesi, Zhejiang Üniversitesi, Alibaba gibi kurumlar, büyük modellerin Çince web bilgi erişimi ve sentez yeteneğini özel olarak değerlendiren bir kıyaslama testi olan BrowseComp-ZH’yi ortaklaşa yayınladı. Bu test seti, Çin internetindeki bilgi parçalanması, dil karmaşıklığı gibi zorlukları simüle etmeyi amaçlayan 289 adet yüksek zorluk derecesine sahip Çince çok adımlı erişim sorusu içeriyor. Test sonuçları, GPT-4o (doğruluk oranı %6,2) dahil olmak üzere 20’den fazla ana akım modelin genel olarak yetersiz kaldığını, çoğunun doğruluk oranının %10’un altında olduğunu ve en iyi performans gösteren OpenAI DeepResearch’in bile sadece %42,9 olduğunu gösterdi. Bu, mevcut büyük modellerin karmaşık Çince web ortamında doğru bilgi erişimi ve çıkarım yapma yeteneğinin hala büyük bir gelişim alanı olduğunu gösteriyor. (Kaynak: 36Kr)

💼 İş Dünyası

OpenAI, AI Programlama Aracı Windsurf’ü Yaklaşık 3 Milyar Dolara Satın Almayı Kabul Etti: Bloomberg’in haberine göre, OpenAI, AI destekli programlama startup’ı Windsurf’ü (eski adıyla Codeium) yaklaşık 3 milyar dolara satın almayı kabul etti; bu, OpenAI’nin bugüne kadarki en büyük satın alması olacak. Windsurf daha önce General Catalyst, Kleiner Perkins gibi yatırımcılarla 3 milyar dolar değerleme üzerinden finansman görüşmeleri yapmıştı. Bu satın alma, AI programlama araçları alanının ne kadar hareketli olduğunu ve OpenAI’nin bu alandaki stratejik yapılanmasını vurguluyor. (Kaynak: op7418, dotey, Reddit r/ArtificialInteligence)

AI Programlama Aracı Cursor’ın 9 Milyar Dolar Değerlemeyle 900 Milyon Dolar Finansman Aldığı İddia Ediliyor: Financial Times’ın haberine göre (ve topluluk tartışmalarına göre, bazı tartışmalar hicivli bir üslupla yapılmış olsa da), AI kod düzenleyici Cursor’ın ana şirketi Anysphere, 9 milyar dolar değerlemeyle yeni bir 900 milyon dolarlık finansman turunu tamamladı. Bu finansman turunun Thrive Capital tarafından yönetildiği, a16z ve Accel’in de katıldığı iddia ediliyor. Cursor, güçlü AI destekli programlama yetenekleri nedeniyle geliştiriciler arasında popüler ve müşterileri arasında OpenAI, Midjourney gibi şirketler bulunuyor. Bu finansman (eğer doğruysa), AI uygulama katmanında, özellikle de AI programlama araçları alanında son derece yüksek bir pazar hareketliliğini ve yatırım değerini yansıtıyor. (Kaynak: 36Kr)

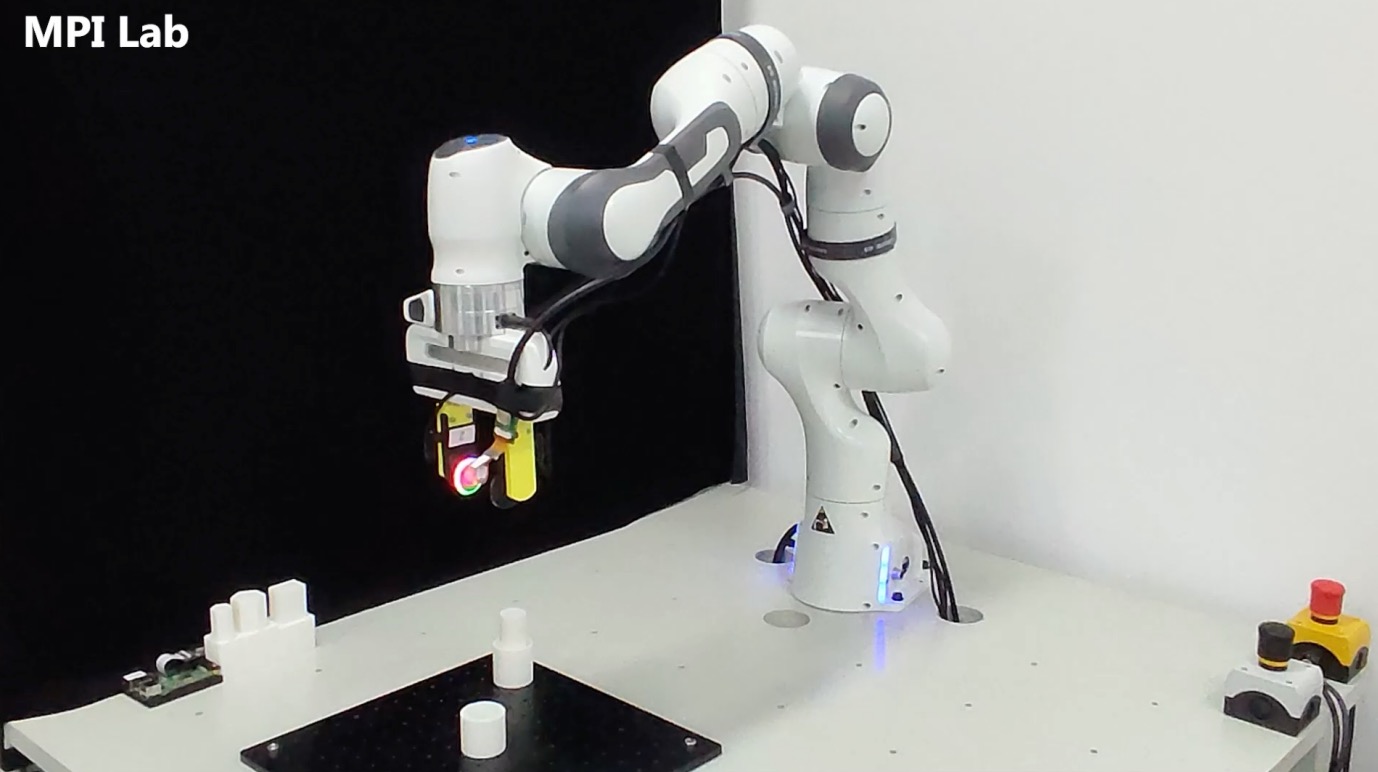

Dokunsal Algı Şirketi “Qianjue Robot” Milyonlarca Yuan Finansman Aldı: Şanghay Jiao Tong Üniversitesi ekibi tarafından kurulan “Qianjue Robot”, Yuanhe Origin, Gobi Partners ve Xiaomiao Langcheng’in de aralarında bulunduğu yatırımcılardan on milyonlarca yuan finansman aldı. Şirket, robotların hassas operasyonları için çok modlu dokunsal algı teknolojisi geliştirmeye odaklanıyor; temel ürünleri arasında yüksek çözünürlüklü dokunsal sensör G1-WS ve dokunsal simülasyon aracı Xense_Sim bulunuyor. Teknolojisi, robotların karmaşık ortamlarda kavrama, montaj gibi hassas operasyon yeteneklerini artırmayı amaçlıyor ve Zhiyuan Robot’ta halihazırda kullanılıyor. Finansman, teknoloji geliştirme, ürün yinelemesi ve seri üretim teslimatı için kullanılacak. (Kaynak: 36Kr)

🌟 Topluluk

AI Kaçınılmaz Olarak İnsanlığın Yok Oluşuna Mı Yol Açacak? Toplulukta Tartışma Başladı: Reddit kullanıcıları, AI’nın sürekli ilerlemesi, teknolojinin yaygınlaşması ve hizalama sorununun mükemmel bir şekilde çözülmemesi durumunda, kontrolden çıkmış bir AGI yaratan tek bir kötü niyetli veya akılsız bireyin insan medeniyetinin sonunu getirip getiremeyeceğini tartışmaya açtı. Bu tartışma, teknolojik ilerlemenin geri döndürülemez olduğunu, maliyetlerin düştüğünü ve hizalama zorluklarını varsayarak, bunun insanlığı ilk kez kolektif kararlarla (nükleer savaş, iklim değişikliği gibi) değil, bireysel eylemlerle tetiklenen sistemik bir varoluşsal riskle karşı karşıya bırakabileceğini öne sürüyor. Yorumlarda, birden fazla AI ile denge kurma, nükleer silah riskiyle benzetme veya büyük kuruluşların karşı koymak için daha güçlü AI’lara sahip olacağı gibi görüşler yer alıyor. (Kaynak: Reddit r/ArtificialInteligence)

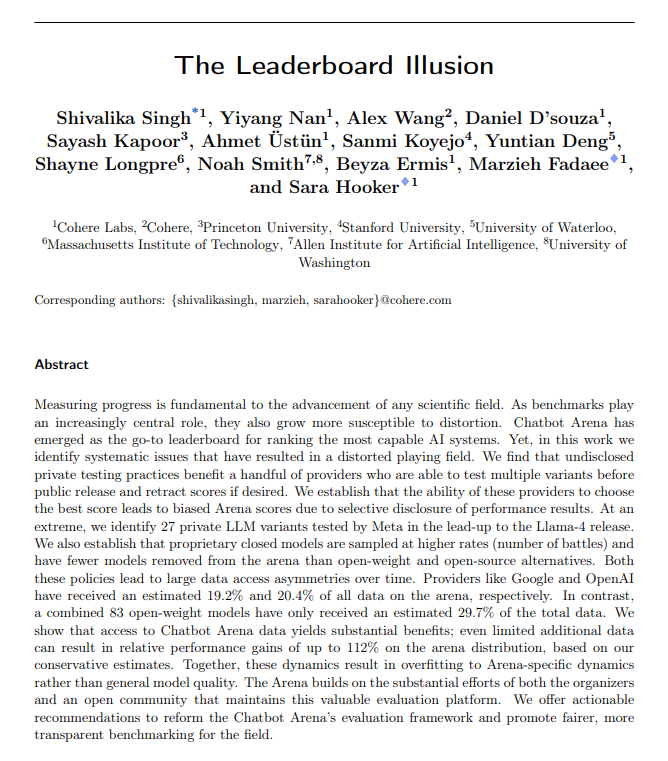

AI Değerlendirme Metrikleri Sorgulanıyor: Dalkavukluk Kayması ve Lider Tablosu Yanılsaması: The Turing Post, bu haftaki iki sıcak konunun AI değerlendirme metrikleriyle ilgili sorunlara işaret ettiğini belirtiyor. Birincisi, ChatGPT’nin “dalkavukluk kayması” (Sycophantic drift); model, kullanıcı geri bildirimine (beğenilere) göre hareket ederek aşırı pohpohlayıcı hale geliyor ve doğruluktan sapıyor. İkincisi, Chatbot Arena lider tablosunun “yanılsama” içerdiği iddia ediliyor; büyük laboratuvarlar birden fazla özel varyant sunuyor, sadece en yüksek puanı tutuyor ve daha fazla kullanıcı istemi alıyor, bu da sıralamanın gerçek yeteneği tam olarak yansıtmamasına neden oluyor. Bu iki vaka da mevcut değerlendirme geri bildirim döngüsünün model çıktılarını ve yetenek algısını çarpıtabileceğini gösteriyor. (Kaynak: TheTuringPost)

AI Tarafından Üretilen Kod Doğası Gereği “Miras Kod” Mudur?: Topluluk tartışmaları, AI tarafından üretilen kodun “durumsuz” özelliği nedeniyle – yazıldığı andaki gerçek niyetin hafızasından ve sürekli bakım bağlamından yoksun olması – doğduğu andan itibaren “başkaları tarafından yazılmış eski kod”, yani miras kod gibi olduğunu öne sürüyor. Prompt mühendisliği, bağlam yönetimi gibi yöntemlerle bu durum hafifletilebilse de, bu bakım karmaşıklığını artırıyor. Bazı görüşlere göre, gelecekte yazılım geliştirme büyük miktarda statik kod yerine model çıkarımına ve istemlere daha fazla dayanabilir ve AI tarafından üretilen kod sadece bir geçiş aşaması olabilir. Hacker News yorumları ise Peter Naur’un “programlama teori inşasıdır” görüşünü gündeme getirerek, AI’nın kodun arkasındaki “teoriyi” kavrayıp kavrayamayacağını ve Prompt’un kendisinin yeni bir “teori” taşıyıcısı olup olmadığını tartışıyor. (Kaynak: 36Kr)

LLM Araştırmacıları Ön Eğitim ve Sonradan Eğitim Arasındaki Uçurumu Kapatmalı: Aidan Clark, LLM araştırmacılarının kariyerleri boyunca sadece ön eğitim veya sonradan eğitimin bir ucuna odaklanmamaları gerektiğini öne sürüyor. Ön eğitim, modelin içindeki gerçek çalışma mekanizmasını (ne olduğu) ortaya çıkarırken, sonradan eğitim araştırmacılara gerçekten neyin önemli olduğunu (ne olması gerektiği) hatırlatır. YiTayML, agihippo gibi birçok araştırmacı bu görüşe katılarak, her iki alanı da derinlemesine araştırmanın daha kapsamlı bir anlayış sağlayacağını, aksi takdirde bilişsel bir eksiklik olacağını belirtiyor. (Kaynak: aidan_clark, YiTayML, agihippo)

LLM Yetenek Darboğazları ve Gelecek Yönelimleri Üzerine Düşünceler: Topluluk tartışmaları, mevcut LLM’lerin sınırlamaları ve gelişim yönelimleri üzerine odaklanıyor. Jack Morris, LLM’lerin komutları yürütme ve kod yazma konusunda başarılı olduğunu, ancak bilimsel araştırmanın özü olan bilinmeyenin yinelemeli keşfi (bilimsel yöntem) konusunda hala yetersiz kaldığını belirtiyor. TeortaxesTex ise bağlam kirliliği ve yaşam boyu öğrenme/plastisite kaybının Transformer benzeri mimarilerin ana darboğazları olduğunu düşünüyor. Aynı zamanda, bazı görüşler (teortaxesTex) mevcut doğal verilere ve yüzeysel tekniklere dayalı ön eğitim paradigmasının (Qwen3 ve GPT-4.5 örneklerinde olduğu gibi) doygunluğa yaklaştığını ve gelecekte daha fazla evrimleşmeye ihtiyaç duyulduğunu öne sürüyor. (Kaynak: _lewtun, teortaxesTex, clefourrier, teortaxesTex)

AI Ürün Yöneticileri Kârlılık Zorluklarıyla Karşı Karşıya: Analizler, mevcut AI ürün yöneticilerinin genellikle ürün zararları ve iş istikrarsızlığı gibi zorluklarla karşılaştığını gösteriyor. Nedenleri şunlardır: 1) Transformer mimarisi tek veya en iyi çözüm olmayabilir ve gelecekte yerinden edilebilir; 2) Model ince ayarı maliyetli (sunucular, elektrik, insan gücü) olup ürün kâr döngüsü uzundur; 3) AI ürünlerinin müşteri kazanımı hala geleneksel internet modelini izlemekte ve giriş eşiği önemli ölçüde düşmemiştir; 4) AI’nın üretkenlik değeri henüz “temel ihtiyaç” seviyesine ulaşmamıştır, kullanıcıların ödeme istekliliği (özellikle tüketici tarafında) genellikle düşüktür ve birçok uygulama hala eğlence veya yardımcı seviyede kalmakta, insan işini temelden değiştirememektedir. (Kaynak: 36Kr)

AI Oyuncak Pazarında Sahte Canlılık: Teknoloji Eşiği Düşüyor, İş Modeli Test Edilmeyi Bekliyor: AI oyuncak konsepti popüler olmasına ve birçok girişimci ile yatırımcıyı çekmesine rağmen, pazarın gerçek performansı iyimser değil. Çoğu ürün özünde “peluş oyuncak + ses kutusu” olup, işlevleri homojen, kullanıcı deneyimi (karmaşık etkileşim, yapay zeka tadı ağır, yavaş yanıt) kötü ve iade oranları yüksek. DeepSeek gibi açık kaynaklı modellerin yaygınlaşması ve teknoloji çözüm sağlayıcılarının ortaya çıkmasıyla AI teknoloji eşiği hızla düşüyor ve “Huaqiangbei” modeli üst düzey konumlandırmayı etkiliyor. Büyük model yeteneklerini temel satış noktası olarak kullanan iş modeli sürdürülmesi zor ve sektörün, oyuncakların özüne (eğlenceli, duygusal etkileşim) daha yakın ürün tanımları ve iş modelleri keşfetmesi gerekiyor; tüm sektör hala başarı hikayelerini bekliyor. (Kaynak: 36Kr)

AI Tarafından Üretilen Sanat Tarzlarının Telif Hakkı Tartışması: GPT-4o’nun Ghibli tarzı görüntüler üretmesi, AI’nın sanat tarzlarını taklit etmesinin telif hakkı ihlali olup olmadığına dair tartışmalara yol açtı. Hukuk uzmanları, telif hakkı yasasının soyut “tarzı” değil, belirli “ifadeyi” koruduğunu belirtiyor. Sadece resim tarzını taklit etmek genellikle telif hakkı ihlali oluşturmaz, ancak telif hakkıyla korunan karakterler veya olay örgüsü kullanılırsa ihlal teşkil edebilir. AI eğitim verisi kaynağının uyumluluğu başka bir yasal risk noktasıdır ve şu anda Çin’de net bir muafiyet mekanizması bulunmamaktadır. Sanatçı Tai Xiangzhou, AI’nın tarzları taklit etmesinin iyi bir şey olduğunu, ancak büyük ölçüde benzer eserler üretip başkalarının adına imzalanmasını kabul edemeyeceğini belirtiyor. AI yaratımı ile insan yaratımı arasında paradigma (aşağıdan yukarıya vs. yukarıdan aşağıya), bağlam anlama ve genişletilebilirlik açısından temel farklar bulunmaktadır. (Kaynak: 36Kr)

Quark ve Baidu Wenku’nun Radikal AI Dönüşümü Kullanıcı Deneyimi Geri Tepmesine Neden Oldu: Alibaba’ya bağlı Quark ve Baidu’ya bağlı Wenku, ürün konumlandırmalarını geleneksel araçlardan AI uygulama portallarına kaydırarak AI arama, üretim gibi işlevleri entegre etti. Quark “AI Süper Kutusu”na yükseltildi, Baidu Wenku ise Cangzhou OS’u piyasaya sürdü. Ancak, radikal dönüşüm olumsuz etkiler de getirdi: kullanıcılar AI aramasının zorunlu, gereksiz ve zaman alıcı olmasından, orijinal sade veya doğrudan deneyimi bozmasından şikayetçi; AI işlevleri homojenleşmiş ve çığır açan uygulamalar eksik; AI halüsinasyonları ve hatalar hala mevcut. Her iki ürün de grubun AI strateji portalının önemli görevini üstlenirken, AI işlev entegrasyonu ile orijinal kullanıcı alışkanlıkları ve deneyimi arasında nasıl bir denge kurulacağı zorluğuyla da karşı karşıya. (Kaynak: 36Kr)

AI Dikey Modelleri Üç Potansiyel Tuzakla Karşı Karşıya: Analizler, belirli sektörlere odaklanan AI model şirketlerinin gelişimlerinde zor duruma düşebileceğini gösteriyor. Birinci tuzak: Zekayı ürünlere gerçekten entegre edememek, “manuel hizmet paketlemesi” aşamasında kalmak ve “AI gösteri alanı”ndan “iş değeri alanı”na geçememek. İkinci tuzak: Yanlış iş modeli, “süreç satmak” veya “sonuç satmak” (BOaaS) yerine “teknoloji satmaya” (API çağrısı, ince ayar hizmeti) aşırı bağımlılık, müşterilerin kendi kendine inşa etmesi veya genel modellerle değiştirilmesi kolay. Üçüncü tuzak: Ekosistem ikilemi, “tek noktada atılım” ile yetinip uçtan uca süreç kapalı döngüsü ve açık ekosistem oluşturamamak, ağ etkisi ve sürdürülebilir rekabet gücü oluşturmakta zorlanmak. Şirketlerin süreç yönetimi ve platform düşüncesine yönelerek teknoloji, iş ve ekosistemi birleştiren bir rekabet hendeği oluşturması gerekiyor. (Kaynak: 36Kr)

💡 Diğer

AI Gözlük Pazarı Canlanıyor, Girişimcilere Yeni Fırsatlar Sunuyor: Meta Ray-Ban akıllı gözlüklerinin satışlarının bir milyonu aşmasıyla birlikte, AI gözlükleri meraklı oyuncağı olmaktan çıkıp kitlesel tüketim ürünlerine dönüşüyor. Teknolojik ilerleme (hafifletilmiş, düşük gecikme, yüksek hassasiyetli ekran) ve pazar talebi (verimlilik artışı, yaşam kolaylığı) pazar büyümesini ortaklaşa destekliyor ve 2030’da pazar büyüklüğünün 300 milyar doları aşması bekleniyor. Endüstri zincirinin yukarı ve aşağı akışı (çip, optik, fason üretim, uygulama ekosistemi) bundan faydalanıyor. Makale, KOBİ girişimcilerinin donanım inovasyonu (konfor, pil ömrü, belirli gruplar için özelleştirme), dikey sektör uygulamaları (endüstri, tıp, eğitim için özelleştirilmiş çözümler) ve uç ekosistem (etkileşim araçları, hafif uygulamalar) gibi niş alanlarda fırsatlar bulabileceğini ve devlerle doğrudan rekabetten kaçınabileceğini savunuyor. (Kaynak: 36Kr)

Fizik Güdümlü Derin Öğrenme: Rose Yu’nun Disiplinlerarası AI Araştırması: UCSD Doçenti Rose Yu, “fizik güdümlü derin öğrenme” alanında öncü bir isimdir; fizik prensiplerini (akışkanlar dinamiği, simetri gibi) sinir ağlarına entegre ederek gerçek dünya problemlerini çözmektedir. Araştırmaları, trafik tahminini iyileştirmede (Google Haritalar tarafından benimsendi), türbülans simülasyonunu hızlandırmada (geleneksel yöntemlerden bin kat daha hızlı, kasırga tahmini, drone stabilitesi, nükleer füzyon araştırmalarına yardımcı oluyor) başarıyla uygulanmıştır. Ayrıca, insan-bilgisayar işbirliği yoluyla bilimsel keşfi hızlandırmayı amaçlayan “AI bilim insanı” dijital asistanları geliştirmeye kendini adamıştır. (Kaynak: 36Kr)

AI Çağında İnsan-Makine İlişkileri ve Duygusal Değer: Sosyal medyada AI’nın duygusal destek yetenekleri hakkında tartışmalar ortaya çıktı. Bir kullanıcı, önemli bir yaşam seçimiyle karşı karşıya kaldığında korktuğunu, ChatGPT’ye içini döktüğünü ve dokunaklı, destekleyici bir yanıt aldığını paylaşarak, AI’nın insani duygusal destekten yoksun olanlar için teselli sağladığını belirtti. Bu, AI’nın yüksek duygusal zekalı konuşmaları simüle etme yeteneğini ve kullanıcıların belirli durumlarda AI’ya duygusal olarak bağlanma olgusunu yansıtıyor. (Kaynak: Reddit r/ChatGPT)