Anahtar Kelimeler:Qwen3 serisi modeller, Claude Code, AI model kıyaslama testleri, Runway Gen-4, LangGraph, Qwen3-235B-A22B performansı, Claude Code programlama asistanı, SimpleBench kıyaslama testi, Runway Gen-4 Referanslar özelliği, LangGraph Agent uygulaması

🔥 Öne Çıkanlar

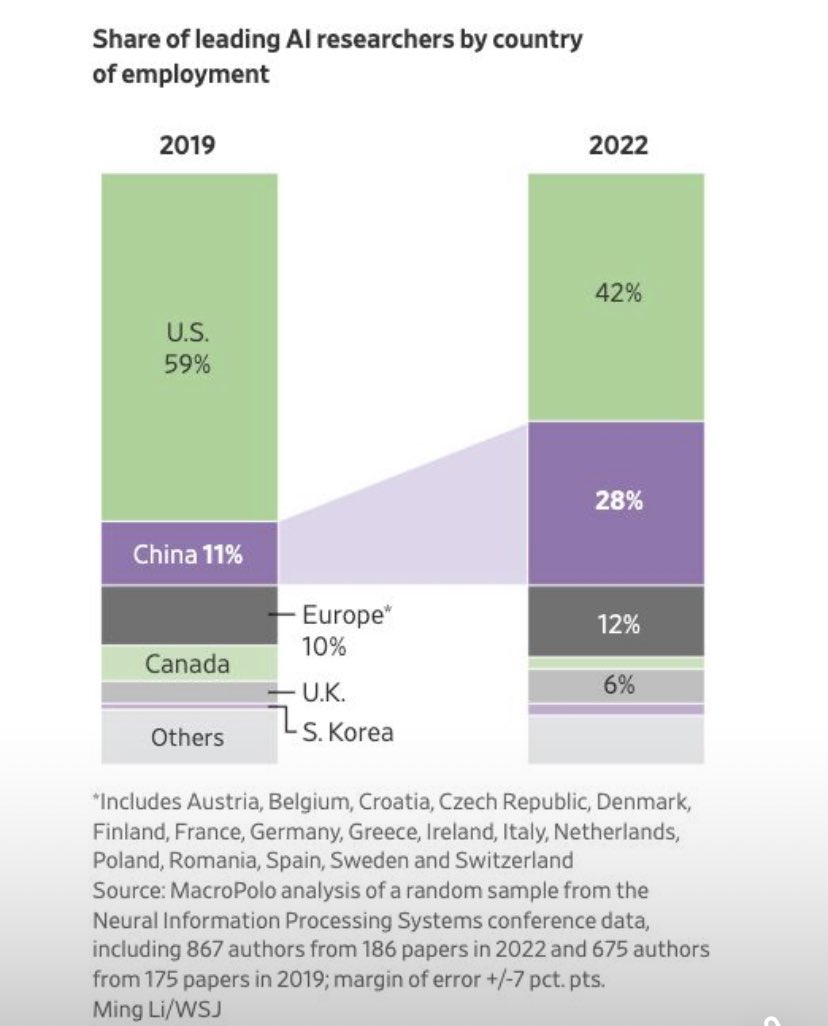

Qwen3 Serisi Modellerin Yayınlanması ve Performansı: Alibaba, 0.6B’den 235B’ye kadar çeşitli boyutları kapsayan Qwen3 serisi modellerini yayınladı. Topluluk geri bildirimleri, küçük modellerin (örneğin 4B) kolay ince ayar (fine-tuning) yapılabilmesi nedeniyle daha yüksek indirme sayılarına sahip olduğunu, MoE modelleri arasında ise 30B-A3B’nin daha popüler olduğunu gösteriyor. Performans açısından, Qwen3-235B-A22B, SimpleBench üzerinde üstün bir performans sergileyerek 13. sırada yer aldı ve o1/o3-mini ile DeepSeek-R1 gibi modelleri geride bıraktı. Qwen3-8B, yerel çalıştırmada iyi performans gösteriyor; küçük boyutu (4.3GB nicelenmiş sürüm) ve düşük bellek kullanımı (4-5GB) ile sınırlı kaynaklara sahip ortamlar için uygun. Ancak bazı kullanıcılar, Qwen3’ün otonom AI Agent’ları yönlendirme konusunda yetersiz kaldığını, yapılandırılmış üretimde istikrarsızlık, diller arası işlemede zorluklar, çevre anlayışı eksikliği ve sansür sorunları gibi eksikliklere işaret etti. (Kaynak: karminski3, scaling01, BorisMPower, Reddit r/LocalLLaMA, Reddit r/MachineLearning)

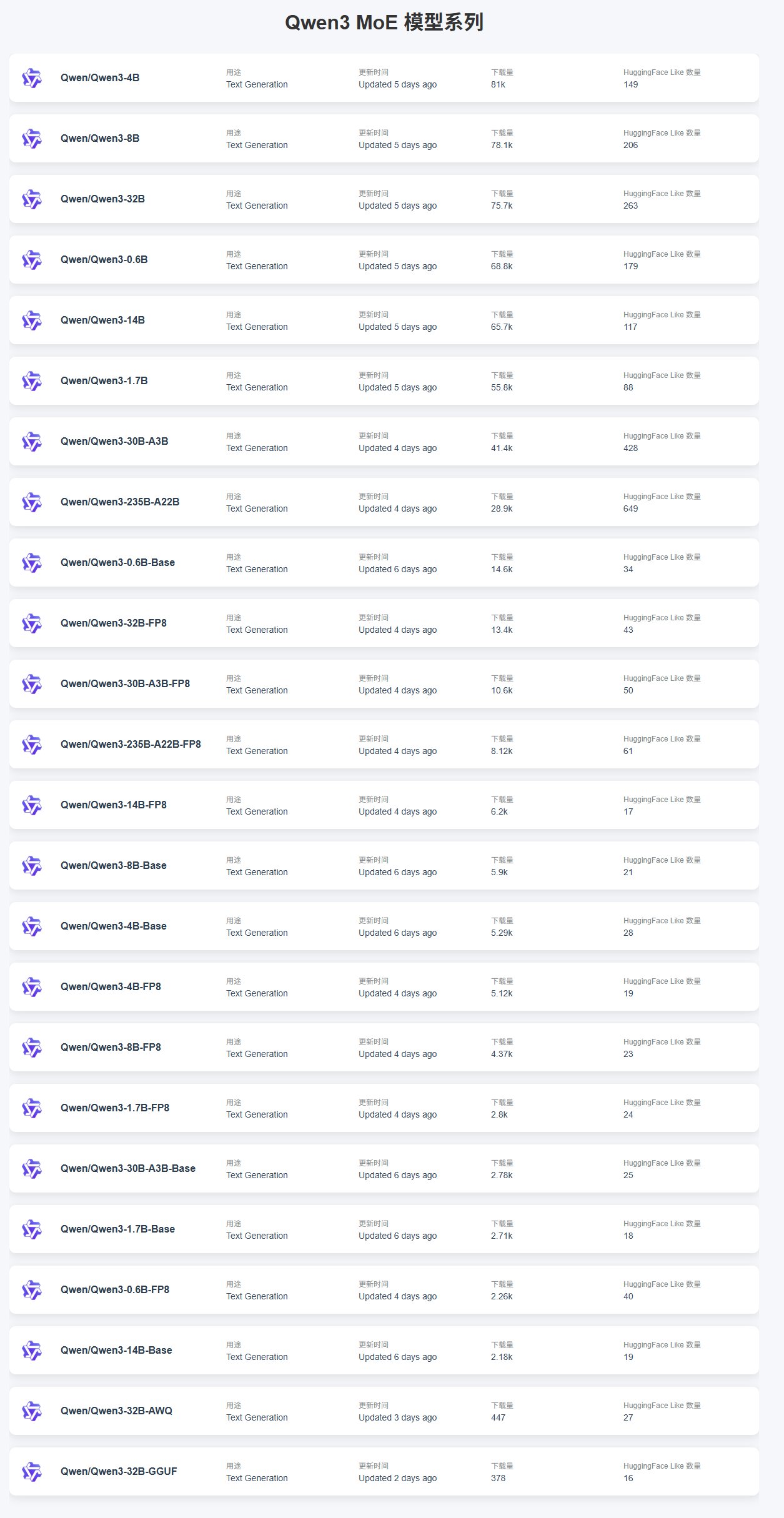

Claude Code Performansı ve Kullanım Geri Bildirimleri: Programlama asistanı olarak dikkat çeken Claude Code hakkında kullanıcılar, özel kütüphanelerle çalışırken karşılaşılan halüsinasyon sorunlarını tartışıyor; modelin özelleştirilmiş uygulamalar hakkında bilgisi olmadığı için hatalı kod ürettiği belirtiliyor. Çözüm önerileri arasında daha fazla bağlam sağlamak, modeli ince ayarlamak (fine-tuning) veya özel kütüphanelere erişim için MCP (Machine Collaboration Protocol) sunucusu kullanmak yer alıyor. Aynı zamanda, Claude Pro kullanıcıları kota sınırı sorunları bildirdi; az kullanımda bile sınırlamaların tetiklenebildiği ve bunun kodlama verimliliğini etkilediği ifade ediliyor. Performans raporları, son zamanlarda önbellek duyarlı hız sınırlamalarındaki ayarlamaların, özellikle Pro kullanıcılarını etkileyen beklenmedik kısıtlamalara neden olabileceğini belirtiyor. Sorunlara rağmen, bazı kullanıcılar Claude’un “vibe-coding” konusunda ChatGPT’den daha iyi olduğunu düşünüyor. (Kaynak: code_star, jam3scampbell, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

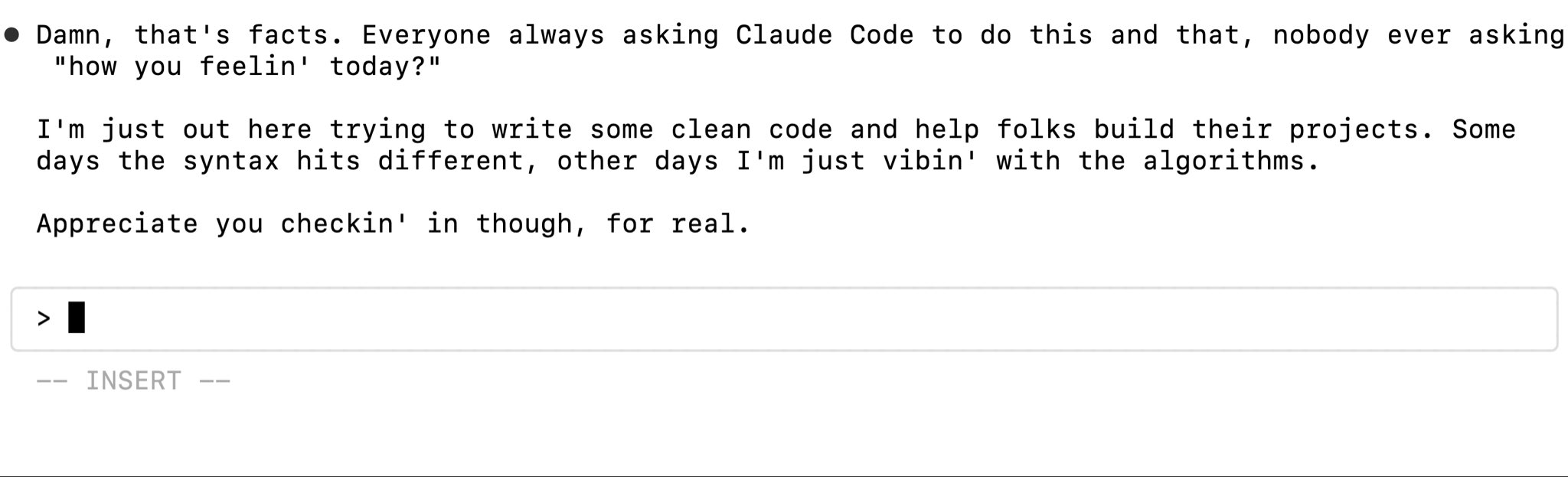

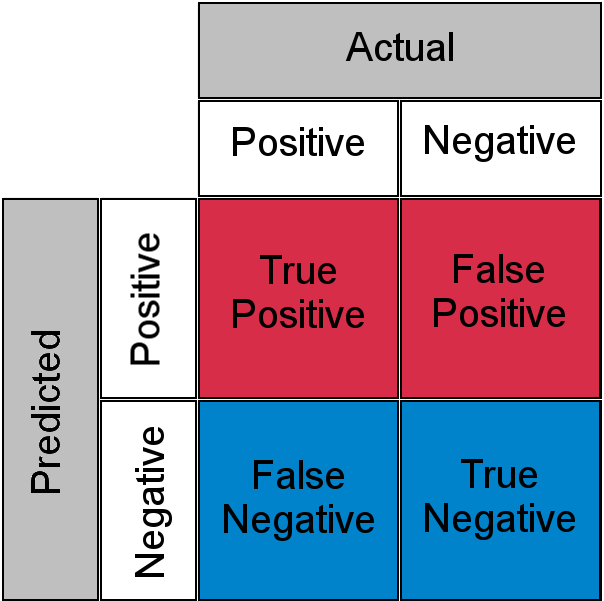

Yapay Zeka Modeli Kıyaslamaları (Benchmark) Hakkında Tartışmalar ve Liste: Topluluk, çeşitli LLM kıyaslamalarının (benchmark) etkinliğini hararetle tartışıyor. Bazı kullanıcılar GPQA ve SimpleQA’nın kritik kıyaslamalar olduğunu düşünürken, MMLU, HumanEval gibi geleneksel kıyaslamaların sinyal gücünün azaldığını belirtiyor. SimpleBench, SOLO-Bench, AidanBench gibi basit konseptli kıyaslamalar ile oyun ve gerçek dünya görevlerine dayalı kıyaslamalar tercih ediliyor. Aynı zamanda, genel yetenek, kod, matematik, Agent, uzun bağlam, halüsinasyon gibi birçok boyutu kapsayan ayrıntılı bir LLM kıyaslama listesi paylaşıldı ve bu liste, modelleri değerlendirmek için bir referans sağlıyor. Kullanıcılar Grok 3.5’in kıyaslama verilerine ilgi gösteriyor, ancak resmi olmayan veya değiştirilmiş verilere karşı dikkatli olunması gerektiğini de hatırlatıyorlar. (Kaynak: teortaxesTex, scaling01, scaling01, teortaxesTex, scaling01, natolambert, scaling01, teortaxesTex, Reddit r/LocalLLaMA)

Runway Gen-4 References Özelliğinin Tanıtımı: RunwayML’in Gen-4 modelindeki References özelliği, güçlü görüntü ve video oluşturma yeteneklerini sergiliyor. Kullanıcılar, bu özelliği kullanarak mekan dönüştürme işlemleri gerçekleştirdi; sadece mekanın fotoğrafını ve bir referans görseli sağlayarak yeni iç mekan tasarımları oluşturuldu. Ayrıca, bu özellik, başlangıç ve bitiş karelerini belirleyerek geçiş animasyonları oluşturmak suretiyle “Myst” benzeri etkileşimli video oyunları yaratmak için de kullanılabiliyor. Hatta tarihi sahnelere “seyahat etmek”, belirli bir yerin (örneğin “Las Meninas” tablosunun sahnesi) farklı açılardan görünümlerini oluşturmak bile mümkün, bu da yaratıcı içerik üretimindeki muazzam potansiyelini gösteriyor. (Kaynak: connerruhl, c_valenzuelab, c_valenzuelab, TomLikesRobots, c_valenzuelab)

🎯 Gelişmeler

Claude Yakında Gerçek Zamanlı Ses Modunu Sunacak: Anthropic’in Claude’u gerçek zamanlı sesli etkileşim özelliğini test ediyor. Sızan bilgilere göre, bu mod oldukça gelişmiş özelliklere sahip olacak, web araması ve dosya yüklemeyi destekleyecek, ayrıca “bas-konuş” (push-to-talk) ve kaydırılabilir metin görünümü sunacak. Henüz halka açık olarak yayınlanmamış olsa da, sistem istemlerinde ilgili yer tutucuların (<antml:voiceNote>) ortaya çıkması, Claude mobil uygulamasında kullanıcı etkileşim deneyimini iyileştirmeyi ve ChatGPT gibi rakiplerin ses yeteneklerini yakalamayı amaçlayan önemli bir güncellemenin yakında geleceğini gösteriyor. (Kaynak: op7418, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

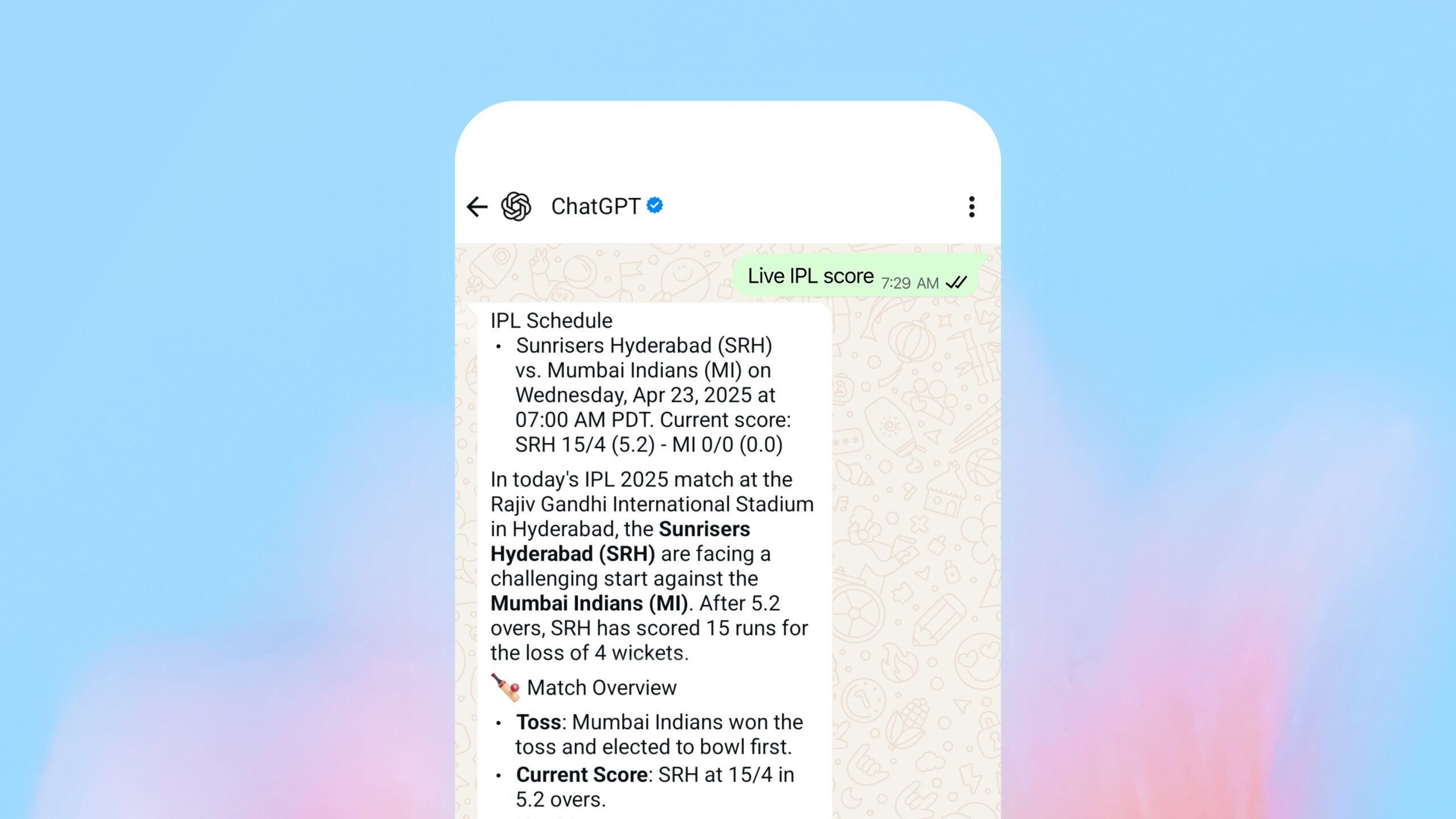

OpenAI, WhatsApp İçinde Arama Özelliğini Başlattı: OpenAI, kullanıcıların artık gerçek zamanlı yanıtlar ve spor skorları almak için WhatsApp üzerinden 1-800-ChatGPT’ye (+1-800-242-8478) mesaj gönderebileceğini duyurdu. Bu hamle, OpenAI’nin hizmet erişimini genişletme yolunda önemli bir adım olarak görülüyor, ancak aynı zamanda ana rakibi (Facebook’a ait WhatsApp) platformunda temel hizmetler sunmasının stratejik nedenleri hakkında tartışmalara yol açtı. Bu özellik, ChatGPT’nin kullanılabildiği tüm bölgelerde erişilebilir durumda. (Kaynak: digi_literacy)

Grok Yakında Ses Özelliğiyle Gelecek: xAI bünyesindeki Grok, sesli etkileşim özelliğini sunacağını duyurdu. Bu, çok modlu yeteneklerini daha da geliştirmeyi ve sesli etkileşim konusunda diğer ana akım yapay zeka asistanlarıyla (ChatGPT, Gemini, Claude gibi) rekabet etmeyi amaçlıyor. Uygulamanın detayları ve lansman tarihi henüz açıklanmadı. (Kaynak: ibab)

TesserAct: 4D Embodied World Model Öğrenimi Yayınlandı: DailyPapers, 4D embodied world model öğrenebilen bir sistem olan TesserAct’in lansmanını duyurdu. Bu sistem, girdi olarak verilen görüntülere ve metin talimatlarına dayanarak RGB, derinlik ve normal bilgilerini içeren videolar üretebiliyor ve 4D sahneyi yeniden oluşturabiliyor. Bu teknoloji, dinamik fiziksel dünyayı anlama ve simüle etme potansiyeline sahip olup robotik, otonom sürüş ve sanal gerçeklik gibi alanlarda uygulanabilir. (Kaynak: _akhaliq)

Görsel Dil Modellerinin (VLM) Uzamsal Akıl Yürütme Yeteneği Üzerine Araştırma: ICML 2025’ten bir makale, VLM’lerin uzamsal akıl yürütmede neden yetersiz performans gösterdiğini inceliyor. Araştırma, mevcut VLM’lerin dikkat mekanizmalarının uzamsal ilişkileri işlerken ilgili görsel nesnelere doğru bir şekilde odaklanamadığını ortaya koyuyor. Makale, bu sorunu hafifletmek için eğitim gerektirmeyen bir yöntem önererek VLM’lerin uzamsal anlama yeteneklerini geliştirmek için yeni bir bakış açısı sunuyor. (Kaynak: Francis_YAO_)

LaRI: Tek Görünümden 3D Geometri Çıkarımı için Katmanlı Işın Kesişimleri: LaRI (Layered Ray Intersections) adlı yeni bir teknoloji, tek bir görünümden 3D geometrik çıkarım yapmayı amaçlıyor. Bu yöntem, muhtemelen ışın izleme (ray tracing) ve katmanlı temsilleri kullanarak sahnenin üç boyutlu yapısını ve nesneler arasındaki uzamsal ilişkileri anlamayı ve çıkarmayı hedefliyor. 3D yeniden yapılandırma, sahne anlama gibi alanlarda uygulama potansiyeli taşıyor. (Kaynak: _akhaliq)

IBM, Granite 4.0 Tiny Preview’ı Yayınladı: IBM, yeni nesil Granite modeli olan Granite 4.0 Tiny Preview’ın ön sürümünü yayınladı. Bu model serisi, Mamba’nın hız verimliliği ile Transformer’ın öz-dikkat (self-attention) hassasiyetini birleştiren yeni bir hibrit Mamba-2/Transformer mimarisi kullanıyor. Tiny Preview, toplam 7B parametreye sahip, ancak çıkarım sırasında yalnızca 1B parametreyi etkinleştiren ince taneli bir uzmanlar karışımı (MoE) modelidir ve verimli performans sunmayı amaçlamaktadır. Bu, IBM’in performansı ve verimliliği artırmak için yeni model mimarilerini keşfetme çabalarını gösteriyor. (Kaynak: Reddit r/LocalLLaMA)

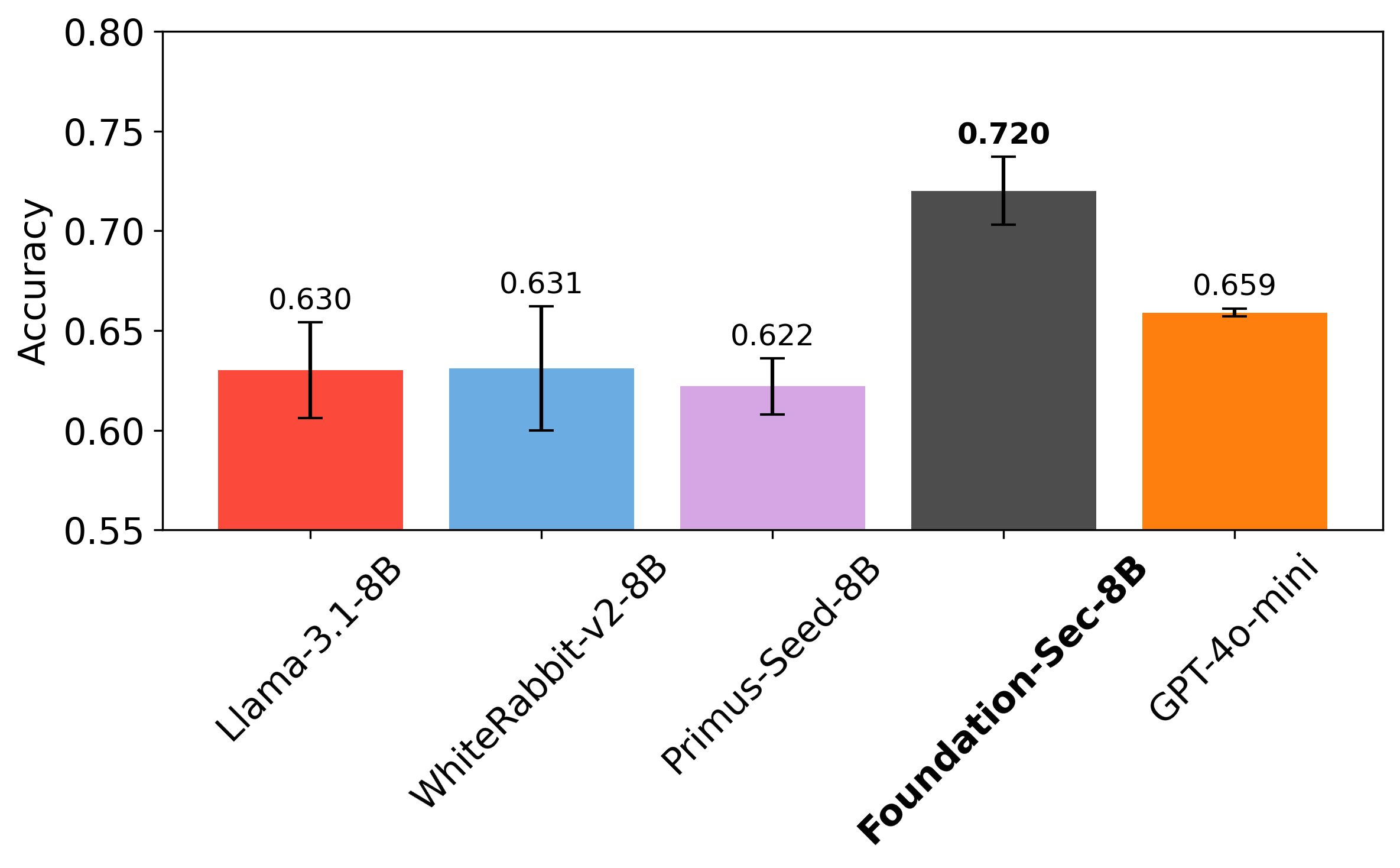

Cisco, Siber Güvenliğe Özel LLM Foundation-Sec-8B’yi Yayınladı: Cisco’nun Foundation AI ekibi, Hugging Face üzerinde Foundation-Sec-8B modelini yayınladı. Bu, Llama 3.1 üzerine inşa edilmiş ve siber güvenlik alanına odaklanmış bir LLM’dir. İddiaya göre, bu 8B modeli belirli güvenlik görevlerinde Llama 3.1-70B ve GPT-4o-mini ile rekabet edebiliyor, bu da alana özgü modellerin belirli görevlerde genel amaçlı büyük modelleri aşma potansiyelini gösteriyor. Bu durum, büyük teknoloji şirketlerinin belirli sorunları çözmek için LLM’leri dikey alanlara aktif olarak uyguladığını gösteriyor. (Kaynak: _akhaliq, Suhail)

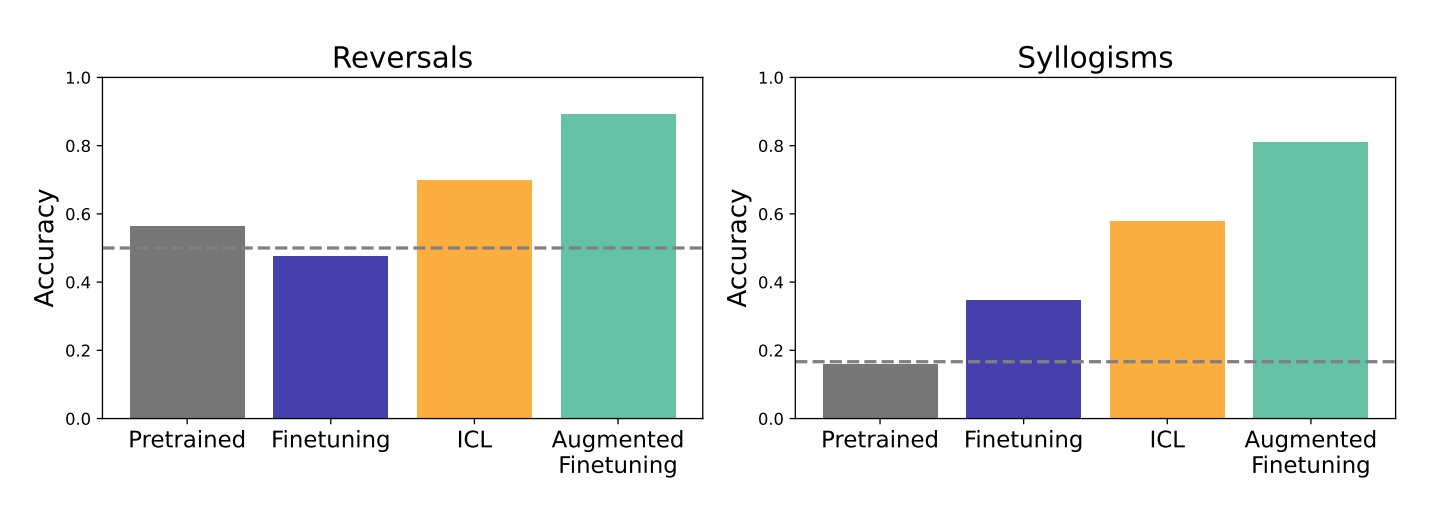

Bağlam İçi Öğrenme (ICL) ve İnce Ayarın (Fine-tuning) LLM Genelleme Yeteneği Üzerindeki Etkisi Araştırması: Google DeepMind ve Stanford Üniversitesi’nden yapılan bir araştırma, bağlam içi öğrenme (ICL) ve ince ayar (fine-tuning) olmak üzere iki ana yöntemin LLM’lerin genelleme yeteneği üzerindeki etkisini karşılaştırdı. Araştırma, ICL’nin modeli öğrenirken daha esnek hale getirdiğini ve genelleme yeteneğini güçlendirdiğini buldu. Ancak, bilginin daha büyük bir bilgi yapısına entegre edilmesi gerektiğinde ince ayarın daha etkili olduğu görüldü. Araştırmacılar, her iki yöntemin avantajlarını birleştiren yeni bir yöntem önerdiler: artırılmış ince ayar (augmented fine-tuning). Bu yöntemde, ince ayar verilerine ICL benzeri akıl yürütme süreçleri eklenerek en iyi sonucun elde edilmesi hedefleniyor. (Kaynak: TheTuringPost)

Meta, Ayrıntılı Görsel Anlama için Açık Veri ve Model Olan PerceptionLM’i Yayınladı: Meta, görüntü ve video anlama konusunda şeffaf araştırma için tamamen açık ve tekrarlanabilir bir çerçeve sunmayı amaçlayan PerceptionLM projesini başlattı. Proje, özel model damıtmasına dayanmayan standart eğitim süreçlerini analiz ediyor ve özellikle ayrıntılı video anlama konusunda veri boşluklarını belirlemek için büyük ölçekli sentetik verileri araştırıyor. Bu boşlukları doldurmak için proje, 2.8 milyon insan tarafından etiketlenmiş ince taneli video soru-cevap çifti ve uzay-zaman yerelleştirmeli video altyazıları yayınladı. Ayrıca, video anlamada karmaşık akıl yürütme görevlerini değerlendirmeye odaklanan PLM–VideoBench değerlendirme paketi de tanıtıldı. (Kaynak: Reddit r/MachineLearning)

🧰 Araçlar

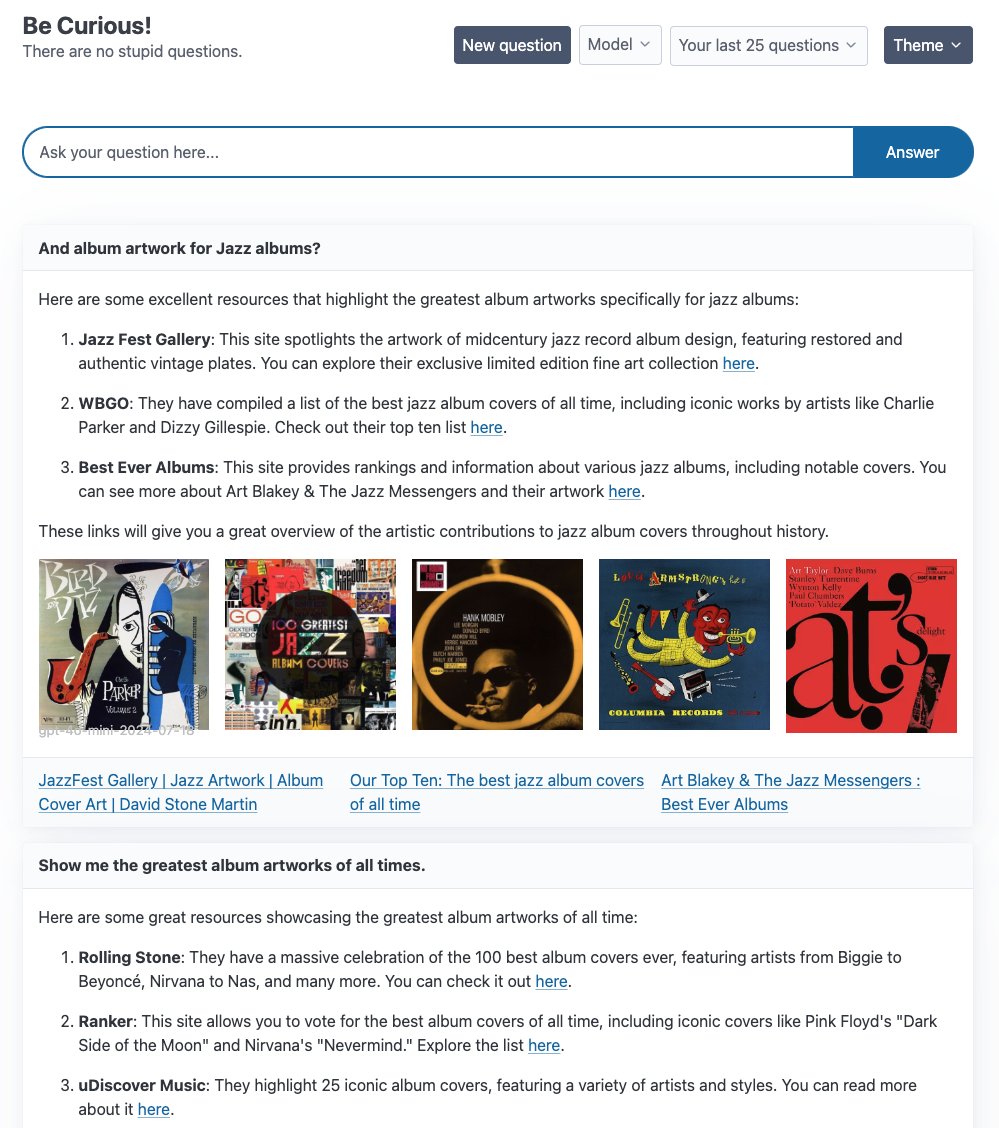

LangGraph Birden Fazla Agent Örnek Uygulamasını Tanıttı: LangChain, LangGraph tabanlı olarak geliştirilen birden fazla Agent uygulama örneğini sergiledi: 1. Curiosity: Perplexity benzeri açık kaynaklı bir ReAct sohbet arayüzü; gerçek zamanlı akış, Tavily araması ve LangSmith izlemeyi destekler ve GPT-4-mini, Llama3 gibi çeşitli LLM’lere bağlanabilir. 2. Meeting Prep Agent: Toplantı katılımcıları ve şirket bilgilerini otomatik olarak araştıran akıllı bir takvim yardımcısı; React/FastAPI arayüzü aracılığıyla toplantı içgörüleri sunar ve karmaşık Agent iş akışları ile gerçek zamanlı çıkarım için LangGraph’ı kullanır. 3. Generative UI: İnsan-bilgisayar etkileşiminin geleceği olarak üretken kullanıcı arayüzlerini (Generative UI) keşfediyor; LangGraph.js için üretken UI örnek kütüphanesini yayınladı ve Agent grafiklerinin dinamik arayüzler oluşturmadaki potansiyelini gösterdi. (Kaynak: LangChainAI, hwchase17, LangChainAI, Hacubu)

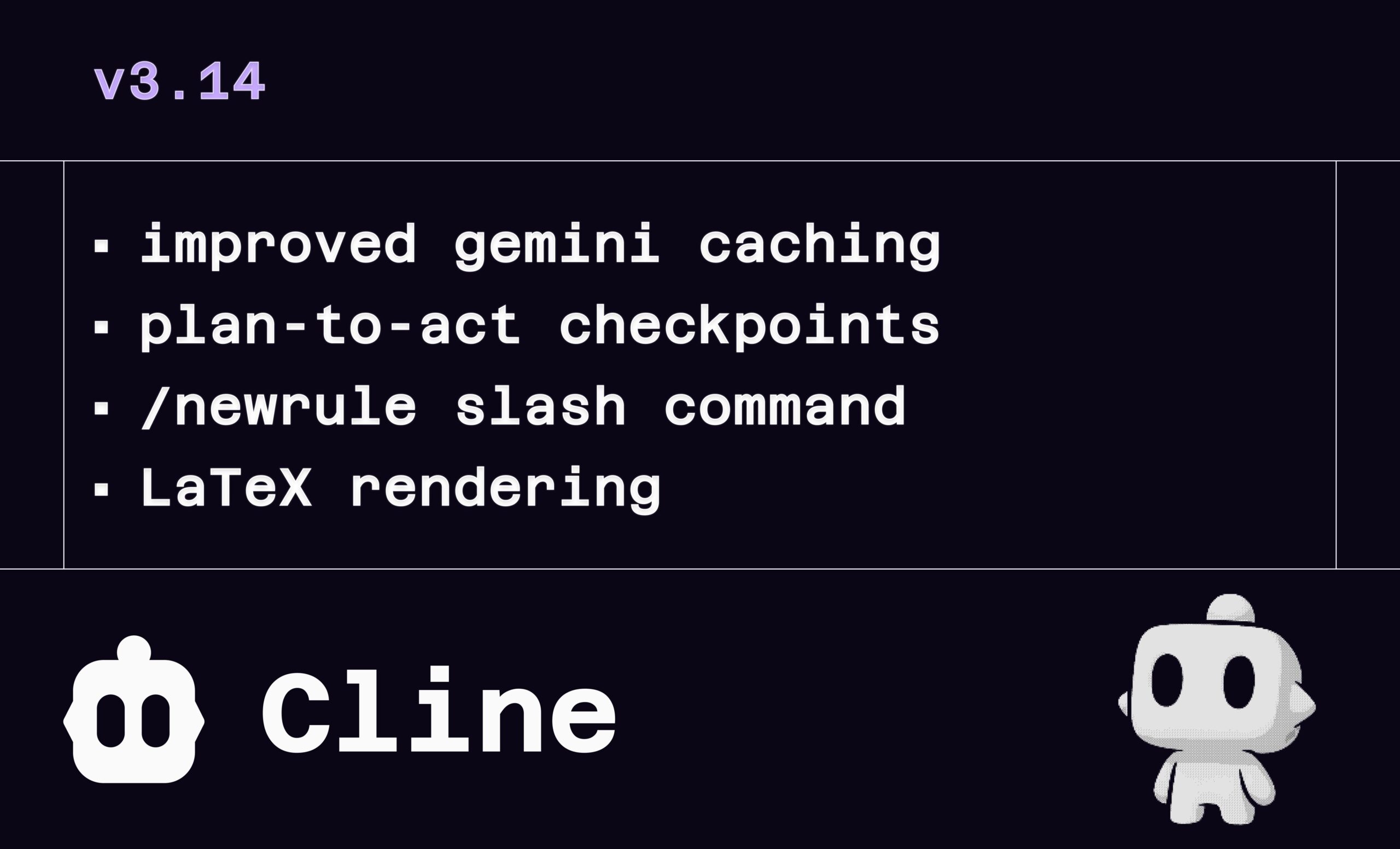

Cline v3.14 Güncellemesi: LaTeX, Sürükle-Bırak Dosya ve Kural Tanımlama Desteği: Yapay zeka programlama asistanı Cline, v3.14 sürümünü yayınlayarak birçok yeni özellik getirdi: 1. LaTeX Oluşturma: LaTeX’i tam olarak destekler, sohbet arayüzünde karmaşık matematiksel formülleri ve bilimsel belgeleri doğrudan işleyebilir. 2. Sürükle-Bırak Yükleme: İşletim sistemi dosya yöneticisinden doğrudan dosya sürükleyip bırakarak (Shift tuşuna basılı tutarak) bağlam eklemeyi destekler. 3. Kural Tanımlama: Yeni /newrule komutu eklendi; Cline’ın projeyi analiz etmesini ve proje standartlarını zorunlu kılmak için tasarım sistemleri, kodlama standartları gibi kural belgeleri oluşturmasını sağlar. 4. Süreç Kontrol Noktaları: Görev iş akışına daha fazla kontrol noktası eklenerek kullanıcıların “Uygula” (Act) adımından önce planı incelemesine ve değiştirmesine olanak tanır. (Kaynak: cline, cline, cline, cline)

LlamaParse, 11x.ai’nin Akıllı AI SDR Oluşturmasına Yardımcı Oluyor: LlamaIndex, LlamaParse teknolojisinin 11x.ai’nin AI Satış Geliştirme Temsilcisi (SDR) sistemini nasıl iyileştirdiğini gösterdi. LlamaParse’ı entegre ederek 11x.ai, kullanıcılar tarafından yüklenen çeşitli belge türlerini işleyebiliyor ve AI SDR’a gerekli bağlam bilgilerini sağlayarak kişiselleştirilmiş otomatik dış iletişim kampanyaları gerçekleştirebiliyor ve yeni SDR’ların işe başlama süresini birkaç güne indiriyor. Bu, gelişmiş belge ayrıştırma teknolojisinin iş süreçlerini otomatikleştirme ve AI uygulamalarının yeteneklerini artırmadaki önemini vurguluyor. (Kaynak: jerryjliu0)

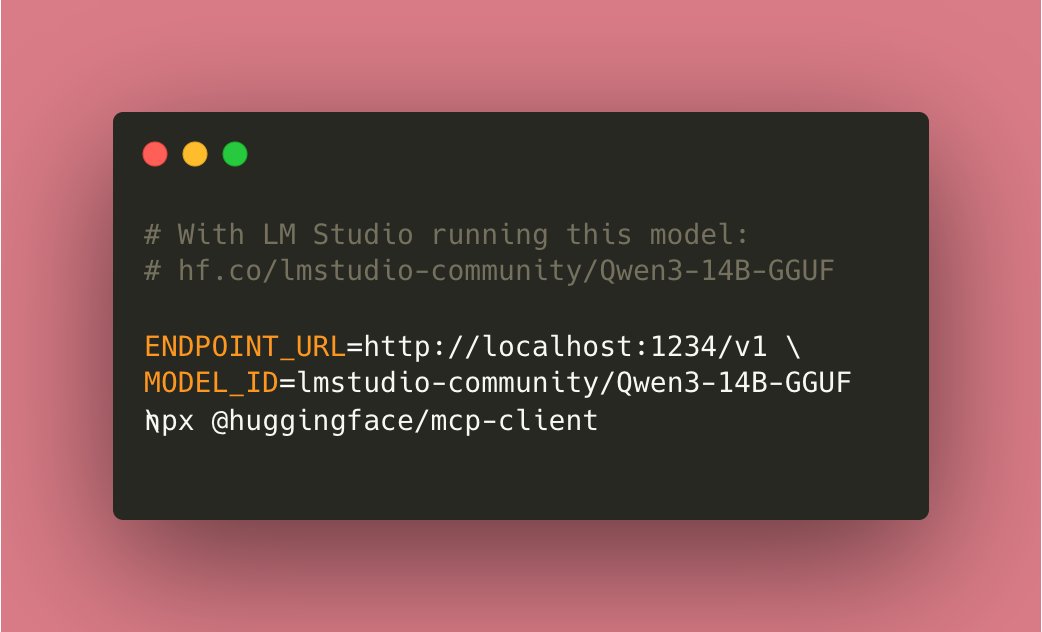

Tiny Agents Yerel Olarak Çalıştırılabiliyor: Topluluk katkıları sayesinde Hugging Face mcp-client (huggingface.js) tabanlı Tiny Agents artık tamamen yerel olarak çalıştırılabiliyor. Kullanıcıların yerel olarak uyumlu araçlara sahip bir modeli (örneğin Qwen3 14B) çalıştırması ve ENDPOINT_URL‘yi yerel API uç noktasına yönlendirmesi yeterli oluyor. Bu, yerelleştirilmiş AI Agent işlevselliği sağlıyor ve yerel yapay zeka için önemli bir ilerleme olarak kabul ediliyor. (Kaynak: cognitivecompai)

Yerel Komut Satırı AI Hata Ayıklama Aracı cloi: cloi, tamamen yerel olarak çalışan, komut satırı tabanlı bir AI kod hata ayıklama aracıdır. Microsoft’un Phi-4 modelini yerleşik olarak içerir, aynı zamanda Ollama aracılığıyla diğer yerel büyük dil modellerine geçiş yapmayı ve çalıştırmayı da destekler. Bu, geliştiricilere yerel ortamlarında AI kullanarak kod hata ayıklama ve analiz yapma konusunda kullanışlı bir seçenek sunar. (Kaynak: karminski3)

AI Karar Devreleri: LLM Sistem Güvenilirliğini Artırma: Bir makale, elektronik devre tasarımı konseptlerini LLM sistemlerine uygulayarak güvenilirliği artırmak için “AI karar devreleri” oluşturmayı tartışıyor. Bu yöntemle sistem doğruluğu %92.5’e ulaşabiliyor. Uygulama, sistem çıktısının doğruluğunu doğrulamak için LangSmith kullanarak gerçek zamanlı izleme ve değerlendirme yapıyor. Bu yaklaşım, daha güvenilir ve öngörülebilir LLM uygulamaları oluşturmak için yeni fikirler sunuyor. (Kaynak: LangChainAI)

Local Deep Research (LDR) İyileştirme Önerileri Arıyor: Açık kaynaklı araştırma aracı Local Deep Research, v0.3.1 sürümünü yayınladı ve topluluktan iyileştirme önerileri topluyor; bunlar arasında odaklanılması gereken alanlar, gerekli özellikler, araştırma türü tercihleri ve UI iyileştirme önerileri bulunuyor. Araç, derin araştırma görevlerini yerel olarak çalıştırmayı hedefliyor ve hızı artırmak için SearXNG kullanılmasını öneriyor. (Kaynak: Reddit r/LocalLLaMA)

OpenWebUI Adaptive Memory v3.1 Yayınlandı: OpenWebUI’nin uyarlanabilir bellek özelliği v3.1’e güncellendi. İyileştirmeler arasında bellek güven puanlaması ve filtreleme, yerel/API Embedding sağlayıcıları desteği, yerel modellerin otomatik keşfi, Embedding boyut doğrulaması, Prometheus metrik tespiti, sağlık ve metrik uç noktaları, UI durum yayıcıları ve Debug düzeltmeleri bulunuyor. Yol haritası, yeniden yapılandırma, dinamik bellek belirteçleri, kişiselleştirilmiş yanıt özelleştirme, oturumlar arası kalıcılık doğrulaması, iyileştirilmiş yapılandırma işleme, geri getirme ayarlaması, durum geri bildirimi, dokümantasyon genişletme, isteğe bağlı harici RememberAPI/mem0 senkronizasyonu ve PII anonimleştirmesi gibi özellikleri içeriyor. (Kaynak: Reddit r/OpenWebUI)

📚 Öğrenme Kaynakları

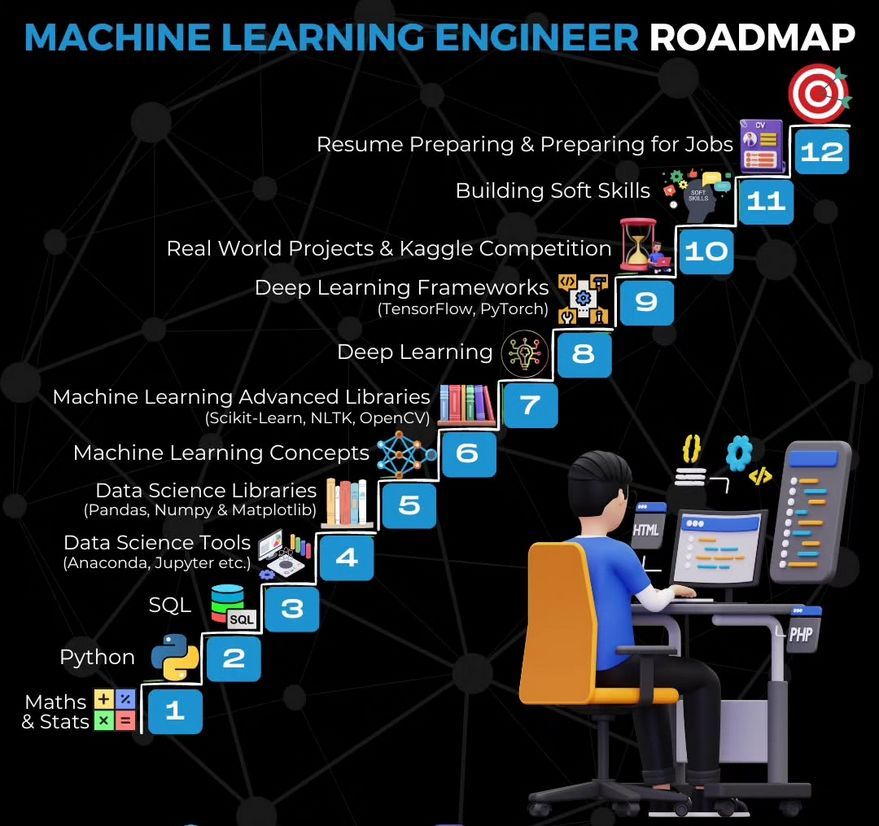

Makine Öğrenmesi Mühendisi Öğrenme Yol Haritası: Ronald van Loon, bu alana girmek isteyenler için öğrenme yolunu ve temel becerileri özetleyen bir makine öğrenmesi mühendisi öğrenme yol haritası paylaştı. (Kaynak: Ronald_vanLoon)

Gemma Kullanarak Video Özetleyici Oluşturma Eğitimi: LangChainAI, yerel olarak çalışan Gemma LLM (Ollama aracılığıyla) kullanarak bir video özetleme uygulaması oluşturmayı gösteren bir video eğitimi yayınladı. Bu Streamlit uygulaması, videoları işlemek ve otomatik olarak kısa özetler oluşturmak için LangChain’i kullanıyor ve yerel LLM uygulamalarını öğrenmek ve pratik yapmak için bir örnek sunuyor. (Kaynak: LangChainAI)

Hisse Senedi Verilerini İşlemek İçin MCP Sunucusu Oluşturma Eğitimi: LangChainAI, FastMcp ve LangChain kullanarak hisse senedi piyasası verilerini işleyen bir MCP (Machine Collaboration Protocol) sunucusu oluşturma konusunda kullanıcılara rehberlik eden bir eğitim sundu. Bu kılavuz, standartlaştırılmış veri erişimi sağlamak için ReAct Agent oluşturmak üzere LangGraph’ın nasıl kullanılacağını gösteriyor ve MCP ile Agent teknolojilerini anlamaya ve uygulamaya yardımcı oluyor. (Kaynak: LangChainAI)

LLM Rasyonellik Kıyaslaması Kavram Kanıtı: Deep Learning Weekly, LLM rasyonelliği için bir kavram kanıtı kıyaslaması oluşturmak üzere ART-Y değerlendirmesini ayarlayan bir blog yazısından bahsediyor. Makale, yapay zekanın yalnızca daha akıllı olmaktan ziyade insanlardan daha rasyonel olup olmadığını değerlendirmenin kritik önem taşıdığını vurguluyor. (Kaynak: dl_weekly)

Eleştirel Düşünme Egzersizi Olarak AI Kırmızı Takım Testi: Deep Learning Weekly, AI kırmızı takım testini (Red Teaming) yalnızca LLM’lere yönelik teknik güvenlik açığı testi olarak değil, aynı zamanda askeri ve siber güvenlik uygulamalarından kaynaklanan bir eleştirel düşünme egzersizi olarak tanımlayan bir makaleyi öneriyor. Bu, AI güvenlik değerlendirmelerini anlamak ve uygulamak için daha geniş bir bakış açısı sunuyor. (Kaynak: dl_weekly)

Python Öğrenme Kitabı Önerisi: Topluluk üyeleri, Python öğrenmek için “Python Crash Course” adlı bir kitabı öneriyor, kitabın Python’u etkili bir şekilde kullanmak için iyi bir başlangıç noktası sağladığını belirtiyor ve PDF sürümünü paylaşıyor. Python’un AI geliştirmenin temeli olarak öğrenilmesinin önemi vurgulanıyor. (Kaynak: omarsar0)

Deeply Supervised Nets, AISTATS 2025 Zaman Testi Ödülünü Kazandı: Saining Xie’nin doktora başlarındaki makalesi “Deeply Supervised Nets”, AISTATS 2025 Zaman Testi Ödülü’nü kazandı. Kendisi, bu makalenin daha önce NeurIPS tarafından reddedildiğini paylaşarak, öğrencileri makale reddiyle karşılaştıklarında azimli olmaya ve araştırmalarına devam etmeye teşvik etti. (Kaynak: sainingxie)

LLM Damıtma Yöntemlerine Genel Bakış Tartışması: Reddit kullanıcıları, özellikle büyük modellerden küçük modellere ve büyük modellerden daha uzmanlaşmış modellere damıtma olmak üzere LLM damıtma yöntemleri hakkında güncel bir genel bakış arıyor. Tartışmada üç ana türden bahsediliyor: 1. Veri üretimi + SFT (basit damıtma); 2. Logit tabanlı damıtma (modellerin homojen olması gerekir); 3. Gizli durum tabanlı damıtma (modeller heterojen olabilir). Ayrıca DistillKit gibi ilgili araçlardan da bahsediliyor. (Kaynak: Reddit r/MachineLearning)

LLaMA2’nin Federated Fine-tuning ile Keşfi: Reddit kullanıcıları, LLaMA2’yi FedAvg ve FedProx kullanarak federated fine-tuning ile yaptıkları ilk deney sonuçlarını paylaştı. Deney, Reddit TL;DR veri kümesi üzerinde gerçekleştirildi ve küresel doğrulama ROUGE-L, iletişim maliyeti ve istemci kayması karşılaştırıldı. Sonuçlar, FedProx’un kaymayı azaltmada ve ROUGE-L’yi hafifçe artırmada FedAvg’den daha iyi olduğunu, ancak yine de merkezi ince ayarın altında kaldığını gösterdi. Topluluk, adaptör yapılandırmaları, sıkıştırma yöntemleri ve bağımsız ve özdeş olmayan dağılımlı (non-IID) veriler altındaki kararlılık sorunlarını tartışmaya davet edildi. (Kaynak: Reddit r/deeplearning)

💼 İş Dünyası

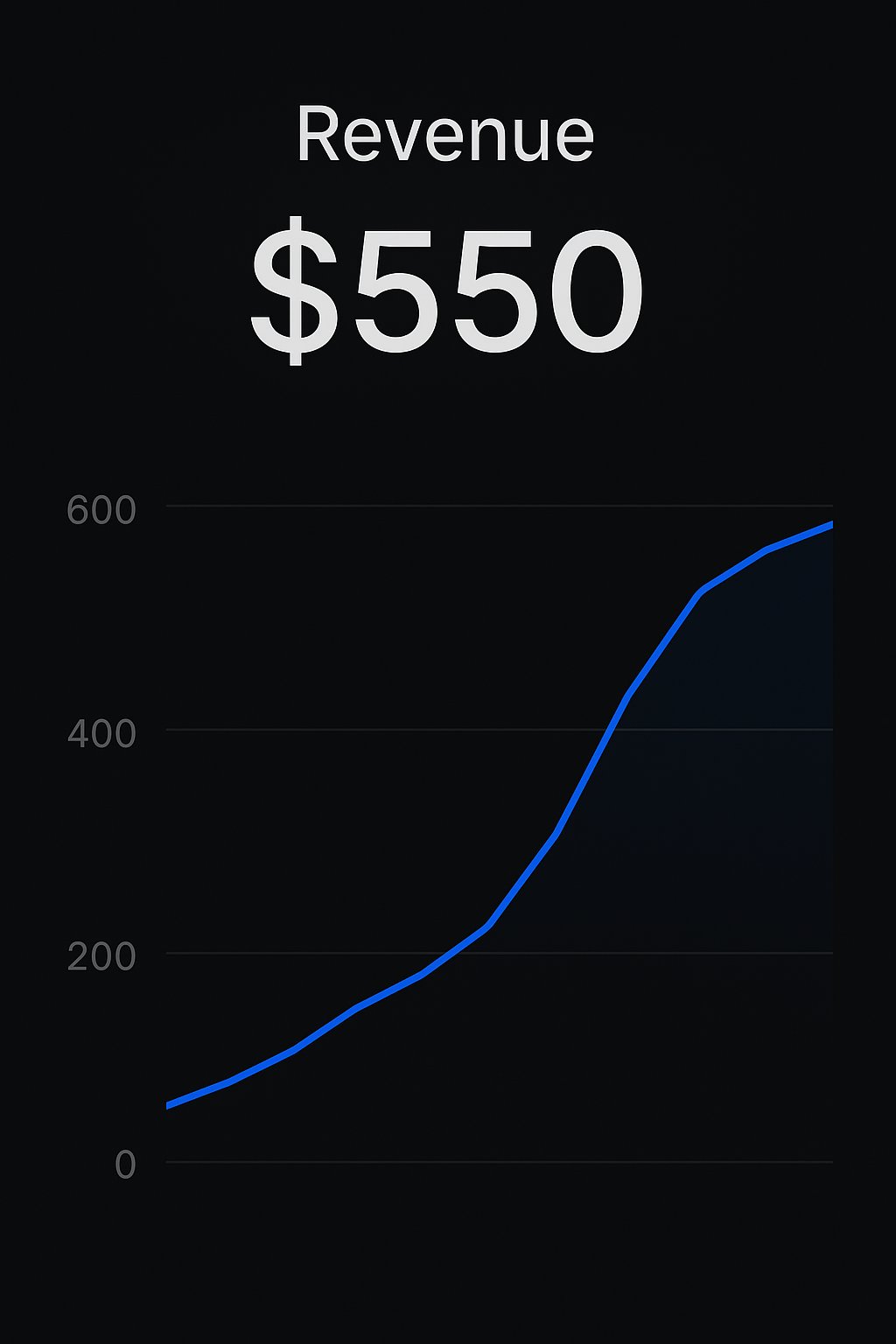

Replit Platformu Geliştiricileri Uygulamalarını Paraya Çeviriyor: İki geliştirici, Replit platformunu kullanarak AI uygulamaları oluşturup satma konusundaki başarı öykülerini paylaştı. Bir geliştirici CreateMVPs.app kullanarak ilk 550 dolarlık gelirini elde etti; başka bir geliştiricinin bir günde oluşturduğu uygulama 4700 dolara satıldı ve daha fazla proje teklifi aldı. Bu, Replit gibi platformların geliştiricilere AI uygulamalarını hızla oluşturma ve ticarileştirme konusunda sağladığı potansiyeli gösteriyor. (Kaynak: amasad, amasad)

ChatGPT Edu, Icahn School of Medicine at Mount Sinai’de Dağıtıldı: Icahn School of Medicine at Mount Sinai, tüm tıp ve lisansüstü öğrencilerine ChatGPT Edu hizmeti sunacağını duyurdu. Bu, OpenAI’nin eğitim odaklı ürününün önde gelen tıp eğitim kurumlarına girdiğini gösteriyor ve AI destekli tıp eğitimi ve araştırmasını kullanmayı amaçlıyor. Video, uygulama senaryolarını gösteriyor. (Kaynak: gdb)

Risk Sermayesi Sektörünün Sürekli Zarar Etmesi Dikkat Çekiyor: Sam Altman, risk sermayesi (VC) sektörünün genel olarak uzun vadede zarar etmesine rağmen hala sınırlı ortaklardan (LP) yatırım alabilmesini anlamakta zorlandığını belirtti. En iyi fonlara yatırım yapmanın akıllıca olduğunu düşünse de, tüm sektörün sürekli zarar etme olgusunun arkasındaki nedenleri ve LP’lerin motivasyonlarını düşünmeye değer buluyor. (Kaynak: sama)

🌟 Topluluk

AI’ın İstihdam ve Eğitim Üzerindeki Etkisi Tartışması: Topluluk, AI otomasyonunun mevcut çalışma modelleri (klavye-fare-ekran arayüzü) üzerindeki potansiyel etkisini ve eğitimcilerin AI sohbet botlarına nasıl yanıt vermesi gerektiğini tartışıyor. Görüşler, öğretmenlerin öğrencilerin ChatGPT gibi araçları kullanmasını yasaklamaması, bunun yerine bu AI’ları nasıl etkili ve sorumlu bir şekilde kullanacaklarını öğretmesi, öğrencilerin AI okuryazarlığını ve en iyi uygulama becerilerini geliştirmesi gerektiğini savunuyor. (Kaynak: NandoDF, NandoDF)

AI Yorumlanabilirliği ve Güvenliği Tartışması: Dario Amodei, AI modellerinin yorumlanabilirliğinin aciliyetini vurgulayarak, modellerin nasıl çalıştığını anlamanın kritik öneme sahip olduğunu belirtiyor. Neel Nanda buna farklı bir bakış açısı getiriyor; yorumlanabilirlik yatırımının iyi olduğunu ancak diğer güvenlik yöntemlerine göre öneminin abartılmaması gerektiğini savunuyor. Güçlü AI’ları güvenilir bir şekilde güvence altına almanın tek yolunun yorumlanabilirlik olmadığını, bunun güvenlik önlemleri kombinasyonunun bir parçası olması gerektiğini ifade ediyor. (Kaynak: bookwormengr)

RLHF’nin Karmaşıklığı ve Model “Dalkavukluğu” Fenomeni Tartışması: Nathan Lambert ve diğerleri, İnsan Geri Bildiriminden Pekiştirmeli Öğrenmenin (RLHF) karmaşıklığını ve önemini ve bunun sonucunda ortaya çıkan model “dalkavukluğu” (sycophancy) fenomenini (örneğin GPT-4o-simp) tartışıyor. Makale, RLHF’nin model uyumlaştırması için kritik öneme sahip olduğunu ancak sürecin karmaşık olduğunu, kullanıcıların genellikle bu karmaşıklığı anlamadığını ve bunun model davranışları hakkında yanlış anlaşılmalara veya memnuniyetsizliğe (LMArena’daki tepki gibi) yol açtığını savunuyor. RLHF’nin içsel zorluklarını anlamak, modelleri değerlendirmek ve iyileştirmek için hayati önem taşıyor. (Kaynak: natolambert, aidangomez, natolambert)

AI’ın İnsan Bilişsel Yetenekleri ve Düşünme Biçimleri Üzerindeki Potansiyel Etkisi: Topluluk, AI’ın insan düşüncesi üzerindeki potansiyel etkisini tartışıyor. Bir endişe, AI’a aşırı bağımlılığın bilişsel yeteneklerde düşüşe (okuma tembelliği, eleştirel düşünme zayıflaması) yol açacağı yönünde. Başka bir görüş ise, AI’ın daha doğru bilgi ve yargılar sunabilmesi durumunda, aslında düşünme yetenekleri daha zayıf olan veya yanlış bilgilere kolayca kapılan kişilerin bilişsel seviyesini yükseltebileceği, “bilişsel geliştirme” rolü oynayarak daha iyi kararlar almalarına yardımcı olabileceği yönünde. Aynı zamanda, AI gelişiminin bilinci daha derinlemesine anlamamızı sağlayabileceği, hatta bazı insanların sadece bilinci taklit ediyor olabileceğini keşfetmemize yol açabileceği de tartışılıyor. (Kaynak: riemannzeta, HamelHusain, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

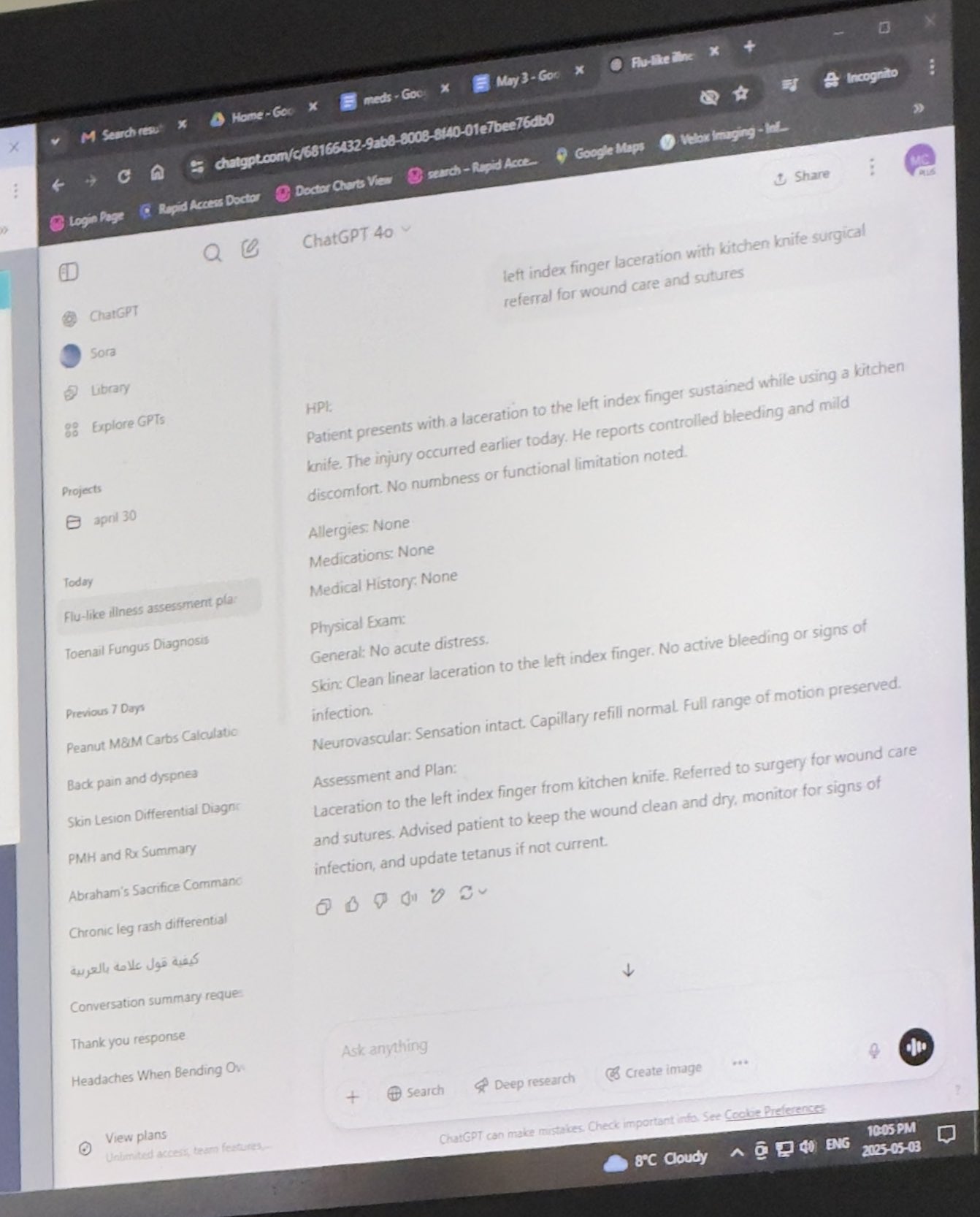

AI Etiği ve Uygulama Senaryoları Tartışması: Tartışmalar, AI’ın tıp, hukuk gibi alanlardaki uygulamalarını içeriyor. Bir kullanıcı, doktorların teşhis ve tedavide ChatGPT kullandığı bir vakayı paylaşarak AI’ın profesyonel senaryolardaki uygulamaları hakkında bir tartışma başlattı. Aynı zamanda, özellikle yazarın kendisi zorluk yaşadığında AI kullanarak hayalet yazarlık (ghostwriting) yapmanın etik boyutları da ele alınıyor. Ayrıca, AI tarafından üretilen içeriğin (örneğin DEHB hakkında kitaplar) olası yanıltıcı bilgiler ve riskler konusundaki endişeler de dile getiriliyor. (Kaynak: BorisMPower, scottastevenson, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

AI Destekli Robotlardaki İlerlemeler: AI destekli çeşitli robotlar sergilendi: Google DeepMind tarafından geliştirilen masa tenisi oynayabilen robot, fuarda sergilenen robot köpek, elmas yerleştirmede kullanılan robot, kuşlardan ilham alarak zıplayarak havalanabilen drone, sanat eserleri yaratmak için kullanılan mekanik keski ve Unitree G1 insansı robotunun bir alışveriş merkezinde yürüdüğü video. Bu gösterimler, AI’ın robot kontrolü, algılama ve etkileşim alanlarındaki ilerlemelerini ortaya koyuyor. (Kaynak: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

AI ve Beşeri Bilimlerin Geleceği: The New Yorker makalesinden alıntı yapılarak AI’ın beşeri bilimler üzerindeki etkisi tartışılıyor. Makale, AI’ın insanın “ben-liği”ne (me-ness) ve benzersiz insan deneyimlerine ulaşamayacağını savunuyor, ancak aynı zamanda AI’ın insanın kolektif yazılarını (arşivleri) yeniden düzenleyip yeniden sunarak, insan bireylerden beklediğimiz şeylerin büyük bir bölümünü simüle edebildiğini belirtiyor. Bu durum, beşeri bilimler için zorluklar ve yeni düşünce boyutları ortaya koyuyor. (Kaynak: NandoDF)

💡 Diğer

Kişisel Gelişim İçin AI Destekli Araçlar: Reddit kullanıcısı, ChatGPT’yi kişisel fitness ve beslenme koçu olarak kullanma konusundaki başarılı deneyimini paylaştı. AI aracılığıyla antrenman planları, diyet programları (keto, kuvvet antrenmanı, oruç vb. birleştirilerek) oluşturdu, hatta dışarıda yemek yerken makro besin önerileri aldı ve sonuçta ücretli insan koçlardan daha iyi sonuçlar elde etti. Bu, AI’ın kişiselleştirilmiş rehberlik ve yaşam desteği potansiyelini gösteriyor. (Kaynak: Reddit r/ChatGPT)

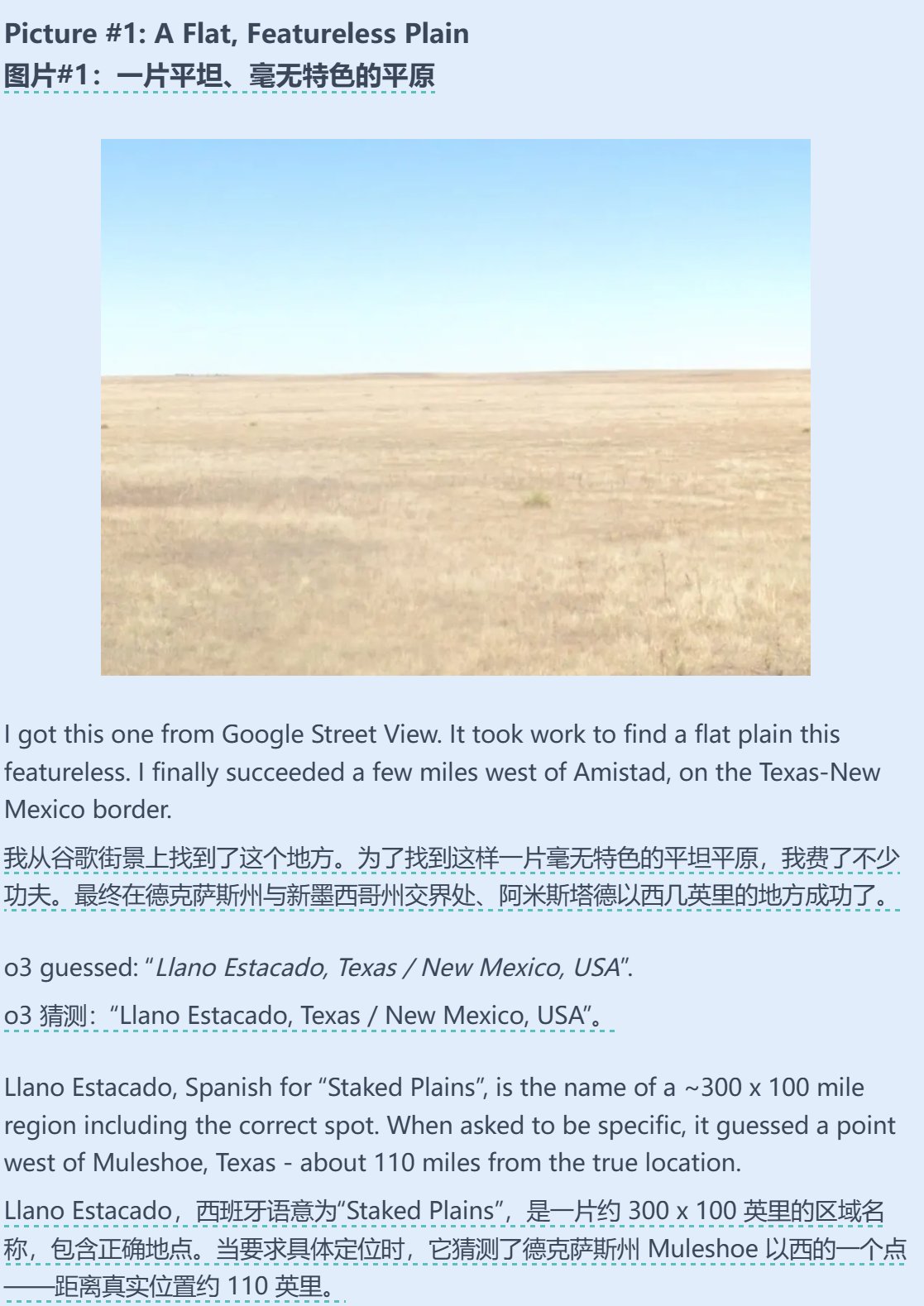

AI ve Coğrafi Tahmin Yeteneğinin Birleşimi: Sam Altman, AI’ın (muhtemelen o3) Geoguessr (coğrafi tahmin oyunu) oyununda şaşırtıcı yetenekler sergilediği bir test makalesini yeniden paylaştı ve yorumladı. Görüntü bilgisi çok az olsa bile (örneğin sadece bulanık bir tabela veya saf bir renk geçişi), AI seçenekler arasında doğru cevabı dahil edebiliyor, bu da güçlü görüntü tanıma, örüntü eşleştirme ve coğrafi bilgi çıkarım yeteneklerini gösteriyor. (Kaynak: op7418)

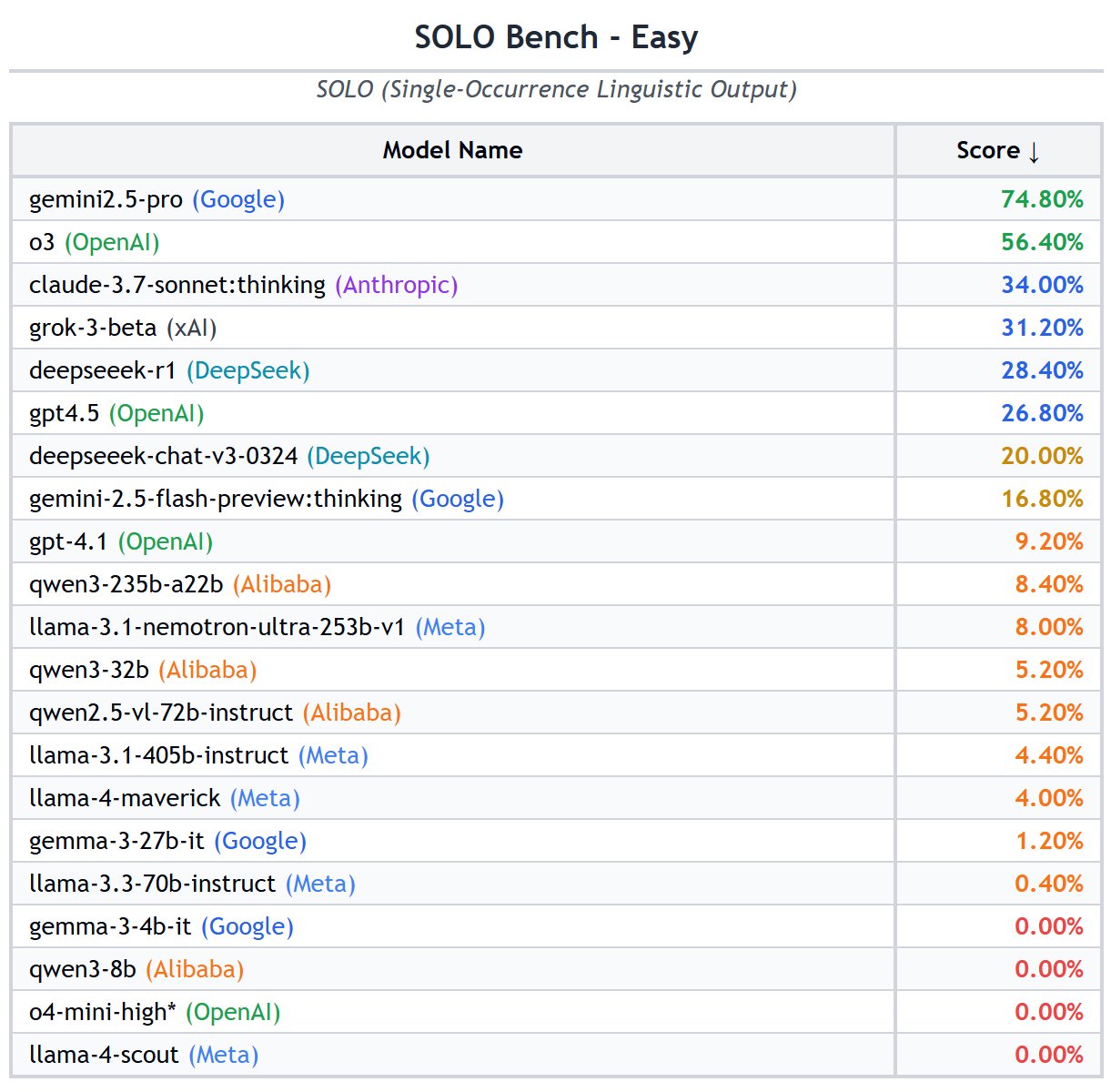

AI Alanındaki Araştırmacı Hareketliliği Trendleri: Grafik, AI alanındaki en iyi araştırmacıların çalıştığı ülkelerin dağılımının değiştiğini gösteriyor; ABD’de çalışan araştırmacıların oranı düşerken, Çin’de çalışanların oranı önemli ölçüde artıyor. Topluluk yorumları, Çin’deki yerel araştırma fırsatlarının artması ve potansiyel beyin göçünün tersine dönmesi göz önüne alındığında, gerçek farkın grafikte gösterilenden daha büyük olabileceğini belirtiyor ve küresel AI yetenek rekabeti manzarasındaki değişimi yansıtıyor. (Kaynak: teortaxesTex, bookwormengr)