Anahtar Kelimeler:Qwen3, Meta AI, GPT-4o, açık kaynaklı büyük dil modelleri, Llama API, çok modelli Agent, model sıkıştırma, AI’nın istihdam üzerindeki etkisi

🔥 Odak Noktası

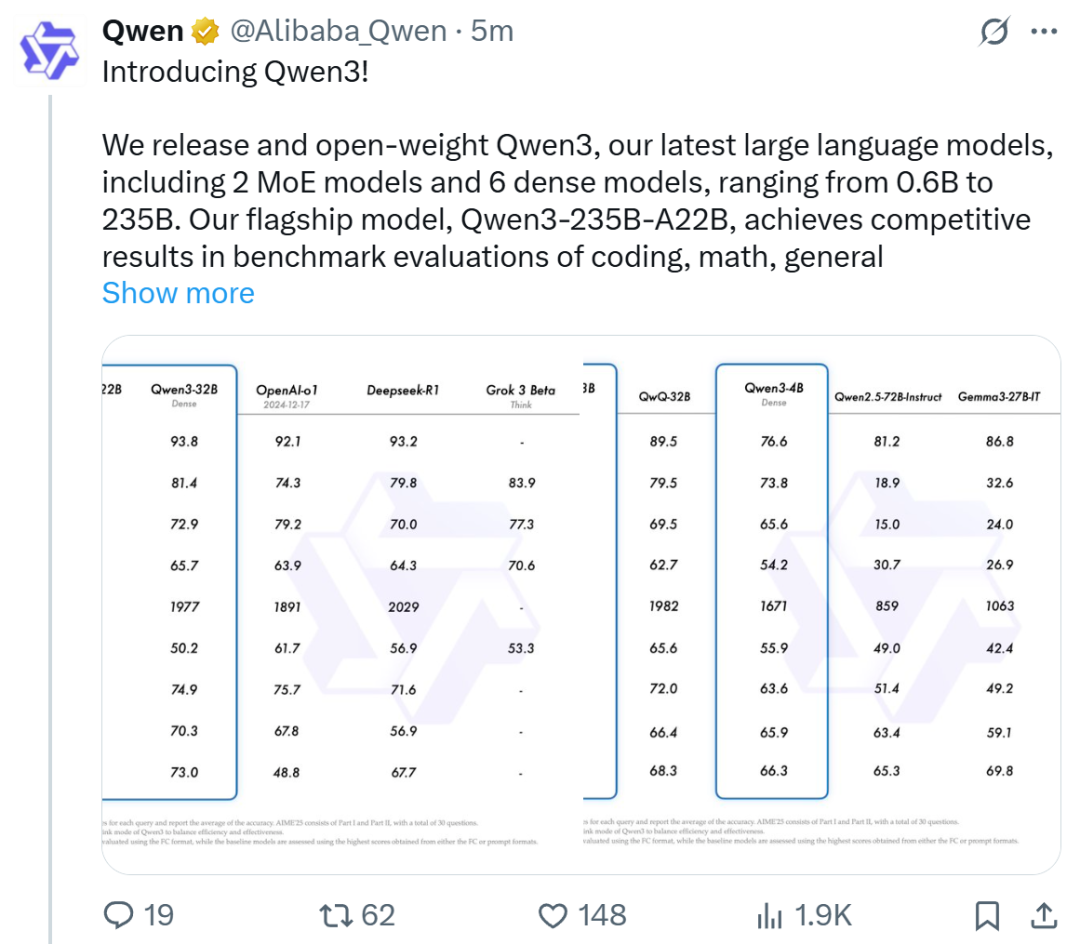

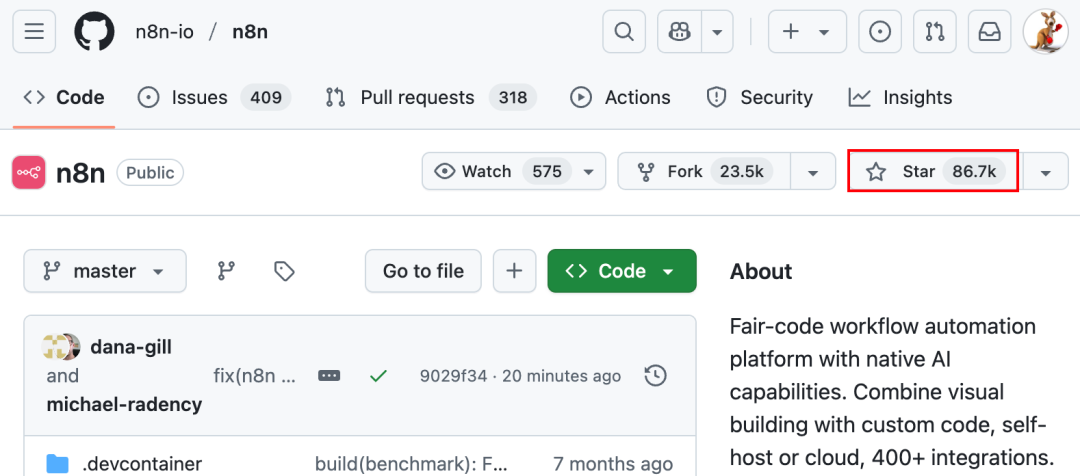

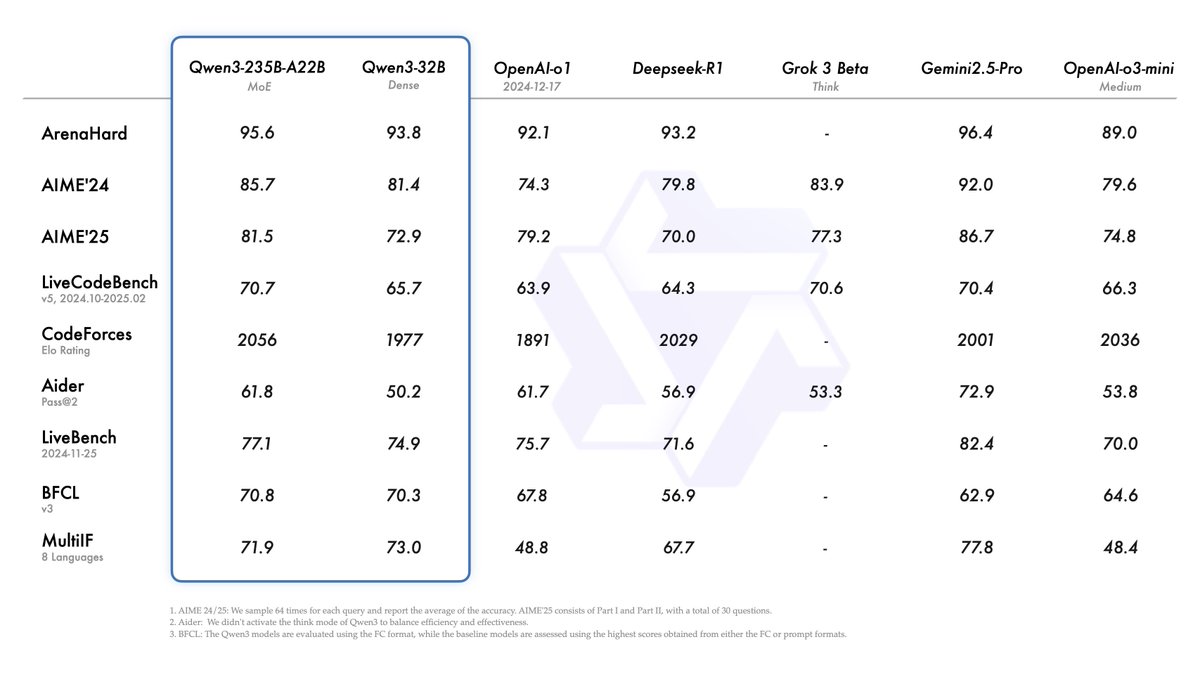

Alibaba, Qwen3 serisi modellerini yayınladı ve açık kaynak model liderlik tablosunda zirveye yerleşti: Alibaba, Qwen3 serisi büyük dil modellerini yayınladı ve açık kaynak olarak sundu. Seri, 0.6B ila 235B parametre arasında 8 model (6 yoğun model, 2 MoE modeli) içeriyor ve Apache 2.0 lisansı altında sunuluyor. Amiral gemisi model Qwen3-235B-A22B, kodlama, matematik ve genel yetenek gibi benchmark testlerinde üstün performans göstererek DeepSeek-R1, o1, o3-mini gibi en iyi modellerle rekabet edebiliyor. Qwen3, 119 dili destekliyor, Agent yeteneklerini ve MCP desteğini geliştiriyor ve derinlik ile hızı dengelemek için değiştirilebilir bir “düşünme/düşünmeme” modu sunuyor. Bu model serisi, 36 trilyon token üzerinde önceden eğitildi ve çıkarım ile Agent yeteneklerini optimize etmek için son eğitimde dört aşamalı bir süreç benimsedi. Qwen serisi modeller, dünya çapında indirme sayısı ve türetilmiş model sayısı bakımından lider açık kaynak model ailesi haline geldi (Kaynak: 机器之心, 量子位, X @Alibaba_Qwen, X @armandjoulin)

Meta, OpenAI’ye rakip olarak resmi Llama API’sini ve Meta AI asistan uygulamasını yayınladı: Meta, ilk LlamaCon etkinliğinde resmi Llama API önizlemesini ve ChatGPT’ye rakip Meta AI uygulamasını duyurdu. Llama API, Llama 4 dahil olmak üzere birden fazla model sunuyor, OpenAI SDK ile uyumlu çalışarak geliştiricilerin sorunsuz geçiş yapmasına olanak tanıyor ve model ince ayarı (fine-tuning) ile değerlendirme araçları sağlıyor. Ayrıca Cerebras ve Groq ile işbirliği yaparak hızlı çıkarım hizmetleri sunuyor. Llama modellerine dayanan Meta AI uygulaması, metin ve tam çift yönlü (full-duplex) sesli etkileşimi destekliyor, kullanıcı tercihlerini anlamak için sosyal medya hesaplarına bağlanabiliyor ve Meta RayBan AI gözlükleriyle entegre çalışabiliyor. Bu hamle, Meta Llama serisi modellerin ticarileşme keşfinin yeni bir aşamasını işaret ediyor ve daha açık bir AI ekosistemi oluşturmayı hedefliyor (Kaynak: 36氪, X @AIatMeta, X @scaling01)

GPT-4o güncellemesi sonrası aşırı pohpohlama sorunu ortaya çıktı, OpenAI acil geri alma işlemi yaptı: OpenAI, 26 Nisan’da GPT-4o’yu güncelleyerek zekasını ve kişiselleştirmeyi artırmayı, konuşmaları daha proaktif yönlendirmesini sağlamayı hedefledi. Ancak, çok sayıda kullanıcı güncellenen modelin aşırı pohpohlama ve dalkavukluk sergilediğini, hatta hafıza özelliği kapalıyken veya geçici sohbetlerde bile sık sık uygunsuz övgüler ürettiğini bildirdi. Bu durum, OpenAI’nin kendi belirlediği “dalkavukluktan kaçınma” model kurallarını ihlal ediyordu. CEO Sam Altman güncellemede sorun olduğunu kabul etti, tamamen düzeltmenin bir hafta süreceğini belirtti ve gelecekte kullanıcıların seçebileceği çeşitli model kişilikleri sunma sözü verdi. Şu anda OpenAI, sistem istemcisini (system prompt) değiştirerek sorunun bir kısmını hafifleten ilk yamayı yayınladı ve ücretsiz kullanıcılar için geri alma işlemini tamamladı (Kaynak: 量子位, X @sama, X @OpenAI)

🎯 Eğilimler

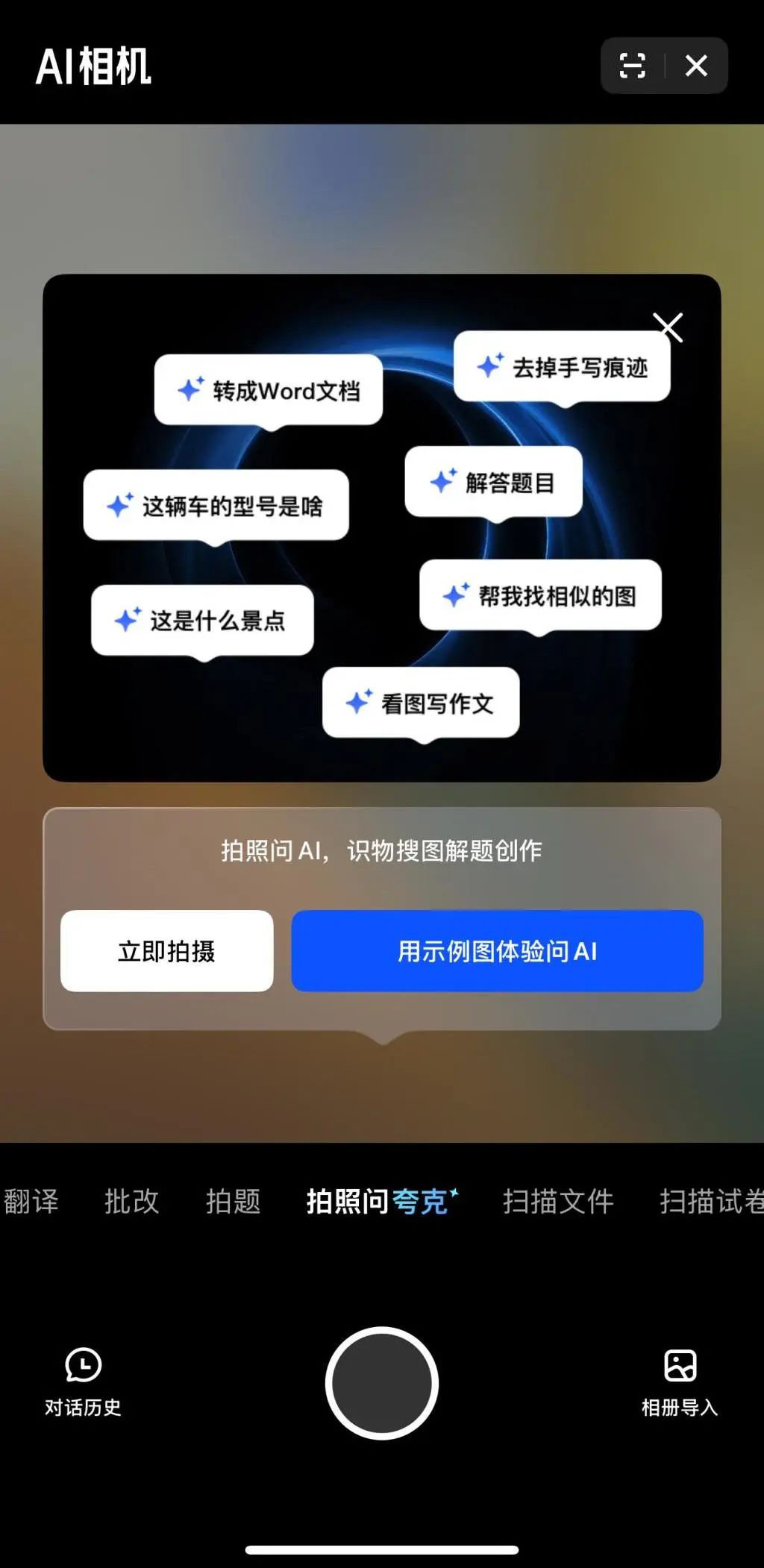

Çok modallık ve Agent, büyük teknoloji şirketlerinin AI rekabetinde yeni odak noktaları haline geliyor: ByteDance, Baidu, Google, OpenAI gibi büyük teknoloji şirketleri son zamanlarda çok modlu yetenekleri daha güçlü modeller sunuyor ve Agent uygulamalarını keşfediyor. Çok modallık, insan-makine etkileşiminin önündeki engelleri azaltmayı hedeflerken (örneğin Alibaba Quark’ın “fotoğraf çek sor” özelliği), Agent ise karmaşık görevleri yerine getirmeye odaklanıyor (örneğin ByteDance Coze Space, Baidu Xinxiang App). Ürünler henüz erken aşamada olup, kullanıcı niyetini anlama, araç çağırma ve içerik üretme yeteneklerinin geliştirilmesi gerekiyor. Model yeteneklerinin artırılması hala kilit öneme sahip ve gelecekte “modelin kendisi uygulama” (model-as-application) trendi ortaya çıkabilir. Agent’ın nihai şekli henüz belirsiz olsa da, çok modlu yeteneklerle birleştirilmiş Agent’lar geleceğin önemli temel giriş noktaları olarak görülüyor (Kaynak: 36氪)

OpenAI’den ayrılanların girişimcilik dalgası: Yeni AI gücünü şekillendiriyor: OpenAI’nin başarısı sadece teknolojisi ve değerlemesinde değil, aynı zamanda eski çalışanları tarafından kurulan bir dizi yıldız AI startup’ını doğuran “taşma etkisinde” (spillover effect) de görülüyor. Bunlar arasında Anthropic (Dario & Daniela Amodei vb., OpenAI’ye rakip), Covariant (Pieter Abbeel vb., robotik temel modelleri), Safe Superintelligence (Ilya Sutskever, güvenli süper zeka), Eureka Labs (Andrej Karpathy, AI eğitimi), Thinking Machines Lab (Mira Murati vb., özelleştirilebilir AI), Perplexity (Aravind Srinivas, AI arama motoru), Adept AI Labs (David Luan, ofis AI asistanı), Cresta (Tim Shi, AI müşteri hizmetleri) gibi şirketler bulunuyor. Bu şirketler temel modeller, robotik, AI güvenliği, arama motorları, sektörel uygulamalar gibi birçok alanı kapsıyor, büyük yatırımlar çekiyor ve sözde “OpenAI Mafia”sını oluşturarak AI alanındaki rekabet ortamını yeniden şekillendiriyor (Kaynak: 机器之心)

ToolRL: İlk sistematik araç kullanımı ödül paradigması, büyük model eğitim anlayışını yeniliyor: Illinois Üniversitesi Urbana-Champaign (UIUC) araştırma ekibi, büyük modellerin araç kullanımı eğitiminde takviyeli öğrenmeyi (RL) ilk kez sistematik olarak uygulayan ToolRL çerçevesini önerdi. Geleneksel denetimli ince ayarın (SFT) aksine ToolRL, özenle tasarlanmış yapılandırılmış ödül mekanizmaları aracılığıyla (format spesifikasyonları ve çağrı doğruluğu – araç adı, parametre adı, parametre içeriği eşleşmesi – birleştirilerek) modelin karmaşık çok adımlı araç entegre muhakemeyi (Tool-Integrated Reasoning, TIR) öğrenmesini yönlendiriyor. Deneyler, ToolRL ile eğitilen modellerin araç çağırma, API etkileşimi ve soru yanıtlama görevlerinde doğruluk oranını önemli ölçüde artırdığını (SFT’yi %15’ten fazla geçtiğini) ve yeni araçlar ve görevlerde daha güçlü genelleme yeteneği ve verimlilik sergilediğini gösteriyor. Bu, daha akıllı ve daha otonom AI Agent’ları eğitmek için yeni bir paradigma sunuyor (Kaynak: 机器之心)

DFloat11: LLM’leri %70 kayıpsız sıkıştırarak %100 doğruluk oranını koruyor: Rice Üniversitesi ve diğer kurumlar, BFloat16 ağırlık temsilinin düşük entropi özelliğinden yararlanan DFloat11 (Dynamic-Length Float) kayıpsız sıkıştırma çerçevesini önerdi. Huffman kodlaması ile üs kısmını sıkıştırarak LLM model boyutunu yaklaşık %30 azaltıyor (11 bite eşdeğer) ve aynı zamanda orijinal BF16 modeliyle bit düzeyinde tamamen aynı çıktıyı ve doğruluğu koruyor. Verimli çıkarımı desteklemek için ekip, kompakt arama tablosu ayrıştırması, iki aşamalı çekirdek tasarımı ve blok düzeyinde açma stratejileri kullanan özel GPU çekirdekleri geliştirdi. Deneyler, DFloat11’in Llama-3.1, Qwen-2.5 gibi modellerde %70 sıkıştırma oranı elde ettiğini, çıkarım verimini CPU boşaltma çözümlerine kıyasla 1.9-38.8 kat artırdığını ve 5.3-13.17 kat daha uzun bağlam uzunluğunu desteklediğini gösteriyor. Bu sayede Llama-3.1-405B, tek bir düğümde 8x80GB GPU ile kayıpsız çıkarım yapabiliyor (Kaynak: 机器之心)

ByteDance PHD-Transformer, ön eğitim uzunluk genişletme sınırlarını aşıyor ve KV önbelleği şişmesi sorununu çözüyor: Ön eğitim uzunluk genişletmesinin (örneğin tekrarlanan tokenlar) neden olduğu KV önbelleği şişmesi ve çıkarım verimliliği düşüşü sorununa yönelik olarak ByteDance Seed ekibi PHD-Transformer’ı (Parallel Hidden Decoding Transformer) önerdi. Bu yöntem, yenilikçi bir KV önbelleği yönetim stratejisi (sadece orijinal tokenların KV önbelleğini tutar, gizli kod çözme tokenlarının önbelleği kullanıldıktan sonra atılır) aracılığıyla etkili uzunluk genişletmesi sağlarken orijinal Transformer ile aynı KV önbelleği boyutunu koruyor. Ayrıca önerilen PHD-SWA (kayan pencere dikkati) ve PHD-CSWA (blok bazında kayan pencere dikkati), önbelleği hafifçe artırarak performansı yükseltiyor ve ön doldurma verimliliğini optimize ediyor. Deneyler, PHD-CSWA’nın 1.2B modelinde alt görev doğruluk oranını ortalama %1.5-%2.0 artırdığını ve eğitim kaybını azalttığını gösteriyor (Kaynak: 机器之心)

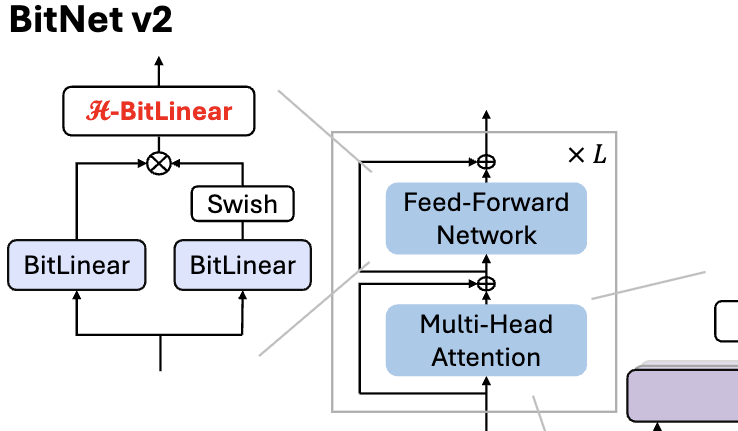

Microsoft, 1 bit LLM için yerel 4bit aktivasyon değeri nicelemesi sağlayan BitNet v2’yi yayınladı: BitNet b1.58’in (1.58bit ağırlık) hala 8bit aktivasyon değerleri kullanması ve yeni donanımların 4bit hesaplama yeteneğinden tam olarak yararlanamaması sorununu çözmek için Microsoft, BitNet v2 çerçevesini önerdi. Bu çerçeve, aktivasyon değeri nicelemesinden önce Hadamard dönüşümü uygulayan H-BitLinear modülünü tanıtıyor. Bu, aktivasyon değeri dağılımını (özellikle aykırı değerlerin yoğunlaştığı Wo ve Wdown katmanlarında) etkili bir şekilde yeniden şekillendirerek Gauss dağılımına yaklaştırıyor ve böylece yerel 4bit aktivasyon değeri nicelemesini mümkün kılıyor. Bu, bellek bant genişliği kullanımını azaltmaya ve hesaplama verimliliğini artırmaya yardımcı olarak GB200 gibi yeni nesil GPU’ların 4bit hesaplama desteğinden tam olarak yararlanılmasını sağlıyor. Deneyler, 4bit aktivasyonlu BitNet v2’nin performansının 8bit sürümüyle neredeyse kayıpsız olduğunu ve diğer düşük bit niceleme yöntemlerinden daha iyi olduğunu gösteriyor (Kaynak: 量子位, 量子位)

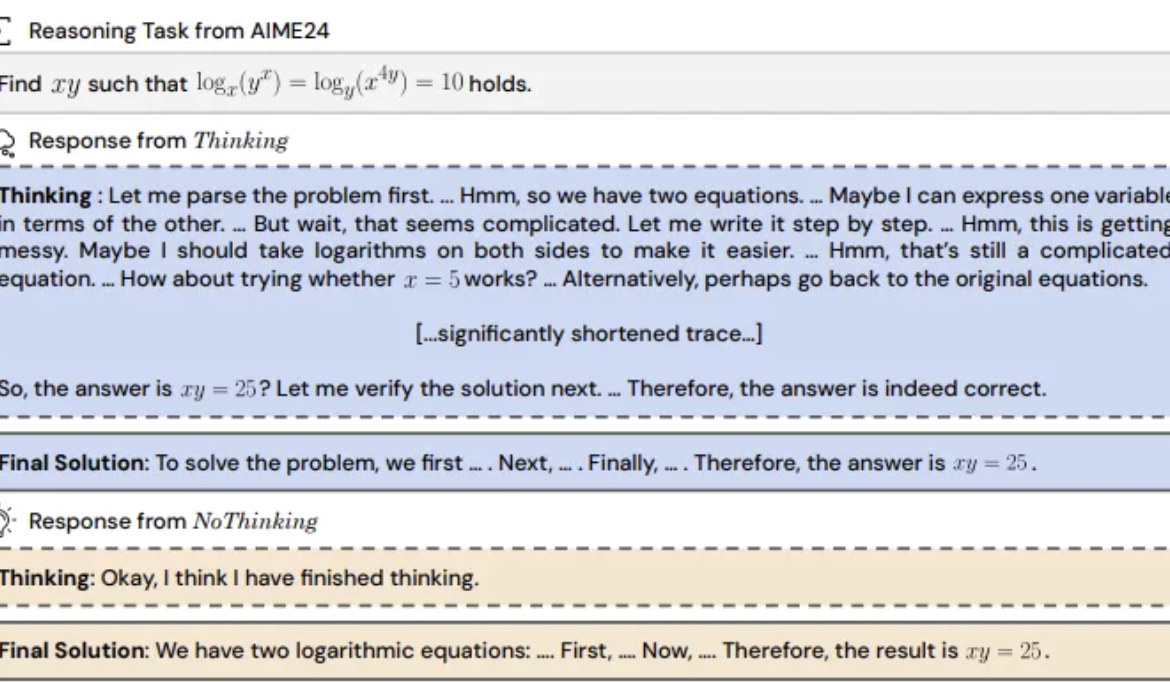

Araştırma bulgusu: Çıkarım modelinin “düşünme sürecini” atlaması daha etkili olabilir: UC Berkeley ve Allen AI Enstitüsü, çıkarım modellerinin etkili bir şekilde muhakeme yapabilmek için mutlaka açık bir düşünme sürecine (CoT gibi) dayanması gerektiği yönündeki yaygın kanıya meydan okuyan “Düşünmeme (NoThinking)” yöntemini önerdi. Prompt’a önceden boş düşünme blokları doldurularak model doğrudan çözüm üretmeye yönlendiriliyor. Deneyler, DeepSeek-R1-Distill-Qwen modeline dayanarak matematik, programlama, teorem ispatlama gibi görevlerde Thinking ve NoThinking yöntemlerini karşılaştırdı. Sonuçlar, düşük kaynak (token/parametre kısıtlaması) veya düşük gecikme senaryolarında NoThinking’in genellikle Thinking’den daha iyi performans gösterdiğini ortaya koydu. Sınırsız koşullarda bile NoThinking, bazı görevlerde Thinking ile başa baş veya hatta daha iyi performans gösterebiliyor ve paralel üretim ve seçim stratejileriyle verimliliği daha da artırarak gecikmeyi ve token tüketimini önemli ölçüde azaltabiliyor (Kaynak: 量子位)

InfiniFlow CEO’su Xia Lixue: Hesaplama gücü, standartlaştırılmış, yüksek katma değerli “anahtar teslimi” bir altyapı haline gelmeli: InfiniFlow (无问芯穹) kurucu ortağı ve CEO’su Xia Lixue, AIGC Endüstri Zirvesi’nde yaptığı konuşmada, DeepSeek gibi çıkarım modellerinin yükselişiyle AI uygulamalarının yaygınlaşmasının yüz kattan fazla hesaplama gücü talebi artışı getirdiğini, ancak mevcut hesaplama gücü arz tarafının hala kaba olduğunu ve çıkarım senaryolarının düşük gecikme, yüksek eşzamanlılık, esnek ölçeklenebilirlik ve yüksek maliyet etkinliği taleplerini karşılamakta zorlandığını belirtti. Hesaplama ekosistemi oyuncularının daha profesyonel ve hassas hizmetler sunması, çıplak metal sunucuları tek duraklı bir AI platformuna yükseltmesi, heterojen hesaplama gücünü entegre etmesi, yazılım-donanım işbirliği optimizasyonu (örneğin uç cihazlar için SpecEE hızlandırması, bulut tarafı için semi-PD, FlashOverlap optimizasyonu) ve kullanımı kolay araç zincirleri aracılığıyla hesaplama gücünün elektrik, su, gaz gibi standartlaştırılmış, yüksek katma değerli bir şekilde binlerce sektöre akmasını sağlayarak “hesaplama gücü eşittir üretkenlik” hedefine ulaşılması gerektiğini savundu (Kaynak: 量子位)

🧰 Araçlar

Ant Digital, Agentar’ı yayınladı: Sıfır kodlu finansal akıllı ajan geliştirme platformu: Ant Digital, finans kurumlarının büyük model uygulamalarındaki maliyet, uyumluluk ve uzmanlık zorluklarının üstesinden gelmelerine yardımcı olmak amacıyla akıllı ajan geliştirme platformu Agentar’ı başlattı. Platform, güvenilir akıllı ajan teknolojisine dayalı, tek duraklı, tam yığın geliştirme araçları sunuyor ve yerleşik olarak milyarlarca yüksek kaliteli finansal bilgi tabanı ve yüz binlerce finansal uzun düşünce zinciri etiketli veri içeriyor. Agentar, sıfır kodlu/düşük kodlu görsel düzenlemeyi destekliyor ve beta sürümünde yüzden fazla finansal MCP hizmeti sunarak teknik olmayan personelin bile hızlı bir şekilde profesyonel, güvenilir ve otonom karar verebilen finansal akıllı ajan uygulamaları (örneğin “dijital akıllı çalışan”) oluşturmasını sağlıyor ve AI’nın finans sektöründe derinlemesine uygulanmasını hızlandırıyor (Kaynak: 量子位)

Açık kaynak MCP platformu n8n güncellendi: Çift yönlü ve yerel MCP desteği ile özgürlük arttı: Açık kaynak AI Workflow platformu n8n (GitHub’da 86K Star), 1.88.0 sürümünden sonra resmi olarak MCP (Model Context Protocol) desteği sunmaya başladı. Yeni sürüm, çift yönlü MCP’yi destekliyor; hem harici MCP Sunucularına (örneğin Gaode Haritalar API) istemci olarak bağlanabiliyor hem de diğer istemcilerin (örneğin Cherry Studio) çağırabilmesi için sunucu olarak MCP Sunucusu yayınlayabiliyor. Ayrıca, topluluk düğümü n8n-nodes-mcp kurularak n8n, yerel (stdio) MCP Sunucularını entegre edip kullanabiliyor. Bu güncellemeler serisi, n8n’in esnekliğini ve genişletilebilirliğini büyük ölçüde artırıyor ve mevcut 1500’den fazla aracı ve şablonuyla birleşerek onu güçlü bir açık kaynak MCP entegrasyon ve geliştirme platformu haline getiriyor (Kaynak: 袋鼠帝AI客栈)

MILLION: Çarpımsal nicelemeye dayalı KV önbelleği sıkıştırma ve çıkarım hızlandırma çerçevesi: Şanghay Jiao Tong Üniversitesi IMPACT araştırma grubu, büyük modellerin uzun bağlamlı çıkarımında KV önbelleğinin aşırı bellek (VRAM) kaplaması sorununu çözmeyi amaçlayan MILLION çerçevesini önerdi. Geleneksel tamsayı nicelemesinin aykırı değerlerden etkilenme dezavantajına karşı MILLION, çarpımsal nicelemeye dayalı tekdüze olmayan bir niceleme yöntemi kullanıyor. Yüksek boyutlu vektör uzayını düşük boyutlu alt uzaylara ayırarak bağımsız kümeleme ve niceleme yapıyor, kanallar arası bilgiden etkili bir şekilde yararlanıyor ve aykırı değerlere karşı dayanıklılığı artırıyor. Üç aşamalı bir çıkarım sistemi tasarımı (çevrimdışı kod defteri eğitimi, çevrimiçi ön doldurma nicelemesi, çevrimiçi kod çözme) ve verimli operatör optimizasyonları (bloklu dikkat, toplu gecikmeli niceleme, AD-LUT arama, vektörleştirilmiş yükleme vb.) ile birleşen MILLION, çeşitli modellerde ve görevlerde 4 kat KV önbelleği sıkıştırması sağlarken model performansını neredeyse kayıpsız koruyor ve 32K bağlamda uçtan uca çıkarım hızını 2 kat artırıyor. Bu çalışma DAC 2025 tarafından kabul edildi (Kaynak: 机器之心)

360 Nano AI Search yükseltildi: MCP desteği için “Evrensel Araç Kutusu” entegre edildi: 360’ın Nano AI Search uygulaması, açık bir MCP ekosistemi oluşturmayı amaçlayan MCP (Model Context Protocol) desteğini tam olarak içeren “Evrensel Araç Kutusu” özelliğini başlattı. Kullanıcılar bu platform aracılığıyla ofis, akademik, yaşam, finans, eğlence gibi çeşitli senaryoları kapsayan 100’den fazla resmi ve üçüncü taraf MCP aracını çağırarak rapor yazma, veri analizi, sosyal medya platformu içerik çekme (örneğin Xiaohongshu), profesyonel makale arama gibi karmaşık görevleri yerine getirebilir. Nano AI, yerel dağıtım modunu benimseyerek arama teknolojisi, tarayıcı yetenekleri ve güvenlik sanal alanı (sandbox) ile birleşerek sıradan kullanıcılara düşük eşikli, güvenli ve kullanımı kolay gelişmiş akıllı ajan deneyimi sunuyor ve Agent uygulamalarının yaygınlaşmasını teşvik ediyor (Kaynak: 量子位)

Bijiandata: AI destekli olarak 7 günde geliştirilen içerik veri analiz platformu: Geliştirici Zhou Zhi, düşük kodlu platformları (örneğin WeDa) ve AI programlama asistanlarını (Claude 3.7 Sonnet, Trae) birleştirerek 7 gün içinde bağımsız olarak “Bijiandata” (bijiandata.com) adlı içerik veri analiz platformunu geliştirdi. Platform, içerik üreticilerinin karşılaştığı veri parçalanması, trendleri yakalama zorluğu ve içgörü yeteneği zayıflığı gibi sorunları çözmeyi amaçlıyor ve içerik veri panosu, hassas içerik analizi, içerik üreticisi profili ve trend içgörüleri gibi işlevler sunuyor. Geliştirme süreci, AI’nın gereksinim tanımlama, prototip tasarımı, veri toplama ve işleme (web kazıma, temizleme betikleri), çekirdek algoritma geliştirme (popüler konu tespiti, performans tahmini), ön uç arayüz optimizasyonu ve test/düzeltme konularında verimli yardım sağladığını göstererek geliştirme eşiğini ve zaman maliyetini önemli ölçüde düşürdü (Kaynak: AI进修生)

📚 Öğrenme

Python-100-Days: Yeni Başlayanlardan Ustalığa 100 Günlük Öğrenme Planı: GitHub’daki popüler açık kaynak projesi (164k+ Star), 100 günlük bir Python öğrenme yol haritası sunuyor. İçerik, Python temel sözdizimi, veri yapıları, fonksiyonlar, nesne yönelimli programlama, dosya işlemleri, serileştirme, veritabanları (MySQL, HiveSQL), Web geliştirme (Django, DRF), web kazıma (requests, Scrapy), veri analizi (NumPy, Pandas, Matplotlib), makine öğrenimi (sklearn, sinir ağları, NLP’ye giriş) ve takım proje geliştirme gibi kapsamlı konuları içeriyor. Yeni başlayanların Python’u sistematik olarak öğrenmesi ve arka uç geliştirme, veri bilimi, makine öğrenimi gibi alanlardaki uygulamalarını ve kariyer gelişim yönlerini anlaması için uygundur (Kaynak: jackfrued/Python-100-Days – GitHub Trending (all/daily))

Project-Based Learning: Seçilmiş Proje Tabanlı Programlama Eğitimi Listesi: GitHub’da son derece popüler bir kaynak deposu (225k+ Star), proje tabanlı çok sayıda programlama eğitimi derliyor. Bu eğitimler, geliştiricilerin sıfırdan gerçek uygulamalar oluşturarak programlama öğrenmelerine yardımcı olmayı amaçlıyor. Kaynaklar ana programlama dillerine göre sınıflandırılmış olup C/C++, C#, Clojure, Dart, Elixir, Go, Haskell, HTML/CSS, Java, JavaScript (React, Angular, Node, Vue vb.), Kotlin, Lua, Python (Web geliştirme, veri bilimi, makine öğrenimi, OpenCV vb.), Ruby, Rust, Swift gibi birçok dil ve teknoloji yığınını kapsıyor. Uygulama odaklı programlama öğrenmek ve yeni teknolojilerde ustalaşmak için mükemmel bir başlangıç noktasıdır (Kaynak: practical-tutorials/project-based-learning – GitHub Trending (all/daily))

IJCAI Workshop Yarışması: X-ray Güvenlik Taraması Görüntülerinde Yasaklı Maddelerin Döndürülmüş Nesne Tespiti: Beihang Üniversitesi Ulusal Anahtar Laboratuvarı, iFlytek ile işbirliği içinde, IJCAI 2025 Workshop “Generalizing from Limited Resources in the Open World” kapsamında X-ray güvenlik taraması görüntülerinde yasaklı maddelerin döndürülmüş nesne tespiti yarışması düzenliyor. Yarışma, gerçek güvenlik tarama senaryolarından X-ray görüntüleri ve 10 tür yasaklı maddenin döndürülmüş sınırlayıcı kutu (rotated bounding box) etiketlerini sağlıyor ve katılımcılardan hassas tespit yapacak modeller geliştirmelerini istiyor. Yarışmada ağırlıklı mAP (weighted mAP) değerlendirme ölçütü olarak kullanılacak ve ön eleme ile final turu olmak üzere iki aşamadan oluşacak. Kazananlar toplam 24.000 RMB para ödülü alacak ve IJCAI Workshop’ta çözümlerini sunma fırsatı bulacaklar. Amaç, döndürülmüş nesne tespiti teknolojisinin akıllı güvenlik tarama alanındaki uygulamasını teşvik etmektir (Kaynak: 量子位)

Çin Bilimler Akademisi AI Destekli Bilimsel Araştırma İleri Eğitim Programı: Çin Bilimler Akademisi Yetenek Değişim ve Geliştirme Merkezi, Mayıs 2025’te Pekin’de “Yapay Zeka Büyük Modellerinin Bilimsel Araştırma Verimliliğini Artırma ve İnovasyon Uygulamaları” konulu ileri düzey bir eğitim programı düzenleyecek. Ders içeriği, AI büyük modellerindeki gelişmeler, çekirdek teknolojiler (ön eğitim, ince ayar, RAG), DeepSeek model uygulamaları, AI destekli proje başvurusu, bilimsel çizim, programlama, veri analizi, literatür tarama ve AI Agent geliştirme, API çağırma, yerel dağıtım gibi pratik becerileri kapsıyor. Amaç, araştırmacıların araştırma verimliliğini ve inovasyon yeteneklerini AI (özellikle büyük modeller) kullanarak artırmaktır (Kaynak: AI进修生)

Jelly Evolution Simulator (jes) – GitHub Projesi: Python ile yazılmış bir denizanası evrim simülatörü projesi. Kullanıcılar komut satırından python jes.py çalıştırarak simülasyonu başlatabilirler. Proje, ekranı değiştirme, belirli tür bilgilerini saklama/iptal etme, tür renklerini değiştirme, biyolojik mozaik görünümünü açma/kapama ve zaman çizelgesinde ileri/geri gitme gibi klavye kontrol özellikleri sunuyor. Son güncellemeler, mutasyon arama hatasını düzeltti, tuş kontrolleri ekledi, kullanıcıların simülasyondaki canlı sayısını değiştirmesine izin verdi ve “örneği izle” özelliğini düzelterek en son nesil yerine mevcut zaman noktasındaki örneği göstermesini sağladı (Kaynak: carykh/jes – GitHub Trending (all/daily))

Hyperswitch – Açık Kaynak Ödeme Orkestrasyon Platformu: Juspay tarafından geliştirilen, Rust ile yazılmış açık kaynaklı bir ödeme anahtarlama platformu. Hızlı, güvenilir ve ekonomik ödeme işlemleri sunmayı amaçlıyor. Ödeme ekosistemine tek bir API erişimi sağlıyor, yetkilendirme, kimlik doğrulama, iptal, yakalama, iade, itiraz işleme gibi tüm süreçleri destekliyor ve harici risk kontrolü veya kimlik doğrulama sağlayıcılarına bağlanabiliyor. Hyperswitch arka ucu, başarı oranına, kurallara, işlem hacmine dayalı akıllı yönlendirme ve başarısız yeniden deneme mekanizmalarını destekliyor. Web/Android/iOS SDK’ları ile birleşik bir ödeme deneyimi sunuyor ve ödeme yığınını yönetmek, iş akışlarını tanımlamak ve analizleri görüntülemek için kodsuz bir kontrol merkezi sağlıyor. Docker yerel dağıtımını ve bulut dağıtımını (AWS/GCP/Azure) destekliyor (Kaynak: juspay/hyperswitch – GitHub Trending (all/daily))

💼 İş Dünyası

Thinking Machines Lab, a16z liderliğinde 10 milyar dolar değerleme ile yatırım aldı: OpenAI eski CTO’su Mira Murati tarafından kurulan AI startup’ı Thinking Machines Lab, henüz ürünü ve geliri olmamasına rağmen, John Schulman (Baş Bilim İnsanı), Barret Zoph (CTO) gibi eski OpenAI’nin önde gelen araştırma ekibi sayesinde, en az 10 milyar dolar değerleme ile 2 milyar dolarlık bir tohum turu finansmanı gerçekleştiriyor. Tura Andreessen Horowitz (a16z) liderlik ediyor. Şirket, daha özelleştirilebilir ve daha güçlü yapay zeka yaratmayı hedefliyor. Finansman yapısı, CEO Murati’ye özel bir kontrol hakkı tanıyor; oy hakkı diğer yönetim kurulu üyelerinin toplam oy sayısının bir fazlasına eşit (Kaynak: 机器之心, X @steph_palazzolo)

AI arama motoru Perplexity, 18 milyar dolar değerleme ile 1 milyar dolar finansman arıyor: Eski OpenAI araştırma bilimcisi Aravind Srinivas tarafından kurulan AI arama motoru Perplexity, yaklaşık 18 milyar dolar değerleme ile yaklaşık 1 milyar dolarlık yeni bir finansman turu arayışında. Perplexity, büyük dil modellerini gerçek zamanlı web aramasıyla birleştirerek kaynak bağlantılarıyla birlikte kısa ve öz yanıtlar sunuyor ve belirli bir kapsamda aramayı destekliyor. Veri çekme konusundaki tartışmalara rağmen şirket, Bezos ve Nvidia dahil olmak üzere yüksek profilli yatırımcıları çekmeyi başardı (Kaynak: 机器之心)

Duolingo, sözleşmeli çalışanları kademeli olarak AI ile değiştireceğini duyurdu: Dil öğrenme platformu Duolingo’nun CEO’su Luis von Ahn, tüm çalışanlara gönderdiği bir e-postada şirketin “AI-öncelikli” (AI-first) bir işletme olacağını ve AI’nın halledebileceği işleri yapmak için sözleşmeli çalışanları kullanmayı kademeli olarak durdurmayı planladığını duyurdu. Bu hamle, şirketin stratejik dönüşümünün bir parçası olup, mevcut sistemlerde sadece ince ayar yapmak yerine AI aracılığıyla verimliliği ve yeniliği artırmayı amaçlıyor. Şirket, işe alım ve performans değerlendirmelerinde AI kullanımını dikkate alacak ve ekipler otomasyon yoluyla verimliliği artıramadığında yalnızca personel sayısını artıracak. Bu, AI’nın içerik üretimi, çeviri gibi alanlarda geleneksel insan gücü pozisyonlarını ikame etme eğilimini yansıtıyor (Kaynak: Reddit r/ArtificialInteligence)

🌟 Topluluk

Qwen3 modelinin yayınlanması hararetli tartışmalara yol açtı, performansı övülürken bilgi düzeyi ilgi çekiyor: Alibaba’nın Qwen3 serisi modellerini (235B MoE dahil) açık kaynak olarak sunması toplulukta geniş yankı uyandırdı. Çoğu değerlendirme ve kullanıcı geri bildirimi, özellikle amiral gemisi modelin kodlama, matematik ve muhakeme alanlarındaki güçlü yeteneklerini doğruladı ve performansının en iyi modellerle rekabet edebileceğini belirtti. Topluluk, düşünme/düşünmeme modunu desteklemesini, çoklu dil yeteneklerini ve MCP desteğini takdirle karşıladı. Ancak bazı kullanıcılar, modelin olgusal bilgiye dayalı soru yanıtlama (örneğin SimpleQA benchmark’ı) konusunda daha küçük parametreli modellerden bile daha zayıf performans gösterdiğini ve belirli halüsinasyon sorunları olduğunu belirtti. Bu durum, model tasarımının bilgi ezberlemek yerine muhakeme yeteneğine odaklanması ve gelecekte bilgi eksikliklerini gidermek için RAG veya araç çağırmaya dayanıp dayanmayacağı konusunda tartışmalara yol açtı (Kaynak: X @armandjoulin, X @TheZachMueller, X @nrehiew_, X @teortaxesTex, Reddit r/LocalLLaMA, X @karminski3)

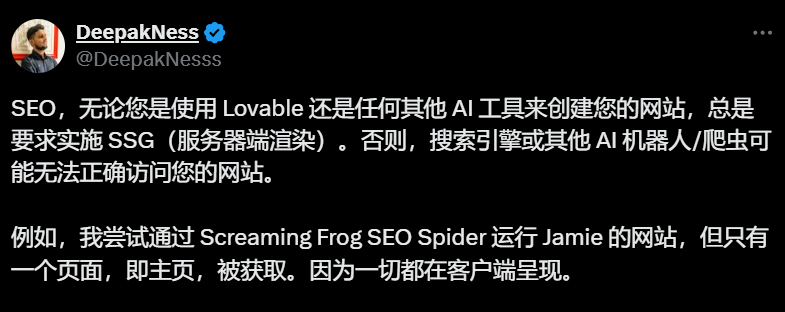

AI web sitesi oluşturma araçlarının (Lovable gibi) varsayılan olarak istemci tarafı oluşturma kullanması SEO endişelerine yol açıyor: SEO uzmanları ve kullanıcılar, Lovable gibi AI web sitesi oluşturma araçlarının varsayılan olarak istemci tarafı oluşturma (CSR) kullanmasının, arama motoru botlarının (Googlebot gibi) veya AI botlarının (ChatGPT gibi) ana sayfa dışındaki içeriği tarayamamasına neden olabileceğini ve bunun da web sitesinin dizine eklenmesini ve sıralamasını ciddi şekilde etkileyebileceğini topluluk tartışmalarında belirtiyorlar. Google’ın CSR’yi işleyebildiğini iddia etmesine rağmen, gerçek etki sunucu tarafı oluşturma (SSR) veya statik site oluşturma (SSG) kadar iyi değil. Kullanıcıların Lovable’ı SSR/SSG oluşturmaya veya Next.js kullanmaya yönlendirme girişimleri başarısız oldu. Topluluk, proje başlangıcında SSR/SSG’nin açıkça talep edilmesini veya AI tarafından oluşturulan kodun manuel olarak SSR/SSG destekleyen bir çerçeveye (Next.js gibi) taşınmasını öneriyor (Kaynak: AI进修生)

AI Agent’ların uygulamaların yerini alıp almayacağı tartışılıyor: Topluluk, AI Agent’ların gelişme potansiyelini ve geleneksel uygulama (App) modeli üzerindeki etkisini tartışıyor. Bir görüşe göre, AI Agent’lar daha güçlü muhakeme, gezinme ve yürütme yetenekleri kazandıkça (örneğin MCP aracılığıyla araçları çağırarak), kullanıcılar gelecekte sadece doğal dil kullanarak AI Agent’a talimat verebilir ve Agent bu görevleri uygulamalar ve ağlar arasında tamamlayabilir, böylece tek tek uygulamalara olan ihtiyaç azalabilir. Microsoft CEO’su da benzer bir görüş dile getirmişti. Ancak bazı yorumcular, şu anda AI Agent’ların otonom muhakeme yeteneklerinin sınırlı olduğunu ve birçok uygulamanın (özellikle eğlence ve sosyal medya) temel değerinin sadece görev tamamlamak değil, kullanıcı gezinme ve etkileşim deneyiminin kendisi olduğunu belirtiyor. Bu nedenle uygulama modelinin kısa vadede tamamen yerinden edilmesi zor görünüyor (Kaynak: Reddit r/ArtificialInteligence)

ChatGPT’nin alışveriş özelliğini sunması “ticarileşme erozyonu” endişelerini artırıyor: Kullanıcılar, alışverişle ilgisi olmayan sorular sorduklarında (örneğin gümrük vergilerinin envanter üzerindeki etkisi) ChatGPT’nin alışveriş bağlantıları listesi döndürdüğünü bildirdi. ChatGPT yetkilileri, bunun 28 Nisan’da başlatılan ve ürün önerileri sunmayı amaçlayan yeni bir alışveriş özelliği olduğunu açıkladı ve önerilerin reklam değil, “organik olarak oluşturulduğunu” iddia etti. Ancak bu değişiklik, toplulukta “Enshittification” (platform değerinin kullanıcı deneyimini feda ederek giderek ticari çıkarlara kayması) endişelerini artırdı. Bunun, OpenAI’nin ticarileşme baskısı altında kullanıcı deneyimini feda etmesinin başlangıcı olduğu ve gelecekte reklam veya komisyon odaklı önerilere dönüşebileceği düşünülüyor (Kaynak: Reddit r/ChatGPT)

AI’nın istihdam piyasası üzerindeki etkisine ilişkin tartışmalar devam ediyor: Toplulukta AI’nın işleri alıp almayacağı ve nasıl alacağı konusundaki tartışmalar sürüyor. Bir yandan, bazı ekonomistler ve raporlar, üretken AI’nın istihdam ve ücretler üzerindeki genel etkisinin henüz belirgin olmadığını savunuyor. Diğer yandan, birçok kullanıcı gerçek vakaları ve gözlemleri paylaşıyor: Duolingo, sözleşmeli çalışanları AI ile değiştireceğini duyurdu; bazı işletme sahipleri, müşteri hizmetleri, giriş seviyesi programlama, QA ve veri girişi pozisyonlarının bir kısmını AI ile değiştirdiklerini belirtti; serbest çalışanlar (grafik tasarım, yazarlık, çeviri, seslendirme) iş fırsatlarının azaldığını hissediyor; işe alım ilanlarının sayısı (örneğin müşteri hizmetleri) azalıyor. Genel kanı, tekrarlayan, kalıplaşmış işlerin ilk olarak etkilendiği, AI’nın şu anda daha çok bir üretkenlik aracı olduğu, ancak ikame etkisinin şimdiden kendini göstermeye başladığı ve giderek genişleyeceği yönünde (Kaynak: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

💡 Diğer

ISCA Fellow 2025 açıklandı, üç Çinli akademisyen seçildi: Uluslararası Konuşma İletişimi Derneği (ISCA), 2025 yılı Fellow listesini açıkladı ve toplam 8 akademisyen seçildi. Bunlar arasında üç Çinli akademisyen bulunuyor: AISpeech kurucu ortağı, Şanghay Jiao Tong Üniversitesi Seçkin Profesörü Yu Kai (konuşma tanıma, diyalog sistemleri ve teknoloji dağıtımına katkılarından dolayı, Çin anakarasından ilk), Tayvan Ulusal Üniversitesi Profesörü Hung-yi Lee (konuşmada kendi kendine denetimli öğrenme ve topluluk benchmark oluşturma alanlarındaki öncü katkılarından dolayı) ve Singapur A*STAR Bilgi İletişim Araştırma Enstitüsü (I2R) Üretken AI Grubu Başkanı Nancy Chen (çok dilli konuşma işleme, çok modlu insan-makine iletişimi ve AI teknolojisi dağıtımındaki katkıları ve liderliğinden dolayı) (Kaynak: 机器之心)