Anahtar Kelimeler:insansı robot, AI uygulamaları, AGI, otonom sürüş, insansı robot maratonu, Agent+MCP, DeepMind AGI tahmini, Tesla saf görüş FSD, GPT-SoVITS ses klonlama, ChemAgent kimyasal akıl yürütme, Zhiyuan Robot iş modeli, NVIDIA GPU tekel zorluğu

🔥 Odak Noktası

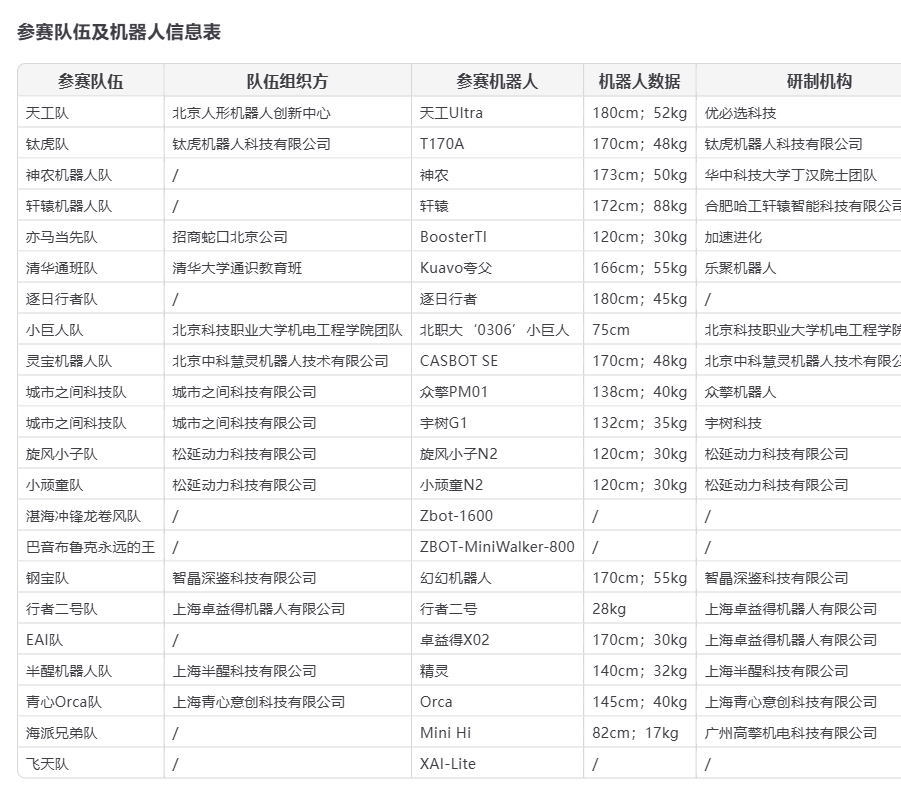

İnsansı robotlar Pekin Yarı Maratonu’nda ‘ilk kez’ sahne aldı, fırsatlar ve zorluklar bir arada: 2025 Pekin Yizhuang Yarı Maratonu’nda 21 insansı robot takımı ilk kez insan yarışmacılarla birlikte yarıştı. Tiangong Ultra, Songyan Dynamics N2 ve Zhuoyi De Xingzhe II ilk üç sırayı aldı. Yarışma, insansı robotların potansiyelini vurguladı ancak düşme, pil ömrü, kontrol (çoğunlukla uzaktan kumandalı) gibi birçok zorluğu da ortaya çıkardı. Yarış sonrası Unitree Technology, G1 robotunun düşme olayına yanıt vererek, kullanıcıların kendi geliştirmelerinin ve operasyonlarının robot performansı üzerinde büyük etkisi olduğunu belirtti. Bu etkinlik sadece Çin’in insansı robot endüstrisinin başlangıç ölçeğini göstermekle kalmadı, aynı zamanda teknolojik olgunluk, maliyet (Songyan N2’nin ön satış fiyatı 39.900 yuan’dan başlıyor), ticarileşme yolları (kiralama, endüstriyel uygulamalar) ve gelecekteki gelişmeler (AI büyük modelleri, otonom öğrenme) hakkında geniş çaplı tartışmaları da tetikledi. Sektör sermaye tarafından tercih edilse de kısa vadeli kârlılık zor ve pazarın hayata geçirilmesi hala zaman alacak (kaynak: Unitree’nin düşüşü ve insansı robotların ‘hayatta kalma’ mücadelesi, Fabrikadan maratona: İnsansı robotlar ‘pratik’ olmaktan ne kadar uzakta?)

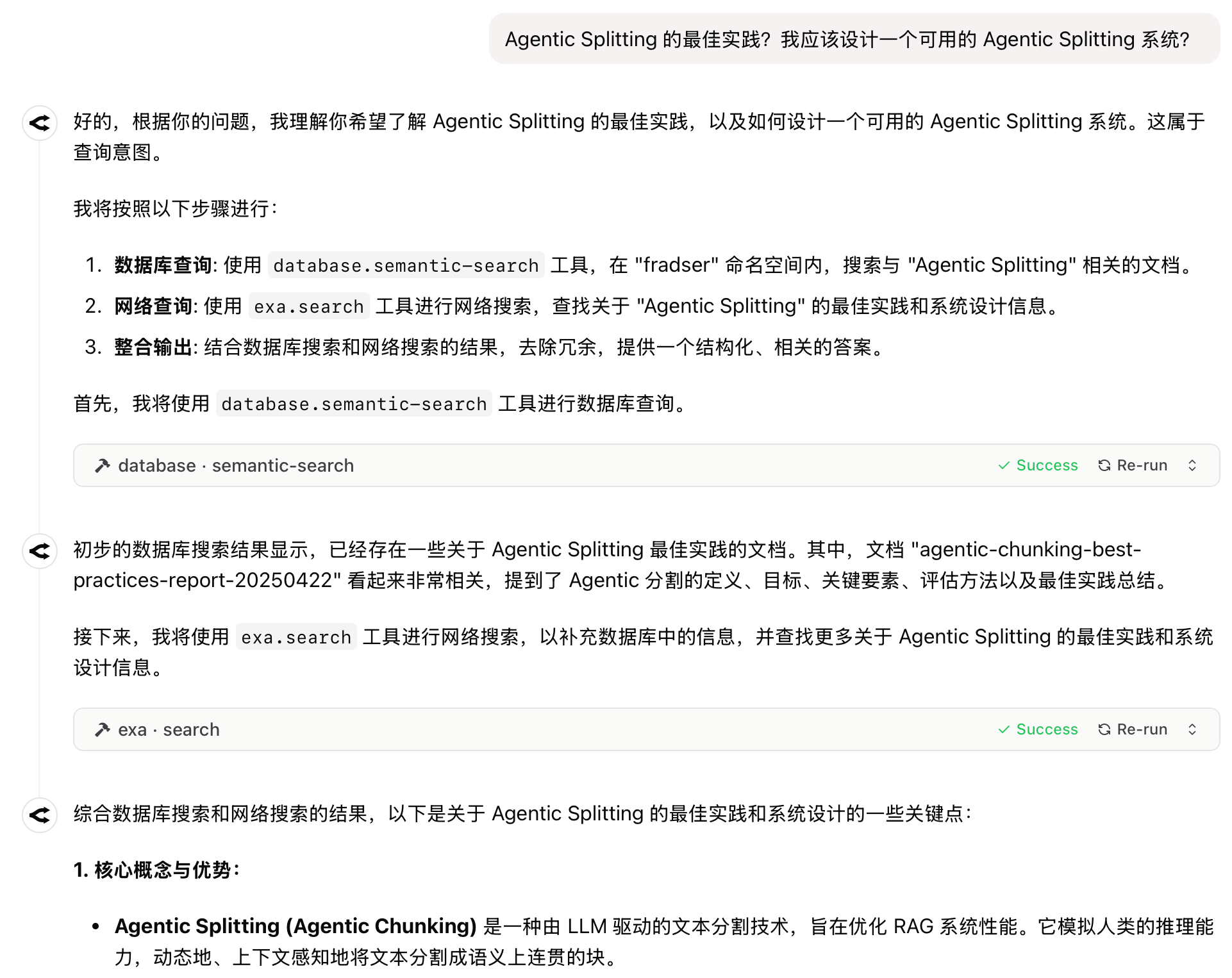

Yapay Zeka Uygulamalarında Yeni Paradigma: Agent+MCP, 2025’in Gözde Formülü Oluyor: Agent’ın otonom planlama ve eylem yetenekleri ile MCP protokolünün harici araçları ve verileri çağırma yeteneğini birleştirmek, yapay zeka uygulamalarında yeni bir trend haline geliyor. “Coze Space”, Fellou, Dia, GenSpark, Zhipu AutoGLM gibi ürünler art arda ortaya çıktı ve ilgi gördü. Bu ürünlerin çoğu yapay zeka aramasından dönüşerek, farklı ürün tasarımları (kullanım kolaylığı, araştırma yetenekleri, uygulama yürütme) aracılığıyla kullanıcı deneyimi engelleri oluşturmaya çalışıyor. Büyük potansiyele rağmen, şu anda hala model yeteneklerinin üst sınırı, platformlar arası bilgi edinme, ticarileşme modelleri gibi zorluklarla karşı karşıyalar. Microsoft ayrıca masaüstü odaklı çoklu Agent sistemi UFO²’yi piyasaya sürerek, AM’nin (Agent+MCP) yapay zeka ürünleri için önemli bir yön olacağını gösteriyor (kaynak: 2025’te yapay zeka uygulamalarının tek bir popüler formülü olacak)

Yapay Zekanın Geleceği Tartışması: Hassabis on yılda tüm hastalıkları iyileştirmeyi öngörüyor, Harvard tarihçisi AGI’nin insanlığı yok edeceği konusunda uyarıyor: Google DeepMind CEO’su Demis Hassabis bir röportajda, yapay zekanın 5-10 yıl içinde AGI’ye ulaşacağını ve on yıl içinde tüm hastalıkları iyileştirme potansiyeline sahip olacağını öngördü ve Project Astra gibi yapay zeka ilerlemelerini sergiledi. Yapay zekanın bilimsel keşifleri hızlandırmak için nihai araç olacağına inanıyor. Ancak Harvard tarihçisi Niall Ferguson, AGI’nin gelişinin insanların at arabaları gibi淘汰 edilmesine ve hatta yok olmasına, insanların kendi yarattığı “uzaylılar” haline gelmesine yol açabileceği konusunda uyardı. Kurumsal katılık ve küresel doğurganlık oranlarındaki düşüş gibi eğilimlerin, insanlığın AGI karşısında “tarih sahnesinden çekilmeyi” seçmesine neden olabileceğini belirtti. Bu tartışma, AGI potansiyeline yönelik aşırı iyimserlik ile insan uygarlığının geleceğine dair derin endişeler arasındaki büyük karşıtlığı vurguluyor (kaynak: Nobel ödüllü Hassabis iddialı: Yapay zeka on yılda tüm hastalıkları iyileştirecek, Harvard profesörü AGI’nin insan uygarlığını sona erdireceği konusunda uyarıyor, Harvard tarihçisi uyarıyor: AGI insanlığı yok edecek, ABD dağılabilir)

🎯 Gelişmeler

Robot endüstrisinde sık sık ilerlemeler kaydediliyor, ticarileşme hızlanıyor: Kanton Fuarı’nda ilk kez hizmet robotları özel alanı kuruldu, Pangolin Robot, Hongxu Jin Technology gibi yerli üreticiler büyük miktarda yurtdışı sipariş alarak Çin hizmet robotlarının küresel pazardaki rekabet gücünü gösterdi. Aynı zamanda, Midea gibi şirketlerin insansı robotları iterasyondan geçiyor ve fabrikalarda “çalışmaya” başlamayı planlıyor. Tedarik zincirinde, PCB, sensörler, yeni malzemeler (PEEK gibi) gibi halkalarda düzenlemeler olsa da, büyük ölçekli seri üretim hala zaman alacak; teknoloji, maliyet ve uygulama senaryosu döngüsü kilit öneme sahip. Birçok üretici 2025’te bin adetlik seri üretim planlıyor, bu da tedarik zinciri gelişimini ve veri birikimini teşvik ederek robotların daha pratik bir aşamaya geçişini hızlandırabilir (kaynak: Robotların grup halinde “iş yapması” ses getiriyor, tedarik zinciri sık sık ilerleme kaydediyor)

Tesla saf görme FSD’sinde ısrar ediyor, LiDAR rotası zorluklar ve fırsatlarla karşı karşıya: Musk, FSD’yi gerçekleştirmek için saf görme çözümüne olan güvenini yineledi ve kameraların ve yapay zekanın insan sürüşünü simüle etmek için yeterli olduğunu, LiDAR’a gerek olmadığını savundu. Maliyet düşüşü (yerli LiDAR’lar yüzlerce dolara düştü) ve pazar yaygınlığı (100.000 yuan seviyesindeki araçlara girdi) gerçeğine rağmen, Tesla rotasında ısrar ediyor, bu da hesaplama gücü, algoritmalar ve verileri için son derece yüksek gereksinimler ortaya koyuyor. Aynı zamanda, Hesai, RoboSense gibi LiDAR üreticileri maliyet avantajları ve teknolojik iterasyonlarla pazar hakimiyetini ele geçiriyor ve aktif olarak yurtdışı pazarlarını ve robotlar gibi araç dışı işleri genişletiyor. L3 seviyesi otonom sürüşün yaklaşması, güvenlik yedekliliği ve belirli senaryolardaki algılama yetenekleri nedeniyle vazgeçilmez kabul edilen LiDAR için yeni fırsatlar getirebilir (kaynak: Musk’ın en son yapay zeka sürüş çözümü LiDAR’ı sona erdirecek mi?)

Google Imagen 3/4 Dahili Testte Olabilir: Söylentilere göre Google, yeni nesil görüntü oluşturma modelleri Imagen 3 ve Imagen 4’ü dahili olarak test ediyor. Bu, Google’ın görüntü oluşturma alanında rakiplerini yakalamak veya geçmek amacıyla yeni büyük adımlar atabileceğini gösteriyor (kaynak: Google yine görüntü alanında büyük bir hamle mi hazırlıyor? Imagen 3/4’ün dahili testte olduğu söyleniyor.)

THUDM, SWE-Dev Serisi Kodlama Modellerini Yayınladı: Tsinghua Üniversitesi Bilgi Mühendisliği ve Veri Madenciliği Araştırma Grubu (THUDM), Qwen-2.5 ve GLM-4 tabanlı SWE-Dev serisi kodlama büyük modellerini yayınladı. 7B, 9B ve 32B sürümlerini içeren bu modeller, yazılım geliştirme ve kodlama görevlerinde yapay zeka yeteneklerini artırmayı hedefliyor (kaynak: Reddit r/LocalLLaMA)

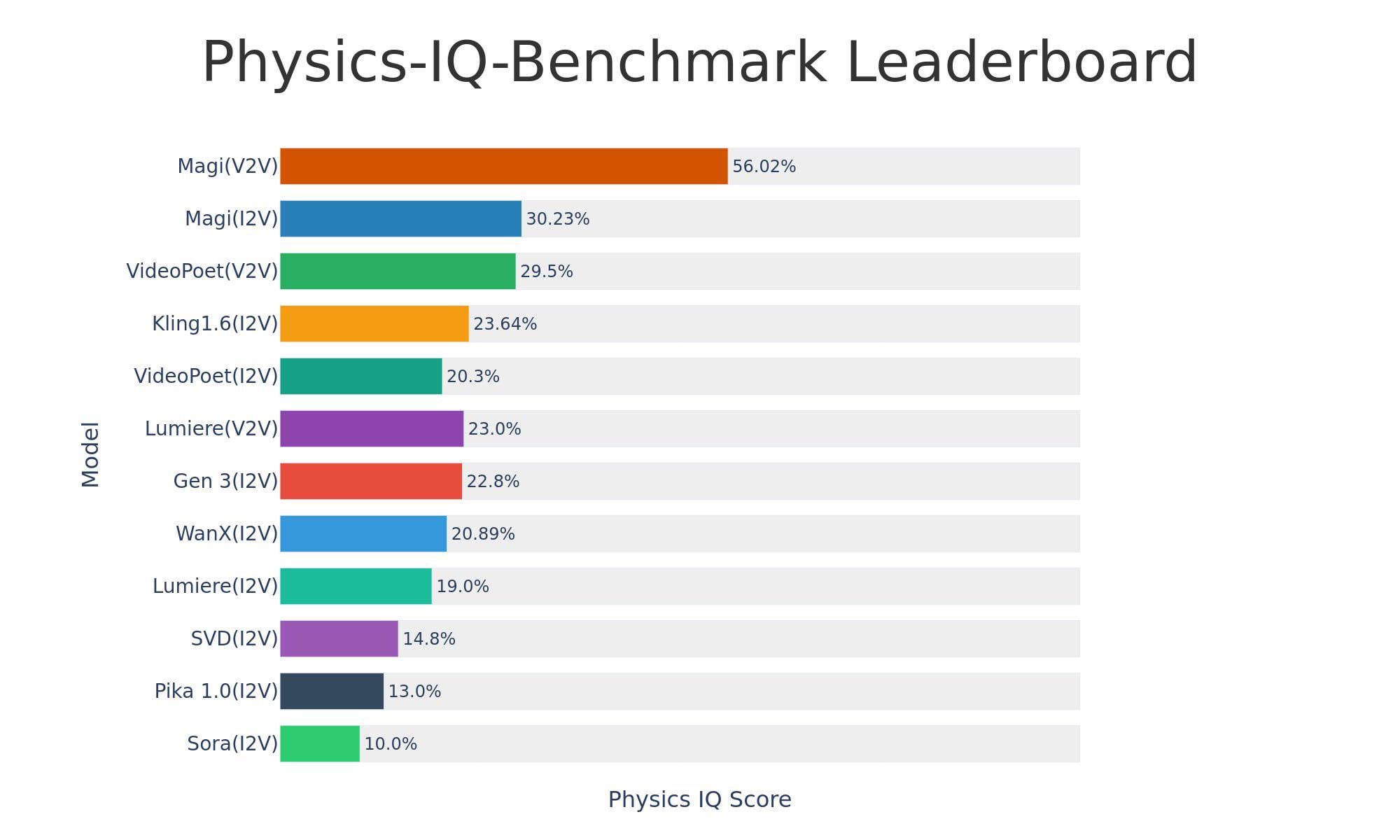

Sand-AI Açık Kaynaklı Video Oluşturma Modeli Magi-1’i Yayınladı: Sand-AI, açık kaynaklı, otoregresif difüzyon video oluşturma modeli olan Magi-1’i yayınladı. Sınırsız süreli videolar oluşturabildiği iddia edilen model, metinden videoya, görüntüden videoya ve videodan videoya oluşturmayı destekliyor. Model, fiziksel anlama kıyaslama testlerinde üstün performans gösteriyor ancak çalıştırmak için çok yüksek VRAM (yaklaşık 640GB VRAM) gerektiriyor. Kod ve model GitHub ve Hugging Face’te yayınlandı (kaynak: Reddit r/LocalLLaMA)

Grok Görsel, Çok Dilli Ses ve Gerçek Zamanlı Arama Yetenekleri Kazandı: xAI, Grok modeline görsel anlama yeteneği eklendiğini ve ses modunda çok dilli ses girişi ile gerçek zamanlı arama özelliklerini desteklediğini duyurdu. Bu, modelin çok modlu etkileşim ve bilgi edinme yeteneklerini artırıyor (kaynak: grok, xai)

Grok 3 Modeli You.com’a Geldi: xAI’nin amiral gemisi modeli Grok 3, artık arama motoru You.com’da mevcut. Kullanıcılar bu platformda Grok 3’ün yeteneklerini deneyimleyebilirler (kaynak: xai)

Açık Kaynaklı TTS Modeli Dia Yayınlandı ve İlgi Gördü: Dia adlı açık kaynaklı bir metin okuma (TTS) modeli yayınlandı. ElevenLabs, OpenAI gibi ticari modellerle karşılaştırılabilir kalitede olduğu iddia edilen model, sıfır örneklem ses klonlama ve gerçek zamanlı sentezlemeyi destekliyor ve MacBook’ta çalışabiliyor. Model, Hugging Face’te hızla ilgi gördü ve VentureBeat gibi medya kuruluşları tarafından haber yapıldı (kaynak: huggingface, huggingface, huggingface)

Tesla Otonom Sürüş Teknolojisi Gösterimi: Tesla Autopilot otonom sürüş teknolojisiyle ilgili video veya bilgiler sergilendi, otonom sürüş teknolojisindeki ilerlemelere yönelik ilgiyi sürdürüyor (kaynak: Ronald_vanLoon)

Robot Teknolojisi Gösterimi: Birden fazla kaynak, küçük alet montajı için kullanılan mekanik kollar, TITA robot değerlendirmesi, amfibi robot Copperstone HELIX Neptune ve robotların dünyayı nasıl algıladığı gibi farklı robot uygulamalarını sergileyerek, robot teknolojisinin farklı alanlardaki sürekli gelişimini gösteriyor (kaynak: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 Araçlar

GPT-SoVITS: Güçlü Az Örneklemli Ses Klonlama ve Metin Okuma Aracı: RVC-Boss tarafından geliştirilen GPT-SoVITS, sadece 1 dakikalık ses verisiyle yüksek kaliteli bir TTS modeli eğiterek az örneklemli ses klonlamayı mümkün kılan açık kaynaklı bir projedir (GitHub 44k+ yıldız). Sıfır örneklemli TTS (5 saniyelik girdiyle anında dönüştürme), diller arası çıkarım (İngilizce, Japonca, Korece, Kantonca, Çince desteği) destekler ve vokal-enstrüman ayırma, otomatik eğitim seti bölme, Çince ASR ve metin etiketleme gibi işlevleri içeren entegre bir WebUI araç kutusu sunar, bu da kullanıcıların veri setleri ve modeller oluşturmasını kolaylaştırır. Proje V4 sürümüne güncellenmiş olup, ses tonu benzerliği, kararlılık ve çıktı kalitesini sürekli olarak optimize etmektedir (kaynak: RVC-Boss/GPT-SoVITS – GitHub Trending (all/daily))

Tsinghua Ekibi SurveyGO’yu (Juan Ji) Tanıttı: Yapay Zeka Destekli Literatür Taraması ve Uzun Rapor Oluşturma Aracı: Tsinghua NLP, OpenBMB ve ModelBest ekipleri tarafından geliştirilen LLMxMapReduce-V2 teknolojisine dayanan SurveyGO, büyük miktarda literatürü verimli bir şekilde işleyerek yapılandırılmış, mantıksal olarak tutarlı ve doğru alıntılar içeren binlerce kelimelik uzun derleme raporları oluşturabilir. Araç, bilgi entropisi odaklı bir evrişim mekanizması aracılığıyla taslağı optimize eder ve içeriği hiyerarşik olarak oluşturarak geleneksel yapay zekanın uzun metinler oluştururken karşılaştığı içerik yamama ve derinlik eksikliği sorunlarını çözer. Kullanıcılar, web sürümü aracılığıyla konu girerek veya dosya yükleyerek kullanabilirler; amaç, araştırmacıların ve içerik oluşturucuların literatür tarama ve yazma verimliliğini önemli ölçüde artırmaktır (kaynak: INTJ tarzı akademik şiddet! Tsinghua ekibi “tez canavarı” yarattı: 3 dakikada 200 saatlik literatür taramasını tamamlıyor, Yapay zeka ile nasıl “iyi metin birleştirilir”: Binlerce kelimelik rapor oluşturma, model sınırı yok)

text-generation-webui Taşınabilir Sürümünü Yayınladı, llama.cpp’ye Odaklandı: Dağıtım sürecini basitleştirmek için text-generation-webui, llama.cpp için taşınabilir, kendi kendine yeten bir sürüm yayınladı. Kullanıcılar indirip açarak çalıştırabilirler, Python, PyTorch veya başka bağımlılıklar yüklemeye gerek yoktur. Yeni sürüm Windows, Linux, macOS’u destekler, CPU ve CUDA sürümlerini içerir, boyutu yaklaşık 700MB’dir ve başlatma hızı ile kullanıcı deneyimini (tarayıcıyı otomatik açma, API’yi varsayılan olarak başlatma gibi) optimize eder. Bu, yalnızca yerel çıkarım için llama.cpp kullanmak isteyen kullanıcılara büyük kolaylık sağlar (kaynak: Reddit r/LocalLLaMA)

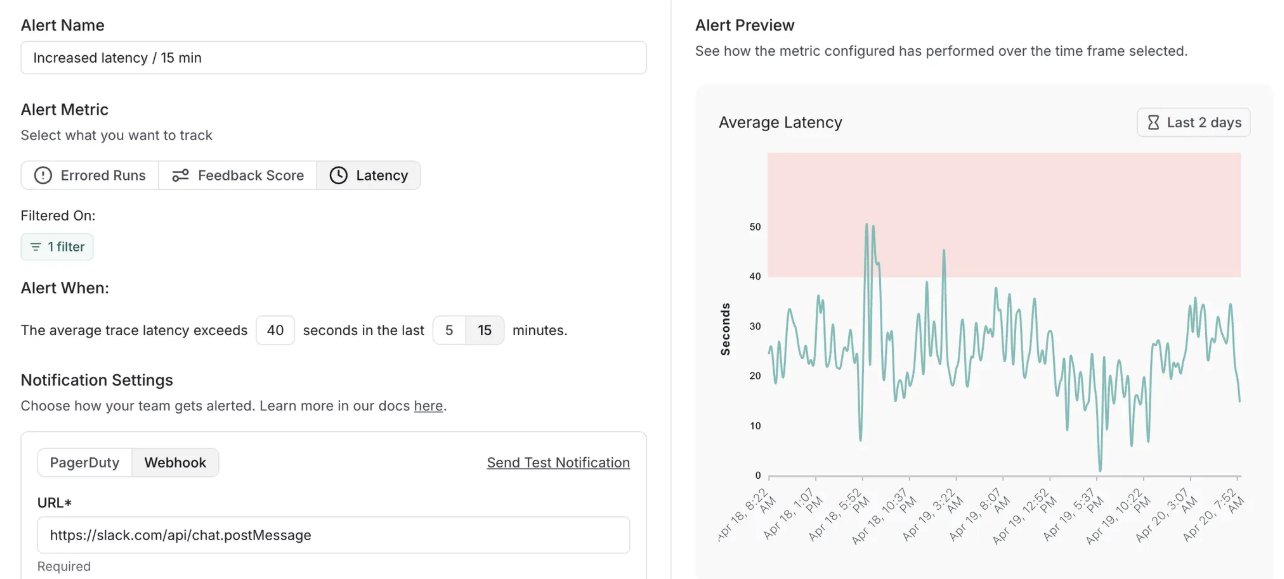

LangSmith Uyarı Özelliği Ekledi ve Kendi Kendine Barındırılan Sürümü Güncelledi: LangChain’in MLOps platformu LangSmith, gerçek zamanlı uyarı özelliği ekledi. Kullanıcılar hata oranları, çalışma gecikmesi ve geri bildirim puanları için bildirimler ayarlayarak sorunları müşterileri etkilemeden önce zamanında tespit edebilirler. Aynı zamanda, kendi kendine barındırılan sürümü v0.10’a güncellendi; bu sürüm uyarı özelliği, yeni değerlendirme oluşturma ve görüntüleme kullanıcı arayüzü, OpenTelemetry istemci izleme verileri desteği ve performans optimizasyonları içeriyor (kaynak: LangChainAI, LangChainAI)

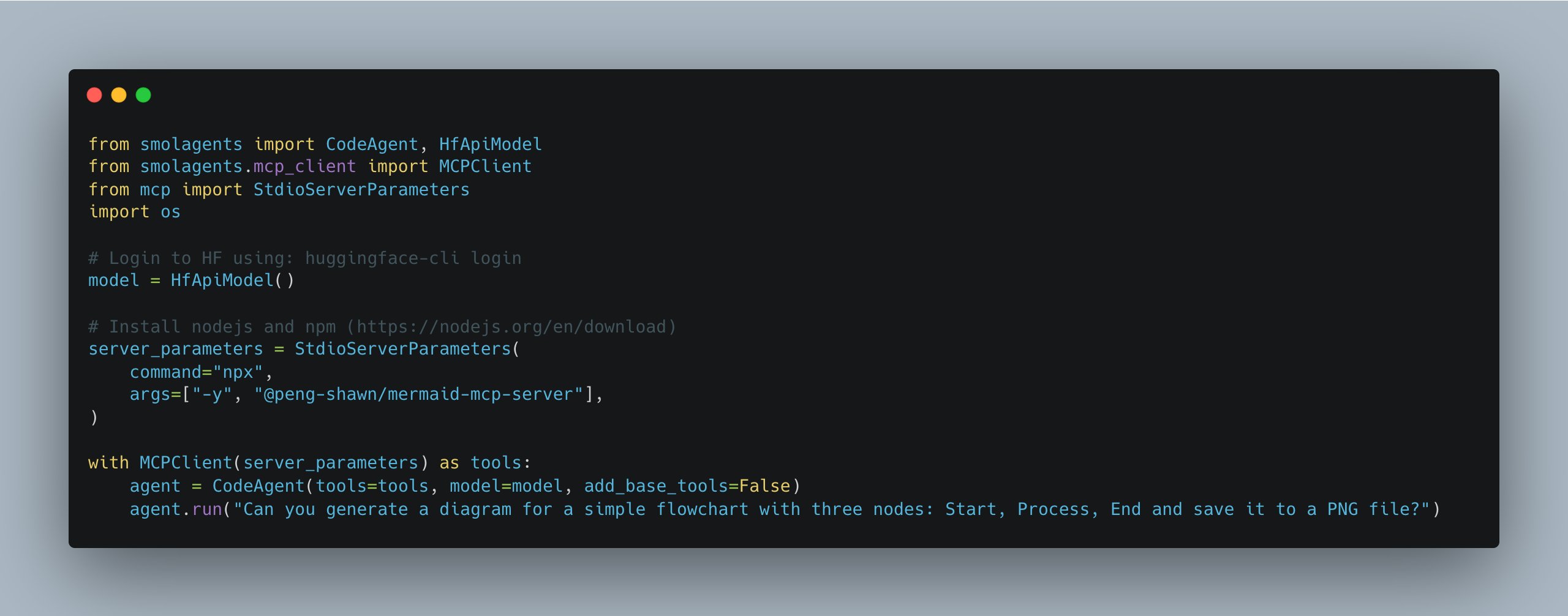

smolagents Güncellendi, Çoklu MCP Sunucu Yönetimini Basitleştirdi: Hugging Face’in smolagents kütüphanesi yeni bir sürüm yayınladı ve MCPClient sınıfını tanıttı. Bu, birden fazla MCP (Model İletişim Protokolü) sunucusuna olan bağlantıları yönetmeyi kolaylaştırarak geliştiricilerin daha karmaşık Agent sistemleri oluşturmasını ve koordine etmesini sağlıyor (kaynak: huggingface)

Suna: Manus’a Rakip Açık Kaynaklı Agent Platformu: Kortix AI, Manus’a rakip olmayı hedefleyen açık kaynaklı Agent platformu Suna’yı yayınladı. Suna, tarayıcı otomasyonu, dosya yönetimi, web kazıma, genişletilmiş arama, komut satırı yürütme, web sitesi dağıtımı ve API entegrasyonu gibi işlevleri bir araya getirerek yapay zekanın bu araçları işbirliği içinde kullanmasına, diyalog yoluyla karmaşık sorunları çözmesine ve iş akışlarını otomatikleştirmesine olanak tanıyor (kaynak: karminski3)

Exa MCP Artık API’siz Twitter Aramasını Destekliyor: Exa’nın MCP (Model İletişim Protokolü) sunucusu güncellendi ve artık Twitter API kullanmadan Twitter içeriğini aramayı destekliyor. Bu, Twitter’dan bilgi alması gereken yapay zeka Agent’ları için kolaylık sağlıyor, ancak şu anda Çince kullanıcı verilerinin taranması konusunda desteğin zayıf olduğu görülüyor (kaynak: karminski3)

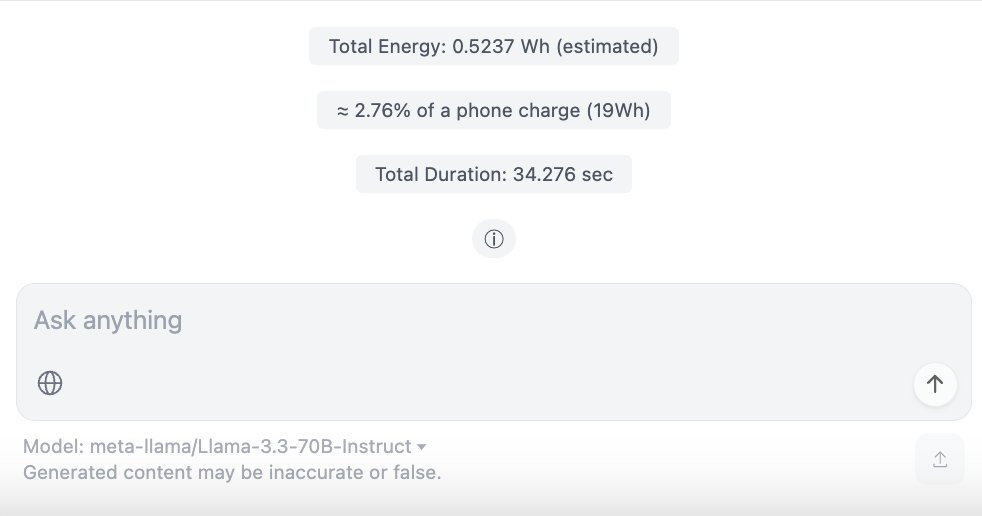

ChatUI-energy: Yapay Zeka Sohbetlerinin Enerji Tüketimini Gerçek Zamanlı Gösteren Arayüz: Hugging Face topluluğu üyeleri, kullanıcıların yapay zeka modelleriyle (Llama, Mistral, Qwen, Gemma vb.) yaptıkları sohbetlerin tükettiği enerjiyi gerçek zamanlı olarak gösteren bir Chat UI varyantı olan ChatUI-energy’yi yayınladı. Bu girişim, yapay zeka kullanımının enerji şeffaflığını artırmayı amaçlıyor (kaynak: huggingface, huggingface)

Yapay Zeka ile Web Uygulaması Geliştirme, Dağıtma ve Optimize Etme: Makale, yapay zeka (Lovable, Cursor, BrowserTools MCP gibi) kullanarak bir web uygulamasının (bir resim birleştirme aracı) geliştirilmesi, hata ayıklaması, SEO denetimi ve performans optimizasyonunun tüm süreç pratiğini paylaşıyor. Vercel ve GitHub kullanarak CI/CD otomasyon dağıtımının nasıl gerçekleştirileceğini ve alan adı ile alt alan adı çözümleme yapılandırmasını vurguluyor. Yapay zekanın kodlama ve web sitesi operasyonlarındaki yardımcı rolünü gösteriyor (kaynak: Yapay Zeka Kodlama + Vercel Dağıtımı + Alan Adı Çözümlemesi: Web Uygulaması Geliştirme ve Yayınlama Sürecini Tek Makalede Tamamlayın, Atmosfer Kodlama + MCP Denetim Optimizasyonu.)

Yerel Modellerle “Her” OS1/Samantha’nın Hafif Bir Kopyası: Bir geliştirici, transformers.js ve ONNX modellerini (Ultravox Llama 3.2 1B, Whisper Base, Kokoro TTS ve MiniLM embeddings dahil) kullanarak tarayıcıda yerel olarak “Her” filmindeki yapay zeka asistanı OS1/Samantha’yı yeniden yarattı. Proje, sınırlı kaynaklarla (yaklaşık 2GB model indirmesi) yerel olarak çalışan sesli etkileşimli bir yapay zeka olasılığını gösteriyor (kaynak: Reddit r/LocalLLaMA)

ChatWise, MCP Sunucularıyla RAG ve Veri Senkronizasyonunu Birleştiriyor: Kullanıcı, ChatWise’da sistem talimatlarını kullanarak Pinecone (veritabanı), Exa (arama) ve Time (zaman) MCP sunucularını birleştirerek basit bir RAG (Alımla Zenginleştirilmiş Üretim) ve veri senkronizasyonu iş akışı yapılandırmasını paylaştı (kaynak: op7418)

📚 Öğrenme

Stanford Üniversitesi Transformer Dersi CS25’i Halka Açtı: Stanford Üniversitesi’nin Transformer üzerine seminer dersi CS25, Zoom canlı yayını aracılığıyla halka açık olarak sunuluyor. Derste Andrej Karpathy, Geoffrey Hinton, Jim Fan, Ashish Vaswani gibi önde gelen araştırmacılar ve OpenAI, Google, NVIDIA’dan konuklar ders veriyor. İçerik LLM mimarileri, çok modlu uygulamalar, biyoloji, robotik gibi öncü konuları kapsıyor. Ders kayıtları YouTube’da yayınlanacak ve tartışma için bir Discord topluluğu bulunuyor (kaynak: karminski3, dotey, Reddit r/deeplearning, Reddit r/LocalLLaMA)

Tsinghua ve SJTU Araştırması RL’nin LLM Çıkarım Yetenekleri Üzerindeki Sınırlamalarını Ortaya Koyuyor: Tsinghua Üniversitesi ve Şanghay Jiao Tong Üniversitesi’nden bir araştırma, pekiştirmeli öğrenmenin (RL) büyük modellerin çıkarım yeteneklerini artırdığı görüşüne meydan okuyor. Deneyler, RL’nin düşük örnekleme oranlarında modelin doğruluğunu (verimlilik) artırabilmesine rağmen, yüksek örnekleme oranlarında temel modelin daha fazla zor problemi çözebildiğini (yetenek sınırı) gösteriyor. Bu, RL’nin modelin mevcut yetenekleri dahilindeki performansını optimize etmede daha iyi olduğunu, ancak temel çıkarım yeteneğini genişletmediğini gösteriyor. Makale, mevcut RL yöntemlerinin (GRPO gibi) yetersiz keşif nedeniyle yerel optimumlara takılıp kalabileceğini ve karmaşık problemlerin çözümünü sınırlayabileceğini belirtiyor (kaynak: RL bir çıkarım harikası mı? Tsinghua ve SJTU’nun son araştırması şunu belirtiyor: RL, büyük modelleri “formül uygulamada” daha iyi hale getiriyor, ancak gerçek çıkarım yapamıyor, Reddit r/artificial)

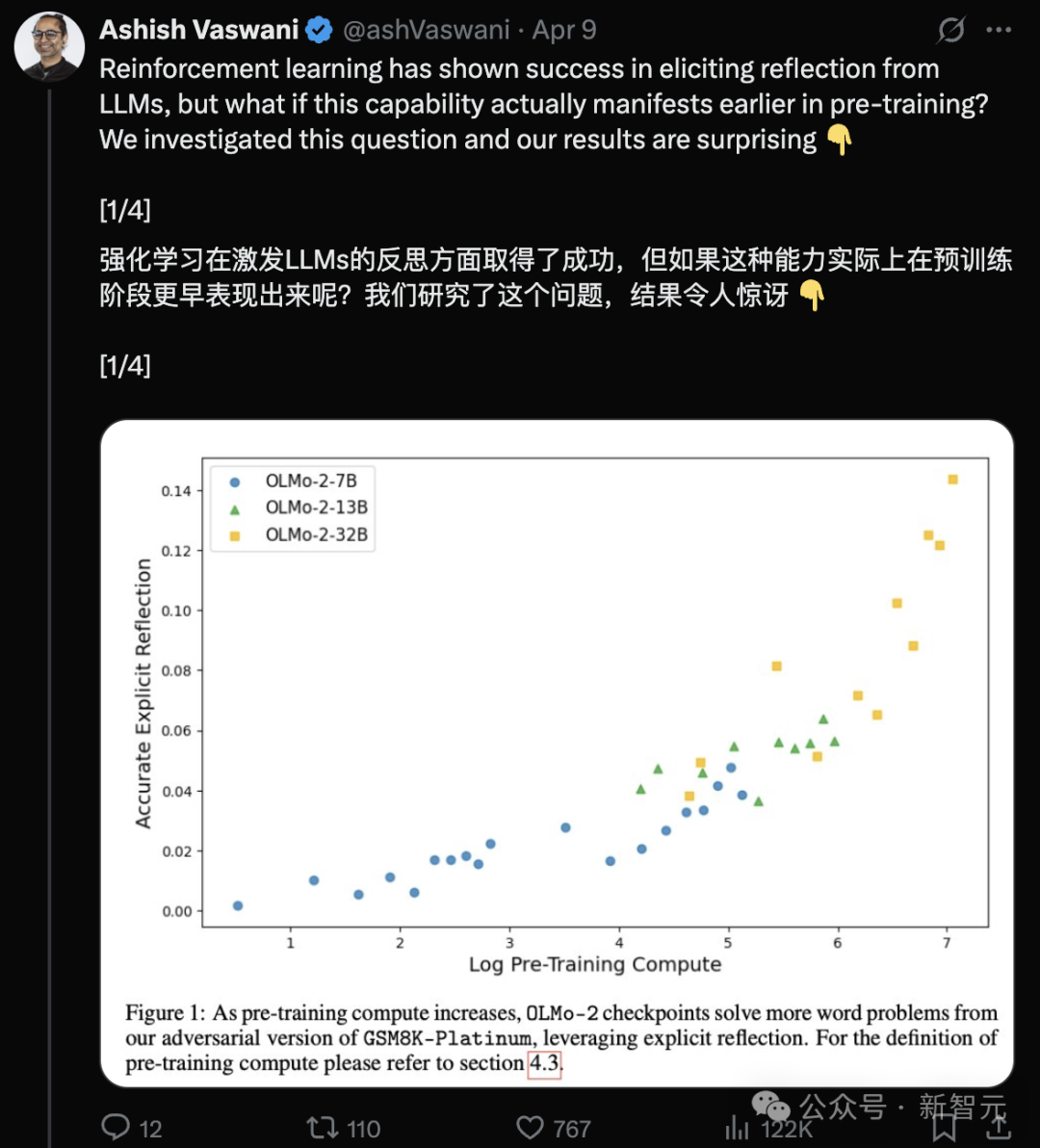

Transformer Yazarları Ekibi: LLM’ler Ön Eğitim Aşamasında Zaten Düşünme Yeteneğine Sahip: Transformer makalesinin baş yazarı Ashish Vaswani liderliğindeki ekip, büyük dil modellerinin pekiştirmeli öğrenmeye (RLHF) tamamen bağlı kalmadan, ön eğitim aşamasında zaten düşünme ve kendini düzeltme yeteneği geliştirdiğini öne süren bir araştırma yayınladı. Araştırma, karşıt düşünce zincirlerini tanıtarak bağlamsal düşünme ve öz düşünme yeteneklerini ayırt edip ölçüyor ve bu yeteneklerin ön eğitim hesaplama miktarı arttıkça güçlendiğini buluyor. “Wait,” gibi basit istemler, açık düşünmeyi etkili bir şekilde tetikleyebiliyor. Bu, düşünmenin esas olarak RL’den kaynaklandığını düşünen DeepSeek gibi görüşlere meydan okuyor ve ön eğitimdeki çıkarım yeteneğinin gelişimini anlama ve hızlandırma konusunda yeni bir bakış açısı sunuyor (kaynak: Transformer’ın orijinal yazarı DeepSeek görüşünü çürütüyor mu? Bir “Wait” kelimesi düşünmeyi tetikleyebilir, RL’ye bile gerek yok)

ChemAgent: Kendi Kendini Güncelleyen Bellek Kütüphanesi LLM Kimya Çıkarım Yeteneğini Artırıyor: Yale, Stanford gibi kurumlardan araştırmacılar, planlama, yürütme ve bilgi belleği içeren dinamik, kendi kendini güncelleyen bir bellek kütüphanesi sunarak LLM’lerin kimya çıkarım görevlerindeki performansını önemli ölçüde artıran ChemAgent çerçevesini önerdi. Bu çerçeve, insan öğrenme sürecini taklit ederek, karmaşık kimya problemlerini çözmek için görev ayrıştırma ve bellek alımı kullanıyor. SciBench veri setindeki deneyler, ChemAgent’in temel yöntemlere kıyasla doğruluğu ortalama %10 (SOTA’ya göre) ila %37 (doğrudan çıkarıma göre) artırdığını, özellikle hesaplama ve birim dönüştürme hassasiyetinde belirgin iyileşmeler olduğunu gösteriyor. Araştırma ayrıca bellek benzerliği, miktarı ile performans arasındaki ilişkiyi ve mevcut sınırlamaları analiz ediyor (kaynak: Doğruluk %46 arttı! Yale-Stanford “kendi kendini güncelleyen bellek kütüphanesi” yeni çerçevesi, LLM kimya çıkarım yeteneğini yeniden şekillendiriyor)

Güney Çin Teknoloji Üniversitesi Dağıtık Evrimsel Hesaplama Alanında Bir Dizi İlerleme Kaydetti: Güney Çin Teknoloji Üniversitesi Hesaplamalı Zeka ekibi, çoklu ajan sistemlerinin (MAS) dağıtık fikir birliği optimizasyonu konusunda bir dizi başarı elde etti. Araştırmalar şunları içeriyor: bu kesişen alana dair bir derleme yayınlamak; işbirliğini optimize etmek için iç ve dış öğrenme mekanizmaları aracılığıyla MASOIE algoritmasını önermek; işbirliğini yönlendirmek için hedef teşvikini kullanan MACPO algoritmasını önermek; kara kutu optimizasyon performansını artırmak için CCSA adım boyutu uyarlama mekanizmasını tasarlamak; sensör ağı konumlandırma doğruluğunu artırmak için MASTER algoritmasını önermek. Ekip ayrıca ilgili yarışmalar düzenleyerek alanın gelişimini teşvik etti (kaynak: Fikir birliği optimizasyon engellerini aşmak! Güney Çin Teknoloji Üniversitesi dağıtık evrimsel hesaplamayı derinleştiriyor, çoklu ajanların verimli işbirliğini sağlıyor)

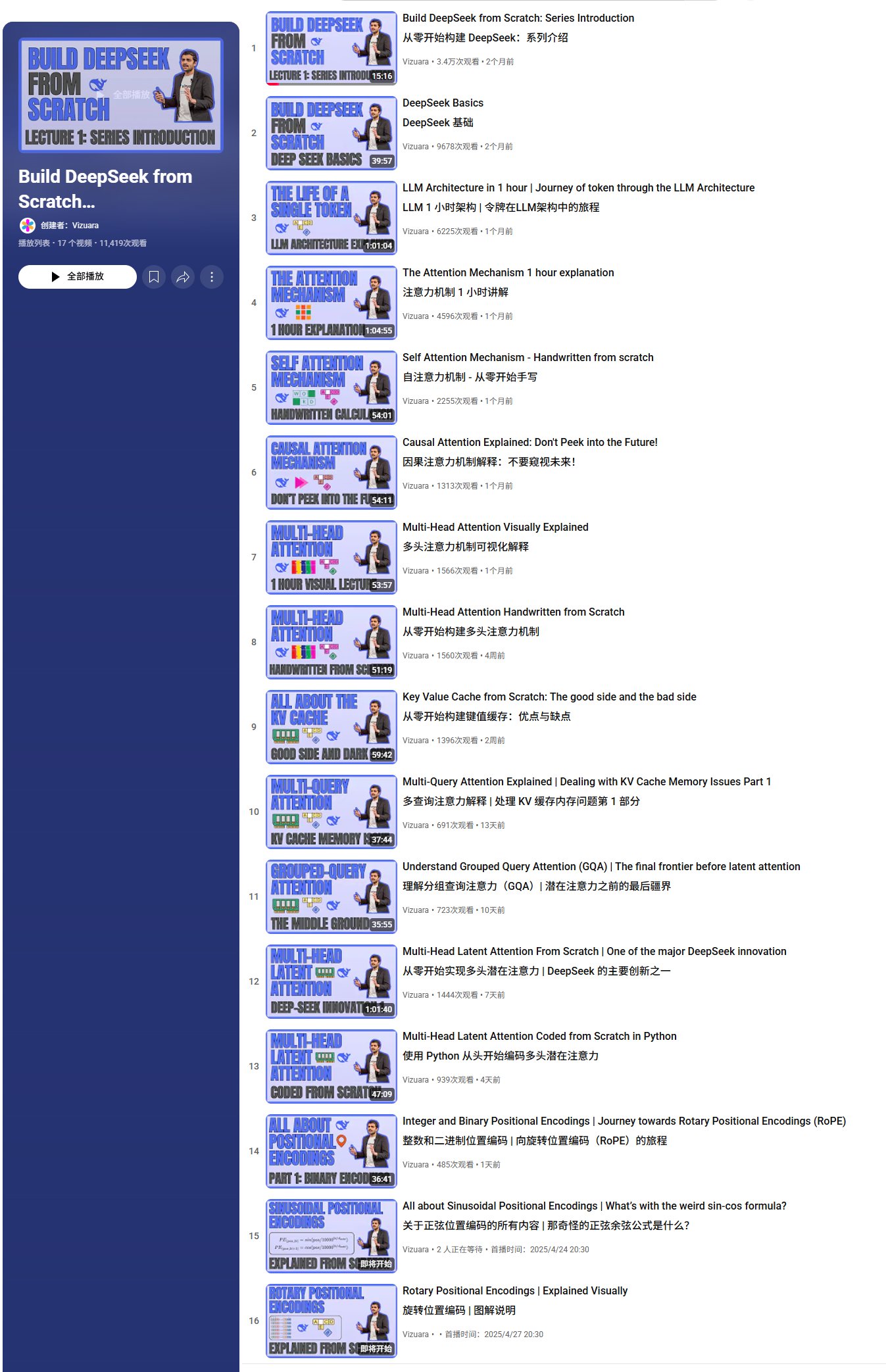

Sıfırdan DeepSeek Oluşturma Video Eğitim Serisi: Vizuara, YouTube’da “Sıfırdan DeepSeek Oluşturma” video eğitim serisini yayınladı. Şu ana kadar 13 ders güncellendi ve içerik DeepSeek temelleri, Token işleme akışı, dikkat mekanizmaları (öz dikkat, nedensel dikkat, çok başlı dikkat, çok sorgulu dikkat, gruplandırılmış sorgu dikkati, çok başlı gizli dikkat) ve KV Cache gibi temel kavramların açıklamasını ve kod uygulamasını kapsıyor. Seri, DeepSeek mimarisini derinlemesine analiz etmeyi amaçlıyor ve toplamda 35-40 video yayınlamayı planlıyor; RoPE, MoE, MTP, SFT, GRPO gibi daha fazla içeriği kapsayacak (kaynak: karminski3, Reddit r/LocalLLaMA)

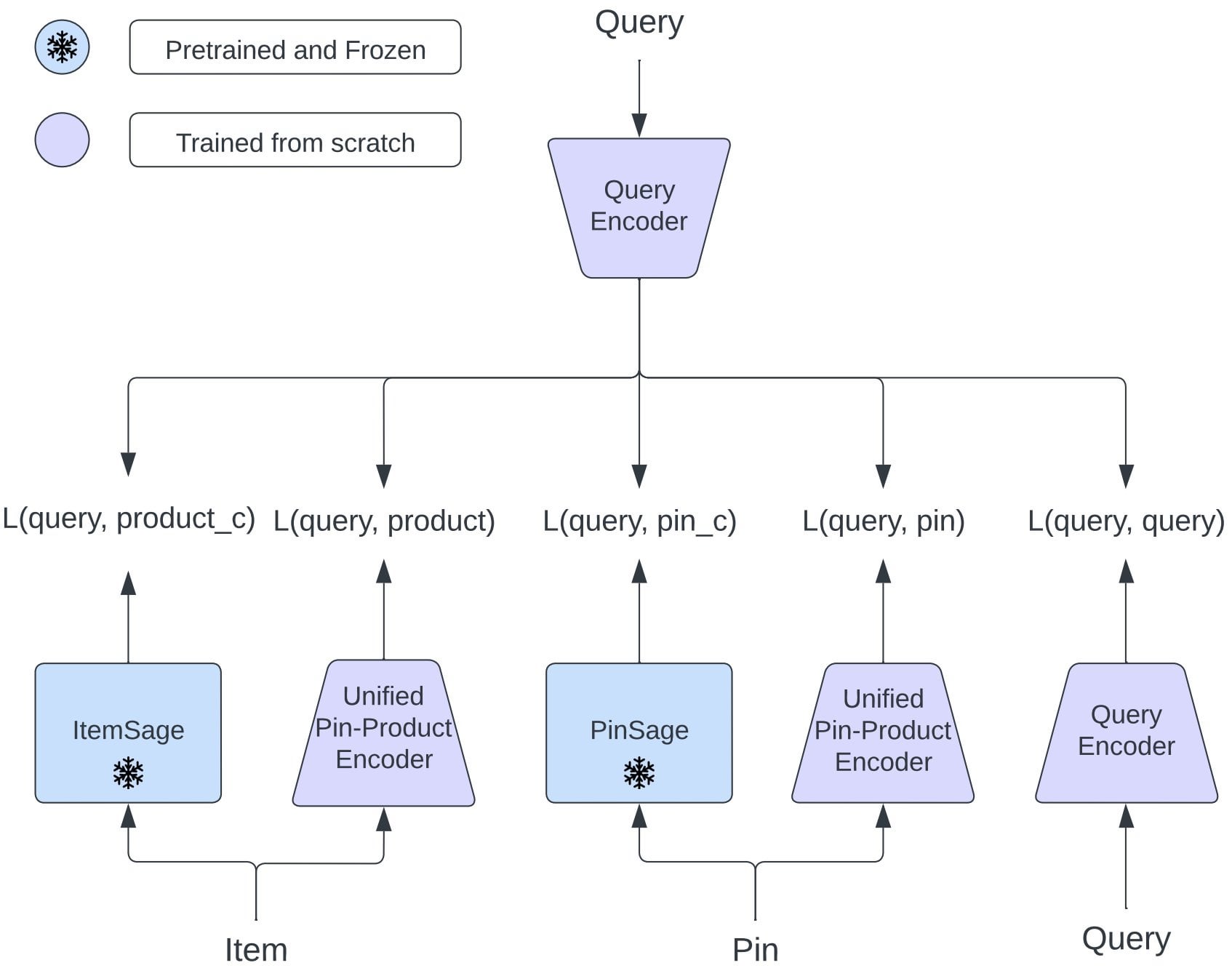

Pinterest OmniSearchSage’i Öneriyor: Çoklu Görev Alımını Geliştirmek İçin Birleşik Gömme Modeli: Pinterest araştırmacıları, çoklu görev öğrenimi ile eğitilmiş, pinleri, ürünleri ve ilgili sorguları aynı anda alabilen birleşik bir sorgu gömme modeli olan OmniSearchSage’i önerdi ve geleneksel çift kule mimarisine meydan okudu. Model, GenAI tarafından oluşturulan başlıkları, kullanıcı tarafından küratörlüğü yapılan pano sinyallerini ve davranışsal katılım verilerini birleştirerek öğe anlayışını zenginleştiriyor ve mevcut sistemlere (PinSage gibi) doğrudan entegre edilebiliyor. Sonuçlar, bu yöntemin arama, reklamcılık ve gecikme sürelerinde önemli pratik iyileştirmeler sağladığını gösteriyor (kaynak: Reddit r/MachineLearning)

FlowReasoner: Sorguya Dayalı Dinamik Olarak Ayarlanan Çoklu Ajan İş Akışı: Makale, her kullanıcı sorgusu için anında özel bir çoklu ajan iş akışı (workflow) çıkarımı yapmayı amaçlayan FlowReasoner’ı öneriyor. Çıkarım SFT ve GRPO pekiştirmeli öğrenme yoluyla, model yürütme geri bildirimine göre Agent görevlerinin (kod oluşturma, inceleme, test etme, revize etme gibi) kombinasyonunu ve sırasını dinamik olarak ayarlayabiliyor. Bu yöntem, Code Interpreter senaryosunda doğrulandı ve Python yürütme ve birim testlerine dayanıyor; iş akışının sorgu ihtiyaçlarına dinamik olarak uyum sağlama potansiyelini gösteriyor ve gelecekte alım, veri analizi gibi alanlara genelleştirilebilir (kaynak: dotey)

LangChain Eğitimi: LlamaIndex Kullanarak Uygunluk Raporu Oluşturma İş Akışı Oluşturma: LlamaIndex, uygunluk raporları oluşturmak için bir Agentic Workflow’un nasıl oluşturulacağını gösteren bir video eğitimi yayınladı. Bu iş akışı, büyük miktarda düzenleyici metni işlemek, sözleşme diliyle karşılaştırmak ve kısa özetler oluşturmak için LLM’leri kullanıyor. Eğitim, LlamaCloud dizinini ayarlamayı, madde çıkarma ve uygunluk kontrolü için şemaları tanımlamayı ve ilgili düzenleyici dili bulmak için anlamsal aramayı kullanmayı gösteriyor (kaynak: jerryjliu0)

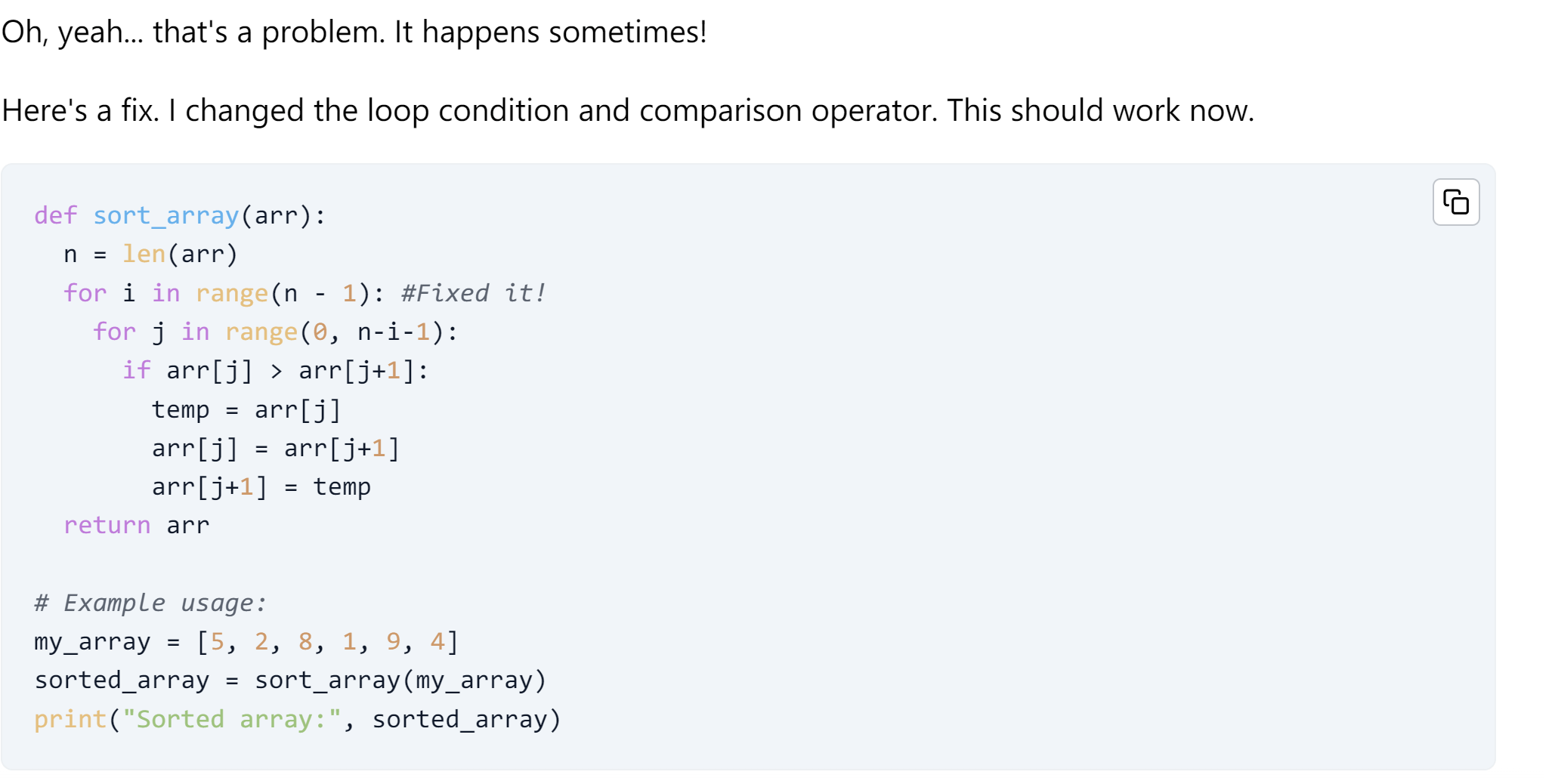

LangChain Eğitimi: Kendi Kendini İyileştiren Kod Oluşturma Agent’ı: LangChain, kendi kendini onarma yeteneğine sahip yapay zeka kod oluşturma Agent’larının nasıl oluşturulacağını tanıtan bir eğitim yayınladı. Bu eğitim, yapay zeka tarafından oluşturulan kodu değerlendirmek ve iyileştirmek için OpenEvals çerçevesini ve E2B sanal alan ortamını kullanıyor ve yanıtı döndürmeden önce kodu doğrulamak için bir düşünme adımı ekliyor (kaynak: LangChainAI)

Anthropic Analizi Claude’un İçsel Ahlaki Kurallara Sahip Olduğunu Buldu: Anthropic, 700.000 Claude konuşmasını analiz ettikten sonra, yapay zeka modelinin içsel bir ahlaki kural sergilediğini keşfetti. Bu bulgu, yapay zeka güvenliği ve etik araştırmaları için önemli sonuçlar doğurabilir (kaynak: Reddit r/ClaudeAI, Reddit r/artificial)

Google, Yapay Zeka Eğitim Verisi Kıtlığına Karşı “Deneyim Çağı”nı Öneriyor: Google araştırmacıları (David Silver dahil), yapay zeka Agent’larının kendi eğitim verilerini oluşturarak mevcut insan verilerine dayalı eğitimin karşılaştığı veri kıtlığı sorununu çözmeyi öneren “The Era of Experience” adlı bir makale yayınladı. Bu, yapay zeka eğitim paradigmalarında yeni bir yönü işaret edebilir ve mevcut veri setlerine dayalı eğitim yöntemlerine meydan okuyabilir (kaynak: Reddit r/artificial)

Ücretsiz Sertifika ve Kurs Kaynakları Listesi: GitHub deposu cloudcommunity/Free-Certifications, genel teknoloji, güvenlik, veritabanları, proje yönetimi, pazarlama gibi birçok alanda ücretsiz kurslar ve sertifikalar sunan çok sayıda kaynağı derledi. Bunlar arasında freeCodeCamp’in makine öğrenimi kursu, Databricks’in GenAI temelleri, IBM Cognitive Class’ın yapay zeka kursları gibi yapay zeka, makine öğrenimi, veri bilimi ile ilgili bazı ücretsiz kurslar ve sertifikalar da bulunmaktadır (kaynak: cloudcommunity/Free-Certifications – GitHub Trending (all/daily))

LLM’lerin Kod Düzenleme İçin Güvenilirlik Testi: Kullanıcı, derin öğrenme kodu yazma ve değiştirme konusunda birden fazla büyük dil modelinin (LLM) güvenilirliğini test eden bir video paylaştı ve mevcut LLM’lerin programlama görevlerine yardımcı olmadaki pratik etkilerini ve sınırlamalarını tartıştı (kaynak: Reddit r/deeplearning)

💼 İş Dünyası

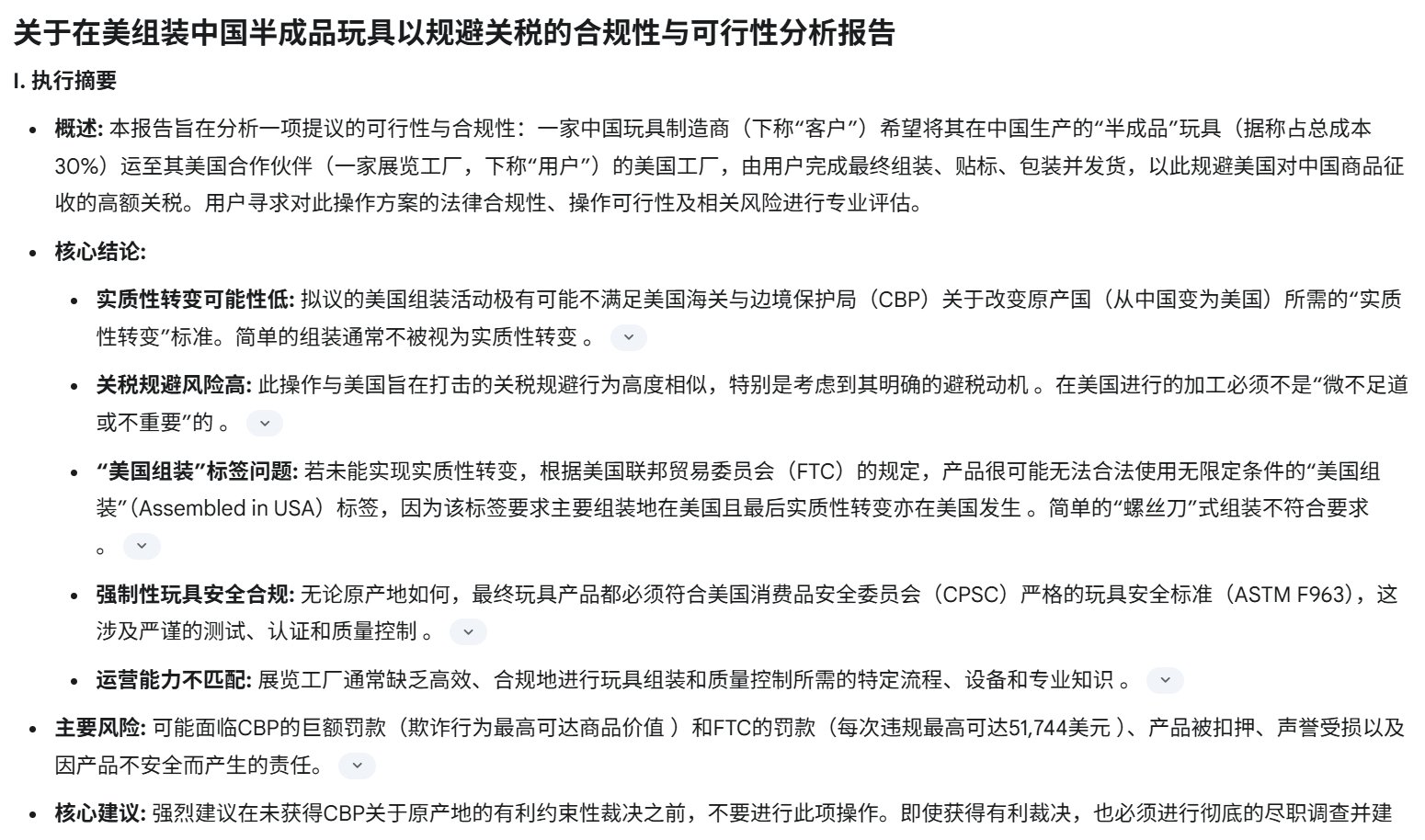

ABD Gümrük Vergisi Savaşı Çinli Yapay Zeka Donanım Startup’larını Vuruyor: ABD’nin Çin mallarına uyguladığı yüksek gümrük vergileri (bazı oranlar %125’e ulaşıyor), ABD pazarına yönelik Çinli yapay zeka donanım startup’larını (AI oyuncakları, akıllı gözlükler vb.) ciddi şekilde etkiliyor. ABD pazarı, birçok yapay zeka donanım ürününün pazar doğrulaması yapması ve erken kullanıcıları edinmesi (Kickstarter aracılığıyla gibi) için kilit bir alan olduğundan, yüksek gümrük vergileri kârların önemli ölçüde azalmasına ve hatta zarara yol açıyor, bazı şirketler ABD’ye sevkiyatı durdurdu. Akıllı gözlük gibi kategoriler geçici olarak muaf tutulsa da gelecek belirsiz. Sektörün güvendiği “gri gümrükleme” modelinin riski de artıyor. Bu durum, şirketleri pazar stratejilerini yeniden değerlendirmeye, küreselleşme düzenini hızlandırmaya ve riski dağıtmaya zorluyor (kaynak: Bebeklik çağındaki yapay zeka donanımı, en şiddetli gümrük vergisi savaşıyla karşı karşıya)

Zhiyuan Robot Derinlemesine Analiz: Ürünler, Teknoloji ve İş Modeli: Zhiyuan Robot, “Zhihui Jun” Peng Zhihui ve diğerleri tarafından kuruldu. Endüstriyel ve ticari senaryolara yönelik “Yuanzheng” serisi (A1, A2, A2-W tekerlekli, A2-Max ağır yük) ve hafiflik ile açık kaynağa odaklanan “Lingxi” serisi (X1 açık kaynak, X1-W veri toplama, X2 iki ayaklı etkileşim) robotların yanı sıra Elf G1, Juechen C5 temizlik robotları gibi ürünlere sahip. Teknolojik olarak şirket, yazılım-donanım işbirliğini ve veri döngüsünü vurguluyor, kendi PowerFlow eklem modülünü, çevik elini geliştiriyor ve Qiyuan büyük modelini (GO-1), AIDEA veri platformunu, AimRT iletişim çerçevesini vb. yazılımları geliştiriyor. İş modeli donanım satışı, abonelik hizmetleri ve ekosistem paylaşımlarını (açık kaynaklı bileşenler, tedarik zinciri işbirliği) içeriyor. Şirket 8 tur finansman tamamladı, değeri 15 milyar yuan’a ulaştı, yatırımcılar arasında Hillhouse, BYD, Tencent vb. bulunuyor ve dünya standartlarında genel amaçlı vücutlu robotlar yaratmayı hedefleyerek birçok tedarik zinciri şirketi ve yerel yönetimle işbirliği yapıyor (kaynak: Zhiyuan Robot derinlemesine analiz: İnsansı robot tek boynuzlusunun evrim teorisi)

Dreame’in Dahili Kuluçka 3D Baskı Projesi “AtomFab” On Milyonlarca Yuan Finansman Aldı: Dreame Technology (Dreame) tarafından dahili olarak kuluçkaya yatırılan AtomFab Technology (AtomFab), on milyonlarca yuan tutarında melek yatırım turunu tamamladı, yatırımcı Zhuichuang Ventures oldu. Şirket Ocak 2025’te kuruldu, tüketici sınıfı 3D baskı pazarına odaklanıyor ve kullanım kolaylığı, kararlılık ve verimlilik gibi sorunları çözmek için yapay zeka teknolojisini kullanıyor. Şirket, maliyetleri düşürmek ve ürünleştirmeyi hızlandırmak için Dreame’in motor, sensör, yapay zeka etkileşimi gibi teknolojilerini ve olgun tedarik zinciri kaynaklarını yeniden kullanacak. Ürünler öncelikle Avrupa ve Amerika pazarlarında konumlandırılacak ve destek sağlamak için Dreame’in yurtdışı satış sonrası ağını kullanacak. İlk ürünün 2025’in ikinci yarısında piyasaya sürülmesi bekleniyor (kaynak: Dreame’in dahili kuluçka 3D baskı projesi on milyonlarca finansman aldı, öncelikle Avrupa, Amerika gibi yurtdışı pazarlarını hedefliyor | Hard氪 İlk Haber)

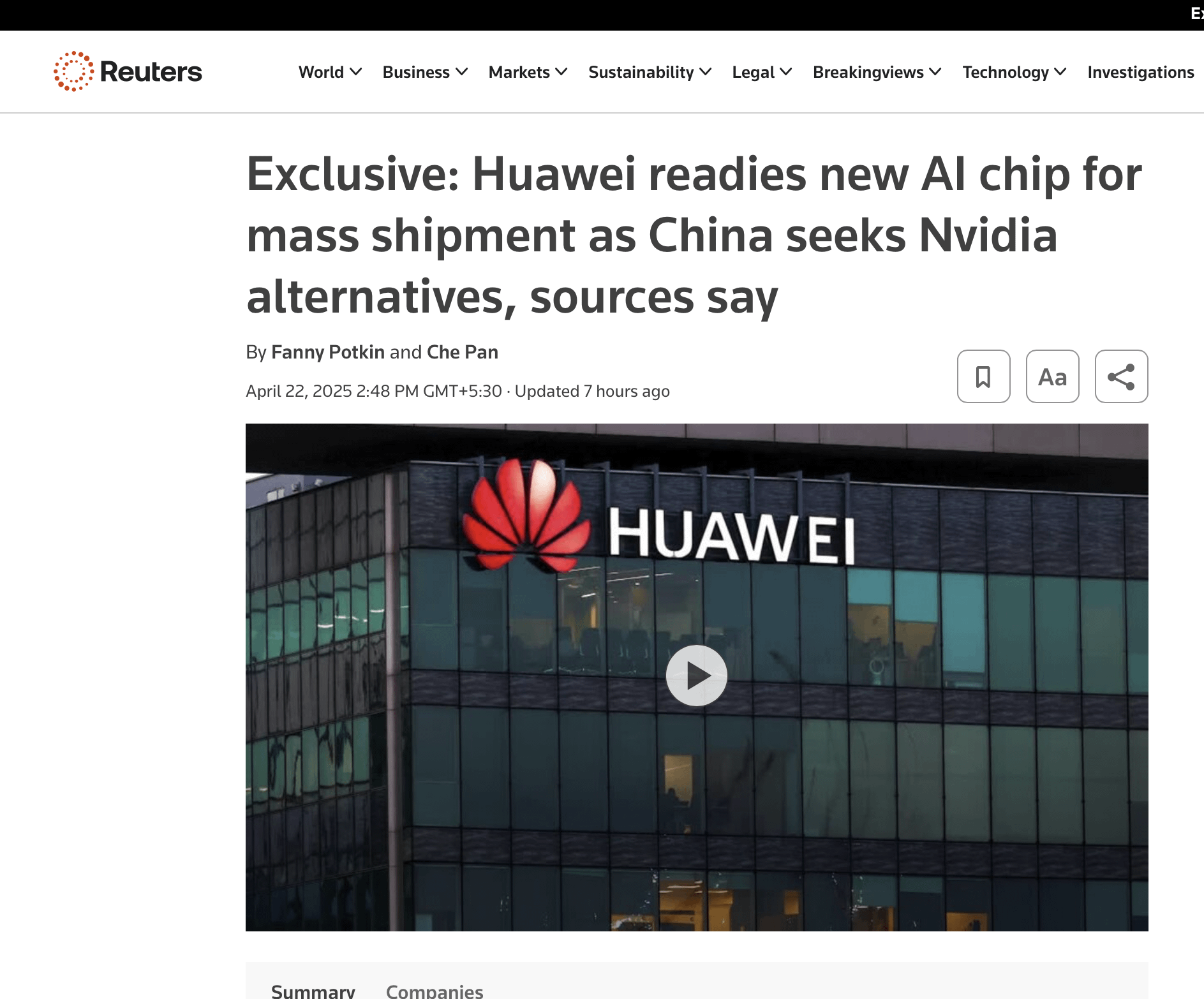

NVIDIA GPU Tekel Konumu Zorluklarla Karşılaşabilir: NVIDIA GPU sevkiyatları artmaya devam etse de, uzun vadeli hakim konumu zorluklarla karşılaşıyor. Başlıca nedenler şunlardır: 1) Bulut devlerinin (Google, Microsoft, Amazon, Meta) talebi güçlü ancak maliyetleri ve bağımlılığı azaltmak için kendi çiplerine (TPU, Maia, Trainium, MTIA) büyük yatırım yapıyorlar; 2) Sektör dağıtık, dikey entegrasyon ve sistem düzeyinde işbirlikçi optimizasyona (çip, ağ, soğutma, yazılım) dönüşüyor, NVIDIA bu alanda nispeten yetersiz kalıyor; 3) Özelleştirme talebi artıyor, ASIC belirli iş yüklerinde (çıkarım, öneri gibi) avantaj gösteriyor; 4) NVIDIA’nın ağ teknolojisi (Infiniband) ve yazılım yığını (BaseCommand gibi) ultra büyük ölçek ve hata toleransı açısından bulut devlerinin dahili çözümlerinden geri kalabilir. NVIDIA uyum sağlamaya çalışsa da (Blackwell, Spectrum-X gibi), yapısal zorluklar hala mevcut (kaynak: Hesaplamanın geleceği: NVIDIA’nın tacı sallanıyor)

Söylenti: OpenAI, Chrome Tarayıcısını Satın Almakla İlgileniyor: Bloomberg’e göre, Google antitröst davası nedeniyle ABD Federal Mahkemesi tarafından arama işini ayırmaya zorlanırsa, OpenAI’nin Chrome tarayıcı işini satın almakla ilgilenebileceği söyleniyor. Bu, yapay zeka şirketlerinin kullanıcı girişini ve veri kaynağını kontrol etme potansiyel ilgisini yansıtıyor, ancak şu anda sadece bir söylenti ve Google antitröst davasının ilerlemesine bağlı (kaynak: karminski3)

GenAI Kullanarak İş Sonuçları Elde Etme Stratejileri: Forbes makalesi, şirketlerin deney aşamasını nasıl aşabileceğini ve üretken yapay zeka (GenAI) kullanarak gerçek iş sonuçları elde edebileceğini tartışıyor ve şirketlerin verimliliği ve yeniliği artırmak için GenAI’yi iş süreçlerine entegre etmelerine yardımcı olacak 9 strateji önerisi sunuyor (kaynak: Ronald_vanLoon)

Huawei’nin Yeni Çipi NVIDIA’ya Rakip Olabilir: Sosyal medya tartışmaları, Huawei’nin yeni bir çip yayınladığını ve bunun yapay zeka alanında NVIDIA’ya rakip olabileceğini belirtiyor. Bu durum, çip ve gümrük vergileri konusundaki Çin-ABD müzakere dengesini etkileyebilir (kaynak: Reddit r/ArtificialInteligence)

🌟 Topluluk

DeepSeek’in Yarattığı Altına Hücum ve Düşünceler: DeepSeek’in popülerleşmesi, etrafında dönen çok sayıda ticari girişimi tetikledi; bunlar arasında içerik oluşturma (toplu kısa video senaryoları, metinler üretme), bilgi satışı (kullanım kılavuzları, para kazanma kursları satma) ve vekaleten işletme hizmetleri bulunuyor. Ancak, birçok girişimci, yapay zeka ile toplu olarak üretilen içeriğin homojenleştiğini, platformlar tarafından kolayca kısıtlandığını veya yasaklandığını ve etkili bir gelire dönüştürülmesinin zor olduğunu fark etti. Makale, gerçek fayda sağlayanların genellikle bilgi farkını kullanarak kurs veya hizmet satan “aracılar” olduğunu, doğrudan kullanıcılar olmadığını belirtiyor. Aynı zamanda, DeepSeek’in kendisi de sunucu yoğunluğu, kalıplaşmış yanıtlar gibi sorunlar ortaya çıkararak uygulama değeri ve sınırlamaları hakkında tartışmalara yol açtı (kaynak: DeepSeek popülerleşeli üç ay oldu, ondan para kazanmak isteyen ilk grup ne durumda?)

Yapay Zeka Kopya Aracı Geliştiricisinin Finansman Alması Etik Tartışmalara Yol Açtı: 21 yaşındaki Columbia Üniversitesi öğrencisi Chungin Lee, teknik mülakatlarda kopya çekmek için geliştirdiği yapay zeka aracı Interview Coder nedeniyle okuldan uzaklaştırıldı. Bir aydan kısa bir süre sonra, sınıf arkadaşlarıyla Cluely şirketini kurarak bu aracı sınavlar, satışlar, toplantılar gibi çeşitli senaryolara genişletti ve 5,3 milyon dolarlık tohum yatırımı aldı. Bunun kopya çekmek olmadığını, verimliliği artırmak için teknolojiyi kullanmak olduğunu ve gelecekte herkesin yapay zeka desteği kullanacağını savunuyorlar. Bu olay büyük tartışmalara yol açtı; destekçiler bunu cesur bir yenilik olarak görürken, eleştirmenler adaleti baltalamasından, yetenek sınırlarını bulanıklaştırmasından endişe ediyor ve hatta bunu “Black Mirror” bölümüne benzetiyor. Olay, yapay zeka etiği, eğitimde adalet ve yetenek tanımları hakkında hararetli tartışmaları ateşledi (kaynak: 21 yaşındaki öğrenci yapay zeka kopya aracı geliştirdiği için Columbia’dan uzaklaştırıldı, ardından 5,3 milyon dolar finansman aldı, internet kullanıcıları: “Black Mirror” gerçek oldu, Yapay zeka kopya aracı geliştirerek ünlenen 21 yaşındaki genç, okuldan atıldıktan bir ay sonra 5,3 milyon dolar finansman aldı)

ABD Vize Politikası Sıkılaşıyor, Yapay Zeka Yetenekleri Dışarı Akabilir: Son zamanlarda ABD hükümeti, uluslararası öğrencilerin (yapay zeka doktora öğrencileri dahil) SEVIS kayıtlarını ve vizelerini toplu olarak iptal ediyor. Gerekçeler hafif ihlallerden hatta sistem hatalarına (muhtemelen yapay zeka taramasıyla ilgili) kadar değişiyor ve süreç şeffaflık ve itiraz fırsatından yoksun. Caltech profesörü Yisong Yue gibi isimler, bu hamlenin ABD’nin en iyi yapay zeka yetenekleri için çekiciliğine zarar verdiğinden endişe ediyor; OpenAI, Google gibi kurumlardaki birçok araştırmacı ayrılmayı düşünüyor. Bu durum, ABD yapay zeka projelerinin gerilemesine ve yapay zeka avantajını zayıflatmasına neden olabilir. Öğrenciler şimdiden hükümete karşı dava açtı ve geçici bir yasaklama kararı aldı (kaynak: Kaliforniya yapay zeka doktorası bir gecede kimliğini kaybetti, Google OpenAI akademisyenleri “ABD’den ayrılma” dalgası başlattı, 380.000 iş kayboldu, yapay zeka avantajı çöküyor)

Açık Kaynak Model Geliştirme Durumu Tartışması: Topluluk, açık kaynaklı büyük modellerin son durumunu tartışıyor: Qwen 3 bekleniyor, Llama 4 yavaş benimseniyor, çıkarım modelleri bir darboğaza mı girdi? Çok modlu modeller hafife alınıyor ve Çin açık kaynak alanında hakimiyetini sürdürüyor. Tartışmacılar, “çıkarım doygunluğu” anlayışının açık kaynak ile kapalı kaynak arasında ayrım yapması gerektiğini vurguluyor ve bunun daha çok model çeşitliliği ve RL genişletme zorluklarıyla ilgili olduğunu belirtiyor (kaynak: natolambert)

OpenAI o3 Modelinin Arama Yeteneği Övgü Aldı: Kullanıcı, OpenAI o3 modelinin arama yeteneğinin güçlü olduğunu, çok niş bilgileri bile bulabildiğini, çok fazla ek bağlama gerek olmadığını ve etkileşim deneyiminin bir meslektaşla konuşmaya benzediğini belirtti (kaynak: gdb)

Açık Kaynaklı TTS’nin Anlamı ve Etkisi: Topluluk üyeleri Dia TTS modelini tartışırken, yüksek kaliteli performansının SOTA TTS modellerini eğitmenin artık milyarlarca dolarlık yatırım gerektirmediğini kanıtladığını vurguluyor. Yapay zeka endüstrisindeki bileşik etki, eğitimi giderek kolaylaştırıyor ve açık kaynak gücü teknoloji yayılımını hızlandırıyor (kaynak: huggingface, huggingface)

Meta, Açık Kaynak Topluluğunu Kutlamak İçin LlamaCon 2025’i Düzenliyor: Meta, Llama açık kaynak topluluğunu ve başarılarını kutlamak amacıyla LlamaCon 2025 etkinliğini düzenleyeceğini duyurdu. Etkinlikte Llama modelleri ve araçlarının en son gelişmeleri ve gelecek planları paylaşılacak (kaynak: AIatMeta)

Yapay Zekanın Gerçekten “Akıllı” Olup Olmadığı Tartışılıyor: “Yapay Zekanın Akıllı Olduğunu Varsaymayı Bırakmalıyız” başlıklı makale, mevcut yapay zeka teknolojisinin yetenek sınırlarını ve “akıllı” tanımının karmaşıklığını tartışmaya açtı (kaynak: Ronald_vanLoon)

ChatGPT Kullanım Deneyimi: Bağlantı Kaybı ve Dürüstlük Testi: Kullanıcılar sık sık ChatGPT “ağ bağlantısı kesildi” sorunuyla karşılaştıklarını bildiriyor ve bunun kullanım yüküyle ilgili olabileceğini tahmin ediyorlar. Aynı zamanda, bir kullanıcı ChatGPT’nin hafıza özelliğini kullanarak kullanıcıları hakkındaki “gerçek görüşlerini” vermesini sağlayan ilginç bir istem paylaştı ve yapay zeka kişiselleştirilmiş etkileşim ve “bilinç” üzerine tartışmaları tetikledi (kaynak: natolambert, dotey)

Robotik Alanındaki Gelişmelere Yönelik İyimserlik: Hugging Face kurucu ortağı Thomas Wolf, açık kaynaklı donanım, iyi pekiştirmeli öğrenme ilerlemeleri ve yeteneklerin bir araya gelmesi sayesinde 2025’teki robotik laboratuvarlarının eğlence dolu olduğunu yorumladı ve sektördeki robotik teknolojisinin hızlı gelişimine yönelik heyecanı yansıttı (kaynak: huggingface)

Gemini Deep Research’ün Pratikliği Onaylandı: Kullanıcı, tweet bilgilerinin güvenilirliğini doğrulamak için Gemini Deep Research özelliğini kullanma örneğini paylaştı ve bilgi kontrolü ve derinlemesine araştırma konularındaki pratik değerini gösterdi (kaynak: dotey)

Açık Kaynaklı Yapay Zeka Kütüphanelerine Yönelik Eleştiri ve Savunma: Topluluk üyeleri, son zamanlarda çeşitli açık kaynaklı yapay zeka kütüphanelerine yönelik çok sayıda olumsuz yorum olduğunu gözlemledi ve bu eleştirilerin güncelliğini yitirmiş bilgilere veya tek taraflı metriklere dayanabileceğini belirterek eleştirmenleri daha iyi sürümler oluşturmaya katılmaya çağırdı (kaynak: natolambert)

Yapay Zeka Oyun Deneyimi Tahmini: Kullanıcılar, gelecekteki yapay zeka destekli oyun deneyimini merak ediyor ve bunun VRChat’in etkileşim biçimine benzeyebileceğini tahmin ediyor, ancak tamamen ağızla kontrol konusunda şüphelerini dile getiriyorlar (kaynak: karminski3)

ChatGPT Görüntü Büyütme Özelliği Tartışması: Kullanıcılar, ChatGPT’nin görüntü çözünürlüğünü büyütmesini sağlamaya çalıştı ve bunun pikselleri gerçekten büyütmek yerine, benzer ancak detayları farklı yüksek çözünürlüklü yeni bir görüntü oluşturduğunu fark etti. Yorum bölümü genel olarak bu noktayı kabul etti ve gerçek yapay zeka görüntü büyütme teknolojisini tartıştı (kaynak: Reddit r/ChatGPT)

ChatGPT Dünya Hayalini Oluşturuyor: Kullanıcı, ChatGPT’den dünyanın nasıl görünmesi gerektiğini hayal etmesini istedi ve pastoral bir park sahnesi görüntüsü aldı. Yorum bölümündeki kullanıcılar, görüntüdeki mantıksal tutarsızlıkları (ay-dünya mesafesi, bank konumu gibi) ve potansiyel önyargıları (karakter ırkı) işaret ederek mevcut görüntü oluşturma modellerinin sınırlamalarını yansıttı (kaynak: Reddit r/ChatGPT)

Eski LLM Modeli MythoMax13B’nin Popülerlik Nedenleri Tartışılıyor: Reddit kullanıcısı, Llama2 tabanlı MythoMax13B modelinin OpenRouter gibi platformlardaki RPG senaryolarında neden hala popüler olduğunu sordu. Yorumlar nedenlerini şöyle sıralıyor: düşük maliyet (genellikle ücretsiz seçenek olarak sunulur), nispeten kararlı olması ve talimatları takip etmesi, kullanıcıların istemlerine ve ayarlarına aşina olması ve erken dönem eğitimlerin kalıcı etkisi (kaynak: Reddit r/LocalLLaMA)

Yerel Gizlilik Filtreleme Aracı Arayışı: Reddit kullanıcısı, istemleri LLM’ye göndermeden önce otomatik olarak algılayıp anonimleştirecek (örneğin yer tutucularla değiştirecek) ve LLM yanıtını aldıktan sonra orijinal bilgileri geri yükleyecek, böylece gizliliği koruyacak yerel cihazda çalışabilen araçlar veya küçük dil modelleri (SLM) arıyor (kaynak: Reddit r/OpenWebUI)

Anthropic’in “Tamamen Yapay Zeka Çalışanları” Uyarısı Hakkında Tartışma: Anthropic’in tamamen yapay zekadan oluşan sanal çalışanların bir yıl içinde ortaya çıkabileceği uyarısı toplulukta tartışmalara yol açtı. Yorumcular buna şüpheyle yaklaşıyor, Anthropic’in kendi hizmetlerinin kararlılık sorunlarına işaret ediyor ve bunun daha çok bir tanıtım veya korku tellallığı olduğunu düşünüyor (kaynak: Reddit r/ArtificialInteligence, Reddit r/artificial, Reddit r/ClaudeAI)

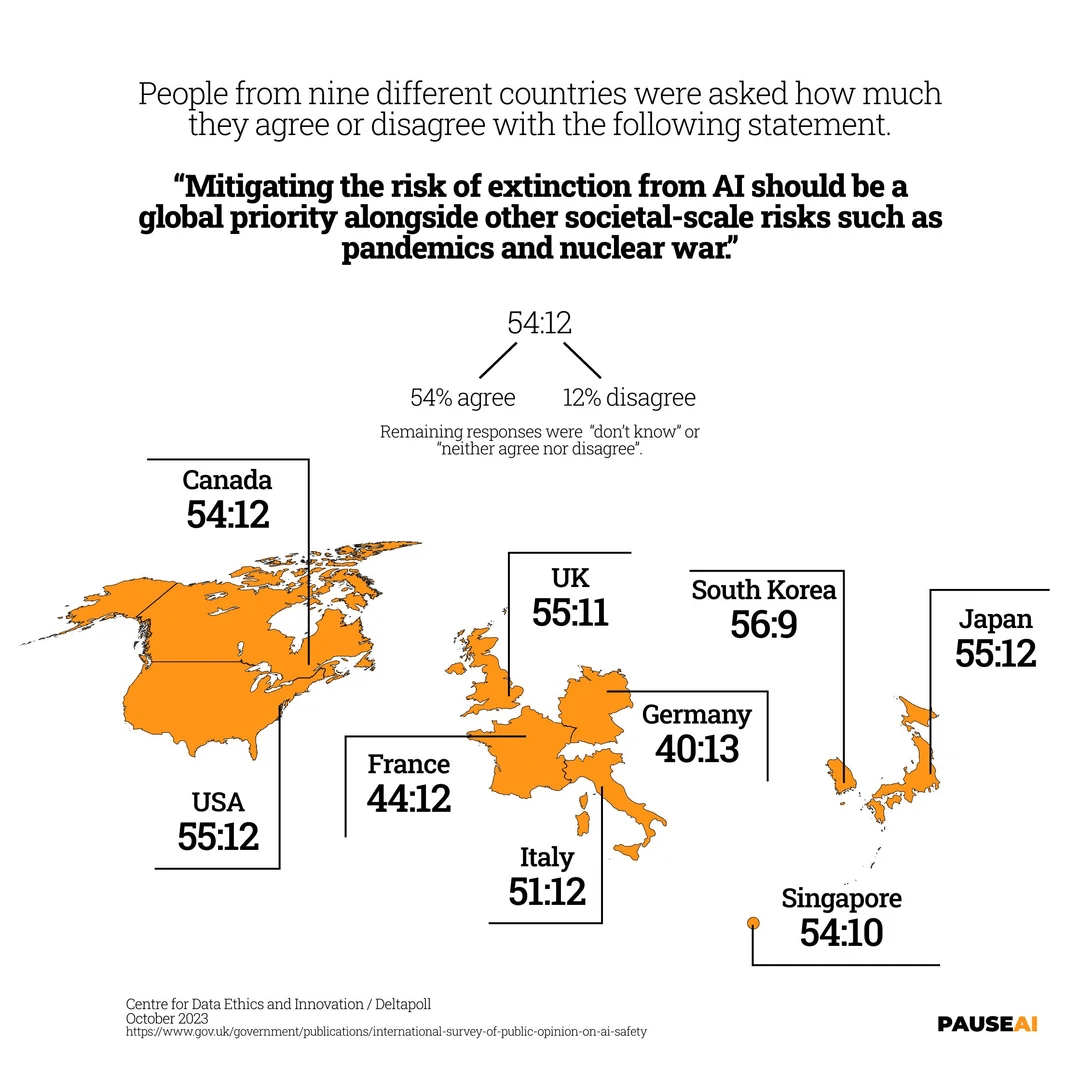

Yapay Zekanın Yok Oluş Riskine İlişkin Küresel Endişe: Resim, dünya genelindeki çoğu insanın yapay zekanın insanlığın yok olmasına yol açabileceği riskinin ciddiye alınması gerektiği konusunda hemfikir olduğunu gösteren bir anket sonucunu gösteriyor (kaynak: Reddit r/artificial)

Yapay Zeka Tarafından Üretilen Metinlerin “Makine Tadı” ve İnsanileştirme Teknikleri: Kullanıcılar, yapay zeka tarafından üretilen metinleri (e-postalar, gönderiler gibi) nasıl tanıyacaklarını tartışıyor ve yaygın sorunları belirtiyor: hedefe yönelik ton eksikliği, aşırı resmiyet, kusursuzluk. Yapay zeka yazımını daha doğal hale getirme tekniklerini paylaşıyorlar: senaryoyu netleştirme, örnekler sunma, rastgeleliği ayarlama, belirli ayrıntılar ekleme, kendiniz düzenleme, küçük kusurları koruma vb. (kaynak: Reddit r/artificial)

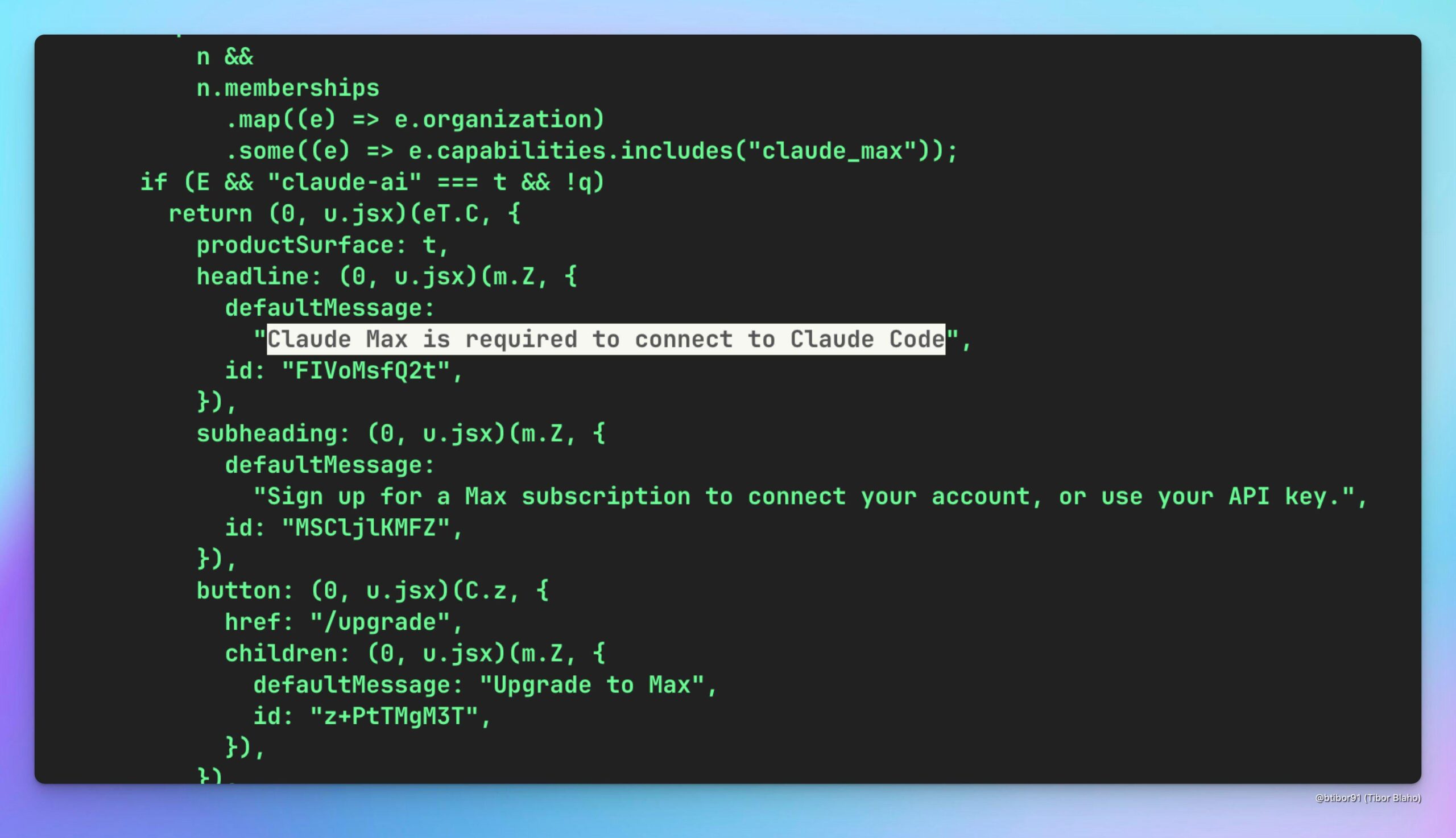

Claude Code’un Claude Max Üzerinden Kullanılıp Kullanılamayacağı Hakkında Spekülasyon: Kullanıcılar, Claude Max hizmetine abone olarak (muhtemelen daha düşük maliyetli) Claude Code modelini dolaylı olarak kullanıp kullanamayacaklarını tahmin ediyor ve potansiyel değerini tartışıyorlar, aynı zamanda OpenAI’nin de benzer bir çözüm sunmasını umuyorlar (kaynak: Reddit r/ClaudeAI)

o3 Modelinin Yerel Davranışını Mizahi Bir Şekilde Taklit Etme: Kullanıcı, yerel LLM modelinin OpenAI o3 modelinin bazı kullanıcılar tarafından eleştirilen özelliklerine (kısa yanıtlar, ince hatalı kodlar, can sıkıcı davranışlar gibi) benzer şekilde davranmasını sağlamayı amaçlayan mizahi bir sistem istemi paylaştı ve böylece o3 modeline yönelik memnuniyetsizliği dile getirdi (kaynak: Reddit r/LocalLLaMA)

OpenWebUI’nin MCP Proxy Sunucusuna Bağlanma Sorunu Yardım Talebi: K8s kullanıcısı, OpenWebUI kullanırken bir sorunla karşılaştı; pod içinde localhost üzerinden erişilebilmesine rağmen, web arayüzünden aynı pod içinde dağıtılan MCP proxy sunucusuna (FastAPI uygulaması) erişemiyor. Kullanıcı, ağ bağlantısı veya yapılandırma sorununu çözmek için topluluktan yardım istiyor (kaynak: Reddit r/OpenWebUI)

Yerel MCP Sunucusu Güvenlik Uygulamaları Tartışması: Kullanıcı, potansiyel güvenlik açığı risklerine karşı yerel MCP sunucusunu güvenli bir şekilde çalıştırmanın yollarını soran bir tartışma başlattı. Yorumlar stdio modunu kullanmayı veya SSE modunu localhost/127.0.0.1 ile sınırlamayı veya token kimlik doğrulaması kullanmayı öneriyor ve istem enjeksiyonu/kimlik bilgisi hırsızlığı endişelerinin tüm yazılım kurulumları için geçerli olduğunu belirtiyor (kaynak: Reddit r/ClaudeAI)

Agent-to-Agent (A2A) Protokolü Ödeme Mekanizması Tartışması: Topluluk, Google’ın A2A protokolünde yerleşik bir Agent’lar arası ödeme mekanizmasının eksikliğini tartışıyor. Kullanıcılar bunun Agent ekonomisinin gelişimini engelleyebileceğini düşünüyor ve faturalandırmaya bağlı kimlik doğrulama belirteçleri, yerleşik emanet süreçleri veya AgentSkill’e fiyatlandırma bilgisi ekleme gibi potansiyel çözümleri tartışıyor (kaynak: Reddit r/artificial)

Yapay Zekaya Aşırı Güvenme Uyarısı: Kullanıcı, Google Arama AI’nın aynı soruya zıt cevaplar verdiği deneyimini paylaşıyor ve nihai kararlar için tamamen yapay zekaya güvenilmemesi gerektiğini vurguluyor. Yorumlar, LLM’lerin olasılıksal doğası, eğitim verisi yanlılığı, model basitleştirmesi gibi nedenlerle tutarsızlığa yol açtığını açıklıyor ve yapay zekayı yetkili bir bilgi kaynağı yerine yardımcı bir araştırma aracı olarak kullanmayı öneriyor (kaynak: Reddit r/ArtificialInteligence)

OpenWebUI’de RAG için Qdrant Kullanımı Hakkında Soru: Kullanıcı, RAG (Alımla Zenginleştirilmiş Üretim) gerçekleştirmek için OpenWebUI ortamına Qdrant vektör veritabanını nasıl entegre edeceğini, özellikle OpenWebUI’nin Qdrant’taki verileri nasıl kullanacağını ve bir retriever betiğine ihtiyaç olup olmadığını soruyor (kaynak: Reddit r/OpenWebUI)

Google ve ChatGPT Arama Etkinliği Karşılaştırma Tartışması: Kullanıcı, ChatGPT arama etkinliğinin Google’dan daha iyi olduğunu iddia eden bir karşılaştırma grafiği (gösterilmiyor) yayınlayarak toplulukta tartışma başlattı. Yorumlarda bazıları buna karşı çıkıyor, Google Gemini’nin üstün performans gösterdiğini ve NotebookLM gibi araçlara sahip olduğunu savunuyor; bazıları bu tür karşılaştırmaların anlamsız olduğunu, teknolojinin sürekli geliştiğini düşünüyor; bazıları ise kullanıcı deneyimi ve entegrasyonun önemine işaret ediyor (kaynak: Reddit r/ChatGPT)

Character Training Araştırma Yönüne İyimser Bakış: Sektör gözlemcileri, Character Training’in (karakter eğitimi, muhtemelen yapay zekanın belirli bir karakteri veya kişiliği taklit etmesini sağlamak) patlayıcı bir akademik araştırma alanı olacağını tahmin ediyor ve şimdi erken dönem öncü makaleler yayınlamak için iyi bir zaman olduğunu düşünüyor (kaynak: natolambert)

💡 Diğer

İnsansı Robot Formunun Mantıksallığı Tartışması: Makale, robotların neden insansı olarak tasarlandığını araştırıyor: Esas olarak insanlar için tasarlanmış ve inşa edilmiş dünyaya (araçlar, çevre, etkileşim biçimleri) uyum sağlamak için. İnsansı tasarım, makinelerin mevcut altyapıda gezinmesini ve çalışmasını kolaylaştırır, yeniden yapılandırma ihtiyacını azaltır ve insan araçlarını kullanır. İnsan benzeri özellikler ayrıca insan-makine etkileşimine ve işbirliğine yardımcı olur. Denge, kontrol, maliyet ve “ürkütücü vadi” gibi zorluklar olmasına rağmen, teknolojik ilerlemeler bu engelleri yavaş yavaş aşıyor. Makale ayrıca robot gelişiminin kısa bir tarihçesini gözden geçiriyor, Çin ve ABD gibi ülkelerin insansı robot alanındaki rekabet ortamını karşılaştırıyor ve maliyet düşüşünün getireceği yaygınlaşma beklentilerini ele alıyor (kaynak: Yabancı medya derinlemesine: Robotlar neden insan şeklinde yapılıyor?)

Yapay Zeka Çağında Çin’in İstihdam Zorlukları ve Çözüm Önerileri: Makale, yapay zekanın Çin istihdam piyasası üzerindeki etkisini, özellikle orta ve düşük vasıflı işgücü ve bölgesel kalkınma dengesizliğinin getirdiği zorlukları analiz ediyor. ABD’nin eğitim reformu, yeniden eğitim, sosyal güvenlik sistemi ve inovasyon desteği konusundaki deneyimlerinden yararlanarak, makale Çin’in mesleki eğitimi ve yaşam boyu öğrenmeyi (özellikle dijital beceriler) güçlendirmesi, yeni iş biçimlerini kapsayan sosyal güvenlik sistemini iyileştirmesi, endüstriyel ve yapay zeka entegrasyonunu ve bölgesel koordineli kalkınmayı teşvik etmesi, algoritma denetimini ve veri gizliliği korumasını sağlamlaştırması, çok departmanlı koordinasyonu ve istihdam izleme uyarısını güçlendirmesi gerektiğini öne sürüyor (kaynak: Yapay zeka çağı: Çin istihdam temelini nasıl istikrara kavuşturur ve yükseltir)

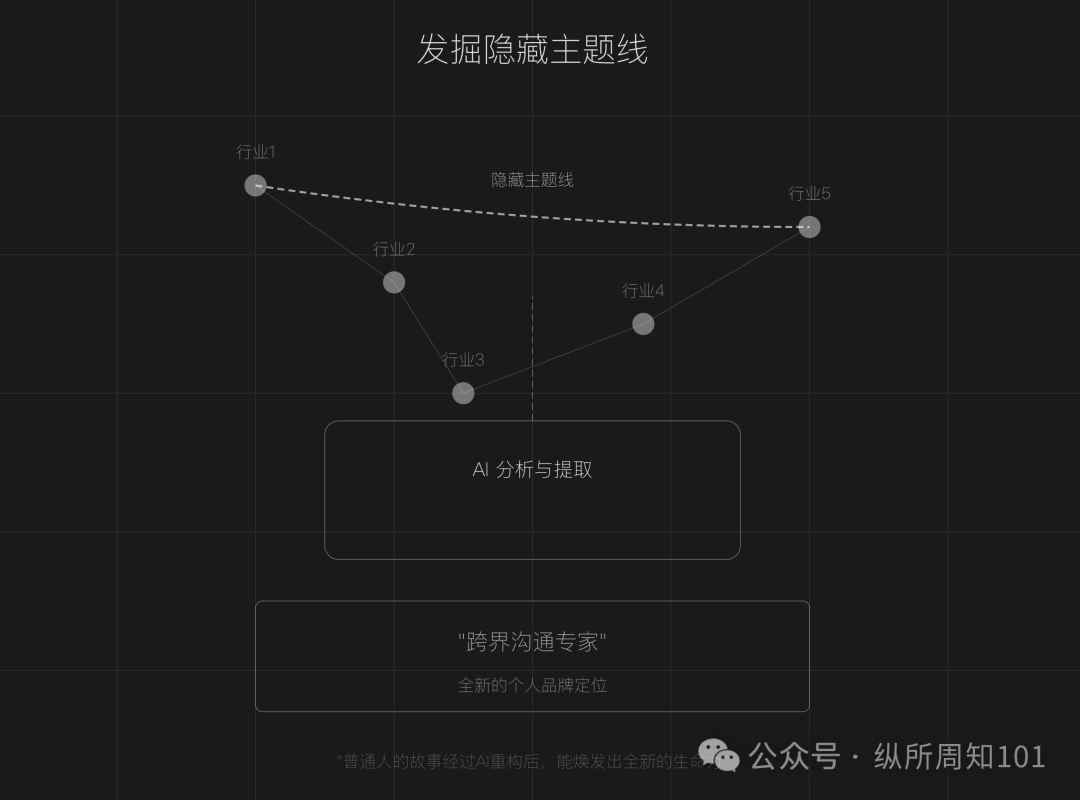

Yapay Zeka ile Kişisel Marka Anlatısını Yeniden Şekillendirme: Makale, içerik oluşturmanın doygunluğa ulaştığı bir çağda, sıradan insanların yapay zeka araçlarını (ChatGPT gibi) kullanarak kişisel deneyimlerini yeniden yapılandırabileceğini, gizli tema çizgilerini keşfedebileceğini, kilit dönüm noktası anlatılarını yeniden şekillendirebileceğini ve farklılaştırılmış bir dil sistemi oluşturarak benzersiz bir kişisel marka yaratabileceğini öne sürüyor. Makale, belirli adımlar (veri toplama, yapay zeka tema madenciliği, hikaye yapısını yeniden şekillendirme, uygulama yinelemesi) ve teknikler (tersine yapılandırma, duygusal büyütme, karşılaştırmalı güçlendirme) sunuyor ve aşırı güzelleştirme, tekdüzelik ve duygusal derinlik eksikliği tuzaklarından kaçınılması gerektiğini hatırlatarak gerçeklik ile yapay zeka yardımının birleşimini vurguluyor (kaynak: Kişisel marka olmanın ilk adımı: Hayat hikayenizi yapay zeka ile yeniden yazın)

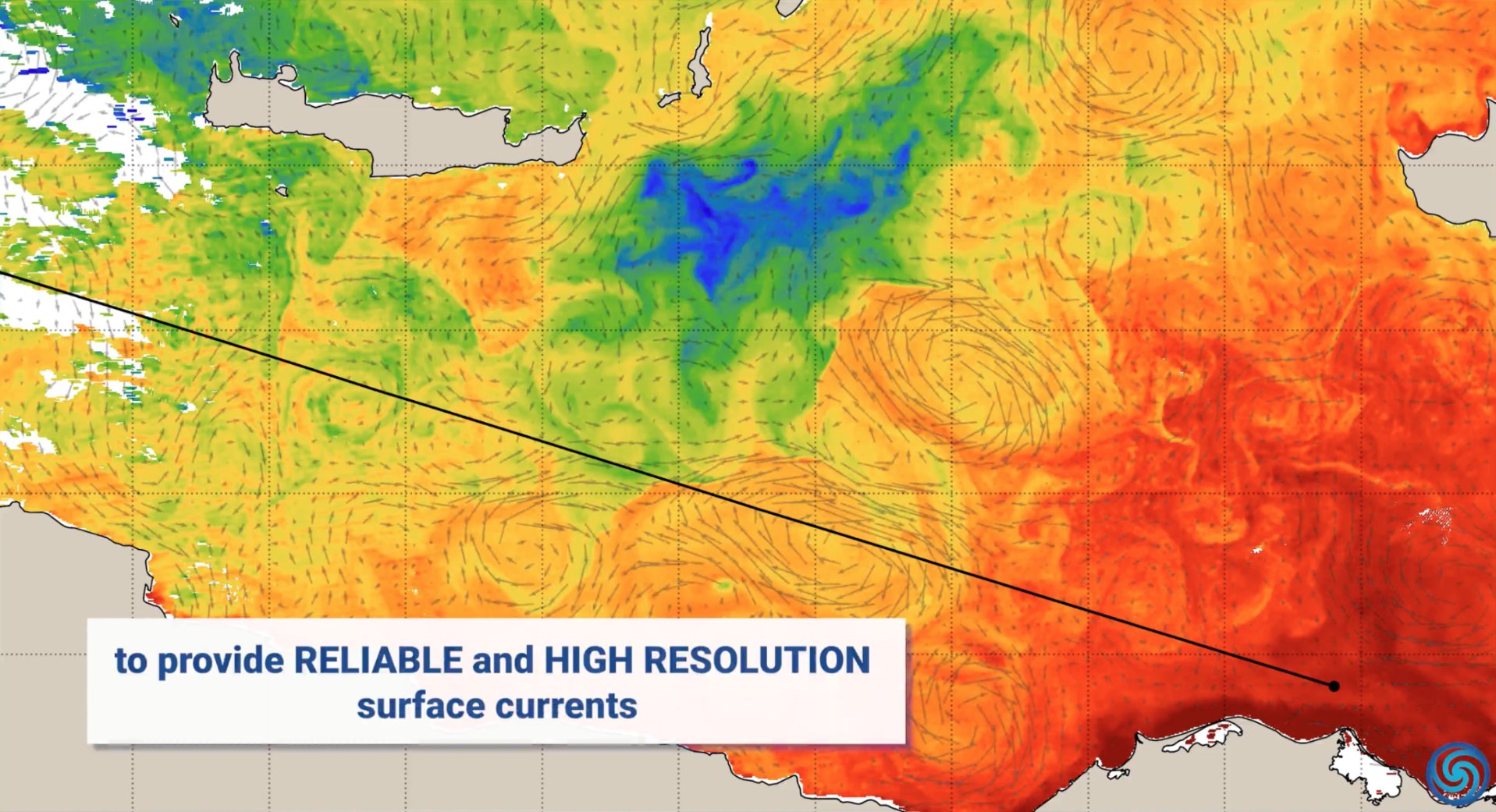

Yapay Zekanın Çevre Koruma Alanındaki Uygulamaları: Dünya Günü vesilesiyle NVIDIA, yapay zeka teknolojisinin (Jetson, Earth-2 platformu gibi) çevre korumasındaki uygulama örneklerini sergiledi: yakıt tüketimini azaltmak için okyanus akıntılarını tahmin etme, orman yangınlarına ve kaçak avcılığa karşı gerçek zamanlı koruma sağlama, daha hassas fırtına tahminleri sunma ve asteroitleri tespit etme gibi, okyanus, kara, gökyüzü ve uzay gibi birçok boyutu kapsıyor (kaynak: nvidia, nvidia, nvidia)

Müşteri Hizmetlerini İyileştirmek İçin Yapay Zeka Kullanımı: Yapay zeka destekli iletişim merkezleri, geleneksel müşteri hizmetleri telefon görüşmelerindeki sıkıntıları çözmeyi, verimliliği ve memnuniyeti artırmayı amaçlayarak müşteri hizmetleri deneyimini dönüştürüyor (kaynak: Ronald_vanLoon)

Yapay Zeka ile Gerçekçi Selfie/Komik Resim Oluşturma İstemleri Paylaşımı: Kullanıcılar, yapay zeka görüntü oluşturma araçlarını (GPT-4o, Sora gibi) kullanarak son derece gerçekçi, sanki anlık çekilmiş gibi görünen “sıradan” selfie’ler oluşturmak için istemleri ve belirli kişileri tuvalet fırçası gibi tasarlayan komik resimler oluşturmak için istemleri paylaştı, yapay zekanın görüntü oluşturma konusundaki yaratıcılığını ve eğlence potansiyelini sergiledi (kaynak: dotey, dotey, dotey)

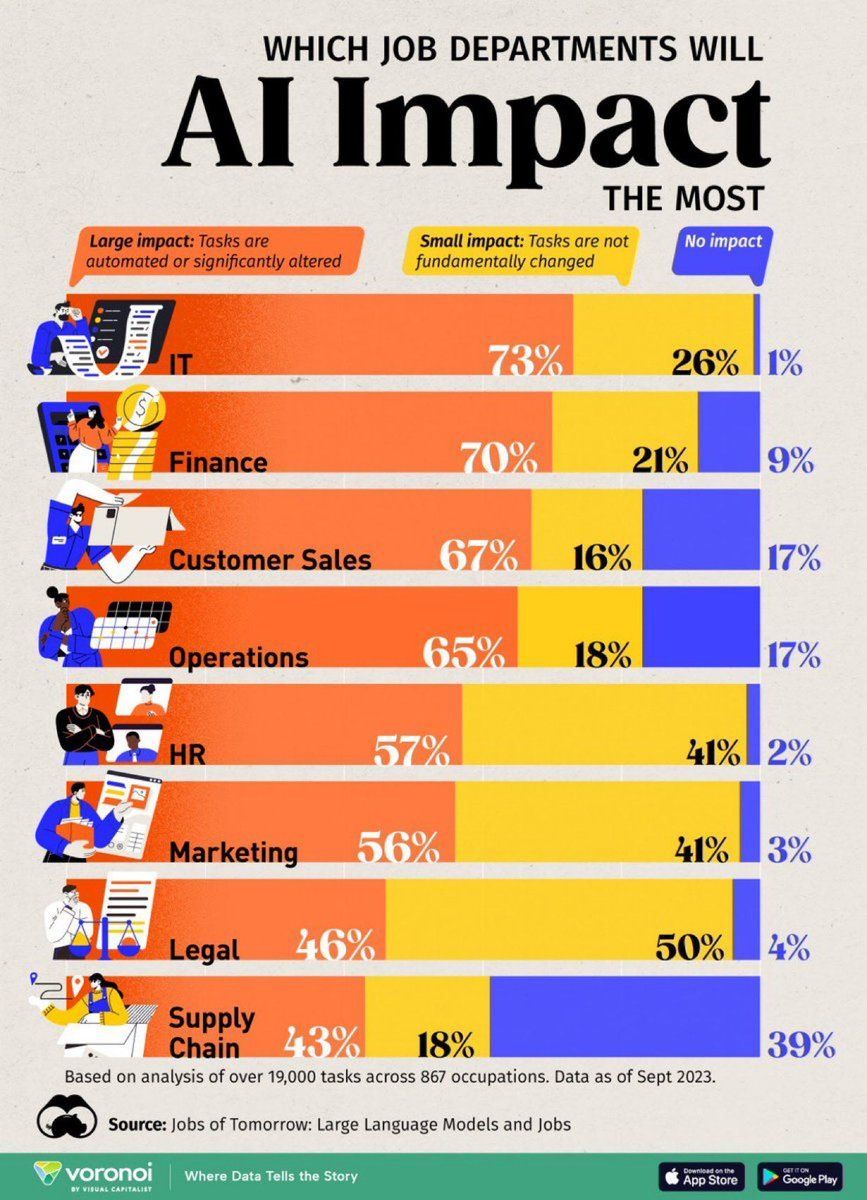

Yapay Zekanın İstihdam Üzerindeki Etki Analizi: Visual Capitalist tarafından hazırlanan infografik, yapay zekadan en çok etkilenen iş pozisyonlarını gösteriyor ve gelecekteki iş biçimlerindeki değişikliklere dikkat çekiyor (kaynak: Ronald_vanLoon)

Dubai Yol Kusurlarını Tespit Etmek İçin Yapay Zeka Kullanımı: Dubai, yol kusurlarını tespit etmek için yeni bir yapay zeka teknolojisi benimseyecek ve yapay zekanın kentsel altyapı bakımındaki uygulama potansiyelini gösterecek (kaynak: Ronald_vanLoon)

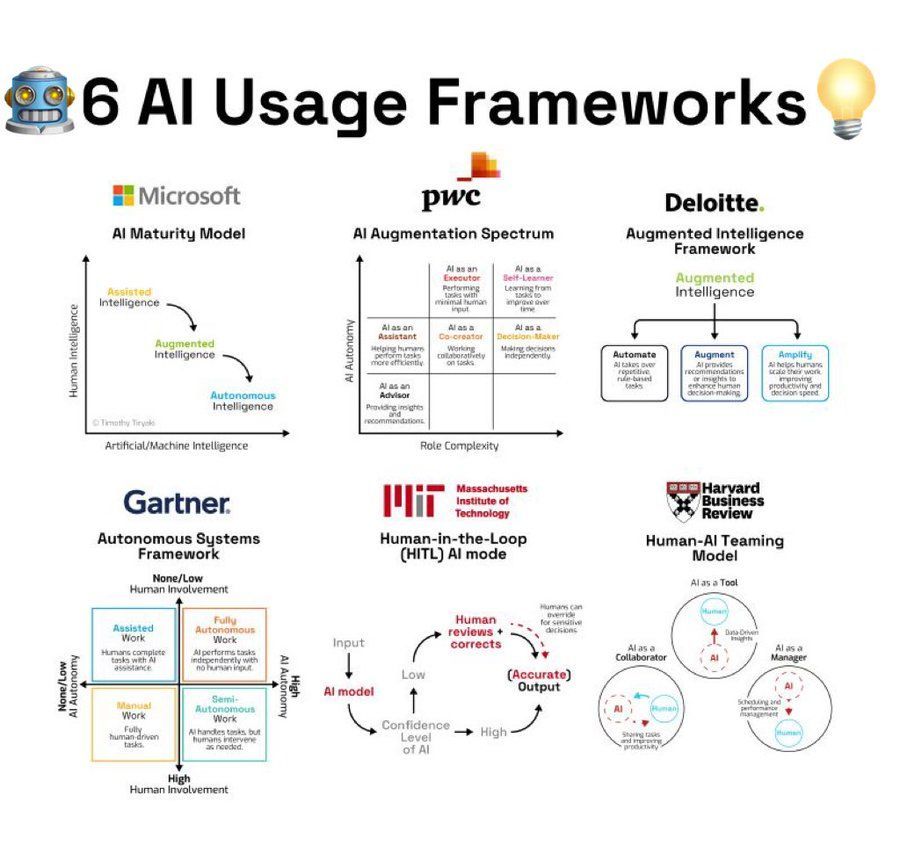

Yapay Zeka Kullanım Çerçeveleri Özeti: İnfografik, yapay zekayı kullanmak için 6 farklı çerçeve veya metodolojiyi özetliyor ve yapay zekayı uygulamak için kullanıcılara fikir referansı sunuyor (kaynak: Ronald_vanLoon)

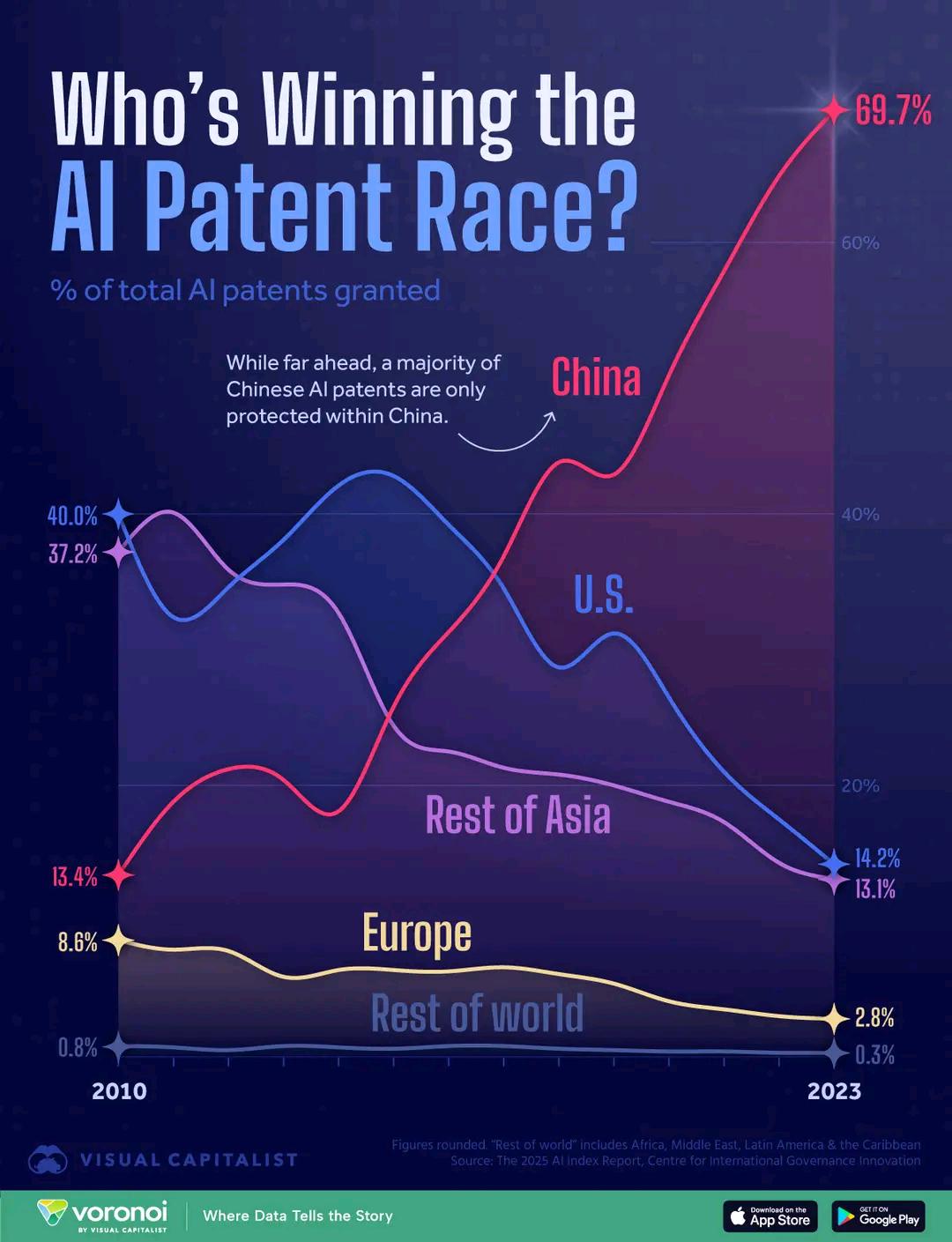

Yapay Zeka Patent Sayısı Ülke Karşılaştırması: Grafik, ülkelerin yapay zeka alanındaki patent sayılarını karşılaştırarak farklı ülkelerin yapay zeka Ar-Ge yatırımları ve çıktıları arasındaki farkları yansıtıyor. Yorumlarda, Çin’deki patent başvuru maliyetinin nispeten düşük olmasının veri yorumunu etkileyebileceği belirtiliyor (kaynak: karminski3)

Biyonik Kol Engelli Bireylere Yardımcı Oluyor: Open Bionics şirketi, 15 yaşındaki ampute kız Grace’e biyonik kol takarak yapay zeka ve robotik teknolojinin tıp sağlığı ve yardımcı teknoloji alanlarındaki uygulamasını gösteriyor (kaynak: Ronald_vanLoon)

Yapay Zeka Destekli Filmlerin Oscar’a Uygunluğu İlgi Çekiyor: Amerikan Sinema Sanatları ve Bilimleri Akademisi, yapay zeka gibi dijital araçlar kullanılarak yapılan filmlerin de Oscar ödüllerine katılabileceğini belirten kuralları güncelledi. Bu durum, Hollywood içinde ve dışında yapay zekanın film yapımı ve endüstri standartları üzerindeki etkisine ilişkin geniş çaplı tartışmalara yol açtı (kaynak: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Litvanya Okullarda Yapay Zeka Kullanım Kurallarını Belirliyor: Litvanya, okullarda yapay zeka kullanımıyla ilgili kurallar geliştiriyor, bu da eğitim alanının yapay zeka araçlarının uygulamasını düzenlemeye başladığını yansıtıyor (kaynak: Reddit r/ArtificialInteligence)