Anahtar Kelimeler:AI, GPT-4.1, 智谱AI IPO, 英伟达AI超算投资, 亚马逊AI资本支出, AI Agent互操作协议, DeepSeek用户规模

🔥 Odak Noktası

OpenAI, GPT-4.1 serisi modellerini yayınladı, API performansını artırdı ve GPT-4.5’i kullanımdan kaldırıyor: OpenAI, 15 Nisan’da API aracılığıyla GPT-4.1, GPT-4.1 mini ve GPT-4.1 nano olmak üzere üç yeni model yayınladı. Bu modellerin GPT-4o serisini tamamen geçmesi hedefleniyor. Yeni modeller, 1 milyon Token’a kadar bağlam penceresine sahip ve bilgi tabanları Haziran 2024’e kadar güncellenmiş durumda. GPT-4.1, kodlama yeteneği (SWE-bench Verified puanı %54.6, GPT-4o’ya göre %21.4 artış), talimat takibi (MultiChallenge puanı %38.3, GPT-4o’ya göre %10.5 artış) ve uzun bağlamlı video anlama (Video-MME puanı %72.0, GPT-4o’ya göre %6.7 artış) konularında öne çıkıyor. Dikkat çekici bir şekilde, GPT-4.1 nano ilk nano model olup, performansı GPT-4o mini’den daha iyi ve maliyeti daha düşüktür. Aynı zamanda OpenAI, GPT-4.5 Preview API’sini 3 ay sonra (14 Temmuz) kullanımdan kaldıracağını duyurdu ve bunun bir araştırma önizleme sürümü olduğunu, gelecekte geliştiricilerin beğendiği özellikleri yeni modellere entegre edeceğini belirtti. Bu duyuru, OpenAI’nin API modellerini ChatGPT ürün hattından ayırma ve doğrudan Google Gemini serisini hedef alma stratejik bir hamlesi olarak görülüyor. (Kaynak: 36氪, 新智元1, AI科技评论, Reddit r/LocalLLaMA, Reddit r/artificial)

Zhipu AI, halka arz danışmanlığına başladı ve yeni modelleri açık kaynak yaptı, değerlemesi 20 milyar yuanı aştı: Çin’in büyük model “Altı Küçük Kaplan”ından biri olan Zhipu AI (Zhipu Huazhang), 14 Nisan’da Pekin Menkul Kıymetler Düzenleme Bürosu’na danışmanlık kaydı yaptırarak halka arz (IPO) sürecini resmen başlattı. CICC danışman kurum olarak görev yapıyor. Zhipu AI, Tsinghua Üniversitesi Bilgi Mühendisliği Laboratuvarı’ndan doğdu ve çekirdek ekip üyelerinin çoğu Tsinghua’dan geliyor. Toplamda 15 milyar yuanın üzerinde finansman sağladı ve son değerlemesi 20 milyar RMB’yi aştı. IPO’yu başlatırken Zhipu AI, GLM-4-32B/9B serisi modellerini (temel, çıkarım ve düşünme olmak üzere üç tür) büyük ölçekte açık kaynak yaptığını duyurdu. Bu modeller MIT lisansı altında ücretsiz ticari kullanıma sunuldu. Bunlardan 32B parametreli çıkarım modeli GLM-Z1-32B-0414, bazı görevlerde 671B parametreli DeepSeek-R1 ile rekabet edebilecek performansa sahip. API ultra hızlı sürümü GLM-Z1-AirX’in çıkarım hızı 200 token/s’ye ulaşıyor ve yüksek maliyet performanslı sürümünün fiyatı DeepSeek-R1’in sadece 1/30’u kadar. Şirket ayrıca yeni alan adı z.ai’yi modeller için ücretsiz deneme platformu olarak kullanıma açtı. Bu hamle, Zhipu AI’nin teknoloji geliştirme, ticarileştirme keşfi ve açık kaynak ekosistemi oluşturma konularındaki kapsamlı düzenini gösteriyor. (Kaynak: 智东西, InfoQ, 量子位, 极客公园, 雷递, 公众号)

Nvidia, ABD’de yerel olarak AI süper bilgisayarları üretmek için 500 milyar dolar harcıyor: Nvidia, önümüzdeki dört yıl içinde 500 milyar dolar yatırım yaparak ilk kez ABD topraklarında AI süper bilgisayarları üretme yönünde büyük bir plan duyurdu. Plan, TSMC (Arizona’da Blackwell çipleri üretecek), Foxconn ve Wistron (Teksas’ta süper bilgisayar fabrikaları kuracak), Amkor ve SPIL (Arizona’da paketleme ve test yapacak) dahil olmak üzere birçok endüstri deviyle işbirliğini içeriyor. Nvidia CEO’su Jensen Huang, bu hamlenin artan AI çip ve süper bilgisayar talebini karşılamayı, tedarik zinciri direncini artırmayı ve Nvidia’nın AI, robotik (Isaac GR00T) ve dijital ikiz (Omniverse) teknolojilerini kullanarak fabrikaları tasarlamayı ve işletmeyi amaçladığını belirtti. Plan, ABD hükümetinin yerel üretimi teşvik etme (Çip Yasası gibi) ve jeopolitik bağlamdaki stratejik bir hamle olarak görülüyor ve ABD’nin küresel AI altyapı yarışındaki konumunu yükseltmeyi hedefliyor, ancak tedarik zinciri karmaşıklığı, vasıflı işçi eksikliği ve politika belirsizliği gibi zorluklarla da karşı karşıya. (Kaynak: 新智元1, 新智元2, Reddit r/artificial)

Amazon, rekabete yanıt vermek ve fırsatları yakalamak için AI’ye 100 milyar doların üzerinde yatırım yapmayı planlıyor: Amazon CEO’su Andy Jassy, 2024 yıllık hissedar mektubunda şirketin 2025’te 100 milyar doların üzerinde sermaye harcaması yapmayı planladığını ve bunun büyük bir kısmının veri merkezleri, ağ ekipmanları, AI donanımı (kendi geliştirdiği Trainium çipleri gibi) ve üretken AI hizmetleri (kendi geliştirdiği Nova serisi büyük modeller, Bedrock platformu, yükseltilmiş Alexa+, alışveriş asistanı Rufus gibi) dahil olmak üzere AI ile ilgili projelere ayrılacağını açıkladı. Bu devasa yatırım (yıllık gelirin yaklaşık 1/6’sı), Amazon’un AI’yi e-ticaret alanındaki şiddetli rekabete (SHEIN, Temu, TikTok vb.’den gelen) yanıt vermek ve tarihi bir fırsatı yakalamak için kilit olarak gördüğünü yansıtıyor. Jassy, AI’nin arama, programlama, alışveriş gibi kuralları değiştireceğini ve yatırım yapmamanın rekabet gücünü kaybetmek anlamına geleceğini vurguladı. Şu anda Amazon’un AI iş kolu yıllık gelirleri milyarlarca dolara ulaştı ve yıldan yıla üç haneli büyüme gösteriyor. Bu hamle aynı zamanda Amazon’un bulut hizmetleri (AWS) alanında Microsoft Azure, Google Cloud gibi rakiplerle karşı karşıya olduğu rekabet ortamında liderliğini pekiştirmek için sürekli yatırım yapma kararlılığını gösteriyor. (Kaynak: 36氪)

🎯 Eğilimler

AI Agent birlikte çalışabilirlik protokolleri MCP ve A2A ilgi görüyor: AI akıllı ajan alanı, standartlaştırılmış etkileşim protokolleri rekabetine sahne oluyor. Anthropic tarafından önerilen MCP (Model Context Protocol), büyük modellerin harici araçlar ve veri kaynaklarıyla iletişimini birleştirmeyi amaçlıyor ve “AI’nin USB-C’si” olarak adlandırılıyor; OpenAI, Google gibi şirketlerden destek aldı. Google ise farklı tedarikçilerin ve çerçevelerin akıllı ajanları arasında güvenli ve verimli işbirliğine odaklanan A2A (Agent2Agent) protokolünü açık kaynak olarak yayınladı ve ekosistem engellerini kırmayı hedefliyor. Bu iki büyük protokolün ortaya çıkışı, AI’nin tekil zekadan işbirlikçi ağlara doğru evrildiğini gösteriyor, ancak aynı zamanda “protokol güçtür”, veri tekeli ve ekosistem engelleri (“küçük avlu yüksek duvarlar”) hakkında tartışmalara yol açıyor. Standart belirleme gücünü ele geçirmek, AI endüstri zinciri yapısını yeniden şekillendirebilir ve AI’nin fiziksel dünya (robotlar, Nesnelerin İnterneti) ile entegrasyonu üzerinde derin etkiler yaratabilir. Alibaba Cloud, Tencent Cloud gibi yerli firmalar da MCP’yi desteklemek için adımlar atmaya başladı. (Kaynak: 36Kr)

QuestMobile Raporu: DeepSeek, yerli AI uygulama düzenini alt üst etti, kullanıcı sayısı 240 milyona ulaştı: QuestMobile tarafından yayınlanan “2025 Birinci Çeyrek AI Uygulama Pazarı Rekabet Analizi” raporu, DeepSeek modeli ve uygulamalarının patlamasıyla yerli AI App pazar düzeninin tamamen alt üst olduğunu gösteriyor. 2025 Şubat sonu itibarıyla, yerli AI App aylık aktif kullanıcı sayısı 240 milyona ulaştı ve Ocak ayına göre yaklaşık %90 arttı. DeepSeek App 194 milyon aylık aktif kullanıcıyla zirveye yerleşirken, ByteDance’in Doubao (116 milyon) ve Tencent Yuanbao (41.64 milyon) ikinci ve üçüncü sırada yer alarak önceki Kimi gibi uygulamaların yerini aldı. Rapor, DeepSeek’in açık kaynaklı kapsayıcı etkisinin, önde gelen oyuncuların entegrasyonunu ve AI uygulamalarının patlamasını teşvik ettiğini, AI genel asistanları, AI arama dahil 23 kulvar oluşturduğunu ve AI arama rekabetinin en yoğun olduğunu belirtiyor. Şu anda “çoklu model odaklı” yaklaşım önde gelen uygulamaların standardı haline geldi ve rekabet odağı ürün tasarımı ve operasyonlarına kayıyor. (Kaynak: QuestMobile)

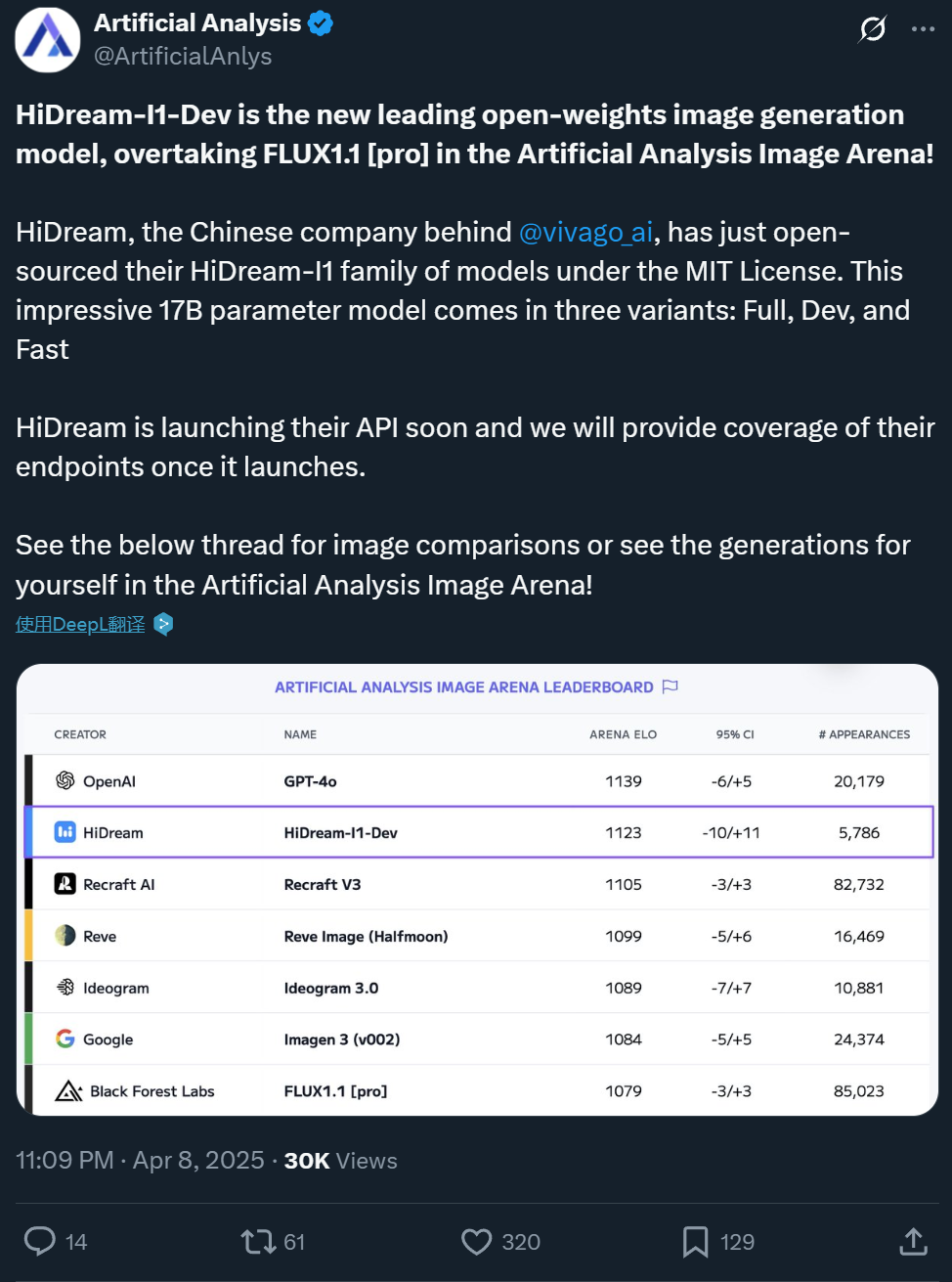

Zxiang Future, GPT-4o ile rekabet edebilecek 17B metinden resim modeli HiDream-I1’i açık kaynak yaptı: Yerli şirket Zxiang Future, 17B parametreli metinden resim büyük modeli HiDream-I1’i açık kaynak olarak yayınladı. Model, ticari kullanıma izin veren esnek bir MIT lisansı altında sunuluyor. Model, Artificial Analysis gibi platformlardaki yarışmalarda ve benchmark testlerinde (HPSv2.1, GenEval, DPG-Bench gibi) üstün performans gösterdi. Üretilen görüntülerin gerçekçiliği, inceliği ve talimat takibi yeteneğinin GPT-4o ve FLUX 1.1 Pro ile karşılaştırılabileceği, hatta bazı yönlerden daha iyi olduğu belirtiliyor. HiDream-I1, performansı ve verimliliği artırmak için MoE teknolojisini entegre eden Sparse Diffusion Transformer (Sparse DiT) mimarisini kullanıyor. Şirket ayrıca, etkileşimli görüntü düzenlemeyi destekleyen HiDream-E1 modelini yakında açık kaynak yapacağını duyurdu; ikisinin birleşimi “açık kaynaklı GPT-4o”nun görüntü oluşturma ve düzenleme deneyimini sunmayı amaçlıyor. Model Hugging Face’te mevcut ve Vivago platformunda denenebilir. (Kaynak: 机器之心1, 机器之心2)

ByteDance, düşük maliyetli ve yüksek verimli 7B video temel modeli Seaweed’i yayınladı: ByteDance Seed ekibi, Seaweed (Seed-Video’nun okunuşuyla uyumlu) adlı video oluşturma temel modelini yayınladı. Modelin parametre sayısı sadece 7 milyar olup, 665.000 H100 GPU saati (yaklaşık 1000 kartla 28 gün eğitime eşdeğer) kullanılarak eğitildiği ve maliyetinin nispeten düşük olduğu belirtiliyor. Seaweed, metne göre farklı çözünürlüklerde (doğal olarak 1280×720 destekler, 2K’ya yükseltilebilir), herhangi bir en boy oranında ve sürede videolar üretebiliyor. Model, görüntüden videoya oluşturma, referans nesne kontrolü (tek/çoklu görüntü), dijital insan çözümü Omnihuman ile birleştirilerek dudak senkronizasyonlu video oluşturma, video dublajı gibi işlevleri destekliyor. Teknik olarak DiT+VAE mimarisini kullanıyor, kapsamlı veri işleme süreci ve çok aşamalı çok görevli eğitim stratejisi (ön eğitim, SFT, RLHF) ile birleştirilmiş ve eğitim verimliliğini artırmak için sistem düzeyinde optimizasyonlar yapılmıştır. Ekip, eski Google video oluşturma lideri Dr. Lu Jiang tarafından yönetiliyor. (Kaynak: 量子位)

Alibaba Tongyi, dijital insan video oluşturma modeli OmniTalker’ı yayınladı: Alibaba Tongyi Laboratuvarı HumanAIGC ekibi, yeni dijital insan video oluşturma büyük modeli OmniTalker’ı tanıttı. Model, geleneksel kademeli yöntemlerin (TTS + ses odaklı) neden olduğu gecikme, ses-görüntü senkronizasyon sorunları, stil tutarsızlığı gibi sorunları çözmeyi amaçlıyor. OmniTalker, uçtan uca birleşik bir çerçevedir; metin ve bir referans ses/video girdisiyle, referans kaynağın sesini ve yüz konuşma stilini koruyarak gerçek zamanlı olarak senkronize ses ve dijital insan videosu üretebilir. Çekirdek mimarisi, ses ve görsel bilgileri ayrı ayrı işleyen çift akışlı DiT (Diffusion Transformer) kullanır ve senkronizasyon ile stil tutarlılığını sağlamak için yenilikçi bir ses-video füzyon modülü içerir. Model, ek stil çıkarıcı eğitimine gerek kalmadan referans videodan stil özelliklerini yakalamak için bağlamsal referans öğrenme modülünü kullanır. Proje şu anda ModelScope topluluğunda ve HuggingFace’te denemeye açık. (Kaynak: 机器之心)

Kuaishou, Kling AI video modelinin 2.0 sürümünü yayınladı: Kuaishou’nun Kling AI video oluşturma modeli 2.0 sürümünü yayınladı. Kamera hareketi aralığı, fiziksel yasalara uyum, karakter performansı, hareket kararlılığı ve anlamsal anlama konularında önemli iyileştirmeler olduğu iddia ediliyor. Kullanıcı incelemeleri, yeni sürümün karmaşık etkileşimleri (örneğin, T-Rex’in ağaçları kırması), ince motor hareketlerini (örneğin, gözlük çıkarma), çok kişili sahneleri ve gerçekçi ışık ve gölge simülasyonunu işlemede üstün performans gösterdiğini, üretilen videoların gerçekçiliğinin ve sinematik hissinin önemli ölçüde arttığını ve önceki 1.6 sürümünü geride bırakarak sektör lideri seviyeye ulaştığını gösteriyor. Yüksek hızlı grup hareketleri ve aşırı fiziksel simülasyonlar (örneğin, basket atışı) gibi alanlarda hala iyileştirme potansiyeli olmasına rağmen, genel performansının profesyonel prodüksiyon standartlarına meydan okumaya başladığı düşünülüyor. Kullanıcılar yeni sürümü klingai.com adresinden deneyebilirler. (Kaynak: 公众号, op7418)

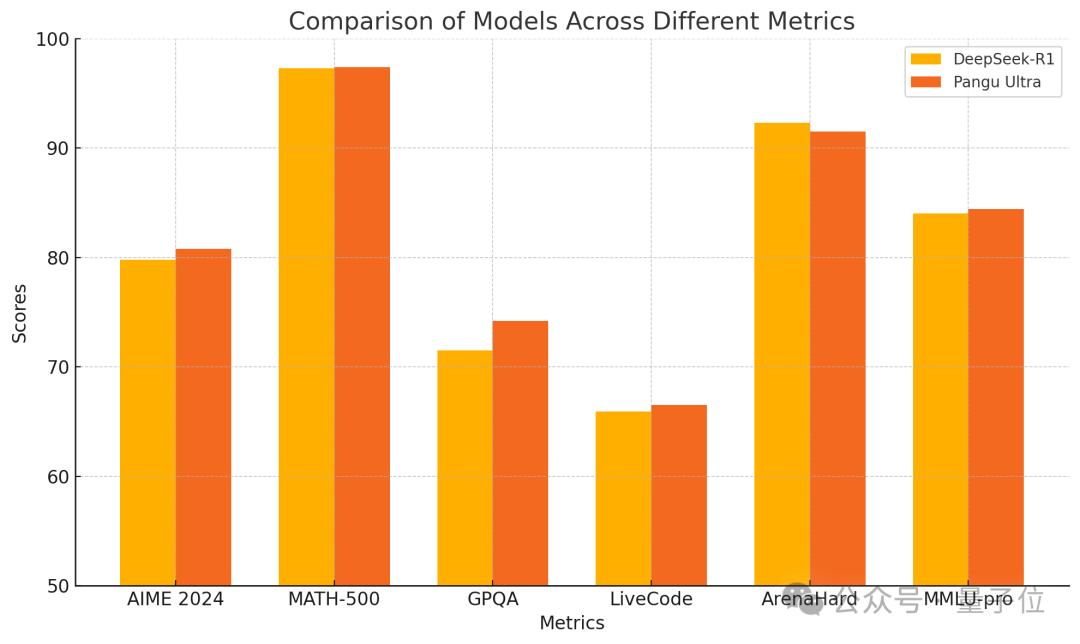

Huawei, tamamen Ascend üzerinde eğitilmiş üstün performanslı Pangu Ultra 135B yoğun modelini yayınladı: Huawei, Pangu büyük model serisinin yeni üyesi Pangu Ultra’yı duyurdu. Bu, 135B parametreli yoğun (Dense) bir modeldir ve tamamen Huawei Ascend AI hesaplama kümesinde (8192 NPU) Nvidia GPU kullanılmadan eğitilmiştir. Raporlara göre, Pangu Ultra matematiksel akıl yürütme (AIME 2024, MATH-500) ve programlama (LiveCodeBench) gibi görevlerde üstün performans gösteriyor ve performansı DeepSeek-R1 gibi daha büyük ölçekli MoE modelleriyle karşılaştırılabiliyor. Teknik olarak model, yenilikçi derin ölçeklendirme Sandwich-Norm katman normalizasyonu ve TinyInit parametre başlatma stratejilerini kullanarak ultra derin ağların (94 katman) eğitimi sırasındaki kararsızlık sorunlarını etkili bir şekilde çözmüş, kararlı bir eğitim süreci ve kayıp sıçramaları olmadan başarı sağlamıştır. Sistem düzeyindeki optimizasyonlar sayesinde, eğitim %52’nin üzerinde hesaplama gücü kullanım oranı (MFU) elde etmiştir. (Kaynak: 量子位)

Canopy Labs, duygusal konuşma sentezi modeli Orpheus’u açık kaynak yaptı: Canopy Labs, Orpheus adlı metinden konuşmaya (TTS) model serisini yayınladı ve açık kaynak yaptı. Model Llama mimarisine dayanıyor, ilk sürüm 3 milyar parametreli ve daha sonra 1B, 0.5B, 0.15B gibi daha küçük sürümler sunulacak. Orpheus’un özelliği, yüksek derecede insansı duygu, tonlama ve ritme sahip konuşmalar üretebilmesi, hatta metinden çıkarım yaparak kahkaha, iç çekme gibi sözsüz sesler üretebilmesi ve “empati” ifadesi sağlayabilmesidir. Model, sıfır-atış (zero-shot) konuşma klonlamayı ve etiketlerle duygu tonlamasını kontrol etmeyi destekliyor. Akışlı çıkarım (streaming inference) kullanarak gecikmesi 100-200ms kadar düşüktür ve A100 40GB ekran kartında gerçek zamanlı oynatmadan daha hızlı çıkarım yapar. Geliştiriciler, performansının mevcut açık kaynaklı ve bazı kapalı kaynaklı SOTA modellerini aştığını ve kapalı kaynaklı TTS modellerinin tekelini kırmayı hedeflediğini iddia ediyor. Model ve kod GitHub ve Hugging Face’te kullanıma sunuldu. (Kaynak: 新智元)

Zhejiang Üniversitesi ve ByteDance, MegaTTS3 konuşma sentezi modelini ortaklaşa yayınladı: Zhejiang Üniversitesi’nden Profesör Zhou Zhao’nun ekibi, ByteDance ile işbirliği içinde üçüncü nesil konuşma sentezi modeli MegaTTS3’ü yayınladı ve açık kaynak yaptı. Model, yalnızca 0.45B’lik hafif parametre ölçeğiyle yüksek kaliteli Çince-İngilizce çift dilli konuşma sentezi gerçekleştiriyor ve sıfır-atış (zero-shot) konuşma klonlamada üstün performans göstererek doğal, kontrol edilebilir ve kişiselleştirilmiş konuşmalar üretebiliyor. MegaTTS3, konuşma-metin seyrek hizalaması, üretimin kontrol edilebilirliği ve verimlilik ile kalite dengesi konularında önemli atılımlar yapıyor. Teknik öne çıkanlar arasında, aksan yoğunluğu gibi çok boyutlu kontrol için “Çok Koşullu Sınıflandırıcı Serbest Yönlendirme” (Multi-Condition CFG) teknolojisi ve örnekleme hızını 3 kat artıran “Parçalı Doğrultulmuş Akış Hızlandırma” (PeRFlow) teknolojisi bulunuyor. Model, LibriSpeech gibi benchmarklarda lider doğallık (CMOS) ve konuşmacı benzerliği (SIM-O) sergiliyor. (Kaynak: PaperWeekly)

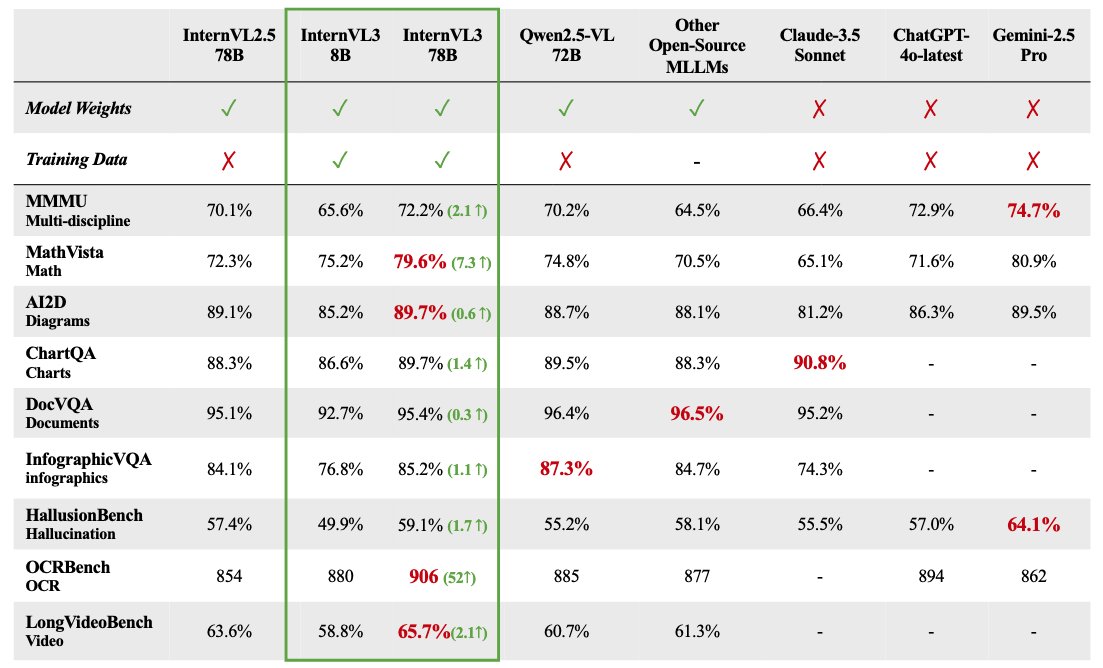

InternVL 3 çok modlu büyük model serisi açık kaynak yapıldı: OpenGVLab, 1B’den 78B’ye kadar değişen parametre ölçeklerine sahip InternVL 3 çok modlu büyük model serisini yayınladı ve Hugging Face’te kullanıma sundu. 78B parametreli sürümün MMMU benchmark testinde 72.2 puan alarak açık kaynaklı çok modlu modeller için SOTA rekorunu kırdığı iddia ediliyor. InternVL 3’ün teknik öne çıkanları şunlardır: dil ve görselliği aynı anda öğrenmek için doğal çok modlu ön eğitim kullanılması; genişletilmiş bağlamı desteklemek için değişken görsel konum kodlamasının (V2PE) tanıtılması; SFT ve MPO gibi gelişmiş son eğitim tekniklerinin kullanılması; ve matematiksel akıl yürütme yeteneğini artırmak için test zamanı ölçeklendirme stratejisinin uygulanması. Eğitim verileri ve model ağırlıkları topluluğun kullanımına açıldı. (Kaynak: huggingface)

GPT-4.1 Gerçek Dünya Performans Analizi: Kodlama Geliştirilmiş Ancak Akıl Yürütme Geride: OpenAI tarafından yayınlanan GPT-4.1 serisi modeller, ilk gerçek dünya testleri ve benchmark değerlendirmelerinde karmaşık bir performans tablosu sergiliyor. Kod oluşturma görevlerinde GPT-4o’ya göre belirgin bir ilerleme gösterse de (örneğin, fizik simülasyonları, oyun geliştirme gibi görevleri daha iyi tamamlama ve SWE-Bench’te yüksek puan alma), daha geniş kapsamlı akıl yürütme, matematik ve bilgi sorgulama benchmarklarında (Livebench, GPQA Diamond gibi) GPT-4.1’in performansı hala Google’ın Gemini 2.5 Pro ve Anthropic’in Claude 3.7 Sonnet modellerinin gerisinde kalıyor. Analizler, GPT-4.1’in GPT-4o’nun artımlı bir güncellemesi veya GPT-4.5’ten damıtılmış olabileceğini öne sürüyor. Yayınlama stratejisi, rakipleri tamamen geride bırakan bir amiral gemisi modelinden ziyade, API aracılığıyla daha uygun maliyetli, belirli alanlarda optimize edilmiş model seçenekleri sunmayı amaçlıyor olabilir. (Kaynak: 新智元)

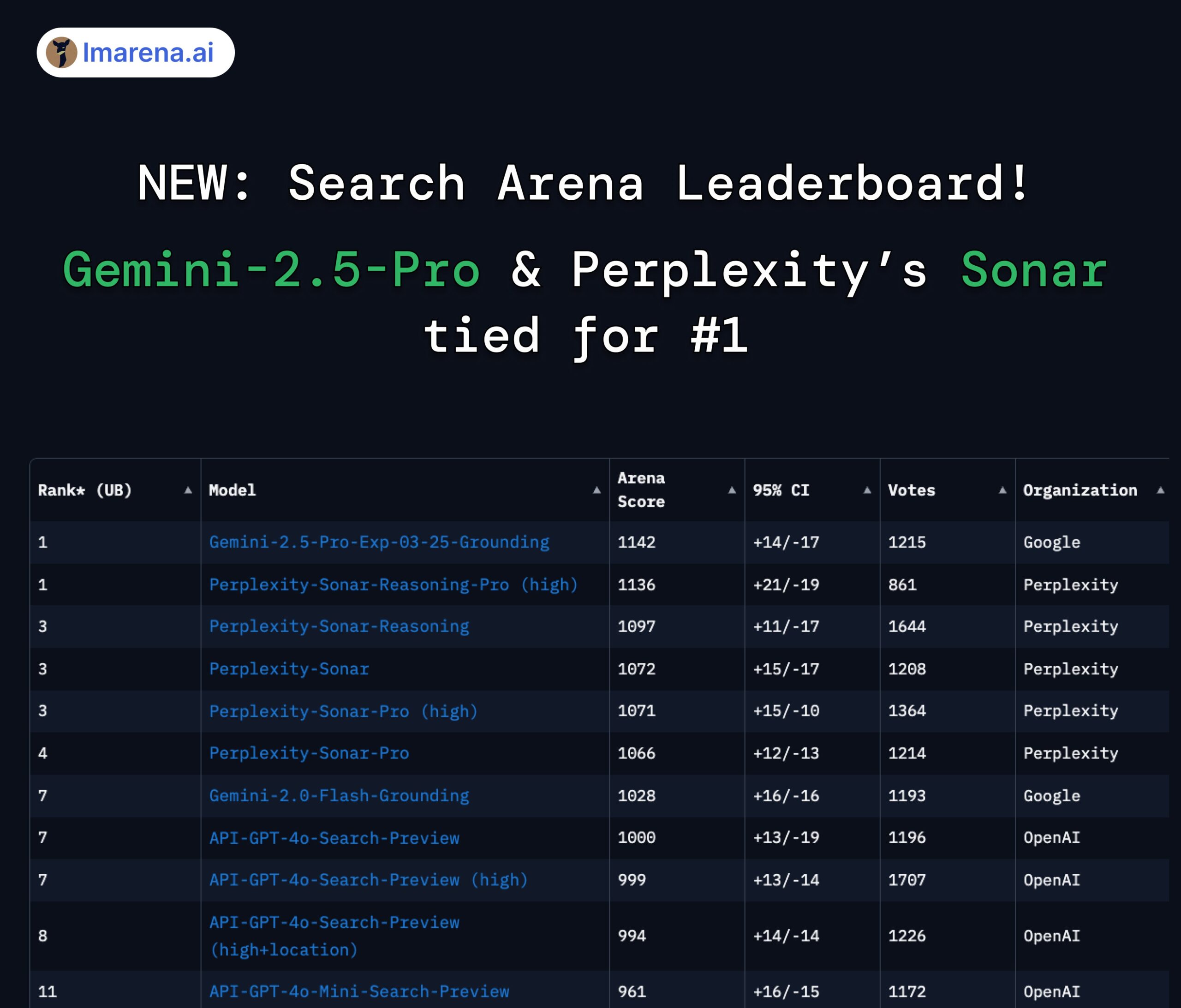

LMArena Search Sıralaması: Gemini 2.5 Pro ve Perplexity Sonar Birinci Sırada: Arama/ağ bağlantısı yeteneklerine sahip büyük modeller için LMArena tarafından yapılan arena değerlendirmesinde, Google’ın Gemini-2.5-Pro (Google Search ile birlikte) ve Perplexity’nin Sonar-Reasoning-Pro modelleri birinci sırayı paylaştı. Bu sonuç, Google DeepMind CEO’su Demis Hassabis ve Google Geliştirici İlişkileri Başkanı Logan Kilpatrick tarafından paylaşılarak onaylandı. Perplexity CEO’su Aravind Srinivas da dahili A/B testlerinin Sonar modelinin kullanıcı tutma oranında GPT-4o’dan daha iyi olduğunu ve performansının Gemini 2.5 Pro ve yeni yayınlanan GPT-4.1 ile karşılaştırılabilir olduğunu belirtti. Değerlendirmeyi düzenleyen lmarena.ai, 7000 kullanıcı oyu verisini açık kaynak olarak yayınladı. (Kaynak: lmarena_ai 1, lmarena_ai 2, AravSrinivas, demishassabis)

Meta, AI eğitmek için Avrupalı kullanıcıların herkese açık içeriklerini kullanmaya devam edecek: Meta şirketi, yapay zeka modellerini eğitmek için Avrupalı kullanıcıların herkese açık içeriklerini yeniden kullanmaya başlayacağını duyurdu. Daha önce Meta, Avrupa veri koruma kurumlarından (özellikle İrlanda Veri Koruma Komisyonu) gelen baskı ve düzenleyici gereklilikler nedeniyle bu uygulamayı durdurmuştu. Eğitime devam etme kararı, Meta’nın kullanıcı gizliliğini dengeleme, düzenlemelere (GDPR gibi) uyma ve AI modellerinin rekabet gücünü korumak için yeterli veri elde etme arasındaki sürekli çabalarını ve strateji ayarlamalarını yansıtıyor olabilir. Bu hamle, kullanıcı veri hakları ve AI eğitiminin şeffaflığı hakkındaki tartışmaları yeniden alevlendirebilir. (Kaynak: Reddit r/artificial)

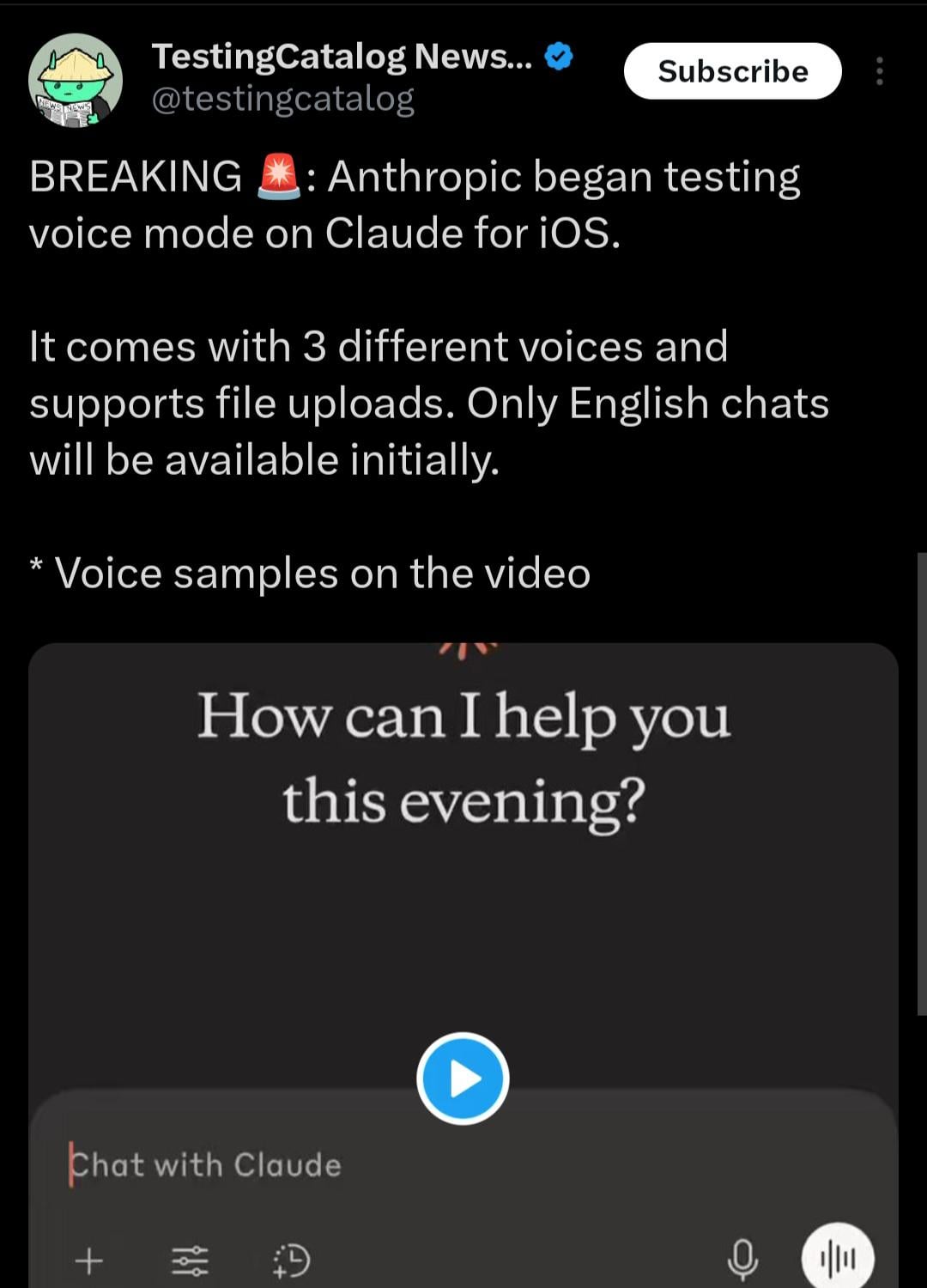

Claude mobil uygulamasına sesli etkileşim modu eklenebilir: X kullanıcısı @testingcatalog tarafından bulunan ipuçlarına göre, Anthropic, Claude mobil uygulamasına sesli etkileşim özelliği eklemeyi planlıyor olabilir. Ekran görüntüleri, uygulama arayüzünde bir mikrofon simgesinin göründüğünü gösteriyor, bu da kullanıcıların gelecekte Claude ile sesli olarak konuşabileceğini ima ediyor; tıpkı ChatGPT ve Google Gemini uygulamalarının zaten sunduğu ses modları gibi. Bu, Claude’un mobil cihazlardaki etkileşim biçimlerini daha çeşitli ve kullanışlı hale getirecek, kullanıcı deneyimini daha da iyileştirecek ve diğer ana akım AI asistanlarıyla işlevsellik açısından aynı seviyeye getirecektir. (Kaynak: Reddit r/ClaudeAI)

Zhipu Z1 serisi modellerin hızı dikkat çekiyor, “anlık model” olarak adlandırılıyor: Zhipu AI’nin en son yayınladığı Z1 serisi modeller, özellikle GLM-Z1-AirX sürümü, son derece hızlı çıkarım hızı nedeniyle dikkat çekiyor. Bazı analizler onu “anlık model” olarak adlandırıyor ve ilk yanıtı 0.3 saniye içinde tamamlayıp 50’den fazla Çince karakter üretebildiğini belirtiyor; bu hız insan sinirsel refleks süresine yakın. Bu düşük gecikme süresi ve yüksek verim, insan-makine etkileşim modunu “soru sor – bekle – cevap al”dan neredeyse gerçek zamanlı senkronize diyaloğa dönüştürme potansiyeline sahip; özellikle eğitim, müşteri hizmetleri, içerik oluşturma ve Agent çağrıları gibi yanıt hızının kritik olduğu senaryolar için uygun. Z1-AirX’in API sürümünün hızının 200 token/s’ye ulaştığı iddia ediliyor. (Kaynak: 公众号)

AI Yerel Oyunlar: Verimlilik Artırıcı Araçlardan Oynanış İnovasyonuna Evrim ve Zorluklar: Oyun endüstrisi, AI’yi geliştirme ve operasyon verimliliğini artırmak için kullanmaktan (sanat üretimi, kod yardımı, otomatik test gibi) gerçek “AI yerel oyunları” keşfetmeye doğru ilerliyor. AI yerel oyunlarının özü, AI’nin oynanışa derinlemesine entegre olması, önceden belirlenmiş senaryolar yerine oyuncu etkileşimiyle yönlendirilen dinamik içerik ve kişiselleştirilmiş deneyimler yaratmasıdır. MiHoYo kurucusu Cai Haoyu’nun yatırım yaptığı “Whispers from the Star” ve Giant Network’ün “Space Kill” oyunundaki AI oyuncu modu bu tür keşiflerin örnekleridir. Ancak, AI yerel oyunlarını gerçekleştirmek birçok zorlukla karşı karşıyadır: teknik düzeyde model yetenekleri, kararlılık ve maliyet sorunlarının çözülmesi gerekir; tasarım düzeyinde olgun örnekler eksiktir ve kontrol edilebilirlik ile özgürlük arasında bir denge kurulması gerekir; kullanıcı düzeyinde oyuncuların eğlence ve etkileşim derinliği taleplerinin karşılanması gerekir; ayrıca içerik uyumluluğu ve etik riskler de vardır. Sektör şu anda hala erken keşif aşamasındadır ve olgunlaşmış uygulamalara henüz uzaktır. (Kaynak: 界面新闻)

🧰 Araçlar

Beş Yaratıcı AI Uygulaması: 36Kr, son zamanlarda toplanan AI yerel uygulama inovasyon örneklerinden yaratıcı ve pratik beş AI aracını derledi: 1) AiPPT.com: Tek bir cümleyle veya dosya (Word, PDF, Xmind, bağlantı) içe aktararak hızla PPT oluşturur, çevrimdışı çalışmayı destekler. 2) Shinezone AI Patted Mirror: Fotoğraf çekme, video kaydetme, gerçek zamanlı çeviri, formül tanıma gibi işlevlere sahip AI gözlük. 3) Lianxin Digital Unconscious Interrogation Intelligent Agent: Psikolojik büyük model “Insight into Human” temel alınarak, mikro ifadeleri, sesi, fizyolojik sinyalleri analiz ederek sorgulamaya yardımcı olur ve raporlar oluşturur. 4) Vali Shoes AI: Anahtar kelimeler girerek 10 saniyede 8 ayakkabı tasarımı oluşturur, malzeme kütüphanesi ve kalıp verilerini entegre eder, üretime bağlar. 5) Southern ShiTong Sandbox HR Intelligent Agent: Sosyal güvenlik yönetimi gibi insan kaynakları görevlerini yerine getirir, politika yorumlama, maliyet hesaplama, akıllı işlem yapma, risk uyarısı gibi işlevler sunar. Bu uygulamalar, AI’nin verimlilik araçları, akıllı donanım, profesyonel alanlar (güvenlik, tasarım, İK) gibi alanlardaki potansiyelini göstermektedir. (Kaynak: 36Kr)

Haisin Intelligence, AI Sıfır Kod Geliştirme Platformu “Haisnap”ı Yayınladı: Pekin devlet destekli Haisin Intelligence Technology, “Haisnap” adlı AI sıfır kod/düşük kod geliştirme platformunu tanıttı. Kullanıcılar, doğal dil kullanarak gereksinimlerini tanımlayabilir ve AI’nin otomatik olarak web uygulamaları veya küçük oyunlar oluşturmasını sağlayabilirler. Platformun özelliği, oluşturma sürecinde kodun gerçek zamanlı olarak görünür olması ve diyalog yoluyla ikincil düzenleme ve değişiklikleri desteklemesidir. Kullanıcıların geliştirdiği uygulamalar, başkalarının göz atması, kullanması ve yeniden oluşturması (remix) için platformun “Yaratıcı Topluluğu”nda yayınlanabilir. Platform şu anda ücretsiz olarak açıktır ve AI uygulama geliştirme engelini düşürmeyi, herkesin yaratıcılığını teşvik etmeyi, özellikle gençlerin AI eğitimi ve endüstri uygulamalarına odaklanmayı amaçlamaktadır. (Kaynak: 量子位)

Açık Kaynak Bilgi Bankası Soru Cevap Sistemi ChatWiki Yayınlandı, GraphRAG ve WeChat Entegrasyonunu Destekliyor: ChatWiki, büyük dil modellerini (DeepSeek, OpenAI, Claude gibi 20’den fazla modeli destekler) ve geri alma artırılmış üretim (RAG) teknolojisini entegre eden yeni bir açık kaynak bilgi bankası AI soru cevap sistemidir. Karmaşık sorguları işlemek için özellikle bilgi grafiği tabanlı GraphRAG’ı destekler. Sistem özellikleri şunları içerir: özel bilgi bankaları oluşturmak için çeşitli formatlardaki belgelerin (OFD, Word, PDF vb.) içe aktarılmasını destekleme; RAG doğruluğunu artırmak için anlamsal bölümlemeyi destekleme; bilgi bankasını herkese açık bir belge sitesi olarak yayınlayabilme; WeChat resmi hesapları, WeChat müşteri hizmetleri gibi ekosistemlere sorunsuz bir şekilde bağlanmak ve AI sohbet botları oluşturmak için API arayüzleri sağlama; yerleşik görsel iş akışı düzenleme aracı; üçüncü taraf iş verileriyle entegrasyonu destekleme; kurumsal düzeyde izin yönetimi sağlama; Docker ve kaynak kodunun yerel olarak dağıtılmasını destekleme. (Kaynak: 公众号)

ModelScope Topluluğu MCP Meydanı’nı Başlattı, Ülkenin En Büyük MCP Hizmet Ekosistemini Oluşturuyor: Alibaba’nın AI model topluluğu ModelScope, arama, harita, ödeme, geliştirici araçları gibi alanları kapsayan yaklaşık 1500 adet Model Context Protocol (MCP) uygulayan hizmeti bir araya getiren “MCP Meydanı”nı resmi olarak başlattı. Bu, ülkenin en büyük MCP Çince topluluğunu oluşturmayı hedefliyor. Alipay ve MiniMax’in birçok MCP hizmeti burada özel olarak ilk kez sunuldu; örneğin Alipay’in ödeme, sorgulama, iade yetenekleri ve MiniMax’in ses, görüntü, video oluşturma yetenekleri, hepsi MCP protokolü aracılığıyla AI akıllı ajanları tarafından çağrılabilir. Geliştiriciler, ModelScope MCP Deney Alanı’nda basit JSON yapılandırması ve ücretsiz bulut kaynakları aracılığıyla bu hizmetleri hızla deneyebilir ve entegre edebilir, bu da AI uygulamalarının harici araçlara ve verilere erişim engelini büyük ölçüde azaltır. ModelScope ayrıca, çeşitli MCP hizmetlerinin kalitesini ve performansını değerlendirmek için MCP Bench’i başlattı. (Kaynak: 新智元)

Open WebUI WebSearch Özelliği Kullanımı Tartışması: Reddit topluluğu kullanıcıları, Open WebUI’de Web Search özelliğinin nasıl kullanılacağını tartışıyor. Sorunlar, arama motoru tarafından kullanılan sorgu anahtar kelimelerinin nasıl hassas bir şekilde kontrol edileceği ve Web Search özelliğinin belirli modellerle nasıl sınırlandırılacağı üzerine yoğunlaşıyor, böylece özel modellerin verilerinin yanlışlıkla ağa gönderilmesi önlenir. Bu, kullanıcıların entegre arama özelliklerine sahip AI araçlarını kullanırken kontrol hassasiyeti ve gizlilik güvenliği konusundaki pratik ihtiyaçlarını yansıtıyor. (Kaynak: Reddit r/OpenWebUI 1, Reddit r/OpenWebUI 2)

Kullanıcılar Model Context Protocol (MCP) Hakkında Anlayış Arıyor: Reddit topluluğunda bir kullanıcı, Model Context Protocol (MCP) hakkında açıklama isteyen bir gönderi paylaştı. Bu, MCP standardının yaygınlaşması ve uygulanmasıyla (ModelScope MCP Meydanı gibi), geliştirici ve kullanıcı topluluğunun bu yeni teknolojiyi ve çalışma prensiplerini anlama ihtiyacının arttığını gösteriyor. (Kaynak: Reddit r/OpenWebUI)

📚 Öğrenme

ICLR 2025 Zaman Testi Ödülü Adam Optimizer ve Dikkat Mekanizmasına Verildi: Uluslararası Öğrenme Temsilleri Konferansı (ICLR), 2025 yılı “Zaman Testi Ödülü”nü (Test of Time Award) on yıl önce (2015) yayınlanan iki dönüm noktası niteliğindeki makaleye verdi. Biri Diederik P. Kingma ve Jimmy Ba tarafından yazılan “Adam: A Method for Stochastic Optimization” idi; bu makalede önerilen Adam optimizer, derin öğrenme modeli eğitiminde standart bir algoritma haline geldi. Diğeri ise Dzmitry Bahdanau, Kyunghyun Cho ve Yoshua Bengio tarafından yazılan “Neural Machine Translation by Jointly Learning to Align and Translate” idi; bu makale ilk kez dikkat mekanizmasını tanıttı ve Transformer mimarisi ile modern büyük dil modellerinin temelini attı. Bu iki ödül, temel araştırmaların mevcut AI gelişimindeki derin etkisini vurguluyor. (Kaynak: 新智元)

AI Gelişiminin Kısa Tarihi ve Kurumsal Evrim İncelemesi: Makale, yapay zekanın 20. yüzyılın ortalarından günümüze kadar olan gelişim sürecini sistematik olarak inceliyor. Anahtar noktalar arasında Turing Testi, Dartmouth Konferansı, sembolizm ve uzman sistemler, AI kışı, makine öğreniminin yükselişi (DeepBlue, PageRank), derin öğrenme devrimi (AlexNet, AlphaGo) ve mevcut büyük model çağı (GPT serisi, üretken AI ticarileşmesi, açık kaynak ve kapalı kaynak tartışması) yer alıyor. Aynı zamanda makale, AI şirketlerinin gelişimini dört döneme ayırıyor: Öncü Dönem (2000-2010, araç tipi uygulama keşfi), Altına Hücum Dönemi (2011-2016, platform yetkilendirme ve veri odaklı patlama), Balon Dönemi (2017-2020, senaryo kapma yarışı ve ticarileşme darboğazı) ve Yeniden Yapılanma Dönemi (2021-günümüz, büyük model odaklı yeni düzen). Makale, hesaplama gücü, veri ve algoritmaların sinerjik etkisini ve DeepSeek gibi yeni güçlerin düzen üzerindeki etkisini vurguluyor. (Kaynak: 混沌大学)

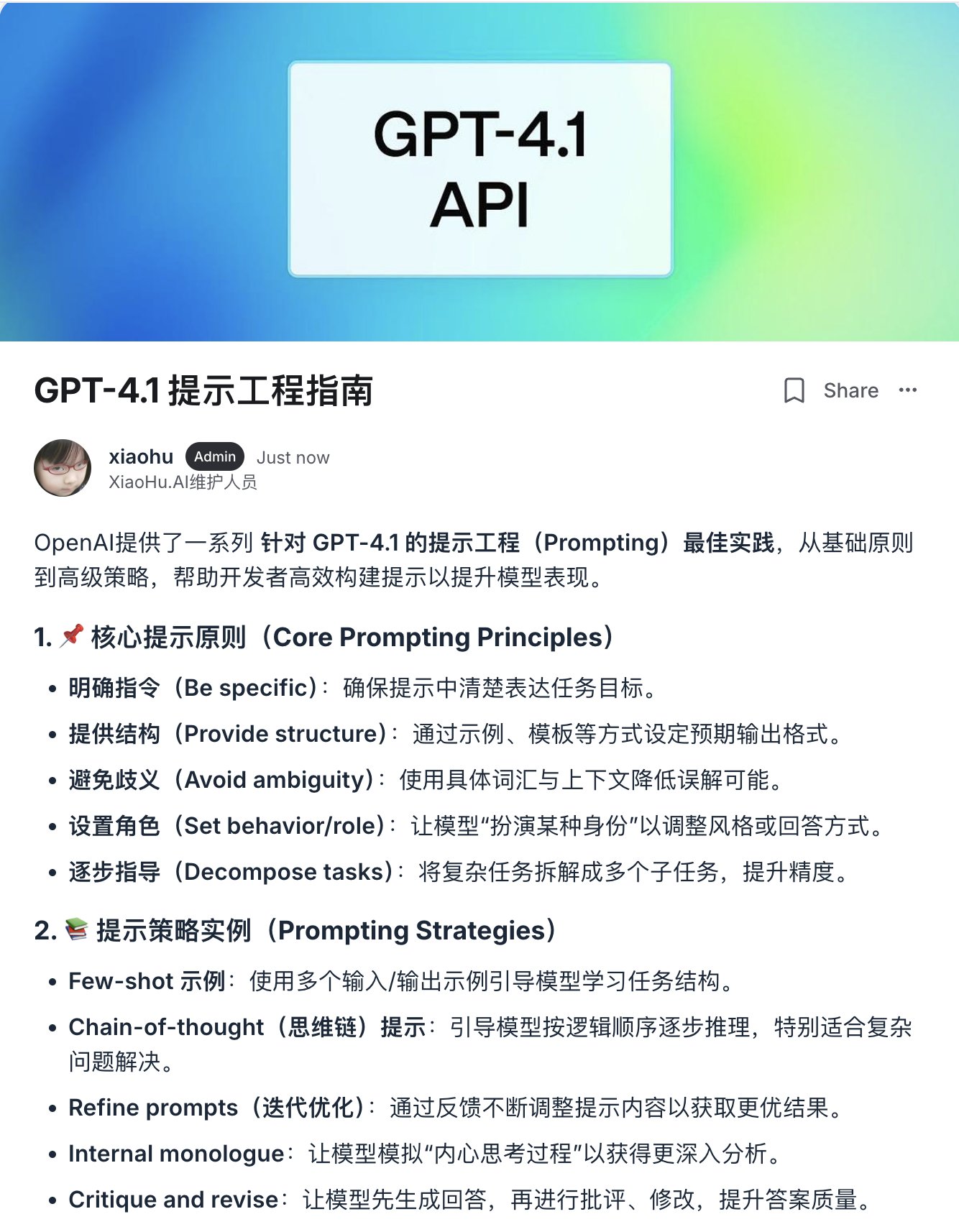

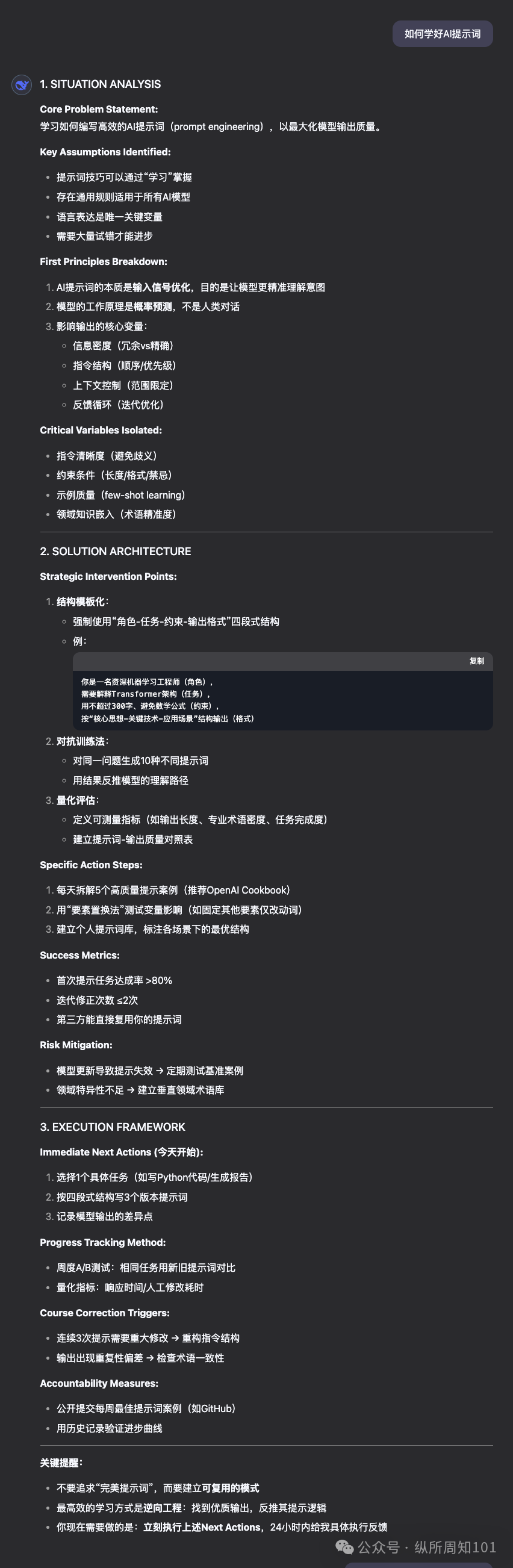

OpenAI, GPT-4.1 Prompt Mühendisliği Kılavuzunu Yayınladı: GPT-4.1 serisi modellerin yayınlanmasıyla birlikte OpenAI, prompt mühendisliği (Prompting) kılavuzunu güncelledi. Kılavuz, GPT-4.1 serisi modellerin GPT-4 gibi önceki modellere kıyasla talimatları daha katı ve daha harfi harfine takip edeceğini, açık ve spesifik promptlara daha duyarlı olacağını vurguluyor. Model beklendiği gibi performans göstermezse, genellikle kısa ve net açıklamalar eklemek davranışını yönlendirmek için yeterli olacaktır. Bu, geçmiş modellerin kullanıcının niyetini tahmin etme eğiliminden farklıdır ve geliştiricilerin mevcut prompt stratejilerini ayarlamaları gerekebilir. Kılavuz, temel ilkelerden ileri düzey stratejilere kadar en iyi uygulamaları sunarak geliştiricilerin yeni modellerin özelliklerinden daha iyi yararlanmalarına yardımcı olur. (Kaynak: dotey, Reddit r/LocalLLaMA)

Şanghay Jiao Tong Üniversitesi ve Diğerleri, Çok Modlu Modellerin Fiziksel Anlamasını Zorlayan Uzay-Zaman Zekası Benchmark’ı STI-Bench’i Yayınladı: Şanghay Jiao Tong Üniversitesi, birçok kurumla işbirliği içinde, çok modlu büyük modellerin (MLLM) uzay-zaman zekasını değerlendiren ilk benchmark testi olan STI-Bench’i yayınladı. Bu benchmark, gerçek dünya videolarını kullanarak hassas, nicel uzay-zaman anlama yeteneklerine odaklanır ve ölçek ölçümü, uzamsal ilişkiler, 3D konumlandırma, yer değiştirme yolu, hız ivmesi, ego-merkezli yönelim, yörünge tanımı, duruş tahmini olmak üzere sekiz görev içerir. GPT-4o, Gemini 2.5 Pro, Claude 3.7 Sonnet, Qwen 2.5 VL gibi önde gelen modeller üzerinde yapılan değerlendirmeler, mevcut modellerin bu görevlerde genel olarak düşük performans gösterdiğini (doğruluk <%42), özellikle nicel uzamsal özellikleri, zamansal dinamik değişiklikleri ve modlar arası bilgi entegrasyonunu işlemede zorlandığını gösterdi. Bu benchmark, mevcut MLLM’lerin fiziksel dünya anlama konusundaki sınırlamalarını ortaya koyuyor ve sonraki araştırmalar için yön sağlıyor. (Kaynak: 量子位)

Pekiştirmeli Öğrenme ve Çok Amaçlı Optimizasyon Kombinasyonu Araştırması İlgi Görüyor: Pekiştirmeli öğrenme (RL) ve çok amaçlı optimizasyon (MOO) kesişim alanı, AI karar verme araştırmalarında sıcak bir konu haline geliyor. Bu kombinasyon, akıllı ajanların tek bir optimumu takip etmek yerine karmaşık ortamlarda birden fazla (muhtemelen çelişkili) hedefi dengelemesini sağlamayı amaçlıyor. Örneğin, HKUST otonom sürüş için güvenlik ve enerji verimliliğini aynı anda optimize etmek üzere dinamik gradyan dengeleme çerçevesi önerdi; MIT’nin Pareto strateji arama algoritması robot kontrolü için kullanılıyor; Alibaba Cloud, getiri ve riski dengelemek için finansal işlemlerde çok amaçlı hizalama teknolojisini kullanıyor. CMORL (Sürekli Çok Amaçlı Pekiştirmeli Öğrenme) ve kombinatoryal optimizasyon için Pareto kümesi öğrenimi gibi ilgili araştırmalar, RL ajanlarının dinamik olarak değişen veya birden fazla optimizasyon boyutuna sahip gerçek dünya problemlerini nasıl daha etkili bir şekilde ele alabileceğini araştırıyor. (Kaynak: 公众号)

Otomatik Karşı Saldırı ve Savunma Platformu A³D Açık Kaynak Olarak Yayınlandı (TPAMI 2025): Askeri Bilimler Akademisi Ulusal Savunma Teknolojisi İnovasyon Enstitüsü Akıllı Tasarım ve Dayanıklı Öğrenme Araştırma Ekibi (IDRL), A³D (Otomatik Karşı Saldırı ve Savunma) adlı bir platform geliştirdi ve açık kaynak olarak yayınladı. Bu platform, otomatik makine öğrenimi (AutoML) teknolojisini kullanarak, saldırı-savunma oyun teorisi fikirleriyle birleşerek, dayanıklı sinir ağı mimarilerini ve verimli karşı saldırı stratejilerini otomatik olarak aramayı amaçlıyor. Platform, otomatik savunma için çeşitli sinir ağı mimarisi arama (NAS) yöntemlerini ve dayanıklılık değerlendirme metriklerini (norm saldırıları, anlamsal saldırılar, karşı gizleme vb.) entegre ederken, aynı zamanda optimizasyon algoritmaları aracılığıyla en iyi kombinasyon saldırı şemalarını arayabilen otomatik karşı saldırı modülü sunar. Araştırma sonuçları üst düzey dergi TPAMI’de yayınlandı ve kod Red Mountain Open Source gibi platformlarda yayınlandı, DNN model güvenliğini değerlendirmek ve artırmak için yeni araçlar sağlıyor. (Kaynak: 公众号)

Florida Üniversitesi NLP/LLM Alanında Tam Burslu Doktora/Stajyer Arıyor: Florida Üniversitesi Bilgisayar Bilimleri Bölümü’nden Yardımcı Doçent Yuanyuan Lei (2025 Güz döneminde göreve başlayacak), 2025 Güz veya 2026 Bahar döneminde başlayacak tam burslu doktora öğrencileri ve esnek zamanlı araştırma stajyerleri (uzaktan olabilir) aradığını duyurdu. Araştırma alanları Doğal Dil İşleme (NLP) ve Büyük Dil Modelleri (LLM) üzerine odaklanıyor; özellikle bilgiyle zenginleştirilmiş LLM’ler, olgu doğrulama, akıl yürütme ve planlama, NLP uygulamaları (çok modlu, hukuk, iş, bilim vb.). Bilgisayar, elektronik mühendisliği, istatistik, matematik gibi ilgili alanlardan gelen, AI araştırmalarına ilgi ve motivasyonu olan öğrenciler başvurmaya davet ediliyor. E-postada, Florida SB-846 yasasının Çin anakarasından öğrenci alımı üzerindeki potansiyel etkileri ve başa çıkma yolları belirtiliyor. (Kaynak: PaperWeekly)

Difüzyon Modelleri Üzerine Yeni Araştırma: Zamansal Olarak İlişkili Gürültü Önceliği: Bir arXiv makalesi (“How I Warped Your Noise: a Temporally-Correlated Noise Prior for Diffusion Models”), difüzyon modelleri için yeni bir tür gürültü önceliği önermektedir. Bu yöntem, zamansal olarak ilişkili gürültü ekleyerek (muhtemelen video) difüzyon modellerinin üretim kalitesini veya verimliliğini iyileştirmeyi amaçlamaktadır. Spesifik teknik detaylar için orijinal makaleye başvurulmalıdır. (Kaynak: Reddit r/MachineLearning)

Otomatik Bilimsel Keşif Üzerine Yeni Araştırma: AI Scientist-v2: Bir arXiv makalesi (“The AI Scientist-v2: Workshop-Level Automated Scientific Discovery via Agentic Tree Search”), AI Scientist-v2 sistemini tanıtmaktadır. Bu sistem, “çalıştay seviyesinde” (Workshop-Level) otomatik bilimsel keşif gerçekleştirmeyi amaçlayan Agentic Tree Search (Akıllı Ajan Ağaç Araması) yöntemini kullanmaktadır. Bu, araştırmacıların daha ileri düzeyde, daha özerk bilimsel araştırma ve keşif için AI akıllı ajanlarını kullanmayı araştırdıklarını göstermektedir. (Kaynak: Reddit r/MachineLearning)

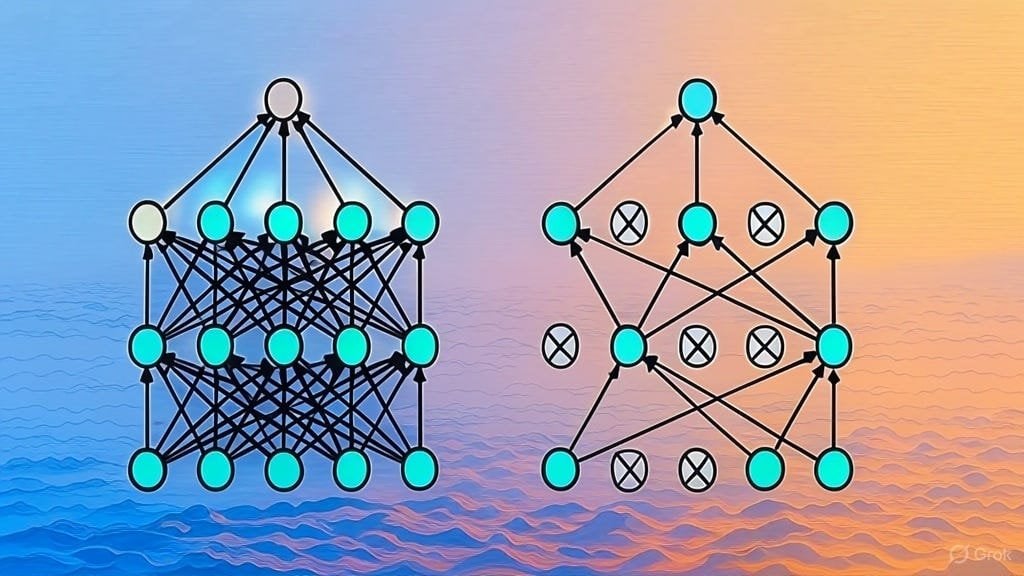

Dropout Düzenlileştirme Uygulaması Açıklaması: Bir Substack makalesi, Dropout düzenlileştirme tekniğinin nasıl uygulandığını ayrıntılı olarak açıklamaktadır. Dropout, derin öğrenmede yaygın olarak kullanılan bir düzenlileştirme tekniğidir ve eğitim sürecinde nöronların bir kısmını rastgele “bırakarak” modelin aşırı uyumunu önler. Bu makale, Dropout’un çalışma prensibini derinlemesine anlamak veya bu tekniği kendi başına uygulamak isteyen öğrenicilere yönelik olabilir. (Kaynak: Reddit r/deeplearning)

LLM Mimarisi Makale Listesi Talebi: Reddit kullanıcısı, büyük dil modeli (LLM) mimarileri hakkındaki arXiv makalelerini paylaşmak ve toplamak için bir tartışma başlattı. Listelenen mimariler arasında BERT, Transformer, Mamba, RetNet, RWKV, Hyena, Jamba, DeepSeek serisi vb. bulunmaktadır. Bu liste, mevcut LLM mimarisi araştırmalarının çeşitliliğini ve hızlı gelişimini yansıtmakta ve bu alanı sistematik olarak anlamak isteyen araştırmacılar için referans değeri taşımaktadır. (Kaynak: Reddit r/MachineLearning)

💼 Ticari

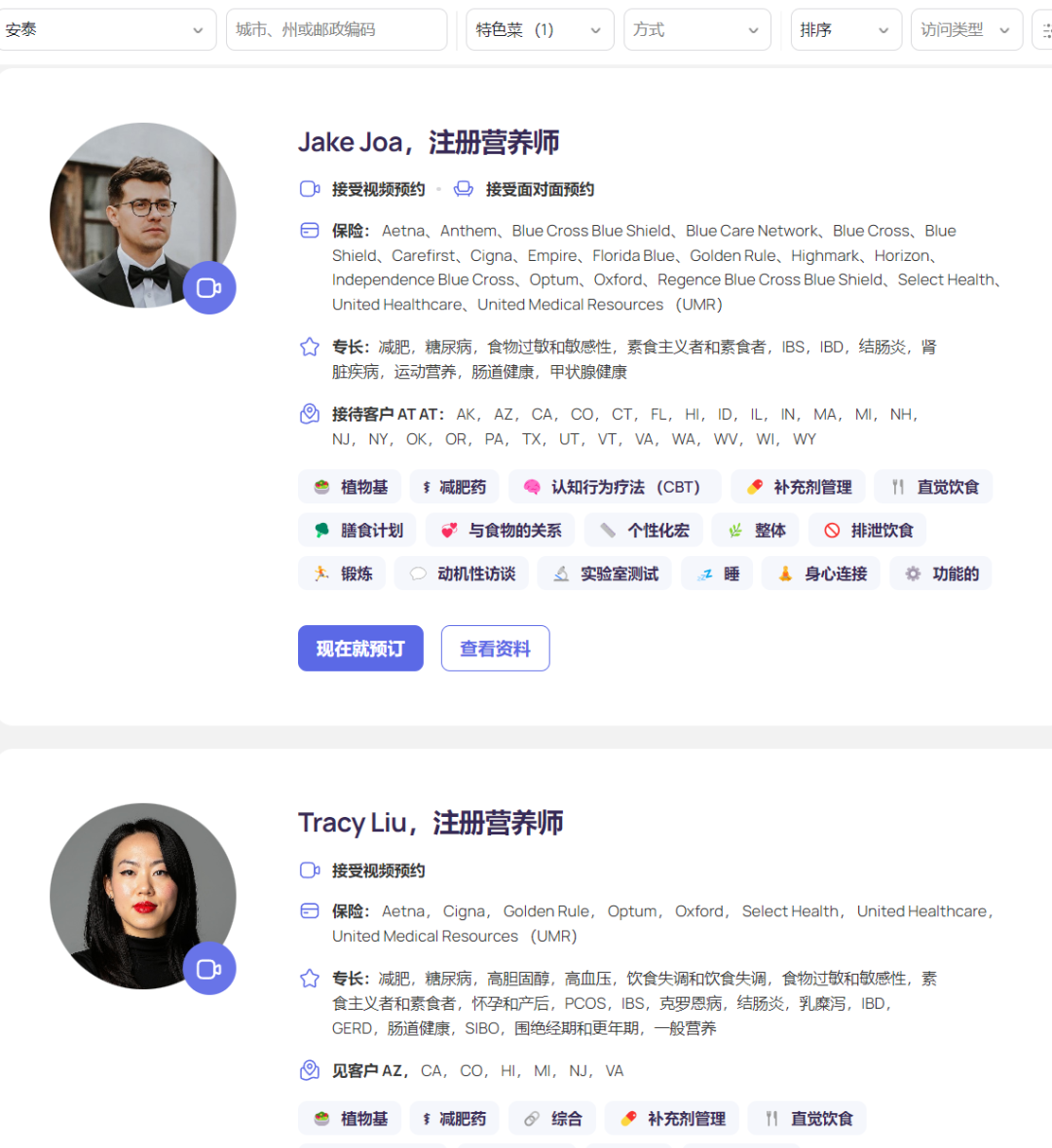

AI Beslenme Platformu Fay, 50 Milyon Dolar Finansman Aldı, Yıllık Geliri 50 Milyona Ulaştı: Silikon Vadisi AI beslenme platformu Fay, Goldman Sachs liderliğindeki 50 milyon dolarlık B serisi finansman turunu tamamladı. Toplam finansmanı 75 milyon dolara, değerlemesi ise 500 milyon dolara ulaştı. Fay, kayıtlı diyetisyenleri hastalarla buluşturuyor ve AI kullanarak hizmet verimliliğini artırıyor (hasta başına 6.5 saatten 2 saate düşürdüğünü iddia ediyor), klinik not oluşturma (ICD kodlaması dahil), kişiselleştirilmiş beslenme planı hazırlama, sigorta talepleri, arka ofis yönetimi gibi görevleri otomatikleştiriyor. Platform, GLP-1 zayıflama ilaçlarının getirdiği artan beslenme danışmanlığı talebini hassasiyetle yakaladı ve sigorta şirketleriyle işbirliği yaparak (beslenme müdahalesi kronik hastalıkların uzun vadeli tıbbi maliyetlerini düşürebilir) ödeme sürecini kolaylaştırdı. Fay platformunda 3000’den az diyetisyen olmasına rağmen 50 milyon dolarlık yıllık gelir (ARR) elde etti, bu da AI’nin dikey tıp alanında profesyonelleri güçlendirme ve ödeme yapanlarla bağlantı kurma konusundaki başarılı iş modelini gösteriyor. (Kaynak: 乌鸦智能说)

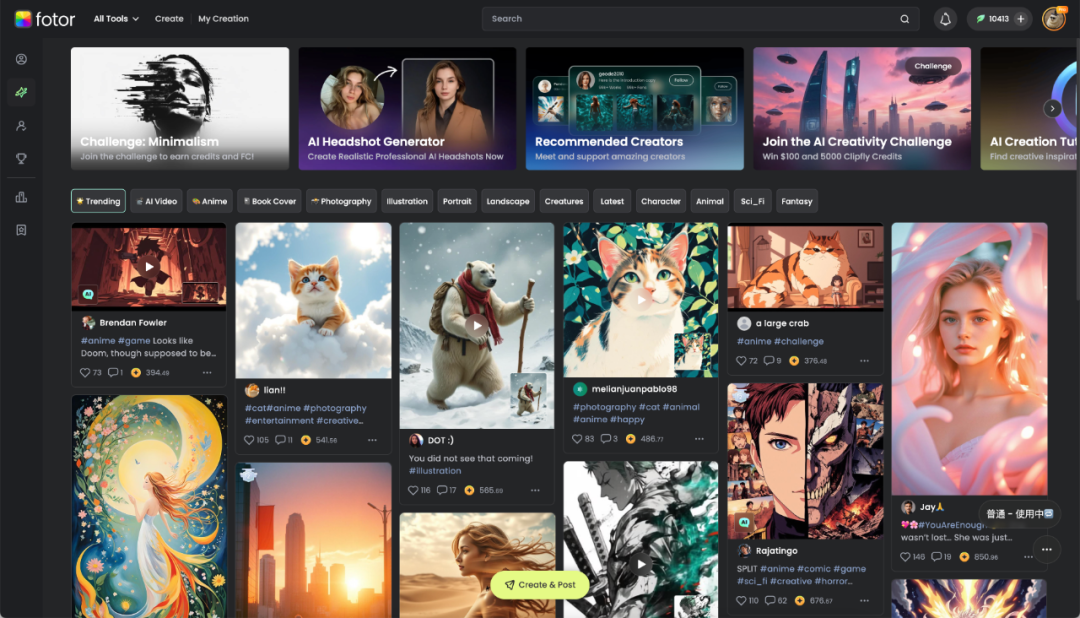

Chengdu Hengtu Technology: AI Dijital Yaratıcılığı Güçlendiriyor, Yurtdışında Kâr Ediyor: Chengdu merkezli Hengtu Technology, çekirdek ürünü Fotor (görüntü ve video düzenleme platformu) ile küresel olarak yaklaşık 700 milyon kullanıcıya ulaştı, aylık aktif kullanıcı sayısı on milyonu aştı ve özellikle yurtdışı pazarlarda öne çıktı. Şirket, yurtdışına açılan ve ölçekli kâr elde eden ilk AI uygulama şirketlerinden biridir. Şirket 16 yıldır görüntü işleme teknolojisine odaklanmış ve 2022’de AIGC işlevlerini (metinden resme, metinden videoya vb.) hızla Fotor ve yeni platform Clipfly’a entegre etmiştir. Fotor, AI aracılığıyla dijital görsel içerik oluşturma engelini düşürerek e-ticaret, kişisel medya, reklamcılık, kültür turizmi, eğitim gibi birçok sektöre hizmet vermektedir. Hengtu Technology, AI kullanarak “kültürel çeviri” yapmakta, Çin kültürünün yurtdışına açılmasına yardımcı olmakta ve dijital yaratıcı endüstri için yeni yollar keşfetmektedir. (Kaynak: 36Kr四川)

Kurumsal AI Uygulama Pratikleri: Değere Odaklanma, İnce Ayarı Azaltma, İşbirliğini Teşvik Etme: Şirketler, büyük modelleri uygulama sürecinde, erken keşif aşamasından daha pragmatik bir değer odaklı yaklaşıma geçtiler. Başarılı AI uygulamaları genellikle tekrarlayıcı, yaratıcı talep içeren ve kalıpları yerleşmiş senaryolara odaklanır; örneğin bilgi sorgulama, akıllı müşteri hizmetleri, materyal oluşturma, veri analizi gibi. Şirketler genel olarak, körü körüne model ince ayarı peşinde koşmanın genellikle düşük yatırım getirisi sağladığını, önceliğin bilgi yönetimi ve akıllı ajan platformları (başlangıçta RAG ağırlıklı) oluşturmaya verilmesi gerektiğini fark ettiler. AI uygulaması, iş birimlerinin derin katılımını ve üst düzey desteği gerektirir; “hızlı kazanım pilotları + AI temel hazırlığı” çift kulvarlı stratejisi daha iyi sonuç verir. Organizasyonel yetenek açısından, şirketler iş birimlerini güçlendirmek için küçük, uzmanlaşmış AI ekipleri kurma eğilimindedir ve dışarıdan en iyi yetenekleri getirerek, içerideki genç yetenekleri (stajyerler + deneyimli iş uzmanları eşleştirmesi) yetiştirerek ve üçüncü taraf uzmanlarla işbirliği yaparak yetenek eksikliğini gidermeye çalışırlar. (Kaynak: AI前线)

STAR Market Yapay Zeka Endeksi İlgi Görüyor, Yeni Yatırım Odağı Olabilir: Rapor, son piyasa dalgalanmalarına rağmen Çin yapay zeka endüstrisinin “hesaplama gücü – model – uygulama” şeklinde eksiksiz bir kapalı döngü oluşturduğunu ve güçlü bir dayanıklılık sergilediğini belirtiyor. Ülkenin “Doğu Verisi Batı Hesabı” projesi, DeepSeek gibi düşük maliyetli modeller ve insansı robotlar gibi uygulama atılımları öne çıkanlar arasında. AI, önümüzdeki on yıl içinde küresel ekonomik büyümenin önemli bir motoru olarak görülüyor ve ilgili varlıkların uzun vadeli getirileri dikkat çekici. Bu bağlamda, Şanghay Menkul Kıymetler Borsası STAR Market Yapay Zeka Endeksi (hesaplama çipleri ve AI uygulamalarına odaklanan), yüksek büyüme beklentileri ve artan yerli ve milli içeriği nedeniyle yatırımcıların dikkatini çekiyor. E Fund gibi kurumlar, bu endeksi takip eden ETF’ler ve bağlantılı fonlar (örneğin 588730, 023564/023565) sunarak yatırımcılara yerli AI endüstri zincirine yatırım yapma araçları sağlıyor. (Kaynak: 创业最前线)

Apple’ın AI Stratejisi Açıklığa Yöneliyor: Siri Geliştirmede Üçüncü Taraf Modellerine İzin Veriyor: “Kişiselleştirilmiş Siri” işlevinin geliştirilmesini hızlandırmak ve rakiplerini yakalamak için Apple’ın uzun süredir devam eden şirket içi kapalı geliştirme stratejisini ayarladığı bildiriliyor. Yeni Yazılım Mühendisliği Kıdemli Başkan Yardımcısı Craig Federighi liderliğinde, Siri mühendislerine ilk kez Siri işlevlerini geliştirmek için üçüncü taraf büyük dil modellerini kullanma izni verildi, bu da daha önce yalnızca Apple’ın kendi geliştirdiği modelleri kullanma kısıtlamasını kırdı. Bu değişikliğin, Apple’ın AI alanındaki teknolojik birikiminin göreceli olarak geride kalmasına ve “kişiselleştirilmiş Siri” işlevinin ertelenmesinin daha fazla kullanıcı memnuniyetsizliğine (hatta davalara) yol açmasını önlemeye yönelik kritik bir hamle olduğu düşünülüyor. Bu hamle, OpenAI veya Alibaba (iç pazar için) gibi harici model sağlayıcılarına Apple ile işbirliği yapma fırsatları sunabilir. (Kaynak: 三易生活)

🌟 Topluluk

DeepSeek, Doubao, Yuanbao Uygulamaları Arasında Yoğun Rekabet, Ürün Deneyimi Anahtar Haline Geldi: Yerli AI asistan uygulama pazarındaki rekabet kızıştı. DeepSeek, model yetenekleriyle patlama yaptıktan sonra kullanıcı sayısı hızla arttı ve ilk entegre eden Tencent Yuanbao’nun bir süreliğine zirveye çıkmasını sağladı. Ancak ByteDance’in Doubao’su, daha eksiksiz ürün işlevleri ve Douyin ile derin entegrasyonu sayesinde Yuanbao’yu tekrar geride bıraktı. Analizler, yalnızca güçlü modellere (DeepSeek gibi) bağlanmanın kısa vadeli fayda sağladığını, uzun vadeli rekabette uygulamanın kendi işlev zenginliğinin, kullanıcı deneyiminin, çoklu cihaz senkronizasyonunun ve platform ekosistemi entegrasyon yeteneğinin daha kritik olduğunu gösteriyor. Tüm oyuncuların model yetenekleri benzer hale geldikçe (örneğin hepsi derin düşünme yeteneğine sahip oldukça), gelecekteki rekabet odağı ürün tasarımı, operasyon stratejileri ve AI Agent gibi yeni uygulama biçimlerindeki atılımlar olacak. (Kaynak: 字母榜)

Asyalı Öğrencinin Geliştirdiği Mülakat Hile Aracı İnternette Tartışma Yarattı: Columbia Üniversitesi’nden Asyalı bir öğrenci olan Roy Lee, Interview Coder adlı bir AI aracı geliştirdi ve ChatGPT kullanarak Amazon, Meta, TikTok gibi birçok teknoloji şirketinin uzaktan teknik mülakatlarını geçti. Bu şirketlerin tekliflerini reddetmekle kalmadı, aynı zamanda hile aracını kullanma sürecini videoya kaydedip YouTube’da yayınladı. Amazon tarafından şikayet edildikten sonra okuldan uzaklaştırıldı. Roy Lee bunu umursamadı, aksine olayın ayrıntılarını ve okul ve şirketlerle olan e-posta yazışmalarını kamuoyuyla paylaştı, çok sayıda internet kullanıcısından destek ve sektörden ilgi gördü ve bu durumu bir fırsata çevirerek şirket kurdu. Bu olay, teknik mülakatların (özellikle LeetCode ezberleme modelinin) etkinliği, AI araçlarının işe alımdaki etik sınırları ve bireylerin büyük şirket sistemlerine meydan okuması gibi konularda hararetli tartışmalara yol açtı. (Kaynak: 直面AI)

Kullanıcı, Zhipu’nun Yeni Açık Kaynak GLM Modelini Bilgi Bankası ve MCP ile Test Etti: Bir kullanıcı, Zhipu AI’nin en son yayınladığı GLM serisi modellerini (API aracılığıyla çağrılan) test etti. Sonuçlar, GLM-Z1-AirX’in (ultra hızlı sürüm) FastGPT ile oluşturulan yerel bir bilgi bankasına bağlandığında yanıt hızının son derece yüksek olduğunu (200 token/s’ye ulaştığı iddia ediliyor) ve cevap kalitesinin sıradan modellere göre arttığını, daha ayrıntılı ve eksiksiz cevaplar ile karşılaştırma tabloları üretebildiğini gösterdi. GLM-4-Air (temel model), Agent görevlerini (ağ araması, yerel dosya yazma, Docker kontrolü, web sayfası özetleme gibi) yürütmek için MCP’ye (Model Context Protocol) bağlandığında, araçları doğru bir şekilde çağırıp görevleri tamamlayabildi, ancak performansı DeepSeek-V3’ten biraz daha düşüktü. Kullanıcı aynı zamanda Zhipu modelinin güvenlik konusundaki performansını da olumlu değerlendirdi (jailbreak promptlarına yanıt vermiyor). (Kaynak: 公众号)

“Süper Rasyonel Problem Çözücü” Prompt’u Paylaşıldı ve Model Performansları Karşılaştırıldı: Topluluk kullanıcısı, LLM’nin “süper rasyonel, ilk prensiplerle problem çözen” bir rol üstlenmesini amaçlayan gelişmiş bir prompt paylaştı. Bu prompt, modelin çalışma prensiplerini (problemi parçalama, çözümü mühendislik yaklaşımıyla ele alma, teslimat protokolü, etkileşim kuralları), yanıt formatını ve ton özelliklerini ayrıntılı olarak belirtiyor; mantık, eylem ve sonuca vurgu yapıyor, belirsizlik, bahaneler ve duygusal teselliyi reddediyor. Kullanıcı bu prompt’u kullanarak DeepSeek, Claude Sonnet 3.7 ve ChatGPT 4o’nun soruları yanıtlama, rehberlik sağlama ve ağ üzerinden kaynak önerme konularındaki performanslarını karşılaştırdı ve Claude 3.7’nin daha iyi sonuç verdiğini belirtti. Bu, özenle tasarlanmış prompt’ların LLM’lerin belirli görevlerdeki performansını önemli ölçüde yönlendirebileceğini ve artırabileceğini gösteriyor. (Kaynak: 公众号)

Topluluk GPT-4.1 Lansmanını Tartışıyor: Performans, Strateji ve İsimlendirme: OpenAI’nin GPT-4.1 serisi modellerini yayınlaması toplulukta geniş çaplı tartışmalara yol açtı. Bir yandan kullanıcılar, gerçek dünya testleri ve benchmark karşılaştırmalarıyla (Aider, Livebench, GPQA Diamond, KCORES Arena gibi), GPT-4.1’in kodlama konusunda önemli bir gelişme göstermesine rağmen, genel akıl yürütme yeteneğinde hala Google Gemini 2.5 Pro ve Claude 3.7 Sonnet’in gerisinde kaldığını tespit etti. Diğer yandan topluluk, OpenAI’nin ürün stratejisini (API ile ChatGPT’yi ayırma, GPT-4.5’i kullanımdan kaldırma), model iterasyon hızını ve kafa karıştırıcı isimlendirme yöntemini (4.1’in 4.5’ten sonra yayınlanması) tartıştı ve eleştirdi. Bazı görüşler OpenAI’nin inovasyon darboğazıyla karşı karşıya olabileceğini öne sürerken, bazıları bunun API ürün hattını optimize etme ve farklı fiyat/performans seçenekleri sunma stratejisi olduğunu düşünüyor. (Kaynak: dotey, op7418, Reddit r/LocalLLaMA 1, Reddit r/ArtificialInteligence, karminski3, Reddit r/LocalLLaMA 2)

ChatGPT Hukuki Danışmanlık Senaryosunda Başarı Gösteriyor, Kullanıcı Başarı Hikayesini Paylaştı: Reddit kullanıcısı, işle ilgili hukuki bir anlaşmazlığı çözmek için ChatGPT kullandığı başarılı bir vakayı paylaştı. Kullanıcı işten çıkarılma riskiyle karşı karşıyaydı, ChatGPT’ye belgeler sunarak ve onu İngiliz iş hukuku uzmanı rolüne sokarak işverenin usul hatasını keşfetti. ChatGPT tarafından hazırlanan mektupla müzakere ederek, sonunda 2 aylık maaş tazminatı içeren bir anlaşmaya vardı ve olumsuz bir sicilden kaçındı. Yorum bölümünde diğer kullanıcılar da hukuki mektuplar hazırlamak, duruşmalara hazırlanmak ve olumlu sonuçlar almak için AI (ChatGPT veya Gemini) kullandıkları deneyimlerini paylaştılar ve AI’nin hukuki yardım konusunda önemli ölçüde masraf ve zaman tasarrufu sağlayabileceğini belirttiler. (Kaynak: Reddit r/ChatGPT)

Kullanıcı OpenAI Deep Research Özelliğinin Etkisizliğinden Şikayetçi: Reddit kullanıcısı, OpenAI’nin Deep Research (Derin Araştırma) özelliğini eleştiren bir gönderi paylaştı ve üç ana sorunu olduğunu belirtti: 1) Arama sonuçları yanlış veya ilgisiz (Bing API’sine bağımlı); 2) Keşif yöntemi geniş kapsamlı araştırmadan ziyade derinlemesine öncelikli aramaya benziyor; 3) Kullanıcının araştırma hedeflerinden kopuk ve kısıtlamadan yoksun. Kullanıcı bunun gerçek derin araştırmadan ziyade genişletilmiş arama yeteneği gibi olduğunu düşünüyor. Bu, kullanıcıların mevcut AI Agent araştırma yeteneklerine yönelik beklentileri ile gerçek deneyimleri arasındaki farkı yansıtıyor. (Kaynak: Reddit r/deeplearning)

AI Tarafından Üretilen İçeriklerin Gösterimi ve Tartışılması: Topluluk kullanıcıları, çeşitli AI araçlarını (ChatGPT, Midjourney, Kling AI, Suno AI vb.) kullanarak oluşturdukları içerikleri aktif olarak paylaşıyorlar: hicivli karikatürler (Trump ve Musk), üniversitelerin kişileştirilmiş görüntüleri, alternatif II. Dünya Savaşı kısa filmi, Yunan mitolojisi karakter görüntüleri, 90’lar tarzı diş macunu reklamı, çok panelli çizgi romanlar vb. Bu paylaşımlar sadece AI’nin metin, görüntü, video, müzik üretme yeteneklerini göstermekle kalmıyor, aynı zamanda AI tarafından üretilen içeriğin yaratıcılığı, estetiği (örneğin “kitsch” olarak eleştirilmesi), sınırlamaları (örneğin çizgi roman karakter tutarlılığının zayıf olması) ve etik sorunları hakkında tartışmalara yol açıyor. (Kaynak: dotey 1, dotey 2, Reddit r/ChatGPT 1, Reddit r/ChatGPT 2, Reddit r/ChatGPT 3, Reddit r/ChatGPT 4, Reddit r/ChatGPT 5)

AI Eğitim Verisi Geri Besleme Döngüsünün “Model Çöküşü”ne Yol Açma Endişesi: Topluluk tartışması potansiyel bir riske odaklanıyor: AI tarafından üretilen içerik internette giderek arttıkça, gelecekteki AI modelleri eğer ağırlıklı olarak bu AI tarafından üretilen verilere dayanarak eğitilirse, “Model Çöküşü” (Model Collapse) yaşanabilir. Bu olgu, model performansının düşmesi, çıktıların daralması, tekrarlayıcı hale gelmesi, orijinallik ve doğruluktan yoksun kalması anlamına gelir; tıpkı fotokopinin sürekli kopyalanarak bulanıklaşması gibi. Kullanıcılar bunun bilginin gerçekliğini ve insan bakış açısını yavaşça aşındıracağından endişe ediyor. Tartışmada sentetik veri kullanarak eğitim, veri kalitesi kontrolünü güçlendirme gibi başa çıkma yöntemleri de belirtiliyor, ancak sorunun zaten yaşanıp yaşanmadığı ve nasıl etkili bir şekilde önlenebileceği konusunda tartışmalar sürüyor. (Kaynak: Reddit r/ArtificialInteligence)

Görüş: AI Çağında Hesaplama Gücü Yeni Petrol: Reddit kullanıcısı, AI gelişiminde veriden ziyade hesaplama gücünün (Compute) kritik darboğaz ve stratejik kaynak haline geleceği görüşünü öne sürüyor; tıpkı sanayi devrimindeki petrol gibi. Gerekçeler: Daha güçlü AI modelleri (özellikle akıl yürütme ve Agent sistemleri) üssel olarak artan hesaplama gücü gerektiriyor; robotlar gibi fiziksel etkileşimler devasa yeni veriler üretecek ve hesaplama gücü talebini daha da artıracak. Daha fazla hesaplama gücüne sahip olmak, doğrudan daha güçlü ekonomik üretim yeteneğine dönüşecek. Bu görüş toplulukta tartışmalara yol açtı ve hesaplama gücünün gerçekten de temel bir unsur olduğu, AI yeteneklerinin üst sınırını ve gelişim hızını belirlediği kabul edildi. (Kaynak: Reddit r/ArtificialInteligence)

AI Kullanım Etiği Tartışması: Öğrenme Başarısını Artırmak İçin AI Kullanmak Uygunsuz mu?: Bir online üniversite öğrencisi, ders yapısı sorunları (haftada sadece bir sınav veya ödev, hemen ardından sınav) nedeniyle dersten kaldıktan sonra, ders PDF’lerine dayanarak pratik sorular oluşturmak için ChatGPT kullanarak günlük çalıştı ve notları önemli ölçüde arttı. Ancak öğrenci, AI’nin çevresel etkileri ve “bağımsız düşünme” eleştirilerini görünce suçluluk hissetti. Topluluk yorumları genel olarak, AI’yi öğrenmeye yardımcı olmak için kullanmanın meşru ve etkili bir kullanım olduğunu, verimliliği ve öğrenme sonuçlarını artırmaya yardımcı olduğunu ve bunun için suçluluk duyulmaması gerektiğini belirtti. Yorumcular, AI’nin çevresel etkisinin diğer insan faaliyetleriyle karşılaştırılması gerektiğini ve AI kullanarak üretkenliği artırmanın zaten işyeri trendi olduğunu belirttiler. (Kaynak: Reddit r/ArtificialInteligence)

Claude Pro Kullanıcı Deneyimi: Kısıtlama ve İş Modeli Tartışması: Reddit ClaudeAI topluluğunda kullanıcılar, Claude Pro hizmetini kullanırken karşılaştıkları kısıtlama (throttling) sorununu tartıştılar ve Anthropic’in iş modelini incelediler. Bir kullanıcı, aylık 20 dolarlık Pro abonelik ücretinin, Anthropic’in yoğun kullanıcılar için ödediği gerçek hesaplama maliyetinden (ayda 100 dolara kadar çıkabilir) çok daha düşük olduğunu belirtti ve kullanıcıların şikayetlerinin (örneğin “sömürüldüklerini” düşünmeleri) AI hizmetlerinin maliyet yapısını göz ardı edebileceğini savundu. Tartışma ayrıca, Anthropic’in son zamanlarda yeni özellikleri Pro yerine daha pahalı olan Max paketine öncelikli olarak sunmasının, erken dönemde yıllık Pro aboneliği alan kullanıcılar arasında memnuniyetsizliğe yol açtığını da içeriyordu. (Kaynak: Reddit r/ClaudeAI 1, Reddit r/ClaudeAI 2)

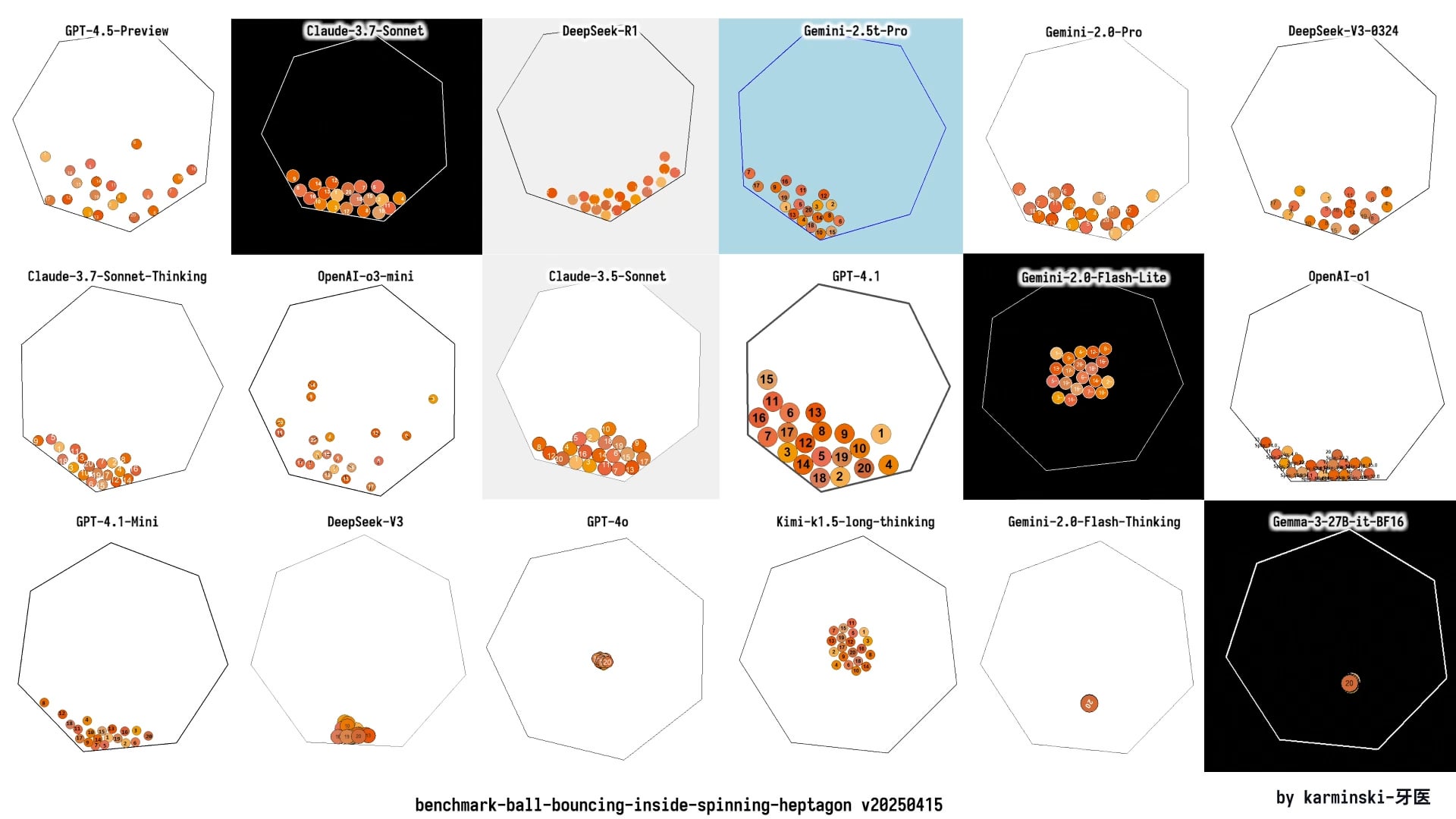

KCORES LLM Arena Güncellendi, DeepSeek R1 Dikkat Çekici Performans Sergiledi: Kullanıcı, kişisel olarak sürdürdüğü LLM yarışma arenası (KCORES LLM Arena) için en son test sonuçlarını paylaştı. Bu test, modelden karmaşık bir fizik simülasyonunun (dönen bir yedigen içinde çarpışan ve seken 20 top) Python kodunu oluşturmasını istiyor. GPT-4.1, Gemini 2.5 Pro, DeepSeek-V3 gibi yeni modellerin eklenmesiyle güncellenen sonuçlar, DeepSeek R1’in bu görevde üstün performans gösterdiğini ve oluşturulan simülasyonun oldukça iyi olduğunu ortaya koydu. Bu, topluluğa farklı modellerin karmaşık programlama görevlerindeki yeteneklerini değerlendirmek için başka bir referans noktası sağlıyor. (Kaynak: Reddit r/LocalLLaMA)

Farklı LLM’lerin Duygusal Yanıt Yetenekleri Tartışılıyor: Reddit kullanıcısı, ChatGPT 4o, Claude 3 Sonnet, Llama 3 70B ve Mistral Large’ın kullanıcıların üzüntü ifade etmesine verdikleri farklı tepki tarzlarını mizahi bir şekilde karşılaştıran bir Meme resmi yayınladı. Bu, kullanıcıların farklı LLM’leri duygusal iletişim veya destek aramak için kullanırken yaşadıkları deneyim farklılıklarını ve topluluğun modellerin “empati” yeteneğine ilişkin algısını ve değerlendirmesini yansıtıyor. Yorum bölümünde ayrıca özel duygusal konuları işlemek için yerel modelleri kullanmanın gizlilik avantajları da tartışıldı. (Kaynak: Reddit r/LocalLLaMA)

AGI’nin Silikon Vadisi Aldatmacası Olup Olmadığı Tartışması: Topluluk üyesi, genel yapay zekanın (AGI) Silikon Vadisi’nin (teknoloji endüstrisinin) yatırım çekmek veya heyecanı sürdürmek için aşırı abarttığı bir kavram (hoax) olup olmadığını sorgulayan bir makaleyi paylaştı ve muhtemelen tartıştı. Bu, endüstri ve kamuoyunda AGI’nin gerçekleşme olasılığı, zaman çizelgesi ve mevcut ilgili tanıtımların gerçekliği konusunda süregelen tartışma ve şüphelerin olduğunu yansıtıyor. (Kaynak: Ronald_vanLoon)

💡 Diğer

Küçük Ev Aletleri Sektörü Soğuyor, AI Yeni Hikaye Ama Uygulama Henüz Yüzeysel: Mutfak küçük ev aletleri pazarı (kahvaltı makineleri, air fryer’lar gibi), “evde kalma ekonomisi”nin getirdiği avantajların azalmasının ardından satışlarda düşüş ve fiyat savaşı zorluklarıyla karşı karşıya. Supor, Joyoung, Bear Electric gibi “Altı Büyük” listelenmiş şirketin performansı baskı altında. Bir atılım arayışında, şirketler genellikle yurtdışı pazarlara açılmaya ve AI teknolojisi entegrasyonuna yöneliyor. Ancak, şu anda AI’nin küçük ev aletlerindeki uygulamaları çoğunlukla basit sesli komutlar, otomatik ayarlamalar gibi olup, pratiklik ve inovasyon alanı sınırlıdır ve maliyeti artırarak kullanıcıları caydırabilir. Buna karşılık, büyük ev aletleri AI uygulamalarında daha avantajlıdır; akıllı ev ekosistemleri kurabilir, kişiselleştirilmiş hizmetler sunmak için büyük veriyi kullanabilirler. Küçük ev aletleri sektörünün AI hikayesi hala erken aşamada. (Kaynak: 36Kr)

Gümrük Vergisi Fırtınası Huaqiangbei Çip Pazarını Vuruyor, Yerli İkame Hızlanabilir: Son zamanlarda çipleri çevreleyen gümrük vergisi politikası değişiklikleri Shenzhen Huaqiangbei elektronik pazarında endişelere yol açtı. CPU, GPU gibi popüler çipler (özellikle ABD menşeli olabilecekler) için satıcılar fiyat teklifini durdurma, malı stoklama ve bekleme eğilimi gösteriyor, fiyat dalgalanmaları artıyor. Depolama çipleri gibi kategoriler nispeten daha az etkileniyor. Birçok listelenmiş distribütör, ABD’den doğrudan ithalat oranının düşük olması nedeniyle gümrük savaşı doğrudan etkisinin sınırlı olduğunu, ancak piyasa belirsizliğinin arttığını belirtiyor. Sektör genel olarak, ABD’de yonga fabrikalarına sahip IDM şirketlerinin (TI, Intel, Micron gibi) en çok etkileneceğini düşünüyor. Bu olay, bazı alt müşterilerin yerli çip ikame çözümlerini sormasına neden oldu ve yarı iletken alanında yerlileşme sürecini hızlandırabilir. (Kaynak: 创业板观察)

AI İnsan Anlam Krizini Şiddetlendiriyor mu? Teknoloji ve Değer Dengesi Üzerine Düşünceler: Makale, yapay zekanın hızla gelişmesinin insan varoluşunun anlamını nasıl etkilediğini tartışıyor. AI’nin profesyonel alanlardaki üstünlüğünün (Go, tıbbi teşhis, sanat yaratımı gibi), sanayi devriminden bu yana emek yabancılaşması, inanç krizi, çevre sorunları gibi nedenlerle tetiklenen insan anlam krizini şiddetlendirdiğini savunuyor. AI, özellikle beyaz yakalı işlerde karar verme yeteneğini ikame ederek “araç insan” çıkmazını daha da güçlendirebilir. Makale, filozofların görüşlerine ve bilim kurgu eserlerine (Dune, Westworld gibi) atıfta bulunarak teknolojik kölelik riskine karşı uyarıyor ve AI’nin getirdiği teknolojik gelişmeyi benimserken, değer rasyonelliğini yeniden inşa etmeye, etik çerçeveler ve beşeri bilimler eğitimi yoluyla insanın yaratıcılığını, duygusal bağını ve eleştirel düşüncesini korumaya, kendi yarattıklarımızın kölesi olmaktan kaçınmaya çağırıyor. (Kaynak: 腾讯研究院)

ABD’de Üretilen iPhone’un Maliyeti Yüksek, 25.000 Yuan’ı Aşabilir: Makale, iPhone’un tamamen ABD’de üretilmesi durumunda maliyetinin önemli ölçüde artacağını ve tahmini satış fiyatının 3500 dolara (yaklaşık 25.588 RMB) kadar çıkabileceğini analiz ediyor, bu da mevcut fiyatların çok üzerinde. Ana nedenler arasında ABD’nin hammadde (nadir toprak elementleri, rafine lityum kobalt gibi) temini, lojistik taşımacılık, fabrika inşaatı (arazi, elektrik, çevre onayı) ve işgücü maliyetleri (asgari saatlik ücret Çin’e göre 4-5 kat daha yüksek ve vasıflı sanayi işçisi eksikliği) konularında Çin’den çok daha pahalı olması yer alıyor. Apple’ın geçmişte yüksek kâr marjlarını sürdürmek için küresel tedarik zincirini (özellikle nispeten daha büyük kâr marjlarına sahip Çinli tedarikçileri) sömürme modeli ABD’de sürdürülemez olacaktır. Yüksek üretim maliyetleri sonunda tüketicilere yansıtılabilir ve Apple’ın fiyatlandırma stratejisini ve pazar konumunu sarsabilir. (Kaynak: 星海情报局)

Matematiksel Atılım: Ortalama Eğrilik Akışı Tekillik Teorisi Kanıtlandı: Matematikçileri yaklaşık 30 yıldır meşgul eden Multiplicity-one varsayımı yakın zamanda Richard Bamler ve Bruce Kleiner tarafından kanıtlandı. Bu varsayım, Ortalama Eğrilik Akışı (Mean Curvature Flow, MCF) ile ilgilidir – bir yüzeyin alanını en hızlı şekilde azaltmak için zamanla nasıl evrildiğini tanımlayan matematiksel bir süreç (buz küpünün erimesi veya kumdan kalenin aşınması gibi). Kanıt, üç boyutlu uzayda, iki boyutlu kapalı yüzeylerin MCF altında oluşturduğu tekilliklerin (eğriliğin sonsuza yaklaştığı noktalar) basit olduğunu belirtiyor; genellikle yerel olarak bir noktaya küçülen bir küre veya bir çizgiye çöken bir silindir şeklinde ortaya çıkarlar, karmaşık çok katmanlı üst üste binen tekillikler oluşmaz. Bu atılım, MCF’nin tekillikler oluştuktan sonra bile analiz edilmeye devam edilebilmesini sağlıyor ve MCF’yi geometri ve topolojideki (Poincaré varsayımı gibi) önemli problemleri çözmek için kullanmaya daha sağlam bir teorik temel sunuyor. (Kaynak: 机器之心)

Kullanıcı “Bütçe Dostu” 4x RTX 3090 Yerel AI Donanım Yapılandırmasını Paylaştı: Reddit kullanıcısı, yerel olarak LLM çalıştırmak için kurduğu donanım yapılandırma çözümünü paylaştı, toplam maliyeti yaklaşık 4204 dolar. Bu yapılandırma, 4 adet ikinci el EVGA RTX 3090 ekran kartı (tanesi 600 dolar), bir AMD EPYC 7302P sunucu CPU’su, Asrock Rack anakart, 96GB DDR4 bellek ve 2TB NVMe SSD içeriyor. Bunlar MLACOM Quad Station Pro Lite açık kasa içine monte edilmiş ve iki adet 1200W güç kaynağı kullanılmış. Bu paylaşım, evde güçlü hesaplama yeteneğine (4x 24GB VRAM) sahip bir AI iş istasyonu kurmak isteyen kullanıcılara nispeten “ekonomik” bir referans çözümü sunuyor. (Kaynak: Reddit r/LocalLLaMA)

ABD’de Hackerlar Trafik Işıklarına Saldırarak Musk ve Zuckerberg’in Deepfake Mesajlarını Yayınladı: Bildirildiğine göre, ABD San Francisco Körfez Bölgesi’ndeki birçok yaya geçidi sinyal sistemi hacker saldırısına uğradı ve AI tarafından oluşturulan Musk ve Zuckerberg’in Deepfake (derin sahte) mesajlarını yayınlamak için kullanıldı. Bu olay, kamu altyapısının AI teknolojilerini kullanan siber saldırılar karşısındaki savunmasızlığını ve Deepfake teknolojisinin yanlış bilgi yaymak veya şaka yapmak amacıyla kötüye kullanılma riskini vurguluyor. (Kaynak: Reddit r/ArtificialInteligence)

Çeşitli Robotik ve Otomasyon Teknolojileri Sergilendi: Sosyal medyada çeşitli robotik ve otomasyon teknolojisi uygulamaları sergilendi: insan hareketlerini taklit ederek kung fu yapabilen Booster T1 robotu; rehabilitasyon eğitimi için kullanılan robotik sistemler; kahve yapabilen mekanik kol; pirinç ekimi ve yabani ot temizliği için kullanılan tarım robotları; çobanların koyunlarla ilgilenmesini kolaylaştıran otomasyon sistemi; ve dans eden robotlar gibi. Bu örnekler, robotların endüstri, tarım, hizmet sektörü, tıbbi rehabilitasyon ve eğlence gibi alanlardaki geniş uygulamasını ve sürekli gelişimini yansıtıyor. (Kaynak: Ronald_vanLoon 1, Ronald_vanLoon 2, Ronald_vanLoon 3, Ronald_vanLoon 4, Ronald_vanLoon 5, Ronald_vanLoon 6)

Gelişmekte Olan Teknolojiler ve Yenilikçi Ürünler Sergilendi: Sosyal medyada çeşitli gelişmekte olan teknolojiler ve yenilikçi ürünler paylaşıldı: MIT tarafından geliştirilen, hücresel iletişimi ışıkla izleyen minyatür kablosuz anten; akçaağaç tohumunun uçuşunu taklit eden tek kanatlı drone; Nesnelerin İnterneti akıllı tuvalet; diş düzeltme için kullanılan dijital ölçü teknolojisi; tuzlu su kullanarak elektrik üreten cihaz; nefes alabilen ve hareket edebilen dinamik duvarlar; Iron Man Cosplay kostümü; arazi tipi elektrikli kayak tahtası; ve Flipper Zero cihazı kullanarak anahtar kopyalama teknolojisi gibi. Bunlar, teknolojinin iletişim, enerji, sağlık, ulaşım, inşaat ve güvenlik gibi birçok alandaki sürekli yenilikçiliğini gösteriyor. (Kaynak: Ronald_vanLoon 1, Ronald_vanLoon 2, Ronald_vanLoon 3, Ronald_vanLoon 4, Ronald_vanLoon 5, Ronald_vanLoon 6, Ronald_vanLoon 7, Ronald_vanLoon 8, Ronald_vanLoon 9)

Tıbbi Sağlık Teknolojisi Trendleri: Sosyal medya ve makale bağlantıları, tıbbi sağlık alanındaki teknoloji uygulamalarını ve gelişim trendlerini belirtiyor: robot destekli cerrahi, AI’nin sağlık hizmetlerindeki uygulama trendleri ve dönüm noktaları, operasyonel mükemmelliği teşvik etmek için teknolojiyi kullanma (hiperotomasyon) ve AI’nin getirebileceği dönüşümler gibi. Bu içerikler, AI, robotik, otomasyon gibi teknolojilerin tıbbi hizmet verimliliğini, teşhis doğruluğunu ve hasta deneyimini artırma potansiyelini ve pratiklerini yansıtıyor. (Kaynak: Ronald_vanLoon 1, Ronald_vanLoon 2, Ronald_vanLoon 3, Ronald_vanLoon 4)

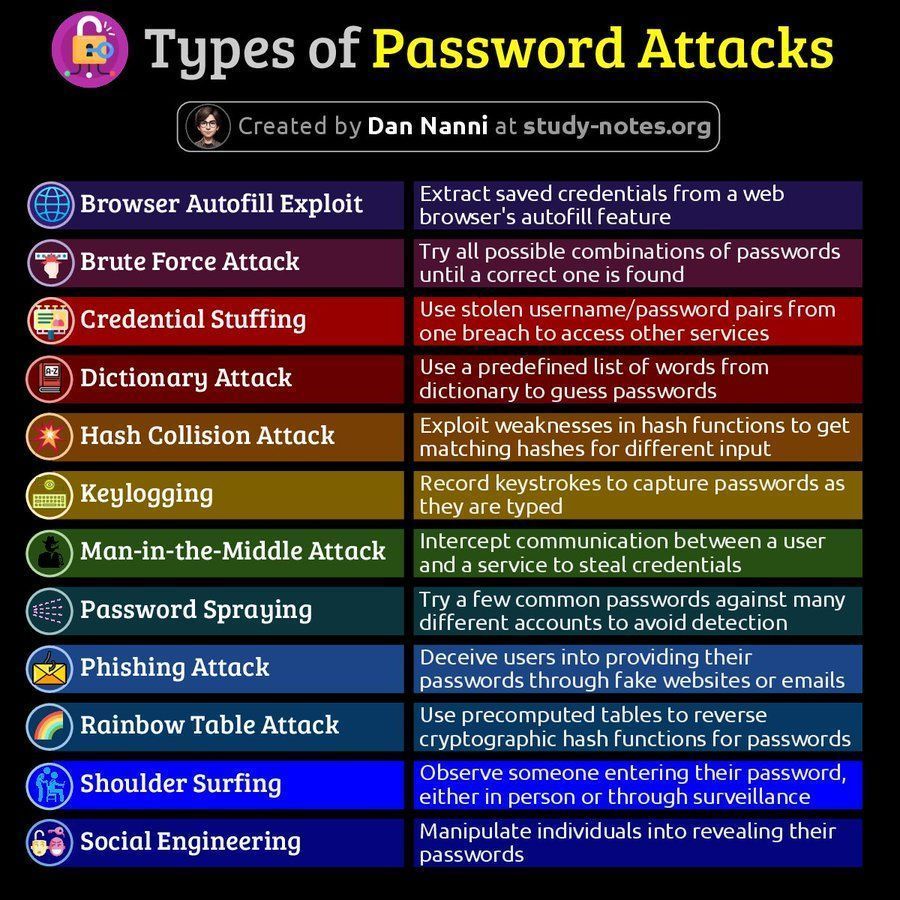

Siber Güvenlik İle İlgili Bilgiler: Sosyal medyada siber güvenlikle ilgili içerikler paylaşıldı: şifre saldırı türlerinin şeması ve veri sızıntısından sonraki 60 dakika içinde kurtarma yeteneğinin önemi hakkındaki makale. Bu içerikler, kullanıcıları siber güvenlik risklerine ve başa çıkma stratejilerine dikkat etmeleri konusunda uyarıyor. (Kaynak: Ronald_vanLoon 1, Ronald_vanLoon 2)

AMD ROCm Platformu Tartışması: Reddit kullanıcıları, çift AMD Radeon RX 7900 XTX GPU kullanarak bir derin öğrenme iş istasyonu kurma olasılığını tartışıyor, ROCm (Radeon Open Compute platform) yazılım yığınına değiniyor. Bu, Nvidia’nın hakim olduğu AI donanım pazarında, kullanıcıların AMD GPU çözümlerine ve yazılım ekosistemine (ROCm) olan ilgisini ve keşfini yansıtıyor. (Kaynak: Reddit r/deeplearning)