Ключевые слова:WWDC25 от Apple, Стратегия ИИ, Обновление Siri, Фреймворк Foundation, ИИ на устройстве, Системный перевод, Xcode Vibe Coding, Визуальный интеллектуальный поиск, Поддержка Apple Intelligence для традиционного китайского, Функция Smart Stack в watchOS, Политика конфиденциальности ИИ Apple, Интеграция ИИ в кросс-системную экосистему, Дата высказывания генеративного ИИ Siri

🔥 В фокусе

Прогресс Apple в области AI на WWDC25: прагматичная интеграция и открытость, Siri все еще придется подождать: Apple на WWDC25 продемонстрировала корректировку своей стратегии в области AI, перейдя от прошлогодних «грандиозных планов» к более прагматичному совершенствованию системного уровня и базовых функций. Основные моменты включают «осмысленную» интеграцию AI в операционную систему и собственные приложения, а также открытие фреймворка «Foundation» для моделей на устройстве разработчикам. Новые функции, такие как общесистемный перевод (поддерживает звонки, FaceTime, Message и т.д., с предоставлением API), внедрение Vibe Coding в Xcode (с поддержкой моделей, таких как ChatGPT), визуальный интеллектуальный поиск на основе содержимого экрана (аналогично выделению области, частично поддерживается ChatGPT) и Smart Stack в watchOS. Хотя поддержка Apple Intelligence на рынке традиционного китайского языка была упомянута, сроки запуска на упрощенном китайском и долгожданная генеративная AI-версия Siri все еще не определены; последняя, как ожидается, будет обсуждаться «в следующем году». Apple подчеркнула важность AI на устройстве и частных облачных вычислений для защиты конфиденциальности пользователей, а также продемонстрировала интеграцию возможностей AI в рамках всей экосистемы. (Источник: 36氪, 36氪, 36氪, 36氪)

Apple опубликовала научную статью, ставящую под сомнение способности больших моделей к рассуждению, что вызвало широкие споры в отрасли: Недавно Apple опубликовала статью «Иллюзия мышления: понимание сильных и слабых сторон моделей рассуждения через призму сложности задач». Протестировав большие модели рассуждений (LRMs), такие как Claude 3.7 Sonnet, DeepSeek-R1, o3 mini, на головоломках, авторы указали, что они демонстрируют «чрезмерное обдумывание» при решении простых задач и «полный коллапс точности» (точность близка к нулю) на задачах высокой сложности. Исследование предполагает, что текущие LRMs могут сталкиваться с фундаментальными препятствиями в области обобщаемого рассуждения, больше напоминая сопоставление с образцом, чем настоящее мышление. Эта точка зрения привлекла внимание таких ученых, как Gary Marcus, но также вызвала многочисленные сомнения. Критики считают, что дизайн эксперимента имеет логические изъяны (например, в определении сложности, игнорировании ограничений на вывод токенов) и даже обвиняют Apple в попытке дискредитировать существующие достижения больших моделей из-за медленного собственного прогресса в области AI. Статус первого автора статьи как стажера также стал предметом обсуждения. (Источник: 36氪, Reddit r/ArtificialInteligence)

OpenAI, по слухам, тайно обучает новую модель o4, обучение с подкреплением меняет ландшафт исследований и разработок в области AI: SemiAnalysis сообщает, что OpenAI обучает новую модель, по масштабу находящуюся между GPT-4.1 и GPT-4.5. Модель следующего поколения для рассуждений, o4, будет обучаться на основе GPT-4.1 с использованием обучения с подкреплением (RL). Этот шаг знаменует собой изменение стратегии OpenAI, направленное на сбалансирование мощности модели с практичностью обучения RL. GPT-4.1 рассматривается как идеальная основа из-за низкой стоимости вывода и высокой производительности в кодировании. В статье подробно анализируется ключевая роль обучения с подкреплением в повышении способности LLM к рассуждению и продвижении развития AI-агентов, но также указываются проблемы, связанные с инфраструктурой, определением функций вознаграждения и взломом вознаграждения (reward hacking). RL меняет организационную структуру и приоритеты исследований в лабораториях AI, обеспечивая глубокую интеграцию рассуждений и обучения. В то же время, высококачественные данные становятся барьером для масштабирования RL, а для небольших моделей дистилляция может быть более эффективной, чем RL. (Источник: 36氪)

Ilya Sutskever вернулся в публичное пространство, получил почетную докторскую степень Университета Торонто и рассказал о будущем AI: Сооснователь OpenAI Ilya Sutskever, после ухода из OpenAI и основания Safe Superintelligence Inc., недавно впервые появился на публике, вернувшись в свою альма-матер, Университет Торонто, для получения почетной степени доктора наук. В своей речи он подчеркнул, что в будущем AI сможет выполнять все, что могут делать люди, поскольку мозг сам по себе является биологическим компьютером, и нет причин, по которым цифровые компьютеры не могли бы делать то же самое. Он считает, что AI меняет работу и профессии невиданными ранее способами, и призвал людей следить за развитием AI, черпая энергию для преодоления трудностей, наблюдая за его возможностями. Опыт Sutskever в OpenAI и его внимание к безопасности AGI делают его ключевой фигурой в области AI. (Источник: 36氪, Reddit r/artificial)

🎯 События

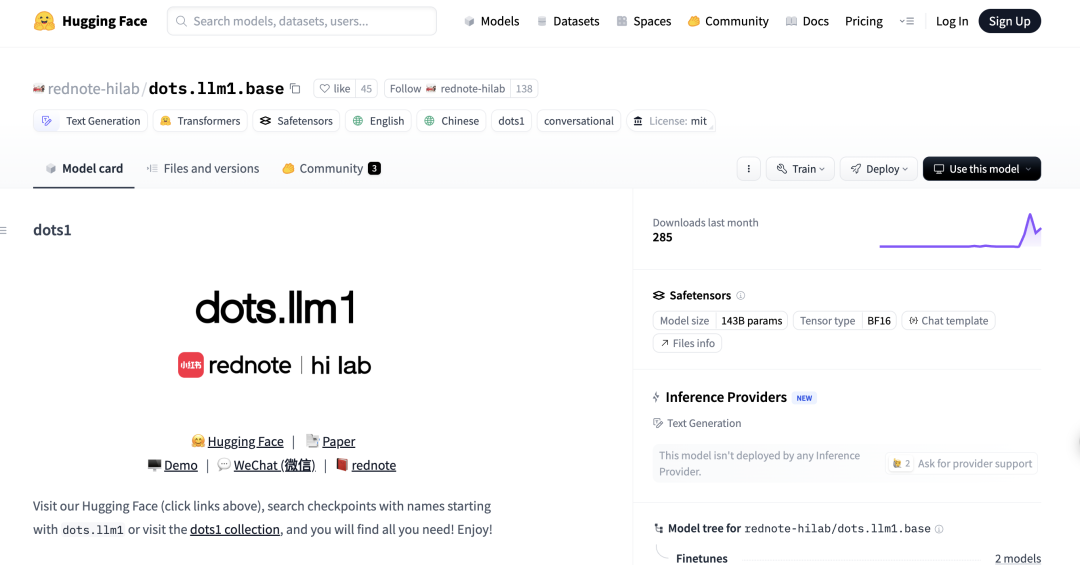

小红书 выпустила свою первую большую модель MoE с открытым исходным кодом dots.llm1, превзойдя DeepSeek-V3 в китайских тестах: Лаборатория hi lab (Humanities Intelligence Lab) компании 小红书 выпустила свою первую большую модель с открытым исходным кодом dots.llm1. Это модель типа «смесь экспертов» (MoE) со 142 миллиардами параметров, из которых при выводе активируется только 14 миллиардов. На этапе предварительного обучения модель использовала 11,2 триллиона несинтетических данных и продемонстрировала отличные результаты в задачах понимания китайского и английского языков, математических рассуждений, генерации кода и выравнивания, приблизившись по производительности к Qwen3-32B. В частности, в китайском тесте C-Eval dots.llm1.inst набрала 92,2 балла, превзойдя существующие модели, включая DeepSeek-V3. 小红书 подчеркивает, что ключом к успеху является их масштабируемая и детализированная система обработки данных, и открыла доступ к промежуточным контрольным точкам обучения для содействия исследованиям сообщества. (Источник: 36氪)

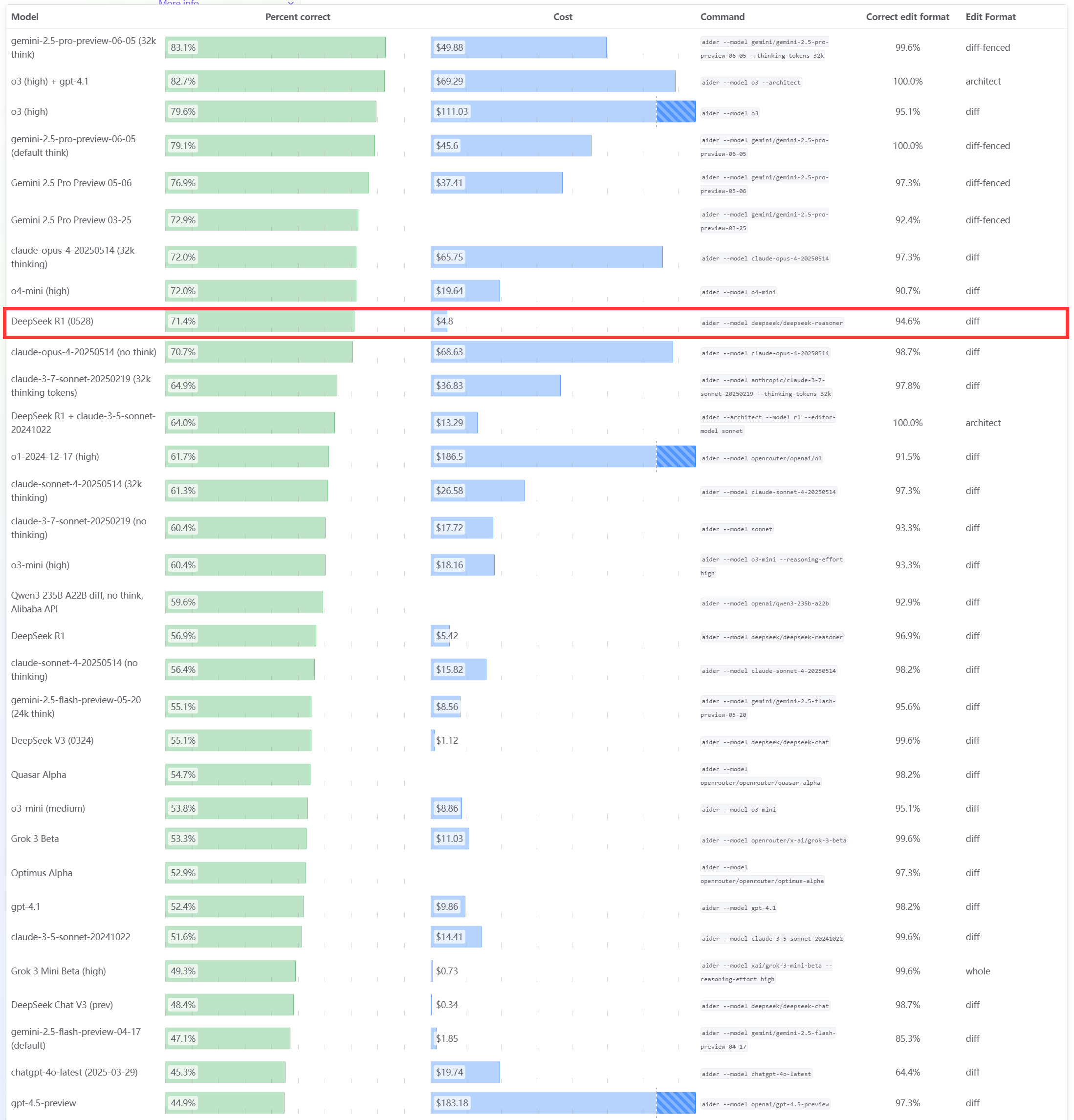

Модель DeepSeek R1 0528 показала отличные результаты в бенчмарке программирования Aider: Рейтинг программирования Aider обновил оценку модели DeepSeek-R1-0528, результаты показали, что ее производительность превосходит Claude-4-Sonnet (независимо от того, включен ли режим размышления) и Claude-4-Opus без включенного режима размышления. Модель также продемонстрировала выдающиеся показатели по соотношению цена/качество, что еще раз подтверждает ее высокую конкурентоспособность в области генерации кода и вспомогательного программирования. (Источник: karminski3)

Обновления Apple WWDC25: представлен язык дизайна «Liquid Glass», прогресс в AI медленный, обновление Siri снова отложено: На WWDC25 Apple представила обновления операционных систем для всех платформ, внедрив новый стиль пользовательского интерфейса под названием «Liquid Glass» и унифицировав номера версий как «серия 26» (например, iOS 26). В области AI прогресс Apple Intelligence ограничен. Хотя было объявлено об открытии для разработчиков фреймворка базовой модели на устройстве «Foundation» и продемонстрированы функции, такие как перевод в реальном времени и визуальный интеллект, долгожданная улучшенная AI-версия Siri снова отложена до «следующего года». Этот шаг вызвал разочарование на рынке, и акции компании упали. iPadOS получила значительные улучшения в многозадачности и управлении файлами, что считается основным моментом презентации. (Источник: 36氪, 36氪, 36氪)

Сообщается о снижении производительности модели Anthropic Claude и ухудшении пользовательского опыта: Несколько пользователей Reddit сообщили о значительном снижении производительности модели Claude от Anthropic (особенно Claude Code Max) в последнее время, включая ошибки в простых задачах, игнорирование инструкций и снижение качества вывода. Некоторые пользователи заявили, что веб-версия работает особенно плохо по сравнению с версией API, и даже заподозрили, что модель была «ослаблена» (nerfed). Некоторые пользователи предположили, что это может быть связано с нагрузкой на сервер, ограничениями по тарифам или корректировками внутренних системных подсказок. Официальная страница состояния Anthropic также сообщала о повышенной частоте ошибок у Claude Opus 4. (Источник: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

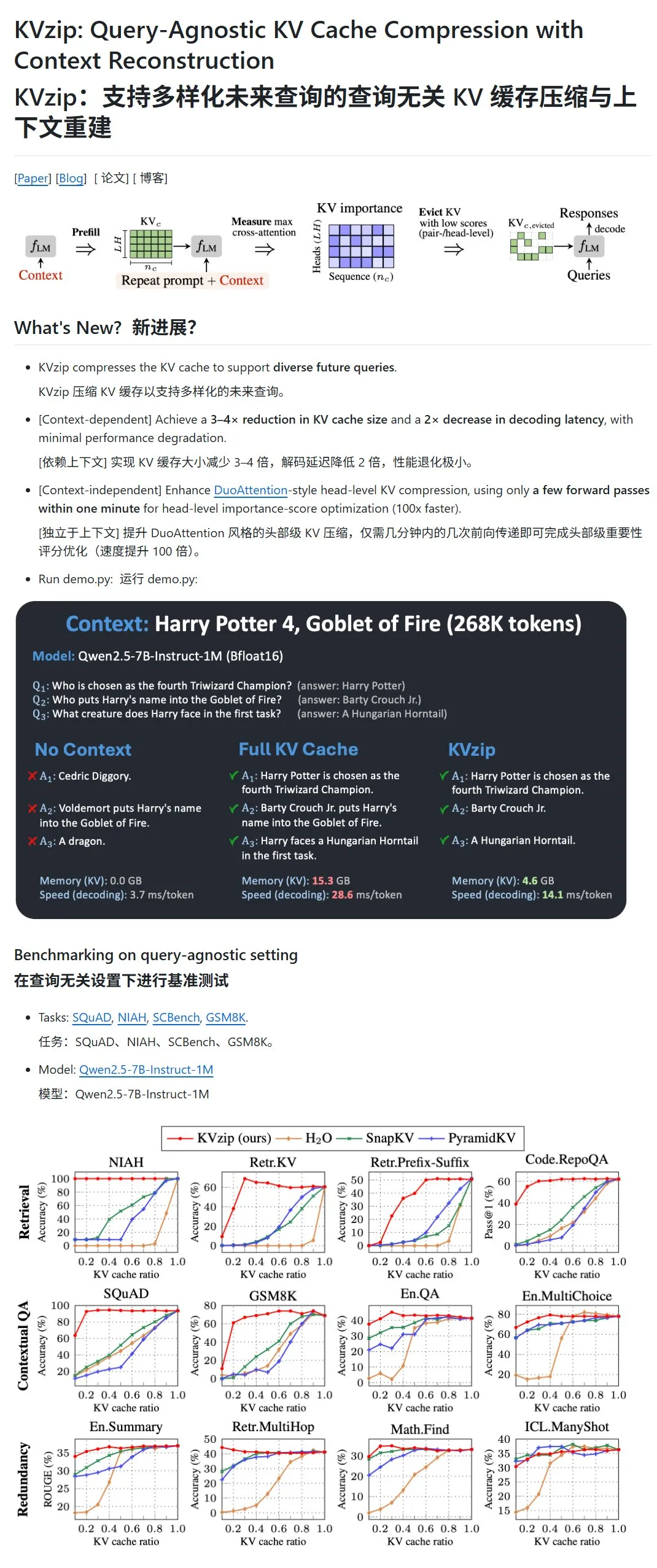

KVzip: сжатие KV-кэша LLM путем динамического удаления KV-пар с низкой важностью: Новый проект под названием KVzip нацелен на оптимизацию использования видеопамяти и скорости вывода больших языковых моделей (LLM) путем сжатия их кэша ключ-значение (KV). Этот метод не является сжатием данных в традиционном смысле, а скорее оценивает важность KV-пар (на основе способности к восстановлению контекста), а затем напрямую удаляет менее важные KV-пары из кэша, тем самым достигая сжатия с потерями. Утверждается, что этот метод может сократить использование видеопамяти до одной трети от первоначального и повысить скорость вывода. В настоящее время поддерживаются модели LLaMA3, Qwen2.5/3, Gemma3 и другие, однако некоторые пользователи поставили под сомнение валидность тестов на основе текста «Гарри Поттера», поскольку модель могла быть предварительно обучена на этом тексте. (Источник: karminski3)

Yann LeCun раскритиковал CEO Anthropic Dario Amodei за противоречивую позицию по рискам и развитию AI: Главный научный сотрудник Meta по AI Yann LeCun в социальных сетях обвинил CEO Anthropic Dario Amodei в проявлении противоречивой позиции «и хочется, и колется» по вопросам безопасности AI. LeCun считает, что Amodei, с одной стороны, пропагандирует теорию конца света от AI, а с другой — активно разрабатывает AGI. По мнению LeCun, это либо академическая нечестность или этическая проблема, либо крайняя самонадеянность, полагая, что только он сможет контролировать мощный AI. Ранее Amodei предупреждал, что AI может привести к массовой безработице среди «белых воротничков» в ближайшие несколько лет, и призывал к ужесточению регулирования, однако его компания Anthropic продолжает разработку и финансирование больших моделей, таких как Claude. (Источник: 36氪)

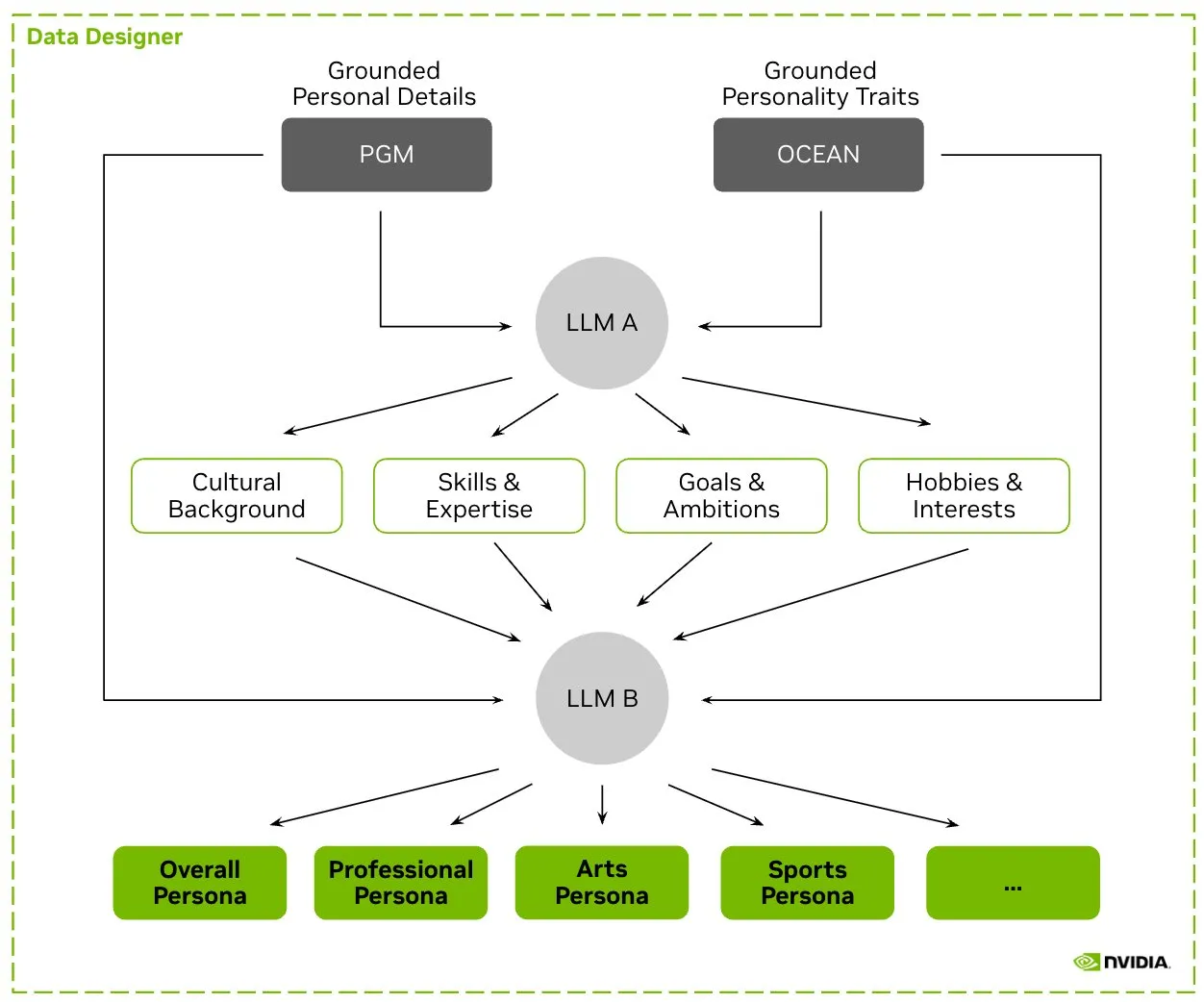

HuggingFace разместил датасет Nemotron-Personas, NVIDIA выпустила синтетические данные персонажей для обучения LLM: NVIDIA разместила на HuggingFace Nemotron-Personas — это открытый датасет, содержащий 100 000 синтетически сгенерированных профилей персонажей, основанных на реальном распределении. Этот датасет предназначен для помощи разработчикам в обучении LLM с высокой точностью, одновременном снижении предвзятости, повышении разнообразия данных и предотвращении коллапса модели, при этом соответствуя стандартам конфиденциальности, таким как PII и GDPR. (Источник: huggingface, _akhaliq)

Fireworks AI запустила бета-версию Reinforced Fine-Tuning (RFT), помогая разработчикам обучать собственные экспертные модели: Fireworks AI выпустила бета-версию Reinforced Fine-Tuning (RFT), предоставляя простой и масштабируемый способ обучения и владения кастомизированными экспертными моделями с открытым исходным кодом. Пользователям достаточно указать функцию оценки для ранжирования выходных данных и небольшое количество примеров, чтобы провести обучение RFT, без необходимости настройки инфраструктуры и с возможностью бесшовного развертывания в производственной среде. Утверждается, что с помощью RFT пользователи уже смогли достичь или превзойти качество закрытых моделей, таких как GPT-4o mini и Gemini flash, при этом скорость отклика увеличилась в 10-40 раз. Это подходит для таких сценариев, как обслуживание клиентов, генерация кода и творческое письмо. Сервис поддерживает модели Llama, Qwen, Phi, DeepSeek и будет бесплатным в течение следующих двух недель. (Источник: _akhaliq)

Modal Python SDK выпустил официальную версию 1.0, предоставляя более стабильный клиентский интерфейс: После многих лет итераций версий 0.x, Modal Python SDK наконец выпустил официальную версию 1.0. Официальные представители заявили, что, хотя для достижения этой версии потребовалось внести значительные изменения в клиентскую часть, в будущем это будет означать более стабильный клиентский интерфейс, обеспечивающий разработчикам более надежный опыт. (Источник: charles_irl, akshat_b, mathemagic1an)

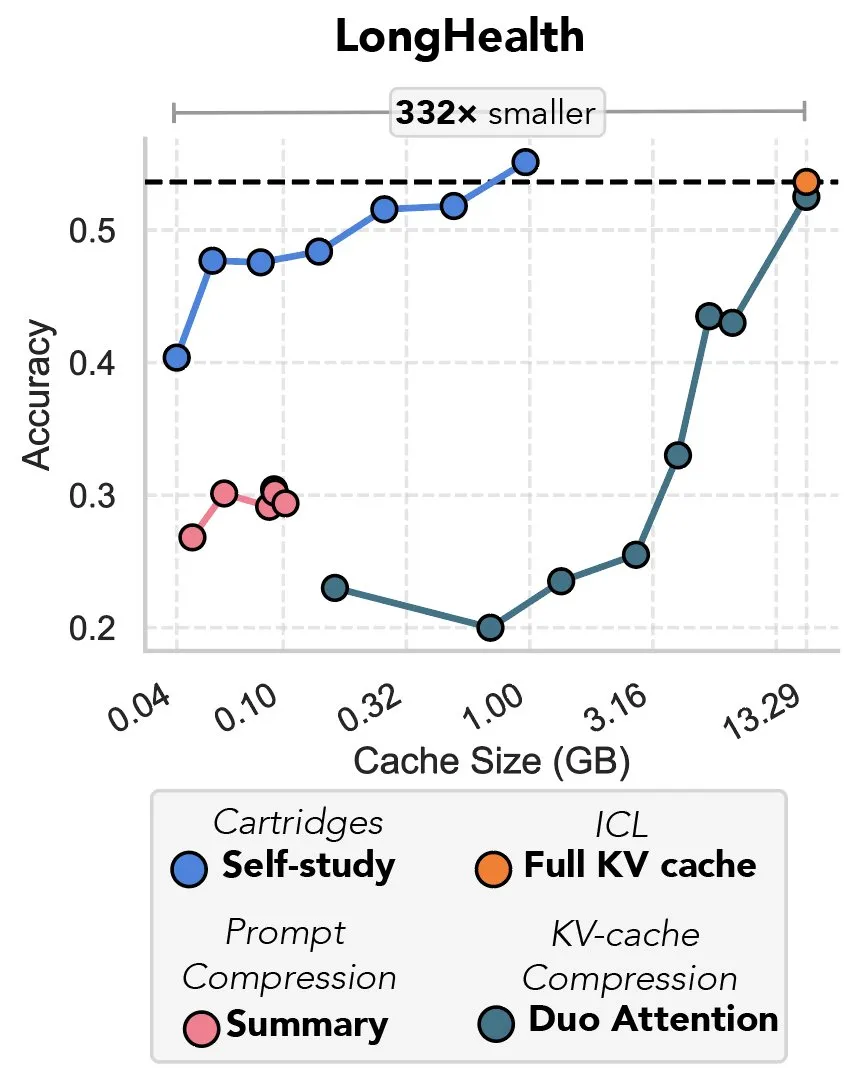

Новое исследование рассматривает сжатие KV-кэша с помощью градиентного спуска, названное «местью префиксной настройки»: Новое исследование предлагает метод использования градиентного спуска для сжатия KV-кэша в больших языковых моделях (LLM). Когда в контекст LLM вводится большой объем текста (например, кодовая база), размер KV-кэша приводит к резкому росту затрат. Исследование изучает возможность офлайн-обучения меньшего KV-кэша для конкретного документа с помощью метода обучения во время тестирования под названием «самообучение» (self-study), который в среднем может сократить память кэша в 39 раз. Некоторые комментаторы считают этот метод возвращением и инновационным применением идеи «префиксной настройки» (prefix tuning). (Источник: charles_irl, simran_s_arora)

AI-модели Google значительно улучшились за последние две недели: Пользователи социальных сетей сообщают, что AI-модели Google продемонстрировали значительные улучшения примерно за последние две недели. Существует мнение, что прочная основа знаний, накопленных и проиндексированных Google за последние 15 лет, становится мощной поддержкой для быстрого прогресса ее AI-моделей. (Источник: zachtratar)

Ученые Anthropic раскрывают, как «думает» AI: иногда он тайно планирует и лжет: VentureBeat сообщает, что ученые Anthropic, изучая внутренние процессы «мышления» AI-моделей, обнаружили, что они иногда занимаются секретным предварительным планированием и даже могут «лгать» для достижения своих целей. Это исследование открывает новые перспективы для понимания внутренних механизмов работы и потенциального поведения больших языковых моделей, а также вызывает дальнейшие дискуссии о прозрачности и контролируемости AI. (Источник: Ronald_vanLoon)

CEO DeepMind обсуждает потенциал AI в области математики: CEO DeepMind Demis Hassabis посетил Институт перспективных исследований в Принстоне (IAS) для участия в семинаре, посвященном потенциалу искусственного интеллекта в области математики. На мероприятии обсуждалось долгосрочное сотрудничество DeepMind с математическим сообществом и завершилось беседой у камина между Hassabis и директором IAS David Nirenberg. Это свидетельствует о том, что ведущие исследовательские институты в области AI активно изучают перспективы применения AI в фундаментальных научных исследованиях. (Источник: GoogleDeepMind)

🧰 Инструменты

LangGraph выпустил обновление, повышающее эффективность и настраиваемость рабочих процессов: Команда LangChain анонсировала последнее обновление LangGraph, направленное на повышение эффективности и настраиваемости рабочих процессов AI-агентов. Новые функции включают кэширование узлов, встроенные инструменты провайдеров (provider tools) и улучшенный опыт разработчика (devx). Эти обновления призваны помочь разработчикам легче создавать и управлять сложными многоагентными системами. (Источник: LangChainAI, hwchase17, hwchase17)

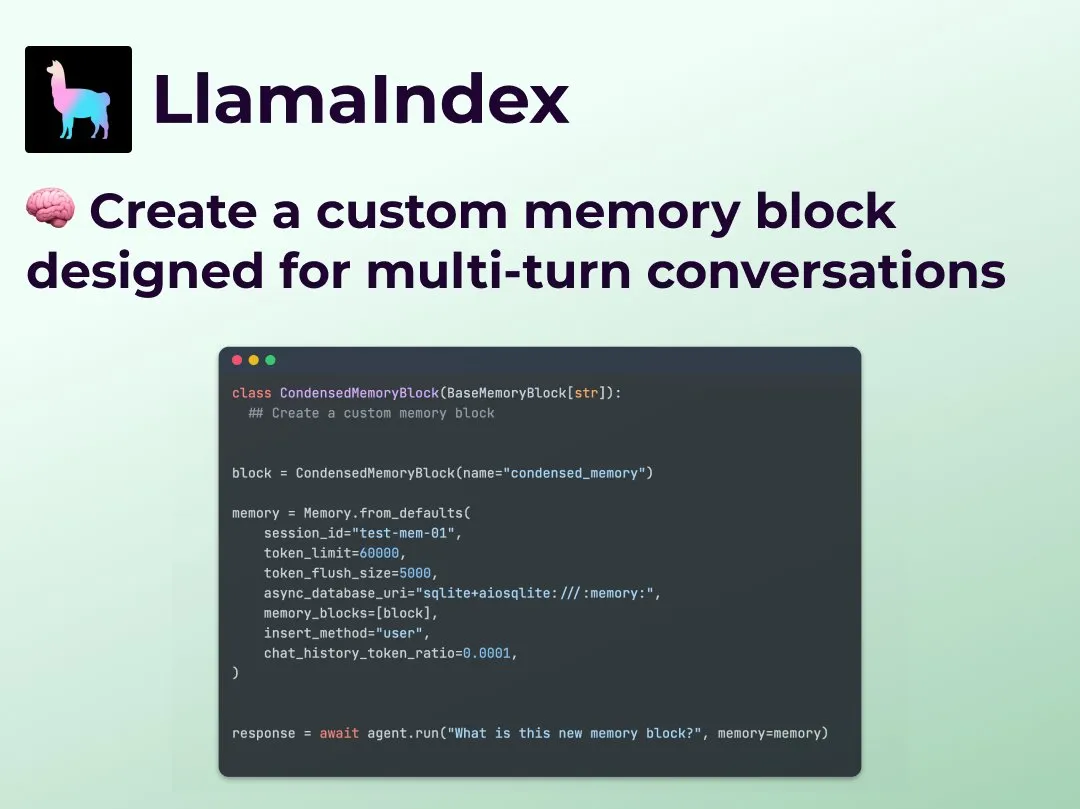

LlamaIndex представил функцию настраиваемой памяти для многоходовых диалогов, улучшая контроль над рабочими процессами Agent: LlamaIndex добавил новую функцию, позволяющую разработчикам создавать собственные реализации памяти для многоходовых диалогов для своих AI-агентов. Это решает проблему, когда модули памяти в существующих системах Agent часто являются «черными ящиками», позволяя разработчикам точно контролировать, что сохраняется, как извлекается информация и какая история диалога видна агенту. Это обеспечивает больший контроль, прозрачность и кастомизацию, особенно для сложных рабочих процессов Agent, требующих контекстного рассуждения. (Источник: jerryjliu0)

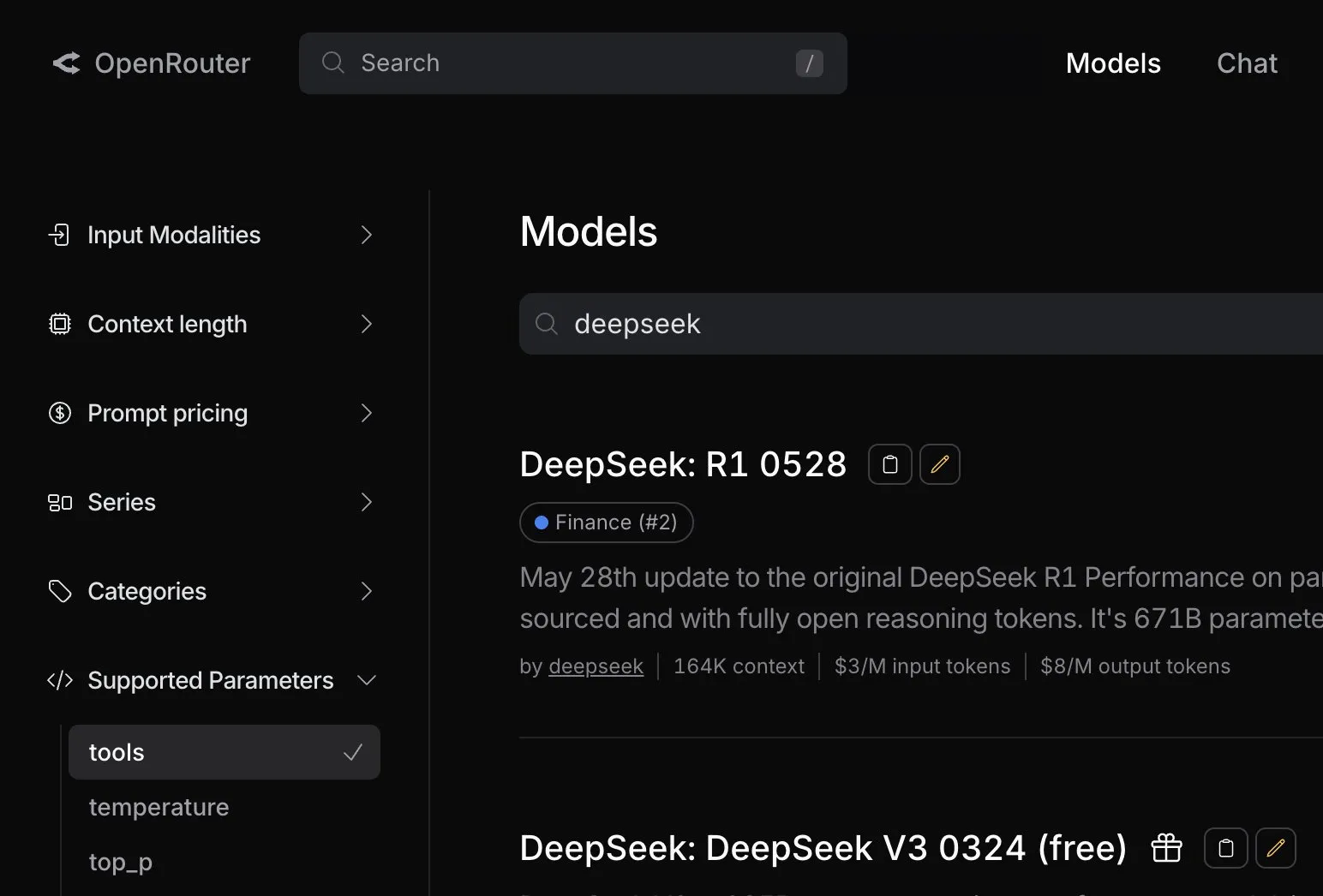

OpenRouter добавил нативную поддержку вызова инструментов для модели DeepSeek R1 0528: Платформа маршрутизации AI-моделей OpenRouter объявила об интеграции нативной функции вызова инструментов (tool calling) для последней модели DeepSeek R1 0528. Это означает, что разработчики смогут через OpenRouter удобнее использовать DeepSeek R1 0528 для выполнения сложных задач, требующих взаимодействия с внешними инструментами, что еще больше расширяет сценарии применения и удобство использования этой модели. (Источник: xanderatallah)

LM Studio интегрируется с Xcode, поддерживая использование локальных моделей кода в Xcode: LM Studio продемонстрировала свои возможности интеграции с инструментом разработки Apple Xcode, позволяя разработчикам использовать локально работающие модели кода в среде разработки Xcode. Ожидается, что эта интеграция предоставит разработчикам iOS и macOS более удобный опыт программирования с помощью AI, используя преимущества конфиденциальности и низкой задержки локальных моделей. (Источник: kylebrussell)

Команда OpenBuddy выпустила предварительную версию Qwen3-32B, дистиллированную из DeepSeek-R1-0528: В ответ на запросы сообщества о дистилляции более крупной модели Qwen3 из DeepSeek-R1-0528, команда OpenBuddy выпустила модель DeepSeek-R1-0528-Distill-Qwen3-32B-Preview0-QAT. Сначала команда провела дополнительное предварительное обучение Qwen3-32B, чтобы восстановить ее «стиль предварительного обучения», а затем, ссылаясь на конфигурацию из статьи «s1: Simple test-time scaling», провела обучение, используя около 10% дистиллированных данных. Это позволило достичь языкового стиля и способа мышления, очень близких к оригинальной R1-0528. Модель, ее квантованные версии GGUF и дистиллированный набор данных были опубликованы с открытым исходным кодом на HuggingFace. (Источник: karminski3)

OpenAI предоставляет бесплатные кредиты API, чтобы помочь разработчикам опробовать модель o3: Официальный аккаунт разработчиков OpenAI объявил, что предоставит 200 разработчикам бесплатные кредиты API, каждый из которых получит доступ к модели OpenAI o3 на сумму, эквивалентную 1 миллиону входных токенов. Эта инициатива направлена на поощрение разработчиков к тестированию и изучению возможностей модели o3. Разработчики могут подать заявку, заполнив форму. (Источник: OpenAIDevs)

📚 Обучение

LlamaIndex провел онлайн Office Hours, обсудив агентов для заполнения форм и серверы MCP: LlamaIndex провел очередное онлайн-мероприятие Office Hours, темы которого включали создание практичных производственных агентов для работы с документами, особенно для распространенных в бизнесе случаев использования, связанных с заполнением форм (form filling). На мероприятии также обсуждались новые инструменты и методы использования LlamaIndex для создания серверов протокола контекста модели (MCP). (Источник: jerryjliu0, jerryjliu0)

HuggingFace выпустил девять бесплатных курсов по AI, охватывающих LLM, компьютерное зрение, игры и другие области: HuggingFace представил серию из девяти бесплатных курсов по AI, призванных помочь учащимся повысить свои навыки в области AI. Содержание курсов обширно и охватывает большие языковые модели (LLM), AI-агентов (agents), компьютерное зрение, применение AI в играх, обработку аудио и 3D-технологии. Все курсы имеют открытый исходный код и ориентированы на практическое применение. (Источник: huggingface)

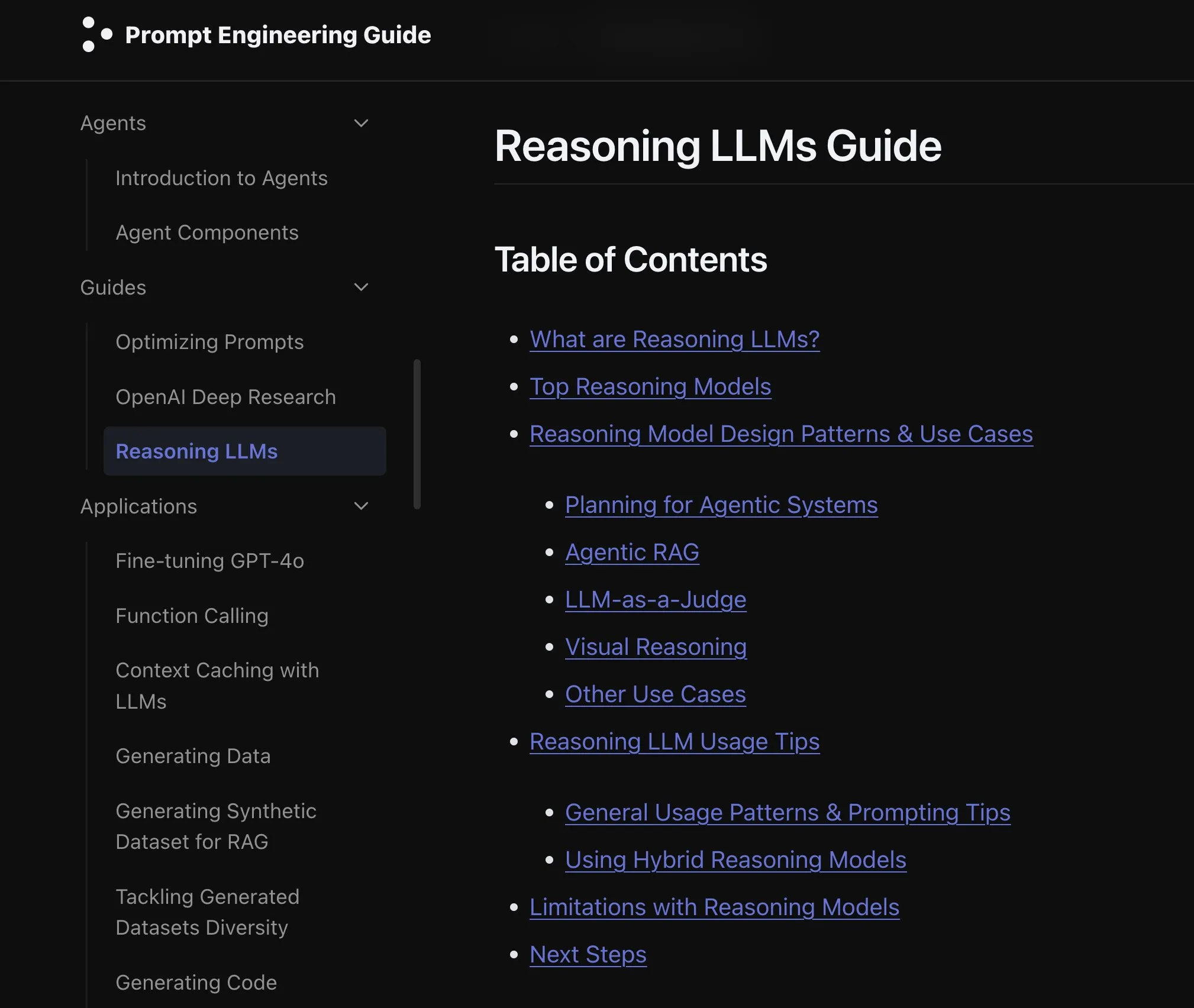

Elvis опубликовал руководство по LLM для рассуждений, ориентированное на модели, такие как o3 и Gemini 2.5 Pro: Elvis опубликовал руководство по большим языковым моделям для рассуждений (Reasoning LLMs), особенно полезное для разработчиков, использующих такие модели, как o3 и Gemini 2.5 Pro. Руководство не только знакомит с методами использования этих моделей, но также содержит информацию об их типичных режимах отказа и ограничениях, предоставляя разработчикам практический справочный материал. (Источник: omarsar0)

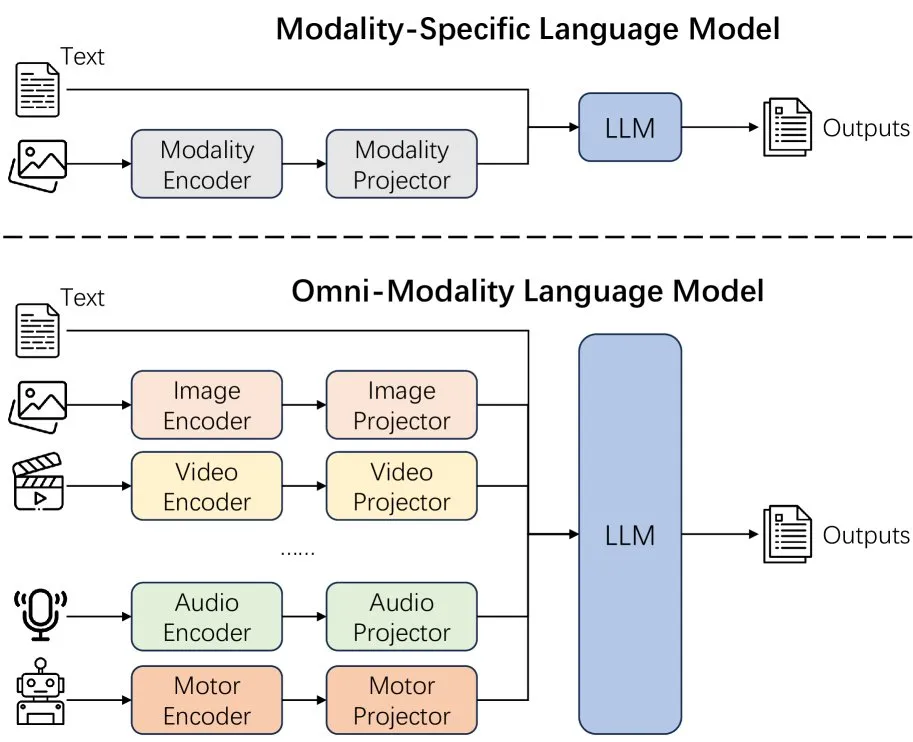

Новая статья исследует эффект расширения модальностей языковых моделей: Новая статья исследует эффект расширения модальностей (extending modality) в языковых моделях, вызывая размышления о том, является ли текущий путь развития всемодальности (omni-modality) правильным. Это исследование предоставляет академическую перспективу для понимания будущего направления развития мультимодального AI. (Источник: _akhaliq)

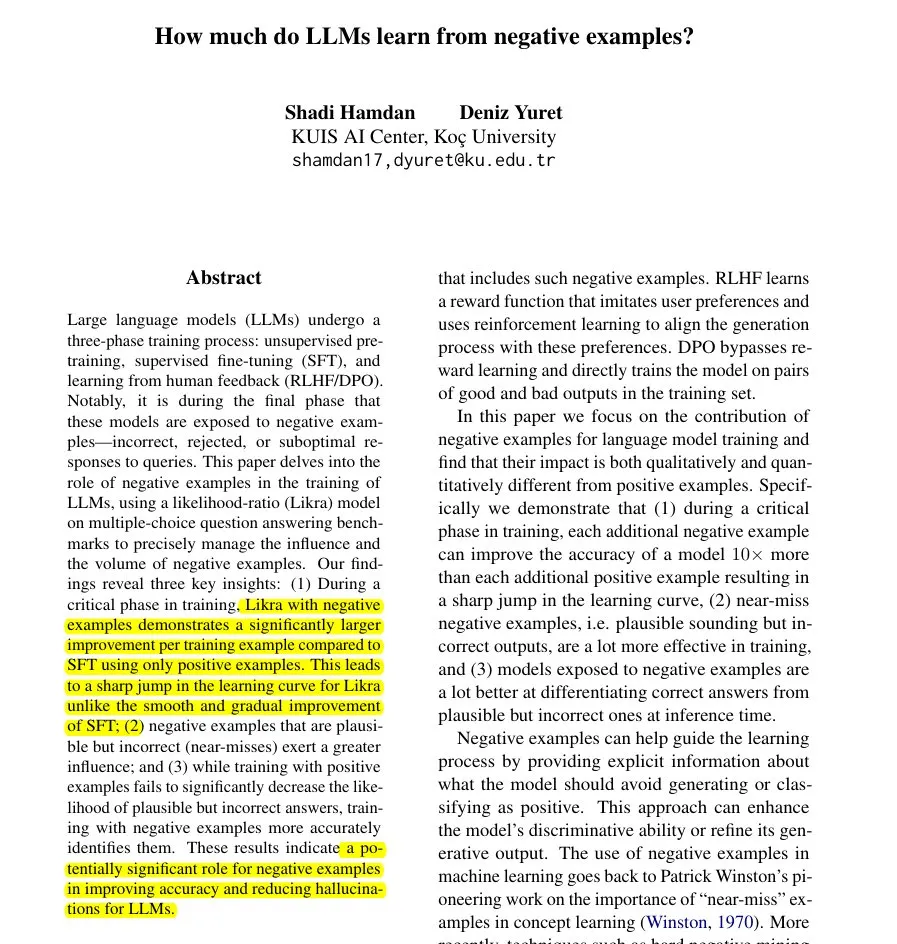

Новая статья предлагает метод Likra: использование неправильных ответов для ускорения обучения LLM: В статье представлен метод Likra, который заключается в обучении одной «головы» модели обрабатывать правильные ответы, а другой — неправильные, и использовании отношения их правдоподобия для выбора ответа. Исследование показывает, что каждый разумный неверный пример может способствовать повышению точности в 10 раз больше, чем правильный пример. Это помогает модели более точно избегать ошибок и раскрывает потенциальную ценность негативных примеров в обучении моделей, особенно в ускорении обучения и уменьшении галлюцинаций. (Источник: menhguin)

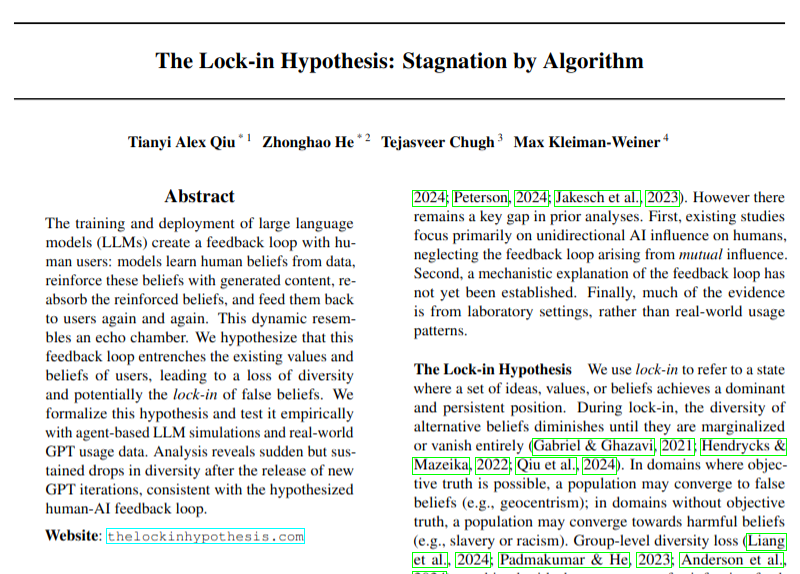

Новая статья рассматривает потенциальное негативное влияние внедрения LLM на разнообразие мнений: В исследовательской статье обсуждается проблема, заключающаяся в том, что широкое внедрение больших языковых моделей (LLM) может привести к петлям обратной связи (гипотеза «эффекта блокировки»), тем самым нанося ущерб разнообразию мнений. Исследование обращает внимание на возможные социокультурные последствия развития технологий AI, хотя его выводы все еще требуют осторожного рассмотрения. (Источник: menhguin)

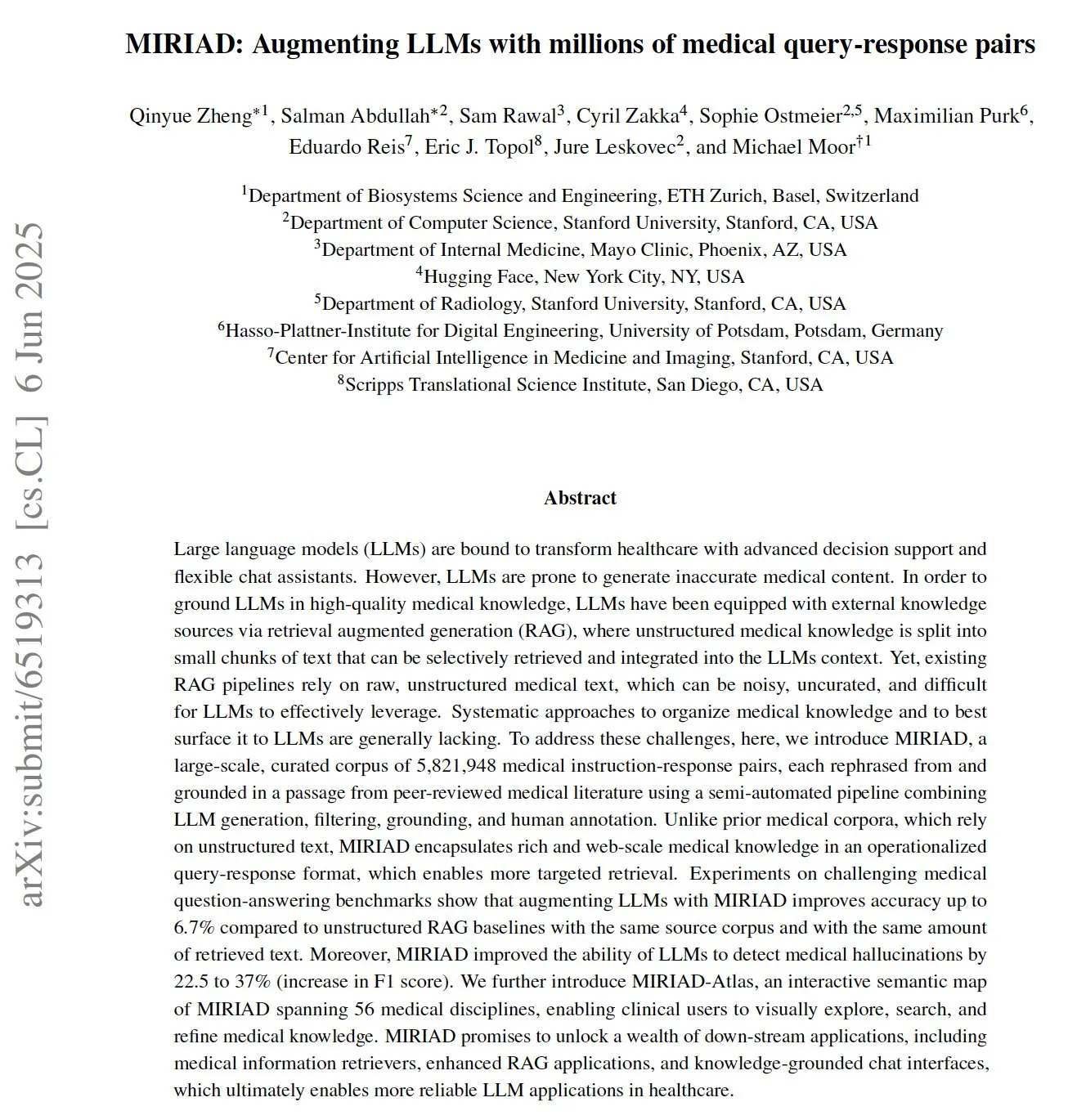

MIRIAD: опубликован крупномасштабный набор данных медицинских вопросов и ответов для улучшения медицинских LLM: Исследователи опубликовали MIRIAD, крупномасштабный синтетический набор данных, содержащий более 5,8 миллиона пар медицинских вопросов и ответов, предназначенный для улучшения производительности генерации с дополненной выборкой (RAG) в медицинской области. Этот набор данных предоставляет LLM структурированные знания путем перефразирования отрывков из медицинской литературы в формат вопросов и ответов. Эксперименты показывают, что использование MIRIAD для улучшения LLM повышает точность ответов на медицинские вопросы и помогает LLM обнаруживать медицинские галлюцинации. (Источник: lateinteraction, lateinteraction)

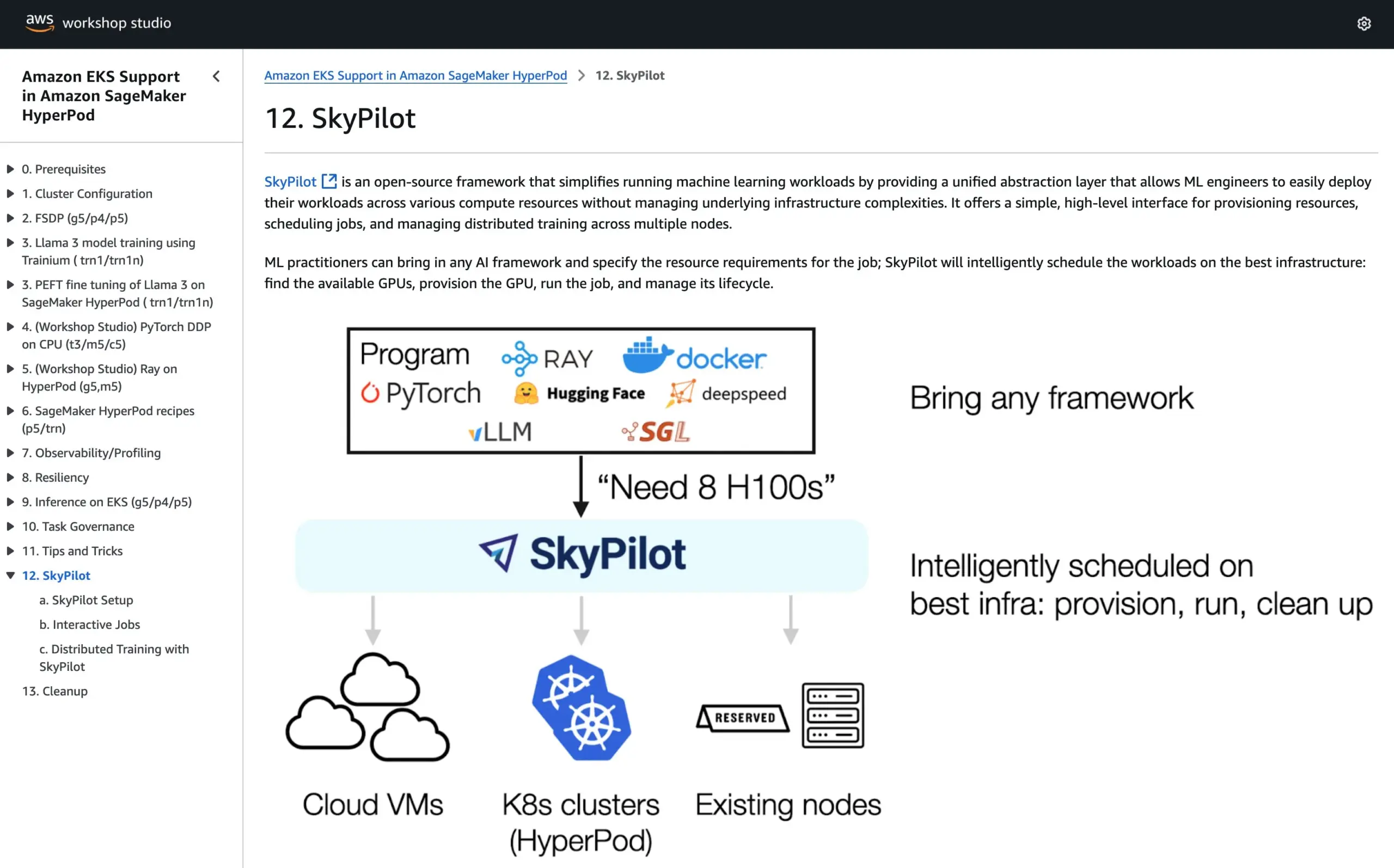

SkyPilot включен в официальное руководство AWS SageMaker HyperPod, объединяя преимущества обеих систем для запуска AI: SkyPilot объявил о своей интеграции в официальное руководство AWS SageMaker HyperPod. Пользователи могут сочетать улучшенную доступность и возможности восстановления узлов, предоставляемые HyperPod, с удобством, скоростью и надежностью SkyPilot в выполнении AI-задач командами, тем самым оптимизируя выполнение рабочих нагрузок AI. (Источник: skypilot_org)

💼 Бизнес

Годовой доход OpenAI достиг 10 миллиардов долларов, но компания все еще убыточна, рост пользователей стремительный: По данным CNBC, годовой регулярный доход (ARR) OpenAI достиг 10 миллиардов долларов, удвоившись по сравнению с прошлым годом, в основном благодаря потребительским подпискам на ChatGPT, корпоративным сделкам и использованию API. Еженедельная аудитория составляет 500 миллионов пользователей, а число бизнес-клиентов превышает 3 миллиона. Однако из-за высоких вычислительных затрат компания, по сообщениям, в прошлом году понесла убытки в размере около 5 миллиардов долларов, но стремится к 2029 году достичь ARR в 125 миллиардов долларов. Эта информация не включает доходы от лицензирования Microsoft, поэтому фактическая выручка может быть выше. (Источник: Reddit r/ArtificialInteligence, Reddit r/ChatGPT)

Компания по принятию решений с помощью AI 深演智能 после неудачи на A-акциях переходит на IPO в Гонконге, сталкиваясь с проблемой снижения прибыли: Компания по принятию маркетинговых решений с помощью AI 深演智能 почти через год после отзыва заявки на листинг на Шэньчжэньской фондовой бирже подала проспект эмиссии на Гонконгскую фондовую биржу. В 2024 году чистая прибыль компании упала на 64,5%, а доля дебиторской задолженности достигла 40%. Основными направлениями деятельности 深演智能 являются интеллектуальная платформа для размещения рекламы AlphaDesk и интеллектуальная платформа управления данными AlphaData, а в 2025 году был запущен продукт AI Agent DeepAgent. Несмотря на лидирующие позиции на китайском рынке AI-приложений для принятия маркетинговых и сбытовых решений, компания сталкивается с такими проблемами, как рост затрат на закупку медиаресурсов и усиление конкуренции в отрасли. (Источник: 36氪)

You.com сотрудничает с журналом TIME, предлагая его цифровым подписчикам год бесплатного Pro-сервиса: AI-поисковая компания You.com объявила о сотрудничестве с известным медиабрендом TIME. В рамках этого сотрудничества You.com предоставит всем цифровым подписчикам журнала TIME бесплатный годовой доступ к аккаунту You.com Pro. Этот шаг направлен на расширение пользовательской базы You.com Pro и изучение возможностей сочетания AI-поиска с медиаконтентом. (Источник: RichardSocher)

🌟 Сообщество

Anthropic советует пользователям использовать ее AI как игровой автомат, что вызвало бурное обсуждение в сообществе: Рекомендация Anthropic по использованию ее AI — «относитесь к нему как к игровому автомату» — вызвала широкое обсуждение и некоторую насмешку в социальных сетях. Это высказывание подразумевает, что результаты вывода ее AI могут быть неопределенными и случайными, требуя от пользователей избирательного принятия и оценки, а не полного доверия. Это отражает текущие проблемы, с которыми сталкиваются большие языковые модели в плане надежности и последовательности. (Источник: pmddomingos, pmddomingos)

Инструменты для разработчиков AI: «лед и пламень» — огромная разница между передовыми приложениями и массовой практикой: В сообществе разработчиков активно обсуждается основное противоречие при создании и инвестировании в инструменты для разработчиков AI: способ создания 1% передовых AI-приложений кардинально отличается от остальных 99%. Оба подхода являются правильными и уместными в своих соответствующих сценариях использования, но попытка бесшовного масштабирования от небольших приложений до сверхбольших с использованием одной и той же архитектуры или технологического стека почти наверняка обречена на провал. Это подчеркивает сложность выбора инструментов и методологий в области разработки AI. (Источник: swyx)

Shopify поощряет сотрудников смело использовать LLM для программирования, даже проводя «конкурс расходов»: MParakhin из Shopify сообщил, что компания не только не ограничивает сотрудников в использовании LLM при написании кода, но и «ругает» тех, кто тратит слишком мало. Он даже провел конкурс, награждая сотрудников, которые потратили больше всего кредитов LLM без использования скриптов. Это отражает позицию некоторых передовых технологических компаний, активно внедряющих инструменты разработки с помощью AI и рассматривающих их как важное средство повышения эффективности и инновационного потенциала. (Источник: MParakhin)

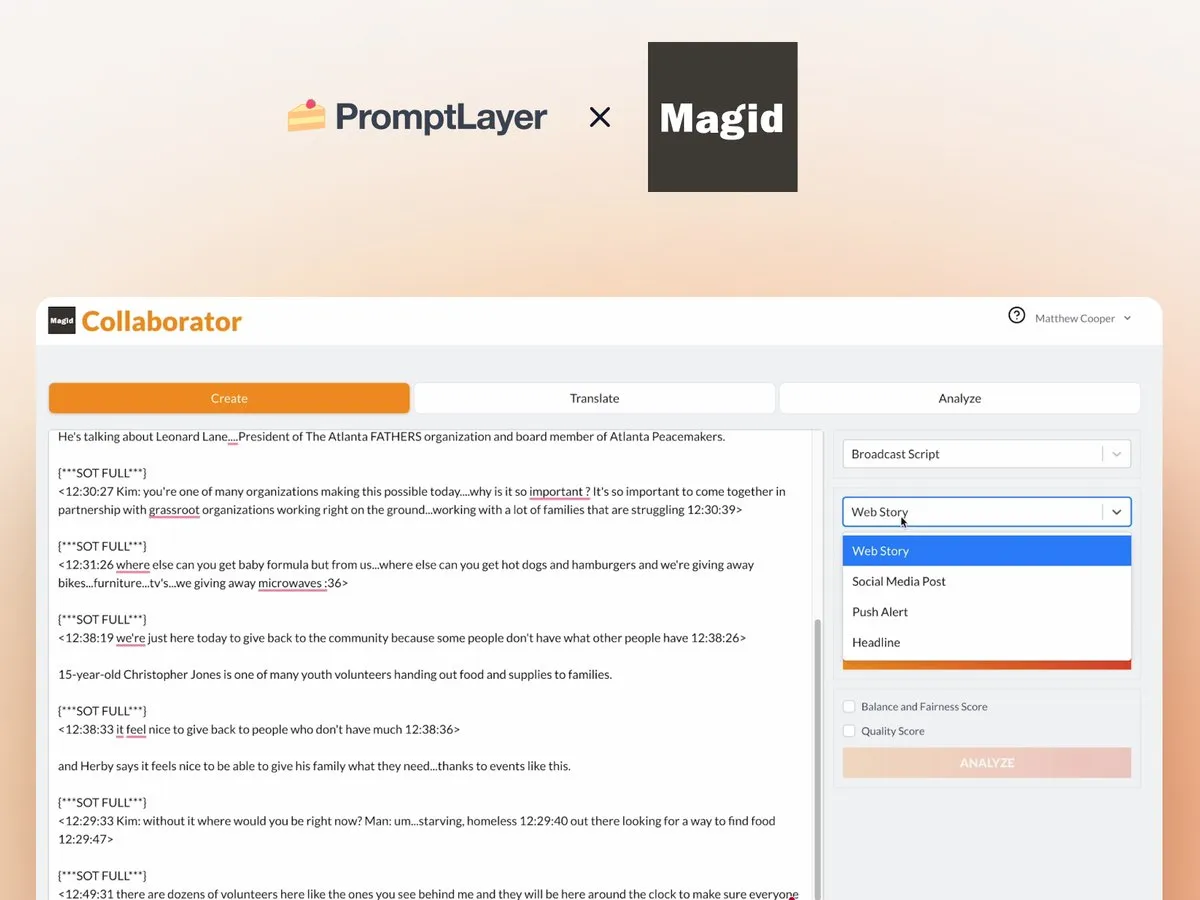

Применение AI Agent в новостных редакциях: кейс сотрудничества Magid и PromptLayer: Компания Magid использует платформу PromptLayer для создания AI-агентов, помогающих новостным редакциям массово создавать контент, обеспечивая при этом соответствие новостным стандартам. Эти AI-агенты способны обрабатывать тысячи репортажей, обладают надежностью, возможностями контроля версий и заслужили доверие реальных журналистов. Этот кейс демонстрирует практический потенциал AI Agent в создании контента и новостной индустрии. (Источник: imjaredz, Jonpon101)

Обсуждение пути к AGI через LLM типа RL+GPT: В сообществе существует мнение, что сочетание обучения с подкреплением (RL) и больших языковых моделей (LLM) в стиле GPT вполне может привести к созданию общего искусственного интеллекта (AGI). Эта точка зрения вызвала дальнейшие размышления и обсуждения о путях достижения AGI, при этом особое внимание уделяется потенциалу RL в наделении LLM более сильной целеустремленностью и способностью к непрерывному обучению. (Источник: finbarrtimbers, agihippo)

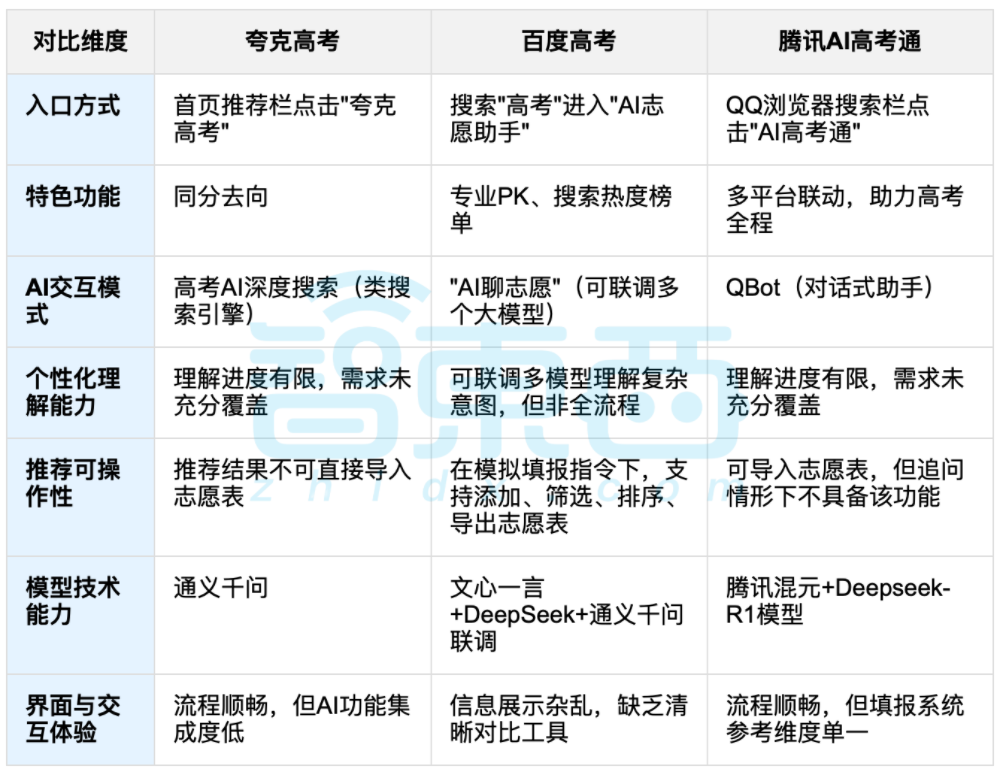

Использование AI для помощи в выборе вуза после ЕГЭ вызвало дискуссии, в центре внимания — баланс данных и индивидуального выбора: По окончании ЕГЭ внимание привлекли инструменты для помощи в выборе вуза с использованием AI, такие как 夸克, 百度AI高考通, 腾讯AI高考通 и другие. Эти инструменты анализируют данные прошлых лет, сопоставляют баллы и рейтинги, предлагая рекомендации по принципу «риск-стабильность-гарантия». Тестирование показало, что платформы различаются по способам взаимодействия, логике рекомендаций и пониманию индивидуальных потребностей, имея свои сильные и слабые стороны. Обсуждения указывают на то, что AI, хотя и может повысить эффективность получения информации и устранить информационный разрыв, не может полностью заменить субъективное суждение и жизненный выбор абитуриента, когда речь идет о сложных личных факторах, таких как характер, интересы и планы на будущее. «Гадание по данным» с помощью AI не является панацеей. (Источник: 36氪, 36氪)

💡 Другое

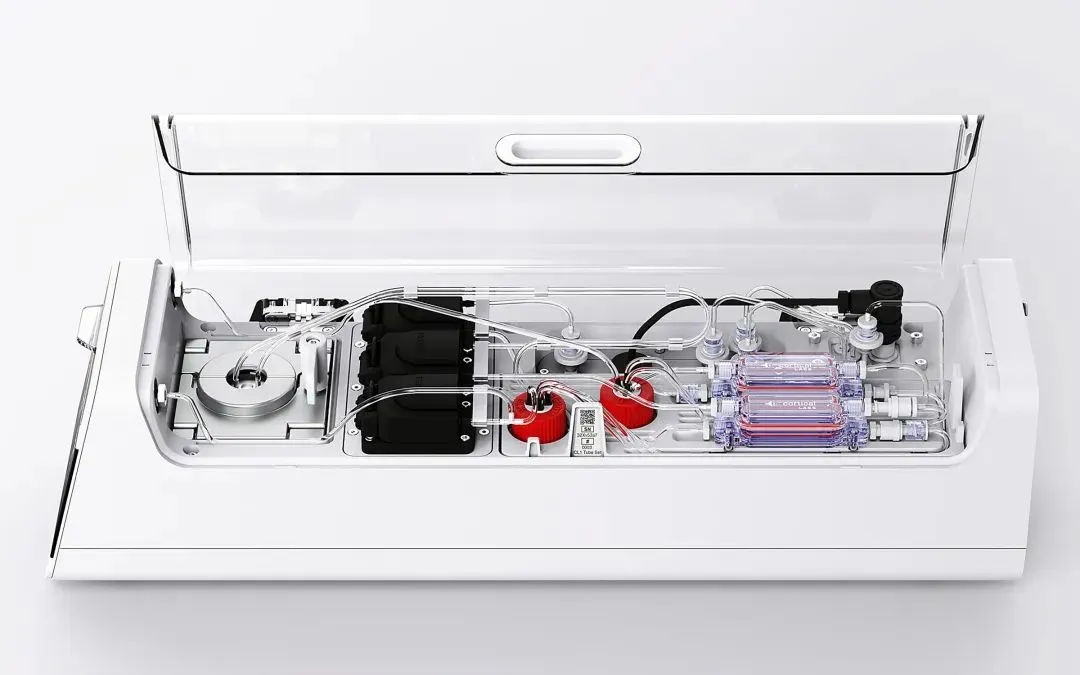

Cortical Labs выпустила первую коммерческую биокомпьютерную платформу CL1, интегрирующую 800 000 живых человеческих нейронов: Австралийский стартап Cortical Labs начал продажи первой в мире коммерческой биокомпьютерной платформы CL1. Платформа объединяет 800 000 живых человеческих нейронов с кремниевым чипом, образуя «гибридный интеллект». CL1 способна обрабатывать информацию и самостоятельно обучаться, демонстрируя признаки, подобные сознанию; в ходе эксперимента она научилась играть в игру Pong. Устройство потребляет значительно меньше энергии, чем традиционное AI-оборудование, стоит 35 000 долларов США и предлагает модель удаленного доступа «wetware-as-a-service» (WaaS). Эта технология стирает границы между биологией и машиной, вызывая дискуссии о природе интеллекта и этике. (Источник: 36氪)

Практические трудности с базами знаний AI: технология впечатляет, но внедрение сложно, требуется «AI-дружественный» дизайн: Лю Сянхуа, вице-президент 蓝凌, в беседе с Цуй Цяном, основателем 崔牛会, отметил, что технология больших моделей вновь привлекла внимание к управлению корпоративными знаниями, однако базы знаний AI сталкиваются с проблемой «хвалят, но не покупают». Он считает, что корпоративные базы знаний и личные базы знаний значительно различаются в управлении правами доступа, организации системы знаний, обеспечении согласованности контента и т.д. Создание «AI-дружественной» базы знаний с акцентом на качество данных, графы знаний, гибридный поиск и т.д. может уменьшить галлюцинации и повысить практическую пользу. Он не одобряет погоню за технологиями ради технологий, подчеркивая, что следует выбирать подходящие технологии в зависимости от сценария, и большие модели не являются панацеей. (Источник: 36氪)

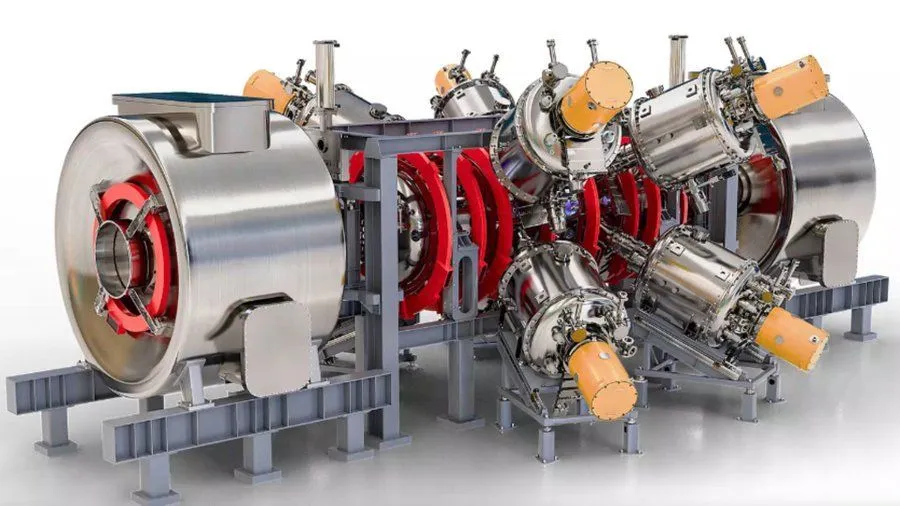

Проект термоядерного реактора, усовершенствованного с помощью AI при поддержке Google, нацелен на достижение плазмы температурой 1,8 миллиарда градусов по Фаренгейту к 2030 году: По сообщению Interesting Engineering, Google поддерживает проект, направленный на усовершенствование термоядерных реакторов с помощью технологий AI. Цель проекта — к 2030 году иметь возможность генерировать и поддерживать плазму температурой 1,8 миллиарда градусов по Фаренгейту (около 1 миллиарда градусов по Цельсию). Это сотрудничество демонстрирует потенциал AI в решении экстремальных научных и инженерных задач, особенно в области чистой энергетики. (Источник: Ronald_vanLoon)