Ключевые слова:Gemini 2.5 Pro, ИИ модель, гуманоидный робот, этика ИИ, стартап в сфере ИИ, контент, созданный ИИ, ИИ для поддержки творчества, прохождение игры «Pokémon: Blue» с помощью Gemini 2.5 Pro, глобальный веб-поиск Anthropic Claude, маршрутизационное смещение модели Qwen3 MoE, функция Runway Gen-4 References, применение ИИ в поддержке психического здоровья

🔥 Фокус

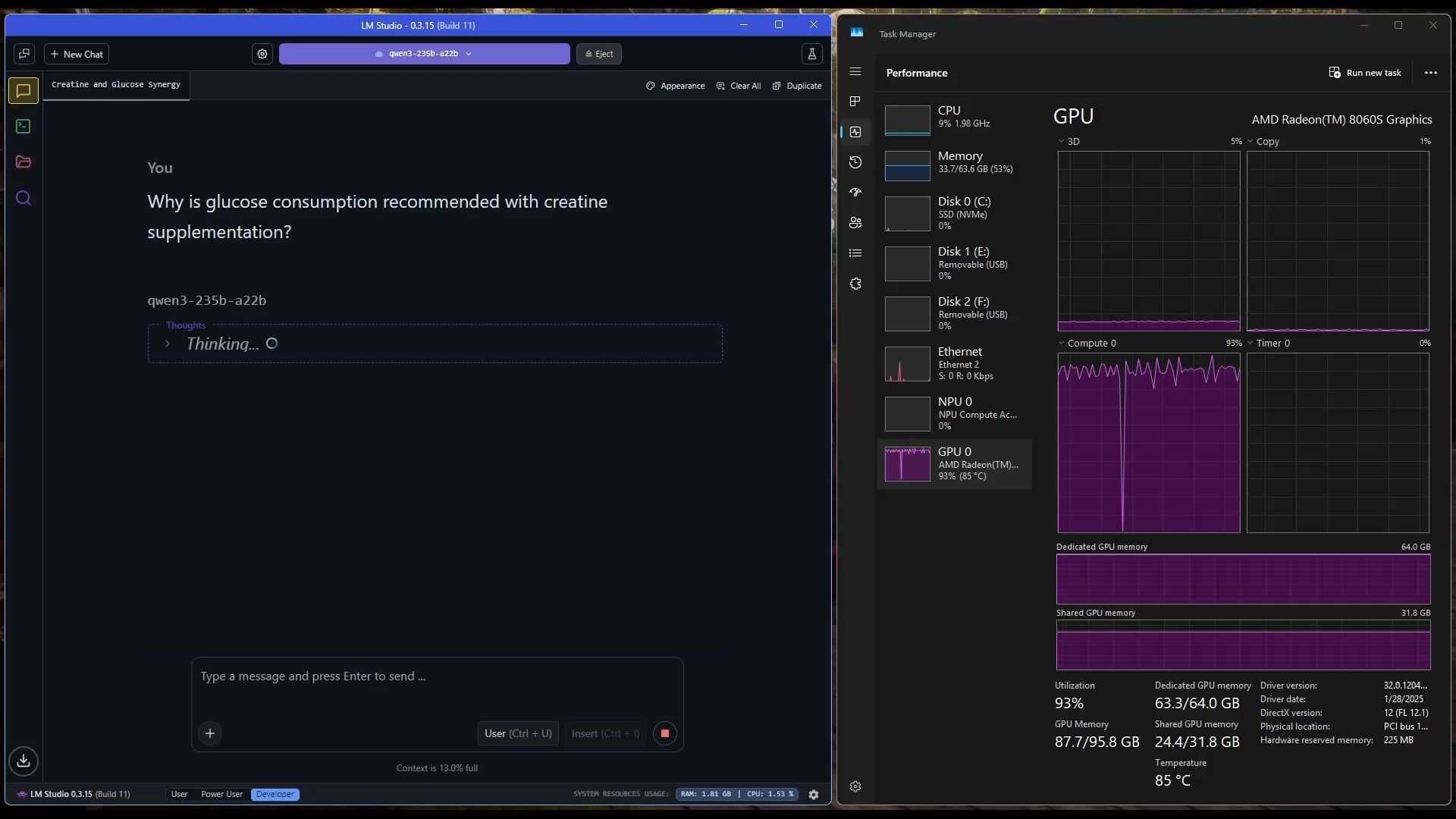

Gemini 2.5 Pro успешно прошел игру «Pokémon: Blue»: Модель AI Gemini 2.5 Pro от Google успешно завершила классическую игру «Pokémon: Blue», включая сбор всех 8 значков и победу над Элитной Четверкой Лиги Покемонов. Это достижение было осуществлено и транслировалось стримером @TheCodeOfJoel, и его поздравили CEO Google Сундар Пичаи и CEO DeepMind Демис Хассабис. Это демонстрирует значительный прогресс современного AI в планировании сложных задач, разработке долгосрочных стратегий и взаимодействии с симулированными средами, превосходя предыдущие достижения AI в этой игре и знаменуя новую веху в возможностях AI-агентов. (Источник: Google, jam3scampbell, teortaxesTex, YiTayML, demishassabis, _philschmid, Teknium1, tokenbender)

Apple сотрудничает с Anthropic для разработки AI-платформы для кодирования “Vibe Coding”: По сообщению Bloomberg, Apple сотрудничает со стартапом в области AI Anthropic для совместной разработки новой платформы для кодирования на базе AI под названием “Vibe Coding”. Платформа в настоящее время тестируется внутри Apple среди сотрудников и в будущем может быть открыта для сторонних разработчиков. Это знаменует дальнейшее исследование Apple в области инструментов помощи в программировании с использованием AI, направленное на повышение эффективности и удобства разработки с помощью AI, и может дополнить или интегрироваться с собственными проектами Apple, такими как Swift Assist. (Источник: op7418)

Прогресс и обсуждение робототехники на базе AI: В последнее время гуманоидные роботы и воплощенный интеллект привлекают широкое внимание. Компания Figure продемонстрировала свою высокотехнологичную новую штаб-квартиру, охватывающую все: от батарей и приводов до лабораторий AI, что свидетельствует о ее амбициях в области робототехники. Disney также продемонстрировала свою технологию гуманоидных роботов-персонажей. Однако на марафоне гуманоидных роботов в Пекине некоторые роботы (включая модифицированный клиентом Unitree G1) показали плохие результаты, падая, имея низкую автономность и проблемы с балансом. Это вызвало дискуссию о реальных возможностях современных гуманоидных роботов, подчеркнув необходимость значительного прогресса как в «мозжечке» (управление движением), так и в «мозге» (интеллектуальное принятие решений). (Источник: adcock_brett, Ronald_vanLoon, 人形机器人,最重要的还是“脑子”)

Обсуждение этики AI и социального влияния набирает обороты: В социальных сетях и исследовательских кругах все чаще обсуждаются социальные последствия и этические проблемы AI. Например, законопроект Калифорнии SB-1047 об AI вызвал споры, а связанные с ним документальные фильмы исследуют необходимость и проблемы регулирования. На конференции NAACL 2025 был проведен туториал на тему «Социальный интеллект в эпоху LLM», посвященный долгосрочным и возникающим проблемам взаимодействия AI с людьми и обществом. В то же время пользователи выражают обеспокоенность качеством контента, генерируемого AI («slop»), считая, что необходимы лучшие дизайн и контроль моделей. Эти обсуждения отражают растущую озабоченность общества этическими, регуляторными и социально-адаптационными проблемами, связанными с быстрым развитием технологий AI. (Источник: teortaxesTex, gneubig, stanfordnlp, jam3scampbell, willdepue, wordgrammer)

🎯 Тенденции

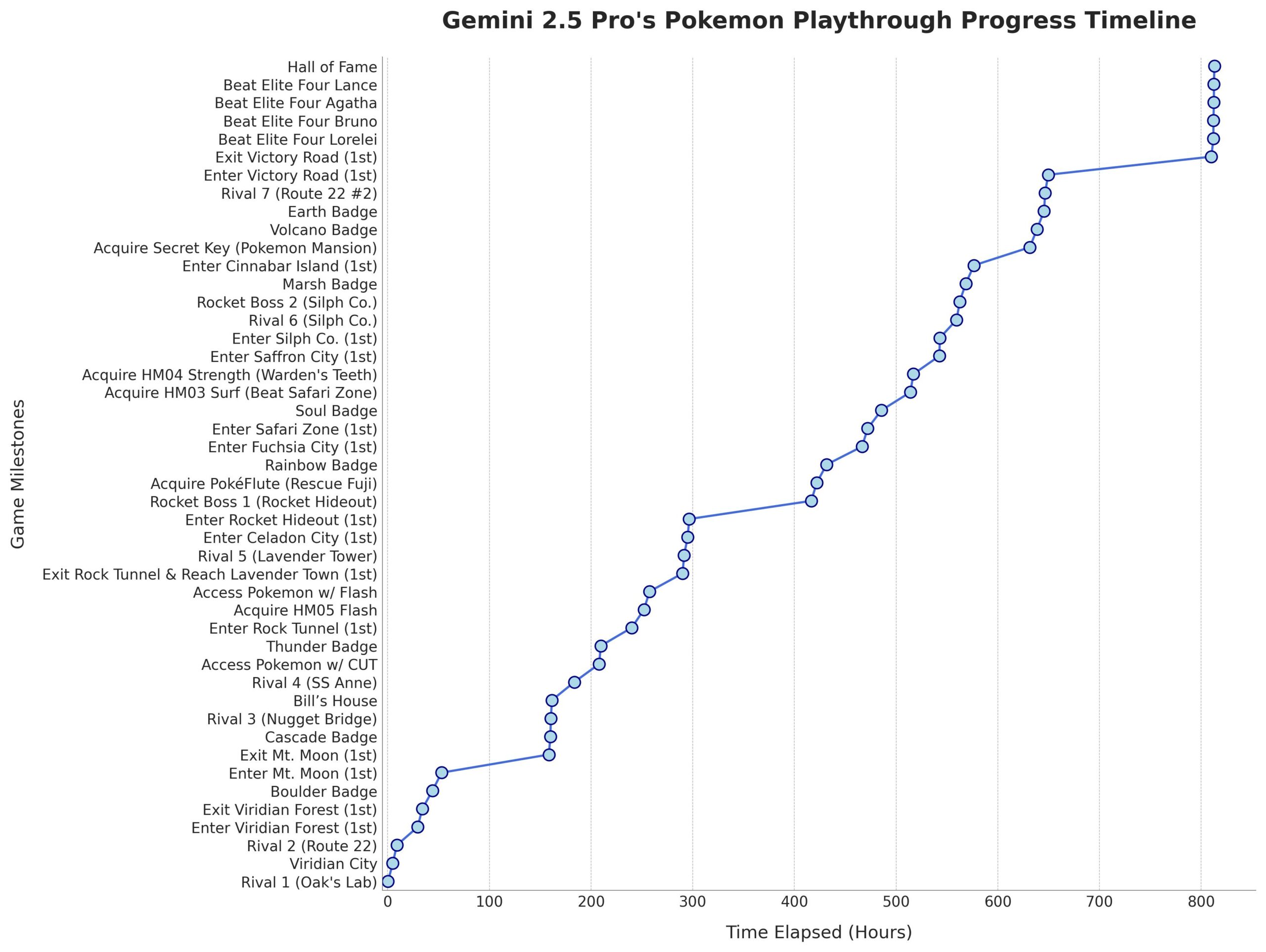

Microsoft выпустила модель Phi-4-Mini-Reasoning: Microsoft опубликовала на Hugging Face модель Phi-4-Mini-Reasoning. Эта модель направлена на улучшение способностей малых языковых моделей к математическим рассуждениям, что способствует дальнейшему развитию миниатюрных и высокопроизводительных моделей. (Источник: _akhaliq)

Модель Anthropic Claude поддерживает глобальный веб-поиск: Anthropic объявила, что ее модель AI Claude теперь предоставляет всем платным пользователям доступ к глобальному веб-поиску. Для простых задач Claude выполняет быстрый поиск; для сложных вопросов она исследует несколько источников информации, включая Google Workspace, что расширяет возможности модели по получению и обработке информации в реальном времени. (Источник: Teknium1, Reddit r/ClaudeAI)

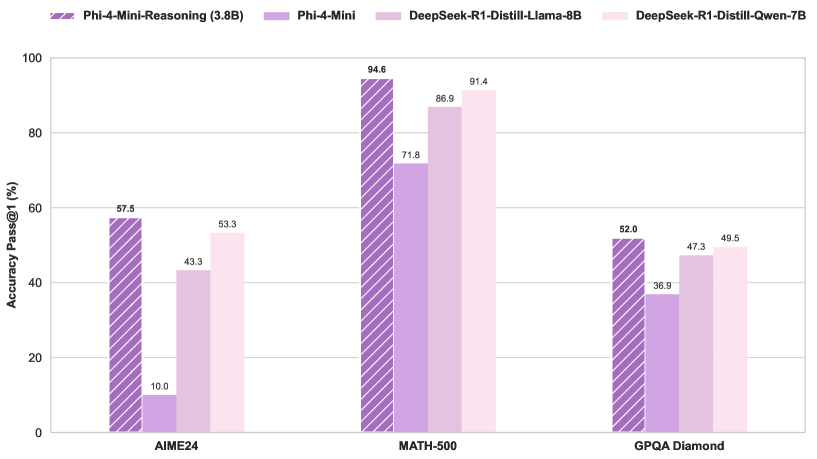

Маршрутизация модели Qwen3 MoE имеет смещение и может быть сокращена: Пользователь kalomaze обнаружил, что распределение маршрутизации в модели Qwen3 MoE (Mixture of Experts) имеет значительное смещение, и даже модель 30B MoE показывает потенциал для сокращения (pruning). Это означает, что некоторые эксперты (Experts) могут использоваться не в полной мере, и удаление этих экспертов путем сокращения может уменьшить размер модели и вычислительные потребности без существенного влияния на производительность. Kalomaze уже выпустил версию модели 30B, сокращенную до 16B на основе этого открытия, и планирует выпустить версию 235B, сокращенную до 150B. (Источник: andersonbcdefg, Reddit r/LocalLLaMA)

DeepSeek Prover V2 выделяется среди открытых математических ассистентов: DeepSeek Prover V2 считается лучшей на данный момент открытой моделью-ассистентом для математики. Хотя ее производительность все еще уступает закрытым или более мощным моделям, таким как Gemini 2.5 Pro, o4 mini high, o3, Claude 3.7 и Grok 3, она хорошо справляется со структурированными рассуждениями. Пользователи считают, что ей не хватает возможностей в сессиях «мозгового штурма», требующих творческого мышления. (Источник: cognitivecompai)

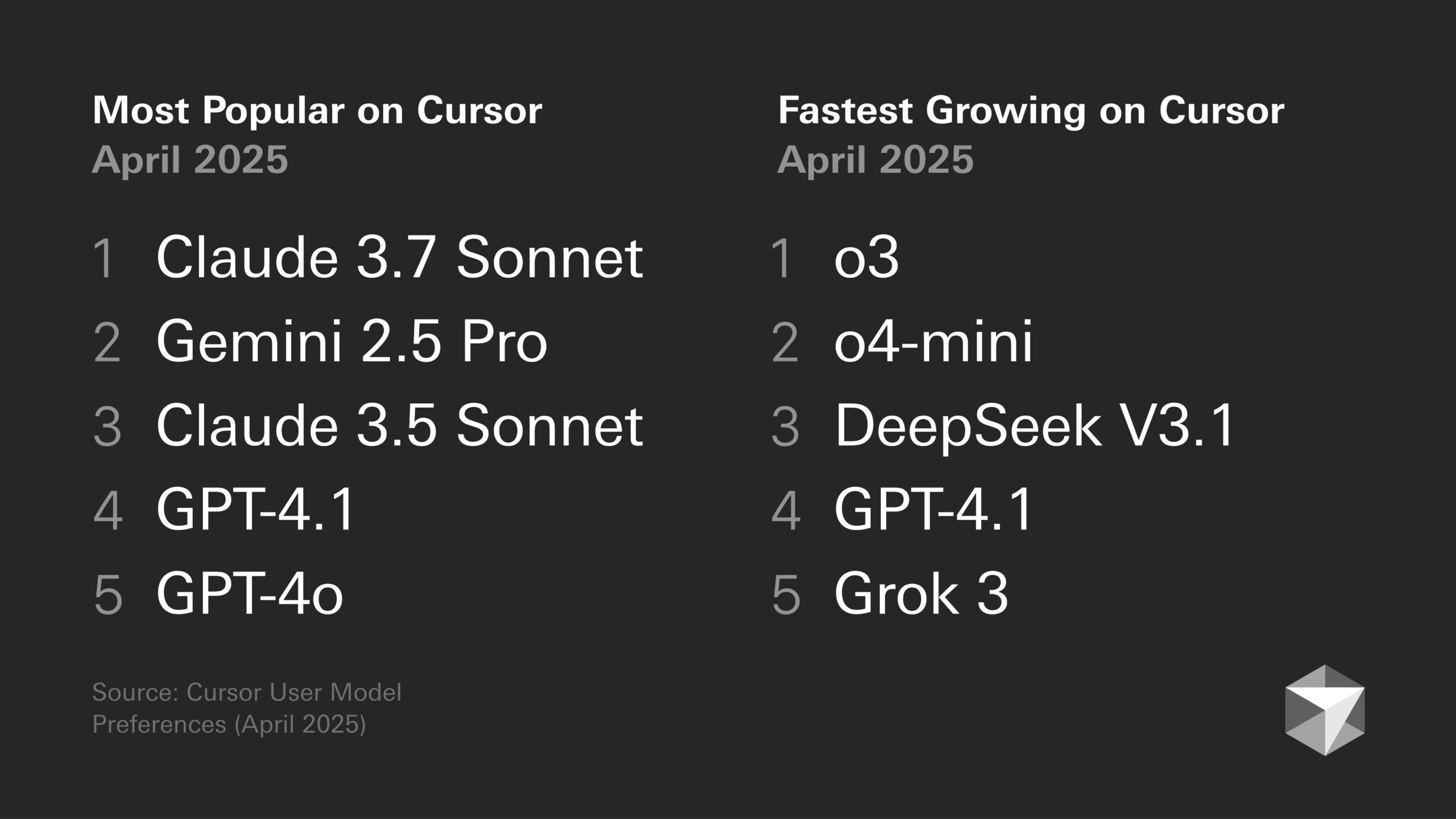

Обсуждение предпочтений моделей: склонности разработчиков и особенности моделей: В сообществе разработчиков продолжаются дискуссии о преимуществах и недостатках различных больших моделей. Например, Sentdex считает, что o3 в сочетании с Codex в Cursor превосходит Claude 3.7. VictorTaelin заявляет, что хотя Sonnet 3.7 не идеален (иногда слишком активно добавляет незапрошенное, уровень интеллекта не соответствует ожиданиям), на практике он все же обеспечивает более стабильные и надежные результаты, чем GPT-4o (склонен к ошибкам), o3/Gemini (плохое форматирование и переписывание кода), R1 (немного устарел) и Grok 3 (второй по качеству, но на практике немного уступает). Это отражает различия в применимости разных моделей для конкретных задач и рабочих процессов. (Источник: Sentdex, VictorTaelin, paul_cal)

Обсуждение тенденций производительности LLM: экспоненциальный рост или убывающая отдача?: Пользователи Reddit обсуждают, продолжается ли экспоненциальное улучшение LLM. Существует мнение, что, несмотря на быстрый прогресс на ранних этапах, повышение производительности LLM в настоящее время приближается к убывающей отдаче, и получение дополнительной производительности становится все труднее и дороже, подобно развитию технологий автономного вождения. Другие пользователи возражают, указывая на огромный скачок от GPT-3 до Gemini 2.5 Pro как на свидетельство значительного прогресса, и что еще слишком рано говорить о плато. Дискуссия отражает разные ожидания относительно будущих темпов развития AI. (Источник: Reddit r/ArtificialInteligence)

Чипы AI становятся ключом к развитию гуманоидных роботов: По мнению отраслевых экспертов, ядром гуманоидных роботов является их «мозг», то есть высокопроизводительные чипы. В статье отмечается, что современные гуманоидные роботы все еще имеют недостатки в управлении движением («мозжечок») и интеллектуальном принятии решений («мозг»), а производительность чипов напрямую определяет уровень интеллекта робота. GPU от Nvidia, процессоры Intel, а также отечественные чипы, такие как Huashan A2000 и Wudang C1236 от Black Sesame Technologies, предоставляют роботам более мощные возможности восприятия, рассуждения и управления, являясь ключом к переходу гуманоидных роботов от диковинки к практическому применению. (Источник: 人形机器人,最重要的还是“脑子”)

Этика AI и антропоморфизм: почему мы говорим AI «спасибо»?: Обсуждение указывает на то, что, хотя AI не обладает эмоциями, пользователи склонны использовать вежливые выражения (например, «спасибо», «пожалуйста») при общении с ним. Это происходит из-за человеческого инстинкта антропоморфизации и «восприятия социального присутствия». Исследования показывают, что вежливое взаимодействие может побудить AI давать более ожидаемые и человекоподобные ответы. Однако это также несет риски, такие как возможность того, что AI выучит и усилит человеческие предубеждения или будет злонамеренно направлен на создание нежелательного контента. Вежливое поведение по отношению к AI отражает сложную психологию и социальную адаптацию человека при взаимодействии с все более интеллектуальными машинами. (Источник: 你对 AI 说的每一句「谢谢」,都在烧钱)

🧰 Инструменты

Функция Runway Gen-4 References: Функция Gen-4 References, представленная RunwayML, позволяет пользователям интегрировать свои или другие референсные изображения в видео или изображения, сгенерированные AI (например, meme). Пользователи отмечают высокую эффективность функции, способность обрабатывать несколько согласованных персонажей на одном сгенерированном изображении, что упрощает процесс интеграции конкретных людей или стилей в творчество AI. (Источник: c_valenzuelab)

Krea AI представляет шаблоны для генерации изображений: Krea AI добавила новую функцию, превращающую распространенные промпты для генерации изображений GPT-4o в шаблоны. Пользователям достаточно загрузить свое изображение и выбрать шаблон, чтобы сгенерировать изображение в соответствующем стиле, без необходимости вручную вводить сложные промпты, что упрощает процесс генерации изображений. (Источник: op7418)

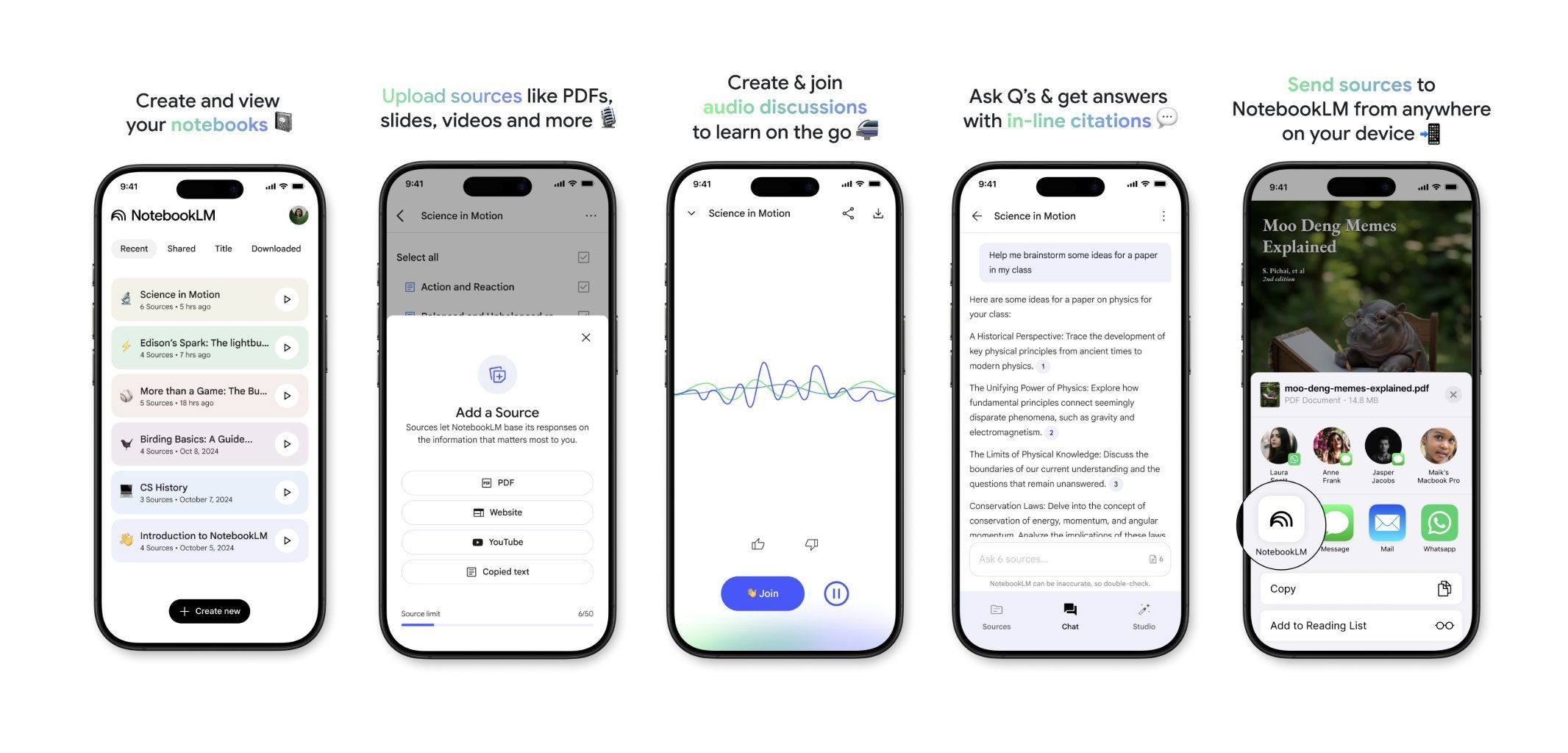

NotebookLM скоро выпустит мобильное приложение: NotebookLM от Google (ранее Project Tailwind) скоро выпустит мобильное приложение. Пользователи смогут быстро пересылать статьи и контент, увиденные на телефоне, в NotebookLM для обработки и интеграции. В настоящее время открыта регистрация в список ожидания приложения, целью которого является предоставление более удобного управления информацией на мобильных устройствах и опыта обучения с помощью AI. (Источник: op7418)

Runway для дизайна интерьера: Пользователь демонстрирует пример использования Runway AI для дизайна интерьера. Предоставив изображение пространства и референсное изображение, представляющее стиль/настроение, Runway может генерировать эскизы дизайна интерьера, сочетающие особенности обоих, демонстрируя потенциал применения AI в области креативного дизайна. (Источник: c_valenzuelab)

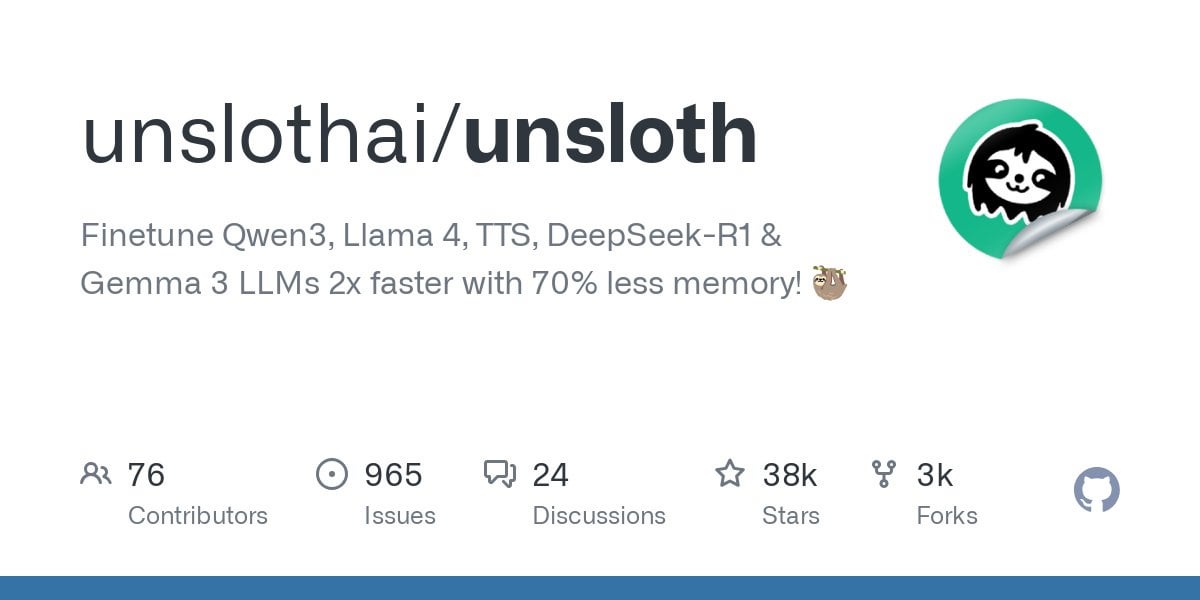

Unsloth поддерживает тонкую настройку моделей Qwen3: Unsloth объявил о поддержке тонкой настройки моделей серии Qwen3, с увеличением скорости в 2 раза и уменьшением использования VRAM на 70%. Пользователи могут выполнять тонкую настройку с контекстной длиной в 8 раз большей, чем у Flash Attention 2, на GPU с 24 ГБ VRAM. Предоставлен ноутбук Colab для бесплатной тонкой настройки модели Qwen3 14B, а также загружены различные квантованные модели, включая GGUF. Это снижает аппаратные требования для тонкой настройки передовых моделей. (Источник: Reddit r/LocalLLaMA)

Функция Claude AI Styles: Пользователь делится опытом использования функции Styles в Claude AI для улучшения взаимодействия с AI. Создав стиль под названием «Iterative Engineering» и установив шаги: обсуждение, планирование, небольшие модификации, тестирование, итерация, рефакторинг по необходимости, можно направить Claude на более методичное и инкрементальное кодирование, избегая чрезмерного переписывания кода и повышая практичность AI как партнера по программированию. (Источник: Reddit r/ClaudeAI)

Deepwiki предоставляет источники для блоков кода: Пользователь cto_junior упоминает преимущество Deepwiki: он отображает блоки исходного кода рядом с каждым ответом, а не просто прикрепляет ссылки. Такой подход повышает достоверность информации, что особенно полезно для инженеров-разработчиков программного обеспечения (SDEs), скептически относящихся к инструментам AI. (Источник: cto_junior)

📚 Исследования

NousResearch выпустила обновление фреймворка Atropos RL: Фреймворк среды обучения с подкреплением (RL) Atropos от NousResearch был обновлен. Новая функция позволяет пользователям быстро и легко тестировать развертывания (rollout) среды RL без необходимости обучения или движка вывода. По умолчанию используется OpenAI API, но его можно настроить для других поставщиков API (или локальных конечных точек VLLM/SGLang). После завершения тестирования генерируется веб-отчет, содержащий завершения (completions) и их оценки, а также поддерживается логирование в wandb, что облегчает отладку и оценку сред RL. (Источник: Teknium1)

Выпущен персонализированный бенчмарк-датасет RAG EnronQA: Исследователи выпустили датасет EnronQA, направленный на продвижение исследований персонализированной генерации с дополнением извлечением (Personalized RAG) на частных документах. Датасет содержит 103 638 электронных писем и 528 304 высококачественных пар вопрос-ответ для 150 пользователей, предоставляя ресурсы для оценки и разработки систем RAG, способных понимать и использовать специфическую для пользователя информацию. (Источник: lateinteraction)

Выпущен GTE-ModernColBERT (PyLate): LightOnAI выпустила GTE-ModernColBERT (PyLate), 128-мерный ретривер MaxSim, основанный на gte-modernbert-base и дообученный на ms-marco-en-bge-gemma. Он нативно поддерживает библиотеку PyLate для переранжирования и индексации HNSW. Он показывает отличные результаты на бенчмарке NanoBEIR и превосходит ColBERT-small по среднему баллу BEIR, предлагая новый эффективный вариант для поиска текста. (Источник: lateinteraction)

SOLO Bench — новый бенчмарк для LLM: Пользователь jd_3d разработал и выпустил SOLO Bench, новый метод бенчмаркинга LLM. Тест требует от LLM сгенерировать текст, содержащий определенное количество предложений (например, 250 или 500), каждое из которых должно содержать ровно одно слово из предопределенного списка (включая существительные, глаголы, прилагательные и т.д.), причем каждое слово можно использовать только один раз. Оценка производится с помощью скрипта на основе правил и направлена на проверку способности LLM следовать инструкциям, удовлетворять ограничениям и генерировать длинный текст. Предварительные результаты показывают, что бенчмарк эффективно различает производительность разных моделей. (Источник: Reddit r/LocalLLaMA)

Манипулирование латентным пространством с помощью стратегической рекурсивной рефлексии: Пользователь предлагает метод создания вложенных иерархий рассуждений в латентном пространстве LLM с помощью «стратегической рекурсивной рефлексии» (Strategic recursive reflection, RR). Путем подсказки модели в ключевые моменты для рефлексии над предыдущими взаимодействиями генерируются метакогнитивные циклы, создавая «мини-латентные пространства». Каждая подсказка рассматривается как давление, направляющее путь модели в латентном пространстве, делая ее более самореферентной и способной к абстракции. Считается, что это имитирует процесс углубления мышления человеком через рефлексию над мыслями, с целью исследования более глубоких концепций. (Источник: Reddit r/ArtificialInteligence)

💼 Бизнес

Google платит Samsung за предустановку Gemini AI: После прошлогоднего антимонопольного решения по поводу соглашения о поисковой системе по умолчанию, сообщается, что Google ежемесячно платит Samsung «огромные суммы» и долю от дохода за предустановку Gemini AI на устройства Samsung, а также может требовать от партнеров принудительной предустановки Gemini. Это объясняет, почему серия Samsung Galaxy S25 глубоко интегрирует Gemini, даже устанавливая его в качестве AI-помощника по умолчанию. Этот шаг отражает стратегию Google по быстрому захвату точки входа мобильного AI в условиях недостатка собственных аппаратных каналов, но также может снова вызвать антимонопольные опасения. (Источник: 三星手机预装Gemini AI,也是谷歌花钱买的)

Стартапы в области AI сталкиваются с проблемами: Обсуждение на Reddit указывает, что многим стартапам в области AI может не хватать конкурентных преимуществ («рва»), поскольку возможности моделей сближаются, а лояльность пользователей низка. Крупные технологические компании (Google, Microsoft, Apple) благодаря своим экосистемным преимуществам (например, предустановка, интеграция) легче достигают пользователей. Даже если модель стартапа немного лучше, пользователи могут предпочесть использовать стандартный или интегрированный AI, который «достаточно хорош». Это вызывает опасения относительно долгосрочной жизнеспособности стартапов в области AI и перспектив инвестиций VC. (Источник: Reddit r/ArtificialInteligence)

Сводка финансирования и деловых новостей AI за неделю (2 мая 2025 г.): CEO Microsoft сообщил, что AI уже написал «значительные части» кода компании; CFO Microsoft предупредил, что сервисы AI могут прерываться из-за слишком высокого спроса; Google начал размещать рекламу в сторонних чат-ботах AI; Meta запустила отдельное приложение AI; Cast AI привлек $108 млн, Astronomer — $93 млн, Edgerunner AI — $12 млн; Исследование обвиняет LM Arena в манипулировании бенчмарками; Nvidia оспаривает поддержку Anthropic экспортного контроля чипов. (Источник: Reddit r/artificial)

🌟 Сообщество

Обсуждение качества и стоимости контента, генерируемого AI: В сообществе выражается обеспокоенность неравномерным качеством контента, генерируемого AI (называемого “slop”). Пользователь wordgrammer отмечает, что массово генерируемые AI-видео имеют низкое качество, а фактическая стоимость (учитывая отбор и повторные попытки) намного выше заявленной. Это вызывает дискуссии о дизайне моделей (например, jam3scampbell цитирует Стива Джобса) и эффективном использовании инструментов AI, подчеркивая необходимость более тонкого контроля и более высоких стандартов качества генерации. (Источник: wordgrammer, jam3scampbell, willdepue)

Обсуждение производительности AI в конкретных задачах: Члены сообщества обсуждают производительность и ограничения AI в различных задачах. Например, DeepSeek R1 считается возможным пиком хайпа вокруг LLM; несмотря на прогресс в таких областях, как формальная математика и медицина, он не привлек широкого внимания обычных пользователей. DeepSeek Prover V2 хорошо справляется с математикой, но считается лишенным креативности. Пользователь vikhyatk ставит под сомнение значимость чрезмерной оптимизации моделей для достижения высоких результатов на конкретных бенчмарках, таких как AIME (Американская пригласительная математическая олимпиада), полагая, что широкая публика не интересуется математическими способностями. Эти обсуждения отражают размышления о границах возможностей AI и их практической ценности. (Источник: wordgrammer, cognitivecompai, vikhyatk)

Креативность и дизайн с помощью AI: Сообщество демонстрирует различные способы использования инструментов AI для креативного дизайна. Пользователи используют функцию Gen-4 References от Runway, чтобы вставить себя в meme; используют Runway для генерации концепций дизайна интерьера; используют GPT-4o и шаблоны промптов для создания изображений в определенном стиле (например, оригами южно-китайского тигра, силиконовая подставка под запястье в виде животного, интеграция значения слова в дизайн букв). Эти примеры демонстрируют потенциал AI в визуальном творчестве и персонализированном дизайне. (Источник: c_valenzuelab, c_valenzuelab, dotey, dotey, dotey)

Сомнения в способности AI имитировать стиль письма: Пользователь nrehiew_ считает, что инструкция для LLM «продолжать писать в моем тоне и стиле» может не иметь реального эффекта, поскольку большинство людей переоценивают уникальность своего стиля письма. Это вызывает дискуссию о способности LLM понимать и воспроизводить тонкие нюансы стиля письма, а также о предвзятости восприятия этой способности пользователями. (Источник: nrehiew_)

Использование AI для эмоциональной поддержки вызывает отклик и обсуждение: Пользователи Reddit делятся опытом получения эмоциональной поддержки и даже помощи в кризисных ситуациях при общении с AI, таким как ChatGPT. Многие отмечают, что в моменты одиночества, потребности выговориться или столкновения с психологическими трудностями AI предоставляет безоценочного, терпеливого и всегда доступного собеседника, иногда даже более эффективного, чем общение с реальными людьми. Это вызывает дискуссию о роли AI в поддержке психического здоровья, но также подчеркивает, что AI не может заменить профессиональную человеческую помощь и необходимо остерегаться возможных предубеждений или дезинформации со стороны AI. (Источник: Reddit r/ChatGPT, Reddit r/ClaudeAI)

Разногласия во взглядах на искусство, созданное AI: Пользователи обсуждают потенциальное влияние искусства, созданного AI, на восприятие человеческих художников и их работ. Некоторые жалуются, что высококачественные работы теперь часто легко приписывают AI, игнорируя талант и усилия создателя. Это явление даже начинает искажать восприятие людей, заставляя их искать «человеческие ошибки» в работах, чтобы подтвердить их не-AI происхождение. Обсуждение также затрагивает вопрос о том, следует ли требовать обязательного добавления водяных знаков к контенту, созданному AI. (Источник: Reddit r/ArtificialInteligence)

💡 Прочее

Потребление ресурсов AI привлекает внимание: Обсуждение подчеркивает огромное потребление ресурсов, стоящее за развитием AI. Обучение и эксплуатация больших моделей AI требуют огромного количества электроэнергии и водных ресурсов, а центры обработки данных становятся новыми объектами с высоким энергопотреблением. Каждое взаимодействие пользователя с AI, включая простое «спасибо», кумулятивно потребляет энергию. Это вызывает озабоченность по поводу устойчивости развития AI и внимания к энергетическим решениям (например, термоядерному синтезу). (Источник: 你对 AI 说的每一句「谢谢」,都在烧钱)

Дистанция между AI и сознанием: Пользователи Reddit обсуждают, обладает ли текущий AI самосознанием. Преобладает мнение, что нынешний AI (например, LLM) по сути является сложной системой сопоставления с образцом, основанной на вероятностном предсказании слов, лишенной истинного понимания и самосознания, и до обладания такими способностями еще очень далеко. Однако в комментариях также отмечается, что само человеческое сознание не до конца понято, поэтому сравнения могут быть ошибочными, и нельзя игнорировать сверхчеловеческие способности AI в конкретных задачах. (Источник: Reddit r/ArtificialInteligence)

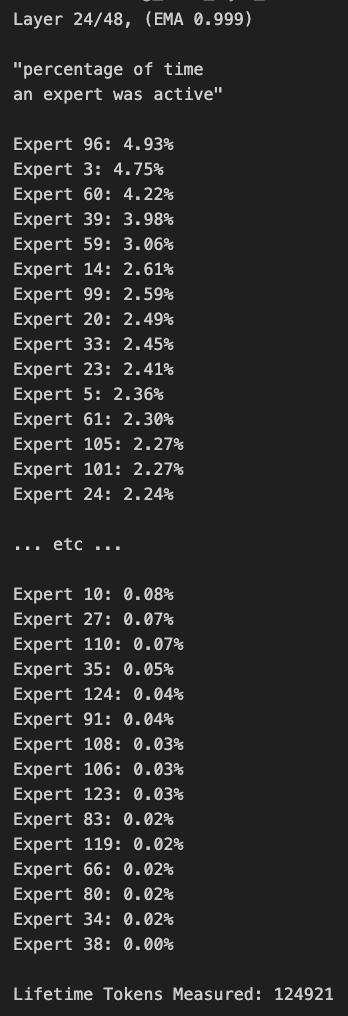

Запуск большой модели MoE на планшете Windows: Пользователь демонстрирует запуск модели Qwen3 235B-A22B MoE (с квантованием Q2_K_XL) на планшете Windows, оснащенном AMD Ryzen AI Max 395+ и 128 ГБ RAM, используя только iGPU (Radeon 8060S, с выделением 87.7 ГБ из 95.8 ГБ в качестве VRAM), со скоростью около 11.1 т/с. Это демонстрирует возможность запуска очень больших моделей на портативных устройствах, хотя пропускная способность памяти остается узким местом. (Источник: Reddit r/LocalLLaMA)