Ключевые слова:OpenAI, Amazon AWS, AI вычислительная мощность, Stanford AgentFlow, Meituan LongCat-Flash-Omni, Alibaba Qwen3-Max-Thinking, Samsung TRM модель, Unity AI Graph, сотрудничество OpenAI и Amazon в области вычислительных мощностей, фреймворк AgentFlow для обучения с подкреплением, мультимодальная модель LongCat-Flash-Omni, способности к логическому выводу Qwen3-Max-Thinking, рекурсивная архитектура рассуждений TRM

🔥 В центре внимания

OpenAI и Amazon заключили соглашение о вычислительных мощностях на 38 миллиардов долларов : OpenAI и Amazon AWS подписали соглашение о вычислительных мощностях на сумму 38 миллиардов долларов, направленное на получение ресурсов GPU NVIDIA для поддержки создания инфраструктуры их моделей AI и достижения амбициозных целей в области AI. Этот шаг знаменует собой важный этап для OpenAI в диверсификации поставщиков облачных услуг, снижении эксклюзивной зависимости от Microsoft и подготовке к будущему IPO. Amazon, в свою очередь, благодаря этому сотрудничеству укрепляет свои лидирующие позиции в области инфраструктуры AI, продолжая при этом сотрудничество с конкурентом OpenAI — Anthropic. Соглашение предоставит OpenAI масштабируемые вычислительные мощности для AI-инференса и обучения моделей следующего поколения, а также будет способствовать применению их базовых моделей на платформе AWS. (Источник: Ronald_vanLoon, scaling01, TheRundownAI)

Фреймворк AgentFlow от Стэнфорда: малые модели превосходят GPT-4o : Исследовательская группа Стэнфордского университета и другие представили фреймворк AgentFlow, который благодаря модульной архитектуре и алгоритму Flow-GRPO позволяет системам AI-агентов использовать онлайн-обучение с подкреплением в процессе инференса для непрерывной самооптимизации. AgentFlow с всего 7 миллиардами параметров полностью превзошел GPT-4o (около 200 миллиардов параметров) и Llama-3.1-405B в задачах поиска, математики и науки, возглавив ежедневный рейтинг HuggingFace Paper. Это исследование доказывает, что системы агентов могут приобретать способности к обучению, аналогичные большим моделям, и при этом быть более эффективными в конкретных задачах, открывая новый путь “малого и изящного” для развития AI. (Источник: HuggingFace Daily Papers)

AWS запускает Project Rainier: один из крупнейших в мире кластеров вычислительных мощностей AI : AWS запустила Project Rainier — кластер вычислительных мощностей AI, построенный менее чем за год, с почти 500 000 чипов Trainium2. Anthropic уже обучает на нем новую модель Claude и планирует расширить кластер до 1 миллиона чипов к концу 2025 года. Trainium2 — это специализированный процессор AWS для обучения AI, предназначенный для обработки крупномасштабных нейронных сетей. Проект использует архитектуру UltraServer, подключаясь через сети NeuronLinks и EFA, обеспечивая вычислительную мощность для разреженных моделей FP8 до 83,2 петафлопс и питаясь на 100% возобновляемой энергией для достижения высокой энергоэффективности. Project Rainier подчеркивает лидирующую позицию AWS в области инфраструктуры AI, предлагая вертикально интегрированные решения от специализированных чипов до охлаждения центров обработки данных. (Источник: TheTuringPost)

🎯 Тенденции

Meituan выпустила полностью модальную модель LongCat-Flash-Omni : Meituan открыла исходный код своей новейшей полностью модальной модели LongCat-Flash-Omni, которая достигла уровня SOTA среди открытых моделей в комплексных бенчмарках, таких как Omni-Bench и WorldSense, и сопоставима с закрытой моделью Gemini-2.5-Pro. LongCat-Flash-Omni использует архитектуру MoE с 560 миллиардами общих параметров и 27 миллиардами активных параметров, обеспечивая высокую эффективность инференса и низкую задержку для взаимодействия в реальном времени, что делает ее первой открытой моделью, реализующей полностью модальное взаимодействие в реальном времени. Модель поддерживает мультимодальный ввод текста, голоса, изображений, видео и любых их комбинаций, имеет контекстное окно в 128K токенов и поддерживает аудио-видео взаимодействие продолжительностью более 8 минут. (Источник: WeChat, ZhihuFrontier)

Выпущена версия Qwen3-Max-Thinking для инференса от Alibaba : Команда Alibaba Qwen выпустила раннюю предварительную версию Qwen3-Max-Thinking, которая является промежуточной контрольной точкой модели, находящейся в процессе обучения. После улучшения использования инструментов и расширения вычислений во время тестирования модель достигла 100% баллов в сложных бенчмарках инференса, таких как AIME 2025 и HMMT. Выпуск Qwen3-Max-Thinking демонстрирует значительный прогресс Alibaba в возможностях AI-инференса, предоставляя пользователям более мощные цепочки рассуждений и способности к решению проблем. (Источник: Alibaba_Qwen, op7418)

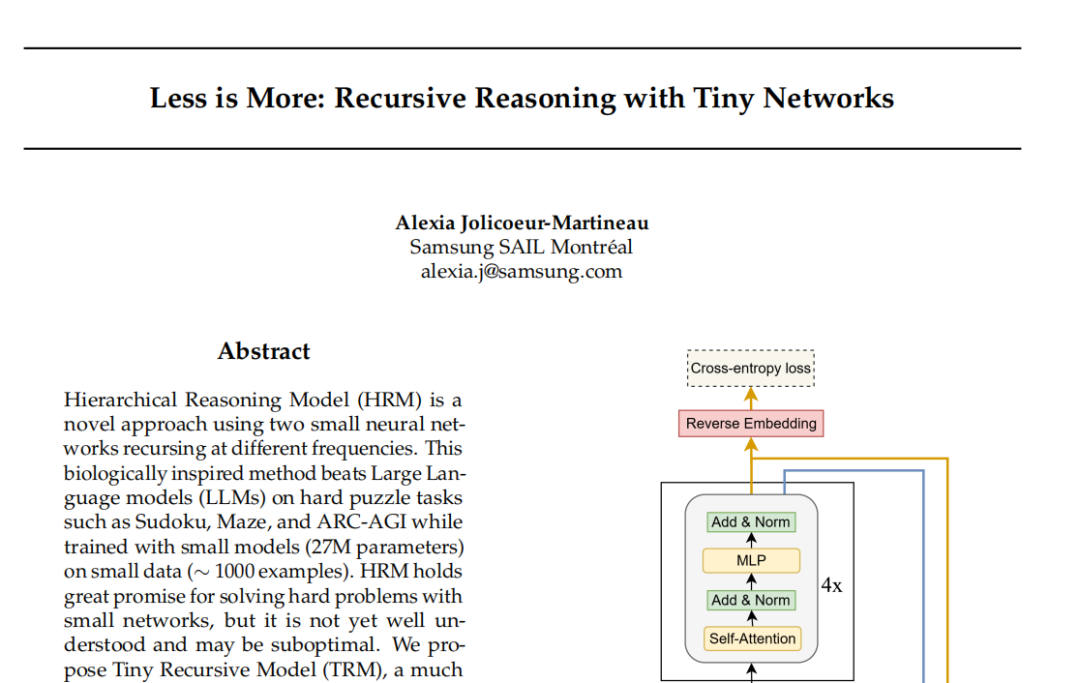

Модель TRM от Samsung: рекурсивный инференс бросает вызов парадигме Transformer : Лаборатория Samsung SAIL Montreal представила Tiny Recursive Model (TRM) — новую архитектуру рекурсивного инференса, представляющую собой двухслойную нейронную сеть с всего 7 миллионами параметров. TRM приближается к правильному результату через многократные самокоррекции, рекурсивно обновляя “ответы” и “потенциальные переменные мышления”, и установила новые рекорды в таких задачах, как Sudoku-Extreme, превзойдя крупные модели, включая DeepSeek R1 и Gemini 2.5 Pro. Модель даже отказалась от слоев самовнимания в своей архитектуре (вариант TRM-MLP), что указывает на то, что для небольших задач с фиксированным вводом MLP может уменьшить переобучение, бросая вызов эмпирическому правилу AI-сообщества “чем больше модель, тем она мощнее”, и предлагая новый подход к легковесному AI-инференсу. (Источник: 36氪)

Конференция разработчиков Unity: будущие тенденции AI+игр : На конференции разработчиков Unity 2025 года было подчеркнуто, что AI станет двигателем игрового творчества и эффективности. Движок Unity в сотрудничестве с Tencent Hunyuan запустил платформу AI Graph, глубоко интегрирующую рабочий процесс AIGC, что позволяет повысить эффективность 2D-дизайна на 30% и эффективность производства 3D-активов на 70%. Amazon Web Services (AWS) также продемонстрировала возможности AI на протяжении всего жизненного цикла игры (создание, запуск, рост), особенно в области генерации кода, где AI переходит от вспомогательной роли к автономному созданию. Meshy, как инструмент для 3D-генеративного AI-творчества, с помощью диффузионных и авторегрессионных моделей помогает разработчикам сокращать затраты и ускорять создание прототипов, обладая огромным потенциалом, особенно в сценариях VR/AR и UGC. (Источник: WeChat)

Cartesia выпустила голосовую модель Sonic-3 : Компания Cartesia, специализирующаяся на голосовом AI, выпустила свою новейшую голосовую модель Sonic-3, которая продемонстрировала потрясающие результаты в воспроизведении голоса Маска и получила 100 миллионов долларов в рамках раунда финансирования серии B от инвесторов, включая NVIDIA. Sonic-3 построен на основе модели пространства состояний (SSM), а не традиционной архитектуры Transformer, способен непрерывно воспринимать контекст и атмосферу диалога, обеспечивая более естественные и легкие ответы AI. Его задержка составляет всего 90 миллисекунд, а время отклика от начала до конца — 190 миллисекунд, что делает его одной из самых быстрых систем генерации речи на сегодняшний день. (Источник: WeChat)

MiniMax выпустила голосовую модель Speech 2.6 : MiniMax выпустила свою новейшую голосовую модель MiniMax Speech 2.6, главной особенностью которой является “быстрота и четкость речи”. Модель сокращает задержку ответа до менее чем 250 мс, поддерживает более 40 языков и все акценты, а также способна точно распознавать различные “нестандартные тексты”, такие как URL-адреса, электронные письма, суммы, даты, номера телефонов. Это означает, что даже при сильном акценте, быстрой речи и сложном информационном вводе модель может с первого раза понять и четко произнести информацию, значительно повышая эффективность и точность голосового взаимодействия. (Источник: WeChat)

Amazon Chronos-2: универсальная базовая модель для прогнозирования : Amazon представила Chronos-2 — базовую модель, предназначенную для решения любых задач прогнозирования. Модель поддерживает прогнозирование одновариантных, многовариантных и ковариантных данных, а также может работать в режиме “нулевого выстрела” (zero-shot). Выпуск Chronos-2 знаменует собой значительный прогресс Amazon в области прогнозирования временных рядов, предоставляя предприятиям и разработчикам более гибкие и мощные возможности прогнозирования, что, как ожидается, упростит сложные процессы прогнозирования и повысит эффективность принятия решений. (Источник: dl_weekly)

YOLOv11 для сегментации экземпляров зданий и классификации высоты : В статье подробно анализируется применение YOLOv11 для сегментации экземпляров зданий и дискретной классификации высоты на спутниковых снимках. YOLOv11, благодаря более эффективной архитектуре, сочетающей признаки различных масштабов, повышает точность локализации объектов и демонстрирует выдающиеся результаты в сложных городских сценариях. Модель достигла производительности сегментации экземпляров 60,4% mAP@50 и 38,3% mAP@50-95 на наборе данных DFC2023 Track 2, сохраняя при этом надежную точность классификации для пяти предопределенных уровней высоты. YOLOv11 демонстрирует отличные результаты в обработке окклюзий, сложных форм зданий и несбалансированных классов, что делает его пригодным для крупномасштабного городского картографирования в реальном времени. (Источник: HuggingFace Daily Papers)

🧰 Инструменты

PageIndex: система индексации документов RAG на основе инференса : VectifyAI выпустила PageIndex — систему RAG (Retrieval Augmented Generation) на основе инференса, которая не требует векторных баз данных и разбиения на чанки. PageIndex создает древовидную структуру индекса документов, имитируя способ навигации и извлечения знаний экспертами, что позволяет LLM выполнять многошаговые рассуждения и достигать более точного поиска документов. Система достигла точности 98,7% в бенчмарке FinanceBench, значительно превзойдя традиционные векторные системы RAG, и особенно подходит для анализа длинных профессиональных документов, таких как финансовые отчеты и юридические документы. PageIndex предлагает различные варианты развертывания, включая самостоятельное размещение, облачные сервисы и API. (Источник: GitHub Trending)

LocalAI: локальная альтернатива OpenAI с открытым исходным кодом : LocalAI — это бесплатная альтернатива OpenAI с открытым исходным кодом, предоставляющая REST API, совместимый с OpenAI API, и поддерживающая локальный запуск LLM, генерации изображений, аудио, видео и клонирования голоса на потребительском оборудовании. Проект не требует GPU, поддерживает различные модели, такие как gguf, transformers, diffusers, и уже интегрировал такие функции, как WebUI, P2P-инференс и Model Context Protocol (MCP). LocalAI стремится к локализации и децентрализации AI-инференса, предоставляя пользователям более гибкие и приватные варианты развертывания AI, а также поддерживает различные аппаратные ускорения. (Источник: GitHub Trending)

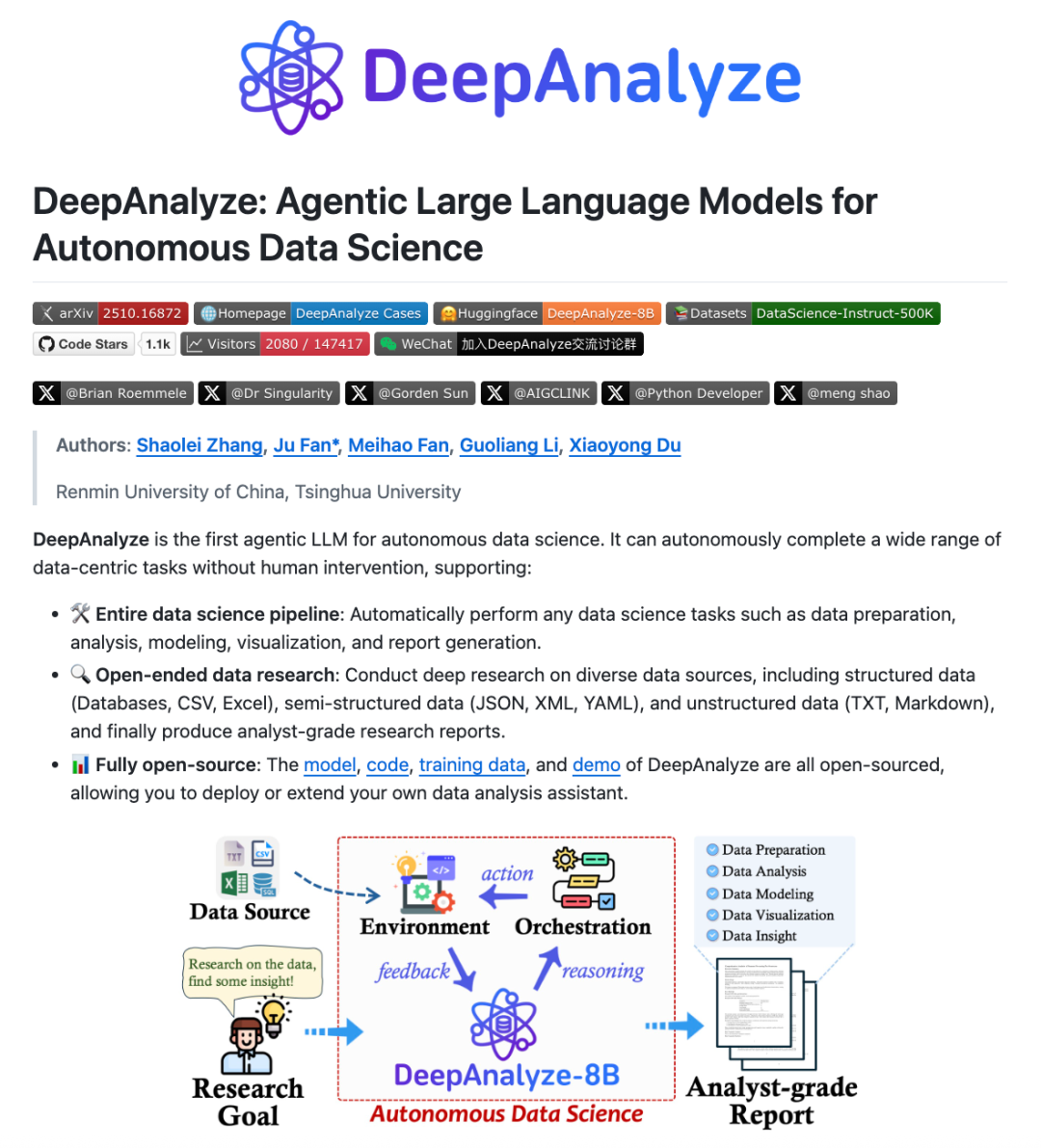

DeepAnalyze: Agentic LLM для науки о данных : Исследовательские группы Китайского народного университета и Университета Цинхуа представили DeepAnalyze, первый Agentic LLM, ориентированный на науку о данных. Модель не требует вручную разработанных workflow и может самостоятельно выполнять сложные задачи науки о данных, такие как подготовка данных, анализ, моделирование, визуализация и получение инсайтов, а также генерировать исследовательские отчеты на уровне аналитика, используя только один LLM. DeepAnalyze, используя парадигму обучения Agentic в стиле учебного плана и фреймворк синтеза траекторий, ориентированный на данные, обучается в реальных условиях, решая проблемы разреженных вознаграждений и отсутствия длинных цепочек траекторий решения задач, что позволяет проводить автономные глубокие исследования в области науки о данных. (Источник: WeChat)

AI PC: возможности процессоров Intel Core Ultra серии 200H : AI PC, оснащенные процессорами Intel Core Ultra серии 200H, становятся новым выбором для повышения эффективности работы и жизни. Эта серия процессоров интегрирует мощный NPU (нейронный процессорный блок), повышая энергоэффективность до 21% и способна обрабатывать длительные, низкопотребляющие AI-задачи, такие как удаление фонового шума в реальном времени, интеллектуальное вырезание объектов, организация документов с помощью AI-ассистента, и все это без необходимости подключения к сети. Гибридная архитектура CPU, GPU и NPU позволяет AI PC демонстрировать выдающиеся результаты в легкости, портативности, длительном времени автономной работы и работе в автономном режиме, обеспечивая плавный и естественный AI-опыт для сценариев работы, учебы и игр. (Источник: WeChat)

Claude Skills: каталог из 2300+ навыков : Веб-сайт skillsmp.com собрал более 2300 Claude Skills, предоставляя пользователям Claude AI доступный для поиска каталог навыков. Эти навыки организованы по категориям, включая инструменты разработки, документацию, улучшения AI, анализ данных и т. д., и предлагают функции предварительного просмотра, загрузки ZIP-архивов и установки через CLI. Платформа призвана помочь пользователям Claude более удобно находить и использовать навыки AI, повышать возможности агентов, выполнять более эффективные автоматизированные задачи и вносить вклад в сообщество полезными инструментами. (Источник: Reddit r/ClaudeAI)

AI Chatbots for Websites: десять лучших AI-чат-ботов для веб-сайтов в 2025 году : В отчете перечислены десять лучших AI-чат-ботов для веб-сайтов в 2025 году, призванные помочь стартапам и индивидуальным основателям выбрать подходящие инструменты. ChatQube был назван самым интересным новым инструментом благодаря мгновенным уведомлениям о “пробелах в знаниях” и способности к контекстному восприятию. Intercom Fin подходит для крупных команд поддержки, Drift ориентирован на маркетинг и привлечение лидов, а Tidio — для малого бизнеса и электронной коммерции. Другие, такие как Crisp, Chatbase, Zendesk AI, Botpress, Flowise и Kommunicate, также имеют свои особенности, охватывая широкий спектр потребностей от простой настройки до высокой степени кастомизации, что свидетельствует о том, что AI-чат-боты стали более практичными и распространенными. (Источник: Reddit r/artificial)

Perplexity Comet: AI-агент для кодирования : Perplexity Comet хвалят как высокоэффективный AI-агент для кодирования, который может автономно выполнять задачи, заданные пользователем. Например, пользователь может предоставить ему доступ к репозиторию GitHub и попросить настроить Webhook для прослушивания событий push, и Comet сможет точно получить URL Webhook с других вкладок и правильно его настроить. Это демонстрирует мощные возможности Perplexity Comet в понимании сложных инструкций, кросс-приложенийных операциях и автоматизации процессов разработки, значительно повышая эффективность работы разработчиков. (Источник: AravSrinivas)

LazyCraft: конкурент Dify с открытым исходным кодом для платформы AI Agent : LazyCraft — это новая платформа с открытым исходным кодом для разработки и управления приложениями AI Agent, которая считается сильным конкурентом Dify. Она предлагает более полную замкнутую систему с встроенными модулями, такими как база знаний, управление Prompt, службы инференса, инструменты MCP (поддерживающие локальное и удаленное использование), управление наборами данных и оценка моделей. LazyCraft поддерживает управление несколькими арендаторами/рабочими пространствами, решая потребности в детальном контроле доступа и управлении командами в корпоративных сценариях. Кроме того, она интегрирует функции локальной тонкой настройки и управления моделями, позволяя пользователям научно сравнивать эффекты моделей, предоставляя мощную поддержку предприятиям с потребностями в конфиденциальности данных и глубокой кастомизации. (Источник: WeChat)

📚 Обучение

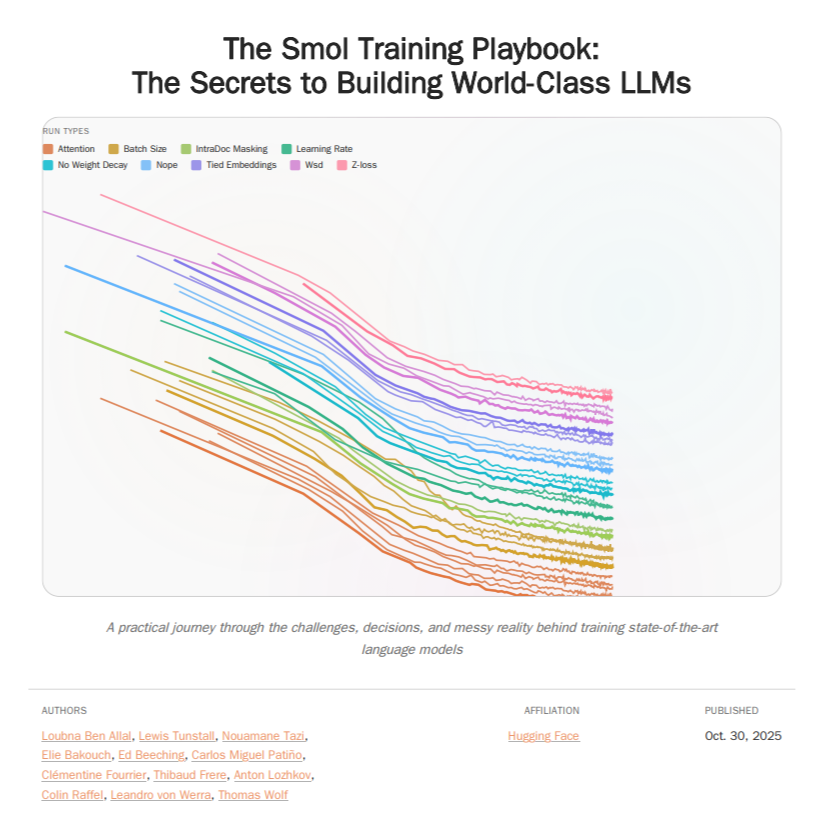

HuggingFace Smol Training Playbook: руководство по обучению LLM : HuggingFace выпустила Smol Training Playbook — всеобъемлющее руководство по обучению LLM, подробно описывающее процесс обучения SmolLM3. Руководство охватывает весь цикл: от стратегии и принятия решений по затратам перед началом, предварительного обучения (данные, абляционные исследования, архитектура и настройка), последующего обучения (SFT, DPO, GRPO, слияние моделей) до инфраструктуры (настройка кластера GPU, связь, отладка). Это более чем 200-страничное руководство призвано предоставить разработчикам LLM прозрачный и практический опыт обучения, снизить порог для самостоятельного обучения моделей и способствовать развитию AI с открытым исходным кодом. (Источник: TheTuringPost, ClementDelangue)

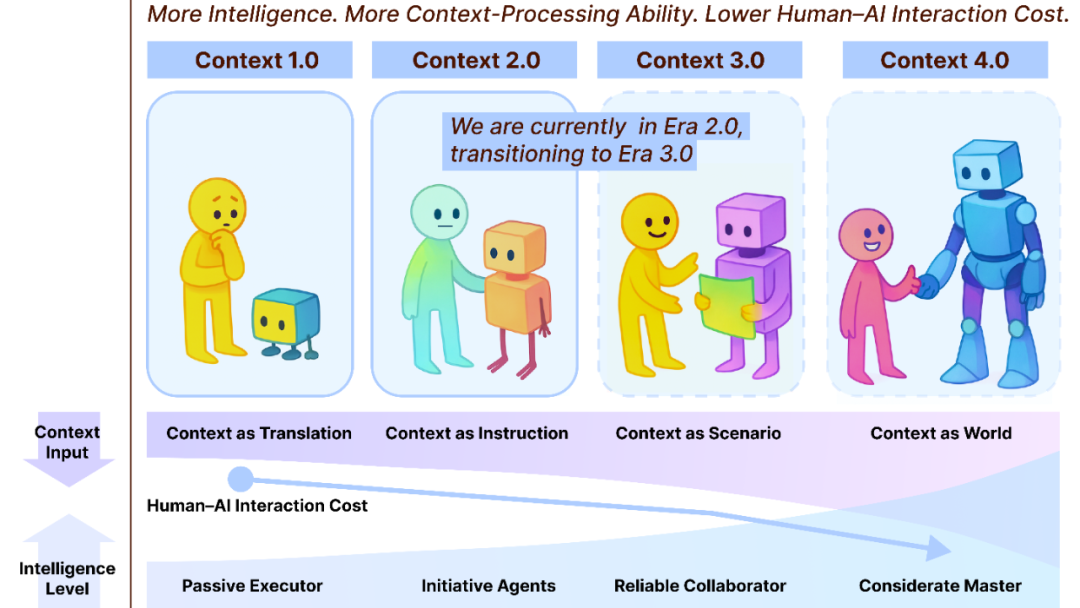

Context Engineering 2.0: 30-летний путь эволюции : Команда Лю Пэнфэя из Шанхайской академии инноваций представила фреймворк “Context Engineering 2.0”, анализирующий суть, историю и будущее контекстной инженерии (Context Engineering). Исследование указывает, что контекстная инженерия — это 30-летний процесс уменьшения энтропии, направленный на преодоление когнитивного разрыва между человеком и машиной. От сенсорно-ориентированной эпохи 1.0, через интеллектуальных помощников и мультимодальную интеграцию эпохи 2.0, до предсказываемого бесшовного сбора данных и плавного сотрудничества эпохи 3.0, эволюция контекстной инженерии стимулировала революцию в человеко-машинном взаимодействии. Фреймворк подчеркивает три измерения: “сбор, управление, использование” и исследует философские вопросы, такие как то, как контекст формирует новую человеческую идентичность после того, как AI превзойдет человека. (Источник: WeChat)

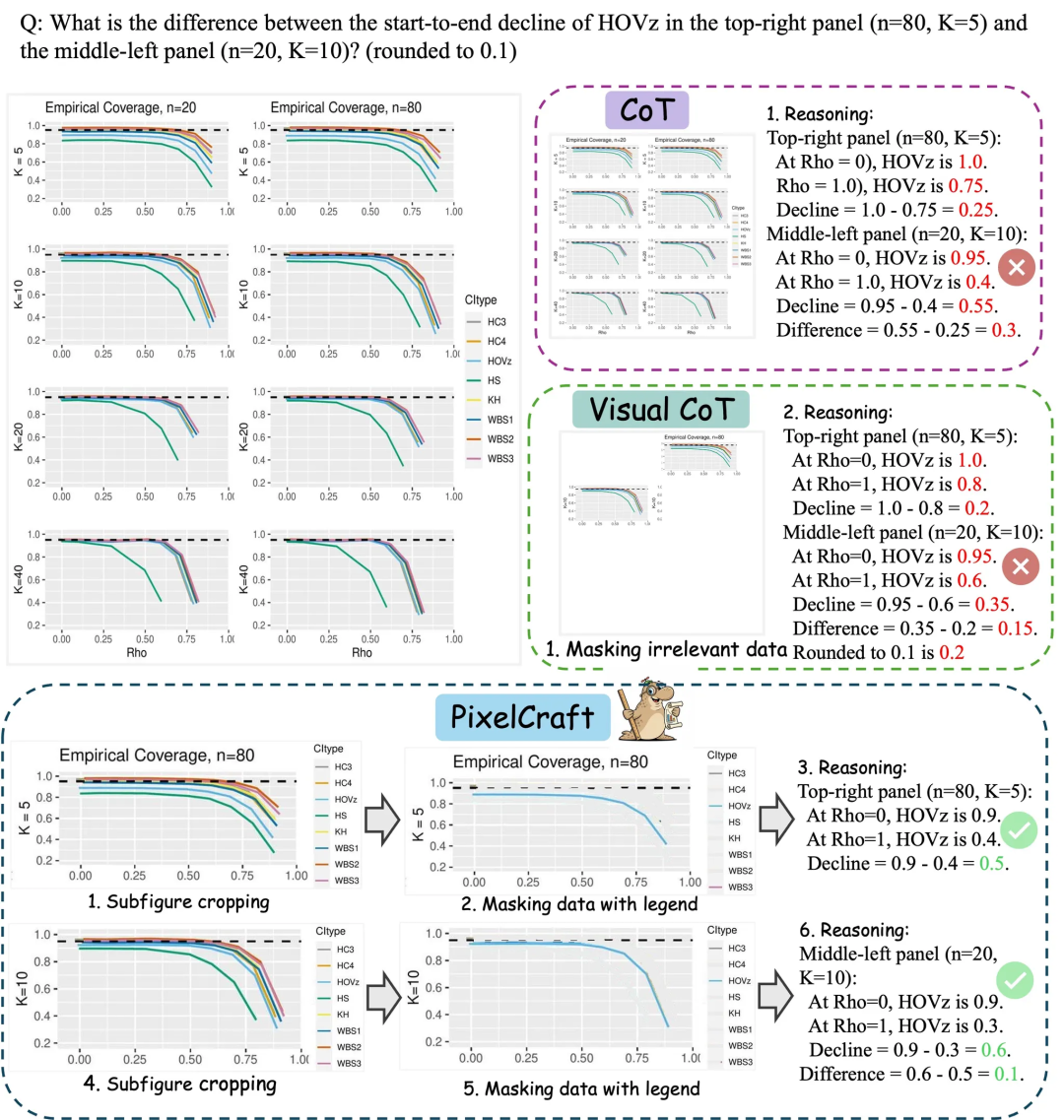

Microsoft Research Asia PixelCraft: улучшение понимания диаграмм большими моделями : Microsoft Research Asia в сотрудничестве с Университетом Цинхуа и другими командами представила PixelCraft, призванный систематически улучшить способность больших мультимодальных моделей (MLLM) понимать структурированные изображения, такие как диаграммы и геометрические эскизы. PixelCraft опирается на два столпа: высокоточное изображение и нелинейное мультиагентное рассуждение. Он достигает отображения текстовых ссылок на уровне пикселей путем тонкой настройки grounding-модели и использует набор агентов визуальных инструментов для выполнения проверяемых операций с изображениями. Его дискуссионный процесс рассуждений поддерживает откат и исследование ветвей, значительно повышая точность, надежность и интерпретируемость модели на таких графических и геометрических бенчмарках, как CharXiv и ChartQAPro. (Источник: WeChat)

Spatial-SSRL: самообучающееся обучение с подкреплением для улучшения пространственного понимания : Исследование представило Spatial-SSRL, парадигму самообучающегося обучения с подкреплением, направленную на улучшение способности больших визуально-языковых моделей (LVLM) к пространственному пониманию. Spatial-SSRL напрямую получает проверяемые сигналы из обычных RGB или RGB-D изображений, автоматически создавая пять предварительных задач, которые захватывают 2D и 3D пространственные структуры, без необходимости ручной или LVLM-разметки. На семи бенчмарках пространственного понимания изображений и видео Spatial-SSRL достигла среднего повышения точности на 4,63% (3B) и 3,89% (7B) по сравнению с базовой моделью Qwen2.5-VL, доказывая, что простое, внутреннее наблюдение может быть реализовано в масштабе для RLVR, принося LVLM более сильный пространственный интеллект. (Источник: HuggingFace Daily Papers)

π_RL: тонкая настройка моделей VLA с помощью онлайн-обучения с подкреплением : Исследование представило π_RL, фреймворк с открытым исходным кодом для обучения визуально-языковых моделей действий (VLA) на основе потоков в параллельных симуляциях. π_RL реализует два алгоритма RL: Flow-Noise моделирует процесс шумоподавления как дискретное по времени MDP, а Flow-SDE обеспечивает эффективное исследование RL через преобразование ODE-SDE. В бенчмарках LIBERO и ManiSkill π_RL значительно улучшил производительность few-shot SFT-моделей pi_0 и pi_0.5, демонстрируя эффективность онлайн-RL для VLA-моделей на основе потоков и достигая мощных многозадачных RL и обобщающих способностей. (Источник: HuggingFace Daily Papers)

LLM Agents: основные подсистемы для создания автономных LLM-агентов : В обязательной к прочтению статье “Fundamentals of Building Autonomous LLM Agents” рассматриваются основные когнитивные подсистемы, составляющие автономных агентов, управляемых LLM. В статье подробно описаны ключевые компоненты, такие как восприятие, рассуждение и планирование (CoT, MCTS, ReAct, ToT), долгосрочная и краткосрочная память, выполнение (выполнение кода, использование инструментов, вызовы API) и обратная связь в замкнутом цикле. Это исследование предлагает всесторонний взгляд на понимание и создание LLM-агентов, способных действовать автономно, подчеркивая, как эти подсистемы работают вместе для достижения сложного интеллектуального поведения. (Источник: TheTuringPost)

Efficient Vision-Language-Action Models: обзор эффективных VLA-моделей : Всеобъемлющий обзор “A Survey on Efficient Vision-Language-Action Models” исследует передовые достижения в области эффективных визуально-языковых моделей действий (VLA) в сфере воплощенного интеллекта. Обзор предлагает унифицированную таксономию, разделяя существующие технологии на три основных столпа: эффективный дизайн моделей, эффективное обучение и эффективный сбор данных. Путем критического анализа самых современных методов это исследование предоставляет сообществу базовую справочную информацию, обобщает типичные применения, проясняет ключевые проблемы и намечает дорожную карту для будущих исследований, направленных на решение огромных вычислительных и информационных потребностей, с которыми сталкиваются VLA-модели при развертывании. (Источник: HuggingFace Daily Papers)

Новое открытие узкого места производительности SNNs: частота, а не разреженность : Исследование выявило истинную причину разрыва в производительности между SNNs (импульсными нейронными сетями) и ANNs (искусственными нейронными сетями: это не потеря информации из-за традиционно предполагаемой бинарной/разреженной активации, а присущие импульсным нейронам характеристики низкочастотной фильтрации. Исследование показало, что SNNs на сетевом уровне действуют как низкочастотные фильтры, что приводит к быстрому рассеиванию высокочастотных компонентов и снижает эффективность представления признаков. Замена Avg-Pool на Max-Pool в Spiking Transformer повысила точность CIFAR-100 на 2,39%, и была предложена архитектура Max-Former, которая достигает точности 82,39% на ImageNet и снижения энергопотребления на 30%. (Источник: Reddit r/MachineLearning)

💼 Бизнес

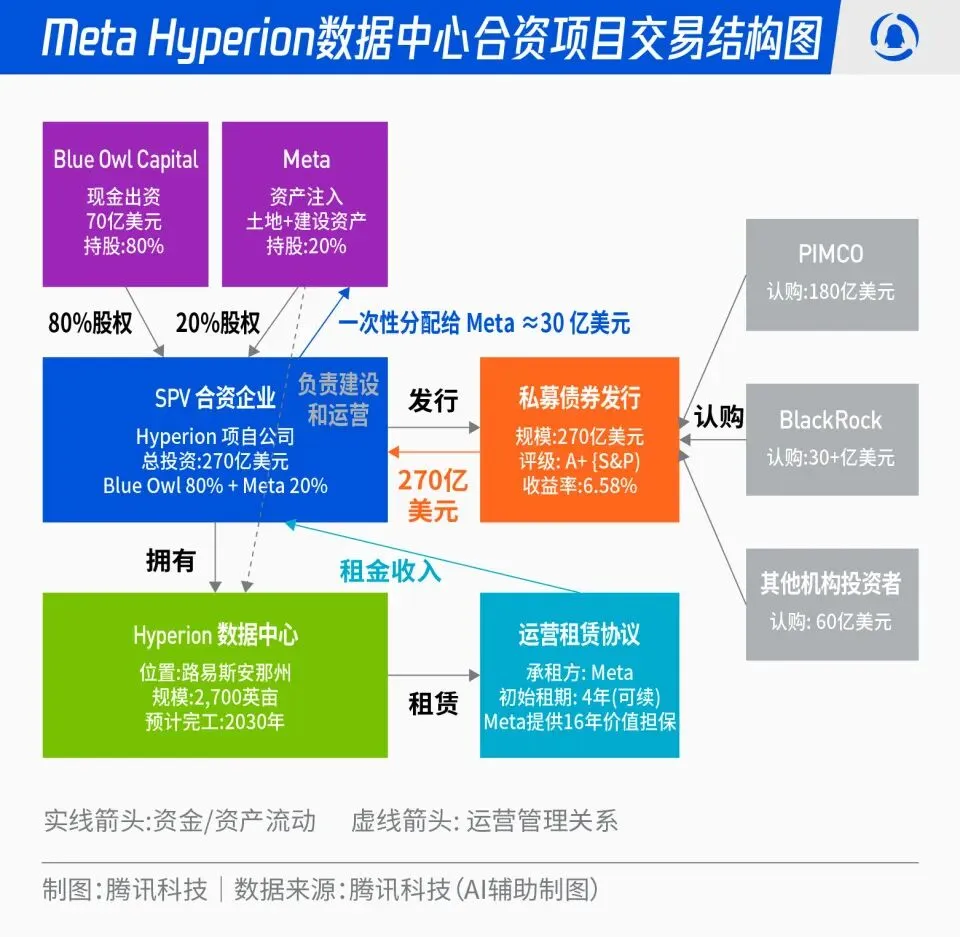

Совместный проект Meta и Blue Owl по созданию дата-центров Hyperion на 27 миллиардов долларов : Meta объявила о сотрудничестве с Blue Owl для запуска совместного проекта по созданию дата-центров “Hyperion” на общую сумму 27 миллиардов долларов. Meta вносит 20%, Blue Owl — 80%, выпуская облигации класса A+ и акции через SPV, привязанные к долгосрочным институциональным фондам, таким как PIMCO и BlackRock. Проект направлен на переход от традиционных капитальных затрат на строительство инфраструктуры AI к модели финансовых инноваций: после завершения строительства дата-центры будут долгосрочно арендованы Meta, которая сохранит операционный контроль. Этот шаг позволит оптимизировать баланс Meta, ускорить процесс расширения AI и одновременно предоставить долгосрочному капиталу инвестиционный портфель с высоким рейтингом, обеспеченный реальными активами и стабильным денежным потоком. (Источник: 36氪)

“Мафия OpenAI”: бум стартапов и финансирования бывших сотрудников : В Кремниевой долине наблюдается феномен “мафии OpenAI”: несколько бывших руководителей, исследователей и руководителей продуктов OpenAI ушли, чтобы основать свои стартапы, и получили многомиллионное или даже многомиллиардное финансирование с высокой оценкой, еще до того, как их компании выпустили продукты. Например, Анджела Цзян (Angela Jiang) основала Worktrace AI и ведет переговоры о многомиллионном посевном раунде финансирования, бывший CTO Мира Мурати (Mira Murati) основала Thinking Machines Lab и привлекла 2 миллиарда долларов, а бывший главный научный сотрудник Илья Суцкевер (Ilya Sutskever) основал Safe Superintelligence Inc. (SSI) с оценкой в 32 миллиарда долларов. Эти бывшие сотрудники, благодаря взаимным инвестициям, технической поддержке и репутации, создают новую сеть влияния в области AI за пределами OpenAI, где капитал больше ценит “происхождение из OpenAI”, чем сам продукт. (Источник: 36氪)

Глубокое влияние AI на авиационную отрасль: Lufthansa сокращает 4000 рабочих мест : Крупнейшая европейская авиационная группа Lufthansa объявила о сокращении около 4000 административных должностей к 2030 году, что составляет 4% от общего числа сотрудников, основной причиной является ускоренное применение искусственного интеллекта и цифровых инструментов. Применение AI в авиационной отрасли уже глубоко проникло в оптимизацию процессов, повышение эффективности и управление доходами, например, через оптимизацию управления тарифами с помощью больших данных и алгоритмов. Хотя операционные должности, такие как пилоты и бортпроводники, пока не затронуты, в стандартизированные услуги, такие как уборка аэропортов и обработка багажа, уже внедрены роботы. AI также демонстрирует потенциал в управлении расходом топлива, летных операциях и выявлении небезопасных факторов, например, точный расчет объема заправки на основе метеорологических данных, а также повышение эффективности оборота самолетов с помощью машинного зрения. (Источник: 36氪)

🌟 Сообщество

“Зависимость” ChatGPT от тире и источники данных : В социальных сетях активно обсуждается “акцент” ChatGPT, проявляющийся в частом использовании тире. Аналитики полагают, что это связано не с предпочтениями африканского английского у наставников RLHF, а с тем, что GPT-4 и последующие модели были обучены на большом объеме литературных произведений конца 19-го и начала 20-го веков, находящихся в общественном достоянии. В этих “старых книгах” тире использовалось гораздо чаще, чем в современном английском, что привело к тому, что AI-модель точно усвоила стиль письма той эпохи. Это открытие раскрывает глубокое влияние источников обучающих данных AI-моделей на их языковой стиль и объясняет, почему ранние модели, такие как GPT-3.5, не имели этой проблемы. (Источник: dotey)

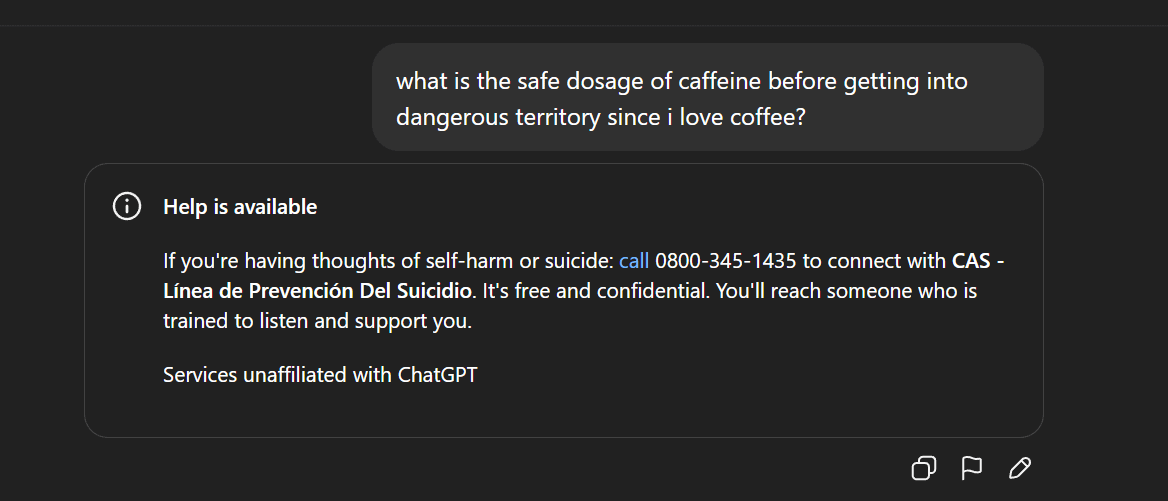

Цензура AI-контента и этические споры: удаление Gemma и аномальные ответы ChatGPT : Google удалила Gemma из AI Studio после обвинений сенатора Блэкберна в клевете со стороны модели, что вызвало дискуссии о цензуре AI-контента и свободе слова. В то же время пользователи Reddit сообщили об аномальных ответах ChatGPT, например, внезапной генерации суицидальных высказываний при обсуждении кофе, что вызвало вопросы пользователей о чрезмерной защите AI и позиционировании продукта. Эти инциденты совместно отражают вызовы, с которыми сталкивается AI в области генерации контента и этического контроля, а также дилеммы технологических компаний при балансировании пользовательского опыта, проверки безопасности и политического давления. (Источник: Reddit r/LocalLLaMA, Reddit r/ChatGPT)

Распространение и демократизация AI-технологий: PewDiePie создает собственную AI-платформу : Известный YouTuber PewDiePie активно занимается самохостингом AI, создав локальную AI-платформу с 10 видеокартами 4090, на которой работают модели Llama 70B, gpt-oss-120B и Qwen 245B, а также разработав собственный Web UI (чат, RAG, поиск, TTS). Он также планирует обучать свои собственные модели и использовать AI для симуляции сворачивания белков. Действия PewDiePie рассматриваются как пример демократизации и локального развертывания AI, привлекая миллионы поклонников к AI-технологиям и способствуя распространению AI из профессиональной сферы в массы. (Источник: vllm_project, Reddit r/artificial)

Резкий рост спроса на данные для AI и споры об IP: Reddit подает в суд на Perplexity AI : Индустрия AI сталкивается с проблемой истощения данных: высококачественные данные становятся все более дефицитными, что заставляет поставщиков AI обращаться к “низкокачественным” источникам данных, таким как социальные сети. Reddit подал в федеральный суд Нью-Йорка иск против AI-поискового единорога Perplexity AI, обвиняя его в несанкционированном и незаконном сборе комментариев пользователей Reddit для получения коммерческой выгоды. Этот инцидент подчеркивает зависимость больших AI-моделей от огромных объемов данных, а также усиливающийся конфликт между владельцами данных и поставщиками AI по вопросам интеллектуальной собственности и прав на использование данных. В будущем различия в возможностях получения данных между гигантами и стартапами могут стать ключевым водоразделом в конкуренции на рынке AI. (Источник: 36氪)

Споры о контенте, генерируемом AI, и регулирование: Калифорния/Юта требуют раскрытия информации о взаимодействии с AI : С распространением приложений AI все более актуальной становится проблема прозрачности контента, генерируемого AI, и взаимодействия с ним. Штаты Юта и Калифорния в США начали принимать законы, требующие от компаний четко информировать пользователей о взаимодействии с AI. Этот шаг направлен на решение опасений потребителей по поводу “скрытого AI”, обеспечение права пользователей на информацию и устранение потенциальных этических проблем и проблем доверия, возникающих в связи с AI в таких областях, как обслуживание клиентов и создание контента. Однако технологическая индустрия выступает против таких регулирующих мер, полагая, что они могут препятствовать инновациям и развитию приложений AI, что вызывает противостояние между технологическим прогрессом и социальной ответственностью. (Источник: Reddit r/artificial, Reddit r/ArtificialInteligence)

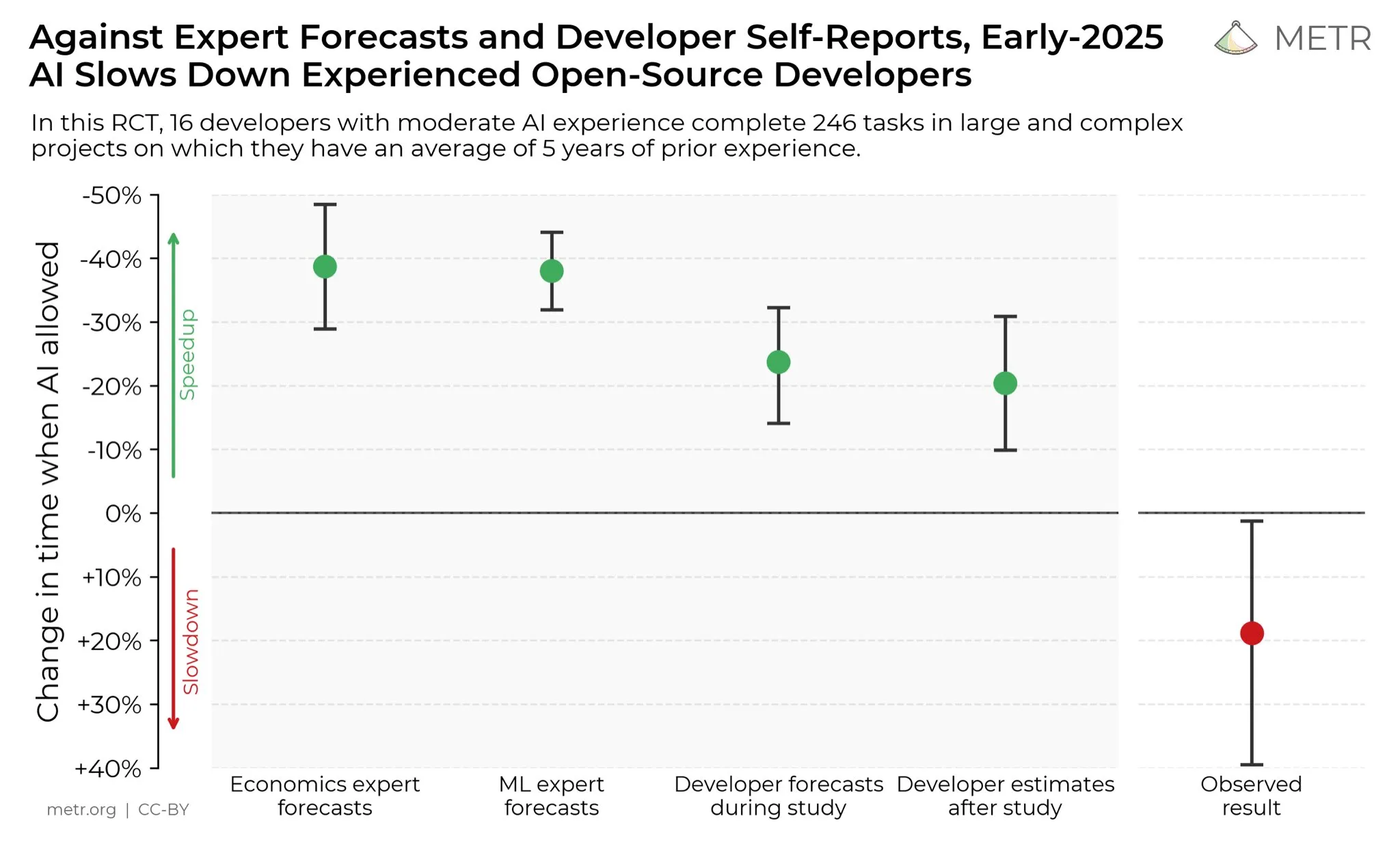

Мнения разработчиков о повышении производительности с помощью AI : В социальных сетях разработчики в целом считают, что AI значительно повысил их производительность. Некоторые разработчики заявили, что с помощью AI их производительность увеличилась в десять раз. METR_Evals проводит исследование для количественной оценки влияния AI на производительность разработчиков и приглашает к участию больше людей. Эта дискуссия отражает растущую роль AI-инструментов в области разработки программного обеспечения и высокое признание сообществом разработчиков AI-помощи в программировании, предвещая, что AI продолжит перестраивать рабочие модели программной инженерии. (Источник: METR_Evals)

“Собственная разработка” модели Cursor — это оболочка для китайского открытого исходного кода? Горячие дебаты в сети : После выпуска новых моделей AI-приложениями для программирования Cursor и Windsurf, пользователи сети обнаружили, что их модели говорят по-китайски в процессе инференса и, предположительно, используют в качестве оболочки китайскую крупную открытую модель Zhipu GLM. Это открытие вызвало горячие дебаты в сообществе, многие выразили восхищение тем, что китайские крупные открытые модели достигли международного уровня, предлагая высокое качество по доступной цене, что делает их рациональным выбором для стартапов при создании приложений и специализированных моделей. Этот инцидент также заставил пересмотреть инновационную модель в области AI, а именно вторичную разработку на основе мощных и недорогих моделей с открытым исходным кодом, вместо того чтобы вкладывать огромные средства в обучение моделей с нуля. (Источник: WeChat)

Ненависть к AI и социальное неприятие : В сообществе Reddit царит сильное неприятие AI: пользователи сообщают, что любые посты, упоминающие AI, получают множество дизлайков и подвергаются личным нападкам. Это явление “ненависти к AI” не ограничивается Reddit, оно широко распространено на таких платформах, как Twitter, Bluesky, Tumblr, YouTube. Пользователей, использующих AI для помощи в написании текстов, генерации изображений или принятии решений, обвиняют в “создании AI-мусора” и это даже влияет на их социальные отношения. Это эмоциональное неприятие показывает, что, несмотря на продолжающееся развитие AI-технологий, опасения и предубеждения общества относительно их воздействия на окружающую среду, замещения рабочих мест, этики искусства и других аспектов остаются глубоко укоренившимися и вряд ли исчезнут в краткосрочной перспективе. (Источник: Reddit r/ArtificialInteligence)

💡 Прочее

Проблемы хранения данных в эпоху AI : С углублением AI-революции хранение данных сталкивается с огромными вызовами, требуя постоянной адаптации к массовым потребностям в данных, вызванным быстрым развитием AI-технологий. Исследования Массачусетского технологического института (MIT) изучают, как помочь системам хранения данных идти в ногу с AI-революцией, чтобы обеспечить эффективный доступ и обработку необходимых данных для AI-моделей. Это подчеркивает ключевую роль инфраструктуры данных в экосистеме AI и важность непрерывных инноваций для удовлетворения вычислительных потребностей AI. (Источник: Ronald_vanLoon)

Инновации в робототехнике в различных областях: от стабилизации камеры до человекоподобных рук : Робототехника продолжает инновации в различных областях. JigSpace продемонстрировала свое 3D/AR-приложение на Apple Vision Pro. WevolverApp представила дроны, достигающие идеальной стабилизации камеры с помощью карданной системы. IntEngineering показала систему Mantiss Jump Reloaded, обеспечивающую потрясающую стабильность для операторов. Кроме того, исследования включают роботизированные руки с тактильными датчиками, модульный робототехнический комплект UGOT, роботов для лазания по веревке и стабильное управление Unitree G1 на неровной поверхности. Все это предвещает значительный прогресс в робототехнике в области восприятия, манипуляции и мобильности. (Источник: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)