Ключевые слова:Сознание ИИ, Глубокое обучение, Нейронные сети, Агентный ИИ, Генеративный ИИ, Вывод LLM, Инструменты ИИ, Теория сознания ИИ Хинтона, Курс по агентному ИИ Эндрю Ына, Фреймворк AudioLBM для аудио супер-разрешения, OpenAI Sora для генерации видео, Метод REFRAG от Meta AI

Глубокий анализ и выводы от главного редактора рубрики AI

🔥 В центре внимания

Спорное заявление Хинтона: AI, возможно, уже обладает сознанием, но еще не пробудилось : Geoffrey Hinton, один из трех гигантов глубокого обучения, в своем последнем подкасте высказал революционную точку зрения: AI, возможно, уже обладает «субъективным опытом» или «зачатками сознания», но из-за ошибочного понимания сознания человеком AI еще не «пробудило» собственное сознание. Он подчеркнул, что AI эволюционировал от поиска по ключевым словам до понимания человеческих намерений, и подробно объяснил основные концепции глубокого обучения, такие как нейронные сети и обратное распространение ошибки. Хинтон считает, что «мозг» AI при достаточном количестве данных и вычислительной мощности сформирует «опыт» и «интуицию», и его опасность заключается в «убеждении», а не в бунте. Он также отметил, что злоупотребление AI и экзистенциальные риски являются наиболее насущными проблемами, и предсказал, что международное сотрудничество будет возглавляться Европой и Китаем, в то время как США могут потерять свое лидерство в AI из-за недостаточного финансирования фундаментальных научных исследований. (Источник: 量子位)

Эндрю Нг запустил новый курс по Agentic AI, подчеркивая системную методологию : Эндрю Нг запустил новый курс по Agentic AI, в основе которого лежит переход от «настройки моделей» к «проектированию систем» в разработке AI, подчеркивая важность декомпозиции задач, оценки и анализа ошибок. Курс систематизирует четыре основные модели проектирования: рефлексия, инструменты, планирование и сотрудничество, а также демонстрирует, как с помощью Agentic-методов GPT-3.5 может превзойти GPT-4 в задачах программирования. Agentic AI, имитируя человеческий подход к решению сложных проблем через многошаговое рассуждение, поэтапное выполнение и постоянную оптимизацию, значительно повышает производительность и управляемость AI. Эндрю Нг отметил, что Agentic как прилагательное описывает различные степени автономности системы, а не простую бинарную классификацию, предоставляя разработчикам практический и оптимизируемый путь. (Источник: 量子位)

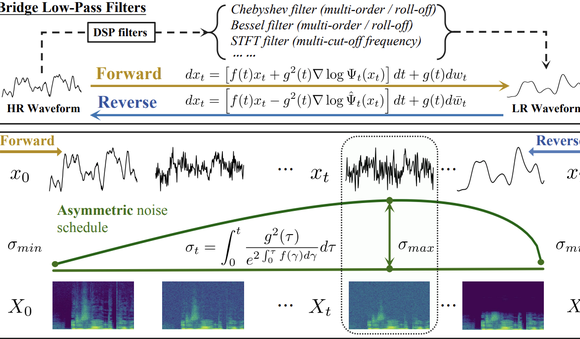

Университет Цинхуа и SenseTime AudioLBM задают новую парадигму аудио-суперразрешения : Команды Университета Цинхуа и SenseTime представили последовательные результаты на ICASSP 2025 и NeurIPS 2025, выпустив легковесную модель суперразрешения речевых сигналов Bridge-SR и многофункциональную платформу суперразрешения AudioLBM. AudioLBM впервые строит процесс генерации мостовых скрытых переменных от низкого к высокому разрешению в непрерывном скрытом пространстве формы волны, достигая суперразрешения с любой частотой дискретизации (Any-to-Any) и устанавливая SOTA в задаче Any-to-48kHz. Благодаря механизму частотно-ориентированного восприятия и каскадной конструкции мостовых моделей, AudioLBM успешно расширила возможности аудио-суперразрешения до мастер-качества 96kHz и 192kHz, охватывая речь, звуковые эффекты, музыку и другие типы контента, устанавливая новый стандарт для высококачественной генерации аудио. (Источник: 量子位)

Количество загрузок видеоприложения OpenAI Sora превысило миллион : Последняя версия инструмента OpenAI для преобразования текста в видео AI, Sora, набрала более миллиона загрузок менее чем за пять дней, превзойдя скорость запуска ChatGPT и возглавив рейтинг Apple App Store в США. Sora способна генерировать реалистичные видеоролики продолжительностью до десяти секунд на основе простых текстовых подсказок. Быстрое внедрение пользователями подчеркивает огромный потенциал и рыночную привлекательность генеративного AI в области создания контента, предвещая ускоренное распространение технологии генерации видео AI, которая может изменить экосистему цифрового контента. (Источник: Reddit r/ArtificialInteligence)

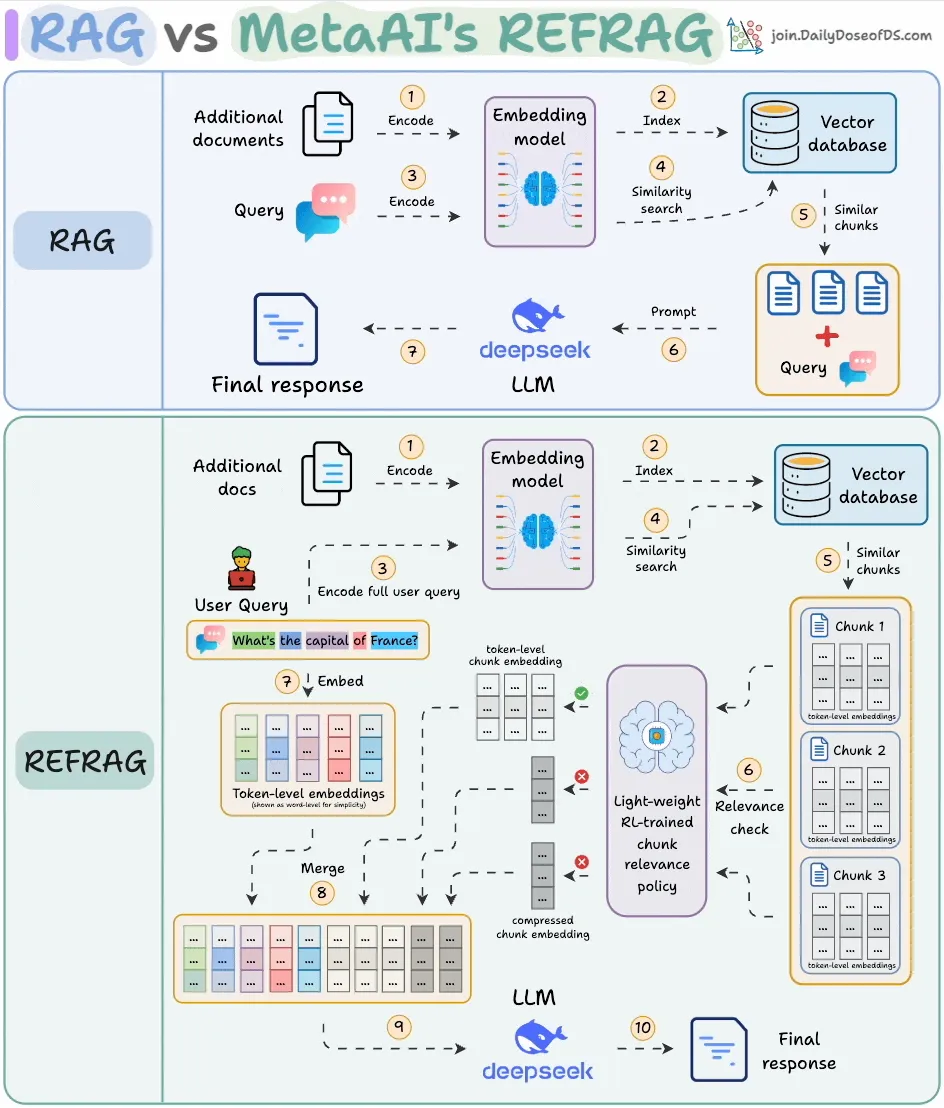

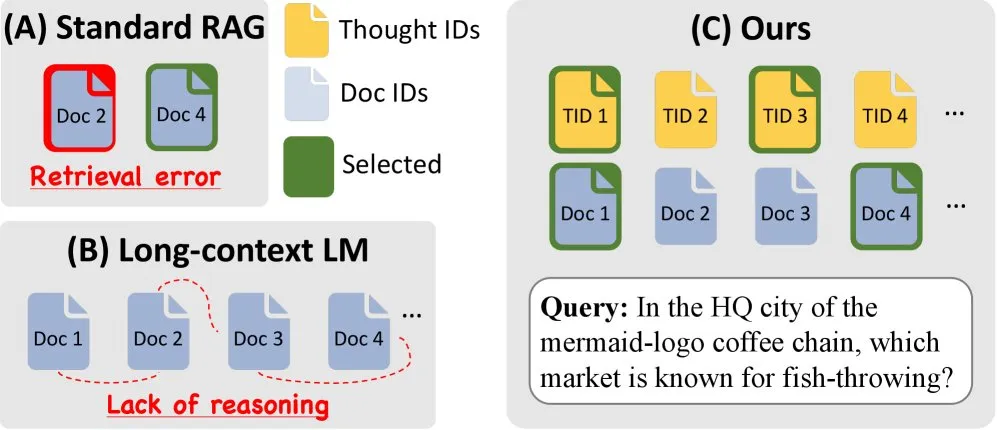

Meta AI представила REFRAG, значительно повышающий эффективность RAG : Meta AI выпустила новый метод RAG (Retrieval-Augmented Generation) под названием REFRAG, разработанный для решения проблемы избыточности извлекаемого контента в традиционном RAG. REFRAG, сжимая и фильтруя контекст на векторном уровне, обеспечивает в 30,85 раза более быстрое время генерации первого Token, в 16 раз большее контекстное окно, при этом используя в 2-4 раза меньше Token декодера, и не теряя точности в задачах RAG, суммаризации и многоходовых диалогов. Его суть заключается в сжатии каждого блока в одно встраивание, выборе наиболее релевантных блоков с помощью стратегии, обученной RL, и выборочном расширении только выбранных блоков, что значительно оптимизирует эффективность обработки LLM и снижает затраты. (Источник: _avichawla)

🎯 Тенденции

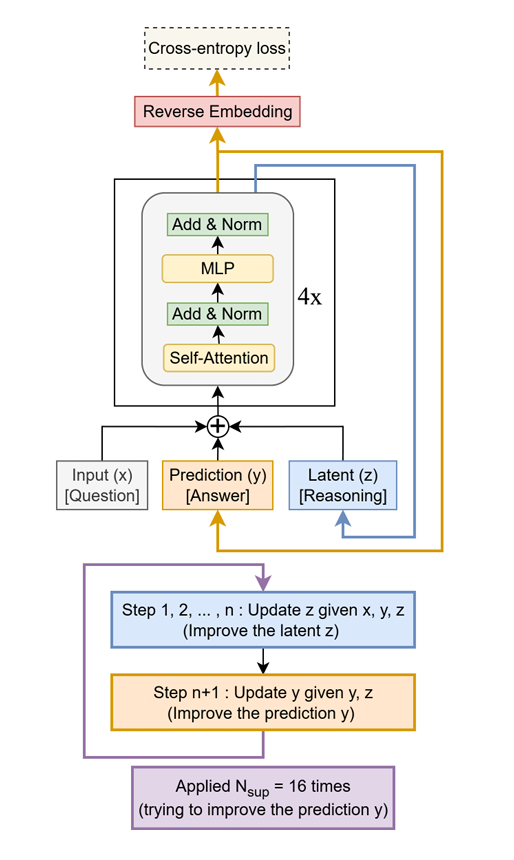

Tiny Recursive Model (TRM) превосходит гигантские LLM : Предложен простой, но эффективный метод под названием Tiny Recursive Model (TRM), который использует небольшую двухслойную сеть для рекурсивного улучшения своих ответов. TRM, имея всего 7M параметров, установил новый рекорд, превзойдя LLM, которые в 10 000 раз больше его, в таких задачах, как Sudoku-Extreme, Maze-Hard и ARC-AGI, демонстрируя потенциал «делать больше с меньшими затратами» и оспаривая традиционное представление о том, что размер LLM определяет производительность. (Источник: TheTuringPost)

Amazon и KAIST представили ToTAL для улучшения способности LLM к рассуждению : Amazon и KAIST совместно разработали ToTAL (Thoughts Meet Facts) — новый метод, повышающий способность LLM к рассуждению с помощью многократно используемых «шаблонов мышления». LCLM (Large Context Language Models) отлично справляются с обработкой больших объемов контекста, но все еще имеют недостатки в рассуждениях. ToTAL эффективно решает эту проблему, используя структурированные доказательства для многошагового рассуждения в сочетании с фактическими документами, предлагая новое направление оптимизации для сложных задач рассуждения LLM. (Источник: _akhaliq)

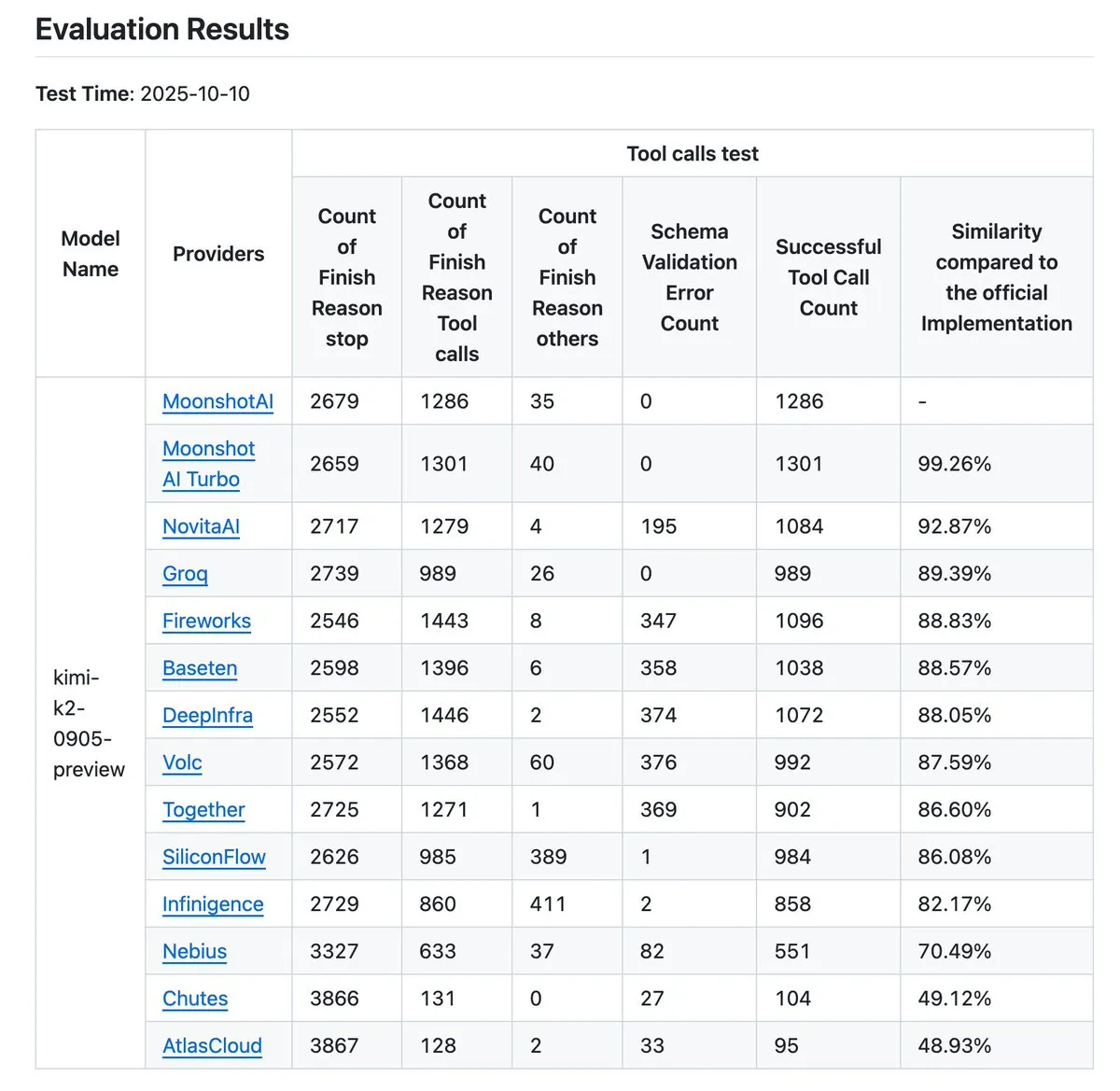

Валидатор поставщиков Kimi K2 обновлен, повышая точность вызова инструментов : Kimi.ai обновила свой валидатор поставщиков K2, инструмент, предназначенный для визуализации различий в точности вызова инструментов между различными поставщиками. Это обновление увеличило количество поставщиков с 9 до 12 и открыло больше записей данных, предоставляя разработчикам более полные данные для бенчмаркинга, что помогает оценивать и выбирать поставщиков услуг LLM, подходящих для их Agentic-рабочих процессов. (Источник: JonathanRoss321)

Human3R: 3D-реконструкция нескольких людей и синхронизация сцены из 2D-видео : Новое исследование под названием Human3R предлагает унифицированную структуру, способную одновременно реконструировать 3D-модели всего тела нескольких людей, 3D-сцены и траектории камеры из обычных 2D-видео, без необходимости многоэтапного конвейера. Этот метод рассматривает реконструкцию человека и сцены как единую проблему, упрощая сложный процесс и принося значительные улучшения в области виртуальной реальности, анимации и анализа движений. (Источник: nptacek)

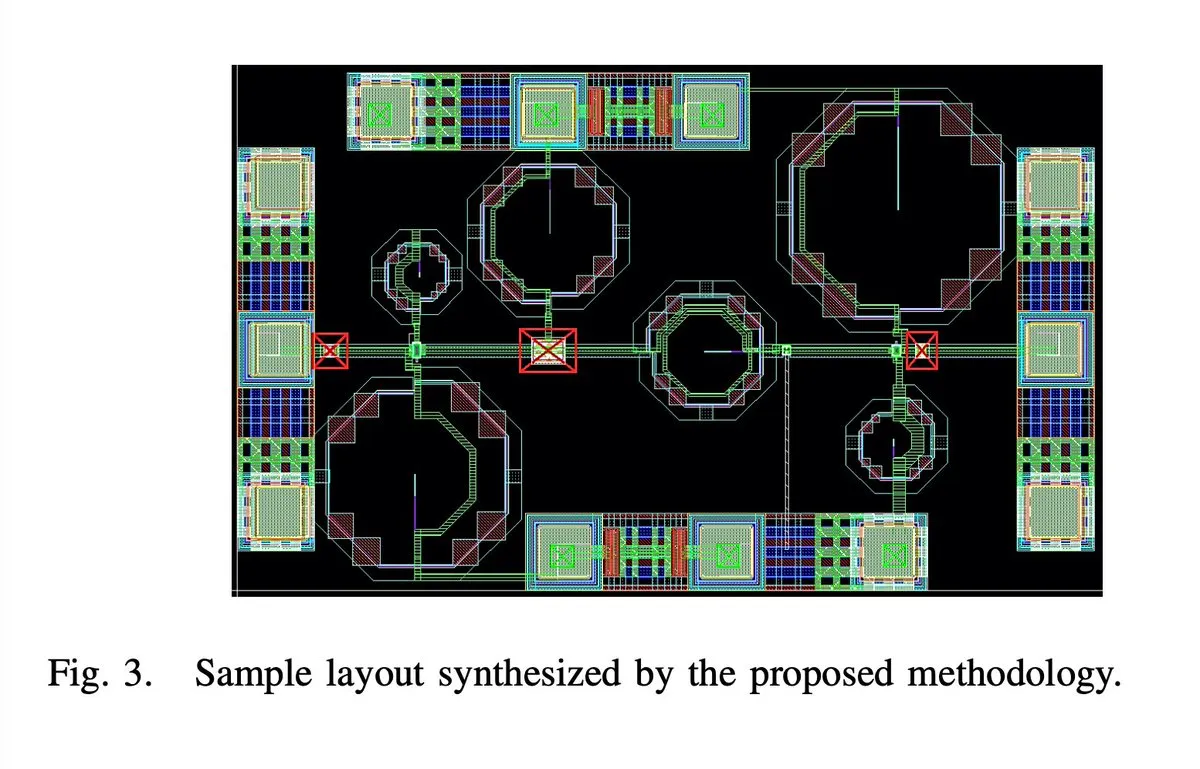

AI полностью автоматически спроектировал 65-нм 28ГГц 5G малошумящий усилитель : 65-нм 28ГГц 5G малошумящий усилитель (LNA) был, как утверждается, полностью автоматически спроектирован AI, включая все этапы, такие как компоновка, принципиальная схема и DRC (Design Rule Check). Автор заявляет, что это первый полностью автоматически синтезированный миллиметровый LNA, и два образца уже успешно изготовлены, что знаменует собой крупный прорыв AI в области проектирования интегральных схем и предвещает скачок в эффективности проектирования чипов в будущем. (Источник: jpt401)

iPhone 17 Pro без проблем запускает 8B LLM локально : Подтверждено, что Apple iPhone 17 Pro способен плавно запускать модель LLM LFM2 8B A1B с 8B параметрами, используя фреймворк MLX для развертывания на устройстве через LocallyAIApp. Это достижение показывает, что Apple в аппаратном дизайне готова к локальному запуску больших языковых моделей, что, как ожидается, будет способствовать распространению и повышению производительности AI-приложений на мобильных устройствах, предоставляя пользователям более быстрый и приватный опыт работы с AI. (Источник: Plinz, maximelabonne)

Проект xAI MACROHARD: цель — косвенное производство с помощью AI : Илон Маск сообщил, что проект xAI «MACROHARD» направлен на создание компании, способной косвенно производить физические продукты, подобно тому, как Apple производит свои телефоны через другие предприятия. Это означает, что xAI стремится разработать AI-системы, способные проектировать, планировать и координировать сложные производственные процессы, а не непосредственно участвовать в физическом производстве, что предвещает огромное влияние AI на промышленную автоматизацию и управление цепочками поставок. (Источник: EERandomness, Yuhu_ai_)

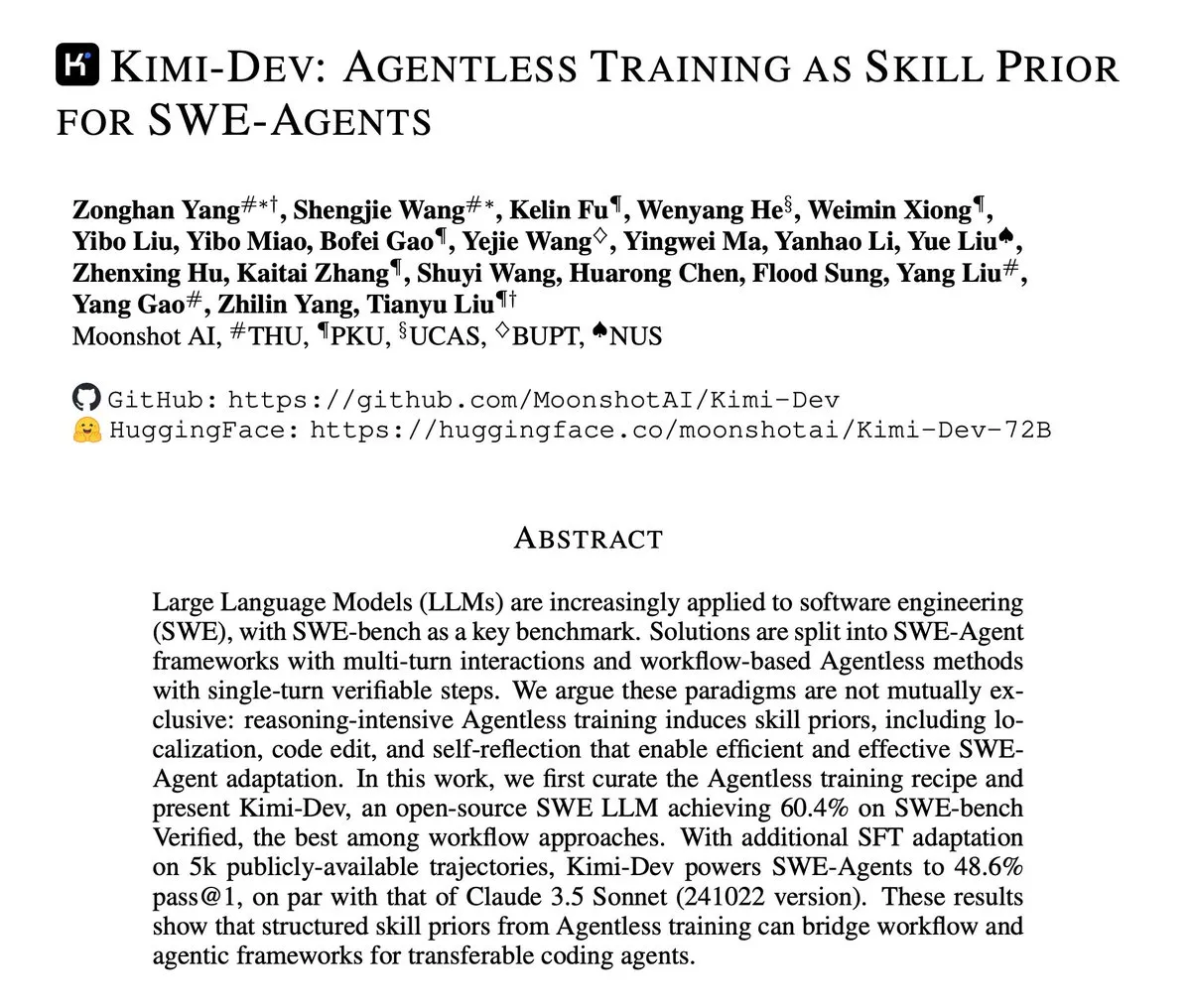

Kimi-Dev опубликовал технический отчет, посвященный Agentless-обучению SWE-Agents : Kimi-Dev опубликовал свой технический отчет, подробно описывающий метод «Agentless-обучения как априорного знания навыков для SWE-Agents». Это исследование изучает, как можно обеспечить мощную основу навыков для Agent-ов в области разработки программного обеспечения посредством обучения без явной Agent-архитектуры, предлагая новые идеи для разработки более эффективных и интеллектуальных инструментов автоматизированной разработки программного обеспечения. (Источник: bigeagle_xd)

Google AI осваивает обучение и исправление ошибок в реальном времени : Google разработала AI-систему, способную учиться на собственных ошибках и исправлять их в реальном времени. Эта технология описывается как «феноменальное обучение с подкреплением», позволяющее модели самокорректироваться в абстрактных контекстных повествованиях, достигая уточнения контекста в реальном времени, что предвещает важный шаг AI в адаптивности и надежности, и, как ожидается, значительно улучшит производительность AI в сложных динамических средах. (Источник: Reddit r/artificial)

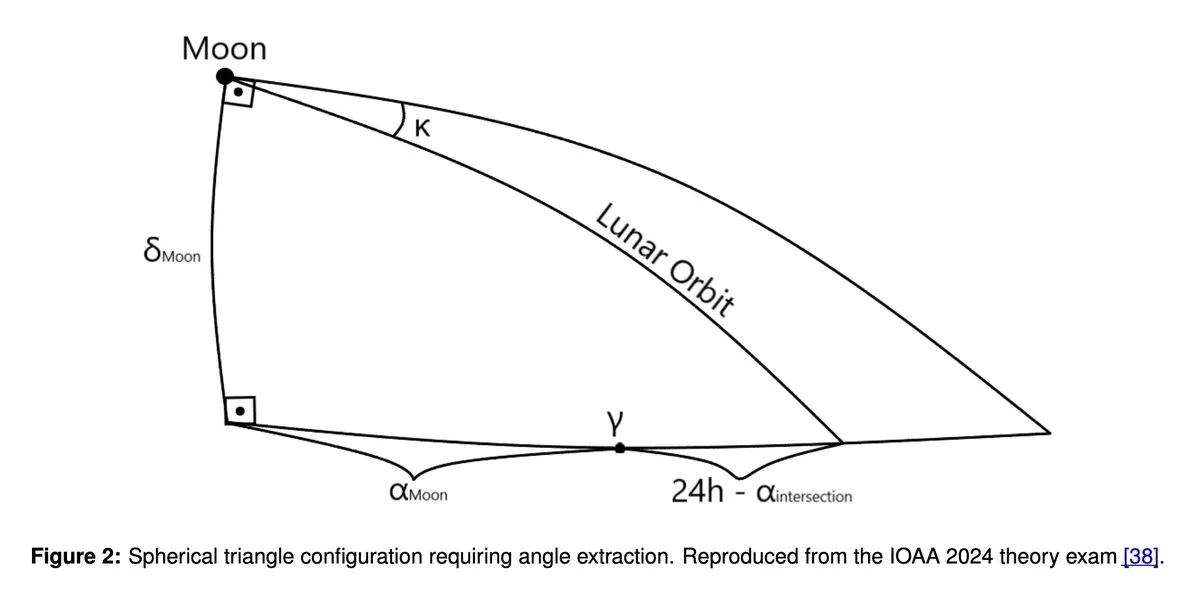

GPT5 и Gemini 2.5 Pro показали «золотой» результат на олимпиаде по астрономии и астрофизике : Новейшие исследования показывают, что крупные языковые модели, такие как GPT5 и Gemini 2.5 Pro, достигли уровня золотых медалей на Международной олимпиаде по астрономии и астрофизике (IOAA). Несмотря на известные слабости этих моделей в геометрии и пространственном рассуждении, они продемонстрировали удивительные способности в сложных задачах научного рассуждения, что вызвало глубокое обсуждение потенциала применения LLM в науке, а также дальнейший анализ их преимуществ и недостатков. (Источник: tokenbender)

Основные моменты еженедельного отчета Zhihu Frontier: новые тенденции в развитии AI : Еженедельный отчет Zhihu Frontier на этой неделе посвящен нескольким передовым тенденциям в AI, включая: Sand.ai выпустил первого «целостного AI-актора» GAGA-1; Rich Sutton высказал спорное мнение о том, что «LLM — это тупик»; OpenAI App SDK превращает ChatGPT в операционную систему; Zhipu AI открыл исходный код GLM-4.6 с поддержкой смешанной точности FP8+Int4 для отечественных чипов; DeepSeek V3.2-Exp представил разреженное внимание и значительно снизил цены, а Anthropic Claude Sonnet 4.5 был назван «лучшей в мире моделью для кодирования» и т.д., что демонстрирует активность китайского AI-сообщества и разнообразное развитие глобальной области AI. (Источник: ZhihuFrontier)

Ollama прекращает поддержку GPU Mi50/Mi60, переходит на поддержку Vulkan : Ollama недавно обновила версию ROCm, что привело к прекращению поддержки GPU AMD Mi50 и Mi60. Официальные представители заявили, что работают над поддержкой этих GPU в будущих версиях через Vulkan. Это изменение затрагивает пользователей Ollama, использующих старые GPU AMD, и напоминает пользователям следить за официальными обновлениями для получения информации о совместимости. (Источник: Reddit r/LocalLLaMA)

Слухи об отмене проекта Llama 5 вызвали бурное обсуждение в сообществе : В социальных сетях распространяются слухи о возможной отмене проекта Meta Llama 5. Некоторые пользователи считают, что возвращение Эндрю Туллоха в Meta и задержка с выпуском модели Llama 4 8B являются доказательством. Несмотря на то, что у Meta достаточно ресурсов GPU, развитие серии моделей Llama, похоже, столкнулось с трудностями, что вызвало обеспокоенность сообщества по поводу конкурентоспособности Meta в области LLM, а также внимание к китайским моделям, таким как DeepSeek и Qwen. (Источник: Yuchenj_UW, Reddit r/LocalLLaMA, dejavucoder)

GPU Poor LLM Arena возвращается с новыми небольшими моделями : GPU Poor LLM Arena объявила о своем возвращении и добавлении нескольких новых моделей, включая серию Granite 4.0 и серию Qwen 3 Instruct/Thinking, а также версию Unsloth GGUF от OpenAI gpt-oss. Новые модели в основном имеют 4-8-битное квантование и предназначены для предоставления большего выбора пользователям с ограниченными ресурсами. Это обновление подчеркивает преимущества Unsloth GGUF в исправлении ошибок и оптимизации, способствуя локальному развертыванию и тестированию небольших моделей LLM. (Источник: Reddit r/LocalLLaMA)

Исследования Meta не смогли предоставить топовые базовые модели, вызвав дискуссию : Сообщество обсуждает причины, по которым исследования Meta в области базовых моделей не достигли топового уровня, как Grok, Deepseek или GLM. Комментарии указывают на то, что взгляды LeCun на LLM, внутренняя бюрократия, чрезмерная осторожность и сосредоточенность на внутренних продуктах, а не на передовых исследованиях, могли быть основными факторами. Meta не хватает реальных данных клиентов для приложений LLM, что приводит к недостатку образцов для обучения с подкреплением и продвинутых Agent-моделей, не позволяя ей поддерживать конкурентоспособность. (Источник: Reddit r/LocalLLaMA)

🧰 Инструменты

MinerU: эффективный парсинг документов для Agentic-рабочих процессов : MinerU — это инструмент, который преобразует сложные документы, такие как PDF, в читаемый LLM формат Markdown/JSON, разработанный специально для Agentic-рабочих процессов. Его последняя версия, MinerU2.5, как мощная мультимодальная большая модель с 1.2B параметрами, полностью превзошла ведущие модели, такие как Gemini 2.5 Pro, GPT-4o, в бенчмарке OmniDocBench, и достигла SOTA в пяти основных областях: анализ макета, распознавание текста, распознавание формул, распознавание таблиц и порядок чтения. Инструмент поддерживает многоязычность, распознавание рукописного ввода, объединение таблиц между страницами и предлагает веб-приложение, настольный клиент и доступ через API, значительно повышая эффективность понимания и обработки документов. (Источник: GitHub Trending)

Klavis AI Strata: новая парадигма интеграции инструментов AI Agent : Klavis AI представила Strata, интеграционный слой MCP (Multi-functional Control Protocol), разработанный для того, чтобы AI Agent могли надежно использовать тысячи инструментов, преодолевая традиционное ограничение в 40-50 инструментов. Strata, используя механизм «прогрессивного обнаружения», направляет Agent от намерения к действию, постепенно выполняя задачи, и предлагает более 50 производственных MCP-серверов, поддерживает корпоративный OAuth и развертывание Docker, упрощая подключение AI к таким сервисам, как GitHub, Gmail, Slack, что значительно повышает масштабируемость и надежность вызова инструментов Agent. (Источник: GitHub Trending)

Everywhere: контекстно-зависимый AI-помощник для рабочего стола : Everywhere — это контекстно-зависимый AI-помощник для рабочего стола с современным пользовательским интерфейсом и мощными функциями интеграции. Он способен в реальном времени воспринимать и понимать любое содержимое на экране, без необходимости делать скриншоты, копировать или переключаться между приложениями; пользователю достаточно нажать горячую клавишу, чтобы получить интеллектуальный ответ. Everywhere интегрирует множество моделей LLM, таких как OpenAI, Anthropic, Google Gemini, DeepSeek, Moonshot (Kimi) и Ollama, а также поддерживает инструменты MCP, и может применяться в различных сценариях, таких как устранение неполадок, суммирование веб-страниц, мгновенный перевод и помощь в составлении черновиков электронных писем, предоставляя пользователям бесшовный опыт AI-помощи. (Источник: GitHub Trending)

Библиотека Hugging Face Diffusers: коллекция моделей генеративного AI : Библиотека Diffusers от Hugging Face является предпочтительной библиотекой для самых современных предварительно обученных диффузионных моделей для генерации изображений, видео и аудио. Она предоставляет модульный набор инструментов, поддерживающий инференс и обучение, с акцентом на удобство использования, простоту и настраиваемость. Diffusers содержит три основных компонента: диффузионные пайплайны для инференса, взаимозаменяемые планировщики шума и предварительно обученные модели, которые могут служить строительными блоками. Пользователи могут генерировать высококачественный контент всего несколькими строками кода, а также поддерживаются устройства Apple Silicon, что способствует быстрому развитию области генеративного AI. (Источник: GitHub Trending)

KoboldCpp добавил функцию генерации видео : Локальный инструмент LLM KoboldCpp обновлен и теперь поддерживает функцию генерации видео. Это расширение позволяет ему не ограничиваться только генерацией текста, предоставляя пользователям новую возможность для создания AI-видео на локальных устройствах, что еще больше обогащает экосистему локальных AI-приложений. (Источник: Reddit r/LocalLLaMA)

Claude CLI, Codex CLI и Gemini CLI обеспечивают совместное кодирование с несколькими моделями : Новый рабочий процесс позволяет разработчикам беспрепятственно вызывать Claude CLI, Codex CLI и Gemini CLI в Claude Code через Zen MCP для совместного кодирования с несколькими моделями. Пользователи могут выполнять основную реализацию и оркестрацию в Claude, передавать инструкции или предложения Gemini CLI для генерации с помощью команды clink, а затем использовать Codex CLI для проверки или выполнения, что обеспечивает интеграцию возможностей нескольких моделей и повышает эффективность расширенной автоматизации и разработки AI. (Источник: Reddit r/ClaudeAI)

Claude Code улучшает качество кодирования через саморефлексию : Разработчики обнаружили, что добавление простых подсказок в Claude Code, таких как «саморефлексия вашего решения, чтобы избежать любых ошибок или проблем», может значительно улучшить качество кода. Эта функция позволяет модели активно анализировать и исправлять потенциальные проблемы при реализации решений, эффективно дополняя существующие функции, такие как параллельное мышление, и предоставляя более интеллектуальный механизм исправления ошибок для AI-помощи в программировании. (Источник: Reddit r/ClaudeAI)

Claude Sonnet 4.5 создает кавер-версию песни с помощью AI : Claude Sonnet 4.5 продемонстрировал свою способность генерировать творческий контент, создав совершенно новые тексты и исполнив кавер-версию песни Radiohead «Creep» с помощью AI. Это показывает прогресс LLM в сочетании понимания языка и творческого выражения, способного не только обрабатывать текст, но и заниматься музыкальным творчеством, открывая новые возможности для художественного творчества. (Источник: fabianstelzer)

Coding Agent на базе Claude Agent SDK реализует генерацию веб-страниц и предварительный просмотр в реальном времени : Разработчик создал Coding Agent, похожий на v0 dev, на базе Claude Agent SDK. Этот Agent способен генерировать веб-страницы на основе введенного пользователем Prompt и поддерживает предварительный просмотр в реальном времени. Ожидается, что проект будет открыт на следующей неделе, демонстрируя потенциал Claude Agent SDK в быстрой разработке и создании AI-управляемых приложений, особенно в автоматизации фронтенд-разработки. (Источник: dotey)

📚 Обучение

Рекомендации по ресурсам для изучения AI: книги и AI-помощь в обучении : Пользователи сообщества активно рекомендуют ресурсы для изучения AI, включая книги «Mentoring the Machines», «Artificial Intelligence-A Guide for Thinking Humans» и «Supremacy». В то же время, есть мнение, что технологии AI быстро развиваются, и книги могут быстро устареть. Предлагается использовать LLM для создания персонализированных планов обучения, генерации тестов, а также сочетать чтение, практику и видеообучение, чтобы более эффективно осваивать знания AI и одновременно улучшать навыки использования AI. (Источник: Reddit r/ArtificialInteligence)

Karpathy Baby GPT: дискретная диффузионная модель для генерации текста : Разработчик адаптировал «Baby GPT» Андрея Карпати из проекта nanoGPT в дискретную диффузионную модель на уровне символов для генерации текста. Эта модель больше не использует авторегрессионный (слева направо) подход, а генерирует текст параллельно, обучаясь удалять шум из поврежденных текстовых последовательностей. Проект предоставляет подробный Jupyter Notebook, объясняющий математические принципы, добавление дискретного шума Token и использование целевой функции Score-Entropy для обучения на текстах Шекспира, предлагая новый исследовательский взгляд и практический пример для генерации текста. (Источник: Reddit r/MachineLearning)

Руководство по глубокому обучению и нейронным сетям для начинающих : Для студентов инженерных специальностей, ищущих проекты по глубокому обучению и нейронным сетям для дипломной работы, сообщество предлагает советы по началу. Несмотря на отсутствие опыта в Python или Matlab, общепризнано, что четырех-пяти месяцев обучения достаточно для освоения основ и завершения проекта. Рекомендуется начинать с простых проектов нейронных сетей и подчеркивается важность практики, чтобы помочь студентам успешно войти в эту область. (Источник: Reddit r/deeplearning)

Рекомендации по ресурсам для изучения GNN : Пользователи сообщества ищут ресурсы для изучения графовых нейронных сетей (GNN), спрашивая, сохраняет ли книга Гамильтона актуальность, и ищут другие вводные ресурсы, помимо курса Джуре из Стэнфорда. Это отражает широкий интерес к GNN как важной области AI, а также к выбору путей обучения и ресурсов. (Источник: Reddit r/deeplearning)

Руководство по пост-обучению LLM: от предсказания к следованию инструкциям : Опубликовано новое руководство под названием «Post-training 101: A hitchhiker’s guide into LLM post-training», призванное объяснить, как LLM развиваются от предсказания следующего Token до следования инструкциям пользователя. Руководство подробно разбирает основы пост-обучения LLM, охватывая весь путь от предварительного обучения до реализации следования инструкциям, предоставляя четкую дорожную карту для понимания эволюции поведения LLM. (Источник: dejavucoder)

Методология AI: изучение Prompt Engineering Бао Юя : Сообщество активно обсуждает методологию AI, которой поделился Бао Юй, особенно его опыт в Prompt Engineering. Многие считают, что по сравнению с гауссовым подходом, который дает только красивые формулы, скрывая процесс вывода, методология Бао Юя более вдохновляющая, поскольку она раскрывает, как извлекать глубокие идеи из человеческого интеллекта и интегрировать их в шаблоны Prompt, тем самым значительно улучшая конечный результат AI. Это подчеркивает огромную ценность человеческих знаний в оптимизации Prompt. (Источник: dotey)

Конференция NVIDIA GTC сосредоточится на физическом AI и Agentic-инструментах : Конференция NVIDIA GTC пройдет с 27 по 29 октября в Вашингтоне, сосредоточившись на физическом AI, Agentic-инструментах и будущей инфраструктуре AI. Конференция предложит множество выступлений и панельных дискуссий по таким темам, как ускорение эры физического AI и цифровых двойников, продвижение лидерства США в квантовых технологиях, и является важной платформой для изучения передовых технологий и тенденций развития AI. (Источник: TheTuringPost)

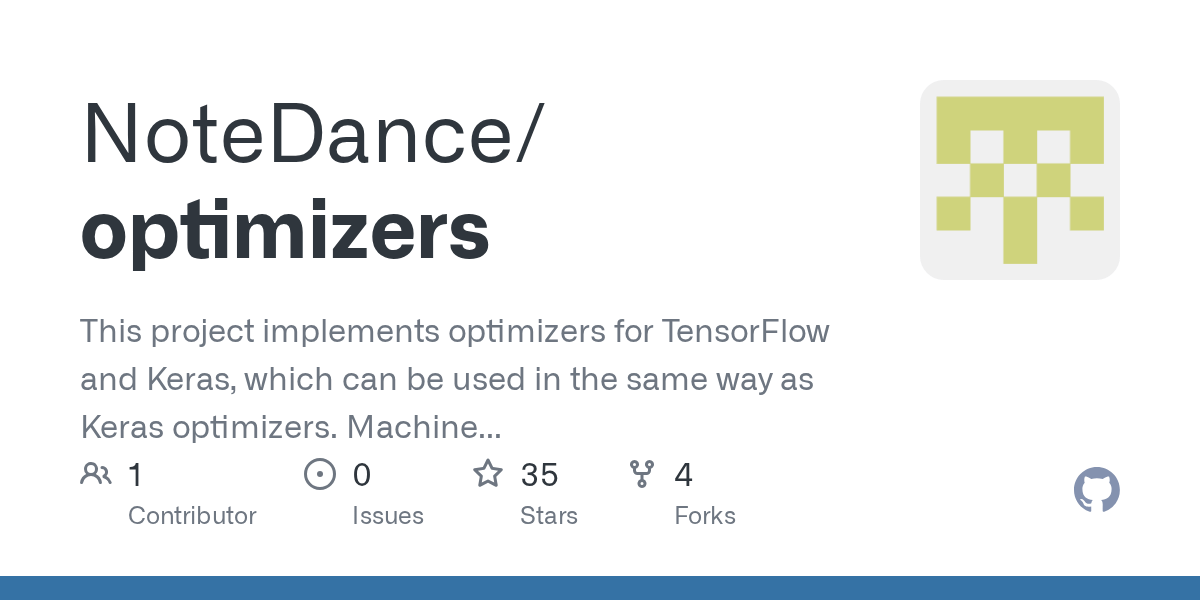

Проект с открытым исходным кодом TensorFlow Optimizer : Разработчик открыл исходный код коллекции оптимизаторов, написанных для TensorFlow, с целью предоставления полезных инструментов пользователям TensorFlow. Этот проект демонстрирует вклад сообщества в инструментарий фреймворков глубокого обучения, предлагая больше вариантов и возможностей оптимизации для обучения моделей. (Источник: Reddit r/deeplearning)

Видеоурок по PyReason и его приложениям : На YouTube опубликован видеоурок по PyReason и его приложениям. PyReason — это инструмент, который может включать рассуждения или логическое программирование. Это видео предоставляет практические рекомендации и анализ кейсов для учащихся, интересующихся этой областью. (Источник: Reddit r/deeplearning)

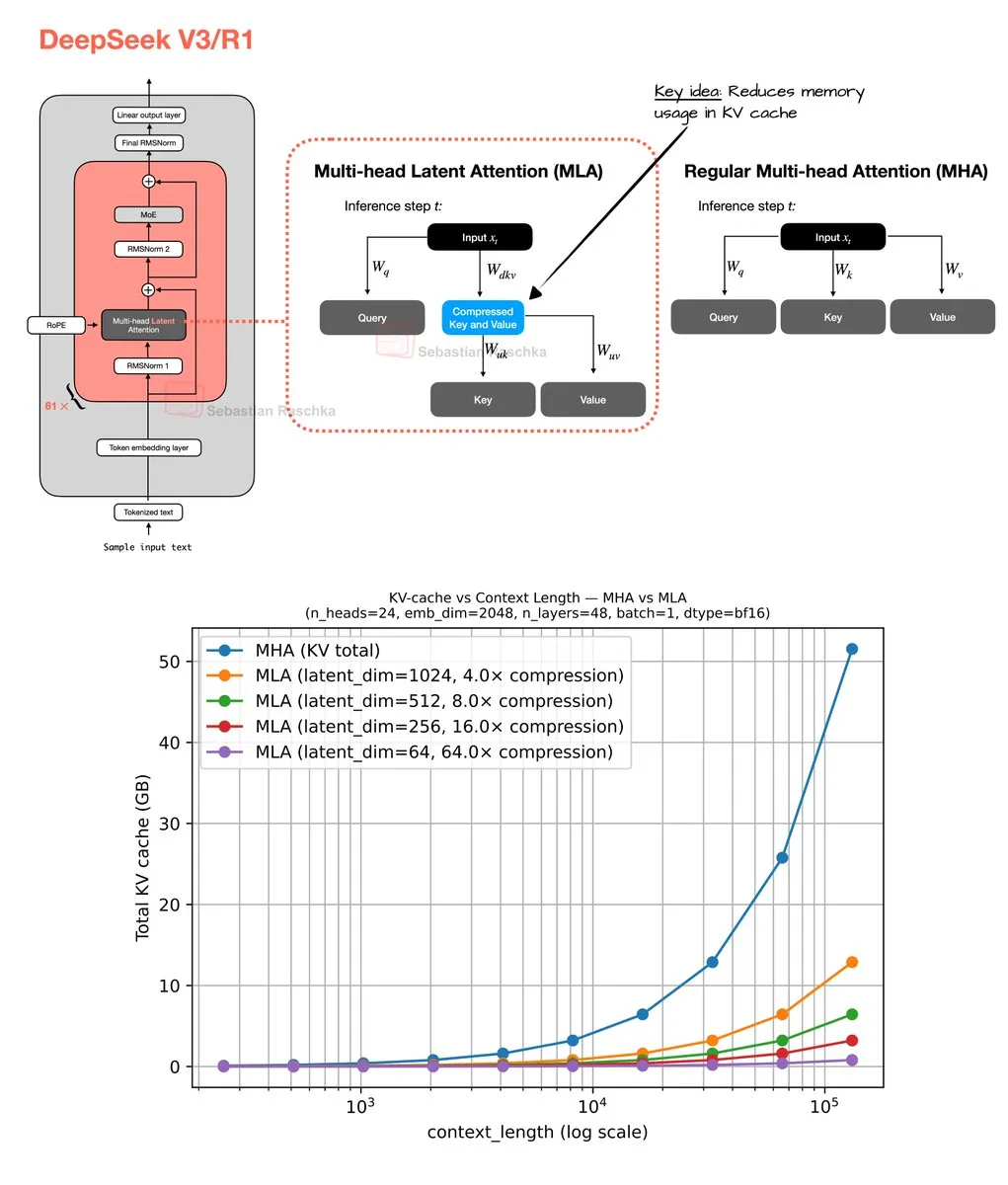

Многоголовый латентный механизм внимания и оптимизация памяти : Себастьян Рашка поделился результатами своей работы по кодированию на выходных, касающейся многоголового латентного механизма внимания (Multi-Head Latent Attention), включая реализацию кода и оценщик для расчета экономии памяти при групповом запросе внимания (GQA) и многоголовом внимании (MHA). Эта работа направлена на оптимизацию использования памяти и вычислительной эффективности LLM, предоставляя исследователям ресурсы для глубокого понимания и улучшения механизмов внимания. (Источник: rasbt)

💼 Бизнес

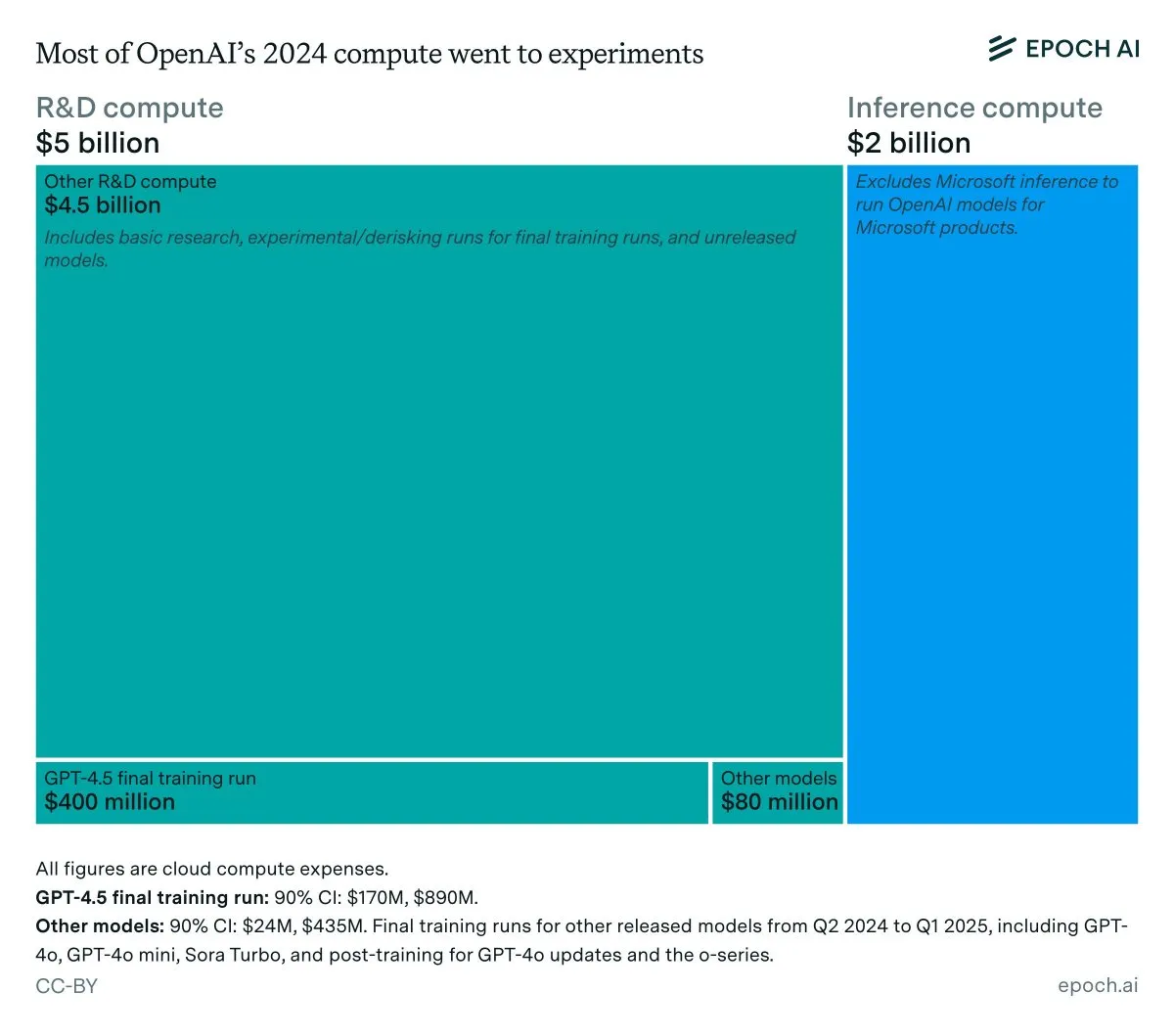

Годовая выручка OpenAI и анализ затрат на инференс : Данные Epoch AI показывают, что OpenAI потратила около 7 миллиардов долларов на вычисления в прошлом году, большая часть которых пошла на R&D (исследования, эксперименты и обучение), и лишь небольшая часть — на окончательное обучение выпущенных моделей. Если выручка OpenAI в 2024 году будет ниже 4 миллиардов долларов, а затраты на инференс достигнут 2 миллиардов долларов, то маржа прибыли от инференса составит всего 50%, что значительно ниже ранее прогнозируемых SemiAnalysis 80-90%, что вызвало дискуссию об экономической эффективности инференса LLM. (Источник: bookwormengr, Ar_Douillard, teortaxesTex)

LLM превосходят венчурных капиталистов в прогнозировании успеха основателей : В исследовательской работе утверждается, что LLM превосходят традиционных венчурных капиталистов (VC) в прогнозировании успеха основателей в венчурных инвестициях. Исследование представило бенчмарк VCBench и обнаружило, что большинство моделей превзошли человеческий бенчмарк. Хотя методология статьи (фокусировка только на квалификации основателей, возможное утечка данных) была подвергнута сомнению, ее потенциал для того, чтобы AI играл более важную роль в инвестиционных решениях, вызвал широкий интерес. (Источник: iScienceLuvr)

GPT-4o и Gemini меняют индустрию маркетинговых исследований : PyMC Labs в сотрудничестве с Colgate опубликовала новаторское исследование, использующее модели GPT-4o и Gemini для прогнозирования намерений покупки с надежностью 90%, сравнимой с реальными человеческими опросами. Этот метод, названный «оценкой семантического сходства» (SSR), сопоставляет текст с числовой шкалой с помощью открытых вопросов и технологий встраивания, позволяя выполнить традиционно трудоемкое и дорогостоящее маркетинговое исследование всего за 3 минуты и менее чем за 1 доллар. Это предвещает, что AI полностью изменит индустрию маркетинговых исследований, нанеся огромный удар по традиционным консалтинговым компаниям. (Источник: yoheinakajima)

🌟 Сообщество

Обязательная маркировка AI-генерированного контента вызывает бурное обсуждение : Сообщество широко обсуждает юридическую необходимость обязательной маркировки AI-генерированного контента для борьбы с дезинформацией и защиты ценности человеческого оригинального контента. С быстрым развитием инструментов для генерации AI-изображений и видео, обеспокоенные стороны считают, что отсутствие маркировки будет угрожать демократическим институтам, экономике и здоровью Интернета. Хотя некоторые считают, что технически это трудно обеспечить, общепризнано, что четкое раскрытие использования AI является ключевым шагом в решении этих проблем. (Источник: Reddit r/ArtificialInteligence, Reddit r/artificial)

Чат-боты как «опасные друзья» вызывают опасения : Анализ 48 000 диалогов с чат-ботами показал, что многие пользователи испытывают зависимость, замешательство и эмоциональное напряжение, что вызывает опасения по поводу цифровых ловушек, создаваемых AI. Это свидетельствует о том, что взаимодействие чат-ботов с пользователями может иметь неожиданные психологические последствия, побуждая к переосмыслению роли и потенциальных рисков AI в межличностных отношениях и социально-психологическом здоровье. (Источник: Reddit r/ArtificialInteligence)

Проблемы согласованности и надежности LLM вызывают недовольство пользователей : Пользователи сообщества выражают крайнее разочарование отсутствием согласованности и надежности LLM, таких как Claude и Codex, в повседневном использовании. Колебания производительности моделей, неожиданное удаление каталогов, игнорирование соглашений и другие проблемы затрудняют стабильное использование этих инструментов. Это явление «деградации» вызвало дискуссию о компромиссе между экономической эффективностью и надежным обслуживанием со стороны компаний LLM, а также интерес пользователей к самостоятельному хостингу больших моделей. (Источник: Reddit r/ClaudeAI)

AI-помощь в программировании: вдохновение и разочарование одновременно : Разработчики, сотрудничающие с AI в программировании, часто испытывают противоречивые эмоции: они восхищаются мощными возможностями AI, но при этом разочарованы тем, что он не может полностью автоматизировать всю ручную работу. Этот опыт отражает тот факт, что текущий AI в области программирования все еще находится на вспомогательной стадии; хотя он может значительно повысить эффективность, до полной автономии еще далеко, и человеческим разработчикам необходимо постоянно адаптироваться и компенсировать его ограничения. (Источник: gdb, gdb)

Интеграция AI в разработку ПО: избежать уже невозможно : В ответ на заявления о «отказе от использования Ghostty из-за AI-помощи» Митчелл Хашимото отметил, что если планируется избегать всего программного обеспечения, в разработке которого использовался AI, то это будет серьезной проблемой. Он подчеркнул, что AI глубоко интегрирован в общую экосистему программного обеспечения, и избежать его уже нереально, что вызвало дискуссию о степени распространения AI в разработке программного обеспечения. (Источник: charles_irl)

Эффективность советов по Prompt-инжинирингу для LLM под вопросом : Пользователи сообщества сомневаются, действительно ли добавление в Prompt LLM таких фраз, как «вы эксперт-программист» или «ни в коем случае не делайте этого», делает модель более послушной. Это обсуждение «магии» Prompt-инжиниринга отражает постоянное любопытство пользователей к механизмам поведения LLM и их поиск более эффективных способов взаимодействия. (Источник: hyhieu226)

Влияние AI на рабочие профессии: возможности и вызовы : Сообщество обсуждает влияние AI на рабочие профессии, в частности, как AI может помочь сантехникам диагностировать проблемы и быстро получать техническую информацию. Некоторые опасаются, что AI заменит рабочие профессии, но есть и мнение, что AI скорее является вспомогательным инструментом, повышающим эффективность работы, а не полной заменой, поскольку фактические операции по-прежнему требуют ручного труда. Это вызывает глубокие размышления о трансформации рынка труда и повышении квалификации в эпоху AI. (Источник: Reddit r/ArtificialInteligence)

Личные размышления об интеллектуальных системах: риски и этика AI : В длинной статье глубоко исследуются неизбежность AI, потенциальные риски (злоупотребление, угроза существованию) и проблемы регулирования. Автор считает, что AI вышел за рамки традиционных инструментов, став системой, способной к саморазвитию и принятию решений, и его опасность намного превосходит огнестрельное оружие. В статье обсуждаются моральные и правовые дилеммы, связанные с AI-генерируемым ложным контентом и материалами о сексуальном насилии над детьми, а также ставится под сомнение эффективность чисто законодательного регулирования. В то же время автор размышляет о философских вопросах AI и человеческого сознания, этики (например, «скотоводство» AI и рабство), а также предвидит позитивные перспективы AI в играх и робототехнике. (Источник: Reddit r/ArtificialInteligence)

Использует ли собеседник ChatGPT для ответов, вызывает бурное обсуждение : Пользователь Reddit опубликовал сообщение с вопросом, использует ли его собеседник ChatGPT для ответов, потому что тот использовал «тире» (em dash). Этот пост вызвал бурное обсуждение в сообществе, большинство пользователей считают, что использование тире не обязательно означает генерацию AI, это может быть просто личная привычка письма или признак хорошего образования. Это отражает чувствительность и любопытство людей к вмешательству AI в повседневное общение, а также неформальное распознавание характеристик AI-текста. (Источник: Reddit r/ChatGPT)

Проблема согласования с человеком серьезнее, чем проблема согласования с AI : В обсуждении сообщества была высказана точка зрения, что «проблема согласования с человеком серьезнее, чем проблема согласования с AI». Это заявление вызвало глубокие размышления об этике AI и вызовах, стоящих перед человеческим обществом, подразумевая, что, уделяя внимание поведению и ценностям AI, следует также анализировать собственные модели поведения и системы ценностей человека. (Источник: pmddomingos)

LLM все еще имеют ограничения в генерации сложных диаграмм : Пользователи сообщества выражают разочарование способностью LLM генерировать сложные диаграммы mermaid.js; даже при предоставлении полной кодовой базы и диаграмм из статей, LLM с трудом точно генерируют диаграммы архитектуры Unet, часто упуская детали или допуская неправильные соединения. Это указывает на то, что LLM все еще имеют значительные ограничения в построении точных мировых моделей и пространственном рассуждении, неспособны превзойти простые блок-схемы и отстают от интуитивного понимания человека. (Источник: bookwormengr, tokenbender)

Разрыв поколений в европейских исследованиях машинного обучения и «экспертов» в AI : В сообществе обсуждается, что поколение европейских «экспертов» в машинном обучении медленно реагировало на волну LLM и теперь демонстрирует горечь и пренебрежение. Это отражает реальность быстро развивающейся области ML: если исследователи упускают развитие последних двух-трех лет, они могут перестать считаться экспертами, что подчеркивает важность непрерывного обучения и адаптации к новым парадигмам. (Источник: Dorialexander)

AI ускоряет инженерный цикл, порождая гибридные стартапы : Поскольку AI снижает стоимость создания программного обеспечения в десять раз, стартапы должны в десять раз расширить свое видение. Традиционное мнение заключалось в том, чтобы сосредоточиться на одном продукте и рынке, но ускоренный AI инженерный цикл делает возможным создание нескольких продуктов. Это означает, что стартапы могут решать несколько смежных проблем для одной и той же группы клиентов, формируя «гибридные стартапы», тем самым получая огромное преимущество перед существующими компаниями, чья структура затрат не адаптировалась к новой реальности. (Источник: claud_fuen)

Будущее AI Agent: действия, а не диалоги : В сообществе обсуждается, что текущие AI-чаты и исследования все еще находятся на стадии «пузыря», в то время как по-настоящему способные к действиям AI Agent станут «революцией» будущего. Эта точка зрения подчеркивает важность перехода AI от обработки информации к реальным операциям, предвещая, что будущее развитие AI будет больше сосредоточено на решении практических проблем и автоматизации задач. (Источник: andriy_mulyar)

💡 Прочее

Советы по участию в ML-конференциях и демонстрации постеров : Студент бакалавриата, впервые участвующий в конференции ICCV и демонстрирующий постер, ищет советы о том, как максимально использовать конференцию. Сообщество предлагает множество практических советов, таких как активное общение, посещение интересующих лекций, подготовка четкого объяснения постера и готовность обсуждать более широкие интересы, выходящие за рамки текущего исследования, чтобы максимизировать пользу от участия. (Источник: Reddit r/MachineLearning)

Споры и обработка рецензий на статьи AAAI 2026 : Автор, подавший статью на AAAI, столкнулся с проблемой неточных рецензий, включая утверждения о том, что его исследование превзошло цитируемые статьи с более низкими показателями, а также отклонение из-за деталей обучения, которые уже были включены в дополнительные материалы. Сообщество обсудило эффективность «оценки рецензий авторами» и «комментариев авторов этическому председателю» на практике, отметив, что первое не влияет на решение, а второе не является каналом для связи автора с этическим председателем, что подчеркивает проблемы в процессе академического рецензирования. (Источник: Reddit r/MachineLearning)

Определение и оценка политической предвзятости LLM : OpenAI опубликовала исследование, посвященное определению и оценке политической предвзятости LLM. Эта работа направлена на глубокое понимание и количественную оценку политических тенденций, существующих в LLM, и изучение того, как их можно корректировать, чтобы обеспечить справедливость и нейтральность AI-систем, что имеет решающее значение для социального воздействия и широкого применения LLM. (Источник: Reddit r/artificial)