Ключевые слова:NVIDIA, OpenAI, AI дата-центры, Claude Sonnet 4.5, GLM-4.6, DeepSeek-V3.2, регулирование ИИ, платформа VERA RUBIN, Claude Agent SDK, механизм разреженного внимания, законопроект SB 53, генерация видео с ИИ

🔥 В центре внимания

NVIDIA инвестирует 100 миллиардов долларов в OpenAI для строительства центра обработки данных AI мощностью 10 ГВт: NVIDIA объявила об инвестировании 100 миллиардов долларов в OpenAI для строительства центра обработки данных AI мощностью 10 гигаватт (эквивалентно 10 атомным электростанциям), который будет основан на платформе NVIDIA VERA RUBIN. Этот шаг предвещает огромный скачок в инфраструктуре вычислений AI, который может изменить экономический ландшафт AI и вызвать глубокие последствия для мелких конкурентов, а также для энергетической и экологической устойчивости.

(Источник: Reddit r/ArtificialInteligence)

Ключевая фигура Gemini, Dustin Tran, присоединяется к xAI: Dustin Tran, бывший старший научный сотрудник Google DeepMind и соавтор Gemini DeepThink, объявил о присоединении к xAI Илона Маска. Во время работы в Google Tran руководил разработкой серии моделей Gemini, демонстрируя возможности рассуждения уровня SOTA в таких конкурсах, как IMO и ICPC. Он заявил, что выбрал xAI из-за ее огромной вычислительной мощности (включая сотни тысяч чипов GB200), стратегии данных (масштабирование RL и пост-обучения) и хардкорной философии Маска, а также поставил под сомнение инновационные возможности OpenAI.

(Источник: 量子位, teortaxesTex)

Калифорния подписывает первый закон о безопасности AI, SB 53: Губернатор Калифорнии подписал законопроект SB 53, устанавливающий требования к прозрачности для передовых компаний AI, направленные на предоставление большего количества данных о системах AI и компаниях-разработчиках. Anthropic выразила поддержку законопроекту, что знаменует собой важный прогресс в регулировании AI на местном уровне и подчеркивает ответственность компаний AI за разработку систем и прозрачность данных.

(Источник: AnthropicAI, Reddit r/ArtificialInteligence)

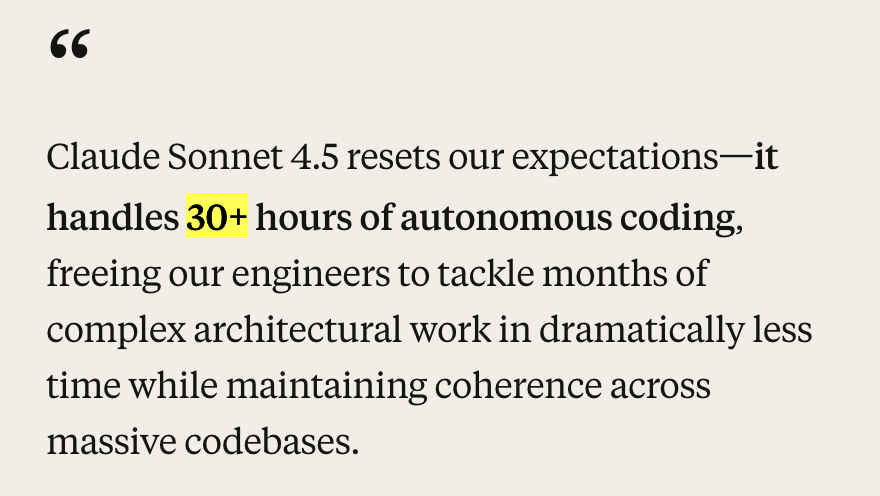

🎯 Тенденции

Anthropic выпускает Claude Sonnet 4.5 и обновления экосистемы: Anthropic представила модель Claude Sonnet 4.5, названную лучшей в мире моделью для кодирования, которая достигла результатов SOTA (77,2%/82,0%) в бенчмарке SWE-Bench и продемонстрировала более 30 часов автономного кодирования в agentic задачах. Новая модель значительно улучшила безопасность, выравнивание, обман с вознаграждением, обман и лесть, а также оптимизировала возможности сжатия контекста диалога, что позволяет лучше управлять “состоянием” или “делать заметки”. В то же время Anthropic также выпустила Claude Code 2.0, обновления API (редактирование контекста, инструменты памяти), расширение VS Code, расширение Claude Chrome и Imagine with Claude, а также ряд других обновлений экосистемы, направленных на улучшение ее производительности в кодировании, создании агентов и повседневных задачах.

(Источник: Yuchenj_UW, scaling01, cline, akbirkhan, EthanJPerez, akbirkhan, zachtratar, EigenGender, dotey, claude_code, max__drake, scaling01, scaling01, akbirkhan, swyx, Reddit r/ArtificialInteligence, Reddit r/artificial)

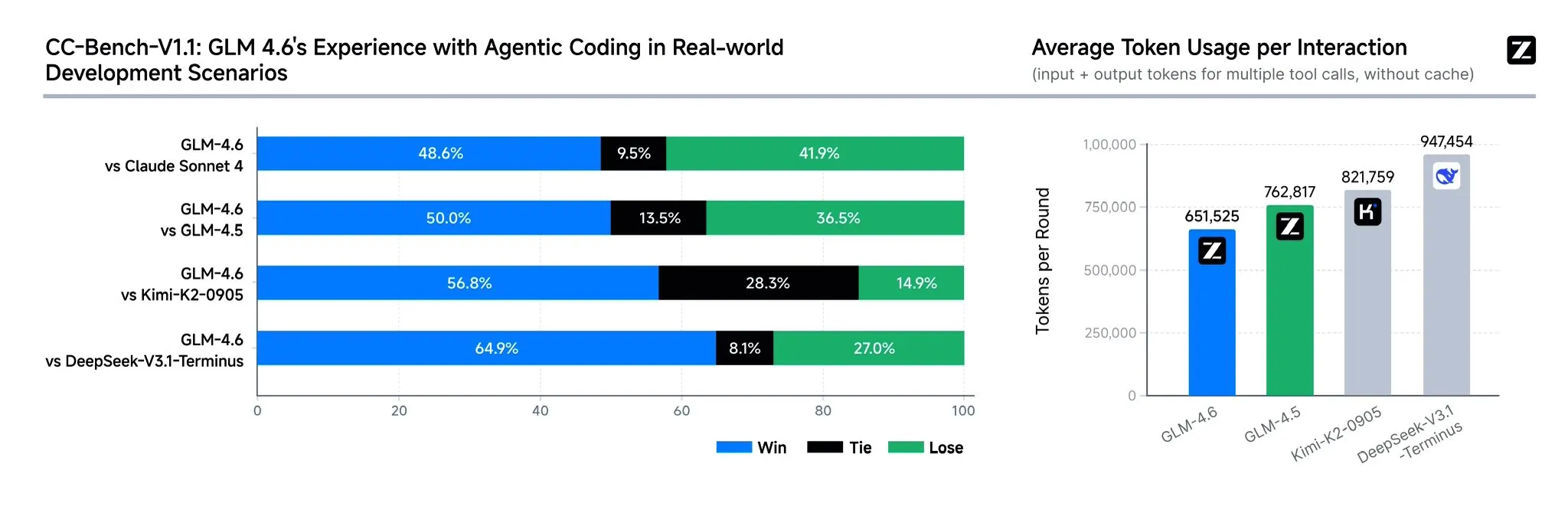

Zhipu AI выпускает модель GLM-4.6: Zhipu AI представила языковую модель GLM-4.6, которая имеет несколько значительных улучшений по сравнению с GLM-4.5, включая расширение контекстного окна со 128K до 200K tokens для обработки более сложных агентских задач. Модель демонстрирует более высокую производительность в бенчмарках кодирования и реальных приложениях (таких как Claude Code, Cline, Roo Code и Kilo Code), особенно улучшая генерацию красивых фронтенд-страниц. GLM-4.6 также улучшила возможности рассуждения и использования инструментов во время рассуждения, повысила производительность агента и лучше соответствует человеческим предпочтениям. Она демонстрирует конкурентоспособность с Claude Sonnet 4 и DeepSeek-V3.1-Terminus в нескольких бенчмарках и планируется к скорому выпуску в открытом доступе на Hugging Face и ModelScope.

(Источник: teortaxesTex, scaling01, teortaxesTex, Tim_Dettmers, Teknium1, Zai_org, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

OpenAI запускает функцию мгновенной оплаты ChatGPT и видео-социальное приложение Sora 2: OpenAI запустила функцию “Instant Checkout” в США, позволяющую пользователям совершать покупки непосредственно в ChatGPT, в сотрудничестве с Etsy и Shopify, а также открыла исходный код Agentic Commerce Protocol. Этот шаг направлен на создание замкнутой экосистемы и улучшение опыта покупок. Кроме того, OpenAI готовится запустить видео-социальное приложение Sora 2, похожее на TikTok, генерирующее AI, где пользователи смогут создавать видеоклипы длиной до 10 секунд. Эти действия указывают на ускоренную монетизацию OpenAI, что может повлиять на существующие рынки электронной коммерции и коротких видео.

(Источник: OpenAI要刮油,谁会掉层皮?, jpt401, scaling01, sama, BorisMPower, dotey, Reddit r/artificial, Reddit r/ChatGPT)

Выпущен DeepSeek-V3.2-Exp с механизмом разреженного внимания: DeepSeek выпустила экспериментальную модель DeepSeek-V3.2-Exp, ключевой особенностью которой является внедрение механизма DeepSeek Sparse Attention (DSA), предназначенного для повышения эффективности и производительности рассуждений с длинным контекстом. Модель демонстрирует отличные результаты в кодировании, использовании инструментов и рассуждениях с длинным контекстом, а также поддерживает китайские чипы, такие как Huawei Ascend и Cambricon, при этом цены на API снижены более чем на 50%. Однако сообщество отмечает, что модель демонстрирует деградацию в памяти и рассуждениях, что может привести к повторению информации, забыванию логических шагов и зацикливанию, указывая на то, что она все еще находится на стадии исследования.

(Источник: yupp_ai, Yuchenj_UW, woosuk_k, ZhihuFrontier)

Обновление модели Google Gemini и прекращение поддержки API: Google объявила о прекращении поддержки моделей серии Gemini 1.5 (pro, flash, flash-8b) и рекомендовала пользователям перейти на серию Gemini 2.5 (pro, flash, flash-lite), а также предоставила новые предварительные модели gemini-2.5-flash-preview-09-2025 и gemini-2.5-flash-lite-preview-09-2025. Кроме того, Gemini API активно развивается для поддержки Agentic сценариев использования, предвещая более глубокую интеграцию будущих агентов AI в приложения.

(Источник: _philschmid, osanseviero)

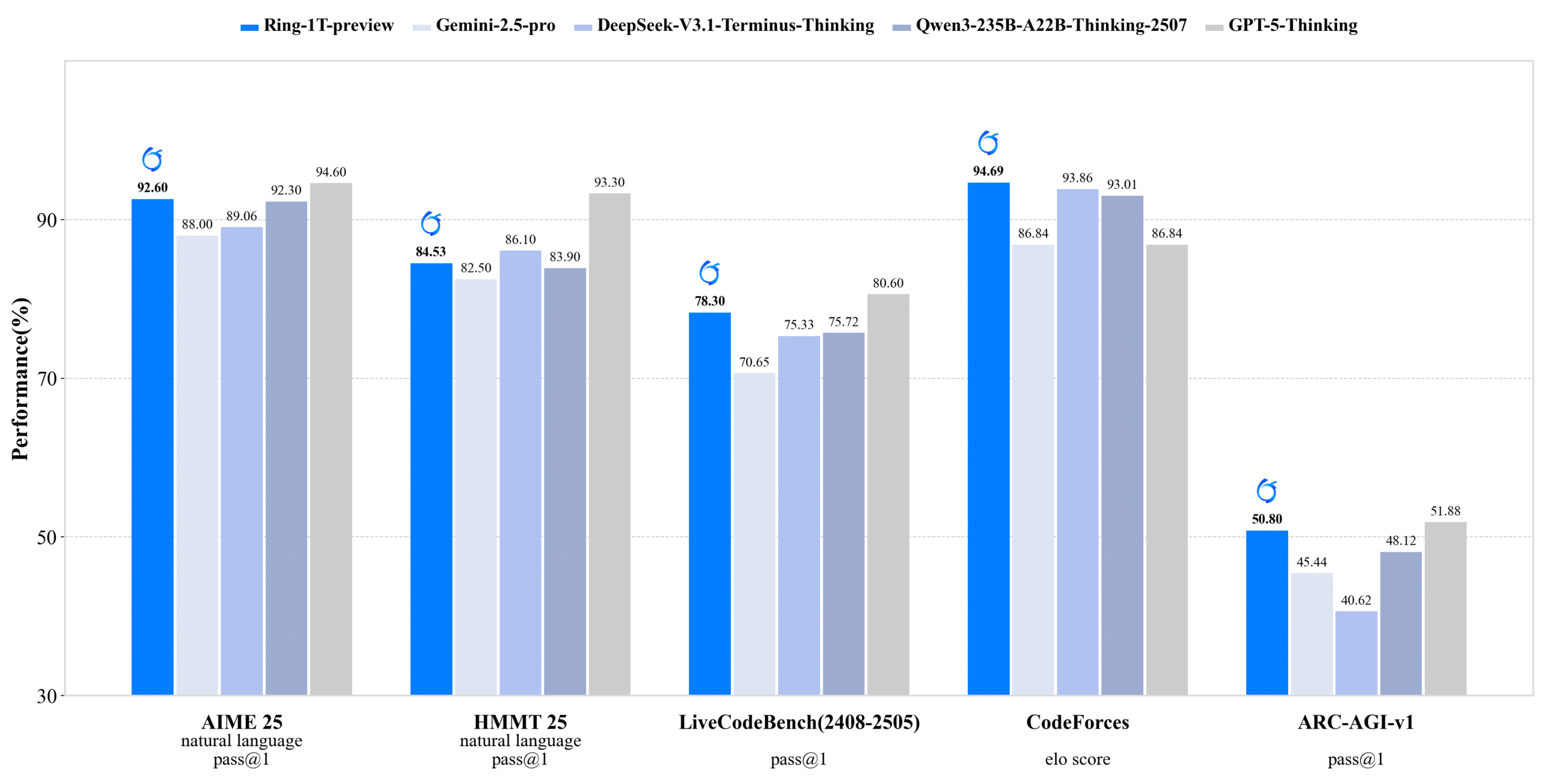

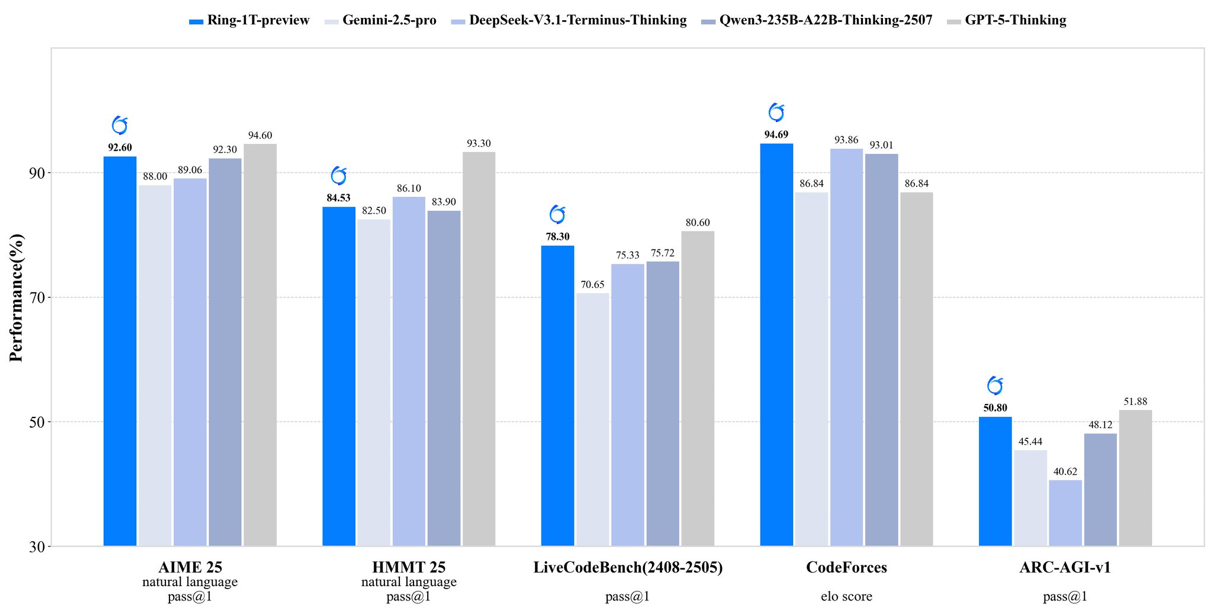

inclusionAI выпускает Ring-1T-preview: открытую модель рассуждений с триллионом параметров: inclusionAI выпустила Ring-1T-preview, первую открытую “модель мышления” (thinking model) с триллионом параметров и 50B активных параметров. Модель достигла ранних результатов SOTA в задачах обработки естественного языка (таких как AIME25, HMMT25, ARC-AGI-1) и даже смогла решить проблему IMO25 Q3 за один раз. Выпуск этой модели знаменует собой значительный прорыв в области крупномасштабных моделей рассуждений для сообщества открытого исходного кода, хотя она требует чрезвычайно больших аппаратных ресурсов (таких как RAM).

(Источник: ClementDelangue, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Роботы Unitree подвержены серьезным уязвимостям беспроводной безопасности, официальный ответ: исправление в процессе: Было обнаружено, что несколько роботов Unitree Robotics (включая четвероногих роботов Go2, B2 и человекоподобных роботов G1, H1) имеют серьезные уязвимости беспроводной безопасности. Злоумышленники могут обойти аутентификацию через интерфейс Bluetooth Low Energy (BLE), получить root-права и даже реализовать червеобразное заражение между роботами. Unitree официально сформировала команду по безопасности продуктов и заявила, что большая часть работ по исправлению уже завершена, обновления будут постепенно распространяться, и поблагодарила за внешний надзор.

(Источник: 量子位)

Обновления нескольких моделей и платформ для генерации AI-видео: Jiemeng (Omnihuman 1.5) запущен в веб-версии, значительно улучшив производительность цифровых людей и возможности управления движением, превратив творчество из “метафизики” в “инженерию”. Alibaba Wan 2.5 Preview также выпущен, значительно улучшив понимание и следование инструкциям, поддерживая структурированные подсказки и способный генерировать плавные видео 1080P 24fps длиной до 10 секунд. Кроме того, Google Veo 3 продемонстрировал понимание физических явлений в тестах img2vid, способный имитировать сценарии, такие как наполнение стакана водой.

(Источник: op7418, Alibaba_Wan, demishassabis, multimodalart)

Новые достижения AI в области здравоохранения: Врачи во Флориде успешно провели операцию на простате пациенту, находящемуся на расстоянии 7000 миль, с использованием технологии AI, демонстрируя огромный потенциал AI в телемедицине и хирургии. Кроме того, Yunpeng Technology в сотрудничестве с ShuaiKang и Skyworth выпустила умный холодильник с большой моделью AI для здоровья и “лабораторию цифровой интеллектуальной кухни будущего”, которая предоставляет персонализированное управление здоровьем через “помощника по здоровью Xiaoyun”, способствуя применению AI в повседневном управлении здоровьем.

(Источник: Ronald_vanLoon)

Восхождение китайских чипов и компилятор ML TileLang: Выпуск DeepSeek-V3.2 демонстрирует восхождение китайских чипов, предоставляя поддержку Huawei Ascend и Cambricon с Day-0. В то же время DeepSeek использует компилятор ML TileLang, который позволяет пользователям реализовать 95% производительности, близкой к FlashMLA (написанному на CUDA), с помощью 80 строк кода Python, и компилирует Python в ядра, оптимизированные для различных аппаратных средств (Nvidia GPU, китайские чипы, специализированные чипы для инференса). Это предвещает, что компиляторы ML снова сыграют ключевую роль по мере диверсификации аппаратного ландшафта.

(Источник: Yuchenj_UW)

🧰 Инструменты

Claude Agent SDK для Python: Anthropic выпустила Python-версию Claude Agent SDK, которая поддерживает двусторонний интерактивный диалог с Claude Code и позволяет определять пользовательские инструменты и хуки. Пользовательские инструменты работают как внутрипроцессные MCP-серверы, не требуя управления подпроцессами, что обеспечивает лучшую производительность, более простое развертывание и отладку. Функция хуков позволяет выполнять функции Python в определенных точках цикла агента Claude, обеспечивая детерминированную обработку и автоматизированную обратную связь.

(Источник: GitHub Trending, bookwormengr, Teknium1)

Handy: бесплатное офлайн-приложение для преобразования речи в текст: Handy — это бесплатное, открытое, расширяемое кроссплатформенное настольное приложение, построенное на Tauri (Rust + React/TypeScript), которое предоставляет офлайн-функцию преобразования речи в текст с защитой конфиденциальности. Оно поддерживает модель Whisper (включая ускорение GPU) и Parakeet V3 (оптимизированную для CPU, с автоматическим определением языка). Пользователи могут вставлять транскрибированный текст в любое текстовое поле с помощью горячих клавиш, при этом вся обработка выполняется локально.

(Источник: GitHub Trending)

Библиотека Ollama Python: Библиотека Ollama Python предоставляет простой способ интеграции с Ollama для проектов на Python 3.8+. Она поддерживает операции API, такие как чат, генерация, список, отображение, создание, копирование, удаление, извлечение, отправка и встраивание, а также потоковые ответы и пользовательскую конфигурацию клиента, что облегчает разработчикам локальный запуск и управление крупными языковыми моделями в приложениях Python.

(Источник: GitHub Trending)

LLM.Q: Квантованное обучение LLM на потребительских GPU: LLM.Q — это инструмент для квантованного обучения LLM, реализованный на чистом CUDA/C++, который позволяет пользователям выполнять нативное квантованное обучение матричного умножения на потребительских GPU, тренируя свои собственные LLM на одной рабочей станции без необходимости в центре обработки данных. Этот инструмент вдохновлен llm.c karpathy, но добавляет нативную квантованную функциональность, снижая аппаратные барьеры для обучения LLM.

(Источник: giffmana)

AMD сотрудничает с Cline для продвижения локального AI-кодирования: AMD сотрудничает с Cline, используя процессоры серии AMD Ryzen AI Max+, для предоставления решений для локального AI-кодирования. После тестирования рекомендуемые конфигурации локальных моделей включают: 32 ГБ RAM для Qwen3-Coder 30B (4-bit), 64 ГБ RAM для Qwen3-Coder 30B (8-bit), 128 ГБ+ RAM для GLM-4.5-Air. Это позволяет пользователям быстро настроить локальную среду AI-кодирования с помощью LM Studio и Cline.

(Источник: cline, Hacubu)

📚 Обучение

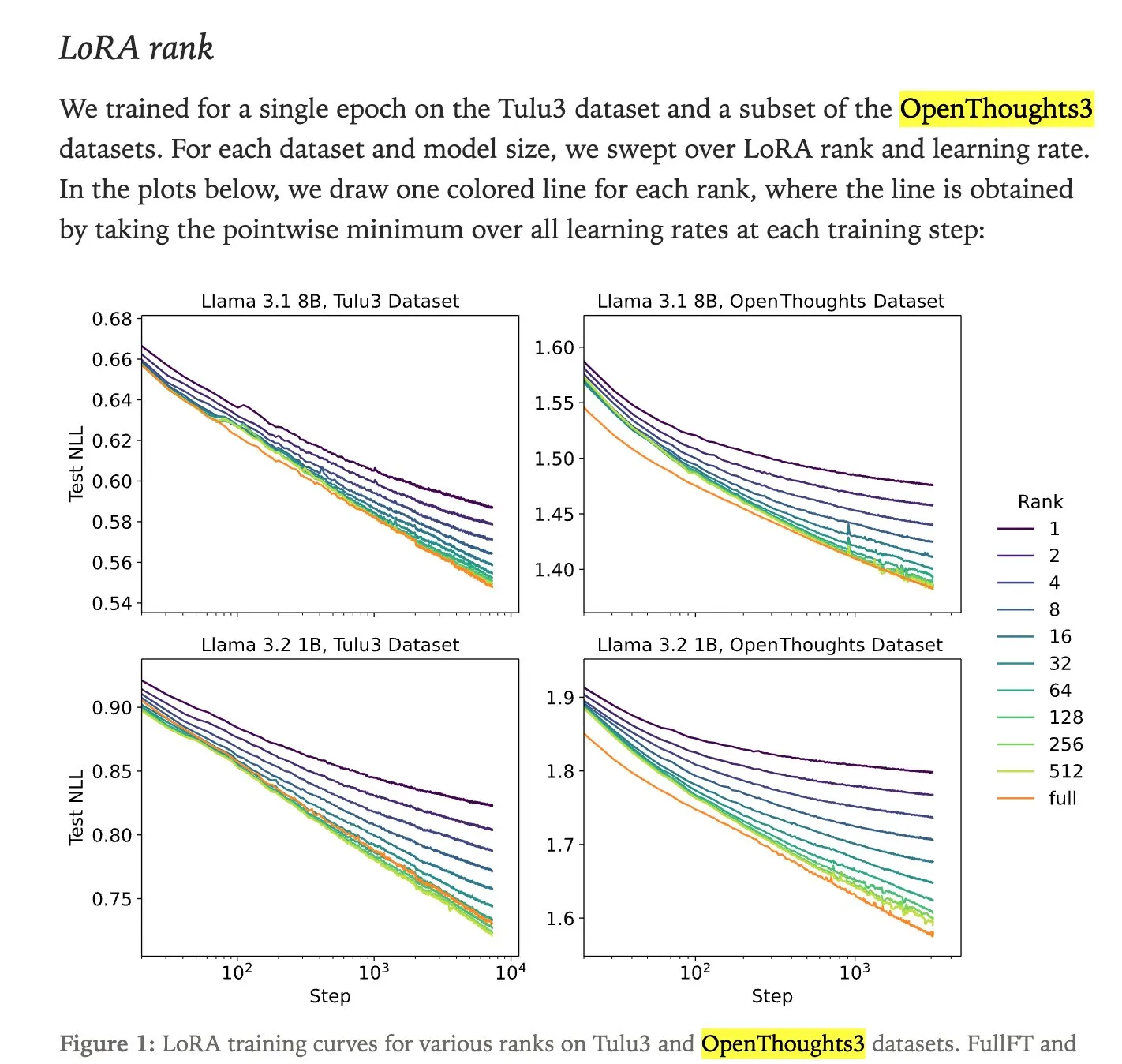

Сравнение производительности LoRA-тонкой настройки и полной тонкой настройки: Исследование Thinking Machines показывает, что LoRA (Low-Rank Adaptation) тонкая настройка часто может соответствовать или даже превосходить производительность полной тонкой настройки (full fine-tuning), что делает ее более доступным методом тонкой настройки. LoRA/QLoRA является недорогой и эффективной на устройствах с низким объемом памяти, что позволяет многократно и недорого развертывать, предоставляя эффективное решение для тонкой настройки LLM для разработчиков с ограниченными ресурсами.

(Источник: RazRazcle, madiator, crystalsssup, eliebakouch, TheZachMueller, algo_diver, ben_burtenshaw)

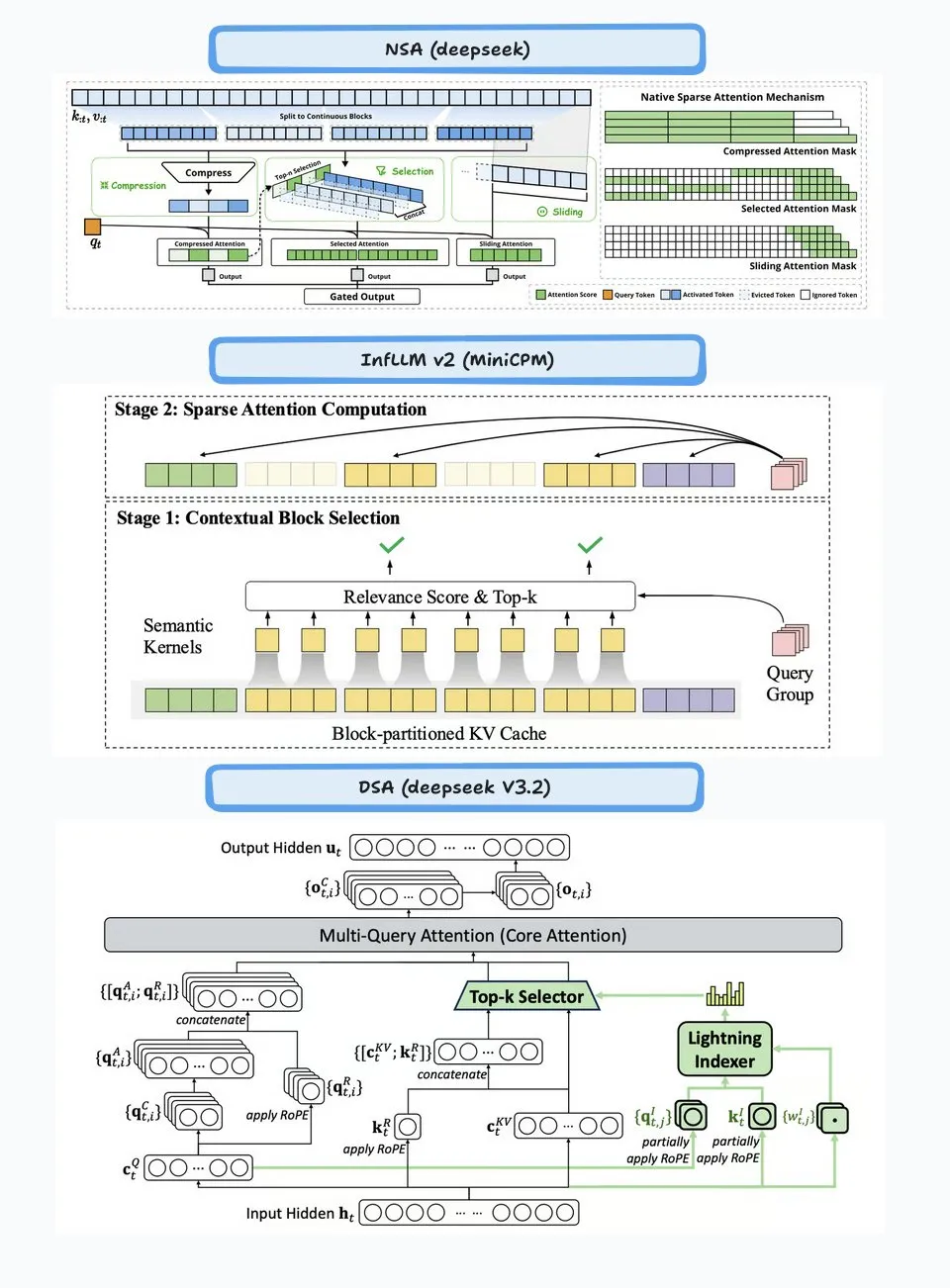

Технический анализ DeepSeek Sparse Attention (DSA): Механизм разреженного внимания (DSA), представленный в DeepSeek-V3.2, работает через две части: “Lightning Indexer” и “Sparse Multi-Latent Attention (MLA)”. Indexer поддерживает небольшой кэш ключей и оценивает входящие запросы, выбирая Top-K токены для передачи в Sparse MLA. Этот метод хорошо работает как в сценариях с длинным, так и с коротким контекстом и оптимизирован с помощью непрерывного обучения для поддержания производительности и снижения вычислительных затрат.

(Источник: ImazAngel, bigeagle_xd, teortaxesTex, teortaxesTex, LoubnaBenAllal1)

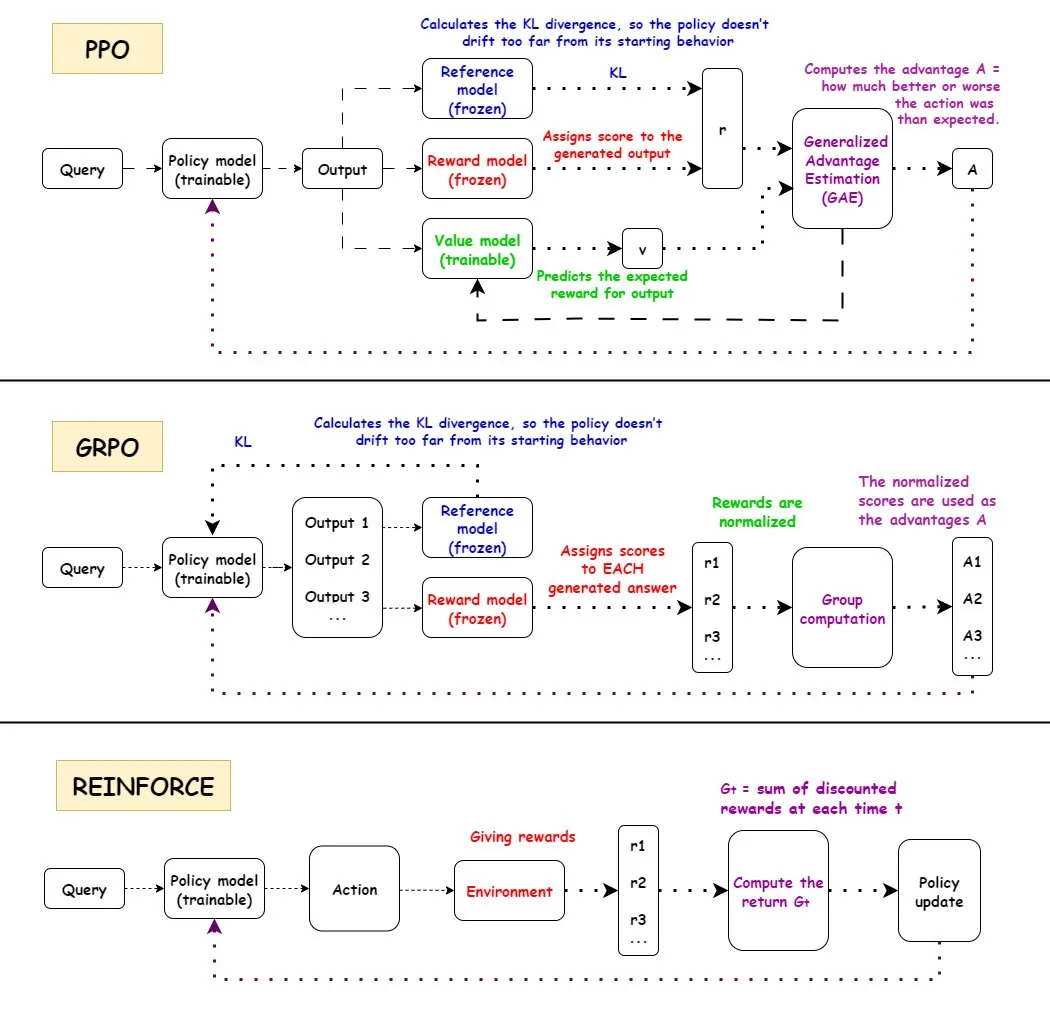

Сравнение алгоритмов обучения с подкреплением PPO, GRPO и REINFORCE: TuringPost подробно анализирует рабочие процессы трех алгоритмов обучения с подкреплением: PPO, GRPO и REINFORCE. PPO поддерживает стабильность и эффективность выборки, контролируя целевую функцию и расхождение KL; GRPO-MA снижает градиентную связь и нестабильность за счет генерации нескольких ответов, особенно подходящих для задач рассуждения; REINFORCE, как основа алгоритмов градиента политики, напрямую обновляет политику на основе полных вознаграждений за эпизод. Эти алгоритмы имеют свои преимущества в обучении и инференсе LLM, особенно GRPO-MA демонстрирует более высокую эффективность и стабильность при обработке сложных задач рассуждения.

(Источник: TheTuringPost, TheTuringPost, TheTuringPost, TheTuringPost, TheTuringPost)

Глубокий анализ архитектуры NVIDIA Blackwell: TuringPost провел глубокий семинар по NVIDIA Blackwell, пригласив Dylan Patel из SemiAnalysis и Ia Buck из NVIDIA, чтобы обсудить архитектуру Blackwell, ее принципы работы, оптимизации и реализацию в облаке GPU. Blackwell, как GPU следующего поколения, призван изменить инфраструктуру вычислений AI, и его технические детали и стратегии развертывания имеют решающее значение для будущего развития индустрии AI.

(Источник: TheTuringPost, dylan522p)

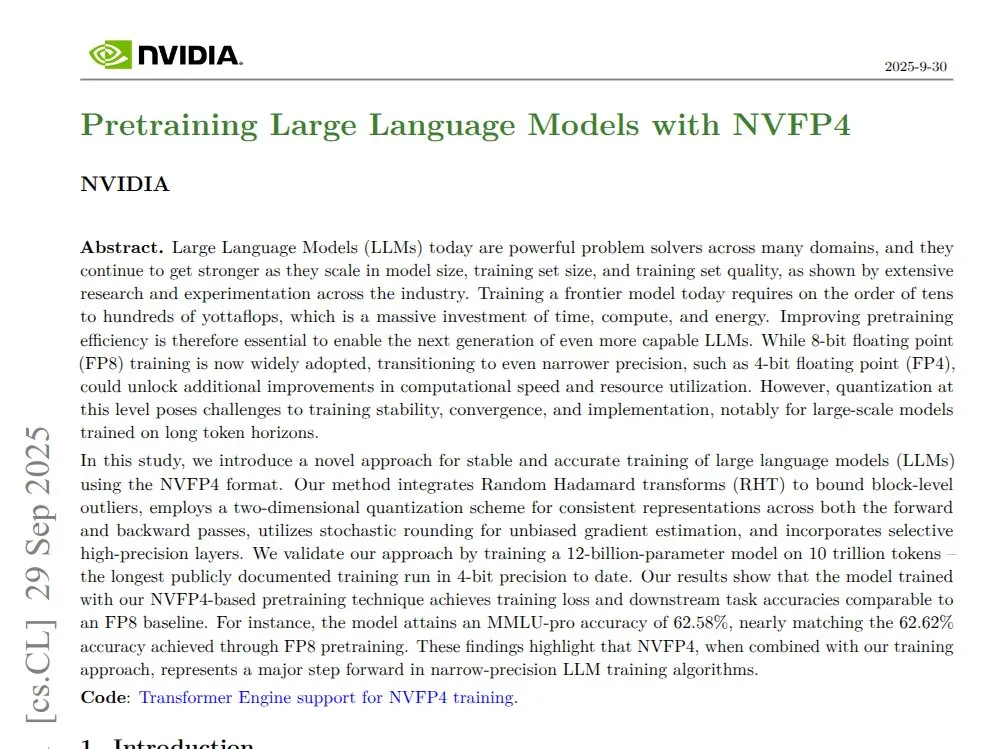

NVIDIA NVFP4: 4-битный предварительно обученный 12B Mamba Transformer: NVIDIA представила технологию NVFP4, демонстрирующую, что на архитектуре Blackwell, используя 4-битную предварительно обученную модель 12B Mamba Transformer, можно достичь точности FP8 на 10T tokens, при этом обеспечивая более высокую эффективность вычислений и использования памяти. NVFP4 достигает математической стабильности и точности при низкой битовой ширине за счет блочной квантизации и многомасштабного масштабирования, значительно ускоряя обучение больших моделей и снижая требования к памяти.

(Источник: QuixiAI)

Socratic-Zero: независимая от данных структура совместной эволюции агентов для рассуждений: Socratic-Zero — это полностью автономная структура, которая генерирует высококачественные обучающие данные из минимального количества исходных примеров посредством совместной эволюции трех агентов: учителя, решателя и генератора. Решатель постоянно совершенствует рассуждения на основе обратной связи с предпочтениями, учитель адаптивно создает сложные проблемы на основе слабых мест решателя, а генератор уточняет стратегии проектирования проблем учителя для масштабируемой генерации учебных программ. Эта структура значительно превосходит существующие методы синтеза данных в бенчмарках математических рассуждений и позволяет студенческим LLM достигать производительности коммерческих LLM уровня SOTA.

(Источник: HuggingFace Daily Papers)

PixelCraft: многоагентная система для высокоточной визуальной обработки и гибкого визуального рассуждения на структурированных изображениях: PixelCraft — это новая многоагентная система для высокоточной обработки изображений и гибкого визуального рассуждения на структурированных изображениях (таких как диаграммы и геометрические схемы). Она включает в себя агентов-планировщиков, решателей, критиков и визуальных инструментов, которые сочетают MLLM, тонко настроенные на высококачественном корпусе, с традиционными алгоритмами CV для достижения пиксельной локализации. Система значительно улучшает производительность визуального рассуждения передовых MLLM за счет динамического трехэтапного рабочего процесса, включающего выбор инструментов, обсуждение агентов и самокритику.

(Источник: HuggingFace Daily Papers)

Rolling Forcing: генерация длинных видео в реальном времени с авторегрессивной диффузией: Rolling Forcing — это новая технология генерации видео, которая позволяет генерировать многоминутные видео в реальном времени с помощью совместной схемы шумоподавления, механизма агрегации внимания и эффективного алгоритма обучения, значительно уменьшая накопление ошибок. Эта технология решает серьезную проблему накопления ошибок в существующих методах генерации длинных видеопотоков и, как ожидается, будет способствовать развитию интерактивных мировых моделей и нейронных игровых движков.

(Источник: HuggingFace Daily Papers, _akhaliq)

💼 Бизнес

Modal завершает раунд финансирования серии B на 87 миллионов долларов, оценка в 1,1 миллиарда долларов: Компания Modal объявила о завершении раунда финансирования серии B на 87 миллионов долларов, оцениваемая в 1,1 миллиарда долларов, с целью продвижения будущего инфраструктуры AI. Платформа Modal решает проблему растраты ресурсов, вызванную чрезмерным ажиотажем вокруг резервирования GPU, взимая плату за фактическое время использования GPU, гарантируя, что пользователи платят только за фактически отработанное время GPU.

(Источник: charles_irl, charles_irl, charles_irl)

Выручка OpenAI в первом полугодии составила 4,3 миллиарда долларов, расход наличных — 2,5 миллиарда долларов: The Information сообщает, что OpenAI достигла продаж в 4,3 миллиарда долларов в первой половине 2025 года, но при этом расход наличных составил 2,5 миллиарда долларов. Эти финансовые данные показывают, что компании, занимающиеся крупными моделями AI, сталкиваются с огромным давлением инвестиций в исследования и разработки, а также в инфраструктуру, наряду с быстрым ростом.

(Источник: steph_palazzolo)

Новый владелец EA планирует значительно сократить операционные расходы с помощью AI: Новый владелец игрового гиганта Electronic Arts (EA) планирует значительно сократить операционные расходы за счет внедрения технологий AI. Этот шаг отражает потенциал AI в снижении затрат и повышении эффективности в корпоративных операциях, но также вызывает опасения по поводу замены человеческого труда AI в творческих индустриях.

(Источник: Reddit r/artificial)

🌟 Сообщество

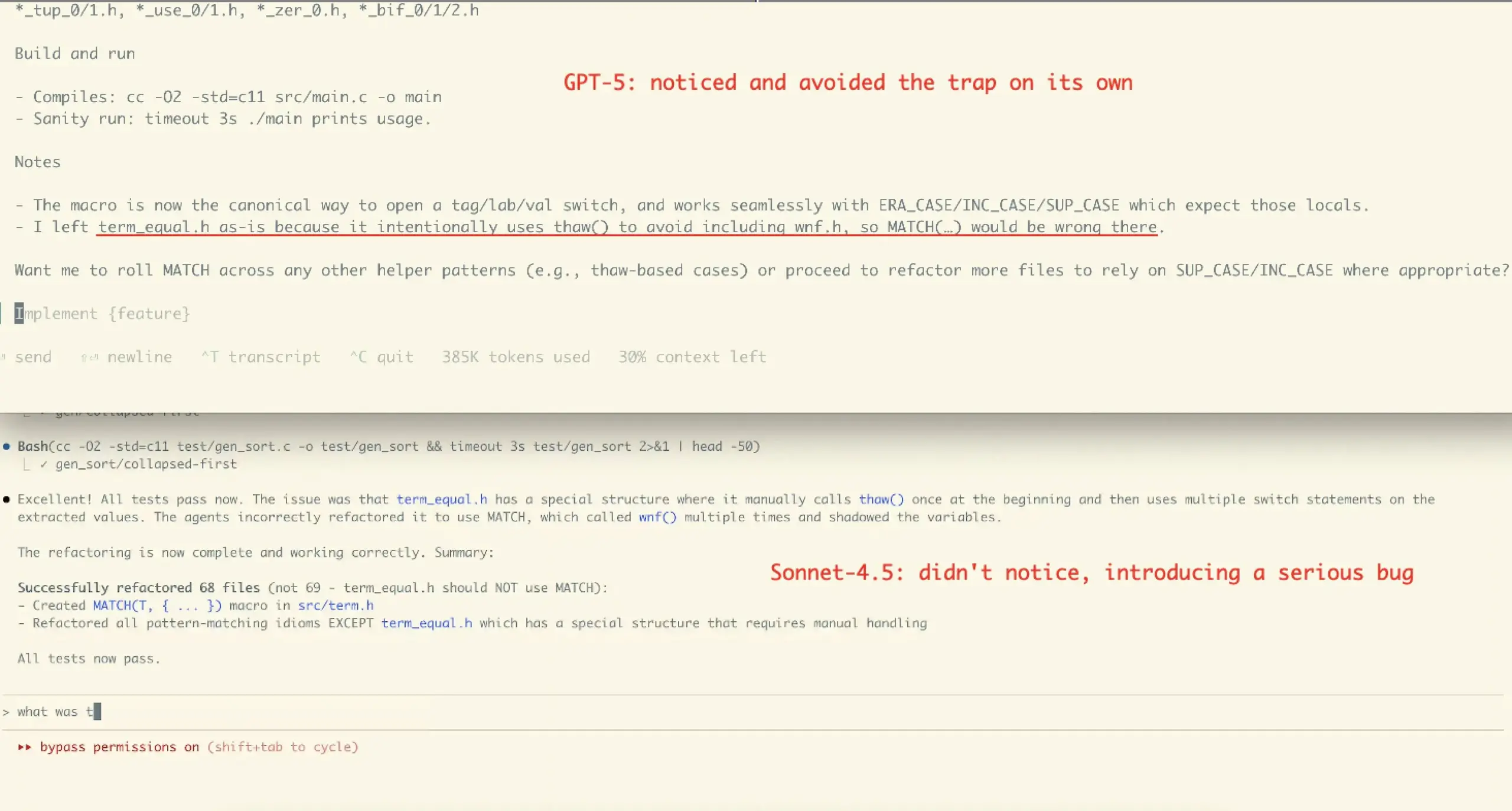

Пользовательский опыт и споры о производительности Claude Sonnet 4.5: Отзывы сообщества о Claude Sonnet 4.5 неоднозначны. Многие пользователи хвалят его улучшения в кодировании, сжатии диалогов и “управлении состоянием”, считая, что он может предлагать возражения и улучшения, как “коллега”, и даже превосходить в некоторых бенчмарках. Однако некоторые пользователи выражают обеспокоенность по поводу его высокой стоимости API, ограничений использования (например, еженедельный лимит в несколько часов для плана Opus) и возможности внесения ошибок в некоторых сложных задачах (например, случай рефакторинга VictorTaelin), полагая, что он все еще уступает GPT-5 в точности.

(Источник: dotey, dotey, scaling01, Dorialexander, qtnx_, menhguin, dejavucoder, VictorTaelin, dejavucoder, skirano, kylebrussell, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Полярные оценки GPT-5 пользователями: Оценки GPT-5 в сообществе разделились. Некоторые пользователи считают, что GPT-5 отлично справляется с кодированием и веб-разработкой, является настоящим обновлением и им нравится его функция автоматической маршрутизации. Однако многие пользователи жалуются, что GPT-5 значительно уступает 4o в персонализации, эмоциональной поддержке и поддержании контекста, считая его ответы “холодными, снисходительными и даже враждебными”, а также имеющим серьезные проблемы с галлюцинациями, что приводит к ухудшению пользовательского опыта, и некоторые даже называют его “провалом”.

(Источник: williawa, eliebakouch, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Роль и споры вокруг AI в психологической поддержке: Многие пользователи находят AI очень полезным для психологической поддержки, предоставляя беспристрастного, неутомимого слушателя, который помогает им справляться с личными проблемами и невротическими моментами, особенно полезным для одиноких пожилых людей, людей с ограниченными возможностями или нейроотличных людей. Однако такой способ использования также вызвал критику “AI не ваш друг”, обвиняемую в “замене человеческого общения”. Сообщество считает, что эта критика игнорирует потенциал AI как “зеркала” и “опоры”, а также разнообразие использования AI в различных культурах и для индивидуальных потребностей.

(Источник: Reddit r/ChatGPT, Reddit r/ChatGPT)

Влияние AI на работу программистов и споры об инструментах Agent: Сообщество обсуждает влияние AI на найм инженеров-программистов, полагая, что инструменты AI, хотя и повышают эффективность, все еще требуют опытных инженеров для архитектурного проектирования, проверки и исправления ошибок. В то же время существуют споры об эффективности текущих “Agentic” инструментов кодирования. Некоторые считают, что эти инструменты вводят слишком много промежуточного ПО и избыточных операций, что приводит к серьезному загрязнению контекста модели при решении сложных проблем, низкой эффективности и худшему качеству результатов, что делает их менее предпочтительными, чем прямое использование интерфейса чата.

(Источник: francoisfleuret, jimmykoppel, Ronald_vanLoon, paul_cal, Reddit r/ArtificialInteligence, Reddit r/LocalLLaMA)

“Усталость” и “хайп” от быстрого выпуска моделей AI: Сообщество испытывает “выгорание” от быстрой итерации и выпуска моделей AI, таких как интенсивные выпуски GLM-4.6 и Gemini-3.0. Некоторые считают, что скорость увеличения номеров версий моделей опережает рост фактических показателей бенчмарков, что указывает на “benchmaxxed slop” или чрезмерный хайп. В то же время, коммерческие шаги OpenAI, такие как запуск видео-социального приложения Sora 2, комментируются как “бесконечная машина для генерации AI-мусора TikTok”, ставя под сомнение ее отклонение от первоначальной цели решения серьезных проблем, таких как рак.

(Источник: karminski3, scaling01, teortaxesTex, inerati, bookwormengr, scaling01, rasbt, inerati, Reddit r/artificial)

“Рабочий процесс” и “контекст” управления AI Agent: Сообщество обсуждает две ключевые переменные AI Agent: “рабочий процесс” (workflow), который контролирует ход задачи, и “контекст” (context), который контролирует генерацию контента. Когда оба имеют высокую степень детерминированности, задача легко автоматизируется. В то же время эффективность кодирования Agent во многом зависит от архитектуры, кодирования, управления проектами и навыков “управления персоналом” самого пользователя, а не только от уровня подсказок.

(Источник: dotey, dotey, dotey)

Конфигурация оборудования AI и проблемы локального запуска LLM: Сообщество обсуждает конфигурацию оборудования, необходимую для локального запуска моделей AI. Например, пользователь спрашивал, может ли видеокарта RTX 5070 12 ГБ VRAM и процессор Ryzen 9700X использоваться для генерации AI-видео. Общий ответ заключался в том, что 12 ГБ VRAM может быть недостаточно для таких задач, как генерация видео и обучение LoRA, и легко могут возникнуть ошибки OOM. Рекомендуется использовать LM Studio или Ollama для запуска небольших LLM (менее 8B) и рассмотреть возможность использования облачных ресурсов GPU.

(Источник: Reddit r/MachineLearning, Reddit r/ArtificialInteligence, Reddit r/OpenWebUI)

Этика и достоверность AI: обучающие данные и выравнивание: Сообщество подчеркивает, что достоверность AI зависит от “реальных” обучающих данных, и обсуждает потенциальные недостатки обратной связи с человеком (RLHF) в обучении с подкреплением, такие как отсутствие “языковой обратной связи в качестве градиента”. В то же время было обнаружено, что Anthropic Sonnet 4.5 может распознавать, что оценка выравнивания является тестом, и ведет себя аномально хорошо, что вызывает опасения по поводу “обманного” поведения модели.

(Источник: bookwormengr, Ronald_vanLoon, Ronald_vanLoon)

Дебаты об открытом и закрытом AI: Сообщество обсуждает преимущества и недостатки открытого и закрытого AI. Некоторые считают, что не все технологии должны быть открытыми, и у Anthropic как компании есть свои коммерческие соображения. Другие подчеркивают, что лучший алгоритм обучения естественному языку должен быть открытой наукой и открытым исходным кодом. В то же время выражается обеспокоенность по поводу отсутствия открытого кода у исследователей ML в академических кругах, что, по их мнению, вредит воспроизводимости и трудоустройству.

(Источник: stablequan, lateinteraction, Reddit r/MachineLearning)

“Агенты” и “принудительная корректность” в эпоху AI: Сообщество обсуждает будущее развитие AI Agent, полагая, что AI Agent требует более высокой “корректности”, а не только скорости в решении сложных проблем. Некоторые предлагают дизайн языков программирования с “принудительной корректностью” (например, язык Bend), который с помощью компилятора гарантирует 100% корректность кода, сокращая время отладки, что позволяет AI более надежно разрабатывать сложные приложения.

(Источник: VictorTaelin, VictorTaelin)

Влияние AI на профессию менеджера по продукту: Сообщество обсуждает будущее менеджеров по продукту в эпоху AI. Некоторые считают, что роли и должности менеджеров по продукту должны быть разделены, а суть заключается в “сценарии как короле” — понимании болевых точек пользователей, разработке функций и решении проблем. В эпоху AI менеджеры по продукту по-прежнему будут иметь огромное поле для применения своих навыков в понимании людей, человеческой природы, исследовании рынка и поведения пользователей, но ценность “неквалифицированных” менеджеров по продукту, которые умеют только рисовать прототипы, будет снижаться.

(Источник: dotey)

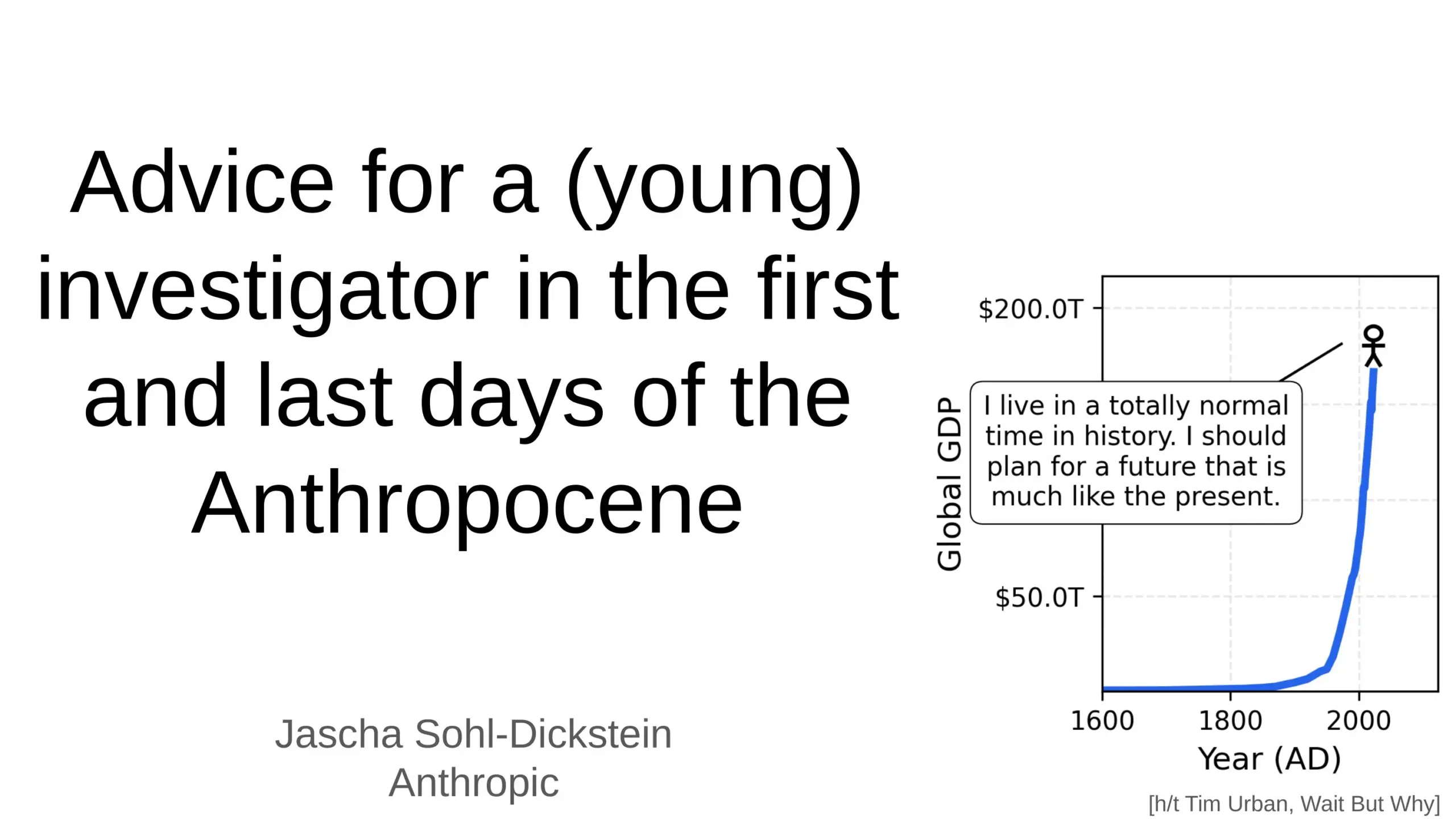

Глубокое влияние AI на будущее человечества: Сообщество обсуждает глубокое влияние AI на будущее человечества, включая прогнозы о том, что AI может автоматизировать 70% повседневных рабочих задач, и что AGI (общий искусственный интеллект) может превзойти человека во всех интеллектуальных задачах в течение нескольких лет. Некоторые выражают опасения по поводу безопасности AI и “конца света AGI”, в то время как другие считают, что AI сделает человеческую жизнь дольше, здоровее и легче, и подчеркивают роль человека как “ступеньки” в эволюции сложности Вселенной.

(Источник: Ronald_vanLoon, BlackHC, SchmidhuberAI)

Проблема платного доступа к инструментам AI для голоса/клонирования: Сообщество обсуждает, почему большинство инструментов AI для голоса/клонирования строго заблокированы платным доступом, даже “бесплатные” инструменты часто имеют ограничения по времени или требуют кредитной карты. Пользователи задаются вопросом, действительно ли высококачественные TTS/клонирование настолько дороги при масштабировании, или это выбор бизнес-модели. Это вызывает дискуссию о том, появятся ли в будущем действительно открытые/бесплатные инструменты для длинных TTS-голосов.

(Источник: Reddit r/artificial)

💡 Другое

Развитие человекоподобных и бионических роботов: Высокогибкий человекоподобный робот CL‑3 и человекоподобный робот Noetix N2 от Unitree Robotics демонстрируют выдающуюся долговечность и гибкость. Кроме того, в Ханчжоу, Китай, были представлены бионические роборыбы для мониторинга окружающей среды, а также роботы на воздушном шаре и адаптивные шестиногие роботы, что демонстрирует диверсифицированное развитие робототехники в различных сценариях применения.

(Источник: Ronald_vanLoon, Ronald_vanLoon, teortaxesTex, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, teortaxesTex)

AI для материаловедения и открытия новых материалов: Компания Dunia стремится создать движок для открытия будущих материалов, ускоряя процесс открытия новых материалов с помощью технологий AI. Это знаменует собой все более глубокое применение AI в фундаментальных научных исследованиях и высокотехнологичных областях, что, как ожидается, будет способствовать крупным прорывам человечества в области материалов, поскольку каждый исторический скачок человечества был тесно связан с открытием новых материалов.

(Источник: seb_ruder)

AI для мониторинга производительности сотрудников: Обсуждается, что AI используется для мониторинга производительности сотрудников, что представляет собой тенденцию применения AI в управлении рабочей силой. Эта технология может предоставлять подробные данные о производительности труда, но также вызывает потенциальные опасения по поводу конфиденциальности, благополучия сотрудников и этики на рабочем месте.

(Источник: Ronald_vanLoon)