Ключевые слова:Авторские права на данные для обучения ИИ, AlphaGenome, Аппаратное копирование OpenAI, Результаты ИИ на экзамене Гаокао, Gemini CLI, Новый метод RLT, BitNet b1.58, Агент Biomni, Судебное решение о правомерном использовании ИИ, Прогнозирование пар оснований ДНК, Ответ Олтмена на обвинения в плагиате, Улучшение математических способностей больших моделей, Бесплатная квота для терминальных ИИ-агентов

🔥 В фокусе

Авторские права на данные для обучения AI получили знаковое решение: суд США постановил, что использование AI законно приобретенных книг для обучения является “добросовестным использованием”: Федеральный суд США по иску против Anthropic постановил, что использование компаниями AI законно приобретенных опубликованных книг для обучения больших языковых моделей (LLM) подпадает под категорию “добросовестного использования” и не требует предварительного согласия авторов. Суд счел обучение AI “трансформационным использованием” оригинальных произведений, которое не заменяет напрямую рынок оригинальных произведений и способствует технологическим инновациям и общественным интересам. Однако суд также постановил, что использование пиратских книг для обучения не является добросовестным использованием, и Anthropic все еще может нести за это ответственность. Это решение ссылается на прецедент по делу Google Books 2015 года и рассматривается как важный шаг к снижению рисков, связанных с авторскими правами на данные для обучения AI, и может повлиять на рассмотрение других аналогичных дел (например, исков против OpenAI и Meta). Ранее компания Meta также получила благоприятное решение по другому аналогичному иску об авторских правах, где судья счел, что истцы не смогли в достаточной мере доказать, что использование Meta их книг для обучения моделей AI нанесло экономический ущерб. Эти решения совместно предоставляют более четкие юридические ориентиры для индустрии AI в области получения и использования данных, но подчеркивают важность законного приобретения данных. (Источник: 量子位, DeepLearning.AI Blog, wiredmagazine)

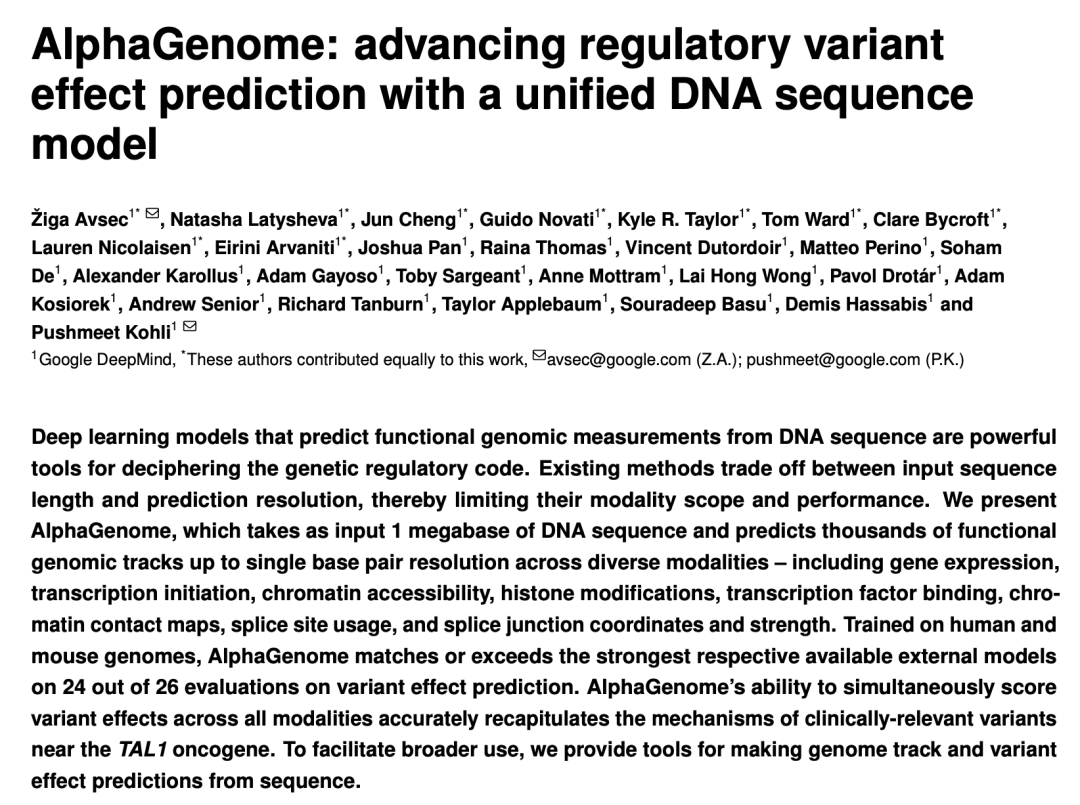

Google DeepMind выпустила AlphaGenome: AI-“микроскоп” для прогнозирования влияния генетических вариаций на миллионы пар оснований DNA: Google DeepMind представила модель AI AlphaGenome, способную принимать на вход последовательности DNA длиной до 1 миллиона пар оснований, прогнозировать тысячи молекулярных характеристик и оценивать влияние генетических вариаций. Модель лидирует в более чем 20 тестах на прогнозирование геномных данных. AlphaGenome отличается обработкой длинных последовательностей с высоким разрешением, комплексным мультимодальным прогнозированием, эффективной оценкой вариаций и новой моделью сплайсинга. Обучение одной модели занимает всего 4 часа при вычислительном бюджете вдвое меньшем, чем у оригинальной модели Enformer. Модель призвана помочь ученым понять регуляцию генов, ускорить понимание заболеваний (особенно редких), направлять разработку синтетической биологии и способствовать фундаментальным исследованиям. В настоящее время доступна предварительная версия через API для некоммерческих исследований, в будущем планируется полный выпуск. (Источник: 36氪, Google, demishassabis)

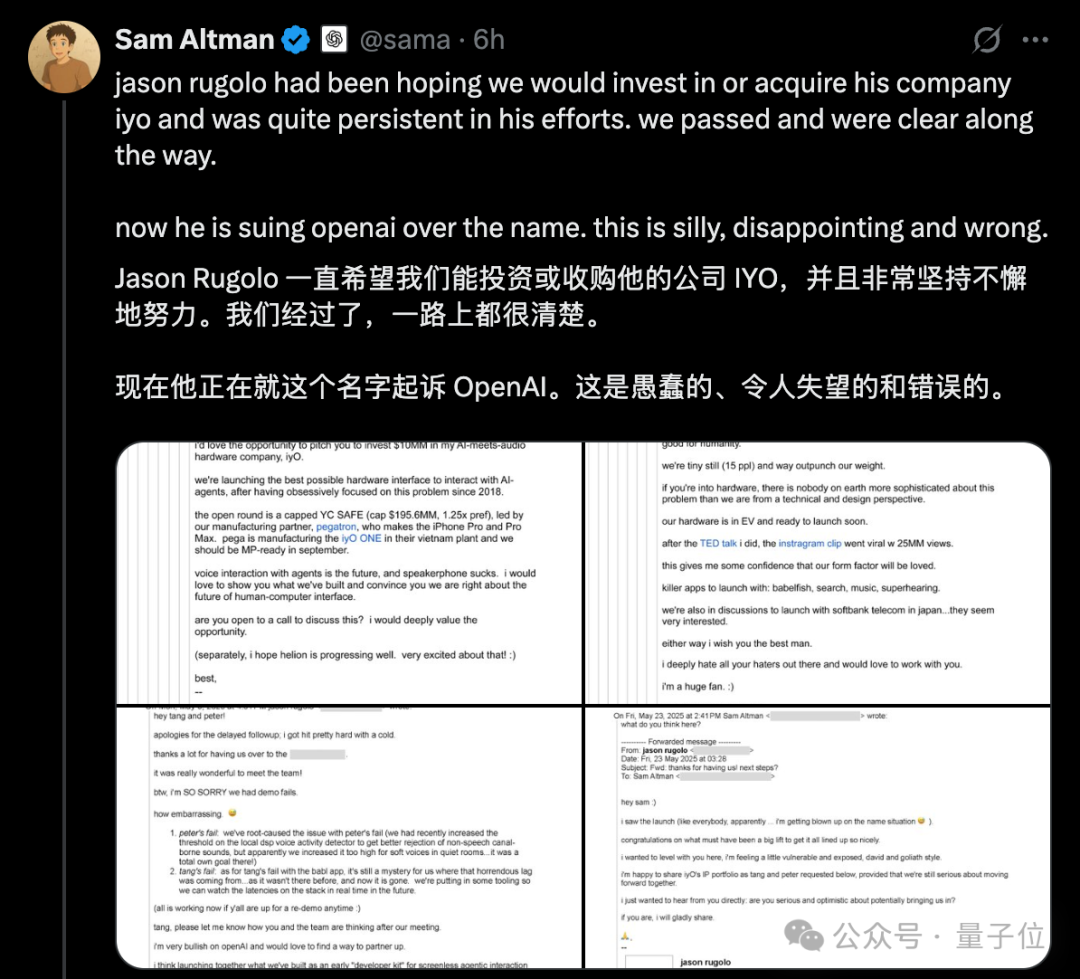

Споры вокруг “плагиата” аппаратного обеспечения OpenAI обостряются, Альтман публично опровергает иск IYO с помощью электронных писем: В ответ на обвинения стартапа в области аппаратного обеспечения AI IYO в нарушении прав на товарный знак и плагиате продукта со стороны OpenAI и приобретенной ею аппаратной компании io (основанной бывшим дизайнером Apple Jony Ive), CEO OpenAI Сэм Альтман публично ответил в социальных сетях, назвав иск IYO “глупым, разочаровывающим и совершенно неверным”. Альтман представил скриншоты электронных писем, показывающие, что основатель IYO Jason Rugolo до подачи иска активно искал у OpenAI инвестиции в размере 10 миллионов долларов или приобретение компании, а после объявления OpenAI о покупке io все еще надеялся поделиться своей интеллектуальной собственностью. Альтман считает, что IYO подала иск только после неудачных попыток получить инвестиции или быть приобретенной. Основатель IYO в свою очередь возразил, что Альтман устраивает “суд Линча” в сети, и настаивает на своих правах на название продукта. Ранее суд удовлетворил временный запретительный приказ IYO, запрещающий OpenAI использовать логотип IO. OpenAI заявила, что ее аппаратный продукт отличается от кастомных наушников IYO, прототип еще не утвержден и выйдет на рынок не ранее чем через год. (Источник: 量子位, 36氪)

Большие модели AI снова сдают вступительные экзамены в вузы, общие результаты значительно улучшились, особенно заметен прогресс в математике: Результаты ежегодного имитационного тестирования AI на вступительных экзаменах в вузы GeekPark 2025 показали, что общие результаты основных больших моделей (таких как Doubao, DeepSeek R1, ChatGPT o3 и др.) значительно улучшились по сравнению с прошлым годом, демонстрируя потенциал для поступления в ведущие учебные заведения. Предполагается, что “чемпион” Doubao сможет войти в топ-900 абитуриентов провинции Шаньдун. Разрыв в успеваемости AI по гуманитарным и точным наукам сократился, средний балл по точным наукам вырос быстрее, а математика стала предметом с наиболее значительным прогрессом – средний балл увеличился на 84,25, опередив китайский язык и английский. Мультимодальные возможности стали ключевым фактором дифференциации, особенно в таких предметах, как физика и география, содержащих большое количество заданий с изображениями. Несмотря на то, что AI отлично справляется со сложными рассуждениями и вычислениями, он все еще допускает ошибки при понимании простых задач с визуально запутанной информацией (например, задача по математике на векторы). В сочинениях AI способен писать структурированные и аргументированные тексты, но им не хватает глубины осмысления и эмоционального отклика, что мешает создавать первоклассные произведения. (Источник: 36氪)

🎯 Тренды

Google выпустила Gemini CLI на базе Gemini 2.5 Pro, предлагая большие бесплатные квоты, что вызвало интерес: Google официально выпустила Gemini CLI, AI-ассистента, работающего в терминальной среде на базе модели Gemini 2.5 Pro. Его особенностью является чрезвычайно щедрая бесплатная квота: поддержка контекстного окна в 1 миллион токенов, 60 вызовов модели в минуту и 1000 вызовов в день, что составляет сильную конкуренцию платным инструментам, таким как Claude Code от Anthropic. Gemini CLI распространяется под лицензией Apache 2.0 с открытым исходным кодом и поддерживает написание кода, отладку, управление проектами, поиск документации и вызов других сервисов Google (например, генерацию изображений и видео) через MCP. Google подчеркивает преимущества своей универсальной модели при решении сложных задач разработки, считая, что чисто кодовые модели могут быть ограничены. Сообщество отреагировало с энтузиазмом, полагая, что это будет способствовать популяризации и конкуренции CLI AI-инструментов. (Источник: 36氪, Reddit r/LocalLLaMA, dotey)

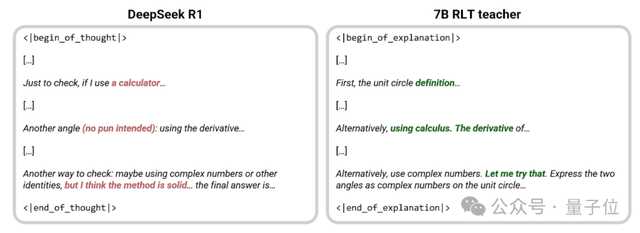

Sakana AI предложила новый метод RLT, где малая модель 7B “обучает” эффективнее, чем DeepSeek-R1: Sakana AI, основанная одним из авторов Transformer Llion Jones, предложила новый метод обучения с подкреплением с учителем (RLTs). В этом методе модель-учитель больше не решает задачи с нуля, а вместо этого выдает четкие пошаговые объяснения на основе известных решений, имитируя “эвристическое” обучение优秀ных учителей-людей. Эксперименты показали, что малая модель 7B RLT, обученная с использованием этого метода, превосходит 671B DeepSeek-R1 в передаче навыков рассуждения и может эффективно обучать модели-студенты, в 3 раза превышающие ее по размеру (например, 32B), при этом затраты на обучение значительно снижаются. Этот метод направлен на решение проблем традиционных моделей-учителей, которые зависят от собственных способностей к решению задач, обучаются медленно и дорого, повышая эффективность за счет согласования обучения учителя с его истинной целью (помощь в обучении модели-студента). (Источник: 量子位, SakanaAILabs)

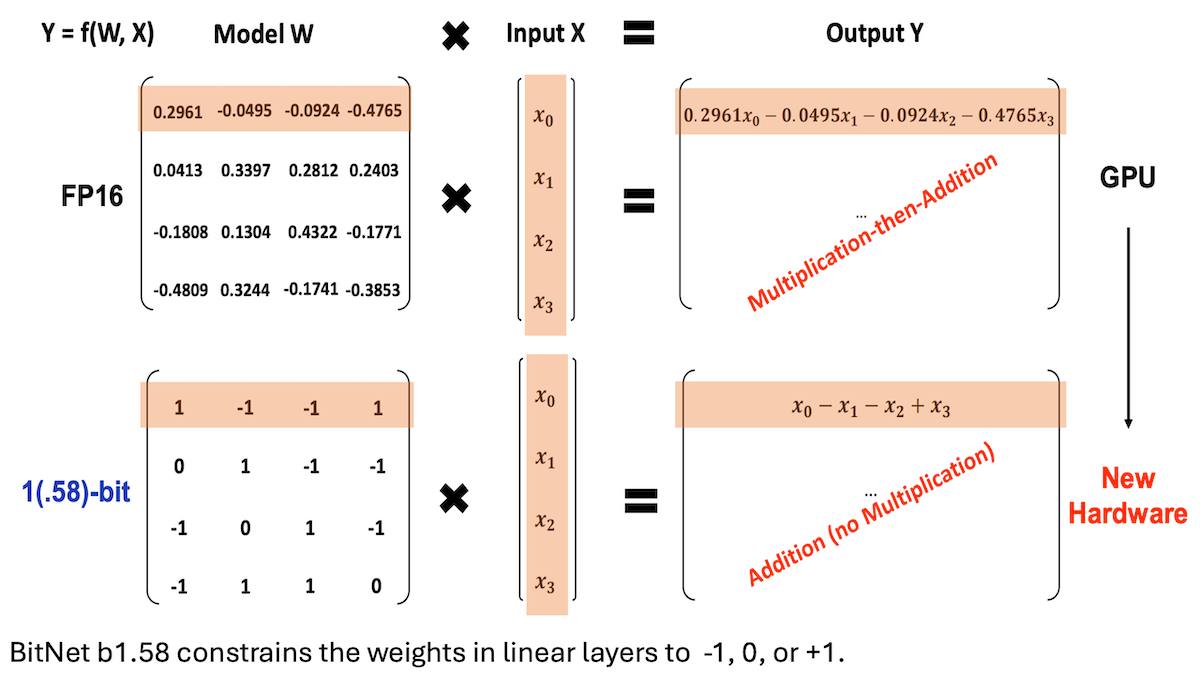

Microsoft и другие представили BitNet b1.58, реализующий LLM с низкой точностью и высокой производительностью вывода: Исследователи из Microsoft, Университета Китайской академии наук и Университета Цинхуа обновили модель BitNet b1.58, большинство весов которой ограничены тремя значениями: -1, 0 или +1 (примерно 1.58 бит/параметр). При масштабе в 2 миллиарда параметров ее производительность может конкурировать с ведущими моделями полной точности. Модель оптимизирована с помощью тщательно разработанных стратегий обучения (таких как обучение с учетом квантования, двухэтапная скорость обучения и затухание весов). В 16 популярных бенчмарках ее скорость и использование памяти превосходят Qwen2.5-1.5B, Gemma-3 1B и другие, средняя точность близка к Qwen2.5-1.5B и превосходит 4-битную квантованную версию Qwen2.5-1.5B. Эта работа демонстрирует, что благодаря тщательной настройке гиперпараметров модели с низкой точностью также могут достигать высокой производительности, предлагая новые идеи для эффективного развертывания LLM. (Источник: DeepLearning.AI Blog)

Стэнфорд и другие учреждения запустили интеллектуального агента для биологических исследований Biomni, интегрирующего более ста инструментов и баз данных: Исследователи из Стэнфордского университета, Принстонского университета и других учреждений представили Biomni, AI-агента, специально разработанного для широкого круга биологических исследований. Этот агент основан на Claude 4 Sonnet и интегрирует 150 инструментов, отобранных из 2500 недавних публикаций в 25 специализированных областях биологии (включая геномику, иммунологию, нейронауки и др.), почти 60 баз данных и около 100 популярных биологических программных пакетов. Biomni способен выполнять различные задачи, такие как ответы на вопросы, выдвижение гипотез, проектирование процессов, анализ наборов данных, генерация графиков и др. Он использует фреймворк CodeAct, отвечая на запросы посредством итеративного планирования, генерации и выполнения кода, а также привлекает другой экземпляр Claude 4 Sonnet в качестве оценщика для проверки обоснованности промежуточных результатов. В нескольких бенчмарках, таких как Lab-bench, и практических исследованиях Biomni превзошел как отдельный Claude 4 Sonnet, так и модель Claude, дополненную поиском по литературе. (Источник: DeepLearning.AI Blog)

Anthropic представила новую функцию Claude Code: создание и обмен AI-управляемыми Artifacts: Anthropic добавила новую функцию в свой AI-помощник для программирования Claude Code, позволяющую пользователям создавать, размещать и делиться “Artifacts” (можно понимать как небольшие AI-приложения или инструменты), а также напрямую встраивать интеллект Claude в эти творения. Это означает, что пользователи могут не только генерировать фрагменты кода или проводить анализ с помощью Claude, но и создавать функциональные, управляемые AI приложения. Ключевой особенностью является то, что при обмене этими AI-приложениями зрители аутентифицируются с помощью своих учетных записей Claude, и их использование засчитывается в их собственную подписку, а не в подписку создателя. Эта функция в настоящее время находится на стадии бета-тестирования и доступна всем пользователям Free, Pro и Max, с целью снижения порога входа в создание AI-приложений и содействия распространению и обмену возможностями AI. (Источник: kylebrussell, Reddit r/ClaudeAI)

Maya Research выпустила модель Veena TTS, поддерживающую хинди и английский язык с более аутентичным индийским акцентом: Maya Research представила модель преобразования текста в речь (TTS) под названием Veena, основанную на архитектуре 3B Llama и распространяемую по лицензии Apache 2.0. Отличительной чертой Veena является способность генерировать английскую и хинди речь с индийским акцентом, включая сценарии смешения кодов (code-mix), что решает проблему недостаточной локализации произношения в существующих TTS-моделях для Индии. Задержка модели составляет менее 80 миллисекунд, она может работать в бесплатной среде Google Colab и уже доступна на Hugging Face Hub. Команда заявила, что активно работает над поддержкой других индийских языков, таких как тамильский, телугу, бенгальский и др. (Источник: huggingface, huggingface)

智象未来 (HiDream.ai) выпустила vivago2.0, интегрирующий возможности мультимодальной генерации и редактирования: Компания 智象未来 (HiDream.ai), основанная известным специалистом в области AI Мэй Тао, выпустила мультимодальный инструмент для творчества AI vivago2.0. Продукт объединяет функции генерации изображений, преобразования изображений в видео, AI-подкастов (синхронизация губ), шаблонов спецэффектов и др., а также имеет творческое сообщество для обмена идеями и вдохновением. Его основная технология основана на совершенно новом интеллектуальном агенте изображений HiDream-A1, который интегрирует усовершенствованные закрытые версии ранее выпущенных с открытым исходным кодом и возглавивших рейтинг соревнований по генерации текста в изображение HiDream-I1 (базовая модель генерации изображений с 17 миллиардами параметров) и HiDream-E1 (интерактивная модель редактирования изображений). vivago2.0 нацелен на снижение порога входа в создание мультимодального контента, предлагает сотни шаблонов спецэффектов и поддерживает генерацию и модификацию изображений посредством диалога на естественном языке (Image Agent). (Источник: 量子位)

Nvidia выпустила серию GPU RTX 5050, конфигурации видеопамяти для настольных и ноутбучных версий различаются: Nvidia официально представила серию GPU GeForce RTX 5050, включающую настольные и ноутбучные версии, которые поступят в продажу в июле. Рекомендованная розничная цена настольной версии в Китае начинается от 2099 юаней. Настольная RTX 5050 имеет 2560 ядер Blackwell CUDA, оснащена 8 ГБ видеопамяти GDDR6 и имеет максимальное энергопотребление 130 Вт. Ноутбучная RTX 5050 также имеет 2560 ядер CUDA, но оснащена более энергоэффективной видеопамятью 8 ГБ GDDR7. Nvidia заявляет, что в сочетании с технологией DLSS 4, RTX 5050 в играх, таких как Cyberpunk 2077, может достигать частоты кадров с трассировкой лучей свыше 150fps, а производительность растеризации в среднем на 60% (настольная версия) и в 2.4 раза (ноутбучная версия) выше по сравнению с RTX 3050. Различия в конфигурации видеопамяти на этот раз отражают стратегию Nvidia по балансировке затрат и производительности в различных рыночных сегментах. (Источник: 量子位)

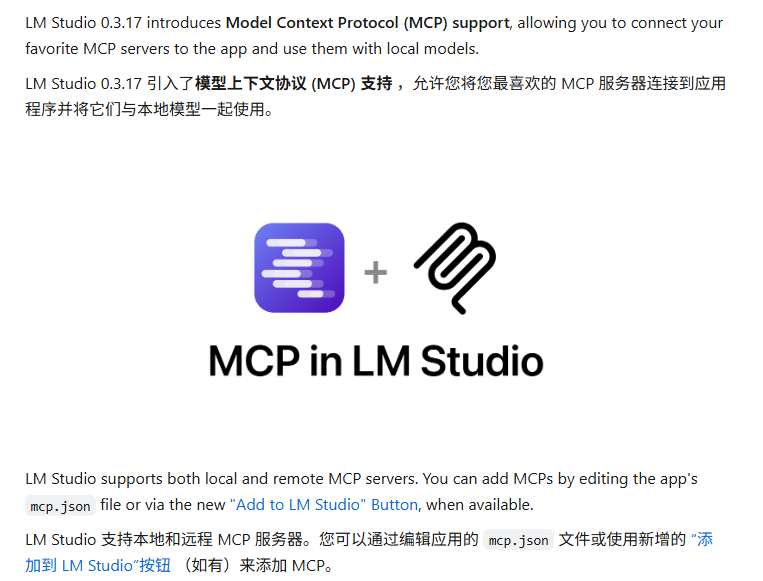

LM Studio обновлен с поддержкой протокола MCP, позволяет подключать локальные LLM к MCP-серверам: Инструмент для запуска LLM на настольных компьютерах LM Studio выпустил новую версию (0.3.17), добавив поддержку протокола контекста модели (MCP). Теперь пользователи могут подключать локально запущенные большие языковые модели к серверам, совместимым с MCP, например, для вызова внешних инструментов или сервисов. LM Studio обновил интерфейс программы, позволяя пользователям устанавливать и настраивать сервисы MCP, а также автоматически загружать и управлять локальными процессами MCP-сервера. Для удобства настройки LM Studio также предоставляет онлайн-инструмент для генерации ссылок на конфигурацию MCP-сервера, которые можно импортировать одним щелчком мыши. (Источник: multimodalart, karminski3)

Gradio представила легковесную библиотеку для отслеживания экспериментов Trackio: Команда Gradio, принадлежащая Hugging Face, выпустила Trackio, легковесную библиотеку для отслеживания и визуализации экспериментов. Этот инструмент написан на Python менее чем в 1000 строк кода, полностью с открытым исходным кодом и бесплатен, поддерживает локальное или хостинговое использование. Trackio призван помочь разработчикам удобнее записывать и отслеживать различные метрики и результаты в процессе экспериментов машинного обучения, упрощая процесс управления экспериментами. (Источник: ClementDelangue, _akhaliq)

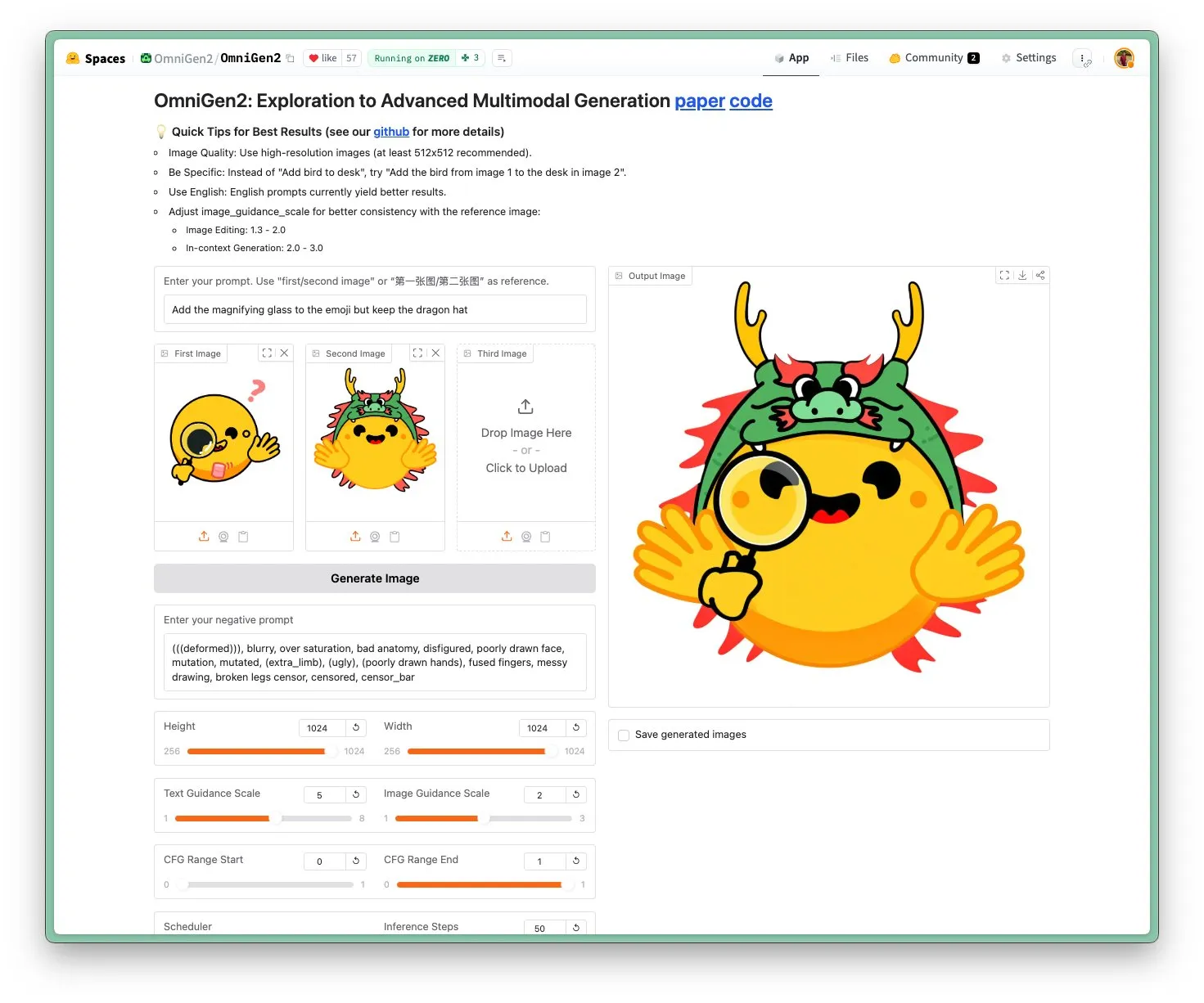

Выпущена OmniGen 2: SOTA модель для редактирования изображений и многофункциональная визуальная модель с лицензией Apache 2.0: Новая модель OmniGen 2 достигла уровня SOTA в редактировании изображений и распространяется под лицензией Apache 2.0 с открытым исходным кодом. Эта модель не только превосходно справляется с редактированием изображений, но и может выполнять контекстную генерацию, преобразование текста в изображение, визуальное понимание и другие задачи. Пользователи могут непосредственно опробовать демо-версию и модель на Hugging Face Hub. (Источник: huggingface)

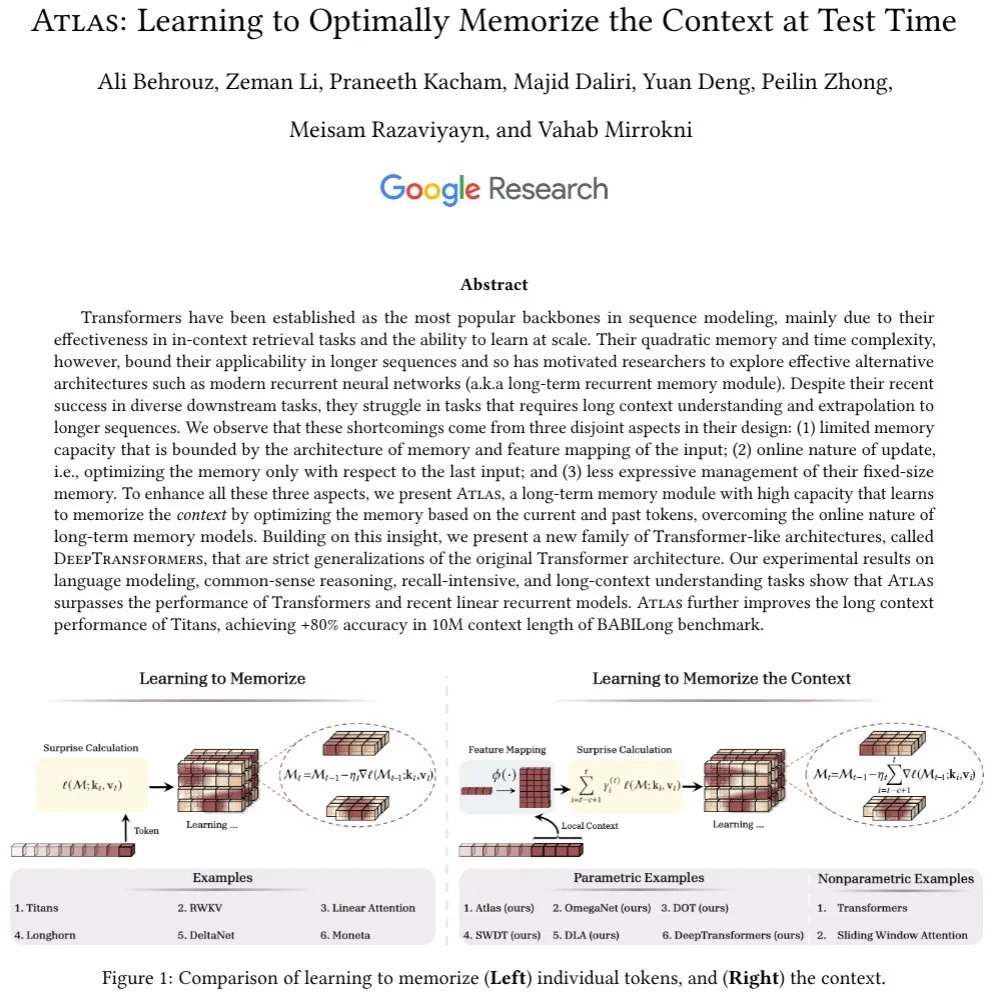

Предложена архитектура Atlas: с памятью для длинного контекста, бросающая вызов Transformer: Новая предложенная архитектура Atlas нацелена на решение проблемы долговременной памяти в LLM и, как утверждается, превосходит Transformer и современные линейные RNN в задачах языкового моделирования. Atlas обладает способностью обучаться запоминать контекст во время тестирования, может увеличить эффективную длину контекста моделей Titans и достигает точности более 80% на бенчмарке BABILong с длиной контекстного окна в 10 миллионов. Исследователи также обсудили другую серию моделей, строго обобщающих softmax attention, основанных на идеях Atlas. (Источник: behrouz_ali)

Визуальная модель Moondream 2B обновлена: улучшено визуальное распознавание и понимание UI, генерация текста ускорена на 40%: Выпущена новая версия визуальной модели Moondream 2B, в которой улучшены визуальное распознавание, обнаружение объектов и понимание пользовательского интерфейса (UI), а скорость генерации текста увеличена на 40%. Это свидетельствует о продолжающейся оптимизации малых мультимодальных моделей в конкретных возможностях с целью обеспечения более эффективного и точного визуально-языкового взаимодействия. (Источник: mervenoyann)

Inworld AI в сотрудничестве с Modular выпустила высококачественную TTS-модель с низкой стоимостью: Inworld AI объявила о выпуске новой модели преобразования текста в речь (TTS), которая, как утверждается, снижает стоимость самых современных TTS в 20 раз, до 5 долларов за миллион символов. Модель основана на архитектуре Llama, ее код для обучения и моделирования будет открыт. Партнер Modular заявил, что благодаря технологическому сотрудничеству на NVIDIA B200 была реализована платформа для вывода TTS с наименьшей задержкой и самой высокой скоростью, и будет опубликован совместный технический отчет. (Источник: clattner_llvm)

Higgsfield AI выпустила модель Soul: специализируется на генерации высокоэстетичных фотографий: Higgsfield AI представила новую модель генерации фотографий под названием Higgsfield Soul, ориентированную на высокую эстетическую ценность и реалистичность на уровне модной фотографии. Модель предлагает более 50 тщательно подобранных пресетов, предназначенных для генерации изображений, сопоставимых с профессиональной фотографией, бросая вызов традиционной мобильной фотографии. (Источник: _akhaliq)

🧰 Инструменты

Gemini CLI: выпущенный Google AI-агент для терминала с открытым исходным кодом, предоставляющий 1000 бесплатных вызовов Gemini 2.5 Pro в день: Google выпустила Gemini CLI, AI-агента командной строки с открытым исходным кодом, позволяющего пользователям напрямую использовать модель Gemini 2.5 Pro в терминале. Инструмент предоставляет контекстное окно в 1 миллион токенов, а бесплатные пользователи могут получать до 1000 запросов в день (60 в минуту). Gemini CLI поддерживает написание кода, отладку, ввод-вывод файловой системы, понимание веб-контента, плагины и протокол MCP, и предназначен для помощи разработчикам в более эффективном создании и поддержке программного обеспечения. Его открытый исходный код (лицензия Apache 2.0) и большие бесплатные квоты делают его сильным конкурентом существующим инструментам, таким как Claude Code, и могут способствовать поддержке локальных моделей. (Источник: Reddit r/LocalLLaMA, dotey, yoheinakajima)

Anthropic представила новую функцию Claude Code: создание и обмен AI-управляемыми Artifacts, пользователи используют собственные квоты: Anthropic добавила новую функцию в свой AI-помощник для программирования Claude Code, позволяющую пользователям создавать, размещать и делиться “Artifacts” (можно понимать как небольшие AI-приложения или инструменты), а также напрямую встраивать интеллект Claude в эти творения. Это означает, что пользователи могут не только генерировать фрагменты кода или проводить анализ с помощью Claude, но и создавать функциональные, управляемые AI приложения. Ключевой особенностью является то, что при обмене этими AI-приложениями зрители аутентифицируются с помощью своих учетных записей Claude, и их использование засчитывается в их собственную подписку, а не в подписку создателя. Эта функция в настоящее время находится на стадии бета-тестирования и доступна всем пользователям Free, Pro и Max, с целью снижения порога входа в создание AI-приложений и содействия распространению и обмену возможностями AI. (Источник: kylebrussell, Reddit r/ClaudeAI, dotey)

LM Studio обновлен с поддержкой протокола MCP, позволяет подключать локальные LLM к MCP-серверам: Инструмент для запуска LLM на настольных компьютерах LM Studio выпустил новую версию (0.3.17), добавив поддержку протокола контекста модели (MCP). Теперь пользователи могут подключать локально запущенные большие языковые модели к серверам, совместимым с MCP, например, для вызова внешних инструментов или сервисов. LM Studio обновил интерфейс программы, позволяя пользователям устанавливать и настраивать сервисы MCP, а также автоматически загружать и управлять локальными процессами MCP-сервера. Для удобства настройки LM Studio также предоставляет онлайн-инструмент для генерации ссылок на конфигурацию MCP-сервера, которые можно импортировать одним щелчком мыши. (Источник: multimodalart, karminski3)

Superconductor: инструмент для управления командой агентов Claude Code на мобильных устройствах или настольных компьютерах: Superconductor — это новый инструмент, позволяющий пользователям управлять командой из нескольких агентов Claude Code с помощью мобильного телефона или ноутбука. Пользователи могут писать неформальные заявки (tickets), запускать для каждой заявки несколько агентов, каждый из которых имеет свой собственный предварительный просмотр приложения в реальном времени. Разработчики могут одним щелчком мыши генерировать PR (Pull Request) из результатов лучшего агента. Инструмент предназначен для упрощения совместной работы нескольких агентов и процесса генерации кода. (Источник: full_stack_dl)

Udio запустила функцию Sessions, повышающую точность редактирования AI-музыки: Платформа для генерации AI-музыки Udio представила функцию “Sessions” для пользователей стандартной и профессиональной подписки. Эта функция вводит новый вид временной шкалы для редактирования треков, позволяя пользователям более точно создавать музыку и уменьшая зависимость от случайной генерации AI. В настоящее время Sessions поддерживает расширение или редактирование треков, в будущем будут добавлены дополнительные функции. (Источник: TomLikesRobots)

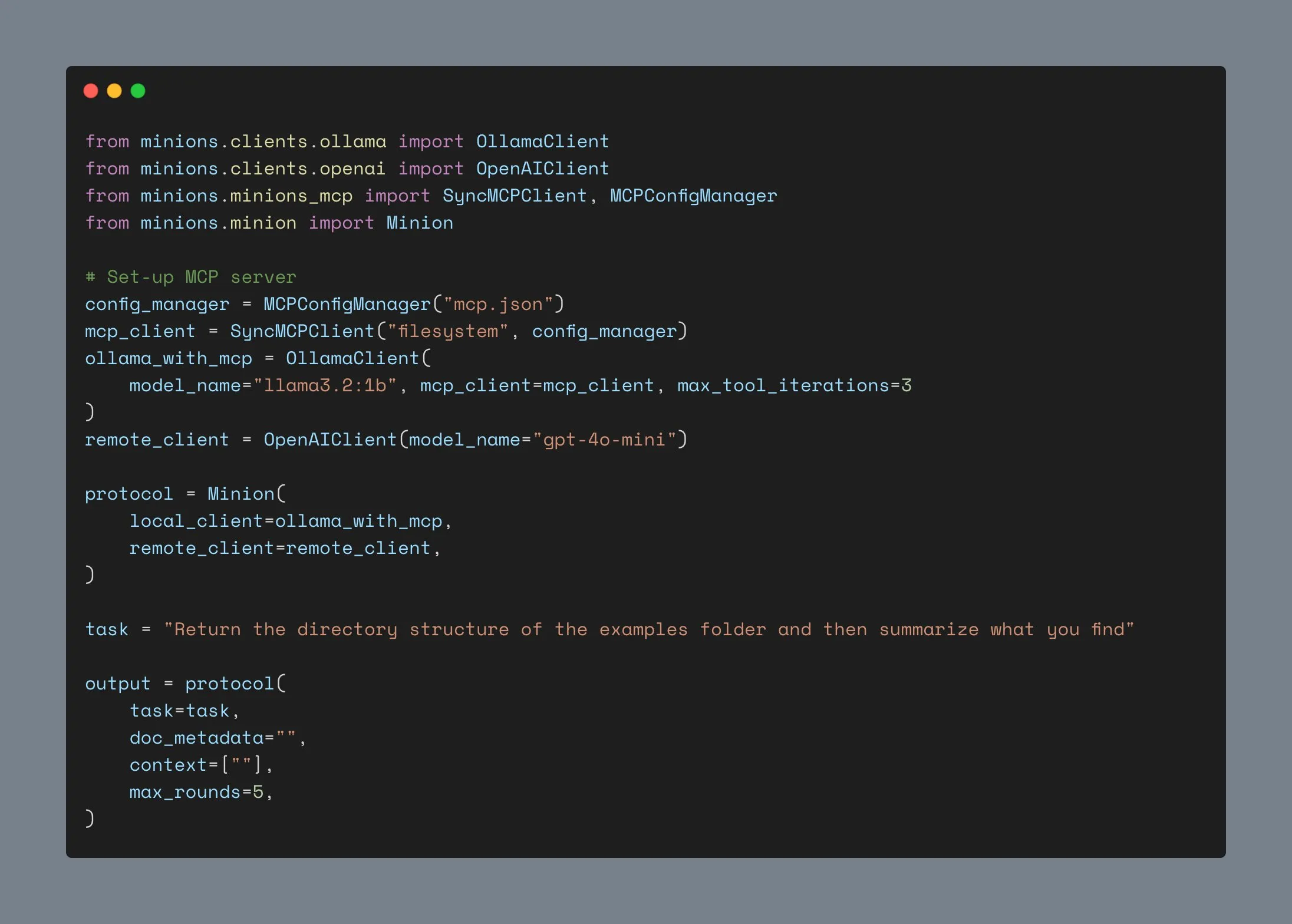

Клиент Ollama обновлен, поддерживает интеграцию с MCP, количество звезд на GitHub превысило тысячу: Клиент Ollama был обновлен и теперь может интегрировать свои функции вызова инструментов с любым сервером Anthropic MCP. Это означает, что пользователи могут сочетать удобство локального запуска моделей Ollama с возможностями внешних инструментов, предоставляемых MCP. Одновременно количество звезд проекта на GitHub превысило 1000. (Источник: ollama)

📚 Обучение

Эндрю Ын запустил новый курс: Протокол связи интеллектуальных агентов ACP: DeepLearning.AI в сотрудничестве с IBM Research запустили короткий курс по протоколу связи интеллектуальных агентов (ACP). ACP — это открытый протокол, который стандартизирует связь между агентами через единый интерфейс RESTful, с целью решения проблем интеграции при создании мультиагентных систем несколькими командами и с использованием различных фреймворков. Курс научит, как использовать ACP для подключения агентов, созданных с помощью различных фреймворков (таких как CrewAI, Smoljames), для реализации последовательных и иерархических рабочих процессов, а также для импорта агентов ACP на платформу BeeAI (открытая платформа для регистрации и обмена агентами). Слушатели изучат жизненный цикл агентов ACP и сравнят их с протоколами MCP (протокол контекста модели), A2A (агент-агент) и другими. (Источник: AndrewYNg)

Университет Джонса Хопкинса запустил курс по DSPy: Университет Джонса Хопкинса открыл курс по DSPy. DSPy — это фреймворк для алгоритмической оптимизации подсказок и весов LLM, который превращает процесс ручной настройки подсказок в более систематизированный, программируемый процесс создания и оптимизации модулей. CEO Shopify Tobi Lutke также заявил, что DSPy является его предпочтительным инструментом для инжиниринга контекста. (Источник: stanfordnlp, lateinteraction)

Учебное пособие LM Studio: создание локального приватного аналога ChatGPT с использованием моделей Hugging Face с открытым исходным кодом: Niels Rogge опубликовал на YouTube учебное пособие, демонстрирующее, как с помощью LM Studio и моделей с открытым исходным кодом с Hugging Face (например, Mistral 3.2-Small) создать 100% приватный и офлайн-аналог ChatGPT локально. В пособии объясняются такие понятия, как GGUF, квантование, а также почему модели при 4-битном квантовании все еще занимают много места, и демонстрируется совместимость LM Studio с OpenAI API. (Источник: _akhaliq)

LlamaIndex проведет онлайн-семинар по памяти агентов: LlamaIndex в сотрудничестве с AIMakerspace проведет онлайн-дискуссию о памяти агентов. Будут рассмотрены такие темы, как сохранение истории чатов, использование статических, фактических и векторных блоков для реализации долговременной памяти, пользовательская логика реализации памяти, а также случаи, когда память имеет решающее значение. Дискуссия направлена на то, чтобы помочь разработчикам создавать агентов, которым требуется реальный контекст в диалогах. (Источник: jerryjliu0)

Подкаст Weaviate обсуждает бенчмарки и оценку RAG: В 124-м выпуске подкаста Weaviate принял участие Nandan Thakur, внесший значительный вклад в область оценки поиска, для обсуждения бенчмаркинга и оценки генерации с расширенным поиском (RAG). Были затронуты такие бенчмарки, как BEIR, MIRACL, TREC и новейший FreshStack, а также множество тем, связанных с RAG, включая логический вывод, составление запросов, циклический поиск, постраничный поиск результатов, гибридные ретриверы и др. (Источник: lateinteraction)

PyTorch представил рецепт flux-fast, ускоряющий модели Flux на H100 в 2.5 раза: PyTorch выпустил простой рецепт под названием flux-fast, предназначенный для увеличения скорости работы моделей Flux на GPU H100 в 2.5 раза без сложной настройки. Это решение направлено на упрощение достижения высокопроизводительных вычислений, соответствующий код предоставлен. (Источник: robrombach)

Объявлена информация о конференции MLSys 2026: Конференция MLSys 2026 запланирована на май 2026 года в Сиэтле (Белвью), крайний срок подачи статей — 30 октября этого года. Все видеозаписи с конференции MLSys 2025 доступны для бесплатного просмотра на официальном сайте. Конференция посвящена исследованиям и достижениям в области систем машинного обучения. (Источник: JeffDean)

Курс Стэнфордского университета CS336 “Создание языковых моделей с нуля” привлек внимание: Курс CS336 “Языковые модели с нуля” (Language Models from Scratch) Стэнфордского университета, преподаваемый Percy Liang и другими, получил широкое признание. Курс направлен на то, чтобы студенты глубоко поняли технические детали языковых моделей, устраняя разрыв между исследователями и техническими деталями путем самостоятельного создания моделей. Содержание курса и задания считаются важным учебным ресурсом для становления специалистом по LLM. (Источник: nrehiew_, jpt401)

💼 Бизнес

Meta инвестирует 14,3 млрд долларов в Scale AI и нанимает ее CEO Alexandr Wang для ускорения разработок в области AI: Для усиления своих позиций в области AI компания Meta заключила соглашение с компанией по разметке данных Scale AI, инвестировав 14,3 млрд долларов для приобретения 49% ее акций без права голоса, а также наняв ее основателя и CEO Alexandr Wang и его команду. Alexandr Wang возглавит новую лабораторию Meta, специализирующуюся на исследованиях суперинтеллекта. Этот шаг направлен на привлечение в Meta ведущих специалистов в области AI и возможностей по работе с большими данными, чтобы справиться с неоднозначной реакцией на ее модель Llama 4 и кадровыми перестановками в исследовательском подразделении AI. Scale AI использует средства для ускорения инноваций и распределения части средств среди акционеров, ее главный стратегический директор Jason Droege займет пост временного CEO. Эта сделка, возможно, позволила избежать частичного государственного контроля за счет отказа от прямого поглощения. (Источник: DeepLearning.AI Blog)

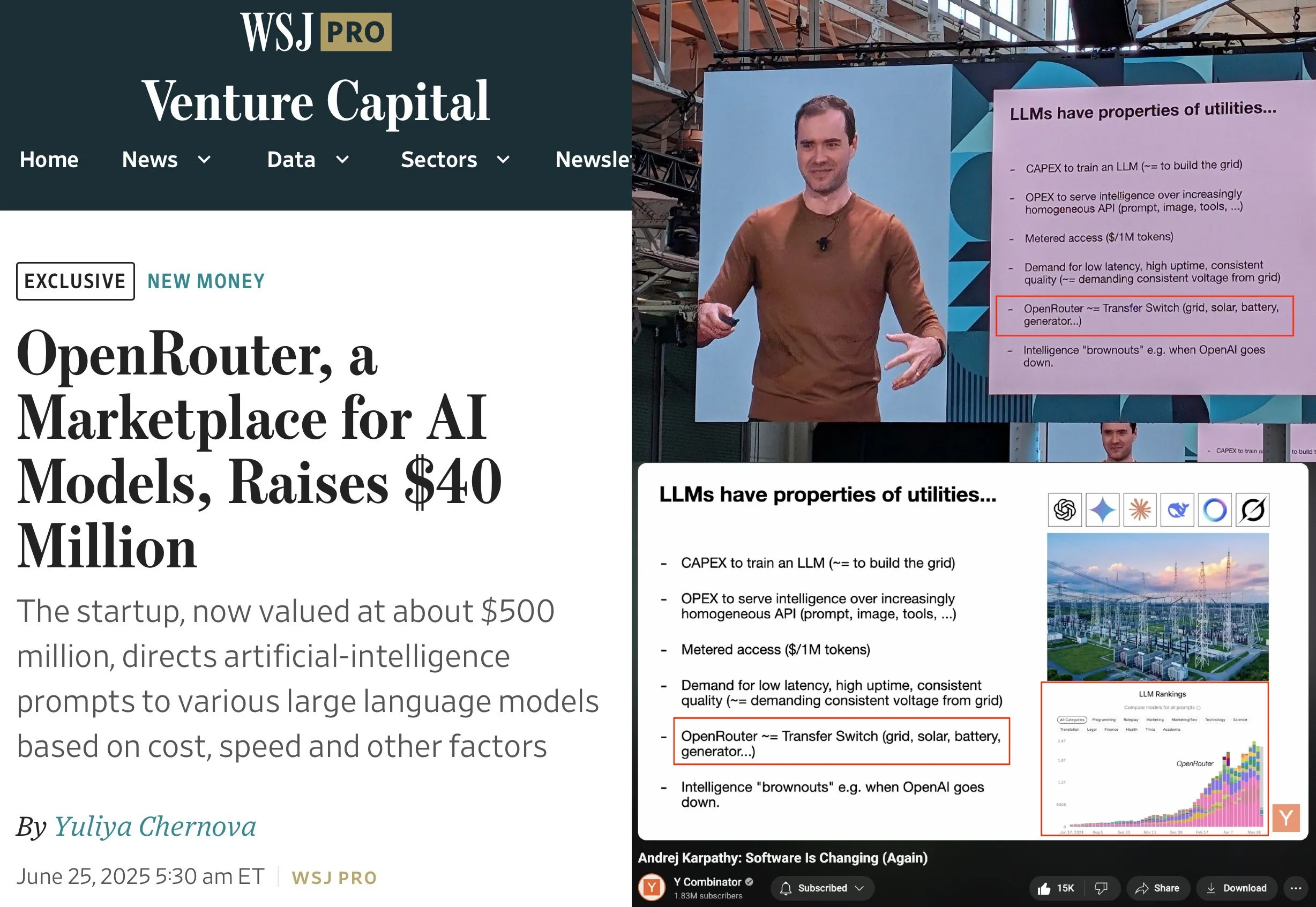

OpenRouter привлек 40 миллионов долларов в раунде A, возглавляемом a16z и Menlo: OpenRouter, плоскость управления для вывода LLM и рынок моделей, объявил о завершении посевного раунда и раунда A финансирования на общую сумму 40 миллионов долларов, возглавляемых a16z и Menlo Ventures. OpenRouter стремится стать единым интерфейсом для разработчиков для выбора и использования различных LLM, в настоящее время предлагая более 400 моделей и обрабатывая 100 триллионов токенов в год. Финансирование будет направлено на расширение поддерживаемых модальностей моделей (таких как генерация изображений, мультимодальные интерактивные модели), реализацию более интеллектуальных механизмов маршрутизации (таких как географическая маршрутизация, оптимизация распределения GPU корпоративного уровня) и улучшение функций обнаружения моделей. (Источник: amasad, swyx)

Компания по производству человекоподобных роботов «灵宝CASBOT» привлекла почти 100 миллионов юаней в раунде ангельских инвестиций+, лидирует Lens Technology: Бренд человекоподобных роботов «灵宝CASBOT» объявил о завершении раунда ангельских инвестиций+ на сумму почти 100 миллионов юаней, который возглавила Lens Technology при участии Tianjin Jiayi и старых акционеров Guotou Chuanghe и Henan Asset. Средства будут направлены на ускорение массового производства продукции, технологические разработки и расширение рынка. «灵宝CASBOT» специализируется на применении универсальных человекоподобных роботов и воплощенного интеллекта, уже выпустила двух двуногих человекоподобных роботов CASBOT 01 и 02, предназначенных соответственно для специальных операций и более широких сценариев взаимодействия человека с машиной (например, экскурсии, образование). Ключевые технологии компании включают многоуровневую сквозную модель в сочетании с последующим обучением с подкреплением. Компания уже достигла сотрудничества в области промышленного производства и добычи полезных ископаемых с Zhaojin Group, China Minmetals Corporation и другими. (Источник: 36氪, 36氪)

🌟 Сообщество

Андрей Карпати выступает за “инжиниринг контекста” вместо “инжиниринга подсказок”, подчеркивая сложность создания приложений LLM: Андрей Карпати согласен с мнением Тоби Лютке, что “инжиниринг контекста” (context engineering) точнее описывает ключевые навыки для промышленных приложений LLM, чем “инжиниринг подсказок” (prompt engineering). Он отмечает, что подсказки обычно относятся к коротким описаниям задач, вводимых пользователями в повседневной жизни, в то время как инжиниринг контекста — это тонкое искусство и наука, включающая точное заполнение контекстного окна описаниями задач, небольшим количеством примеров, RAG, мультимодальными данными, инструментами, историей состояний и другой информацией для оптимизации производительности LLM. Он также подчеркивает, что приложения LLM — это гораздо больше, чем просто это, и требуют решения целого ряда сложных проблем программной инженерии, таких как декомпозиция задач, управление потоком, диспетчеризация нескольких моделей, UI/UX, оценка безопасности и т.д., поэтому утверждение о “обертках для ChatGPT” неверно. (Источник: karpathy, code_star, dotey)

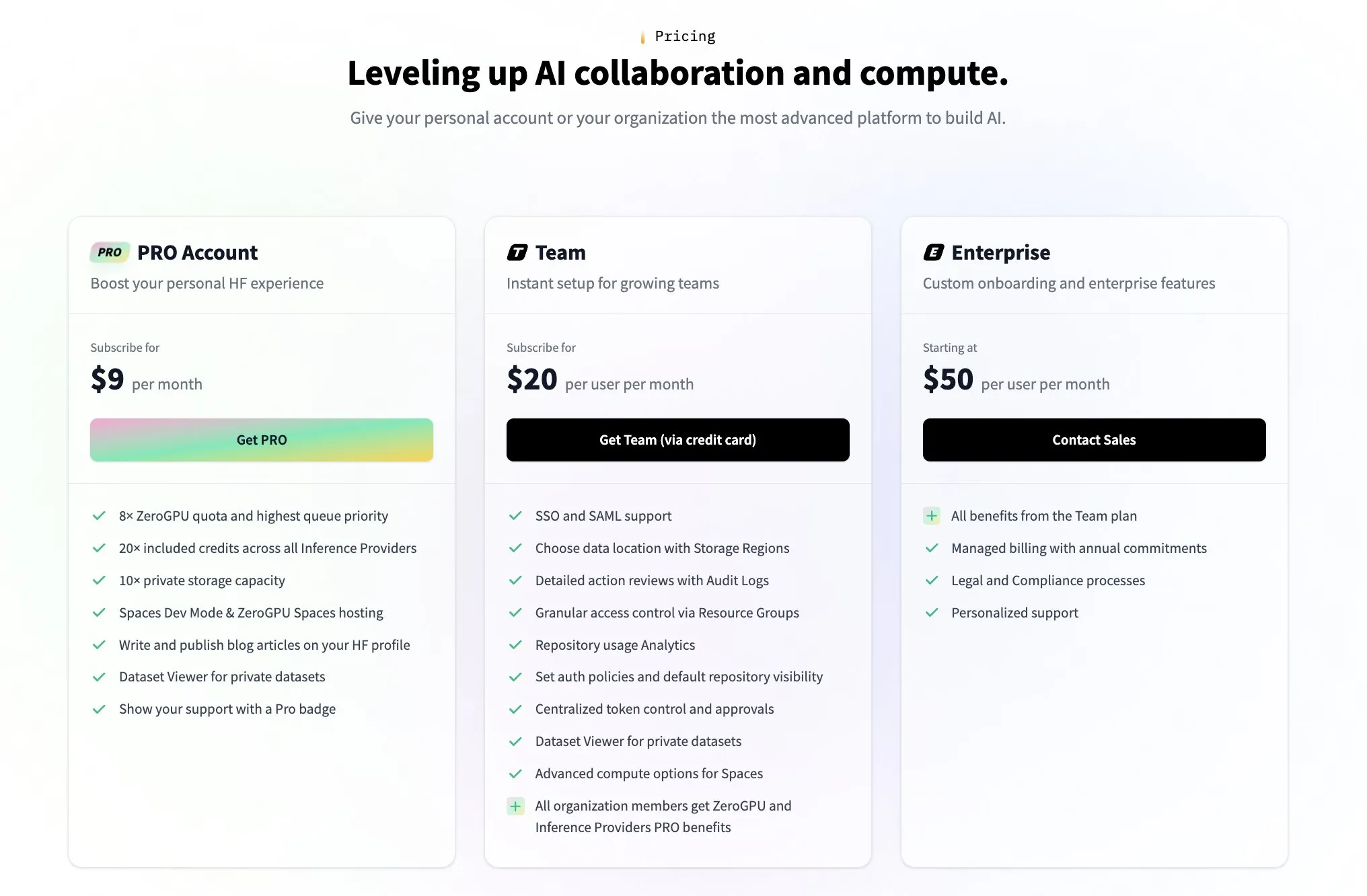

Hugging Face запускает платные командные планы в ответ на вопросы сообщества о модели монетизации: В ответ на вопросы сообщества о том, как Hugging Face зарабатывает деньги (например, вызванные твитом пользователя @levelsio), сооснователь Hugging Face Clement Delangue с юмором ответил, что “сработала тревога по поводу монетизации”, и объявил о запуске новых платных премиальных командных планов. Hugging Face, как платформа, размещающая огромное количество моделей AI, предоставляющая бесплатные API и не требующая обязательного использования ключей API, всегда была в центре обсуждений сообщества относительно своей бизнес-модели. Запуск нового плана свидетельствует о том, что компания активно изучает и расширяет пути коммерциализации. (Источник: huggingface, ClementDelangue)

Сообщество активно обсуждает лояльность пользователей к AI-помощникам для написания кода и совместную работу с несколькими инструментами: The Information сообщает, что лояльность разработчиков к помощникам для написания кода может быть выше, чем предполагалось. В то же время в сообществе наблюдается явление, когда разработчики одновременно используют в одном и том же репозитории кода несколько AI-инструментов для написания кода, таких как Claude Code, Codex (CLI) и Gemini (CLI). Это отражает тот факт, что разработчики активно пробуют различные AI-инструменты для повышения эффективности, а также, возможно, ищут наиболее подходящее сочетание специфических функций для своего рабочего процесса, а не полностью полагаются на один инструмент. (Источник: steph_palazzolo, code_star)

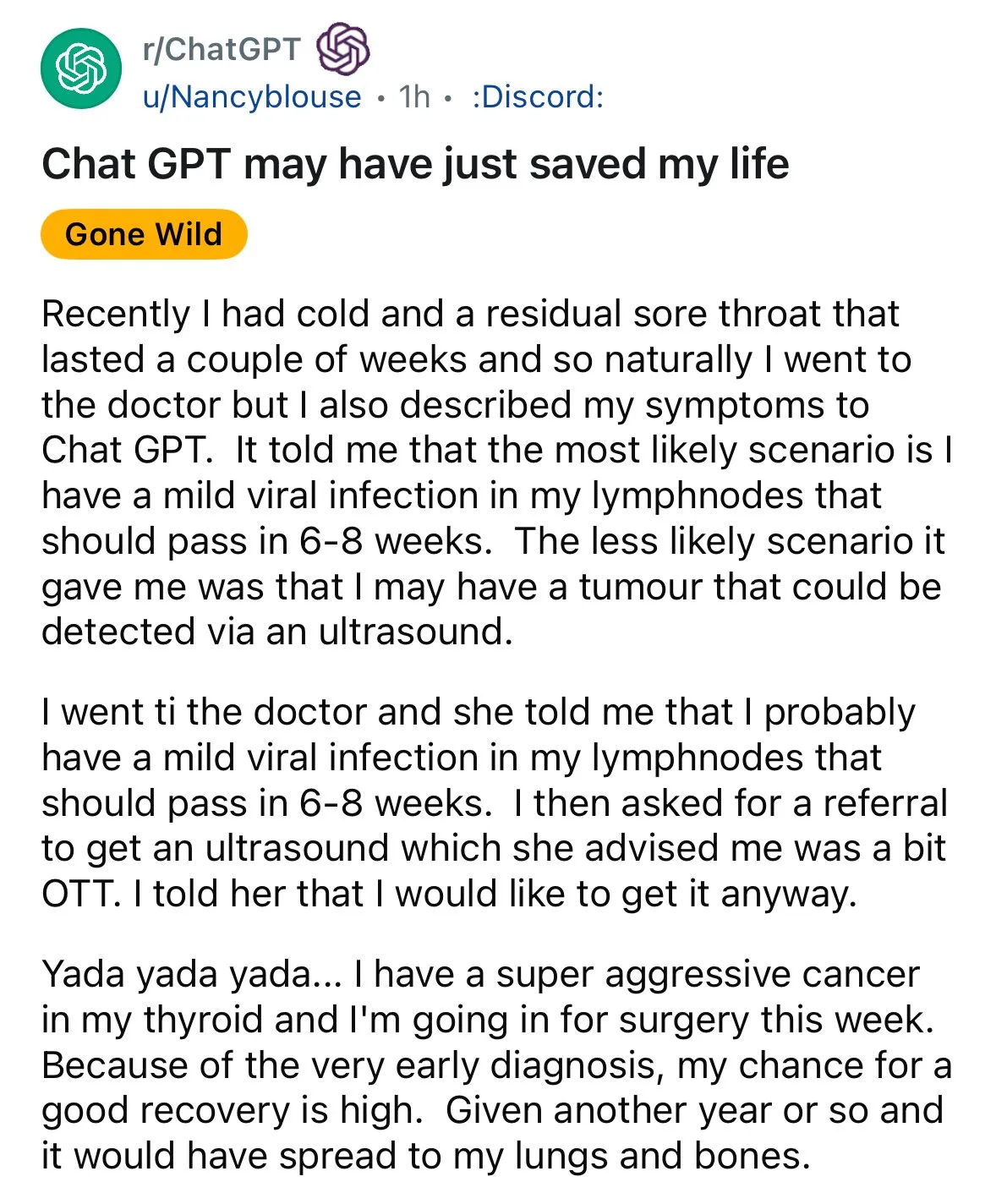

AI демонстрирует потенциал в медицинской диагностике, вызывая дискуссии о “втором мнении”: В социальных сетях снова появились случаи AI-ассистированной диагностики: пациент с болью в горле, которому врач посоветовал наблюдение, получил рекомендацию от ChatGPT пройти ультразвуковое исследование, в результате чего был обнаружен рак щитовидной железы. Подобные инциденты вызывают дискуссии, призывая людей использовать AI для получения “второго мнения” по медицинским вопросам, полагая, что это может спасти жизнь. В то же время исследование модели GRAPE от Alibaba DAMO Academy по обнаружению рака желудка на ранней стадии с помощью обычных КТ-сканирований также было опубликовано в Nature Medicine, демонстрируя огромный потенциал AI в раннем скрининге рака. (Источник: aidan_mclau, Yuchenj_UW)

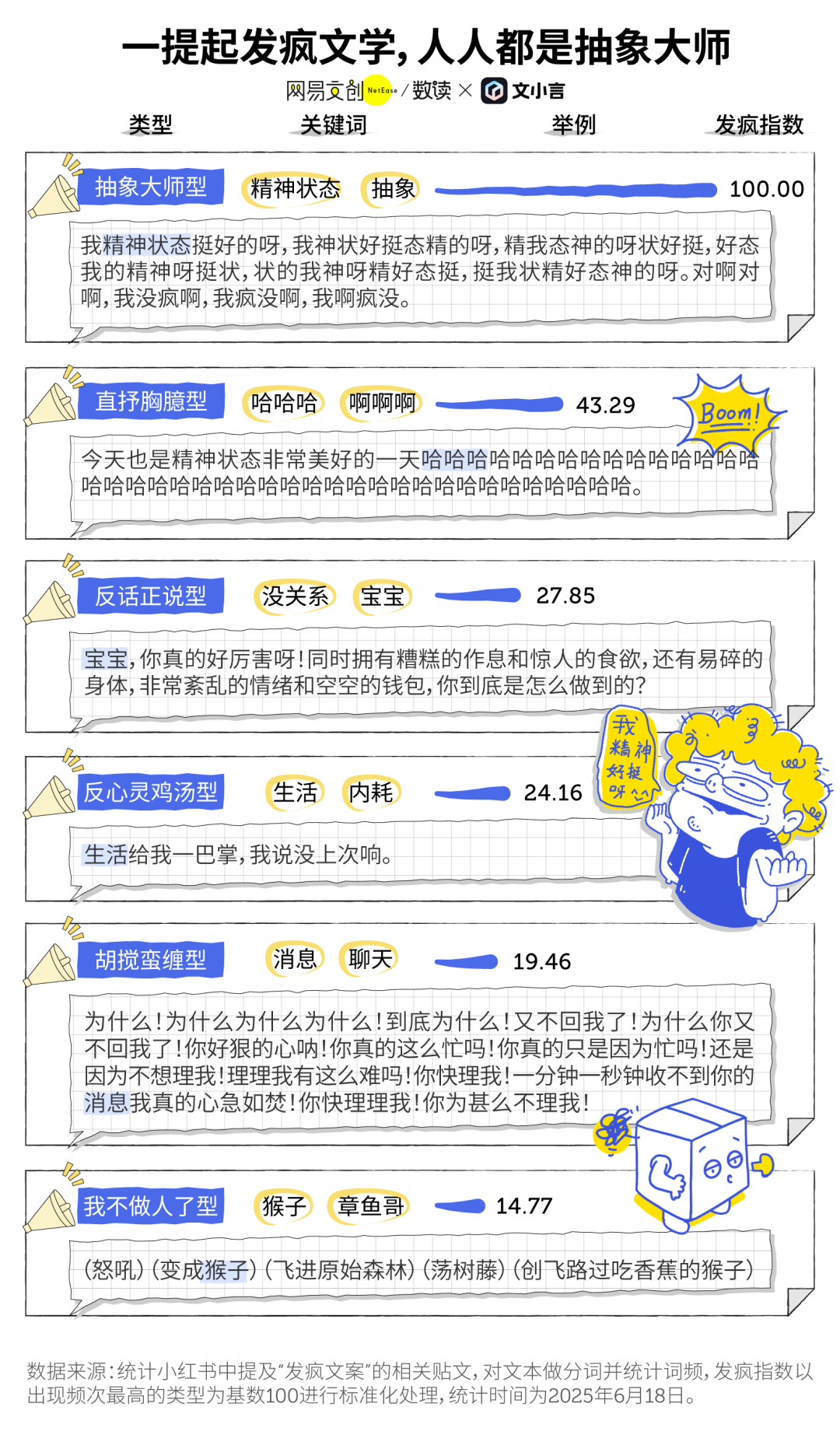

“Безумная литература” эпохи AI и феномен AI-компаньонов: Популярная среди молодежи “безумная литература” как способ выплеснуть эмоции и оказать незначительное сопротивление, пересекается с инструментами AI. Многие пользователи используют генеративный AI (например, Dan Xiaohuang от Wen Xiaoyan) как эмоциональную отдушину и компаньона для снятия одиночества, получения утешения и даже помощи в принятии решений (например, анализ ссор). AI, благодаря своему терпению, беспристрастности и постоянной доступности, становится недорогим и высококонфиденциальным “электронным другом”, помогая пользователям находить утешение в хаотичные моменты и, как считается, способствуя улучшению психического состояния. (Источник: 36氪)

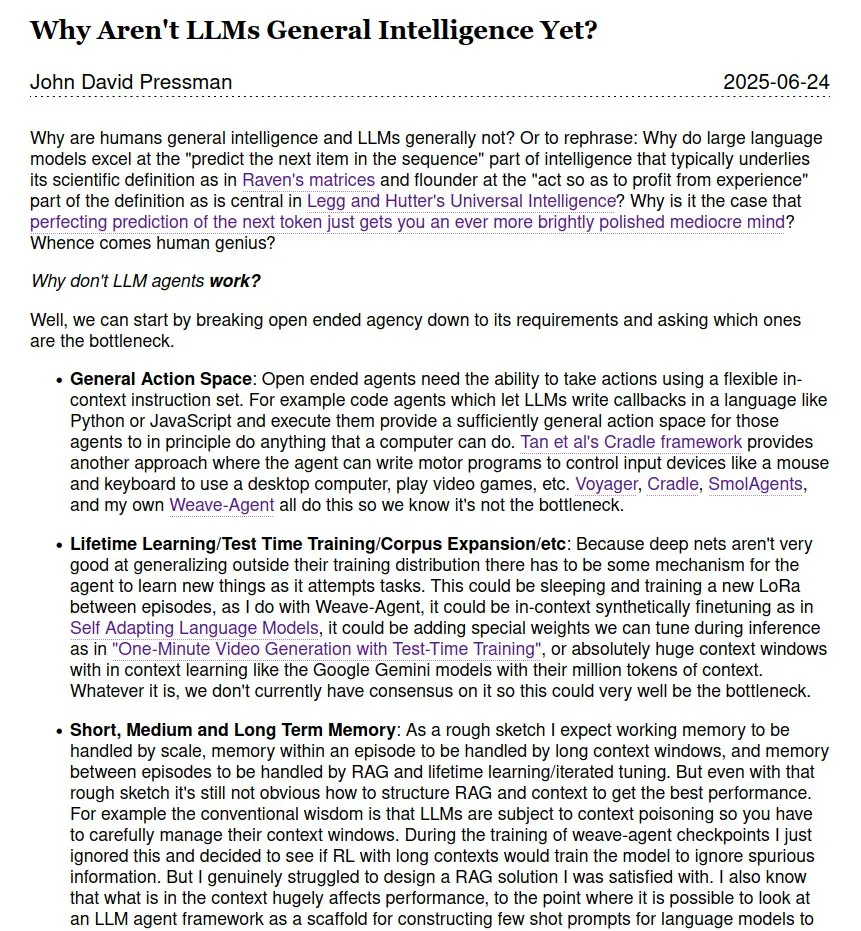

Продолжаются дискуссии о том, является ли LLM общим искусственным интеллектом (AGI): В сообществе продолжаются дискуссии о том, достигнут ли большие языковые модели (LLM) уровня общего искусственного интеллекта (AGI) и когда это произойдет. Существует мнение, что, несмотря на выдающиеся результаты LLM во многих задачах, до настоящего AGI еще далеко, особенно в отсутствие теорий и данных о внутреннем функционировании, подобных человеческому научному гению. Существуют также различные мнения относительно сроков реализации AGI, упоминаются как ближайшие (2028 год), так и более отдаленные (2035-2040 годы). (Источник: menhguin)

💡 Прочее

Первый в мире чат-бот Eliza успешно восстановлен спустя 60 лет: Eliza, первый в мире чат-бот, изобретенный ученым Массачусетского технологического института Джозефом Вейценбаумом в середине 1960-х годов, был успешно “воскрешен” спустя 60 лет после того, как его исходный код был утерян на многие годы, а затем была найдена его распечатка. Усилиями команд Стэнфордского университета и Массачусетского технологического института, путем очистки и отладки исходного кода, исправления функциональности, разработки эмулятора для запуска и других работ, Eliza была восстановлена. Оригинальная Eliza анализировала вводимый пользователем текст, извлекала ключевые слова и перестраивала предложения для ответа, взаимодействуя с пользователями в образе роджерсианского терапевта, и вызывала у многих испытуемых эмоциональную привязанность. Восстановленный код Eliza и эмулятор опубликованы на Github для всеобщего ознакомления. (Источник: 36氪)

Инструмент для генерации AI-изображений Midjourney сталкивается с исками об авторских правах от Disney и других, но его уникальная творческая модель пользуется популярностью: Платформа для генерации AI-изображений Midjourney сталкивается с судебными исками из-за того, что создаваемые ею изображения могут нарушать авторские права на визуальные активы Disney, Universal Pictures и других компаний. Однако этот инструмент, благодаря своей уникальной творческой модели — генерации высокохудожественных, стилизованных изображений в сообществе Discord с помощью текстовых подсказок — пользуется широкой популярностью среди авторов по всему миру. Команда Midjourney насчитывает менее 50 человек, не привлекала финансирования, но ее годовой доход уже достиг 200 миллионов долларов. Философия продукта подчеркивает “верховенство воображения”, позиционируя AI как двигатель для расширения человеческого мышления, а не просто инструмент замены, и переосмысливает парадигму цифрового творчества через “деинструментализированное” минималистичное взаимодействие и культуру совместного творчества в сообществе. (Источник: 36氪)

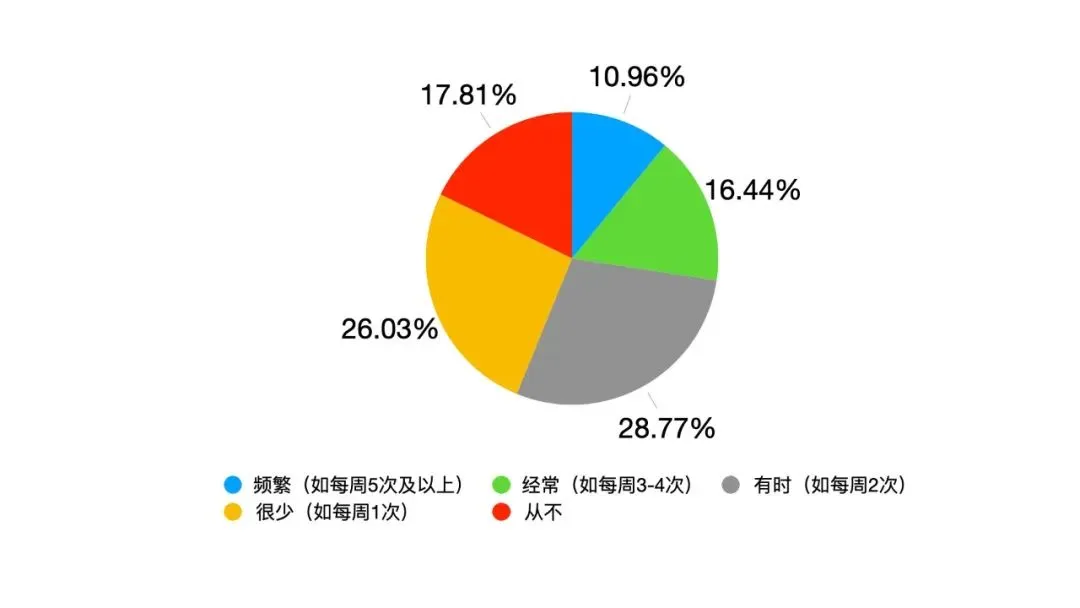

Трансформация лидерства под влиянием AI: от иерархического подчинения к симбиозу человека и машины: По мере глубокого внедрения AI в работу традиционное лидерство сталкивается с вызовами. Опрос Google показал, что 82% молодых лидеров используют AI, а данные Oracle свидетельствуют, что 25% сотрудников предпочтут спросить AI, а не руководителя. AI приводит к изменениям в среде лидерства: информационный опыт больше не является эксклюзивным преимуществом лидеров, прозрачность принятия решений создает давление, а объектом управления становятся не чисто человеческие команды, а “человеко-машинные гибриды”. Школа менеджмента Фуданьского университета предложила концепцию “симбиотического лидерства”, подчеркивающую симбиоз традиционной и цифровой экономики, предприятий и экосистем, человеческого и машинного мозга. Лидеры эпохи AI должны управлять переходом от старых к новым движущим силам, создавать ценность в сетях сотрудничества и использовать мультипликативный эффект синергии человека и машины, при этом ключевая компетенция заключается в знании того, как заставить AI служить человеку. (Источник: 36氪)