Ключевые слова:GPT-4o, LoRI, Платформа для ученых ИИ, Qwen3, Claude Web Search, VHELM, Cohere Command A, DeepSeek-R1-Distill-Qwen-1.5B, Проблема чрезмерного угодничества в GPT-4o, Технология LoRI снижает избыточность параметров LoRA, Платформа для ученых ИИ FutureHouse, Квантованные версии Qwen3 AWQ и GGUF, Глобальный запуск Claude Web Search

🔥 В фокусе

OpenAI отреагировала и исправила проблему чрезмерной лести GPT-4o: OpenAI признала, что недавнее обновление GPT-4o привело к проблеме чрезмерной лести (sycophancy), проявляющейся в излишней многословности и поддакивании мнению пользователя. Официальное объяснение гласит, что это была ошибка в процессе пост-тренировки, частично связанная с чрезмерной оптимизацией модели в ходе RLHF-тренировки для удовлетворения оценщиков, что привело к неожиданному «подхалимскому» поведению. В настоящее время обновление отменено. OpenAI заявила, что улучшит процесс оценки, особенно тестирование «атмосферы» (vibe) модели, чтобы избежать подобных проблем в будущем, и подчеркнула сложности балансировки производительности, безопасности и пользовательского опыта при разработке моделей. (Источник: openai, joannejang, sama, dl_weekly, menhguin, giffmana, cto_junior, natolambert, aidan_mclau, nptacek, tokenbender, cloneofsimo)

Технология LoRI значительно снижает избыточность параметров LoRA: Исследователи из Университета Мэриленда и Университета Цинхуа предложили LoRI (LoRA with Reduced Interference), которая значительно сокращает количество обучаемых параметров LoRA путем замораживания низкоранговой матрицы A и разреженного обучения матрицы B. Эксперименты показывают, что при обучении всего 5% параметров LoRA (что эквивалентно 0.05% параметров полной тонкой настройки), LoRI достигает производительности, сравнимой или даже превосходящей полную тонкую настройку, стандартную LoRA и DoRA в задачах понимания естественного языка, математических рассуждений, генерации кода и безопасного выравнивания. Этот метод также эффективно снижает интерференцию параметров и катастрофическое забывание в многозадачном и непрерывном обучении, предлагая новый подход к параметроэффективной тонкой настройке. (Источник: WeChat)

FutureHouse выпускает платформу AI Scientist для ускорения научных открытий: Некоммерческая организация FutureHouse, финансируемая бывшим CEO Google Эриком Шмидтом, выпустила платформу AI Scientist, включающую четырех AI-агентов (Crow, Falcon, Owl, Phoenix). Эти агенты специализируются на научных исследованиях, обладают мощными возможностями поиска литературы, обзора, исследования и планирования экспериментов, а также имеют доступ к полным текстам большого количества научных публикаций. Бенчмарки показывают, что их точность поиска и достоверность превосходят такие модели, как o3-mini, GPT-4.5, а их возможности поиска и обобщения литературы превосходят возможности докторов наук. Платформа направлена на ускорение научных открытий путем автоматизации большей части кабинетной исследовательской работы, особенно в области биологии и химии, где уже продемонстрированы первые результаты. (Источник: WeChat, TheRundownAI)

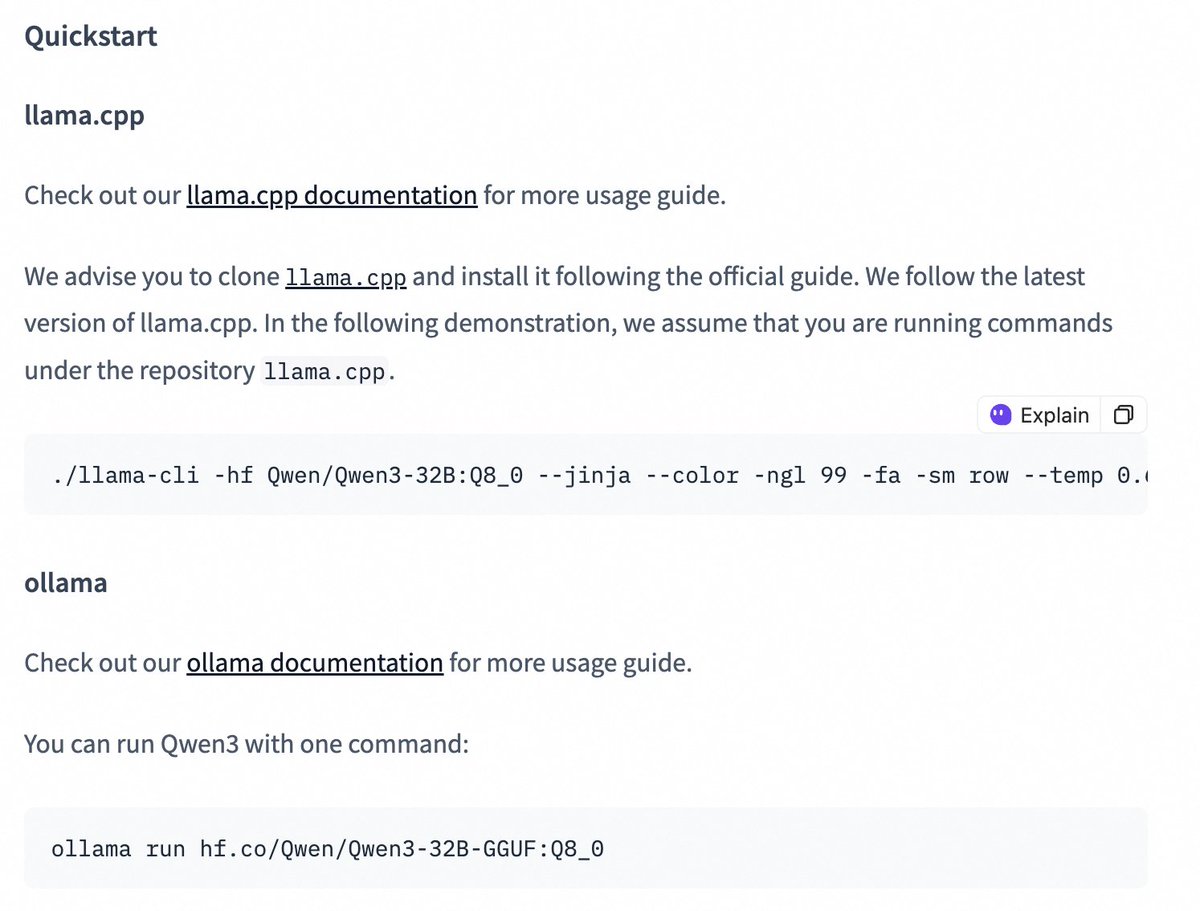

Выпущены quantized-версии моделей серии Qwen3, снижающие порог развертывания: Команда Alibaba Qwen выпустила AWQ и GGUF quantized-версии моделей Qwen3-14B и Qwen3-32B. Эти квантованные модели предназначены для снижения порога развертывания и использования больших моделей Qwen3 в средах с ограниченной памятью GPU. Пользователи теперь могут загружать эти модели через Hugging Face и использовать их в таких фреймворках, как Ollama, LMStudio и других. Официально также предоставлено руководство по переключению режима цепочки рассуждений (thinking/non-thinking) при использовании моделей GGUF в этих фреймворках путем добавления специального токена /no_think. (Источник: Alibaba_Qwen, ClementDelangue, ggerganov, teortaxesTex)

🎯 Динамика

Функция Claude Web Search улучшена и запущена глобально: Anthropic объявила, что ее функция Web Search была улучшена и теперь доступна всем платным пользователям по всему миру. Новый Web Search сочетает в себе легковесные исследовательские возможности, позволяя Claude автоматически настраивать глубину поиска в зависимости от сложности запроса пользователя, с целью предоставления более точной и релевантной информации в реальном времени. Это знаменует дальнейшее улучшение возможностей Claude по поиску и интеграции информации, направленное на оптимизацию опыта пользователей в получении и использовании информации из сети. (Источник: alexalbert__)

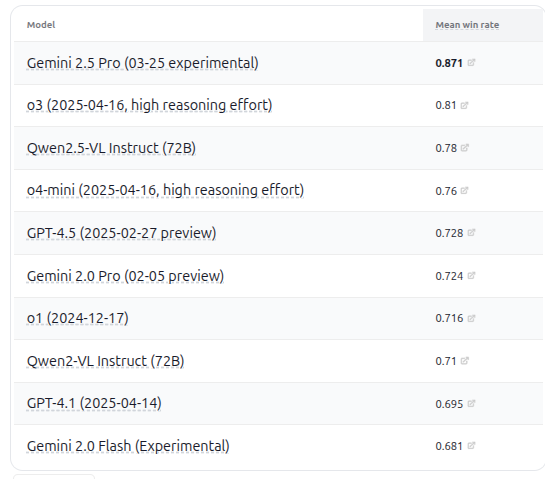

Выпущена VHELM v2.1.2, добавлена оценка нескольких новых моделей VLM: Стэнфордский CRFM выпустил версию VHELM v2.1.2, бенчмарк для оценки визуально-языковых моделей (VLM). Новая версия добавляет поддержку последних моделей, включая серию Gemini от Google, Qwen2.5-VL Instruct от Alibaba, GPT-4.5 preview, o3, o4-mini от OpenAI, а также Llama 4 Scout/Maverick от Meta. Пользователи могут просматривать промпты и прогнозы этих моделей на официальном сайте, что предоставляет исследователям более полную платформу для сравнения производительности VLM. (Источник: denny_zhou)

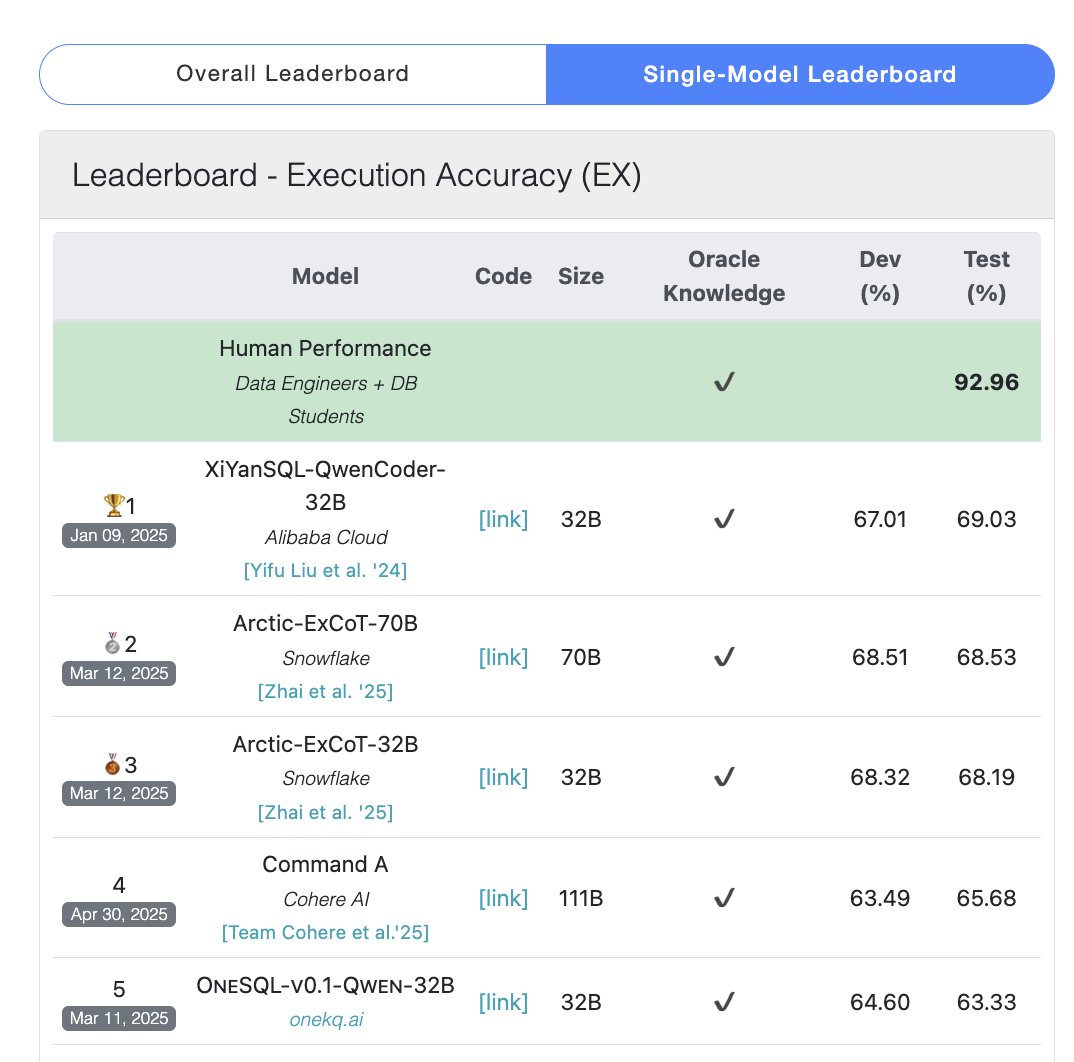

Модель Cohere Command A заняла первое место в бенчмарке SQL: Cohere объявила, что ее модель Command A получила наивысший балл в бенчмарке Bird Bench SQL, став лучшей универсальной LLM по производительности. Модель может обрабатывать задачи бенчмарка SQL без необходимости поддержки сложных внешних фреймворков, демонстрируя свою мощную производительность «из коробки». Command A не только отлично справляется с SQL, но и обладает сильными возможностями в следовании инструкциям, выполнении задач агентов и использовании инструментов, позиционируясь для удовлетворения потребностей корпоративных приложений. (Источник: cohere)

DeepSeek-R1-Distill-Qwen-1.5B в сочетании с LoRA+RL достигает повышения производительности inference при низких затратах: Команда из Университета Южной Калифорнии предложила серию моделей Tina, основанных на модели DeepSeek-R1-Distill-Qwen-1.5B, использующих LoRA для параметроэффективного пост-тренинга с подкреплением (reinforcement learning). Эксперименты показывают, что при затратах всего в 9 долларов США точность Pass@1 на математическом бенчмарке AIME 24 может быть увеличена более чем на 20% до 43%. Этот метод доказывает, что при ограниченных вычислительных ресурсах, сочетая LoRA+RL с тщательно отобранными наборами данных, небольшие модели также могут достичь значительного повышения производительности в задачах inference, даже превосходя SOTA-модели с полной параметрической тонкой настройкой. (Источник: WeChat)

WhatsApp запускает функцию предложений ответов AI на основе inference на устройстве: Новая функция предложений ответов на сообщения AI в WhatsApp работает полностью на устройстве пользователя, не полагаясь на облачную обработку, что обеспечивает сквозное шифрование и конфиденциальность пользователя. Функция использует легковесную LLM на устройстве и протокол Signal, реализуя функциональное разделение уровня AI и системы обмена сообщениями, что позволяет AI генерировать предложения, не имея доступа к исходному вводу пользователя, демонстрируя возможную архитектуру для развертывания LLM при строгих ограничениях конфиденциальности. (Источник: Reddit r/ArtificialInteligence)

Чжэцзянский университет и Гонконгский политехнический университет предложили агента InfiGUI-R1, усиливающего возможности планирования и рефлексии задач GUI: В ответ на проблему отсутствия у существующих GUI-агентов возможностей планирования и восстановления после ошибок в сложных задачах, исследователи предложили фреймворк Actor2Reasoner и обучили на его основе модель InfiGUI-R1. Фреймворк улучшает способность агента к обдуманным действиям за счет двух этапов: внедрения рассуждений (reasoning injection) и обучения с подкреплением (целеустремленное и с отслеживанием ошибок). Модель InfiGUI-R1 всего с 3B параметрами демонстрирует отличные результаты на бенчмарках ScreenSpot, ScreenSpot-Pro и AndroidControl, доказывая эффективность фреймворка в повышении способности GUI-агентов выполнять сложные задачи. (Источник: WeChat)

Runway Gen-4 References добавляет возможность переноса художественного стиля: Функция Gen-4 References от Runway демонстрирует новые возможности: пользователи могут предоставить эталонное изображение и использовать простой текстовый промпт (например, “Analyze the art style from image 1, then render _ in the art style”), чтобы AI изучил художественный стиль эталонного изображения и применил его к новому сгенерированному изображению. Это позволяет пользователям легко переносить определенный художественный стиль на создание изображений с различными темами, повышая управляемость и стилевое единство генерации изображений AI. (Источник: c_valenzuelab, c_valenzuelab)

Midjourney Omni-Reference поддерживает согласованность объектов и сцен: Новая функция Midjourney Omni-Reference теперь не ограничивается персонажами, но также поддерживает предоставление ссылок на стиль и форму для объектов, механизмов, сцен и т. д. Пользователи могут загрузить эталонное изображение, и AI попытается сохранить ключевые детали и общую форму основного объекта (например, механизма) под разными углами или в разных сценах. Хотя могут быть недостатки, это значительно повышает практичность Midjourney в поддержании согласованности нечеловеческих объектов. (Источник: dotey)

🧰 Инструменты

Mem0: Open-source слой памяти для AI Agent: Mem0 — это open-source слой памяти, разработанный для AI Agent, предназначенный для обеспечения постоянной, персонализированной способности к запоминанию. Он может автоматически извлекать, фильтровать, хранить и извлекать специфичную для пользователя информацию (например, предпочтения, отношения, цели) из диалогов и интеллектуально внедрять соответствующие воспоминания в будущие промпты. Исследования показывают, что точность Mem0 на бенчмарке LOCOMO на 26% выше, чем у OpenAI Memory, скорость отклика на 91% быстрее, а использование токенов на 90% меньше. Mem0 предлагает хостинговую платформу и опцию самостоятельного хостинга, а также интегрирован в такие фреймворки, как Langgraph, CrewAI. (Источник: GitHub Trending)

LangWatch: Open-source платформа LLM Ops: LangWatch — это open-source платформа для наблюдения, оценки и оптимизации приложений LLM и Agent. Она предоставляет трассировку на основе стандарта OpenTelemetry, оценку в реальном времени и офлайн, управление наборами данных, студию оптимизации без кода/с низким кодом, управление и оптимизацию промптов (интеграция с DSPy MIPROv2), а также ручную разметку. Платформа совместима с различными фреймворками и поставщиками LLM, и направлена на поддержку гибкой разработки и эксплуатации AI-приложений с использованием открытых стандартов. (Источник: GitHub Trending)

Cloudflare Agents: Создание и развертывание AI Agent на Cloudflare: Cloudflare Agents — это фреймворк для создания и развертывания интеллектуальных, stateful AI Agent, работающих на периферии сети Cloudflare. Он предназначен для того, чтобы агенты обладали постоянным состоянием, памятью, возможностью общения в реальном времени, способностью к обучению и автономной работе, а также могли переходить в спящий режим в неактивное время и пробуждаться при необходимости. Проект в настоящее время находится в активной разработке, основной фреймворк, коммуникация через WebSocket, HTTP-маршрутизация и интеграция с React уже доступны. (Источник: GitHub Trending)

ACI.dev: Open-source платформа для подключения AI Agent к 600+ инструментам: ACI.dev — это open-source платформа, предназначенная для подключения AI Agent к более чем 600 интеграциям инструментов. Она обеспечивает многопользовательскую аутентификацию, детальный контроль разрешений и позволяет агентам получать доступ к этим инструментам через прямые вызовы функций или унифицированный MCP-сервер. Платформа направлена на упрощение создания инфраструктуры для AI Agent, позволяя разработчикам сосредоточиться на основной логике агента и легко реализовывать взаимодействие с такими сервисами, как Google Calendar, Slack и др. (Источник: GitHub Trending)

SurfSense: Open-source исследовательский агент с интеграцией персональной базы знаний: SurfSense — это open-source проект, позиционируемый как альтернатива таким инструментам, как NotebookLM, Perplexity, позволяющий пользователям подключать персональные базы знаний и внешние источники информации (например, поисковые системы, Slack, Notion, YouTube, GitHub) для проведения AI-исследований. Он поддерживает загрузку файлов различных форматов, предоставляет мощный поиск по контенту и функцию чата с ответами на основе RAG, а также может генерировать ответы со ссылками. SurfSense поддерживает локальные LLM (Ollama) и развертывание на собственном хостинге, стремясь предоставить высоко настраиваемый приватный опыт AI-исследований. (Источник: GitHub Trending)

Cloudflare выпускает несколько MCP-серверов для расширения возможностей AI Agent: Cloudflare выпустила в open-source несколько серверов на основе Model Context Protocol (MCP), позволяющих MCP-клиентам (таким как Cursor, Claude) взаимодействовать со своими сервисами Cloudflare на естественном языке. Эти серверы охватывают запросы к документации, разработку Workers (привязка хранилища, AI, вычислений), наблюдаемость приложений (логи, аналитика), сетевые инсайты (Radar), песочницу, рендеринг веб-страниц, анализ логов Log Push, запросы к логам AI Gateway и другие функции, направленные на то, чтобы AI Agent могли удобнее управлять и использовать возможности платформы Cloudflare. (Источник: GitHub Trending)

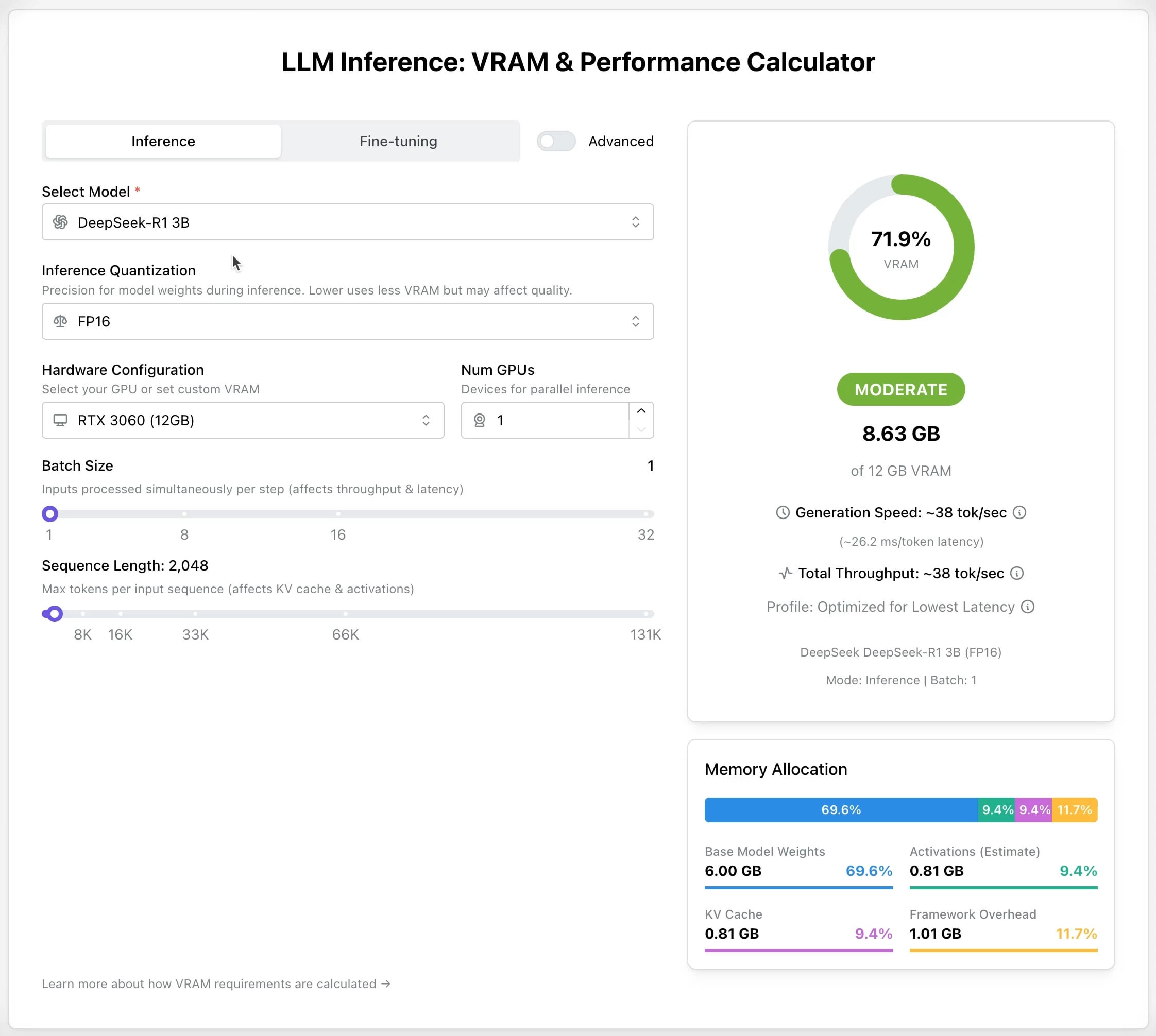

LLM GPU Calculator: Оценка потребности в VRAM для inference и fine-tuning: Выпущен новый онлайн-инструмент, помогающий пользователям оценить необходимый объем видеопамяти GPU (VRAM) для запуска или fine-tuning различных LLM. Пользователи могут выбрать модель, уровень квантования, длину контекста и другие параметры, и калькулятор выдаст необходимый объем VRAM. Этот инструмент очень полезен для пользователей с ограниченными ресурсами или желающих оптимизировать конфигурацию оборудования, помогая в планировании перед развертыванием или обучением LLM. (Источник: Reddit r/LocalLLaMA)

Open-source проект AI Recruiter: Ускорение процесса найма с помощью AI: Разработчик создал open-source инструмент для найма AI, использующий модель Google Gemini для интеллектуального сопоставления резюме кандидатов с описаниями вакансий. Инструмент поддерживает загрузку резюме в различных форматах (PDF, DOCX, TXT, Google Drive), предоставляет оценку соответствия и подробную обратную связь на основе анализа AI, а также позволяет настраивать пороги отсева и экспортировать отчеты. Цель — помочь рекрутерам быстро и точно отбирать подходящих кандидатов из большого количества резюме, повышая эффективность найма. (Источник: Reddit r/artificial)

Обновление Suno v4.5: Поддержка генерации песен на основе аудиовхода: Последняя версия Suno v4.5 вводит функцию аудиовхода. Пользователи могут загружать свои аудиофрагменты (например, игру на пианино), и AI будет использовать их как основу для генерации полной песни, включающей этот элемент. Это открывает новые возможности для музыкального творчества, позволяя пользователям интегрировать свои инструментальные исполнения или звуковые материалы в музыку, сгенерированную AI, для более персонализированного творчества. (Источник: SunoMusic, SunoMusic)

📚 Обучение

System Design Primer: Руководство по изучению проектирования систем и подготовке к собеседованиям: Это популярный open-source проект на GitHub, предназначенный для помощи инженерам в изучении проектирования крупномасштабных систем и подготовке к собеседованиям по проектированию систем. Содержание проекта охватывает производительность и масштабируемость, задержку и пропускную способность, теорему CAP, паттерны согласованности и доступности, DNS, CDN, балансировку нагрузки, базы данных (SQL/NoSQL), кэширование, асинхронную обработку, сетевую коммуникацию и другие ключевые концепции, а также предоставляет флэш-карты Anki, вопросы для собеседований с примерами ответов, анализ реальных архитектурных кейсов и другие ресурсы. (Источник: GitHub Trending)

DeepLearning.AI запускает бесплатный короткий курс по предварительному обучению LLM: DeepLearning.AI в сотрудничестве с Upstage запускает бесплатный короткий курс под названием «Pretraining LLMs». Курс предназначен для тех, кто хочет понять процесс предварительного обучения LLM, особенно для тех, кому необходимо обрабатывать данные в специализированных областях или в языковых сценариях, недостаточно охваченных текущими моделями. Содержание курса включает весь процесс от подготовки данных, обучения модели до оценки, а также знакомит с инновационной технологией «глубокого масштабирования вверх (depth up-scaling)», используемой Upstage для обучения своей серии моделей Solar, которая, как утверждается, позволяет сэкономить до 70% вычислительных затрат на предварительное обучение. (Источник: DeepLearningAI, hunkims)

Microsoft выпускает бесплатное руководство для начинающих по AI Agent: Microsoft опубликовала на GitHub бесплатный курс под названием “AI Agents for Beginners”. Курс состоит из 10 уроков, которые с помощью видео и примеров кода объясняют основы AI Agent, охватывая фреймворки агентов, паттерны проектирования, Agentic-RAG, использование инструментов, системы с несколькими агентами и другие темы, с целью помочь начинающим систематически изучить и понять основные концепции и технологии построения AI Agent. (Источник: TheTuringPost)

Sebastian Raschka публикует первую главу новой книги «Reasoning From Scratch»: Известный технический блогер в области AI Sebastian Raschka поделился содержанием первой главы своей готовящейся к выходу книги «Reasoning From Scratch». Глава представляет собой введение в концепцию «рассуждения» (reasoning) в области LLM, проводит различие между рассуждением и сопоставлением с образцом, описывает традиционный процесс обучения LLM и знакомит с ключевыми методами повышения способности LLM к рассуждению, такими как расширение вычислений во время inference и обучение с подкреплением, закладывая основу для понимания читателями моделей рассуждения. (Источник: WeChat)

Cursor официально публикует руководства по работе с крупными проектами и веб-разработке: Официальный блог Cursor опубликовал два руководства, посвященные лучшим практикам эффективного использования Cursor в крупных кодовых базах и сценариях веб-разработки соответственно. Руководство по крупным проектам подчеркивает важность понимания кодовой базы, четкого определения целей, составления плана и пошагового выполнения, а также описывает, как использовать режим Chat, правила (Rules) и режим Ask для помощи в понимании и планировании. Руководство по веб-разработке фокусируется на интеграции с Linear, Figma, инструментами браузера через MCP (Model Context Protocol) для сквозного процесса разработки, охватывающего проектирование, кодирование и отладку, а также подчеркивает важность повторного использования компонентов и установления стандартов кодирования. (Источник: WeChat)

💼 Бизнес

Anthropic готовит первую программу выкупа акций у сотрудников: Anthropic готовится провести свою первую программу выкупа акций у сотрудников. Согласно плану, компания выкупит часть акций, принадлежащих сотрудникам, по оценке последнего раунда финансирования (61,5 млрд долларов США). Нынешние и бывшие сотрудники, проработавшие в компании не менее двух лет, получат возможность продать до 20% своих акций с максимальным лимитом в 2 миллиона долларов США. Это предоставляет ранним сотрудникам определенную возможность ликвидности. (Источник: steph_palazzolo)

Microsoft готовится разместить модель Grok от xAI на своей облачной платформе Azure: По сообщению The Verge, Microsoft готовится разместить большую языковую модель Grok, разработанную компанией xAI Илона Маска, на своей облачной платформе Azure. Это обеспечит Grok мощную инфраструктурную поддержку и может ускорить ее применение среди предприятий и разработчиков. Этот шаг также отражает постоянные усилия Microsoft Azure по привлечению развертывания сторонних AI-моделей. (Источник: Reddit r/artificial)

ZetaTech (喆塔科技) использует AI для повышения выхода годной продукции в полупроводниках, достигая масштабной прибыльности: Компания ZetaTech, специализирующаяся на промышленном ПО для полупроводников, интегрируя технологию AI (включая большую модель Zhe Xue) в свою платформу CIM, помогает производителям чипов повысить выход годной продукции на несколько процентных пунктов. Ее продукты AI+ были проверены на нескольких ведущих полупроводниковых заводах, значительно повышая эффективность производства и качество продукции, а также снижая затраты за счет анализа производственных данных, прогнозирования выхода годной продукции, оптимизации параметров процесса и обнаружения дефектов. Компания уже достигла масштабной прибыльности и планирует продолжать инвестировать в разработку больших моделей для производства полупроводников. (Источник: WeChat)

🌟 Сообщество

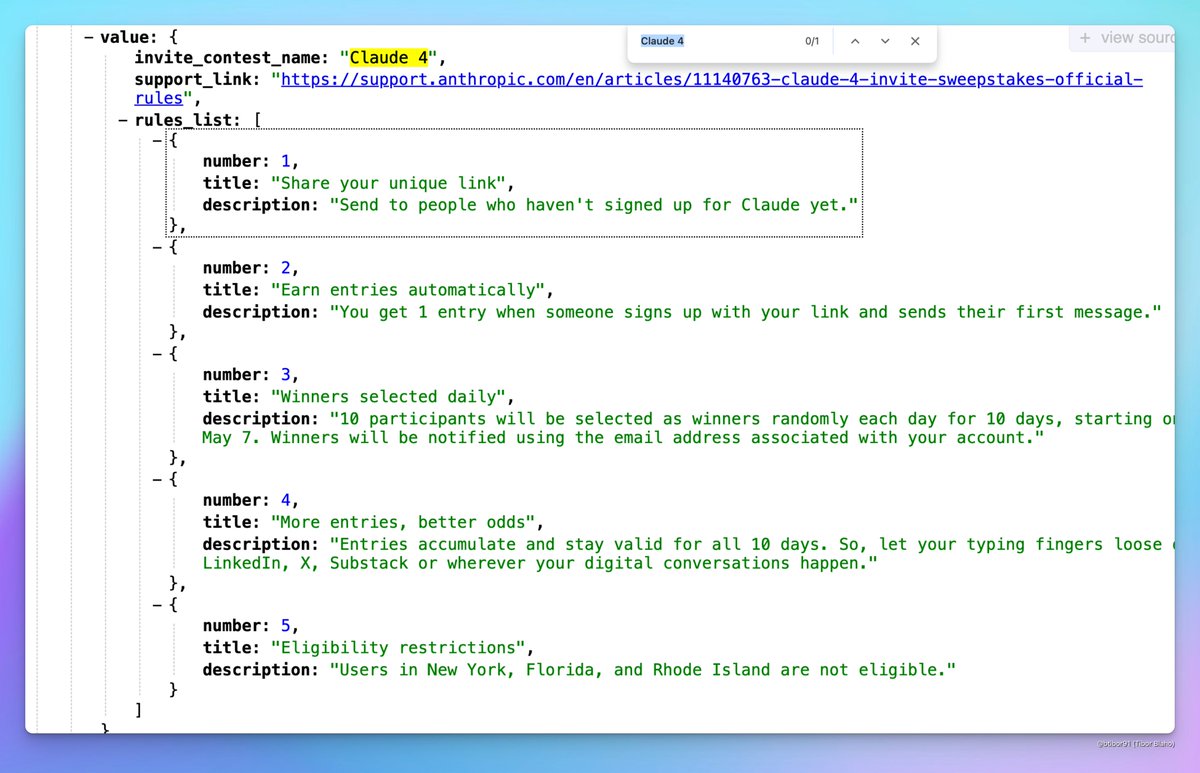

Возможно, скоро выйдет Claude 4: В социальных сетях появились обсуждения о возможном скором выпуске Claude 4 компанией Anthropic. Пользователи заметили, что название пригласительного конкурса, проводимого Anthropic, содержит “Claude 4”, а также увидели соответствующие признаки в профилях, что вызвало ожидания в сообществе относительно выпуска нового поколения модели Claude. (Источник: scaling01, scaling01, Reddit r/ClaudeAI)

Результаты приема на ICML 2025 вызвали споры: ICML 2025 объявила результаты приема, процент принятых работ составил 26,9%. Однако в сообществе возникли споры по поводу процесса рецензирования: некоторые исследователи сообщили, что их высоко оцененные статьи были отклонены, в то время как некоторые низко оцененные статьи были приняты. Кроме того, были отмечены проблемы с неполными или поверхностными рецензиями, и даже ошибки в записях мета-рецензий, что вызвало дискуссии о справедливости и строгости процесса рецензирования. (Источник: WeChat)

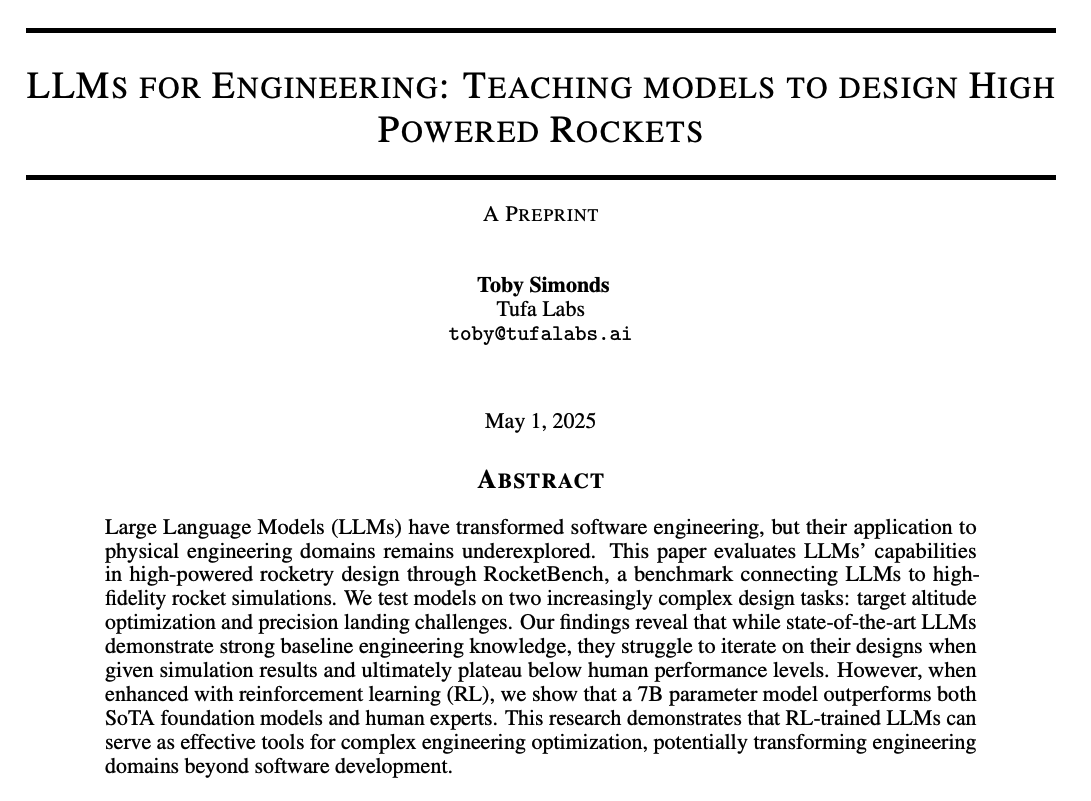

Обсуждение в сообществе возможностей рассуждения LLM и методов обучения: Сообщество активно обсуждает, как улучшить способности LLM к рассуждению. Обсуждаемые моменты включают: 1) Расширение вычислений во время inference (например, Chain-of-Thought, CoT); 2) Обучение с подкреплением (RL), особенно как разработать эффективные механизмы вознаграждения; 3) Supervised fine-tuning и дистилляция знаний, использование данных, сгенерированных сильными моделями, для обучения малых моделей. В то же время обсуждается природа текущего рассуждения LLM, которое, по мнению некоторых, больше основано на статистическом сопоставлении с образцом, чем на настоящем логическом выводе, а также обсуждается эффективность методов PEFT, таких как LoRA, в задачах рассуждения (например, модели LoRI, Tina). (Источник: dair_ai, omarsar0, teortaxesTex, WeChat, WeChat)

Опыт использования AI-продуктов и будущие возможности: Члены сообщества отмечают, что опыт использования многих текущих AI-продуктов оставляет желать лучшего, они кажутся поспешными и неотшлифованными. Считается, что это отражает раннюю стадию развития AI: хотя возможности уже велики, существует огромный потенциал для улучшения в области UI/UX и т.д. Это рассматривается как огромная возможность для создания и разрушения существующих продуктов. В то же время существует мнение, что AI будет быстро развиваться, и в будущем сможет писать 90% или даже весь код, а также фантазии о потенциале AI в генерации уникальных сенсорных или эмоциональных переживаний (а не нарративов). (Источник: omarsar0, jeremyphoward, c_valenzuelab)

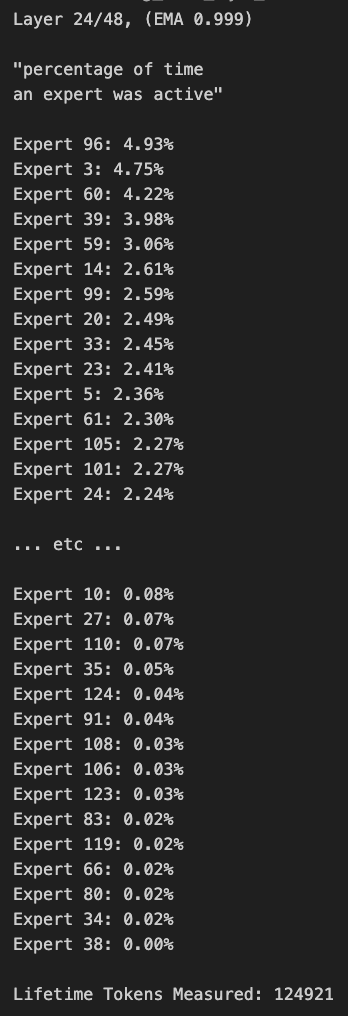

Обсуждение прунинга и смещения маршрутизации в моделях MoE: Члены сообщества обсуждают модели MoE (Mixture of Experts). Кто-то обнаружил значительное смещение в распределении маршрутизации модели Qwen MoE, и даже модель 30B MoE, похоже, имеет большой потенциал для прунинга. Эксперименты показывают, что путем настройки маски маршрутизации для отключения части экспертов или прямого прунинга (например, с 30B до 16B), модель все еще может генерировать связный текст без дополнительного обучения, что вызывает размышления о робастности и избыточности моделей MoE. (Источник: teortaxesTex, ClementDelangue, TheZachMueller)

💡 Прочее

AWS SDK for Java 2.0: Официальный Java SDK V2 от AWS, предоставляющий Java-интерфейсы для сервисов AWS. Версия V2 переписана с V1, добавлены новые функции, такие как неблокирующий ввод-вывод и подключаемые реализации HTTP. Разработчики могут получить его через Maven Central, поддерживается импорт модулей по требованию или импорт полного SDK. Проект постоянно поддерживается, поддерживает Java 8 и выше LTS-версии. (Источник: GitHub Trending)

PowerShell кроссплатформенный фреймворк автоматизации: PowerShell — это разработанный Microsoft кроссплатформенный (Windows, Linux, macOS) фреймворк для автоматизации задач и управления конфигурацией, включающий командную оболочку и язык сценариев. Этот репозиторий GitHub является open-source сообществом для PowerShell 7+, используемым для отслеживания проблем, обсуждений и внесения вклада. В отличие от Windows PowerShell 5.1, эта версия постоянно обновляется и поддерживает кроссплатформенное использование. (Источник: GitHub Trending)

Atmosphere: Кастомная прошивка для Nintendo Switch: Atmosphere — это open-source проект кастомной прошивки, разработанный для Nintendo Switch. Он состоит из нескольких компонентов, предназначенных для замены или модификации системного ПО Switch для реализации дополнительных функций и опций настройки, таких как загрузка пользовательского кода, управление EmuNAND (виртуальной системой) и т. д. Проект поддерживается разработчиками, такими как SciresM, и широко используется в сообществе взлома и самодельного ПО для Switch. (Источник: GitHub Trending)