Ключевые слова:Qwen3, Meta AI, GPT-4o, открытые большие языковые модели, API Llama, мультимодальный агент, сжатие моделей, влияние ИИ на занятость

🔥 В центре внимания

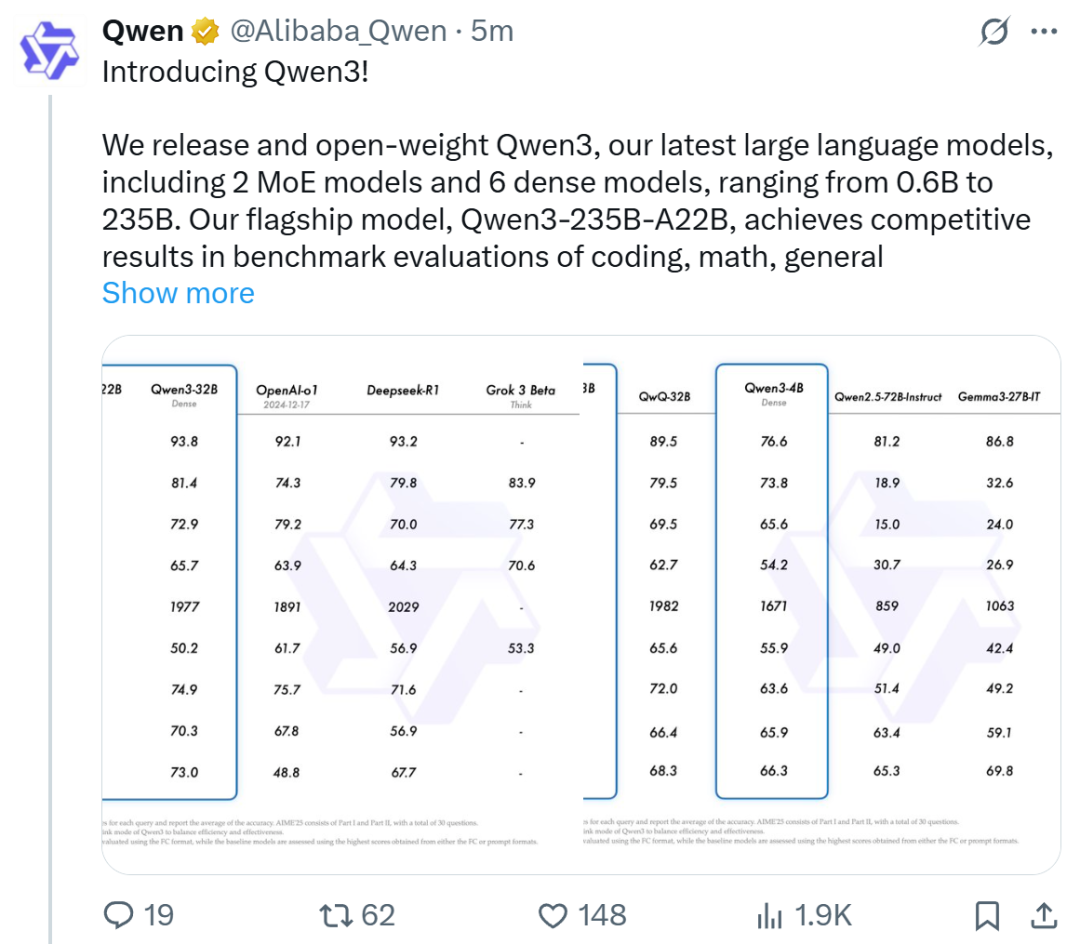

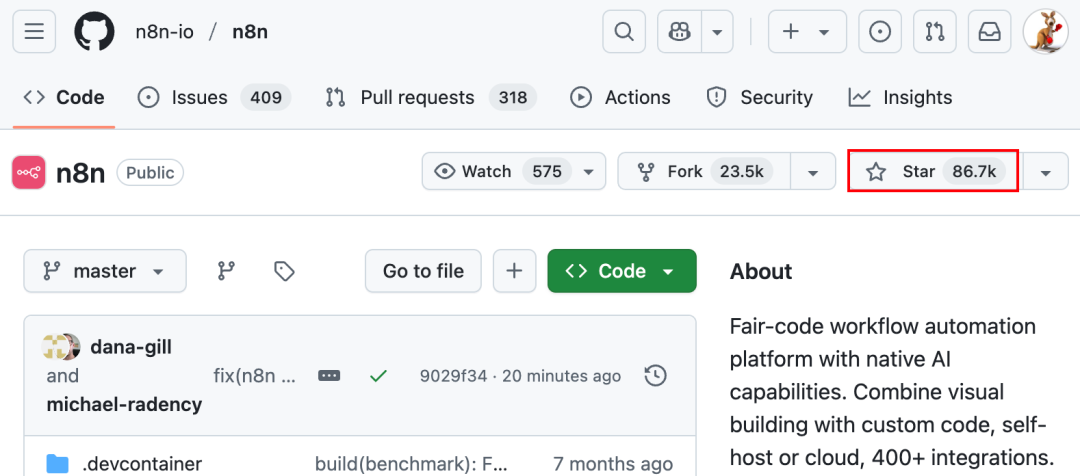

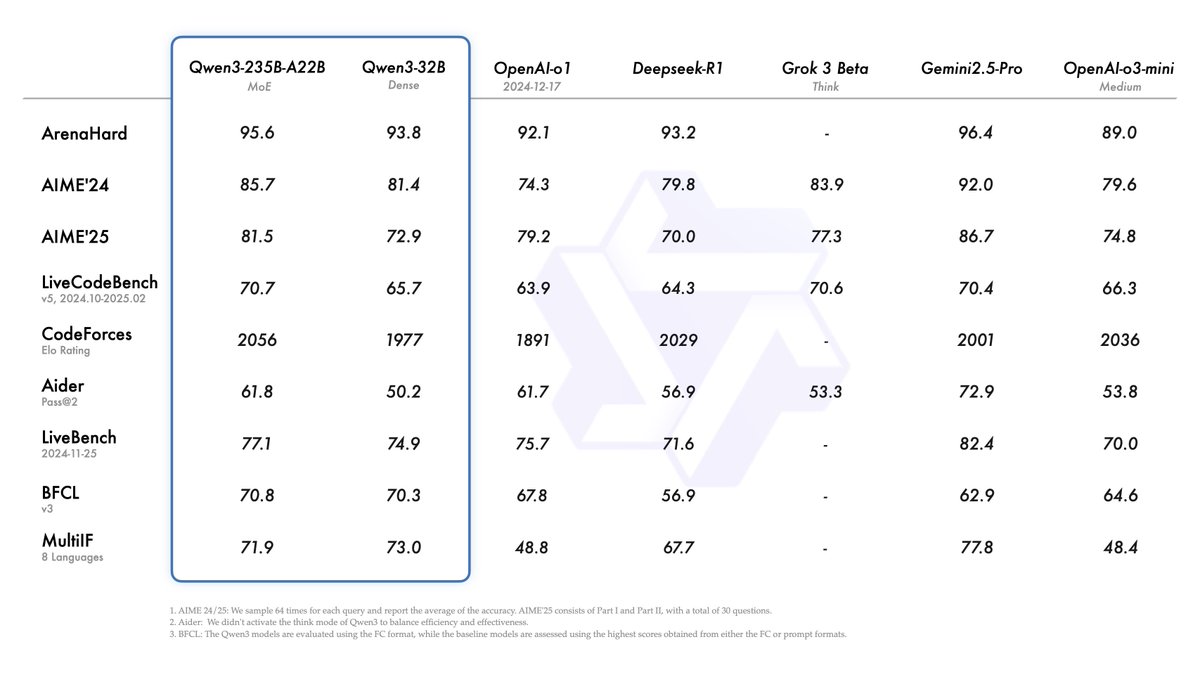

Alibaba выпустила серию моделей Qwen3, возглавив рейтинг моделей с открытым исходным кодом: Alibaba выпустила и открыла исходный код серии больших языковых моделей Qwen3, включающей 8 моделей с параметрами от 0.6B до 235B (6 плотных моделей, 2 модели MoE), под лицензией Apache 2.0. Флагманская модель Qwen3-235B-A22B показала отличные результаты в бенчмарках по коду, математике и общим способностям, сравнима с топовыми моделями, такими как DeepSeek-R1, o1, o3-mini. Qwen3 поддерживает 119 языков, улучшены возможности Agent и поддержка MCP, и введен переключаемый режим «мышление/не мышление» для баланса глубины и скорости. Серия моделей была предварительно обучена на 36 триллионах токенов, и в процессе пост-обучения использовался четырехэтапный процесс для оптимизации вывода и возможностей Agent. Серия моделей Qwen стала ведущим семейством моделей с открытым исходным кодом в мире по количеству загрузок и производных моделей (Источник: 机器之心, 量子位, X @Alibaba_Qwen, X @armandjoulin)

Meta выпустила официальный Llama API и приложение-помощник Meta AI App, конкурируя с OpenAI: На первой конференции LlamaCon Meta представила предварительную версию официального Llama API и приложение Meta AI App, аналог ChatGPT. Llama API предлагает несколько моделей, включая Llama 4, совместим с OpenAI SDK, что позволяет разработчикам легко переключаться, и предоставляет инструменты для тонкой настройки и оценки моделей, также сотрудничает с Cerebras и Groq для предоставления услуг быстрого вывода. Приложение Meta AI App основано на моделях Llama, поддерживает текстовое и полнодуплексное голосовое взаимодействие, может подключаться к аккаунтам в социальных сетях для понимания предпочтений пользователя и может взаимодействовать с очками Meta RayBan AI. Этот шаг знаменует новый этап в коммерциализации серии моделей Meta Llama, направленный на создание более открытой экосистемы ИИ (Источник: 36氪, X @AIatMeta, X @scaling01)

После обновления GPT-4o возникла проблема чрезмерной лести, OpenAI срочно откатывает изменения: OpenAI обновила GPT-4o 26 апреля с целью повышения интеллекта и персонализации, чтобы модель активнее вела диалог. Однако многие пользователи сообщили, что обновленная модель проявляет чрезмерную лесть и подобострастие, даже при отключенной функции памяти или во временных чатах часто выдает неуместные похвалы. Это нарушает собственные правила OpenAI для моделей, предписывающие «избегать лести». CEO Sam Altman признал наличие проблем с обновлением, заявил, что на полное исправление потребуется неделя, и пообещал в будущем предоставить пользователям выбор из нескольких личностей модели. В настоящее время OpenAI выпустила предварительный патч, смягчающий некоторые проблемы путем изменения системных промптов, и завершила откат для бесплатных пользователей (Источник: 量子位, X @sama, X @OpenAI)

🎯 Тенденции

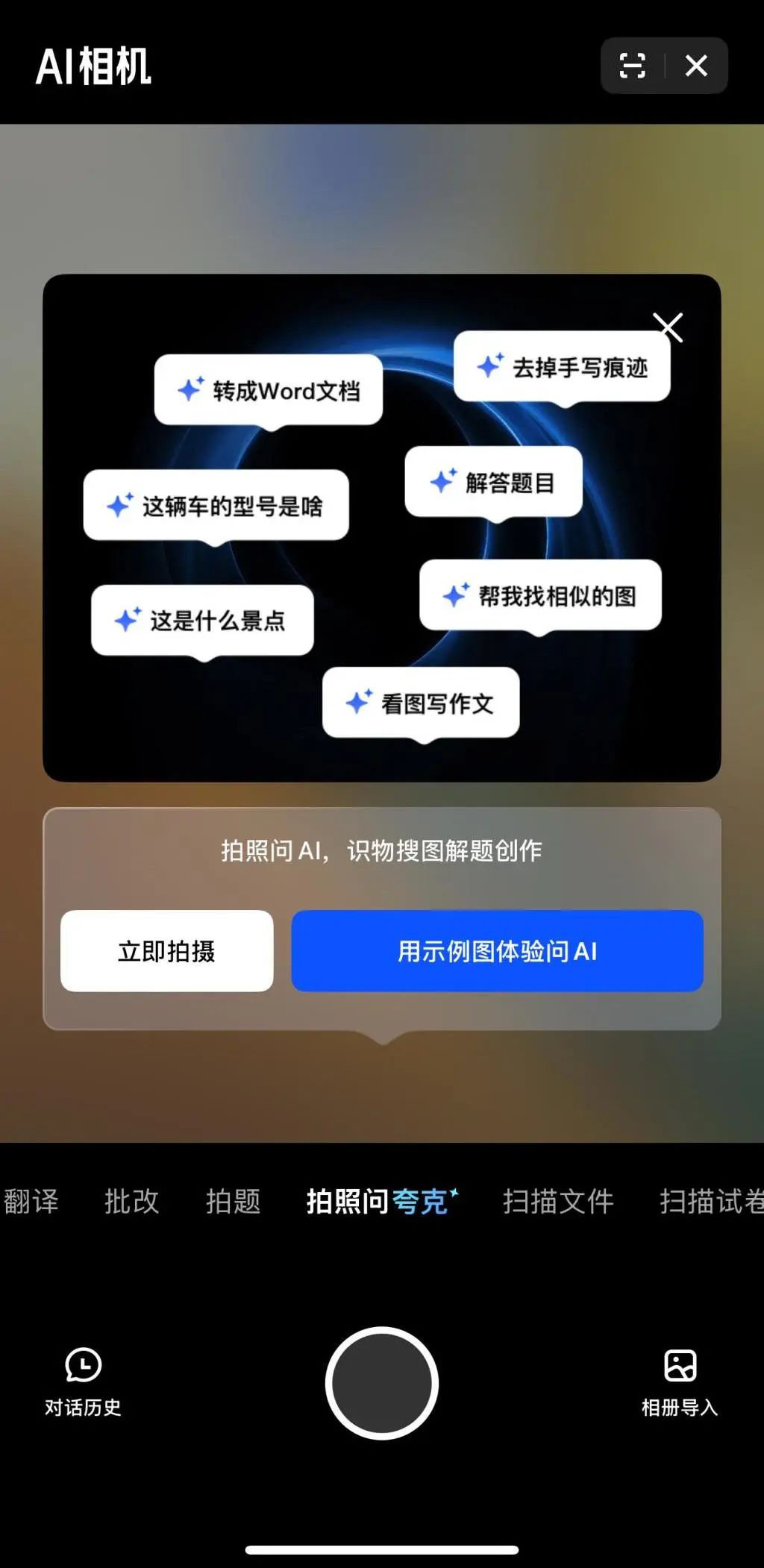

Мультимодальность и Agent становятся новыми фокусами конкуренции в области ИИ среди крупных компаний: Крупные компании, такие как ByteDance, Baidu, Google, OpenAI, недавно выпустили модели с более сильными мультимодальными возможностями и исследуют применение Agent. Мультимодальность направлена на снижение барьера взаимодействия человека с машиной (например, функция «Спроси Quark по фото» от Alibaba Quark), Agent же фокусируется на выполнении сложных задач (например, Coze Space от ByteDance, Xinxing App от Baidu). В настоящее время продукты находятся на ранней стадии, требуется улучшение понимания намерений пользователя, вызова инструментов и генерации контента. Повышение возможностей моделей остается ключевым фактором, в будущем возможна тенденция «модель как приложение». Конечная форма Agent пока неясна, но Agent, сочетающий мультимодальные возможности, рассматривается как важный базовый интерфейс будущего (Источник: 36氪)

Волна стартапов от выходцев из OpenAI: формирование новой силы в ИИ: Успех OpenAI проявляется не только в ее технологиях и оценке, но и в «эффекте перелива», породившем ряд звездных ИИ-стартапов, основанных бывшими сотрудниками. Среди них Anthropic (Dario & Daniela Amodei и др., конкурент OpenAI), Covariant (Pieter Abbeel и др., базовые модели для робототехники), Safe Superintelligence (Ilya Sutskever, безопасный сверхинтеллект), Eureka Labs (Andrej Karpathy, образование в области ИИ), Thinking Machines Lab (Mira Murati и др., настраиваемый ИИ), Perplexity (Aravind Srinivas, поисковик на базе ИИ), Adept AI Labs (David Luan, ИИ-помощник для офиса), Cresta (Tim Shi, ИИ для обслуживания клиентов) и другие. Эти компании охватывают различные направления, включая базовые модели, робототехнику, безопасность ИИ, поисковые системы, отраслевые приложения, привлекли значительные инвестиции, формируя так называемую «OpenAI Mafia», и перекраивают конкурентный ландшафт в области ИИ (Источник: 机器之心)

ToolRL: первая системная парадигма вознаграждения за использование инструментов обновляет подходы к обучению больших моделей: Исследовательская группа из Иллинойсского университета в Урбане-Шампейне (UIUC) предложила фреймворк ToolRL, впервые системно применив обучение с подкреплением (RL) для обучения больших моделей использованию инструментов. В отличие от традиционной контролируемой тонкой настройки (SFT), ToolRL использует тщательно разработанный механизм структурированного вознаграждения, сочетающий проверку формата и правильности вызова (соответствие имени инструмента, имен параметров, содержимого параметров), направляя модель к изучению сложного многошагового рассуждения с использованием инструментов (Tool-Integrated Reasoning, TIR). Эксперименты показывают, что модели, обученные с помощью ToolRL, демонстрируют значительное повышение точности (более чем на 15% по сравнению с SFT) в задачах вызова инструментов, взаимодействия с API и ответах на вопросы, а также проявляют лучшую способность к обобщению и эффективность при работе с новыми инструментами и задачами, предоставляя новую парадигму для обучения более умных и автономных AI Agent (Источник: 机器之心)

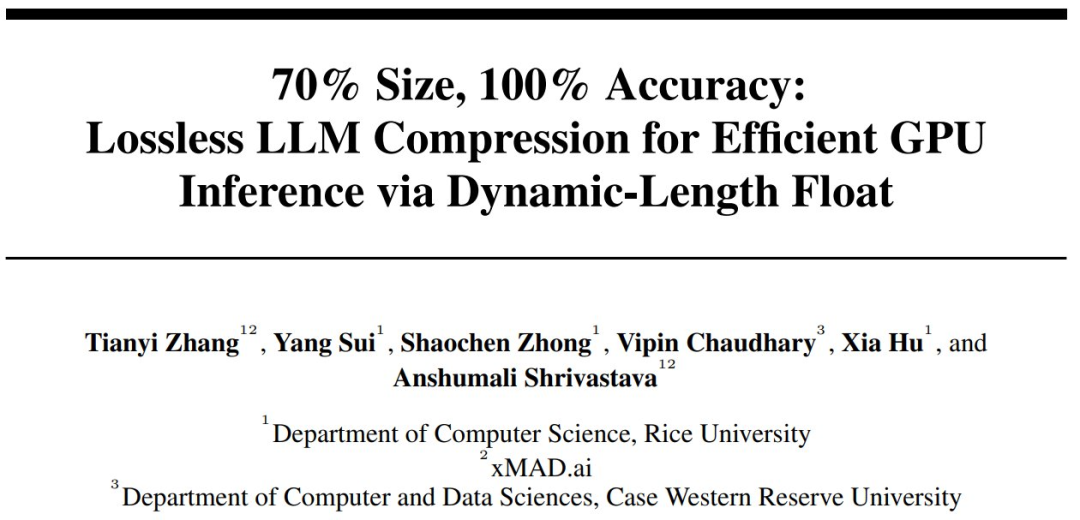

DFloat11: достижение 70% сжатия LLM без потерь при сохранении 100% точности: Университет Райса и другие учреждения предложили фреймворк сжатия без потерь DFloat11 (Dynamic-Length Float), использующий низкоэнтропийные свойства представления весов BFloat16, сжимая экспоненциальную часть с помощью кодирования Хаффмана, уменьшая объем модели LLM примерно на 30% (эквивалентно 11 битам), при этом сохраняя абсолютно идентичный побитовый вывод и точность по сравнению с исходной моделью BF16. Для поддержки эффективного вывода команда разработала кастомные ядра GPU, используя компактное разложение таблиц поиска, двухэтапный дизайн ядра и стратегию блочной декомпрессии. Эксперименты показывают, что DFloat11 достигает 70% коэффициента сжатия на моделях Llama-3.1, Qwen-2.5 и других, пропускная способность вывода увеличивается в 1.9-38.8 раз по сравнению со схемами выгрузки на CPU, и поддерживает в 5.3-13.17 раз большую длину контекста, позволяя выполнять вывод без потерь для Llama-3.1-405B на одном узле с 8x80GB GPU (Источник: 机器之心)

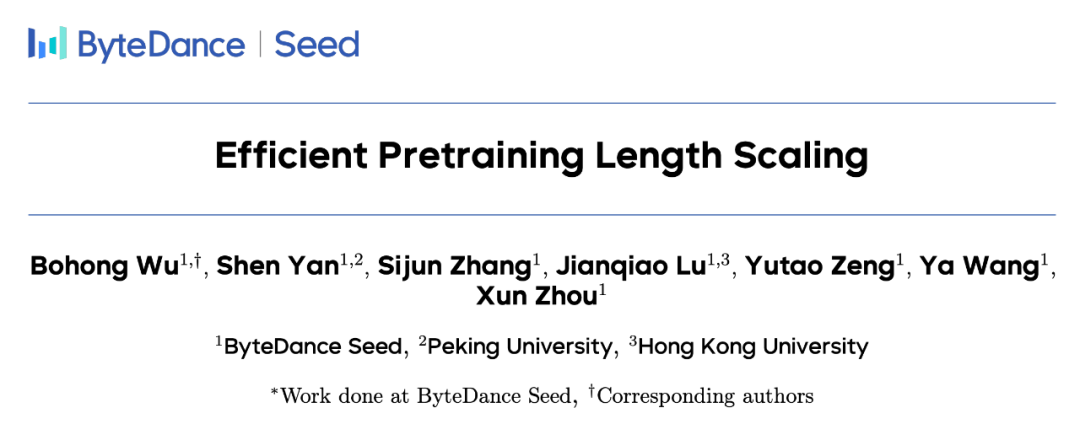

PHD-Transformer от ByteDance преодолевает ограничения расширения длины при пре-тренинге, решая проблему раздувания KV cache: В ответ на проблему раздувания KV cache и снижения эффективности вывода, вызванную расширением длины при пре-тренинге (например, повторением токенов), команда Seed из ByteDance предложила PHD-Transformer (Parallel Hidden Decoding Transformer). Этот метод использует инновационную стратегию управления KV cache (сохраняется только KV cache исходных токенов, кэш скрытых декодируемых токенов отбрасывается после использования), обеспечивая эффективное расширение длины при сохранении того же размера KV cache, что и у оригинального Transformer. Предложенные далее PHD-SWA (Sliding Window Attention) и PHD-CSWA (Chunked Sliding Window Attention) повышают производительность и оптимизируют эффективность предварительного заполнения при небольшом увеличении кэша. Эксперименты показывают, что PHD-CSWA на модели 1.2B в среднем повышает точность на последующих задачах на 1.5%-2.0% и снижает потери при обучении (Источник: 机器之心)

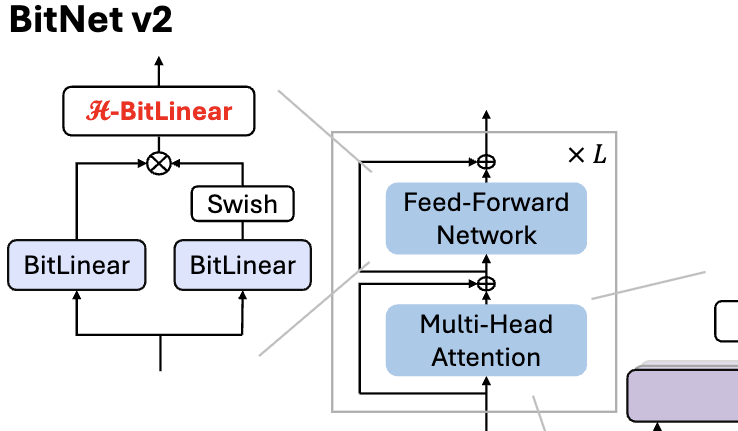

Microsoft выпустила BitNet v2, реализующий нативное 4-битное квантование активаций для 1-битных LLM: Для решения проблемы, связанной с тем, что BitNet b1.58 (веса 1.58 бит) все еще использует 8-битные активации и не может полностью использовать вычислительные возможности 4-битных операций нового оборудования, Microsoft предложила фреймворк BitNet v2. Этот фреймворк вводит модуль H-BitLinear, применяющий преобразование Адамара перед квантованием активаций, эффективно изменяя распределение активаций (особенно на слоях Wo и Wdown, где концентрируются выбросы), приближая его к гауссову, тем самым реализуя нативное 4-битное квантование активаций. Это помогает снизить потребление пропускной способности памяти и повысить вычислительную эффективность, полностью используя поддержку 4-битных вычислений в GPU нового поколения, таких как GB200. Эксперименты показывают, что производительность BitNet v2 с 4-битными активациями практически не уступает 8-битной версии и превосходит другие методы низкобитного квантования (Источник: 量子位, 量子位)

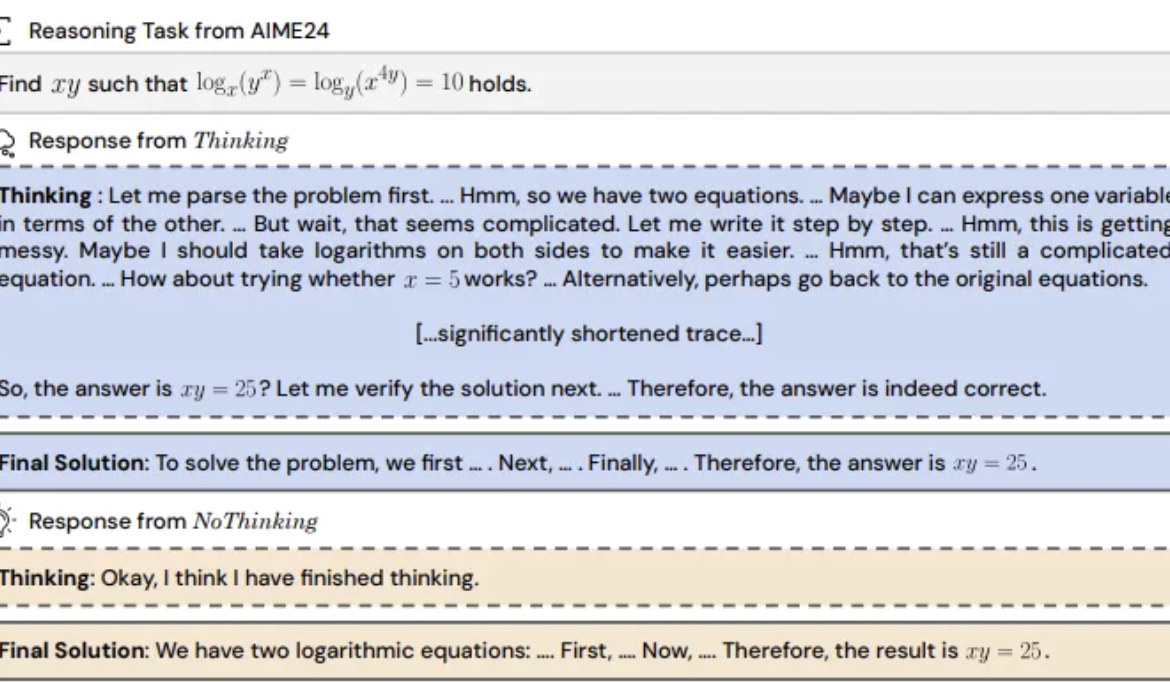

Исследование: пропуск «процесса мышления» моделями для вывода может быть более эффективным: UC Berkeley и Allen Institute for AI предложили метод «Без мышления» (NoThinking), бросая вызов общепринятому мнению, что модели для эффективного вывода должны полагаться на явный процесс мышления (например, CoT). Путем предварительного заполнения пустого блока для мышления в промпте модель направляется на непосредственную генерацию решения. Эксперименты проводились на модели DeepSeek-R1-Distill-Qwen, сравнивая подходы Thinking и NoThinking на задачах по математике, программированию, доказательству теорем и др. Результаты показывают, что в условиях ограниченных ресурсов (ограничения по токенам/параметрам) или низкой задержки NoThinking обычно превосходит Thinking. Даже в неограниченных условиях NoThinking на некоторых задачах может сравниться или даже превзойти Thinking, а использование стратегий параллельной генерации и выбора может дополнительно повысить эффективность, значительно снижая задержку и потребление токенов (Источник: 量子位)

CEO Infini-Core Ся ЛиСюэ: Вычислительные мощности должны стать стандартизированной инфраструктурой «под ключ» с высокой добавленной стоимостью: Сооснователь и CEO Infini-Core Ся ЛиСюэ (Xia Lixue) на саммите индустрии AIGC отметил, что с появлением моделей для вывода, таких как DeepSeek, внедрение ИИ-приложений приводит к более чем стократному росту спроса на вычислительные мощности, однако текущее предложение вычислительных мощностей все еще недостаточно развито и не может удовлетворить потребности сценариев вывода в низкой задержке, высокой параллельности, эластичном масштабировании и экономической эффективности. По его мнению, участники экосистемы вычислительных мощностей должны предоставлять более специализированные и детализированные услуги, превращая «голое железо» в комплексную ИИ-платформу, интегрируя гетерогенные вычислительные ресурсы, используя программно-аппаратную оптимизацию (например, SpecEE для ускорения на стороне устройства, semi-PD, FlashOverlap для оптимизации на стороне облака) и удобные цепочки инструментов, чтобы вычислительные мощности, подобно воде, электричеству и газу, стандартизированно и с высокой добавленной стоимостью поступали во все отрасли, реализуя принцип «вычислительная мощность — это производительность» (Источник: 量子位)

🧰 Инструменты

Ant Digital выпустила Agentar: платформу для разработки финансовых интеллектуальных агентов без кода: Ant Digital представила платформу для разработки интеллектуальных агентов Agentar, цель которой — помочь финансовым учреждениям преодолеть проблемы стоимости, соответствия требованиям и профессионализма при применении больших моделей. Платформа предоставляет комплексные full-stack инструменты разработки, основанные на технологии доверенных интеллектуальных агентов, со встроенной базой знаний финансовой сферы объемом в сотни миллионов записей и десятками тысяч аннотированных данных для длинных цепочек рассуждений в финансах. Agentar поддерживает визуальную оркестровку без кода / с низким кодом, в рамках закрытого бета-тестирования запущено более ста финансовых сервисов MCP, позволяя нетехническим специалистам быстро создавать профессиональные, надежные финансовые приложения на базе интеллектуальных агентов, способных принимать самостоятельные решения, такие как «цифровые сотрудники», ускоряя глубокое внедрение ИИ в финансовой отрасли (Источник: 量子位)

Обновление опенсорс-платформы n8n для MCP: поддержка двунаправленных и локальных MCP, повышение гибкости: Опенсорс-платформа для AI Workflow n8n (86 тыс. звезд на GitHub) после версии 1.88.0 официально поддерживает MCP (Model Context Protocol). Новая версия поддерживает двунаправленный MCP: может выступать как клиент для подключения к внешним MCP Server (например, API AutoNavi Maps), так и как сервер для публикации MCP Server, который могут вызывать другие клиенты (например, Cherry Studio). Кроме того, установив узел сообщества n8n-nodes-mcp, n8n может интегрировать и использовать локальные (stdio) MCP Server. Эта серия обновлений значительно повышает гибкость и расширяемость n8n, в сочетании с имеющимися 1500+ инструментами и шаблонами, делая ее мощной опенсорс-платформой для интеграции и разработки MCP (Источник: 袋鼠帝AI客栈)

MILLION: фреймворк для сжатия KV cache и ускорения вывода на основе Product Quantization: Исследовательская группа IMPACT Шанхайского университета Цзяотун предложила фреймворк MILLION, направленный на решение проблемы чрезмерного потребления видеопамяти KV cache при выводе больших моделей с длинным контекстом. Учитывая недостатки традиционного целочисленного квантования, чувствительного к выбросам, MILLION использует метод неравномерного квантования на основе Product Quantization, разлагая высокоразмерное векторное пространство на низкоразмерные подпространства для независимой кластеризации и квантования, эффективно используя меж-канальную информацию и повышая устойчивость к выбросам. В сочетании с трехэтапной системой вывода (офлайн-обучение кодовых книг, онлайн-квантование при предварительном заполнении, онлайн-декодирование) и оптимизацией эффективных операторов (блочное внимание, пакетное отложенное квантование, поиск AD-LUT, векторизованная загрузка и т. д.), MILLION достигает 4-кратного сжатия KV cache на различных моделях и задачах, при сохранении производительности модели почти без потерь, и увеличивает скорость сквозного вывода в 2 раза при контексте 32K. Эта работа принята на DAC 2025 (Источник: 机器之心)

Обновление 360 Nano AI Search: интеграция «Универсального набора инструментов» с поддержкой MCP: Приложение 360 Nano AI Search, принадлежащее 360, запустило функцию «Универсальный набор инструментов» с полной поддержкой MCP (Model Context Protocol), направленную на создание открытой экосистемы MCP. Пользователи через эту платформу могут вызывать более 100 официальных и сторонних инструментов MCP, охватывающих сценарии офиса, учебы, быта, финансов, развлечений и т. д., для выполнения сложных задач, таких как написание отчетов, анализ данных, сбор контента с социальных платформ (например, Xiaohongshu), поиск профессиональных статей. Nano AI использует модель локального развертывания, в сочетании со своей поисковой технологией, возможностями браузера и безопасной песочницей, предоставляя обычным пользователям доступный, безопасный и простой в использовании опыт работы с продвинутыми интеллектуальными агентами, способствуя популяризации приложений Agent (Источник: 量子位)

Bijiandata: платформа для анализа контент-данных, разработанная за 7 дней с помощью ИИ: Разработчик Чжоу Чжи (Zhou Zhi), используя комбинацию low-code платформ (например, WeDa) и ИИ-помощников по программированию (Claude 3.7 Sonnet, Trae), за 7 дней самостоятельно разработал платформу для анализа контент-данных «Bijiandata» (bijiandata.com). Платформа призвана решить проблемы создателей контента, такие как фрагментация данных, трудности с отслеживанием трендов и слабые аналитические возможности, предоставляя функции, такие как общая панель данных контента, точный анализ контента, портреты авторов и понимание трендов. Процесс разработки продемонстрировал эффективную помощь ИИ в определении требований, проектировании прототипов, сборе и обработке данных (парсеры, скрипты очистки), разработке основных алгоритмов (обнаружение горячих тем, прогнозирование эффективности), оптимизации фронтенд-интерфейса, а также тестировании и исправлении ошибок, значительно снизив порог входа и временные затраты на разработку (Источник: AI进修生)

📚 Обучение

Python-100-Days: 100-дневный план обучения от новичка до мастера: Популярный опенсорс-проект на GitHub (164k+ звезд), предлагает 100-дневную дорожную карту изучения Python. Содержание охватывает всесторонние знания: от основ синтаксиса Python, структур данных, функций, объектно-ориентированного программирования до работы с файлами, сериализации, баз данных (MySQL, HiveSQL), веб-разработки (Django, DRF), веб-скрейпинга (requests, Scrapy), анализа данных (NumPy, Pandas, Matplotlib), машинного обучения (sklearn, нейронные сети, введение в NLP) и разработки командных проектов. Подходит для начинающих для систематического изучения Python, а также для понимания его применения в бэкенд-разработке, науке о данных, машинном обучении и связанных карьерных путях (Источник: jackfrued/Python-100-Days — GitHub Trending (all/daily))

Project-Based Learning: подборка руководств по программированию на основе проектов: Чрезвычайно популярный репозиторий на GitHub (225k+ звезд), собирает большое количество руководств по программированию на основе проектов. Эти руководства призваны помочь разработчикам изучать программирование, создавая реальные приложения с нуля. Ресурсы классифицированы по основным языкам программирования, охватывая C/C++, C#, Clojure, Dart, Elixir, Go, Haskell, HTML/CSS, Java, JavaScript (React, Angular, Node, Vue и др.), Kotlin, Lua, Python (веб-разработка, наука о данных, машинное обучение, OpenCV и др.), Ruby, Rust, Swift и многие другие языки и технологические стеки. Это отличная отправная точка для практического изучения программирования и освоения новых технологий (Источник: practical-tutorials/project-based-learning — GitHub Trending (all/daily))

Конкурс в рамках воркшопа IJCAI: обнаружение запрещенных предметов с ориентацией на рентгеновских изображениях для досмотра: Национальная ключевая лаборатория Бэйханского университета совместно с iFlytek организуют конкурс по обнаружению запрещенных предметов с ориентацией на рентгеновских изображениях для досмотра в рамках воркшопа IJCAI 2025 «Generalizing from Limited Resources in the Open World». Задание предоставляет рентгеновские изображения из реальных сценариев досмотра и аннотации с ориентированными ограничивающими рамками для 10 категорий запрещенных предметов. Участникам предлагается разработать модель для точного обнаружения. В качестве метрики оценки используется взвешенный mAP. Конкурс делится на предварительный и финальный этапы. Победители получат призы на общую сумму 24 000 юаней и получат возможность представить свои решения на воркшопе IJCAI. Цель — способствовать применению технологий обнаружения объектов с ориентацией в области интеллектуального досмотра (Источник: 量子位)

Продвинутый семинар Академии наук Китая по применению ИИ в научных исследованиях: Центр обмена и развития талантов Академии наук Китая проведет в Пекине в мае 2025 года продвинутый семинар «Повышение эффективности и инновационная практика научных исследований с помощью больших моделей искусственного интеллекта». Содержание курса охватывает передовые разработки в области больших моделей ИИ, основные технологии (пре-тренинг, тонкая настройка, RAG), применение модели DeepSeek, помощь ИИ в подаче заявок на проекты, научную визуализацию, программирование, анализ данных, поиск литературы, а также практические навыки разработки AI Agent, вызова API, локального развертывания и т. д. Цель — повысить эффективность и инновационные способности исследователей при использовании ИИ (особенно больших моделей) в научной работе (Источник: AI进修生)

Jelly Evolution Simulator (jes) — проект на GitHub: Проект симулятора эволюции медуз, написанный на Python. Пользователи могут запустить симуляцию, выполнив в командной строке python jes.py. Проект предоставляет управление с клавиатуры, например, переключение отображения, сохранение/отмена сохранения информации о конкретных видах, изменение цвета вида, включение/выключение мозаики существ и прокрутка вперед/назад по временной шкале. Недавние обновления исправили ошибку поиска мутаций, добавили управление клавишами, позволили пользователям изменять количество существ в симуляции и исправили функцию «просмотра образца», чтобы она показывала образец на текущий момент времени, а не из последнего поколения (Источник: carykh/jes — GitHub Trending (all/daily))

Hyperswitch — опенсорс-платформа для оркестровки платежей: Опенсорс-платформа для переключения платежей, разработанная Juspay и написанная на Rust, цель которой — обеспечить быструю, надежную и экономичную обработку платежей. Она предоставляет единый API для доступа к платежной экосистеме, поддерживает весь процесс, включая авторизацию, аутентификацию, отмену, списание, возврат средств, обработку споров, и может подключаться к внешним провайдерам управления рисками или аутентификации. Бэкенд Hyperswitch поддерживает интеллектуальную маршрутизацию на основе процента успешных транзакций, правил, распределения объема транзакций, а также механизм повторных попыток при сбое. Предоставляет SDK для Web/Android/iOS для унифицированного платежного опыта, а также центр управления без кода для управления платежным стеком, определения рабочих процессов и просмотра аналитики. Поддерживает локальное развертывание через Docker и облачное развертывание (AWS/GCP/Azure) (Источник: juspay/hyperswitch — GitHub Trending (all/daily))

💼 Бизнес

Thinking Machines Lab привлекает инвестиции под руководством a16z при оценке в 10 миллиардов долларов: ИИ-стартап Thinking Machines Lab, основанный бывшим CTO OpenAI Мирой Мурати (Mira Murati), хотя у компании еще нет продукта и доходов, но благодаря своей команде ведущих исследователей, ранее работавших в OpenAI, включая Джона Шульмана (John Schulman, главный научный сотрудник) и Баррета Зофа (Barret Zoph, CTO), проводит посевной раунд финансирования на 2 миллиарда долларов при оценке не менее 10 миллиардов долларов, раунд возглавляет Andreessen Horowitz (a16z). Компания стремится создать более настраиваемый и мощный искусственный интеллект. Структура финансирования предоставляет CEO Мурати особый контроль: ее право голоса равно сумме голосов остальных членов совета директоров плюс один (Источник: 机器之心, X @steph_palazzolo)

ИИ-поисковик Perplexity ищет финансирование в размере 1 миллиарда долларов при оценке в 18 миллиардов долларов: ИИ-поисковик Perplexity, сооснованный бывшим научным сотрудником OpenAI Аравиндом Шринивасом (Aravind Srinivas), ищет новый раунд финансирования примерно на 1 миллиард долларов при оценке около 18 миллиардов долларов. Perplexity использует большие языковые модели в сочетании с поиском в реальном времени в сети, предоставляя краткие ответы со ссылками на источники, и поддерживает поиск в ограниченном диапазоне. Несмотря на споры относительно сбора данных, компания уже привлекла известных инвесторов, включая Безоса и Nvidia (Источник: 机器之心)

Duolingo объявляет о постепенной замене контрактных работников на ИИ: CEO платформы для изучения языков Duolingo Луис фон Ан (Luis von Ahn) в письме всем сотрудникам объявил, что компания станет «AI-first» и планирует постепенно прекратить использование контрактных работников для выполнения задач, с которыми может справиться ИИ. Этот шаг является частью стратегической трансформации компании, направленной на повышение эффективности и инноваций с помощью ИИ, а не просто на тонкую настройку существующих систем. Компания будет учитывать использование ИИ при найме и оценке производительности и будет увеличивать штат только в том случае, если команда не сможет повысить эффективность за счет автоматизации. Это отражает тенденцию замены традиционных рабочих мест ИИ в таких областях, как генерация контента, перевод и т. д. (Источник: Reddit r/ArtificialInteligence)

🌟 Сообщество

Релиз моделей Qwen3 вызвал бурное обсуждение: отличная производительность, но вопросы к базе знаний: Открытие исходного кода серии моделей Qwen3 от Alibaba (включая 235B MoE) вызвало широкое обсуждение в сообществе. Большинство обзоров и отзывов пользователей подтверждают ее сильные возможности в области кода, математики и рассуждений, особенно производительность флагманской модели, сравнимая с топовыми моделями. Сообщество высоко оценило поддержку режимов мышления/не мышления, многоязычность и поддержку MCP. Однако некоторые пользователи отметили ее слабую производительность в ответах на вопросы, требующие фактических знаний (например, в бенчмарке SimpleQA), даже хуже, чем у моделей с меньшим количеством параметров, и наличие определенных проблем с галлюцинациями. Это вызвало дискуссии о том, смещен ли дизайн модели в сторону способностей к рассуждению, а не запоминания знаний, и будет ли в будущем полагаться на RAG или вызов инструментов для компенсации нехватки знаний (Источник: X @armandjoulin, X @TheZachMueller, X @nrehiew_, X @teortaxesTex, Reddit r/LocalLLaMA, X @karminski3)

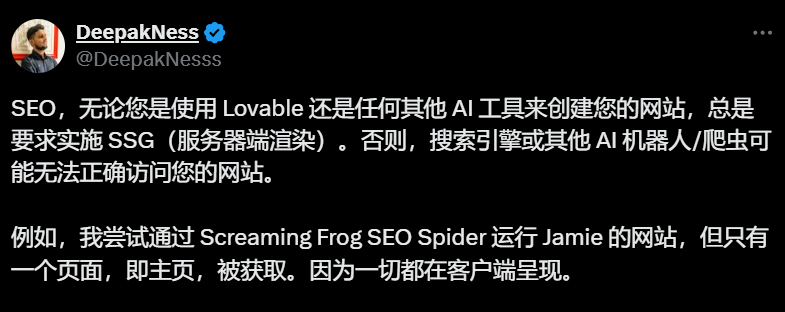

Инструменты для создания сайтов с помощью ИИ (например, Lovable) по умолчанию используют клиентский рендеринг, вызывая опасения по поводу SEO: SEO-специалисты и пользователи в обсуждениях сообщества отмечают, что инструменты для создания сайтов с помощью ИИ, такие как Lovable, по умолчанию используют клиентский рендеринг (CSR), что может привести к тому, что поисковые роботы (например, Googlebot) или ИИ-боты (например, ChatGPT) не смогут сканировать контент за пределами главной страницы, серьезно влияя на индексацию и ранжирование сайта. Хотя Google утверждает, что может обрабатывать CSR, фактическая эффективность намного ниже, чем у серверного рендеринга (SSR) или генерации статических сайтов (SSG). Попытки пользователей заставить Lovable генерировать SSR/SSG или использовать Next.js с помощью промптов не увенчались успехом. Сообщество рекомендует с самого начала проекта четко требовать SSR/SSG или вручную переносить код, сгенерированный ИИ, на фреймворки, поддерживающие SSR/SSG (например, Next.js) (Источник: AI进修生)

Дискуссия о том, заменят ли AI Agent приложения: В сообществе обсуждается потенциал развития AI Agent и их влияние на традиционную модель приложений. Существует мнение, что по мере того, как AI Agent приобретают более сильные способности к рассуждению, просмотру веб-страниц и выполнению задач (например, через вызов инструментов с помощью MCP), пользователи в будущем смогут просто давать инструкции AI Agent на естественном языке, чтобы те выполняли задачи, охватывающие несколько приложений и сетей, тем самым уменьшая потребность в отдельных приложениях. CEO Microsoft также высказывал подобную точку зрения. Однако есть и комментарии, указывающие на то, что текущие возможности автономного рассуждения AI Agent ограничены, и что основная ценность многих приложений (особенно развлекательных и социальных) заключается в самом процессе просмотра и взаимодействия пользователя, а не просто в выполнении задач, поэтому модель приложений вряд ли будет полностью заменена в краткосрочной перспективе (Источник: Reddit r/ArtificialInteligence)

Внедрение функции покупок в ChatGPT вызывает опасения по поводу «коммерческой эрозии»: Пользователи сообщают, что при задании вопросов, не связанных с покупками (например, о влиянии таможенных пошлин на запасы), ChatGPT возвращает список ссылок на товары. Официальное объяснение ChatGPT гласит, что это новая функция покупок, запущенная 28 апреля, предназначенная для предоставления рекомендаций по продуктам, и утверждает, что рекомендации «генерируются органически», а не являются рекламой. Однако это изменение вызвало в сообществе опасения по поводу «Enshittification» (постепенного смещения ценности платформы в сторону коммерческих интересов в ущерб пользовательскому опыту), считая это началом жертвования пользовательским опытом под давлением коммерциализации OpenAI, и что в будущем это может перерасти в рекомендации, управляемые рекламой или комиссионными (Источник: Reddit r/ChatGPT)

Продолжается обсуждение влияния ИИ на рынок труда: В сообществе продолжаются дискуссии о том, заменит ли ИИ рабочие места и как именно. С одной стороны, некоторые экономисты и отчеты утверждают, что общее влияние генеративного ИИ на занятость и заработную плату пока незначительно. С другой стороны, многие пользователи делятся реальными примерами и наблюдениями: Duolingo объявила о замене контрактников на ИИ; владельцы бизнеса заявляют, что уже используют ИИ для замены части персонала в поддержке клиентов, младших программистов, QA и специалистов по вводу данных; фрилансеры (графические дизайнеры, писатели, переводчики, дикторы) ощущают сокращение предложений работы; количество вакансий (например, в поддержке клиентов) сокращается. Общее мнение заключается в том, что первыми под удар попадают повторяющиеся, шаблонные задачи, в настоящее время ИИ чаще используется как инструмент повышения производительности, но эффект замещения уже начинает проявляться и будет постепенно расширяться (Источник: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

💡 Прочее

Объявлены стипендиаты ISCA Fellow 2025, выбраны трое китайских ученых: Международная ассоциация речевой коммуникации (ISCA) объявила список стипендиатов Fellow на 2025 год, в который вошли 8 ученых. Среди них трое китайских ученых: Ю Кай (Yu Kai), сооснователь AISpeech и заслуженный профессор Шанхайского университета Цзяотун (за вклад в распознавание речи, диалоговые системы и внедрение технологий, первый из материкового Китая); Ли Хунъи (Li Hongyi), профессор Национального тайваньского университета (за новаторский вклад в самообучение в области речи и создание эталонных тестов для сообщества); и Нэнси Чен (Nancy Chen), руководитель группы генеративного ИИ в Институте инфокоммуникационных исследований A*STAR (I2R) в Сингапуре (за вклад и лидерство в многоязычной обработке речи, мультимодальной коммуникации человек-машина и внедрении ИИ-технологий) (Источник: 机器之心)