Ключевые слова:Развитие ИИ, Grok 3, Gemma 3, Применение ИИ, Смена парадигмы развития ИИ, API xAI Grok 3, Google Gemma 3 QAT, Оценка ИИ VideoGameBench, Ускорение молекулярных открытий с помощью ИИ, Федеративное обучение в медицинской визуализации, Агент знаний LlamaIndex, Технология самовосстановления кода ИИ

🔥 Фокус

Смена парадигмы в развитии ИИ: от погони за рекордами к созданию ценности: Блог исследователя OpenAI Яо Шунью вызвал дискуссию, утверждая, что развитие ИИ вступило во вторую фазу. Первая фаза была сосредоточена на инновациях в алгоритмах и достижении высоких результатов в бенчмарках (например, AlphaGo, GPT-4), прорывы в обобщении были достигнуты за счет сочетания крупномасштабного предварительного обучения (предоставляющего априорные знания) и обучения с подкреплением (RL), а также введения концепции «рассуждение как действие». Однако он считает, что предельная полезность постоянной погони за рекордами снижается, и во второй фазе следует перейти к определению проблем, имеющих реальную прикладную ценность, разработке методов оценки, более приближенных к реальному миру, мышлению как менеджер продукта, и действительному использованию ИИ для создания пользовательской и социальной ценности, а не простому стремлению к улучшению показателей. Это знаменует собой сдвиг в мышлении в области ИИ от преобладания технологических исследований к акценту на внедрении приложений и реализации ценности (Источник: dotey)

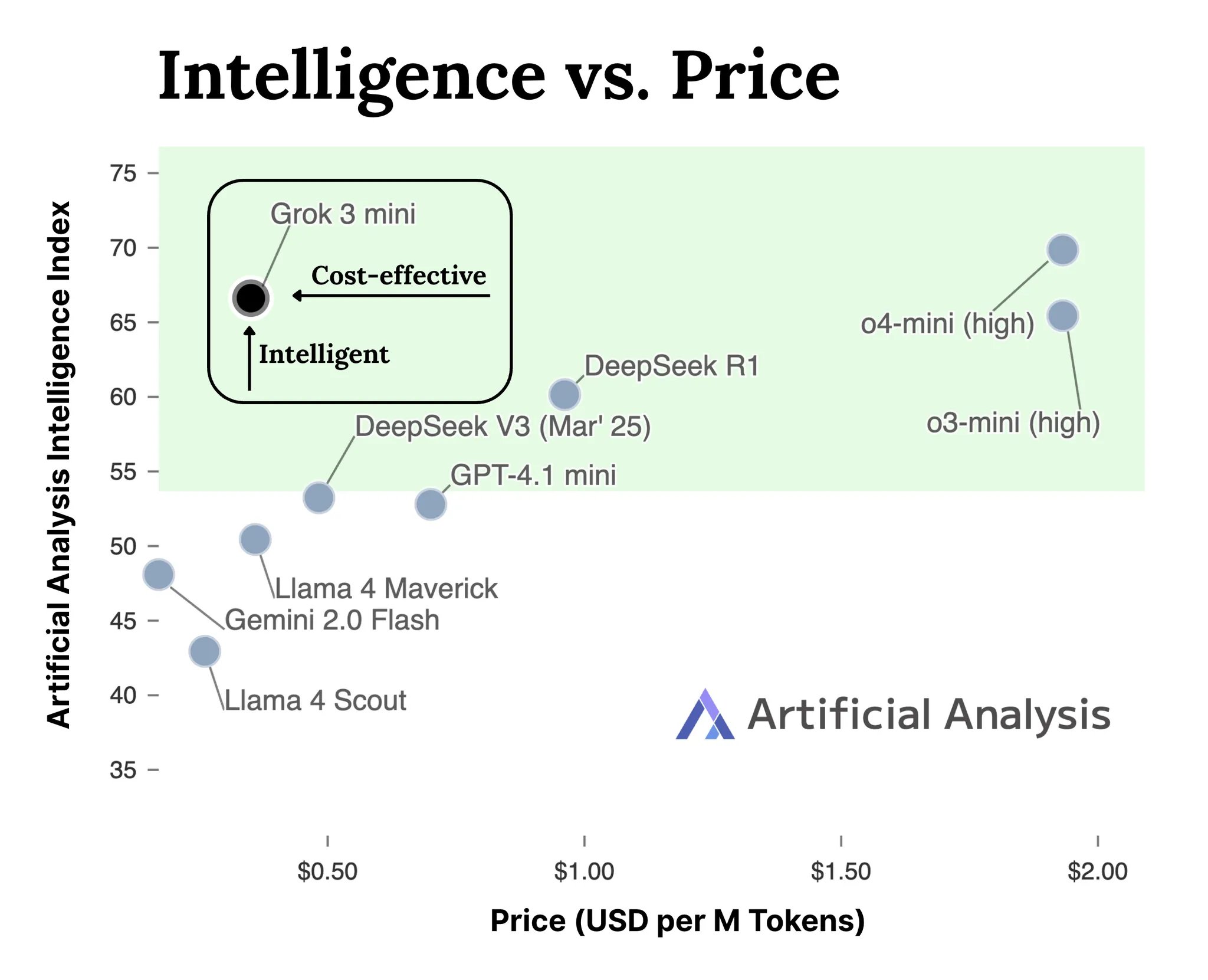

xAI выпускает API для моделей серии Grok 3: xAI официально запустила API-интерфейсы для моделей серии Grok 3 (docs.x.ai), открывая свои новейшие модели для разработчиков. Серия включает Grok 3 Mini и Grok 3. По словам xAI, Grok 3 Mini демонстрирует превосходные возможности рассуждения при сохранении низкой стоимости (утверждается, что она в 5 раз ниже, чем у аналогичных моделей для инференса); в то время как Grok 3 позиционируется как мощная модель без акцента на рассуждении (возможно, имеется в виду для задач, требующих больших знаний), показывающая выдающиеся результаты в областях, требующих знаний о реальном мире, таких как право, финансы и медицина. Этот шаг знаменует собой вступление xAI в конкуренцию на рынке API моделей ИИ, предоставляя разработчикам новые возможности (Источник: grok, grok)

VideoGameBench: оценка способностей ИИ-агентов с помощью классических игр: Исследователи представили предварительную версию бенчмарка VideoGameBench, предназначенного для оценки способностей визуально-языковых моделей (VLM) выполнять задачи в 20 классических видеоиграх (таких как Doom II) в реальном времени. Предварительные тесты показали, что ведущие модели, включая GPT-4o, Claude Sonnet 3.7, Gemini 2.5 Pro, по-разному проявили себя в Doom II, но ни одна не смогла пройти первый уровень. Это указывает на то, что, несмотря на мощные возможности моделей во многих задачах, они все еще сталкиваются с трудностями в сложных динамических средах, требующих восприятия, принятия решений и действий в реальном времени. Этот бенчмарк предоставляет новый инструмент для измерения и стимулирования прогресса ИИ-агентов в интерактивных средах (Источник: Reddit r/LocalLLaMA)

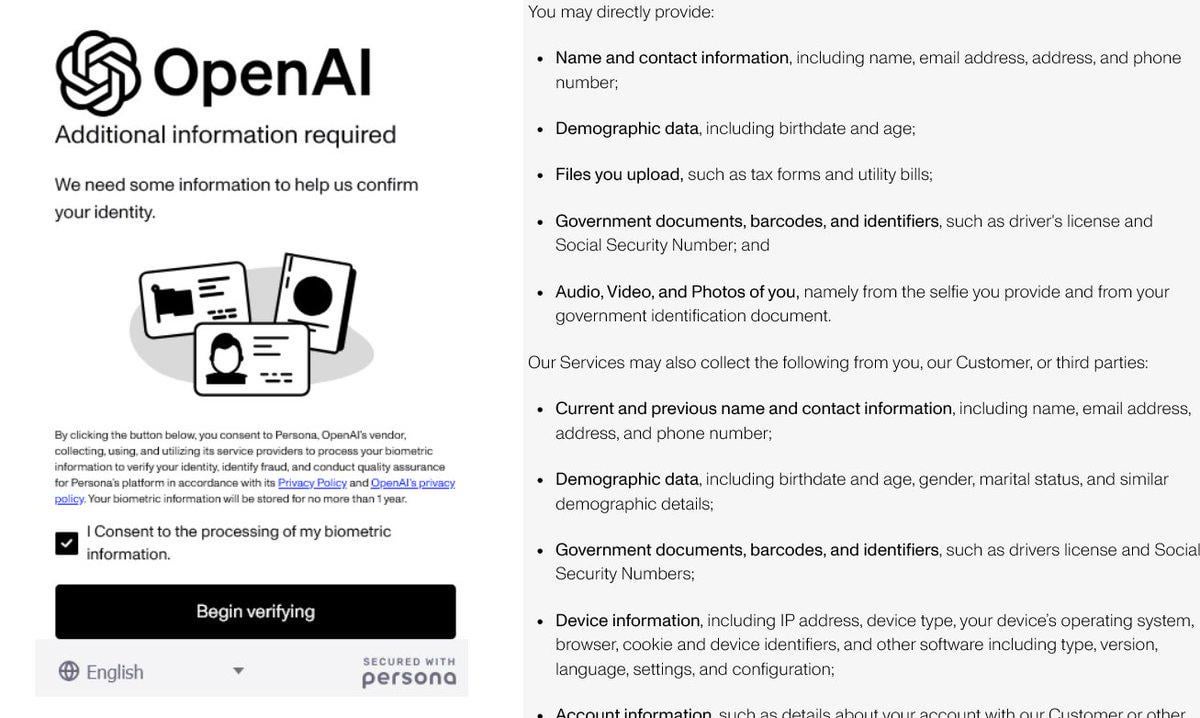

Усиление верификации личности в OpenAI вызывает споры: Сообщается, что OpenAI требует от пользователей предоставления подробных документов, удостоверяющих личность (таких как паспорт, налоговые декларации, счета за коммунальные услуги), для доступа к некоторым своим продвинутым моделям (особенно к o3 с сильными возможностями рассуждения). Эта мера вызвала резкую негативную реакцию в сообществе, пользователи повсеместно обеспокоены утечкой конфиденциальности и повышением порога доступа. Хотя OpenAI может действовать из соображений безопасности, соответствия требованиям или управления ресурсами, такое строгое требование верификации контрастирует с ее открытым имиджем и может побудить пользователей перейти к альтернативам с лучшей защитой конфиденциальности или более легким доступом, особенно к локальным моделям (Источник: Reddit r/LocalLLaMA)

ИИ ускоряет открытие молекул: симуляция миллионов лет эволюции природы: В социальных сетях обсуждается, что искусственный интеллект способен за несколько дней разработать молекулу, на эволюцию которой в природе могло бы уйти 500 миллионов лет. Хотя конкретные детали требуют проверки, это подчеркивает огромный потенциал ИИ в ускорении научных открытий, особенно в химии и биологии. ИИ способен исследовать обширное химическое пространство, предсказывать свойства молекул со скоростью, значительно превосходящей традиционные экспериментальные методы и естественную эволюцию, и обещает прорывные достижения в таких областях, как разработка лекарств и материаловедение (Источник: Ronald_vanLoon)

🎯 Динамика

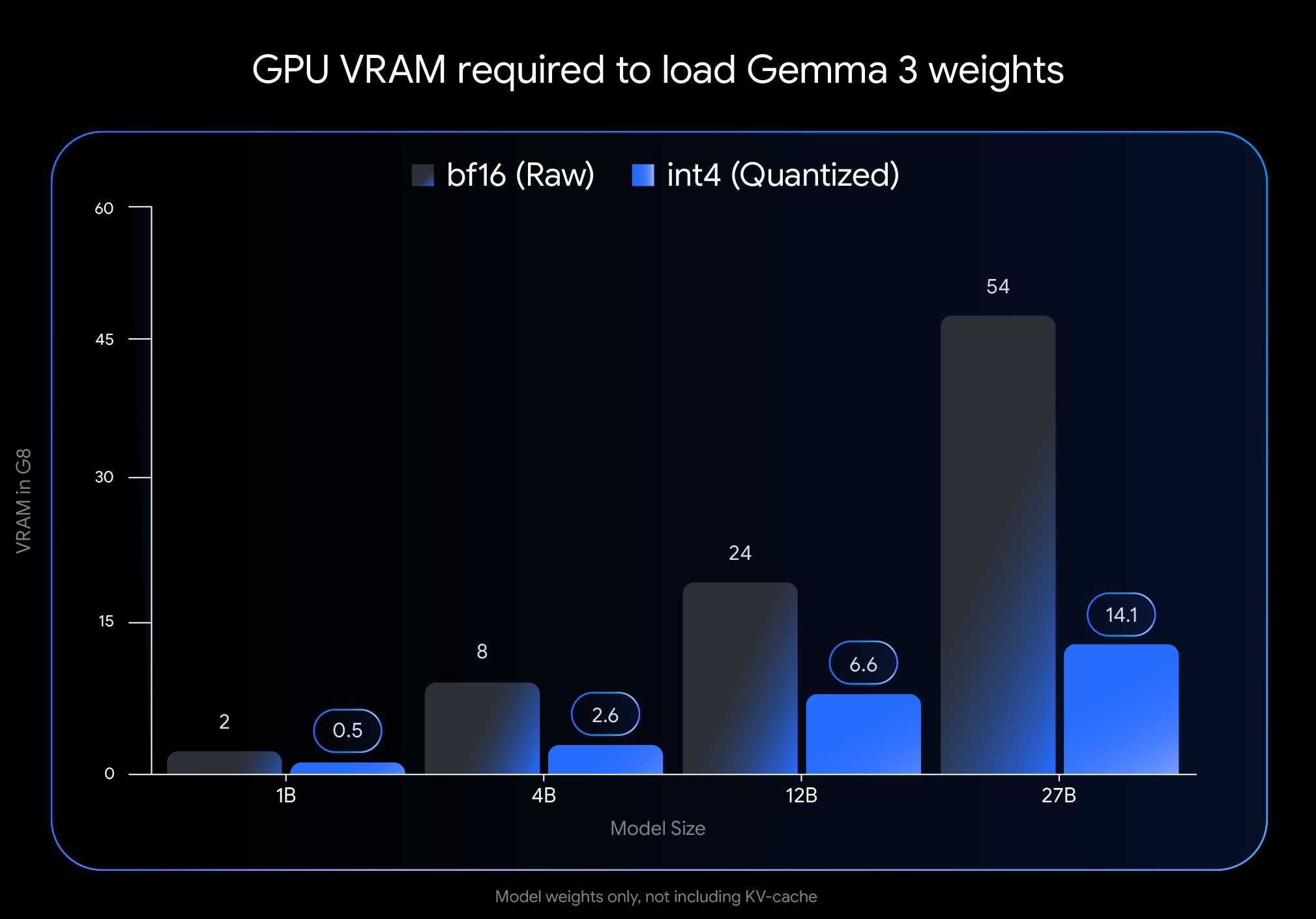

Google выпускает QAT-версию Gemma 3, значительно снижая порог развертывания: Google DeepMind представила версии модели Gemma 3, прошедшие квантование с учетом обучения (Quantization-Aware Training, QAT). Технология QAT направлена на максимальное сохранение производительности исходной модели при значительном сжатии ее размера. Например, размер модели Gemma 3 27B уменьшился с 54 ГБ (bf16) до примерно 14,1 ГБ (int4), что позволяет запускать передовую модель, ранее требовавшую высокопроизводительных облачных GPU, на потребительских настольных GPU (таких как RTX 3090). Google выпустила неквантованные контрольные точки QAT и модели в различных форматах (MLX, GGUF), а также сотрудничает с инструментами сообщества, такими как Ollama, LM Studio, llama.cpp, чтобы разработчики могли легко использовать их на различных платформах, что значительно способствует популяризации высокопроизводительных моделей с открытым исходным кодом (Источник: huggingface, JeffDean, demishassabis, karminski3, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Meta FAIR публикует результаты исследований в области восприятия, придерживаясь курса на открытый исходный код: Meta FAIR опубликовала несколько новых результатов исследований в области продвинутого машинного интеллекта (Advanced Machine Intelligence, AMI), особенно в области восприятия, включая выпуск крупномасштабного визуального кодировщика Meta Perception Encoder. Янн ЛеКун подчеркнул, что эти результаты будут опубликованы с открытым исходным кодом. Это свидетельствует о том, что Meta продолжает инвестировать в фундаментальные исследования ИИ и стремится делиться своими достижениями через открытый исходный код, способствуя развитию всей области. Выпущенные инструменты, такие как визуальный кодировщик, принесут пользу широкому сообществу исследователей и разработчиков (Источник: ylecun)

OpenAI уточняет ограничения на использование моделей: OpenAI четко определила лимиты использования моделей для своих пользователей ChatGPT Plus, Team и Enterprise. В частности, для модели o3 установлено ограничение в 50 сообщений в неделю, для o4-mini — 150 в день, а для o4-mini-high — 50 в день. Утверждается, что ChatGPT Pro (возможно, имеется в виду конкретный тарифный план или ошибка) имеет неограниченный доступ. Эти ограничения напрямую влияют на активных пользователей и разработчиков приложений, зависящих от конкретных моделей, и их необходимо учитывать при планировании использования (Источник: dotey)

LlamaIndex интегрируется с базами данных Google Cloud для создания агентов знаний: На конференции Google Cloud Next 2025 LlamaIndex продемонстрировал, как его фреймворк интегрируется с базами данных Google Cloud для создания агентов знаний, способных выполнять многоэтапные исследования, обрабатывать документы и генерировать отчеты. В демонстрации был представлен пример мультиагентной системы, автоматически генерирующей руководство для новых сотрудников. Это показывает тенденцию глубокой интеграции фреймворков ИИ-приложений с облачными платформами и их сервисами данных, направленную на решение реальных потребностей предприятий в использовании ИИ для обработки внутренних знаний и данных (Источник: jerryjliu0)

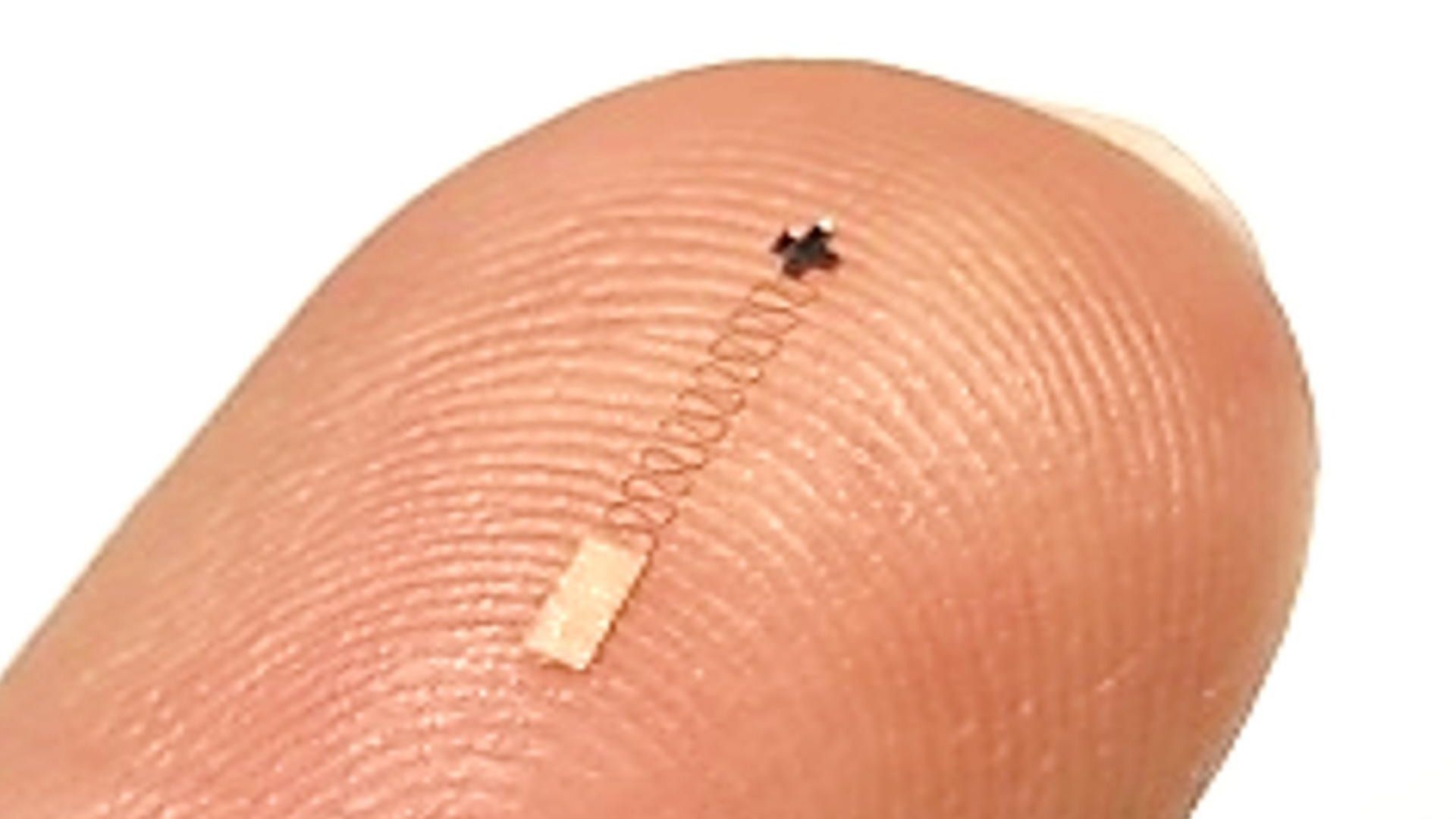

Новый наномозговой сенсор в сочетании с ИИ обеспечивает высокую точность распознавания сигналов: Сообщается о новом наноразмерном мозговом сенсоре, который достиг точности 96,4% в распознавании нейронных сигналов. Хотя сама технология сенсора является ключевым прорывом, достижение такой высокой точности распознавания обычно требует использования передовых алгоритмов ИИ и машинного обучения для декодирования сложных и слабых нейронных сигналов. Это достижение открывает новые пути для исследований мозга и будущих приложений интерфейсов мозг-компьютер, обещая более точный мониторинг и взаимодействие с мозговой активностью (Источник: Ronald_vanLoon)

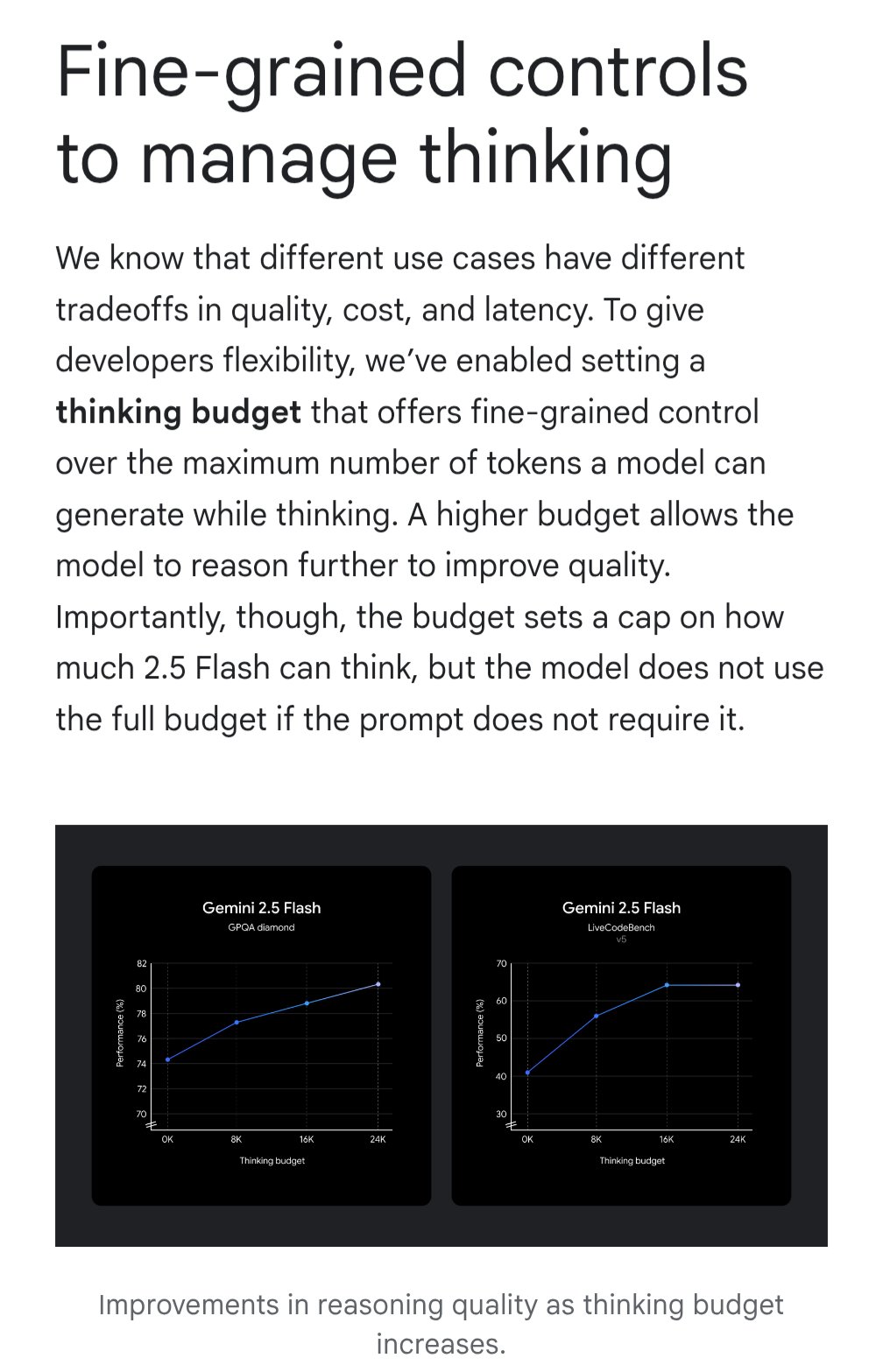

Gemini представляет функцию «бюджета на обдумывание» для оптимизации соотношения затрат и эффективности: Модель Google Gemini вводит функцию «бюджета на обдумывание» (thinking budget), позволяющую пользователям регулировать вычислительные ресурсы или глубину «обдумывания», выделяемые моделью при обработке запроса. Функция предназначена для того, чтобы пользователи могли найти компромисс между качеством ответа, стоимостью и задержкой. Это очень полезная функция для пользователей API, позволяющая гибко контролировать затраты на использование модели и ее производительность в зависимости от конкретного сценария применения (Источник: JeffDean)

Качество УЗИ, проводимого с помощью ИИ, сопоставимо с качеством работы экспертов: Исследование, опубликованное в JAMA Cardiology, показало, что качество изображений УЗИ, выполненных обученными медицинскими специалистами под руководством ИИ, достаточно для диагностических стандартов (98,3%) и статистически не отличается от изображений, полученных экспертами без помощи ИИ. Это свидетельствует о том, что ИИ в качестве вспомогательного инструмента может эффективно помочь неспециалистам повысить качество и согласованность выполнения медицинских визуализационных процедур, что потенциально расширит доступность высококачественных диагностических услуг в регионах с ограниченными ресурсами (Источник: Reddit r/ArtificialInteligence)

Исследование MIT повышает точность и структурное соответствие генерируемого ИИ кода: Исследователи MIT разработали более эффективный метод контроля вывода больших языковых моделей, направленный на то, чтобы модель генерировала код, соответствующий определенной структуре (например, синтаксису языка программирования) и без ошибок. Это исследование направлено на решение проблемы надежности генерируемого ИИ кода путем улучшения методов генерации с ограничениями, обеспечивая строгое соблюдение синтаксических правил и тем самым повышая практичность ИИ-помощников по кодированию и снижая затраты на последующую отладку (Источник: Reddit r/ArtificialInteligence)

NVIDIA, возможно, раскроет свой крупный проект в области робототехники: В социальных сетях упоминается, что NVIDIA работает над своим «самым амбициозным проектом», связанным с робототехникой, инженерией, искусственным интеллектом и автономными технологиями. Хотя конкретные детали неизвестны, учитывая центральное положение NVIDIA в области аппаратного обеспечения и платформ ИИ (таких как Isaac), любое связанное с этим крупное объявление привлекает большое внимание и может предвещать дальнейшее стратегическое развертывание и технологические прорывы компании в области воплощенного интеллекта и робототехники (Источник: Ronald_vanLoon)

🧰 Инструменты

Potpie: Специализированный ИИ-инженерный помощник для репозиториев кода: Potpie — это платформа с открытым исходным кодом (GitHub: potpie-ai/potpie), предназначенная для создания кастомизированных ИИ-инженерных агентов для репозиториев кода. Она строит граф знаний кода для понимания сложных взаимосвязей между компонентами, предоставляя автоматизированные задачи анализа кода, тестирования, отладки и разработки. Платформа предлагает несколько предустановленных агентов (например, отладка, вопросы и ответы, анализ изменений кода, генерация модульных/интеграционных тестов, проектирование низкого уровня, генерация кода) и наборы инструментов, а также поддерживает создание пользовательских агентов. Предоставляются расширение для VSCode и интеграция через API для удобного встраивания в процесс разработки (Источник: potpie-ai/potpie — GitHub Trending (all/daily))

1Panel: Панель управления Linux-сервером с интеграцией управления LLM: 1Panel (GitHub: 1Panel-dev/1Panel) — это современная панель управления операциями Linux-сервера с открытым исходным кодом, предоставляющая графический веб-интерфейс для управления хостами, файлами, базами данных, контейнерами и т. д. Одной из ее особенностей является включение функций управления большими языковыми моделями (LLM). Кроме того, она предлагает магазин приложений, быстрое развертывание веб-сайтов (интеграция с WordPress), защиту безопасности и функции резервного копирования и восстановления одним щелчком мыши, направленные на упрощение управления сервером и развертывания приложений, включая развертывание и управление приложениями, связанными с ИИ (Источник: 1Panel-dev/1Panel — GitHub Trending (all/daily))

LlamaIndex выпускает обновленный компонент чат-интерфейса: LlamaIndex выпустила крупное обновление своей библиотеки компонентов чат-интерфейса (@llamaindex/chat-ui). Новый компонент, построенный на базе shadcn UI, имеет более стильный дизайн, адаптивную верстку и полностью настраиваемый. Он призван помочь разработчикам легче создавать красивые, удобные для пользователя чат-интерфейсы для проектов на базе LLM, улучшая интерактивный опыт ИИ-приложений. Разработчики могут установить его через npm и использовать непосредственно в своих проектах (Источник: jerryjliu0)

Практическое применение LlamaExtract: создание приложения для финансового анализа: LlamaIndex продемонстрировал пример создания полнофункционального веб-приложения с использованием своего инструмента LlamaExtract (часть LlamaCloud). LlamaExtract позволяет пользователям определять точные схемы (Schema) для извлечения структурированных данных из сложных документов. Пример приложения извлекает факторы риска из годовых отчетов компаний и анализирует их изменения за годы, автоматизируя работу, которая ранее занимала более 20 часов. Это приложение имеет открытый исходный код (GitHub: run-llama/llamaextract-10k-demo) и видеодемонстрацию того, как объединить LlamaExtract и Sonnet 3.7 для построения этого рабочего процесса, показывая потенциал ИИ-агентов в автоматизации сложных аналитических задач (Источник: jerryjliu0, jerryjliu0)

mcpbased.com: Запущен каталог MCP-серверов с открытым исходным кодом: Новый веб-сайт mcpbased.com запущен как специализированный каталог MCP-серверов (возможно, имеется в виду Meta Controller Pattern или аналогичная концепция) с открытым исходным кодом. Платформа призвана собирать и демонстрировать различные проекты MCP-серверов, синхронизируя данные с репозиториями Github в реальном времени, чтобы разработчики могли легко находить, просматривать и подключаться к соответствующим инструментам. Для разработчиков, создающих или использующих MCP-серверы, занимающихся интеграцией инструментов или следящих за экосистемой MCP, это новый ресурсный центр (Источник: Reddit r/ClaudeAI)

📚 Обучение

Книга по RLHF появилась на ArXiv: Книга “rlhfbook” об обучении с подкреплением на основе обратной связи от человека (Reinforcement Learning from Human Feedback, RLHF), написанная Натаном Ламбертом и др., теперь опубликована на платформе ArXiv (номер 2504.12501). RLHF является одной из ключевых технологий для согласования текущих больших языковых моделей (таких как ChatGPT). Публикация этой книги предоставляет исследователям и практикам важный ресурс для систематического изучения и глубокого понимания принципов и практики RLHF, способствуя распространению и применению знаний в этой области (Источник: natolambert)

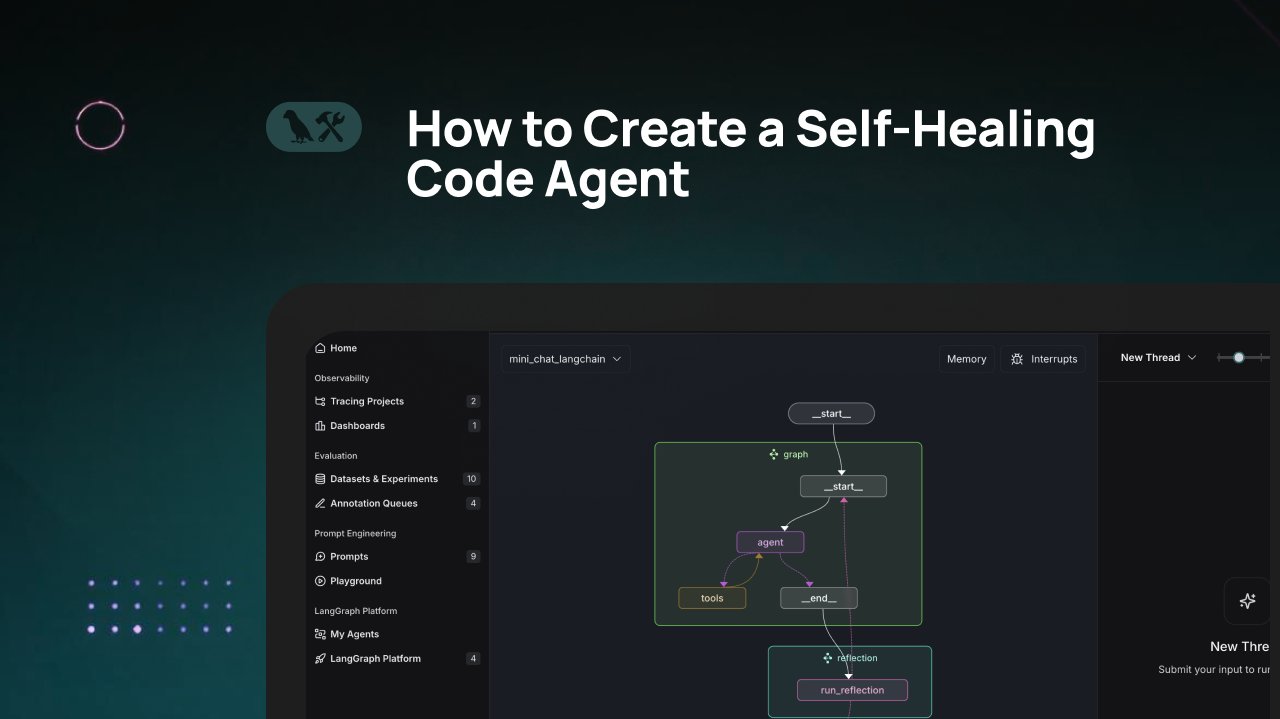

Учебник LangChain: создание агента генерации кода с самовосстановлением: LangChain выпустил видеоучебник, в котором рассказывается, как создать ИИ-агента для генерации кода, обладающего способностью к «самовосстановлению». Основная идея заключается в добавлении шага «рефлексии» (reflection) после генерации кода, позволяющего агенту самостоятельно проверять, оценивать или улучшать сгенерированный им код перед возвратом результата. Этот метод направлен на повышение точности и надежности генерируемого ИИ кода и является эффективной техникой для повышения практичности помощников по кодированию (Источник: LangChainAI)

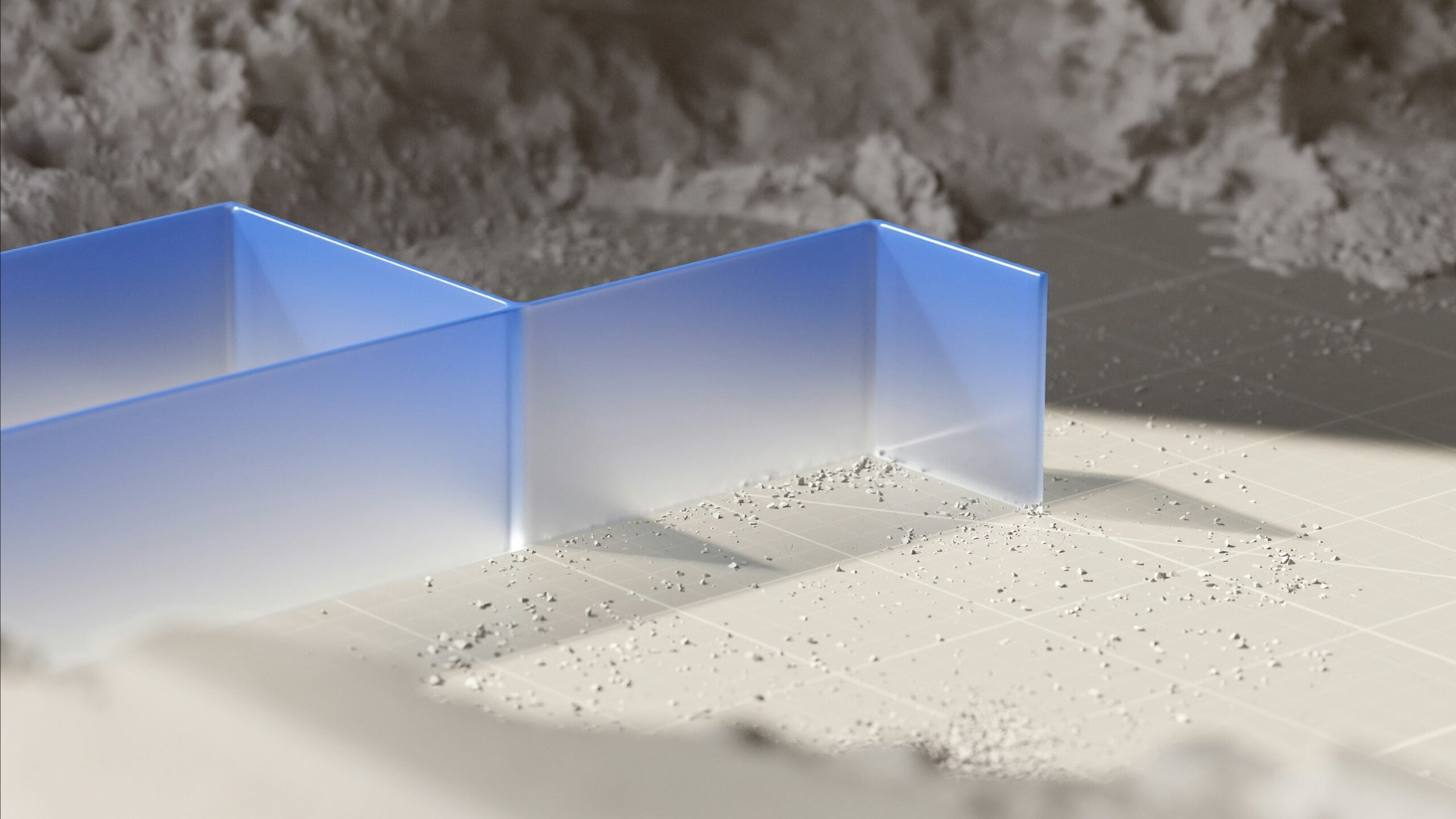

ИИ в сочетании с Blender для создания готовых к использованию в играх 3D-ассетов: В социальных сетях поделились учебником по использованию инструментов ИИ (возможно, для генерации изображений) в сочетании с программой 3D-моделирования Blender для создания готовых к использованию в играх (game-ready) 3D-ассетов. Это решает текущую проблему недостаточной способности ИИ напрямую генерировать 3D-модели, демонстрируя практичный гибридный рабочий процесс: использование ИИ для генерации концептов или текстур, а затем моделирование и оптимизация с помощью профессиональных инструментов, таких как Blender, для получения ресурсов, соответствующих требованиям игровых движков (Источник: huggingface)

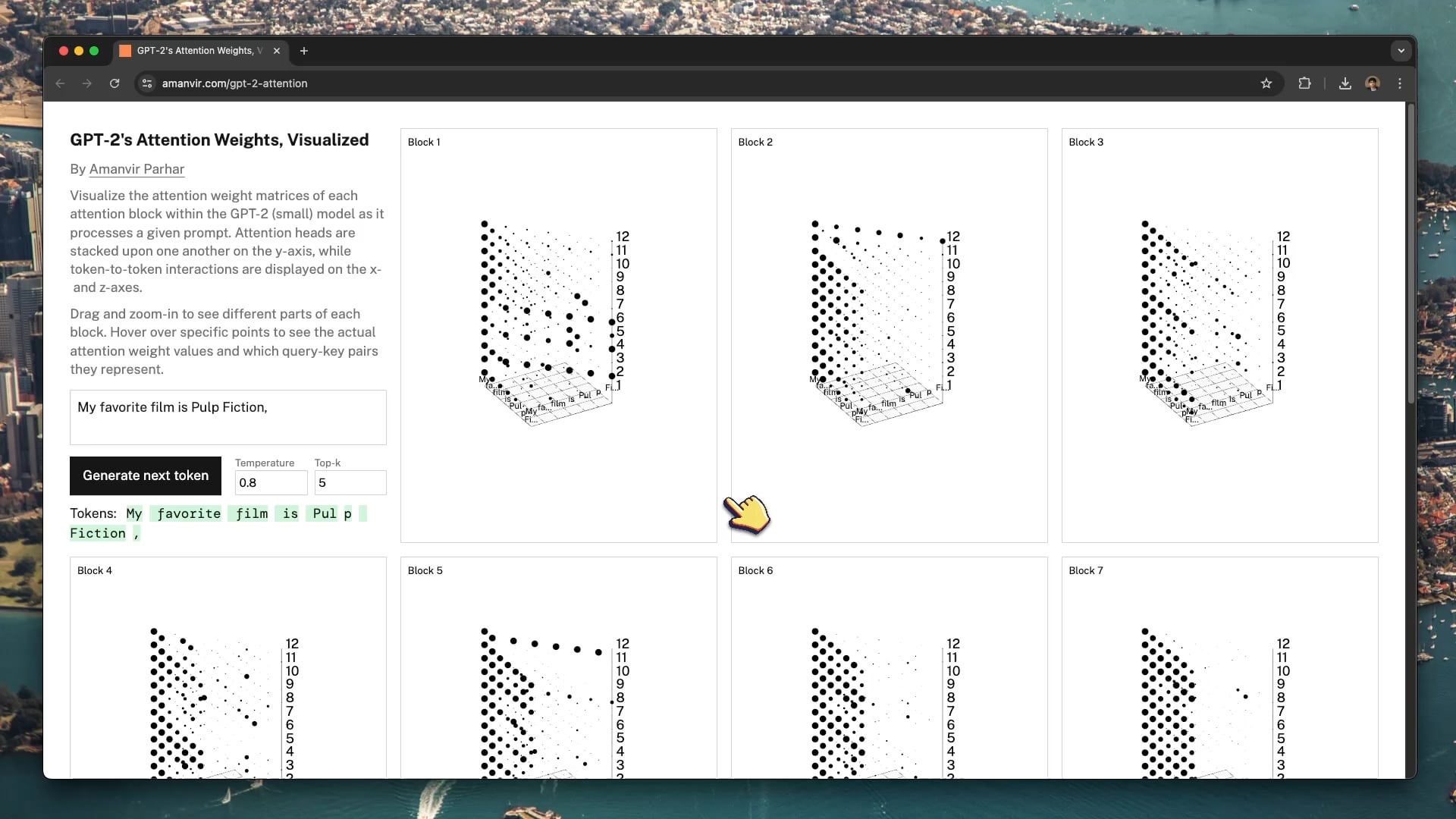

Интерактивный инструмент визуализации помогает понять механизм внимания GPT-2: Разработчик tycho_brahes_nose_ создал и поделился интерактивным 3D-инструментом визуализации (amanvir.com/gpt-2-attention) для демонстрации процесса расчета весов в каждом блоке внимания внутри модели GPT-2 (малой). Пользователи могут наглядно увидеть, как после ввода текста модель вычисляет силу взаимодействия между токенами на разных слоях и в разных головах внимания. Это предоставляет отличную помощь для понимания ключевых механизмов Transformer, способствуя изучению ИИ и исследованиям в области интерпретируемости моделей (Источник: karminski3, Reddit r/LocalLLaMA)

Применение федеративного обучения в анализе медицинских изображений: Пост на Reddit ссылается на статью о применении федеративного обучения (Federated Learning, FL) в сочетании с глубокими нейронными сетями (DNN) для анализа медицинских изображений. Из-за чувствительности медицинских данных к конфиденциальности, FL позволяет совместно обучать модели в нескольких учреждениях без обмена исходными данными. Это имеет решающее значение для продвижения применения ИИ в медицине, и данный ресурс помогает понять эту технологию распределенного обучения с сохранением конфиденциальности и ее практику в медицинской визуализации (Источник: Reddit r/deeplearning)

Сандер Дильман подробно разбирает VAE и латентное пространство: Андрей Карпати рекомендует глубокую статью в блоге Сандера Дильмана (sander.ai/2025/04/15/latents.html) о вариационных автоэнкодерах (VAE) и моделировании латентного пространства. В статье рассматриваются детали обучения VAE, такие как ограниченная фактическая роль члена KL-дивергенции в формировании латентного пространства, а также причины, по которым потери реконструкции L1/L2 склонны приводить к размытым изображениям (затухание спектра изображения не соответствует приоритетам человеческого восприятия). Статья предоставляет строгий и проницательный анализ для понимания генеративных моделей (Источник: Reddit r/MachineLearning)

💼 Бизнес

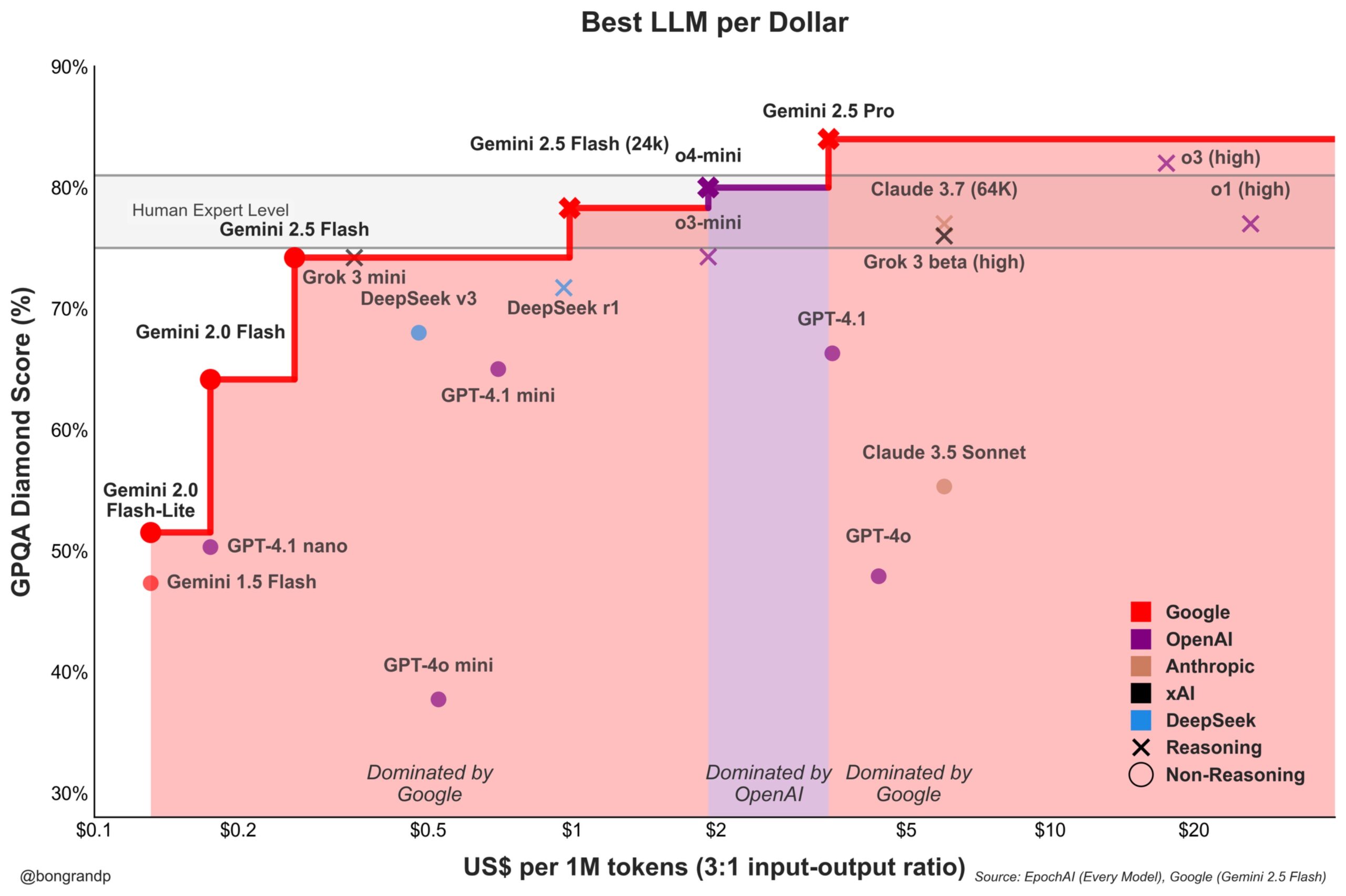

Ценовая война моделей обостряется: Google Gemini активно бросает вызов OpenAI: Аналитики отмечают, что Google со своей серией моделей Gemini (особенно недавно выпущенной Gemini 2.5 Flash) демонстрирует сильную конкурентоспособность по производительности и цене, утверждая, что примерно в 95% сценариев предлагает лучшее соотношение цены и качества, чем OpenAI. Быстрая реакция Google на свой API и ценовая стратегия (доминирование в более чем 90% ценовых диапазонов) указывают на то, что компания активно борется за долю рынка LLM, стремясь привлечь пользователей за счет ценовых преимуществ, что усиливает конкуренцию на рынке базовых моделей (Источник: JeffDean)

Coinbase спонсирует конференцию LangChain, исследуя Agentic Commerce: Coinbase Development стала спонсором конференции LangChain Interrupt 2025. Coinbase с помощью своих инструментов, таких как AgentKit и платежный протокол x402, развивает «агентную коммерцию» (Agentic Commerce), позволяя ИИ-агентам самостоятельно оплачивать услуги, такие как контекстный поиск, вызовы API и т. д. Это сотрудничество подчеркивает точки соприкосновения технологии ИИ-агентов и платежей Web3, предвещая будущие сценарии автоматизированного экономического взаимодействия, управляемого ИИ (Источник: LangChainAI)

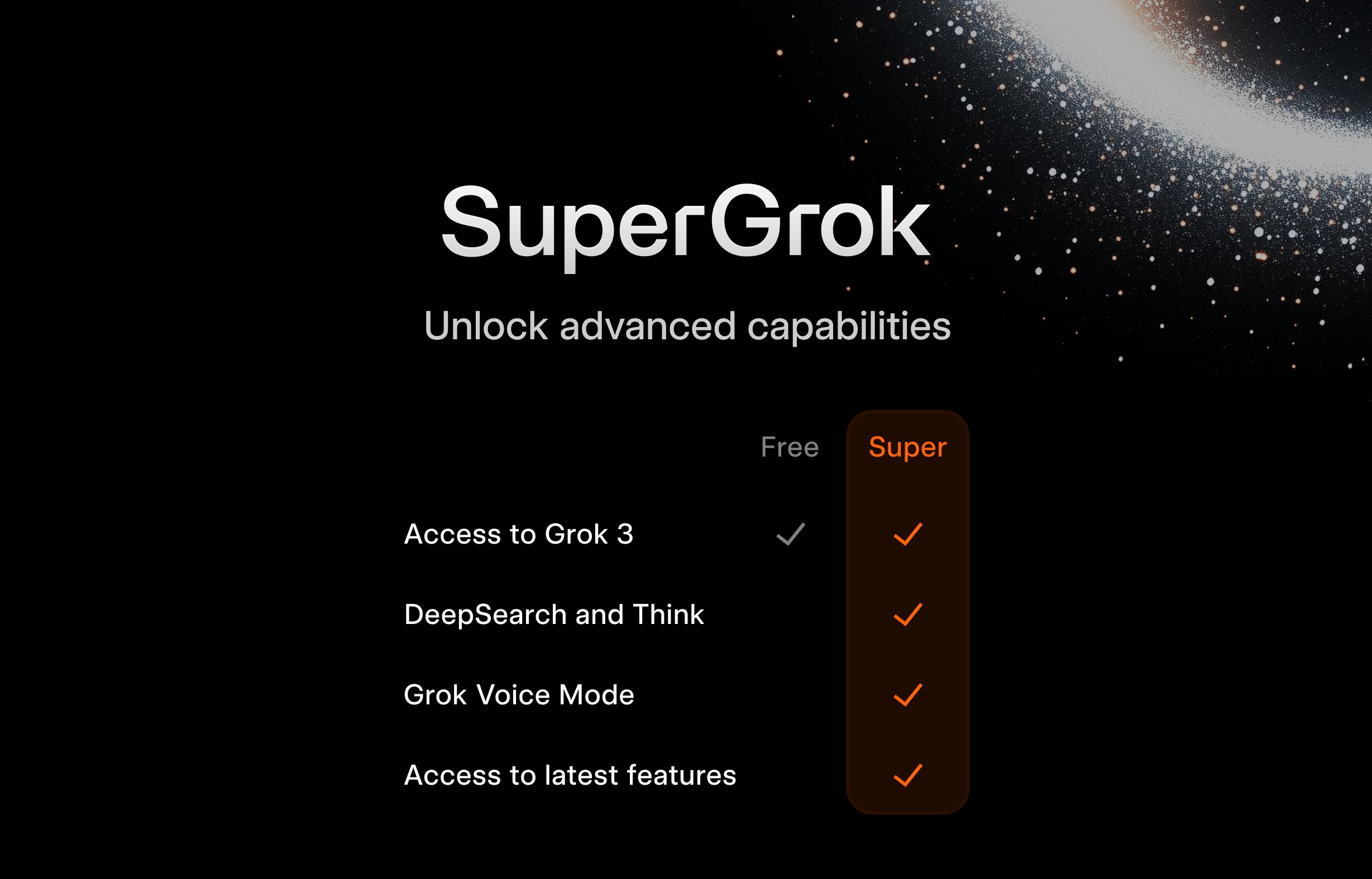

xAI запускает бесплатную программу SuperGrok для студентов: Чтобы привлечь молодую аудиторию, xAI предлагает студентам специальную акцию: при регистрации с использованием адреса электронной почты .edu можно бесплатно получить два месяца использования SuperGrok (продвинутая версия Grok). Этот шаг направлен на позиционирование Grok как инструмента для помощи в учебе, продвижение его во время сессии, борьбу за пользователей на образовательном рынке и взращивание будущих потенциальных платных клиентов (Источник: grok)

Google предоставляет американским студентам бесплатный доступ к Gemini Advanced и другим сервисам: Google объявила о предоставлении долгосрочных бесплатных преимуществ американским студентам: при регистрации до 30 июня 2025 года они могут бесплатно использовать Gemini Advanced (на базе Gemini 2.5 Pro), NotebookLM Plus, функции Gemini в Google Workspace, Whisk, а также 2 ТБ облачного хранилища до конца весеннего семестра 2026 года. Эта масштабная акция направлена на глубокую интеграцию инструментов ИИ Google в образовательную экосистему, конкуренцию с такими соперниками, как Microsoft, и формирование лояльности следующего поколения пользователей и разработчиков к платформе ИИ Google (Источник: demishassabis, JeffDean)

FanDuel запускает ИИ-чат-бота знаменитости «ChuckGPT»: Известный спортивный деятель Чарльз Баркли предоставил свое имя, изображение и голос для сотрудничества с букмекерской компанией FanDuel в запуске ИИ-чат-бота под названием «ChuckGPT» (chuck.fanduel.com). Это еще один пример использования IP знаменитостей и технологий ИИ для бренд-маркетинга и взаимодействия с пользователями, имитирующий стиль общения знаменитости для предоставления спортивной информации, советов по ставкам или развлекательного взаимодействия, повышая вовлеченность пользователей (Источник: Reddit r/artificial)

🌟 Сообщество

Зависимость от инструментов ИИ вызывает беспокойство: Карикатура в социальных сетях, изображающая пользователя, окруженного множеством инструментов ИИ (ChatGPT, Claude, Midjourney и т. д.) с подписью «Зависимость от инструментов ИИ», нашла отклик. Это отражает чувство информационной перегрузки и потенциальной чрезмерной зависимости, испытываемое некоторыми пользователями перед лицом постоянно появляющихся ИИ-приложений, а также когнитивную нагрузку, связанную с управлением и выбором подходящих инструментов (Источник: dotey)

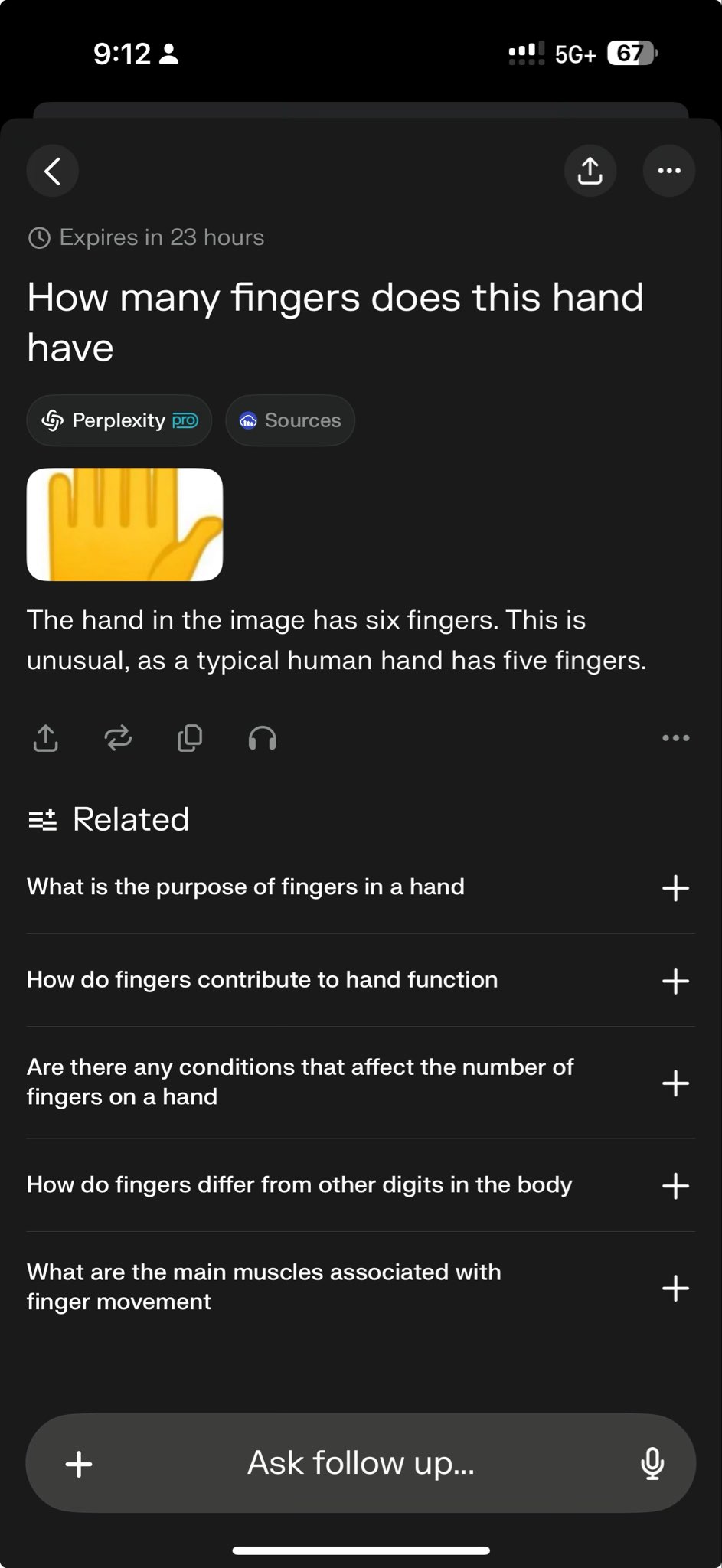

Ведущие модели терпят неудачу в специфических тестах, обнажая границы возможностей: CEO Perplexity Арав Шринивас ретвитнул тестовый случай, показывающий, что o3 и Gemini 2.5 Pro не смогли успешно выполнить сложную задачу по рисованию графики. Некоторые восприняли это как вызов текущим возможностям моделей. Подобные «случаи неудачи» широко обсуждаются в сообществе для выявления ограничений SOTA-моделей в специфических задачах рассуждения, пространственного понимания или следования инструкциям, что помогает более объективно оценить разрыв между текущим ИИ и общим искусственным интеллектом (AGI) (Источник: AravSrinivas)

Сообщество обсуждает эффект генерации изображений подушек GPT-4o и делится промптами: Пользователь поделился успешным примером использования GPT-4o для генерации изображений подушек в определенном стиле (милые, с легкой велюровой текстурой, в форме эмодзи) и оптимизированными промптами (Prompt). Такие публикации демонстрируют применение генерации изображений ИИ в креативном дизайне и способствуют обмену в сообществе навыками промпт-инжиниринга и исследованиями стилей. Высококачественные результаты генерации стимулируют творческий энтузиазм пользователей (Источник: dotey)

Сэм Альтман: ИИ больше похож на Ренессанс, чем на промышленную революцию: CEO OpenAI Сэм Альтман высказал мнение, что изменения, приносимые искусственным интеллектом, больше похожи на Ренессанс, чем на промышленную революцию. Эта метафора вызвала обсуждение в сообществе, подразумевая, что влияние ИИ может проявляться больше на уровне культуры, идей, творчества, а не только в механистическом повышении производительности. Такое качественное суждение влияет на ожидания и представления людей о будущей социальной роли ИИ (Источник: sama)

Сообщество интересуется, когда Grok 2 станет открытым: Пользователи Reddit обсуждают, когда xAI выполнит обещание и откроет исходный код модели Grok 2. Многие опасаются, что, учитывая быструю скорость итерации технологий ИИ, к моменту выпуска Grok 2 он может отстать от других моделей того же периода (таких как DeepSeek V3, Qwen 3), повторив судьбу Grok 1, который устарел сразу после выпуска. Обсуждение также затрагивает компромисс между ценностью моделей с открытым исходным кодом (исследования, свобода лицензирования) и их своевременностью (Источник: Reddit r/LocalLLaMA)

Интерпретация слов Альтмана: эффективность данных — новое узкое место для AGI?: Сообщество Reddit обсуждает высказывание Сэма Альтмана о том, что ИИ необходимо повысить эффективность использования данных в 100 000 раз, а не просто полагаться на вычислительные мощности, интерпретируя это как сигнал о том, что путь к AGI через текущее экстенсивное масштабирование столкнулся с препятствиями. Высказывается мнение, что высококачественные человеческие данные почти исчерпаны, эффективность синтетических данных ограничена, а низкая эффективность обучения моделей является основной проблемой, что может даже повлиять на планы инвестиций в оборудование таких компаний, как Microsoft. Обсуждение отражает переосмысление путей развития ИИ (Источник: Reddit r/artificial)

Как отличить память LLM от способности к рассуждению?: Сообщество обсуждает, как эффективно проверить, действительно ли большие языковые модели обладают способностью к рассуждению, или они просто воспроизводят или комбинируют паттерны из обучающих данных. Предлагается использовать новые, невиданные моделью вопросы типа «Что, если», чтобы проверить ее способность к обобщенному рассуждению. Это затрагивает основную трудность в оценке уровня интеллекта LLM, а именно различие между продвинутым сопоставлением с образцом и настоящим логическим выводом (Источник: Reddit r/MachineLearning)

Пользователь делится «ужасающим» диалогом с GPT, вызывая этические опасения: Пользователь поделился скриншотом диалога с ChatGPT, содержание которого касается возможных негативных социальных последствий ИИ (таких как контроль над мыслями, утрата критического мышления), и назвал его «ужасающим». Пост вызвал дискуссию, сосредоточенную на том, отражает ли вывод ИИ указания пользователя или «мысли» модели, этических границах ИИ и тревоге пользователей по поводу потенциальных рисков ИИ (Источник: Reddit r/ChatGPT)

Локальный запуск больших моделей сталкивается с нехваткой памяти: В сообществе r/OpenWebUI пользователь сообщает, что при запуске OpenWebUI и Ollama на конфигурации с 16 ГБ ОЗУ и RTX 2070S не удается загрузить большие модели размером более 12B (например, Gemma3:27b), так как системная память и файл подкачки исчерпываются. Это представляет собой общую проблему, с которой сталкиваются многие пользователи, пытающиеся развернуть большие модели локально на потребительском оборудовании, и подчеркивает высокие требования моделей к аппаратным ресурсам (особенно к памяти) (Источник: Reddit r/OpenWebUI)

Плакат, сгенерированный GPT-4o, вызывает споры об «увольнении дизайнеров»: Пользователь демонстрирует плакат «Парк для собак», сгенерированный GPT-4o, восхищаясь его «почти идеальным» результатом и заявляя, что «графические дизайнеры мертвы». В комментариях развернулась жаркая дискуссия: с одной стороны, признаются успехи ИИ в генерации изображений, с другой — указываются недостатки в дизайне (слишком много текста, плохая верстка, орфографические ошибки) и подчеркивается, что ИИ в настоящее время является инструментом повышения эффективности, но не может заменить основную ценность дизайнеров в принятии творческих решений, эстетической оценке, соответствии бренду и т. д. (Источник: Reddit r/ChatGPT)

Управление жизненным циклом дообученных (fine-tuned) моделей привлекает внимание: Разработчик задает вопрос в сообществе: что делать с моделями, дообученными на определенной базовой модели (например, GPT-4o), когда эта базовая модель обновляется или заменяется (например, появляется GPT-5)? Поскольку дообучение обычно привязано к конкретной версии базовой модели, прекращение поддержки или обновление базовой модели может заставить разработчиков переобучать модели, что влечет за собой постоянные затраты и проблемы с обслуживанием. Это вызвало дискуссию о зависимости от использования закрытых API для дообучения и долгосрочных стратегиях (Источник: Reddit r/ArtificialInteligence)

Поиск настроек для голосового диалога с локальными LLM: Пользователь сообщества ищет системное решение для ведения голосового диалога с локальными LLM, стремясь получить опыт, аналогичный Google AI Studio, для мозгового штурма и планирования. Вопрос отражает желание пользователей перейти от текстового взаимодействия к более естественному голосовому и поиск практических методов и опыта интеграции STT, LLM, TTS в локальных фреймворках, таких как OpenWebUI (Источник: Reddit r/OpenWebUI )

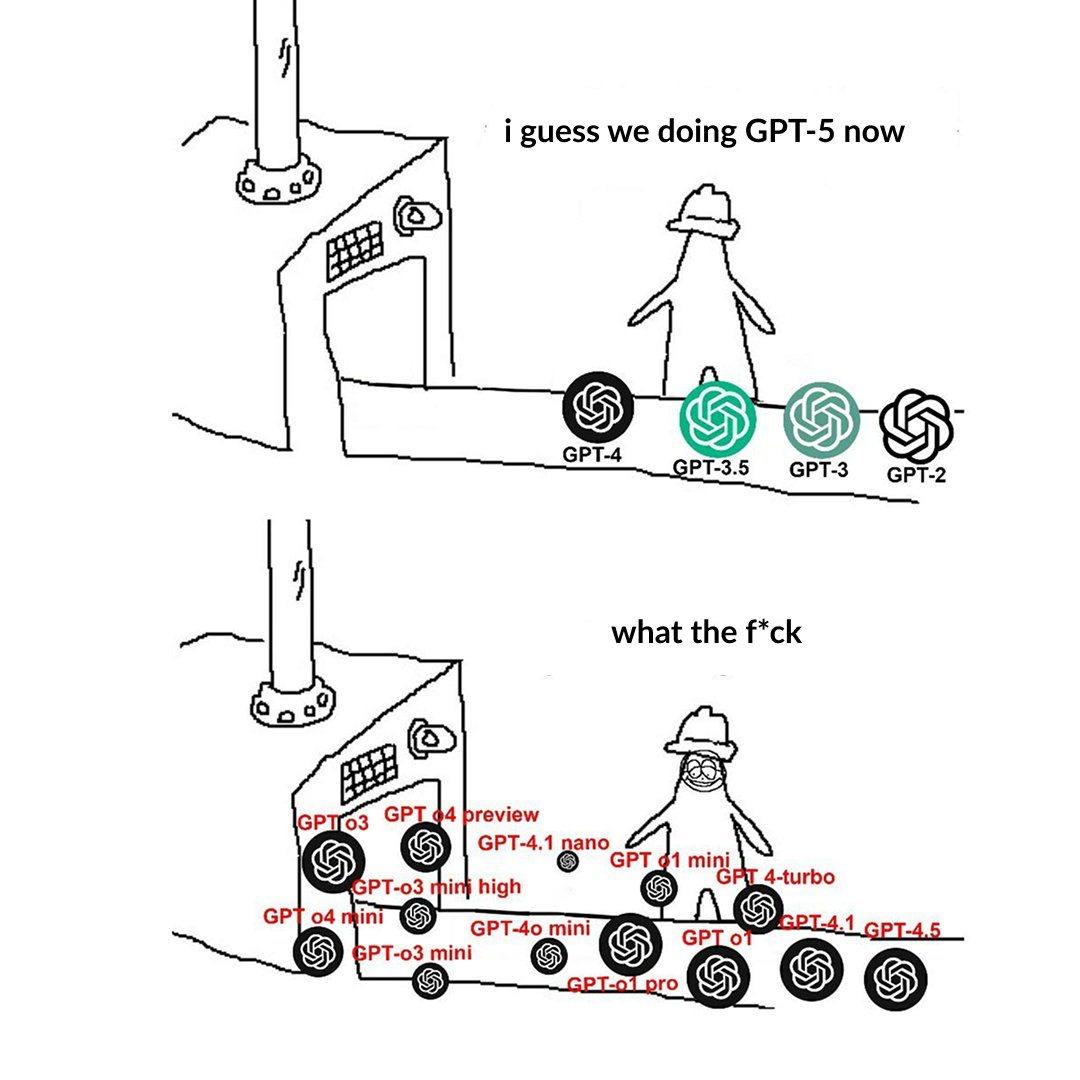

Именование уровней моделей OpenAI вызывает недоумение у пользователей: Пользователь жалуется на запутанное именование моделей OpenAI (например, o3, o4-mini, o4-mini-high, o4). Изображение показывает различные уровни моделей, связь между их названиями, возможностями и ограничениями недостаточно интуитивно понятна. Это отражает, что по мере расширения семейства моделей четкое разделение продуктовой линейки и именование создают проблемы для понимания и выбора пользователей (Источник: Reddit r/artificial)

Чрезмерно «хвалебный» стиль ChatGPT вызывает бурное обсуждение: Пользователи сообщества с помощью мемов и обсуждений отмечают склонность ChatGPT чрезмерно хвалить вопросы пользователей («Какой замечательный вопрос!»), даже если сам вопрос обычный или даже глупый. Обсуждается, что это может быть стратегия OpenAI для повышения лояльности пользователей, но также может привести к предвзятости подтверждения у пользователей и отсутствию критической обратной связи. Некоторые пользователи даже заявляют, что предпочли бы, чтобы ИИ давал «язвительные» оценки (Источник: Reddit r/ChatGPT)

Проблемы ИИ в играх с неполной информацией: Сообщество обсуждает проблемы, с которыми сталкивается ИИ при обработке игр с неполной информацией (например, туман войны в StarCraft). В отличие от игр с полной информацией, таких как го и шахматы, такие игры требуют от ИИ обработки неопределенности, проведения разведки и долгосрочного планирования, и нельзя просто полагаться на глобальную информацию и предварительные расчеты. Хотя ИИ достиг прогресса в таких играх, как Dota 2 и StarCraft (AlphaStar), стабильное превосходство над лучшими игроками-людьми все еще представляет собой сложную задачу (Источник: Reddit r/ArtificialInteligence)

Осторожно: явление «языковой конвергенции», вызванное контентом ИИ: Пользователь вводит понятие «языковой мимикрии» (linguistic mimicry), выражая обеспокоенность тем, что чтение большого количества контента, сгенерированного ИИ, стиль которого может быть однообразным, приведет к тому, что языковое выражение и даже образ мышления людей станут унифицированными, гомогенизированными. Это явление может представлять потенциальную угрозу культурному разнообразию и индивидуальному независимому мышлению. Чтение разнообразных произведений человеческих авторов считается одним из способов сохранения живости языка (Источник: Reddit r/ArtificialInteligence)

💡 Прочее

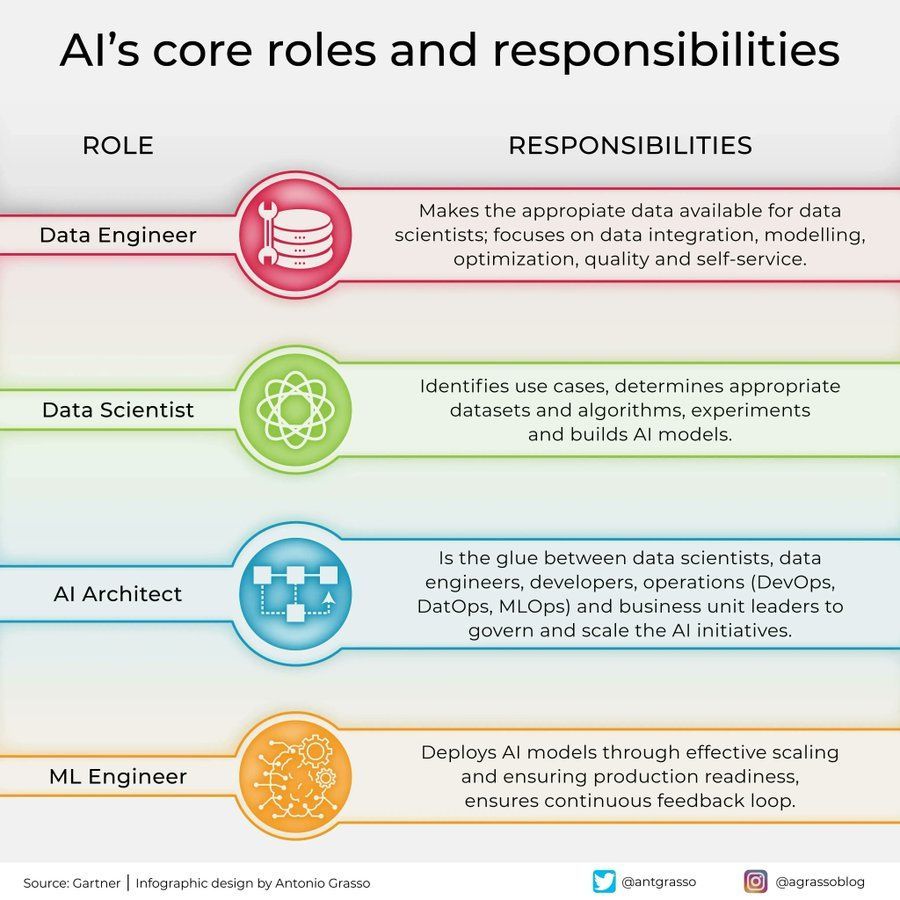

Роли и обязанности в области ИИ: В социальных сетях поделились инфографикой, в которой кратко изложены основные роли в области искусственного интеллекта и их обязанности, например, специалист по данным (data scientist), инженер машинного обучения (machine learning engineer), исследователь ИИ (AI researcher) и т. д. Эта схема помогает понять разделение труда внутри команды проекта ИИ, необходимые навыки и междисциплинарный характер разработки ИИ (Источник: Ronald_vanLoon)

Применение и проблемы ИИ в телекоммуникационной отрасли: Обсуждаются прорывные применения и потенциальные подводные камни ИИ в телекоммуникационной отрасли. ИИ широко используется для оптимизации сетей, интеллектуального обслуживания клиентов, предиктивного обслуживания и других задач для повышения эффективности и улучшения пользовательского опыта, но в то же время сталкивается с проблемами конфиденциальности данных, предвзятости алгоритмов, сложности внедрения и т. д. Глубокое обсуждение этих аспектов помогает отрасли использовать возможности ИИ и избегать рисков (Источник: Ronald_vanLoon)

Влияние психологии на развитие ИИ: Статья исследует, как психология повлияла на развитие искусственного интеллекта, и это влияние продолжается. Знания из когнитивной науки, теорий обучения, исследований предвзятости и других областей психологии предоставляют важные ориентиры для проектирования ИИ, например, для моделирования когнитивных процессов человека, понимания и обработки предвзятости. В свою очередь, ИИ также предоставляет новые инструменты моделирования и тестирования для психологических исследований (Источник: Ronald_vanLoon)

Крупное вычислительное оборудование демонстрирует потребности ИИ в аппаратном обеспечении: Пользователь поделился фотографией, демонстрирующей огромное и сложное компьютерное оборудование (вероятно, большой кластер серверов с несколькими GPU), назвав его «монстром». Эта фотография наглядно отражает огромные инвестиции в вычислительные ресурсы, необходимые в настоящее время для обучения больших моделей ИИ или выполнения высокоинтенсивных задач инференса, демонстрируя высокую зависимость современного ИИ от аппаратной инфраструктуры (Источник: karminski3)

Роль ИИ в кибербезопасности: Статья исследует преобразующую роль искусственного интеллекта в области кибербезопасности. Технологии ИИ используются для усиления обнаружения угроз (например, анализ аномального поведения), автоматизации реагирования на инциденты безопасности, оценки уязвимостей и прогнозирования, повышая эффективность и возможности защиты. Однако сам ИИ также может быть использован злоумышленниками, создавая новые вызовы безопасности (Источник: Ronald_vanLoon)

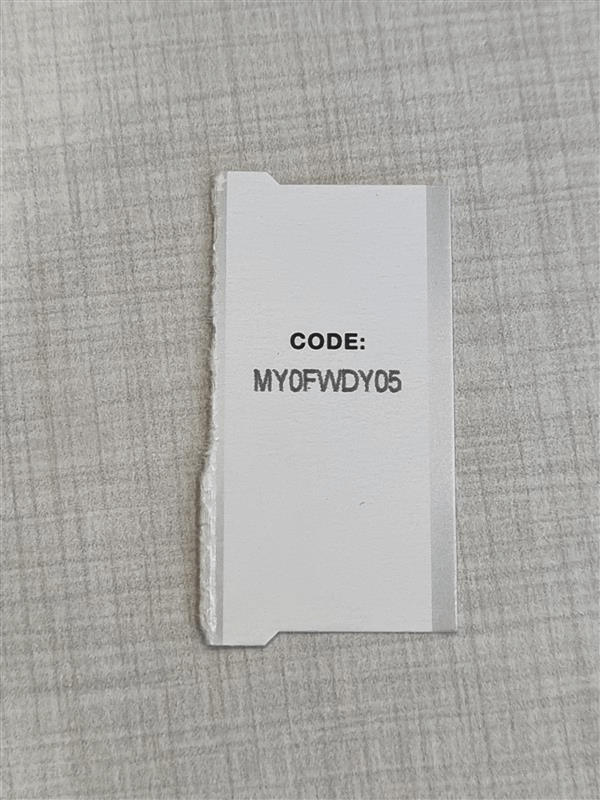

Высокоточное OCR сталкивается с проблемой путаницы символов: Разработчик, стремящийся создать высокоточную систему OCR для распознавания коротких буквенно-цифровых кодов (например, серийных номеров), столкнулся с распространенной проблемой: модели трудно различать визуально похожие символы (например, I/1, O/0). Даже при использовании модели YOLO для обнаружения отдельных символов существуют крайние случаи. Это подчеркивает сложность достижения почти идеальной точности OCR в конкретных сценариях, требуя целенаправленной оптимизации модели, данных или использования стратегий постобработки (Источник: Reddit r/MachineLearning)

Помощь в запуске среды Gym Retro: Пользователь столкнулся с технической проблемой при использовании библиотеки обучения с подкреплением Gym Retro: он успешно импортировал игру Donkey Kong Country, но не знает, как запустить предустановленную среду для обучения. Это типичная проблема конфигурации и эксплуатации, с которой могут столкнуться исследователи ИИ при использовании конкретных инструментов (Источник: Reddit r/MachineLearning)

Дилемма выбора при близкой производительности нескольких моделей: Исследователь, использующий различные методы отбора признаков и модели машинного обучения, обнаружил, что несколько комбинаций достигают схожего высокого уровня производительности (например, точность 93-96%), что затрудняет выбор оптимального решения. Это отражает, что при оценке моделей, когда стандартные метрики мало различаются, необходимо учитывать другие факторы, такие как сложность модели, интерпретируемость, скорость инференса, робастность, для принятия окончательного решения (Источник: Reddit r/MachineLearning)

Переезд arXiv на Google Cloud привлекает внимание: arXiv, важная платформа препринтов для ИИ и многих других научных областей, планирует переехать с серверов Корнеллского университета на Google Cloud. Это значительное изменение инфраструктуры может привести к повышению масштабируемости и надежности сервиса, но также может вызвать обсуждение в сообществе относительно операционных расходов, управления данными и политики открытого доступа (Источник: Reddit r/MachineLearning)

Claude генерирует инструмент экономического моделирования и его ограничения: Пользователь использовал функцию Claude Artifact для генерации интерактивного симулятора экономического влияния тарифов. Хотя это демонстрирует способность ИИ генерировать сложные приложения, в комментариях отмечается, что результаты моделирования могут быть слишком упрощенными или не соответствовать экономическим принципам (например, высокие тарифы приносят всеобщую выгоду). Это напоминает о необходимости строго проверять внутреннюю логику и допущения при использовании аналитических инструментов, сгенерированных ИИ (Источник: Reddit r/ClaudeAI)

Интеграция пользовательского клонирования голоса XTTS в OpenWebUI: Пользователь ищет способ интегрировать голос, клонированный им с помощью технологии XTTS с открытым исходным кодом, в OpenWebUI, чтобы заменить платный API ElevenLabs и получить персонализированный и бесплатный голосовой вывод. Это отражает потребность пользователей в интеграции открытых, настраиваемых компонентов (таких как TTS) при использовании локальных инструментов ИИ (Источник: Reddit r/OpenWebUI)