Ключевые слова:AI-модель, OCR-технология, AI-инфраструктура, Крупная языковая модель, AI-агент, Мультимодальная модель, Оптимизация энергопотребления ИИ, Открытая экосистема ИИ, OCR-модель DeepSeek, Мультимодальный вывод Gemini 3, Мировая модель Emu3.5, Гибридная архитектура внимания Kimi Linear, Технология складывания памяти AgentFold

Подборка главного редактора рубрики AI

🔥 В фокусе

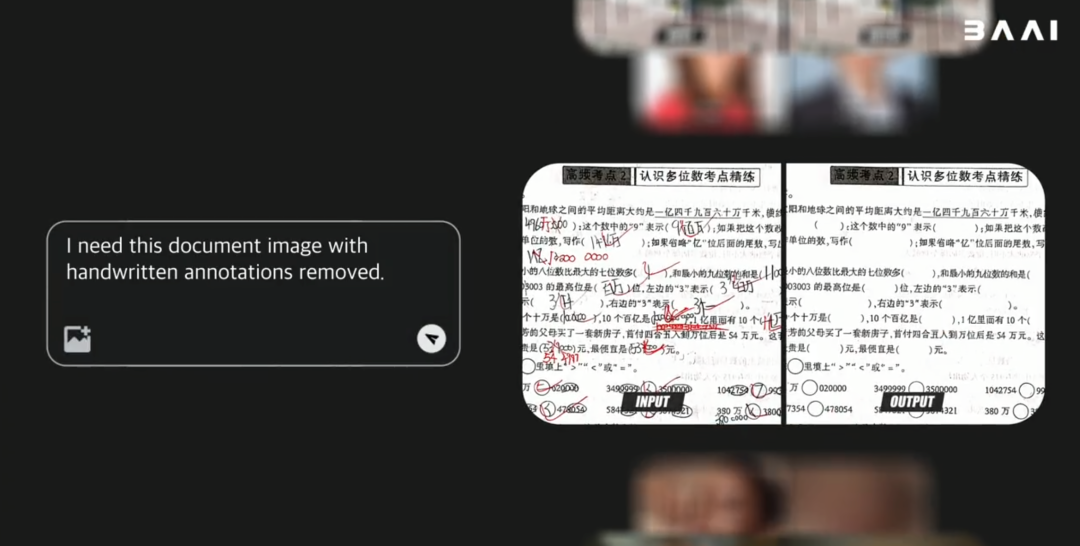

Модель DeepSeek OCR: новый прорыв в памяти AI и оптимизации энергопотребления : DeepSeek представила модель OCR, ключевое новшество которой заключается в способе обработки и хранения информации. Модель сжимает текстовую информацию в формат изображений, значительно сокращая вычислительные ресурсы, необходимые для работы, что может помочь уменьшить растущий углеродный след AI. Этот метод имитирует человеческую память через иерархическое сжатие, размывая неважное содержимое для экономии места, сохраняя при этом высокую эффективность. Исследование привлекло внимание таких экспертов, как Andrej Karpathy, которые считают, что изображения могут быть более подходящими для ввода в LLM, чем текст, открывая новые направления для памяти AI и агентских приложений. (Источник: MIT Technology Review)

Технологические гиганты продолжают вкладывать значительные средства в инфраструктуру AI : Microsoft, Meta и Google, а также другие технологические гиганты, объявили в своих последних финансовых отчетах о дальнейшем значительном увеличении расходов на инфраструктуру AI. Meta прогнозирует капитальные затраты в размере 70-72 миллиардов долларов в этом году и планирует дальнейшее расширение в следующем году; доход Microsoft Intelligent Cloud впервые превысил 30 миллиардов долларов, а Azure и другие облачные сервисы выросли на 40%, при этом ожидается, что мощность AI увеличится на 80%. Генеральный директор Google Пичаи подчеркнул, что комплексный подход к AI обеспечивает мощный импульс, и анонсировал скорый выпуск Gemini 3. Эти инвестиции отражают оптимистичные ожидания гигантов относительно будущих прорывов в AI и их решимость захватить рыночное преимущество. (Источник: Wired, Reddit r/artificial)

Anthropic обнаружила, что LLM обладают ограниченной «интроспективной способностью» : Последнее исследование Anthropic показывает, что большие языковые модели (LLM), такие как Claude, обладают «настоящим интроспективным сознанием», хотя эта способность пока ограничена. Исследование изучило, могут ли LLM распознавать свои внутренние мысли или просто генерировать разумные ответы на основе вопросов. Это открытие предполагает, что LLM могут обладать более глубоким самосознанием, чем ожидалось, что имеет важное значение для понимания и разработки более интеллектуальных и осознанных систем AI. (Источник: Anthropic, Reddit r/artificial)

Extropic выпустила новый термодинамический вычислительный аппарат TSU, заявляя о прорыве в энергопотреблении AI : Компания Extropic представила новое вычислительное устройство TSU (Thermodynamic Sampling Unit), в основе которого лежит «вероятностный бит» (P-bit), способный мерцать между 0 и 1 с программируемой вероятностью, что направлено на достижение 10 000-кратного повышения эффективности энергопотребления AI. Компания выпустила чип X0, настольный тестовый комплект XTR0 и коммерческий TSU Z1, а также открыла библиотеку Thermol для симуляции TSU на GPU. Хотя определение базового уровня повышения эффективности вызывает вопросы, это направление нацелено на решение огромного дефицита вычислительной мощности и энергии для AI, что может привести к потенциальному изменению парадигмы в вычислениях AI. (Источник: TheRundownAI, pmddomingos, op7418)

🎯 Тенденции

Google анонсирует скорый выпуск Gemini 3, усиливая тенденцию к специализации семейства моделей AI : Генеральный директор Google Сундар Пичаи на телефонной конференции по финансовым результатам анонсировал, что новая флагманская модель Gemini 3 будет выпущена позднее в этом году. Он подчеркнул, что семейство моделей AI Google движется к специализации: Gemini фокусируется на мультимодальном выводе, Veo используется для генерации видео, Genie — для интерактивных агентов, а Nano — для интеллектуальных устройств. Эта стратегия указывает на переход Google от единой универсальной модели к взаимосвязанной системной архитектуре, оптимизированной для различных сценариев, чтобы повысить надежность, снизить задержки и поддерживать развертывание на периферии. (Источник: Reddit r/ArtificialInteligence, shlomifruchter)

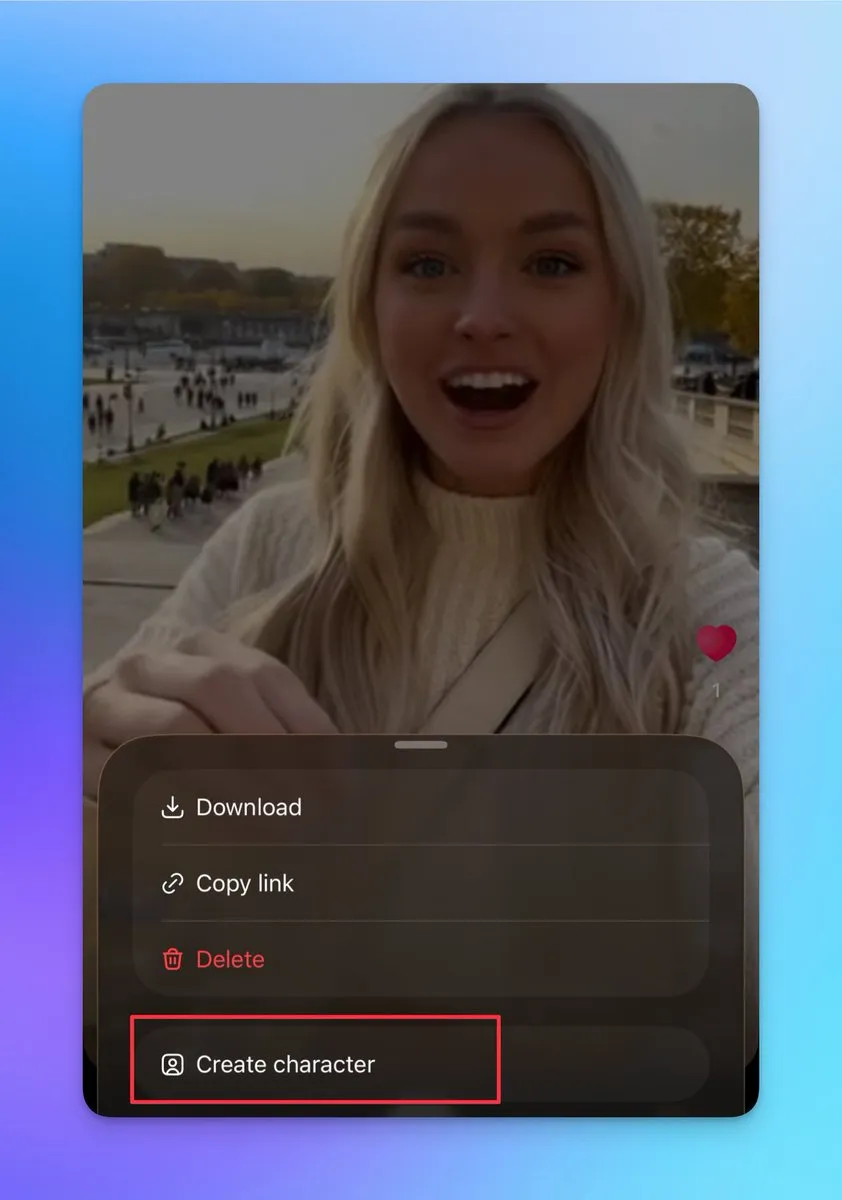

Sora 2 добавила функции пользовательских персонажей и склейки видео, поддерживая создание непрерывных длинных видеороликов : Sora 2 недавно обновила ряд важных функций, включая поддержку создания других персонажей (нельзя загружать реальные фотографии, но можно создавать из существующих видеоперсонажей). Пользователи могут использовать эту функцию для обеспечения согласованности персонажей, что критически важно для создания непрерывных длинных видеороликов. Кроме того, страница черновиков теперь поддерживает публикацию нескольких склеенных видео, а на странице поиска добавлен рейтинг, демонстрирующий шоу с реальными людьми и мастеров вторичного творчества. Эти обновления значительно повысили творческую гибкость и интерактивность Sora 2, что, как ожидается, значительно увеличит количество ее ежедневных активных пользователей. (Источник: op7418, billpeeb, op7418)

BAAI выпустил открытую мультимодальную мировую модель Emu3.5, превосходящую Gemini-2.5-Flash-Image по производительности : Пекинский институт искусственного интеллекта (BAAI) выпустил открытую мультимодальную мировую модель Emu3.5 с 34 миллиардами параметров. Модель использует архитектуру Decoder-only Transformer, способна одновременно обрабатывать задачи с изображениями, текстом и видео, унифицируя их в задачу предсказания следующего состояния. Emu3.5 предварительно обучена на огромных объемах видеоданных из Интернета, обладает способностью понимать пространственно-временную непрерывность и причинно-следственные связи, демонстрируя выдающиеся результаты в визуальном повествовании, визуальном руководстве, редактировании изображений, исследовании мира и воплощенных операциях, особенно значительно улучшая физическую реалистичность. Ее производительность сопоставима и даже превосходит Gemini-2.5-Flash-Image (Nano Banana). (Источник: 36氪)

Moonshot AI выпустила модель Kimi Linear с гибридной линейной архитектурой внимания : Moonshot AI представила модель Kimi Linear, 48B-параметрическую модель на основе гибридной линейной архитектуры внимания (KDA) с 3B активных параметров, поддерживающую контекстную длину в 1M. Kimi Linear значительно повышает производительность и аппаратную эффективность для задач с длинным контекстом за счет оптимизации Gated DeltaNet, сокращая потребность в KV-кэше до 75% и увеличивая пропускную способность декодирования в 6 раз. Модель демонстрирует превосходные результаты в нескольких бенчмарках, превосходя традиционные модели с полным вниманием, и была выпущена в двух версиях на Hugging Face. (Источник: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, bigeagle_xd)

Модель MiniMax M2 придерживается архитектуры Full Attention, подчеркивая проблемы при развертывании в производстве : Руководитель предварительного обучения MiniMax M2 Хаохай Сунь объяснил, почему модель M2 по-прежнему использует архитектуру Full Attention, а не линейное или разреженное внимание. Он отметил, что, хотя эффективное внимание теоретически может сэкономить вычислительную мощность, в реальных промышленных системах его производительность, скорость и цена по-прежнему трудно превзойти Full Attention. Основные узкие места заключаются в ограничениях систем оценки, высоких экспериментальных затратах на сложные задачи вывода и незрелости инфраструктуры. MiniMax считает, что при стремлении к возможностям длинного контекста качество данных, система оценки и оптимизация инфраструктуры более важны, чем просто изменение архитектуры внимания. (Источник: Reddit r/LocalLLaMA, ClementDelangue)

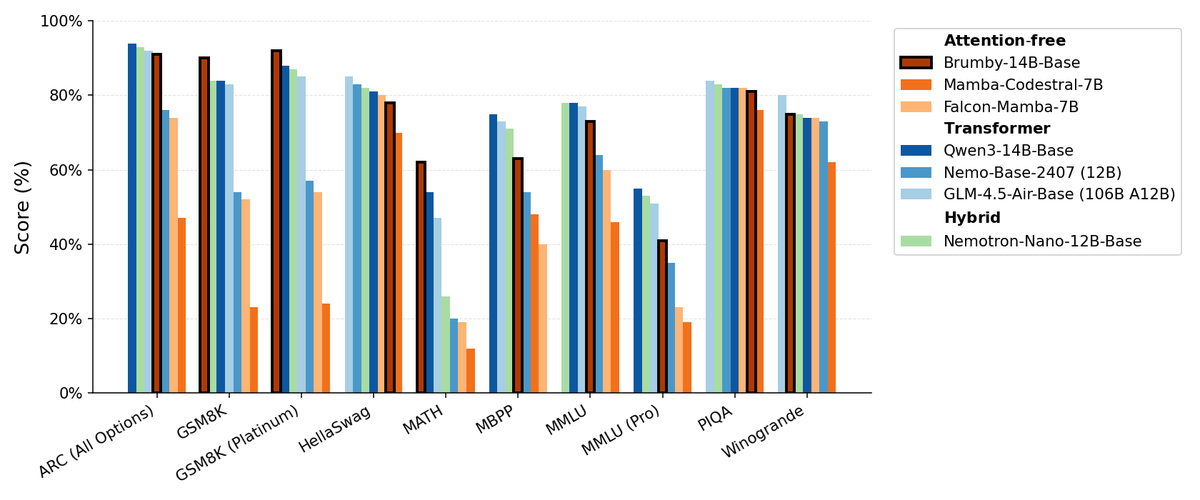

Manifest AI выпустила Brumby-14B-Base, исследуя базовые модели без внимания : Manifest AI выпустила Brumby-14B-Base, заявляя, что это самая мощная на данный момент базовая модель без внимания, обученная с 14 миллиардами параметров при стоимости всего 4000 долларов. Модель сопоставима по производительности с Transformer и гибридными моделями аналогичного размера, предвещая возможное медленное завершение эры Transformer. Этот прогресс открывает новые возможности для архитектуры моделей AI, особенно демонстрируя огромный потенциал в снижении затрат на обучение, бросая вызов доминирующему положению традиционных механизмов внимания. (Источник: ClementDelangue, teortaxesTex)

Новая модель Nemotron на базе Qwen3 32B оптимизирует качество ответов LLM : NVIDIA выпустила Qwen3-Nemotron-32B-RLBFF, большую языковую модель, доработанную на основе Qwen/Qwen3-32B, предназначенную для повышения качества генерируемых LLM ответов в режиме мышления по умолчанию. Эта исследовательская модель значительно превосходит оригинальную Qwen3-32B в бенчмарках Arena Hard V2, WildBench и MT Bench, а также демонстрирует производительность, аналогичную DeepSeek R1 и O3-mini, но при этом стоимость вывода составляет менее 5%, что свидетельствует о прогрессе в производительности и эффективности. (Источник: Reddit r/LocalLLaMA)

Архитектура Mamba по-прежнему имеет преимущества в обработке длинного контекста, но ограничена в параллельном обучении : Архитектура Mamba демонстрирует выдающиеся результаты в обработке длинного контекста (миллионы токенов), избегая проблемы взрывного роста памяти у Transformer. Однако ее основное ограничение заключается в сложности распараллеливания во время обучения, что препятствует ее широкому распространению в более крупных приложениях. Несмотря на существование различных линейных микшеров и гибридных архитектур, проблема параллельного обучения Mamba остается ключевым узким местом для ее крупномасштабного применения. (Источник: Reddit r/MachineLearning)

NVIDIA выпустила ARC, Rubin, Omniverse DSX и другие продукты, укрепляя лидерство в инфраструктуре AI : NVIDIA сделала ряд важных объявлений на конференции GTC, включая NVIDIA ARC (Airborne RAN Computer) в сотрудничестве с Nokia для разработки 6G, суперкомпьютер Rubin третьего поколения стоечного масштаба, Omniverse DSX (чертеж для виртуального совместного проектирования и эксплуатации гигабитных фабрик AI), а также NVIDIA Drive Hyperion (стандартизированная архитектура для роботакси) в сотрудничестве с Uber. Эти анонсы показывают, что NVIDIA меняет свою позицию с производителя чипов на архитектора национальной инфраструктуры, подчеркивая «сделано в США» и энергетическую гонку, чтобы справиться с вызовами эпохи AI и 6G. (Источник: TheTuringPost, TheTuringPost)

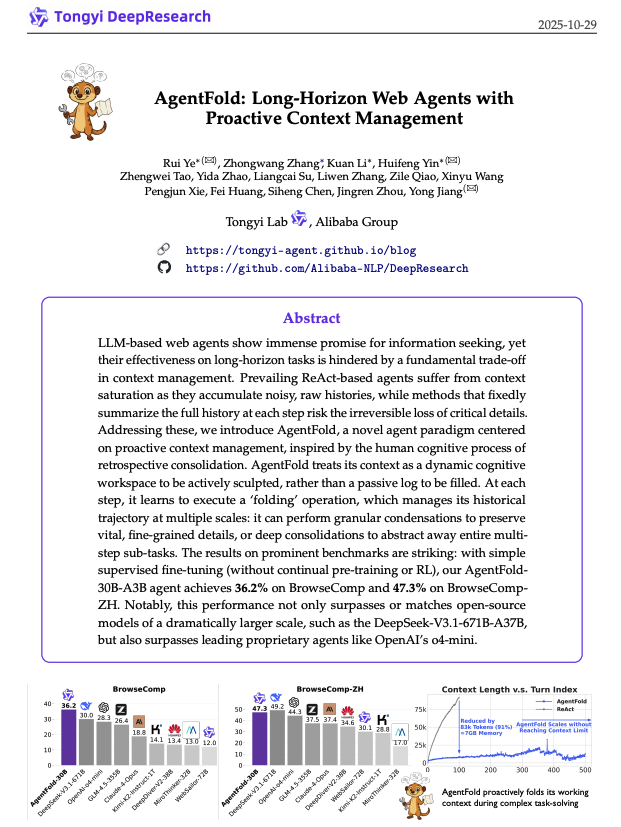

AgentFold: адаптивное управление контекстом для повышения эффективности веб-агентов : AgentFold предложил новую технику контекстного инжиниринга, которая сжимает прошлые мысли агента в структурированную память с помощью «свертывания памяти» (Memory Folding), динамически управляя когнитивным рабочим пространством. Этот метод решает проблему перегрузки контекста у традиционных агентов ReAct и демонстрирует выдающиеся результаты в бенчмарках, таких как BrowseComp, превосходя крупные модели, такие как DeepSeek-V3.1-671B. AgentFold-30B достигает конкурентоспособной производительности с меньшим количеством параметров, значительно повышая эффективность разработки и развертывания веб-агентов. (Источник: omarsar0)

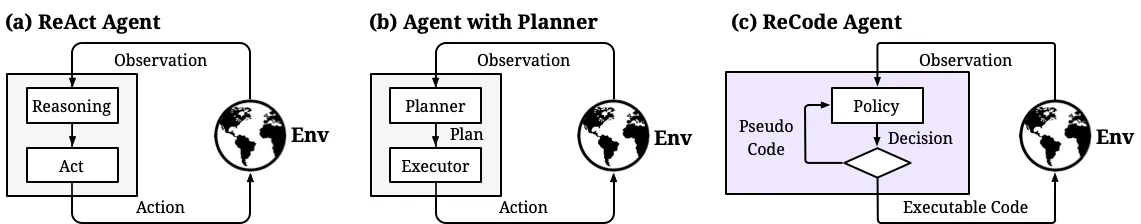

ReCode: унификация планирования и действий для динамического контроля детализации решений AI-агентов : ReCode (Recursive Code Generation) — это новый метод параметрически эффективной тонкой настройки (PEFT), который унифицирует представление планирования и действий AI-агентов, рассматривая высокоуровневое планирование как рекурсивную функцию, разлагаемую на мелкозернистые действия. Этот метод позволяет достичь производительности SOTA всего с 0,02% обучаемых параметров и снижает потребление памяти GPU. ReCode позволяет агентам динамически адаптироваться к различным уровням детализации решений, обучаться иерархическому принятию решений и значительно превосходит традиционные методы по эффективности и использованию данных, являясь важным шагом к достижению человекоподобного рассуждения. (Источник: dotey, ZhihuFrontier)

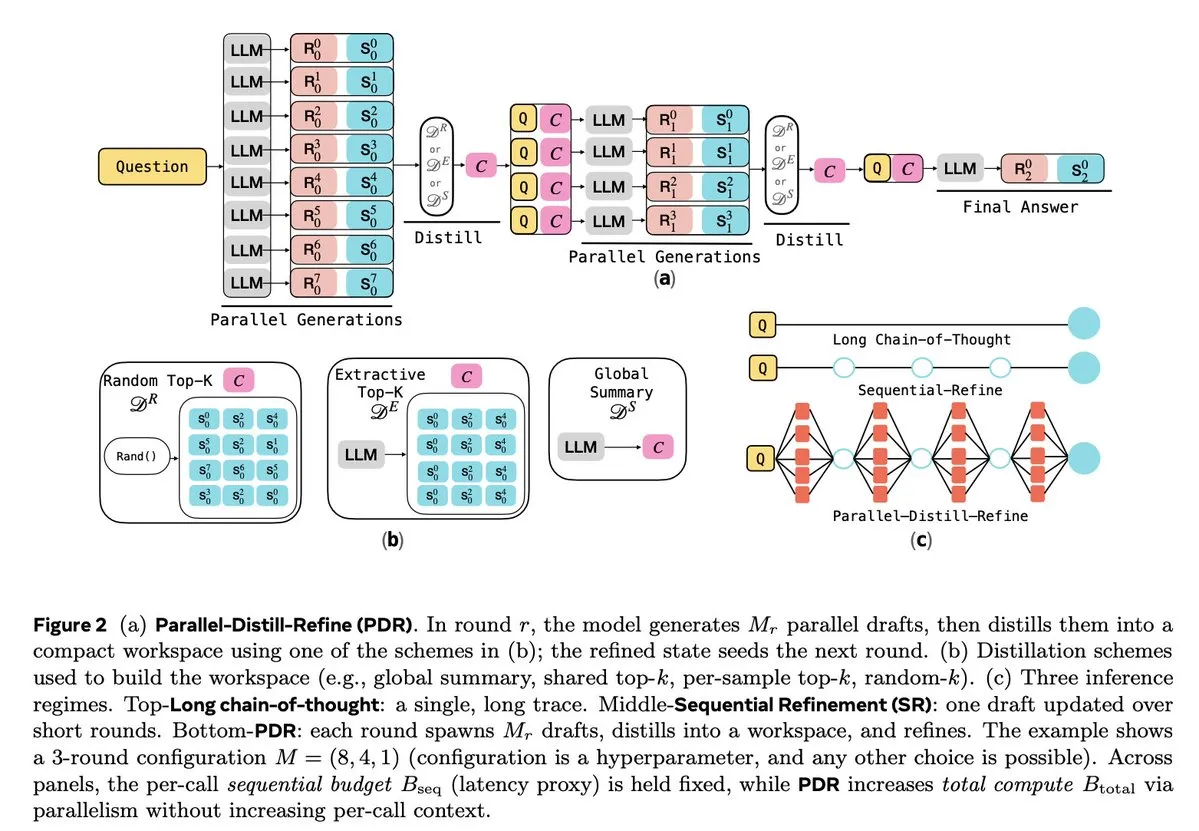

Оптимизация вывода LLM и обучения с подкреплением : Ряд исследований направлен на повышение эффективности и надежности вывода LLM. Parallel-Distill-Refine (PDR) снижает затраты и задержки для сложных задач вывода за счет параллельной генерации и уточнения черновиков. Flawed-Aware Policy Optimization (FAPO) вводит механизм поощрения и наказания для исправления дефектных паттернов в процессе вывода, повышая надежность. Фреймворк PairUni балансирует задачи понимания и генерации мультимодальных LLM за счет парного обучения и алгоритма оптимизации Pair-GPRO. PM4GRPO использует методы процессного майнинга для усиления способности моделей стратегии к выводу через обучение с подкреплением GRPO, ориентированное на вывод. Протокол Fortytwo, в свою очередь, обеспечивает выдающуюся производительность группового вывода AI и мощную устойчивость к состязательным подсказкам за счет распределенного консенсуса ранжирования между узлами. (Источник: NandoDF, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

🧰 Инструменты

Tencent выпустила WeKnora с открытым исходным кодом: фреймворк для понимания и поиска документов на базе LLM : Tencent выпустила WeKnora с открытым исходным кодом, фреймворк для понимания документов и семантического поиска на базе LLM, разработанный специально для обработки сложных, гетерогенных документов. Он использует модульную архитектуру, сочетающую мультимодальную предварительную обработку, семантическое векторное индексирование, интеллектуальный поиск и вывод LLM, следуя парадигме RAG, чтобы предоставлять высококачественные, контекстно-зависимые ответы путем объединения соответствующих блоков документов и вывода модели. WeKnora поддерживает различные форматы документов, модели встраивания и стратегии поиска, а также предлагает удобный веб-интерфейс и API, поддерживает локальное развертывание и частные облака, обеспечивая суверенитет данных. (Источник: GitHub Trending)

Jan: открытая офлайн-альтернатива ChatGPT, поддерживающая локальный запуск LLM : Jan — это открытая альтернатива ChatGPT, которая может работать на компьютере пользователя на 100% офлайн. Она позволяет пользователям загружать и запускать LLM с HuggingFace (такие как Llama, Gemma, Qwen, GPT-oss и т. д.) и поддерживает интеграцию с облачными моделями, такими как OpenAI, Anthropic. Jan предлагает настраиваемых помощников, совместимый с OpenAI API и интеграцию с протоколом контекста модели (MCP), подчеркивая защиту конфиденциальности и предоставляя пользователям полный контроль над локальным опытом AI. (Источник: GitHub Trending)

Claude Code: набор инструментов разработчика и экосистема навыков от Anthropic : Claude Code от Anthropic значительно повышает эффективность работы разработчиков благодаря ряду «навыков» и агентов. Среди них: коннектор Rube MCP (подключает Claude к более чем 500 приложениям), набор инструментов разработчика Superpowers (предоставляет команды /brainstorm, /write-plan, /execute-plan), пакет документов (для работы с Word/Excel/PDF), Theme Factory (автоматизация руководств по бренду) и Systematic Debugging (симуляция процесса отладки для опытных разработчиков). Эти инструменты, благодаря модульной конструкции и контекстной осведомленности, помогают разработчикам автоматизировать рабочие процессы, проверять код, рефакторить и исправлять ошибки, а также позволяют нетехническим командам создавать собственные небольшие инструменты. (Источник: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

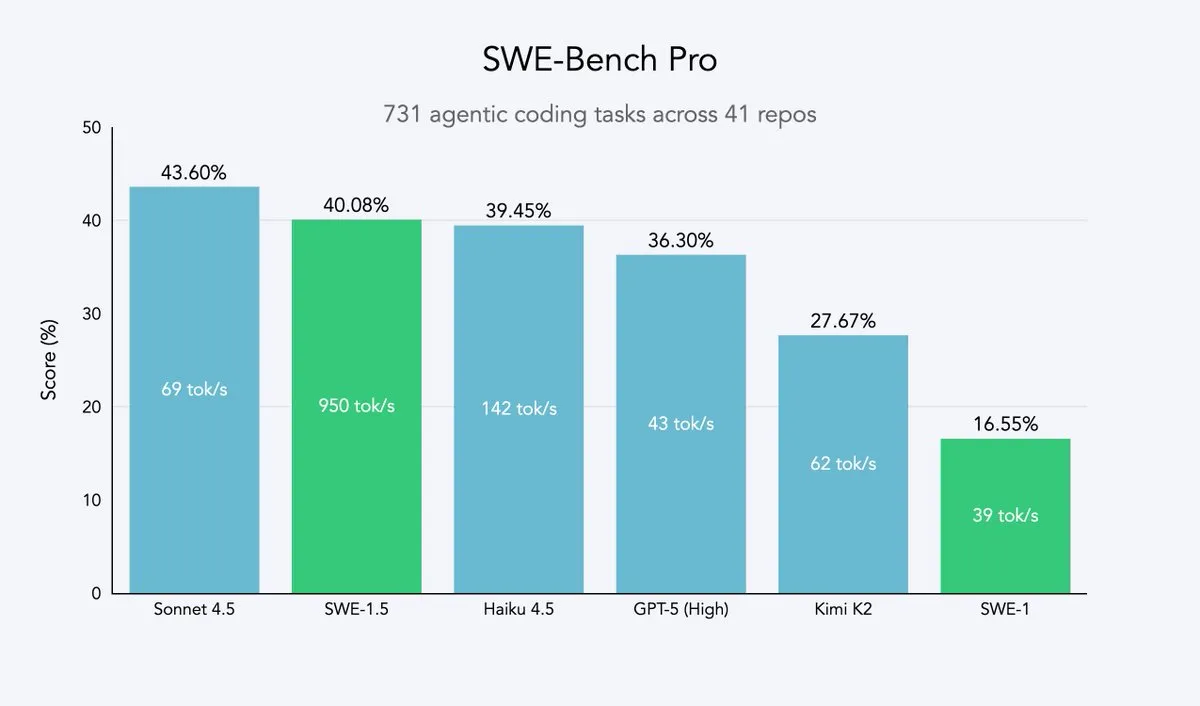

Cursor 2.0 и Windsurf: кодовые агенты стремятся к скорости и эффективности : Cursor и Windsurf выпустили модели кодовых агентов и платформу 2.0, ориентированные на оптимизацию скорости. Их стратегия заключается в тонкой настройке с использованием обучения с подкреплением на базе открытых больших моделей (таких как Qwen3) и развертывании на оптимизированном оборудовании для достижения эффекта «среднего интеллекта, но сверхбыстрой скорости». Этот подход является эффективной стратегией для компаний, занимающихся кодовыми агентами, позволяя им приблизиться к парето-оптимуму скорости и интеллекта при минимальных затратах ресурсов. Модель SWE-1.5 от Windsurf устанавливает новый стандарт скорости, достигая при этом почти SOTA производительности кодирования. (Источник: dotey, Smol_AI, VictorTaelin, omarsar0, TheRundownAI)

Perplexity Patents: первый AI-агент для патентных исследований, расширяющий возможности IP-интеллекта : Perplexity запустила Perplexity Patents, первого в мире AI-агента для патентных исследований, призванного сделать IP-интеллект доступным для всех. Этот инструмент поддерживает поиск и исследование патентов, а в будущем будет запущен Perplexity Scholar, ориентированный на академические исследования. Это нововведение значительно упростит процессы поиска и анализа патентов, предоставляя инноваторам, юристам и исследователям эффективные и простые в использовании услуги по интеллектуальной собственности. (Источник: AravSrinivas)

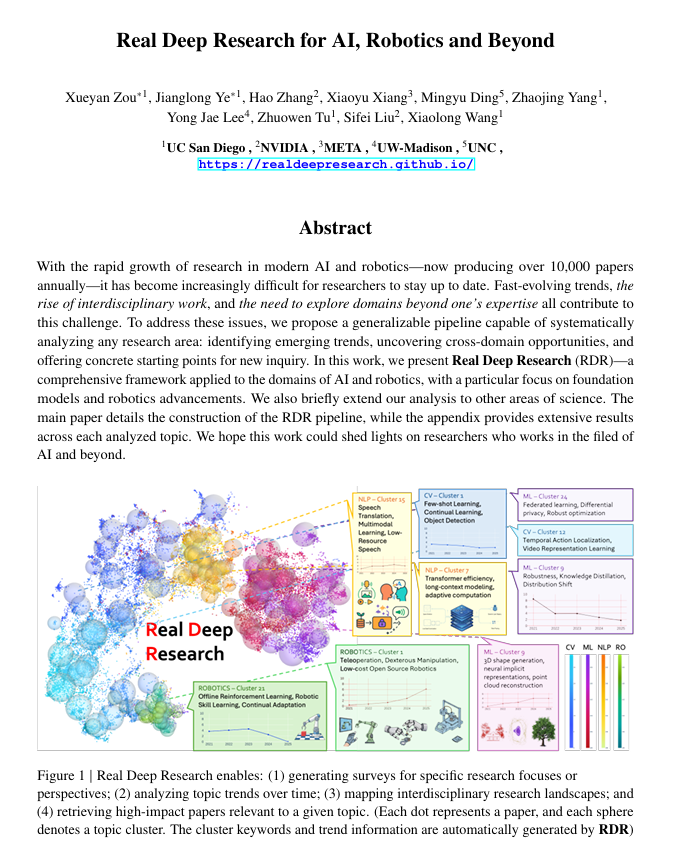

Real Deep Research (RDR): фреймворк для глубоких научных исследований на базе AI : Real Deep Research (RDR) — это фреймворк на базе AI, разработанный для помощи исследователям в отслеживании быстрого развития современной науки. RDR устраняет разрыв между экспертными обзорами и автоматизированным поиском литературы, предоставляя масштабируемые аналитические процессы, анализ тенденций, междисциплинарные связи и генерируя структурированные, высококачественные резюме. Он служит комплексным инструментом исследования, помогая ученым лучше понять общую картину. (Источник: TheTuringPost)

LangSmith запустил Agent Builder без кода, позволяя нетехническим командам создавать агентов : LangSmith от LangChainAI запустил Agent Builder без кода, призванный снизить порог для создания AI-агентов, позволяя нетехническим командам легко создавать их. Этот инструмент, благодаря диалоговому UX для создания агентов, встроенной функции памяти, помогающей агентам запоминать и улучшаться, а также возможности совместного создания агентов нетехническими командами и разработчиками, ускоряет популяризацию и применение AI-агентов. (Источник: LangChainAI)

Verdent интегрирует MiniMax-M2, повышая возможности и эффективность кодирования : Verdent теперь поддерживает модель MiniMax-M2, предоставляя пользователям передовые возможности кодирования, высокопроизводительных агентов и эффективную активацию параметров. Бесплатное тестирование MiniMax-M2 через Verdent в VS Code позволяет разработчикам наслаждаться более интеллектуальным, быстрым и экономичным опытом кодирования. Эта интеграция приносит мощные возможности MiniMax-M2 более широкому сообществу разработчиков. (Источник: MiniMax__AI)

Base44 запускает новый Builder, ускоряя преобразование концепций в приложения : Base44 выпустила совершенно новый Builder, что знаменует собой фундаментальное изменение в ее подходе к работе. Новый Builder больше похож на опытного разработчика, способного проводить исследования перед сборкой, получать контекст из нескольких источников, интеллектуально отлаживать и принимать обоснованные архитектурные решения. Это обновление призвано в десять раз ускорить преобразование концепций в функциональные приложения, значительно повышая эффективность разработки. (Источник: MS_BASE44)

Qdrant и Confluent сотрудничают для создания AI-агентов, осведомленных о контексте в реальном времени : Qdrant и Confluent сотрудничают, чтобы предоставлять свежий, актуальный контекст для интеллектуальных AI-агентов и корпоративных приложений через Confluent Streaming Agents и Real-Time Context Engine. Возможности векторного поиска Qdrant в сочетании с потоковыми данными Confluent в реальном времени позволяют разработчикам создавать и масштабировать событийно-ориентированные, контекстно-осведомленные AI-агенты, тем самым раскрывая весь потенциал агентского AI и значительно сокращая время решения проблем и снижая затраты в таких сценариях, как реагирование на инциденты. (Источник: qdrant_engine, qdrant_engine)

📚 Обучение

ICLR26 Paper Finder: инструмент для поиска AI-статей на основе LLM : Разработчик создал ICLR26 Paper Finder — инструмент, использующий языковую модель в качестве основы для поиска статей на конкретных конференциях по AI. Пользователи могут выполнять запросы по названию, ключевым словам и даже аннотациям статей, причем поиск по аннотациям обеспечивает наивысшую точность. Инструмент размещен на личном сервере и Hugging Face, предоставляя исследователям AI эффективный способ поиска литературы. (Источник: Reddit r/deeplearning, Reddit r/MachineLearning)

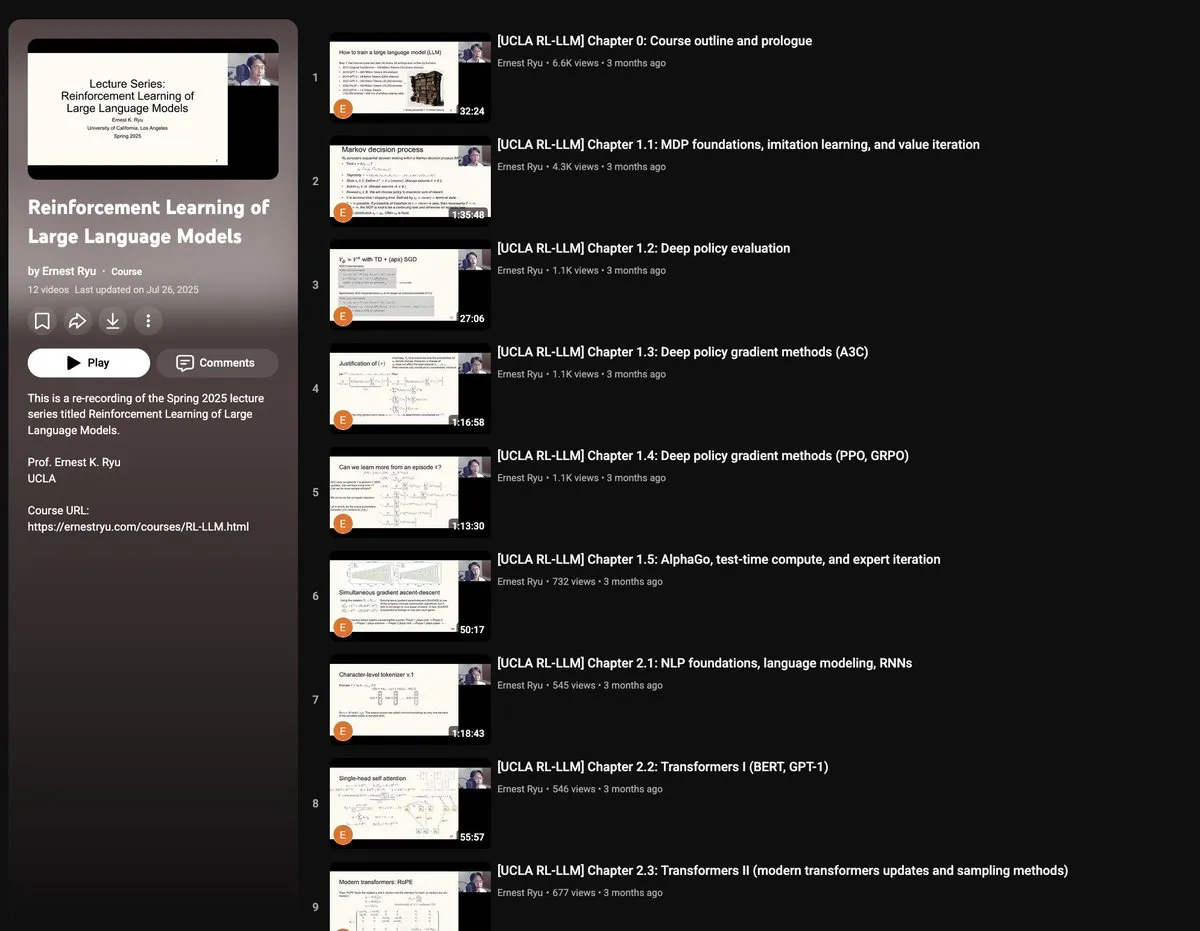

Весенний курс UCLA 2025 года: обучение с подкреплением для больших языковых моделей : UCLA предложит весной 2025 года курс «Обучение с подкреплением для больших языковых моделей», охватывающий широкий круг тем RLxLLM, включая основы, вычисления во время тестирования, RLHF (обучение с подкреплением на основе обратной связи от человека) и RLVR (обучение с подкреплением на основе проверяемых вознаграждений). Этот новый цикл лекций предоставляет исследователям и студентам возможность глубоко изучить передовые теории и практики обучения с подкреплением для LLM. (Источник: algo_diver)

Руководство по Autoencoder от руки: понимание основ генеративного AI : ProfTomYeh опубликовал подробное 7-шаговое руководство по Autoencoder (автокодировщику), нарисованное от руки, призванное помочь читателям понять эту нейронную сеть, играющую ключевую роль в сжатии, шумоподавлении и изучении богатых представлений данных. Autoencoder является основой многих современных генеративных архитектур, и это руководство интуитивно объясняет принципы его работы по кодированию и декодированию информации, являясь ценным ресурсом для изучения основных концепций генеративного AI. (Источник: ProfTomYeh)

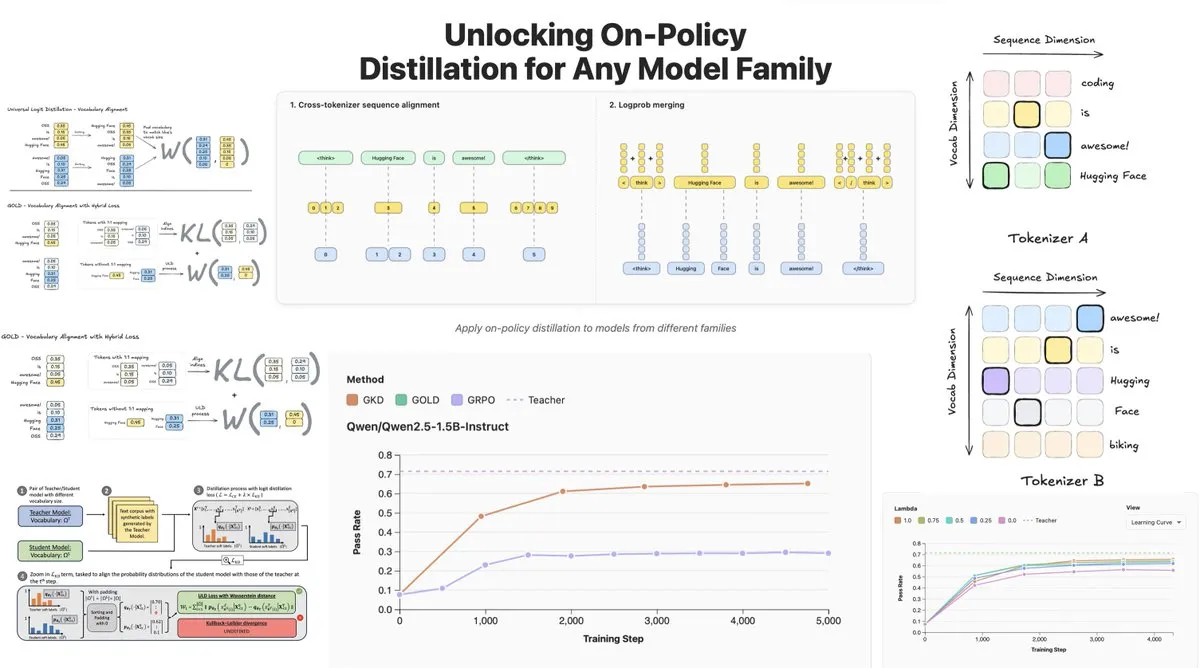

Hugging Face выпустила On-Policy Logit Distillation, поддерживающую дистилляцию между моделями : Hugging Face представила General On-Policy Logit Distillation (GOLD), расширяющую методы дистилляции политики, позволяя дистиллировать любую модель-учитель в любую модель-ученик, даже если их Tokenizer’ы отличаются. Эта технология была интегрирована в библиотеку TRL, что позволяет разработчикам выбирать любую пару моделей из Hub для дистилляции, обеспечивая огромную гибкость и способность восстановления производительности для пост-обучения LLM, особенно решая проблему снижения общей производительности после тонкой настройки в определенной области. (Источник: clefourrier, winglian, _lewtun)

Lumi: Google DeepMind использует Gemini 2.5 для помощи в чтении статей на arXiv : Команда PAIR из Google DeepMind выпустила Lumi, инструмент, использующий большую модель Gemini 2.5 для помощи в чтении статей на arXiv. Lumi может добавлять к статьям резюме, ссылки и встроенные вопросы-ответы, помогая исследователям читать умнее и эффективнее, повышая эффективность понимания научной литературы. (Источник: GoogleDeepMind)

💼 Бизнес

AI способствует рекордно высоким доходам технологических гигантов, впечатляющие финансовые отчеты Microsoft и Google : Материнская компания Google Alphabet и Microsoft достигли знаковых результатов в своих последних финансовых отчетах, при этом AI стал основным двигателем роста. Квартальный доход Alphabet впервые превысил 100 миллиардов долларов, достигнув 102,3 миллиарда долларов, Google Cloud вырос на 34%, а 70% существующих клиентов используют продукты AI. Доход Microsoft вырос на 18% до 77,7 миллиарда долларов, доход Intelligent Cloud впервые превысил 30 миллиардов долларов, а рост облачных сервисов Azure достиг 40%, что свидетельствует о значительном влиянии AI. Обе компании планируют значительно увеличить капитальные затраты на AI, чтобы укрепить свои лидирующие позиции в области AI и получить признание на рынке капитала. (Источник: 36氪, Yuchenj_UW)

CTO Block: AI-агент Goose автоматизирует 60% сложной работы, качество кода не имеет прямой связи с успехом продукта : CTO Block (ранее Square) Дханджи Р. Прасанна рассказал, как компания сэкономила 12 000 сотрудникам 8-10 часов рабочего времени в неделю за 8 недель с помощью открытого фреймворка AI-агентов «Goose». Goose, основанный на протоколе контекста модели (MCP), может подключаться к корпоративным инструментам для автоматизации написания кода, генерации отчетов, обработки данных и других задач. Прасанна подчеркнул, что AI-ориентированные компании должны переориентироваться как технологические компании и провести реорганизацию. Он высказал контринтуитивную точку зрения, что «качество кода не имеет прямой связи с успехом продукта», считая, что ключевым является решение проблем пользователя, и призвал инженеров принять AI, отметив, что опытные и начинающие инженеры наиболее восприимчивы к инструментам AI. (Источник: 36氪)

Индустрия цифровых людей вступает в фазу выживания, производство 3D-цифровых людей переходит на платформенную модель : С взрывным ростом больших моделей индустрия цифровых людей сталкивается с перестановками, компании без возможностей AI выбывают. Рынок 2D-цифровых людей занимает 70,1%, в то время как 3D-цифровые люди ограничены технологическими итерациями и высокой стоимостью GPU. Ведущие компании, такие как MoFa Technology, подчеркивают, что 3D-цифровые люди должны соответствовать возможностям больших моделей, и указывают на накопление высококачественных данных, дефицит талантов и мощные художественные способности как на ключевые факторы. Тенденции в отрасли показывают, что производство 3D-цифровых людей развивается в сторону платформенной модели, а прогресс в технологиях AI снижает затраты, делая возможным масштабирование приложений. Такие компании, как Yingmou Technology и Baidu, также запустили платформы для 3D-генерации, стремясь использовать цифровых людей в качестве инфраструктуры для расширения возможностей большего числа сценариев применения. (Источник: 36氪)

🌟 Сообщество

Сложное восприятие эмоций и доверия к AI пользователями: сравнение R2D2 и ChatGPT : В социальных сетях активно обсуждается разница в эмоциональной связи пользователей с R2D2 и ChatGPT. Пользователи считают R2D2 милым из-за его уникального характера, преданности и «лошадиного» образа, а также потому, что он не затрагивает реальные социально-этические проблемы. В то время как ChatGPT, как «настоящий фальшивый AI», из-за своей практичности, ограничений цензуры контента и потенциальных опасений по поводу слежки, с трудом устанавливает такую же эмоциональную связь. Это сравнение показывает, что ожидания пользователей от AI заключаются не только в интеллекте, но и в «гуманизированном» опыте взаимодействия и восприятии социального воздействия. (Источник: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Ограничения AI-психологического консультирования и необходимость вмешательства человека : С ростом популярности AI-продуктов для психологического консультирования люди начинают использовать AI для решения проблем одиночества и психологических трудностей. Исследования показывают, что около 22% работников поколения Z обращались к психологу, а почти половина консультировалась с AI. AI имеет преимущества в предоставлении информации, исключении факторов и сопровождении, но не может заменить человеческого психолога в эмпатии, понимании «атмосферы» и управлении темпом терапии. Примеры показывают, что AI требует механизма ручного прерывания при выявлении экстремальных рисков, а человек незаменим в оценке границы между эмоциями и патологиями, накоплении опыта и невербальном общении. AI должен в основном выполнять повторяющиеся, вспомогательные задачи и снижать порог обращения за помощью, конечная цель — вернуть человека к реальным межличностным отношениям. (Источник: 36氪)

Взаимодействие пожилых людей с большими моделями: от «образа жизни» к определению «алгоритма» : Фуданьский университет и лаборатория Tencent SSV Time Lab провели годичное исследование, обучая 100 пожилых людей использованию больших моделей. Исследование показало, что отношение пожилых людей к AI не является отторжением, а скорее «прагматичным технологическим взглядом», основанным на жизненном опыте. Их больше волнует, может ли технология интегрироваться в повседневную жизнь и обеспечивать companionship, а не ее предельные функции. В процессе калибровки доверия пожилые люди демонстрировали различные модели, такие как «ограниченная коррекция», «совместная взаимность» и «когнитивная ригидность», а также «нерешительность в вопросах» и «гендерный разрыв». Они ожидают от больших моделей быть «полубогом-предсказателем», «надежным врачом», «другом для общения» и «игрушкой для отдыха», то есть технологией, которая более мягко понимает и ближе к повседневной жизни, «понимающей человека». Это указывает на то, что ценность технологии заключается в том, как долго она может ждать, а не в том, как быстро она работает, призывая к «симбиотической», а не «адаптированной к возрасту» технологии, ориентированной на чувства, ритм и достоинство человека. (Источник: 36氪)

Социальное влияние AI: от мониторинга конфиденциальности до энергопотребления и изменений в занятости : В социальных сетях широко обсуждается многогранное влияние AI на общество. Пользователи обеспокоены тем, что AI уже осуществляет «невидимый мониторинг» через различные приложения, поисковые системы и камеры, предсказывая и влияя на личное поведение, а не в научно-фантастическом стиле управления роботами. В то же время огромная потребность центров обработки данных AI в энергии и воде вызывает протесты сообществ, приводя к отключениям электроэнергии и нехватке водных ресурсов. Кроме того, AI повышает производительность в генерации кода и автоматизации задач, но вызывает дискуссии об изменениях в структуре занятости, а также о проблемах качества кода AI для эффективности производства. Эти обсуждения отражают сложные эмоции общественности по поводу удобств и потенциальных рисков, приносимых технологиями AI. (Источник: Reddit r/artificial, MIT Technology Review, MIT Technology Review, Ronald_vanLoon, Ronald_vanLoon)

Быстрая эволюция терминологии и концепций в области AI : Обсуждения в сообществе указывают на быструю эволюцию терминологии и концепций в области AI. Например, «обучение/создание модели» часто относится к «тонкой настройке», а «тонкая настройка», в свою очередь, считается новой формой «инженерии подсказок/контекста». Эти изменения отражают усложнение технологического стека AI и потребность в более тонких операциях. Кроме того, в отношении компромисса между скоростью и интеллектом модели разработчики предпочитают «медленные, но умные» модели, поскольку они дают более надежные результаты, даже если это означает большее время ожидания. (Источник: dejavucoder, dejavucoder, dejavucoder)

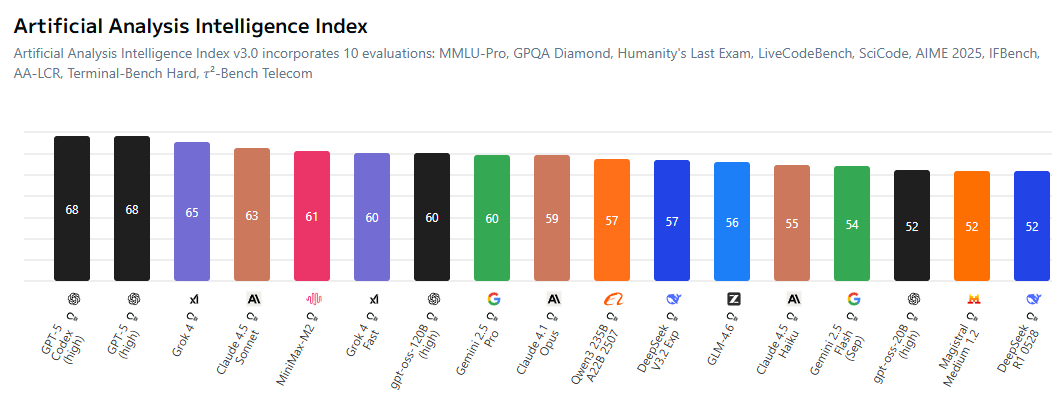

Усиление конкуренции между открытыми и проприетарными моделями AI : В сообществе активно обсуждается сокращение разрыва между открытыми и проприетарными моделями AI, что вынуждает закрытые лаборатории быть более конкурентоспособными в ценообразовании. Открытые модели, такие как MiniMax-M2, демонстрируют выдающиеся результаты в AI Index при крайне низких затратах. В то же время китайские компании и стартапы активно открывают исходный код технологий AI, в то время как американские компании в этом отношении отстают. Эта тенденция предвещает наступление эры, когда «каждый будет обучать модели на основе открытого исходного кода», способствуя демократизации и инновациям в технологиях AI. (Источник: ClementDelangue, huggingface, clefourrier, huggingface)

Влияние AI-генерированного контента на традиционные отрасли и этические вызовы : AI-генерированный контент все глубже проникает в традиционные отрасли, например, «AI-художники» попадают в музыкальные чарты, а технологии дипфейков используются для мошенничества (например, фальшивая речь Хуан Жэньсюня, продвигающая мошенническую криптовалюту). Эти явления вызывают дискуссии о авторском праве, этике и регулировании. В то же время AI также предоставляет новые инструменты повышения производительности в генерации кода, автоматизированном управлении аккаунтами в социальных сетях, но качество и надежность генерируемого контента по-прежнему требуют человеческого вмешательства для проверки. Это подчеркивает проблему балансирования технологических инноваций с социальной ответственностью и этическими нормами в процессе популяризации AI. (Источник: Reddit r/artificial, 36氪, jeremyphoward)

Внимание AI-исследовательского сообщества к качеству данных и оценке : AI-исследовательское сообщество все больше внимания уделяет ключевой роли качества данных в обучении моделей, отмечая, что получение высококачественных данных является более сложной задачей, чем аренда GPU или написание кода. В то же время широко обсуждаются ограничения существующих бенчмарков, поскольку считается, что они не могут полностью отражать истинные возможности моделей и легко подвергаются чрезмерной оптимизации. Исследователи призывают к разработке более информативных и реалистичных систем оценки для содействия здоровому развитию исследований в области AI. (Источник: code_star, code_star, clefourrier, tokenbender)

Применение и перспективы AI в здравоохранении : AI демонстрирует огромный потенциал в области здравоохранения, например, Cloudpeng Technology выпустила новые продукты AI+здоровье, включая интеллектуальную кухонную лабораторию и умный холодильник с большой моделью AI для здоровья, предлагающие персонализированное управление здоровьем. Кроме того, MONAI, набор инструментов AI для медицинских изображений, предоставляет открытый фреймворк PyTorch. Экзоскелеты на базе AI помогают пользователям инвалидных колясок стоять и ходить, а диагностические агенты LLM обучаются диагностическим стратегиям в виртуальной клинической среде. Эти достижения предвещают, что AI глубоко изменит услуги здравоохранения, от повседневного управления здоровьем до вспомогательной диагностики и лечения. (Источник: 36氪, GitHub Trending, Ronald_vanLoon, Ronald_vanLoon, HuggingFace Daily Papers)

Организационные изменения и потребности в талантах в эпоху AI : С распространением AI предприятия сталкиваются с глубокими изменениями в организационной структуре и потребностях в талантах. CTO Block Дханджи Р. Прасанна подчеркивает, что компании должны переориентироваться как «технологические компании» и перейти от «системы генерального директора» к «функциональной системе», чтобы сосредоточить техническое внимание. Инструменты AI, такие как Goose, могут значительно повысить производительность, но высокоуровневая архитектура и дизайн по-прежнему требуют опытных инженеров. При найме компании больше ценят обучающееся и критическое мышление, а не просто навыки использования инструментов AI. AI также размывает границы должностей, нетехнические должности начинают использовать инструменты AI, способствуя формированию модели сотрудничества «человек-машинный коллектив». (Источник: 36氪, MIT Technology Review, NandoDF, SakanaAILabs)

💡 Прочее

Продолжающиеся инновации в многофункциональной робототехнике : Область робототехники демонстрирует разнообразные инновации, включая робота SpiRobs, вдохновленного осьминогом, плавающие дроны, робота Helix для сортировки посылок, а также человекоподобных роботов, помогающих в проверке качества на заводе NIO. Эти достижения охватывают биомиметический дизайн, автоматизацию, человеко-машинное сотрудничество и адаптацию к особым условиям, предвещая широкий потенциал робототехники в промышленности, военном деле и повседневных приложениях. (Источник: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Углубление концепции AI Agent и рыночные перспективы : AI Agent определяется как интеллектуальная сущность, способная рассуждать и адаптироваться подобно человеку, обеспечивая бесшовный диалог между человеком и машиной. Они рассматриваются как тенденция будущего труда, и на рынке появляется множество инструментов для создания AI Agent. Основная ценность AI Agent заключается в том, чтобы стать «производственным инструментом», способным выполнять реальные задачи, а не просто вспомогательным инструментом для «чата», и их развитие будет способствовать глубокому применению AI в различных областях. (Источник: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, dotey)

AI и автономное вождение: автопарк Uber использует новые чипы Nvidia, способствуя развитию роботакси : Следующее поколение автономных транспортных средств Uber будет использовать новые чипы Nvidia, что, как ожидается, снизит стоимость роботакси. Платформа Nvidia Drive Hyperion представляет собой стандартизированную архитектуру для автомобилей, готовых к использованию в качестве роботакси, и сотрудничество с Uber будет способствовать распространению технологий автономного вождения среди потребителей. Это указывает на ускоренное развитие применения AI в транспортной сфере, направленное на создание более безопасных и экономичных услуг автономного вождения. (Источник: MIT Technology Review, TheTuringPost)