Palavras-chave:Modelo de IA, Tecnologia OCR, Infraestrutura de IA, Modelo de Linguagem Grande, Agente de IA, Modelo multimodal de IA, Otimização de consumo de energia em IA, Ecossistema de código aberto em IA, Modelo DeepSeek OCR, Raciocínio multimodal Gemini 3, Modelo de mundo Emu3.5, Arquitetura de atenção mista Kimi Linear, Tecnologia de dobramento de memória AgentFold

Seleção do Editor da Coluna de IA

🔥 Em Foco

Modelo DeepSeek OCR: Novo avanço na memória de IA e otimização do consumo de energia : A DeepSeek lançou um modelo OCR, cuja inovação central reside na forma como processa informações e armazena memórias. O modelo comprime informações de texto em formato de imagem, reduzindo significativamente os recursos computacionais necessários para sua execução, o que pode aliviar a crescente pegada de carbono da IA. Este método simula a memória humana através de compressão hierárquica, desfocando conteúdo menos importante para economizar espaço, mantendo alta eficiência. Esta pesquisa atraiu a atenção de especialistas como Andrej Karpathy, que acreditam que imagens podem ser mais adequadas como entrada para LLMs do que texto, abrindo novas direções para a memória de IA e aplicações de agentes. (Fonte: MIT Technology Review)

Gigantes da tecnologia continuam a investir pesadamente em infraestrutura de IA : Gigantes da tecnologia como Microsoft, Meta e Google anunciaram em seus últimos relatórios financeiros que continuarão a aumentar significativamente os gastos com infraestrutura de IA. A Meta prevê que seus gastos de capital atingirão US$ 70-72 bilhões este ano e planeja expandir ainda mais no próximo ano; a receita da Microsoft Intelligent Cloud ultrapassou US$ 30 bilhões pela primeira vez, com o Azure e outros serviços de nuvem crescendo 40%, e a capacidade de IA deverá aumentar 80%. O CEO do Google, Pichai, enfatizou que a abordagem de pilha completa de IA trouxe um forte impulso e previu o lançamento iminente do Gemini 3. Esses investimentos refletem o otimismo dos gigantes em relação aos futuros avanços da IA e sua determinação em capturar a liderança de mercado. (Fonte: Wired, Reddit r/artificial)

Anthropic descobre que LLMs possuem “introspecção” limitada : Uma nova pesquisa da Anthropic revela que Large Language Models (LLMs) como o Claude possuem “consciência introspectiva genuína”, embora essa capacidade ainda seja limitada. O estudo investiga se os LLMs podem reconhecer seus próprios pensamentos internos ou se apenas geram respostas plausíveis com base nas perguntas. Esta descoberta sugere que os LLMs podem ter um nível de autoconsciência mais profundo do que o esperado, o que é significativo para a compreensão e o desenvolvimento de sistemas de IA mais inteligentes e conscientes. (Fonte: Anthropic, Reddit r/artificial)

Extropic lança novo hardware de computação termodinâmica TSU, alegando avanço no consumo de energia de IA : A Extropic lançou um novo dispositivo de computação, o TSU (Thermodynamic Sampling Unit), cujo núcleo é o “P-bit” (probabilistic bit), que pode oscilar entre 0 e 1 com uma probabilidade programável, visando alcançar uma melhoria de 10.000 vezes na eficiência energética da IA. A empresa lançou o chip X0, o kit de teste de desktop XTR0 e o TSU de nível comercial Z1, e abriu o código da biblioteca de software Thermol para simulação de TSU em GPU. Embora a definição de sua referência de melhoria de eficiência tenha sido questionada, esta direção visa resolver a enorme lacuna de poder computacional e energia da IA, trazendo uma potencial mudança de paradigma para a computação de IA. (Fonte: TheRundownAI, pmddomingos, op7418)

🎯 Tendências

Google anuncia o lançamento iminente do Gemini 3, reforçando a tendência de especialização da família de modelos de IA : O CEO do Google, Sundar Pichai, anunciou durante a teleconferência de resultados que a nova versão do modelo carro-chefe, Gemini 3, será lançada ainda este ano. Ele enfatizou que a família de modelos de IA do Google está caminhando para a especialização, com Gemini focado em raciocínio multimodal, Veo para geração de vídeo, Genie para agentes interativos e Nano para inteligência em dispositivos. Esta estratégia indica que o Google está mudando de um único modelo geral para uma arquitetura de sistema interconectada e otimizada para diferentes cenários, a fim de melhorar a confiabilidade, reduzir a latência e suportar a implantação em edge. (Fonte: Reddit r/ArtificialInteligence, shlomifruchter)

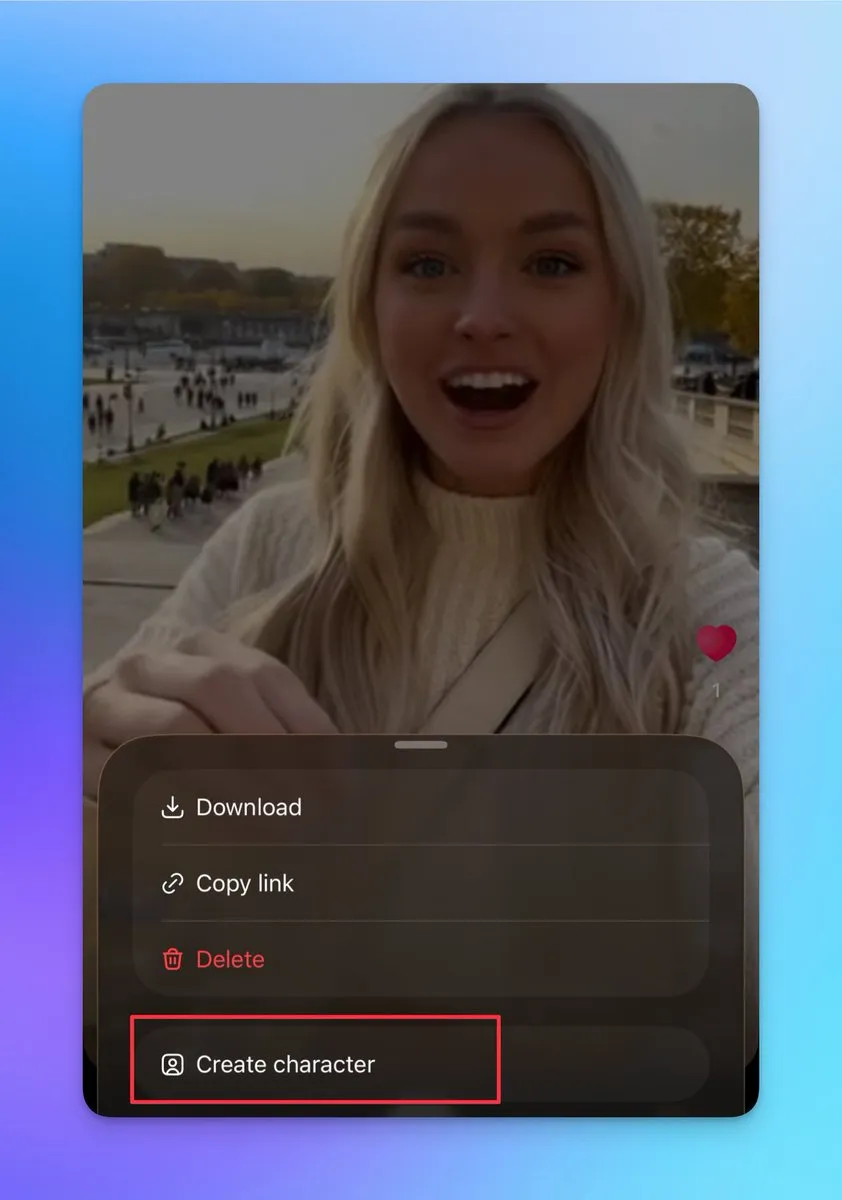

Sora 2 adiciona funções de personagem personalizado e junção de vídeo, suportando criação contínua de vídeos longos : O Sora 2 atualizou recentemente várias funções importantes, incluindo suporte para criar outros personagens (não é possível fazer upload de fotos reais, mas pode-se criar a partir de pessoas em vídeos existentes), permitindo aos usuários garantir a consistência dos personagens, o que é crucial para construir vídeos longos e contínuos. Além disso, a página de rascunho suporta a junção de vários vídeos antes da publicação, e a página de pesquisa adicionou um ranking, exibindo shows ao vivo de pessoas reais e criadores de conteúdo secundário. Essas atualizações aumentam significativamente a flexibilidade criativa e a interatividade do usuário do Sora 2, com potencial para aumentar drasticamente seus usuários ativos diários. (Fonte: op7418, billpeeb, op7418)

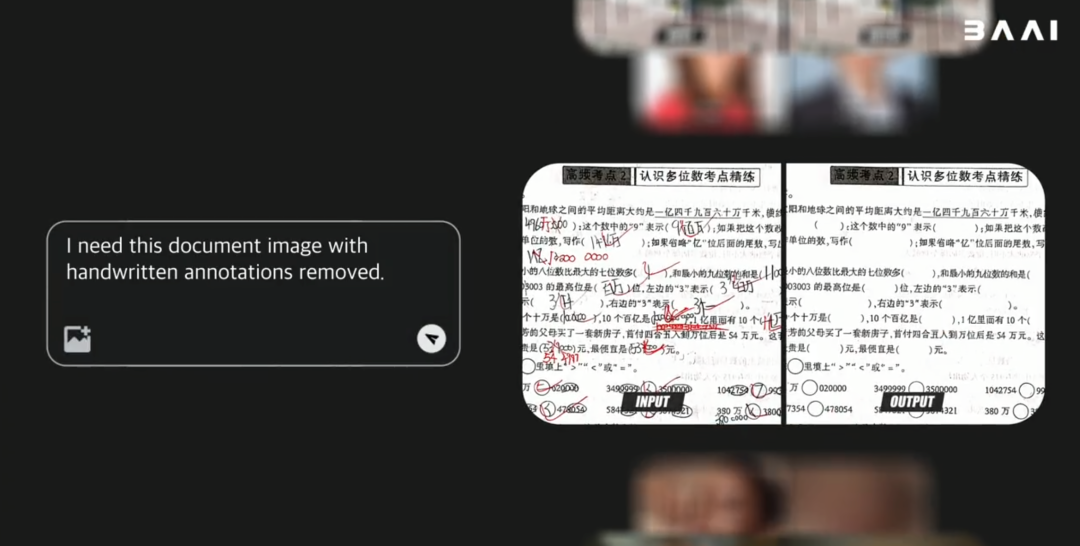

Zhiyuan lança modelo de mundo multimodal de código aberto Emu3.5, superando o desempenho do Gemini-2.5-Flash-Image : O Instituto de Inteligência Artificial de Pequim (BAAI) lançou o Emu3.5, um modelo de mundo multimodal de código aberto com 34B parâmetros. Este modelo, baseado na estrutura Decoder-only Transformer, pode lidar simultaneamente com tarefas de imagem, texto e vídeo, unificando-as em uma tarefa de previsão de próximo estado. O Emu3.5 é pré-treinado em vastos dados de vídeo da internet, possuindo a capacidade de compreender a continuidade espaço-temporal e as relações causais. Ele se destaca em narrativa visual, orientação visual, edição de imagem, exploração de mundo e operações corporificadas, com melhorias significativas na fidelidade física, e seu desempenho é comparável ou até superior ao Gemini-2.5-Flash-Image (Nano Banana). (Fonte: 36氪)

Moonshot AI lança modelo Kimi Linear, utilizando arquitetura de atenção linear híbrida : A Moonshot AI lançou o modelo Kimi Linear, um modelo de 48B parâmetros baseado na arquitetura de atenção linear híbrida (KDA), com 3B parâmetros ativos e suporte para 1M de comprimento de contexto. O Kimi Linear otimiza o Gated DeltaNet, melhorando significativamente o desempenho em tarefas de contexto longo e a eficiência de hardware, reduzindo a necessidade de cache KV em até 75% e aumentando o throughput de decodificação em 6 vezes. O modelo apresenta excelente desempenho em vários benchmarks, superando os modelos tradicionais de atenção completa, e lançou duas versões de código aberto no Hugging Face. (Fonte: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, bigeagle_xd)

Modelo MiniMax M2 mantém arquitetura de atenção completa, destacando desafios na implantação em produção : Haohai Sun, chefe de pré-treinamento do MiniMax M2, explicou por que o modelo M2 ainda usa a arquitetura Full Attention em vez de atenção linear ou esparsa. Ele apontou que, embora a atenção eficiente possa teoricamente economizar poder computacional, em sistemas de nível industrial reais, seu desempenho, velocidade e preço ainda são difíceis de superar a Full Attention. Os principais gargalos estão nas limitações dos sistemas de avaliação, nos altos custos experimentais de tarefas de inferência complexas e na infraestrutura imatura. A MiniMax acredita que, ao buscar a capacidade de contexto longo, a qualidade dos dados, o sistema de avaliação e a otimização da infraestrutura são mais cruciais do que simplesmente mudar a arquitetura de atenção. (Fonte: Reddit r/LocalLLaMA, ClementDelangue)

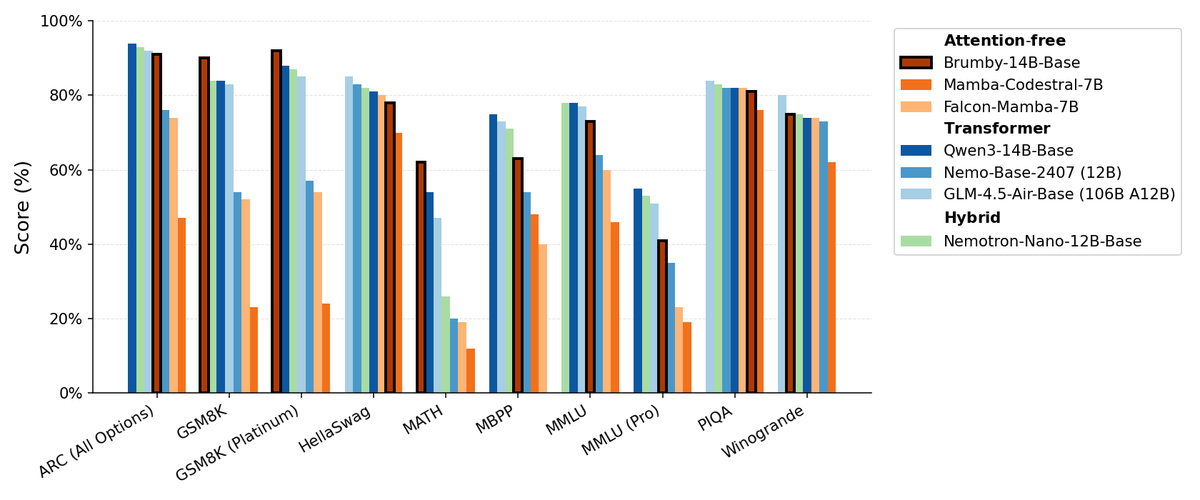

Manifest AI lança Brumby-14B-Base, explorando modelos base sem atenção : A Manifest AI lançou o Brumby-14B-Base, alegando ser o modelo base sem atenção mais poderoso até o momento, treinado com 14 bilhões de parâmetros a um custo de apenas US$ 4.000. O modelo tem desempenho comparável a Transformers e modelos híbridos de tamanho semelhante, sugerindo que a era Transformer pode estar lentamente chegando ao fim. Este avanço oferece novas possibilidades para a arquitetura de modelos de IA, especialmente na redução dos custos de treinamento, e desafia o domínio dos mecanismos de atenção tradicionais. (Fonte: ClementDelangue, teortaxesTex)

Novos modelos Nemotron baseados em Qwen3 32B, otimizando a qualidade de resposta de LLMs : A NVIDIA lançou o Qwen3-Nemotron-32B-RLBFF, um Large Language Model ajustado com base no Qwen/Qwen3-32B, projetado para melhorar a qualidade das respostas geradas por LLMs no modo de pensamento padrão. Este modelo de pesquisa supera significativamente o Qwen3-32B original em benchmarks como Arena Hard V2, WildBench e MT Bench, e tem desempenho semelhante ao DeepSeek R1 e O3-mini, mas com um custo de inferência inferior a 5%, demonstrando avanços em desempenho e eficiência. (Fonte: Reddit r/LocalLLaMA)

Arquitetura Mamba ainda tem vantagens no processamento de contexto longo, mas treinamento paralelo é limitado : A arquitetura Mamba se destaca no processamento de contexto longo (milhões de tokens), evitando o problema de explosão de memória dos Transformers. No entanto, sua principal limitação é a dificuldade de paralelização durante o treinamento, o que impede sua popularização em aplicações de maior escala. Apesar da existência de vários mixers lineares e arquiteturas híbridas, o desafio do treinamento paralelo da Mamba continua sendo um gargalo crucial para sua aplicação em larga escala. (Fonte: Reddit r/MachineLearning)

NVIDIA lança ARC, Rubin, Omniverse DSX, etc., fortalecendo a liderança em infraestrutura de IA : A NVIDIA fez uma série de anúncios importantes na conferência GTC, incluindo NVIDIA ARC (Airborne RAN Computer) em parceria com a Nokia para desenvolver 6G, Rubin (supercomputador de terceira geração em escala de rack), Omniverse DSX (um projeto para design colaborativo virtual e operação de fábricas de IA de gigabits) e NVIDIA Drive Hyperion (arquitetura padronizada para táxis robóticos) em parceria com a Uber. Esses lançamentos indicam que a NVIDIA está se posicionando de fabricante de chips para arquiteta de infraestrutura nacional, enfatizando “Made in USA” e a corrida energética para enfrentar os desafios da era da IA e do 6G. (Fonte: TheTuringPost, TheTuringPost)

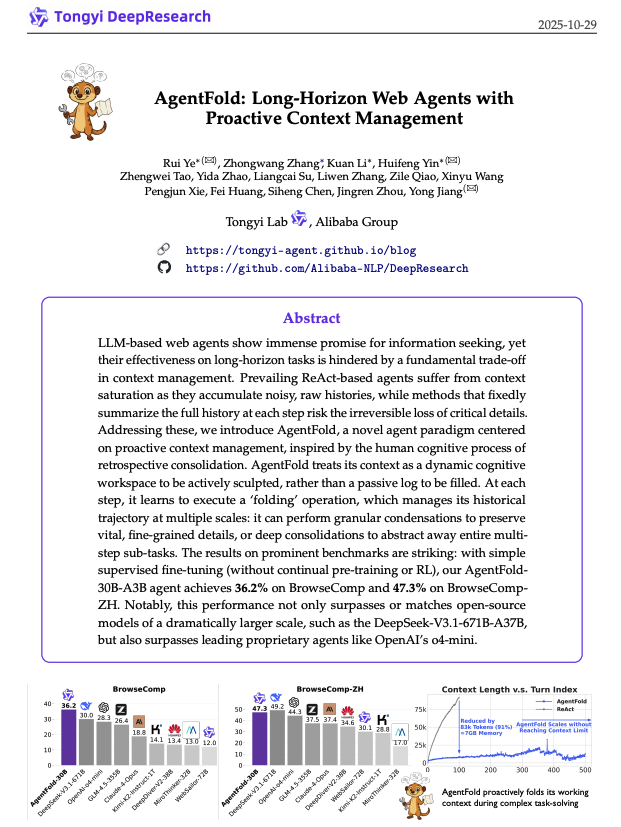

AgentFold: Gerenciamento adaptativo de contexto, melhorando a eficiência de agentes web : O AgentFold propõe uma nova técnica de engenharia de contexto, que comprime os pensamentos anteriores do agente em memória estruturada através de “Memory Folding”, gerenciando dinamicamente o espaço de trabalho cognitivo. Este método resolve o problema de sobrecarga de contexto dos agentes ReAct tradicionais e apresenta excelente desempenho em benchmarks como BrowseComp, superando grandes modelos como DeepSeek-V3.1-671B. O AgentFold-30B alcança desempenho competitivo com um número menor de parâmetros, melhorando significativamente a eficiência de desenvolvimento e implantação de agentes web. (Fonte: omarsar0)

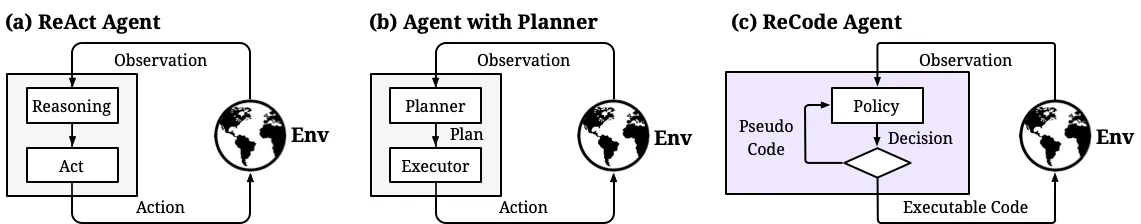

ReCode: Unificando planejamento e ação para controle dinâmico da granularidade de decisão de agentes de IA : ReCode (Recursive Code Generation) é um novo método de fine-tuning eficiente em parâmetros (PEFT) que unifica a representação de planejamento e ação de agentes de IA, tratando o planejamento de alto nível como uma função recursiva que pode ser decomposta em ações de granularidade fina. Este método alcança desempenho SOTA com apenas 0,02% dos parâmetros de treinamento e reduz o consumo de memória da GPU. O ReCode permite que os agentes se adaptem dinamicamente a diferentes granularidades de decisão, aprendam decisões hierárquicas e superem significativamente os métodos tradicionais em eficiência e utilização de dados, sendo um passo importante para alcançar o raciocínio semelhante ao humano. (Fonte: dotey, ZhihuFrontier)

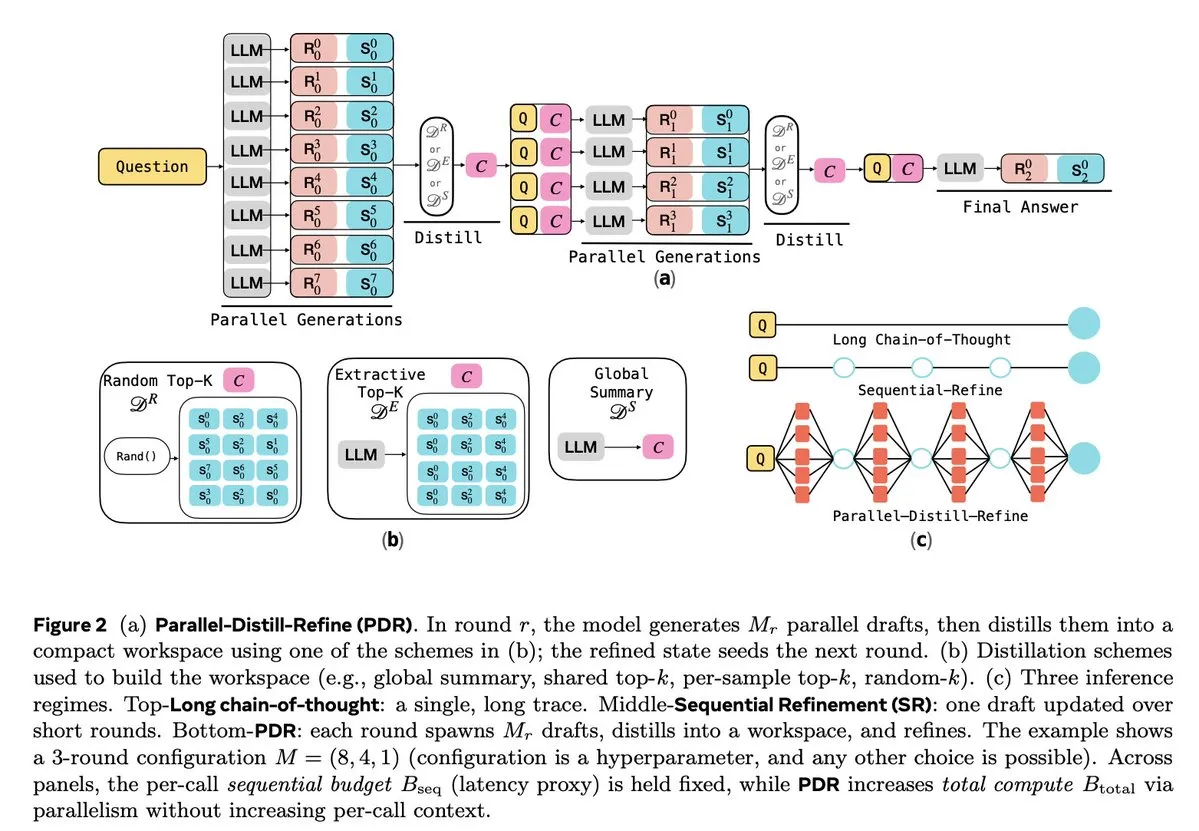

Otimização de inferência e aprendizado por reforço de LLMs : Várias pesquisas se dedicam a melhorar a eficiência e a confiabilidade da inferência de LLMs. O Parallel-Distill-Refine (PDR) reduz o custo e a latência de tarefas de inferência complexas através da geração e refino paralelo de rascunhos. O Flawed-Aware Policy Optimization (FAPO) introduz um mecanismo de recompensa e penalidade para corrigir padrões de falha no processo de inferência, aumentando a confiabilidade. A estrutura PairUni equilibra as tarefas de compreensão e geração de LLMs multimodais através de treinamento pareado e do algoritmo de otimização Pair-GPRO. O PM4GRPO utiliza técnicas de mineração de processos para aprimorar a capacidade de inferência de modelos de política através de aprendizado por reforço GRPO com consciência de inferência. O protocolo Fortytwo, por sua vez, alcança excelente desempenho na inferência de grupos de IA e forte resistência a prompts adversariais através de consenso de classificação distribuído e peer-to-peer. (Fonte: NandoDF, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

🧰 Ferramentas

Tencent lança WeKnora de código aberto: Estrutura de compreensão e recuperação de documentos impulsionada por LLM : A Tencent lançou o WeKnora de código aberto, uma estrutura de compreensão de documentos e recuperação semântica baseada em LLM, projetada especificamente para lidar com documentos complexos e heterogêneos. Ele adota uma arquitetura modular, combinando pré-processamento multimodal, indexação de vetores semânticos, recuperação inteligente e inferência de LLM, seguindo o paradigma RAG. Ao combinar blocos de documentos relevantes e inferência de modelo, ele alcança respostas de alta qualidade e sensíveis ao contexto. O WeKnora suporta vários formatos de documento, modelos de incorporação e estratégias de recuperação, e oferece uma interface web e API amigáveis, suportando implantação local e nuvem privada, garantindo a soberania dos dados. (Fonte: GitHub Trending)

Jan: Alternativa de ChatGPT offline de código aberto, suporta execução local de LLMs : Jan é uma alternativa de ChatGPT de código aberto que pode ser executada 100% offline no computador do usuário. Ele permite que os usuários baixem e executem LLMs do HuggingFace (como Llama, Gemma, Qwen, GPT-oss, etc.) e suporta integração com modelos de nuvem como OpenAI e Anthropic. Jan oferece assistentes personalizados, API compatível com OpenAI e integração com o Model Context Protocol (MCP), enfatizando a proteção da privacidade para fornecer aos usuários uma experiência de IA local com controle total. (Fonte: GitHub Trending)

Claude Code: Kit de ferramentas para desenvolvedores e ecossistema de habilidades da Anthropic : O Claude Code da Anthropic, através de uma série de “habilidades” e agentes, melhora significativamente a produtividade dos desenvolvedores. Isso inclui o conector Rube MCP (conectando Claude a mais de 500 aplicativos), o kit de ferramentas de desenvolvimento Superpowers (fornecendo comandos /brainstorm, /write-plan, /execute-plan), o pacote de documentos (lidando com Word/Excel/PDF), o Theme Factory (automação de guias de marca) e o Systematic Debugging (simulando o processo de depuração de desenvolvedores seniores). Essas ferramentas, com design modular e capacidade de reconhecimento de contexto, ajudam os desenvolvedores a automatizar fluxos de trabalho, revisão de código, refatoração e correção de erros, e até mesmo permitem que equipes não técnicas criem suas próprias pequenas ferramentas. (Fonte: Reddit r/ClaudeAI, Reddit r/ClaudeAI)

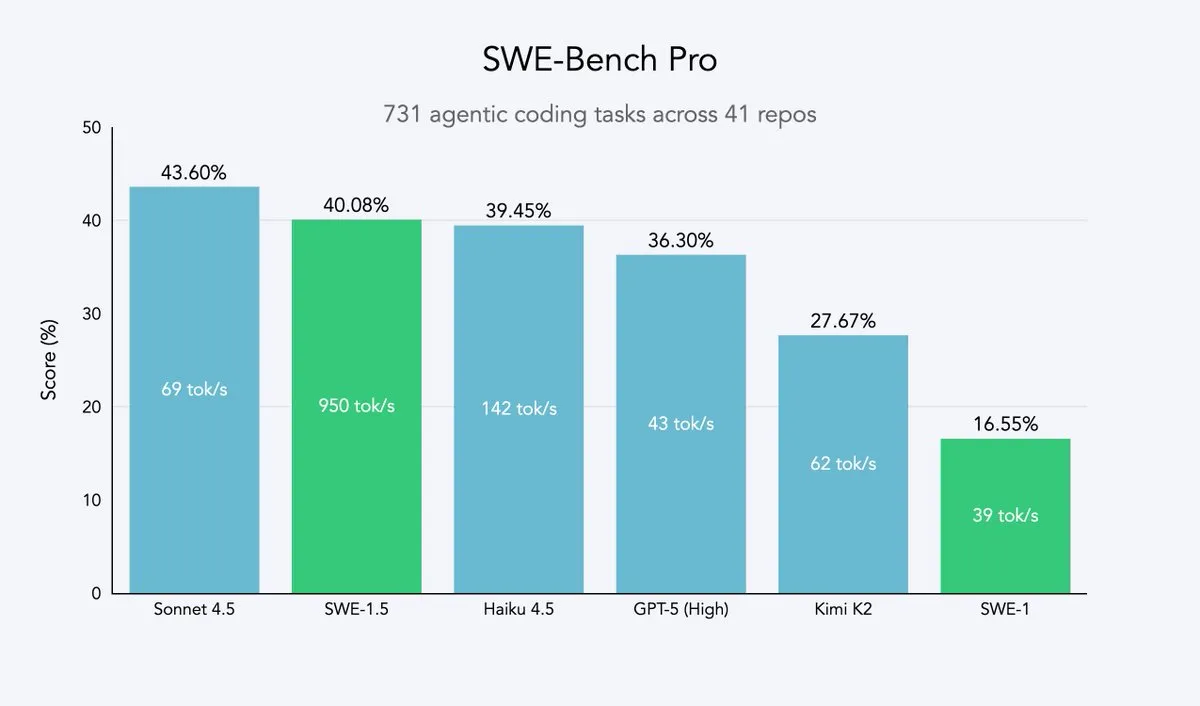

Cursor 2.0 e Windsurf: Agentes de código em busca de velocidade e eficiência : Cursor e Windsurf lançaram modelos de agentes de código e a plataforma 2.0 focados na otimização de velocidade. Sua estratégia é basear-se em grandes modelos de código aberto (como Qwen3), realizar fine-tuning com aprendizado por reforço e implantá-los em hardware otimizado para alcançar um efeito de “inteligência média, mas velocidade ultra-rápida”. Esta abordagem é uma estratégia eficiente para empresas de agentes de código, permitindo-lhes aproximar-se da fronteira de Pareto de velocidade e inteligência com o mínimo custo de recursos. O modelo SWE-1.5 da Windsurf estabelece um novo padrão de velocidade ao mesmo tempo em que alcança um desempenho de codificação próximo ao SOTA. (Fonte: dotey, Smol_AI, VictorTaelin, omarsar0, TheRundownAI)

Perplexity Patents: Primeiro agente de pesquisa de patentes de IA, capacitando a inteligência de IP : A Perplexity lançou o Perplexity Patents, o primeiro agente de pesquisa de patentes de IA do mundo, com o objetivo de tornar a inteligência de IP acessível a todos. Esta ferramenta permite a pesquisa e o estudo de patentes, e no futuro lançará o Perplexity Scholar, focado em pesquisa acadêmica. Esta inovação simplificará enormemente os processos de busca e análise de patentes, fornecendo serviços de inteligência de propriedade intelectual eficientes e fáceis de usar para inovadores, advogados e pesquisadores. (Fonte: AravSrinivas)

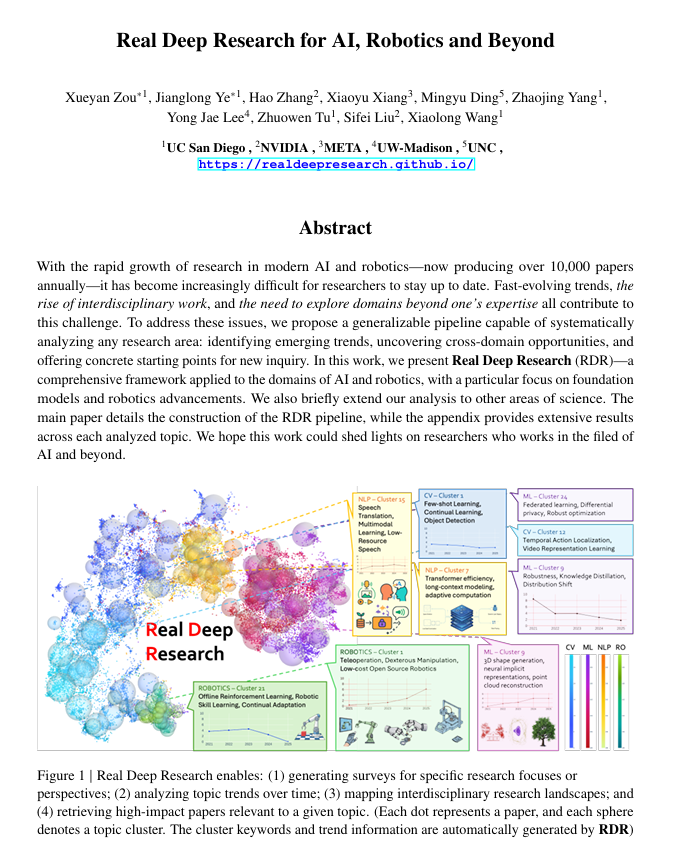

Real Deep Research (RDR): Estrutura de pesquisa profunda impulsionada por IA : O Real Deep Research (RDR) é uma estrutura impulsionada por IA projetada para ajudar pesquisadores a acompanhar o rápido desenvolvimento da ciência moderna. O RDR preenche a lacuna entre pesquisas escritas por especialistas e a mineração automatizada de literatura, fornecendo processos de análise escaláveis, análise de tendências, insights de conexão entre domínios e gerando resumos estruturados e de alta qualidade. Ele serve como uma ferramenta de pesquisa abrangente, ajudando os pesquisadores a entender melhor o panorama geral. (Fonte: TheTuringPost)

LangSmith lança Agent Builder sem código, capacitando equipes não técnicas a construir agentes : O LangSmith da LangChainAI lançou o Agent Builder sem código, com o objetivo de reduzir a barreira para a construção de agentes de IA, permitindo que equipes não técnicas criem agentes facilmente. Esta ferramenta acelera a popularização e aplicação de agentes de IA através de uma UX de construção de agentes conversacional, funcionalidade de memória integrada para ajudar os agentes a lembrar e melhorar, e capacitando equipes não técnicas e desenvolvedores a construir agentes juntos. (Fonte: LangChainAI)

Verdent integra MiniMax-M2, melhorando a capacidade e eficiência de codificação : O Verdent agora suporta o modelo MiniMax-M2, oferecendo aos usuários capacidades avançadas de codificação, agentes de alto desempenho e ativação eficiente de parâmetros. Ao experimentar o MiniMax-M2 gratuitamente no VS Code através do Verdent, os desenvolvedores podem desfrutar de uma experiência de codificação mais inteligente, rápida e econômica. Esta integração leva o poder do MiniMax-M2 a uma comunidade de desenvolvedores mais ampla. (Fonte: MiniMax__AI)

Base44 lança novo Builder, acelerando a conversão de conceito em aplicação : A Base44 lançou o novo Builder, marcando uma mudança fundamental em sua forma de trabalhar. O novo Builder é mais como um desenvolvedor especialista, capaz de pesquisar antes de construir, obter contexto de múltiplas fontes, depurar inteligentemente e tomar decisões arquitetônicas informadas. Esta atualização visa acelerar em dez vezes a velocidade de conversão de conceitos em aplicações funcionais, melhorando drasticamente a eficiência do desenvolvimento. (Fonte: MS_BASE44)

Qdrant e Confluent colaboram para capacitar agentes de IA com consciência de contexto em tempo real : A Qdrant e a Confluent colaboraram, através dos Confluent Streaming Agents e do Real-Time Context Engine, para fornecer contexto fresco e em tempo real para agentes de IA inteligentes e aplicações empresariais. A capacidade de busca vetorial da Qdrant, combinada com os dados de streaming em tempo real da Confluent, permite que os desenvolvedores construam e escalem agentes de IA orientados a eventos e conscientes do contexto, desbloqueando assim todo o potencial da IA baseada em agentes e reduzindo drasticamente o tempo de resolução e os custos em cenários como resposta a incidentes. (Fonte: qdrant_engine, qdrant_engine)

📚 Aprendizado

ICLR26 Paper Finder: Ferramenta de busca de artigos de IA baseada em LLM : Um desenvolvedor criou o ICLR26 Paper Finder, uma ferramenta que utiliza modelos de linguagem como base para buscar artigos de conferências específicas de IA. Os usuários podem pesquisar por título, palavras-chave ou até mesmo resumos de artigos, sendo a busca por resumo a mais precisa. A ferramenta foi hospedada em um servidor pessoal e no Hugging Face, proporcionando aos pesquisadores de IA uma forma eficiente de recuperar literatura. (Fonte: Reddit r/deeplearning, Reddit r/MachineLearning)

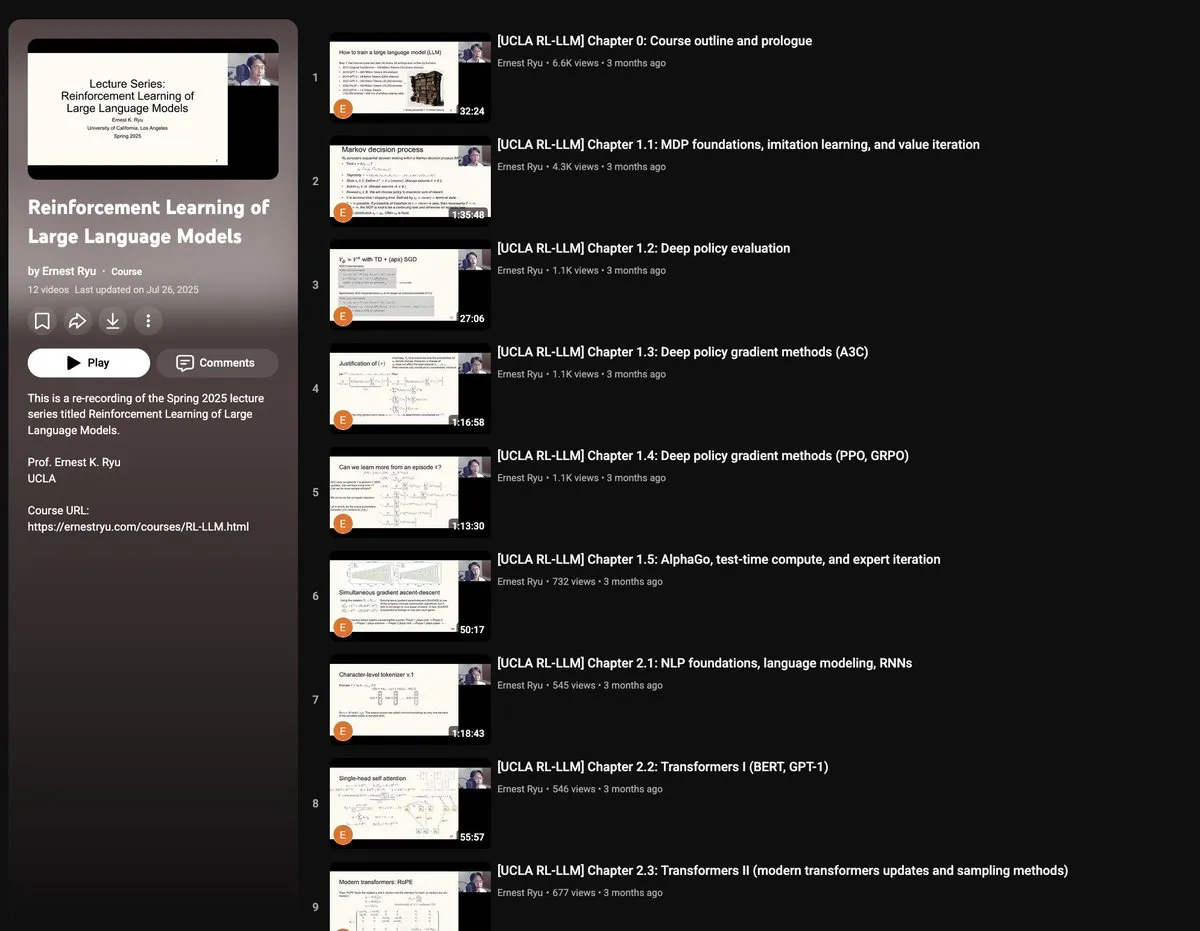

Curso da UCLA Primavera 2025: Aprendizado por Reforço para Large Language Models : A UCLA oferecerá um curso de “Aprendizado por Reforço para Large Language Models” na primavera de 2025, cobrindo uma ampla gama de tópicos de RLxLLM, incluindo fundamentos, computação em tempo de teste, RLHF (Reinforcement Learning from Human Feedback) e RLVR (Reinforcement Learning from Verifiable Rewards). Este novo conjunto de palestras oferece a pesquisadores e estudantes a oportunidade de aprofundar-se nas teorias e práticas de ponta do aprendizado por reforço de LLMs. (Fonte: algo_diver)

Guia de Autoencoder desenhado à mão: Entendendo os fundamentos da IA generativa : O ProfTomYeh publicou um guia detalhado de 7 passos para Autoencoder desenhado à mão, com o objetivo de ajudar os leitores a entender esta rede neural que desempenha um papel crucial na compressão, denoising e aprendizado de representações ricas de dados. O Autoencoder é a base de muitas arquiteturas generativas modernas, e este guia explica intuitivamente como ele funciona para codificar e decodificar informações, sendo um recurso valioso para aprender os conceitos centrais da IA generativa. (Fonte: ProfTomYeh)

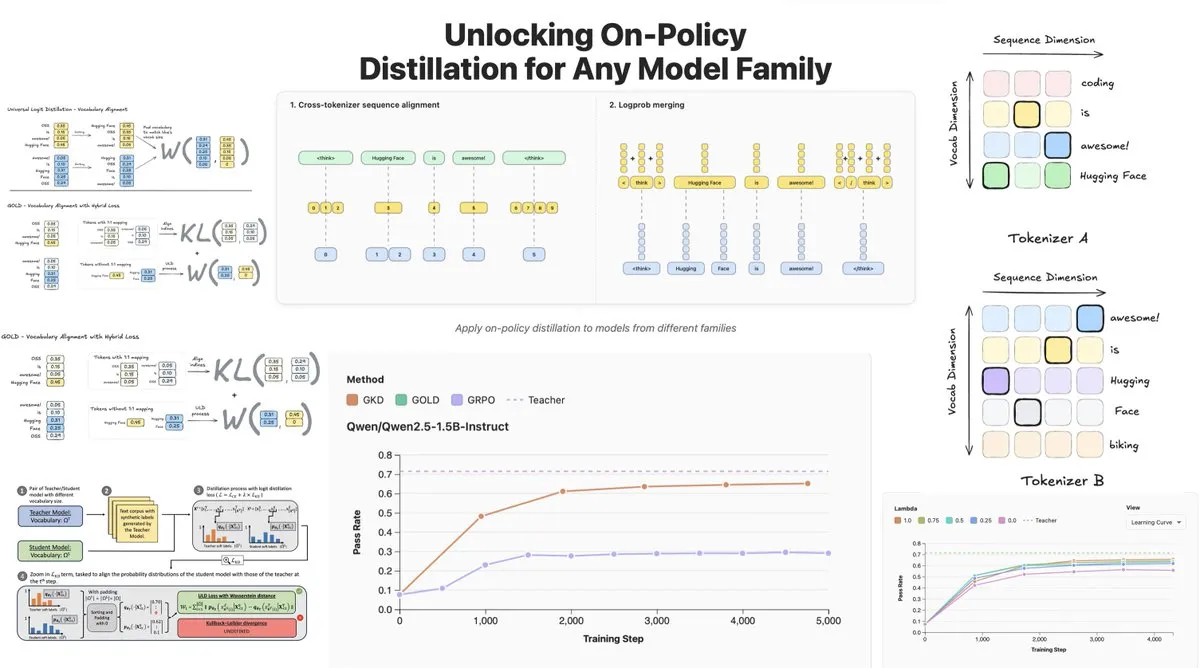

Hugging Face lança On-Policy Logit Distillation, suportando destilação entre modelos : A Hugging Face lançou o General On-Policy Logit Distillation (GOLD), que estende os métodos de destilação de política para permitir a destilação de qualquer modelo professor para qualquer modelo aluno, mesmo que seus Tokenizers sejam diferentes. Esta tecnologia foi integrada à biblioteca TRL, permitindo que os desenvolvedores selecionem qualquer par de modelos do Hub para destilação, proporcionando grande flexibilidade e capacidade de recuperação de desempenho para o pós-treinamento de LLMs, especialmente resolvendo o problema de degradação do desempenho geral após o fine-tuning em domínios específicos. (Fonte: clefourrier, winglian, _lewtun)

Lumi: Google DeepMind utiliza Gemini 2.5 para auxiliar na leitura de artigos do arXiv : A equipe PAIR do Google DeepMind lançou o Lumi, uma ferramenta que utiliza o grande modelo Gemini 2.5 para auxiliar na leitura de artigos do arXiv. O Lumi pode adicionar resumos, referências e perguntas e respostas inline aos artigos, ajudando os pesquisadores a ler de forma mais inteligente e eficiente, melhorando a eficácia da compreensão da literatura científica. (Fonte: GoogleDeepMind)

💼 Negócios

IA impulsiona receita recorde de gigantes da tecnologia, relatórios financeiros da Microsoft e Google brilham : A Alphabet, controladora do Google, e a Microsoft alcançaram resultados históricos em seus últimos relatórios financeiros, com a IA sendo o principal motor de crescimento. A Alphabet ultrapassou US$ 100 bilhões em receita trimestral pela primeira vez, atingindo US$ 102,3 bilhões, com o Google Cloud crescendo 34% e 70% dos clientes existentes usando produtos de IA. A receita da Microsoft cresceu 18% para US$ 77,7 bilhões, com a receita da Intelligent Cloud ultrapassando US$ 30 bilhões pela primeira vez e os serviços de nuvem Azure crescendo 40%, impulsionados significativamente pela IA. Ambas as empresas planejam aumentar drasticamente os gastos de capital em IA para consolidar sua liderança no campo da IA e obter o reconhecimento do mercado de capitais. (Fonte: 36氪, Yuchenj_UW)

CTO da Block: AI Agent Goose automatiza 60% do trabalho complexo, qualidade do código e sucesso do produto não têm relação direta : Dhanji R. Prasanna, CTO da Block (antiga Square), compartilhou como a empresa economizou 8-10 horas de trabalho por semana para 12.000 funcionários em 8 semanas através da estrutura de AI Agent de código aberto “Goose”. O Goose, baseado no Model Context Protocol (MCP), pode conectar ferramentas empresariais para automatizar a escrita de código, geração de relatórios, processamento de dados e outras tarefas. Prasanna enfatizou que as empresas nativas de IA devem se reposicionar como empresas de tecnologia e ajustar suas estruturas organizacionais. Ele apresentou a visão contraintuitiva de que “a qualidade do código não tem relação direta com o sucesso do produto”, argumentando que a chave é se o produto resolve os problemas do usuário, e encorajou engenheiros a abraçar a IA, com engenheiros seniores e novatos mostrando a maior aceitação de ferramentas de IA. (Fonte: 36氪)

Indústria de humanos digitais entra em fase de eliminação, produção de humanos digitais 3D migra para plataformas : Com a explosão dos grandes modelos, a indústria de humanos digitais enfrenta uma reestruturação, com empresas sem capacidade de IA sendo eliminadas. O mercado de humanos digitais 2D representa 70,1%, enquanto os humanos digitais 3D são limitados pela iteração tecnológica e altos custos de GPU. Empresas líderes como MoFa Technology enfatizam que os humanos digitais 3D precisam corresponder às capacidades dos grandes modelos e apontam o acúmulo de dados de alta qualidade, talentos escassos e forte capacidade artística como cruciais. A tendência da indústria mostra que a produção de humanos digitais 3D está se movendo para plataformas, e o avanço da tecnologia de IA reduziu os custos, tornando possível a aplicação em escala. Empresas como YingMou Technology e Baidu também lançaram plataformas de geração 3D, visando usar humanos digitais como infraestrutura para capacitar mais cenários de aplicação. (Fonte: 36氪)

🌟 Comunidade

Percepção complexa dos usuários sobre emoção e confiança na IA: Comparação entre R2D2 e ChatGPT : As redes sociais debatem as diferenças entre R2D2 e ChatGPT na conexão emocional do usuário. Os usuários consideram o R2D2 adorável por seu temperamento único, lealdade e imagem “semelhante a um cavalo”, e não envolve questões éticas sociais reais. Já o ChatGPT, como uma “IA falsa real”, é difícil de estabelecer o mesmo vínculo emocional devido à sua praticidade, restrições de censura de conteúdo e potenciais preocupações com vigilância. Essa comparação revela que as expectativas dos usuários em relação à IA não se limitam à inteligência, mas também à sua experiência de interação “humanizada” e à percepção de seu impacto social. (Fonte: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Limitações do aconselhamento psicológico por IA e a necessidade de intervenção humana : Com o surgimento de produtos de aconselhamento psicológico por IA, as pessoas começam a usar a IA para resolver problemas de solidão e saúde mental. Estudos mostram que cerca de 22% dos profissionais da Geração Z consultaram um psicólogo, e quase metade consultou a IA. A IA tem vantagens em fornecer informações, eliminar fatores e oferecer companhia, mas não pode substituir o papel dos psicólogos humanos na empatia, na compreensão do “clima” e na condução do ritmo do tratamento. Casos mostram que a IA requer um mecanismo de interrupção manual ao identificar riscos extremos, e os humanos são indispensáveis no julgamento da fronteira entre emoção e patologia, no acúmulo de experiência e na comunicação não verbal. A IA deve assumir principalmente tarefas repetitivas e auxiliares, e reduzir o limiar de busca por ajuda, com o objetivo final de guiar as pessoas de volta a relacionamentos interpessoais reais. (Fonte: 36氪)

Interação entre idosos e grandes modelos: Definindo “algoritmos” a partir de “modos de vida” : A Universidade Fudan e o Tencent SSV Time Lab, entre outras instituições, realizaram um estudo de um ano, ensinando 100 idosos a usar grandes modelos. A pesquisa descobriu que a atitude dos idosos em relação à IA não é de resistência, mas de uma “visão pragmática da tecnologia” baseada em suas experiências de vida. Eles se preocupam mais se a tecnologia pode se integrar ao cotidiano e oferecer companhia, em vez de funcionalidades extremas. Na calibração da confiança, os idosos exibiram vários padrões, como “correção limitada”, “reciprocidade colaborativa” e “solidificação cognitiva”, e também existiam “hesitação ao perguntar” e uma “lacuna de gênero”. Eles esperam que os grandes modelos sejam “adivinhos”, “médicos confiáveis”, “amigos para conversar” e “brinquedos para relaxar”, ou seja, uma tecnologia que compreenda mais gentilmente, mais próxima da vida diária e “compreenda as pessoas”. Isso mostra que o valor da tecnologia reside em quanto tempo ela pode esperar, e não em quão rápido ela pode correr, apelando para que a tecnologia seja “simbiótica” em vez de “adaptada para idosos”, usando os sentimentos, o ritmo e a dignidade humanos como medida. (Fonte: 36氪)

Impacto social da IA: Da vigilância da privacidade ao consumo de energia e transformação do emprego : As redes sociais discutem amplamente os múltiplos impactos da IA na sociedade. Os usuários temem que a IA já esteja realizando “vigilância invisível” através de vários aplicativos, buscas e câmeras, prevendo e influenciando o comportamento individual, em vez de um controle robótico de ficção científica. Ao mesmo tempo, a enorme demanda por energia e recursos hídricos dos data centers de IA provoca protestos comunitários, levando a interrupções de energia e escassez de água. Além disso, a IA melhora a produtividade na geração de código e tarefas automatizadas, mas levanta discussões sobre mudanças na estrutura do emprego e desafios à eficiência da produção pela qualidade do código de IA. Essas discussões refletem as emoções complexas do público em relação às conveniências e riscos potenciais trazidos pela tecnologia de IA. (Fonte: Reddit r/artificial, MIT Technology Review, MIT Technology Review, Ronald_vanLoon, Ronald_vanLoon)

Rápida evolução de termos e conceitos no campo da IA : A comunidade discute que os termos e conceitos no campo da IA estão evoluindo rapidamente. Por exemplo, “treinar/construir um modelo” frequentemente se refere a “fine-tuning”, e “fine-tuning” é considerado uma nova forma de “prompt/context engineering”. Essa mudança reflete a complexidade crescente da pilha tecnológica de IA e a necessidade de operações mais refinadas. Além disso, em relação ao trade-off entre velocidade e inteligência do modelo, os desenvolvedores tendem a preferir modelos “lentos e inteligentes”, pois fornecem resultados mais confiáveis, mesmo que isso signifique mais tempo de espera. (Fonte: dejavucoder, dejavucoder, dejavucoder)

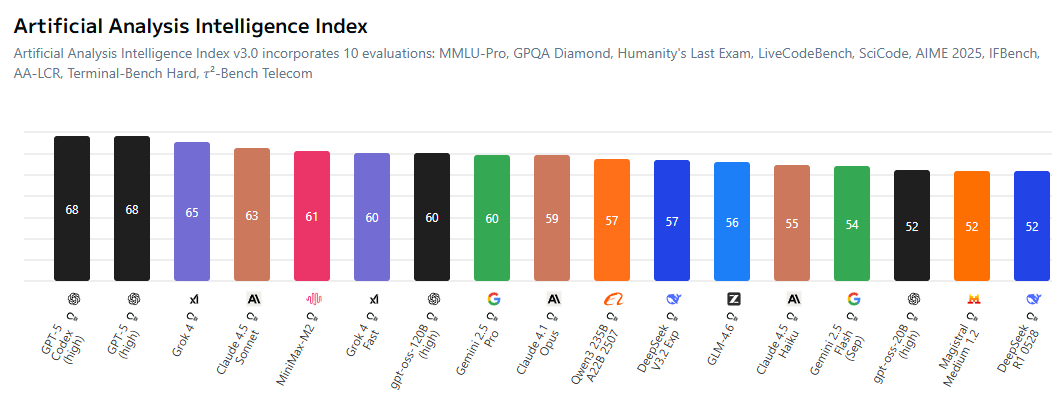

Ecossistema de IA de código aberto e concorrência acirrada com modelos proprietários : A comunidade discute que a lacuna entre os modelos de IA de código aberto e os modelos proprietários está diminuindo, forçando os laboratórios de código fechado a serem mais competitivos em termos de preços. Modelos de código aberto como o MiniMax-M2 apresentam excelente desempenho no AI Index e têm um custo extremamente baixo. Ao mesmo tempo, empresas chinesas e startups estão ativamente abrindo o código de tecnologias de IA, enquanto as empresas americanas estão relativamente atrasadas nesse aspecto. Essa tendência prevê uma era em que “todos treinarão modelos baseados em código aberto” no campo da IA, impulsionando a democratização e a inovação da tecnologia de IA. (Fonte: ClementDelangue, huggingface, clefourrier, huggingface)

Impacto do conteúdo gerado por IA nas indústrias tradicionais e desafios éticos : O conteúdo gerado por IA está cada vez mais penetrando nas indústrias tradicionais, como “artistas” impulsionados por IA que chegam às paradas musicais, e a tecnologia deepfake sendo usada para fraudes (como um falso discurso de Jensen Huang promovendo um golpe de criptomoeda). Esses fenômenos levantam discussões sobre direitos autorais, ética e regulamentação. Ao mesmo tempo, a IA também trouxe novas ferramentas de produtividade na geração de código e gerenciamento automatizado de contas de mídia social, mas a qualidade e a confiabilidade do conteúdo gerado ainda exigem revisão humana. Isso destaca os desafios de equilibrar a inovação tecnológica com a responsabilidade social e as normas éticas na popularização da IA. (Fonte: Reddit r/artificial, 36氪, jeremyphoward)

Comunidade de pesquisa de IA foca na qualidade dos dados e avaliação : A comunidade de pesquisa de IA está cada vez mais atenta ao papel crucial da qualidade dos dados no treinamento de modelos, e aponta que obter dados de alta qualidade é mais desafiador do que alugar GPUs ou escrever código. Ao mesmo tempo, há uma ampla discussão sobre as limitações dos benchmarks existentes, argumentando que eles podem não refletir totalmente a verdadeira capacidade dos modelos e são facilmente otimizados em excesso. Os pesquisadores pedem o desenvolvimento de sistemas de avaliação mais informativos e realistas para promover o desenvolvimento saudável da pesquisa de IA. (Fonte: code_star, code_star, clefourrier, tokenbender)

Aplicações e perspectivas da IA na área da saúde : A IA demonstra um enorme potencial na área da saúde, por exemplo, a YunPeng Technology lançou novos produtos de IA+saúde, incluindo um laboratório de cozinha inteligente e uma geladeira inteligente equipada com um grande modelo de saúde de IA, oferecendo gerenciamento de saúde personalizado. Além disso, o MONAI, como kit de ferramentas de IA para imagens médicas, oferece uma estrutura de código aberto PyTorch. Exosqueletos impulsionados por IA ajudam usuários de cadeira de rodas a ficar em pé e andar, e agentes de diagnóstico LLM aprendem estratégias de diagnóstico em ambientes clínicos virtuais. Esses avanços preveem que a IA transformará profundamente os serviços de saúde, desde o gerenciamento diário da saúde até o diagnóstico e tratamento assistidos. (Fonte: 36氪, GitHub Trending, Ronald_vanLoon, Ronald_vanLoon, HuggingFace Daily Papers)

Transformação organizacional e demanda por talentos na era da IA : Com a popularização da IA, as empresas enfrentam profundas transformações na estrutura organizacional e na demanda por talentos. Dhanji R. Prasanna, CTO da Block, enfatiza que as empresas precisam se reposicionar como “empresas de tecnologia” e mudar de um “sistema de gerência geral” para um “sistema funcional” para concentrar o foco tecnológico. Ferramentas de IA como o Goose podem aumentar significativamente a produtividade, mas a arquitetura e o design de alto nível ainda exigem engenheiros seniores. Na contratação, as empresas valorizam mais a mentalidade de aprendizado e o pensamento crítico do que simplesmente as habilidades de uso de ferramentas de IA. A IA também borra as fronteiras dos cargos, com cargos não técnicos começando a usar ferramentas de IA, impulsionando a formação de um modelo de colaboração “grupo humano-máquina”. (Fonte: 36氪, MIT Technology Review, NandoDF, SakanaAILabs)

💡 Outros

Inovação contínua em tecnologia robótica multifuncional : O campo da robótica demonstra inovações diversificadas, incluindo o robô SpiRobs inspirado em polvos, drones capazes de nadar, o robô Helix para classificação de pacotes e robôs humanoides que auxiliam na inspeção de qualidade na fábrica da NIO. Esses avanços abrangem design biomimético, automação, colaboração humano-robô e adaptabilidade a ambientes especiais, prevendo o amplo potencial da tecnologia robótica em aplicações industriais, militares e cotidianas. (Fonte: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Aprofundamento do conceito de AI Agent e perspectivas de mercado : AI Agents são definidos como entidades inteligentes capazes de raciocinar e se adaptar como humanos, permitindo uma conversa fluida entre humanos e máquinas. Eles são vistos como a tendência futura do trabalho, com inúmeras ferramentas de construção de AI Agent surgindo no mercado. O valor central dos AI Agents reside em se tornarem “ferramentas de produção” capazes de executar tarefas reais, e não apenas ferramentas auxiliares de “bate-papo”, e seu desenvolvimento impulsionará a aplicação profunda da IA em vários campos. (Fonte: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, dotey)

IA e direção autônoma: Frota da Uber adota novos chips Nvidia, impulsionando o desenvolvimento de táxis robóticos : A próxima geração da frota de veículos autônomos da Uber adotará os novos chips da Nvidia, com a expectativa de reduzir os custos dos táxis robóticos. A plataforma Drive Hyperion da Nvidia é uma arquitetura padronizada para veículos “prontos para táxis robóticos”, e a parceria com a Uber impulsionará a popularização da tecnologia de direção autônoma para os consumidores. Isso indica que a aplicação da IA no setor de transporte está acelerando, visando serviços de direção autônoma mais seguros e econômicos. (Fonte: MIT Technology Review, TheTuringPost)