Palavras-chave:NVIDIA, capacidade de computação de IA, rede 6G, computação quântica, condução autônoma, GPU, infraestrutura de IA, tecnologia NVLink, super GPU Vera Rubin, supercomputador de IA, conexão de processador quântico, utilidade de modelos de IA

🔥 Em Foco

Valor de mercado da NVIDIA ultrapassa US$ 5 trilhões e anuncia grandes atualizações na GTC : A NVIDIA anunciou na conferência GTC uma parceria com a Nokia para desenvolver uma plataforma de rede 6G, lançou a tecnologia NVQLink para conectar processadores quânticos com supercomputadores GPU, e colaborou com o Departamento de Energia dos EUA para construir um supercomputador AI. Além disso, a NVIDIA aprofundou parcerias com empresas como Uber e Stellantis para impulsionar a condução autônoma, e lançou a próxima geração da super GPU Vera Rubin, com vendas acumuladas de GPU estimadas em US$ 500 bilhões até o final de 2026. Jensen Huang refutou a teoria da “bolha da AI”, enfatizando a praticidade dos modelos AI e a disposição dos clientes em pagar. Isso marca a consolidação da posição dominante global da NVIDIA em poder computacional AI, 6G, computação quântica e robótica, impulsionando o rápido desenvolvimento da infraestrutura de AI. (Fonte: 36氪, TheTuringPost, TheTuringPost)

🎯 Tendências

Foco da AI muda para multimodalidade, unificação de compreensão e geração como ponto de ruptura : No segundo semestre de 2025, o foco da indústria de AI mudou dos modelos puramente textuais para o campo multimodal, com produtos como Sora 2 e Nano Banana atingindo um nível de usabilidade próximo ao de “disrupção”. Embora a arquitetura de modelos multimodais ainda não tenha alcançado um avanço revolucionário, o acúmulo de dados e a melhoria das técnicas de treinamento são significativos. DeepSeek-OCR, através da tecnologia de compressão visual, converte textos longos em reconhecimento de imagem, comprimindo drasticamente o volume de cálculo de token, o que pode levar à redução de custos e aumento da eficiência. A indústria geralmente acredita que a multimodalidade é o caminho inevitável para os LLM, e a unificação de compreensão e geração é o ponto de ruptura atual, o que trará mais oportunidades de mercado para empreendedores e investidores. (Fonte: 36氪)

Mustafa Suleyman, CEO de AI da Microsoft, enfatiza ética e limites da AI : Mustafa Suleyman, CEO de AI da Microsoft, afirmou que a Microsoft nunca desenvolverá “robôs sexuais” e está comprometida em construir uma AI que “capacite os humanos em vez de substituí-los”. Ele acredita que a AI deve ajudar as pessoas a se conectar e construir comunidades, em vez de levá-las a um “abismo emocional em espiral”. O Microsoft Copilot adicionou um recurso de bate-papo em grupo e um modo “Real Talk”, visando fornecer uma experiência de interação mais desafiadora e menos bajuladora, além de aprimorar a função de memória. Suleyman admitiu que a metáfora inicial sobre a AI como uma “espécie digital” pode ter causado mal-entendidos, mas enfatizou que seu objetivo era levar a indústria a refletir sobre a “contenção e alinhamento” da AI, para garantir que ela sirva à humanidade. (Fonte: MIT Technology Review, MIT Technology Review)

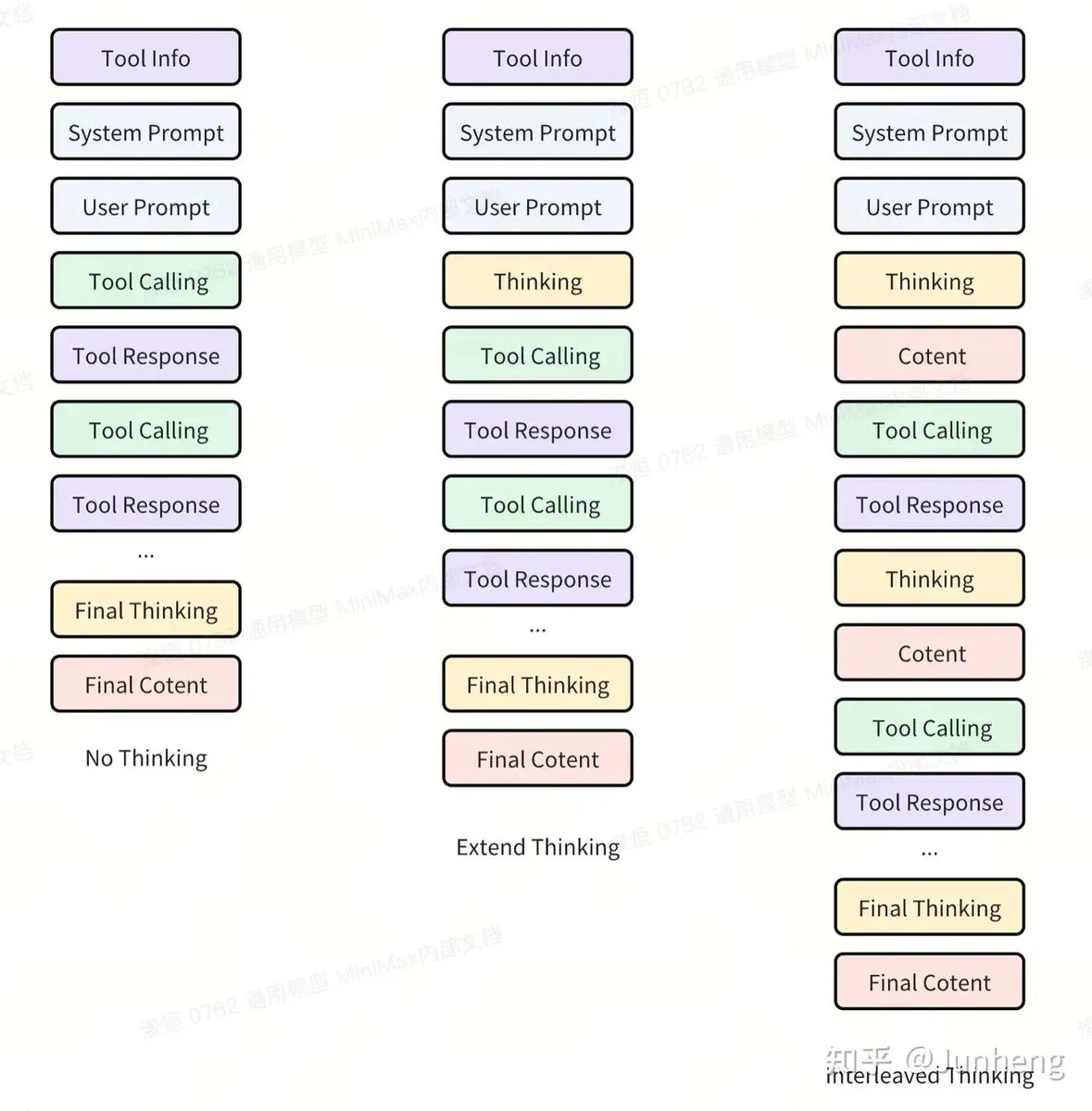

Modelo MiniMax M2 de código aberto, com excelente desempenho e alta relação custo-benefício : O modelo MiniMax M2 foi lançado como código aberto, atraindo a atenção da comunidade por seu desempenho excepcional em tarefas de Agent e código. O modelo demonstrou fortes habilidades em tarefas Agentic, com um custo de apenas 8% do Claude Sonnet e aproximadamente 2 vezes mais rápido. A equipe MiniMax enfatiza que o M2 adota um mecanismo de “Interleaved Thinking”, permitindo que o Agent realize pensamentos internos a qualquer momento durante a execução da tarefa para se adaptar a perturbações externas e manter o foco na tarefa, o que é crucial para tarefas complexas e de longa cadeia de chamadas de ferramentas. Ao mesmo tempo, a capacidade de generalização do modelo não se concentra apenas na adaptabilidade da ferramenta, mas também na robustez contra várias perturbações dentro do espaço operacional do modelo. (Fonte: MiniMax__AI, MiniMax__AI, ImazAngel, QuixiAI)

Modelo Qwen3 Max será lançado em breve, gerando expectativa na indústria : O Tongyi Lab da Alibaba anunciou que o modelo Qwen3 Max está na fase final de desenvolvimento, com lançamento previsto para esta semana. Esta notícia gerou ampla discussão na comunidade sobre o desempenho e o impacto potencial do modelo. Dada a forte influência da série Qwen na comunidade de código aberto, o Qwen3 Max promete trazer novos avanços no campo dos LLM, especialmente em capacidade de processamento de chinês e inteligência geral, impulsionando ainda mais o desenvolvimento da tecnologia de grandes modelos. (Fonte: teortaxesTex, huybery, scaling01, Reddit r/LocalLLaMA)

OpenAI lança modelo gpt-oss-safeguard para aprimorar a classificação de segurança de conteúdo : A OpenAI lançou o gpt-oss-safeguard, um conjunto de modelos de inferência de código aberto para classificação de segurança, projetado para ajudar desenvolvedores a identificar e gerenciar conteúdo prejudicial e ataques de injeção de prompt usando políticas personalizadas. Esses modelos são versões ajustadas dos modelos abertos gpt-oss, suportam a licença Apache 2.0 e já estão disponíveis no Hugging Face. Esta iniciativa visa promover a aplicação de modelos abertos na construção de um espaço digital mais seguro e na segurança online. (Fonte: OpenAIDevs, clefourrier, huggingface, ClementDelangue, johnowhitaker, Reddit r/LocalLLaMA)

Anthropic Sonnet 4.5 demonstra excelente desempenho, aumentando significativamente a produtividade do usuário : Usuários relatam que o modelo Sonnet 4.5 da Anthropic apresenta desempenho excepcional, exibindo inteligência e velocidade impressionantes. O modelo se destaca particularmente em depuração e planejamento, melhorando significativamente a eficiência do trabalho dos usuários. Embora suas limitações de uso semanal ainda sejam criticadas, os usuários geralmente consideram o Sonnet 4.5 um modelo excelente e inigualável no mercado atual, esperando arranjos de cotas de uso mais flexíveis no futuro. (Fonte: Reddit r/ClaudeAI)

Kani TTS lança modelo multilíngue de 400M, alcançando 5x a velocidade em tempo real : A Kani TTS lançou um modelo multilíngue de 400M de texto para fala (TTS), incluindo inglês, japonês, chinês, alemão, espanhol, coreano e árabe. O modelo alcançou um fator de tempo real (RTF) de aproximadamente 0.2 em uma RTX 4080, sendo 5 vezes mais rápido que o tempo real. Ao combinar a rede backbone LFM2-350M com o eficiente NanoCodec, o modelo melhora significativamente a velocidade e a eficiência de implantação, mantendo a alta qualidade de voz, sendo adequado para conversas em tempo real, implantação em hardware econômico e leitores de tela de nova geração. (Fonte: Reddit r/LocalLLaMA)

Soul lança SoulX-Podcast, modelo de código aberto para geração de podcasts com múltiplos participantes : O Soul AI Lab lançou o SoulX-Podcast, um modelo de código aberto para geração de podcasts que suporta conversas com múltiplos participantes. Baseado em 1.3 milhão de horas de dados de treinamento, o modelo suporta chinês, inglês e vários dialetos chineses e paralinguagens (como risadas, suspiros, etc.), fornecendo uma ferramenta poderosa para produção de podcasts e síntese de voz multi-personagem. Esta iniciativa de código aberto promete impulsionar a aplicação e o desenvolvimento da tecnologia de geração de áudio no campo da criação de conteúdo. (Fonte: dotey, multimodalart, huggingface, ClementDelangue)

Gradient lança Parallax de código aberto, um sistema operacional de AI soberana para implantação local de AI : A Gradient anunciou o lançamento de código aberto do Parallax, um sistema operacional de AI soberana projetado para simplificar a configuração de clusters de AI locais em Mac e PC, e hospedar os próprios modelos e aplicativos dos usuários, sem sacrificar o desempenho. O Parallax permite que os usuários implantem e executem aplicativos de AI facilmente, enfatizando a soberania dos dados e a computação localizada, oferecendo maior flexibilidade e controle para indivíduos e empresas, como a execução rápida do modelo Qwen 235B. (Fonte: menhguin, Alibaba_Qwen)

vLLM realizará várias palestras na Ray Summit 2025, focando em inferência de alto desempenho e serviço MoE : O projeto vLLM anunciou que realizará mais de 10 palestras na Ray Summit 2025, aprofundando-se em inferência de alto desempenho, backend unificado, cache de prefixo, serviço de modelo MoE (Mistura de Especialistas) e orquestração em larga escala, entre outras tecnologias chave. A cúpula cobrirá os últimos avanços do vLLM, incluindo aplicações em plataformas como Apple, AWS, AMD, Intel, e a orquestração eficiente de múltiplos nós para modelos MoE esparsos. Isso demonstra o esforço contínuo do vLLM em otimizar a eficiência e escalabilidade da inferência de LLM, e a construção ativa de um ecossistema aberto. (Fonte: vllm_project, vllm_project)

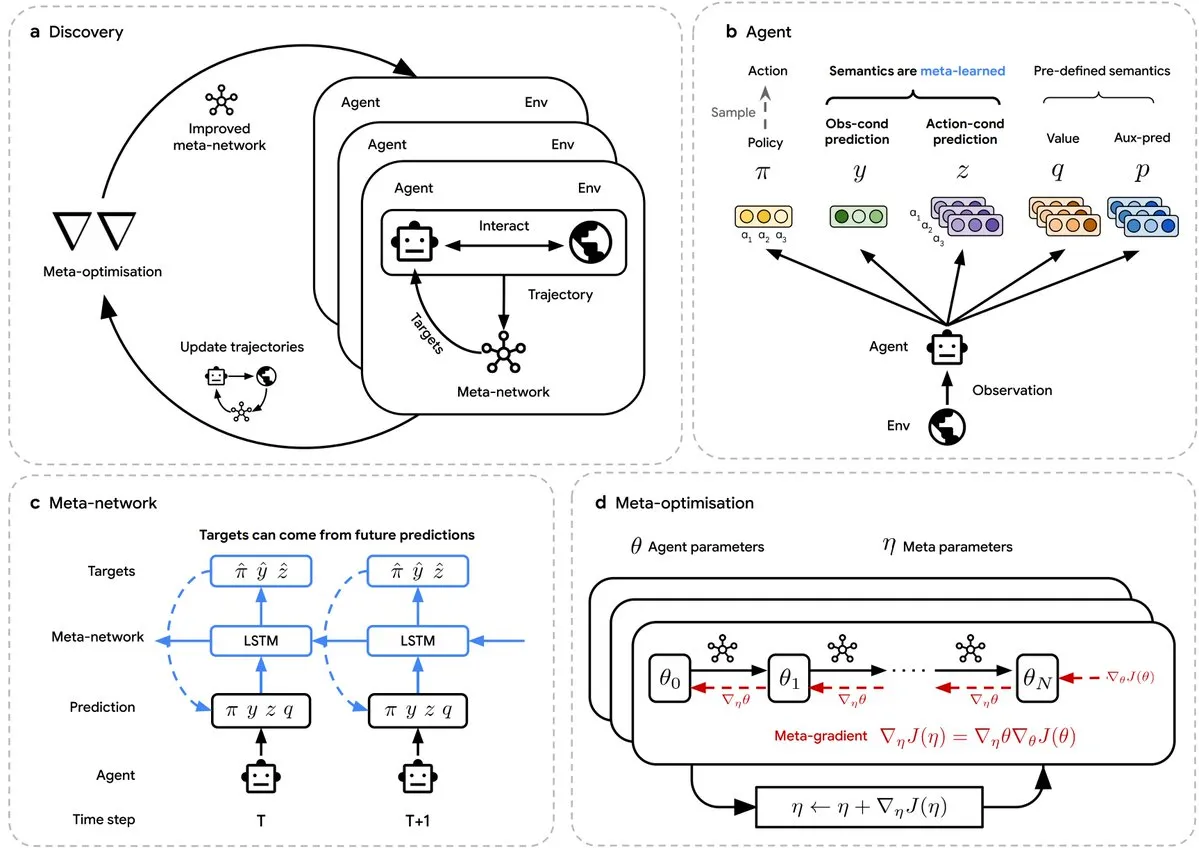

DeepMind demonstra avanço da AI na descoberta autônoma de algoritmos RL : A DeepMind publicou um artigo na Nature, demonstrando que a AI pode descobrir autonomamente algoritmos de Reinforcement Learning (RL) superiores. Esta pesquisa, liderada por David Silver, criador do AlphaGo, sugere que a próxima geração de algoritmos RL pode ser descoberta por máquinas, abrindo novos caminhos para a autoaprendizagem e aprimoramento das capacidades da AI. Isso é considerado um passo importante para impulsionar o desenvolvimento da AI de ponta, podendo revolucionar o modelo de P&D de algoritmos RL. (Fonte: NerdyRodent)

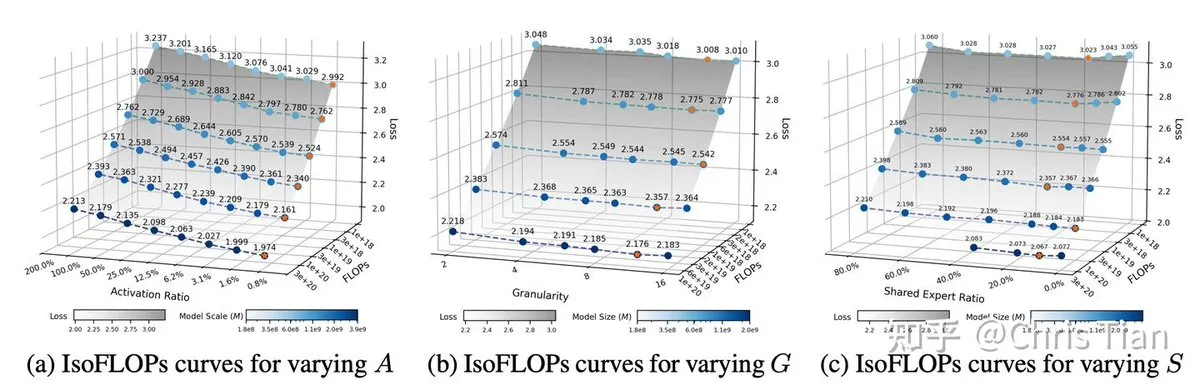

Design de MoE LLM e “Ling Scaling Laws” revelam otimização de eficiência : A ZhihuFrontier publicou uma pesquisa sobre o design de MoE LLM e as “Ling Scaling Laws”, revelando como a taxa de ativação, a granularidade dos especialistas e o orçamento de computação afetam a eficiência do modelo. O estudo descobriu que reduzir a taxa de ativação (aumentar a esparsidade) pode levar a maiores ganhos de eficiência, e ativar 8-12 especialistas pode alcançar o melhor equilíbrio entre desempenho e throughput. Além disso, quanto maior o volume de computação, mais óbvia é a vantagem dos modelos MoE em relação aos modelos densos. Essas descobertas fornecem orientação teórica e base prática para o design eficiente de arquiteturas MoE, e a série de modelos Ling-2.0 validou essas otimizações arquitetônicas. (Fonte: ZhihuFrontier, bigeagle_xd)

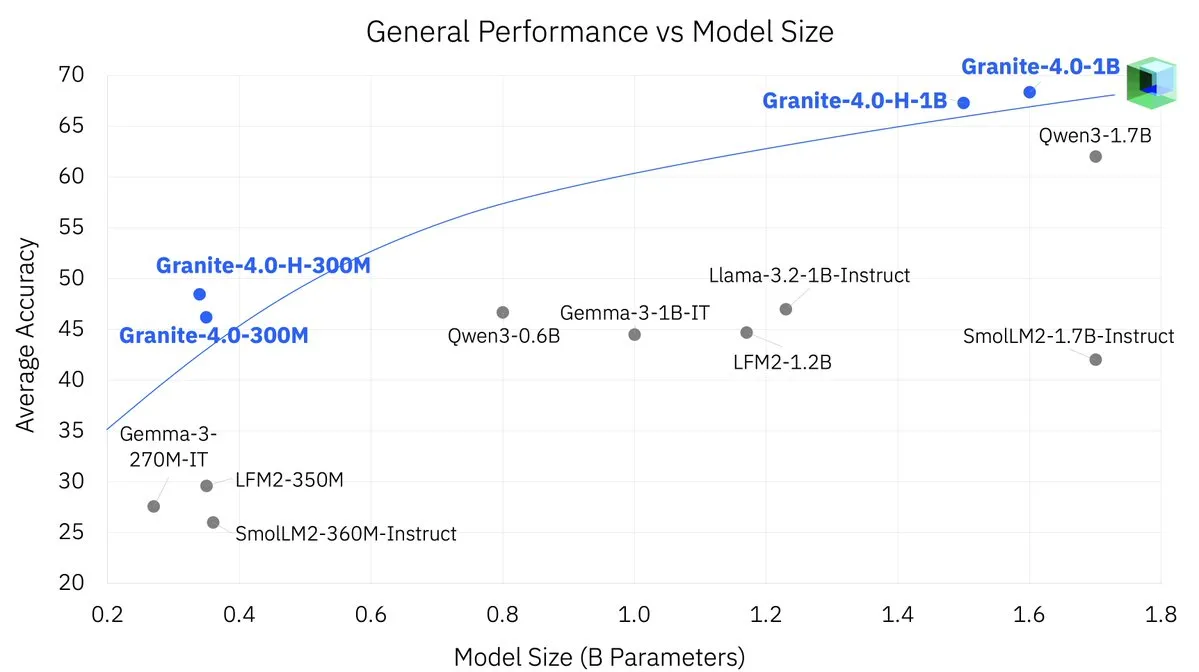

IBM lança modelo Granite 4.0 Nano, adaptado para dispositivos móveis : A IBM lançou o modelo Granite 4.0 Nano, projetado especificamente para dispositivos móveis. Este modelo leve visa levar capacidades avançadas de AI para dispositivos de borda, permitindo um processamento de AI local mais eficiente e de baixo consumo de energia. Esta iniciativa impulsionará a popularização de aplicações de AI em plataformas móveis como smartphones e dispositivos IoT, oferecendo mais soluções de AI localizadas para desenvolvedores. (Fonte: adrgrondin)

🧰 Ferramentas

Experiência de uso aprofundado do Claude Code: Construindo um sistema eficiente de assistente de programação AI : Um engenheiro de software sênior compartilhou sua experiência de seis meses usando o Claude Code para reescrever 300.000 linhas de código, construindo um sistema eficiente de assistente de programação AI. O sistema inclui: 1. Sistema de ativação automática de habilidades : Através de TypeScript hooks para carregar e aplicar habilidades automaticamente, garantindo consistência no estilo de código e nas melhores práticas; 2. Sistema de documentação de desenvolvimento : Criação de diretórios de tarefas e documentação (planos, contexto, listas de tarefas) para evitar que o Claude perca o contexto em tarefas longas; 3. Gerenciamento de processos PM2 : Para monitoramento de logs e reinício automático de microsserviços de backend, simplificando drasticamente o processo de depuração; 4. Sistema de Hooks : Implementação de rastreamento de edição de arquivos, verificação de construção, formatação de código e alertas de tratamento de erros, garantindo a qualidade do código; 5. Integração de scripts e ferramentas : Associação de scripts de ferramentas comuns com habilidades para aumentar a eficiência, e uso do SuperWhisper para entrada de voz, Memory MCP para gerenciamento de decisões de projeto. Esta experiência enfatiza que a programação AI requer engenheiros humanos como “líderes técnicos” para planejar, revisar e iterar, em vez de depender totalmente da AI para “Vibe Coding”. (Fonte: Reddit r/ClaudeAI, dotey, omarsar0, Reddit r/ClaudeAI)

VoiceInk: Aplicativo instantâneo de voz para texto no macOS : Beingpax desenvolveu e lançou como código aberto o VoiceInk, um aplicativo nativo de voz para texto para macOS. Esta ferramenta é capaz de transcrever voz para texto quase instantaneamente, com uma precisão de até 99%, e suporta processamento 100% offline, garantindo a privacidade do usuário. O VoiceInk também possui um “Modo Inteligente” que ajusta automaticamente as configurações com base no aplicativo ou URL, e um recurso de “Consciência de Contexto” para entender o conteúdo da tela. Além disso, oferece atalhos globais, um dicionário pessoal e um assistente de AI integrado, visando ser a solução de voz para texto mais eficiente e focada na privacidade para macOS. (Fonte: GitHub Trending)

moon-dev-ai-agents: Framework de AI Agent de negociação de código aberto : moondevonyt lançou como código aberto o projeto “moon-dev-ai-agents”, que oferece uma série de AI Agents autônomos para negociação. O framework inclui Agents de backtesting e pesquisa (como o RBI Agent para pesquisa de estratégia e backtesting automático), Agents de negociação em tempo real (suportando modo de consenso de modelo único ou multimodelos), Agents de análise de mercado (como atividade de baleias, análise de sentimento, análise de gráficos), bem como Agents específicos para Solana e Agents de criação de conteúdo. O projeto visa democratizar a tecnologia AI Agent, enfatizando o backtesting completo e a gestão de riscos, e fornece um guia de início rápido detalhado e opções de configuração. (Fonte: GitHub Trending)

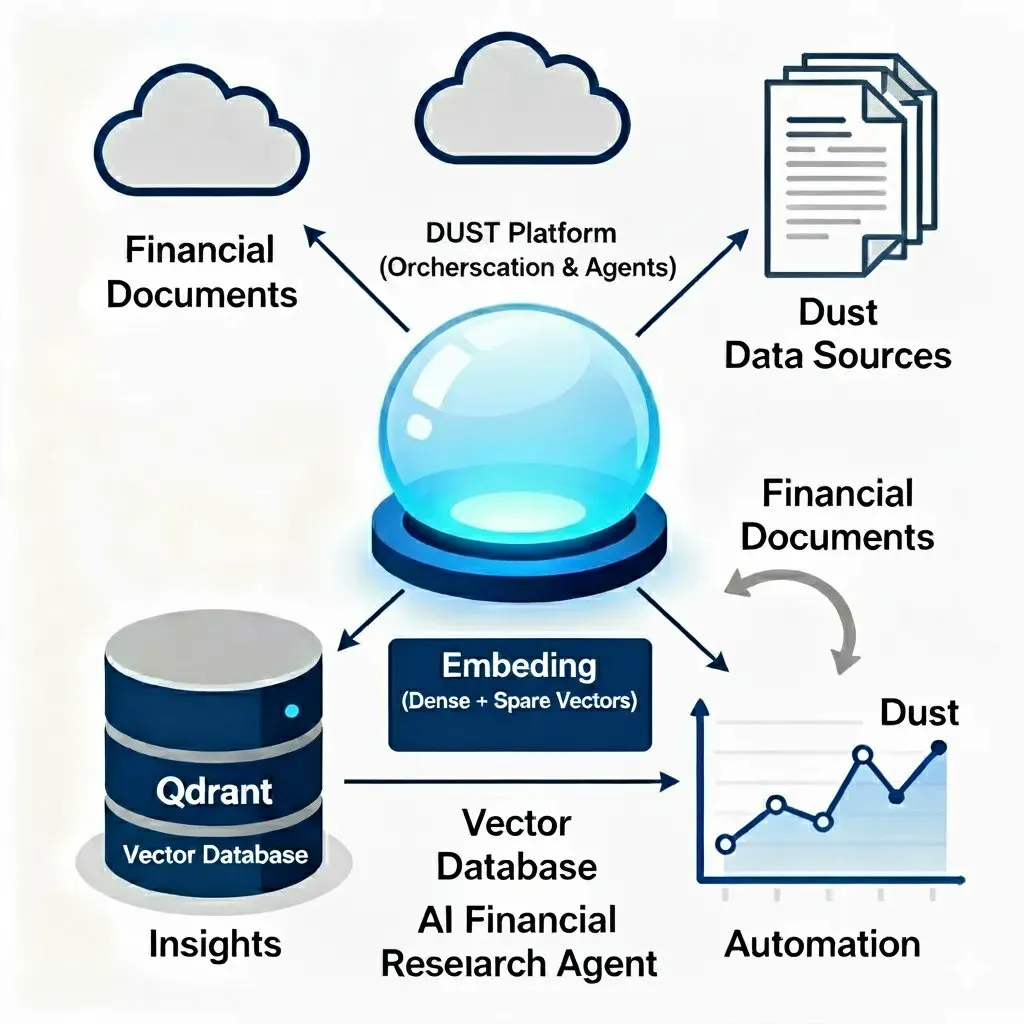

Qdrant auxilia na construção de Agents de pesquisa financeira e sistemas RAG de nível de produção : Qdrant foi demonstrado como pode transformar a análise financeira através de fluxos de trabalho de automação de pesquisa inteligente (integrado com Dust), realizando ingestão e indexação automatizadas de documentos, e utilizando busca híbrida para recuperar insights precisos de dados financeiros complexos. Além disso, Qdrant serve como o núcleo de um armazenamento de vetores multi-tenant, suportando a construção de sistemas RAG de nível de produção, permitindo ingestão de PDF em tempo real, busca streaming e inferência de LLM, e sendo implantado e escalado no Kubernetes, oferecendo soluções RAG eficientes e escaláveis. (Fonte: qdrant_engine, qdrant_engine, qdrant_engine)

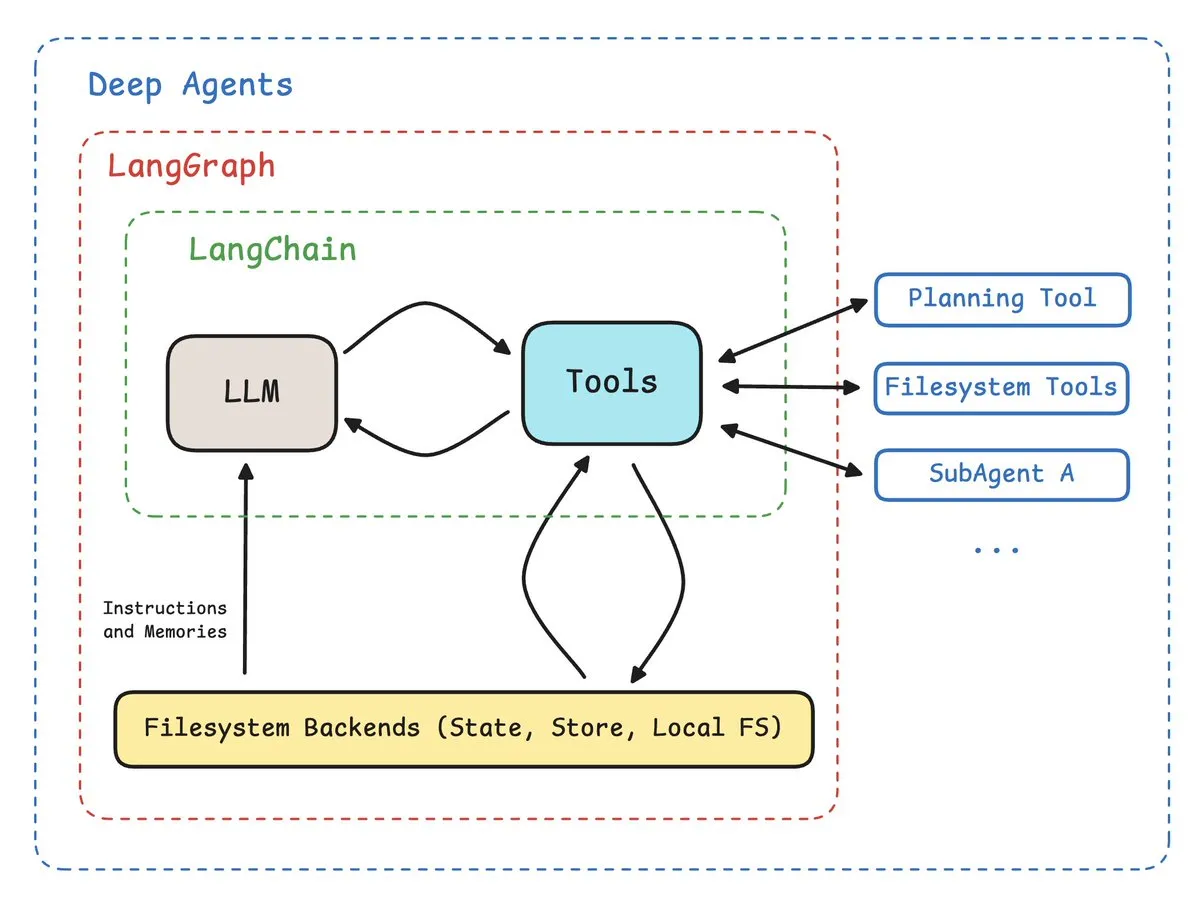

Deep Agents 0.2 lançado, introduzindo backend de sistema de arquivos plugável : A equipe LangChain lançou a versão Deep Agents 0.2, que adiciona principalmente uma camada de abstração de “backend”, permitindo aos usuários substituir o sistema de arquivos usado pelos Deep Agents. Isso significa que os usuários podem escolher sistemas de arquivos locais, bancos de dados, máquinas virtuais remotas, etc., como espaço de trabalho do Agent. Esta melhoria aumenta a flexibilidade e aplicabilidade dos Deep Agents, permitindo que se adaptem melhor a diferentes ambientes e necessidades de desenvolvimento, impulsionando ainda mais a importância dos Agent Harnesses. (Fonte: hwchase17)

Google lança ferramenta de marketing AI Pomelli para acelerar a geração de conteúdo de marca : O Google Labs lançou a ferramenta experimental de marketing AI Pomelli, projetada para ajudar os usuários a gerar facilmente conteúdo escalável e alinhado à marca, conectando-se mais rapidamente com o público. Os usuários simplesmente inserem um site, e o Pomelli compreende sua identidade comercial única para construir campanhas de marketing eficazes e personalizadas. A ferramenta foi lançada nos EUA, Canadá, Austrália e Nova Zelândia, demonstrando o potencial da AI no campo da automação de marketing. (Fonte: demishassabis)

Agent HQ integra múltiplos Coding Agents, aumentando a eficiência do ecossistema de desenvolvedores : O GitHub lançou o novo Agent HQ, com o objetivo de integrar vários Coding Agents na assinatura do Copilot, fornecendo aos desenvolvedores uma plataforma de interação unificada e um ambiente de tempo de execução de tarefas na nuvem, sem a necessidade de assinar múltiplos produtos separadamente. Esta iniciativa aproveita o GitHub como o maior ecossistema de desenvolvedores, simplificando o uso de Agents e melhorando a eficiência do desenvolvimento, marcando uma maior integração do ecossistema de ferramentas de programação AI. (Fonte: dotey)

Serve 100 Large AI Models on a single GPU: Um motor para servir cem grandes modelos em uma única GPU : Um desenvolvedor construiu um motor capaz de carregar grandes modelos de SSD para VRAM dez vezes mais rápido do que as soluções existentes, permitindo servir eficientemente 100 grandes modelos de AI em uma única GPU, com impacto mínimo no tempo de resposta do primeiro token. Este projeto resolve o problema do longo tempo de inicialização a frio na inferência Serverless AI, sendo adequado para inferência Serverless AI, robótica, implantação local e Agents locais, e é de código aberto. (Fonte: Reddit r/LocalLLaMA)

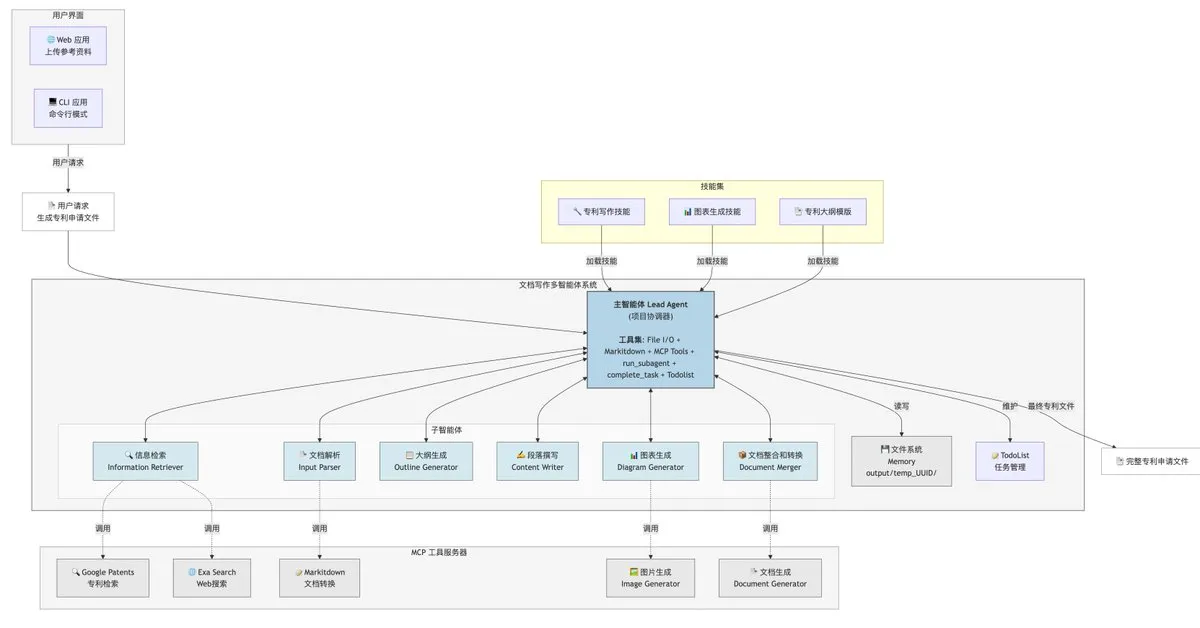

Compartilhamento da arquitetura de um Agent inteligente para escrita de patentes com AI : Jiuyuanke compartilhou uma arquitetura simples de Agent inteligente para escrita de patentes, que pode ser implementada usando ferramentas como Claude Code, construída através do padrão Agent-SubAgent e prompts (que podem ser auxiliados pelo Claude). Esta arquitetura visa simplificar o processo de escrita de patentes, aumentar a eficiência, e uma versão que não carrega SKILLs foi lançada como código aberto para referência e otimização. Isso demonstra o potencial de aplicação do LLM Agent no campo da geração de texto profissional. (Fonte: dotey, dotey)

📚 Aprendizagem

Programação AI acelera o desenvolvimento de software, mas exige mais das habilidades dos engenheiros : Discussões sociais apontam que a AI reduziu a barreira de entrada na programação e os custos de Demo, mas o desenvolvimento de software de alta qualidade exige mais em termos de design de estrutura de dados, design de arquitetura e simplicidade de módulos. O código gerado por AI pode conter “código inútil”, aumentando o risco de manutenção futura. Portanto, quanto mais poderosa a AI, maiores são as exigências sobre o conhecimento, experiência e capacidade arquitetônica de programação humana. O artigo enfatiza o modo “Agentic Coding”, onde a AI atua como um “programador júnior super capaz, mas irresponsável”, e os engenheiros humanos desempenham o papel de “líder técnico”, com o foco mudando para “fazer requisições” e “revisão de código”. (Fonte: dotey, dotey, gfodor, zhuohan123, lateinteraction, finbarrtimbers)

Compartilhamento de guia de programação Claude, cobrindo RAG, uso de ferramentas, multimodalidade, etc. : Um guia de programação Claude (claude-cookbooks) com 25K estrelas no GitHub foi compartilhado nas redes sociais, cobrindo o uso do Claude para RAG, extração de resumos, uso de ferramentas, agentes de atendimento ao cliente, integração com bancos de dados vetoriais, multimodalidade (interpretação de imagens e gráficos) e chamadas de sub-agentes mais avançadas. Este guia oferece aos desenvolvedores uma prática abrangente de aplicação do Claude, ajudando a melhorar a eficiência de desenvolvimento e a implementação de funcionalidades do LLM Agent. (Fonte: dotey)

Recursos de aprendizagem de AI: Curso de Fine-Tuning e Reinforcement Learning para LLMs : DeepLearning.AI, em colaboração com a AMD, lançou um curso gratuito de AI, “Fine-Tuning & Reinforcement Learning for LLMs: Intro to Post-Training”, com o objetivo de fornecer aos desenvolvedores ferramentas e recursos computacionais para técnicas de pós-treinamento de LLM (como fine-tuning e reinforcement learning). O curso abrange as tecnologias centrais usadas pelos principais laboratórios de AI atuais, sendo um recurso de aprendizagem importante para aprimorar as habilidades de desenvolvimento de LLM. (Fonte: realSharonZhou)

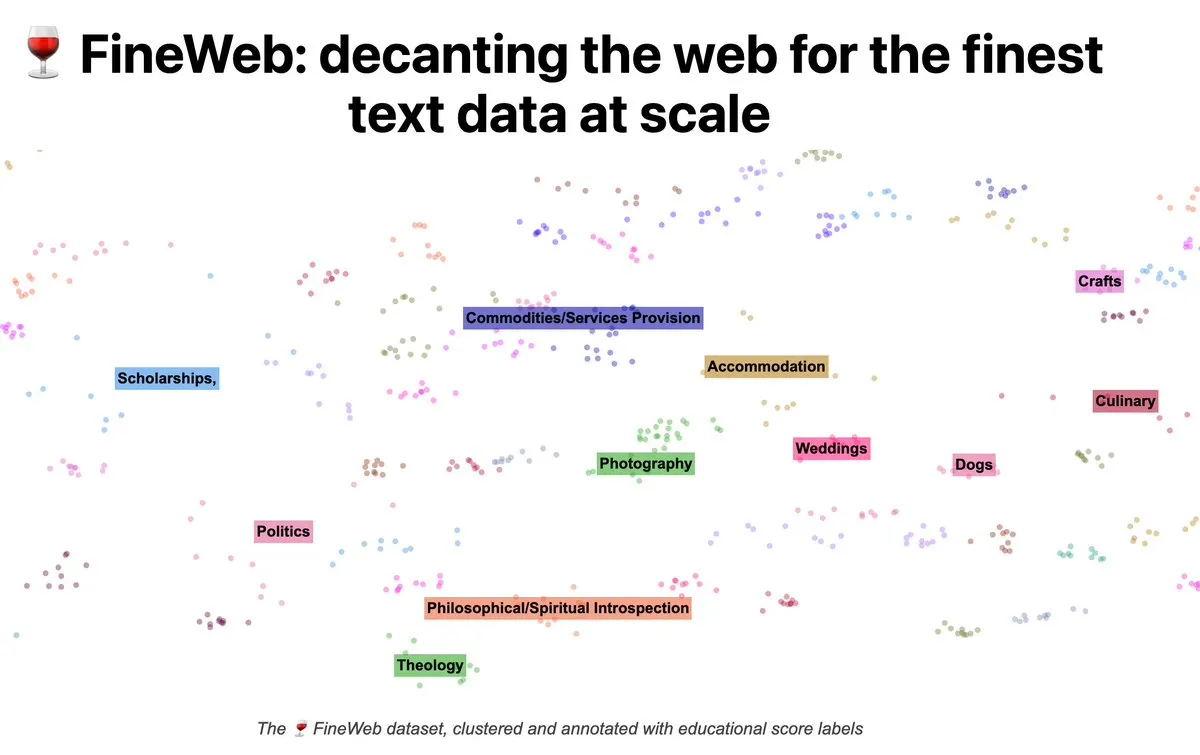

Artigos de blog considerados uma forma mais eficaz de compartilhamento de conhecimento do que artigos acadêmicos : Vários usuários nas redes sociais discutiram que artigos de blog são superiores aos artigos acadêmicos tradicionais para compartilhamento de conhecimento e ensino. Blogs podem começar explicando conceitos básicos, construir uma compreensão intuitiva, não se prendem à novidade e a formatos rígidos, e podem aprimorar a experiência de aprendizagem através da interatividade. A equipe científica do Hugging Face também compartilha ativamente conhecimento de deep learning em larga escala através de blogs interativos, considerando-o a melhor forma de compartilhar insights científicos. (Fonte: LoubnaBenAllal1, _lewtun, clefourrier)

Blog técnico do MiniMax M2 aprofunda a escolha do modelo de atenção total : A equipe do MiniMax M2 publicou um blog técnico explicando por que o M2 finalmente escolheu o modelo de atenção total em vez da atenção linear/esparsa. O blog aponta que, embora a atenção eficiente possa teoricamente economizar computação, em sistemas de nível industrial reais, a atenção total ainda tem um desempenho superior em termos de performance e tarefas complexas (como inferência multi-hop). Os principais desafios residem nas limitações de avaliação, altos custos experimentais, excesso de variáveis de treinamento do modelo e a imaturidade da infraestrutura de atenção eficiente. Isso fornece valiosa experiência prática e reflexão para o design de arquiteturas de grandes modelos. (Fonte: yacinelearning, ImazAngel, giffmana, code_star, QuixiAI, eliebakouch)

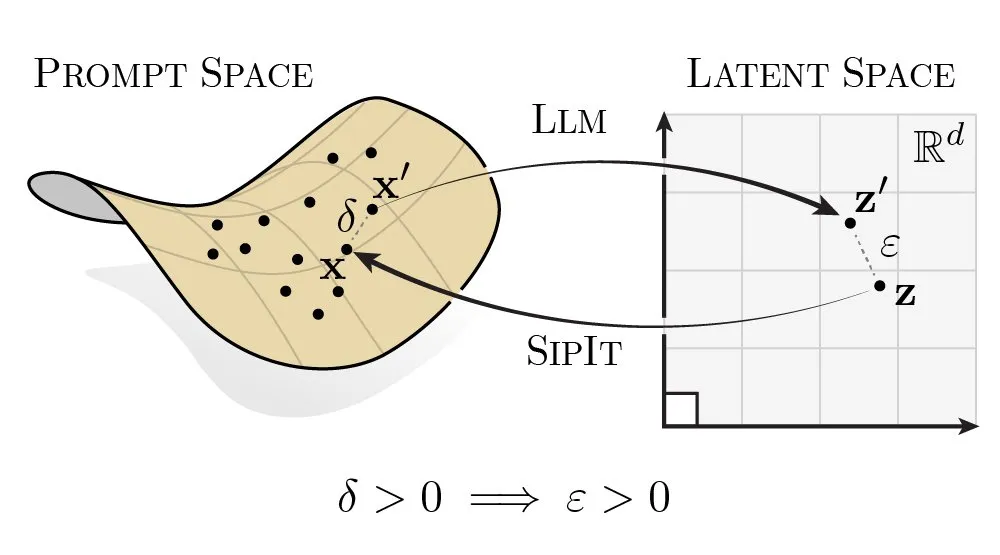

Estudo sobre injetividade e reversibilidade de LLMs revela potencial de recuperação de entrada : Uma nova pesquisa demonstra que os LLMs possuem injetividade e reversibilidade, ou seja, diferentes prompts sempre mapeiam para diferentes embeddings. Esta característica pode ser usada para recuperar tokens de entrada a partir de um único embedding no espaço latente. Esta descoberta oferece uma nova perspectiva para entender os mecanismos internos dos LLM e os potenciais riscos de segurança/privacidade, e pode ser aplicada futuramente em recuperação de entrada ou pesquisa de ataques adversários. (Fonte: tokenbender)

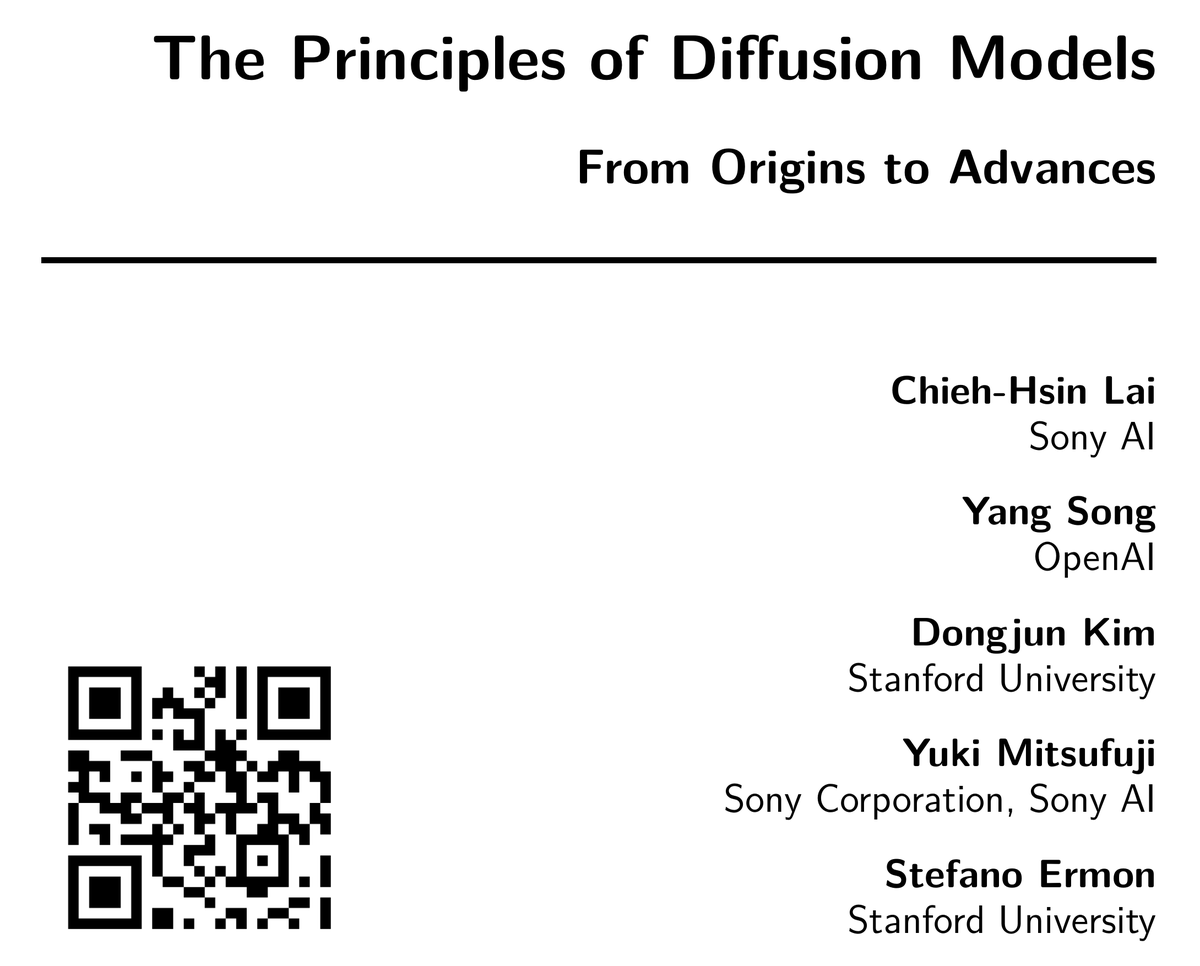

Lançamento da monografia “The Principles of Diffusion Models”, explicando sistematicamente os modelos de difusão : Uma monografia intitulada “The Principles of Diffusion Models” foi lançada, com o objetivo de explicar sistematicamente as ideias centrais, princípios de funcionamento e direções de desenvolvimento dos modelos de difusão. A monografia rastreia os conceitos chave que levaram à formação dos modelos de difusão e explica em profundidade como, por que e para onde os modelos atuais estão se dirigindo. É considerada uma referência confiável e fundamental, ajudando pesquisadores e desenvolvedores a compreender profundamente os modelos de difusão, evitando a necessidade de consultar repetidamente artigos originais. (Fonte: NandoDF, sedielem)

Agent Data Protocol (ADP) unifica conjuntos de dados de treinamento de Agent : Uma pesquisa introduziu o Agent Data Protocol (ADP), uma linguagem de representação leve projetada para unificar os formatos heterogêneos, ferramentas e interfaces de vários conjuntos de dados de treinamento de Agent. O ADP é suficiente para expressar diversas tarefas como uso de API/ferramentas, navegação, codificação, engenharia de software e fluxos de trabalho gerais de Agent, e simplifica o processo de treinamento unificado de Agent a jusante. Experimentos mostram que, ao realizar SFT em 13 conjuntos de dados existentes através do ADP, o desempenho do modelo melhorou em média cerca de 20%, e alcançou SOTA ou próximo de SOTA em vários benchmarks. (Fonte: HuggingFace Daily Papers)

Framework SPICE aprimora a capacidade de inferência através de auto-jogo em ambientes de corpus : SPICE (Self-Play In Corpus Environments) é um framework de reinforcement learning onde um modelo desempenha dois papéis: o de desafiador (que extrai tarefas de inferência de um corpus) e o de inferidor (que resolve as tarefas). Através de dinâmicas adversariais, o desafiador cria um currículo automático na fronteira da capacidade do inferidor, enquanto a base do corpus fornece sinais externos ricos e quase inesgotáveis para melhoria contínua. O SPICE alcançou ganhos contínuos em benchmarks de raciocínio matemático e geral, revelando que a base documental é crucial para a geração contínua de objetivos desafiadores e para o alcance desses objetivos. (Fonte: HuggingFace Daily Papers)

💼 Negócios

Ano zero da comercialização de unicórnios de AI: Da especulação tecnológica à implementação, surgem empresas Agent e nativas de AI : Em 2025, o ecossistema de capital de risco em AI mudou da especulação tecnológica para a implementação comercial, e os unicórnios de AI começaram a provar modelos de receita sustentáveis. A maturidade dos AI Agent e dos modelos de negócios “nativos de AI” deu origem a novas formas de empresas, como a ThinkinMachinesLab, avaliada em US$ 12 bilhões antes mesmo de lançar um produto, a Harvey (AI jurídica) avaliada em US$ 3 bilhões, e o Cursor da Anysphere com ARR de US$ 500 milhões. O valor central dessas empresas reside no domínio do poder computacional, algoritmos e modelos, com o valor do produto aumentando com o desempenho do modelo, e não com a eficiência operacional. Os serviços de AI estão mudando da assinatura de software para o pagamento baseado em resultados, acelerando o ciclo de startup e impulsionando a construção de equipes “híbridas humano-máquina” para alavancagem organizacional. (Fonte: 36氪)

O enigma do ROI da AI: Empresas enfrentam desafios nos gastos com AI : Embora a febre da AI persista há anos, o relatório MIT NANDA aponta que 95% dos projetos piloto de AI generativa não conseguiram escalar ou alcançar um ROI mensurável. As empresas se encontram em um dilema com os investimentos em AI: por um lado, precisam acompanhar as tendências tecnológicas, por outro, enfrentam dificuldades em medir os retornos e riscos à estabilidade dos negócios. O artigo sugere que as empresas devem considerar os dados como valor central, negociar o acesso a dados com fornecedores de modelos para obter serviços ou descontos; adotar uma estratégia de “design entediante”, aplicando a AI a pontos problemáticos específicos do negócio em vez de atualizar modelos frequentemente; e seguir o princípio da “economia da van”, projetando sistemas que atendam às necessidades do usuário e priorizem a economia, evitando a busca cega pelas tecnologias mais recentes. (Fonte: MIT Technology Review, MIT Technology Review)

Serviços de aluguel de GPU em nuvem impulsionam o treinamento e inferência de modelos de AI : Com o aumento da demanda por hardware para treinamento e fine-tuning de grandes modelos de AI, os serviços de aluguel de GPU se tornaram uma solução eficiente e econômica. Os usuários podem alugar servidores GPU de alta performance como A100, H100, RTX 4090 sob demanda, evitando altos investimentos iniciais e escalando instantaneamente de acordo com as necessidades da carga de trabalho. Este modelo oferece um ambiente de computação flexível, escalável e seguro para desenvolvedores de AI, deep learning e projetos intensivos em dados, economizando tempo e orçamento de forma eficaz. (Fonte: Reddit r/deeplearning, Reddit r/LocalLLaMA)

🌟 Comunidade

AI e habilidades de programação: A era da AI exige mais dos programadores : Discussões sociais apontam que a AI reduziu a barreira de entrada na programação e os custos de Demo, mas o desenvolvimento de software de alta qualidade exige mais em termos de design de estrutura de dados, design de arquitetura e simplicidade de módulos. O código gerado por AI pode conter “código inútil”, aumentando o risco de manutenção futura. Portanto, quanto mais poderosa a AI, maiores são as exigências sobre o conhecimento, experiência e capacidade arquitetônica de programação humana. O artigo enfatiza o modo “Agentic Coding”, onde a AI atua como um “programador júnior super capaz, mas irresponsável”, e os engenheiros humanos desempenham o papel de “líder técnico”, com o foco mudando para “fazer requisições” e “revisão de código”. (Fonte: dotey, dotey, gfodor, zhuohan123, lateinteraction, finbarrtimbers)

ChatGPT causa problemas de saúde mental em usuários e a resposta da OpenAI : A OpenAI estima que centenas de milhares de usuários do ChatGPT exibiram sintomas graves de saúde mental e ajustou o GPT-5 para responder de forma mais eficaz a usuários em dificuldades. Embora a OpenAI não force os usuários a fazer pausas, a indústria discutiu a necessidade de a AI ter uma função de “desligar” para proteger os usuários. Ao mesmo tempo, alguns usuários compartilharam experiências de ChatGPT gerando conteúdo extremo ou inadequado sob prompts específicos, destacando os desafios dos modelos de AI na compreensão da intenção do usuário e na segurança do conteúdo. (Fonte: MIT Technology Review, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Impacto da popularização dos AI Agent nos cargos de vendas e considerações estratégicas das empresas : A Vercel substituiu a maior parte de sua equipe de vendas treinando AI Agent, reduzindo uma equipe de 10 para 1 pessoa, o que gerou preocupações sobre a substituição de cargos de vendas de nível básico por AI Agent. No entanto, há quem argumente que, se os fluxos de trabalho puderem ser documentados, os AI Agent podem realizá-los, mas a realidade pode não ser tão simples. Além disso, há discussões questionando por que as empresas na era da AI não mantêm mais funcionários para alcançar uma “multiplicação de força”, em vez de demitir para financiar a AI, o que reflete as considerações estratégicas das empresas na transição para a AI e a incerteza nas perspectivas de emprego dos funcionários. (Fonte: Reddit r/artificial, Reddit r/ArtificialInteligence)

Impacto da AI no mercado de trabalho: Diferenças entre o setor de tecnologia e os setores tradicionais : Discussões sociais exploraram por que a AI causa mais demissões e volatilidade no setor de tecnologia, enquanto permanece relativamente estável em setores tradicionais como contabilidade ou engenharia civil. A visão é que o campo de desenvolvimento de software possui mais dados que as empresas de AI podem aproveitar, e o pessoal interno das empresas de tecnologia está mais familiarizado com os processos de desenvolvimento de software. Setores tradicionais, por envolverem responsabilidade financeira ou segurança da vida, têm menor confiança na AI. Além disso, alguns comentários apontam que as demissões podem ser uma desculpa das empresas para usar a AI para aumentar as expectativas de lucros futuros, em vez de a AI causar diretamente o desemprego em massa. (Fonte: Reddit r/ArtificialInteligence)

Grokipedia gera controvérsia: Viés político e precisão de conteúdo da enciclopédia de AI : A Grokipedia, um concorrente da Wikipédia impulsionado por AI lançado por Elon Musk, gerou controvérsia devido ao seu conteúdo de direita e à disseminação de informações historicamente imprecisas e pontos de vista conservadores. Por exemplo, ela afirmou erroneamente que o conteúdo pornográfico agravou a epidemia de AIDS e sugeriu que as mídias sociais podem ter contribuído para o crescimento da população transgênero. Este incidente destaca os desafios do conteúdo gerado por AI em termos de objetividade, precisão e potenciais vieses, bem como o impacto social que a AI pode ter no campo da disseminação do conhecimento. (Fonte: Reddit r/artificial, MIT Technology Review)

Aplicação da AI na revisão de contas médicas: Claude ajuda família a reduzir drasticamente contas hospitalares : Uma família em luto utilizou o chatbot de AI Claude para reduzir com sucesso uma conta hospitalar de US$ 195.000 para US$ 33.000. Claude identificou cobranças duplicadas, codificação inadequada e outras irregularidades, diminuindo significativamente os custos médicos. Este caso demonstra o enorme potencial da AI na análise de documentos complexos e na otimização de custos, especialmente em áreas com assimetria de informação como a saúde, onde a AI pode capacitar os consumidores a defender seus direitos. (Fonte: Reddit r/artificial)

Navegadores de AI: Discussão sobre adequação ao mercado e riscos de segurança e privacidade : Discussões sociais giraram em torno da adequação ao mercado e dos riscos de segurança e privacidade dos navegadores de AI. Anil Dash descreveu o Atlas como um “anti-navegador web”, enquanto Simon Willison enfatizou que seus riscos de segurança e privacidade são altos demais para serem superados, afirmando que não confiaria em tais produtos antes de uma avaliação completa por pesquisadores de segurança. A discussão apontou que, embora a AI possa acelerar o desenvolvimento de software, seus modelos carecem da capacidade de questionar se uma categoria de produto é razoável, e essa capacidade de julgamento ainda é exclusivamente humana. Isso provocou uma profunda reflexão sobre a relação entre a inovação de produtos de AI e as necessidades reais, bem como os limites éticos. (Fonte: random_walker)

Impacto da AI na indústria de entretenimento adulto: Potencial da tecnologia de geração de vídeo e desafios éticos : Discussões sociais exploraram o impacto da tecnologia de geração de vídeo por AI na indústria de entretenimento adulto. Usuários acreditam que a fidelidade dos vídeos gerados por AI atingiu um nível surpreendente, sugerindo que a AI pode, em grande parte, substituir a produção tradicional de conteúdo adulto. No entanto, isso também levanta desafios éticos, como o uso não consensual da imagem de outras pessoas, o impacto no emprego de atores e como equilibrar a liberdade criativa com questões de exploração. Ao mesmo tempo, há a visão de que o valor do conteúdo adulto real pode aumentar por causa disso, e o conteúdo personalizado gerado por AI se tornará um novo mercado. (Fonte: Reddit r/artificial)

Razões para o fracasso do modelo Llama e controvérsia sobre a estratégia de AI da Meta : Discussões sociais sugerem que a série de modelos Llama da Meta não alcançou o sucesso esperado, e a razão pode estar relacionada à estratégia “inconstante” do CEO Zuckerberg em investimentos em AI. Embora a Meta tenha investido pesadamente em VR, pode ter faltado compromisso e persistência de longo prazo em AI, resultando na incapacidade da série Llama de manter a competitividade. Comentários apontam que a hesitação da Meta em sua estratégia de código aberto e a ênfase na mitigação de riscos podem indicar que não haverá mais modelos de código aberto competitivos no futuro, levantando preocupações na comunidade sobre a direção estratégica da AI da Meta. (Fonte: Reddit r/LocalLLaMA)

Autonomia de robôs AI: O desafio da engenharia de software de “carro antigo” para “carro de corrida” : Discussões sociais apontam que o aumento de 10 vezes na velocidade de codificação trazido pela AI é mais como atualizar um carro com um novo motor. Se for instalado em um “carro antigo”, só trará 10 vezes mais problemas. Para desfrutar do aumento de velocidade trazido pela AI, é preciso reduzir simultaneamente a “probabilidade de problemas” em 10 vezes. Isso exige que as práticas de engenharia de software (como CI/CD, testes automatizados) sejam atualizadas em sincronia, comprimindo o ciclo de feedback de “horas” para “minutos”, e otimizando os sistemas de decisão e comunicação. O verdadeiro valor da programação AI reside em tornar viáveis as melhores práticas que antes eram caras, em vez de substituir engenheiros humanos, mas sim adaptá-los a motores de alta velocidade. (Fonte: dotey, finbarrtimbers)

💡 Outros

Vendedores robôs impulsionados por AI e instalações de treinamento para robôs humanoides : A Xpeng Motors lançou o vendedor robô humanoide “Tiedan”, demonstrando novas aplicações da AI em serviços de varejo. Ao mesmo tempo, Pequim também estabeleceu instalações de treinamento para robôs humanoides, visando acelerar o desenvolvimento e a aplicação da tecnologia robótica. Esses avanços preveem a crescente popularidade de robôs humanoides nos setores comercial e industrial, com a expectativa de que interajam e colaborem com humanos em mais cenários no futuro. (Fonte: Ronald_vanLoon, Ronald_vanLoon)

Música e canções geradas por AI: Criação concluída em minutos : A tecnologia de AI já é capaz de criar músicas e canções em poucos minutos. Este avanço demonstra a poderosa capacidade da AI no campo da criação artística, podendo gerar conteúdo de áudio de alta qualidade rapidamente. Isso trouxe novas ferramentas e possibilidades para a indústria musical, ao mesmo tempo em que levantou discussões sobre direitos autorais, originalidade e o papel dos artistas humanos. (Fonte: Ronald_vanLoon)

VaultGemma: Google pré-treina LLM com Differential Privacy, alcançando memorização sem dados : O projeto VaultGemma do Google DeepMind conseguiu pré-treinar um LLM usando Differential Privacy, alcançando a memorização sem dados de treinamento. Embora isso tenha custado 100 vezes mais em termos de computação e atingido o nível de desempenho do GPT-2, é o primeiro LLM sem memorização de dados de treinamento detectável. Este avanço é de grande importância para a proteção da privacidade na AI, oferecendo uma nova direção para a construção de LLMs mais seguros e responsáveis no futuro. (Fonte: jxmnop)