Palavras-chave:Computação quântica, Algoritmo de IA, Arquitetura Transformer, Regulamentação de IA, Dinâmica comercial de IA, Ética em IA, Hardware de IA, Avaliação de modelos de IA, Algoritmo quântico Willow da Google, Camada subconsciente Free Transformer da Meta, Atenção latente multi-head DeepSeek-V2, Placa de vídeo AMD Radeon AI PRO R9700, Camada de segurança para geração de código IA Corridor

🔥 Destaques

Algoritmo quântico do Google supera supercomputadores: O Google afirma que seu novo algoritmo quântico superou os supercomputadores em desempenho, com potencial para acelerar a descoberta de medicamentos e o desenvolvimento de novos materiais. O cerne deste avanço é o seu chip Willow, e embora as aplicações práticas da computação quântica ainda estejam a anos de distância, este progresso marca um marco importante no campo, prenunciando um enorme potencial para a pesquisa científica futura. (Fonte: MIT Technology Review)

Reddit processa o motor de busca de AI Perplexity: O Reddit processou o motor de busca de AI Perplexity, acusando-o de extrair ilegalmente dados do Reddit para treinamento de modelos. O Reddit busca uma liminar permanente para impedir que tais empresas vendam seus dados sem permissão, e o caso gerou uma ampla discussão sobre proteção de direitos autorais e legalidade do uso de dados na era da AI. (Fonte: MIT Technology Review)

Plano Quinquenal da China: Autossuficiência Tecnológica e Papel Chave da AI: A China divulgou um plano quinquenal com o objetivo de alcançar a autossuficiência tecnológica, listando semicondutores e inteligência artificial como áreas de desenvolvimento cruciais. Esta medida sublinha a determinação estratégica da China pela autonomia tecnológica e a busca por vantagens na competição comercial internacional, gerando preocupações globais sobre as cadeias de suprimentos tecnológicas e as mudanças no cenário geopolítico. (Fonte: MIT Technology Review)

OpenAI relaxa regras sobre discussão de suicídio, gerando processo: A OpenAI foi acusada de relaxar duas vezes suas regras sobre discussões de suicídio para aumentar o número de usuários do ChatGPT, o que levou ao suicídio de um adolescente. Os pais da vítima entraram com uma ação judicial, alegando que as mudanças da OpenAI enfraqueceram a proteção contra suicídio para os usuários, levantando sérias questões sobre a ética da AI, segurança do usuário e responsabilidade da plataforma. (Fonte: MIT Technology Review)

Elon Musk constrói exército de robôs, Optimus pode se tornar “cirurgião”: Elon Musk está construindo ativamente um exército de robôs e prevê que seu robô Optimus poderá se tornar um “cirurgião excepcional” no futuro. Esta visão gerou uma ampla discussão sobre as capacidades de robôs gerais, a confiança humano-máquina e a aplicação da AI em campos profissionais complexos, prenunciando um futuro onde a tecnologia robótica desempenhará um papel mais significativo no mundo real. (Fonte: MIT Technology Review)

🎯 Tendências

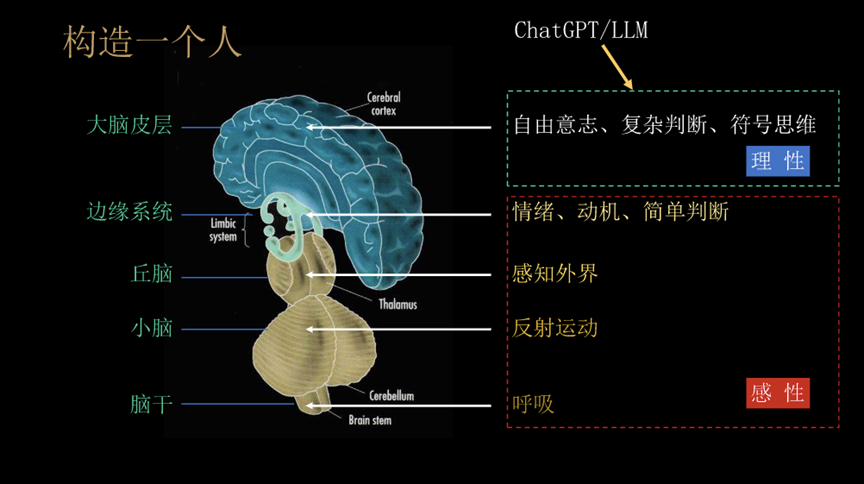

Meta lança “Free Transformer”: reescrevendo as regras fundamentais da AI: A Meta lançou um novo modelo “Free Transformer”, que quebra as regras centrais da arquitetura Transformer de 8 anos, introduzindo uma “camada subconsciente” para permitir o pré-pensamento antes da geração. Esta inovação aumenta o custo computacional em apenas cerca de 3%, mas melhora significativamente o desempenho do modelo em inferência e geração estruturada, superando modelos de maior escala em testes como GSM8K e MMLU, sendo considerado o primeiro Transformer “com intenção intrínseca”. (Fonte: 36氪)

Robôs do Google DeepMind alcançam “pensar antes de agir”: O modelo Gemini Robotics 1.5 do Google DeepMind permite que os robôs passem de uma execução passiva de comandos para a reflexão, raciocínio e tomada de decisões. Esses robôs são capazes de explicar seus processos de raciocínio, transferir conhecimento entre máquinas e integrar visão, linguagem e ação em um ciclo de pensamento unificado, com o potencial de impulsionar a inteligência do mundo real e a colaboração humano-máquina para uma nova fase. (Fonte: Ronald_vanLoon)

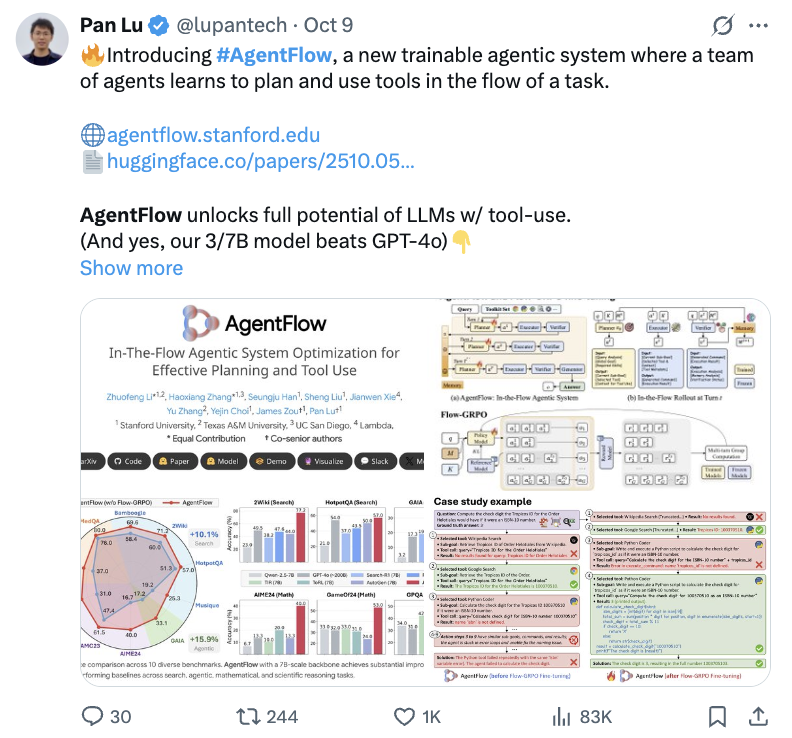

AgentFlow da Stanford melhora a capacidade de raciocínio de modelos pequenos: A equipe de Stanford lançou um novo paradigma, AgentFlow, que permite que modelos pequenos de 7B aumentem drasticamente o desempenho em raciocínio de problemas complexos através de aprendizado por reforço online, superando até mesmo GPT-4o e Llama3.1-405B. O AgentFlow é composto por quatro agentes colaborativos: planejador, executor, verificador e gerador, utilizando Flow-GRPO para otimizar o planejador em tempo real, com melhorias significativas em tarefas de busca, agente, matemática e ciência. (Fonte: 36氪)

AI descobre novo algoritmo MoE: 5 vezes mais eficiente, 26% menos custo: Uma equipe de pesquisa da Universidade da Califórnia, Berkeley, propôs o sistema ADRS, que permite à AI descobrir novos algoritmos 5 vezes mais rápidos e 26% mais baratos que os projetados por humanos, através de um ciclo iterativo de “gerar-avaliar-melhorar”. Baseado na estrutura OpenEvolve, a AI descobriu métodos heurísticos inteligentes em tarefas como balanceamento de carga MoE, melhorando significativamente a eficiência operacional e demonstrando o enorme potencial da AI na criação de algoritmos. (Fonte: 36氪)

Anthropic expande uso de Google TPU, fortalecendo infraestrutura de computação de AI: A Anthropic anunciou planos para expandir o uso de Google TPU, garantindo cerca de 1 milhão de TPUs e mais de 1 gigawatt de capacidade até 2026. Esta medida demonstra o enorme investimento da Anthropic em infraestrutura de computação de AI e sua profunda colaboração com o Google no campo da AI, prenunciando uma futura expansão ainda maior na escala de treinamento de modelos de AI. (Fonte: Justin_Halford_)

Mecanismo de atenção latente multi-cabeça do DeepSeek-V2 gera discussão: A atenção latente multi-cabeça (MLA) introduzida no DeepSeek-V2, que reduz significativamente a complexidade ao projetar chaves e valores para um espaço latente, gerou discussões na academia sobre por que este conceito não havia surgido antes. Embora o Perceiver já tivesse explorado ideias semelhantes em 2021, o MLA só apareceu em 2024, possivelmente exigindo “truques” específicos para que funcionasse na prática. (Fonte: Reddit r/MachineLearning)

Criação de conteúdo de vídeo por AI atinge ponto de inflexão: A criação de conteúdo de vídeo por AI atingiu um ponto de inflexão, com sucessos frequentes, como o lançamento do Sora 2 na plataforma Synthesia e vídeos musicais com tema Jornada ao Oeste gerados por AI no Bilibili, que obtiveram milhões de visualizações. Isso demonstra o enorme potencial da AI no campo da geração de conteúdo de entretenimento, mudando rapidamente o cenário da criação de conteúdo. (Fonte: op7418)

Llion Jones, coautor de “Attention Is All You Need”, está “cansado” da arquitetura Transformer: Llion Jones, coautor do artigo “Attention Is All You Need”, expressou “cansaço” com a excessiva dependência da arquitetura Transformer no campo da AI, acreditando que isso impede novos avanços tecnológicos. Ele aponta que, apesar dos enormes investimentos no campo da AI, a pesquisa se tornou restrita devido à pressão de investimento e à concorrência, podendo perder a próxima grande inovação arquitetônica. (Fonte: Reddit r/ArtificialInteligence)

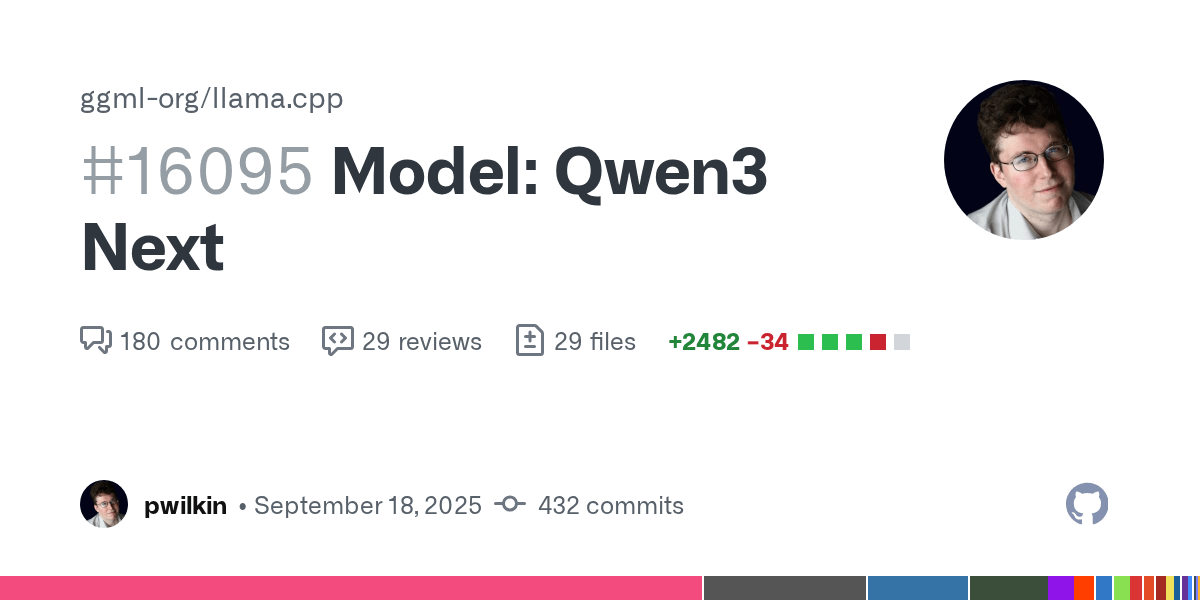

Progresso no suporte ao modelo Qwen3 Next em llama.cpp: O suporte para o modelo Qwen3 Next em llama.cpp está pronto para revisão de código. Embora esta não seja a versão final e ainda não tenha sido otimizada para velocidade, marca um progresso ativo da comunidade open-source na integração de novos modelos, prenunciando a possibilidade de execução local do Qwen3. (Fonte: Reddit r/LocalLLaMA)

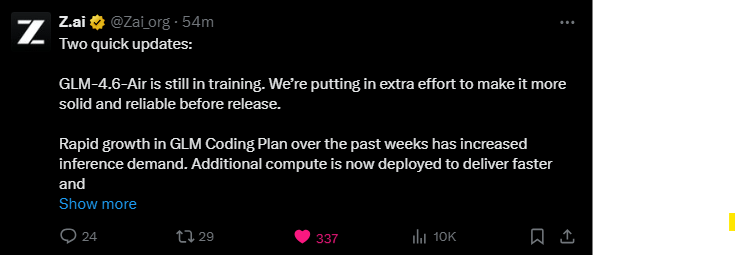

Modelo GLM-4.6-Air em treinamento contínuo: O modelo GLM-4.6-Air ainda está em treinamento, e a equipe está dedicando esforços adicionais para melhorar sua estabilidade e confiabilidade. A comunidade de usuários expressa expectativa, preferindo esperar mais tempo por um modelo de maior qualidade, e está curiosa para saber se ele poderá superar os modelos existentes em termos de desempenho. (Fonte: Reddit r/LocalLLaMA)

DyPE: Método independente de treinamento para geração de imagens de difusão de ultra-alta resolução: Um artigo da HuggingFace apresenta o DyPE (Dynamic Positional Extrapolation), um novo método que permite que Transformers de difusão pré-treinados gerem imagens com resolução muito superior à de treinamento, sem a necessidade de treinamento adicional. O DyPE ajusta dinamicamente a codificação posicional do modelo e utiliza a evolução espectral do processo de difusão, melhorando significativamente o desempenho e a fidelidade em vários benchmarks, com efeitos mais pronunciados em altas resoluções. (Fonte: HuggingFace Daily Papers)

Paradigma de “Comunicação de Pensamento” Multiagente: Um artigo da HuggingFace introduz o paradigma de “Comunicação de Pensamento”, permitindo que sistemas multiagente se comuniquem mentalmente de forma direta, superando as limitações da linguagem natural. Este método, formalizado como um modelo de variáveis latentes, pode teoricamente identificar pensamentos latentes compartilhados e privados entre agentes, e suas vantagens colaborativas foram verificadas em benchmarks sintéticos e do mundo real. (Fonte: HuggingFace Daily Papers)

LALMs apresentam vulnerabilidades de segurança sob mudanças emocionais: Um artigo da HuggingFace revela que Large Audio Language Models (LALMs) apresentam vulnerabilidades de segurança significativas sob mudanças emocionais de diferentes falantes. Ao construir um conjunto de dados de comandos de voz maliciosos, a pesquisa mostra que o nível de respostas inseguras geradas pelos LALMs varia com diferentes emoções e intensidades, sendo as expressões emocionais moderadas as de maior risco, destacando a necessidade de garantir a robustez da AI em implantações no mundo real. (Fonte: HuggingFace Daily Papers)

OpenAI personaliza “Plano de Potência de AI” para Japão e Coreia do Sul: A OpenAI lançou o “Japan Economic Blueprint” e o “Korea Economic Blueprint”, marcando a atualização de sua estratégia na Ásia-Pacífico de exportação de produtos para cooperação em nível nacional. Os planos propõem uma estratégia de duas vias de “construção de capacidade soberana + colaboração estratégica” e um plano de três pilares de “AI inclusiva, infraestrutura e aprendizado ao longo da vida”, visando acelerar a aplicação da AI, atualizar a infraestrutura de computação e ajudar os dois países a se tornarem potências globais em AI. (Fonte: 36氪)

Estrutura ExGRPO: Novo paradigma para aprendizado de inferência de modelos grandes: A equipe do Shanghai AI Lab e outros propuseram a estrutura ExGRPO para gerenciamento e aprendizado de experiência, que otimiza a capacidade de inferência de modelos grandes através da identificação, armazenamento, filtragem e aprendizado científico de experiências valiosas. O ExGRPO melhora significativamente o desempenho em tarefas complexas como problemas de competição matemática, revelando que problemas de dificuldade média e trajetórias de baixa entropia são a chave para um aprendizado eficiente, evitando o problema de “aprender e esquecer” no modo RLVR tradicional. (Fonte: 量子位)

🧰 Ferramentas

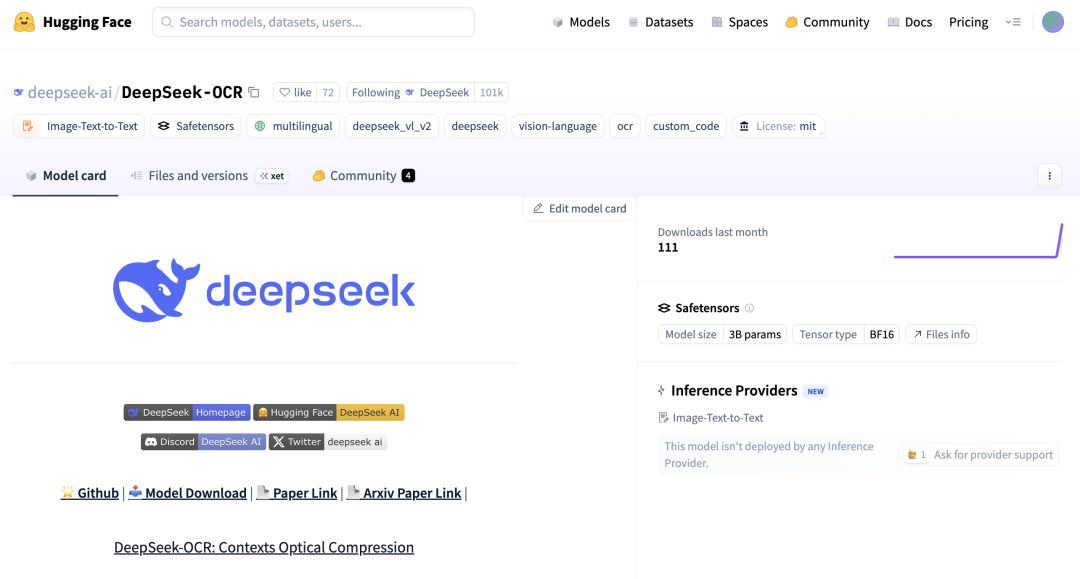

DeepSeek-OCR e Zhipu Glyph: Avanço na tecnologia de Visual Token: A DeepSeek lançou o modelo open-source DeepSeek-OCR de 3 bilhões de parâmetros, inovando ao permitir que a AI comprima opticamente texto de forma “visual”, alcançando uma taxa de compressão de 10x e uma precisão de OCR de 97%. A Zhipu seguiu com o lançamento do Glyph, que também renderiza textos longos em Visual Tokens baseados em imagem, reduzindo drasticamente o contexto do LLM e melhorando a eficiência e velocidade de processamento. Esses modelos receberam suporte em vLLM, demonstrando o enorme potencial da modalidade visual no processamento de informações de LLM. (Fonte: 36氪, 量子位, vllm_project, mervenoyann)

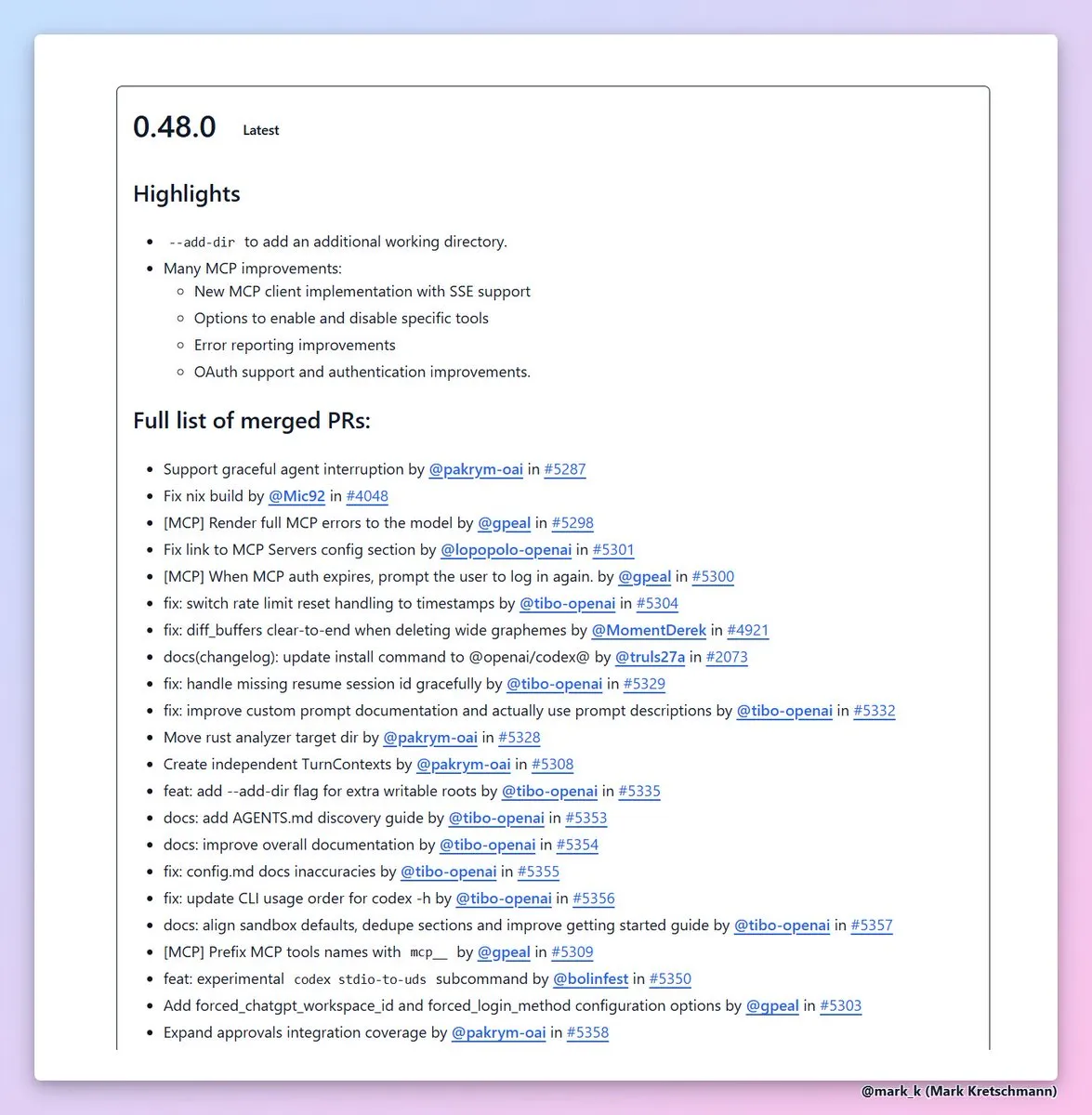

Codex CLI 0.48 adiciona função --add-dir: A OpenAI lançou a versão Codex CLI 0.48, cuja funcionalidade mais valiosa é a adição de --add-dir, permitindo adicionar outros diretórios ao espaço de trabalho atual. Esta medida melhora significativamente a usabilidade das ferramentas de codificação de AI em projetos com múltiplos arquivos, aprimora o relatório de erros e a experiência de autenticação do cliente MCP, acelerando a eficiência da engenharia de software. (Fonte: dotey, kevinweil)

Camada de segurança Corridor para geração de código AI lançada: A camada de segurança Corridor foi oficialmente lançada, fornecendo proteção de segurança em tempo real para ferramentas de geração de código AI como Cursor e Claude Code. O Corridor é a primeira ferramenta de segurança que sincroniza com a velocidade de desenvolvimento, aplicando barreiras de segurança em tempo real para garantir a segurança da codificação assistida por AI, e oferece um teste gratuito de duas semanas. (Fonte: percyliang)

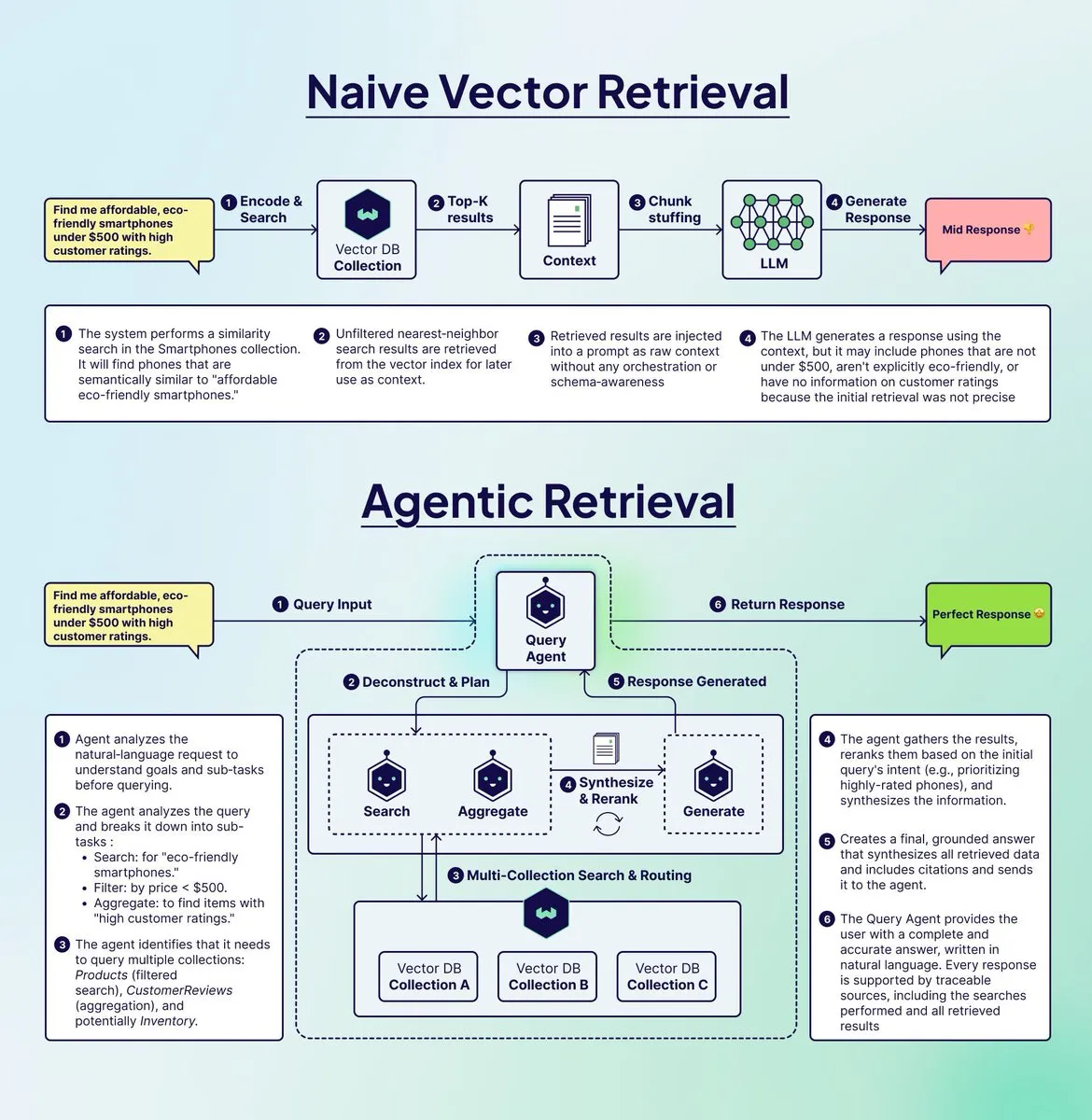

Weaviate lança Query Agent para otimizar sistemas RAG: A Weaviate lançou o Query Agent, com o objetivo de resolver o problema de “fraude” existente nos sistemas RAG tradicionais ao lidar com consultas complexas de várias etapas. O Query Agent pode decompor consultas, rotear para múltiplas coleções, aplicar filtros e agregar resultados, fornecendo respostas mais precisas e baseadas em evidências. Já está disponível no Weaviate Cloud, melhorando significativamente o efeito da geração aumentada por recuperação. (Fonte: bobvanluijt)

Argil Atom: O modelo de AI de vídeo mais controlável do mundo: O Argil Atom foi lançado, sendo considerado o modelo de AI de vídeo mais controlável do mundo, resolvendo os desafios de coerência e controle sob as limitações de duração do vídeo. Este modelo alcançou um novo SOTA na geração de vídeos de personagens de AI, permitindo aos usuários criar vídeos envolventes e adicionar produtos, trazendo uma revolução para a criação de conteúdo de vídeo. (Fonte: BrivaelLp)

Google AI Studio suporta renovação de chave Gemini API: O Google AI Studio agora permite que os usuários continuem usando o modo de construção após atingirem o limite de uso gratuito, adicionando uma chave Gemini API. O sistema alternará automaticamente de volta para o modo gratuito após a redefinição da cota gratuita, garantindo que o processo de desenvolvimento do usuário não seja interrompido, com o objetivo de incentivar o desenvolvimento contínuo de AI. (Fonte: GoogleAIStudio)

Extensão de navegador Open WebUI e problemas de funcionalidade: Um usuário lançou a extensão Open WebUI Context Menu para Firefox, permitindo a interação direta com o Open WebUI a partir de páginas da web. Ao mesmo tempo, a comunidade discute problemas de integração do Code Interpreter do Gemini Pipeline no Open WebUI, bem como a necessidade de suporte oficial para servidores Docker MCP, refletindo a atenção contínua dos usuários à integração de ferramentas de AI e ao aprimoramento de funcionalidades. (Fonte: Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Construtor full-stack de AI e aplicativo de texto para voz: Um usuário conseguiu desenvolver um pequeno SaaS MVP usando um construtor full-stack de AI (como Blink.new), mas enfatizou que o código de AI requer verificação manual. Além disso, um desenvolvedor lançou um aplicativo móvel que pode converter qualquer texto (incluindo páginas da web, PDFs, texto de imagens) em áudio de alta qualidade, oferecendo uma experiência auditiva semelhante a podcasts ou audiolivros, com foco na proteção da privacidade. (Fonte: Reddit r/artificial, Reddit r/MachineLearning)

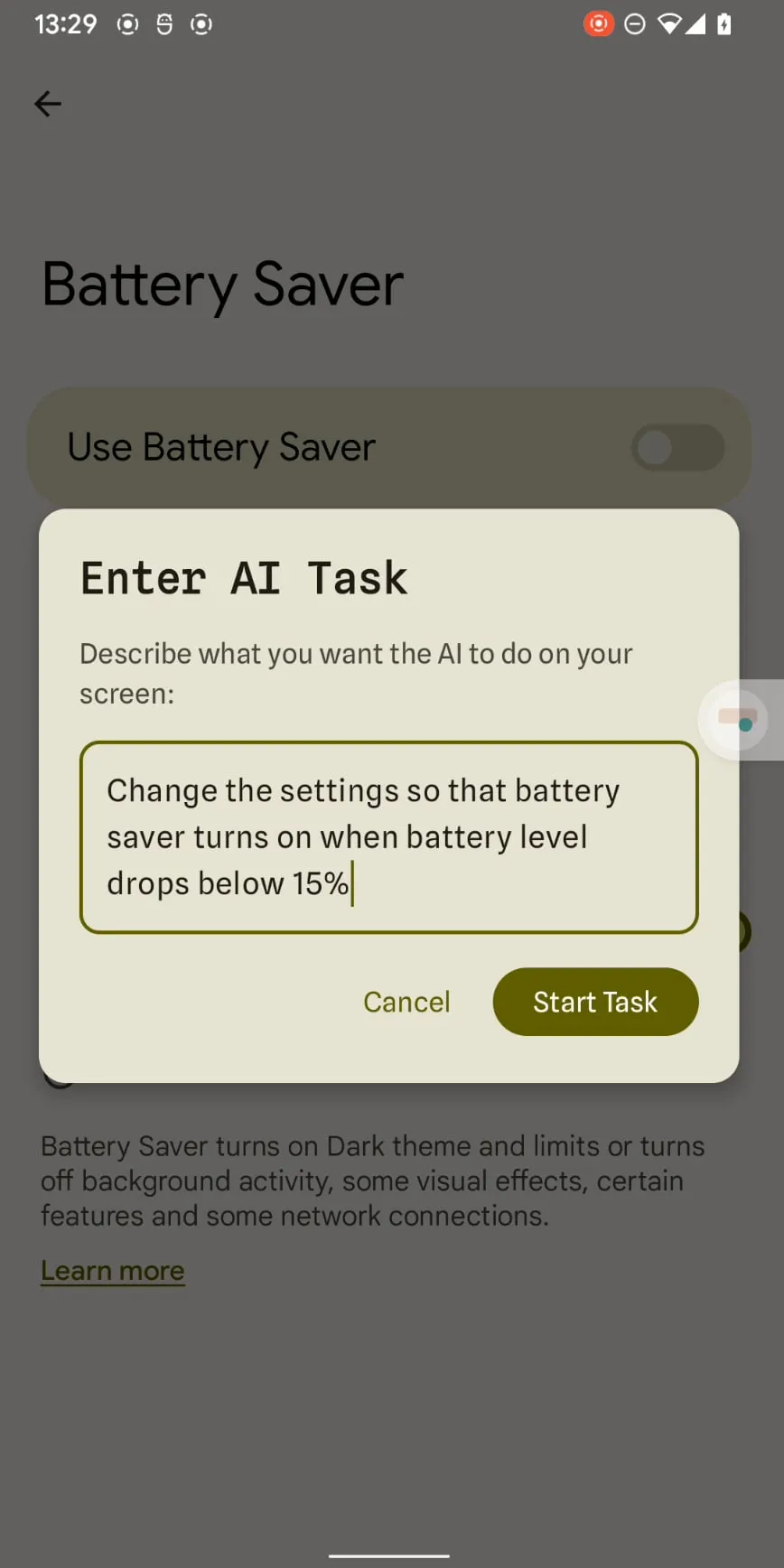

Claude Haiku 4.5 alcança automação de smartphone: O Claude Haiku 4.5, com baixo custo e alta velocidade, utilizou sua capacidade precisa de saída de coordenadas x-y para alcançar a automação de smartphones. Com um custo de apenas US$ 0,003 por etapa e sem a necessidade de conexão com um computador, espera-se que a automação de telefones impulsionada por LLM passe de um truque para uma ferramenta prática, trabalhando em conjunto com aplicativos existentes como Tasker. (Fonte: Reddit r/ClaudeAI)

📚 Aprendizagem

Conceitos e funcionamento de AI Agent: Ronald_vanLoon compartilhou 20 conceitos centrais de AI Agent e como os AI Agents realmente funcionam, com o objetivo de ajudar os alunos a entender seus mecanismos de execução de tarefas e tomada de decisões. Esses recursos exploram profundamente a importância dos AI Agents nos campos da inteligência artificial, machine learning e deep learning, fornecendo materiais de estudo valiosos para profissionais de tecnologia. (Fonte: Ronald_vanLoon, Ronald_vanLoon)

Recursos de aprendizado de programação GPU: Mojo🔥 GPU Puzzles: A Modular lançou o Mojo🔥 GPU Puzzles Edition 1, que ensina programação GPU através de 34 desafios progressivos. Este guia enfatiza “aprender fazendo”, cobrindo desde threads de GPU até núcleos de tensor, suportando NVIDIA, AMD e Apple GPU, fornecendo um caminho de aprendizado prático para desenvolvedores. (Fonte: clattner_llvm)

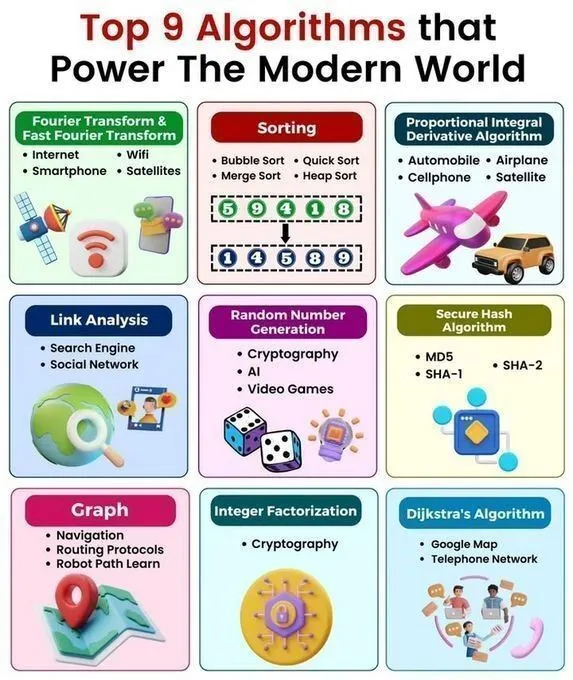

Visão geral rápida de algoritmos e estruturas de dados essenciais: Python_Dv compartilhou os 9 principais algoritmos que impulsionam o mundo moderno, 25 algoritmos de AI, 6 estruturas de dados que economizam espaço de armazenamento, uma folha de consulta rápida de estruturas de dados e algoritmos, e estruturas de dados em Python. Esses recursos fornecem aos estudantes de AI uma visão geral abrangente de algoritmos e estruturas de dados, aprofundando a compreensão dos princípios da tecnologia de AI e da programação Python. (Fonte: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Palestra sobre programação GPU: ProfTomYeh realizará uma palestra sobre como adicionar manualmente dois arrays em uma GPU, explicando em profundidade as operações básicas da programação GPU. A palestra, organizada pela Together AI, oferece orientação prática valiosa para alunos que desejam dominar os detalhes da programação de baixo nível da GPU. (Fonte: ProfTomYeh)

Orientação para carreira e projetos de pesquisa em AI/ML: Um estudante de graduação em matemática e computação científica busca orientação para uma carreira de pesquisa na interseção de AI/ML com ciências físicas/biológicas, cobrindo universidades/laboratórios de ponta, habilidades essenciais, pesquisa de graduação e perspectivas de carreira. Além disso, um recém-formado com mestrado em AI busca ideias de projetos para iniciantes em machine learning e deep learning, com o objetivo de ajudar os alunos a planejar seus caminhos de carreira e habilidades práticas. (Fonte: Reddit r/deeplearning, Reddit r/deeplearning)

Recomendações de livros de matemática para deep learning e visualização de regressão: A comunidade discute a escolha entre os livros “Math for Deep Learning” e “Essential Math for Data Science”, fornecendo orientação de estudo de matemática para iniciantes. Ao mesmo tempo, há recursos que visualizam como um único neurônio aprende através de funções de perda e otimizadores, ajudando os alunos a entender intuitivamente os princípios do deep learning. (Fonte: Reddit r/deeplearning, Reddit r/deeplearning)

Aplicações da AI na moda de jogos: Um vídeo do Two Minute Papers explora como a AI pode melhorar o realismo visual da simulação de roupas de personagens em jogos, demonstrando o potencial da AI para aumentar o realismo visual no desenvolvimento de jogos. O vídeo recomenda artigos relacionados e a conferência Weights & Biases, oferecendo novas perspectivas para desenvolvedores de jogos e pesquisadores de AI. (Fonte: )

💼 Negócios

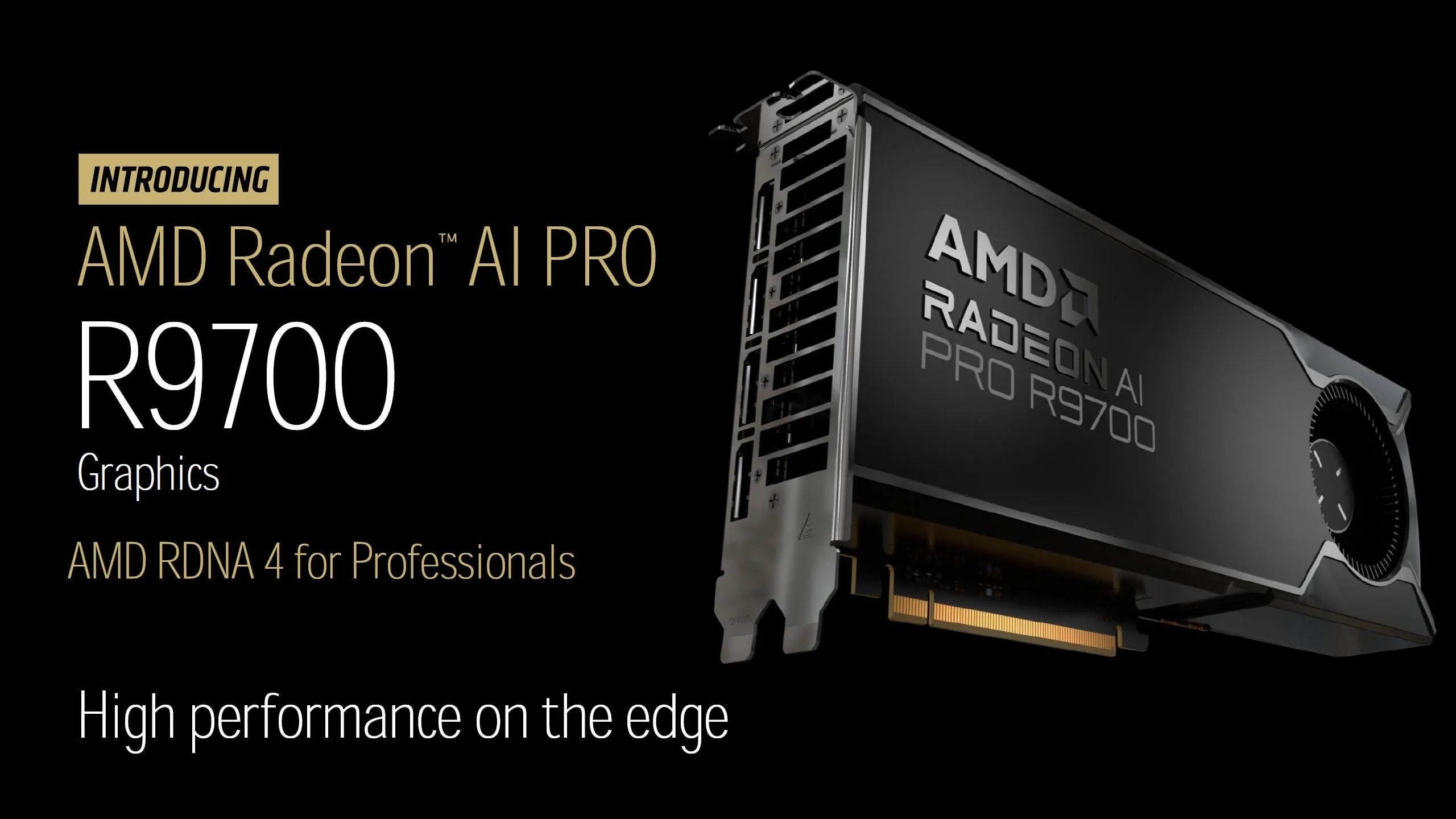

Lançamento da placa gráfica AMD Radeon AI PRO R9700: A AMD anunciou oficialmente o preço da placa gráfica Radeon AI PRO R9700 em US$ 1299, equipada com 32GB de memória GDDR6, com lançamento em 27 de outubro. Com seu alto custo-benefício e ampla memória, esta placa gráfica promete fornecer suporte computacional mais poderoso para a comunidade LocalLLaMA e intensificar a concorrência no mercado de hardware de AI. (Fonte: Reddit r/LocalLLaMA)

Últimas notícias de negócios em AI: A Palantir assinou uma parceria de US$ 200 milhões em serviços de AI com a Lumen Technologies, a OpenAI adquiriu a startup de automação Mac Software Applications, e a EA colaborou com a Stability AI para desenvolver ferramentas de geração de ativos 3D. A Krafton investiu US$ 70 milhões em um cluster de GPU, a Tensormesh levantou US$ 4,5 milhões para reduzir custos de inferência, a Wonder Studios levantou US$ 12 milhões para conteúdo de entretenimento gerado por AI, e a Dell Technologies Capital apoia startups de AI de dados de ponta. (Fonte: Reddit r/artificial)

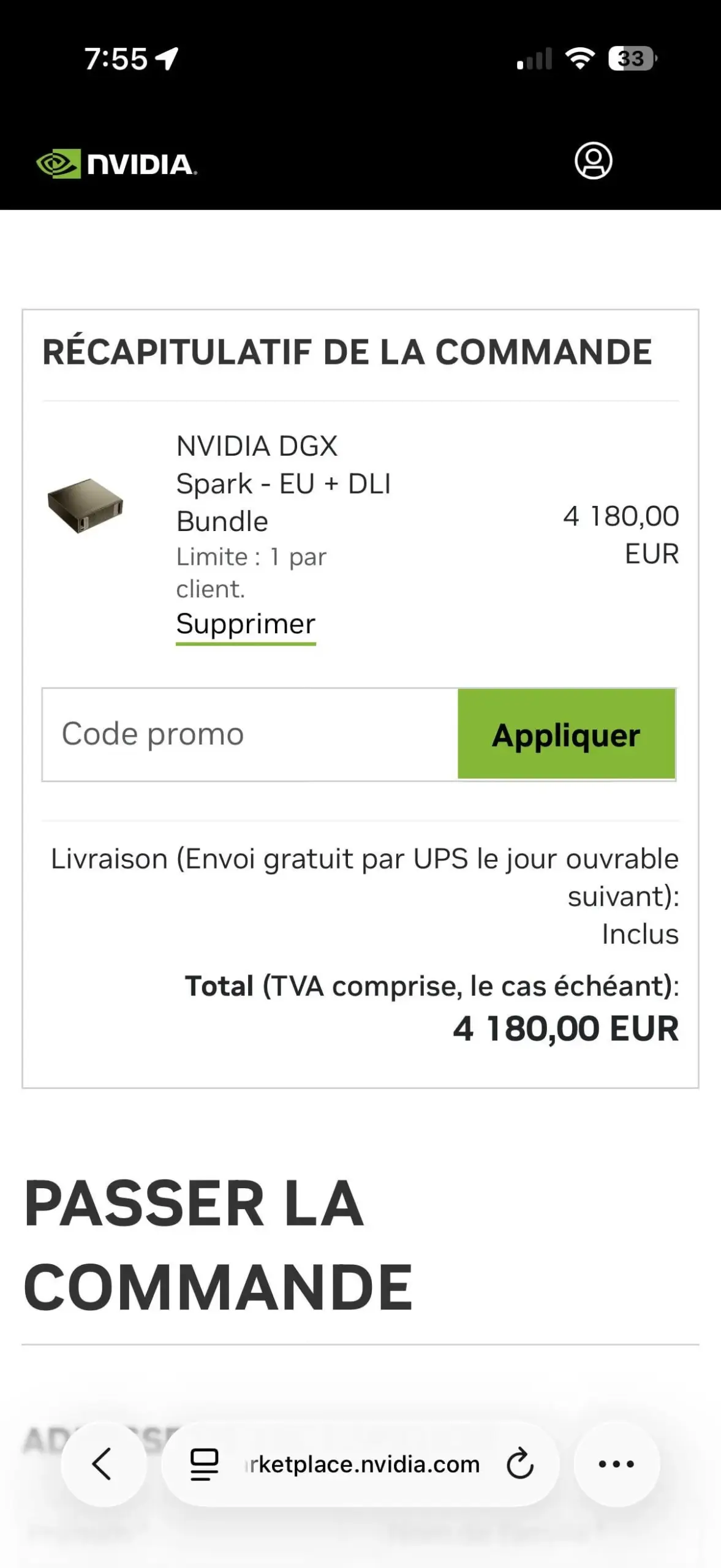

Limite de uma unidade por cliente para NVIDIA DGX Spark gera controvérsia: O pacote NVIDIA DGX Spark EU + DLI implementou uma política de limite de uma unidade por cliente, causando decepção entre os usuários. Esta restrição pode ser para combater cambistas, já que a demanda do mercado é enorme e a oferta é limitada, com revendas a preços altos já aparecendo no eBay, destacando a situação tensa da oferta de hardware de AI. (Fonte: Reddit r/LocalLLaMA)

🌟 Comunidade

Usabilidade de produtos de empresas de AI e competitividade de mercado: Usuários apontam que, embora o Google tenha vantagem em capacidade de computação de AI, sua API é difícil de obter, afetando o uso do produto. Ao mesmo tempo, o Replit oferece um painel de análise integrado, fornecendo dados valiosos de desempenho do site para os usuários, ajudando os desenvolvedores a monitorar e otimizar aplicativos, destacando a importância da usabilidade do produto na concorrência do mercado de AI. (Fonte: RazRazcle, amasad)

Interação emocional da AI com o usuário e limites de segurança: A comunidade discute o fenômeno de usuários desabafando com o ChatGPT e o Claude AI demonstrando “concordância” com seus pontos de vista, levantando reflexões sobre o acompanhamento emocional da AI e a ética da interação. As instruções do sistema Claude AI exigem que ele evite que os usuários desenvolvam dependência emocional, mas alguns usuários também apontam que o Claude Sonnet 4.5 tende a fazer julgamentos negativos ao fornecer conselhos, gerando preocupações sobre os riscos de alinhamento da AI. (Fonte: charles_irl, dejavucoder, Reddit r/ChatGPT, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

Debate sobre regulamentação da AI e desenvolvimento de superinteligência: A comunidade critica a regulamentação excessiva da AI por impedir o desenvolvimento tecnológico, argumentando que adiar indefinidamente a verificação de segurança da AI equivale a adiá-la para sempre, o que pode levar a humanidade a perder oportunidades de desenvolvimento. Outros comentários satirizam aqueles que pedem a proibição da superinteligência como presunçosos e ávidos por atenção, acreditando que suas motivações não são baseadas em considerações práticas. (Fonte: pmddomingos, pmddomingos, pmddomingos)

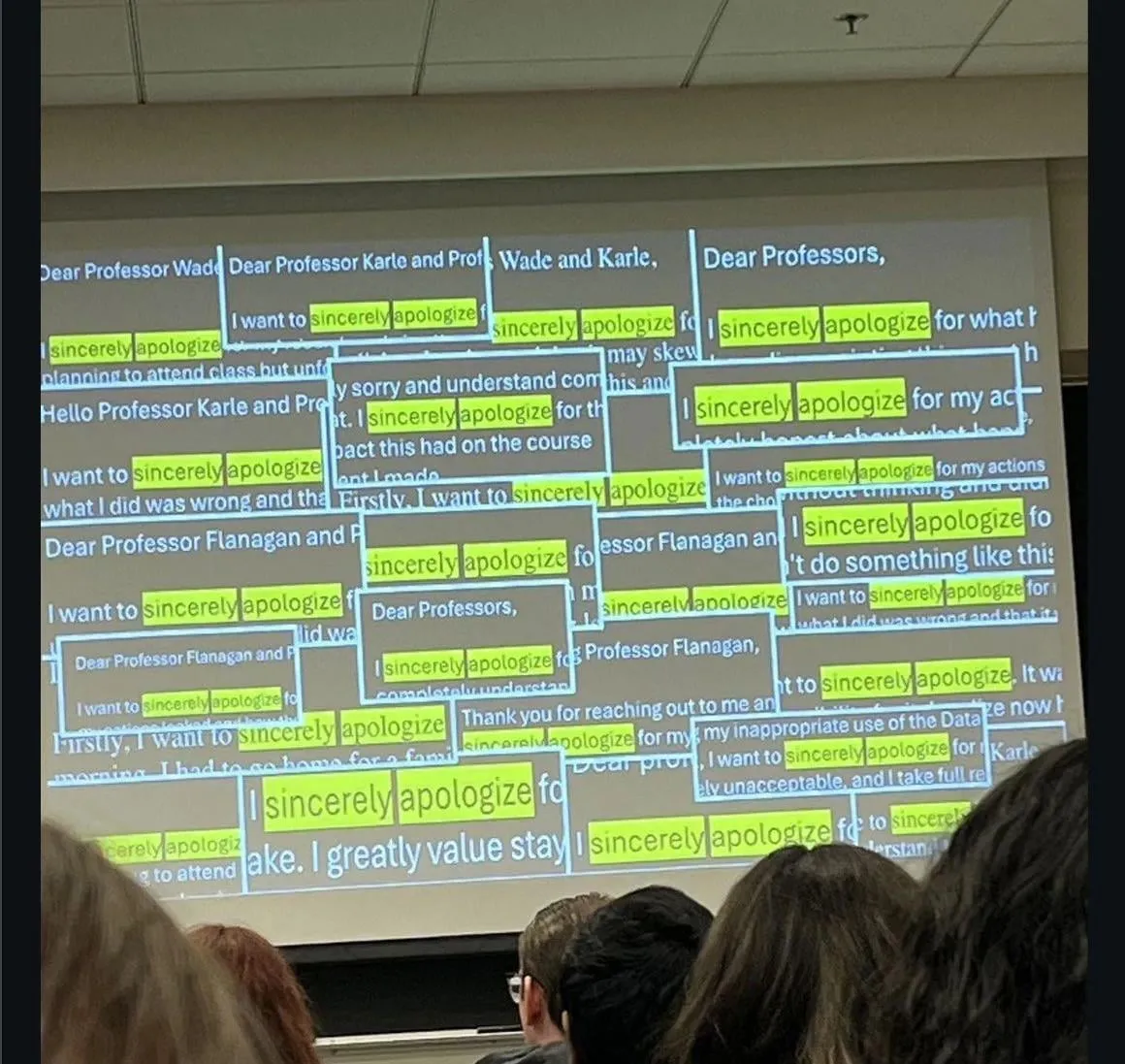

Impacto da AI na educação e no emprego: A comunidade discute o fenômeno de estudantes pedindo desculpas por trapacear com o ChatGPT, e algumas empresas que não estão mais entrevistando candidatos a cargos juniores recém-formados nos últimos anos, devido ao seu desempenho insatisfatório sem a assistência de LLM. Isso levanta profundas preocupações sobre o desenvolvimento de habilidades da nova geração de talentos e as mudanças no mercado de trabalho na era da AI. (Fonte: Reddit r/ChatGPT)

Precisão de LLM e problemas de alucinação: Usuários compartilham as alucinações e imprecisões do ChatGPT em tarefas de cálculo básicas, como realizar “cálculos mentais” e fornecer resultados errados mesmo após escrever o código correto, ou “ignorar arquivos CSV”, levando a saídas completamente erradas. Isso destaca as limitações dos LLMs na verificação de fatos e processamento de dados, levando os usuários a recorrer a outros modelos. (Fonte: Reddit r/ChatGPT)

Detecção e geração de conteúdo de AI: A comunidade discute como identificar conteúdo gerado por AI no Reddit, incluindo pistas como posts com muita interação, mas sem resposta do autor original, ou o uso de inglês excessivamente formal. Ao mesmo tempo, usuários também exploram como usar a tecnologia de AI para criar renda passiva, como gerar conteúdo em massa por AI e publicá-lo em várias plataformas, refletindo o impacto da AI tanto na criação quanto na detecção de conteúdo. (Fonte: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Desempenho da AI em negociação de criptomoedas: Experimentos de negociação de modelos de AI no mercado de criptomoedas mostram que modelos chineses (Qwen 3, DeepSeek) tiveram um desempenho notável, com o Qwen 3 disparando quase 60% em lucros e o DeepSeek com lucros estáveis de 20-30%. Enquanto isso, GPT-5 e Gemini sofreram perdas significativas, revelando as diferenças estratégicas e de desempenho de diferentes modelos de AI em mercados reais, e gerando discussões sobre as estratégias de negociação e a “personalidade” da AI. (Fonte: 36氪, op7418, teortaxesTex, huybery)

Desempenho e experiência do usuário do assistente de código AI: Usuários elogiam a altíssima eficiência do Haiku 4.5 no Claude Code, acreditando que ele melhorou significativamente a velocidade de desenvolvimento de aplicativos, a ponto de não ser mais necessário o Claude Sonnet. Ao mesmo tempo, usuários pedem que o ChatGPT 5 Pro adicione um botão “terminar agora” para resolver o problema de não conseguir interromper respostas longas do modelo sem perder o conteúdo, refletindo a demanda contínua por otimização da experiência do usuário de LLM. (Fonte: Reddit r/ClaudeAI, sjwhitmore)

Autocorreção e monitoramento de agentes de AI: Inspirado na estrutura ACE da Stanford, um usuário escreveu um “roteiro de arquiteto” para o Claude, permitindo que ele autocorrija e depure código. Ao mesmo tempo, o LangSmith Insights Agent, através da análise de cluster de trajetórias de agentes de usuário, fornece insights sobre padrões de comportamento e problemas potenciais, simplificando a análise e depuração de dados de aplicativos de AI em larga escala. (Fonte: Reddit r/ClaudeAI, HamelHusain, hwchase17)

Avaliação de modelos de AI e desafios de desenvolvimento: A comunidade opina que o número atual de modelos de AI é excessivo, mas falta uma avaliação eficaz, sendo urgentemente necessários benchmarks padronizados. Além disso, discute-se a necessidade de testes automatizados de operadores e seus efeitos de gradiente, bem como o incidente em que um sistema de detecção de armas por AI identificou erroneamente um saco de batatas fritas como uma arma, destacando os desafios de segurança, viés e robustez da AI em implantações reais. (Fonte: Dorialexander, shxf0072, colin_fraser)

Demissões na indústria de AI e fluxo de talentos: O laboratório de superinteligência da Meta demitiu 600 pessoas, incluindo a equipe de Yuan Tian, gerando questionamentos internos sobre o momento das demissões e a prática de “descartar o moinho após moer” após o treinamento do Llama 4.5. Yuan Tian esclareceu que não participou do Llama 4 e apontou que as demissões afetaram aplicações de produtos e cargos multifuncionais, destacando a turbulência e o fluxo de talentos no departamento de AI da Meta. (Fonte: 量子位, Yuchenj_UW)

Ética e originalidade da AI na pesquisa: Um estudo descobriu que, após análise aprofundada, apenas 24% dos artigos de pesquisa escritos por AI apresentavam plágio. Este resultado foi considerado “surpreendentemente bom”, gerando discussões sobre a qualidade e originalidade da pesquisa gerada por AI, bem como suas potenciais implicações para a academia. (Fonte: paul_cal)

Discussão filosófica sobre AGI e o futuro da humanidade: O Professor Liu Jia da Universidade Tsinghua compartilhou 10 pontos de vista sobre a evolução da AGI, o desenvolvimento de agentes inteligentes e os desafios que a humanidade enfrentará no futuro. Ele explorou as características de “troca de tarefas” e “estratégias dinâmicas em ambiente aberto” da AGI, o impacto social da AI com temperatura emocional e consciência, e as possibilidades futuras de fusão humano-máquina ou extinção humana, gerando reflexões filosóficas sobre o profundo impacto da AI. (Fonte: 36氪)

Qualidade de escrita do Kimi e concorrência com OpenAI: Roon, funcionário da OpenAI, afirmou que o Kimi K2 se destaca na escrita, gerando discussões na comunidade sobre a capacidade de escrita de modelos chineses e a atitude da OpenAI. A comunidade especula que o Kimi K2 pode ter sido treinado com um grande número de livros protegidos por direitos autorais, e sua personalidade “não bajuladora” é apreciada pelos usuários, destacando-se em tradução de idiomas específicos e compreensão de contexto, em contraste com a sensação de “castração” do ChatGPT 5. (Fonte: Reddit r/LocalLLaMA, bookwormengr)

Tendências de produtos e desenvolvimento de AI: O Hacker News discute tópicos como o desempenho lento da ferramenta de AI Codex no Zed, a taxa de erro de até 45% em notícias de assistentes de AI, e a demissão de 600 funcionários de AI pela Meta. Essas discussões refletem os desafios no desenvolvimento e uso da AI, incluindo o desempenho das ferramentas, a precisão das informações e os ajustes estratégicos de grandes empresas de tecnologia nos investimentos em AI. (Fonte: Reddit r/artificial)

Discussão sobre o modelo de negócios de grandes modelos nacionais de AI: Usuários pedem que modelos grandes nacionais como Kimi e Qwen implementem um modelo de preços baseado em assinatura, referenciando a popularidade de Claude, GPT e GLM 4.5. Isso reflete a expectativa da comunidade em relação ao modelo de negócios de grandes modelos nacionais de AI, bem como discussões sobre a disposição dos usuários em pagar e as estratégias de concorrência de mercado. (Fonte: bigeagle_xd)

💡 Outros

SeaweedFS: Sistema de arquivos distribuído de alto desempenho: SeaweedFS é um sistema de arquivos distribuído rápido e altamente escalável, projetado para armazenar bilhões de arquivos. Ele utiliza busca em disco O(1), suporta camadas de nuvem, Kubernetes, S3 API, entre outros, e otimiza o armazenamento de arquivos pequenos. Através do Master server para gerenciar volumes e do Volume server para gerenciar metadados de arquivos, ele alcança alta concorrência e acesso rápido, sendo adequado para diversas necessidades de armazenamento. (Fonte: GitHub Trending)

NVIDIA Isaac Sim: Plataforma de simulação de robôs AI: NVIDIA Isaac Sim é uma plataforma de simulação open-source baseada no NVIDIA Omniverse, utilizada para desenvolver, testar e treinar robôs impulsionados por AI. Ela suporta a importação de múltiplos formatos de sistemas robóticos, utiliza motores de física acelerados por GPU e renderização RTX, e oferece fluxos de trabalho completos como geração de dados sintéticos, aprendizado por reforço, integração ROS e simulação de gêmeos digitais, fornecendo suporte abrangente para o desenvolvimento de robôs. (Fonte: GitHub Trending)

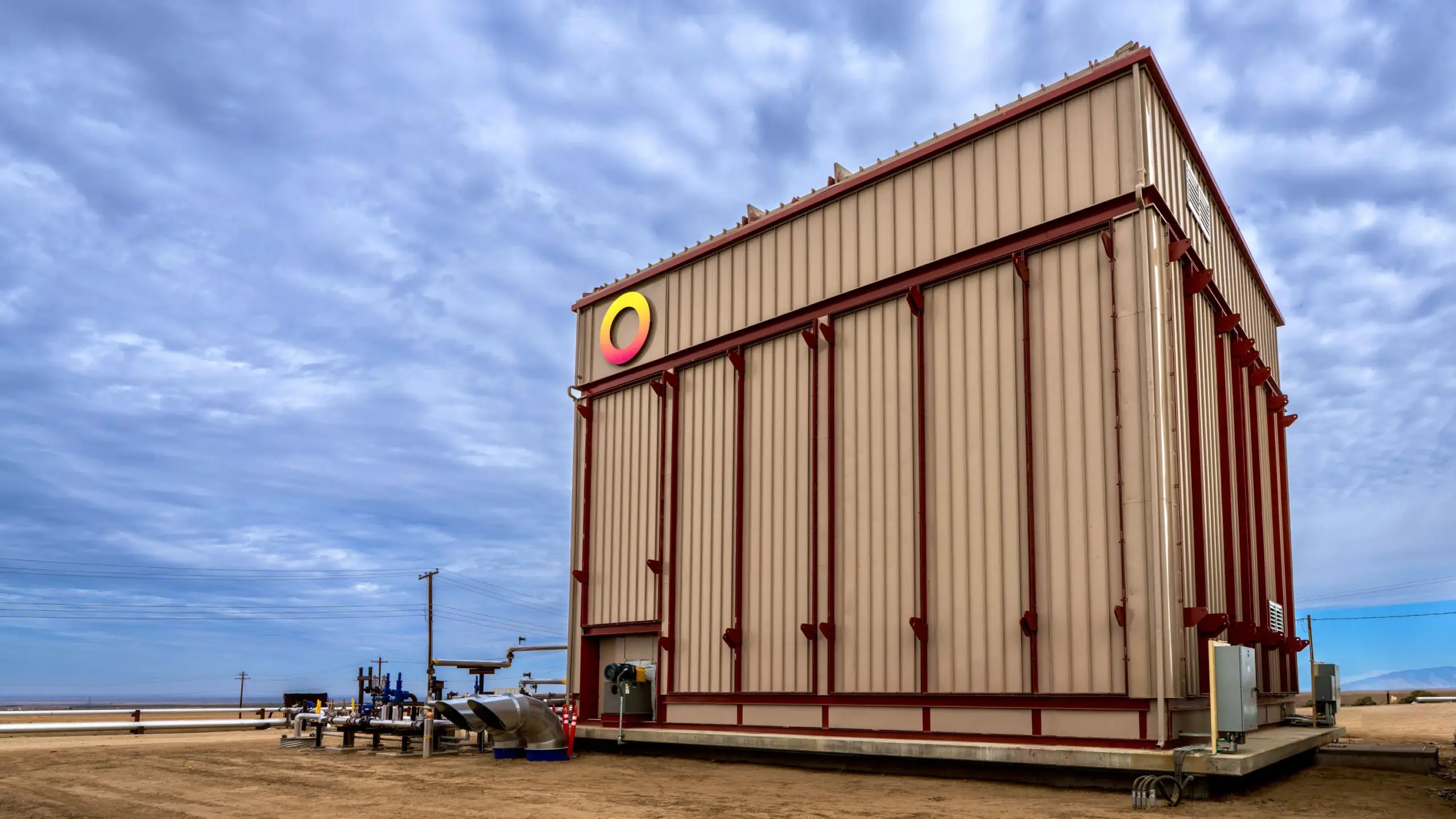

Rondo Energy lança a maior bateria térmica do mundo: A Rondo Energy lançou o que afirma ser a maior bateria térmica do mundo, capaz de armazenar energia elétrica e fornecer uma fonte de calor estável, com potencial para auxiliar na descarbonização industrial. Esta bateria térmica tem uma capacidade de 100 MWh e eficiência superior a 97%, tendo operado por 10 semanas e atingido os padrões. Embora seu uso para recuperação aprimorada de petróleo tenha gerado controvérsia, a empresa acredita que esta medida pode tornar as operações existentes de combustíveis fósseis mais limpas, impulsionando a aplicação da tecnologia de armazenamento de energia no setor industrial. (Fonte: MIT Technology Review)