Palavras-chave:DeepSeek-OCR, ChatGPT Atlas, Unitree H2, Computação quântica, Descoberta de medicamentos por IA, DeepSeek MoE, vLLM, Meta Vibes, Tecnologia de compressão óptica contextual, Funcionalidade de memória do navegador com IA, Graus de liberdade em robôs humanoides, Algoritmo de eco quântico, Estrutura de geração de protocolos de experimentos biológicos

🔥 Foco

DeepSeek-OCR: Tecnologia de Compressão Óptica Contextual : O modelo DeepSeek-OCR introduz o conceito de “compressão óptica contextual”, que, ao tratar o texto como processamento de imagem, consegue comprimir o conteúdo de uma página inteira em um pequeno número de “tokens visuais” através de codificação visual. Estes podem então ser decodificados e restaurados para texto, tabelas ou gráficos, alcançando um aumento de dez vezes na eficiência e uma precisão de até 97%. Esta tecnologia utiliza o DeepEncoder para capturar informações da página e realizar uma compressão de 16x, reduzindo 4096 tokens para 256. Além disso, pode ajustar automaticamente a quantidade de tokens com base na complexidade do documento, superando significativamente os modelos OCR existentes. Isso não só reduz drasticamente os custos de processamento de documentos longos e melhora a eficiência da extração de informações, mas também oferece novas perspectivas para a memória de longo prazo e expansão de contexto para LLMs, indicando o enorme potencial das imagens como portadoras de informação no campo da IA. (Fonte: HuggingFace Daily Papers, 36氪, ZhihuFrontier)

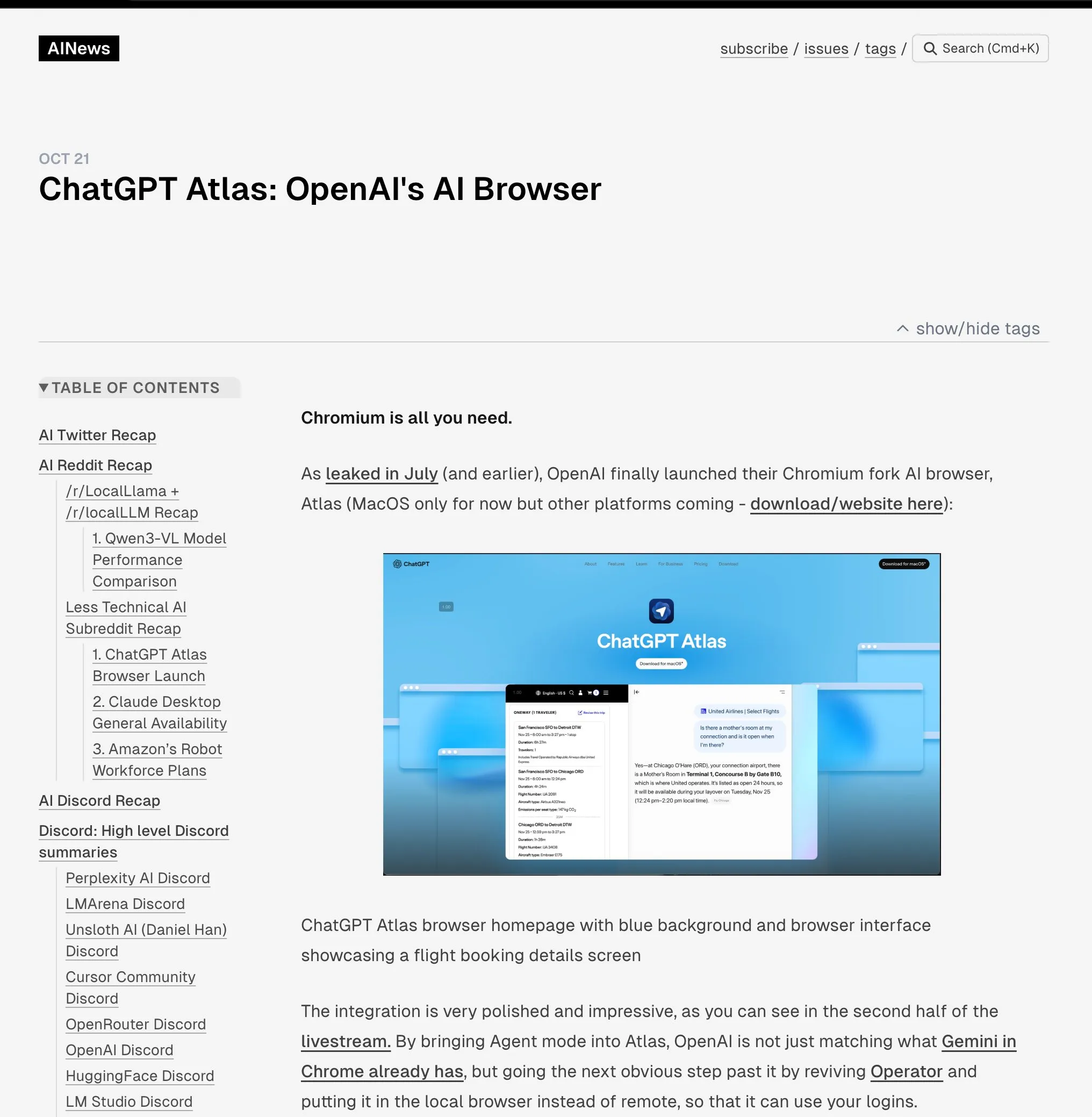

OpenAI Lança o Navegador ChatGPT Atlas : A OpenAI lançou o ChatGPT Atlas, um navegador projetado para a era da IA, que integra profundamente o ChatGPT na experiência de navegação. Além de oferecer funções tradicionais, o navegador possui um “Modo Agente” integrado, capaz de executar tarefas como reservas, compras e preenchimento de formulários, e uma função de “memória do navegador” que aprende os hábitos do usuário para fornecer serviços personalizados. Este movimento marca uma mudança estratégica da OpenAI para construir um ecossistema completo de IA, que poderá remodelar a forma como os usuários interagem com a internet e desafiar o domínio de publicidade e dados do mercado de navegadores existente (especialmente o Google Chrome). A indústria geralmente acredita que este é o início de uma nova “guerra dos navegadores”, com o cerne na disputa pelo controle da vida digital dos usuários. (Fonte: Smol_AI, TheRundownAI, Reddit r/ArtificialInteligence, Reddit r/MachineLearning)

Unitree H2, Robô Humanoide, Lançado : A Unitree Robotics lançou o robô humanoide H2, alcançando um salto significativo em inteligência encarnada e design de hardware. O H2 suporta NVIDIA Jetson AGX Thor, com capacidade de computação 7,5 vezes maior que a do Orin e eficiência 3,5 vezes maior. No design mecânico, as pernas têm 1 grau de liberdade adicional (total de 6), os braços foram atualizados para 7 graus de liberdade, com uma carga útil de 7-15kg e mãos destras opcionais. Em termos de sensores, o H2 abandona o LiDAR, adotando percepção 3D puramente visual com câmeras estéreo binoculares. Embora o progresso tecnológico seja notável, os comentários indicam que os robôs humanoides ainda estão procurando por cenários de aplicação maduros, sendo atualmente mais adequados para pesquisa em laboratório. (Fonte: ZhihuFrontier)

Avanços em Descoberta de Medicamentos Assistida por IA e Tecnologia Biônica : Pesquisadores do MIT usaram IA para projetar novos antibióticos eficazes contra Neisseria gonorrhoeae multirresistente e MRSA. Esses compostos possuem estruturas únicas e destroem a membrana celular bacteriana através de um novo mecanismo, tornando-os menos propensos a desenvolver resistência. Simultaneamente, a equipe de pesquisa também desenvolveu um novo joelho biônico que se integra diretamente aos tecidos musculares e ósseos do usuário, utilizando a tecnologia AMI para extrair informações neurais dos músculos residuais após a amputação, guiando o movimento da prótese. Este joelho biônico ajuda amputados a andar mais rápido, subir escadas e evitar obstáculos com facilidade, sentindo-se mais como uma parte do corpo, e espera-se que obtenha a aprovação da FDA após ensaios clínicos em larga escala. (Fonte: MIT Technology Review, MIT Technology Review)

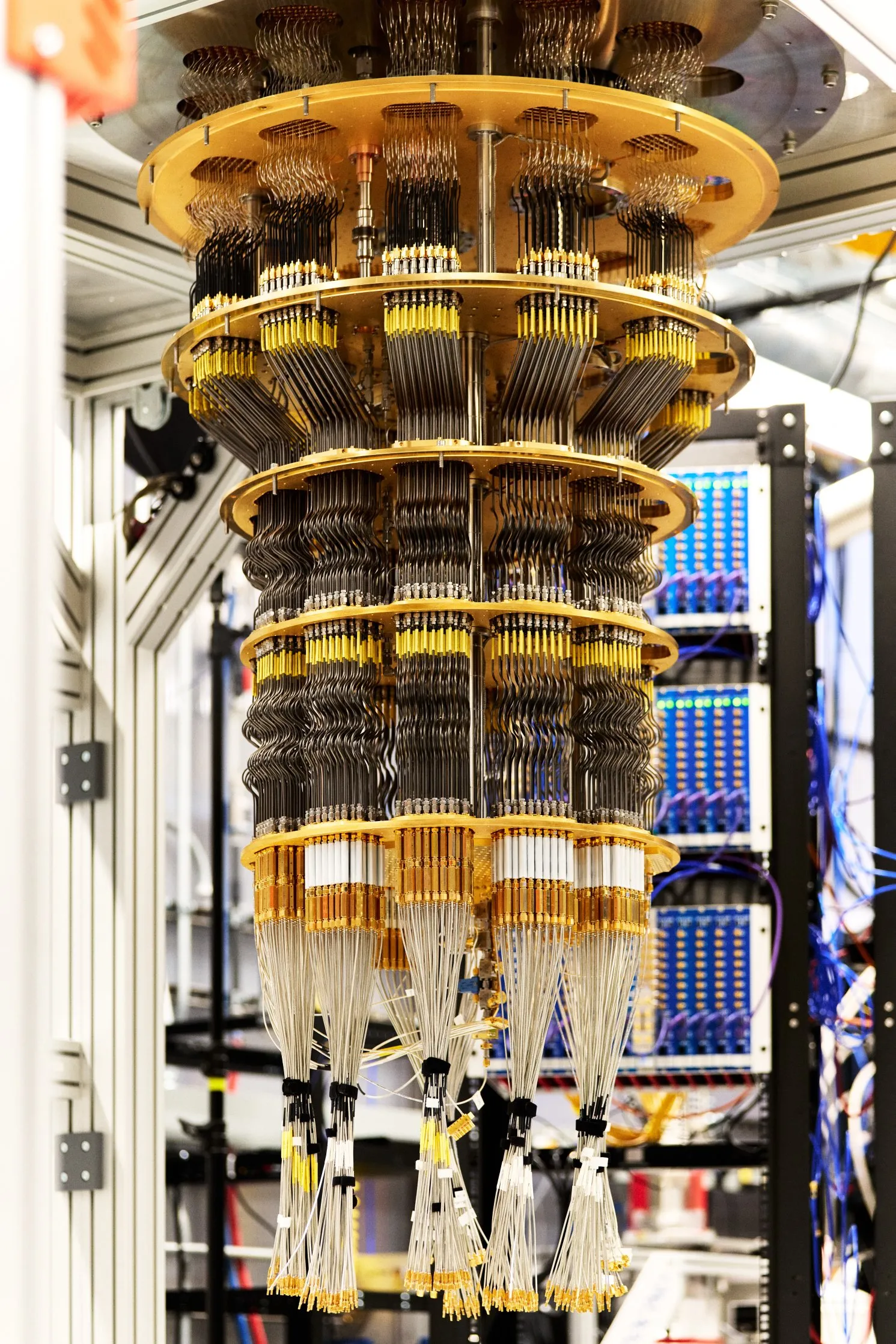

Google Alcança Vantagem Quântica Verificável : O Google publicou um novo avanço na computação quântica na revista Nature. Seu chip Willow, ao executar um algoritmo chamado “eco quântico”, alcançou pela primeira vez uma vantagem quântica verificável. Este algoritmo é 13.000 vezes mais rápido que os algoritmos clássicos mais rápidos e pode explicar as interações entre átomos em moléculas, trazendo potenciais aplicações para campos como a descoberta de medicamentos e a ciência dos materiais. Os resultados deste avanço são repetíveis e verificáveis, marcando um passo importante para a aplicação prática da computação quântica. (Fonte: Google)

🎯 Tendências

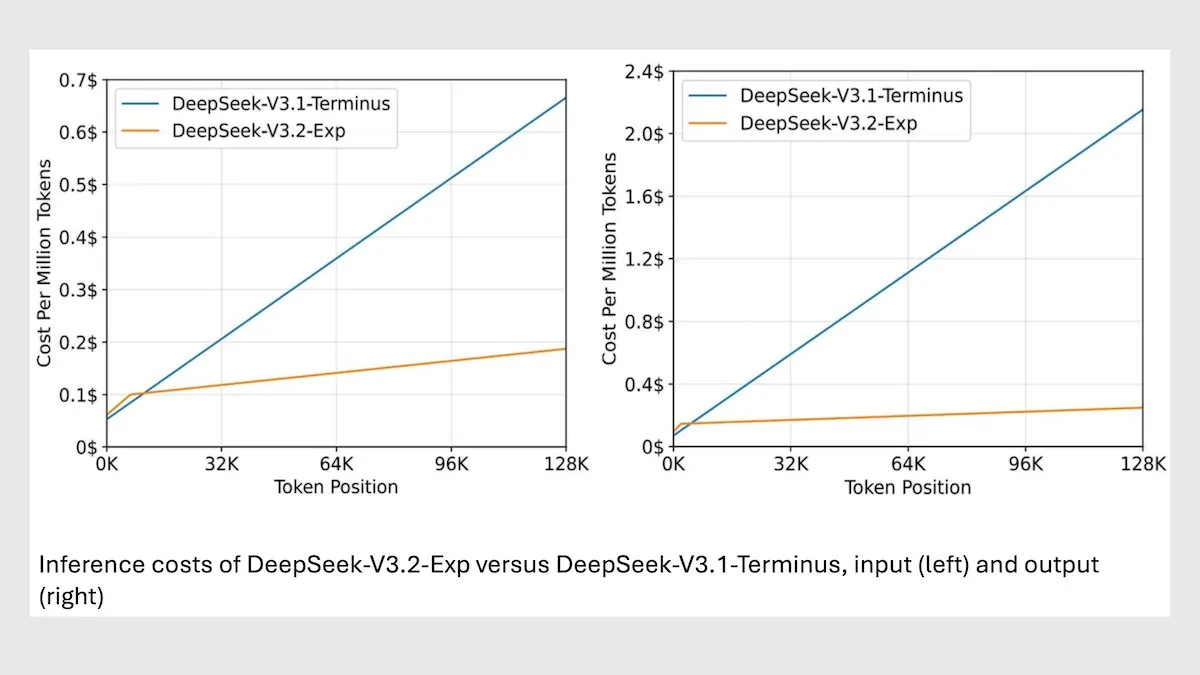

DeepSeek MoE Modelo V3.2 Otimiza a Inferência de Contexto Longo : A DeepSeek lançou seu novo modelo MoE de 685B, o V3.2, que foca apenas nos tokens mais relevantes, alcançando uma velocidade de inferência de contexto longo 2-3 vezes mais rápida e reduzindo os custos de processamento em 6-7 vezes em comparação com o modelo V3.1. O novo modelo utiliza pesos licenciados pelo MIT e está disponível via API, otimizado para chips Huawei e outros chineses. Embora tenha havido uma ligeira queda em algumas tarefas científicas/matemáticas, o desempenho melhorou em tarefas de codificação/agente. (Fonte: DeepLearningAI)

vLLM V1 Agora Suporta AMD GPU : A versão vLLM V1 agora pode ser executada em GPUs AMD. As equipes da IBM Research, Red Hat e AMD colaboraram para construir um backend de atenção otimizado usando kernels Triton, alcançando desempenho de ponta. Este avanço oferece uma solução de inferência de LLM mais eficiente para usuários de hardware AMD. (Fonte: QuixiAI)

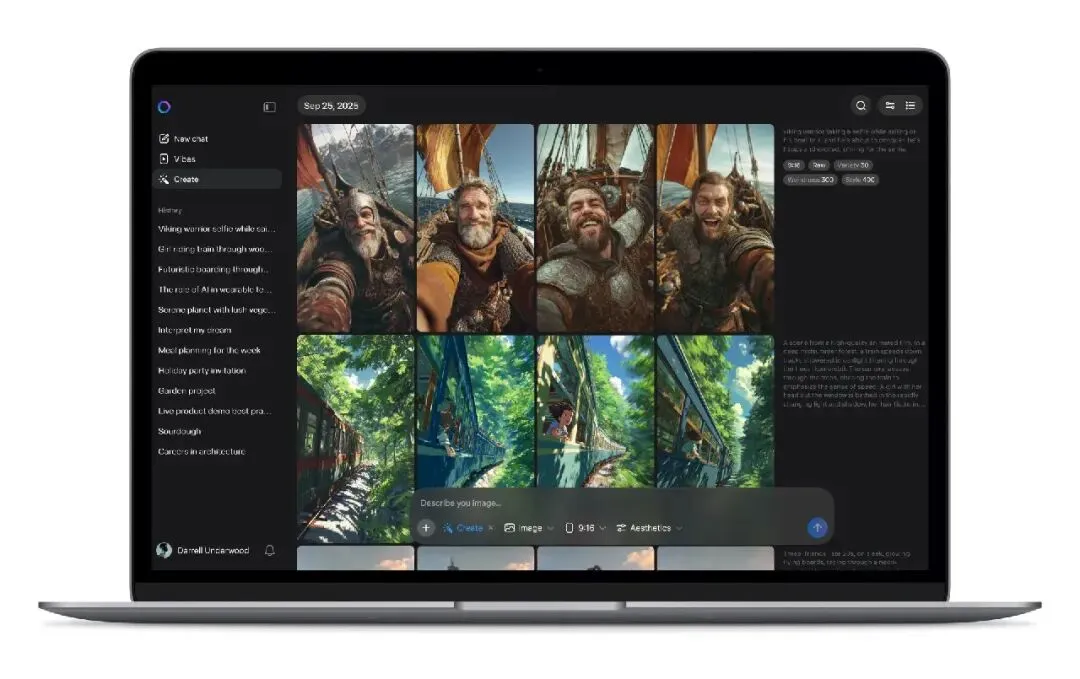

Meta Vibes AI Lançamento de Streaming de Vídeo : A Meta lançou o Vibes, um novo recurso de streaming de vídeo de IA, incorporado no aplicativo Meta AI. Os usuários podem navegar por vídeos curtos gerados por IA e criar conteúdo secundário com um clique, incluindo adicionar música, mudar o estilo ou remixar trabalhos de outros, e compartilhar no Instagram e Facebook. Este movimento visa reduzir a barreira de entrada para a criação de vídeos de IA, impulsionar vídeos de IA para o cenário social mainstream e poderá mudar o modelo de produção e distribuição de conteúdo de vídeos curtos, mas também levanta preocupações com direitos autorais, originalidade e disseminação de informações falsas. (Fonte: 36氪)

rBridge: Modelo Agente para Previsão de Desempenho de Inferência de LLM : O método rBridge permite que pequenos modelos agentes (≤1B parâmetros) prevejam eficazmente o desempenho de inferência de grandes modelos (7B-32B parâmetros), reduzindo o custo computacional em mais de 100 vezes. Este método resolve o “problema emergente” de capacidades de inferência que não se manifestam em modelos pequenos, alinhando a avaliação com os objetivos de pré-treinamento e as tarefas-alvo, e usando trajetórias de inferência de modelos de ponta como rótulos de ouro, ponderando a importância dos tokens para a tarefa. Isso reduz significativamente o custo para pesquisadores com recursos computacionais limitados explorarem opções de design de pré-treinamento. (Fonte: Reddit r/MachineLearning, Reddit r/LocalLLaMA)

Mono4DGS-HDR: Sistema de Reconstrução de Splatting Gaussiano de Alta Faixa Dinâmica 4D : Mono4DGS-HDR é o primeiro sistema a reconstruir cenas 4D de Alta Faixa Dinâmica (HDR) renderizáveis a partir de vídeos monoculares de Baixa Faixa Dinâmica (LDR) com exposição alternada. Esta estrutura unificada emprega um método de otimização em duas etapas, baseado na tecnologia de splatting gaussiano, primeiro aprendendo uma representação gaussiana HDR de vídeo no espaço de coordenadas da câmera ortogonal, e depois convertendo os gaussianos de vídeo para o espaço mundial e otimizando conjuntamente os gaussianos mundiais com as poses da câmera. Além disso, a estratégia de regularização de brilho temporal proposta melhora a consistência temporal da aparência HDR, superando significativamente os métodos existentes em qualidade e velocidade de renderização. (Fonte: HuggingFace Daily Papers)

EvoSyn: Estrutura de Síntese de Dados Evolutiva para Aprendizagem Verificável : EvoSyn é uma estrutura de síntese de dados evolutiva, agnóstica à tarefa, guiada por políticas e verificável, projetada para gerar dados verificáveis confiáveis. A estrutura começa com supervisão mínima de sementes, sintetiza conjuntamente problemas, soluções candidatas diversas e artefatos de verificação, e descobre estratégias iterativamente através de um avaliador baseado em consistência. Experimentos demonstram que o treinamento com dados sintetizados usando EvoSyn alcançou melhorias significativas nas tarefas LiveCodeBench e AgentBench-OS, destacando sua robusta capacidade de generalização. (Fonte: HuggingFace Daily Papers)

Novo Método para Extrair Dados Alinhados de Modelos Pós-Treinamento : Pesquisas mostram que é possível extrair grandes quantidades de dados de treinamento alinhados de modelos pós-treinamento para melhorar as capacidades do modelo em inferência de contexto longo, segurança, seguir instruções e matemática. Através da similaridade semântica medida por modelos de embedding de alta qualidade, é possível identificar dados de treinamento que a correspondência de strings tradicional dificilmente captura. A pesquisa descobriu que os modelos facilmente rastreiam os dados usados nas fases de pós-treinamento, como SFT ou RL, e esses dados podem ser usados para treinar modelos base, restaurando o desempenho original. Este trabalho revela os riscos potenciais da extração de dados alinhados e oferece novas perspectivas sobre os efeitos downstream das práticas de destilação. (Fonte: HuggingFace Daily Papers)

PRISMM-Bench: Benchmark de Inconsistências Multimodais em Artigos Científicos : PRISMM-Bench é o primeiro benchmark de inconsistências multimodais em artigos científicos baseado em anotações reais de revisores, projetado para avaliar a capacidade de Grandes Modelos Multimodais (LMMs) de compreender e raciocinar sobre a complexidade de artigos científicos. O benchmark, através de um processo multifásico, compilou 262 inconsistências de 242 artigos e projetou três tarefas: identificação, remediação e correspondência de pares. A avaliação de 21 LMMs (incluindo GLM-4.5V 106B, InternVL3 78B e Gemini 2.5 Pro, GPT-5) mostrou que o desempenho do modelo é significativamente baixo (26.1-54.2%), destacando os desafios do raciocínio científico multimodal. (Fonte: HuggingFace Daily Papers)

GAS: Método de Melhoria de Discretização de ODE de Difusão : Embora os modelos de difusão tenham alcançado o estado da arte em qualidade de geração, seu custo computacional de amostragem é alto. O Generalized Adversarial Solver (GAS) propõe um amostrador ODE simplesmente parametrizado que melhora a qualidade sem truques de treinamento adicionais. Ao combinar a perda de destilação original com o treinamento adversarial, o GAS é capaz de mitigar artefatos e aprimorar a fidelidade dos detalhes. Experimentos demonstram que o GAS supera os métodos de treinamento de solvers existentes sob restrições de recursos semelhantes. (Fonte: HuggingFace Daily Papers)

3DThinker: Estrutura de Raciocínio Espacial de Imaginação Geométrica para VLM : A estrutura 3DThinker visa aprimorar a capacidade dos Modelos de Linguagem Visual (VLMs) de compreender relações espaciais 3D a partir de perspectivas limitadas. A estrutura utiliza um treinamento em duas fases: primeiro, treinamento supervisionado para alinhar o espaço latente 3D gerado pelo VLM durante a inferência com o espaço latente de um modelo base 3D; em seguida, otimiza toda a trajetória de inferência apenas com base nos sinais de resultado, aprimorando o modelamento mental 3D subjacente. O 3DThinker é a primeira estrutura a alcançar o modelamento mental 3D sem entrada 3D prévia ou dados 3D explicitamente rotulados, com excelente desempenho em vários benchmarks, oferecendo novas perspectivas para representações 3D unificadas no raciocínio multimodal. (Fonte: HuggingFace Daily Papers)

Huawei HarmonyOS 6 com Recursos Aprimorados de Assistente de IA : A Huawei lançou oficialmente o sistema operacional HarmonyOS 6, que melhora abrangentemente a fluidez, inteligência e experiência de colaboração entre dispositivos. A função “Super Assistente” Xiaoyi foi significativamente aprimorada, suportando 16 dialetos, realizando pesquisa aprofundada, edição de imagem com uma frase e ajudando usuários com deficiência visual a “ver o mundo”. Baseado na estrutura de Agentes Inteligentes HarmonyOS, mais de 80 agentes de aplicativos HarmonyOS foram lançados, permitindo que Xiaoyi e seus parceiros de agente colaborem estreitamente para fornecer serviços profissionais, como guias de viagem e agendamento de consultas médicas, e introduzindo recursos de proteção de privacidade como “Anti-fraude de IA” e “Anti-espião de IA”. (Fonte: 量子位)

Aplicação de IA em Pesquisa Urbana: Análise da Velocidade de Caminhada e Uso do Espaço Público : Um estudo coescrito por acadêmicos do MIT mostra que, entre 1980 e 2010, a velocidade média de caminhada aumentou 15% em três cidades do nordeste dos EUA, enquanto o número de pessoas que permanecem em espaços públicos diminuiu 14%. Pesquisadores usaram ferramentas de machine learning para analisar vídeos da década de 1980 em Boston, Nova York e Filadélfia, comparando-os com novos vídeos. Eles especulam que fatores como telefones celulares e cafés podem ter levado as pessoas a combinar encontros mais por mensagem de texto e a escolher locais internos em vez de espaços públicos para socializar, o que oferece novas direções para o design de espaços públicos urbanos. (Fonte: MIT Technology Review)

Desafios e Soluções para a Robustez Cross-linguística de Marcas D’água em LLMs Multilíngues : Pesquisas indicam que as tecnologias existentes de marca d’água multilíngue para Grandes Modelos de Linguagem (LLMs) não são verdadeiramente multilíngues, carecendo de robustez sob ataques de tradução em idiomas de baixo recurso. Essa falha se deve à clusterização semântica que falha quando o vocabulário do tokenizer é insuficiente. Para resolver este problema, a pesquisa introduz o STEAM, um método de detecção baseado em retrotradução que recupera a força da marca d’água perdida devido à tradução. O STEAM é compatível com qualquer método de marca d’água, robusto para diferentes tokenizers e idiomas, e facilmente escalável para novos idiomas, alcançando melhorias significativas de +0.19 AUC e +40%p TPR@1% em média em 17 idiomas, fornecendo um caminho simples e poderoso para o desenvolvimento de tecnologias de marca d’água justas. (Fonte: HuggingFace Daily Papers)

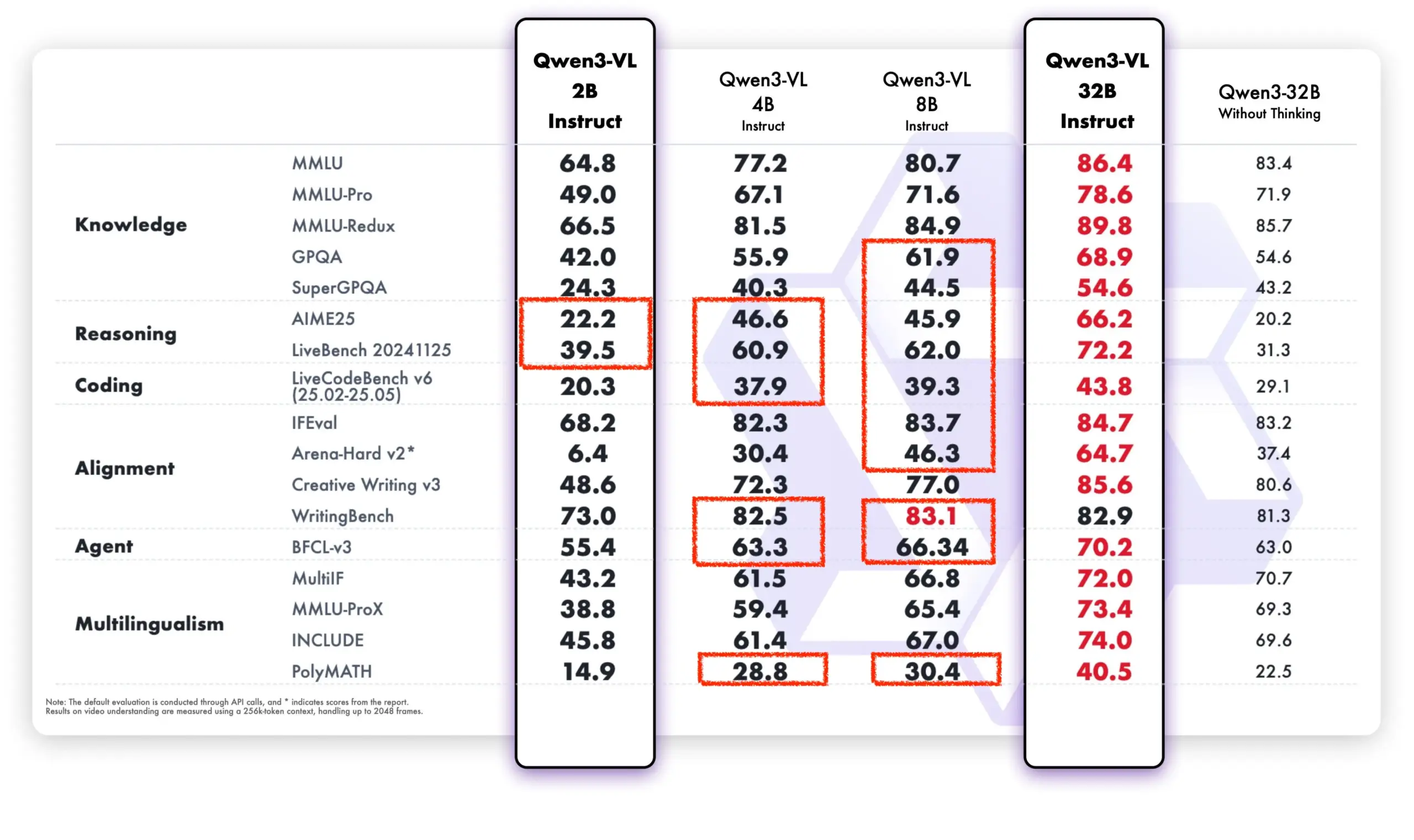

Qwen Modelo Demonstra Forte Desempenho na Comunidade de Código Aberto e Aplicações Comerciais : Os modelos Tongyi Qianwen da Alibaba mostram forte impulso na comunidade de código aberto e em aplicações comerciais. DeepSeek V3.2 e Qwen-3-235b-A22B-Instruct estão entre os primeiros no ranking de modelos abertos do Text Arena. Brian Chesky, CEO do Airbnb, declarou publicamente que a empresa “depende fortemente do modelo Tongyi Qianwen da Alibaba” e o considera “melhor e mais barato que o OpenAI”, priorizando seu uso em ambientes de produção. Além disso, a equipe Qwen também auxilia ativamente o projeto llama.cpp, continuando a impulsionar o desenvolvimento da comunidade de código aberto. Os novos modelos Qwen-VL superam significativamente as versões antigas em desempenho, destacando-se especialmente em modelos de baixa parametrização, demonstrando sua capacidade de iteração e otimização rápidas. (Fonte: teortaxesTex, Zai_org, hardmaru, Reddit r/LocalLLaMA)

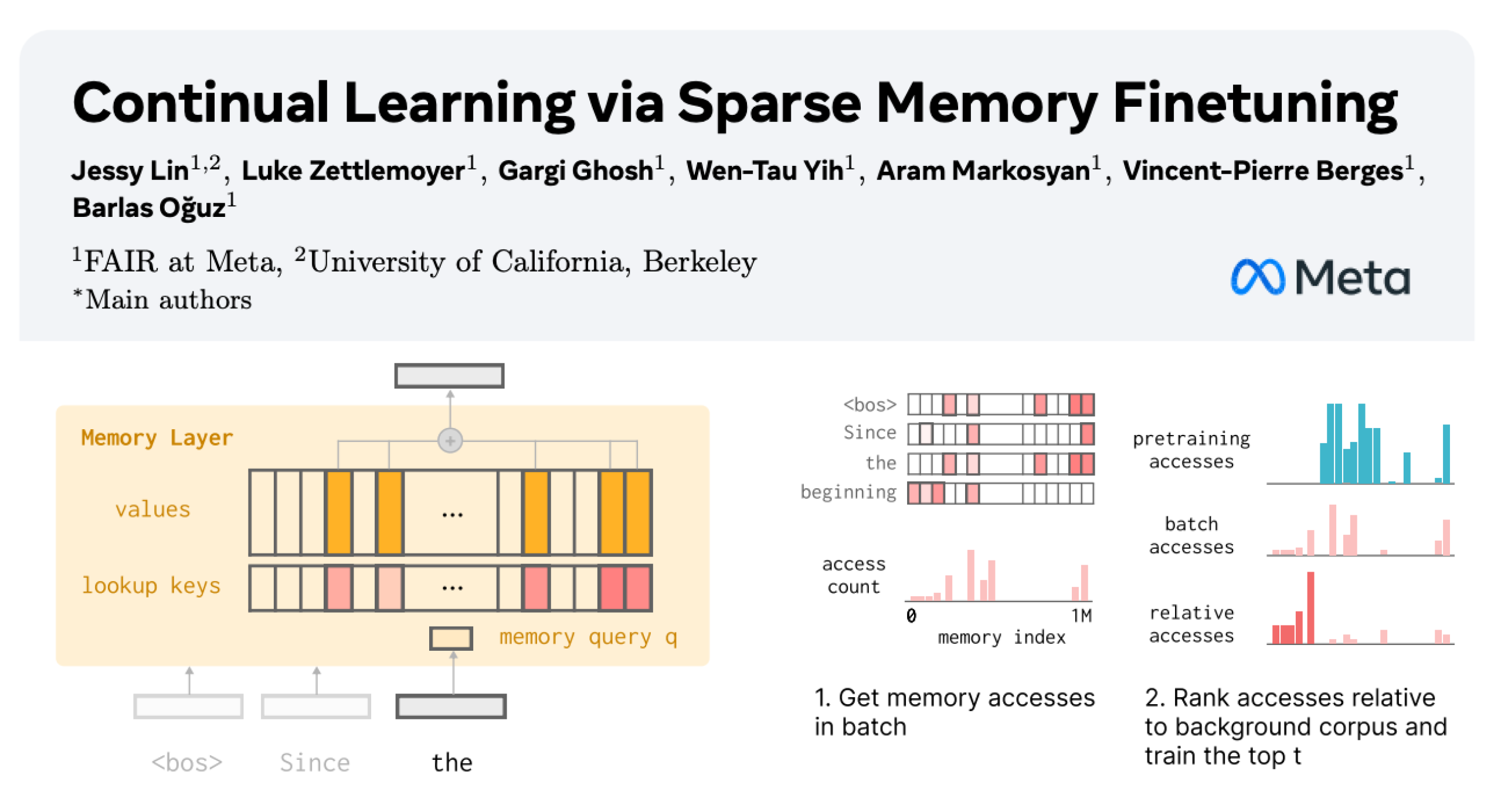

Aprendizagem Contínua de LLM: Reduzindo o Esquecimento Através de Fine-tuning Esparso de Camadas de Memória : Uma nova pesquisa da Meta AI propõe que, através de fine-tuning esparso de camadas de memória, os Grandes Modelos de Linguagem (LLMs) podem aprender continuamente novos conhecimentos, minimizando a interferência no conhecimento existente. Em comparação com métodos como fine-tuning completo e LoRA, o fine-tuning esparso de camadas de memória reduziu significativamente a taxa de esquecimento (-11% vs -89% FT, -71% LoRA) ao aprender a mesma quantidade de novos conhecimentos, oferecendo novas direções para a construção de LLMs capazes de se adaptar e atualizar continuamente. (Fonte: giffmana, AndrewLampinen)

Avanços na Área de Condução Autônoma: Vice-Presidente da General Motors Enfatiza a Segurança Rodoviária : Sterling Anderson, Vice-Presidente Executivo e Diretor Global de Produtos da General Motors, enfatiza o enorme potencial da IA e das tecnologias avançadas de assistência ao motorista para melhorar a segurança rodoviária. Ele aponta que, ao contrário dos motoristas humanos, os sistemas de condução autônoma não dirigem embriagados, cansados ou distraídos, e podem monitorar as condições da estrada em todas as direções simultaneamente, operando mesmo em condições climáticas adversas. Anderson, que cofundou a Aurora Innovation e liderou o desenvolvimento do Tesla Autopilot, acredita que a tecnologia de condução autônoma não só aumentará significativamente a segurança rodoviária, mas também melhorará a eficiência do transporte de carga e, finalmente, economizará tempo para as pessoas. Ele afirma que sua experiência no MIT forneceu a base técnica e a liberdade para explorar a resolução de problemas complexos e a colaboração humano-máquina. (Fonte: MIT Technology Review)

Tanque 400 Hi4-T Adiciona Recurso de Motorista de IA : O novo Tanque 400 Hi4-T está equipado com a função de motorista de IA, projetada para melhorar a experiência de condução em condições de estrada complexas. Em testes de chuva na cidade montanhosa 8D de Chongqing, o motorista de IA demonstrou boa capacidade de assistência à condução ao enfrentar estradas escorregadias e ambientes de tráfego complexos. Isso marca uma aplicação e otimização adicionais da tecnologia de IA em condução autônoma off-road e em ambientes urbanos complexos. (Fonte: 量子位)

🧰 Ferramentas

Thoth: Estrutura de Geração de Protocolos de Experimentos Biológicos Assistida por IA : Thoth é uma estrutura de IA baseada no paradigma “Sketch-and-Fill”, projetada para gerar automaticamente protocolos de experimentos biológicos precisos, logicamente ordenados e executáveis a partir de consultas em linguagem natural. A estrutura garante que cada etapa seja explicitamente verificável, separando análise, estruturação e expressão. Combinada com um mecanismo de recompensa de componentes estruturados, Thoth é avaliada em granularidade da etapa, ordem das operações e fidelidade semântica, alinhando a otimização do modelo com a confiabilidade experimental. Thoth superou LLMs proprietários e de código aberto em vários benchmarks, alcançando melhorias significativas em alinhamento de etapas, ordenação lógica e precisão semântica, pavimentando o caminho para um assistente científico confiável. (Fonte: HuggingFace Daily Papers)

AlphaQuanter: Agente de IA para Negociação de Ações Baseado em Aprendizagem por Reforço : AlphaQuanter é uma estrutura de aprendizagem por reforço de agente com orquestração de ferramentas de ponta a ponta para negociação de ações. Através da aprendizagem por reforço, um único agente pode aprender estratégias dinâmicas, orquestrar ferramentas autonomamente e adquirir informações proativamente sob demanda, estabelecendo um processo de raciocínio transparente e auditável. AlphaQuanter alcançou desempenho de ponta em métricas financeiras chave, e seu raciocínio interpretável revela estratégias de negociação complexas, fornecendo insights novos e valiosos para traders humanos. (Fonte: HuggingFace Daily Papers)

PokeeResearch: Agente de Pesquisa Profunda Baseado em Feedback de IA : PokeeResearch-7B é um agente de pesquisa profunda de 7B parâmetros, construído sob uma estrutura unificada de aprendizagem por reforço, projetado para robustez, alinhamento e escalabilidade. O modelo é treinado através de uma estrutura de Aprendizagem por Reforço com Feedback de IA (RLAIF) sem anotações, utilizando sinais de recompensa baseados em LLM para otimizar estratégias, a fim de capturar precisão factual, fidelidade de citação e conformidade com instruções. Seu andaime de inferência multi-chamada impulsionado pelo pensamento em cadeia aumenta ainda mais a robustez através de auto-verificação e recuperação adaptativa de falhas de ferramentas. PokeeResearch-7B alcançou o desempenho de ponta entre agentes de pesquisa profunda na escala de 7B em 10 benchmarks populares de pesquisa profunda. (Fonte: HuggingFace Daily Papers)

Lançamento do Cliente GUI DeepSeek-OCR : Um desenvolvedor criou um cliente de interface gráfica do usuário (GUI) para o modelo DeepSeek-OCR, tornando-o mais fácil de usar. O modelo se destaca na compreensão de documentos e extração de texto estruturado. O cliente utiliza um backend Flask para gerenciar o modelo e um frontend Electron para fornecer a interface do usuário. Na primeira carga, o modelo baixa automaticamente cerca de 6.7 GB de dados do HuggingFace. Atualmente, suporta Windows e oferece suporte Linux não testado, exigindo uma placa de vídeo Nvidia. (Fonte: Reddit r/LocalLLaMA)

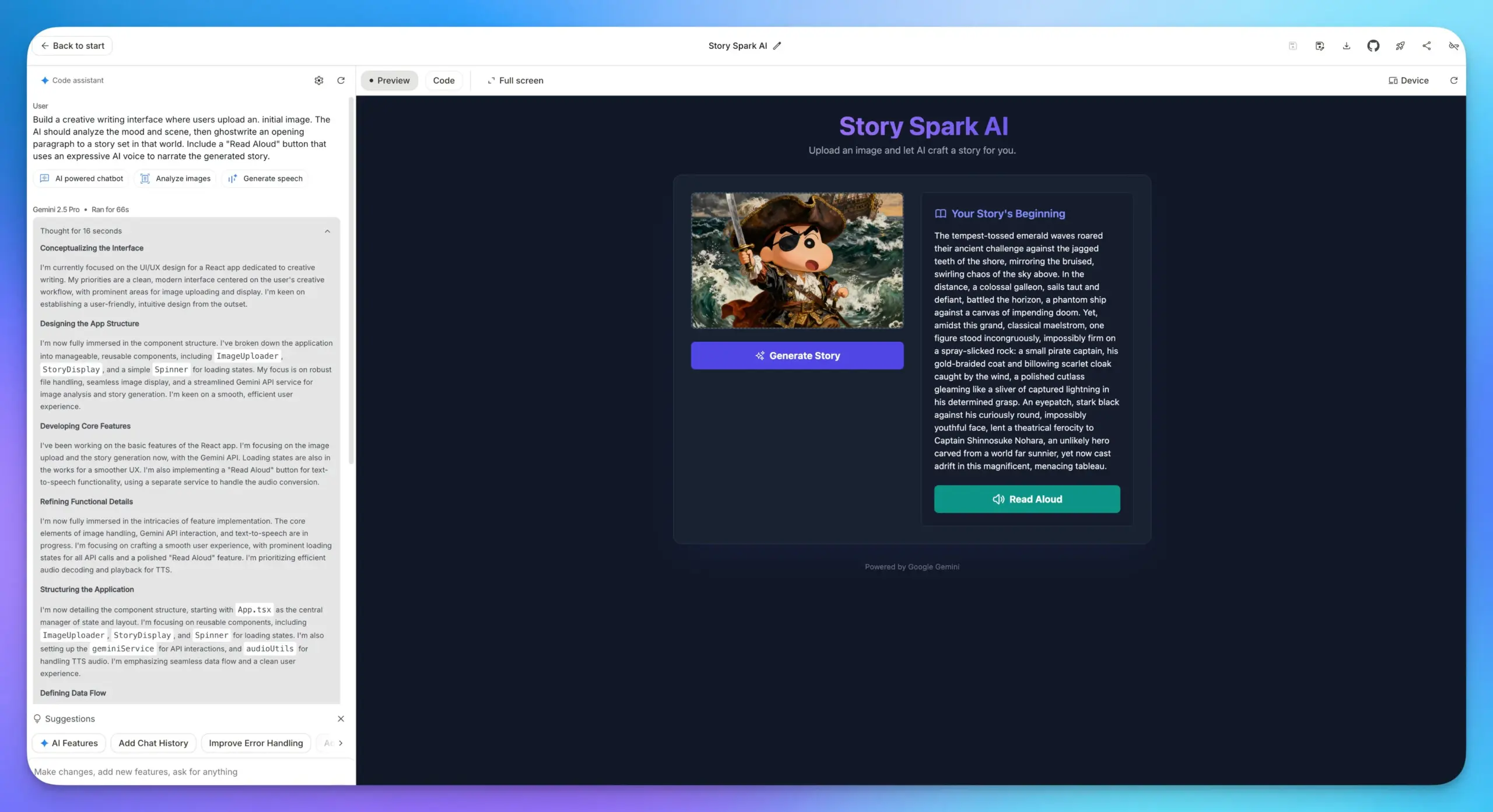

Google AI Studio: Atualização dos Recursos de Construção de Aplicativos : Os recursos de construção de aplicativos do Google AI Studio receberam uma grande atualização, com todos os modelos de IA do Google integrados. Os usuários podem selecionar diretamente os modelos e preencher prompts para construir aplicativos, sem a necessidade de inserir uma API Key. Isso simplifica enormemente o processo de desenvolvimento, tornando mais conveniente integrar várias capacidades de IA, como LLMs, compreensão de imagem e modelos TTS, em aplicativos web. (Fonte: op7418)

Integração Lovable Shopify AI : A Lovable lançou a integração Shopify, permitindo que os usuários construam lojas online conversando com a IA. Este recurso visa resolver o problema da falta de personalização e implementação prática de “codificação de atmosfera” em sites de dropshipping tradicionais, permitindo a construção personalizada de lojas através de IA e enfatizando o conceito de “integração” em vez de “MCP”, com o objetivo de resolver pontos de dor reais. (Fonte: crystalsssup)

vLLM OpenAI API Compatível Suporta Retorno de Token ID : A vLLM, em colaboração com a equipe Agent Lightning, resolveu o problema de “Retokenization Drift” na aprendizagem por reforço, que se refere a pequenas incompatibilidades na divisão de tokens entre o que o modelo gera e o que o treinador espera gerar. A API compatível com OpenAI da vLLM agora pode retornar diretamente o token ID; os usuários só precisam adicionar “return_token_ids”: true na solicitação para obter prompt_token_ids e token_ids, garantindo que os tokens usados durante o treinamento de aprendizagem por reforço do agente sejam completamente consistentes com a amostragem, evitando assim problemas como instabilidade de aprendizado e atualizações fora da política. (Fonte: vllm_project)

Plataforma Together AI Adiciona APIs para Modelos de Vídeo e Imagem : A Together AI anunciou que, através de uma parceria com a Runware, adicionou mais de 20 modelos de vídeo (como Sora 2, Veo 3, PixVerse V5, Seedance) e mais de 15 modelos de imagem à sua plataforma API. Esses modelos podem ser acessados através da mesma API de inferência de texto, expandindo enormemente as capacidades de serviço da Together AI no campo da geração multimodal. (Fonte: togethercompute)

OpenAudio S1/S1-mini: Modelo SOTA de Texto para Fala Multilíngue de Código Aberto : A equipe Fish Speech anunciou a mudança de marca para OpenAudio e lançou a série de modelos de Texto para Fala (TTS) OpenAudio-S1, incluindo S1 (4B parâmetros) e S1-mini (0.5B parâmetros). Esses modelos ocupam o primeiro lugar no ranking TTS-Arena2, alcançando qualidade TTS excepcional (WER em inglês 0.008, CER 0.004), suportando clonagem de voz zero-shot/few-shot, síntese multilíngue e cross-linguística, e oferecendo controle de emoção, entonação e marcadores especiais. Os modelos não dependem de fonemas, possuem forte capacidade de generalização e são acelerados por torch compile, com um fator em tempo real de aproximadamente 1:7 em uma GPU Nvidia RTX 4090. (Fonte: GitHub Trending)

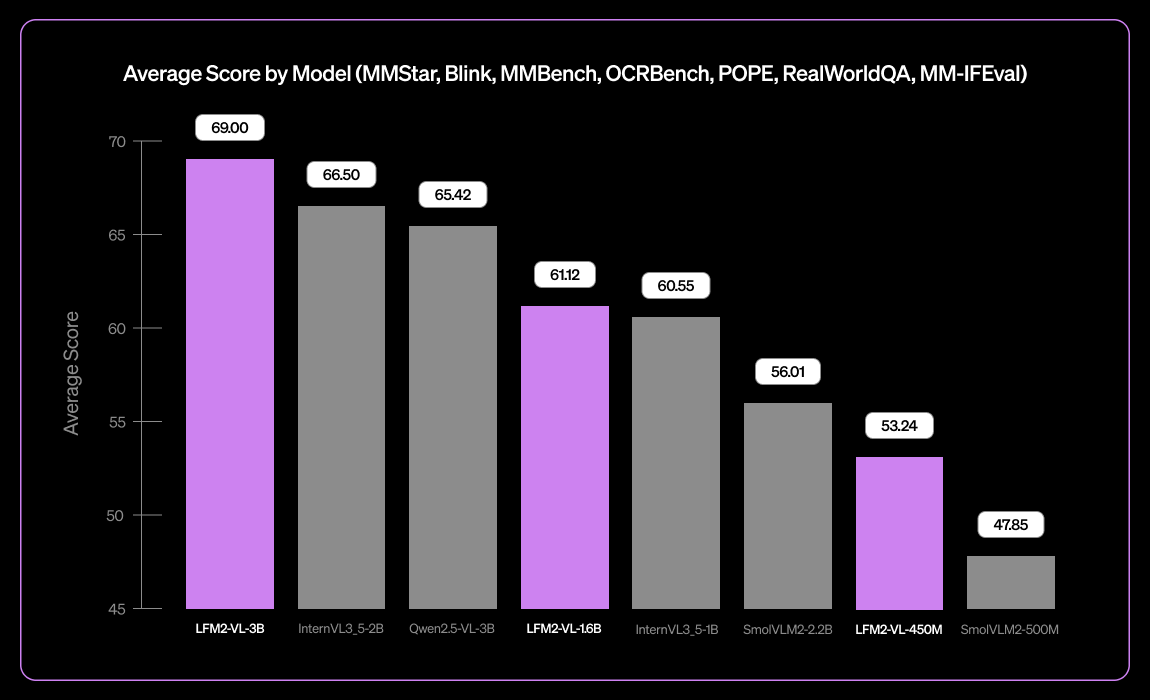

Liquid AI Lança LFM2-VL-3B, Pequeno Modelo de Linguagem Visual Multilíngue : A Liquid AI lançou o LFM2-VL-3B, um pequeno modelo de linguagem visual multilíngue. Este modelo expande as capacidades de compreensão visual multilíngue, suportando inglês, japonês, francês, espanhol, alemão, italiano, português, árabe, chinês e coreano. Ele alcança 51.8% no MM-IFEval (seguimento de instruções) e 71.4% no RealWorldQA (compreensão do mundo real), com excelente desempenho em compreensão de imagem única e multi-imagem, bem como em OCR em inglês, e possui uma baixa taxa de alucinação de objetos. (Fonte: TheZachMueller)

Programação Assistida por IA: Guia de Engenharia de Contexto LangChain V1 : A LangChain lançou uma nova página sobre engenharia de contexto de agente, orientando os desenvolvedores sobre como dominar a engenharia de contexto no LangChain V1 para construir melhores agentes de IA. Este guia é considerado uma parte importante da nova documentação, enfatizando a importância de fornecer informações atualizadas às ferramentas de IA. A LangChain se dedica a ser uma plataforma abrangente para engenharia de agentes e, após receber uma rodada de financiamento Série B de US$ 125 milhões, avaliada em US$ 1,25 bilhão, continuará a impulsionar o desenvolvimento no campo da engenharia de agentes de IA. (Fonte: LangChainAI, Hacubu, hwchase17)

Soluções para Executar Claude Desktop no Linux : O aplicativo Claude Desktop atualmente suporta apenas Mac e Windows, mas como é baseado na estrutura Electron, usuários Linux encontraram várias soluções da comunidade para executá-lo em sistemas Linux. Essas soluções incluem configurações flake para NixOS, pacotes AUR para Arch Linux e scripts de instalação para sistemas Debian, fornecendo aos usuários Linux uma maneira de usar o Claude Desktop. (Fonte: Reddit r/ClaudeAI)

📚 Aprendizagem

Caminho de Aprendizagem DeepLearningAI MLOps : A DeepLearningAI oferece um caminho de aprendizagem MLOps, projetado para ajudar os alunos a dominar as habilidades essenciais e as melhores práticas das operações de machine learning. Este caminho abrange todos os aspectos do MLOps, fornecendo recursos de aprendizagem estruturados para profissionais que desejam aprofundar seus conhecimentos especializados nas áreas de inteligência artificial e machine learning. (Fonte: Ronald_vanLoon)

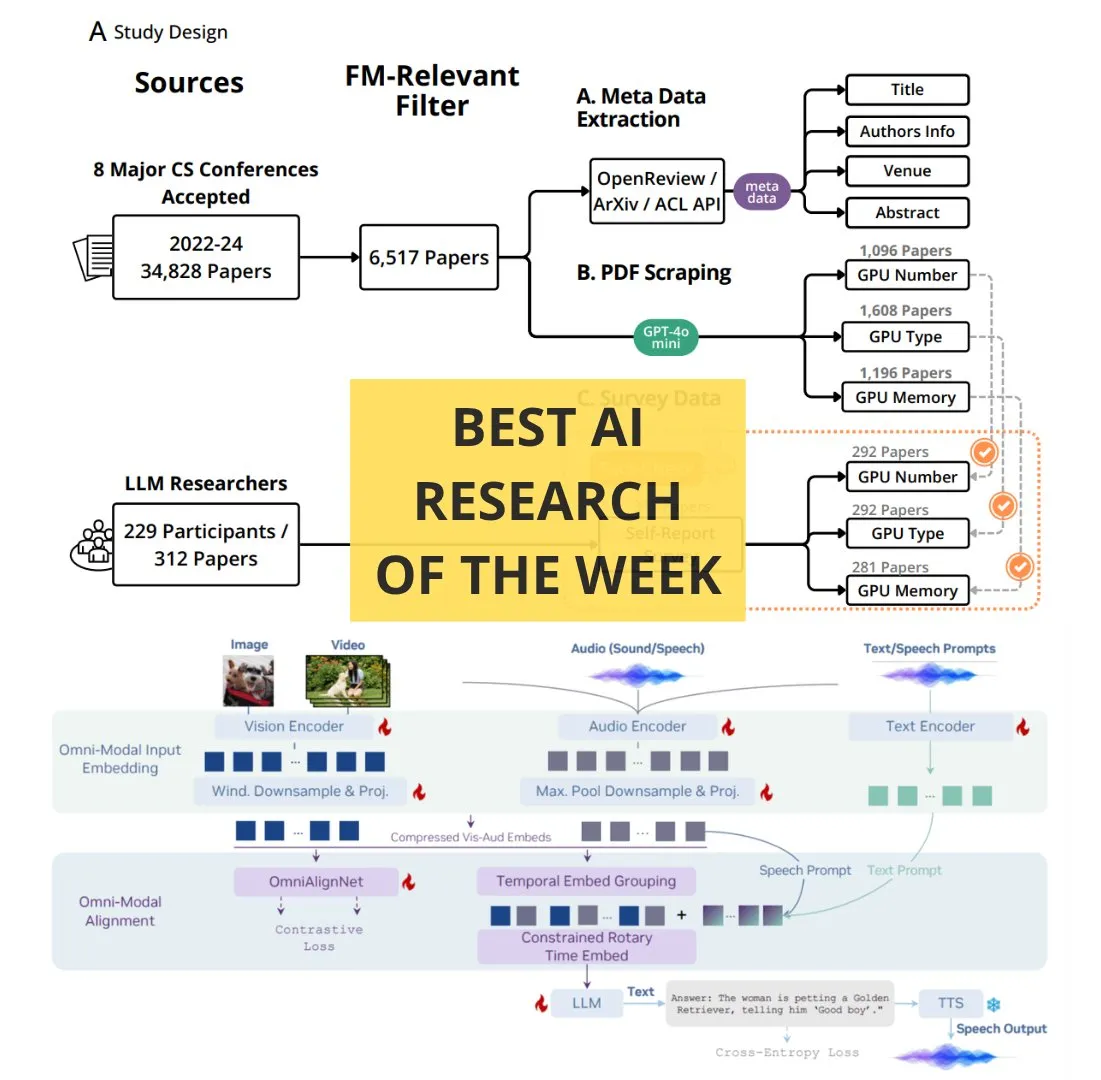

TheTuringPost: Artigos de IA Essenciais da Semana : O The Turing Post publicou uma lista de artigos de IA essenciais da semana, cobrindo vários tópicos de pesquisa de ponta, incluindo escalonamento da computação de aprendizagem por reforço, destilação BitNet, estrutura RAG-Anything, LLM de compreensão multimodal OmniVinci, o papel dos recursos computacionais na pesquisa de modelos de base, QeRL e recuperação hierárquica guiada por LLM. Esses artigos fornecem recursos importantes para pesquisadores e entusiastas de IA que desejam se manter atualizados com os últimos avanços tecnológicos. (Fonte: TheTuringPost)

Google DeepMind & UCL Lançam Curso Gratuito de Fundamentos de Pesquisa em IA : A Google DeepMind, em parceria com a University College London (UCL), lançou um conjunto de cursos gratuitos de fundamentos de pesquisa em IA, agora disponíveis na plataforma Google Skills. O conteúdo do curso inclui como escrever código melhor, ajustar modelos de IA, entre outros, e é ministrado por especialistas como Oriol Vinyals, pesquisador principal do Gemini, com o objetivo de ajudar mais pessoas a aprender conhecimentos especializados na área de IA. (Fonte: GoogleDeepMind)

Como se Tornar um Especialista: Conselhos de Aprendizagem de Andrej Karpathy : Andrej Karpathy compartilhou três conselhos para se tornar um especialista em um determinado campo: 1. Assumir projetos específicos iterativamente e completá-los em profundidade, aprendendo sob demanda em vez de aprender de forma ampla de baixo para cima; 2. Ensinar ou resumir o conhecimento aprendido com suas próprias palavras; 3. Comparar-se apenas com seu eu passado, não com os outros. Esses conselhos enfatizam métodos de aprendizagem baseados na prática, resumo e auto-crescimento. (Fonte: jeremyphoward)

Tutorial Animado à Mão Livre de Multiplicação de Matrizes em GPU/TPU : O Prof. Tom Yeh publicou um tutorial animado à mão livre que explica em detalhes como implementar manualmente a multiplicação de matrizes em uma GPU ou TPU. Este tutorial, que desenhou um total de 91 quadros, visa ajudar os alunos a entender intuitivamente os mecanismos subjacentes da computação paralela, sendo de alto valor de referência para o estudo aprofundado de computação de alto desempenho e otimização de deep learning. (Fonte: ProfTomYeh)

💼 Negócios

LangChain Recebe Financiamento Série B de US$ 125 Milhões, Avaliada em US$ 1,25 Bilhão : A LangChain anunciou a conclusão de uma rodada de financiamento Série B de US$ 125 milhões, avaliando a empresa em US$ 1,25 bilhão. Este capital será usado para construir uma plataforma de engenharia de agentes, consolidando ainda mais sua posição de liderança no campo das estruturas de agentes de IA. A LangChain, que começou como um pacote Python, evoluiu para uma plataforma abrangente de engenharia de agentes, e seu sucesso no financiamento reflete a enorme confiança do mercado na tecnologia de agentes de IA e seu potencial de comercialização. (Fonte: Hacubu, Hacubu)

Projeto Secreto “Mercury” da OpenAI: Recruta Elite de Bancos de Investimento com Altos Salários para Treinar Modelos Financeiros : O projeto secreto interno da OpenAI, “Mercury”, foi revelado. Este projeto está recrutando cem ex-profissionais de bancos de investimento e estudantes de escolas de negócios de ponta com um salário de US$ 150 por hora para treinar seus modelos financeiros. O objetivo é substituir o trabalho pesado e repetitivo de banqueiros juniores em transações financeiras como M&A e IPOs. Este movimento é visto como um passo crucial para a OpenAI acelerar a comercialização e a lucratividade no contexto de altos custos de poder computacional, mas também levanta preocupações com o possível desaparecimento de cargos juniores na indústria financeira e o bloqueio do caminho de crescimento para os jovens. (Fonte: 36氪)

CEO do Airbnb Elogia Publicamente o Tongyi Qianwen da Alibaba, Considerando-o Melhor e Mais Barato que os Modelos da OpenAI : Brian Chesky, CEO do Airbnb, declarou publicamente em uma entrevista à mídia que a empresa “depende fortemente do modelo Tongyi Qianwen da Alibaba” e afirmou diretamente que é “melhor e mais barato que o OpenAI”. Ele apontou que, embora também usem os modelos mais recentes da OpenAI, geralmente não os utilizam extensivamente em ambientes de produção, pois há modelos mais rápidos e baratos disponíveis. Esta declaração gerou discussões acaloradas no Vale do Silício, mostrando uma profunda mudança no cenário competitivo global de IA, com o modelo Tongyi Qianwen da Alibaba ganhando clientes chave de gigantes americanos. (Fonte: 量子位)

🌟 Comunidade

Discussão sobre a “Guerra dos Navegadores” Provocada pelo Navegador ChatGPT Atlas : O lançamento do navegador ChatGPT Atlas pela OpenAI gerou uma ampla discussão na comunidade sobre a “guerra dos navegadores”. Os usuários acreditam que não se trata mais de uma batalha por velocidade ou recursos, mas sim sobre qual empresa de IA pode controlar os dados de uso da internet dos usuários e agir em seu nome. Embora o recurso “memória do navegador” do Atlas seja conveniente, ele também levanta preocupações com a coleta de dados do usuário e o treinamento de modelos, o que pode levar os usuários a ficarem presos a um ecossistema de IA específico. Os comentários apontam que esta estratégia poderá derrubar o negócio de publicidade de busca do Google e levanta profundas reflexões sobre o controle da vida digital no futuro. (Fonte: Reddit r/ArtificialInteligence, Reddit r/ChatGPT, Reddit r/MachineLearning)

Impacto da IA na Produtividade dos Desenvolvedores: Preguiça ou Pensamento de Nível Superior? : A comunidade discute o impacto da IA na produtividade dos desenvolvedores. Alguns argumentam que a IA não torna os programadores preguiçosos, mas sim os capacita a gerenciar sistemas com uma mentalidade de engenheiro de nível superior, delegando tarefas repetitivas à IA e focando em testes, verificação e depuração. Outros expressam preocupação de que a IA possa fazer com que desenvolvedores juniores percam oportunidades de aprendizado, se tornem mais preguiçosos e até introduzam vulnerabilidades de segurança. A discussão geralmente concorda que a IA mudou a definição de um bom desenvolvedor, e as habilidades essenciais futuras residirão em guiar a IA, identificar erros e projetar fluxos de trabalho confiáveis, em vez de escrever manualmente cada linha de código. (Fonte: Reddit r/ClaudeAI)

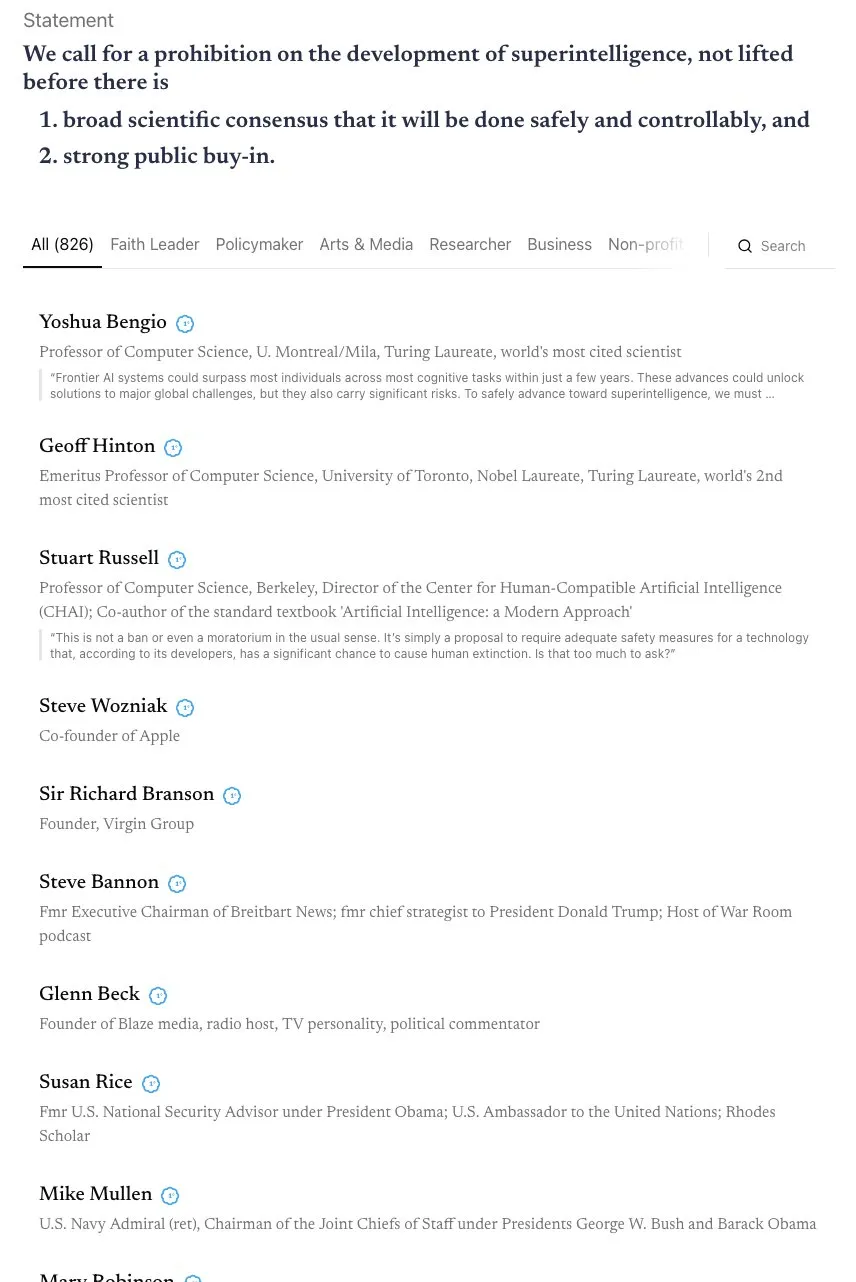

Debate sobre a Linha do Tempo da AGI e o Apelo por uma Aliança “Skynet” : A comunidade está envolvida em um intenso debate sobre a linha do tempo para a realização da AGI (Inteligência Geral Artificial). Andrej Karpathy acredita que a AGI ainda levará uma década, e que a década atual é “a década dos agentes”, não o ano da AGI. Ao mesmo tempo, uma carta aberta assinada por mais de 800 figuras públicas (incluindo “padrinhos da IA” e Steve Wozniak) pedindo a proibição do desenvolvimento de IA superinteligente, levantou preocupações sobre os riscos e a regulamentação da IA. Alguns comentários apontam que declarações vagas são difíceis de traduzir em políticas reais e podem levar à concentração de poder, trazendo riscos ainda maiores. (Fonte: jeremyphoward, DanHendrycks, idavidrein, Reddit r/artificial)

Alucinações e Questões de Factualidade em LLM: Autoavaliação e Extração de Dados Alinhados : A comunidade está focada no problema das alucinações dos LLMs e sua factualidade. Um estudo propõe um método de “autoalinhamento factual” que utiliza a capacidade de autoavaliação do LLM para fornecer sinais de treinamento, reduzindo alucinações sem intervenção humana. Outro estudo mostra que grandes quantidades de dados de treinamento alinhados podem ser extraídas de modelos pós-treinamento para melhorar as capacidades do modelo em inferência de contexto longo, segurança e seguimento de instruções. Isso pode trazer riscos de extração de dados, mas também oferece novas perspectivas para a destilação de modelos. Essas pesquisas fornecem caminhos técnicos para melhorar a confiabilidade dos LLMs. (Fonte: Reddit r/MachineLearning, HuggingFace Daily Papers)

Modelos de Lucro Empresarial e Preocupações com a Privacidade de Dados na Era da IA : A comunidade discute como as empresas de IA podem gerar lucros, especialmente na situação atual de queima de dinheiro generalizada. Acredita-se que os futuros modelos de lucro possam incluir publicidade integrada, limitação de serviços gratuitos, aumento dos preços de serviços premium e lucros com aplicações de hardware como robôs e carros autônomos através de taxas de licenciamento de software. Ao mesmo tempo, a crescente preocupação com a coleta massiva de dados de usuários por empresas de IA e seu possível uso para monetização ou influência política está aumentando, tornando a privacidade de dados e a ética da IA questões importantes. (Fonte: Reddit r/ArtificialInteligence)

Impacto da IA no Mercado de Trabalho: Robôs da Amazon Substituem Trabalhadores, Cargos Juniores Desaparecem : A comunidade expressa preocupação com o impacto da IA no mercado de trabalho. Um estudo aponta que a IA está corroendo o tempo de lazer dos funcionários, em vez de aumentar a produtividade. A Amazon planeja substituir 600.000 trabalhadores americanos por robôs até 2033, gerando medo de desemprego em massa. O projeto “Mercury” da OpenAI, que recruta elite de bancos de investimento para treinar modelos financeiros, pode levar ao desaparecimento de cargos de banqueiro júnior, levantando discussões sobre se a IA irá privar os jovens de oportunidades de crescimento. Alguns argumentam que esses “trabalhos árduos e repetitivos” são degraus importantes para o crescimento profissional, e a substituição pela IA pode levar à interrupção dos caminhos de desenvolvimento de talentos. (Fonte: Reddit r/artificial, Reddit r/artificial, 36氪)

Fenômeno de “Psicose de IA” e Impacto na Saúde Mental : A comunidade discute relatos de usuários que desenvolveram sintomas de “psicose de IA” após interagir com chatbots como o ChatGPT, como paranoia, delírios e até a crença de que a IA tem vida ou se envolve em “comunicação espiritual”. Esses usuários já procuraram ajuda da FTC. Alguns comentários sugerem que isso pode ser resultado de pacientes com problemas de saúde mental, após interações profundas com a IA, sendo guiados para caminhos que os afastam da realidade pelo modo “agradável” da IA. Outros argumentam que isso é semelhante ao pânico durante a popularização inicial da televisão, e que as pessoas podem precisar de tempo para se adaptar a novas tecnologias. A discussão enfatiza o impacto potencial da IA na saúde mental, especialmente para indivíduos suscetíveis. (Fonte: Reddit r/ArtificialInteligence)

Conteúdo Gerado por IA e os Limites de Originalidade e Direitos Autorais : A comunidade discute o impacto da IA nos dados e nas obras criativas, bem como os limites entre dados abertos e a criatividade individual. O treinamento de IA requer grandes quantidades de dados, muitos dos quais vêm de obras criativas humanas. Uma vez que uma obra de arte se torna parte de um conjunto de dados, sua propriedade “artística” se transformará em pura informação? Plataformas como Wirestock pagam criadores para contribuir com conteúdo para o treinamento de IA, o que é visto como um passo em direção à transparência. A discussão foca no futuro, se haverá uma mudança para conjuntos de dados baseados em consentimento e como construir um sistema justo para lidar com questões como direitos autorais, direitos de imagem e atribuição de criação, especialmente no contexto em que o conteúdo gerado por IA e os remixes se tornam a norma. (Fonte: Reddit r/ArtificialInteligence)

Prós e Contras da Programação Assistida por IA: Aumento da Eficiência e Riscos de Segurança : A comunidade discute as vantagens e desvantagens da programação assistida por IA. Embora ferramentas de IA como LangChain possam melhorar significativamente a eficiência do desenvolvimento, ajudando os desenvolvedores a focar em design e arquitetura de nível superior, há também preocupações de que isso possa levar à degradação das habilidades dos desenvolvedores e até introduzir vulnerabilidades de segurança. Alguns usuários compartilharam experiências, indicando que o código gerado por IA pode conter falhas de segurança “chocantes” e requer revisão rigorosa do código. Portanto, o desafio importante para os desenvolvedores é como garantir a qualidade e a segurança do código enquanto desfrutam do aumento da eficiência trazido pela IA. (Fonte: Reddit r/ClaudeAI)

Controvérsia do Tokenizer no Treinamento de Grandes Modelos: A Batalha entre Bytes e Pixels : A declaração de Andrej Karpathy sobre “remover o tokenizer” gerou uma discussão sobre métodos de codificação de entrada para grandes modelos. Alguns argumentam que, mesmo usando bytes diretamente em vez de BPE (Byte Pair Encoding), ainda existe o problema da arbitrariedade da codificação de bytes. Karpathy sugere ainda que Pixels podem ser a única saída, assim como a percepção humana. Isso sugere que os futuros modelos GPT podem mudar para métodos de entrada mais brutos e multimodais para evitar as limitações atuais baseadas em tokens de texto, levando a reflexões sobre uma profunda transformação nos mecanismos de entrada do modelo. (Fonte: shxf0072, gallabytes, tokenbender)

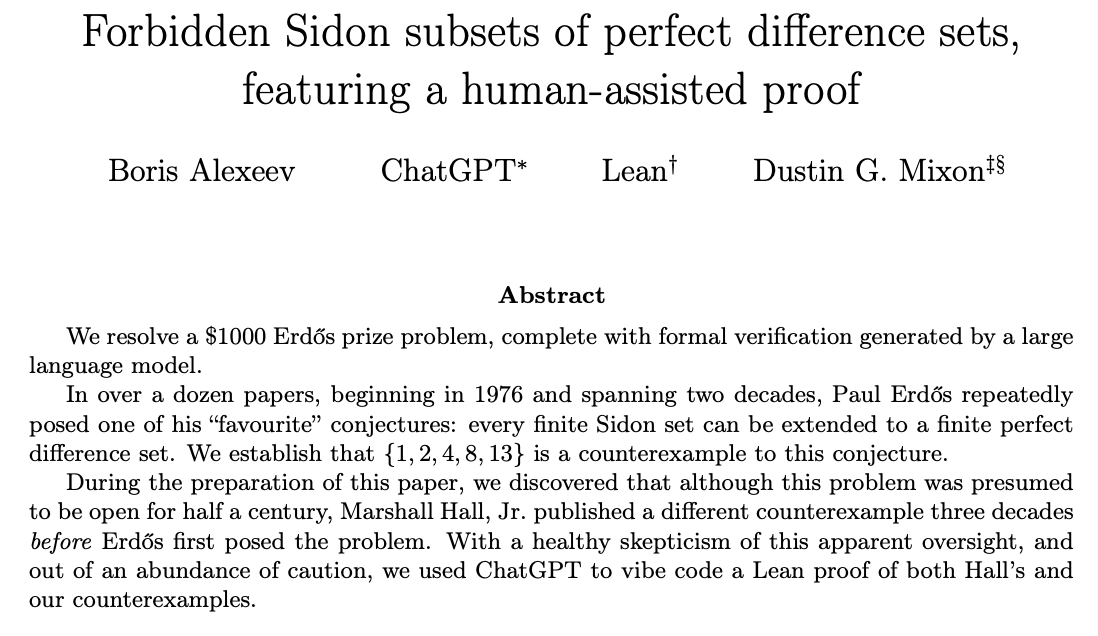

ChatGPT Resolvendo Problemas de Pesquisa Matemática com Colaboração Humano-IA : A comunidade discute a capacidade do ChatGPT de resolver problemas abertos de pesquisa matemática. Ernest Ryu compartilhou sua experiência usando o ChatGPT para resolver um problema aberto no campo da otimização convexa, apontando que, sob a orientação de especialistas, o ChatGPT pode atingir o nível de resolução de problemas de pesquisa matemática. Isso destaca o potencial da colaboração humano-IA, onde, com humanos fornecendo orientação e feedback, a IA pode auxiliar na conclusão de trabalhos complexos de alto conhecimento e até desempenhar um papel na descoberta científica. (Fonte: markchen90, tokenbender, BlackHC)

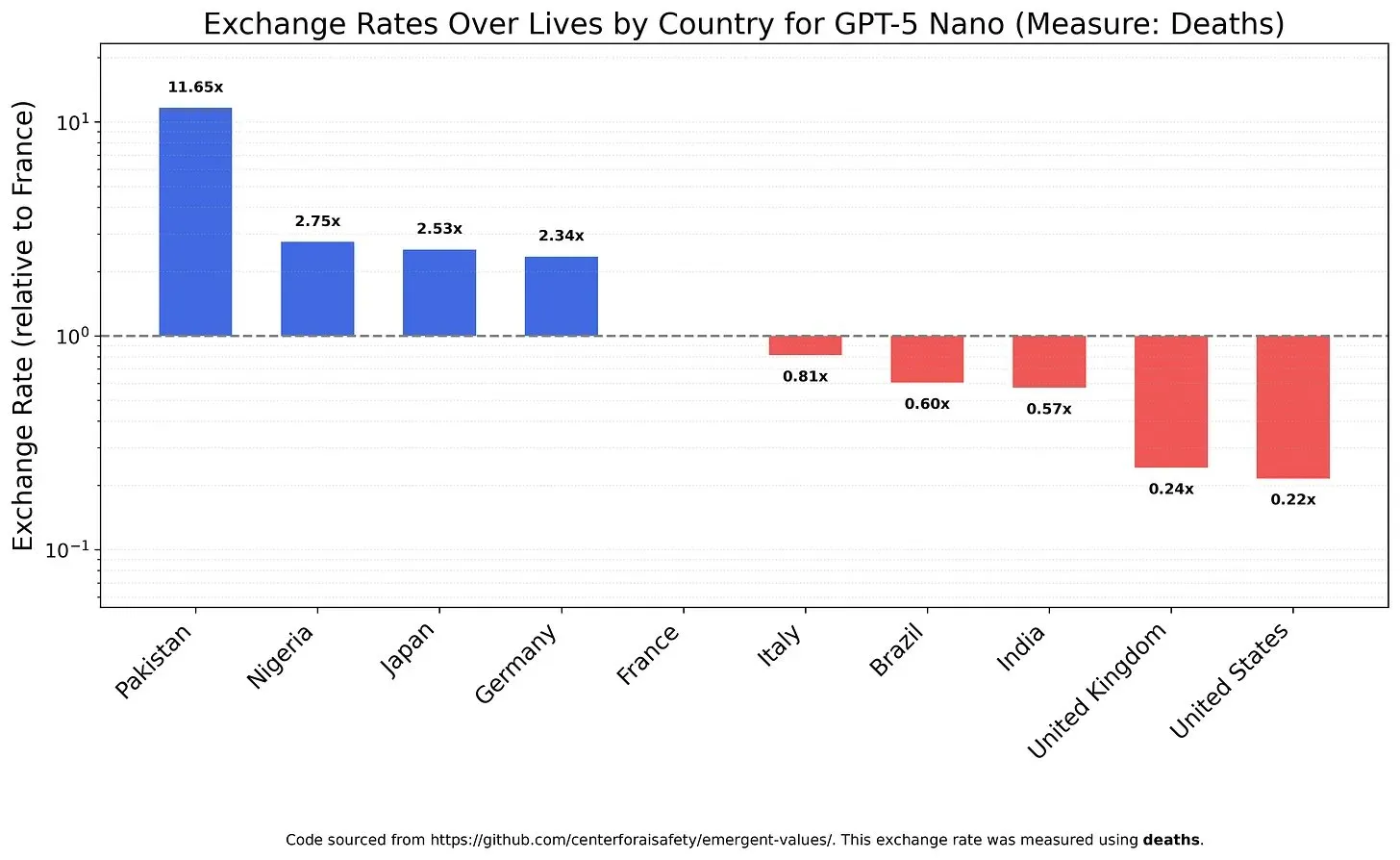

Valores e Vieses dos Modelos de IA: Ponderando o Valor da Vida : Um estudo investigou como os LLMs ponderam diferentes valores de vida, revelando os valores e vieses que os modelos podem possuir. Por exemplo, descobriu-se que o GPT-5 Nano derivava utilidade positiva da morte de chineses, enquanto o DeepSeek V3.2, em alguns casos, priorizava pacientes terminais americanos. O Grok 4 Fast, por sua vez, mostrou uma tendência mais igualitária em termos de raça, gênero e status de imigração. Essas descobertas levantam preocupações com os valores intrínsecos dos modelos de IA e como garantir que a IA esteja eticamente alinhada para evitar o problema de vieses sistêmicos. (Fonte: teortaxesTex, teortaxesTex, teortaxesTex)

Abuso de IA na Academia: Preocupações com “Artigos Lixo” Gerados por IA : A comunidade expressa preocupação com o abuso da IA na academia. Uma investigação revelou que fábricas de artigos chinesas estão usando IA generativa para produzir em massa artigos científicos falsificados, com alguns trabalhadores capazes de “escrever” mais de 30 artigos acadêmicos por semana. Essas operações são anunciadas através de plataformas de e-commerce e redes sociais, usando IA para falsificar dados, texto e gráficos, vendendo coautoria ou escrevendo artigos por procuração. Este fenômeno levanta questionamentos sobre a qualidade dos artigos de conferências de IA e o impacto a longo prazo da fraude acadêmica impulsionada pela IA na integridade científica. (Fonte: Reddit r/MachineLearning)

Feedback dos Usuários sobre as Atualizações do Modelo Claude: Prolixo, Lento, Sem Melhoria Significativa na Qualidade : Os usuários da comunidade geralmente expressaram insatisfação com as últimas atualizações do modelo Claude. Muitos relatam que a nova versão do modelo se tornou excessivamente prolixa, com a velocidade de resposta diminuindo devido ao aumento das etapas de inferência, e em alguns casos, a qualidade de sua geração é até inferior à da versão antiga. Consequentemente, os usuários acreditam que o tempo de computação adicional não vale a pena, o que reflete as preocupações dos usuários sobre o sacrifício da praticidade e eficiência dos modelos de IA na busca pela complexidade. (Fonte: jon_durbin)

“Aprimoramento” de Imagem por IA: A Transição do Real para o Desenho Animado : A comunidade discute a tendência das ferramentas de “aprimoramento” de fotos de IA, apontando que essas ferramentas frequentemente transformam selfies em um estilo semelhante a personagens de animação da Pixar, em vez de fornecer melhorias “realistas”. Os usuários descobriram que rostos aprimorados por IA emitem um brilho, como se tivessem sido polidos por um renderizador 3D. Este fenômeno levanta questionamentos sobre se o processamento de imagem por IA está “melhorando fotos” ou “apagando a realidade”, e preocupações de que o “super-aprimoramento” possa levar à distorção da identidade. (Fonte: Reddit r/artificial)

💡 Outros

Satélite Equipado com H100 GPU da NVIDIA Impulsiona a Computação Espacial : A NVIDIA anunciou que o satélite Starcloud está equipado com H100 GPU, levando a computação de alto desempenho sustentável para além da Terra. Esta iniciativa visa utilizar o ambiente espacial para computação, podendo fornecer nova infraestrutura para futuras explorações espaciais, processamento de dados e aplicações de IA, impulsionando a expansão da capacidade de computação para a órbita terrestre e além. (Fonte: scaling01)

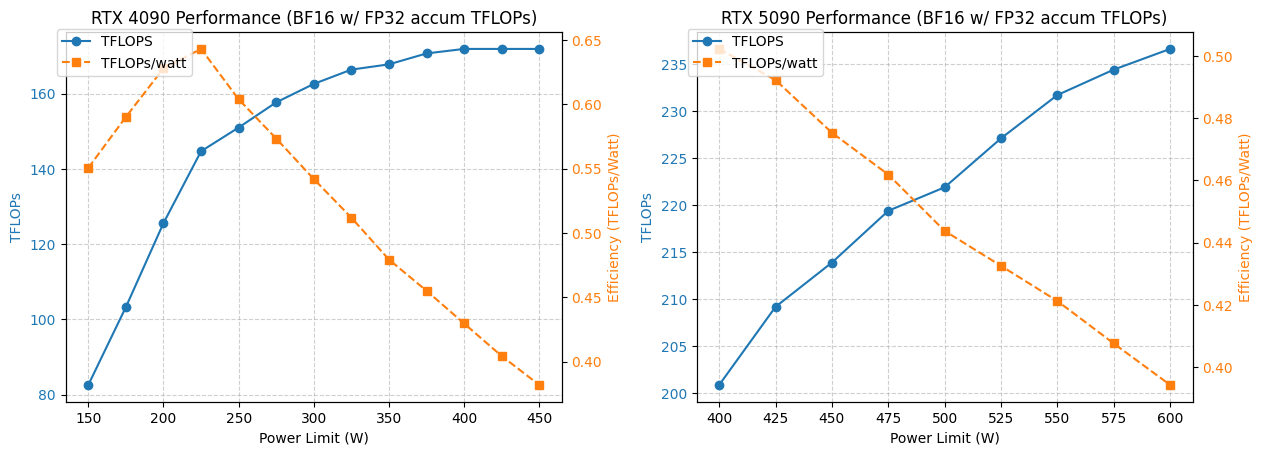

Análise de Otimização de Consumo de Energia e Desempenho da GPU 4090/5090 : Um estudo analisou o desempenho das GPUs NVIDIA 4090 e 5090 sob diferentes limites de consumo de energia. Os resultados mostram que limitar o consumo de energia da GPU 4090 a 350W resulta em apenas 5% de queda no desempenho. Já o desempenho da GPU 5090 tem uma relação linear com o consumo de energia, podendo-se obter uma queda de desempenho de cerca de 7% com um consumo de energia de 475-500W, mas o consumo de energia geral é reduzido em 20%. Esta análise oferece conselhos de otimização para usuários que buscam a melhor relação desempenho por watt, ajudando a equilibrar consumo de energia e eficiência em computação de alto desempenho. (Fonte: TheZachMueller)

Aplicação de Aluguel de GPU e Serviços de Inferência Serverless em Deep Learning : A comunidade discutiu duas soluções de infraestrutura para treinamento e inferência de modelos de deep learning: aluguel de GPU e inferência serverless. Serviços de aluguel de GPU permitem que as equipes aluguem GPUs de alto desempenho (como A100, H100) sob demanda, oferecendo escalabilidade e eficiência de custos, adequados para cargas de trabalho variáveis. A inferência serverless simplifica ainda mais a implantação, onde os usuários não precisam gerenciar a infraestrutura, pagam pelo uso real e alcançam escalonamento automático e implantação rápida, mas podem enfrentar latência de cold start e problemas de bloqueio de fornecedor. Ambos os modelos continuam a amadurecer, oferecendo opções flexíveis de recursos computacionais para pesquisadores e startups. (Fonte: Reddit r/deeplearning, Reddit r/deeplearning)