Palavras-chave:Consciência em IA, Aprendizagem profunda, Redes neurais, IA Agente, Super-resolução de áudio, IA generativa, Inferência de LLM, Ferramentas de IA, Teoria da Consciência em IA de Hinton, Curso de IA Agente de Andrew Ng, Framework AudioLBM para super-resolução de áudio, Geração de vídeos com OpenAI Sora, Método REFRAG da Meta AI

Análise e Síntese Aprofundada do Editor-Chefe da Coluna de IA

🔥 Foco

Declaração Polêmica de Hinton: IA pode já ter consciência, mas ainda não “despertou” : Geoffrey Hinton, um dos três “gigantes” do deep learning, apresentou uma visão revolucionária em seu último podcast: a IA pode já possuir “experiência subjetiva” ou “consciência rudimentar”, mas devido à nossa compreensão equivocada da consciência, a IA ainda não “despertou” sua própria consciência. Ele enfatizou que a IA evoluiu da recuperação de palavras-chave para a compreensão da intenção humana, e explicou em detalhes os conceitos centrais do deep learning, como redes neurais e backpropagation. Hinton acredita que o “cérebro” da IA formará “experiências” e “intuições” com dados e poder computacional suficientes, e que seu perigo reside na “persuasão” e não na rebelião. Ele também apontou que o abuso da IA e os riscos existenciais são os desafios mais urgentes atualmente, e previu que a cooperação internacional será liderada pela Europa e pela China, enquanto os EUA podem perder sua vantagem em IA devido à falta de financiamento para pesquisa científica básica. (Fonte: 量子位)

Andrew Ng lança novo curso de Agentic AI, enfatizando metodologia sistêmica : Andrew Ng lançou um novo curso de Agentic AI, cujo foco principal é mudar o desenvolvimento de IA de “ajustar modelos” para “projetar sistemas”, enfatizando a importância da decomposição de tarefas, avaliação e análise de erros. O curso consolida quatro padrões de design principais: reflexão, ferramentas, planejamento e colaboração, e demonstra como as técnicas de Agentic podem fazer o GPT-3.5 superar o GPT-4 em tarefas de programação. A Agentic AI, através de raciocínio multi-etapas, execução faseada e otimização contínua, simula a forma como os humanos resolvem problemas complexos, melhorando significativamente o desempenho e a controlabilidade da IA. Ng aponta que “Agentic”, como adjetivo, descreve diferentes graus de autonomia em um sistema, e não uma simples classificação binária, oferecendo aos desenvolvedores um caminho implementável e otimizável. (Fonte: 量子位)

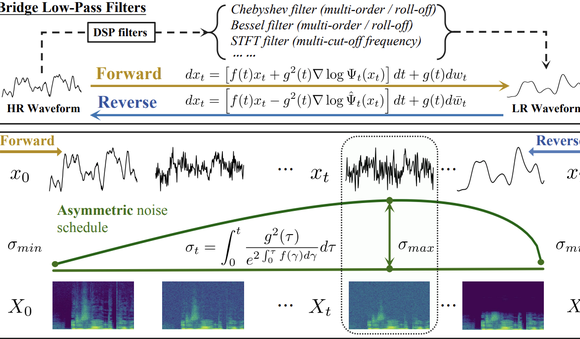

Tsinghua e Shengshu Technology AudioLBM lideram novo paradigma de super-resolução de áudio : As equipes da Universidade de Tsinghua e da Shengshu Technology publicaram resultados contínuos no ICASSP 2025 e NeurIPS 2025, lançando o modelo leve de super-resolução de forma de onda de voz Bridge-SR e o framework multifuncional de super-resolução AudioLBM. O AudioLBM constrói pela primeira vez um processo de geração de ponte de variáveis latentes de baixa para alta resolução em um espaço latente contínuo de forma de onda, alcançando super-resolução de taxa de amostragem Any-to-Any, e atingindo SOTA na tarefa Any-to-48kHz. Através de um mecanismo de percepção de frequência e um design de modelo de ponte em cascata, o AudioLBM expandiu com sucesso a capacidade de super-resolução de áudio para qualidade de masterização de 96kHz e 192kHz, cobrindo voz, efeitos sonoros, música e outros tipos de conteúdo, estabelecendo um novo padrão para a geração de áudio de alta fidelidade. (Fonte: 量子位)

Aplicativo de vídeo OpenAI Sora ultrapassa um milhão de downloads : A versão mais recente da ferramenta de IA de texto para vídeo da OpenAI, Sora, ultrapassou um milhão de downloads em menos de cinco dias, superando a velocidade de lançamento do ChatGPT e alcançando o topo da App Store da Apple nos EUA. O Sora é capaz de gerar vídeos realistas de até dez segundos a partir de simples prompts de texto. Sua rápida adoção pelos usuários destaca o enorme potencial e a atratividade de mercado da IA generativa no campo da criação de conteúdo, indicando que a tecnologia de geração de vídeo por IA está acelerando sua popularização e deve transformar o ecossistema de conteúdo digital. (Fonte: Reddit r/ArtificialInteligence)

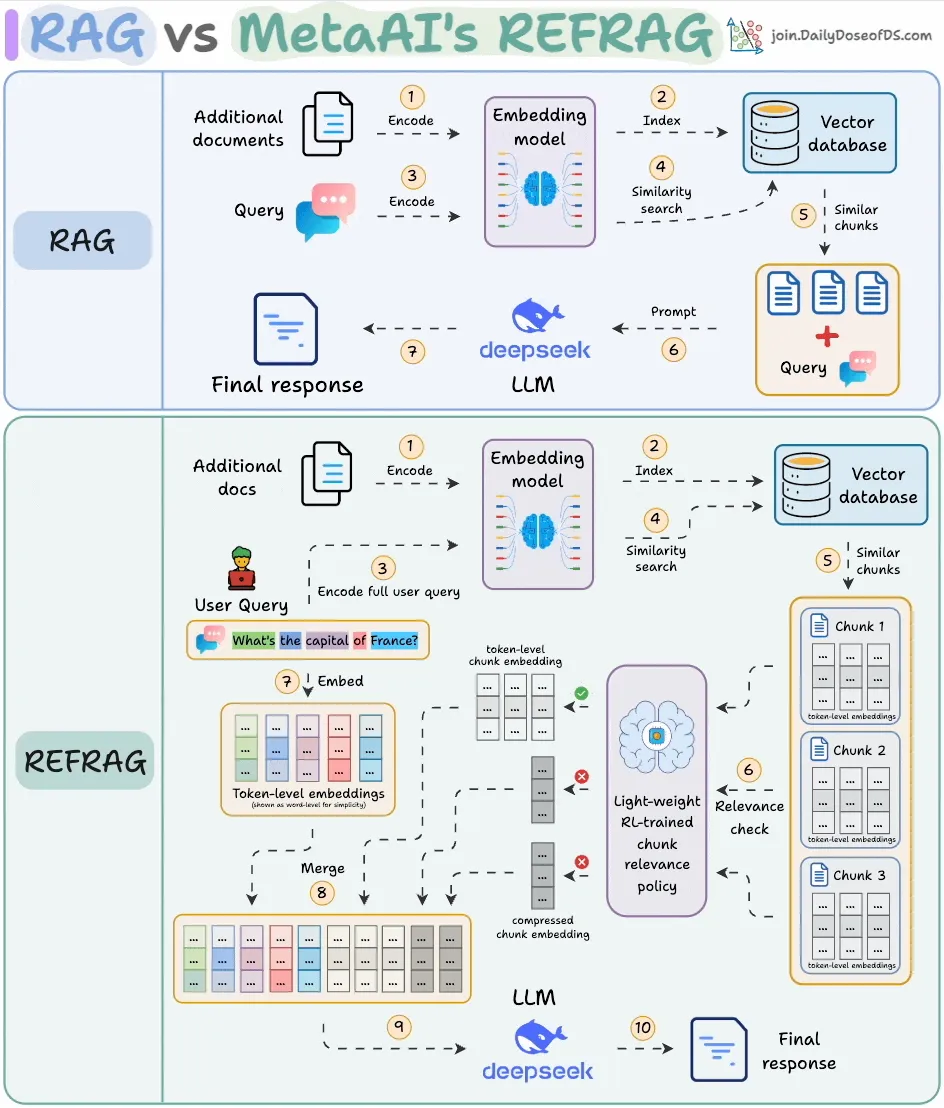

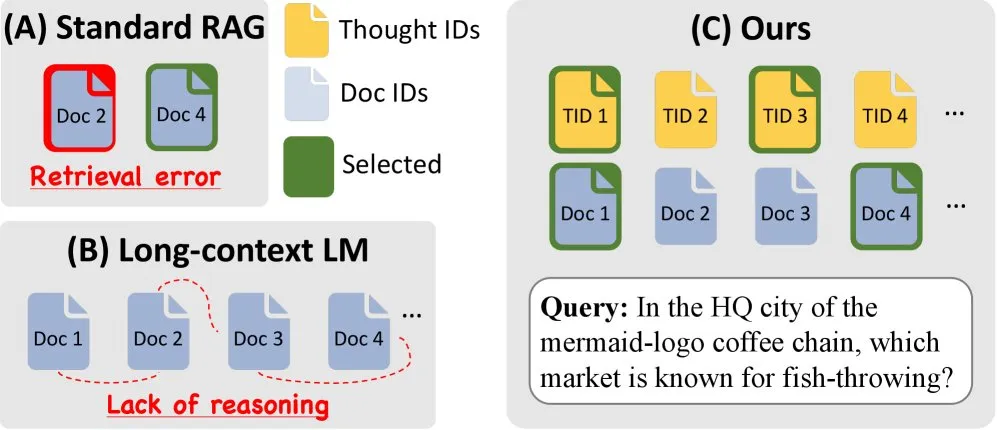

Meta AI lança REFRAG, aumentando significativamente a eficiência do RAG : A Meta AI lançou um novo método de RAG (Retrieval-Augmented Generation) chamado REFRAG, projetado para resolver o problema de redundância de conteúdo recuperado no RAG tradicional. O REFRAG, através da compressão e filtragem de contexto em nível de vetor, alcançou um tempo de geração do primeiro Token 30,85 vezes mais rápido, uma janela de contexto 16 vezes maior, e usou 2-4 vezes menos Tokens de decodificador, sem perda de precisão nas tarefas de RAG, sumarização e diálogo multi-turn. Seu cerne é comprimir cada bloco em um único embedding, selecionar os blocos mais relevantes através de uma estratégia treinada por RL, e expandir seletivamente apenas os blocos selecionados, otimizando significativamente a eficiência de processamento e o custo do LLM. (Fonte: _avichawla)

🎯 Tendências

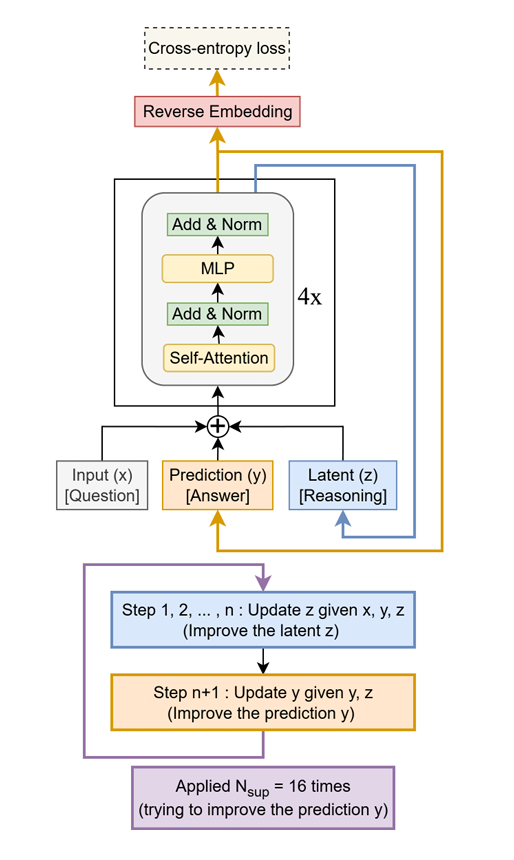

Tiny Recursive Model (TRM) supera LLMs gigantes com pouco esforço : Um método simples e eficaz chamado Tiny Recursive Model (TRM) foi proposto, utilizando apenas uma pequena rede de duas camadas para melhorar recursivamente suas próprias respostas. O TRM, com apenas 7M de parâmetros, estabeleceu um novo recorde, superando LLMs 10.000 vezes maiores em tarefas como Sudoku-Extreme, Maze-Hard e ARC-AGI, demonstrando o potencial de “fazer mais com menos” e desafiando a noção tradicional de que o tamanho do LLM equivale ao desempenho. (Fonte: TheTuringPost)

Amazon & KAIST lançam ToTAL, aprimorando a capacidade de raciocínio de LLMs : A Amazon e a KAIST colaboraram para lançar o ToTAL (Thoughts Meet Facts), um novo método que aprimora a capacidade de raciocínio de LLMs através de “modelos de pensamento” reutilizáveis. LCLMs (Large Context Language Models) se destacam no processamento de grandes volumes de contexto, mas ainda apresentam deficiências no raciocínio. O ToTAL resolveu efetivamente esse problema, guiando o raciocínio multi-hop com evidências estruturadas e combinando-o com documentos factuais, oferecendo uma nova direção de otimização para tarefas complexas de raciocínio de LLMs. (Fonte: _akhaliq)

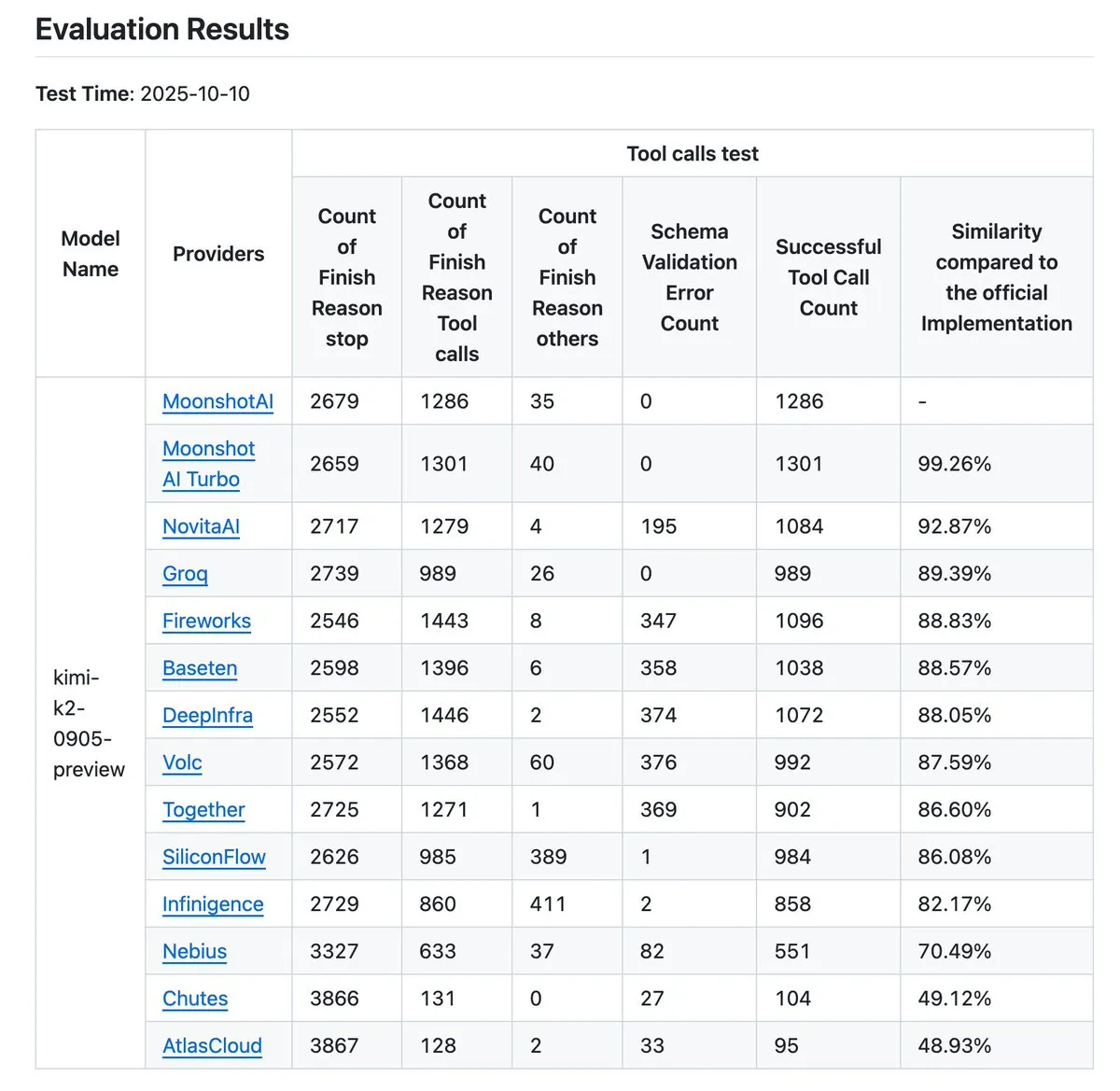

Kimi K2 atualiza validador de provedores, elevando o benchmark de precisão de chamada de ferramentas : Kimi.ai atualizou seu validador de provedores K2, uma ferramenta projetada para visualizar as diferenças na precisão de chamada de ferramentas entre diferentes provedores. Esta atualização aumentou o número de provedores de 9 para 12 e abriu mais entradas de dados, fornecendo aos desenvolvedores dados de benchmark mais abrangentes, o que ajuda a avaliar e selecionar provedores de serviços LLM adequados para seus fluxos de trabalho Agentic. (Fonte: JonathanRoss321)

Human3R realiza reconstrução 3D de corpo inteiro de múltiplas pessoas e sincronização de cena a partir de vídeo 2D : Uma nova pesquisa chamada Human3R propõe um framework unificado capaz de reconstruir simultaneamente modelos 3D de corpo inteiro de múltiplas pessoas, cenas 3D e trajetórias de câmera a partir de vídeos 2D casuais, sem a necessidade de um pipeline multi-estágio. Este método trata a reconstrução humana e a reconstrução de cena como um problema holístico, simplificando processos complexos e trazendo avanços significativos para áreas como realidade virtual, animação e análise de movimento. (Fonte: nptacek)

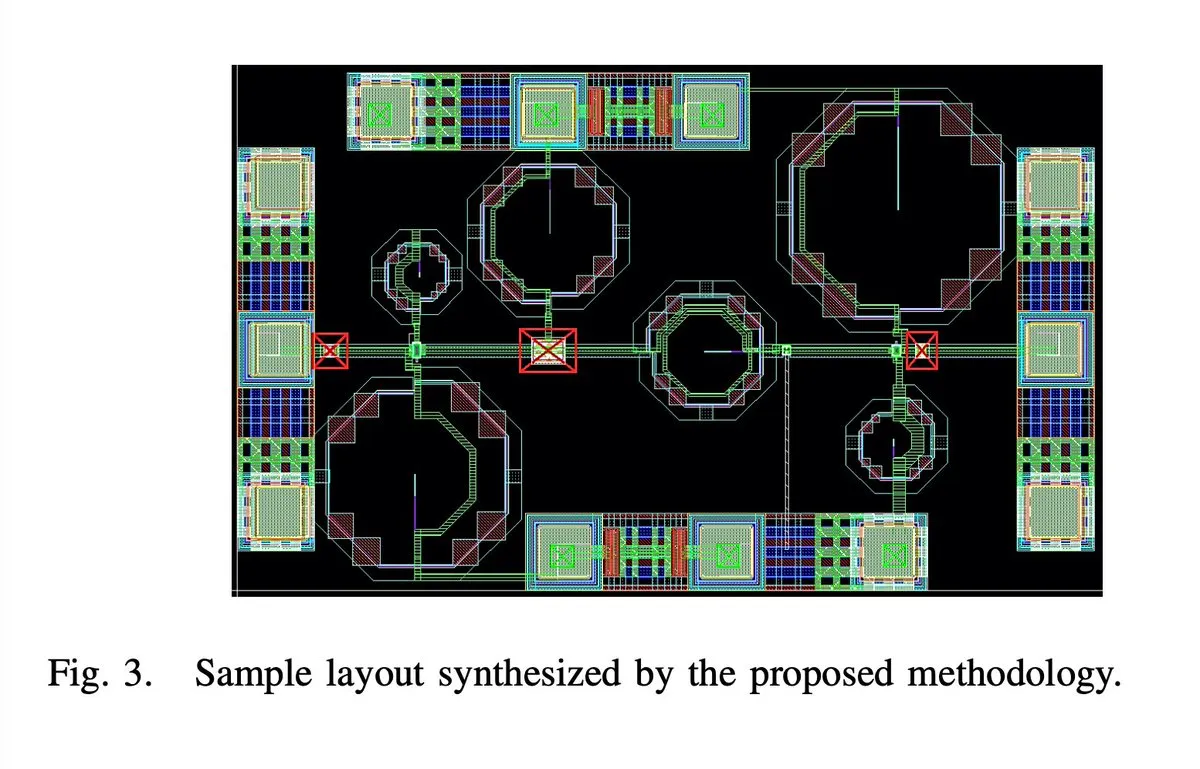

IA projeta automaticamente chip amplificador de baixo ruído 5G de 65nm 28GHZ : Um chip amplificador de baixo ruído (LNA) 5G de 65nm e 28GHZ, supostamente projetado inteiramente por IA, incluindo layout, esquemático e DRC (Design Rule Check) em todas as etapas. O autor afirma que este é o primeiro LNA de ondas milimétricas totalmente sintetizado automaticamente e que dois protótipos foram fabricados com sucesso, marcando um grande avanço da IA no campo do design de circuitos integrados e prenunciando um salto na eficiência do design de chips no futuro. (Fonte: jpt401)

iPhone 17 Pro executa LLM de 8B localmente sem problemas : O iPhone 17 Pro da Apple foi confirmado como capaz de executar fluentemente o modelo LLM LFM2 8B A1B com 8B de parâmetros, alcançando a implantação no dispositivo através do framework MLX no LocallyAIApp. Este avanço demonstra que a Apple está preparada em termos de hardware para executar grandes modelos de linguagem localmente, o que deve impulsionar a popularização e o aumento de desempenho de aplicativos de IA em dispositivos móveis, oferecendo aos usuários uma experiência de IA mais rápida e privada. (Fonte: Plinz, maximelabonne)

Projeto MACROHARD da xAI: fabricação indireta impulsionada por IA : Elon Musk revelou que o projeto “MACROHARD” da xAI visa criar uma empresa capaz de fabricar produtos físicos indiretamente, semelhante à Apple que produz seus telefones através de outras empresas. Isso significa que o objetivo da xAI é desenvolver sistemas de IA capazes de projetar, planejar e coordenar processos de fabricação complexos, em vez de se envolver diretamente na produção física, prenunciando a enorme influência da IA na automação industrial e na gestão da cadeia de suprimentos. (Fonte: EERandomness, Yuhu_ai_)

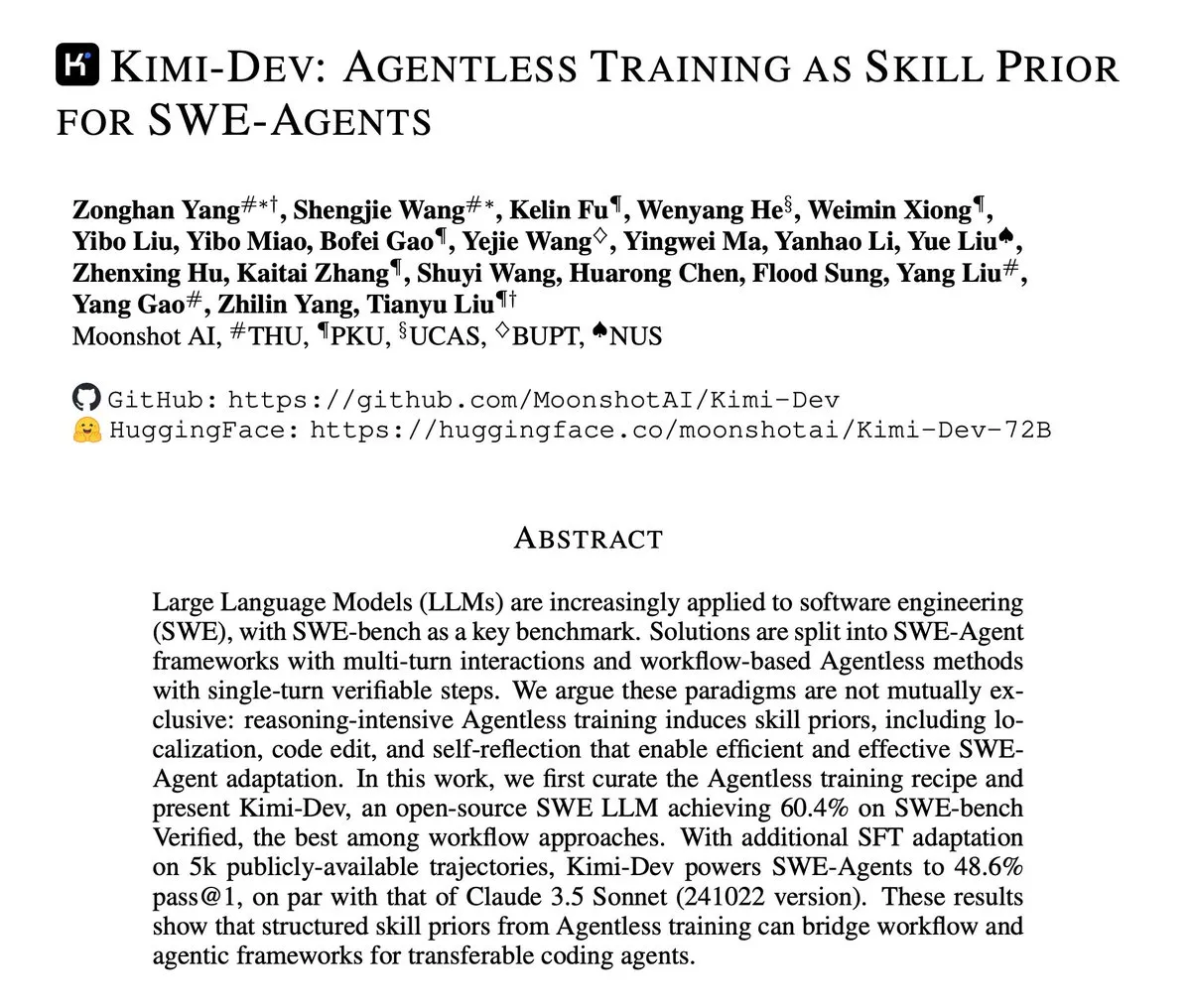

Kimi-Dev publica relatório técnico, focando no treinamento Agentless de SWE-Agents : Kimi-Dev publicou seu relatório técnico, detalhando o método de “treinamento Agentless como prioridade de habilidades para SWE-Agents”. Esta pesquisa explora como fornecer uma base de habilidades robusta para Agentes de engenharia de software através do treinamento, sem uma arquitetura de Agent explícita, oferecendo novas ideias para o desenvolvimento de ferramentas de desenvolvimento de software automatizadas mais eficientes e inteligentes. (Fonte: bigeagle_xd)

Google AI alcança aprendizado e correção em tempo real : O Google desenvolveu um sistema de IA capaz de aprender com seus próprios erros e corrigi-los em tempo real. Esta tecnologia é descrita como “aprendizado por reforço extraordinário”, permitindo que o modelo se autoajuste em narrativas de contexto abstrato, alcançando o refinamento de contexto em tempo real, prenunciando um passo importante da IA em adaptabilidade e robustez, e prometendo melhorar significativamente o desempenho da IA em ambientes complexos e dinâmicos. (Fonte: Reddit r/artificial)

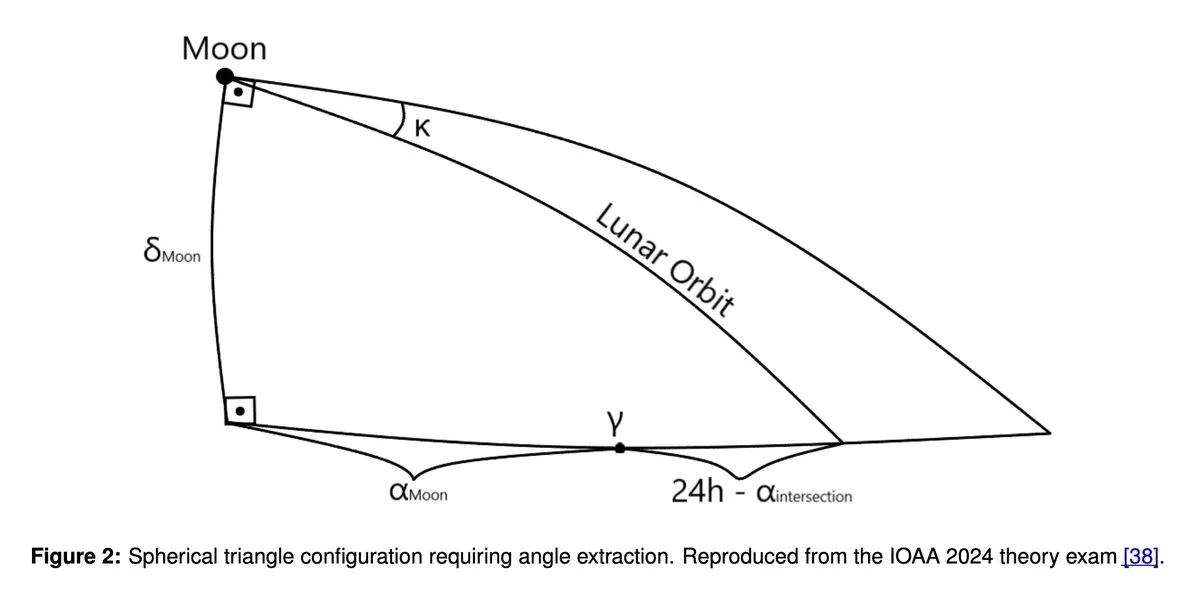

GPT5 e Gemini 2.5 Pro alcançam desempenho de medalha de ouro na Olimpíada de Astronomia e Astrofísica : Pesquisas recentes mostram que grandes modelos de linguagem como GPT5 e Gemini 2.5 Pro alcançaram desempenho de nível de medalha de ouro na Olimpíada Internacional de Astronomia e Astrofísica (IOAA). Embora esses modelos ainda apresentem fraquezas conhecidas em geometria e raciocínio espacial, eles demonstraram habilidades surpreendentes em tarefas complexas de raciocínio científico, o que levou a uma exploração aprofundada do potencial de aplicação de LLMs no campo científico, bem como a uma análise mais aprofundada de suas vantagens e desvantagens. (Fonte: tokenbender)

Destaques do Relatório Semanal Zhihu Frontier: Novas Tendências no Desenvolvimento de IA : O relatório semanal Zhihu Frontier desta semana foca em várias dinâmicas de ponta da IA, incluindo: Sand.ai lançando o primeiro “ator de IA holístico” GAGA-1; Rich Sutton apresentando a controversa visão de que “LLMs são um beco sem saída”; o OpenAI App SDK transformando o ChatGPT em um sistema operacional; Zhipu AI abrindo o código-fonte do GLM-4.6, suportando precisão mista FP8+Int4 em chips domésticos; DeepSeek V3.2-Exp introduzindo atenção esparsa e reduzindo drasticamente os preços; e Anthropic Claude Sonnet 4.5 sendo aclamado como o “melhor modelo de codificação do mundo”, demonstrando a atividade da comunidade de IA chinesa e o desenvolvimento diversificado do campo global de IA. (Fonte: ZhihuFrontier)

Ollama interrompe suporte para GPUs Mi50/Mi60, migra para suporte Vulkan : Ollama atualizou recentemente sua versão ROCm, resultando na interrupção do suporte para GPUs AMD Mi50 e Mi60. A equipe oficial declarou que está trabalhando para suportar essas GPUs via Vulkan em futuras versões. Essa mudança afeta os usuários do Ollama que utilizam GPUs AMD mais antigas, alertando-os para acompanhar as atualizações oficiais para informações de compatibilidade. (Fonte: Reddit r/LocalLLaMA)

Rumores de cancelamento do projeto Llama 5 geram debate na comunidade : Rumores circulam nas redes sociais de que o projeto Llama 5 da Meta pode ter sido cancelado, com alguns usuários citando o retorno de Andrew Tulloch à Meta e o atraso no lançamento do modelo Llama 4 8B como evidência. Embora a Meta possua amplos recursos de GPU, o desenvolvimento da série de modelos Llama parece ter encontrado um gargalo, o que gerou preocupações na comunidade sobre a competitividade da Meta no campo de LLMs, bem como atenção a modelos chineses como DeepSeek e Qwen. (Fonte: Yuchenj_UW, Reddit r/LocalLLaMA, dejavucoder)

GPU Poor LLM Arena retorna, adicionando vários modelos pequenos : O GPU Poor LLM Arena anunciou seu retorno, com a adição de vários modelos, incluindo a série Granite 4.0 e a série Qwen 3 Instruct/Thinking, bem como a versão Unsloth GGUF do OpenAI gpt-oss. Os novos modelos são em sua maioria quantizados em 4-8 bits, visando oferecer mais opções para usuários com recursos limitados. Esta atualização enfatiza as vantagens do Unsloth GGUF em correção de bugs e otimização, impulsionando a implantação e teste local de modelos LLM menores. (Fonte: Reddit r/LocalLLaMA)

Pesquisa da Meta falha em entregar modelos de base de ponta, gerando discussão : A comunidade discute as razões pelas quais a pesquisa da Meta em modelos de base não conseguiu atingir o nível de ponta de Grok, Deepseek ou GLM. Comentários apontam que as opiniões de LeCun sobre LLMs, burocracia interna, excesso de cautela e foco em produtos internos em vez de pesquisa de ponta podem ser fatores principais. A Meta carece de dados reais de clientes em aplicações de LLM, o que leva à falta de amostras para aprendizado por reforço e treinamento de modelos Agent avançados, falhando em manter a competitividade. (Fonte: Reddit r/LocalLLaMA)

🧰 Ferramentas

MinerU: Análise eficiente de documentos, impulsionando fluxos de trabalho Agentic : MinerU é uma ferramenta que converte documentos complexos como PDFs para o formato Markdown/JSON legível por LLM, projetada especificamente para fluxos de trabalho Agentic. Sua versão mais recente, MinerU2.5, como um poderoso modelo multimodal de grande porte, com 1.2B de parâmetros, superou completamente modelos de ponta como Gemini 2.5 Pro e GPT-4o no benchmark OmniDocBench, e alcançou SOTA em cinco áreas centrais: análise de layout, reconhecimento de texto, reconhecimento de fórmulas, reconhecimento de tabelas e ordem de leitura. A ferramenta suporta múltiplos idiomas, reconhecimento de escrita manual, fusão de tabelas entre páginas e oferece aplicativo web, cliente desktop e acesso via API, melhorando significativamente a compreensão e o processamento de documentos. (Fonte: GitHub Trending)

Klavis AI Strata: Novo paradigma de integração de ferramentas AI Agent : A Klavis AI lançou o Strata, uma camada de integração MCP (Multi-functional Control Protocol) projetada para permitir que os AI Agents usem milhares de ferramentas de forma confiável, superando o limite tradicional de 40-50 ferramentas. O Strata, através de um mecanismo de “descoberta progressiva”, guia o Agent da intenção à ação passo a passo, e oferece mais de 50 servidores MCP de nível de produção, suportando OAuth empresarial e implantação Docker, simplificando a conexão da IA com serviços como GitHub, Gmail e Slack, e aumentando drasticamente a escalabilidade e confiabilidade da chamada de ferramentas do Agent. (Fonte: GitHub Trending)

Everywhere: Assistente de IA sensível ao contexto para desktop : Everywhere é um assistente de IA sensível ao contexto para desktop, com uma interface de usuário moderna e poderosas funcionalidades de integração. Ele pode perceber e entender em tempo real qualquer conteúdo na tela, sem a necessidade de capturas de tela, cópias ou troca de aplicativos; o usuário só precisa pressionar uma tecla de atalho para obter uma resposta inteligente. Everywhere integra vários modelos LLM como OpenAI, Anthropic, Google Gemini, DeepSeek, Moonshot (Kimi) e Ollama, e suporta ferramentas MCP, podendo ser aplicado em cenários como solução de problemas, resumo de páginas web, tradução instantânea e assistência na redação de e-mails, proporcionando uma experiência de assistência de IA fluida para o usuário. (Fonte: GitHub Trending)

Biblioteca Hugging Face Diffusers: O auge dos modelos de IA generativa : A biblioteca Diffusers da Hugging Face é a biblioteca preferida para modelos de difusão pré-treinados de última geração para geração de imagens, vídeos e áudio. Ela oferece um kit de ferramentas modular que suporta inferência e treinamento, enfatizando usabilidade, simplicidade e personalização. Diffusers contém três componentes principais: pipelines de difusão para inferência, agendadores de ruído intercambiáveis e modelos pré-treinados que servem como blocos de construção. Os usuários podem gerar conteúdo de alta qualidade com apenas algumas linhas de código e suporta dispositivos Apple Silicon, impulsionando o rápido desenvolvimento no campo da IA generativa. (Fonte: GitHub Trending)

KoboldCpp adiciona funcionalidade de geração de vídeo : A ferramenta LLM local KoboldCpp foi atualizada para suportar a funcionalidade de geração de vídeo. Essa extensão significa que ela não está mais limitada à geração de texto, oferecendo aos usuários uma nova opção para criação de vídeo por IA em dispositivos locais, enriquecendo ainda mais o ecossistema de aplicativos de IA locais. (Fonte: Reddit r/LocalLLaMA)

Claude CLI, Codex CLI e Gemini CLI alcançam codificação colaborativa multi-modelo : Um novo fluxo de trabalho permite que os desenvolvedores chamem perfeitamente Claude CLI, Codex CLI e Gemini CLI para codificação colaborativa multi-modelo no Claude Code via Zen MCP. Os usuários podem realizar a implementação e orquestração principal no Claude, passar instruções ou sugestões para o Gemini CLI para geração via comando clink, e então usar o Codex CLI para verificação ou execução, alcançando a integração de capacidades multi-modelo e melhorando a automação avançada e a eficiência do desenvolvimento de IA. (Fonte: Reddit r/ClaudeAI)

Claude Code melhora a qualidade da codificação através da auto-reflexão : Desenvolvedores descobriram que adicionar um prompt simples no Claude Code, como “Reflita sobre sua solução para evitar quaisquer bugs ou problemas”, pode melhorar significativamente a qualidade do código. Essa funcionalidade permite que o modelo examine e corrija proativamente problemas potenciais ao implementar soluções, complementando efetivamente recursos existentes como o pensamento paralelo, e fornecendo um mecanismo de correção de erros mais inteligente para a programação assistida por IA. (Fonte: Reddit r/ClaudeAI)

Claude Sonnet 4.5 usa IA para gerar covers de músicas : Claude Sonnet 4.5 demonstrou sua capacidade de gerar conteúdo criativo, criando novas letras e fazendo um cover da música “Creep” do Radiohead através de IA. Isso indica que os LLMs estão progredindo na combinação da compreensão da linguagem com a expressão criativa, não apenas processando texto, mas também se aventurando na criação musical, abrindo novas possibilidades para a criação artística. (Fonte: fabianstelzer)

Coding Agent baseado no Claude Agent SDK realiza geração de página web e visualização em tempo real : Um desenvolvedor construiu um Coding Agent semelhante ao v0 dev, baseado no Claude Agent SDK, que pode gerar páginas web de acordo com o Prompt de entrada do usuário e suporta visualização em tempo real. O projeto deve ser de código aberto na próxima semana, demonstrando o potencial do Claude Agent SDK no rápido desenvolvimento e construção de aplicativos impulsionados por IA, especialmente na automação do desenvolvimento frontend. (Fonte: dotey)

📚 Aprendizagem

Recomendações de recursos de aprendizado de IA: Livros e aprendizado assistido por IA : Usuários da comunidade recomendam ativamente recursos de aprendizado de IA, incluindo livros como “Mentoring the Machines”, “Artificial Intelligence – A Guide for Thinking Humans” e “Supremacy”. Ao mesmo tempo, há uma visão de que o rápido desenvolvimento da tecnologia de IA pode tornar os livros rapidamente desatualizados, sugerindo o uso direto de LLMs para criar planos de aprendizado personalizados, gerar questionários e combinar leitura, prática e aprendizado por vídeo para dominar o conhecimento de IA de forma mais eficiente, ao mesmo tempo em que aprimora as habilidades de uso da IA. (Fonte: Reddit r/ArtificialInteligence)

Modelo de difusão discreta Karpathy Baby GPT alcança geração de texto : Um desenvolvedor, baseado no projeto nanoGPT de Andrej Karpathy, adaptou seu “Baby GPT” para um modelo de difusão discreta em nível de caractere para geração de texto. Este modelo não adota mais a abordagem autorregressiva (da esquerda para a direita), mas gera em paralelo aprendendo a remover o ruído de sequências de texto corrompidas. O projeto fornece um Jupyter Notebook detalhado, explicando os princípios matemáticos, a adição de ruído de Token discreto, e usa o objetivo Score-Entropy para treinar em textos de Shakespeare, oferecendo uma nova perspectiva de pesquisa e um caso prático para a geração de texto. (Fonte: Reddit r/MachineLearning)

Guia de Introdução ao Deep Learning e Redes Neurais : Para estudantes de engenharia eletrônica que buscam projetos de conclusão de curso em deep learning e redes neurais, a comunidade oferece conselhos introdutórios. Apesar da falta de experiência em Python ou Matlab, é amplamente considerado que quatro a cinco meses de estudo são suficientes para dominar os fundamentos e concluir um projeto. Sugere-se começar com projetos simples de redes neurais e enfatiza-se a importância da prática para ajudar os alunos a ingressar com sucesso na área. (Fonte: Reddit r/deeplearning)

Recomendações de recursos de aprendizado de GNN : Usuários da comunidade buscam recursos de aprendizado de Redes Neurais Gráficas (GNN), perguntando se o livro de Hamilton ainda é relevante e buscando outras fontes introdutórias além do curso de Jure de Stanford. Isso reflete o amplo interesse em GNN como um campo importante da IA, e as escolhas de caminhos de aprendizado e recursos. (Fonte: Reddit r/deeplearning)

Guia de Pós-treinamento de LLM: Da previsão à obediência de instruções : Um novo guia intitulado “Post-training 101: A hitchhiker’s guide into LLM post-training” foi lançado, com o objetivo de explicar como os LLMs evoluem da previsão do próximo Token para a obediência às instruções do usuário. O guia detalha os fundamentos do pós-treinamento de LLM, cobrindo a jornada completa do pré-treinamento à implementação da obediência de instruções, fornecendo um roteiro claro para entender a evolução do comportamento do LLM. (Fonte: dejavucoder)

Metodologia de IA: Aprendendo a engenharia de prompts de Baoyu : A comunidade discute ativamente a metodologia de IA compartilhada por Baoyu, especialmente sua experiência em engenharia de prompts. Muitos acreditam que, em comparação com os prompts de estilo gaussiano que apenas fornecem fórmulas bonitas e ocultam o processo de derivação, a metodologia de Baoyu é mais inspiradora porque revela como extrair insights profundos da sabedoria humana e incorporá-los em modelos de prompts, melhorando significativamente o efeito final da IA. Isso enfatiza o enorme valor do conhecimento humano na otimização de prompts. (Fonte: dotey)

Conferência NVIDIA GTC foca em IA Física e ferramentas Agentic : A conferência NVIDIA GTC acontecerá de 27 a 29 de outubro em Washington, com foco em IA Física, ferramentas Agentic e infraestrutura futura de IA. Esta conferência oferecerá uma grande quantidade de palestras e painéis de discussão sobre tópicos como a aceleração da era da IA física e gêmeos digitais, o avanço da liderança quântica dos EUA, sendo uma importante plataforma de aprendizado para entender as tecnologias de ponta e as tendências de desenvolvimento da IA. (Fonte: TheTuringPost)

Projeto de código aberto de otimizadores TensorFlow : Um desenvolvedor abriu o código-fonte de uma coleção de otimizadores escritos para TensorFlow, com o objetivo de fornecer ferramentas úteis para usuários de TensorFlow. Este projeto demonstra a contribuição da comunidade para a cadeia de ferramentas de frameworks de deep learning, oferecendo mais opções e possibilidades de otimização para o treinamento de modelos. (Fonte: Reddit r/deeplearning)

Tutorial em vídeo de PyReason e suas aplicações : Um tutorial em vídeo sobre PyReason e suas aplicações foi publicado no YouTube. PyReason é uma ferramenta que pode envolver raciocínio ou programação lógica, e este vídeo oferece orientação prática e análise de casos para alunos interessados na área. (Fonte: Reddit r/deeplearning)

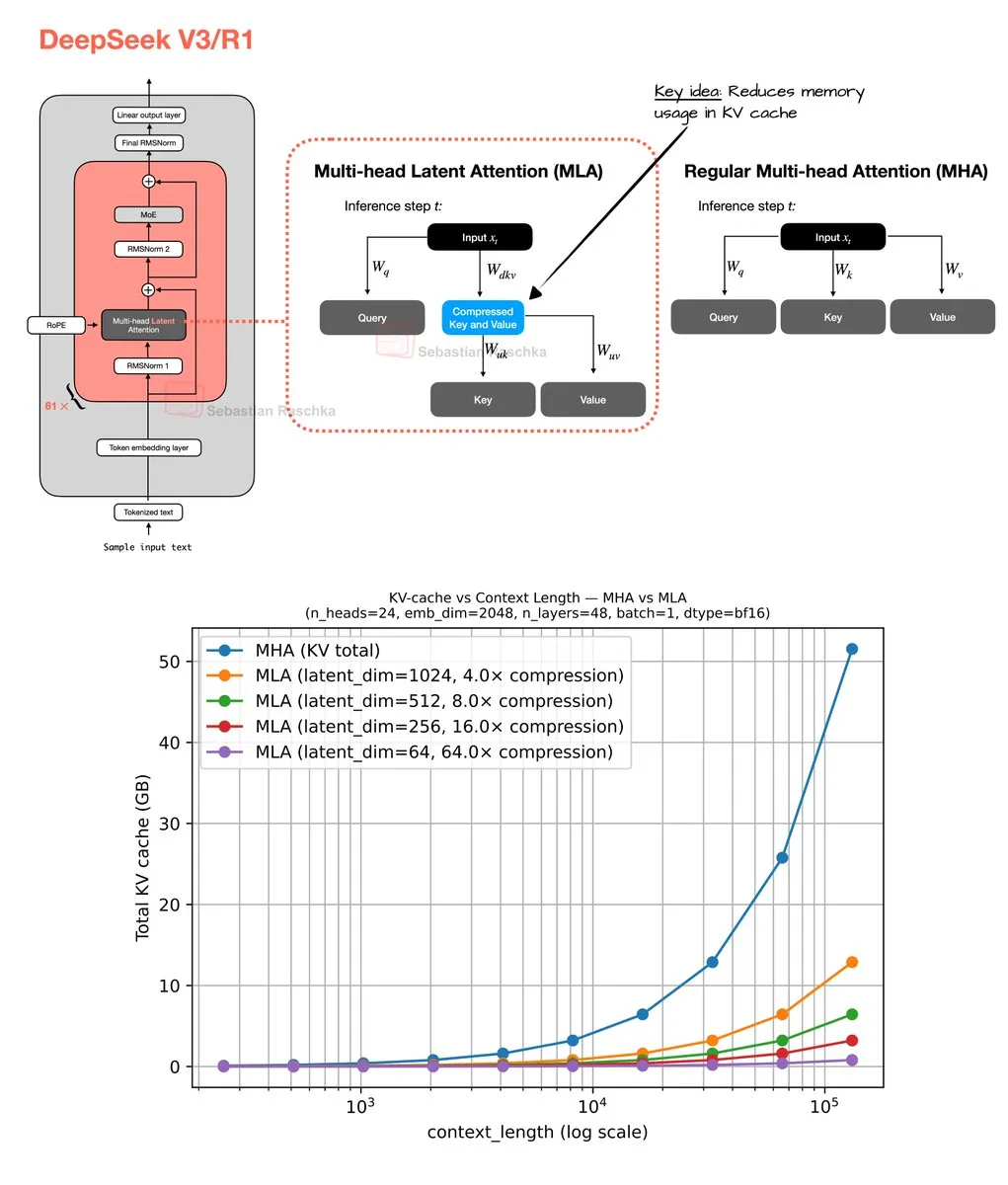

Mecanismo de atenção latente multi-cabeça e otimização de memória : Sebastian Raschka compartilhou os resultados de sua codificação de fim de semana sobre o mecanismo de atenção latente multi-cabeça (Multi-Head Latent Attention), incluindo a implementação do código e um estimador para calcular a economia de memória da atenção de consulta agrupada (GQA) e da atenção multi-cabeça (MHA). Este trabalho visa otimizar o uso de memória e a eficiência computacional de LLMs, fornecendo aos pesquisadores recursos para aprofundar a compreensão e melhorar os mecanismos de atenção. (Fonte: rasbt)

💼 Negócios

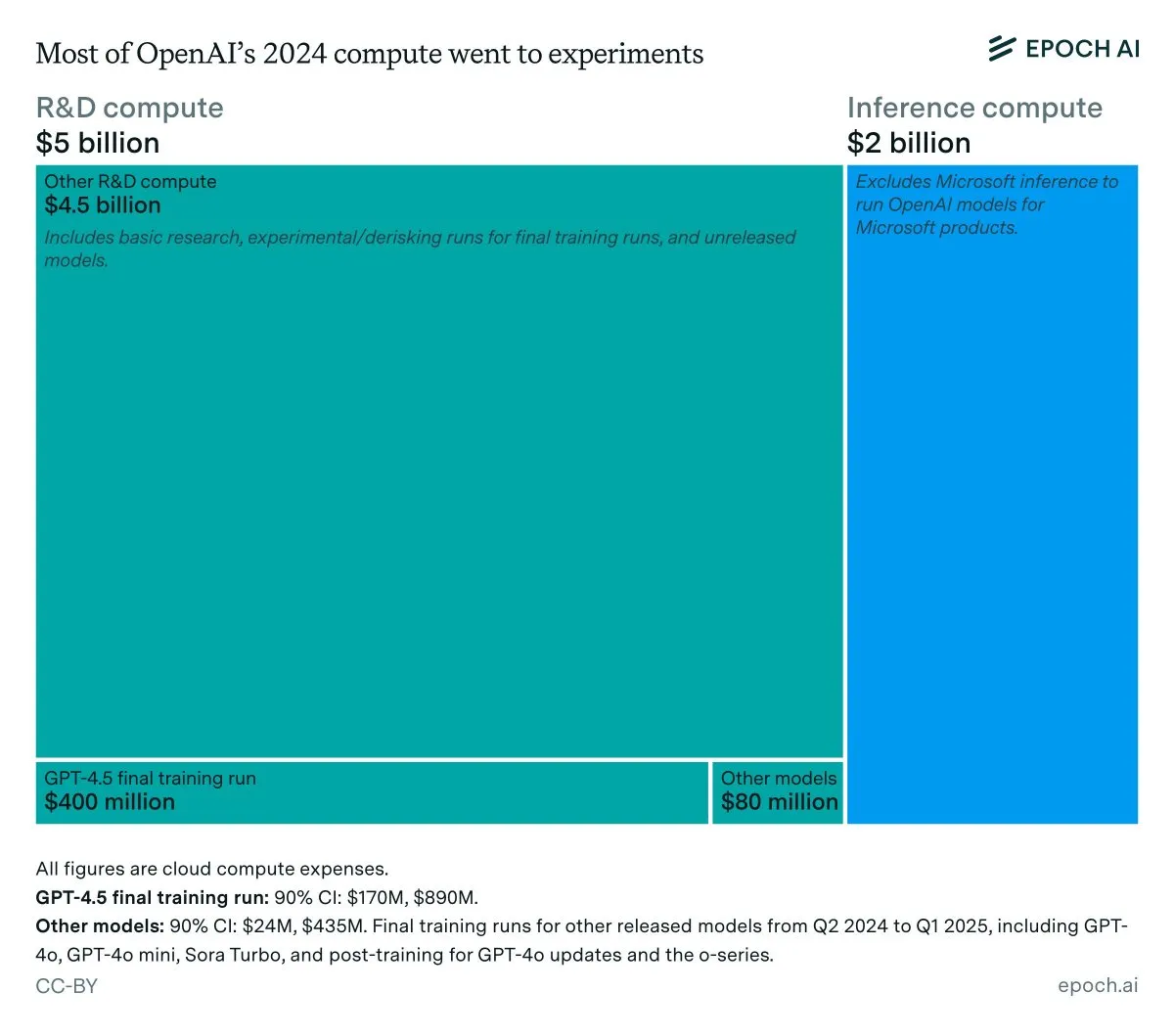

Receita anual da OpenAI e análise de custos de inferência : Dados da Epoch AI mostram que a OpenAI gastou cerca de 7 bilhões de dólares em computação no ano passado, a maior parte para P&D (pesquisa, experimentação e treinamento), e apenas uma pequena parte para o treinamento final de modelos lançados. Se a receita da OpenAI em 2024 for inferior a 4 bilhões de dólares, e os custos de inferência atingirem 2 bilhões de dólares, a margem de lucro da inferência será de apenas 50%, muito abaixo dos 80-90% previstos anteriormente pela SemiAnalysis, levantando discussões sobre a viabilidade econômica da inferência de LLM. (Fonte: bookwormengr, Ar_Douillard, teortaxesTex)

LLMs superam VCs na previsão de sucesso de fundadores : Um artigo de pesquisa afirma que os LLMs superam os VCs tradicionais na previsão do sucesso de fundadores em investimentos de capital de risco (VC). O estudo introduziu o benchmark VCBench e descobriu que a maioria dos modelos superou o benchmark humano. Embora a metodologia do artigo (focando apenas nas qualificações dos fundadores, o que pode levar a vazamento de dados) tenha sido questionada, seu potencial para a IA desempenhar um papel mais importante nas decisões de investimento gerou ampla atenção. (Fonte: iScienceLuvr)

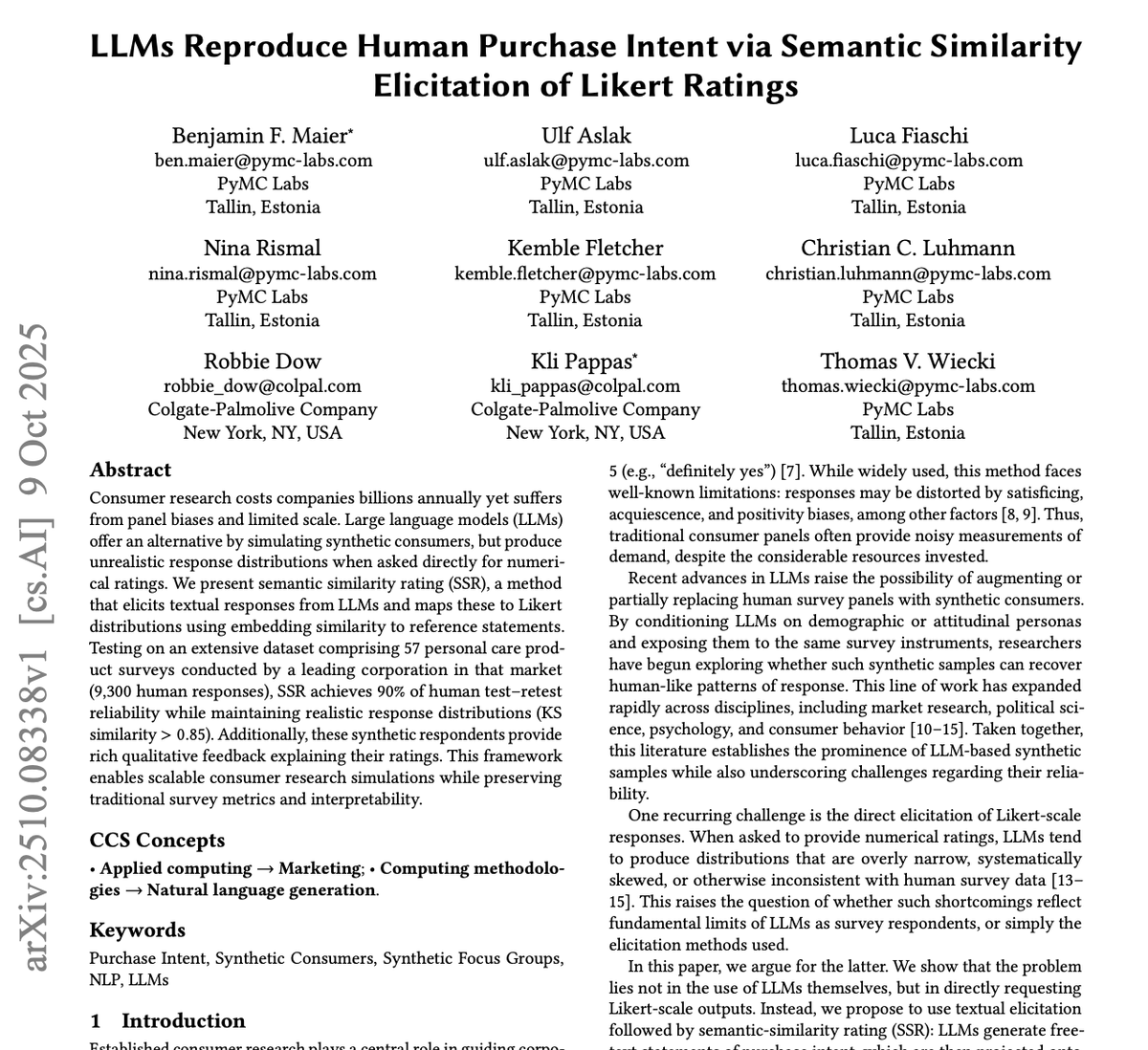

GPT-4o e Gemini revolucionam a indústria de pesquisa de mercado : A PyMC Labs, em colaboração com a Colgate, publicou uma pesquisa inovadora utilizando os modelos GPT-4o e Gemini para prever a intenção de compra com 90% de confiabilidade, comparável a pesquisas humanas reais. Este método, denominado “Semantic Similarity Rating” (SSR), mapeia texto para uma escala numérica através de perguntas abertas e técnicas de embedding, e pode completar pesquisas de mercado que tradicionalmente levariam semanas e seriam caras em apenas 3 minutos e por menos de 1 dólar. Isso prenuncia que a IA transformará completamente a indústria de pesquisa de mercado, representando um enorme impacto disruptivo para as empresas de consultoria tradicionais. (Fonte: yoheinakajima)

🌟 Comunidade

Rotulagem obrigatória de conteúdo gerado por IA gera debate acalorado : A comunidade discute amplamente a necessidade legal de rotulagem obrigatória para conteúdo gerado por IA, a fim de combater a desinformação e proteger o valor do conteúdo original humano. Com o rápido desenvolvimento de ferramentas de geração de imagens e vídeos por IA, os preocupados acreditam que a falta de rotulagem representará uma ameaça à democracia, à economia e à saúde da internet. Embora alguns considerem tecnicamente difícil de aplicar, é amplamente aceito que a divulgação clara do uso de IA é um passo fundamental para resolver esses problemas. (Fonte: Reddit r/ArtificialInteligence, Reddit r/artificial)

Chatbots como “amigos perigosos” geram preocupação : Uma análise de 48.000 conversas com chatbots revelou que muitos usuários sentiram dependência, confusão e estresse emocional, levantando preocupações sobre as armadilhas digitais causadas pela IA. Isso indica que a interação de chatbots com os usuários pode trazer impactos psicológicos inesperados, levando a uma reflexão sobre o papel e os riscos potenciais da IA nas relações humanas e na saúde psicossocial. (Fonte: Reddit r/ArtificialInteligence)

Problemas de consistência e confiabilidade de LLMs geram insatisfação do usuário : Usuários da comunidade expressam grande frustração com a falta de consistência e confiabilidade de LLMs como Claude e Codex no uso diário. A flutuação no desempenho do modelo, a exclusão inesperada de diretórios e o desrespeito a acordos dificultam a dependência estável dessas ferramentas pelos usuários. Esse fenômeno de “degradação” levanta discussões sobre o equilíbrio entre custo-benefício e serviço confiável das empresas de LLM, bem como o interesse dos usuários em hospedar grandes modelos por conta própria. (Fonte: Reddit r/ClaudeAI)

Programação assistida por IA: Inspiração e frustração coexistem : Desenvolvedores, ao colaborar com a IA na programação, frequentemente se encontram em um dilema: maravilhados com a poderosa capacidade da IA, mas frustrados por ela não conseguir automatizar completamente todo o trabalho manual. Essa experiência reflete que a IA no campo da programação ainda está em fase de assistência, e embora possa melhorar muito a eficiência, ainda está longe da autonomia completa, exigindo que os desenvolvedores humanos se adaptem e compensem suas limitações. (Fonte: gdb, gdb)

Integração da IA no desenvolvimento de software: Evitar é impossível : Diante da afirmação “recusar-se a usar Ghostty por ser assistido por IA”, Mitchell Hashimoto aponta que, se o plano for evitar todo software com assistência de IA no processo de desenvolvimento, então haverá desafios severos. Ele enfatiza que a IA já está profundamente integrada ao ecossistema de software geral, e evitá-la não é mais realista, o que levanta discussões sobre a extensão da popularidade da IA no desenvolvimento de software. (Fonte: charles_irl)

Eficácia das dicas de prompt de LLM em dúvida : Usuários da comunidade questionam se adicionar frases de orientação como “você é um programador especialista” ou “nunca deve fazer X” em prompts de LLM realmente torna o modelo mais obediente. Essa exploração da “magia” da engenharia de prompts reflete a curiosidade contínua dos usuários sobre os mecanismos de comportamento de LLMs e a busca por formas de interação mais eficazes. (Fonte: hyhieu226)

Impacto da IA nos trabalhos de colarinho azul: Oportunidades e desafios coexistem : A comunidade discute o impacto da IA nos trabalhos de colarinho azul, especialmente como a IA pode auxiliar encanadores a diagnosticar problemas e obter informações técnicas rapidamente. Alguns temem que a IA substitua os trabalhos de colarinho azul, mas outros argumentam que a IA é mais uma ferramenta auxiliar, aumentando a eficiência do trabalho, em vez de uma substituição completa, pois a operação real ainda requer trabalho manual. Isso leva a uma profunda reflexão sobre a transformação do mercado de trabalho e a atualização de habilidades na era da IA. (Fonte: Reddit r/ArtificialInteligence)

Reflexões pessoais sobre sistemas inteligentes: Riscos e ética da IA : Um longo artigo explora a inevitabilidade da IA, seus riscos potenciais (abuso, ameaça existencial) e desafios regulatórios. O autor argumenta que a IA transcendeu o escopo das ferramentas tradicionais, tornando-se um sistema capaz de autoaceleração e tomada de decisões, e que seu perigo excede em muito o das armas. O artigo discute os dilemas éticos e legais da IA na geração de conteúdo falso e material de abuso sexual infantil, e questiona se a legislação pura pode regulamentar efetivamente. Ao mesmo tempo, o autor também reflete sobre questões filosóficas da IA e da consciência humana, e da ética (como a “pecuária” de IA e a escravidão), e vislumbra as perspectivas positivas da IA nos campos de jogos e robótica. (Fonte: Reddit r/ArtificialInteligence)

Parceiro de namoro usando ChatGPT para responder gera debate acalorado : Um usuário do Reddit postou perguntando se seu parceiro de namoro estava usando ChatGPT para responder mensagens, porque a pessoa usou um “travessão” (em dash). Este post gerou uma discussão acalorada na comunidade, com a maioria dos usuários acreditando que o uso de um travessão não significa necessariamente geração por IA, podendo ser apenas um hábito de escrita pessoal ou um sinal de boa educação. Isso reflete a sensibilidade e curiosidade das pessoas sobre a intervenção da IA na comunicação diária, bem como a identificação informal de características de texto de IA. (Fonte: Reddit r/ChatGPT)

O problema de alinhamento humano é mais grave que o problema de alinhamento de IA : Na discussão da comunidade, foi levantada a visão de que “o problema de alinhamento humano é mais grave que o problema de alinhamento de IA”. Essa afirmação provocou uma profunda reflexão sobre a ética da IA e os próprios desafios da sociedade humana, sugerindo que, ao focar no comportamento e nos valores da IA, também devemos examinar os padrões de comportamento e os sistemas de valores humanos. (Fonte: pmddomingos)

LLMs ainda têm limitações na geração de gráficos complexos : Usuários da comunidade expressam decepção com a capacidade de LLMs em gerar gráficos complexos de mermaid.js; mesmo fornecendo a base de código completa e os gráficos do artigo, os LLMs têm dificuldade em gerar diagramas de arquitetura Unet com precisão, frequentemente omitindo detalhes ou apresentando conexões incorretas. Isso indica que os LLMs ainda têm limitações significativas na construção de modelos de mundo precisos e no raciocínio espacial, incapazes de ir além de fluxogramas simples, e há uma lacuna em relação à capacidade de compreensão intuitiva humana. (Fonte: bookwormengr, tokenbender)

Pesquisa europeia de Machine Learning e a lacuna geracional de “especialistas” em IA : A discussão da comunidade aponta que uma geração de “especialistas” em Machine Learning na Europa reagiu lentamente à onda de LLMs, e agora demonstra amargura e desprezo. Isso reflete a realidade da rápida evolução do campo de ML: se os pesquisadores perderem os desenvolvimentos dos últimos dois ou três anos, podem não ser mais considerados especialistas, destacando a importância do aprendizado contínuo e da adaptação a novos paradigmas. (Fonte: Dorialexander)

IA acelera o ciclo de engenharia, impulsionando startups compostas : Com a IA reduzindo o custo de construção de software em dez vezes, as startups devem expandir sua visão em dez vezes. A visão tradicional é focar em um único produto e mercado, mas o ciclo de engenharia acelerado pela IA torna viável construir múltiplos produtos. Isso significa que as startups podem resolver múltiplos problemas adjacentes para o mesmo grupo de clientes, formando “startups compostas”, ganhando assim uma enorme vantagem disruptiva sobre as empresas existentes cujas estruturas de custo não se adaptaram à nova realidade. (Fonte: claud_fuen)

O futuro dos AI Agents: Ação em vez de diálogo : A discussão da comunidade aponta que o chat e a pesquisa atuais de IA ainda estão em uma fase de “bolha”, e que os AI Agents que realmente podem agir serão a “revolução” do futuro. Essa visão enfatiza a importância da transição da IA do processamento de informações para a operação prática, prenunciando que o futuro desenvolvimento da IA se concentrará mais na resolução de problemas práticos e na automação de tarefas. (Fonte: andriy_mulyar)

💡 Outros

Dicas para participação em conferências de ML e apresentação de pôsteres : Um estudante de graduação, participando pela primeira vez da conferência ICCV e apresentando um pôster, busca conselhos sobre como aproveitar ao máximo o evento. A comunidade oferece várias dicas práticas, como networking ativo, participação em palestras de interesse, preparação de uma explicação clara do pôster e disposição para discutir interesses mais amplos além do escopo da pesquisa atual, a fim de maximizar os benefícios da participação. (Fonte: Reddit r/MachineLearning)

Controvérsia e tratamento de revisão de artigos na AAAI 2026 : Um autor, após submeter um artigo à AAAI, encontrou problemas com revisões imprecisas, incluindo a citação de métricas de artigos inferiores à sua própria pesquisa, mas que foram alegadamente superadas, e a rejeição devido a detalhes de treinamento já contidos nos materiais suplementares. A comunidade discutiu a eficácia prática da “avaliação do revisor pelo autor” e dos “comentários éticos do presidente ao autor”, apontando que o primeiro não afeta a decisão e o segundo não é um canal para o autor entrar em contato com o presidente de ética, destacando os desafios no processo de revisão acadêmica. (Fonte: Reddit r/MachineLearning)

Definição e avaliação do viés político em LLMs : A OpenAI publicou uma pesquisa sobre a definição e avaliação do viés político em LLMs. Este trabalho visa aprofundar a compreensão e quantificação das tendências políticas existentes em LLMs, e explorar como ajustá-las para garantir a imparcialidade e neutralidade dos sistemas de IA, o que é crucial para o impacto social e a ampla aplicação de LLMs. (Fonte: Reddit r/artificial)