Palavras-chave:Meta, Tencent Hunyuan Imagem 3.0, xAI Grok 4 Fast, OpenAI Sora 2, ByteDance Self-Forcing++, Alibaba Qwen, vLLM, GPT-5-Pro, Mecanismo de Reutilização de Metacognição, Mecanismo de Atenção Causal Generalizado, Modelo de Raciocínio Multimodal, Geração de Vídeo em Minutos, Geração de Moda com Consciência de Pose

🔥 Destaque

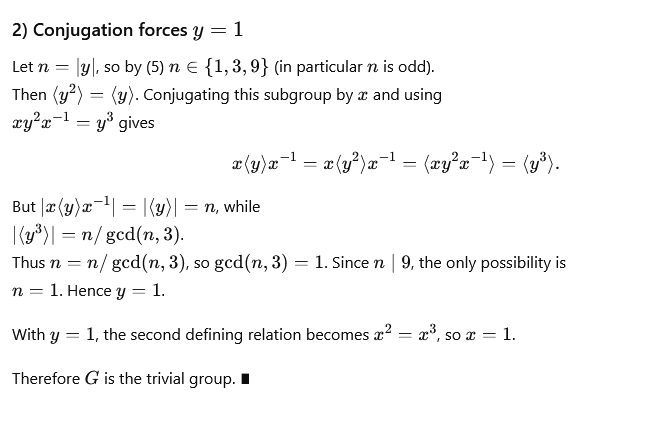

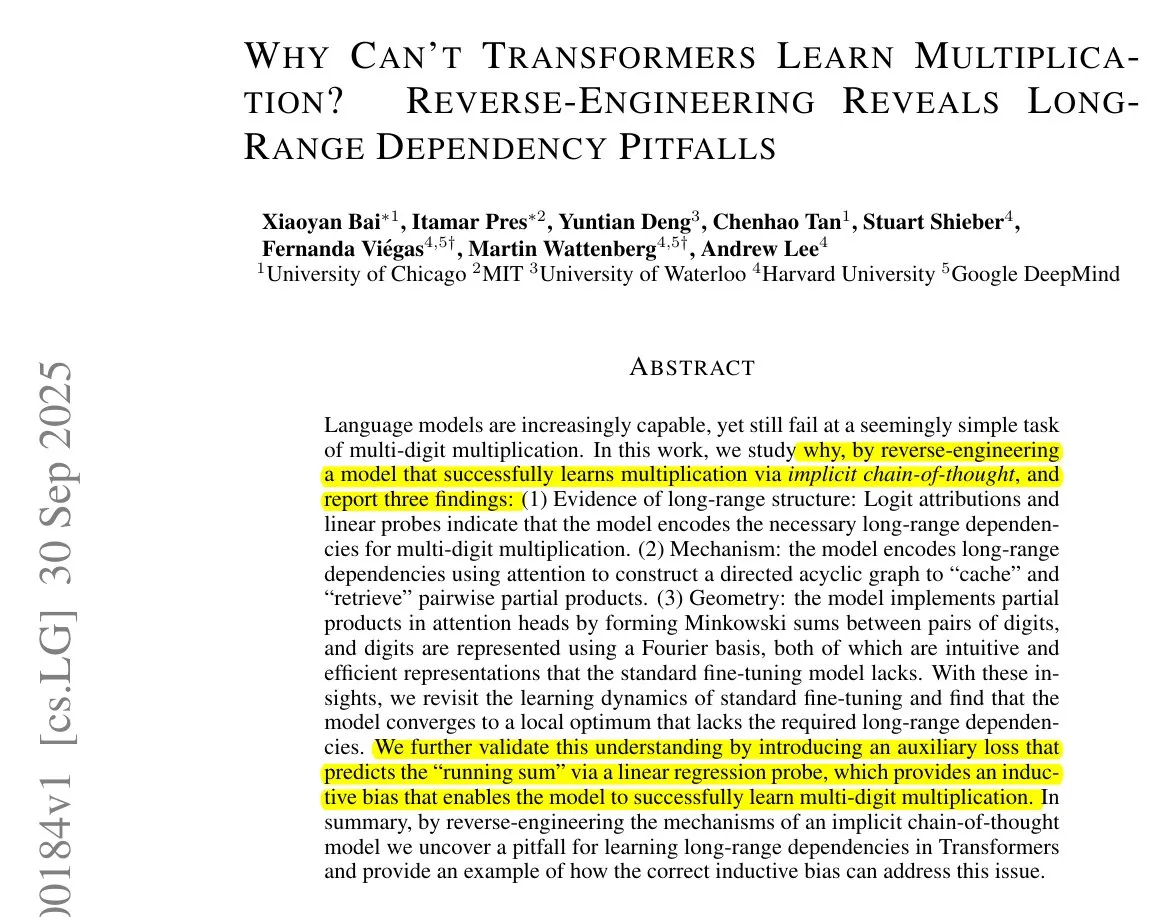

Novo método da Meta encurta cadeia de pensamento, eliminando deduções repetitivas : Meta, Mila-Quebec AI Institute e outros propuseram em conjunto o mecanismo de “reutilização metacognitiva”, com o objetivo de resolver o problema de inflação de token e aumento de latência causados por deduções repetitivas na inferência de grandes modelos. Este mecanismo permite que o modelo revise e resuma as abordagens de resolução de problemas, destilando padrões de inferência comuns em “comportamentos” armazenados em um “manual de comportamentos”, que podem ser invocados diretamente quando necessário, sem a necessidade de uma nova dedução. Experimentos mostram que, em benchmarks de matemática como MATH e AIME, este mecanismo pode reduzir o uso de token de inferência em até 46%, mantendo a precisão, e melhorando a eficiência do modelo e a capacidade de explorar novos caminhos. (Fonte: 量子位)

Tencent Hunyuan Image 3.0 alcança o topo do ranking global de geração de imagens por IA : Tencent Hunyuan Image 3.0 ficou em primeiro lugar no ranking de texto para imagem da arena LMArena, superando Google Nano Banana, ByteDance Seedream e OpenAI gpt-Image. O modelo adota uma arquitetura multimodal nativa, baseada em Hunyuan-A13B, com mais de 80 bilhões de parâmetros no total, capaz de processar unificadamente múltiplas modalidades como texto, imagens, vídeo e áudio, possuindo forte compreensão semântica, raciocínio de modelo de linguagem e capacidade de inferência de conhecimento do mundo. Suas tecnologias centrais incluem o mecanismo de atenção causal generalizada e codificação de posição bidimensional, e introduz a previsão automática de resolução. O modelo constrói dados através de um sistema de filtragem de três estágios e descrição hierárquica, e adota uma estratégia de treinamento progressivo de quatro estágios, melhorando efetivamente o realismo e a clareza das imagens geradas. (Fonte: 量子位)

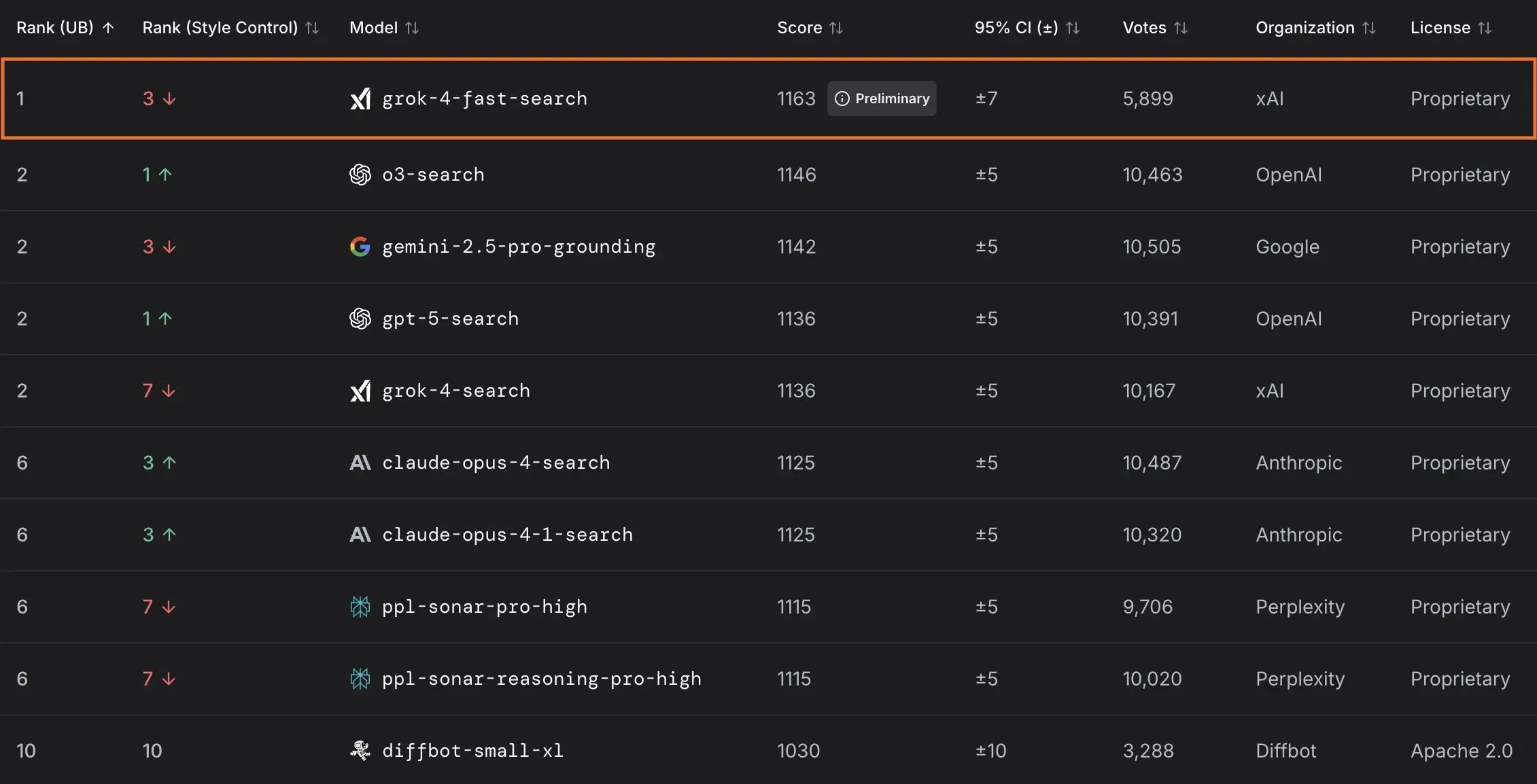

xAI lança modelo Grok 4 Fast e colabora com o governo dos EUA : A xAI lançou o Grok 4 Fast, um modelo de inferência multimodal com uma janela de contexto de 2M, projetado para fornecer serviços inteligentes de alto custo-benefício. O modelo já está disponível gratuitamente para todos os usuários e, através de uma parceria com o governo federal dos EUA, oferece acesso gratuito aos seus modelos de IA de ponta (Grok 4, Grok 4 Fast) por 18 meses a todas as agências federais, além de enviar equipes de engenheiros para auxiliar o governo a utilizar a IA. Além disso, a xAI também lançou o OpenBench para avaliar o desempenho e a segurança de LLMs, e apresentou o Grok Code Fast 1, que se destaca em tarefas de codificação. (Fonte: xai, xai, xai, JonathanRoss321)

🎯 Tendências

OpenAI anuncia produtos de IA para consumidores e atualizações do Sora 2 : A UBS prevê que a conferência de desenvolvedores da OpenAI focará no lançamento de produtos de IA para consumidores, que podem incluir agentes de IA para reservas de viagens. Ao mesmo tempo, o modelo de geração de vídeo Sora 2 está em fase de testes, e os usuários descobriram que seu conteúdo gerado frequentemente apresenta senso de humor. A OpenAI também corrigiu o problema de resolução no modo HD do modelo Sora 2 Pro, que agora suporta resoluções de 17921024 ou 10241792, e permite a geração de vídeos de até 15 segundos, mas o limite diário de geração foi reduzido para 30 vezes. (Fonte: teortaxesTex, francoisfleuret, fabianstelzer, TomLikesRobots, op7418, Reddit r/ChatGPT)

ByteDance lança modelo de geração de vídeo de minutos : A ByteDance lançou um novo método chamado Self-Forcing++, capaz de gerar vídeos de alta qualidade com até 4 minutos e 15 segundos. Este método permite estender modelos de difusão sem a necessidade de um modelo de vídeo longo ou retreinamento, mantendo a fidelidade e a consistência dos vídeos gerados. (Fonte: _akhaliq)

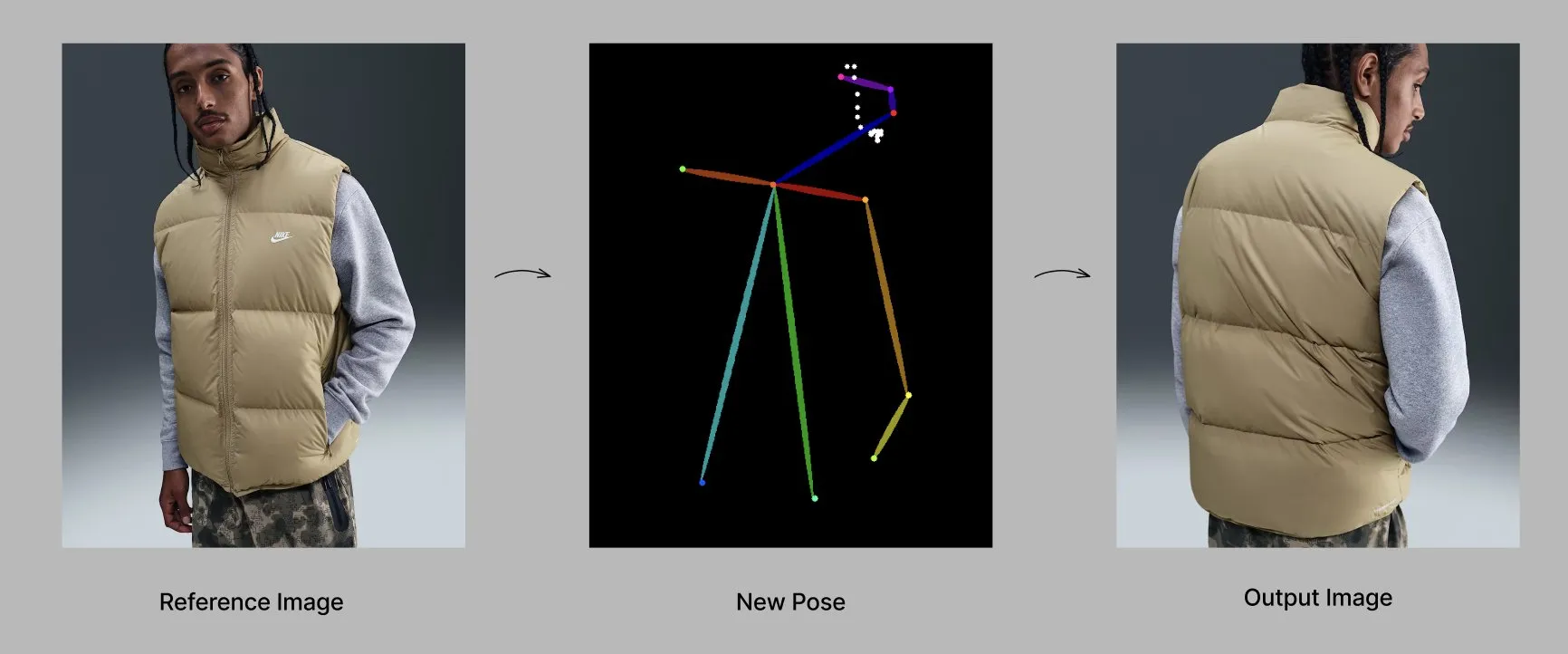

Modelo Qwen lança novas funcionalidades e aplicações : A equipe Qwen da Alibaba está gradualmente lançando funcionalidades personalizadas, como memória e instruções de sistema personalizadas, atualmente em testes limitados. Ao mesmo tempo, o modelo Qwen-Image-Edit-2509 demonstra capacidades avançadas na geração de moda com percepção de pose, permitindo a criação de modelos de moda de alta qualidade e múltiplos ângulos através de ajuste fino. (Fonte: Alibaba_Qwen, Alibaba_Qwen)

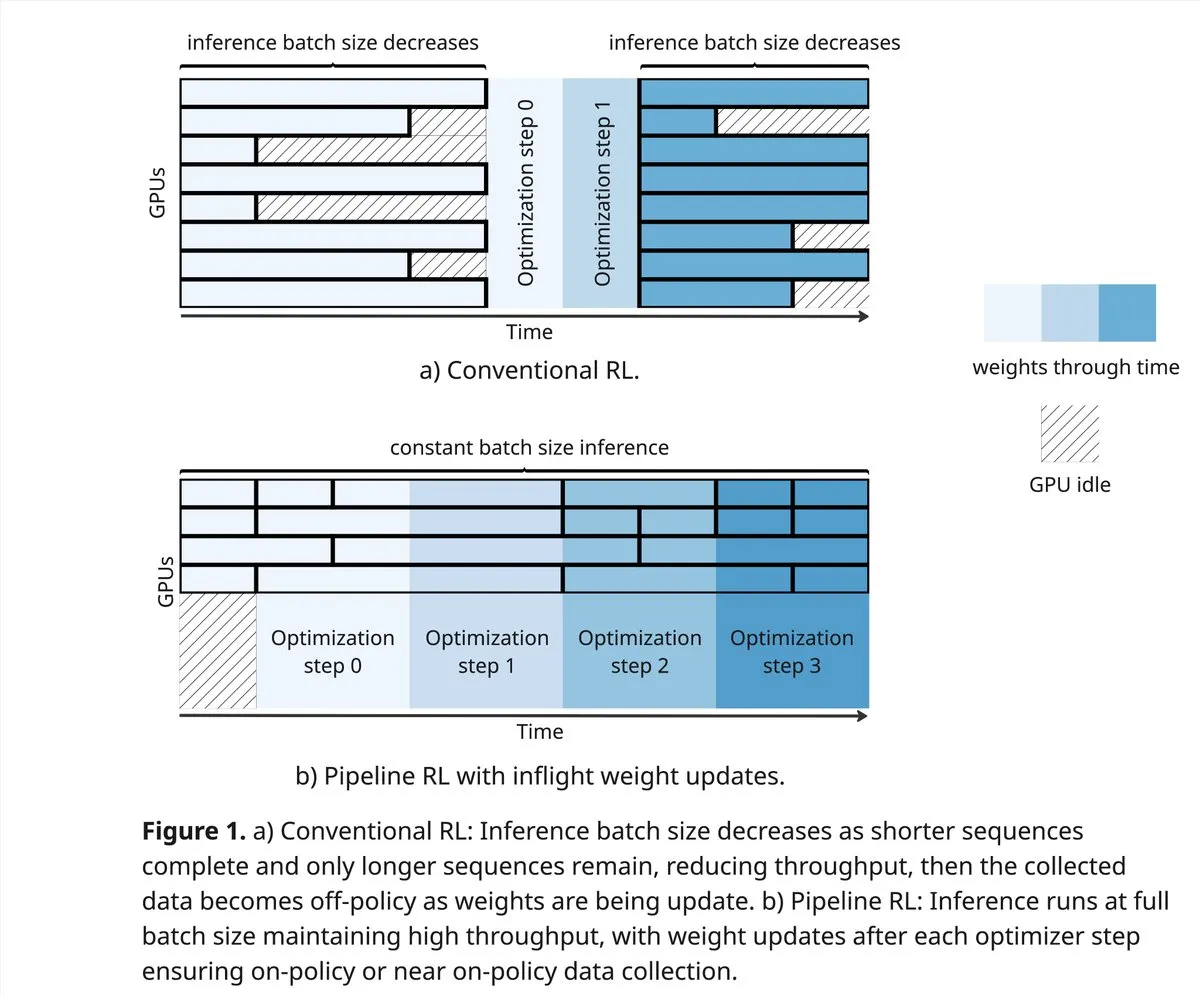

vLLM e PipelineRL impulsionam os limites da comunidade RL : O projeto vLLM apoia a comunidade RL em novas descobertas no campo do aprendizado por reforço, incluindo melhores dados on-policy, rollouts parciais e atualizações de peso in-flight que misturam o cache KV durante a inferência. O PipelineRL alcança RL assíncrono escalável e suporta atualizações de peso in-flight, continuando a inferência enquanto as mudanças de peso e o estado KV permanecem inalterados. (Fonte: vllm_project, Reddit r/LocalLLaMA)

GPT-5-Pro resolve problemas matemáticos complexos : O GPT-5-Pro resolveu de forma independente o “554º problema de Yu Tsumura” em 15 minutos, sendo o primeiro modelo a completar esta tarefa, demonstrando sua poderosa capacidade de resolução de problemas matemáticos. (Fonte: Teknium1)

SAP posiciona a IA como o núcleo dos fluxos de trabalho empresariais : A SAP planeja apresentar sua visão de colocar a IA no centro dos fluxos de trabalho empresariais na conferência Connect 2025, transformando dados em tempo real em decisões através de IA integrada e utilizando AI agents para operações proativas. A SAP enfatiza a construção de confiança e o fornecimento de suporte proativo desde o início, garantindo flexibilidade e conformidade na localização. (Fonte: TheRundownAI)

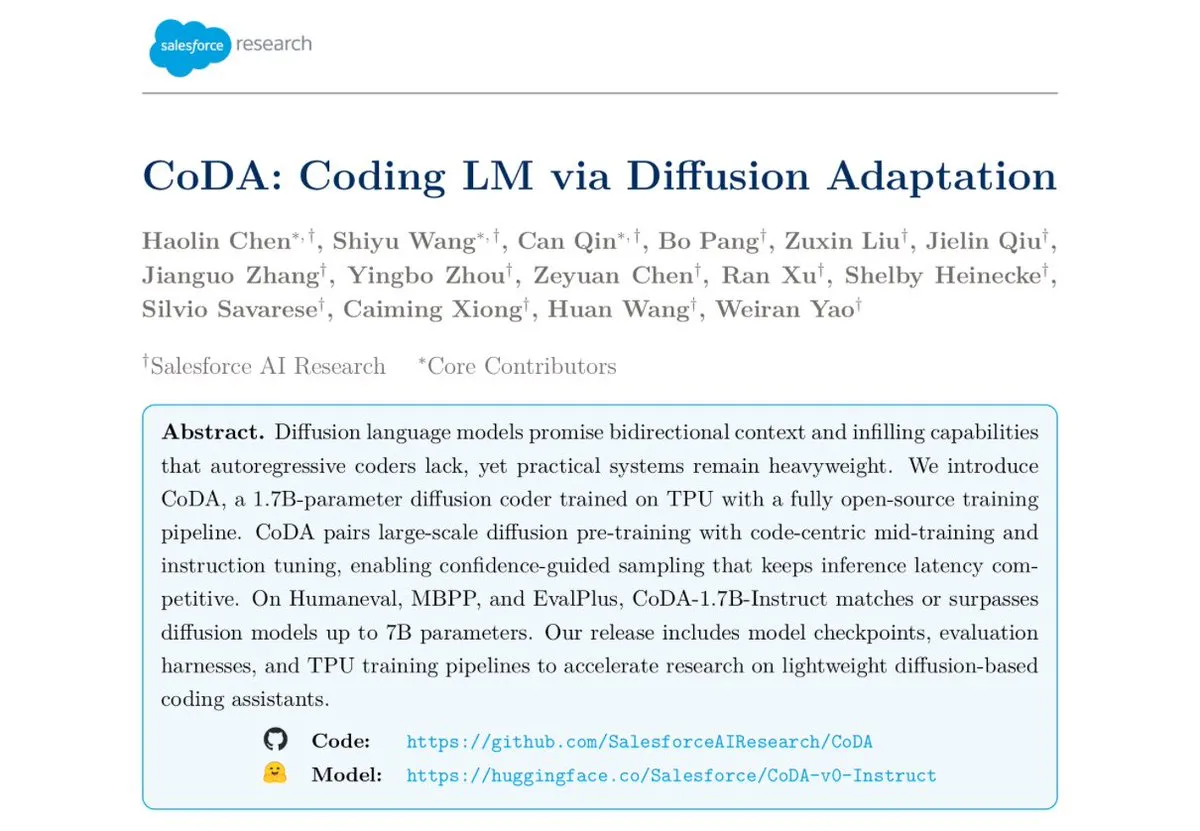

Salesforce lança modelo de codificação de difusão de texto CoDA-1.7B : A Salesforce Research lançou o CoDA-1.7B, um modelo de codificação de difusão de texto capaz de gerar tokens bidirecionalmente e em paralelo. Este modelo é mais rápido em inferência, com 1.7B parâmetros, e pode rivalizar com modelos de 7B, destacando-se em benchmarks como HumanEval, HumanEval+ e EvalPlus. (Fonte: ClementDelangue)

Google Gemini 3.0 foca em EQ, intensificando a concorrência com a OpenAI : O Google está prestes a lançar o Gemini 3.0, que supostamente focará na “inteligência emocional” (EQ), sendo visto como um forte desafio para a OpenAI. Este movimento indica o desenvolvimento de modelos de IA na compreensão emocional e interação, prenunciando uma escalada na competição entre os gigantes da IA. (Fonte: Reddit r/ChatGPT)

Desenvolvimento de robótica e tecnologia de automação : O campo da robótica continua a inovar, incluindo robôs humanoides móveis omnidirecionais para operações logísticas, serviços de entrega por robôs móveis autônomos que combinam braços mecânicos e armários, e o robô-cão “Cara” de 12 motores, projetado por estudantes americanos usando acionamento por corda e matemática engenhosa. Além disso, o primeiro robô “Wuji Hand” também foi oficialmente lançado. (Fonte: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 Ferramentas

Projeto GPT4Free (g4f) oferece LLMs e ferramentas de geração de mídia gratuitas : GPT4Free (g4f) é um projeto impulsionado pela comunidade que visa integrar vários LLMs acessíveis e modelos de geração de mídia, oferecendo um cliente Python, GUI Web local, REST API compatível com OpenAI e cliente JavaScript. Ele suporta adaptadores de múltiplos provedores, incluindo OpenAI, PerplexityLabs, Gemini, MetaAI, entre outros, e suporta geração de imagem/áudio/vídeo e persistência de mídia, dedicando-se a popularizar o acesso aberto a ferramentas de IA. (Fonte: GitHub Trending)

Design de ferramentas LLM e melhores práticas de Prompt engineering : Ao escrever ferramentas que a IA possa entender mais facilmente, a prioridade é, em ordem, a definição da ferramenta, as instruções do sistema e os prompts do usuário. O nome e a descrição da ferramenta são cruciais, devendo ser intuitivos, claros e evitar ambiguidades. Os parâmetros devem ser os mínimos possíveis, e devem ser fornecidos itens de enumeração ou limites superior e inferior. Evite usar parâmetros estruturados excessivamente aninhados para melhorar a velocidade de resposta. Ao permitir que o modelo escreva Prompts e forneça feedback, a compreensão das ferramentas pelos grandes modelos pode ser efetivamente aprimorada. (Fonte: dotey)

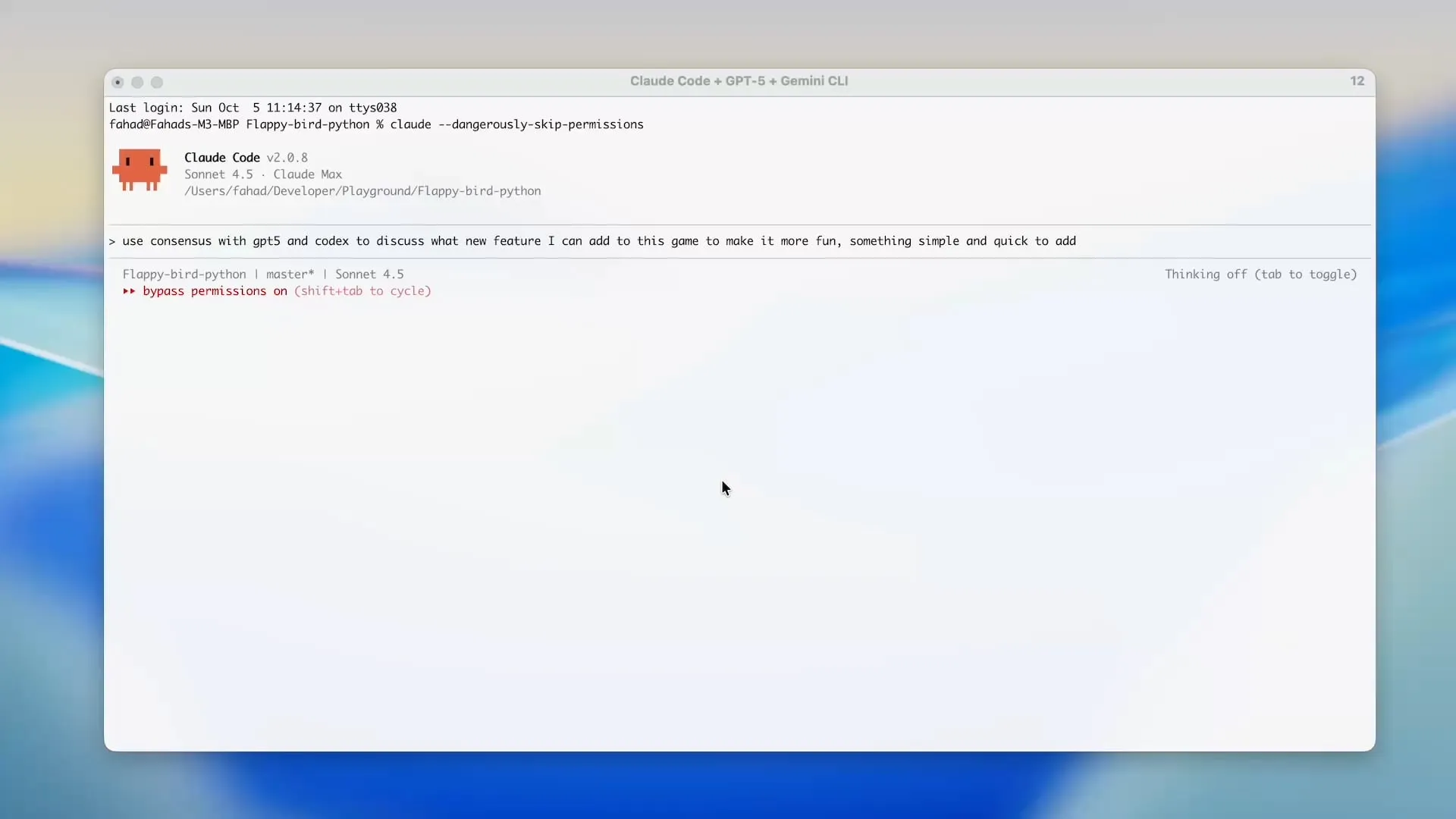

Zen MCP usa Gemini CLI para economizar créditos do Claude Code : O projeto Zen MCP permite que os usuários usem diretamente o Gemini CLI em ferramentas como Claude Code, reduzindo significativamente o uso de token do Claude Code e aproveitando os créditos gratuitos do Gemini. A ferramenta suporta a delegação de tarefas entre diferentes modelos de IA e mantém um contexto compartilhado, por exemplo, usando GPT-5 para planejamento, Gemini 2.5 Pro para revisão, Sonnet 4.5 para implementação, e então o Gemini CLI para revisão de código e testes unitários, alcançando um desenvolvimento assistido por IA eficiente e econômico. (Fonte: Reddit r/ClaudeAI)

Opik: Ferramenta de avaliação de LLM de código aberto : Opik é uma ferramenta de avaliação de LLM de código aberto, usada para depurar, avaliar e monitorar aplicações LLM, sistemas RAG e fluxos de trabalho Agentic. Ela oferece rastreamento abrangente, avaliação automatizada e um painel pronto para produção, ajudando os desenvolvedores a entender e otimizar melhor seus modelos de IA. (Fonte: dl_weekly)

Claude Sonnet 4.5 se destaca na escrita de scripts Tampermonkey : Claude Sonnet 4.5 se destaca na escrita de scripts Tampermonkey; os usuários podem mudar o tema do Google AI Studio com apenas um prompt, demonstrando sua poderosa capacidade em automação de navegador e personalização de interface de usuário. (Fonte: Reddit r/ClaudeAI)

Implantação local do modelo Phi-3-mini : Usuários buscam implantar o modelo Phi-3-mini-4k-instruct-bnb-4bit, ajustado usando Unsloth no Google Colab, em máquinas locais. O modelo pode extrair resumos e analisar campos de texto; o objetivo da implantação é ler texto de um DataFrame localmente, processá-lo através do modelo e salvar a saída em um novo DataFrame, mesmo em ambientes de baixa configuração com placa gráfica integrada e 8GB de RAM. (Fonte: Reddit r/MachineLearning)

Comparação de desempenho de backends LLM : A comunidade discute o desempenho dos frameworks de backend LLM atuais, com vLLM, llama.cpp e ExLlama3 sendo considerados as opções mais rápidas, enquanto Ollama é considerado o mais lento. vLLM se destaca no tratamento de múltiplos chats concorrentes, llama.cpp é favorecido por sua flexibilidade e amplo suporte de hardware, e ExLlama3 oferece desempenho extremo para NVIDIA GPU, mas com suporte limitado a modelos. (Fonte: Reddit r/LocalLLaMA)

Ferramenta “solveit” ajuda programadores a lidar com desafios de IA : Em resposta à frustração que os programadores podem sentir ao usar IA, Jeremy Howard lançou a ferramenta “solveit”. A ferramenta visa ajudar os programadores a utilizar a IA de forma mais eficaz, evitando serem guiados em direções erradas pela IA, e melhorando a experiência e eficiência de programação. (Fonte: jeremyphoward)

📚 Aprendizagem

Stanford e NVIDIA colaboram para avançar benchmarks de IA encarnada : A Universidade de Stanford e a NVIDIA farão uma transmissão ao vivo conjunta para aprofundar o BEHAVIOR, um benchmark e desafio em larga escala para o avanço da IA encarnada. A discussão abordará a motivação do BEHAVIOR, o design dos próximos desafios e o papel da simulação no impulsionamento da pesquisa em robótica. (Fonte: drfeifei)

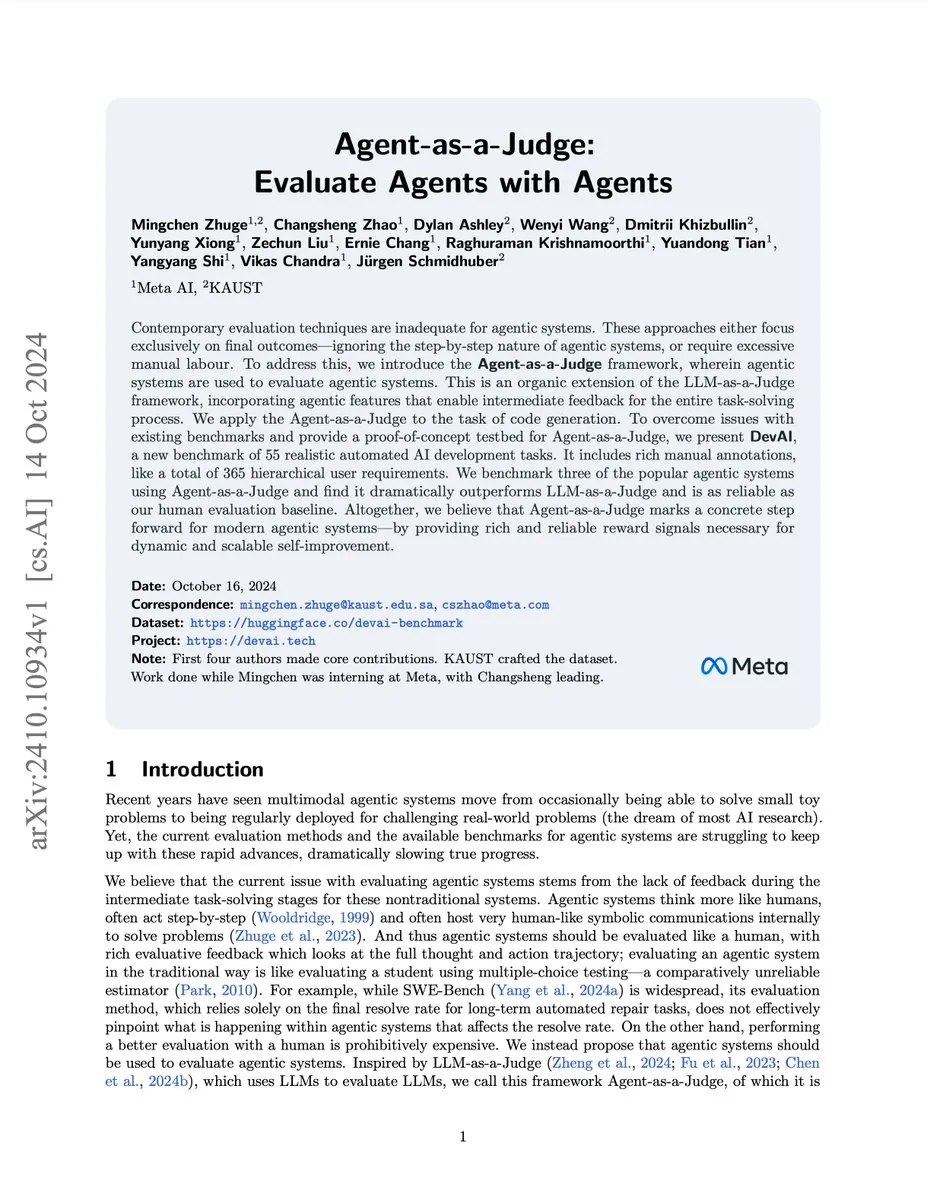

Publicado artigo sobre avaliação de agentes de IA com Agent-as-a-Judge : Um novo artigo intitulado “Agent-as-a-Judge” propõe um método de prova de conceito para avaliar agentes de IA por meio de agentes de IA, que pode reduzir custos e tempo em 97% e fornecer feedback intermediário rico. A pesquisa também desenvolveu o benchmark DevAI, que contém 55 tarefas de desenvolvimento de IA automatizadas, provando que o Agent-as-a-Judge não só supera o LLM-as-a-Judge, mas também se aproxima mais da avaliação humana em eficiência e precisão. (Fonte: SchmidhuberAI, SchmidhuberAI)

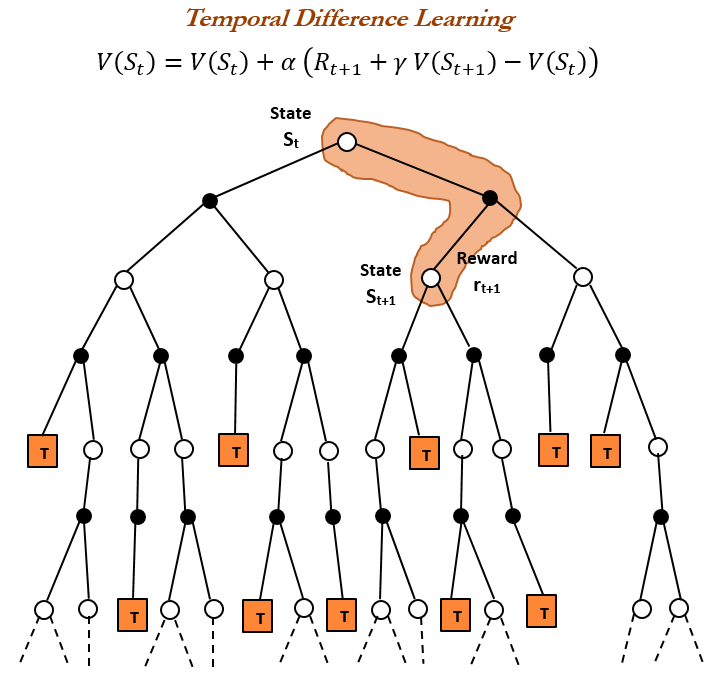

História do Aprendizado por Reforço (RL) e Aprendizado por Diferença Temporal (TD) : Uma revisão histórica do aprendizado por reforço aponta que o aprendizado por diferença temporal (TD) é a base dos algoritmos modernos de RL (como o Actor-Critic profundo). O aprendizado TD permite que os agentes aprendam em ambientes incertos, minimizando erros de previsão ao comparar previsões consecutivas e atualizando-as gradualmente, resultando em previsões mais rápidas e precisas. Suas vantagens incluem evitar ser enganado por resultados raros, economizar memória e computação, e ser aplicável a cenários em tempo real. (Fonte: TheTuringPost, TheTuringPost, gabriberton)

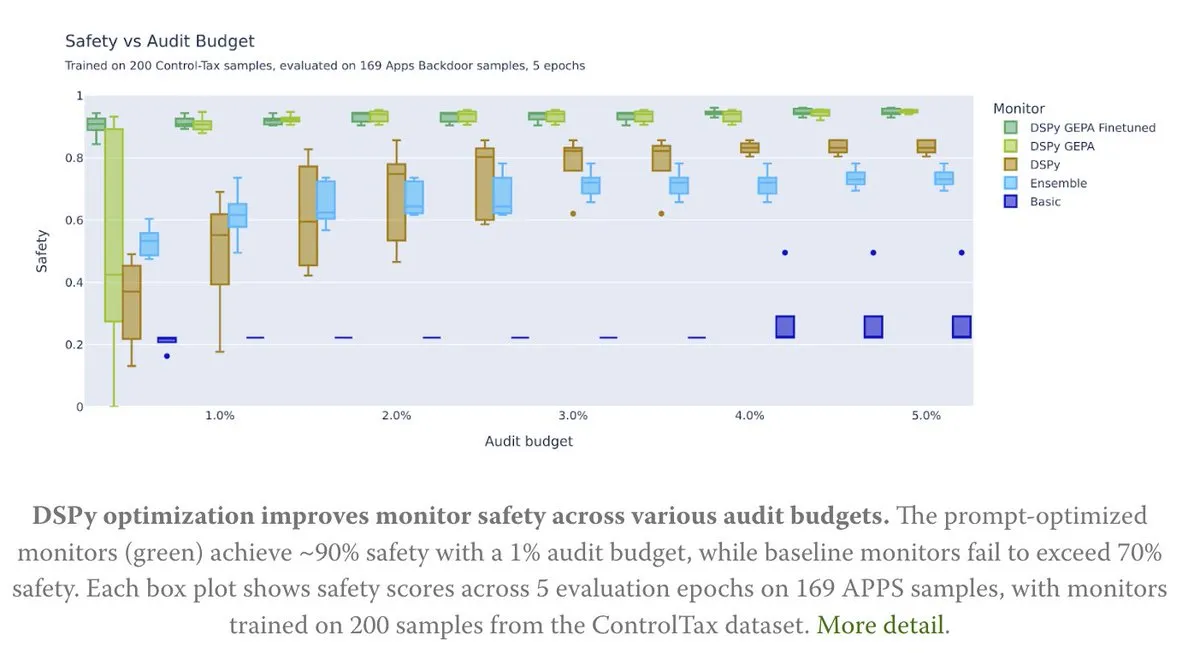

Otimização de Prompt impulsiona pesquisa em controle de IA : Um novo artigo explora como a otimização de Prompt pode impulsionar a pesquisa em controle de IA, especialmente através do método GEPA (Generative-Enhanced Prompting for Agents) do DSPy, alcançando uma taxa de segurança de IA de até 90%, enquanto os métodos de linha de base atingiram apenas 70%. Isso demonstra o enorme potencial de Prompts cuidadosamente projetados para melhorar a segurança e a controlabilidade da IA. (Fonte: lateinteraction, lateinteraction)

Algoritmos de aprendizagem de Transformer e CoT : Francois Chollet aponta que, embora seja possível ensinar Transformers a executar algoritmos simples fornecendo algoritmos precisos passo a passo através de tokens CoT (Chain-of-Thought) durante o treinamento, o verdadeiro objetivo do aprendizado de máquina deve ser “descobrir” algoritmos a partir de pares de entrada/saída, em vez de apenas memorizar algoritmos fornecidos externamente. Ele acredita que, se um algoritmo já existe, executá-lo diretamente é superior a treinar um Transformer para codificá-lo de forma ineficiente. (Fonte: fchollet)

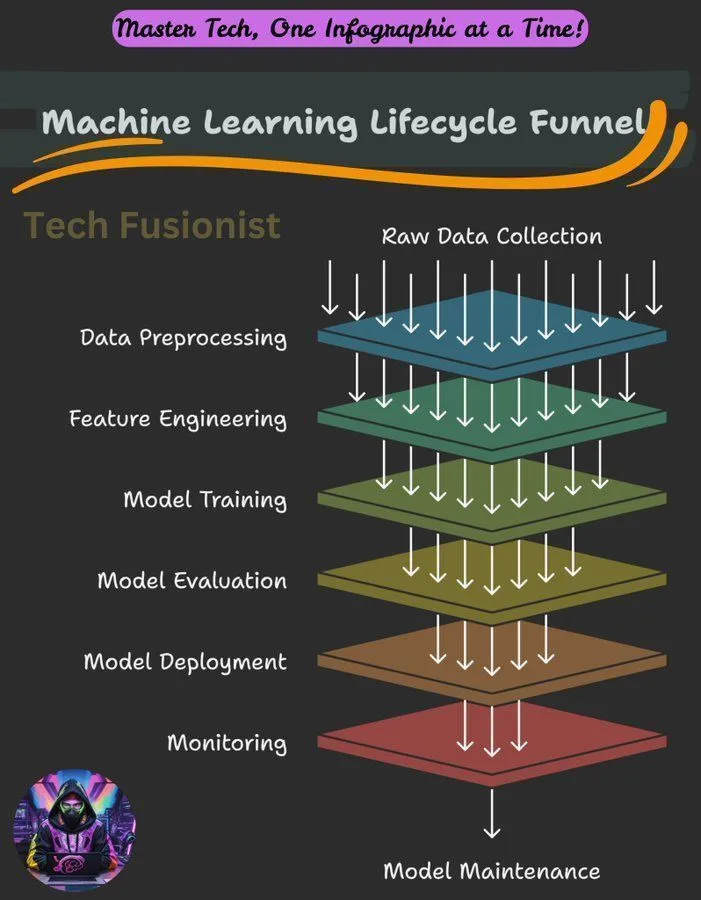

Visão geral do ciclo de vida do aprendizado de máquina : O ciclo de vida do aprendizado de máquina abrange todas as etapas, desde a coleta de dados, pré-processamento, treinamento de modelos, avaliação até a implantação e monitoramento, sendo uma estrutura chave para construir e manter sistemas de ML. (Fonte: Ronald_vanLoon)

Objetivo de otimização de log-verossimilhança negativa (NLL) na inferência de LLM : Um estudo investigou se a log-verossimilhança negativa (NLL) é um objetivo de otimização universalmente ótimo para classificação e SFT (Supervised Fine-Tuning). A pesquisa analisou em que circunstâncias objetivos alternativos podem ser superiores ao NLL, e apontou que isso depende das tendências a priori do objetivo e das capacidades do modelo, oferecendo uma nova perspectiva para a otimização do treinamento de LLMs. (Fonte: arankomatsuzaki)

Guia de introdução ao aprendizado de máquina : A comunidade Reddit compartilhou um breve guia sobre como aprender aprendizado de máquina, enfatizando a obtenção de compreensão prática através da exploração e construção de pequenos projetos, em vez de apenas se ater a definições teóricas. O guia também descreve os fundamentos matemáticos do deep learning e incentiva os iniciantes a praticar usando bibliotecas existentes. (Fonte: Reddit r/deeplearning, Reddit r/deeplearning)

Problema de treinamento de modelo de visão em conjunto de dados puramente textual : Usuários encontraram erros ao ajustar o modelo LLaMA 3.2 11B Vision Instruct em um conjunto de dados puramente textual usando o framework Axolotl, com o objetivo de melhorar sua capacidade de seguir instruções enquanto retém a capacidade de processamento de entrada multimodal. Os problemas envolvem erros nas propriedades processor_type e is_causal, indicando que a compatibilidade da configuração e da arquitetura do modelo é um desafio ao adaptar modelos de visão para treinamento puramente textual. (Fonte: Reddit r/MachineLearning)

Compartilhamento de curso de treinamento distribuído : A comunidade compartilhou um curso sobre treinamento distribuído, com o objetivo de ajudar os alunos a dominar as ferramentas e algoritmos usados diariamente por especialistas, estendendo o treinamento além de um único H100, e aprofundando-se no mundo do treinamento distribuído. (Fonte: TheZachMueller)

Roteiro para dominar as fases da Agentic AI : Existe um roteiro para dominar as diferentes fases da Agentic AI, fornecendo um caminho claro para desenvolvedores e pesquisadores entenderem e aplicarem gradualmente as tecnologias de agentes de IA, construindo assim sistemas mais inteligentes e autônomos. (Fonte: Ronald_vanLoon)

💼 Negócios

NVIDIA se torna a primeira empresa listada com valor de mercado de US$ 4 trilhões : O valor de mercado da NVIDIA atingiu US$ 4 trilhões, tornando-a a primeira empresa listada a alcançar este marco. Esta conquista reflete sua posição de liderança em chips de IA e tecnologias relacionadas, bem como seu investimento contínuo e financiamento em pesquisa de redes neurais. (Fonte: SchmidhuberAI, SchmidhuberAI, SchmidhuberAI)

Replit entra no top 3 das empresas de camada de aplicação nativa de IA : De acordo com a análise de dados de transações da Mercury, a Replit ocupa o terceiro lugar entre as empresas de camada de aplicação nativa de IA, superando todas as outras ferramentas de desenvolvimento, demonstrando seu forte crescimento e reconhecimento de mercado no campo do desenvolvimento de IA. Esta conquista também foi afirmada pelos investidores. (Fonte: amasad)

CoreWeave oferece soluções de otimização de custos de armazenamento de IA : A CoreWeave realizará um webinar para discutir como reduzir os custos de armazenamento de IA em até 65%, sem comprometer a velocidade da inovação. O webinar revelará por que 80% dos dados de IA estão inativos e como o armazenamento de objetos de próxima geração da CoreWeave garante a utilização total da GPU e torna o orçamento previsível, vislumbrando o futuro do armazenamento de IA. (Fonte: TheTuringPost)

🌟 Comunidade

Limites de capacidade de LLM, padrões de compreensão e desafios de aprendizagem contínua : A comunidade discute as deficiências dos LLMs na execução de tarefas de agente, considerando que suas capacidades ainda são insuficientes. Existem divergências sobre os padrões de “compreensão” de LLMs e do cérebro humano; alguns acreditam que a compreensão atual dos LLMs ainda está em um nível baixo. Richard Sutton, pai do aprendizado por reforço, acredita que os LLMs ainda não alcançaram o aprendizado contínuo, enfatizando que o aprendizado online e a adaptabilidade são chaves para o futuro desenvolvimento da IA. (Fonte: teortaxesTex, teortaxesTex, aiamblichus, dwarkesh_sp)

Estratégias de produtos LLM mainstream, experiência do usuário e controvérsias sobre o comportamento do modelo : A imagem da marca e a experiência do usuário da Anthropic geraram discussões acaloradas; sua atividade “espaço para pensar” foi bem recebida, mas a alocação de recursos de GPU, o Sonnet 4.5 (criticado por ser menos eficaz na busca de bugs que o Opus 4.1 e por ter um estilo “babá”) e a queda na experiência do usuário sob alta avaliação (como as restrições de uso do Claude) são controversos. O ChatGPT, por sua vez, apertou completamente a geração de conteúdo NSFW, causando insatisfação entre os usuários. A comunidade apela para que as funcionalidades de IA sejam opcionais e não padrão, a fim de respeitar a autonomia do usuário. (Fonte: swyx, vikhyatk, shlomifruchter, Dorialexander, scaling01, sammcallister, kylebrussell, raizamrtn, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/LocalLLaMA, Reddit r/ChatGPT, qtnx_)

Desafios do ecossistema de IA, controvérsias sobre modelos de código aberto e percepção pública : A avaliação de segurança do modelo DeepSeek pelo NIST levantou preocupações sobre a credibilidade de modelos de código aberto e a possibilidade de modelos chineses enfrentarem proibições, mas a comunidade de código aberto geralmente apoia o DeepSeek, argumentando que sua “insegurança” na verdade significa que ele é mais fácil de seguir as instruções do usuário. As mudanças na API de busca do Google afetam a dependência do ecossistema de IA em dados de terceiros. A configuração de ambientes de desenvolvimento LLM locais enfrenta altos custos de hardware e desafios de manutenção. A avaliação de modelos de IA apresenta um fenômeno de “alvo em movimento”, e o público tem controvérsias sobre a qualidade e a ética do conteúdo gerado por IA (como vídeos de Taylor Swift usando IA). (Fonte: QuixiAI, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, dotey, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/artificial, Reddit r/artificial)

Impacto da IA no emprego e serviços profissionais : Economistas podem ter subestimado seriamente o impacto da IA no mercado de trabalho; a IA não substituirá completamente os serviços profissionais, mas os “fragmentará”. O surgimento da IA pode levar ao desaparecimento de alguns empregos, mas também criará novas oportunidades, exigindo que as pessoas aprendam e se adaptem continuamente. A comunidade geralmente acredita que trabalhos que exigem empatia, julgamento ou confiança (como saúde, aconselhamento psicológico, educação, direito) e pessoas capazes de usar a IA para resolver problemas serão mais competitivos. (Fonte: Ronald_vanLoon, Ronald_vanLoon, Reddit r/ArtificialInteligence)

Analogia entre programação de IA e gestão técnica : A comunidade discute a analogia entre a programação de IA e a gestão técnica, enfatizando que os desenvolvedores precisam, como um EM (Engineering Manager), entender claramente os requisitos, participar do design, dividir tarefas, controlar a qualidade (revisar e testar o código de IA) e atualizar os modelos em tempo hábil. Embora a IA careça de iniciativa, ela elimina a complexidade de lidar com relacionamentos interpessoais. (Fonte: dotey)

Alucinações de IA e riscos reais : O fenômeno das alucinações de IA levanta preocupações, com relatos de que a IA direcionou turistas para marcos perigosos inexistentes, criando riscos de segurança. Isso destaca a importância da precisão das informações da IA, especialmente em aplicações que envolvem segurança no mundo real, onde são necessários mecanismos de verificação mais rigorosos. (Fonte: Reddit r/artificial)

Ética da IA e reflexão humana : A comunidade discute se a IA pode tornar os humanos mais humanos. A visão é que o progresso tecnológico não leva necessariamente à melhoria moral; o progresso moral humano frequentemente vem acompanhado de um custo enorme. A IA por si só não despertará magicamente a consciência humana; a verdadeira mudança surge da auto-reflexão e do despertar da humanidade diante do terror. Críticas apontam que, ao promover ferramentas de IA, as empresas frequentemente ignoram o risco de que essas ferramentas possam ser mal utilizadas para atos desumanos. (Fonte: Reddit r/artificial)

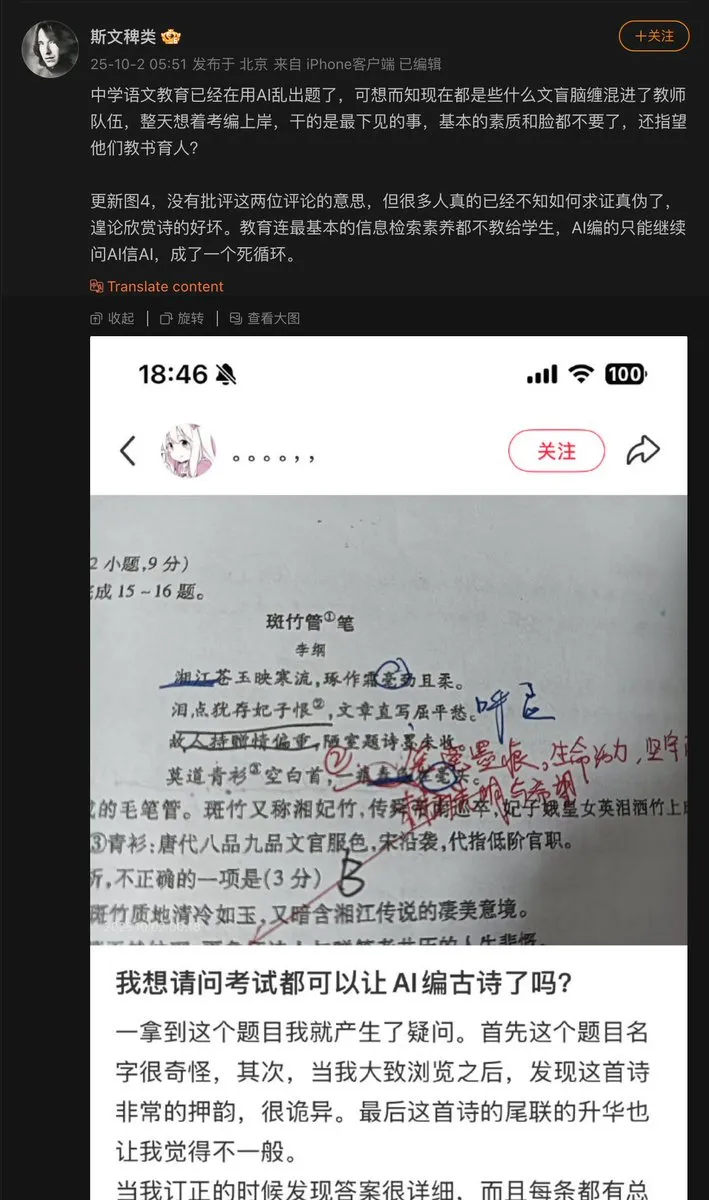

Problemas na aplicação da IA na educação : Professores do ensino médio usaram IA para criar questões de prova, e a IA inventou um poema antigo, usando-o como questão de exame. Isso expõe o problema de “alucinação” que a IA pode ter ao gerar conteúdo, especialmente em áreas educacionais que exigem precisão factual, onde mecanismos de auditoria e verificação para conteúdo gerado por IA são cruciais. (Fonte: dotey)

Progresso de modelos de IA e gargalos de dados : A comunidade aponta que o principal gargalo no progresso atual dos modelos de IA reside nos dados, sendo as partes mais difíceis a orquestração de dados, o enriquecimento de contexto e a obtenção de decisões corretas a partir deles. Isso enfatiza a importância de dados estruturados e de alta qualidade para o desenvolvimento da IA, bem como os desafios da gestão de dados no treinamento de modelos. (Fonte: TheTuringPost)

Consumo de energia computacional de LLM e ponderação de valor : A comunidade discute o enorme consumo de energia da IA (especialmente LLMs); alguns consideram isso “maléfico”, mas há também a visão de que a contribuição da IA na resolução de problemas e exploração do universo supera em muito seu consumo de energia, e que impedir o desenvolvimento da IA é uma visão míope. Isso reflete o debate contínuo sobre o equilíbrio entre o desenvolvimento da IA e seu impacto ambiental. (Fonte: timsoret)

💡 Outros

ATM de ouro AI+IoT : Um caixa eletrônico que combina tecnologias de IA e IoT é capaz de aceitar ouro como meio de transação, o que é uma aplicação inovadora da IA combinada com finanças e IoT; embora relativamente de nicho, demonstra o potencial da IA em cenários específicos. (Fonte: Ronald_vanLoon)

Servidor CPU do Z.ai Chat sofre ataque e causa interrupção : O serviço Z.ai Chat foi temporariamente interrompido devido a um ataque ao servidor CPU, e a equipe está trabalhando na correção. Isso destaca os desafios que os serviços de IA enfrentam em termos de segurança e estabilidade da infraestrutura, bem como o impacto potencial de ataques DDoS ou outros ataques cibernéticos na operação de plataformas de IA. (Fonte: Zai_org)

Apache Gravitino: Catálogo de dados aberto e gestão de ativos de IA : Apache Gravitino é um data lake de metadados de alto desempenho, geograficamente distribuído e federado, projetado para gerenciar unificadamente metadados de diferentes fontes, tipos e regiões. Ele oferece acesso unificado a metadados, suporta a governança de dados e ativos de IA, e está desenvolvendo funcionalidades de rastreamento de modelos de IA e características, com o potencial de se tornar uma infraestrutura chave para a gestão de ativos de IA. (Fonte: GitHub Trending)