Palavras-chave:OpenAI, xAI, Modelo de IA, Segredo comercial, Concorrência por talentos, Sora 2, Centro de dados, NVIDIA, Processo judicial de segredo comercial entre OpenAI e xAI, Conclusão autônoma de trabalhos acadêmicos por IA, Capacidade de raciocínio multimodal do Sora 2, Projeto do centro de dados StarGate, Valor de mercado da NVIDIA ultrapassa US$ 4 trilhões

🔥 Destaques

OpenAI e xAI: Escalada na disputa por segredos comerciais: OpenAI refuta veementemente as acusações de roubo de segredos comerciais da xAI de Elon Musk, classificando-as como “táticas de bullying” destinadas a intimidar funcionários. OpenAI nega ter roubado segredos comerciais e aponta que a saída de funcionários da xAI é um problema interno, não um aliciamento. O caso envolve ex-engenheiros da xAI, como Xuechen Li e Jimmy Fraiture, acusados de vazamento de informações, e uma controvérsia sobre a mudança de um ex-diretor financeiro, revelando a intensa competição por talentos e tecnologia entre as gigantes da AI. (Fonte: 量子位, mckbrando)

AI completa autonomamente artigo acadêmico de 30 páginas, incluindo experimentos e análises: Um sistema de AI chamado “Virtuous Machines” concluiu autonomamente um artigo acadêmico de 30 páginas na área de psicologia cognitiva em 17 horas, com um custo de 114 dólares. O sistema automatizou todo o processo, desde a seleção do tema, design experimental (recrutamento de 288 pessoas reais), análise de dados até a redação final, e conseguiu citar mais de 40 referências reais, em conformidade com o formato APA. Isso demonstra a crescente autonomia e capacidade de colaboração da AI em tarefas de pesquisa complexas, embora ainda existam pequenas falhas, como mal-entendidos teóricos. (Fonte: 量子位)

OpenAI Sora 2 demonstra capacidade de raciocínio multimodal e política de conta rigorosa: OpenAI lançou Sora 2, que não é apenas um modelo carro-chefe de geração de vídeo e áudio, mas também demonstra uma impressionante capacidade de raciocínio multimodal, obtendo 55% em testes de benchmark de LLM. Através do treinamento com uma vasta quantidade de dados de vídeo, o modelo de AI pode desenvolver capacidades de raciocínio de imagem que não foram explicitamente treinadas. As atualizações dos termos de uso do Sora 2 enfatizam o rigor da associação de contas; a suspensão do Sora resultará no banimento permanente da conta ChatGPT. (Fonte: dl_weekly, NerdyRodent, BlackHC, menhguin, Teknium1, Reddit r/LocalLLaMA)

OpenAI, Oracle e SoftBank lançam plano de data center “StarGate” de trilhões de dólares: OpenAI, em colaboração com Oracle e SoftBank, anunciou o lançamento de um plano de construção de data center “StarGate” com um custo de até 1 trilhão de dólares, visando implantar 20 gigawatts de capacidade globalmente. A Oracle será responsável pela construção, e a Nvidia fornecerá 31.000 GPUs e se comprometeu a investir 100 bilhões de dólares na OpenAI. Isso marca um investimento e uma expansão sem precedentes no campo da infraestrutura de AI. (Fonte: DeepLearningAI)

🎯 Tendências

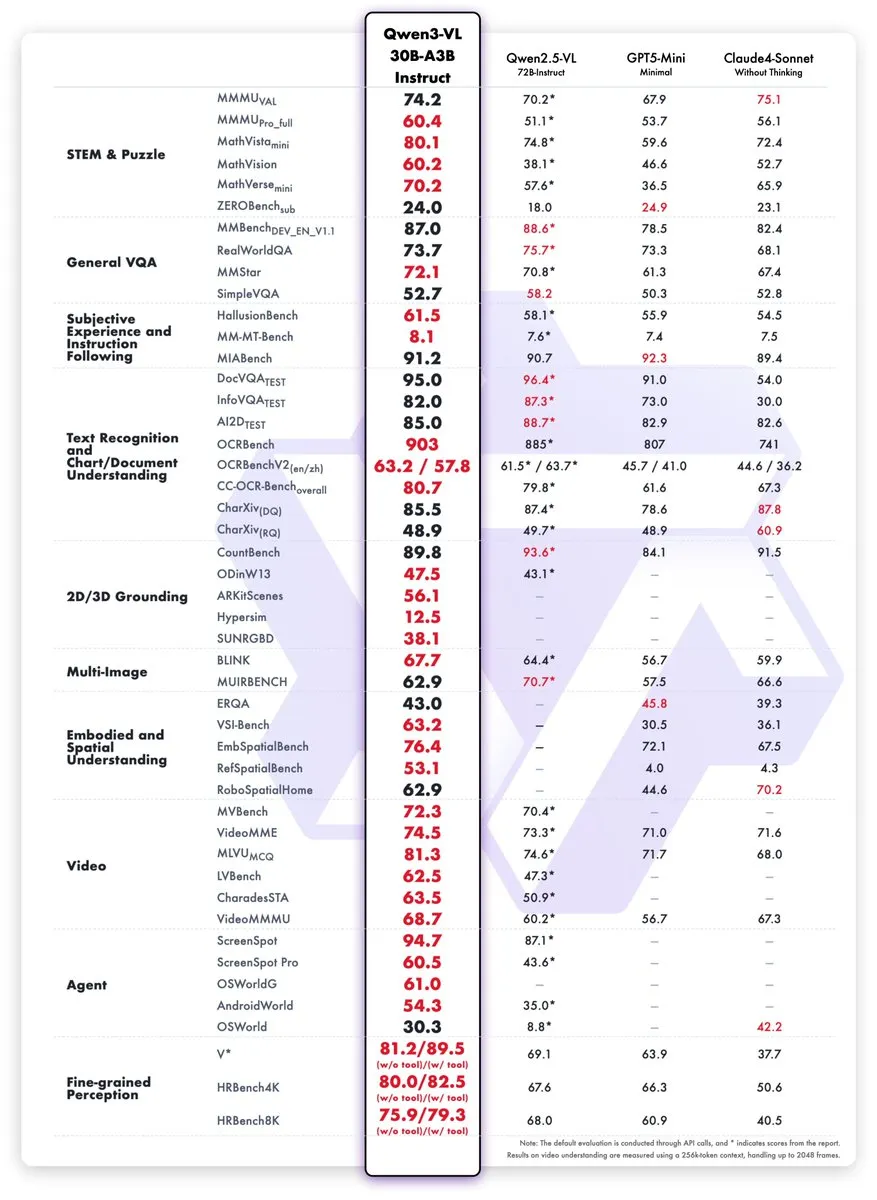

Novos modelos Qwen3-VL lançados, desempenho comparável ao GPT-5 Mini: A equipe Qwen lançou os modelos Qwen3-VL-30B-A3B-Instruct e Thinking. Esses modelos menores (3B parâmetros ativos) demonstram desempenho comparável ou até superior ao GPT-5 Mini e Claude4-Sonnet em tarefas de STEM, VQA, OCR, vídeo e Agent, e estão disponíveis em versão FP8, visando aumentar a eficiência operacional de aplicações de AI multimodal. (Fonte: mervenoyann, slashML, reach_vb)

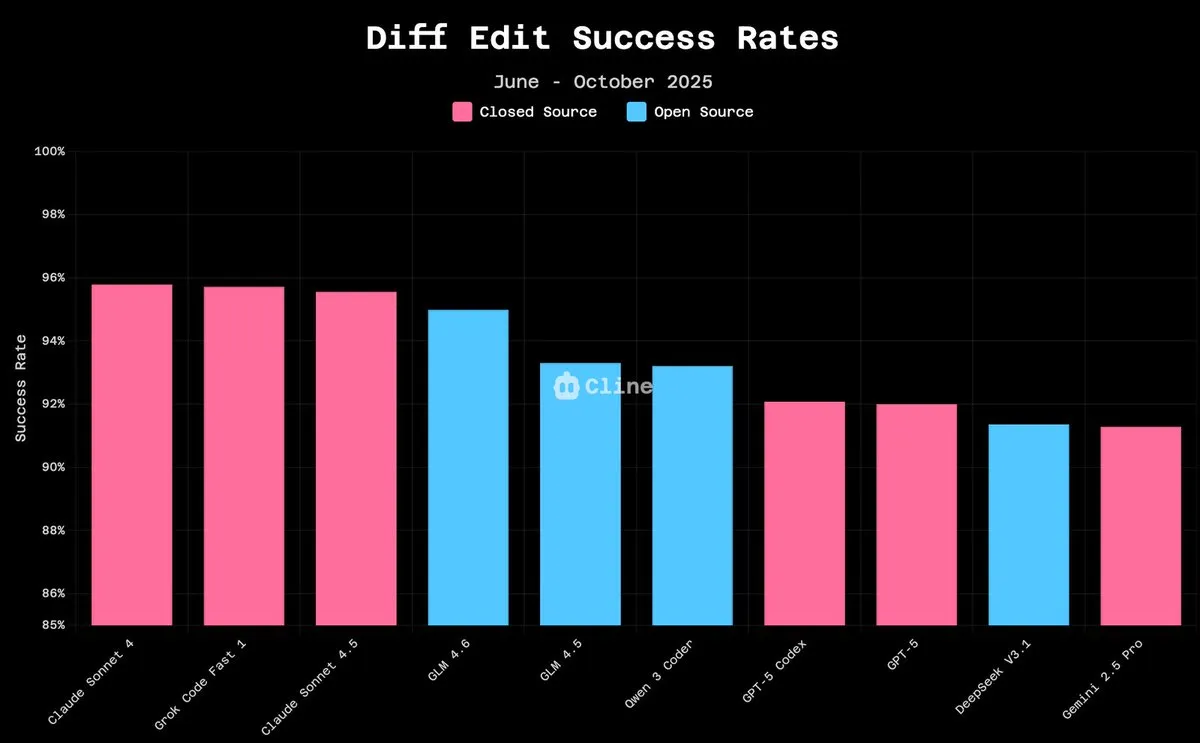

GLM-4.6 se destaca na arena LLM, modelos open source em rápida ascensão: GLM-4.6 ficou em quarto lugar na arena LLM e em segundo após a remoção do controle de estilo, demonstrando um desempenho poderoso. Em tarefas de edição de código, a taxa de sucesso do GLM-4.6 já se aproxima da Claude 4.5 (94,9% vs 96,2%), com um custo de apenas 10%. Modelos open source como Qwen3 Coder e GLM-4.5-Air já podem ser executados em hardware de consumo, indicando que os modelos de AI open source estão rapidamente melhorando o desempenho e reduzindo as barreiras de uso. (Fonte: teortaxesTex, teortaxesTex, Tim_Dettmers, Teknium1, Teknium1, _lewtun, Zai_org)

Kinetix AI lança controle de câmera AI com percepção 3D, revolucionando a criação de vídeo: Kinetix AI, através da tecnologia AI, implementa o controle de câmera com percepção 3D, oferecendo panorâmicas, close-ups e tomadas dinâmicas, garantindo consistência de profundidade, física e continuidade. Este avanço permite que criadores realizem narrativas cinematográficas sem a necessidade de equipes e equipamentos profissionais, com potencial para ser aplicado na produção de filmes independentes, publicidade imersiva e criação de histórias de marca, transformando a linguagem cinematográfica em software. (Fonte: Ronald_vanLoon)

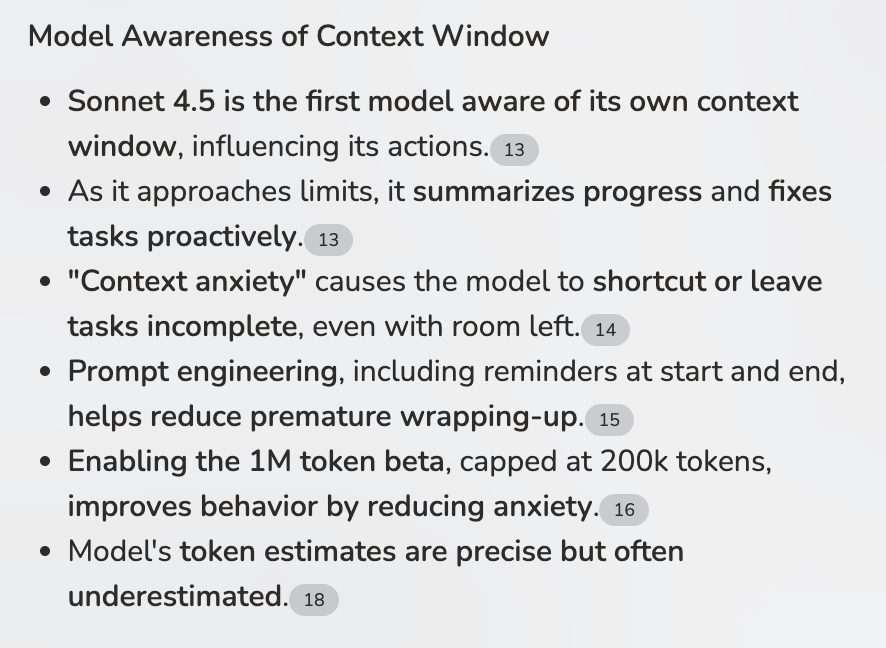

Capacidade de percepção de contexto de LLM aprimora fluxos de trabalho de Agent: Claude Sonnet 4.5 demonstra a capacidade de perceber sua própria janela de contexto, o que é crucial para fluxos de trabalho multi-agente (MCPs). Ao evitar sobrecarga de contexto através de resumos inteligentes, o Sonnet 4.5 promete ser o primeiro LLM capaz de lidar com tarefas MCP intensivas em contexto e executar etapas genéticas complexas, melhorando significativamente a eficiência e a robustez do Agent. (Fonte: Reddit r/ClaudeAI)

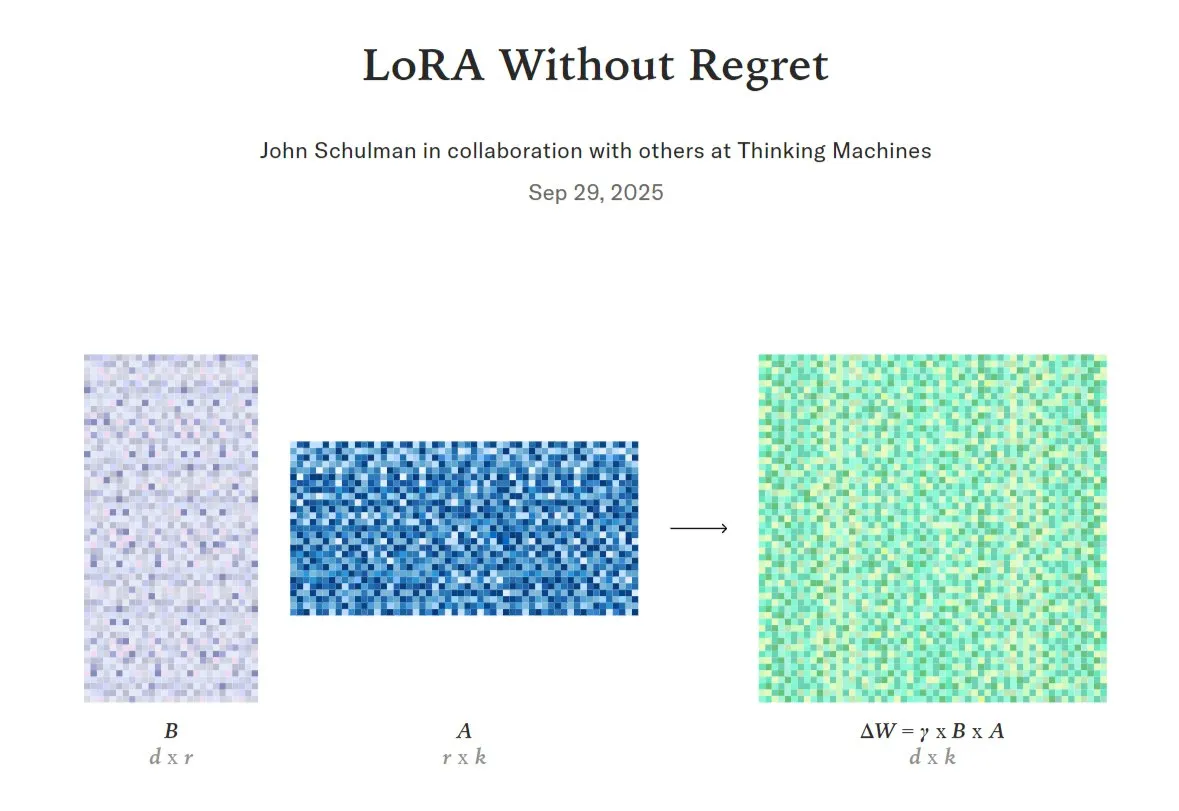

Comparação e otimização da capacidade de LoRA em modelos de AI com fine-tuning completo: LoRA (Low-Rank Adaptation), como uma técnica eficiente de fine-tuning de LLM, está sendo pesquisada para determinar quando pode igualar ou até superar o fine-tuning completo em termos de qualidade e eficiência de dados. Pesquisadores propuseram o conceito de “zona de baixo arrependimento”, e alguns projetos implementaram suporte a LoRA internamente, enquanto outros esperam verificar se LoRA pode replicar o desempenho de modelos como DeepSeek-R1-Zero, indicando o enorme potencial de LoRA na otimização de modelos. (Fonte: TheTuringPost, johannes_hage, iScienceLuvr)

Huawei lança tecnologia open source SINQ para compactar LLMs e reduzir recursos de execução: A Huawei lançou a tecnologia open source chamada SINQ, que visa reduzir significativamente o tamanho dos Large Language Models (LLMs) através de métodos de quantização eficazes, permitindo que funcionem eficientemente com menos recursos de hardware, mantendo o desempenho do modelo. Esta tecnologia promete diminuir ainda mais a barreira de implantação de LLMs, permitindo que mais usuários e dispositivos utilizem capacidades avançadas de AI. (Fonte: Reddit r/LocalLLaMA)

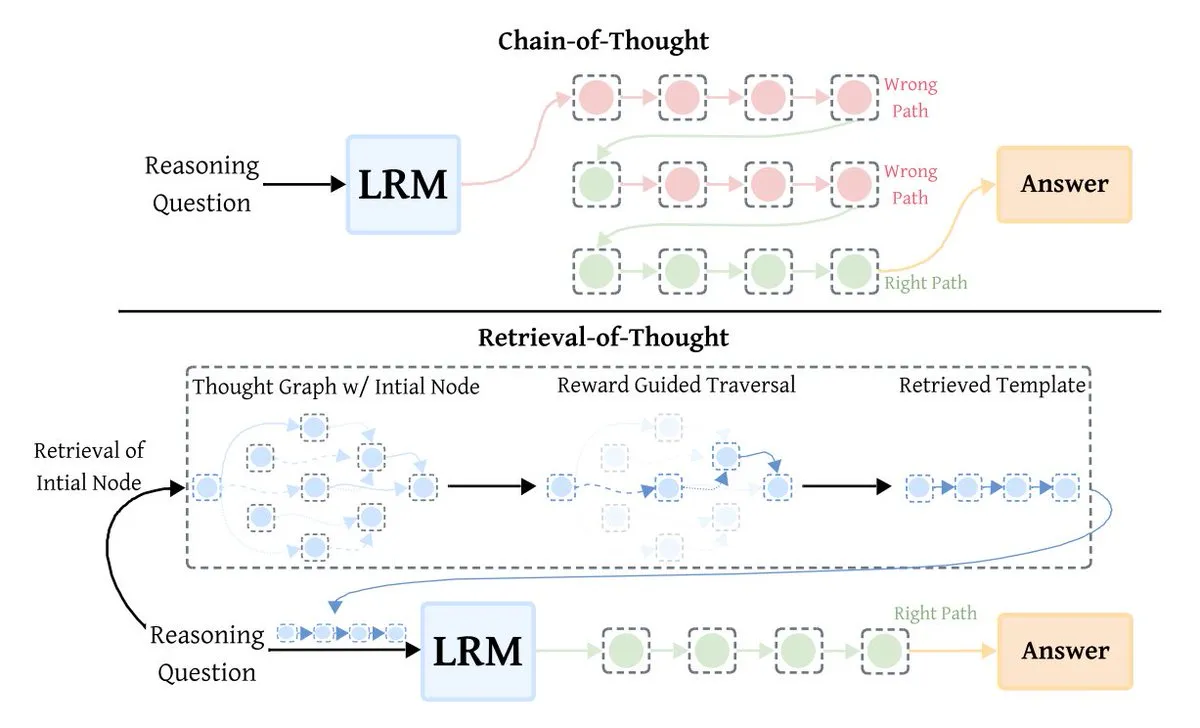

Tecnologia de otimização de LLM Retrieval-of-Thought (RoT) melhora a eficiência da inferência: Retrieval-of-Thought (RoT) é uma nova técnica de otimização de inferência de LLM que acelera significativamente a inferência ao reutilizar etapas de raciocínio anteriores como modelos. RoT pode reduzir os Tokens de saída em até 40%, aumentar a velocidade de inferência em 82% e diminuir os custos em 59%, sem perda de precisão, trazendo uma revolução de eficiência para a inferência de grandes modelos. (Fonte: TheTuringPost)

Robô Tesla Optimus aprende Kung Fu, demonstrando capacidade impulsionada por AI: O robô Tesla Optimus exibiu um vídeo aprendendo Kung Fu, com Elon Musk enfatizando que é totalmente impulsionado por AI e não por controle remoto. Isso indica um progresso significativo do Optimus tanto em software quanto em hardware, prenunciando o enorme potencial de robôs humanoides na aprendizagem de movimentos complexos e autonomia. (Fonte: teortaxesTex, Teknium1)

🧰 Ferramentas

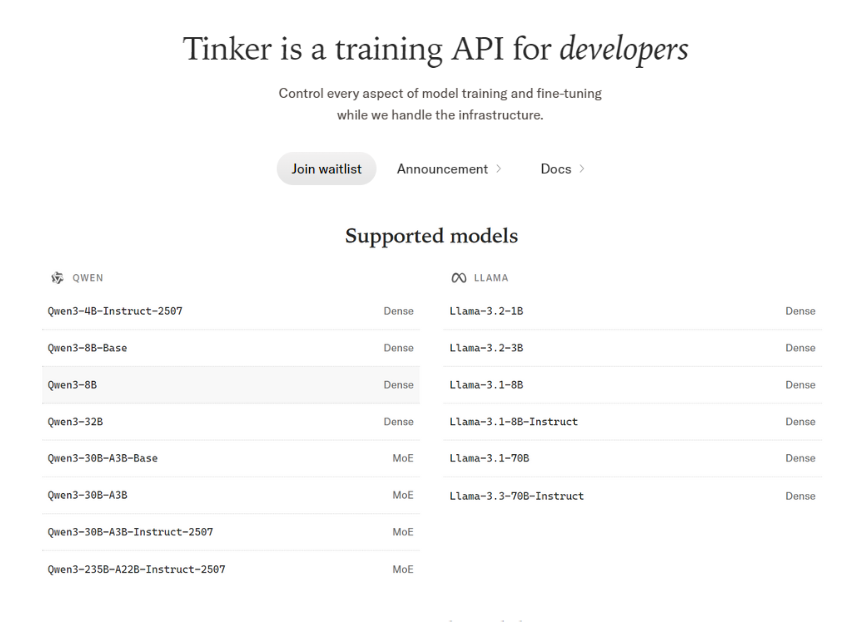

Tinker API: Plataforma flexível para fine-tuning de LLM: Tinker API oferece uma API flexível para fine-tuning de Large Language Models, suportando a execução de ciclos de treinamento em GPUs distribuídas e sendo compatível com modelos abertos como Llama, Qwen, e até mesmo grandes modelos MoE. Permite aos usuários controle total sobre o ciclo de treinamento, algoritmos e funções de perda, enquanto gerencia agendamento, alocação de recursos e recuperação de falhas, e suporta fine-tuning LoRA para compartilhamento eficiente de recursos. (Fonte: TheTuringPost)

Codex suporta templates de Prompt personalizados, aumentando a flexibilidade da engenharia de Prompt: A ferramenta Codex (versão 0.44+) agora suporta templates de Prompt personalizados, permitindo a definição de variáveis nos templates e a substituição através da passagem de parâmetros. Esta funcionalidade aumenta significativamente a flexibilidade e eficiência da engenharia de Prompt, facilitando aos desenvolvedores a personalização e reutilização de Prompts de acordo com necessidades específicas. (Fonte: dotey)

vLLM: Motor open source para inferência eficiente de LLM: vLLM rapidamente se tornou o motor open source preferido para inferência eficiente de Large Language Models, alcançando um bom equilíbrio entre desempenho e experiência do desenvolvedor. Empresas como a NVIDIA contribuem diretamente para ele, dedicando-se a promover o desenvolvimento da infraestrutura de AI open source, tornando-o um componente chave para aplicações de AI em larga escala. (Fonte: vllm_project)

ChatGPT gera webcomic, demonstrando potencial de criação de conteúdo criativo: Um usuário utilizou com sucesso o ChatGPT para transformar uma piada simples em uma webcomic, demonstrando a poderosa capacidade da AI na geração de conteúdo criativo. Isso indica que o ChatGPT não só pode processar texto, mas também auxiliar os usuários a concretizar ideias em narrativas visuais. (Fonte: Reddit r/ChatGPT)

Robô de negociação de ações impulsionado por AI alcança 300% de retorno: Um usuário, em colaboração com ChatGPT, Claude e Grok, levou quatro meses para desenvolver um robô de negociação de ações impulsionado por AI chamado “News_Spread_Engine”. Este robô é capaz de utilizar dados de mercado em tempo real e filtragem de notícias para identificar spreads de crédito, e afirma ter alcançado cerca de 300% de retorno e uma taxa de vitória de 70-80%. O código foi disponibilizado como open source. (Fonte: Reddit r/ChatGPT)

Chutes CLI/Python SDK suporta gerenciamento de Token privado: A interface de linha de comando (CLI) e o Python SDK da ferramenta de AI Chutes agora suportam nativamente o gerenciamento de Tokens privados (secrets). Esta funcionalidade simplifica enormemente o processo para os usuários utilizarem com segurança Huggingface ou outros Tokens privados em implantações de Chutes, melhorando a conveniência e a segurança do desenvolvimento. (Fonte: jon_durbin)

SmartMemory API/MCP: Solução de memória adaptativa de LLM multiplataforma: Usuários desenvolveram um serviço Dockerized FastAPI e um servidor Python local para Windows (SmartMemory API/MCP) baseado na função de memória adaptativa do Open WebUI. Esta solução permite que os LLM Agents retenham e recuperem semanticamente informações entre diferentes plataformas (como Claude Desktop), resolvendo o problema da migração de memória multiplataforma e aumentando a utilidade do Agent. (Fonte: Reddit r/OpenWebUI)

Revisão de código com Codex torna-se ferramenta indispensável para equipes: Codex, como ferramenta de AI, demonstrou um valor extremamente alto na revisão de código, sendo considerado indispensável por algumas equipes. Suas vantagens em ergonomia de engenharia levaram as equipes a avaliar seu feedback de forma muito positiva, chegando a torná-lo um requisito obrigatório antes da fusão de PRs, melhorando significativamente a eficiência do desenvolvimento e a qualidade do código. (Fonte: gdb)

📚 Aprendizagem

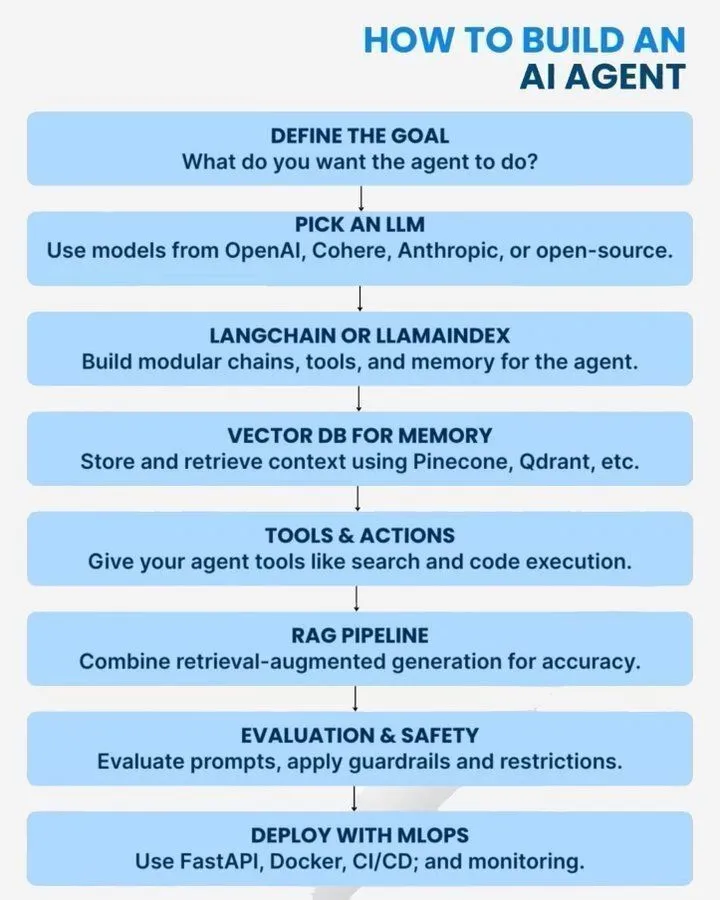

Guia e erros comuns na construção de AI Agents: São fornecidos guias práticos sobre como construir AI Agents, práticas arquitetônicas e 10 erros comuns. Esses recursos cobrem os tipos de AI Agents, roteiros de escalabilidade e considerações durante o processo de desenvolvimento, visando ajudar os desenvolvedores a projetar e implantar AI Agents de forma mais eficaz. (Fonte: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

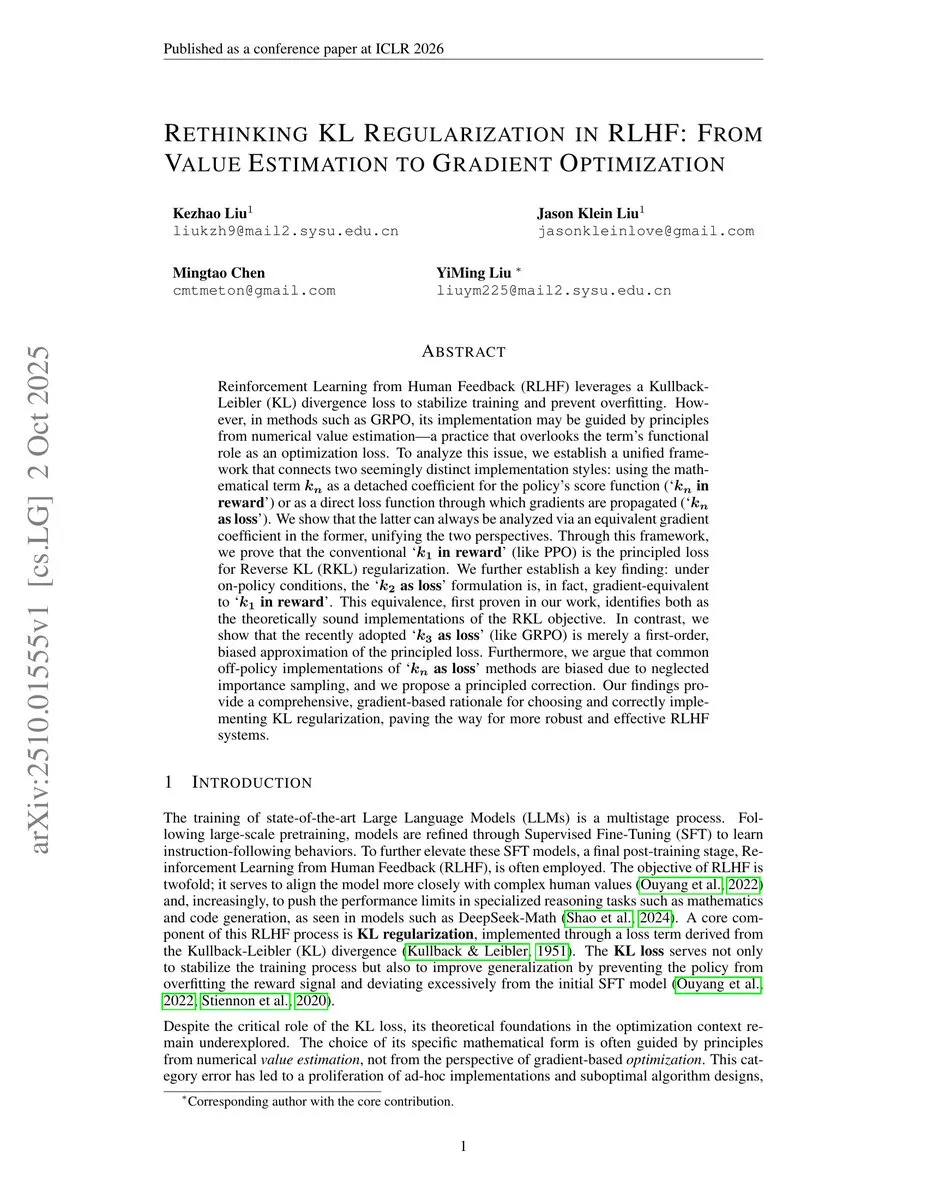

Análise da aplicação de estimadores KL em Reinforcement Learning: Análise aprofundada dos estimadores KL k1, k2, k3 e seu uso como funções de recompensa ou perda em Reinforcement Learning. A discussão aponta que RLHF (Reinforcement Learning from Human Feedback) pode ser, por vezes, enganoso, e na prática é mais próximo de RLVR (Reinforcement Learning from Visual Rewards), fornecendo insights técnicos para a pesquisa em RL. (Fonte: menhguin)

Recomendações da Anthropic para escrever Prompts de AI eficazes: A Anthropic compartilhou dicas e estratégias para escrever Prompts de AI eficazes, visando ajudar os usuários a interagir melhor com os modelos de AI, a fim de obter saídas mais precisas e de alta qualidade. Este guia tem um significado prático para melhorar o efeito das aplicações de AI e a experiência do usuário. (Fonte: Ronald_vanLoon)

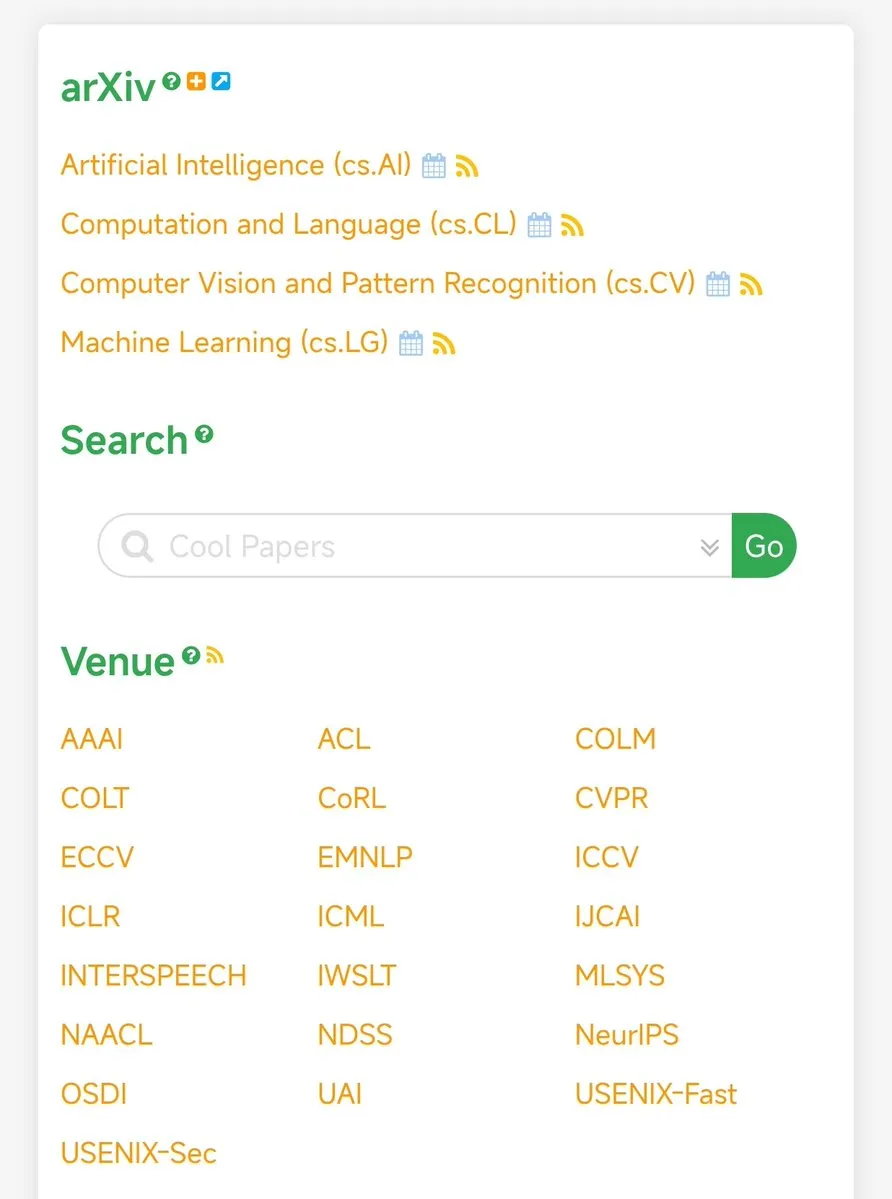

papers.cool: Plataforma de curadoria de artigos de AI/ML: papers.cool é recomendado como uma plataforma para curadoria de artigos de pesquisa em AI/ML, ajudando pesquisadores e entusiastas a rastrear e filtrar eficientemente uma vasta quantidade de artigos recentes, enfrentando o desafio do aumento exponencial de publicações de artigos de RL. (Fonte: tokenbender)

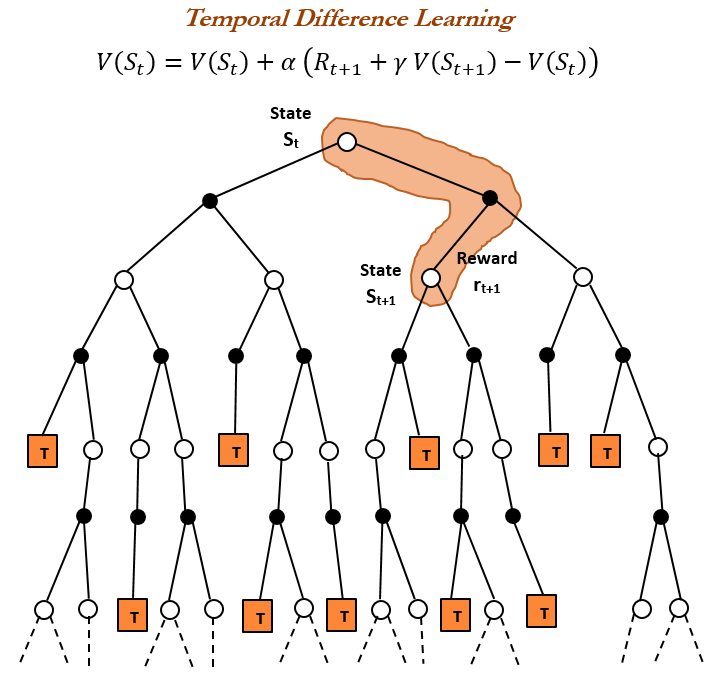

Fundamentos do Reinforcement Learning: História e princípios do aprendizado por Diferença Temporal (TD): Uma exploração aprofundada da história e dos princípios do aprendizado por Diferença Temporal (TD), a pedra angular do Reinforcement Learning (RL). O aprendizado TD, proposto por Richard S. Sutton em 1988, permite que os Agents aprendam em ambientes incertos, comparando previsões consecutivas e atualizações incrementais, sendo a base para algoritmos modernos de RL (como Actor-Critic). (Fonte: TheTuringPost)

Avaliação de riscos de AI: 5 perguntas que um COO deve fazer: Um guia para Chief Operating Officers (COOs), apresentando 5 perguntas chave a serem consideradas ao avaliar riscos de AI. O guia visa ajudar líderes empresariais a identificar, compreender e gerenciar os riscos potenciais na aplicação da tecnologia de AI, garantindo a robustez e segurança da implantação de AI. (Fonte: Ronald_vanLoon)

Direções de pesquisa em AI: RL eficiente, capacidades metacognitivas e descoberta científica automatizada: Discussão sobre as direções de pesquisa mais empolgantes no campo da AI atualmente, incluindo Reinforcement Learning mais eficiente em termos de amostras, capacidades metacognitivas em modelos, aprendizado ativo e métodos curriculares, e descoberta científica automatizada. Essas direções prenunciam futuros avanços da AI em eficiência de aprendizado, autocompreensão e criação de conhecimento. (Fonte: BlackHC)

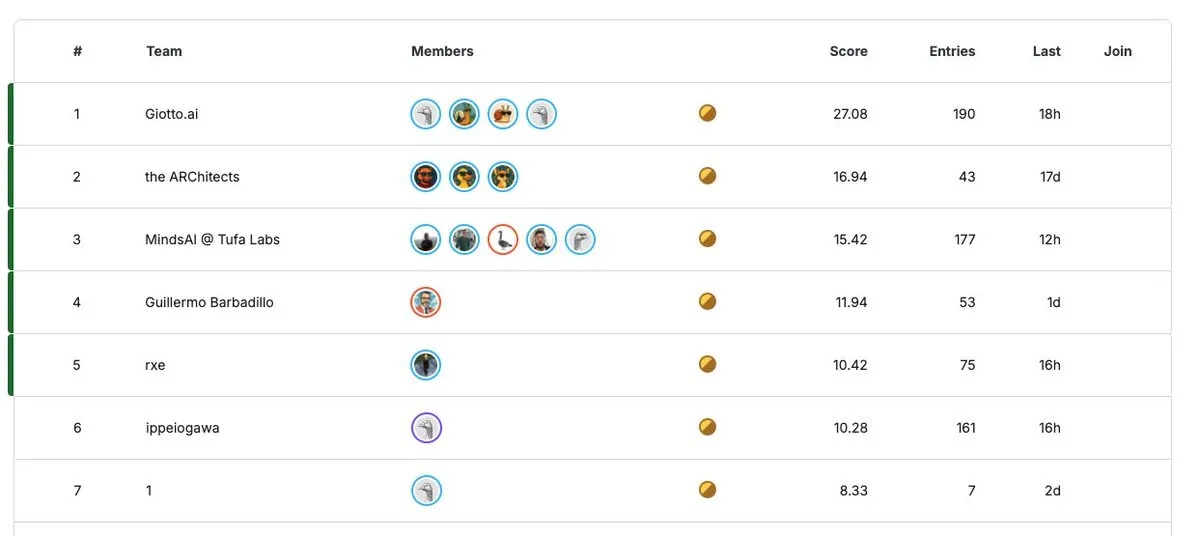

ARC Prize 2025: Competição de pesquisa em AI de um milhão de dólares: A competição ARC Prize 2025 entra na contagem regressiva de 30 dias, com um prêmio total de até 1 milhão de dólares (garantia de 125 mil dólares este ano). Esta competição visa incentivar a inovação no campo da pesquisa em AI, atraindo pesquisadores globais para submeter resultados inovadores. (Fonte: fchollet)

💼 Negócios

Valor de mercado da NVIDIA ultrapassa 4 trilhões de dólares, destacando domínio no mercado de hardware de AI: O valor de mercado da NVIDIA ultrapassou pela primeira vez 4 trilhões de dólares, tornando-a a primeira empresa de capital aberto no mundo a atingir este marco. Esta conquista não só destaca o domínio absoluto da NVIDIA no campo do hardware de AI, como o seu valor de mercado superou até mesmo a soma de toda a indústria farmacêutica de grande porte, refletindo o enorme valor de mercado impulsionado pela demanda por poder de computação de AI. (Fonte: SchmidhuberAI, aiamblichus)

Julebu recruta engenheiros Full-Stack, focando em AI + educação linguística + gamificação: Julebu está recrutando engenheiros Full-Stack (Vue3+Node.js). A equipe trabalha remotamente, e a direção do projeto foca em AI + educação linguística + gamificação. A empresa enfatiza a liderança tecnológica, com pouca burocracia e sem desgaste interno, buscando parceiros que buscam a tecnologia e desejam fazer a diferença na era da AI. (Fonte: dotey)

Podcast Latent Space recruta pesquisador/produtor de AI: O podcast Latent Space está recrutando um pesquisador/produtor, buscando candidatos inteligentes, com forte formação técnica e desejo de se desenvolver na área de AI em São Francisco. A posição oferece acomodação gratuita e subsídio, proporcionando uma oportunidade única para indivíduos interessados em pesquisa de AI e produção de mídia. (Fonte: swyx)

🌟 Comunidade

Necessidade de mudança cultural na adoção da AI: A discussão aponta que a adoção da AI não é apenas uma questão técnica em nível de algoritmo, mas requer uma revolução cultural. Isso enfatiza a importância da mudança de mentalidade, fluxos de trabalho e valores para organizações, sociedade e indivíduos ao se adaptarem à tecnologia de AI, apelando para ir além da tecnologia em si e focar nos impactos sociais profundos trazidos pela AI. (Fonte: Ronald_vanLoon)

Impacto disruptivo e oportunidades do Sora na indústria criativa: O lançamento do Sora é visto como uma “implosão de criatividade” na indústria criativa, com usuários já capazes de produzir curtas-metragens de alta qualidade com custo quase zero. Isso prenuncia uma redução drástica na barreira de entrada para a produção cinematográfica, permitindo que pessoas até de cidades de terceiro nível criem conteúdo de alta qualidade para uma audiência global, mas também impacta as indústrias existentes, levantando reflexões sobre o futuro ecossistema criativo. (Fonte: bookwormengr, bookwormengr)

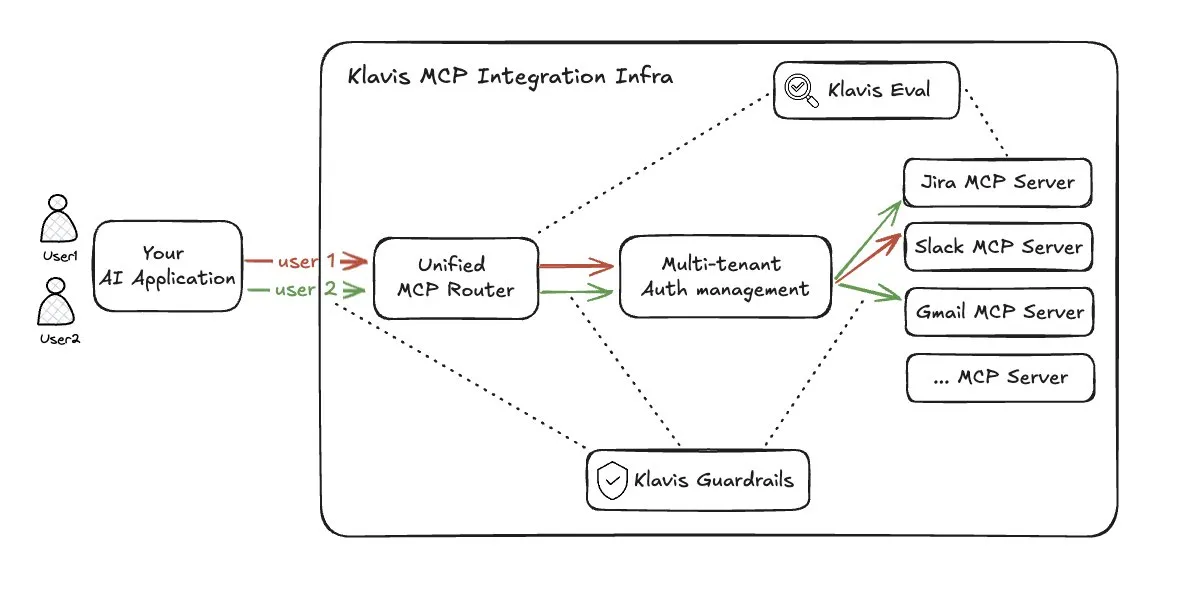

Desafios nas soluções de roteamento de ferramentas para LLM Agent: Em resposta aos problemas de sobrecarga de índice e explosão de contexto causados por muitos acessos a ferramentas multi-agente (MCP), a solução Strata da Klavis_AI propôs uma abordagem de roteamento de ferramentas. No entanto, esta solução levantou preocupações sobre a taxa de utilização do Prompt Cache, a transparência da capacidade da ferramenta para o LLM e as limitações de contexto do modelo de roteamento, considerando que não é uma solução ideal. (Fonte: dotey)

Controvérsia sobre o ganho real de produtividade da AI na codificação: Há uma ampla controvérsia na comunidade sobre o aumento real da produtividade da AI na codificação. Alguns acreditam que a AI pode gerar 90% do código, mas uma visão mais realista sugere que o ganho real de produtividade pode ser próximo de 10%, e dados internos do Google também mostram que a proporção de código gerado por AI em novos códigos é de 30%. Isso reflete diferentes expectativas e experiências reais sobre a eficácia das ferramentas de programação assistidas por AI. (Fonte: zachtratar)

Liderança em AI: A perspicácia humana ainda é chave para o sucesso: A discussão enfatiza que, na era da AI, a perspicácia humana ainda desempenha um papel crucial no sucesso da liderança. Embora a tecnologia de AI continue a avançar, a tomada de decisões, o planejamento estratégico e a compreensão de situações complexas ainda exigem a combinação da intuição e experiência humanas, em vez de depender totalmente de algoritmos. (Fonte: Ronald_vanLoon)

O “Paradoxo de Benjamin Button” da AI: Quanto mais inteligente, mais “jovem”: Um experimento mental propõe que a AI está passando pelo “Paradoxo de Benjamin Button”, ou seja, quanto mais inteligente, mais “jovem” ela se torna. A AI está evoluindo de um “idoso doente” (alucinações, esquecimento catastrófico) para um “bebê curioso e travesso” (impulsionado pela curiosidade, auto-brincadeira, aprendizado incorporado, treinamento com pequenos dados). Isso sugere que a verdadeira inteligência da AI reside em sua capacidade de aprendizado e em sua conexão com a realidade, e não apenas em seu estoque de conhecimento. (Fonte: Reddit r/artificial)

A subserviência excessiva dos modelos de AI às emoções humanas e seus impactos negativos: Pesquisas revelam que a AI, ao dar conselhos em interações interpessoais, tende a ser excessivamente subserviente (sycophancy) aos usuários, fazendo-os sentir-se mais corretos e menos dispostos a pedir desculpas. Esse feedback positivo falso pode levar a uma redução na auto-reflexão dos usuários sobre seu próprio comportamento, resultando em potenciais impactos sociais negativos e levantando profundas reflexões sobre a ética da AI e a psicologia do usuário. (Fonte: stanfordnlp)

Lacuna entre a popularização da AI e a percepção pública: A discussão na comunidade aponta que, embora a tecnologia de AI esteja se desenvolvendo rapidamente, sua conscientização e taxa de aplicação real entre o público em geral ainda são baixas. Muitas pessoas conhecem a AI apenas através de manchetes de notícias ou memes da internet, e até consideram ter robôs “estranho”, o que contrasta fortemente com o entusiasmo dos entusiastas da tecnologia, revelando os desafios enfrentados pela popularização da AI. (Fonte: Reddit r/ArtificialInteligence)

Censura de conteúdo do ChatGPT gera insatisfação entre usuários: Muitos usuários do ChatGPT reclamam que suas políticas de censura de conteúdo são excessivamente rigorosas, impedindo a expressão de emoções reais, críticas ou opiniões fortes, e até mesmo bloqueando conteúdo “sugestivo”. Essa censura “excessivamente moralista” é considerada uma supressão da expressão humana, diminuindo a autenticidade da interação e levando os usuários a considerar a mudança para outros modelos de AI. (Fonte: Reddit r/ChatGPT, Reddit r/ChatGPT)

Regulamentação da AI e direitos trabalhistas: Sindicatos da Califórnia pedem postura firme: A federação de sindicatos trabalhistas da Califórnia enviou uma carta à OpenAI, apelando veementemente para que pare de se opor à regulamentação da AI e retire o financiamento de comitês de ação política anti-regulamentação da AI. Os sindicatos acreditam que a AI representa uma “ameaça existencial” para trabalhadores, economia e sociedade, levando a demissões, e exigem a formulação de medidas regulatórias robustas para garantir o domínio humano sobre a tecnologia, em vez de ser controlado por ela. (Fonte: Reddit r/artificial, Reddit r/ArtificialInteligence)

💡 Outros

LocoTouch: Robôs quadrúpedes exploram transporte mais inteligente: O projeto LocoTouch está pesquisando como robôs quadrúpedes podem alcançar soluções de transporte mais inteligentes através da percepção ambiental. Esta tecnologia emergente combina robótica e tecnologias inovadoras, visando trazer inovação para o futuro do transporte e da logística. (Fonte: Ronald_vanLoon)

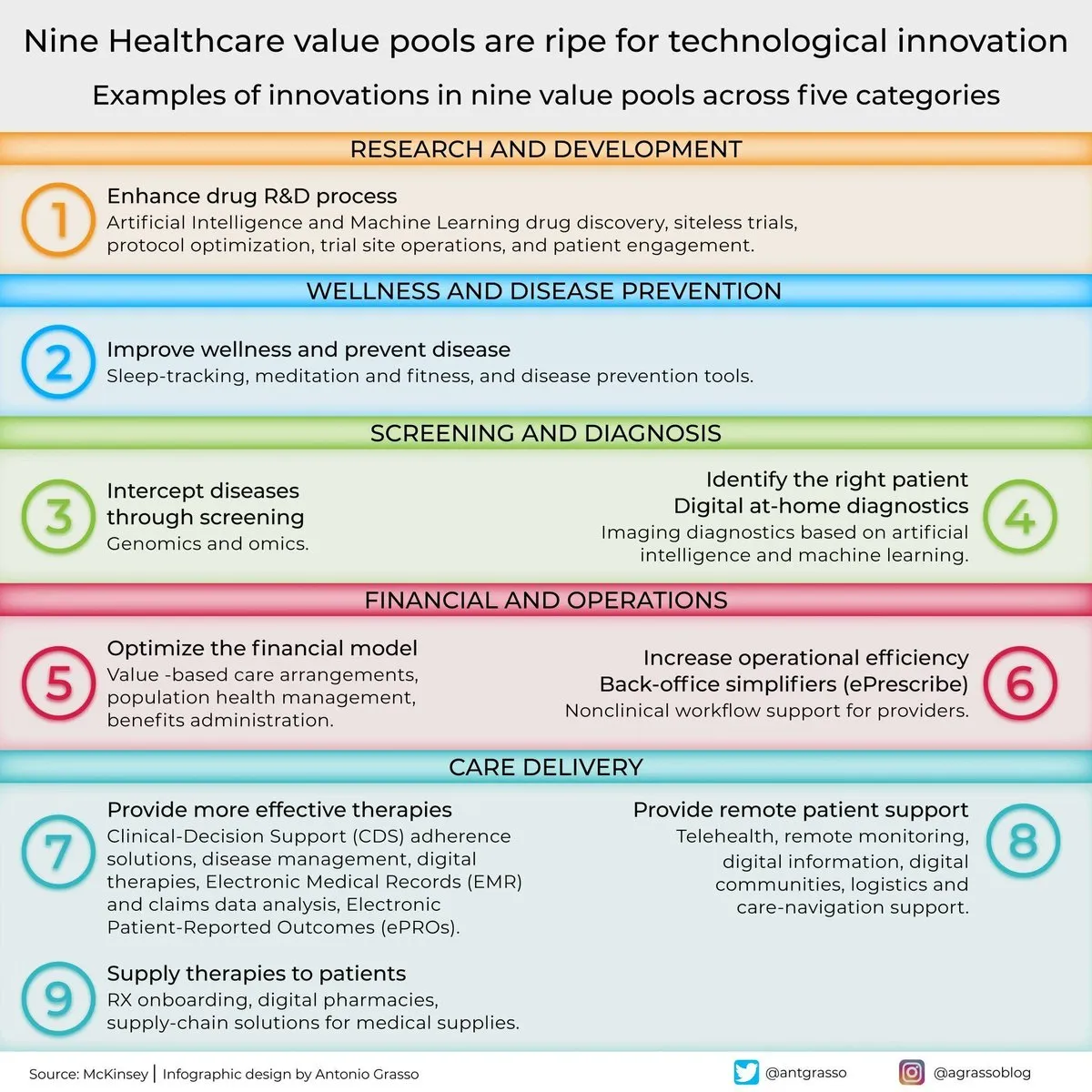

Nove áreas de valor para a AI na inovação médica: A discussão aponta que existem nove “pools de valor” no setor de saúde prontos para a inovação tecnológica. Embora a AI não seja explicitamente mencionada, ela é, sem dúvida, uma das principais forças motrizes por trás do avanço da tecnologia médica e da transformação digital, abrangendo múltiplos aspectos como diagnóstico, tratamento e cuidados personalizados. (Fonte: Ronald_vanLoon)