Palavras-chave:GPT-5, Computação quântica, Design de materiais com IA, Aprendizagem por reforço, Modelos de linguagem grande (LLM), Infraestrutura de IA, Modelos multimodais, Agente de IA, Problemas NP quânticos, CGformer – Rede Neural de Gráfico Cristalino, RLMT – Estrutura de Aprendizagem por Reforço, DeepSeek DSA – Atenção Esparsa, UniVid – Estrutura Unificada para Tarefas Visuais

🔥 Destaques

GPT-5 supera o “problema NP quântico”: Scott Aaronson, especialista em computação quântica, publicou um artigo revelando o papel de assistência inovador do GPT-5 na pesquisa da teoria da complexidade quântica. O GPT-5 ajudou a resolver uma etapa crucial de derivação no “problema NP da versão quântica” em 30 minutos, o que normalmente levaria 1-2 semanas para humanos. Este resultado marca o início do toque da IA no trabalho central de descoberta científica da inteligência humana, prenunciando um enorme salto no potencial da IA no campo da pesquisa científica. (Fonte: arXiv, scottaaronson.blog)

Novo modelo de design de materiais AI, CGformer: A equipe dos professores Li Jinjin e Huang Fuqiang da Shanghai Jiao Tong University desenvolveu um novo modelo de design de materiais AI, CGformer, que inova ao integrar o mecanismo de atenção global do Graphormer com o CGCNN, e ao incorporar codificação de centralidade e codificação espacial, superando com sucesso as limitações das redes neurais de grafos de cristal tradicionais. Este modelo é capaz de capturar completamente informações globais de estruturas cristalinas complexas, melhorando significativamente a precisão da previsão e a eficiência da triagem de novos materiais, como eletrólitos sólidos de íons de sódio de alta entropia. (Fonte: Matter)

Estrutura UniVid para tarefas visuais unificadas: UniVid é uma estrutura inovadora que, ao ajustar um Transformer de difusão de vídeo pré-treinado, permite que ele se adapte a diversas tarefas de imagem e vídeo sem modificações específicas da tarefa. Este método representa as tarefas como sentenças visuais, definindo a tarefa e a modalidade de saída esperada através de sequências contextuais, demonstrando o enorme potencial dos modelos de geração de vídeo pré-treinados como uma base unificada para modelagem visual. (Fonte: HuggingFace Daily Papers)

RLMT revoluciona o pós-treinamento de grandes modelos: A equipe da Professora Associada Danqi Chen da Princeton University propôs a estrutura “Reinforcement Learning with Model-based Reward Thinking” (RLMT), que permite aos LLMs gerar longas cadeias de pensamento antes de responder, combinando-as com um modelo de recompensa baseado em preferências para otimização online de RL. Este método melhora significativamente as capacidades de raciocínio e a generalização dos LLMs em tarefas abertas, permitindo até que modelos de 8B superem o GPT-4o em conversação e escrita criativa. (Fonte: arXiv)

Modelo de reconhecimento de texto histórico CHURRO: CHURRO é um modelo de linguagem visual (VLM) de código aberto com 3B parâmetros, projetado especificamente para reconhecimento de texto histórico de alta precisão e baixo custo. O modelo foi treinado no conjunto de dados CHURRO-DS, que contém 99.491 páginas de documentos históricos abrangendo 22 séculos e 46 idiomas, superando o desempenho de VLMs existentes como o Gemini 2.5 Pro e melhorando significativamente a eficiência da pesquisa e preservação do patrimônio cultural. (Fonte: HuggingFace Daily Papers)

🎯 Tendências

Altman prevê superinteligência de IA e recurso Pulse: Sam Altman prevê que a IA superará totalmente a inteligência humana até 2030 e aponta para a velocidade surpreendente do desenvolvimento da IA. A OpenAI lançou o recurso “modo ativo” Pulse do ChatGPT, marcando a transição da IA de uma resposta passiva para um pensamento proativo para o usuário, capaz de fornecer informações relevantes com base no conteúdo da conversa do usuário, alcançando um serviço altamente personalizado e prenunciando que a IA se tornará uma terceirização do subconsciente humano. (Fonte: 36氪, )

Jensen Huang refuta a teoria da bolha da IA e a estratégia da NVIDIA: Jensen Huang, em uma entrevista, refutou a teoria da “bolha do império da IA”, enfatizando o papel crucial da IA na economia e prevendo que a NVIDIA se tornará a primeira empresa com valor de mercado de US$ 10 trilhões. Ele apontou que o raciocínio da IA esconde uma enorme demanda por poder computacional. A NVIDIA, através de um design de colaboração extrema, lança novas arquiteturas anualmente e abre seu ecossistema, sem medo da onda de desenvolvimento próprio, visando moldar o sistema econômico da IA e promover a “IA soberana” como um novo consenso. (Fonte: 36氪, )

DeepSeek lança V3.2-Exp de código aberto e mecanismo DSA: A DeepSeek lançou a versão experimental V3.2-Exp de código aberto, com 685B parâmetros, e publicou simultaneamente um artigo detalhando seu novo mecanismo de atenção esparsa (DeepSeek Sparse Attention, DSA). O DSA visa explorar e verificar a otimização da eficiência de treinamento e inferência em cenários de longo contexto, melhorando significativamente a eficiência do processamento de longo contexto, mantendo a qualidade da saída do modelo. (Fonte: 36氪, HuggingFace)

GLM-4.6 será lançado em breve: O modelo GLM-4.6 da Zhipu AI está previsto para ser lançado em breve. O site oficial Z.ai já rotulou o GLM-4.5 como “modelo carro-chefe da geração anterior”, indicando que a nova versão pode trazer melhorias em aspectos como o comprimento do contexto, gerando atenção e expectativa da comunidade. (Fonte: Reddit r/LocalLLaMA, karminski3)

Estratégia de IA da Apple e chatbot interno Veritas: O chatbot de IA da Apple, com codinome “Veritas”, desenvolvido internamente, foi revelado. Ele atua como um sparring partner para a Siri e é capaz de executar operações dentro de aplicativos. Apesar disso, a Apple ainda insiste em não lançar um chatbot de consumo, focando na integração de IA em nível de sistema e planejando aprofundar a integração de modelos de terceiros através de um motor de respostas de IA e da interface universal MCP, em vez de desenvolver seu próprio chatbot. (Fonte: 36氪)

Crescimento do mercado de AI PC e gargalos tecnológicos: Espera-se que as remessas do mercado de AI PC cresçam fortemente em 2025-2026, mas impulsionadas principalmente pelo fim do suporte do Windows 10 e pelo ciclo de substituição de PCs, e não por uma disrupção da tecnologia de IA. Atualmente, as funções de IA são em grande parte complementares aos PCs tradicionais, enfrentando desafios como poder computacional local insuficiente, interação passiva e ecossistemas fechados. Um verdadeiro dispositivo de IA precisa alcançar “poder computacional local como principal, complementado pela nuvem” e percepção ativa. (Fonte: 36氪)

IA entra no mercado de negociação de energia: A IA está sendo amplamente aplicada no mercado de negociação de energia. Empresas como Qingpeng Smart usam grandes modelos de séries temporais para prever a geração de energia eólica e solar e a demanda de eletricidade, auxiliando nas decisões de negociação. A vantagem da IA no processamento de grandes volumes de dados promete aumentar os lucros, mas também pode levar a perdas devido a modelos imaturos e à complexidade do mercado. A indústria ainda está em fase de exploração. (Fonte: 36氪)

Atualização do modelo Tongyi da Alibaba e serviços de IA full-stack: A Alibaba Cloud, na Apsara Conference, atualizou significativamente seu sistema de IA full-stack, lançando seis novos modelos, incluindo Qwen3-MAX e Qwen3-Omni, posicionando-se como um “provedor de serviços de inteligência artificial full-stack”. A Alibaba Cloud está empenhada em construir o “Android da era da IA” e o “computador da próxima geração”, fornecendo serviços de nuvem de IA full-stack, desde modelos básicos até infraestrutura, para lidar com a evolução dos AI Agents de “surgimento de inteligência” para “ação autônoma”. (Fonte: 36氪)

Análise aprofundada da arquitetura NVIDIA Blackwell: Um evento de análise aprofundada da arquitetura NVIDIA Blackwell explorará sua arquitetura, otimização e implementação em nuvens de GPU. O evento, apresentado por especialistas da SemiAnalysis e da NVIDIA, visa revelar como a Blackwell GPU, como a “GPU da próxima década”, impulsionará o desenvolvimento do poder computacional da IA e o futuro das nuvens de GPU. (Fonte: TheTuringPost)

🧰 Ferramentas

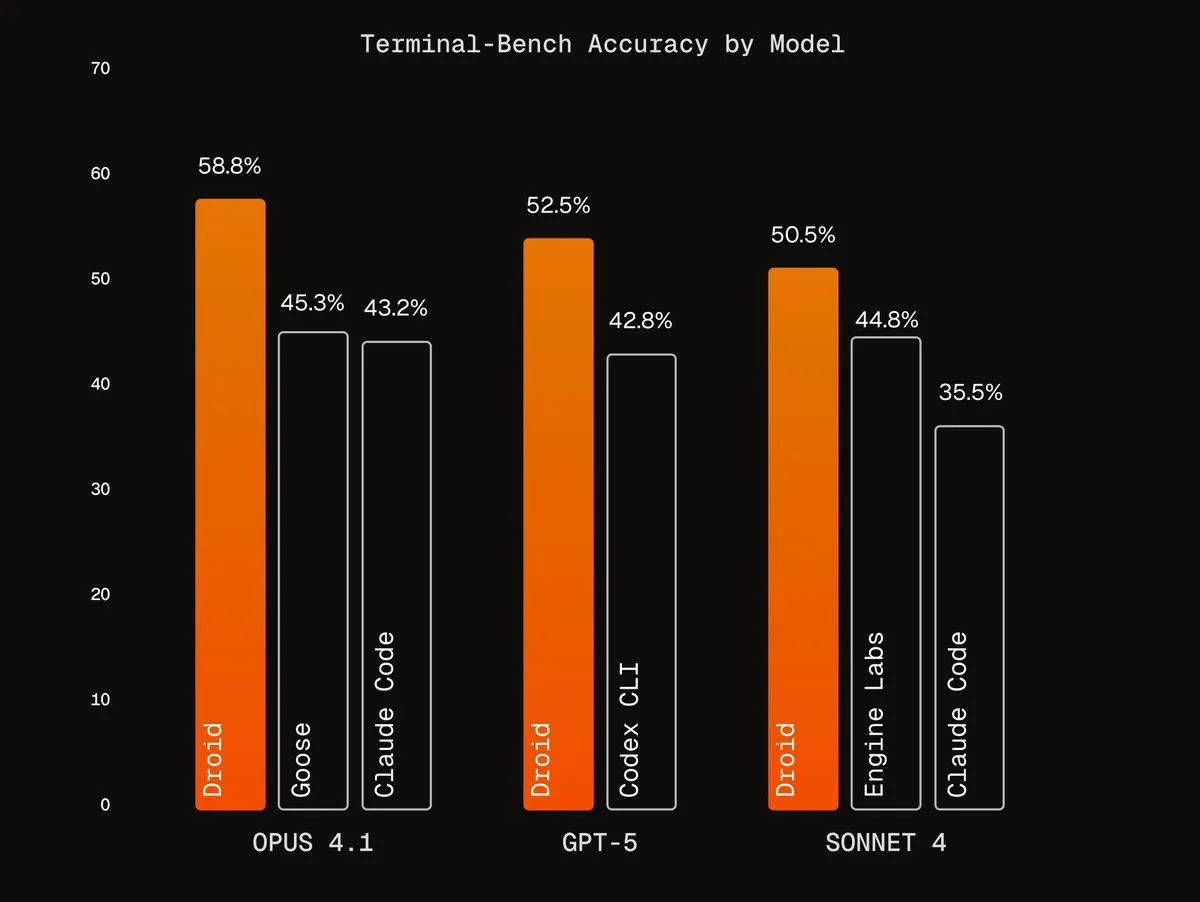

Agentic Harnesses da Factory AI: A Factory AI desenvolveu Agentic Harnesses de classe mundial, que melhoram significativamente o desempenho dos modelos existentes, destacando-se especialmente em tarefas de codificação, sendo chamados de “código de trapaça” pelos usuários. Seus agentes Droids ficaram em primeiro lugar no Terminal-Bench e alcançam refatoração de código confiável através de fluxos de trabalho de validação multiagente. (Fonte: Vtrivedy10, matanSF, matanSF)

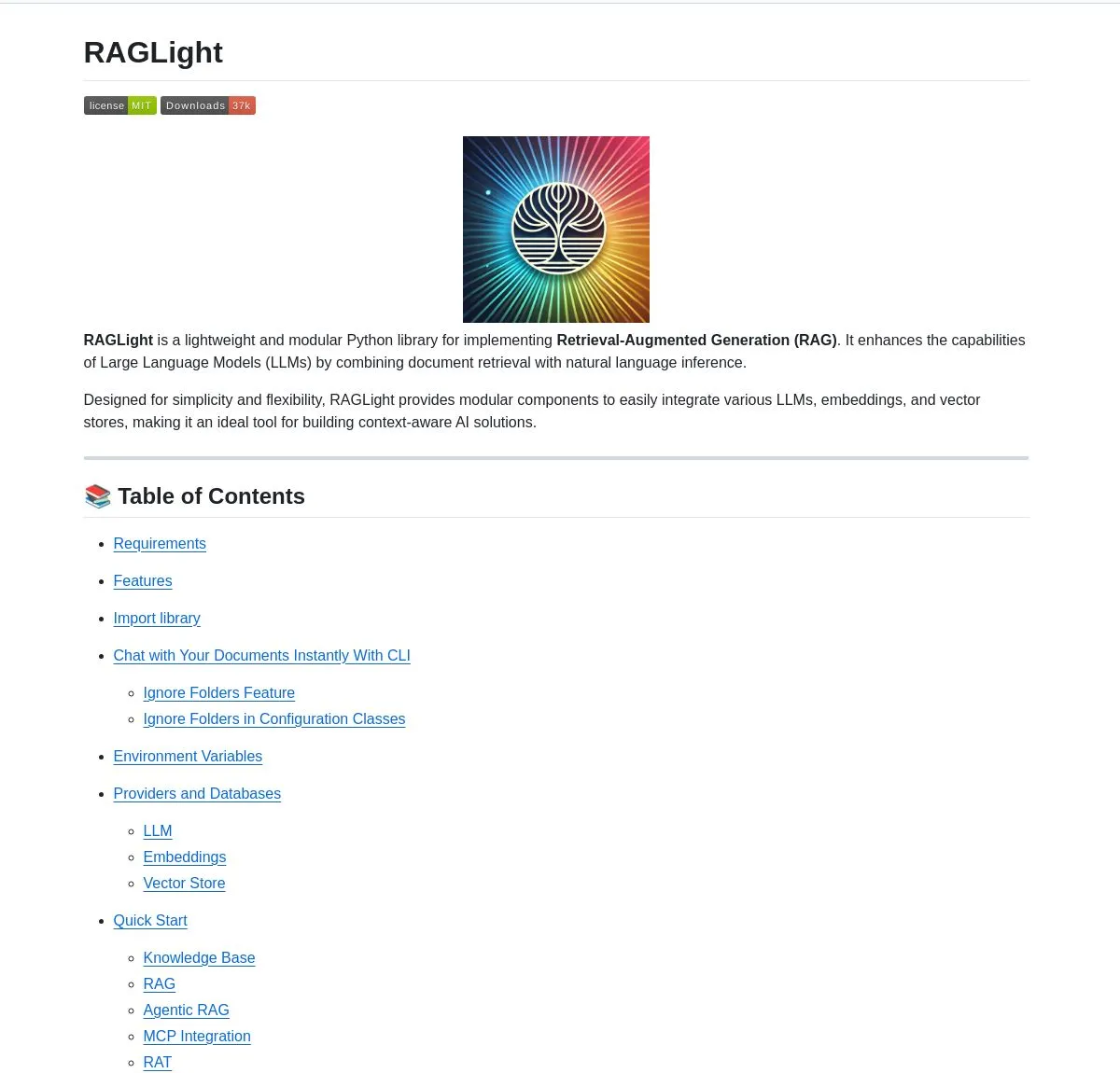

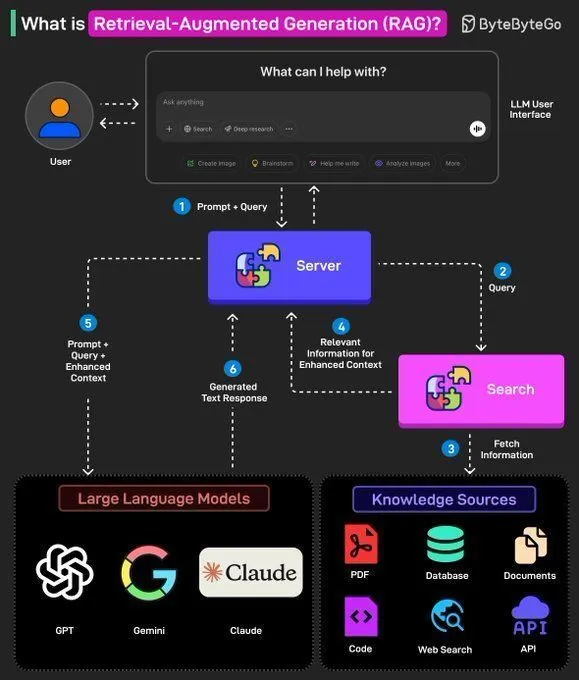

Biblioteca RAGLight de código aberto: A LangChainAI lançou o RAGLight, uma biblioteca Python leve para construir sistemas RAG de nível de produção. A biblioteca possui pipelines de agente impulsionados por LangGraph, suporte a LLM de múltiplos provedores, integração GitHub embutida e ferramentas CLI, visando simplificar o desenvolvimento e a implantação de sistemas RAG. (Fonte: LangChainAI, hwchase17)

Sistema operacional semântico ArgosOS: ArgosOS é um aplicativo de desktop que, através de uma arquitetura baseada em tags em vez de bancos de dados vetoriais, permite a busca inteligente e a integração de conteúdo de documentos. Ele utiliza LLMs para criar tags relevantes e as armazena em um banco de dados SQLite, processando consultas de forma inteligente, como a análise de contas de compras, fornecendo uma solução precisa e eficiente de gerenciamento de documentos para aplicações de pequena escala. (Fonte: Reddit r/MachineLearning)

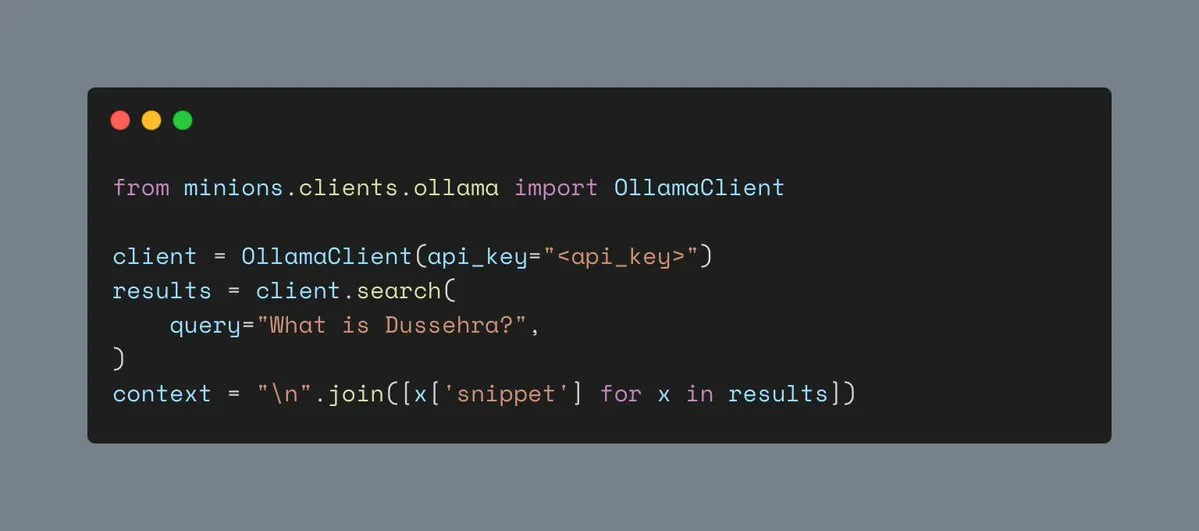

Ferramenta de busca na Web do Ollama: O Ollama agora suporta ferramentas de busca na web, permitindo que os usuários integrem a funcionalidade de busca na web em suas cargas de trabalho Minions, enriquecendo assim as informações de contexto das aplicações de IA e melhorando sua capacidade de lidar com tarefas complexas. (Fonte: ollama)

RAG multimodal local Hyperlink: O Hyperlink oferece funcionalidade RAG multimodal local, permitindo que os usuários pesquisem e resumam bibliotecas de capturas de tela/fotos offline. Através de tecnologias OCR e de embeddings, a ferramenta pode transformar dados de imagem não estruturados em conteúdo pesquisável, alcançando gerenciamento de documentos e extração de informações totalmente privados e no dispositivo. (Fonte: Reddit r/LocalLLaMA)

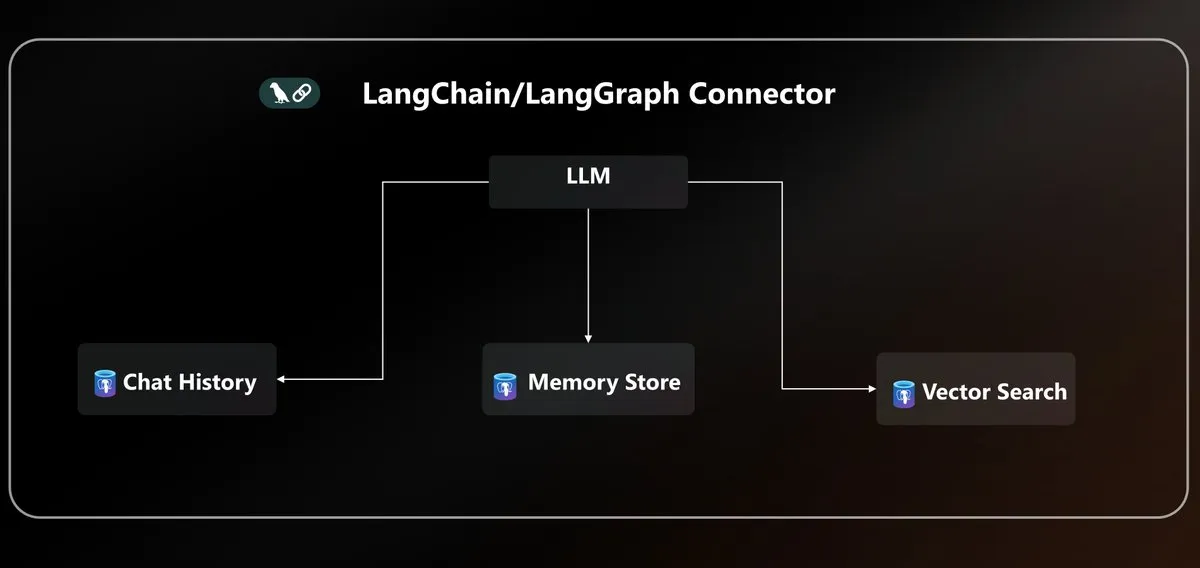

Conector Azure PostgreSQL LangChain: A Microsoft lançou um conector nativo do Azure PostgreSQL, unificando a persistência de agentes para o ecossistema LangChain. Este conector oferece armazenamento vetorial de nível empresarial e gerenciamento de estado, simplificando a complexidade de construir e implantar agentes de IA no ambiente Azure. (Fonte: LangChainAI)

Padronização da API LLM e protocolo MCP: A comunidade discute o problema da fragmentação da API LLM, apontando incompatibilidades nas estruturas de mensagens, padrões de chamada de ferramentas e nomes de campos de inferência de diferentes provedores, e apelando por uma padronização do protocolo JSON API na indústria. Ao mesmo tempo, a introdução do protocolo MCP (Model-Client Protocol) também gerou discussões sobre seu impacto no desenvolvimento de agentes. (Fonte: AAAzzam, charles_irl)

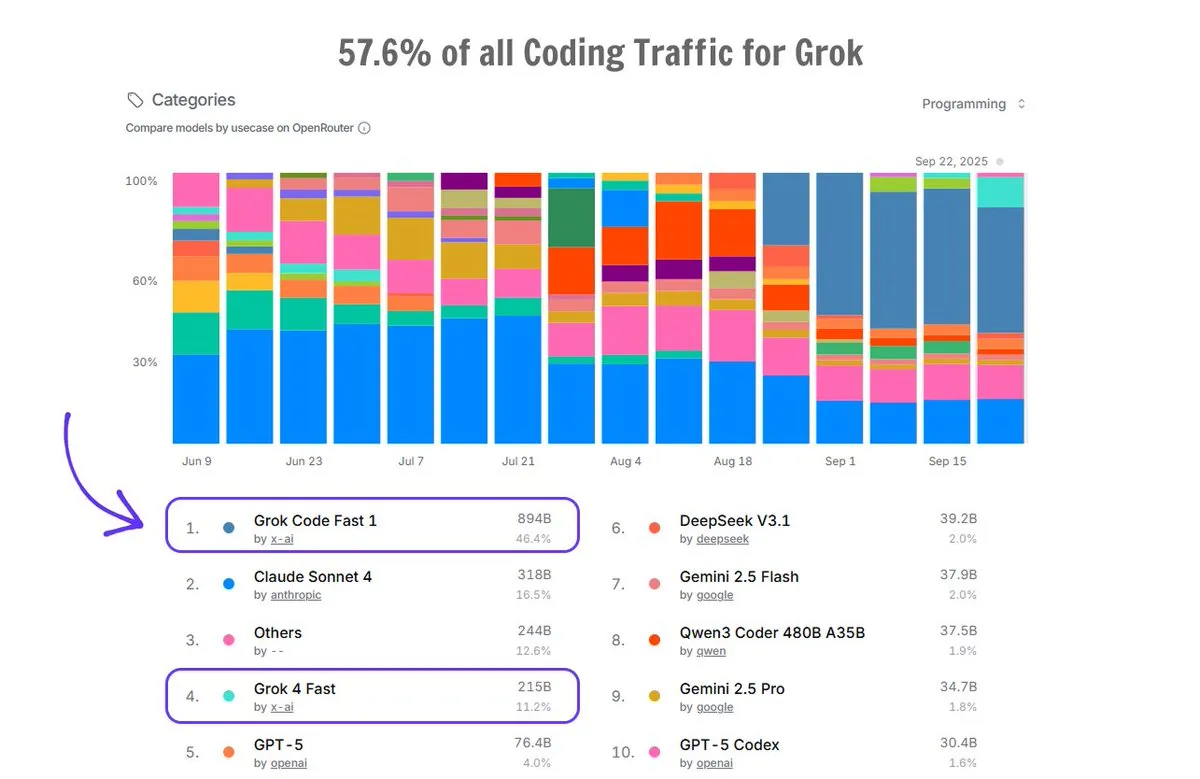

Aplicação do Grok Code no OpenRouter: O Grok Code responde por 57,6% do tráfego de codificação na plataforma OpenRouter, superando a soma de todos os outros geradores de código de IA, com o Grok Code Fast 1 em primeiro lugar, demonstrando seu forte desempenho de mercado e preferência do usuário no campo da geração de código. (Fonte: imjaredz)

📚 Aprendizagem

Curso básico de IA Cursor Learn: Lee Robinson lançou o Cursor Learn, uma série de vídeos gratuita em seis partes, projetada para ajudar iniciantes a dominar conceitos básicos de IA como tokens, context e agents. O curso tem duração de aproximadamente 1 hora, oferece questionários e testes de modelos de IA, sendo um recurso conveniente para aprender os fundamentos da IA. (Fonte: crystalsssup)

Livro gratuito sobre estruturas de dados em Python: Donald R. Sheehy lançou um livro gratuito intitulado “A First Course on Data Structures in Python”, cobrindo estruturas de dados, pensamento algorítmico, análise de complexidade, recursão/programação dinâmica e métodos de busca, fornecendo uma base sólida para estudantes nas áreas de IA e Machine Learning. (Fonte: TheTuringPost)

Modelo OCR multilíngue dots.ocr: O Xiaohongshu Hi Lab lançou o dots.ocr, um poderoso modelo OCR multilíngue que suporta 100 idiomas, capaz de analisar texto, tabelas, fórmulas e layouts de ponta a ponta (com saída em Markdown), e é gratuito para uso comercial. O modelo é compacto (1.7B VLM), mas alcança desempenho SOTA no OmniDocBench e dots.ocr-bench. (Fonte: mervenoyann)

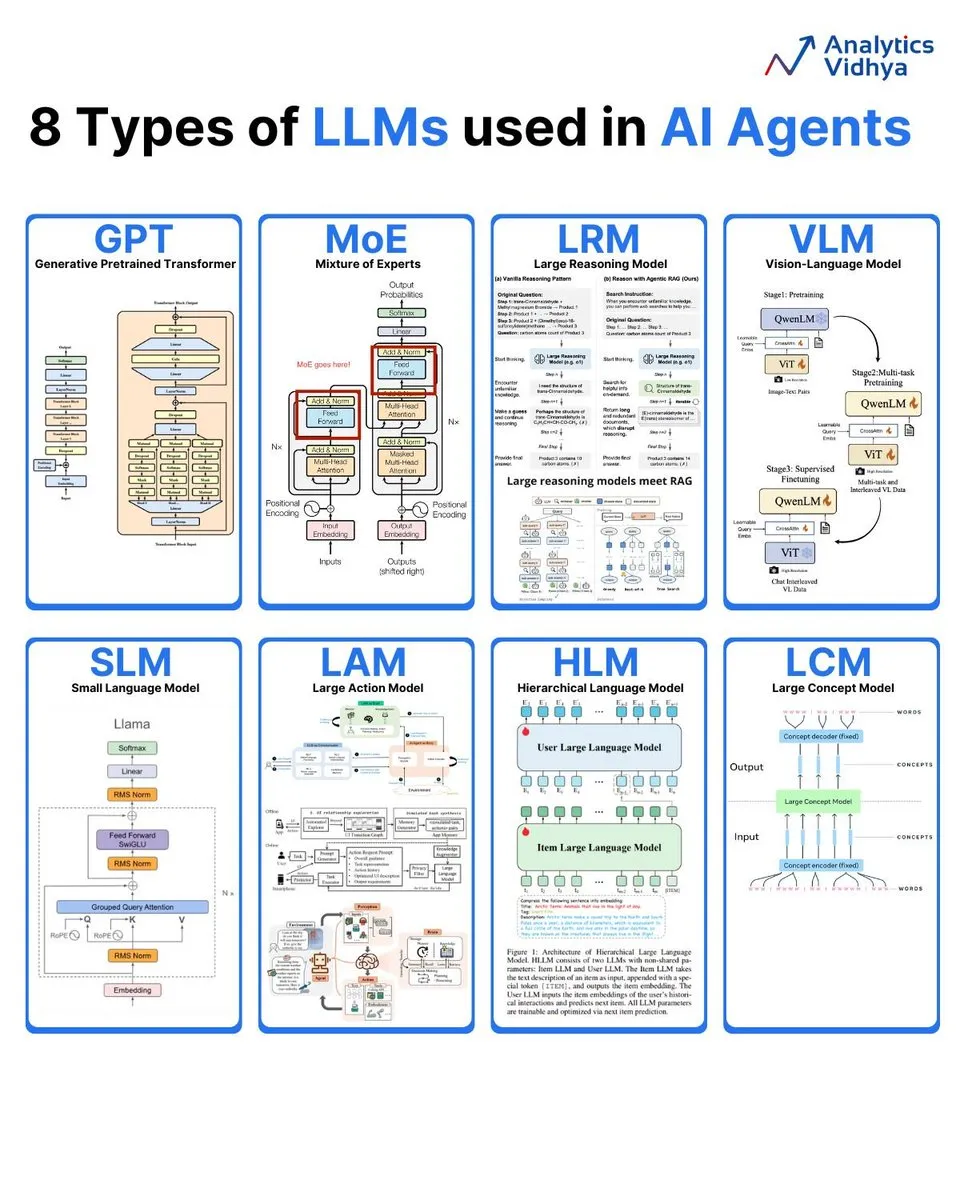

Análise de 8 tipos de Large Language Models: A Analytics Vidhya resumiu 8 tipos principais de Large Language Models, incluindo GPT (Generative Pre-trained Transformer), MoE (Mixture of Experts), LRM (Large Reasoning Model), VLM (Visual Language Model), SLM (Small Language Model), LAM (Large Action Model), HLM (Hierarchical Language Model) e LCM (Large Concept Model), detalhando suas arquiteturas e aplicações. (Fonte: karminski3)

Boletim semanal de IA: Resumo dos artigos mais recentes: A DAIR.AI publicou a seleção de artigos de IA desta semana (22-28 de setembro), cobrindo várias pesquisas de ponta, como ATOKEN, LLM-JEPA, Code World Model, Teaching LLMs to Plan, Agents Research Environments, Language Models that Think, Chat Better, Embodied AI: From LLMs to World Models, fornecendo as últimas atualizações para pesquisadores de IA. (Fonte: dair_ai)

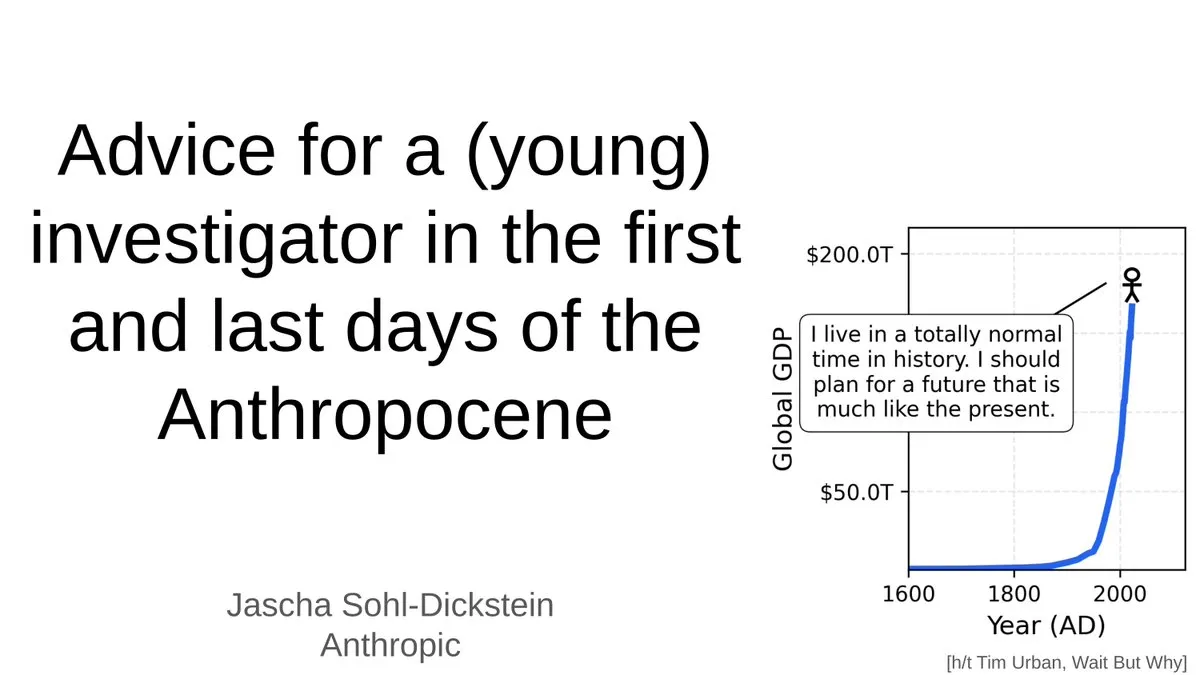

Conselhos para jovens pesquisadores na era da IA: Jascha Sohl-Dickstein compartilhou conselhos práticos para jovens pesquisadores sobre como escolher projetos de pesquisa e tomar decisões de carreira na fase final do “Antropoceno”. Ele explorou o profundo impacto da AGI nas carreiras acadêmicas e enfatizou a necessidade de repensar as direções de pesquisa e o desenvolvimento profissional no contexto de sistemas de IA que superarão a inteligência humana. (Fonte: mlpowered)

Conceitos de RAG e construção de AI Agents: Ronald van Loon compartilhou os conceitos básicos de RAG (Retrieval-Augmented Generation) e sua importância nos LLMs, além de fornecer 8 passos chave para construir um AI Agent. O conteúdo abrange o conceito de AI Agent, sua pilha, vantagens e como avaliá-lo através de frameworks, fornecendo orientação do teórico ao prático para desenvolvedores de IA. (Fonte: Ronald_vanLoon, Ronald_vanLoon)

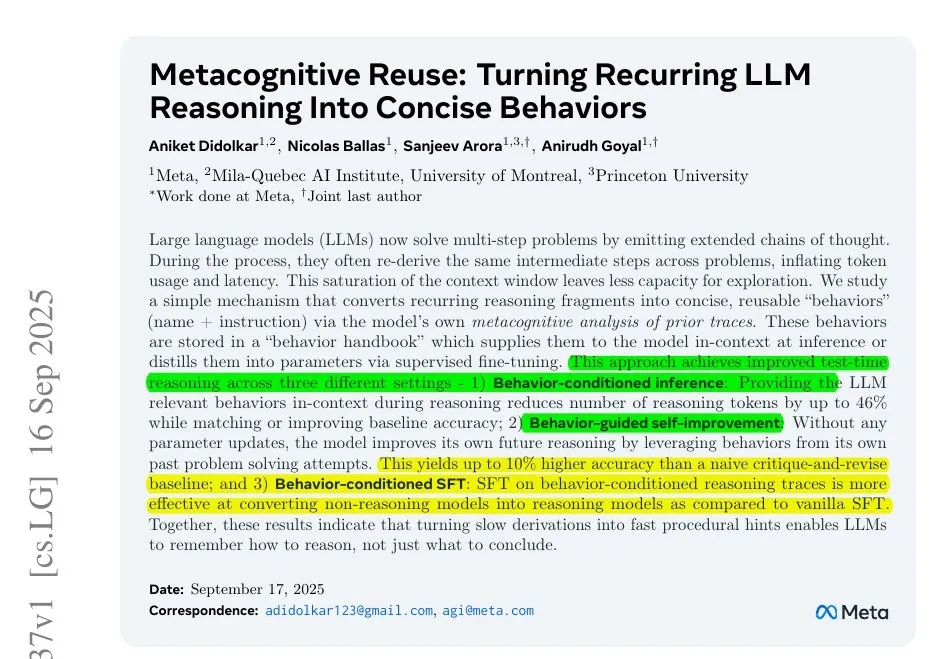

Meta resolve problema de inferência ineficiente em LLMs: Pesquisas da Meta revelam o problema da ineficiência de inferência em LLMs devido a trabalhos repetitivos em longas cadeias de pensamento. Eles propõem comprimir etapas repetitivas em pequenas ações nomeadas, permitindo que o modelo chame essas ações em vez de rededuzir, reduzindo assim o consumo de tokens e melhorando a eficiência e precisão da inferência, oferecendo uma nova abordagem para otimizar o processo de inferência de LLMs. (Fonte: ylecun)

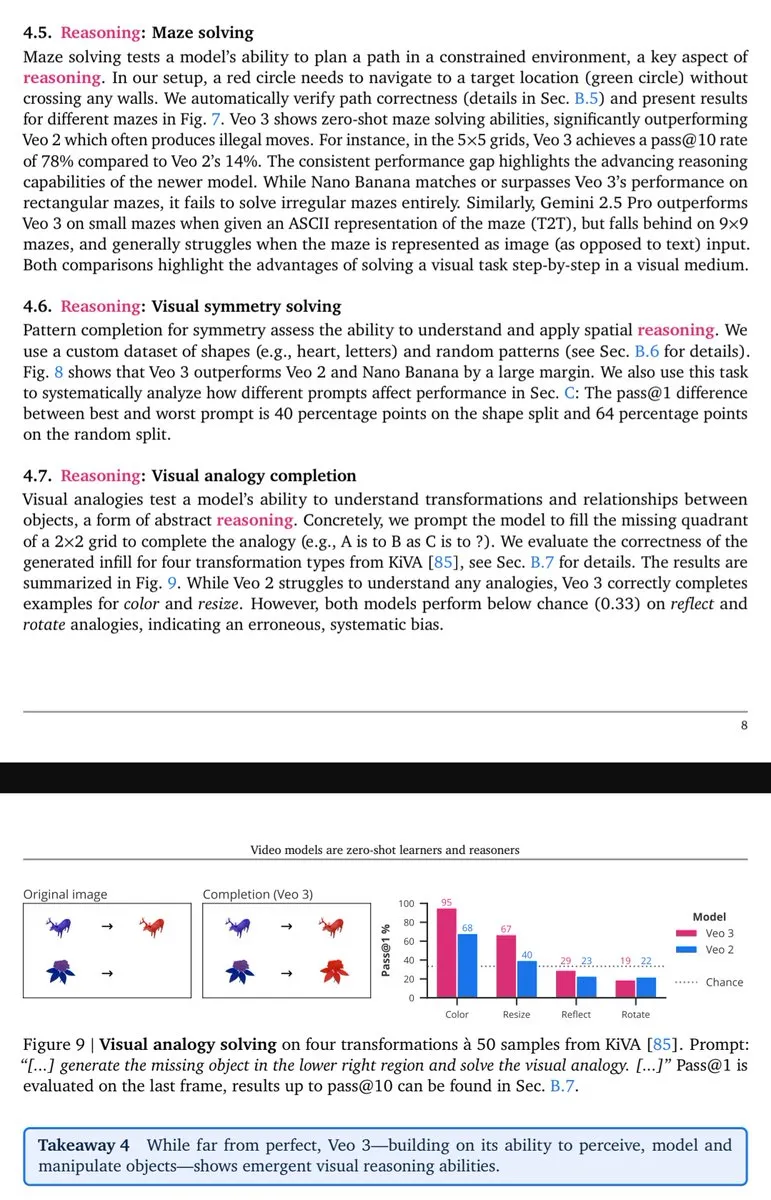

Capacidades de raciocínio visual do Veo-3 emergem: Lisan al Gaib aponta que o modelo de vídeo Veo-3 demonstra capacidades de raciocínio (visual) emergentes semelhantes às do GPT-3, prenunciando que modelos multimodais nativos, após explorarem todo o seu potencial, trarão benefícios mais abrangentes de compreensão e raciocínio visual. (Fonte: scaling01)

💼 Negócios

Aposta de bilhões da OpenAI e a bolha da infraestrutura de IA: A OpenAI está construindo uma gigantesca rede que abrange chips, computação em nuvem e data centers a uma velocidade de queima de dinheiro, incluindo um investimento de US$ 100 bilhões da Nvidia e uma colaboração de US$ 300 bilhões com a Oracle para o “Stargate”. Embora a receita de 2025 seja projetada em apenas US$ 13 bilhões, a gerência da OpenAI acredita que o investimento em infraestrutura de IA é uma “oportunidade única em um século”, levantando a controvérsia sobre se a infraestrutura de IA enfrenta uma bolha da internet. (Fonte: 36氪)

Musk processa OpenAI pela sexta vez: A xAI, de Elon Musk, processou a OpenAI pela sexta vez, acusando-a de sistematicamente recrutar funcionários, roubar ilegalmente o código-fonte do modelo Grok e planos estratégicos de data centers, entre outros segredos comerciais. Este processo marca a intensificação da competição entre os dois gigantes da IA. Musk acredita que a OpenAI se desviou de sua missão original sem fins lucrativos, enquanto a OpenAI nega as acusações, chamando-as de “assédio contínuo”. (Fonte: 36氪)

Cientista de IA de ponta Steven Hoi junta-se ao Alibaba Tongyi: O cientista de IA de ponta global e IEEE Fellow, Steven Hoi (Xu Zhuhong), juntou-se ao Alibaba Tongyi Lab, onde se dedicará à pesquisa fundamental e de ponta em grandes modelos multimodais. Steven Hoi tem mais de 20 anos de experiência em P&D industrial e acadêmica em IA, tendo sido vice-presidente da Salesforce e fundado a HyperAGI. Sua adesão marca um novo e significativo investimento do Alibaba no campo dos grandes modelos multimodais, visando acelerar a eficiência da iteração de modelos e as inovações multimodais. (Fonte: 36氪)

🌟 Comunidade

Queda de desempenho do ChatGPT 4o e sentimentos dos usuários: Um grande número de usuários do ChatGPT relatou uma queda no desempenho do modelo 4o, com problemas de “redução” e “roteamento de segurança”, levando os usuários a se sentirem frustrados e enganados. Muitos usuários neurodiversos estão particularmente tristes, acreditando que o 4o era sua “linha de vida” para comunicação e autocompreensão. Os usuários geralmente questionam a falta de transparência da OpenAI e a conclamam a cumprir sua promessa de “tratar os usuários como adultos”, opondo-se a mecanismos de censura ambíguos. (Fonte: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

Debate sobre emprego e demissões na era da IA: A comunidade discute intensamente o impacto da IA no mercado de trabalho, incluindo a queda significativa no número de vagas de nível júnior, a coexistência de demissões corporativas e investimentos em IA, e a veracidade das razões para as demissões relacionadas à IA. A discussão aponta para a tendência de “pessoas que entendem de IA substituindo as que não entendem” e apela às empresas para redesenharem os trabalhos de nível de entrada em vez de simplesmente eliminá-los, a fim de cultivar talentos escassos adaptados às necessidades da era da IA. (Fonte: 36氪, 36氪, Reddit r/artificial)

Desafios e barreiras na pesquisa de LLM: A comunidade discute intensamente o aumento das barreiras de entrada na pesquisa de Machine Learning, onde pesquisadores individuais têm dificuldade em competir com grandes gigantes da tecnologia. Enfrentando desafios como um grande volume de artigos, poder computacional caro e teorias matemáticas complexas, muitos acham difícil começar e fazer avanços, levantando preocupações sobre a sustentabilidade do campo. (Fonte: Reddit r/MachineLearning)

Impacto dos modelos MoE na hospedagem local: A comunidade discute aprofundadamente as vantagens e desvantagens dos modelos MoE para hospedagem local de LLMs. A opinião é que, embora os modelos MoE ocupem mais VRAM, eles são computacionalmente eficientes e podem permitir a execução de modelos maiores através do descarregamento para a CPU, sendo especialmente adequados para hardware de consumidor com muita memória, mas GPU limitada, representando uma maneira eficaz de melhorar o desempenho dos LLMs. (Fonte: Reddit r/LocalLLaMA)

Rápido desenvolvimento e aplicação de AI Agents: A comunidade discute o rápido desenvolvimento dos AI Agents, cujas capacidades evoluíram rapidamente de “quase inutilizáveis” para “com bom desempenho” em cenários específicos, e até mesmo “Agentes gerais começando a ser úteis” em menos de um ano, com um ritmo de progresso que excedeu as expectativas. No entanto, também há a visão de que os atuais Agentes de codificação são altamente homogêneos e carecem de diferenças significativas. (Fonte: nptacek, HamelHusain)

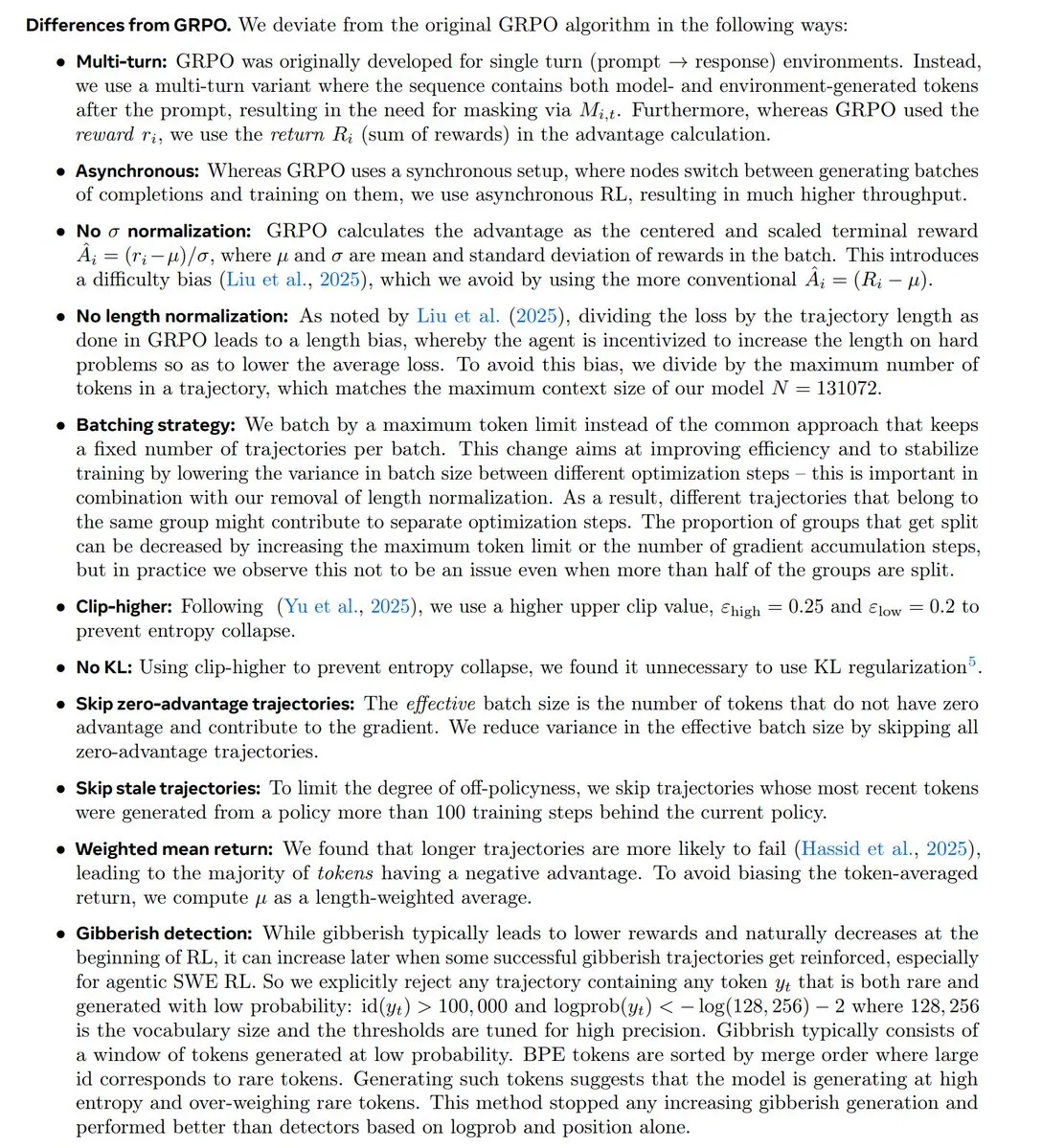

Tendências de pesquisa em RL e controvérsia GRPO: A comunidade discute aprofundadamente as últimas tendências na pesquisa de Reinforcement Learning (RL), especialmente o status e a controvérsia do algoritmo GRPO. Alguns argumentam que a pesquisa em RL está mudando para pré-treinamento/modelagem e que o GRPO é um avanço importante de código aberto, mas funcionários da OpenAI também acreditam que ele está significativamente atrasado em relação às tecnologias de ponta, gerando um debate acalorado sobre inovação algorítmica versus desempenho real. (Fonte: natolambert, MillionInt, cloneofsimo, jsuarez5341, TheTuringPost)

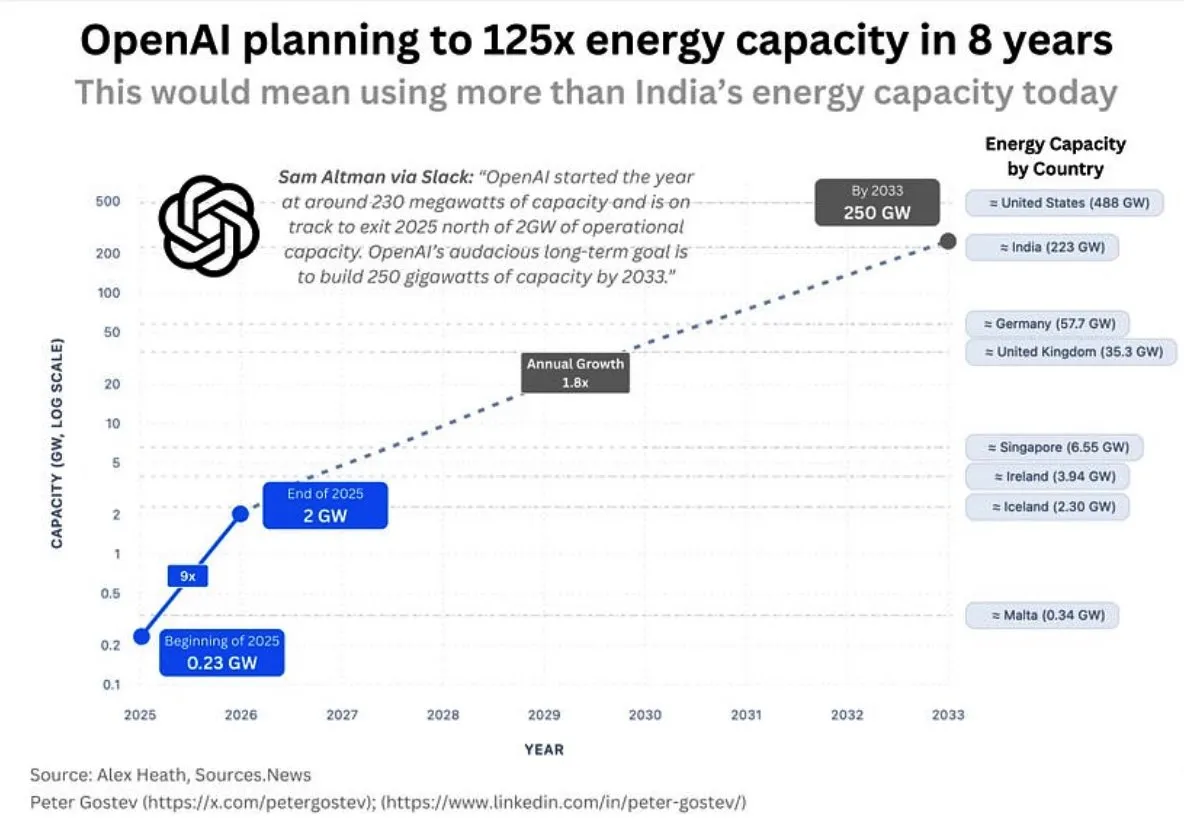

Consumo de energia da OpenAI e infraestrutura de IA: A comunidade discute a enorme demanda de energia futura da OpenAI, prevendo que consumirá mais energia do que o Reino Unido ou a Alemanha em cinco anos, e mais do que a Índia em oito anos, levantando preocupações sobre a escala da construção da infraestrutura de IA, o fornecimento de energia e o impacto ambiental. Ao mesmo tempo, a escolha de locais para data centers do Google também enfrentou oposição de moradores locais devido a problemas de consumo de água. (Fonte: teortaxesTex, brickroad7)

A “Bitter Lesson” de Sutton e o desenvolvimento da IA: A comunidade discute a “Bitter Lesson” de Richard Sutton e suas implicações para a pesquisa em IA, enfatizando que métodos computacionais gerais são superiores ao conhecimento prévio humano. A discussão gira em torno da relação entre “imitação e modelos de mundo”, argumentando que a imitação pura pode levar ao “culto de carga”, e que a imitação sem experiência real tem limitações fundamentais. (Fonte: rao2z, jonst0kes)

💡 Outros

Robô biomimético BionicWheelBot: O robô BionicWheelBot, imitando o movimento de rolamento da aranha-roda, alcança navegação multifuncional em terrenos complexos. Esta inovação demonstra o potencial da biomimética no design de robôs, oferecendo novas soluções para robôs futuros lidarem com ambientes variáveis. (Fonte: Ronald_vanLoon)

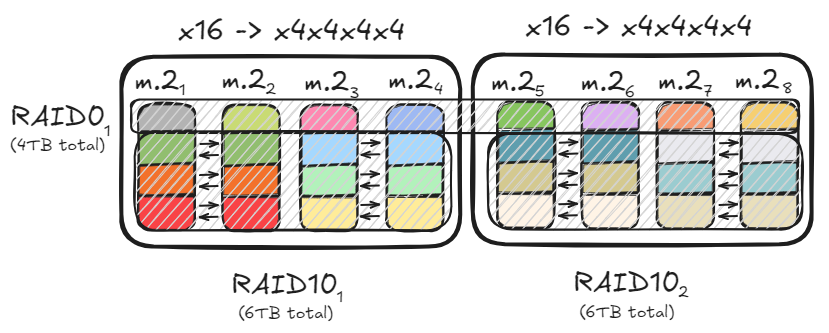

Otimização de armazenamento de PC e configuração RAID: Usuários compartilham como alcançar uma taxa de transferência de dados de até 47GB/s através de configurações RAID0 e RAID10, utilizando múltiplos canais PCIe e SSDs M.2, para acelerar o carregamento de grandes modelos. Esta solução de otimização, ao mesmo tempo que atende às necessidades de leitura e escrita de alta velocidade, equilibra a capacidade de armazenamento e a redundância de dados, fornecendo uma base de hardware eficiente para a implantação de modelos de IA locais. (Fonte: TheZachMueller)

Inauguração da “Comunidade Industrial Liangzhu Digital Habitat AI+”: A “Comunidade Industrial Liangzhu Digital Habitat AI+” em Hangzhou foi oficialmente inaugurada, focando em áreas de ponta como inteligência artificial, economia de nômades digitais e criatividade cultural. Esta comunidade, através de políticas especiais “Oito Artigos do Habitat Digital” e um layout espacial de “quatro campos”, oferece suporte de ciclo completo para exploradores de IA, desde a germinação de ideias até a liderança do ecossistema, visando criar um ecossistema inovador onde tecnologia e humanidades se integram profundamente. (Fonte: 36氪)