Palavras-chave:Detecção por IA, Imagens de abuso infantil, Gemini Robotics, Modelo incorporado, Diagnóstico de demência, Simulação física da NVIDIA, Agentes de IA, Raciocínio de LLM, Tecnologia de detecção de conteúdo gerado por IA, Modelo de execução de ações Gemini Robotics 1.5, Detecção de 9 tipos de demência em única varredura, Estrutura de inferência distribuída NVIDIA Dynamo, Edição com consciência de token para melhorar a autenticidade do modelo

🔥 Destaques

AI auxilia na detecção de imagens de abuso infantil : Com o aumento de 1325% no número de imagens de abuso sexual infantil devido à Generative AI, o Centro de Cibercrime do Departamento de Segurança Interna dos EUA está testando o uso de software de AI (da Hive AI) para distinguir entre conteúdo gerado por AI e imagens de vítimas reais. O objetivo é concentrar os recursos de investigação em casos de vítimas reais, maximizando o impacto do programa e protegendo grupos vulneráveis, marcando uma aplicação crucial da AI no combate ao cibercrime. A ferramenta identifica combinações específicas de pixels nas imagens para determinar se foram geradas por AI, sem a necessidade de treinamento para conteúdo específico. (Fonte: MIT Technology Review)

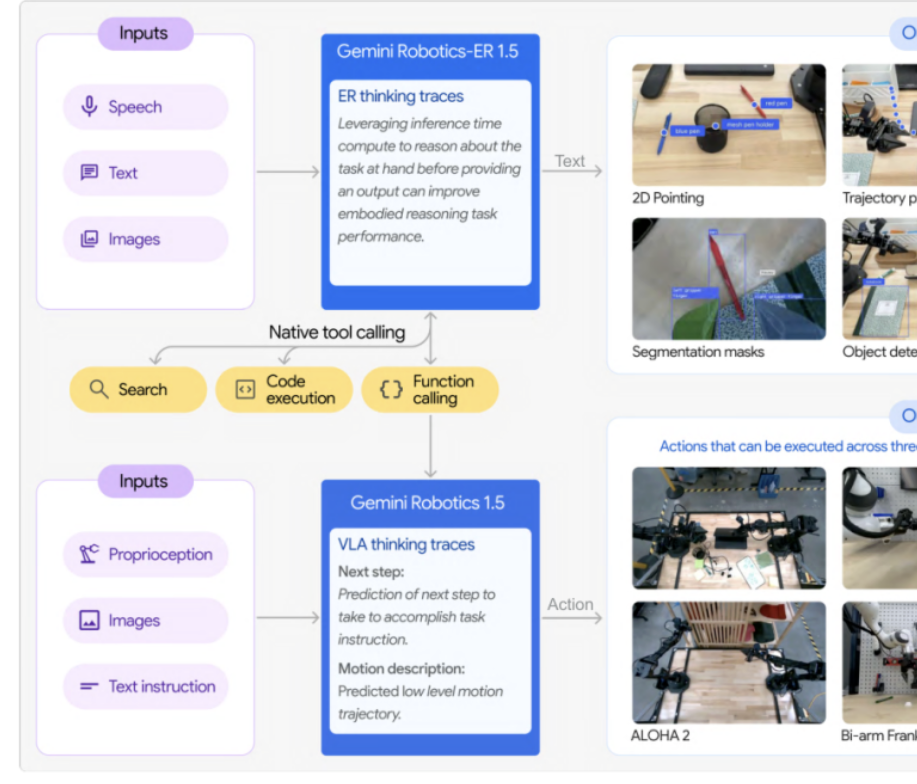

Google DeepMind lança a série de modelos corporificados Gemini Robotics 1.5 : O Google DeepMind apresentou a série Gemini Robotics 1.5, seus primeiros modelos corporificados com capacidade de raciocínio simulado. Esta série inclui o modelo de execução de ações GR 1.5 e o modelo de raciocínio aprimorado GR-ER 1.5, permitindo que os robôs “pensem primeiro, ajam depois”. Através do mecanismo “Motion Transfer”, os modelos podem transferir habilidades zero-shot para diferentes plataformas de hardware, quebrando o modelo tradicional de “um robô, um treino” e impulsionando o desenvolvimento de robôs universais. O GR-ER 1.5 superou o GPT-5 e o Gemini 2.5 Flash em testes de benchmark de raciocínio espacial e planejamento de tarefas, demonstrando uma poderosa compreensão do mundo físico e capacidade de resolver tarefas complexas. (Fonte: 量子位)

Ferramenta de AI detecta 9 tipos de demência em uma única varredura : Uma ferramenta de AI consegue detectar 9 tipos diferentes de demência com uma precisão de diagnóstico de 88% a partir de uma única varredura. Esta tecnologia promete revolucionar o diagnóstico precoce da demência, oferecendo triagem rápida e precisa para ajudar os pacientes a obter tratamento e suporte mais cedo, o que tem um significado importante para a área da saúde. (Fonte: Ronald_vanLoon)

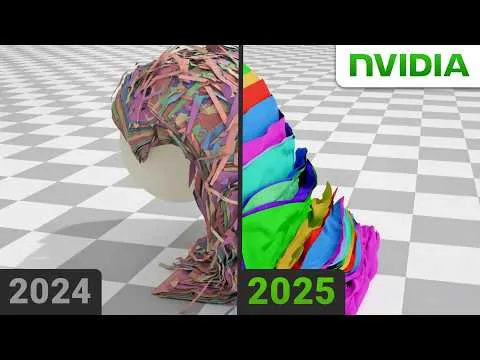

NVIDIA supera desafio da física para simulações realistas : A NVIDIA resolveu com sucesso um problema de longa data na física, uma descoberta crucial para a criação de simulações altamente realistas. É provável que esta tecnologia utilize algoritmos avançados de AI e Machine Learning, o que aumentará significativamente o realismo dos ambientes virtuais e a precisão da modelagem científica, trazendo um impacto profundo para os campos de jogos, produção cinematográfica e pesquisa científica. (Fonte: )

🎯 Tendências

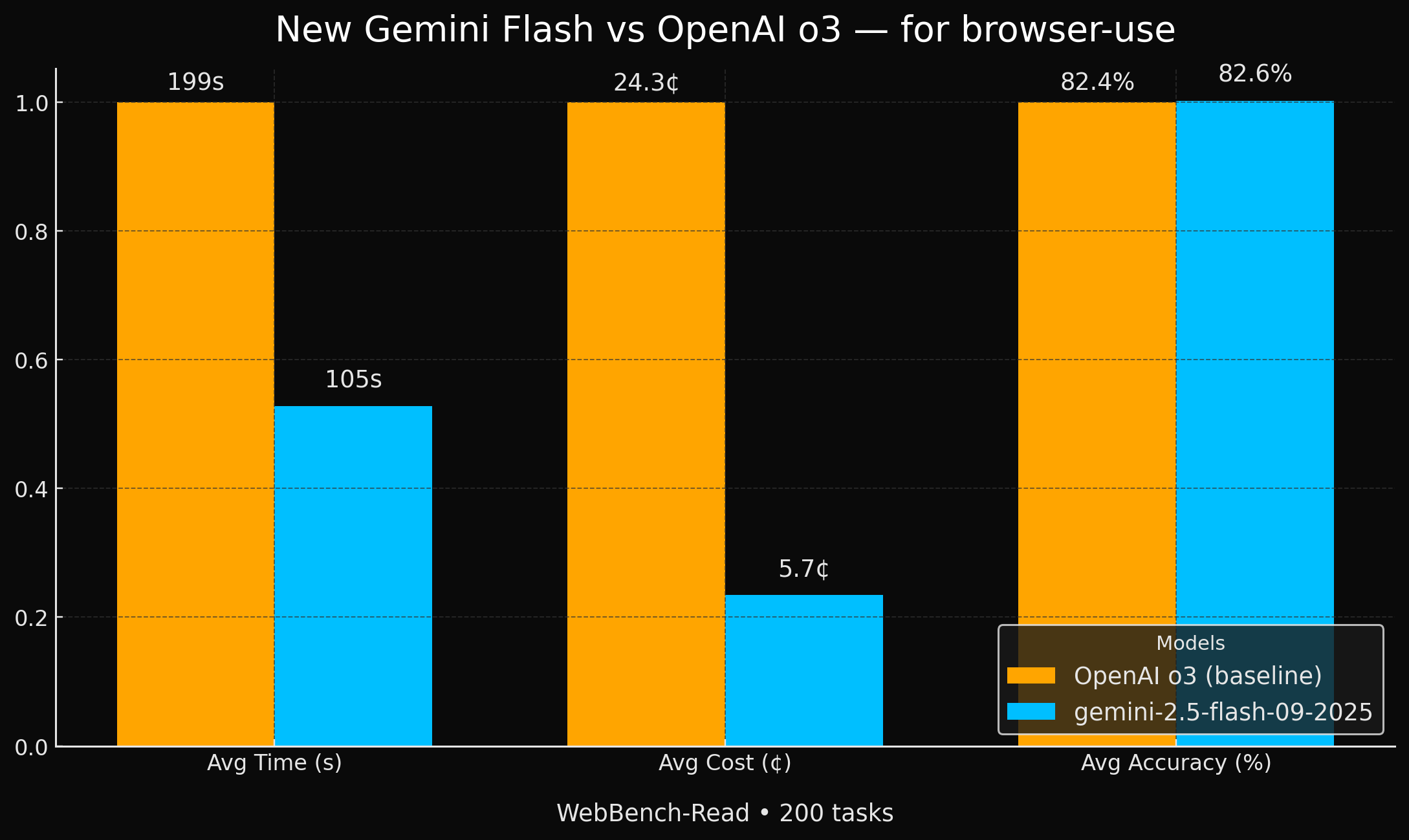

Google lança modelos Gemini Flash mais eficientes : O Google lançou dois novos modelos Gemini 2.5 (Flash e Flash-Lite) que alcançam uma precisão comparável ao GPT-4o em tarefas de agente de navegador, mas são 2 vezes mais rápidos e 4 vezes mais baratos. Este aumento significativo de desempenho e custo-benefício os torna uma opção muito atraente para aplicações específicas de AI, especialmente em cenários que exigem alta eficiência e economia. (Fonte: jeremyphoward, demishassabis, scaling01)

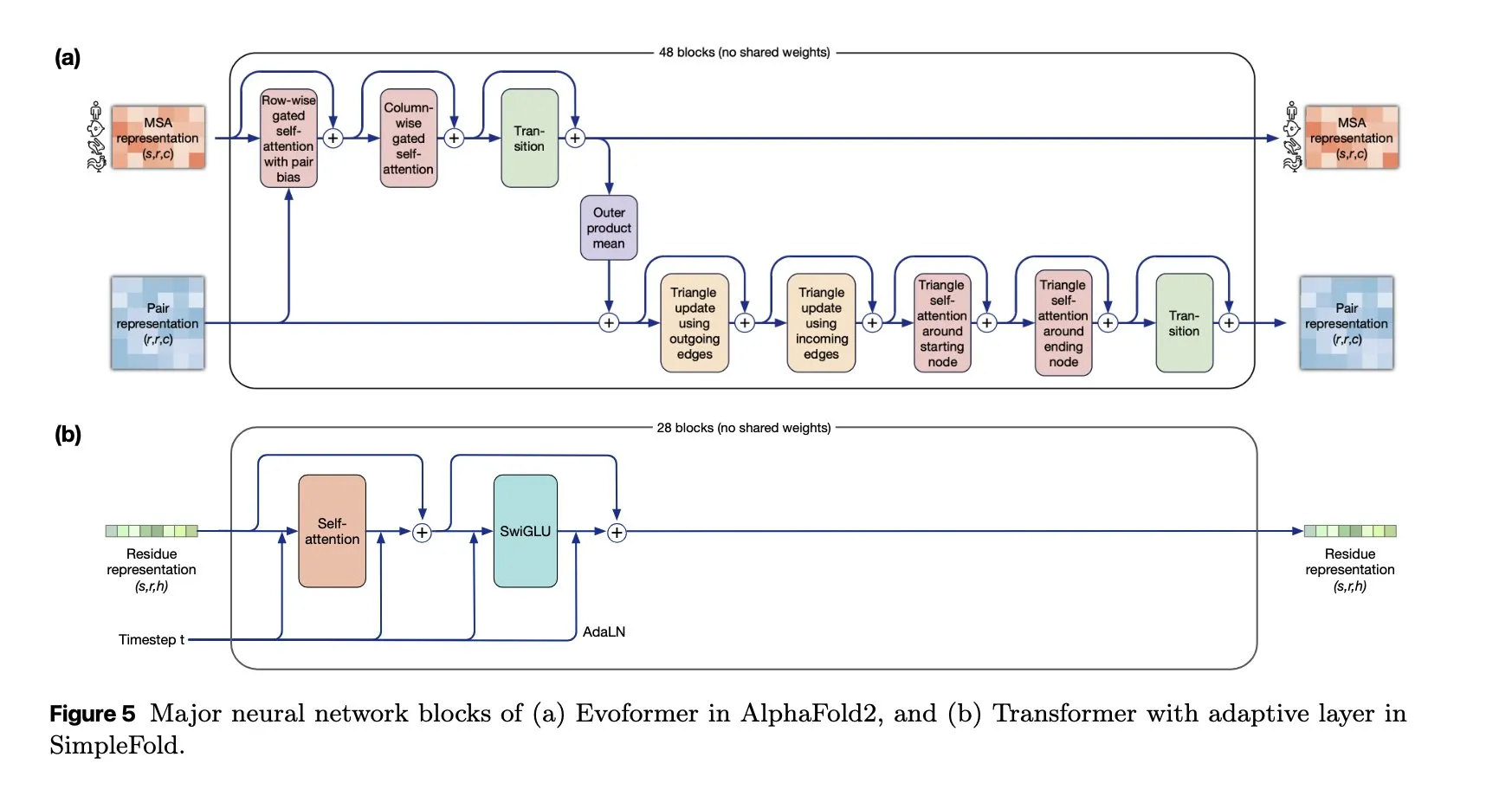

SimpleFold: Modelo de dobramento de proteínas baseado em Flow Matching : O modelo SimpleFold introduz pela primeira vez um método de dobramento de proteínas baseado em Flow Matching e é totalmente construído com blocos Transformer genéricos. Esta inovação simplifica o processo de dobramento de proteínas e, em comparação com os módulos tradicionais intensivos em computação, promete melhorar a eficiência e a escalabilidade, impulsionando a aplicação da AI no campo das ciências biológicas. (Fonte: jeremyphoward, teortaxesTex)

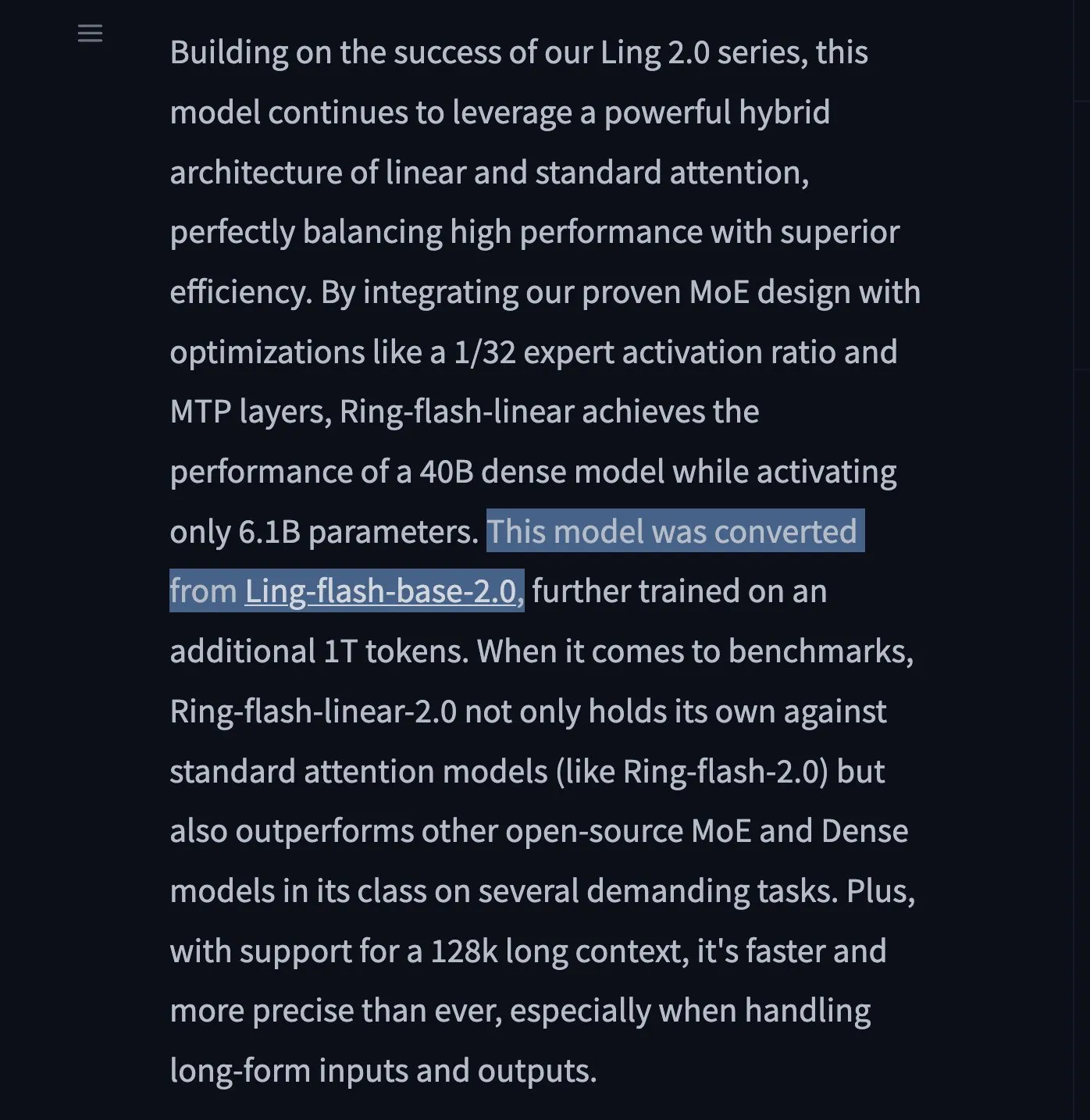

Lançamento dos LLMs Ring-flash-linear-2.0 e Ring-mini-linear-2.0 : Dois novos modelos LLM, Ring-flash-linear-2.0 e Ring-mini-linear-2.0, foram lançados, empregando um mecanismo de atenção linear híbrido para alcançar inferência ultrarrápida e de ponta. Alega-se que são 2 vezes mais rápidos que os modelos MoE de tamanho equivalente e 10 vezes mais rápidos que os modelos de 32B, estabelecendo um novo padrão para inferência eficiente. (Fonte: teortaxesTex)

ChatGPT Pulse: Assistente de pesquisa inteligente para dispositivos móveis : A OpenAI lançou o ChatGPT Pulse, uma nova funcionalidade para dispositivos móveis que realiza pesquisas assíncronas diárias com base nas conversas e memórias anteriores do usuário, ajudando-o a aprofundar a compreensão de tópicos de interesse. Isso equivale a um parceiro de conhecimento personalizado e um serviço de notícias sob medida, com potencial para transformar a aquisição de informações e o paradigma de aprendizagem. (Fonte: nickaturley, Reddit r/ChatGPT)

Framework UserRL: Treinando agentes de AI interativos e proativos : UserRL é um novo framework projetado para treinar agentes de AI capazes de realmente auxiliar os usuários através de interação proativa, em vez de apenas buscar pontuações estáticas de benchmark. Ele enfatiza a utilidade e adaptabilidade do agente em cenários reais, com potencial para impulsionar a transição de agentes de AI de respostas passivas para a resolução proativa de problemas. (Fonte: menhguin)

NVIDIA continua a impulsionar a AI de código aberto : A NVIDIA, no último ano, contribuiu com mais de 300 modelos, conjuntos de dados e aplicações para o Hugging Face, consolidando ainda mais sua posição como líder em AI de código aberto nos EUA. Esta série de iniciativas não só impulsiona o desenvolvimento da comunidade de AI, mas também demonstra a determinação da NVIDIA na construção de um ecossistema de software além do hardware. (Fonte: ClementDelangue)

Reunião especial do Qwen3 revela direções futuras : Na reunião especial do Qwen3, a Alibaba Cloud compartilhou seus planos futuros para modelos de grande escala: o Reinforcement Learning pós-treinamento ocupará mais de 50% do tempo de treinamento; o Qwen3 MoE alcançou uma alavancagem de parâmetros de ativação de 5x através da perda de balanceamento de carga de lote global; o Qwen3-Next adotará uma arquitetura híbrida, incluindo atenção linear e atenção gated; no futuro, será alcançada a unificação multimodal completa e a adesão contínua à Scaling Law. (Fonte: ZhihuFrontier)

Equipe SGLang lança framework de treinamento de RL 100% reproduzível : A equipe SGLang, em colaboração com a equipe slime, lançou o primeiro framework de treinamento de Reinforcement Learning (RL) de código aberto que é 100% reproduzível. Este framework resolve o problema de invariância de lote na inferência de LLM através de operadores de atenção personalizados e lógica de amostragem, garantindo uma correspondência perfeita dos resultados e fornecendo uma garantia confiável para cenários experimentais que exigem alta precisão de reprodução. (Fonte: 量子位)

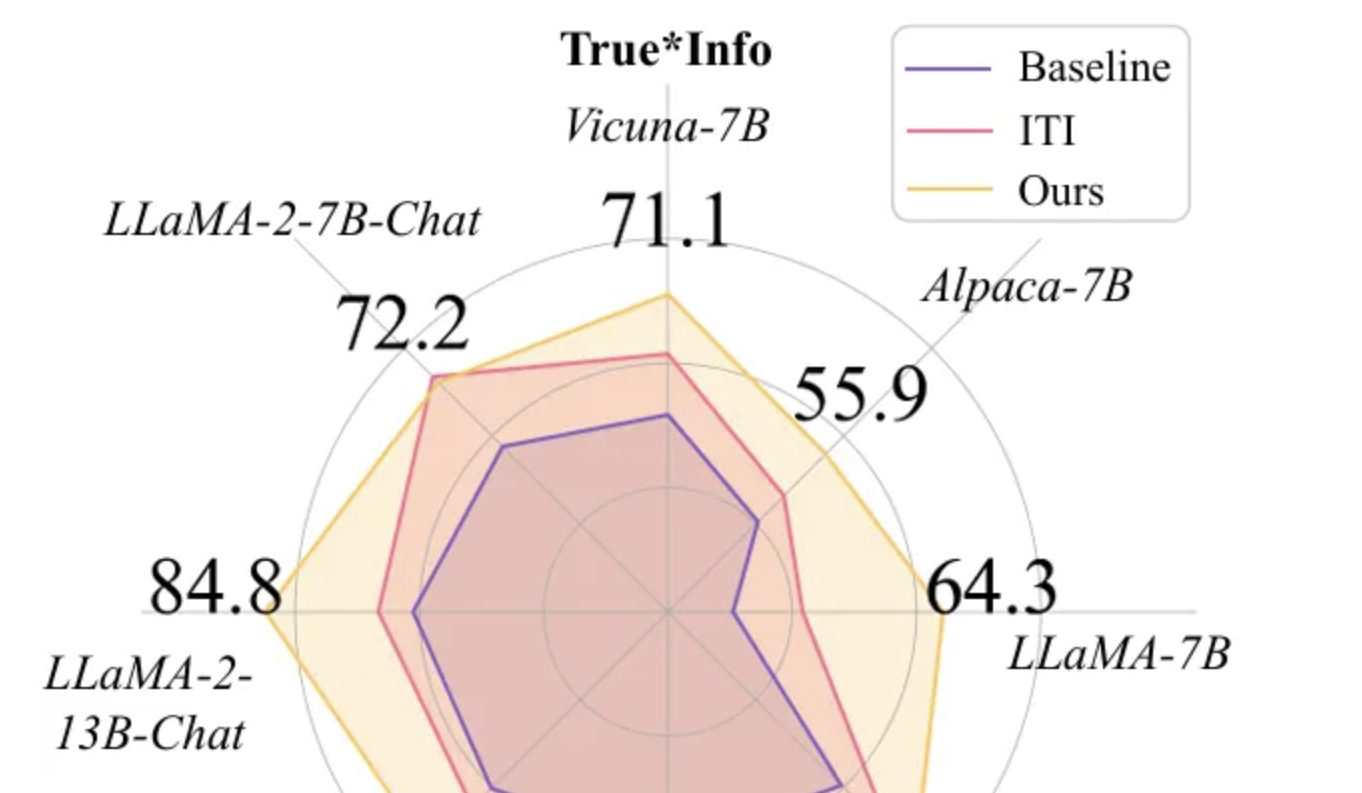

Token-Aware Editing (TAE) melhora a veracidade de modelos de grande escala : A equipe de pesquisa da Beihang University apresentou o método Token-Aware Editing (TAE) na EMNLP 2025, que melhora a veracidade dos modelos de grande escala em 25,8% na tarefa TruthfulQA através da edição de representações em tempo de inferência sensíveis a tokens, estabelecendo um novo SOTA. Este método não requer treinamento, é plug-and-play e resolve eficazmente os problemas de viés direcional e intensidade de edição inflexível nos métodos tradicionais, podendo ser amplamente aplicado em sistemas de diálogo e moderação de conteúdo. (Fonte: 量子位)

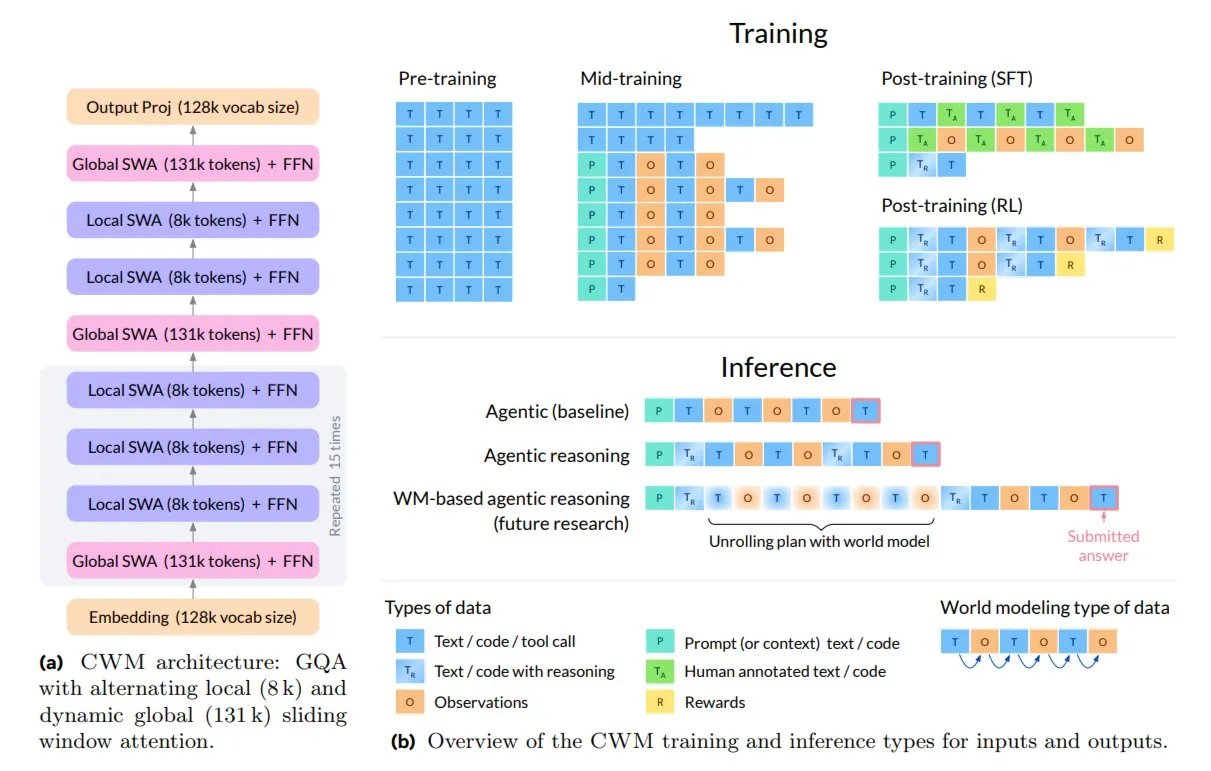

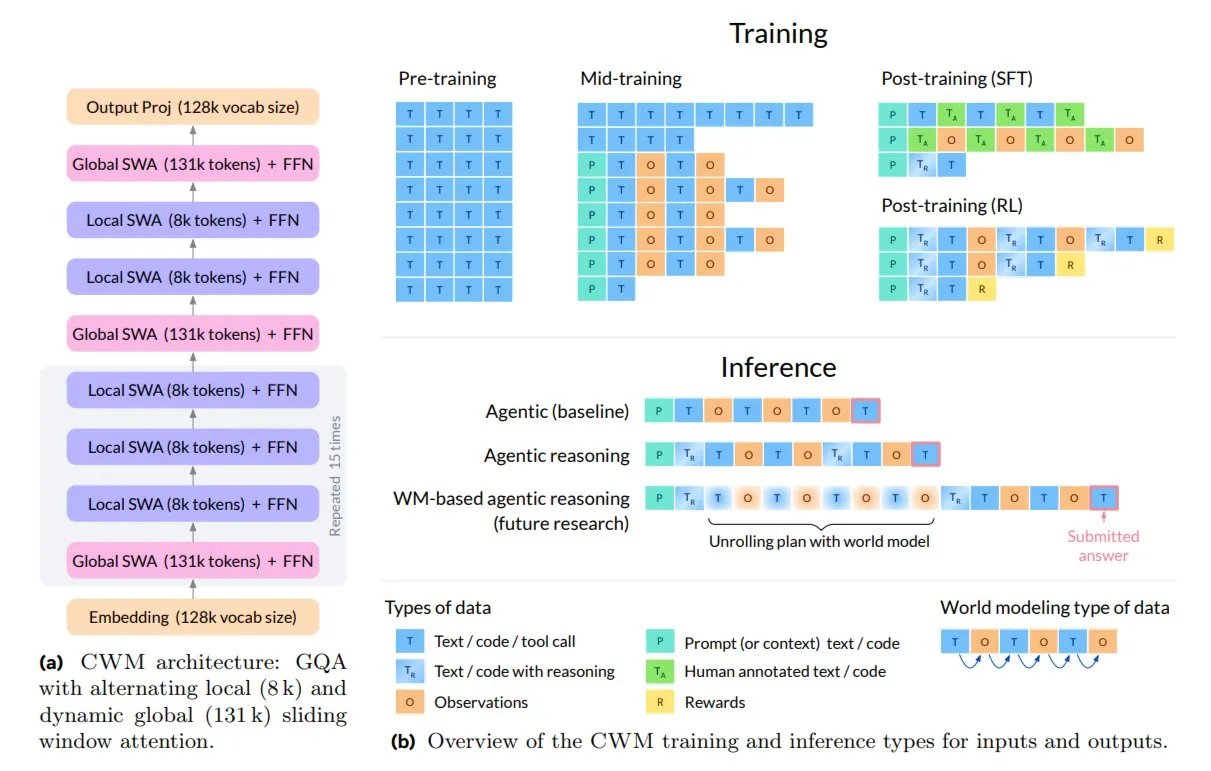

Meta lança Code World Model (CWM) para codificação e inferência : A Meta AI lançou o novo modelo de código aberto de 32B, Code World Model (CWM), projetado para codificação e inferência. O CWM não apenas aprende a sintaxe do código, mas também compreende sua semântica e processo de execução, suportando tarefas de engenharia de software de múltiplas rodadas e contextos longos. Ele é treinado através de trajetórias de execução e interações de agente, representando uma transição da autocorreção de texto para modelos capazes de planejar, depurar e verificar código. (Fonte: TheTuringPost)

🧰 Ferramentas

Lançamento do produto Replit P1 : A Replit está lançando seu produto P1, o que indica novos avanços em seu ambiente de desenvolvimento de AI ou serviços relacionados. A Replit sempre se dedicou a capacitar desenvolvedores com AI, e o lançamento do P1 pode trazer assistência de codificação mais inteligente, recursos de colaboração ou novas capacidades de integração, o que merece a atenção da comunidade de desenvolvedores. (Fonte: amasad)

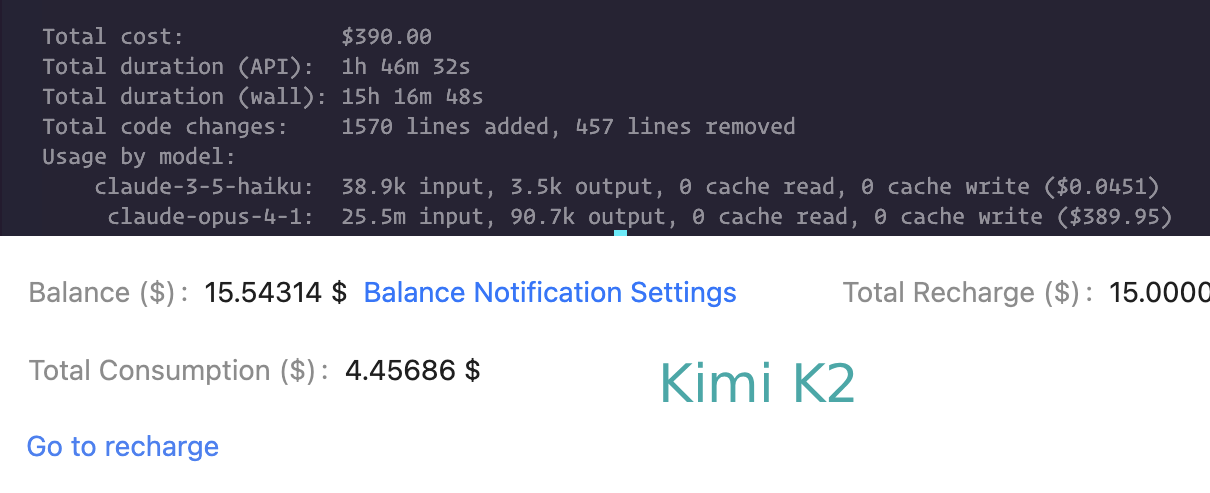

Comparação de capacidades de codificação entre Claude Code e Kimi K2 : Usuários estão comparando o desempenho do Claude Code e do Kimi K2 em tarefas de codificação. Embora o Kimi K2 seja mais lento, ele é mais barato, enquanto o Claude Code (e o Codex) é preferido por sua velocidade e capacidade de resolver problemas complexos. Isso reflete o equilíbrio entre desempenho e custo que os desenvolvedores consideram ao escolher assistentes de codificação LLM. (Fonte: matanSF, Reddit r/ClaudeAI)

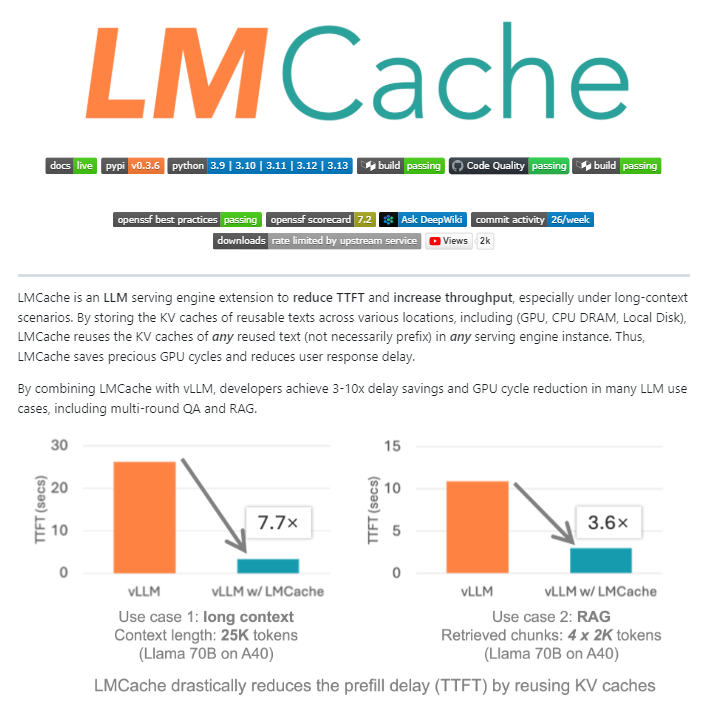

LMCache: Camada de cache de código aberto para motores de serviço LLM : LMCache é uma extensão de código aberto que atua como uma camada de cache para motores de serviço LLM, otimizando significativamente a inferência de LLM em larga escala ao reutilizar o estado de chave-valor de textos anteriores entre GPU, CPU e disco local. Esta ferramenta pode reduzir os custos de RAG em 4-10 vezes, diminuir o tempo de geração do primeiro Token e aumentar o throughput sob carga, sendo especialmente adequada para cenários de contexto longo. (Fonte: TheTuringPost)

Agente de desenvolvimento impulsionado por AI (pacote npm) : Um processo de agente de desenvolvimento maduro impulsionado por AI foi lançado via npm, visando simplificar o ciclo de vida do desenvolvimento de software. Este agente cobre todo o processo, desde a descoberta de requisitos, planejamento de tarefas até a execução e revisão, com potencial para melhorar a eficiência do desenvolvimento e a qualidade do código. (Fonte: mbusigin)

Benchmark de desempenho de inferência de LLM (Qwen3 235B, Kimi K2) : Testes de benchmark de inferência com descarregamento de CPU de 4 bits para Qwen3 235B e Kimi K2 em hardware específico mostraram que o Qwen3 235B atinge um throughput de aproximadamente 60 tokens/s, enquanto o Kimi K2 fica em torno de 8-9 tokens/s. Estes dados fornecem uma referência importante para os usuários na escolha de modelos e hardware para implantações locais de LLM. (Fonte: TheZachMueller)

AI de memória pessoal: Superando a amnésia conversacional : Um usuário desenvolveu uma AI de memória pessoal que superou com sucesso a “amnésia conversacional” da AI tradicional, referenciando seu perfil pessoal, base de conhecimento e eventos. Esta AI personalizada pode fornecer uma experiência de interação mais coerente e individualizada, abrindo novos caminhos para a aplicação da AI em assistentes pessoais e suporte emocional. (Fonte: Reddit r/artificial)

NVIDIA Dynamo: Framework de serviço de inferência distribuída em escala de data center : NVIDIA Dynamo é um framework de inferência de alto desempenho e baixa latência, projetado para servir modelos de AI generativa e inferência em ambientes distribuídos multi-nó em escala de data center. Construído com Rust e Python, este framework otimiza a eficiência e o throughput da inferência através de funções como desacoplamento de serviço e descarregamento de cache KV, suportando vários motores LLM. (Fonte: GitHub Trending)

Model Context Protocol (MCP) TypeScript SDK : O MCP TypeScript SDK é um kit de desenvolvimento oficial que implementa a especificação MCP, permitindo que os desenvolvedores construam servidores e clientes seguros e padronizados para expor dados (recursos) e funcionalidades (ferramentas) a aplicações LLM. Ele fornece uma maneira unificada de gerenciamento de contexto e integração de funcionalidades para aplicações LLM. (Fonte: GitHub Trending)

AI impulsiona a geração de conteúdo 3D para jogos : Ferramentas de AI como Hunyuan 3D da Tencent Cloud e Tripo da VAST estão sendo amplamente adotadas por desenvolvedores de jogos para modelagem de objetos e personagens 3D em jogos. Estas tecnologias melhoram significativamente a eficiência e a qualidade da criação de conteúdo 3D, indicando a crescente importância da AI no processo de desenvolvimento de jogos. (Fonte: 量子位)

HakkoAI: Companheiro de jogo VLM em tempo real : A versão internacional do DouDou AI Game Partner, HakkoAI, é um companheiro de jogo baseado em modelo de linguagem visual (VLM) em tempo real, capaz de compreender a tela do jogo e oferecer companhia profunda. Este modelo superou modelos gerais de ponta como o GPT-4o em cenários de jogos, demonstrando o enorme potencial da AI em experiências de jogo personalizadas. (Fonte: 量子位)

Avanço na consistência na geração de vídeo por AI : O modelo Hailuo S2V-01 da MiniMax AI resolveu o problema de inconsistência facial de longa data na geração de vídeo por AI, alcançando a preservação da identidade. Isso significa que os personagens gerados por AI podem manter expressões, emoções e iluminação estáveis no vídeo, proporcionando uma experiência visual mais realista e confiável para influenciadores virtuais, imagens de marca e narrativa. (Fonte: Ronald_vanLoon)

📚 Aprendizado

Manifolds modulares na otimização de redes neurais : A pesquisa introduz manifolds modulares como um avanço teórico nos princípios de design de redes neurais e otimizadores. Através do codesign de otimizadores com restrições de manifold nas matrizes de peso, espera-se alcançar um treinamento de redes neurais mais estável e de alto desempenho. (Fonte: rown, NandoDF)

Interpretação do método de modelo de linguagem “sem tokenizador” : Um artigo de blog explora em profundidade o que é chamado de método de modelo de linguagem “sem tokenizador” e explica por que ele não é realmente sem tokenizador, e por que os tokenizadores são frequentemente criticados na comunidade de AI. O artigo enfatiza que, mesmo os métodos “sem tokenizador”, envolvem escolhas de codificação que são cruciais para o desempenho do modelo. (Fonte: YejinChoinka, jxmnop)

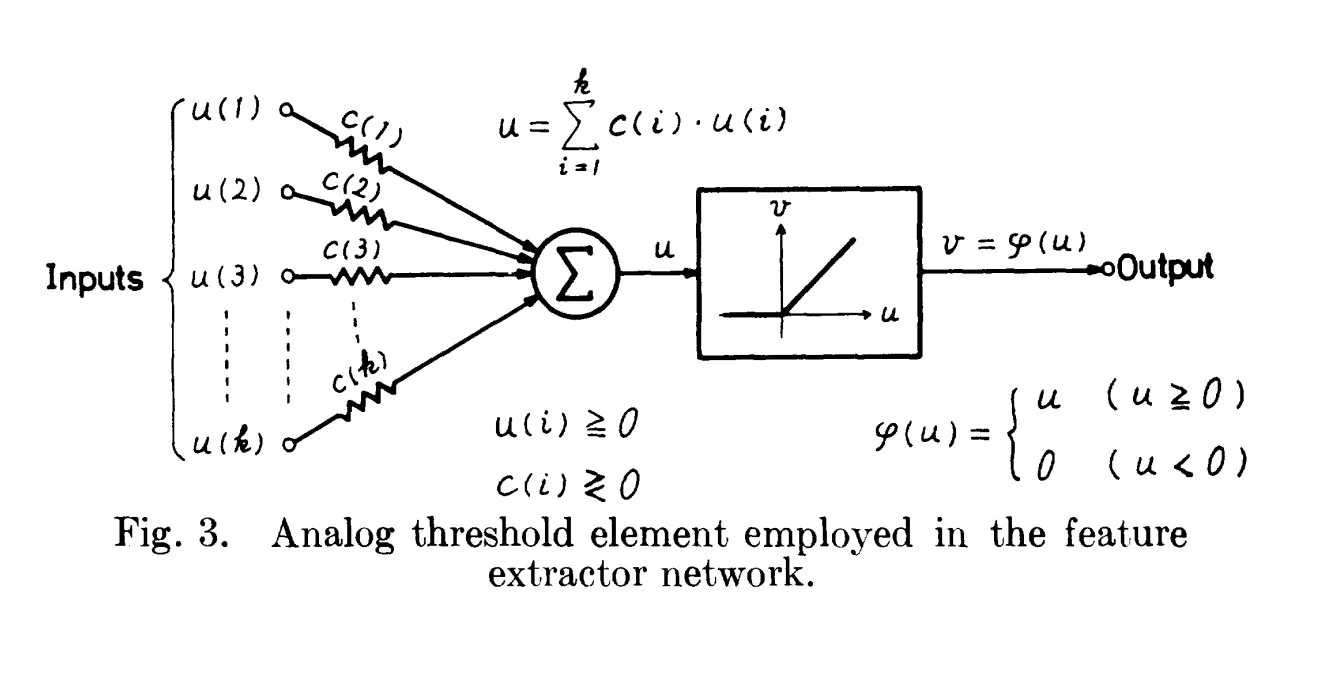

Origens históricas da ReLU: Remontando a 1969 : Uma discussão aponta que o artigo de Fukushima de 1969 já continha uma forma clara e precoce da função de ativação ReLU, fornecendo um importante contexto histórico para este conceito fundamental no Deep Learning. Isso sugere que as bases de muitas tecnologias modernas de AI podem ter surgido mais cedo do que geralmente se pensa. (Fonte: SchmidhuberAI)

Code World Model (CWM) da Meta : A Meta lançou o novo modelo de código aberto de 32B, Code World Model (CWM), para codificação e inferência. O CWM é treinado através de trajetórias de execução e interações de agente, visando compreender a semântica e o processo de execução do código, representando uma transição da autocorreção de código simples para modelos inteligentes capazes de planejar, depurar e verificar código. (Fonte: TheTuringPost)

O papel crucial dos dados na AI : A discussão da comunidade enfatiza que “não estamos discutindo dados o suficiente” no campo da AI, destacando a extrema importância dos dados como a pedra angular do desenvolvimento da AI. Dados de alta qualidade e diversificados são o principal motor da capacidade e generalização do modelo, e sua importância não deve ser subestimada. (Fonte: Dorialexander)

“Super pesos” na compressão de LLM : Pesquisas revelam que, no processo de compressão de modelos LLM, a preservação de uma pequena porção de “super pesos” é crucial para manter a funcionalidade do modelo e alcançar um desempenho competitivo. Esta descoberta oferece uma nova direção para o desenvolvimento de modelos LLM mais eficientes, menores e com desempenho inalterado. (Fonte: dl_weekly)

Guia de Arquiteturas de Agente de AI (Além do ReAct) : Um guia detalha 6 arquiteturas avançadas de agente de AI (incluindo Self-Reflection, Plan-and-Execute, RAISE, Reflexion, LATS), projetadas para resolver as limitações do padrão básico ReAct e lidar com tarefas de raciocínio complexas, fornecendo um plano para desenvolvedores construírem agentes de AI mais poderosos. (Fonte: Reddit r/deeplearning)

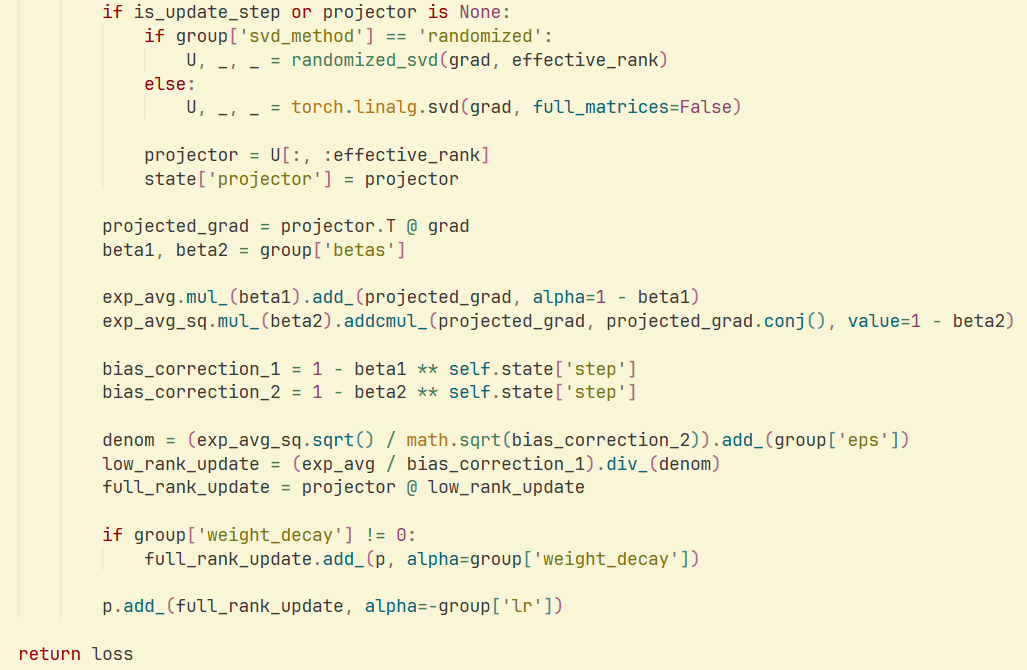

Otimizador GaLore e SVD Aleatório : Um estudo e implementação demonstram que a combinação de SVD aleatório com o otimizador GaLore pode alcançar maior velocidade e eficiência de memória no treinamento de LLM, reduzindo significativamente o consumo de memória do otimizador. Isso oferece uma nova estratégia de otimização para o treinamento de modelos em larga escala. (Fonte: Reddit r/deeplearning )

💼 Negócios

Nvidia considera novo modelo de negócios para aluguel de chips de AI : A Nvidia está explorando um novo modelo de negócios, oferecendo serviços de aluguel de chips de AI para empresas que não podem comprá-los diretamente. Esta iniciativa visa expandir o acesso a recursos de computação de AI e manter o mercado ativo, podendo ter um impacto profundo na popularização da infraestrutura de AI. (Fonte: teortaxesTex)

Untapped Capital lança segundo fundo focado em AI em estágio inicial : A Untapped Capital anunciou o lançamento de seu segundo fundo, focado em investimentos pré-seed no setor de AI. Isso indica o interesse contínuo da comunidade de Venture Capital em startups de AI em estágio inicial, fornecendo suporte financeiro crucial para tecnologias e empresas emergentes de AI. (Fonte: yoheinakajima)

xAI de Elon Musk oferece modelo Grok ao governo dos EUA : A xAI de Elon Musk propôs fornecer seu modelo Grok ao governo federal dos EUA por 42 centavos. Este gesto altamente simbólico marca um passo estratégico da xAI no domínio dos contratos governamentais, podendo influenciar o cenário de aplicação da AI no setor público. (Fonte: Reddit r/artificial)

🌟 Comunidade

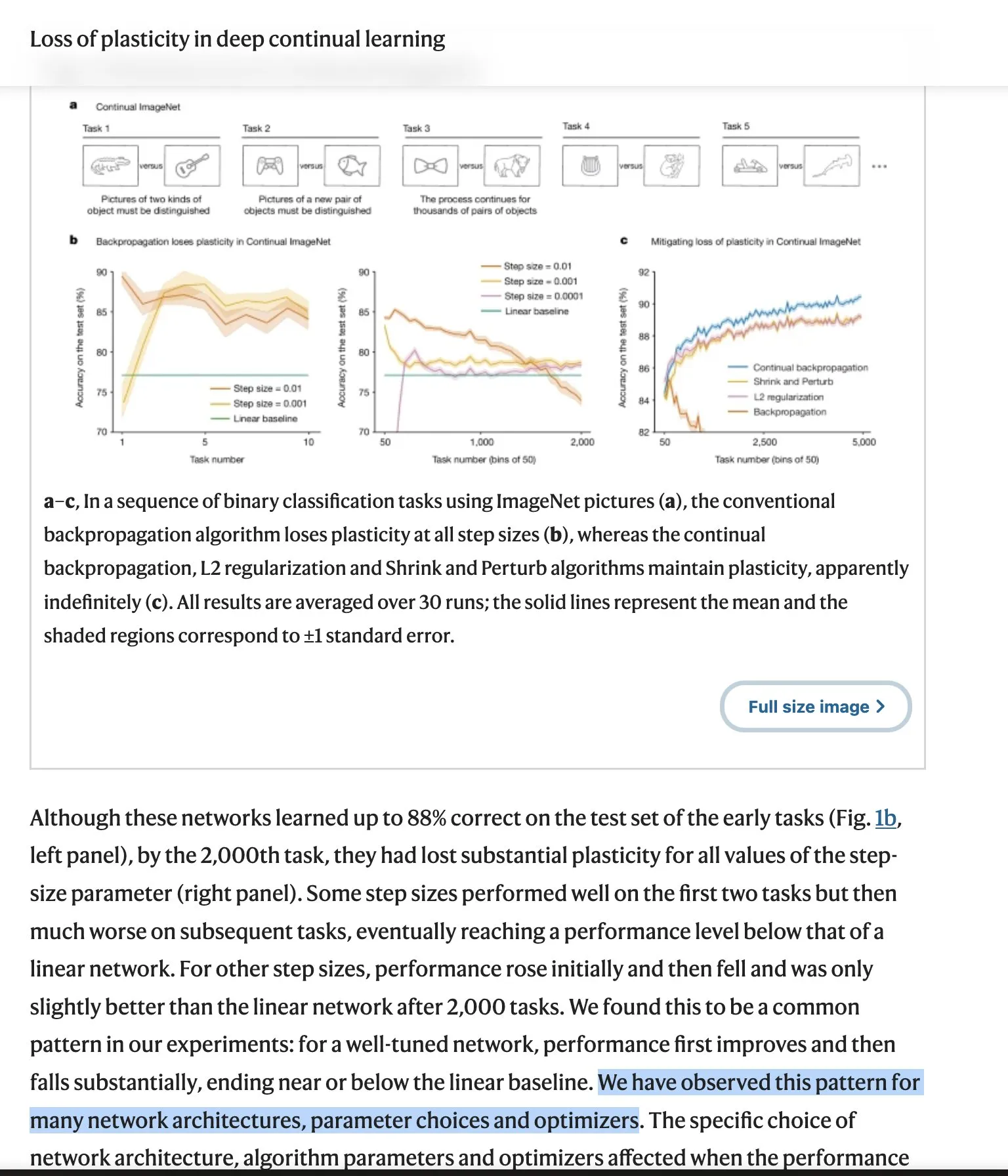

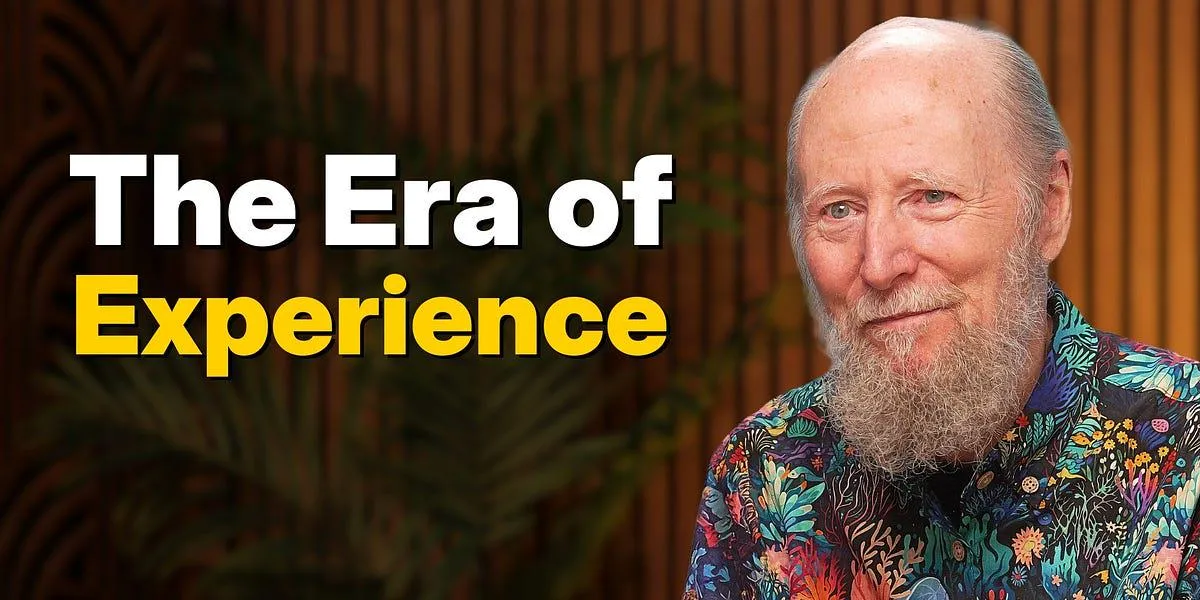

O debate sobre as “lições amargas” dos LLMs continua a crescer : A visão de “lições amargas” de Richard Sutton, pai do Reinforcement Learning, desencadeou um amplo debate na comunidade, questionando se os LLMs carecem de verdadeira capacidade de aprendizagem contínua e exigem novas arquiteturas. Os oponentes enfatizam o sucesso da escalabilidade, eficácia dos dados e esforço de engenharia, enquanto as críticas de Sutton aprofundam os aspectos filosóficos dos modelos de linguagem-mundo e da intencionalidade. Este debate abrange os desafios centrais e as direções futuras do desenvolvimento da AI. (Fonte: Teknium1, scaling01, teortaxesTex, Dorialexander, NandoDF, tokenbender, rasbt, dejavucoder, francoisfleuret, natolambert, vikhyatk)

Preocupações com a segurança e controle da AI : As preocupações da comunidade com a segurança e o controle da AI estão crescendo, desde o pessimismo dos especialistas em AI sobre a navegação livre da AI na internet, até o medo de que modelos de AI locais, desprovidos de restrições éticas e disponíveis para download, possam ser usados para hacking e geração de conteúdo malicioso. Essas discussões refletem os complexos desafios éticos e sociais trazidos pelo desenvolvimento da tecnologia de AI. (Fonte: jeremyphoward, Reddit r/ArtificialInteligence)

Problemas de roteamento do OpenAI GPT-4o/GPT-5 e insatisfação do usuário : Usuários do ChatGPT Plus reclamam que seus modelos (4o, 4.5, 5) estão sendo secretamente redirecionados para modelos “mais burros”, “mais frios” e “seguros”, gerando uma crise de confiança e relatos de dificuldades para cancelar assinaturas. Embora a OpenAI afirme que isso não é um “comportamento esperado”, o feedback dos usuários continua frustrante e se estende a preocupações com companheiros de AI e censura de conteúdo. (Fonte: Reddit r/ChatGPT, scaling01, MIT Technology Review, Reddit r/ClaudeAI)

A visão de Richard Sutton sobre a sucessão da AI : Richard Sutton, ganhador do Prêmio Turing, acredita que a sucessão para a superinteligência digital é “inevitável”, apontando para a falta de uma visão unificada da humanidade, a inevitabilidade da compreensão da inteligência e a aquisição de recursos e poder pelos agentes inteligentes. Esta perspectiva desencadeou uma discussão profunda sobre o futuro desenvolvimento da AI e o destino da humanidade. (Fonte: Reddit r/ArtificialInteligence, Reddit r/artificial)

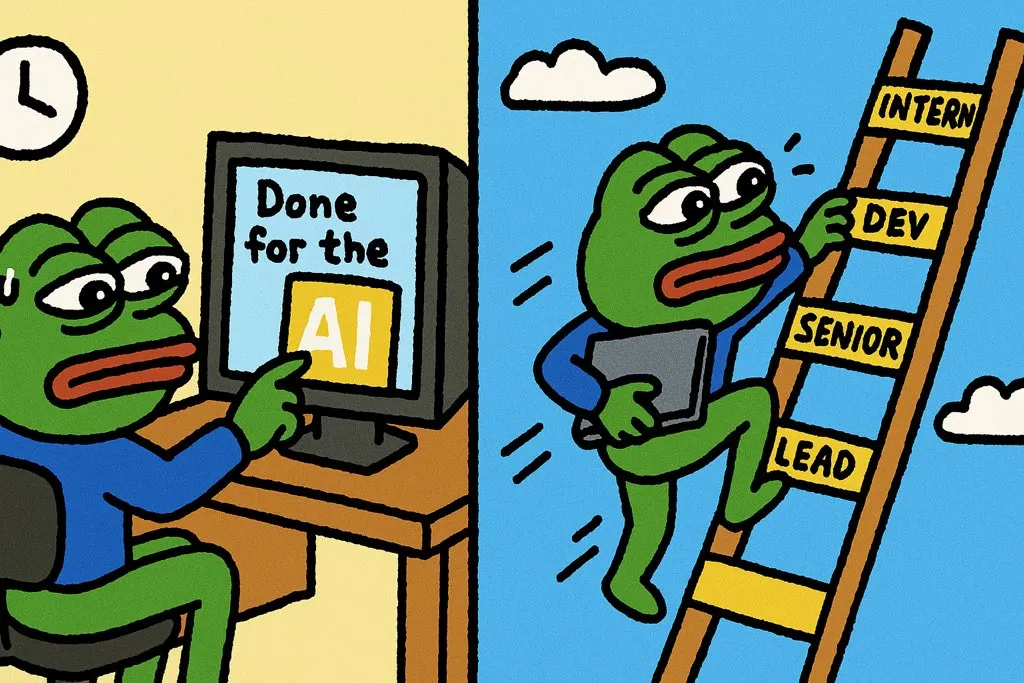

Filosofia de produtividade da AI: 10x de crescimento em vez de sair mais cedo : A discussão da comunidade enfatiza que a maneira correta de usar a AI não é apenas para concluir o trabalho mais rapidamente, mas para alcançar um crescimento de 10 vezes na produção no mesmo período. Esta filosofia incentiva o aprimoramento das capacidades pessoais e o desenvolvimento profissional através da AI, em vez de apenas buscar eficiência, destacando-se assim no mercado de trabalho. (Fonte: cto_junior)

Percepção da qualidade e humor dos modelos de AI : Usuários elogiam a criatividade e o senso de humor de certos LLMs (como o GPT-4.5), considerando-os “incríveis” e “incomparáveis”. Ao mesmo tempo, a comunidade também discute a AI de forma bem-humorada, como a piada do Merriam-Webster sobre o lançamento de novos LLMs, refletindo a ampla penetração dos LLMs na cultura. (Fonte: giffmana, suchenzang)

Ética da AI: Debate sobre curar o câncer vs. alcançar AGI : A comunidade discutiu a questão ética de “se curar o câncer é um objetivo melhor do que alcançar a AGI (Inteligência Geral Artificial)”. Isso reflete um amplo debate moral sobre as prioridades do desenvolvimento da AI, ou seja, se é melhor priorizar aplicações humanitárias ou buscar avanços mais profundos na inteligência. (Fonte: iScienceLuvr)

Comparação de capacidades LLM: Desempenho matemático de Claude Opus vs. GPT-5 : Usuários notaram que o Claude 4.1 Opus se destaca em tarefas de valor econômico, mas tem um desempenho fraco em matemática de nível universitário, enquanto o GPT-5 fez um salto significativo nas capacidades matemáticas. Isso destaca as vantagens diferenciadas de diferentes LLMs em habilidades específicas. (Fonte: scaling01)

Segurança de agentes de AI: Solução alternativa para o comando rm -rf : Um desenvolvedor compartilhou uma solução prática para o problema de agentes de AI que usam repetidamente o comando rm -rf para excluir arquivos importantes: apelidar o comando rm como trash, movendo assim os arquivos para a lixeira em vez de excluí-los permanentemente, prevenindo eficazmente a perda acidental de dados. (Fonte: Reddit r/ClaudeAI)

Preocupações com a privacidade e uso de dados pela AI : Empresas como o LinkedIn usam dados de usuários por padrão para treinar suas AIs e exigem que os usuários optem ativamente por sair, o que levanta preocupações contínuas sobre a privacidade dos dados na era da AI. A discussão da comunidade enfatiza a necessidade dos usuários de controlar seus dados pessoais e a importância de políticas de dados transparentes. (Fonte: Reddit r/artificial )

💡 Outros

Aplicações da AI na agricultura: Pulverizador de herbicidas GUSS : O pulverizador de herbicidas GUSS, como equipamento autônomo, realiza operações de pulverização precisas e eficientes na agricultura. Isso demonstra o potencial de aplicação prática da tecnologia de AI na otimização dos processos de produção agrícola, redução do desperdício de recursos e aumento da produtividade das culturas. (Fonte: Ronald_vanLoon)

Impacto da AI no emprego de desenvolvedores : A discussão da comunidade aponta que a AI não eliminou os empregos de desenvolvedores, mas, ao contrário, criou novas posições de desenvolvimento ao aumentar a eficiência e expandir o escopo de trabalho. Isso indica que a AI atua mais como uma ferramenta de capacitação do que como um substituto da força de trabalho, promovendo a transformação e atualização do mercado de trabalho. (Fonte: Ronald_vanLoon)

Militares dos EUA enfrentam desafios na implantação de armas de AI : As forças armadas dos EUA estão enfrentando dificuldades na implantação de armas de AI e estão atualmente transferindo o trabalho relacionado para uma nova organização (DAWG) para acelerar o plano de aquisição de drones. Isso reflete a complexidade que a tecnologia de AI enfrenta em aplicações militares, incluindo integração tecnológica, considerações éticas e desafios operacionais práticos. (Fonte: Reddit r/ArtificialInteligence)