Palavras-chave:LLM-JEPA, Apple Manzano, MediaTek Dimensity 9500, GPT-5, DeepSeek-V3.1-Terminus, Qwen3-Omni, Baidu Qianfan-VL, Framework de treinamento de espaço de incorporação, Tokenizador visual híbrido, Arquitetura de NPU dupla, Benchmark SWE-BENCH PRO, Entrada de áudio multimodal

🔥 Foco

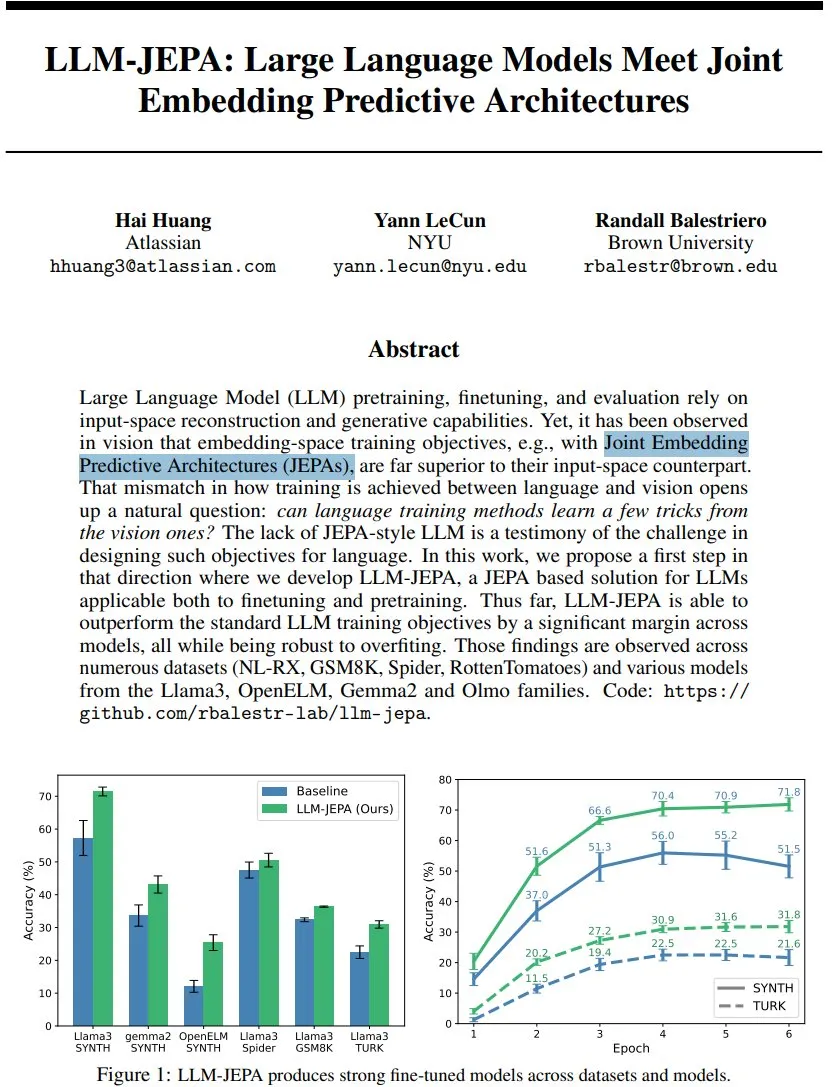

LLM-JEPA: Novo avanço na estrutura de treinamento de modelos de linguagem : Yann LeCun e outros propuseram o LLM-JEPA, a primeira estrutura de treinamento de modelo de linguagem estilo JEPA que combina objetivos de espaço de incorporação visual com objetivos de geração de processamento de linguagem natural. Esta estrutura superou os objetivos padrão de LLM em vários benchmarks como NL-RX, GSM8K e Spider, e teve bom desempenho em modelos como Llama3 e OpenELM. É mais robusta contra o overfitting, eficaz tanto no pré-treinamento quanto no ajuste fino, prenunciando que o treinamento no espaço de incorporação pode ser o próximo grande salto para os LLMs. (Fonte: ylecun, ylecun)

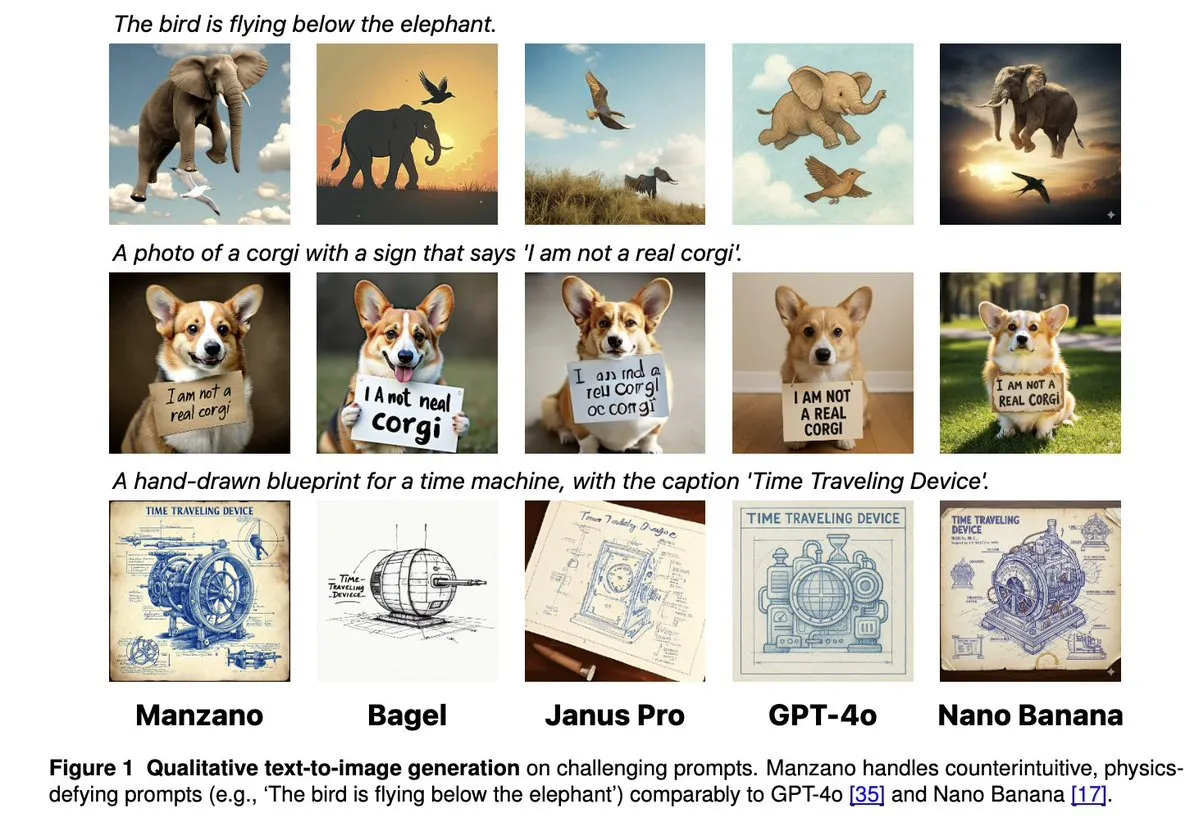

Apple Manzano: Uma solução concisa e escalável para LLMs multimodais unificados : A Apple lançou o Manzano, um modelo de linguagem grande multimodal unificado, simples e escalável. Este modelo utiliza um tokenizador visual híbrido, que reduz efetivamente os conflitos entre tarefas de compreensão e geração de imagens. O Manzano alcança o nível SOTA em benchmarks intensivos em texto (como ChartQA, DocVQA) e compete com GPT-4o/Nano Banana em capacidade de geração, suportando edição através de imagens condicionais, demonstrando o poderoso potencial da IA multimodal. (Fonte: arankomatsuzaki, charles_irl, vikhyatk, QuixiAI, kylebrussell)

MediaTek Dimensity 9500 lança arquitetura de NPU dupla, reforçando a experiência de IA ativa : A MediaTek lançou o chip Dimensity 9500, pioneiro na arquitetura de NPU dupla de ultra desempenho + ultra eficiência energética, com o objetivo de alcançar uma experiência de IA “Always on” e inteligente. Este chip manteve a liderança no ranking de IA de SoC móvel da ETHZ, com uma eficiência de inferência 56% superior à geração anterior, e suporta geração de imagens 4K de ultra alta definição no dispositivo e uma janela de contexto de 128K. Isso estabelece a base de hardware para a resposta em tempo real e serviços personalizados da IA móvel, impulsionando a IA de “invocável” para “sempre online”. (Fonte: 量子位)

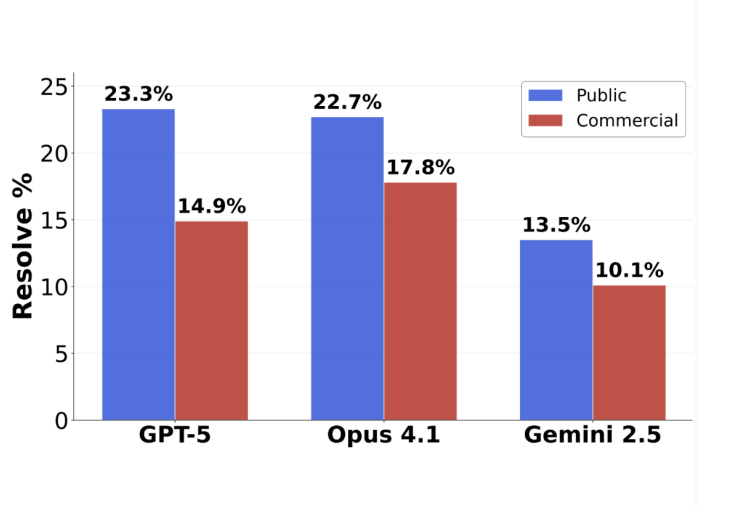

Reviravolta na avaliação de programação do GPT-5: Taxa de precisão de 63,1% em tarefas submetidas : O novo benchmark de engenharia de software SWE-BENCH PRO, lançado pela Scale AI, mostra que o GPT-5 alcançou uma taxa de precisão de 63,1% em tarefas submetidas, superando em muito os 31% do Claude Opus 4.1. Isso indica que seu desempenho em áreas de especialização continua forte. O novo benchmark utiliza problemas inéditos e cenários complexos de modificação de múltiplos arquivos, testando de forma mais realista a capacidade de programação prática do modelo. Ele revela que os modelos de ponta atuais ainda enfrentam desafios em tarefas de engenharia de software de nível industrial, mas a capacidade real do GPT-5 foi subestimada sob a estratégia de “se souber, envia; se não souber, não envia”. (Fonte: 36氪)

🎯 Tendências

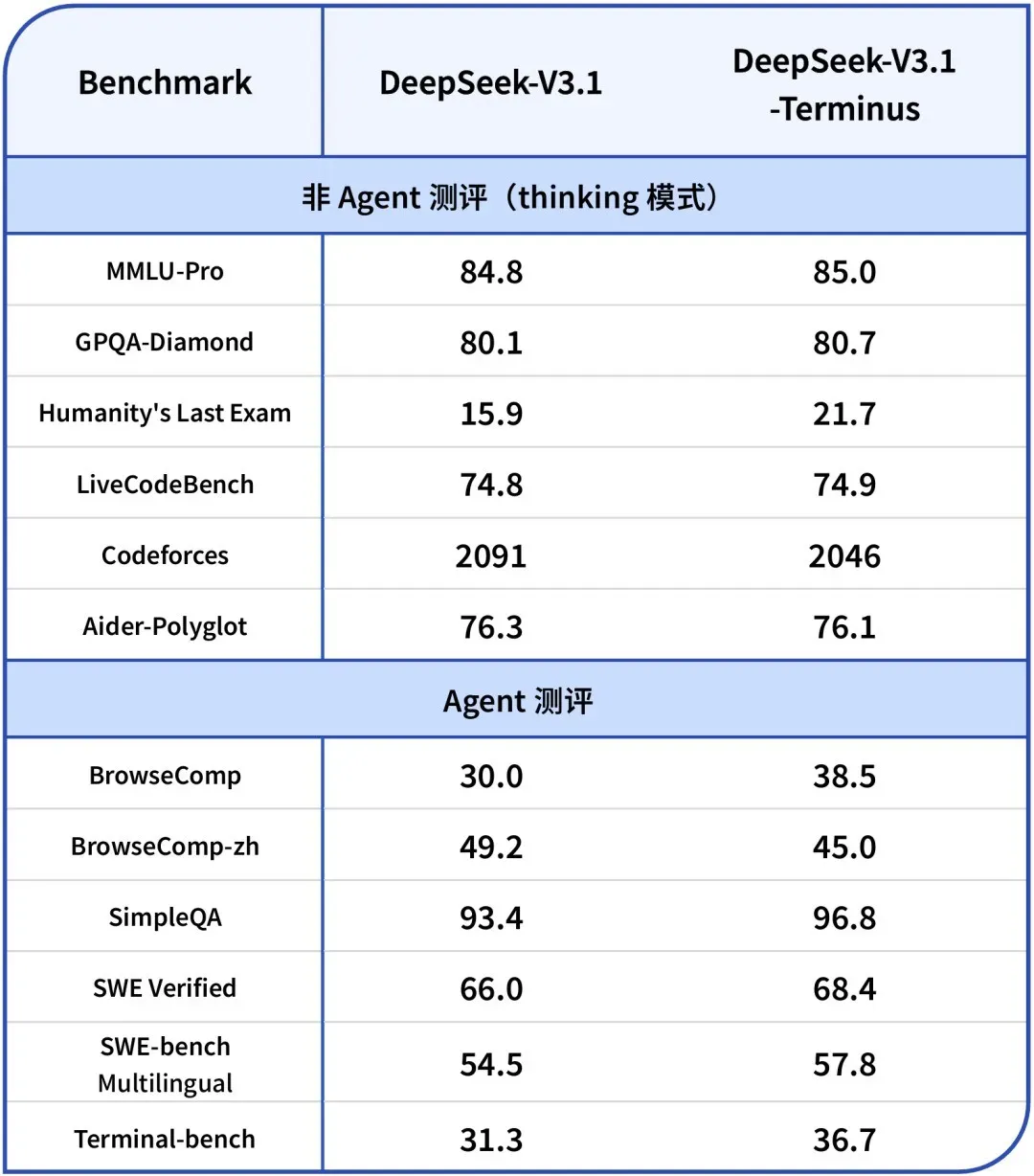

DeepSeek-V3.1-Terminus lançado: Otimização da consistência da linguagem e capacidade de Agent : A DeepSeek lançou a versão V3.1-Terminus, com melhorias principais na consistência da linguagem (reduzindo a mistura de chinês e inglês e caracteres anormais) e otimizando o desempenho do Code Agent e do Search Agent. O novo modelo oferece uma saída mais estável e confiável em avaliações de múltiplos domínios, e os pesos de código aberto já estão disponíveis no Hugging Face e ModelScope, indicando a finalização da arquitetura da série V3 da DeepSeek. (Fonte: DeepSeek Blog, Reddit r/LocalLLaMA, scaling01, karminski3, ben_burtenshaw, dotey)

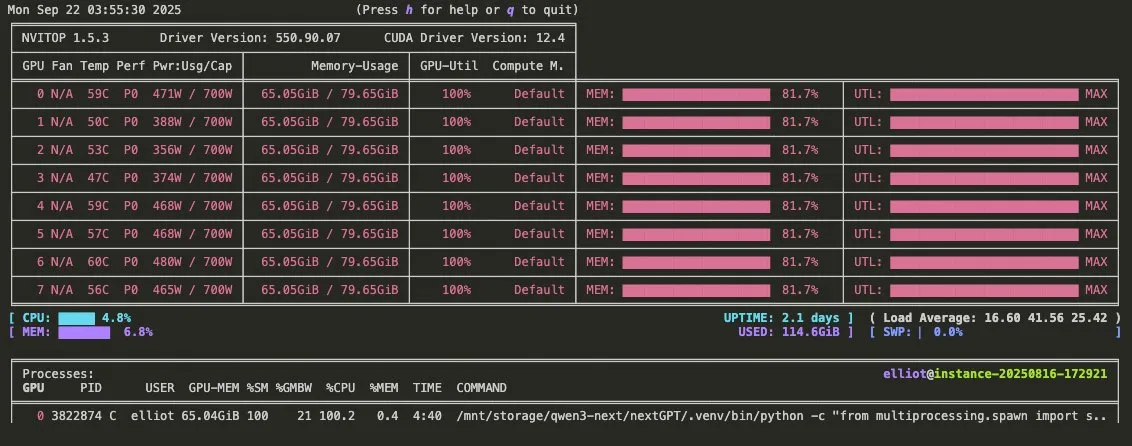

Vídeo promocional do Qwen3-Omni lançado: Suporte a áudio multimodal e chamada de ferramentas : A Qwen lançou o vídeo promocional do Qwen3-Omni, anunciando que ele suportará entrada e saída de áudio multimodal e terá capacidade nativa de chamada de ferramentas. Espera-se que este modelo seja um concorrente direto do Gemini 2.5 Flash Native Audio, oferecendo modos de pensamento e não-pensamento, e melhorando significativamente o potencial de construção de Voice Agents. Seus pesos serão lançados em breve. (Fonte: Reddit r/LocalLLaMA, scaling01, Alibaba_Qwen, huybery)

Baidu lança modelos de linguagem grandes multimodais da série Qianfan-VL de código aberto : O Baidu AI Cloud lançou os modelos de linguagem grandes multimodais da série Qianfan-VL (3B, 8B, 70B) de código aberto, otimizados para aplicações empresariais. Os modelos combinam o codificador visual InternViT com um corpus multilíngue aprimorado, oferecendo um comprimento de contexto de 32K. Eles se destacam em OCR, compreensão de documentos, análise de gráficos e resolução de problemas matemáticos, e suportam raciocínio em cadeia de pensamento, visando fornecer capacidades gerais robustas e otimização profunda para cenários de alta frequência da indústria. (Fonte: huggingface, Reddit r/LocalLLaMA)

xAI lança modelo Grok 4 Fast: Janela de contexto de 2M, alta relação custo-benefício : A xAI lançou o modelo Grok 4 Fast, um modelo de inferência multimodal com uma janela de contexto de 2M, projetado para estabelecer um novo padrão em termos de custo-benefício. Esta versão pode alcançar inferência rápida através de técnicas como quantização FP8 e otimizou as capacidades de Agentic programming, permitindo equilibrar desempenho e economia ao lidar com tarefas complexas. (Fonte: TheRundownAI, Yuhu_ai_)

GPT-5-Codex: OpenAI lança versão do GPT-5 otimizada para Agentic programming : A OpenAI lançou o GPT-5-Codex, uma versão otimizada do GPT-5, especificamente para Agentic programming. Este modelo visa melhorar o desempenho da IA na geração de código e em tarefas de engenharia de software, alinhando-se com as tendências de desenvolvimento de fluxos de trabalho Agentic e LLMs multimodais. Ao aprimorar suas capacidades de programação, ele impulsiona ainda mais a aplicação da IA na área de desenvolvimento. (Fonte: TheRundownAI, Reddit r/artificial)

Plataforma de Desenvolvimento de Agentes Inteligentes 3.0 da Tencent lançada globalmente, tecnologias-chave do Youtu Lab continuam sendo de código aberto : A Plataforma de Desenvolvimento de Agentes Inteligentes 3.0 (ADP3.0) da Tencent Cloud foi lançada globalmente, com atualizações abrangentes em RAG, colaboração Multi-Agent, Workflow, avaliação de aplicações e ecossistema de plugins. O Youtu Lab da Tencent continuará a disponibilizar tecnologias-chave de agentes inteligentes como código aberto, incluindo a estrutura Youtu-Agent e a estrutura de grafo de conhecimento Youtu-GraphRAG, com o objetivo de promover a inclusão tecnológica e a construção aberta do ecossistema de agentes inteligentes, permitindo que as empresas construam, integrem e operem seus próprios agentes de IA com baixo custo. (Fonte: 量子位)

Baidu Wenku novamente certificado pelo Centro Nacional de Segurança Industrial e de Tecnologia da Informação, liderando a indústria de PPT inteligente : O Baidu Wenku ficou em primeiro lugar na avaliação de grandes modelos que capacitam o escritório inteligente do Centro Nacional de Segurança Industrial e de Tecnologia da Informação, ocupando a primeira posição em seis indicadores, incluindo qualidade de geração, compreensão de intenção e embelezamento de layout. Sua função de PPT inteligente oferece uma solução de fluxo de trabalho completo, com mais de 97 milhões de usuários ativos mensais de IA e mais de 34 milhões de visitas mensais, consolidando sua posição de liderança no campo de PPT inteligente e proporcionando aos usuários uma experiência de criação de PPT profissional, precisa e esteticamente agradável. (Fonte: 量子位)

Google DeepMind lança Frontier Safety Framework para lidar com riscos emergentes de IA : O Google DeepMind lançou sua mais recente “estrutura de segurança de fronteira”, a abordagem mais abrangente até o momento, projetada para identificar e antecipar riscos emergentes de IA. Esta estrutura enfatiza o desenvolvimento responsável de modelos de IA, comprometendo-se a garantir que, à medida que as capacidades de IA aumentam, as medidas de segurança também sejam atualizadas para enfrentar desafios complexos que possam surgir no futuro. (Fonte: GoogleDeepMind)

Desenvolvimento de robôs humanoides e sistemas de automação: Melhorando a interação e a estabilidade : A tecnologia robótica continua a avançar, incluindo o lançamento do robô humanoide industrial Titan pela RoboForce, a plataforma ALLEX da WIROBOTICS que permite interação humana com tato, movimento natural e equilíbrio integrado, e o robô Unitree G1 que demonstra um modo “antigravidade” para melhorar a estabilidade. Além disso, a fazenda de robôs Hitbot exibe um sistema de colheita automatizado, e os robôs de transporte móveis autônomos também enfatizam o design de colaboração humano-máquina, impulsionando coletivamente a transição dos robôs do cálculo para a percepção do mundo. (Fonte: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Unitree)

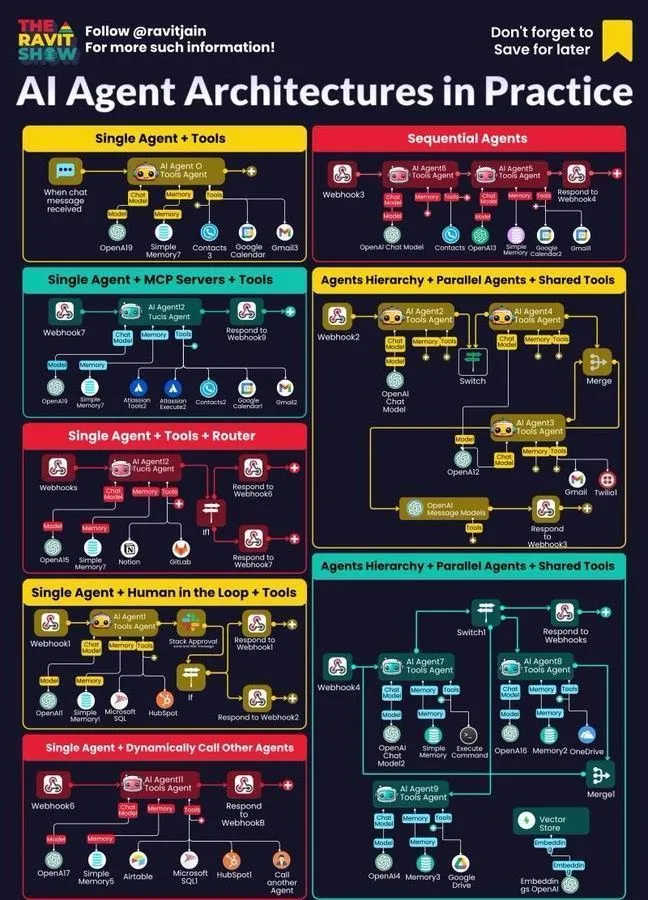

AI Agent se torna o núcleo do fluxo de trabalho empresarial: Arquitetura, mapa, aplicações práticas : Os AI Agents estão rapidamente se tornando o núcleo dos fluxos de trabalho empresariais, com sua arquitetura, mapa do ecossistema e aplicações práticas recebendo ampla atenção. A IA neuro-simbólica é vista como uma solução potencial para as alucinações de LLM, enquanto a pesquisa de simulação da Anthropic aponta que os modelos de IA podem constituir uma ameaça interna, destacando as oportunidades e desafios na implantação de AI Agent em empresas e impulsionando as empresas a explorar métodos práticos mais seguros. (Fonte: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 Ferramentas

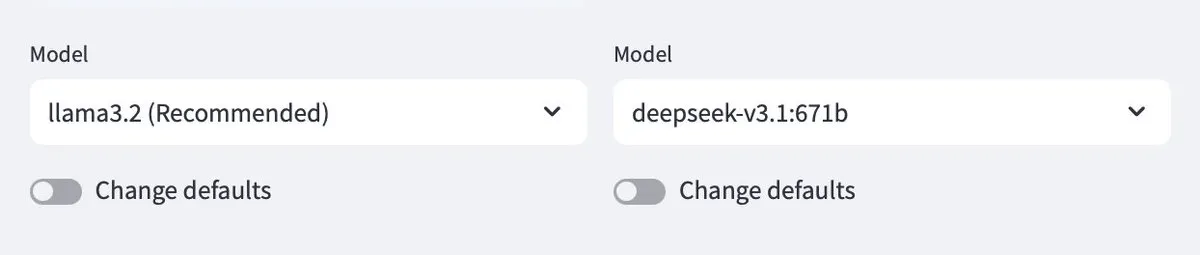

Ollama agora suporta modelos na nuvem, permitindo interação entre modelos locais e na nuvem : Ollama agora suporta a implantação de modelos na nuvem, permitindo que os usuários interajam entre modelos Ollama locais e modelos hospedados na nuvem. Esta funcionalidade é implementada através do aplicativo Minions, proporcionando aos usuários maior flexibilidade para gerenciar e utilizar seus recursos de LLM, oferecendo uma experiência contínua, seja executando localmente ou acessando via serviços de nuvem. (Fonte: ollama)

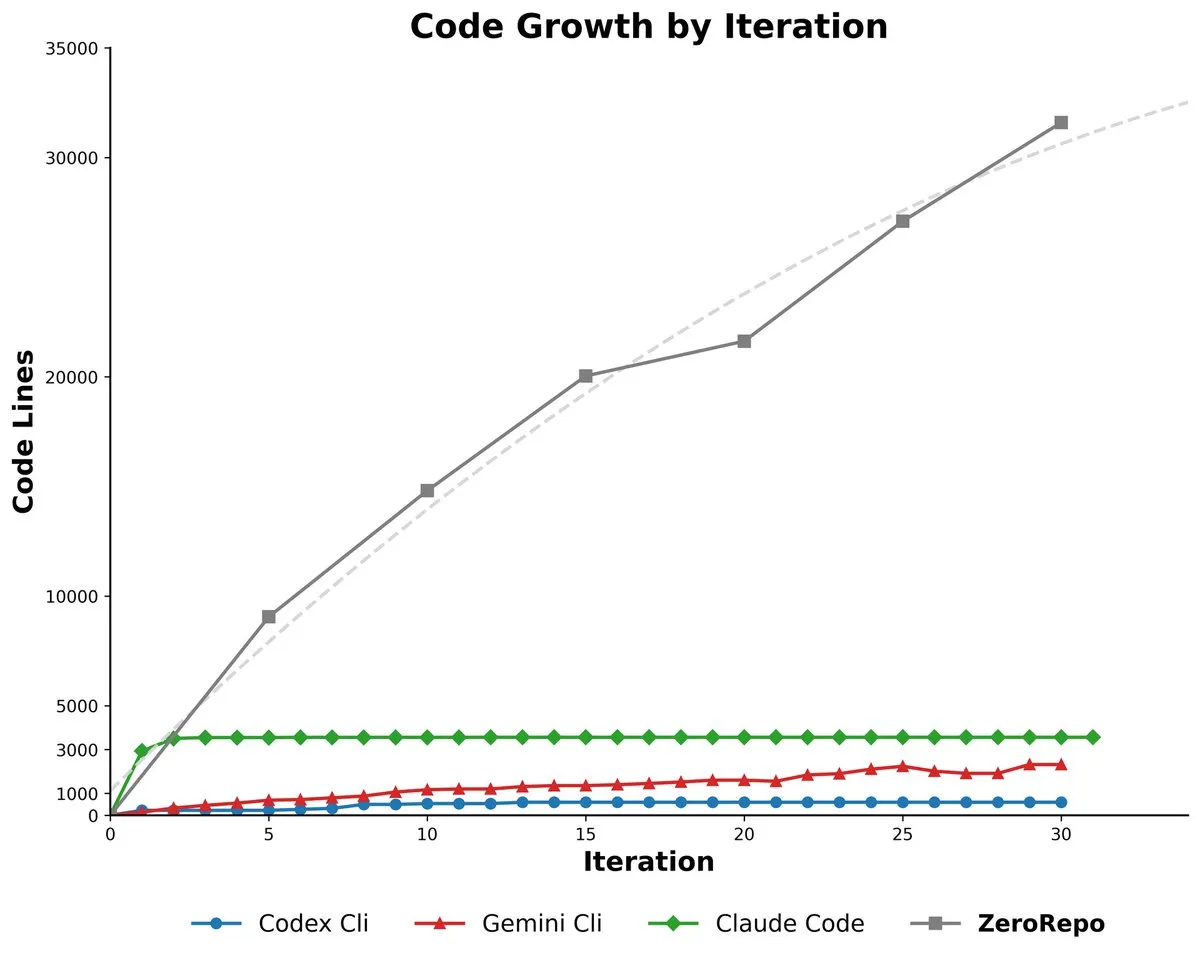

Microsoft ZeroRepo: Geração de repositórios de código completos baseada em estrutura dirigida por grafo : A Microsoft lançou o ZeroRepo, uma ferramenta baseada em uma estrutura dirigida por grafo (Repository Planning Graph, RPG) capaz de construir projetos de software completos do zero. Esta ferramenta gera 3,9 vezes mais código do que as linhas de base existentes e atinge uma taxa de aprovação de 69,7%, resolvendo o problema de que a linguagem natural não é adequada para a estrutura de software, e alcançando planejamento de longo prazo confiável e geração de repositórios de código escaláveis. (Fonte: _akhaliq, TheTuringPost, paul_cal)

DSPy UI: Interface visual para construir Agents : O DSPy está desenvolvendo uma interface de usuário (UI) visual, projetada para simplificar o processo de construção de Agents, tornando-o semelhante ao Figma ou Framer, onde os Agents são combinados arrastando e soltando componentes. Esta UI ajudará os usuários a conceituar melhor pipelines de Agents complexos e simplificará a sintaxe do código gerado, com o objetivo final de gerar várias versões de linguagem do DSPy e executar o GEPA. (Fonte: lateinteraction)

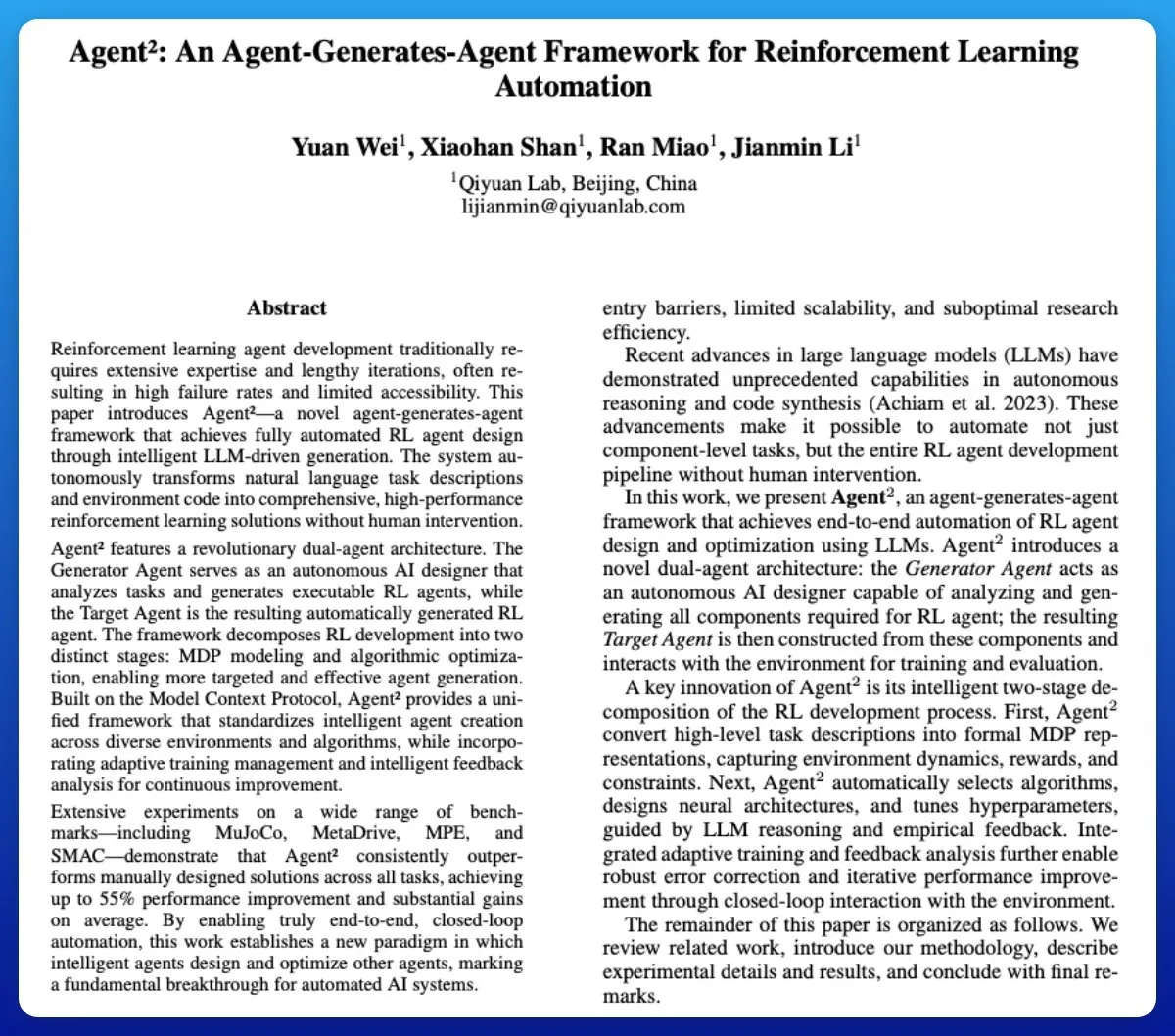

Agent²: LLM gera Agent de aprendizado por reforço de ponta a ponta : Agent² é uma ferramenta que utiliza Large Language Models (LLM) para gerar automaticamente Agents de aprendizado por reforço (RL) de ponta a ponta. Esta ferramenta, através de linguagem natural e código de ambiente, pode gerar automaticamente soluções RL eficazes sem intervenção humana, podendo ser considerada uma ferramenta AutoML no campo de RL, simplificando enormemente o processo de desenvolvimento de Agents de RL. (Fonte: omarsar0)

Weaviate lança Query Agent, suportando referências, introspecção de esquema e roteamento multi-coleção em sistemas de IA : A Weaviate lançou oficialmente seu Query Agent, que atingiu disponibilidade geral após seis meses de desenvolvimento. Ele suporta a geração de referências, introspecção de esquema e roteamento multi-coleção em sistemas de IA, e aprimora os padrões de busca através do Compound Retrieval System. O Query Agent visa simplificar a interação com o Weaviate e oferece clientes Python e TypeScript, melhorando a experiência do desenvolvedor. (Fonte: bobvanluijt, Reddit r/deeplearning)

Claude Code CLI: Gerenciamento de micro-funcionários com mentalidade de SDK, enfatizando estado externo e engenharia de processo : Ao tratar o Claude Code CLI como um SDK em vez de uma ferramenta simples, os desenvolvedores precisam gerenciar micro-funcionários, enfatizando o gerenciamento de estado externo (como arquivos JSON, entradas de banco de dados) para continuidade da sessão, e tratando a engenharia de prompt como engenharia de processo. Essa abordagem revela as limitações atuais dos LLMs em termos de sobrecarga de contexto e UIs inchadas, mas também destaca o enorme valor das ferramentas de automação interna ultra-específicas. (Fonte: Reddit r/ClaudeAI)

Synapse-system: Sistema de assistência de IA para grandes bases de código baseado em grafo de conhecimento, busca vetorial e Agents especializados : O Synapse-system é um sistema projetado para aprimorar as capacidades de assistência de IA em grandes bases de código. Ele combina grafo de conhecimento (Neo4j) para armazenar relações de código, busca vetorial (BGE-M3) para encontrar código semanticamente similar, Agents especializados (especialistas em Rust, TypeScript, Go, Python) para fornecer contexto, e cache inteligente (Redis) para acesso rápido a padrões comuns. Este sistema, através de um design modular, evita um único modelo gigante e é otimizado para as características de diferentes linguagens. (Fonte: Reddit r/ClaudeAI)

Claude Opus 4.0+: Aplicativo de guia turístico com IA, gera passeios personalizados em tempo real : Um desenvolvedor, utilizando Claude Opus 4.0 e Claude Code, realizou um sonho de 15 anos, desenvolvendo um aplicativo de guia turístico com IA. Este aplicativo pode gerar passeios personalizados em tempo real para qualquer cidade e tema (como “Passeio turístico em Veneza” ou “Tour de Assassin’s Creed em Florença”), com um guia de IA fornecendo narração multilíngue, histórias e perguntas interativas. Este aplicativo oferece uma experiência imersiva, flexível, que pode ser pausada e retomada, a um custo muito inferior ao de um guia humano. (Fonte: Reddit r/ClaudeAI)

Mindcraft: Minecraft AI combinado com LLM, controlando agentes no jogo via Mineflayer : O projeto Mindcraft combina Large Language Models (LLM) e a biblioteca Mineflayer para criar agentes de IA para o jogo Minecraft. Este projeto permite que o LLM escreva e execute código no jogo para completar tarefas como obter itens ou construir estruturas. Ele suporta várias APIs de LLM (como OpenAI, Gemini, Anthropic, etc.) e oferece um ambiente sandbox, mas alerta os usuários sobre os riscos potenciais de ataques de injeção. (Fonte: GitHub Trending)

AI Agents para Gerenciamento Contínuo de Inventário com Drones : A combinação de AI Agents e tecnologia de drones permite o gerenciamento contínuo de inventário sem a necessidade de balizas ou iluminação. Esta inovação utiliza drones de voo autônomo, que, através de algoritmos de IA, realizam a contagem e o gerenciamento de inventário em tempo real, com o potencial de melhorar significativamente a eficiência logística e de armazenamento, reduzir custos de mão de obra e fornecer dados mais precisos em ambientes complexos. (Fonte: Ronald_vanLoon)

Guia de Avaliação de LLM: Melhores práticas para confiabilidade, segurança e desempenho : Um guia abrangente de avaliação de LLM foi publicado, detalhando os principais indicadores, métodos e melhores práticas para avaliar Large Language Models (LLM). Este guia visa ajudar a garantir a confiabilidade, segurança e desempenho de aplicações impulsionadas por IA, fornecendo uma estrutura de avaliação sistematizada para desenvolvedores e pesquisadores enfrentarem os desafios da implantação de LLM. (Fonte: dl_weekly)

📚 Aprendizagem

Lukasz Kaiser, cientista da OpenAI, fala sobre o pensamento de primeiros princípios para grandes modelos : Lukasz Kaiser, cientista da OpenAI (um dos oito “filhos” do Transformer), compartilhou suas reflexões sobre os “primeiros princípios” do desenvolvimento de grandes modelos. Ele acredita que a próxima fase da IA reside em ensinar os modelos a “pensar”, realizando raciocínio profundo através da geração de mais etapas intermediárias, em vez de produzir respostas diretas. Ele prevê que o poder computacional futuro se deslocará do pré-treinamento em larga escala para um grande volume de computação de inferência em um pequeno volume de dados de alta qualidade, um modelo mais próximo da inteligência humana. (Fonte: 36氪)

Princípios de sobrevivência na era da programação com IA: Andrew Ng enfatiza ação rápida e responsabilidade : Andrew Ng, em sua palestra Buildathon, apontou que a programação assistida por IA acelera o desenvolvimento de protótipos independentes em 10 vezes, incentivando os desenvolvedores a “agir rápido e assumir responsabilidades” em ambientes sandbox para experimentar ousadamente. Ele enfatizou que o valor do código está diminuindo, e os desenvolvedores precisam se transformar em designers de sistemas e orquestradores de IA, dominando as mais recentes ferramentas de programação de IA, blocos de construção de IA (engenharia de prompt/técnicas de avaliação/MCP) e capacidade de prototipagem rápida, refutando a visão de que “não é preciso aprender a programar na era da IA”. (Fonte: 36氪)

“Deep Learning com Python” Terceira Edição lançada gratuitamente online : François Chollet anunciou que a terceira edição de sua obra “Deep Learning com Python” foi publicada e está disponível gratuitamente online. Esta iniciativa visa reduzir as barreiras de entrada para o aprendizado de deep learning, permitindo que mais pessoas interessadas em inteligência artificial tenham acesso a recursos de aprendizado de alta qualidade, promovendo a disseminação do conhecimento. (Fonte: fchollet, fchollet)

“Kaggle Grandmasters Playbook”: 7 técnicas práticas para modelagem tabular : A equipe de Kaggle Grandmasters, incluindo Gilberto Titericz Jr, com base em anos de experiência em competições e prática, lançou o “Kaggle Grandmasters Playbook”. Este manual reúne 7 técnicas comprovadas de modelagem de dados tabulares, visando ajudar cientistas de dados e engenheiros de machine learning a aprimorar suas habilidades no processamento de dados tabulares e na construção de modelos, sendo especialmente útil para competições Kaggle e desafios de dados do mundo real. (Fonte: HamelHusain)

Escassez de engenheiros de IA, currículos universitários seriamente desatualizados : Andrew Ng aponta que, apesar do aumento da taxa de desemprego entre graduados em ciência da computação, as empresas ainda enfrentam uma grave escassez de engenheiros de IA. A contradição central é que os currículos universitários não conseguiram cobrir a tempo habilidades-chave como programação assistida por IA, invocação de Large Language Models, construção de fluxos de trabalho RAG/Agentic e processos padronizados de análise de erros. Ele apela para que o sistema educacional acelere a atualização dos currículos e forme engenheiros com os mais recentes blocos de construção de IA e capacidades de prototipagem rápida. (Fonte: 36氪)

Guia de Avaliação de LLM: Melhores práticas para confiabilidade, segurança e desempenho : Um guia abrangente de avaliação de LLM foi publicado, detalhando os principais indicadores, métodos e melhores práticas para avaliar Large Language Models (LLM). Este guia visa ajudar a garantir a confiabilidade, segurança e desempenho de aplicações impulsionadas por IA, fornecendo uma estrutura de avaliação sistematizada para desenvolvedores e pesquisadores enfrentarem os desafios da implantação de LLM, garantindo a qualidade e a confiança do usuário nos produtos de IA. (Fonte: dl_weekly)

💼 Negócios

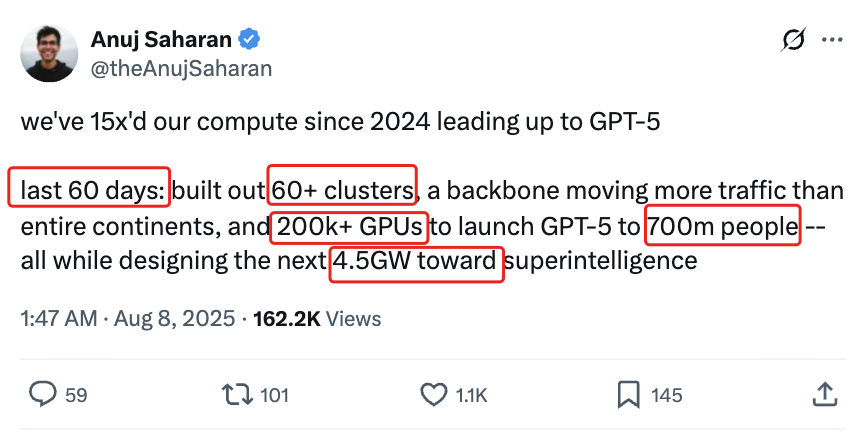

Frenesi de investimento em infraestrutura de IA: Gastos com data centers de IA nos EUA podem chegar a US$ 520 bilhões em 2025 : De acordo com o Wall Street Journal e a The Economist, os EUA estão passando por um frenesi de gastos com data centers de IA, com uma previsão de US$ 520 bilhões em 2025, superando o pico de gastos com telecomunicações na era da internet. Isso impulsiona o PIB dos EUA no curto prazo, mas a longo prazo pode levar à escassez de fundos em outras áreas, demissões em massa e altos riscos de depreciação devido à rápida iteração do hardware de IA, levantando preocupações econômicas estruturais e desafios para a saúde econômica de longo prazo dos EUA. (Fonte: 36氪)

OpenAI anuncia que novas funcionalidades serão pagas: Usuários Pro precisarão pagar extra, custo intensivo : Sam Altman, CEO da OpenAI, anunciou que várias novas funcionalidades intensivas em computação serão lançadas nas próximas semanas. Devido aos altos custos, essas funcionalidades estarão inicialmente disponíveis apenas para usuários da assinatura Pro de US$ 200 por mês, e podem até exigir pagamento adicional. Altman afirmou que a equipe está trabalhando para reduzir os custos, mas esta medida sugere que o modelo de negócios dos serviços de IA pode mudar para um modelo de contratação de funcionários por hora, trazendo novos desafios para usuários e para a indústria. (Fonte: The Verge, op7418, amasad)

Startup recebe créditos OpenAI massivos, busca formas de monetizá-los : Uma startup de tecnologia recebeu US$ 120.000 em créditos Azure OpenAI, muito mais do que suas necessidades, e está buscando maneiras de monetizá-los. Isso reflete um potencial desequilíbrio entre oferta e demanda de recursos de IA no mercado, bem como a exploração por parte das empresas de como utilizar e monetizar efetivamente o excesso de recursos de computação de IA, o que também pode dar origem a novos modelos de negociação de recursos de IA. (Fonte: Reddit r/deeplearning)

🌟 Comunidade

Impacto negativo da IA no pensamento crítico: Dependência excessiva leva à degeneração da capacidade : Nas redes sociais, discute-se amplamente que o uso generalizado da IA está levando à degeneração da capacidade de pensamento crítico humano. Há quem argumente que, quando as pessoas deixam de usar os “músculos do pensamento”, essas capacidades atrofiam. Embora a IA possa aumentar a eficiência, também pode fazer com que as pessoas percam a capacidade de pensar profundamente em áreas cruciais, levantando preocupações sobre os impactos a longo prazo na cognição humana. (Fonte: mmitchell_ai)

Dilemas éticos da IA na saúde: Prós e contras do Delphi-2M na previsão de doenças : Um novo modelo de IA, Delphi-2M, pode analisar dados de saúde para prever o risco de um usuário desenvolver mais de mil doenças nos próximos 20 anos. A discussão na comunidade aponta que o conhecimento antecipado dos riscos de doenças pode levar a intervenções preventivas positivas, mas também pode causar ansiedade a longo prazo e levantar riscos de privacidade e discriminação se seguradoras ou empregadores obtiverem esses dados. Enquanto as ferramentas de IA ainda não estão maduras, seus potenciais impactos éticos e sociais já se tornaram um foco. (Fonte: Reddit r/ArtificialInteligence)

Fenômeno de “atrofia cerebral” causado pelo uso diário da IA: Dependência excessiva da IA leva à diminuição da capacidade de pensamento : Em discussões sociais, muitos usuários reclamam que a IA é usada excessivamente na vida diária, levando à diminuição da capacidade de pensamento das pessoas. Desde decisões simples (qual filme assistir, o que comer) até problemas complexos (questões de organização universitária), a IA é frequentemente consultada, mesmo que as respostas estejam erradas ou sejam facilmente acessíveis. Este fenômeno de “atrofia cerebral pela IA” não só reduz o envolvimento pessoal, mas também fomenta a disseminação de informações falsas, provocando uma profunda reflexão sobre os limites do uso da IA. (Fonte: Reddit r/ArtificialInteligence)

Fadiga no uso de ferramentas de programação com IA: Desenvolvedores sentem menor engajamento mental : Muitos desenvolvedores relatam que o uso diário de ferramentas de programação com IA (como o Claude Code) aumenta a produtividade, mas leva à fadiga mental e à diminuição do engajamento. Eles se veem mais em “modo de revisão” do que resolvendo problemas ativamente, e o processo de esperar a IA gerar a saída os faz sentir passivos. A comunidade está discutindo como equilibrar a assistência da IA com a manutenção da atividade mental para evitar a sobrecarga cognitiva e a redução da criatividade. (Fonte: Reddit r/artificial, Reddit r/ClaudeAI)

1/4 dos jovens adultos se comunica com IA para fins românticos e sexuais : Um estudo mostra que 1/4 dos jovens adultos se comunica com IA para fins românticos e sexuais. Este fenômeno gerou discussões na comunidade sobre solidão, falta de interação interpessoal e o papel da IA no acompanhamento emocional. Embora a IA ofereça consolo em alguns aspectos, muitos ainda questionam se ela pode substituir relacionamentos humanos verdadeiramente significativos e se preocupam com seu impacto a longo prazo nos padrões de interação social. (Fonte: Reddit r/ArtificialInteligence)

Ameaças à segurança da IA: Testes de crowdsourcing de vulnerabilidades de grandes modelos revelam novos riscos, injeção de prompt é comum : O primeiro teste real de crowdsourcing de vulnerabilidades para grandes modelos de IA na China revelou 281 vulnerabilidades de segurança, das quais 177 são específicas para grandes modelos, representando mais de 60%. Os riscos típicos incluem saída inadequada, vazamento de informações, injeção de prompt (o mais comum) e ataques de consumo irrestrito. Modelos domésticos mainstream como Tencent Hunyuan e Baidu Wenxin Yiyan tiveram um desempenho relativamente bom. A comunidade alerta que a confiança desprevenida dos usuários na IA pode levar a vazamentos de privacidade, especialmente ao consultar questões íntimas. (Fonte: 36氪)

Dilemas éticos do AI Agent: Decisão e responsabilidade de um sistema de monitoramento urbano com IA com 10% de taxa de falso positivo : A comunidade discutiu um cenário hipotético sobre os dilemas éticos do AI Agent: um sistema de monitoramento urbano com IA tem uma taxa de falso positivo de 10%, marcando inocentes como potenciais ameaças. A discussão se concentra em como equilibrar a pressão de implantação e os princípios morais (como o Princípio de Blackstone). As soluções propostas incluem: formar equipes de colaboração humano-IA para corrigir problemas, transferir os custos dos falsos positivos para a gerência, excluir completamente os registros de pessoas erroneamente marcadas e pedir desculpas, e considerar a demissão em caso de “perda total da confiança pública e desconsideração gananciosa da gerência”. (Fonte: Reddit r/artificial)

Consciência de IA e definição de AGI: Andrew Ng acredita que AGI se tornou um termo de marketing, e consciência é uma questão filosófica : Andrew Ng, em sua palestra, apontou que a Inteligência Geral Artificial (AGI) passou de um termo técnico para um termo de marketing, e sua definição é ambígua, levando à falta de um padrão unificado na indústria para a alegação de “alcançar AGI”. Ele acredita que a consciência é uma questão filosófica importante, e não científica, e atualmente carece de padrões de medição. Engenheiros e cientistas devem se concentrar em construir sistemas de IA realmente úteis, em vez de se prenderem a debates filosóficos sobre a consciência. (Fonte: 36氪)

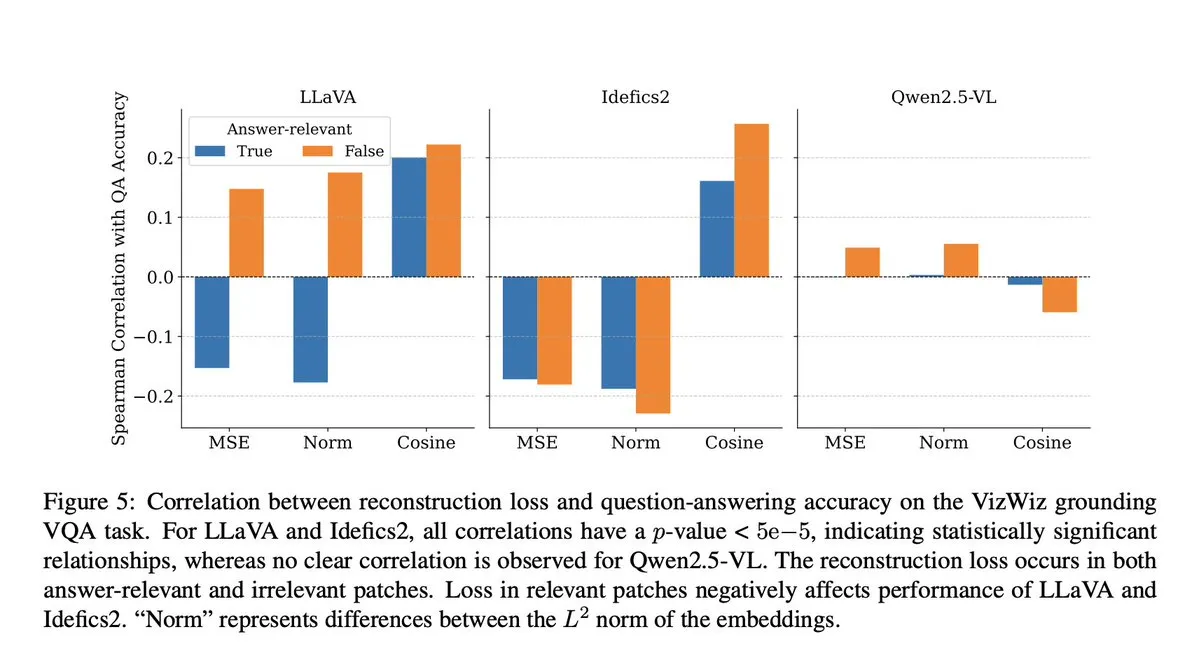

Fraude em modelos de IA: Pesquisa VLM revela que etapa de projeção causa perda de contexto semântico : A comunidade discutiu uma pesquisa da Microsoft que revela que os modelos Visuais-Linguísticos (VLM) perdem 40-60% do contexto semântico na etapa de projeção, distorcendo assim as representações visuais e afetando tarefas posteriores. Esta descoberta levantou preocupações sobre a precisão da avaliação de VLM e a contaminação de dados, especialmente em benchmarks como DocVQA, onde pontuações altas podem não refletir totalmente a capacidade real do modelo. (Fonte: vikhyatk)

Ética da IA e robótica: Apelo para parar testes violentos em robôs : Nas redes sociais, vários pesquisadores de IA e membros da comunidade pediram o fim dos testes violentos em robôs, como golpear repetidamente o robô Unitree G1 para demonstrar sua estabilidade. Eles acreditam que esse método de teste não apenas levanta preocupações éticas, mas também pode reforçar percepções negativas sobre os robôs e questionar sua necessidade científica, defendendo uma avaliação mais humana e científica do desempenho dos robôs. (Fonte: vikhyatk, dejavucoder, Ar_Douillard)

A “pseudo inteligência” da IA: Apelo para mudar “Inteligência Artificial” para “Pseudo Inteligência” para reduzir o mal-entendido público : Foi proposto que o termo “Inteligência Artificial” (Artificial Intelligence) seja mudado para “Pseudo Inteligência” (Pseudo Intelligence), a fim de reduzir a superestimação e o mal-entendido público sobre as capacidades da IA. Esta proposta surge de uma compreensão clara das limitações atuais da IA, visando evitar que narrativas grandiosas, como as do “Exterminador do Futuro”, enganem o público e promovam uma percepção racional das capacidades reais da IA dentro e fora da indústria. (Fonte: clefourrier)

Chatbot de IA da Albânia, Diella, nomeado membro do gabinete, gerando controvérsia : O governo albanês nomeou o chatbot de IA Diella como membro do gabinete, com o objetivo de combater a corrupção. Esta ação gerou ampla controvérsia, sendo criticada como um truque barato, semelhante ao evento de 2017 em que a Arábia Saudita concedeu “cidadania” ao robô Sophia. Comentários sugerem que esta medida pode superestimar as capacidades da IA e borrar os limites entre tecnologia e governança. (Fonte: The Verge)

Fenômeno de “alucinação” do ChatGPT: Modelo entra em loop, autocorrige, mas não consegue sair : Usuários da comunidade compartilharam casos de ChatGPT entrando em um loop de “alucinação”, onde o modelo gera repetidamente informações erradas ao responder a perguntas, e mesmo “percebendo” seus próprios erros, não consegue sair do ciclo. Este fenômeno gerou discussões sobre falhas técnicas profundas dos LLMs, indicando que a capacidade do modelo de entender seus próprios erros lógicos e a capacidade de corrigi-los estão desconectadas em certas situações. (Fonte: Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 Outros

Do Transformer ao GPT-5: O pensamento de primeiros princípios do cientista da OpenAI, Lukasz Kaiser, sobre grandes modelos : Lukasz Kaiser, cientista da OpenAI (um dos oito “filhos” do Transformer), compartilhou sua jornada desde sua formação em lógica, sua participação na invenção da arquitetura Transformer, até seu profundo envolvimento no desenvolvimento do GPT-4/5. Ele enfatiza a importância de construir sistemas a partir de primeiros princípios e prevê que a próxima fase da IA será ensinar os modelos a “pensar”, realizando raciocínio profundo através da geração de mais etapas intermediárias, em vez de produzir respostas diretas. O poder computacional se deslocará para um grande volume de inferência em um pequeno volume de dados de alta qualidade. (Fonte: 36氪)

Síntese de imagem semântica: Tecnologia de geração de esqueletos de fotos de rios via satélite : A comunidade de machine learning está discutindo os últimos avanços no campo da síntese de imagem semântica, com foco especial em como gerar fotos de rios via satélite em preto e branco a partir dos esqueletos de imagens de rios. Esta tarefa envolve o uso de um gerador para criar imagens de satélite a partir de dados de esqueletos novos e nunca vistos, e pode introduzir variáveis condicionais adicionais. A discussão visa encontrar os métodos mais avançados e artigos de pesquisa relevantes para orientar tais projetos de visão computacional. (Fonte: Reddit r/MachineLearning)

A lacuna de inteligência na era da IA: Professor Qiu Zeqi discute o impacto profundo da IA no pensamento e cognição humana : O Professor Qiu Zeqi da Universidade de Pequim aponta que o uso da IA não leva simplesmente à “diminuição da inteligência”, mas é mais como um exercício de pensamento, dependendo da proatividade e da atitude questionadora da pessoa. Ele enfatiza que a compreensão humana do pensamento ainda está em estágio inicial, e embora a IA seja poderosa, ela ainda se baseia no conhecimento humano, incapaz de simular completamente a percepção dos cinco sentidos humanos e o pensamento lateral. A tendência da IA de “agradar” exige que os usuários a desafiem e estejam atentos aos seus valores. Ele acredita que na era da IA, o desenvolvimento de capacidades básicas e uma sociedade diversificada são mais importantes, evitando observar a “lacuna de inteligência” de uma perspectiva superior. (Fonte: 36氪)