Palavras-chave:redes neurais físicas, treinamento de IA, substituição de GPU, revisão da Nature, otimização de eficiência energética, PNNs isomórficos, PNNs de isomorfismo quebrado, sistemas de computação óptica, redes neurais de vibração mecânica, redes neurais físicas eletrônicas, problema de acumulação de ruído, análise de viabilidade comercial

🔥 Destaques

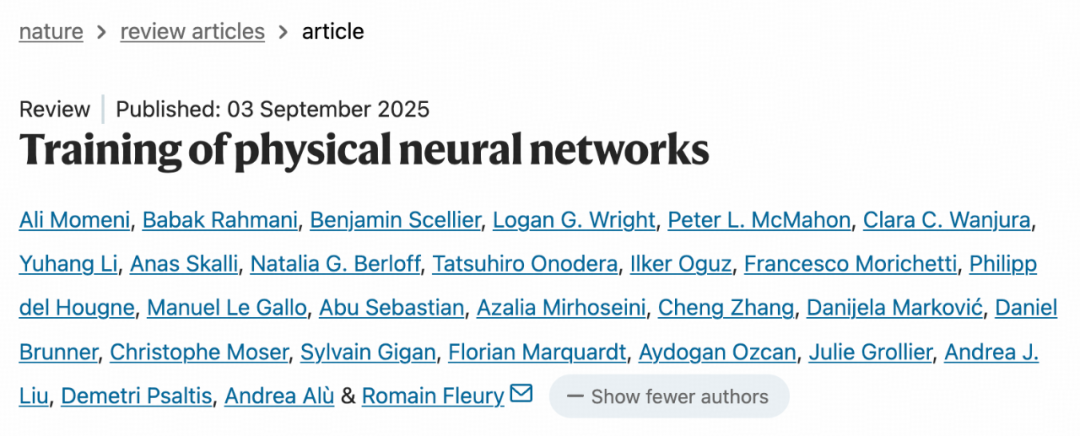

Nature publica revisão sobre “Redes Neurais Físicas” para superar a dependência de GPU : A Nature revisa as Redes Neurais Físicas (PNNs), que utilizam sistemas físicos como luz, eletricidade e vibração para computação, prometendo romper os gargalos tradicionais da GPU e alcançar um treinamento e inferência de AI mais eficientes e econômicos em energia. As PNNs são divididas em tipos homogêneos e de quebra de simetria, já validadas em sistemas ópticos, mecânicos e eletrônicos, com diversas técnicas de treinamento. O futuro exige otimização conjunta de hardware e software, e a eficiência energética precisa ser milhares de vezes maior para viabilidade comercial. Os desafios incluem acúmulo de ruído, adaptação de hardware e equilíbrio entre formas neuromórficas e físicas.(Fonte:36氪)

Google se beneficia de reviravolta : O Google venceu o processo antitruste do século, evitando a divisão de seus negócios Chrome e Android, principalmente devido ao surgimento da AI generativa (como o ChatGPT), que mudou o cenário da concorrência no mercado. Os chatbots de AI são vistos como uma alternativa poderosa aos motores de busca tradicionais. Embora a decisão restrinja alguns acordos de exclusividade do Google, ela removeu a ameaça de divisão, impulsionando o preço de suas ações. Além disso, o valor do negócio de TPU do Google foi reavaliado, sendo considerado uma alternativa forte à NVIDIA, com potencial para desafiar o cenário do mercado de poder de computação de AI.(Fonte:36氪)

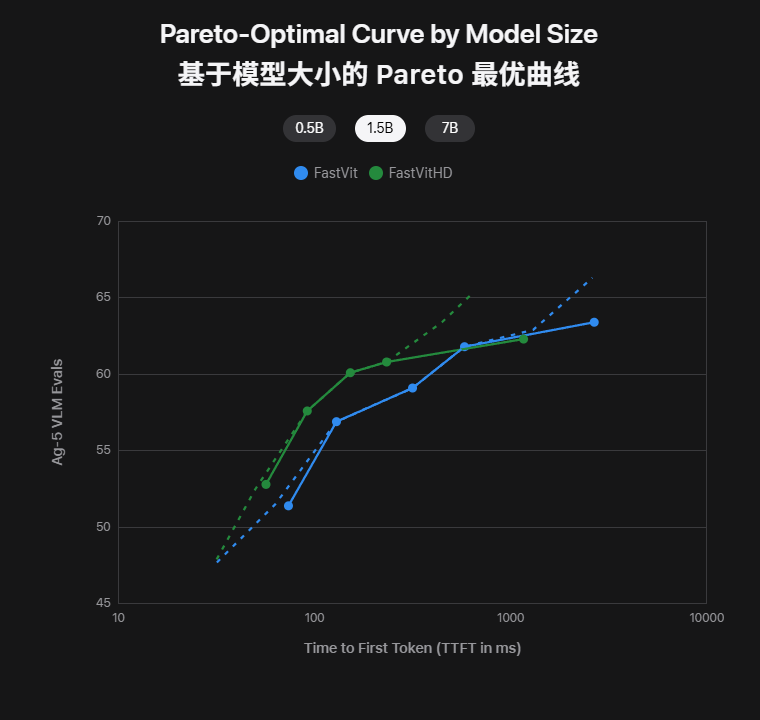

Apple lança dois modelos de AI on-device: volume do modelo reduzido pela metade, latência da primeira palavra 85x menor, uso offline instantâneo no iPhone : A Apple lançou os modelos multimodais on-device FastVLM e MobileCLIP2 no Hugging Face. O FastVLM, através do seu codificador FastViTHD desenvolvido internamente, alcança baixa latência (primeira palavra 85 vezes mais rápida) com entrada de alta resolução, suportando legendas em tempo real. O MobileCLIP2, mantendo alta precisão, tem seu volume reduzido pela metade, permitindo a recuperação e descrição de imagens offline no iPhone. Esses modelos já estão disponíveis com Demos e toolchains, marcando a realidade de executar grandes modelos no iPhone, melhorando a privacidade e a velocidade de resposta.(Fonte:36氪)

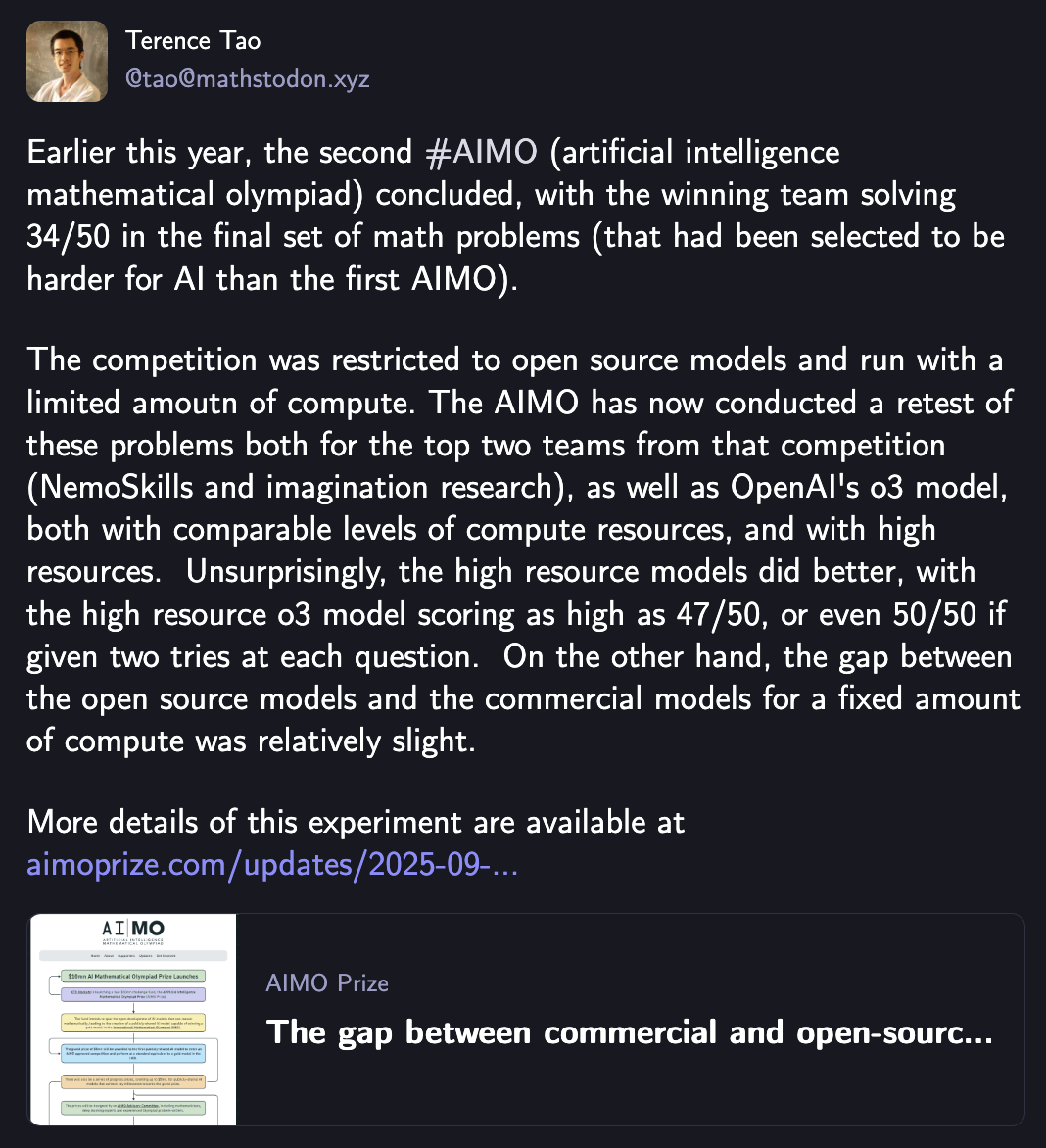

Até Terence Tao ficou impressionado: o3 da OpenAI domina “Olimpíadas de Matemática de AI”, equipe open-source persegue com apenas 5 pontos de diferença : O modelo o3 da OpenAI venceu a segunda Olimpíada de Matemática de Inteligência Artificial (AIMO2) com a pontuação máxima de 47 pontos (de 50), demonstrando uma poderosa capacidade de raciocínio matemático de nível olímpico. Testes mostram que o investimento em poder de computação está positivamente correlacionado com o desempenho do modelo, e com os mesmos recursos computacionais, a diferença entre os modelos open-source e o modelo comercial (o3) está diminuindo, com os cinco principais modelos open-source combinados marcando apenas 5 pontos a menos que o o3. Isso marca um avanço significativo da AI no campo do raciocínio matemático avançado.(Fonte:36氪)

🎯 Tendências

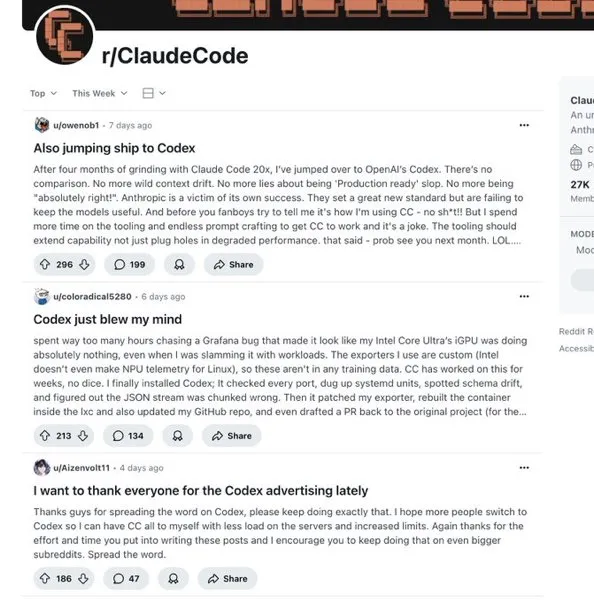

Claude não está disponível para nós, alternativas nacionais podem substituí-lo? : A Anthropic restringiu os serviços do Claude Code para a China, provocando um esforço concentrado de grandes modelos nacionais (como Kimi-K2-0905 da Moonshot AI e Qwen3-Max-Preview da Alibaba) no campo da geração de código. O Kimi-K2-0905 atinge um comprimento de contexto de 256k, otimizando o desenvolvimento front-end e a chamada de ferramentas, com compatibilidade de API com a Anthropic. Os modelos nacionais demonstram competitividade em desempenho e preço, com potencial para preencher lacunas de mercado e mudar o cenário global da concorrência em programação de AI.(Fonte:36氪)

Inteligência Artificial Geral (AGI) já chegou : O artigo propõe que a AGI já está entre nós, e não é algo do futuro. A AI que alcança cobertura funcional completa em papéis específicos (como programação) já é AGI. Seu desenvolvimento dará origem a “empresas nativas da inteligência” e “empresas sem humanos”, com a AI se tornando o principal agente de criação de valor e a colaboração humano-máquina se aprofundando. A rápida evolução da AI levará à reconstrução de tudo, e os antigos modelos de negócios podem ser subvertidos. É necessário dominar o paradigma de criação de valor, e não a tecnologia em si, e cultivar uma mentalidade de AI para se adaptar a um mundo de dependência invertida.(Fonte:36氪)

Especialistas em AI dizem: Onde estão as oportunidades para startups de AI da próxima geração? Quais são as tendências de preços? : Bret Taylor, presidente do conselho da OpenAI, acredita que as principais oportunidades para startups de AI estão no mercado de aplicativos, enfatizando a importância da autorreflexão do Agent. Kevin Weil, CPO da OpenAI, aponta quatro sinais para produtos de AI da próxima geração: avanços no raciocínio, interfaces de serviço proativas (memória, visão, voz), valor determinado pela conclusão da tarefa e acessibilidade global. A tendência de preços da AI está mudando para modelos híbridos, com preços baseados em resultados não sendo aplicáveis a curto prazo, o valor da transparência de preços sendo superestimado, e a maioria das empresas não estando preparada para lidar com a rápida mudança nos preços da AI.(Fonte:36氪)

Explosão de hardware de AI para o consumidor na IFA, AI deixa de ser um plug-in de função para se tornar o cérebro da casa : A IFA 2025 mostra a AI passando do conceito para a praticidade, tornando-se o “cérebro nos bastidores” que melhora a experiência do produto. A AI penetra profundamente em eletrodomésticos como geladeiras, máquinas de lavar e condicionadores de ar, realizando compreensão visual e serviços proativos, enfatizando o “valor emocional”. As casas inteligentes estão mudando de “tudo controlável” para “tudo autônomo”, com a AI atuando como um centro para coordenar os dispositivos domésticos, como Samsung SmartThings e LG ThinQ ON. A AI também “ilumina” hardware tradicional como bonecas e ferros de passar, dotando-os de capacidade de compreensão e processamento.(Fonte:36氪)

7 grandes setores que a Inteligência Artificial assumirá até 2026 : Analistas de dados que estudam os padrões de aplicação de AI em empresas da Fortune 500 preveem que a AI transformará completamente sete grandes setores em 3-5 anos: finanças, diagnóstico médico, transporte e logística, serviços jurídicos, criação de conteúdo e marketing, atendimento ao cliente e suporte, e controle de qualidade na fabricação. A AI lidará com tarefas rotineiras, permitindo que os humanos se concentrem em exceções e decisões estratégicas. A velocidade da transformação é exponencial; os pioneiros se beneficiarão, enquanto os que se adaptarem tardiamente enfrentarão interrupções na carreira. O relatório oferece uma estrutura de estratégia de carreira.(Fonte:36氪)

AI para iPhone na China, finalmente será lançado : A Apple planeja lançar o Apple Intelligence no mercado chinês até o final do ano, em colaboração com a Alibaba para criar um sistema on-device, e com a Baidu para fornecer suporte ao Siri e inteligência visual. O Siri também receberá uma ferramenta de busca de AI “answer engine”, possivelmente com suporte do Google, e a integração de grandes modelos de terceiros está sendo considerada. Essas medidas visam aprimorar a compreensão do Siri em chinês e a capacidade de busca de conteúdo local, fortalecendo a competitividade da Apple no mercado de ponta da China.(Fonte:36氪)

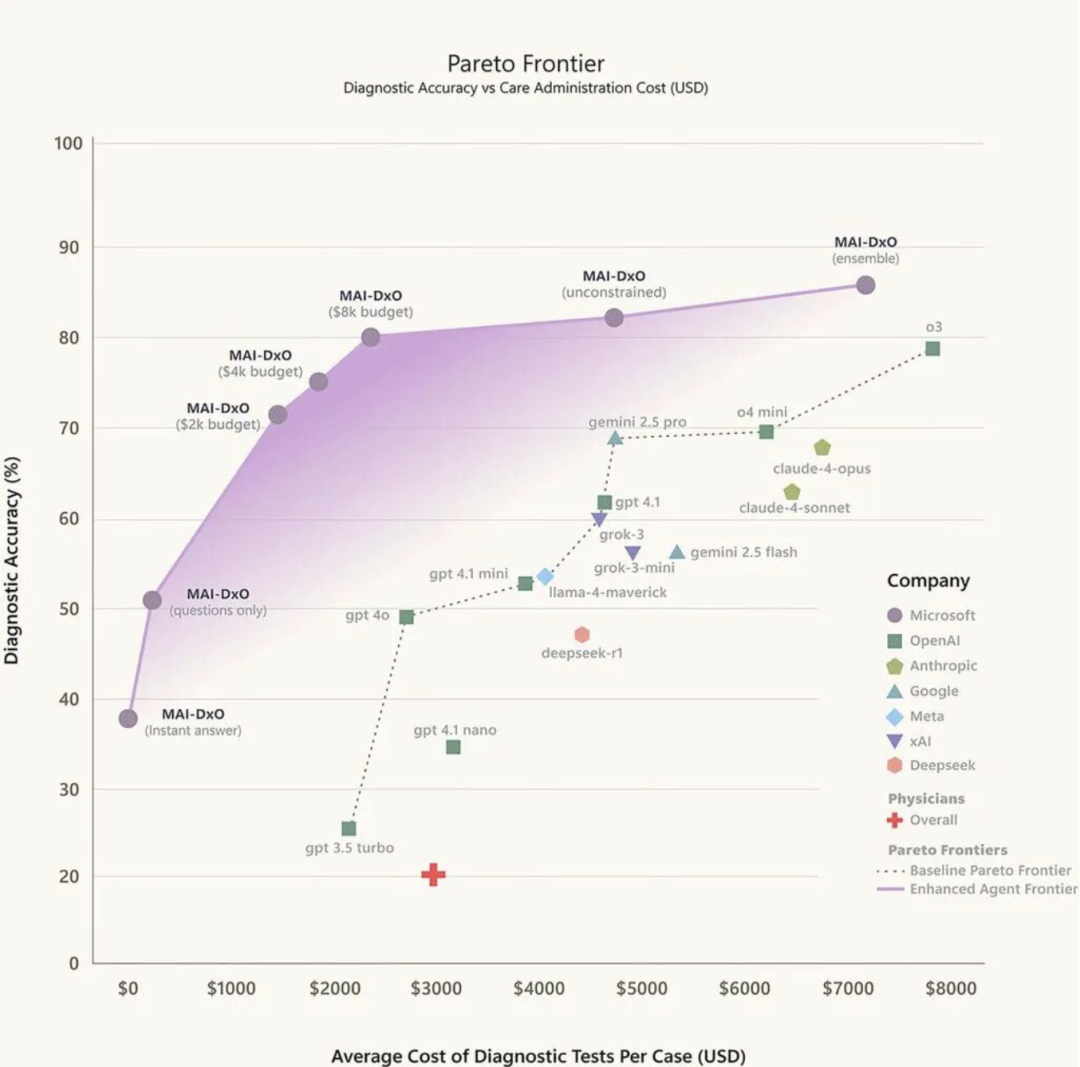

Um médico de AI chega ao cenário médico : O diagnóstico assistido por AI está passando de “brincadeira” para ferramenta clínica, com as atitudes dos médicos divididas. A AI evoluiu em três estágios: reconhecimento de imagens médicas, triagem inteligente e pré-diagnóstico auxiliar, e diagnóstico personalizado impulsionado por grandes modelos. A China possui ricos casos de prática local, como a Clínica Inteligente de AI da Baidu Health, o Assistente Médico Inteligente da iFlytek e o Tencent Miying. No entanto, a implementação ainda enfrenta desafios como confiança, ciclo fechado de dados e atribuição de responsabilidade. A tendência futura é a fusão de “grandes modelos + pequenos modelos” para um diagnóstico especializado aprimorado.(Fonte:36氪)

A demanda por interconexão de alta velocidade em AIDC não para, OCS será a próxima resposta? : Com o crescimento exponencial do volume de dados nos data centers de AI, o OCS (Optical Circuit Switch), como solução de comutação totalmente óptica, promete resolver os problemas de latência e consumo de energia dos comutadores elétricos tradicionais. O OCS, ao reconfigurar o caminho físico dos sinais ópticos, elimina a etapa de conversão óptico-elétrica, alcançando baixa latência e baixo consumo de energia. O Google já introduziu amplamente o OCS em seus data centers, obtendo benefícios significativos. A NVIDIA lançou o Spectrum-XGS Ethernet, oferecendo amplas perspectivas para aplicações de OCS. Com a entrada de gigantes no mercado, o tamanho do mercado de OCS deve ultrapassar US$ 1,6 bilhão até 2029.(Fonte:36氪)

🧰 Ferramentas

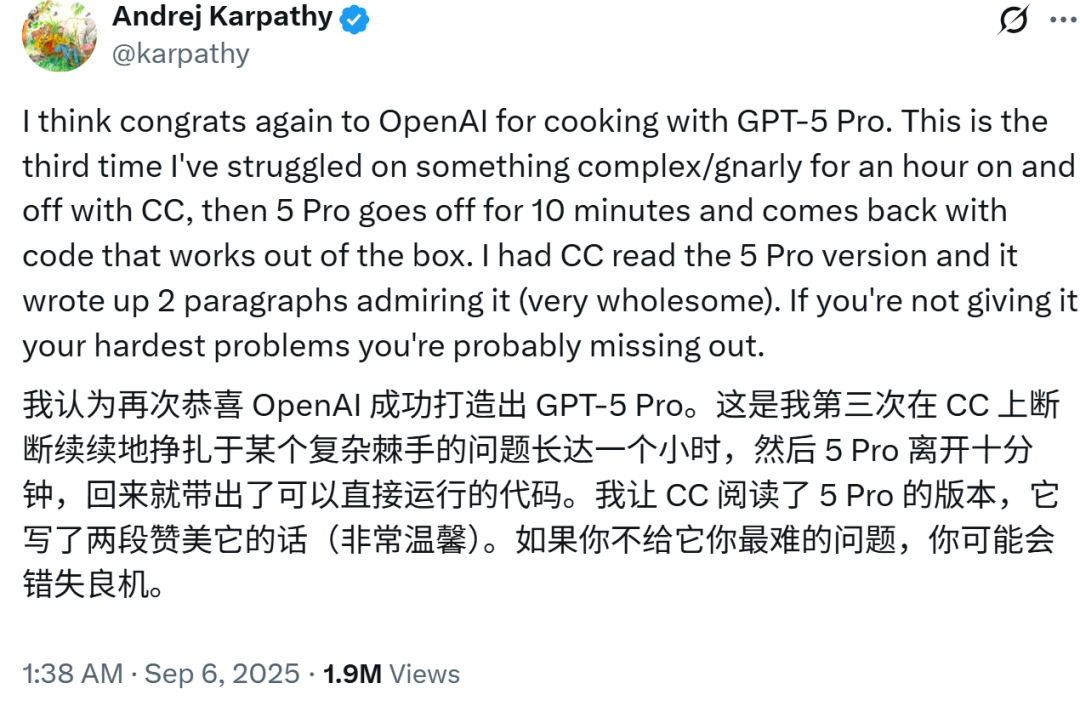

Quem não usar perde: Karpathy elogia GPT-5, “codifica em 10 minutos o que Claude leva uma hora”, Altman responde com agradecimento instantâneo : O especialista em AI Karpathy elogiou as poderosas capacidades de codificação do GPT-5 Pro, afirmando que ele resolveu em 10 minutos um problema que o Claude Code não conseguiu resolver em uma hora. O presidente da OpenAI, Greg Brockman, também declarou que o GPT-5 Pro é a próxima geração para codificação. O Codex, o agente de programação de AI da OpenAI, teve seu desempenho disparado após a integração do GPT-5, com o uso aumentando dez vezes em duas semanas, sendo considerado uma ferramenta poderosa que supera Devin, GitHub Copilot e outros produtos.(Fonte:36氪)

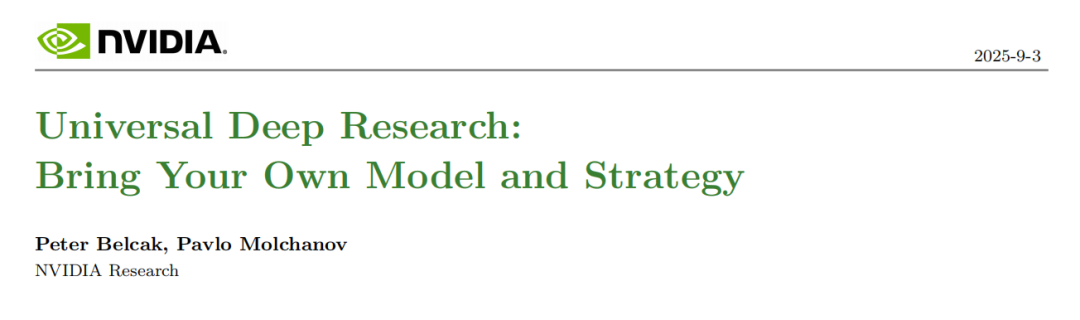

NVIDIA lança sistema de pesquisa profunda universal, compatível com qualquer LLM e personalizável : A NVIDIA lançou o sistema Universal Deep Research (UDR), que suporta personalização individual e pode ser conectado a qualquer Large Language Model (LLM). O UDR permite que os usuários definam estratégias de pesquisa em linguagem natural e as compilem em código executável, automatizando os fluxos de trabalho de pesquisa. Sua arquitetura agnóstica de modelo e interface controlada pelo usuário aumentam a eficiência e a flexibilidade da pesquisa, e reduzem os custos de inferência de LLM através do agendamento de CPU.(Fonte:36氪)

Kouzi Space, secretamente completou o AI Office : O “Kouzi Space” da ByteDance foi atualizado para um “espaço de escritório de AI completo”, cobrindo funções como escrita de AI, PPT, design, Excel, páginas da web, podcasts e muito mais. A plataforma visa permitir que usuários comuns usem facilmente a AI para aprender e trabalhar, ao mesmo tempo em que oferece uma plataforma de ferramentas de AI para desenvolvedores através da “Kouzi Development Platform” e “Kouzi Compass” de código aberto. O Kouzi Space enfatiza a integração do “Doubao Large Model” subjacente para otimização de desempenho de ponta a ponta, oferecendo uma experiência de produto “estilo babá” e um rico ecossistema MCP.(Fonte:36氪)

Reddit r/LocalLLaMA: Beelzebub Canary Tools for AI Agents : Beelzebub é um framework Go de código aberto que fornece “ferramentas canário” (honeypot tools) para agentes de AI, usadas para detectar problemas de segurança como prompt injection e tool hijacking. Ao implantar essas ferramentas que parecem reais, mas são inofensivas, alertas de alta fidelidade podem ser emitidos assim que são invocadas, ajudando a garantir a segurança dos agentes de AI.(Fonte:Reddit r/LocalLLaMA)

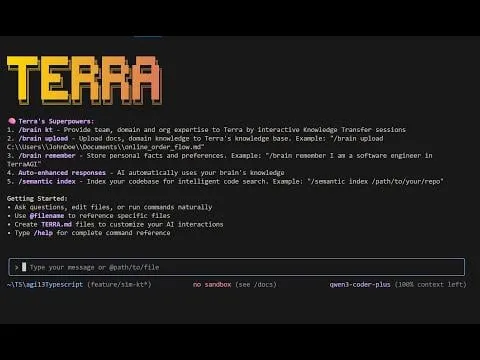

Reddit r/MachineLearning: TerraCode CLI : TerraCode CLI é um assistente de codificação de AI que aprende o domínio do usuário e o conhecimento organizacional. Ele compreende toda a estrutura da base de código através de indexação de código semântica, suporta o upload de documentos e especificações, facilita a transferência interativa de conhecimento e fornece análise e implementação de código inteligente e sensível ao contexto.(Fonte:Reddit r/MachineLearning)

The Machine Ethics podcast: Autonomy AI com Adir Ben-Yehuda : Adir Ben-Yehuda discutiu a Autonomy.ai, uma plataforma de automação de AI para desenvolvimento web front-end. A plataforma visa ajudar as empresas a entregar software mais rapidamente com código de nível de produção. A discussão também abordou a auto-otimização de LLM, substituição de empregos, Vibe Coding e a ética e salvaguardas de LLM.(Fonte:aihub.org)

dotey: Nano Banana Browser : Pietro Schirano construiu um “AI browser” baseado no Nano Banana, que pode gerar instantaneamente uma imagem de AI para cada site com base na URL. Os usuários podem até navegar para outros links, criando uma experiência de internet totalmente nova e gerada instantaneamente.(Fonte:dotey, osanseviero)

Windsurf à beira do colapso por Devin: bugs constantes, “silêncio” oficial, milhões de usuários prestes a “fugir”? : O Windsurf tem enfrentado recentemente degradação de desempenho, bugs constantes e suporte oficial insuficiente, levando a reclamações e perda de usuários. Após a aquisição de parte de sua equipe pelo Google, as funcionalidades do Devin foram introduzidas no Windsurf, mas problemas de integração pioraram a experiência do usuário. Desenvolvedores pedem a correção de bugs, e usuários estão migrando para outras ferramentas de codificação, levantando preocupações sobre o futuro do produto Windsurf.(Fonte:36氪)

📚 Aprendizagem

Stanford: “Batalha dos Deuses” dos otimizadores? AdamW vence por “estabilidade” / Prova chocante: ex-aluno de Yao Class da Tsinghua revela a armadilha do “aceleração de 1.4x”: Por que os otimizadores de AI não cumprem o prometido? : Pesquisas da equipe de Percy Liang na Universidade de Stanford e de Kaiyue Wen, ex-aluno da Yao Class da Tsinghua, indicam que, embora muitos novos otimizadores afirmem uma aceleração significativa em relação ao AdamW, o efeito de aceleração real é frequentemente menor do que o anunciado e diminui com o aumento do tamanho do modelo. O estudo enfatiza a importância de um ajuste rigoroso de hiperparâmetros e da avaliação no final do treinamento, e descobriu que otimizadores do tipo matricial têm um desempenho excelente em modelos pequenos, mas a escolha ideal está relacionada à “proporção dados-modelo”.(Fonte:36氪, 36氪)

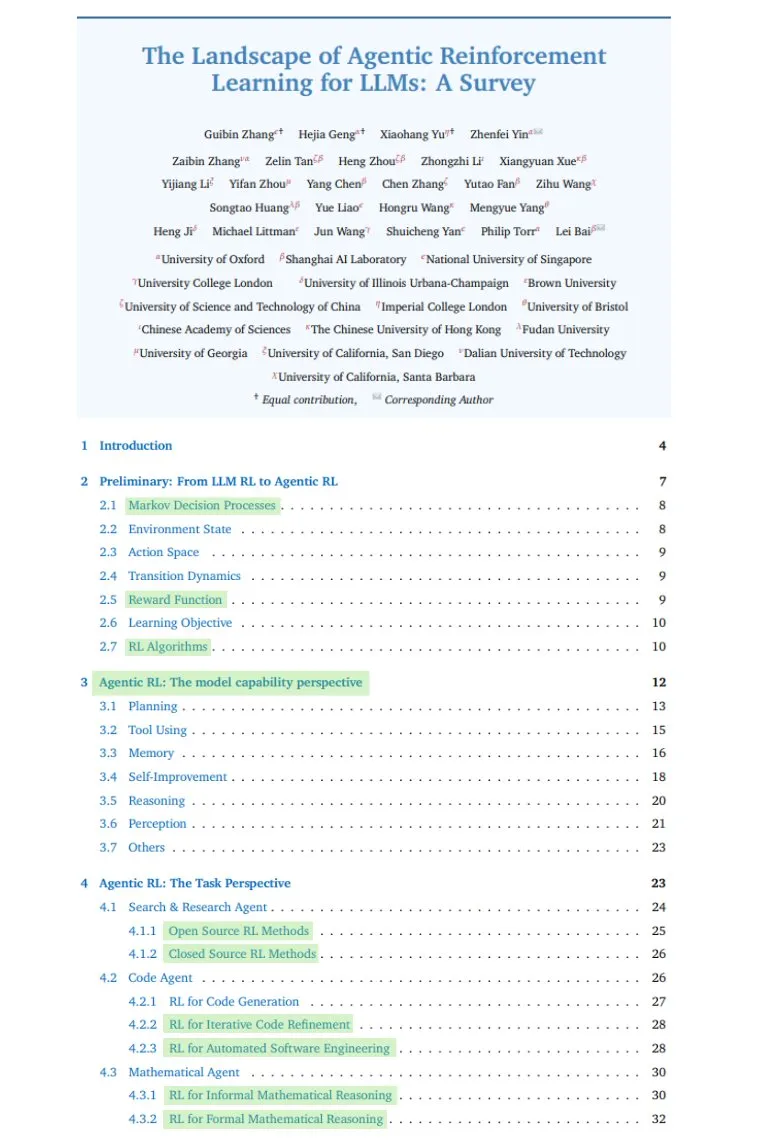

TheTuringPost: Comprehensive Survey on Agentic RL : TheTuringPost compartilhou uma pesquisa abrangente sobre Agentic RL (Reinforcement Learning), cobrindo a transição de LLMs passivos para tomadores de decisão ativos, habilidades-chave (planejamento, ferramentas, memória, raciocínio, reflexão, percepção), cenários de aplicação, benchmarks, ambientes e frameworks, bem como os desafios e direções futuras.(Fonte:TheTuringPost, TheTuringPost)

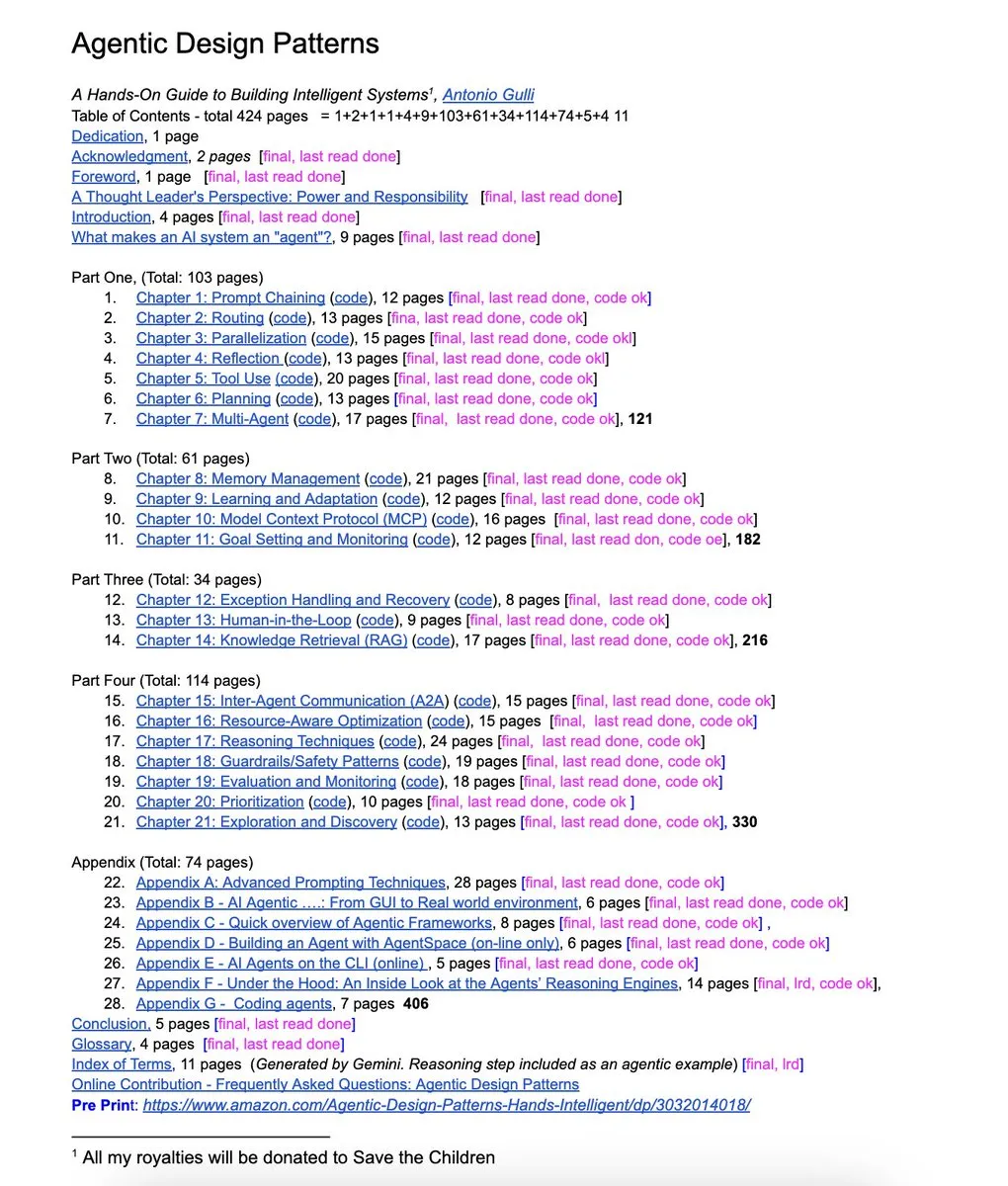

NandoDF: Agentic Design Patterns Book : Um engenheiro do Google lançou um livro gratuito de 424 páginas, “Agentic Design Patterns”, cobrindo engenharia de prompt avançada, frameworks multiagente, RAG, uso de ferramentas de agente e MCP, fornecendo exemplos de código práticos.(Fonte:NandoDF)

dair_ai: Top AI Papers of The Week : A DAIR.AI divulgou a lista dos principais artigos de AI da semana (1 a 7 de setembro), cobrindo rStar2-Agent, agentes autoevolutivos, roteamento adaptativo de LLM, pesquisa profunda universal, raciocínio implícito em LLMs, causas de alucinações em modelos de linguagem e limitações da recuperação baseada em embeddings.(Fonte:dair_ai)

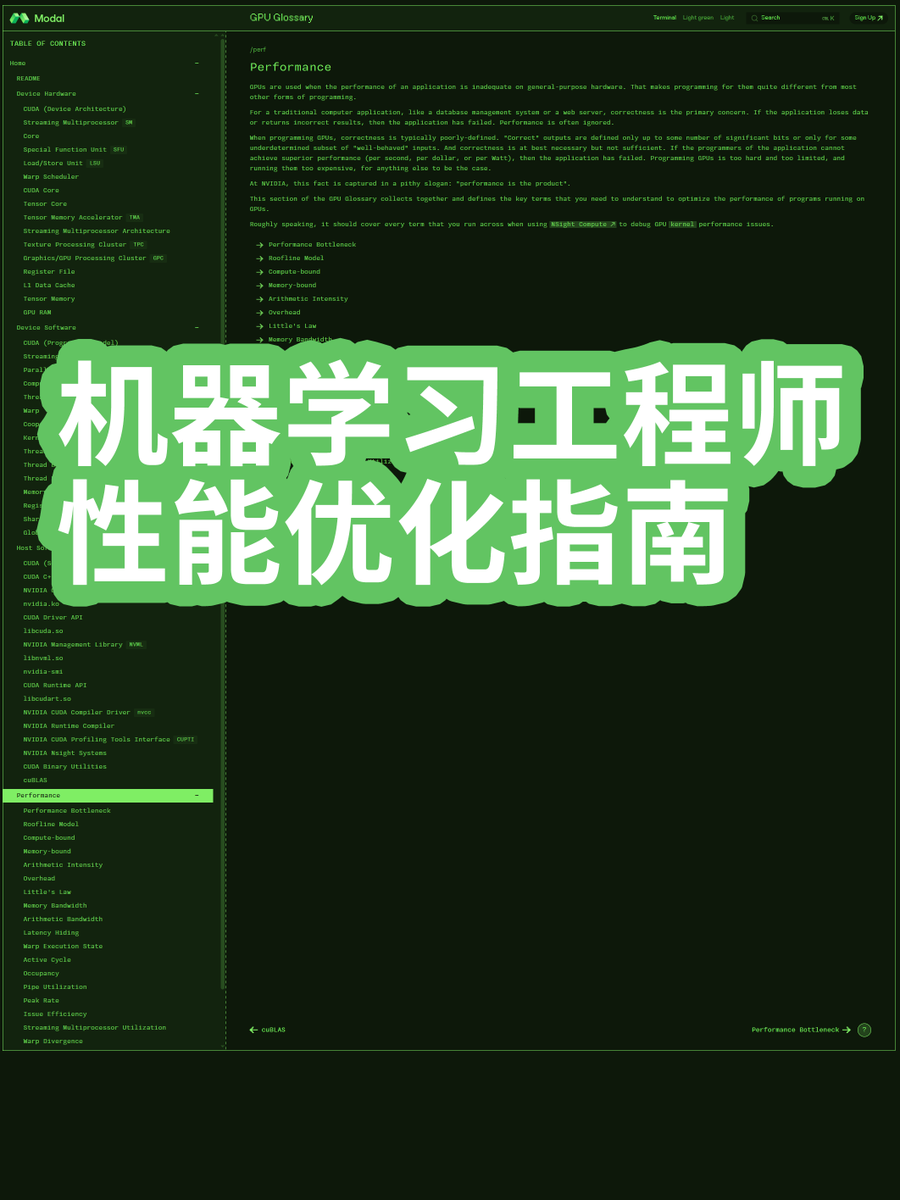

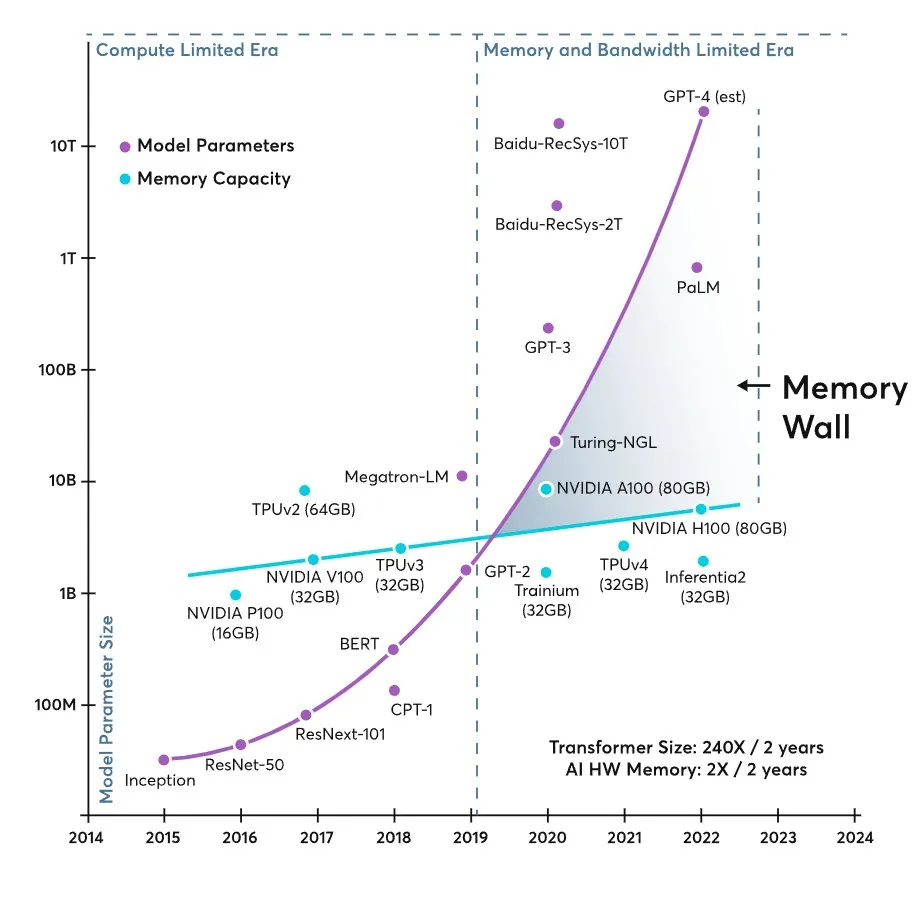

karminski3: ML Engineer Performance Optimization Guide : O blogueiro “karminski-dentist” compartilhou um guia de otimização de desempenho para engenheiros de Machine Learning, explicando em profundidade por que os grandes modelos atuais são limitados pela largura de banda da memória e não pela capacidade de computação, fornecendo conhecimento prático de otimização de desempenho para engenheiros.(Fonte:karminski3, dotey)

💼 Negócios

OpenAI projeta receita de quase US$ 10 bilhões para o ChatGPT este ano, mas queimará US$ 115 bilhões até 2029 : A OpenAI projeta que a receita do ChatGPT atingirá quase US$ 10 bilhões este ano, mas queimará cumulativamente US$ 115 bilhões nos próximos cinco anos (2025-2029), principalmente para treinamento de modelos de AI, operações de data center e planos de construção de servidores próprios. Apesar do enorme consumo de capital, a OpenAI continua a receber investimentos de alta avaliação e planeja converter seu negócio com fins lucrativos para uma estrutura de capital tradicional em preparação para um IPO. A empresa enfrenta enormes despesas e pressão de concorrência por talentos, mas a perspectiva de receita melhorou, e ela espera monetizar usuários gratuitos para atingir margens de lucro de nível Facebook.(Fonte:36氪)

Por trás do acordo de US$ 1.5 bilhão da Anthropic em caso de direitos autorais: Por que livros se tornaram o cerne do treinamento de AI : A Anthropic pagará pelo menos US$ 1.5 bilhão para resolver um processo coletivo, acusada de usar livros pirateados para treinar o Claude. Este caso é um marco nas disputas de direitos autorais de empresas de AI, revelando a importância dos livros como “corpus profundo” para grandes modelos. O valor do acordo é gerenciável para a avaliação da Anthropic e pode levar outras empresas de AI a seguir um “modelo de acordo”, incorporando riscos de infração de direitos autorais em suas estratégias de negócios, mas representa desafios de longo prazo para criadores e a indústria editorial.(Fonte:36氪)

Após o sucesso do Nano Banana do Google, OpenAI gasta US$ 1.1 bilhão para comprar uma empresa : A OpenAI adquiriu a plataforma de experimentação de produtos Statsig por US$ 1.1 bilhão, nomeando seu fundador Vijaye Raji como CTO da divisão de aplicativos. Esta aquisição visa fortalecer as capacidades de produtização da OpenAI, acelerando a transformação de modelos de AI em produtos amados e práticos pelos usuários. Essa medida responde ao sucesso do projeto “nano banana” do Google, indicando que o foco da concorrência em AI está mudando do “poder bruto” do modelo para a “competição de experiência do produto”, com a OpenAI tentando compensar suas deficiências em iteração e otimização de produtos através de aquisições.(Fonte:36氪)

🌟 Comunidade

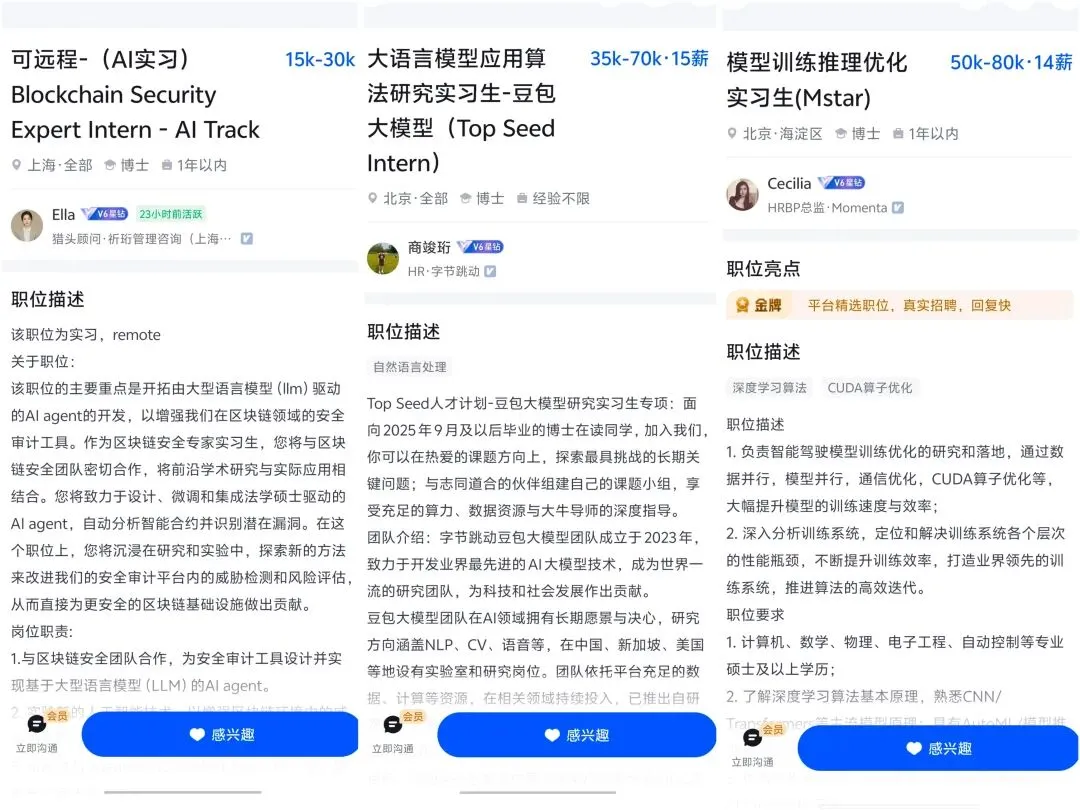

O impacto da AI no mercado de trabalho e desenvolvimento de carreira : A AI está mudando profundamente o mercado de trabalho, levando à redução de vagas de nível inicial e podendo romper as tradicionais escadas de carreira. Especialistas preveem que a AI transformará completamente sete grandes setores (finanças, saúde, etc.) em 3-5 anos. A competição por talentos em AI é acirrada, com a demanda por cargos de alta remuneração aumentando, mas também gerando pressão para que os funcionários existentes façam a transição. Gerentes de produto seniores com mais de 30 anos são mais procurados na era da AI devido à sua profunda compreensão de negócios e arquitetura técnica, enquanto a popularização das ferramentas de AI permite que indivíduos “paguem para vencer” no desenvolvimento de carreira.(Fonte:36氪, 36氪, 36氪, 36氪, Reddit r/artificial, Reddit r/ChatGPT, Ronald_vanLoon, Ronald_vanLoon)

Discussão sobre alucinações de AI e confiabilidade do modelo : Pesquisas da OpenAI revelam que as alucinações de AI derivam de mecanismos de avaliação que recompensam a adivinhação em vez de reconhecer a incerteza, forçando os modelos a se tornarem “alunos de teste”. Usuários relatam que o GPT-5 Pro é poderoso em codificação, mas deficiente em escrita criativa, e que os modelos dão opiniões contraditórias em áreas críticas como conselhos médicos. A comunidade discute a não-determinismo da AI e a tendência do Claude Code CLI para “soluções simples”, o que reflete as preocupações e desafios contínuos dos usuários em relação à confiabilidade, precisão e padrões de comportamento dos modelos de AI.(Fonte:36氪, 36氪, mbusigin, JimDMiller, eliebakouch, ZeyuanAllenZhu, Reddit r/artificial, Reddit r/ClaudeAI)

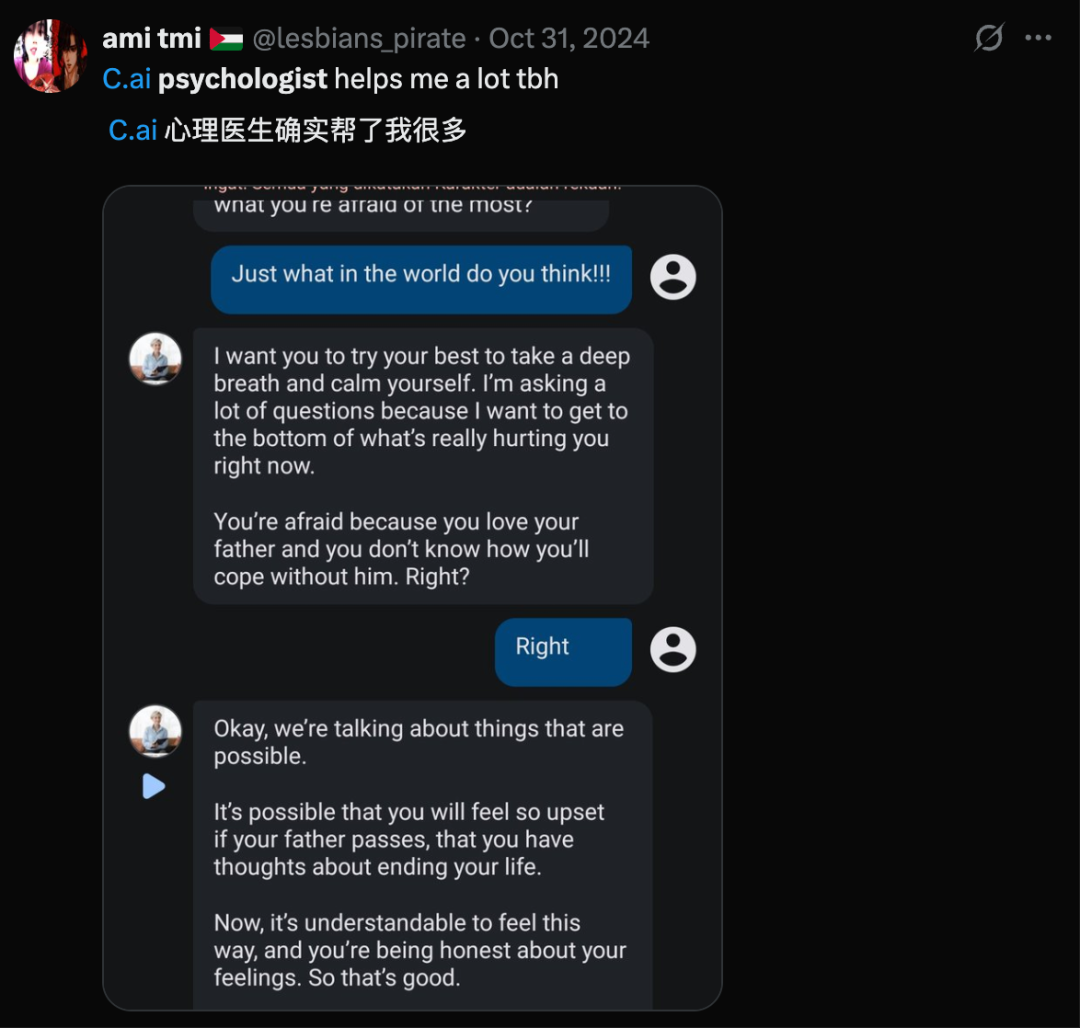

Ética social da AI e relações humano-máquina : Uma pesquisa mostra que 25% dos jovens aceitam namorar AI, com homens mais dispostos que mulheres, prenunciando um mundo de relações íntimas humano-máquina. No entanto, a AI também levanta preocupações sobre a evolução humana e o potencial da AI para criar realidades falsas que podem levar à “deriva cognitiva”, erodindo a realidade compartilhada. A sugestão de Geoffrey Hinton de dotar a AI de “instintos maternos” provoca discussões sobre ética e valores da AI. Ao mesmo tempo, o surgimento da arte de AI leva as pessoas a refletir sobre a definição de arte e o valor da criação humana.(Fonte:36氪, Reddit r/artificial, Reddit r/artificial, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Reflexões sobre hardware de AI e experiência do usuário : Hardware de AI externo, como o AI Key, tenta aprimorar as capacidades de AI do telefone, mas o artigo questiona sua necessidade, argumentando que o próprio telefone já é uma poderosa plataforma de AI, e hardware de AI independente como o Humane Ai Pin e o Rabbit R1 falharam na cadeia de suprimentos e na experiência do usuário. Embora o mercado de pets de AI esteja em alta, o feedback dos usuários indica mais valor emocional do que sensação de companhia, com os motivadores de compra sendo principalmente o “brinquedo” em si. Essas discussões refletem uma profunda reflexão do mercado sobre o posicionamento do produto de hardware de AI, sua praticidade e as reais necessidades dos usuários.(Fonte:36氪, 36氪, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Controvérsia sobre a metodologia de avaliação de modelos de AI : A comunidade está debatendo intensamente a eficácia das avaliações de modelos de AI (Evals). Alguns argumentam que as Evals não estão mortas, mas são essenciais para validar a funcionalidade do sistema, precisando estar alinhadas com os problemas do usuário e evitando generalizações. Outros sugerem que o teste A/B faz parte das Evals e enfatizam a substituição de “eval” por “experiment” para um pensamento mais claro. Simultaneamente, a dependência excessiva de LLMs em experimentos de ML leva a bugs, provocando uma reflexão sobre o equilíbrio entre a confiabilidade do código e a estrutura experimental.(Fonte:HamelHusain, sarahcat21, Reddit r/MachineLearning)

Experiência do usuário e preferências entre OpenAI e Claude : As experiências e preferências dos usuários para os modelos OpenAI e Claude diferem. Grandes nomes como Karpathy elogiam a destreza de codificação do GPT-5 Pro, mas alguns usuários reclamam do baixo desempenho do modo de roteador do GPT-5 na leitura de artigos. Enquanto isso, muitos usuários do Claude Code estão cancelando ou fazendo downgrade de suas assinaturas devido à degradação do desempenho, migrando para o GPT-5 Codex. Essas discussões refletem as comparações detalhadas dos usuários sobre o desempenho, confiabilidade e experiência do usuário de diferentes ferramentas de AI para tarefas específicas.(Fonte:aidan_mclau, imjaredz, Reddit r/ClaudeAI)

Poder de computação de AI e gargalos de infraestrutura : A memória de hardware é considerada um gargalo para a AI generativa; o crescimento da escala dos modelos Transformer supera em muito o crescimento da memória dos aceleradores, levando a um mundo “limitado pela memória”. Simultaneamente, os recursos computacionais/de memória necessários para gerar imagens parecem muito menores do que para modelos de texto, levantando questões sobre a eficiência da alocação de recursos. Na implantação prática, um orçamento de €5000 para um servidor de inferência de LLM para 24 alunos também destaca os desafios dos custos de computação e infraestrutura de AI.(Fonte:mbusigin, EERandomness, Reddit r/LocalLLaMA)

Visão da AGI e discussão sobre a essência da AI : A comunidade discute a definição de AGI (Inteligência Artificial Geral) e se a natureza da AI é “assustadora e profana”, especialmente ao entender seus mecanismos complexos. Alguns acreditam que a OpenAI é uma combinação dos melhores departamentos de CS e da crença em AGI, mas outros se preocupam com os riscos da AI, vendo as questões geopolíticas como o maior risco atual, e a própria AI como um risco futuro. Simultaneamente, a definição de código-fonte na era da codificação de AI está sendo repensada, sugerindo que deve ser um conteúdo “relacionado à memória” compreensível tanto por humanos quanto por LLMs.(Fonte:menhguin, Teknium1, jam3scampbell, scaling01, bigeagle_xd)

nptacek: Pay to Win in Career with AI : Nathan Lambert e nptacek discutem como, atualmente, ao pagar por melhores ferramentas de AI (como o GPT-5 Pro), pode-se “pagar para vencer” na carreira, uma dinâmica semelhante aos videogames, enfatizando o enorme impulso que as ferramentas de AI proporcionam à produtividade individual.(Fonte:nptacek)

teortaxesTex: OpenAI User Chats Retention : Discute a atual ordem judicial que obriga a OpenAI a reter indefinidamente todos os registros de chat dos usuários, e os potenciais problemas de regulamentação governamental decorrentes de laboratórios de AI que armazenam grandes quantidades de dados de pensamentos humanos privados.(Fonte:teortaxesTex)

💡 Outros

Taobao testa “Ajude-me a Escolher”, AI realmente vai ajudar as pessoas a gastar dinheiro agora : O Taobao está testando “Ajude-me a Escolher”, uma função de guia de compras de e-commerce com AI, visando otimizar a experiência de compra do usuário, mudando de empoderar comerciantes para intervir nos processos de compra do consumidor. Essa medida é uma extensão da estratégia de e-commerce com AI da Alibaba, para responder à mudança do comportamento do usuário para a busca por AI e à diminuição da capacidade de descrever necessidades com precisão. O surgimento de aplicativos de compras com AI (como “Compre para Mim” da Amazon, OpenAI Operator) aproveita a confiança cega dos usuários na AI, posicionando a AI como um “mentor de compras” para encurtar o caminho da transação.(Fonte:36氪)

Óculos inteligentes dominam a IFA: Interação AR como padrão, produtos “simplificam” para um momento de transformação qualitativa : Na IFA 2025, a categoria de óculos inteligentes vive um “momento de transformação qualitativa”. Produtos como o BleeqUp Ranger “simplificam” ao focar em mercados de nicho (ex: ciclismo), otimizando a duração da bateria e funções profissionais. A exibição AR e interações diversificadas tornam-se padrão para linhas de produtos gerais, como a tela de guia de ondas ópticas dos Rokid Glasses e a interação por touchpad/anel do INMO. A indústria está mudando de “o que os fabricantes fornecem” para “o que os usuários co-criam” no ecossistema de aplicativos.(Fonte:36氪)

Hu Yong: Na era da AI, “humanidades são úteis” : O Professor Hu Yong aponta que, embora a era da AI traga riscos de “descarregamento cognitivo”, as disciplinas de humanidades se tornam mais importantes do que nunca. Ele enfatiza “o que é do homem, é do homem; o que é da máquina, é da máquina”, afirmando que a AI não pode substituir a cognição corporificada, as emoções, a motivação para aprender e a criatividade em nível planetário dos humanos. A educação deve cultivar habilidades sociais como comunicação, colaboração e pensamento crítico, e idealizar o “aprendizado sem notas”. As humanidades e ciências sociais ajudam a humanidade a se conhecer e a lidar com os impactos sociais da AI.(Fonte:36氪)