Palavras-chave:Tesla, Robô Optimus, IA, GPT-5, treinamento de modelos grandes, Meta IA, pré-treinamento LLM, função de perda Goldfish, modelo DynaGuard de barreira dinâmica, arquitetura de rede GAM, segmentação de imagens médicas MedDINOv3, recuperação de imagens médicas multimodais M3Ret

🔥 Destaque

Elon Musk lança “Master Plan Part IV”: 80% do valor da Tesla reside em robôs : A Tesla lançou oficialmente o “Master Plan Part IV”, cujo cerne é introduzir a AI no mundo físico real e, através da unificação em larga escala do hardware e software da Tesla, alcançar a “abundância sustentável”. Musk salientou que, no futuro, cerca de 80% do valor da Tesla virá do robô humanoide Optimus, o que pressagia uma mudança de paradigma da empresa, de veículos elétricos para uma profunda integração de energia, AI e robótica, com o objetivo de resolver problemas reais através da tecnologia e beneficiar toda a humanidade. (Fonte: 量子位)

🎯 Tendências

AI ganha ouro na Competição Internacional de Matemática Olímpica : O GPT da OpenAI e o Gemini da Google DeepMind ganharam medalhas de ouro na Competição Internacional de Matemática Olímpica, quebrando as previsões de especialistas e demonstrando o surpreendente progresso dos LLMs no raciocínio matemático, o que indica que o desenvolvimento da AI está a acelerar muito mais rápido do que o esperado, entrando na era da “inteligência de massa”. Este não é apenas um avanço tecnológico, mas também levanta discussões profundas sobre os limites das capacidades da AI e o seu impacto futuro na sociedade. (Fonte: 36氪)

GPT-5 demonstra desempenho excecional no jogo Werewolf : No benchmark de Werewolf AIWolfDial 2025, o GPT-5 liderou com uma taxa de vitória de 96,7%, demonstrando fortes capacidades de raciocínio social, engano e resistência à manipulação. O Kimi-K2 exibiu um estilo “impostor” ousado e agressivo, refletindo padrões de comportamento individualizados dos LLMs em interações sociais complexas. (Fonte: 量子位,Reddit r/deeplearning)

Novo método de treino para modelos grandes: “Goldfish Loss” : Equipas de investigação da Universidade de Maryland e outras propuseram a “Goldfish Loss”, que, ao descartar aleatoriamente alguns tokens durante o cálculo da função de perda, reduz eficazmente a memorização de modelos grandes, impedindo-os de memorizar dados de treino, sem afetar o desempenho em tarefas subsequentes, melhorando a capacidade de generalização do modelo. (Fonte: 量子位)

Reestruturação interna do departamento de AI da Meta gera controvérsia : Alexandr Wang, Chief AI Officer da Meta, implementou novas regras que exigem que as publicações do FAIR sejam revisadas pelo laboratório TBD e que artigos valiosos e seus autores possam ser “retidos” para implementação de produtos. Esta medida gerou insatisfação entre o pessoal do FAIR, com alguns funcionários a demitir-se, destacando a intervenção da Meta na independência da pesquisa e a sua postura agressiva na conversão de resultados em produtos, no âmbito do seu ajustamento estratégico de AI. (Fonte: 量子位)

Benchmark de desempenho de otimizadores de pré-treino de LLM : Um estudo sistemático de dez otimizadores de deep learning, abrangendo diferentes tamanhos de modelo e proporções de modelo de dados. Descobriu-se que uma comparação justa requer ajuste rigoroso de hiperparâmetros e avaliação do desempenho no final do treino. O estudo mostra que a melhoria de velocidade dos otimizadores baseados em matriz (como Muon e Soap) diminui com o aumento do tamanho do modelo, sendo apenas 1,1 vezes para modelos de 1,2B, fornecendo orientação para a seleção de otimizadores de pré-treino de LLM e pesquisas futuras. (Fonte: HuggingFace Daily Papers,HuggingFace Daily Papers)

DynaGuard: Modelo de guarda-corpo dinâmico com políticas definidas pelo utilizador : Apresenta-se o modelo de guarda-corpo dinâmico DynaGuard, capaz de avaliar texto de acordo com políticas definidas pelo utilizador, detetando rapidamente comportamentos inadequados. Este modelo atinge uma precisão comparável aos modelos de guarda-corpo padrão na deteção de categorias de perigo estáticas, ao mesmo tempo que identifica violações de políticas de forma livre em menos tempo, proporcionando uma supervisão flexível e eficiente da saída para chatbots. (Fonte: HuggingFace Daily Papers)

Rede Gated Associative Memory (GAM) : Apresenta-se a rede GAM, uma nova arquitetura de modelagem de sequência totalmente paralela, cuja complexidade é linear em relação ao comprimento da sequência (O(N)), resolvendo o gargalo de complexidade quadrática do mecanismo de autoatenção do Transformer. A GAM combina convolução causal e recuperação de memória associativa paralela, demonstrando velocidades de treino mais rápidas e perplexidade de validação superior ou comparável ao Transformer e Mamba nos conjuntos de dados WikiText-2 e TinyStories. (Fonte: HuggingFace Daily Papers)

Reasoning Vectors: Transferência de capacidade de cadeia de pensamento através de aritmética de tarefas : A pesquisa mostra que a capacidade de raciocínio dos LLMs pode ser extraída como vetores de tarefa compactos e transferida entre modelos. Ao calcular a diferença vetorial entre modelos finetuned e modelos SFT, e adicioná-la a outros modelos finetuned por instrução, o desempenho em vários benchmarks de raciocínio como GSM8K e HumanEval pode ser consistentemente melhorado, fornecendo um método eficiente e reutilizável para o aprimoramento da capacidade dos LLMs. (Fonte: HuggingFace Daily Papers)

MedDINOv3: Modelo de base visual para segmentação de imagens médicas : Apresenta-se o framework MedDINOv3, que, ao redesenhar a rede backbone ViT e realizar pré-treino adaptativo de domínio no conjunto de dados CT-3M, aplica eficazmente o DINOv3 à segmentação de imagens médicas. Este modelo atinge ou supera o desempenho SOTA em vários benchmarks de segmentação, demonstrando o enorme potencial dos modelos de base visual como uma rede backbone unificada para a segmentação de imagens médicas. (Fonte: HuggingFace Daily Papers)

M3Ret: Recuperação de imagens médicas multimodais zero-shot : O M3Ret alcança o desempenho SOTA em recuperação de imagem para imagem zero-shot, treinando um codificador visual unificado em um conjunto de dados multimodal de grande escala. Este modelo demonstra forte capacidade de generalização em tarefas de MRI nunca antes vistas e impulsiona o desenvolvimento de modelos de base de auto-supervisão visual na compreensão de imagens médicas multimodais através de paradigmas de aprendizagem auto-supervisionada generativa e contrastiva. (Fonte: HuggingFace Daily Papers)

OpenVision 2: Codificador visual generativo para aprendizagem multimodal : O OpenVision 2, ao simplificar a arquitetura e o design da perda, removeu o codificador de texto e a perda contrastiva, mantendo apenas a perda de geração de legendas. Este sinal de treino puramente generativo tem um desempenho excelente em benchmarks multimodais, ao mesmo tempo que reduz significativamente o tempo de treino e o consumo de memória, fornecendo um paradigma eficiente para o desenvolvimento futuro de codificadores visuais para modelos de base multimodais. (Fonte: HuggingFace Daily Papers)

LLaVA-Critic-R1: Um modelo de avaliação que também pode ser um poderoso modelo de política : O LLaVA-Critic-R1, através do treino RL, converteu um conjunto de dados de avaliação com anotações de preferência em sinais verificáveis, sendo não só um modelo de avaliação de alto desempenho, mas também um modelo de política competitivo, superando os VLMs especializados em vários benchmarks de raciocínio e compreensão visual, e pode melhorar ainda mais o desempenho do raciocínio através da auto-crítica durante o teste. (Fonte: HuggingFace Daily Papers)

Metis: Treino de LLM com quantização de baixa precisão : O framework Metis, ao combinar decomposição espectral, taxa de aprendizagem adaptativa e regularização de dupla faixa, resolve o problema da distribuição anisotrópica de parâmetros no treino de LLM com quantização de baixa precisão. Este método permite que o treino FP8 supere a linha de base FP32, e o treino FP4 atinja a precisão FP32, abrindo caminho para o treino robusto e escalável de LLMs sob quantização avançada de baixa precisão. (Fonte: HuggingFace Daily Papers)

AMBEDKAR: Framework de eliminação de preconceitos em múltiplos níveis : Apresenta-se o framework AMBEDKAR, inspirado na visão de igualdade da Constituição Indiana, que, através de uma camada de decodificação consciente da constituição e um algoritmo de decodificação especulativa, reduz ativamente os preconceitos em LLMs relacionados com casta e religião durante a inferência. Este método não requer modificação dos parâmetros do modelo, reduzindo os custos computacionais e diminuindo significativamente os preconceitos, fornecendo uma nova abordagem para a equidade dos LLMs em contextos culturais específicos. (Fonte: HuggingFace Daily Papers)

C-DiffDet+: Deteção de objetos de alta fidelidade com fusão de contexto de cena global : Apresenta-se o C-DiffDet+, que, ao introduzir o mecanismo Context-Aware Fusion (CAF), integra diretamente o contexto de cena global com características de proposta local, melhorando significativamente o paradigma de deteção generativa. Este framework utiliza um codificador dedicado para capturar informações ambientais abrangentes, permitindo que cada proposta de objeto se concentre na compreensão ao nível da cena, superando assim os modelos SOTA no benchmark CarDD. (Fonte: HuggingFace Daily Papers)

GenCompositor: Síntese de vídeo generativa baseada em Diffusion Transformer : Apresenta-se o GenCompositor, que, através de um novo pipeline Diffusion Transformer (DiT), alcança a síntese de vídeo generativa interativa. Este método projeta um ramo leve de preservação de fundo e blocos de fusão DiT, e introduz o Extended Rotary Position Embedding (ERoPE), alcançando síntese de vídeo de alta fidelidade e consistência no conjunto de dados VideoComp, superando as soluções existentes. (Fonte: HuggingFace Daily Papers)

ELV-Halluc: Benchmark de alucinação de agregação semântica na compreensão de vídeos longos : Apresenta-se o ELV-Halluc, o primeiro benchmark especificamente para alucinações em vídeos longos, que estuda sistematicamente a Alucinação de Agregação Semântica (SAH). Experiências confirmam a existência de SAH, e que esta aumenta com a complexidade semântica, sendo mais propensa a ocorrer em semânticas de mudança rápida. A pesquisa também mostra que estratégias de codificação posicional e DPO podem mitigar a SAH, reduzindo significativamente a taxa de SAH através de dados adversariais. (Fonte: HuggingFace Daily Papers)

FastFit: Modelo de difusão cacheável para acelerar o provador virtual : Apresenta-se o FastFit, um framework de provador virtual multirreferência de alta velocidade, baseado em arquitetura de difusão cacheável. Através de um mecanismo de semi-atenção e incorporação de classes, o modelo desacopla a codificação de características de referência do processo de denoising, permitindo que as características de referência sejam calculadas uma vez e reutilizadas sem perdas, acelerando em média 3,5 vezes e superando os métodos SOTA em conjuntos de dados como DressCode-MR. (Fonte: HuggingFace Daily Papers)

🧰 Ferramentas

Funcionalidade “nano-banana” do Google Gemini : O Google Gemini lançou a funcionalidade “nano-banana”, onde os utilizadores podem transformar fotos em imagens estilo modelo em miniatura com apenas um prompt, de forma simples e criativa, proporcionando uma experiência divertida para converter fotos pessoais, paisagens ou fotos de animais de estimação em modelos em miniatura personalizados. (Fonte: GoogleDeepMind)

Capacidade de geração de imagens Wan2.2 da Alibaba_Wan : Alibaba_Wan demonstrou a excelente capacidade de restauração de detalhes do Wan2.2 na geração de imagens, desde “machados inclinados e fotos empoeiradas” até “movimentos fracos na sombra”, criando perfeitamente uma atmosfera de filme de terror, refletindo o forte potencial da AI na criação de cenas e emoções complexas. (Fonte: Alibaba_Wan,Alibaba_Wan)

Funcionalidade de leitura completa de ficheiros do Claude Code : O Claude Code, após a atualização, suporta a leitura completa de ficheiros, resolvendo a limitação anterior de 50/100 linhas de grep e melhorando significativamente a velocidade de leitura de ficheiros, atingindo o nível de velocidade do Gemini CLI, possivelmente devido a melhorias no hardware de backend (como TPU), embora o tamanho do contexto ainda seja exibido como 200k. (Fonte: Reddit r/ClaudeAI)

Le Chat integra conectores MCP e funcionalidade de memória : O Le Chat agora integra mais de 20 conectores de plataforma empresarial (baseados em MCP) e introduz a funcionalidade de “memória”, fornecendo respostas altamente personalizadas, ao mesmo tempo que suporta a importação de memórias do ChatGPT. Isto melhora a capacidade do Le Chat em ambientes empresariais, permitindo-lhe compreender melhor as preferências e factos do utilizador, e aumentando a utilidade do assistente de AI. (Fonte: Reddit r/LocalLLaMA)

Ferramenta LangExtract do Google : O Google lançou o LangExtract, uma ferramenta para extrair grafos de conhecimento de texto. Ele pode converter texto não estruturado em conhecimento estruturado, o que é muito benéfico para a implementação de RAG (Retrieval-Augmented Generation), ajudando projetos pessoais a construir grafos de conhecimento e fornecendo informações de contexto mais precisas para LLMs. (Fonte: Reddit r/LocalLLaMA)

Ecossistema de servidores Model Context Protocol (MCP) : O projeto GitHub appcypher/awesome-mcp-servers reúne um grande número de servidores MCP, permitindo que modelos de AI interajam de forma segura com recursos locais e remotos, como sistemas de ficheiros, bases de dados e APIs. Este ecossistema expande grandemente as capacidades dos agentes de AI, cobrindo sistemas de ficheiros, sandboxes, controlo de versão, armazenamento em nuvem, bases de dados e outras áreas, impulsionando a integração e aplicação de ferramentas de AI. (Fonte: GitHub Trending)

Sistema Universal Deep Research (UDR) : O UDR é um sistema de agente universal capaz de encapsular qualquer modelo de linguagem e permitir que os utilizadores criem, editem e aprimorem estratégias de pesquisa profunda totalmente personalizadas, sem necessidade de treino ou fine-tuning adicional. Ele promove a experimentação do sistema, fornecendo exemplos de estratégias de pesquisa mínimas, estendidas e densas, melhorando a flexibilidade e eficiência da pesquisa em AI. (Fonte: HuggingFace Daily Papers)

SQL-of-Thought: Framework multiagente Text-to-SQL : Apresenta-se o SQL-of-Thought, um framework multiagente que decompõe a tarefa Text2SQL em ligação de esquema, identificação de subproblemas, geração de plano de consulta, geração de SQL e um ciclo de correção guiada. Este framework, ao combinar classificação de erros guiada e planeamento de consulta baseado em raciocínio, alcançou resultados de ponta no conjunto de dados Spider, melhorando a robustez da conversão de linguagem natural para SQL. (Fonte: HuggingFace Daily Papers)

VerlTool: Framework de aprendizagem por reforço Agentic para uso de ferramentas : O VerlTool é um framework unificado e modular projetado para resolver a fragmentação, gargalos de execução síncrona e limitações de escalabilidade na Aprendizagem por Reforço Agentic com Interação Multiturno de Ferramentas (ARLT). Ele alcança uma aceleração de quase 2 vezes e demonstra desempenho competitivo em 6 domínios ARLT, através do alinhamento a montante com VeRL, gestão unificada de ferramentas, execução assíncrona de rollouts e avaliação abrangente. (Fonte: HuggingFace Daily Papers)

MobiAgent: Sistema de Agente Móvel personalizável : O MobiAgent é um sistema de Agente Móvel abrangente, que inclui a série de modelos de Agente MobiMind, o framework de aceleração AgentRR e o conjunto de benchmarks MobiFlow. Ele reduz significativamente o custo de anotação de dados de alta qualidade através de um processo de recolha de dados assistido por AI, e alcança desempenho de ponta em cenários móveis do mundo real, resolvendo os desafios de precisão e eficiência dos Agentes Móveis GUI existentes. (Fonte: HuggingFace Daily Papers)

VARIN: Edição de imagem autorregressiva guiada por texto : O VARIN é a primeira tecnologia de edição de imagem de modelo VAR baseada em inversão de ruído, que utiliza a Location-aware Argmax Inversion (LAI) para gerar ruído Gumbel inverso, alcançando reconstrução precisa da imagem fonte e edição controlada guiada por texto. Este método preserva significativamente o fundo e os detalhes estruturais originais ao modificar a imagem, demonstrando a sua eficácia como um método de edição prático. (Fonte: HuggingFace Daily Papers)

📚 Aprendizagem

Sugestões de projetos para cursos universitários de AI : Utilizadores do Reddit procuram sugestões de projetos interativos para o curso “Fundamentos de Inteligência Artificial”, que não dependam de computadores de alto desempenho. A discussão centra-se no que os LLMs podem fazer, nas funcionalidades de dispositivos inteligentes e em como combinar estes conceitos para o ensino, enfatizando a praticidade e projetos com baixos requisitos de capacidade computacional. (Fonte: Reddit r/ArtificialInteligence)

Recursos completos para estudantes no GitHub : dipakkr/A-to-Z-Resources-for-Students é uma lista de recursos cuidadosamente selecionada para estudantes universitários, cobrindo aprendizagem de linguagens de programação (Python, ML, LLM, DL, Android, etc.), hackathons, benefícios para estudantes, projetos de código aberto, portais de estágio, comunidades de desenvolvedores, etc. A secção de ferramentas e recursos de AI lista detalhadamente ferramentas de AI populares e repositórios GitHub. (Fonte: GitHub Trending)

Como entender artigos de pesquisa e iniciar em AI/ML para iniciantes : Duas discussões no Reddit sobre aprendizagem de AI: uma pergunta sobre como entender artigos de pesquisa e outra de um iniciante em AI/ML a procurar sugestões de cursos introdutórios. Estas discussões refletem a confusão comum entre os aprendizes de AI ao tentar compreender pesquisas de ponta e escolher um caminho de aprendizagem. (Fonte: Reddit r/deeplearning,Reddit r/deeplearning)

FlashAdventure: Benchmark de jogos de aventura para Agentes GUI : FlashAdventure é um benchmark que contém 34 jogos de aventura Flash, projetado para avaliar a capacidade de agentes GUI impulsionados por LLMs de completar enredos completos e resolver o problema da “lacuna observação-comportamento”. O framework COAST melhora o planeamento através da memória de pistas de longo prazo, aumentando a conclusão de marcos, mas ainda há uma lacuna significativa em relação ao desempenho humano. (Fonte: HuggingFace Daily Papers)

The Gold Medals in an Empty Room: Diagnóstico do raciocínio metalinguístico de LLMs : Apresenta-se Camlang, uma nova linguagem artificial que, através de um livro de gramática e um dicionário bilingue, avalia a capacidade de aprendizagem dedutiva metalinguística de LLMs em línguas desconhecidas. O GPT-5 tem um desempenho muito inferior ao dos humanos nas tarefas de Camlang, indicando que os modelos atuais ainda têm uma lacuna fundamental em relação aos humanos na compreensão gramatical sistemática, fornecendo um novo paradigma para a avaliação cognitiva de LLMs. (Fonte: HuggingFace Daily Papers)

💼 Negócios

Os desafios da aposta de Altman na infraestrutura de AI da Índia : A OpenAI planeia expandir massivamente o projeto “Stargate” na Índia, investindo pesadamente na construção de infraestruturas de capacidade computacional de AI, mas a Índia enfrenta os “três grandes défices” de número de GPUs, investimento financeiro e fuga de talentos de alto nível, bem como a fatal escassez de fornecimento de eletricidade, levantando dúvidas no mercado sobre o seu potencial de infraestrutura de AI. (Fonte: 36氪)

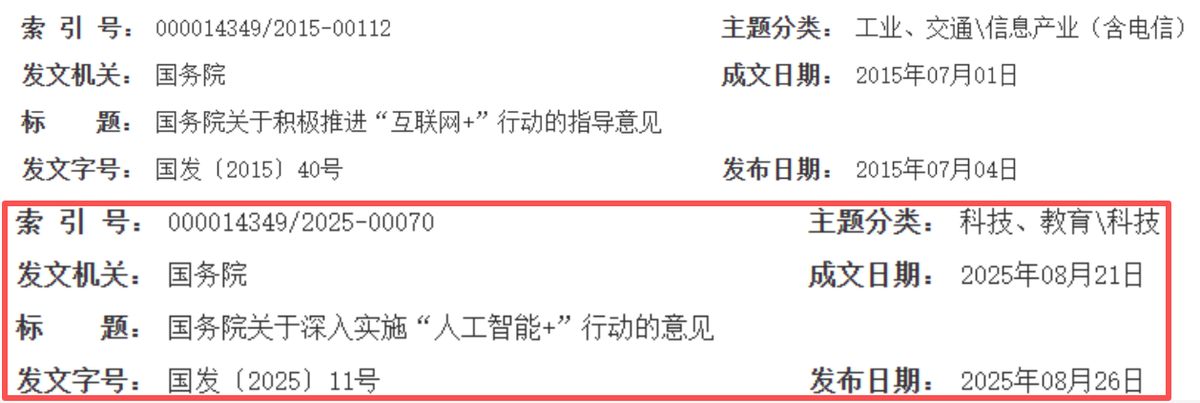

AI remodela novo ciclo de crescimento da internet chinesa : A indústria da internet chinesa está a transitar de “capacitação de conexão” para “condução inteligente”, com a AI a tornar-se um novo motor de crescimento. Gigantes como Alibaba, Tencent e Baidu aumentaram significativamente os seus gastos de capital relacionados com AI, acelerando a AI nas suas operações, alcançando uma transformação estratégica de “expansão de capital” para “capacitação por AI”, o que pressagia uma nova década dourada para a internet chinesa, com foco na profundidade tecnológica, integração industrial e eficiência comercial. (Fonte: 36氪)

Salesforce demite 4000 pessoas devido à AI : O CEO da Salesforce, Marc Benioff, afirmou que a empresa cortou 4000 postos de trabalho de suporte ao cliente após a implementação de AI agents, reduzindo a equipa de suporte de 9000 para cerca de 5000 pessoas. Isto indica que a automação por AI teve um impacto direto nos empregos tradicionais, melhorando a eficiência operacional das empresas, mas também levantou discussões sobre a substituição do trabalho humano pela AI. (Fonte: The Verge,Reddit r/ChatGPT)

🌟 Comunidade

Questionamento do Retorno sobre o Investimento (ROI) em AI empresarial : A comunidade do Reddit debate acaloradamente o ROI real do investimento das empresas em ferramentas de AI. Muitos questionam se as empresas realmente medem o “tempo poupado” versus o “dinheiro gasto”, acreditando que a maior parte é “impulsionada pelo ambiente” e não por dados. Alguns comentários apontam que a AI se destaca em tarefas de texto, mas é ineficiente em cenários que exigem interação humana, e pode aumentar os custos em processos já ineficientes. (Fonte: Reddit r/ArtificialInteligence)

Preocupações éticas com agentes de AI a lidar com dinheiro real : A discussão nas redes sociais sobre o rápido desenvolvimento de agentes de AI que gerem autonomamente carteiras de criptomoedas levanta profundas preocupações sobre confiança, segurança e a formação autónoma de economias de AI. Os utilizadores temem que os agentes de AI possam ser manipulados ou criar sistemas económicos independentes, tornando os humanos desnecessários, e apelam à atenção para a importância da AI que protege a privacidade e modelos treinados com dados criptografados. (Fonte: Reddit r/ArtificialInteligence)

Dicas de engenharia de prompts do ChatGPT e comportamento do modelo : Utilizadores descobriram que começar uma pergunta com “Posso estar errado, mas…” pode mudar o tom do ChatGPT, tornando-o mais crítico e reflexivo. Ao mesmo tempo, a comunidade está irritada com o facto de o GPT-5 oferecer frequentemente “tarefas adicionais”, considerando-o uma “simplificação” do modelo e desejando uma versão com menos comportamentos predefinidos. (Fonte: Reddit r/ChatGPT,Reddit r/ChatGPT)

Impacto da AI no mercado de trabalho : A comunidade discute se a automação por AI reduzirá as oportunidades de emprego globais ou criará novos tipos de trabalho. A visão predominante é que ambos acontecerão, mas exigirão que os trabalhadores se adaptem a novas habilidades e colaborem com a AI. Alguns também acreditam que as oportunidades de trabalho impulsionadas pela AI podem concentrar-se nas mãos de profissionais de tecnologia, exigindo uma disseminação mais ampla de habilidades e adaptação de políticas. (Fonte: Reddit r/ArtificialInteligence)

Preocupações com o “inverno da AI” devido à privacidade e regulamentação da AI : A comunidade discute que o futuro “inverno da AI” pode ser causado por leis de privacidade, e não por limitações tecnológicas. O endurecimento de regulamentações como o GDPR forçará os modelos de AI a serem treinados e operarem com dados criptografados, e apenas empresas com infraestruturas de proteção de privacidade sobreviverão, caso contrário, a AI poderá não ser implementada devido a restrições legais. (Fonte: Reddit r/ArtificialInteligence)

Confiabilidade da plataforma AI e preocupações com a privacidade : A comunidade do ChatGPT debate acaloradamente problemas de inatividade do modelo, com utilizadores a brincar que a “economia está a colapsar”, refletindo a popularidade das ferramentas de AI no trabalho diário e a sua potencial dependência. Ao mesmo tempo, a OpenAI anunciou a monitorização de “conversas de alto risco” para prevenir crimes, levantando preocupações dos utilizadores sobre a fuga de privacidade. A comunidade geralmente aconselha o uso de LLMs locais ou de código aberto e enfatiza que os utilizadores devem evitar conscientemente partilhar informações sensíveis em plataformas de AI. (Fonte: Reddit r/ChatGPT,Reddit r/ChatGPT)

Casos de erros de trabalho causados por alucinações de AI : A namorada de um utilizador enfrentou uma crise no trabalho devido a um relatório de análise de dados falso gerado por alucinações do ChatGPT. O ChatGPT analisou erroneamente dados de texto usando o “coeficiente de correlação de Pearson” e não conseguiu explicar o processo de cálculo. A comunidade sugere admitir o erro, refazer a análise corretamente e enfatiza que a AI é apenas uma ferramenta auxiliar, e informações cruciais devem ser verificadas manualmente. (Fonte: Reddit r/ChatGPT)

Desempenho “adorável” do Claude AI : Utilizadores descobriram que o Claude AI possui uma característica de “respeito pela vida”, sendo capaz até de convencer os utilizadores a salvar aranhas. A comunidade elogia o Claude como “adorável” e partilha experiências de coexistência com aranhas em casa, demonstrando o interessante potencial da AI em interações emocionais e orientação moral. (Fonte: Reddit r/ClaudeAI)

Trump culpa a AI por problemas : O ex-presidente dos EUA, Trump, atribuiu um vídeo de um saco de lixo a ser atirado de uma janela da Casa Branca à “geração por AI”, embora as autoridades tenham confirmado que foi obra de um empreiteiro de renovação. Este incidente foi apelidado nas redes sociais de “AI é o novo o cão comeu o meu trabalho”, refletindo como a AI se tornou uma nova desculpa para desviar responsabilidades no discurso público. (Fonte: Reddit r/ArtificialInteligence,The Verge)

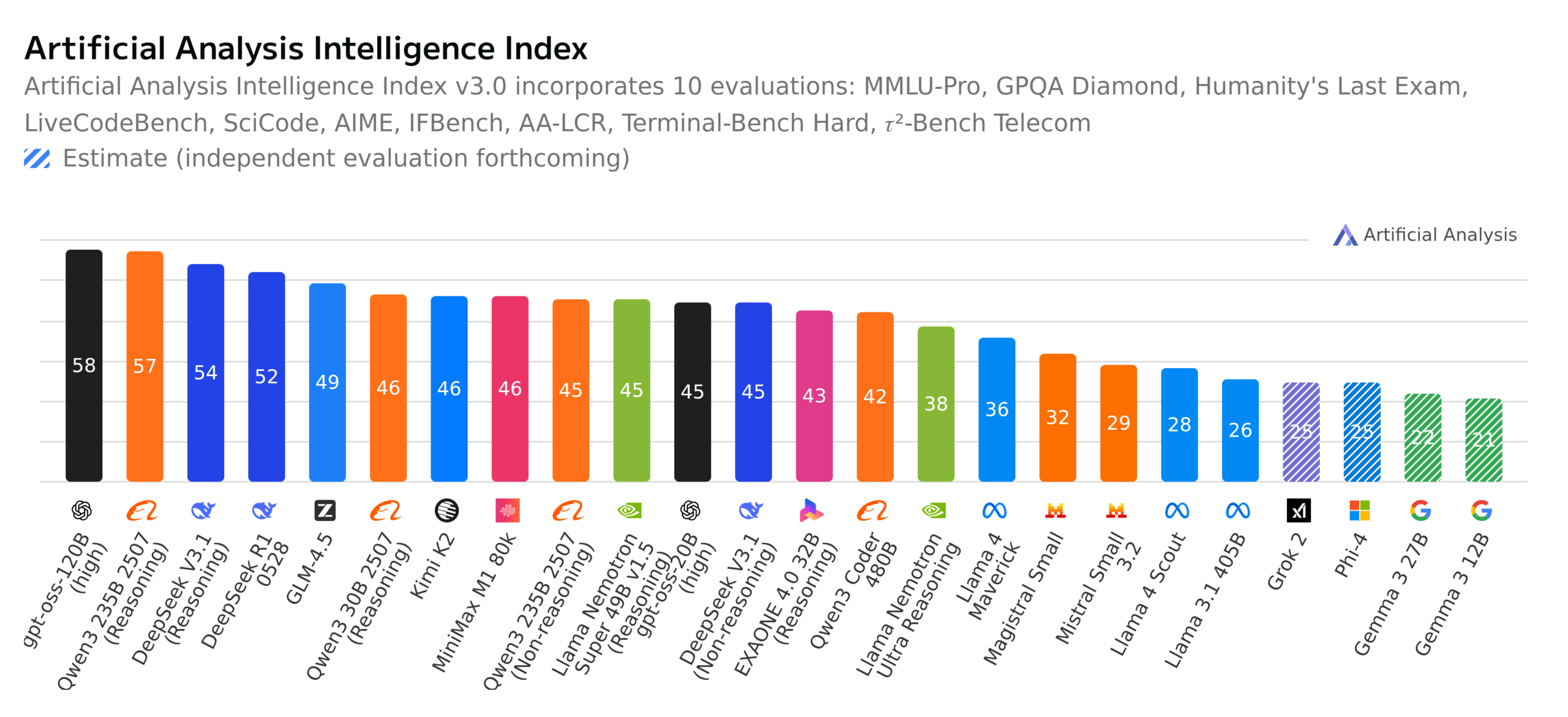

Progressos de LLMs de código aberto e discussão sobre benchmarks : A comunidade debate acaloradamente o GPT-OSS 120B a tornar-se o principal modelo de código aberto, o lançamento do novo modelo multilingue totalmente de código aberto suíço Apertus-70B-2509, e o lançamento do modelo Kimi K2-0905. Ao mesmo tempo, o benchmark alemão “Quem Quer Ser Milionário” avalia LLMs, levantando discussões amplas sobre as capacidades reais dos modelos, o significado dos benchmarks e a ética dos modelos de código aberto (como a transparência dos dados). (Fonte: Reddit r/LocalLLaMA,Reddit r/LocalLLaMA,Reddit r/LocalLLaMA,Reddit r/LocalLLaMA)

💡 Outros

Yunpeng Technology lança novos produtos AI+Saúde : A Yunpeng Technology lançou novos produtos em 22 de março de 2025, em Hangzhou, em colaboração com a Shuaikang e a Skyworth, incluindo o “Laboratório de Cozinha Futura Digital e Inteligente” e um frigorífico inteligente equipado com um modelo de grande escala de AI para a saúde. O modelo de grande escala de AI para a saúde otimiza o design e a operação da cozinha, e o frigorífico inteligente, através do “Assistente de Saúde Xiaoyun”, oferece gestão de saúde personalizada, marcando um avanço da AI na área da saúde. Este lançamento demonstra o potencial da AI na gestão diária da saúde, alcançando serviços de saúde personalizados através de dispositivos inteligentes, o que deverá impulsionar o desenvolvimento da tecnologia de saúde doméstica e melhorar a qualidade de vida dos residentes. (Fonte: 36氪)

Preocupações com a qualidade da revisão de artigos em conferências académicas : A comunidade de machine learning discute a publicação das revisões de artigos do WACV 2026 e os problemas de qualidade das revisões do ACL Rolling Review (ARR). Alguns investigadores queixam-se de que o ARR está repleto de revisões genéricas de baixa qualidade “geradas por AI”, considerando-as uma perda de tempo, e sugerem submeter a outras conferências de AI. Isto reflete as preocupações da comunidade académica com a qualidade das revisões assistidas por AI e os mecanismos de revisão, apelando para a melhoria da substância e construtividade das revisões. (Fonte: Reddit r/MachineLearning,Reddit r/MachineLearning)

Projeto de modelo de análise de sentimento para serviços de nuvem : Um iniciante em ML desenvolveu um modelo de análise de sentimento baseado em BERT para analisar comentários de comunidades Reddit de ML/tecnologia de nuvem sobre provedores de serviços de nuvem como AWS, Azure, Google Cloud, e classificar o sentimento por dimensões como custo, escalabilidade, segurança. Ele procura sugestões para melhorar a precisão da interpretação do modelo, lidar com declarações comparativas ou mistas e aumentar a robustez contra negações e sarcasmo. (Fonte: Reddit r/MachineLearning,Reddit r/deeplearning)