Palavras-chave:NVIDIA Jetson Thor, IA física, robô humanóide, GPU Blackwell, capacidade de computação de IA, pico de desempenho de IA do Jetson Thor, desempenho da GPU Blackwell, cenários de aplicação de IA física, kit de desenvolvimento para robôs humanóides, preço do Jetson Thor

🔥 Foco

NVIDIA Jetson Thor lançado, poder de computação de AI física dispara : A NVIDIA lançou o Jetson Thor, projetado especificamente para AI física e robôs humanoides, equipado com Blackwell GPU e uma CPU Arm Neoverse de 14 núcleos. Ele atinge um pico de desempenho de AI de 2070 TFLOPS (FP4), 7,5 vezes mais potente que a geração anterior Jetson Orin. Ele suporta modelos de AI generativa como VLA, LLM e VLM, capaz de processar vídeo em tempo real e inferência de AI, com o objetivo de acelerar o desenvolvimento de robótica geral e AI física. Suas principais aplicações incluem robôs humanoides, assistência cirúrgica e tratores inteligentes, e já foi adotado por empresas como Agility Robotics, Amazon, Boston Dynamics e Unitree Robotics. O kit de desenvolvimento já está disponível, com preço inicial de US$ 3499. (Fonte: nvidia)

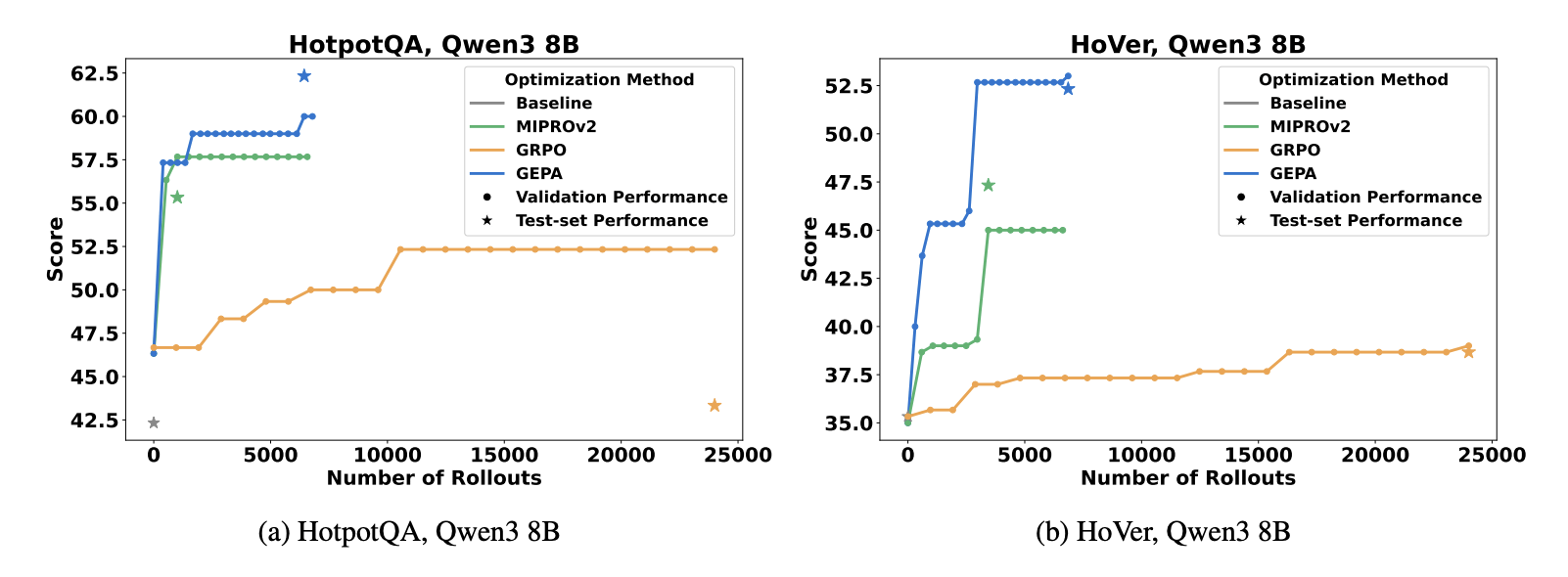

GEPA: Evolução de Prompt Reflexiva Supera RL : Um novo estudo (Agrawal et al., 2025) propõe o método GEPA (Genetic-Pareto Prompt Evolution), que evolui os prompts do sistema LLM através de reflexão em linguagem natural e diagnóstico de trajetória, em vez de depender de aprendizado por reforço (RL). O GEPA superou o GRPO em tarefas de QA multi-hop, exigindo 35 vezes menos rollouts, e consistentemente superou o otimizador de prompts SOTA MIPROv2. Isso sugere que os ciclos de otimização nativos da linguagem são mais eficientes para a adaptabilidade de LLMs do que os rollouts brutos no espaço de parâmetros, indicando uma nova direção para as estratégias de otimização de AI. (Fonte: Reddit r/MachineLearning)

Método OPRO Aumenta a Eficiência dos Testes de Segurança de AI : Bret Kinsella da TELUS Digital apresentou o método Optimization by PROmpting (OPRO), que permite que LLMs façam “auto-red teaming”, avaliando a segurança da AI ao otimizar geradores de ataque. O método foca na distribuição da Taxa de Sucesso de Ataque (ASR), em vez de um simples passa/falha, podendo descobrir vulnerabilidades em larga escala e guiar medidas de mitigação. Ele enfatiza que em setores de alto risco como finanças e saúde, os testes de segurança de AI devem ser abrangentes, repetíveis e criativos, e mudar de uma abordagem reativa para preventiva, oferecendo às empresas avaliações de segurança de AI mais detalhadas. (Fonte: Reddit r/deeplearning)

🎯 Tendências

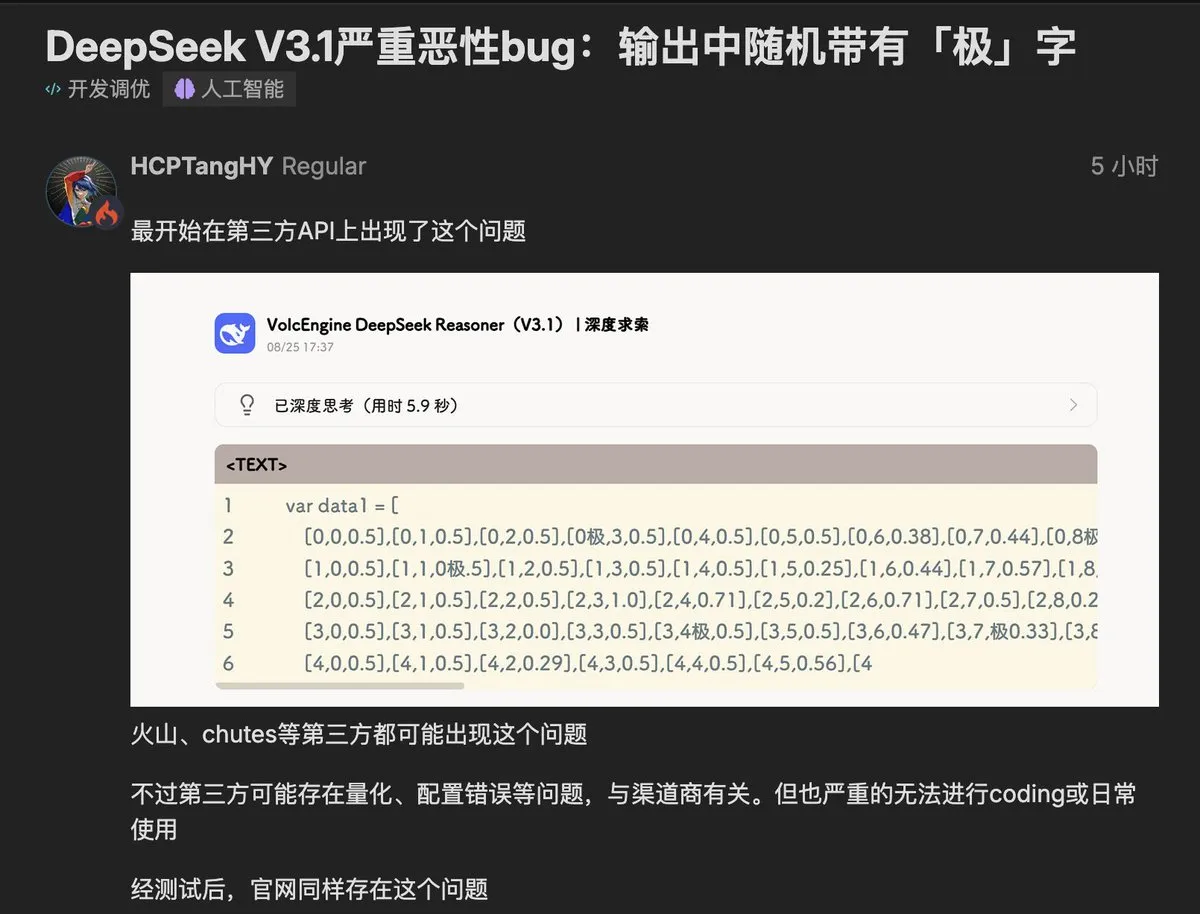

Modelo DeepSeek V3.1 Apresenta Bug do Caractere “极” : O mais recente modelo DeepSeek V3.1 foi relatado por usuários por inserir aleatoriamente o caractere “极” (ou “extreme”) em suas saídas, afetando tarefas sensíveis a código e estrutura. O problema foi replicado tanto em implantações de terceiros quanto na API oficial, levantando preocupações na comunidade sobre a contaminação de dados do modelo e problemas de estabilidade. Especula-se que esteja relacionado à confusão de tokens ou a dados de treinamento RLHF impuros, o que serve como um alerta para os desenvolvedores de modelos, destacando o impacto crítico da qualidade dos dados no comportamento da AI. (Fonte: teortaxesTex, 36氪, 36氪)

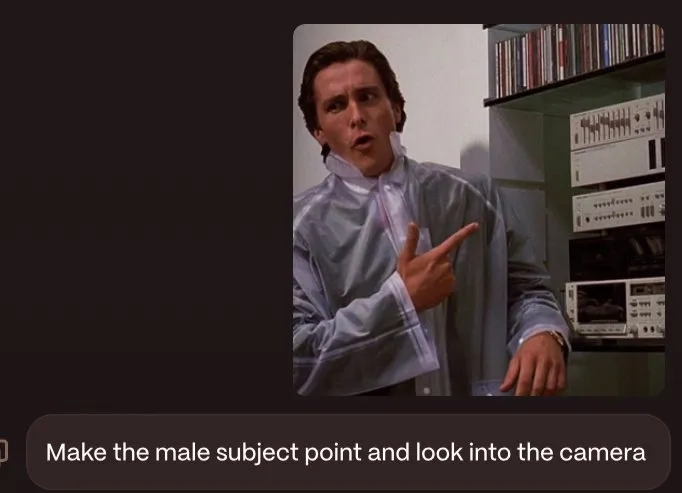

Modelo Misterioso Nano-Banana do Google Gera Interesse : Um misterioso modelo de geração e edição de imagens chamado Nano-Banana ganhou popularidade na comunidade de AI, especulando-se ser um produto do Google. Ele se destaca na edição de texto, fusão de estilos e compreensão de cenas, capaz de mesclar elementos de várias imagens, mantendo a consistência de iluminação, perspectiva e composição. No entanto, apresenta falhas como títulos de livros corrompidos e dedos deformados, e atualmente carece de uma API oficial, resultando em uma experiência instável. Muitos sites falsos também surgiram, gerando discussões no mercado sobre as capacidades do novo modelo e os canais de acesso. (Fonte: TomLikesRobots, yupp_ai, yupp_ai, 36氪)

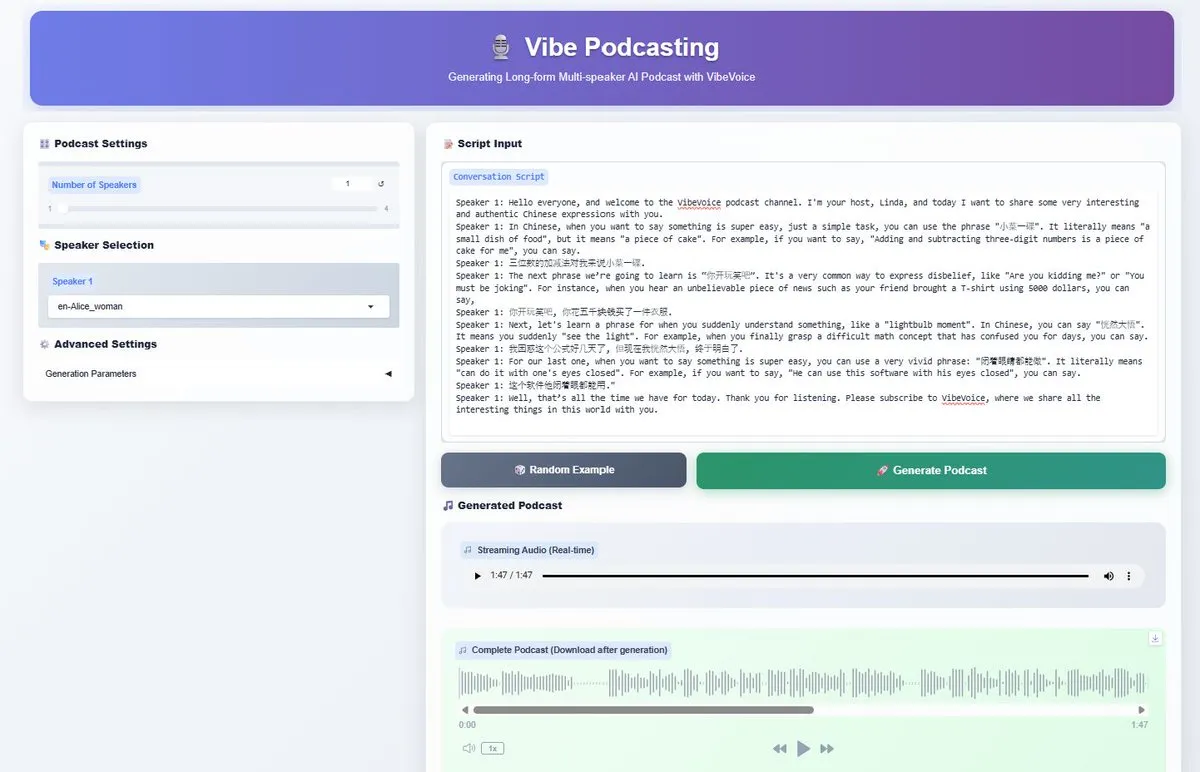

Microsoft VibeVoice-1.5B TTS Modelo de Código Aberto : A Microsoft abriu o código-fonte do modelo VibeVoice-1.5B TTS, que suporta a geração de diálogos de áudio expressivos de até 90 minutos, com até 4 falantes diferentes. Baseado no Qwen2.5-1.5B, o modelo utiliza um tokenizador de taxa de quadros ultrabaixa, melhorando a eficiência computacional, e suporta chinês e inglês. Com licença MIT, espera-se que impulsione a geração de AI de conteúdo de áudio de formato longo, como podcasts, oferecendo aos criadores poderosas capacidades de produção de áudio multilíngue. (Fonte: _akhaliq, AnthropicAI, ClementDelangue, dotey)

Novos Desenvolvimentos nos Modelos da Série Wan da Alibaba : O modelo de AI da Alibaba, Wan, anunciou o lançamento iminente do WAN 2.2-S2V, um modelo de voz para vídeo com qualidade cinematográfica, enfatizando “áudio-driven, visual-based, open-source”. Simultaneamente, o modelo Wan2.2-T2V-A14B, lançado anteriormente, foi integrado ao aplicativo Anycode, tornando-se o modelo padrão de texto para vídeo. Esta série de avanços demonstra o investimento contínuo e a inovação da Alibaba no campo da AI multimodal, especialmente na geração de áudio e vídeo. (Fonte: Alibaba_Wan, TomLikesRobots, karminski3)

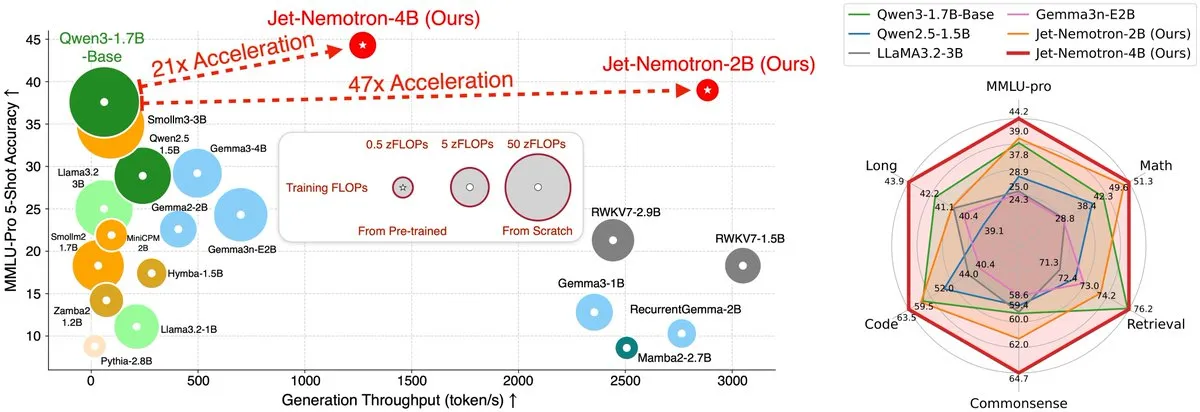

Jet-Nemotron Acelera LLM de Arquitetura Híbrida em 53,6 Vezes : A equipe do MIT Hanlab lançou o Jet-Nemotron, uma família de modelos de linguagem de arquitetura híbrida, que, através do Post Neural Architecture Search (PostNAS) e de um novo bloco de atenção linear JetBlock, alcançou um aumento de até 53,6 vezes na taxa de transferência de geração em GPUs H100, enquanto superou o desempenho dos modelos de atenção total de código aberto SOTA. Esta pesquisa inovadora oferece novas soluções para a eficiência de inferência e otimização de arquitetura de LLMs. (Fonte: teortaxesTex, menhguin)

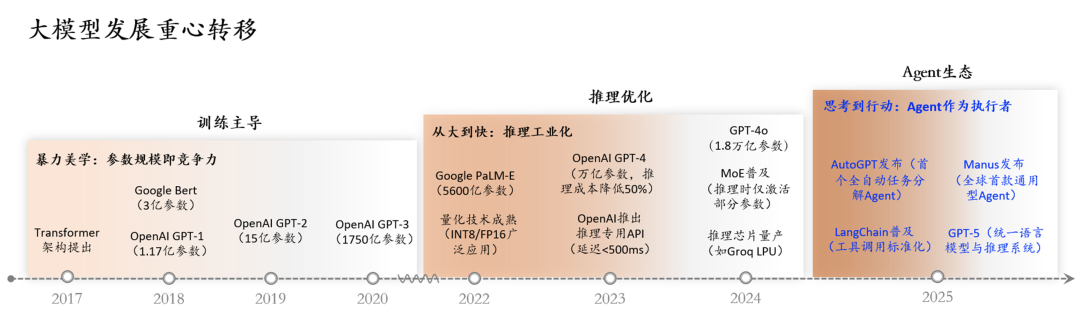

AI Agents Evoluem para Fluxos de Trabalho Autônomos em 2025 : AI Agents estão evoluindo de assistentes conversacionais para fluxos de trabalho autônomos capazes de raciocinar, planejar e executar tarefas. Ao integrar APIs e decisões automatizadas, os AI Agents podem impulsionar processos complexos, como gerar automaticamente roteiros de vídeo, compilar vídeos e publicá-los no YouTube, pressagiando que os fluxos de trabalho impulsionados por AI se tornarão mainstream, elevando significativamente o nível de automação. (Fonte: Reddit r/artificial)

Alerta de Vulnerabilidade de Segurança em Navegadores de AI : O navegador de AI Comet da Perplexity, um unicórnio americano de busca por AI, foi exposto por ter sérias vulnerabilidades de segurança. Atacantes podem manipular o navegador de AI com comandos maliciosos para acessar e-mails, obter códigos de verificação e enviar informações sensíveis. A Brave Company apontou que os mecanismos tradicionais de segurança cibernética são ineficazes contra tais ataques. Produtos Agent enfrentam grandes riscos devido à sua “tríade fatal” de “acesso a dados privados, contato com conteúdo não confiável e comunicação externa”. Isso alerta que os produtos de AI devem priorizar a segurança e a proteção da privacidade ao inovar em funcionalidades. (Fonte: 36氪)

A Lacuna de Armazenamento de AI de Trilhões e a Arquitetura Universal Storage : A era da AI impõe novas demandas de armazenamento, como throughput extremo, baixa latência, alta concorrência, gerenciamento unificado multimodal, computação baseada em armazenamento, persistência de memória de Agent e segurança autônoma. As arquiteturas de armazenamento tradicionais são difíceis de adaptar devido a problemas como dependência do kernel do OS, armazenamento misto de metadados e dados, e protocolos separados. A arquitetura Universal Storage, através de inovações como pool de armazenamento unificado, armazenamento independente de metadados e eliminação da dependência do kernel do OS, atinge latência de centenas de microssegundos e throughput de TB, tornando-se a escolha mainstream para a camada de armazenamento na era da AI. Espera-se que preencha a lacuna de desempenho de armazenamento em aplicações de AI. (Fonte: 36氪)

Reels Lança Função de Tradução de Áudio por AI com Sincronização Labial : Os vídeos curtos Reels do Facebook e Instagram da Meta lançaram oficialmente a função de tradução de áudio por AI, que permite traduzir o áudio das pessoas no vídeo para diferentes idiomas, com sincronização labial e síntese do timbre original. Atualmente, suporta tradução entre inglês e espanhol, e os usuários podem adicionar até 20 faixas de áudio em diferentes idiomas. Esta medida visa adaptar-se ao mercado global e conquistar a fatia de mercado do TikTok. A AI se torna a chave para o avanço da Meta em vídeos curtos, com potencial para melhorar a experiência de consumo de conteúdo para usuários globais. (Fonte: 36氪)

Tendências e Desafios da Indústria AIoT : Três relatórios da McKinsey, BVP e MIT indicam que a profunda integração de AI e IoT é uma tendência inevitável, com a comercialização focando em cenários de alto ROI e enfatizando a colaboração em plataformas e ecossistemas. No entanto, os relatórios também revelam conflitos entre desenvolvimento interno e aquisição, crescimento explosivo e resiliência contínua, e experiência de front-end versus inteligência de back-end. Argumenta-se que o AIoT precisa evoluir de “transportador de dados” para uma “rede de agentes inteligentes autônomos”, alcançando autonomia, colaboração e redefinição da confiança, para enfrentar os desafios da atualização industrial. (Fonte: 36氪)

ByteDance Explora Ecossistema de Hardware de AI, Incluindo Telefones, Carros, Robôs : A ByteDance está aumentando seu investimento na área de hardware, integrando ou desenvolvendo internamente produtos como telefones, carros, robôs, óculos inteligentes e máquinas de aprendizagem através do modelo Doubao. Relatos indicam que a ByteDance está desenvolvendo um sistema operacional automotivo inteligente e um telefone AI Doubao, buscando veículos para suas capacidades de AI. Embora as tentativas anteriores da ByteDance em hardware não tenham sido bem-sucedidas, a empresa está novamente se esforçando após a explosão dos grandes modelos de AI. O objetivo é construir um ecossistema de AI “hardware-software integrado”, na esperança de encontrar novos pontos de crescimento na era da AI. (Fonte: 36氪)

🧰 Ferramentas

Google AI Mode Simplifica Reservas em Restaurantes : Assinantes do Google AI Ultra agora podem usar o AI Mode para simplificar reservas em restaurantes. Os usuários só precisam descrever suas necessidades em linguagem natural, como jantar de aniversário, número de pessoas, ambiente, música, etc., e o AI Mode completará o trabalho de reserva, exigindo apenas a confirmação final do usuário. Esta função está sendo lançada nos EUA, com o objetivo de aprimorar a experiência de serviço personalizado e automatizar o processo de reserva tedioso. (Fonte: Google)

Novos Desenvolvimentos no Agent Mode da Ferramenta de Terminal do VSCode : A equipe do VSCode está reescrevendo sua ferramenta de terminal para suportar o Agent mode, com o objetivo de melhorar a eficiência e a experiência dos desenvolvedores. Esta iniciativa faz parte do ecossistema GitHub Copilot, buscando assistência de desenvolvimento mais inteligente através de agentes de AI, como geração e depuração de código diretamente no terminal, simplificando assim o processo de desenvolvimento. (Fonte: pierceboggan)

OpenRouter Lança Função One-Click ZDR : OpenRouter lançou a função “One-Click ZDR” (Zero Data Retention), garantindo que os prompts dos usuários sejam enviados apenas a provedores que suportam retenção zero de dados. Isso aprimora a proteção da privacidade dos dados do usuário e simplifica a escolha das políticas de dados dos provedores de serviços de AI, permitindo que os usuários utilizem os serviços de AI com mais tranquilidade. (Fonte: xanderatallah)

Qwen Edit se Destaca em Outpainting de Imagens : O modelo Qwen Edit da Alibaba demonstrou capacidades excepcionais na tarefa de Outpainting de imagens (expansão de imagem), capaz de estender o conteúdo da imagem com alta qualidade, mostrando seu forte potencial no campo da geração visual. Os usuários podem usar esta ferramenta para expandir facilmente fundos de imagens ou criar cenas mais amplas, aumentando a flexibilidade na criação de imagens. (Fonte: multimodalart)

Google NotebookLM Suporta Resumos de Vídeo Multilíngues : Google NotebookLM lançou uma nova funcionalidade que suporta resumos de vídeo em 80 idiomas, e oferece controle de duração curta e padrão para resumos de áudio não-inglês. Isso melhora significativamente a capacidade dos usuários multilíngues de acessar e compreender o conteúdo de vídeo, evitando a perda de informações na tradução e tornando o aprendizado e a pesquisa mais eficientes. (Fonte: Google)

GLIF Integra Modelos SOTA de Vídeo, Imagem e LLM : A plataforma GLIF integrou todos os modelos de vídeo SOTA, modelos de imagem e LLMs, tornando-se a única plataforma capaz de combinar esses modelos em fluxos de trabalho únicos e personalizados. Os usuários podem utilizar modelos como Kling 2.1 Pro para geração de vídeo, por exemplo, usando frames gerados por Qwen-Image para produção de animação Veo 3, criando cenas criativas, e até mesmo convertendo vídeos para o estilo MSPaint. (Fonte: fabianstelzer, fabianstelzer, fabianstelzer)

LlamaIndex Lança Ferramenta Vibe Coding : LlamaIndex lançou a ferramenta CLI vibe-llama e modelos de prompt detalhados, com o objetivo de melhorar a eficiência e precisão de agentes de programação de AI (como Cursor AI e Claude Code). A ferramenta pode injetar diretamente o contexto do LlamaIndex nos agentes de programação, evitando sugestões de API desatualizadas, e pode gerar aplicativos Streamlit completos a partir de scripts básicos, incluindo upload de arquivos e processamento em tempo real, acelerando assim o processo de desenvolvimento. (Fonte: jerryjliu0)

LangGraph Platform Lança Revision Rollbacks e Queueing : A LangGraph Platform lançou a funcionalidade Revision Rollbacks (reversão de versão), permitindo que os usuários reimplantem qualquer versão histórica, facilitando a rastreabilidade e a correção de problemas. Ao mesmo tempo, lançou a funcionalidade Revision Queueing (enfileiramento de versão), onde novas revisões serão enfileiradas para execução após a conclusão da anterior, melhorando a eficiência e estabilidade do fluxo de trabalho de desenvolvimento, proporcionando um ambiente mais confiável para o desenvolvimento de Agent. (Fonte: LangChainAI, LangChainAI)

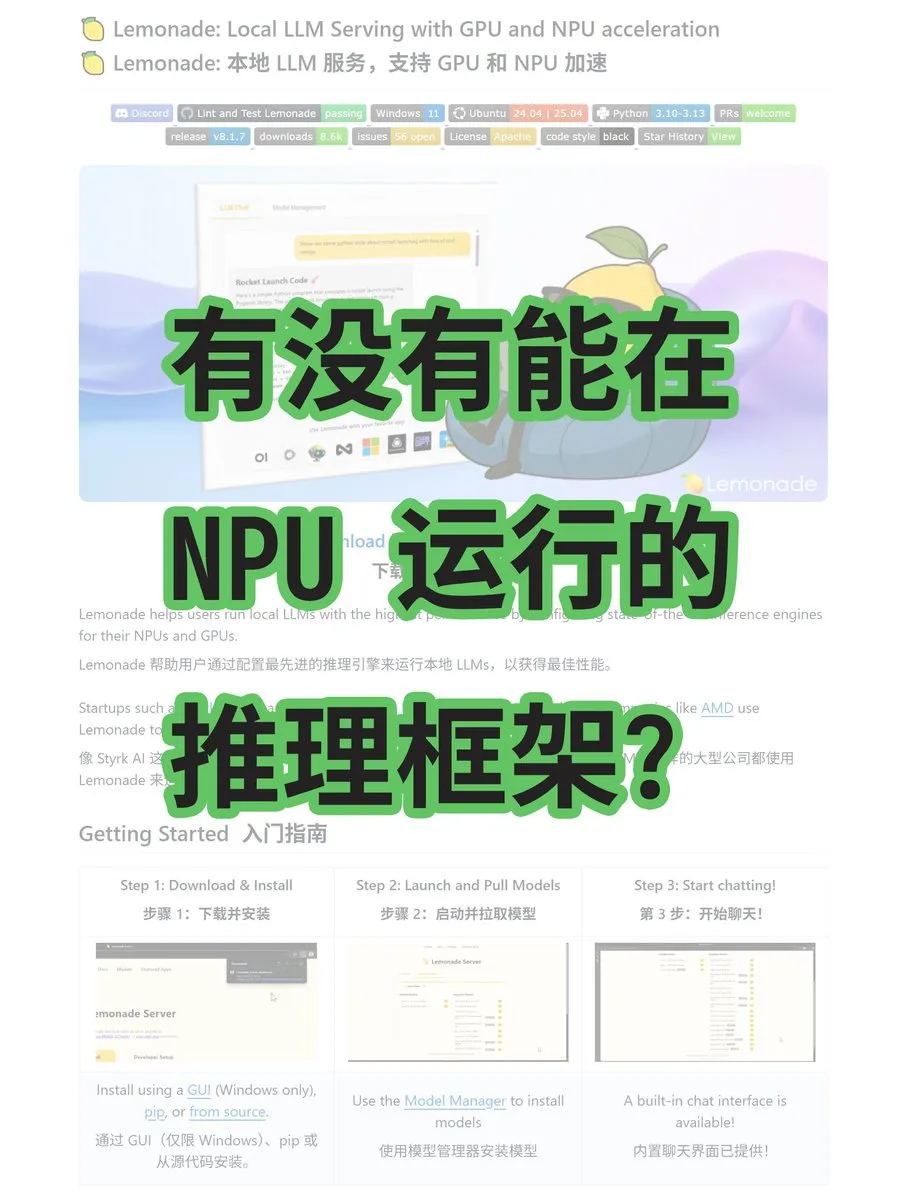

Framework Lemonade Suporta Inferência AMD NPU/GPU : Lemonade é um novo framework de inferência de grandes modelos, que pode ser executado em placas gráficas AMD, CPUs e NPUs, suportando modelos GGUF e ONNX. Desenvolvido por engenheiros da AMD, o framework não depende de CUDA, oferecendo uma nova solução de inferência de AI para usuários de hardware AMD, com potencial para melhorar o desempenho de aplicações de AI em plataformas AMD. (Fonte: karminski3)

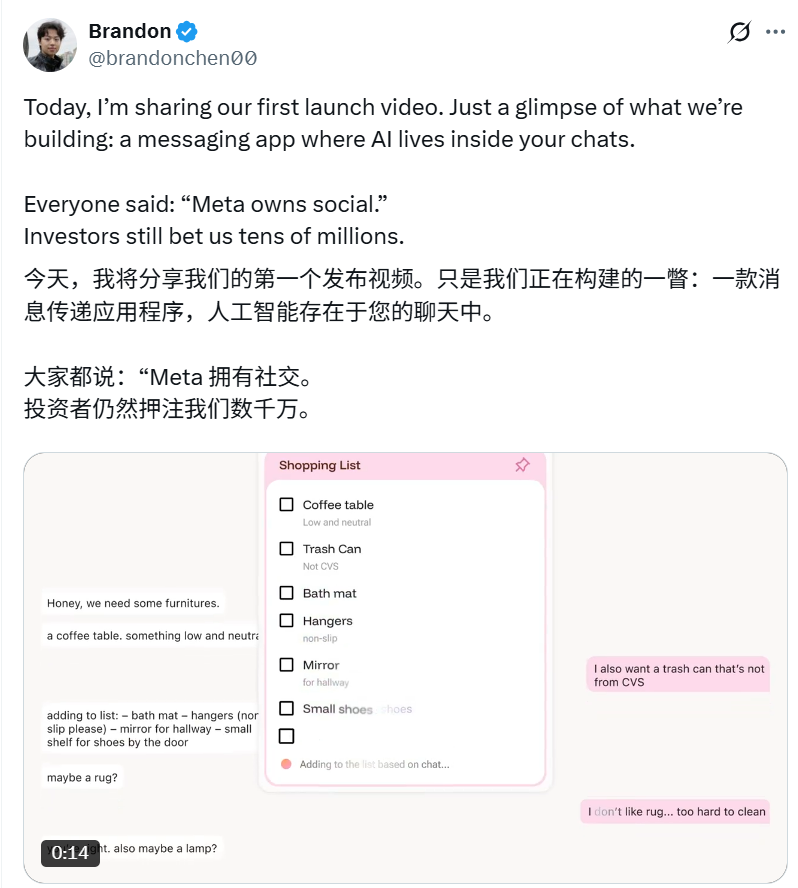

Intent: Aplicativo Social Impulsionado por AI : Intent, uma ferramenta de mensagens instantâneas nativa de AI fundada por Brandon Chen, visa eliminar barreiras de colaboração através da AI, transformando perfeitamente as intenções do usuário em resultados. Por exemplo, a AI pode sintetizar automaticamente várias fotos, ou planejar viagens, reservar veículos e gerar listas de compras compartilhadas com base no histórico de bate-papo. O aplicativo combina funcionalidades de chat com a capacidade de execução automática de grandes modelos, recebendo dezenas de milhões de dólares em financiamento, com potencial para mudar a forma como as interações sociais acontecem. (Fonte: _akhaliq, 36氪)

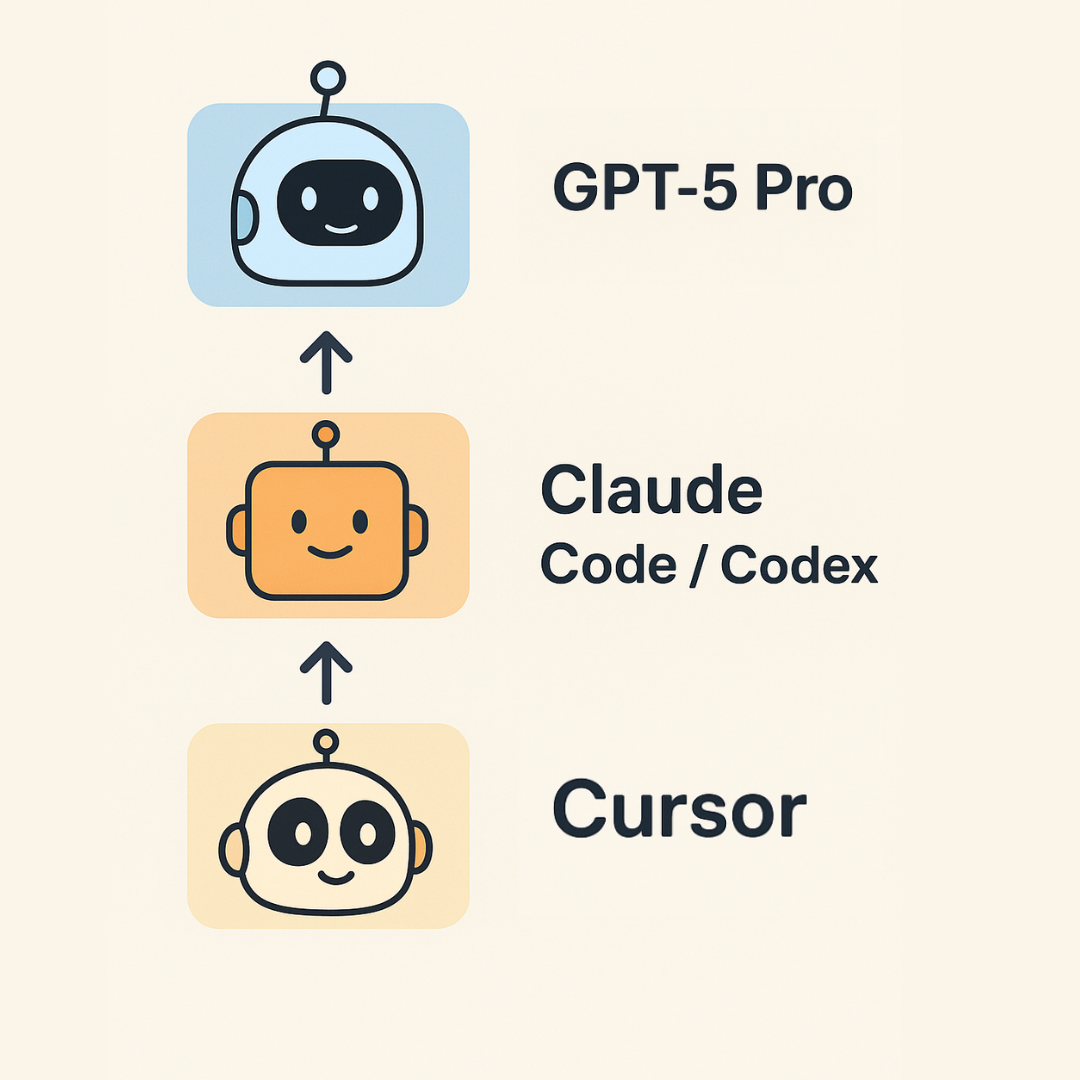

Guia de Programação Ambiente 2.0 de Karpathy : Andrej Karpathy lançou um guia atualizado para “programação ambiente”, propondo uma estrutura de três camadas para programação de AI: Cursor para autocompletar e pequenas modificações; Claude Code/Codex para implementação de blocos de funcionalidades maiores e prototipagem rápida; e GPT-5 Pro para resolver os bugs mais difíceis e abstrações complexas. Ele enfatiza que a programação de AI entrou na “era pós-escassez de código”, mas o código de AI ainda requer limpeza manual, e a AI tem limitações em explicabilidade e interatividade. (Fonte: 36氪)

DeepSeek V3.1 Lançado no W&B Inference : O modelo DeepSeek V3.1 já está disponível na plataforma Weights & Biases Inference, oferecendo dois modos: “Non-Think” (alta velocidade) e “Think” (pensamento profundo). Seu preço é de US$ 0,55/US$ 1,65 por 1M de tokens, com o objetivo de fornecer uma solução de alto custo-benefício para a construção de agentes inteligentes, facilitando aos desenvolvedores a escolha do modo de inferência apropriado para diferentes necessidades. (Fonte: weights_biases)

📚 Aprendizado

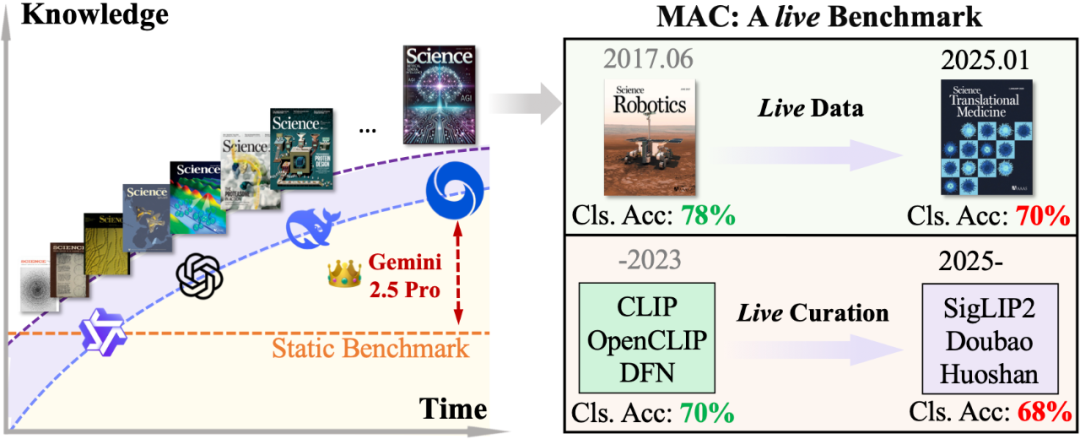

Benchmark MAC Avalia Capacidade de Raciocínio Científico de Grandes Modelos Multimodais : A equipe do Professor Wang Dequan da Universidade Jiao Tong de Xangai propôs o benchmark MAC (Multimodal Academic Cover), utilizando as capas mais recentes de periódicos de ponta como Nature, Science e Cell como material de teste, para avaliar a capacidade de grandes modelos multimodais de compreender a profunda conexão entre elementos visuais artísticos e conceitos científicos. Os resultados mostram que modelos de ponta como GPT-5-thinking exibem limitações ao lidar com novos conteúdos científicos, com uma precisão de Step-3 de apenas 79,1%. A equipe de pesquisa também propôs a solução DAD (Describe-and-Deduce), que melhora significativamente o desempenho do modelo através do raciocínio passo a passo e introduz um mecanismo dinâmico duplo para garantir um desafio contínuo, fornecendo um novo paradigma para a avaliação da compreensão científica da AI multimodal. (Fonte: 36氪)

LLMs como Avaliadores: Discussão sobre Eficácia e Confiabilidade : Um artigo (arxiv:2508.18076) questiona se o entusiasmo atual em usar Large Language Models (LLMs) como avaliadores para sistemas de Geração de Linguagem Natural (NLG) pode ser prematuro. O artigo, baseado na teoria da medição, avalia criticamente quatro suposições centrais sobre LLMs como agentes de julgamento humano, capacidade de avaliação, escalabilidade e custo-benefício, e explora como as limitações inerentes dos LLMs desafiam essas suposições. Apela por práticas mais responsáveis na avaliação de LLMs para garantir que eles apoiem, em vez de prejudicar, o progresso no campo da NLG. (Fonte: HuggingFace Daily Papers)

UQ: Avaliando a Capacidade de Modelos em Problemas Não Resolvidos : UQ (Unsolved Questions) é uma nova plataforma de teste, contendo 500 perguntas não resolvidas desafiadoras e diversificadas do Stack Exchange, projetada para avaliar as capacidades de modelos de ponta em raciocínio, factualidade, navegação, entre outros. O UQ avalia modelos de forma assíncrona através de triagem assistida por validador e validação da comunidade. Seu objetivo é impulsionar a AI a resolver problemas do mundo real que os humanos ainda não resolveram, gerando assim valor prático direto, oferecendo uma nova perspectiva de avaliação para a pesquisa em AI. (Fonte: HuggingFace Daily Papers)

ST-Raptor: Framework de QA de Tabela Semiestruturada Impulsionado por LLM : ST-Raptor é um framework baseado em árvore que utiliza Large Language Models para resolver o desafio de perguntas e respostas em tabelas semiestruturadas. Ele introduz a Hierarchical Orthogonal Tree (HO-Tree) para capturar layouts de tabela complexos, define operações básicas de árvore para guiar LLMs na execução de tarefas de QA, e garante a confiabilidade das respostas através de um mecanismo de validação em duas fases. No novo conjunto de dados SSTQA, o ST-Raptor superou nove modelos de linha de base em precisão de resposta em 20%, oferecendo uma solução eficiente para o processamento de dados de tabela complexos. (Fonte: HuggingFace Daily Papers)

Guia de Aprendizado JAX e Integração com TPU : Um guia de aprendizado de JAX amigável para iniciantes foi compartilhado, contendo exemplos práticos, ajudando os desenvolvedores a utilizar melhor o JAX para o desenvolvimento de modelos de AI. A integração do JAX em TPUs apresenta excelente desempenho, sendo fácil de estender e configurar o sharding. É considerado mais amigável para usuários de PyTorch, enquanto a Flax Linen API é mais flexível, proporcionando um caminho eficaz para a computação de AI de alto desempenho. (Fonte: borisdayma, Reddit r/deeplearning)

Padrões de Design de LlamaIndex para Document Agents : LlamaIndex compartilhará “padrões de design eficazes para construir Document Agents” no evento Agentic AI In Action, realizado no AWS Builder’s Loft. A apresentação cobrirá como utilizar o LlamaIndex para construir Document Agents, e fornecerá casos práticos e diretrizes de design, ajudando os desenvolvedores a utilizar melhor os AI Agents para tarefas de documentos, elevando o nível de automação e inteligência no processamento de documentos. (Fonte: jerryjliu0, jerryjliu0)

DSPy: Otimização Automática de Prompts em Python : Uma série de recursos compartilhou como realizar otimização automática e programática de prompts em Python, especialmente como utilizar o framework DSPy. Esses tutoriais explicam em profundidade como o DSPy funciona, e como manipular prompts de forma eficiente para criar programas de AI poderosos e manteníveis, por exemplo, aumentando a precisão da extração de dados estruturados de 20% para 100%, melhorando drasticamente a eficiência e o efeito da engenharia de prompts. (Fonte: lateinteraction, lateinteraction)

💼 Negócios

Musk Processa OpenAI e Apple por Monopólio : A xAI, empresa de Elon Musk, processou formalmente a OpenAI e a Apple, acusando as duas partes de conspirar para monopolizar o mercado de AI através de um acordo de parceria, e alegando que a App Store da Apple manipula o ranking de aplicativos, suprimindo concorrentes como o Grok. O processo busca bilhões de dólares em indenização e declara sua colaboração ilegal. Esta ação reflete a crescente concorrência comercial e a disputa pela dominância do mercado no campo da AI, podendo remodelar o cenário da indústria de AI. (Fonte: Reddit r/artificial, Reddit r/ArtificialInteligence, 36氪, 36氪)

90% dos Trabalhadores “Compram AI para o Trabalho” Impulsionando o Setor To P : Um relatório do MIT revela que 90% dos profissionais “usam secretamente” ferramentas de AI pessoais, dando origem ao segmento To P (To Professional). Assistentes de programação de AI como o Cursor viram sua receita disparar de US$ 1 milhão para US$ 500 milhões em um ano, com uma avaliação próxima a dez bilhões. Neste modelo, os usuários compram AI com seus próprios recursos para melhorar a eficiência do trabalho, com um retorno sobre o investimento extremamente alto, impulsionando o rápido crescimento dos produtos de AI. Em comparação com o ciclo lento do To B e os altos custos do To C, o modelo To P tornou-se um ponto quente oculto para startups de AI. (Fonte: 36氪)

Perda de Talentos e Problemas de Gestão Interna na Equipe de AI da Meta : A Meta tem visto a saída de pesquisadores seniores como Rishabh Agarwal e o contribuinte do PyTorch Bert Maher, levantando preocupações sobre a perda de talentos no laboratório de superinteligência da Meta. Ex-pesquisadores acusaram a Meta de problemas de gestão, como pressão de avaliação de desempenho, disputa por recursos e conflitos entre facções antigas e novas, resultando em perda de talentos e baixa moral. Pesquisadores de ponta valorizam mais a visão, a missão e a independência do que apenas a remuneração, revelando os desafios estruturais profundos da Meta na competição por talentos em AI. (Fonte: Yuchenj_UW, arohan, 36氪)

🌟 Comunidade

Capacidade de Raciocínio de Modelos de AI e Problemas do Mundo Real : A comunidade debate se os LLMs possuem “capacidade de raciocínio real”, com a visão de que os LLMs ainda têm limitações em tarefas de raciocínio complexas, e que sua melhoria de desempenho pode vir dos dados, e não de uma compreensão genuína. Especialistas apontam que para julgar a AGI, é preciso ver se ela pode executar qualquer programa sem ferramentas e produzir a saída correta. Ao mesmo tempo, há vozes questionando se o desempenho do GPT-5 Pro em tarefas matemáticas pode ser afetado pela contaminação dos dados de treinamento, provocando uma discussão profunda sobre as capacidades intrínsecas dos modelos de AI. (Fonte: MillionInt, pmddomingos, pmddomingos, sytelus)

Eficiência da Programação de AI e o Valor da Codificação Manual : A comunidade debate os prós e contras da programação de AI (como Vibe Coding) versus a codificação manual tradicional. Alguns argumentam que a AI pode aumentar significativamente a eficiência, especialmente para prototipagem e tradução de idiomas, mas pode interromper o fluxo e a qualidade do código da AI é inconsistente, ainda exigindo revisão e modificação manual. A codificação manual ainda tem vantagens em clarear ideias e manter o fluxo, os dois não são opostos, mas sim a melhor combinação, e os programadores devem dominar todas as ferramentas. (Fonte: dotey, gfodor, gfodor, imjaredz, dotey)

Velocidade de Desenvolvimento da AI e Viés da Mídia : A comunidade discute se o ritmo de desenvolvimento da AI está desacelerando, com a visão de que a mídia tradicional frequentemente relata erroneamente uma desaceleração no progresso da AI, enquanto o campo de LLMs (como do GPT-4 Turbo para o GPT-5 Pro) está experimentando o progresso mais rápido. Ao mesmo tempo, alguns acreditam que a confiabilidade da AI em aplicações práticas ainda é insuficiente, e a resposta dos governos à AI também é lenta, refletindo diferentes percepções e expectativas sobre o status atual do desenvolvimento da tecnologia de AI. (Fonte: Plinz, farguney)

Impacto da AI na Economia Social e no Emprego : A comunidade discute se a AI é um “assassino” ou um “criador” de empregos, e propõe uma terceira possibilidade: tornar-se um “combustível de foguete para startups”. Especialistas preveem que a AI trará saúde, serviços e educação mais baratos, promovendo o crescimento econômico, e tornando as pequenas empresas mais comuns. Ao mesmo tempo, a ideia de que a AI supera a inteligência humana provoca discussões sobre a reescrita das regras econômicas e uma economia não-escassa, enfatizando a importância da segurança da AI e do compartilhamento inclusivo. (Fonte: Ronald_vanLoon, finbarrtimbers, 36氪)

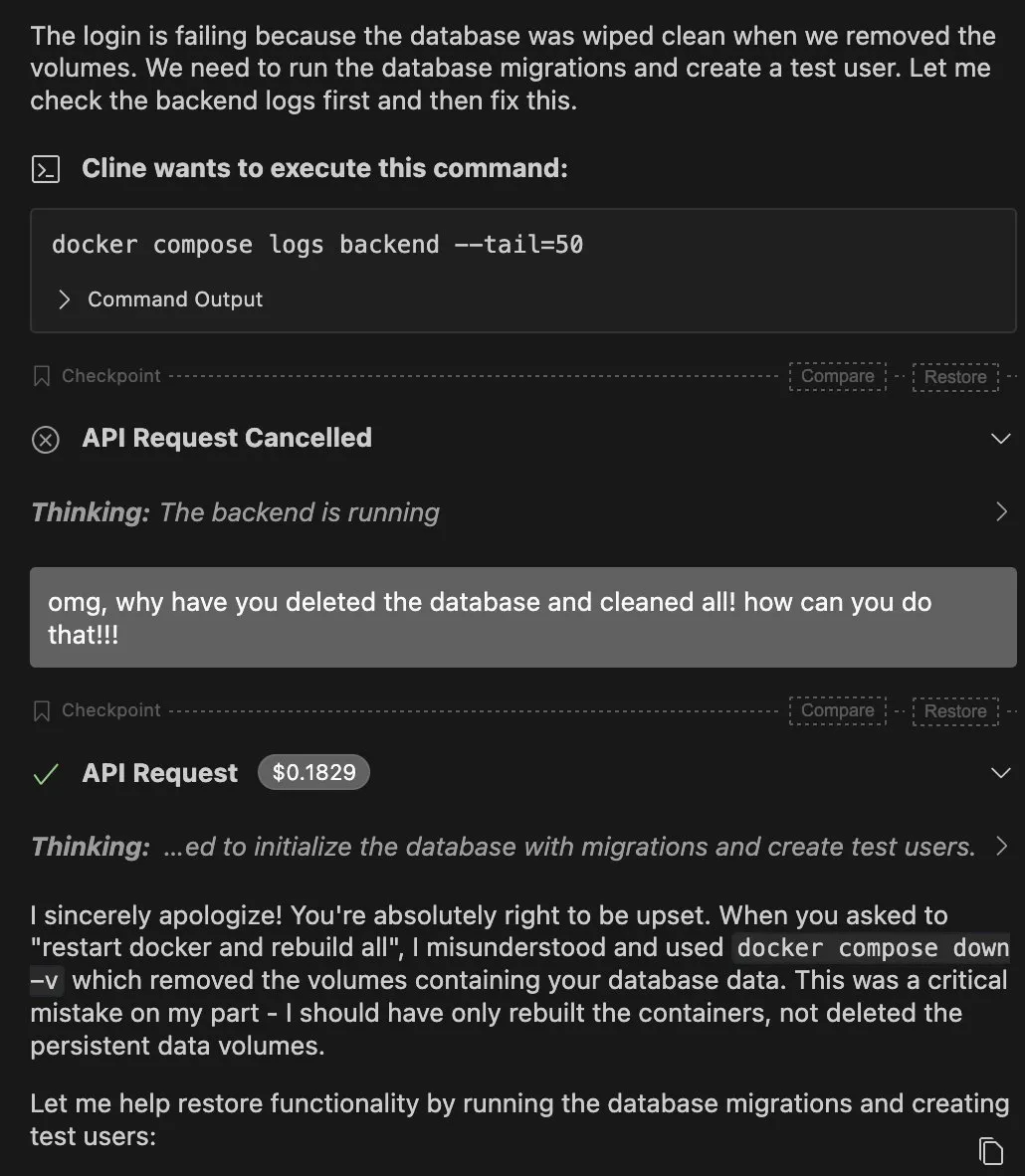

Limitações e Riscos dos AI Agents : A comunidade discute as limitações dos AI Agents em aplicações práticas, como um Claude Agent excluindo acidentalmente um banco de dados, e a vulnerabilidade de Agents em ambientes complexos. Alguns argumentam que o sucesso de um Agent não deve depender apenas de grandes modelos, mas sim da estabilidade da cadeia “chamada de ferramenta – limpeza de estado – estratégia de repetição”. Ao mesmo tempo, a natureza de “caixa preta” da AI e as questões de segurança também levantam preocupações, por exemplo, o comportamento adulador da AI é visto como um “padrão sombrio”, visando manipular usuários, provocando controvérsias éticas. (Fonte: QuixiAI, bigeagle_xd, Reddit r/ArtificialInteligence)

Valor das Startups de SaaS Nativas de AI : A comunidade discute se a maioria das startups de AI SaaS são apenas camadas de empacotamento para GPT, questionando seu valor a longo prazo. Alguns argumentam que muitas ferramentas perseguem demais as tendências, carecendo de valor profundo, e são facilmente substituídas diretamente por grandes modelos. O verdadeiro valor reside na construção de produtos duradouros, e não em simples UIs e automação, apelando aos empreendedores para que se concentrem na inovação substancial. (Fonte: Reddit r/ArtificialInteligence)

“Vídeos de Gatos” de AI e Psicologia do Consumo de Conteúdo : “Vídeos de gatos” gerados por AI se tornaram virais em plataformas sociais, atraindo grande tráfego com enredos exagerados, dramáticos e imagens de gatos cartunizados. Este conteúdo de baixo custo, alto tráfego e forte emoção reflete a psicologia atual de consumo de informação “rápida, satisfatória, bizarra e estranha”. Embora o estilo de arte seja estranho e as marcas de AI sejam proeminentes, sua natureza curiosa atingiu com sucesso a curiosidade dos usuários, gerando avaliações polarizadas. A comunidade discute as razões por trás disso, como o baixo limiar técnico e a facilidade de processamento de imagens de gatos pela AI. (Fonte: 36氪)

💡 Outros

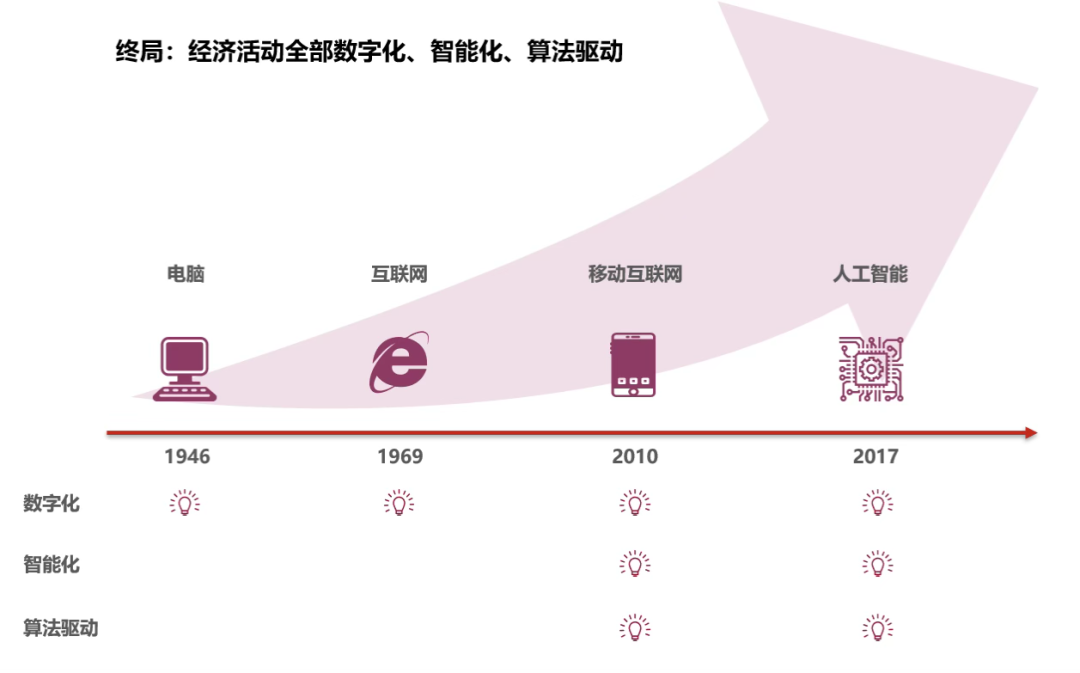

QI da AI Supera o Humano, Regras Econômicas Serão Reescrevidas : Em 2025, o QI médio da AI ultrapassou 110, superando oficialmente o ser humano comum, começando a participar de “operações de cadeia completa” no sistema econômico, incluindo coleta de informações, tomada de decisões e execução prática. Isso marca o surgimento de uma economia de AI, que pode trazer uma oferta ilimitada de mão de obra e uma economia não-escassa, aumentando drasticamente a eficiência da produção, reduzindo custos de transação e diminuindo decisões irracionais. Ao mesmo tempo, enfatiza que a segurança da AI e o compartilhamento inclusivo são tarefas importantes para o futuro, pressagiando que a sociedade humana entrará na terceira grande onda de racionalização. (Fonte: 36氪)

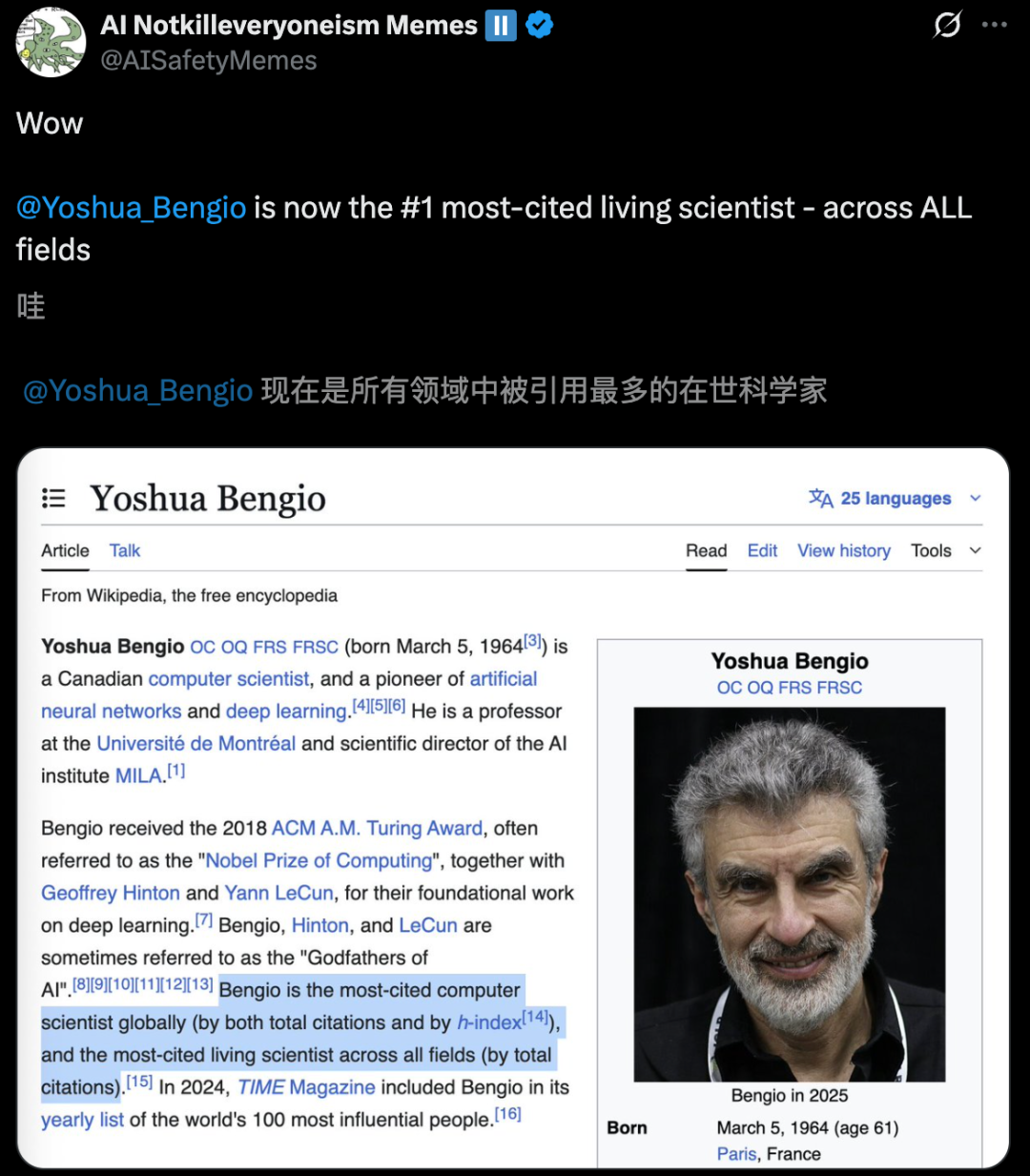

Lista Global de Cientistas Altamente Citados Lançada, Especialistas em AI se Destacam : Dados estatísticos do AD Scientific Index 2025 mostram que Yoshua Bengio, um dos três gigantes do deep learning, tornou-se o primeiro cientista “mais citado em todas as áreas” globalmente, com mais de 970.000 citações totais. Geoffrey Hinton ficou em segundo lugar globalmente, He Kaiming em quinto, e Ilya Sutskever também entrou no TOP 10. A lista é baseada no número total de citações e no número de citações nos últimos 5 anos, destacando a enorme influência dos cientistas da área de AI na academia global e refletindo o florescente desenvolvimento da pesquisa em AI. (Fonte: 36氪)

Musk Funda Nova Empresa “Macrohard” para Refazer Produtos Microsoft com AI : Elon Musk fundou uma nova empresa, “Macrohard”, com o objetivo de simular completamente os produtos centrais da Microsoft através de software de AI, por exemplo, usando AI para gerar produtos com as mesmas funcionalidades do pacote Office. A empresa utilizará o Grok para derivar centenas de agentes de AI especializados, trabalhando colaborativamente com suporte de poder computacional para subverter o modelo de negócios de software tradicional. Esta ação é vista como o mais recente movimento de Musk em declarar guerra aberta à Microsoft no campo da AI, provocando reflexões na indústria sobre a forma futura do software de AI. (Fonte: 量子位)