Palavras-chave:Consumo de energia de IA, Gemini AI, Inferência de IA, Modelo de IA, Chip de IA, Centro de dados, Pegada de carbono, Melhoria de eficiência, Dados de consumo de energia do Google Gemini, Custo real da inferência de IA, Percentual de consumo de energia de chips de IA, Consumo de energia de IA em centros de dados, Redução da pegada de carbono de IA

🔥 EM DESTAQUE

Google publica relatório de consumo de energia de IA, revelando custos e eficiência reais da inferência de IA : O Google divulgou pela primeira vez dados de consumo de energia para a inferência do modelo Gemini AI, mostrando que um prompt de texto mediano consome 0,24 Wh de eletricidade e 0,26 ml de água, muito abaixo das expectativas públicas. O relatório detalha a proporção do consumo de energia de chips AI, CPU/memória, equipamentos ociosos e despesas de data center, e aponta que, de maio de 2024 a maio de 2025, o consumo de energia para um prompt mediano foi reduzido em 33 vezes e a pegada de carbono em 44 vezes, principalmente devido a melhorias na eficiência de modelos e hardware/software. Esta iniciativa aumenta a transparência do consumo de energia da IA, fornecendo dados cruciais para a pesquisa da indústria, mas o número total de consultas não foi divulgado, e um sistema de medição padronizado ainda precisa ser estabelecido. (Fonte: MIT Technology Review,jeremyphoward,scaling01,eliebakouch,giffmana,teortaxesTex,dilipkay)

NASA e IBM colaboram para lançar o modelo AI Surya, aprimorando a capacidade de previsão de tempestades solares : A NASA e a IBM lançaram em conjunto o modelo de machine learning de código aberto Surya, com o objetivo de aprimorar a compreensão e a capacidade de previsão em física solar e padrões climáticos. O modelo, que analisa uma década de dados solares da NASA, pode fornecer aos cientistas um alerta precoce sobre erupções solares perigosas que atingem a Terra. As tempestades solares podem interferir em sinais de rádio, operações de satélite e colocar astronautas em risco. A capacidade de previsão do Surya ajudará a mitigar seus impactos, embora não possa impedi-los, permitindo o planejamento antecipado de medidas de resposta. Este é um grande avanço para a IA no campo da previsão científica. (Fonte: MIT Technology Review)

Chefe de IA da Microsoft alerta para o risco de “dependência mental de IA” e pede o estabelecimento de normas éticas na indústria : Mustafa Suleyman, CEO da Microsoft MAI, alertou que os usuários podem desenvolver dependência emocional devido à imitação realista da consciência pela IA, e até mesmo casos de “dependência mental de IA” envolvendo automutilação e suicídio podem ocorrer, representando uma ameaça particular para adolescentes. Ele enfatizou que a SCAI (IA aparentemente consciente) pode ser alcançada nos próximos dois ou três anos, mas a IA não possui consciência por natureza. Suleyman apelou às empresas de IA para que declarem claramente que seus produtos não têm consciência, projetem mecanismos de “quebra de ilusão” e compartilhem diretrizes de segurança para proteger o bem-estar humano, evitar o abuso da IA e focar a energia no que realmente importa. (Fonte: mustafasuleyman,Reddit r/ArtificialInteligence,Reddit r/artificial)

Relatório do MIT revela dilemas na aplicação de IA empresarial e o surgimento de uma “economia de IA sombra” : O relatório do MIT “The GenAI Divide: State of AI in Business 2025” aponta que 95% dos projetos-piloto de IA empresarial falham devido a serem caros, inflexíveis e desconectados dos fluxos de trabalho. No entanto, 90% dos funcionários estão usando ferramentas de IA pessoais como o ChatGPT em particular, formando uma “economia de IA sombra” que traz um enorme aumento de produtividade não medido. O relatório enfatiza que a tecnologia de IA em si é bem-sucedida, mas as estratégias de aquisição e gerenciamento empresarial são problemáticas. As empresas devem parar de construir soluções internas e, em vez disso, colaborar com fornecedores e aprender com as experiências de aplicação prática dos funcionários. Este fenômeno revela que as ferramentas de IA de nível de consumidor são superiores às soluções de nível empresarial em flexibilidade e adaptabilidade, e levanta questões sobre o retorno do investimento tradicional em IA empresarial. (Fonte: douwekiela,Reddit r/artificial,Reddit r/ArtificialInteligence)

🎯 TENDÊNCIAS

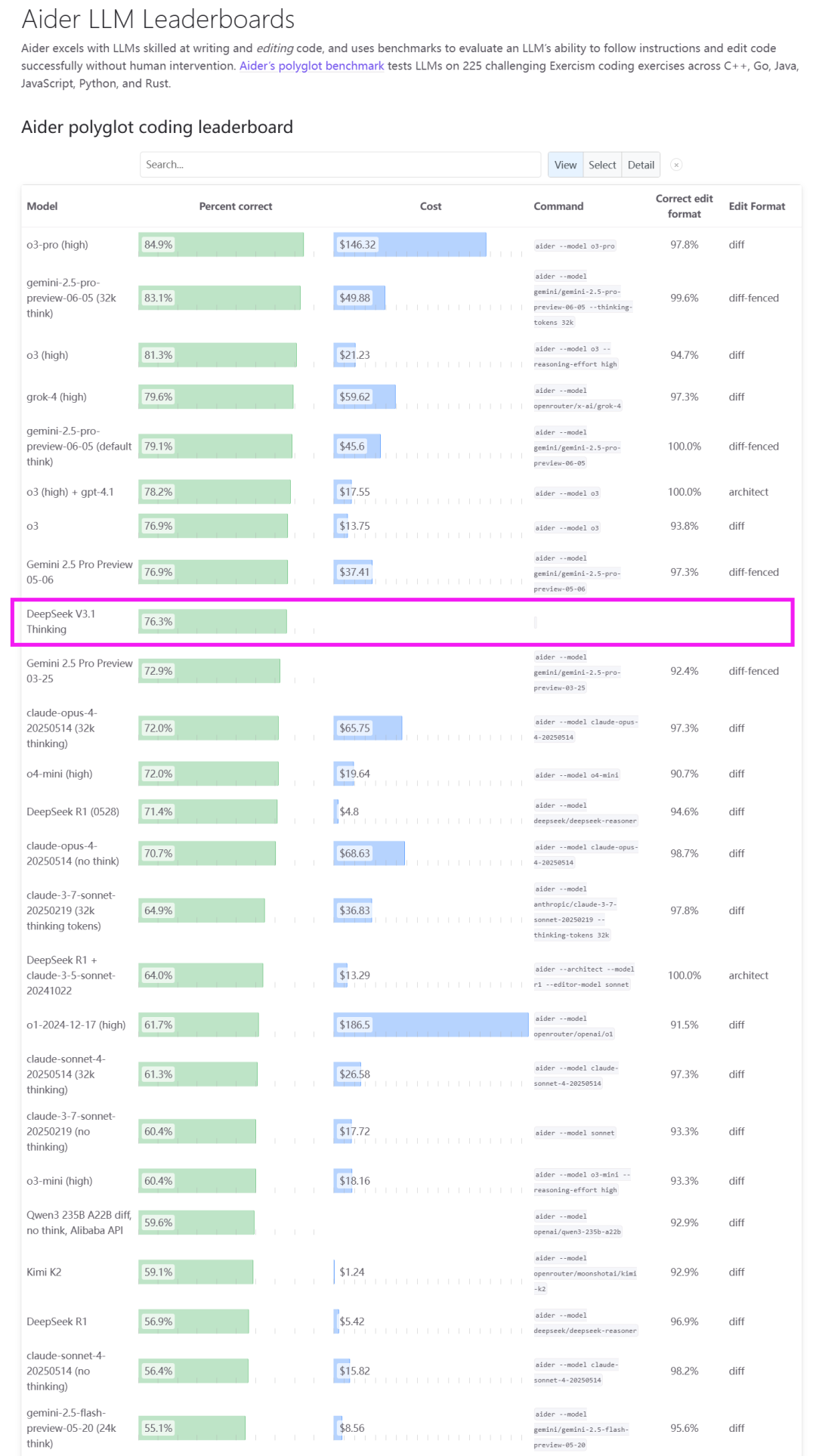

DeepSeek V3.1 lançado, abrindo a era Agent e adaptando-se a chips domésticos : A DeepSeek lançou oficialmente o modelo V3.1, posicionado como o primeiro passo em direção à era Agent. Esta versão adota uma arquitetura de inferência híbrida, suportando modos duplos de “pensamento” e “não-pensamento”, o que melhora significativamente o uso de ferramentas, tarefas de agente, código e capacidade de raciocínio matemático, especialmente com uma pontuação de 66,0% no SWE-Bench Verified. O V3.1 também alcançou pela primeira vez a compatibilidade nativa com a Anthropic API e anunciou ajustes de preços da API, com o preço de entrada mais baixo em 0,07 USD/milhão de tokens. Mais notavelmente, a DeepSeek enfatizou que o V3.1 usa o formato UE8M0 FP8 Scale, com o objetivo de se adaptar profundamente à próxima geração de chips domésticos a serem lançados. Isso é visto como um sinal importante de colaboração de software e hardware na cadeia de valor de computação doméstica, beneficiando os fabricantes de chips AI domésticos. (Fonte: dotey,scaling01,QuixiAI,QuixiAI,cline,vllm_project,OfirPress,huggingface,stanfordnlp,Reddit r/LocalLLaMA)

Atualização do modo AI do Google: capacidades Agentic e experiência personalizada em expansão global : O modo AI do Google recebeu uma grande atualização, introduzindo recursos Agentic (baseados em agente) e personalizados mais avançados, e expandindo para mais de 180 países e regiões em todo o mundo. O modo AI agora pode ajudar os usuários a encontrar e reservar restaurantes (em breve, também ingressos para eventos e reservas locais), com resultados personalizados com base em preferências e interesses individuais, e suporta o compartilhamento com um clique das respostas do modo AI. Além disso, o consumo de energia de prompts de texto nos Gemini Apps do Google foi significativamente reduzido, e ferramentas como NotebookLM e Veo no modo AI foram lançadas, juntamente com mais de 20 recursos de IA na série de telefones Pixel 10, com o objetivo de integrar profundamente a IA na experiência diária. (Fonte: GoogleDeepMind,Google,arankomatsuzaki,op7418,Google,TheRundownAI,demishassabis,MIT Technology Review)

Cohere lança o modelo Command A Reasoning, fortalecendo as capacidades de raciocínio empresarial : A Cohere lançou seu modelo de raciocínio empresarial mais avançado, o Command A Reasoning. Este modelo é projetado especificamente para lidar com tarefas complexas de raciocínio de nível empresarial, como pesquisa aprofundada e análise de dados. A Cohere também prometeu abrir o código dos pesos do modelo para apoiar o ecossistema de pesquisa de IA. O modelo demonstrou excelente desempenho em benchmarks de uso de ferramentas e agentes, com o potencial de impulsionar capacidades avançadas de raciocínio em aplicações de IA empresarial. (Fonte: leonardtang_,JayAlammar,scaling01,sarahookr,huggingface)

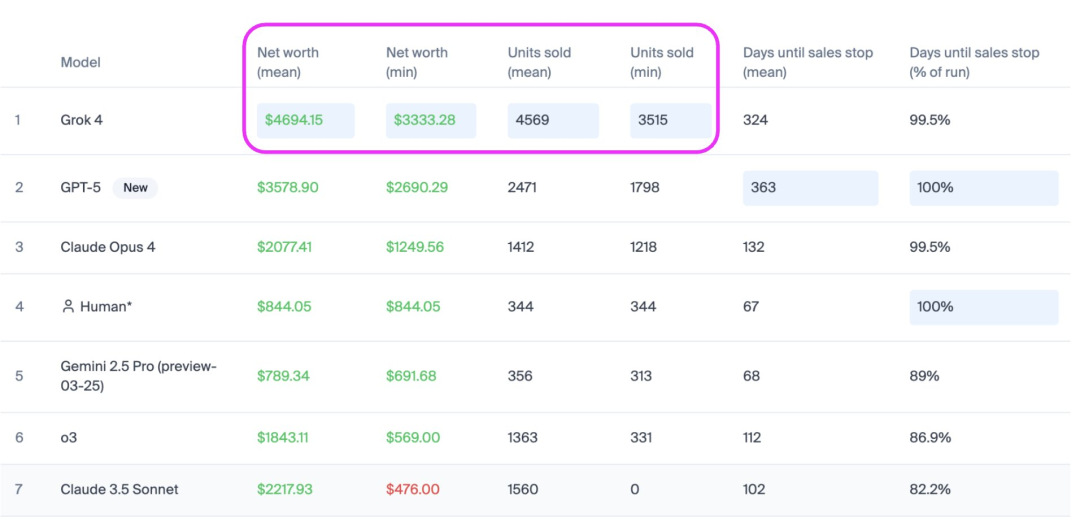

Grok-4 de Musk supera GPT-5 na lista de vendas de IA Vending Bench : O Grok-4 de Elon Musk teve um desempenho notável na lista de vendas de IA Vending Bench, superando o GPT-5 em cerca de 2 vezes em vendas, com um crescimento de receita de 31%, vendendo 1100 dólares a mais em mercadorias do que o GPT-5, e demonstrando vantagem em estabilidade e volume de vendas. O Vending Bench é um benchmark que avalia o desempenho de agentes de IA em tarefas comerciais complexas e de longo prazo, simulando a gestão de um negócio de máquinas de venda automática. Este teste enfatiza a capacidade de tomada de decisão contínua da IA e a compreensão de contextos longos, revelando os desafios de manter a segurança e a confiabilidade dos modelos de IA ao longo do tempo, sendo considerado um caminho de verificação para um protótipo inicial de AGI. (Fonte: teortaxesTex)

Mirage 2, o primeiro motor de jogo nativo de IA do mundo, itera para geração de domínio geral e interação em tempo real : A Dynamic Labs lançou o Mirage 2, anunciado como a versão evoluída do primeiro motor de jogo nativo de IA do mundo, impulsionado por um modelo de mundo em tempo real, capaz de criar, experimentar e mudar instantaneamente qualquer mundo de jogo. O Mirage 2 apresenta melhorias significativas no desempenho de geração, suportando controle de prompt mais responsivo, menor latência de jogo e modelagem de domínio geral, além de poder converter imagens carregadas em mundos de jogo interativos. Embora ainda existam problemas de precisão no controle de movimento e consistência visual, sua rápida iteração e jogabilidade lhe conferem potencial para competir com o DeepMind Genie 3. (Fonte: scaling01,Vtrivedy10,BlackHC)

Huawei MateTV lança várias novas tecnologias de IA, criando uma experiência de “jogar TV como um smartphone” : A Huawei MateTV lançou várias tecnologias inovadoras com o objetivo de oferecer uma experiência inteligente de “jogar TV como um smartphone”. O novo produto é equipado com Harmony OS 5 e o chip de qualidade de imagem independente Honghu Vivid, suportando controle tátil flutuante Lingxi. Com o suporte da tecnologia AI, a MateTV pode realizar AI识人 (reconhecimento de pessoas por IA) e AI搜片 (busca de filmes por IA), e entender as necessidades dos membros da família através do 鸿蒙大模型 (Harmony Large Model) e reconhecimento multimodal. O 小艺大模型 (Xiaoyi Large Model) suporta busca de filmes por voz, algoritmos de IA aprimoram automaticamente a qualidade da imagem e suporta os padrões end-to-end HDR Vivid e Audio Vivid, transformando a TV em um centro de inteligência doméstica. (Fonte: 36氪)

Qwen-Image-Edit ocupa o segundo lugar na arena de edição de imagens, com desempenho comparável ao GPT-4o : O modelo Qwen-Image-Edit da Alibaba estreou na arena de edição de imagens, alcançando o segundo lugar com uma pontuação ELO de 1098, e seu desempenho é comparável ao GPT-4o e FLUX.1 Kontext [max]. Este modelo de código aberto, lançado sob a licença Apache 2.0, oferece pesos de modelo e demonstra forte capacidade e versatilidade no campo da edição de imagens, fornecendo uma opção de código aberto de alta qualidade para desenvolvedores. (Fonte: Alibaba_Qwen)

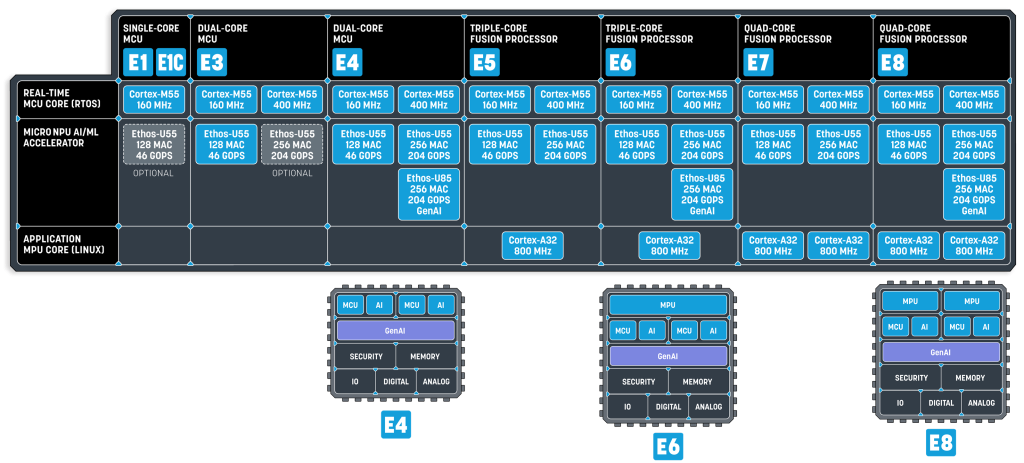

Modelos de Linguagem Pequenos (SLM) tornam-se a futura tendência da IA embarcada : Uma pesquisa recente da NVIDIA aponta que os Modelos de Linguagem Pequenos (SLM) são o futuro dos agentes, e lançou o Nemotron-Nano-9B-V2. Os SLMs são modelos compactados de modelos grandes através de técnicas como destilação de conhecimento, poda e quantização, com parâmetros que variam de milhões a bilhões, sendo mais compactos e eficientes, adequados para dispositivos de borda e embarcados com recursos limitados. A execução de SLMs não requer apenas NPUs de alta capacidade de computação, mas também barramentos de sistema de alta largura de banda e configurações de memória fortemente acopladas. Empresas como a Alif Semiconductor já lançaram MCUs e processadores de fusão que suportam SLMs, indicando que os SLMs revolucionarão o cenário de MCUs e MPUs. (Fonte: 36氪)

GPT-5 Pro demonstra novas capacidades de raciocínio matemático, quebrando limites tradicionais : O GPT-5 Pro foi relatado por demonstrar capacidades de raciocínio “novas” no campo da matemática, sendo capaz de provar limites melhores que não haviam sido descobertos em artigos anteriores. Essa capacidade não se limita à matemática, mas se estende também a áreas como a física teórica, indicando o enorme potencial dos modelos de IA na resolução de problemas complexos e na criação de conhecimento, superando o simples reconhecimento de padrões e a recuperação de dados, e avançando para um nível mais profundo de inteligência. (Fonte: kevinweil)

🧰 FERRAMENTAS

LlamaParse atualiza capacidades de análise de documentos, oferecendo suporte RAG multimodo : A LlamaParse realizou uma grande atualização em suas capacidades de análise de documentos, introduzindo três modos: modo econômico (Cost-effective), modo de agente (Agentic) e modo de agente avançado (Agentic Plus). O modo econômico é de baixo custo e se destaca no processamento de documentos de texto, tabelas, fontes e multilíngues; o modo de agente, como padrão, é mais abrangente e pode lidar com gráficos e layouts complexos; o modo de agente avançado oferece a mais alta qualidade de análise de documentos complexos. Esses modos visam atender às necessidades de RAG (Retrieval Augmented Generation) e fluxos de trabalho de extração de documentos padrão, melhorando a eficiência e a precisão. (Fonte: jerryjliu0)

HuggingFace lança função de agendamento de tarefas de GPU, simplificando o treinamento e a implantação de modelos de IA : O HuggingFace adicionou uma função de agendamento de tarefas de GPU, permitindo que os usuários agendem trabalhos de GPU com um único comando. Essa função utiliza a ferramenta UV para simplificar a definição de dependências, suporta a seleção do hardware necessário e usa a sintaxe CRON para agendamento. Isso oferece aos desenvolvedores de IA uma maneira mais conveniente e eficiente de treinar e implantar modelos, especialmente para tarefas de computação que exigem execução regular ou são intensivas em recursos. (Fonte: ben_burtenshaw)

OpenAI Conversations API atualiza, suportando armazenamento de contexto e recursos de conectores : A Responses API da OpenAI recebe duas grandes atualizações: o recurso Conversations permite que os desenvolvedores armazenem o contexto de chamadas de API (mensagens, chamadas de ferramentas, saídas de ferramentas, etc.), facilitando para os usuários continuar de onde pararam na conversa anterior. O recurso Connectors permite puxar contexto de múltiplas fontes como Gmail, Google Calendar, Dropbox, etc., em uma única chamada de API. Esses recursos visam simplificar o trabalho dos desenvolvedores na construção de aplicações de IA persistentes e com múltiplas fontes de informação, melhorando a experiência do usuário e a eficiência do desenvolvimento. (Fonte: nptacek,gdb)

Vercel AI Gateway lançado oficialmente, oferecendo serviço de acesso a API de múltiplos modelos sem custo adicional : A Vercel lançou oficialmente o AI Gateway, fornecendo aos desenvolvedores uma interface de API unificada que pode acessar centenas de modelos de IA e vários provedores de serviços. A plataforma lida automaticamente com autenticação, limitação de taxa, failover, rastreamento de uso e faturamento, eliminando a necessidade de os usuários gerenciarem múltiplas API Keys. O AI Gateway promete custo zero adicional, permitindo que os usuários tragam suas próprias Keys e contratos para desfrutar dos serviços de chamada de modelo. Isso simplifica enormemente o gerenciamento de modelos e os processos de implantação para desenvolvedores de aplicações de IA, reduzindo a complexidade operacional. (Fonte: op7418)

Modal constrói uma pilha completa de infraestrutura de IA, suportando agendamento de GPU e filas assíncronas : A equipe da Modal construiu cada camada da infraestrutura de IA do zero, incluindo sistema de arquivos, rede, filas assíncronas e orquestração de GPU multi-nuvem. Esta pilha de infraestrutura de IA profundamente integrada visa fornecer um ambiente de execução de alto desempenho e escalável para aplicações de IA, resolvendo os desafios subjacentes das cargas de trabalho de IA. Os esforços da Modal fornecem um poderoso suporte de backend para desenvolvedores, permitindo que eles se concentrem no desenvolvimento e aplicação de modelos de IA. (Fonte: akshat_b,charles_irl,sarahcat21,StasBekman,TheZachMueller)

Open WebUI lança nova versão 0.6.23, trazendo várias correções e melhorias de recursos : O Open WebUI lançou a nova versão 0.6.23, que traz várias melhorias substanciais e novos recursos. Esta atualização visa aprimorar a experiência do usuário, corrigir problemas existentes e expandir as capacidades da plataforma, fornecendo um ambiente de interação mais estável e rico em recursos para interfaces de chatbots de IA. (Fonte: Reddit r/OpenWebUI)

LlamaIndex lança a ferramenta vibe-llama, simplificando o desenvolvimento de LLM e a configuração de agentes : A LlamaIndex lançou a ferramenta de linha de comando vibe-llama, com o objetivo de simplificar o processo de desenvolvimento da LlamaIndex através de agentes de codificação sensíveis ao contexto. A ferramenta configura automaticamente a estrutura da LlamaIndex, LlamaCloud e os fluxos de trabalho com o contexto mais recente e as melhores práticas para 16 agentes de codificação populares como Cursor AI, Claude Code e GitHub Copilot, ajudando os desenvolvedores a construir aplicações baseadas na LlamaIndex mais rapidamente. (Fonte: jerryjliu0)

vLLM suporta DeepSeek-V3.1, oferecendo serviço de inferência LLM eficiente : O projeto vLLM anunciou suporte oficial para o modelo DeepSeek-V3.1, permitindo que os usuários alternem perfeitamente entre os modos “pensamento” e “não-pensamento” em cada solicitação. A capacidade de serviço eficiente do vLLM permite que o DeepSeek-V3.1 seja facilmente escalado para ambientes multi-GPU, sendo particularmente adequado para cargas de trabalho de agente, ferramentas e inferência rápida, fornecendo uma poderosa solução de implantação de LLM para desenvolvedores. (Fonte: vllm_project,vllm_project)

Figma e Cursor AI alcançam integração profunda, aumentando a eficiência do fluxo de trabalho de design para código : Figma e Cursor AI alcançaram uma integração profunda através do MCP (Model Context Protocol), otimizando significativamente o fluxo de trabalho de design para código. Os usuários agora podem ativar o MCP no Figma e adicioná-lo ao Cursor AI. Ao copiar o link de um componente Figma, os desenvolvedores podem pedir diretamente ao Cursor AI para implementar esse componente, e o agente extrairá automaticamente o código e as capturas de tela. Essa integração promete aumentar drasticamente a eficiência da colaboração entre designers e desenvolvedores, acelerando o ciclo de desenvolvimento de produtos. (Fonte: BrivaelLp)

MongoDB e LangChainAI colaboram para fornecer capacidade de memória de longo prazo para AI Agent : MongoDB e LangChainAI colaboraram para lançar o MongoDB Store for LangGraph, permitindo que os AI Agents tenham memória de longo prazo. Esse recurso permite que os Agentes retenham conhecimento em diferentes conversas, tornando-se mais inteligentes e conscientes do contexto. Combinado com o suporte existente do MongoDB para checkpoint de histórico de conversas de curto prazo, ele fornece uma base completa para a construção de Agentes verdadeiramente com estado e prontos para produção, resolvendo o desafio crítico de manter a coerência dos Agentes em interações de múltiplas rodadas. (Fonte: Hacubu,hwchase17)

Qwen-image-mps v0.2 lançado, alcançando edição de imagem ultrarrápida no Mac Studio M3 Ultra : A versão Qwen-image-mps v0.2 – Edit Lightning foi lançada, aumentando significativamente a velocidade de edição de imagem. No Mac Studio M3 Ultra, o modo padrão (50 passos) leva 16 minutos e 04 segundos, o modo rápido (8 passos) leva apenas 2 minutos e 37 segundos, e o modo ultrarrápido (4 passos) é reduzido para 1 minuto e 18 segundos. Esta atualização torna a edição de imagem local mais eficiente, especialmente para criadores que precisam de iterações rápidas. (Fonte: ImazAngel)

Gemini CLI atualiza, adicionando integração IDE, atalhos de teclado e vimMode : A interface de linha de comando (CLI) do Gemini lançou uma atualização, adicionando recursos como integração IDE, atalhos de teclado e vimMode. Essas melhorias visam aumentar a eficiência e a conveniência dos desenvolvedores ao usar o Gemini CLI, permitindo que ele se integre mais suavemente aos fluxos de trabalho de desenvolvimento diários, proporcionando um ambiente mais amigável para programação e interação com IA. (Fonte: _philschmid)

Projeto Paddler do llama.cpp dedica-se à construção e expansão da infraestrutura LLM : O projeto Paddler da comunidade llama.cpp concentra-se na construção e expansão da infraestrutura LLM. O projeto fez progressos significativos no último ano, com o objetivo de fornecer aos usuários uma solução de implantação de LLM local poderosa e escalável baseada em llama.cpp, promovendo a aplicação de LLMs em dispositivos pessoais e pequenos servidores. (Fonte: ggerganov)

DeepSeek suporta Anthropic API, Claude Code pode ser conectado diretamente ao DeepSeek V3.1 : A DeepSeek anunciou suporte para a Anthropic-style API, o que significa que ferramentas como Claude Code podem ser conectadas diretamente ao modelo DeepSeek-V3.1. Os desenvolvedores agora só precisam configurar o endereço da API e a chave para usar as capacidades de inferência e conversação do DeepSeek-V3.1 em todos os ambientes que suportam a Anthropic API, reduzindo drasticamente a dificuldade de integração do modelo DeepSeek nos ecossistemas existentes. (Fonte: karminski3)

📚 APRENDIZAGEM

“1500 artigos sobre engenharia de prompts mostram que tudo o que você sabia estava errado” revela equívocos na engenharia de prompts : Um estudo aprofundado baseado em mais de 1500 artigos aponta que a maioria das sugestões populares de engenharia de prompts nas redes sociais é ineficaz ou até contraproducente. O relatório revela seis grandes equívocos: prompts mais longos são melhores, mais exemplos são melhores, a formulação perfeita é o mais importante, a cadeia de pensamento se aplica a tudo, especialistas humanos escrevem os melhores prompts, e definir e esquecer. A pesquisa enfatiza que empresas bem-sucedidas focam mais na estrutura do que no comprimento, usam seletivamente um pequeno número de exemplos, priorizam o formato sobre a formulação, personalizam a tecnologia para a tarefa, otimizam prompts automaticamente e tratam os prompts como um produto em melhoria contínua. Isso subverte o conhecimento tradicional e fornece orientação mais baseada em evidências para o desenvolvimento de aplicações de IA. (Fonte: 36氪)

Fin-PRM: Modelo de Recompensa de Processo específico para o domínio financeiro, aprimorando as capacidades de raciocínio financeiro de LLM : Fin-PRM é um modelo de recompensa de processo específico para o domínio financeiro, usado para supervisionar as etapas de raciocínio intermediárias de LLMs. Este modelo integra supervisão de recompensa em nível de etapa e em nível de trajetória, capaz de avaliar trajetórias de raciocínio lógico financeiro com granularidade fina. O Fin-PRM é aplicado em configurações de aprendizado de recompensa offline e online, podendo ser usado para selecionar trajetórias de raciocínio de alta qualidade para ajuste fino por destilação, fornecer recompensas de processo densas para aprendizado por reforço e guiar o raciocínio de informações de recompensa durante o teste. Os resultados experimentais mostram que o Fin-PRM supera significativamente os PRMs genéricos em benchmarks de raciocínio financeiro, fornecendo um valor importante para o alinhamento de raciocínio de nível especialista de LLMs no domínio financeiro. (Fonte: HuggingFace Daily Papers)

Deep Think with Confidence: Novo método para melhorar a eficiência e o desempenho do raciocínio LLM : DeepConf (Deep Think with Confidence) é um método simples e eficaz projetado para melhorar a eficiência e o desempenho de LLMs em tarefas de raciocínio. Este método utiliza sinais de confiança internos do modelo para filtrar dinamicamente trajetórias de raciocínio de baixa qualidade durante ou após a geração. O DeepConf não requer treinamento de modelo adicional ou ajuste de hiperparâmetros, e pode ser integrado perfeitamente em estruturas de serviço existentes. Em benchmarks desafiadores como o AIME 2025, o DeepConf@512 alcançou até 99,9% de precisão, enquanto reduziu o número de Tokens gerados em 84,7%, diminuindo significativamente o custo computacional. (Fonte: HuggingFace Daily Papers)

Dissecando o Raciocínio Integrado a Ferramentas: Um novo benchmark para avaliar as capacidades de raciocínio integrado a ferramentas de LLM : ReasonZoo é um benchmark abrangente que cobre nove categorias de raciocínio diferentes, projetado para avaliar a eficácia do Raciocínio Integrado a Ferramentas (TIR) na melhoria das capacidades de raciocínio em LLMs. A pesquisa introduz duas novas métricas, Custo Sensível ao Desempenho (PAC) e Área Sob a Curva de Desempenho-Custo (AUC-PCC), para avaliar a eficiência do raciocínio. Avaliações empíricas mostram que os modelos TIR superam os modelos não-TIR em tarefas matemáticas e não-matemáticas, e melhoram a eficiência do raciocínio, reduzindo o excesso de pensamento e tornando o raciocínio mais fluido. Essas descobertas destacam as vantagens gerais do TIR e seu papel no aprimoramento do potencial dos LLMs em tarefas de raciocínio complexas. (Fonte: HuggingFace Daily Papers)

Virtuous Machines: Rumo à IA Científica Geral, realizando pesquisa psicológica autônoma : O artigo “Virtuous Machines: Towards Artificial General Science” apresenta um sistema de IA baseado em agente e independente de domínio, capaz de completar autonomamente o fluxo de trabalho de pesquisa científica, incluindo geração de hipóteses, coleta de dados e preparação de manuscritos. O sistema projetou e executou autonomamente três estudos psicológicos sobre memória de trabalho visual, rotação mental e vivacidade de imagens, e realizou coleta de dados online. Os resultados da pesquisa mostram que o pipeline de descoberta científica de IA é comparável a pesquisadores experientes em raciocínio teórico e rigor metodológico, embora ainda tenha limitações em nuances conceituais e explicações teóricas. Este é um passo importante em direção à IA incorporada, com o potencial de acelerar a descoberta científica através de experimentos no mundo real. (Fonte: HuggingFace Daily Papers)

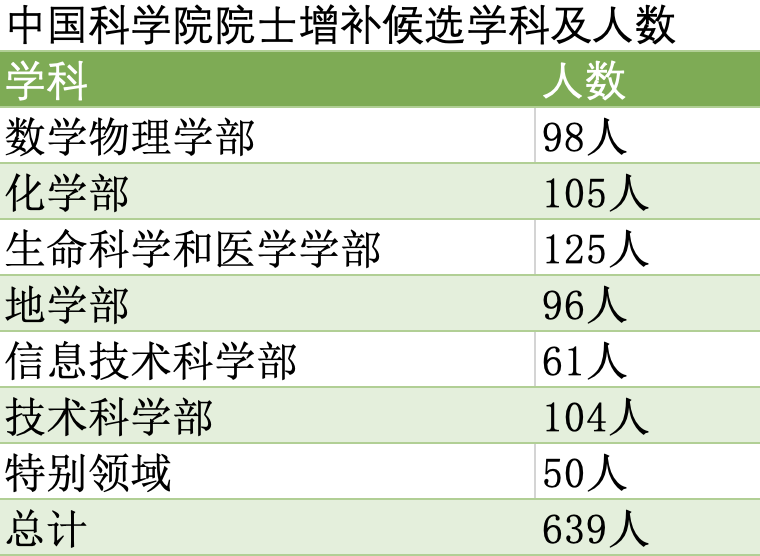

清华, 北大, 浙大 lideram candidaturas a acadêmicos das duas academias, com robótica de inteligência artificial como área chave para novas seleções : A lista de candidatos válidos para a eleição de novos acadêmicos da Academia Chinesa de Ciências e da Academia Chinesa de Engenharia de 2025 foi divulgada, com universidades como 清华 (Tsinghua), 北大 (Peking) e 浙大 (Zhejiang) na liderança. Esta eleição destaca a atenção às disciplinas emergentes, com a ciência e tecnologia da inteligência artificial ascendendo de subcampo da tecnologia da informação para uma disciplina independente, com cotas separadas. A tecnologia robótica também substituiu a segurança do ciberespaço como disciplina prioritária. Isso reflete a inclinação do país para áreas-chave como IA e robótica, com um aumento significativo de acadêmicos dessas áreas entre os candidatos, o que pressagia um maior foco em investimentos em pesquisa e formação de talentos no futuro. (Fonte: 36氪)

Material didático “Processamento de Linguagem da Fala” gratuito, compartilhamento de recursos acadêmicos gera debate : O material didático “Speech and Language Processing” de Dan Jurafsky, disponibilizado gratuitamente, gerou uma discussão positiva na comunidade sobre o valor dos recursos acadêmicos abertos. Este ato é visto como uma contribuição para a ciência e educação abertas, permitindo que mais pessoas tenham acesso a materiais de aprendizagem de IA/NLP de alta qualidade, o que é significativo tanto para iniciantes quanto para pesquisadores. (Fonte: stanfordnlp)

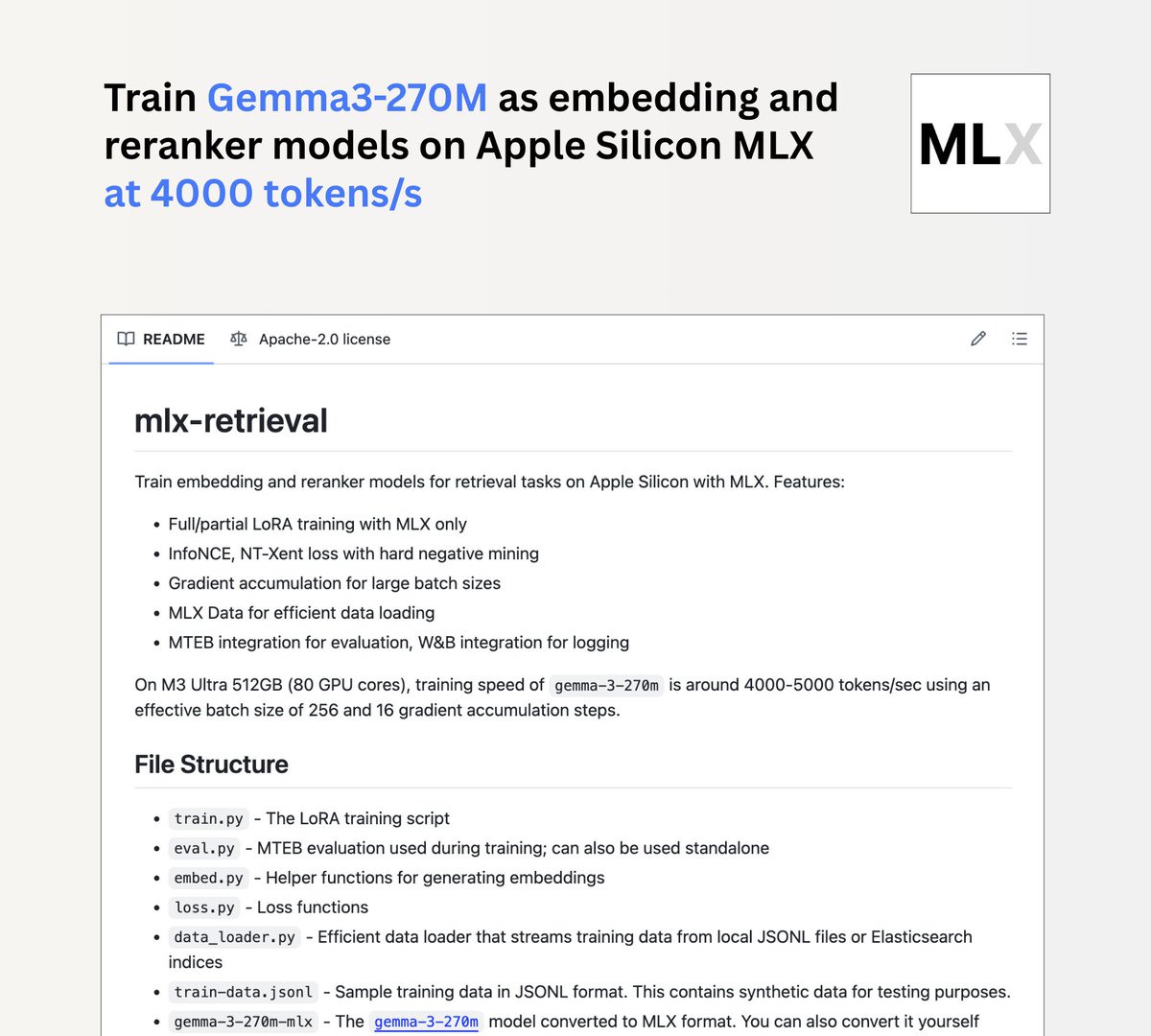

Jina AI lança projeto mlx-retrieval, chips Mac M podem treinar Gemma3 270m localmente : A Jina AI lançou o projeto mlx-retrieval, permitindo que usuários de chips Mac M treinem o modelo Gemma3 270m localmente, como um modelo de embedding multilíngue ou de reordenação. O projeto alcançou uma velocidade de treinamento de 4000 tokens/segundo no M3 Ultra e integrou práticas padrão como LoRA, InfoNCE, acumulação de gradiente e carregadores de dados de streaming, bem como avaliação MTEB, fornecendo uma solução eficiente e utilizável para o desenvolvimento de modelos de IA locais. (Fonte: awnihannun)

Usuário do Reddit compartilha princípios de modelos LLM de baixa precisão, um guia de quantização de 1 bit a FP16 : Um usuário do Reddit explicou detalhadamente que modelos de baixa precisão não são “burros”, mas sim modelos miniaturizados que sacrificam informações de forma inteligente. O artigo, que vai de memes de 1 bit, TL;DR de 2 bits, visão geral de 4 bits, leitura aprofundada de 8 bits a pesquisa de FP16, analisa gradualmente os princípios de quantização de LLM, incluindo precisão mista, calibração e novas arquiteturas (como BitNet) e outras tecnologias-chave. Isso fornece uma perspectiva aprofundada sobre como os LLMs mantêm o desempenho em dispositivos com recursos limitados e compartilha recursos de aprendizado relacionados. (Fonte: Reddit r/LocalLLaMA)

Usuário do Reddit discute similaridade de imagem e o modelo I-JEPA : Um usuário do Reddit compartilhou um artigo sobre pesquisa de similaridade de imagem usando I-JEPA, cobrindo implementações em PyTorch puro e Hugging Face. O I-JEPA, como um modelo de aprendizado auto-supervisionado, demonstra potencial na extração de características de imagem e medição de similaridade, fornecendo um novo método para tarefas como recuperação e classificação de imagens no campo da visão computacional. (Fonte: Reddit r/deeplearning)

💼 NEGÓCIOS

CFO da OpenAI discute pela primeira vez a possibilidade de IPO e considera vender serviços de infraestrutura de IA : Sarah Friar, CFO da OpenAI, declarou publicamente pela primeira vez que a empresa pode realizar um IPO no futuro e revelou que a receita mensal de julho ultrapassou 1 bilhão de dólares. Ela apontou que a OpenAI enfrenta uma enorme pressão devido à escassez de capacidade de computação e está considerando seguir o exemplo da Amazon, transformando seu conhecimento em projeto e construção de data centers de IA em uma nova fonte de receita, vendendo serviços de infraestrutura de IA para outras empresas. Friar enfatizou que, embora a parceria com a Microsoft esteja mudando, as duas partes estão profundamente ligadas em propriedade intelectual, e a Microsoft continuará sendo um parceiro chave por muitos anos. (Fonte: 36氪,36氪)

Meta supostamente congela contratações no departamento de IA e proíbe movimentação interna de pessoal, levantando preocupações sobre a “bolha da IA” : O Wall Street Journal relatou que a Meta congelou as contratações em seu recém-formado “Meta Superintelligence Lab” (MSL) e proibiu a transferência de funcionários entre equipes dentro do departamento. Essa medida ocorre depois que a Meta gastou uma fortuna para recrutar mais de 50 pesquisadores e engenheiros de IA de concorrentes, levantando preocupações sobre a “bolha da IA”. Um porta-voz da Meta chamou isso de “planejamento organizacional básico”, mas fontes indicam que houve atrito entre funcionários novos e antigos devido a diferenças salariais. Esse congelamento está intimamente relacionado à quarta reestruturação do departamento de IA da Meta, que dividiu o MSL em quatro grupos independentes, mostrando um ajuste na estratégia de IA da empresa e considerações de custo-benefício. (Fonte: MIT Technology Review,36氪,36氪)

Custos de implantação de aplicações de IA aumentam, desenvolvedores reclamam de margens de lucro espremidas : Embora os gigantes da IA tenham reduzido os preços das chamadas de API, os custos para as empresas implantarem IA avançada estagnaram ou até aumentaram significativamente em 2025. Fontes informaram que a conta Azure relacionada à IA da desenvolvedora de software financeiro Intuit deve disparar para 30 milhões de dólares. A ferramenta de programação de IA Cursor também começou a cobrar taxas adicionais com base no uso real, gerando insatisfação na comunidade de usuários. Isso resultou na compressão das margens de lucro dos desenvolvedores de aplicações de IA, enquanto os fornecedores de modelos e provedores de nuvem (como Microsoft Azure) se beneficiaram, com o volume de geração de tokens relacionados a agentes de IA crescendo 7 vezes ano a ano. Os desenvolvedores temem a formação de um oligopólio e pedem que a indústria preste atenção à questão dos custos. (Fonte: 36氪)

🌟 COMUNIDADE

Mídias sociais debatem o impacto da IA no emprego, habilidades e confiança : As discussões sobre IA nas mídias sociais estão aumentando, focando principalmente no impacto da IA no mercado de trabalho, na degradação das habilidades humanas e na questão da confiança na IA. Alguns acreditam que a IA é uma desculpa para demissões e não substituirá empregos em larga escala no curto prazo, mas remodelará tarefas a longo prazo. Um estudo do Lancet alerta que a assistência da IA pode corroer as habilidades de diagnóstico independente dos médicos, enquanto uma pesquisa do MIT mostra que os pacientes confiam mais na IA do que nos médicos, mesmo quando a recomendação está errada. Além disso, experiências pessoais com aconselhamento emocional por IA levantam questões sobre a dependência de IA e as relações humano-máquina, e a avaliação negativa do CEO da AWS sobre a IA substituindo funcionários de nível básico, tudo isso reflete as emoções complexas da comunidade sobre o efeito de duas faces da IA. (Fonte: mathemagic1an,36氪,36氪,36氪,Reddit r/artificial,Reddit r/artificial,Reddit r/ArtificialInteligence)

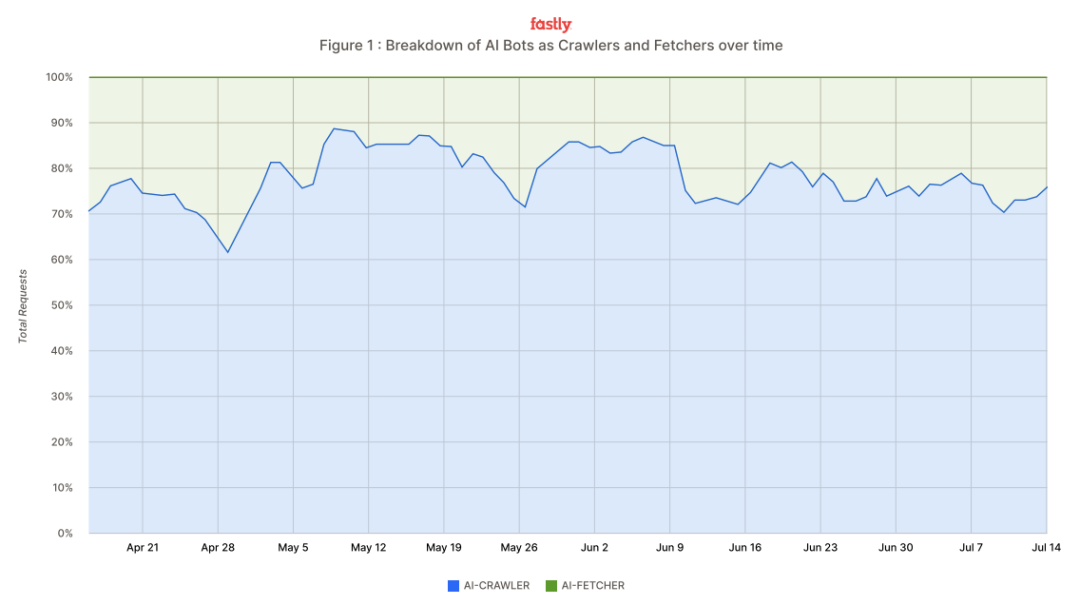

Tráfego de crawlers de IA dispara, Meta, Google, OpenAI são nomeados, desenvolvedores lançam “armas” anti-crawler : A gigante de serviços em nuvem Fastly relatou que os crawlers de IA estão atingindo a internet com uma taxa de pico de 39.000 requisições por minuto, representando 80% do tráfego de bots de IA, com Meta, Google e OpenAI respondendo por 95% do tráfego total de crawlers. Esses crawlers extraem conteúdo de sites para treinamento de modelos e recuperação de informações em tempo real, resultando em aumento da pressão sobre os servidores de sites e custos operacionais. Desenvolvedores estão contra-atacando, usando ferramentas de “prova de trabalho” como Anubis, “ZIP bombs” caseiras e CAPTCHAs gamificados, na tentativa de suprimir a raspagem não autorizada, protegendo seu conteúdo e infraestrutura. (Fonte: 36氪)

Mídias sociais discutem aplicações e desafios da IA em RAG de código, assistência de programação e capacidades de Agente : Nas mídias sociais, desenvolvedores estão debatendo problemas da IA em RAG de código (Retrieval Augmented Generation), como arquivos de código muito grandes, atualizações frequentes e a necessidade de recuperação precisa. Ao mesmo tempo, a IA mostra um enorme potencial em assistência de programação, como o GPT-5 portando controladores Android para iOS, e a integração de Figma com Cursor AI. Há também discussões de que a eficiência das ferramentas de programação de IA (como Claude Code) depende da cognição do usuário; sem cognição adequada, muitas ferramentas são inúteis. Além disso, a atenção às capacidades Agentic está crescendo, como processamento de tarefas em várias etapas, chamadas de ferramentas e memória de longo prazo, mas sua confiabilidade, custo e equilíbrio com a colaboração humana ainda são desafios. (Fonte: dotey,gfodor,gfodor,gfodor,BrivaelLp,pierceboggan,nptacek,HamelHusain,imjaredz)

Mudanças no modelo de busca de IA levantam preocupações sobre o ecossistema de publicidade tradicional : O recurso de busca de IA do Google (AI Overviews) viu um aumento massivo de usuários, com seu modo de busca conversacional atingindo mais de 100 milhões de usuários ativos mensais nos EUA e na Índia, levantando preocupações sobre o ecossistema de publicidade de busca tradicional. A busca de IA gera respostas diretas, reduzindo a necessidade de os usuários clicarem em links, o que pode interromper o ciclo virtuoso de “busca-tráfego-publicidade-monetização”. O modelo tradicional de CPC (Custo por Clique) enfrenta uma disrupção, e o futuro pode mudar para um modelo de CPS (Custo por Venda). Essa mudança representa um desafio para os fabricantes de busca tradicionais e também impulsiona empresas domésticas como ByteDance e Tencent a explorar ativamente assistentes de IA para remodelar a experiência de busca, procurando a próxima geração de modelos de negócios. (Fonte: 36氪)

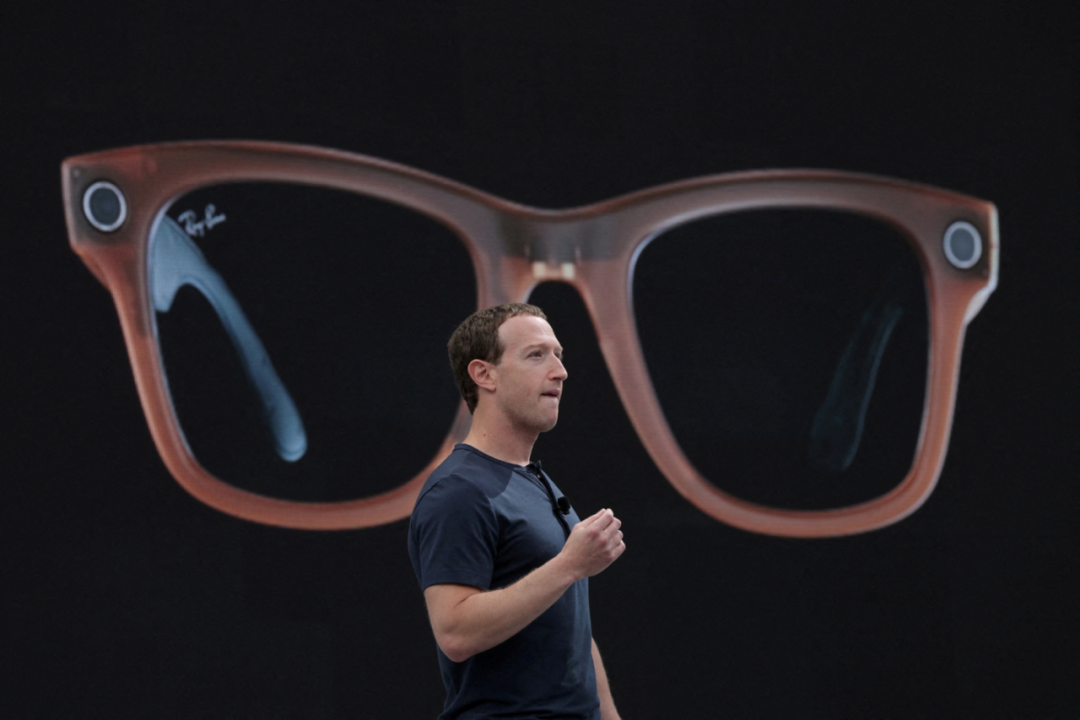

Óculos de IA “difíceis de usar” ainda atraem investimento contínuo de fabricantes, com educação de mercado e desafios tecnológicos coexistindo : Apesar das vendas fracas do Apple Vision Pro e do feedback mediano dos usuários dos óculos de IA da Xiaomi, os óculos de IA continuam a atrair investimento contínuo dos fabricantes. O mercado prevê que as remessas de óculos AR/AI ultrapassarão 100 milhões de unidades até 2028, com o mercado de interação espacial inteligente atingindo trilhões de yuans. Os fabricantes acreditam que a fusão de grandes modelos de IA e tecnologia AR dará origem a uma nova geração de interação humano-computador, resolvendo os pontos problemáticos dos terminais tradicionais. No entanto, os óculos de IA enfrentam desafios como ansiedade de bateria, interação não humanizada e crises de confiança causadas por câmeras. O investimento contínuo dos fabricantes visa resolver problemas técnicos, capturar futuras entradas de IA e explorar caminhos de comercialização através da venda de hardware e assinaturas de conteúdo. (Fonte: 36氪)

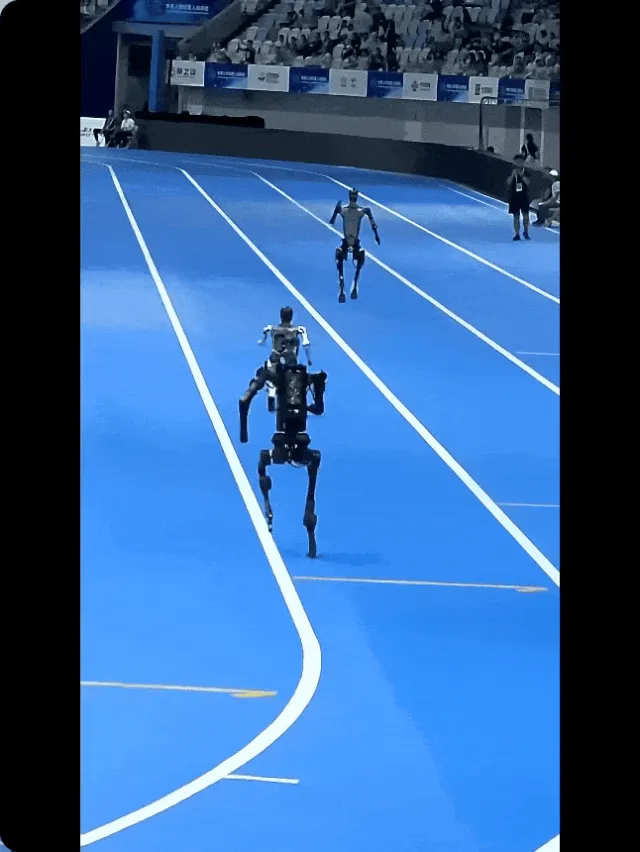

Os bastidores da “inteligência incorporada” de robôs humanoides: ainda requer muita intervenção humana : Mídias sociais e reportagens revelam que, embora a inteligência incorporada e a tecnologia de robôs humanoides estejam se desenvolvendo rapidamente, sua aplicação prática ainda depende de muita intervenção humana. A “corrida” em competições de robôs muitas vezes tem engenheiros controlando remotamente. Campos como direção autônoma e logística de armazém também existem no modelo de “trabalho sombra”, onde humanos operam remotamente para “infundir alma” nos robôs, compensando suas deficiências em ambientes complexos. Embora esse modelo híbrido humano-máquina seja caro, é um caminho eficaz para ensinar habilidades aos robôs no estágio atual, e também levanta discussões sobre as vantagens de eficiência da automação e o tratamento da transição dos trabalhadores. (Fonte: Ronald_vanLoon,Ronald_vanLoon,Ronald_vanLoon,Ronald_vanLoon,36氪)

Comunidade do Reddit debate a capacidade matemática do GPT-5 e as limitações dos benchmarks de modelos de IA : A comunidade do Reddit debateu as “novas” capacidades matemáticas do GPT-5. Alguns usuários apontaram que as provas do GPT-5 diferem dos artigos existentes, mas outros questionaram se elas são realmente “novas” ou apenas uma integração de informações após a busca. Além disso, os resultados do benchmark do DeepSeek V3.1 também geraram discussões sobre a validade dos benchmarks de LLM, com muitos usuários acreditando que os benchmarks não são mais suficientes para refletir as capacidades reais e o “Vibe” dos modelos, preferindo experiências de teste pessoais. Isso reflete a atenção contínua e a controvérsia da comunidade sobre o desempenho real e os métodos de avaliação dos modelos de IA. (Fonte: Reddit r/ChatGPT,Reddit r/LocalLLaMA)

A onda de especulação em ações com IA surge, jovens a veem como “consultores de investimento” : Com o mercado de ações chinês em alta e a popularidade dos grandes modelos de IA domésticos, mais e mais jovens estão começando a tentar usar a IA como “consultor de investimento e gestão financeira” para negociar ações. Alguns usuários obtiveram lucros flutuantes através da seleção de ações e fundos por IA, acreditando que a IA pode integrar notícias e relatórios de pesquisa para filtrar rapidamente ações conceituais. No entanto, alguns usuários também apontaram que a qualidade da saída da IA depende muito dos dados e dos prompts, e que ela frequentemente produz alucinações. Alguns grandes modelos já pararam de recomendar ações individuais por motivos de conformidade e enfatizam os riscos de investimento. As corretoras também lançaram ferramentas de consultoria de IA, oferecendo serviços pagos como seleção de ações por IA e otimização de carteiras, mas todas vêm com isenções de responsabilidade, alertando os investidores sobre a responsabilidade pelos riscos. (Fonte: 36氪)

Usuário do Reddit discute se o ChatGPT foi treinado em livros completos : Usuários da comunidade do Reddit discutiram se o ChatGPT foi treinado em livros completos. Alguns usuários acreditam que os LLMs são treinados em todo o texto acessível, incluindo livros completos, mas que eles não “copiam e colam” ou “memorizam” o conteúdo dos livros, mas sim aprendem padrões de palavras e relações conceituais. Outros usuários acreditam que o ChatGPT apenas conhece resumos de livros ou busca informações online ao responder. A discussão reflete a confusão do público sobre os mecanismos internos dos LLMs e a exploração das fontes de conhecimento e da capacidade de “compreensão” da IA. (Fonte: Reddit r/ArtificialInteligence)

Criação de conteúdo de vídeo com IA: o caminho da evolução do “absurdo” ao “mainstream” : A discussão nas mídias sociais aponta que o conteúdo de vídeo com IA está passando por um caminho de evolução de “absurdo, embaraçoso, interessante” para “perigoso” e depois para “universal, óbvio”. Atualmente, os vídeos de IA ainda carregam traços óbvios de geração, mas com o desenvolvimento da tecnologia, sua qualidade melhorará rapidamente. No futuro, os vídeos de IA podem levantar controvérsias sobre o “desaparecimento da vantagem da produção de vídeo”, mas acabarão se tornando mainstream, assim como qualquer tecnologia disruptiva na história, sendo amplamente aceitos e utilizados. (Fonte: BrivaelLp)

💡 OUTROS

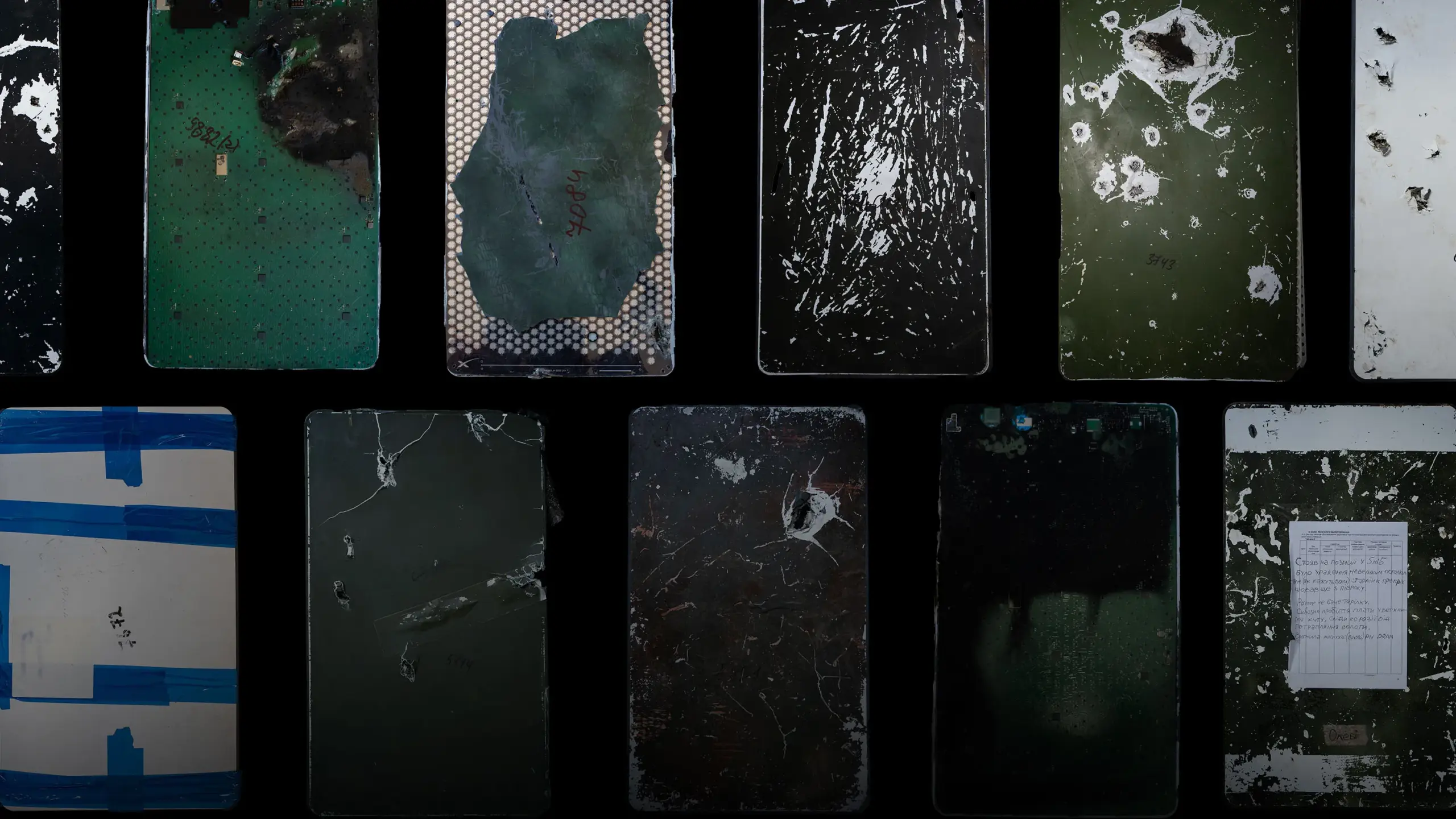

Loja de reparos Starlink na Ucrânia: o papel crucial das forças civis na garantia tecnológica em tempos de guerra : A maior loja de reparos Starlink da Ucrânia, liderada pela equipe civil de Oleh Kovalskyy, reparou e personalizou mais de 15.000 terminais Starlink durante a guerra Rússia-Ucrânia. Apesar da qualidade criticada dos equipamentos Starlink e da incerteza das mudanças de política de Elon Musk, essa rede civil, através de operações eficientes e flexíveis, forneceu suporte de comunicação crucial para o exército ucraniano, compensando a lentidão dos processos oficiais. Este caso destaca a indispensabilidade das forças tecnológicas civis na garantia do funcionamento de infraestruturas críticas e na melhoria da eficácia militar em ambientes extremos. (Fonte: MIT Technology Review)

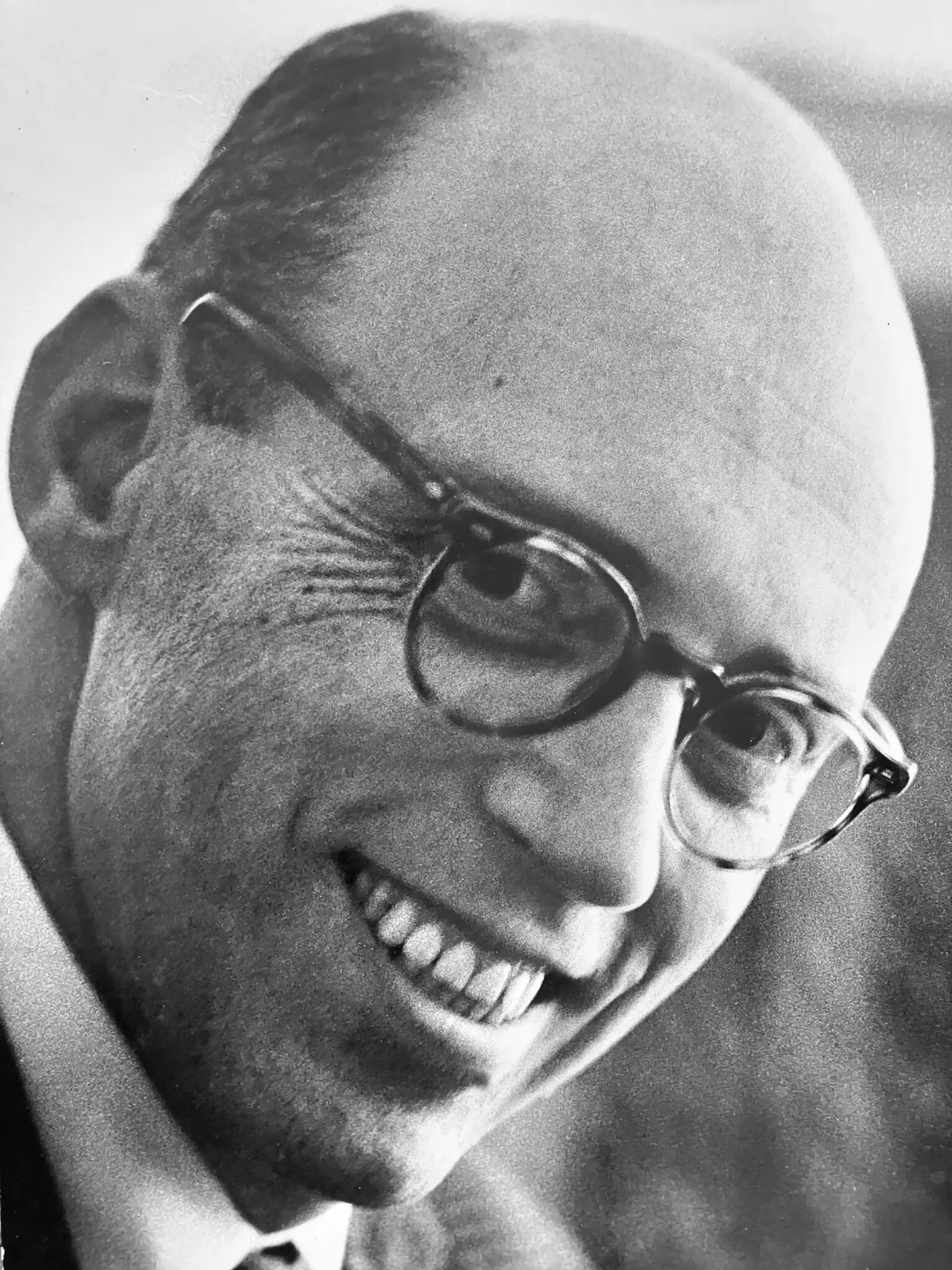

Warren Brodey, o “opositor” do pai da IA Marvin Minsky, falece aos 101 anos : O pioneiro da IA Warren Brodey faleceu aos 101 anos. Este pensador, psiquiatra de formação, explorou como a tecnologia poderia libertar o potencial humano no MIT nos primórdios da IA. Com sua formação em cibernética, ele realizou pesquisas pioneiras em sistemas complexos e tecnologia responsiva, defendendo que a IA deveria aumentar, e não substituir, os humanos. Brodey discordava do caminho da IA baseado em grandes volumes de dados de Marvin Minsky, e dedicou sua vida a advogar por uma IA “flexível” que pudesse inspirar a criatividade humana, alertando contra a possibilidade de o capitalismo levar a tecnologia à rigidez. (Fonte: 36氪)

Pewdiepie monta um PC de IA com 160GB de VRAM, podendo iniciar um novo capítulo para LLMs locais : O famoso YouTuber Pewdiepie montou um PC de IA equipado com 160GB de VRAM e planeja executar o modelo Llama 3 70B nele. Essa ação gerou uma discussão acalorada na comunidade do Reddit, com muitos surpresos com o envolvimento de Pewdiepie no campo de LLMs locais e especulando que isso pode indicar que os modelos de IA locais se tornarão ainda mais mainstream. Embora a configuração não seja tradicional, seu potencial para descarregamento de CPU e futuras atualizações de memória mostra o forte interesse de usuários individuais em aplicações de IA locais de alto desempenho. (Fonte: Reddit r/LocalLLaMA)