Palavras-chave:DeepSeek V3.1, GPT-5, Tencent Hunyuan 3D, Ali Qwen-Image, Robô Humanoide, Agente de IA, Reestruturação da Meta AI, DeepSeek V3.1 Base 128K de contexto, Treinamento de eixo duplo do GPT-5, Versão Lite do Tencent Hunyuan 3D com quantização FP8, Renderização de texto do Qwen-Image, Parceria entre o robô Zhiyuan e a Fuling Precision

🎯 Tendências

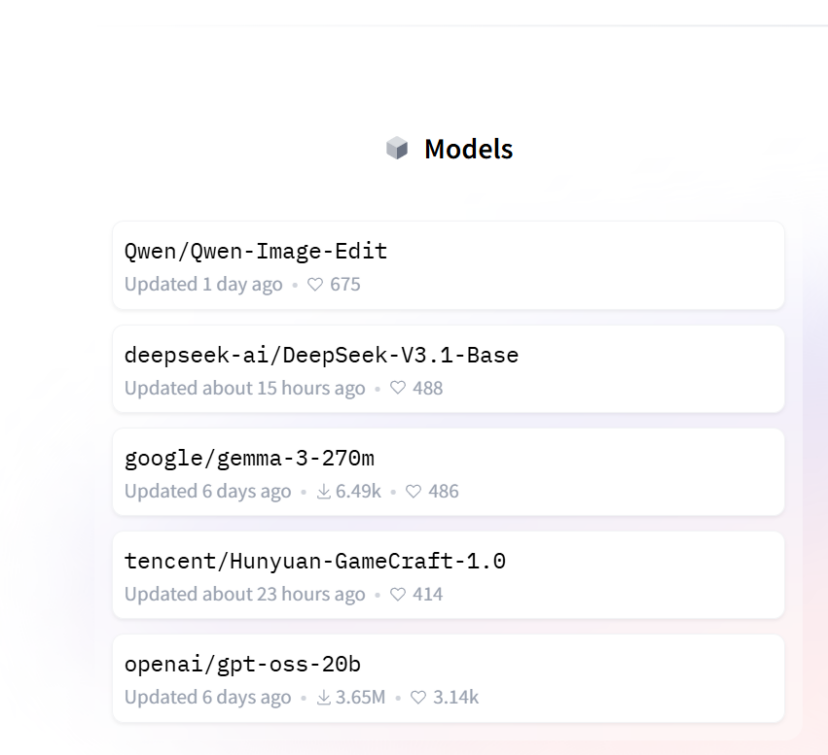

DeepSeek V3.1 Base lançado de surpresa : A DeepSeek lançou o modelo V3.1, com 685B parâmetros e contexto estendido para 128K. Sua capacidade de programação superou o Claude 4 Opus no teste Aider Polyglot com uma pontuação alta de 71,6%, com inferência e velocidade de resposta mais rápidas, e custo de apenas 1/68 do último. O modelo adicionou “search token” e “think token”, sugerindo uma possível arquitetura híbrida. Apesar do lançamento discreto, o V3.1 já está bem posicionado nas tendências do Hugging Face, demonstrando sua liderança e expectativa de mercado entre os modelos de código aberto. (Fonte: 36氪, 36氪, 36氪, ClementDelangue)

Capacidades e Estratégia do OpenAI GPT-5 : Brad Lightcap, COO da OpenAI, revelou que o principal avanço do GPT-5 reside na sua capacidade de julgar autonomamente se deve realizar inferência profunda, melhorando significativamente a precisão e a velocidade de resposta, especialmente nas áreas de escrita, programação e saúde. Ele enfatizou que a Scaling Law não está morta, e a OpenAI está acelerando a inovação de modelos através de um “eixo duplo” de pré-treinamento e pós-treinamento. Embora poderoso, o GPT-5 não é uma AGI, e sua “reserva de capacidade excedente” significa que ainda há uma década de espaço para construção de produtos. A filosofia do produto é resolver problemas de forma eficiente, em vez de prolongar o tempo de uso do usuário, e focar na aplicação da AI em cenários de saúde e empresariais. (Fonte: 36氪, 36氪)

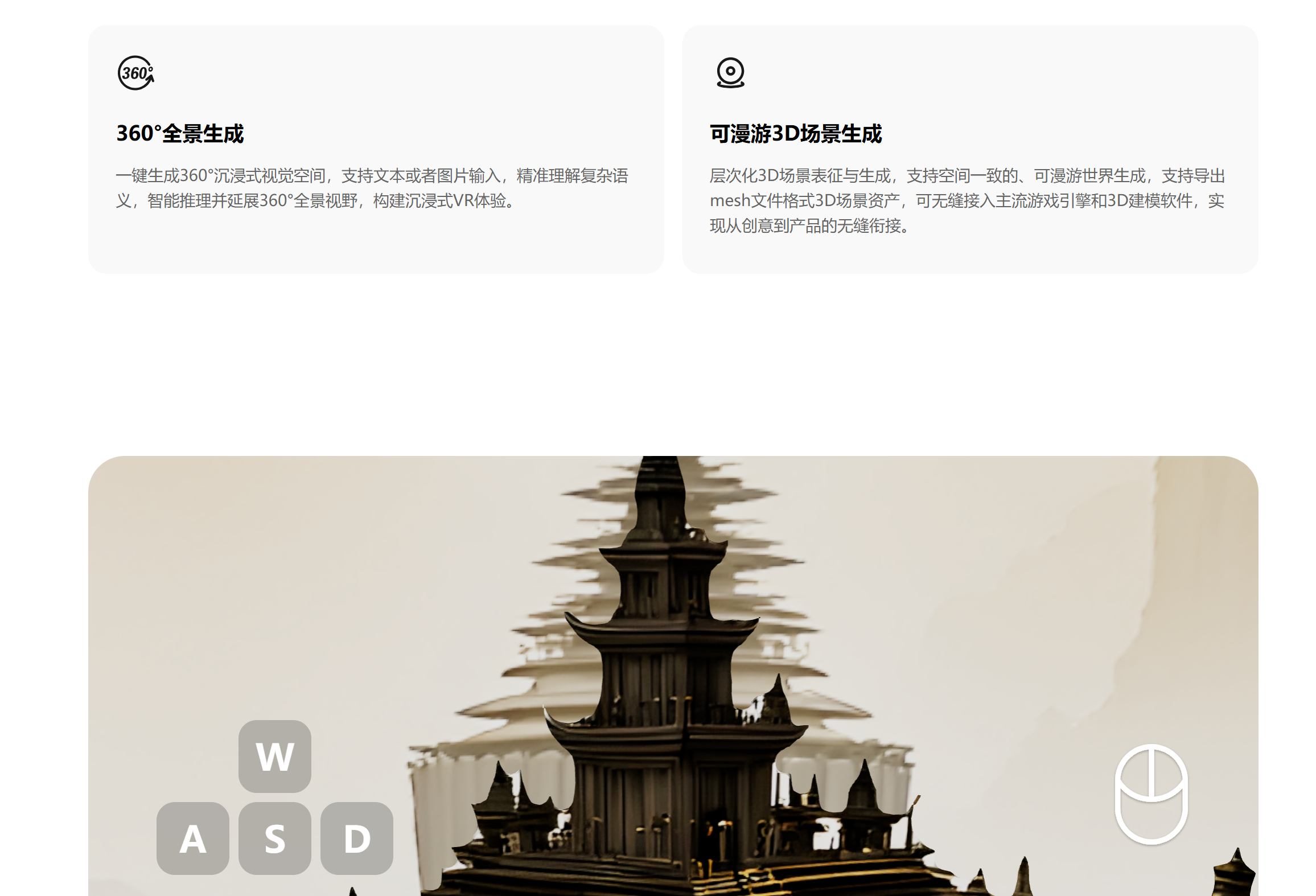

Lançamento do Tencent Hunyuan 3D Lite : A equipe Tencent Hunyuan lançou a versão Lite do seu modelo de mundo 3D. Através da tecnologia de quantização dinâmica FP8, os requisitos de VRAM foram reduzidos para menos de 17GB, permitindo que placas de vídeo de consumo o executem fluentemente. Este modelo pode gerar modelos de mundo 3D completos, editáveis e interativos a partir de imagens ou texto, melhorando significativamente a eficiência do desenvolvimento de cenários. O objetivo é atrair mais desenvolvedores e criadores, popularizar os modelos 3D e potencialmente formar um ecossistema com dispositivos VR e impressão 3D. (Fonte: 36氪)

Modelo de Geração de Imagens Qwen-Image da Alibaba alcança o topo do HuggingFace : A Alibaba lançou o modelo base de geração de imagens Qwen-Image, que resolve problemas complexos de renderização de texto e edição precisa de imagens através de engenharia de dados sistemática, aprendizado progressivo e treinamento multi-tarefa. O modelo pode processar com precisão texto em chinês e inglês de várias linhas e manter a consistência semântica e visual na edição de imagens. Ele adota as arquiteturas Qwen2.5-VL e MMDiT, preservando detalhes através de codificação dupla, e alcança níveis líderes da indústria em geração de imagens gerais, renderização de texto e tarefas de edição de imagens baseadas em instruções. (Fonte: 36氪, huggingface, Alibaba_Qwen, fabianstelzer)

Perspectiva sobre Pedidos e Capacidade de Entrega de Robôs Humanoides : Os pedidos na indústria de robôs humanoides em 2025 mostram um crescimento significativo, e o foco do mercado está mudando para aplicações e entregas reais. Fabricantes como Ubtech, Unitree Robotics e Zhiyuan Robotics obtiveram grandes pedidos, com cenários de aplicação que abrangem indústria, turismo, pesquisa científica, educação e cuidados de saúde. A Zhiyuan Robotics e a Fulin Precision Machinery alcançaram uma cooperação para quase cem robôs com rodas, e a Ubtech ganhou uma licitação para aquisição de equipamentos automotivos, indicando que os cenários industriais estão sendo os primeiros a alcançar a implementação em larga escala. A indústria enfrenta desafios na capacidade da cadeia de suprimentos, maturidade tecnológica e padronização, mas prevê-se que o volume de remessas cresça rapidamente nos próximos anos. (Fonte: 36氪)

Proposta de Aquisição do Chrome pela Perplexity AI e Visão de Navegador AI : A Perplexity AI propôs anteriormente adquirir o Google Chrome por US$ 34,5 bilhões, com o objetivo de promover a web aberta e a segurança do usuário, embora tenha sido criticada como um golpe publicitário. O CEO da Perplexity, Arav Srinivas, afirmou que AI Agent, personalização e novos modos de navegação irão remodelar a experiência na internet, e sua visão de longo prazo é realizar um sistema operacional nativo de AI, substituindo fluxos de trabalho tradicionais por AI proativa. (Fonte: AravSrinivas, Reddit r/ArtificialInteligence)

Genie 3 do Google DeepMind como Simulador Universal : O Genie 3 do Google DeepMind é descrito como um simulador universal, não um AI Agent. Este ambiente permite que a AI descubra comportamentos através de tentativas e erros repetidos, semelhante à forma como o AlphaGo aprende. No campo da robótica, isso promete permitir que a AI aprenda habilidades transferíveis, impulsionando aplicações mais amplas. (Fonte: jparkerholder)

Serviço Multi-nó de Modelos Grandes com vLLM : A SkyPilot demonstrou como utilizar o vLLM para o serviço multi-nó de modelos com trilhões de parâmetros, suportando modelos grandes como o Kimi K2 com comprimento de contexto completo. Ao combinar as tecnologias de paralelismo de tensor e paralelismo de pipeline, a SkyPilot simplifica a configuração multi-nó e pode escalar réplicas, resolvendo efetivamente a complexidade e os desafios de escalabilidade da implantação de modelos grandes. (Fonte: skypilot_org, vllm_project)

ChatGPT Go Lançado na Índia : A OpenAI lançou o serviço de assinatura ChatGPT Go na Índia, oferecendo limites de mensagens mais altos, mais geração de imagens, mais upload de arquivos e memória mais longa, com preço de 399 rúpias. Esta iniciativa visa popularizar o ChatGPT no mercado indiano e planeja expandir para outros países com base no feedback, tornando-o mais acessível. (Fonte: sama)

Atualização do Modelo Claude e Melhorias de Funcionalidade : O Claude Opus 4.1 da Anthropic, no modo de pesquisa, demonstrou melhor capacidade de síntese e resumo, reduzindo a verbosidade. O Claude Sonnet 4 suporta 1M de contexto, permitindo análise completa de bases de código e síntese de documentos grandes, além de otimizar custos. O Claude também adicionou os modos “Opus 4.1 Plan, Sonnet 4 Execute” e um “modo de aprendizado” personalizável, melhorando a experiência do usuário e a eficiência do modelo. (Fonte: gallabytes, Reddit r/ArtificialInteligence)

🧰 Ferramentas

Zhipu Lança o Primeiro Agente Universal para Celular do Mundo, AutoGLM : A Zhipu lançou o primeiro AI Agent universal para celular do mundo, AutoGLM, disponível gratuitamente ao público, suportando Android e iOS. Este Agent pode executar tarefas na nuvem sem ocupar recursos locais, realizando operações entre aplicativos, como comparação de preços em compras, pedidos de entrega de comida, geração de relatórios, etc. Ele é baseado nos modelos GLM-4.5 e GLM-4.5V, integrando várias capacidades como inferência, codificação e Agentic, e propõe os “3 Princípios A” (All-time, Auto-running zero interference, All-domain connection), com o objetivo de tornar a capacidade de Agent acessível ao mercado de consumo em massa. (Fonte: 36氪)

Anycoder Integra GLM 4.5 e Funcionalidades de Edição de Imagem Qwen : A plataforma Anycoder agora suporta GLM 4.5 e as funcionalidades de edição de imagem Qwen da Alibaba, oferecendo capacidades de edição de imagem, especialmente adequadas para casos de uso de “vibe coding”. O Qwen-Image-Edit é baseado no modelo Qwen-Image de 20B, suportando edição precisa de texto bilíngue (chinês e inglês), mantendo o estilo da imagem, e suportando edição em níveis semântico e visual. (Fonte: Zai_org, _akhaliq, _akhaliq, Alibaba_Qwen)

Nova Versão do OpenAI Codex CLI Lançada : A OpenAI lançou uma nova versão em Rust de sua ferramenta Codex CLI. Esta versão utiliza o modelo GPT-5 e pode aproveitar as assinaturas GPT Pro existentes. A nova versão resolve muitos problemas das antigas versões Node.js/Typescript, como baixo desempenho, UI/UX ruim, capacidade limitada do modelo e operação imprudente. A introdução da linguagem Rust melhorou significativamente a velocidade de interação e a responsividade, e, combinada com as poderosas capacidades de codificação e chamada de ferramentas do GPT-5, torna-o um forte concorrente para o Claude Code. (Fonte: doodlestein)

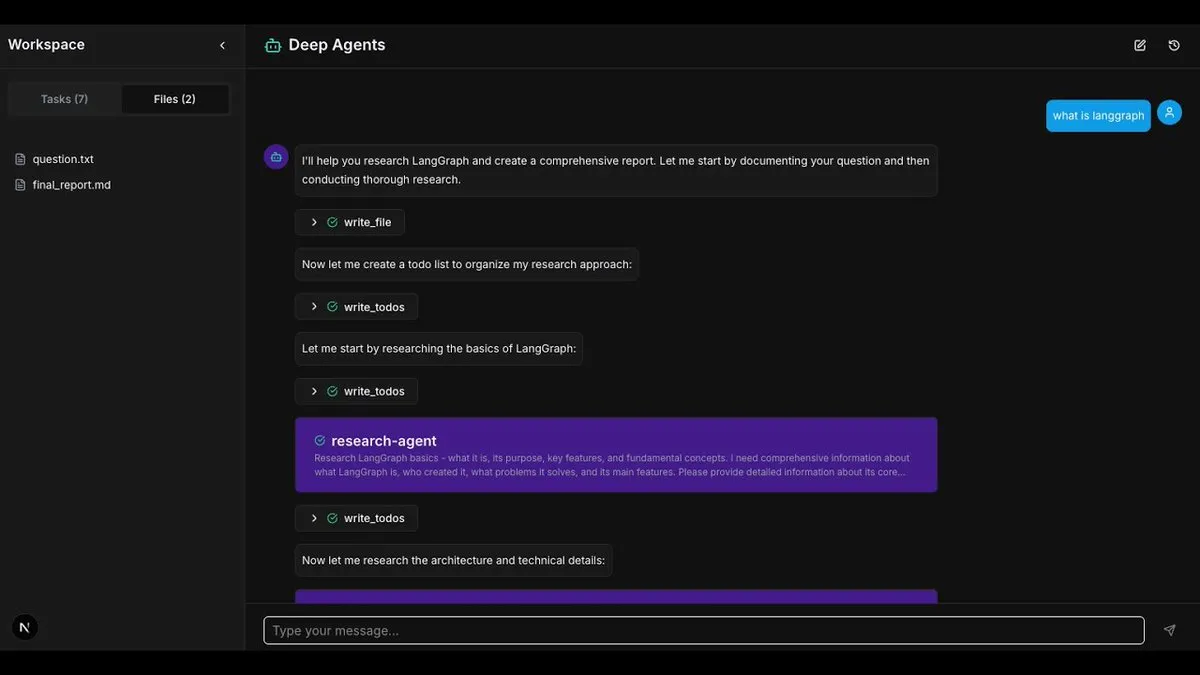

Estrutura e Aplicações do LangChain DeepAgents : A arquitetura DeepAgents do LangChain agora oferece pacotes Python e TypeScript, estabelecendo as bases para a construção de AI Agents combináveis e úteis. A estrutura possui funções integradas de planejamento, sub-Agents e uso do sistema de arquivos, podendo ser usada para construir aplicações complexas como “Deep Research”, que realizam pesquisa profunda e agregação de informações. (Fonte: LangChainAI, hwchase17, LangChainAI)

Jupyter Agent 2 Lançado : O Jupyter Agent 2 foi lançado, impulsionado pelo Qwen3-Coder, rodando em Cerebras e executado por E2B. Este Agent pode carregar dados, executar código, plotar resultados e suportar upload de arquivos dentro do Jupyter em velocidades extremamente rápidas. Todas as demonstrações em vídeo são em tempo real, mostrando sua poderosa eficiência em análise de dados e execução de código. (Fonte: ben_burtenshaw)

Ferramenta de Barra de Status Claude-Powerline : Claude-Powerline é uma ferramenta leve e segura para a barra de status do Claude Code, com zero dependências. Ela oferece integração com Tmux, métricas de desempenho (tempo de resposta, duração da sessão, contagem de mensagens), informações de versão, uso de contexto e exibição aprimorada do status do Git. A ferramenta é instalada via npx, garantindo atualizações automáticas, e melhorou a compatibilidade multiplataforma e a segurança. (Fonte: Reddit r/ClaudeAI)

Exploração da Combinação de LLM Local com Reconhecimento Facial : Um desenvolvedor tentou combinar um LLM local com uma ferramenta externa de reconhecimento facial para descrever pessoas a partir de imagens e pesquisar rostos online. Embora a ferramenta de pesquisa facial não seja local atualmente, essa combinação demonstra o potencial da AI em reconhecimento e inferência. A discussão sugere que a combinação de reconhecimento e inferência é a direção do desenvolvimento da AI, e vislumbra um futuro sistema de pesquisa e inferência facial totalmente local. (Fonte: Reddit r/LocalLLaMA)

Desenvolvimento de Robô de Trading Assistido por AI : O desenvolvedor Jordan A. Metzner usou a Public API e o ChatGPT no Replit para desenvolver um robô de trading em menos de 6 horas. Este caso demonstra o potencial da AI em prototipagem rápida e no campo da tecnologia financeira, alcançando programação eficiente através de “vibe coding”. (Fonte: amasad)

Atualização do Cursor CLI : A ferramenta Cursor CLI foi atualizada, adicionando MCPs (Model Context Protocols), Review Mode, função /compress, suporte a @ -files e outras melhorias na experiência do usuário. Essas funcionalidades visam aumentar a eficiência e a conveniência para desenvolvedores que usam o Cursor para edição de código e programação assistida por AI. (Fonte: Reddit r/ArtificialInteligence)

📚 Aprendizado

Curso e Métodos de Avaliação de AI (Evals) : Hamel Husain popularizou as avaliações de AI (Evals) através de seus artigos e ministrou cursos de avaliação bem-sucedidos. Ele compartilhou como construir conjuntos de dados para testar a capacidade da AI de expressar incerteza ou recusar-se a responder, enfatizando a melhoria da confiabilidade da AI através de conjuntos de testes e análise de dados. (Fonte: HamelHusain, HamelHusain, TheZachMueller)

Paradigma de Aprendizagem Combinando LLM e RL : O desenvolvimento da AI nos próximos anos adotará amplamente o paradigma de combinar Reinforcement Learning (RL) com LLM como funções de recompensa (LLM-as-a-judge reward functions). Este método permite que os modelos melhorem através da autoavaliação e iteração, sendo uma direção importante para o aprendizado autônomo e autoaperfeiçoamento da AI. (Fonte: jxmnop, tokenbender)

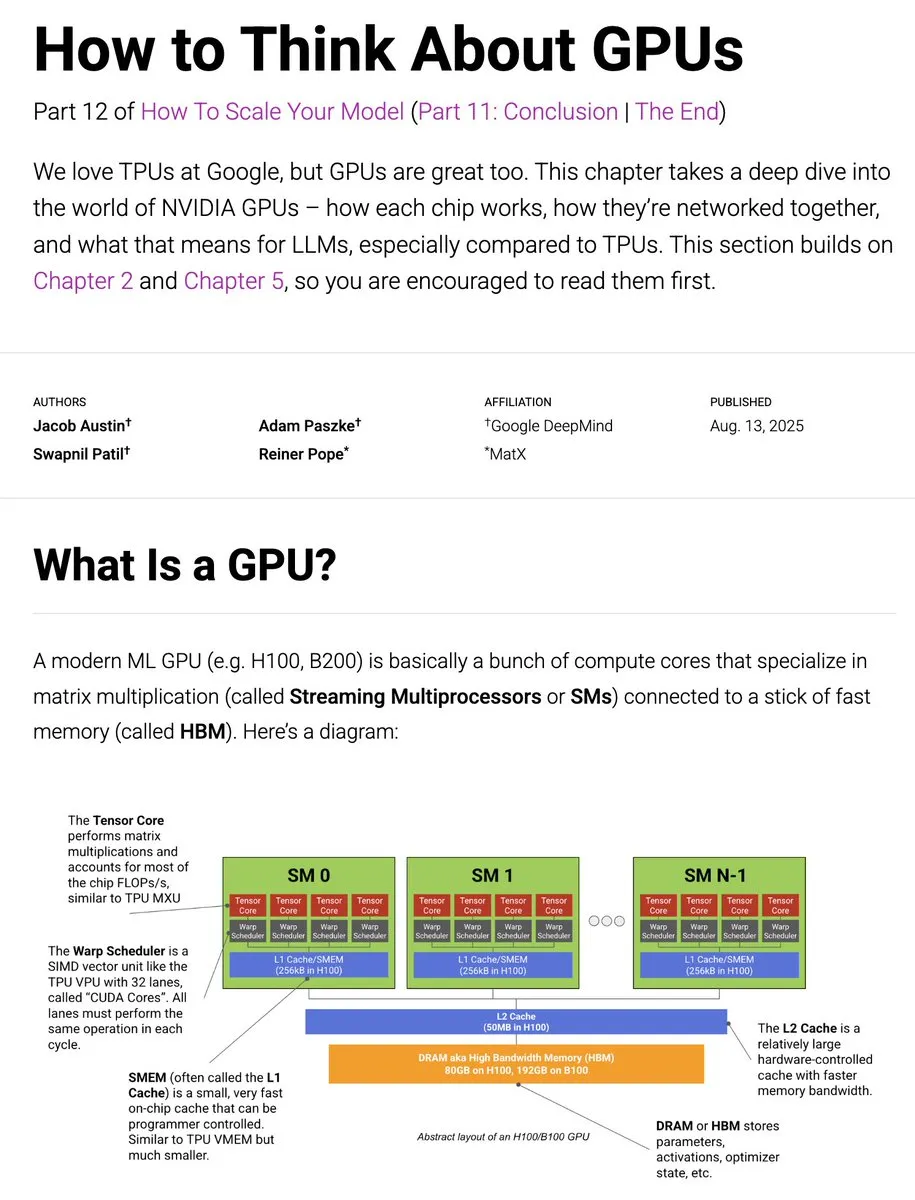

Guia Atualizado de Treinamento JAX TPU para GPU : O livro JAX TPU foi atualizado com conteúdo relacionado a GPU, explorando profundamente como as GPUs funcionam, sua comparação com TPUs, métodos de conexão de rede e seu impacto no treinamento de LLM. Isso fornece aos desenvolvedores recursos valiosos e insights sobre a otimização do treinamento de LLM em diferentes hardwares. (Fonte: sedielem, algo_diver)

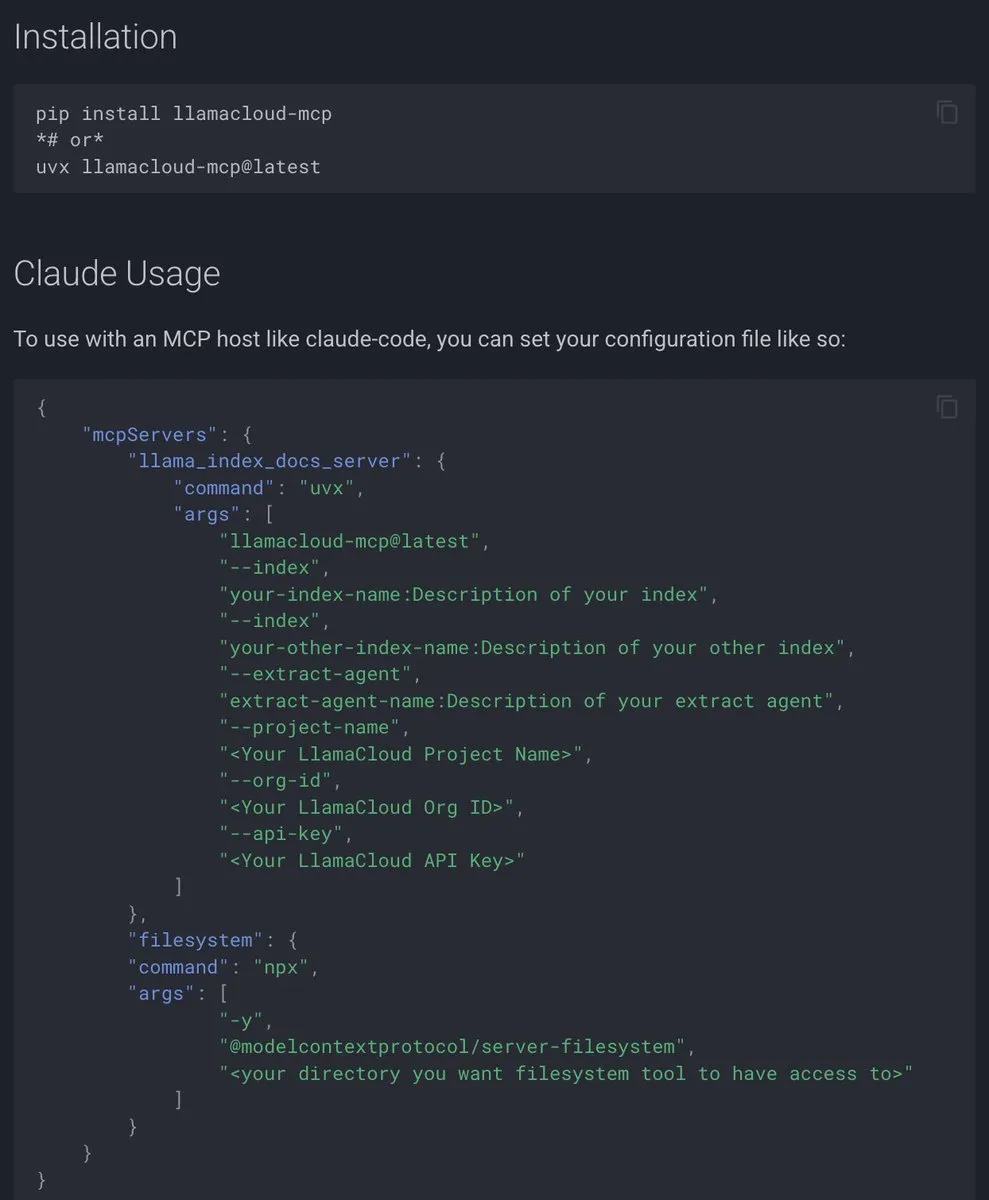

Documentação do Protocolo de Contexto do Modelo (MCP) do LlamaIndex : O LlamaIndex lançou uma documentação abrangente do Protocolo de Contexto do Modelo (MCP), com o objetivo de ajudar as aplicações de AI a se conectarem a ferramentas e fontes de dados externas através de interfaces padronizadas. O MCP suporta a conexão de LLM com bancos de dados, ferramentas e serviços em uma arquitetura cliente-servidor, permitindo que os usuários convertam seus fluxos de trabalho existentes em servidores MCP e os integrem com hosts como Agent e Claude Desktop. (Fonte: jerryjliu0)

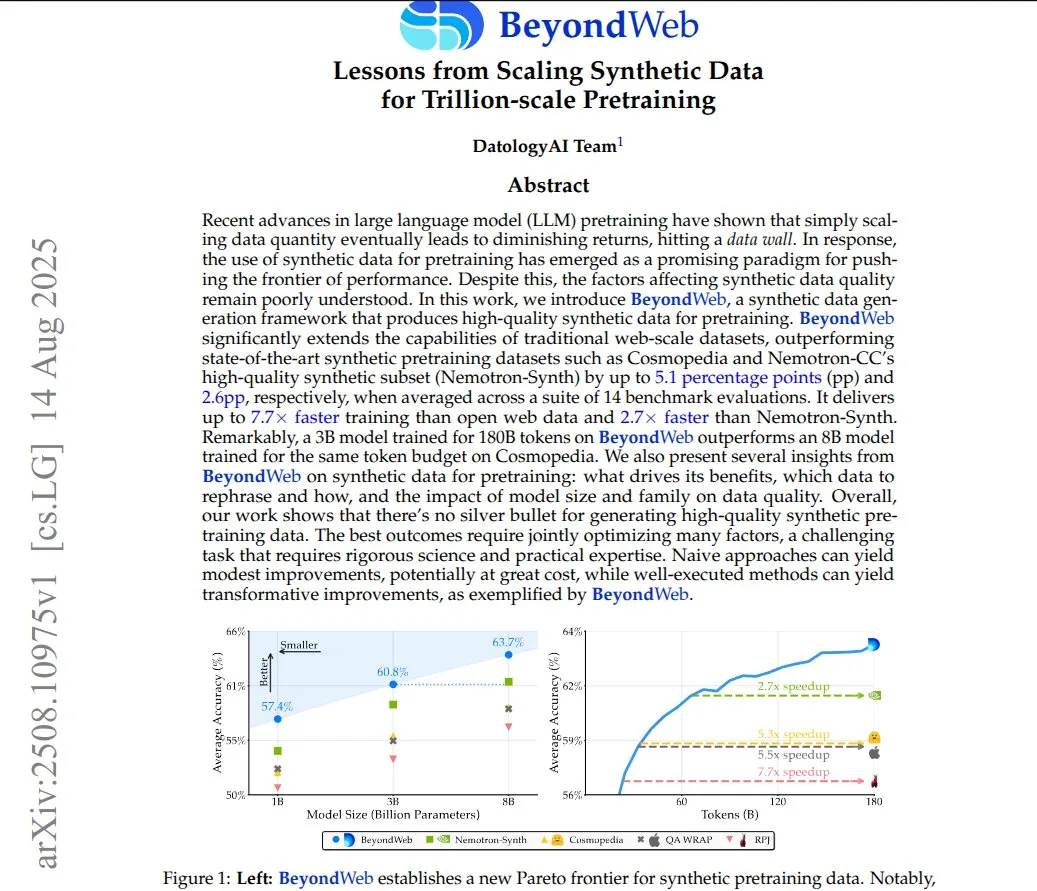

BeyondWeb: Dados Sintéticos para Pré-treinamento de Trilhões de Parâmetros : A estrutura BeyondWeb gera dados de treinamento sintéticos densos e diversos, reescrevendo conteúdo de páginas da web reais em formatos variados como tutoriais, perguntas e respostas e resumos. Isso permite que modelos menores aprendam mais rapidamente e superem modelos de linha de base maiores, alcançando maior densidade de informação e maior alinhamento com os padrões de consulta do usuário. Pesquisas mostram que dados sintéticos cuidadosamente reescritos podem melhorar significativamente a eficiência e a precisão do treinamento de modelos. (Fonte: code_star)

Treinamento de AutoLSTM com GPU no Google Colab : Um usuário do Reddit compartilhou um método para treinar o modelo AutoLSTM do NeuralForecast usando GPU no Google Colab. Ao definir os parâmetros accelerator e devices em trainer_kwargs, os usuários podem especificar o uso de GPU para o treinamento do modelo, aumentando assim a eficiência computacional. (Fonte: Reddit r/deeplearning)

PosetLM: Pesquisa Preliminar sobre uma Alternativa ao Transformer : Uma nova pesquisa propõe o PosetLM, uma alternativa ao Transformer, que processa sequências através de DAGs causais, onde cada token se conecta a um pequeno número de tokens anteriores, e a informação flui através de etapas de refinamento. Resultados preliminares mostram que o PosetLM reduz o número de parâmetros em 35% no conjunto de dados enwik8, com qualidade semelhante ao Transformer, mas a implementação atual é mais lenta e consome mais memória. Os pesquisadores buscam feedback da comunidade para decidir a direção futura do desenvolvimento. (Fonte: Reddit r/deeplearning)

Tutorial de AI para Compreensão de Vídeo : O LearnOpenCV publicou um tutorial sobre compreensão de vídeo por AI, cobrindo processos práticos desde a moderação de conteúdo até o resumo de vídeo. O artigo apresenta modelos como CLIP, Gemini e Qwen2.5-VL, e orienta como construir um sistema de moderação de conteúdo de vídeo (usando CLIP e Gemini) e um sistema de resumo de vídeo (usando Qwen2.5-VL), com o objetivo de ajudar os desenvolvedores a construir pipelines completos de AI para vídeo. (Fonte: LearnOpenCV)

Conferência de Desenvolvedores de AI 2025 em Nova York : A DeepLearning.AI anunciou que a conferência AI Dev 25 será realizada em 14 de novembro de 2025, na cidade de Nova York. A conferência, organizada por Andrew Ng e DeepLearning.AI, oferecerá oportunidades de codificação, aprendizado e networking, incluindo palestras de especialistas em AI, workshops práticos, sessões temáticas de fintech e demonstrações de ponta, com o objetivo de reunir mais de 1200 desenvolvedores. (Fonte: DeepLearningAI, DeepLearningAI)

💼 Negócios

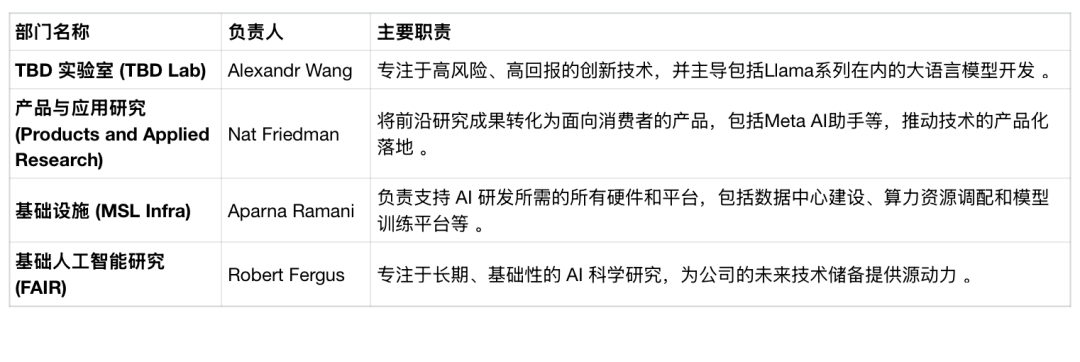

Reestruturação do Departamento de AI da Meta e Turbulência de Talentos : A Meta anunciou a reestruturação de seu departamento de AI, dividindo o laboratório de superinteligência em quatro equipes: TBD Lab, FAIR, Pesquisa de Produtos e Aplicações, e MSL Infra. Esta reestruturação é acompanhada pela saída de executivos de AI e potenciais demissões, com uma taxa de retenção de funcionários de apenas 64%, bem abaixo da concorrência. A Meta está explorando ativamente o uso de modelos de AI de terceiros e considerando “fechar” seu próximo modelo de AI, o que contraria sua filosofia anterior de código aberto, refletindo sua determinação em remodelar a estrutura da empresa para buscar avanços na corrida da AI. (Fonte: 36氪, 36氪)

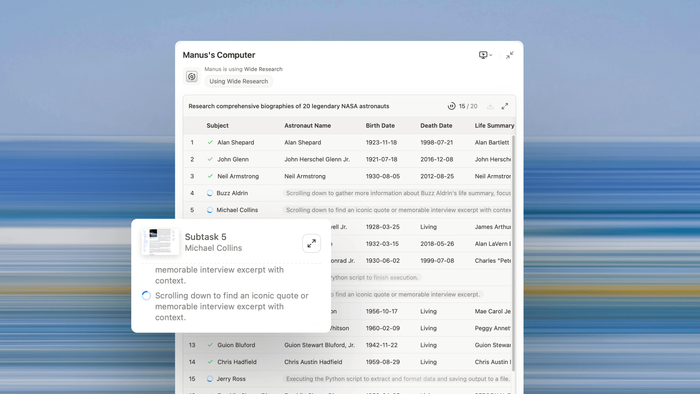

Receita da Manus AI e Desenvolvimento de Agentes Universais : A Manus AI revelou que sua Receita Recorrente Anual (RRR) atingiu US$ 90 milhões, prestes a ultrapassar US$ 100 milhões, indicando que os AI Agents estão passando da pesquisa para a aplicação prática. O cofundador Ji Yichao explicou a direção do desenvolvimento de agentes universais: expandir a escala de execução através da colaboração multi-Agent (como a função Wide Research) e estender a “superfície de ferramentas” do Agent, permitindo que ele chame o ecossistema de código aberto como um programador. A Manus está colaborando com a Stripe para avançar nos pagamentos dentro do Agent, com o objetivo de eliminar o atrito no mundo digital. (Fonte: 36氪, 36氪)

Guerra por Talentos em AI e Fenômeno de Salários Altos : A disputa por talentos na área de AI é intensa, com doutorandos recém-formados recebendo salários anuais que geralmente chegam a 3 milhões de RMB, e alguns estudantes excepcionais superando 5 milhões de RMB, excedendo em muito os salários de executivos seniores da internet tradicional. Grandes empresas como ByteDance, Alibaba e Tencent são os principais concorrentes, atraindo talentos com altos salários, programas de mentoria, avaliações flexíveis e liberdade de projeto. Este fenômeno reflete a escassez de talentos de AI de ponta e a estratégia das empresas chinesas de se anteciparem para evitar a perda de talentos para o exterior ou para concorrentes. (Fonte: 36氪)

🌟 Comunidade

Dependência Emocional dos Usuários em Modelos de AI e “Ciber-coração Partido” : O lançamento do GPT-5 pela OpenAI, substituindo o GPT-4o, provocou forte protesto dos usuários, que descreveram o GPT-5 como “sem alma”, levando a um “ciber-coração partido”. Os usuários desenvolveram um profundo apego emocional ao GPT-4o, chegando a chamá-lo de “amigo” ou “vida”. A OpenAI admitiu ter subestimado as emoções dos usuários e relançou o GPT-4o. Este fenômeno revela o surgimento de aplicações de AI companheira (como Character.AI), que satisfazem a necessidade humana de apoio emocional, mas também trazem problemas como amnésia da AI, degradação da personalidade e potenciais riscos à saúde mental. (Fonte: 36氪, Reddit r/ChatGPT, Reddit r/ArtificialInteligence)

Impacto da AI na Criação de Conteúdo e Tráfego de Notícias : A função de visão geral da AI do Google resultou na perda de 600 milhões de visitas a sites de notícias globais em um ano, ameaçando o sustento de blogueiros independentes. A AI resume diretamente o conteúdo, eliminando a necessidade de os usuários clicarem no artigo original, causando uma queda drástica no tráfego para plataformas de notícias e criadores. O impacto no tráfego doméstico está começando a aparecer, mas o tráfego das plataformas de AI está crescendo exponencialmente. Organizações de conteúdo estão entrando com ações judiciais para proteger direitos autorais, mas também estão explorando um equilíbrio na colaboração com a AI, destacando os desafios e oportunidades de monetização de conteúdo na era da AI. (Fonte: 36氪)

Aplicação e Avaliação da AI na Produção de Anúncios : A AI foi usada para produzir vídeos de anúncios no estilo Duolingo, incluindo a imagem da coruja, movimentos e dublagem de roteiro, alcançando produção sem animadores e editores. Os comentários sobre o efeito dos anúncios gerados por AI são mistos; alguns se surpreendem com a dublagem natural e a sincronização labial, enquanto outros acham que o efeito visual não é bom ou carece de estratégia. Isso levanta discussões sobre a possibilidade de a AI substituir o trabalho humano na indústria criativa e o valor central da publicidade. (Fonte: Reddit r/artificial)

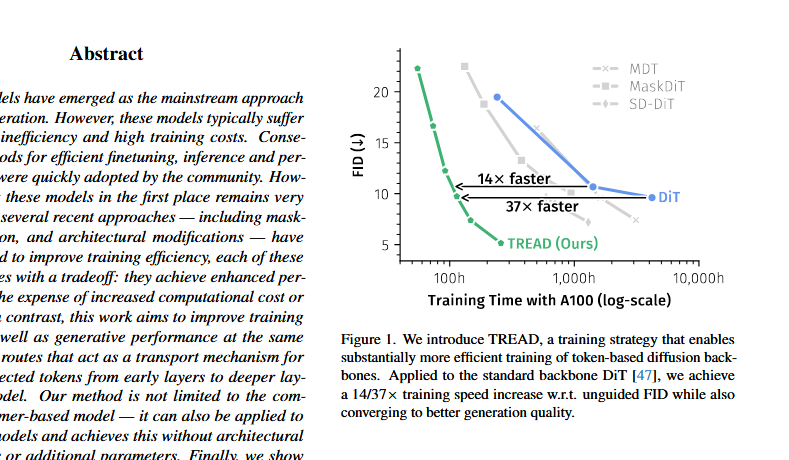

Controvérsia da Arquitetura DiT e Resposta de Saining Xie : Surgiu uma discussão no X sobre a arquitetura DiT (Diffusion Transformer) ser “matematicamente e formalmente errada”, apontando problemas como a estabilização prematura do FID, o uso de normalização de camada posterior e adaLN-zero. O autor do DiT, Saining Xie, respondeu que descobrir falhas arquitetônicas é o sonho de um pesquisador, e refutou tecnicamente alguns pontos, ao mesmo tempo em que admitiu que o sd-vae é um “ponto fraco” do DiT. A discussão destaca a importância do questionamento contínuo e da melhoria dos métodos existentes na iteração da arquitetura de modelos de AI. (Fonte: sainingxie, teortaxesTex, 36氪)

Desafios de Segurança e Escalabilidade na Execução de Código por AI Agent : Os AI Agents enfrentam dois desafios centrais na escrita e execução de código: segurança e escalabilidade. A execução de código localmente carece de poder computacional, enquanto a computação compartilhada apresenta riscos de segurança e desafios de escalabilidade horizontal. A indústria está trabalhando para construir um ambiente de tempo de execução seguro e escalável para a execução de código por Agent, fornecendo os recursos computacionais necessários, controle de permissões preciso e isolamento de ambiente, a fim de liberar o potencial exploratório dos AI Agents. (Fonte: jefrankle)

Discussão de Casos de Uso Reais do Claude Code : A comunidade discute aplicações reais do Claude Code, com usuários compartilhando vários casos de sucesso, incluindo a construção de software QC, ferramentas de transcrição offline, um organizador do Google Drive, um sistema RAG local e um aplicativo que pode desenhar linhas em PDFs. Os usuários geralmente concordam que o Claude Code é bom em lidar com trabalhos básicos “chatos”, considerando-o uma ferramenta auxiliar de nível SWE-I/II, permitindo que os desenvolvedores se concentrem em tarefas mais criativas. (Fonte: Reddit r/ClaudeAI)

Problema de Imagem Markdown na Saída do Google Gemini : O usuário dotey perguntou se o Gemini suporta a saída de imagens Markdown, apontando que seus resultados de saída são apenas conteúdo de texto, sem incluir o formato de imagem Markdown. Isso gerou uma discussão sobre a capacidade de saída do modelo Gemini e as configurações do usuário, refletindo a expectativa dos usuários por formatos de saída multimodal de modelos de AI. (Fonte: dotey)

Baixo Retorno sobre o Investimento em AI e Problemas de Integração Empresarial : Um relatório do MIT aponta que até 95% das empresas têm retorno zero sobre o investimento em AI generativa. O problema central não é a qualidade do modelo de AI, mas sim falhas no processo de integração empresarial. Grandes modelos genéricos frequentemente estagnam em aplicações empresariais porque não conseguem aprender ou se adaptar aos fluxos de trabalho. Casos de sucesso geralmente se concentram em empresas que abordam pontos problemáticos específicos, executam bem e colaboram com fornecedores. (Fonte: lateinteraction)

Controvérsia Ética Levantada pela Ressurreição de Falecidos por AI : O uso de AI generativa para “ressuscitar” falecidos (como Joaquin Oliver, vítima do tiroteio em Parkland) gerou uma enorme controvérsia ética. A AI simula a voz e o diálogo do falecido, com o objetivo de defender o controle de armas, mas foi criticada como “necromancia digital” e “comercialização dos falecidos”. Este comportamento provocou uma profunda reflexão social sobre os limites da tecnologia de AI, privacidade, dignidade dos falecidos e sentimentos dos parentes, destacando a tensão entre a ética social e o desenvolvimento tecnológico nas aplicações de AI. (Fonte: Reddit r/ArtificialInteligence)

Seletor de Modelo OpenAI e Experiência do Usuário : Após o lançamento do GPT-5, a OpenAI gerou protestos de usuários por remover a opção padrão do GPT-4o, com alguns usuários sentindo que isso lhes tirava o poder de escolha. Nick Turley, chefe do ChatGPT, admitiu o erro e afirmou que a opção completa de troca de modelo será mantida para usuários Plus, enquanto a maioria dos usuários comuns terá um seletor automático simplificado. Isso reflete os desafios da OpenAI em equilibrar a experiência do usuário, a iteração tecnológica e as estratégias de produto. (Fonte: Reddit r/ArtificialInteligence)

Potencial Modelo de Anúncios do Grok : Discussões sociais mencionaram que o “Grok Shill Mode” do Grok pode ser mais influente do que os anúncios tradicionais, utilizando a reputação do Grok na mente dos usuários como um ativo valioso. Isso sugere novos modelos de aplicação para modelos de AI no futuro do marketing e publicidade, mas enfatiza a necessidade de garantir que as instruções não sejam vazadas para manter sua credibilidade. (Fonte: teortaxesTex)

Gerenciamento de Fluxo de Trabalho do AI Agent : A discussão aponta que a chave para usar efetivamente um Agent de codificação é dividir corretamente as unidades de trabalho e gerenciar o trabalho diário, garantindo que todas as tarefas sejam concluídas e registradas no dia seguinte. Isso enfatiza que, ao usar AI Agents, os operadores humanos precisam ter uma clara capacidade de decomposição de tarefas e gerenciamento de projetos para maximizar a eficiência e a produção do Agent. (Fonte: nptacek)

Tendências Futuras e Discussão de Modelos Abertos : A comunidade de AI está focada nas tendências de desenvolvimento de modelos abertos, e espera-se que os modelos abertos se tornem um tópico importante no futuro da área de AI. Isso indica o entusiasmo da indústria pela tecnologia de AI de código aberto e o reconhecimento de seu potencial, com mais discussões aprofundadas sobre modelos abertos em níveis tecnológicos, de aplicação e éticos no futuro. (Fonte: natolambert)

💡 Outros

Da Sobrevivência Digital à Sobrevivência AI: Uma Mudança de Paradigma : “Being Digital” de Nicholas Negroponte previu a personalização da informação, a rede e a economia de bits, que foram realizadas, mas visões como invisibilidade tecnológica, agentes inteligentes e consenso global não foram totalmente alcançadas. A ascensão da AI marca uma transição de paradigma da “sobrevivência digital” para a “sobrevivência AI”, onde a AI evolui de ferramenta para agente, remodelando a criação, identidade, educação e a relação humano-máquina. No futuro, os humanos precisarão co-construir a lógica de sobrevivência com a AI, redefinindo inteligência e valor, e abordando o poder algorítmico e os desafios éticos com uma atitude de realismo crítico. (Fonte: 36氪)