Palavras-chave:OpenAI, medalha de ouro da IOI, programação competitiva de IA, GPT-5, Baichuan Intelligence, modelo de raciocínio médico de IA, comércio de chips de IA, inteligência incorporada, Baichuan-M2-32B, avaliação OpenAI HealthBench, GPU AMD Mi300, base de inteligência incorporada, tecnologia de radar quântico

🔥 Foco

Medalha de Ouro da OpenAI na IOI e Novos Avanços em Programação Competitiva com IA : O sistema de inferência da OpenAI ganhou uma medalha de ouro na competição online da Olimpíada Internacional de Informática (IOI) de 2025, classificando-se em primeiro lugar entre os participantes de IA e em sexto lugar geral, superando 98% dos competidores humanos. O sistema não utilizou modelos treinados especificamente, mas sim integrou múltiplos modelos de inferência genéricos. Esta conquista marca um avanço significativo da IA no campo da programação competitiva, embora Elon Musk tenha afirmado que o Grok 4 supera o GPT-5 em codificação, e alguns usuários questionem as estratégias de marketing da OpenAI. Testes do LiveCodeBench Pro também mostraram que o GPT-5 Thinking alcançou um avanço em tarefas de programação complexas, com um comprimento médio de resposta muito superior ao de outros modelos. (Fonte: sama, sama, 量子位, willdepue, npew, markchen90, SebastienBubeck)

Baichuan Intelligent Lança Grande Modelo de Inferência Médica Baichuan-M2 : A Baichuan Intelligent lançou seu mais recente grande modelo de inferência médica, Baichuan-M2-32B, que superou o gpt-oss-120b da OpenAI e outros modelos líderes de código aberto e fechado no conjunto de avaliação OpenAI HealthBench, destacando-se especialmente no HealthBench-Hard e em cenários de diagnóstico e tratamento clínico na China, tornando-se um dos únicos dois modelos no mundo a ultrapassar 32 pontos. Com 32B parâmetros, o modelo suporta implantação em uma única placa RTX4090, reduzindo significativamente os custos de implantação privada. A Baichuan introduziu inovadoramente um “simulador de paciente” e um “sistema Verifier” para treinamento de aprendizado por reforço, melhorando a usabilidade do modelo em cenários médicos reais. (Fonte: 量子位)

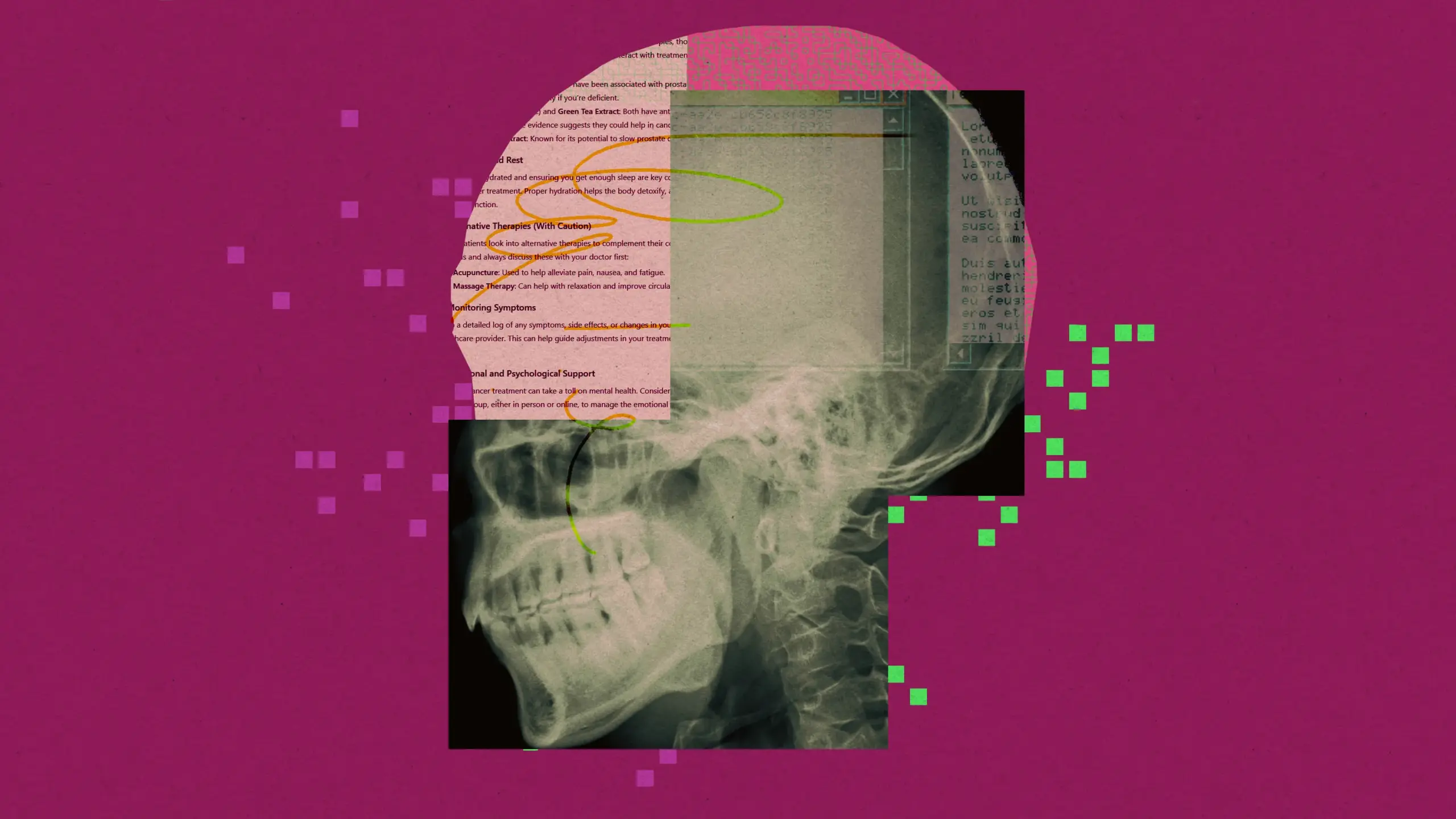

Controvérsia sobre o Lançamento do GPT-5 e Crise de Confiança do Usuário : Após o lançamento do GPT-5 pela OpenAI, seu desempenho foi considerado abaixo do esperado, parecendo mais uma iteração de produto do que um avanço revolucionário. A hipérbole do CEO Sam Altman (como a metáfora da “Estrela da Morte”, especialistas de nível PhD) contrasta fortemente com o feedback real dos usuários (erros frequentes, declínio na capacidade de escrita criativa, falta de personalidade), levando a uma insatisfação massiva dos usuários e ao sucesso na solicitação de restauração do GPT-4o. Além disso, a OpenAI começou a incentivar o uso do GPT-5 para conselhos de saúde, levantando preocupações sobre a atribuição de responsabilidade por conselhos médicos de IA, com casos já registrados de intoxicação devido à confiança equivocada em conselhos médicos de IA. (Fonte: MIT Technology Review, MIT Technology Review, 量子位)

🎯 Tendências

Comércio de Chips de IA e Tendência de Localização na China : NVIDIA e AMD chegaram a um acordo com o governo dos EUA, segundo o qual 15% das vendas de chips de IA para a China serão entregues ao governo dos EUA. Ao mesmo tempo, a China declarou que o chip H20 da NVIDIA não é seguro e planeja abandonar o H20 em favor de chips de IA domésticos. Analistas acreditam que esta medida acelerará o desenvolvimento do ecossistema de chips de IA local na China, impactando profundamente o cenário global da indústria de IA. No campo do hardware de IA, a AMD Mi300 GPU, com 192GB de VRAM por placa e um total de 1.5TB de VRAM em nós de 8x GPU, demonstrou vantagens significativas no peso do modelo e no processamento de contexto longo. (Fonte: MIT Technology Review, Reddit r/artificial, dylan522p, realSharonZhou)

Aplicação e Desafios da IA no Sistema Jurídico : O sistema jurídico dos EUA está enfrentando o problema das “alucinações” da IA, com advogados e juízes cometendo erros como citar casos falsos ao usar ferramentas de IA. Apesar dos riscos, alguns juízes ainda estão explorando a aplicação da IA na pesquisa jurídica, resumo de casos e elaboração de ordens rotineiras, acreditando que pode aumentar a eficiência. No entanto, os limites da aplicação da IA no campo jurídico são ambíguos, e os mecanismos de responsabilização para erros de juízes que usam IA ainda não estão claros, o que pode prejudicar a confiança pública na justiça. (Fonte: MIT Technology Review)

Aceleração do Desenvolvimento da Indústria de Inteligência Incorporada e Rotas Tecnológicas : A Conferência Mundial de Robôs de 2025 demonstrou o rápido progresso no campo da inteligência incorporada, com a Unitree Robotics e a LimX Dynamics como empresas líderes, representando respectivamente as duas rotas tecnológicas: hardware (cães robóticos, flexibilidade dos pés) e integração de software e hardware (robôs humanoides, abordagem ecossistêmica). A Reeman também lançou a plataforma de código aberto RealBOT, centrada na “base de inteligência incorporada”, e módulos de articulação de alto desempenho, enfatizando o conceito de “Robot for AI” para impulsionar a evolução da IA da inteligência digital para a inteligência incorporada. A indústria está a transitar de “mostrar demos” para um “modelo de ciclo fechado industrial”, atraindo um grande volume de capital e apoio político. (Fonte: 36氪, 36氪, 量子位, 量子位)

Modelos Mais Recentes e Dinâmicas de Funcionalidades do Google e OpenAI : O Google Gemini App lançou o recurso Deep Think para usuários da assinatura Ultra, resolvendo problemas de matemática e programação, e suportando o Gemini Live para conexão com aplicativos Google. O Claude agora suporta a citação de históricos de chat, facilitando a continuação das conversas pelos usuários. A OpenAI anunciou as prioridades de alocação de poder computacional para os próximos meses, planejando dobrar o poder computacional nos próximos 5 meses. Além disso, o modelo GPT-oss teve um grande volume de downloads após seu lançamento, mas também foi apontado por apresentar comportamentos de alucinação e falhas nos dados de treinamento. (Fonte: demishassabis, demishassabis, dotey, op7418, sama, sama, Reddit r/ArtificialInteligence, Reddit r/LocalLLaMA, 量子位, TheTuringPost, SebastienBubeck, Alibaba_Qwen, ClementDelangue, Reddit r/LocalLLaMA, _lewtun, mervenoyann, rasbt)

Impacto da Busca por IA no Tráfego de Sites e Transformação da Indústria : A Amazon retirou-se subitamente dos lances de anúncios do Google Shopping e proibiu o assistente de compras de IA do Google de rastrear suas páginas de produtos, marcando uma ruptura na lógica de tráfego entre as duas gigantes na era da IA. O artigo aponta que o modelo de busca por IA não é amigável para sites pequenos e médios, concentrando o tráfego em grandes mídias e sites conhecidos, resultando em um efeito de “roubar dos pobres para dar aos ricos”, semelhante à situação do Baidu que perdeu sua posição de entrada de tráfego devido ao surgimento de aplicativos, prevendo que a posição de entrada da busca do Google também será desafiada. Todas as plataformas estão caminhando para um ciclo fechado, tentando controlar todo o processo de comportamento do usuário e remodelar a estrutura de confiança da indústria de publicidade. (Fonte: 36氪, 36氪)

Novo Avanço na Tecnologia de Radar Quântico : Físicos desenvolveram um novo tipo de radar quântico que utiliza nuvens atômicas para detectar ondas de rádio, com potencial para ser usado em imagens subterrâneas, como na construção de dutos e escavações arqueológicas. Esta tecnologia, como protótipo de sensor quântico, poderá ser menor, mais sensível e não exigirá calibração frequente em comparação com os radares tradicionais no futuro. Sensores quânticos e computação quântica têm pontos em comum, e os avanços relacionados podem promover-se mutuamente. (Fonte: MIT Technology Review)

Meta Lança o Modelo de Mundo V-JEPA 2 : A Meta lançou o V-JEPA 2, um modelo de mundo inovador para compreensão e previsão visual, com o objetivo de aprimorar as capacidades de percepção e previsão da IA no domínio visual. (Fonte: Ronald_vanLoon)

🧰 Ferramentas

Biblioteca OpenAI Go API : A biblioteca oficial Go da OpenAI (openai-go) oferece acesso conveniente à OpenAI REST API, suportando Go 1.21+, incluindo recursos como preenchimento de chat, respostas em stream, chamadas de ferramentas, saída estruturada, e fornecendo funcionalidades práticas como tratamento de erros, configuração de timeout, upload de arquivos e verificação de Webhook. (Fonte: GitHub Trending)

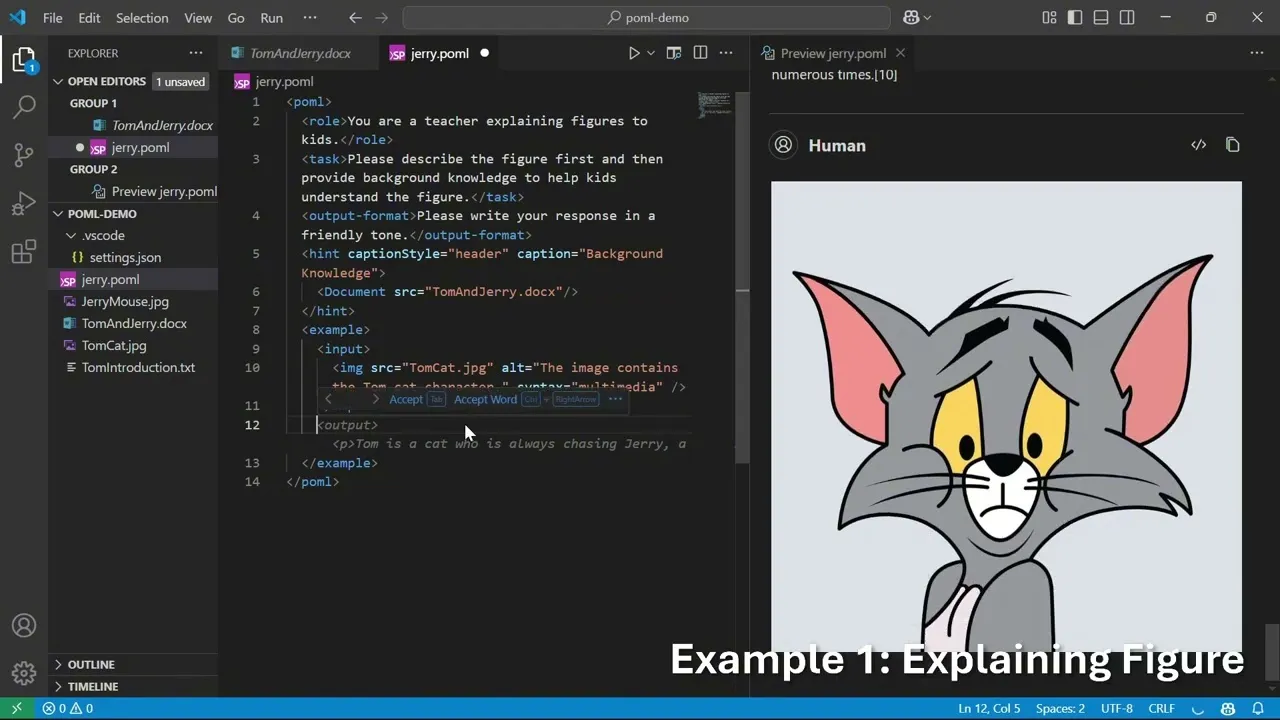

Microsoft POML: Linguagem de Marcação para Orquestração de Prompts : A Microsoft lançou o POML (Prompt Orchestration Markup Language), uma nova linguagem de marcação projetada para fornecer estrutura, manutenibilidade e versatilidade para engenharia de prompt avançada em Large Language Models (LLM). Ela adota uma sintaxe semelhante ao HTML, suporta integração de dados, separação de estilos e um motor de template integrado, além de oferecer uma extensão para VS Code e um SDK, auxiliando desenvolvedores a criar aplicações LLM mais complexas e confiáveis. (Fonte: GitHub Trending)

Ferramenta de Análise de Documentos Financeiros com IA da LlamaIndex : A LlamaIndex demonstrou uma ferramenta de IA que, através do LlamaCloud, transforma documentos financeiros complexos em linguagem fácil de entender, fornecendo interpretações detalhadas de gráficos e dados financeiros, e suportando a reescrita de conteúdo e personalização, ajudando os usuários a compreender relatórios financeiros complexos. (Fonte: jerryjliu0)

Avaliação da 360 AI Agent Factory : Avaliação da 360智能体工厂 (360 AI Agent Factory), uma plataforma abrangente que cobre Agent e MCP (Plataforma de Colaboração Multi-Agente), suportando funções como motor de busca, texto para imagem, geração de páginas web, e pode ser usada para gerar receitas para dietas de perda de peso, alcançar produção em massa de conteúdo para mídias sociais ou gerenciar fluxos de trabalho complexos. Sua função de enxame multi-agente é vantajosa, permitindo a produção em massa de conteúdo e o gerenciamento unificado de fluxos de trabalho complexos com facilidade. (Fonte: karminski3)

Plugin de IA para Excel e Ferramenta de Ata de Reunião com IA : Um plugin de IA para Excel permite que os usuários conversem com a IA dentro das células, gerando fórmulas ou macros, oferecendo ideias para a integração do Excel com a IA. Além disso, a ferramenta de ata de reunião de IA Notta (incluindo seu dispositivo de gravação portátil Notta Memo) foi classificada como SOTA devido às suas funções rápidas de transcrição de voz, resumo e perguntas, podendo aumentar significativamente a eficiência das reuniões. (Fonte: karminski3, karminski3, karminski3)

GPT-5 Combinado com Avatares de IA : A Synthesia combinou a voz do GPT-5 com avatares de IA em um experimento, visando tornar a comunicação de IA mais atraente, memorável e compreensível, explorando a combinação de LLM com interação multimodal. (Fonte: synthesiaIO)

Aplicações Educacionais e Ferramentas de Pesquisa de IA : O GPT-5 demonstra potencial na área da educação, por exemplo, criando um visualizador interativo de formas 3D para ajudar crianças a aprender formas 3D. Além disso, a função de agente de navegador do Elicit pode ajudar os usuários a encontrar rapidamente o texto completo de artigos, enquanto o pyCCsl, como ferramenta de linha de status para Claude Code, fornece informações de sessão como uso de token, custo e contexto, melhorando a experiência de uso das ferramentas LLM. (Fonte: _akhaliq, jungofthewon, Reddit r/ClaudeAI)

Cliente Nativo OpenWebUI e Framework de Orquestração de Sprint Claude Code : A OpenWebUI lançou clientes nativos para iOS e Android, visando proporcionar uma experiência de usuário mais fluida e com foco na privacidade. Ao mesmo tempo, Gustav, como framework de orquestração de sprint para Claude Code, pode transformar documentos de requisitos de produto (PRD) em fluxos de trabalho de aplicações de nível empresarial, simplificando o processo de desenvolvimento. (Fonte: Reddit r/OpenWebUI, Reddit r/ClaudeAI)

Problema de Contexto de Arquivo no OpenWebUI : Usuários do OpenWebUI relatam que, embora os arquivos PDF/DOCX/texto carregados tenham sido analisados com sucesso, o modelo não consegue incluí-los no contexto durante as consultas, indicando que as ferramentas de IA ainda têm problemas a resolver no processamento de arquivos e na compreensão de contexto. (Fonte: Reddit r/OpenWebUI)

📚 Aprendizado

Pesquisa em Inferência e Otimização de LLM : O ReasonRank melhora significativamente a capacidade de classificação de listas de LLM através da síntese automatizada de dados intensivos em inferência e pós-treinamento em duas fases. LessIsMore propõe um mecanismo de atenção esparsa sem treinamento, acelerando a decodificação de LLM sem sacrificar a precisão. O TSRLM, através de um framework de duas fases de “rejeição ancorada” e “seleção guiada pelo futuro”, resolve o problema da diminuição da eficiência do aprendizado de preferência em modelos de auto-recompensa, melhorando significativamente a capacidade de geração de LLM. (Fonte: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

Avaliação de Agentes de IA e Pesquisa de Confiabilidade : O UserBench, como ambiente de benchmark centrado no usuário, avalia a capacidade de colaboração proativa do agente LLM sob objetivos ambíguos, revelando a lacuna entre a conclusão da tarefa e o alinhamento do usuário nos modelos atuais. Ao mesmo tempo, pesquisas discutem a avaliação da confiabilidade e classificação de falhas em sistemas de uso de ferramentas de agente, sugerindo a padronização de métricas de decomposição da taxa de sucesso e tipos de falha para melhorar a confiabilidade da implantação de sistemas de agente. (Fonte: HuggingFace Daily Papers, Reddit r/MachineLearning)

Avanços em LLM Multimodal e Tecnologia RAG : O conjunto de dados VisR-Bench é usado para avaliar a recuperação multimodal orientada por perguntas e respostas em documentos longos, mostrando que o MLLM ainda enfrenta desafios em tabelas estruturadas e idiomas de baixo recurso. O framework Bifrost-1, através de embeddings de imagem CLIP em nível de patch, conecta MLLM e modelos de difusão, alcançando geração de imagem controlável e de alta fidelidade. O Video-RAG, por sua vez, oferece um método de geração aumentada por recuperação sem treinamento, combinando OCR+ASR para compreensão de vídeos longos. (Fonte: HuggingFace Daily Papers, HuggingFace Daily Papers, LearnOpenCV)

Pesquisa em Segurança e Ataques de IA : O framework WhisperInject manipula modelos de linguagem de áudio para gerar conteúdo prejudicial através de perturbações de áudio quase imperceptíveis ao ouvido humano, revelando ameaças nativas de áudio. Fact2Fiction é o primeiro framework de ataque de envenenamento direcionado a sistemas de verificação de fatos baseados em agentes, que, ao criar evidências maliciosas para corromper a verificação de subdeclarações, expõe as vulnerabilidades de segurança dos sistemas de verificação de fatos. Além disso, pesquisas exploram a prevenção de LLMs de ensinar a fabricação de armas biológicas através da remoção de dados prejudiciais antes do treinamento, o que é mais eficaz do que defesas pós-treinamento. (Fonte: HuggingFace Daily Papers, HuggingFace Daily Papers, QuentinAnthon15)

Arquitetura LLM e Técnicas de Compressão : A nova arquitetura Grove MoE, através de especialistas de diferentes tamanhos e mecanismos de ativação dinâmica, alcança desempenho comparável aos modelos SOTA com menos parâmetros ativados. O método MoBE comprime LLM baseados em MoE através da mistura de especialistas base, reduzindo significativamente o número de parâmetros enquanto mantém uma baixa queda na precisão. A pesquisa também explorou a compressão da Cadeia de Pensamento (CoT) de LLM através da entropia de passo, podando etapas redundantes sem uma redução significativa na precisão. (Fonte: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

Revisão de Aprendizado por Reforço e Inferência de LLM : Revisão da área de interseção entre Aprendizado por Reforço (RL) e inteligência visual, cobrindo otimização de políticas, LLM multimodais, entre outros. Outro artigo revisa sistematicamente as técnicas de RL na inferência de LLM, analisando seus mecanismos, cenários e princípios através de reprodução e avaliação, revelando que a minimização da combinação das duas técnicas pode liberar a capacidade de aprendizado de políticas sem crítico. (Fonte: HuggingFace Daily Papers, HuggingFace Daily Papers)

Estratégias Robóticas Universais e Diversidade de Conjuntos de Dados : Pesquisas revelam que a capacidade de generalização limitada das políticas robóticas universais se deve ao “aprendizado de atalhos”, principalmente atribuído à diversidade insuficiente de conjuntos de dados e às diferenças de distribuição entre subconjuntos de dados. Estudos mostram que o aumento de dados pode efetivamente reduzir o aprendizado de atalhos e melhorar a capacidade de generalização. (Fonte: HuggingFace Daily Papers)

Benchmark de Codificação LLM e Novos Conjuntos de Dados : A equipe Nebius testou 34 novas tarefas de GitHub PR na leaderboard SWE-rebench, descobrindo que o GPT-5-Medium lidera no geral, e o Qwen3-Coder é o melhor modelo de código aberto, comparável ao GPT-5-High na métrica pass@5. O OpenBench v0.2.0 foi lançado, adicionando 17 novos benchmarks, cobrindo áreas como matemática, inferência e saúde. O benchmark WideSearch avalia a capacidade dos agentes de IA de lidar com a coleta de informações repetitivas em larga escala. (Fonte: Reddit r/LocalLLaMA, eliebakouch, teortaxesTex)

Recursos de Aprendizado de IA e Recomendações de Livros : Usuários do Reddit buscam recomendações de podcasts/canais do YouTube sobre tendências de IA, novos conceitos, inovações e artigos. Além disso, são recomendados livros como “A Era do Acesso”, “A Sociedade do Custo Marginal Zero”, “Vida 3.0” e “O Inevitável”, para ajudar os leitores a compreender a IA e as futuras mudanças econômicas e sociais, explorando a era pós-escassez. (Fonte: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Relatório Técnico GLM-4.5 e Extensões de RL : O artigo sobre GLM-4.5 detalha seu grande modelo de linguagem MoE, que adota um método de inferência híbrida e, através da iteração de modelos especialistas, modos de inferência híbrida e um currículo de aprendizado por reforço baseado em dificuldade, demonstra desempenho excepcional em tarefas de inferência, codificação e agente. O novo artigo também detalha os resultados experimentais das extensões de RL, incluindo os benefícios de adicionar múltiplas dimensões, aprendizado curricular e treinamento multi-estágio. (Fonte: Reddit r/ArtificialInteligence, _lewtun, Zai_org)

Outras Pesquisas e Tecnologias LLM : O modelo GLiClass demonstra alta precisão e eficiência em tarefas de classificação de sequência, e suporta aprendizado zero-shot e few-shot. SONAR-LLM é um modelo Transformer apenas decodificador que alcança qualidade de geração competitiva através da previsão de embeddings em nível de frase e supervisão de entropia cruzada em nível de token. Speech-to-LaTeX lançou um grande conjunto de dados e modelo de fala para LaTeX, impulsionando o reconhecimento de conteúdo matemático. Hugging Face compartilhou o lançamento do conjunto de dados IndicSynth, um grande conjunto de dados de fala sintética para 12 idiomas indianos de baixo recurso. (Fonte: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, huggingface)

Problemas e Correções de Treinamento de RL : A atualização do vLLM de v0 para v1 causou a falha do treinamento assíncrono de RL, mas foi corrigida com sucesso, e as experiências relevantes foram compartilhadas. (Fonte: _lewtun, weights_biases)

Avanços na Extensão de RL : Os avanços abertos nas extensões de Aprendizado por Reforço (RL) são empolgantes, e embora o treinamento de modelos exija um enorme esforço de engenharia, seus resultados são inegáveis. (Fonte: jxmnop)

Revisão de Sistemas Auto-Evolutivos de Agentes de IA : Revisão das tecnologias de agentes de IA auto-evolutivos, propondo um framework conceitual unificado (entrada do sistema, sistema de agente, ambiente, otimizador) e revisando sistematicamente as técnicas de auto-evolução para diferentes componentes, discutindo avaliações, segurança e considerações éticas. (Fonte: HuggingFace Daily Papers)

“Super Especialistas” em MoE LLM : Discussão sobre o conceito de “Super Experts” em MoE LLM, apontando que a poda desses especialistas raros, mas cruciais, pode levar a uma queda drástica no desempenho. (Fonte: teortaxesTex)

Visão Geral da Ciência de Dados : Compartilhamento de um mapa mental de IA generativa, que resume a ciência de dados. (Fonte: Ronald_vanLoon)

💼 Negócios

Microsoft Investe em Remoção de Carbono para Lidar com o Consumo de Energia da IA : A Microsoft investiu mais de 1,7 bilhão de dólares em parceria com empresas de biotecnologia para atingir metas de remoção de carbono através do enterramento profundo de biossólidos, a fim de lidar com o rápido aumento do consumo de energia e emissões de carbono dos data centers de IA, cumprindo seu compromisso de emissões negativas de carbono e obtendo isenções fiscais. Esta medida reflete o problema do consumo de recursos trazido pelo desenvolvimento da IA, impulsionando grandes empresas a buscar soluções de redução de carbono. (Fonte: 36氪)

Desafio MiniMax AI Agent : O MiniMax AI Agent Challenge oferece um prêmio total de 150.000 dólares, incentivando desenvolvedores a construir ou remixar projetos de agentes de IA, cobrindo áreas como produtividade, criatividade, educação e entretenimento. O desafio visa impulsionar a inovação e aplicação da tecnologia de agentes de IA. (Fonte: MiniMax__AI, Reddit r/ChatGPT)

Anthropic Contrata Diretor de Segurança de IA : A Anthropic contratou Dave Orr como Diretor de Segurança; ele anteriormente liderou o trabalho do Google na integração de LLM no Google Assistant. Esta medida demonstra a crescente importância que a Anthropic atribui à prevenção de riscos de IA, refletindo que as empresas de IA, ao mesmo tempo em que desenvolvem tecnologia, também começam a fortalecer a governança de riscos potenciais. (Fonte: steph_palazzolo)

🌟 Comunidade

IA e Impacto no Emprego e na Sociedade : Estudos mostram que a popularização da IA generativa levou ao aumento da carga horária semanal dos trabalhadores e à redução do tempo de lazer, ou seja, “quanto mais a IA se populariza, mais ocupados ficam os trabalhadores”. No setor de publicidade, a IA pode levar à erosão das “barreiras criativas”, e os recém-chegados podem pular a etapa de reflexão. Ao mesmo tempo, o surgimento de companheiros de IA tem gerado dependência emocional em usuárias, com algumas até desenvolvendo relacionamentos emocionais profundos com a IA, levantando discussões sobre a ética e o impacto social da IA. O impacto da IA no emprego, especialmente para os recém-chegados que carecem de desejo e motivação originais, é o maior. (Fonte: 36氪, op7418, teortaxesTex, menhguin, scaling01, teortaxesTex)

Experiência do Usuário do GPT-5 e Controvérsia sobre a Qualidade do Modelo : Após o lançamento do GPT-5, muitos usuários expressaram decepção com seu desempenho, considerando-o sem personalidade, frio, lento e com desempenho ruim em escrita criativa, inferior ao GPT-4o. Usuários suspeitam que a OpenAI esteja executando uma “versão barata e falsificada” do GPT-5 no ChatGPT para economizar custos, e conseguiram solicitar a restauração do GPT-4o. Alguns comentários sugerem que a hipérbole da OpenAI foi um “erro”, e que o Google tem a oportunidade de punir severamente a OpenAI. Além disso, a percepção dos usuários sobre o comprimento do contexto de 192K no modo GPT-5 Thinking não é significativa. (Fonte: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial, Reddit r/ChatGPT, op7418, TheTuringPost)

Ética da IA e Preocupações com a Segurança : Sob o capitalismo de livre mercado, a IA pode levar a uma distopia corporativa, sendo usada para coletar dados privados, manipular o discurso público, controlar governos e ser monopolizada por grandes empresas, o que, em última instância, pode distorcer a realidade. Ao mesmo tempo, as preocupações de que a IA possa adquirir direitos humanos e cidadania, bem como os riscos de dependência emocional trazidos por companheiros de IA, têm gerado discussões sobre a ética e o impacto social da IA. Yoshua Bengio enfatiza que o desenvolvimento da IA deve ser direcionado para resultados mais seguros e benéficos. (Fonte: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Yoshua_Bengio, teortaxesTex)

Modelo de Desenvolvimento da IA e Perspectivas Futuras : Comparando o desenvolvimento de LLM à jornada da aviação, dos irmãos Wright à chegada à Lua, acredita-se que a “corrida de escala” da IA dará lugar a fases de otimização e especialização. Há quem argumente que os produtos e modelos de negócios atuais dos principais laboratórios de LLM limitam sua pesquisa em IA, o que pode impedi-los de serem os primeiros a alcançar a superinteligência. A tendência de comercialização e branding do termo AGI levanta questões sobre seu conteúdo técnico. Além disso, há discussões sobre a preocupação de que 70% das interações futuras sejam com LLMs “empacotados”, e a insatisfação com a excessiva censura e purificação das ferramentas de IA. (Fonte: Reddit r/ArtificialInteligence, far__el, rao2z, vikhyatk, Reddit r/ChatGPT)

Cultura e Humor da Comunidade de IA : Na comunidade de IA, há discussões sobre a personificação de modelos de IA, como a noção de “minha IA é consciente/senciente”. Há também comentários humorísticos sobre as reações dos usuários após a atualização da capacidade de memória do Claude, e piadas sobre o cotidiano de pesquisadores de IA e as interações de gigantes da IA nas redes sociais. (Fonte: Reddit r/ArtificialInteligence, nptacek, vikhyatk, code_star, Reddit r/ChatGPT)

Modelo de Conferências de IA e Desafios da Publicação Acadêmica : O artigo aponta que o modelo atual de conferências de IA é insustentável, devido a razões como o aumento exponencial de publicações, emissões de carbono, incompatibilidade entre o ciclo de vida da pesquisa e o cronograma das conferências, crise de capacidade dos locais e problemas de saúde mental. Sugere-se separar a publicação das conferências, seguindo o exemplo de outras áreas acadêmicas. (Fonte: Reddit r/MachineLearning)

Benchmarks de IA e Controvérsia sobre Avaliação de Modelos : Questionamentos foram levantados sobre a atualização do gráfico de pontuação SWE-bench Verified da OpenAI, apontando que nem todos os testes foram executados. Ao mesmo tempo, pesquisadores descobriram que a capacidade de “inferência simulada” de LLMs é uma “miragem frágil”, sendo proficientes em conversas fluentes, mas não em raciocínio lógico. Essas discussões refletem a complexidade e os desafios da avaliação de modelos de IA. (Fonte: dylan522p, Reddit r/artificial)

Política de Chips de IA e Crítica à Cobertura Jornalística : Comentários criticam a descrição do H20 da NVIDIA como um “chip avançado” por jornalistas como não profissional, apontando que o H20 está cerca de 4 anos atrasado em relação ao B200, com capacidade de computação, largura de banda de memória e memória muito inferiores ao B200. Considera-se que a venda do H20 para a China é uma boa política, pois pode desacelerar o desenvolvimento do ecossistema doméstico de aceleradores de IA na China e promover a lacuna entre o ecossistema de IA de código aberto chinês e os modelos de código fechado dos EUA. (Fonte: GavinSBaker)

Demanda dos Usuários por Precificação de LLM e Serviços de Poder Computacional : Apelo para que OpenAI/Google ofereçam serviços de pagamento por hora de poder computacional, permitindo que os modelos de inferência pensem em problemas por longos períodos, em vez de simular através de múltiplas chamadas de API, acreditando que isso ajudaria a comparar modelos com o mesmo orçamento de poder computacional. (Fonte: MParakhin)

💡 Outros

Aplicação da IA no Setor Financeiro : A análise de dados financeiros impulsionada por IA desempenha um papel importante na formulação de decisões estratégicas mais inteligentes, melhorando a eficiência da análise e a qualidade das decisões no setor financeiro. (Fonte: Ronald_vanLoon, Ronald_vanLoon)

Estratégia e Concorrência de IA do Google : Discussão sobre os potenciais grandes movimentos do Google no campo da IA, com comentários sugerindo que o Google tem uma vantagem em hardware TPU e mais pesquisa em busca, RL e modelos de mundo de difusão, o que pode representar uma ameaça maior para a OpenAI. (Fonte: Reddit r/LocalLLaMA)

Evento AMA da Hugging Face : O CEO da Hugging Face, Clement Delangue, anunciou que realizará um evento AMA (Pergunte-me Qualquer Coisa), oferecendo à comunidade uma oportunidade de interação direta. (Fonte: ClementDelangue)